Заявление о преимуществе 35 U.S.C. §119

Настоящая Патентная заявка притязает на приоритет (a) Предварительной патентной заявки номер 60/721416, озаглавленной "A VIDEO TRANSCODER FOR REAL-TIME STREAMING AND MOBILE BROADCAST APPLICATIONS", зарегистрированной 27 сентября 2005 года, (b) Предварительной патентной заявки номер 60/789377, озаглавленной "A VIDEO TRANSCODER FOR REAL-TIME STREAMING AND MOBILE BROADCAST APPLICATIONS", зарегистрированной 4 апреля 2006 года, (c) Предварительной заявки номер 60/727643, озаглавленной "METHOD AND APPARATUS FOR SPATIO-TEMPORAL DEINTERLACING AIDED BY MOTION COMPENSATION FOR FIELD-BASED VIDEO", зарегистрированной 17 октября 2005 года, (d) Предварительной заявки номер 60/727644, озаглавленной "METHOD AND APPARATUS FOR SHOT DETECTION IN VIDEO STREAMING", зарегистрированной 17 октября 2005 года, (e) Предварительной заявки номер 60/727640, озаглавленной "A METHOD AND APPARATUS FOR USING AN ADAPTIVE GOP STRUCTURE IN VIDEO STREAMING", зарегистрированной 17 октября 2005 года, (f) Предварительной заявки номер 60/730145, озаглавленной "INVERSE TELECINE ALGORITHM BASED ON STATE MACHINE", зарегистрированной 24 октября 2005 года, и (g) Предварительной заявки номер 60/789048, озаглавленной "SPATIO-TEMPORAL DEINTERLACING AIDED BY MOTION COMPENSATION FOR FIELD-BASED MULTIMEDIA DATA", зарегистрированной 3 апреля 2006 года. Все семь этих предварительных патентных заявок назначены ее правопреемнику и тем самым полностью содержатся в данном документе по ссылке.

Ссылка на находящиеся одновременно на рассмотрении Заявки на патент

Настоящая заявка на патент связана с патентной заявкой (США) № 11/373577, озаглавленной "CONTENT CLASSIFICATION FOR MULTIMEDIA PROCESSING", зарегистрированной 10 марта 2006 года, назначенной правопреемнику этой заявки и таким образом явно содержащейся в данном документе по ссылке.

Уровень техники

Область техники, к которой относится изобретение

Настоящая заявка направлена на устройства и способы перекодирования видеоданных для потоковой передачи в реальном времени, а более конкретно к перекодированию видеоданных для потоковой передачи в реальном времени в мобильном широковещательном приложении.

Уровень техники

Эффективное видеосжатие используется во множестве мультимедийных приложений, таких как потоковая передача видео и видеотелефония, вследствие ограниченных ресурсов полосы пропускания и непостоянства доступной полосы пропускания. Конкретные стандарты кодирования видео, такие как MPEG-4 (ISO/IEC), H.264 (ITU) или аналогичное кодирование видео, предоставляют высокоэффективное кодирование, оптимально подходящее для таких приложений, как беспроводная широковещательная передача. Некоторые мультимедийные данные, например, цифровые телевизионные представления, как правило, кодируются согласно другим стандартам, таким как MPEG-2. Соответственно, транскодеры используются для того, чтобы перекодировать или преобразовывать мультимедийные данные, кодированные согласно одному стандарту (к примеру, MPEG-2), в другой стандарт (к примеру, H.264) до беспроводной широковещательной передачи.

Усовершенствованные оптимизированные по скорости кодеки могут предоставлять преимущества по устойчивости к ошибкам, восстановлению после ошибок и масштабируемости. Более того, применение информации, определенной из самих мультимедийных данных, также может предоставлять дополнительные усовершенствования по кодированию, в том числе устойчивость к ошибкам, восстановление после ошибок и масштабируемость. Соответственно, существует потребность в транскодере, который предоставляет высокоэффективную обработку и сжатие мультимедийных данных, который использует информацию, определенную из самих мультимедийных данных, и является масштабируемым и устойчивым к ошибкам для применения во множестве приложений мультимедийных данных, в том числе мобильной широковещательной передаче потоковой мультимедийной информации.

Сущность изобретения

Каждое из изобретаемых устройств и способов, основанных на содержимом перекодирования, описанных и проиллюстрированных, имеет несколько аспектов, ни один из которых не отвечает исключительно за требуемые атрибуты. Не ограничивая объем этого изобретения, далее будут кратко обсуждены его наиболее заметные признаки. После рассмотрения этого обсуждения, а более точно, после прочтения раздела, озаглавленного "Подробное описание изобретения", станет понятно, как признаки данного управляемого содержимым перекодирования предоставляют усовершенствования в устройства и способы обработки мультимедийных данных.

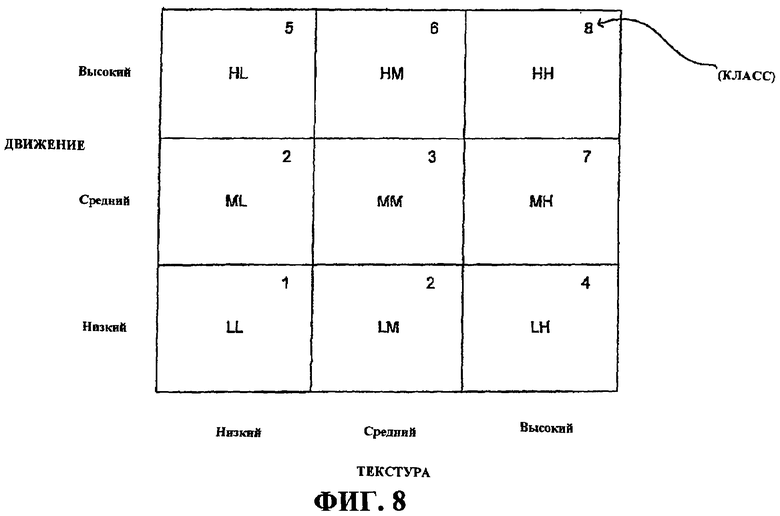

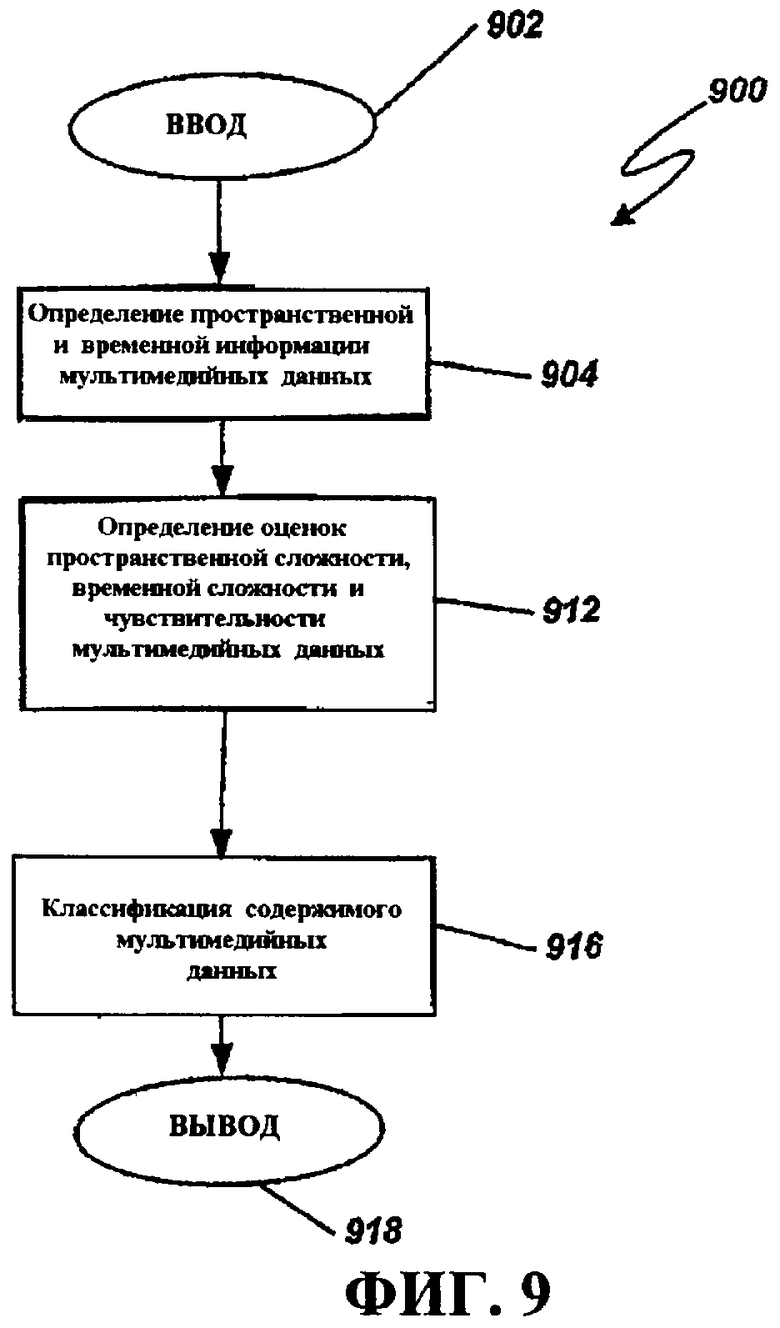

Изобретаемые аспекты, описанные в данном документе, относятся к использованию информации содержимого для различных способов кодирования мультимедийных данных и в различных модулях и компонентах кодера, например, кодера, используемого в транскодере. Транскодер может управлять перекодированием мультимедийных данных с помощью информации содержимого. Информация содержимого может приниматься из другого источника, например, метаданных, которые принимаются вместе с видео. Транскодер может быть сконфигурирован для того, чтобы формировать информацию содержимого с помощью множества различных операций обработки. В некоторых аспектах транскодер формирует классификацию содержимого мультимедийных данных, которая затем используется в одном или более процессов кодирования. В некоторых аспектах управляемый содержимым транскодер может определять пространственную и временную информацию содержимого мультимедийных данных и использовать информацию содержимого для кодирования с одинаковым качеством с учетом содержимого по каналам и основанного на классификации сжатия/назначения битов.

В некоторых аспектах информация содержимого (к примеру, метаданные, показатели содержимого и/или классификация содержимого) мультимедийных данных получается и вычисляется, а затем предоставляется компонентам транскодера для использования в обработке мультимедийных данных для кодирования. Например, препроцессор может использовать определенную информацию содержимого для обнаружения смены сцен, преобразования из видеоформата в фильм (IVTC), устранения чересстрочной развертки, компенсации движения и подавления шумов (к примеру, двумерного вейвлет-преобразования) и пространственно-временного ослабления шумов, к примеру, удаления дефектов изображения, подавления ревербераций, разблокирования и/или снижения шумности. В некоторых аспектах препроцессор также может использовать информацию содержимого для понижающей дискретизации пространственного разрешения, к примеру, определения соответствующих "защищенных" зон и зон "управления движущимися объектами" при понижающей дискретизации со стандартного разрешения (SD) до четверти логической матрицы видеографики (QVGA).

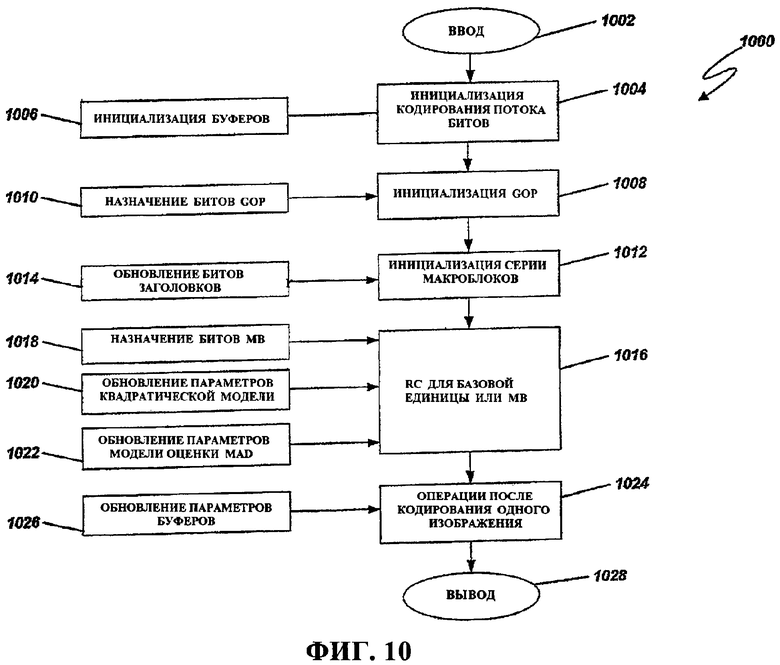

В некоторых аспектах кодер включает в себя модуль классификации содержимого, который сконфигурирован так, чтобы вычислять информацию содержимого. Кодер может использовать классификацию содержимого для управления скоростью передачи в битах (к примеру, назначения битов) при определении параметров квантования для каждого MB, для оценки движения, например, выполнения цветовой оценки движения (ME), выполнения предсказания векторов движения (MV), масштабируемости при предоставлении базового уровня и уровня улучшения, а также для устойчивости к ошибкам посредством использования классификации содержимого так, чтобы влиять на схемы иерархии предсказания и устойчивости к ошибкам, в том числе, к примеру, процессы адаптивного внутреннего обновления, выравнивания границ и предоставление избыточных данных I-кадра в уровне улучшения. В некоторых аспектах транскодер использует классификацию содержимого во взаимодействии с мультиплексором данных для поддержания оптимального качества мультимедийных данных в каналах. В некоторых аспектах кодер может использовать информацию классификации содержимого для принудительного периодического появления I-кадров в кодированных данных, чтобы обеспечить быстрое переключение каналов. Эти реализации также могут применять I-блоки, которые могут требоваться в кодированных данных для устойчивости к ошибкам, с тем чтобы переключение с произвольным доступом и устойчивость к ошибкам (на основе, к примеру, классификации содержимого) могли эффективно комбинироваться посредством иерархии предсказания, чтобы повысить эффективность кодирования с увеличением запаса устойчивости по ошибкам.

В одном аспекте способ обработки мультимедийных данных содержит классификацию содержимого мультимедийных данных и кодирование мультимедийных данных в первой группе данных и во второй группе данных на основе классификации содержимого, причем первая группа данных содержит коэффициент, а вторая группа данных содержит первое дифференциальное уточнение, ассоциативно связанное с коэффициентом первой группы данных. Кодирование может включать в себя определение скорости передачи битов на основе классификации содержимого мультимедийных данных и кодирование мультимедийных данных на основе скорости передачи битов. Классификация содержимого может содержать определение сложности мультимедийных данных, и при этом выбранные мультимедийные данные кодируются на основе сложности мультимедийных данных. Сложность может содержать временную сложность или пространственную сложность либо временную сложность и пространственную сложность. Кодирование может включать в себя кодирование мультимедийных данных так, чтобы обеспечить декодирование только первой группы данных или первой группы данных и второй группы данных в одну комбинированную группу данных. Первое дифференциальное уточнение может указывать разность между выбранным видеокадром и данными кадра, вытекающими из декодирования первой группы данных. Первая группа данных может быть базовым уровнем, а вторая группа данных может быть уровнем улучшения. Помимо этого, способ может включать в себя выбор коэффициента из одного из коэффициента остаточной ошибки исходного базового уровня и коэффициента остаточной ошибки исходного уровня улучшения и вычисления первого дифференциального уточнения на основе коэффициента и коэффициента остаточной ошибки исходного уровня улучшения. Кодирование дополнительно может содержать кодирование информации заголовков макроблоков и информации вектора движения в первой группе данных. Кодирование дополнительно может содержать квантование первой группы данных с первым размером шага и квантование второй группы данных со вторым размером шага, при этом первый размер шага и второй размер шага соотносятся посредством коэффициента масштабирования. Кодирование дополнительно может включать в себя определение первого параметра квантования, имеющего первый размер шага квантования, для использования при кодировании первой группы данных и определение второго параметра квантования, имеющего второй размер шага квантования, для использования при кодировании второй группы данных, при этом первый и второй параметры квантования определяются на основе информации содержимого выбранных данных кадра и при этом упомянутый первый размер шага квантования более грубый, чем упомянутый второй размер шага квантования. В другом аспекте кодирование включает в себя кодирование первой группы данных с помощью I-кадров и P-кадров либо любой их комбинации и кодирование второй группы данных с помощью I-кадров, P-кадров и B-кадров либо любой их комбинации.

В другом аспекте устройство кодирования мультимедийных данных включает в себя средство классификации содержимого мультимедийных данных, средство кодирования мультимедийных данных в первой группе данных и во второй группе данных на основе классификации содержимого, причем первая группа данных содержит коэффициент, а вторая группа данных содержит первое дифференциальное уточнение, ассоциативно связанное с коэффициентом первой группы данных. Средство кодирования может содержать средство для определения скорости передачи битов на основе классификации содержимого мультимедийных данных и кодирования мультимедийных данных на основе скорости передачи битов. Средство классификации содержимого может включать в себя средство определения сложности мультимедийных данных, и при этом выбранные мультимедийные данные кодируются на основе сложности мультимедийных данных, причем сложность содержит временную сложность или пространственную сложность либо временную сложность и пространственную сложность. Средство кодирования может содержать средство для того, чтобы обеспечить декодирование только первой группы данных или первой группы данных и второй группы данных в одну комбинированную группу данных.

В другом аспекте устройство включает в себя модуль классификации содержимого мультимедийных данных, сконфигурированный так, чтобы классифицировать содержимое мультимедийных данных и предоставлять данные классификации содержимого, и кодер, сконфигурированный так, чтобы кодировать мультимедийные данные в первой группе данных и во второй группе данных на основе классификации содержимого, причем первая группа данных содержит коэффициент, а вторая группа данных содержит первое дифференциальное уточнение, ассоциативно связанное с коэффициентом первой группы данных. Кодер может включать в себя компонент скорости передачи битов, сконфигурированный так, чтобы определять назначение битов на основе классификации содержимого, при этом компонент кодирования дополнительно сконфигурирован так, чтобы кодировать выбранные мультимедийные данные с помощью назначения битов.

В другом аспекте машиночитаемый носитель содержит инструкции, которые при исполнении инструктируют машине классифицировать содержимое мультимедийных данных и кодировать мультимедийные данные в первой группе данных и во второй группе данных на основе классификации содержимого, причем первая группа данных содержит коэффициент, а вторая группа данных содержит первое дифференциальное уточнение, ассоциативно связанное с коэффициентом первой группы данных.

В другом аспекте процессор сконфигурирован так, чтобы классифицировать содержимое мультимедийных данных и кодировать мультимедийные данные в первой группе данных и во второй группе данных на основе классификации содержимого, причем первая группа данных содержит коэффициент, а вторая группа данных содержит первое дифференциальное уточнение, ассоциативно связанное с коэффициентом первой группы данных.

Краткое описание чертежей

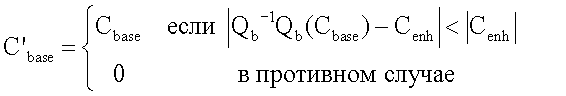

Фиг.1A - это блок-схема мультимедийной широковещательной системы, включающей в себя транскодер для перекодирования между различными видеоформатами.

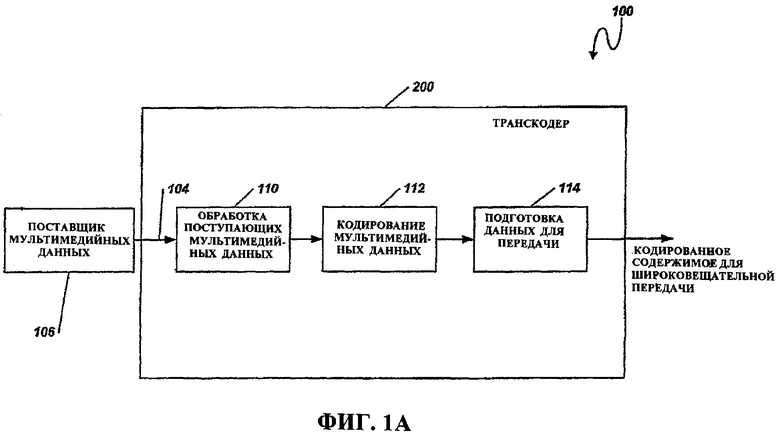

Фиг.1B - это блок-схема кодера, сконфигурированного так, чтобы кодировать мультимедийные данные и предоставлять кодированную первую группу данных и кодированную вторую группу данных.

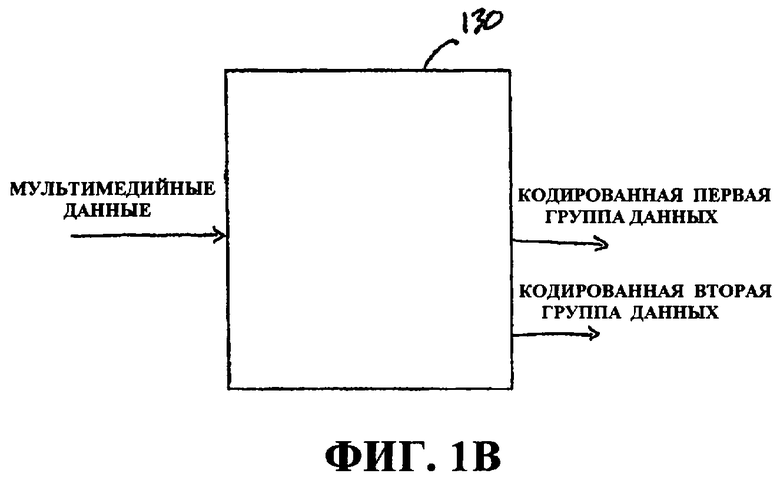

Фиг.1C - это блок-схема процессора, сконфигурированного так, чтобы кодировать мультимедийные данные.

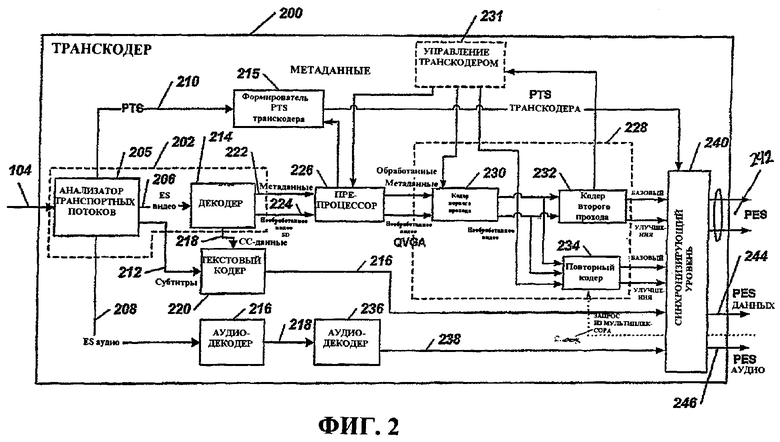

Фиг.2 - это блок-схема примера транскодера системы по фиг.1.

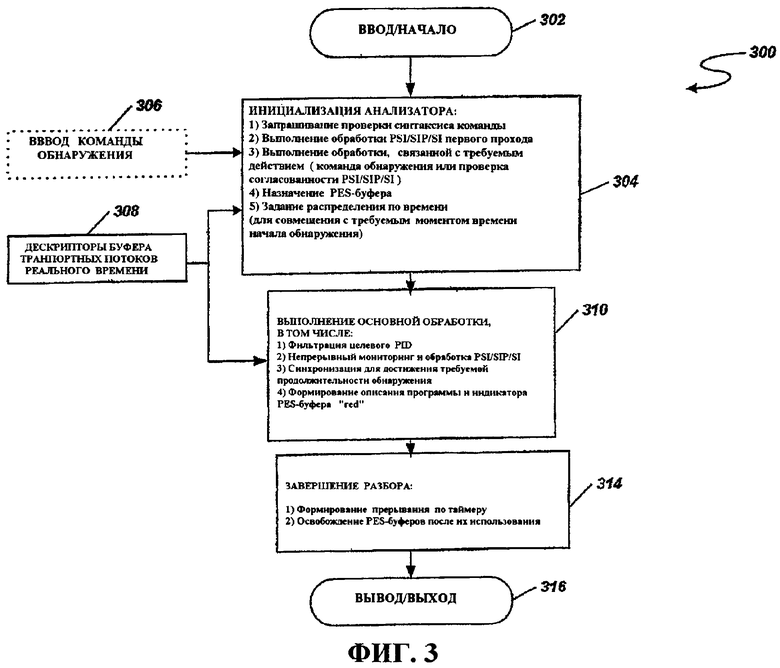

Фиг.3 - это блок-схема последовательности операций способа, иллюстрирующая работу анализатора, используемого в транскодере по фиг.2.

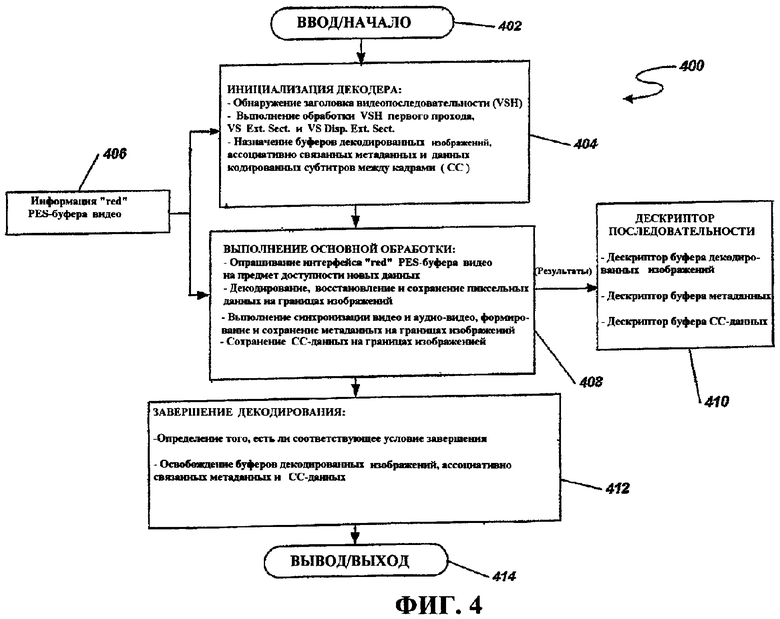

Фиг.4 - это блок-схема последовательности операций способа, иллюстрирующая работу декодера, используемого в транскодере по фиг.2.

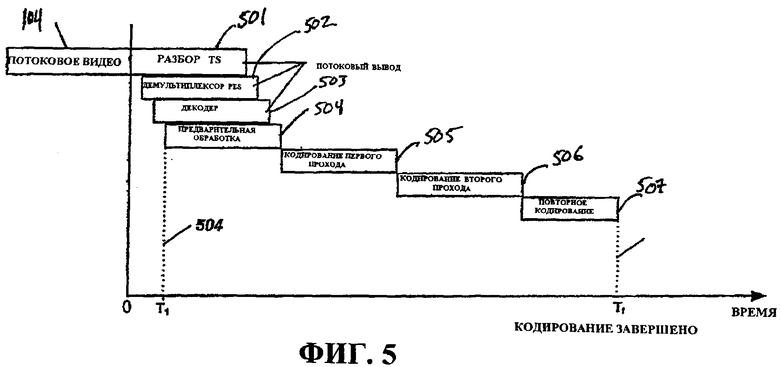

Фиг.5 - это системная временная схема, иллюстрирующая последовательность операций, выполняемых посредством транскодера по фиг.2.

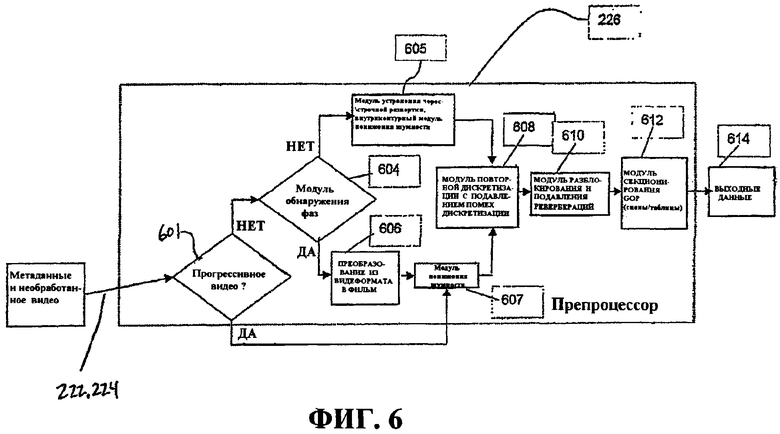

Фиг.6 - это блок-схема, иллюстрирующая последовательность операций и функций препроцессора, которые могут быть использованы в транскодере по фиг.2.

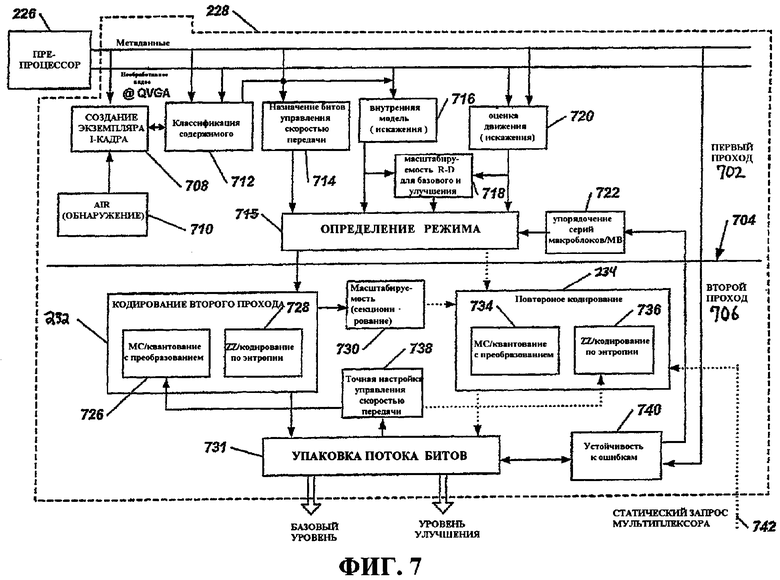

Фиг.7 - это блок-схема примерного двухпроходного кодера, который может быть использован в транскодере по фиг.2.

Фиг.8 иллюстрирует пример классификационной диаграммы, которая иллюстрирует один аспект того, как ассоциативно связывать значения текстуры и движения с классификацией содержимого.

Фиг.9 - это блок-схема последовательности операций способа, иллюстрирующая примерную операцию классификации содержимого, например, для использования в кодере по фиг.7.

Фиг.10 - это блок-схема последовательности операций способа, иллюстрирующая операцию управления скоростью, например, для использования в кодере по фиг.7.

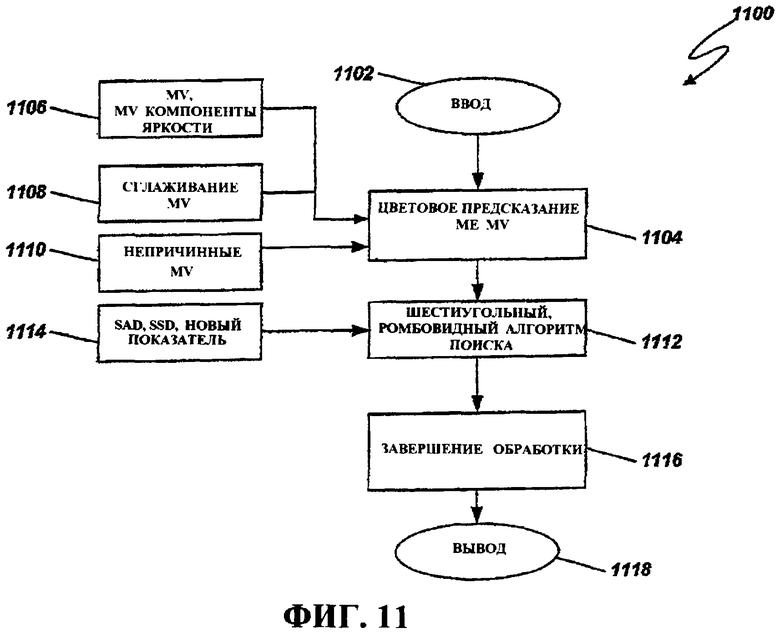

Фиг.11 - это блок-схема последовательности операций способа, иллюстрирующая работу примерного блока оценки движения, например, для использования в кодере по фиг.7.

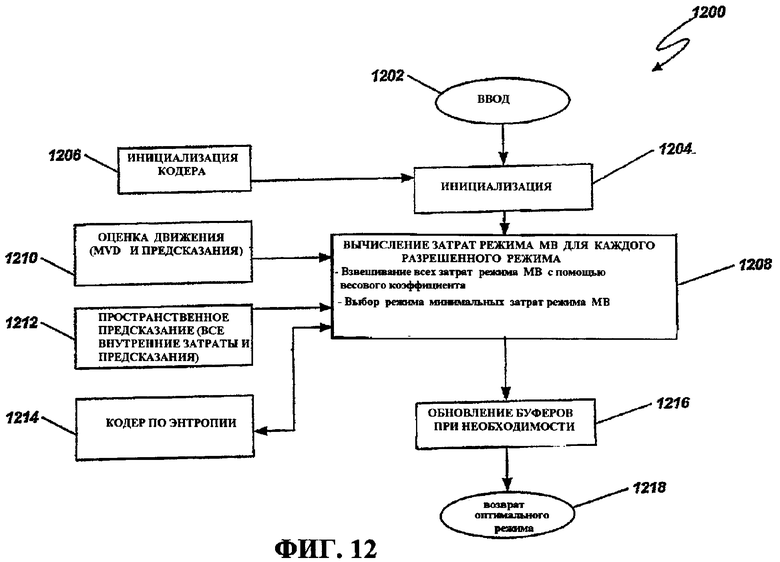

Фиг.12 - это блок-схема последовательности операций способа, иллюстрирующая работу примерной функции кодера для определения режима, например, для использования в кодере по фиг.7.

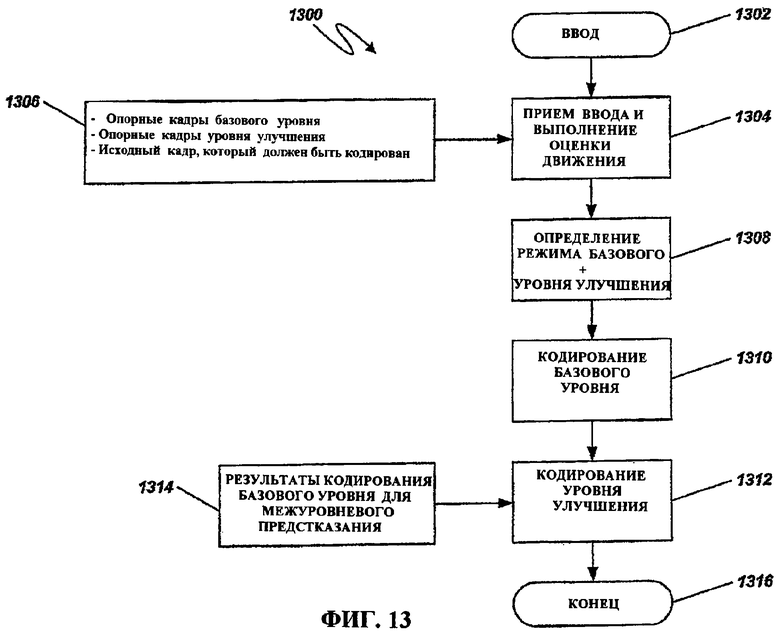

Фиг.13 - это блок-схема последовательности операций способа, иллюстрирующая примерную операцию осуществления масштабируемости для использования в кодере по фиг.7.

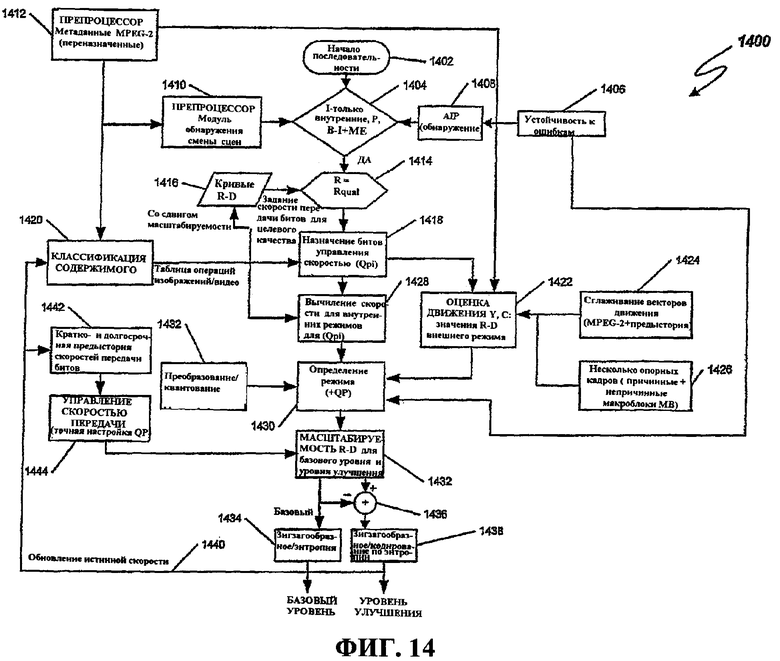

Фиг.14 - это блок-схема последовательности операций способа, иллюстрирующая примерную операцию осуществления потока данных с искажением в зависимости от скорости, как происходит, к примеру, в кодере по фиг.7.

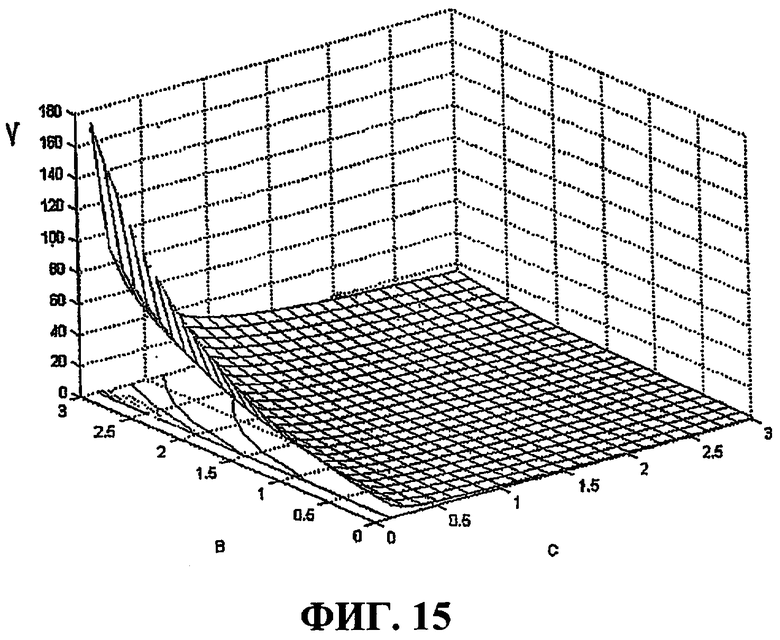

Фиг.15 - это график, иллюстрирующий взаимосвязь между сложностью кодирования, назначенными битами и визуальным качеством человека.

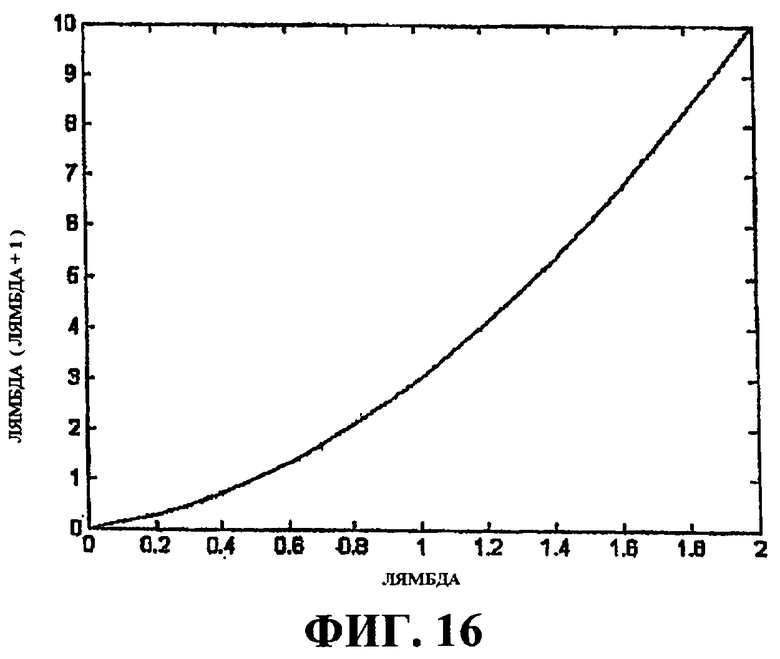

Фиг.16 - это график, иллюстрирующий нелинейную схему обнаружения сцен.

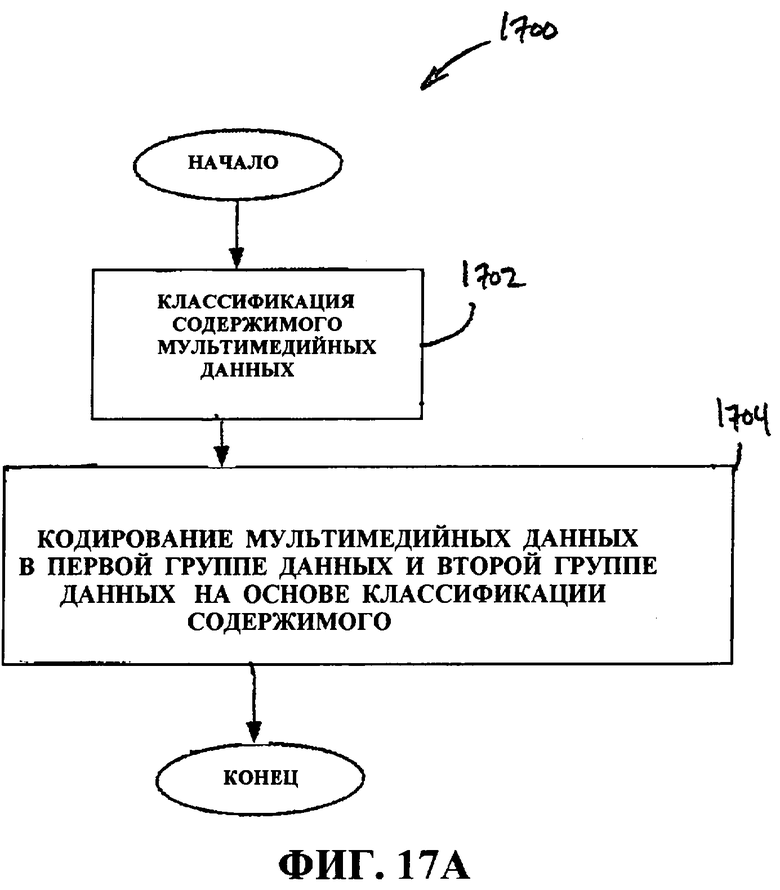

Фиг.17A - это блок-схема последовательности операций способа, иллюстрирующая обработку мультимедийных данных, которые получены, приняты или иным образом доступны.

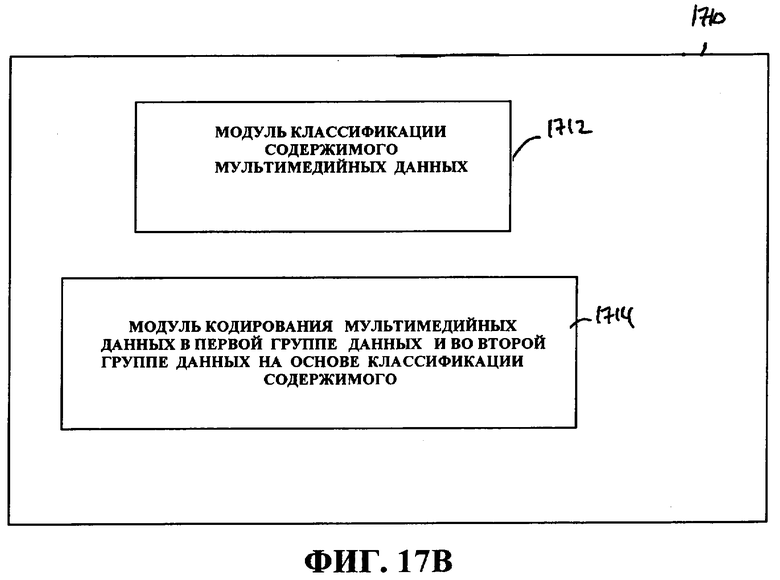

Фиг.17B - это блок-схема системы кодирования мультимедиа.

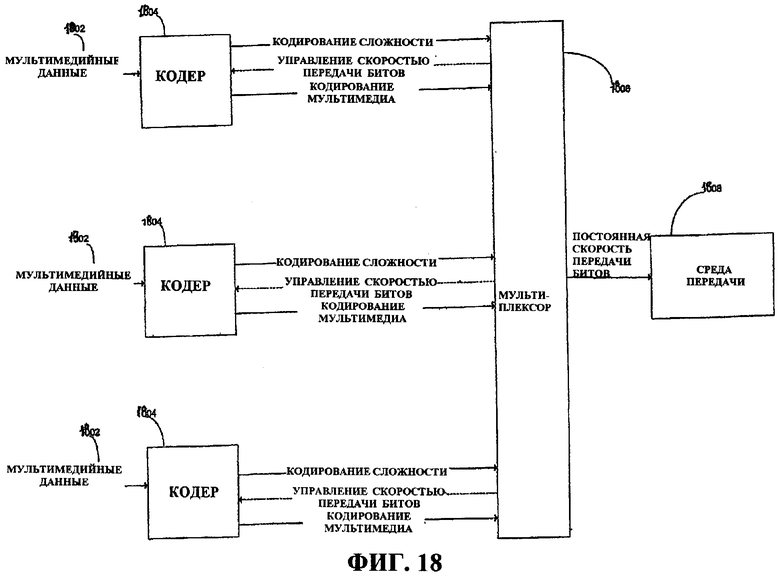

Фиг.18 - это схема, иллюстрирующая процесс устранения чересстрочной развертки с помощью оценки/компенсации движения.

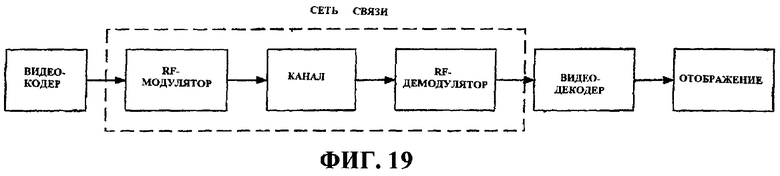

Фиг.19 - это блок-схема мультимедийной системы связи.

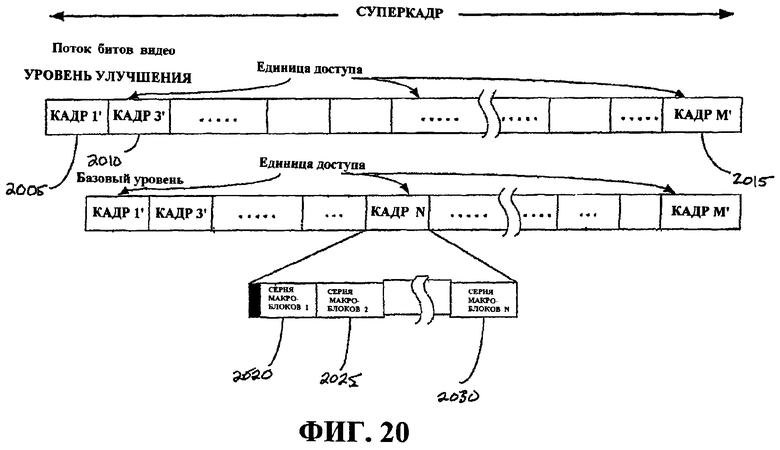

Фиг.20 - это схема, иллюстрирующая организацию видеопотока битов в уровне улучшения и базовом уровне.

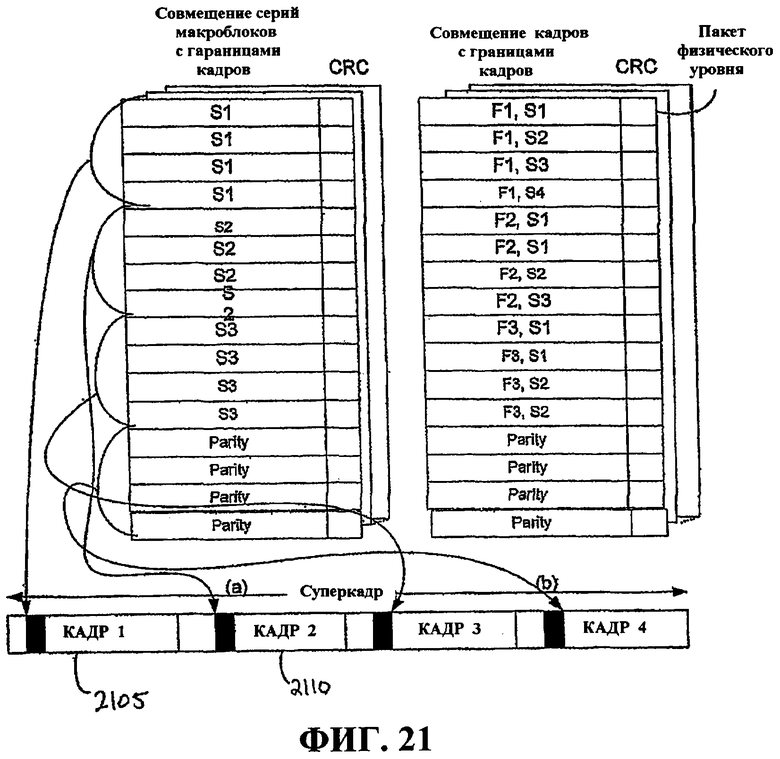

Фиг.21 - это схема, иллюстрирующая совмещение серий макроблоков с границами видеокадров.

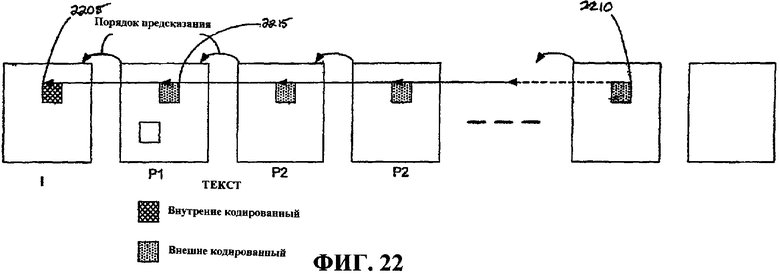

Фиг.22 - это блок-схема, иллюстрирующая иерархию предсказания.

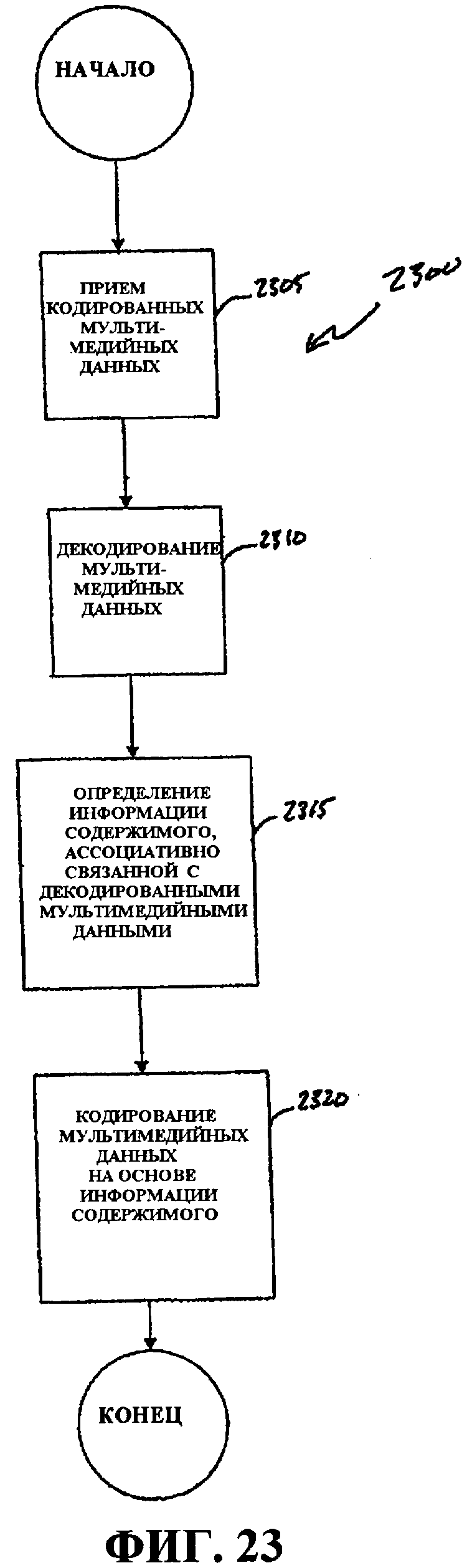

Фиг.23 - это блок-схема последовательности операций, иллюстрирующая способ кодирования мультимедийных данных на основе информации содержимого.

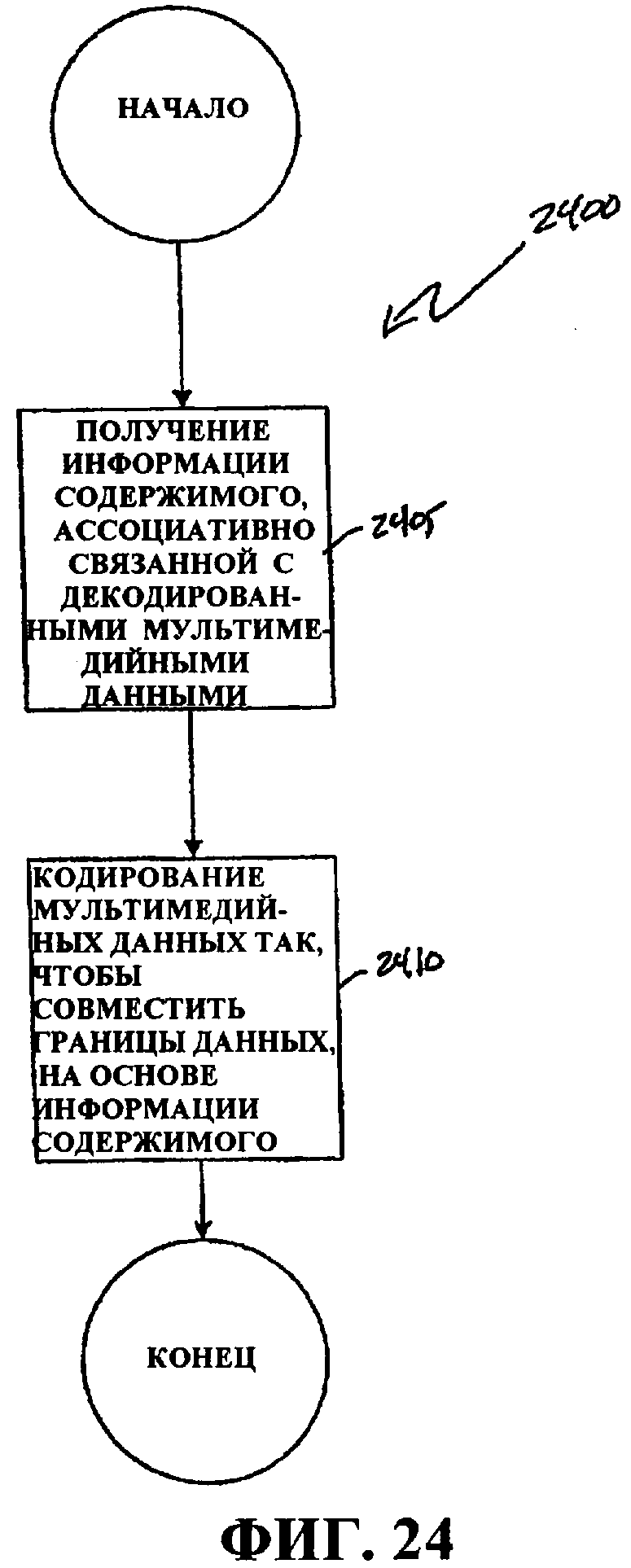

Фиг.24 - это блок-схема последовательности операций, иллюстрирующая способ кодирования мультимедийных данных, так чтобы совмещать границы данных на основе уровня информации содержимого.

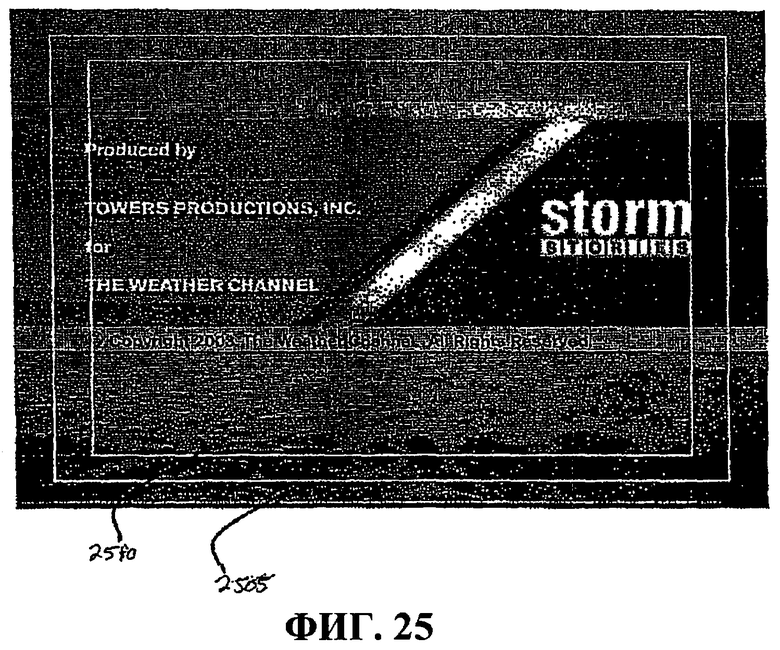

Фиг.25 - это график, иллюстрирующий защищенную область движущихся объектов и защищенную область тайтлов кадра данных.

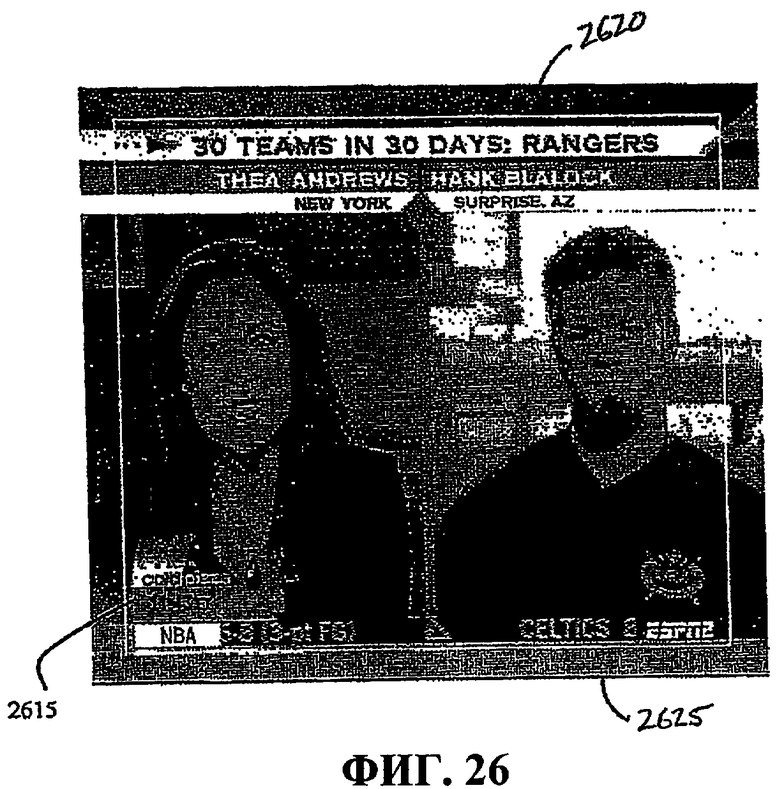

Фиг.26 - это график, иллюстрирующий защищенную область движущихся объектов кадра данных.

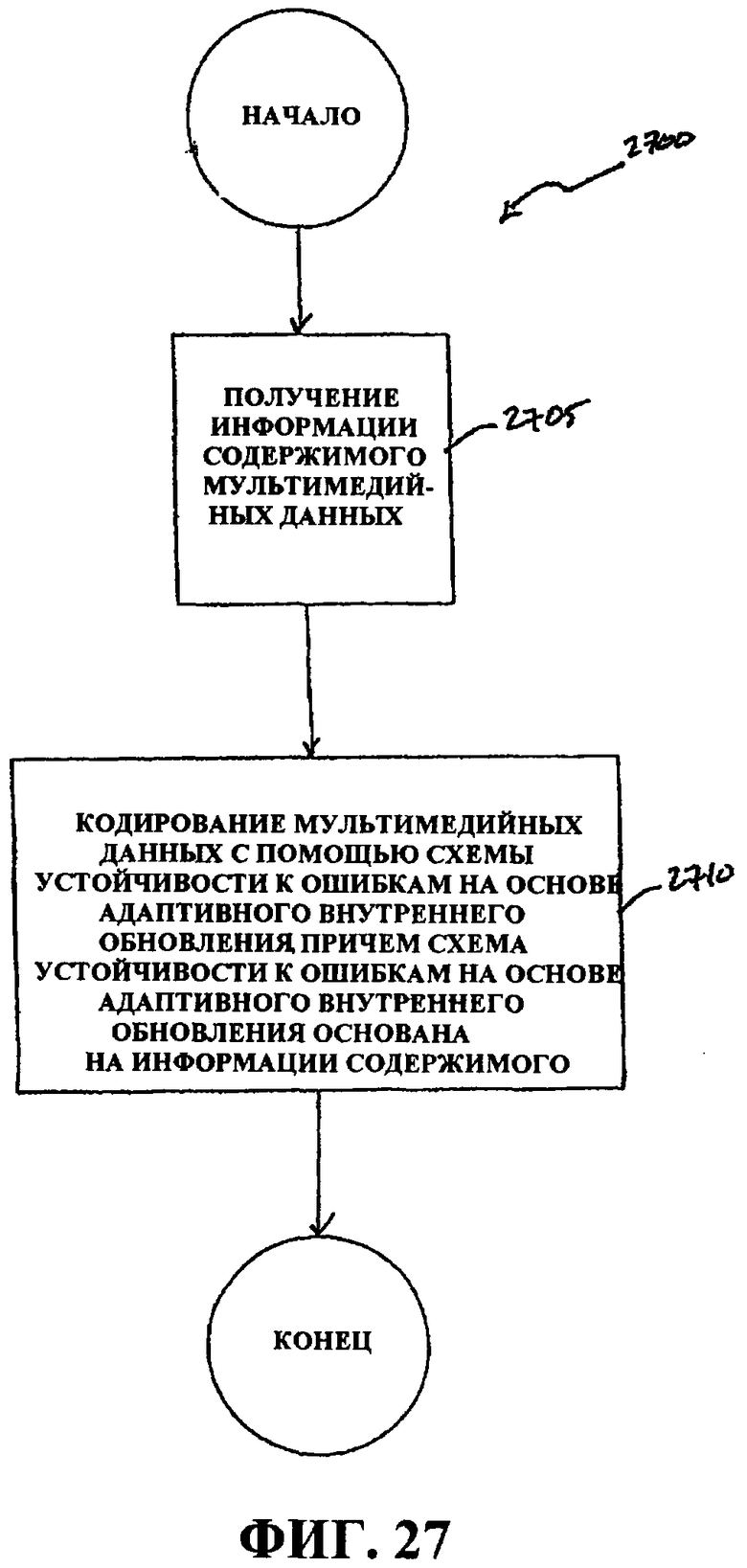

Фиг.27 - это блок-схема последовательности операций, иллюстрирующая процесс кодирования мультимедийных данных с помощью адаптивного внутреннего обновления на основе информации мультимедийного содержимого.

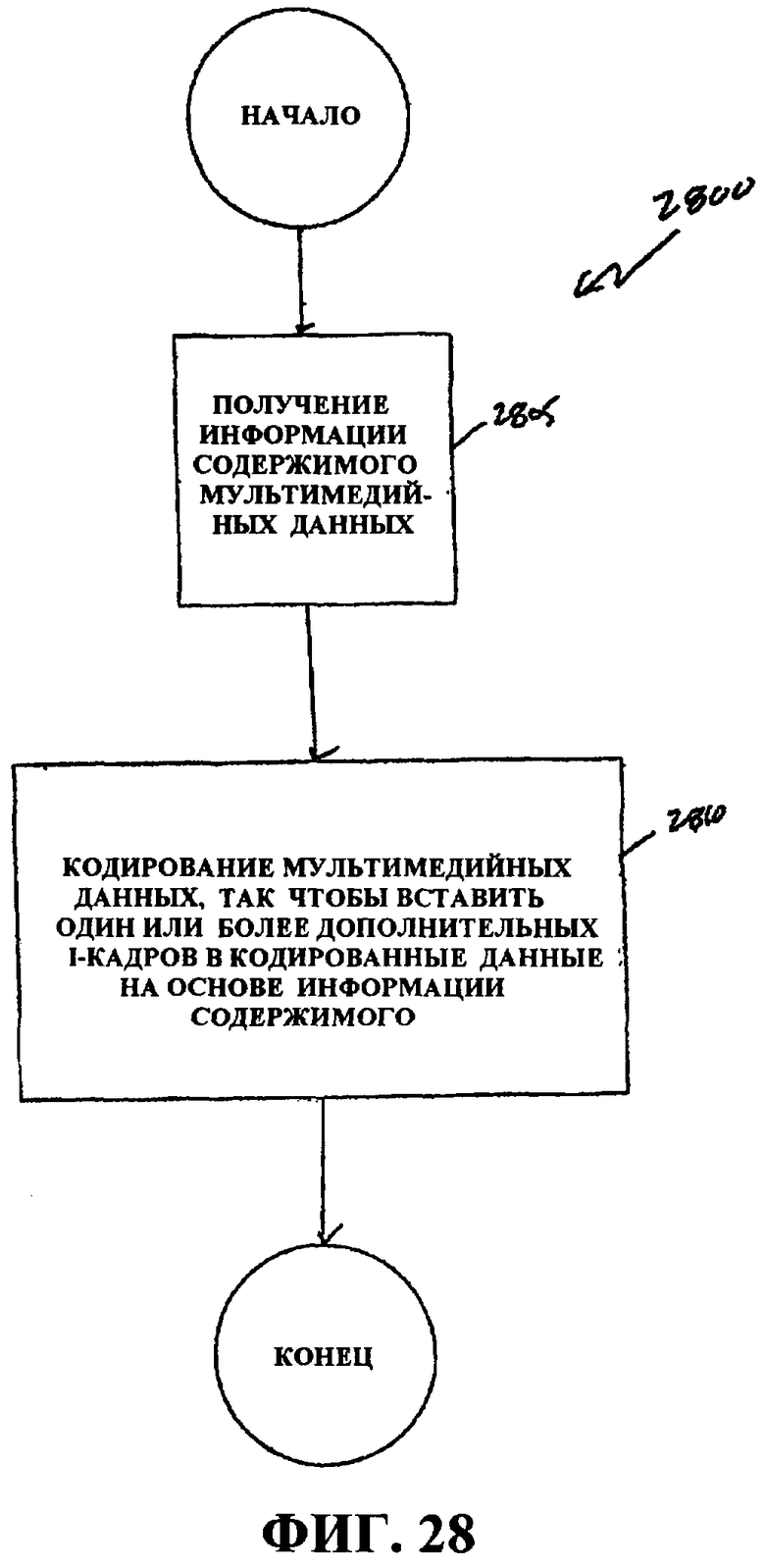

Фиг.28 - это блок-схема последовательности операций, иллюстрирующая процесс кодирования мультимедийных данных с помощью избыточных I-кадров на основе информации мультимедийного содержимого.

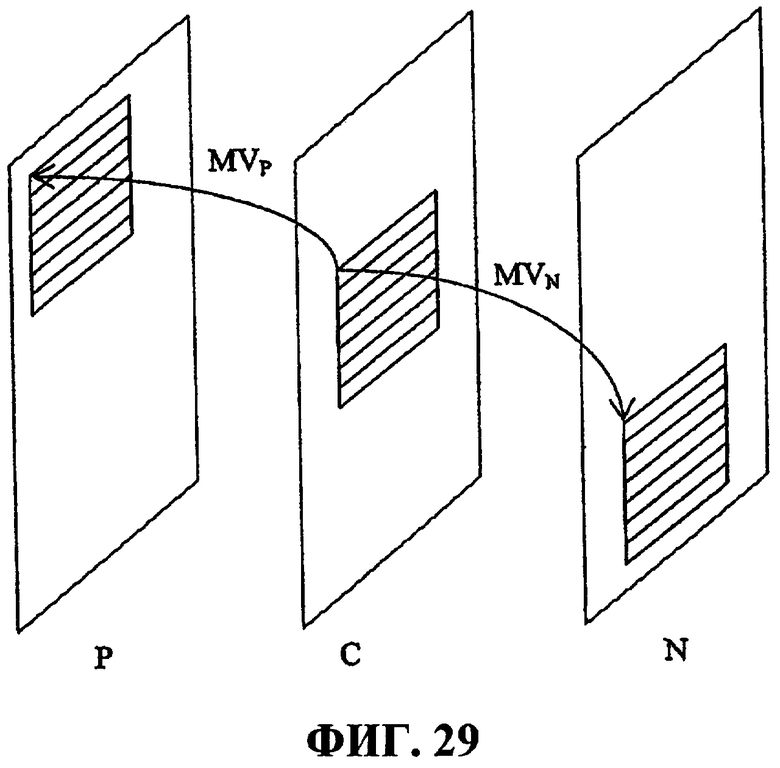

Фиг.29 иллюстрирует векторы компенсации движения между текущим кадром и предыдущим кадром MVP и текущим кадром и следующим кадром MVN.

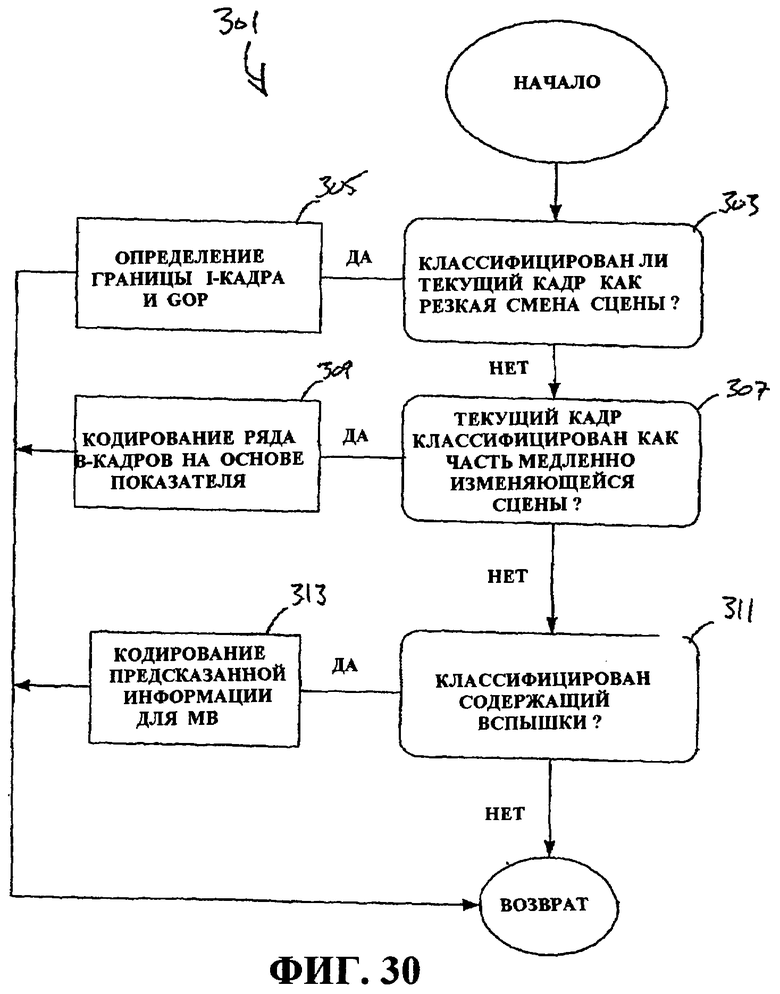

Фиг.30 - это блок-схема последовательности операций способа, иллюстрирующая обнаружение кадров.

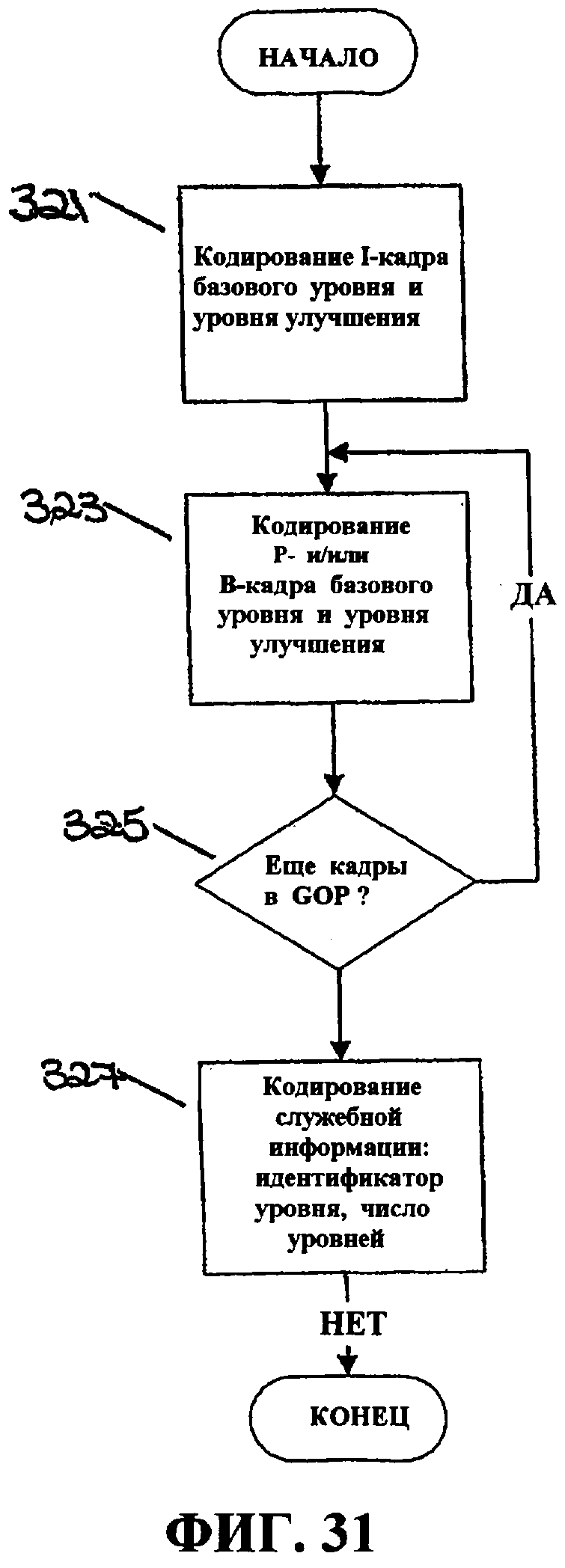

Фиг.31 - это блок-схема последовательности операций способа, иллюстрирующая кодирование базового уровня и уровня улучшения.

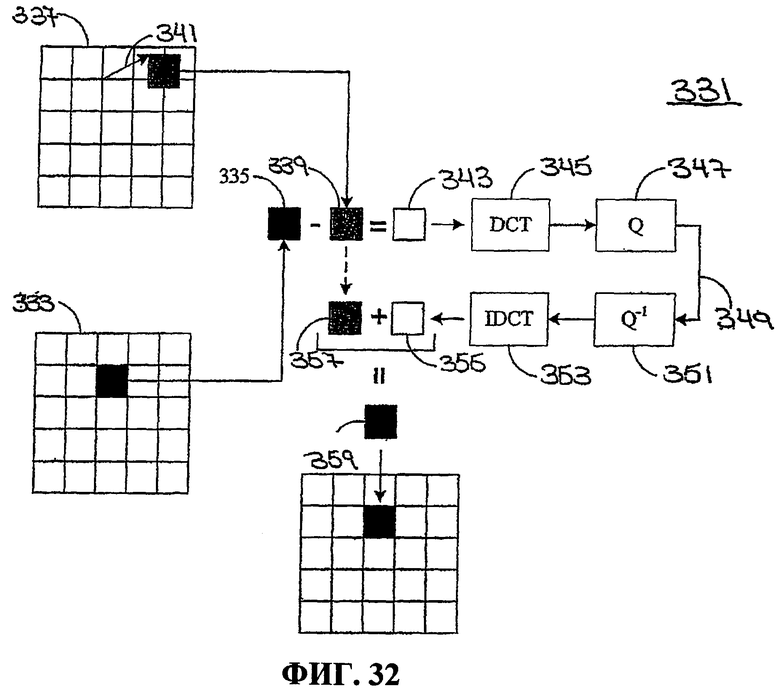

Фиг.32 - это схематичное представление, иллюстрирующее кодирование макроблока.

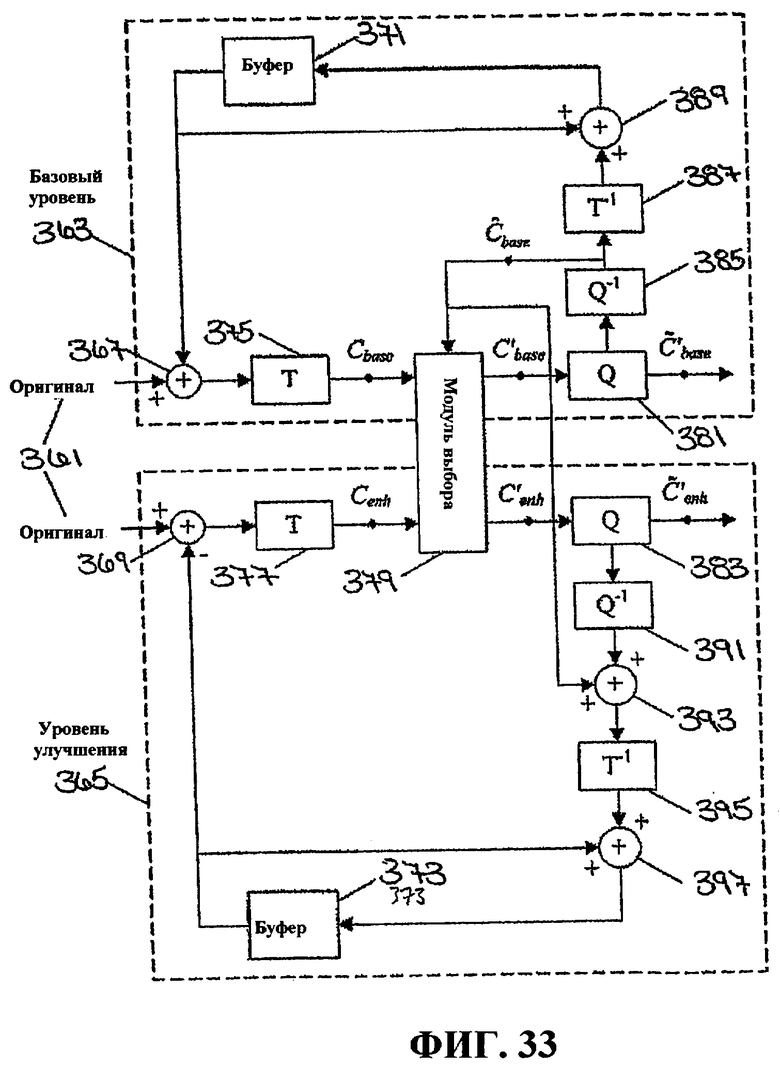

Фиг.33 - это схематичное представление, иллюстрирующее модули для кодирования базового уровня и уровня улучшения.

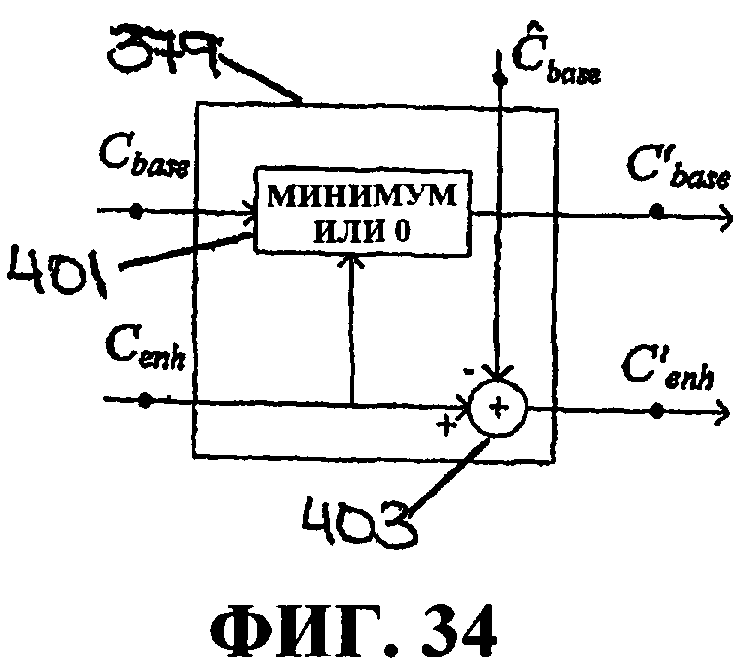

Фиг.34 иллюстрирует пример процесса в блоке выбора коэффициентов базового уровня и уровня улучшения.

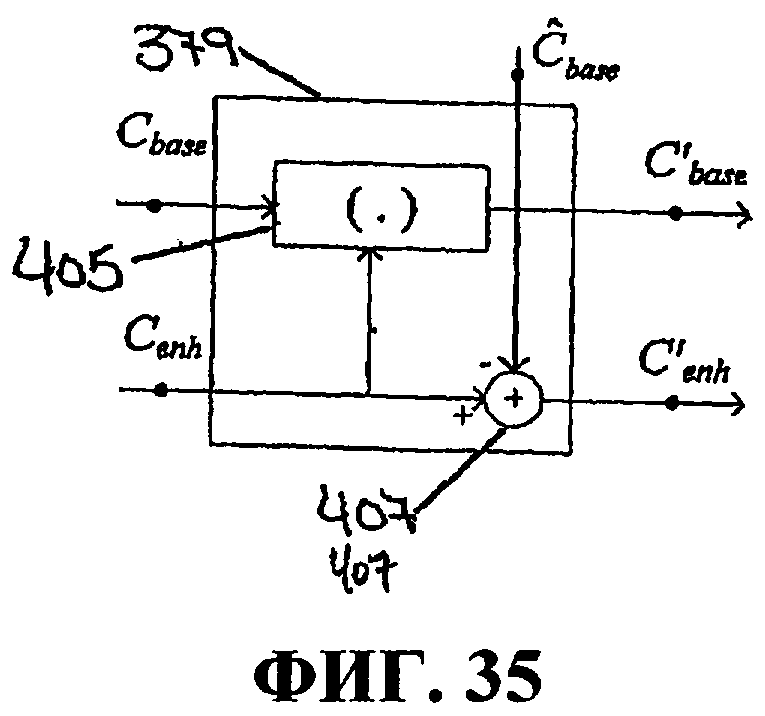

Фиг.35 иллюстрирует еще один пример процесса в блоке выбора коэффициентов базового уровня и уровня улучшения.

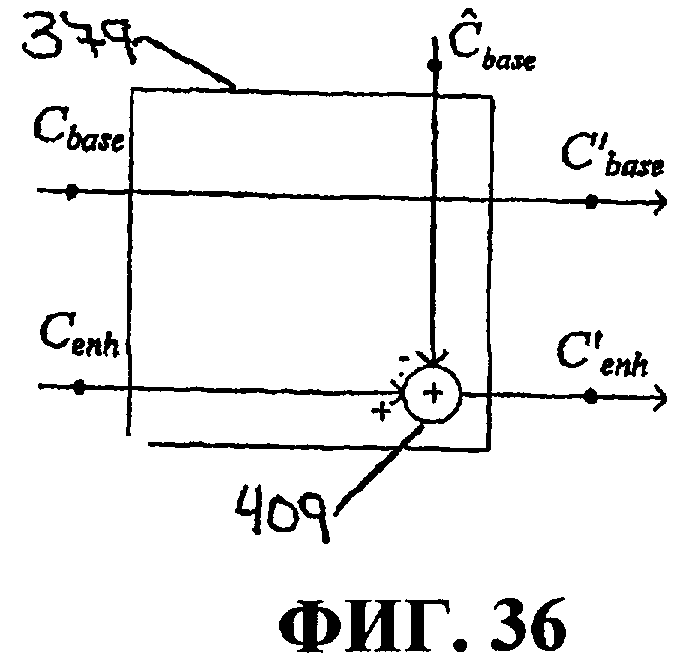

Фиг.36 иллюстрирует еще один пример процесса в блоке выбора коэффициентов базового уровня и уровня улучшения.

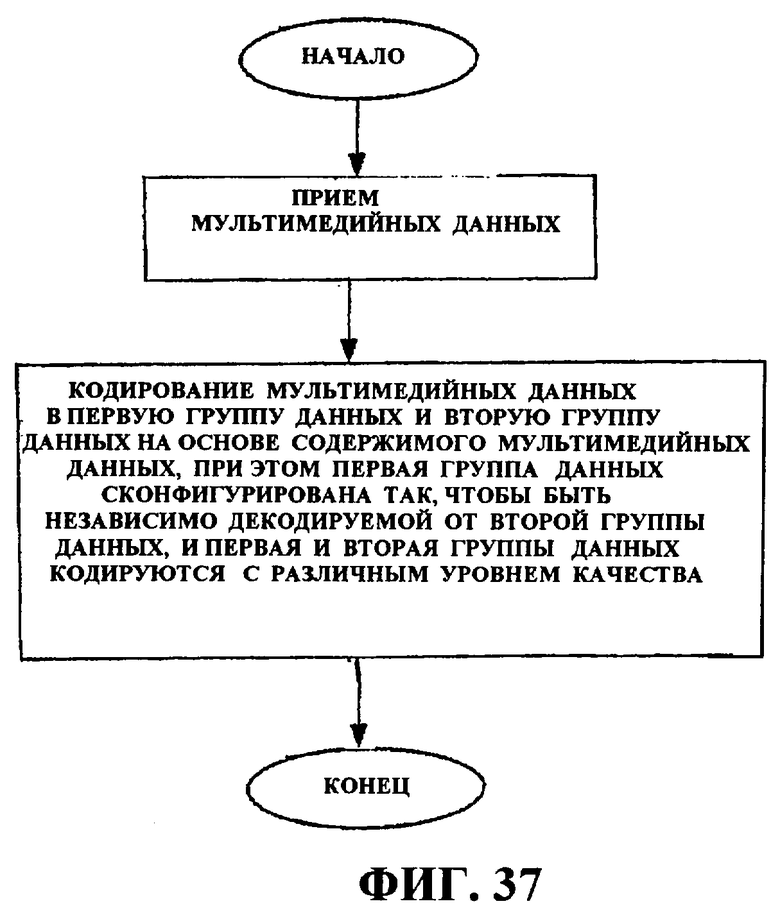

Фиг.37 - это блок-схема последовательности операций способа, иллюстрирующая кодирование мультимедийных данных на основе информации содержимого.

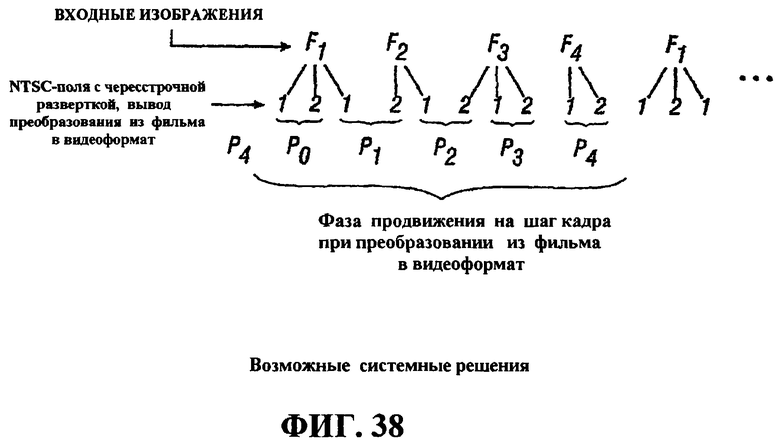

Фиг.38 - это схема, иллюстрирующая возможные системные решения в процессе преобразования из видеоформата в фильм.

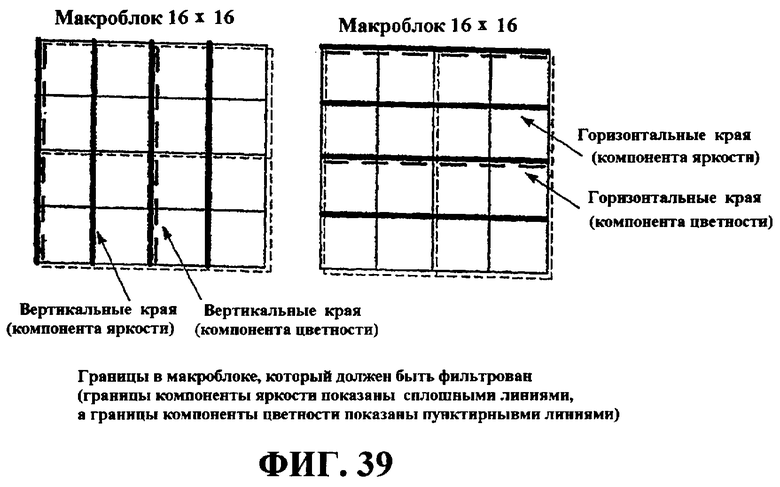

Фиг.39 иллюстрирует границы в макроблоке, которые должны быть отфильтрованы посредством процесса разблокирования.

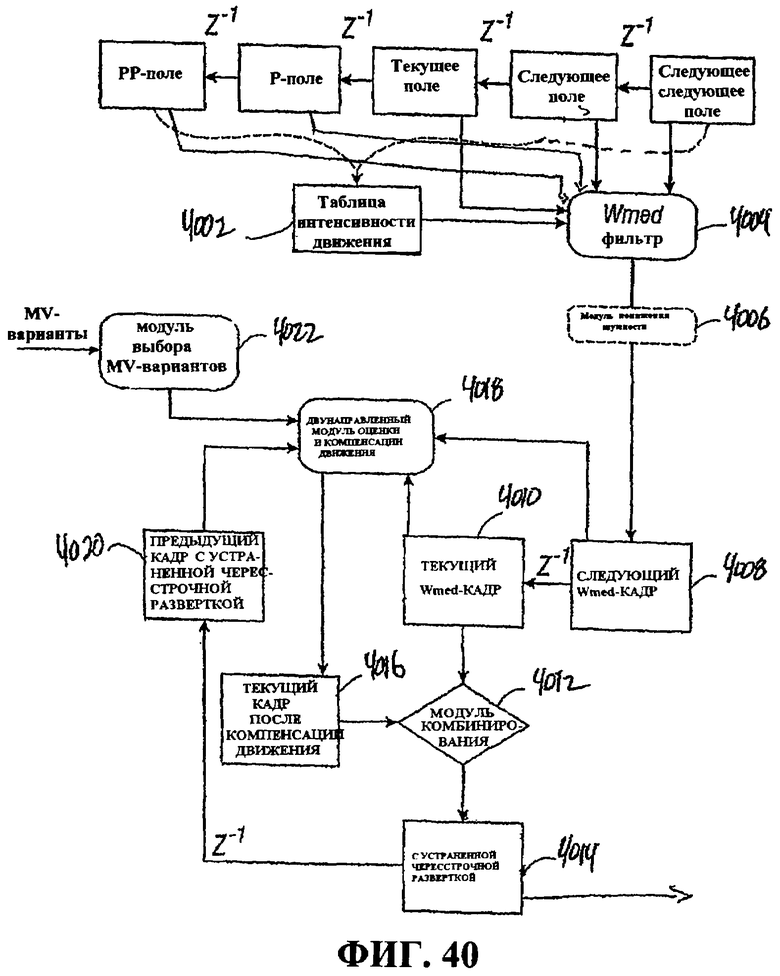

Фиг.40 - это схема, иллюстрирующая процесс пространственно-временного устранения чересстрочной развертки (деинтерлейсинга).

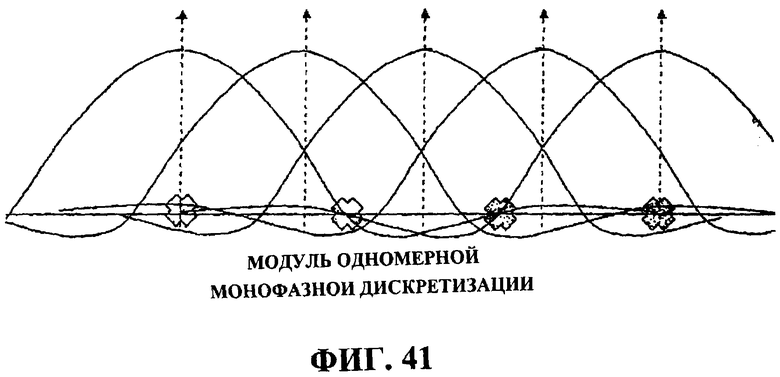

Фиг.41 иллюстрирует пример одномерной монофазной повторной дискретизации.

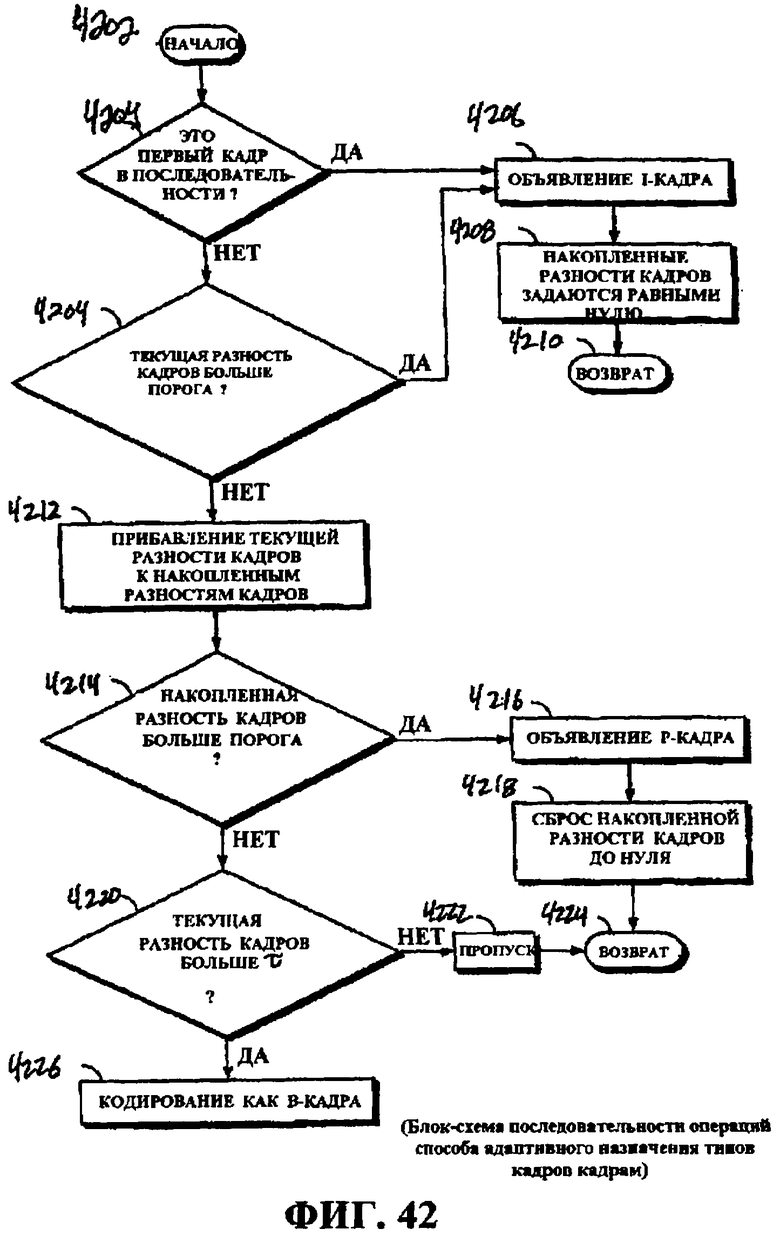

Фиг.42 - это блок-схема последовательности операций способа, иллюстрирующая пример адаптивной GOP-структуры в потоковой передаче видео.

Следует отметить, что аналогичные номера ссылок означают аналогичные детали по всем представлениям на чертежах соответствующим образом.

Подробное описание изобретения

Последующее подробное описание направлено на определенные аспекты, описываемые в данной заявке. Тем не менее, изобретение может быть осуществлено большим количеством различных способов. Ссылка в этом подробном описании на "один аспект" или "аспект" означает, что конкретный признак, конструкция или характеристика, описываемые в связи с аспектом, включены, по меньшей мере, в один аспект. Вхождение фразы "в одном аспекте", "согласно одному аспекту" или "в некоторых аспектах" в разных местах данного подробного описания не обязательно все указывают на тот же аспект, а также не являются отдельными или альтернативными аспектами, взаимоисключающими другие аспекты. Более того, описаны различные признаки, которые могут быть продемонстрированы посредством некоторых аспектов, но не посредством других. Аналогично, описаны различные требования, которые могут быть требованиями для некоторых аспектов, но не для других аспектов.

Последующее описание включает в себя подробные сведения для того, чтобы предоставить полное понимание примеров. Тем не менее, специалистам в данной области техники следует понимать, что примеры могут быть использованы на практике, даже если все подробности процесса или устройства в примере или аспекте не пояснены или проиллюстрированы в данном документе. Например, на блок-схемах могут быть показаны электрические компоненты, которые не иллюстрируют все электрические соединения или все электрические элементы компонента, чтобы не отвлекать от понимания примеров ненужными подробностями. В других случаях такие компоненты, другие структуры и методики могут быть подробно показаны, чтобы дополнительно пояснить примеры.

Настоящее устройство относится к устройствам и способам управления кодированием и перекодированием с помощью информации содержимого кодируемых мультимедийных данных. "Информация содержимого" или "содержимое" (мультимедийных данных) - это обширные термины, означающие информацию, связанную с содержимым мультимедийных данных, и могут включать в себя, например, метаданные, показатели, вычисленные из мультимедийных данных, и относящуюся к содержимому информацию, ассоциативно связанную с одним или более показателями, например, классификацию содержимого. Информация содержимого может быть предоставлена в кодер или определена посредством кодера в зависимости от конкретного варианта применения. Информация содержимого может быть использована для многих аспектов кодирования мультимедийных данных, в том числе обнаружения смены сцен, временной обработки, пространственно-временного понижения шумов, понижающей дискретизации, определения скоростей передачи битов для квантования, масштабирование устойчивости к ошибкам, сохранения оптимального качества мультимедиа в широковещательных каналах и быстрого переключения каналов. С помощью одного или более этих аспектов транскодер может управлять обработкой мультимедийных данных и формировать связанные с содержимым кодированные мультимедийные данные. Описания и чертежи в данном документе, которые описывают аспекты перекодирования, также могут быть применены к аспектам кодирования и аспектам декодирования.

Устройства и способы транскодера связаны с перекодированием из одного формата в другой и подробно описываются в данном документе как связанные с перекодированием видео MPEG-2 в улучшенный масштабируемый формат H.264 для передачи по беспроводным каналам в мобильные устройства, иллюстрирующие некоторые аспекты. Тем не менее, описание перекодирования видео MPEG-2 в формат H.264 не выступает в качестве ограничения области применения изобретения, а является просто примером некоторых аспектов изобретения. Раскрытые устройства и способы предоставляют высокоэффективную архитектуру, которая поддерживает устойчивое к ошибкам кодирование с помощью возможностей произвольного доступа и разбиения на уровне и также может быть применена к перекодированию и/или кодированию видеоформатов, отличных от MPEG-2 и H.264.

"Мультимедийные данные" или просто "мультимедиа" при использовании в данном документе являются обширным термином, который включает в себя видеоданные (которые могут включать в себя аудиоданные), аудиоданные или и видеоданные, и аудиоданные. "Видеоданные" или "видео" при использовании в данном документе является широким термином, относящимся к основанным на кадрах или основанным на полях данным, которые включают в себя одно или более изображений или связанных последовательностей изображений, содержащих текст, информацию изображений и/или аудиоданных, и могут быть использованы для того, чтобы означать мультимедийные данные (к примеру, термины могут быть использованы взаимозаменяемо), если не указано иное.

Ниже описываются примеры различных компонентов транскодера и примеры процессов, которые могут использовать информацию содержимого для кодирования мультимедийных данных.

Фиг.1A - это блок-схема, иллюстрирующая поток данных некоторых аспектов системы 100 широковещательной передачи мультимедийных данных. В системе 100 поставщик 106 мультимедийных данных передает кодированные мультимедийные данные 104 в транскодер 200. Кодированные мультимедийные данные 104 принимаются посредством транскодера 200, который обрабатывает мультимедийные данные 104 в "сырые" необработанные мультимедийные данные на этапе 110. Обработка на блоке 110 декодирует и разбирает кодированные мультимедийные данные 104 и дополнительно обрабатывает мультимедийные данные, чтобы подготовить их к кодированию в другой формат. Декодированные мультимедийные данные предоставляются на этап 112, где мультимедийные данные кодируются в предварительно определенный мультимедийный формат или стандарт. После того как мультимедийные данные кодированы, на этапе 114 они подготавливаются для передачи, например, посредством беспроводной широковещательной системы (к примеру, сотовой телефонной широковещательной сети или посредством другой сети связи). В некоторых аспектах принятые мультимедийные данные 104 кодированы согласно стандарту MPEG-2. После того как перекодированные мультимедийные данные 104 декодированы, транскодер 200 кодирует мультимедийные данные в стандарт H.264.

Фиг.1B - это блок-схема транскодера 130, который может быть сконфигурирован так, чтобы выполнять обработку на этапах 110 и 112 фиг.1A. Транскодер 130 может быть сконфигурирован так, чтобы принимать мультимедийные данные, декодировать и разбирать мультимедийные данные на пакетированные элементарные потоки (к примеру, субтитры, аудио, метаданные, "необработанное" видео, CC-данные и временные метки представления), кодировать их в требуемый формат и предоставлять кодированные данные для дополнительной обработки или передачи. Транскодер 130 может быть сконфигурирован так, чтобы предоставлять кодированные данные в две или более группы данных, например, кодированную первую группу данных и кодированную вторую группу данных, что упоминается как многоуровневое кодирование. В некоторых примерах аспектов различные группы данных (или уровни) в схеме многоуровневого кодирования могут кодироваться на различных уровнях качества и форматироваться так, что данные, кодированные в первой группе данных, имеют худшее качество (к примеру, предоставляют меньший уровень визуального качества при отображении), чем данные, кодированные во второй группе данных.

Фиг.1C - это блок-схема процессора 140, который может быть сконфигурирован так, чтобы перекодировать мультимедийные данные, и может быть сконфигурирован так, чтобы выполнять часть или всю обработку, проиллюстрированную на этапах 110 и 112 по фиг.1A. Процессор 140 может включать в себя модули 124a...n, выполнять один или более процессов перекодирования, описанных в данном документе, в том числе декодирование, разбор, предварительную обработку и кодирование, и использовать информацию содержимого для обработки. Процессор 140 также включает в себя внутреннее запоминающее устройство 122 и может быть сконфигурирован так, чтобы обмениваться данными с внешним запоминающим устройством 120 напрямую или косвенно посредством другого устройства. Процессор 140 также включает в себя модуль 126 связи, сконфигурированный так, чтобы обмениваться данными с одним или более устройствами, внешними для процессора 140, в том числе принимать мультимедийные данные и предоставлять кодированные данные, такие как данные, кодированные в первой группе данных, и данные, кодированные во второй группе данных. В некоторых примерах аспектов различные группы данных (или уровни) в схеме многоуровневого кодирования могут кодироваться на различных уровнях качества и форматироваться так, что данные, кодированные в первой группе данных, имеют худшее качество (к примеру, предоставляют меньший уровень визуального качества при отображении), чем данные, кодированные во второй группе данных.

Транскодер 130 или его компоненты препроцессора 140 (сконфигурированные для перекодирования), а также процессы, содержащиеся в нем, могут быть реализованы посредством аппаратных средств, программного обеспечения, микропрограммного обеспечения, промежуточного программного обеспечения, микрокода или комбинации вышеозначенного. Например, анализатор, декодер, препроцессор или кодер могут быть автономными компонентами, включенными как аппаратные средства, микропрограммное обеспечение, промежуточное программное обеспечение в компонент другого устройства, или могут быть реализованы в микрокоде либо программном обеспечении, которое приводится в исполнение в процессоре, либо как комбинация вышеозначенного. Когда реализован в программном обеспечении, микропрограммном обеспечении, промежуточном программном обеспечении или микрокоде, программный код или сегменты кода, которые выполняют процессы компенсации движения, классификации кадров и кодирования, могут быть сохранены на машиночитаемом носителе, таком как носитель хранения. Сегмент кода может представлять процедуру, функцию, подпрограмму, программу, стандартную процедуру, вложенную процедуру, модуль, комплект программного обеспечения, класс или любое сочетание инструкций, структур данных или операторов программы. Сегмент кода может быть связан с другим сегментом кода или аппаратной схемой посредством передачи и/или приема информации, данных, аргументов, параметров или содержимого памяти.

Иллюстративный пример архитектуры транскодера

Фиг.2 иллюстрирует блок-схему примера транскодера, который может быть использован для транскодера 200, проиллюстрированного в мультимедийной широковещательной системе 100 по фиг.1. Транскодер 200 содержит анализатор/декодер 202, препроцессор 226, кодер 228 и синхронизирующий уровень 240, дополнительно описанные ниже. Транскодер 200 сконфигурирован так, чтобы использовать информацию содержимого мультимедийных данных 104 для одного или более аспектов процесса перекодирования, как описано в данном документе. Информация содержимого может быть получена из источника, внешнего для транскодера 200, через мультимедийные метаданные или вычислена посредством транскодера, например, посредством препроцессора 226 или кодера 228. Компоненты, показанные на фиг.2, иллюстрируют компоненты, которые могут быть включены в транскодер, который использует информацию содержимого для одного или более процессов перекодирования. В конкретной реализации один или более компонентов транскодера 200 могут быть исключены либо могут быть включены дополнительные компоненты. Дополнительно, части транскодера и процессов перекодирования описаны для того, чтобы предоставить возможность специалистам в данной области техники использовать на практике изобретение, даже если все подробности процесса или устройства могут не описываться в данном документе.

Фиг.5 иллюстрирует временную схему в качестве графической иллюстрации временной взаимосвязи работы различных компонентов и/или процессов транскодера 200. Как показано на фиг.5, кодированное потоковое видео 104 (кодированные мультимедийные данные), например, видео MPEG-2 сначала принимается в произвольный нулевой момент времени (0) посредством анализатора 205 (фиг.2). Далее видеопоток разбирается 501, демультиплексируется 502 и декодируется 503, например, посредством анализатора 205 в комбинации с декодером 214. Как проиллюстрировано, эти процессы могут выполняться параллельно с небольшим смещением по времени, чтобы предоставить потоковый вывод данных обработки в препроцессор 226 (фиг.2). В момент времени T1 504, после того как препроцессор 226 принял достаточно данных от декодера 214 для того, чтобы начать вывод результатов обработки, оставшиеся этапы обработки становятся последовательными по характеру, при этом кодирование 505 первого прохода, кодирование 506 второго прохода и повторное кодирование 507 выполняется последовательно после предварительной обработки до завершения повторного кодирования в момент времени Tf 508.

Транскодер 200, описанный в данном документе, может быть сконфигурирован так, чтобы перекодировать различные мультимедийные данные, и многие из процессов применяются к тому типу мультимедийных данных, который перекодируется. Хотя некоторые из примеров, предоставляемых в данном документе, относятся к перекодированию данных MPEG-2 в данные H.264, эти примеры не предназначены для того, чтобы ограничивать изобретение этими данными. Аспекты кодирования, описываемые ниже, могут быть применены к перекодированию любого соответствующего стандарта мультимедийных данных в другой соответствующий стандарт мультимедийных данных.

Анализатор/декодер

Снова ссылаясь на фиг.2, анализатор/декодер 202 принимает мультимедийные данные 104. Анализатор/декодер 202 включает в себя анализатор транспортных потоков ("анализатор") 205, который принимает мультимедийные данные 104 и разбирает данные на элементарный поток (ES) видео 206, ES 208 аудио, временные метки представления (PTS) 210 и другие данные, такие как субтитры 212. ES переносит один тип данных (видео или аудио) из одного видео- или аудиокодера. Например, ES видео содержит видеоданные для последовательности данных, включающие в себя заголовок последовательности и все подчасти последовательности. Пакетированный элементарный поток, или PES, состоит из одного ES, который составлен в пакеты, каждый из которых в типичном варианте начинается с добавленного заголовка пакета. PES-поток содержит только один тип данных из одного источника, к примеру, из одного видео- или аудиокодера. PES-пакеты имеют переменную длину, не соответствующую фиксированной длине транспортных пакетов, и могут быть гораздо длиннее, чем транспортный пакет. Когда транспортные пакеты сформированы из PES-потока, PES-заголовок может быть помещен в начало рабочих данных транспортного пакета, сразу после заголовка транспортного пакета. Оставшееся содержимое PES-пакета заполняет рабочие данные последовательных транспортных пакетов, пока PES-пакет не будет полностью использован. Конечный транспортный пакет может быть заполнен до фиксированной длины, к примеру, посредством дополнения байтами, к примеру, байтами = 0xFF (все единицы).

Анализатор 205 передает ES 206 видео в декодер 214, который является частью анализатора/декодера 202, показанной здесь. В других конфигурациях анализатор 205 и декодер 214 являются отдельными компонентами. PTS 210 отправляются в PTS-формирователь 215 транскодера, который может формировать отдельные временные метки представления, конкретные для транскодера 200, для использования при компоновке данных, которые должны быть отправлены из транскодера 200 в широковещательную систему. PTS-формирователь 215 транскодера может быть сконфигурирован так, чтобы предоставлять данные в синхронизирующий уровень 240 транскодера 200, чтобы координировать синхронизацию широковещательной передачи данных.

Фиг.3 иллюстрирует блок-схему последовательности операций одного примера процесса 300, которому анализатор 205 может следовать при разборе различных пакетированных элементарных потоков, описанных выше. Процесс 300 начинается на этапе 302, когда мультимедийные данные 104 принимаются от поставщика 106 содержимого (фиг.1). Процесс 300 переходит к этапу 304, на котором выполняется инициализация анализатора 205. Инициализация может активироваться посредством независимо сформированной команды 306 сбора данных. Например, процесс, который независим от анализатора 205 и основан на внешне принимаемом ТВ-расписании и информации настройки каналов, может формировать команду 306 сбора данных. Дополнительно, могут быть введены дескрипторы 308 буфера транспортного потока (TS) реального времени, чтобы помогать в инициализации и для основной обработки.

Как проиллюстрировано на этапе 304, инициализация может включать в себя запрос проверки синтаксиса команд, выполнение обработки PSI/PSIP/SI первого прохода (конкретная для программы информация/программа и протокол системной информации/системная информация), выполнение обработки, конкретно связанной либо с командой сбора данных, либо с проверкой согласованности PSI/PSIP/SI, назначение PES-буферов для каждого PES и задание распределения по времени (к примеру, для совмещения с требуемым моментом начала сбора данных). PES-буферы содержат разобранные ES-данные и передают все разобранные ES-данные в соответствующие аудиодекодер 216, тестовый декодер 220, декодер 214 или PTS-формирователь 215 транскодера.

После инициализации процесс 300 переходит к этапу 310 для основной обработки принимаемых мультимедийных данных 104. Обработка на этапе 310 может включать в себя фильтрацию целевых идентификаторов пакетов (PID), непрерывный мониторинг и обработку PSI/PSIP/SI и процесс распределения по времени (к примеру, для достижения требуемой продолжительности сбора данных), с тем чтобы поступающие мультимедийные данные передавались в соответствующие PES-буферы. Как результат обработки мультимедийных данных на этапе 310 формируются программный дескриптор и индикатор PES-буфера "read", которые взаимодействуют с декодером 214 (фиг.2) так, как описано ниже.

После этапа 310 процесс 300 переходит к этапу 314, на котором выполняется завершение операций разбора, формирование прерывания таймера и освобождение PES-буферов после их использования. Следует отметить, что PES-буферы имеются для всех релевантных элементарных потоков программы, упомянутых в дескрипторе, например, потоков аудио, видео и субтитров.

Снова ссылаясь на фиг.2, анализатор 205 отправляет ES 208 аудио в аудиодекодер 216 для соответствия реализации транскодера и предоставляет кодированный текст 216 в синхронизирующий уровень 240 и декодирует аудиоинформацию. Информация 212 субтитров доставляется в текстовый декодер 220. Данные 218 кодированных субтитров между кадрами (CC) из декодера 214 также предоставляются в текстовый кодер 220, который кодирует информацию 212 субтитров и CC-данные 218 в формате, осуществляемом посредством транскодера 200.

Анализатор/декодер 202 также включает в себя декодер 214, который принимает ES 206 видео. Декодер 214 может формировать метаданные, ассоциативно связанные с видеоданными, декодирует кодированный пакетированный элементарный видеопоток в необработанное видео 224 (например, в формате стандартного разрешения) и обрабатывает видеоданные кодированных субтитров между кадрами в ES-поток видео.

Фиг.4 иллюстрирует блок-схему последовательности операций, показывающую один пример процесса 400 декодирования, который может быть выполнен посредством декодера 214. Процесс 400 начинается с ввода данных 206 элементарного видеопотока на этапе 402. Процесс 400 переходит к этапу 404, на котором декодер инициализируется. Инициализация может включать в себя ряд задач, в том числе обнаружение заголовка видеопоследовательности (VSH), выполнение VSH первого прохода, обработку видеопоследовательности (VS) и дисплейного расширения VS (включая видеоформат, составные цвета и матричные коэффициенты) и назначение буферов данных так, чтобы надлежащим образом буферизовать декодированное изображение, ассоциативно связанные метаданные и данные кодированных субтитров между кадрами (CC). Дополнительно, информация 406 "read" PES-буфера видео, предоставляемая посредством анализатора 205, вводится (к примеру, которая может быть сформирована посредством процесса 300 на этапе 310 по фиг.3).

После инициализации на этапе 404 процесс 400 переходит к этапу 408, на котором основная обработка ES видео выполняется посредством декодера 214. Основная обработка включает в себя запрашивание информации "read" PES-буфера видео или "интерфейса" для доступности новых данных, декодирование ES видео, восстановление и сохранение пиксельных данных при синхронизации границ изображений, метаданных формирования видео и аудио-видео и сохранение на границах изображений и сохранение CC-данных на границах изображений. Этап 410 результатов основной обработки 408 включает в себя формирование дескрипторов последовательности, дескрипторов буфера декодированных изображений, дескрипторов буферов метаданных и дескрипторов буферов CC-данных.

После основной обработки 408 процесс 400 переходит к этапу 412, на котором он выполняет процесс завершения. Процесс завершения может включать в себя определение условий завершения, в том числе отсутствие новых данных, появляющихся в течение конкретного времени выше предварительно определенного порога, обнаружение конечного кода последовательности и/или обнаружение явного сигнала завершения. Процесс завершения дополнительно может включать в себя освобождение декодированного изображения, ассоциативно связанных метаданных и буферов CC-данных после их использования посредством препроцессора, который описывается ниже. Процесс 400 завершается на этапе 414, где он может перейти в состояние ожидания ES видео, который должен быть принят в качестве ввода.

Препроцессор

Фиг.2 и подробнее фиг.6 иллюстрируют примерный аспект препроцессора 226, который может использовать информацию содержимого для одной или более операций предварительной обработки. Препроцессор 226 принимает метаданные 222 и декодированные "необработанные" видеоданные 224 от анализатора/декодера 202. Препроцессор 226 сконфигурирован так, чтобы выполнять определенные типы обработки для видеоданных 224 и метаданных 222 и предоставлять обработанное мультимедиа (к примеру, опорные кадры базового уровня, опорные кадры уровня улучшения, информацию полосы пропускания, информацию содержимого) и видео в кодер 228. Такая предварительная обработка мультимедийных данных позволяет повышать визуальную четкость, подавление наложения спектра и эффективность сжатия данных. В общем, препроцессор 226 принимает видеопоследовательности, предоставляемые посредством декодера 214 в анализаторе/декодере 202, и преобразует видеопоследовательности в прогрессивные видеопоследовательности для дополнительной обработки (к примеру, кодирования) посредством кодера 228. В некоторых аспектах препроцессор 226 может быть сконфигурирован для множества операций, в том числе операций преобразования из видеоформата в фильм, устранения чересстрочной развертки, фильтрации (к примеру, удаления дефектов изображения, подавления ревербераций, разблокирования и снижения шумности), изменения размера (к примеру, понижающей дискретизации пространственного разрешения со стандартного разрешения до четверти логической матрицы видеографики (QVGA)) и формирования GOP-структуры (к примеру, вычисления формирования таблицы сложности, обнаружения смены сцен и обнаружения затенения/вспышки).

Препроцессор 226 может использовать метаданные от декодера для того, чтобы затрагивать одну или более операций предварительной обработки. Метаданные могут включать в себя информацию, связанную, описывающую или классифицирующую содержимое мультимедийных данных ("информацию содержимого"); в частности, метаданные могут включать в себя классификацию содержимого. В некоторых аспектах метаданные не включают в себя информацию содержимого, требуемую для операций кодирования. В этих случаях препроцессор 226 может быть сконфигурирован так, чтобы определять информацию содержимого и использовать информацию содержимого для операций предварительной обработки и/или предоставлять информацию содержимого в другие компоненты транскодера 200, к примеру, декодер 228. В некоторых аспектах препроцессор 226 может использовать эту информацию содержимого для того, чтобы воздействовать на секционирование GOP, определять соответствующий тип фильтрации и/или определять параметры кодирования, которые передаются в кодер.

Фиг.6 показывает иллюстративный пример различных этапов обработки, которые могут быть включены в препроцессор 226, и иллюстрирует обработку, которая может быть выполнена посредством препроцессора 226. В этом примере препроцессор 226 принимает метаданные и видео 222, 224 и предоставляет выходные данные 614, содержащие (обработанные) метаданные и видео, в кодер 228. В типичном варианте предусмотрено три типа видео, которое может приниматься. Во-первых, принимаемое видео может быть прогрессивным видео, где не требуется устранение чересстрочной развертки. Во-вторых, видеоданные могут быть видео, преобразованным из фильма в видеоформат, чересстрочным видео, преобразованным из кинопоследовательностей в 24 кадра в секунду, в данном случае видео. В-третьих, видео может быть чересстрочным видео, не преобразованным из фильма в видеоформат. Препроцессор 226 может обрабатывать эти типы видео так, как описано ниже.

На этапе 601 препроцессор 226 определяет то, являются ли принятые видеоданные 222, 224 прогрессивным видео. В некоторых случаях это может быть определено из метаданных, если метаданные содержат эту информацию, либо посредством обработки самих видеоданных. Например, процесс преобразования из видеоформата в фильм, описанный ниже, позволяет определять то, является ли принимаемое видео 222 прогрессивным видео. Если является, процесс переходит к этапу 607, на котором операции фильтрации (к примеру, снижения шумности) выполняются для видео, чтобы уменьшить шум, такой как белый гауссовый шум. Если видеоданные 222, 224 не являются прогрессивным видео, на этапе 601 процесс переходит к этапу 604 к модулю 604 обнаружения фаз.

Модуль 604 обнаружения фаз различает видео, которое изначально преобразовано из фильма в видеоформат и которое начиналось в стандартном широковещательном формате. Если принято решение о том, что видео преобразовано из фильма в видеоформат (путь решения "ДА", выходящий из модуля 604 обнаружения фаз), преобразованное из фильма в видеоформат видео возвращается в исходный формат при обратном преобразовании 606 из видеоформата в фильм. Избыточные кадры идентифицируются и устраняются, а поля, извлеченные из того же видеокадра, переплетаются в полное изображение. Поскольку последовательность восстановленных киноизображений фотографически записана с регулярными интервалами в 1/24 секунды, процесс оценки движения, выполняемый в модуле 612 секционирования GOP или декодере 228, является более точным при использовании преобразованных из видеоформата в фильм изображений, чем преобразованных из фильма в видеоформат данных, которые имеют нерегулярную временную базу.

В одном аспекте модуль 604 обнаружения фаз принимает конкретные решения после приема видеокадра. Эти решения включают в себя: (i) является текущее видео из вывода преобразования из фильма в видеоформат, а фаза продвижения на шаг кадра 3:2 является одной из пяти фаз P0, P1, P2, P3 и P4, показанных на фиг.38, или нет; и (ii) видео сформировано как традиционное NTSC. Это решение обозначается как фаза P5. Данные решения отображаются как выводы модуля 604 обнаружения фаз, показанного на фиг.2. Путь из модуля 604 обнаружения фаз, помеченный "ДА", активирует преобразование 606 из видеоформата в фильм, указывая то, что оно предоставлено с корректной фазой продвижения на шаг кадра, с тем чтобы оно могло отсортировать поля, которые сформированы из одного фотографического изображения, и комбинировать их. Путь из модуля 604 обнаружения фаз, помеченный "НЕТ", аналогично активирует модуль 605 устранения чересстрочной развертки, чтобы разделить видимый NTSC-кадр на поля для оптимальной обработки. Модуль 604 обнаружения фаз может непрерывно анализировать видеокадры, поскольку различные типы видео могут приниматься в любое время. В качестве примера, видео, соответствующее NTSC-стандарту, может быть вставлено в видео в качестве рекламы. После преобразования из видеоформата в фильм результирующее прогрессивное видео отправляется в модуль снижения шумности (фильтр) 607, который может быть использован для того, чтобы понижать белый гауссов шум.

Когда традиционное NTSC-видео распознается (путь "НЕТ" из модуля 601 обнаружения фаз), оно передается в модуль 605 устранения чересстрочной развертки для сжатия. Модуль 605 устранения чересстрочной развертки преобразует чересстрочные поля в прогрессивное видео, и операции понижения шумности затем могут быть выполнены для прогрессивного видео. Один иллюстративный пример обработки устранения чересстрочной развертки описан ниже.

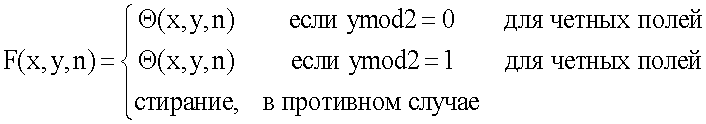

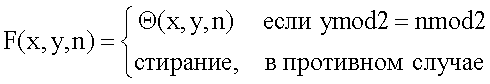

Традиционные аналоговые видеоустройства, такие как телевизоры, выполняют рендеринг видео чересстрочным способом, т.е. эти устройства передают строки развертки с четными номерами (четное поле) и строки развертки с нечетными номерами (нечетное поле). С точки зрения дискретизации сигналов, это эквивалентно пространственно-временной субдискретизации в шаблоне, описанном посредством:

где Θ означает изображение исходного кадра, F означает чересстрочное поле, а (x,y,n) представляет горизонтальную, вертикальную и временную позицию пиксела, соответственно.

Без потери общности можно предположить, что n=0 - это четное поле в данном описании, так что вышеприведенное уравнение 1 упрощается следующим образом:

Поскольку прореживание не выполняется в горизонтальном направлении, шаблон субдискретизации может быть проиллюстрирован в следующей n-y координате.

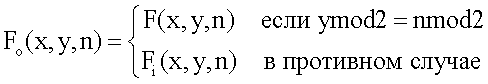

Цель модуля устранения чересстрочной развертки заключается в том, чтобы преобразовывать чересстрочное видео (последовательность полей) в нечересстрочные прогрессивные кадры (последовательность кадров). Другими словами, интерполировать четные и нечетные поля так, чтобы "восстановить" или сформировать полнокадровые изображения. Это может быть представлено посредством уравнения 3:

где F i представляет результаты устранения чересстрочной развертки для отсутствующих пикселов.

Фиг.40 - это блок-схема, иллюстрирующая определенные аспекты модуля 605 устранения чересстрочной развертки, который использует Wmed-фильтрацию и оценку движения для того, чтобы формировать прогрессивный кадр из чересстрочных мультимедийных данных. Верхняя часть фиг.40 показывает таблицу 4002 интенсивности движения, которая может быть сформирована с помощью информации из текущего поля, двух предыдущих полей (поля PP и поля P) и двух последующих полей (поля Next и поля Next Next). Таблица 4002 интенсивности движения категоризирует или секционирует текущий кадр на два или более различных уровня движения и может быть сформирована посредством пространственно-временной фильтрации, описанной подробнее ниже. В некоторых аспектах таблица 4002 интенсивности движения сформирована так, чтобы идентифицировать статичные области, области медленного движения и области быстрого движения, как описано в ссылках к уравнениям 4-8 ниже. Пространственно-временной фильтр, к примеру, Wmed-фильтр 4004 фильтрует чересстрочные мультимедийные данные с помощью критериев на основе таблицы интенсивности движения и формирует пространственно-временной подготовленный кадр с устраненной чересстрочной разверткой. В некоторых аспектах процесс Wmed-фильтрация влечет за собой горизонтальное соседство в [-1, 1], вертикальное соседство в [-3, 3] и временное соседство в пять последующих полей, которые представлены посредством пяти полей (поле PP, поле P, поле Current, поле Next, поле Next Next), проиллюстрированных на фиг.40, где Z -1 представляет задержку одного поля. Относительно поля Current поле Next и поле P являются полями без четности, а поле PP и поле Next Next являются полями с четностью. "Соседство", используемое для пространственно-временной фильтрации, означает пространственное и временное размещение полей и пикселов, фактически используемых в ходе операции фильтрации, и может быть проиллюстрировано как "апертура", как показано, например, на фиг.6 и 7.

Модуль 605 устранения чересстрочной развертки также может включать в себя модуль 4006 понижения шумности (фильтр понижения шумности), сконфигурированный так, чтобы отфильтровывать пространственно-временной подготовленный кадр с устраненной чересстрочной разверткой, сформированный посредством Wmed-фильтра 4004. Понижение шумности пространственно-временного подготовленного кадра с устраненной чересстрочной разверткой делает последующий процесс поиска движения более точным, особенно если исходная последовательность чересстрочных мультимедийных данных загрязнена белым шумом. Он также может удалять, по меньшей мере, частично помехи дискретизации между четными и нечетными строками в Wmed-изображении. Модуль 4006 понижения шумности может быть реализован как множество фильтров, включая модуль понижения шумности на основе вейвлет-сжатия и вейвлет-фильтра Винера. Модуль понижения шумности может быть использован для того, чтобы удалять шум из варианта Wmed-кадра, прежде чем он дополнительно обрабатывается с помощью информации компенсации движения, и может удалять шум, который присутствует в Wmed-кадре, и сохранять наличие сигнала вне зависимости от частотного содержимого сигнала. Различные типы фильтров понижения шумности могут быть использованы, в том числе вейвлет-фильтры. Вейвлеты - это класс функций, используемых для того, чтобы локализовать данный сигнал как в пространственной области, так и в области масштабирования. Фундаментальная идея относительно вейвлетов заключается в том, чтобы анализировать сигнал при различных масштабах или разрешениях, с тем чтобы незначительные изменения в вейвлет-представлении формировали соответствующие небольшие изменения в исходном сигнале.

Вейвлет-сжатие или вейвлет-фильтр Винера также может быть применен как модуль понижения шумности. Вейвлет-сжатие состоит из вейвлет-преобразования сигнала шума, за которым следует сжатие небольших вейвлет-коэффициентов до нуля (или меньшего значения) при оставлении неизмененными больших коэффициентов. В завершение обратное преобразование выполняется для того, чтобы получить оцененный сигнал.

Фильтрация с понижением шумности повышает точность компенсации движения в шумных окружениях. Понижение шумности с вейвлет-сжатием может влечь за собой сжатие в области вейвлет-преобразования и в типичном варианте содержит три этапа: линейное прямое вейвлет-преобразование, нелинейное понижение шумности со сжатием и линейное обратное вейвлет-преобразование. Фильтр Винера - это MSE-оптимальный линейный фильтр, который может быть использован для того, чтобы улучшать изображения, ухудшенные посредством аддитивного шума и размывания. Эти фильтры, в общем, известны в данной области техники и описываются, например, в работе "Ideal spatial adaptation by wavelet shrinkage", указанной выше, и в работе авторов S. P. Ghael, A. M. Sayeed и R. G. Baraniuk, "Improvement Wavelet denoising via empirical Wiener filtering", Proceedings of SPIE, том 3169, стр. 389-399, Сан-Диего, июль 1997 года, которые явно полностью содержатся в данном документе по ссылке.

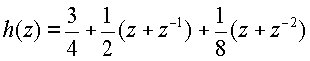

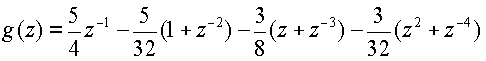

В некоторых аспектах фильтр понижения шумности основан на аспекте биортогонального кубического B-сплайнового вейвлет-фильтра (4, 2). Один такой фильтр может быть задан посредством выполнения прямого и обратного преобразования:

(прямое преобразование)

(прямое преобразование)

и

(обратное преобразование)

Применение фильтра понижения шумности позволяет повысить точность компенсации движения в шумном окружении. Реализации таких фильтров дополнительно описаны в работе "Ideal spatial adaptation by wavelet shrinkage", авторы D.L. Donoho и I.M. Johnstone, Biometrika, том 8, стр.425-455, 1994 год, которые явно полностью содержатся в данном документе по ссылке.

Нижняя часть фиг.40 иллюстрирует аспект для определения информации движения (к примеру, вариантов векторов движения, оценки движения, компенсации движения) чересстрочных мультимедийных данных. В частности, фиг.40 иллюстрирует схему оценки движения и компенсации движения, которая используется для того, чтобы сформировать предварительный прогрессивный кадр после компенсации движения из выбранного кадра, и затем комбинируется с предварительным Wmed-кадром, чтобы сформировать "конечный" прогрессивный кадр, показанный как текущий кадр 4014 с устраненной чересстрочной разверткой. В некоторых аспектах варианты (или оценки) векторов движения (MV) чересстрочных мультимедийных данных предоставляются в модуль устранения чересстрочной развертки из внешних модулей оценки движения и используются для того, чтобы предоставлять начальную точку для двунаправленного модуля оценки и компенсации движения (ME/MC) 4018. В некоторых аспектах модуль 4022 выбора MV-вариантов использует ранее определенные MV для соседних блоков для MV-вариантов обрабатываемых блоков, например, MV предыдущих обработанных блоков, к примеру, блоков в предыдущем кадре 4020 с устраненной чересстрочной разверткой. Компенсация движения может осуществляться двунаправленно на основе предыдущего кадра 70 с устраненной чересстрочной разверткой и следующего (к примеру, будущего) Wmed-кадра 4008. Текущий Wmed-кадр 4010 и текущий кадр 4016 после компенсации движения (MC) объединяются или комбинируются посредством модуля 4012 комбинирования. Результирующий текущий кадр 4014 с устраненной чересстрочной разверткой, теперь прогрессивный кадр, предоставляется обратно в ME/MC 4018, чтобы быть использованным как предыдущий кадр 4020 с устраненной чересстрочной разверткой, а также передается за пределы модуля 605 устранения чересстрочной развертки для последующей обработки.

Можно выделить схемы предсказания устранения чересстрочной развертки, содержащие межполевую интерполяцию, из внутриполевой интерполяции с помощью схемы устранения чересстрочной развертки Wmed+MC. Другими словами, пространственно-временная Wmed-фильтрация может быть использована, в первую очередь, для целей внутриполевой интерполяции, тогда как межполевая интерполяция может выполняться в ходе компенсации движения. Это снижает пиковое соотношение "сигнал-шум" результата Wmed, но визуальное качество после того, как применена компенсация движения, является более удовлетворительным, поскольку дефектные пикселы из неточных решений режима внутриполевого предсказания удаляются из процесса Wmed-фильтрации.

После соответствующей обработки преобразования из видеоформата в фильм или устранения чересстрочной развертки на этапе 608 прогрессивное видео обрабатывается для подавления помех дискретизации и повторной дискретизации (к примеру, изменения размера). В некоторых аспектах повторной дискретизации модуль повторной дискретизации фазы реализован для изменения размера изображений. В одном примере понижающей дискретизации соотношение между исходным и измененным изображением может быть p/q, где p и q - это относительно простые числа. Общее число фаз равно p. Частота отсечки полифазного фильтра в некоторых аспектах равна 0,6 для коэффициентов изменения размера примерно в 0,5. Частота отсечки не совпадает точно с коэффициентом изменения размера, чтобы повысить высокочастотную характеристику последовательности измененного размера. Это неизбежно предоставляет определенные помехи дискретизации. Тем не менее, хорошо известно, что человеческий глаз предпочитает резкие, но с небольшими помехами изображения размытым и не содержащим помех изображениям.

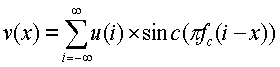

Фиг.41 иллюстрирует пример полифазной повторной дискретизации, показывающий фазы, если соотношение изменения размера составляет 3/4. Частота отсечки, проиллюстрированная на фиг.41, также составляет 3/4. Исходные пикселы проиллюстрированы на вышеуказанном чертеже с вертикальными осями. Синусоидальная функция также нарисована центрированной вокруг осей, чтобы представлять форму сигнала фильтра. Поскольку частота отсечки выбрана так, чтобы быть такой же, что и соотношение повторной дискретизации, нули синусоидальной функции перекрывают позицию пикселов после изменения размера, проиллюстрированного на фиг.41 с помощью пересечений. Чтобы найти значение пиксела после изменения размера, доля может быть просуммирована из исходных пикселов, как показано в следующем уравнении:

где f c - это частота отсечки. Вышеуказанный одномерный полифазный фильтр может быть применен к горизонтальному направлению и вертикальному направлению.

Другой аспект повторной дискретизации (изменения размера) учитывает развертку за пределами экрана. В телевизионном сигнале NTSC изображение имеет 486 строк развертки, а в цифровом видео может иметь 720 пикселов для каждой строки развертки. Тем не менее, не все полное изображение видно на телевизоре вследствие несовпадений между размером и форматом экрана. Часть изображения, которая не видна, называется разверткой за пределами экрана.

Чтобы помочь широковещательным станциям помещать полезную информацию в область, видимую как можно большим числом телевизоров. Общество инженеров кино и телевидения (SMPTE) задало конкретные размеры кадра движущихся объектов, называемые защищенной областью движущихся объектов и защищенной областью тайтлов. См. руководящие указания SMPTE RP 27.3-1989 "Specifications for Safe Action and Safe Title Areas Test Pattern for Television Systems". Защищенная область движущихся объектов задается посредством SMPTE как область, в которой должны находиться все существенные движущиеся объекты. Защищенная область тайтлов задается как область, в которой вся полезная информация может быть заключена, чтобы обеспечить видимость на большинстве домашних телевизионных приемников.

Например, ссылаясь на фиг.25, защищенная область 2510 движущихся объектов занимает по центру 90% экрана, давая 5% границу вокруг. Защищенная область 2505 тайтлов занимает по центру 80% экрана, давая 10% границы. Ссылаясь теперь на фиг.26, поскольку защищенная область тайтлов слишком мала, чтобы добавить дополнительное содержимое в изображение, некоторые станции помещают текст в защищенную область движущихся объектов, которая находится внутри белого прямоугольного окна 2615.

Обычно черные границы могут быть видны в развертке за пределами экрана. Например, на фиг.26 черные границы отображаются в верхней стороне 2620 и нижней стороне 2625 изображения. Эти черные границы могут быть удалены в развертке за пределами экрана, поскольку видео H.264 применяет расширение границ при оценке движения. Расширенные черные границы позволяют увеличивать остаток. Консервативно, граница может быть обрезана на 2% и затем выполнено изменение размера. Фильтры для изменения размера могут быть сформированы соответствующим образом. Отсечение выполняется для того, чтобы удалить развертку за пределами экрана до полифазной понижающей дискретизации.

Снова ссылаясь на фиг.6, прогрессивное видео затем переходит к этапу 610, где выполняются операции разблокирования и подавления ревербераций. Два типа помех, "блокировка" и "реверберации", как правило, возникают в приложениях видеосжатия. Помехи изображения возникают, поскольку алгоритмы сжатия делят каждый кадр на блоки (к примеру, блоки 8x8). Каждый блок восстанавливается с некоторыми небольшими ошибками, и ошибки по краям блока зачастую контрастируют с ошибками по краям соседних блоков, делая границы блоков видимыми. В отличие от этого помехи ревербераций появляются как искажения по краям элементов изображений. Помехи реверберации возникают, поскольку кодер отбрасывает слишком много информации при квантовании высокочастотных DCT-коэффициентов. В некоторых иллюстративных примерах деблокирование и подавление ревербераций может использовать фильтры нижних частот с FIR (конечной импульсной характеристикой), чтобы скрывать эти видимые помехи.

В одном примере обработки деблокирования фильтр деблокирования может быть применен ко всем краям блоков 4x4 кадра, за исключением краев на границе кадра и всех краев, для которых процесс фильтра деблокирования отключен. Этот процесс фильтрации должен выполняться на основе макроблоков после завершения процесса составления кадров, причем все макроблоки в кадре обрабатываются в порядке увеличения адресов макроблоков. Для каждого макроблока вертикальные края фильтруются первыми, слева направо, а затем горизонтальные края фильтруются сверху вниз. Процесс фильтра деблокирования компоненты яркости выполняется по четырем краям из 16 выборок, и процесс фильтра деблокирования для каждой компоненты цветности выполняется по двум краям из 8 выборок для горизонтального направления и для вертикального направления, как показано на фиг.39. Значения выборки выше и слева от текущего макроблока, которые, возможно, уже модифицированы посредством операции процесса деблокирования для предыдущих макроблоков, должны быть использованы в качестве входных данных процесса фильтра деблокирования для текущего макроблока и могут быть дополнительно модифицированы в ходе фильтрации текущего макроблока. Значения выборки, модифицированные в ходе фильтрации вертикальных краев, могут быть использованы в качестве входных данных для фильтрации горизонтальных краев для того же макроблока. Процесс деблокирования может быть активирован для компонент яркости и цветности отдельно.

В примере обработки подавления ревербераций двумерный фильтр может быть адаптивно применен так, чтобы сглаживать области около краев. Краевые пикселы подвергаются небольшой фильтрации или не подвергаются фильтрации, чтобы избежать размывания.

Модуль секционирования GOP

После деблокирования и подавления ревербераций прогрессивное видео обрабатывается посредством модуля 612 секционирования GOP. Размещение GOP может включать в себя обнаружение смены кадров, формирование таблиц сложности (к примеру, временных, пространственных таблиц полосы пропускания) и адаптивное секционирование GOP. Все вышеозначенное описывается далее.

A. Обнаружение смены сцен

Обнаружение кадров относится к определению того, когда кадр в группе изображений (GOP) предоставляет данные, которые указывают то, что произошла смена сцены. В общем, в GOP кадры могут не иметь существенной смены для любых двух или трех (или большего числа) соседних кадров либо могут быть медленные смены либо быстрые смены. Разумеется, эти классификации смены сцен при необходимости могут быть дополнительно разбиты до большего уровня смены в зависимости от варианта применения.

Обнаружение смены кадров или сцен важно для эффективного кодирования видео. В типичном варианте, когда GOP не изменяется значительно, за I-кадром в начале GOP следует ряд предиктивных кадров, позволяет в значительной степени кодировать видео так, чтобы последующее декодирование и отображение видео было визуально приемлемым. Тем не менее, когда сцена сменяется, резко или медленно, дополнительные I-кадры и меньшее кодирование с предсказанием (P-кадры и B-кадры) может требоваться, чтобы предоставить впоследствии декодированные визуально приемлемые результаты.

Системы и способы обнаружения кадров и кодирования, которые повышают производительность существующих систем кодирования, описываются ниже. Эти аспекты могут быть реализованы в модуле 612 секционирования GOP препроцессора 226 (фиг.7) либо включены в устройство кодера, которое может работать с или без препроцессора. Данные аспекты используют статистику (или показатели), которые включают в себя статистические сравнения между соседними кадрами видеоданных, чтобы определять то, если возникла резкая смена сцен, сцена медленно сменяется или имеются вспышки камеры в сцене, которые могут особенно усложнять кодирование видео. Статистика может быть получена от препроцессора и затем отправлена в устройство кодирования, либо она может быть сформирована в устройстве кодирования (к примеру, посредством процессора, сконфигурированного так, чтобы выполнять компенсацию движения). Результирующая статистика помогает в принятии решения по обнаружению смены сцен. В системе, которая осуществляет перекодирование, зачастую имеется надлежащий препроцессор или конфигурируемый процессор. Если препроцессор выполняет устранение чересстрочной развертки с помощью компенсации движения, статистика компенсации движения доступна и готова к применению. В таких системах алгоритм обнаружения кадров может немного повысить сложность системы.

Иллюстративный пример модуля обнаружения кадров, описанный в данном документе, должен использовать только статистику из предыдущего кадра, текущего кадра и следующего кадра, а следовательно, имеет очень небольшую задержку. Модуль обнаружения кадров различает несколько различных типов событий кадров, в том числе резкую смену сцен, монтажный переход и другую медленную смену сцен, а также вспышку камеры. Посредством определения различных типов событий кадров с различными стратегиями в кодере эффективность кодирования и визуальное качество улучшается.

Обнаружение смены сцен может быть использовано для любой системы кодирования видео, чтобы она интеллектуально сохраняла биты посредством вставки I-кадра с фиксированным интервалом. В некоторых аспектах информация содержимого, полученная посредством препроцессора (к примеру, либо содержащаяся в метаданных, либо вычисленная посредством препроцессора 226), может быть использована для обнаружения смены сцен. Например, в зависимости от информации содержимого, пороговые значения и другие критерии, описанные ниже, могут динамически корректироваться для различных типов видеосодержимого.

Кодирование видео обычно выполняется для структурированной группы изображений (GOP). GOP обычно начинается с внутренне кодированного кадра (I-кадра), за которым следует последовательность из P (прогнозирующих) или B (двунаправленных) кадров. В типичном варианте I-кадр может сохранять все данные, требуемые для того, чтобы отображать кадр, B-кадр базируется на данных в предшествующих и последующих кадрах (к примеру, содержащих только данные, измененные из предыдущего кадра или отличающиеся от данных в следующем кадре), а P-кадр содержит данные, которые изменены с предыдущего кадра. В большинстве случаев между I-кадрами вставляются P-кадры и B-кадры в кодированном видео. В отношении размера (к примеру, числа битов, используемых для того, чтобы кодировать кадр) I-кадры в типичном варианте гораздо больше P-кадров, которые, в свою очередь, больше B-кадров. Для эффективной обработки кодирования, передачи и декодирования длина GOP должна быть достаточно большой для того, чтобы снижать фактические потери из больших I-кадров, и достаточно маленькой для того, чтобы противостоять несовпадению между кодером и декодером или ухудшению качества канала. Помимо этого, макроблоки (MB) в P-кадрах могут быть внутренне кодированными по той же причине.

Обнаружение смены сцен может быть использовано видеокодером для того, чтобы определять соответствующую длину GOP и вставлять I-кадры на основе длины GOP вместо вставки зачастую ненужного I-кадра с фиксированным интервалом. В практической системе потоковой передачи видео качество канала связи обычно ухудшается посредством битовых ошибок или потерь пакетов. То, где размещаются I-кадры или I-MB, может существенно влиять на качество декодированного видео и удобство просмотра. Одна схема кодирования заключается в том, чтобы использовать внутренне кодированные кадры для изображений или частей изображений, которые имеют существенное отличие в сравнении с совместно размещенными предыдущими изображениями или частями изображений. Обычно эти зоны не могут эффективно и рационально предсказываться при оценке движения, и кодирование может выполняться более эффективно, если эти зоны исключены из методик межкадрового кодирования (к примеру, кодирования с помощью B-кадров и P-кадров). В контексте ухудшения качества канала эти зоны, вероятно, испытывают распространение ошибок, которое может быть уменьшено или исключено (либо практически исключено) посредством внутрикадрового кодирования.

Части видео GOP могут быть классифицированы на две или более категорий, при этом каждая зона может иметь различные критерии внутрикадрового кодирования, которые могут зависеть от конкретной реализации. В качестве примера, видео может быть классифицировано на три категории: резкая смена сцен, монтажный переход и другие медленные смены сцен, а также вспышки камеры.

Резкие смены сцен включают в себя кадры, которые значительно отличаются от предыдущего кадра, обычно вызываемые работой камеры. Поскольку содержимое этих кадров отличается от содержимого предыдущего кадра, кадры резкой смены сцен должны быть кодированы как I-кадры.

Монтажный переход и другие медленные изменения сцен включают в себя медленное переключение сцен, обычно вызываемое посредством вычислительной обработки съемки камерой. Постепенное смешивание двух различных сцен может выглядеть более приятным для человеческих глаз, но налагает сложную задачу на кодирование видео. Компенсация движения не может эффективно уменьшить скорость передачи битов этих кадров, и большее число внутренних MB может быть обновлено для этих кадров.

Вспышки камеры, или события вспышки камеры, возникают, когда содержимое кадра включает в себя вспышки камеры. Эти вспышки имеют относительно небольшую длительность (к примеру, один кадр) и являются очень яркими, так что пикселы в кадре, визуализирующем вспышки, демонстрируют очень высокую яркость относительно соответствующей области в соседнем кадре. Вспышки камеры сдвигают яркость изображения внезапно и быстро. Обычно продолжительность вспышки камеры меньше продолжительности временного маскирования зрительной системы человека (HVS), которая в типичном варианте задается равной 44 мс. Человеческие глаза не чувствительны к качеству этих коротких всплесков яркости, и поэтому они могут быть кодированы более грубо. Поскольку кадры вспышке не могут эффективно обрабатываться с помощью компенсации движения и они являются плохим вариантом предсказания для будущих кадров, грубое кодирование этих кадров не снижает эффективность кодирования будущих кадров. Сцены, классифицированные как вспышки, не должны быть использованы для того, чтобы предсказывать другие кадры вследствие "искусственной" высокой яркости, и другие кадры не могут быть эффективно использованы для того, чтобы предсказывать эти кадры, по той же причине. После идентификации эти кадры могут быть извлечены, поскольку они могут потребовать относительно высокого объема обработки. Один вариант состоит в том, чтобы удалять вспышки камеры и кодировать коэффициент DC на их месте; это решение является простым, вычислительно быстрым и экономит много битов.

Когда любые из вышеприведенных категорий кадров обнаружены, объявляется событие кадра. Обнаружение кадров полезно не только для того, чтобы повышать эффективность кодирования, оно также может помочь в идентификации поиска и индексации видеосодержимого. Один иллюстративный аспект процесса обнаружения сцен описан ниже. В этом примере, процесс обнаружения кадров сначала вычисляет информацию, или показатели, для выбранного кадра, обрабатываемого для обнаружения кадров. Показатели могут включать в себя информацию из двумерной обработки оценки и компенсации движения для видео и других основанных на яркости показателей.

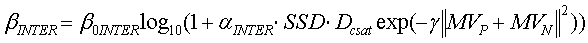

Чтобы выполнять двумерную оценку/компенсацию движения, видеопоследовательность должна быть предварительно обработана с помощью модуля двунаправленной компенсации движения, который сопоставляет каждый блок 8x8 текущего кадра с блоками в двух кадрах, наиболее близких к соседним кадрам, один в прошлом и один в будущем. Блок компенсации движения формирует векторы движения и разностные показатели для каждого блока. Фиг.29 - это иллюстрация, которая демонстрирует пример сопоставления пикселов текущего кадра C с прошлым кадром P и будущим (или следующим) кадром N и показывает векторы движения для сопоставленных пикселов (прошлый вектор движения MVP и будущий вектор движения MVN). Общее описание формирования двунаправленных векторов движения и связанного кодирования, в общем, приводится ниже со ссылкой на фиг.32.

После определения информации двунаправленного движения (к примеру, информации движения, которая идентифицирует MB (наиболее совпадающие) в соответствующих соседних кадрах, дополнительные показатели могут быть сформированы (к примеру, посредством модуля компенсации движения в модуле 612 секционирования GOP или другом соответствующем компоненте) посредством различных сравнений текущего кадра со следующим кадром и предыдущим кадром. Модуль компенсации движения может формировать разностный показатель для каждого блока. Разностным показателем может быть сумма квадратов разностей (SSD) или сумма абсолютной разности (SAD). Без потери общности здесь в качестве примера используется SAD.

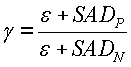

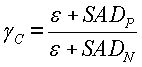

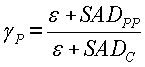

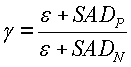

Для каждого кадра соотношение SAD, также упоминаемое как "коэффициент контрастности", вычисляется следующим образом:

где SAD P и SAD N - это сумма абсолютных разностей прямого и обратного разностного показателя соответственно. Следует отметить, что знаменатель содержит небольшое положительное число ε, чтобы не допустить ошибки деления на нуль. Числитель также содержит ε, чтобы компенсировать влияние единицы в знаменателе. Например, если предыдущий кадр, текущий кадр и следующий кадр идентичны, поиск движения должен давать SADP=SADN=0. В этом случае вышеуказанные формирователи вычисления γ=1 вместо 0 или бесконечности.

Гистограмма яркости может быть вычислена для каждого кадра. В типичном варианте мультимедийные изображения имеют глубину яркости (к примеру, число "элементов разрешения") в восемь битов. Глубина яркости, используемая для вычисления гистограммы яркости согласно некоторым аспектам, может быть задана равной 16, чтобы получить гистограмму. В других аспектах глубина яркости может быть задана равной соответствующему числу, которое может зависеть от типа обрабатываемых данных, доступной вычислительной мощности или других предварительно определенных критериев. В некоторых аспектах глубина яркости может задаваться динамически на основе вычисленного или принятого показателя, например, содержимого данных.

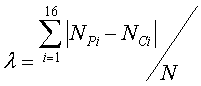

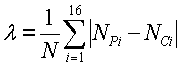

Нижеприведенное уравнение иллюстрирует один пример вычисления разности гистограмм яркости (лямбды):

где NPi - это число блоков в i-том элементе разрешения для предыдущего кадра, NCi - это число блоков в i-том элементе разрешения для текущего кадра, а N - это общее число блоков в кадре. Если разность гистограмм яркости предыдущего и текущего кадра полностью непохожа (или непересекающаяся), то λ=2.

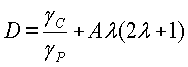

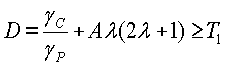

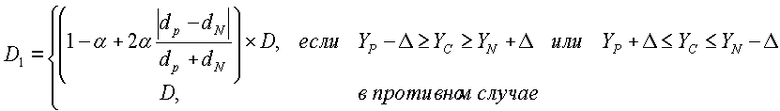

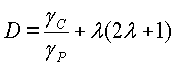

Используя эта информацию, показатель разности кадров (D) вычисляется следующим образом:

где A - это константа, выбранная посредством варианта применения,  и

и

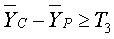

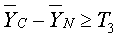

Выбранный (текущий кадр) классифицируется как кадр резкой смены сцен, если разностный показатель кадров удовлетворяет критерию, показанному в уравнении 9:

где A - это константа, выбранная посредством варианта применения, а T 1 - это порог.

В одном примере, который показывает моделирование, задание A=1 и T1=5 предоставляет хорошую производительность обнаружения. Если текущий кадр является кадром резкой смены сцен, то γc должно быть большим, а γp должно быть маленьким. Соотношение γc/γp может быть использовано вместо только γc, с тем чтобы показатель был нормализован к уровню активности.