Уровень техники

Настоящее изобретение относится к устройству обработки информации, включающему в себя множество сенсорных панелей, способу обработки информации для устройства обработки информации и программе для него.

Описание предшествующего уровня техники

Из прошлого известны устройства обработки информации, включающие в себя множество сенсорных панелей. Например, выложенная заявка на патент Японии №2003-150273 (фиг.1, 4, 10 и т.д.; далее именуемая как патентный документ 1) раскрывает персональный цифровой секретарь (PDA) типа наручных часов, в котором множество панелей, включающие в себя жидкокристаллические панели (LCD), соединенные в единое целое со множеством сенсорных панелей, соединены шарнирным элементом.

Сущность изобретения

Однако в PDA, раскрытом в патентном документе 1, сенсорной панелью обнаруживается только операция с кнопкой, отображаемой на каждой жидкокристаллической панели. Соответственно, когда обнаруживаются операции касания на множестве сенсорных панелей, то PDA неспособен связывать и управлять отображением соответствующих объектов в качестве целевых объектов операций между множеством сенсорных панелей. То есть PDA неспособен выполнять единую, комплексную обработку данных на множестве сенсорных панелей.

Ввиду вышеописанных обстоятельств существует потребность в устройстве обработки информации, способе обработки информации и соответствующей программе, которые способны связывать и управлять отображением соответствующих объектов в качестве целевых объектов операций между множеством сенсорных панелей в соответствии с операциями касания, определяемыми на множестве сенсорных панелей, и выполнять единую, комплексную обработку данных.

Согласно варианту осуществления настоящего изобретения, обеспечивается устройство обработки информации, включающее в себя первую сенсорную панель, вторую сенсорную панель и контроллер. Первая сенсорная панель отображает первый объект и обнаруживает первую операцию касания пользователем первого объекта. Вторая сенсорная панель отображает второй объект и обнаруживает вторую операцию касания пользователем второго объекта. Контроллер связывает и изменяет отображенный первый объект и отображенный второй объект, когда вторая операция касания обнаруживается в пределах заданного промежутка времени после обнаружения первой операции касания.

Устройство для обработки информации, имеющее такую структуру, может связывать и управлять отображением объектов в качестве целевых объектов операций между соответствующими сенсорными панелями в соответствии с операциями касания, обнаруженными первой и второй сенсорными панелями и, таким образом, выполнять единую, комплексную обработку данных. Соответственно, поскольку устройство обработки информации может обрабатывать множество объектов не только по отдельности, но также и комплексно, по сравнению со случаем, когда используется единственная сенсорная панель, то возможно увеличение гибкости обработки в соответствии с вариантами использования, определяемыми пользователем.

В данном случае заданный промежуток времени составляет, например, около 0-3 секунд, но не ограничивается этим. Другими словами, заданный промежуток времени также включает в себя случай, когда первая операция касания и вторая операция касания обнаружены одновременно. Первая и вторая сенсорные панели включают в себя панели, которые содержат емкостной датчик бесконтактного типа, при этом первая и вторая операции касания включают в себя операции, которые не сопровождаются физическим контактом с первой и второй сенсорными панелями. Кроме того, первый и второй объекты включают в себя, например, значок, окно, целый экран и различные другие изображения. Первый и второй объекты могут быть объектом, полученным с помощью разделения единого объекта, и отображаться на первой сенсорной панели и второй сенсорной панели, или они могут отображаться отдельно и индивидуально.

Первая операция касания и вторая операция касания могут быть операциями в противоположных направлениях.

Соответственно, с помощью установки операций касания для связывания и изменения первого и второго объектов, которые производятся в противоположных направлениях, устройство для обработки информации позволяет пользователю легко распознавать разницу с нормальной, несвязанной операцией касания и интуитивно вводить операцию касания. В результате устройство обработки информации может также не допустить ошибочную операцию пользователя. В данном случае противоположные друг другу направления включают в себя операции не только в линейном направлении, но также в криволинейном направлении и во вращательном направлении.

Контроллер может отображать первый объект на второй сенсорной панели и отображать второй объект на первой сенсорной панели, когда вторая операция касания обнаружена в пределах заданного промежутка времени с момента обнаружения первой операции касания.

Соответственно, пользователь может переключать отображение объектов или экранов, отображаемых на первой и второй сенсорных панелях, с помощью интуитивных операций касания.

Первый объект и второй объект могут отображаться как часть единого третьего объекта. В этом случае первая операция касания и вторая операция касания могут быть операциями во вращательном направлении. В этом случае контроллер может поворачивать третий объект, когда вторая операция касания обнаружена в пределах заданного промежутка времени с момента обнаружения первой операции касания.

Соответственно, пользователь может не только рассматривать один объект на множестве сенсорных панелей, но также поворачивать объект с помощью легких и интуитивных операций, которые аналогичны операции вращения реального объекта.

Первый объект и второй объект могут отображаться как часть единого третьего объекта. В этом случае первая операция касания и вторая операция касания могут быть операциями в противоположных направлениях перемещения. В этом случае контроллер может изменять третий объект таким образом, что третий объект разделяется, когда вторая операция касания обнаружена в пределах заданного промежутка времени с момента обнаружения первой операции касания.

Соответственно, пользователь может не только рассматривать один объект на множестве сенсорных панелей, но также изменять объект с помощью легких и интуитивных операций, которые аналогичны операции разделения реального документа или подобной операции.

В этом случае устройство обработки информации может дополнительно включать в себя запоминающее устройство для сохранения данных, соответствующих третьему объекту, а контроллер может удалить данные из запоминающего устройства, когда третий объект изменяется таким образом, что этот третий объект разделяется.

Соответственно, пользователь может интуитивно выполнить обработку удаления данных, соответствующих третьему объекту, рассматривая обработку удаления как операцию разделения третьего объекта.

Первая операция касания и вторая операция касания могут быть операциями с перемещением по направлению друг к другу. В этом случае контроллер может изменять первый объект и второй объект таким образом, что первый объект и второй объект объединяются в один объект, когда вторая операция касания обнаружена в пределах заданного промежутка времени с момента обнаружения первой операции касания.

Соответственно, пользователь может объединять объекты, отображаемые на первой и второй сенсорных панелях в один объект с помощью легких и интуитивных операций, которые аналогичны операции сближения реальных объектов и собирания их.

Устройство обработки информации может дополнительно включать в себя датчик для обнаружения предмета, находящегося на заданном расстоянии от первой сенсорной панели и второй сенсорной панели. В этом случае контроллер может связывать и изменять отображаемый первый объект и отображаемый второй объект, когда вторая операция касания обнаружена в пределах заданного промежутка времени с момента обнаружения первой операции касания и предмет обнаруживается датчиком.

В этом случае предмет, который присутствует на заданном расстоянии, является, например, рукой пользователя, и более точно, базовым участком между двумя пальцами.

Соответственно, например, в том случае, когда первая операция касания является вводом с помощью пальца руки пользователя, а вторая операция касания является вводом с помощью другого пальца руки, то устройство обработки информации может надежно распознать, что операции касания являются вводом с помощью двух пальцев благодаря обнаружению руки датчиком. Соответственно, в том случае, когда только первая операция касания является вводом, а со второй сенсорной панелью случайно контактирует другой предмет, то устройство обработки информации может не допустить ошибочное обнаружение и ошибочное изменение отображения из-за контакта с другим предметом. Это происходит потому, что в этом случае сам предмет обнаруживается датчиком, но обнаруживается на расстоянии, меньшем заданного расстояния.

Кроме того, в этом случае контроллер может изменять отображаемый первый объект и отображаемый второй объект в первом режиме, когда предмет обнаруживается датчиком, и изменять отображаемый первый объект и отображаемый второй объект во втором режиме, который отличается от первого режима, когда предмет не обнаруживается датчиком.

Таким образом, в соответствии с наличием факта обнаружения предмета датчиком устройство обработки информации может изменять первый и второй объекты в различных режимах даже в том случае, когда обнаруживаются одинаковые первая и вторая операции. Таким образом, устройство обработки информации может выполнять обработку большего количества последовательностей в соответствии с первой и второй операциями касания и повышать дружественность по отношению к пользователю.

Устройство обработки информации может дополнительно включать в себя запоминающее устройство для сохранения первых данных, соответствующих первому объекту, и вторых данных, соответствующих второму объекту. В этом случае первая операция касания может быть операцией, окружающей первый объект в заданном направлении вращения, а вторая операция касания может быть операцией, окружающей второй объект в заданном направлении вращения. В этом случае контроллер может вызывать группирование и сохранение запоминающим устройством первых данных и вторых данных, когда вторая операция касания обнаружена в пределах заданного промежутка времени с момента обнаружения первой операции касания.

Соответственно, пользователь может группировать и сохранять первые данные и вторые данные, соответствующие первому и второму объектам, осуществляя только легкие и интуитивные операции окружения первого и второго объектов.

Согласно другому варианту осуществления настоящего изобретения, обеспечивается способ обработки информации, включающий в себя отображение первого объекта с помощью первой сенсорной панели и обнаружение первой операции касания пользователем первого объекта. Кроме того, способ обработки информации включает в себя отображение второго объекта с помощью второй сенсорной панели и обнаружение второй операции касания пользователем второго объекта. Когда вторая операция касания обнаруживается в пределах заданного промежутка времени с момента обнаружения первой операции касания, то отображенный первый объект и отображенный второй объект связываются и изменяются.

Согласно еще одному варианту осуществления настоящего изобретения, обеспечивается программа, вызывающая выполнение устройством обработки информации, включающим в себя первую сенсорную панель и вторую сенсорную панель первого этапа обнаружения, второго этапа обнаружения и этапа управления отображением. Первый этап обнаружения включает в себя отображение первого объекта с помощью первой сенсорной панели и обнаружение первой операции касания пользователем первого объекта. Второй этап обнаружения включает в себя отображение второго объекта с помощью второй сенсорной панели и обнаружение второй операции касания пользователем второго объекта. Этап управления отображением включает в себя связывание и изменение отображаемого первого объекта и отображаемого второго объекта, когда вторая операция касания обнаружена в пределах заданного промежутка времени с момента обнаружения первой операции касания.

Как описано выше, согласно вариантам осуществления настоящего изобретения, возможно выполнять единую, комплексную обработку с помощью соединения и управления отображением объектов как целевых объектов операций между множеством сенсорных панелей в соответствии с операциями касания, обнаруженными на множестве сенсорных панелей.

Эти и другие цели, признаки и преимущества настоящего изобретения станут более понятными с учетом нижеследующего подробного описания лучших вариантов осуществления изобретения, проиллюстрированных прилагаемыми чертежами.

Краткое описание чертежей

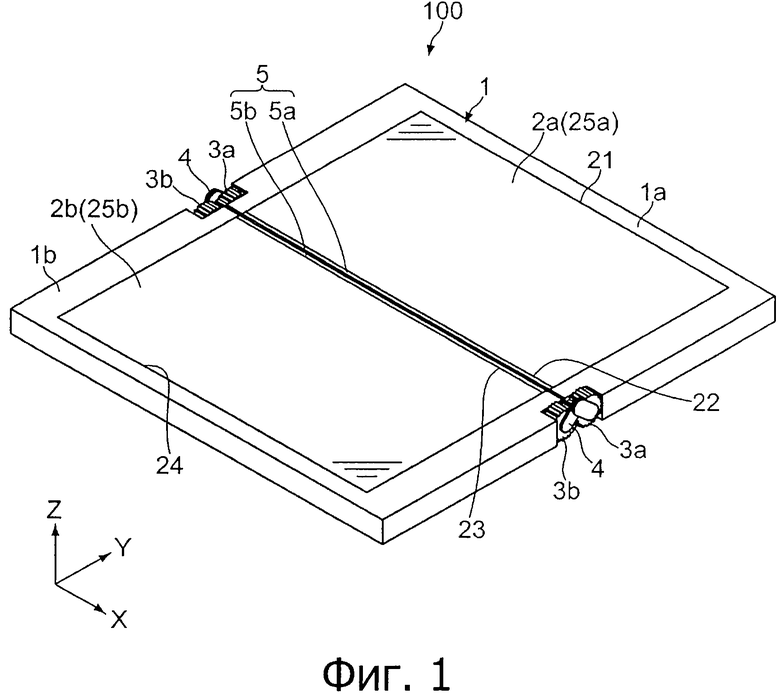

Фиг.1 - схема, показывающая внешний вид портативного информационного устройства согласно варианту осуществления настоящего изобретения;

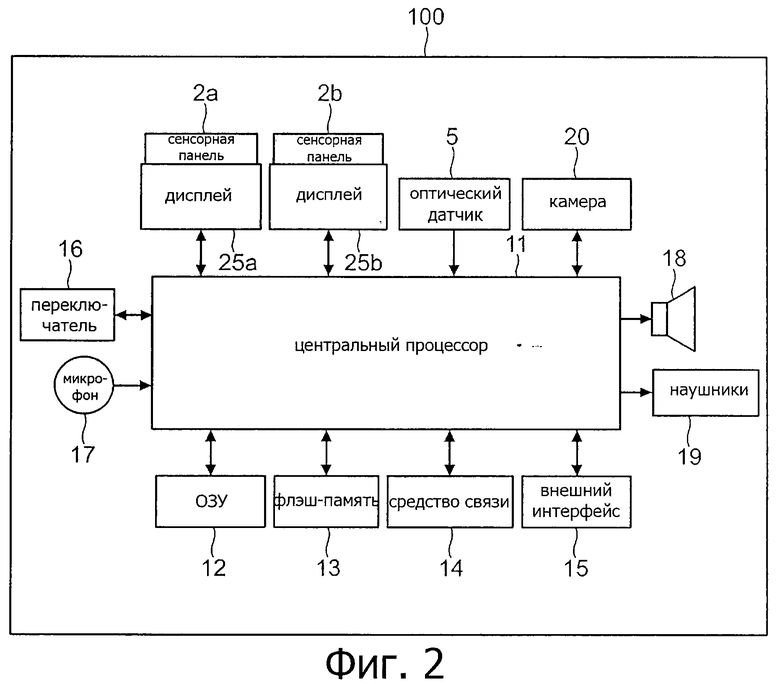

фиг.2 - схема, показывающая структуру аппаратной части портативного информационного устройства согласно варианту осуществления настоящего изобретения;

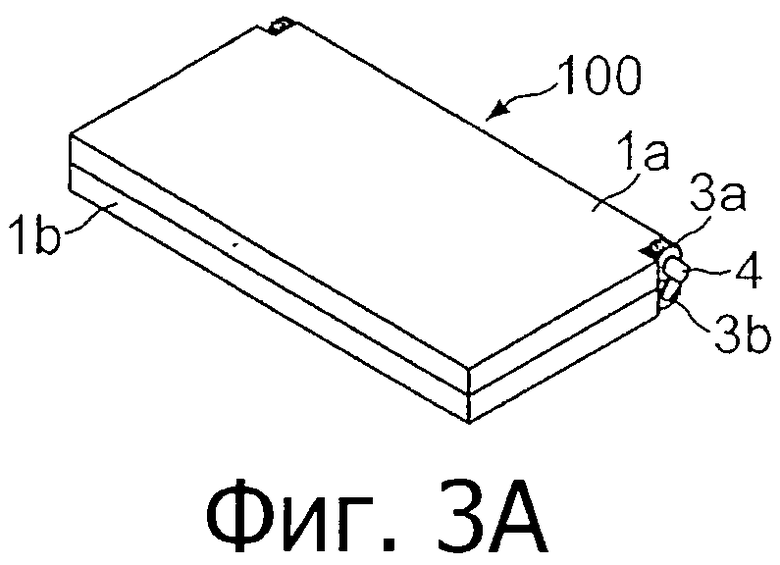

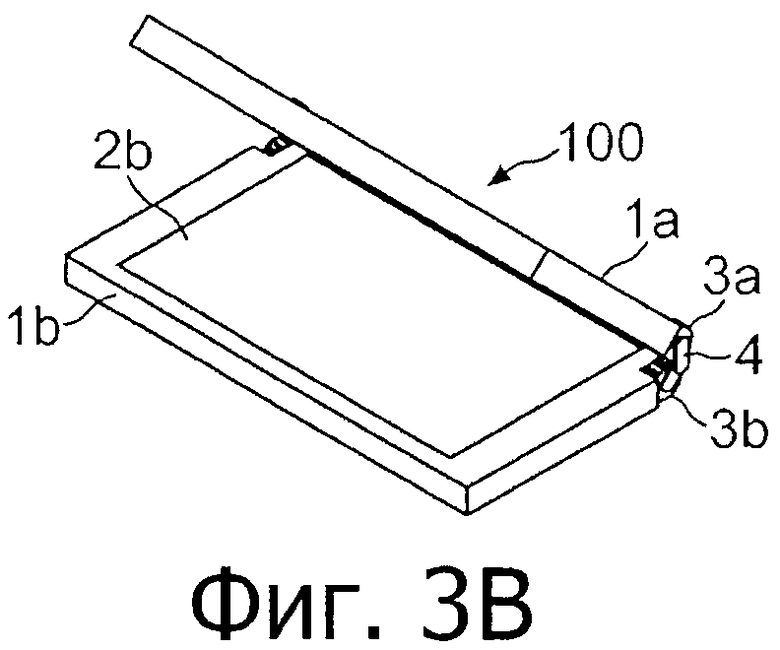

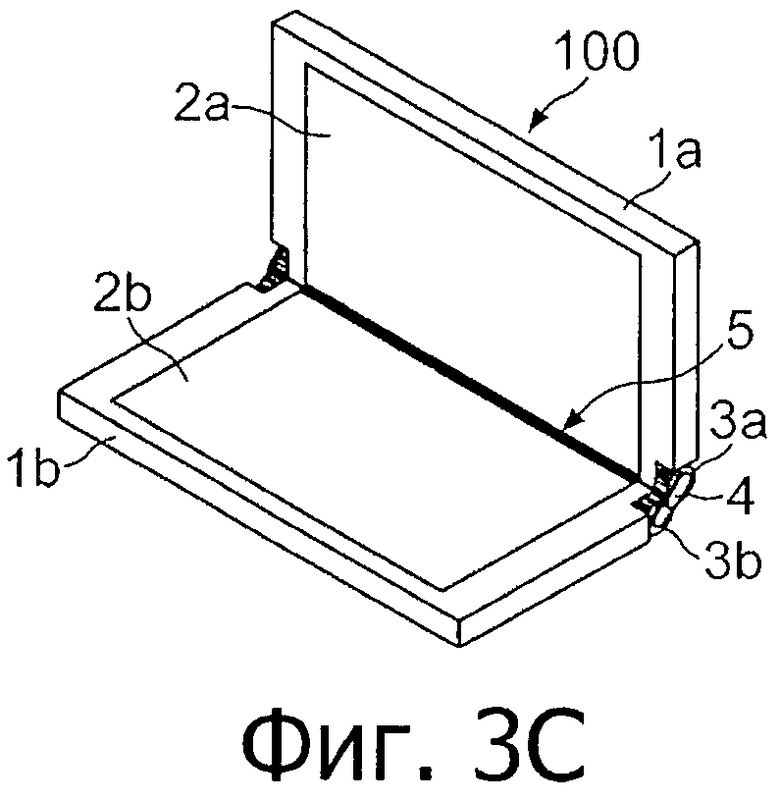

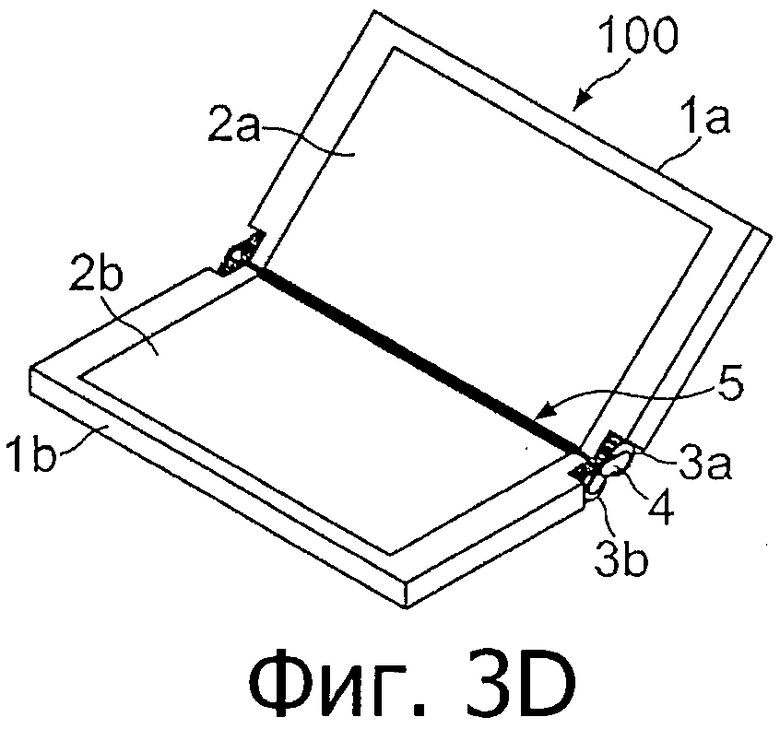

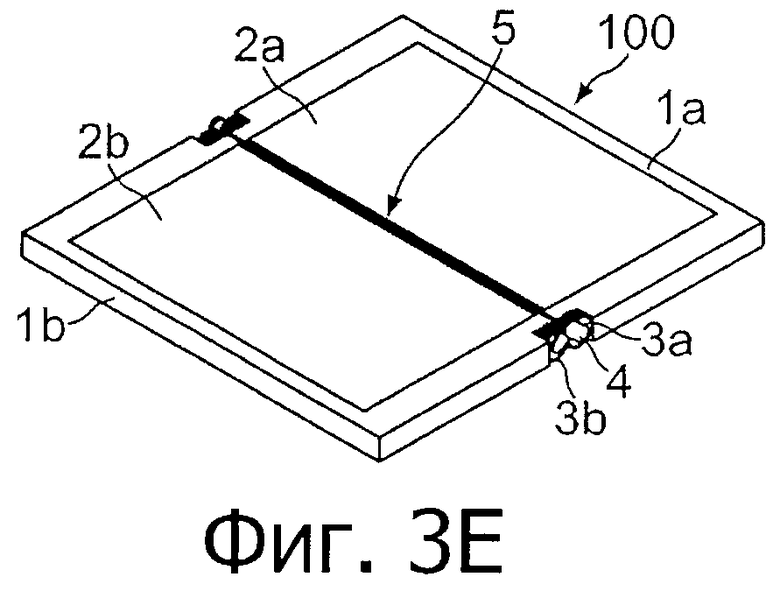

фиг.3 - схемы, показывающие портативное информационное устройство в открытом и закрытом состоянии согласно варианту осуществления настоящего изобретения;

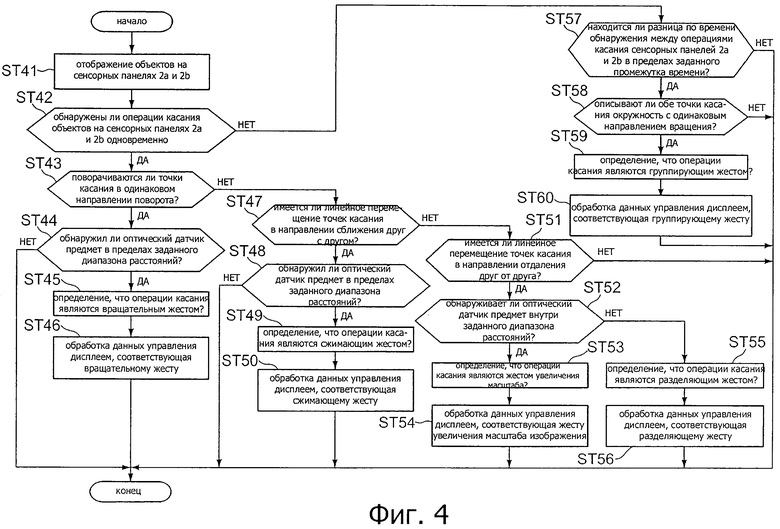

фиг.4 - блок-схема, показывающая процесс обработки данных в соответствии с операцией касания портативным информационным устройством согласно варианту осуществления настоящего изобретения;

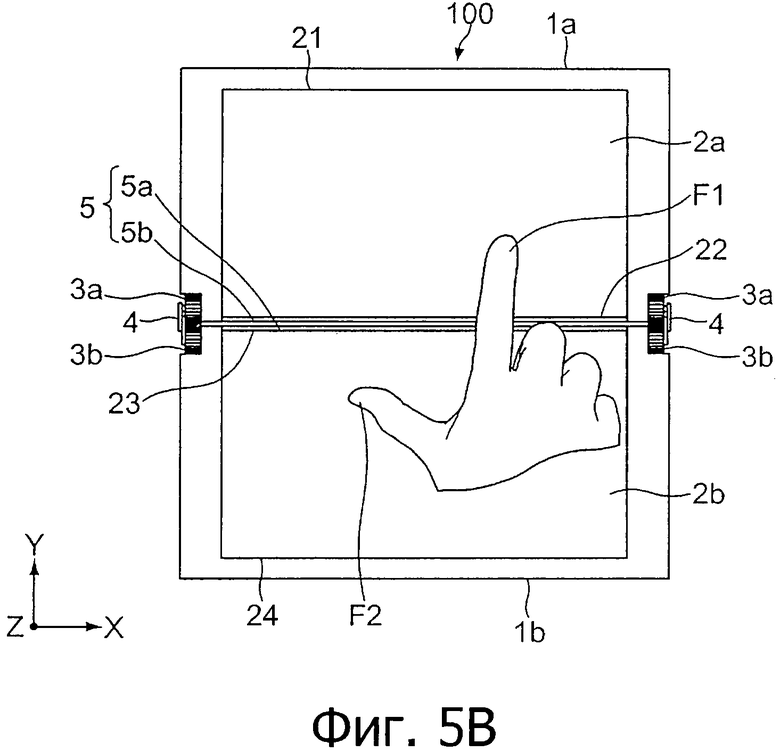

фиг.5 - схемы, показывающие пример состояния вращательного жеста в портативном информационном устройстве согласно варианту осуществления настоящего изобретения, рассматриваемого с направления плоскости сенсорной панели;

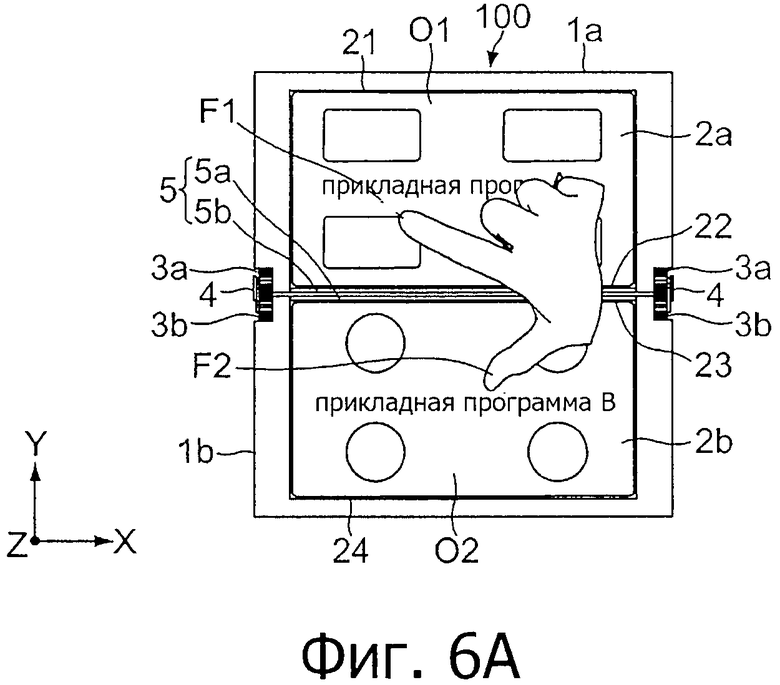

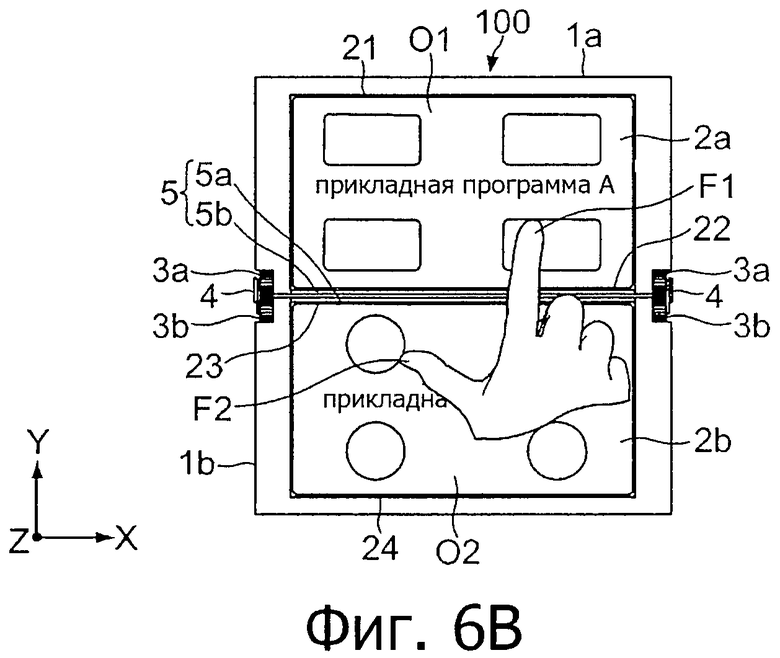

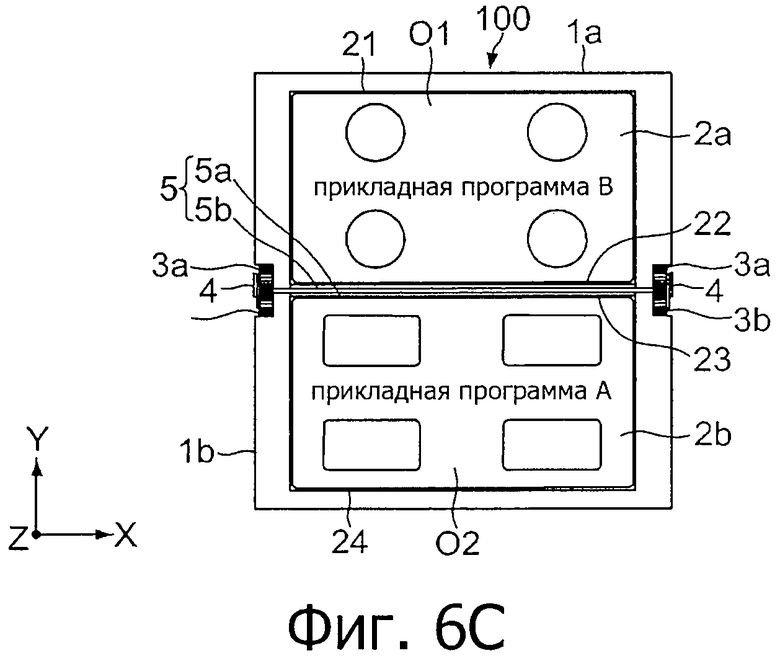

фиг.6 - схемы, показывающие частный пример обработки отображения, соответствующей вращательному жесту, показанному на фиг.5;

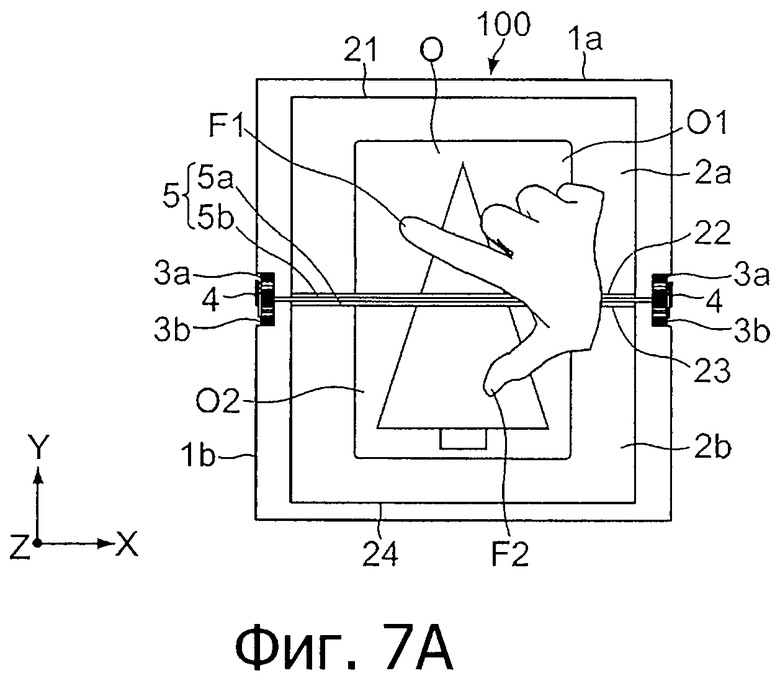

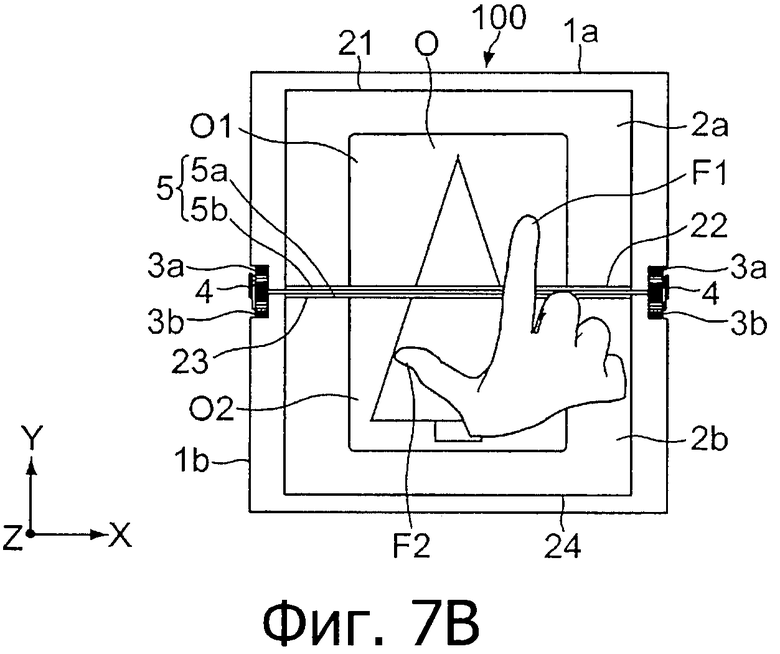

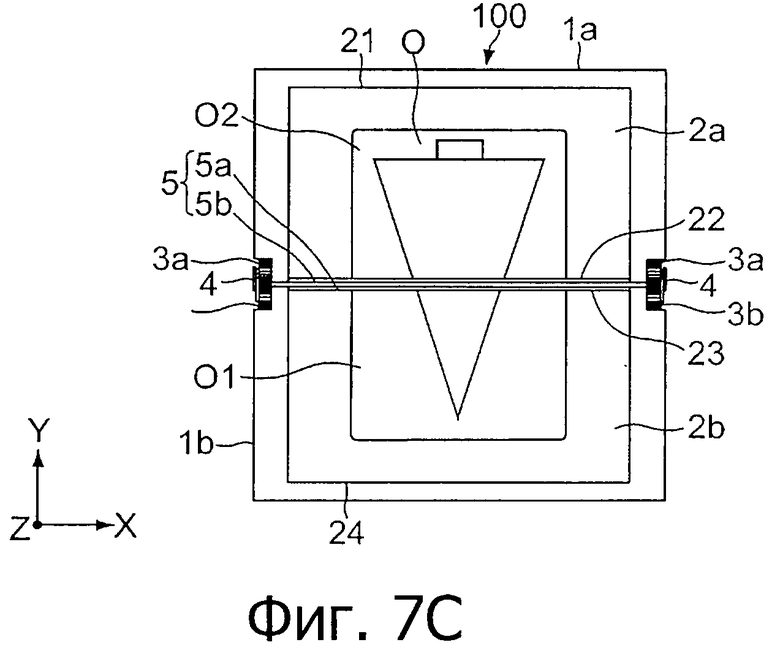

фиг.7 - схемы, показывающие другой частный пример обработки отображения, соответствующей вращательному жесту, показанному на фиг.5;

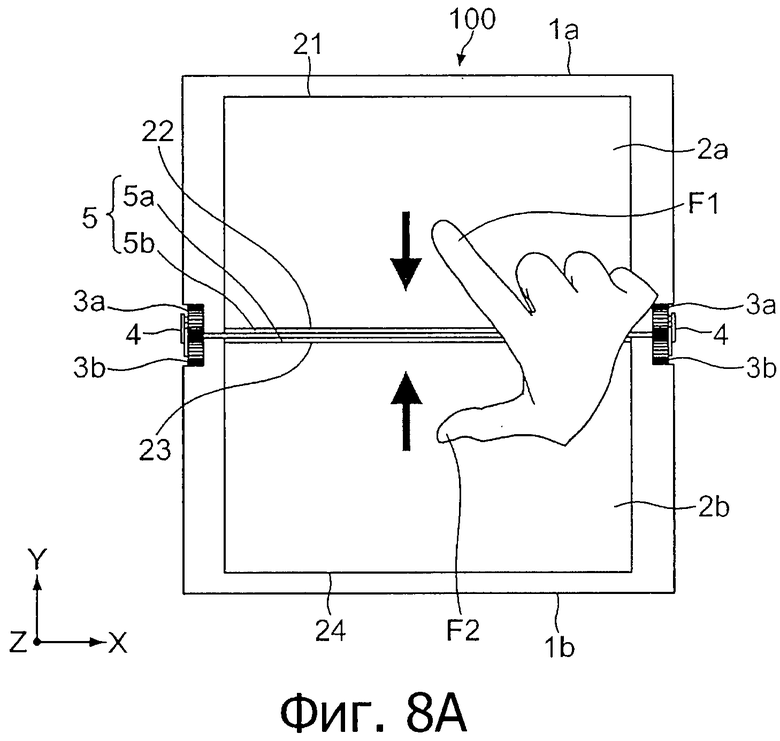

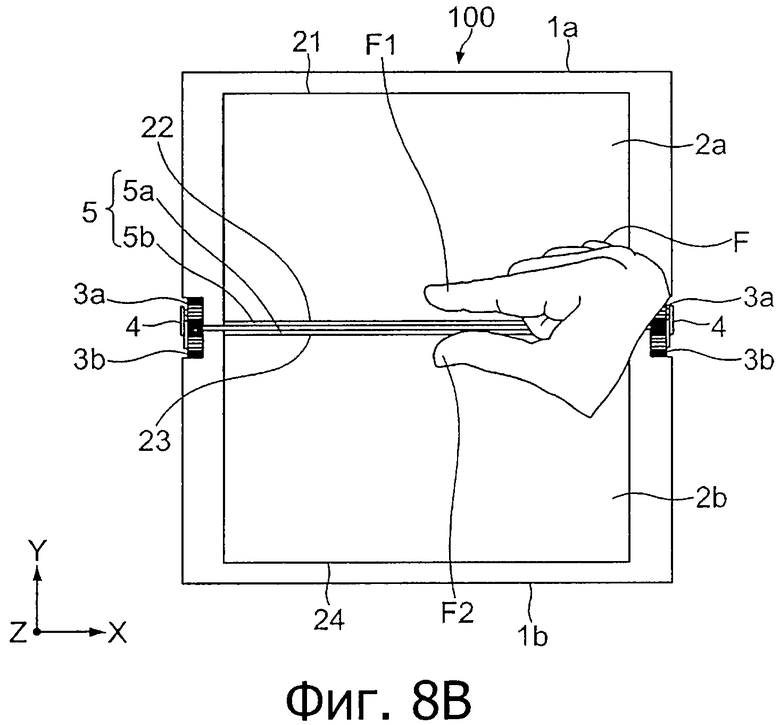

фиг.8 - схемы, показывающие пример состояния сжимающего жеста в портативном информационном устройстве согласно варианту осуществления настоящего изобретения, рассматриваемого с направления плоскости сенсорной панели;

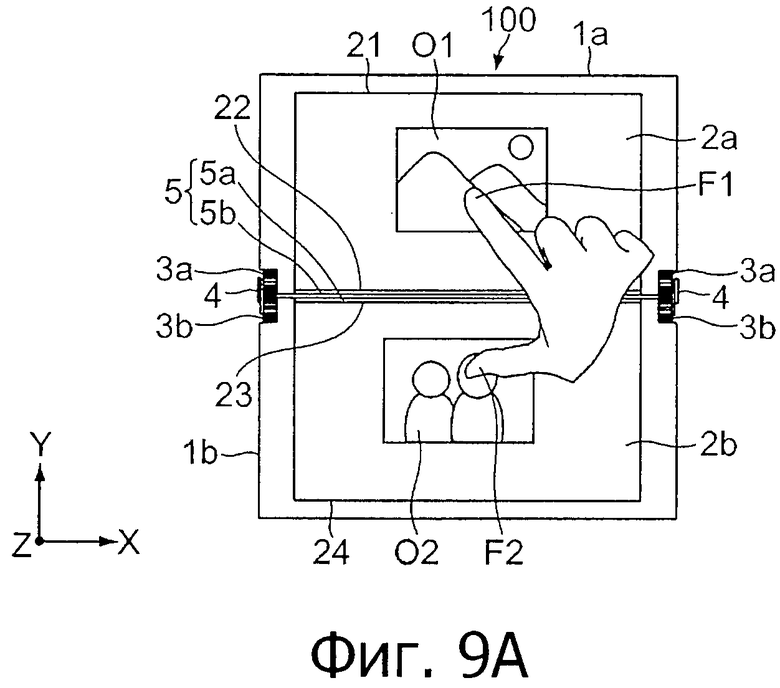

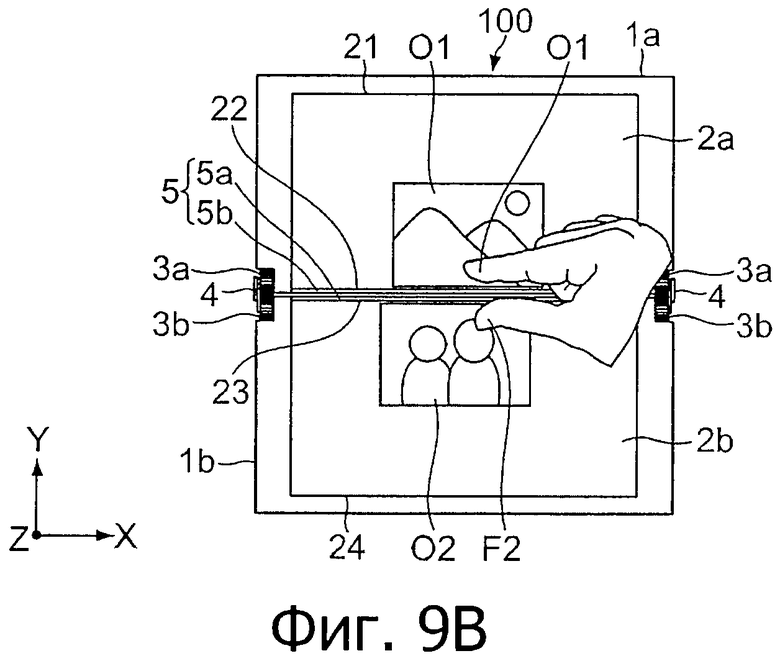

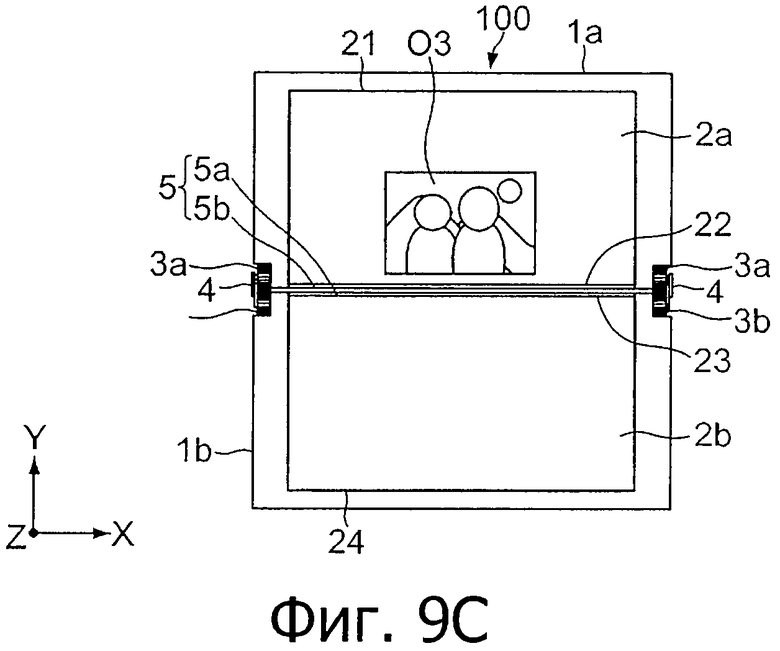

фиг.9 - схемы, показывающие частный пример обработки отображения, соответствующей сжимающему жесту, показанному на фиг.8;

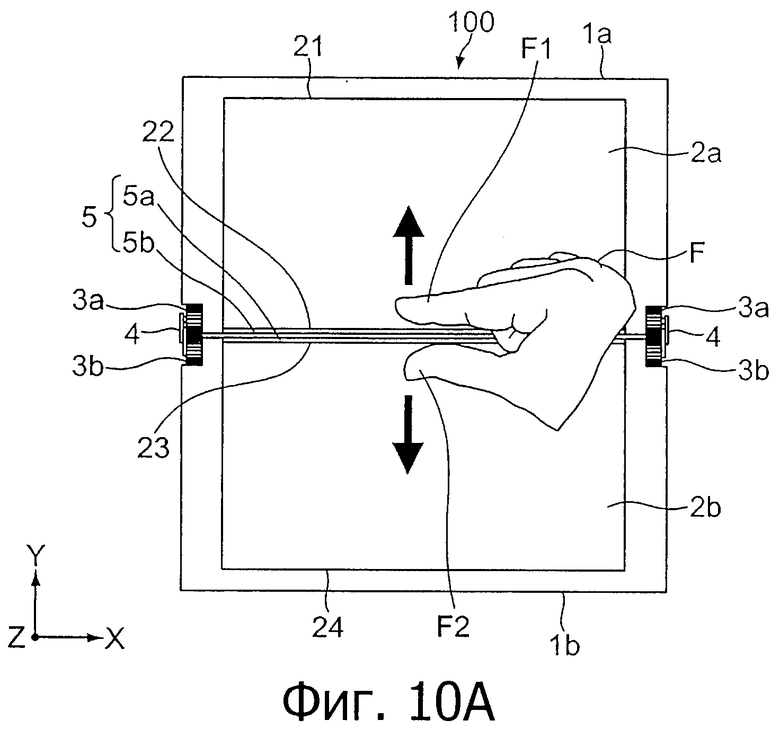

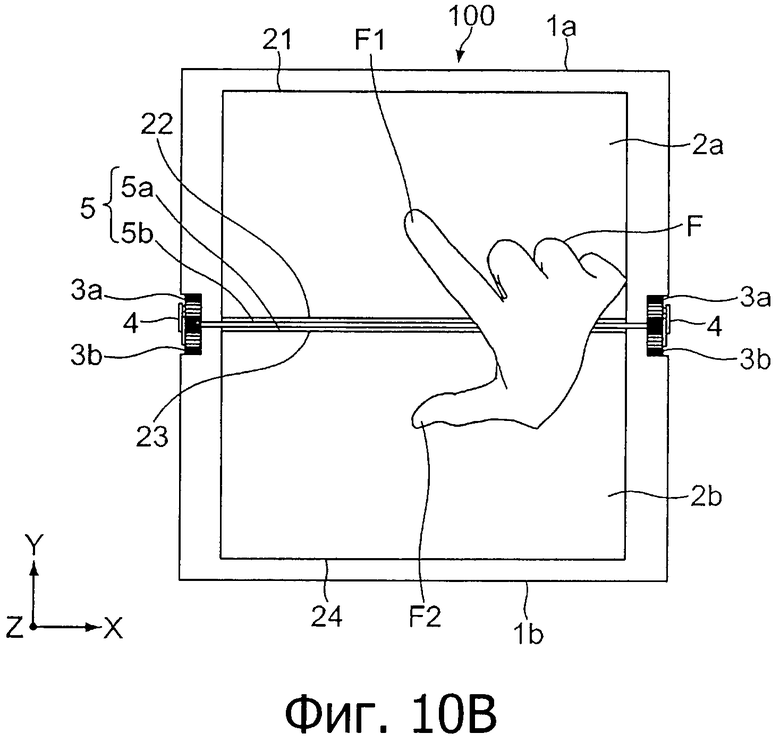

фиг.10 - схемы, показывающие пример состояния жеста увеличения масштаба в портативном информационном устройстве согласно варианту осуществления настоящего изобретения, рассматриваемого с направления плоскости сенсорной панели;

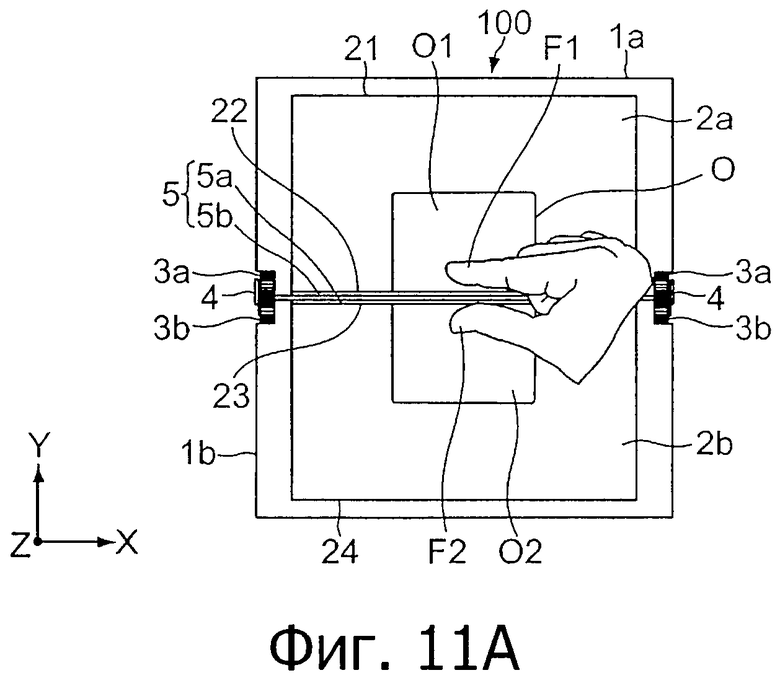

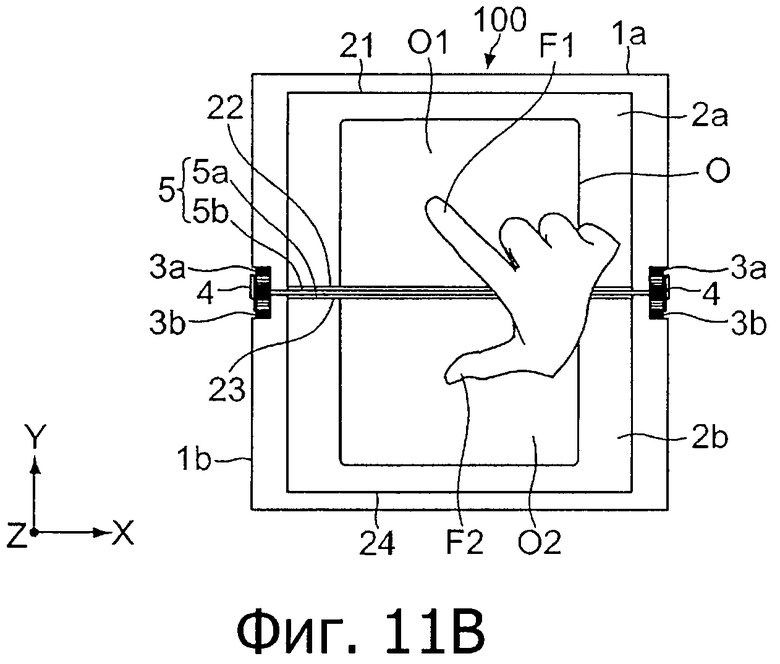

фиг.11 - схемы, показывающие частный пример обработки отображения, соответствующей жесту увеличения масштаба изображения, показанному на фиг.10;

фиг.12 - схемы, показывающие пример состояния разделяющего жеста в портативном информационном устройстве согласно варианту осуществления настоящего изобретения, рассматриваемого с направления плоскости сенсорной панели;

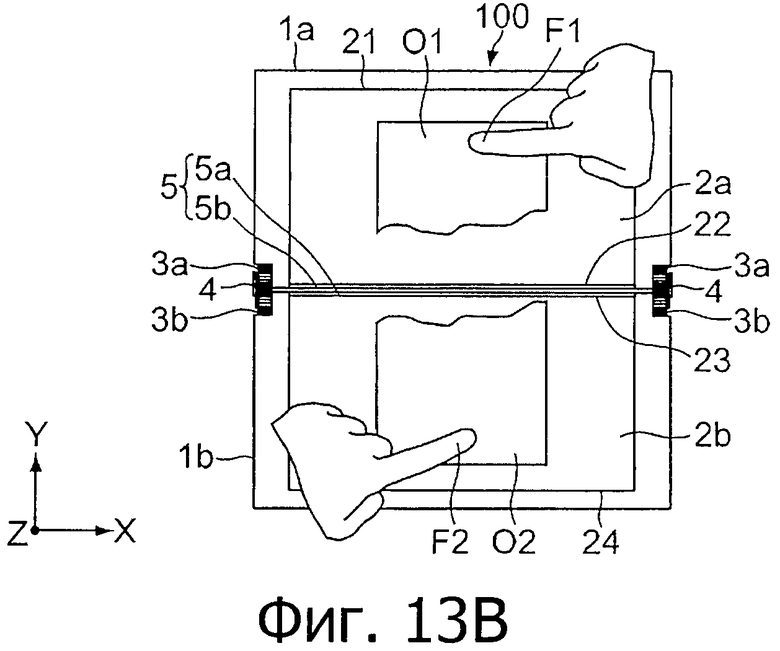

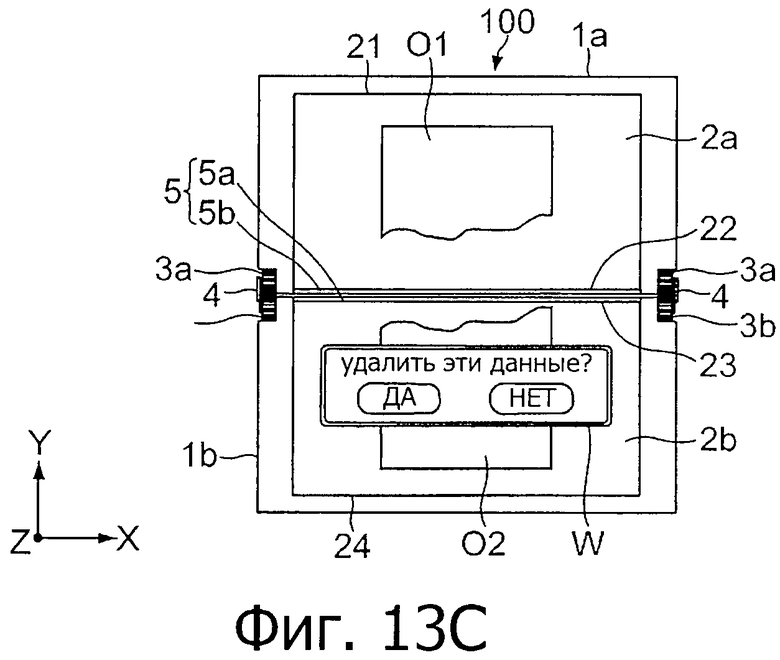

фиг.13 - схемы, показывающие частный пример обработки отображения, соответствующей разделяющему жесту, показанному на фиг.12;

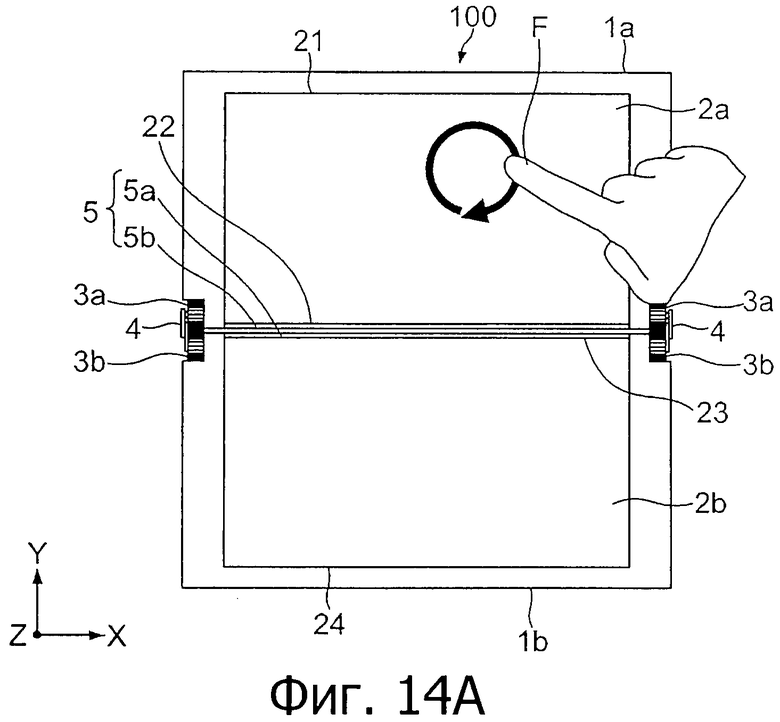

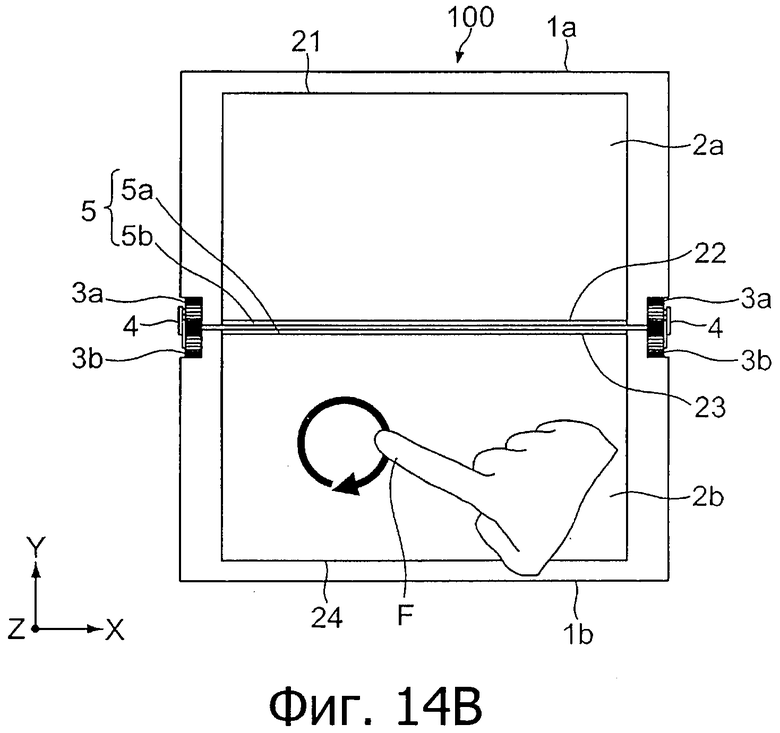

фиг.14 - схемы, показывающие пример состояния группирующего жеста в портативном информационном устройстве согласно варианту осуществления настоящего изобретения, рассматриваемого с направления плоскости сенсорной панели; и

фиг.15 - схемы, показывающие частный пример обработки отображения, соответствующей группирующему жесту, показанному на фиг.14.

Описание предпочтительных вариантов осуществления изобретения

Ниже описан вариант осуществления настоящего изобретения будет описываться со ссылкой на чертежи.

Общий план портативного информационного устройства

Фиг.1 - схема, показывающая внешний вид портативного информационного устройства, согласно варианту осуществления настоящего изобретения.

Как показано на чертеже, портативное информационное устройство 100 включает в себя так называемый корпус 1 двухстворчатого типа, в котором два корпуса 1а и 1b соединены с возможностью поворота (в открываемом состоянии). Фиг.1 показывает состояние, в котором корпуса 1а и 1b открыты. Пользователь работает с портативным информационным устройством 100, когда оно находится в этом состоянии.

Корпуса 1а и 1b включают в себя, соответственно, сенсорные панели 2а и 2b, находящиеся на поверхностях корпусов, которые могут быть подвергнуты воздействию в открытом состоянии. Сенсорные панели 2а и 2b составляют единое целое соответственно с дисплеями 25а и 25b. Сенсорная панель 2а включает в себя сенсорную поверхность, имеющую концевую сторону 21 и концевую сторону 22, противоположную концевой стороне 21. Аналогично, сенсорная панель 2b включает в себя сенсорную поверхность, имеющую концевую сторону 23 и концевую сторону 24, противоположную конечной стороне 23. Сенсорные панели 2а и 2b обнаруживают операции касания, осуществляемые пальцем пользователя на объекте, отображаемом на дисплеях 25а и 25b. Пользователь вводит операции касания, используя два пальца одной руки (обычно большой палец и указательный палец), или палец одной руки и палец другой руки (обычно указательные пальцы). Обычно операция касания включает в себя операцию перетаскивания пальца в произвольном направлении (операцию проведения пальцем по сенсорным панелям 2а и 2b) или операцию с кликом (простым касанием), но операции этим не ограничиваются.

Корпус 1а включает в себя зубчатые элементы 3а на обеих боковых поверхностях со стороны концевой стороны 22, а корпус 1b включает в себя зубчатые элементы 3b с концевой стороны 23. Зубчатые элементы 3а и зубчатые элементы 3b соединены и находятся во взаимозамкнутом состоянии с помощью соединительных элементов 4. Каждый соединительный элемент 4 имеет такую конструкцию, что концы двух пластин (или стержней) соединены с возможностью поворота, а другие концы двух пластин (или стержней) соединены с осями поворота зубчатых элементов 3а и 3b. С помощью зубчатых элементов 3а и 3b и соединительных элементов 4 корпуса 1а и 1b соединены с возможностью поворота. При такой конструкции расстояние между сенсорной панелью 2а корпуса 1а и сенсорной панелью 2b корпуса 1b может быть ближе, чем в том случае, когда корпуса 1а и 1b соединены, например, с использованием шарнирных петель.

Между конечной стороной 22 сенсорной панели 2а и конечной стороной 23 сенсорной панели 2b предусмотрен оптический датчик 5. Оптический датчик 5 включает в себя участок 5а оптического датчика, который тянется непрерывно на корпусе 1а от конечной стороны 22 сенсорной панели 2а, и участок 5b, который тянется непрерывно на корпусе 1b от конечной стороны 23 сенсорной панели 2b. Сенсорная поверхность сенсорной панели 2а, сенсорная поверхность сенсорной панели 2b и поверхность оптического датчика 5 обеспечиваются таким образом, чтобы они были расположены в одной плоскости, когда корпуса 1а и 1b находятся в открытом состоянии.

Структура аппаратной части портативного информационного устройства

Фиг.2 - схема, показывающая структуру аппаратной части портативного информационного устройства 100.

Как показано на чертеже, портативное информационное устройство 100 включает в себя, помимо сенсорных панелей 2а и 2b (дисплеев 25а и 25b) и оптического датчика 5, центральный процессор 11, оперативное запоминающее устройство (ОЗУ) 12 и флэш-память 13. Портативное информационное устройство 100 также включает в себя средство 14 связи, внешний интерфейс 15, средство 16 переключения, микрофон 17 громкоговоритель 18, наушник 19 и камеру 20.

Центральный процессор 11 обменивается сигналами с соответствующими элементами портативного информационного устройства 100 для выполнения различных операций и в целом осуществления управления различными типами обработки данных для управления отображением (изменением отображения) и выполнения другой обработки, которая соответствует операциям касания (жестам касания), осуществляемым на сенсорных панелях 2а и 2b.

ОЗУ 12 используется как рабочая зона центрального процессора 11 и временно сохраняет различные типы данных, включающие в себя различные графические интерфейсы пользователя (GUI) (объекты), которые должны быть обработаны процессором 11, и такие программы, как приложения для выполнения различных типов обработки отображения, соответствующих операциям касания, осуществляемым на сенсорных панелях 2а и 2b.

Флэш-память 13 использует, например, тип логической операции NAND (НЕ-И). Флэш-память 13 сохраняет различные типы данных, включающих в себя такие изображения, как различные значки и различные программы, например такие, как управляющие программы, которые должны выполняться центральным процессором 11, и приложения для выполнения различных типов обработки отображения. Приложение может сохраняться на других носителях записи, таких как карта памяти (не показана). Портативное информационное устройство 100 может включать в себя жесткий диск вместо или в дополнение к флэш-памяти 13.

Средство 14 связи является интерфейсом для подключения портативного информационного устройства 100 к Интернету или к локальной сети (LAN), согласно стандарту сети Ethernet (зарегистрированный товарный знак), беспроводной локальной сети и т.п.

Внешний интерфейс 15 обменивается различными типами данных через проводное или беспроводное соединение с внешним устройством на основе различных стандартов универсальной последовательной шины (USB), беспроводной локальной сети и т.п. Внешний интерфейс 15 может альтернативно быть интерфейсом для подключения различных карт памяти, таких как карта памяти "memory stick".

Средство 16 переключения принимает на себя операции, соответствующие функциям, эквивалентным таким функциям, которые нельзя выполнить с помощью операции касания панелей 2а и 2b, например такие, как включение/выключение источника питания (не показан), и включение различных функций, и функциям, которые могут быть выполнены с помощью операции касания панелей 2а и 2b, и передает входные сигналы к центральному процессору 11.

Микрофон 17 вводит звуковой сигнал, такой как голос пользователя, для речевых сообщений в случае, когда портативное информационное устройство 100 соединено с другими устройствами в сети через средство 14 связи.

Громкоговоритель 18 и наушник 19 выводят звуковые сигналы, которые хранятся во флэш-памяти 13 или подобном устройстве или вводятся из средства 14 связи или микрофона 17.

Камера 20 фиксирует неподвижное изображение и движущееся изображение с помощью устройства съемки изображения, такого как датчик на структуре КМОП (комплементарный металлооксидный полупроводник) и датчик на приборе с зарядовой связью (ПЗС). Снятые данные сохраняются в ОЗУ 12 или флэш-памяти 13, или передаются на другие устройства в компьютерной сети через средство 14 связи.

Хотя в качестве рабочей системы для сенсорных панелей 2а и 2b используется система с резистивной пленкой или система с применением емкостных датчиков, вместо этих систем могут использоваться другие системы, например такие, как система на электромагнитной индукции, система с матричным переключателем, система поверхностной упругой волны и система с использованием инфракрасных лучей. Когда в качестве рабочей системы используется система с применением емкостных датчиков, то «операция касания» в этом варианте осуществления изобретения включает в себя не только случай, когда палец пользователя находится в физическом контакте с сенсорными панелями 2а и 2b, но также и случай, когда палец пользователя подносится достаточно близко в пределах дальности, на которой может быть обнаружено изменение емкости.

Оптический датчик 5 является, например, датчиком отражающего типа и включает в себя светоизлучающее устройство, такое как светодиод (LED), который излучает инфракрасный свет, и принимающее свет устройство, такое как фотодиод и фототранзистор. Оптический датчик 5 обнаруживает, присутствует ли предмет в пределах заданной дальности над оптическим датчиком 5. В этом варианте осуществления изобретения оптический датчик 5 обнаруживает, присутствует ли рука (или палец) пользователя в пределах заданной дальности над оптическим датчиком 5. То есть оптический датчик 5 обнаруживает, находится ли рука пользователя над оптическим датчиком 5, так чтобы два пальца пользователя находились напротив сенсорных панелей 2а и 2b. В этом случае заданная дальность составляет, например, около 3-15 см, но этим не ограничивается.

В том случае, когда обнаруживаются операции касания сенсорных панелей 2а и 2b, и обнаруживается предмет, присутствующий в пределах заданной дальности, то делается вывод, что пользователь выполняет операции касания с помощью двух пальцев. Например, в том случае, когда пользователь осуществляет операции касания сенсорных панелей 2а и 2b с помощью большого и указательного пальцев, то базовый участок между большим и указательным пальцами обнаруживается оптическим датчиком 5. С другой стороны, в том случае, когда операции касания обнаруживаются, но оптическим датчиком 5 не обнаруживается никакого предмета в пределах заданной дальности, то делается вывод, что пользователь коснулся сенсорной панели 2а пальцем одной руки, и коснулся сенсорной панели 2b пальцем другой руки.

Хотя это не показано, портативное информационное устройство 100 также включает в себя кабель и гибкую подложку для электрического соединения между сенсорными панелями 2а и 2b. Кабель и гибкая подложка могут быть проведены через зубчатые элементы 3а и 3b и соединительные элементы 4.

Дисплеи 25а и 25b являются, например, жидкокристаллическими дисплеями (LCD) или дисплеями с активной матрицей управляющих элементов на тонкопленочных транзисторах (TFT) или подобного типа, или органическими электролюминисцентными дисплеями, и отображает различные графические интерфейсы пользователя (GUI) (объекты) для операций касания, такие как значок, окно и весь экран, а также другие изображения. Дисплеи 25а и 25b выполнены как единое целое с сенсорными панелями 2а и 2b, как было описано выше.

Функционирование портативного информационного устройства

Далее будет описана работа портативного информационного устройства 100, имеющего вышеописанную структуру.

Операция открывания и закрывания портативного информационного устройства

Сначала будет описана операция открывания и закрывания портативного информационного устройства 100. Фиг.3 - схемы, показывающие открытое и закрытое положения портативного информационного устройства 100.

Как показано на фиг.3А, когда пользователь поднимает корпус 1а в положении, например, когда корпуса 1а и 1b закрыты, то зубчатые элементы 3а и 3b, и соединительные элементы 4 поворачиваются, чтобы открыть корпус 1а, как показано на фиг.3B-3D. Соответственно, сенсорные панели 2а и 2b раскрываются. Затем, как показано на фиг.3Е, корпуса 1а и 1b фиксируются, когда они открыты на 180 градусов; таким образом поверхности касания сенсорных панелей 2а и 2b и оптический датчик 5 располагаются в одной плоскости. Операция касания пользователя вводится в состоянии, показанном на фиг.3Е. В таком состоянии поверхности касания находятся в одной плоскости, и для пользователя становится возможным выполнять интуитивные операции, не беспокоясь о том, что сенсорные панели разные и что оптический датчик находится между сенсорными панелями.

Обработка данных для управления отображением объекта на портативном информационном устройстве

Далее описана обработка для управления отображением, в которой объекты, соответствующие операциям касания (жесты касания), обнаруживаемые сенсорными панелями 2а и 2b портативного информационного устройства 100, будут связываться друг с другом. В последующем описании центральный процессор 11 описывается как исполнительное устройство для операций, но операции центрального процессора (ЦПУ) 11 выполняются во взаимодействии с программой, находящейся в ОЗУ 12.

Фиг.4 - блок-схема, показывающая процесс обработки для управления отображением объекта, выполненным портативным информационным устройством 100.

Как показано на чертеже, сначала ЦПУ 11 отображает объекты на сенсорных панелях 2а и 2b (этап 41). Потом ЦПУ 11 определяет, обнаружены ли операции касания объектов на сенсорных панелях 2а и 2b одновременно (этап 42). В данном случае «одновременно» может не означать одновременно в строгом смысле этого слова и включает в себя случай, когда каждая из операций касания обнаружена, например, в пределах 0,5 секунд.

В том случае, когда операции касания обнаружены одновременно (ДА), ЦПУ 11 определяют, поворачиваются ли точки касания обнаруженных операций касания в одинаковом направлении поворота (этап 43). Когда делается вывод, что точки касания поворачиваются в одинаковом направлении поворота (ДА), то ЦПУ 11 определяет, обнаруживает ли оптический датчик 5 предмет (руку) в пределах заданной дальности (этап 44). В том случае, когда предмет (рука) не обнаружен в пределах заданной дальности (НЕТ), то ЦПУ 11 делает вывод, что обнаруженные операции касания являются ошибочным обнаружением и прекращает обработку управления отображением для связывания объектов.

В том случае, когда предмет (рука) обнаружена в пределах заданной дальности (ДА), то ЦПУ 11 делает вывод, что операции касания представляют собой вращательный жест (этап 45).

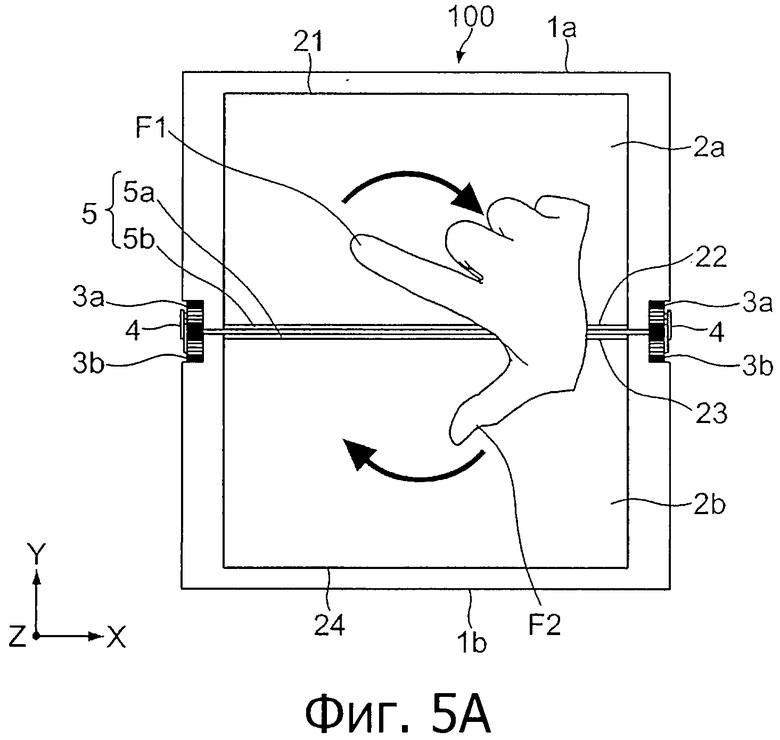

Фиг.5 - схемы, показывающие пример состояния вращательного жеста в портативном информационном устройстве, рассматриваемого с направления плоскости сенсорных панелей 2а и 2b.

Как показано на фиг.5А и 5В, пользователь касается сенсорных панелей 2а и 2b двумя пальцами соответственно F1 и F2 (большим и указательным) и делает вращательные движения пальцами в направлениях, показанных на чертеже стрелками, при этом базовый участок пальцев служит в качестве оси вращения. В этом случае ЦПУ 11 обнаруживает операции касания в этом направлении вращения, а также подтверждает, что рука обнаружена оптическим датчиком 5.

Вернемся к фиг.4. При обнаружении вращательного жеста, ЦПУ 11 выполняет обработку управления отображением (изменение отображения), соответствующую вращательному жесту (этап 46). Фиг.6 содержит схемы, показывающие частный пример обработки управления отображением, соответствующей вращательному жесту. Фиг.6А и 6В показывают состояние, когда вводится вращательный жест, а фиг.6С показывает состояние после ввода вращательного жеста.

Как показано на фиг.6А, объекты O1 и O2, например экраны графического интерфейса пользователя (GUI) для прикладных программ А и В, которые выполняются портативным информационным устройством 100, отображаются на сенсорных панелях 2а и 2b. В этом положении пользователь вводит вращательный жест с помощью двух пальцев F1 и F2, как показано на фиг.6А и 6В. Затем ЦПУ 11 выполняет обработку обмена друг с другом экрана графического интерфейса пользователя (GUI) прикладной программы А и экрана графического интерфейса пользователя (GUI) прикладной программы В между сенсорными панелями 2а и 2b, как показано на фиг.6С.

Как показано на чертеже, ЦПУ 11 выполняет обработку изменения экранов целиком в соответствии с вращательным жестом, но может также изменять положения других объектов (изображений), таких как окна и значки, между сенсорными панелями 2а и 2b.

Фиг.7 - схемы, показывающие другой частный пример обработки управления отображением, соответствующей вращательному жесту. Фиг.7А и 7В показывают состояние, когда вводится вращательный жест, а фиг.7С показывает состояние после ввода вращательного жеста.

Как показано на фиг.7А, верхний участок O1 и нижний участок O2 одного объекта О, такого как изображение, отображаются, соответственно, на сенсорных панелях 2а и 2b. В этом положении пользователь вводит вращательный жест, описанный выше, с помощью двух пальцев F1 и F2, как показано на фиг.7А и 7B. Затем ЦПУ 11 поворачивает объект О на 180 градусов, при этом ось Z на этих чертежах в качестве оси вращения, как показано на фиг.7С.

ЦПУ 11 может поворачивать объект О не только на 180 градусов, но также на угол, соответствующий углу вращения вращательного жеста (величине перемещения соответствующих точек касания).

Снова вернемся к фиг.4. Когда производится определение при выполнении этапа 43, что точки касания не поворачиваются в одинаковом направлении поворота (НЕТ), то ЦПУ 11 определяет, имеется ли линейное перемещение точек касания в направлении сближения друг с другом (этап 47). Когда делается вывод, что точки касания линейно перемещаются в направлении сближения друг с другом (ДА), то ЦПУ 11 определяет, обнаруживает ли оптический датчик 5 предмет (руку) в пределах заданной дальности (этап 48). В том случае, когда предмет (рука) не обнаруживается в пределах заданной дальности (НЕТ), ЦПУ 11 делает вывод, что обнаруженные операции касания является ошибочным обнаружением и прекращает обработку управления отображением для связывания объектов.

В том случае, когда предмет (рука) обнаружен в пределах заданной дальности (ДА), ЦПУ 11 делает вывод, что обнаруженные операции касания являются сжимающим жестом (этап 49).

Фиг.8 - схемы, показывающие пример положения сжимающего жеста в портативном информационном устройстве, рассматриваемого с направления плоскости сенсорных панелей 2а и 2b.

Как показано на фиг.8А и 8В, пользователь касается сенсорных панелей 2а и 2b с помощью, соответственно, двух пальцев F1 и F2 (большого и указательного) и линейно перемещает пальцы в противоположных направлениях, при этом точки касания двух пальцев F1 и F2 перемещаются в направлении сближения друг с другом (в направлении стрелок, показанных на чертеже). То есть пользователь осуществляет жест касания, подобный сжиманию чего-либо с помощью двух пальцев F1 и F2 или соединению двух пальцев F1 и F2. В этом случае ЦПУ 11 обнаруживает операции касания в линейном и противоположном направлениях, при которых точки касания перемещаются ближе друг к другу, и подтверждает, что рука обнаружена оптическим датчиком 5.

Снова вернемся к фиг.4. Когда определяется сжимающий жест, ЦПУ 11 выполняет обработку управления отображением (изменения отображения), соответствующую сжимающему жесту (этап 50). Фиг.9 являются схемами, показывающими частный пример обработки данных управления отображением, соответствующей сжимающему жесту. Фиг.9А и 9В показывают состояние при вводе сжимающего жеста, а фиг.9С показывает состояние после ввода сжимающего жеста.

Как показано на фиг.9А, объект O1, такой как изображение пейзажа (задний план), отображается на сенсорной панели 2а, а объект O2, такой как изображение людей, отображается на сенсорной панели 2b. В этом состоянии пользователь вводит сжимающий жест, описанный выше, с помощью двух пальцев F1 и F2, как показано на фиг.9А и 9В. Затем ЦПУ 11 перемещает объекты O1 и O2 в сторону оптического датчика, как показано на фиг.9 В. Кроме того, например в том случае, когда расстояние между обоими объектами O1 и O2 (расстояние между обеими точками касания) меньше или равно заданному расстоянию, ЦПУ 11 объединяет объект O1 и объект O2 и отображает их, как показано на фиг.9С. То есть ЦПУ 11 объединяет объект O2 как изображение людей, с объектом O1, как изображение пейзажа, на объекте O1, а также генерирует и отображает объект O3 как новое изображение на сенсорной панели 2а (или сенсорной панели 2b).

При обработке управления отображением предполагаются различные типы обработки, отличающиеся от описанной выше обработки для объединения объектов, соответствующих сжимающему жесту. Например, ЦПУ 11 может выполнять управление дисплеем, при котором слизеподобный или ячеечный объекты отображаются на сенсорных панелях 2а и 2b и объединяются в один в соответствии со сжимающим жестом. Такое управление дисплеем может быть применено к игровому приложению или подобной функции.

Кроме того, в соответствии со сжимающим жестом по отношению к двум объектам, таким как изображения, ЦПУ 11 может выполнять обработку, при которой оба объекта хранятся в одном элементе данных альбома во флэш-памяти 13 или подобной памяти.

Снова вернемся к фиг.4. Когда производится определение при выполнении этапа 47, что точки касания не перемещаются линейно в направлениях перемещения, сближаясь друг с другом (НЕТ), то ЦПУ 11 определяет, имеется ли линейное перемещение точек касания в направлении отдаления друг от друга (этап 51).

Когда делается вывод, что точки касания не перемещаются линейно в направлениях отдаления друг от друга (НЕТ), то ЦПУ 11 определяет, что обнаруживаемый жест не является вводом и прекращает обработку управления отображением для соединения объектов.

Когда делается вывод, что точки касания перемещаются линейно в направлениях отдаления друг от друга (ДА), то ЦПУ 11 определяет, обнаружил ли оптический датчик 5 предмет (руку) в пределах заданной дальности (этап 52).

В случае, когда предмет (рука) обнаруживается в пределах заданной дальности (ДА), то ЦПУ 11 определяет, что операции касания являются жестом увеличения масштаба (этап 53).

Фиг.10 является схемами, показывающими пример состояния жеста увеличения масштаба изображения, рассматриваемого с направления плоскости сенсорных панелей 2а и 2b.

Как показано на фиг.10А и 10В, пользователь касается сенсорных панелей 2а и 2b двумя пальцами, соответственно F1 и F2 (большим и указательным), и линейно перемещает пальцы в противоположных направлениях, при этом точки касания двух пальцев F1 и F2 удаляются друг от друга (направления показаны стрелками на чертеже).

Этот жест является жестом, противоположным по направлению сжимающему жесту. В этом случае ЦПУ 11 обнаруживает операции касания в линейном и противоположном направлениях, при этом точки касания перемещаются в направлении удаления друг от друга, а также подтверждает, что рука обнаружена оптическим датчиком 5.

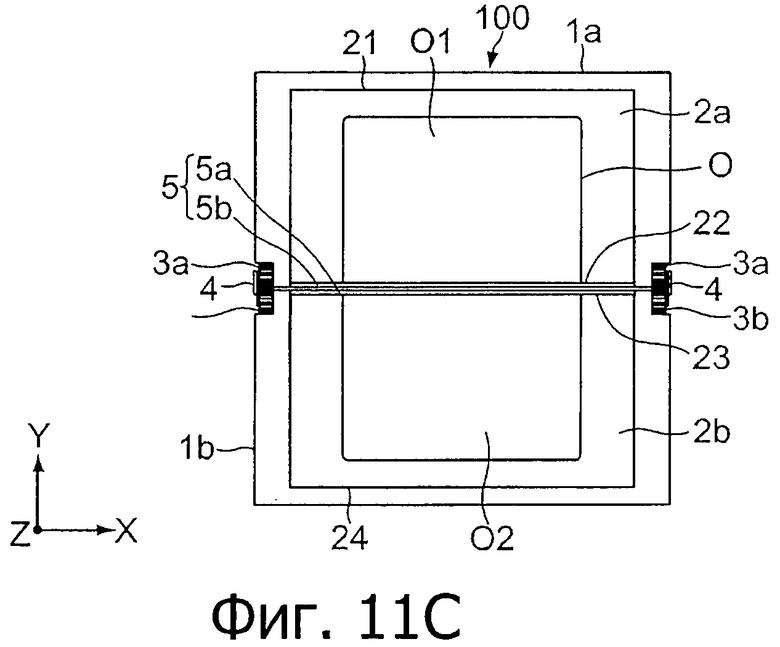

Снова вернемся к фиг.4. Когда обнаруживается жест увеличения масштаба изображения, ЦПУ 11 выполняет обработку управления отображением (изменения отображения), соответствующую жесту увеличения масштаба изображения (этап 53). Фиг.11 являются схемами, показывающими частный пример обработки управления отображением, соответствующей жесту увеличения масштаба изображения. Фиг.11А и 11В показывают состояние при вводе жеста увеличения масштаба изображения, а фиг.11C показывает состояние после ввода жеста увеличения масштаба изображения.

Как показано на фиг.11А, верхний участок O1 и нижний участок O2 одного объекта О, такого как изображение и окно, отображается соответственно на сенсорных панелях 2а и 2b. В этом состоянии пользователь вводит описанный выше жест увеличения масштаба с помощью двух пальцев F1 и F2, как показано на фиг.11А и 11В. После этого ЦПУ 11 увеличивает масштаб объекта О, как показано на фиг.11С. То есть ЦПУ 11 показывает увеличенный объект О в виде объектов O1 и O2 соответственно на сенсорных панелях 2а и 2b.

Снова вернемся к фиг.4. В том случае, когда предмет (рука) не обнаруживается в пределах заданной дальности на этапе 52 (НЕТ), то ЦПУ 11 определяет, что операции касания являются разделяющим жестом (этап 55).

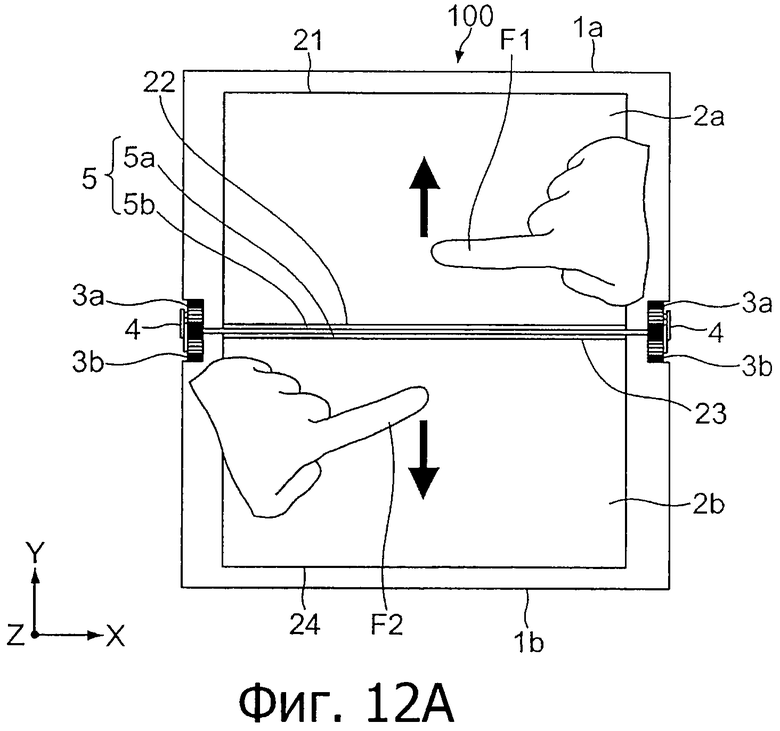

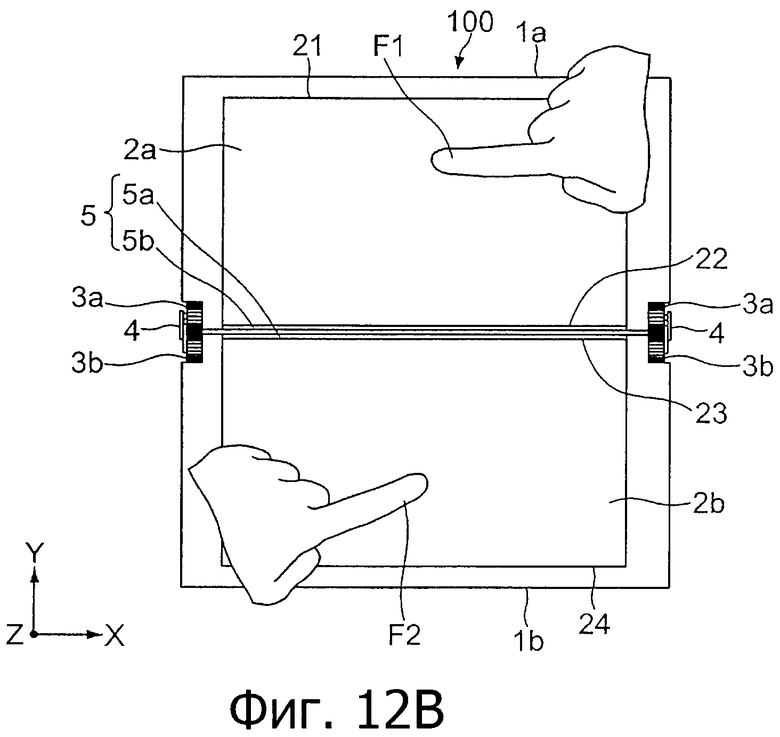

Фиг.12 являются схемами, показывающими пример состояния разделяющего жеста, рассматриваемого с направления плоскости сенсорных панелей 2а и 2b.

Как показано на фиг.12А и 12В, пользователь касается сенсорных панелей 2а и 2b соответственно пальцем F1 одной руки и пальцем F2 другой руки (указательными пальцами) и линейно перемещает пальцы в противоположных направлениях, при этом точки касания двух пальцев F1 и F2 перемещаются в направлении удаления друг от друга (в направлении стрелок, показанных на чертеже).

Операции касания аналогичны перемещению в том случае, когда пользователь разрывает реальный документ. В данном случае направление перемещения операций касания аналогично направлению при описанном выше жесте увеличения масштаба. Соответственно, пользователь выполняет операции касания таким образом, чтобы оба пальца F1 и F2 или обе руки не располагались над оптическим датчиком 5. То есть даже при операциях касания в одинаковом направлении жест увеличения масштаба и разделяющий жест отличаются друг от друга в зависимости от наличия обнаружения оптическим датчиком 5. ЦПУ 11 обнаруживает операции касания в линейном и противоположном направлениях, в которых точки касания перемещаются в направлении друг от друга, и подтверждает, что рука не обнаружена оптическим датчиком 5.

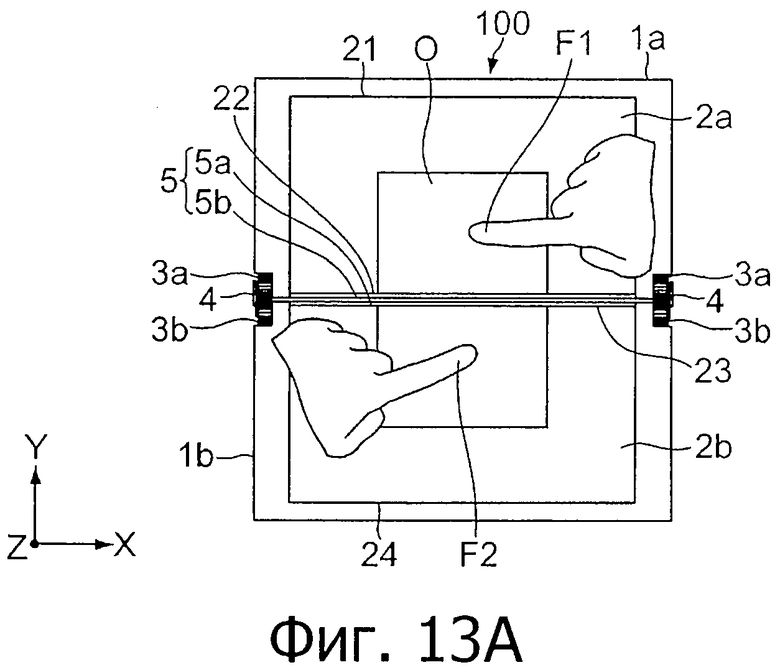

Снова вернемся к фиг.4. Когда обнаруживается разделяющий жест, ЦПУ 11 осуществляет обработку управления отображением (изменения отображения), соответствующую разделяющему жесту (этап 56). Фиг.13 являются схемами, показывающими частный пример обработки управления отображением, соответствующей разделяющему жесту. Фиг.13А и 13В показывают состояние при вводе разделяющего жеста, а фиг.9С показывает положение после ввода разделяющего жеста.

Как показано на фиг.13А, верхний участок O1 и нижний участок O2 одного объекта О, например такого, как файл с документом, отображается соответственно на сенсорных панелях 2а и 2b. В этом состоянии пользователь вводит описанный выше разделяющий жест с помощью двух пальцев F1 и F2, как показано на фиг.13А и 13В. После этого ЦПУ 11 изменяет объект О таким образом, что объект О разделяется на часть O1 и другую часть O2, как показано на фиг.13В.

Кроме того, как показано на фиг.13С, ЦПУ 11 может отображать всплывающее окно W для подтверждения удаления данных, соответствующих объекту О пользователем из флэш-памяти 13 или подобного устройства. В этом случае пользователь выбирает, удалить ли данные или нет, с помощью операции касания всплывающего окна W. ЦПУ 11 осуществляет обработку, соответствующую этому выбору.

Снова вернемся к фиг.4. Когда при выполнении этапа 42 определяется, что операции касания не обнаруживаются (НЕТ) одновременно, то ЦПУ 11 определяет, находится ли разница по времени обнаружения между операциями касания сенсорных панелей 2а и 2b в пределах заданного промежутка времени (этап 57).

То есть ЦПУ 11 определяет, обнаружена ли операция касания сенсорной панели 2b (2а) в пределах заданного промежутка времени с момента обнаружения первой операции касания сенсорной панели 2а (2b). В данном случае заданный промежуток времени составляет, например, около 3 с, но этим не ограничивается.

Когда делается вывод, что разница по времени обнаружения не находится в пределах заданного промежутка времени (НЕТ), то ЦПУ 11 прекращает обработку управления отображением для связывания объектов.

Когда делается вывод, что разница по времени обнаружения находится в пределах заданного промежутка времени (ДА), то ЦПУ 11 определяет, описывают ли обе точки касания окружность с одинаковым направлением вращения (этап 58). Когда делается вывод, что обе точки касания не описывают окружность с одинаковым направлением вращения (НЕТ), то ЦПУ 11 прекращает обработку управления дисплеем для связывания объектов.

Когда делается вывод, что обе точки касания описывают окружность с одинаковым направлением вращения (ДА), то ЦПУ 11 делает вывод, что операции касания являются группирующим жестом (этап 59).

Фиг.14 являются схемами, показывающими пример состояния группирующего жеста в портативном информационном устройстве, рассматриваемого с направления плоскости сенсорных панелей 2а и 2b.

Как показано на фиг.14А, пользователь сначала касается сенсорной панели 2а пальцем F (указательный палец) одной руки и перемещает палец F таким образом, чтобы описать окружность в заданном направлении вращения, например по часовой стрелке. Потом, в пределах заданного промежутка времени, пользователь касается сенсорной панели 2b пальцем F и перемещает палец F таким образом, чтобы описать окружность в том же направлении вращения, что и направление вращения на сенсорной панели 2а. ЦПУ 11 обнаруживает последовательность таких операций касания, как вычерчивание окружностей, в качестве группирующего жеста.

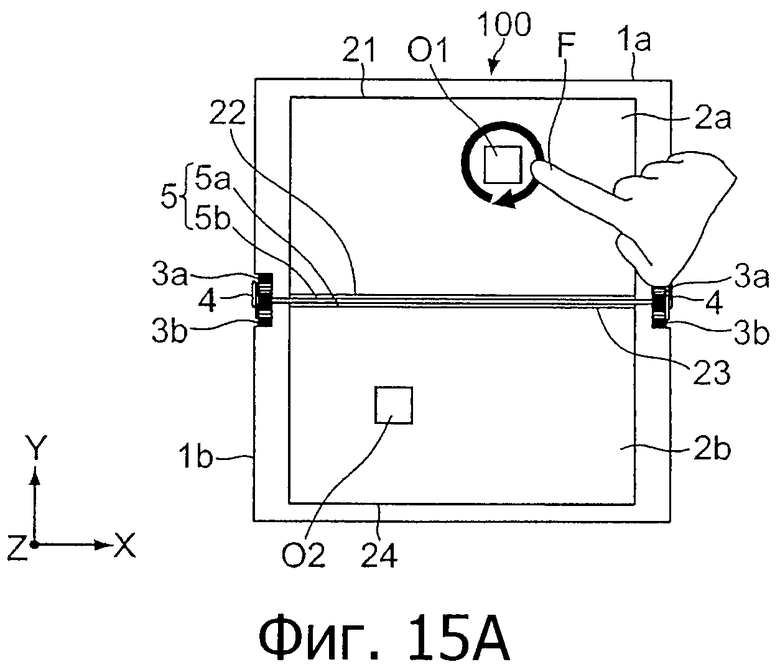

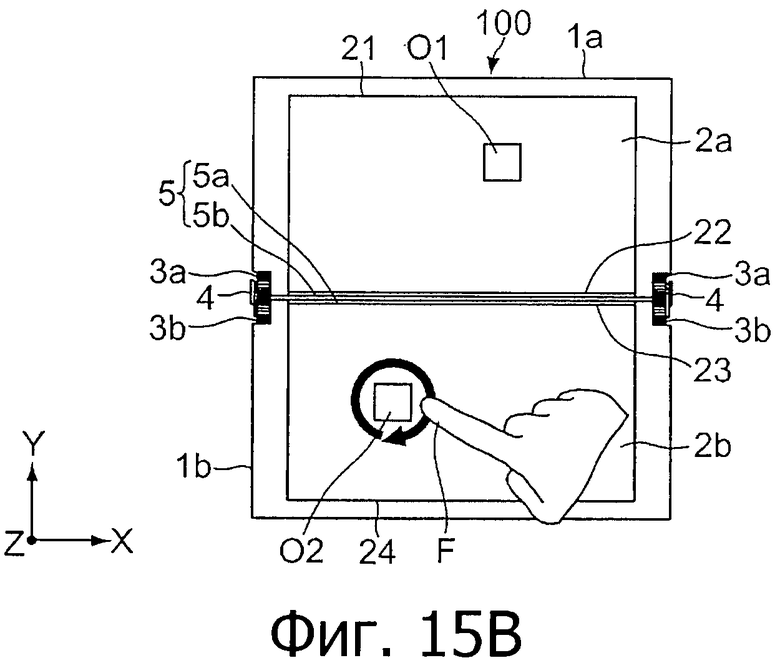

Снова вернемся к фиг.4. Когда обнаруживается группирующий жест, ЦПУ 11 осуществляет обработку управления отображением (изменением отображения), соответствующую группирующему жесту (этап 60). Фиг.15 являются схемами, показывающими частный пример обработки управления отображением, соответствующей группирующему жесту. Фиг.15А и 15В показывают состояние при вводе группирующего жеста, а фиг.15С показывают состояние после ввода группирующего жеста.

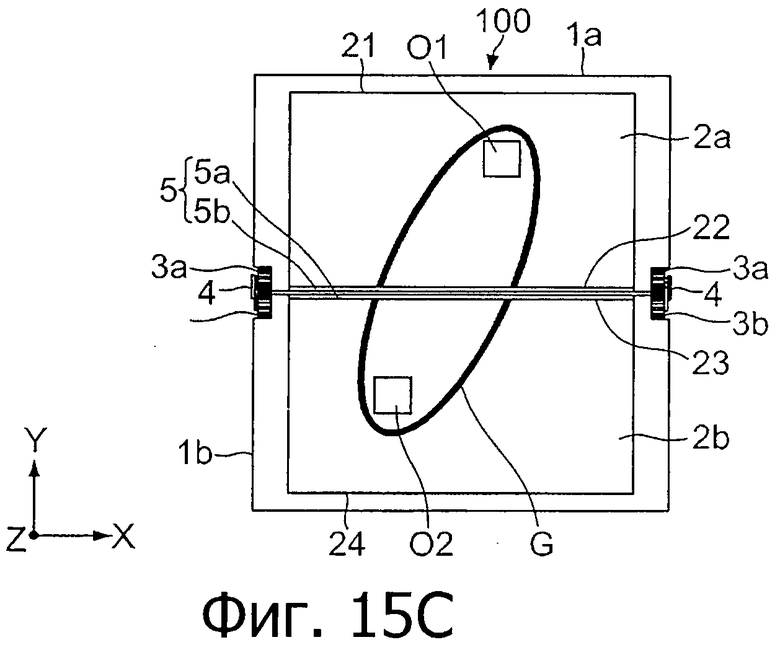

Как показано на фиг.15А, объекты O1 и O2, такие как значки файла, отображаются соответственно на сенсорных панелях 2а и 2b. В этом состоянии пользователь вводит описанный выше группирующий жест с помощью пальца F, в пределах заданного промежутка времени, как показано на фиг.15А и 15В. После этого ЦПУ 11 показывает групповую рамку G, окружающую объекты O1 и O2, как показано на фиг.15С.

Кроме того, ЦПУ 11 группирует данные, соответствующие объектам O1 и O2 (значкам файла), окруженные групповой рамкой G, и сохраняет их на флэш-память или подобное устройство.

Кроме того, в этом случае ЦПУ 11 может отображать на сенсорных панелях 2а или 2b текст или изображение, показывающее, что процесс группирования был выполнен. Например, ЦПУ 11 показывает текст или изображение на сенсорной панели 2b, на которой отображается повторно окруженный объект O2. Текст или изображение могут, разумеется, отображаться на сенсорной панели 2а.

Объекты O1 и O2 могут не быть значком, но могут быть файлом с изображениями или документами, и занимаемая ими область может быть любого размера, лишь бы только он был меньше сенсорных поверхностей сенсорных панелей 2а и 2b.

Помимо случая окружения двух объектов, возможен случай обнаружения операций касания, в которых последовательно окружаются три или более объектов, ЦПУ 11 может аналогично группировать эти объекты.

С приведенной выше обработкой прекращается обработка управления отображением для связывания объектов.

Использования двух сенсорных панелей

В отношении использования двух сенсорных панелей 2а и 2b в этом варианте осуществления изобретения допускаются различные виды использования.

Например, как описывалось выше, две сенсорные панели 2а и 2b могут использоваться как единый экран. В этом случае один объект отображается на обеих сенсорных панелях 2а и 2b, и выполняется единая комплексная обработка данных, соответствующая операциям касания сенсорных панелей 2а и 2b.

Кроме того, одна сенсорная панель 2а (2b) может быть использована на «сетевой» стороне, а другая сенсорная панель 2b (2а) может быть использована на клиентской стороне.

На «сетевой» стороне отображается изображение, загруженное из компьютера сетевого провайдера услуг через средство 14 связи. На клиентской стороне отображается изображение файла или тому подобного, хранящегося в портативном информационном устройстве 100.

С помощью ввода различных жестов касания, описанных выше, в отношении соответствующих объектов на «сетевой» стороне и клиентской стороне, пользователь может вызвать выполнение портативным информационным устройством 100 обработки данных, такой как переключение положений отображения объектов, комбинирование и группирование.

Более того, две сенсорные панели 2а и 2b могут использоваться для решения задач в многозадачном режиме.

В этом случае, с помощью совместного ввода различных жестов касания, описанных выше, в отношении соответствующих объектов между сенсорными панелями 2а и 2b, пользователь может переключать отображаемые положения экранов задач или объединить соответствующие задачи в одну задачу.

Сущность настоящего изобретения

Как описано выше, согласно настоящему изобретению портативное информационное устройство 100 может связывать и изменять отображение соответствующих объектов, являющихся целевыми объектами жеста касания, в соответствии с операциями касания (жестами касания) двух сенсорных панелей 2а и 2b.

Соответственно, поскольку портативное информационное устройство 100 может обрабатывать множество объектов не только по отдельности, но также и совместно, то по сравнению со случаем, когда используется одна сенсорная панель, возможно увеличить гибкость обработки данных, в соответствии с вариантами использования, реализуемыми пользователем.

Кроме того, поскольку жесты касания аналогичны операции вращения реального объекта или документа, операции сжатия, операции расширения, операции разделения или подобного рода операции, то пользователь может интуитивно выполнять обработку управления отображением, относящимся к соответствующим жестам.

Измененные примеры

Настоящее изобретение не ограничивается только теми вариантами осуществления изобретения, которые описаны выше, и может иметь различные модификации, не выходя за рамки сущности настоящего изобретения.

В описанном выше варианте осуществления настоящего изобретения, изображенном на фиг.12 и 13, приводится пример, в котором такой жест, как разделяющий жест в вертикальном направлении на этих чертежах (направление Y). Однако разделяющий жест может производиться и в горизонтальном направлении (направление X) или наклонном направлении.

В том случае, когда разделяющий жест производится в горизонтальном направлении, может быть такой случай, при котором направление жеста аналогично направлению вращательного жеста, показанного на фиг.5 и 6, хотя имеется разница между линейным и криволинейным направлениями. Однако за счет подтверждения обнаружения присутствия, осуществляемого оптическим датчиком 5, ЦПУ 11 может надежно проводить различия обоих жестов и не допускать ошибочного обнаружения.

В описанном выше варианте осуществления изобретения портативное информационное устройство 100 обнаруживает все жесты касания: вращательный, объединяющий, увеличивающий, разрывающий и группирующий, а также выполняет обработку управления отображением (изменением отображения), соответствующую этим жестам. Однако портативному информационному устройству 100 требуется только обладать способностью обнаружения по меньшей мере одного из этих жестов и выполнять обработку управления отображением, соответствующую этому жесту.

В описанном выше варианте осуществления изобретения был описан пример, в котором портативное информационное устройство 100 снабжено двумя сенсорными панелями 2а и 2b. Однако количество сенсорных панелей не ограничивается двумя, если только это количество больше одного, и та же самая обработка, что и описанная выше, может быть выполнена между этими сенсорными панелями.

В описанном выше варианте осуществления изобретения операции касания сенсорных панелей 2а и 2b вводятся с помощью пальца пользователя, но могут вводиться с помощью инструмента, такого как перо для ввода данных.

Примеры портативного информационного устройства 100, для которого может быть применено настоящее изобретение в варианте осуществления изобретения, включают в себя различные устройства обработки информации, такие как сотовый телефон, персональный цифровой секретарь, смартфон, портативный музыкальный/видео плеер, электронный словарь и электронный органайзер.

Более того, настоящее изобретение не ограничивается портативным информационным устройством и аналогичным образом применимо к различным стационарным устройствам обработки информации.

Настоящая заявка на патент содержит объект изобретения, связанный с объектом, раскрытым в японской приоритетной заявке на патент JP 2009-097724, поданной в Патентное ведомство Японии 14 апреля 2009 г., все содержание которой включено в настоящую заявку путем ссылки.

Специалистам в данной области техники должно быть понятно, что различные модификации, комбинации, подкомбинации и видоизменения могут иметь место в зависимости от требований к конструкции и других факторов в той степени, в какой они находятся в пределах объема прилагаемой формулы изобретения или ее эквивалентов.

Изобретение относится к устройству обработки информации, включающему в себя множество сенсорных панелей, и к способу обработки информации. Техническим результатом является обеспечение возможности связывать и управлять отображением объектов в качестве целевых объектов операций между множеством сенсорных панелей в соответствии с операциями касания на множестве сенсорных панелей. Устройство обработки информации содержит первую сенсорную панель для отображения первого объекта и обнаружения первой операции касания пользователем первого объекта; вторую сенсорную панель для отображения второго объекта и обнаружения второй операции касания пользователем второго объекта; и контроллер для связывания и изменения отображаемого первого объекта и отображаемого второго объекта, когда вторая операция касания обнаруживается в пределах заданного промежутка времени с момента обнаружения первой операции касания, при этом первый объект и второй объект отображаются как часть единого третьего объекта, причем первая операция касания и вторая операция касания являются операциями с вращательным направлением, при этом контроллер выполнен с возможностью поворота третьего объекта, когда вторая операция касания обнаруживается в пределах заданного промежутка времени с момента обнаружения первой операции касания. 2 н. и 8 з.п. ф-лы, 36 ил.

1. Устройство обработки информации, содержащее:

первую сенсорную панель для отображения первого объекта и обнаружения первой операции касания пользователем первого объекта;

вторую сенсорную панель для отображения второго объекта и обнаружения второй операции касания пользователем второго объекта; и

контроллер для связывания и изменения отображаемого первого объекта и отображаемого второго объекта, когда вторая операция касания обнаруживается в пределах заданного промежутка времени с момента обнаружения первой операции касания,

при этом первый объект и второй объект отображаются как часть единого третьего объекта,

причем первая операция касания и вторая операция касания являются операциями с вращательным направлением,

при этом контроллер выполнен с возможностью поворота третьего объекта, когда вторая операция касания обнаруживается в пределах заданного промежутка времени с момента обнаружения первой операции касания.

2. Устройство обработки информации по п.1, в котором первая операция касания и вторая операция касания являются операциями в противоположных направлениях.

3. Устройство обработки информации по п. 2, в котором контроллер выполнен с возможностью отображения первого объекта на второй сенсорной панели и отображения второго объекта на первой сенсорной панели, когда вторая операция касания обнаруживается в пределах заданного промежутка времени с момента обнаружения первой операции касания.

4. Устройство обработки информации по п.2,

в котором первая операция касания и вторая операция касания дополнительно являются операциями с перемещением в направлении удаления друг от друга,

при этом контроллер выполнен с возможностью изменения третьего объекта таким образом, что третий объект разделяется, когда вторая операция касания обнаруживается в пределах заданного промежутка времени с момента обнаружения первой операции касания.

5. Устройство обработки информации по п.4, дополнительно содержащее:

запоминающее устройство для хранения данных, соответствующих третьему объекту,

при этом контроллер выполнен с возможностью удаления данных из запоминающего устройства, когда третий объект изменен таким образом, что третий объект разделяется.

6. Устройство обработки информации по п.2,

в котором первая операция касания и вторая операция касания дополнительно являются операциями в направлении приближения друг к другу,

при этом контроллер выполнен с возможностью изменения первого объекта и второго объекта таким образом, что первый объект и второй объект объединяются в один объект, когда вторая операция касания обнаруживается в пределах заданного промежутка времени с момента обнаружения первой операции касания.

7. Устройство обработки информации по п.2, дополнительно содержащее:

датчик для обнаружения предмета, который присутствует на заданном расстоянии от первой сенсорной панели и второй сенсорной панели,

при этом контроллер выполнен с возможностью связи и изменения отображаемого первого объекта и отображаемого второго объекта, когда вторая операция касания обнаруживается в пределах заданного промежутка времени с момента обнаружения первой операции касания и предмет обнаруживается датчиком.

8. Устройство обработки информации по п.7,

в котором контроллер выполнен с возможностью изменения отображаемого первого объекта и отображаемого второго объекта в первом режиме, когда предмет обнаруживается датчиком, и изменения отображаемого первого объекта и отображаемого второго объекта во втором режиме, отличном от первого режима, когда предмет не обнаруживается датчиком.

9. Устройство обработки информации по п.1, дополнительно содержащее:

запоминающее устройство для хранения первых данных, соответствующих первому объекту, и вторых данных, соответствующих второму объекту,

причем первая операция касания является операцией окружения первого объекта в заданном направлении вращения,

вторая операция касания является операцией окружения второго объекта в заданном направлении вращения,

при этом контроллер выполнен с возможностью вызывать группирование и сохранение запоминающим устройством первых данных и вторых данных, когда вторая операция касания обнаруживается в пределах заданного промежутка времени с момента обнаружения первой операции касания.

10. Способ обработки информации, содержащий этапы, на которых:

отображают первый объект первой сенсорной панелью и обнаруживают первую операцию касания пользователем первого объекта;

отображают второй объект второй сенсорной панелью и обнаруживают вторую операцию касания пользователем второго объекта; и

связывают и изменяют отображаемый первый объект и отображаемый второй объект, когда вторая операция касания обнаруживается в пределах заданного промежутка времени с момента обнаружения первой операции касания,

при этом отображают первый объект и второй объект как часть единого третьего объекта,

причем первая операция касания и вторая операция касания являются операциями с вращательным направлением,

при этом выполняют поворот третьего объекта, когда обнаруживают вторую операцию касания в пределах заданного промежутка времени с момента обнаружения первой операции касания.

| US 6545669 B1, 08.04.2003 | |||

| Станок для изготовления деревянных ниточных катушек из цилиндрических, снабженных осевым отверстием, заготовок | 1923 |

|

SU2008A1 |

| RU 2007109208 A, 10.07.2007 | |||

| RU 2007111996 A, 10.09.2007 | |||

Авторы

Даты

2015-02-10—Публикация

2010-04-07—Подача