Настоящее изобретение в целом относится к медицинской визуализации. В частности, настоящее изобретение применимо для сегментации исследуемых областей на медицинских изображениях и будет описано в настоящем документе со ссылкой на эту область применения. Однако следует понимать, что оно также применимо в других областях использования и необязательно ограничивается вышеуказанным применением.

Сегментацию исследуемых областей (Region of Interest, ROI) используют при анализе тканей и структур на медицинских изображениях, например, с целью обнаружения заболевания и/или анализа прогрессирования заболевания. Сегментация включает определение границ структуры и/или тканей и может включать измерения, основанные на определенных границах и других характеристиках, таких как интенсивность, размер, форма и/или изменение показателей измерений от одного изображения к другому. Сегментацию используют во многих методах визуализации, таких как магнитно-резонансная томография (МРТ), ультразвуковое исследование (УЗ), рентгеновская компьютерная томография (РКТ), позитронно-эмиссионная томография (ПЭТ), однофотонная эмиссионная компьютерная томография (ОФЭКТ), их комбинации и т.п.

Сегментация целевых исследуемых областей (ИО) может быть затруднена по причине изменения интенсивности, размера и форм ввиду природы ИО, при этом доступны различные методы и различные параметры визуализации для каждого метода. Целевые ИО, подлежащие анализу, могут включать в себя опухоли, узлы, лимфатические узлы, ткани, имеющие непрозрачность наподобие матового стекла, которые может распознавать обученный медицинский работник, но которые не могут быть получены из медицинского атласа. С помощью методов представляют различные виды изображений структур и/или метаболические активности. Целевые ИО могут обладать обнаруживаемыми признаками, общими с окружающими структурами/органами/тканями. В каждом методе могут использоваться различные параметры визуализации, которые для одного и того же субъекта и в одно и то же время представляют различные виды изображений.

Одним из подходов является определение целевой ИО медицинским работником вручную с помощью набора инструментов для указания на целевую ИО. Например, с помощью инструмента рисования линий и/или инструмента рисования многоугольных форм медицинский работник очерчивает аппроксимацию целевой ИО. Как правило, в основе инструментов лежит компьютерная мышь и/или световое перо, используемые для рисования форм вдоль границы. Алгоритм сегментации дополнительно детализирует грубо нарисованную форму для сегментации тканей и/или структуры. Данный подход предполагает направление вычислительных ресурсов компьютера на целевую ИО, заданную вручную, и занимает у медицинского работника достаточно много времени, что снижает производительность при анализе медицинским работником большого количества изображений. Данный процесс является утомительным и отнимающим много времени, и в целом рассматривается как неэкономичный, даже для изображений отдельного субъекта, не говоря уже о большом количестве субъектов, для которых были сформированы изображения в приборе, осуществляющем визуализацию.

Другим подходом является полная автоматизация, которая выполняет сегментацию всех тканей и/или структур на изображении без ввода со стороны медицинского работника. Несмотря на то, что данный подход экономит ограниченные ресурсы медицинского работника, алгоритмы сегментации иногда не дают результата ввиду изменчивости структур. Существенные количества вычислительных ресурсов и времени тратятся на сегментацию структур, не используемых при анализе.

Гибридные подходы включают различные аспекты каждого их указанных методов, при которых ввод со стороны медицинского работника, как правило, задает точку и/или многоугольную форму с помощью устройства ввода, управляемого вручную. Устройства ручного ввода требуют сноровки и времени для координации движений устройства с представлениями местоположения ввода относительно изображения. Основные операционные системы включают в себя параметры для управления курсором с помощью мыши, такие как скорость щелчка, скорость указателя, траектории указателя, представление указателя и т.п., отражающие воздействие устройства ввода на продуктивность и производительность отдельного пользователя компьютера.

В US 2006/112334 А1 раскрыт способ модификации части цифрового изображения. В одном из вариантов реализации, цифровое изображение отображают на дисплее и определяют данные о взгляде пользователя, просматривающего изображение на дисплее. После этого определяют часть изображения, просматриваемого пользователем, которая соответствует полученным данным о взгляде для определения области взгляда. Полученную область взгляда модифицируют для генерирования модифицированной области взгляда, и отображают результирующую модифицированную область взгляда на дисплее.

В US 2005/069206 А1 раскрыты системы и способы анализа зрительного внимания к изображению. Согласно одному из аспектов, зрительное внимание к изображению моделируют путем предварительной обработки изображения для генерирования количественного набора блоков изображения. После этого из количественных блоков изображения генерируют основанную на контрасте карту особенностей изображения для моделирования от одного до трех уровней зрительного внимания к изображению.

Нижеследующее описание раскрывает новую и улучшенную сегментацию исследуемой области, управляемую посредством отслеживания взгляда, которая решает вышеуказанные и прочие проблемы.

Согласно одному из аспектов, система сегментации исследуемой области (ИО) содержит устройство отображения, устройство отслеживания взгляда, устройство сбора точек взгляда, устройство определения границ и устройство определения области. Устройство отображения отображает изображение. Устройство отслеживания взгляда предоставляет отслеженные точки взгляда относительно отображенного изображения. Устройство сбора точек взгляда выбирает точки взгляда из предоставленных точек взгляда, соответствующих исследуемой области (ИО) на отображенном изображении. Устройство определения границ оценивает границу на основании выбранных точек взгляда. Устройство определения области выполняет сегментацию ИО на основании оцененной границы.

Согласно другому аспекту, способ сегментации исследуемой области (ИО) включает отображение изображения. Генерируют точки взгляда относительно отображенного изображения. Выбирают точки взгляда из сгенерированных точек взгляда, соответствующих исследуемой области (ИО) на отображенном изображении. Оценивают границу на основании выбранных точек взгляда. Выполняют сегментацию ИО на основании оцененной границы.

Одним из преимуществ является определение целевой исследуемой области с помощью кластера точек взгляда.

Другое преимущество заключается в ускорении ввода медицинским работником при определении целевой ИО.

Другое преимущество заключается в специфике ввода при определении целевой ИО.

Другое преимущество заключается в минимизации взаимодействия с пользователем.

Другое преимущество заключается в распределении полученных изначально пространственных местоположений и/или величин изображения, указывающих на целевую ИО.

Другое преимущество заключается в ускорении сегментации от первоначального ввода до сегментированной целевой ИО.

Другие дополнительные преимущества станут понятны специалисту в данной области техники после ознакомления и понимания следующего подробного описания.

Настоящее изобретение может быть реализовано с использованием различных компонентов и схем размещения компонентов, а также посредством различных этапов и последовательностей этапов. Чертежи служат лишь в целях иллюстрации предпочтительных вариантов реализации и не должны рассматриваться в качестве ограничения настоящего изобретения.

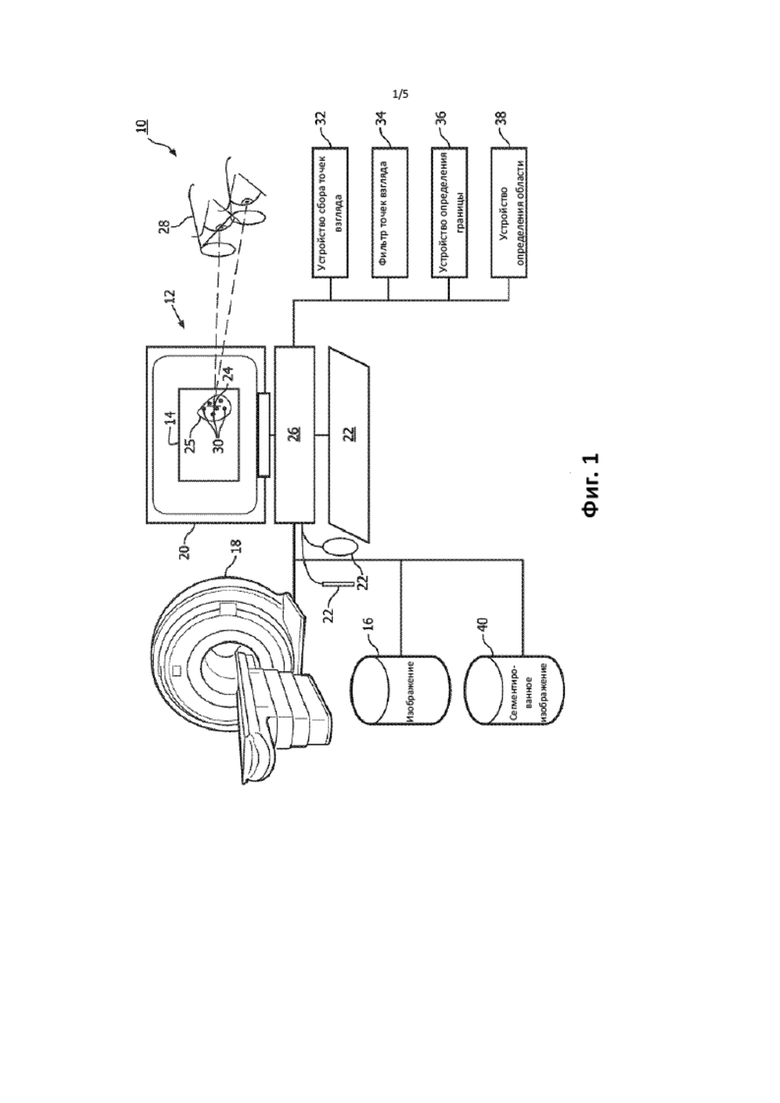

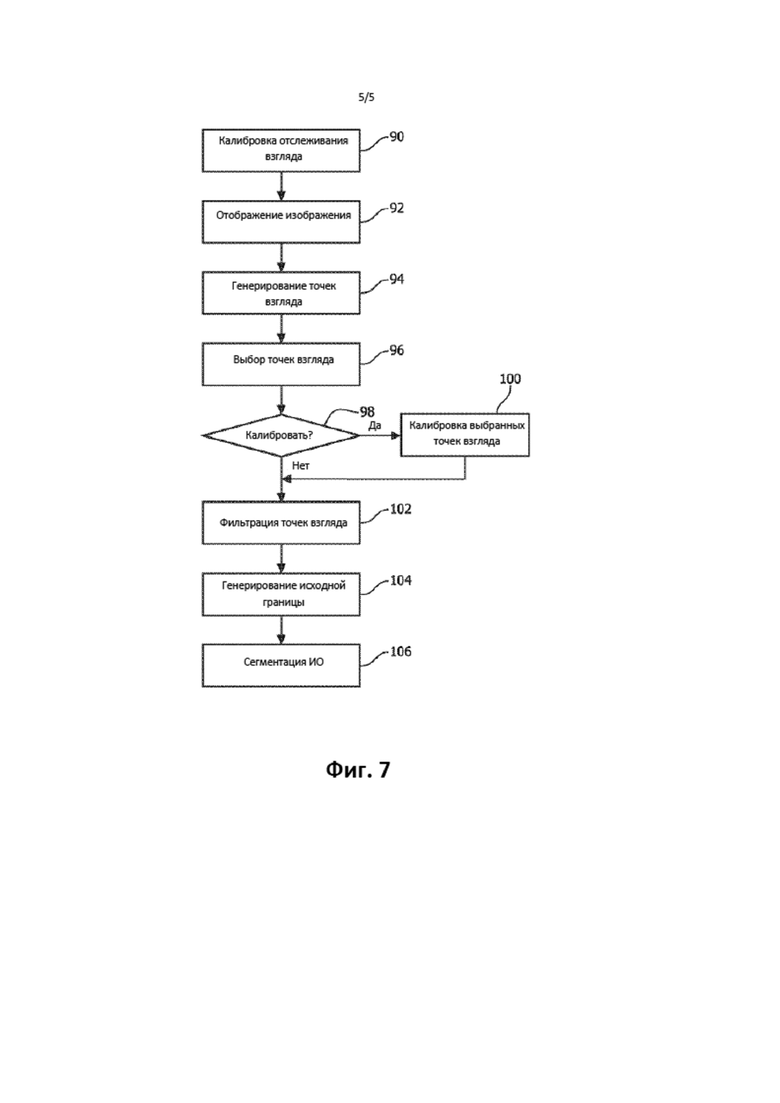

На фиг. 1 схематически изображен вариант реализации системы сегментации исследуемой области, управляемой отслеживанием взгляда.

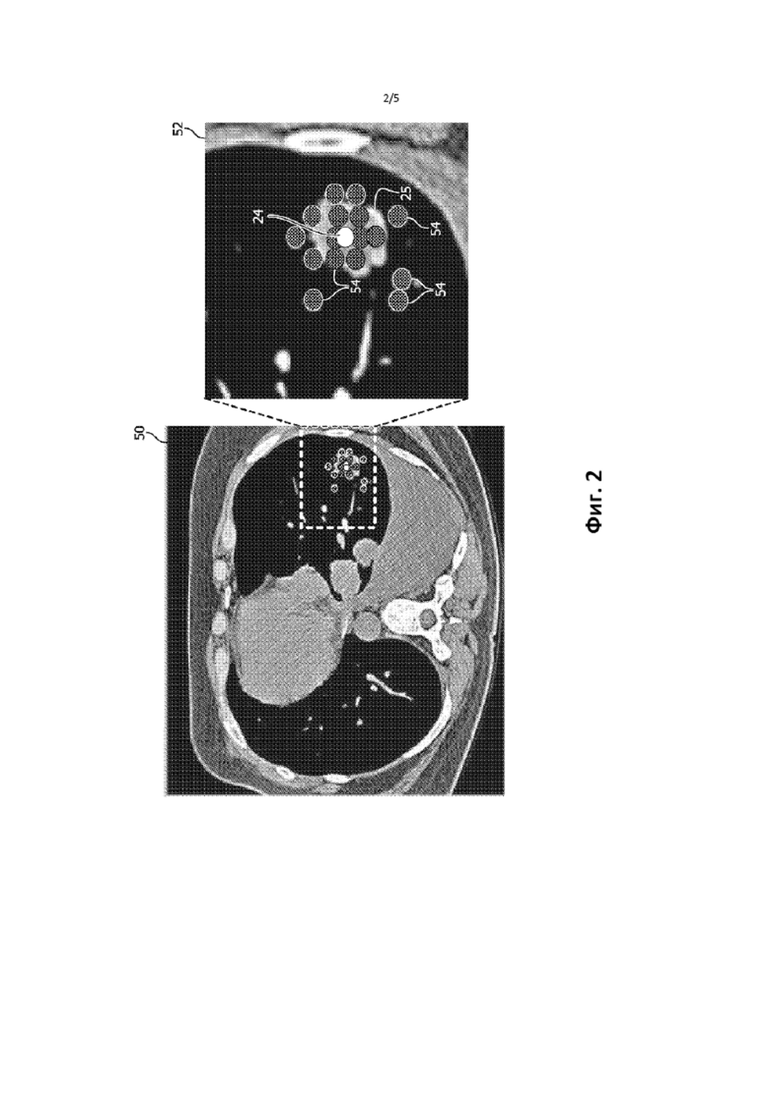

На фиг. 2 схематически изображен пример медицинского изображения с разнесенным видом отображенного изображения и точек взгляда.

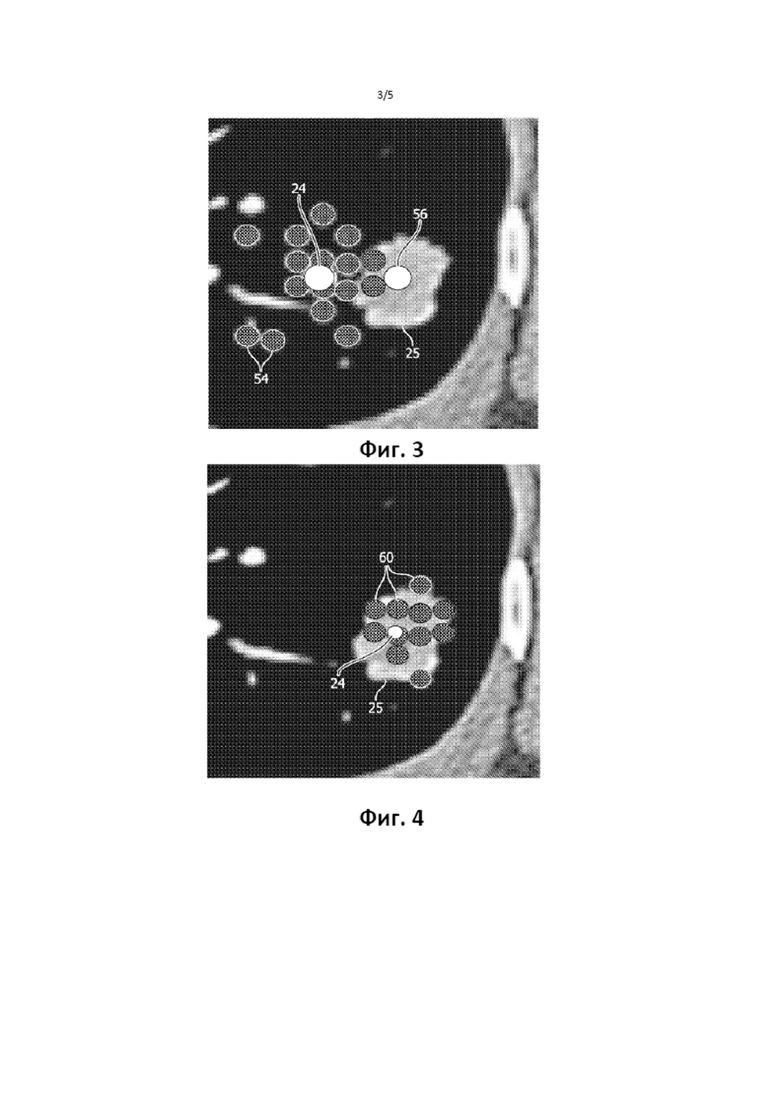

На фиг. 3 изображен пример медицинского изображения с калибровочной настройкой.

На фиг. 4 изображен пример медицинского изображения с отфильтрованными точками взгляда.

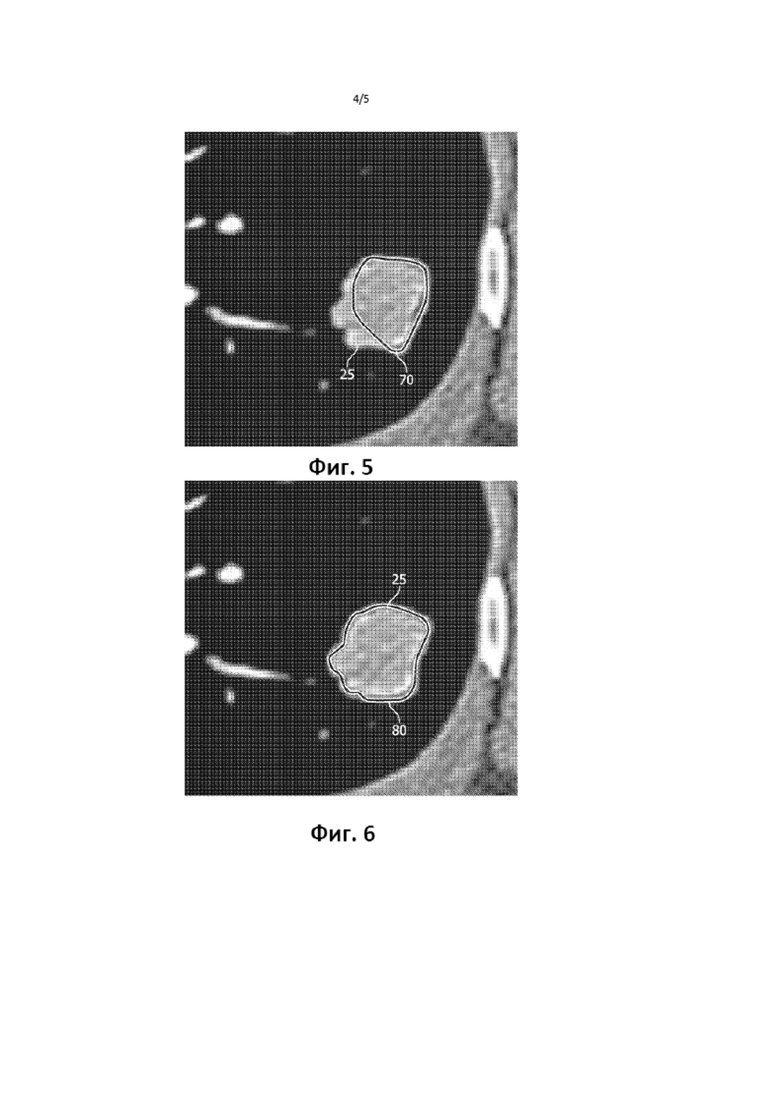

На фиг. 5 изображен пример медицинского изображения с исходной границей, основанной на отфильтрованных точках взгляда.

На фиг. 6 изображен пример медицинского изображения с сегментированной ИО.

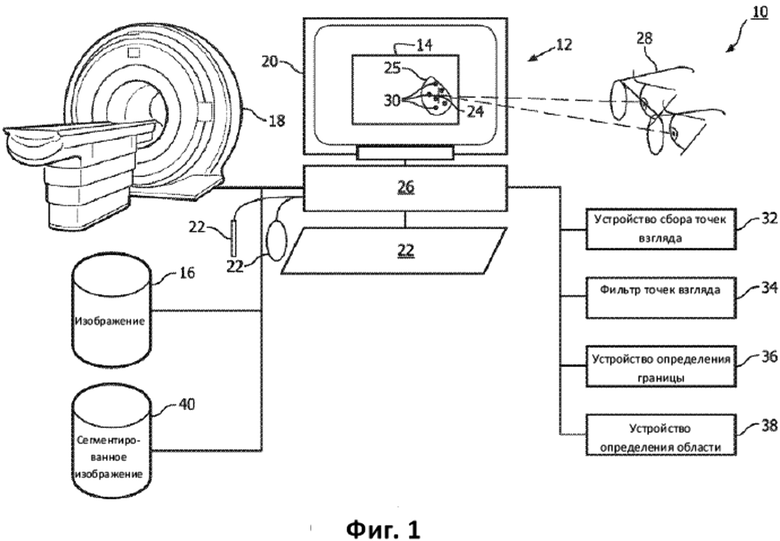

На фиг. 7 изображена диаграмма одного способа использования варианта реализации сегментации ИО, управляемой точкой взгляда.

На фиг. 1 схематически изображен вариант реализации системы 10 сегментации исследуемой области, управляемой отслеживанием взгляда. Компьютер или вычислительное устройство 12 принимает изображение 14 из хранилища 16 или от устройства 18 медицинской визуализации, которое генерирует медицинское изображение субъекта. Компьютер 12 подходящим образом реализован в виде рабочей станции, портативного компьютера, смартфона, планшета и т.п. Отображенное изображение может представлять собой двумерное изображение, двумерные срезы трехмерного объемного представления, двумерное представление трехмерного объема и т.п. Отображенное изображение 14 может содержать движение. Хранилище 16 содержит доступное системное хранилище, такое как система передачи и архивации изображений (СПАИ), рентгенологическую систему отделения, систему историй болезни пациента и/или хранилище с непосредственным доступом, такое как «облачное» хранилище, локальное хранилище и т.п. Устройство 18 медицинской визуализации представляет собой устройство, которое генерирует медицинские изображения субъекта, такое как сканер магнитно-резонансной томографии (МРТ), сканер компьютерной томографии (КТ), сканер позитронно-эмиссионной томографии (ПЭТ), сканер однофотонной эмиссионной компьютерной томографии (ОФЭКТ), ультразвуковой (УЗ) сканер, их комбинации, и т.п. Компьютер 12 содержит устройство 20 отображения, которое отображает принятое изображение. Компьютер 12 содержит один или более процессоров 26 для обработки данных.

Компьютер 12 содержит одно или более устройств 22 ввода, таких как мышь, световое перо, клавиатура, микрофон, сенсорный экран и т.п., с помощью которых вводят опорную точку или точку 24 локализации относительно отображенного изображения 14. Например, с помощью указателя манипулятора-мыши, расположенного в исследуемой области (ИО) 25, щелчок кнопки мыши определяет точку 24 локализации в пространстве и времени. Точка 24 локализации может быть представлена на отображенном изображении, например, цветной точкой или геометрической формой, контрастными перекрестными нитями и т.п.

Устройство или средство 28 отслеживания взгляда генерирует точки 30 взгляда относительно отображенного изображения 14. Устройство 28 отслеживания взгляда может быть установлено относительно компьютера 12 и/или устройства 20 отображения, и/или содержать устройство, выполненное с возможностью ношения на теле, такое как очки, и т.п. Например, портативные системы отслеживания взгляда Tobii™, присоединяемые и калибруемые с портативными компьютерами и рабочими станциями, используют микропроекторы для создания паттернов корнеальных рефлексов для оценки направления взгляда. Датчики изображений записывают паттерны корнеальных рефлексов с разрешением, достаточным для определения точек взгляда. Устройство 28 отслеживания взгляда может содержать калибровочные операции для калибровки точек 30 взгляда относительно устройства 20 отображения и/или отображенного изображения 14. Устройство 28 отслеживания взгляда может содержать профили, откалиброванные под взгляд отдельных пользователей. Устройство 28 отслеживания взгляда генерирует точки 30 взгляда в режиме реального времени, таком как, например, 30 точек взгляда в секунду.

В одном из вариантов реализации, устройство 28 отслеживания взгляда отслеживает и представляет входные данные, указывающие на точку 24 локализации. Например, в случае, когда взгляд направлен на локализованную область на протяжении заданного периода времени и/или когда он сопровождается другим вводом, таким как голосовая команда, точка локализации фиксируется в пространстве и времени.

Устройство сбора точек взгляда, процессор, компьютерная подпрограмма или средство 32 выбирает точки взгляда из сгенерированных точек 30 взгляда, соответствующих ИО 25 на отображенном изображении 14. Каждая точка взгляда соотнесена с системой координат отображенного изображения 14. Точка 24 локализации задает пространственную и временную близость точек 30 взгляда. Например, точка локализации в ИО определяет расстояние до каждой точки взгляда относительно ИО, временное соотношение с ИО в примере с изображениями, основанными на движении, и временное соотношение с точкой локализации, такое как ± 1 секунда времени точки локализации.

Временная близость может содержать точки 30 взгляда в заданном временном окне или интервале [Т0, T1] относительно точки 24 локализации. Например, выбранные точки взгляда включают точки взгляда, отслеженные во временном интервале за одну секунду до точки локализации. В другом примере, выбранные точки взгляда включают точки взгляда, отслеженные во временном интервале между одной секундой перед точкой локализации и полусекундой после точки локализации. Точки взгляда отбирают часто, например, 30 раз в секунду. Заданный интервал [Т0, T1] выбирают достаточно большим для генерирования подходящей выборки или выбора отслеженных точек 30 взгляда. Заданный временной интервал [Т0, T1] определяют во временной близости к точке 24 локализации, например, времени перед и/или после фиксации точки локализации для расположения точек взгляда в пространственной близости к ИО. Распределение выбранных точек взгляда обеспечивает больше информации, например, вариантности, чем ввод одного местоположения, указывающего на ИО.

Фильтр точек взгляда, процессор, компьютерная подпрограмма или средство 34 фильтрует выбранные точки взгляда в соответствии с характеристиками изображения соответствующей ИО 25. Например, точки 30 взгляда, соответствующие интенсивностям пикселов, подобным интенсивности пиксела точки 24 локализации, включаются в отфильтрованные точки взгляда. Характеристики изображения могут содержать пространственное измерение и/или значения пикселов изображения. Фильтр 34 точек взгляда использует анализ характеристик изображения между пространственными местоположениями точек 30 взгляда и точкой 24 локализации методом максимального правдоподобия.

Устройство определения границы, процессор, компьютерная подпрограмма или средство 36 оценивает границу на основании выбранных точек взгляда. В одном варианте реализации, выбранные точки взгляда представляют собой точки взгляда, отфильтрованные фильтром 34 точек взгляда. Граница изменяется от дискретных точек в точках 30 взгляда к непрерывной ограничивающей области или объему, который аппроксимирует область или объем отображенного изображения 14 в ИО 25.

Устройство определения области, выполняющий сегментацию процессор, компьютерная подпрограмма или средство 38 сегментирует ИО 25 на основании сгенерированной границы. Устройство определения области использует алгоритм для расширения и/или сужения границы до ИО 25 на основании характеристик изображения, а также использует сгенерированную границу в качестве первичной оценки для входных данных автоматизированного алгоритма сегментации. Сегментированную ИО 25 отдельно отображают на отображенном изображении 14 и/или сохраняют в хранилище 40 данных об изображении, таком как доступное системное хранилище и/или хранилище с непосредственным доступом. Область и/или измерения объема могут быть выполнены с помощью сегментированной ИО 25. Например, сегментированная ИО может быть использована для определения роста опухоли на основании сегментации ИО на одном изображении субъекта и на более позднем изображении того же субъекта.

Устройство 32 сбора точек взгляда, фильтр 34 точек взгляда, устройство 36 определения границы и устройство 38 определения области подходящим образом реализованы в устройстве 26 обработки данных, таком как электронный процессор или электронное устройство обработки, содержащееся в компьютере 12, или в сетевом служебном компьютере, функционально соединенном с компьютером 12 по сети, или т.п. Более того, раскрытые технологии сбора, фильтрации, определения границы и сегментации подходящим образом реализованы с помощью энергонезависимого носителя информации, хранящего инструкции (например, программное обеспечение), выполненные с возможностью чтения устройством обработки данных и выполнения устройством обработки данных для выполнения раскрытых технологий.

На фиг. 2 изображен пример медицинского изображения 50 и увеличенный вид 52 части отображенного изображения 14, на котором изображены выбранные точки 54 взгляда. ИО 25 представляет собой белесую область, по существу покрытую выбранными точками 54 взгляда. Выбранные точки 54 взгляда изображены в шахматном порядке. Выбранные точки 54 взгляда могут быть обозначены различными цветами, формами и/или интенсивностями, отличающимися от отображенного изображения 14. Точка 24 локализации обозначена белым кругом. Точка локализации может быть обозначена различными цветами, формами и/или различными интенсивностями, которые отличаются от отображенного изображения 14 и выбранных точек 54 взгляда. Например, точка локализации обозначена мигающей точкой, а точки взгляда обозначены желтыми точками на полутоновом сером изображении. Выбранные точки 54 взгляда собраны в перечень из точек, сгенерированных устройством отслеживания взгляда за одну секунду до щелчка мышью. Точки, собранные в перечень, пространственно связаны с точкой 24 локализации и с отображенным изображением 14.

На фиг. 3 показан увеличенный вид 52 примера медицинского изображения с точками взгляда, на котором изображена калибровочная настройка или дополнительный ввод с одного или более устройств 22 ввода. Точка 24 локализации и выбранные точки 54 взгляда отображены на расстоянии от ИО 25. Устройство 32 сбора точек взгляда калибрует пространственное расположение выбранных точек 54 взгляда относительно ИО 25. Например, после ввода пространственного расположения 56, такого как ввод щелчком мыши или перетаскивание с нажатой кнопкой мыши на необходимую ИО 25, калибровка точек взгляда в устройстве 32 основана на несовпадении между точкой 24 локализации и перемещенной точкой 60 локализации. Расстояние между точкой 24 локализации и перемещенной точкой 60 локализации обеспечивает калибровочную меру, применяемую к выбранным точкам 54 взгляда, основанным на точке 24 локализации. Калиброванное измерение учитывает как систематические погрешности пользователей, так и системные ошибки. Надлежащим образом выровненная точка локализации, например полученный в результате переход, представлена на увеличенном виде 52 на фиг. 2.

На фиг. 4 изображен увеличенный вид примера медицинского изображения с отфильтрованными точками 60 взгляда. В одном варианте реализации, анализ методом максимального правдоподобия, выполняемый фильтром 34 точек взгляда, детализирует выбранные точки 54 взгляда до поднабора. В анализе методом максимального правдоподобия используют сходство интенсивностей, сходство градиентов и/или пространственное расстояние между пикселами точки 24 локализации и каждой точкой взгляда для фильтрации. Предусмотрены другие технологии фильтрации. Выбранные точки 54 взгляда, которые вероятно являются схожими, включают в отфильтрованный поднабор; а выбранные точки 54 взгляда, которые вероятно не являются схожими, исключают. Например, выбранные точки взгляда, изображенные на фиг. 2, которые расположены в темной области, исключены, а выбранные точки взгляда, расположенные в белесой области ИО включены в отфильтрованные точки 60 взгляда. На медицинских изображениях с учетом природы ИО, в каждом методе доступны различные методы и различные медицинские параметры, а выбранные точки 54 взгляда зашумлены, например, точки взгляда расположены около и за пределами ИО, и исключаются в результате фильтрации.

На фиг. 5 изображен пример медицинского изображения с исходной границей 70, основанной на отфильтрованных точках 60 взгляда. Устройство 36 определения границы генерирует границу с помощью модели или алгоритма активного контура, и/или алгоритма сквозного счета. Алгоритмы преобразуют пространственные точки со значениями пикселов, представленные точками взгляда или отфильтрованными точками взгляда, в непрерывную границу. Исходная граница 70 может быть отображена на устройстве 20 отображения. На представленном в качестве примера медицинском изображении, исходная граница 70 представлена в виде непрерывно ограниченной области с жирной линией в шахматном порядке. Исходная граница 70 может быть представлена с помощью различных текстур, цветов, выделений и т.д., отличающихся по контрасту от отображенного изображения 14.

На фиг. 6 изображен пример медицинского изображения с сегментированной ИО 80. Устройство 38 определения области сегментирует ИО 25 с использованием исходной границы 70 в качестве входных данных. Устройство 38 определения области сегментирует ИО 25 с помощью технологии автоматической сегментации области, такой как алгоритм наращивания областей, алгоритм активного контура, алгоритм выделения краев и/или алгоритм сквозного счета, основанный на области. В одном варианте реализации, функция стоимости сравнивает значений пикселов из местоположений пикселов в пределах текущей границы для определения включения в модифицированную границу. Сегментированная ИО 80 может быть отображена на отображенном изображении 14, отображена отдельно, дополнительно использована для измерений области или объема, и/или сохранена в хранилище 40 данных об изображении. На представленном в качестве примера медицинском изображении, сегментированная ИО 80 представлена непрерывной «шахматной» линией, окружающей ИО 25, которая отображена белесой на темной окружающей области. Сегментированная ИО 80 может быть отображена с помощью цвета, текстур, подсветок и т.д., отличающихся по контрастности от отображенного изображения 14.

На фиг. 7 представлен способ использования варианта реализации сегментации ИО, управляемой точкой взгляда, в виде блок-схемы. На этапе или посредством модуля 90 калибруют отслеживание взгляда. Калибровка отслеживания взгляда с помощью устройства 28 отслеживания взгляда калибрует взгляд пользователя до системы координат устройства 20 отображения. Калибровка может включать построение и/или обновление профиля пользователя, который сохраняют и повторно используют. Например, может быть отображена точка и измеренную точку взгляда пользователя калибруют до отображаемой точки. Калибровка может быть уточнена посредством повторения данной технологии при отображении дополнительных точек в различных местоположениях на экране.

На этапе или посредством модуля 92 изображение 14 отображают на экране. Отображаемое изображение 14 может быть принято из хранилища 16 данных об изображении, таком как доступное системное хранилище, хранилище с непосредственным доступом и т.п.

На этапе или посредством модуля 94 генерируют точки 30 взгляда относительно отображенного изображения 14 с помощью устройства 28 отслеживания взгляда. Каждая точка взгляда содержит временной и пространственный параметр. Например, точка взгляда содержит временную метку, Ti, и местоположение, (xi, yi), относительно устройства отображения и/или отображенного изображения. Местоположения относительно устройства отображения преобразуют в местоположения относительно отображенного изображения.

На этапе или посредством модуля 96, точки 30 взгляда выбирают из сгенерированных точек 30 взгляда, соответствующих ИО 25 на отображенном изображении 14. Ввод с одного или более устройств 22 ввода определяет точку 24 локализации. Ввод фиксирует точку в пространстве и времени. Соответствующий заданный временной интервал используют для выбора точек взгляда, выбранных из сгенерированных точек 30 взгляда в пределах заданного временного интервала. Например, щелчок мыши вводит местоположение изображения и происходит во время Tm, при этом Tm соответствует заданному временному интервалу, составляющему 0,8 секунды, смещенному на 0,2 секунды перед вводом, [Tm - 1.0 секунда, Tm - 0.2 секунды], выбирает сгенерированные точки взгляда, которые имели место в пределах интервала [Tm - 1.0 секунда, Tm - 0.2 секунды]. Выбранные точки 54 взгляда указывают на ввод пользователем ИО 25, подлежащей использованию для сегментации.

На этапе принятия решения или посредством модуля 98 определяют калибровку. Калибровка использует входные данные для выполнения преобразования выбранных точек 54 взгляда. Например, при отображении выбранных точек взгляда, система приостанавливает ввод. На этапе или посредством модуля 100, выбранные точки 54 взгляда калибруют с помощью входных данных. Например, операция ввода перетаскиванием с нажатой кнопкой мыши преобразует выбранные точки взгляда относительно отображенного изображения, например, передвигает отображенные точки взгляда. Переход может использовать точку 24 локализации в качестве опорной точки для преобразования. В одном варианте реализации, преобразование использует выбранные точки взгляда в качестве соединенного облака или кластера точек взгляда для перемещения облака или кластера за одну операцию ввода.

Выбранные точки 54 взгляда могут быть отфильтрованы на этапе или посредством модуля 102. Фильтр использует анализ значений пикселов точки 24 локализации и значений пикселов выбранных точек 54 взгляда методом максимального правдоподобия для определения включения/исключения в отфильтрованных точках 60 взгляда. Анализ методом максимального правдоподобия использует сходство интенсивности, сходство градиента и/или пространственное расстояние. Например, для исключения выбранных точек взгляда, превышающих максимальное расстояние, используют расстояние от точки локализации. В одном варианте реализации, отображают отфильтрованные точки 60 взгляда, и дополнительный ввод может также удалить отдельные отфильтрованные точки взгляда.

На этапе или посредством модуля 104 генерируют исходную оцененную границу 70 на основании отфильтрованных точек 60 взгляда. В одном варианте реализации, границу 70 генерируют на основании выбранных точек 54 взгляда. Границу 70 генерируют с помощью устройства 36 определения границы, используя, например, алгоритм активного контура или алгоритм сквозного счета. Алгоритмы используют в качестве входных данных отфильтрованные точки 60 взгляда, а также местоположения и значения пикселов отображенного изображения 14, и генерируют непрерывную границу, например, волнообразную границу.

На этапе или посредством модуля 106, ИО 25 сегментируют на основании оцененной границы 70. Устройство 38 определения области использует технологию автоматической сегментации для расширения/сужения оцененной границы 70 до сегментированной ИО 80. Технология автоматической сегментации включает, например, алгоритм наращивания областей, алгоритм активного контура, алгоритм выделения краев и/или алгоритм сквозного счета, основанный на области.

Этапы могут повторяться для других ИО. Этапы могут включать повтор других этапов и/или возвращение к ним. Например, могут повторять калибровку 100 выбранных точек. В другом примере, исходя из отображения выбранных точек 54 взгляда и/или отфильтрованных точек 60 взгляда, обработка может вернуться обратно к генерированию 94 точек взгляда или калибровке 90 отслеживания взгляда.

Следует понимать, что для конкретных иллюстративных вариантов реализации, представленных в данном документе, описаны некоторые структурные и/или функциональные признаки, включенные в определенные элементы и/или компоненты. Однако предполагается, что эти признаки могут, в такой же или схожей степени, а также подобным образом быть включены в другие элементы и/или компоненты, где это применимо. Следует также понимать, что различные аспекты иллюстративных вариантов реализации могут быть выборочно реализованы соответствующим образом для получения других альтернативных вариантов реализации, пригодных для желаемых применений, при этом в других альтернативных вариантах реализации, таким образом, будут реализованы соответствующие преимущества включенных в данный документ аспектов изобретения.

Следует также понимать, что конкретные элементы или компоненты, описанные в настоящем документе, могут обладать своей функциональностью, пригодным образом реализованной в качестве аппаратного обеспечения, программного обеспечения, встроенного программного обеспечения или их комбинации. Дополнительно, следует понимать, что некоторые элементы, описанные в настоящем документе, объединенные вместе, могут быть отдельными элементами или иным образом разделены при подходящих условиях. Подобным образом, множество конкретных функций, описанные выполняющимися одним конкретным элементом, могут выполняться множеством различных элементов, действующих независимо для выполнения отдельных функций; или некоторые отдельные функции могут быть разделены и выполняться множеством различных элементов, действующих совместно. При необходимости, некоторые элементы или компоненты, также описанные и/или показанные в настоящем документе как отличающиеся друг от друга, могут быть физически или функционально скомбинированы, где это применимо.

Иными словами, настоящее изобретение было описано со ссылкой на предпочтительные варианты осуществления. Очевидно, что специалистам после ознакомления и понимания данного раскрытия будут очевидны модификации и изменения. Предполагается, что изобретение должно пониматься как включающее все такие модификации и изменения в такой степени, как они представлены в рамках прилагаемой формулы изобретения или ее эквивалентов. То есть, следует понимать, что вышеописанные и другие признаки и функции, или их альтернативы, могут быть скомбинированы желаемым образом во множество других различных систем или применений, а также то, что ряд непредусмотренных или неочевидных альтернатив, модификаций, вариаций или улучшений, описанных в настоящем документе, могут быть соответствующим образом выполнены специалистом в данной области техники, которые, как предполагается, также охватываются прилагаемой формулой изобретения.

| название | год | авторы | номер документа |

|---|---|---|---|

| СПОСОБ И СИСТЕМА ДЛЯ ВЫЯВЛЕНИЯ ОБЪЕМНЫХ ОБРАЗОВАНИЙ ПОЧЕК НА КОМПЬЮТЕРНЫХ ТОМОГРАММАХ БРЮШНОЙ ПОЛОСТИ | 2024 |

|

RU2839531C1 |

| СПОСОБ ВИЗУАЛИЗАЦИИ ДИНАМИЧЕСКОЙ АНАТОМИЧЕСКОЙ СТРУКТУРЫ | 2020 |

|

RU2808612C2 |

| Система и способ оценки усталости врача | 2022 |

|

RU2800312C1 |

| ИЗМЕРЕНИЕ ТЕЛА | 2013 |

|

RU2635226C2 |

| СПОСОБ И УСТРОЙСТВО ДЛЯ СЕГМЕНТАЦИИ ФОНА НА ОСНОВЕ ЛОКАЛИЗАЦИИ ДВИЖЕНИЯ | 2001 |

|

RU2276407C2 |

| СПОСОБ ВЫЯВЛЕНИЯ ОНКОЗАБОЛЕВАНИЙ В ОРГАНАХ МАЛОГО ТАЗА И СИСТЕМА ДЛЯ РЕАЛИЗАЦИИ СПОСОБА | 2023 |

|

RU2814790C1 |

| СЕГМЕНТАЦИЯ ТКАНЕЙ ЧЕЛОВЕКА НА КОМПЬЮТЕРНОМ ИЗОБРАЖЕНИИ | 2017 |

|

RU2654199C1 |

| СИСТЕМА И СПОСОБ ДЛЯ ОБЪЕДИНЕНИЯ УЛЬТРАЗВУКОВЫХ ИЗОБРАЖЕНИЙ В РЕАЛЬНОМ ВРЕМЕНИ С РАНЕЕ ПОЛУЧЕННЫМИ МЕДИЦИНСКИМИ ИЗОБРАЖЕНИЯМИ | 2007 |

|

RU2468436C2 |

| Способ компьютерной диагностики деформаций суставов конечностей человека на цифровых медицинских рентгенографических изображениях | 2019 |

|

RU2757707C2 |

| СИСТЕМА ДЛЯ РАСПОЗНАВАНИЯ И ОТСЛЕЖИВАНИЯ ПАЛЬЦЕВ | 2012 |

|

RU2605370C2 |

Изобретение относится к области вычислительной техники. Техническим результатом заявленного изобретения является реализация улучшенной сегментации исследуемой области, управляемой посредством отслеживания взгляда. Технический результат достигается за счет того, что система сегментации исследуемой области (ROI) содержит устройство отображения, устройство отслеживания взгляда, устройство сбора точек взгляда, устройство определения границы, устройство определения области, фильтр точек взгляда. Устройство отслеживания взгляда генерирует точки взгляда относительно отображенного изображения. Устройство определения границ оценивает границу на основании выбранных точек взгляда. Устройство определения области выполняет сегментацию исследуемой области. 2 н. и 11 з.п. ф-лы, 7 ил.

1. Система (10) сегментации исследуемой области (ROI), содержащая:

устройство (20) отображения, выполненное с возможностью отображения изображения (14);

устройство (28) отслеживания взгляда, выполненное с возможностью генерирования точек взгляда относительно отображенного изображения (14);

устройство (32) сбора точек взгляда, выполненное с возможностью выбора точек взгляда из сгенерированных точек (30) взгляда, соответствующих исследуемой области (25) отображенного изображения (14);

устройство (36) определения границы, выполненное с возможностью оценки границы (70) на основании выбранных точек (54, 60) взгляда; и

устройство (38) определения области, выполненное с возможностью сегментации исследуемой области (25) на основании сгенерированной границы (70),

фильтр (34) точек взгляда, выполненный с возможностью фильтрации выбранных точек взгляда в соответствии с характеристиками изображения точки (24) локализации, причем фильтр (34) точек взгляда выполнен с возможностью фильтрации с помощью анализа методом максимального правдоподобия по меньшей мере одного из следующего:

сходства интенсивности между пикселом изображения, соответствующим точке локализации, и пикселами изображения, соответствующими выбранным точкам взгляда;

сходства градиента между пикселом изображения, соответствующим точке локализации, и пикселами изображения, соответствующими выбранным точкам взгляда; или

пространственного расстояния между пикселом изображения, соответствующим точке локализации, и пикселами изображения, соответствующими выбранным точкам взгляда.

2. Система (10) сегментации исследуемой области по п. 1, в которой устройство (32) сбора точек взгляда дополнительно выполнено с возможностью генерирования точки (24) локализации из сгенерированных точек (30) взгляда, при этом точка локализации определяет пространственное расположение на отображенном изображении в пределах исследуемой области, и точка локализации задает пространственную и временную близость выбранных точек (54) взгляда; причем

устройство (20) отображения дополнительно выполнено с возможностью отображения визуального представления точки (24) локализации относительно отображенного изображения (14).

3. Система (10) сегментации исследуемой области по п. 1, которая дополнительно содержит:

компьютерное устройство (22) ввода, выполненное с возможностью ввода точки (24) локализации, определяющей пространственное расположение на отображенном изображении в пределах исследуемой области, при этом точка локализации задает временную близость выбранных точек (54) взгляда; причем

устройство (20) отображения дополнительно выполнено с возможностью отображения визуального представления точки (24) локализации относительно отображенного изображения (14).

4. Система (10) сегментации исследуемой области по одному из пп. 1-3, в которой устройство (36) определения границы дополнительно выполнено с возможностью генерирования границы (70) на основании отфильтрованных точек (60) взгляда.

5. Система (10) сегментации исследуемой области по одному из пп. 2-4, в которой устройство (20) отображения выполнено с возможностью отображения визуальных представлений выбранных точек (54) взгляда; а

устройство (32) сбора точек взгляда дополнительно выполнено с возможностью калибровки пространственного расположения выбранных точек взгляда относительно исследуемой области на основании ввода с компьютерного устройства (22) ввода, определяющего местоположение (56) отображенного изображения (14).

6. Система (10) сегментации исследуемой области по одному из пп. 1-5, в которой устройство (36) определения границы выполнено с возможностью генерирования оцененной границы (70) с помощью по меньшей мере одного из следующего: алгоритма активного контура и алгоритма сквозного счета.

7. Система сегментации исследуемой области по одному из пп. 1-6, в которой устройство (38) определения области выполнено с возможностью дальнейшей сегментации исследуемой области (25) на основании по меньшей мере одного из следующего:

алгоритма наращивания областей;

алгоритма активного контура;

алгоритма выделения краев; или

алгоритма сквозного счета.

8. Система сегментации исследуемой области по одному из пп. 1-7, в которой устройство (28) отслеживания взгляда содержит по меньшей мере одно из следующего: неподвижно установленного устройства и устройства, выполненного с возможностью ношения на теле.

9. Система сегментации исследуемой области по одному из пп. 1-8, в которой отображенное изображение (14) принято по меньшей мере от одного из следующего:

системы передачи и архивации изображений (16); и

устройства (18) медицинской визуализации.

10. Способ сегментации исследуемой области (ROI), включающий:

отображение (92) изображения;

генерирование (94) точек взгляда относительно отображенного изображения;

выбор (96) точек взгляда из сгенерированных точек (30) взгляда, соответствующих исследуемой области (25) отображенного изображения (14);

оценку (104) границы (70) на основании выбранных точек (54) взгляда; и

сегментацию (106) исследуемой области (25) на основании оцененной границы,

фильтрацию (102) выбранных точек взгляда в соответствии с характеристиками изображения точки (24) локализации, причем

фильтрация (102) использует анализ методом максимального правдоподобия по меньшей мере одного из следующего:

сходства интенсивности между пикселом изображения, соответствующим точке локализации, и пикселами изображения, соответствующими выбранным точкам взгляда;

сходства градиента между пикселом изображения, соответствующим точке локализации, и пикселами изображения, соответствующими выбранным точкам взгляда; или

пространственного расстояния между пикселом изображения, соответствующим точке локализации, и пикселами изображения, соответствующими выбранным точкам взгляда.

11. Способ сегментации исследуемой области по п. 10, в котором выбор (96) включает:

ввод точки локализации, определяющей пространственное расположение на отображенном изображении в пределах исследуемой области, причем точка локализации определяет временную близость выбранных точек взгляда; и

отображение визуального представления точки локализации относительно указанного изображения.

12. Способ сегментации исследуемой области по одному из пп. 10, 11, в котором оценка (104) границы основана на отфильтрованных точках взгляда.

13. Способ сегментации исследуемой области по одному из пп. 10-12, который дополнительно включает:

отображение визуального представления выбранных точек взгляда и

калибровку (100) пространственного расположения выбранных точек взгляда относительно исследуемой области на основании ввода местоположения (56) изображения с компьютерного устройства (22) ввода.

| Пломбировальные щипцы | 1923 |

|

SU2006A1 |

| EP 0 816 985 A2, 07.01.1998 | |||

| Приспособление для точного наложения листов бумаги при снятии оттисков | 1922 |

|

SU6A1 |

| CN 102221881 A, 19.10.2011 | |||

| Изложница с суживающимся книзу сечением и с вертикально перемещающимся днищем | 1924 |

|

SU2012A1 |

| Изложница с суживающимся книзу сечением и с вертикально перемещающимся днищем | 1924 |

|

SU2012A1 |

| Многоступенчатая активно-реактивная турбина | 1924 |

|

SU2013A1 |

Авторы

Даты

2018-12-03—Публикация

2015-10-10—Подача