Перекрестная ссылка на родственные заявки

Настоящая заявка испрашивает преимущество по предварительной заявке США №62/552,032, поданной 30 августа 2017 г., содержание которой полностью включено в настоящий документ посредством ссылки.

Предпосылки создания изобретения

Различные технологии сжатия цифрового видео обеспечивают эффективную передачу, распределение и просмотр цифрового видео. Некоторые примеры стандартизированных технологий сжатия видео включают в себя H.261, MPEG-1, MPEG-2, H.263, MPEG-4 (часть 2) и H.264/MPEG-4 (часть 10) AVC. Усовершенствованные технологии сжатия видео, такие как высокоэффективное кодирование видеоизображений (HEVC), могут обеспечивать двукратное сжатие, или для них требуется в два раза меньшая скорость передачи при том же качестве видео по сравнению с H.264/AVC.

Изложение сущности изобретения

Описаны системы, способы и средства для динамического представления клиентом «картинки в картинке» (PIP). Клиент может, например, использовать любое устройство, такое как проводное устройство, (например, телевизор (TV)) или модуль беспроводной передачи/приема (WTRU) (например, смарт-телевизор, портативное беспроводное устройство и т.д.). Устройство может принимать видеосодержимое от сервера и идентифицировать объект в видеосодержимом с использованием по меньшей мере одного из распознавания объекта или метаданных. Метаданные могут включать в себя информацию, которая указывает местоположение объекта в пределах кадра видеосодержимого. Метаданные могут быть обеспечены в видеосодержимом или вместе с видеосодержимым. Устройство может принимать информацию о выборе объекта пользователем и определять данные о положении объекта в кадрах видеосодержимого с использованием по меньшей мере одного из распознавания объекта или метаданных (например, отслеживать объект в кадрах видеосодержимого). Устройство может отображать увеличенную версию и версию с задержкой во времени для видео с объектом в PIP во всех кадрах видеосодержимого. Местоположение PIP в пределах каждого кадра может быть фиксированным (например, заданным и не связанным с местоположением объекта в пределах каждого кадра) или может быть основано на местоположении объекта в пределах каждого кадра (например, может быть «плавающим» в каждом видеокадре на основании местоположения объекта, может быть расположено в ближайшем к объекту углу и т.д.).

В некоторых примерах устройство может принимать видеосодержимое от сервера и идентифицировать объект в видеосодержимом с использованием по меньшей мере одного из распознавания объекта или метаданных. Устройство может принимать информацию о выборе объекта пользователем и определять данные о положении объекта в кадрах видеосодержимого с использованием по меньшей мере одного из распознавания объекта или метаданных (например, отслеживать объект в кадрах видеосодержимого). Устройство может отображать увеличенную версию объекта в пределах окна «картинки в картинке» (PIP) во всех кадрах видеосодержимого, в которых, например, местоположение PIP в кадрах определяют на основании данных о положении объекта в кадрах видеосодержимого (например, PIP является «плавающим» во всех кадрах на основании местоположения отслеживаемого объекта). PIP может представлять собой меньшее окно в пределах кадров видеосодержимого.

В некоторых примерах устройство может принимать видеосодержимое от сервера (например, сервера содержимого). Устройство может определять первое положение объекта в пределах первого кадра видеосодержимого на основании распознавания объекта или метаданных. Например, устройство может идентифицировать объект (например, на основании распознавания объекта или метаданных) и определять местоположение объекта в кадре видеосодержимого (например, на основании распознавания объекта или метаданных). Устройство может определять положение первого окна на основании первого положения объекта. Например, положение первого окна может быть напрямую связано с положением объекта в первом видеокадре (например, может накладываться на него или охватывать его). Первое окно может включать в себя визуально увеличенную часть первого кадра, а визуально увеличенная часть первого кадра может включать в себя объект. Устройство может отображать первое окно в пределах первого кадра на устройстве отображения.

Устройство может определять второе положение объекта в пределах второго кадра видеосодержимого на основании распознавания объекта или метаданных, причем, например, второй кадр во времени может быть расположен после первого кадра в видеосодержимом (например, после него). Второе положение объекта может отличаться от первого положения объекта (например, это может выглядеть как перемещение объекта в кадрах). Устройство может определять положение второго окна на основании второго положения объекта. Второе окно может включать в себя визуально увеличенную часть второго видеокадра, а визуально увеличенная часть второго видеокадра может включать в себя объект. Положение второго окна может отличаться от положения первого окна (например, в зависимости от изменения положения объекта от первого кадра ко второму кадру). Устройство может отображать второе окно в пределах второго кадра на устройстве отображения. В некоторых примерах устройство может отображать информацию, относящуюся к объекту в пределах второго кадра (например, информацию, наложенную на объект).

Устройство может отслеживать множество объектов и при отслеживании множества объектов оно может создавать объединенное окно для объектов, если объекты находятся в непосредственной близости друг от друга. Например, устройство может определять положение второго объекта (например, второго футболиста) в пределах третьего кадра видеосодержимого на основании распознавания объекта или метаданных и определять положение окна, содержащего второй объект, в третьем кадре на основании положения второго объекта в пределах третьего кадра. Устройство может также определять третье положение объекта (например, «первого» объекта) в пределах третьего кадра на основании распознавания объекта или метаданных и определять положение окна, содержащего объект, в третьем кадре на основании третьего положения объекта. Затем устройство может определять, что окно, содержащее объект в третьем кадре, накладывается на окно, содержащее второй объект в третьем кадре. Тогда устройство может отображать объединенное окно, содержащее первый объект и второй объект в пределах третьего кадра, на устройстве отображения. Расположение объединенного окна может быть, например, основано на положении первого объекта и положении второго объекта в третьем кадре (например, таким образом, что объединенное окно включает в себя как первый объект, так и второй объект).

Устройство может разделять объединенное окно при удалении объектов из множества отслеживаемых объектов друг от друга. Например, устройство может определять положение объекта в пределах четвертого кадра видеосодержимого на основании распознавания объекта или метаданных и определять положение окна, содержащего объект, в четвертом кадре на основании положения объекта в пределах четвертого кадра. Устройство может определять положение второго объекта в пределах четвертого кадра на основании распознавания объекта или метаданных и определять положение окна, содержащего второй объект, в четвертом кадре на основании положения второго объекта в пределах четвертого кадра. После этого устройство может определять, что на окно, содержащее объект в четвертом кадре, больше не накладывается окно, содержащее второй объект, в четвертом кадре, тогда устройство может отображать на устройстве отображения окно, содержащее объект, и окно, содержащее второй объект в пределах четвертого кадра (например, отображать два отдельных окна, по одному для каждого объекта).

Устройство может обеспечивать задержку во времени отображения окна, которое включает в себя отслеживаемый объект. Например, устройство может определять третье положение объекта в пределах третьего кадра видеосодержимого на основании распознавания объекта или метаданных. После этого устройство может отображать третье окно в заданном местоположении в пределах четвертого кадра на устройстве отображения, причем четвертый кадр во времени расположен после третьего кадра. Заданное местоположение может быть, например, не связано с местоположением объекта и/или может быть фиксированным местоположением во всех видеокадрах. В некоторых примерах третье окно может включать в себя визуально увеличенную часть третьего видеокадра, а визуально увеличенная часть третьего видеокадра может включать в себя объект.

Устройство может обеспечивать пользователя возможностью выбора доступных для выбора объектов и/или обеспечивает пользователя возможностью выбора объекта для PIP (например, для увеличения в пределах PIP). Например, первое окно может включать в себя визуально увеличенную часть первого видеокадра, основанную на выборе пользователем объекта. Кроме того, устройство может также обеспечивать пользователя возможностью циклического прохождения множества объектов для выбора. Например, устройство может идентифицировать множество объектов в пределах более раннего видеокадра видеосодержимого, причем множество объектов содержит объект. Пользователь может выбирать множество объектов (например, доступных для выбора). Устройство может отображать множество окон в пределах более раннего видеокадра, каждое из множества окон может включать в себя соответствующий объект из указанного множества объектов, и при этом, например, каждое из множества окон может обеспечивать указание соответствующего объекта. Устройство может циклически проходить активное окно из множества окон на основании пользовательского ввода. Активное окно может представлять собой, например, выделенное окно, с помощью которого пользователь может также определять, какой объект в данный момент доступен для выбора. Устройство может принимать информацию о выборе пользователем объекта из множества объектов и увеличивать объект в первом окне на основании выбора пользователя. Устройство может также обеспечивать пользователя возможностью удаления объектов из множества объектов. Например, устройство может принимать информацию о выборе пользователем нежелательного окна из множества окон и прекращать отображение нежелательного окна (например, исключать объект из списка объектов, которые пользователь может циклически перебирать).

Описаны системы, способы и средства для масштабирования отслеживаемого видео. С помощью отслеживания на стороне клиента (на устройстве) или локального отслеживания пользователи могут выбирать произвольные объекты для отслеживания и масштабирования. В дополнение к отслеживанию на стороне клиента или в качестве его альтернативы, например, могут быть предоставлены метаданные отслеживания (например, видеовещание может включать в себя передачу метаданных, описывающих местоположения объектов в видеокадрах). Метаданные могут включать в себя расширенную информацию об отслеживаемых объектах. Пользователь может взаимодействовать с представленным объектом (например, в окне «картинки в картинке» (PIP)) для получения дополнительной информации. Масштабирование видео (например, в PIP) может быть обеспечено в фиксированном местоположении и/или в плавающем местоположении (например, перемещающемся вместе с отслеживаемым объектом). Может быть обеспечено одновременное отслеживание и масштабирование множества объектов (например, во множестве PIP). Пользователь может циклически перебирать множество отслеживаемых объектов и выбирать из них требуемый объект (например, для переключения отслеживаемого и масштабируемого объекта в PIP). Масштабирование PIP может быть обеспечено с помощью дополнительных функций, таких как объединение множества окон PIP, разделение окна PIP, фиксация положения и масштабирования, масштабирование временной задержки, PIP и социальные сети, а также изменение положения PIP.

Краткое описание чертежей

Схожие позиции на чертежах указывают на схожие элементы.

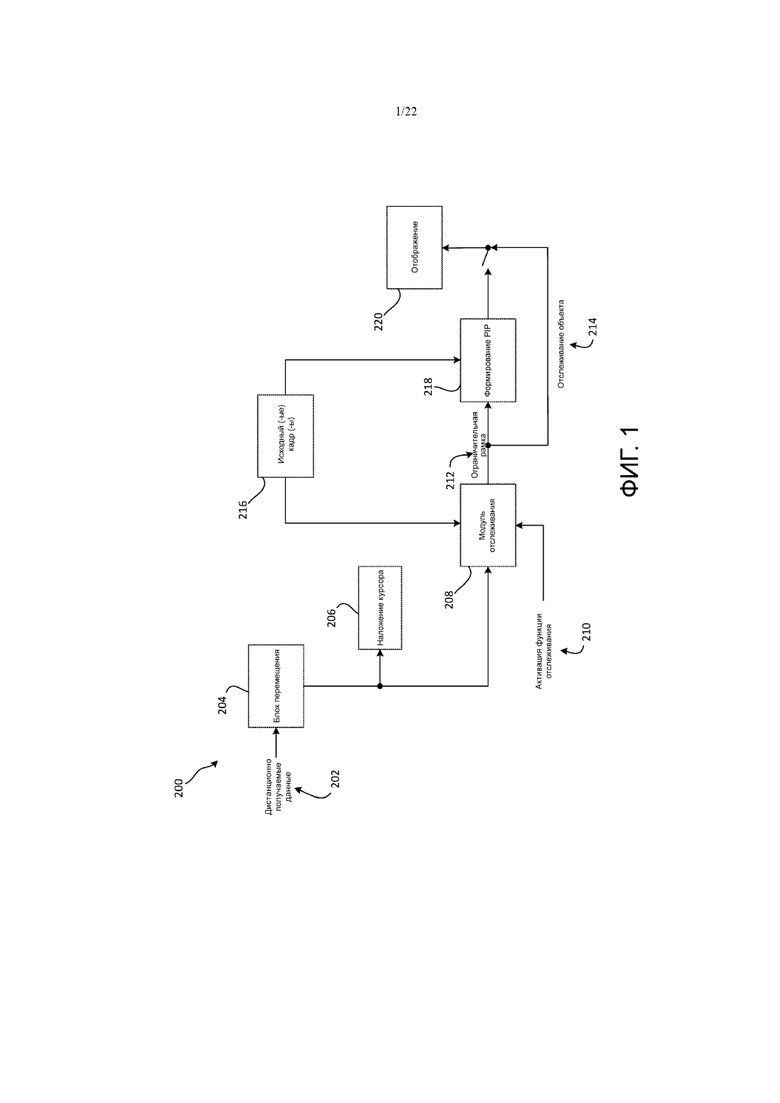

На фиг. 1 представлен пример схемы системы телевизионного устройства с отслеживанием на устройстве.

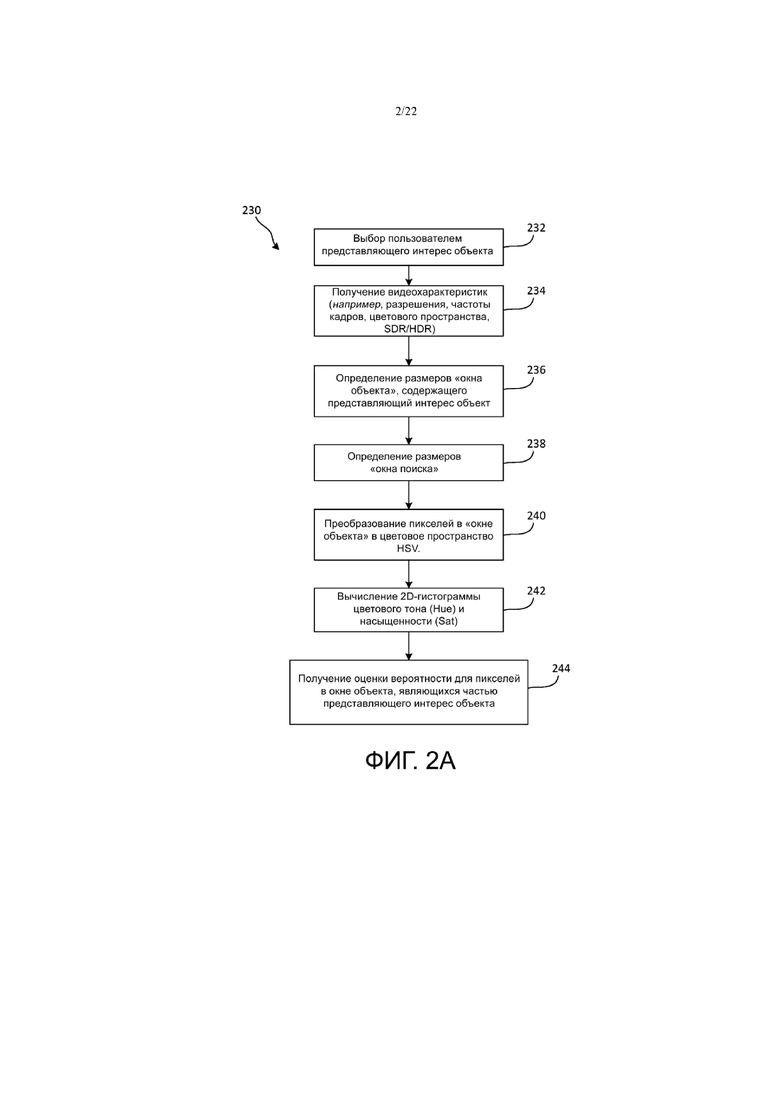

На фиг. 2A и фиг. 2B представлены примеры отслеживания объекта на стороне клиента.

На фиг. 3 представлен пример исходного положения окна объекта (например, красная рамка) и положения окна поиска (например, желтая рамка).

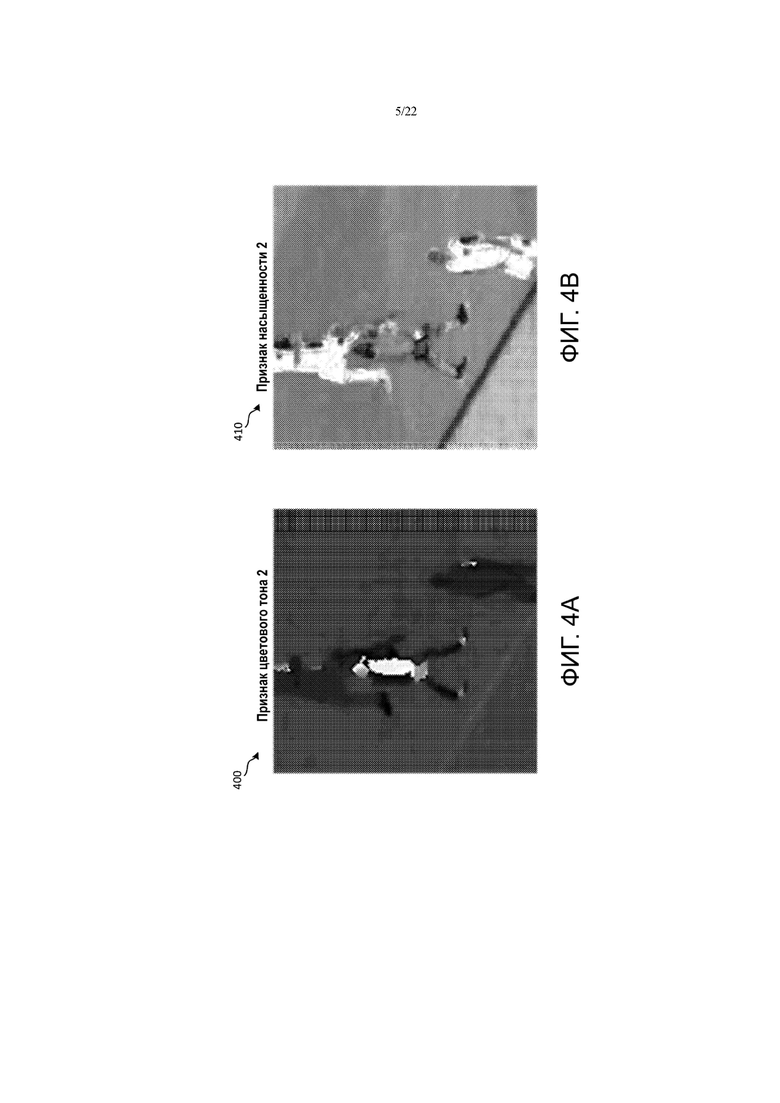

На фиг. 4A и фиг. 4B представлены примеры признаков насыщенности (фиг. 4A) и цветового тона (фиг. 4B) в блоке поиска видеокадра.

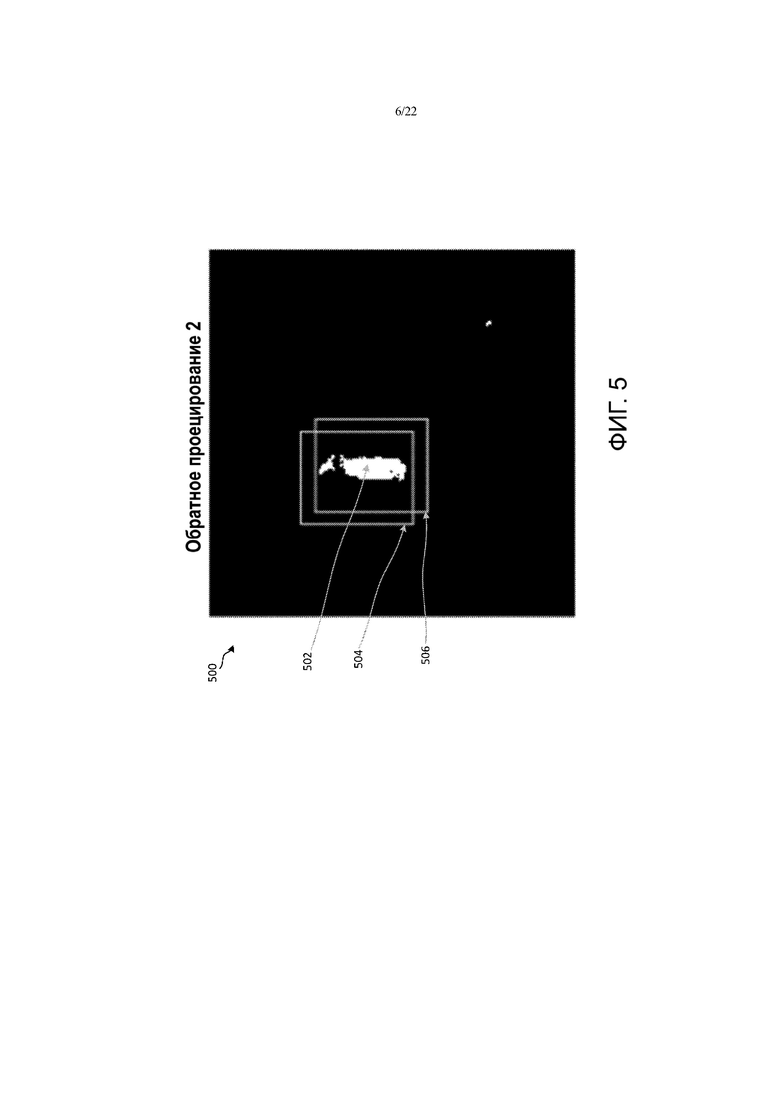

На фиг. 5 представлен пример вероятности обратного проецирования и целевого окна.

На фиг. 6 представлен пример нового положения окна объекта (например, красная рамка) и положения окна поиска (например, желтая рамка).

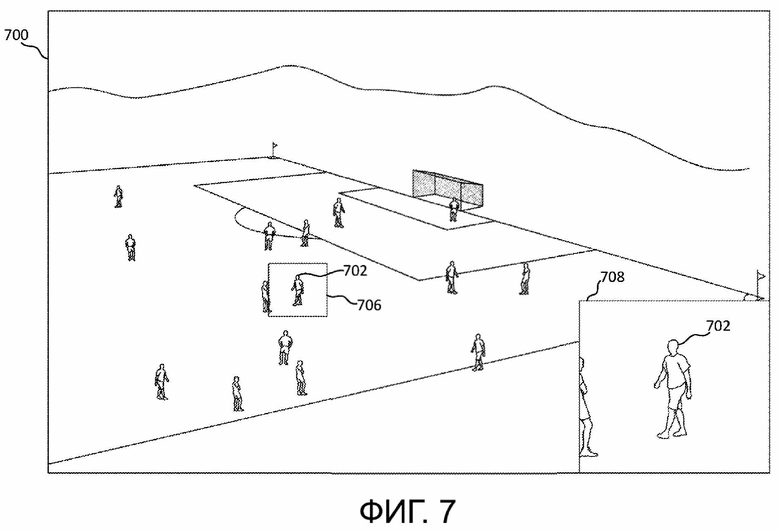

На фиг. 7 представлен пример отслеживаемого объекта, масштабированного в окне PIP (например, в нижней правой рамке).

На фиг. 8 представлен пример вероятности для объекта, примененной к кадру.

На фиг. 9 представлен пример карты вероятности, очищенной путем удаления откликов вне поля.

На фиг. 10 представлен пример результата инициирования и деинициирования морфологических операций.

На фиг. 11 представлен пример отслеживания множества объектов с использованием информации, полученной из метаданных.

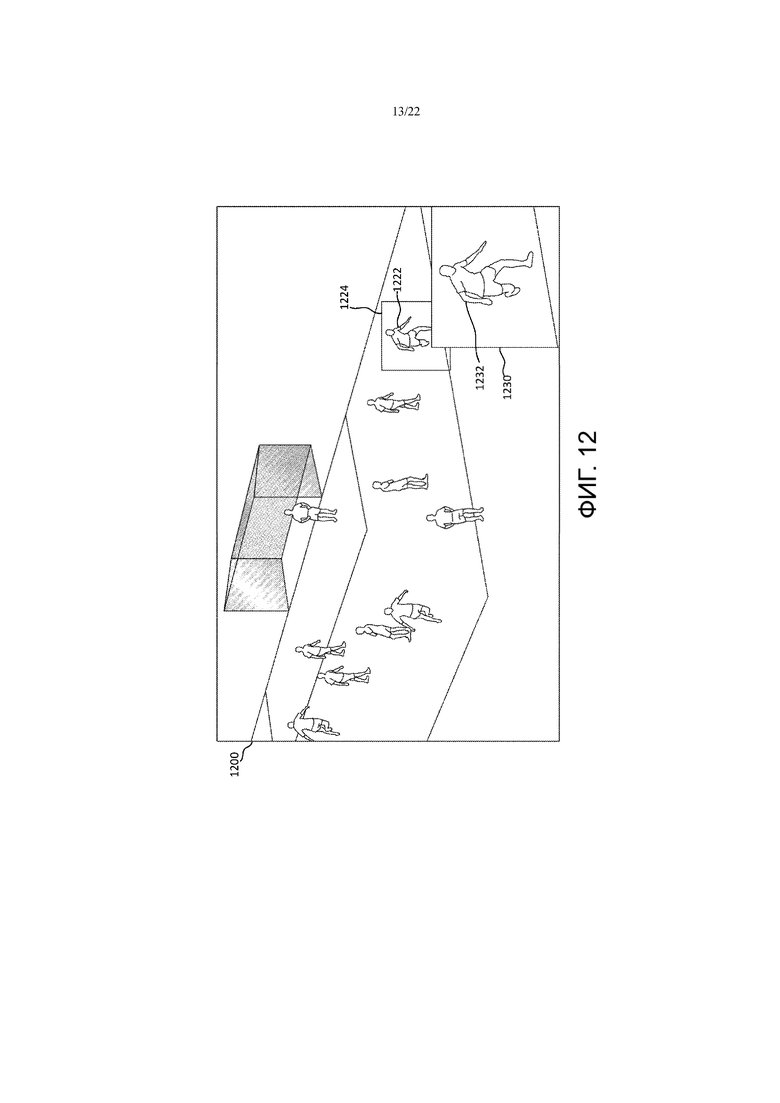

На фиг. 12 представлен пример выбранного объекта, масштабированного в PIP в фиксированном местоположении (например, в нижнем правом углу).

На фиг. 13 представлен пример выбранного объекта, масштабированного в PIP в плавающем окне (например, над выделенным объектом).

На фиг. 14 представлен пример циклического перебора множества отслеживаемых объектов.

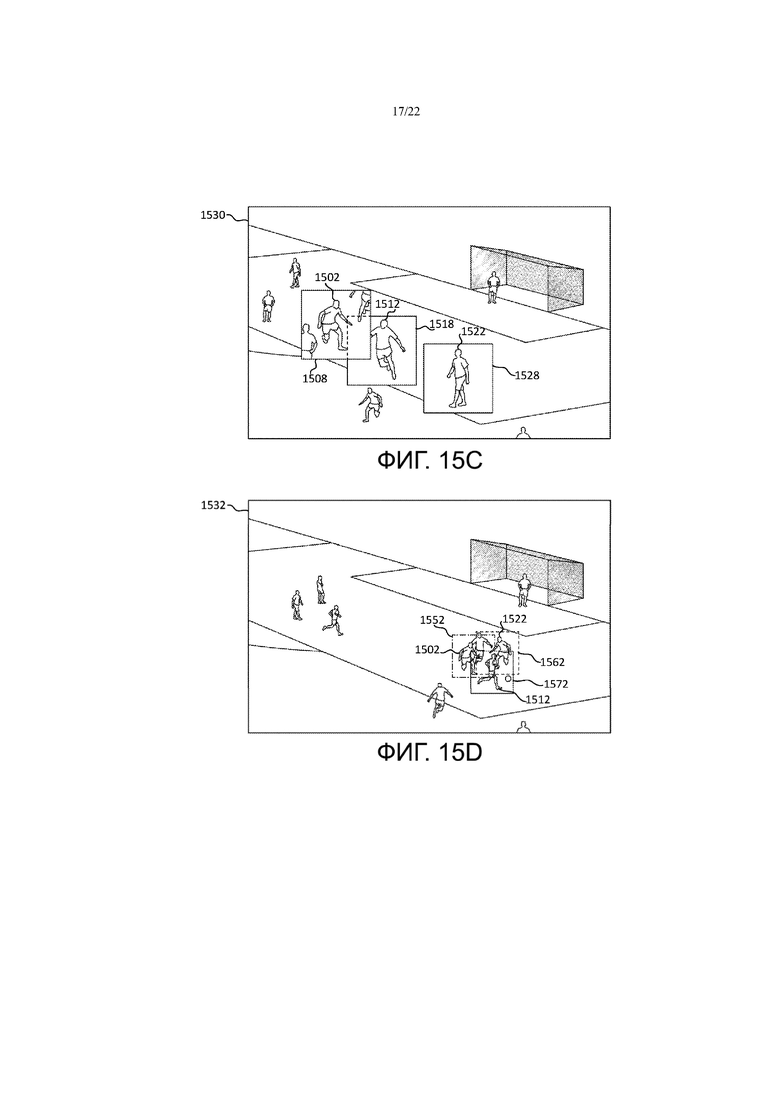

На фиг. 15A-F представлены примеры объединения множества окон PIP для множества отслеживаемых объектов.

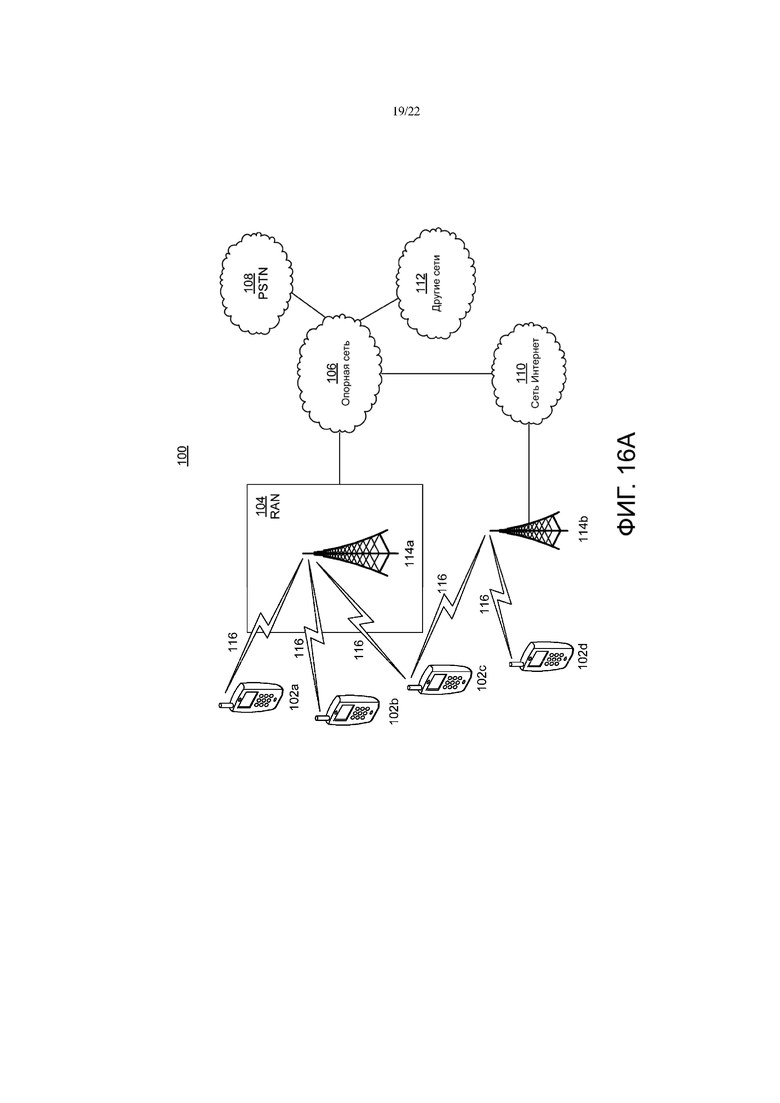

На фиг. 16A представлена схема системы, иллюстрирующая пример системы связи, в которой могут быть реализованы один или более описанных вариантов осуществления.

На фиг. 16B представлена схема системы, иллюстрирующая пример модуля беспроводной передачи/приема (WTRU), который может быть использован в системе связи, показанной на фиг. 16A, в соответствии с вариантом осуществления.

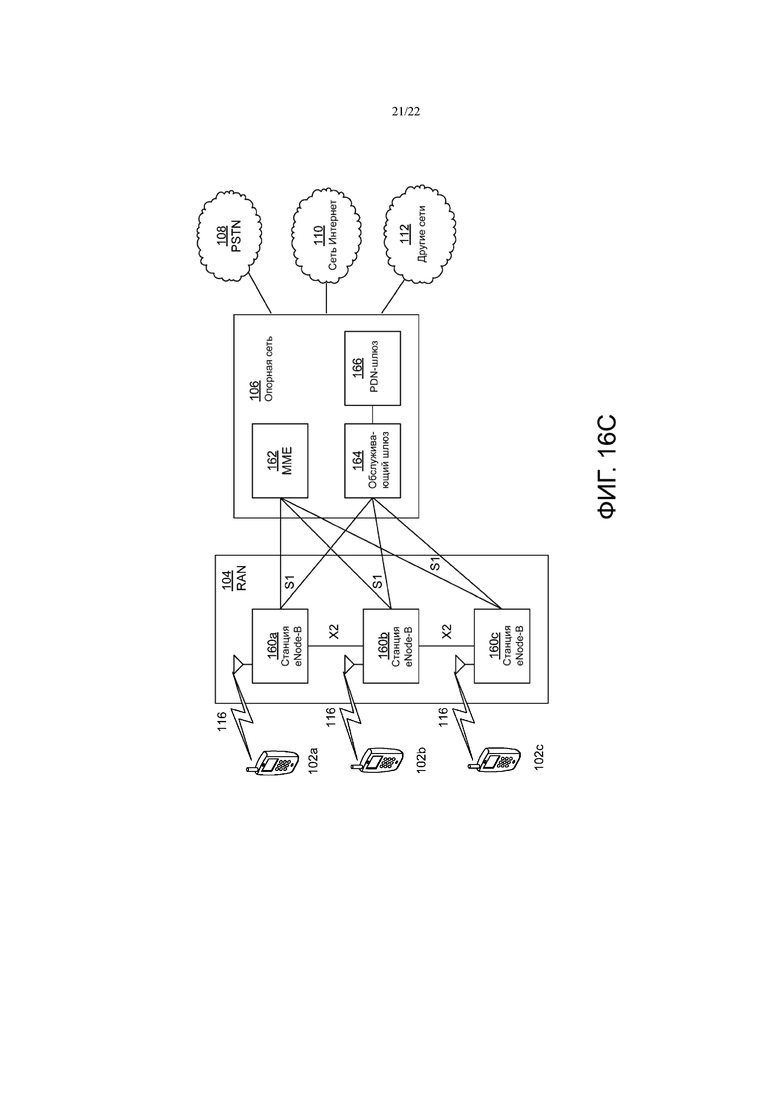

На фиг. 16C представлена схема системы, иллюстрирующая пример сети радиодоступа (RAN) и пример опорной сети (CN), которые могут быть использованы в системе связи, показанной на фиг. 16A, в соответствии с вариантом осуществления.

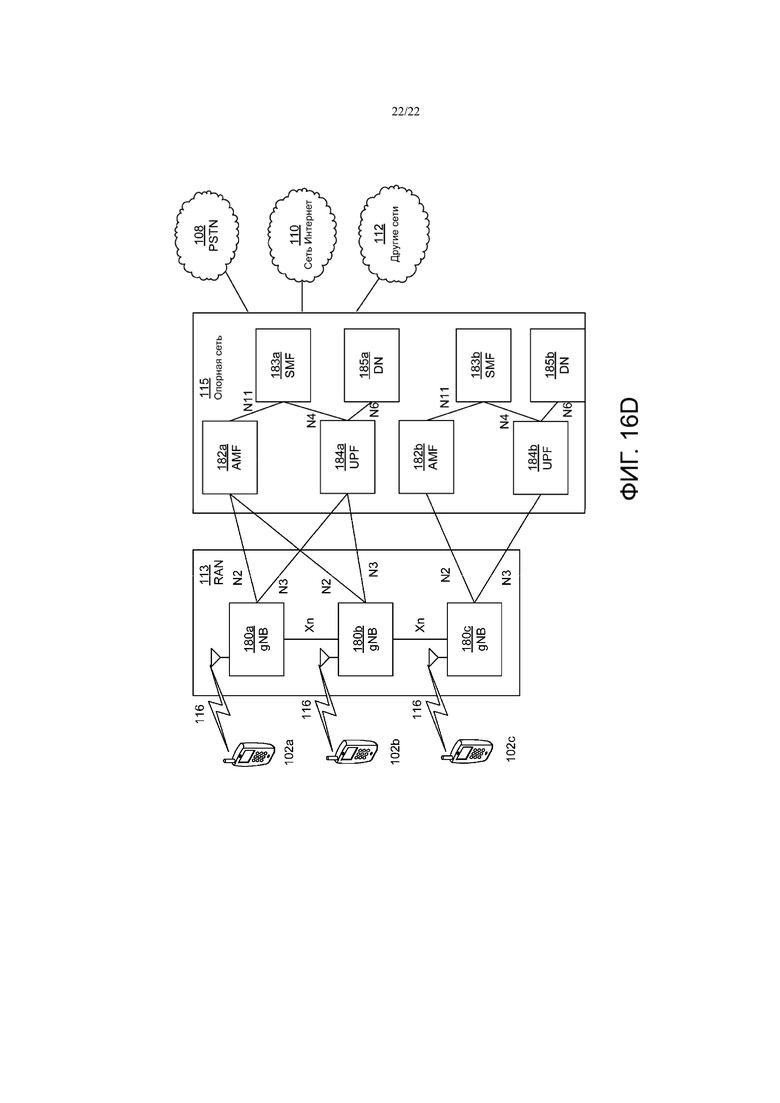

На фиг. 16D представлена схема системы, иллюстрирующая другой пример RAN и дополнительный пример CN, которые могут быть использованы в системе связи, показанной на фиг. 16A, в соответствии с вариантом осуществления.

Подробное описание

Далее приведено подробное описание иллюстративных вариантов осуществления со ссылкой на различные фигуры. Хотя в настоящем описании приведены подробные примеры возможных вариантов реализации, следует отметить, что данное подробное описание приведено в качестве примера и ни в коей мере не ограничивает объем заявки.

Смарт-телевизор выполнен с возможностью обеспечения взаимодействия с телевизионным содержимым. В примере телевизор может обеспечивать пользователя возможностью перемещения по видео с использованием функции экранной лупы. Пользователь может вручную выбирать содержимое окна «картинки в картинке» (PIP), например, с помощью указания на область экрана. Функции увеличения и/или PIP могут улучшать интерфейс зрителя телевизора. Функция PIP может быть использована, например, для отслеживания второго видеоисточника на наличие активности (например, пользователь может смотреть второй телевизионный канал в окне PIP, одновременно просматривая первый телевизионный канал в основной зоне дисплея). Можно менять местами основной вид и вид PIP.

Информация отслеживания, которую может передавать телевизионная вещательная компания извне, может быть использована, например, для создания представления положений игрока (например, чтобы помочь зрителю в навигации по сцене). Может быть создан граф активности (например, с использованием аудиоданных и данных о местоположении игрока), например, чтобы помочь зрителю в навигации по сцене.

Просмотр телепередач может быть статичным и неперсонализированным. Функция PIP может быть использована для отображения второго видеоисточника в небольшом окне основного телевизионного дисплея. Окно PIP может быть назначено другому каналу или видеовходу. Пользователь может выбирать канал или источник для отображения в PIP путем выполнения минимальной настройки и взаимодействия.

Усовершенствованные технологии анализа изображений могут поддерживать предоставление пользователю набора пикселей и описания содержимого. Пользователь может, например, просматривать конкретную часть видео крупным планом или в увеличенном масштабе. Может быть предусмотрена экранная лупа, благодаря которой пользователь может управлять экраном, масштабируя интересующие его области при перемещении по видеосодержимому. Пользователь может перемещать экранную лупу (например, путем перемещения удаленного или другого указывающего устройства), например, для слежения за представляющим интерес объектом.

Отслеживание объекта может быть использовано для управления представлением изменений масштаба видео. Отслеживание объекта может включать в себя, например, отслеживание объектов на стороне клиента, выбранных пользователем. Информация о местоположении объекта может быть представлена в виде метаданных с видеокадрами. Для выбора из множества интересующих пользователя объектов может быть использовано указывающее устройство (например, удаленное). Указывающее устройство может быть использовано, например, для выбора (например, одного) представляющего интерес объекта (например, одного игрока в команде) и (например, в результате этого) один или более связанных (например, дополнительных) объектов (например, множество игроков той же команды) может быть (например, дополнительно) выбрано и отслежено (например, наряду с выбранным объектом). Может быть предусмотрено множество режимов использования (например, масштабирование фиксированного PIP и масштабирование плавающего PIP). Объект может быть выбран для отслеживания и/или обработки (например, масштабирования), например, автоматически (например, на основании одного или более критериев выбора) и/или путем (например, пользователем) циклического перебора множества отслеживаемых объектов.

Может быть выполнен выбор содержимого, отслеживание объекта (например, локально управляемое на устройстве или путем отслеживания метаданных, принятых вместе с содержимым) и воспроизведение (например, в PIP), например, в фиксированном местоположении или в плавающем режиме (например, на основании отслеживаемых данных).

На фиг. 1 представлен пример схемы 200 системы устройства отображения (например, телевизора) с отслеживанием на устройстве. Дистанционно получаемые данные 202 от компонента дистанционного управления могут быть приняты блоком 204 перемещения устройства отображения. Дистанционно получаемые данные 202 могут включать в себя информацию, относящуюся к выбору пользователем объекта видеокадра. Пользователь может использовать компонент дистанционного управления для выбора представляющего интерес объекта (например, для осуществления отслеживания). Компонент дистанционного управления может быть выполнен с возможностью, например, «дистанционного перемещения», с помощью которого пользователь может управлять указателем на экране. Блок 204 перемещения может определять местоположение указателя пользователя на основании дистанционно получаемых данных 202. Курсор 206 может быть наложен на видеокадр на устройстве отображения для, например, указания пользователю объекта, который он может выбрать для PIP.

В некоторых вариантах осуществления компонент дистанционного управления может быть не дистанционным, а, например, может включать в себя сенсорный экран для выбора объекта. В таких примерах дистанционно получаемые данные 202 могут быть переданы непосредственно в модуль 208 отслеживания (например, CamShift) устройства отображения.

Модуль 208 отслеживания может принимать информацию о положении объекта, например, при активации функции 210 отслеживания (например, при нажатии на кнопку на компоненте дистанционного управления). Модуль 208 отслеживания может также принимать исходный видеокадр 216 (например, который включает в себя объект). Положение объекта можно отслеживать во всех видеокадрах 216 с течением времени. Ограничительная рамка (например, указание объекта в виде небольшой рамки) может быть определена и отображена вокруг объекта в видеокадре (например, в каждом исходном видеокадре 216).

Информация о положении объекта может быть передана, например, в модуль 218 формирования PIP. Модуль 218 формирования PIP может также включать в себя исходные видеокадры 216. В случае активации модуля 208 формирования PIP он выполнен с возможностью создания окна (например, окна PIP) вокруг некоторой части видеокадра, которая включает в себя объект. В некоторых примерах модуль 208 формирования PIP может визуально увеличивать часть видеокадра, которая включает в себя объект, в пределах окна PIP (например, может быть выполнена операция масштабирования). Визуальное увеличение (например, масштабирование) может быть выполнено, например, с использованием процедуры масштабирования изображения, такой как интерполяция (например, билинейная или бикубическая) или изменение частоты дискретизации (например, алгоритм Ланцоша). Модуль 218 формирования PIP может накладывать окно PIP на исходный видеокадр 216. Полученный кадр может упоминаться как комбинированная рамка (например, исходный видеокадр плюс окно PIP). Модуль 218 формирования PIP может передавать комбинированный кадр на дисплей 220 для представления пользователю.

Окно PIP может иметь увеличенный размер, например, по сравнению с ограничительной рамкой для объекта, определяющей масштабирование. В примере ограничительная рамка для объекта может быть определена в 200 x 225 пикселей. В качестве примера коэффициента масштабирования может приведено значение 2x. Окно PIP, отображающее масштабированный объект, может иметь размер, например, 400 x 450 пикселей. Окно PIP может отображаться, например, в фиксированном местоположении экрана (например, в углу экрана) или в мобильном/перемещающемся местоположении (например, в плавающем PIP), например, оно может перемещаться вместе с отслеживаемым объектом. В некоторых примерах окно PIP может дополнительно перемещаться между углами дисплея (например, на основании местоположения объекта, на основании отображаемой информации, относящейся к нижележащим исходным видеокадрам и т.д.). Окно PIP, включающее в себя масштабированный объект, может отображаться, например, на основании положения (например, центрального положения) объекта, когда объект и связанное с ним положение (например, центральное положение) могут изменяться с течением времени. Плавающее окно PIP может, например, перекрывать или блокировать объект, на котором оно может быть основано, например, вместе с зоной, окружающей объект.

Отслеживание на стороне клиента (на устройстве) позволяет пользователям выбирать объекты (например, произвольные объекты) для отслеживания, благодаря чему возможности взаимодействия с пользователем могут стать лучше (например, пользователи смогут выбирать интересующие их объекты). С помощью устройства можно визуально увеличивать один или более объектов на основании выбора пользователя. Благодаря отслеживанию на стороне клиента можно избежать необходимости приема информации о положении объекта в рамках телевещания (например, поскольку клиент может выполнять отслеживание на основании распознавания объекта). За счет отслеживания на стороне клиента система интерактивного масштабирования может работать с любым принятым содержимым. Объемом необходимых вычислений на устройстве можно управлять, например, путем реализации алгоритмов, которые могут использовать незначительные ресурсы и могут быть выполнены в режиме реального времени. Для отслеживания местоположений объектов в видеокадрах с течением времени можно использовать один или более алгоритмов отслеживания видеообъектов, таких как, например, «CAMshift» и «сдвиг среднего значения», хотя могут быть использованы и другие алгоритмы.

Поток отслеживания объекта может включать в себя множество (например, две) ступеней, таких как ступень инициализации и ступень отслеживания. На фиг. 2A представлен пример процедуры 230 инициализации отслеживания объекта на стороне клиента. На фиг. 3A представлен пример видеокадра 300, который включает в себя объект 302, положение 304 окна объекта и положение 306 окна поиска.

Устройство может определять один или более объектов для отслеживания. Например, устройство может определять объект (-ы) для отслеживания на основании выбора пользователя на этапе 232. Пользователь может выбирать один или более объектов (например, произвольный объект). В примере пользователь может использовать компонент дистанционного управления или другое указывающее устройство для перемещения, рисования или иного определения местоположения курсора или рамки вокруг экрана и указания (например, путем нажатия на кнопку) желания отслеживать выбранный объект. Устройство может выполнять отслеживание объекта на основании начального положения объекта. На этапе 234 устройство может принимать видеохарактеристики (например, разрешение, частоту кадров, цветовое пространство, SDR/HDR) видеокадра.

На этапе 236 устройство может определять окно объекта (например, окно 304 объекта), которое включает в себя представляющий интерес объект (например, объект 302). Устройство может определять размер окна объекта, например, на основании видеохарактеристик (например, разрешения, частоты кадров, цветового пространства, SDR/HDR). На этапе 238 устройство может определять окно поиска (например, окно 306 поиска). Окно поиска может быть использовано при отслеживании объекта от кадра к кадру. Устройство может определять размер окна поиска с использованием характеристик видеокадров.

Устройство может создавать (например, формировать) карту вероятности, например, для определения вероятности того, что пиксель в пределах окна объекта является частью объекта. Для формирования карты вероятности устройство может использовать различные признаки. Например, для формирования карты вероятности устройство может использовать цветовую гистограмму. Для получения оценки вероятности устройство может анализировать окно объекта, включающее в себя объект. На этапе 240 устройство может преобразовать пиксели в окне объекта, например, в цветовое пространство HSV. На этапе 242 устройство может вычислять двухмерную (2D) гистограмму значений цветового тона и насыщенности (например, как показано в примере на фиг. 4A-B) пикселей в пределах окна объекта. На фиг. 4A представлен пример признаков 400 цветового тона в блоке поиска видеокадра, а на фиг. 4B представлен пример признаков 410 насыщенности в блоке поиска видеокадра). На этапе 244 устройство может использовать 2D-гистограмму, например, для получения оценки вероятности того, что пиксель является частью отслеживаемого объекта. На фиг. 5 представлен пример вероятности обратного проецирования и целевого окна 500. На фиг. 5 показан пример изображения 502, представляющего попиксельную вероятность, а также прямоугольники 504, 506, иллюстрирующие перемещение обнаруженной области при итерациях типа «сдвиг среднего значения».

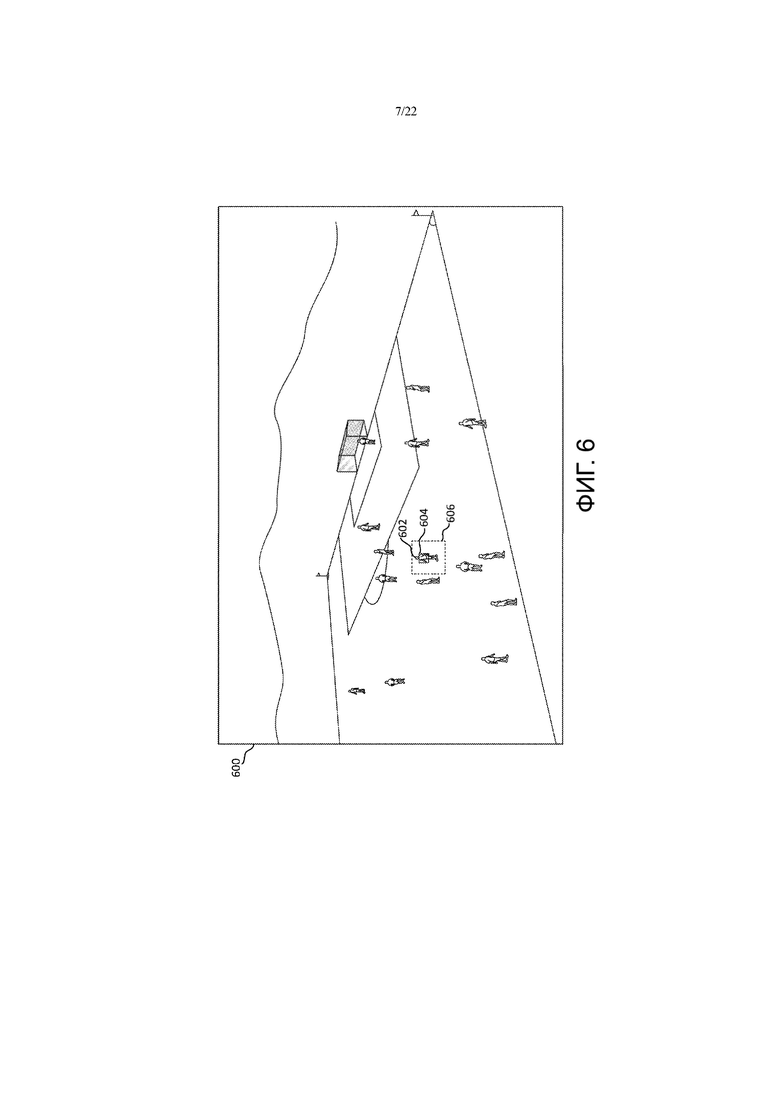

На фиг. 2B представлен пример процедуры 250 отслеживания объекта на стороне клиента. На фиг. 6 представлен пример видеокадра 600, который включает в себя объект 602, с окном 604 объекта и окном 606 поиска. Видеокадр 600 во времени может быть получен после видеокадра 300 (например, может поступать после видеокадра 300). Объект 602 видеокадра 600 может представлять собой тот же объект, что и объект 302 видеокадра 300.

Процедуру 250 отслеживания объекта можно выполнять (например, в последующих видеокадрах), например, до прекращения пользователем отслеживания объекта (например, объекта 602) или до потери отслеживания объекта. На этапе 252 устройство может преобразовывать пиксели в окне поиска (например, в окне 606 поиска) в цветовое пространство HSV. На этапе 254 устройство может вычислять 2D-гистограмму значений цветового тона и насыщенности пикселей в пределах окна поиска. На этапе 256 устройство может получать оценку вероятности того, что пиксели в окне поиска являются пикселями представляющего интерес объекта. Например, устройство может выполнять поиск в пределах окна поиска для представляющего интерес объекта, например, путем создания карты вероятности для пикселей в пределах окна поиска. Например, устройство может использовать вероятность для каждого пикселя в пределах окна поиска для определения, относится ли пиксель к отслеживаемому объекту.

Если на этапе 258 устройство не находит объект, на этапе 268 оно может определять, осталось ли время на таймере поиска. Если на таймере поиска осталось время, устройство может увеличивать размер окна поиска и/или понижать порог вероятности на этапе 270 и продолжать поиск объекта в окне поиска. Например, устройство может увеличивать окно поиска и/или уменьшать порог вероятности (например, при достаточном количестве времени перед возможным отображением декодированного кадра на экране), например, если объект не найден в окне поиска на этапе 258. Если на этапе 268 определено истечение срока действия таймера поиска, на этапе 272 устройство может обеспечивать какую-либо визуальную подсказку о потере отслеживания объекта и завершать выполнение алгоритма на этапе 274. Например, устройство может отображать визуальную подсказку или указание для сообщения пользователю о потере отслеживания объекта, и пользователь может при желании выбирать новый объект (например, повторно выбирать тот же объект) для отслеживания.

Устройство может определять новое положение объекта в пределах видеокадра (например, по сравнению с местоположением объекта в более ранних видеокадрах), когда объект находится в пределах окна поиска. Например, если устройство находит объект в пределах окна поиска на этапе 258, устройство может использовать фильтр сглаживания в положении окна объекта на этапе 260. Например, устройство может использовать фильтр для сглаживания отслеживаемого положения объекта с течением времени, например для минимизации флуктуаций и улучшения возможностей взаимодействия с пользователем (например, положение объекта может значительно варьироваться). В устройстве можно использовать фильтры сглаживания любого типа (например, фильтр нижних частот, медианный фильтр) и переменное количество прошлых положений объекта, например, в зависимости от типа содержимого (например, фильмы, спортивные соревнования и т.д.).

Устройство может обновлять положения окна объекта и окна поиска на основании положения объекта (на этапе 262). Например, устройство может применять фильтр, например, путем отслеживания N прошлых положений для отслеживаемого объекта, причем N представляет собой количество предыдущих видеокадров, в которых был идентифицирован объект. В фильтре может быть использовано положение объекта из одного или более прошлых видеокадров и/или текущего видеокадра для получения обновленного положения объекта для текущего видеокадра, например, в соответствии со следующей формулой или логикой:

обновленное положение текущего видеокадра = фильтр (текущее положение, N предыдущих положений)

В примере медианный фильтр может быть применен к текущему положению (t0) с N = 4 предыдущих положений (t1, t2, t3, t4), в результате чего, например:

обновленное положение для текущего кадра = медиана {pos(t0), pos(t1), pos(t2), pos(t3), pos(t4)}

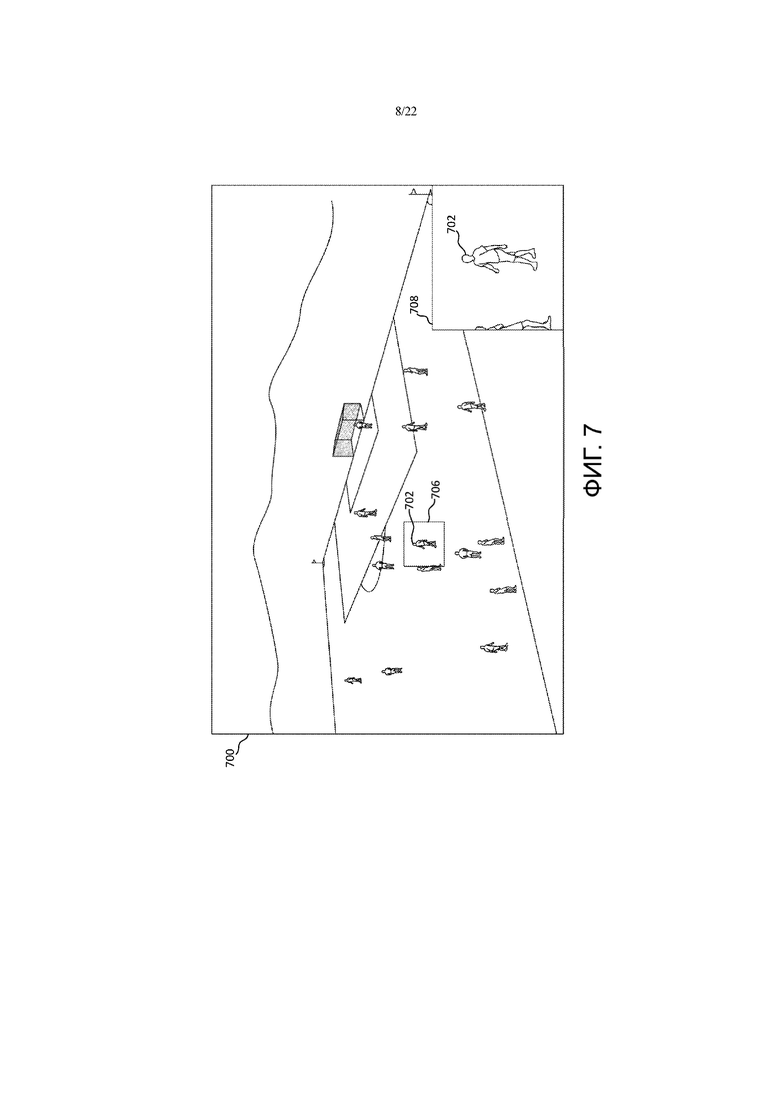

Устройство может обновлять положение окна объекта (например, кадр за кадром), например, для слежения за объектом по мере его перемещения в видеокадрах. Устройство может обновлять положение окна поиска (например, кадр за кадром), которое может быть центрировано вокруг окна объекта. Устройство может визуально увеличивать (например, масштабировать) часть видеокадра, которая включена в окно объекта, на этапе 264. Устройство может отображать итоговый видеокадр в окне PIP, которое включает часть видеокадра, которая включает объект, на этапе 266. Например, устройство может отображать окно PIP в виде фиксированного окна (например, как показано на фиг. 7) или в виде плавающего окна (например, местоположение этого окна зависит от местоположения объекта, например окно перемещается по экрану дисплея от кадра к кадру по мере перемещения объекта в кадрах).

На фиг. 7 показан пример видеокадра 700, который включает в себя отслеживаемый объект 702, масштабированный в окне 708 PIP. Видеокадр 700 может представлять собой такой же видеокадр, как и видеокадр 600, изображенный на фиг. 6, но со включением накладываемого окна 708 PIP. Соответственно, объект 702 может быть таким же, как и объект 602. Визуально увеличенная часть видеокадра, включенная в окно 708 PIP, может представлять собой такую же визуально увеличенную часть видеокадра, какая находится в пределах окна 706 поиска. Уровень масштабирования для окна PIP 708 может быть выбран (например), выбран автоматически), например, на основании характеристик видеокадра, выбранных пользователем (например, из набора доступных уровней масштабирования), и/или т.п.

Устройство может использовать пиксели, которые определены (например, путем выбора пользователем) для создания цветовых гистограмм и обеспечения основы для поиска в одном или более последующих кадрах. Устройство может определять цветовую гистограмму на основании подмножества пикселей, например, на основании объекта и фоновой сегментации или порога различения цвета. Объект может перемещаться по сцене с течением времени, может изменяться освещение и/или объект может переворачиваться с открытием при этом новой визуальной информации, которая не была видна в предыдущем видеокадре. Таким образом, более ранняя (например, начальная) цветовая гистограмма может больше не обеспечивать хороших результатов при идентификации объекта в окне поиска. Таким образом, устройство может обновлять цветовую гистограмму, используемую для вычисления оценки вероятности для пикселя, являющегося частью отслеживаемого объекта (например, обновлять цветовую гистограмму на основании информации в последующих видеокадрах).

Устройство может отслеживать один или более объектов в видеокадрах. Устройство может отслеживать объект локально (например, в случае идентификации объекта с использованием удаленного указывающего устройства). В примере устройство может задействовать выбор объекта для инициализации отслеживания множества объектов (например, игроков одной команды), которые могут присутствовать в видеокадре. Например, объект может быть выбран для отслеживания (например, путем указания). Устройство может вычислять карту вероятности для определения пикселей, которые могут быть частью объекта, например, путем обратного проецирования (BackProjection). Обратное проецирование может быть использовано, например, в небольшой соседней области вокруг предыдущего положения отслеживаемого объекта, например, для поиска нового положения. К видеокадру может быть применена карта вероятности, с помощью которой можно выделять аналогичные объекты (например, игроков одной команды).

На фиг. 8 показан пример вероятности для объекта, примененной к видеокадру 800. На фиг. 8 показан пример выбора (например, одиночного) объекта и применения карты вероятности к (например, целому) кадру. Отдельные яркие (например, белые) пятна могут соответствовать игрокам одной команды. Как показано на фигуре, может наблюдаться значительный отклик от похожих цветов, расположенных вне поля (например, фанаты в одежде, соответствующей цвету команды). Устройство может отклонять (например, пропускать) дополнительные элементы, расположенные вне поля (например, белые элементы, расположенные вне поля), например, путем идентификации границы поля (например, с помощью цветового тона) для фокусировки на ярких пятнах в пределах поля.

На фиг. 9 показан пример карты 900 вероятности, очищенной путем удаления откликов вне поля видеокадра 800 (например, путем удаления ярких пятен, соответствующих фанатам, маркетинговым баннерам и другим объектам, которые расположены вне игрового поля). Устройство может унифицировать области поля, например, путем инициирования и деинициирования морфологического приложения обработки изображений.

На фиг. 10 показан пример результата 1000 инициирования и деинициирования морфологических операций с использованием карты 900 вероятности, показанной на фиг. 9. Как показано в результате 1000, с помощью устройства можно идентифицировать семь ярких пятен, соответствующих семи игрокам выбранной команды (например, семи объектам). Устройство может использовать местоположения семи ярких пятен, например, для инициализации отслеживания каждого соответствующего игрока. Устройство может повторно использовать гистограмму, соответствующую выбранному объекту, для множества (например, всех) объектов, за счет чего, например, можно предотвратить необходимость для устройства повторного создания отдельных гистограмм объекта для каждого из множества объектов. Устройство может идентифицировать множество объектов (например, игроков в одинаковой форме одной команды) и отслеживания объектов (например, как описано выше), например, на основании выбора одного инициализатора (например, выбора одного игрока).

Устройство может принимать метаданные отслеживания, например, в видеопотоке или вместе с видеопотоком. Устройство может использовать метаданные для идентификации и/или отслеживания одного или более объектов (например, идентификации и/или отслеживания местоположений одного или более объектов), например, в дополнение к отслеживанию на стороне клиента или в качестве альтернативы отслеживанию на стороне клиента. Например, видеовещание может включать в себя передачу метаданных, описывающих местоположение объектов в каждом видеокадре, например, в качестве альтернативы выполнению локального отслеживания объектов на стороне клиента или в дополнение к нему. В примере для описания ограничительной рамки могут быть использованы сообщения с информацией для дополнительной оптимизации (SEI) (например, SEI-сообщение прямоугольного панорамирования и сканирования) в стандартах H.264 и H.265 кодирования видеоизображений. Сообщение может описывать диапазон пикселей в ограничительной рамке, которые могут соответствовать идентификатору объекта. Видеосервер может использовать улучшенное отслеживание объекта, например, когда ресурсы для отслеживания объектов могут быть ограничены на устройстве на стороне клиента. Можно отслеживать множество объектов (например, в режиме реального времени или в автономном режиме с помощью видеосервера) и могут широковещательно передавать информацию об их положении, благодаря чему на устройстве отображения пользователи могут выбирать объекты из множества объектов и переключать целевой объект отслеживания с помощью списка отслеживаемых объектов.

Для улучшения отслеживания объекта могут быть применены и другие способы. Например, каждый видеообъект (например, каждый игрок спортивной команды) может иметь микросхему радиочастотной идентификации (РЧИД), обеспечивающую точное отслеживание (например, во время футбольного матча). Информация от микросхем РЧИД может быть преобразована в положения отслеживаемых объектов, передаваемые в видеопотоке. Устройство может принимать информацию отслеживания посредством широковещательно передаваемого видеопотока и может использовать информацию о местоположении от микросхем РЧИД для отслеживания объектов (например, игроков) во всех видеокадрах.

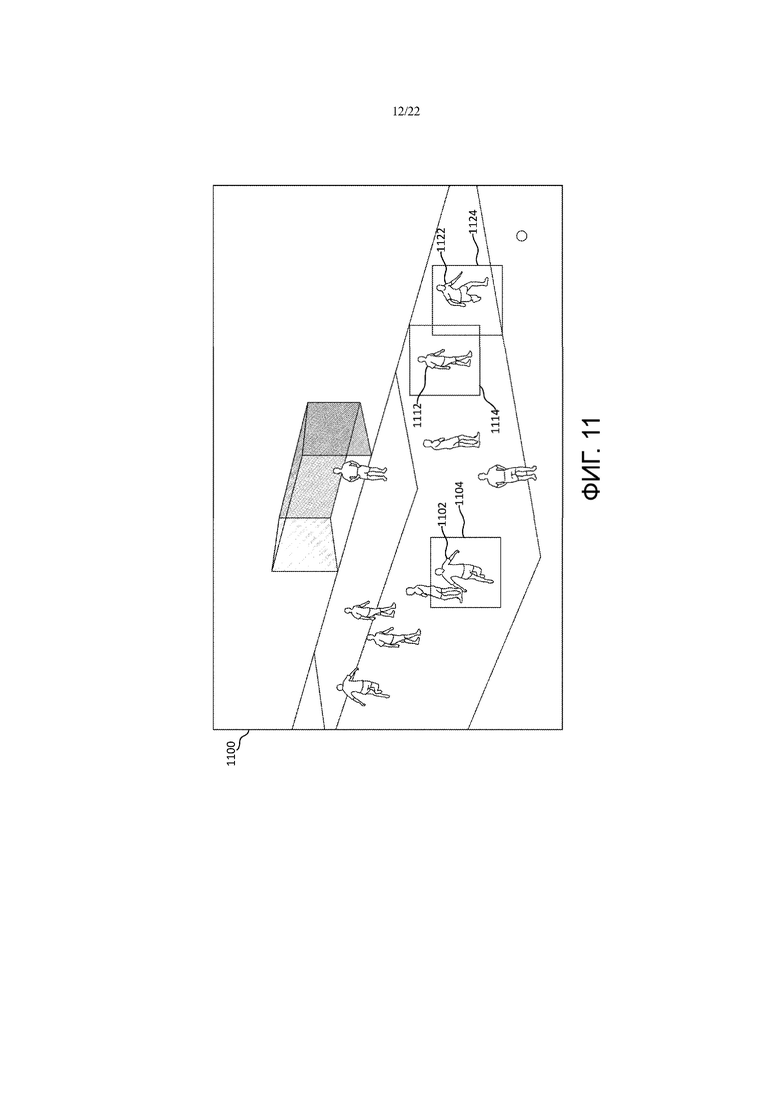

Устройство (например, клиентское) может извлекать информацию из битового видеопотока (например, извлекать сообщения SEI), например, при получении информации отслеживания объекта от сервера в видеопотоке. Информация отслеживания может включать в себя, например, местоположение объекта в пределах видеокадра, размер «рамки объекта» и/или другие (например, дополнительные или альтернативные) метаданные, которые могут быть релевантными (например, идентификатор объекта, имя или положение игрока, название команды, к которой относится игрок, и т.д.). Устройство может накладывать рамки на подмножество объектов на экране, например, как показано на фиг. 11.

На фиг. 11 представлен пример отслеживания множества объектов с использованием информации, полученной из метаданных. Например, устройство может отслеживать объект 1102 и может отображать отслеживаемый объект 1102 в пределах окна 1104, которое включает в себя часть видеокадра и отслеживаемый объект 1102. Устройство может отслеживать объект 1112 и может отображать отслеживаемый объект 1112 в пределах окна 1114, которое включает в себя часть видеокадра и отслеживаемый объект 1112. Устройство может дополнительно отслеживать объект 1122 и может отображать отслеживаемый объект 1122 в пределах окна 1124, которое включает в себя часть видеокадра и отслеживаемый объект 1122. Объекты 1102, 1112, 1122 могут быть выбраны клиентом (например, на основании одного или более критериев, которые могут быть фиксированными или выбираемыми, таких как игроки команды, наиболее важные игроки команды и т.д.). Пользователь может выбирать объекты 1102, 1112, 1122 на основании предпочтений (например, определений пользователя) или путем выбора из меню с вариантами выбора. Пользователь может выбирать объекты 1102, 1112, 1122 для отслеживания. Устройство может отслеживать объекты 1102, 1112, 1122 во всех видеокадрах и может отображать окно, которое включает в себя отслеживаемый объект в каждом соответствующем кадре.

Устройство может визуально увеличивать объект (например, масштабировать) и может отображать визуально увеличенный объект в пределах окна PIP на дисплее, например, как показано на фиг. 12. На фиг. 12 показан пример видеокадра 1200, который включает в себя окно 1224 вокруг объекта 1222, и окно 1230 PIP, которое представляет визуально увеличенную копию объекта 1232 из видеокадра 1200. Хотя оно показано как фиксированное окно 1230 PIP (например, окно 1230 PIP находится в фиксированном местоположении, например, в нижнем правом углу), следует понимать, что устройство может отображать плавающее окно PIP, которое накладывается на объект 1222. Следует понимать, что видеокадр 1200 может быть таким же, как видеокадр 1100, но со включением окна 1230 PIP и с удалением окон 1104, 1114. Хотя в окне 1230 PIP дополнительно представлена визуально увеличенная версия объекта 1232, в некоторых примерах размер и конфигурация окна 1230 PIP могут быть выбраны с предотвращением визуального увеличения объекта 1222 в пределах окна PIP 1230.

Благодаря устройству пользователь сможет взаимодействовать с объектом (например, объектом, расположенным в пределах окна PIP). Устройство может принимать метаданные, которые включают в себя расширенную информацию об отслеживаемых объектах. В примере метаданные могут включать в себя, например, имя актрисы в фильме или статистику в режиме реальном времени для игрока в игре «NFL». С помощью устройства пользователь может взаимодействовать с объектом в PIP для получения дополнительной информации об объекте. В примере метаданные могут включать в себя идентификатор объекта, который может быть использован устройством для запроса информации из базы данных (например, локальной или дистанционная базы данных) или с веб-сайта. Устройство может, например, извлекать из метаданных идентификатор объекта, который может соответствовать объекту, показанному в PIP. Устройство может запрашивать доступную информацию из базы данных или с веб-сайта и может отображать информацию на экране дисплея (например, в главном окне или окне PIP, в его меню и т.д.). Устройство может отображать информацию в фиксированном местоположении экрана или в плавающем накладывающемся окне, которое может следовать за положением соответствующего отслеживаемого объекта. Устройство может автоматически отображать информацию пользователю/зрителю, например, аналогично «бегущим» новостям, отображаемым по периметру (например, по нижнему краю) экрана. Представление информации об объекте, интересующем пользователя/зрителя, в PIP может представлять собой информацию, релевантную для пользователя/зрителя, по сравнению с представлением общей информации, которая может быть неподходящей или может содержать какую-либо информацию, не интересующую пользователя. Эта функция может взаимодействовать с пользователем и создавать ощущение персонализации.

В примере устройство может быть использовано в системе, которая отображает PIP на втором экране (например, на экране второго телевизора, смартфоне, планшете и т.д.), за счет чего можно предотвратить преграждение участка пространства на экране телевизора. Второй экран может обеспечивать лучшее взаимодействие с пользователем (например, покупку одежды, которую носит актриса в фильме) и может содержать форму прямой или косвенной рекламы и предполагать получение дохода за широковещательную передачу информации.

Устройство может отображать окно PIP в фиксированном местоположении, или окно PIP может перемещаться по экрану вместе с объектом (например, в зависимости от местоположения объекта). Устройство может принимать информацию отслеживания объекта (например, на основании распознавания объекта или метаданных) и устройство может создавать окно PIP с использованием информации отслеживания объекта. В некоторых примерах окно PIP может находиться в фиксированном местоположении (например, в нижнем правом углу экрана) независимо от местоположения объекта. Устройство может сопоставлять отслеживаемое содержимое с фиксированным местоположением PIP, например, как показано в окне 1230 PIP на фиг. 12. Содержимое PIP может следовать за отслеживаемым объектом 1222, например, с применением информации о положении локально отслеживаемого объекта и/или отслеживании метаданных, которые могут быть приняты с видеосодержимым. Часть видеокадра в пределах окна 1230 PIP может быть увеличена (например, с помощью различных коэффициентов, которые могут быть выбраны зрителем), например, как показано на фиг. 12. Кроме того, в некоторых примерах окно 1230 PIP выполнено по форме и размеру с возможностью предотвращения визуального увеличения объекта 1222 в пределах окна 1230 PIP.

На устройстве может отображаться плавающее окно PIP, причем, например, местоположение плавающего окна PIP зависит от местоположения отслеживаемого объекта. Устройство может принимать информацию отслеживания объекта (например, на основании локального распознавания объекта или принятых метаданных) и устройство может определять местоположение для окна PIP с использованием информации отслеживания объекта (например, на основании локального распознавания объекта или принятых метаданных).

На фиг. 13 представлен пример видеокадра 1300, который включает в себя плавающее окно 1304 PIP, которое включает в себя отслеживаемый объект 1302. Устройство может отображать плавающее окно 1304 PIP поверх отслеживаемого объекта 1302. Устройство может определять местоположение отслеживаемого объекта 1302 (например, на основании локального распознавания объекта или принятых метаданных) и на основании местоположения отслеживаемого объекта 1302 определять местоположение плавающего окна 1304 PIP. Соответственно, в некоторых примерах положение окна 1304 PIP может быть привязано к объекту 1302, когда объект 1302 перемещается по экрану дисплея в видеокадрах. Например, устройство может отображать окно 1304 PIP непосредственно поверх объекта 1302 (например, по центру объекта 1302), таким образом скрывая исходный отслеживаемый объект 1302, или в альтернативном варианте осуществления устройство может отображать окно 1304 PIP в некотором местоположении (например, в одном из четырех углов экрана дисплея) на основании местоположения отслеживаемого объекта 1302 (например, в углу, наиболее близком к отслеживаемому объекту 1302). Как показано на фигуре, часть видеокадра в пределах окна 1304 PIP может быть дополнительно визуально увеличена (например, включая сам объект 1302). Однако в некоторых примерах размер и конфигурация окна 1304 PIP могут быть выбраны с возможностью предотвращения визуального увеличения объекта 1302 в пределах окна 1304 PIP.

С помощью устройства пользователь может циклически перебирать множество отслеживаемых объектов, например, для выбора одного или более отслеживаемых объектов (например, для переключения отслеживаемого и/или масштабируемого объекта в окне PIP, для удаления объектов из списка активно отслеживаемых объектов, и т.д.). На фиг. 14 представлен пример способа 1400, выполняемого устройством, с помощью которого пользователь может циклически перебирать множество отслеживаемых объектов 1-N. Объекты могут быть упорядочены в виде списка, например, сервером (например, метаданные могут включать в себя информацию о способе упорядочивания отслеживаемых объектов в списке) и/или клиентом или пользователем. Устройство может (например, после приема информации отслеживания в метаданных) упорядочивать отслеживаемые объекты в соответствии с предпочтениями пользователя (например, в алфавитном порядке, по командам, по выбору пользователя и/или по порядку подмножества доступных объектов и т.д.). В альтернативном или дополнительном варианте осуществления устройство может использовать одну или более процедур для создания списка отслеживаемых объектов (например, на основании идентификатора объекта). В примере, в котором N объектов могут быть отслежены во всех видеокадрах, с помощью устройства пользователь может выбирать объект (например, объект i) для масштабирования в PIP. Пользователь может выбирать объект, например, с помощью выбора одного или более объектов из перемещаемого видео или приостановленного видеокадра (например, при возобновлении воспроизведения в случае выбора одного или более объектов).

Когда список будет создан, а пользователь готов циклически перебирать объекты для выбора для окна PIP, устройство может создавать активное окно. Устройство может отображать объект в пределах активного окна для указания пользователю текущего объекта для выбора. Активное окно может, например, выглядеть аналогично окну PIP (но, например, без визуального увеличения части видеокадра, которая включает в себя объект). В некоторых случаях активное окно может иметь цвет или форму, отличные от цвета или формы окна PIP. С помощью устройства пользователь может циклически перебирать объекты в соответствии со списком (например, списком 1402), в котором циклически перебирают объекты 1-N в соответствующем активном окне. Например, когда пользователь выполняет указанный циклический перебор, объект в пределах активного окна может представлять собой следующий отслеживаемый объект из списка (например, на основании введенных пользователем данных). После достижения конца списка устройство может возвращаться в начало списка, например, как показано на фиг. 14. Положение активного окна может быть фиксированным (например, всегда в углу экрана) или может быть плавающим (например, в зависимости от местоположения объекта, выделенного активным окном).

Устройство может выполнять одну или более дополнительных функций PIP, таких как, без ограничений, объединение множества окон PIP, разделение окна PIP на множество окон PIP, блокирование содержимого в пределах окна PIP, увеличение или минимизация содержимого окна PIP, обеспечение временной задержки для содержимого в окне PIP, включение социальных сетей в окно PIP или вместе с ним, изменение положения окна PIP (например, на основании выбора пользователя) и/или т.п.

На фиг. 15A-F представлены примеры объединения множества окон PIP для множества отслеживаемых объектов. На фиг. 15A представлен пример видеокадра 1500, который включает в себя множество отслеживаемых объектов. На фиг. 15B представлен пример видеокадра 1500’, который включает в себя множество окон PIP масштабирования, соответствующих множеству отслеживаемых объектов. На фиг. 15C представлен пример видеокадра 1530, который включает в себя множество окон PIP масштабирования, накладывающихся в случае приближения отслеживаемых объектов друг к другу. На фиг. 15D представлен пример видеокадра 1532, который включает в себя множество отслеживаемых объектов, накладывающихся друг на друга. На фиг. 15E представлен пример видеокадра 1532’, который включает в себя объединенное окно PIP, которое включает в себя множество накладывающихся объектов. На фиг. 15F представлен пример видеокадра 1532’’, который включает в себя объединенное окно PIP, которое включает в себя множество накладывающихся объектов.

Устройство может отслеживать множество целевых объектов во всем множестве видеокадров. Устройство может выполнять отслеживание объекта (например, идентификацию объектов и/или определение местоположений объектов в пределах каждого видеокадра) с помощью способа распознавания объекта (например, на устройстве) и/или на основании метаданных (например, которые могут быть приняты в виде части видеопотока или широковещательной передачи). Устройство может выбирать и/или с его помощью пользователь может выбирать множество отслеживаемых объектов для одновременного отображения (например, масштабированного или немасштабированного отображения). Устройство может отображать множество окон PIP (например, плавающих или фиксированных окон PIP) для множества отслеживаемых объектов. Например, как показано на видеокадре 1500, изображенном на фиг. 15A, устройство может отслеживать объекты 1502, 1512, 1522 и для каждого из отслеживаемых объектов 1502, 1512, 1522 устройство может отображать окно вокруг объекта, например, окна 1504, 1514, 1524. Кроме того, устройство может визуально увеличивать часть кадра, которая включает в себя отслеживаемые объекты, в пределах окон. Например, устройство может отображать кадр 1500’ который включает в себя окно 1506, 1516, 1526, отображающее визуально увеличенную часть видеокадра, которая включает в себя отслеживаемый объект 1502, 1512, 1522 соответственно. Следует понимать, что местоположение окон 1504, 1514, 1524, показанных на фиг. 15A, и окон 1506, 1516, 1526, показанных на фиг. 15B, может быть определено на основании местоположения каждого соответствующего объекта 1502, 1512, 1522 (например, расположение по центру поверх объекта и перемещение вместе с объектом в видеокадрах).

Устройство может отображать множество плавающих окон PIP (например, по одному для каждого отслеживаемого объекта), которые перемещаются в видеокадрах (т.е. которые перемещаются по мере последовательного отображения множества видеокадров с течением времени). Например, плавающие окна PIP могут перемещаться независимо друг от друга в соответствии с перемещением отслеживаемых объектов, связанных с каждым из плавающих окон PIP. В некоторых случаях окна PIP, связанные с отслеживаемыми объектами, могут приближаться друг к другу или накладываться по мере перемещения отслеживаемых объектов с течением времени (например, во всех видеокадрах), в результате чего одно или более окон PIP может быть исключено.

Например, как показано в видеокадре 1530, изображенном на фиг. 15C, окна 1508 и 1518, связанные с объектами 1502 и 1512 соответственно, накладываются, в то время как окно 1528, связанное с объектом 1522, не накладывается на другое окно. Два или более объектов могут сближаться, а их плавающие окна PIP могут (например, также) сближаться друг с другом или начинать накладываться. Устройство может объединять окна PIP множества отслеживаемых объектов в одно окно PIP большего размера (например, объединенное окно PIP), которое может включать в себя масштабированный вид множества объектов (например, объектов, связанных с объединенными окнами PIP), например, как показано на фиг. 15D-F.

Как показано в видеокадре 1532, изображенном на фиг. 15D, устройство может отслеживать множество объектов 1502, 1512, 1522, которым соответствуют окна 1552, 1562, 1572 (например, окна поиска или окна PIP), накладывающиеся друг на друга. Устройство может создавать объединенное окно PIP, которое включает в себя соответствующие отслеживаемые объекты. Например, как показано в видеокадре 1532’, изображенном на фиг. 15E, устройство может создавать и отображать объединенное окно 1550 PIP, которое включает в себя отслеживаемые объекты 1502, 1512, 1522. Устройство может определять местоположение объединенного окна PIP на основании местоположений отслеживаемых объектов 1502, 1512, 1522 (например, таким образом, что отслеживаемые объекты 1502, 1512, 1522 относительно центрированы в пределах окна PIP). В некоторых случаях в объединенном окне PIP может быть отображена увеличенная часть видеокадра, которая включает в себя нижележащие отслеживаемые объекты. Например, как показано в видеокадре 1532", показанном на фиг. 15F, устройство может создавать и отображать объединенное окно 1560 PIP, которое включает в себя визуально увеличенную часть видеокадра 1532", которая включает в себя отслеживаемые объекты 1502, 1521, 1522. Объединенное окно PIP может быть плавающим (например, как показано на фиг. 15E-F) или может быть фиксированным в заданном местоположении (например, в углу видеокадра). Например, при отображении дополнительных видеокадров объединенное окно PIP может перемещаться вместе с соответствующими отслеживаемыми объектами 1502, 1512, 1522.

Устройство может разделять объединенное окно PIP на два или более отдельных окна PIP, если, например, один или более отслеживаемых объектов 1502, 1512, 1522 перемещаются друг от друга и их соответствующие окна PIP больше не накладываются, если они были отображены в виде отдельных окон PIP (например, на основании одного или более порогов приближения). Если окна PIP плавающие, после разделения окна PIP могут (например, снова) перемещаться независимо в соответствии с перемещением нижележащих отслеживаемых объектов 1502, 1512, 1522.

В устройстве можно использовать пороговые значения приближения, с помощью которых могут быть заданы одна или более степеней близости или удаленности отдельных отслеживаемых объектов (например, сравнивать расстояния между положениями объекта с первым пороговым значением расстояния), например, для определения необходимости объединения двух или более соответствующих плавающих окон PIP. В альтернативном или дополнительном варианте осуществления устройство может принимать решение об объединении окон PIP на основании обнаружения наложения отображаемых окон PIP. В устройстве можно использовать пороговые значения приближения, которые могут определять некоторую степень удаленности или близости отдельных отслеживаемых объектов (например, сравнивать расстояние между положениями объекта со вторым пороговым значением расстояния), например, при принятии решения о разделении объединенного (например, плавающего) окна PIP на два или более компонента-окна PIP. В альтернативном или дополнительном варианте осуществления устройство может принимать решение о разделении объединенного (например, плавающего) окна PIP, например, на основании определения того, что два или более компонента-окна PIP, которые могут быть образованы в результате указанного разделения, могут пространственно не накладываться (например, не будут) внутри видеокадра.

Устройство может выполнять фиксацию и масштабирование видеокадра, например, на основании команды пользователя (например, выбора объекта, подлежащего отслеживанию и/или масштабированию). Например, устройство может фиксировать видеокадр, например, на основании команды пользователя. Пользователь может перемещать центр масштабирования по видеокадру. Эта функция может быть полезной, например, при просмотре спортивных состязаний, и с ее помощью пользователь может останавливать действие и рассматривать объекты в главном окне, например, для изучения положения игроков (например, на поле, корте). В устройстве можно использовать окно PIP для отображения видеотрансляции (например, для продолжения просмотра транслируемого видео), в то время как другое окно PIP может быть использовано для масштабирования зафиксированного видеокадра.

Устройство может отображать отложенную во времени версию объекта в пределах окна PIP во множестве кадров видеосодержимого. Местоположение окна PIP в пределах каждого кадра может быть фиксированным (например, заданным и не связанным с местоположением объекта в пределах каждого кадра) или может быть основано на местоположении объекта в пределах каждого кадра (например, может быть «плавающим» в каждом видеокадре в зависимости от местоположения объекта, может быть расположено в ближайшем к объекту углу и т.д.). Кроме того, отложенная во времени версия объекта в пределах окна PIP может быть визуально увеличена (например, вместе с окружающим видеокадром, захваченным в окне PIP). Например, устройство может отображать первое окно PIP, которое включает в себя часть видеокадра, в пределах (например, или накладывающуюся) последующего во времени видеокадра. Другими словами, в некоторых случаях устройство может отображать окно PIP с визуально увеличенным содержимым с задержкой (например, на несколько секунд), например, чтобы пользователь мог просмотреть главное окно и просмотреть окно PIP после идентификации важной игры или сцены. Расположение окна PIP может быть зафиксировано в пределах заданного местоположения (например, такого как угол дисплея). Устройство может сохранять окно, которое включает в себя объект во всем множестве кадров (например, 120 кадров, эквивалентные 4 секундам при 30 Гц телевещании), и может отображать последующие видеокадры, которые включают в себя отложенное во времени окно PIP с задержкой (например, 4 секунды). В некоторых примерах с помощью устройства пользователь может включать/выключать окно PIP (например, отложенное во времени окно PIP).

В устройстве может быть обеспечена возможность использования содержимого окна PIP совместно с социальными сетями. Например, у пользователя может возникнуть желание поделиться с друзьями интересной информацией из телепередачи. С помощью устройства пользователь может использовать компонент дистанционного управления для получения экранного снимка окна PIP. Пользователь может комментировать экранный снимок, рисовать поверх него, добавлять эффекты и т.д. С помощью устройства пользователь может поделиться исходным или измененным (например, прокомментированным) экранным снимком окна PIP с другими пользователями (например, с помощью социальных сетей), например, в контексте законного использования или в рекламном контексте. Например, благодаря поставщикам информации пользователи, возможно, смогут делиться частями своего информационного содержимого в маркетинговых целях (например, создавать анонс нового шоу или фильма) или участвовать в конкурсе (например, голосовать за понравившийся момент в шоу или любимого певца в конкурсе). Устройство может быть выполнено с возможностью (например, для обеспечения общего доступа в социальных сетях) отправки экранного снимка окна PIP с телевизора в связанное приложение в мобильном устройстве, а значит, пользователь сможет поделиться им в социальных сетях.

С помощью устройства пользователь может изменять положение окна PIP (например, в контексте зафиксированного окна PIP). Например, пользователь может заинтересоваться информацией, отображаемой в нижней части экрана. С помощью устройства пользователь может перемещать зафиксированное окно PIP в другую часть экрана (например, для просмотра интересующей информации). В некоторых случаях устройство может быть выполнено с возможностью автоматического определения с переключением местоположения окна PIP, например, на основании текущего местоположения отслеживаемого объекта (например, если объект находится слишком близко к одному углу, устройство может перемещать окно PIP в другой угол), на основании информации из нижележащего видеосодержимого (например, если в нижнем правом углу отображается результат игры или информация об игроке) и т.д. В некоторых примерах пользователь может дополнительно использовать компонент дистанционного управления для активации функции изменения положения PIP. Устройство может перемещать окно PIP в новое местоположение, которое может быть указано пользователем. Новое местоположение может представлять собой другое фиксированное местоположение окна PIP (например, другой угол или край дисплея). Зафиксированное окно PIP может (например, в альтернативном или дополнительном варианте осуществления) быть преобразовано в «плавающее» окно PIP, положение которого может зависеть от (например, отцентрировано) соответствующего положения отслеживаемого объекта.

На фиг. 16A представлена схема, иллюстрирующая пример системы 100 связи, в которой могут быть реализованы один или более описанных вариантов осуществления. Система 100 связи может представлять собой систему множественного доступа, от которой множество пользователей беспроводной связи получают содержимое, такое как голосовая информация, данные, видео, обмен сообщениями, широковещание и т.п. Система 100 связи может быть выполнена с возможностью предоставления множеству пользователей беспроводной связи доступа к такому содержимому посредством совместного использования системных ресурсов, включая ширину полосы пропускания беспроводного соединения. Например, в системах 100 связи может быть использован один или более способов доступа к каналу, таких как множественный доступ с кодовым разделением каналов (CDMA), множественный доступ с временным разделением каналов (TDMA), множественный доступ с частотным разделением каналов (FDMA), множественный доступ с ортогональным частотным разделением каналов (OFDMA), FDMA с одной несущей (SC-FDMA), расширенное OFDM с безызбыточным расширенным дискретным преобразованием Фурье (DFT) с синхропакетом (ZT UW DTS-s OFDM), OFDM с синхропакетом (UW-OFDM), OFDM с фильтрацией ресурсного блока, блок фильтров со множеством несущих (FBMC) и т.п.

Как показано на фиг. 16A, система 100 связи может включать в себя модули 102a, 102b, 102c, 102d беспроводной передачи/приема (WTRU), RAN 104/113, CN 106/115, коммутируемую телефонную сеть 108 общего пользования (PSTN), сеть Интернет 110 и другие сети 112, хотя следует понимать, что описанные варианты осуществления предполагают возможность применения любого количества WTRU, базовых станций, сетей и/или элементов сети. Каждый из модулей WTRU 102a, 102b, 102c, 102d может представлять собой устройство любого типа, выполненное с возможностью функционирования и/или взаимодействия в среде беспроводной связи. Например, модули WTRU 102a, 102b, 102c, 102d, любой из которых может называться станцией и/или STA, могут быть выполнены с возможностью передачи и/или приема радиосигналов и могут включать в себя оборудование пользователя (UE), мобильную станцию, стационарный или мобильный абонентский модуль, абонентский модуль, пейджер, сотовый телефон, карманный персональный компьютер (PDA), смартфон, ноутбук, нетбук, персональный компьютер, беспроводной датчик, точку доступа или устройство Mi-Fi, устройство Интернета физических объектов (IoT), часы или другие носимые устройства, устанавливаемый на голове дисплей (HMD), транспортное средство, беспилотный летательный аппарат, медицинское устройство и приложения (например, применяемые в дистанционной хирургии), промышленное устройство и приложения (например, роботизированные и/или другие беспроводные устройства, работающие в условиях промышленной и/или автоматизированной технологической цепочки), электронное устройство для потребителей, устройство, работающее в коммерческой и/или промышленной беспроводной сети, и т.п. Любой из WTRU 102a, 102b, 102c и 102d можно взаимозаменяемо называть UE.

Системы 100 связи могут также включать в себя базовую станцию 114a и/или базовую станцию 114b. Каждая из базовых станций 114a, 114b может представлять собой устройство любого типа, выполненное с возможностью беспроводного взаимодействия с по меньшей мере одним из WTRU 102a, 102b, 102c, 102d для облегчения доступа к одной или более сетям связи, таким как CN 106/115, сеть Интернет 110 и/или другие сети 112. В качестве примера базовые станции 114a, 114b могут представлять собой базовые приемопередающие станции (BTS), станции Node-B, станции eNode B, станции Home Node B, станции Home eNode B, базовую станцию следующего поколения (gNB), NodeB на основе NR, контроллер пункта связи, точку доступа (AP), беспроводной маршрутизатор и т.п. Хотя базовые станции 114a, 114b показаны как отдельный элемент, следует понимать, что базовые станции 114a, 114b могут включать в себя любое количество взаимно соединенных базовых станций и/или элементов сети.

Базовая станция 114a может быть частью RAN 104/113, которая может также включать в себя другие базовые станции и/или элементы сети (не показаны), такие как контроллер базовой станции (BSC), контроллер радиосети (RNC), ретрансляционные узлы и т.п. Базовая станция 114a и/или базовая станция 114b могут быть выполнены с возможностью передачи и/или приема радиосигналов на одной или более частотах несущих, которые могут называться сотой (не показана). Эти частоты могут относиться к лицензированному спектру, нелицензированному спектру или к комбинации лицензированного и нелицензированного спектров. Сота может обеспечивать покрытие для беспроводного сервиса в конкретной географической зоне, которая может быть относительно фиксированной или которая может изменяться с течением времени. Сота может быть дополнительно разделена на секторы соты. Например, сота, связанная с базовой станцией 114a, может быть разделена на три сектора. Таким образом, в одном варианте осуществления базовая станция 114a может включать в себя три приемопередатчика, т.е. по одному для каждого сектора соты. В варианте осуществления базовая станция 114a может использовать технологию «множественного входа - множественного выхода» (MIMO) и может использовать множество приемопередатчиков для каждого сектора соты. Например, для передачи и/или приема сигналов в требуемых пространственных направлениях можно использовать формирование лучей.

Базовые станции 114a, 114b могут обмениваться данными с одним или более из WTRU 102a, 102b, 102c, 102d по радиоинтерфейсу 116, который может представлять собой любую подходящую систему беспроводной связи (например, для передачи сигналов в радиочастотном (РЧ), микроволновом спектре, спектре сантиметровых волн, спектре микрометровых волн, инфракрасном (ИК), ультрафиолетовом (УФ) спектре, спектре видимого света и т.п.). Радиоинтерфейс 116 может быть установлен с использованием любой подходящей технологии радиодоступа (RAT).

Более конкретно, как указано выше, система 100 связи может представлять собой систему множественного доступа и может использовать одну или более схем доступа к каналу, например CDMA, TDMA, FDMA, OFDMA, SC-FDMA и т.п. Например, базовая станция 114a в RAN 104/113 и модули WTRU 102a, 102b, 102c могут реализовывать технологию радиосвязи, такую как универсальный наземный доступ (UTRA) для универсальной системы мобильной связи (UMTS), которая может устанавливать радиоинтерфейс 115/116/117 с использованием широкополосного CDMA (WCDMA). Технология широкополосного множественного доступа с кодовым разделением (WCDMA) может включать в себя протоколы связи, такие как высокоскоростной пакетный доступ (HSPA) и/или усовершенствованный HSPA (HSPA+). HSPA может включать в себя высокоскоростной пакетный доступ по нисходящей (DL) линии связи (HSDPA) и/или высокоскоростной пакетный доступ по восходящей (UL) линии связи (HSUPA).

В варианте осуществления базовая станция 114a и модули WTRU 102a, 102b, 102c могут реализовывать такую технологию радиосвязи, как сеть наземного радиодоступа UMTS последующего поколения (E-UTRA), которая может устанавливать радиоинтерфейс 116 с использованием стандарта долгосрочного развития сетей связи (LTE), и/или LTE-Advanced (LTE-A), и/или LTE-Advanced Pro (LTE-A Pro).

В варианте осуществления базовая станция 114a и WTRU 102a, 102b, 102c могут реализовывать такую технологию радиосвязи, как новая технология радиодоступа (NR Radio Access), которая может устанавливать радиоинтерфейс 116 с использованием технологии New Radio (NR).

В варианте осуществления базовая станция 114a и модули WTRU 102a, 102b, 102c могут реализовывать множество технологий радиодоступа. Например, базовая станция 114a и модули WTRU 102a, 102b, 102c могут совместно реализовывать радиодоступ LTE и радиодоступ NR, например, с использованием принципов двусторонней связи (DC). Таким образом, радиоинтерфейс, используемый WTRU 102a, 102b, 102c, может характеризоваться применением множества типов технологий радиодоступа и/или передачами, отправляемыми на базовые станции / с базовых станций, относящихся к множеству типов (например, eNB и gNB).

В других вариантах осуществления базовая станция 114a и модули WTRU 102a, 102b, 102c могут реализовывать технологии радиосвязи, такие как IEEE 802.11 (т.е. Wireless Fidelity (WiFi)), IEEE 802.16 (т.е. глобальная совместимость для микроволнового доступа (WiMAX)), CDMA2000, CDMA2000 1X, CDMA2000 EV-DO, временный стандарт 2000 (IS-2000), временный стандарт 95 (IS-95), временный стандарт 856 (IS-856), глобальная система мобильной связи (GSM), развитие стандарта GSM с увеличенной скоростью передачи данных (EDGE), GSM EDGE (GERAN) и т.п.

Базовая станция 114b, показанная на фиг. 16A, может представлять собой, например, беспроводной маршрутизатор, станцию Home Node B, станцию Home eNode B или точку доступа, и в ней может быть использована любая подходящая RAT для облегчения обеспечения беспроводной связи в локализованной зоне, такой как коммерческое предприятие, жилое помещение, транспортное средство, учебное заведение, промышленный объект, воздушный коридор (например, для использования беспилотными летательными аппаратами), проезжая часть и т.п. В одном варианте осуществления базовая станция 114b и модули WTRU 102c, 102d могут реализовывать технологию радиосвязи, такую как IEEE 802.11, для создания беспроводной локальной сети (WLAN). В варианте осуществления базовая станция 114b и модули WTRU 102c, 102d могут реализовывать технологию радиосвязи, такую как IEEE 802.15, для создания беспроводной персональной сети (WPAN). В еще одном варианте осуществления базовая станция 114b и модули WTRU 102c, 102d могут использовать RAT на основе сот (например, WCDMA, CDMA2000, GSM, LTE, LTE-A, LTE-A Pro, NR и т.д.) для создания пикосоты или фемтосоты. Как показано на фиг. 16A, базовая станция 114b может иметь прямое соединение с сетью Интернет 110. Таким образом, для базовой станции 114b может не требоваться доступ к сети Интернет 110 посредством CN 106/115.

RAN 104/113 может обмениваться данными с CN 106/115, которая может представлять собой сеть любого типа, выполненную с возможностью предоставления услуг передачи голосовой информации, данных, приложений и/или голосовой связи по протоколу (VoIP) Интернета одному или более из модулей WTRU 102a, 102b, 102c, 102d. К данным могут быть предъявлены различные требования по качеству обслуживания (QoS), например различные требования по производительности, требования к задержке, требования к отказоустойчивости, требования к надежности, требования к скорости передачи данных, требования к мобильности и т.п. CN 106/115 может обеспечивать управление вызовами, услуги биллинга, услуги мобильной связи на основе местоположения, предварительно оплаченные вызовы, возможность связи с сетью Интернет, распределение видеосигналов и т.п. и/или реализовывать функции высокоуровневой защиты, такие как аутентификация пользователей. Хотя на фиг. 16A это не показано, следует понимать, что RAN 104/113 и/или CN 106/115 могут прямо или косвенно осуществлять связь с другими RAN, которые используют такую же RAT, что и RAN 104/113, или другую RAT. Например, в дополнение к соединению с RAN 104/113, которая может использовать технологию радиосвязи NR, CN 106/115 может также осуществлять связь с другой RAN (не показана), использующей технологию радиосвязи GSM, UMTS, CDMA 2000, WiMAX, E-UTRA или WiFi.

CN 106/115 может также выступать в качестве шлюза для модулей WTRU 102a, 102b, 102c, 102d для обеспечения доступа к сети PSTN 108, сети Интернет 110 и/или другим сетям 112. PSTN 108 может включать в себя телефонные сети с коммутацией каналов, которые предоставляют традиционные услуги телефонной связи (POTS). Интернет 110 может включать в себя глобальную систему взаимно соединенных компьютерных сетей и устройств, которые используют распространенные протоколы связи, такие как протокол управления передачей (TCP), протокол пользовательских дейтаграмм (UDP) и/или протокол Интернета (IP) в наборе протоколов Интернета TCP/IP. Сети 112 могут включать в себя проводные и/или беспроводные сети связи, которые принадлежат другим поставщикам услуг и/или предоставлены ими для использования. Например, сети 112 могут включать в себя другую CN, соединенную с одной или более RAN, которые могут использовать такую же RAT, как и RAN 104/113, или иную RAT.

Некоторые или все WTRU 102a, 102b, 102c, 102d в системе связи 100 могут включать в себя многорежимные возможности (например, WTRU 102a, 102b, 102c, 102d могут включать в себя множество приемопередатчиков для взаимодействия с различными беспроводными сетями по различным беспроводным линиям связи). Например, WTRU 102c, показанный на фиг. 16A, может быть выполнен с возможностью обмена данными с базовой станцией 114a, в которой может быть использована технология радиосвязи на основе сот, а также с базовой станцией 114b, в которой может быть использована технология радиосвязи IEEE 802.

На фиг. 16B представлена системная схема, иллюстрирующая пример WTRU 102. Как показано на фиг. 16B, WTRU 102 может включать в себя, помимо прочего, процессор 118, приемопередатчик 120, передающий/приемный элемент 122, динамик/микрофон 124, клавиатуру 126, дисплей / сенсорную панель 128, несъемное запоминающее устройство 130, съемное запоминающее устройство 132, источник 134 питания, набор 136 микросхем глобальной системы определения местоположения (GPS) и/или другие периферийные устройства 138. Следует понимать, что WTRU 102 может включать в себя любую подкомбинацию вышеперечисленных элементов и при этом все еще соответствовать варианту осуществления.

Процессор 118 может представлять собой процессор общего назначения, процессор специального назначения, традиционный процессор, цифровой сигнальный процессор (DSP), множество микропроцессоров, один или более микропроцессоров, связанных с ядром DSP, контроллер, микроконтроллер, специализированные интегральные схемы (ASIC), схемы программируемых пользователем вентильных матриц (FPGA), интегральную микросхему (IC) любого другого типа, конечный автомат и т.п. Процессор 118 может выполнять кодирование сигналов, обработку данных, управление питанием, обработку ввода/вывода и/или любые другие функциональные возможности, с помощью которых модуль WTRU 102 работает в среде беспроводной связи. Процессор 118 может быть соединен с приемопередатчиком 120, который может быть сопряжен с передающим/приемным элементом 122. Хотя на фиг. 16B процессор 118 и приемопередатчик 120 показаны в виде отдельных компонентов, следует понимать, что процессор 118 и приемопередатчик 120 могут быть совместно встроены в электронный блок или микросхему.

Передающий/приемный элемент 122 может быть выполнен с возможностью передачи сигналов на базовую станцию (например, базовой станции 114a) по радиоинтерфейсу 116 или приема сигналов от нее. Например, в одном варианте осуществления передающий/приемный элемент 122 может представлять собой антенну, выполненную с возможностью передачи и/или приема РЧ-сигналов. В варианте осуществления передающий/приемный элемент 122 может представлять собой излучатель/детектор, выполненный с возможностью передачи и/или приема, например, сигналов в ИК-спектре, УФ-спектре или спектре видимого света. В еще одном варианте осуществления передающий/приемный элемент 122 может быть выполнен с возможностью передачи и/или приема сигналов как в РЧ-спектре, так и в спектре видимого света. Следует понимать, что передающий/приемный элемент 122 может быть выполнен с возможностью передачи и/или приема любой комбинации радиосигналов.