ВКЛЮЧЕНИЕ ПОСРЕДСТВОМ ССЫЛКИ

[0001] Настоящее изобретение испрашивает приоритет патентной заявки США №17/010,403, «Method and Apparatus for Cross-Component Filtering», поданной 2 сентября 2020 г., которая испрашивает приоритет предварительной заявки США №62/901,118, «Of Cross-Component Adaptive Loop Filter», поданной 16 сентября 2019 г. Содержание предыдущих заявок, таким образом, включено посредством ссылки в полном объеме.

ОБЛАСТЬ ТЕХНИКИ, К КОТОРОЙ ОТНОСИТСЯ ИЗОБРЕТЕНИЕ

[0002] В настоящей заявке описаны варианты осуществления, в целом относящиеся к видеокодированию.

УРОВЕНЬ ТЕХНИКИ

[0003] Описание уровня техники приведено здесь с целью представления в целом контекста изобретения. Работа авторов изобретения, в той мере, в какой она описана в этом разделе, а также аспекты описания, которые не могут квалифицироваться как уровень техники на момент подачи заявки, ни прямо, ни косвенно не признаются уровнем техники, лежащим в основе настоящего изобретения.

[0004] Кодирование и декодирование видеосигнала может осуществляться с использованием предсказания между изображениями с компенсацией движения. Цифровое видео без сжатия может включать в себя последовательность изображений, каждое из которых имеет пространственный размер, например, 1920×1080 отсчетов яркости и связанных с ними отсчетов цветности. Последовательность изображений может иметь фиксированную или переменную частоту смены изображений (неформально также называемую «частотой кадров»), например, 60 изображений в секунду, или 60 Гц. Видео без сжатия предъявляет значительные требования к битовой скорости. Например, видео 1080р60 4:2:0 с 8 битами на отсчет (разрешение отсчетов яркости 1920x1080 при частоте кадров 60 Гц) требует полосы около 1,5 Гбит/с. Час такого видео требует объема памяти более 600 ГБ.

[0005] Одной целью кодирования и декодирования видеосигнала может быть снижение избыточности во входном видеосигнале путем сжатия. Сжатие может способствовать смягчению вышеупомянутых требований к полосе или объему памяти, в ряде случаев на два порядка величины или более. Можно использовать как сжатие без потерь, так и сжатие с потерями, а также их комбинацию. Сжатие без потерь относится к методам реконструкции точной копии исходного сигнала из сжатого исходного сигнала. При использовании сжатия с потерями реконструированный сигнал может быть не идентичен исходному сигналу, но расхождение между исходным и реконструированным сигналами достаточно мало, так чтобы реконструированный сигнал можно было использовать для намеченного применения. Сжатие с потерями широко применяется для видео. Допустимая степень искажения зависит от применения; например, пользователи некоторых заказных потоковых приложений могут мириться с более высокими искажениями, чем пользователи телевещательных приложений. Достижимая степень сжатия может отражать, что более высокое разрешенное/допустимое искажение может давать более высокую степень сжатия.

[0006] Кодер и декодер видеосигнала может использовать методы из нескольких широких категорий, включающих в себя, например, компенсацию движения, преобразование, квантование и энтропийное кодирование.

[0007] Технологии видеокодека могут включать в себя методы, известные как внутреннее кодирование. При внутреннем (интра-) кодировании значения отсчетов представляются без ссылки на отсчеты или другие данные из ранее реконструированных опорных изображений. В некоторых видеокодеках изображение пространственно разделяется на блоки отсчетов. Когда все блоки отсчетов кодируются в интра-режиме, изображение называется интра-изображением. Интра-изображения и их производные, например, изображения, полученные в режиме независимого обновления декодера, могут использоваться для сброса состояния декодера, что позволяет использовать их как первое изображение в битовом потоке кодированного видео и видеосеансе, или как неподвижное изображение. Отсчеты интра-блока могут подвергаться преобразованию, и коэффициенты преобразования могут квантоваться до энтропийного кодирования. Внутреннее предсказание может быть методом минимизации значений отсчетов в области предварительного преобразования. В ряде случаев, чем меньше значение DC (постоянной составляющей) после преобразования, и чем меньше коэффициенты АС (переменных составляющих), тем меньше битов требуется при данном размере шага квантования для представления блока после энтропийного кодирования.

[0008] Традиционное внутреннее кодирование, известное, например, из технологий кодирования поколения MPEG-2, не использует внутреннего предсказания. Однако некоторые более современные технологии сжатия видео включают в себя методы, которые пытаются, например, из данных окружающих отсчетов и/или метаданных, полученных в ходе кодирования/декодирования пространственно соседних и предшествующих в порядке декодирования, блоков данных. Такие методы далее именуются методами «внутреннего предсказания». Заметим, что по меньшей мере в некоторых случаях внутреннее предсказание осуществляется только с использованием опорных данных из текущего изображения, подлежащего реконструкции, но не из опорных изображений.

[0009] Может использоваться много разных форм внутреннего предсказания. Когда в данной технологии видеокодирования может использоваться более одного из таких методов, используемый метод может кодироваться в режиме внутреннего предсказания. В некоторых случаях, режимы могут иметь подрежимы и/или параметры, которые могут кодироваться по отдельности или включаться в кодовое слово режима. Использование того или иного кодового слова для данной комбинации режимов/подрежимов/параметров может оказывать влияние на выигрыш в эффективности кодирования посредством внутреннего предсказания и, следовательно, на технологию энтропийного кодирования, используемую для перевода кодовых слов в битовый поток.

[0010] Определенный режим внутреннего предсказания впервые был задан в Н.264, уточнен в Н.265, и дополнительно уточнен в более современных технологиях кодирования, например, модели совместного исследования (JEM, Joint Exploration Model), универсального видеокодирования (VVC, Versatile Video Coding) и наборе эталонов (BMS, Benchmark Set). Блок предсказателя может формироваться с использованием значений соседних отсчетов, принадлежащих уже доступным отсчетам. Значения соседних отсчетов копируются в блок предсказателя согласно направлению. Ссылка на используемое направление может кодироваться в битовом потоке или может сама предсказываться.

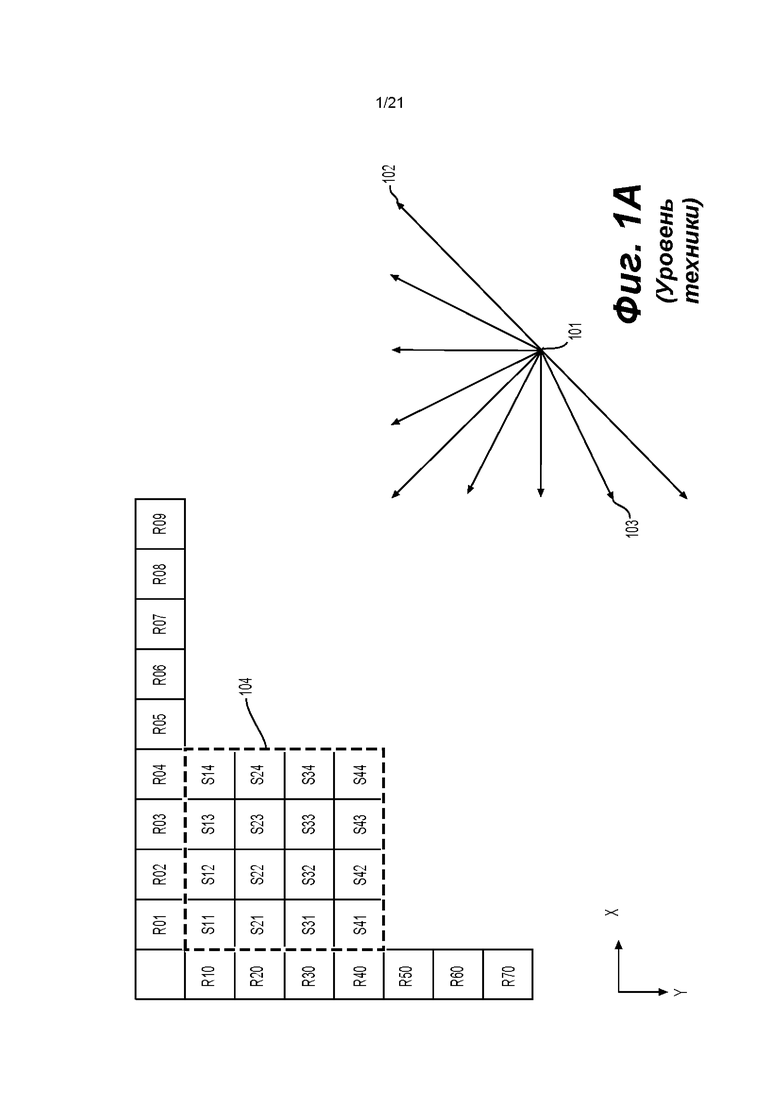

[0011] В нижнем правом углу фиг. 1А изображено подмножество из девяти направлений предсказателя множества, известного из 33 возможных направлений предсказателя Н.265 (соответствующих 33 угловым режимам из 35 интра-режимов). Точка (101), где сходятся стрелки, представляет предсказываемый отсчет. Стрелки представляют направление, из которого предсказывается отсчет. Например, стрелка (102) указывает, что отсчет (101) предсказывается из отсчета или отсчетов, расположенного(ых) вверху справа, под углом 45 градусов к горизонтали. Аналогично, стрелка (103) указывает, что отсчет (101) предсказывается из отсчета или отсчетов расположенного(ых) внизу слева от отсчета (101), под углом 22,5 градусов к горизонтали.

[0012] В верхнем левом углу фиг. 1А в верхнем левом углу изображен квадратный блок (104) 4×4 отсчетов (указанный жирной пунктирной линией). Квадратный блок (104) включает в себя 16 отсчетов, каждый из которых обозначен буквой «S», позицией по оси Y (например, индексом строки) и позицией по оси X (например, индексом столбца). Например, отсчет S21 является вторым отсчетом по оси Y (сверху) и первым (слева) отсчетом по оси X. Аналогично, отсчет S44 является четвертым отсчетом в блоке (104) по обеим осям Y и X. Поскольку блок имеет размер 4×4 отсчета, S44 располагается внизу справа. Дополнительно показаны опорные отсчеты, которые следуют аналогичной схеме нумерации. Опорный отсчет обозначается буквой R, своей Y-позицией (например, индексом строки) и Х-позицией (индексом столбца) относительно блока (104). В обоих Н.264 и Н.265 предсказанные отсчеты соседствуют с блоком, подлежащим реконструкции; поэтому нет необходимости использовать отрицательные значения.

[0013] Предсказание внутри изображения может работать путем копирования опорных значений отсчетов из соседних отсчетов, указанных сигнализируемым направлением предсказания. Например, предположим, что битовый поток кодированного видео включает в себя сигнализацию, которая, для этого блока, указывает направление предсказания, обозначенное стрелкой (102) то есть отсчеты предсказываются из предсказанного(ых) отсчета или отсчетов, расположенного(ых) вверху справа, под углом 45 градусов к горизонтали. В этом случае отсчеты S41, S32, S23 и S14 предсказываются из одного и того же опорного отсчета R05. Затем отсчет S44 предсказывается из опорного отсчета R08.

[0014] В некоторых случаях значения множества опорных отсчетов можно комбинировать, например посредством интерполяция, для вычисления опорного отсчета; в особенности, когда направления не кратны 45 градусам.

[0015] Количество возможных направлений увеличивается по мере развития технологий видеокодирования. В Н.264 (2003 год) можно было представлять девять разных направлений. В Н.265 это количество увеличилось до 33 (2013 год), и JEM/VVC/BMS, во время составления данного описания, может поддерживать до 65 направлений. Были проведены эксперименты для выявления наиболее вероятных направлений, и некоторые методы энтропийного кодирования используются для представления этих вероятных направлений малым количеством битов, ценой утраты некоторых менее вероятных направлений. Дополнительно, сами направления иногда можно предсказывать из соседних направлений, используемых в соседних, уже декодированных, блоках.

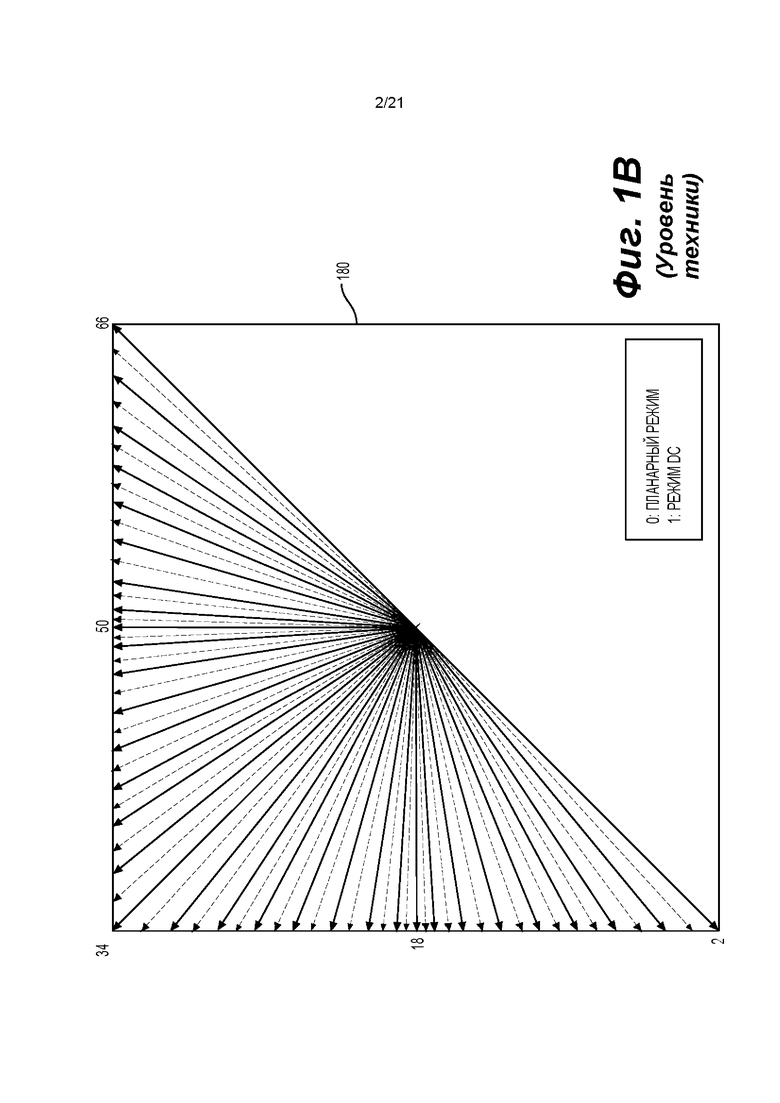

[0016] На фиг. 1 В показана диаграмма (180), где изображено 65 направлений внутреннего предсказания согласно JEM для иллюстрации увеличения количества направлений предсказания с течением времени.

[0017] Картирование битов направлений внутреннего предсказания в битовом потоке кодированного видео, которые представляют направление, может отличаться от одной технологии видеокодирования к другой технологии видеокодирования; и может охватывать, например, от простого прямого отображения направления предсказания до режима внутреннего предсказания, кодовых слов, сложных адаптивных схем, задействующих наиболее вероятные режимы, и аналогичных методов. Однако во всех случаях могут существовать некоторые направления, возникновение которых в видеоконтенте статистически менее вероятно, чем для некоторых других направлений. Поскольку целью сжатия видео является снижение избыточности, эти менее вероятные направления, в хорошо работающей технологии видеокодирования, будут представляться большим количеством битов, чем более вероятные направления.

[0018] Компенсация движения может представлять собой технологию сжатия с ошибками и может относиться к технологиям, в которых блок данных отсчетов из предварительно реконструированного изображения или его части (опорное изображение) после пространственного сдвига в направлении, указанном вектором движения (далее - MV (motion vector)) используется для предсказания вновь реконструируемого изображения или его части. В некоторых случаях опорное изображение может совпадать с текущим изображением, подлежащим реконструкции. Вектора MV имеют два измерения, X и Y, или три измерения, при этом третье измерение является индикацией используемого опорного изображения (последнее, косвенно может являться временным измерением).

[0019] В некоторых технологиях сжатия видео MV, применяемый к определенной области данных отсчетов может предсказываться на основе других MV, например, связанных с другой областью данных отсчетов, пространственно смежной с реконструируемой областью и предшествующим MV в порядке декодирования. Эти действия могут по существу уменьшить объем данных, требующихся для кодирования MV, в результате чего устраняется избыточность и увеличивается степень сжатия. Предсказание М V может эффективно работать, например, поскольку при кодировании входного видеосигнала, поступающего из камеры (известного как «естественный видеосигнал»), существует статистическая вероятность, что области больше области, к которой применяется отдельный MV, перемещаются в аналогичном направлении и, таким образом, могут в некоторых случаях предсказываться с использованием аналогичного вектора движения, полученного из векторов MV соседней области. Это приводит к тому, что MV, найденный для заданной области, должен быть аналогичным или совпадающим с MV, предсказанным на основе окружающих векторов MV, и, в свою очередь, может быть представлен после энтропийного кодирования меньшим количеством битов, чем было бы возможно при использовании непосредственного кодирования MV. В некоторых случаях предсказание MV может быть примером безошибочного сжатия сигнала (а именно: векторов MV), полученного из исходного сигнала (а именно: потока отсчетов). В других случаях само предсказание MV может выполняться с ошибками, например, из-за ошибок округления при вычислении предсказателя на основе нескольких окружающих векторов MV.

[0020] Различные механизмы предсказания MV описываются в H.265/HEVC (рекомендация ITU-T Н.265, «High Efficiency Video Coding» (Высокоэффективное кодирование видео, декабрь 2016 г)). Из множества механизмов предсказания MV, предлагаемых в рекомендации Н.265, здесь описывается технология, называемая «пространственное объединение» (spatial merge).

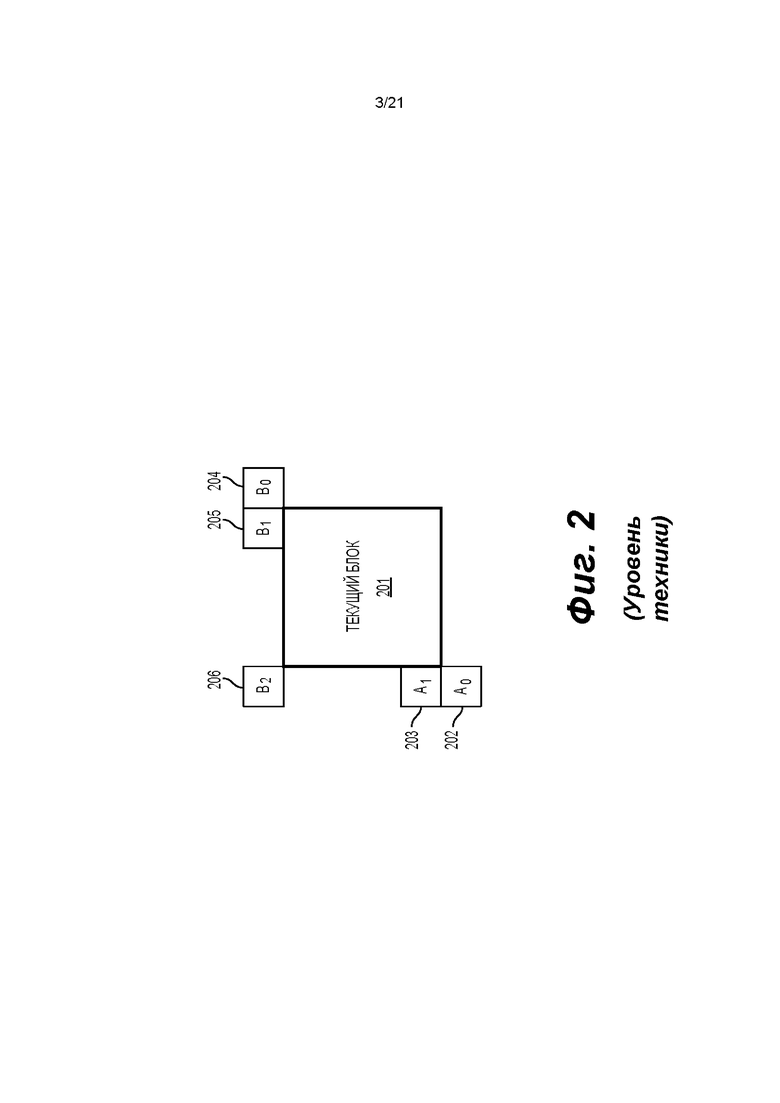

[0021] На фиг. 2 показано, что текущий блок (201) содержит отсчеты, найденные кодером в процессе поиска движения, предсказываемые на основе предшествующего блока такого же размера, который был пространственно смещен. Вместо непосредственного кодирования MV может быть получен на основе метаданных, связанных с одним или более опорными изображениями, например, из нового (в порядке декодирования) опорного изображения, с использованием MV, связанного с любым из пяти окружающих отсчетов, обозначенных как А0, А1 и В0, В1, В2 (202-206, соответственно). В Н.265 для предсказания MV могут использоваться предсказатели из того же опорного изображения, которое используется соседним блоком.

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

[0022] Аспекты изобретения предусматривают способы и устройства для кодирования/декодирования видео. В некоторых примерах устройство для видеодекодирования включает в себя схему обработки. Схема обработки может декодировать кодированную информацию блока кодирования (СВ, coding block) цветности из битового потока кодированного видео. Кодированная информация может указывать на то, что кросс-компонентный фильтр применяется к СВ цветности. Кодированная информация также может указывать формат субдискретизации цветности и тип отсчетов цветности, который указывает относительное положение отсчета цветности относительно по меньшей мере одного отсчета яркости в соответствующем СВ яркости. Схема обработки может определить маску кросс-компонентного фильтра на основе по меньшей мере одного из формата субдискретизации цветности и типа отсчетов цветности. Схема обработки может генерировать первый промежуточный СВ посредством применения контурного фильтра к СВ цветности. Схема обработки может генерировать второй промежуточный СВ посредством применения кросс-компонентного фильтра с определенной маской к соответствующему СВ яркости. Схема обработки может определить отфильтрованный СВ цветности на основе первого промежуточного СВ и второго промежуточного СВ.

[0023] Например, тип отсчетов цветности передается в битовом потоке кодированного видео.

[0024] Например, количество коэффициентов кросс-компонентного фильтра передается в битовом потоке кодированного видео. Схема обработки может определить маску кросс-компонентного фильтра на основе количества коэффициентов фильтра и по меньшей мере одного из формата субдискретизации цветности и типа отсчетов цветности.

[0025] Например, используется формат субдискретизации цветности 4:2:0. По меньшей мере один отсчет яркости включает в себя четыре отсчета яркости - верхний-левый отсчет, верхний-правый отсчет, нижний-левый отсчет и нижний-правый отсчет. Тип отсчетов цветности представляет собой один из шести типов отсчетов цветности 0-5, указывающих шесть относительных позиций 0-5, соответственно; при этом шесть относительных позиций 0-5 отсчета цветности соответствуют левой-центральной позиции между верхним-левым и нижним-левым отсчетами, центральной позиции из четырех отсчетов яркости, верхней левой позиции, совмещенной с верхним-левым отсчетом, верхней-центральной позиции между верхним-левым и верхним-правым отсчетами, нижней левой позиции, совмещенной с нижним-левым отсчетом, и нижней-центральной позиции между нижним-левым и нижним-правым отсчетами, соответственно. Схема обработки может определить маску кросс-компонентного фильтра на основе типа отсчетов цветности. Например, битовый поток кодированного видео включает в себя флаг кросс-компонентной линейной модели (CCLM, cross-component linear model), указывающий, что тип отсчетов цветности равен 0 или 2.

[0026] Например, кросс-компонентный фильтр является кросс-компонентным адаптивным контурным фильтром (CC-ALF, Cross-Component Adaptive Loop Filter), a контурный фильтр является адаптивным контурным фильтром (ALF, Adaptive Loop Filter).

[0027] Согласно варианту осуществления диапазон коэффициентов кросс-компонентного фильтра меньше или равен К битам, где К - это положительное целое число. Например, коэффициенты кросс-компонентного фильтра кодируются с использованием кодирования с фиксированной длиной кодов. Например, схема обработки может смещать значения отсчетов яркости соответствующего СВ яркости, чтобы получить динамический диапазон 8 битов на основе динамического диапазона значений отсчетов яркости более 8 битов, где К равно 8 битам. Схема обработки может применять кросс-компонентный фильтр с определенной маской к смещенным значениям отсчетов яркости.

[0028] В некоторых примерах устройство для видеодекодирования включает в себя схему обработки. Схема обработки может декодировать кодированную информацию СВ цветности из битового потока кодированного видео. Кодированная информация может указывать на то, что кросс-компонентный фильтр применяется к СВ цветности на основе соответствующего СВ яркости. Схема обработки может генерировать субдискретизированный СВ яркости посредством применения фильтра понижающей дискретизации к соответствующему СВ яркости, при этом коэффициент горизонтальной субдискретизации цветности и коэффициент вертикальной субдискретизации цветности между СВ цветности и субдискретизированным СВ яркости равны единице. Схема обработки может генерировать первый промежуточный СВ посредством применения контурного фильтра к СВ цветности. Схема обработки может генерировать второй промежуточный СВ посредством применения кросс-компонентного фильтра к субдискретизированному СВ яркости, где маска кросс-компонентного фильтра не зависит от формата субдискретизации цветности и типа отсчетов цветности СВ цветности. Тип отсчетов цветности может указывать относительное положение отсчета цветности относительно по меньшей мере одного отсчета яркости в соответствующем СВ яркости. Схема обработки может определить отфильтрованный СВ цветности на основе первого промежуточного СВ и второго промежуточного СВ. Например, фильтр понижающей дискретизации соответствует фильтру, применяемому к совмещенным отсчетам яркости в режиме CCLM. Например, используется фильтр понижающей дискретизации {1,2,1;1,2,1}/8 и формат субдискретизации цветности 4:2:0. Например, кросс-компонентный фильтр имеет одну из следующих масок - ромбовидную маску 7×7, квадратную маску 7×7, ромбовидную маску 5×5, квадратную маску 5×5, ромбовидную маску 3×3 и квадратную маску 3×3.

[0029] Аспекты изобретения также предусматривают компьютерно-считываемый носитель, где хранятся инструкции, которые, при выполнении компьютером для видеодекодирования, предписывают компьютеру осуществлять описанный способ видеодекодирования.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

[0030] Дополнительные особенности, характер и различные преимущества раскрытого изобретения будут понятны из нижеследующего подробного описания и прилагаемых чертежей, на которых:

[0031] фиг. 1А - схематическое представление подмножества режимов внутреннего предсказания;

[0032] фиг. 1В - представление направлений внутреннего предсказания;

[0033] фиг. 2 - схематическое представление текущего блока и окружающих его кандидатов на пространственное объединение в одном примере;

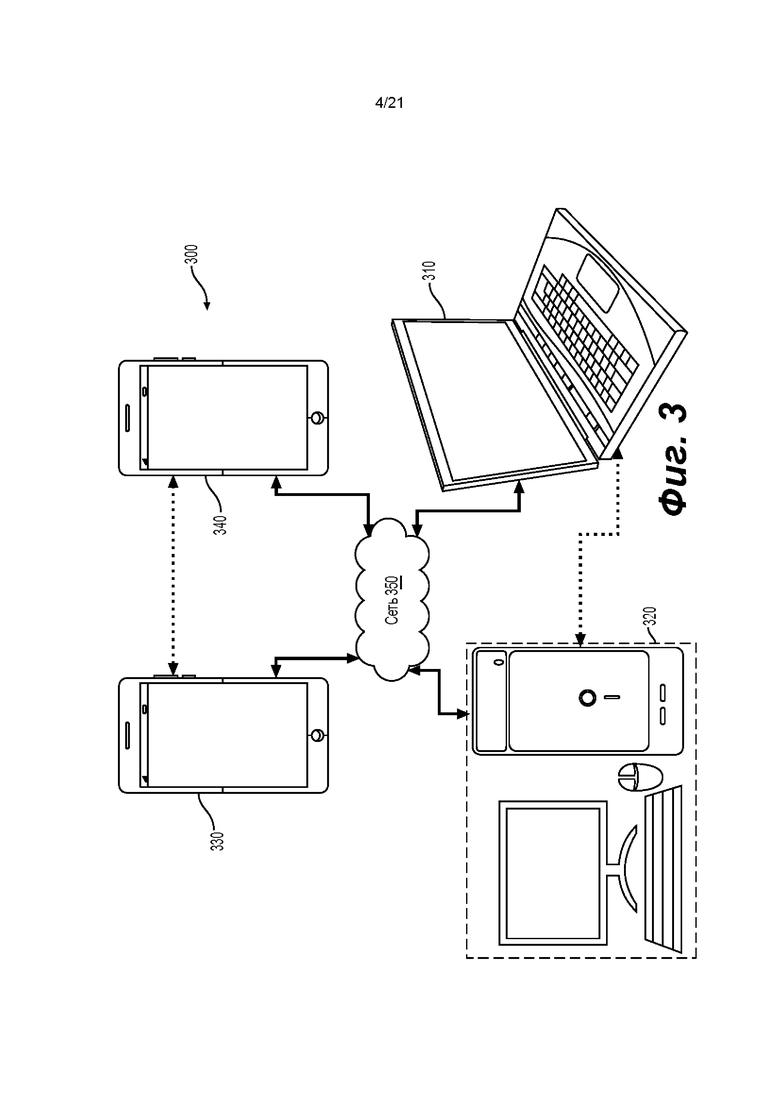

[0034] фиг. 3 - упрощенная блок-схема системы (300) связи согласно варианту осуществления настоящего изобретения;

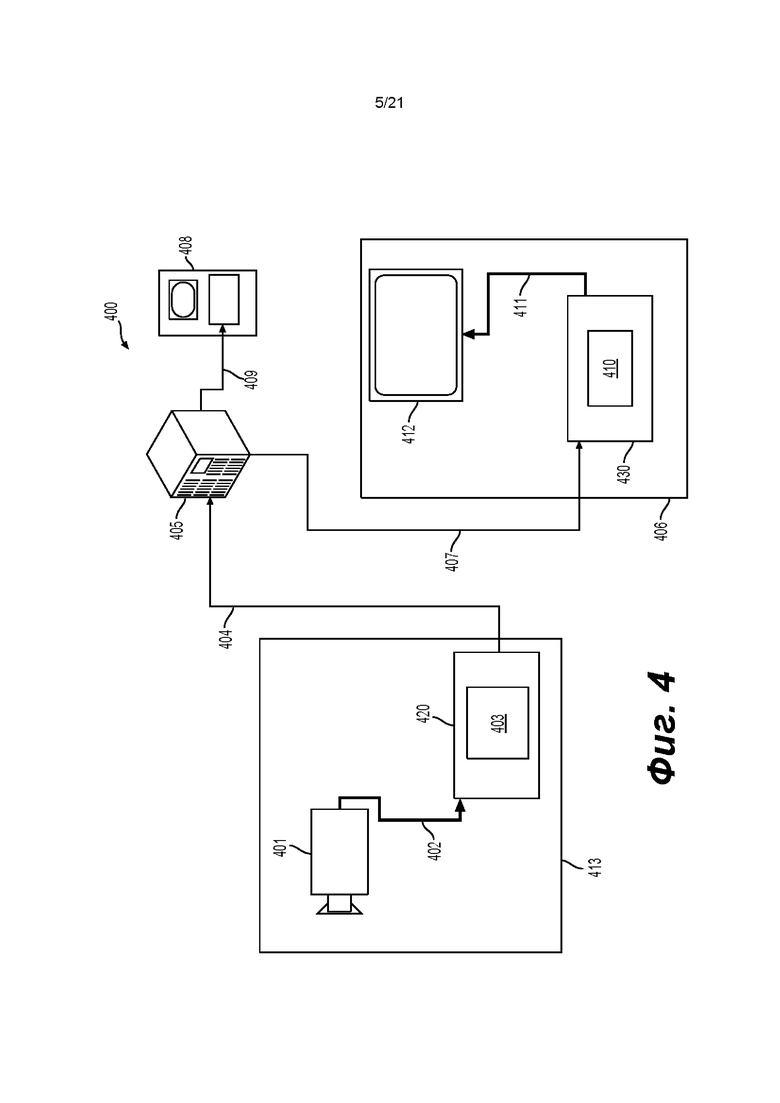

[0035] фиг. 4 - упрощенная блок-схема системы (400) связи согласно варианту осуществления настоящего изобретения;

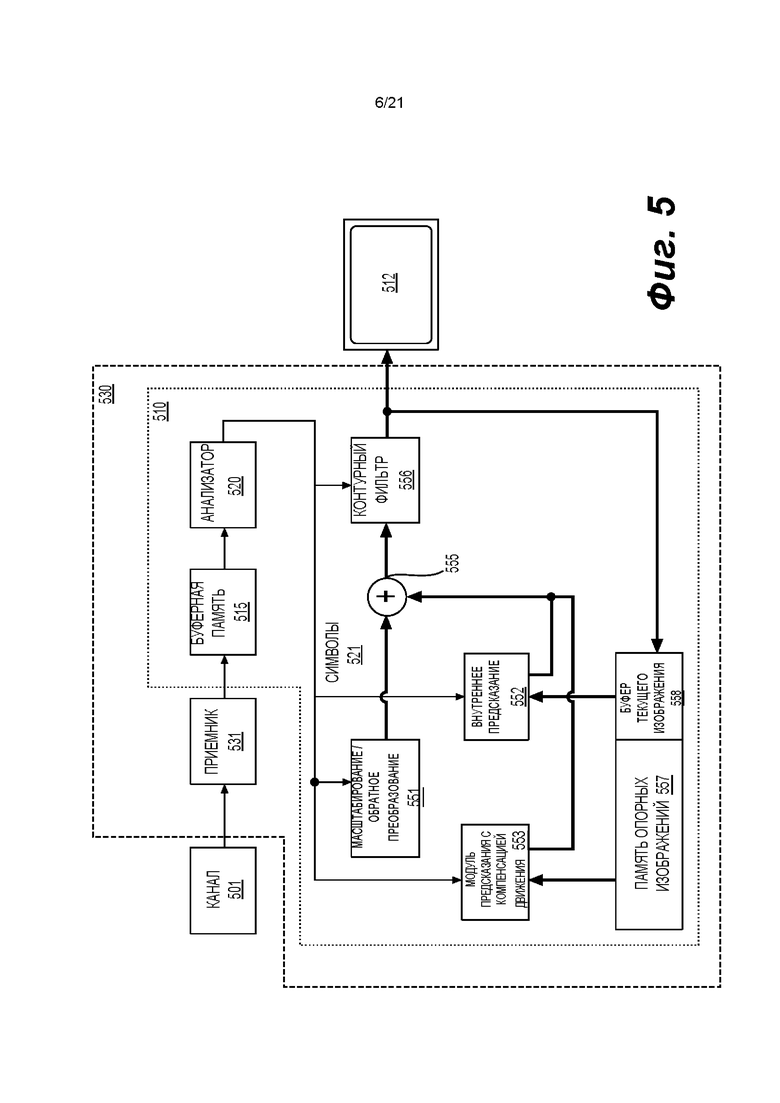

[0036] фиг. 5 - упрощенная блок-схема декодера согласно варианту осуществления настоящего изобретения;

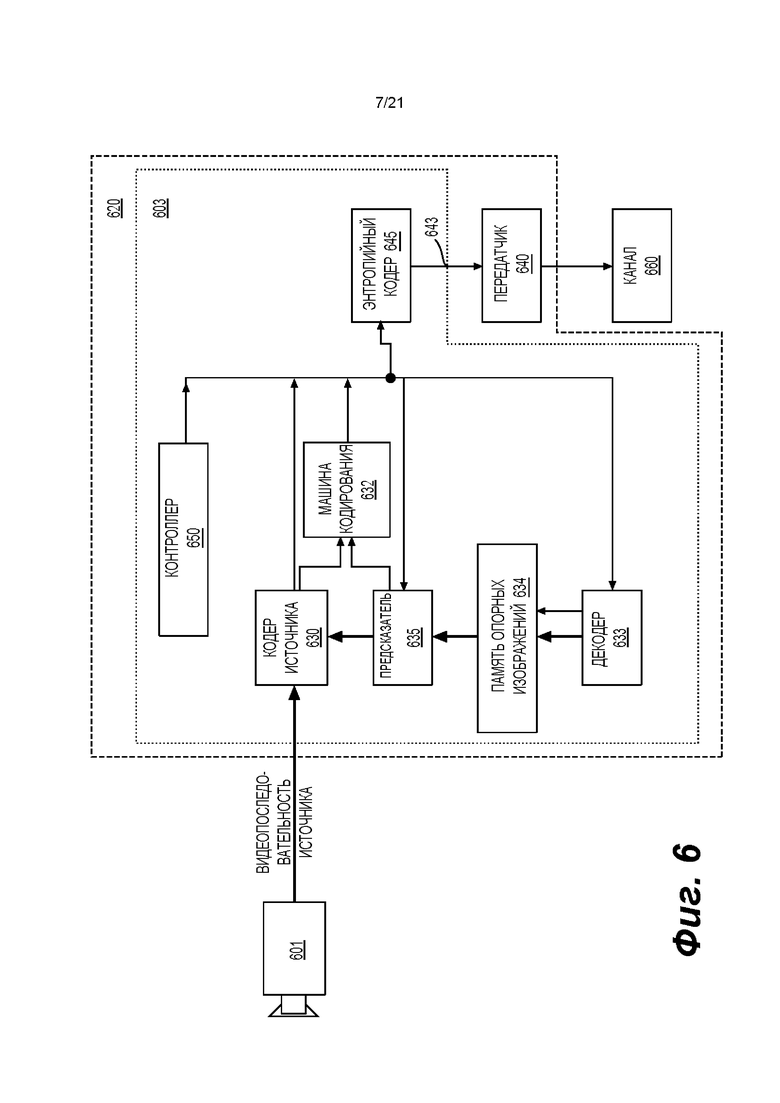

[0037] фиг. 6 - упрощенная блок-схема кодера согласно варианту осуществления настоящего изобретения;

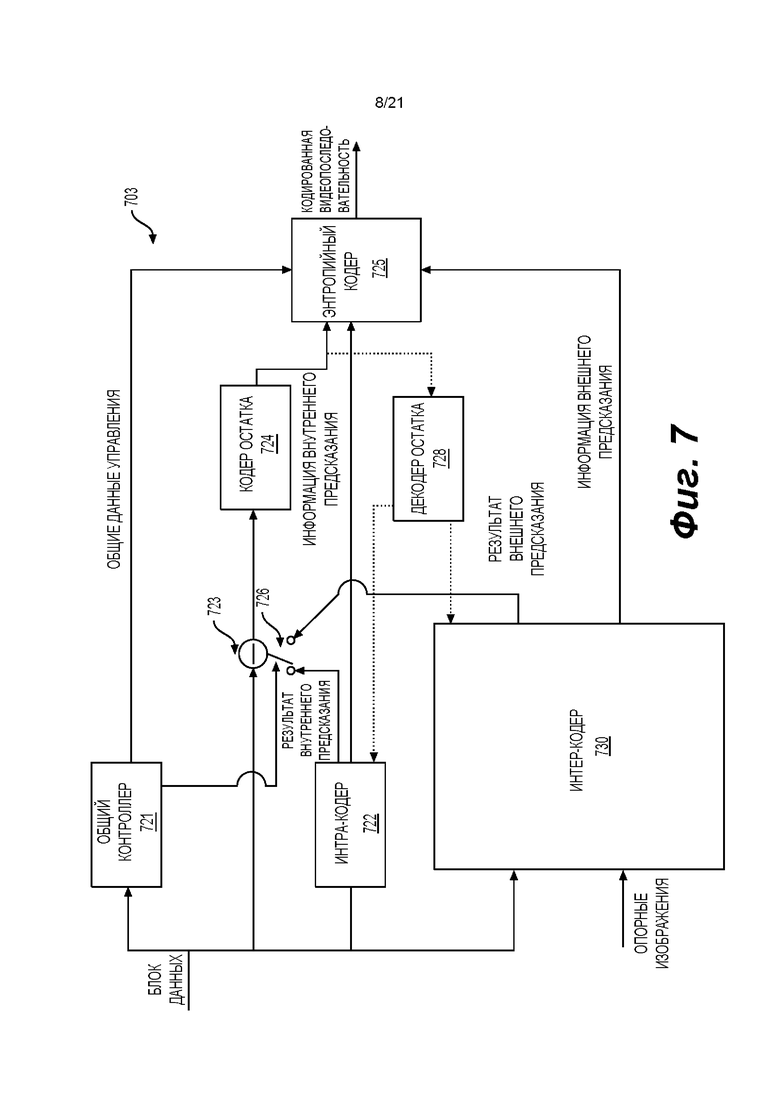

[0038] фиг. 7 - блок-схема кодера согласно другому варианту осуществления настоящего изобретения;

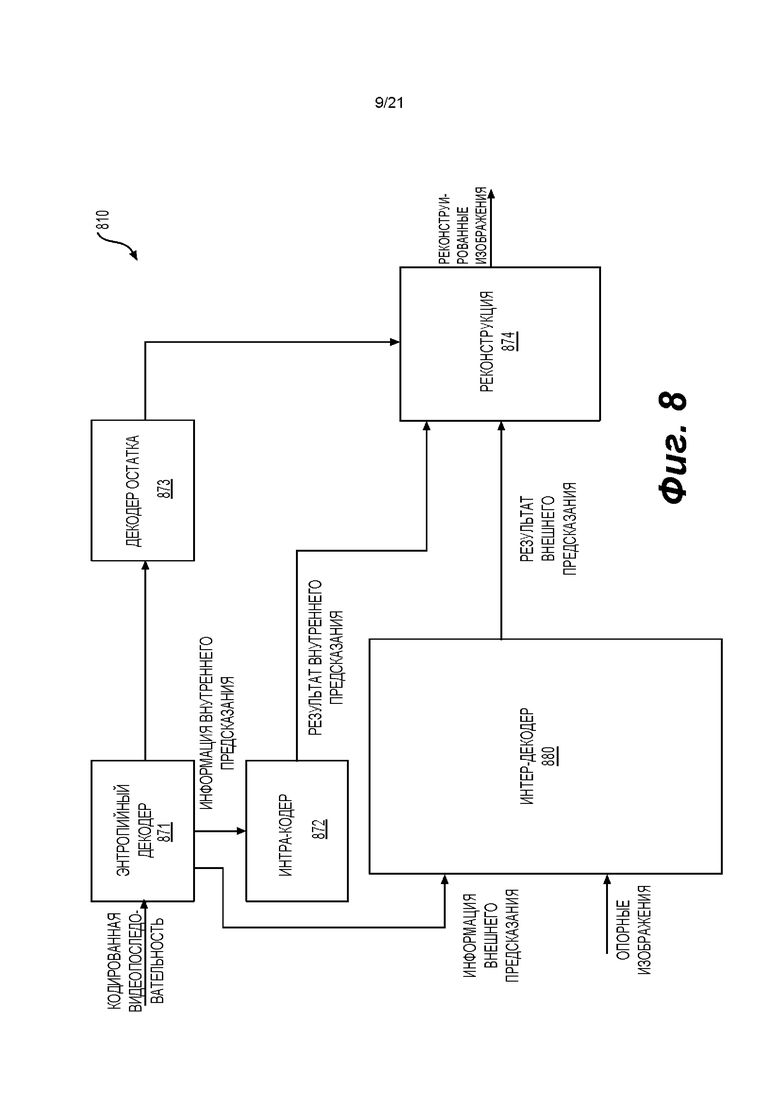

[0039] фиг. 8 - блок-схема декодера согласно другому варианту осуществления настоящего изобретения;

[0040] фиг. 9 - примеры масок фильтров согласно вариантам осуществления настоящего изобретения;

[0041] фиг. 10A-10D - примеры позиций с субдискретизацией, используемых для вычисления градиентов согласно вариантам осуществления настоящего изобретения;

[0042] фиг. 11А-11В - примеры процесса фильтрации по виртуальным границам согласно вариантам осуществления настоящего изобретения;

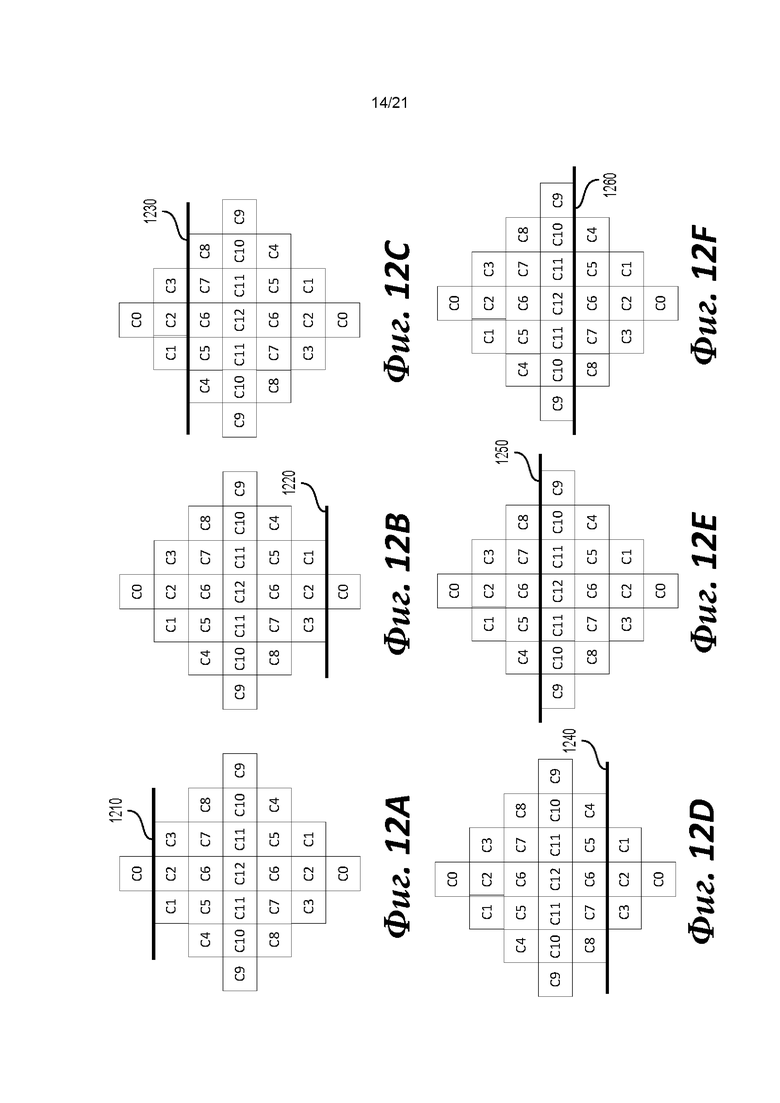

[0043] фиг. 12A-12F - примеры операций симметричного заполнения на виртуальных границах согласно вариантам осуществления настоящего изобретения;

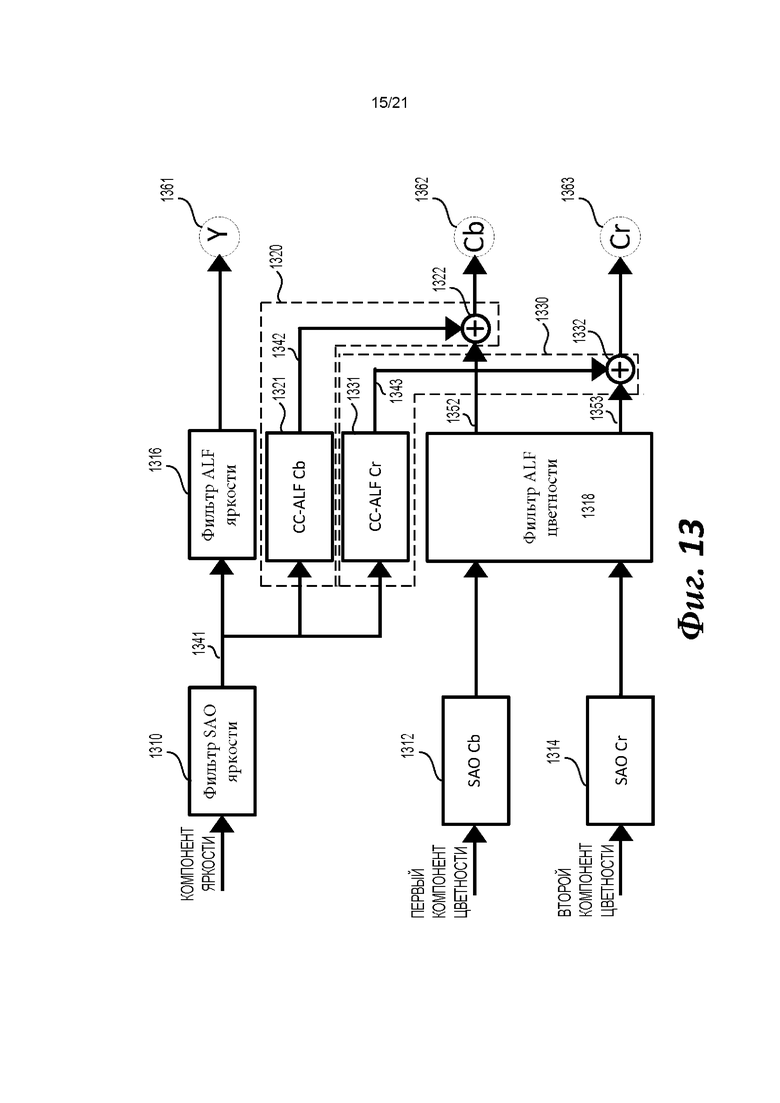

[0044] фиг. 13 - пример функциональной схемы для генерации компонентов яркости и цветности согласно варианту осуществления настоящего изобретения;

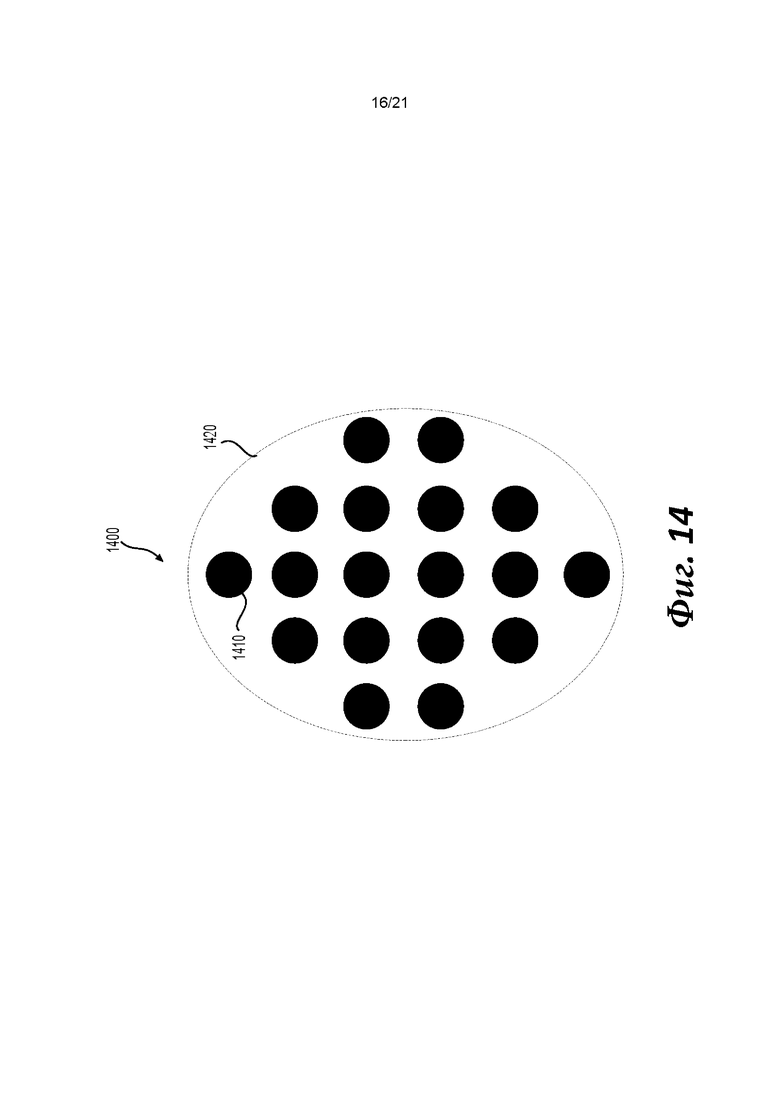

[0045] фиг. 14 - пример фильтра 1400 согласно варианту осуществления настоящего изобретения;

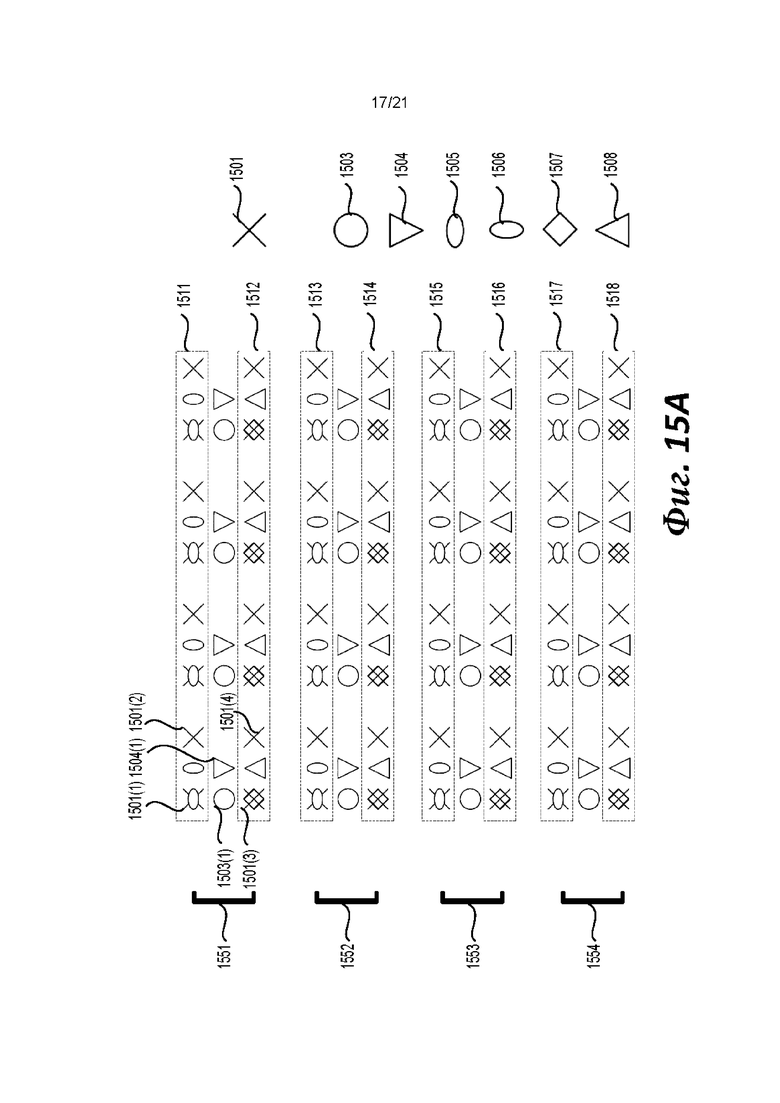

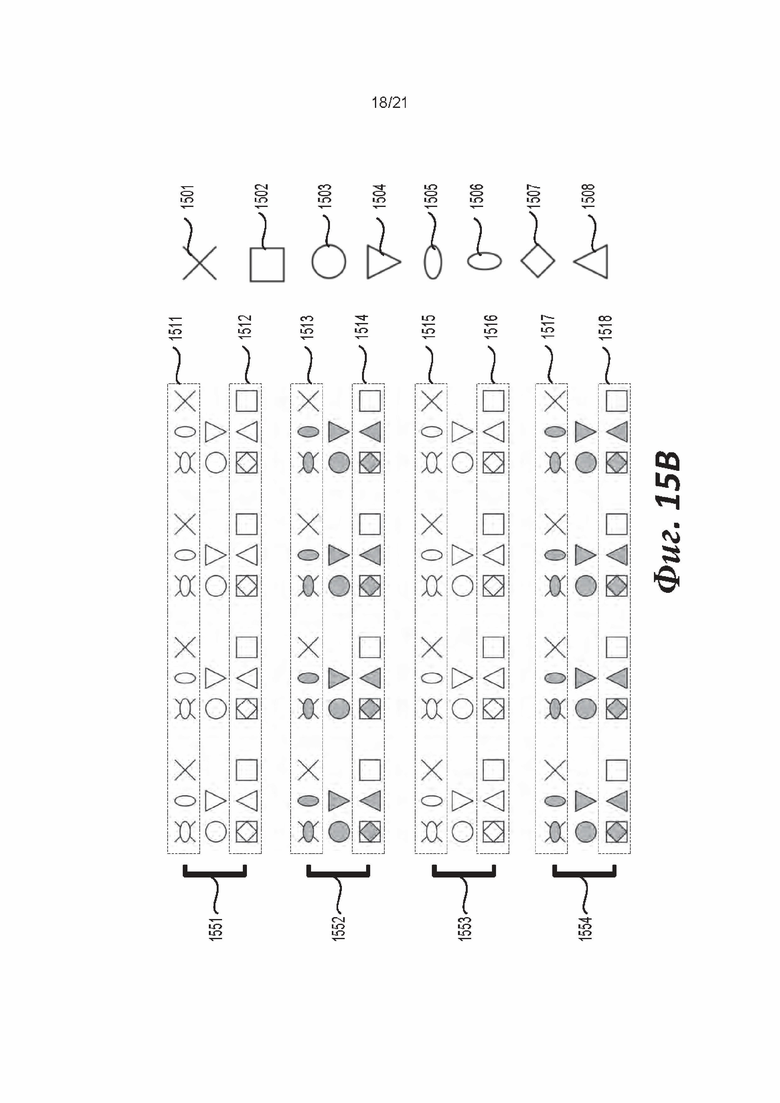

[0046] фиг. 15А-15В - пример расположения отсчетов цветности относительно отсчетов яркости согласно вариантам осуществления настоящего изобретения;

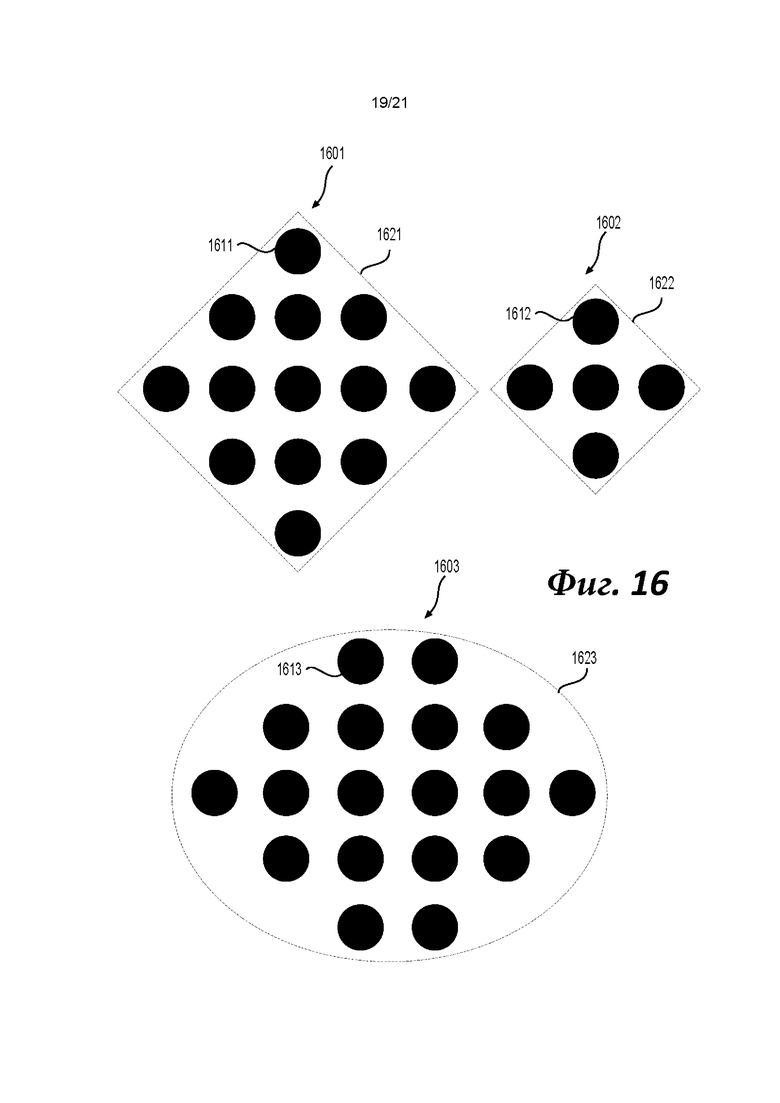

[0047] фиг. 16 - примеры масок (1601)-(1603) соответствующих кросс-компонентных адаптивных контурных фильтров (CC-ALF) согласно вариантам осуществления настоящего изобретения;

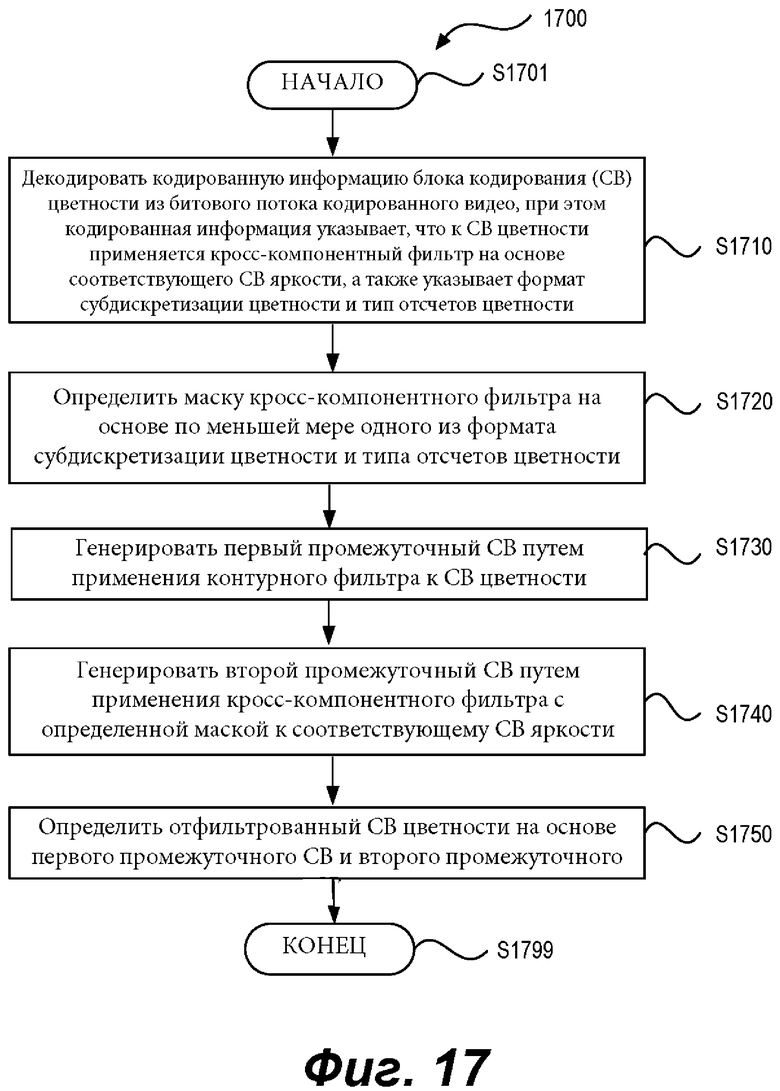

[0048] фиг. 17 - блок-схема операций процесса (1700) согласно варианту осуществления настоящего изобретения;

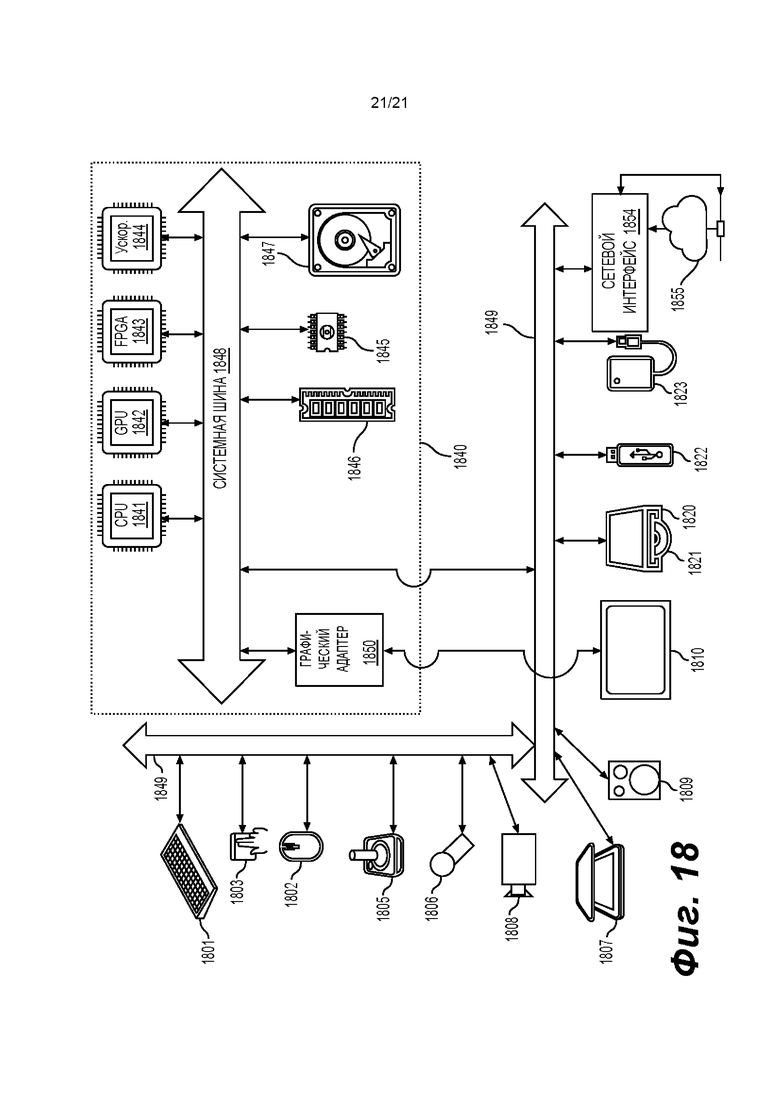

[0049] фиг. 18 - схема компьютерной системы согласно варианту осуществления настоящего изобретения.

ПОДРОБНОЕ ОПИСАНИЕ ВАРИАНТОВ ОСУЩЕСТВЛЕНИЯ

[0050] На фиг. 3 показана упрощенная блок-схема системы (300) связи согласно варианту осуществления настоящего изобретения. Система (300) связи включает в себя множество оконечных устройств, которые могут осуществлять связь друг с другом, например, через сеть (350). Например, система (300) связи включает в себя первую пару оконечных устройств (310) и (320), соединенных между собой через сеть (350). В примере, приведенном на фиг. 3, первая пара оконечных устройств (310) и (320) осуществляет однонаправленную передачу данных. Например, оконечное устройство (310) может кодировать видеоданные (например, поток видеоизображений, захваченных оконечным устройством (310)), для передачи в другое оконечное устройство (320) через сеть (350). Кодированные видеоданные могут передаваться в форме одного или более битовых потоков кодированного видео. Оконечное устройство (320) может принимать кодированные видеоданные из сети (350), декодировать кодированные видеоданные для восстановления видеоизображений и отображения видеоизображений согласно восстановленным видеоданным. Однонаправленная передача данных может быть свойственна приложениям служб массовой информации и т.п.

[0051] В другом примере, система (300) связи включает в себя вторую пару оконечных устройств (330) и (340) которые осуществляют двунаправленную передачу кодированных видеоданных, которые могут возникать, например, в ходе видеоконференцсвязи. Для двунаправленной передачи данных, в порядке примера, каждое оконечное устройство из оконечных устройств (330) и (340) может кодировать видеоданные (например, поток видеоизображений, захваченных оконечным устройством) для передачи в другое оконечное устройство из оконечных устройств (330) и (340) через сеть (350). Каждое оконечное устройство из оконечных устройств (330) и (340) также может принимать кодированные видеоданные, передаваемые другим оконечным устройством из оконечных устройств (330) и (340), и может декодировать кодированные видеоданные для восстановления видеоизображений и отображать видеоизображения на доступном устройстве отображения согласно восстановленным видеоданным.

[0052] В примере, приведенном на фиг. 3, оконечные устройства (310), (320), (330) и (340) могут быть проиллюстрированы как серверы, персональные компьютеры и смартфоны, но это не ограничивает принципы настоящего изобретения. Варианты осуществления настоящего изобретения находят применение для портативных компьютеров, планшетных компьютеров, медиаплееров и/или специального оборудования для видеоконференцсвязи. Сеть (350) представляет любое количество сетей, которые переносят кодированные видеоданные между оконечными устройствами (310), (320), (330) и (340), включая, например, проводные и/или беспроводные сети связи. Сеть (350) связи позволяет обмениваться данными в режиме канальной коммутации и/или пакетной коммутации. Иллюстративные сети включают в себя телекоммуникационные сети, локальные сети, глобальные сети и/или Интернет. В целях настоящего рассмотрения, архитектура и топология сети (350) могут не иметь отношения к настоящему изобретению, если конкретно не указаны ниже.

[0053] На фиг. 4 показано, в порядке примера применения раскрытого изобретения, размещение видеокодера и видеодекодера в окружении потоковой передачи. Раскрытое изобретение может быть в равной степени применимо к другим применениям обработки видео, включая, например, видеоконференцсвязь, цифровое телевидение, хранение сжатого видео на цифровых носителях, в том числе на CD-диске, DVD-диске, карте памяти и т.п., и т.д.

[0054] Система потоковой передачи может включать в себя подсистему (413) захвата, которая может включать в себя источник (401) видеосигнала, например, цифровую камеру, создающую, например, поток (402) видеоизображений, не подвергнутых сжатию. Например, поток (402) видеоизображений включает в себя отсчеты, взятые цифровой камерой. Поток (402) видеоизображений, изображенный жирной линией, чтобы подчеркнуть большой объем данных по сравнению с кодированными видеоданными (404) (или битовыми потоками кодированного видео), может обрабатываться электронным устройством (420), которое включает в себя видеокодер (403), подключенный к источнику (401) видеосигнала. Видеокодер (403) может включать в себя оборудование, программное обеспечение или их комбинацию для обеспечения или реализации аспектов раскрытого изобретения, как более подробно описано ниже. Кодированные видеоданные (404) (или битовый поток (404) кодированного видео), изображенные тонкой линией, чтобы подчеркнуть меньший объем данных по сравнению с потоком (402) видеоизображений, могут храниться на потоковом сервере (405) для использования в будущем. Одна или более клиентских подсистем потоковой передачи, например, клиентские подсистемы (406) и (408) на фиг. 4, могут осуществлять доступ к потоковому серверу (405) для извлечения копий (407) и (409) кодированных видеоданных (404). Клиентская подсистема (406) может включать в себя видеодекодер (410), например, в электронном устройстве (430). Видеодекодер (410) декодирует входящую копию (407) кодированных видеоданных и создает исходящий поток (411) видеоизображений, который может визуализироваться на дисплее (412) (например, отображающем экране) или другом устройстве визуализации (не показано). В некоторых системах потоковой передачи, кодированные видеоданные (404), (407) и (409) (например, битовые потоки видео) могут кодироваться согласно тем или иным стандартам кодирования/сжатия видео. Примеры этих стандартов включают в себя ITU-T Recommendation Н.265. Например, разрабатывается стандарт видеокодирования под официальным названием «универсальное видеокодирование» (VVC, Versatile Video Coding). Раскрытое изобретение может использоваться в контексте VVC.

[0055] Заметим, что электронные устройства (420) и (430) могут включать в себя другие компоненты (не показаны). Например, электронное устройство (420) может включать в себя видеодекодер (не показан), и электронное устройство (430) также может включать в себя видеокодер (не показан).

[0056] На фиг. 5 показана блок-схема видеодекодера (510) согласно варианту осуществления настоящего изобретения. Видеодекодер (510) может входить в состав электронного устройства (530). Электронное устройство (530) может включать в себя приемник (531) (например, приемные схемы). Видеодекодер (510) может использоваться вместо видеодекодера (410) в примере, приведенном на фиг. 4.

[0057] Приемник (531) может принимать одну или более кодированных видеопоследовательностей для декодирования видеодекодером (510); в том же или другом варианте осуществления, по одной кодированной видеопоследовательности за раз, где декодирование каждой кодированной видеопоследовательности не зависит от других кодированных видеопоследовательностей. Кодированная видеопоследовательность может приниматься из канала (501), который может быть аппаратной/программной линией связи с запоминающим устройством, где хранятся кодированные видеоданные. Приемник (531) может принимать кодированные видеоданные с другими данными, например, кодированными аудиоданными и/или вспомогательными потоками данных, которые могут ретранслироваться на соответствующие им используемые объекты (не показаны). Приемник (531) может отделять кодированную видеопоследовательность от других данных. Для борьбы с джиттером сети буферная память (515) может быть подключена между приемником (531) и энтропийным декодером / анализатором (520) (далее «анализатором (520)»). В некоторых вариантах применения буферная память (515) входит в состав видеодекодера (510). В других она может не входить в состав видеодекодера (510) (не показан). В прочих вариантах может существовать буферная память (не показана) вне видеодекодера (510), например, для борьбы с джиттером сети, помимо другой буферной памяти (515) в составе видеодекодера (510), например, для управления хронированием доигрывания. Когда приемник (531) принимает данные от устройства хранения/ретрансляции с достаточной полосой и управляемостью или из изосинхронной сети, буферная память (515) может быть не нужна или может быть мала. Для использования в пакетных сетях наилучшей попытки, например, в Интернете, буферная память (515) может требоваться, может быть сравнительно большой и может иметь преимущественно адаптивный размер, и по меньшей мере частично может быть реализована в операционной системе или аналогичных элементах (не показаны) вне видеодекодера (510).

[0058] Видеодекодер (510) может включать в себя анализатор (520) для реконструкции символов (521) из кодированной видеопоследовательности. Категории этих символов включают в себя информацию, используемую для управления работой видеодекодера (510), и возможно информацию для управления устройством визуализации, например, устройством (512) визуализации (например, отображающим экраном), которое не является неотъемлемой частью электронного устройства (530), но может быть подключено к электронному устройству (530), как показано на фиг. 5. Информация управления для устройств(а) визуализации может представлять собой сообщения информации дополнительного улучшения (SEI, Supplemental Enhancement Information) или фрагменты набора параметров информации пригодности видео (VUI, Video Usability Information) (не показаны). Анализатор (520) может анализировать / энтропийно декодировать принятую кодированную видеопоследовательность. Кодирование кодированной видеопоследовательности может осуществляться согласно методу или стандарту видеокодирования и может следовать различным принципам, в том числе кодированию с переменной длиной серии, кодированию по Хаффману, арифметическому кодированию с контекстной чувствительностью или без нее и т.д. Анализатор (520) может извлекать из кодированной видеопоследовательности набор параметров подгруппы для по меньшей мере одной из подгрупп пикселей в видеодекодере на основании по меньшей мере одного параметра, соответствующего группе. Подгруппы могут включать в себя группы изображений (GOP, Groups of Pictures), изображения, тайлы, слайсы, макроблоки, единицы кодирования (CU, Coding Units), блоки, единицы преобразования (TU, Transform Units), единицы предсказания (PU, Prediction Units) и т.д. Анализатор (520) также может извлекать из кодированной видеопоследовательности информацию, например, коэффициенты преобразования, значения параметров квантователя, векторы движения и т.д.

[0059] Анализатор (520) может осуществлять операцию энтропийного декодирования / анализа видеопоследовательности, принятой из буферной памяти (515), для создания символов (521).

[0060] Для реконструкции символов (521) могут использоваться несколько разных модулей в зависимости от типа кодированного видеоизображения или его частей (например, интер- и интра-изображения, интер- и интра-блока) и других факторов. Какие модули используются, и как, может определяться информацией управления подгруппами, выделенной из кодированной видеопоследовательности анализатором (520). Поток такой информации управления подгруппами между анализатором (520) и множественными модулями для простоты в дальнейшем не показан.

[0061] Помимо ранее упомянутых функциональных блоков, видеодекодер (510) может принципиально подразделяться на несколько функциональных модулей, как описано ниже. В практической реализации, работающей в условиях коммерческих ограничений, многие из этих модулей тесно взаимодействуют друг с другом и могут, по меньшей мере частично, встраиваться один в другой. Однако в целях описания раскрытого изобретения уместно принципиальное подразделение на нижеперечисленные функциональные модули.

[0062] Первым модулем является модуль (551) масштабирования / обратного преобразования. Модуль (551) масштабирования / обратного преобразования принимает квантованный коэффициент преобразования, а также информацию управления, включающую в себя используемое преобразование, размер блока, коэффициент квантования, матрицы масштабирования квантования и т.д. в качестве символа(ов) (521) от анализатора (520). Модуль (551) масштабирования / обратного преобразования может выводить блоки, содержащие значения отсчетов, которые можно вводить в агрегатор (555).

[0063] В ряде случаев, выходные отсчеты блока (551) масштабирования / обратного преобразования могут относиться к внутренне-кодированному блоку; то есть блоку, который не использует предсказанную информацию из ранее реконструированных изображений, но может использовать предсказанную информацию из ранее реконструированных частей текущего изображения. Такая предсказанная информация может обеспечиваться модулем (552) предсказания внутри изображения. В ряде случаев модуль (552) предсказания внутри изображения генерирует блок такого же размера и формы, как блок, подлежащий реконструкции, с использованием информации ранее реконструированного окружения, извлеченной из буфера (558) текущего изображения. Буфер (558) текущего изображения буферизует, например, частично реконструированное текущее изображение и/или полностью реконструированное текущее изображение. Агрегатор (555) в ряде случаев добавляет для каждого отсчета информацию предсказания, сгенерированную модулем (552) внутреннего предсказания, в информацию выходных отсчетов, обеспеченную модулем (551) масштабирования / обратного преобразования.

[0064] В других случаях выходные отсчеты модуля (551) масштабирования / обратного преобразования могут относиться к внутренне кодированному блоку, возможно, с компенсацией движения. В таком случае модуль (553) предсказания с компенсацией движения может осуществлять доступ к памяти (557) опорных изображений для извлечения отсчетов, используемых для предсказания. После применения компенсации движения к извлеченным отсчетам в соответствии с символами (521), относящимися к блоку, эти отсчеты могут добавляться агрегатором (555) к выходному сигналу модуля (551) масштабирования / обратного преобразования (в этом случае именуемому остаточными отсчетами или остаточным сигналом) для генерации информации выходных отсчетов. Адреса в памяти (557) опорных изображений, откуда модуль (553) предсказания с компенсацией движения извлекает предсказанные отсчеты, могут регулироваться векторами движения, доступными модулю (553) предсказания с компенсацией движения, в форме символов (521), которые могут иметь, например, компоненты X, Y и опорного изображения. Компенсация движения также может включать в себя интерполяцию значений отсчетов, извлеченных из памяти (557) опорных изображений, когда используются точные векторы движения под-отсчетов, механизмы предсказания векторов движения и т.д.

[0065] К выходным отсчетам агрегатора (555) можно применять различные методы контурной фильтрации в модуле (556) контурного фильтра. Технологии сжатия видео могут включать в себя технологии деблокирующего фильтра под управлением параметров, включенных в кодированную видеопоследовательность (также именуемую «битовым потоком кодированного видео») и становиться доступными модулю (556) контурного фильтра в качестве символов (521) от анализатора (520), но также могут реагировать на метаинформацию, полученную в ходе декодирования предыдущих (в порядке декодирования) частей кодированного изображения или кодированной видеопоследовательности, а также реагировать на ранее реконструированные и подвергнутые контурной фильтрации значения отсчетов.

[0066] Модуль (556) контурного фильтра может выдавать поток отсчетов, который может поступать на устройство (512) визуализации, а также сохраняться в памяти (557) опорных изображений для использования в будущем предсказании между изображениями.

[0067] Некоторые кодированные изображения, будучи полностью реконструированными, могут использоваться в качестве опорных изображений для будущего предсказания. Например, когда кодированное изображение, соответствующее текущему изображению, полностью реконструировано, и кодированное изображение идентифицировано как опорное изображение (например, анализатором (520)), буфер (558) текущего изображения может становиться частью памяти (557) опорных изображений, и свежий буфер текущего изображения может повторно выделяться до начала реконструкции следующего кодированного изображения.

[0068] Видеодекодер (510) может осуществлять операции декодирования согласно заранее заданной технологии сжатия видео, например, по стандарту ITU-T Rec. Н.265. Кодированная видеопоследовательность может согласовываться с синтаксисом, заданным используемой(ым) технологией или стандартом сжатия видео, в том смысле, что кодированная видеопоследовательность может придерживаться как синтаксиса технологии или стандарта сжатия видео, так и профилей, задокументированных в технологии или стандарте сжатия видео. В частности, профиль может выбирать некоторые инструменты как инструменты, доступные для использования только под этим профилем, из всех инструментов, доступных в технологии или стандарте сжатия видео. Также для согласованности может быть необходимо, чтобы сложность кодированной видеопоследовательности оставалась в границах, заданных уровнем технологии или стандарта сжатия видео. В ряде случаев, уровни ограничивают максимальный размер изображения, максимальную частоту кадров, максимальную частоту отсчетов для реконструкции (измеряемую, например, в мегаотсчетах в секунду), максимальный размер опорного изображения и т.д. Пределы, установленные уровнями, в ряде случаев могут дополнительно ограничиваться спецификациями гипотетического эталонного декодера (HRD, Hypothetical Reference Decoder) и метаданными для управления буфером HRD, сигнализируемого в кодированной видеопоследовательности.

[0069] Согласно варианту осуществления приемник (531) может принимать дополнительные (избыточные) данные с кодированным видео. Дополнительные данные могут быть включены как часть кодированной(ых) видеопоследовательности(ей). Дополнительные данные могут использоваться видеодекодером (510) для правильного декодирования данных и/или более точной реконструкции исходных видеоданных. Дополнительные данные могут представлять собой, например, слои улучшения во времени, пространстве или отношения сигнал/шум (SNR, Signal Noise Ratio), избыточные слайсы, избыточные изображения, коды прямой коррекции ошибок и т.д.

[0070] На фиг. 6 показана блок-схема видеокодера (603) согласно варианту осуществления настоящего изобретения. Видеокодер (603) входит в состав электронного устройства (620). Электронное устройство (620) включает в себя передатчик (640) (например, передающую схему). Видеокодер (603) может использоваться вместо видеокодера (403) в примере, приведенном на фиг. 4.

[0071] Видеокодер (603) может принимать отсчеты видео от источника (601) видеосигнала (который не входит в состав электронного устройства (620) в примере, показанном на фиг. 6), который может захватывать видеоизображение(я), поддежащее(ие) кодированию видеокодером (603). В другом примере источник (601) видеосигнала входит в состав электронного устройства (620).

[0072] Источник (601) видеосигнала может обеспечивать исходную видеопоследовательность, подлежащую кодированию видеокодером (603) в форме потока отсчетов цифрового видео любой подходящей битовой глубины (например, 8 битов, 10 битов, 12 битов и т.д.), любого цветового пространства (например, ВТ.601 Y CrCB, RGB и т.д.), и любой подходящей структуры дискретизации (например, Y CrCb 4:2:0, Y CrCb 4:4:4). В системе службы массовой информации источником (601) видеосигнала может быть запоминающее устройство, где хранится ранее подготовленное видео. В системе видеоконференцсвязи источником (601) видеосигнала может быть камера, которая захватывает информацию локального изображения как видеопоследовательность. Видеоданные могут обеспечиваться как множество отдельных изображений, которые создают ощущение движения при наблюдении в последовательности. Сами изображения могут быть организованы как пространственный массив пикселей, где каждый пиксель может содержать один или более отсчетов в зависимости от используемых структуры дискретизации, цветового пространства и т.д. Специалисту в данной области техники нетрудно понять соотношение между пикселями и отсчетами. Нижеследующее описание посвящено отсчетам.

[0073] Согласно варианту осуществления настоящего изобретения видеокодер (603) может кодировать и сжимать изображения исходной видеопоследовательности в кодированную видеопоследовательность (643) в реальном времени или с учетом любых других временных ограничений, налагаемых применением. Установление надлежащей скорости кодирования является одной из функций контроллера (650). В некоторых вариантах осуществления контроллер (650) управляет другими функциональными модулями, как описано ниже, и функционально подключен к другим функциональным модулям. Подключение для простоты не показано. Параметры, установленные контроллером (650), могут включать в себя параметры, связанные регулировкой частоты (пропуск изображения, квантователь, значение лямбда, применяемое при оптимизация скорости-искажения т.д.), размер изображения, схему групп изображений (GOP, Group Of Pictures), максимальную зону поиска вектора движения и т.д. Контроллер (650) может быть выполнен с возможностью иметь другие подходящие функции, относящиеся к видеокодеру (603), оптимизированному для той или иной конструкции системы.

[0074] В некоторых вариантах осуществления видеокодер (603) выполнен с возможностью работать в петле кодирования. В качестве очень упрощенного описания, в порядке примера, петля кодирования может включать в себя исходный кодер (630) (например, отвечающий за создание символов, например, потока символов, на основе входного изображения, подлежащего кодированию, и опорного(ых) изображения(ий)) и (локальный) декодер (633), встроенный в видеокодер (603). Декодер (633) реконструирует символы для создания данных отсчетов, аналогично тому, как это делал бы (удаленный) декодер (поскольку любое сжатие между символами и битовым потоком кодированного видео происходит без потерь в технологиях сжатия видео, рассматриваемых в раскрытом изобретении). Реконструированный поток отсчетов (данные отсчетов) поступают в память (634) опорных изображений. Поскольку декодирование потока символов приводит к результатам, с точностью до бита, не зависящим от положения декодера (локального или удаленного), содержимое памяти (634) опорных изображений также будет одинаковым с точностью до бита для локального кодера и удаленного кодера. Другими словами, предсказанная часть кодера «видит» в качестве отсчетов опорного изображения точно такие же значения отсчетов, как «видел» бы декодер при использовании предсказания в ходе декодирования. Этот фундаментальный принцип синхронизма опорного изображения (и, в итоге, дрейф, если синхронизм не удается поддерживать, например, вследствие канальных ошибок) используется также в некоторых связанных областях техники.

[0075] «Локальный» декодер (633) может действовать таким же образом, как «удаленный» декодер, например, видеодекодер (510), подробно вышеописанный со ссылкой на фиг. 5. Однако, опять же, согласно фиг. 5, поскольку символы доступны, и кодирование/декодирование символов в кодированную видеопоследовательность энтропийным кодером (645) и анализатором (520) может осуществляться без потерь, части энтропийного декодирования видеодекодера (510), включающие в себя буферную память (515) и анализатор (520), могут быть не полностью реализованы в локальном декодере (633).

[0076] При этом можно сделать вывод, что любая технология декодирования, присутствующая в декодере, за исключением анализа/энтропийного декодирования, также обязательно должна присутствовать, по существу в идентичной функциональной форме в соответствующем кодере. По этой причине раскрытое изобретение сконцентрировано на работе декодера. Описание технологий кодирования может быть сокращено, поскольку они являются обратными подробно описанным технологиям декодирования. Только в некоторых областях требуется более детальное описание, которое приведено ниже.

[0077] Согласно некоторым примерам, в ходе работы исходный кодер (630) может осуществлять кодирование с предсказанием и компенсацией движения, при котором входное изображение кодируется с предсказанием на основании одного или более ранее кодированных изображений из видеопоследовательности, указанных как «опорные изображения». Таким образом, машина (632) кодирования кодирует различия между пиксельными блоками входного изображения и пиксельными блоками опорного изображения(й), которое(ые) может(ут) выбираться в качестве предсказанной(ых) ссылки(ок) на входное изображение.

[0078] Локальный видеодекодер (633) может декодировать кодированные видеоданные изображений, которые могут быть указаны как опорные изображения, на основе символов, созданных исходным кодером (630). Операции машины (632) кодирования могут быть преимущественно процессами с потерями. Когда кодированные видеоданные могут декодироваться в видеодекодере (не показан на фиг. 6), реконструированная видеопоследовательность обычно может представлять собой копию исходной видеопоследовательности с некоторыми ошибками. Локальный видеодекодер (633) дублирует процессы декодирования, которые могут осуществляться видеодекодером на опорных изображениях, и может предписывать сохранение реконструированных опорных изображений в кэш-памяти (634) опорных изображений. Таким образом, видеокодер (603) может локально сохранять копии реконструированных опорных изображений, имеющие такое же содержимое, как реконструированные опорные изображения, которые будут получены видеодекодером на стороне приемника (в отсутствие ошибок передачи).

[0079] Предсказатель (635) может осуществлять поиски предсказания для машины (632) кодирования. Таким образом, для нового изображения, подлежащего кодированию, предсказатель (635) может искать в памяти (634) опорных изображений данные отсчетов (в качестве кандидатов на роль опорных пиксельных блоков) или те или иные метаданные, например, векторы движения опорного изображения, формы блоков и т.д., которые могут служить надлежащей ссылкой для предсказания новых изображений. Предсказатель (635) может работать на основе «блоки отсчетов - пиксельные блоки» для нахождения надлежащих ссылок для предсказания. В ряде случаев, согласно результатам поиска, полученным предсказателем (635), входное изображение может иметь ссылки для предсказания, извлеченные из множества опорных изображений, хранящихся в памяти (634) опорных изображений.

[0080] Контроллер (650) может управлять операциями кодирования исходного кодера (630), включая, например, установление параметров и параметров подгруппы, используемых для кодирования видеоданных.

[0081] Выходной сигнал всех вышеупомянутых функциональных модулей может подвергаться энтропийному кодированию в энтропийном кодере (645). Энтропийный кодер (645) переводит символы, сгенерированные различными функциональными модулями, в кодированную видеопоследовательность путем сжатия символов без потерь согласно технологиям, например, кодирования по Хаффману, кодирования с переменной длиной серии, арифметического кодирования и т.д.

[0082] Передатчик (640) может буферизовать кодированную(ые) видеопоследовательность(и), созданную энтропийным кодером (645), для подготовки к передаче через канал (660) связи, который может быть аппаратной/программной линией связи с запоминающим устройством, где хранятся кодированные видеоданные. Передатчик (640) может объединять кодированные видеоданные от видеокодера (603) с другими данными, подлежащими передаче, например, кодированными аудиоданными и/или вспомогательными потоками данных (источники не показаны).

[0083] Контроллер (650) может управлять работой видеокодера (603). В ходе кодирования контроллер (650) может назначать каждому кодированному изображению тот или иной тип кодированного изображения, который может определять методы кодирования, применимые к соответствующему изображению. Например, изображениям часто могут назначаться следующие типы изображения:

[0084] Интра-изображение (I-изображение), которое можно кодировать и декодировать без использования какого-либо другого изображения в последовательности в качестве источника предсказания. Некоторые видеокодеки допускают разные типы интра-изображений, включая, например, изображения в формате независимого обновления декодера («IDR», Independent Decoder Refresh). Специалисту в данной области техники известны разновидности 1-изображений и их соответствующие варианты применения и особенности.

[0085] Предсказанное изображение (Р-изображение), которое можно кодировать и декодировать с использованием внутреннего предсказания или внешнего предсказания с использованием не более одного вектора движения и опорного индекса для предсказания значений отсчетов каждого блока.

[0086] Двунаправленно-предсказанное изображение (В-изображение), которое можно кодировать и декодировать с использованием внутреннего предсказания или внешнего предсказания с использованием не более двух векторов движения и опорных индексов для предсказания значений отсчетов каждого блока. Аналогично, мультипредсказанные изображения могут использовать более двух опорных изображений и связанные метаданные для реконструкции единого блока.

[0087] Исходные изображения обычно допускают пространственное разделение на множество блоков отсчетов (например, блоки 4×4, 8×8, 4×8 или 16×16 отсчетов каждый) и кодирование на поблочной основе (блок за блоком). Блоки могут кодироваться предиктивно со ссылкой на другие (ранее кодированные) блоки, определенные назначением кодирования, применяемым к соответствующим изображениям этих блоков. Например, блоки 1-изображений могут кодироваться без предсказания или с предсказанием со ссылкой на ранее кодированные блоки того же изображения (пространственным предсказанием или внутренним предсказанием). Пиксельные блоки Р-изображений могут кодироваться с предсказанием, посредством пространственного предсказания или временного предсказания со ссылкой на одно ранее кодированное опорное изображение. Блоки В-изображений могут кодироваться с предсказанием, посредством пространственного предсказания или временного предсказания со ссылкой на одно или два ранее кодированных опорных изображения.

[0088] Видеокодер (603) может осуществлять операции кодирования согласно заранее заданной технологии или стандарту видеокодирования, например, ITU-T Rec. Н.265. В своей работе видеокодер (603) может осуществлять различные операции сжатия, в том числе операции предиктивного кодирования, которые используют временные и пространственные избыточности во входной видеопоследовательности. Поэтому кодированные видеоданные могут согласовываться с синтаксисом, заданным используемой технологией или стандартом видеокодирования.

[0089] Согласно варианту осуществления передатчик (640) может передавать дополнительные данные с кодированным видео. Исходный кодер (630) может включать такие данные как часть кодированной видеопоследовательности. Дополнительные данные могут содержать временные/пространственные/SNR слои улучшения, другие формы избыточных данных, например, избыточные изображения и слайсы, сообщения SEI, фрагменты набора параметров VUI и т.д.

[0090] Видео может захватываться как множество исходных изображений (видеоизображений) во временной последовательности. Предсказание внутри изображения (часто сокращенно именуемое «внутренним предсказанием») использует пространственную корреляцию в данном изображении, а предсказание между изображениями использует (временную или иную) корреляцию между изображениями. Например, конкретное изображение, подлежащее кодированию/декодированию, которое именуется «текущим изображением», разбивается на блоки. Когда блок в текущем изображении аналогичен опорному блоку в ранее кодированном и все еще буферизованном опорном изображении в видео, блок в текущем изображении может кодироваться вектором, который именуется «вектором движения». Вектор движения указывает на опорный блок в опорном изображении и может иметь третье измерение, идентифицирующее опорное изображение, в случае использования множественных опорных изображений.

[0091] В некоторых вариантах осуществления метод двойного предсказания может использоваться при предсказании между изображениями. Согласно методу двойного предсказания, используются два опорных изображения, например, первое опорное изображение и второе опорное изображение, которые оба предшествуют в порядке декодирования текущему изображению в видео (но могут быть в прошлом и будущем, соответственно, в порядке отображения). Блок в текущем изображении может кодироваться первым вектором движения, который указывает на первый опорный блок в первом опорном изображении, и вторым вектором движения, который указывает на второй опорный блок во втором опорном изображении. Блок может предсказываться комбинацией первого опорного блока и второго опорного блока.

[0092] Дополнительно, метод режима объединения может использоваться в предсказании между изображениями для повышения эффективности кодирования.

[0093] Согласно некоторым вариантам осуществления изобретения, предсказания, например, предсказания между изображениями и предсказания внутри изображения, осуществляются поблочно. Например, согласно стандарту HEVC, изображение в последовательности видеоизображений разбивается на единицы дерева кодирования (CTU, Coding Tree Units) для сжатия, CTU в изображении имеют одинаковый размер, например 64×64 пикселя, 32×32 пикселя или 16×16 пикселей. В общем случае CTU включает в себя три блока дерева кодирования (СТВ, Coding Tree Blocks), а именно, один СТВ яркости и два СТВ цветности. Каждый CTU может рекурсивно делиться квадрадеревом на одну или более единиц кодирования (CU). Например, CTU размером 64×64 пикселя может делиться на одну CU размером 64×64 пикселя или на четыре CU размером 32×32 пикселя или 16 CU размером 16×16 пикселей. Например, каждая CU анализируется для определения типа предсказания для CU, например, типа внешнего предсказания или типа внутреннего предсказания. CU делится на одну или более единиц предсказания (PU) в зависимости от временной и/или пространственной предсказуемости. В целом, каждая PU включает в себя блок (РВ) предсказания яркости и два РВ цветности. Согласно варианту осуществления операция предсказания при кодировании (кодировании/декодировании) осуществляется в единице блока предсказания. Используя блок предсказания яркости в качестве примера блока предсказания, блок предсказания включает в себя матрицу значений (например, значений яркости) для пикселей, например, 8×8 пикселей, 16×16 пикселей, 8×16 пикселей, 16×8 пикселей и т.п.

[0094] На фиг. 7 показана схема видеокодера (703) согласно другому варианту осуществления изобретения. Видеокодер (703) выполнен с возможностью приема блока обработки (например, блока предсказания) значений отсчетов в текущем видеоизображении в последовательности видеоизображений и кодирования блока обработки в кодированное изображение, которое составляет часть кодированной видеопоследовательности. Например, видеокодер (703) используется вместо видеокодера (403) в примере, приведенном на фиг. 4.

[0095] В примере HEVC видео кодер (703) принимает матрицу значений отсчетов для блока обработки, например, блока предсказания 8×8 отсчетов и т.п. Видеокодер (703) определяет, наилучшим ли образом кодируется блок обработки в интра-режиме, интер-режиме или режиме двойного предсказания с использованием, например, оптимизации скорость-искажения. Когда блок обработки подлежит кодированию в интра-режиме, видеокодер (703) может использовать метод внутреннего предсказания для кодирования блока обработки в кодированное изображение; и когда блок обработки подлежит кодированию в интер-режиме или режиме двойного предсказания, видеокодер (703) может использовать метод внешнего предсказания или двойного предсказания, соответственно, для кодирования блока обработки в кодированное изображение. В некоторых технологиях видеокодирования, режим объединения может быть подрежимом предсказания между изображениями, где вектор движения выводится из одного или более предсказателей вектора движения без привлечения кодированного компонента вектора движения вне предсказателей. В некоторых других технологиях видеокодирования может присутствовать компонент вектора движения, применимый к данному блоку. В порядке примера, видеокодер (703) включает в себя другие компоненты, например, модуль определения режима (не показан) для определения режима блоков обработки.

[0096] В примере, приведенном на фиг. 7, видеокодер (703) включает в себя интер-кодер (730), интра-кодер (722), вычислитель (723) остатка, переключатель (726), кодер (724) остатка, общий контроллер (721) и энтропийный кодер (725), соединенные друг с другом как показано на фиг. 7.

[0097] Интер-кодер (730) выполнен с возможностью приема отсчетов текущего блока (например, блока обработки), сравнения блока с одним или более опорными блоками в опорных изображениях (например, блоками в предыдущих изображениях и более поздних изображениях), генерации информации внешнего предсказания (например, описания избыточной информации согласно методу внутреннего кодирования, векторов движения, информации режима объединения), и вычисления результатов внешнего предсказания (например, блока предсказания) на основании информации внешнего предсказания с использованием любого подходящего метода. В некоторых примерах опорными изображениями являются декодированные опорные изображения, которые декодируются на основе информации кодированного видео.

[0098] Интра-кодер (722) выполнен с возможностью приема отсчетов текущего блока (например, блока обработки), в ряде случаев сравнения блока с блоками, ранее кодированными в том же изображении, генерирования квантованных коэффициентов после преобразования, и в ряде случаев также информации внутреннего предсказания (например, информации направления внутреннего предсказания согласно одному или более методам внутреннего кодирования). В порядке примера, интра-кодер (722) также вычисляет результаты внутреннего предсказания (например, блок предсказания) на основании информации внутреннего предсказания и опорных блоков в том же изображении.

[0099] Общий контроллер (721) выполнен с возможностью определения общих данных управления и управления другими компонентами видеокодера (703) на основе общих данных управления. Например, общий контроллер (721) определяет режим блока и выдает сигнал управления на переключатель (726) на основе режима. Например, когда режим является интра-режимом, общий контроллер (721) управляет переключателем (726) для выбора результата интра-режима для использования вычислителем (723) остатка, и управляет энтропийным кодером (725) для выбора информации внутреннего предсказания и включения информации внутреннего предсказания в битовый поток; и когда режим является интер-режимом, общий контроллер (721) управляет переключателем (726) для выбора результата внешнего предсказания для использования вычислителем (723) остатка, и управляет энтропийным кодером (725) для выбора информации внешнего предсказания и включения информации внешнего предсказания в битовый поток.

[0100] Вычислитель (723) остатка выполнен с возможностью вычисления разности (данных остатка) между принятым блоком и результатами предсказания, выбранными из интра-кодера (722) или интер-кодера (730). Кодер (724) остатка выполнен с возможностью действовать на основе данных остатка для кодирования данных остатка для генерации коэффициентов преобразования. Например, кодер (724) остатка выполнен с возможностью преобразования данных остатка из пространственной области в частотную область и генерирования коэффициентов преобразования. Затем коэффициенты преобразования подвергаются обработке квантования для получения квантованных коэффициентов преобразования. В различных вариантах осуществления видеокодер (703) также включает в себя декодер (728) остатка. Декодер (728) остатка выполнен с возможностью осуществления обратного преобразования и генерирования декодированных данных остатка. Декодированные данные остатка могут надлежащим образом использоваться интра-кодером (722) и интер-кодером (730). Например, интер-кодер (730) может генерировать декодированные блоки на основе декодированных данных остатка и информации внешнего предсказания, и интра-кодер (722) может генерировать декодированные блоки на основе декодированных данных остатка и информации внутреннего предсказания. Декодированные блоки надлежащим образом обрабатываются для генерации декодированных изображений, и декодированные изображения могут буферизоваться в схеме памяти (не показана) и в некоторых примерах использоваться в качестве опорных изображений.

[0101] Энтропийный кодер (725) выполнен с возможностью форматирования битового потока так, чтобы он включал в себя кодированный блок. Энтропийный кодер (725) выполнен с возможностью включать различную информацию согласно подходящему стандарту, например, стандарту HEVC. Например, энтропийный кодер (725) выполнен с возможностью включать общие данные управления, выбранную информацию предсказания (например, информацию внутреннего предсказания или информацию внешнего предсказания), информацию остатка и другую подходящую информацию в битовый поток. Заметим, что согласно раскрытому изобретению при кодировании блока в подрежиме объединения любого из интер-режима и режима двойного предсказания, информация остатка отсутствует.

[0102] На фиг. 8 показана схема видеодекодера (810) согласно другому варианту осуществления изобретения. Видеодекодер (810) выполнен с возможностью приема кодированных изображений, составляющих часть кодированной видеопоследовательности, и декодирования кодированных изображений для генерации реконструированных изображений. Например, видеодекодер (810) используется вместо видеодекодера (410) в примере, приведенном на фиг. 4.

[0103] В примере, приведенном на фиг. 8, видеодекодер (810) включает в себя энтропийный декодер (871), интер-декодер (880), декодер (873) остатка, модуль (874) реконструкции и интра-декодер (872), соединенные друг с другом как показано на фиг. 8.

[0104] Энтропийный декодер (871) может быть выполнен с возможностью реконструкции из кодированного изображения некоторых символов, которые представляют синтаксические элементы, образующие кодированное изображение. Такие символы могут включать в себя, например, режим кодирования блока (например, интра-режим, интер-режим, режим двойного предсказания, при этом последние два в подрежиме объединения или другом подрежиме), информацию предсказания (например, информацию внутреннего предсказания или информацию внешнего предсказания), которая может идентифицировать определенный отсчет или метаданные, используемые для предсказания интра-декодером (872) или интердекодером (880), соответственно, информацию остатка в форме, например, квантованных коэффициентов преобразования и т.п. Например, когда режим предсказания является режимом внутреннего или двойного предсказания, информация внешнего предсказания поступает на интер-декодер (880); а когда тип предсказания является типом внутреннего предсказания, информация внутреннего предсказания поступает на интра-декодер (872). Информация остатка может подвергаться обратному квантованию и поступать на декодер (873) остатка.

[0105] Интер-декодер (880) выполнен с возможностью приема информации внешнего предсказания и генерирования результатов внешнего предсказания на основании информации внешнего предсказания.

[0106] Интра-декодер (872) выполнен с возможностью приема информации внутреннего предсказания и генерирования результатов предсказания на основании информации внутреннего предсказания.

[0107] Декодер (873) остатка выполнен с возможностью осуществления обратного квантования для извлечения деквантованных коэффициентов преобразования и обработки деквантованных коэффициентов преобразования для преобразования остатка из частотной области в пространственную область. Декодер (873) остатка также может требовать некоторой информации управления (включать параметр квантователя (QP, Quantizer Parameter)), и эта информация может обеспечиваться энтропийным декодером (871) (путь данных не показан, поскольку это может быть только информация управления малого объема).

[0108] Модуль (874) реконструкции выполнен с возможностью объединения, в пространственной области, остатка на выходе декодера (873) остатка и результатов предсказания (на выходе модулей внешнего или внутреннего предсказания, в зависимости от ситуации) для формирования реконструированного блока, который может входить в состав реконструированного изображения, которое, в свою очередь, может входить в состав реконструированного видео. Заметим, что другие подходящие операции, например, операция деблокирования и т.п., могут осуществляться для повышения визуального качества.

[0109] Заметим, что видеокодеры (403), (603) и (703) и видеодекодеры (410), (510) и (810) могут быть реализованы с использованием любого подходящего метода. Согласно варианту осуществления видеокодеры (403), (603) и (703) и видеодекодеры (410), (510) и (810) могут быть реализованы с использованием одной или более интегральных схем. В другом варианте осуществления видеокодеры (403), (603) и (603) и видеодекодеры (410), (510) и (810) могут быть реализованы с использованием одного или более процессоров, которые выполняют программные инструкции.

[0110] Для уменьшения помех кодерами/декодерами может применяться адаптивный контурный фильтр (ALF) с адаптацией фильтра на основе блоков. Для компонента яркости для блока яркости 4×4 может быть выбран один из множества фильтров (например, из 25 фильтров), например, на основе направления и активности локальных градиентов.

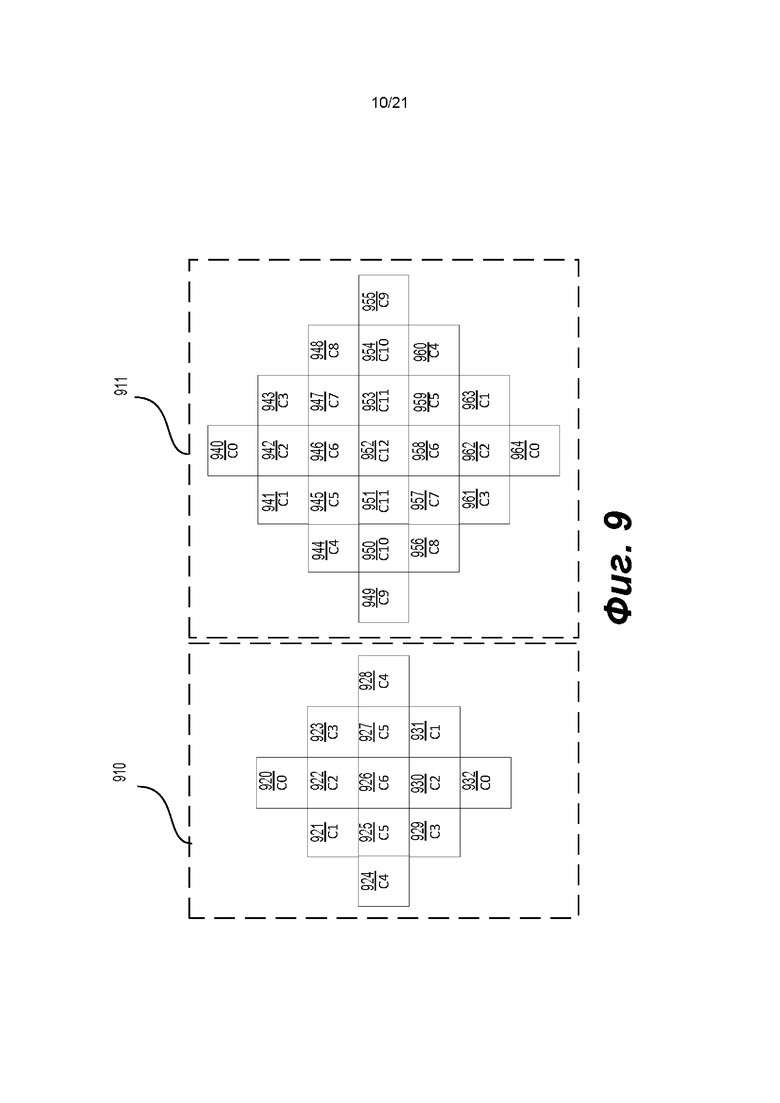

[0111] ALF может иметь любую подходящую маску и размер. На фиг. 9 ALF (910)-(911) имеют форму ромба - например, ромбовидную маску 5×5 для ALF (910) и ромбовидную маску 7×7 для ALF (911). В ALF (910) для фильтрации и формирования ромбовидной маски могут использоваться элементы (920)-(932). Для элементов (920)-(932) может использоваться семь значений (например, С0-С6). В ALF (911) для фильтрации и формирования ромбовидной маски могут использоваться элементы (940)-(964). Для элементов (940)-(964) может использоваться тринадцать значений (например, С0-С12).

[0112] В некоторых примерах на фиг. 9 используются по два ALF (910)-(911) ромбовидной маски. Фильтр (910) ромбовидной маски 5×5 может применяться для компонентов цветности (например, блоков цветности, СВ цветности), а фильтр (911) ромбовидной маски 7×7 - для компонента яркости (например, блока яркости, СВ яркости). В ALF могут использоваться и другие подходящие формы и размеры. Например, может использоваться фильтр с ромбовидной маской 9×9.

[0113] Коэффициенты фильтров в позициях, обозначенных значениями (например, С0-С6 в (910) или С0-С12 в (920)), могут быть ненулевыми. Кроме того, когда ALF включает в себя функцию ограничения, значения ограничения в позициях могут быть ненулевыми.

[0114] Для классификации блоков компонента яркости тот или иной 4×4 блок (или блок яркости, СВ яркости) может быть отнесен к какой-либо категории или классифицирован как один из многих (например, 25) классов. Индекс С классификации может быть получен на основе параметра D направленности и квантованного значения А активности А с использованием уравнения (1).

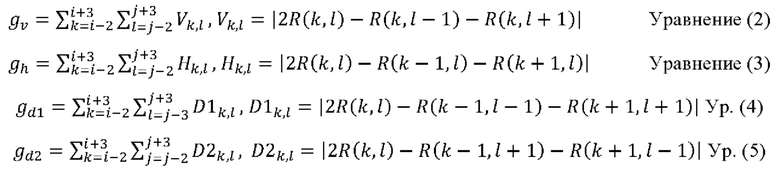

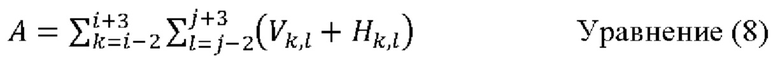

Для вычисления параметра направленности D и квантованного значения  градиенты gv, gh, gd1 и gd2 по вертикали, по горизонтали и по двум диагональным направлениям (например, d1 и d2), соответственно, могут вычисляться с использованием одномерного оператора Лапласа следующим образом:

градиенты gv, gh, gd1 и gd2 по вертикали, по горизонтали и по двум диагональным направлениям (например, d1 и d2), соответственно, могут вычисляться с использованием одномерного оператора Лапласа следующим образом:

где индексы i и j относятся к координатам верхнего левого отсчета в рамках блока 4×4, a R(k, l) указывает реконструированный отсчет в координатах (k, l). Направления (например, d1 и d2) могут относиться к двум диагональным направлениям.

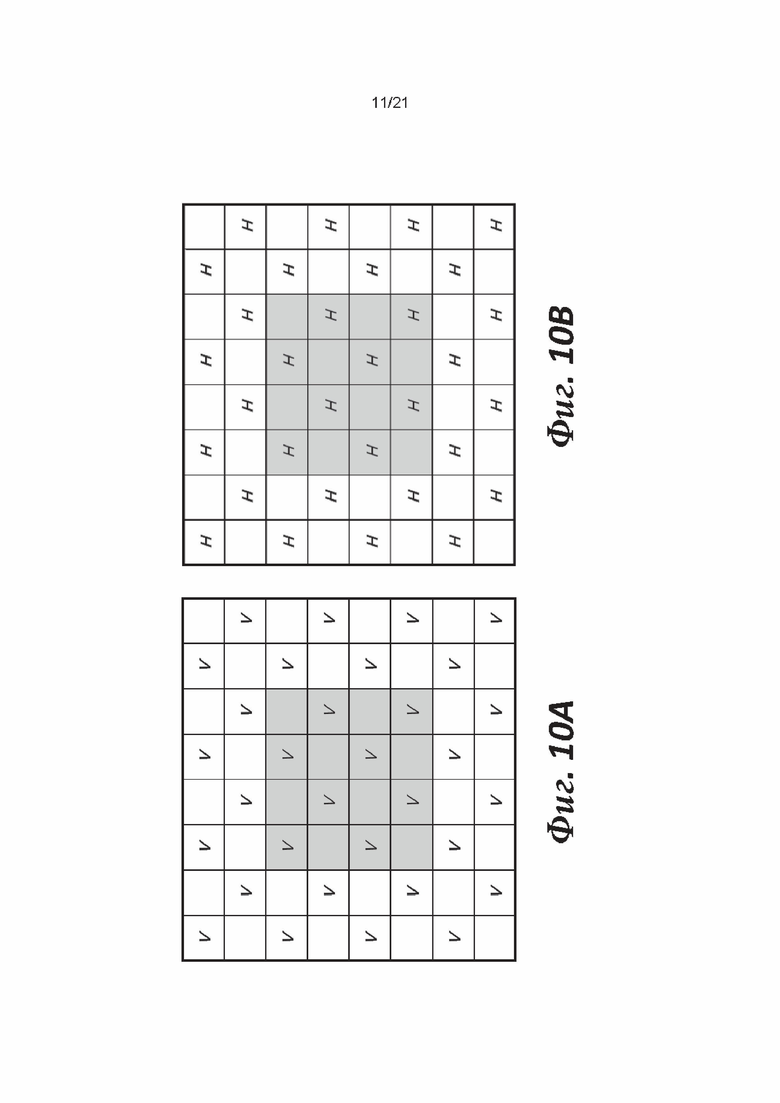

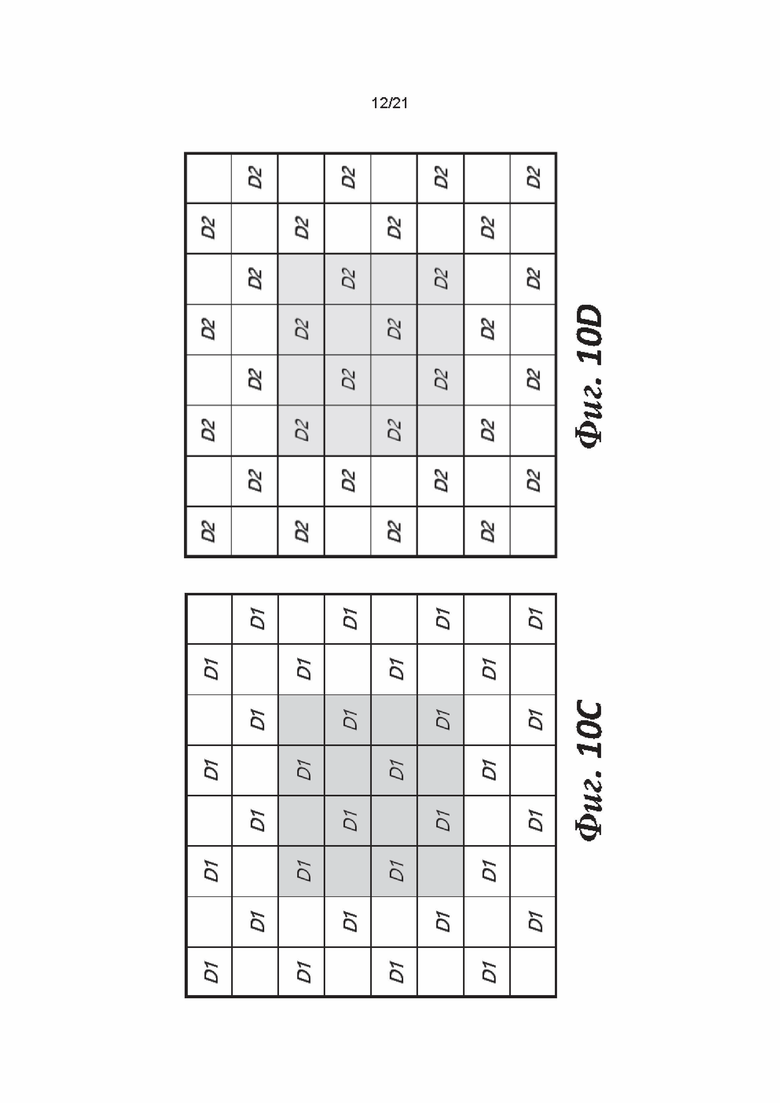

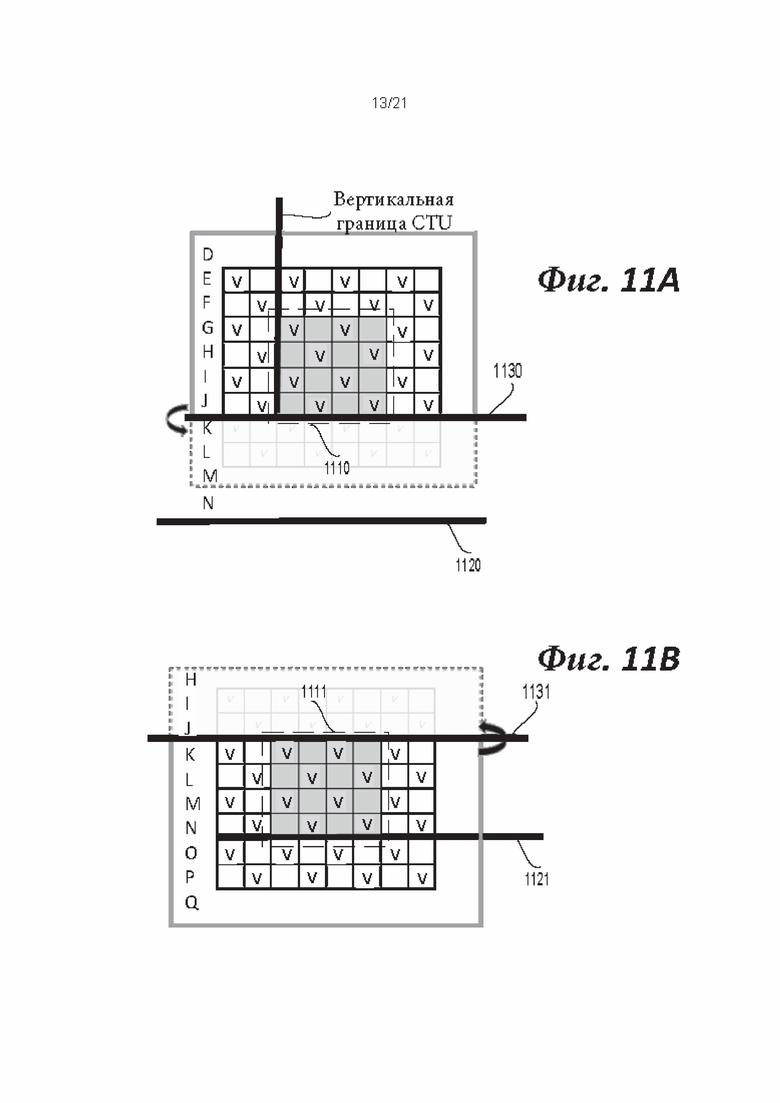

[0115] Для упрощения описанной выше классификации блоков можно применить вычисление с использованием одномерного оператора Лапласа с субдискретизацией. На фиг. 10A-10D показаны примеры позиций с субдискретизацией, используемых для вычисления градиентов gv, gh, gd1 и gd2 по вертикали (фиг. 10А), по горизонтали (фиг. 10В) и по двум диагональным направлениям d1 (фиг. 10С) и d2 (фиг. 10D), соответственно. Одни и те же позиции с субдискретизацией могут использоваться для вычисления градиентов по разным направлениям. На фиг. 10А метки «V» указывают позиции с субдискретизацией для вычисления градиента gv по вертикали. На фиг. 10В метки «Н» указывают позиции с субдискретизацией для вычисления градиента gh, по горизонтали. На фиг. 10С метки «D1» указывают позиции с субдискретизацией для вычисления диагонального градиента gd1 d1. На фиг. 10D метки «D2» указывают позиции с субдискретизацией для вычисления диагонального градиента gd2 d2.

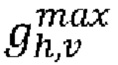

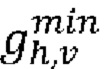

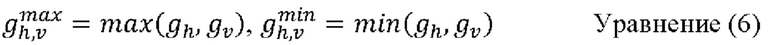

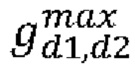

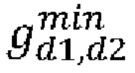

[0116] Максимальное  и минимальное

и минимальное  значения градиентов горизонтального gv и вертикального gh направлений могут быть установлены следующим образом:

значения градиентов горизонтального gv и вертикального gh направлений могут быть установлены следующим образом:

Максимальное  и минимальное

и минимальное  значения градиентов двух диагональных направлений gd1 и gd2 могут быть установлены следующим образом:

значения градиентов двух диагональных направлений gd1 и gd2 могут быть установлены следующим образом:

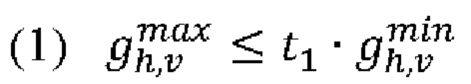

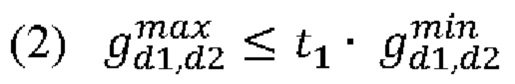

Параметр направленности D может быть получен на основе указанных выше значений и двух пороговых значений t1 и t2, как показано ниже:

Шаг 1. Если  и

и  являются истинными уравнениями, то для D устанавливается значение 0.

являются истинными уравнениями, то для D устанавливается значение 0.

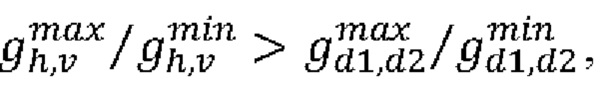

Шаг 2. Если  то перейдите к шагу 3; в противном случае перейдите к шагу 4.

то перейдите к шагу 3; в противном случае перейдите к шагу 4.

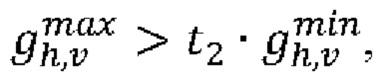

Шаг 3. Если  то для D устанавливается значение 2; в противном случае для D устанавливается значение 1.

то для D устанавливается значение 2; в противном случае для D устанавливается значение 1.

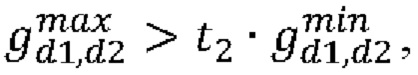

Шаг 4. Если  то для D устанавливается значение 4; в противном случае для D устанавливается значение 3.

то для D устанавливается значение 4; в противном случае для D устанавливается значение 3.

[0117] Значение активности можно А вычислить следующим образом:

A можно дополнительно квантовать до диапазона от 0 до 4 включительно; квантованное значение обозначается как

[0118] Для компонентов цветности в изображении классификация блоков не применяется, и, таким образом, один набор коэффициентов ALF может применяться для каждого компонента цветности.

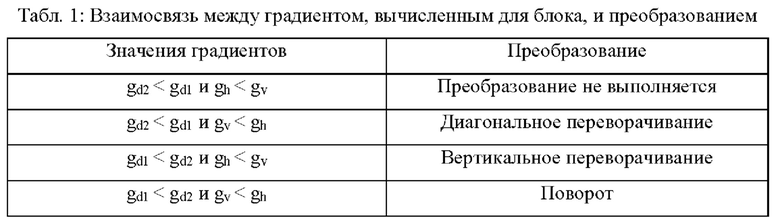

[0119] Геометрические преобразования могут применяться к коэффициентам фильтра и к соответствующим значениям ограничения фильтров (также называемым «значениями ограничения»). Перед фильтрацией того или иного блока (например, блока яркости 4×4) геометрические преобразования, такие как поворот или диагональное и вертикальное переворачивание, могут быть применены к коэффициентам f(k, l) фильтров и к соответствующим значениям c(k, l) ограничения фильтров, например, в зависимости от значений градиентов (например, gv, gh, gd1 и/или gd2), вычисленных для этого блока. Геометрические преобразования, применяемые к коэффициентам f(k, l) фильтра и к соответствующим значениям c(k, l) ограничения фильтра, могут быть эквивалентны применению геометрических преобразований к отсчетам в области, поддерживаемой этим фильтром. Геометрические преобразования могут сделать различные блоки, к которым применяется ALF, более похожими путем выравнивания соответствующей направленности.

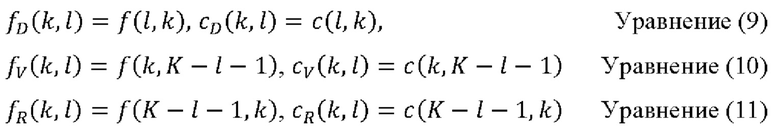

[0120] Три геометрических преобразования, включая диагональное переворачивание, вертикальное переворачивание и поворот, могут быть выполнены, как описано уравнениями (9)-(11), соответственно.

где К - это размер ALF или фильтра, a 0≤k, l≤K-1- координаты коэффициентов. Например, позиция (0,0) - это верхний левый угол, а позиция (K - 1, K - 1) - нижний правый угол фильтра f или матрицы значений ограничения (или матрицы ограничения) с. Преобразования могут применяться к коэффициентам f (k, l) фильтра и значениям с(k, l) ограничения в зависимости от значений градиентов, вычисленных для этого блока. Пример взаимосвязи между преобразованиями и четырьмя градиентами приводится в Табл. 1.

[0121] В некоторых вариантах осуществления параметры фильтра ALF передаются в наборе параметров адаптации (APS, Adaptation Parameter Set) для изображения. В APS может передаваться один или более наборов (например, до 25 наборов) из коэффициентов фильтров яркости и индексов значений ограничения. Например, набор из одного или более наборов может включать в себя коэффициенты фильтров яркости и один или более индексов значений ограничения. Может передаваться один или более наборов (например, до восьми наборов) из коэффициентов фильтров цветности и индексов значений ограничения. Для уменьшения объема данных сигнализации могут быть объединены коэффициенты фильтров различных классификаций (например, с разными индексами классификации) для компонентов яркости. В заголовке слайса могут передаваться индексы APS, используемых для текущего слайса.

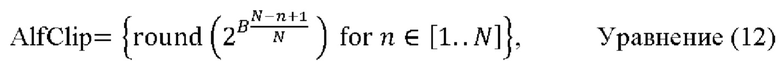

[0122] Согласно варианту осуществления индекс значения ограничения (также называемый «индексом ограничения») может быть декодирован из APS. Индекс значения ограничения может использоваться для определения соответствующего значения ограничения, например на основе взаимосвязи между индексом значения ограничения и соответствующим значением ограничения. Эта взаимосвязь может быть определена заранее и сохранена в декодере. Например, взаимосвязь описывается в таблице, например в таблице яркости (например, используемой для СВ яркости) из индекса значения ограничения и соответствующего значения ограничения, таблице цветности (например, используемой для СВ цветности) из индекса значения ограничения и соответствующего значения ограничения. Значение ограничения может зависеть от битовой глубины B. Битовая глубина B может относиться к внутренней битовой глубине, битовой глубине реконструированных отсчетов в подлежащем фильтрации СВ или т.п. В некоторых примерах таблица (например, таблица яркости, таблица цветности) формируется с использованием уравнения (12).

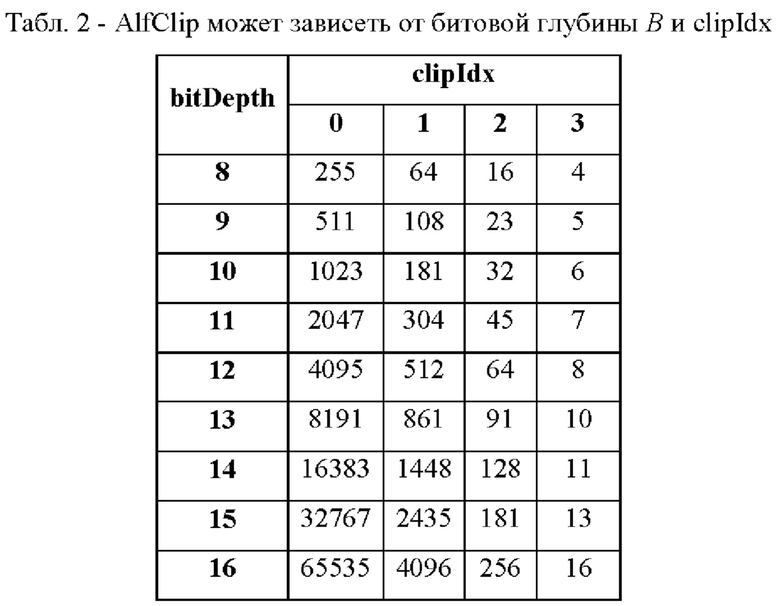

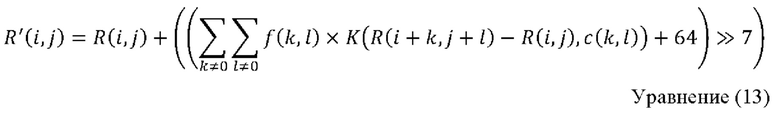

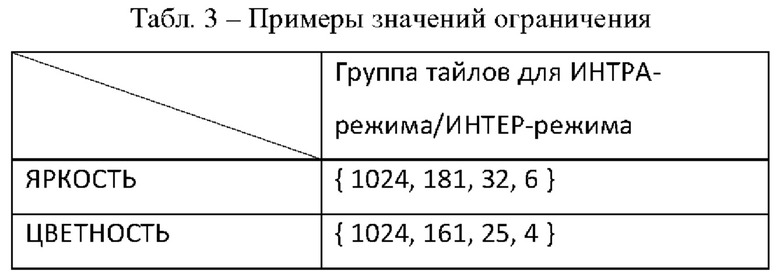

где AlfClip - это значение ограничения, B - битовая глубина (например, bitDepth), N (например, N=4) - количество разрешенных значений ограничения, а (n-1) - индекс значения ограничения (также называемый «индексом ограничения» или clipIdx). В Табл. 2 показан пример таблицы, полученной с использованием уравнения (12) с N=4. Индекс ограничения (n-1) в Табл. 2 может иметь значение 0, 1, 2 и 3, а n - 1, 2, 3 и 4 соответственно. Табл. 2 может использоваться для блоков яркости или блоков цветности.

[0123] В заголовке текущего слайса может передаваться один или более индексов APS (например, до семи индексов APS) для указания наборов фильтров яркости, которые могут использоваться для текущего слайса. Управление процессом фильтрации может выполняться на одном или более подходящих уровнях, например на уровне изображений, на уровне слайсов, на уровне СТВ и/или т.п. Согласно варианту осуществления управление процессом фильтрации может дополнительно выполняться на уровне СТВ. Может передаваться флаг для указания того, применяется ли ALF к СТВ яркости. СТВ яркости может выбрать набор фильтров из множества фиксированных наборов фильтров (например, из 16 фиксированных наборов фильтров) и набора(ов) фильтров (также называемых «передаваемым(ыми) набором(ами) фильтров»), которые передаются в APS. Индекс набора фильтров может передаваться для СТВ яркости для указания набора фильтров (например, набора фильтров из множества фиксированных наборов фильтров и передаваемого(мых) набора(ов) фильтров), который должен быть применен. Множество фиксированных наборов фильтров может быть предварительно определено и жестко закодировано в кодере и декодере и может называться «предварительно определенными наборами фильтров».

[0124] Для компонента цветности в заголовке слайса может быть передан индекс APS для указания наборов фильтров цветности, которые должны использоваться для текущего слайса. На уровне СТВ индекс набора фильтров может передаваться для каждого СТВ цветности, если в APS установлено более одного фильтра цветности.

[0125] Коэффициенты фильтров можно квантовать с нормой, равной 128. Для снижения сложности перемножения может применяться согласование битовых потоков с тем, чтобы коэффициент позиции, отличной от центральной, мог находиться в диапазоне от -27 до 27 - 1 включительно. Например, коэффициент центральной позиции не передается в битовом потоке и может считаться равным 128.

[0126] В некоторых вариантах осуществления синтаксис и семантика индекса ограничения и значений ограничения определены следующим образом: alf_luma_clip_idx[sfIdx][j] может использоваться для указания индекса ограничения значения ограничения для использования перед умножением на j-ый коэффициент переданного фильтра яркости, указанного sfIdx. Требование согласования битовых потоков может включать в себя следующее: значения от alf_luma_clip_idx[sfIdx][j] с sfIdx=0 для alf_luma_num_filters_signalled_minus 1 и j=0 - 11 должны находиться в диапазоне от 0 до 3 включительно.