Перекрестные ссылки на родственные заявки

В соответствии с применимым патентным законодательством и/или правилами Парижской конвенции, настоящая заявка оформлена для того, чтобы своевременно заявить о праве на приоритет и преимущества международной заявки на выдачу патента No. PCT/CN2019/077429, поданной 8 марта 2019 г. Для всех целей согласно законодательству, полное описание указанной выше заявки включено посредством ссылки в качестве части описания настоящей заявки.

Область техники, к которой относится изобретение

Настоящий патентный документ относится к способам, устройствам и системам для кодирования видео.

Уровень техники

Сегодня много усилий прилагается для совершенствования характеристик и производительности современных технологий видео кодеков с целью достижения более высоких коэффициентов сжатия данных или разработки алгоритмов кодирования и декодирования видео, обладающих меньшей сложностью или допускающих параллельную реализацию. Эксперты из промышленности недавно предложили несколько новых инструментов кодирования видео, и в настоящее время проводится тестирование для определения их эффективности.

Раскрытие сущности изобретения

Предложены устройства, системы и способы, относящиеся к кодированию цифрового видео и, в частности, к передаче в виде сигнализации сообщения об этапе квантования и взаимодействию внутриконтурного переформирования на блочной основе с другими инструментами при кодировании видео. Это может быть применено к существующим стандартам кодирования видео, таким как стандарт высокоэффективного видеокодирования (HEVC), или к стандартам (например, универсальное видео кодирование ((Versatile Video Coding)), разработка которых еще не завершена. Это может быть также применимо к будущим стандартам кодирования видео или к будущим видеокодекам.

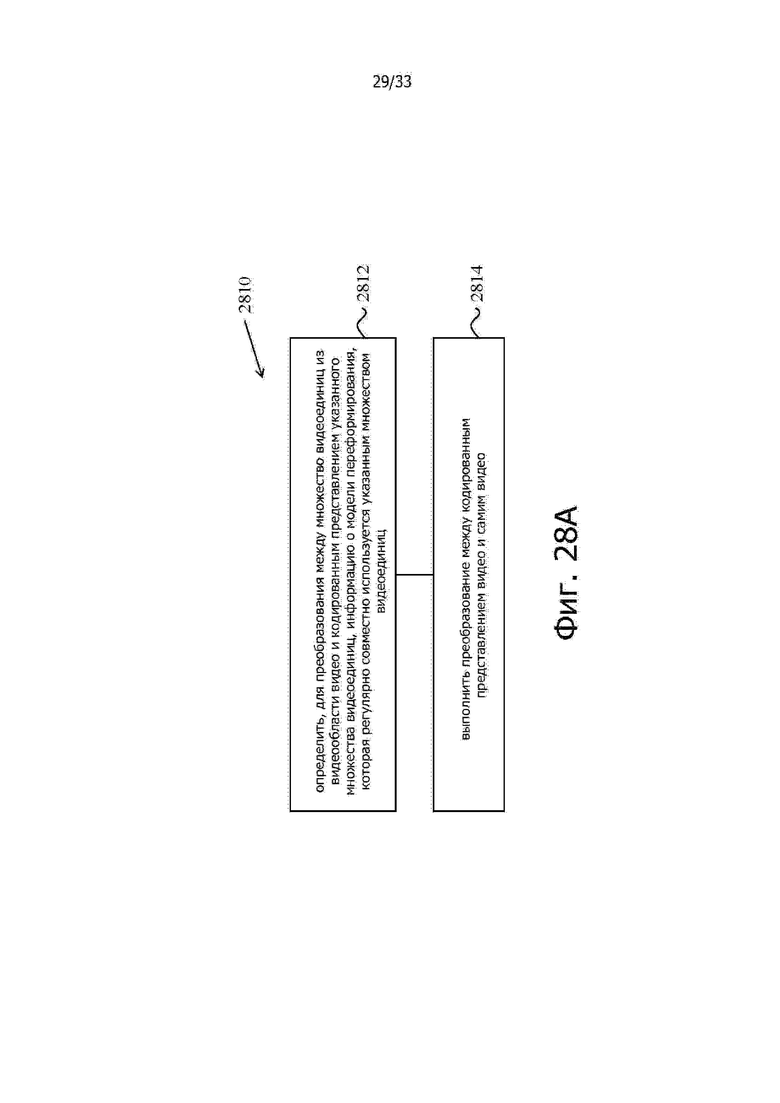

Согласно одному репрезентативному аспекту предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этапы, на которых: определяют, для преобразования между множеством видеоединиц видеообласти видео и кодированным представлением указанного множества видеоединиц, информацию о модели переформирования, обычно совместно используемой указанным множеством видеоединиц; и выполняют преобразование между кодированным представлением видео и самим видео, причем указанная информация о модели переформирования предоставляет информацию для построения видеоотсчетов в первой области и во второй области и/или масштабирования остатка цветностной составляющей от видеоединицы цветностной составляющей.

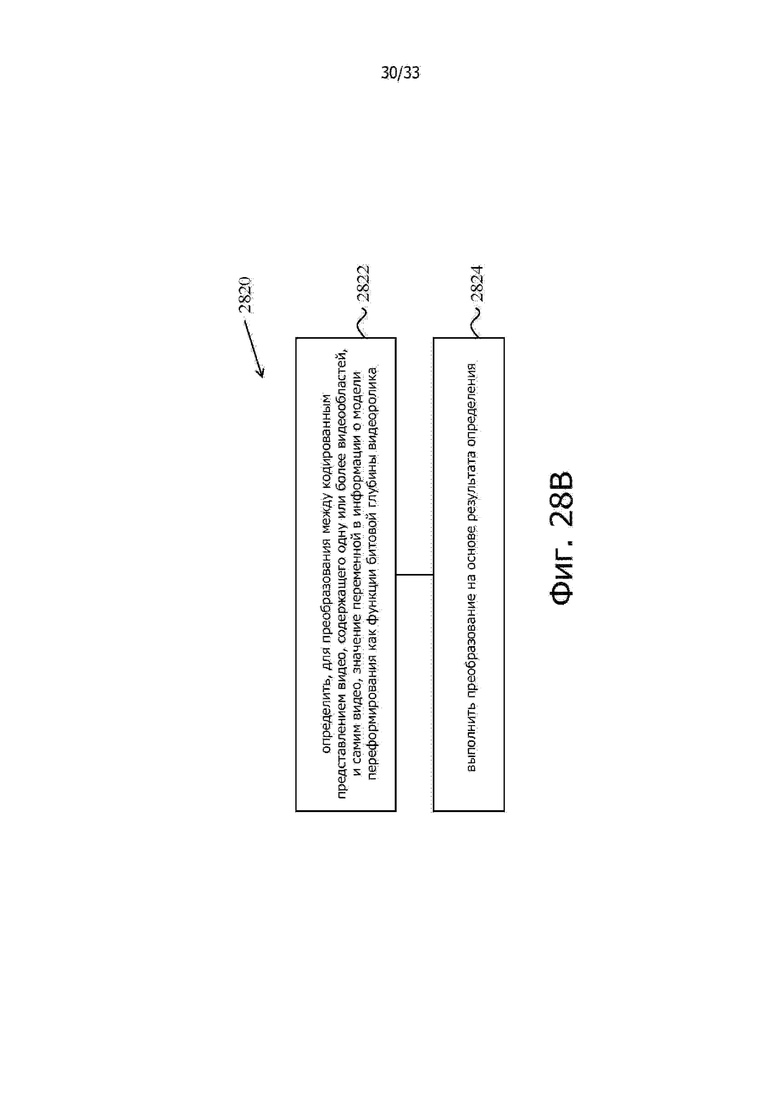

Согласно другому репрезентативному аспекту предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этапы, на которых определяют, для преобразования между кодированным представлением видео, содержащего одну или более видеообластей, и самим видеороликом, значение переменной в информации о модели переформирования в зависимости от битовой глубины видео, и выполняют преобразование на основе определения, при этом информация о переформировании применима для внутриконтурного переформирования (in-loop reshaping (ILR)) некоторых из указанной одной или более видеообластей, и информация о модели переформирования предоставляет информацию о реконструкции видеоединицы видеообласти на основе представления в первой области и во второй области и/или о масштабировании остатка цветностной составляющей от видеоединицы цветностной составляющей.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этап, на котором выполняют преобразование между кодированным представлением видео, содержащего одну или более видеообластей, и самим видео, причем кодированное представление содержит информацию о модели переформирования, применимой для внутриконтурного переформирования (ILR) некоторых из указанной одной или более видеообластей, при этом информация о модели переформирования предоставляет информацию для реконструкции видеоединицы видеообласти на основе представления видеоединицы в первой области и во второй области и/или о масштабировании остатка цветностной составляющей от видеоединицы цветностной составляющей, и информация о модели переформирования была инициализирована на основе правила инициализации.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этапы, на которых определяют, для преобразования между кодированным представлением видео, содержащего одну или более видеообластей, и самим видео, следует ли активизировать или отменить активизацию внутриконтурного переформирования (ILR); и выполняют преобразование на основе указанного определения, при этом кодированное представление содержит информацию о модели переформирования, применимой для переформирования ILR некоторых из указанной одной или более видеообластей, и информация о модели переформирования предоставляет информацию для реконструкции видеообласти на основе первой области и второй области и/или масштабирования остатка цветностной составляющей от видеоединицы цветностной составляющей, при этом на этапе определения определяют отменить активизацию переформирования ILR в случае, когда информация о модели переформирования не инициализирована.

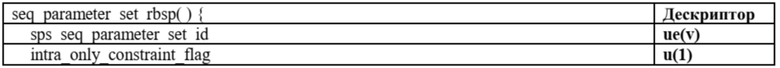

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Способ содержит этап, на котором выполняют преобразование между кодированным представлением видео, содержащим одну или боле видеообластей, и самим видео, причем кодированное представление содержит информацию о модели переформирования, применимой к внутриконтурному переформированию (ILR) для некоторых из указанной одной или более видеообластей, при этом информация о модели переформирования предоставляет информацию для реконструкции видеоединицы видеообласти на основе первой области и второй области и/или масштабирования остатка цветностной составляющей от видеоединицы цветностной составляющей, причем информация о модели переформирования включена в кодированное представление, только если видеообласть кодирована с использованием конкретного типа кодирования.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этапы, на которых определяют для преобразования между первой видеообластью видео и кодированным представлением первой видеообласти, может ли информация о переформировании из второй видео области быть использована для преобразования на основе правила; и выполняют преобразование в соответствии с определением.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этап, на котором выполняют преобразование между видеообластью видеоролика и кодированным представлением видеообласти, так что текущая видеообласть кодирована с использованием кодирования с внутрикадровым прогнозированием, при этом кодированное представление соответствует правилу форматирования, которое определяет информацию о модели переформирования в кодированном представлении условно на основе значения флага в кодированном представлении на уровне видеообласти.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этап, на котором выполняют преобразование между кодированным представлением видео, содержащего одну или более видеообластей, и самим видео, причем кодированное представление содержит информацию о модели переформирования, применимую для внутриконтурного переформирования (ILR) некоторых из указанной одной или более видеообластей, причем информация о модели переформирования предоставляет информацию для реконструкции видеоединицы видеообласти на основе представления в первой области и во второй области и/или масштабирования остатка цветностной составляющей от видеоединицы цветностной составляющей, при этом информация о модели переформирования содержит набор параметров, куда входит синтаксический элемент, определяющий разность между допустимым максимальным индексом бина и максимальным индексом бина, подлежащим использованию при реконструкции, и указанный параметр находится в некоем диапазоне.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Способ содержит этап, на котором выполняют преобразование между кодированным представлением видео, содержащим одну или более видеообластей, и самим видео, причем кодированное представление содержит информацию о модели переформирования, применимой для внутриконтурного переформирования (ILR) некоторых из указанной одной или более видеообластей, при этом информация о модели переформирования предоставляет информацию для реконструкции видеоединицы видеообласти на основе представления в первой области и во второй области и/или масштабирования остатка цветностной составляющей от видеоединицы цветностной составляющей, причем указанная информация о модели переформирования содержит набор параметров, куда входит максимальный индекс бина, подлежащий использованию при реконструкции, и максимальный индекс бина выводится как первое значение, равное сумме минимального индекса бина, подлежащего использованию при реконструкции, и синтаксического элемента, который представляет собой целое число без знака и который передается в виде сигнализации после минимального индекса бина.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этап, на котором выполняют преобразование между кодированным представлением видео, содержащего одну или более видеообластей, и самим видео, причем кодированное представление содержит информацию о модели переформирования, применимой для внутриконтурного переформирования (ILR) некоторых из указанной одной или более видеообластей, при этом информация о модели переформирования предоставляет информацию для реконструкции видеоединицы видеообласти на основе представления в первой области и во второй области и/или масштабирования остатка цветностной составляющей от видеоединицы цветностной составляющей, причем информация о модели переформирования содержит набор параметров, куда входит первый синтаксический элемент, определяющий число битов, используемых для представления второго синтаксического элемента, специфицирующего абсолютное значение кодового слова приращения, из соответствующего бина, причем первый синтаксический элемент имеет значение меньше порогового значения.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этап, на котором выполняют преобразование между кодированным представлением видео, содержащего одну или более видеообластей, и самим видео, причем кодированное представление содержит информацию о модели переформирования, применимой для внутриконтурного переформирования (ILR) некоторых из указанной одной или более видеообластей, причем указанная информация о модели переформирования предоставляет информацию для реконструкции видеоединицы видеообласти на основе представления в первой области и во второй области и/или масштабирования остатка цветностной составляющей от видеоединицы цветностной составляющей, при этом информация о модели переформирования содержит набор параметров, куда входит i-ый параметр, который представляет крутизну i-ого бина, используемого при переформировании ILR, и имеет значение на основе (i-1)-го параметра, причем i является положительным целым числом.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этап, на котором выполняют преобразование между кодированным представлением видео, содержащего одну или более видеообластей, и самим видео, причем кодированное представление содержит информацию о модели переформирования, применимой для внутриконтурного переформирования (ILR) некоторых из указанной одной или более видеообластей, при этом информация о модели переформирования предоставляет информацию для реконструкции видеоединицы видеообласти на основе представления в первой области и во второй области и/или масштабирования остатка цветностной составляющей от видеоединицы цветностной составляющей, причем информация о модели переформирования, используемой при переформировании ILR, содержит набор параметров, куда входит параметр reshape_model_bin_delta_sign_CW [ i ], каковой не передается в виде сигнализации, и параметр RspDeltaCW[ i ] = reshape_model_bin_delta_abs_CW [ i ], который всегда является положительным числом.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этап, на котором выполняют преобразование между кодированным представлением видео, содержащего одну или более видеообластей, и самим видео, причем кодированное представление содержит информацию о модели переформирования, применимой для внутриконтурного переформирования (ILR) некоторых из указанной одной или более видеообластей, при этом информация о модели переформирования предоставляет информацию для реконструкции видеоединицы видеообласти на основе представления в первой области и во второй области и/или масштабирования остатка цветностной составляющей от видеоединицы цветностной составляющей, причем информация о модели переформирования содержит набор параметров, куда входит параметр invAvgLuma, для использования значений яркостной составляющей для масштабирования в зависимости от цветового формата видеообласти.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этап, на котором выполняют преобразование между текущим видеоблоком видео и кодированным представлением видео, причем процедура преобразования содержит процедуру обратного отображения изображения для преобразования реконструированных отсчетов яркостной составляющей изображения в модифицированные реконструированные отсчетов яркостной составляющей изображения, при этом процедура обратного отображения изображения содержит процедуру усечения, при которой верхняя граница и нижняя граница устанавливаются по отдельности друг от друга.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Способ содержит этап, на котором выполняют преобразование между кодированным представлением видео, содержащего одну или более видеообластей, и самим видео, причем кодированное представление содержит информацию о модели переформирования, применимой для внутриконтурного переформирования (ILR) некоторых из указанной одной или более видео областей, причем информация о модели переформирования предоставляет информацию для реконструкции видеоединицы видеообласти на основе представления в первой области и во второй области и/или масштабирования остатка цветностной составляющей от видеоединицы цветностной составляющей, при этом информации о модели переформирования содержит набор параметров, куда входит величина поворота, ограниченная функцией Pivot[ i ]<=T.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этап, на котором выполняют преобразование между представлением видео, содержащего одну или более видеообластей, и самим видео, причем кодированное представление содержит информацию, применимую для внутриконтурного переформирования (ILR), и предоставляет параметры для реконструкции видеоединицы видеообласти на основе представления в первой области и во второй области и/или масштабирования остатка цветностной составляющей от видеоединицы цветностной составляющей, при этом параметр квантования (quantization parameter (QP)) цветностной составляющей имеет сдвиг, значение которого выводится для каждого блока или единицы преобразования.

Согласно другому репрезентативному аспекту, предлагаемая технология может быть использована для предоставления способа обработки видео. Этот способ содержит этап, на котором выполняют преобразование между представлением видео, содержащего одну или более видеообластей, и самим видео, причем кодированное представление содержит информацию, применимую для внутриконтурного переформирования (ILR), и предоставляет параметры для реконструкции видеоединицы видеообласти на основе представления в первой области и во второй области и/или масштабирования остатка цветностной составляющей от видеоединицы цветностной составляющей, при этом параметр квантования (QP) яркостной составляющей имеет сдвиг, значение которого выводится для каждого блока или единицы преобразования.

Один или более описанных выше способов могут быть применены, как в вариантах реализации на стороне кодирующего устройства, так и в вариантах реализации на стороне декодирующего устройства.

Кроме того, в соответствии с одним из репрезентативных аспектов предложено устройство в видеосистеме, содержащее процессор и энергонезависимое запоминающее устройство с записанными в нем командами. Команды при исполнении процессором вызывают выполнение процессором любого одного или более из раскрытых способов.

Кроме того, предложен компьютерный программный продукт, хранящийся на энергонезависимых читаемых компьютером носителях информации, причем компьютерный программный продукт содержит программный код для выполнения любого одного или более из раскрытых способов.

Приведенные выше и другие аспекты и признаки предлагаемой технологии рассмотрены более подробно на прилагаемых чертежах, в описании и в формуле изобретения.

Краткое описание чертежей

Фиг. 1 показывает пример построения списка объединяемых кандидатов.

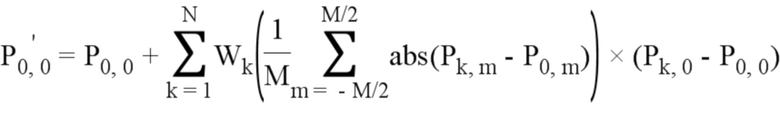

Фиг. 2 показывает пример позиций пространственных кандидатов.

Фиг. 3. показывает пример пар кандидатов, подвергаемых контролю избыточности, из совокупности пространственных объединяемых кандидатов

Фиг. 4A и 4B показывают примеры положения второй единицы прогнозирования (prediction unit (PU)) на основе размера и формы текущего блока.

Фиг. 5 показывает пример масштабирования векторов движения для временных объединяемых кандидатов.

Фиг. 6 показывает пример позиций кандидатов для временных объединяемых кандидатов.

Фиг. 7 показывает пример комбинированного двунаправлено интерполированного (прогнозируемого) объединяемого кандидата.

Фиг. 8 показывает пример построения кандидата с прогнозированием вектора движения.

Фиг. 9 показывает пример масштабирования векторов движения для пространственных объединяемых кандидатов.

Фиг. 10 показывает пример прогнозирования движения с использованием алгоритма прогнозирования альтернативного временного вектора движения (alternative temporal motion vector prediction (ATMVP)).

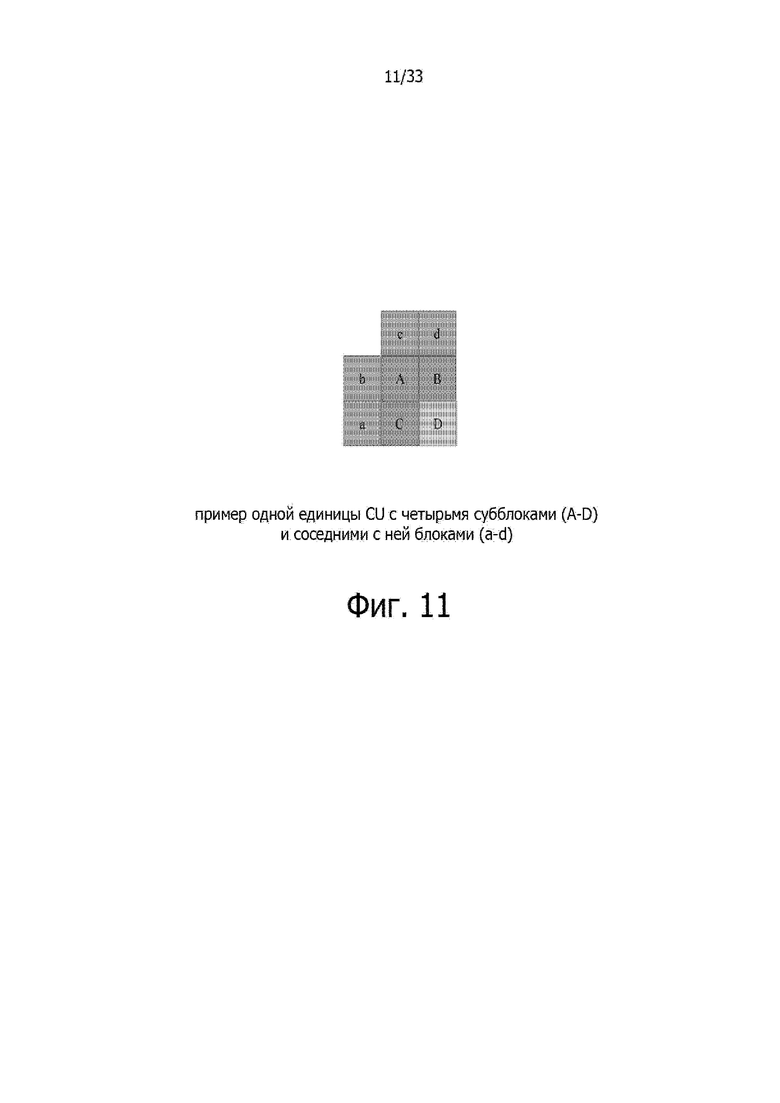

Фиг. 11 показывает пример прогнозирования пространственно-временного вектора движения.

Фиг. 12 показывает пример соседних отсчетов для определения параметров компенсации освещенности.

Фиг. 13A и 13B показывают иллюстрации в соединении с 4-параметрической аффинной моделью и 6-параметрической аффинной моделью, соответственно.

Фиг. 14 показывает пример аффинного поля вектора движения на один суб-блок.

Фиг. 15A и 15B показывают примеры 4-параметрической и 6-параметрической аффинных моделей, соответственно.

Фиг. 16 показывает пример прогнозирования вектора движения для аффинного режима межкадрового прогнозирования для изначально аффинных кандидатов.

Фиг. 17 показывает пример прогнозирования вектора движения для аффинного режима межкадрового прогнозирования для сконструированных аффинных кандидатов.

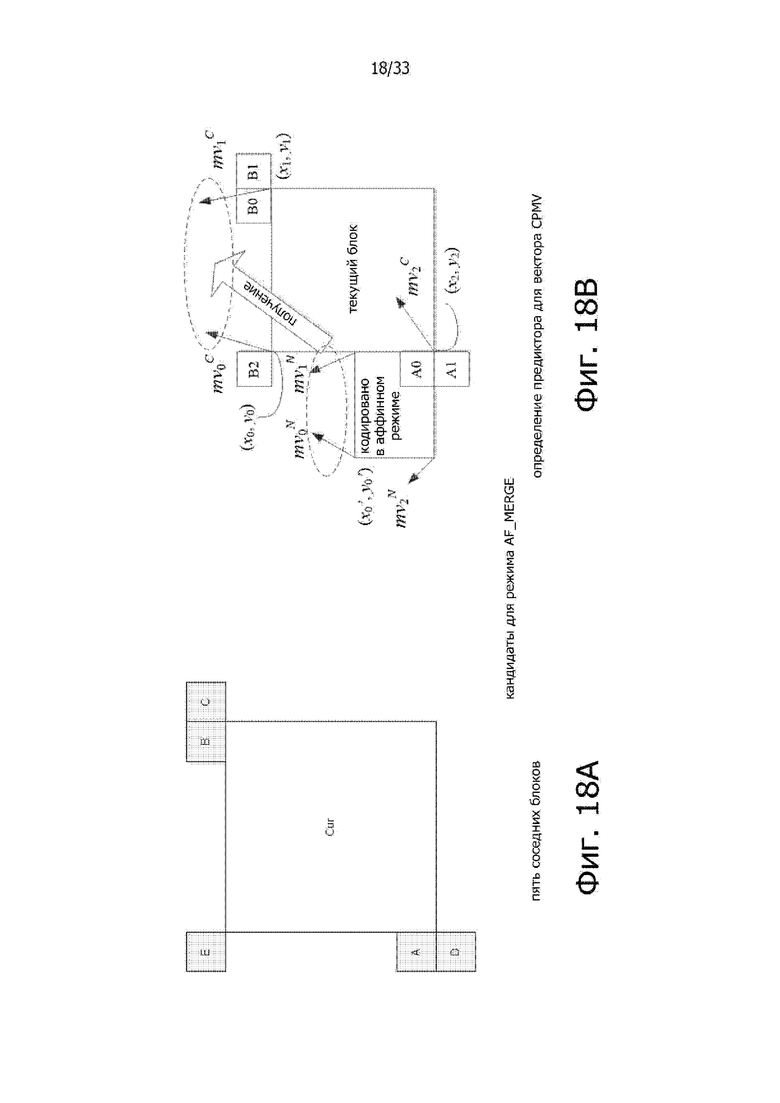

Фиг. 18A и 18B показывает иллюстрацию в соединении с аффинным режимом объединения.

Фиг. 19 показывает пример положений кандидатов для режима объединения аффинных объектов.

Фиг. 20 показывает пример процедуры поиска выражения окончательного вектора движения (ultimate motion vector expression (UMVE)).

Фиг. 21 показывает пример точки поиска выражения UMVE.

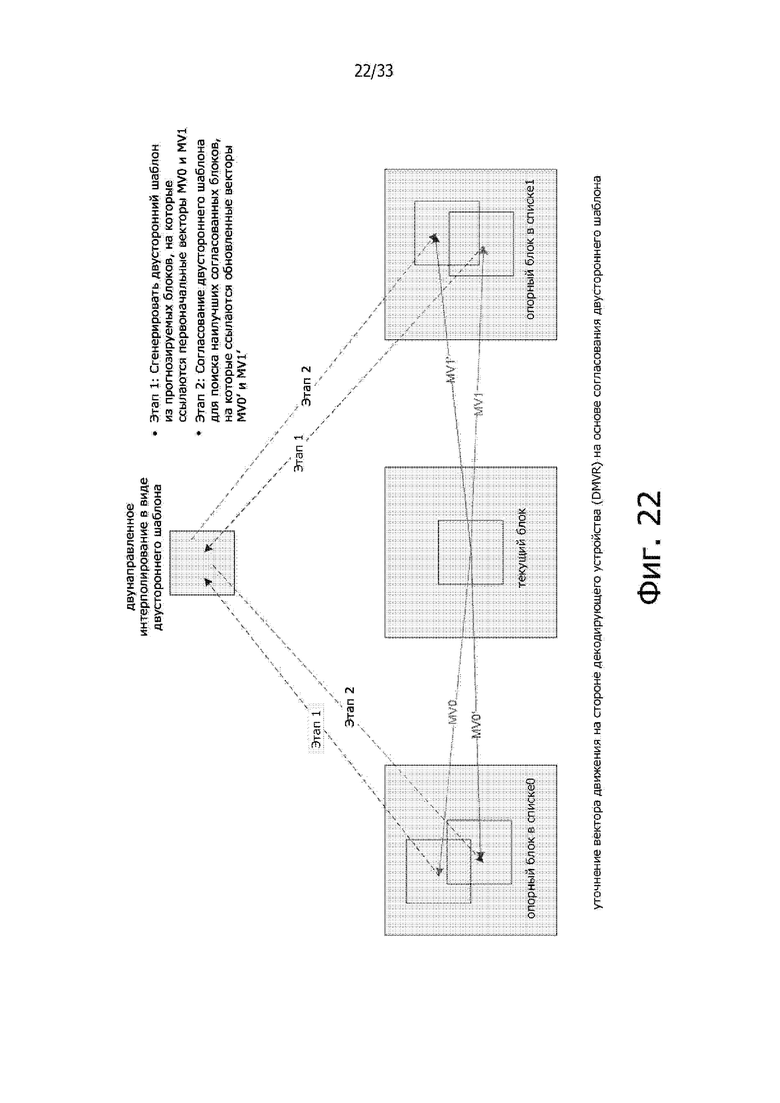

Фиг. 22 показывает пример уточнения вектора движения на стороне декодирующего устройства (decoder side motion vector refinement (DMVR)).

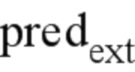

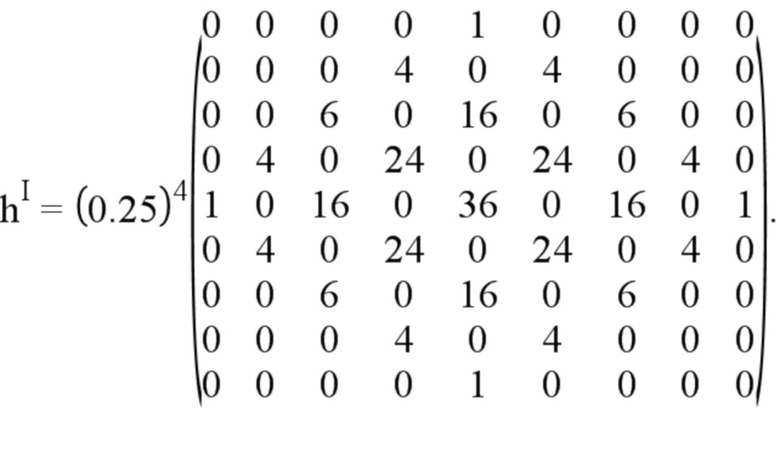

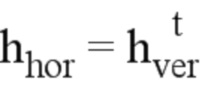

Фиг. 23 показывает пример логической схемы процедуры декодирования с применением этапа переформирования.

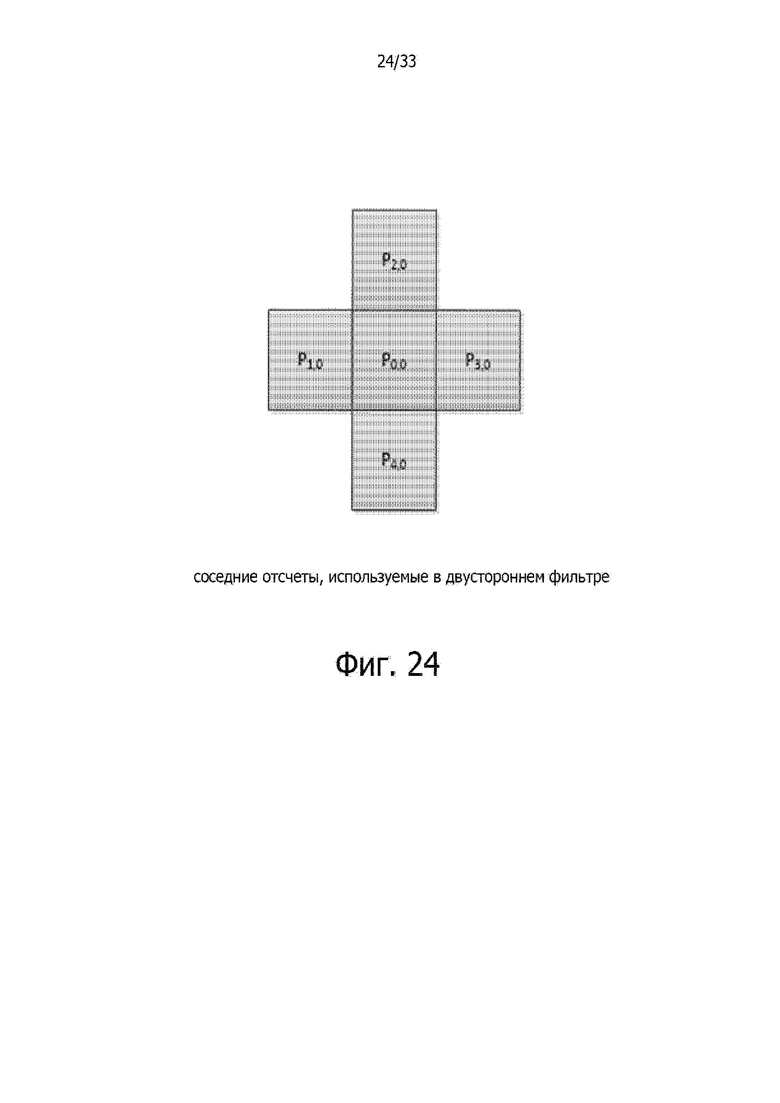

Фиг. 24 показывает пример отсчетов в двустороннем фильтре.

Фиг. 25 показывает примеры отсчетов в окнах, используемых при вычислениях весовых коэффициентов.

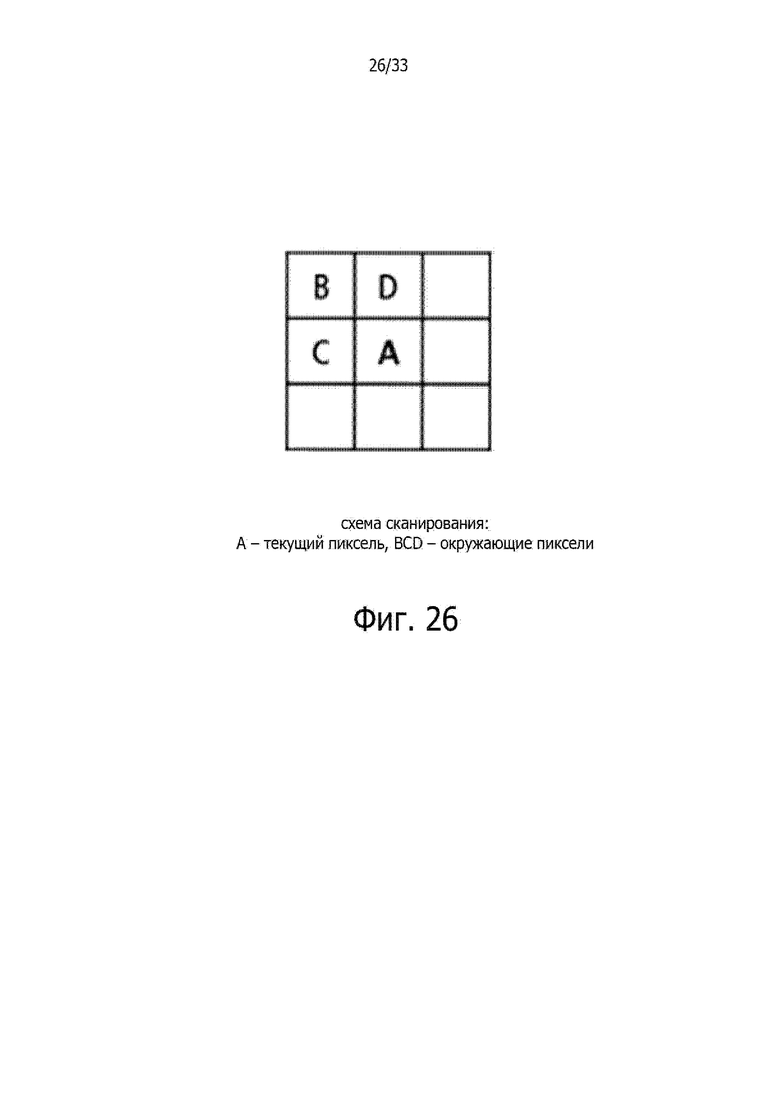

Фиг. 26 показывает пример схемы сканирования.

Фиг. 27A и 27B показывают блок-схемы примеров аппаратной платформы для реализации способа обработки визуальной информации, описываемого в настоящем документе.

Фиг. 28A – 28E показывают логические схемы примеров способов обработки видео на основе некоторых вариантов реализации предлагаемой технологии.

Осуществление изобретения

1. Кодирование видео в стандарте кодирования HEVC/H.265

Стандарты кодирования видео развивались главным образом через разработку хорошо известных стандартов ITU-T и ISO/IEC. Союз ITU-T выпустил стандарты H.261 и H.263, организация ISO/IEC выпустила стандарты MPEG-1 и MPEG-4 Visual, а также эти две организации совместно выпустили стандарты H.262/MPEG-2 Video и H.264/MPEG-4 Advanced Video Coding (AVC) (усовершенствованное видео кодирование) и H.265/HEVC. Со времени стандарта H.262, стандарты кодирования видео основаны на гибридной структуре кодирования видео, использующей временное прогнозирование плюс трансформационное кодирование. Для исследований в области технологий кодирования видео будущего, которые будут разработаны после технологии кодирования HEVC, группа экспертов по кодированию видео (VCEG) и группа экспертов по кинематографии (MPEG) в 2015 г. совместно основали Объединенную группу исследований в области видео (Joint Video Exploration Team (JVET)). С тех пор группа JVET разработала множество способов и ввела их в эталонное программное обеспечение, называемое Совместной исследовательской моделью (Joint Exploration Model (JEM)). В апреле 2018 г. группа VCEG (Q6/16) и отдел ISO/IEC JTC1 SC29/WG11 (MPEG) создали объединенную группу экспертов в области видео (Joint Video Expert Team (JVET)) для работ над стандартом VVC, имея целью добиться снижения требуемой скорости передачи битов данных на 50% по сравнению с кодированием HEVC. Самая последняя версия проекта стандарта VVC, т.е. Универсального видео кодирования (Проект 2) (Versatile Video Coding (Draft 2)), может быть найдена по адресу: http://phenix.it-sudparis.eu/jvet/doc_end_user/documents/11_Ljubljana/wg11/JVET-K1001-v7.zip.

Самая последняя эталонная версия программного обеспечения для стандарта кодирования VVC, называемая VTM, может быть найдена по адресу: https://vcgit.hhi.fraunhofer.de/jvet/VVCSoftware_VTM/tags/VTM-2.1

2.1. Межкадровое прогнозирование в стандарте кодирования HEVC/H.265

Каждая единица межкадрового прогнозирования PU (prediction unit (единица прогнозирования)) имеет параметры движения для одного или двух списков опорных изображений. Совокупность параметров движения содержит вектор движения и индекс опорного изображения. Сообщение об использовании одного или двух списков опорных изображений может быть также передано в виде сигнализации с применением параметра inter_pred_idc. Векторы движения могут быть в явной форме закодированы в виде приращений относительно предикторов.

Когда единица CU кодирована в режиме пропуска, с этой единицей CU ассоциирована одна единица PU, и при этом нет ни значительных коэффициентов остатка, ни кодированного приращения вектора движения или индекса опорного изображения. Режим объединения специфицирован таким образом, что параметры движения для текущей единицы PU получают из соседних единиц PU, включая пространственные и временные кандидаты. Режим объединения может быть применен к любой единице PU межкадрового прогнозирования, не только в режиме пропуска. Альтернативой для режима объединения является передача параметров движения в явном виде, где векторы движения (более точно, разности векторов движения (motion vector difference (MVD)) относительно предиктора вектора движения), соответствующий индекс опорного изображения для каждого списка опорных изображений и показатель использования списка опорных изображений передают в виде сигнализации в явной форме для каждой единицы PU. Этот тип режима называется в этом документе усовершенствованным прогнозированием вектора движения (advanced motion vector prediction (AMVP)).

Когда сигнализация указывает, что следует использовать один из двух списков опорных изображений, единицу PU создают из одного блока отсчетов. Это называется «однонаправленным прогнозированием» (‘uni-prediction’). Однонаправленное прогнозирование доступно для срезов обоих видов – P-среза (P-slice) или среза со ссылкой на предыдущий срез (предсказанного среза) и B-среза (B-slice) или среза со ссылками на предыдущий и последующий срезы (или двунаправлено интерполированного среза).

Когда сигнализация указывает, что следует использовать оба списка опорных изображений, единицу PU создают из двух блоков отсчетов. Это называется «двунаправленной интерполяцией (прогнозированием)» (‘bi-prediction’). Двунаправленная интерполяция доступна только для B-срезов.

Следующий текст предлагает подробности режимов межкадрового прогнозирования, специфицированных в стандарте кодирования HEVC. Описание будет начато с режима объединения.

2.1.1. Список опорных изображений

В стандарте кодирования HEVC, термин «межкадровое прогнозирование» используется для обозначения прогнозирования, выводимого из элементов данных (например, значений отсчетов или векторов движения) опорных изображений, отличных от декодируемого в текущий момент изображения (текущего изображения). Аналогично стандарту кодирования H.264/AVC, изображение можно прогнозировать из нескольких опорных изображений. Опорные изображения, используемые для межкадрового прогнозирования, организованы в одном или нескольких списках опорных изображений. Индекс опоры идентифицирует, какие из опорных изображений в списке следует использовать для создания прогнозируемого сигнала.

Один список опорных изображений, Список 0, используется для P-среза, и два списка опорных изображений, Список 0 и Список 1, используются для B-срезов. Следует отметить, что опорные изображения из Списка 0/1 могут быть из прошлых и будущих изображений с точки зрения захвата/представления на дисплее этих изображений.

2.1.2. Режим объединения

2.1.2.1. Определение кандидатов для режима объединения

Когда единицу PU прогнозируют с использованием режима объединения, индекс, указывающий на входную позицию в список объединяемых кандидатов, выделяют путем синтаксического анализа из потока битов данных и используют для извлечения информации о движении. Процедура построения указанного списка специфицирована в стандарте кодирования HEVC и может быть суммирована в соответствии со следующей последовательностью этапов:

• Этап 1: Определение первоначального списка кандидатов

• Этап 1.1: Определение пространственных кандидатов

• Этап 1.2: Контроль избыточности для пространственных кандидатов

• Этап 1.3: Определение временных кандидатов

• Этап 2: Вставка дополнительных кандидатов

• Этап 2.1: Создание двунаправлено интерполированных кандидатов

• Этап 2.2: Вставка кандидатов с нулевым движением

Эти этапы схематично показаны на фиг. 1. Для получения пространственных объединяемых кандидатов, выбирают максимум четверых объединяемых кандидатов из совокупности кандидатов, расположенных в пяти различных позициях. Для получения временных объединяемых кандидатов выбирают максимум одного объединяемого кандидата из двух кандидатов. Поскольку в декодирующем устройстве предполагается постоянное число кандидатов для каждой единицы PU, если число кандидатов, полученное после этапа 1, не достигает максимального числа объединяемых кандидатов (MaxNumMergeCand), передаваемого в форме сигнализации в заголовке среза, генерируют дополнительных кандидатов. Поскольку число кандидатов является постоянным, индекс наилучшего объединяемого кандидата кодируют с использованием усеченной унарной бинаризации (truncated unary binarization (TU)). Если размер единицы CU равен 8, все единицы PU из текущей единицы CU совместно используют один список объединяемых кандидатов, который идентичен списку объединяемых кандидатов для единицы прогнозирования размером 2N×2N.

В последующем, операции, ассоциированные с приведенными выше этапами, описаны подробно.

2.1.2.2. Определение пространственных кандидатов

При получении пространственных объединяемых кандидатов выбирают максимум четырех объединяемых кандидатов из совокупности кандидатов, расположенных в позициях, показанных на фиг. 2. Кандидатов выбирают в следующем порядке A1, B1, B0, A0 и B2. Позицию B2 учитывают только тогда, когда какая-либо из единиц PU, которые должны быть в позициях A1, B1, B0, A0, недоступна (например, потому, что эта единица принадлежит другому срезу или другой плитке) или кодирована с применением внутрикадрового прогнозирования. После добавления кандидата в позиции A1 добавление остальных кандидатов должно происходить с контролем избыточности, что обеспечивает исключение кандидатов с одинаковой информацией о движении из списка, так что эффективность кодирования улучшается. Для уменьшения вычислительной сложности не все возможные пары кандидатов рассматривают в процессе упомянутого контроля избыточности. Напротив, учитывают только пары, связанные стрелкой на фиг. 3, и какого-либо кандидата добавляют в список только в том случае, если соответствующий кандидат, использованный для контроля избыточности, не имеет такую же самую информацию о движении. Другим источником дублированной информации о движении является “вторая единица PU”, ассоциированная с разбиениями, отличными от 2Nx2N. В качестве примера, фиг. 4A и 4B показывают вторую единицу PU для случаев N×2N и 2N×N, соответственно. Когда текущую единицу PU разбивают как N×2N, кандидат в позиции A1 не учитывается при построении списка. На деле, добавление этого кандидата приведет к тому, что две единицы прогнозирования будут иметь одинаковую информацию о движении, что является избыточным с точки зрения требования иметь только одну единицу PU в единице кодирования. Аналогично, позицию B1 не учитывают, когда текущую единицу PU разбивают как 2N×N.

2.1.2.3. Определение временных кандидатов

На этом этапе в список добавляют только одного кандидата. В частности, при получении этого временного объединяемого кандидата, формируют масштабированный вектор движения на основе расположенной в этом же месте единицы PU, принадлежащей изображению, имеющему наименьшую разницу порядковых номеров картинки (Picture Order Count (POC)) относительно текущего изображения в рассматриваемом списке опорных изображений. О списке опорных изображений, который должен быть использован для получения расположенной в том же месте единицы PU, сигнализируют в явной форме в заголовке среза, а фиг. 5 показывает пример получения масштабированного вектора движения для временного объединяемого кандидата (как показывает штриховая линия), который масштабируют из вектора движения для расположенной в том же месте единицы PU с использованием расстояний по порядковым номерам (POC-расстояний), tb и td, где расстояние tb определяют как разницу номеров POC между опорным изображением для текущего изображения и самим текущим изображением и расстояние td определяют как разницу номеров POC между опорным изображением для расположенного в том же месте изображения и самим расположенным в том же месте изображением. Индекс опорного изображения для временного объединяемого кандидата устанавливают равным нулю. Практическая реализация процедуры масштабирования описана в спецификации стандарта кодирования HEVC. Для B-среза получают два вектора движения, один для списка 0 опорных изображений и другой для списка 1 опорных изображений, и комбинируют эти векторы для получения двунаправлено интерполированного объединяемого кандидата.

В расположенной в том же месте единице PU (Y), принадлежащей опорному кадру, позицию для временного кандидата выбирают между кандидатами C0 и C1, как показано на фиг. 6. Если единица PU в позиции C0 недоступна, кодирована с применением внутрикадрового прогнозирования или находится вне текущей строки единиц дерева кодирования (current coding tree unit (CTU)) (единица CTU также называется наибольшей единицей кодирования (LCU, largest coding unit)), используют позицию C1. В противном случае, для получения временного объединяемого кандидата используют позицию C0.

2.1.2.4. Вставка дополнительных кандидатов

Помимо пространственно-временных объединяемых кандидатов имеются еще два дополнительных типа объединяемых кандидатов: комбинированный двунаправлено интерполированный объединяемый кандидат и нулевой объединяемый кандидат. Комбинированных двунаправлено интерполированных объединяемых кандидатов генерируют с использованием пространственных и временных объединяемых кандидатов. Комбинированный двунаправлено интерполированный объединяемый кандидат используется только для B-среза. Таких комбинированных двунаправлено интерполированных кандидатов генерируют путем комбинирования параметров движения из первого списка опорных изображений для первоначального кандидата с параметрами движения из второго списка опорных изображений для другого кандидата. Если эти две группы параметров формируют разные гипотезы движения, они создадут нового двунаправлено интерполированного кандидата. В качестве примера, на фиг. 7 показан случай, где двух кандидатов из исходного списка (слева), имеющих параметры mvL0 и refIdxL0 или mvL1 и refIdxL1, используют для создания комбинированного двунаправлено интерполированного объединяемого кандидата, добавляемого в конечный список (справа). Имеются многочисленные правила относительно построения таких комбинаций, учитываемые при генерации таких дополнительных объединяемых кандидатов.

Кандидатов с нулевым движением вставляют для заполнения оставшихся входных позиций в списке объединяемых кандидатов и тем самым достижения максимальной емкости MaxNumMergeCand списка. Эти кандидаты имеют нулевое пространственное смещение, а индекс опорного изображения начинается с нуля и увеличивается каждый раз, когда в список добавляют нового кандидата с нулевым движением. Число опорных кадров, используемых этими кандидатами, равно одному и двум для однонаправленного прогнозирования и двунаправленного прогнозирования, соответственно. В некоторых вариантах, для этих кандидатов контроль избыточности не осуществляется.

2.1.3. Усовершенствованное прогнозирование вектора движения (AMVP)

Прогнозирование AMVP использует пространственно-временную корреляцию вектора движения с соседними единицами PU, что используется для передачи параметров движения в явной форме. При построении списка векторов-кандидатов движения сначала проверяют доступность временных соседних единиц PU в позициях слева сверху, исключают избыточных кандидатов и добавляют нулевой вектор, чтобы сделать список кандидатов постоянной длины. Тогда кодирующее устройство может выбрать наилучшего предиктора из списка кандидатов и передать соответствующий индекс, указывающий выбранного кандидата. Аналогично передаче индекса объединения посредством сигнализации, индекс наилучшего вектора движения кодируют с использованием усеченной унарной бинаризации. Максимальное значение, подлежащее кодированию, в этом случае равно 2 (например, см. фиг. 8). В последующих разделах приведены подробности процедуры получения кандидата при прогнозировании вектора движения.

2.1.3.1. Получение кандидатов при прогнозировании AMVP

Фиг. 8 суммирует процедуру получения кандидата при прогнозировании вектора движения.

При прогнозировании векторов движения рассматривают два типа векторов-кандидатов движения: пространственный вектор-кандидат движения и временной вектор-кандидат движения. Для формирования пространственного вектора-кандидата движения в конечном итоге получают два вектора-кандидата движения на основе векторов движения для каждой из единиц PU, расположенных в пяти разных позициях, как было ранее показано на фиг. 2.

Для формирования временного вектора-кандидата движения выбирают одного вектора-кандидата движения из двух кандидатов, получаемых на основе двух разных расположенных в одном месте позиций. После создания первого списка пространственно-временных кандидатов из этого списка исключают дублированные векторы-кандидаты движения. Если число потенциальных кандидатов больше двух, векторы-кандидаты движения, для которых индекс опорного изображения в ассоциированном списке опорных изображений больше 1, исключают из этого списка. Если это число пространственно-временных векторов движения кандидатов меньше двух, в список добавляют дополнительный нулевой вектор-кандидат движения.

2.1.3.2. Пространственные векторы-кандидаты движения

Для получения пространственных векторов-кандидатов движения, учитывают максимум двух потенциальных кандидатов из совокупности пяти потенциальных кандидатов, получаемых из единиц PU, расположенных в позициях, как это ранее показано на фиг. 2, эти позиции являются такими же, как при объединении движения. Порядок формирования для левой стороны от текущей единицы PU задан как кандидат A0, кандидат A1 и масштабированный кандидат A0, масштабированный кандидат A1. Порядок формирования для верхней стороны от текущей единицы PU задан как кандидат B0, кандидат B1, кандидат B2, масштабированный кандидат B0, масштабированный кандидат B1, масштабированный кандидат B2. Для каждой стороны, поэтому, имеются четыре случая, которые могут быть использованы в качестве вектора-кандидата движения, где в двух случаях не требуется использовать пространственное масштабирование, и в двух случаях пространственное масштабирование применяется. Эти четыре разных случая суммированы следующим образом.

• Нет пространственного масштабирования

- (1) Одинаковый список опорных изображений и одинаковый индекс опорного изображения (одинаковый порядок POC)

- (2) Разные списки опорных изображений, но одинаковое опорное изображение (одинаковый порядок POC)

• Пространственное масштабирование

- (3) Одинаковый список опорных изображений, но разные опорные изображения (разный порядок POC)

- (4) Разные списки опорных изображений и разные опорные изображения (разный порядок POC)

Случаи без пространственного масштабирования проверяют первыми, после чего проверяют случаи, позволяющие пространственное масштабирование. Пространственное масштабирование рассматривается, когда порядок POC различается между опорным изображением для соседней единицы PU и опорным изображением для текущей единицы PU независимо от списка опорных изображений. Если все единицы PU кандидатов слева недоступны или кодированы с применением внутрикадрового прогнозирования, допускается масштабирование вектора движения для единицы сверху, чтобы способствовать параллельному определению векторов-кандидатов MV слева и сверху. В противном случае для вектора движения единицы сверху пространственное масштабирование не допускается.

Как показано в примере, приведенном на фиг. 9, для случая пространственного масштабирования, вектор движения для соседней единицы PU масштабируют способом, аналогичным временному масштабированию. Основное различие состоит в том, что в качестве входных данных используют список опорных изображений и индекс текущей единицы PU; фактическая процедура масштабирования является такой же, как в случае временного масштабирования.

2.1.3.3. Временные векторы-кандидаты движения

Помимо получения индекса опорного изображения, все процедуры для формирования временных объединяемых кандидатов являются такими же, как и для формирования пространственных векторов-кандидатов движения (как показано в примере на фиг. 6). Индекс опорного изображения сообщают посредством сигнализации декодирующему устройству.

2.2. Способы прогнозирования векторов движения на основе суб-единиц CU в модели JEM

В модели JEM с использованием деревьев квадратов плюс двоичные деревья (quadtrees plus binary trees (QTBT)), каждая единица CU может иметь самое большее один набор параметров движения на каждое направление прогнозирования. В некоторых вариантах, рассматриваются два способа прогнозирования векторов движения на уровне суб-единиц CU в кодирующем устройстве путем разделения большой единицы CU на суб-единицы CU и формирования информации движения для всех суб-единиц CU из большой единицы CU. Способ прогнозирования альтернативного временного вектора движения (ATMVP) позволяет каждой единице CU осуществлять выборку нескольких наборов информации движения из нескольких блоков меньше текущей единицы CU в расположенном в том же месте опорном изображении. При использовании способа прогнозирования пространственно-временного вектора движения (spatial-temporal motion vector prediction (STMVP)) векторы движения суб-единиц CU формируют рекурсивным способом с применением предиктора временного вектора движения и пространственного соседнего вектора движения.

С целью сохранения более точного поля движения для прогнозирования движения суб-единицы CU сжатие движения для опорных кадров может быть в текущий момент не активизировано.

2.2.1. Прогнозирование альтернативного временного вектора движения

На фиг. 10 показан пример прогнозирования альтернативного временного вектора движения (ATMVP). Согласно способу прогнозирования альтернативного временного вектора движения (ATMVP), способ прогнозирования временного вектора движения (temporal motion vector prediction (TMVP)) модифицируют путем выборки нескольких наборов информации о движении (включая векторы движения и опорные индексы) из блоков меньше текущей единицы CU. Суб-единицы CU представляют собой квадратные блоки размером N×N (по умолчанию N устанавливают равным 4).

Способ прогнозирования ATMVP осуществляет прогнозирование векторов движения суб-единиц CU в пределах единицы CU в два этапа. На первом этапе идентифицируют соответствующий блок в опорном изображении с так называемым временным вектором. Опорное изображение также называется изображением источника движения. На втором этапе разбивают единицу CU на суб-единицы CU и получают векторы движения, равно как опорные индексы каждой суб-единицы CU, из блока, соответствующего каждой суб-единице CU.

На первом этапе, опорное изображение и соответствующий блок определяют посредством информации о движения пространственно соседних блоков для текущей единицы CU. Чтобы избежать повторяющихся процедур сканирования соседних блоков, используют первого объединяемого кандидата из списка объединяемых кандидатов для текущей единицы CU. Первый доступный вектор движения, равно как и ассоциированный опорный индекс устанавливают в качестве временного вектора и индекса для изображения источника движения. Таким способом, при использовании прогнозирования ATMVP, соответствующий блок может быть более точно идентифицирован, по сравнению со способом прогнозирования TMVP, где соответствующий блок (иногда называемый расположенным в том же месте блоком) всегда находится в нижней правой или в центральной позиции относительно текущей единицы CU.

На втором этапе, соответствующий блок суб-единицы CU идентифицируют посредством временного вектора в изображении источника движения путем добавления временного вектора к координате текущей единице CU. Для каждой суб-единицы CU, информацию о движении ее соответствующего блока (наименьшую сетку движения, покрывающую центральный отсчет) используют для получения информации о движении для рассматриваемой суб-единицы CU. После идентификации информации о движении соответствующего блока размером N×N ее преобразуют в векторы движения и опорные индексы текущей суб-единицы CU, таким же образом как способ прогнозирования TMVP в стандарте кодирования HEVC, где применяются масштабирование движения и другие процедуры. Например, декодирующее устройство проверяет, удовлетворяется ли условие малой задержки, (т.е. порядковые номера POC для всех опорных изображений для текущего изображения меньше порядкового номера POC для текущего изображения) и возможно использует вектор MVx движения (например, вектор движения, соответствующий списку опорных изображений X) для прогнозирования вектора MVy движения (при X равном 0 или 1 и Y равным 1−X) для каждой суб-единицы CU.

2.2.2. Прогнозирования пространственно-временного вектора движения (STMVP)

Согласно этому способу векторы движения суб-единиц CU формируют рекурсивным способом, следуя порядку сканирования растра. Фиг. 11 иллюстрирует эту концепцию. Рассмотрим единицу CU размером 8×8, содержащую четыре суб-единицы CU размером 4×4, а именно A, B, C и D. Соседние блоки размером 4×4 в текущем кадре маркированы как a, b, c и d.

Процедура определения движения для суб-единицы CU A начинается с идентификации ее двух соседей в пространстве. Первый сосед представляет собой блок размером N×N, расположенный выше суб-единицы CU A (блок c). Если этот блок c недоступен или кодирован с применением внутрикадрового прогнозирования, проверяют другие блоки размером N×N, находящиеся выше суб-единицы CU A, (слева направо, начиная с блока c). Второй сосед представляет собой блок слева от суб-единицы CU A (блок b). Если блок b недоступен или кодирован с применением внутрикадрового прогнозирования, проверяют другие блоки, находящиеся слева от суб-единицы CU A (сверху вниз, начиная с блока b). Информацию о движении, получаемую от соседних блоков для каждого списка, масштабируют к первому опорному кадру для конкретного рассматриваемого списка. Далее, формируют предиктор временного вектора движения (TMVP) для суб-блока A с применением такой же процедуры формирования предиктора TMVP, как это специфицировано в стандарте кодирования HEVC. Информацию о блоке, расположенном в одном месте с блоком D, выбирают и масштабируют соответственно. В конечном итоге, после вызова и масштабирования информации о движения все доступные векторы движения (до 3 векторов) усредняют по отдельности для каждого опорного списка. Усредненный вектор движения назначают в качестве вектора движения для текущей суб-единицы CU.

2.2.3. Сигнализация о режиме прогнозирования движения для суб-единицы CU

Режимы суб-единицы CU активизированы в качестве дополнительных объединяемых кандидатов, так что для сигнализации об этих режимах не требуется никакой дополнительный синтаксический элемент. В список объединяемых кандидатов для каждой единицы CU добавляют двух дополнительных объединяемых кандидатов для представления режима прогнозирования ATMVP и режима прогнозирования STMVP. Если набор параметров последовательности указывает, что активизированы режим прогнозирования ATMVP и режим прогнозирования STMVP, могут быть использованы вплоть до семи объединяемых кандидатов. Логика кодирования дополнительных объединяемых кандидатов является такой же, как для объединяемых кандидатов в основной модели HM, что означает, для каждой единицы CU в P-срезе или в B-срезе, что могут потребоваться две дополнительные проверки избыточности (RD) для двух дополнительных объединяемых кандидатов.

В модели JEM, все бины с индексом объединения кодированы с применением контекстно-зависимого двоичного арифметического кодирования (CABAC (Context-based Adaptive Binary Arithmetic Coding)). В то же время, при кодировании HEVC, только первый бин подвергают контекстно-зависимому кодированию, а остальные бины кодируют независимо от контекста.

2.3. Локальная компенсация освещенности в модели JEM

Локальная компенсация освещенности (Local Illumination Compensation (LIC)) основана на линейной модели изменений освещенности, использующей масштабный коэффициент a и сдвиг b. Причем эту компенсацию активизируют и отменяют активизацию адаптивно для каждой единицы кодирования (CU), кодированной с применением межкадрового прогнозирования.

Когда компенсация LIC применяется для единицы CU, применяют метод наименьших квадратов для получения параметров a и b с использованием соседних отсчетов относительно текущей единицы CU и соответствующих им опорных отсчетов. Более конкретно, как иллюстрирует фиг. 12, используются субдискретизированные (субдискретизация в соотношении 2:1) соседние отсчеты относительно единицы CU и соответствующие отсчеты (идентифицированные информацией о движении текущей единицы CU или суб-единицы CU) из опорного изображения.

2.3.1. Получение прогнозируемых блоков

Параметры компенсации IC получают и применяют для каждого направления прогнозирования по отдельности. Для каждого направления прогнозирования генерируют первый прогнозируемый блок с использованием декодированной информации о движении, а затем получают временной прогнозируемый блок путем применения модели компенсации LIC. После этого, указанные два временных прогнозируемых блока используют для получения конечного прогнозируемого блока.

Когда единицу CU кодируют с применением режима объединения, копируют флаг компенсации LIC из соседних блоков способом, аналогичным кодированию информации о движении в режиме объединения; в противном случае флаг компенсации LIC передают в виде сигнализации для единицы CU, чтобы указать, применяется компенсация LIC или нет.

Когда для некоторого изображения активизирована компенсация LIC, необходимо осуществить дополнительную проверку избыточности (RD) на уровне единиц CU, чтобы определить, применяется ли компенсация LIC для какой-либо единицы CU. Если для какой-то единицы CU активизирована компенсация LIC, используют сумму абсолютных разностей с исключением среднего (mean-removed sum of absolute difference (MR-SAD)) и трансформированную по преобразованию Адамара сумму абсолютных разностей с исключением среднего (mean-removed sum of absolute Hadamard-transformed difference (MR-SATD)) вместо суммы абсолютных разностей (SAD) и трансформированной по преобразованию Адамара суммы абсолютных разностей (SATD), для поиска целочисленного движения элементов изображения и поиска дробного движения элементов изображения, соответственно.

Для уменьшения сложности кодирования, в модели JEM применяется следующая схема кодирования.

• Компенсацию LIC не активизируют для всего изображения, когда нет заметных изменений освещенности между текущим изображением и соответствующими ему опорными изображениями. Для идентификации этой ситуации, в кодирующем устройстве вычисляют гистограммы для текущего изображения и для каждого опорного изображения, соответствующего этому текущему изображения. Если разница гистограмм между текущим изображением и каждым из опорных изображений для этого текущего изображения меньше конкретной порогового значения, компенсацию LIC для текущего изображения не активизируют; в противном случае активизируют эту компенсацию LIC для текущего изображения.

2.4. Способы межкадрового прогнозирования при кодировании VVC

Имеется ряд новых инструментов кодирования для усовершенствования межкадрового прогнозирования, таких как адаптивное разрешение разницы векторов движения (Adaptive motion vector difference resolution (AMVR)) для передачи сигнализации о разнице MVD, аффинный режим прогнозирования, треугольный режим прогнозирования (Triangular prediction mode (TPM)), режим прогнозирования ATMVP, обобщенное двунаправленное прогнозирование (Generalized Bi-Prediction (GBI)), двунаправленный оптический поток (Bi-directional Optical flow (BIO)).

2.4.1. Структура блоков кодирования в стандарте кодирования VVC

В стандарте кодирования VVC, принята структура Дерево квадратов/Двоичное дерево/Множественное дерево (QuadTree/BinaryTree/MulitpleTree (QT/BT/TT)) для разбиения изображения на квадратные или прямоугольные блоки.

Помимо структуры QT/BT/TT, в стандарте кодирования VVC также принято раздельное дерево (известное как двойное дерево кодирования) для I-кадров (кадров с внутрикадровым прогнозированием). В случае раздельного дерева, сигнализацию о структуре блоков кодирования передают по отдельности для яркостной и цветностной составляющих.

2.4.2 Адаптивное разрешение разницы векторов движения

В стандарте кодирования HEVC, разности векторов движения (motion vector difference (MVD)) (между вектором движения и прогнозируемым вектором движения для единицы PU) сообщают в виде сигнализации в единицах четвертей яркостных отсчетов, когда флаг use_integer_mv_flag равен 0 в заголовке среза. В стандарт кодирования VVC, введено локально адаптивное разрешение векторов движения (AMVR). В стандарте кодирования VVC, разность MVD может быть кодирована в единицах четвертей яркостных отсчетов, целых яркостных отсчетов или четверок яркостных отсчетов (т.е. ¼-pel, 1-pel, 4-pel, здесь pel = элемент изображения (picture element)). Разрешением разностей MVD управляют на уровне единиц кодирования (CU), а флаги разрешения разностей MVD условно передают в виде сигнализации для каждой единицы CU, имеющей по меньшей мере одну ненулевую составляющую разности MVD.

Для единицы CU, имеющей по меньшей мере одну ненулевую составляющую разности MVD, передают в виде сигнализации первый флаг для указания, используется ли точность в одну четверть единицы измерения яркостного отсчета для вектора MV в этой единице CU. Когда первый флаг (равный 1) указывает, что точность в четверть единицы измерения яркостного отсчета не используется для вектора MV, передают в виде сигнализации другой флаг для указания, что используется точность в одну целую единицу измерения яркостного отчета или в четыре единицы измерения яркостных отсчета для вектора MV.

Когда первый флаг разрешения разности MVD для единицы CU равен нулю, или не кодирован для единицы CU (это означает, что все разности MVD для этой единицы CU являются нулевыми), для этой единицы CU используется точность в четверть единицы измерения яркостного отсчета для вектора MV. Когда единица CU использует точность в одну единицу измерения яркостного отсчета для вектора MV или в четыре единицы измерения яркостных отсчетов для вектора MV, прогнозы MVP в списке кандидатов прогнозирования AMVP для этой единицы CU округляют до соответствующей точности.

2.4.3 Аффинное прогнозирование с компенсацией движения

В стандарте кодирования HEVC, для прогнозирования с компенсацией движения (motion compensation prediction (MCP)) применяется только модель поступательного движения. Однако в реальном мире возможны движения многих типов, например, приближение/удаление, вращение, перспективные движения и/или другие нерегулярные движения. В стандарте кодирования VVC, применяется упрощенное аффинное прогнозирование с компенсацией движения с 4-параметрической аффинной моделью и 6-параметрической аффинной моделью. Как показано на фиг. 13A и 13B, поле аффинного движения блока описывается двумя векторами движения контрольной точки (control point motion vectors (CPMV)) для 4-параметрической аффинной модели, и тремя векторами CPMV для 6-параметрической аффинной модели, соответственно.

Поле вектора движения (motion vector field (MVF)) для блока описывается следующим уравнением в соответствии с 4-параметрической аффинной моделью (где 4 параметра модели определены как переменные a, b, e и f) в уравнении (1) и 6-параметрической аффинной моделью (где 6 параметров модели определены как переменные a, b, c, d, e и f) в уравнении (2), соответственно:

здесь, (mvh0, mvh0) обозначает вектор движения контрольной точки (CP) в верхнем левом углу, и (mvh1, mvh1) обозначает вектор движения контрольной точки в верхнем правом углу и (mvh2, mvh2) обозначает вектор движения контрольной точки в нижнем левом углу, все три этих вектора движения называются векторами движения контрольной точки (CPMV), (x, y) представляет координаты репрезентативной точки относительно верхнего левого отсчета в текущем блоке и (mvh(x,y), mvv(x,y)) обозначает вектор движения, полученный для отсчета, расположенного в точке (x, y). Векторы движения точек CP можно передать в виде сигнализации (как в аффинном режиме прогнозирования AMVP) или получить в реальном времени (как в аффинном режиме объединения). Параметры w и h представляют ширину и высоту текущего блока. На практике разбиение осуществляется посредством операции сдвига вправо и округления. В документе VTM, репрезентативная точка определена как центральная позиция суб-блока, например, когда координаты левого верхнего угла суб-блока относительно верхнего левого отсчета в текущем блоке обозначены (xs, ys), координаты репрезентативной точки определены как (xs+2, ys+2). Для каждого суб-блока (например, размером 4×4 в документе VTM), репрезентативную точку используют для определения вектора движения для всего суб-блока в целом.

С целью дальнейшего упрощения прогнозирования с компенсацией движения применяется прогнозирование с аффинным преобразованием. Для получения вектора движения для каждого суб-блока размером M×N (оба числа M и N установлены равными 4 в сегодняшней версии кодирования VVC) можно вычислить вектор движения центрального отсчета соответствующего суб-блока, как показано на фиг. 14, согласно Уравнениям (1) и (2) и округлить его в соответствии с дробной точностью 1/16 вектора движения. Затем могут быть применены интерполяционные фильтры для компенсации движения с точностью 1/16-элемента изображения с целью генерации прогноза для каждого суб-блока с полученным вектором движения. Аффинный режим вводит интерполяционные фильтры для 1/16-элемента изображения.

После прогнозирования MCP, высокоточный вектор движения для каждого суб-блока округляют и сохраняют с той же точностью, как и обычный вектор движения.

2.4.3.1. Передача сигнализации об аффинном прогнозировании

Аналогично модели поступательного движения здесь также имеются два режима передачи сигнализации дополнительной информации вследствие аффинного прогнозирования. Это режимы AFFINE_INTER и AFFINE_Merge.

2.4.3.2. Режим AF_INTER

Для единиц CU, у которых и ширина, и высота больше 8, может быть применен режим AF_INTER. Сигнализацию флага аффинности на уровне единиц CU передают в потоке битов данных для индикации, используется ли режим AF_INTER.

В этом режиме, для каждого списка опорных изображений (Список 0 или Список 1), конструируют список кандидатов аффинного прогнозирования AMVP с тремя типами аффинных предикторов движения в следующем порядке, где каждый кандидат содержит оценку векторов CPMV для текущего блока. В виде сигнализации передают разности между наилучшими векторами CPMV, найденными на стороне кодирующего устройства, (такими как mv0 mv1 mv2 на фиг. 17) и оценками этих векторов CPMV. В дополнение к этому, получают индекс кандидата аффинного прогнозирования AMVP, от которого определяют оценки векторов CPMV, и далее передают в виде сигнализации.

на фиг. 17) и оценками этих векторов CPMV. В дополнение к этому, получают индекс кандидата аффинного прогнозирования AMVP, от которого определяют оценки векторов CPMV, и далее передают в виде сигнализации.

1) Первоначальные аффинные предикторы движения

Порядок проверки аналогичен случаю пространственного прогнозирования MVP при построении списка прогнозирования AMVP в стандарте кодирования HEVC. Во-первых, получают левый первоначальный аффинный предиктор движения от первого блока в группе {A1, A0}, кодированной в аффинном режиме и имеющей то же самое опорное изображение, как и текущий блок. Во-вторых, указанный выше первоначальный аффинный предиктор движения получают из первого блока в группе {B1, B0, B2}, кодированной в аффинном режиме и имеющей то же самое опорное изображение, как и текущий блок. На фиг. 16 показаны пять блоков A1, A0, B1, B0, B2.

Когда найден соседний блок для кодирования в аффинном режиме, векторы CPMV для единицы кодирования, покрывающей этот соседний блок, используются для получения предикторов векторов CPMV для текущего блока. Например, если блок A1 кодирован в неаффинном режиме и блок A0 кодирован в 4-параметрическом аффинном режиме, из блока A0 будет получен левый первоначальный аффинный предиктор вектора MV. В таком случае, векторы CPMV для единицы CU, покрывающей блок A0, обозначенные как MV0N для верхнего левого вектора CPMV и MV1N

для верхнего левого вектора CPMV и MV1N для верхнего правого вектора CPMV на фиг. 18B, используются для получения оценок векторов CPMV для текущего блока, обозначенных как MV0C, MV1C, MV2C для верхней левой (с координатами (x0, y0)), верхней правой (с координатами (x1, y1)) и нижней правой позиций (с координатами (x2, y2)) текущего блока.

для верхнего правого вектора CPMV на фиг. 18B, используются для получения оценок векторов CPMV для текущего блока, обозначенных как MV0C, MV1C, MV2C для верхней левой (с координатами (x0, y0)), верхней правой (с координатами (x1, y1)) и нижней правой позиций (с координатами (x2, y2)) текущего блока.

2) Сконструированные аффинные предикторы движения

Сконструированный активный предиктор движения состоит из векторов движения контрольных точек (CPMV), полученных из соседних блоков, кодированных с применением межкадрового прогнозирования, как показано на фиг. 17, так что эти блоки имеют одно и то же опорное изображение. Если текущая аффинная модель движения является 4-параметрической аффинной моделью, число векторов CPMV равно 2, в противном случае, если текущая аффинная модель движения является 6-параметрической аффинной моделью, число векторов CPMV равно 3. Верхний левый вектор CPMV  получают посредством вектора MV в первом блоке из группы {A, B, C}, кодированном с применением межкадрового прогнозирования и имеющем то же самое опорное изображение, как текущий блок. Верхний правый вектор CPMV

получают посредством вектора MV в первом блоке из группы {A, B, C}, кодированном с применением межкадрового прогнозирования и имеющем то же самое опорное изображение, как текущий блок. Верхний правый вектор CPMV  получают посредством вектора MV в первом блоке из группы {D, E}, кодированном с применением межкадрового прогнозирования и имеющем то же самое опорное изображение, как текущий блок. Нижний левый вектор CPMV

получают посредством вектора MV в первом блоке из группы {D, E}, кодированном с применением межкадрового прогнозирования и имеющем то же самое опорное изображение, как текущий блок. Нижний левый вектор CPMV  получают посредством вектора MV в первом блоке из группы {F, G}, кодированном с применением межкадрового прогнозирования и имеющем то же самое опорное изображение, как текущий блок.

получают посредством вектора MV в первом блоке из группы {F, G}, кодированном с применением межкадрового прогнозирования и имеющем то же самое опорное изображение, как текущий блок.

- Если текущая аффинная модель движения является 4-параметрической аффинной моделью, тогда сконструированный аффинный предиктор движения вставляют в список кандидатов, только если найдены оба вектора  и

и  , иными словами, векторы

, иными словами, векторы  и

и  используются в качестве оценок векторов CPMV для верхней левой (с координатами (x0, y0)), и верхней правой (с координатами (x1, y1)) позиций текущего блока.

используются в качестве оценок векторов CPMV для верхней левой (с координатами (x0, y0)), и верхней правой (с координатами (x1, y1)) позиций текущего блока.

- Если текущая аффинная модель движения является 6-параметрической аффинной моделью, тогда сконструированный аффинный предиктор движения вставляют в список кандидатов, только если найдены все три вектора  ,

,  и

и  , иными словами, векторы

, иными словами, векторы  ,

,  и

и  используются в качестве оценок векторов CPMV для верхней левой (с координатами (x0, y0)), верхней правой (с координатами (x1, y1)) и нижней правой (с координатами (x2, y2)) позиций текущего блока.

используются в качестве оценок векторов CPMV для верхней левой (с координатами (x0, y0)), верхней правой (с координатами (x1, y1)) и нижней правой (с координатами (x2, y2)) позиций текущего блока.

При вставке сконструированного аффинного предиктора движения в список кандидатов никакая процедура усечения не применяется.

3) Обычные предикторы движения AMVP

Последующее применяется до тех пор, пока число аффинных предикторов движения не достигнет максимума.

1) Формирование аффинного предиктора движения путем установления всех векторов CPMV равными вектору  , если имеется.

, если имеется.

2) Формирование аффинного предиктора движения путем установления всех векторов CPMV равными вектору  , если имеется.

, если имеется.

3) Формирование аффинного предиктора движения путем установления всех векторов CPMV равными вектору  , если имеется.

, если имеется.

4) Формирование аффинного предиктора движения путем установления всех векторов CPMV равными прогнозу HEVC TMVP, если имеется.

5) Формирование аффинного предиктора движения путем установления всех векторов CPMV равными нулевому вектору MV.

Отметим, что вектор  уже сформирован при построении аффинного предиктора движения.

уже сформирован при построении аффинного предиктора движения.

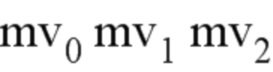

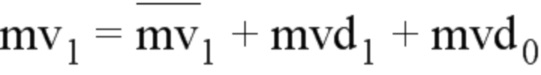

В режиме AF_INTER, если используется аффинный режим с 4/6 параметрами, требуются 2/3 контрольные точки, и поэтому необходимо кодировать 2/3 разности MVD для этих контрольных точек, как показано на фиг. 15A. В документе JVET-K0337 предлагается формировать вектор MV следующим образом, т.е. разности mvd1 и mvd2 прогнозируют на основе разности mvd0.

Здесь параметры  , mvdi и mv1 представляют собой прогнозируемый вектор движения, разницу векторов движения и вектор движения верхнего левого пикселя (i = 0), верхнего правого пикселя (i = 1) или левого нижнего пикселя (i = 2) соответственно, как показано на фиг. 15B. Пожалуйста, отметьте, что добавление двух векторов движения (например, mvA(xA, yA) и mvB(xB, yB)) эквивалентно суммированию двух компонентов по отдельности, иными словами, формула newMV = mvA + mvB и два компонента вектора newMV установлены равными (xA + xB) и (yA + yB), соответственно.

, mvdi и mv1 представляют собой прогнозируемый вектор движения, разницу векторов движения и вектор движения верхнего левого пикселя (i = 0), верхнего правого пикселя (i = 1) или левого нижнего пикселя (i = 2) соответственно, как показано на фиг. 15B. Пожалуйста, отметьте, что добавление двух векторов движения (например, mvA(xA, yA) и mvB(xB, yB)) эквивалентно суммированию двух компонентов по отдельности, иными словами, формула newMV = mvA + mvB и два компонента вектора newMV установлены равными (xA + xB) и (yA + yB), соответственно.

2.4.3.3. Режим AF_Merge

Когда единицу CU применяют в режиме AF_Merge, она получает первый блок, кодированный в аффинном режиме от действительных соседних реконструированных блоков. При этом блок-кандидат выбирают в следующем порядке – от левого и далее верхний, сверху справа, слева снизу и к верхнему левому, как показано на фиг. 18A (обозначены по порядку как A, B, C, D, E). Например, если соседний слева снизу блок кодируют в аффинном режиме, как обозначено символом A0 на фиг. 18B, осуществляют выборку векторов mv0N, mv1N и mv2N движения контрольных точек (CP) в верхнем левом углу, верхнем правом углу и левом нижнем углу соседней единицы CU/PU, которая содержит блок A. И далее вектор движения mv0C, mv1C и mv2C (который используется только для 6-параметрической аффинной модели) для верхнего левого угла/верхнего правого/нижнего левого угла для текущей единицы CU/PU вычисляют на основе указанных векторов mv0N, mv1N и mv2N. Следует отметить, что в документе VTM-2.0, суб-блок (например, блок размером 4×4 в документе VTM), расположенный в верхнем левом углу, сохраняет вектор mv0, суб-блок, расположенный в верхнем правом углу, сохраняет вектор mv1, если текущий блок кодирован в аффинном режиме. Если текущий блок кодирован в соответствии с 6-параметрической аффинной моделью, тогда суб-блок, расположенный в нижнем левом углу, сохраняет вектор mv2; в противном случае (при 4-параметрической аффинной модели), левый нижний блок (LB) сохраняет вектор mv2’. Другие суб-блоки сохраняют векторы MV, используемые для компенсации MC.

После вычисления вектора CPMV для текущей единицы CU определяют векторы mv0C, mv1C и mv2C в соответствии с упрощенной аффинной моделью движения по Уравнениям (1) и (2), и генерируют поле MVF для текущей единицы CU. Для идентификации, кодирована ли текущая единица CU в режиме AF_Merge, может быть в виде сигнализации передан в потоке битов данных флаг аффинности, если по меньшей мере один соседний блок кодирован в аффинном режиме.

В документах JVET-L0142 и JVET-L0632 список аффинных объединяемых кандидатов конструируют в соответствии со следующими этапами:

1) Вставка первоначальных аффинных кандидатов

Термин «первоначальный аффинный кандидат» означает, что кандидат получен из аффинной модели движения соседнего с ним действительного блока, кодированного в аффинном режиме. Из аффинной модели движения соседних блоков получают максимум двух первоначальных аффинных кандидатов и вставляют их в список кандидатов. Для левого предиктора сканирование производится в порядке {A0, A1}; для верхнего предиктора сканирование производится в порядке {B0, B1, B2}.

2) Вставка сконструированных аффинных кандидатов

Если число кандидатов в списке аффинных объединяемых кандидатов меньше параметра MaxNumAffineCand (например, 5), в список кандидатов вставляют сконструированных аффинных кандидатов. Термин «сконструированный аффинный кандидат» означает, что кандидат сконструирован путем комбинирования информации о движении соседей в каждой контрольной точке.

а) Информацию о движении для контрольных точек определяют сначала на основе специфицированных соседей в пространстве и соседей во времени, показанных на фиг. 19. Символ CPk (k=1, 2, 3, 4) обозначает k-ую контрольную точку. Позиции A0, A1, A2, B0, B1, B2 и B3 являются пространственными позициями для прогнозирования точек CPk (k=1, 2, 3); символ T обозначает позицию во времени для прогнозирования точки CP4.

Точки CP1, CP2, CP3 и CP4 имеют координаты (0, 0), (W, 0), (H, 0) и (W, H), соответственно, где W и H представляют ширину и высоту текущего блока.

Информацию о движении для каждой контрольной точки получают в соответствии со следующим порядком приоритетности:

- Для точки CP1, приоритетность проверки имеет вид B2->B3->A2. Блок B2 используется, если он доступен. В противном случае, если блок B2 недоступен, используется блок B3. Если оба блока B2 и B3 недоступны, используется блок A2. Если все три кандидата недоступны, информация о движении для точки CP1 получена быть не может.

- Для точки CP2, приоритетность проверки имеет вид B1->B0.

- Для точки CP3, приоритетность проверки имеет вид A1->A0.

- Для точки CP4, используется параметр T.

b) Во-вторых, для конструирования аффинного объединяемого кандидата используется комбинация контрольных точек.

I. Для конструирования 6-параметрического аффинного кандидата необходима информация о движении для трех контрольных точек. Эти три контрольные точки можно выбрать из одной из следующих четырех комбинаций ({CP1, CP2, CP4}, {CP1, CP2, CP3}, {CP2, CP3, CP4}, {CP1, CP3, CP4}). Комбинации {CP1, CP2, CP3}, {CP2, CP3, CP4}, {CP1, CP3, CP4} будут преобразованы в 6-параметрическую модель движения, представленную верхней левой, верхней правой и нижней левой контрольными точками.

II. Для построения 4-параметрического аффинного кандидата необходима информация о движении двух контрольных точек. Эти две контрольные точки можно выбрать из одной из следующих двух комбинаций ({CP1, CP2}, {CP1, CP3}). Эти две комбинации будут преобразованы в 4-параметрическую модель движения, представленную верхней левой и верхней правой контрольными точками.

III. Комбинации сконструированных аффинных кандидатов вставляют в список кандидатов в следующем порядке:

{CP1, CP2, CP3}, {CP1, CP2, CP4}, {CP1, CP3, CP4}, {CP2, CP3, CP4}, {CP1, CP2}, {CP1, CP3}

i. Для каждой комбинации проверяют опорные индексы в списке X для каждой точки CP, если они все одинаковы, тогда такая комбинация имеет действительные векторы CPMV для списка X. Если комбинация не имеет действительных векторов CPMV для обоих списков – списка 0 и списка 1, тогда эту комбинацию маркируют как недействительную. В противном случае комбинация является действительной, и соответствующие векторы CPMV вносят в список объединения суб-блоков.

3) Заполнение нулевыми векторами движения

Если число кандидатов в списке аффинных объединяемых кандидатов меньше 5, в список кандидатов вставляют нулевые векторы движения до тех пор, пока список не станет полным.

Более конкретно, для списка объединяемых кандидатов суб-блоков, 4-параметрический объединяемый кандидат имеет векторы MV, установленные на (0, 0), а направление прогнозирования установлено в одну сторону от списка 0 (для P-среза) и в обе стороны (для B-среза).

2.4.4. Объединение с разностями векторов движения (Merge with motion vector difference (MMVD))

В документе JVET-L0054, представлено предельное выражение вектора движения (ultimate motion vector expression) (UMVE, также известное как MMVD). Параметр UMVE используется вместе с режимом пропуска или режимом объединения с предлагаемым способом выражения вектора движения.

Параметр UMVE повторно использует объединяемого кандидата, как такого же, как те, что входят в обычный список объединяемых кандидатов в стандарте кодирования VVC. Из совокупности объединяемых кандидатов может быть выбран базовый кандидат и далее расширен посредством предлагаемого способа выражения вектора движения.

Параметр UMVE предлагает новый способ представления разности векторов движения (MVD), согласно которому для представления такой разности MVD используются начальная точка, значение движения и направление движения.

Этот предлагаемый способ использует список объединяемых кандидатов, как он есть. Но для расширения UMVE рассматриваются только кандидаты, имеющие тип слияния по умолчанию (MRG_TYPE_DEFAULT_N).

Индекс базового кандидата определяет начальную точку. Этот индекс базового кандидата обозначает наилучшего кандидата из совокупности кандидатов, входящих в список, следующим образом.

Таблица 1. Индекс (IDX) базового кандидата

Если число базовых кандидатов равно 1, сигнализацию об этом индексе (IDX) базового кандидата не передают.

Индекс расстояния представляет собой информацию о значении движения. Индекс расстояния обозначает предварительно заданное расстояние от информации о начальной точке. Это предварительно заданное расстояние определено следующим образом:

Таблица 2. Индекс (IDX) расстояния

Индекс направления представляет направление разности MVD относительно начальной точки. Индекс направления может представлять четыре направления, как показано ниже.

Таблица 3. Индекс (IDX) направления

В некоторых вариантах, флаг расширения UMVE передают виде сигнализации сразу после передачи флага пропуска или флага объединения. Если флаг пропуска или объединения является истинным, выполняют синтаксический анализ флага UMVE. Если флаг UMVE равен 1, выполняют синтаксический анализ синтаксиса расширения UMVE. Но если этот флаг не равен 1, выполняют синтаксический анализ флага аффинности (AFFINE). Если флаг AFFINE равен 1, это означает аффинный (AFFINE) режим. Но если этот флаг не равен 1, выполняют синтаксический анализ индекса пропуска/объединения для режима пропуска/объединения в документе VTM.

Дополнительный буфер строк из-за появления кандидатов UMVE не требуется, поскольку кандидат пропуска/объединяемый кандидат из программного обеспечения непосредственно используется в качестве базового кандидата. Используя входной индекс UMVE, определяют дополнение вектора MV непосредственно перед компенсацией движения. Нет необходимости держать буфер длинной строки для этого.

В текущем состоянии общего текста либо первый, либо второй объединяемый кандидат из списка объединяемых кандидатов может быть выбран в качестве базового кандидата.

Параметр UMVE также известен как параметр «Объединение» (Merge) с разностями векторов MV Differences (MMVD).

2.4.5. Уточнение вектора движения на стороне декодирующего устройства (Decoder-side Motion Vector Refinement (DMVR))

При двунаправленном прогнозировании, для прогнозирования области одного блока, комбинируют два прогнозируемых блока, сформированных с использованием вектора движения (MV) из списка0 и вектора MV из списка1, соответственно, для образования одного прогнозируемого сигнала. Согласно способу уточнения вектора движения на стороне декодирующего устройства (DMVR) дополнительно уточняют два вектора движения, используемые при двунаправленном прогнозировании.

В модели JEM векторы движения уточняют посредством процедуры согласования двусторонних шаблонов. Такое согласование двусторонних шаблонов применяют в декодирующем устройстве для осуществления поиска на основе искажений между двусторонним шаблоном и реконструированными отсчетами в опорных изображениях с целью получения уточненного вектора MV без передачи дополнительной информации о движении. Пример изображен на фиг. 22. Двусторонний шаблон генерируют в виде взвешенной (т.е. усредненной) комбинации двух прогнозируемых блоков от первоначальных вектора MV0 из списка0 и вектора MV1 из списка1, соответственно, как показано на фиг. 22. Операция согласования шаблонов содержит вычисление стоимостных оценок между генерируемым шаблоном и областью отсчетов (вокруг первоначального прогнозируемого блока) в опорном изображении. Для каждого из двух опорных изображений вектор MV, который дает минимальную стоимость шаблонов, рассматривают в качестве обновленного вектора MV из соответствующего списка для замены исходного вектора. В модели JEM, осуществляют поиск среди девяти векторов MV кандидатов для каждого списка. Эта совокупность девяти векторов MV кандидатов содержит исходный вектор MV и 8 окружающих векторов MV со сдвигом на один яркостной отсчет от исходного вектора MV в каком-либо – в горизонтальном направлении или вертикальном направлении, или в обоих направлениях. Наконец, два новых вектора MV, т.е. векторы MV0′ и MV1′, как показано на фиг. 22, используются для генерации результатов двунаправленного прогнозирования. В качестве меры стоимости используется сумма абсолютных разностей (sum of absolute differences (SAD)). Пожалуйста, заметьте, что при вычислении стоимости прогнозируемого блока, генерируемого одним из окружающих векторов MV, для получения прогнозируемого блока фактически используется округленный (до целых элементов изображения (пикселей)) вектор MV вместо фактического вектора MV.

Для дальнейшего упрощения процедуры уточнения DMVR, документ JVET-M0147 предлагает ряд изменений в структуру модели JEM. Более конкретно, принятая процедура уточнения DMVR в документе VTM-4.0 (должен выйти в свет вскоре) имеет следующие основные признаки:

• Раннее завершение с (0,0) позиции в сумме SAD между списком0 и списком1

• Размер блока для процедуры уточнения DMVR W*H>=64 && H>=8

• Разбиение единицы CU на несколько суб-блоков размером 16x16 для процедуры уточнения DMVR при размере единицы CU > 16*16

• Размер опорного блока (W+7)*(H+7) (для яркостной составляющей)

• Поиск по 25 точкам на основе суммы SAD по целым пикселям (т.е. диапазон уточняющего поиска (+-) 2, один этап)

• Процедура уточнения DMVR на основе билинейной интерполяции

• Зеркальное отображение разности MVD между списком0 и списком1, чтобы позволить двустороннее согласование