Область техники, к которой относится изобретение

Настоящее изобретение относится к устройству обработки информации и способу обработки информации, и компьютерной программе, и, более конкретно, к устройству обработки информации и способу обработки информации, и компьютерной программе, которые позволяют пользователю легко находить произвольные изображения или находить только характерные изображения среди изображений, сфотографированных к этому моменту времени, и просматривать изображения.

Уровень техники

В цифровой фотокамере (см. JP-A-2007-019685) количество фотографируемых изображений с каждым годом увеличивается, по мере того, пользователь использует цифровую фотокамеру. В результате, пользователь часто сохраняет слишком много изображений, чтобы разобраться с ними, во встроенной памяти типа флэш или на съемном носителе записи.

В таком случае, в цифровых камерах в последние годы, в качестве способа представления изображений, часто используют способ представления изображений в виде одной группы (папки и т.д.) на основе даты, времени или тому подобное (ниже называется способом представления в прошлом).

Сущность изобретения

Однако когда используют способ представления в прошлом для пользователя, одна группа означает группу определенных событий. Поэтому, даже если принять способ представления в прошлом, по мере того, как пользователь использует цифровую камеру в течение нескольких лет, количество групп событий также увеличивается. Это затрудняет для пользователя управление группами событий.

В последние годы было предъявлен ряд требований к поиску произвольных изображений или поиску только характерных изображений среди изображений, сфотографированных до настоящего времени, и просмотру изображений, в частности, например, поиску только изображений, в которых показан один и тот же человек, и просмотру этих изображений.

Для удовлетворения таких требований, используя способ представления в прошлом, хотя изображения, включенные в группу событий, связаны друг с другом, трудно проверить взаимосвязь с другими событиями. Поэтому пользователь должен полностью проверять группы событий, используя экран указателей и т.п. или используя программные средства поиска, которые имеют функцию поиска.

Однако даже когда пользователь использует программное средство поиска в прошлом, пользователю трудно найти требуемое изображение, если только пользователь не установит правильно слово признака. Многие пользователи не способны в достаточной степени представить изображения, используя нормальные строки знаков и выражений при поиске изображения, и желают получать изображения с использованием абстрактных слов и значений. Однако когда такие пользователи используют программное средство поиска в прошлом, пользователям трудно получить ожидаемые результаты.

Как пояснялось выше, в представленной ситуации трудно удовлетворить требованиям поиска произвольных изображений или поиска только характерных изображений среди изображений, сфотографированных до настоящего момента времени, и просмотра этих изображений.

Поэтому желательно обеспечить для пользователя возможность простого поиска произвольных изображений или поиска характерных изображений среди изображений, сфотографированных до настоящего времени, и просмотра этих изображений.

В соответствии с вариантом воплощения настоящего изобретения, предложено устройство обработки информации, включающее в себя: средство дисплея, предназначенное для отображения изображения; средство приема входной операции, предназначенное для приема операции, вводимой пользователем; и средство управления дисплеем, предназначенное для выполнения, когда средство приема входной операции принимает заданную операцию для корневого изображения, отображаемого в средстве дисплея, управления дисплеем для обеспечения отображения средством дисплея взаимосвязанного изображения, которое взаимосвязано с корневым изображением.

Степень взаимосвязи между всеми изображениями, которые могли бы представлять корневое изображение или связанные с ним изображения, и/или другие изображения, рассчитывают на основе одного или больше пунктов классификации. Средство управления дисплеем находит одно или больше взаимосвязанных изображений из всех изображений на основе степени взаимосвязи между корневым изображением и другими изображениями и обеспечивает отображение средством дисплея найденного одного или больше взаимосвязанных изображений.

Элементы классификации определяют заранее на основе дополнительной информации, относящейся к изображениям.

Когда средство управления дисплеем обеспечивает отображение средством дисплея корневого изображения, средство управления дисплеем находит одно или больше взаимосвязанных изображений.

Средство управления дисплеем обеспечивает, когда операция, выполняемая пользователем, который передвигает палец в заданном направлении на заданное расстояние, при поддержании контакта пальца со средством дисплея, представлена как операция передвижения, отображение средством дисплея соответствующего изображения, когда средство приема входной операции принимает операцию передвижения.

Средство управления дисплеем обеспечивает отображение средством дисплея соответствующего изображения в положении, в котором закончилась операция передвижения.

Заданные один или больше пунктов классификации связаны с каждым из направлений операций передвижения. Средство управления дисплеем находит одно или больше взаимосвязанных изображений на основе степени взаимосвязи, рассчитанной на основе пунктов классификации, соответствующих направлениям операции передвижения.

Средство управления дисплеем обеспечивает последовательное отображение средством дисплея новых взаимосвязанных изображений каждый раз, когда средство приема входной операции принимает операцию передвижения.

Средство управления дисплеем устанавливает, когда средство приема входной операции принимает операцию передвижения для взаимосвязанного изображения, это взаимосвязанное изображение как новое корневое изображение и обеспечивает отображение средством дисплея нового взаимосвязанного изображения, относящегося к новому корневому изображению.

Операцию передвижения выполняют, начиная с корневого изображения или взаимосвязанного изображения.

Средство управления дисплеем дополнительно обеспечивает, когда средство приема входной операции принимает операцию контакта с корневым изображением пальца пользователя, отображение средством дисплея изображений пунктов классификации, обозначающих соответствующие один или больше пунктов классификации, и находит, когда детектируют операцию контакта пальца пользователя с заданными одним или больше изображениями пунктов классификации, одно или больше взаимосвязанных изображений на основе степени взаимосвязи, рассчитанной на основе пункта классификации, обозначенного изображением пункта классификации, для которого была выполнена операция контакта.

Средство управления анализирует, когда средство приема входной операции принимает операцию контакта пальца пользователя с корневым изображением, изображение на основе положения, где была выполнена операция контакта, устанавливает элемент классификации на основе результата анализа, и выполняет поиск одного или больше взаимосвязанных изображений на основе степени взаимосвязи, рассчитанной на основе установленного элемента классификации.

Устройство обработки информации дополнительно включает в себя средство сохранения, предназначенное для сохранения информации предыстории управления дисплеем средством управления дисплеем.

В качестве управления дисплеем средство управления дисплеем дополнительно обеспечивает, когда средство приема входной операции принимает операцию контакта пальца пользователя с корневым изображением или взаимосвязанным изображением, отображение средством дисплея информации предыстории, сохраненной в средстве сохранения.

Средство управления дисплеем выполняет поиск, когда средство приема входной операции принимает операцию контакта пальца пользователя с изображением, включенным в информацию предыстории, одного или больше изображений, взаимосвязанных с изображением, установленным как корневое изображение, и обеспечивает отображение средством дисплея взаимосвязанных изображений.

В соответствии с другими вариантами воплощения настоящего изобретения предложен способ обработки информации и компьютерная программа, соответствующие устройству обработки информации.

В способе обработки информации и в компьютерной программе в соответствии с вариантами воплощения настоящего изобретения в устройстве обработки информации, которое отображает изображение и принимает входную операцию пользователя, когда принимают заданную операцию для отображения корневого изображения, отображают взаимосвязанное изображение, взаимосвязанное с корневым изображением.

Как пояснялось выше, в соответствии с вариантами воплощения настоящего изобретения, поскольку изображения, сфотографированные до настоящего времени, устанавливают как корневые изображения или взаимосвязанные изображения, становится возможным легко находить произвольные изображения или находить только характерные изображения среди изображений, сфотографированных до настоящего времени, и просматривать эти изображения.

Краткое описание чертежей

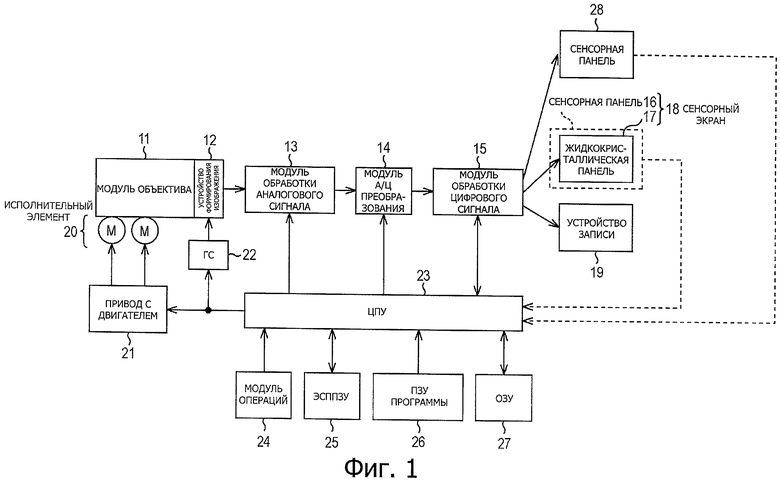

На фиг.1 показана блок-схема примера конфигурации устройства формирования изображения в качестве примера устройства обработки информации в соответствии с вариантом воплощения настоящего изобретения;

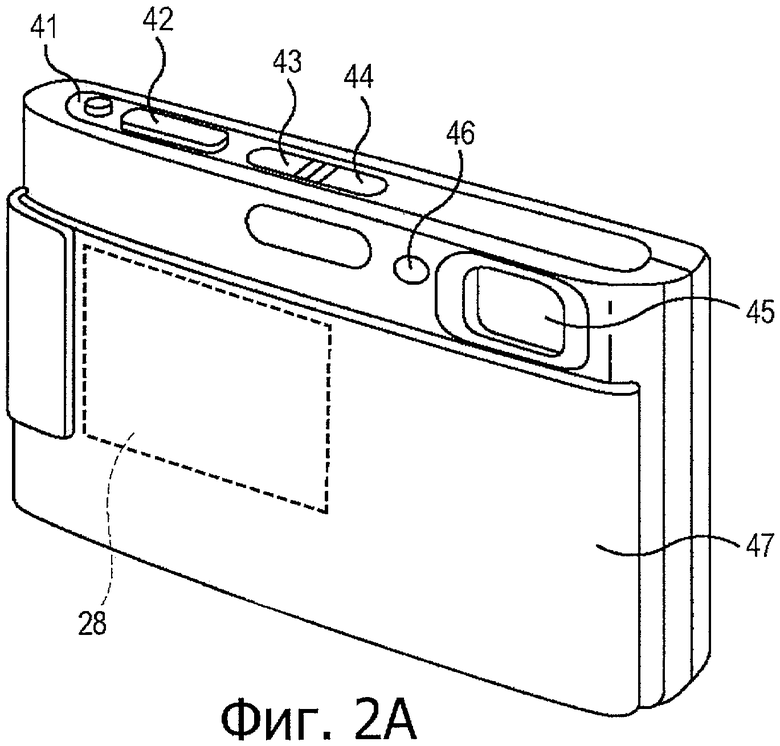

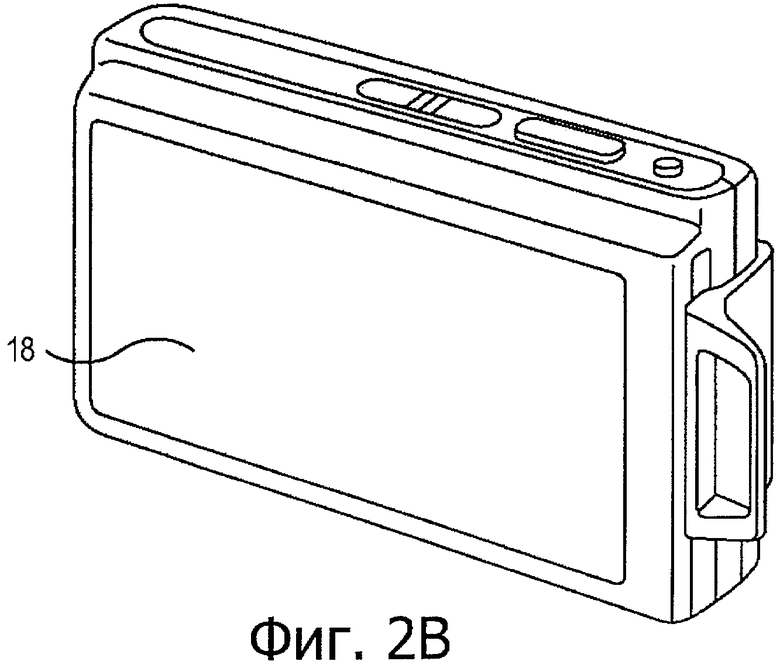

на фиг.2А и 2В показаны виды в перспективе примера внешней конфигурации устройства формирования изображения, показанного на фиг.1;

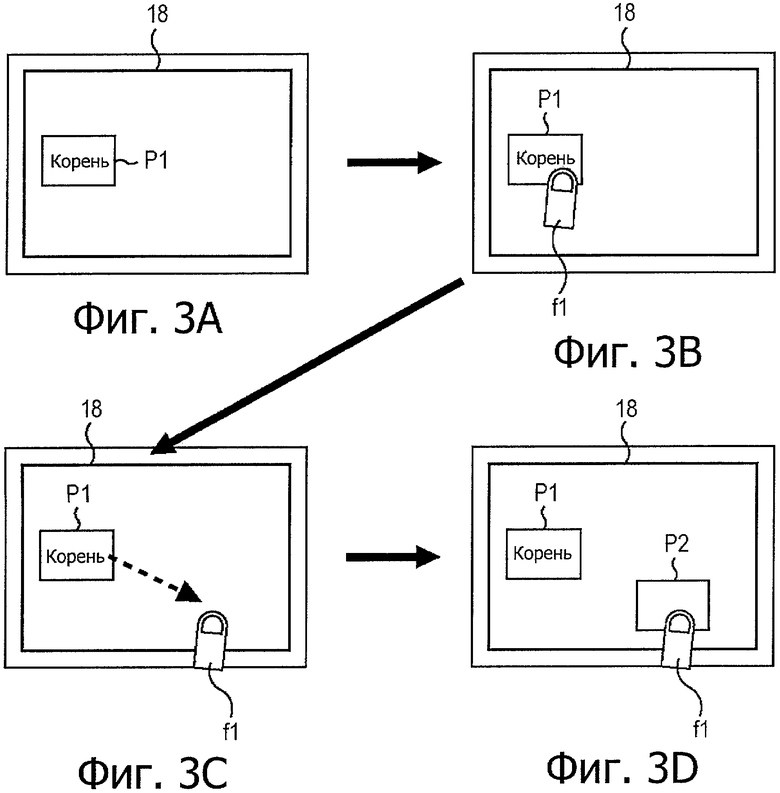

на фиг.3А-3Е показаны схемы, поясняющие первый пример способа работы при поиске взаимосвязанных изображений устройства формирования изображения;

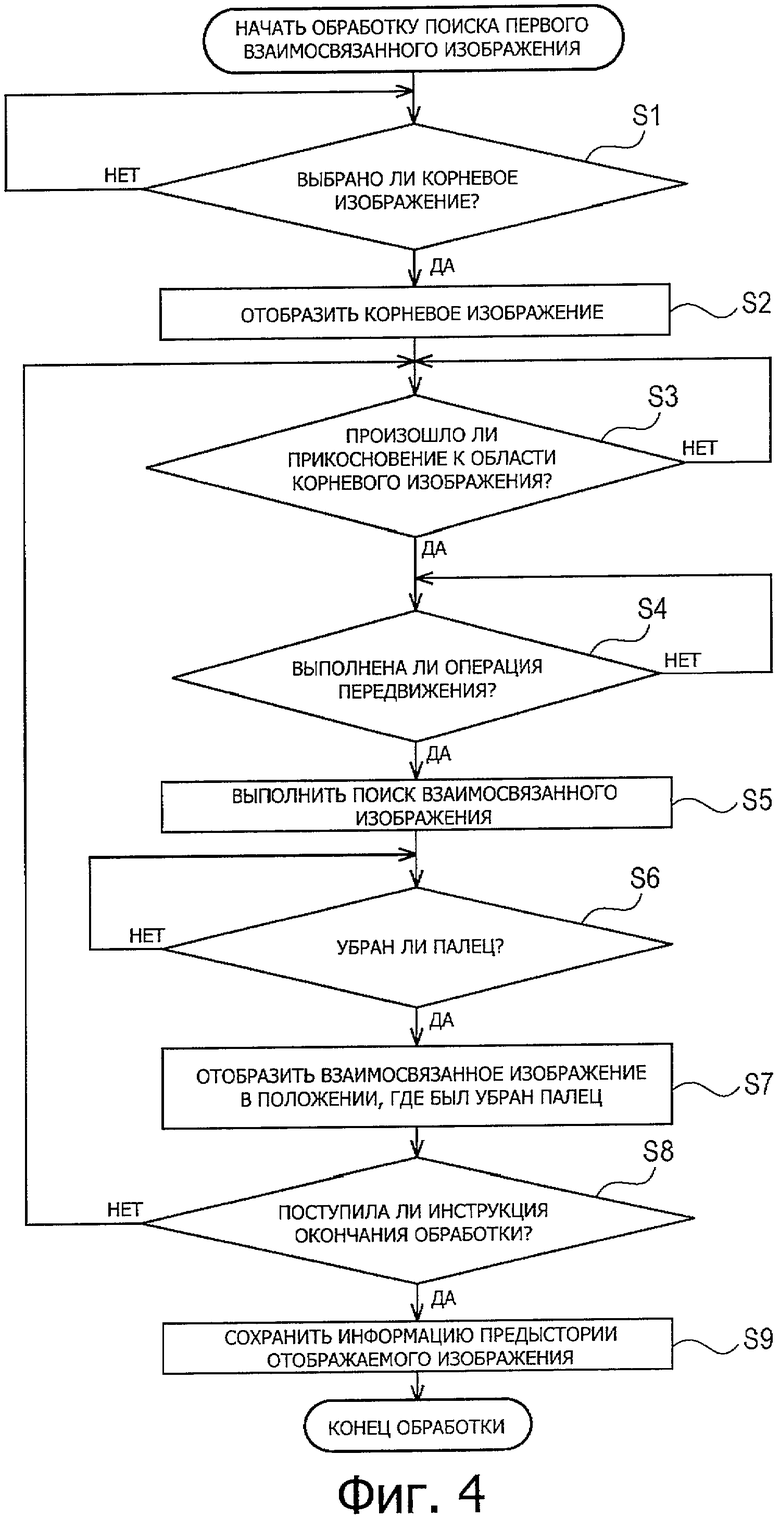

на фиг.4 показана блок-схема последовательности операций, поясняющая пример первой обработки поиска взаимосвязанного изображения;

на фиг.5 показана блок-схема последовательности операций, поясняющая пример обработки поиска взаимосвязанного изображения 1А;

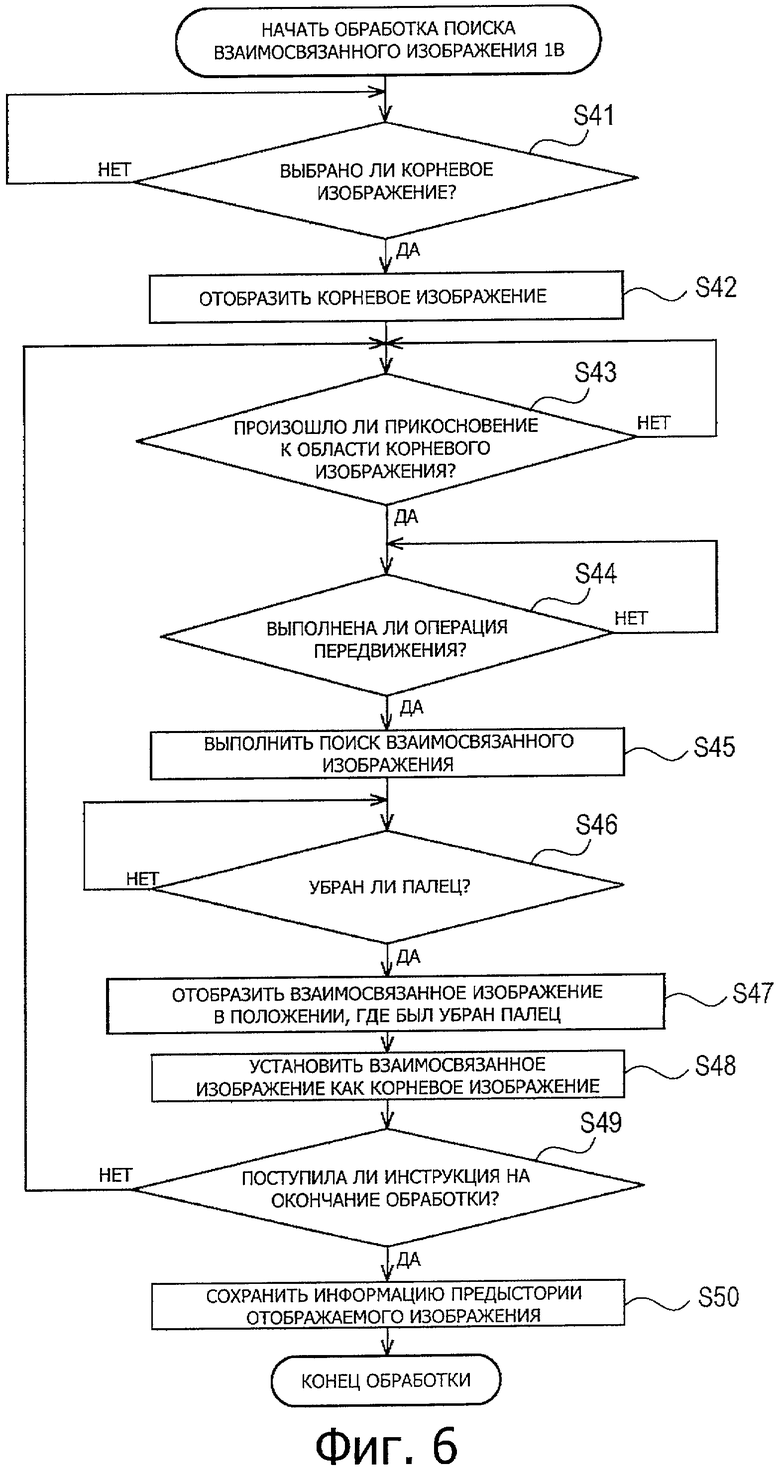

на фиг.6 показана блок-схема последовательности операций, поясняющая пример обработки поиска взаимосвязанного изображения 1В;

на фиг.7А-7Е показаны схемы, поясняющие второй пример способа работы при поиске взаимосвязанного изображения устройства формирования изображения;

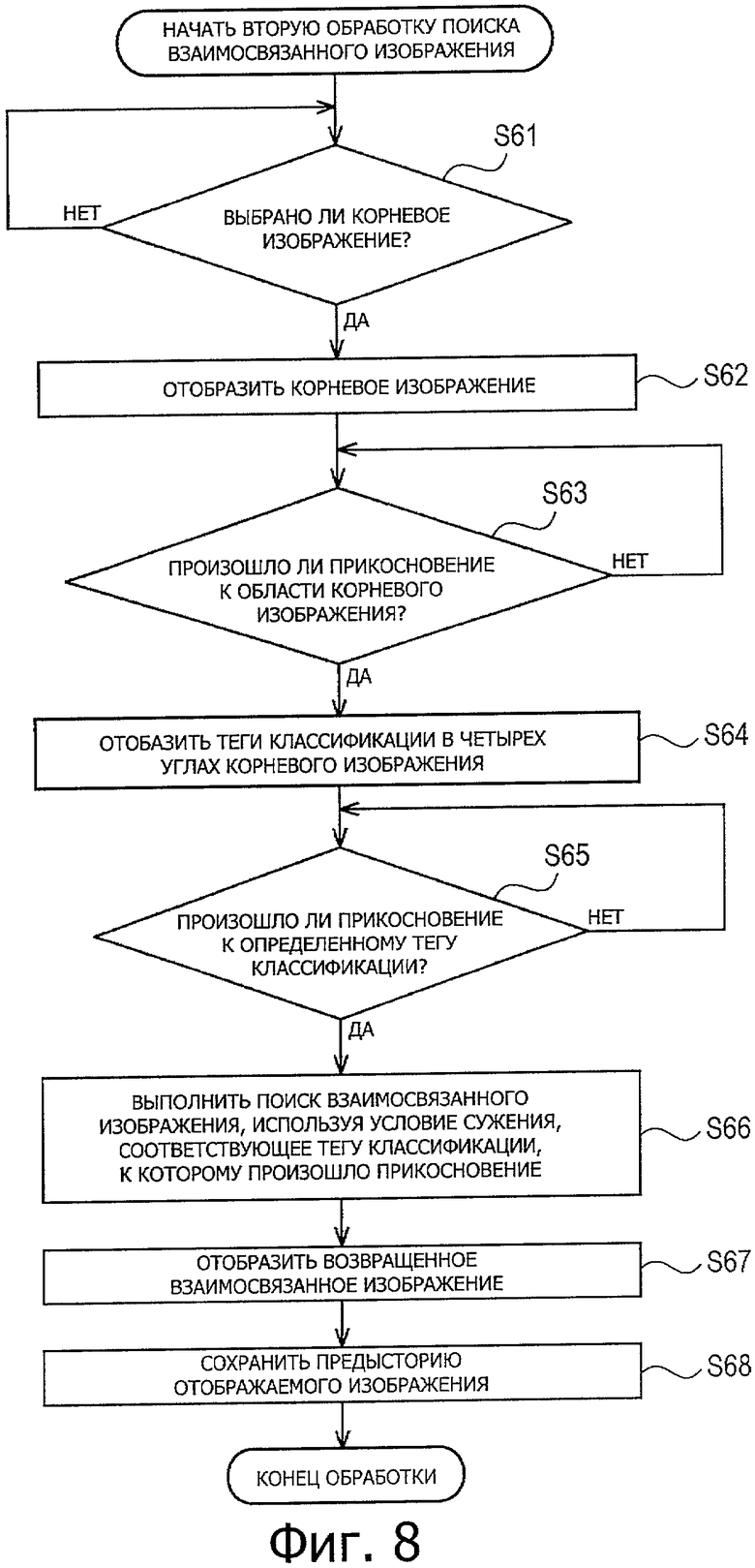

на фиг.8 показана блок-схема последовательности операций, поясняющая пример второй обработки поиска взаимосвязанного изображения;

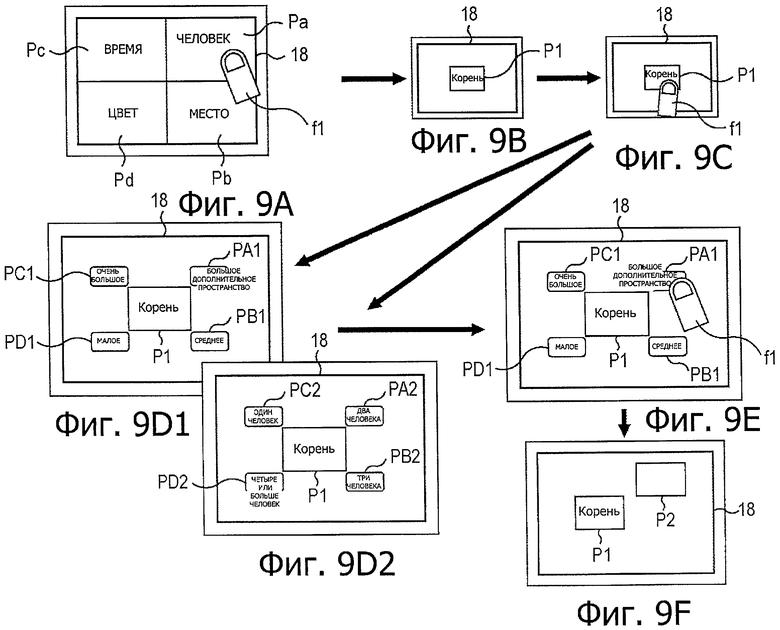

на фиг.9А-9F показаны схемы, поясняющие третий пример способа работы при поиске взаимосвязанного изображения устройства формирования изображения;

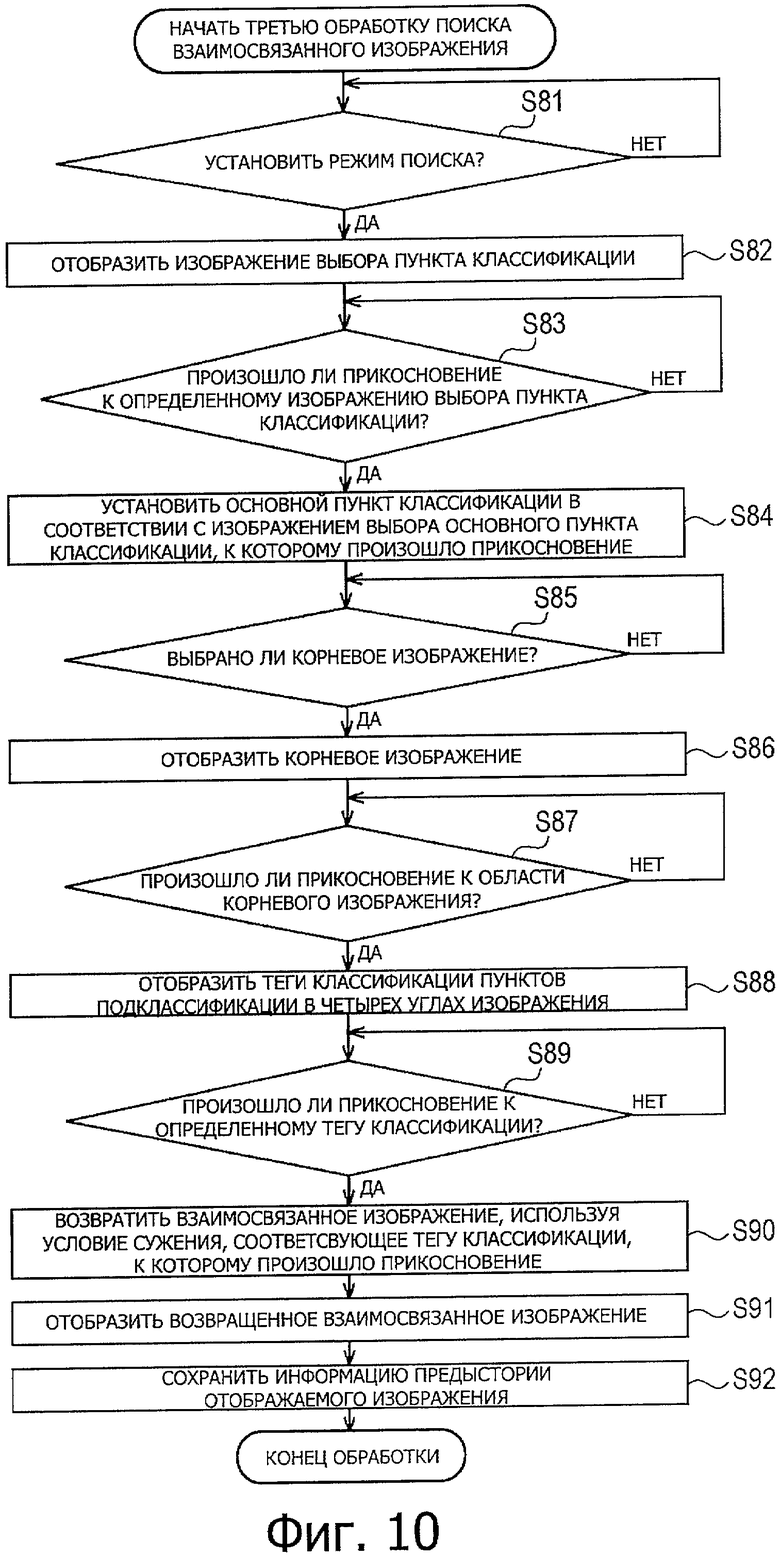

на фиг.10 показана блок-схема последовательности операций, поясняющая пример третьей обработки поиска взаимосвязанного изображения;

на фиг.11 показана схема, поясняющая пример способа использования уменьшенных изображений, в качестве способа представления пунктов классификации;

на фиг.12А - 12Е показаны схемы, поясняющие четвертый пример способа работы при поиске взаимосвязанного изображения устройства формирования изображения;

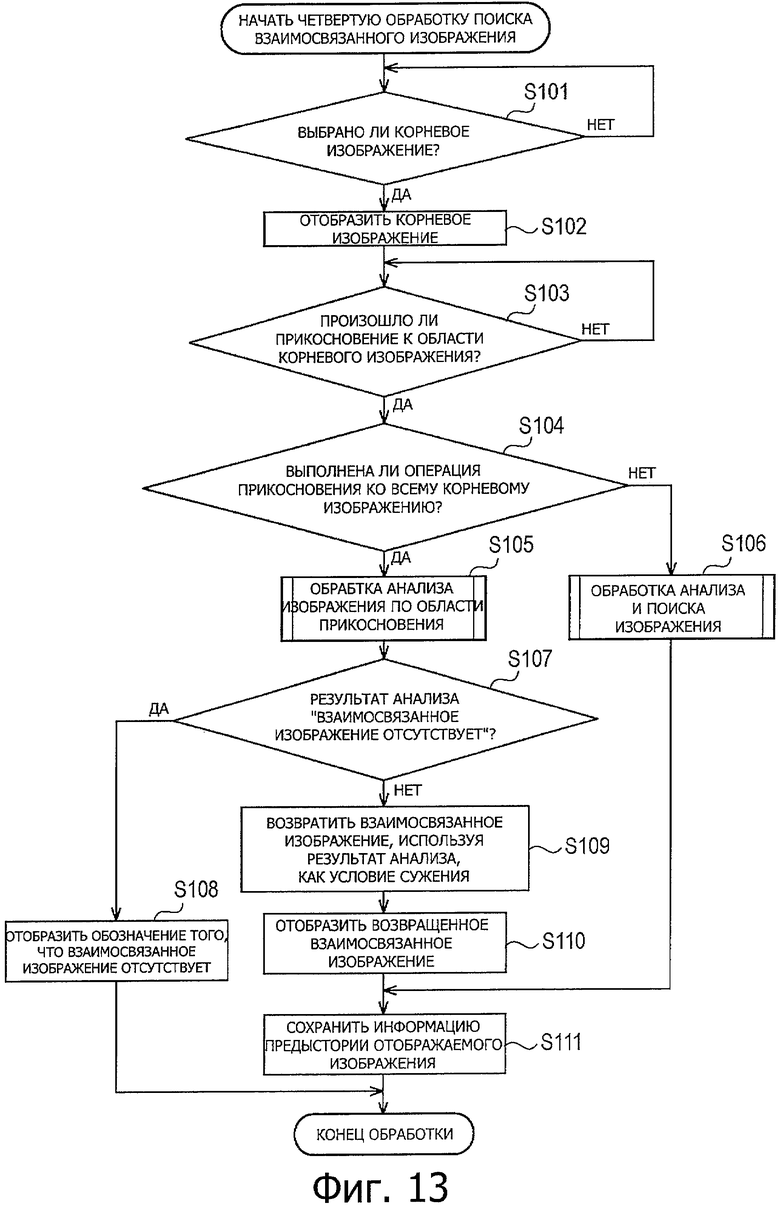

на фиг.13 показана блок-схема последовательности операций, поясняющая пример четвертой обработки поиска взаимосвязанного изображения;

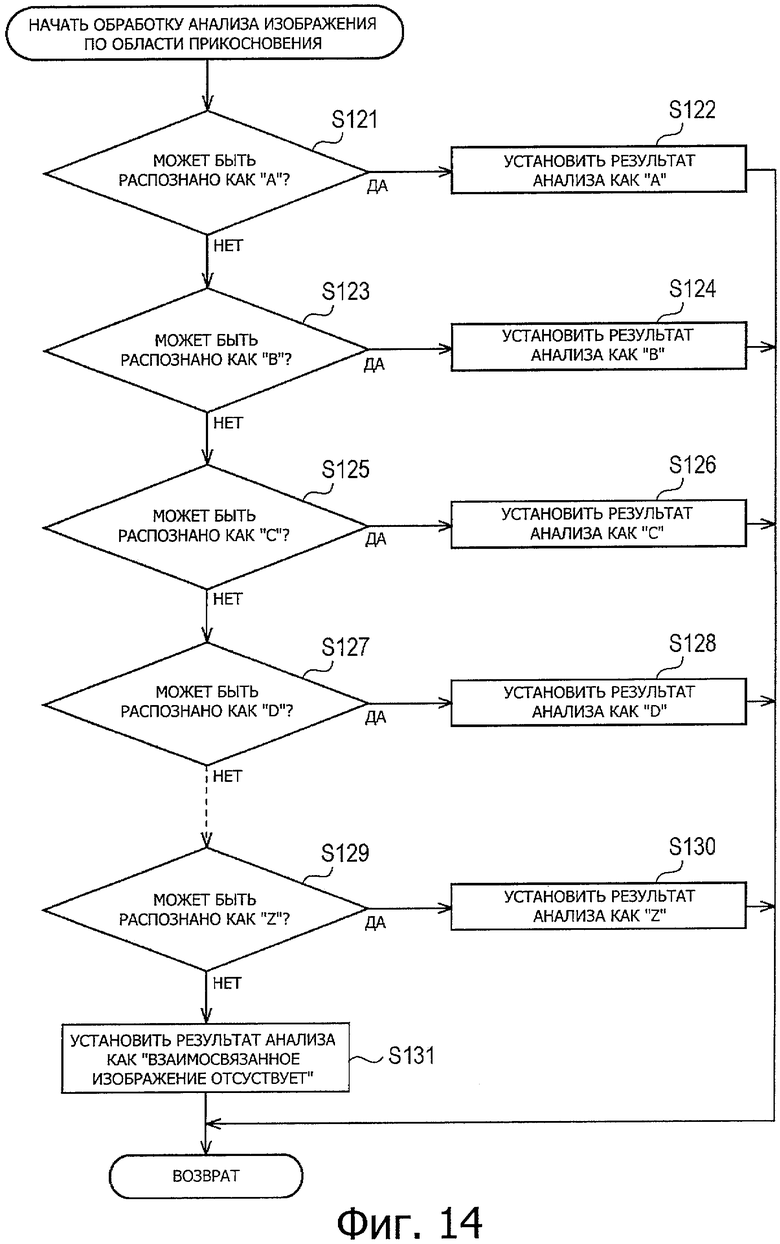

на фиг.14 показана блок-схема последовательности операций, поясняющая подробный пример обработки анализа изображения по площади контакта на этапе S65 обработки поиска четвертого взаимосвязанного изображения;

на фиг.15 показана блок-схема последовательности операций, подробно поясняющая пример обработки анализа и поиска изображения на этапе S66 обработки поиска четвертого взаимосвязанного изображения;

на фиг.16 показана схема, поясняющая пример операции поиска взаимосвязанного меню устройства формирования изображения;

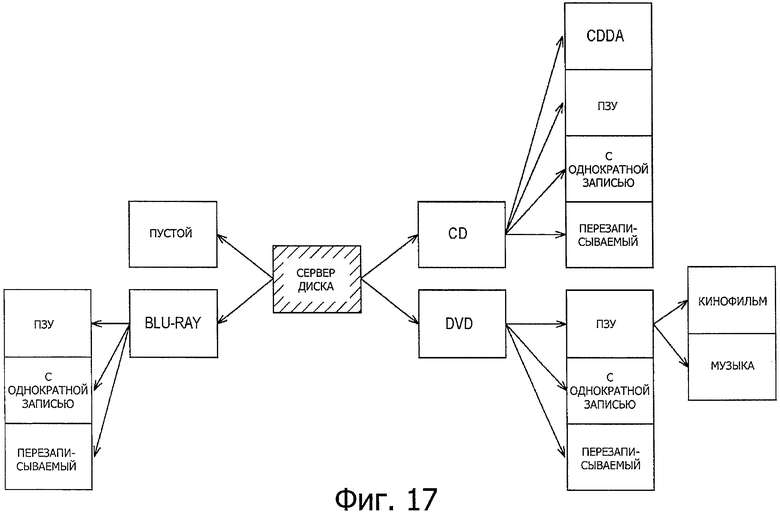

на фиг.17 показана схема, поясняющая другой пример операции поиска взаимосвязанного меню устройства формирования изображения;

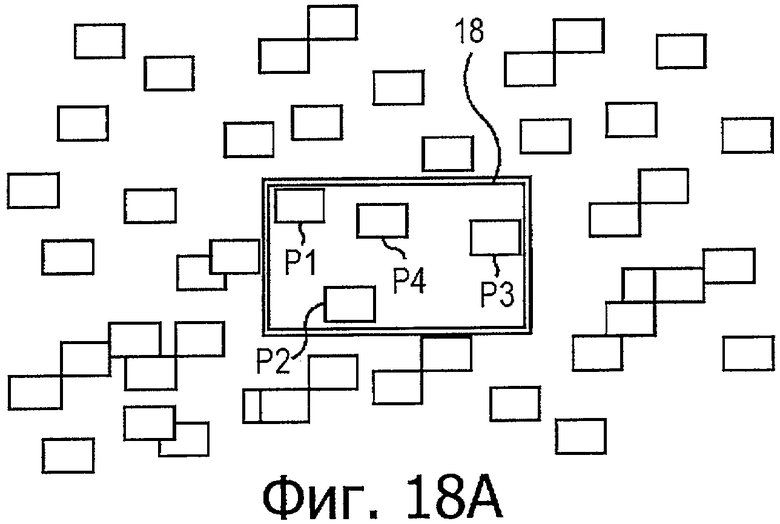

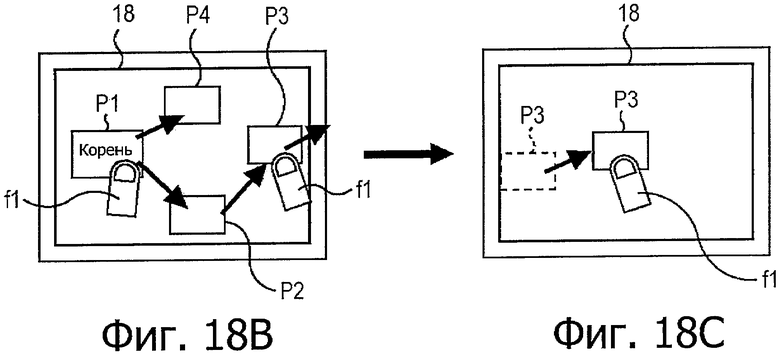

на фиг.18А-18С показаны схемы, поясняющие пятый пример способа работы при поиске взаимосвязанного изображения устройства формирования изображения;

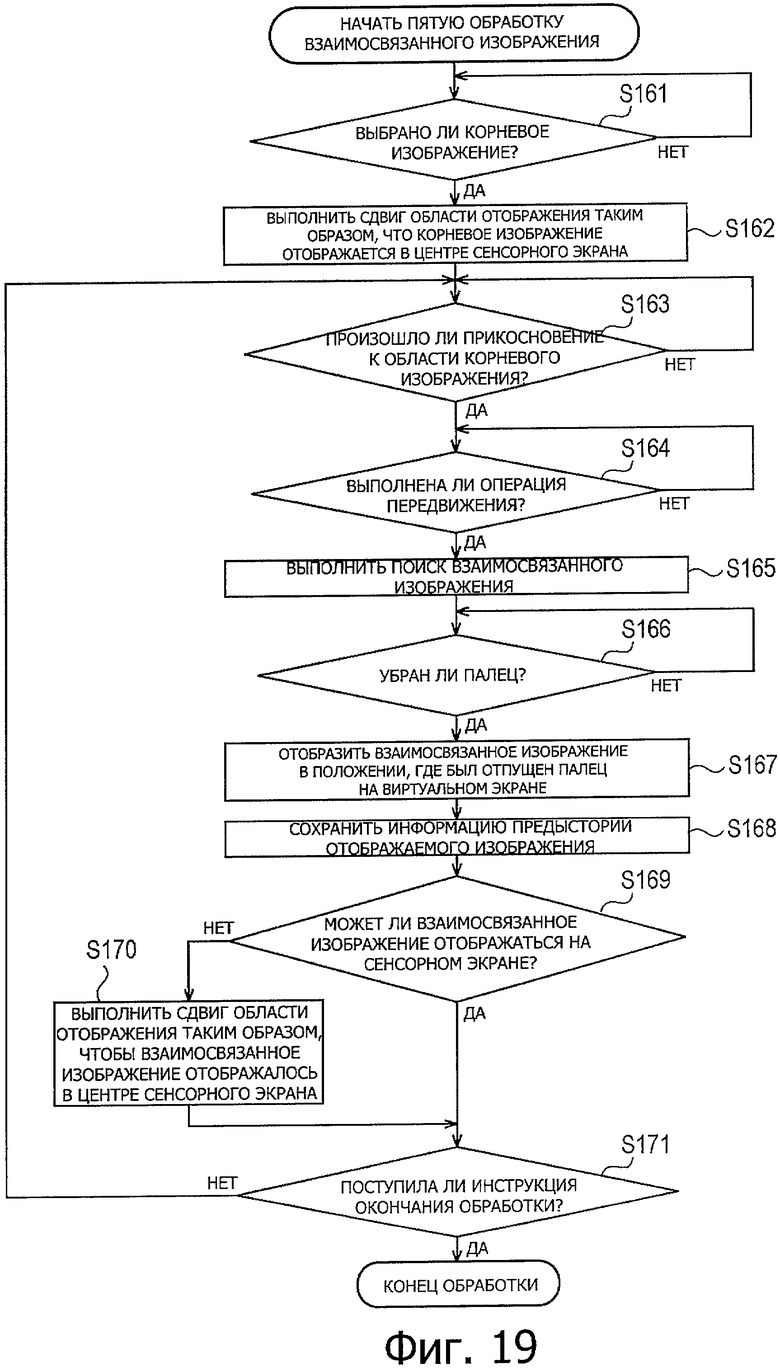

на фиг.19 показан блок-схема последовательности операций, поясняющая пример пятой обработки поиска взаимосвязанного изображения;

на фиг.20А-20С показаны схемы, поясняющие пример способа работы, связанного с обработкой отображения увеличенного/уменьшенного изображения;

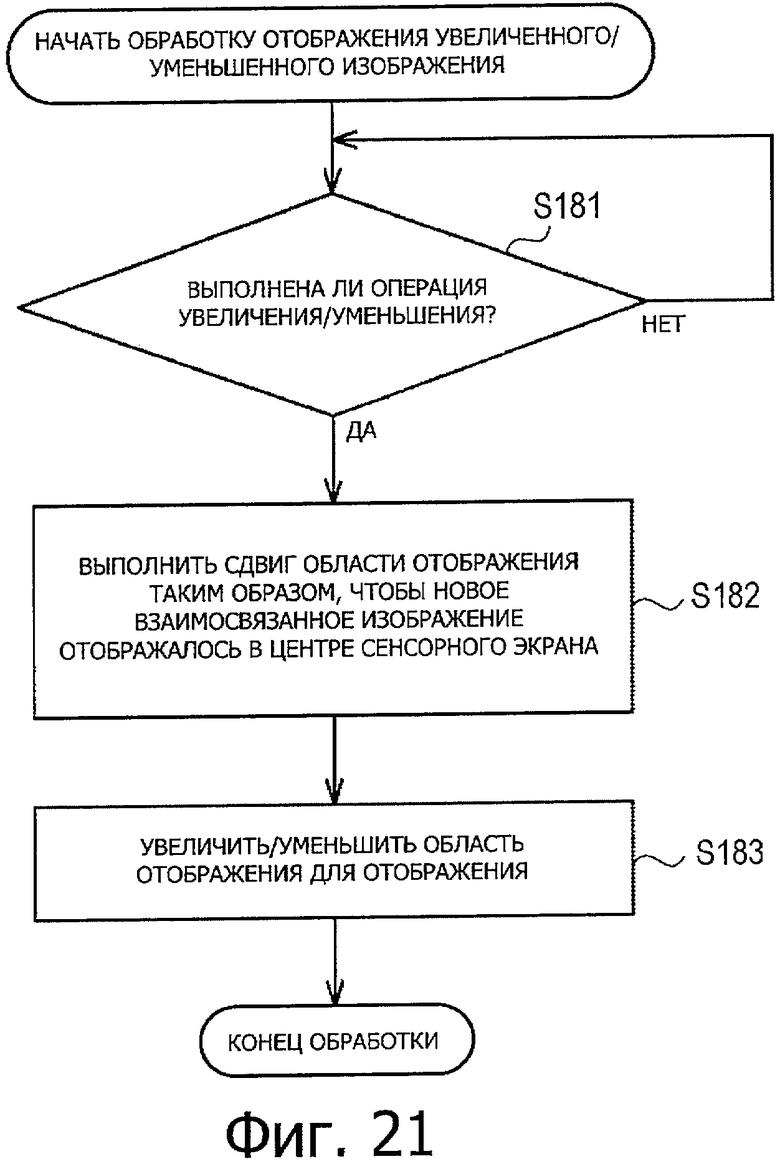

на фиг.21 показана блок-схема последовательности операций, поясняющая пример обработки отображения увеличенного/уменьшенного изображения; и

на фиг.22 показана блок-схема примера конфигурации устройства обработки информации в соответствии с вариантом воплощения настоящего изобретения, который отличается от примера конфигурации, показанного на фиг.1.

Подробное описание изобретения

Варианты воплощения настоящего изобретения подробно поясняются ниже со ссылкой на прилагаемые чертежи.

На фиг.1 показана блок-схема примера конфигурации устройства формирования изображения в качестве примера устройства обработки информации в соответствии с вариантом воплощения настоящего изобретения.

В примере, показанном на фиг.1, устройство формирования изображения включает в себя компоненты от модуля 11 объектива до сенсорной панели 28.

Модуль 11 объектива включает в себя фотографический объектив, стопор и линзы фокусирования. Устройство 12 формирования изображения, такое как CCD (ПЗС, прибор с зарядовой связью) установлено на оптическом пути света объекта, который проходит через модуль 11 объектива.

Устройство 12 формирования изображения, модуль 13 обработки аналогового сигнала, модуль 14 A/D (А/Ц, аналого-цифрового) преобразования и модуль 15 обработки цифрового сигнала соединены в указанном порядке.

Жидкокристаллическая панель 17, устройство 19 записи и сенсорная панель 28 соединены с модулем 15 обработки цифрового сигнала.

Исполнительный элемент 20, предназначенный для регулировки стопора, включенного в модуль 11 объектива, и движения линз фокусирования, соединен с модулем 11 объектива. Привод 21 с двигателем также соединен с исполнительным элементом 20. Привод 21 с двигателем выполняет управление приводом для исполнительного элемента 20.

CPU (ЦПУ, центральное процессорное устройство) 23 управляет всем устройством формирования изображения. Поэтому модуль 13 обработки аналогового сигнала, модуль 14 А/Ц преобразования, модуль 15 обработки цифрового сигнала, привод 21 с двигателем, TG (ГС, генератор синхронизации) 22, модуль 24 операций, EEPROM (ЭСППЗУ, электрически стираемое программируемое ПЗУ) 25, ROM (ПЗУ, постоянное запоминающее устройство) 26 программы, RAM (ОЗУ, оперативное запоминающее устройство) 27, сенсорная панель 16 и сенсорная панель 28 соединены с ЦПУ 23.

Сенсорный экран 18 включает в себя сенсорную панель 16 и жидкокристаллическую панель 17. Сенсорная панель 28 расположена на поверхности устройства формирования изображения, противоположной сенсорному экрану 18, то есть на поверхности на стороне объектива формирования изображения (см. фиг.2А и 2В, которые описаны ниже).

Устройство 19 записи включает в себя оптический диск, такой как DVD (ЦУД, цифровой универсальный диск), полупроводниковое запоминающее устройство, такое как карта памяти, или другие съемные носители записи. Устройство 19 записи можно устанавливать с возможностью отсоединения в основной корпус устройства формирования изображения.

В СППЗУ 25 сохраняется информация различного рода. Другая информация, такая как информация, которая должна быть сохранена, даже когда состояние питания установлено в положение "выключено", содержится в СППЗУ 25.

В ПЗУ 26 программы содержится программа, выполняемая ЦПУ 23, и данные, необходимые для выполнения программы.

В ОЗУ 27 временно сохраняется программа и данные, необходимые как рабочая область, когда ЦПУ 23 выполняет различного рода обработку.

Ниже представлен обзор работы всего устройства формирования изображения, имеющего конфигурацию, показанную на фиг.1.

ЦПУ 23 выполняет программу, сохраненную в ПЗУ 26 программы, для управления, таким образом, модулями устройства формирования изображения. ЦПУ 23 выполняет заданную обработку в соответствии с сигналом из сенсорной панели 16 или сенсорной панели 28, и сигналом из модуля 24 операций. Конкретный пример такой обработки поясняется ниже со ссылкой на блок-схемы последовательности операций.

Пользователь выполняет операции с модулем 24 операций, и из этого модуля сигнал, соответствующий операции, поступает в ЦПУ 23.

Когда палец пользователя введен в контакт с сенсорным экраном 18 или сенсорной панелью 28, например, палец прикасается в произвольном положении к сенсорному экрану 18 или к сенсорной панели 28, то есть пользователь выполняет ввод заданной операции, сенсорный экран 18 или сенсорная панель 28 детектирует координату положения контакта. Сенсорный экран 18 или сенсорная панель 28 передает электрический сигнал, обозначающий детектированную координату (ниже называется сигналом координаты), в ЦПУ 23. ЦПУ 23 распознает координату положения контакта из сигнала координаты, получает заданную информацию, связанную с этой координатой, и выполняет заданную обработку на основе информации.

В данном описании "контакт" включает в себя не только статистический контакт (контакт только в одной заданной области), но также и динамический контакт (контакт объекта контакта, такого как палец, который движется, вычерчивая заданную траекторию). Например, передвижение пальцем по изображению, такое как при переворачивании листа бумаги, представляет собой форму контакта.

Модуль 11 объектива выдвигается из корпуса или помещается внутри корпуса устройства формирования изображения в соответствии с приводом исполнительного элемента 20. Кроме того, регулировку стопора, включенного в модуль 11 объектива и движение линзы фокусирования, включенной в модуль 11 объектива, выполняют в соответствии с приводом исполнительного элемента 20.

ГС 22 обеспечивает сигнал синхронизации в устройстве 12 формирования изображения на основе управления ЦПУ 23. В соответствии с сигналом синхронизации управляют временем экспозиции и т.п. в устройстве 12 формирования изображения.

Устройство 12 формирования изображения работает на основе сигнала синхронизации, который поступает из ГС 22, принимая, таким образом, свет объекта, падающий через модуль 11 объектива, и выполняя фотоэлектрическое преобразование. Устройство 12 формирования изображения передает в модуль 13 обработки аналогового сигнала аналоговый сигнал изображения, соответствующий принятому количеству света. Привод 21 с двигателем осуществляет привод исполнительного элемента 20 под управлением ЦПУ 23.

Модуль 13 обработки аналогового сигнала применяет, на основе управления ЦПУ 23, обработку аналогового сигнала, такую как усиление аналогового сигнала изображения, поступающего из устройства 12 формирования изображения. Модуль 13 обработки аналогового сигнала предоставляет в модуль 14 А/Ц преобразования аналоговый сигнал изображения, полученный в результате обработки аналоговых сигналов.

Модуль 14 А/Ц преобразования выполняет А/Ц преобразование аналогового сигнала изображения из модуля 13 обработки аналогового сигнала на основе управления ЦПУ 23. Модуль 14 А/Ц преобразования предоставляет в модуль 15 обработки цифрового сигнала цифровой сигнал изображения, полученный в результате А/Ц преобразования.

Модуль 15 обработки цифрового сигнала применяет на основе управления, выполняемого ЦПУ 23, обработку цифровых сигналов, такую как обработку удаления шумов в цифровом сигнале изображения, предоставленном из модуля 14 А/Ц преобразования. Модуль 15 обработки цифрового сигнала обеспечивает отображение жидкокристаллической панелью 17 изображения, соответствующего цифровому сигналу изображения, в качестве сфотографированного изображения.

Модуль 15 обработки цифрового сигнала выполняет кодирование со сжатием, в соответствии с заданной системой кодирования со сжатием, такой как JPEG (ОГЭФ, объединенная группа экспертов по машинной обработке фотографических изображений), цифрового сигнала изображения, представляемого из модуля 14 А/Ц преобразования. Модуль 15 обработки цифрового сигнала обеспечивает запись устройством 19 записи кодированного со сжатием цифрового сигнала изображения.

Модуль 15 обработки цифрового сигнала считывает кодированный со сжатием цифровой сигнал изображения из устройства 19 записи, декодирует с расширением цифровой сигнал изображения в соответствии с системой декодирования с расширением, которая соответствует заданной системе кодирования со сжатием. Модуль 15 обработки цифрового сигнала обеспечивает отображение на жидкокристаллической панели 17 изображения, соответствующего цифровому сигналу изображения, в качестве записанного изображения.

Кроме того, модуль 15 обработки цифрового сигнала генерирует, на основе управления ЦПУ 23, изображение кадра, используемое для представления функции AF (АФ, автофокус) (ниже называется кадром АФ), и обеспечивает отображение изображения на жидкокристаллической панели 17.

Изображение, снятое устройством 12 формирования изображения (сфотографированное изображение), отображают на жидкокристаллической панели 17. В этом случае, кадр АФ устанавливают в изображении, отображаемом на жидкокристаллической панели 17. Фокусированием управляют на основе изображения в кадре АФ.

Как пояснялось выше, устройство формирования изображения имеет функцию АФ. Функция АФ включает в себя, помимо функции управления фокусом, функцию установки кадра АФ в произвольном положении на изображении, отображаемом на жидкокристаллической панели 17. Кроме того, функция АФ включает в себя функцию управления положением, размером и т.п. кадра АФ в соответствии с любой операцией, выполняемой на сенсорном экране 18, включающем в себя жидкокристаллическую панель 17 и сенсорную панель 16.

Обработка для реализации функции АФ реализуется с помощью ЦПУ 23, которое считывает программу из ПЗУ 26 программы и выполняет эту программу. Кроме того, устройство формирования изображения имеет функцию АЕ (АЭ, автоматической экспозиции) и функцию AWB (АББ, автоматической регулировки баланса белого цвета). Эти функции также реализуются с помощью ЦПУ 23, которое считывает программу из ПЗУ 26 программы.

Кроме того, функция АФ, функция АЭ и функция АББ представляют собой просто иллюстрации функций устройства формирования изображения. Устройство формирования изображения имеет различные функции, относящиеся к фотографированию изображения. Помимо различных видов функций основные функции, относящиеся к фотографированию, называются основными функциями, и прикладные функции, относящиеся к фотографированию, называются прикладными функциями. В качестве основных функций, помимо функции АФ, функции АЭ и функции АББ, например, можно использовать "функцию выбора режима фотографирования" и "функцию установки таймера фотографирования". В качестве прикладной функции, например, можно использовать "функцию изменения количества пикселей" и "функцию регулировки цветности".

На фиг.2А и 2В показаны виды в перспективе примера внешней конфигурации устройства формирования изображения в соответствии с примером, показанным на фиг.1.

Из поверхностей устройства формирования изображения поверхность, противоположная объекту, когда пользователь фотографирует объект, то есть поверхность, на которой расположен модуль 11 объектива, называется передней поверхностью. С другой стороны, из поверхностей устройства формирования изображения поверхность, противоположная пользователю, когда пользователь фотографирует объект, то есть поверхность на противоположной стороне от передней поверхности, называется задней поверхностью. Кроме того, из поверхностей устройства формирования изображения поверхность, расположенная на верхней стороне, и поверхность, расположенная на нижней стороне, когда пользователь фотографирует объект, называются верхней поверхностью и нижней поверхностью соответственно.

На фиг.2А показан вид в перспективе примера внешней конфигурации передней поверхности устройства формирования изображения. На фиг.2В показан вид в перспективе примера внешней конфигурации задней поверхности устройства формирования изображения.

Передняя поверхность устройства формирования изображения может быть закрыта крышкой 47 объектива. Когда крышка 47 объектива на передней поверхность открывается вниз, как показано на чертеже, устройство формирования изображения изменяет свое состояние с переходом в состояние, показанное на фиг.2А. Как показано на фиг.2А, в верхней части передней поверхности, с которой снята закрывающая объектив крышка 47, находятся объектив 45 фотографирования и осветитель 46 АФ, включенный в модуль 11 объектива, расположенные в этом порядке с правой стороны в верхней части. В нижней части передней поверхности, которая закрыта крышкой 47 объектива, расположена сенсорная панель 28 на участке рядом с центром устройства формирования изображения, за который пользователь не держит устройство, когда фотографирует объект.

Осветитель 46 АФ также выполняет функцию лампы автоспуска. На верхней поверхности устройства формирования изображения расположены рычаг 41 степени увеличения (ТЕЛЕИЗОБРАЖЕНИЕ/ШИРОКОУГОЛЬНОЕ ИЗОБРАЖЕНИЕ), кнопка 42 затвора, кнопка 43 воспроизведения и кнопка 44 питания в данном порядке слева направо на фиг.2А. Рычаг 41 степени увеличения, кнопка 42 затвора, кнопка 43 воспроизведения и кнопка 44 питания включены в модуль 24 операций, показанный на фиг.1.

Как показано на фиг.2В, сенсорный экран 18 расположен по всей задней поверхности устройства формирования изображения.

Как пояснялось выше, поскольку сенсорный экран 18 расположен на задней поверхности устройства формирования изображения, когда пользователь фотографирует объект, пользователь может выполнять операцию GUI (ТИП, графический интерфейс пользователя) с использованием сенсорного экрана 18, удерживая переднюю поверхность устройства формирования изображения направленной на объект.

В качестве операции ГИП для сенсорного экрана 18, например, в данном варианте воплощения, принята операция поиска и возврата изображения, имеющего сильную взаимосвязь с корневым изображением (ниже называется взаимосвязанное изображение), в отношении корневого изображения (ниже называется корневым изображением). Такая операция представляет собой операцию, для которой нет необходимости обеспечивать специальный экран поиска или тому подобное и операция выполняется интуитивно с использованием сенсорного экрана 18. Поэтому эта операция представляет собой операцию, которая позволяет пользователю легко находить взаимосвязанное изображение. Поэтому такая операция ниже называется операцией поиска взаимосвязанного изображения.

В качестве исходного условия операции поиска взаимосвязанного изображения предполагается, что цели, которые могут представлять собой корневое изображение или взаимосвязанное изображение (ниже называются целевыми изображениями поиска), представляют собой все изображения, записанные в устройстве 19 записи. Предполагается, что для всех целевых изображений поиска степень силы взаимосвязи уже была получена из базы данных или тому подобное заранее на основе, например, дополнительной информации, поясняющейся ниже.

Поиск, относящийся к степени силы взаимосвязи, не ограничивается примером, пояснявшимся выше. Степень силы взаимосвязи может быть определена каждый раз, когда выполняют операцию поиска взаимосвязанного изображения. Однако для упрощения пояснения предполагается, что степень силы взаимосвязи уже была заранее определена во всех вариантах воплощения, описанных в данном описании.

В качестве дополнительной информации, например, в данном варианте воплощения предполагается, что применяется информация лица, информация положения/места, информация времени и информация цвета. Информация лица означает информацию, относящуюся к лицу человека, и информацию, достаточную для идентификации человека. Информация положения/места означает информацию, относящуюся к широте и долготе, полученную с помощью GPS (СГН, Система глобальной навигации) или тому подобное, или информацию (название места), которую можно распознавать как специфическое место с помощью распознавания изображения для изображения. Информация времени означает информацию, относящуюся к времени фотографирования. Информация цвета означает информацию, относящуюся к цвету, использованному в большинстве мест на изображении.

Целевое изображение поиска не ограничивается неподвижным изображением и включает в себя движущееся изображение. Однако когда движущееся изображение представляет собой целевое изображение поиска, дополнительная информация движущегося изображения представляет собой группу информации, получаемую из соответствующих единичных изображений (полей, кадров и т.п.), формирующих движущееся изображение.

Корневое изображение отличается от других изображений, и его отображают для ясного представления корневого изображения. Например, корневое изображение может отображаться более крупно, чем другие изображения, может отображаться более ярко, чем другие изображения, или может быть окружено рамкой.

Первый пример операции поиска взаимосвязанного изображения поясняется ниже со ссылкой на фиг.3А-3Е.

Вначале пользователь выбирает произвольное изображение как корневое изображение P1. Сама операция выбора не ограничена конкретно. Когда выбирают корневое изображение Р1, состояние отображения сенсорного экрана 18 изменяется на состояние, показанное на фиг.3А. Состояние, в котором корневое изображение Р1 отображают на сенсорном экране 18, показано на фиг.3А.

В то время как состояние отображения сенсорного экрана 18 представляет собой состояние, показанное на фиг.3А, пользователь вводит палец f1 в контакт с корневым изображением Р1 (область на сенсорном экране 18, в котором отображается корневое изображение Р1), как показано на фиг.3В. Затем, как показано на фиг.3С, пользователь выполняет операцию передвижения пальца f1 в заданном направлении на заданное расстояние (в примере, показанном на фиг.3А-3Е, расстояние, обозначенное пунктирной стрелкой), начиная с корневого изображения Р1, с поддержанием контакта с сенсорным экраном 18. Такая операция ниже называется операцией передвижения.

Далее, когда пользователь отпускает палец f1, состояние отображения сенсорного экрана 18 переходит в состояние, показанное на фиг.3D. На сенсорном экране 18 взаимосвязанное изображение Р2 для корневого изображения Р1 отображается в области, где палец f1 был отпущен, в то время как корневое изображение Р1 отображалось в исходной области. Взаимосвязанное изображение Р2 может представлять собой любое одно из множества взаимосвязанных изображений, относящихся к корневому изображению Р1. Однако, в данном варианте воплощения, изображение, имеющее наибольшую степень силы взаимосвязи с корневым изображением Р1, отображается как взаимосвязанное изображение Р2.

Далее, когда пользователь отпускает палец f1 после ввода пальца f1 в контакт с взаимосвязанным изображением Р2 и выполнения операции передвижения, как показано на фиг.3Е, взаимосвязанное изображение Р3 отображается в области, где был отпущен палец f1.

Взаимосвязанное изображение Р3 в некотором случае представляет собой взаимосвязанное изображение для корневого изображения Р1 и в других случаях представляет собой взаимосвязанное изображение для взаимосвязанного изображения Р2.

Когда пользователь снимает палец f1 с сенсорного экрана 18, это означает конец операции передвижения. Поэтому каждый раз, когда выполняется операция передвижения, взаимосвязанные изображения корневого изображения Р1 последовательно отображаются в области, в точке, в которой была закончена операция передвижения на сенсорном экране 18, в порядке степени силы взаимосвязи взаимосвязанных изображений. Другими словами, пользователь может выполнять операцию, как если бы пользователь выполнял поиск взаимосвязанных изображений с повторением операции передвижения.

Кроме того, также возможно придать значение направлению операции передвижения. Соответствующие пункты классификации взаимосвязи с корневым изображением Р1 ассоциированы с соответствующими направлениями операции передвижения. Вследствие этого, когда многократно выполняют операцию передвижения в заданном направлении, взаимосвязанные изображения последовательно отображаются на сенсорном экране 18 в порядке степени силы взаимосвязи пунктов классификации, ассоциированных с заданным направлением. Такие пункты классификации можно определять как условия поиска для взаимосвязанных изображений. Поэтому пункты классификации также называются условиями сужения, в соответствующих случаях.

В частности, например, в данном варианте воплощения предполагается, что "человек", "место", "время" и "цвет" приняты как условия сужения (пунктов классификации). В этом случае предполагается, что степень силы взаимосвязи "человека", "места", "времени" и "цвета" уже была получена заранее, соответственно, используя информацию лица, информацию положения/места, информацию времени и информацию цвета из дополнительной информации.

Например, предполагается, что условие "время" связано с наклонным направлением вверх и вправо операции передвижения, и условие "человек" взаимосвязано с наклонным направлением вниз и вправо операции передвижения.

В этом случае, например, взаимосвязанное изображение Р2, показанное на фиг.3Е, то есть взаимосвязанное изображение Р2, отображаемое после выполнения операции передвижения в наклонном направлении вниз и вправо, представляет собой взаимосвязанное изображение, имеющее сильную взаимосвязь в отношении условия "человек", с корневым изображением Р1, например, взаимосвязанное изображение, включающее в себя того же человека, что и корневое изображение Р1.

С другой стороны, например, взаимосвязанное изображение Р4, показанное на фиг.3Е, то есть взаимосвязанное изображение Р4, отображаемое после выполнения операции передвижения в наклонном направлении вверх и вправо, представляет собой взаимосвязанное изображение, имеющее сильную взаимосвязь в отношении условия "время" с корневым изображением Р1, например, взаимосвязанное изображение, сфотографированное во время, близкое к времени фотографирования корневого изображения Р1.

Далее поясняется обработка, выполняемая устройством формирования изображения, показанным на фиг.1, в ответ на пример операции в соответствии с фиг.3А-3Е, то есть операция в соответствии с первым примером операции поиска взаимосвязанного изображения. Обработка, выполняемая устройством формирования изображения, в ответ на операцию поиска взаимосвязанного изображения, ниже называется обработкой поиска взаимосвязанного изображения. В частности, обработка поиска взаимосвязанного изображения в ответ на операцию К-го примера (К представляет собой целое значение, равное или больше 1) операции поиска взаимосвязанного изображения в соответствии с данным вариантом воплощения называется К-ой обработкой поиска взаимосвязанного изображения.

Подробный пример обработки поиска первого взаимосвязанного изображения, выполняемой, когда взаимосвязанное изображение, найденное в результате операции поиска взаимосвязанного изображения, представляет собой взаимосвязанное изображение (в примере, показанном на фиг.3А-3Е, взаимосвязанное изображение Р2 или Р4) для корневого изображения (в примере, показанном на фиг.3А-3Е, корневое изображение Р1), представляет собой обработку поиска взаимосвязанного изображения 1А. Подробный пример первой обработки поиска взаимосвязанного изображения, выполняемой с взаимосвязанным изображением, найденным с помощью операции поиска изображения, представляет собой взаимосвязанное изображение (в примере, показанном на фиг.3А-3Е, взаимосвязанное изображение Р3) для взаимосвязанного изображения (в примере, показанном на фиг.3А-3Е, для взаимосвязанного изображения Р2), представляет собой обработку поиска взаимосвязанного изображения 1В. Обработка такого рода поясняется ниже со ссылкой на фиг.5 и 6.

На фиг.4 показана блок-схема последовательности операций, предназначенная для пояснения примера первой обработки поиска взаимосвязанного изображения.

На этапе S1 ЦПУ 23 определяет, было ли выбрано корневое изображение.

Когда корневое изображение не выбрано, ЦПУ 23 определяет на этапе S1, что корневое изображение не было выбрано (НЕТ на этапе S1), и возвращает обработку на этап S1. До тех пор, пока корневое изображение не будет выбрано, ЦПУ 23 многократно выполняет обработку определения на этапе S1.

После этого, когда корневое изображение будет выбрано, ЦПУ 23 определяет, что корневое изображение было выбрано (ДА на этапе S1), и обработка переходит на этап S2.

На этапе S2 ЦПУ 23 управляет модулем 15 обработки цифрового сигнала для отображения корневого изображения на сенсорном экране 18. Корневое изображение может отображаться в произвольной области сенсорного экрана 18. Однако целесообразно отображать корневое изображение в области, определенной с учетом простоты операции передвижения, выполняемой после этого. Например, в примере, показанном на фиг.3А-3Е, как показано на фиг.3А, корневое изображение Р1 отображают в области с левого конца сенсорного экрана 18, учитывая операцию передвижения в направлении вправо.

На этапе S3 ЦПУ 23 определяет, было ли прикосновение к области корневого изображения сенсорного экрана 18.

Когда не было прикосновения ни к одной из областей корневого изображения, ЦПУ 23 определяет на этапе S3, что ни к одной из областей корневого изображения не было прикосновения (НЕТ на этапе S3) и возвращает обработку на этап S3. До тех пор, пока не произойдет прикосновение с любой одной из областей корневого изображения, ЦПУ 23 многократно выполняет обработку определения на этапе S3.

После этого, когда произойдет прикосновение к любой области в корневом изображении, ЦПУ 23 определяет на этапе S3, что произошло прикосновение к области корневого изображения (ДА на этапе S3), и обработка переходит на этап S4.

Например, как показано на фиг.3В, когда палец f1 прикасается к области корневого изображения Р1, сигнал координаты подают в ЦПУ 23 из сенсорной панели 16, включенной в сенсорный экран 18.

Поэтому, когда сигнал координаты подают в ЦПУ 23, при обработке, выполняемой на этапе S3, ЦПУ 23 определяет, что произошло прикосновение к области корневого изображения (ДА на этапе S3) и распознает место контакта (координату корневого изображения Р1) по сигналу координаты.

Когда распознанное место контакта находится за пределами области отображения корневого изображения Р1, ЦПУ 23 определяет на этапе S3, что не было прикосновения ни к одной из областей корневого изображения (НЕТ на этапе S3), возвращает обработку на этап S3 и повторяет обработку на этапе S3 и последующих этапах.

С другой стороны, когда распознанное место контакта находится внутри области отображения корневого изображения P1, CPU 23 определяет на этапе S3, что произошло прикосновение к области корневого изображения (ДА на этапе S3), и обработка переходит на этап S4.

На этапе S4 ЦПУ 23 определяет, была ли выполнена операция передвижения, начиная с корневого изображения.

ЦПУ 23 может определять, путем отслеживания сигнала координаты из сенсорной панели 16, включенной в сенсорный экран 18, была ли выполнена операция передвижения. Другими словами, ЦПУ 23 может распознавать траекторию пальца f1 по временной последовательности сигнала координат. Поэтому ЦПУ 23 детектирует, на основе результата распознавания, выполняется ли операция передвижения.

Поэтому, когда операцию передвижения не детектируют в соответствии с результатом распознавания траектории движения пальца f1, ЦПУ 23 определяет на этапе S4, что операция передвижения не была выполнена (НЕТ на этапе S4), возвращает обработку на этап S4 и многократно выполняет обработку на этапе S4 и последующих этапах. Другими словами, до тех пор, пока операция передвижения не будет детектирована, ЦПУ 23 многократно выполняет обработку определения на этапе S4.

После этого, когда операция передвижения, начинающаяся с корневого изображения, будет детектирована в соответствии с результатом распознавания траектории движения пальца f1, ЦПУ 23 определяет на этапе S4, что операция передвижения была выполнена (ДА на этапе S4) и переводит обработку на этап S5. Например, в примере, показанном на фиг.3А-3Е, когда состояние отображения сенсорного экрана 18 изменяется на состояние, показанное на фиг.3С, ЦПУ 23 определяет на этапе S4, что операция передвижения была выполнена (ДА на этапе S4) и переводит обработку на этап S5.

На этапе S5 ЦПУ 23 выполняет поиск взаимосвязанного изображения среди всех изображений, записанных в устройстве 19 записи. В этом варианте воплощения ЦПУ 23 выполняет поиск изображения, имеющего наибольшую степень силы взаимосвязи с корневым изображением, как с взаимосвязанным изображением. Однако когда установлены различные условия сужения, поиск взаимосвязанного изображения выполняют, используя условия сужения, ассоциированные с направлениями операции передвижения.

На этапе S6 ЦПУ 23 определяет, убран ли палец f1 с сенсорного экрана 18, то есть была ли закончена операция передвижения. В частности, когда сигнал координаты больше не поступает из сенсорной панели 16, включенной в сенсорный экран 18, ЦПУ 23 может определить, что палец f1 был убран.

Поэтому, пока поступает сигнал координаты, ЦПУ 23 определяет на этапе S6, что палец f1 не убран (НЕТ на этапе S6), и возвращает обработку на этап S6. Другими словами, пока продолжается операция передвижения, ЦПУ 23 многократно выполняет обработку определения на этапе S6.

После этого, когда ввод сигнала координаты прекращается, то есть когда операция передвижения заканчивается, ЦПУ 23 определяет на этапе S6, что палец f1 убран (ДА на этапе S6), и обработка переходит на этап S7.

На этапе S7 ЦПУ 23 управляет модулем 15 обработки цифрового сигнала для отображения взаимосвязанного изображения в положении, в котором палец f1 был убран с сенсорного экрана 18.

Например, в примере, показанном на фиг.3А-3Е, когда палец f1 убирают в положении, показанном на фиг.3D на сенсорном экране 18, взаимосвязанное изображение Р2 отображают в этом положении.

На этапе S8 ЦПУ 23 определяет, поступила ли инструкция на окончание обработки. До тех пор, пока не поступит инструкция на окончание обработки, ЦПУ 23 определяет на этапе S8, что инструкция на окончание обработки не поступила (НЕТ на этапе S8), возвращает обработку на этап S3 и повторяет обработку на этапе S3 и последующих этапах. В частности, каждый раз, когда выполняется операция передвижения, начинающаяся с корневого изображения (например, корневого изображения Р1, показанного на фиг.3А-3Е), многократно выполняют обработку цикла - результат ДА на этапе S3, результат ДА на этапе S4, этап S5, результат ДА на этапе S6, этап S7 и результат НЕТ на этапе S8, и новое взаимосвязанное изображение отображают в положении, где палец f1 был убран (положение, где закончилась операция передвижения). Вследствие этого, множество взаимосвязанных изображений (например, взаимосвязанных изображений Р2 и Р4, показанных на фиг.3D и 3Е) могут отображаться в отношении корневого изображения (например, корневого изображения Р1, показанного на фиг.3А-3Е). Другими словами, в результате повторения операции передвижения пользователь может многократно выполнять обработку цикла - результат ДА на этапе S4, этап S5, результат ДА на этапе S6, этап S7 и результат НЕТ на этапе S8, как если бы пользователь выполнял поиск взаимосвязанного изображения для корневого изображения.

После этого, когда поступает инструкция на окончание обработки, ЦПУ 23 определяет на этапе S8, что поступила инструкция на окончание обработки (ДА на этапе S8), и обработка переходит на этап S9.

На этапе S9, в качестве результата обработки на этапах S1-S8, ЦПУ 23 сохраняют информацию предыстории корневых изображений и различных взаимосвязанных изображений, отображавшихся на сенсорном экране 18 (далее называется информацией предыстории отображаемых изображений) в устройстве 19 записи.

После этого первая обработка поиска взаимосвязанного изображения заканчивается.

Хотя это не показано на чертеже, например, ЦПУ 23 также может управлять модулем 15 обработки цифрового сигнала для отображения на сенсорном экране 18, когда детектируют операцию контакта пользователя на корневом изображении или взаимосвязанном изображении пальца f1 или тому подобное, информации предыстории отображаемого изображения, сохраненной в устройстве 19 записи.

Хотя это не показано на чертеже, например, ЦПУ 23 может выполнять поиск, когда детектируют операцию контакта на изображении, включенном в информацию предыстории отображаемого изображения пальца f1 пользователя или тому подобное, одно или больше взаимосвязанных изображений с изображением, установленным как корневое изображение, и обеспечивать отображение взаимосвязанных изображений на сенсорном экране 18.

Первый пример операции поиска взаимосвязанного изображения пояснялся выше со ссылкой на фиг.3А-3Е. Пример первой обработки поиска взаимосвязанного изображения, соответствующий первому примеру, пояснялся выше со ссылкой на блок-схему последовательности операций, показанную на фиг.4.

Пример обработки поиска взаимосвязанного изображения 1А, соответствующий первому примеру, поясняется ниже со ссылкой на блок-схему последовательности операций на фиг.5. Этот пример представляет собой подробный пример обработки поиска первого взаимосвязанного изображения, выполняемой, когда взаимосвязанное изображение, найденное в ходе операции поиска взаимосвязанного изображения, представляет собой взаимосвязанное изображение для корневого изображения (корневого изображения Р1 в примере, показанном на фиг.3А-3Е).

Соответствующие виды обработки на этапах S21-S27 по фиг.5 представляют собой, в принципе, те же виды обработки, что и соответствующие виды обработки на этапах S1-S7 на фиг.4. Поэтому пояснение этих видов обработки здесь не приведено.

Поэтому ниже поясняется обработка после того, как ЦПУ 23 управляет, при обработке на этапе S27, модулем 15 обработки цифрового сигнала для отображения взаимосвязанного изображения в положении, где палец был убран с сенсорного экрана 18. Когда такая обработка на этапе S27 заканчивается, обработка переходит на этап S28.

На этапе S28 ЦПУ 23 определяет, произошло ли прикосновение в области взаимосвязанного изображения, отображаемого на сенсорном экране 18. Другими словами, ЦПУ 23 определяет, произошло ли прикосновение в области взаимосвязанного изображения (в примере, показанном на фиг.3А-3Е, к взаимосвязанного изображения Р2), отображаемого на этапе S27.

Когда не произошло прикосновение ни в одной области взаимосвязанного изображения, ЦПУ 23 определяет на этапе S28, что прикосновение не произошло ни к одной области взаимосвязанного изображения (НЕТ на этапе S28), и возвращает обработку на этап S28. До тех пор, пока не произойдет прикосновение к любой области взаимосвязанного изображения, ЦПУ 23 будет многократно выполнять обработку определения на этапе S28.

После того, как произойдет прикосновение к любой области взаимосвязанного изображения, ЦПУ 23 определяет на этапе S28, что произошло прикосновение к области взаимосвязанного изображения (ДА на этапе S28), и обработка переходит на этап S29.

Например, как показано на фиг.3Е, когда палец f1 прикасается к области взаимосвязанного изображения Р2, сигнал координат поступает в ЦПУ 23 из сенсорной панели 16, включенной в сенсорный экран 18.

Поэтому когда сигнал координаты вводят в ЦПУ 23 при обработке на этапе S28, ЦПУ 23 определяет, что произошло прикосновение к области корневого изображения (ДА на этапе S28) и распознает место контакта (координату корневого изображения Р2) по сигналу координаты.

Когда распознанное место контакта находится за пределами области отображения корневого изображения Р2, ЦПУ 23 определяет на этапе S28, что не произошло прикосновение ни к одной области корневого изображения (НЕТ на этапе S28), обработка возвращается на этап S28 и повторяется обработка на этапе S28 и последующих этапах.

С другой стороны, когда распознанное место контакта находится внутри области отображения корневого изображения Р2, ЦПУ 23 определяет на этапе S28, что произошло прикосновение к области корневого изображения (ДА на этапе S28), и обработка переходит на этап S29.

На этапе S29 ЦПУ 23 определяет, была ли выполнена операция передвижения, начинающаяся с корневого изображения.

ЦПУ 23 может определить путем отслеживания сигнал координаты от сенсорной панели 16, включенной в сенсорный экран 18, была ли выполнена операция передвижения. Другими словами, ЦПУ 23 может распознавать траекторию пальца f1 по временной последовательности сигнала координаты. Поэтому ЦПУ 23 детектирует, на основе результата распознавания, была ли выполнена операция передвижения.

Поэтому когда операция передвижения не детектируется в соответствии с результатом распознавания траектории движения пальца f1, ЦПУ 23 определяет на этапе S29, что операция передвижения не была выполнена (НЕТ на этапе S29), возвращает обработку на этап S29 и многократно выполняет обработку на этапе S29 и последующих этапах. Другими словами, до тех пор, пока не будет детектирована операция передвижения, ЦПУ 23 многократно выполняет обработку определения на этапе S29.

После того, как будет детектирована операция передвижения, начинающаяся с взаимосвязанного изображения, в соответствии с результатом распознавания траектории движения пальца f1, ЦПУ 23 определяет на этапе S29, что была выполнена операция передвижения (ДА на этапе S29), и переводит обработку на этап S30.

На этапе S30 ЦПУ 23 выполняет поиск взаимосвязанного изображения среди всех изображений, записанных в устройстве 19 записи. В данном варианте воплощения ЦПУ 23 выполняет поиск изображения, имеющего наибольшую степень силы взаимосвязи с корневым изображением, как с взаимосвязанным изображением. Однако изображение, имеющее наибольшую степень силы взаимосвязи с корневым изображением Р1, исключая взаимосвязанное изображение, отображаемое в данный момент времени (в примере, показанном на фиг.3А-3Е, взаимосвязанное изображение Р2), среди взаимосвязанных изображений для корневого изображения Р1, отображается как взаимосвязанное изображение Р3. Другими словами, взаимосвязанное изображение Р3 представляет собой изображение, имеющее вторую наибольшую степень силы взаимосвязи с корневым изображением Р1, которое распложено рядом с взаимосвязанным изображением Р2. Если будут установлены различные условия сужения, взаимосвязанное изображение находят с использованием условий сужения, ассоциированных с направлениями операции передвижения.

На этапе S31 ЦПУ 23 определяет, был ли убран палец f1 с сенсорного экрана 18, то есть была ли закончена операция передвижения. В частности, когда сигнал координаты больше не поступает от сенсорной панели 16, включающей в себя в сенсорный экран 18, ЦПУ 23 может определить, что палец f1 был убран.

Поэтому, по мере того, как сигнал координаты поступает на вход, ЦПУ 23 определяет на этапе S31, что палец f1 еще не был убран (НЕТ на этапе S31), и возвращает обработку на этап S31. Другими словами, пока продолжается операция передвижения, ЦПУ 23 многократно выполняет обработку определения на этапе S31.

После этого, когда ввод сигнала координаты прекращается, то есть когда заканчивается операция передвижения, ЦПУ 23 определяет на этапе S31, что палец f1 был убран (ДА на этапе S31), и обработка переходит на этап S32.

На этапе S32 ЦПУ 23 управляет модулем 15 обработки цифрового сигнала для отображения взаимосвязанного изображения в положении, в котором был убран палец f1 на сенсорном экране 18.

Например, в примере, показанном на фиг.3А-3Е, когда палец f1 убирают в положении Р3, показанном на фиг.3Е на сенсорном экране 18, взаимосвязанное изображение Р3 отображается в этом положении.

На этапе S33 ЦПУ 23 определяет, поступила ли инструкция окончания обработки. До тех пор, пока не поступит инструкция окончания обработки, ЦПУ 23 определяет на этапе S33, что инструкция окончания обработки еще не поступила (НЕТ на этапе S33), возвращает обработку на этап S23 и повторяет обработку на этапе S23 и последующих этапах. В частности, каждый раз, когда выполняют операцию передвижения, начинающуюся с корневого изображения (например, корневого изображения Р1, показанного на фиг.3А-3Е) многократно выполняется обработка цикла на этапах S23-S33, и новое взаимосвязанное изображение отображают в положении, где палец f1 был убран (положение, где закончилась операция передвижения). Следовательно, множество взаимосвязанных изображений (например, взаимосвязанные изображения Р2 и Р4, показанные на фиг.3D и 3Е), можно отображать относительно корневого изображения (например, корневого изображения P1, показанного на фиг.3А-3Е). Другими словами, путем повторения операции передвижения пользователь может многократно выполнять обработку цикла этапов S23-S33, как в случае, когда пользователь выполняет поиск взаимосвязанного изображения для корневого изображения.

После этого, когда поступает инструкция окончания обработки, ЦПУ 23 определяет на этапе S33, что поступила инструкция на окончание обработки (ДА на этапе S33), и обработка переходит на этап S34.

На этапе S34 в результате обработки, выполняемой на этапах S21-S33, ЦПУ 23 сохраняет информацию предыстории для корневых изображений и различных взаимосвязанных изображений, отображавшихся на сенсорном экране 18 (ниже называется информацией предыстории отображаемых изображений) в устройстве 19 записи.

После этого обработка поиска взаимосвязанного изображения 1А заканчивается. Пример обработки поиска взаимосвязанного изображения 1В, который соответствует первому примеру, поясняется со ссылкой на блок-схему последовательности операций, показанную на фиг.6. Этот пример представляет собой подробный пример первой обработки поиска взаимосвязанного изображения, выполняемой, когда взаимосвязанное изображение, получаемое в результате операции поиска взаимосвязанного изображения, представляет собой взаимосвязанные изображения для взаимосвязанного изображения (в примере, показанном на фиг.3А-3Е, взаимосвязанное изображение Р2).

Соответствующие виды обработки на этапах S41-S47, показанных на фиг.6, представляют собой, в принципе, такую же обработку, как и соответствующие виды обработки, выполняемые на этапах S1-S7, показанных на фиг.4. Поэтому пояснение обработки такого вида исключено.

Поэтому поясняется обработка после того, как ЦПУ 23 управляет, при обработке на этапе S47, модулем 15 обработки цифрового сигнала, для отображения взаимосвязанного изображения в положении, где палец был убран с сенсорного экрана 18. Когда заканчивается такая обработка на этапе S47, обработка переходит на этап S48.

На этапе S48 ЦПУ 23 устанавливает взаимосвязанное изображение как корневое изображение. В частности, ЦПУ 23 устанавливает взаимосвязанное изображение (в примере, показанном на фиг.3А-3Е, взаимосвязанное изображение Р2), отображаемое на этапе S47, как корневое изображение.

На этапе S49 ЦПУ 23 определяет, поступила ли инструкция на окончание обработки. До тех пор, пока не поступит инструкция на окончание обработки, ЦПУ 23 определяет на этапе S49, что инструкция на окончание обработки не поступила (НЕТ на этапе S49), возвращает обработку на этап S43 и повторяет обработку на этапе S43 и последующих этапах. В частности, каждый раз, когда выполняется операция передвижения, начинающаяся с корневого изображения (например, корневого изображения Р1 или Р2, показанных на фиг.3А-3Е), многократно выполняется обработка цикла, состоящего из этапов S43-S49, и новое взаимосвязанное изображение отображают в положении, где был убран палец f1 (положение, где закончилась операция передвижения). Следовательно, множество взаимосвязанных изображений (например, взаимосвязанное изображение Р3, показанное на фиг.3Е) можно отображать в отношении корневого изображения (например, корневого изображения Р1 или Р2, показанного на фиг.3А-3Е). Другими словами, в результате многократного повторения операции передвижения пользователь может многократно выполнять обработку цикла, состоящего из этапов S43-S49, как если бы пользователь выполнял поиск взаимосвязанного изображения для корневого изображения.

После этого, когда поступает инструкция на окончание обработки, ЦПУ 23 определяет на этапе S49, что поступила инструкция на окончание обработки (ДА на этапе S49), и обработка переходит на этап S50.

На этапе S50, в результате обработки на этапах S41-S49, ЦПУ 23 сохраняет информацию предыстории корневых изображений и различных взаимосвязанных изображений, отображавшихся на сенсорном экране 18 (ниже называется информацией предыстории отображаемых изображения) в устройстве 19 записи.

Следовательно, обработка поиска взаимосвязанного изображения 1В заканчивается.

Второй пример операции поиска взаимосвязанного изображения поясняется со ссылкой на фиг.7А-7Е. Пример обработки поиска второго взаимосвязанного изображения, соответствующей второму примеру, поясняется со ссылкой на блок-схему последовательности операций по фиг.8.

Вначале пользователь выбирает произвольное изображение как корневое изображение Р1. Сама операция выбора не ограничена специально. Когда выбирают корневое изображение Р1, состояние отображения сенсорного экрана 18 изменяется на состояние, показанное на фиг.7А. На фиг.7А показана схема состояния, в котором корневое изображение Р1 отображается в центре сенсорного экрана 18.

Когда пользователь прикасается пальцем f1 к корневому изображению Р1, отображаемому на сенсорном экране 18 в состоянии, показанном на фиг.7А, отображение сенсорного экрана 18 переходит в состояние, показанное на фиг.7С. Как показано на фиг.7С, изображения PA-PD, в которых представлены пункты классификации (условие сужения), отображаются, например, в четырех углах корневого изображения P1. Изображения PA-PD, в которых отображаются пункты классификации, ниже называются тегами PA-PD классификации.

Когда пользователь прикасается пальцем f1 к тегу классификации, в котором отображается пункт классификации, требуемый для использования для поиска взаимосвязанного изображения, вместе с тегами PA-PD классификации, пользователь может выбрать пункт классификации. Затем изображение, имеющее наибольшую степень силы взаимосвязи в выбранном пункте классификации среди взаимосвязанных изображений корневого изображения Р1, отображается на сенсорном экране 18 как взаимосвязанное изображение. Выбор пункта классификации может быть выполнен не только путем прикосновении к тегу классификации пальцем f1, но также и в результате операции передвижения пальца f1 в определенном направлении тегов PA-PD классификации. В данном варианте воплощения пункт классификации выбирают путем прикосновения к тегу классификации пальцем f1.

Например, в примере на фиг.7А-7Е, как представлено на фиг.7D, поскольку палец f1 прикоснулся к тегу РА классификации, в котором отображается "человек", этот пункт условия "человек" выбирают как пункт классификации. Затем, как показано на фиг.7Е, изображение Р2, имеющее сильную взаимосвязь в отношении условия "человек" с корневым изображением Р1, например, изображение Р2, включающее в себя того же человека, что и в корневом изображении Р1, отображается как взаимосвязанное изображение.

Если сравнить первый пример (фиг.3А-3Е) и второй пример (фиг.7А-7Е) операции поиска взаимосвязанного изображения, даже в первом примере пользователь может выполнять поиск взаимосвязанного изображения без определенного назначения. Однако в первом примере, поскольку взаимосвязь с корневым изображением Р1 не была ясно представлена, первый пример не соответствует случаю, когда пользователь выполняет поиск только изображения, имеющего определенную взаимосвязь.

С другой стороны, во втором примере, когда прикасаются к корневому изображению, например, соответствующие пункты классификации отображаются вокруг корневого изображения. В примере, показанном на фиг.7А-7Е, отображают теги PA-PD классификации. Поэтому когда пользователь выбирает требуемые пункты классификации среди пунктов классификации, пользователь может отображать изображение, имеющее самую сильную взаимосвязь с корневым изображением в выбранном пункте классификации в качестве взаимосвязанного изображения. Используя второй пример, таким образом, пользователь может легко выполнить поиск, например, только изображения, на котором сфотографирован определенный человек.

На фиг.8 показана блок-схема последовательности операций, предназначенная для пояснения примера обработки поиска взаимосвязанного изображения, которая соответствует второму примеру обработки поиска взаимосвязанного изображения, пояснявшемуся со ссылкой на фиг.7А-7Е, то есть второй обработке поиска взаимосвязанного изображения.

На этапе S61 ЦПУ 23 определяет, было ли выбрано корневое изображение.

Когда корневое изображение не выбрано, ЦПУ 23 определяет на этапе S61, что корневое изображение не выбрано (НЕТ на этапе S61), и возвращается к обработке на этапе S61. Другими словами, до тех пор, пока не будет выбрано корневое изображение, ЦПУ 23 многократно выполняет обработку определения на этапе S61.

После этого, когда выбирают корневое изображение, ЦПУ 23 определяет на этапе S61, что было выбрано корневое изображение (ДА на этапе S61), и обработка переходит на этап S62.

На этапе S62 ЦПУ 23 управляет модулем 15 обработки цифрового сигнала для отображения корневого изображения на сенсорном экране 18. Корневое изображение может отображаться в произвольной области сенсорного экрана 18. Однако целесообразно отображать корневое изображение в области, определенной после этого с учетом отображения пунктов классификации. Например, в примере, показанном на фиг.7А-7Е, как показано на фиг.7А, корневое изображение Р1 отображается в области в центре сенсорного экрана 18.

На этапе S63 ЦПУ 23 определяет, произошло ли прикосновение к области корневого изображения на сенсорном экране 18.

В случае, если не было прикосновения ни к одной области корневого изображения, ЦПУ 23 определяет на этапе S63, что ни к одной области корневого изображения не было прикосновения (НЕТ на этапе S63), и возвращает обработку на этап S63. Другими словами, до тех пор, пока не произойдет прикосновение к любой области корневого изображения, ЦПУ 23 многократно выполняет обработку определения на этапе S63.

После этого, когда прикасаются к любой области в корневом изображении, ЦПУ 23 определяет на этапе S63, что произошло прикосновение к области в корневом изображении (ДА на этапе S63), и обработка переходит на этап S64.

На этапе S64 ЦПУ 23 управляет модулем 15 обработки цифрового сигнала для отображения тегов классификации в четырех углах корневого изображения на сенсорном экране 18. Например, в примере, показанном на фиг.7А-7Е, как показано на фиг.7С, отображаются теги классификации PA-PD. В примере, описанном со ссылкой на фиг.8, места отображения тегов классификации установлены в этих четырех углах в соответствии с примером, показанным на фиг.7А-7Е. Однако места отображения не ограничиваются примером, описанным со ссылкой на фиг.8. Форма отображения пунктов классификации не ограничивается тегами классификации, если только пункты классификации могут быть представлены пользователю.

На этапе S65 ЦПУ 23 определяет, произошло ли прикосновение к определенному тегу классификации среди тегов классификации, отображаемых на сенсорном экране 18.

Если не было прикосновения ни к одному из тегов классификации, отображаемых на сенсорном экране 18, ЦПУ 23 определяет на этапе S65, что ни к одному из тегов классификации не было прикосновения (НЕТ на этапе S65), и возвращает обработку на этап S65. Другими словами, до тех пор, пока не произойдет прикосновение к одному из тегов классификации, отображаемых на экране 18, ЦПУ 23 многократно выполняет обработку определения на этапе S65.

После этого, когда произойдет прикосновение к определенному тегу классификации среди тегов классификации, отображаемых на сенсорном экране 18, ЦПУ 23 определяет на этапе S65, что произошло прикосновение к определенному тегу классификации среди тегов классификации (ДА на этапе S65), и обработка переходит на этап S66.

В этапе S66 ЦПУ 23 выполняет поиск среди всех изображений, записанных в устройстве 19 записи, взаимосвязанного изображения, используя условие сужения (пункт классификации), соответствующее тегу классификации, к которому произошло прикосновение. Другими словами, в данном варианте воплощения изображение, имеющее наивысшую степень силы взаимосвязи с корневым изображением в условиях сужения (пункт классификации), соответствующих тегу классификации, к которому произошло прикосновение, возвращают как взаимосвязанное изображение.

На этапе S67 ЦПУ 23 управляет модулем 15 обработки цифрового сигнала для отображения возвращенного взаимосвязанного изображения на сенсорном экране 18.

Например, в примере, показанном на фиг.7А-7Е, как представлено на фиг.7D, когда палец f1 прикасается к тегу РА классификации, ЦПУ 23 определяет на этапе S65 обработки, что произошло прикосновение к определенному тегу классификации (ДА на этапе S65). Во время обработки на этапе S66 ЦПУ 23 возвращает, как взаимосвязанное изображение Р2, изображение, имеющее наивысшую степень силы взаимосвязи в отношении "человека" с корневым изображением Р1. При обработке на этапе S67 ЦПУ 23 отображает взаимосвязанное изображение Р2 рядом с областью, где отображается тег РА классификации "человек". Место отображения взаимосвязанного изображения Р2 не ограничено специально примером, показанным на фиг.7А-7Е, и его выбирают произвольно. Однако при выборе такого места, как в примере, показанном на фиг.7А-7Е, пользователь может легко распознавать, что взаимосвязанное изображение Р2 представляет собой изображение, имеющее высокую степень взаимосвязи в отношении пунктов классификации "человек", обозначенного тегом РА классификации.

На этапе S68 ЦПУ 23 сохраняет информацию предыстории отображаемых изображений в устройстве 19 записи.

После этого заканчивается обработка поиска второго взаимосвязанного изображения.

Как в примере, пояснявшемся со ссылкой на фиг.4, при обработке на этапах S67 и S68 ЦПУ 23 может определять, поступила ли инструкция окончания обработки, может возвращаться к обработке на соответствующем этапе, пока не поступит инструкция окончания обработки, и может переходить к обработке на этапе S68 только, когда поступит инструкция окончания обработки.

Второй пример операции поиска взаимосвязанного изображения пояснялся выше со ссылкой на фиг.7А-7Е. Пример второй обработки поиска взаимосвязанного изображения, соответствующий второму примеру, пояснялся выше со ссылкой на блок-схему последовательности операций, показанную на фиг.8.

Третий пример операции поиска взаимосвязанного изображения поясняется ниже со ссылкой на фиг.9А-9F. Пример третьей обработки поиска взаимосвязанного изображения, соответствующий третьему примеру, поясняется со ссылкой на блок-схему последовательности операций, показанную на фиг.10.

Вначале для выполнения операции поиска взаимосвязанного изображения пользователь устанавливает состояние операции ЦПУ 23 в состояние операции, в котором может быть выполнена обработка поиска взаимосвязанного изображения (ниже называется режим поиска). Затем состояние отображения сенсорного экрана 18 изменяется на состояние, показанное на фиг.9А. Другими словами, как показано на фиг.9А, изображения PA-PD для выбора пунктов классификации (условия сужения) отображаются на сенсорном экране 18. Изображения PA-PD, в которых отображаются пункты классификации, называются изображениями PA-PD выбора пункта классификации.

Когда пользователь прикасается пальцем f1 к изображению пункта классификации, в котором отображается пункт классификации, требуемый для использования для поиска взаимосвязанного изображения, среди изображений PA-PD пунктов классификации, пользователь может выбрать этот пункт классификации.

После этого, как во втором примере, пользователь выбирает произвольное изображение как корневое изображение Р1. Сама операция выбора не ограничена специально. Когда выбирают корневое изображение Р1, состояние отображения сенсорного экрана 18 изменяется на состояние, показанное на фиг.9В. Состояние, в котором корневое изображение Р1 отображается в центре сенсорного экрана 18, показано на фиг.9В.

В состоянии, показанном на фиг.9В, когда пользователь прикасается пальцем f1 к корневому изображению Р1, отображаемому на сенсорном экране 18, отображение сенсорного экрана 18 переходит в состояние, показанное на фиг.9D1 или 9D2. Когда пункт классификации, соответствующий выбранному изображению пункта классификации, представлен как основной пункт классификации (основной ключ), и пункты классификации (сужающее условие), полученные в результате более точной классификации основного пункта классификации, представлены как пункты подклассификации (вспомогательный ключ), теги РА1-PD1 или РА2-PD2 классификации, относящиеся к пунктам подклассификации, отображают, например, в четырех углах корневого изображения Р1.

В примере, показанном на фиг.9А-9F, поскольку палец f1 прикасается к изображению РА пункта классификации в состоянии, показанном на фиг.9А, выбирают основной пункт классификации "человек".

Пункты подклассификации, классифицируемые в отношении размера лица в изображении, например, представляют собой "очень большой", "большой", "средний" и "малый". Поэтому, состояние, в котором тег РС1 классификации, обозначающий "очень большой", тег РА1 классификации, обозначающий "большой", тег РВ1 классификации, обозначающий "средний", и тег PD1 классификации, обозначающий "малый", отображают в четырех углах корневого изображения Р1, представлено на фиг.9D1.

Что касается условия "человек", как пункта подклассификации, классифицируемого по количеству людей, включенных в изображение, например, существует "один человек", "два человека", "три человека" и "четыре или больше человек". Поэтому состояние, в котором тег РС2 классификации, обозначающий "один человек", тег РА2 классификации, обозначающий "два человека", тег РВ2 классификации, обозначающие "три человека", и тег PD2 классификации, обозначающий "четыре или больше человек", отображают в четырех углах корневого изображения Р1, иллюстрируется на фиг.9D2.

Когда пользователь прикасается пальцем f1 к тегу классификации, в котором отображается пункт подклассификации, требуемый для использования для поиска взаимосвязанного изображения среди тегов РА1-PD1 или РА2-PD2 классификации, пользователь может выбрать пункт подклассификации. Затем изображение, имеющее наибольшую степень силы взаимосвязи в выбранном пункте подклассификации, отображается на сенсорном экране 18 как взаимосвязанное изображение.

В частности, например, в примере, показанном на фиг.9А-9F, как представлено на фиг.9Е, палец f1 прикасается к тегу РА1 классификации, в котором отображается условие "большой" "человек". Поэтому условие "большой" выбирают как пункт подклассификации. Затем, как показано на фиг.9F, изображение Р2, имеющее сильную взаимосвязь в отношении "большой" "человек" с корневым изображением Р1, например, изображение Р2, включающее размер "большой" лица того же человека, что и в корневом изображении Р1, отображается как взаимосвязанное изображение.

Как пояснялось выше, например, когда взаимосвязанное изображение возвращают, используя основной пункт классификации, присутствуют пункты подклассификации, предоставленные в отношении размера лица "человека", показанного на изображении, количества "человек", показанных на изображении и т.п. Поскольку пользователь может обозначить эти пункты подклассификации, пользователь может выполнять поиск требуемого одного изображения, при определенном ограничении композиции.

На фиг.10 показана блок-схема последовательности операций, поясняющая пример обработки поиска взаимосвязанного изображения, соответствующего третьему примеру операции поиска взаимосвязанного изображения, пояснявшемуся со ссылкой на фиг.9А-9F, то есть обработки поиска третьего взаимосвязанного изображения.

На этапе S81 ЦПУ 23 определяет, установлен ли режим работы ЦПУ 23 в режим поиска.

Когда режим поиска не установлен, ЦПУ 23 определяет на этапе S81, что режим работы ЦПУ 23 не установлен в режим поиска (НЕТ на этапе S81), и возвращает обработку на этап S81. Другими словами, до тех пор, пока не будет установлен режим поиска, ЦПУ 23 многократно выполняет обработку определения на этапе S81.

После этого, когда выбирают корневое изображение, ЦПУ 23 определяет на этапе S81, что режим работы ЦПУ 23 установлен в режим поиска (ДА на этапе S81), и обработка переходит на этап S82.

На этапе S82 ЦПУ 23 управляет модулем 15 обработки цифрового сигнала для отображения изображений выбора пункта классификации на сенсорном экране 18. Например, в примере, показанном на фиг.9А-9F, как показано на фиг.9А, отображают изображения PA-PD выбора пункта классификации.

На этапе S83 ЦПУ 23 определяет, произошло ли прикосновение к определенному изображению выбора пункта классификации среди изображений выбора пунктов классификации на сенсорной панели 16.

Когда не было прикосновения ни к одному из изображений выбора пункта классификации, отображаемых на сенсорном экране 18, ЦПУ 23 определяет на этапе S83, что не было прикосновения ни к одному из экранов выбора пунктов классификации (НЕТ на этапе S83), и возвращает обработку на этап S83. Другими словами, до тех пор, пока не произойдет прикосновение к одному из изображений выбора пункта классификации, отображаемых на сенсорном экране 18, ЦПУ 23 многократно выполняет обработку определения на этапе S83.

После этого, когда произойдет прикосновение к определенному изображению выбора пункта классификации среди изображений выбора пунктов классификации, отображаемых на сенсорном экране 18, ЦПУ 23 определяет на этапе S83, что произошло прикосновение к определенному изображению выбора пункта классификации (ДА на этапе S83), и обработка переходит на этап S84.

На этапе S84 ЦПУ 23 устанавливает основной пункт классификации, соответствующий изображению выбора пункта классификации, к которому произошло прикосновение.

Например, в примере, показанном на фиг.9А-9F, поскольку палец f1 был приведен в контакт с изображением РА пункта классификации в состоянии, показанном на фиг.9А, ЦПУ 23 определяет при обработке на этапе S83, что произошло прикосновение к определенному изображению выбора пункта классификации (ДА на этапе S83). При обработке на этапе S84 ЦПУ 23 выбирает основной пункт классификации "человек".

На этапе S85 ЦПУ 23 определяет, было ли выбрано корневое изображение.

Когда корневое изображение не выбрано, ЦПУ 23 определяет на этапе S85, что корневое изображение не выбрано (НЕТ на этапе S85), и возвращает обработку на этап S85. Другими словами, до тех пор, пока не будет выбрано корневое изображение, ЦПУ 23 многократно выполняет обработку определения на этапе S85.

После этого, когда будет выбрано корневое изображение, ЦПУ 23 определяет на этапе S85, что корневое изображение было выбрано (ДА на этапе S85), и обработка переходит на этап S86.

На этапе S86 ЦПУ 23 управляет модулем 15 обработки цифрового сигнала для отображения корневого изображения на сенсорном экране 18. Корневое изображение можно отображать в произвольной области сенсорного экрана 18. После этого, целесообразно отображать корневое изображение в области, определенной с учетом отображения пунктов подклассификации. Например, в примере, показанном на фиг.9А-9F, как показано на фиг.9В, корневое изображение Р1 отображается в области в центре сенсорного экрана 18.

На этапе S87 ЦПУ 23 определяет, произошло ли прикосновение к области в корневом изображении на сенсорном экране 18.

Когда не было прикосновения ни к одной области корневого изображения, ЦПУ 23 определяет на этапе S87, что ни к одной из областей корневого изображения не было прикосновения (НЕТ на этапе S87), и возвращает обработку на этап S87. Другими словами, до тех пор, пока не произойдет прикосновение к какой-либо области корневого изображения, ЦПУ 23 многократно выполняет обработку определения на этапе S87.

После этого, когда происходит прикосновение к какой-либо области корневого изображения, ЦПУ 23 определяет на этапе S87, что произошло прикосновение к области корневого изображения (ДА на этапе S87), и обработка переходит на этап S88.

На этапе S88 ЦПУ 23 управляет модулем 15 обработки цифрового сигнала для отображения тегов классификации пунктов подклассификации в четырех углах корневого изображения на сенсорном экране 18. Например, в примере, показанном на фиг.9А-9F, как представлено на фиг.9D1 или 9D2, теги РА1-PD1 или РА2-PD2 классификации отображаются как теги классификации пунктов подклассификации, соответствующих условию "человек". В примере, пояснявшемся со ссылкой на фиг.10, места отображения тегов классификации установлены в четырех углах в соответствии с примером, показанным на фиг.9А-9F. Однако места отображения не ограничиваются примером, пояснявшимся со ссылкой на фиг.10. Форма отображения пунктов классификации не ограничивается тегом классификации, если только пункт классификации может быть представлен пользователю.

На этапе S89 ЦПУ 23 определяет, произошло ли прикосновение к определенному тегу классификации среди тегов классификации, отображаемых на сенсорном экране 18.

В случае, если не было прикосновения ни к одному из тегов классификации, отображаемых на сенсорном экране 18, ЦПУ 23 определяет на этапе S89, что не было прикосновении ни одному из тегов классификации (НЕТ на этапе S89), и возвращает обработку на этап S89. Другими словами, до тех пор, пока не произойдет прикосновение к одному из тегов классификации, отображаемых на сенсорном экране 18, ЦПУ 23 многократно выполняет обработку определения на этапе S89.

После этого, когда произойдет прикосновение к определенному тегу классификации среди тегов классификации, отображаемых на сенсорном экране 18, ЦПУ 23 определяет на этапе S89, что произошло прикосновение к определенному тегу классификации среди тегов классификации (ДА на этапе S89), и обработка переходит на этап S90.

На этапе S90 ЦПУ 23 возвращает среди всех изображений, записанных в устройстве 19 записи, связанное изображение, используя условие сужения (элемент подклассификации), соответствующее тегу классификации, в котором произошло прикосновение. Другими словами, в данном варианте воплощения изображение, имеющее наибольшую степень силы взаимосвязи с корневым изображением в условиях сужения (пункт подклассификации), соответствующих тегу классификации, к которому произошло прикосновение, возвращают как взаимосвязанное изображение.

На этапе S91 ЦПУ 23 управляет модулем 15 обработки цифрового сигнала для отображения найденного взаимосвязанного изображения на сенсорном экране 18.