Область техники, к которой относится изобретение

Настоящее изобретение относится к устройству и способу обработки изображения, обучающемуся устройству и способу обучения и программе. Более конкретно, настоящее изобретение относится к устройству и способу обработки изображений, обучающемуся устройству и способу обучения и программе, которые позволяют с легкостью выбирать изображение, которое оценивается как приемлемое для просмотра.

Уровень техники

В случае использования функции создания альбома для организации изображений, полученные посредством захвата изображений, таких как фотографии, или функции последовательной демонстрации изображений, пользователи должны выбирать изображения, подлежащие сохранению или отображению. Однако выбор необходимых изображений из большого количества изображений представляет собой трудную задачу.

Так, например, в качестве технологии для выбора так называемого наилучшего снимка, то есть изображения, оцениваемого как приемлемое для просмотра пользователем, из числа множества изображений, известна технология выбора наилучшего снимка из числа множества непрерывно снимаемых изображений (смотри, например, PTL 1).

В дополнение к этому, в качестве технологий, относящихся к изображениям, также известны технологии для оценки фотографического качества изображения на основе резкости изображения, качества изображения лица и наличия или отсутствия блика (смотри, например, PTL 2), и технология для обнаружения лица на изображении и выбора и извлечения оптимальной композиции в соответствии с результатом этого обнаружения (смотри, например, PTL 3).

Список упоминаемых документов

Патентная литература

PTL 1: публикация японской нерассмотренной патентной заявки номер 2006-311340

PTL 2: публикация японской нерассмотренной патентной заявки номер (перевод патентной заявки РСТ 2005-521927

PTL 3: публикация японской нерассмотренной патентной заявки 2007-27971

Сущность изобретения

Техническая задача

Однако в технологиях, описанных выше, было трудно надежно оценить то, является ли оцениваемое изображение изображением, оцениваемым как приемлемое для рассмотрения пользователем, то есть изображением, на котором объект виден четко.

Например, технология для выбора наилучшего снимка из числа непрерывно снимаемых изображений включает в себя оценку нерезкости и экспозиции всего изображения. Однако оценка нерезкости или экспозиции обычных изображений, отличных от изображений, полученных непрерывной съемкой, не обязательно может привести к более высокой оценке хорошо снятых изображений.

В общем, иначе говоря, на фотографии, на которой объект находится в фокусе на размытом фоне, объект виден четко и, следовательно, такая фотография часто является хорошо снятым кадром, именуемым наилучшим снимком. Однако использование технологии, описанной в PTL 1, для изображений, отличных от непрерывно снимаемых изображений, может привести к тому, что в качестве наилучшего снимка будет выбрано изображение, на котором в фокусе находится все изображение, а не изображение, на котором в фокусе находится объект, но фон является размытым.

В дополнение к этому, в технологии, описанной в PTL 2, поскольку качество изображения оценивается на основе предположения, что объектом является человеческое лицо, то в случае, при котором на изображении нельзя обнаружить лица, качество изображения оценивается с использованием резкости и наличия или отсутствия блика. Следовательно, в таком случае, изображение, на котором в фокусе находится все изображение, может иметь более высокую оценку, чем изображение, на котором в фокусе находится объект, но фон является размытым.

Кроме того, технология, описанная в PTL 3, делает возможной извлечение оптимальной композиции, но не позволяет оценить, является ли изображение хорошо снятым изображением. Кроме того, эта технология не позволяет извлечь оптимальную композицию в случае, при котором изображение не включает в себя в качестве объекта человеческое лицо.

Настоящее изобретение было сделано с учетом такой ситуации и предназначено для обеспечения более надежной оценки того, является ли оцениваемое изображение изображением, при котором объект виден четко.

Решение задачи

Устройство обработки изображений в первом аспекте настоящего изобретения включает в себя средство генерирования для генерирования на основе входного изображения, информации указания объекта для указания области объекта на входном изображении и средство определения для определения степени размытости объекта в области, включающей в себя объект на входном изображении, причем область используется в качестве целевой области для обработки с использованием информации указания объекта и входного изображения.

Средство генерирования может быть снабжено средством генерирования информационной карты для извлечения значения признака для признака области объекта из входного изображения и генерирования информационной карты, представляющей значение признака в каждой области входного изображения, и средством генерирования информации указания объекта для генерирования информации указания объекта посредством выполнения взвешенного суммирования множества информационных карт, представляющих значение признака для указанного признака, которые отличаются друг от друга.

Средство определения можно заставить определять четкость контура в области объекта, чтобы тем самым определить степень размытости объекта.

Средство генерирования информационной карты можно заставить извлекать значение признака из входного изображения для генерирования изображения признака, представляющего значение признака в каждой области входного изображения, и можно дополнительно заставить генерировать множество изображений признака, имеющих разрешения, отличающиеся друг от друга, на основе изображения признака и определять разность между множеством изображений признака, чтобы тем самым сгенерировать информационную карту.

Способ обработки изображений или программа в первом аспекте настоящего изобретения включает в себя этапы, на которых: генерируют, на основе входного изображения, информацию указания объекта для указания области объекта на входном изображении и определяют степень размытости объекта в области, включающей в себя объект на входном изображении, причем область используется в качестве целевой области для обработки с использованием информации указания объекта и входного изображения.

В первом аспекте настоящего изобретения на основе входного изображения генерируется информация указания объекта для указания области объекта на входном изображении, и информация указания объекта и входное изображение используются для определения степени размытости объекта в области, включающей в себя объект на входном изображении, причем область используется в качестве целевой области для обработки.

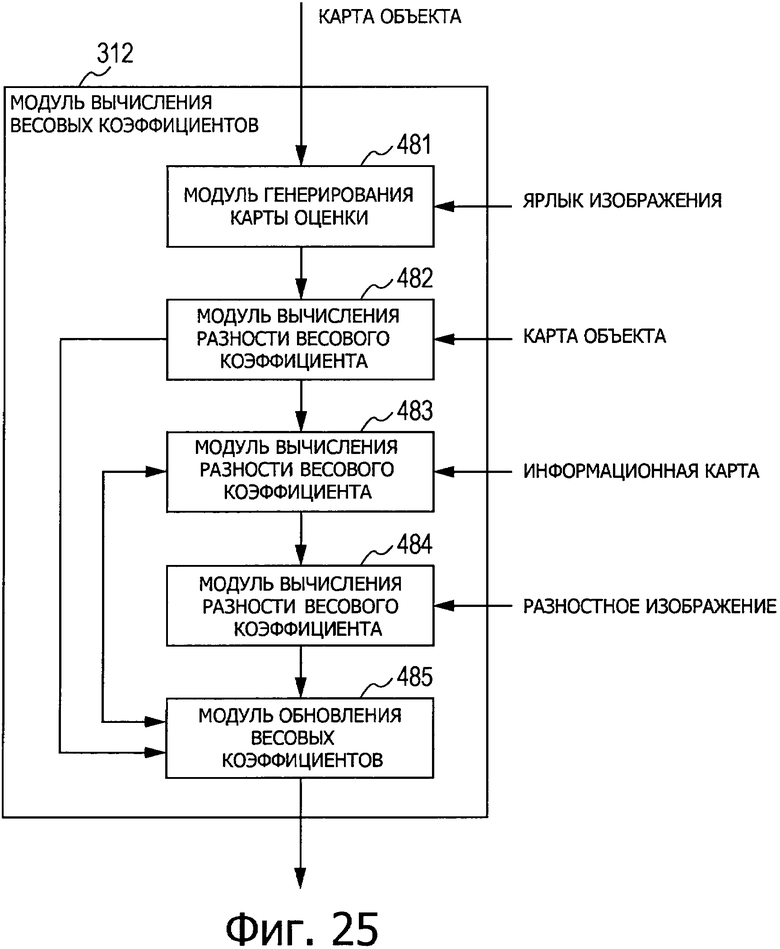

Обучающееся устройство во втором аспекте настоящего изобретения представляет собой обучающееся устройство, которое определяет весовой коэффициент, используя обучение на основе нейронной сети, причем весовой коэффициент используется для генерирования карты объекта для указания области объекта на изображении, включающее в себя: средство генерирования информационной карты, предназначенное для извлечения значения признака для признака области объекта из обучающего изображения, которое включает в себя объект и которое используется для обучения, и генерирования информационной карты, представляющей значение признака в каждой области обучающего изображения; средство генерирования карты объекта для генерирования карты объекта посредством выполнения взвешенного суммирования, используя весовой коэффициент, множества информационных карт, представляющих значение признака для этого признака, которые отличаются друг от друга, средство вычисления величины изменения весового коэффициента для вычисления величины изменения, на которую должен быть изменен весовой коэффициент, с использованием карты объекта и ярлыка изображения, который определен заранее и который представляет область объекта на обучающем изображении, и средство обновления для суммирования величины изменения с весовым коэффициентом и обновления весового коэффициента.

Способ обучения или программа во втором аспекте настоящего изобретения представляет собой способ обучения или программу для определения весового коэффициента с использованием обучения на основе нейронной сети, причем весовой коэффициент используется для генерирования карты объекта для указания области объекта на изображении, включающие в себя этапы, на которых: извлекают значения признака для признака области объекта из обучающего изображения, которое включает в себя объект и которое используется для обучения, и генерируют информационную карту, представляющую значение признака в каждой области обучающего изображения; генерируют карту объекта посредством выполнения взвешенного суммирования, используя весовой коэффициент, множества информационных карт, представляющих значение признака для этого признака, которые отличаются друг от друга; вычисляют величину изменения, на которую должен быть изменен весовой коэффициент, используя карту объекта и ярлык изображения, который определен заранее и который представляет область объекта на обучающем изображении; и суммируют величину изменения с весовым коэффициентом и обновляют весовой коэффициент.

Во втором аспекте настоящего изобретения в ходе процесса обучения для определения весового коэффициента с использованием обучения на основе нейронной сети, причем весовой коэффициент используется для генерирования карты объекта для указания области объекта на изображении, из обучающего изображения, которое включает в себя объект и которое используется для обучения, извлекают значение признака для признака области объекта и генерируют информационную карту, представляющую значение признака в каждой области обучающего изображения; генерируют карту объекта, выполняя взвешенное суммирование, используя весовой коэффициент, множества информационных карт, представляющих значение признака для этого признака, которые отличаются друг от друга; вычисляют величину изменения, на которую должен быть изменен весовой коэффициент с использованием карты объекта и ярлыка изображения, который определен заранее и который представляет область объекта на обучающем изображении; и суммируют величину изменения с весовым коэффициентом и обновляют весовой коэффициент.

Полезные результаты изобретения

В соответствии с первым аспектом настоящего изобретения имеется возможность оценивать изображение. В частности, согласно первому аспекту настоящего изобретения имеется возможность с более высокой надежностью выбирать изображение, на котором, как оценивается, объект виден четко.

В дополнение к этому, в соответствии со вторым аспектом настоящего изобретения имеется возможность определять весовой коэффициент, который используется для оценки изображения. В частности, согласно второму аспекту настоящего изобретения имеется возможность предоставить весовой коэффициент, который используется для более надежного выбора изображения, на котором, как оценивается, объект виден четко.

Краткое описание чертежей

Фиг.1 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию варианта осуществления устройства обработки изображений, к которому применимо настоящее изобретение.

Фиг.2 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля извлечения информации о яркости.

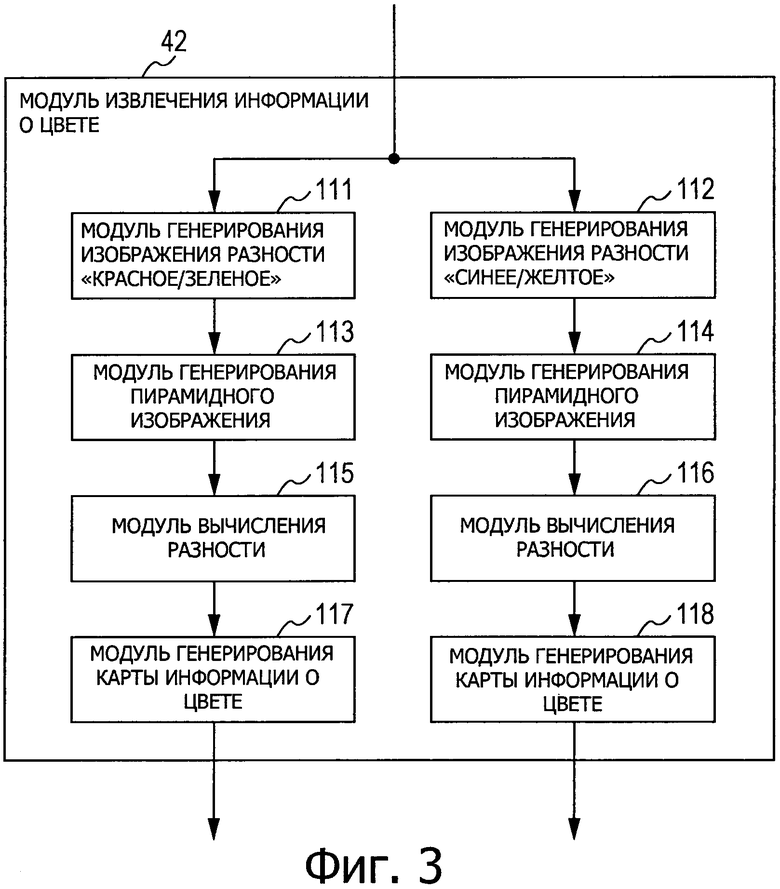

Фиг.3 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля извлечения информации о цвете.

Фиг.4 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля извлечения информации о контурах.

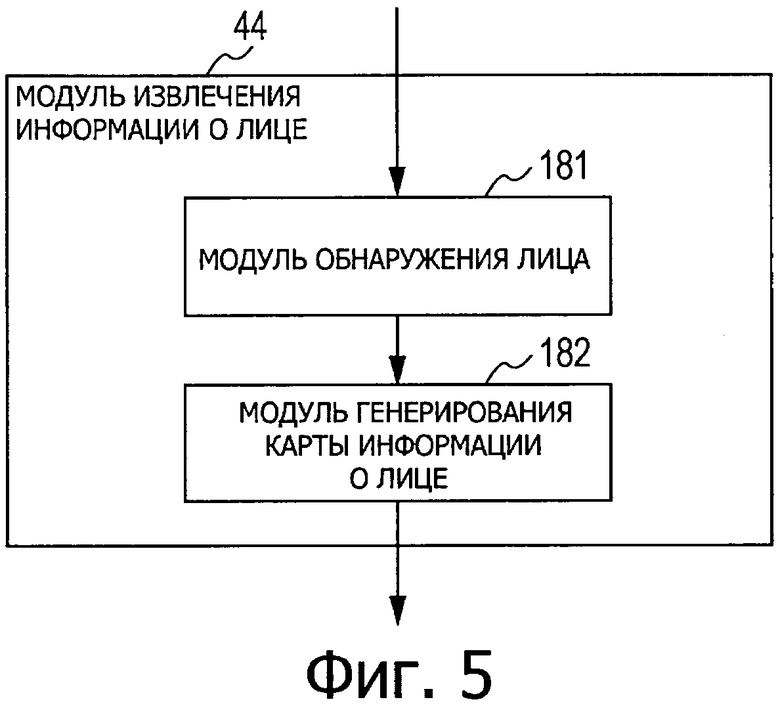

Фиг.5 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля извлечения информации о лице, показанного на фиг.1.

Фиг.6 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля извлечения информации о движении.

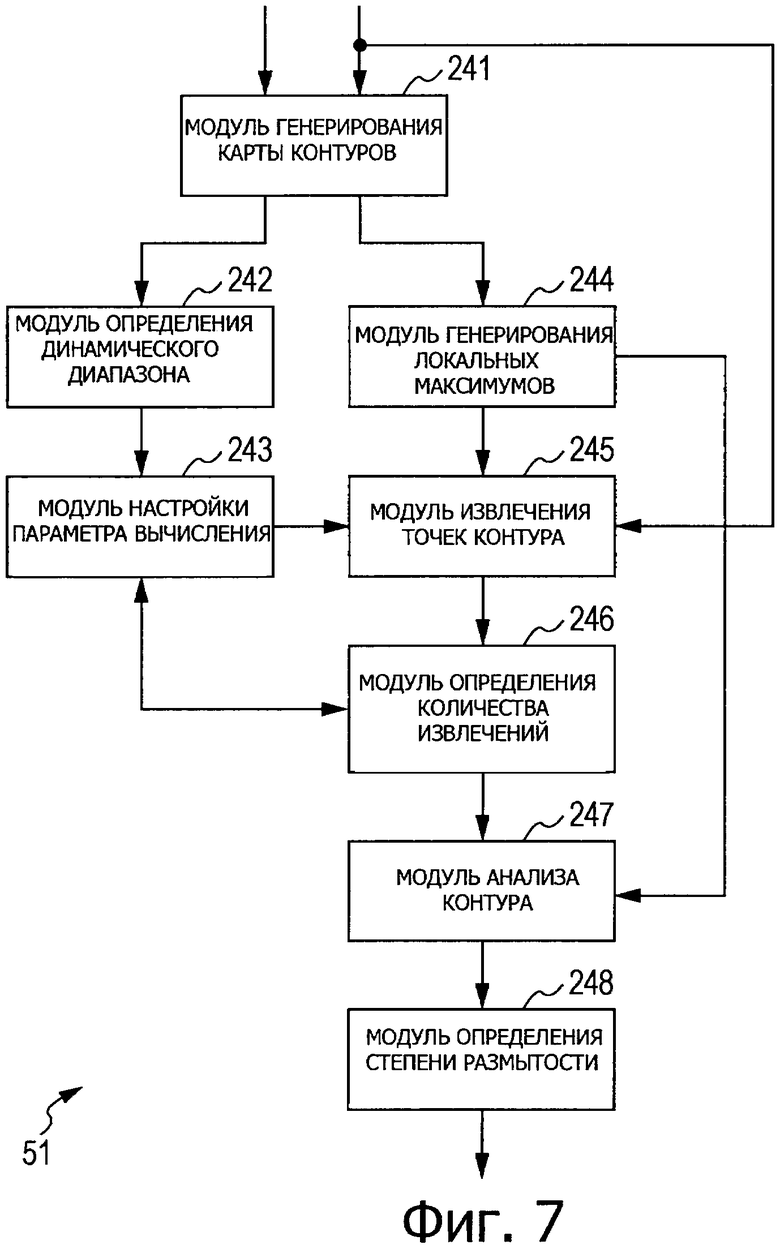

Фиг.7 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля определения размытости.

Фиг.8 представляет собой блок-схему алгоритма, поясняющую процесс оценки изображения.

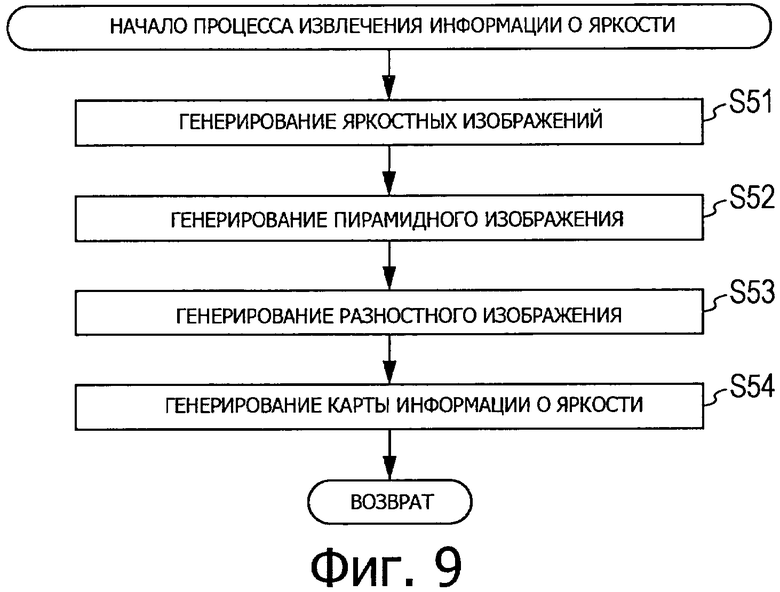

Фиг.9 представляет собой блок-схему алгоритма, поясняющую процесс извлечения информации о яркости.

Фиг.10 представляет собой блок-схему алгоритма, поясняющую процесс извлечения информации о цвете.

Фиг.11 представляет собой блок-схему алгоритма, поясняющую процесс извлечения информации о контурах.

Фиг.12 представляет собой блок-схему алгоритма, поясняющую процесс извлечения информации о лице.

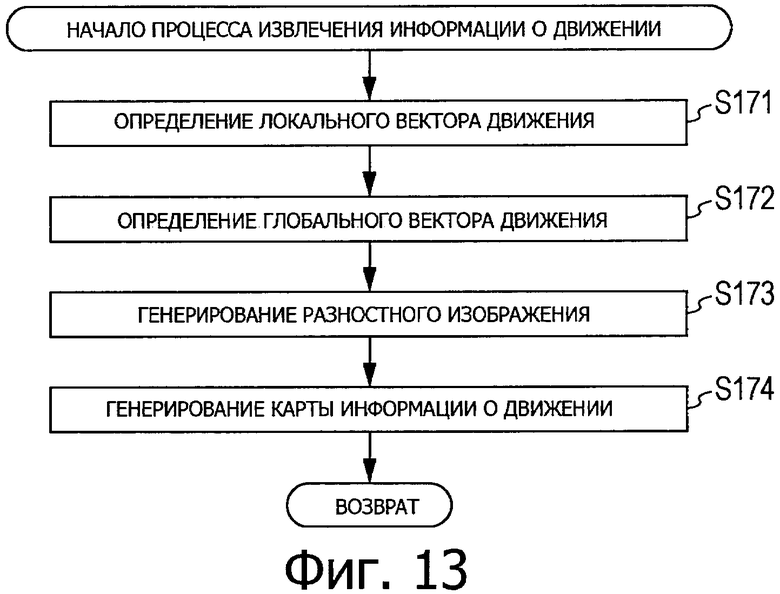

Фиг.13 представляет собой блок-схему алгоритма, поясняющую процесс извлечения информации о движении.

Фиг.14 представляет собой блок-схему алгоритма, поясняющую процесс определения размытости.

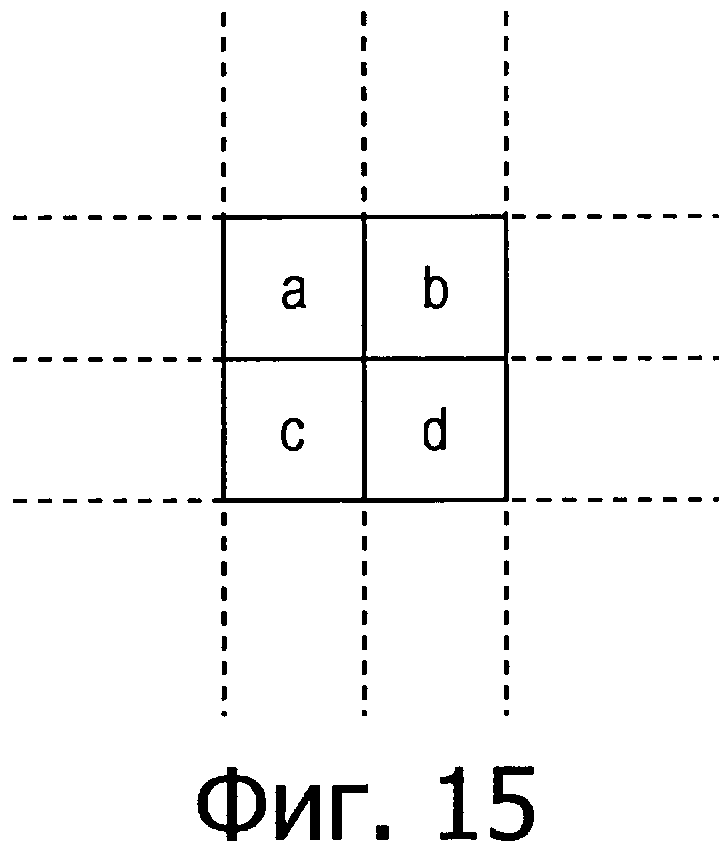

Фиг.15 представляет собой схему, поясняющую генерирование карты контуров.

Фиг.16 представляет собой схему, поясняющую генерирование локальных максимумов.

Фиг.17 представляет собой схему, поясняющую примеры структуры контура.

Фиг.18 представляет собой схему, дающую общее представление об обучении на основе нейронной сети.

Фиг.19 представляет собой схему, дающую общее представление об обучении на основе нейронной сети.

Фиг.20 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию варианта осуществления обучающегося устройства, в котором применено настоящее изобретение.

Фиг.21 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля извлечения объекта.

Фиг.22 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля извлечения информации о яркости.

Фиг.23 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля извлечения информации о цвете.

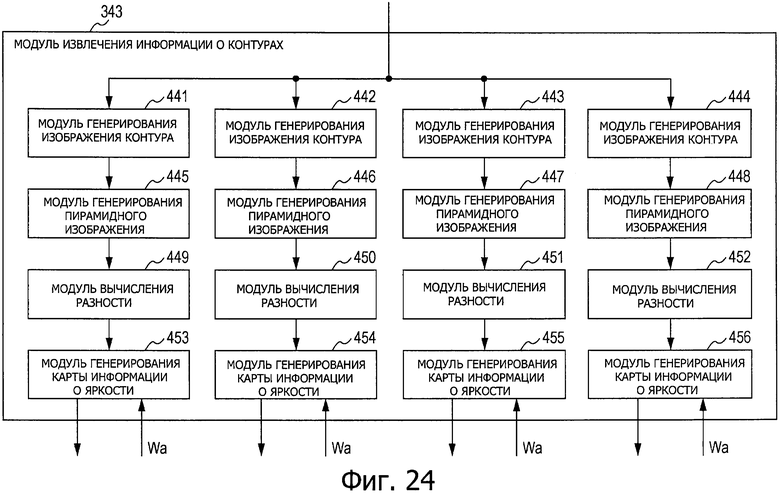

Фиг.24 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля извлечения информации о контурах.

Фиг.25 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля вычисления весовых коэффициентов.

Фиг.26 представляет собой блок-схему алгоритма, поясняющую процесс обучения.

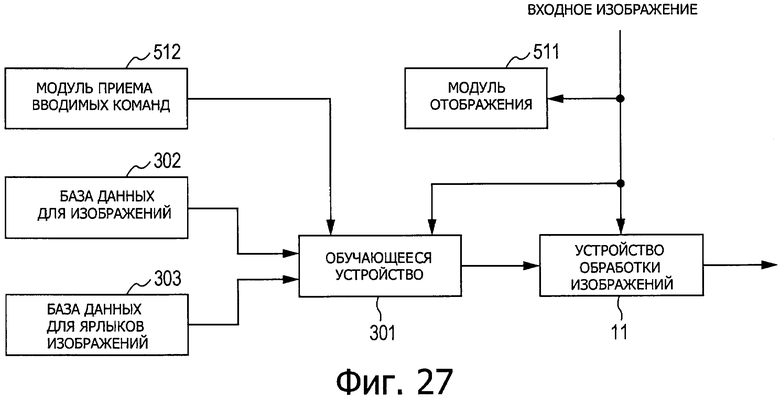

Фиг.27 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию системы оценки изображений.

Фиг.28 представляет собой схему, иллюстрирующую приведенную в качестве примера конфигурацию компьютера.

Описание вариантов осуществления изобретения

Далее со ссылкой на чертежи будут объяснены варианты осуществления, к которым применяется настоящее изобретение.

Конфигурация устройства обработки изображений

Фиг.1 представляет собой блок-схему, иллюстрирующую приведенную в качестве примера конфигурацию варианта осуществления устройства обработки изображений, к которому применимо настоящее изобретение.

Устройство (11) обработки изображений установлено, например, в устройстве захвата изображения, таком как фотокамера, и выполняет оценку входного изображения, которое было захвата. При оценке входного изображения изображение, для которого, согласно оценке, объект на входном изображении не расфокусирован или размыт, но виден четко, расценивается как хорошо снятое изображение, а именно как наилучший снимок. Наоборот, изображение с размытым объектом или изображение, которое выглядит передержанным, расценивается как плохо снятое изображение, а именно как плохой снимок.

Таким образом, входное изображение, для которого, согласно оценке, объект выглядит более четко, расценивается как изображение, которое более приемлемо для рассмотрения пользователем, и ему дается более высокое значение оценки (оценки в баллах). Затем, например, в случае, при котором входное изображение имеет значение оценки, большее некоторого заданного порогового значения или равное ему, входное изображение расценивается как наилучший снимок.

Устройство (11) обработки изображений выполнено с возможностью использования модуля (21) извлечения объекта и модуля (22) определения, и на модуль (21) извлечения объекта и модуль (22) определения подается входное изображение, полученное захватом изображения.

Модуль (21) извлечения объекта обнаруживает объект на поданном входном изображении, генерирует карту объекта, которая представляет собой информацию для указания области, включающей в себя объект на входном изображении, и подают карту объекта на модуль (22) определения. В данном случае обнаружение объекта выполняется в предположении, что объектом является предмет на входном изображении, который признан привлекающим внимание пользователя в случае, когда пользователь смотрит на входное изображение, то есть предмет, на который, согласно оценке, пользователь направляет свой взгляд. Следовательно, термин "объект" не обязательно ограничивается человеком.

Модуль (21) извлечения объекта выполнен с использованием модуля (41) извлечения информации о яркости, модуля (42) извлечения информации о цвете, модуля (43) извлечения информации о контурах, модуля (44) извлечения информации о лице, модуля (45) извлечения информации о движении и модуля (46) генерирования карты объекта.

Модуль (41) извлечения информации о яркости генерирует на основании поданного входного изображения, карту информации о яркости, указывающую информацию о яркости в каждой области входного изображения, и предоставляет карты информации о яркости модулю (46) генерирования карты объекта. Модуль (42) извлечения информации о цвете генерирует на основании поданного входного изображения карту информации о цвете, указывающую информацию о цветах в каждой области входного изображения, и предоставляет карты информации о цвете модулю (46) генерирования карты объекта.

Модуль (43) извлечения информации о контурах генерирует на основании поданного входного изображения карту информации о контурах, указывающую информацию о контурах в каждой области входного изображения, и предоставляет карты информации о контурах модулю (46) генерирования карты объекта. Модуль (44) извлечения информации о лице генерирует на основании поданного входного изображения карту информации о лице, указывающую информацию о человеческом лице как объекте в каждой области входного изображения, и предоставляет карты информации о лице модулю (46) генерирования карты объекта. Модуль (45) извлечения информации о движении генерирует на основании поданного входного изображения карту информации о движении, указывающую информацию о движении в каждой области входного изображения, и предоставляет карты информации о движении модулю (46) генерирования карты объекта.

Отметим, что далее карты: от карты информации о яркости до карт информации о движении, выводимые из модулей: от модуля (41) извлечения информации о яркости до модуля (45) извлечения информации о движении, будут также именоваться просто как информационные карты, если только их не требуется по отдельности отличить друг от друга. Информация, входящая в состав этих информационных карт, считается элементами информации, указывающими значения признаков для большего количества признаков, входящих в состав области, включающей в себя объект, и размещение элементов информации в соответствии с каждой областью входного изображения называется информационной картой. Таким образом, можно сказать, что информационная карта представляет собой информацию, указывающую значение признака в каждой области входного изображения.

Таким образом, область на входном изображении, соответствующая области с более высоким объемом информации на каждой информационной карте, то есть область с более высоким значением признака, становится областью, которая с большей вероятностью включает в себя объект, и отдельные информационные карты позволяют описать область, включающую в себя объект на входном изображении.

Модуль (46) генерирования карты объекта линейным образом объединяет карты информации о яркости, карты информации о цвете, карты информации о контурах, карты информации о лицах и карты информации о движении, предоставляемые из модулей: от модуля (41) извлечения информации о яркости до модуля (45) извлечения информации о движении для генерирования карты объекта. Иначе говоря, информация (значения признаков) карт: от карт информации о яркости до карт информации о движении, по каждой области подвергается взвешенному суммированию для каждой из областей, расположенных в одном и том же месте, и генерируется карта объекта. Модуль (46) генерирования карты объекта предоставляет сгенерированную карту объекта модулю (22) определения.

Модуль (22) определения вычисляет оценку в баллах, служащую в качестве показателя для оценки входного изображения с использованием предоставляемого входного изображения и карты объекта, предоставляемой модулем (46) генерирования карты объекта, входящим в состав модуля (21) извлечения объекта, и выводит оценку в баллах. Модуль (22) определения содержит модуль (51) определения размытости, модуль (52) определения экспозиции, модуль (53) определения баланса белого и модуль (54) вычисления оценки в баллах.

Модуль (51) определения размытости использует предоставляемое входное изображение и карту объекта, предоставляемую из модуля (46) генерирования карты объекта, для определения степени размытости объекта в области, включающей в себя объект на входном изображении, то есть области, используемой в качестве целевой области для обработки, и предоставляет результат этого определения модулю (54) вычисления оценки в баллах.

Модуль (52) определения экспозиции определяет на основании поданного входного изображения степень точности экспозиции на всем входном изображении и предоставляет результат этого определения модулю (54) вычисления оценки в баллах. В дополнение к этому, модуль (53) определения баланса белого определяет на основании входного изображения степень точности баланса белого на всем входном изображении и предоставляет результат этого определения модулю (54) вычисления оценки в баллах. Модуль (54) вычисления оценки в баллах вычисляет на основании результатов определения, предоставленных соответственно из модуля (51) определения размытости, модуля (52) определения экспозиции и модуля (53) определения баланса белого, оценку в баллах входного изображения и выводит оценку в баллах.

Далее со ссылкой на фиг.2-7 приводится более подробное пояснение конфигураций модулей: от модуля (41) извлечения информации о яркости до модуля (45) извлечения информации о движении и модуля (51) определения размытости, показанных на фиг.1.

Фиг.2 представляет собой блок-схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля (41) извлечения информации о яркости.

Модуль (41) извлечения информации о яркости содержит модуль (81) генерирования яркостного изображения, модуль (82) генерирования пирамидного изображения, модуль (83) вычисления разности и модуль (84) генерирования карты информации о яркости.

Модуль (81) генерирования изображения яркости использует предоставляемое входное изображение для генерирования яркостного изображения, на котором в качестве пиксельного значения для пикселя используется значение яркости пикселя на входном изображении, и предоставляет это яркостное изображение модулю (82) генерирования пирамидного изображения. При этом значение пикселя требуемого пикселя на яркостном изображении представляет значение яркости пикселя, расположенного на входном изображении в том же месте, что и место расположения этого пикселя.

Модуль (82) генерирования пирамидного изображения генерирует с использованием яркостного изображения, предоставленного из модуля (81) генерирования яркостного изображения, множество яркостных изображений, имеющих разрешения, отличающиеся друг от друга, и предоставляет эти яркостные изображения модулю (83) вычисления разности в качестве пирамидных изображений яркости.

Например, генерируются пирамидные изображения в восемь слоев разрешений, имеющих уровни от L1 до L8, и предполагается, что пирамидные изображения с разрешениями, имеющими уровни от L1 до L8, упорядочены в порядке убывания от пирамидного изображения с разрешением, имеющим уровень L1, являющийся самым высоким уровнем.

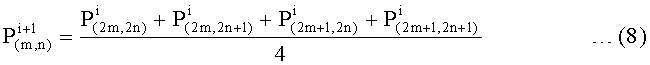

В этом случае яркостное изображение, сгенерированное модулем (81) генерирования яркостного изображения, считается пирамидным изображением уровня L1. В дополнение к этому, среднее значение значений пикселей для четырех смежных пикселей на пирамидном изображении уровня Li (где 1≤i≤7) считается значение пикселя для одного пикселя, соответствующего этим пикселям, на пирамидном изображении уровня L(i+1). Таким образом, пирамидное изображение уровня L(i+1) представляет собой изображение, имеющее горизонтальные и вертикальные размеры, которые составляют половину от пирамидного изображения уровня Li (в случае, когда значения неделимы, они округляются).

Модуль (83) вычисления разности выбирает два пирамидных изображения в различных слоях из множества пирамидных изображений, предоставляемых из модуля (82) генерирования пирамидного изображения, и определяют разность между выбранными пирамидными изображениями для генерирования изображения разности яркостей. Отметим, что поскольку пирамидные изображения в соответствующих слоях отличаются по размеру (количеству пикселей), то во время генерирования изображения разности меньшее пирамидное изображение подвергается повышающему преобразованию в соответствии с большим пирамидным изображением.

Когда сгенерировано заданное количество изображений разности яркостей, модуль (83) вычисления разности нормирует эти сгенерированные разностные изображения и предоставляет результаты модулю (84) генерирования карты информации о яркости. Модуль (84) генерирования карты информации о яркости генерирует на основании разностных изображений, предоставленных из модуля (83) вычисления разности, карты информации о яркости и предоставляет эти карты информации о яркости модулю (46) генерирования карты объекта.

Фиг.3 представляет собой блок-схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля (42) извлечения информации о цвете, показанного на фиг.1.

Модуль (42) извлечения информации о цвете содержит модуль (111) генерирования изображения разности "красное/зеленое", модуль (112) генерирования изображения разности "синее/желтое", модуль (113) генерирования пирамидного изображения, модуль (114) генерирования пирамидного изображения, модуль (115) вычисления разности, модуль (116) вычисления разности, модуль (117) генерирования карты информации о цвете и модуль (118) генерирования карты информации о цвете.

Модуль (111) генерирования изображения разности "красное/зеленое" использует предоставленное входное изображение для генерирования изображения разности "красное/зеленое", на котором в качестве пиксельного значения для пикселя используется разность между R (красной) составляющей и G (зеленой) составляющей пикселя на входном изображении, и предоставляет это изображение разности "красное/зеленое" модулю (113) генерирования пирамидного изображения. Значение пикселя для требуемого пикселя на изображении разности "красное/зеленое" представляет значение разности между красной составляющей и зеленой составляющей пикселя, расположенного на входном изображении в том же самом месте, что и место расположения этого пикселя.

Модуль (112) генерирования изображения разности "синее/желтое" использует предоставленное входное изображение для генерирования изображения разности "синее/желтое", на котором разность между В (синей) составляющей и Y (желтой) составляющей пикселя на входном изображении используется в качестве пиксельного значения для пикселя, и предоставляет это изображение разности "синее/желтое" модулю (114) генерирования пирамидного изображения. Значение пикселя для требуемого пикселя на изображении разности "синее/желтое" представляет значение разности между В (синей) составляющей и Y (желтой) составляющей пикселя, расположенного на входном изображении в том же месте, что и место расположения этого пикселя.

Модуль (113) генерирования пирамидного изображения и модуль (114) генерирования пирамидного изображения используют изображение разности "красное/зеленое" и изображение разности "синее/желтое", предоставленные из модуля (111) генерирования изображения разности "красное/зеленое" и модуля (112) генерирования изображения разности "синее/желтое", для генерирования множества изображений разности "красное/зеленое", имеющих разрешения, отличающиеся друг от друга, и множества изображений разности "синее/желтое", имеющих разрешения, отличающиеся друг от друга. Затем модуль (113) генерирования пирамидного изображения и модуль (114) генерирования пирамидного изображения предоставляют эти сгенерированные изображения разности "красное/зеленое" и изображения разности "синее/желтое" модулю (115) вычисления разности и модулю (116) вычисления разности в качестве пирамидных изображений разностей "красное/зеленое" и пирамидных изображений разностей "синее/желтое".

В качестве пирамидных изображений разностей "красное/зеленое" и пирамидных изображений разностей "синее/желтое", аналогично случаю пирамидных изображений яркости, генерируются, например, пирамидные изображения в восемь слоев с разрешениями, имеющими уровни соответственно от L1 до L8.

Модуль (115) вычисления разности и модуль (116) вычисления разности выбирают два пирамидных изображения в различных слоях из множества пирамидных изображений, предоставляемых из модуля (113) генерирования пирамидного изображения и модуля (114) генерирования пирамидного изображения, и определяют разность между выбранными пирамидными изображениями для генерирования изображения разности для разности "красное/зеленое" и разности "синее/желтое". Отметим, что поскольку пирамидные изображения в соответствующих слоях отличаются по размеру, то во время генерирования разностного изображения меньшее пирамидное изображение подвергается повышающему преобразованию, так чтобы иметь тот же размер, что и большее пирамидное изображение.

Когда сгенерировано заданное количество изображений разности для разностей "красное/зеленое" и заданное количество изображений разности для разностей "синее/желтое", модуль (115) вычисления разности и модуль (116) вычисления разности нормируют эти сгенерированные изображения разности и предоставляют результаты модулю (117) генерирования карты информации о цвете и модулю (118) генерирования карты информации о цвете. Модуль (117) генерирования карты информации о цвете и модуль (118) генерирования карты информации о цвете генерируют на основании изображений разности, предоставляемых из модуля (115) вычисления разности и модуля (116) вычисления разности, карты информации о цвете и предоставляет эти карты информации о цвете модулю (46) генерирования карты объекта. Модуль (117) генерирования карты информации о цвете генерирует карты информации о цвете для разностей "красное/зеленое", а модуль (118) генерирования карты информации о цвете генерирует карты информации о цвете для разностей "синее/желтое".

Фиг.4 представляет собой блок-схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля (43) извлечения информации о контурах, показанного на фиг.1.

Модуль (43) извлечения информации о контурах содержит модули 141-144 генерирования изображений контуров, модули 145-148 генерирования пирамидных изображений, модули 149-152 вычисления разности и модули 153-156 генерирования карты информации о контурах.

Модули 141-144 генерирования изображений контуров выполняют процесс фильтрования на предоставленном входном изображении с использованием фильтра Габора для генерирования, например, изображения контуров, в которых в качестве пиксельного значения для пикселя используется контрастность контура (edge strength) в направлениях 0 градусов, 45 градусов, 90 градусов и 135 градусов, и предоставляют изображения контуров модулям 145-148 генерирования пирамидных изображений.

Например, значение пикселя для требуемого пикселя на изображении контура, сгенерированном модулем (141) генерирования изображения контуров, представляет контрастность контура в направлении 0 градусов для пикселя, который расположен на входном изображении в том же месте, что и место расположения этого пикселя. Отметим, что каждое направление контура относится к направлению, представленному угловой составляющей в функциях Габора, образующих фильтр Габора.

Модули 145-148 генерирования пирамидных изображений генерируют с использованием изображений контуров в соответствующих направлениях, предоставляемых из модулей 141-144 генерирования изображений контуров, множество изображений контуров, имеющих разрешения, отличающиеся друг от друга. Затем модули 145-148 генерирования пирамидных изображений предоставляют эти сгенерированная изображения контуров в соответствующих направлениях модулям 149-152 вычисления разности в качестве пирамидных изображений в соответствующих направлениях контуров.

В качестве пирамидных изображений соответствующих направлений контуров, аналогично случаю пирамидных изображений яркости, генерируются, например, пирамидные изображения в восемь слоев с разрешениями, имеющими соответственно уровни от L1 до L8.

Модули 149-152 вычисления разности выбирают два пирамидных изображения в различных слоях из множества пирамидных изображений, предоставляемых из модулей 145-148 генерирования пирамидных изображений, и определяют разность между выбранными пирамидными изображениями для генерирования изображений разности в соответствующих направлениях контуров. Отметим, что поскольку пирамидные изображения в соответствующих слоях отличаются по размеру, то во время генерирования изображения разности меньшее пирамидное изображение подвергается повышающему преобразованию.

Когда сгенерировано заданное количество изображений в соответствующих направлениях, модули 149-152 вычисления разности нормируют эти сгенерированные изображения разности и предоставляют результаты модулям 153-156 генерирования карт информации о контурах. Модули 153-156 генерирования карт информации о контурах генерируют на основании изображений разности, предоставляемых из модулей 149-152 вычисления разности, карты информации о контурах и предоставляют эти карты информации о контурах модулю (46) генерирования карты объекта.

Фиг.5 представляет собой блок-схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля (44) извлечения информации о лице, показанном на фиг.1.

Модуль (44) извлечения информации о лице содержит модуль (181) обнаружения лица и модуль (182) генерирования карты информации о лице.

Модуль (181) обнаружения лица обнаруживает область человеческого лица, служащего в качестве объекта, на предоставленном входном изображении и предоставляет результат обнаружения модулю (182) генерирования карты информации о лице. Модуль (182) генерирования карты информации о лице генерирует на основании результата обнаружения предоставленного из модуля (181) обнаружения лица карту информации о лице, и предоставляет карту информации о лице модулю (46) генерирования карты объекта.

Фиг.6 представляет собой блок-схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля (45) извлечения информации о движении, показанного на фиг.1.

Модуль (45) извлечения информации о движении содержит модуль (211) извлечения локального вектора движения, модуля (212) извлечения глобального вектора движения, модуля (213) вычисления разности и модуля (214) генерирования карты информации о движении.

Модуль (211) извлечения локального вектора движения использует предоставленное входное изображение и другое входное изображение, имеющее время захвата изображения, отличное от этого входного изображения, для определения вектора движения каждого пикселя на входном изображении в качестве локального вектора движения и предоставляет эти векторы движения модулю (213) вычисления разности. Модуль (212) извлечения глобального вектора движения использует предоставляемое входное изображение и другое входное изображение, имеющее время захвата изображения, отличное от этого входного изображения, для определения вектора движения каждого пикселя на входном изображении и, дополнительно, определения, например, среднего значения этих векторов движения отдельных пикселей в качестве глобального вектора движения, и предоставляет этот глобальный вектор движения модулю (213) вычисления разности. Этот глобальный вектор движения представляет направление движения на всем входном изображении.

Модуль (115) вычисления разности определяет абсолютные значения разностей между локальными векторами движения из модуля (211) извлечения локального вектора движения и глобальным вектором движения из модуля (212) извлечения глобального вектора движения для генерирования изображения разности движения, и предоставляет это изображение разности движения модулю (214) генерирования карты информации о движении. При этом значения пикселя для требуемого пикселя на изображении разности движения представляет абсолютное значение разности между локальным вектором движения пикселя, расположенного на входном изображении в том же месте, что и место расположения этого пикселя, и глобальным вектором движения всего входного изображения. Таким образом, пиксельное значение пикселя на изображении разности движения представляет величину относительного перемещения предмета (или фона), отображаемого в этом пикселе на входном изображении, относительно всего входного изображения, то есть фона.

Модуль (214) генерирования карты информации о движении генерирует на основании изображения разности движения, поступающего из модуля (213) вычисления разности, карту информации о движении, и предоставляет карту информации о движении модулю (46) генерирования карты объекта. Более конкретно отметим, что генерирование карты информации о движении выполняется в случае, при котором в качестве входных изображений предоставляются изображения, захваченные последовательно во времени, например, в случае, при котором входное изображение представляет собой последовательность непрерывно снимаемых изображений или двигающееся изображение.

Фиг.7 представляет собой блок-схему, иллюстрирующую приведенную в качестве примера конфигурацию модуля (51) определения размытости, показанного на фиг.1.

Модуль (51) определения размытости, модуль (241) генерирования карты контуров, модуль (242) определения динамического диапазона, модуль (243) настройки параметра вычисления, модуль (244) генерирования локальных максимумов, модуль (245) извлечения точек контура, модуль (246) определения количества извлечений, модуль (247) анализа контура и модуль (248) определения степени размытости.

Модуль (241) генерирования карты контуров использует предоставленное входное изображение и карту объекта, поступающую из модуля (46) генерирования карты объекта, для извлечения из входного изображения в качестве изображения объекта некоторой области, которая, согласно оценке, включает в себя объект.

В дополнение к этому, модуль (241) генерирования карты контуров определяет на основании изображения объекта контрастность контура изображения объекта в единицах трех типов блоков, имеющих размеры, отличающиеся друг от друга, и генерирует карту контуров, в которой в качестве значения пикселя используется установленная в результате определения контрастность контура. Эта карта контуров генерируется для каждого размера блока, и карты контуров в масштабах от SC1 до SC3 упорядочены от самого малого до самого большого. Модуль (241) генерирования карты контуров предоставляет эти три сгенерированных карты контуров модулю (242) определения динамического диапазона и модулю (244) генерирования локальных максимумов.

Модуль (242) определения динамического диапазона использует карты контуров, поступающие из модуля (241) генерирования карты контуров, для определения динамического диапазона, который представляет собой разность между максимальным значением и минимальным значением контрастности контура изображения объекта, и предоставляет результат этого определения модулю (243) настройки параметра вычисления.

Модуль (243) настройки параметра вычисления настраивает на основании результата определения, предоставляемого из модуля (242) определения динамического диапазона, параметр вычисления, который используется для извлечения точек контура, так что количество извлечений точек контура (в дальнейшем также именуемое как извлекаемое количество точек контура), используемое для определения степени размытости изображения объекта, могло принять надлежащее значение. При этом термин "точки контура" относятся к пикселям, формирующим контуры на изображении.

В дополнение к этому, параметр вычисления включает в себя опорное значение для контура, используемое для определения точки контура, и опорное значение для извлечений, используемое для определения надлежащего количества извлечений точек контура. Модуль (243) настройки параметра вычисления предоставляет опорное значение для контура модулю (245) извлечения точек контура и модулю (246) определения количества извлечений, и предоставляет опорное значение для извлечений модулю (246) определения количества извлечений.

Модуль (244) генерирования локальных максимумов делит каждую из карт контуров, предоставляемых из модуля (241) генерирования карты контуров, на блоки, каждый из которых имеет заданный размер, и извлекает максимальное значение пикселя в каждом блоке для генерирования локального максимума. Локальные максимумы генерируют для каждого из масштабов карт контуров и предоставляют из модуля (244) генерирования локальных максимумов модулю (245) извлечения точек контура и модулю (247) анализа контура. Локальные максимумы, сгенерированные на основе карт контуров в масштабах SC1-SC3 в дальнейшем именуются, соответственно, локальными максимумами LM1-LM3.

Модуль (245) извлечения точек контура извлекает на основании карты объекта, поступающей из модуля (46) генерирования карты объекта, опорного значения для контура, поступающего из модуля (243) настройки параметра вычисления, и локальных максимумов, поступающих из модуля (244) генерирования локальных максимумов, точки контура в области объекта на изображении объекта. В дополнение к этому, модуль (245) извлечения точек контура генерирует таблицу точек контура, указывающую информацию об извлеченных точках контура, и предоставляет эту таблицу точек контура модулю (246) определения количества извлечений. Отметим, что таблицы точек контура, полученные на основе локальных максимумов LM1-LM3, в дальнейшем именуются, соответственно, таблицами ЕТ1-ЕТ3 точек контура.

Модуль (246) определения количества извлечений определяет на основании таблиц точек контура, поступающих из модуля (245) извлечения точек контура, и опорном значении для извлечений, поступающем из модуля (243) настройки параметра вычисления, является ли надлежащим количество извлечений точек контура. В случае, когда количество извлечений точек контура не является надлежащим, модуль (246) определения количества извлечений уведомляет модуль (243) настройки параметра вычисления о том, что количество извлечений точек контура не является надлежащим. В случае, когда количество извлечений точек контура является надлежащим, модуль (246) определения количества извлечений предоставляет текущее опорное значение для контура и таблицу точек контура модулю (247) анализа контура.

Модуль (247) анализа контура выполняет на основании таблиц точек контура, поступающих из модуля (246) определения количества извлечений, анализ точек контура в области объекта в пределах изображения объекта, и предоставляет результат этого анализа модулю (248) определения степени размытости. Модуль (248) определения степени размытости определяет на основании анализа точек контура степень размытости, которая является показателем, указывающим степень размытости объекта на входном изображении, и предоставляет эту степень размытости модулю (54) вычисления оценки в баллах.

Функционирование устройства обработки изображений

В случае, когда входное изображение предоставляется устройству (11) обработки изображений, устройство (11) обработки изображений начинает процесс оценки изображения для определения оценки в баллах, представляющую оценку для входного изображения, и выводит эту оценку в баллах. Процесс оценки изображения будет разъяснен ниже со ссылкой на блок-схему алгоритма, показанную на фиг.8.

На этапе S11 модуль (41) извлечения информации о яркости выполняет процесс извлечения информации о яркости, чтобы на основании предоставленного входного изображения сгенерировать карты информации о яркости, и предоставляет эти карты информации о яркости модулю (46) генерирования карты объекта. Затем на этапе S12 модуль (42) извлечения информации о цвете выполняет процесс извлечения информации о цвете, чтобы на основании предоставленного входного изображения сгенерировать карты информации о цвете, и предоставляет эти карты информации о цвете модулю (46) генерирования карты объекта.

На этапе S13 модуль (43) извлечения информации о контурах выполняет процесс извлечения информации о контурах, чтобы на основании предоставленного входного изображения сгенерировать карты информации о контурах, и предоставляет эти карты информации о контурах модулю (46) генерирования карты объекта. В дополнение к этому, на этапе S14 модуль (44) извлечения информации о лице выполняет процесс извлечения информации о лице, чтобы на основании предоставленного входного изображения сгенерировать карты информации о лице, и предоставляет эти карты информации о лице модулю (46) генерирования карты объекта. Кроме этого, на этапе S15 модуль (45) извлечения информации о движении выполняет процесс извлечения информации о движении, чтобы на основании предоставленного входного изображения сгенерировать карты информации о движении, и предоставляет эти карты информации о движении модулю (46) генерирования карты объекта.

Отметим, что подробности вышеупомянутых процесса извлечения информации о яркости, процесса извлечения информации о цвете, процесса извлечения информации о контурах, процесса извлечения информации о лице и процесса извлечения информации о движении будут описаны ниже. В дополнение к этому уточним, что процесс извлечения информации о движении не выполняется в случае, когда модулю (21) извлечения объекта не предоставляются входные изображения, захваченные последовательно во времени.

На этапе S16 модуль (46) генерирования карты объекта генерирует карту объекта, используя карты: от карт информации о яркости до карт информации о движении, предоставляемые из модулей: от модуля (41) извлечения информации о яркости до модуля (45) извлечения информации о движении, и предоставляет карту объекта модулю (51) определения размытости.

Например, модуль (46) генерирования карты объекта линейным образом объединяет отдельные информационные карты с использованием весовых коэффициентов (Wb) информации, которые представляют собой весовые коэффициенты, заданные для соответствующих информационных карт, и, кроме того, умножает значения пикселей получаемой в результате карты на весовой коэффициент (Wc) объекта, который представляет собой заданный весовой коэффициент для нормирования результатов при создании карты объекта.

Таким образом, принимая, что положение (пиксель), которое представляет интерес на карте объекта, подлежащей определению, в данный момент времени, является "интересующим положением", значения пикселя на отдельных информационных картах в том же самом положении (пикселе), что и интересующее положение, умножаются на весовые коэффициенты (Wb) информации, предназначенные для соответствующих информационных карт, и итоговая сумма значений пикселя, умноженных на весовые коэффициенты (Wb) информации, рассматривается в качестве значения пикселя в интересующем положении. Кроме того, значения пикселя в отдельно взятых положениях на карте объекта, определенной этим способом, умножаются на весовой коэффициент (Wc) объекта, заданный для карты объекта, и результаты нормируются для получения окончательной карты объекта.

Более конкретно отметим, что для генерирования карты объекта в качестве карт информации о цвете используются карты информации о цвете для разностей "красное/зеленое" и карты информации о цвете для разностей "синее/желтое", а в качестве карт информации о контурах используются карты информации о контурах в соответствующих направлениях: 0 градусов, 45 градусов, 90 градусов и 135 градусов. В дополнение к этому, весовой коэффициента (Wc) объекта определяется заранее посредством обучения, а нормирование выполняется таким образом, чтобы значение пикселя каждого пикселя на карте объекта могло быть значением в диапазоне от 0 до 1.

На этапе S17 модуль (51) определения размытости выполняет процесс определения размытости, используя карту объекта, поступающую из модуля (46) генерирования карты объекта, и предоставляемое входное изображение, для определения степени размытости, и предоставляет эту степень размытости модулю (54) вычисления оценки в баллах. Отметим, что в процессе определения размытости, подробное описания которого будет приведено ниже, используется карта объекта, и определяется степень размытости области объекта на входном изображении.

На этапе S18 модуль (52) определения экспозиции выполняет процесс определения экспозиции для определения степени точности экспозиции на всем входном изображении, и предоставляет результат этого определения модулю (54) вычисления оценки в баллах. Например, модуль (52) определения экспозиции использует предоставленное входное изображение для определения распределения (в котором по оси абсцисс откладываются значения соответствующих составляющих: R (красная), G (зеленая), и В (синяя), а по оси ординат откладывается частота (частота появления пикселя) соответствующих составляющих на всем входном изображении, и, исходя из распределения этих составляющих, определяет значение, представляющее степень точности, экспозиции. Это значение, представляющее степень точности экспозиции, определяется, например, в соответствии с разностью между частотами появления соответствующих составляющих с заданным значением по оси абсцисс и заранее заданной частотой на распределении соответствующих составляющих.

На этапе S19 модуль (53) определения баланса белого выполняет процесс определения баланса белого для определения степени точности баланса, белого на всем входном изображении, и предоставляет результат этого определения модулю (54) вычисления оценки в баллах. Например, модуль (53) определения баланса белого определяет на основании предоставленного входного изображения среднюю яркость всего входного изображения, и использует значение, определенное в соответствии со средней яркостью, в качестве значения, представляющего степень точности баланса белого.

Отметим, что из модуля (46) генерирования карты объекта в модуль (52) определения экспозиции и модуль (53) определения баланса белого может быть предоставлена карта объекта, и что процесс определения экспозиции и процесс определения баланса белого могут выполняться только над областью объекта (выступающей как целевая область обработки) на входном изображении, который определен картой объекта.

На этапе S20 модуль (54) вычисления оценки в баллах вычисляет на основании результатов определения, предоставленных, соответственно, из модуля (51) определения размытости, модуля (52) определения экспозиции и модуля (53) определения баланса белого, оценку в баллах для входного изображения, и выводит эту оценку в баллах.

Например, модуль (54) вычисления оценки в баллах линейным образом объединяет предоставленные результаты определения, а именно значение, представляющее степень размытости, значение, представляющее степень неблагоприятности экспозиции, и значение, представляющее степень неблагоприятности баланса белого, используя заранее определенные весовые коэффициенты, и использует полученное в результате значение в качестве оценки в баллах для входного изображения.

В дополнение к этому, модуль (54) вычисления оценки в баллах может также быть выполнен с возможностью выведения, наряду с полученной в результате определения оценкой в баллах, информацию, указывающую, является ли входное изображение наилучшим снимком. Входное изображение считается наилучшим снимком, когда значение полученной в результате определения оценки в баллах больше или равно заданному пороговому значению, и входное изображение считается плохим снимком, когда оценка в баллах меньше порогового значения. Когда оценка в баллах для входного изображения выведена таким образом, процесс оценки изображения завершается.

Устройство (11) обработки изображений генерирует карту объекта из входного изображения способом, описанным выше, и, используя карту объекта, определяет степень размытости области объекта на входном изображении. Затем устройство (11) обработки изображений выполняет оценку входного изображения в отношении степени размытости объекта, степени точности экспозиции и степени точности баланса белого для входного изображения.

Таким образом, степень размытости области объекта на входном изображении определяется с использованием карты объекта, и на основе результата определения определяется оценка в баллах для входного изображения. Это делает возможной более надежную оценку степени, в которой объект на входном изображении является размытым, иначе говоря, степени, в которой этот объект виден четко. Следовательно, имеется возможность более надежно определять, является ли оцениваемое изображение изображением, которое оценивается как приемлемое для рассмотрения пользователем, то есть самым лучшим кадром, и легко и надежно выбирать только входное изображение с высокой оценкой.

В частности, поскольку для определения оценки в баллах для входного изображения учитывается степень размытости объекта, в случае, когда, согласно оценке, область объекта на входном изображении является более размытой, оценка в баллах входного изображения является низкой независимо от того, является ли размытой область на входном изображении, в которой нет объекта (фон). Иначе говоря, если область объекта на входном изображении не является размытой (пока объект находится в фокусе), оценка в баллах для входного изображения является высокой. Следовательно, в случае, когда фон на входном изображении находится в фокусе, а объект является размытым, можно воспрепятствовать тому, чтобы входное изображение было ошибочно определено как наилучший снимок по причине его высокой оценки в баллах.

Использование оценки в баллах, определенной способом, описанным выше, позволило бы с легкостью выбирать из множества входных изображений только входное изображение, расцениваемое как наилучший снимок.

Далее поясняются процессы, соответствующие обработке данных на этапах S11-S15, показанных на фиг.8, со ссылкой, соответственно, на блок-схемы алгоритмов, приведенные на фиг.9-13.

Сначала, со ссылкой на блок-схему алгоритма, приведенную на фиг.9, будет описан процесс извлечения информации о яркости, соответствующий обработке данных на этапе S11, показанном на фиг.8.

На этапе S51 модуль (81) генерирования яркостного изображения генерирует с использованием предоставляемого входного изображения яркостное изображение, и предоставляет это яркостное изображение модулю (82) генерирования пирамидного изображения. Например, модуль (81) генерирования яркостного изображения умножает значения соответствующих красной, зеленой и синей составляющих пикселя на входном изображении на коэффициенты, определенными заранее для соответствующих составляющих, и расценивает сумму значений соответствующих составляющих, умноженных на эти коэффициенты в качестве пиксельного значение для пикселя, расположенного на яркостном изображении в том же положении, что и положение этого пикселя на входном изображении. Таким образом, определяется составляющая яркости в составном сигнале, образованном из составляющей (Y) яркости и цветоразностных составляющих (Cb, Cr). Отметим, что среднее значение для значений, соответствующих красной, зеленой и синей составляющих пикселя, может рассматриваться в качестве пиксельного значения для пикселя на изображении яркости.

На этапе S52 модуль (82) генерирования пирамидного изображения генерирует на основании яркостного изображения, предоставляемого из модуля (81) генерирования яркостного изображения, пирамидные изображения в соответствующих слоях уровней L1-L8, и предоставляет эти пирамидные изображения модулю (83) вычисления разности.

На этапе S53 модуль (83) вычисления разности генерирует разностные изображения, используя пирамидные изображения, предоставляемые из модуля (82) генерирования пирамидного изображения, нормирует изображения разности и предоставляет результаты модулю (84) генерирования карты информации о яркости. Нормирование выполняется таким образом, чтобы пиксельные значения для пикселей на разностных изображениях могли быть значениями в диапазоне, например, от 0 до 255.

В частности, модуль (83) вычисления разности определяет разность между пирамидными изображениями в каждой из комбинаций слоев уровней L6 и L3, уровней L7 и L3, уровней L7 и L4, уровней L8 и L4 и уровней L8 и L5 между пирамидными изображениями в соответствующих слоях яркости. Соответственно, получается в общей сложности пять изображений разности яркости.

Например, в случае, когда должно быть сгенерировано изображение разности для комбинации уровней L6 и L3, пирамидное изображение уровня L6 подвергается повышающему преобразованию в соответствии с размером пирамидного изображения уровня L3. Таким образом, пиксельное значение одного пикселя в пирамидном изображении уровня L6 перед повышающим преобразованием считается соответствующим пиксельным значениям нескольких смежных пикселей, соответствующих этому пикселю в пирамидном изображении уровня L6 после повышающего преобразования. Затем определяется разность между пиксельным значением для пикселя в пирамидном изображении уровня L6 и пиксельным значением для пикселя, расположенного в пирамидном изображении уровня L3 в том же положении, что и положение этого пикселя, и эта разность рассматривается в качестве пиксельного значения для пикселя на разностном изображении.

Процесс генерирования этих разностных изображений эквивалентен выполнению процесса фильтрования на яркостном изображении с использованием полосового фильтра для извлечения заданной частотной составляющей на яркостном изображении. Пиксельное значение для пикселя на разностном изображении, полученном таким образом, представляет разность между значениями яркости пирамидных изображений соответствующих уровней, то есть разность между яркостью заданного пикселя на входном изображении и средней яркостью соседних пикселей.

Обычно область, имеющая большое отличие по яркости от окружающей области на изображении, является областью, которая привлекает внимание человека, рассматривающего изображение, и, следовательно, вероятно, является область объекта. Поэтому про пиксели, имеющие более высокие значения пикселя на каждом разностном изображении, можно сказать, что они представляют область, которая с большей вероятностью является областью объекта.

На этапе S54 модуль (84) генерирования карты информации о яркости генерирует на основании разностного изображения, предоставленного из модуля (83) вычисления разности, карту информации о яркости, и предоставляет эту карту информации о яркости модулю (46) генерирования карты объекта. Когда карта информации о яркости предоставлена из модуля (84) генерирования карты информации о яркости модулю (46) генерирования карты объекта, процесс извлечения информации о яркости заканчивается, и процесс переходит у этапу S12, показанному на фиг.8.

Например, модуль (84) генерирования карты информации о яркости выполняет, для определения одного изображения, взвешенное суммирование предоставленных пяти разностных изображений с использованием разностных весовых коэффициентов (Wa), которые являются заданными весовыми коэффициентами для соответствующих изображений разности. Иначе говоря, пиксельные значения для пикселей, расположенных на соответствующих изображениях разности в одном и том же положении, умножаются на соответствующие разностные весовые коэффициенты (Wa), и определяется итоговая сумма значений пикселей, умноженных на разностные весовые коэффициенты (Wa).

Отметим, что во время генерирования карты информации о яркости, разностные изображения подвергаются повышающему преобразованию таким образом, чтобы отдельные разностные изображения могли иметь одинаковый размер.

Таким образом, модуль (41) извлечения информации о яркости определяет, исходя из входного изображения, яркостное изображение, и генерирует, исходя из этого яркостного изображения, карту информации о яркости. В соответствии с картой информации о яркости, полученной таким образом, имеется возможность легко обнаруживать область, имеющую большое отличие по яркости на входном изображении, то есть область, обращающую на себя внимание наблюдателя, который смотрит на входное изображение.

Далее со ссылкой на блок-схему алгоритма, приведенную на фиг.10, поясняется процесс извлечения информации о цвете, соответствующий обработке данных на этапе S12, показанном на фиг.8.

На этапе S81 модуль (111) генерирования изображения разности "красное/зеленое" генерирует с использованием предоставляемого входного изображения изображение разности "красное/зеленое" и предоставляет это изображение разности "красное/зеленое" модулю (113) генерирования пирамидного изображения.

На этапе S82 модуль (112) генерирования изображения разности "синее/желтое" генерирует с использованием предоставляемого входного изображения изображение разности "синее/желтое" и предоставляет это изображение разности "синее/желтое" модулю (114) генерирования пирамидного изображения.

На этапе S83 модули (113) и (114) генерирования пирамидных изображений генерируют с использованием изображения разности "красное/зеленое", поступающего из модуля (111) генерирования изображения разности "красное/зеленое", и изображения разности "синее/желтое", поступающего из модуля (112) генерирования изображения разности "синее/желтое", пирамидные изображения.

Например, модуль (113) генерирования пирамидного изображения генерирует множество изображений разности "красное/зеленое", имеющих разрешения, отличающиеся друг от друга, чтобы таким образом сгенерировать пирамидные изображения в соответствующих слоях уровней L1-L8, и предоставляет эти пирамидные изображения модулю (115) вычисления разности. Аналогичным образом модуль (114) генерирования пирамидного изображения генерирует множество изображений разности "синее/желтое", имеющих разрешения, отличающиеся друг от друга, чтобы таким образом сгенерировать пирамидные изображения в соответствующих слоях уровней L1-L8, и предоставляет эти пирамидные изображения модулю (116) вычисления разности.

На этапе S84 модули (115) и (116) вычисления разностей генерируют на основании пирамидных изображений, предоставленных из модулей (113) и (114) генерирования пирамидных изображений, разностные изображения, нормируют эти разностные изображения, и предоставляют результаты модулям (117) и (118) генерирования карт информации о цвете. При нормировании разностных изображений, например, пиксельные значения для пикселей становятся значениями в диапазоне от 0 до 255.

Например, модуль (115) вычисления разности определяет разность между пирамидными изображениями в каждой из комбинаций слоев уровней L6 и L3, уровней L7 и L3, уровней L7 и L4, уровней L8 и L4 и уровней L8 и L5 между пирамидными изображениями разностей "красное/зеленое" в соответствующих слоях. Соответственно, получается в общей сложности пять разностных изображений для разностей "красное/зеленое".

Аналогичным образом модуль (116) вычисления разности определяет разность между пирамидными изображениями в каждой из комбинаций слоев уровней L6 и L3, уровней L7 и L3, уровней L7 и L4, уровней L8 и L4 и уровней L8 и L5 из числа пирамидных изображений разностей "синее/желтое" в соответствующих слоях. Соответственно, получается в общей сложности пять разностных изображений для разностей "синее/желтое".

Процесс генерирования этих разностных изображений эквивалентен выполнению процесса фильтрования на изображениях разности "красное/зеленое" или изображениях разности "синее/желтое" с использованием полосового фильтра для извлечения заданной частотной составляющей на изображениях разности "красное/зеленое" или изображениях разности "синее/желтое". Пиксельное значение для пикселя на разностных изображениях, полученных таким образом, представляет разность по определенной цветовой составляющей между пирамидными изображениями соответствующих уровней, то есть разность между определенной цветовой составляющей в пикселе на входном изображении и средним значением этой определенной цветовой составляющей соседних пикселей.

Обычно область, имеющая более выраженный цвет, чем цвет окружающей области на изображении, то есть область, имеющая большое отличие по определенной цветовой составляющей от окружающего участка, является областью, которая привлекает внимание человека, рассматривающего изображение, и, следовательно, вероятно, является область объекта. Поэтому про пиксели, имеющие более высокие значения пикселя на каждом разностном изображении, можно сказать, что они представляют область, которая с большей вероятностью является областью объекта.

На этапе S85, модули (117) и (118) генерирования карт информации о цвете генерируют с использованием разностных изображений, поступающих из модуля (115) вычисления разности, и разностных изображений, поступающих из модуля (116) вычисления разности, карты информации о цвете и предоставляют эти карты информации о цвете модулю (46) генерирования карты объекта.

Например, модуль (117) генерирования карты информации о цвете выполняет, для создания одной карты информации о цвете для разности "красное/зеленое", взвешенное суммирование разностных изображений для разностей "красное/зеленое", предоставляемых из модуля (115) вычисления разности, с использованием заданных разностных весовых коэффициентов (Wa) для соответствующих разностных изображений.

Аналогичным образом модуль (118) генерирования карты информации о цвете выполняет, для создания одной карты информации о цвете для разности "синее/желтое", взвешенное суммирование разностных изображений для разностей "синее/желтое", предоставляемых из модуля (116) вычисления разности, с использованием заданных разностных весовых коэффициентов (Wa). Отметим, что во время генерирования карты информации о цвете, разностные изображения подвергаются повышающему преобразованию таким образом, чтобы отдельные разностные изображения могли иметь одинаковый размер.

Когда модули (117) и (118) генерирования карты информации о цвете предоставляют полученные таким образом карту информации о цвете для разности "красное/зеленое" и карту информации о цвете для разности "синее/желтое" модулю (46) генерирования карты объекта, процесс извлечения информации о цвете завершается, и процесс переходит к этапу S13, показанному на фиг.8.

Таким образом, модуль (42) извлечения информации о цвете определяет, исходя из входного изображения, изображение разности для определенной цветовой составляющей, и генерирует, исходя из этого изображения, карту информации о цвете. В соответствии с картой информации о цвете, полученной таким образом, имеется возможность легко обнаруживать область, имеющую большое отличие по определенной цветовой составляющей на входном изображении, то есть область, обращающую на себя внимание наблюдателя, который смотрит на входное изображение.

Отметим, что хотя в приведенном выше объяснении в качестве информации о цвете, извлекаемой из входного изображения, извлекаются разность между R (красной) составляющей и G (зеленой) составляющей и разность между В (синей) составляющей и Y (желтой) составляющей, модуль (42) извлечения информации о цвете может быть выполнен таким образом, чтобы извлекались цветоразностные составляющие Cr и Cb или им подобные. При этом цветоразностная составляющая Cr представляет собой разность между красной составляющей и яркостной составляющей, а цветоразностная составляющая Cb представляет собой разность между синей составляющей и яркостной составляющей.

Фиг.11 представляет собой блок-схему алгоритма, поясняющую процесс извлечения информации о контурах, соответствующий обработке данных на этапе S13, показанном на фиг.8. Этот процесс извлечения информации о контурах описывается ниже.

На этапе S111 модули 141-144 генерирования изображений контуров выполняют процесс фильтрования на предоставляемом входном изображении с использованием фильтра Габора для генерирования, например, изображения контуров, в которых в качестве пиксельного значения для пикселя используется контрастность контура в направлениях 0 градусов, 45 градусов, 90 градусов и 135 градусов. Затем модули 141-144 генерирования изображений контуров предоставляют изображения контуров модулям 145-148 генерирования пирамидных изображений.

На этапе S112 модули 145-148 генерирования пирамидных изображений генерируют с использованием изображений контуров, поступающих из модулей 141-144 генерирования изображений контуров, пирамидные изображения и предоставляют эти пирамидные изображения модулям 149-152 вычисления разности.

Например, модуль (145) генерирования пирамидного изображения генерирует множество изображений контуров в направлении 0 градусов, имеющих разрешения, отличающиеся друг от друга, чтобы таким образом сгенерировать пирамидные изображения в соответствующих слоях уровней от L1 до L8, и предоставляет эти пирамидные изображения модулю (149) вычисления разности. Аналогичным образом модули 146-148 генерирования пирамидного изображения генерируют пирамидные изображения в соответствующих слоях уровней от L1 до L8, и предоставляют эти пирамидные изображения модулям 150-152 вычисления разности.

На этапе S113 модули 149-152 вычисления разности генерируют с использованием пирамидных изображений, поступающих из модулей 145-148 генерирования пирамидных изображений, разностные изображения, нормируют эти разностные изображения и предоставляют результаты модулям 153-156 генерирования карт информации о контурах. При нормировании разностных изображений, например, пиксельные значения для пикселей становятся значениями в диапазоне от 0 до 255.

Например, модуль (149) вычисления разности определяет разность между пирамидными изображениями в каждой из комбинаций слоев уровней L6 и L3, уровней L7 и L3, уровней L7 и L4, уровней L8 и L4 и уровней L8 и L5 между пирамидными изображениями в направлении 0 градусов в соответствующих слоях, предоставляемых из модуля (145) генерирования пирамидного изображения. Соответственно, получается в общей сложности пять разностных изображений для контура.

Аналогичным образом модули 150-152 вычисления разности определяют разность между пирамидными изображениями в каждой из комбинаций слоев уровней L6 и L3, уровней L7 и L3, уровней L7 и L4, уровней L8 и L4 и уровней L8 и L5 между пирамидными изображениями в соответствующих слоях. Соответственно, получается в общей сложности пять разностных изображений для каждого из контуров в соответствующих направлениях.

Процесс генерирования этих разностных изображений эквивалентен выполнению процесса фильтрования на изображениях контуров с использованием полосового фильтра для извлечения заданной частотной составляющей на изображениях контуров. Пиксельное значение для пикселя на разностных изображениях, полученных таким образом, представляет разность контрастности контура между пирамидными изображениями на соответствующих уровнях, то есть разность между контрастностью контура в заданном положении на входном изображении и средней контрастностью контура в соседних положениях.

Обычно, область, имеющая более высокую контрастность контура, чем контрастность контура в окружающей области на изображении, является областью, которая привлекает внимание человека, рассматривающего изображение, и, следовательно, вероятно, является область объекта. Поэтому про пиксели, имеющие более высокие значения пикселя на каждом разностном изображении, можно сказать, что они представляют область, которая с большей вероятностью является областью объекта.

На этапе S114 модули 153-156 генерирования карт информации о контурах генерируют с использованием разностных изображений, поступающих из модулей 149-152 вычисления разности, карты информации о контурах в соответствующих направлениях и предоставляют эти карты информации о контурах модулю (46) генерирования карты объекта.

Например, модуль (153) генерирования карты информации о контурах выполняет, для создания карты информации о контурах в направлении 0 градусов, взвешенное суммирование разностных изображений, предоставляемых из модуля (149) вычисления разности, с использованием заданных разностных весовых коэффициентов (Wa).

Аналогичным образом модуль (154) генерирования карты информации о контурах выполняет взвешенное суммирование разностных изображений, поступающих из модуля (150) вычисления разности, с использованием разностных весовых коэффициентов (Wa), модуль (155) генерирования карты информации о контурах выполняет взвешенное суммирование разностных изображений, поступающих из модуля (151) вычисления разности, с использованием разностных весовых коэффициентов (Wa), и модуль (156) генерирования карты информации о контурах выполняет взвешенное суммирование разностных изображений, поступающих из модуля (152) вычисления разности, с использованием разностных весовых коэффициентов (Wa). Точно так же получают карты информации о контурах в соответствующих направлениях: 45 градусов, 90 градусов и 135 градусов. Отметим, что во время генерирования карты информации о контурах разностные изображения подвергаются повышающему преобразованию таким образом, чтобы отдельные разностные изображения могли иметь одинаковый размер.

Когда модули 153-156 генерирования карт информации о контурах предоставляют модулю (46) генерирования карты объекта в общей сложности четыре карты информации о контурах в соответствующих направлениях, полученных таким образом, процесс извлечения информации о контурах завершается, и процесс переходит к этапу S14, показанному на фиг.8.

Таким образом, модуль (43) извлечения информации о контурах определяет, исходя из входного изображения, разностное изображение для контура в определенном направлении, и исходя из этого разностного изображения, генерирует карту информации о контурах. В соответствии с картами информации о контурах, полученными таким образом для соответствующих направлений, имеется возможность легко обнаруживать область, имеющую более высокую разность контрастности контура в определенном направлении по сравнению с контрастностью контура в окружающей области на входном изображении, то есть область, обращающую на себя внимание наблюдателя, который смотрит на входное изображение.

Отметим что, хотя в вышеприведенном объяснении для извлечения контуров используется фильтр Габора, процесс извлечения информации о контурах может быть выполнен таким образом, чтобы использовать любой другой фильтр для извлечения контуров, такой как фильтр Собеля или фильтр Робертса (Roberts).

Кроме того, способ извлечения информации, такой как яркость, цвета и контуры, из изображения, пояснение которого было приведено со ссылкой на фиг.9-11, описан подробно, например, в Laurent Itti, Christof Koch, and Ernst Niebur, "A Model of Saliency-Based Visual Attention for Rapid Scene Analysis" (Лоран Итти, Кристоф Коч и Эрнст Нибур, "Модель зрительного внимания на основе выступов, предназначенная для быстрого анализа кадров".

Далее, со ссылкой на блок-схему алгоритма, приведенную на фиг.12, будет пояснен процесс извлечения информации о лице, соответствующий обработке данных на этапе S14, показанном на фиг.8.

На этапе S141 модуль (181) обнаружения лица обнаруживает, исходя из предоставляемого входного изображения, область человеческого лица, и предоставляет результат обнаружения модулю (182) генерирования карты информации о лице. Например, модуль (181) обнаружения лица выполняет процесс фильтрования на входном изображении с использованием фильтра Габора для обнаружения характерных областей, таких как человеческий глаз, рот и нос, на входном изображении, и таким образом обнаруживает область лица на входном изображении.

На этапе S142 модуль (182) генерирования карты информации о лице генерирует с использованием результата обнаружения, поступившего из модуля (181) обнаружения лица, карту информации о лице, и предоставляет эту карту информации о лице модулю (46) генерирования карты объекта.

Например, предположим, что, исходя из входного изображения, в качестве результатов обнаружения лица было обнаружено множество прямоугольных областей (в дальнейшем именуемыми областями-кандидатами) на входном изображении, которые, согласно оценке, включают в себя лицо. При этом предполагается, что множество областей-кандидатов может быть обнаружено вблизи от некоторого заданного положения на входном изображении и что некоторые из этих областей-кандидатов могут перекрывать друг друга. То есть, например, в случае, при котором в отношении области одного лица на входном изображении было получено в качестве областей-кандидатов множество областей, включающих в себя это лицо, некоторые из этих областей-кандидатов перекрывают друг друга.

Модуль (182) генерирования карты информации о лице генерирует в отношении областей-кандидатов, полученных при обнаружении лица, изображение обнаружения, имеющее тот же самый размер, что и входное изображение для каждой из областей-кандидатов. На этом изображении обнаружения пиксельное значение для пикселя в той же области, что и область-кандидат, служащая в качестве целевой области для обработки, считается на изображении обнаружения более высоким, чем пиксельное значение для пикселя в области, отличной от области кандидата.

В дополнение к этому, пиксельные значения для пикселей на изображении обнаружения являются такими, что пиксель, расположенный в том же положении, что и положение расположения пикселя в области-кандидате, которая, согласно оценке, с большей вероятностью включает в себя человеческое лицо, имеет более высокое значение пикселя. Модуль (182) генерирования карты информации о лице суммирует вместе изображения обнаружения, полученные таким образом, для генерирования одного изображения и нормирует это изображение для создания карты информации о лице. Следовательно, пиксель на карте информации о лице, расположенный в той же области, что и область, в которой некоторая часть множества областей-кандидатов перекрывается на входном изображении, имеет более высокое значение пикселя, и вероятность того, что здесь имеется лицо, становится более высокой. Отметим, что нормирование выполняется таким образом, чтобы пиксельные значения для пикселей на карте информации о лице могли быть значениями в диапазоне, например, от 0 до 255.

Когда карта информации о лице сгенерирована, процесс извлечения информации о лице завершается, и процесс переходит к этапу S15, показанному на фиг.8.

Таким образом, модуль (44) извлечения информации о лице обнаруживает лицо на входном изображении и, исходя из результата обнаружения, генерирует карту информации о лице. В соответствии с картой информации о лице, полученной таким образом, имеется возможность легко обнаруживать область человеческого лица, служащего в качестве объекта на входном изображении.

Кроме того, со ссылкой на блок-схему алгоритма, приведенную на фиг.13, будет пояснен процесс извлечения информации о движении, соответствующий обработке данных на этапе S15, показанном на фиг.8.