Настоящая заявка испрашивает приоритет заявки на патент США №61/611,959, поданной 16 марта 2012 года, заявки на патент США №61/624,990, поданной 16 апреля 2012 года, заявки на патент США №61/658,344, поданной 11 июня 2012 года, заявки на патент США №61/663,484, поданной 22 июня 2012 года, и заявки на патент США №61/746,476, поданной 27 декабря 2012 года, содержание которых полностью включено в настоящую заявку посредством ссылки.

ОБЛАСТЬ ТЕХНИКИ, К КОТОРОЙ ОТНОСИТСЯ ИЗОБРЕТЕНИЕ

Настоящее раскрытие относится к кодированию видео.

УРОВЕНЬ ТЕХНИКИ

Возможности цифрового видео могут быть включены в широкий ряд устройств, включая цифровые телевизоры, цифровые системы прямого вещания, беспроводные системы вещания, персональные цифровые помощники (PDA), портативные или настольные компьютеры, планшеты, устройства для чтения электронных книг, цифровые камеры, цифровые записывающие устройства, цифровые медиапроигрыватели, устройства видеоигр, игровые видеоприставки, сотовые или спутниковые радиотелефоны, так называемые смартфоны, устройства для видеотелеконференции, устройства потокового видео и тому подобное. Цифровые видеоустройства осуществляют способы видеокодирования, как, например, описанные в стандартах, определенных MPEG-2, MPEG-4, ITU-T H.263, ITU-T H.264/MPEG-4, часть 10, Продвинутое кодирование (AVC) видеосигнала, стандарт Высокоэффективного Видеокодирования (HEVC), находящийся в разработке в настоящее время, и расширения этих стандартов. Видеоустройства могут передавать, принимать, кодировать, декодировать и/или хранить цифровую видеоинформацию более эффективно путем осуществления подобных способов видеокодирования.

Способы видеокодирования включают в себя пространственное (с внутренним (intra-) кодированием) прогнозирование и/или временное (с внешним (inter-) кодированием) прогнозирование для сокращения или устранения избыточности, присущей для последовательностей видеокадров. Для кодирования видео на основе блоков, видеослайс (например, видеокадр или часть видеокадра) может быть разделен на видеоблоки, которые также называют древовидными блоками, элементами (единицами) (CU) кодирования и/или узлами кодирования. Видеоблоки во внутренне кодированном (I) слайсе изображения кодируются с использованием пространственного прогнозирования по отношению к опорным отсчетам в соседних блоках в том же изображении. Видеоблоки во внешне-кодированном (Р или В) слайсе могут использовать пространственное прогнозирование по отношению к опорным отсчетам в соседних блоках в том же изображении или временное прогнозирование по отношению к опорным отсчетам в других опорных изображениях. Изображения можно также называть кадрами, а опорные изображения можно называть опорными кадрами.

Пространственное или временное прогнозирование имеет своим результатом прогнозирующий блок для блока, который должен быть кодирован. Остаточные данные представляют собой разницы пикселов между исходным блоком, который должен быть кодирован, и прогнозирующим блоком. Внешне-кодированный блок кодируется в соответствии с вектором движения, который указывает на блок опорных отсчетов, формирующих прогнозирующий блок, и остаточными данными, указывающими разницу между закодированным блоком и прогнозирующим блоком. Внутренне-кодированный блок кодируется в соответствии с режимом внутреннего кодирования и остаточными данными. Для дополнительного сжатия остаточные данные могут быть преобразованы из области пикселов в область преобразования, что приведет к остаточным коэффициентам преобразования, которые затем могут быть квантованы. Квантованные коэффициенты преобразования, изначально размещенные в двумерном массиве, могут быть сканированы для воспроизведения одномерного вектора коэффициентов преобразования, и может быть применено энтропийное кодирование для достижения еще большего сжатия.

РАСКРЫТИЕ ИЗОБРЕТЕНИЯ

В общем, настоящее раскрытие описывает различные способы поддержки расширений стандартов кодирования, как, например, развивающийся стандарт Высокоэффективного Видеокодирования (HEVC), с изменением только синтаксиса высокого уровня. Например, настоящее раскрытие описывает способы как в базовой спецификации HEVC, так и в расширениях HEVC многовидового видеокодека и/или трехмерного (3D) видеокодека, где базовый вид сравним с базовой спецификацией HEVC. В общем, «базовая спецификация видеокодирования» может соответствовать спецификации видеокодирования, которая используется для кодирования двумерных, одноуровневых видеоданных. Расширения базовой спецификации видеокодирования могут расширять возможности базовой спецификации видеокодирования, чтобы позволить 3D и/или многоуровневое видеокодирование. Базовая спецификация HEVC представляет собой пример базовой спецификации видеокодирования, в то время как расширения MVC и SVC к базовой спецификации HEVC представляют собой примеры расширений базовой спецификации видеокодирования.

В одном примере способ включает в себя декодирование значения счета порядка изображения (POC) для первого изображения видеоданных, декодирование идентификатора изображения второй размерности для первого изображения и декодирование в соответствии с базовой спецификацией видеокодирования второго изображения на основании по меньшей мере частично значения РОС и идентификатора изображения второй размерности первого изображения. Идентификатор изображения второй размерности может дополнительно быть упрощен до типа изображения, например является ли изображение долгосрочным или краткосрочным изображением, или имеет ли изображение, если оно опорное изображение, то же значение счета порядка изображения (POC), что и изображение, которое ссылается на него. При формировании кандидатов векторов движения из соседних блоков кандидат может считаться недоступным, когда он имеет идентификатор изображения второй размерности, отличный от такового у вектора движения, который должен быть прогнозирован, идентификатор изображения второй размерности которого - это изображение, на которое указывает этот вектор движения, и идентифицированное индексом целевой ссылки.

В другом примере способ включает в себя кодирование значения счета порядка изображения (POC) для первого изображения видеоданных, кодирование идентификатора изображения второй размерности для первого изображения и кодированиев соответствии с базовой спецификацией видеокодирования второго изображения на основании по меньшей мере частично, значения РОС и идентификатора изображения второй размерности первого изображения.

В другом примере устройство включает в себя видеодекодер, выполненный с возможностью декодировать значение счета порядка изображения (POC) для первого изображения видеоданных, декодировать идентификатор изображения второй размерности для первого изображения и декодировать в соответствии с базовой спецификацией видеокодирования второе изображение на основании по меньшей мере частично значения РОС и идентификатора изображения второй размерности первого изображения.

В другом примере, устройство включает в себя видеокодер, выполненный с возможностью кодировать значение счета порядка изображения (POC) для первого изображения видеоданных, кодировать идентификатор изображения второй размерности для первого изображения и кодировать, в соответствии с базовой спецификацией видеокодирования, второе изображение на основании, по меньшей мере, частично, значения РОС и идентификатора изображения второй размерности первого изображения.

В другом примере устройство включает в себя средство декодирования значения счета порядка изображения (POC) для первого изображения видеоданных, средство декодирования идентификатора изображения второй размерности для первого изображения и средство декодирования в соответствии с базовой спецификацией видеокодирования второго изображения на основании по меньшей мере частично значения РОС и идентификатора изображения второй размерности первого изображения.

В другом примере устройство включает в себя средство для кодирования значения счета порядка изображения (POC) для первого изображения видеоданных, средство для кодирования идентификатора изображения второй размерности для первого изображения и средство для кодирования в соответствии с базовой спецификацией видеокодирования, второго изображения на основании по меньшей мере частично, значения РОС и идентификатора изображения второй размерности первого изображения.

В другом примере считываемый компьютером носитель данных, на котором хранятся инструкции, которые, при их исполнении, побуждают процессор декодировать значение счета порядка изображения (POC) для первого изображения видеоданных, декодировать идентификатор изображения второй размерности для первого изображения и декодировать в соответствии с базовой спецификацией видеокодирования второе изображение на основании по меньшей мере частично значения РОС и идентификатора изображения второй размерности первого изображения.

В другом примере считываемый компьютером носитель данных, на котором хранятся инструкции, которые, при их исполнении, побуждают процессор кодировать значение счета порядка изображения (POC) для первого изображения видеоданных, кодировать идентификатор изображения второй размерности для первого изображения и кодировать в соответствии с базовой спецификацией видеокодирования второе изображение на основании по меньшей мере частично значения РОС и идентификатора изображения второй размерности первого изображения.

Детали одного или нескольких примеров указаны в сопровождающих чертежах и последующем описании. Другие особенности, цели и преимущества будут очевидны из описания и чертежей, а также из формулы изобретения.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

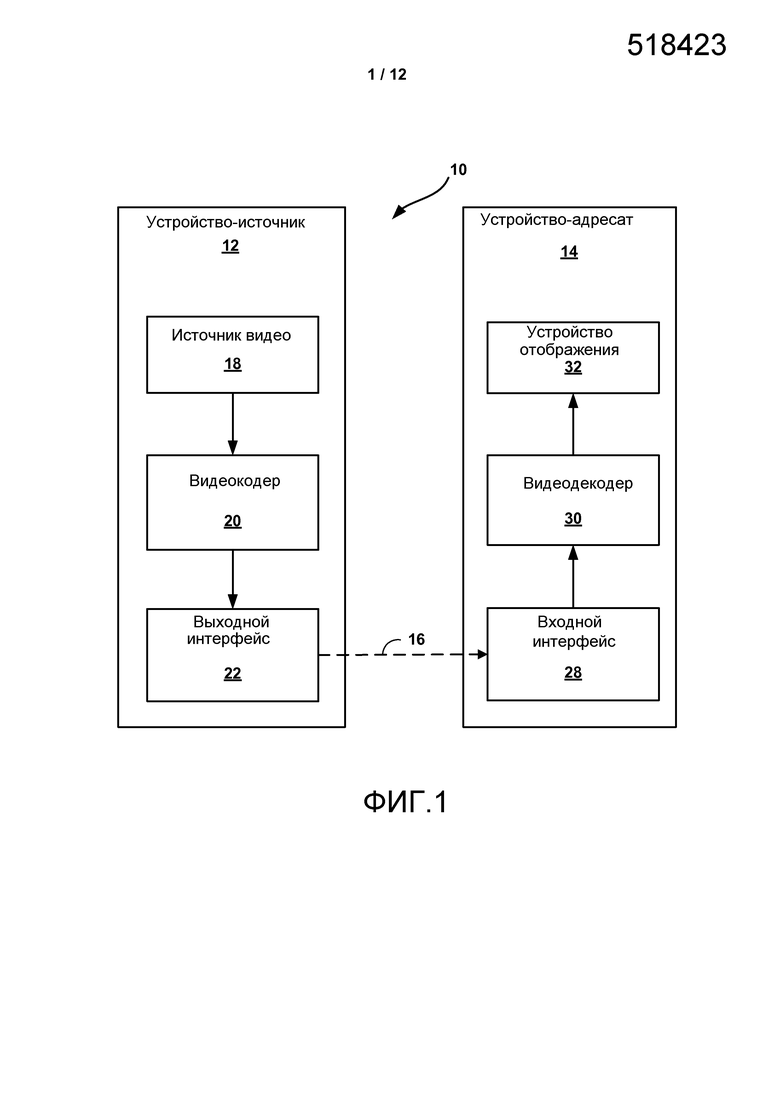

Фиг. 1 является блочной диаграммой, изображающей пример системы кодирования и декодирования видео, которая может использовать способы кодирования видеоданных в соответствии с синтаксическим расширением высокого уровня стандарта видеокодирования.

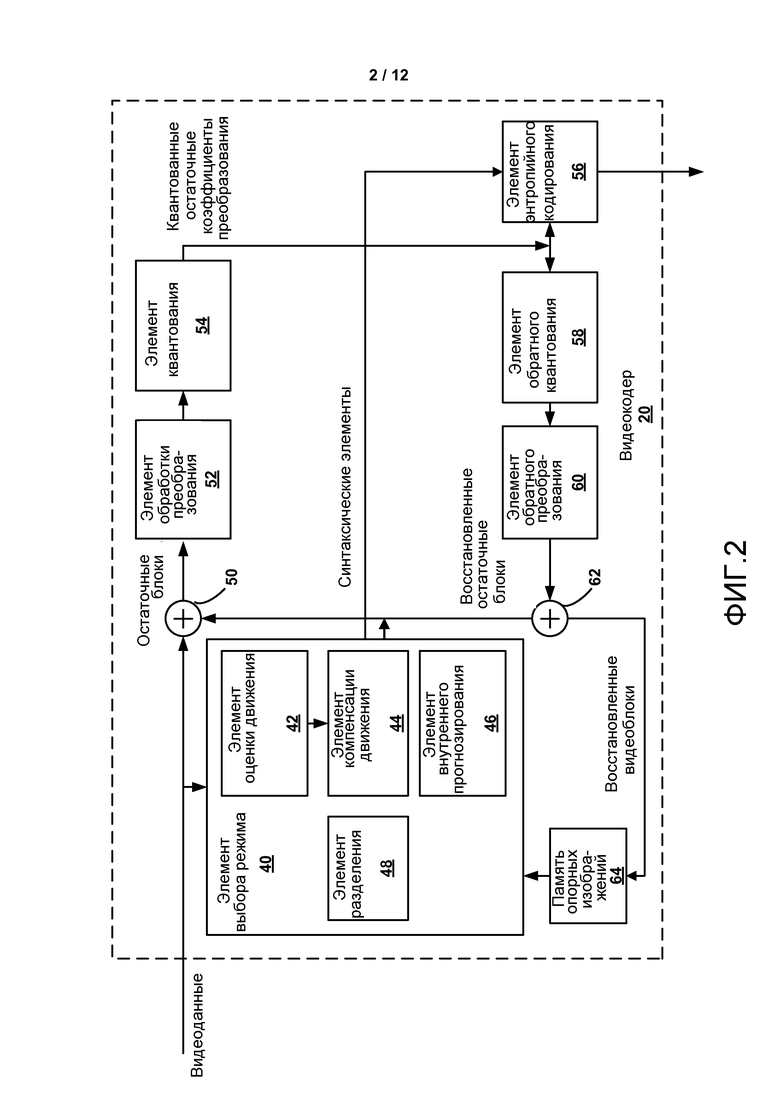

Фиг. 2 является блочной диаграммой, изображающей пример видеокодера, который может осуществлять способы кодирования видеоданных в соответствии с синтаксическим расширением высокого уровня стандарта видеокодирования.

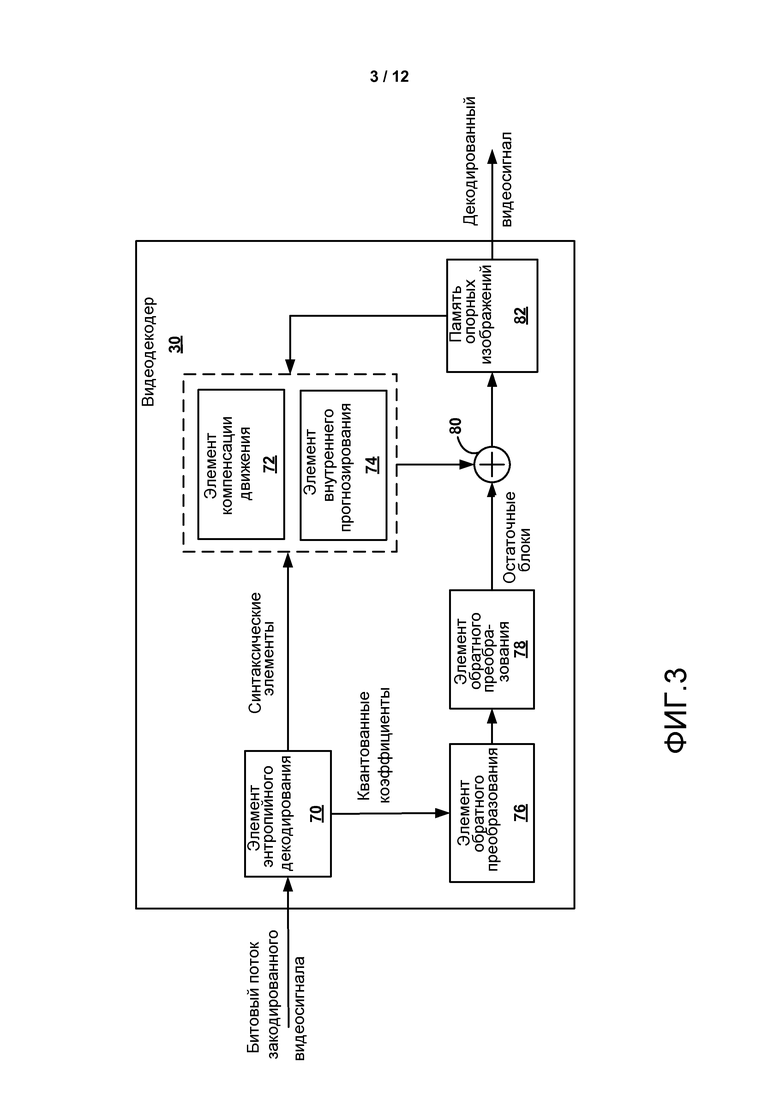

Фиг. 3 является блочной диаграммой, изображающей пример видеодекодера, который может осуществлять способы кодирования видеоданных в соответствии с синтаксическим расширением высокого уровня стандарта видеокодирования.

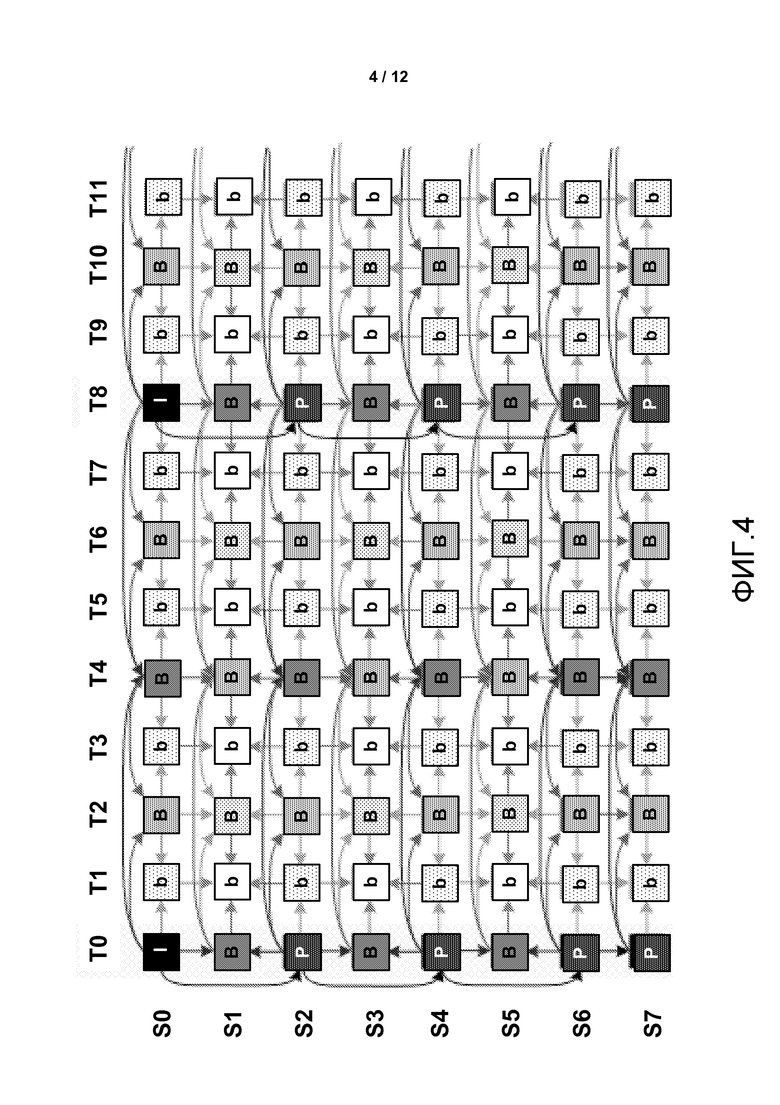

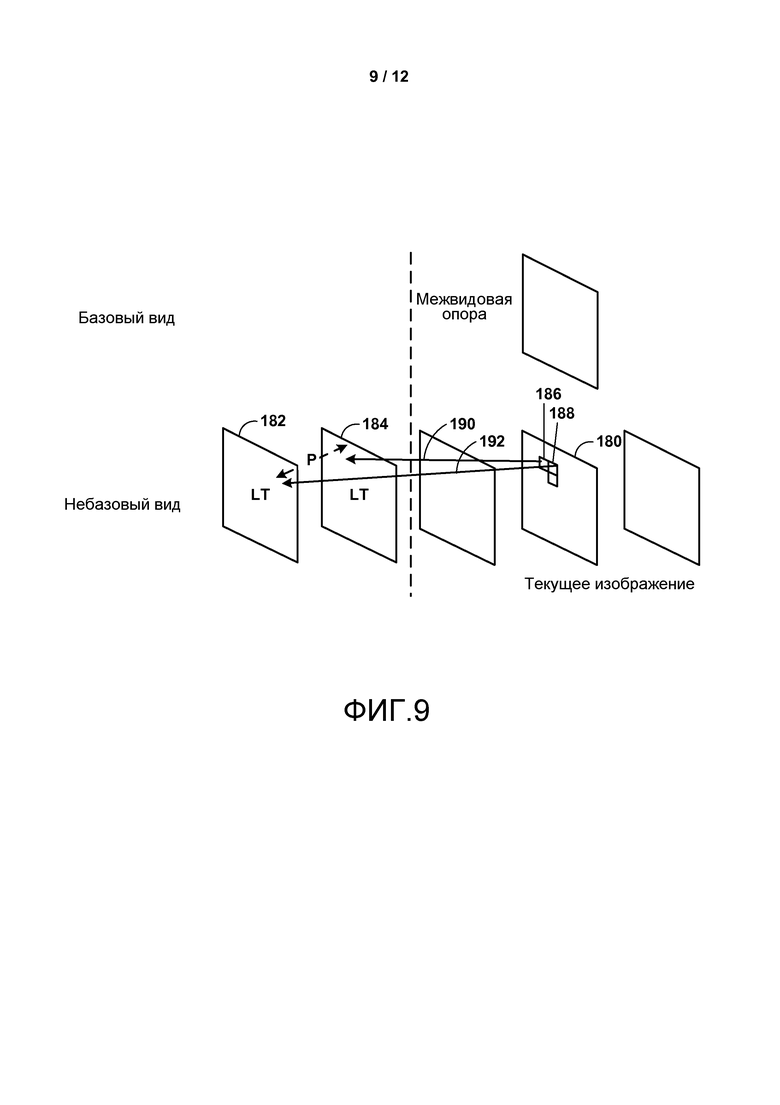

Фиг. 4 является концептуальной диаграммой, изображающей пример модели прогнозирования MVC.

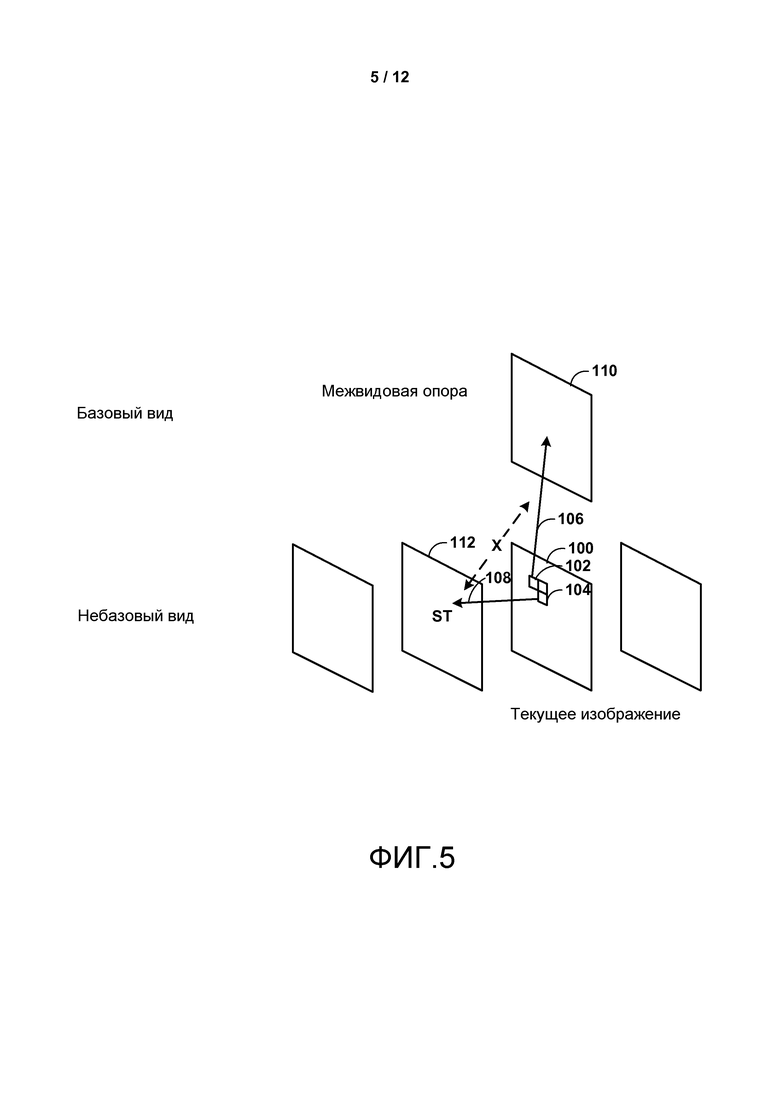

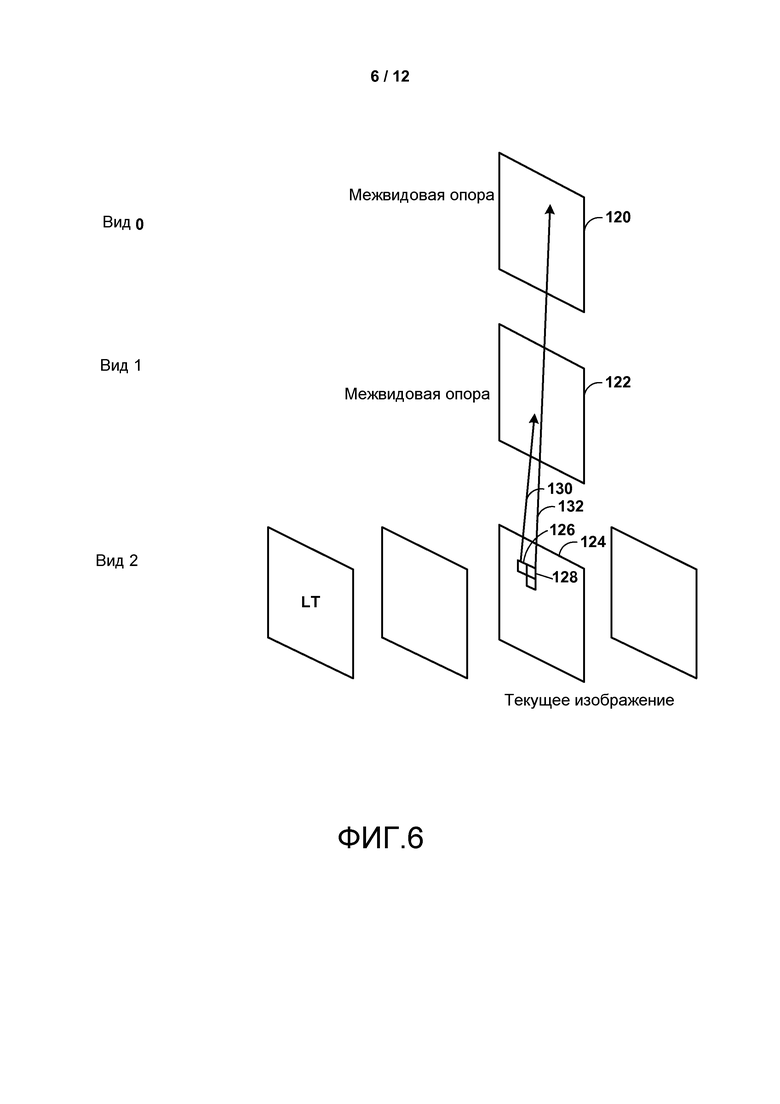

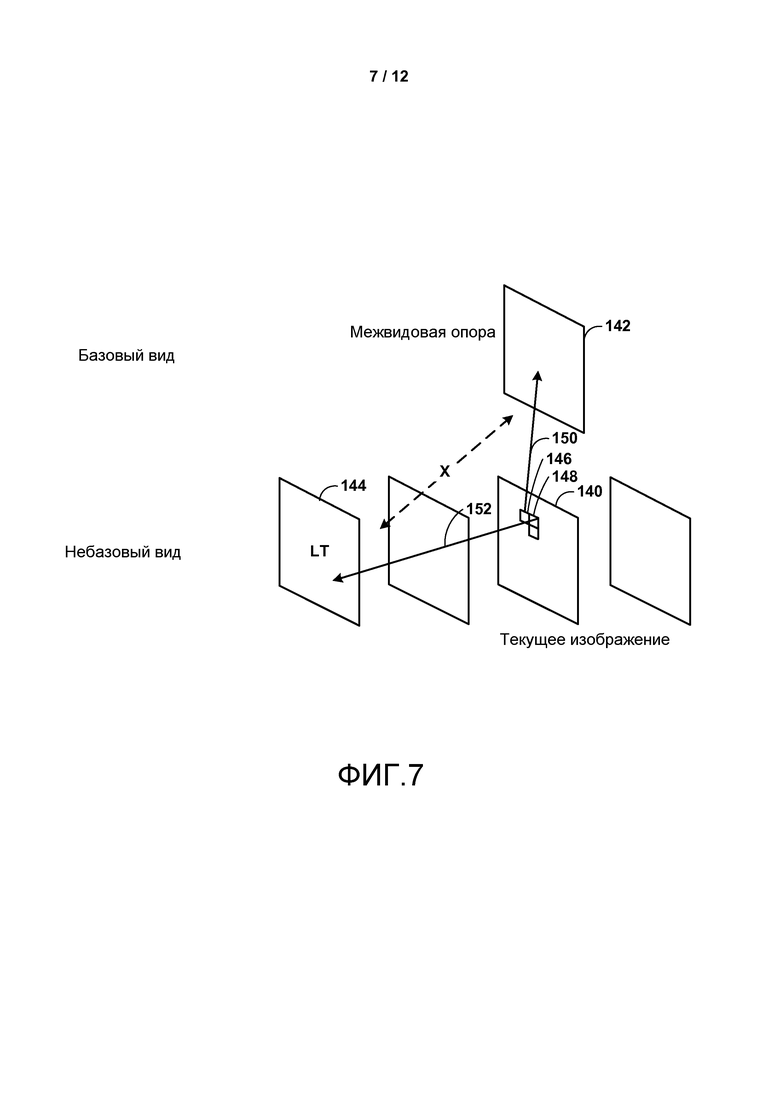

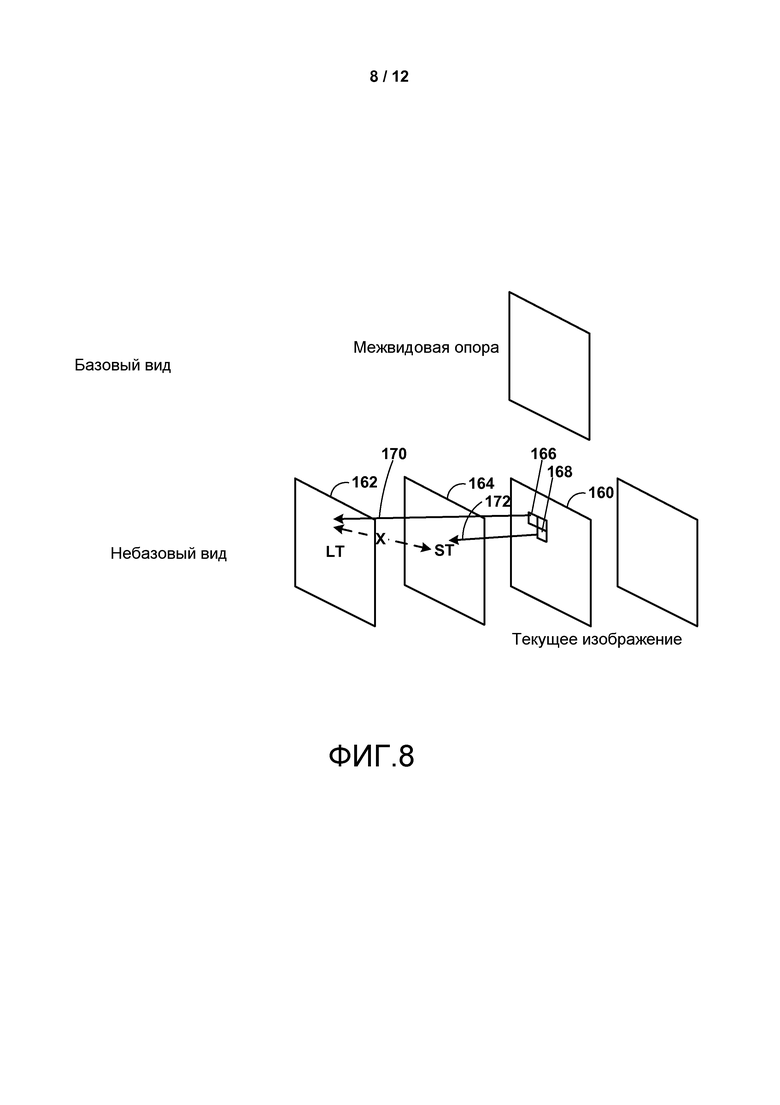

Фиг. 5-9 являются концептуальными диаграммами, изображающими потенциальные проблемы, которые должны быть преодолены для достижения только синтаксического расширения высокого уровня HEVC.

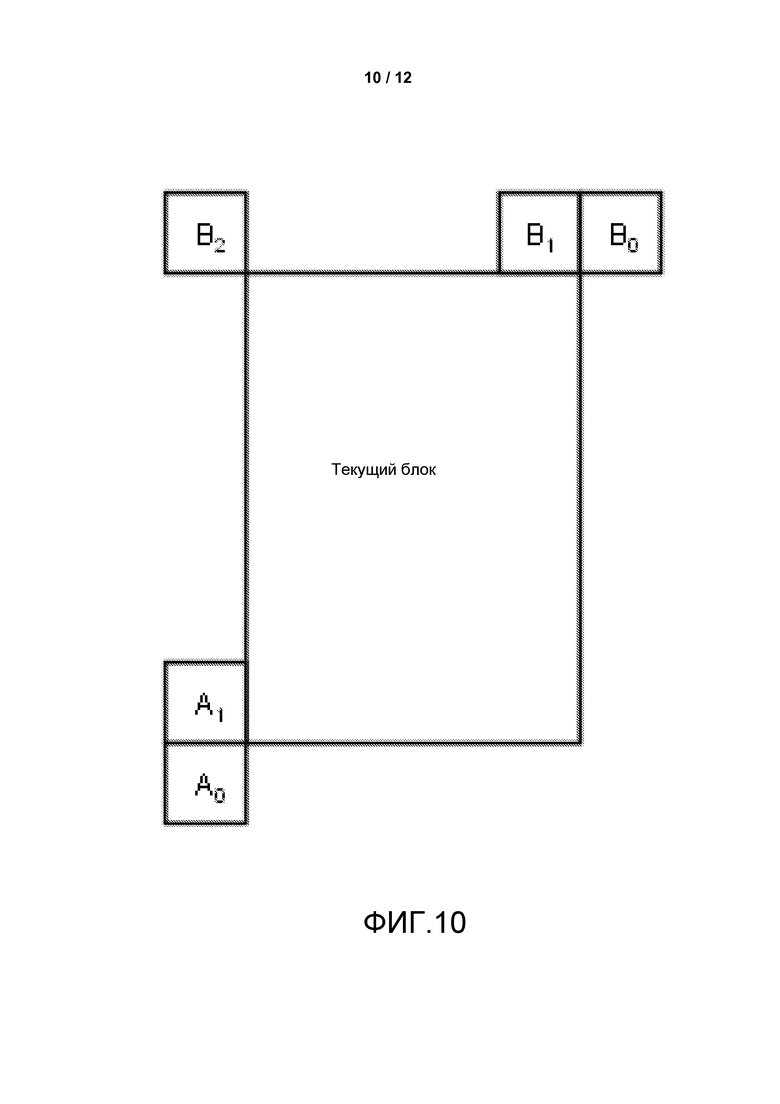

Фиг. 10 является концептуальной диаграммой, изображающей пример группы соседних блоков для текущего блока для использования в прогнозировании вектора движения.

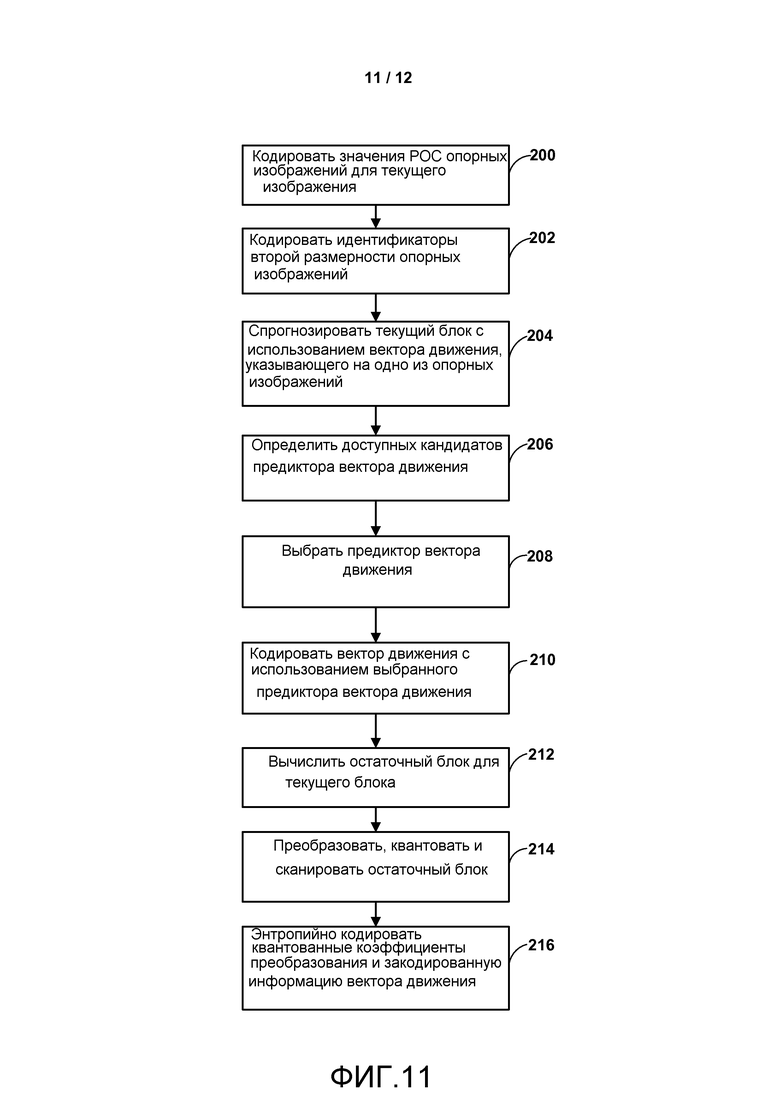

Фиг. 11 является блок-схемой, изображающей пример способа кодирования видеоданных, в соответствии со способами настоящего раскрытия.

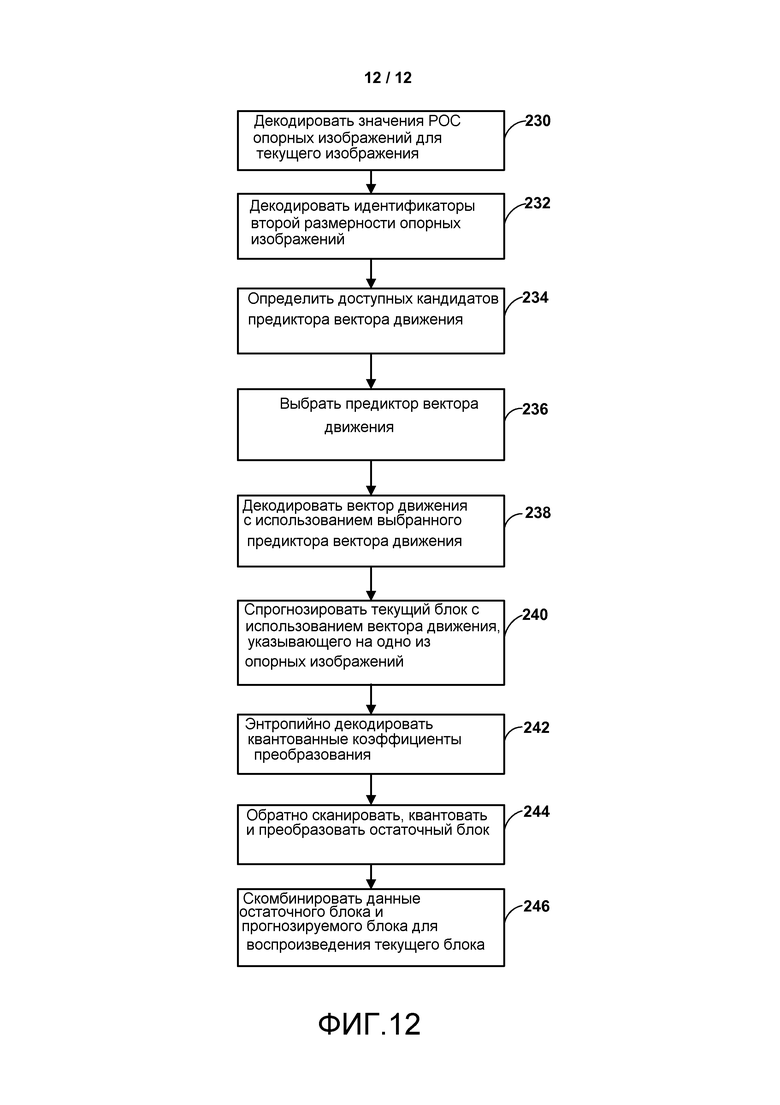

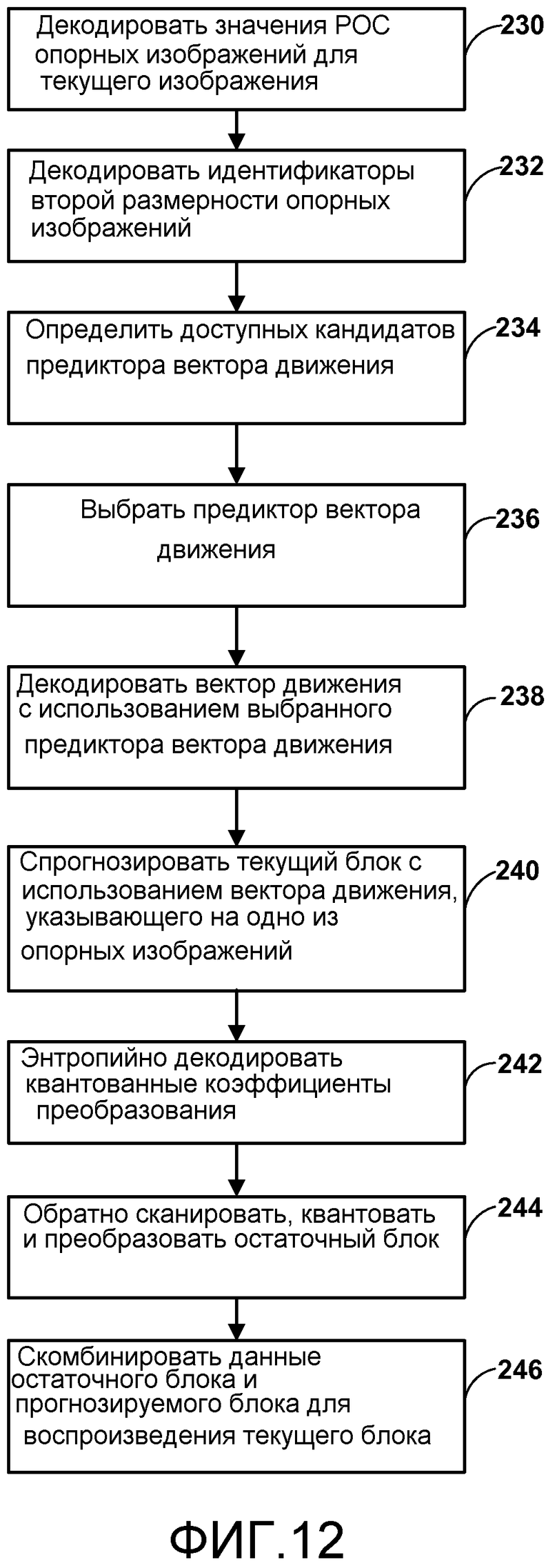

Фиг. 12 является блок-схемой, изображающей пример способа декодирования видеоданных, в соответствии со способами настоящего раскрытия.

ПОДРОБНОЕ ОПИСАНИЕ

В общем, настоящее раскрытие описывает различные способы поддержки расширений стандартов кодирования, как, например, развивающийся стандарт Высокоэффективного Видеокодирования (HEVC), с изменением только синтаксиса (HLS) высокого уровня. Например, настоящее раскрытие описывает способы как в базовой спецификации HEVC, так и в расширениях HEVC многовидового Видеокодирования (MVC) и/или кодирования трехмерного видеосигнала (3DV), где базовый вид сравним с базовой спецификацией HEVC.

Настоящее раскрытие описывает конкретные способы, обеспечивающие профиль только синтаксиса высокого уровня в спецификации расширения HEVC. Термин «межвидовой» в контексте MVC/3DV может быть заменен на «межуровневый» в контексте Масштабируемого Видеокодирования (SVC). То есть хотя описание этих способов первично фокусируется на «межвидовом» кодировании, те же или подобные идеи можно применить к «межуровневым» опорным изображениям для расширения только HLS SVC HEVC.

Фиг. 1 является блочной диаграммой, изображающей пример системы 10 кодирования и декодирования видео, которая может использовать способы кодирования видеоданных в соответствии только с синтаксическим расширением высокого уровня стандарта видеокодирования. Как изображено на Фиг. 1, система 10 включает в себя устройство-источник 12, которое обеспечивает закодированные видеоданные, которые должны быть декодированы позже устройством-адресатом 14. Более конкретно устройство-источник 12 обеспечивает видеоданные устройству-адресату 14 по считываемому компьютером носителю 16. Устройство-источник 12 и устройство-адресат 14 могут содержать любое из широкого диапазона устройств, включая настольные компьютеры, ноутбуки (то есть портативные компьютеры), планшетные компьютеры, телевизионные приставки, телефонные трубки, как, например, так называемые смартфоны, так называемые смартпады, телевизоры, камеры, устройства отображения, цифровые медиаплееры, игровые видеоприставки, устройство потокового видео или тому подобное. В некоторых случаях устройство-источник 12 и устройство-адресат 14 могут быть оборудованы для беспроводной связи.

Устройство-адресат 14 может принимать закодированные видеоданные, которые должны быть декодированы по считываемому компьютером носителю 16. Считываемый компьютером носитель 16 может содержать любой тип носителя или устройства, способного перемещать закодированные видеоданные от устройства-источника 12 к устройству-адресату 14. В одном примере считываемый компьютером носитель 16 может содержать носитель связи для разрешения устройству-источнику 12 передавать закодированные видеоданные напрямую устройству-адресату 14 в реальном времени. Закодированные видеоданные могут быть модулированы в соответствии со стандартом связи, как, например, протокол беспроводной связи, и переданы устройству-адресату 14. Носитель связи может содержать любой беспроводной или проводной носитель связи, как, например, радиочастотный (RF) спектр или одна или несколько физических линий передачи. Носитель связи может формировать часть пакетной сети, как, например, локальная сеть, региональная сеть или глобальная сеть, как, например, Интернет. Носитель связи может включать в себя роутеры, переключатели, базовые станции или любое другое оборудование, которое может быть использовано для усиления связи от устройства-источника 12 к устройству-адресату 14.

В некоторых примерах закодированные данные могут быть выведены от выходного интерфейса 22 устройству хранения. Подобным образом доступ к закодированным данным может быть осуществлен от устройства хранения с помощью входного интерфейса. Устройство хранения может включать в себя любое из разнообразных распределенных носителей данных или носителей данных локального доступа, как, например, накопитель на жестких дисках, диски Blu-ray, DVD, CD-ROM, флэш-память, энергозависимое или энергонезависимое запоминающее устройство, или любые другие подходящие цифровые носители данных для хранения закодированных видеоданных. В дополнительном примере устройство хранения может соответствовать файловому серверу или другому промежуточному устройству хранения, которое может хранить закодированное видео, сформированное устройством-источником 12. Устройство-адресат 14 может осуществлять доступ к сохраненным видеоданным в устройстве хранения по потоковой передаче или загрузке данных. Файловый сервер может быть любым типом сервера, способным хранить закодированные видеоданные и передавать эти закодированные видеоданные устройству-адресату 14. Примеры файловых серверов включают в себя вебсервер (например, для вебсайта), сервер FTP, устройства сетевого хранилища (NAS) данных или накопитель на локальном диске. Устройство-адресат 14 может осуществлять доступ к закодированным видеоданным по любому стандартному соединению данных, включая интернет-соединение. Это может включать в себя беспроводной канал (например, соединение Wi-Fi), проводное соединение (например, DSL, кабельный модем и так далее) или их комбинацию, подходящую для доступа к закодированных видеоданным, хранящимся на файловом сервере. Передача закодированных видеоданных от устройства хранения может быть потоковой передачей, передачей загрузки или их комбинацией.

Способы настоящего раскрытия необязательно ограничены беспроводными применениями или настройками. Способы могут быть применены к кодированию видео для поддержки любого из разнообразных мультимедийных применений, как, например, эфирные телевизионные широковещательные передачи, кабельные телевизионные передачи, спутниковые телевизионные передачи, потоковые передачи видеосигнала по интернету, как, например, динамическая адаптивная потоковая передача по HTTP (DASH), цифровой видеосигнал, который закодирован на носителе данных, декодирование цифрового видеосигнала, хранящегося на носителе данных, или другие применения. В некоторых примерах система 10 может быть выполнена с возможностью поддерживать одностороннюю или двустороннюю передачу видеосигнала для поддержки таких применений, как потоковая передача видеосигнала, воспроизведение видеосигнала, широковещательная передача видеосигнала и/или видеотелефония.

В примере на Фиг. 1 устройство-источник 12 включает в себя источник 18 видео, видеокодер 20 и выходной интерфейс 22. Устройство-адресат 14 включает в себя входной интерфейс 28, видеодекодер 30 и устройство 32 отображения. В соответствии с настоящим раскрытием видеокодер 20 устройства-источника 12 может быть выполнен с возможностью применять способы кодирования видеоданных в соответствии только с синтаксическим расширением высокого уровня стандарта видеокодирования. В других примерах устройство-источник и устройство-адресат могут включать в себя другие компоненты или установки. Например, устройство-источник 12 может принимать видеоданные от внешнего источника 18 видео, как, например, внешняя камера. Подобным образом устройство-адресат 14 может взаимодействовать с внешним устройством отображения вместо того, чтобы включать в себя интегрированное устройство отображения.

Изображенная система 10 на Фиг. 1 является лишь примером. Способы кодирования видеоданных в соответствии только с синтаксическим расширением высокого уровня стандарта видеокодирования могут быть выполнены любым цифровым устройством кодирования и/или декодирования видео. Хотя, в общем, способы настоящего изобретения выполняются устройством видеокодирования, способы могут также быть выполнены видеокодером/декодером, как правило, называемым «CODEC». Более того, способы настоящего раскрытия могут также быть выполнены устройством предварительной обработки видеосигнала. Устройство-источник 12 и устройство-адресат 14 являются лишь примерами таких устройств кодирования, в которых устройство 12 формирует закодированные видеоданные для передачи устройству-адресату 14. В некоторых примерах устройства 12, 14 могут функционировать по сути симметричным образом, так что каждое из устройств 12, 14 включает в себя компоненты кодирования и декодирования видео. Следовательно, система 10 может поддерживать одностороннюю или двустороннюю передачу между видеоустройствами 12, 14, например, для потокового видео, воспроизведения видеосигнала, широковещательной передачи видеосигнала или видеотелефонии.

Источник 18 видео устройства-источника 12 может включать в себя устройство захвата видеосигнала, как, например, видеокамера, видеоархив, содержащий ранее захваченное видео, и/или интерфейс подачи видео для приема видео от провайдера видеосодержимого. В качестве дополнительной альтернативы источник 18 видео может формировать данные компьютерной графики в качестве исходного видео, либо комбинацию видео в реальном времени, архивированного видео и сформированного компьютером видео. В некоторых случаях, если источником 18 видео является видеокамера, то устройство-источник 12 и устройство-адресат 14 могут формировать так называемые камерофоны или видеофоны. Однако, как упомянуто выше, способы, описанные в настоящем изобретении, могут быть применимы к кодированию видео в общем и могут быть применимы в беспроводных и/или проводных применениях. В любом случае захваченное, заранее захваченное или сформированное компьютером видео может быть закодировано видеокодером 20. Закодированная видеоинформация затем может быть выведена выходным интерфейсом 22 на считываемый компьютером носитель 16.

Считываемый компьютером носитель 16 может включать в себя энергозависимые носители, как, например, беспроводная широковещательная или проводная сетевая передача, либо носители данных (то есть энергонезависимые носители данных), как, например, накопитель на жестких дисках, флэш-память, компакт-диск, цифровой видеодиск, диск Blu-ray или другие считываемые компьютером носители данных. В некоторых примерах сетевой сервер (не изображен) может принимать закодированные видеоданные от устройства-источника 12 и обеспечивать закодированные видеоданные устройству-адресату 14, например, по сетевой передаче. Подобным образом вычислительное устройство блока воспроизведения носителя, как, например, блока маркировки диска, может принимать закодированные видеоданные от устройства-источника 12 и производить диск, содержащий закодированные видеоданные. Следовательно, считываемый компьютером носитель 16 можно понимать как включающий в себя один или несколько считываемых компьютером носителей различных форм, в различных примерах.

Входной интерфейс 28 устройства-адресата 14 принимает информацию от считываемого компьютером носителя 16. Информация считываемого компьютером носителя 16 может включать в себя синтаксическую информацию, определенную видеокодером 20, которая также используется видеодекодером 30, которая включает в себя синтаксические элементы, описывающие характеристики и/или обрабатывающие блоки и другие закодированные элементы, например GOP. Устройство 32 отображения отображает закодированные видеоданные пользователю и может содержать любое из разнообразных устройств, как, например, катодно-лучевая трубка (CRT), жидкокристаллический дисплей (LCD), плазменный дисплей, дисплей на органических светодиодах (OLED) или другой тип устройства отображения.

Видеокодер 20 и видеодекодер 30 могут функционировать в соответствии со стандартом видеокодирования, как, например, стандарт Высокоэффективного Видеокодирования (HEVC), находящийся в разработке в настоящее время, и могут соответствовать тестовой модели (HM) HEVC. Последняя рабочая версия HEVC, называемая «Рабочая версия 7 HEVC» или «WD7», описана в документе JCTVC-I1003, Бросс и другие, «Рабочая версия 7 текстовой спецификации высокоэффективного Видеокодирования (HEVC)», Совместная экспертная группа (JCT-VC) по кодированию видео ITU-T SG16 WP3 и ISO/IEC JTC1/SC29/WG11, 9-я встреча: Женева, Швейцария, с 27 апреля 2012 года по 7 мая 2012 года, которую по состоянию на 22 июня 2012 года можно загрузить с http://phenix.it-sudparis.eu/jct/doc_end_user/documents/9_Geneva/wg11/JCTVC-I1003-v3.zip. Как отмечено выше, настоящее раскрытие включает в себя способы расширения HEVC с использованием синтаксиса высокого уровня. Соответственно видеокодер 20 и видеодекодер 30 могут функционировать в соответствии с версией HEVC, расширенной с использованием синтаксиса высокого уровня.

Альтернативно видеокодер 20 и видеодекодер 30 могут функционировать в соответствии с другими частными или промышленными стандартами, как, например, стандарт ITU-T H.264, альтернативно называемый MPEG-4, Часть 10, Продвинутое кодирование (AVC) видеосигнала, или расширениями таких стандартов. Опять же эти расширения могут быть достигнуты с использованием синтаксиса высокого уровня. Способы настоящего изобретения, однако, не ограничены любым конкретным стандартом кодирования. Другие примеры стандартов видеокодирования включают в себя MPEG-2 ITU-T и H.263. Хотя это не изображено на Фиг. 1, в некоторых аспектах видеокодер 20 и видеодекодер 30 могут быть интегрированы с аудиокодером и декодером и могут включать в себя соответствующие элементы MUX-DEMUX или другие технические средства или программное обеспечение для управления кодированием аудио и видео в общем потоке данных или отдельных потоках данных. Если это применимо, то элементы MUX-DEMUX могут соответствовать протоколу мультиплексирования ITU H.223 или другим протоколам, как, например, протокол (UDP) пользовательской датаграммы.

Стандарт ITU-T H.264/MPEG-4 (AVC) был сформулирован Экспертной группой (VCEG) кодирования видео ITU-T совместно с Экспертной группой (MPEG) по движущемуся изображению ISO/IEC как продукт коллективного партнерства, известного как Объединенная команда (JVT) по кодированию видео. В некоторых аспектах, способы, описанные в настоящем раскрытии, могут быть применены к устройствам, которые, в общем, соответствуют стандарту Н.264. Стандарт Н.264 описан в Рекомендации Н.264 ITU-T, Продвинутое видеокодирование для общих аудиовизуальных услуг, исследовательской группой ITU-T, от марта 2005 года, и в настоящем документе может называться стандарт Н.264 или спецификация Н.264, или стандарт H.264/AVC, или спецификация. Объединенная команда (JVT) по кодированию видео продолжает работу над расширениями H.264/MPEG-4 AVC.

Видеокодер 20 и видеодекодер 30 могут быть осуществлены в качестве любой из разнообразных подходящих схем устройства кодирования, как, например, один или несколько микропроцессоров, цифровые сигнальные процессоры (DSP), специализированные интегральные схемы (ASIC), программируемые пользователем вентильные матрицы (FPGA), дискретная логика, программное обеспечение, технические средства, программно-аппаратные средства или любая их комбинация. Когда способы осуществлены частично в программном обеспечении, устройство может хранить инструкции для программного обеспечения на подходящем, энергонезависимом считываемом компьютером носителе и выполнять инструкции в технических средствах с использованием одного или нескольких процессоров для выполнения способов настоящего раскрытия. Каждый из видеокодера 20 и видеодекодера 30 может быть включен в один или несколько устройств кодирования или устройств декодирования, любое из которых может быть интегрировано как часть комбинированного кодера/декодера (CODEC) в соответствующем устройстве.

JCT-VC разрабатывает стандарт HEVC. Усилия по стандартизации HEVC основаны на развивающейся модели устройства видеокодирования, называемого Тестовой моделью (НМ) HEVC. НМ предоставляет несколько дополнительных возможностей устройств видеокодирования по отношению к существующим устройствам в соответствии, например, с ITU-T H.264/AVC. Например, в то время как Н.264 обеспечивает девять режимов кодирования с внутренним прогнозированием, НМ может обеспечивать тридцать три режима кодирования с внутренним прогнозированием.

В общем, рабочая модель НМ описывает, что видеокадр или изображение может быть разделен на последовательность древовидных блоков или наибольших элементов (LCU) кодирования, которые включают в себя отсчеты яркости и цветности. Синтаксические данные внутри битового потока могут определять размер LCU, который является наибольшим элементом кодирования в смысле числа пикселов. Слайс включает в себя число последовательных древовидных блоков в порядке кодирования. Видеокадр или изображение может быть разделено на один или несколько слайсов. Каждый древовидный блок может быть разбит на элементы (CU) кодирования в соответствии с деревом квадратов. В общем, структура данных дерева квадратов включает в себя один узел на CU, с корневым узлом, соответствующим древовидному блоку. Если CU разбит на четыре под-CU, то узел, соответствующий CU, включает в себя четыре концевых узла, каждый из которых соответствует одному из под-CU.

Каждый узел структуры данных дерева квадратов может обеспечивать синтаксические данные соответствующему CU. Например, узел в дереве квадратов может включать в себя флаг разделения, указывающий, разделен ли CU, соответствующий узлу, на под-CU. Синтаксические элементы CU могут быть определены рекурсивно и могут зависеть от того, разделен ли CU на под-CU. Если CU не разделен дополнительно, он называется концевым CU. В настоящем раскрытии четыре под-CU концевого CU будут также называться концевыми CU, даже если нет четкого разделения исходного концевого CU. Например, если CU размера 16×16 не разделен дополнительно, четыре под-CU 8×8 будут также называться концевыми CU, хотя CU 16×16 никогда не был разделен.

CU имеет ту же цель, что и макроблок стандарта Н.264, за исключением того, что CU не имеет отличия в размере. Например, древовидный блок может быть разделен на четыре дочерних узла (также называемых под-CU), и каждый дочерний узел, в свою очередь, может быть родительским узлом и быть разделен на другие четыре дочерних узла. Последний, не разделенный дочерний узел, называемый концевым узлом дерева квадратов, содержит узел кодирования, также называемый концевым CU. Синтаксические данные, связанные с закодированным битовым потоком, могут определять число раз, которое дерево квадратов может быть разделено, называемое максимальной глубиной CU, и может также определять минимальный размер узлов кодирования. Соответственно битовый поток может также определять наименьший элемент (SCU) кодирования. Настоящее раскрытие использует термин «блок» для ссылки на любой из CU, PU или TU в контексте HEVC или подобные структуры данных в контексте других стандартов (например, макроблоки и их подблоки в H.264/AVC).

CU включает в себя узел кодирования, элементы (PU) прогнозирования и элементы (TU) преобразования, связанные с узлом кодирования. Размер CU соответствует размеру узла кодирования и должен быть квадратным по форме. Размер CU может варьироваться от 8х8 пикселов до размера дерева квадратов, максимально 64х64 пикселов или больше. Каждый СU может содержать один или несколько PU и один или несколько ТU. Синтаксические данные, связанные с CU, могут описывать, например, разделение CU на один или несколько PU. Режимы разделения могут отличаться в зависимости от того, является ли CU закодированным в режиме пропуска или прямом режиме, закодированным в режиме внутреннего прогнозирования или закодированным в режиме внешнего прогнозирования. PU может быть разделен так, что по форме он неквадратный. Синтаксические данные, связанные с CU, могут также описывать, например, разделение CU на один или несколько TU в соответствии с деревом квадратов. TU может быть квадратной или неквадратной (например, прямоугольной) формы.

Стандарт HEVC допускает преобразования, в соответствии с TU, которые могут отличаться для различных CU. TU, как правило, имеют размер на основании размера PU внутри заданного CU, определенного для разделенного LCU, хотя это не всегда может быть так. TU, как правило, имеют тот же размер или меньше, чем PU. В некоторых примерах остаточные отсчеты, соответствующие CU, могут быть подразделены на меньшие элементы с использованием структуры дерева квадратов, известной как «остаточное дерево (RQT) квадратов». Концевые узлы RQT могут называться элементами (TU) преобразования. Значения разницы пикселов, связанные с TU, могут быть преобразованы для воспроизведения коэффициентов преобразования, которые могут быть квантованы.

Концевой CU может включать в себя один или несколько элементов (PU) прогнозирования. В общем, PU представляет собой пространственную область, соответствующую всем или части соответствующих CU, и может включать в себя данные для извлечения опорного отсчета для PU. Более того, PU включает в себя данные, относящиеся к прогнозированию. Например, когда PU закодирован во внутреннем режиме, данные для PU могут быть включены в остаточное дерево (RQT) квадратов, которое может включать в себя данные, описывающие режим внутреннего прогнозирования для TU, соответствующего PU. В качестве другого примера, когда PU закодирован во внешнем режиме, PU может включать в себя данные, определяющие один или несколько векторов движения для PU. Данные, определяющие вектор движения для PU, могут описывать, например, горизонтальную компоненту вектора движения, вертикальную компоненту вектора движения, разрешение вектора движения (например, с точностью до одной четвертой пиксела или с точностью до одной восьмой пиксела), опорное изображение, на которое указывает вектор движения, и/или список опорных изображений (например, Список 0, Список 1, или Список С) для вектора движения.

Концевой CU, имеющий один или несколько PU, может также включать в себя один или несколько элементов (TU) преобразования. Элементы преобразования могут быть определены с использованием RQT (также называемого структурой дерева квадратов TU), как описано выше. Например, флаг разделения может указывать, разделен ли концевой CU на четыре элемента преобразования. Затем каждый элемент преобразования может быть дополнительно разделен на дополнительные под-TU. Когда TU не разделен дополнительно, он может называться концевым TU. В общем, для внутреннего кодирования все концевые TU, принадлежащие концевому CU, имеют одинаковый режим внутреннего прогнозирования. То есть, одинаковый режим внутреннего прогнозирования, в общем, применяется для вычисления прогнозированных значений для всех TU концевого CU. Для внутреннего кодирования видеокодер может вычислять остаточное значение для каждого концевого TU с использованием режима внутреннего прогнозирования в качестве разницы между частью CU, соответствующего TU, и исходным блоком. TU необязательно ограничен размером PU. Таким образом, TU могут быть больше или меньше, чем PU. Для внутреннего кодирования PU может быть расположен совместно с соответствующим концевым TU для того же CU. В некоторых примерах максимальный размер концевого TU может соответствовать размеру соответствующего концевого CU.

Более того, TU концевых CU могут также быть связаны с соответственными структурами данных дерева квадратов, называемыми остаточные деревья (RQT) квадратов. То есть концевой CU может включать в себя дерево квадратов, указывающее, как концевой CU разделен на TU. Корневой узел дерева квадратов TU, в общем, соответствует концевому CU, в то время как корневой узел дерева квадратов CU, в общем, соответствует древовидному блоку (или LCU). TU RQT, которые не разделены, называются концевыми TU. В общем, настоящее раскрытие использует термины CU и TU для ссылки на концевой CU и концевой TU соответственно, если только не указано иное.

Видеопоследовательность, как правило, включает в себя ряд видеокадров или изображений. Группа (GOP) изображений, в общем, содержит ряд из одного или нескольких изображений. GOP может включать в себя синтаксические данные в заголовке GOP, заголовке одного или нескольких изображений или в другом месте, которое описывает число изображений, включенных в GOP. Каждый слайс изображения может включать в себя синтаксические данные слайса, которые описывают режим кодирования для соответствующего слайса. Видеокодер 20, как правило, функционирует с видеоблоками внутри отдельных видеослайсов, чтобы закодировать видеоданные. Видеоблок может соответствовать узлу кодирования внутри CU. Видеоблоки могут иметь фиксированные или изменяемые размеры и могут отличаться в размерах в соответствии с конкретным стандартом кодирования.

В качестве примера НМ поддерживает прогнозирование в различных размерах PU. Предположим, что размер конкретного CU равен 2N×2N, тогда НМ поддерживает внутреннее прогнозирование в размерах PU 2N×2N или N×N, и внешнее прогнозирование в симметричных размерах PU 2N×2N, 2N×N, N×2N или N×N. НМ также поддерживает асимметричное разделение для внешнего прогнозирования в размерах PU 2N×nU, 2N×nD, nL×2N и nR×2N. При асимметричном разделении одно направление CU не разделяется, в то время как другое направление разделяется на 25% и 75%. Часть CU, соответствующая 25% разделению, указывается «n», за которым следует указание «Сверху», «Снизу», «Слева» или «Справа». Таким образом, например, «2N×nU» относится к 2N×2N CU, который разделен горизонтально с 2N×0,5N PU сверху и 2N×1,5N PU снизу.

В настоящем раскрытии «N×N» и «N на N» могут быть использованы взаимозаменяемо для ссылки на пиксельные размеры видеоблока относительно вертикальных и горизонтальных размеров, например 16×16 пикселов или 16 на 16 пикселов. В общем, блок 16×16 имеет 16 пикселов в вертикальном направлении (у=16) и 16 пикселов в горизонтальном направлении (х=16). Подобным образом блок N×N, в общем, имеет N пикселов в вертикальном направлении и N пикселов в горизонтальном направлении, где N представляет собой неотрицательное целое значение. Пикселы в блоке могут быть упорядочены в ряды и столбцы. Более того, блоки необязательно должны иметь одинаковое число пикселов в горизонтальном направлении, а также в вертикальном направлении. Например, блоки могут содержать N×M пикселов, где М необязательно равно N.

Вслед за кодированием с внутренним прогнозированием или внешним прогнозированием с использованием PU CU видеокодер 20 может вычислять остаточные данные для TU CU. PU могут содержать синтаксические данные, описывающие способ или режим формирования прогнозных пиксельных данных в пространственном домене (также называемом пиксельным доменом), и TU могут содержать коэффициенты в домене преобразования вслед за применением преобразования, например дискретного косинусного преобразования (DCT), целочисленного преобразования, волнового преобразования или концептуально похожего преобразования к остаточным видеоданным. Остаточные данные могут соответствовать разницам пикселов между пикселами незакодированного изображения и значениями прогнозирования, соответствующими PU. Видеокодер 20 может формировать TU, включающие в себя остаточные данные для CU, а затем преобразовывать TU для воспроизведения коэффициентов преобразования для CU.

Вслед за любыми преобразованиями для воспроизведения коэффициентов преобразования видеокодер 20 может выполнять квантование коэффициентов преобразования. Квантование, в общем, относится к процессу, в котором коэффициенты преобразования квантуются для возможного сокращения количества данных, используемых для представления коэффициентов, что обеспечивает дополнительное сжатие. Процесс квантования может сократить глубину битов, связанную с некоторыми или всеми коэффициентами. Например, значение n-бит может быть округлена до значения m-бит во время квантования, где n больше, чем m.

Вслед за квантованием видеокодер может сканировать коэффициенты преобразования, производя одномерный вектор из двумерной матрицы, включающей в себя квантованные коэффициенты преобразования. Сканирование может быть задумано так, чтобы разместить коэффициенты с высокой энергией (и, следовательно, с низкой частотой) в передней части массива и разместить коэффициенты с низкой энергией (и, следовательно, с высокой частотой) в задней части массива. В некоторых примерах видеокодер 20 может использовать заранее заданный порядок сканирования для сканирования квантованных коэффициентов преобразования для воспроизведения упорядоченного вектора, который можно энтропийно закодировать. В других примерах видеокодер 20 может выполнять адаптивное сканирование. После сканирования квантованных коэффициентов преобразования для формирования одномерного вектора видеокодер 20 может энтропийно кодировать одномерный вектор, например, в соответствии с контекстно-зависимым адаптивным кодированием с переменной длиной кодового слова (CAVLC), контекстно-зависимым адаптивным двоичным арифметическим кодированием (CAВАC), синтаксическим контекстно-зависимым адаптивным двоичным арифметическим кодированием (SBAC), энтропийным кодированием (PIPE) с разделением интервалов вероятности или другой методологией энтропийного кодирования. Видеокодер 20 может также энтропийно кодировать синтаксические элементы, связанные с закодированными видеоданными для использования видеодекодером 30 при декодировании видеоданных.

Для выполнения САВАС видеокодер 20 может назначать контекст внутри контекстной модели символу, который должен быть передан. Контекст может относиться, например, к тому, являются ли соседние значения символа ненулевыми или нет. Для выполнения САVLC видеокодер 20 может выбирать переменную длину кодового слова для символа, который должен быть передан. Кодовые слова в VLC могут быть построены так, что относительно более короткие коды соответствуют наиболее вероятным символам, в то время как более длинные коды соответствуют менее вероятным символам. Таким образом, с помощью использования VLC можно добиться сохранения битов по сравнению, например, с использованием кодовых слов равной длины для каждого символа, который должен быть передан. Определение вероятности может быть основано на контексте, назначенном символу.

Видеокодер 20 может дополнительно отправлять синтаксические данные, как, например, синтаксические данные на основании блока, синтаксические данные на основании кадра и синтаксические данные на основании GOP, видеодекодеру 30, например, в заголовке кадра, заголовке блока, заголовке слайса или заголовке GOP. Синтаксические данные GOP могут описывать число кадров в соответствующей GOP, и синтаксические данные кадра могут указывать режим кодирования/прогнозирования, используемый для кодирования соответствующего кадра.

В общем, настоящее раскрытие описывает различные примеры решений для разрешения только синтаксического расширения высокого уровня (HLS) стандарта видеокодирования, как, например, HEVC. Например, эти способы могут быть использованы для разработки расширения только-HLS для профиля HEVC, как, например, MVC или SVC. Различные примеры описаны далее. Необходимо понимать, что различные примеры описаны отдельно, а элементы любых или всех примеров могут быть скомбинированы в любой комбинации.

В первом примере изменений в текущей базовой спецификации HEVC нет. В расширении HEVC изображение (например, компонента вида) может быть идентифицировано по двум качествам: его значению счета порядка изображения (POC) и идентификатору изображения второй размерности, например значению view_id (которое может идентифицировать вид, в котором изображение представлено). Видеокодеру 20 может потребоваться указать компоненту вида, которая должна быть использована для межвидового прогнозирования, в качестве долгосрочного опорного изображения.

Во втором примере изменений в текущей базовой спецификации HEVC нет. В расширении HEVC могут быть применены следующие изменения. Изображение (например, компонента вида) может быть идентифицировано по двум качествам: значению РОС и идентификатору изображения второй размерности, например view_id. Во втором примере,процесс маркировки дополнительного изображения может быть произведен сразу до кодирования текущей компоненты вида, для маркировки всех межвидовых опорных изображений в качестве долгосрочных опорных изображений. Другой процесс маркировки изображения может быть произведен сразу после кодирования текущей компоненты вида для маркировки каждого межвидового опорного изображения в качестве либо долгосрочного, краткосрочного или «неиспользуемого для ссылки», что является тем же, что его предыдущий статус маркировки до того как была закодирована текущая компонента вида.

В третьем примере способы второго примера используются и дополняются, как описано далее. В дополнение к способам второго примера для каждого межвидового опорного изображения, после того, как оно маркировано в качестве долгосрочного опорного изображения, его значение РОС отображается в новое значение POC, которое не эквивалентно значению РОС любого существующего опорного изображения. После декодирования текущей компоненты вида для каждого межвидового опорного изображения его значение РОС отображается обратно в исходное значение РОС, которое равно текущей компоненте вида. Например, текущая компонента вида может принадлежать виду 3 (предположим, что идентификатор вида равен индексу порядка вида) и может иметь значение РОС, равное 5. Два межвидовых опорных изображения могут иметь свои значения РОС (которые равны 5), конвертированные, например, в 1025 и 2053. После декодирования текущей компоненты вида значения РОС межвидовых изображений могут быть обратно конвертированы в 5.

В четвертом примере способы второго либо третьего примеров могут быть использованы и дополнены, как описано далее. В дополнение к способам первого примера или второго примера, как указано выше, в базовой спецификации HEVC дополнительный прием может быть использован для запрета прогнозирования между любым вектором движения, относящимся к краткосрочному изображению, и другим вектором движения, относящимся к долгосрочным изображениям, особенно во время усовершенствованного прогнозирования вектора движения (AMVP).

В пятом примере в расширении HEVC изображение может быть идентифицировано по двум качествам: значению РОС и идентификатору изображения второй размерности, например view_id. В базовой спецификации HEVC одна или несколько следующих привязок могут быть добавлены (по отдельности или в комбинации). В одном примере (называемом пример 5.1) при идентификации опорного изображения во время AMVP и режима слияния идентификация изображения второй размерности, например индекс порядка вида, может быть использована вместе с РОС. В контексте двумерного 2D декодирования видео в базовой спецификации HEVC идентификация изображения второй размерности всегда может полагаться (устанавливаться) равной 0.

В другом примере (пример 5.2) прогнозирование между временным вектором движения и межвидовым вектором движения запрещается во время AMVP (включая временное прогнозирование вектора движения (TMVP)). Качество вектора движения может быть определено с помощью связанного опорного индекса, который идентифицирует опорное изображение, и то, как на опорное изображение ссылается изображение, содержащее вектор движения, например как на долгосрочное опорное изображение, краткосрочное опорное изображение, или межвидовое опорное изображение. В другом примере (пример 5.3) прогнозирование между временным краткосрочным вектором движения и временным долгосрочным вектором движения может быть запрещено (например, явно или неявно). В другом примере (пример 5.4) прогнозирование между временным краткосрочным вектором движения и временным долгосрочным вектором движения может быть разрешено (например, явно или неявно).

В другом примере (пример 5.5) прогнозирование между векторами движения, ссылающимися на два различных межвидовых опорных изображения, может быть запрещено (например, явно или неявно). Два межвидовых опорных изображения можно рассматривать как имеющие различные типы, если значения идентификаторов изображения второй размерности для них являются различными. В другом примере (пример 5.6) прогнозирование между векторами движения, ссылающимися на два различных межвидовых опорных изображения, может быть разрешено (например, явно или неявно). В другом примере (пример 5.7) прогнозирование между векторами движения, ссылающимися на долгосрочное изображение и межвидовое изображение, может быть разрешено (например, явно или неявно). В другом примере (пример 5.8) прогнозирование между векторами движения, ссылающимися на долгосрочное изображение и межвидовое изображение, может быть запрещено (например, явно или неявно).

В любом из вышеуказанных примеров прогнозирование между двумя векторами движения, ссылающимися на два различных временных краткосрочных опорных изображения, может всегда быть разрешено, и масштабирование из одного в другое на основании значений РОС может быть разрешено. Дополнительно или альтернативно в любом из вышеуказанных примеров прогнозирование между векторами движения, ссылающимися на два различных долгосрочных изображения, может быть запрещено. Конкретные детали различных примеров, описанных выше, обсуждаются более подробно далее.

В общем, настоящее раскрытие ссылается на «вектор движения» или «данные вектора движения» как включающие в себя опорный индекс (то есть указатель на опорное изображение) и х- и у-координаты самого вектора движения. Оба вектора движения - диспаратности и временной вектор движения - могут, в общем, называться «векторами движения». Опорное изображение, соответствующее опорному индексу, может называться опорным изображением, на которое ссылается вектор движения. Если вектор движения ссылается на опорное изображение другого вида, он называется вектор движения диспаратности.

Временной вектор движения может быть краткосрочным временным вектором движения («краткосрочный вектор движения») или долгосрочным временным вектором движения («долгосрочный вектор движения»). Например, вектор движения является краткосрочным, если он ссылается на краткосрочное опорное изображение, в то время как вектор движения является долгосрочным, если он ссылается на долгосрочное опорное изображение. Необходимо отметить, что если не указано иное, вектор движения диспаратности и долгосрочный вектор движения, в общем, описывают различные категории векторов движения, например, для межвидового прогнозирования и временного внутривидового прогнозирования соответственно. Краткосрочное и долгосрочное опорные изображения представляют собой примеры временных опорных изображений.

Видеокодер 20 и видеодекодер 30 могут быть выполнены с возможностью идентифицировать опорное изображение из буфера (DPB) декодированных изображений, который может быть осуществлен в качестве памяти опорных изображений. Процесс идентификации опорного изображения из DPB может быть использован в любом из примеров способов, описанных в настоящем раскрытии. Процесс идентификации опорного изображения из DPB может быть использован для следующих целей в спецификации расширения HEVC: создание группы опорных изображений, создание списка опорных изображений и/или маркировка опорных изображений.

Компонента вида, компонента вида текстуры, компонента вида глубины или масштабируемый уровень (например, с конкретной комбинацией dependency_id и quality_id) могут быть идентифицированы с помощью значения счета порядка изображения (POC) и информации идентификации изображения второй размерности. Информация идентификации изображения второй размерности может включать в себя одно или несколько из следующих: ID вида (view_id) в многовидовом контексте; индекс порядка вида в многовидовом контексте; в 3DV (многовидовой с глубиной) контексте, комбинацию индекса порядка вида и depth_flag (указывающий, является ли текущая компонента вида текстурой или глубиной), например, индекс порядка вида, умноженный на два, плюс значение depth_flag; в контексте SVC, ID уровня (в окружении масштабируемого кодирования, например, в SVC на основании AVC, ID уровня может быть равен dependency_id, умноженному на 16, плюс quality_id); или общий ID уровня (layer_id), например, значение reserved_one_5bits минус 1, причем reserved_one_5bits указана в базовой спецификации HEVC. Необходимо отметить, что общий ID уровня может применяться в смешанном 3DV (многовидовой с глубиной) и масштабируемом сценариях. Вышеуказанные примеры могут применяться к любому многоуровневому кодеку, включая масштабируемый видеокодек, с помощью, например, рассмотрения каждого уровня в качестве вида. Другими словами, для многовидового видеокодирования различные виды могут быть рассмотрены как отдельные уровни.

В некоторых сценариях базовый уровень или зависимый вид могут иметь много представлений, например, вследствие использования различных фильтров повышающей дискретизации/сглаживания, или вследствие факта использования изображения с синтезированным видом для прогнозирования; таким образом, в местоположении одного вида могут быть два изображения, готовых для использования, где одно является обычным восстановленным зависимым изображением вида, а другое является изображением с синтезированным видом, оба имеют одинаковый view_id или индекс порядка вида. В таком случае может быть использована идентификация изображения третьей размерности.

Видеокодер 20 и видеодекодер 30 также могут быть выполнены с возможностью идентифицировать опорное изображение из списка опорных изображений. Буфер (DPB) опорных изображений может быть организован в списки опорных изображений, например RefPicList0, который включает в себя потенциальные опорные изображения, имеющие значения РОС меньше, чем значение РОС текущего изображения, и RefPicList1, который включает в себя потенциальные опорные изображения, имеющие значения РОС больше, чем значение РОС текущего изображения. Способы идентификации опорного изображения из списка опорных изображений используются в качестве привязки для текущей базовой спецификации HEVC. Определенные функции могут быть использованы много раз видеокодером или видеодекодером во время AMVP и режима слияния.

Компонента вида, компонента вида текстуры, компонента вида глубины или масштабируемый уровень (например, с конкретной комбинацией dependency_id и quality_id) могут быть идентифицированы с помощью значения РОС и информации идентификации изображения второй размерности, которая может быть одной из следующих: индекс порядка вида в многовидовом или 3DV контексте. Функция viewOldx (pic) возвращает индекс порядка вида для вида, к которому принадлежит изображение, идентифицированное как «pic». Эта функция возвращает 0 для любой компоненты вида, компоненты вида текстуры или компоненты вида глубины базового вида; ID вида (view_id); в контексте 3DV, комбинацию индекса порядка вида и depth_flag (указывающую, является ли текущая компонента вида текстурой или глубиной): индекс порядка вида, умноженный на 2, плюс значение depth_flag; в контексте SVC, ID уровня (в окружении масштабируемого кодирования, например, SVC на основании AVC, ID уровня может быть равен dependency_id, умноженному на 16, плюс quality_id); или общему ID уровня (layer_id), например, значение reserved_one_5bits минус 1, причем reserved_one_5bits указан в базовой спецификации HEVC. Функция layerId (pic) возвращает layer_id изображения pic. LayerId (pic) возвращает 0 для любой компоненты вида (текстуры) базового вида. LayerId (pic) возвращает 0 для любого изображения (или представления уровня) базового уровня SVC. Необходимо отметить, что общий ID уровня может применяться в смешанном 3DV (многовидовой с глубиной) и масштабируемом сценариях.

В некоторых сценариях базовый уровень или зависимый вид могут иметь множество представлений, например, вследствие использования различных фильтров повышающей дискретизации/сглаживания, или вследствие факта использования изображения с синтезированным видом для прогнозирования; таким образом, в местоположении одного вида, могут быть два изображения, готовых для использования: одно является обычным восстановленным зависимым изображением вида, а другое является изображением с синтезированным видом, оба имеют одинаковый view_id или индекс порядка вида. В таком случае может быть использована идентификация изображения третьей размерности.

Одна или несколько из вышеупомянутых идентификаций изображений второй размерности и/или третьей размерности может быть определена с помощью функции AddPicId (pic).

Видеокодер 20 и видеодекодер 30 могут также быть выполнены с возможностью идентифицировать тип записи в списке опорных изображений. Это может быть использовано в качестве привязки для текущей базовой спецификации HEVC. Любая или все функции, определенные ниже, могут быть использованы много раз видеокодером 20 и/или видеодекодером 30 во время AMVP и/или режима слияния. Любой или все из следующих примеров способов могут быть использованы для идентификации типа записи в списке опорных изображений. В одном примере функция «RefPicType (pic)» возвращает 0, если изображение pic является временным опорным изображением, и возвращает 1, если изображение pic не является временным опорным изображением. В другом примере функция RefPicType (pic) возвращает 0, если изображение имеет тот же РОС, что и текущее изображение, и возвращает 1, если изображение имеет РОС, отличный от РОС текущего изображения.

В другом пример, результатов примеров, описанных выше, можно достичь с помощью замещения использования функции RefPicType (pic) просто на проверку того, равен ли РОС «pic» (аргумент функции) РОС текущего изображения. В некоторых примерах межвидовое опорное изображение может быть промаркировано как «неиспользуемое для ссылки». Межвидовое опорное изображение может быть промаркировано как «неиспользуемое для ссылки». Для упрощения такое изображение называется неопорным изображением в базовой спецификации HEVC. В некоторых примерах изображение, маркированное как «используемое для долгосрочной ссылки» или «используемое для краткосрочной ссылки», может называться опорным изображением в базовой спецификации HEVC. В некоторых примерах функция RefPicType (pic) возвращает 0, если изображение маркировано как «используемое для долгосрочной ссылки» или «используемое для краткосрочной ссылки», и возвращает 1, если изображение маркировано как «неиспользуемое для ссылки». Дополнительно в некоторых примерах, в расширении HEVC, компонента вида сразу после ее декодирования, может быть маркирована как «неиспользуемая для ссылки», независимо от значения синтаксического элемента nal_ref_flag.

После того как весь элемент доступа закодирован, компоненты вида элемента доступа могут быть маркированы как «используемые для краткосрочной ссылки» или «используемые для долгосрочной ссылки», если nal_ref_flag истинен. Альтернативно компонента вида может быть промаркирована только как «используемая для краткосрочной ссылки» либо «используемая для долгосрочной ссылки», если это включено в набор опорных изображений (RPS) последующей компоненты вида в порядке декодирования в том же виде, сразу после того, как извлечен RPS для последующей компоненты вида. Дополнительно в базовой спецификации HEVC текущее изображение сразу после его декодирования может быть маркировано как «неиспользуемое для ссылки».

В некоторых примерах RefPicType (picX, refIdx, LX) возвращает значение RefPicType (pic) в то время когда picX является текущим изображением, причем pic является опорным изображением с индексом refIdx из списка LX опорных изображений изображения picX.

По отношению к примеру, упоминаемому выше в качестве «четвертого примера», видеокодер 20 и видеодекодер 30 могут быть выполнены с возможностью разрешать прогнозирование между долгосрочными опорными изображениями без масштабирования во время AMVP и TMVP. По отношению к AMVP видеокодер 20 и видеодекодер 30 могут быть выполнены с возможностью выполнять модифицированный процесс извлечения кандидатов предиктора вектора движения (MVP). Вводы в процесс могут включать в себя местоположение (хР, уР) яркости, указывающее верхний левый отсчет яркости текущего элемента прогнозирования относительно верхнего левого отсчета текущего изображения, переменные, указывающие ширину и высоту элемента прогнозирования для яркости, nPSW и nPSH, и опорный индекс refIdxLX (где Х равен 0 или 1) разделения текущего элемента прогнозирования. Выводы процесса могут включать в себя (где N замещен либо на А, либо на В, где А соответствует соседним кандидатам слева, а В соответствует соседним кандидатам сверху, как изображено в примере на Фиг. 10) векторы mvLXN движения соседних элементов прогнозирования и флаги availableFlagLXN доступности соседних элементов прогнозирования. Переменная isScaledFlagLX, где Х равен 0 или 1, может полагаться равной 1 или 0.

Видеокодер 20 и видеодекодер 30 могут извлекать вектор mvLXA движения и флаг availableFlagLXA доступности в следующем порядке этапов в одном примере, где подчеркнутый текст представляет собой изменения относительно HEVC WD7:

1. Пусть набор из двух местоположений отсчета будет (xAk, yAk), где k=0, 1, указывающий местоположения отсчета, где xAk=xP-1, yAo=yP+nPSH и yA1=yA0 - MinPuSize. Набор местоположений отсчета (xAk, yAk) представляет собой местоположения отсчета непосредственно с левой стороны левой границы разделения и ее продленной линии.

2. Пусть флаг availableFlagLXA доступности будет первоначально полагаться равным 0, и обе компоненты mvLXA полагаться равными 0.

3. Когда одно или несколько из следующих условий истинно, переменная isScaledFlagLX полагается равной 1, в данном примере:

- Элемент прогнозирования, покрывающий местоположение (xA0, yA0) яркости доступен [Ed. (Ред.) (BB): Переписать с использованием MinCbAddrZS[][] и процесса доступности для минимальных блоков кодирования], и PredMode не MODE_INTRA.

- Элемент прогнозирования, покрывающий местоположение (xA1, yA1) яркости доступен [Ed. (BB): Переписать с использованием MinCbAddrZS[][] и процесса доступности для минимальных блоков кодирования], и PredMode не MODE_INTRA.

4. Для (xAk, yAk) от (xA0, yA0) до (xA1, yA1), где yA1=yA0-MinPuSize, следующее применяется повторно до тех пор, пока availableFlagLXA не равен 1:

- Если элемент прогнозирования, покрывающий местоположение (xAk, yAk) яркости доступен [Ed. (BB): Переписать с использованием MinCbAddrZS[][] и процесса доступности для минимальных блоков кодирования], и PredMode не MODE_INTRA, predFlagLX[xAk][yAk] равен 1, и опорный индекс refIdxLX[xAk][yAk] равен опорному индексу refIdxLX текущего элемента прогнозирования, то availableFlagLXA полагается равным 1, вектор mvLXA движения полагается равным вектору mvLX[xAk][yAk] движения, refIdxA полагается равным refIdxLX[xAk][yAk], а ListA полагается равным ListX.

- Иначе, если элемент прогнозирования, покрывающий местоположение (xAk, yAk) яркости доступен [Ed. (BB): Переписать с использованием MinCbAddrZS[][] и процесса доступности для минимальных блоков кодирования], и PredMode не MODE_INTRA, predFlagLX[xAk][yAk] (где Y=!X) равен 1, и PicOrderCnt(RefPicListY[refIdxLY[xAk][yAk]]) равен PicOrderCnt(RefPicListХ[refIdxLХ]), то availableFlagLXA полагается равным 1, вектор mvLXA движения полагается равным вектору mvLY[xAk][yAk] движения, refIdxA полагается равным refIdxLY[xAk][yAk], а ListA полагается равным ListY, и mvLXA полагается равным mvLXA.

5. Когда availableFlagLXA равен 0, то для (xAk, yAk) от (xA0, yA0) до (xA1, yA1), где yA1=yA0 - MinPuSize, следующее применяется повторно, пока availableFlagLXA не равен 1, в данном примере:

- Если элемент прогнозирования, покрывающий местоположение (xAk, yAk) яркости доступен [Ed. (BB): Переписать с использованием MinCbAddrZS[][] и процесса доступности для минимальных блоков кодирования], и PredMode не MODE_INTRA, predFlagLX[xAk][yAk] равен 1, и RefPicListX[refIdxLX] и refPicListX[refIdxLX[xAk][yAk]] оба являются долгосрочными опорными изображениями или оба являются краткосрочными опорными изображениями, то availableFlagLXA полагается равным 1, вектор mvLXA движения полагается равным вектору mvLX[xAk][yAk] движения, refIdxA полагается равным refIdxLX[xAk][yAk], а ListA полагается равным ListX.

- Иначе, если элемент прогнозирования, покрывающий местоположение (xAk, yAk) яркости доступен [Ed. (BB): Переписать с использованием MinCbAddrZS[][] и процесса доступности для минимальных блоков кодирования], и PredMode не MODE_INTRA, predFlagLY[xAk][yAk] (где Y=!X) равен 1, и RefPicListX[refIdxLX] и RefPicListY[refIdxLY[xAk][yAk]] оба являются долгосрочными опорными изображениями или оба являются краткосрочными опорными изображениями, то availableFlagLXA полагается равным 1, а вектор mvLXA движения полагается равным вектору mvLY[xAk][yAk] движения, refIdxA полагается равным refIdxLY[xAk][yAk], а ListA полагается равным ListY.

- Когда availableFlagLXA равен 1, и оба RefPicListА[refIdxLА] и RefPicListX[refIdxLX] оба являются краткосрочными опорными изображениями, то mvLXA извлекают, как указано ниже (где обозначение 8-### относится к разделам текущей рабочей версии HEVC, то есть к WD7):

tx=(16384+(Abs(td)>>1))/td (8-126)

DistScaleFactor = Clip3(-4096, 4095, (tb* tx+32)>>6) (8-127)

mvLXA=Clip3(-8192, 8191.75, Sign(DistScaleFactor* mvLXA)* ((Abs(DistScaleFactor* mvLXA)+127)>>8)) (8-128),

где td и tb могут быть извлечены так:

td=Clip3(-128, 127, PicOrderCntVal- PicOrderCnt(RefPicListA[refIdxA])) (8-129)

tb=Clip3(-128, 127, PicOrderCntVal- PicOrderCnt(RefPicListX[refIdxLX])) (8-130).

Видеокодер 20 и видеодекодер 30 могут выполнены с возможностью извлекать вектор mvLXB движения и флаг availableFlagLXB доступности в следующем порядке этапов в одном примере, где подчеркнутый текст представляет собой изменения относительно HEVC WD7:

1. Пусть набор из трех местоположений отсчета будет (xВk, yВk), где k=0, 1, 2, указывающая местоположения отсчета, где xВ0=xP+nPSW, xВ1=xВ0 - MinPuSize, хВ2=хP-MinPuSize и yВk=yР-1. Набор местоположений отсчета (xВk, yВk) представляет собой местоположения отсчета непосредственно с верхней стороны границы разделения сверху и ее продленной линии. [Ed. (BB): Определить MinPuSize в SPS, но извлечение должно зависеть от использования флага AMP].

2. Когда уР-1 меньше, чем ((yC>>Log2CtbSize)<<Log2CtbSize), то применяется следующее:

xB0=(xB0>>3)<<3)+((xB0>>3)&1)*7 (8-131)

xB1=(xB1>>3)<<3)+((xB1>>3)&1)*7 (8-132)

xB2=(xB2>>3)<<3)+((xB2>>3)&1)*7 (8-133).

3. Пусть флаг availableFlagLXВ доступности будет первоначально полагаться равным 0, и обе компоненты mvLXВ полагаться равными 0.

4. Для (xВk, yВk) от (xВ0, yВ0) до (xВ2, yВ2), где хВ0=xP+nPSW, xB1=xB0 - MinPuSize и xB2=xP - MinPuSize, то следующее применяется повторно до тех пор, пока availableFlagLXВ не равен 1:

- Если элемент прогнозирования, покрывающий местоположение (xВk, yВk) яркости доступен [Ed. (BB): Переписать с использованием MinCbAddrZS[][] и процесса доступности для минимальных блоков кодирования], и PredMode не MODE_INTRA, predFlagLX[xВk][yВk] равен 1, и опорный индекс refIdxLX[xВk][yВk] равен опорному индексу refIdxLX текущего элемента прогнозирования, то availableFlagLXВ полагается равным 1, вектор mvLXВ движения полагается равным вектору mvLX[xВk][yВk] движения, refIdxВ полагается равным refIdxLX[xВk][yВk], а ListВ полагается равным ListX.

- Иначе, если элемент прогнозирования, покрывающий местоположение (xВk, yВk) яркости доступен [Ed. (BB): Переписать с использованием MinCbAddrZS[][] и процесса доступности для минимальных блоков кодирования], и PredMode не MODE_INTRA, predFlagLY[xВk][yВk] (где Y=!X) равен 1, и PicOrderCnt(RefPicListY[refIdxLY[xВk][yВk]]) равен PicOrderCnt(RefPicListХ[refIdxLХ]), то availableFlagLXВ полагается равным 1, вектор mvLXВ движения полагается равным вектору mvLY[xВk][yВk] движения, refIdxВ полагается равным refIdxLY[xВk][yВk], а ListВ полагается равным ListY.

5. Когда isScaledFlagLX равен 0 и availableFlagLXB равен 1, то mvLXA полагается равным mvLXB, refIdxA полагается равным refIdxB, и availableFlagLXA полагается равным 1.

6. Когда isScaledFlagLX равен 0, то availableFlagLXB полагается равным 0 и для (xВk, yВk) от (xВ0, yВ0) до (xВ2, yВ2), где xВ0=xP+nPSW, xВ1 = xВ0 - MinPuSize, и xВ2=xP-MinPuSize, следующее применяется повторно, пока availableFlagLXВ не равен 1:

- Если элемент прогнозирования, покрывающий местоположение (xВk, yВk) яркости доступен [Ed. (BB): Переписать с использованием MinCbAddrZS[][] и процесса доступности для минимальных блоков кодирования], и PredMode не MODE_INTRA, predFlagLX[xВk][yВk] равен 1, и RefPicListX[refIdxLX] и RefPicListX[refIdxLX[xВk][yВk]] оба являются долгосрочными опорными изображениями или оба являются краткосрочными опорными изображениями, то availableFlagLXВ полагается равным 1, вектор mvLXВ движения полагается равным вектору mvLX[xВk][yВk] движения, refIdxВ полагается равным refIdxLX[xВk][yВk], а ListВ полагается равным ListX.

- Иначе, если элемент прогнозирования, покрывающий местоположение (xВk, yВk) яркости доступен [Ed. (BB): Переписать с использованием MinCbAddrZS[][] и процесса доступности для минимальных блоков кодирования], и PredMode не MODE_INTRA, predFlagLY[xВk][yВk] (где Y=!X) равен 1, и RefPicListX[refIdxLX] и RefPicListY[refIdxLY[xВk][yВk]] оба являются долгосрочными опорными изображениями или оба являются краткосрочными опорными изображениями, то availableFlagLXВ полагается равным 1, а вектор mvLXВ движения полагается равным вектору mvLY[xВk][yВk] движения, refIdxВ полагается равным refIdxLY[xВk][yВk], а ListВ полагается равным ListY.

- Когда availableFlagLXВ равен 1, PicOrderCnt(RefPicListB[refIdxB]) не равен PicOrderCnt(RefPicListX[refIdxLX]), и RefPicListВ[refIdxLВ] и RefPicListX[refIdxLX] оба являются краткосрочными опорными изображениями, то mvLXВ извлекают, как указано ниже (где обозначение 8-### относится к разделам текущей рабочей версии HEVC):

tx = (16384+(Abs(td)>>1))/td (8-134)

DistScaleFactor = Clip3(-4096, 4095, (tb* tx+32)>>6) (8-135)

mvLXB = Clip3(-8192, 8191.75, Sign(DistScaleFactor * mvLXA)* ((Abs(DistScaleFactor* mvLXA)+127)>>8)) (8-136),

где td и tb могут быть извлечены так:

td=Clip3(-128, 127, PicOrderCntVal- PicOrderCnt(RefPicList[refIdxB])) (8-137)

tb=Clip3(-128, 127, PicOrderCntVal- PicOrderCnt(RefPicListX[refIdxLX])) (8-138).

Видеокодер 20 и видеодекодер 30 могут также быть выполнены с возможностью выполнять модифицированный процесс извлечения для временного прогнозирования вектора движения (TMVP) для кодирования векторов движения блоков сигнала яркости. В одном примере вводы в этот процесс включают в себя местоположение (хР, уР) яркости, указывающее верхний левый отсчет яркости текущего элемента прогнозирования относительно верхнего левого отсчета текущего изображения, переменные, указывающие ширину и высоту элемента прогнозирования для яркости, nPSW и nPSH, и опорный индекс разделения refIdxLX (где Х равен 0 или 1) текущего элемента прогнозирования. Выводы этого процесса могут включать в себя прогнозирование mvLXCol вектора движения и флаг availableFlagLXCol доступности.

В одном примере видеокодер 20 и видеодекодер 30 могут выполнять функцию RefPicOrderCnt(picX, refIdx, LX), которая возвращает счет PicOrderCntVal порядка изображения опорного изображения с индексом refIdx из списка LX опорных изображений изображения picХ. Эта функция может быть определена, как указано далее, где (8-141) и подобные ссылки в этом описании относятся к разделам HEVC WD7:

RefPicOrderCnt(picX, refIdx, LX)= PicOrderCnt(RefPicListX[refIdx] изображения PicX) (8-141).

В зависимости от значений slice_type, collocated_from_10_flag и collocated_ref_idx, переменная colPic, определяющая изображение, которое содержит совмещенное разделение, может быть извлечена следующим образом:

- Если slice_type равен В и collocated_from_10_flag равен 0, то переменная colPic определяет изображение, которое содержит совмещенное разделение, как определено RefPicList1[collocated_ref_idx].

- Иначе, (slice_type равен В и collocated_from_10_flag равен 1 либо slice_type равен Р), переменная colPic определяет изображение, которое содержит совмещенное разделение, как указано RefPicList0 [collocated_ref_idx].

Переменная colPu и ее положение (xPCol, yPCol) могут быть извлечены с использованием следующего порядка этапов:

1. Переменная colPu может быть извлечена следующим образом:

yPRb=yP+nPSH (8-139)

- Если (yP>>Log2CtbSize) равна (yPRb>>Log2CtbSize), то горизонтальная компонента правого нижнего положения яркости текущего элемента прогнозирования определяется так:

xPRB=xP+nPSW (8-140)

и переменная colPu полагается равной элементу прогнозирования, покрывающему модифицированное положение, заданное ((xPRb>>4) <<4, (yPRb>>4) <<4) внутри colPic.

- Иначе, ((yP>>Log2CtbSize) не равен (yPRB>>Log2CtbSize)), colPu маркируется как «недоступная».

2. Когда colPU кодируется в режиме внутреннего прогнозирования, либо colPu промаркирована как «недоступная», то применяется следующее:

- Центральное положение яркости текущего элемента прогнозирования определяется так:

xPCtr=(xP+(nPSW>>1) (8-141)

yPCtr=(yP+(nPSH>>1) (8-142)

- Переменная ColPu полагается равной элементу прогнозирования, покрывающему модифицированное положение, заданное ((xPCtr>>4) <<4), (yPCtr>>4) <<4) внутри colPic.

(xPCol, yPCol) полагается равным верхнему левому отсчету яркости colPu относительно верхнего левого отсчета яркости colPic.

Функция LongTermRefPic (picX, refIdx, LX) может быть определена следующим образом. Если опорное изображение с индексом refIdx из списка LX опорных изображений изображения picX было промаркировано как «используемое для долгосрочной ссылки» в момент, когда picX было текущим изображением, то LongTermRefPic (picX, refIdx, LX) возвращает 1; иначе LongTermRefPic (picX, refIdx, LX) возвращает 0.

Переменные mvLXCol и availableFlagLXCol могут быть извлечены следующим образом, где подчеркнутый текст представляет собой изменения относительно HEVC WD7:

- Если одно или несколько следующих условий истинно, то обе компоненты mvLXCol полагаются равными 0, и availableFlagLXCol полагается равным 0.

- colPU кодируется в режиме внутреннего прогнозирования.

- colPu промаркирована как «недоступная».

- pic_temporal_mvp_enable_flag равен 0.

- Иначе, вектор mvCol движения, опорный индекс refIdxCol и идентификатор listCol опорного списка извлекаются следующим образом:

- Если PredFlagL0[xPCol][yPCol] равен 0, то mvCol, refIdxCol и listCol полагаются равными MvL1[xPCol][yPCol], RefIdxL1[xPCol][yPCol] и L1 соответственно.

- Иначе, (PredFlagL0[xPCol][yPCol] равен 1), применяется следующее:

- Если PredFlagL1[xPCol][yPCol] равен 0, то mvCol, refIdxCol и listCol полагаются равными MvL0[xPCol][yPCol], RefIdxL0[xPCol][yPCol] и L0 соответственно.

- Иначе, (PredFlagL1[xPCol][yPCol] равен 1), делаются следующие назначения.

- Если PicOrderCnt(pic) каждого изображения pic в каждом списке опорных изображений меньше или равен PicOrderCntVal, то mvCol, refIdxCol и listCol полагаются равными MvLХ[xPCol][yPCol], RefIdxLХ[xPCol][yPCol] и LХ соответственно, где Х является значением X, для которого вызван этот процесс.

- Иначе, (PicOrderCnt(pic) по меньшей мере одного изображения pic в по меньшей мере одном списке опорных изображений больше, чем PicOrderCntVal, то mvCol, refIdxCol и listCol полагаются равными MvLN[xPCol][yPCol], RefIdxLN[xPCol][yPCol] и LN соответственно, где N является значением collocated_from_10_flag.

- Если одно из следующих условий истинно, то переменная availableFlagLXCol полагается равной 0:

- RefPicListX[refIdxLX] является долгосрочным опорным изображением, и LongTermRefPic(colPic, refIdxCol, listCol) равна 0;

- RefPicListX[refIdxLX] является краткосрочным опорным изображением, и LongTermRefPic(colPic, refIdxCol, listCol) равна 1;

- Иначе, переменная availableFlagLXCol полагается равной 1 и применяется следующее:

- Если RefPicListX[refIdxLX] является долгосрочным опорным изображением, или LongTermRefPic(colPic, refIdxCol, listCol) равна 1, или PicOrderCnt(colPic) - RefPicOrderCnt(colPic, refIdxCol, listCol) равно PicOrderCntVal - PicOrderCnt(RefPicListX[refIdxLX]), то

mvLXCol = mvCol (8-143).

- Иначе, mvLXCol извлекается как масштабированная версия вектора mvCol движения, как определено ниже:

tx=(16384+(Abs(td)>>1))/td (8-144)

DistScaleFactor=Clip3(-4096, 4095, (tb* tx+32)>>6) (8-145)

mvLXCol=Clip3(-8192, 8191.75, Sign(DistScaleFactor* mvCol) * ((Abs(DistScaleFactor* mvCol)+127)>>8)) (8-146),

где td и tb могут быть извлечены так:

td=Clip3(-128, 127, PicOrderCnt(colPic)- RefPicOrderCnt(colPic, refIdxCol, listCol)) (8-147)

tb=Clip3(-128, 127, PicOrderCntVal- PicOrderCnt(RefPicListX[refIdxLX])) (8-148).

В вышеуказанном примере доступность совмещенного блока, используемого во время TMVP, также может зависеть от типа опорного изображения (например, является ли изображение долгосрочным или краткосрочным опорным изображением) для совмещенного блока. То есть даже когда правый нижний блок для TMVP доступен (после этапа 1 в подпункте), то нижний правый блок может дополнительно полагаться недоступным, если вектор движения в блоке ссылается на тип изображения (краткосрочный или долгосрочный), который отличается от типа целевого опорного изображения. Подобным образом центральный блок может дополнительно быть использован для TMVP.

Например, видеокодер 20 и видеодекодер 30 могут быть выполнены с возможностью извлекать предиктор вектора движения для вектора движения яркости в соответствии со следующим подробным примером. Вводы в этот процесс, осуществляемые видеокодером 20 и видеодекодером 30, могут включать в себя:

- местоположение (xP, yP) яркости, определяющее верхний левый отсчет яркости текущего элемента прогнозирования относительно верхнего левого отсчета текущего изображения,

- переменные, определяющие ширину и высоту элемента прогнозирования для яркости, nPSW и NPSH,

- опорный индекс разделения refIdxLX (где Х равен 0 или 1) текущего элемента прогнозирования.

Выводы из этого процесса могут включать в себя:

- прогнозирование mvLXCol вектора движения,

- флаг availableFlagLXCol доступности.

Функция RefPicOrderCnt(picX, refIdx, LX), при выполнении ее видеокодером 20 и/или видеодекодером 30 может возвращать счет PicOrderCntVal порядка изображения опорного изображения из списка LX опорных изображений изображения picX. Пример осуществления этой функции определен следующим образом:

RefPicOrderCnt(picX, refIdx, LX)= PicOrderCnt(RefPicListX[refIdx] изображения picX) (8-141).

В зависимости от значений slice_type, collocated_from_10_flag и collocated_ref_idx, переменная colPic, определяющая изображение, которое содержит совмещенное разделение, может быть извлечена следующим образом:

- Если slice_type равен В и collocated_from_10_flag равен 0, то переменная colPic определяет изображение, которое содержит совмещенное разделение, как определено RefPicList1[collocated_ref_idx].

- Иначе, (slice_type равен В и collocated_from_10_flag равен 1 либо slice_type равен Р), переменная colPic определяет изображение, которое содержит совмещенное разделение, как указано RefPicList0 [collocated_ref_idx].

Видеокодер 20 и видеодекодер 30 могут извлекать переменную colPu и ее положение (xPCol, yPCol) с использованием следующего порядка этапов:

1. Видеокодер 20 и видеодекодер 30 могут извлекать переменную colPu следующим образом:

yPRb = yP + nPSH (8-139)

- Если (yP>>Log2CtbSize) равна (yPRb>>Log2CtbSize), то горизонтальная компонента правого нижнего положения яркости текущего элемента прогнозирования определяется так:

xPRB=xP+nPSW (8-140)

и переменная colPu полагается равной элементу прогнозирования, покрывающему модифицированное положение, заданное ((xPRb>>4)<<4, (yPRb>>4)<<4) внутри colPic.

- Иначе, ((yP>>Log2CtbSize) не равен (yPRb>>Log2CtbSize)), то видеокодер 20 и видеодекодер 30 могут маркировать colPu как «недоступная».

2. Когда colPU кодируется в режиме внутреннего прогнозирования, либо colPu промаркирована как «недоступная», то применяется следующее в данном примере:

- Центральное положение яркости текущего элемента прогнозирования определяется так:

xPCtr=(xP+(nPSW>>1) (8-141)

yPCtr=(yP+(nPSH>>1) (8-142)

- Переменная ColPu полагается равной элементу прогнозирования, покрывающему модифицированное положение, заданное ((xPCtr>>4)<<4), (yPCtr>>4)<<4) внутри colPic.

3. Видеокодер 20 и видеодекодер 30 могут устанавливать (xPCol, yPCol) равным верхнему левому отсчету яркости colPu относительно верхнего левого отсчета яркости colPic.

Функция LongTermRefPic (picX, refIdx, LX) может быть определена следующим образом:

Если опорное изображение с индексом refIdx из списка LX опорных изображений изображения picX было промаркировано как «используемое для долгосрочной ссылки» в момент, когда picX было текущим изображением, то LongTermRefPic (picX, refIdx, LX) возвращает 1; иначе, LongTermRefPic (picX, refIdx, LX) возвращает 0.

Видеокодер 20 и видеодекодер 30 могут извлекать переменные mvLXCol и availableFlagLXCol следующим образом:

availableFlagLXCol полагается равным 0, numTestBlock равен 0.

Если numTestBlock меньше, чем 2, и availableFlagLXCol равен 0, то выполняется следующий порядок:

xPCtr=(xP+(nPSW>>1)