УРОВЕНЬ ТЕХНИКИ

[0001] Одним текущим использованием мобильных устройств является обеспечение "виртуальной" перспективы в окружении реального мира. В настоящее время, некоторые приложения, которые могут быть использованы на мобильных устройствах, используют ввода камеры от устройства и GPS-координаты для визуализации двухмерного изображения на объектах (обычно зданиях) в реальном мире. Эти объекты обычно имеют возможность просмотра с любого положения и обычно выглядят трехмерными, но визуализируются на плоском дисплее мобильного устройства.

[0002] Смешанная реальность является технологией, которая обеспечивает возможность смешивания виртуального объекта с физическим окружением реального мира. Пользователь может носить закрепляемое на голове устройство отображения (HMD), через которое смотрят, для просмотра смешанного изображения реальных объектов и виртуальных объектов, отображаемых в поле обзора пользователя.

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

[0003] Представлена технология, которая обеспечивает возможность для создания виртуального объекта с привязкой к перспективе. Виртуальный объект может потреблять (просматривать, слушать или взаимодействовать с ним) другой пользователь с потребляющим устройством в местоположении, положении и ориентации, которые являются такими же, или близкими к ним, как местоположение, положение и ориентация, где виртуальный объект создан. Объекты могут иметь одно, несколько или много допустимых местоположений, положений и ориентаций потребления, заданных их создателем.

[0004] В одном аспекте, предусматривается устройство, которое может создавать и/или потреблять совместно используемые виртуальные объекты с привязкой к перспективе. Определяются положение, ориентация и местоположение устройства. При потреблении совместно используемого виртуального объекта с привязкой к перспективе, принимается совместно используемый виртуальный объект, который включает в себя данные местоположения визуализации. Совместно используемый виртуальный объект отображается в потребляющем устройстве, если поле обзора потребляющего устройства находится в положении и ориентации, определенных как совпавшие с допустимыми.

[0005] При создании совместно используемого виртуального объекта с привязкой к перспективе, определяются местоположение в глобальных координатах, положение и ориентация для устройства захвата, и создаются данные визуализации совместно используемого виртуального объекта. Данные визуализации включают в себя данные местоположения визуализации для совместно используемого виртуального объекта. Данными местоположения визуализации может по меньшей мере быть местоположение в глобальных координатах, и по меньшей мере одно положение и по меньшей мере одна ориентация для виртуального объекта по отношению к системе локальных координат.

[0006] Это краткое изложение сущности изобретения предоставлено для введения подборки концепций в упрощенной форме, которые дополнительно описаны ниже в "Подробном описании". Это краткое изложение сущности изобретения не предназначено для идентификации ключевых признаков или существенных признаков заявленного изобретения, также не предназначено для использования в качестве помощи в определении объема заявленного изобретения.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

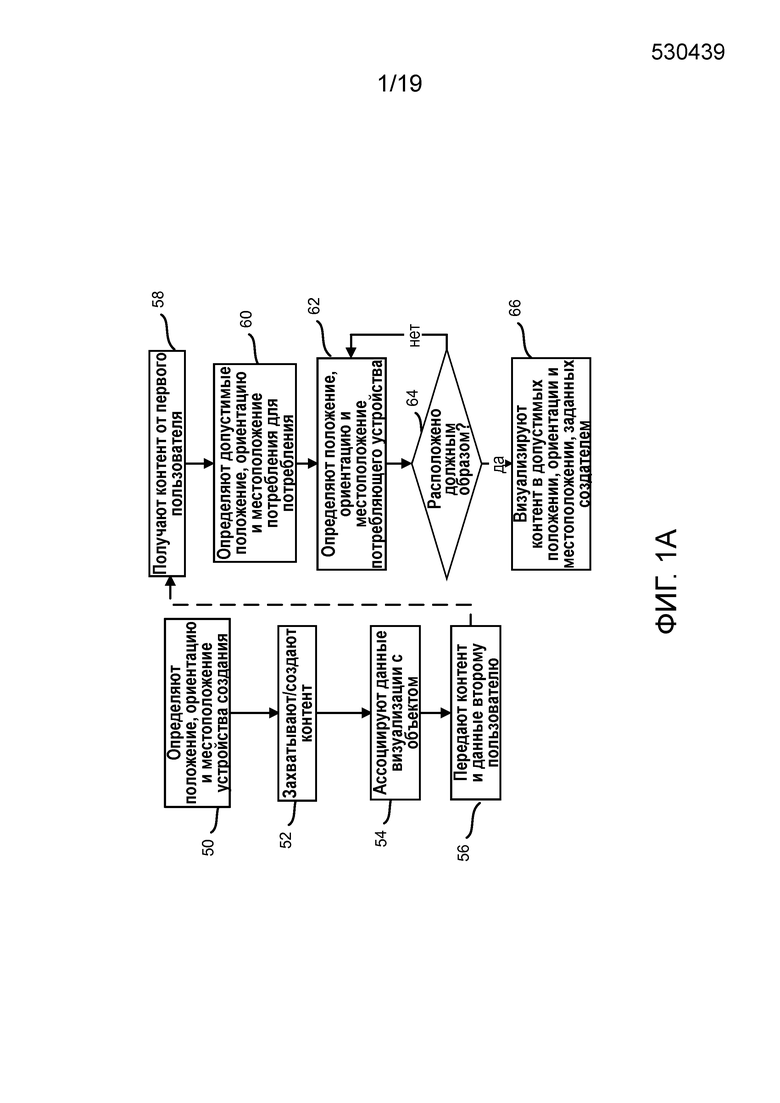

[0007] Фиг. 1A является способом, иллюстрирующим базовую реализацию настоящей технологии.

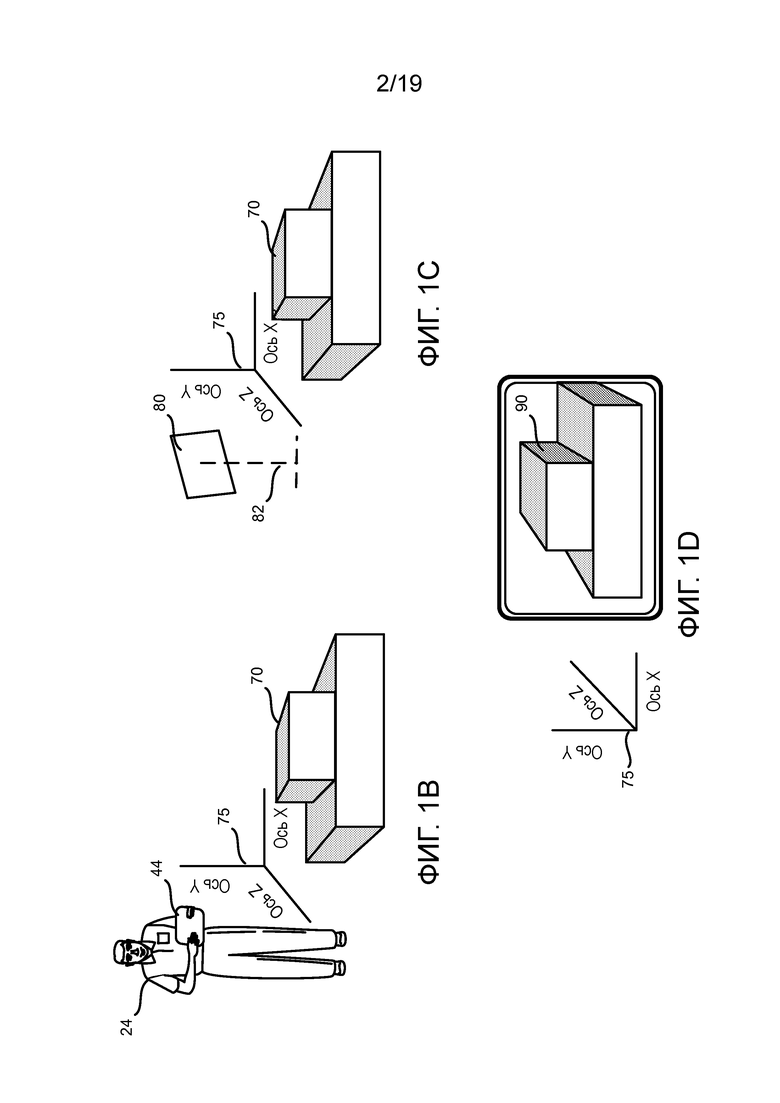

[0008] Фиг. 1B - 1D иллюстрируют пользователя, выполняющего аспекты способа по Фиг. 1A.

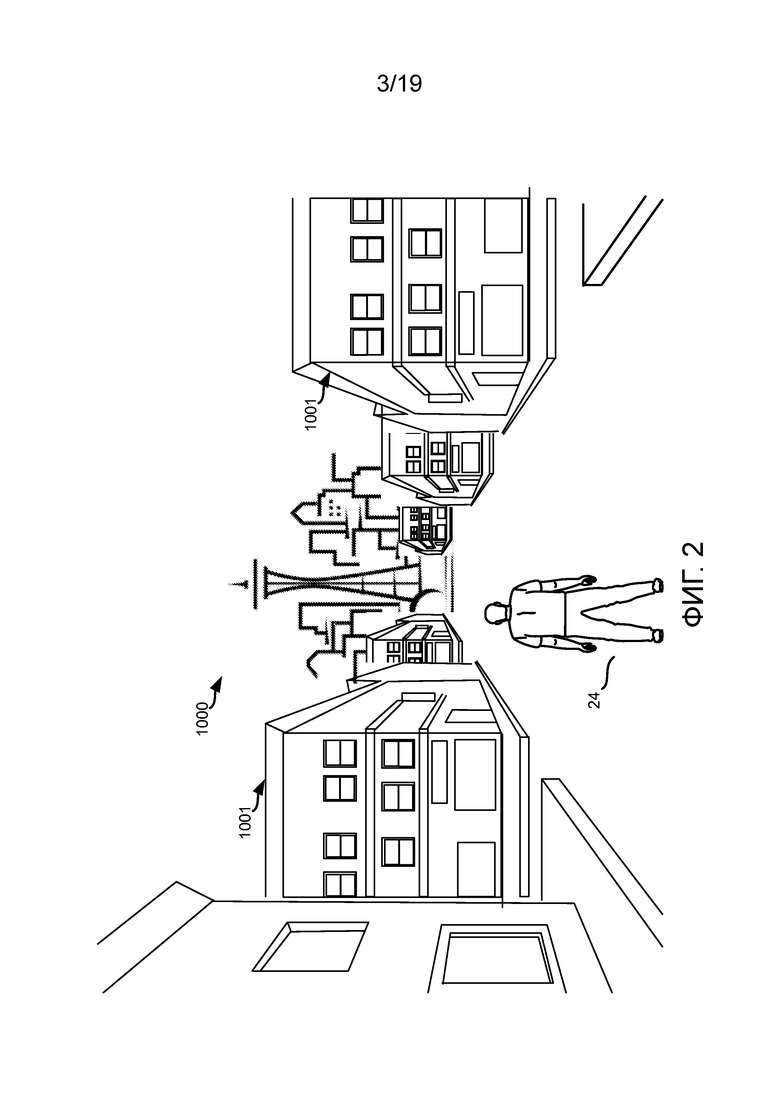

[0009] Фиг. 2 является общим видом пользователя, просматривающего окружение реального мира.

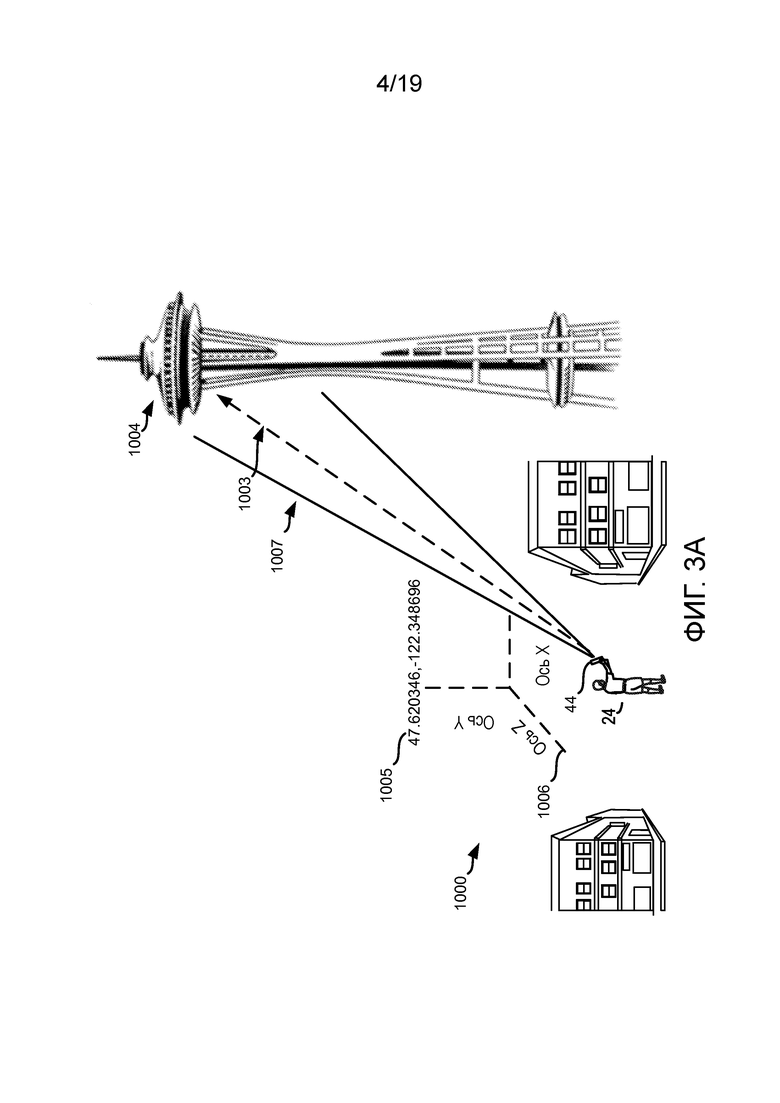

[0010] Фиг. 3A является общим видом пользователя, использующего устройства захвата в окружении реального мира.

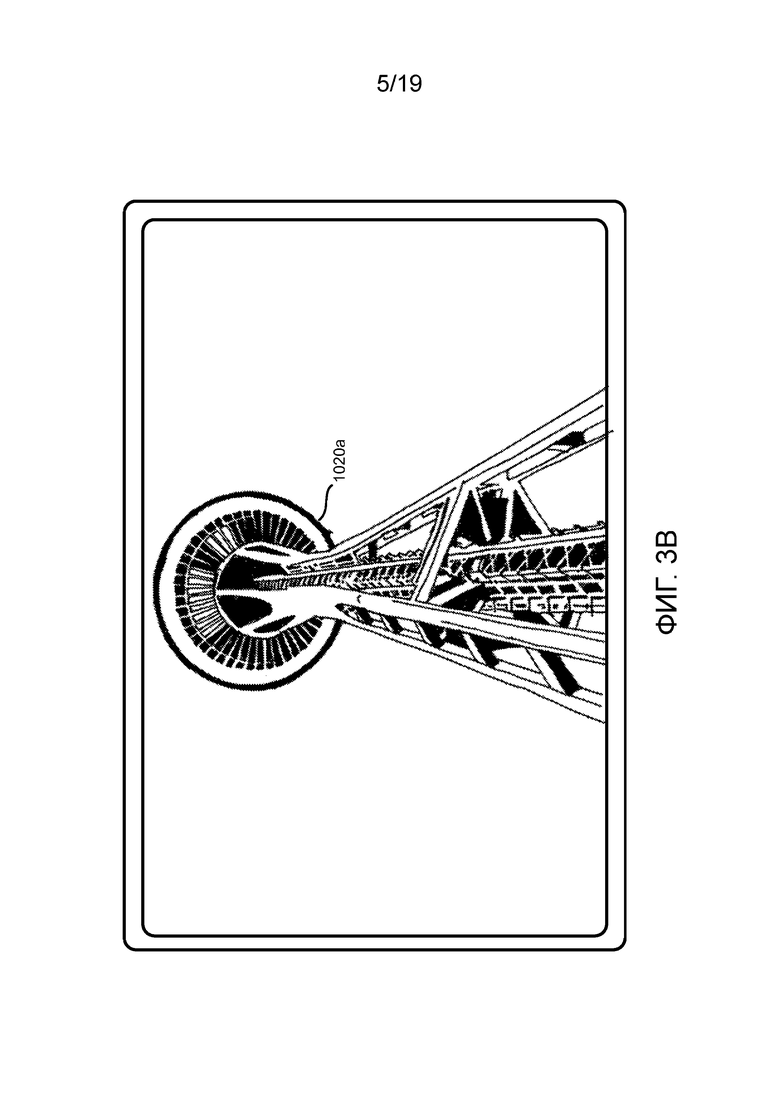

[0011] Фиг. 3B является изображением виртуального объекта, в этом случае изображения, на устройстве захвата пользователя на Фиг. 2.

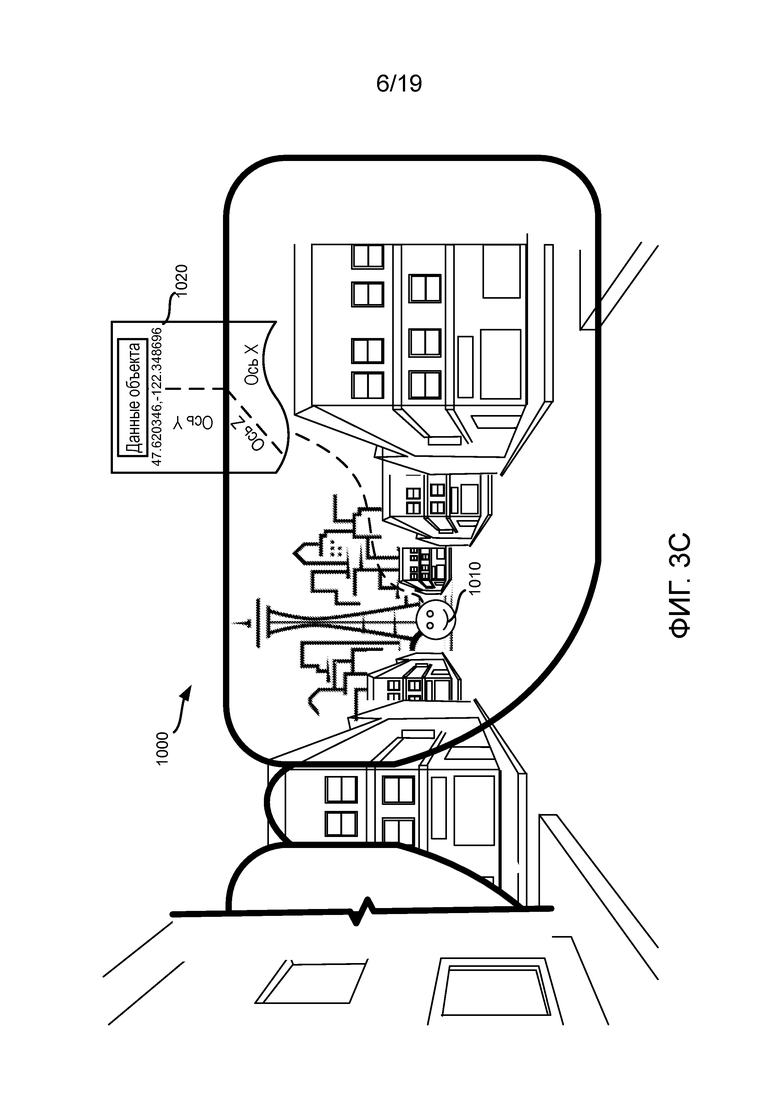

[0012] Фиг. 3C является изображением вида пользователя на Фиг. 2 через закрепляемое на голове устройство отображения, через которое смотрят.

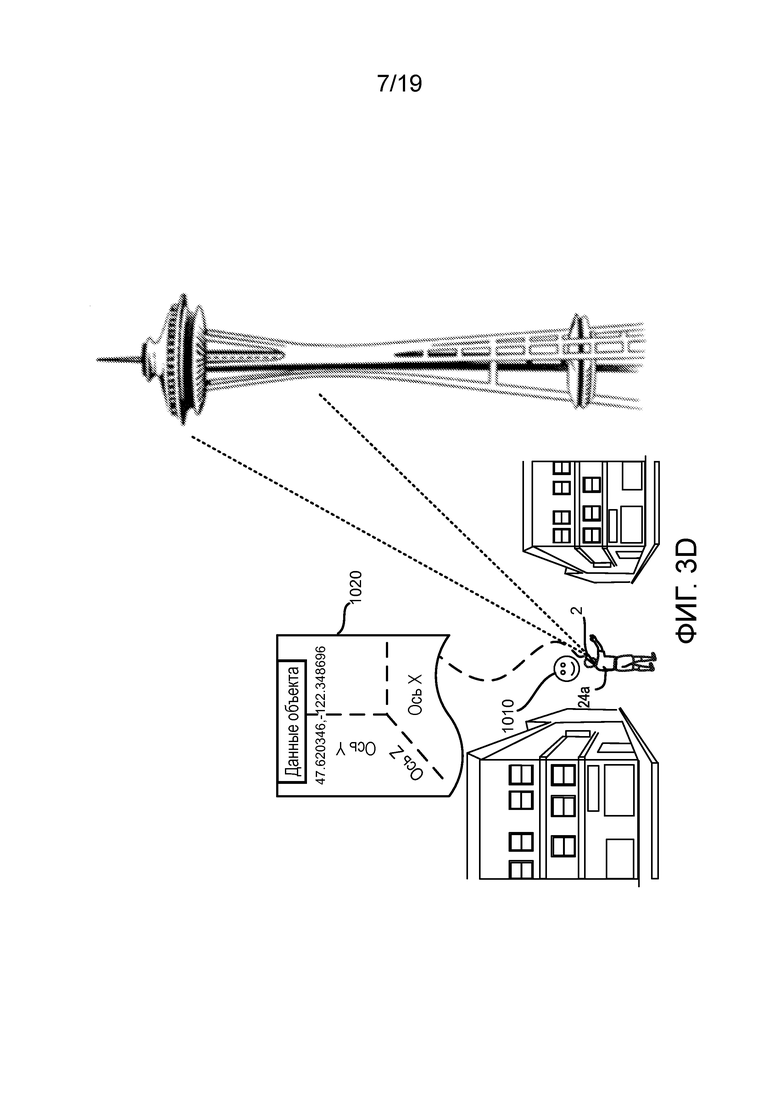

[0013] Фиг. 3D иллюстрирует пользователя в положении, ассоциированном с виртуальным маркером.

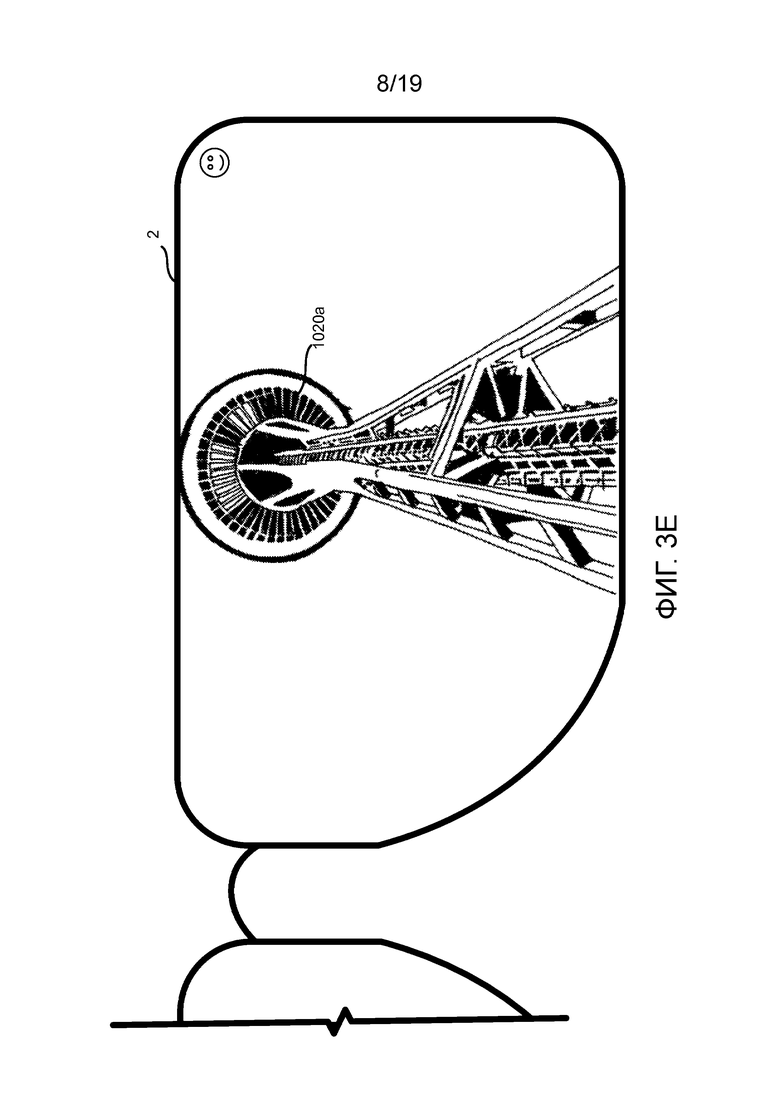

[0014] Фиг. 3E является изображением пользователя закрепляемого на голове устройства отображения, через которое смотрят, просматривающего виртуальный объект, захваченный на Фиг. 3B.

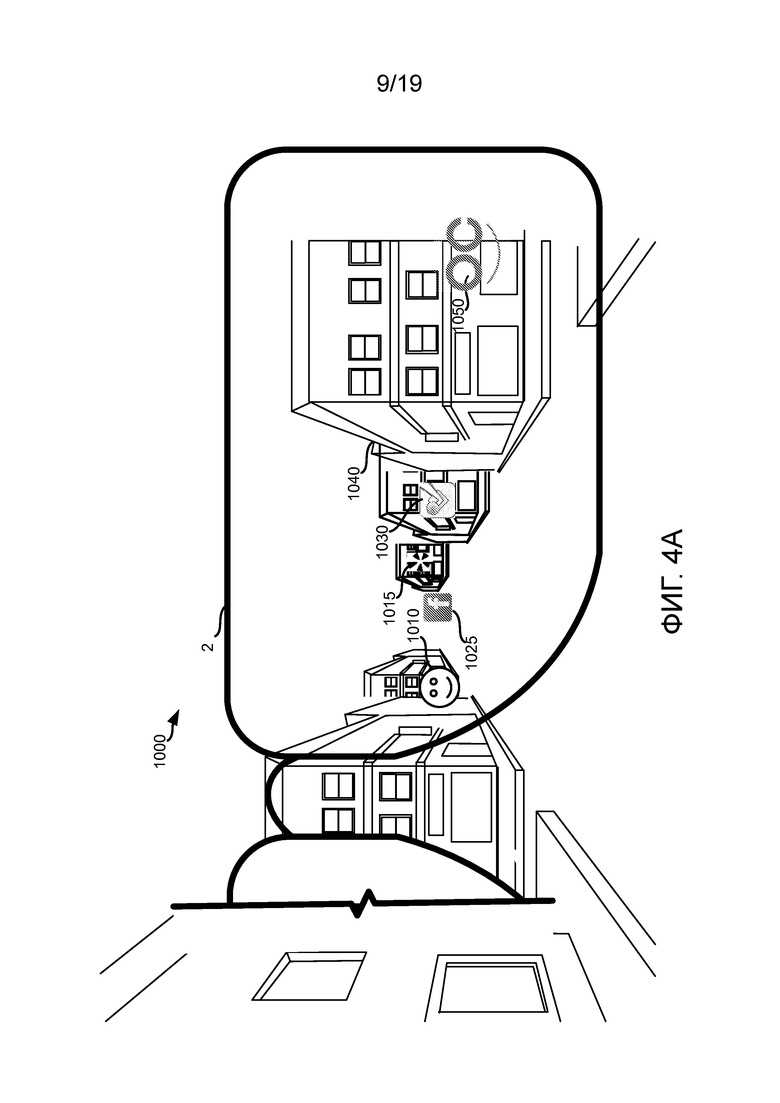

[0015] Фиг. 4A является вторым общим видом пользователя, просматривающего сцену на Фиг. 2 через закрепляемое на голове устройство отображения, через которое смотрят.

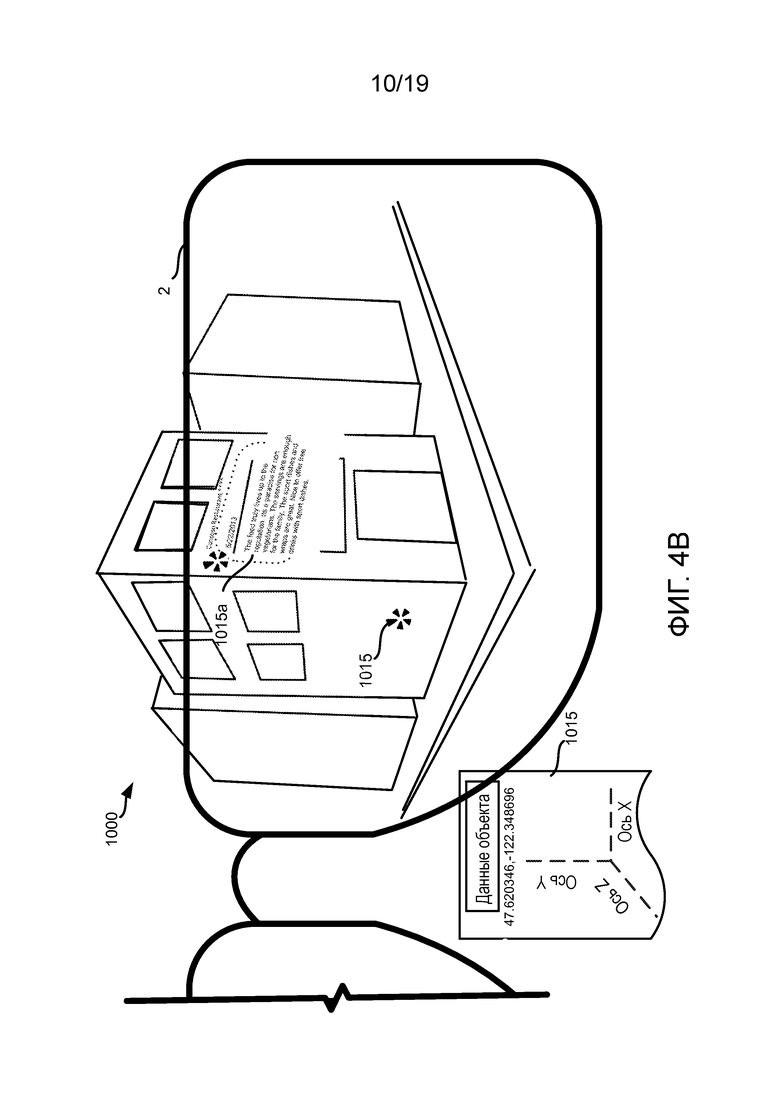

[0016] Фиг. 4B является видом виртуального объекта с привязкой к миру посредством вида закрепляемого на голове устройства отображения, через которое смотрят.

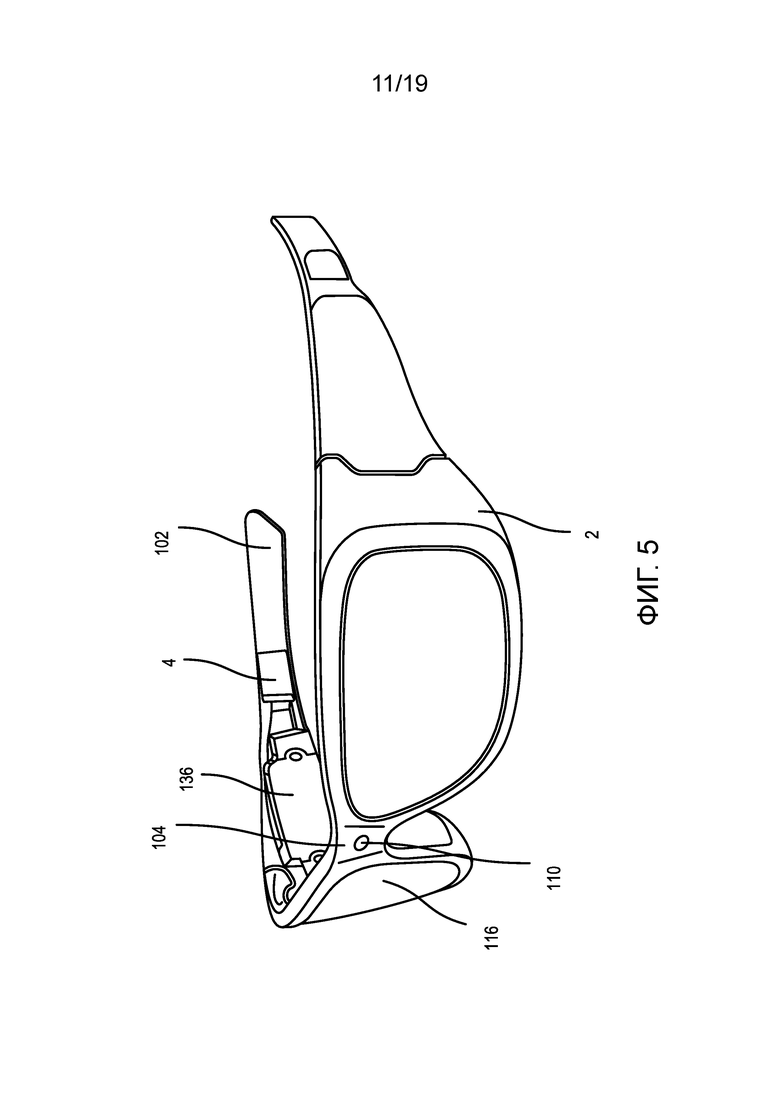

[0017] Фиг. 5 является общим видом одного варианта осуществления закрепляемого на голове блока отображения.

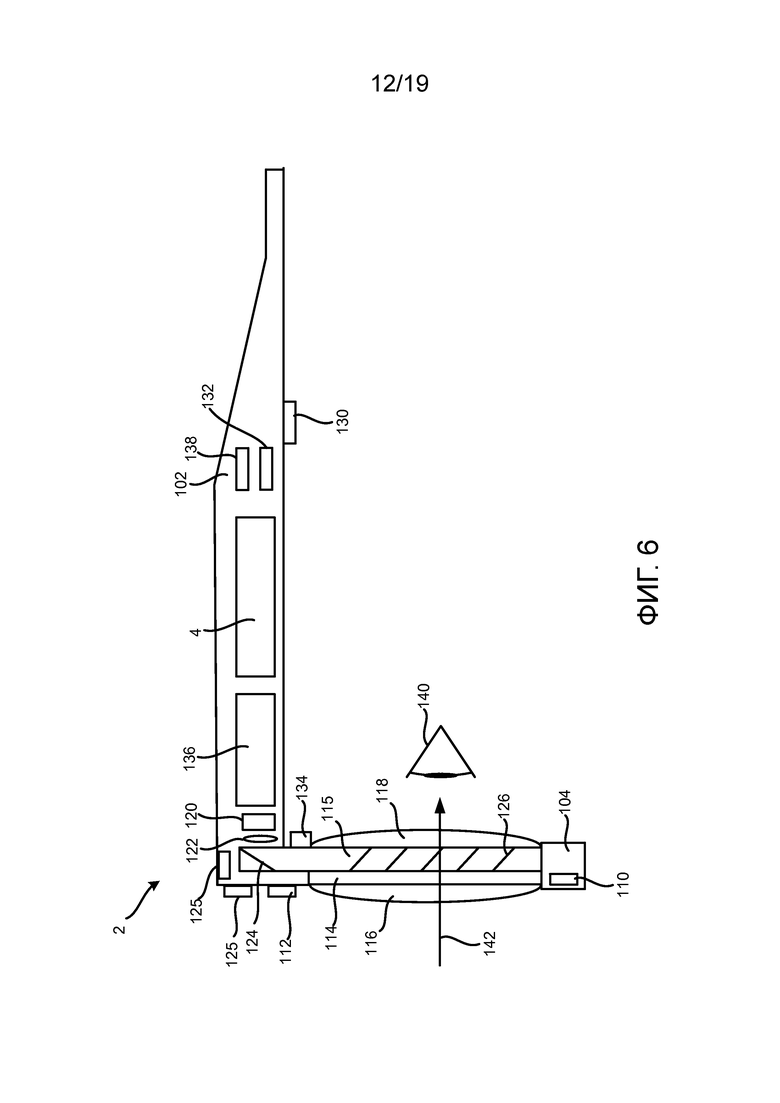

[0018] Фиг. 6 является видом сбоку участка одного варианта осуществления закрепляемого на голове блока отображения.

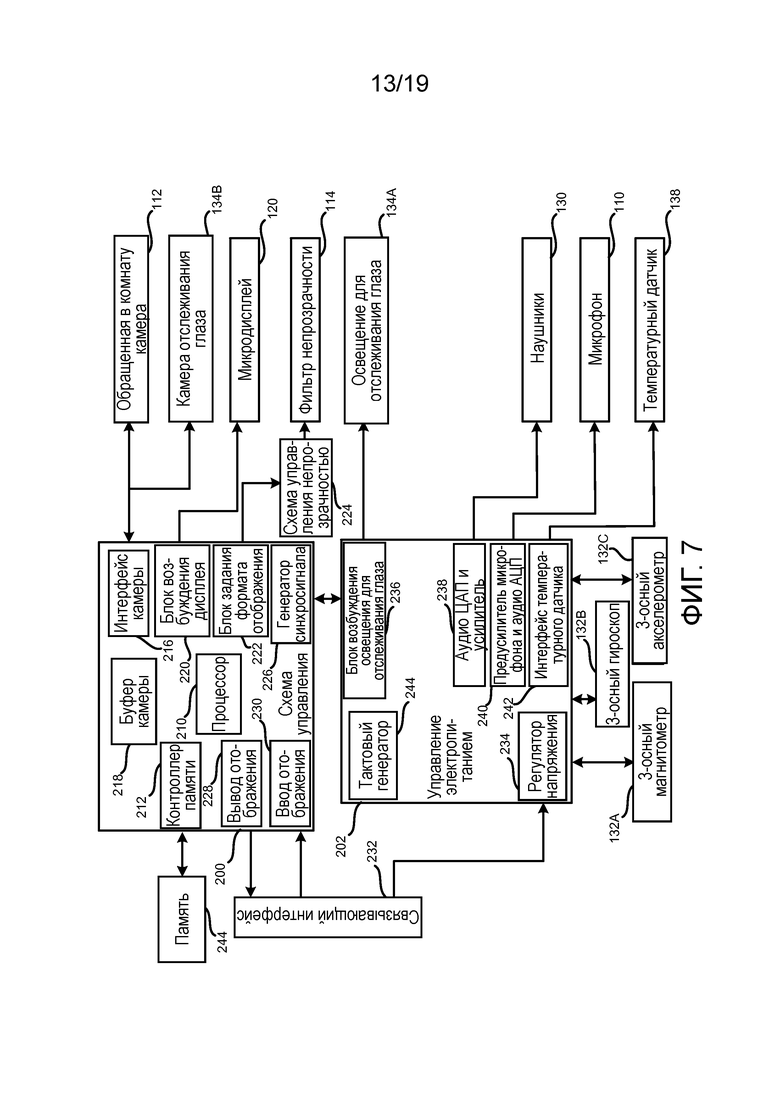

[0019] Фиг. 7 является блок-схемой одного варианта осуществления компонентов закрепляемого на голове блока отображения.

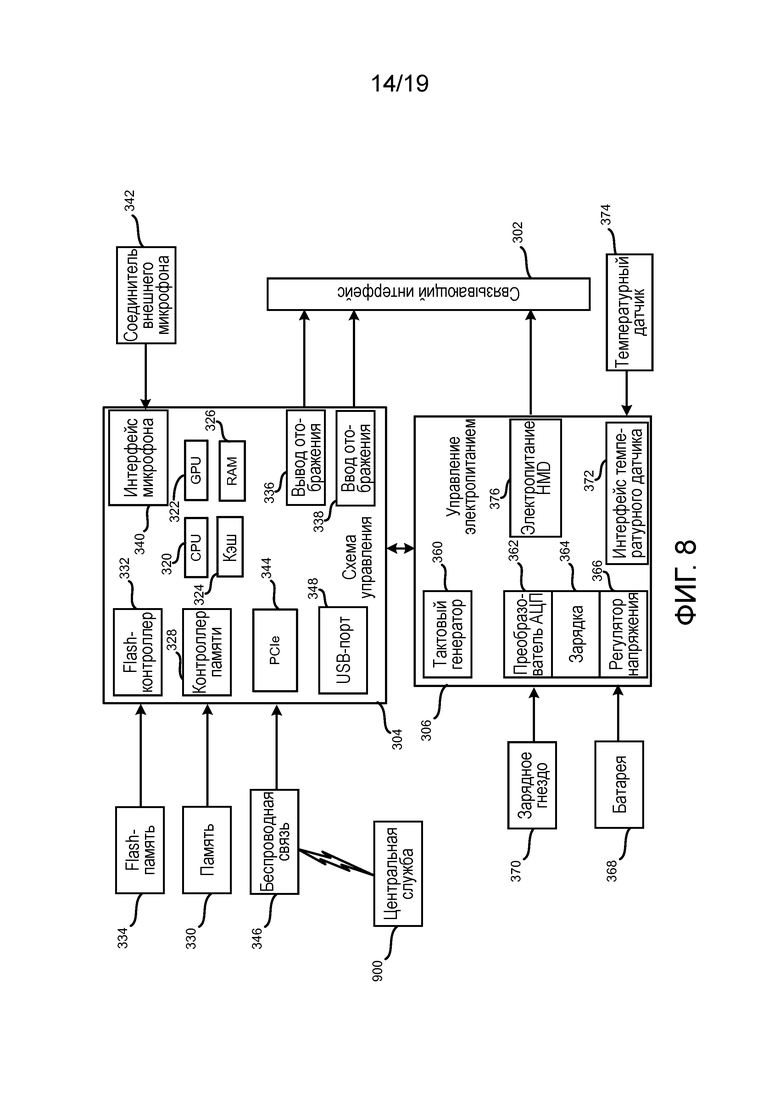

[0020] Фиг. 8 является блок-схемой одного варианта осуществления компонентов блока обработки, ассоциированного с закрепляемым на голове блоком отображения.

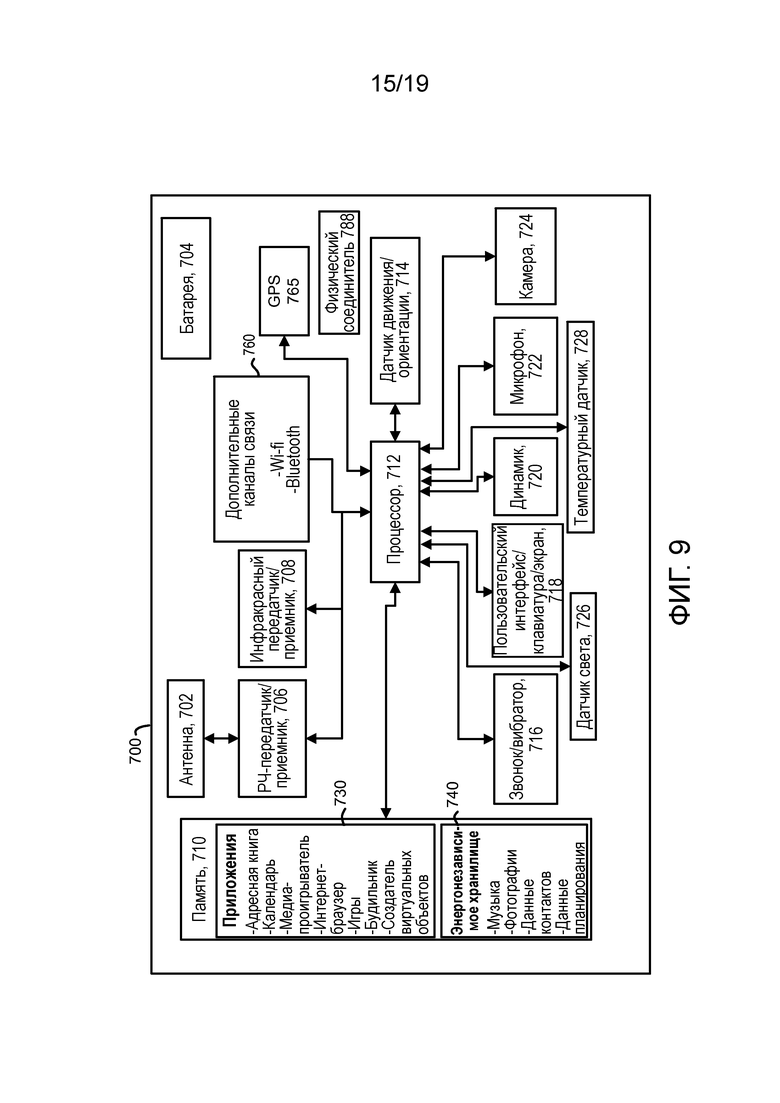

[0021] Фиг. 9 является блок-схемой одного варианта осуществления мобильного или планшетного вычислительного устройства.

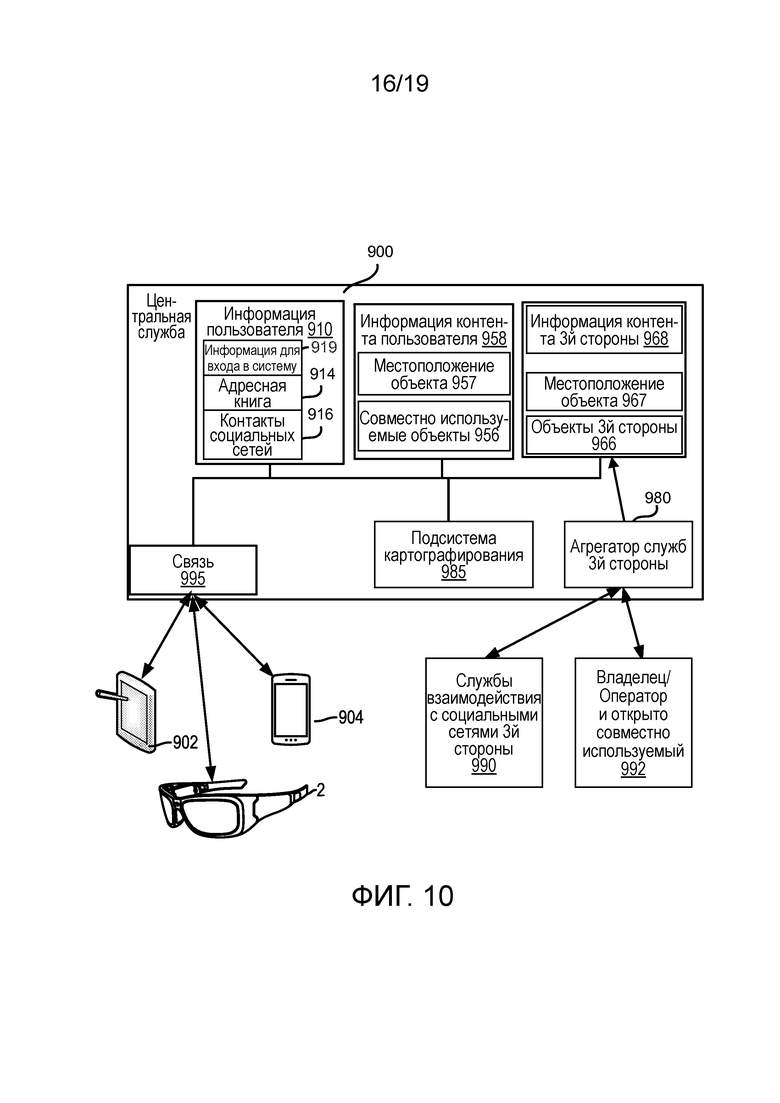

[0022] Фиг. 10 является блок-схемой системы для реализации центральной службы в соответствии с настоящей технологией.

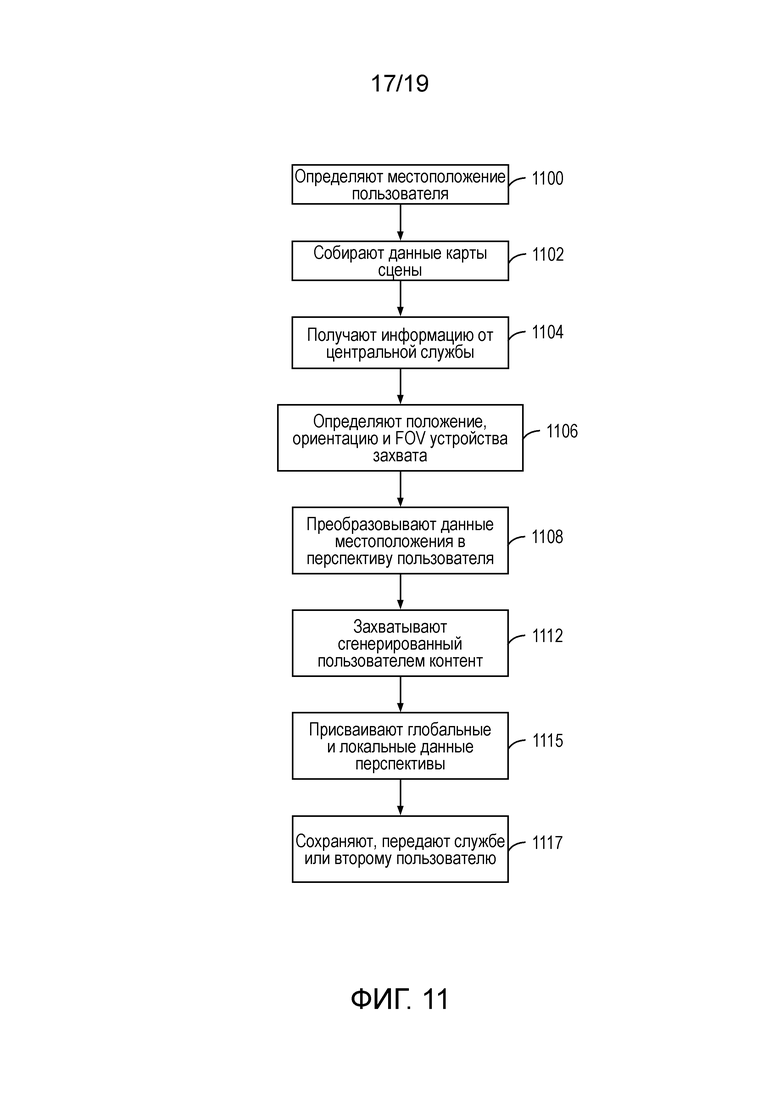

[0023] Фиг. 11 является схемой последовательности операций, изображающей создание контента пользователем или 3-ей стороной.

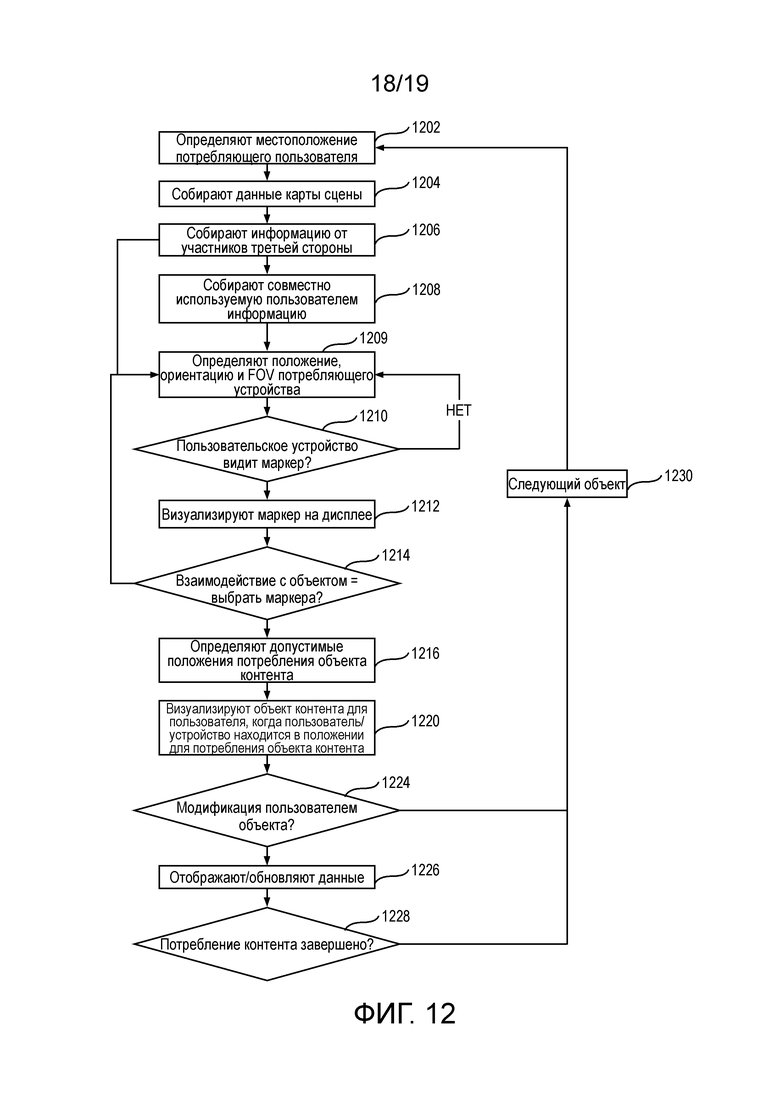

[0024] Фиг. 12 является схемой последовательности операций, иллюстрирующей отображение созданного пользователем контента в соответствии с настоящей технологией.

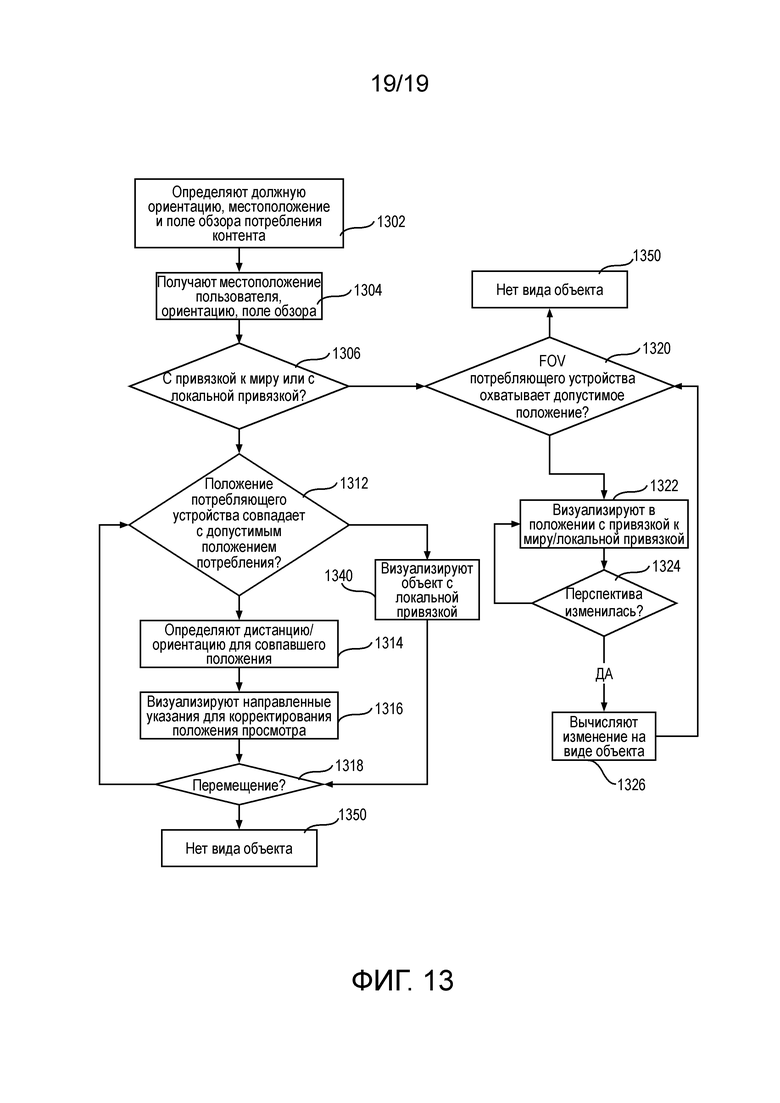

[0025] Фиг. 13 является схемой последовательности операций, иллюстрирующей этап 1222 на Фиг. 12.

ПОДРОБНОЕ ОПИСАНИЕ

[0026] Представлена технология, которая обеспечивает возможность для создания виртуального объекта с привязкой к перспективе в мировом пространстве. Виртуальный объект может потреблять (просматривать, слушать или взаимодействовать с ним) другой пользователь с потребляющим устройством в местоположении, положении и ориентации, которые являются такими же, или близкими к ним, как местоположение, положение и ориентация, где виртуальный объект создан. Объекты могут иметь одно, несколько или много допустимых местоположений, положений и ориентаций потребления, заданных их создателем.

[0027] Технология обеспечивает пользователям возможность создания и совместного использования объектов, которые привязывают потребителей объектов к одной или более перспективам в отношении того, как создатель желает, чтобы наблюдатель воспринимал объект.

[0028] Фиг. 1A является способом, иллюстрирующим первый вариант осуществления настоящей технологии для захвата и совместного использования виртуального объекта с заданной ориентацией и визуализацией. Фиг. 1A будет описана по отношению к Фиг. 1B-1D, которые иллюстрируют пользователя, создающего контент. На этапе 50, определяют положение, ориентацию и местоположение устройства создания. Как будет описано в настоящем документе, положение, ориентация и местоположение могут быть описаны относительно системы глобальных координат и системы локальных координат. На этапе 52, контент создается и захватывается посредством устройства создания. Устройство создания может включать в себя устройство захвата, которое может принять различные типы аудио/виртуальных данных и подаваемую пользователем информацию, которая должна быть предоставлена в виртуальном объекте. На этапе 52, данные местоположения, положения и ориентации могут быть использованы для задания перспективы устройства захвата. Перспектива используется для определения, как совместно используемый виртуальный объект должен быть визуализирован для потребителя. Создание и захват контента может включать в себя данные объекта согласно времени захвата.

[0029] Фиг. 1B иллюстрирует пользователя 24, имеющего устройство создания, в этом случае планшетный компьютер, захватывающий объект 70 реального мира. Пользователь 24 может быть размещен внутри мирового пространства, заданного системой глобальных координат, и ориентация и положение устройства захвата внутри мирового пространства заданы относительно системы 75 локальных координат. Фиг. 1C иллюстрирует перспективу 80 устройства захвата относительно объекта 70 реального мира. Перспектива имеет высоту 82, относящуюся к высоте, на которой пользователь держит устройство 44 захвата, также положение и ориентацию в трех измерениях, которые могут быть описаны посредством координат ориентации относительно системы локальных координат. В примере на Фиг. 1B - 1D, пользователь 24 создает виртуальный объект 90, в этом случае двухмерный снимок, для объекта 70 реального мира. Виртуальный объект 90 проиллюстрирован на Фиг. 1D и имеет перспективу, ассоциированную с устройством 44 создания. На этапе 52, пользователь может также задать одну или более допустимых положений потребления для потребляющего устройства. В одном аспекте, может быть разрешено только одно положение потребления для потребляющего устройства. Это предусматривает потребляющее устройство в том же местоположении, положении и ориентации, как устройство захвата. В других примерах, могут быть предусмотрены многочисленные допустимые положения потребления.

[0030] Хотя пример, показанный на Фиг. 1B - 1D, иллюстрирует создание снимка, многочисленные типы виртуальных объектов могут быть созданы в соответствии с настоящей технологией. Они включают в себя двухмерные и трехмерные виртуальные объекты, которые могут быть визуализированы в различных разных типах вычислительных устройств или устройств обработки.

[0031] Обращаясь к Фиг. 1A, на этапе 54, данные визуализации, содержащие захваченную информацию для виртуального объекта, ассоциированы с местоположением, положением и ориентацией, и хранятся с описанием объекта. На этапе 56, описание объекта, включающее в себя данные визуализации и информацию положения, передают второму пользователю. Как будет рассмотрено ниже, этап 56 может включать в себя передачу данных центральной службе, или непосредственно второму пользователю потребляющего устройства. Как будет также рассмотрено ниже, потребляющее устройство может аналогично быть любым из числа различных типов устройств обработки, включающим в себя, как рассмотрено ниже по отношению к Фиг. 3a-3e, закрепляемое на голове устройство отображения, через которое смотрят.

[0032] На этапе 58, контент извлекают на потребляющем устройстве от первого пользователя. На этапе 60, определяют допустимые положение, ориентацию и местоположения потребления для совместно используемого виртуального объекта. На этапе 62, определяют положение, ориентацию и местоположение потребляющего устройства. В одном варианте осуществления, потребляющее устройство может только визуализировать совместно используемый виртуальный объект, когда потребляющее устройство находится в том же положении, ориентации и местоположении, как устройство захвата. В другом варианте осуществления, потребляющее устройство может визуализировать совместно используемый виртуальный объект, когда потребляющее устройство находится в одном или более из допустимых положения, ориентации и местоположений, заданных устройством создания. В третьем варианте осуществления, потребляющее устройство может визуализировать совместно используемый виртуальный объект, когда потребляющее устройство находится в положении вблизи заданного положения визуализации для виртуального объекта, которая задана устройством захвата, с допустимыми местоположением, положением и ориентацией для потребляющего устройства, заданными относительно положения визуализации.

[0033] Если, на этапе 64, потребляющее устройство не расположено должным образом, то могут быть сделаны регулировки в осуществлении расположения потребляющего устройства. Если устройство на этапе 64 расположено должным образом, содержимое может быть визуализировано в положении, ориентации и местоположении, заданных устройством создания.

[0034] Технология имеет применимость в предоставлении информации пользователям в окружении большого масштаба. Фиг. 2 иллюстрирует пользователя 24, просматривающего окружение 1000 реального мира, различные сцены зданий видны пользователю. Виртуальные объекты могут содержать виды, аудиовизуальные данные или другие типы информации, визуализируемые из перспективы пользователя 24, или на различных объектах реального мира, таких как здания 1001 по Фиг. 2.

[0035] Фиг. 3A - 3E иллюстрируют пользователя технологии в большом окружении реального мира. В этом аспекте, пользователь может создать совместно используемый виртуальный объект, и оставить маркеры в окружении для других пользователей, указывающие, где в окружении существуют совместно используемые виртуальные объекты. Это может обеспечить второму пользователю возможность приближения к маркеру и потребления виртуального объекта, созданного первым пользователем.

[0036] В одном примере, предположим пользователь в отпуске делает снимок конкретной сцены с семьей пользователя, стоящей перед узнаваемым зданием. В дальнейший момент времени, второй пользователь может появиться в сцене, и просмотреть снимок виртуального объекта семьи пользователя перед архитектурным памятником в том же положении и ориентации, в которой был сделан снимок.

[0037] Фиг. 3A иллюстрирует пользователя 24 с устройством 44 создания, использующего устройство для создания виртуального объекта из объекта реального мира, в этом случае здание 1004. Как проиллюстрировано на Фиг. 3A, пользователь имеет перспективу 1003, относящуюся к зданию 1004. Как в примере выше на Фиг. 1A - 1D, перспектива 1003 пользователя может быть связана с местоположением в мире, заданным глобальными координатами 1005, и системой 1006 локальных координат. Поле обзора устройства захвата проиллюстрировано на 1007.

[0038] Поле обзора на перспективе 1003 устройства 44 захвата пользователя проиллюстрировано на Фиг. 3B. На Фиг. 3B, был создан виртуальный объект 1020a содержащий снимок здания 1004. Следует понимать, что система локальных координат 1006 может относится к системе глобальных координат с использованием одной или более позиционных взаимосвязей, обеспечивая возможность ориентации системы локальных координат относительно местоположения, заданного системой глобальных координат.

[0039] Фиг. 3C иллюстрирует общий вид пользователя 24, носящего закрепляемое на голове устройство отображения, через которое смотрят, в окружении 1000 по Фиг. 2. Как будет описано ниже, закрепляемое на голове устройство отображения, через которое смотрят, является устройством недостающей реальности, которое обеспечивает пользователю возможность видеть виртуальные объекты, визуализированные в окружении. На Фиг. 3C, маркер 1010, ассоциированный с описанием 1020 виртуального объекта, представляется носящему закрепляемое на голове устройство 2 отображения, через которое смотрят. (Следует понимать, что описание 1020 объекта, проиллюстрированное на Фиг. 3C и описания объектов, упоминаемые в дальнейшем, не видимы пользователю, за исключением визуализированной формы в качестве виртуального объекта.) В соответствии с технологией, когда пользователь располагает себя в местоположении, ассоциированном с маркером 1010, пользователь может просмотреть или потребить виртуальный объект, созданный пользователем 24.

[0040] Фиг. 3D иллюстрирует пользователя 24A в положении, ассоциированном с маркером 1010. Пользователь 24A носит закрепляемое на голове устройство 2 отображения, через которое смотрят, и располагает себя в тех же местоположении, ориентации и положении относительно устройства создания пользователя 24 на Фиг. 3A. Описание 1020 объекта включает в себя информацию визуализации, также как и глобальные координаты и локальные координаты, задающие допустимое положение визуализации для закрепляемого на голове дисплея 2, через который смотрят.

[0041] Как показано на Фиг. 3e, закрепляемый на голове дисплей, через который смотрят будет визуализировать виртуальный объект 1020a, при этом в допустимом положении визуализации, положение визуализации в этом примере имеет такие же местоположение, положение и ориентацию, как первоначальное устройство создания. Как показано на Фиг. 3E, перспектива пользователя 24A и вид объекта 1020a, созданный на Фиг. 3A, является такой же как перспектива пользователя 24, который создал виртуальный объект 1020a.

[0042] Фиг. 4A и 4B иллюстрируют другой аспект настоящей технологии, включающий в себя пользователя с информацией от третьей стороны при создании и визуализации виртуального объекта. Фиг. 4A является общим видом пользователя, носящего закрепляемое на голове устройство 2 отображения, через которое смотрят, в окружении 1000, где предоставлены множество маркеров. В примере, показанном на Фиг. 4A, проиллюстрирован маркер 1010. Маркер 1010 может быть маркером, предоставленным пользователем и совместно используемым непосредственно с другим пользователем. Также на Фиг. 4A проиллюстрированы маркеры 1015, 1025, 1030, 1040, 1050 данных третьей стороны. Маркеры данных третьей стороны ассоциированы с виртуальными объектами, чья информация может быть получена от служб третьей стороны. Как будет описано ниже, центральная служба может собрать информацию от любой из числа служб третьей стороны, и создать виртуальные объекты в положениях, заданных центральной службой и/или заданных информацией, предоставленной службой третьей стороны. В другом альтернативном варианте, сами службы третьей стороны могут задавать виртуальные объекты для использования в окружении. Например, хозяин ресторана может задать виртуальный объект для отображения в окружении и задать ассоциированный маркер для использования в окружении. Эта цель и ассоциированный виртуальный объект могут быть предоставлены важной службе для отображения пользователям потребляющих устройств.

[0043] Фиг. 4B иллюстрирует общий вид виртуального объекта 1015a, ассоциированного с маркером 1015, на Фиг. 4B. Фиг. 4B также иллюстрирует пример объекта с "привязкой к миру" с множественными допустимыми местоположениями, положениями и ориентациями просмотра. Виртуальный объект 1015a показан как расположенный на стороне здания и включает в себя информацию, предоставленную службой третьей стороны Yelp®. В этом случае, виртуальный объект 1015a является виртуальным объектом с "привязкой к миру", чье положение ассоциировано с физическим объектом (зданием), и может иметь некоторое число допустимых местоположений, ориентаций и положений визуализации относительно положения потребляющего устройства. Например, как только пользователь перемещается на Фиг. 4B относительно здания и виртуального объекта 1015a, виртуальный объект 1015a будет все равно представляться на стороне здания. Поэтому, для просмотра виртуального объекта 1050a доступно некоторое число допустимых положений.

[0044] В примере, показанном на Фиг. 4B, закрепляемое на голове устройство 2 отображения, через которое смотрят считается близким к местоположению визуализации объекта 1015a с привязкой к миру. Местоположения, близкие к местоположению визуализации, будут включать в себя все допустимые местоположения, положения и ориентации, заданные в виртуальном объекте с привязкой к перспективе, в которых может произойти визуализация потребляющим устройством.

[0045] Как отмечено выше, потребляющее устройство и устройство создания могут содержать любое из числа подходящих устройств обработки, которые описаны в настоящем документе. Технология находит особенную применимость при использовании с закрепляемым на голове устройством отображения, через которое смотрят, способным визуализировать объекты в окружении смешанной реальности.

[0046] Когда закрепляемое на голове устройство отображения, через которое смотрят, используется как устройство создания, могут быть созданы различные разные типы виртуальных объектов. В одном аспекте, виртуальный объект может включать в себя комбинацию всех вводов датчиков, доступных в закрепляемом на голове устройстве отображения, через которое смотрят, которые визуализируются обратно для потребляющего пользователя, предполагая, что потребляющее устройство способно визуализировать все вводы. Например, создающий пользователь может записать прохождение по конкретному окружению, которое воспроизводится для потребляющего пользователя по мере совершения пользователем такого же прохождения по окружению. Все аспекты события создания, включающие в себя, например, видеообразы, аудиозвуки и подобное, но могут быть воспроизведены потребляющему пользователю.

[0047] Закрепляемое на голове устройство отображения включает в себя отображающий (дисплейный) элемент и блок обработки (процессорное устройство). Отображающий элемент является до некоторой степени прозрачным, так чтобы пользователь мог смотреть через отображающий элемент на объекты реального мира в пределах поля обзора (FOV) пользователя. Отображающий элемент также предоставляет возможность проецирования виртуальных изображений в FOV пользователя, так чтобы виртуальные изображения могли также появляться рядом и смешиваться с объектами реального мира. Система автоматически отслеживает, куда смотрит пользователь, так чтобы система могла определить, куда вставить виртуальное изображение(я) в FOV пользователя. Как только система узнает куда проецировать виртуальное изображение, изображение проецируется с использованием отображающего элемента.

[0048] В вариантах осуществления, закрепляемое на голове устройство отображения, включающее в себя свой блок обработки, может построить модель окружения со смешанной реальностью, включающую в себя x, y, z положения пользователей по шагу, рысканью и крену, объекты реального мира и виртуальные трехмерные объекты в окружении. Положения каждого закрепляемого на голове устройства отображения, носимого пользователями, в окружении может быть откалибровано под модель окружения и друг под друга. Это обеспечивает системе возможность определения линии зрения и FOV каждого пользователя окружения. Таким образом, виртуальное изображение может быть отображено каждому пользователю, но система определяет отображение виртуального изображения из перспективы каждого пользователя, регулируя виртуальное изображение в отношении параллакса и каких-либо заграждений от других или другими объектами в окружении.

[0049] Пользователь может выбрать взаимодействовать с одним или более из виртуальных объектов, появляющихся в пределах FOV пользователя. Как используется в настоящем документе, термин "взаимодействовать" охватывает как физическое взаимодействие, так и вербальное взаимодействие пользователя с виртуальным объектом. Физическое взаимодействие включает в себя совершение пользователем предварительно заданного жеста с использованием его или ее пальцев, руки и/или другой части(ей) тела, распознаваемой системой смешанной реальности в качестве запроса пользователя к системе на выполнение предварительно заданного действия. Такие предварительно заданные жесты могут включать в себя, но не ограничены этим, указание на, захват, толкание и расположение виртуальных объектов.

[0050] Пользователь может также физически взаимодействовать с виртуальным объектом с помощью его или ее глаз. В некоторых случаях, данные взгляда глаз идентифицируют, где пользователь фокусируется в FOV, и можно таким образом идентифицировать, что пользователь смотрит на конкретный виртуальный объект или объект реального мира. Продолжительный взгляд глаз, или мигание или последовательность мигания, может таким образом быть физическим взаимодействием, посредством которого пользователь выбирает один или более виртуальных объектов. Пользователь, просто смотрящий на виртуальный объект, такой как, просматривающий контент на виртуальной доске отображения, является дополнительным примером физического взаимодействия пользователя с виртуальным объектом.

[0051] Пользователь может в качестве альтернативы или дополнительно взаимодействовать с виртуальными объектами с использованием вербальных жестов, таких как, например, произнесенное слово или фраза, распознаваемая системой смешанной реальности как запрос пользователя к системе на выполнение предварительно заданного действия. Вербальные жесты могут быть использованы совместно с физическими жестами для взаимодействия с одним или более виртуальными объектами в окружении смешанной реальности.

[0052] Фиг. 5-8 иллюстрируют закрепляемое на голове устройство 2 отображения, через которое смотрят, которое в одном варианте осуществления имеет форму очков, носимых на голове пользователя, так чтобы пользователь мог видеть через дисплей и тем самым иметь действительный прямой обзор пространства перед пользователем. Использование термина "действительный прямой обзор" относится в возможности видеть объекты реального мира непосредственно глазами человека, вместо того, чтобы видеть, созданные представления изображений объектов. Например, просматривание комнаты через очки обеспечивает пользователю возможность иметь действительный прямой обзор комнаты, тогда как просмотр видео комнаты на телевизоре не является действительным прямым обзором комнаты. Дополнительные сведения закрепляемого на голове устройства 2 отображения предоставлены ниже.

[0053] Блок 4 обработки может включать в себя значительную часть вычислительной мощности, используемой для функционирования закрепляемого на голове устройства 2 отображения. В вариантах осуществления, блок 4 обработки осуществляет связь беспроводным образом (например, средствами WiFi, Bluetooth, инфракрасной или другой беспроводной связи) с одной или более центральными службами 900.

[0054] Закрепляемое на голове устройство отображения может включать в себя отображающий элемент. Отображающий элемент является до некоторой степени прозрачным, так чтобы пользователь мог смотреть через отображающий элемент на объекты реального мира в пределах поля обзора (FOV) пользователя. Отображающий элемент также предоставляет возможность проецирования виртуальных объектов в FOV пользователя, так чтобы виртуальные объекты могли также появляться рядом с объектами реального мира. Система автоматически отслеживает, куда смотрит пользователь, так чтобы система могла определить, куда вставить виртуальный объект в FOV пользователя. Как только система узнает куда проецировать виртуальный объект, изображение проецируется с использованием отображающего элемента.

[0055] Виртуальные объекты могут включать в себя описание объекта, такое как описание 1020, рассмотренное выше. Описание может включать в себя данные обеспечивающие устройству 2 отображения возможность визуализации виртуального объекта в поле обзора пользователя. Один компонент описания может содержать тип объекта, размер объекта, и одну или более перспектив оптимального просмотра и ориентацию. Каждая перспектива оптимального просмотра может содержать описание оптимальной перспективы для пользовательского вида объекта. Когда виртуальный объект используется совместно, технология, представленная в настоящем документе, использует описание объекта и местоположения и поле обзора каждого пользователя, с которым объект используется совместно, для определения оптимального местоположения, в котором визуализировать объект для каждого пользователя.

[0056] В одном альтернативном варианте, другие вычислительные системы и один или более из блоков обработки могут действовать совместно для построения модели окружения, включающей в себя x, y, z положения в декартовых координатах всех пользователей, объекты реального мира и виртуальные трехмерные объекты в комнате или другом окружении. Положения каждого закрепляемого на голове устройства отображения, носимого пользователями, в окружении может быть откалибровано под модель окружения и друг под друга. Это обеспечивает системе возможность определения линии зрения и FOV каждого пользователя окружения. Таким образом, виртуальный объект может быть отображен каждому пользователю, но отображение виртуального объекта из перспективы каждого пользователя может быть относительным, регулируя виртуальный объект в отношении параллакса и каких-либо заграждений от других или другими объектами в окружении. Модель окружения, называемая здесь картой сцены, так же как и все отслеживание FOV пользователя и объектов в окружении, может быть сгенерирована вычислительными системами и мобильным блоком обработки, работающими сообща или по-отдельности.

[0057] Фиг. 5 и 6 показывают общий вид и вид с боку закрепляемого на голове устройства 2 отображения. Фиг. 6 показывает правую сторону закрепляемого на голове устройства 2 отображения, включающую в себя участок устройства, имеющий дужку 102 и мост 104. В мост 104 встроен микрофон 110 для записи звуков и передачи этих аудиоданных в блок 4 обработки, как описано ниже. Спереди закрепляемого на голове устройства 2 отображения находится обращенная в комнату видеокамера 112, которая может захватывать видео и неподвижные изображения. Эти изображения передаются в блок 4 обработки, как описано ниже.

[0058] Участок оправы закрепляемого на голове устройства 2 отображения будет окружать дисплей (который включает в себя одну или более линз). Для того, чтобы показать компоненты закрепляемого на голове устройства 2 отображения, участок оправы, окружающий дисплей не изображается. Дисплей включает в себя световодный оптический элемент 115, фильтр 114 непрозрачности, прозрачную линзу 116 и прозрачную линзу 118. В одном варианте осуществления, фильтр 114 непрозрачности находится позади и совмещен с прозрачной линзой 116, световодный оптический элемент 115 находится позади и совмещен с фильтром 114 непрозрачности, и прозрачная линза 118 находится позади и совмещена с оптическим элементом 115 направления света. Прозрачные линзы 116 и 118 являются стандартными линзами, используемыми в очках для глаз, и могут быть сделаны в соответствии с любым предписанием (в том числе без предписания). Световодный оптический элемент 115 направляет искусственный свет в глаз. Дополнительные сведения по фильтру 114 непрозрачности и световодному оптическому элементу 115 предоставляются в опубликованной патентной заявке США № 2012/0127284, озаглавленной, "Head-Mounted Display Device Which Provides Surround Video", которая была опубликована 24 мая 2012.

[0059] Схемы 136 управления предусматривают различные электронные компоненты, которые поддерживают другие компоненты закрепляемого на голове устройства 2 отображения. Дополнительные сведения по схемам 136 управления предоставлены ниже относительно Фиг. 7. Внутри находятся или вмонтированы в дужку 102 наушники 130, инерциальный блок 132 измерения и температурный датчик 138. В одном варианте осуществления, показанном на Фиг. 7, инерциальный блок 132 измерения (или IMU 132) включает в себя инерциальные датчики, такие как трехосный магнитометр 132A, трехосный гироскоп 132B и трехосный акселерометр 132C. Инерциальный блок 132 измерения считывает положение, ориентацию и неожиданные ускорения (шаг, крен и рысканье) закрепляемого на голове устройства 2 отображения. IMU 132 может включать в себя другие инерциальные датчики в дополнение к магнитометру 132A, гироскопу 132B и акселерометру 132C или вместо них.

[0060] Микродисплей 120 проецирует изображение через линзу 122. Есть три разных технологии генерирования изображения, которые могут быть использованы для реализации микродисплея 120. Например, микродисплей 120 может быть реализован при использовании технологии трансмиссивного проецирования, где источник модулируется посредством оптически активного материала, подсветка сзади с белым светом. Эти технологии обычно реализуются с использованием дисплеев типа LCD с мощными подсветками и высокими плотностями световой энергии. Микродисплей 120 может также быть реализован с использованием отражающей технологии, для которой внешний свет отражается и модулируется оптически активным материалом. Освещение является подсветкой спереди либо посредством белого источника или RGB-источника, в зависимости от технологии. Цифровая обработка света (DLP), жидкие кристаллы на кремнии (LCOS) и технология отображения Mirasol® от корпорации Qualcomm, все являются примерами отражающих технологий, которые эффективны, так как большая часть энергии отражается от модулированной структуры и может быть использована в настоящей системе. Дополнительно, микродисплей 120 может быть реализован с использованием эмитирующей технологии, где свет генерируется дисплеем. Например, механизм отображения PicoP™ от корпорации Microvision, испускает лазерный сигнал с помощью микрозеркала, направляя либо на крошечный экран, который действует как пропускающий элемент, либо направляется в виде пучка непосредственно в глаз (например, лазером).

[0061] Световодный оптический элемент 115 передает свет от микродисплея 120 в глаз 140 пользователя, носящего закрепляемое на голове устройство 2 отображения. Световодный оптический элемент 115 также обеспечивает возможность передачи света от передней части закрепляемого на голове устройства 2 отображения через световодный оптический элемент 115 в глаз 140, как изображено стрелкой 142, тем самым обеспечивая пользователю возможность иметь действительный прямой обзор пространства перед закрепляемым на голове устройством 2 отображения в дополнение к приему виртуального объекта от микродисплея 120. Таким образом, стенки оптического элемента 115 направления света являются прозрачными. Световодный оптический элемент 115 включает в себя первую отражающую поверхность 124 (например, зеркало или другую поверхность). Свет от микродисплея 120 проходит через линзы 122 и падает на отражающую поверхность 124. Отражающая поверхность 124 отражает падающий свет от микродисплея 120, так чтобы свет был захвачен внутри плоской подложки, содержащей световодный оптический элемент 115, посредством полного внутреннего отражения. После нескольких отражений от поверхностей подложки, захваченные световые волны достигают массива выборочно отражающих поверхностей 126. Следует отметить, что одна из пяти поверхностей помечена как 126, чтобы избежать переполненности чертежа. Отражающие поверхности 126 выводят световые волны, падающие на эти отражающие поверхности, из подложки в глаз 140 пользователя. Дополнительные сведения об оптическом элементе направления света могут быть найдены в патентной заявке США №2008/0285140, озаглавленной "Substrate-Guided Optical Devices", опубликованной 20 ноября 2008.

[0062] Закрепляемое на голове устройство 2 отображения также включает в себя систему для отслеживания положения глаз пользователя. Как будет разъяснено ниже, система будет отслеживать положение и ориентацию пользователя, так чтобы система могла определить FOV пользователя. Однако, человек не будет воспринимать все перед ним. Вместо этого, глаза пользователя будут направлены на поднабор окружения. Вследствие этого, в одном варианте осуществления, система будет включать в себя технологию для отслеживания положения глаз пользователя для того, чтобы скорректировать измерение FOV пользователя. Например, закрепляемое на голове устройство 2 отображения включает в себя блок 134 отслеживания глаза в сборе (Фиг. 6), который имеет осветительное устройство 134A для отслеживания глаза и камеру 134B отслеживания глаза (Фиг. 7). В одном варианте осуществления, осветительное устройство 134A для отслеживания глаза включает в себя один или более инфракрасных (ИК) эмиттеров, которые испускают ИК свет к глазу. Камера 134B отслеживания глаза включает в себя одну или более камер, которые считывают отраженный ИК свет. Положение зрачка может быть идентифицировано известными способами формирования изображения, которые обнаруживают отражение роговой оболочки глаза. Например, см. патент США № 7,401,920, озаглавленный "Head Mounted Eye Tracking и Display System", поданный 22 июля, 2008. Такой способ может локализовать положение центра глаза относительно камеры отслеживания. В общем, отслеживание глаза предусматривает получение изображения глаза и использование методов компьютерного зрения для определения местоположения зрачка внутри глазницы. В одном варианте осуществления, достаточно отследить местоположение одного глаза, так как глаза обычно двигаются синхронно. Однако, возможно отслеживать каждый глаз по-отдельности.

[0063] В одном варианте осуществления, система будет использовать четыре ИК LED и четыре ИК фотодетектора в прямоугольной компоновке, так чтобы один ИК LED и ИК фотодетектор были в каждом угле линзы закрепляемого на голове устройства 2 отображения. Свет от LED отражается от глаз. Величина инфракрасного света, обнаруженного на каждом из четырех ИК фотодетекторов, определяет направление зрачка. То есть, величина белого к черному в глазу будет определять величину света, отраженного от глаза, для этого конкретного фотодетектора. Таким образом, фотодетектор будет иметь показатель величины белого или черного в глазу. Исходя из четырех выборок, система может определить направление глаза.

[0064] Другим альтернативным вариантом является использовать четыре инфракрасных LED, как рассмотрено выше, но один инфракрасный CCD на стороне линзы закрепляемого на голове устройства 2 отображения. CCD будет использовать небольшое зеркало и/или линзу ("рыбий глаз"), так чтобы CCD могло сформировать изображение до 75% видимого глаза от оправы очков. CCD затем считает изображение и использует компьютерное зрение, чтобы найти изображение, как можно более похожее на рассмотренное выше. Таким образом, хотя Фиг. 6 показывает один блок в сборе с одним ИК передатчиком, структура по Фиг. 6 может быть отрегулирована, чтобы иметь четыре ИК передатчика и/или четыре IR датчика. Также может быть также использовано больше или меньше, чем четыре ИК передатчика и/или четыре ИК датчика.

[0065] Другой вариант осуществления для отслеживания направления глаз основывается на отслеживании заряда. Эта идея основывается на наблюдении, что сетчатка несет измеримый положительный заряд, и роговая оболочка глаза имеет отрицательный заряд. Датчики закрепляются посредством ушей пользователя (вблизи наушников 130) для обнаружения электрического потенциала во время вращения глаз и эффективно считывают, что делают глаза в реальном времени. Также могут быть использованы другие варианты осуществления для отслеживания глаз.

[0066] Фиг. 6 показывает половину закрепляемого на голове устройства 2 отображения. Полностью закрепляемое на голове устройство отображения будет включать в себя другой набор прозрачных линз, другой фильтр непрозрачности, другой оптический элемент направления света, другой микродисплей 120, другую линзу 122, обращенную в комнату камеру, блок отслеживания глаза в сборе, микродисплей, наушники и температурный датчик.

[0067] Фиг. 7 является блок-схемой, изображающей различные компоненты закрепляемого на голове устройства 2 отображения. Фиг. 8 является блок-схемой, описывающей различные компоненты блока 4 обработки. Закрепляемое на голове устройство 2 отображения, компоненты которых изображены на Фиг. 7, используется для обеспечения пользователю восприятия смешанной реальности посредством незаметного слияния одного или более виртуальных объектов с пользовательским видом реального мира. Дополнительно, компоненты закрепляемого на голове устройства отображения по Фиг. 7 включают в себя много датчиков, которые отслеживают различные условия. Закрепляемое на голове устройство 2 отображения будет принимать инструкции о виртуальном объекте от блока 4 обработки и будет предоставлять информацию датчика обратно блоку 4 обработки. Блок 4 обработки, компоненты которого изображены на Фиг. 7, будут принимать информацию датчиков от закрепляемого на голове устройства 2 отображения и будут обмениваться информацией и данными с центральной службой 900 (Фиг. 1A). На основе этого обмена информацией и данными, блок 4 обработки определит, где и когда предоставить виртуальный объект пользователю и отправить инструкции соответственно на закрепляемое на голове устройство отображения по Фиг. 4.

[0068] Некоторые из компонентов по Фиг. 7 (например, обращенная в комнату камера 112, камера 134B отслеживания глаза, микродисплей 120, фильтр 114 непрозрачности, освещение 134A для отслеживания глаза, наушники 130 и температурный датчик 138) показаны на заднем плане, чтобы указать, что есть два каждого из устройств, одно для левой стороны и одно для правой стороны закрепляемого на голове устройства 2 отображения. Фиг. 7 показывает схему 200 управления, имеющую связь со схемой 202 управления электропитанием. Схема 200 управления включает в себя процессор 210, контроллер 212 памяти, имеющий связь с памятью 214 (например, D-RAM), интерфейс 216 камеры, буфер 218 камеры, блок 220 возбуждения дисплея, блок 222 задания формата отображения, генератор 226 синхросигнала, интерфейс 228 вывода отображения и интерфейс 230 ввода отображения.

[0069] В одном варианте осуществления, все компоненты схемы 200 управления имеют связь друг с другом посредством выделенных линий или одно или более шин. В другом варианте осуществления, каждый из компонентов схемы 200 управления имеет связь с процессором 210. Интерфейс 216 камеры предусматривает интерфейс для двух обращенных в комнату камер 112 и хранит изображения, принятые от обращенных в комнату камер, в буфере 218 камеры. Блок 220 возбуждения дисплея будет возбуждать микродисплей 120. Блок 222 задания формата отображения предоставляет информацию, о виртуальном объекте, отображаемом на микродисплее 120, схеме 224 управления непрозрачностью, которая управляет фильтром 114 непрозрачности. Генератор 226 синхросигнала используется для предоставления данных синхронизации для системы. Интерфейс 228 вывода отображения является буфером для предоставления изображений из обращенных в комнату камер 112 для блока 4 обработки. Интерфейс 230 ввода отображения является буфером для приема изображений, таких как виртуальный объект, который должен быть отображен на микродисплее 120. Интерфейс 228 вывода отображения и интерфейс 230 ввода отображения осуществляют связь со связывающим интерфейсом 232, который является интерфейсом для блока 4 обработки.

[0070] Схема 202 управления электропитанием включает в себя регулятор 234 напряжения, блок 236 возбуждения освещения для отслеживания глаза, аудио ЦАП и усилитель 238, предусилитель микрофона и аудио АЦП 240, интерфейс 242 температурного датчика и тактовый генератор 244. Регулятор 234 напряжения принимает электропитание от блока 4 обработки через связывающий интерфейс 232 и предоставляет это электропитание другим компонентам закрепляемого на голове устройства 2 отображения. Блок 236 возбуждения освещения для отслеживания глаза предоставляет источник ИК света для освещения 134A для отслеживания глаза, как описано выше. Аудио ЦАП и усилитель 238 выводят аудиоинформацию в наушники 130. Предусилитель микрофона и аудио АЦП 240 предоставляет интерфейс для микрофона 110. Интерфейс 242 температурного датчика является интерфейсом для температурного датчика 138. Схема 202 управления электропитанием также предоставляет электропитание и принимает данные обратно от трехосного магнитометра 132A, трехосного гироскопа 132B и трехосного акселерометра 132C.

[0071] Фиг. 8 является блок-схемой, описывающей различные компоненты блока 4 обработки. Фиг. 8 показывает схему 304 управления, имеющую связь со схемой 306 управления электропитанием. Схема 304 управления включает в себя центральный процессор (CPU) 320, графический процессор (GPU) 322, кэш 324, RAM 326, контроллер 328 памяти, имеющий связь с памятью 330 (например, D-RAM), контроллер 332 flash-памяти, имеющий связь с flash-памятью 334 (или другим типом энергонезависимого хранилища), буфер 336 вывода отображения, имеющий связь с закрепляемым на голове устройством 2 отображения через связывающий интерфейс 302 и связывающий интерфейс 232, буфер 338 ввода отображения, имеющий связь с закрепляемым на голове устройством 2 отображения через связывающий интерфейс 302 и связывающий интерфейс 232, интерфейс 340 микрофона, имеющий связь с соединителем 342 внешнего микрофона для соединения с микрофоном, интерфейс PCI express для соединения с устройством 346 беспроводной связи, и USB-порт(ы) 348. В одном варианте осуществления, устройство 346 беспроводной связи может включать в себя устройство связи с возможностью Wi-Fi, устройство BlueTooth-связи, устройство инфракрасной связи, и т.д. USB-порт может быть использован для подключения блока 4 обработки к вычислительной системе, для того, чтобы загрузить данные или программное обеспечение в блок 4 обработки, также как и блок 4 обработки заряда. В одном варианте осуществления, CPU 320 и GPU 322 являются главными рабочими лошадками для определения того, где, когда и как вставлять виртуальные трехмерные объекты в вид пользователя. Дополнительные сведения предоставлены ниже.

[0072] Схема 306 управления электропитанием включает в себя тактовый генератор 360, аналого-цифровой преобразователь 362, зарядку 364, регулятор 366 напряжения, источник 376 электропитания закрепляемого на голове дисплея и интерфейс 372 температурного датчика, имеющего связь с температурным датчиком 374 (возможно размещенный на наручном ремешке блока 4 обработки). Аналого-цифровой преобразователь 362 используется для контролирования напряжения батареи, температурного датчика и управления функцией заряда батареи. Регулятор 366 напряжения имеет связь с батареей 368 для подачи электропитания системе. Зарядка 364 используется для заряда батареи 368 (посредством регулятора 366 напряжения) при приеме электропитания из зарядного гнезда 370. источник 376 электропитания HMD предоставляет электропитание закрепляемому на голове устройству 2 отображения.

[0073] Как отмечено выше, с настоящей технологией могут быть использованы различные типы устройств обработки. Фиг. 9 является блок-схемой, иллюстрирующей мобильное или планшетное вычислительное устройство. Фиг. 9 является блок-схемой примерного мобильного или планшетного устройства, которое может функционировать в вариантах осуществления технологии, описанной в настоящем документе (например, устройство 44). Изображена примерная электронная схема обычного мобильного устройства. Устройство 700 включает в себя один или более микропроцессоров 712 и память 710 (например, энергонезависимую память, такую как ROM, и энергозависимую память, такую как RAM), которая хранит процессорно-читаемый код, который исполняется одним или более процессорами для процессора 712 управления, чтобы реализовать функциональность, описанную в настоящем документе.

[0074] Мобильное устройство 700 может включать в себя, например, процессоры 712, память 710, включающую в себя приложения, и энергонезависимое хранилище. Процессор 712 может реализовать связь, так же как и любое число приложений, включающих в себя приложения взаимодействия, рассмотренные в настоящем документе. Память 710 может быть любой из разнообразия типов запоминающих носителей информации, включающих в себя энергонезависимую и энергозависимую память. Операционная система устройства обслуживает разные операции мобильного устройства 700 и может содержать пользовательские интерфейсы для операций, таких как совершение и прием телефонных вызовов, передача текстовых сообщений, проверка голосовой почты и подобные. Приложения 730 могут быть любыми из ассортимента программ, такими как приложение камеры для фотографий и/или видео, адресная книга, приложение календаря, медиапроигрыватель, Интернет-браузер, игры, другие мультимедийные приложения, приложение будильника, другие приложения третьей стороны, приложение создания контента, рассмотренное в настоящем документе, и подобные. Компонент 740 энергонезависимого хранилища в памяти 710 содержит данные, такие как веб-кэши, музыка, фотографии, данные контактов, данные планирования и другие файлы.

[0075] Процессор 712 также осуществляет связь с РЧ-схемой 706 передачи/приема, которая в свою очередь соединена с антенной 702, с инфракрасным передатчиком/приемником 708, с любыми дополнительными каналами 760 связи, как например, Wi-Fi или Bluetooth, и с датчиком 714 движения/ориентации, таким как акселерометр. Акселерометры были включены в мобильные устройства для обеспечения таким приложениям, как интеллектуальные пользовательские интерфейсы, которые позволяют пользователям вводить команды посредством жестов, возможности GPS-функциональности внутри помещений, которые вычисляют перемещение и направление устройства, после прерывания контакта с GPS-спутником, и обнаружения ориентации устройства и автоматического изменения отображения с портретного на ландшафтный, когда устройство вращают. Акселерометр может быть предоставлен, например, микроэлектромеханической системой (MEMS), которая является крошечным механическим устройством (размерами в микрометр), встроенным в полупроводниковый чип. Может быть считано направление ускорения, так же как и ориентация, вибрация и удар. Процессор 712 дополнительно осуществляет связь с звонком/вибратором 716, клавиатурой/экраном пользовательского интерфейса, системой 718 биометрических датчиков, динамиком 720, микрофоном 722, камерой 724, световым датчиком 726 и температурным датчиком 728.

[0076] Процессор 712 управляет передачей и приемом беспроводных сигналов. Во время режима передачи, процессор 712 предоставляет голосовой сигнал от микрофона 722, или другой сигнал данных, в РЧ-схему 706 передачи/приема. Схема 706 передачи/приема передает сигнал на удаленную станцию (например, стационарную станцию, оператору, другим сотовым телефонам и т.д.) для связи через антенну 702. Звонок/вибратор 716 используется для сигнализации входящего вызова, текстового сообщения, напоминания календаря, напоминания будильника или другого уведомления пользователю. Во время режима приема, схема 706 передачи/приема принимает голосовой или другой сигнал данных от удаленной станции через антенну 702. Принятый голосовой сигнал предоставляется в динамик 720, тогда как другие принятые сигналы данных также обрабатываются соответствующим образом.

[0077] Дополнительно, физический соединитель 788 может быть использован для соединения мобильного устройства 700 с внешним источником электропитания, таки как AC-адаптер или подключенная к электропитанию док-станция. Физический соединитель 788 может также быть использован как соединение передачи данных с вычислительным устройством. Соединение передачи данных обеспечивает возможность операций, таких как синхронизация данных мобильного устройства с вычислительными данными на другом устройстве.

[0078] GPS-приемопередатчик 765, использующий спутниковую навигацию ретрансляции положения пользовательских приложений, активируется для такой услуги.

[0079] Примерные системы обработки, проиллюстрированные на Фигурах, включают в себя примеры компьютерно-читаемых носителей информации. Компьютерно-читаемые носители информации являются также процессорно-читаемыми носителями информации. Такие носители могут включать в себя энергозависимые и энергонезависимые, съемные и несъемные носители, реализованные для хранения информации, такой как компьютерно-читаемые инструкции, структуры данных, программные модули или другие данные. Компьютерные носители информации включают в себя, но не ограничены этим, RAM, ROM, EEPROM, кэш, флэш-память или память другой технологии, CD-ROM, универсальные цифровые диски (DVD) или другой накопитель на оптическом диске, флэш-карты или карты памяти, магнитные кассеты, магнитную пленку, накопитель медиаданных, жесткий диск, накопитель на магнитном диске или другие магнитные запоминающие устройства, и подобные.

[0080] Как упомянуто выше, информация, созданная и совместно используемая для виртуального объекта с привязкой к перспективе, имеющегося в мировом пространстве, может быть использована с помощью центральной службы 900. В одном аспекте центральная служба проиллюстрирована на Фиг. 10. Центральная служба 900 может функционировать на одном или более устройствах обработки или серверах. Логические компоненты центральной службы 900 проиллюстрированы на Фиг. 10.

[0081] Центральная служба 900 может включать в себя информацию 910 пользователя, информацию 958 контента пользователя, конкурентную информацию 968 третьей стороны, агрегатор 980 служб третьей стороны, подсистема 985 картографирования и интерфейс 995 связи. Интерфейс 995 связи может включать в себя любое число интерфейсов, транспортных уровней и протоколов, обеспечивающих центральной службе 900 возможность осуществления связи с закрепляемым устройством 2 отображения, через которое смотрят, планшетом 902 и мобильным телефоном 904.

[0082] Информация 910 пользователя может включать в себя информацию 919 для входа в систему, требующую от пользователя устройства 2, планшета 902, телефона 904 и центральной службы 900 аутентифицировать свою идентификационную информацию перед осуществлением доступа к защищенной информации, доступной пользователям центральной службы 900. Каждый пользователь может иметь доступной посредством службы 900 адресную книгу 914 пользователя и данные 916 контактов социальных сетей, также как и историю 918 местоположений пользователя. В альтернативных вариантах осуществления, вся или порции информации пользователя могут быть сохранены локально на устройстве.

[0083] Информация 958 контента пользователя включает в себя информацию 957 местоположения контента и созданные пользователем совместно используемые объекты 956 с привязкой к перспективе. Информацией контента пользователя может быть информация по совместно используемым виртуальным объектам, созданным пользователями, такими как пользователь 24 выше, открытым пользователем для совместного использования с другими пользователями центральной службы 900. Информация местоположения объекта 957 может включать в себя, для заданной области, трехмерную карту местоположения, также как и местоположений объектов в данной области, и маркеры, которые должны быть использованы с объектами. Совместно используемые объекты 956 могут включать данные конкретного объекта, ассоциированные с информацией, в информацию 957 местоположения объекта.

[0084] Информация 968 контента третьей стороны также включает в себя информацию 967 местоположения объекта и объекты 966 третьей стороны с привязкой к перспективе. Объекты третьей стороны включают в себя информацию контента, доступную от служб 990 взаимодействия с социальными сетями третьей стороны, которая извлекается из служб 990 взаимодействия с социальными сетями посредством агрегатора 980 служб третьей стороны. Объекты третьей стороны 966 могут быть созданы посредством службам 990 взаимодействия с социальными сетями третьей стороны или созданы посредством центральной службы с использованием подсистемы 985 картографирования и информации, доступной из службы взаимодействия с социальными сетями третьей стороны. Эта информация может включать в себя допустимые местоположения визуализации, рассмотренные выше, также как и любую информацию от пользователей служб взаимодействия с социальными сетями третьей стороны.

[0085] Агрегатор 980 служб третьей стороны извлекает информацию из служб 990 соцсетей третьей стороны, каждая из которых может предоставить информацию, которая может быть использована для заполнения виртуальными объектами. Агрегатор 980 служб третьей стороны взаимодействует с прикладным программным интерфейсом (API) каждой из служб 990 взаимодействия третьей стороны.

[0086] Подсистема 985 картографирования ассоциирует информацию о местоположении в глобальных координатах с данными местоположения от пользователей и от агрегатора 980 служб третьей стороны. Подсистема 985 картографирования также принимает информацию о местоположении от пользовательских устройств и обновляет историю 918 местоположений пользователя. Подсистема картографирования может также предоставить 3D данные сцены закрепляемому на голове устройству 2 отображения, через которое смотрят, планшету 902 и телефону 904. Эта информация может обновляться по мере предоставления информации отслеживания местоположения пользователя от устройства 2 центральной службе 900. Подсистема 985 картографирования может дополнительно ассоциировать тип маркера, который должен быть сгенерирован, с поставщиком служб информации третьей стороны.

[0087] Службы 990 взаимодействия с социальными сетями третьей стороны могут включать в себя со своей информацией глобальные координаты для точек, представляющих интерес, для которых они предоставляют информацию. Многие службы 990 соцсетей третьей стороны включают в себя, вместе и их обзорами, такую информации о местоположении в глобальных координатах. Подсистема 985 картографирования может верифицировать эту информацию, или добавить информацию глобальных координат в сгенерированные пользователем данные. Это местоположение может быть получено из истории местоположений пользователя, также как и ввод в момент времени, когда пользователь создает информацию о конкретной точке, представляющей интерес.

[0088] Агрегатор 980 служб третьей стороны может также принять описания объектов от владельца/оператора и источников публично совместно используемых объектов посредством 19. Его объекты могут быть предоставлены владельцами и операторами зданий, которые должны иметь точечный объект, ассоциированный с их конкретным заведением.

[0089] Совместно используемые объекты 956 и объект 966 третьей стороны включают в себя информацию данных визуализации объекта, также как и одно или более допустимых местоположений потребления, одно или более допустимых положений потребления, и одну или более допустимых ориентаций потребления для потребляющего устройства, стремящегося визуализировать объект. Центральной службой 900 может оперировать один или более системных администраторов, которые предоставляют центральную службу двум носящим закрепляемое на голове устройство 2 отображения, через которое смотрят.

[0090] Фиг. 11 является схемой последовательности операций, иллюстрирующей способ создания совместно используемого виртуального объекта с привязкой к перспективе в соответствии с настоящей технологией. Способ по Фиг. 11 может быть выполнен компонентами блока 4 обработки и/или закрепляемого на голове устройства 2 отображения. Любое одно или более из блока 4 обработки и/или закрепляемого на голове устройства 2 отображения, действующего

самостоятельно или совместно с другой из систем, могут выполнить весь или часть способа.

[0091] Со ссылкой на Фиг. 11, на этапе 1100, определяют местоположение пользователя для пользователя, стремящегося создать данные сцены. Местоположение пользователя может быть получено от GPS-передатчика в пользовательском устройстве и предоставляются глобальные координаты местоположения, описывающие положение пользователя.

[0092] На этапе 1102, может быть разработана карта сцены, идентифицирующая трехмерную геометрию сцены, также как и геометрию и положения объектов внутри сцены вокруг того, где размещается пользователь. В вариантах осуществления, карта сцены, сгенерированная в данном кадре, может включать в себя x, y и z положения в системе локальных координат всех пользователей, объектов реального мира и виртуальных объектов в общем окружении. Карта сцены может быть использована при расположении виртуальных объектов внутри сцены, также как и отображении виртуальных трехмерных объектов с соответствующим заграждением (виртуальный трехмерный объект может быть загражден, или виртуальный трехмерный объект может загородить объект реального мира или другой виртуальный трехмерный объект). Карта сцены может быть получена из устройств захвата, ассоциированных с пользователем, или может быть предоставлена центральной службой 900.

[0093] На этапе 1104, принимают информацию от центральной службы. В одном варианте осуществления, этап 1104 не должен выполняться. Информация, принятая на этапе 1104, может включать в себя шаблоны и описания виртуальных объектов для создания объектов с привязкой к перспективе. Информация о виртуальных объектах может быть помещена в кэш в устройстве обработки или закрепляемом на голове дисплее 2 для обеспечения объектам с привязкой к перспективе возможности более быстрого создания.

[0094] На этапе 1106, делают определение положения, ориентации и FOV пользовательского устройства захвата.

[0095] На этапе 1108, данные местоположения, ориентации, положения и поля обзора преобразовывают в перспективу пользователя. Перспектива пользователя может быть использована для определения допустимых положений визуализации для совместно используемых виртуальных объектов.

[0096] На этапе 1112, захватывают сгенерированный пользователем контент для виртуальных объектов с привязкой к перспективе. В соответствии с технологией, сгенерированный пользователем контент может быть контентом любого типа, который может быть захвачен датчиком устройства, рассмотренным по отношению к разным типам вычислительных систем. Это включает в себя аудиоданные, визуальные данные, данные движения и текст. Сгенерированный пользователем контент используется для построения виртуального объекта с привязкой к перспективе, который будет визуализирован. На этапе 1115, информацию о положении, ориентации и местоположении ассоциируют со сгенерированным пользователем контентом. В дополнение, где объект задается как объект с привязкой к миру, отображаемый из некоторого числа разных перспектив, и могут быть заданы допустимые положения, местоположения и ориентации потребления.

[0097] В примере, показанном на Фиг. 1A-1D, одиночная перспектива может быть задана на основе местоположения, ориентации и положения. В примере, показанном на Фиг. 4B, могут быть заданы многочисленные перспективы, и поэтому многочисленные разные допустимые местоположения потребления доступны для виртуального объекта с привязкой к миру.

[0098] На этапе 1117, виртуальный объект совместно используют со вторым пользователем или передают в центральную службу 900.

[0099] Фиг. 12 иллюстрирует способ, выполняемый устройством потребляющего пользователя (потребляющим устройством), желающего просмотреть виртуальный объект в соответствии с настоящей технологией.

[00100] На этапе 1202, определяют местоположение потребляющего пользователя. Местоположение будет определено со ссылкой на систему глобальных координат, используемую совместно с виртуальным объектами. На этапе 1204, данные карты сцены собирают аналогичным вышеуказанному этапу 1102 образом.

[00101] На этапах 1206 и 1208, объекты с привязкой к перспективе могут быть собраны от других сторон. На этапе 1206, извлекают объекты от участников третьей стороны. На этапе 1208, может быть собрана совместно используемую пользователем информацию объекта на этапе 1208. Совместно используемые виртуальные объекты с привязкой к перспективе на этапах 1206 и 1208 могут быть предоставлены из центральной службы 900, или непосредственно от пользователей-участников. В некоторых вариантах осуществления, информация от участников третьей стороны может быть передана непосредственно на устройство потребляющего пользователя. В дополнительных вариантах осуществления, совместно используемая пользователем информация на этапе 1208 может быть предоставлена пользователями, которые находятся в контакте с потребляющим пользователем. Пользователи, находящиеся в контакте с потребляющим пользователем могут быть физическими лицами, которые ассоциированы с адресной книгой пользователя, прямыми контактами или контактом посредством службы соцсетей, которые идентифицированы как ассоциированные с потребляющим пользователем (например, "друзья").

[00102] На этапе 1209, делают определение положения, ориентации и FOV пользовательского устройства захвата.

[00103] В случаях, когда используются маркеры, такие как маркеры, проиллюстрированные на Фиг. 3C и 4A, на этапе 1210 делают первоначальное определение, находится ли пользователь вблизи одного или более маркеров или нет. Определение на этапе 1210 является обязательным, будут ли маркеры в их ассоциированном местоположении в реальном мире в окружении попадать в поле обзора потребляющего устройства. Следует понимать, что использование маркеров не требуется настоящей технологией. Таким образом этап 1212 может быть опциональным. Используются другие системы совмещения потребляющего пользователя с местоположениями и положениями визуализации совместно используемых виртуальных объектов. Если используются маркеры, и маркеры находятся в пределах FOV потребляющего устройства для пользователя, и маркеры, визуализированные на дисплее потребляющего устройства на этапе 1212.

[00104] На этапе 1214, делают определение относительно того, произошло ли взаимодействие с объектом или нет. Взаимодействие с объектом на этапе 1214 может быть простым, как расположение пользователя относительно маркера в положении, местоположении, и ориентации, в которых допустимо просматривать совместно используемый объект. Когда устройство потребляющего пользователя находится в положении, местоположении и ориентация, объект может быть визуализирован. В других вариантах осуществления, пользователь может активно выбирать маркер перед помещением потребляющего устройства в положении, местоположении и ориентации.

[00105] На этапе 1216, определяют допустимые положения потребления совместно используемого виртуального объекта с привязкой к перспективе. Как отмечено выше, некоторые объекты имеют только одно положение, ориентацию и местоположение, в которых может произойти потребление. Другие объекты могут иметь допустимые положения, ориентации и местоположения потребления.

[00106] На этапе 1220, совместно используемый виртуальный объект с привязкой к перспективе визуализируется для пользователя, когда пользователь и потребляющее устройство находятся в положении, местоположении и ориентации, таких что возникает перспектива пользователя относительно объекта для должного потребления. Потреблением может быть визуализация фотографий, которые показаны, прослушивание конкретных звуков записей и конкретного времени, просматривание видео, чтение текста, игра с интерактивным трехмерным виртуальным объектом, и подобное.

[00107] Дополнительные сведения одного варианта осуществления для выполнения этапа 1220 проиллюстрированы на Фиг. 13.

[00108] В некоторых случаях, разрешается модификация пользователем совместно используемого виртуального объекта с привязкой к перспективе. На этапе 1224, делают определение относительно того, произошла ли модификация пользователем объекта. Модификация пользователем может включать в себя добавление, снабжение аннотациями или изменение объекта пользователем, если разрешения в отношении совместно используемого объекта, обеспечивают возможность такой модификации. Если произошла модификация пользователем объекта, то данные для объекта обновляются и отображаются на этапе 1226. Как только потребление контента заканчивается на этапе 1228, способ переходит с следующему объекту на этапе 1230.

[00109] Фиг. 13 иллюстрирует один способ выполнения этапа 1220 на Фиг. 12. На этапе 1302, делают определение относительно должной ориентации, местоположения, положения потребления контента и перспективы для конкретного объекта. Информация, извлеченная на этапе 1302, задает информацию, доступную от одного или более виртуальных объектов, в которой находятся допустимые положения визуализации. Местоположение, ориентация, положение и поле обзора потребляющего устройства извлекают на этапе 1304.

[00110] На этапе 1306, делают первоначальное определение относительно того, имеет ли совместно используемый виртуальный объект с привязкой к перспективе, который должен быть визуализирован, привязку к миру или локальную привязку.

[00111] Виртуальный объект с привязкой к миру является таким объектом, который проиллюстрирован на Фиг. 4B, где положение объекта привязано к местоположению и ориентации на физическом объекте. Виртуальный объект с локальной привязкой является объектом, где положение потребления привязано к конкретной перспективе пользователя.

[00112] Если совместно используемый виртуальный объект с привязкой к перспективе является объектом с локальной привязкой, но на этапе 1312, делают определение в отношении того, совпадают ли положение, местоположение и ориентация потребляющего устройства и допустимое положение потребления. В этом случае, допустимое положение потребления может быть задано как единственное допустимое положение потребления. Если нет, то на этапе 1314 может быть сделано определение изменений в местоположении, положении и ориентации, которые нужны, чтобы совпадать с местоположением, положением и ориентацией, и на этапе 1316 может быть визуализировано направленное указание для коррекции местоположения, ориентации, и положения пользователя. Это обеспечивает пользователю возможность перемещения в положение для коррекции потребления виртуального объекта. Направления могут быть предоставлены в визуальной или слышимой форме. На этапе 1318 делают определение в отношении того, переместились ли пользователь и потребляющее устройство или нет, и если да, то на этапе 1312 снова делают обнаружение совпадения между фактическим положением устройства и допустимым положением потребления. Когда потребляющее устройство пользователя совпадает с допустимым положением потребления на этапе 1312, на этапе 1340 визуализируют совместно используемый виртуальный объект с привязкой к перспективе.

[00113] Если на этапе 1306 совместно используемый виртуальный объект с привязкой к перспективе является объектом с привязкой к миру, то на этапе 1320 делают определение в отношении того, находится ли потребляющее устройство в одном из некоторого числа допустимых положений, ориентаций и местоположений или нет. В одном аспекте, допустимые положения потребления могут быть определены посредством определения местоположения, положения и ориентации потребляющего устройства. В другом аспекте, для объекта с привязкой к миру, допустимые положения потребления могут быть определены посредством определения поля обзора потребляющего устройства относительно объекта реального мира, в котором виртуальный объект должен быть задан.

[00114] Если происходит совпадение между местоположением, положением и ориентацией потребляющего устройства и допустимым положением, то на этапе 1322 объект визуализируют в положении с привязкой к миру. На этапе 1322, на этапе 1324 делают определение изменения перспективы пользователя, и если перспектива пользователя изменяется относительно совместно используемого виртуального объекта с привязкой к перспективе, на этапе 1326 вычисляют изменение, и способ возвращается на этап 1320, чтобы гарантировать, что потребляющее устройство находится в допустимом местоположении, положении и ориентации по отношению к совместно используемому виртуальному объекту с привязкой к перспективе. Если потребляющие устройства не находятся в корректном положении на этапе 1320, и на этапе 1350 визуализация объекта не происходит.

[00115] Хотя изобретение было описан на языке, характерном для структурных признаков и методологических действий, следует понимать, что объем изобретения, определяемый прилагаемой формулой изобретения, не обязательно ограничен конкретными признаками или описанными выше действиями. Тем не менее, конкретные признаки и действия, описанные выше, разглашены в качестве примерных форм реализации формулы изобретения.

Изобретение относится к ориентации и визуализации виртуального объекта. Техническим результатом является обеспечение создания виртуального объекта с привязкой к ракурсу. Способ содержит этапы, на которых: принимают данные местоположения объекта и данные потребления для совместно используемого виртуального объекта; отображают виртуальный маркер, ассоциированный с совместно используемым виртуальным объектом, в положении маркера, соответствующем географическому местоположению объекта; определяют географическое местоположение потребляющего устройства относительно положения маркера; определяют положение потребляющего устройства и ориентацию потребляющего устройства в системе локальных координат и выводят совместно используемый виртуальный объект на потребляющем устройстве в качестве реакции на совпадение положения потребляющего устройства и ориентации потребляющего устройства соответственно с единственно возможным положением потребления и единственно возможной ориентацией потребления и в качестве реакции на совпадение географического положения потребляющего устройства с положением маркера. 3 н. и 14 з.п. ф-лы, 19 ил.

1. Способ визуализации совместно используемого виртуального объекта в закрепляемом на голове дисплее, через который смотрят, содержащий этапы, на которых:

принимают данные местоположения объекта и данные потребления для совместно используемого виртуального объекта, причем данные местоположения объекта включают в себя, по меньшей мере, географическое местоположение объекта по отношению к системе глобальных координат, и данные потребления включают в себя единственно возможное положение потребления и единственно возможную ориентацию потребления для потребления совместно используемого виртуального объекта по отношению к системе локальных координат потребляющего устройства;

отображают виртуальный маркер, ассоциированный с совместно используемым виртуальным объектом, в положении маркера, соответствующем географическому местоположению объекта, по меньшей мере, когда потребляющее устройство находится на удалении от и нацелено в направлении географического местоположения объекта, причем положение маркера является единственно возможным географическим местоположением, из которого совместно используемый виртуальный объект можно просматривать;

определяют географическое местоположение потребляющего устройства относительно положения маркера;

определяют положение потребляющего устройства и ориентацию потребляющего устройства в системе локальных координат и

выводят совместно используемый виртуальный объект на потребляющем устройстве в качестве реакции на совпадение положения потребляющего устройства и ориентации потребляющего устройства соответственно с единственно возможным положением потребления и единственно возможной ориентацией потребления и в качестве реакции на совпадение географического положения потребляющего устройства с положением маркера.

2. Способ по п. 1, в котором потребляющее устройство выводит совместно используемый виртуальный объект в географическом местоположении объекта, единственно возможном положении потребления и единственно возможной ориентации потребления, так чтобы совместно используемый виртуальный объект имел такой же ракурс по отношению к потребляющему устройству, как по отношению к устройству захвата, использовавшемуся для создания совместно используемого виртуального объекта.

3. Способ по п. 1, в котором упомянутое определение географического положения включает в себя этап, на котором определяют, что потребляющее устройство находится вблизи совместно используемого виртуального объекта и что по меньшей мере одни положение и ориентация совместно используемого виртуального объекта находятся в пределах поля обзора потребляющего устройства.

4. Способ по п. 1, в котором совместно используемый виртуальный объект представляет собой одно или более из звука, визуально отображаемых данных, изображения и видео.

5. Способ по п. 1, в котором потребляющее устройство является устройством обработки первого типа, а совместно используемый виртуальный объект был создан устройством обработки второго типа.

6. Аппаратура для создания совместно используемого виртуального объекта с привязкой к ракурсу, содержащая:

устройство захвата;

устройство обработки, подключенное к устройству захвата, при этом устройство обработки запрограммировано:

определять местоположение в глобальных координатах, положение и ориентацию устройства захвата,

определять параметры, обеспечивающие возможность просмотра совместно используемого виртуального объекта с привязкой к ракурсу, включая создание данных визуализации совместно используемого виртуального объекта, каковые данные включают в себя данные местоположения визуализации для совместно используемого виртуального объекта с привязкой к ракурсу, причем данные местоположения визуализации включают в себя, по меньшей мере, местоположение в глобальных координатах и по меньшей мере одно положение и по меньшей мере одну ориентацию для совместно используемого виртуального объекта с привязкой к ракурсу относительно системы локальных координат в пределах поля обзора потребляющего устройства, причем упомянутые определенные параметры содержат положение просмотра, с которого есть возможность просмотра совместно используемого виртуального объекта с привязкой к ракурсу, при этом отсутствует возможность просмотра совместно используемого виртуального объекта с привязкой к ракурсу из местоположений, отличающихся от этого положения просмотра, и упомянутое определение параметров дополнительно содержит создание виртуального маркера, указывающего местоположение упомянутого положения просмотра, причем виртуальный маркер является видимым c дистанции от виртуального маркера, и

совместно использовать совместно используемый виртуальный объект с привязкой к ракурсу.

7. Аппаратура по п. 6, дополнительно включающая в себя код, программирующий устройство обработки назначать виртуальный маркер положению в глобальных координатах, включенному в данные положения визуализации, ассоциированные с совместно используемым виртуальным объектом с привязкой к ракурсу.

8. Аппаратура по п. 6, дополнительно включающая в себя код, программирующий устройство обработки назначать состояние привязки к миру или состояние локальной привязки к совместно используемому виртуальному объекту с привязкой к ракурсу.

9. Аппаратура по п. 8, дополнительно включающая в себя код, программирующий устройство обработки назначать состояние привязки к миру совместно используемому виртуальному объекту с привязкой к ракурсу и определять для потребляющего устройства множество допустимых местоположений в глобальных координатах, допустимых положений и допустимых ориентаций для визуализации совместно используемого виртуального объекта с привязкой к ракурсу.

10. Аппаратура по п. 8, дополнительно включающая в себя код, программирующий устройство обработки назначать состояние локальной привязки совместно используемому виртуальному объекту с привязкой к ракурсу и определять для потребляющего устройства одно допустимое местоположение в глобальных координатах, положение и ориентацию для визуализации совместно используемого виртуального объекта с привязкой к ракурсу в качестве объекта с локальной привязкой.

11. Аппаратура по п. 6, в которой устройство захвата включает в себя, по меньшей мере, аудиодатчик и видеокамеру, при этом аппаратура дополнительно включает в себя код, программирующий устройство обработки захватывать данные визуализации совместно используемого виртуального объекта с привязкой к ракурсу с использованием аудиодатчика и видеокамеры.

12. Аппаратура по п. 6, дополнительно включающая в себя дисплей, при этом аппаратура дополнительно включает в себя код, программирующий устройство обработки:

принимать данные местоположения визуализации для второго совместно используемого виртуального объекта с привязкой к ракурсу, созданного другим устройством захвата, причем данные местоположения визуализации включают в себя по меньшей мере одно из каждого из допустимого местоположения, допустимого положения и допустимой ориентации,

определять местоположение, положение и ориентацию аппаратуры,

если местоположение, положение и ориентация аппаратуры близки к допустимому местоположению, допустимому положению и допустимой ориентации, визуализировать совместно используемый виртуальный объект в закрепляемом на голове дисплее, через который смотрят.

13. Потребляющее устройство для визуализации совместно используемого виртуального объекта, содержащее:

закрепляемый на голове дисплей и

процессор, подключенный к закрепляемому на голове дисплею, причем процессор запрограммирован: