Область техники

Изобретение, описанное в данном документе, относится к системам и способам для предоставления ощущений дополненной и виртуальной реальности пользователю посредством использования носимого устройства визуализации в координации с неподвижным устройством визуализации.

Уровень техники

Парки развлечений и/или тематические парки могут включать в себя различные развлекательные аттракционы, рестораны и поездки, полезные в предоставлении удовольствия гостям (например, семьям и/или людям всех возрастов) парка развлечений. Области парка развлечений могут иметь различные темы, которые специально нацелены на некоторую аудиторию. Например, некоторые области могут включать в себя темы, которые являются традиционно интересными детям, в то время как другие области могут включать в себя темы, которые являются традиционно интересными более зрелой аудитории. Как правило, местоположения, имеющие темы, ассоциированные с таким парком развлечений, могут называться аттракционом или тематическим аттракционом.

Тематические аттракционы могут быть установлены с помощью неподвижного оборудования, компоновок зданий, реквизита, декораций и т.д., большая часть которого может, в целом, относиться к некоторой теме. В ситуациях, когда другая тема должна быть установлена в том же самом месте, отличительные элементы, ассоциированные со старой темой, могут быть заменены элементами, ассоциированными с более новой темой. В зависимости от сложности темы местоположения это может оказаться очень трудным и затратным по времени, поскольку декорации, мебель, оборудование, реквизит и т.д. могут быть удалены или заменены. Действительно, для некоторых типов аттракционов, относительно сложные темы стали более обычными, чтобы обеспечивать гостям более глубокие ощущения.

Теперь признано, что желательно включать аттракционы, где можно изменять темы аттракционов, или включать или удалять некоторые тематические отличительные признаки в таких аттракционах гибким и эффективным образом относительно традиционных технологий. Также теперь признано, что желательно улучшать иммерсивное восприятие гостей для таких аттракционов и обеспечивать более персонализированное или сугубо индивидуальное восприятие для гостей.

Сущность изобретения

Сущность некоторых вариантов осуществления, описанных в данном документе, излагается ниже. Следует понимать, что эти аспекты представляются просто, чтобы предоставлять читателю краткую сущность этих некоторых вариантов осуществления, и что эти аспекты не предназначены, чтобы ограничивать рамки этого описания. В действительности, это описание может охватывать множество аспектов, которые могут не быть изложены ниже.

В одном варианте осуществления система для предоставления ощущения дополненной реальности, виртуальной реальности и/или смешанной реальности пользователю включает в себя первый дисплей и второй дисплей. Пользователь просматривает окружение реального мира через первый дисплей и второй дисплей. Система включает в себя носимое устройство визуализации, которое включает в себя первый дисплей, и неподвижное устройство визуализации, которое включает в себя второй дисплей. Первый дисплей конфигурируется, чтобы отображать первый слой виртуальных элементов, а второй дисплей конфигурируется, чтобы отображать второй слой виртуальных элементов. Система включает в себя процессор, сконфигурированный, чтобы формировать первый слой виртуальных элементов и второй слой виртуальных элементов. Процессор конфигурируется, чтобы оперативно связываться с носимым устройством визуализации и неподвижным устройством визуализации, чтобы координировать представление первого слоя виртуальных элементов и второго слоя виртуальных элементов.

В одном варианте осуществления система для предоставления ощущения дополненной реальности, виртуальной реальности и/или смешанной реальности пользователю включает в себя транспортное средство для катания пассажиров, неподвижное устройство визуализации и процессор. Транспортное средство для катания пассажиров конфигурируется, чтобы двигаться по пути или треку во время поездки в парке развлечений. Неподвижное устройство визуализации включает в себя прозрачный дисплей, соединенный с транспортным средством для катания пассажиров. Неподвижное устройство визуализации конфигурируется, чтобы накладывать виртуальные элементы на окружение реального мира, которое является видимым сквозь прозрачный дисплей. Процессор конфигурируется, чтобы формировать виртуальные элементы и координировать представление виртуальных элементов с эффектами поездки для поездки.

В одном варианте осуществления способ для предоставления ощущения дополненной реальности, виртуальной реальности и/или смешанной реальности пользователю включает в себя формирование первого слоя виртуальных элементов и второго слоя виртуальных элементов с помощью процессора. Способ также включает в себя отображение в первое время отображения, в ответ на инструкции от процессора, первого слоя виртуальных элементов на первом дисплее. Первый дисплей располагается в носимом устройстве визуализации. Способ дополнительно включает в себя отображение во второе время отображения, в ответ на инструкции от процессора, второго слоя виртуальных элементов на втором дисплее. Второй дисплей располагается в неподвижном устройстве визуализации, которое является физически отдельным от носимого устройства визуализации.

Различные уточнения отличительных признаков, отмеченных выше, могут быть предприняты в отношении различных аспектов настоящего изобретения. Дополнительные отличительные признаки могут также быть включены в эти различные аспекты равным образом. Эти уточнения и дополнительные отличительные признаки могут существовать отдельно или в каком–либо сочетании.

Краткое описание чертежей

Эти и другие признаки, аспекты и преимущества настоящего раскрытия сущности должны становиться более понятными после прочтения нижеприведенного подробного описания со ссылками на прилагаемые чертежи, при этом аналогичные номера ссылок представляют аналогичные части на всех чертежах, на которых:

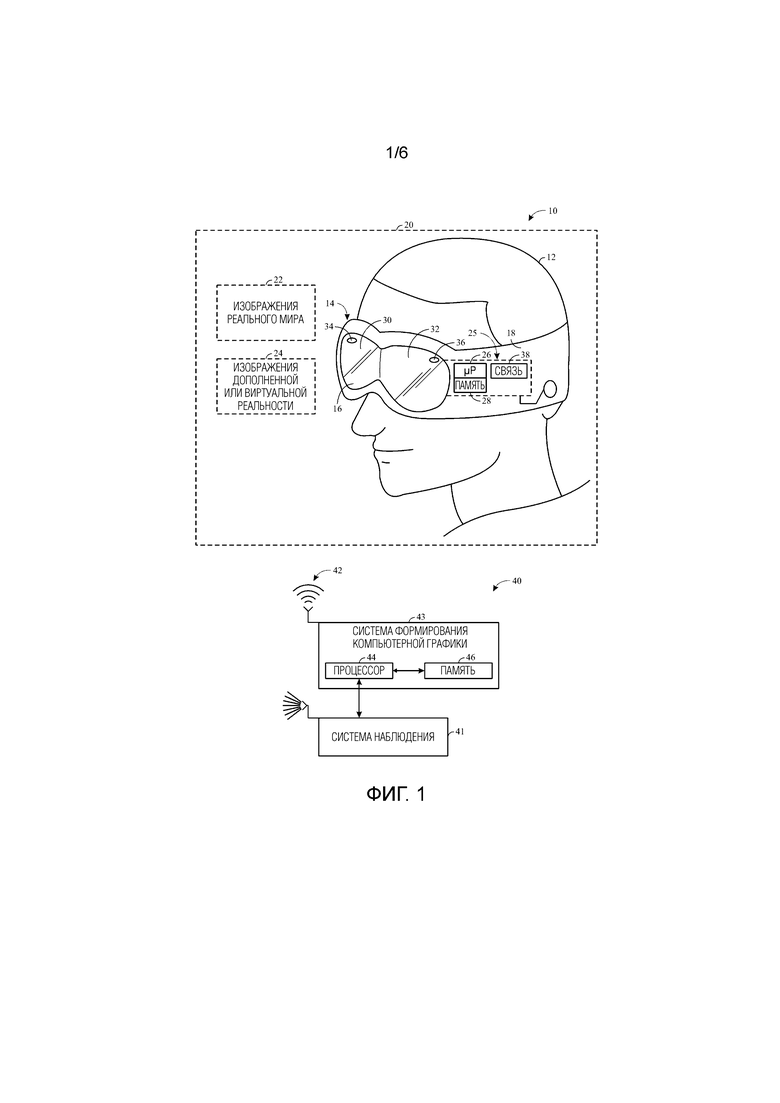

Фиг 1 – иллюстрация варианта осуществления носимого устройства визуализации и системы формирования компьютерной графики, которые могут быть использованы в системе дополненной реальности (AR) или виртуальной реальности (VR), в соответствии с настоящими вариантами осуществления;

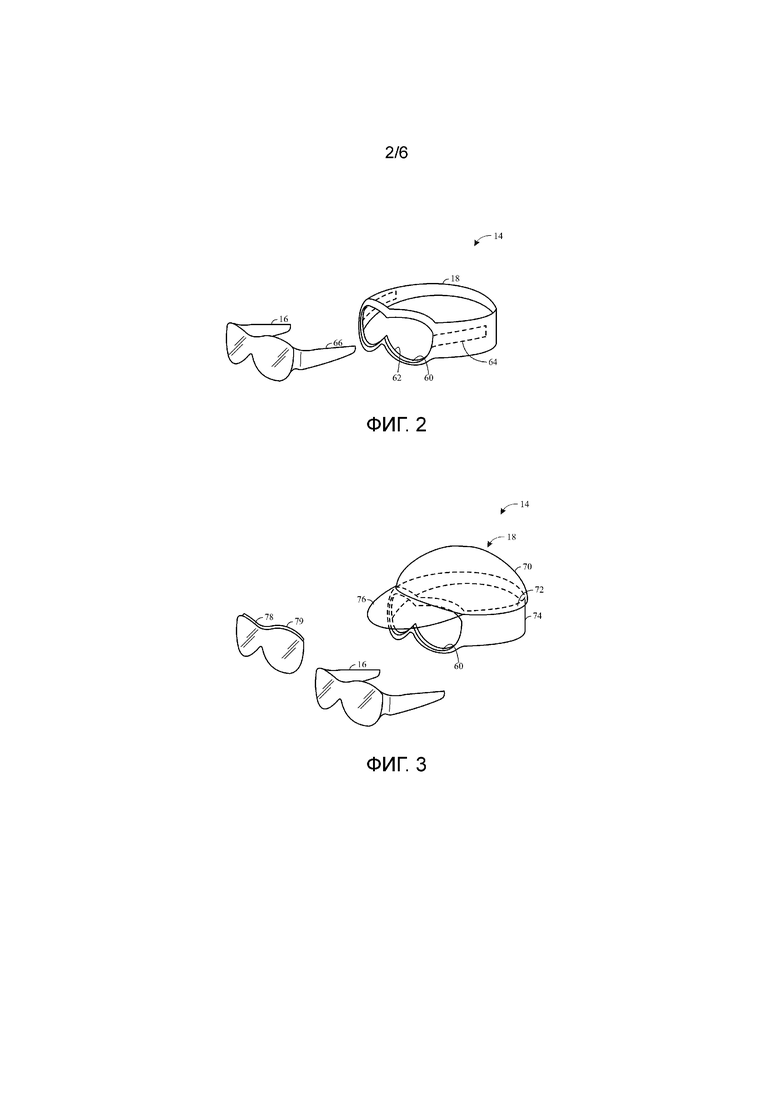

Фиг. 2 – покомпонентный вид в перспективе варианта осуществления носимого устройства визуализации с фиг. 1, в соответствии с настоящими вариантами осуществления;

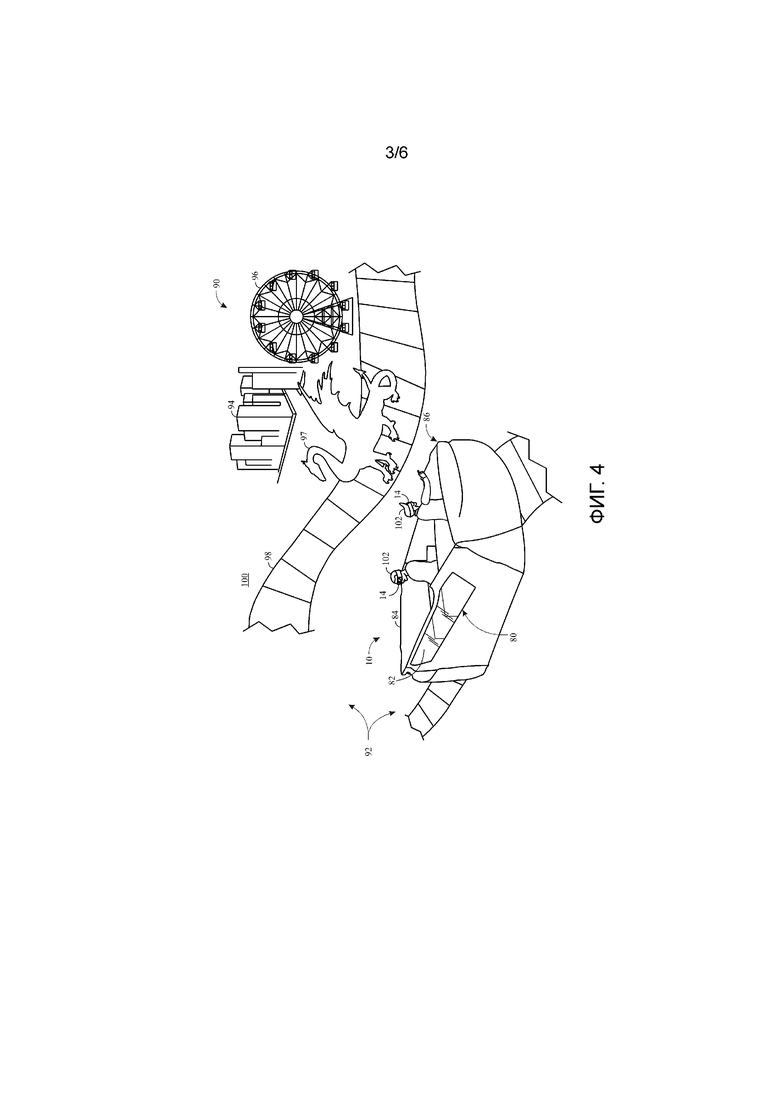

Фиг. 3 – покомпонентный вид в перспективе варианта осуществления носимого устройства визуализации с фиг. 1, в соответствии с настоящими вариантами осуществления;

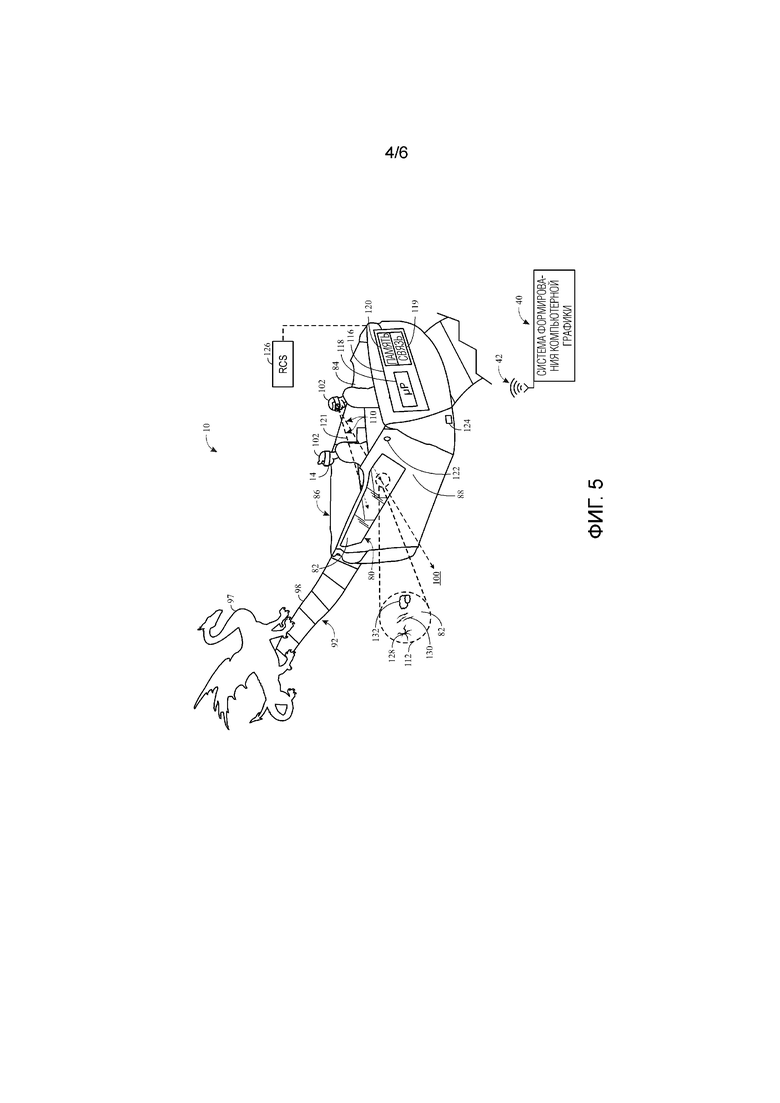

Фиг. 4 - иллюстрация неподвижного устройства визуализации и носимого устройства визуализации системы дополненной реальности (AR) или виртуальной реальности (VR) с фиг. 1, которые могут быть использованы в транспортном средстве для катания пассажиров, в соответствии с настоящими вариантами осуществления;

Фиг. 5 - вид в перспективе транспортного средства для катания пассажиров с фиг. 4, показывающий вариант осуществления системы дополненной реальности (AR) или виртуальной реальности (VR), имеющей неподвижное устройство визуализации, в соответствии с настоящими вариантами осуществления;

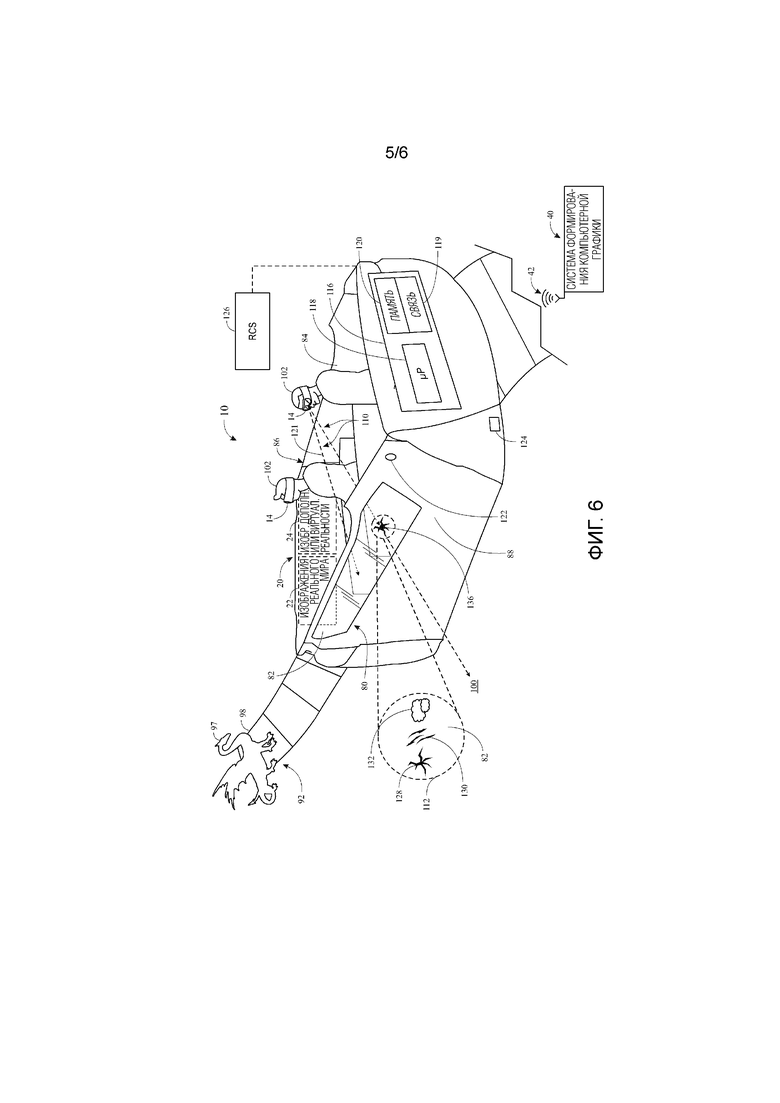

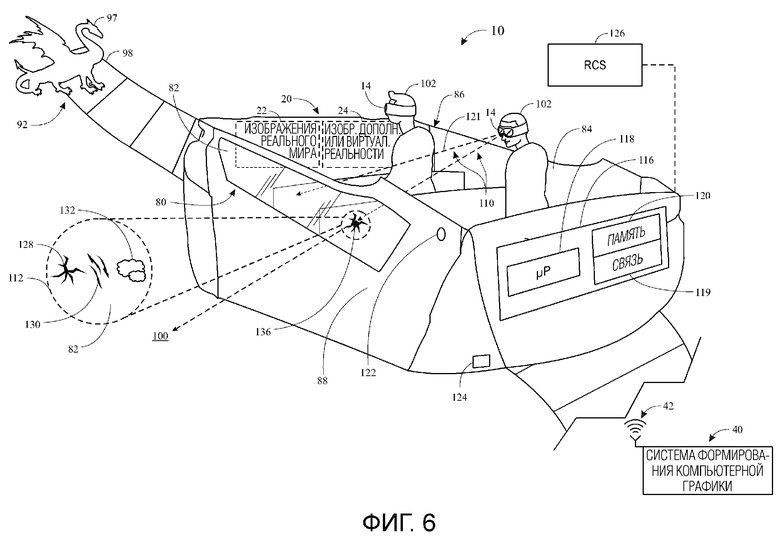

Фиг. 6 - вид в перспективе транспортного средства для катания пассажиров с фиг. 4, показывающий вариант осуществления системы дополненной реальности (AR) или виртуальной реальности (VR), имеющей носимое устройство визуализации и неподвижное устройство визуализации, в соответствии с настоящими вариантами осуществления; и

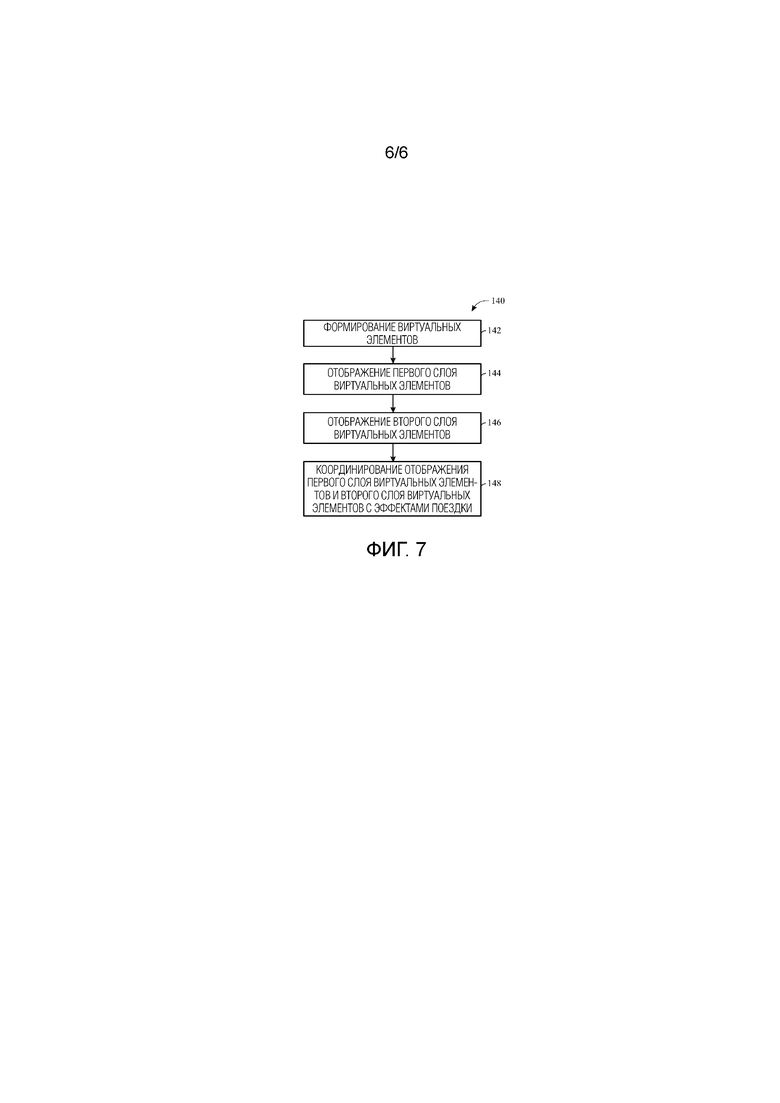

Фиг. 7 - блок–схема последовательности операций способа работы системы дополненной реальности (AR) или виртуальной реальности (VR) с фиг. 4, в соответствии с настоящими вариантами осуществления.

Подробное описание изобретения

Один или более конкретных вариантов осуществления настоящего изобретения будут описаны ниже. Стремясь предоставить краткое описание этих вариантов осуществления, все признаки фактической реализации могут не быть описаны в спецификации. Должно быть понятно, что в разработке любой такой фактической реализации, как в каком–либо проектировании или опытно–конструкторской работе, многочисленные характерные для реализации решения должны быть выполнены, чтобы добиваться конкретных целей разработчиков, таких как согласование со связанными с системой и связанными с бизнесом ограничениями, которые могут изменяться от одной реализации к другой. Кроме того, должно быть понятно, что такая опытно–конструкторская разработка может быть сложной и занимающей время, но, тем не менее, будет установившаяся практика выполнения проекта, изготовления и производства для обычного специалиста в области техники, имеющего преимущество этого открытия.

Настоящие варианты осуществления относятся к системам и способам предоставления ощущения дополненной реальности (AR), ощущения виртуальной реальности (VR), ощущения смешанной реальности (например, сочетания AR и VR) или их сочетания, как части аттракциона, ассоциированного с парком развлечений или тематическим парком. В соответствии с настоящими вариантами осуществления, аттракционы могут необязательно быть ограничены областями парка развлечений. В действительности, аспекты настоящего изобретения могут также относиться к реализации аттракционов в местах за границами парка развлечений, например, в отеле, ассоциированном с парком развлечений, или в транспортных средствах, которые перевозят гостей в и из парка развлечений и/или отеля.

Настоящие варианты осуществления включают в себя, например, сочетания некоторых конфигураций аппаратных средств, конфигураций программного обеспечения (например, алгоритмические структуры), также как некоторые характерные особенности аттракциона, которые могут быть использованы для реализации AR, VR и/или ощущений смешанной реальности. Такие ощущения могут обеспечивать насыщенное ощущение аттракциона для гостей парка развлечений, которые могут быть сугубо индивидуальными, персонализированными и интерактивными.

Например, настоящие варианты осуществления могут включать в себя устройства просмотра, такие как носимые устройства визуализации (например, электронные очки или дисплеи, очки) и неподвижные устройства визуализации (например, прозрачные дисплеи на светоизлучающих диодах [LED], прозрачные дисплеи на органических светоизлучающих диодах [OLED]), через которые гости парка развлечений и работники могут видеть сцены AR, VR и/или смешанной реальности. Следует понимать, что неподвижные устройства визуализации, описанные в данном документе, могут быть прикреплены и/или присоединены к структуре, такой как транспортное средство для катания пассажиров, стена здания или т.п. Неподвижные устройства визуализации могут быть физически отдельными и отличными от носимых устройств визуализации. Некоторые реализации могут быть использованы, чтобы улучшать ощущения гостей, например, посредством виртуального удаления или добавления элементов в окружении, ассоциированном с парком развлечений, чтобы предоставлять регулируемые виртуальные окружения для различных ощущений в одной и той же поездке, чтобы предоставлять возможность гостю иметь ту же точку обзора, что и другому гостю, и т.д.

Некоторые аттракционы в парке развлечений могут включать в себя транспортные средства для катания пассажиров, которые могут быть специально предназначены для взаимодействия с устройствами просмотра, например, чтобы добавлять дополнительную глубину и/или реализм ощущению AR, VR или смешанной реальности. В одном варианте осуществления неподвижные устройства визуализации могут включать в себя прозрачные дисплеи. В одном варианте осуществления традиционные панели и/или окна (например, стеклянные, акриловые) салона транспортного средства для катания пассажиров могут быть заменены прозрачными дисплеями, которые могут дополнять декорации снаружи салона посредством наложения виртуальных изображений и/или видеоизображений на фрагменты или все прозрачные дисплеи (например, прозрачные LED–дисплеи, прозрачные OLED–дисплеи). Например, в одном варианте осуществления, прозрачные дисплеи могут быть использованы, чтобы отображать запотевание, когда транспортное средство для катания пассажиров проезжает мимо анимированной фигуры (например, дракона), чтобы создавать иллюзию того, что анимированная фигура дышит на транспортное средство для катания пассажиров.

Дополнительно или альтернативно, носимые устройства визуализации могут быть использованы, чтобы дополнять восприятие пассажиром окружающей обстановки. Например, носимые устройства визуализации могут создавать иллюзию того, что анимированная фигура входит в салон (например, дракон лезет внутрь или извергает огонь в салон), что может приводить в результате к более иммерсивному ощущению для гостя. Неподвижные устройства визуализации и носимые устройства визуализации могут быть сконфигурированы, чтобы работать независимо, или могут быть функционально соединены посредством контроллера (например, системы формирования компьютерной графики, одного или более процессоров), который может синхронизировать и/или координировать визуализации, отображаемые на неподвижных устройствах визуализации и носимых устройствах визуализации. Контроллер может также синхронизировать и/или координировать ощущение AR, VR и/или смешанной реальности, обеспечиваемое носимыми устройствами визуализации и/или неподвижными устройствами визуализации с внешней аниматроникой или другими элементами поездки, расположенными около пути транспортного средства для катания пассажиров.

Кроме того, некоторые данные могут быть собраны от носимых устройств визуализации, чтобы предоставлять возможность более эффективного использования вычислительной мощности и/или других ресурсов, для адресной рекламы, предоставлять редкие виртуальные элементы (например, "пасхальные яйца"), для инициирования эффектов или корректировки шоу, и т.д. Например, система управления поездкой может определять, посмотрел ли пассажир, носящий носимое устройство визуализации, в некотором направлении (например, чтобы взглянуть на виртуальное изображение на неподвижном устройстве визуализации), перед инициированием перемещения поездки или инициированием других изменений (например, изменения виртуального изображения на неподвижном устройстве визуализации). Данные визуализации сотрудников могут также собираться. Например, система управления поездкой может определять, взглянул ли сотрудник, управляющий поездкой, в некотором направлении (например, чтобы подтверждать, что гости не начали поездку) перед инициированием перемещения поездки. Устройства визуализации могут также быть использованы, чтобы функционировать в качестве индикации на лобовом стекле (HUD) оператора поездки.

Чтобы помочь иллюстрации, фиг. 1 изображает вариант осуществления AR/VR–системы 10, сконфигурированной, чтобы предоставлять возможность пользователю 12 (например, гостю, сотруднику парка развлечений) ощущать (например, просматривать, взаимодействовать) управляемые сцены AR, VR и/или смешанной реальности. В соответствии с некоторыми вариантами осуществления, пользователь 12 может покупать или иначе обеспечиваться носимым устройством 14 визуализации, которое может, в некоторых вариантах осуществления, включать в себя электронные очки 16 (например, AR/VR–очки, дисплейные очки). Как описано более подробно ниже, носимое устройство 14 визуализации может включать в себя носимый фрагмент 18, иллюстрированный как повязка на голове, сконфигурированная, чтобы размещать, по меньшей мере, фрагмент электронных очков 16.

Носимое устройство 14 визуализации может быть использовано отдельно или в сочетании с другими элементами, чтобы создавать сюрреалистическое окружение 20, которое может включать в себя AR–ощущение, VR–ощущение, ощущение смешанной реальности, ощущение созданной при помощи компьютера реальности, их сочетание или другое аналогичное сюрреалистическое окружение для пользователя 12. В частности, носимое устройство 14 визуализации может быть надето пользователем 12 на протяжении всей поездки (например, в транспортном средстве для катания пассажиров) или в другой предварительно определенный момент, такой как во время игры, на входе конкретной области парка развлечений, во время поездки в отель, ассоциированный с парком развлечений, в отеле, и т.д.

В одном варианте осуществления носимое устройство 14 визуализации может включать в себя устройство, в котором некоторые виртуальные элементы могут быть наложены на прозрачную поверхность (например, очки), или может включать в себя устройство, в котором виртуальные элементы накладываются на видеоизображение практически в реальном времени, или их сочетание (например, носимое устройство 14 визуализации может быть приспособлено для переключения между прозрачной и непрозрачной визуализацией пользователя 12). В одном варианте осуществления носимое устройство 14 визуализации может включать в себя элементы, такие как элементы проецирования света, сконфигурированные, чтобы проецировать свет в один или оба глаза пользователя 12, так что виртуальные элементы накладываются поверх объектов реального мира. Такое носимое устройство 14 визуализации может считаться содержащим дисплей с проецированием на сетчатку глаза.

Таким образом, в одном варианте осуществления, пользователь 12 может просматривать окружение реального мира через практически прозрачный комплект электронных очков 16, с некоторыми виртуальными элементами, наложенными на поверхность электронных очков 16 (или глаза пользователя 12), так что пользователь 12 воспринимает, что виртуальные элементы объединены в физическое окружение. В одном варианте осуществления пользователь 12 может просматривать видеоизображение реального времени физического окружения, имеющее наложенные виртуальные элементы.

В одном варианте осуществления, при ношении носимого устройства 14 визуализации, пользователь 12 может чувствовать себя полностью охваченным сюрреалистическим окружением 20 и может воспринимать сюрреалистическое окружение 20 как физическое окружение реального мира, которое включает в себя конкретные виртуальные элементы. В частности, в одном варианте осуществления, носимое устройство 14 визуализации может полностью управлять просмотром пользователя 12 (например, с помощью непрозрачных поверхностей просмотра), так что сюрреалистическое окружение 20 может быть видеоизображением в реальном времени, включающим в себя изображения 22 реального мира для физического окружения, электронным образом объединенные с одним или более изображениями 24 дополненной или виртуальной реальности (например, виртуальными дополнениями).

Изображения 22 реального мира, в целом, предоставляют то, что пользователь 12 будет видеть, даже когда не носит носимое устройство 14 визуализации. Термин "в реальном времени" указывает, что изображения получаются и/или предоставляются во временных рамках, практически близким к времени фактического наблюдения. Более конкретно, в других вариантах осуществления, носимое устройство 14 визуализации может лишь частично управлять обзором пользователя 12 (например, с помощью прозрачных поверхностей просмотра), так что сюрреалистическое окружение 20 является фактическим физическим окружением с изображениями 24 дополненной или виртуальной реальности, наложенными на прозрачные поверхности, или в глаза пользователя 12. В соответствии с дополнительными вариантами осуществления настоящего изобретения изображения 24 дополнительной и виртуальной реальности могут функционировать, чтобы накладывать объект реального мира, так что объект выглядит больше не присутствующим или удаленным (например, объект реального мира полностью или частично загораживается виртуальным объектом или представлением виртуального окружения).

В одном варианте осуществления, и как иллюстрировано в фрагменте разреза носимого устройства 14 визуализации, чтобы поддерживать создание аспектов сюрреалистического окружения 20, носимое устройство 14 визуализации может включать в себя схему 25 обработки, такую как процессор 26 и память 28. Процессор 26 может быть функционально соединен с памятью 28, чтобы исполнять инструкции для выполнения описываемых в настоящее время технологий, например, формирующие изображения 22 реального мира и/или одно или более изображений 24 дополненной или виртуальной реальности (например, виртуальные элементы или изображения). Эти инструкции могут быть закодированы в программах или коде, сохраненном на материальном энергонезависимом компьютерно–читаемом носителе, таком как память 28 и/или другое запоминающее устройство. Процессор 26 может быть процессором общего назначения, устройством с системой на кристалле (SoC), специализированной интегральной схемой (ASIC) или некоторой другой аналогичной конфигурацией процессора. Вместе, память 28 и процессор 26 могут формировать всю или часть AR/VR–системы 10.

В одном варианте осуществления, как дополнительно иллюстрировано, носимое устройство 14 визуализации может также включать в себя пару дисплеев 30 и 32 (например, которые могут быть предоставлены в оправе перед носимым устройством 14 визуализации, где в ином случае находились бы линзы очков), соответственно соответствующих каждому глазу пользователя 12. В одном варианте осуществления может быть применен объединенный дисплей. Соответствующие дисплеи 30 и 32 могут, каждый, включать в себя, в качестве неограничивающего примера, прозрачные линзы, на которые могут накладываться изображения 24 дополненной или виртуальной реальности. В одном варианте осуществления дисплеи 30 и 32 могут быть поверхностями отображения и могут включать в себя элементы (например, схемы, светоизлучатели), расположенные рядом со своими соответствующими периферийными устройствами, сконфигурированными, чтобы накладывать изображения 24 дополненной или виртуальной реальности.

Дополнительно или альтернативно, дисплеи 30 и 32 могут включать в себя непрозрачный жидкокристаллический дисплей (LCD), непрозрачный дисплей на органических светоизлучающих диодах (OLED) или другой аналогичный дисплей, полезный в отображении изображений 22 реального мира и изображений 24 дополненной или виртуальной реальности пользователю 12. В одном варианте осуществления соответствующие дисплеи 30 и 32 могут, каждый, включать в себя прозрачный (например, видимый насквозь) LED–дисплей или прозрачный (например, видимый насквозь) OLED–дисплей, полезный в предоставлении возможности, например, пользователю 12 просматривать изображения 24 дополненной или виртуальной реальности, появляющиеся на соответствующих дисплеях 30 и 32 как наложение на фактическое и физическое окружение (например, аттракцион, ассоциированный с парком развлечений или интерьер транспортного средства для катания пассажиров). Такая конфигурация может также предоставлять возможность пользователю 12 просматривать другие слои виртуальных изображений, появляющихся на других дисплеях, как обсуждается более подробно ниже.

Камеры 34 и 36 носимого устройства 14 визуализации могут соответственно соответствовать точке обзора пользователя 12 и могут быть использованы для захвата видеоданных в реальном времени (например, живого видеоизображения) или сигналов общего освещения физического окружения. В одном варианте осуществления может быть применена единственная камера. Носимое устройство 14 визуализации может также включать в себя дополнительные камеры, чтобы отслеживать движение глаз пользователя, что может быть особенно полезным для вариантов осуществления, где виртуальные элементы проецируются непосредственно на глаза пользователя 12. Элементы 38 связи (например, включающие в себя беспроводной приемопередатчик) носимого устройства 14 визуализации, могут передавать данные в реальном времени (например, видеоданные, данные отслеживания глаз), захваченные посредством соответствующих камер 34 и 36, процессору 26 и/или системе 40 формирования компьютерной графики для обработки.

Как изображено, носимое устройство 14 визуализации может быть соединено с возможностью передачи данных с системой 40 формирования компьютерной графики (например, сервером в парке развлечений) через беспроводную сеть 42 (например, беспроводные локальные вычислительные сети [WLAN], беспроводные глобальные вычислительные сети [WWAN], связь малого радиуса действия [NFC]). Однако в других вариантах осуществления, видеоданные реального времени, захваченные посредством соответствующих камер 34 и 36, могут быть обработаны на носимом устройстве 14 визуализации посредством процессора 26. Дополнительно, элементы 38 связи (например, беспроводной приемопередатчик, входные/выходные соединители), которые соединяются с процессором 26, могут предоставлять возможность микропрограммному обеспечению и/или программному обеспечению, включенному в процессор 26 и память 28, обновляться и/или конфигурироваться для конкретных использований. В одном варианте осуществления беспроводная сеть 42 может соединять с возможностью обмена данными все или некоторые компоненты AR/VR–системы 10.

Другие элементы носимого устройства 14 визуализации могут передавать данные об ориентации, позиционные данные, данные о точке обзора (например, фокусное расстояние, ориентацию, позу), данные отслеживания движения и т.д., полученные и/или произведенные на основе данных, полученных посредством датчиков носимого устройства 14 визуализации. Такие датчики могут включать в себя датчики ориентации и позиции (например, акселерометры, магнетометры, гироскопы, приемники системы глобального позиционирования [GPS]), датчики отслеживания движения (например, электромагнитные и твердотельные датчики отслеживания движения), инерциальные измерительные блоки (IMU) и другие.

В некоторых вариантах осуществления отличительные признаки носимого устройства 14 визуализации (например, геометрические аспекты или метки) могут наблюдаться посредством системы 41 наблюдения (например, одной или более камер), чтобы определять позицию, местоположение, ориентацию и т.д. носимого устройства 14 визуализации и, в свою очередь, позицию, местоположение, ориентацию и т.д. пользователя 12. Система 41 наблюдения может быть соединена с возможностью обмена данными с системой 40 формирования компьютерной графики и использована, чтобы идентифицировать позицию, местоположение, ориентацию и т.д. пользователя 12 (или множества пользователей).

Система 40 формирования компьютерной графики включает в себя схему 43 обработки, такую как процессор 44 (например, процессор общего назначения или другой процессор) и память 46, и может обрабатывать видеоданные в реальном времени (например, живое видеоизображение), данные об ориентации и позиции, данные о точке обзора, или любое их сочетание, принятые от носимого устройства 14 визуализации и системы 41 наблюдения. В частности, система 40 формирования компьютерной графики может использовать эти данные, чтобы формировать систему координат для точного совмещения изображений 24 дополненной или виртуальной реальности с физическим окружением, например, со сформированными изображениями 22 реального мира. В частности, с помощью системы координат, сформированной на основе данных об ориентации, данных о позиции, данных о точке обзора, данных отслеживания движения и т.д., система 40 формирования графики может затем воспроизводить вид изображений 24 дополненной или виртуальной реальности, и в одном варианте осуществления изображений 22 реального мира, способом, который соответствует во времени и пространстве с тем, что пользователь 12 воспримет, если не будет носить носимое устройство 14 визуализации. Система 40 формирования графики может постоянно обновлять (например, в реальном времени) воспроизведение изображений реального мира, чтобы отражать изменение в соответствующей ориентации, позиции и/или движении соответствующего пользователя 12. В некоторых вариантах осуществления система 40 формирования компьютерной графики может отслеживать такие данные, соответствующие множеству пользователей 12 (например, пассажирам транспортного средства для катания пассажиров), когда каждый пользователь 12 (или, по меньшей мере, некоторые пользователи 12) имеют соответствующее носимое устройство 14 визуализации.

Как изложено выше, носимое устройство 14 визуализации включает в себя несколько компонентов и, в целом, может включать в себя электронные очки 16, сконфигурированные, чтобы носиться на голове пользователя 12. Множество различных конфигураций и реализаций электронных очков 16 могут быть использованы, когда различные конфигурации могут иметь различные размеры и формы, чтобы лучше приспосабливаться к различным размерам для различных пользователей 12, также как различные инерциальные компоненты (например, элементы связи, преобразователи, дисплеи), чтобы приспосабливаться к различным реализациям.

Чтобы предоставлять дополнительную гибкость и поддержку для электронных очков 16, носимый фрагмент 18 носимого устройства 14 визуализации может принимать множество форм, например, варианты осуществления которых изображаются на фиг. 2 и 3. На фиг. 2 носимое устройство 14 визуализации включает в себя повязку на голову в качестве носимого фрагмента 18. Такой вариант осуществления носимого фрагмента 18 может включать в себя различные материалы, сконфигурированные, чтобы приспосабливаться к движению пользователя 12, в то же время обеспечивая комфорт (например, эластичные материалы, впитывающие пот материалы, подкладка) для пользователя 12. В настоящее время признается, что может быть желательным иметь отдельный носимый фрагмент 18 и электронные очки 16, чтобы предоставлять возможность стирать носимый фрагмент 18 без риска для схемы 25 обработки (фиг. 1) носимого устройства 14 визуализации. Однако, в некоторых вариантах осуществления, носимый фрагмент 18 может объединять один или более электронных компонентов схемы 25 обработки. В таких вариантах осуществления электронные компоненты в носимом фрагменте 18 могут быть практически изолированы от окружающей среды, чтобы избегать повреждения.

Вариант осуществления носимого фрагмента 18 на фиг. 2 включает в себя область 60 держателя, сконфигурированную, чтобы принимать электронные очки 16 и поддерживать позицию электронных очков 16 относительно глаз пользователя 12 (фиг. 1) во время использования. В этом отношении, область 60 держателя может, в одном варианте осуществления, включать в себя центральный фрагмент 62, закрепляемый по периметру дисплеев 30, 32 (фиг. 1) электронных очков 16, а также боковые фрагменты 64, сконфигурированные, чтобы окружать (например, частично или полностью) дужки 66 электронных очков 16.

Центральный фрагмент 62 области 60 держателя может включать в себя подушку, чтобы предоставлять возможность комфорта пользователя 12, в то время как повязка на голову обеспечивает достаточное сжимающее усилие по отношению к голове пользователя 12 (например, для поддержания позиции электронных очков 16). Центральный фрагмент 62 может, в одном варианте осуществления, включать в себя один или более материалов, имеющих коэффициент трения о кожу, который обеспечивает подходящее сочетание устойчивости и комфорта. Например, гелевые материалы, обычно используемые в носовой области электронных очков 16, могут быть подходящими.

Как иллюстрировано в варианте осуществления на фиг. 3, носимый фрагмент 18 может включать в себя другие отличительные элементы либо в дополнение к повязке на голову, либо вместо повязки на голову. Как изображено, носимый фрагмент 18 включает в себя кепку 70 для ношения поверх головы пользователя 12, также как элементы, аналогичные повязке на голову, изложенной на фиг. 2. В некоторых вариантах осуществления, и как показано, кепка 70 может включать в себя область 72 закрепления, где кепка 70 перекрывается с фрагментом 74 повязки на голову. Область 72 закрепления может включать в себя застегивающие механизмы, такие как застежки–"липучки", застежки–крючки, кнопки, магнитные полосы и т.д., сконфигурированные, чтобы предоставлять возможность скрепления между кепкой 70 и фрагментом 74 повязки на голову. Таким образом, кепка 70 является отделяемой от фрагмента 74 повязки на голову, что предоставляет возможность использовать их по отдельности, стирать отдельно и т.д. Фрагмент 74 повязки на голову, в одном варианте осуществления, может быть объединенным с кепкой 70 (например, пришит к кепке 70), так что фрагмент 74 повязки на голову не является легко снимаемым с кепки 70.

Иллюстрированный вариант осуществления кепки 70 включает в себя козырек 76, который служит для защиты глаз пользователя 12, также как электронных очков 16 и их ассоциированных дисплеев 30, 32 (фиг. 1) от сильных источников освещения, таких как солнце, верхнего освещения и т.д. Козырек 76 может, например, быть особенно полезен в вариантах осуществления, где дисплеи 30, 32 работают на основе оптического отражения и/или являются прозрачными или полупрозрачными. В таких вариантах осуществления козырек 76 может помогать в улучшении воспринимаемого визуального контраста изображений 24 дополненной или виртуальной реальности (фиг. 1) относительно фона физического окружения.

Иллюстрированный вариант осуществления носимого устройства 14 визуализации на фиг. 3 также включает в себя крышку 78 дисплея, сконфигурированную, чтобы помещаться над дисплеями 30, 32 (фиг. 1) электронных очков 16. Крышка 78 дисплея может обеспечивать тень для дисплеев 30, 32, чтобы защищать дисплеи 30, 32 от физического неправильного обращения, обеспечивать степень затененности для улучшенного контраста и визуализации изображений 24 дополненной или виртуальной реальности, для оптической фильтрации и т.д. Крышка 78 дисплея может включать в себя любой подходящий механизм прикрепления, такой как клипса 79, сконфигурированный, чтобы быть съемным и присоединять крышку 78 дисплея к электронным очкам 16. Могут быть использованы другие элементы закрепления, такие как крепления с временным приклеиванием и/или застежки–"липучки".

Обратимся теперь к фиг. 4, показывающему вариант осуществления AR/VR–системы 10, которая может дополнительно включать в себя неподвижное устройство 80 визуализации, которое может состоять из одного или более прозрачных дисплеев 82. Следует понимать, что неподвижное устройство 80 визуализации, описанное в данном документе, может быть прикреплено и/или присоединено к структуре, такой как транспортное средство 86 для катания пассажиров, стена здания или т.п. Неподвижное устройство 80 визуализации может быть физически отдельным и отличным от носимого устройства 14 визуализации. Неподвижное устройство 80 визуализации может быть использовано вместо, или в сочетании с, носимого устройства 14 визуализации на фиг. 1. По существу, прозрачные дисплеи 82 могут быть использованы, чтобы заменять или улучшать ощущение AR, VR или смешанной реальности, создаваемое посредством носимого устройства 14 визуализации. В одном варианте осуществления неподвижное устройство 80 визуализации может добавлять дополнительный слой элементов дополненной или виртуальной реальности, которые пользователь 12 может воспринимать.

В одном варианте осуществления прозрачные дисплеи 82 могут быть соединены с салоном 84 транспортного средства 86 для катания пассажиров. С учетом вышеупомянутого, может быть полезно сначала описать вариант осуществления установки, в котором AR/VR–система 10 может быть использована в парке 90 развлечений, как показано схематично на фиг. 4. Как иллюстрировано, парк 90 развлечений может включать в себя экстремальный аттракцион 92, комплекс сооружений 94 парка развлечений (например, игровые зоны, отели, рестораны, сувенирные магазины) и дополнительные развлекательные аттракционы 96 (например, колесо обозрения, поездку в темноте). В некоторых вариантах осуществления экстремальный аттракцион 92 может включать в себя американские горки или другой аналогичный экстремальный аттракцион 92 и может, таким образом, дополнительно включать в себя путь, такой как система замкнутых треков 98 (например, мили треков 98), которые располагаются вокруг окружающей физической обстановки 100 (например, сооружений 94 парка, дополнительных развлекательных аттракционов 96). Треки 98 могут быть предоставлены как инфраструктура, по которой транспортное средство 86 для катания пассажиров может перемещаться, например, когда пассажир 102 (например, пользователь 12 на фиг. 1) едет в экстремальном аттракционе 92. Хотя только один пассажир 102 показан в иллюстрированном варианте осуществления, транспортное средство 86 для катания пассажиров может быть сконфигурировано, чтобы размещать 1, 2, 3, 4, 5 или более пассажиров 102.

Треки 98 могут, таким образом, определять движение транспортного средства 86 для катания пассажиров. Однако, в одном варианте осуществления, треки 98 могут быть заменены управляемым путем, на котором движение транспортного средства 86 для катания пассажиров может управляться посредством электронной системы, магнитной системы или другой аналогичной инфраструктурой системы, отличной от треков 98. Другими словами, путь поездки транспортного средства 86 для катания пассажиров может не быть физически ограничен точным путем, тем самым, предоставляя пассажиру 102 некоторую степень управления над путем движения, перспективной обзора и т.д.

Когда транспортное средство 86 для катания пассажиров движется по трекам 98, пассажир 102 может обеспечиваться туром движения для физического окружения 100 в области вокруг или рядом с экстремальным аттракционом 92. Транспортное средство 86 для катания пассажиров может дополнительно перемещаться мимо роботизированных устройств (например, аниматронных фигур 97), которые могут быть сконфигурированы, чтобы имитировать человека или животное или придавать реалистичные характеристики иному неодушевленному объекту. Аниматронные фигуры 97 могут быть расположены около фрагментов трека 98 и могут быть сконфигурированы, чтобы взаимодействовать с пассажиром 102 (например, пугать и/или удивлять пассажира 102), когда транспортное средство 86 для катания пассажиров движется по трекам 98. Аниматронные фигуры 97 могут снабжаться мощностью посредством пневматики, гидравлики, электромоторов или любым другим средством, чтобы приводить в действие аниматронные фигуры 97. В то время как пассажир 102 может находить экстремальный аттракцион 92 очень доставляющим удовольствие, может быть полезным улучшать ощущение от поездки для пассажира 102. В частности, вместо необходимости физического просмотра только физического окружения 100, дополнительных развлекательных аттракционов 96 и/или аниматронных фигур 97, расположенных около треков 98, может быть полезным предоставлять пассажиру 102 дополнительное ощущение AR, VR или смешанной реальности. Это может быть сделано, когда транспортное средство 86 для катания пассажиров движется по трекам 98 экстремального аттракциона 92, посредством использования носимого устройства 14 визуализации, неподвижного устройства 80 визуализации или и того, и другого.

Фиг. 5 иллюстрирует вариант осуществления AR/VR–системы 10, в которой пассажир 102 может использовать неподвижное устройство 80 визуализации. Как изложено выше, прозрачные дисплеи 82 неподвижного устройства 80 визуализации могут быть прозрачными LED–дисплеями, прозрачными OLED–дисплеями или любыми дисплеями, подходящими для применения. Прозрачные дисплеи 82 могут быть в значительной степени и/или полностью прозрачными, когда не снабжаются энергией. По существу, в одном варианте осуществления, прозрачные дисплеи 82 могут быть объединены в фрагмент салона 84, такой как боковая панель 88, которая может создавать иллюзию обычного окна (например, стеклянного окна, акрилового окна). Дополнительно или иначе, прозрачные дисплеи 82 могут быть соединены с любым фрагментом транспортного средства 86 для катания пассажиров (например, передним, задним, крышей, полом). Таким образом, пассажир 102 может просматривать физическое окружение 100 через прозрачные дисплеи 82 (как, например, через традиционное окно). В одном варианте осуществления прозрачные дисплеи 82 могут снабжаться энергией (например, непрерывно или периодически в некоторые моменты времени), чтобы быть в значительной степени и/или полностью непрозрачными, что может создавать иллюзию того, что салон 84 полностью заключен в сплошные стены или панели (например, не имеет традиционных окон).

В одном варианте осуществления некоторые виртуальные элементы могут быть наложены на поверхность прозрачных дисплеев 82. Пассажир 102 может просматривать физическое окружение 100 по одной или более линиям взгляда 110, которые могут создаваться, когда пассажир 102 смотрит через прозрачные дисплеи 82. Прозрачные дисплеи 82 могут быть использованы, чтобы накладывать изображения 112 дополненной или виртуальной реальности на линии взгляда 110 пассажира 102. По существу, пассажир 102 может воспринимать то, что виртуальные элементы объединяются (например, физически присутствуют) в физическом окружении 100. Например, прозрачные дисплеи 82 могут лишь частично преграждать линии взгляда 110 пассажира 102 (например, с помощью прозрачных поверхностей просмотра), так что физическое окружение 100, которое пассажир 102 видит, является фактическим окружением с изображениями 112 дополненной или виртуальной реальности, наложенными на прозрачные поверхности просмотра прозрачных дисплеев 82. В одном варианте осуществления пассажир 102 может просматривать в реальном времени видеоизображение физического окружения 100, имеющего наложенные виртуальные элементы на прозрачных дисплеях 82.

В одном варианте осуществления неподвижное устройство 80 визуализации может быть функционально соединено со схемой 116 обработки, которая может быть соединена с транспортным средством 86 для катания пассажиров. Схема 116 обработки может включать в себя процессор 118 (например, процессор общего назначения или другой процессор), элементы 119 связи (например, беспроводной приемопередатчик) и память 120. Процессор 118 может быть функционально соединен с памятью 120, чтобы выполнять инструкции для выполнения описываемых в настоящее время технологий, например, формирования изображений 121 реального мира (например, видеоизображения физического окружения 100 в реальном времени) и/или изображений 112 дополненной или виртуальной реальности. Эти инструкции могут быть закодированы в программах или коде, сохраненном на материальном энергонезависимом компьютерно–читаемом носителе, таком как память 120 и/или другое запоминающее устройство. Процессор 118 может быть процессором общего назначения, устройством с системой на кристалле (SoC), специализированной интегральной схемой (ASIC) или некоторой другой аналогичной конфигурацией процессора. В одном варианте осуществления пассажир 102 может просматривать изображения 112 дополненной или виртуальной реальности и окружающую физическую среду 100 через прозрачные дисплеи 82, когда транспортное средство 86 для катания пассажиров движется по трекам 98 экстремального аттракциона 92. Схема 116 обработки может быть соединена с возможностью обмена данными с системой 40 формирования компьютерной графики (например, в парке развлечений) через элементы 119 связи и/или беспроводную сеть 42. В одном варианте осуществления схема 116 обработки может работать независимо от системы 40 формирования компьютерной графики. Как обсуждается более подробно в данном документе, неподвижное устройство 80 визуализации может быть функционально соединено с процессором 26 (фиг. 1) носимого устройства 14 визуализации (фиг. 1), таким образом, предоставляя возможность изображениям 112 дополненной или виртуальной реальности неподвижного устройства 80 визуализации синхронизироваться и/или координироваться с изображениями 24 дополненной или виртуальной реальности (фиг. 1) носимого устройства 14 визуализации.

В одном варианте осуществления видеоданные реального времени (например, живые видеоданные) могут приниматься от камер 122, соединенных с внешней стороной транспортного средства 86 для катания пассажиров. Хотя только одна камера 122 изображается в показанном варианте осуществления, транспортное средство 86 для катания пассажиров может поддерживать 1, 2, 3, 4, 5 или более камер 122, чтобы захватывать изображения 121 реального мира для физического окружения 100, окружающего транспортное средство 86 для катания пассажиров. Схема 116 обработки может обрабатывать видеоданные реального времени, чтобы формировать и отображать изображения 121 реального мира на прозрачных дисплеях 82. В одном варианте осуществления изображения 121 реального мира могут быть предварительно записаны и сохранены в памяти 120 схемы 116 обработки. Дополнительно, схема 116 обработки может собирать данные об ориентации и позиции, данные о точке обзора или любое их сочетание, принятые от камер 122 и/или дополнительного датчика 124, который может быть соединен с транспортным средством 86 для катания пассажиров. В частности, схема 116 обработки может использовать эти данные, чтобы формировать систему координат, которая может совмещать и синхронизировать и/или координировать сформированные изображения 112 дополненной или виртуальной реальности с изображениями 121 реального мира и/или физическим окружением 100, которое пассажир 102 может просматривать по линиям взгляда 110.

Например, схема 116 обработки может использовать данные, собранные камерами 122 и/или датчиками 124, чтобы формировать изображения 121 реального мира для физического окружения 100 на прозрачных дисплеях 82. В частности, с помощью системы координат, сформированной на основе данных об ориентации, данных о позиции, данных о точке обзора, данных отслеживания движения и т.д., схема 116 обработки может затем воспроизводить вид изображений 112 дополненной или виртуальной реальности, и в одном варианте осуществления изображения 121 реального мира, способом, который соответствует во времени и пространстве тому, что пассажир 102 воспримет, если будет просматривать окружающую обстановку через традиционное окно (например, стеклянное окно). Схема 116 обработки может постоянно обновлять (например, в реальном времени) воспроизведение изображений 112 дополненной или виртуальной реальности и/или изображения 121 реального мира, чтобы отражать изменение в соответствующих ориентации, позиции и/или перемещении линий взгляда 110 пассажира 102.

Дополнительно или иначе, схема 116 обработки может дополнять физическое окружение 100 или изображения 121 реального мира для физического окружения 100, чтобы улучшать ощущение поездки для пассажира 102 (например, изменять физическое окружение 100, чтобы соответствовать теме трека 98). Например, прозрачные дисплеи 82 могут воспроизводить капли дождя или снегопад, чтобы дополнять физическое окружение 100 посредством прозрачных дисплеев 82. В одном варианте осуществления прозрачные дисплеи 82 могут частично или полностью закрывать вид физического окружения 100 изображениями 112 дополненной или виртуальной реальности фиктивной настройки (например, джунгли, космическое пространство и т.д.).

Схема 116 обработки может управлять синхронизацией эффектов поездки или элементов (например, аниматронных фигур 97), которые могут взаимодействовать с пассажиром 102. В одном варианте осуществления синхронизация эффектов поездки может также управляться посредством системы 40 формирования компьютерной графики, отдельной системы 126 управления поездкой или сочетания обеих. Эффекты поездки могут быть синхронизированы и/или скоординированы с изображениями 112 дополненной или виртуальной реальности, которые отображаются на прозрачных дисплеях 82, когда транспортное средство 86 для катания пассажиров движется по трекам 98. Иммерсивное восприятие экстремального аттракциона 92 может быть улучшено для пассажира 102 посредством синхронизации и/или координации эффектов поездки с изображениями 112 дополненной или виртуальной реальности.

Эффекты поездки могут быть скоординированы, чтобы взаимодействовать с транспортным средством 86 для катания пассажиров, когда транспортное средство 86 для катания пассажиров движется по трекам 98 экстремального аттракциона 92. Например, в одном варианте осуществления, аниматронные фигуры 97 могут временно блокировать треки 98 впереди транспортного средства 86 для катания пассажиров, создавая иллюзию того, что транспортное средство 86 для катания пассажиров может столкнуться с аниматронными фигурами 97. В одном варианте осуществления аниматронная фигура 97 (например, дракон) может быть сконфигурирована, чтобы предоставлять иллюзию атаки транспортного средства 86 для катания пассажиров (например, выдыхая огонь в направлении транспортного средства 86 для катания пассажиров). В то время как пассажир 102 может находить взаимодействие с аниматронными фигурами 97 очень волнующим ощущением, в одном варианте осуществления, может быть полезным улучшать ощущение от поездки для пассажира посредством изображений 112 дополненной или виртуальной реальности, которые могут быть синхронизированы и/или скоординированы с движением аниматронных фигур 97.

Например, в одном варианте осуществления, прозрачные дисплеи 82 могут накладывать трещины 128 стекла или повреждение 130 (например, изменение цвета или обугливание от пламени) на линии взгляда 110 пассажира 102. Это может дополнительно улучшать реализм аниматронных фигур 97, воспринимаемых пассажиром 102. В одном варианте осуществления прозрачные дисплеи 82 могут накладывать запотевание 132 (например, от дышащих животных) на линии взгляда 110, которое может создавать иллюзию, в которой пассажир 102 воспринимает аниматронные фигуры 97 как находящиеся в очень непосредственной близости к транспортному средству 86 для катания пассажиров. Дополнительно или иначе, любые желаемые изображения 112 дополненной или виртуальной реальности могут быть сформированы на прозрачных дисплеях 82, которые могут улучшать реализм специальных эффектов. Например, изображения 112 дополненной или виртуальной реальности могут включать в себя разбрызгивание насекомых, повреждение градом и/или покрытие пылью, которые могут улучшать реализм экстремального аттракциона 92.

Фиг. 6 иллюстрирует вариант осуществления AR/VR–системы 10, в которой процессор 102 одновременно использует и носимое устройство 14 визуализации на фиг. 1, и неподвижное устройство 80 визуализации на фиг. 5. Как изложено выше, носимое устройство 14 визуализации может быть использовано вместе с неподвижным устройством 80 визуализации, чтобы улучшать иммерсивное ощущение AR, VR и/или смешанной реальности для пассажира 102. Например, в одном варианте осуществления, носимое устройство 14 визуализации может быть использовано, чтобы улучшать физическое окружение 100 в салоне 84 посредством наложения виртуальных элементов, таких как изображения 24 дополненной или виртуальной реальности, на глаза пассажира 102. По существу, носимое устройство 14 визуализации может создавать сюрреалистическое окружение 20 в салоне 84 транспортного средства 86 для катания пассажиров. В одном варианте осуществления прозрачные дисплеи 82 могут улучшать физическое окружение 100 снаружи салона 84 посредством наложения виртуальных элементов, таких как изображения 112 дополненной или виртуальной реальности, на линии взгляда 110 пассажира 102. Таким образом, пассажир 102 может просматривать изображения 24 дополненной или виртуальной реальности на носимом устройстве 14 визуализации и изображения 112 дополненной или виртуальной реальности на прозрачных дисплеях 82 неподвижного устройства 80 визуализации одновременно или скоординированным образом. Альтернативно, носимое устройство 14 визуализации может создавать сюрреалистическое окружение 20 снаружи салона 84 транспортного средства 86 для катания пассажиров. Таким образом, прозрачные дисплеи 82 могут накладывать виртуальные элементы на переднем плане, а носимое устройство 14 визуализации может дополнять детали на заднем плане.

В одном варианте осуществления прозрачные дисплеи 82 могут показывать окружающую среду, такую как трещины 128 стекла, повреждение 130 и/или запотевание 132, появляющиеся, чтобы воздействовать на внешнюю сторону транспортного средства 86 для катания пассажиров. В одном варианте осуществления носимое устройство 14 визуализации может дополнительно формировать иллюзию среды (например, такую как влага или запотевание 132), поступающей в салоне 84 транспортного средства 86 для катания пассажиров. Это может создавать множество слоев виртуальных элементов в AR–ощущении, VR–ощущении, ощущении смешанной реальности, ощущения созданной при помощи компьютера реальности или их сочетания. Хотя только два слоя описываются в иллюстрированном варианте осуществления, AR/VR–система 10 может быть сконфигурирована, чтобы формировать 1, 2, 3, 4 или более слоев виртуальных элементов, с которыми пассажир 102 может взаимодействовать. Например, множество прозрачных дисплеев 82 могут быть соединены с салоном 84 транспортного средства 86 для катания пассажиров в последовательных слоях (например, уложенных друг на друга), так что каждый прозрачный дисплей 82 может формировать слой виртуальных элементов.

Например, пассажир 102 может смотреть через электронные очки 16 (фиг. 1) носимого устройства 14 визуализации, которое может формировать первый слой виртуальных элементов (например, изображения 24 дополненной или виртуальной реальности). Пассажир 102 может дополнительно просматривать прозрачные дисплеи 82 неподвижного устройства 80 визуализации (например, через электронные очки 16 носимого устройства 14 визуализации), которое может создавать второй слой виртуальных элементов (например, изображения 112 дополненной или виртуальной реальности). AR/VR–система 10 может быть сконфигурирована, чтобы формировать первый слой виртуальных элементов, второй слой виртуальных элементов, дополнительный слой виртуальных элементов или любое их сочетание, чтобы создавать ощущение AR, VR и/или смешанной реальности для пассажира 102.

По существу, в одном варианте осуществления, AR/VR–система 10 может изменять окружающее физическое окружение 100 (например, парк 90 развлечений), воспринимаемое пассажиром 102 через изображения 112 дополненной или виртуальной реальности, сформированные посредством неподвижного устройства 80 визуализации, и AR/VR–система 10 может создавать сюрреалистическое окружение 20 в салоне 84 посредством использования носимого устройства 14 визуализации. В одном варианте осуществления носимое устройство 14 визуализации может дополнительно изменять окружающее физическое окружение 100 либо в сочетании с, либо вместо, прозрачными дисплеями 82.

Изображения 24 и/или 112 дополненной или виртуальной реальности носимого устройства 14 визуализации и неподвижного устройства 80 визуализации, соответственно, могут быть синхронизированы и/или скоординированы посредством процессора 26 (фиг. 1) носимого устройства 14 визуализации, процессора 44 (фиг. 1) системы 40 формирования компьютерной графики, процессора 118 неподвижного устройства 80 визуализации, дополнительного внешнего процессора (например, такого как в системе 126 управления поездкой), или любого их сочетания. Синхронизация и/или координация могут подразумевать корректировку системы координат виртуальных элементов на основе данных об ориентации, позиционных данных, данных о точке обзора, данных отслеживания движения или дополнительных данных, собранных посредством AR/VR–системы 10.

Процессоры 26, 44, 118 или любое их сочетание, могут связываться через беспроводную сеть 42 и могут дополнительно синхронизировать и/или координировать изображения 24 и/или 112 дополненной или виртуальной реальности с эффектами поездки (например, аниматронными фигурами 97). В одном варианте осуществления отдельная компьютерная система синхронизации (например, система 126 управления поездкой) может быть использована для синхронизации и/или координации изображений 24 и/или 112 дополненной или виртуальной реальности и эффектов поездки.

В одном варианте осуществления схема 116 обработки неподвижного устройства 80 визуализации может освобождать долю мощности обработки, которая может потребоваться схеме 25 обработки (фиг. 1) носимого устройства 14 визуализации. Схема 116 обработки неподвижного устройства 80 визуализации может иметь меньшие пространственные ограничения по сравнению со схемой 25 обработки носимого устройства 14 визуализации. Это может предоставлять возможность схеме 116 обработки неподвижного устройства 80 визуализации реализовывать больший и/или более мощный процессор 118. По существу, прозрачные дисплеи 82 могут формировать и отображать большинство изображений 112 дополненной или виртуальной реальности, требуемых во время экстремального аттракциона 92, в то время как носимое устройство 14 визуализации может формировать лишь меньшие детали (например, создавать сюрреалистическое окружение 20 в салоне 84).

Кроме того, неподвижное устройство 80 визуализации может воспроизводить некоторые виртуальные элементы более эффективно по сравнению с носимым устройством 14 визуализации. Например, может быть желательным создавать иллюзию того, что аниматронная фигура 97 придает отличительный элемент 136 (например, пробивает дыру) окну салона 84 транспортного средства 86 для катания пассажиров, как часть спецэффекта экстремального аттракциона 92. В одном варианте осуществления неподвижное устройство 80 визуализации может быть использовано, чтобы создавать иллюзию того, что отличительный элемент 136 был придан окну (например, прозрачному дисплею 82) салона 84. Для того, чтобы такие элементы 136 предоставлялись посредством носимого устройства 14 визуализации, носимое устройство 14 визуализации может нуждаться в постоянном приеме изображений 22 реального мира и обновлении позиции элемента 136 на электронных очках 16, что может требовать существенной мощности обработки. Например, для того, чтобы гарантировать, что элемент 136 остается неподвижным (например, дыра не перемещается относительно окна салона 84), когда точка обзора пассажира 102 изменяется (например, пассажир 102 поворачивается или перемещается относительно окна), носимое устройство 14 визуализации может нуждаться в постоянном приеме изображений 22 реального мира и/или обновлении позиции элемента 136 на электронных очках 16. В таких случаях, предоставление элемента 136 посредством неподвижного устройства 80 визуализации может быть более эффективным.

В одном варианте осуществления AR/VR–система 10 может вместо этого предоставлять элемент 136 на прозрачном дисплее 82. В одном варианте осуществления AR/VR–система 10 может использовать электронные очки 16, чтобы накладывать изображения 24 дополненной или виртуальной реальности для деталей, которые могут быть связаны с элементом 136 (например, осколок стекла, происходящий из дыры в окне), на глаза пассажира 102, так что детали могут появляться в соответствующей позиции относительно элемента 136. По существу, в одном варианте осуществления, носимое устройство 14 визуализации может формировать лишь меньшие изображения 24 дополненной или виртуальной реальности (например, детали, такие как осколок стекла), в то время как неподвижное устройство 80 визуализации может формировать большинство изображений 112 дополненной или виртуальной реальности, включающих в себя элементы, которые остаются неподвижными относительно транспортного средства 86 для катания пассажиров (например, элементы 136, такие как дыра). В эксплуатации, пассажир 102 может просматривать внутренность салона 84 и элемент 136, сформированный посредством прозрачных дисплеев 82, через практически прозрачные электронные очки 16 (фиг. 1). По существу, позиция элемента 136 относительно окна (например, прозрачных дисплеев 82) транспортного средства 86 для катания пассажиров может оставаться постоянной, независимо от ориентации и/или точки обзора пассажира 102. Это может значительно снижать мощность обработки, требуемую носимым устройством 14 визуализации, по сравнению с использованием носимого устройства 14 визуализации для формирования элементов, таких как элемент 136. Таким образом, сочетание носимого элемента 14 визуализации и неподвижного устройства 80 визуализации, и координация этих устройств 14, 80 посредством AR/VR–системы 10, предоставляет более динамическую и эффективную систему, которая преодолевает проблемы с использованием носимого устройства 14 визуализации отдельно для создания ощущения AR, VR и/или смешанной реальности для пользователя 102.

В одном варианте осуществления изображения 24 дополненной или виртуальной реальности, сформированные посредством носимого устройства 14 визуализации, и изображения 112 дополненной или виртуальной реальности, сформированные посредством неподвижного устройства 80 визуализации, синхронизируются и/или координируются, когда транспортное средство 86 для катания пассажиров пересекает экстремальный аттракцион 92, так что виртуальные элементы, ощущаемые пассажиром 102, могут быть восприняты как более реалистичные по сравнению с использованием либо носимого устройства 14 визуализации, либо неподвижного устройства 80 визуализации отдельно. Например, анимированный элемент (например, взрыв) может быть объединен как часть темы экстремального аттракциона 92. Анимированный элемент может сначала быть сформирован посредством прозрачных дисплеев 82 и наложен на окружающее физическое окружение 100, просматриваемое пассажиром 102. Прозрачные дисплеи 82 могут затем формировать иллюзию элементов, таких как трещина 128 в стекле (например, прозрачных дисплеях 82), и может впоследствии формировать иллюзию того, что окно разбивается (например, создаются осколки стекла). Носимое устройство 14 визуализации может затем формировать иллюзию мусора (например, осколков стекла), проплывающего через салон 84 транспортного средства 86 для катания пассажиров. По существу, носимое устройство 14 визуализации и неподвижное устройство 80 визуализации могут создавать ощущение многослойной дополненной или виртуальной реальности для пользователя 102.

Фиг. 7 иллюстрирует блок–схему последовательности операций варианта осуществления процесса 140, чтобы предоставлять AR/VR–улучшения гостям парка развлечений (например, пассажиру 102). Процесс 140 может быть полезен в создании AR–ощущения, VR–ощущения и/или ощущения смешанной реальности во время ощущения парка развлечений, такого как экстремальный аттракцион 92. Процесс 140 может быть образцом инициируемого кода или инструкций, сохраненных на энергонезависимом компьютерно–читаемом носителе (например, памяти 28, 46, 120) и исполняемых, например, посредством процессора 26 носимого устройства 14 визуализации, процессора 44 системы 40 формирования компьютерной графики и/или процессора 118 неподвижного устройства 80 визуализации. Процессоры 26, 44 и/или 118 могут быть соединены с возможностью обмена данными через сеть, такую как беспроводная сеть 42, чтобы принимать и отправлять инструкции, описанные ниже.

Процесс 140 может начинаться с блока 142, формирующего AR/VR–улучшения (например, виртуальные элементы), такие как изображения 24, 112 дополненной или виртуальной реальности. AR/VR–улучшения могут быть предоставлены посредством носимого устройства 14 визуализации, неподвижного устройства 80 визуализации, дополнительного устройства визуализации или любого их сочетания. AR/VR–улучшения могут быть сформированы посредством схемы 25 обработки носимого устройства 14 визуализации, системы 40 формирования компьютерной графики, схемы 116 обработки неподвижного устройства 80 визуализации или любого их сочетания.

В одном варианте осуществления носимое устройство 14 визуализации может включать в себя прозрачные или полупрозрачные поверхности отображения (например, дисплеи 30, 32) и проецировать изображения 24 дополненной или виртуальной реальности в глаза пассажира 102. Дополнительно или альтернативно, как обсуждается более подробно ниже, неподвижные устройства 80 визуализации могут также быть сконфигурированы, чтобы включать в себя прозрачные или полупрозрачные поверхности отображения (например, прозрачные дисплеи 82), которые отображают изображения 112 дополненной или виртуальной реальности на линии взгляда 110 пассажира 102. Например, изображения 112 дополненной или виртуальной реальности могут преграждать фрагмент линий взгляда 110 пассажира 102 (например, пассажир 102 может все еще видеть фрагменты физического окружения 100 через прозрачные дисплеи 82), создавая иллюзию того, что изображения 112 дополненной или виртуальной реальности являются частью физического окружения 100.

Обращаясь теперь к блоку 144, процесс 140 может включать в себя этап, или последовательность этапов, на которых носимое устройство 14 визуализации может покрывать или накладывать (например, посредством дисплеев 30, 32) одно или более изображений 24 дополненной или виртуальной реальности на физическое окружение 100, чтобы формировать первый слой виртуальных элементов, которые должны просматриваться пассажиром 102. Например, процессоры 26, 44, 118 могут покрывать или накладывать изображения 24 дополненной или виртуальной реальности на прозрачные или полупрозрачные поверхности отображения (например, дисплеи 30, 32), через которые пассажир 102 может просматривать физическое окружение 100, таким образом, формируя первый слой виртуальных элементов. В одном варианте осуществления пассажир 102 может просматривать физическое окружение 100 через прозрачные фрагменты дисплеев 30, 32, в то время как носимое устройство 14 визуализации может лишь загораживать фрагмент дисплеев 30, 32 изображениями 24 дополненной или виртуальной реальности. В одном варианте осуществления процессоры 26, 44, 118 могут формировать и/или накладывать изображения дополненной или виртуальной реальности на поток видеоданных изображений 22 реального мира (например, сооружения 94, физическое окружение 100) с помощью одной или более технологий объединения видео и/или оптического объединения.

Обращаясь теперь к блоку 146, процесс 140 может включать в себя этап, или последовательность этапов, на которых неподвижное устройство 80 визуализации может покрывать или накладывать (например, посредством прозрачных дисплеев 82) одно или более изображений 112 дополненной или виртуальной реальности на физическое окружение 100, чтобы формировать второй слой виртуальных элементов, которые должны просматриваться пассажиром 102. Например, процессоры 26, 44, 118 могут покрывать или накладывать изображения 112 дополненной или виртуальной реальности на прозрачные или полупрозрачные поверхности отображения (например, прозрачные дисплеи 82), через которые пассажир 102 может просматривать физическое окружение 100, таким образом, формируя второй слой виртуальных элементов. В одном варианте осуществления пассажир 102 может просматривать физическое окружение 100 через прозрачный дисплей 82, в то время как неподвижное устройство 80 визуализации может лишь загораживать фрагмент прозрачного дисплея 82 изображениями 112 дополненной или виртуальной реальности. В одном варианте осуществления процессоры 26, 44, 118 могут формировать и накладывать изображения 112 дополненной или виртуальной реальности на поток видеоданных изображений 121 реального мира (например, сооружения 94, физическое окружение 100) с помощью одной или более технологий объединения видео и/или оптического объединения. В любом случае, носимое устройство 14 визуализации может формировать первый слой виртуальных элементов (например, через изображения 24 дополненной или виртуальной реальности), и неподвижное устройство 80 визуализации может формировать второй слой виртуальных элементов (например, через изображения 112 дополненной или виртуальной реальности). Дополнительно или иначе, AR/VR–система 10 может быть сконфигурирована, чтобы формировать 1, 2, 3, 4 или более слоев виртуальных элементов.

Обращаясь теперь к блоку 148, процесс 140 может также включать в себя координацию отображения первого слоя и виртуальных элементов и второго слоя виртуальных элементов. Первый слой виртуальных элементов и второй слой виртуальных элементов могут быть синхронизированы и/или координироваться посредством процессоров 26, 44 и/или 118, чтобы улучшать иммерсивное ощущение и реализм виртуальных эффектов, воспринимаемых пассажиром 102 экстремального аттракциона 92. В одном варианте осуществления данные изображения от камер, отличных от камер, расположенных на носимом устройстве 14 визуализации или транспортном средстве 86 для катания пассажиров, могут служить, чтобы обеспечивать синхронизацию и/или координацию между первым слоем виртуальных элементов и вторым слоем виртуальных элементов. Такая синхронизация и/или координация могут быть полезными для триангуляции позиции пассажира 102 на основе известной позиции некоторых неподвижных элементов (например, некоторых мест аттракциона), для определения момента времени некоторых спецэффектов (например, реальных, дополненных или имитируемых фейерверков или взрывов), и других эффектов, описанных ниже.

В одном варианте осуществления процессоры 26, 44, 118 могут принимать и анализировать захваченные в реальном времени данные, такие как данные изображения, позиционные данные и/или входные данные от других электронных устройств. Например, относительно данных изображения, процессоры 26, 44, 118 могут принимать видеоданные реального времени (например, живое видео), захваченные посредством камер 34, 36, 122 носимого устройства 14 визуализации и/или транспортного средства 86 для катания пассажиров. В одном варианте осуществления видеоизображение может быть использовано для формирования изображений 22 и 121 реального времени, которые могут быть отображены на электронных очках 16, или прозрачных дисплеях 82, соответственно. Например, процессоры 26, 44, 118 могут формировать поток видеоданных физического окружения 100 (например, области парка 90 развлечений), который должен отображаться на дисплеях 30, 32 носимого устройства 14 визуализации и/или прозрачных дисплеях 82 неподвижного устройства 80 визуализации.

В одном варианте осуществления процессоры 26, 44, 118 могут воспроизводить первый слой виртуальных элементов и второй слой виртуальных элементов на основе какого–либо одного или сочетания факторов. Такие факторы могут включать в себя позицию или местоположение транспортного средства 86 для катания пассажиров на треках 98 (например, или другое местоположение, когда треки 98 не присутствуют) в любой заданный момент времени во время цикла экстремального аттракциона 92, предварительно определенное расстояние, пройденное транспортным средством 86 для катания пассажиров во время цикла экстремального аттракциона 92, после прохождения предварительно определенного времени, или после того, как одно или более действий были выполнены пассажиром 102 транспортного средства 86 для катания пассажиров.

В других вариантах осуществления носимое устройство 14 визуализации, система 40 формирования компьютерной графики и/или неподвижное устройство 80 визуализации могут выполнять один или более алгоритмов геометрического или фотометрического распознавания по данным видео или изображения, захваченным посредством камер 34, 36, 122, чтобы определять точки расположения пассажира 102 и/или транспортного средства 86 для катания пассажиров. Носимое устройство 14 визуализации, система 40 формирования компьютерной графики и/или неподвижное устройство 80 визуализации могут также использовать эти данные для управления синхронизацией изображений 24, 112 дополненной или виртуальной реальности относительно эффекта поездки (например, аниматронные фигуры 97), чтобы синхронизировать и/или координировать первый слой виртуальных элементов и второй слой виртуальных элементов.

В то время как некоторые варианты осуществления относятся к использованию носимого устройства 14 визуализации и/или неподвижному устройству 80 визуализации в контексте экстремального аттракциона 92, следует понимать, что AR/VR–система 10 может быть использована за пределами экстремального аттракциона 92 и в любом из множества окружений. Например, прозрачные дисплеи 82 могут быть соединены со стенкой, чтобы отображать окна комнаты, и пользователь 12 (например, пассажир 102) может носить электронные очки 16, когда пользователь 12 сидит и/или двигается в комнате, чтобы предоставлять иммерсивое ощущение способом, описанным в данном документе.

В то время как только некоторые отличительные признаки раскрытия были иллюстрированы и описаны в данном документе, множество модификаций и изменений придут на ум специалистам в области техники. Следовательно, следует понимать, что прилагаемая формула изобретения предназначается, чтобы охватывать все такие модификации и изменения как подпадающие под истинный смысл раскрытия.

Технологии, представленные и сформулированные в данном документе, находятся по ссылке и применяются к материальным объектам и конкретным примерам практической природы, которые демонстративно улучшают настоящую техническую область и, по существу, не являются абстрактными, неосязаемыми или чисто теоретическими. Следует отметить, что упоминание признаков в единственном числе не исключает возможности их использования во множественном числе и наоборот.

Система (10) для предоставления ощущения дополненной реальности, виртуальной реальности и/или смешанной реальности пользователю включает в себя первый дисплей (30, 32) и второй дисплей (82). Пользователь просматривает окружение реального мира через первый дисплей (30, 32) и второй дисплей (82). Система 10 включает в себя носимое устройство (14) визуализации, которое включает в себя первый дисплей (30, 32), и неподвижное устройство (80) визуализации, которое включает в себя второй дисплей (82). Первый дисплей (30, 32) конфигурируется, чтобы отображать первый слой виртуальных элементов, а второй дисплей (82) конфигурируется, чтобы отображать второй слой виртуальных элементов. Система (10) включает в себя процессор (26), сконфигурированный, чтобы формировать первый слой виртуальных элементов и второй слой виртуальных элементов. Процессор (26) конфигурируется, чтобы оперативно связываться с носимым устройством (14) визуализации и неподвижным устройством (80) визуализации, чтобы координировать представление первого слоя виртуальных элементов и второго слоя виртуальных элементов. 3 н. и 20 з.п. ф-лы, 7 ил.

1. Система для предоставления ощущения дополненной реальности, виртуальной реальности и/или смешанной реальности пользователю, при этом пользователь просматривает окружение реального мира через первый дисплей и второй дисплей, причем система содержит:

носимое устройство визуализации, содержащее первый дисплей, выполненный с возможностью отображения первого слоя виртуальных элементов;

неподвижное устройство визуализации, содержащее второй дисплей, выполненный с возможностью отображения второго слоя виртуальных элементов; и

процессор, выполненный с возможностью формирования первого слоя виртуальных элементов и второго слоя виртуальных элементов, при этом процессор выполнен с возможностью функциональной связи с носимым устройством визуализации и неподвижным устройством визуализации посредством элементов связи указанной системы, чтобы координировать во времени и пространстве представление первого слоя виртуальных элементов и второго слоя виртуальных элементов.

2. Система по п. 1, в которой первый дисплей является прозрачным или полупрозрачным дисплеем и выполнен с возможностью обеспечения возможности пользователю, при ношении носимого устройства визуализации, просматривать второй дисплей через первый дисплей.

3. Система по п. 1, в которой второй дисплей содержит прозрачный дисплей на светоизлучающих диодах или прозрачный дисплей на органических светоизлучающих диодах.

4. Система по п. 1, в которой второй дисплей соединен с транспортным средством для катания пассажиров.

5. Система по п. 1, в которой процессор выполнен с возможностью координирования представления первого слоя виртуальных элементов и второго слоя виртуальных элементов с элементом, ассоциированным с аттракционом в парке развлечений.

6. Система по п. 1, в которой первый слой виртуальных элементов содержит виртуальное изображение объекта в салоне транспортного средства для катания пассажиров, а второй слой виртуальных элементов содержит виртуальное изображение элемента на окне транспортного средства для катания пассажиров.

7. Система по п. 1, в которой первый слой виртуальных элементов содержит виртуальное изображение объекта, внешнего по отношению к салону транспортного средства для катания пассажиров.

8. Система по п. 1, содержащая одну или более камер или датчиков, выполненных с возможностью наблюдения за окружением реального мира, чтобы обеспечивать координацию представления первого слоя виртуальных элементов и второго слоя виртуальных элементов.

9. Система по п. 1, в которой первый дисплей выполнен с возможностью наложения первого слоя виртуальных элементов на окружение реального мира, видимое пользователем, а второй дисплей выполнен с возможностью наложения второго слоя виртуальных элементов на окружение реального мира, видимое пользователем, при этом процессор выполнен с возможностью координации представления первого слоя виртуальных элементов и второго слоя виртуальных элементов с окружением реального мира, так что первый слой виртуальных элементов, второй слой виртуальных элементов и окружение реального мира одновременно видны пользователю.

10. Система для предоставления ощущения дополненной реальности, виртуальной реальности и/или смешанной реальности пользователю, содержащая:

транспортное средство для катания пассажиров, выполненное с возможностью перемещения по пути во время поездки в парке развлечений;

неподвижное устройство визуализации, содержащее прозрачный дисплей, соединенный с транспортным средством для катания пассажиров, причем неподвижное устройство визуализации выполнено с возможностью наложения виртуальных элементов на окружение реального мира, которое является видимым через прозрачный дисплей; и

процессор, выполненный с возможностью формирования виртуальных элементов и координирования представления виртуальных элементов во времени и пространстве с эффектами поездки для поездки.

11. Система по п. 10, содержащая носимое устройство визуализации, содержащее другой прозрачный дисплей, который выполнен с возможностью отображения дополнительных виртуальных элементов, причем носимое устройство визуализации выполнено с возможностью ношения пользователем в транспортном средстве для катания пассажиров во время поездки.

12. Система по п. 11, в которой процессор выполнен с возможностью координирования представления дополнительных виртуальных элементов с представлением виртуальных элементов и эффектов поездки.

13. Система по п. 10, в которой прозрачный дисплей содержит прозрачный дисплей на светоизлучающих диодах или прозрачный дисплей на органических светоизлучающих диодах.

14. Система по п. 10, в которой процессор выполнен с возможностью координирования представления виртуальных элементов с эффектами поездки, инструктируя неподвижному устройству визуализации накладывать виртуальные элементы в предварительно определенное время во время цикла поездки для поездки.

15. Система по п. 10, в которой виртуальные элементы содержат трещины, запотевание, обугливание, капли дождя, снег или их комбинацию.

16. Система по п. 10, в которой прозрачный дисплей выполнен с возможностью быть непрозрачным при его снабжении энергией, тем самым обеспечивая иллюзию того, что салон транспортного средства для катания пассажиров огорожен сплошными стенками.

17. Система по п. 10, выполненная с возможностью обеспечения пользователю просмотра окружения реального мира через прозрачный дисплей, при этом виртуальные элементы содержат первые элементы, отображенные как движущиеся относительно кабины транспортного средства для катания пассажиров во время части цикла поездки, и вторые элементы, отображенные как неподвижные относительно кабины во время части цикла поездки.

18. Способ для предоставления ощущения дополненной реальности, виртуальной реальности и/или смешанной реальности пользователю, при котором:

формируют с помощью процессора первый слой виртуальных элементов и второй слой виртуальных элементов;