[0001] Настоящая заявка испрашивает приоритет предварительной заявки США № 62/139572, поданной 27 марта 2015 года, и предварительной заявки США № 62/182367, поданной 19 июня 2015 года, полное содержание которых включено в настоящий документ путем ссылки.

ОБЛАСТЬ ТЕХНИКИ, К КОТОРОЙ ОТНОСИТСЯ ИЗОБРЕТЕНИЕ

[0002] Данное раскрытие относится к видеокодированию.

УРОВЕНЬ ТЕХНИКИ

[0003] Возможности цифрового видео могут быть включены в широкий спектр устройств, включая цифровые телевизоры, системы цифрового прямого вещания, беспроводные широковещательные системы, персональные цифровые помощники (PDA), ноутбуки или настольные компьютеры, планшетные компьютеры, электронные книги, цифровые камеры, устройства цифровой записи, цифровые медиаплееры, устройства для видеоигр, игровые приставки, сотовые или спутниковые радиотелефоны, так называемые «смартфоны», устройства для проведения видеоконференций, устройства для потоковой передачи видео и т. п. Цифровые видеоустройства реализуют способы кодирования видео, например способы, описанные в стандартах, определенных MPEG-2, MPEG-4, ITU-T H.263, ITU-T H.264/MPEG-4, часть 10, Усовершенствованное Видеокодирование (AVC), стандарт кодирования высокого качества (HEVC) и в расширениях таких стандартов. Реализуя такие способы кодирования видео, видеоустройства могут более эффективно передавать, принимать, кодировать, декодировать и/или хранить цифровую видеоинформацию.

[0004] Способы видеокодирования включают в себя пространственное (внутрикадровое) предсказание и/или временное (межкадровое) предсказание для уменьшения или удаления избыточности, присущей видеопоследовательностям. Для блочного видеокодирования видеофрагмент (например, видеокадр или часть видеокадра) может быть разделен на видеоблоки, которые также могут упоминаться как древовидные блоки, единицы кодирования (CU) и/или узлы кодирования. Видеоблоки в фрагменте изображения, кодированного с внутренним предсказанием, кодируются с использованием пространственного предсказания относительно опорных выборок в соседних блоках на одном изображении. Видеоблоки во фрагменте изображения, кодированном с внешним предсказанием (P или B), могут использовать пространственное предсказание относительно опорных выборок в соседних блоках в одном и том же изображении или временное предсказание относительно опорных выборок в других опорных изображениях. Изображения могут упоминаться как кадры, а опорные изображения могут упоминаться как опорные кадры.

[0005] Пространственное или временное предсказание приводит к предсказанному блоку для кодируемого блока. Остаточные данные представляют различия в пикселях между исходным блоком, который должен быть закодирован, и предсказанным блоком. Блок, кодированный с внешним предсказанием, кодируется в соответствии с вектором движения, который указывает на блок опорных выборок, формирующих предсказанный блок, и остаточными данными, указывающими разницу между кодированным блоком и предсказанным блоком. Блок, кодированный с внутренним предсказанием, кодируется в соответствии с режимом кодирования с внутренним предсказанием и остаточными данными. Для дальнейшего сжатия остаточные данные могут быть преобразованы из пиксельного домена в домен преобразования, что приводит к остаточным коэффициентам преобразования, которые затем могут быть квантованы. Квантованные коэффициенты преобразования, первоначально расположенные в двумерном массиве, могут сканироваться для получения одномерного вектора коэффициентов преобразования, а для достижения еще большего сжатия может применяться энтропийное кодирование.

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

[0006] Способы настоящего раскрытия относятся к формированию информации движения при видеокодировании. Например, видеокодер (видеокодер или видеодекодер) может генерировать информацию движения, которая не включена в битовый поток, чтобы кодировать видеоданные, которые включены в битовый поток. При выведении информации движения в цикле кодирования или декодирования может быть достигнута экономия битов по сравнению со способами, которые включают информацию движения в битовый поток, например, традиционные способы кодирования с внешним предсказанием.

[0007] В одном примере способ декодирования видеоданных включает в себя выбор режима выведения информации движения из множества режимов выведения информации движения для определения информации движения для текущего блока, причем каждый режим выведения информации движения включает в себя выполнение поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных вне текущего блока, и где информация движения указывает движение текущего блока относительно опорных видеоданных, определяя информацию движения для текущего блока, используя выбранный режим выведения информации движения, и декодирование текущего блока с использованием определенной информации движения и без декодирования синтаксических элементов, представляющих информацию движения.

[0008] В другом примере способ кодирования видеоданных включает в себя выбор режима выведения информации движения из множества режимов выведения информации движения для определения информации движения для текущего блока, причем каждый режим выведения информации движения включает в себя выполнение поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных вне текущего блока, и в котором информация движения указывает движение текущего блока относительно опорных видеоданных, и определение информации движения для текущего блока с использованием выбранного режима выведения информации движения, и кодирование текущего блока с использованием определенной информации движения и без кодирования синтаксических элементов, представляющих информацию движения.

[0009] В другом примере устройство для кодирования видеоданных включает в себя память, выполненную с возможностью хранения текущего блока видеоданных, и один или более процессоров, выполненных с возможностью выбора режима выведения информации движения из множества режимов выведения информации движения для определения информации движения для текущего блока, причем каждый режим выведения информации движения из указанного множества содержит выполнение поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных вне текущего блока, и где информация движения указывает на движение текущего блока относительно опорных видеоданных, определения информации движения для текущего блока, используя выбранный режим выведения информации движения, и кодирования текущего блока с использованием указанной определенной информации движения и без кодирования синтаксических элементов, представляющих информацию движения.

[0010] В другом примере устройство для кодирования видеоданных включает в себя средство для выбора режима выведения информации движения из множества режимов выведения информации движения для определения информации движения для текущего блока, причем каждый способ выведения информации движения из указанного множества включает в себя выполнение поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных вне текущего блока, и в котором информация движения указывает движение текущего блока относительно опорных видеоданных, средство для определения информации движения для текущего блока, используя выбранный режим выведения информации движения, и средство для кодирования текущего блока с использованием определенной информации движения и без декодирования синтаксических элементов, представляющих информацию движения.

[0011] В другом примере на долговременном машиночитаемом носителе содержатся инструкции, хранящиеся на нем, которые при их выполнении приводят к тому, что один или несколько процессоров выбирают режим выведения информации движения из множества режимов выведения информации движения для определения информации движения для текущего блока, причем каждый режим выведения информации движения из указанного множества содержит выполнение поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных вне текущего блока, и где информация движения указывает движение текущего блока относительно опорных видеоданных, определяют информацию движения для текущего блока, используя выбранный режим выведения информации движения, и кодируют текущий блок с использованием определенной информации движения и без декодирования синтаксических элементов, представляющих информацию движения.

[0012] В другом примере способ обработки видеоданных включает в себя определение вектора движения - кандидата для выведения информации движения текущего блока видеоданных, причем информация движения указывает движение текущего блока относительно опорных видеоданных и определение выведенного вектора движения для текущего блока на основе определенного вектора движения - кандидата, в котором определение выведенного вектора движения включает в себя выполнение поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных вне текущего блока.

[0013] В другом примере устройство для обработки видеоданных включает в себя память, выполненный возможностью хранения текущего блока видеоданных, и один или более процессоров, выполненных с возможностью определения вектора движения - кандидата для выведения информации движения текущего блока видеоданных, в котором информация движения указывает движение текущего блока относительно опорных видеоданных, и определения выведенного вектора движения для текущего блока на основе определенного вектора движения - кандидата, причем определение выведенного вектора движения содержит выполнение поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных вне текущего блока.

[0014] В другом примере устройство для обработки видеоданных включает в себя средство для определения вектора движения - кандидата для выведения информации движения текущего блока видеоданных, причем информация движения указывает движение текущего блока относительно опорных видеоданных, и средство для определения выведенного вектора движения для текущего блока на основе определенного вектора движения - кандидата, причем средство для определения выведенного вектора движения содержит средство для выполнения поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных за пределами текущего блока.

[0015] В другом примере долговременный машиночитаемый носитель содержит инструкции, хранящиеся на нем, которые при их выполнении приводят к тому, что один или более процессоров определяют вектор движения - кандидат для выведения информации движения текущего блока видеоданных, причем информация движения указывает движение текущего блока относительно опорных видеоданных, и определения выведенного вектор движения для текущего блока на основе определенного вектора движения - кандидата, причем для определения выведенного вектора движения инструкции приводят к тому, что один или более процессоров выполняют поиск движения для первого набора опорных данных, который соответствует второму набору опорных данных вне текущего блока.

[0016] В другом примере способ обработки видеоданных включает в себя разделение текущего блока видеоданных на множество подблоков для выведения информации движения текущего блока, причем информация движения указывает движение текущего блока относительно опорных видеоданных, выведение, отдельно для каждого соответствующего подблока из множества подблоков, информации движения, содержащее выполнение поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных вне каждого соответствующего подблока, и декодирование множества подблоков на основе выведенной информации движения и без декодирования синтаксических элементов, представляющих информацию движения.

[0017] В другом примере способ обработки видеоданных включает в себя разделение текущего блока видеоданных на множество подблоков для выведения информации движения текущего блока, причем информация движения указывает движение текущего блока относительно опорных видеоданных, выведение, отдельно для каждого соответствующего подблока из множества подблоков, информации движения, содержащее выполнение поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных вне каждого соответствующего подблока, и кодирование множества подблоков на основе выведенной информации движения и без кодирования синтаксических элементов, представляющих информацию движения.

[0018] В другом примере устройство для обработки видеоданных включает в себя память, выполненную с возможностью хранения текущего блока видеоданных, и один или несколько процессоров, выполненных с возможностью разделения текущего блока видеоданных на множество подблоков для выведения информации движения текущего блока, причем информация движения указывает движение текущего блока относительно опорных видеоданных, выведения, отдельно для каждого соответствующего подблока из множества подблоков, информации движения, содержащего выполнение поиска движения для первого набора опорных данных, которые соответствуют второму набору опорных данных вне каждого соответствующего подблока, и кодирования множества подблоков на основе выведенной информации движения и без кодирования синтаксических элементов, представляющих информацию движения.

[0019] В другом примере на долговременном машиночитаемом носителе содержатся инструкции, хранящиеся на нем, которые при их выполнении приводят к тому, что один или более процессоров разделяют текущий блок видеоданных на множество подблоков для выведения информации движения текущего блока, в котором информация движения указывает движение текущего блока относительно опорных видеоданных, выводят, отдельно для каждого соответствующего подблока из указанного множества подблоков, информацию движения, что содержит выполнение поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных вне каждого соответствующего подблока, и декодируют множество подблоков на основе выведенной информации движения и без декодирования синтаксических элементов, представляющих информацию движения.

[0020] В другом примере устройство для обработки видеоданных включает в себя память, выполненную с возможностью хранения текущего изображения, и один или несколько процессоров, выполненных с возможностью получения кодированного битового потока, который содержит множество кодированных изображений, интерполяции одного или нескольких опорных изображений, которые не включаются в кодированный битовый поток, и декодирования видеоданных текущего изображения кодированного битового потока на основе интерполированных одного или более опорных изображений.

[0021] Подробное описание одного или более примеров настоящего раскрытия представлены на прилагаемых чертежах и в описании ниже. Другие признаки, объекты и преимущества будут очевидны из описания, чертежей и формулы изобретения.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

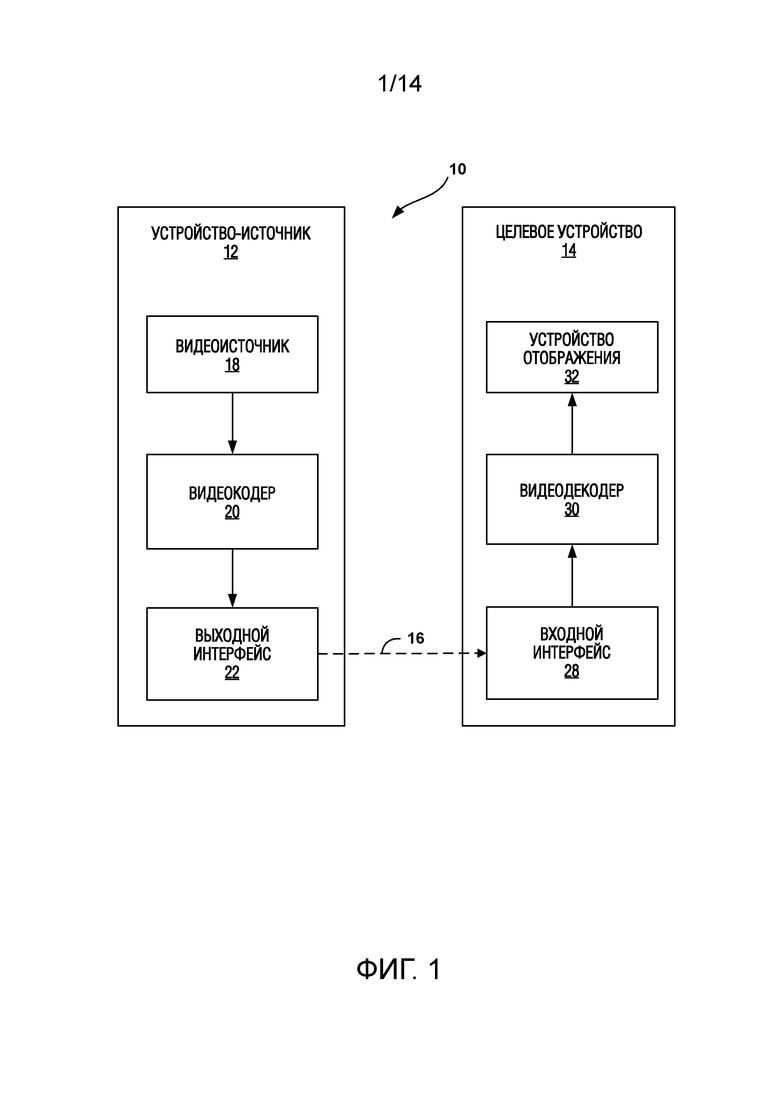

[0022] Фиг. 1 представляет собой блок-схему, иллюстрирующую примерную систему кодирования и декодирования видео, которая может реализовать способы настоящего раскрытия.

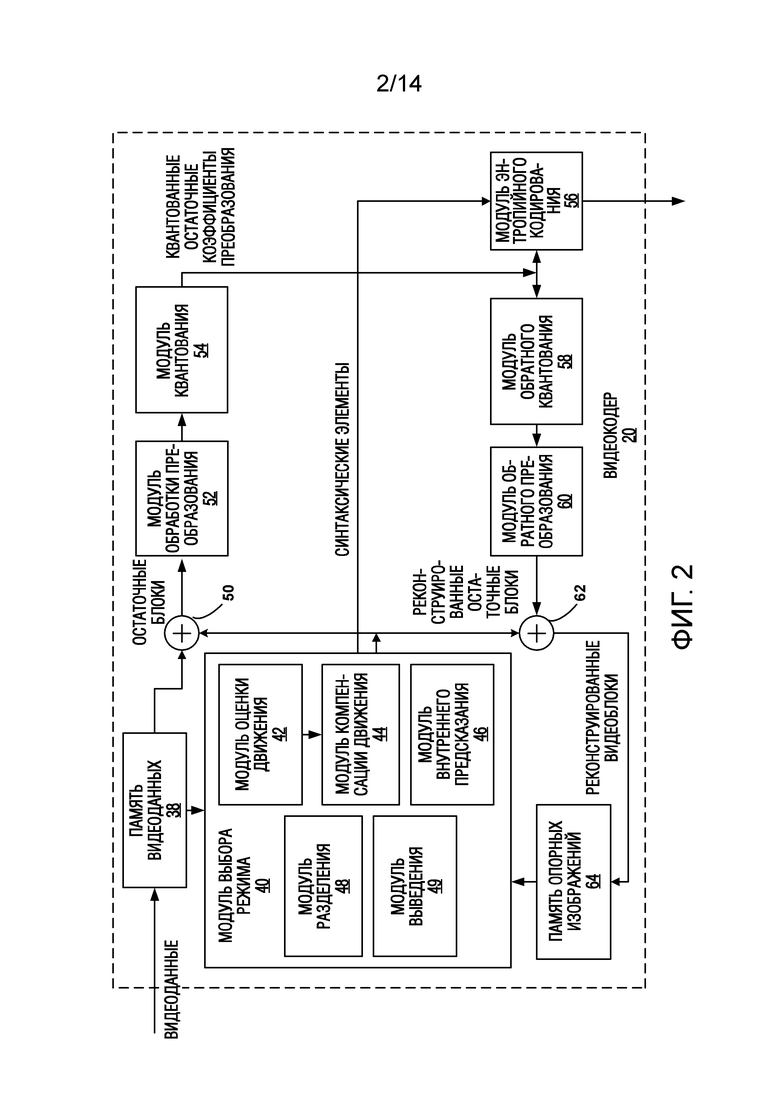

[0023] Фиг. 2 представляет собой блок-схему, иллюстрирующую пример видеокодера, который может реализовывать способы настоящего раскрытия.

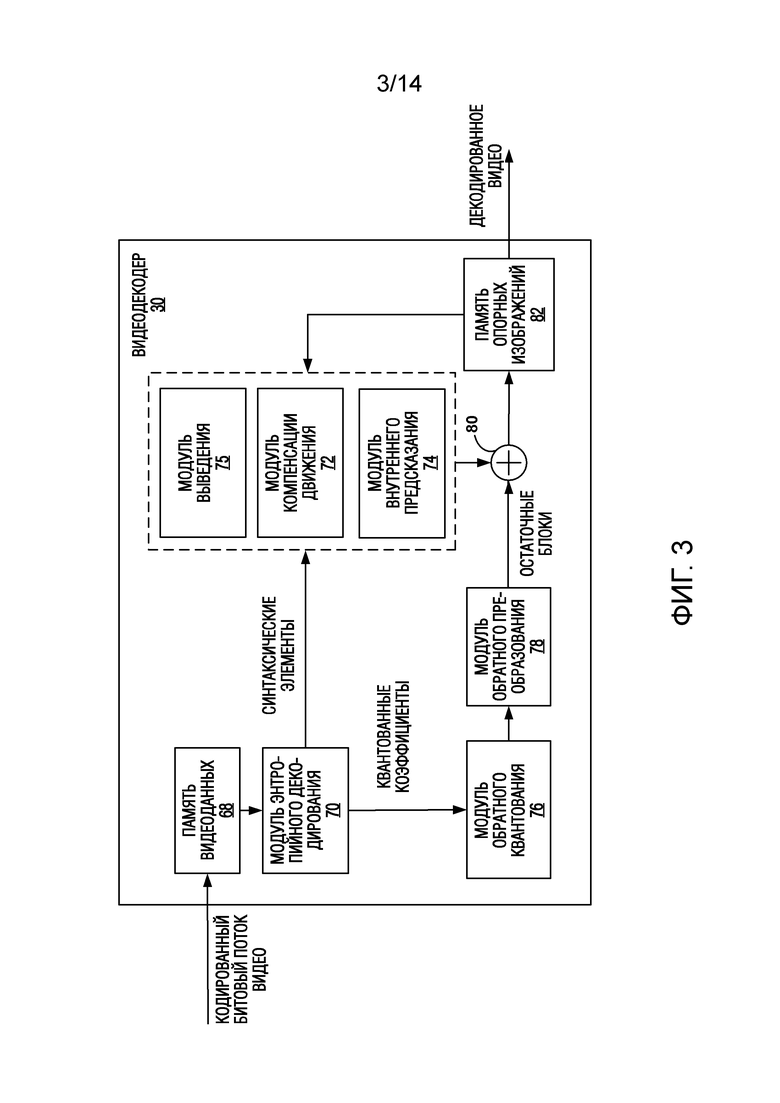

[0024] Фиг. 3 представляет собой блок-схему, иллюстрирующую пример видеодекодера, который может реализовывать способы настоящего раскрытия.

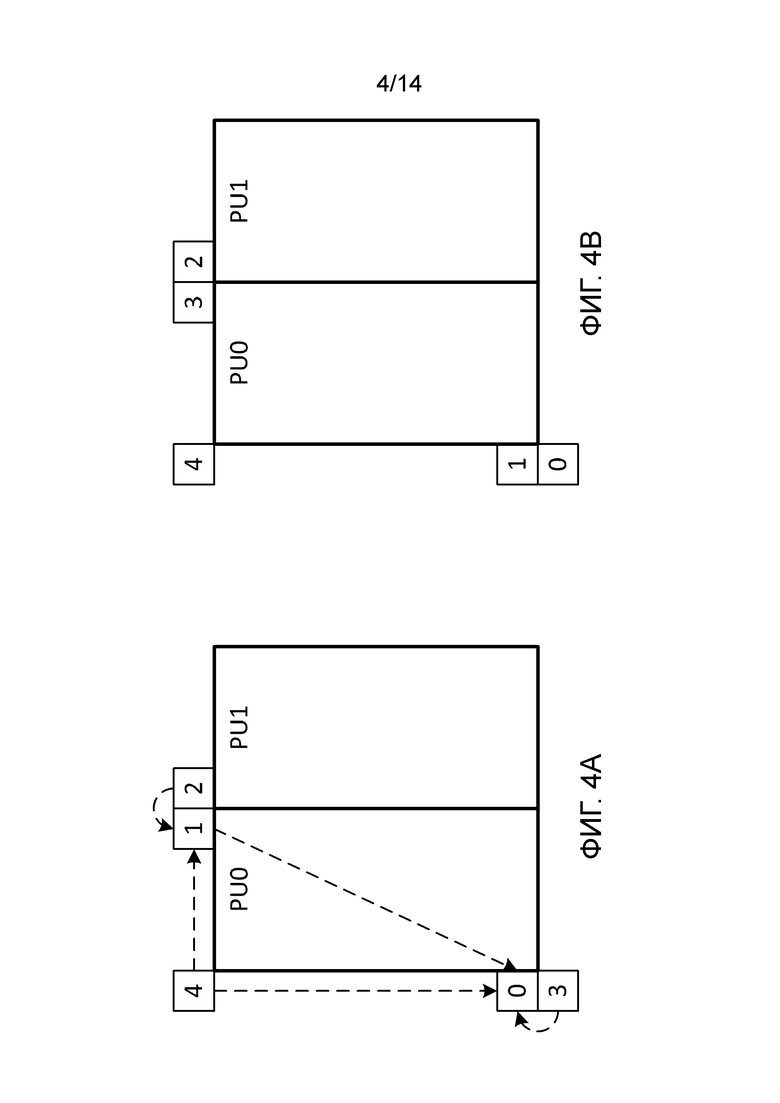

[0025] Фиг.4А и 4В представляют собой концептуальные диаграммы, иллюстрирующие пример соседнего пространственного расположения векторов движения - кандидатов для режима слияния и режима расширенного предсказания движения (AMVP).

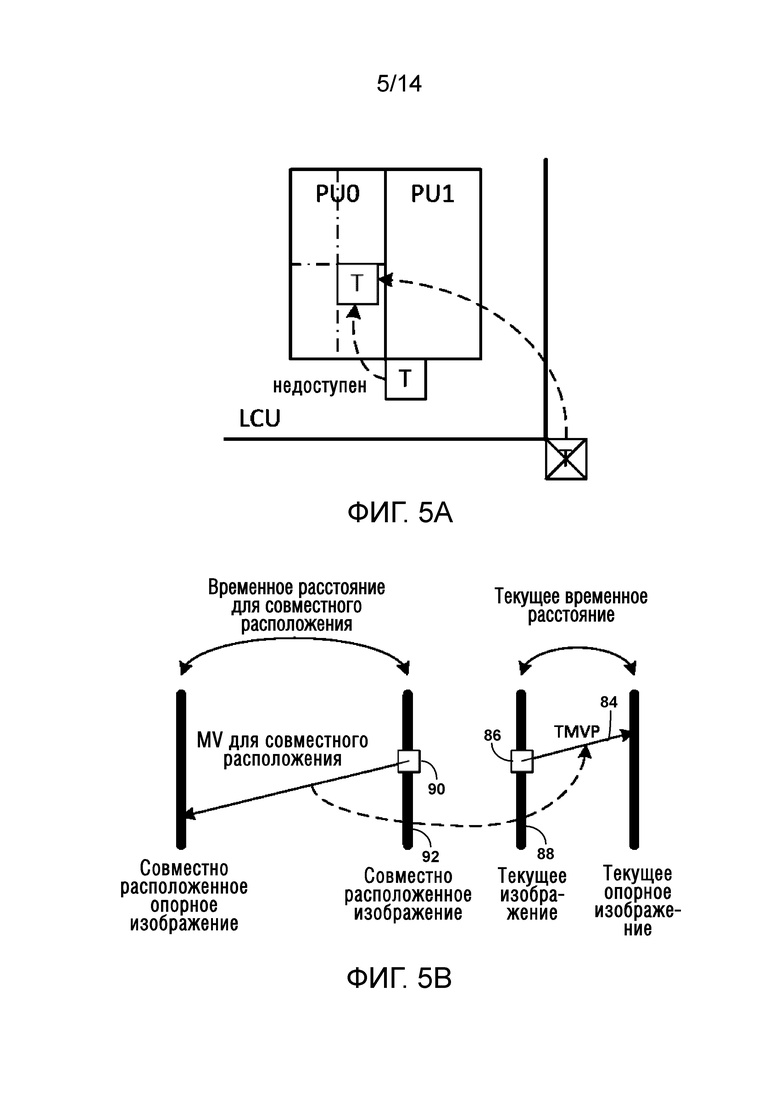

[0026] Фиг. 5А и 5В представляют собой концептуальные диаграммы, иллюстрирующие пример временного предиктора вектора движения - кандидата (TMVP) и масштабирования вектора движения.

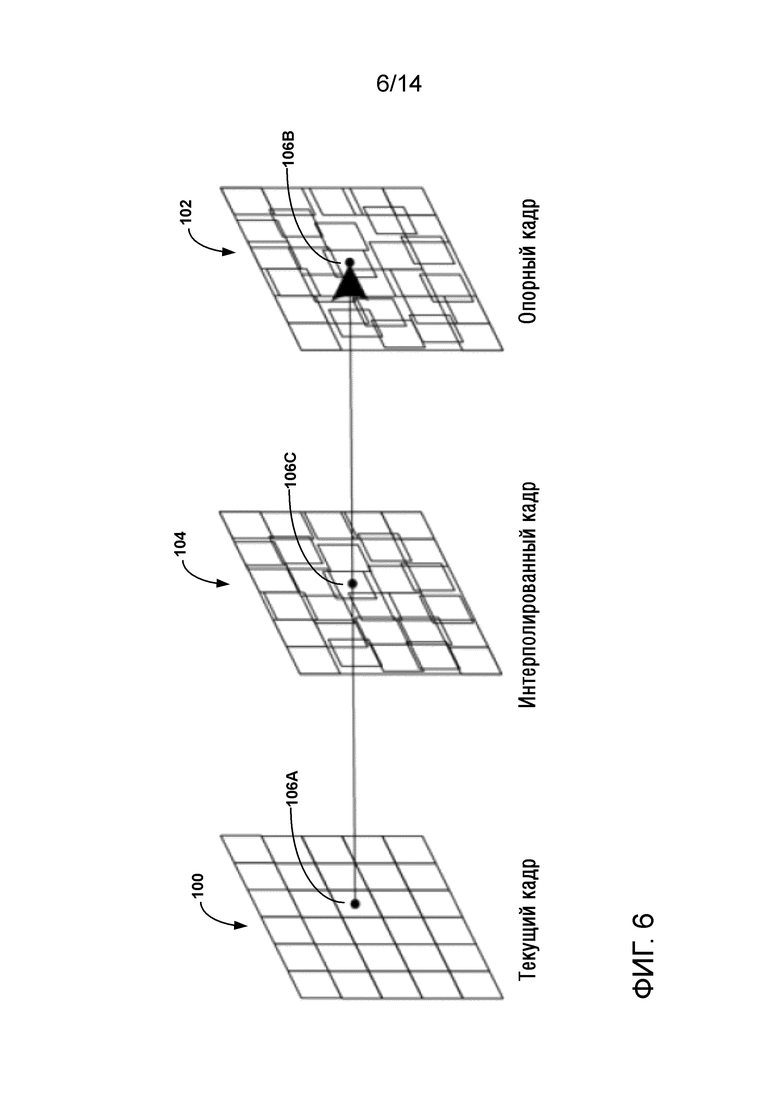

[0027] Фиг. 6 представляет собой концептуальную диаграмму, иллюстрирующую пример односторонней оценки движения (ME) в преобразовании с повышением частоты кадров (FRUC).

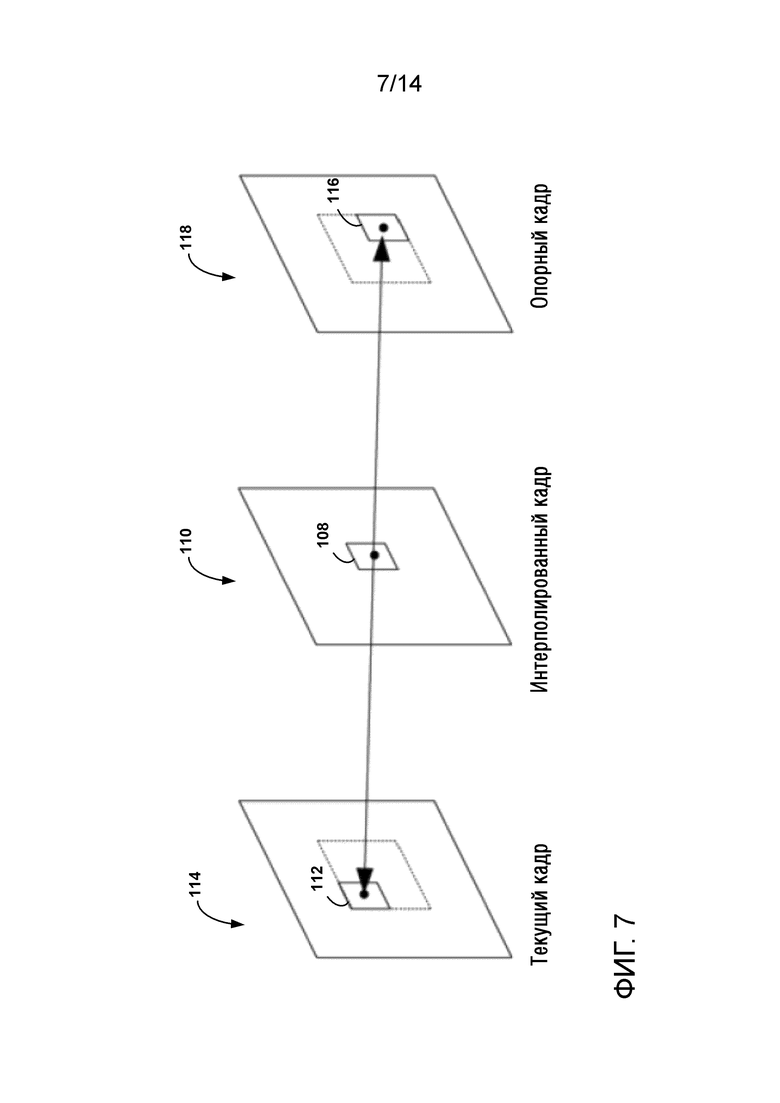

[0028] Фиг. 7 представляет собой концептуальную диаграмму, иллюстрирующую пример двусторонней оценки движения (ME) в FRUC.

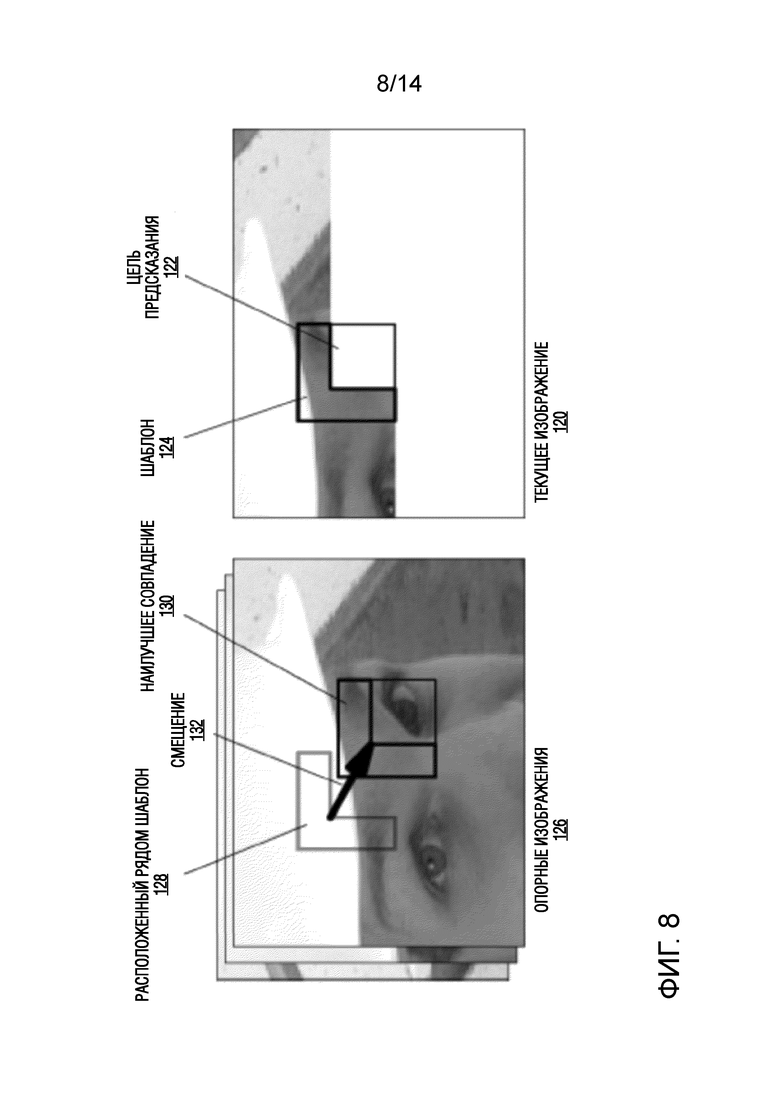

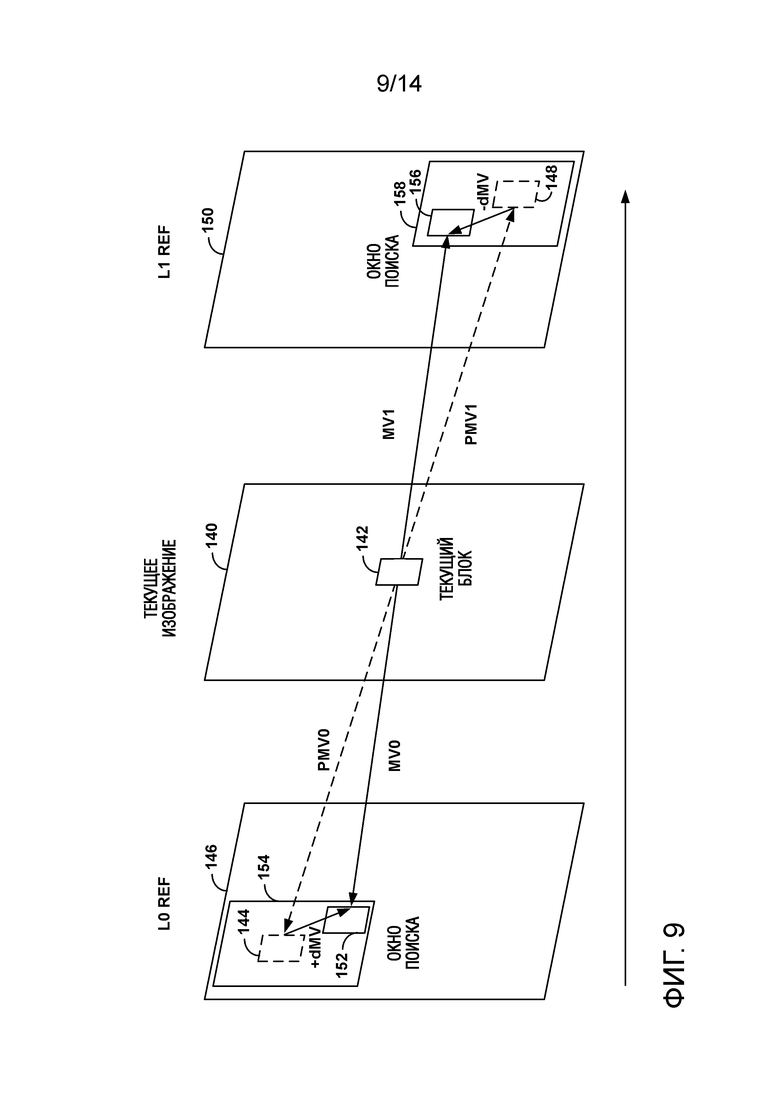

[0029] Фиг. 8 представляет собой концептуальную диаграмму, иллюстрирующую пример выведения вектора движения на стороне декодера на основе согласования с шаблоном (DMVD).

[0030] Фиг. 9 представляет собой концептуальную диаграмму, иллюстрирующую пример двунаправленного выведения вектора движения на основе зеркального отображения в DMVD.

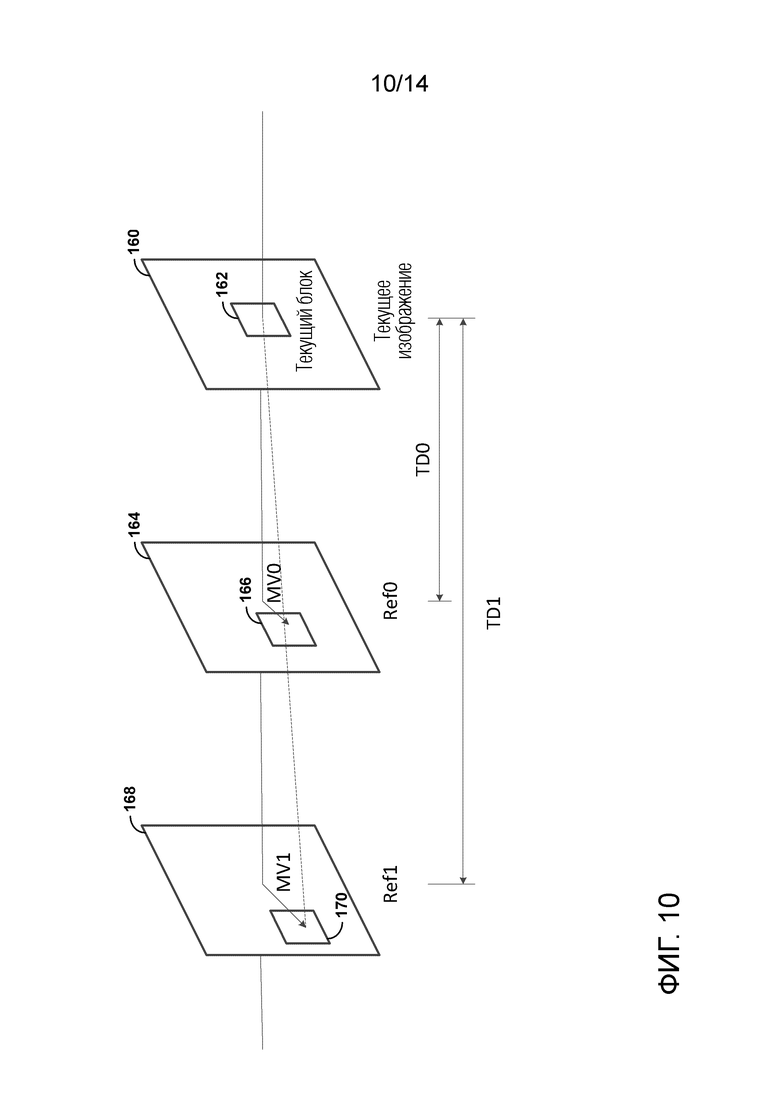

[0031] Фиг. 10 представляет собой концептуальную диаграмму, иллюстрирующую расширенное двустороннее выведение вектора движения на основе согласования с шаблоном.

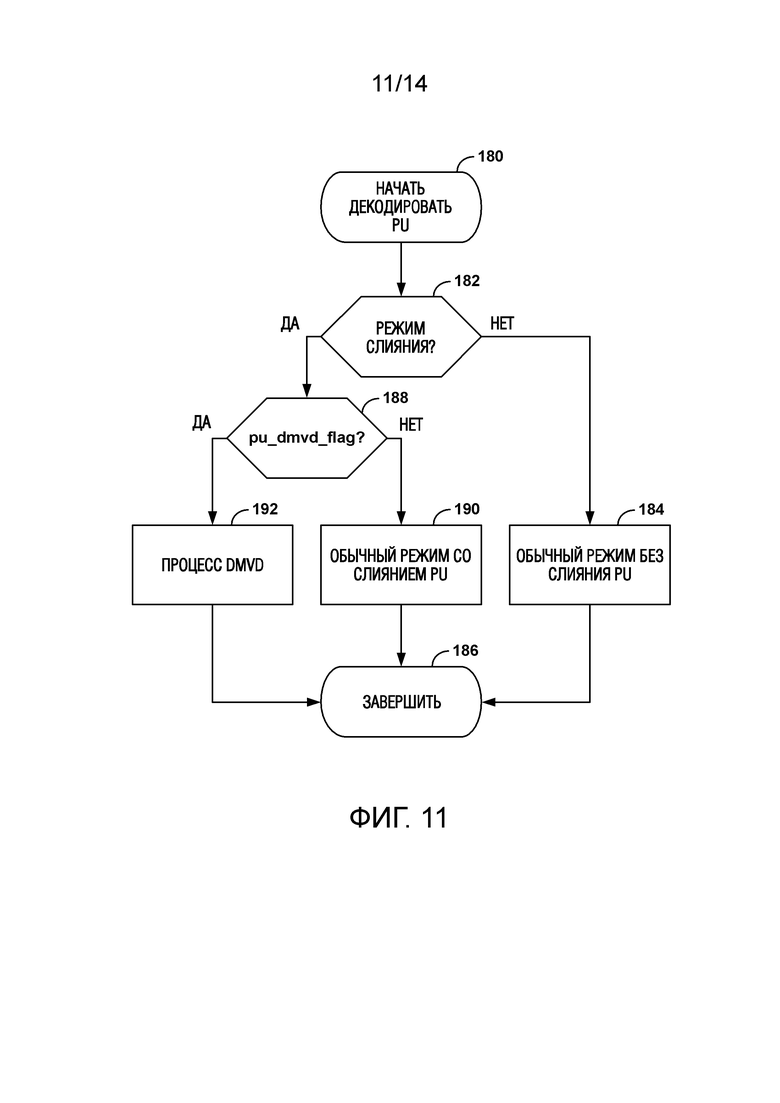

[0032] Фиг. 11 представляет собой блок-схему последовательности операций, иллюстрирующую пример декодирования единицы предсказания (PU) с использованием DMVD.

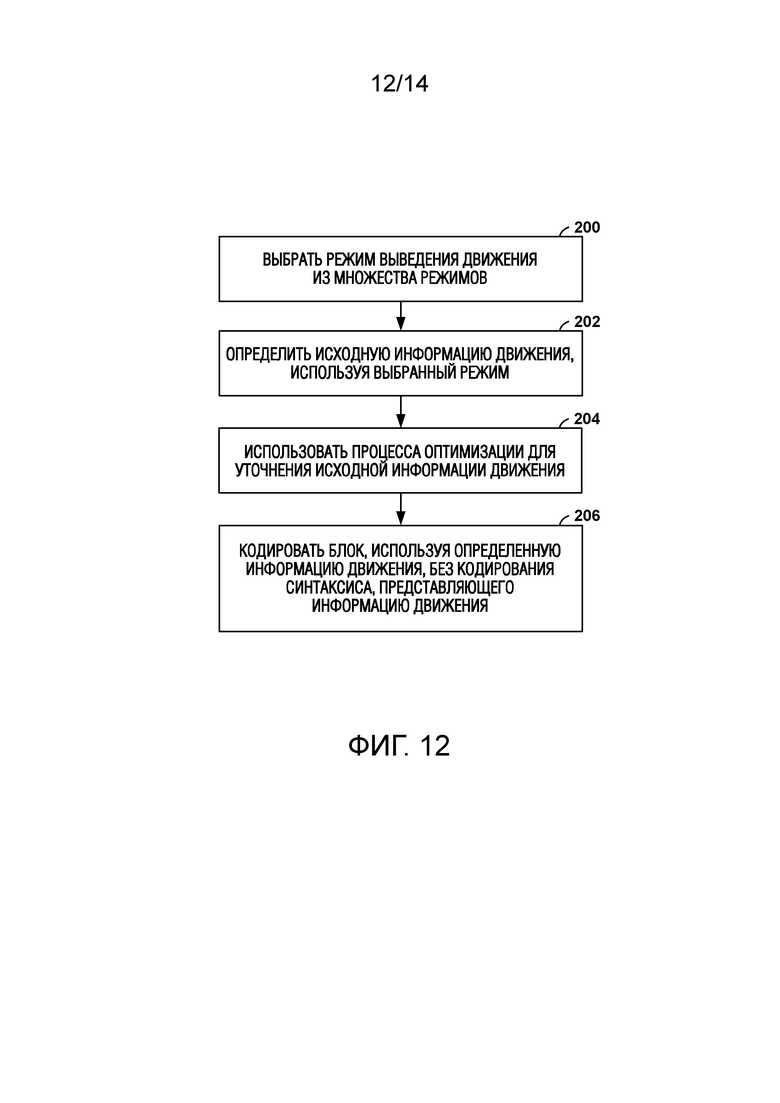

[0033] Фиг. 12 представляет собой блок-схему последовательности операций, иллюстрирующую примерный способ определения режима выведения информации движения для кодирования блока видеоданных.

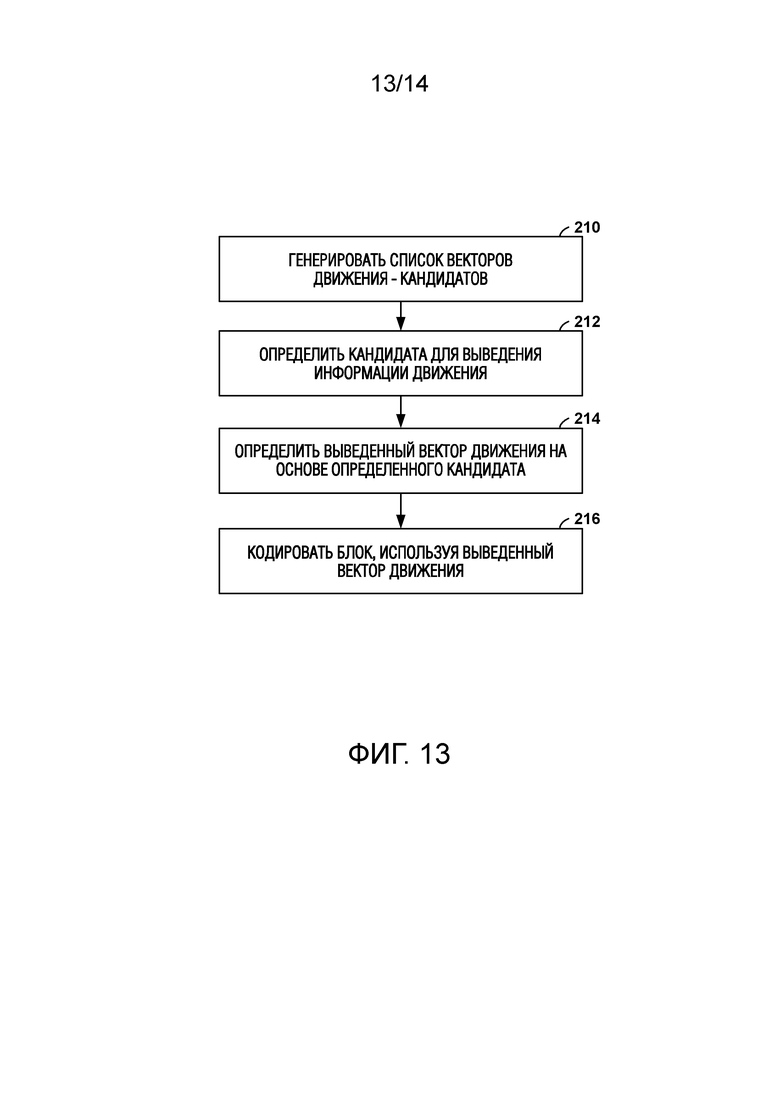

[0034] Фиг. 13 представляет собой блок-схему последовательности операций, иллюстрирующую примерный способ для выведения вектора движения для кодирования блока видеоданных.

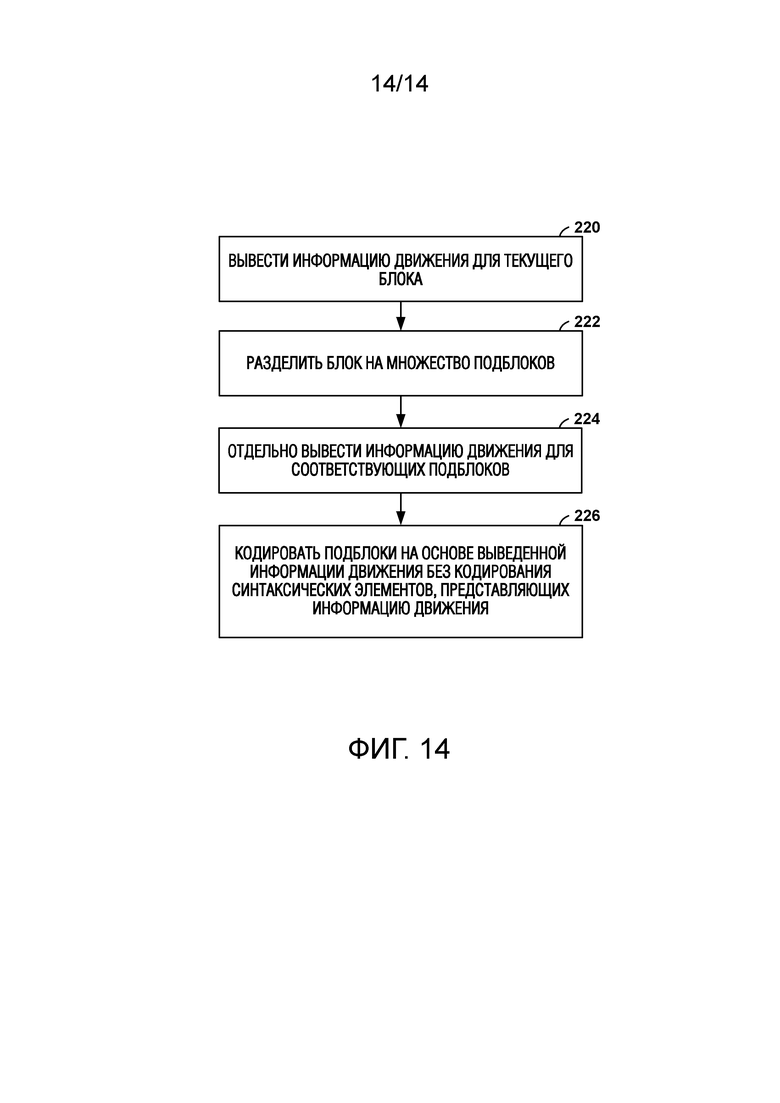

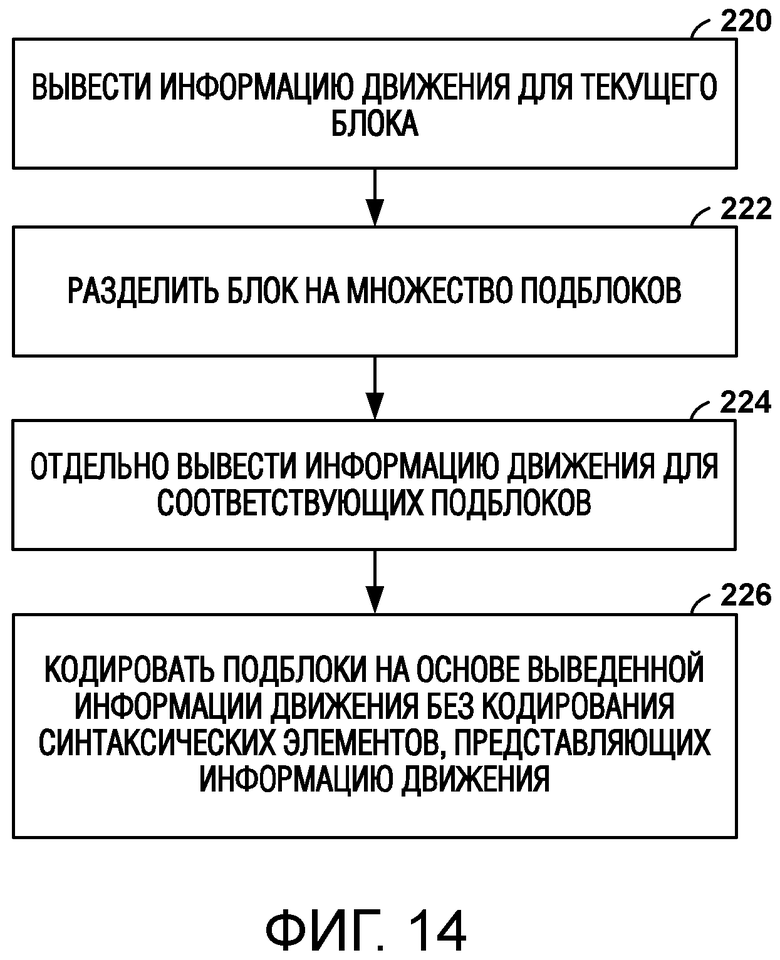

[0035] Фиг. 14 представляет собой блок-схему последовательности операций, иллюстрирующую примерный способ для выведения информации движения для подблоков блока видеоданных.

ПОДРОБНОЕ ОПИСАНИЕ

[0036] Способы настоящего раскрытия относятся к выведению информации движения на стороне декодера, разделению блоков и/или интерполяции видеоданных при кодировании на основе блоков. Эти способы могут применяться к любому из существующих видеокодеков, таких как высокоэффективное видеокодирование (HEVC), или могут представлять собой эффективный инструмент кодирования для любых будущих стандартов видеокодирования.

[0037] Устройства кодирования видеоданных реализуют способы сжатия видео для эффективного кодирования и декодирования видеоданных. Способы сжатия видео могут включать в себя применение пространственного предсказания (например, внутрикадровое предсказание), временного предсказания (например, предсказание между кадрами) и/или другие способы предсказания для уменьшения или удаления избыточности, присущей видеопоследовательности. Видеокодер обычно разбивает каждое изображение исходной видеопоследовательности на прямоугольные области, называемые видеоблоками или единицами кодирования (более подробно описано ниже). Эти видеоблоки могут быть кодированы с использованием определенного режима предсказания.

[0038] Для режимов с внешним предсказанием видеокодер обычно ищет блок, аналогичный тому, который закодирован в кадре в другом временном местоположении, называемом опорным кадром. Видеокодер может ограничить поиск определенным пространственным смещением от блока, подлежащему кодированию. Наилучшее совпадение может быть выявлено с использованием двумерного (2D) вектора движения, который включает в себя компонент горизонтального смещения и компонент вертикального смещения. Для режима внутреннего предсказания видеокодер может формировать предсказанный блок с использованием способов пространственного предсказания на основе данных из ранее закодированных соседних блоков внутри одного и того же изображения.

[0039] Видеокодер может определять ошибку предсказания, то есть разницу между значениями пикселей в кодируемом блоке и предсказанным блоком (также называемым остаточным). Видеокодер может также применять преобразование к ошибке предсказания, например дискретное косинусное преобразование (DCT), для генерации коэффициентов преобразования. После преобразования видеокодер может выполнить квантование коэффициентов преобразования. Кантованные коэффициенты преобразования и векторы движения могут быть представлены с использованием синтаксических элементов и, вместе с управляющей информацией, образуют кодированное представление видеопоследовательности. В некоторых случаях видеокодер может выполнять энтропийное кодирование синтаксических элементов, тем самым дополнительно уменьшая количество битов, необходимое для их представления.

[0040] Видеодекодер может строить, используя синтаксические элементы и управляющую информацию, рассмотренные выше, предсказанные данные (например, предсказанный блок) для декодирования текущего кадра. Например, видеодекодер может сложить предсказанный блок и сжатую ошибку предсказания. Видеодекодер может определять сжатую ошибку предсказания, взвешивая базисные функции преобразования с использованием квантованных коэффициентов. Разница между реконструированным кадром и исходным кадром называется ошибкой реконструкции.

[0041] В некоторых случаях видеодекодер или устройство последующей обработки могут интерполировать изображения на основе одного или нескольких опорных изображений. Такие интерполированные изображения не включаются в кодированный битовый поток. Видеодекодер или устройство последующей обработки могут интерполировать изображения для повышения исходной частоты кадров кодированного битового потока. Этот процесс можно назвать повышением частоты кадров (FRUC). В качестве альтернативы, видеодекодер или устройство последующей обработки могут интерполировать изображения для вставки одного или более изображений, которые пропускались видеокодером для кодирования видеопоследовательности с уменьшенной частотой кадров. В любом случае видеодекодер или устройство последующей обработки интерполируют кадры, которые не были включены в кодированный битовый поток, принятый видеодекодером. Видеодекодер или устройство последующей обработки могут интерполировать изображения с использованием любого из нескольких способов интерполяции, например, с использованием интерполяции кадра с компенсацией движения, повторения кадра или усреднения кадра.

[0042] Хотя определенные способы интерполяции изображений использовались для целей повышения частоты кадров, такие способы не использовались широко при видеокодировании, например, для кодирования видеоданных, которые включены в кодированный битовый поток. Например, способы интерполяции изображений могут быть относительно времязатратными и/или могут требовать относительно больших вычислительных мощностей. Соответственно, такие способы, как правило, не выполнялись в цикле декодирования видеоданных.

[0043] В соответствии с аспектами настоящего раскрытия видеокодер (например, видеокодер или видеодекодер) может выводить информацию движения при кодировании битового потока. Например, видеокодер может генерировать информацию движения, которая не включена в битовый поток, чтобы кодировать видеоданные, которые включены в битовый поток. При выводе информации движения в цикле кодирования или декодирования может быть достигнута экономия битов по сравнению со способами, которые включают информацию движения в битовый поток (например, упомянутые выше способы внешнего предсказания).

[0044] В соответствии с некоторыми аспектами настоящего раскрытия видеокодер может использовать множество способов выведения информации движения во время кодирования. В таких примерах видеокодер может определять режим выведения информации движения, чтобы определить, какие способы выведения информации движения следует использовать для определения информации движения для текущего блока. В целом, использование режима выведения информации движения для выведения информации движения может включать в себя выполнение поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных вне текущего блока. Например, используя режим выведения информации движения (например, способ двустороннего согласования, способ согласования с шаблоном или другой способ, как описано более подробно ниже), видеокодер может выбрать вектор движения - кандидат в списке векторов движения - кандидатов. Видеокодер может выбирать вектор движения - кандидат на основе вектора движения - кандидата, который идентифицирует опорные данные в опорном изображении, которые относительно хорошо совпадают с данными текущего изображения (что также может упоминаться как определение «наилучшего совпадения» опорных данных).

[0045] В некоторых случаях видеокодер может использовать выбранный вектор движения - кандидат для идентификации окна поиска в опорном изображении. Видеокодер может уточнить вектор движения - кандидат на основе опорных данных в окне поиска, который относительно хорошо совпадает с соответствующим данным в текущем изображении. Другими словами, видеокодер может вывести новую информацию движения для текущего блока на основе движения между опорными данными в окне поиска, которые близко соответствует данным в текущем изображении. Затем видеокодер может выполнить компенсацию движения для текущего блока с использованием выведенной информации движения. Таким образом, видеокодер может вывести информацию движения для текущего блока без информации движения, которая сигнализируется в кодированном битовом потоке.

[0046] В соответствии с аспектами настоящего раскрытия в некоторых примерах видеокодер может разделить блок видеоданных на подблоки при выведении информации движения. Например, видеокодер может отдельно выводить информацию движения для каждого подблока большего блока. В некоторых случаях видеокодер может изначально определять информацию движения для блока и использовать выведенную информацию движения в качестве информации движения - кандидата для каждого из подблоков. Затем видеокодер может дополнительно уточнить выведенную информацию движения для каждого из подблоков, например, используя режим выведения информации движения (например, способ двустороннего согласования, способ согласования с шаблоном или другой способ, как более подробно описано ниже).

[0047] Способы настоящего раскрытия могут также включать в себя способы для интерполирования изображений. В некоторых случаях любая комбинация вышеприведенных способов может использоваться для интерполяции изображения, которое не включено в битовый поток, например, аналогично повышению частоты кадров. Однако вместо того, чтобы просто добавлять интерполированное изображение в видеопоследовательность, видеодекодер может использовать интерполированный кадр во время кодирования. Например, видеодекодер может декодировать данные текущего изображения на основе, по меньшей мере, части интерполированного изображения. В некоторых случаях видеодекодер может установить интерполированное изображение, равное текущему изображению. Например, видеодекодер может декодировать синтаксические данные для текущего изображения, которые включены в битовый поток (например, данные заголовка фрагмента и т.п.), интерполировать изображение и установить интерполированное изображение в качестве текущего изображения. В других случаях видеодекодер может интерполировать изображение и декодировать данные для текущего изображения относительно интерполированного изображения. В этом случае, видеодекодер может добавить интерполированное изображение в память опорных изображений для целей предсказания.

[0048] Таким образом, некоторые описанные здесь способы, относящиеся к FRUC, могут в некоторых примерах использоваться для определения информации движения (например, в процессе выведения информации движения на стороне декодера). В других примерах описанные здесь способы, относящиеся к FRUC, могут использоваться для интерполяции видеоданных, например, в качестве опорных данных для кодирования видеоданных, или для вывода.

[0049] Фиг. 1 представляет собой блок-схему, иллюстрирующую пример системы кодирования и декодирования видеосигнала, которая может использовать способы для выведения информации движения, выполнения разбиения блоков и/или интерполяции видеоданных. Как показано на фиг. 1, система 10 включает в себя устройство-источник 12, которое обеспечивает кодированные видеоданные, которые позднее будут декодированы целевым устройством 14. В частности, устройство-источник 12 предоставляет видеоданные целевому устройству 14 через машиночитаемый носитель 16. Устройство-источник 12 и целевое устройство 14 могут содержать любое из широкого спектра устройств, включая настольные компьютеры, ноутбуки (например, лэптопы), планшетные компьютеры, телевизионные приставки, телефонные трубки, например как так называемые «умные» телефоны, планшеты, телевизоры, камеры, устройства отображения, цифровые медиаплееры, консоли для видеоигр, устройства потоковой передачи видео и т.п. В некоторых примерах устройство-источник 12 и целевое устройство 14 могут быть оборудованы для беспроводной связи.

[0050] Целевое устройство 14 может принимать подлежащие декодированию кодированные видеоданные через машиночитаемый носитель 16. Машиночитаемый носитель 16 может содержать любой тип носителя или устройства, способного перемещать кодированные видеоданные из устройства-источника 12 в целевое устройство 14. В одном примере машиночитаемый носитель 16 может содержать среду связи, чтобы обеспечить возможность устройству-источнику 12 передавать кодированные видеоданные непосредственно в целевое устройство 14 в режиме реального времени. Кодированные видеоданные могут модулироваться в соответствии со стандартом связи, таким как протокол беспроводной связи, и передаваться в целевое устройство 14. Среда связи может содержать любую беспроводную или проводную среду связи, такую как радиочастотный (RF) спектр или одну или несколько физических линий передачи. Среда связи может быть частью сети на основе пакетной передачи данных, такой как локальная сеть, региональная сеть или глобальная сеть, такая как Интернет. Среда связи может включать в себя маршрутизаторы, коммутаторы, базовые станции или любое другое оборудование, которое может быть полезно для облегчения связи устройства-источника 12 с целевым устройством 14.

[0051] В некоторых примерах кодированные данные могут выводиться из выходного интерфейса 22 на запоминающее устройство. Аналогичным образом, кодированные данные могут быть доступны из устройства хранения через интерфейс ввода. Устройство хранения может включать в себя любой из множества распределенных или локально доступных носителей данных, таких как жесткий диск, диски Blu-ray, DVD-диски, CD-ROM, флэш-память, энергозависимая или энергонезависимая память или любое другое подходящее цифровое хранилище для хранения кодированных видеоданных. В другом примере запоминающее устройство может соответствовать файловому серверу или другому промежуточному запоминающему устройству, которое может хранить кодированное видео, сгенерированное устройством-источником 12. Целевое устройство 14 может осуществлять доступ к сохраненным видеоданным с устройства хранения посредством потоковой передачи или загрузки. Файловым сервером может быть любой тип сервера, способный хранить кодированные видеоданные и передавать эти закодированные видеоданные в целевое устройство 14. Примеры файловых серверов включают в себя веб-сервер (например, для веб-сайта), FTP-сервер, сетевые устройства хранения (NAS) или локальный диск. Целевое устройство 14 может осуществлять доступ к кодированным видеоданным через любое стандартное соединение для передачи данных, включая подключение к Интернету. Это может включать в себя беспроводной канал (например, соединение Wi-Fi), проводное соединение (например, DSL-модем, кабельный модем) или их комбинацию, подходящую для доступа к закодированным видеоданным, хранящимся на файловом сервере. Передача закодированных видеоданных из устройства хранения может представлять собой поточную передачу, передачу в виде загрузки или их комбинацию.

[0052] Способы настоящего раскрытия необязательно ограничиваются беспроводными приложениями или устройствами. Эти способы могут применяться к видеокодированию в рамках любого из множества мультимедийных приложений, таких как эфирные телевизионные трансляции, передачи кабельного телевидения, передачи спутникового телевидения, потоковое видео в Интернете, например динамическая адаптивная потоковая передача по HTTP (DASH), цифровое видео, которое кодируется на носитель данных, декодирование цифрового видео, хранящегося на носителе данных, или другие приложения. В некоторых примерах система 10 может быть выполнена с возможностью поддержки односторонней или двухсторонней передачи видео для поддержки таких приложений, как потоковое видео, воспроизведение видео, видеовещание и/или видеотелефония.

[0053] В примере на фиг. 1 устройство-источник 12 содержит видеоисточник 18, видеокодер 20 и выходной интерфейс 22. Целевое устройство 14 включает в себя входной интерфейс 28, видеодекодер 30 и устройство 32 отображения. В соответствии с настоящим раскрытием видеокодер 20 устройства-источника 12 может быть выполнен с возможностью применения способов для выведения информации движения, выполнения разбиения блоков и/или интерполяции видеоданных. В других примерах устройство-источник и целевое устройство могут включать в себя другие компоненты или устройства. Например, устройство-источник 12 может принимать видеоданные от внешнего видеоисточника 18, такого как внешняя камера. Аналогичным образом, целевое устройство 14 может взаимодействовать с внешним устройством отображения, а не включать в себя интегрированное устройство отображения.

[0054] Система 10, показанная на фиг. 1, представляет собой всего лишь один пример. Способы выведения информации движения, разделения блоков и/или интерполяции видеоданных могут выполняться с помощью любого устройства кодирования и/или декодирования цифрового видео. Хотя, как правило, способы настоящего раскрытия выполняются устройством видеокодирования, способы также могут выполняться видеокодером/видеодекодером, обычно называемым «кодеком». Кроме того, способы настоящего раскрытия могут также выполняться видеопроцессором. Устройство-источник 12 и целевое устройство 14 являются просто примерами таких устройств кодирования, в которых устройство-источник 12 генерирует кодированные видеоданные для передачи в целевое устройство 14. В некоторых примерах устройства 12 и 14 могут функционировать, по существу, симметрично, так что каждое из устройств 12 и 14 включает в себя компоненты кодирования и декодирования видео. Таким образом, система 10 может поддерживать одностороннюю или двухстороннюю передачу видеосигнала между видеоустройствами 12, 14, например, для потоковой передачи видео, воспроизведения видео, видеовещания или видеотелефонии.

[0055] Видеоисточник 18 устройства-источника 12 может включать в себя устройство видеозахвата, такое как видеокамера, видеоархив, содержащий ранее захваченное видео, и/или интерфейс видеопотока для приема видео от поставщика видеоконтента. В качестве дополнительной альтернативы источник 18 видеосигнала может генерировать данные на основе компьютерной графики в качестве исходного видео или комбинацию видео в реальном времени, архивированного видео и видео с компьютера. В некоторых случаях, если видеоисточник 18 является видеокамерой, устройство-источник 12 и устройство-получатель 14 могут формировать так называемые камерафоны или видеотелефоны. Однако, как упомянуто выше, способы, описанные в этом документе, могут быть применимы к видеокодированию в целом и могут применяться к беспроводным и/или проводным приложениям. В каждом случае захваченное, предварительно захваченное или генерируемое компьютером видео может быть закодировано видеокодером 20. Затем закодированная видеоинформация может выводиться выходным интерфейсом 22 на машиночитаемый носитель 16.

[0056] Машиночитаемый носитель 16 может включать в себя переходные среды, такие как беспроводная широковещательная или проводная сетевая передача, или носитель данных (то есть долговременный носитель данных), такой как жесткий диск, флэш-накопитель, компакт-диск, цифровой видеодиск, Blu-ray-диск или другой машиночитаемый носитель. В некоторых примерах сетевой сервер (не показан) может принимать закодированные видеоданные из устройства-источника 12 и предоставлять закодированные видеоданные целевому устройству 14, например, посредством сетевой передачи. Аналогично, вычислительное устройство установки по изготовлению носителей данных, такой как средство штамповки дисков, может принимать закодированные видеоданные из устройства-источника 12 и создавать диск, содержащий закодированные видеоданные. Следовательно, в различных примерах машиночитаемый носитель 16 можно понимать как включающий в себя один или несколько машиночитаемых носителей различных видов.

[0057] Входной интерфейс 28 целевого устройства 14 принимает информацию от машиночитаемого носителя 16. Информация машиночитаемого носителя 16 может включать в себя синтаксическую информацию, определенную видеокодером 20, которая также используется видеодекодером 30, который включает в себя синтаксические элементы, описывающие характеристики и/или обработку блоков и других единиц кодирования, например, GOP. Устройство 32 отображения отображает декодированные видеоданные пользователю и может содержать любое из множества устройств отображения, таких как электронно-лучевая трубка (CRT), жидкокристаллический дисплей (LCD), плазменный дисплей, дисплей на органических светодиодах (OLED) или другой тип устройства отображения.

[0058] Хотя это не показано на фиг. 1, в некоторых аспектах видеокодер 20 и видеодекодер 30 могут быть объединены с аудиокодером и аудиодекодером и могут включать в себя соответствующие блоки MUX-DEMUX или другое аппаратное и программное обеспечение для обработки кодирования как аудио, так и видео в общем виде Поток данных или отдельные потоки данных. Если это применимо, устройства MUX-DEMUX могут соответствовать протоколу мультиплексора ITU H.223 или другим протоколам, таким как протокол пользовательских дейтаграмм (UDP).

[0059] Как видеокодер 20 так и видеодекодер 30 могут быть реализованы в воде любой из множества подходящих схем кодера, таких как один или несколько микропроцессоров, процессоры цифровых сигналов (DSP), специализированные интегральные схемы (ASIC), программируемые пользователем вентильные массивы (ПЛИС), дискретная логика, программное обеспечение, аппаратное обеспечение, прошивку или любые их комбинации. Когда способы частично реализованы в программном обеспечении, устройство может хранить инструкции для программного обеспечения на подходящем, долговременном машиночитаемом носителе и выполнять инструкции на аппаратных средствах с использованием одного или нескольких процессоров для выполнения способов настоящего раскрытия. Как видеокодер 20 так и видеодекодер 30 может быть включен в один или несколько кодеров или декодеров, каждый из которых может быть интегрирован как часть объединенного кодера/декодера (кодека) в соответствующем устройстве.

[0060] Настоящее раскрытие может в целом ссылаться на то, что видеокодер 20 выполняет «сигнализацию» определенной информации на другое устройство, такое как видеодекодер 30. Термин «сигнализация» обычно может относиться к передаче синтаксических элементов и/или других данных, используемых для декодирования сжатых видеоданных. Такая передача может выполняться в реальном или почти реальном времени. В качестве альтернативы такая передача может происходить в течение определенного промежутка времени, например, может происходить при хранении синтаксических элементов на машиночитаемом носителе данных в кодированном потоке битов во время кодирования, который затем может быть извлечен устройством декодирования в любое время после сохранения на этом носителе.

[0061] Видеоэнкодер 20 и видеодекодер 30 могут работать в соответствии со стандартом кодирования видео. Примеры стандартов кодирования видео, разработанные Объединенной группой сотрудничества по кодированию видео (JCT-VC), а также Совместной группа сотрудничества по разработке расширения 3D-кодирования видео (JCT-3V) Группы экспертов по кодированию видеоматериалов МСЭ-T (VCEG) и ISO/IEC Группы экспертов по движущимся изображениям (MPEG) включают в себя высокоэффективное видеокодирование (HEVC) или ITU-T H.265, включая расширение диапазона, многовидовое расширение (MV-HEVC) и расширение масштабирования (SHVC). Окончательный документ стандарта HEVC опубликован в виде ʺITU-T H.265, SERIES H: AUDIOVISUAL AND MULTIMEDIA SYSTEMS Infrastructure of audiovisual services - Coding of moving video - High efficiency video coding,ʺ Telecommunication Standardization Sector of International Telecommunication Union (ITU), Апрель 2013. В качестве альтернативы, видеоэнкодер 20 и видеодекодер 30 могут работать в соответствии с другими проприетарными или отраслевыми стандартами, такими как ISO/IEC MPEG-4 Visual и ITU-T H.264 (также известный как ISO/IEC MPEG-4 AVC), включая его расширение масштабируемого кодирования видео (SVC) и расширение многовидового кодирования видео (MVC). Однако способы этого раскрытия не ограничиваются каким-либо конкретным стандартом кодирования. Например, способы этого раскрытия могут использоваться с различными другими проприетарными или непроприетарными способами видеокодирования или последующими стандартами, такими как ITU-T H.266.

[0062] Как отмечено выше, для режимов с внешним предсказанием видеоэнкодер 20 может искать блок, аналогичный тому, в отношении которого выполняется кодирование («текущий блок»), в изображении с другим временным положением, называемом опорным изображением. Информация, используемая для идентификации опорного изображения, может упоминаться как информация движения. Например, набор информации движения может быть доступен для каждого блока. Набор информации движения содержит информацию движения для направлений предсказания вперед и назад. Здесь направления предсказания вперед и назад представляют собой два направления предсказания режима двунаправленного предсказания, а термины «вперед» и «назад» необязательно имеют геометрическое значение, напротив, они соответствуют списку 0 опорных изображений (RefPicList0) и списку 1 опорных изображений (RefPicList1) текущего изображения. Когда доступен только один список опорных изображений для изображения или фрагмента, доступен только RefPicList0, и информация движения каждого блока фрагмента всегда относится к направлению вперед.

[0063] В некоторых случаях вектор движения вместе со своим опорным индексом используется в процессах декодирования, причем такой вектор движения со связанным опорным индексом обозначается как единичный предсказательный набор информации движения.

[0064] Для каждого направления предсказания информация движения должна содержать опорный индекс и вектор движения. В некоторых случаях для простоты сам вектор движения может упоминаться таким образом, что предполагается, что он имеет связанный опорный индекс. Опорный индекс используется для определения опорного изображения в текущем списке опорных изображений (RefPicList0 или RefPicList1). Вектор движения имеет горизонтальную и вертикальную составляющие.

[0065] Счетчик последовательности изображений (POC) широко используется в стандартах видеокодирования, чтобы идентифицировать порядок отображения изображения. Хотя бывают случаи, когда два изображения в одной кодированной видеопоследовательности могут иметь одно и то же значение POC, обычно это не происходит в кодированной видеопоследовательности. Когда в битовом потоке присутствуют несколько кодированных видеопоследовательностей, изображения с одинаковым значением POC могут быть ближе друг к другу в терминах порядка декодирования. Значения POC изображений, как правило, используются для построения списка опорных изображений, вывода набора опорных изображений в HEVC, и при масштабировании вектора движения.

[0066] В H.264/AVC каждый внешний макроблок (MB) может быть разделен четырьмя разными способами, включая: один раздел по 16 × 16 MB; два раздела по 16×8 MB; два раздела по 8×16 MB; и четыре раздела по 8×8 MB. Различные разделения MB в одном MB могут иметь разные значения опорного индекса для каждого направления (RefPicList0 или RefPicList1). Когда MB не разбит на четыре раздела 8×8 MB, он имеет только один вектор движения для каждого раздела MB в каждом направлении.

[0067] Когда MB разделен на четыре раздела 8×8 MB, каждый раздел размером 8×8 MB может быть дополнительно разбит на подблоки, каждый из которых может иметь другой вектор движения в каждом направлении. Существует четыре разных способа получения подблоков из раздела 8×8 MB, включая: один блок 8×8; два подблока 8×4; два подблока 4×8; четыре подблока 4×4. Каждый подблок может иметь другой вектор движения в каждом направлении. Таким образом вектор движения присутствует на уровне, более высоком, чем уровень подблока.

[0068] В AVC временный прямой режим может быть разрешен на уровне MB или на уровне разделения MB для режима пропуска или прямого режима в B фрагментах. Для каждого раздела MB векторы движения блока, расположенные вместе с текущим разделом MB в RefPicList1 [0] текущего блока, используются для выведения векторов движения. Каждый вектор движения в совместно размещенном блоке масштабируется на основе расстояний POC. В AVC прямой режим также может предсказывать информацию движения от пространственных соседей, что может упоминаться как пространственный прямой режим.

[0069] В HEVC для генерации кодированного представления изображения видеоэнкодер 20 может генерировать набор блоков дерева кодирования (CTU). Каждый из CTU может содержать блок дерева кодирования (CTB) выборок яркости, два соответствующих CTB с выборками цветности и синтаксические структуры, используемые для кодирования выборок CTB. В монохромных изображениях или изображениях, имеющих три отдельные цветовые плоскости, CTU может содержать один блок CTB и синтаксические структуры, используемые для кодирования выборок блока дерева кодирования.

[0070] Блок дерева кодирования может представлять собой блок NxN выборок. Размер CTB может варьироваться от 16×16 до 64×64 в основном профиле HEVC (хотя технически размеры 8×8 CTB могут поддерживаться). Единица кодирования (CU) может быть того же размера, что и CTB, а может составлять 8×8. Каждая единица кодирования кодируется в одном режиме. CTU также может упоминаться как «блок дерева» или «наибольшая единица кодирования» (LCU). CTU HEVC могут быть в широком смысле аналогичны макроблокам других стандартов, таких как H.264/AVC. Однако CTU не обязательно ограничивается конкретным размером и может включать в себя одну или более единиц кодирования (CU). Фрагмент может включать в себя целое число CTU, упорядоченных последовательно в порядке растрового сканирования.

[0071] Для генерации кодированного CTU видеоэнкодер может рекурсивно выполнять разбиение с деревом квадрантов на блоках дерева кодирования CTU для разделения блоков дерева кодирования на блоки кодирования, отсюда и название «единицы дерева кодирования». Блок кодирования может представлять собой блок NxN выборок. CU может содержать блок кодирования выборок яркости и два соответствующих блока кодирования выборок цветности изображения, которое имеет массив выборок яркости, массив выборок Cb и массив выборок Cr, а также синтаксические структуры, используемые для кодирования выборок блоков кодирования. В монохромных изображениях или изображениях, имеющих три отдельные цветовые плоскости, CU может содержать один блок кодирования и синтаксические структуры, используемые для кодирования выборок блока кодирования.

[0072] Видеоэнкодер 20 может разбивать блок кодирования из CU на один или несколько блоков предсказания. Блок предсказания представляет собой прямоугольный (т. е. квадратный или неквадратный) блок выборок, в отношении которых применяется одно и тоже предсказание. Единица предсказания (PU) из CU может содержать блок предсказания выборок яркости, два соответствующих блока предсказания выборок цветности и синтаксические структуры, используемые для предсказания блоков предсказания. В монохромных изображениях или изображениях с тремя отдельными цветовыми плоскостями PU может содержать один блок предсказания и синтаксические структуры, используемые для предсказания блока предсказания. Видеоэнкодер 20 может генерировать предсказательные блоки яркости, Cb и Cr для блоков предсказания яркости, Cb и Cr каждого PU из CU.

[0073] Видеоэнкодер 20 может использовать внутреннее предсказание или внешнее предсказание для генерации предсказательных блоков для PU. Если видеоэнкодер 20 использует внутреннее предсказание для генерации предсказательных блоков PU, видеокодер 20 может генерировать предсказательные блоки PU на основе декодированных выборок изображения, ассоциированного с PU. Если видеокодер 20 использует внешнее предсказание для генерации предсказательных блоков PU, видеокодер 20 может генерировать предсказательные блоки PU на основе декодированных выборок одного или нескольких изображений, отличных от изображения, связанного с PU. При кодировании CU с внешним кодированием, CU может быть дополнительно разделен на два или четыре PU. Когда в одном CU присутствуют два PU, в некоторых случаях PU могут быть прямоугольниками с половинным размером или двумя прямоугольниками с размером четверть или три четверти CU.

[0074] После того, как видеокодер 20 генерирует предсказательные блоки яркости, Cb и Cr для одной или нескольких PU из CU, видеокодер 20 может генерировать остаточный блок яркости для CU. Каждая выборка в остаточном блоке CU указывает на разницу между выборкой яркости в одном из предсказательных блоков яркости CU и соответствующей выборкой в исходном блоке кодирования яркости CU. Кроме того, видеокодер 20 может генерировать остаточный блок Cb для CU. Каждая выборка в остаточном блоке Cb из CU может указывать разницу между выборкой Cb в одном из предсказательных блоков Cb из CU и соответствующей выборкой в исходном блоке кодирования Cb из CU. Видеокодер 20 может также генерировать остаточный блок Cr для CU. Каждая выборка в остаточном блоке Cr из CU может указывать разницу между выборкой Cr в одном из предсказательных блоков Cr из CU и соответствующей выборкой в исходном блоке кодирования Cr из CU.

[0075] Кроме того, видеокодер 20 может использовать разбиение по дереву квадрантов для разложения остаточных блоков яркости, Cb и Cr из CU в один или несколько блоков преобразования яркости, Cb и Cr. Блок преобразования представляет собой прямоугольный (например, квадратный или неквадратный) блок выборок, в отношении которых применяется одинаковое преобразование. Блок преобразования (TU) CU может содержать блок преобразования выборок яркости, два соответствующих блока преобразования выборок цветности и синтаксические структуры, используемые для преобразования выборок блока преобразования. Таким образом, каждый TU из CU может быть связан с блоком преобразования яркости, блоком преобразования Cb и блоком преобразования Cr. Блок преобразования яркости, связанный с TU, может быть подблоком остаточного блока яркости CU. Блок преобразования Cb может быть подблоком остаточного блока Cb из CU. Блок преобразования Cr может быть подблоком остаточного блока Cr из CU. В монохромных изображениях или изображениях, имеющих три отдельные цветовые плоскости, TU может содержать один блок преобразования и синтаксические структуры, используемые для преобразования выборок блока преобразования.

[0076] Видеокодер 20 может применять одно или несколько преобразований к блоку преобразования яркости TU для генерации блока коэффициентов яркости для TU. Блок коэффициентов может быть двумерным массивом коэффициентов преобразования. Коэффициент преобразования может быть скалярной величиной. Видеокодер 20 может применять одно или несколько преобразований к блоку преобразования Cb TU для генерации блока коэффициентов Cb для TU. Видеокодер 20 может применять одно или несколько преобразований к блоку преобразования Cr TU для создания блока коэффициентов Cr для TU.

[0077] После формирования блока коэффициентов (например, блока коэффициентов яркости, блока коэффициентов Cb или блока коэффициентов Cr) видеокодер 20 может выполнить квантование блока коэффициентов. Квантование обычно относится к процессу, в котором коэффициенты преобразования квантуются, чтобы, возможно, уменьшить объем данных, используемых для представления коэффициентов преобразования, обеспечивая дальнейшее сжатие. После того как видеокодер 20 выполняет квантование блока коэффициентов, видеокодер 20 может выполнить энтропийное кодирование синтаксических элементов, указывающих квантованные коэффициенты преобразования. Например, видеокодер 20 может выполнять контекстно-адаптивное двоичное арифметическое кодирование (CABAC) на синтаксических элементах, указывающих квантованные коэффициенты преобразования.

[0078] Видеокодер 20 может выводить битовый поток, который включает в себя последовательность битов, которая формирует представление кодированных изображений и связанных данных. Битовый поток может содержать последовательность блоков уровня абстракции сети (NAL). Блок NAL представляет собой синтаксическую структуру, содержащую указание типа данных в блоке NAL, и байты, содержащие эти данные, в виде полезной нагрузки исходной последовательности байтов (RBSP), чередующейся по мере необходимости с битами предотвращения эмуляции. Каждый из блоков NAL включает в себя заголовок блока NAL и инкапсулирует RBSP.

[0079] Различные типы блоков NAL могут инкапсулировать различные типы RBSP. Например, первый тип блока NAL может инкапсулировать RBSP для набора параметров изображения (PPS), второй тип блока NAL может инкапсулировать RBSP для кодированного фрагмента, третий тип блока NAL может инкапсулировать RBSP для SEI, и так далее. Блоки NAL, которые инкапсулируют RBSP для данных видеокодирования (в отличие от RBSP для наборов параметров и сообщений SEI), могут упоминаться как единицы NAL уровня видеокодирования (VCL).

[0080] Видеодекодер 30 может принимать битовый поток, генерируемый видеокодером 20. Кроме того, видеодекодер 30 может анализировать битовый поток для получения синтаксических элементов из битового потока. Видеодекодер 30 может реконструировать изображения видеоданных, основываясь, по меньшей мере, частично на синтаксических элементах, полученных из битового потока. Процесс реконструкции видеоданных может быть, в целом, обратным процессу, выполняемому видеокодером 20. Кроме того, видеодекодер 30 может выполнять обратное квантование блоков коэффициентов, связанных с TU текущего CU. Видеодекодер 30 может выполнять обратные преобразования на блоках коэффициентов для реконструкции блоков преобразования, связанных с TU текущего CU. Видеодекодер 30 может реконструировать блоки кодирования текущего CU путем добавления выборок блоков предсказания для PU текущего CU к соответствующим выборкам блоков преобразования TU текущего CU. Реконструируя блоки кодирования для каждого CU изображения, видеодекодер 30 может реконструировать изображение.

[0081] При кодировании CU с внешним предсказанием, для каждого PU присутствует один набор информации движения. Кроме того, каждый PU кодируется с уникальным режимом внешнего предсказания для выведения набора информации движения. В стандарте HEVC для единицы предсказания (PU) существуют два режима внешнего предсказания, называемые слиянием (отбрасывание рассматривается как частный случай слияния) и режим расширенного предсказания вектора движения (AMVP), соответственно.

[0082] В режиме AMVP или слияния список векторов движения (MV) - кандидатов поддерживается для множества предикторов векторов движения. Вектор (векторы) движения текущего PU, также как и опорные индексы в режиме слияния, генерируются путем взятия одного кандидата из списка MV кандидатов.

[0083] Список MV кандидатов содержит до пяти кандидатов для режима слияния и два кандидата для режима AMVP. Кандидат слияния может содержать набор информации движения, например, векторы движения, соответствующие обоим спискам опорных изображений (список 0 и список 1), и опорные индексы. Если кандидат слияния идентифицируется индексом слияния, для предсказания текущих блоков используются опорные изображения, а также определяются связанные векторы движения. Однако в режиме AMVP для каждого потенциального направления предсказания из списка 0 или списка 1 необходимо в явном виде сигнализировать опорный индекс вместе с индексом MVP в списке MV кандидатов, поскольку кандидат AMVP содержит только вектор движения. В режиме AMVP предсказанные векторы движения могут быть дополнительно уточнены.

[0084] Как уже отмечалось выше, кандидат слияния соответствует полному набору информации движения, тогда как кандидат AMVP содержит только один вектор движения для конкретного направления предсказания и опорный индекс. Кандидаты для обоих режимов выводятся аналогично из пространственных и временных соседних блоков, как описано ниже со ссылкой на фиг. 4 и 5.

[0085] В соответствии с аспектами настоящего раскрытия, как описано более подробно ниже, видеокодер 20 и/или видеодекодер 30 могут быть выполнены с возможностью выполнения любой комбинации описанных здесь способов для выведения информации движения, выполнения разбиения блоков и/или интерполяции видеоданных. Что касается выведения информации движения, видеокодер 20 и/или видеодекодер 30 может быть выполнен с возможностью выведения информации движения посредством выполнения поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных вне текущего блока. Соответствие может быть определено на основе степени сходства между опорными данными и может упоминаться здесь как определение «совпадения» или «наилучшего совпадения».

[0086] В некоторых примерах видеокодер 20 и/или видеодекодер 30 могут первоначально кодировать один или несколько синтаксических элементов, которые указывают, разрешен ли процесс вывода движения. В некоторых случаях один или несколько синтаксических элементов могут быть включены в другой режим, такой как режим слияния, описанный выше. Например, как описано более подробно в отношении примера на фиг. 10, видеокодер 20 и/или видеодекодер 30 кодируют один или более синтаксических элементов при выполнении режима слияния (например, флаг, индекс в списке кандидатов слияния и т. п.), которые указывает, выполнять ли выведение движения.

[0087] В случаях, когда выведение движения разрешено, в соответствии с аспектами этого раскрытия видеокодер 20 и/или видеодекодер 30 могут выполнять выведение вектора движения по согласованию с образцом. Например, видеокодер 20 и/или видеодекодер 30 могут кодировать один или несколько синтаксических элементов, которые указывают, какой применяется режим выведения информации движения из множества режимов выведения информации движения. Видеокодер 20 и/или видеодекодер 30 могут кодировать флаг для различения двух режимов выведения информации движения или индекс для различения более двух режимов выведения информации движения. Как описано в данном документе, варианты выведения информации движения по согласованию с образцом, включают в себя двустороннее согласование или согласование с шаблоном.

[0088] Во время процесса выведения движения видеокодер 20 и/или видеодекодер 30 могут выводить исходный вектор движения для всего блока (например, для всего PU) на основе выбранного процесса выведения движения. Например, видеокодер 20 и/или видеодекодер 30 могут использовать векторы движения из списка кандидатов, связанные с режимом слияния, и определять, какой вектор движения из списка кандидатов приводит к лучшему совпадению. То есть видеокодер 20 и/или видеодекодер 30 могут определять, какой вектор движения из списка кандидатов, когда он используется в выбранном процессе выведения движения, приводит к первому набору опорных данных, который соответствует второму набору опорных данных вне текущего блока, например, опорным данным, которые хорошо совпадают с данными текущего изображения или другого опорного изображения. В целом, «наилучшее совпадение» может относиться к видеоданным, наиболее сходным с точки зрения различий пикселей.

[0089] В качестве иллюстративного примера, как описано более подробно со ссылкой на фиг. 8, видеокодер 20 и/или видеодекодер 30 могут выбирать режим выведения информации движения по согласованию с шаблоном. В этом примере, видеокодер 20 и/или видеодекодер 30 могут выбрать вектор движения - кандидат из режима слияния на основе наилучшего вектора кандидата, который приводит к шаблону, который лучше всего совпадает с шаблоном в опорном изображении. Например, видеокодер 20 и/или видеодекодер 30 могут быть выполнены с возможностью выполнения поиска движения для первого набора опорных данных, который соответствует второму набору опорных данных вне текущего блока, причем первый набор опорных данных содержит шаблон в текущем изображении, а второй набор опорных данных содержит шаблон в опорном изображении. В некоторых случаях, как описано более подробно ниже, видеокодер 20 и/или видеодекодер 30 могут дополнительно или альтернативно выбирать вектор движения - кандидат на основе минимальной стоимости согласования.

[0090] Согласно аспектам настоящего раскрытия после определения вектора движения - кандидата видеокодер 20 и/или видеодекодер 30 могут дополнительно уточнить вектор движения - кандидат для выведения информации движения для текущего блока. Например, видеокодер 20 и/или видеодекодер 30 могут выполнять поиск (например, поиск, используя режим выведения информации движения) в предопределенном участке опорного изображения, указанным вектором движения - кандидатом. Видеокодер 20 и/или видеодекодер 30 могут получать информацию движения для текущего блока на основе вектора движения, который указывает опорные данные в предопределенной области, имеющей наилучшее совпадение и/или минимальную стоимость согласования с видеоданными текущего изображения.

[0091] В некоторых случаях в соответствии с аспектами этого раскрытия видеокодер 20 и/или видеодекодер 30 могут разделять блок видеоданных на подблоки при выводе информации движения. Например, видеокодер 20 и/или видеодекодер 30 могут отдельно выводить информацию движения для каждого подблока большего блока. В некоторых случаях видеокодер 20 и/или видеодекодер 30 могут использовать информацию движения, выведенную для блока (например, используя вышеописанный процесс), в качестве информации движения - кандидата для каждого из подблоков. Видеокодер 20 и/или видеодекодер 30 могут затем дополнительно уточнять выведенную информацию движения для каждого из подблоков, например, используя конкретный режим выведения движения (например, способ двустороннего согласования, способ согласования с шаблоном или другой способ, как описано более подробно ниже).

[0092] Фиг. 2 представляет собой блок-схему, иллюстрирующую пример видеокодера 20, который может реализовывать способы для выведения информации движения, выполнения разбиения блоков и/или интерполяции видеоданных. Видеокодер 20 может выполнять кодирование видеоблоков с внешним и внутренним предсказанием в видеофрагментах. Кодирование с внутренним предсказанием основывается на пространственном предсказании для уменьшения или удаления пространственной избыточности в видео в рамках данного видеокадра или изображения. Кодирование с внешним предсказанием использует временное предсказание для уменьшения или удаления временной избыточности в видео в соседних кадрах или изображениях видеопоследовательности. Режим с внутренним предсказанием (I-режим) может относиться к любому из нескольких режимов кодирования в пространственном режиме. Режим с внешним предсказанием, например однонаправленное предсказание (режим P) или двунаправленное предсказание (режим B), может относиться к любому из нескольких режимов временного кодирования.

[0093] Как показано на фиг. 2, видеокодер 20 принимает текущий видеоблок в кодируемом видеокадре. В примере на фиг. 2, видеокодер 20 включает в себя память 38 видеоданных, блок 40 выбора режима, память 64 опорного изображения, сумматор 50, модуль 52 обработки преобразования, блок квантования 54, и модуль 56 энтропийного кодирования. Блок 40 выбора режима, в свою очередь, включает в себя блок 44 компенсации движения, блок 42 оценки движения, блок 46 внутреннего предсказания и блок 48 разделения. Для реконструкции видеоблока видеокодер 20 также включает в себя модуль 58 обратного квантования, блок 60 обратного преобразования и сумматор 62. Также может присутствовать фильтр деблокирования (не показан на фиг.2) для фильтрации границ блоков для удаления артефактов блочности из реконструированного видео. При желании фильтр деблокирования фильтрует выходной сигнал сумматора 62. В дополнение к фильтру деблокирования также могут использоваться дополнительные фильтры (в цикле обработки или после нее). Такие фильтры для краткости не показаны, но при желании могут фильтровать выход сумматора 50 (в качестве фильтра, действующего в цикле обработки).

[0094] В процессе кодирования видеокодер 20 принимает видеокадр или фрагмент, подлежащий кодированию. Кадр или фрагмент можно разделить на несколько видеоблоков. Память 38 видеоданных может сохранять видеоданные, подлежащие кодированию компонентами видеокодера 20. Видеоданные, хранящиеся в памяти 38 видеоданных, могут быть получены, например, из видеоисточника 18. Память 64 опорных изображений, которая может упоминаться как DPB, хранит опорные видеоданные для использования при кодировании видеоданных с помощью видеокодера 20, например, в режимах с внутренним и внешним предсказанием. Память 38 хранения видеоданных и память 64 опорных изображений могут быть образованы любым из множества запоминающих устройств, таких как динамическая память с произвольным доступом (DRAM), в том числе синхронная DRAM (SDRAM), магниторезистивная RAM (MRAM), резистивная RAM (RRAM), или другими типами запоминающих устройств. Память 38 хранения видеоданных и память 64 опорных изображений могут быть обеспечены одним и тем же запоминающим устройством или реализованы в виде отдельных запоминающих устройств. В различных примерах память 38 видеоданных может быть встроенной на одной микросхеме с другими компонентами видеокодера 20 или выполнена как внешняя относительно этих компонентов.

[0095] Модуль 42 оценки движения и модуль 44 компенсации движения выполняют кодирование с внешним предсказанием принятого видеоблока относительно одного или более блоков в одном или более опорных кадрах для обеспечения временного предсказания. Модуль 46 внутреннего предсказания может альтернативно выполнять кодирование с внутренним предсказанием принятого видеоблока относительно одного или более соседних блоков в одном и том же кадре или фрагменте, в качестве блока, подлежащего кодированию, для обеспечения пространственного предсказания. Видеокодер 20 может выполнять несколько проходов кодирования, например, для выбора соответствующего режима кодирования для каждого блока видеоданных.

[0096] Кроме того, модуль 48 разделения может разделять блоки видеоданных на подблоки на основе оценки предыдущих схем разделения в предыдущих проходах кодирования. Например, модуль 48 разделения может сначала разделять кадр или фрагмент на LCU и разбивать каждый из LCU на под-CU на основе анализа скорость-искажение (например, оптимизации скорость-искажение). Модуль 40 выбора режима может дополнительно создавать структуру дерева квадрантов, указывающую на разделение LCU на под-CU. Листья-узлы CU дерева квадрантов могут включать в себя один или более PU и один или более TU.

[0097] Модуль 40 выбора режима может выбирать один из режимов кодирования, с внутренним или внешним предсказанием, например, на основе результата ошибки, и предоставляет результирующий блок, закодированный с внутренним или внешним предсказанием, в сумматор 50 для генерации данных остаточного блока и в сумматор 62 для реконструкции кодированного блока для использования в качестве опорного кадра. Модуль 40 выбора режима также предоставляет синтаксические элементы, такие как векторы движения, индикаторы режима внутреннего предсказания, информацию о разделе и другую подобную синтаксическую информацию, в модуль 56 энтропийного кодирования.

[0098] Модуль 42 оценки движения и модуль 44 компенсации движения могут быть высокоинтегрированными, но показаны как отдельные модули с целью иллюстрации концепции. Оценка движения, выполняемая модулем 42 оценки движения, представляет собой процесс генерации векторов движения, которые оценивают движение видеоблоков. Вектор движения, например, может указывать на перемещение в PU из видеоблока внутри текущего видеокадра или изображения по отношению к предсказательному блоку в опорном кадре (или другой единице кодирования) по отношению к текущему блоку, кодируемому в пределах текущего кадра (или другой единицы кодирования). Предсказательный блок представляет собой блок, для которого установлено, что он хорошо совпадает с кодируемым блоком с точки зрения разности пикселей, что может быть определено по сумме абсолютной разности (SAD), сумме квадратов разности (SSD) или другими разностными метриками.

[0099] В некоторых примерах видеокодер 20 может выполнять быстрый поиск движения для определения вектора движения блока. Существует много способов быстрого поиска движения, предложенных в литературе, таких как поиск способом градиентного спуска на основе блоков (BBGDS), как описано, например, в Lurng-Kuo Liu, Ephraim Feig, ʺA block-based gradient descent search algorithm for block motion estimation in video coding,ʺ IEEE Trans. Circuits Syst. Video Technol., vol. 6, pp, 419-422, Aug.1996, Неограниченный ромбовидный поиск со смещенным центром (UCBDS), как описано, например, в Jo Yew Tham, Surendra Ranganath, Maitreya Ranganath, and Ashraf Ali Kassim, ʺA novel unrestricted center-biased diamond search algorithm for block motion estimation,ʺ IEEE Trans. Circuits Syst. Video Technol., vol. 8, pp. 369-377, Aug. 1998, и гексагональный поиск (HEBS), как описано, например, Ce Zhu, Xiao Lin, and Lap-Pui Chau, ʺ Hexagon-Based Search Pattern for Fast Block Motion Estimation,ʺ IEEE Trans. Circuits Syst. Video Technol., vol. 12, pp. 349-355, May 2002. В основном, эти способы включают в себя поиск только определенного количества позиций внутри окна поиска на основе предопределенных шаблонов поиска. Эти способы обычно хорошо работают при небольшом и умеренном движении.

[0100] В некоторых примерах, видеокодер 20 может вычислять значения для суб-целочисленных положений пикселей опорных изображений, сохраненных в памяти 64 опорных изображений. Например, видеокодер 20 может интерполировать значения одной четверти положения пикселей, один восьмой положения пикселей, или другие дробные положения пикселей опорного изображения. Следовательно, модуль 42 оценки движения может выполнять поиск движения относительно полных положений пикселей и дробных положений пикселей и выводить вектор движения с точностью до дробного пикселя.

[0101] Модуль 42 оценки движения вычисляет оценку вектора движения для PU из видеоблока в фрагменте, кодированном с внутренним предсказанием, сравнивая положение PU с положением предсказательного блока опорного изображения. Опорное изображение может быть выбрано из первого списка опорных изображений (список 0) или второго списка опорных изображений (список 1), каждый из которых идентифицирует одно или более опорных изображений, сохраненных в памяти 64 опорных изображений. Модуль 42 оценки движения отправляет вычисленный вектор движения в модуль 56 энтропийного кодирования и модуль 44 компенсации движения.

[0102] Компенсация движения, выполняемая модулем 44 компенсации движения, может включать в себя выборку или создание предсказательного блока на основе вектора движения, определенного модулем 42 оценки движения. Следует еще раз отметить, что в некоторых примерах модуль 42 оценки движения и модуль 44 компенсации движения могут быть функционально интегрированы. После приема вектора движения для PU текущего видеоблока модуль 44 компенсации движения может выполнять установить положение предсказательного блока, на который указывает вектор движения, в одном из списков опорных изображений. Сумматор 50 формирует остаточный видеоблок путем вычитания значений пикселя предсказательного блока из значений пикселей текущего видеоблока, в отношении которого выполняется кодирование, формируя значения разности пикселей, как обсуждается ниже. В целом, модуль 42 оценки движения выполняет оценку движения относительно компонентов яркости, а модуль 44 компенсации движения использует векторы движения, рассчитанные на основе компонентов яркости как для компонентов цветности, так и для компонентов яркости. Модуль 40 выбора режима может также генерировать синтаксические элементы, связанные с видеоблоками, и видеофрагментом для использования видеодекодером 30 при декодировании видеоблоков видеофрагмента.

[0103] Модуль 46 внутреннего предсказания может выполнить внутреннее предсказание текущего блока в качестве альтернативы внешнему предсказанию, выполняемому модулем 42 оценки движения и модулем 44 компенсации движения, как описано выше. В частности, модуль 46 внутреннего предсказания может определять режим внутреннего предсказания для использования при кодировании текущего блока. В некоторых примерах модуль 46 внутреннего предсказания может кодировать текущий блок, используя различные режимы внутреннего предсказания, например, во время отдельных проходов кодирования, и модуль 46 внутреннего предсказания (или модуль 40 выбора режима в некоторых примерах) может выбирать для использования подходящий режим внутреннего предсказания в протестированных режимах.

[0104] Например, модуль 46 внутреннего предсказания может вычислять значения скорость-искажение, используя анализ скорость-искажение для различных протестированных режимов внутреннего предсказания, и выбирать режим внутреннего предсказания, имеющий наилучшие характеристики скорость-искажение среди протестированных режимов. Анализ скорость-искажение обычно определяет величину искажения (или ошибки) между кодированным блоком и исходным незакодированным блоком, который был закодирован для создания кодированного блока, а также битрейт (то есть количество битов), используемый для создания кодированного блока. Модуль 46 внутреннего предсказания может вычислять отношения искажений и скоростей для различных кодированных блоков, чтобы определить, какой режим внутреннего предсказания имеет наилучшее значение скорость-искажение для блока.

[0105] После выбора режима внутреннего предсказания для блока, модуль 46 внутреннего предсказания может предоставлять информацию, указывающую выбранный режим внутреннего предсказания для блока, в модуль 56 энтропийного кодирования. Модуль 56 энтропийного кодирования может кодировать информацию, указывающую выбранный режим внутреннего предсказания. Видеокодер 20 может включать в передаваемый битовый поток данные конфигурации, которые могут включать в себя множество индексных таблиц режима внутреннего предсказания и множество модифицированных таблиц режима внутреннего предсказания (также называемых таблицами соответствия кодовых слов), определения контекстов кодирования для различных блоков и указание наиболее вероятного режима внутреннего предсказания, индексную таблицу режима внутреннего предсказания и модифицированную индексную таблицу режимов внутреннего предсказания для использования в каждом из контекстов.

[0106] Согласно аспектам настоящего раскрытия, как описано настоящем документе, видеокодер 20 может быть выполнен с возможностью выполнения любой комбинации описанных здесь способов для выведения информации движения, выполнения разбиения блоков и/или интерполяции видеоданных. В частности, некоторые способы настоящего раскрытия могут выполняться посредством модуля 49 выведения. Например, модуль 49 выведения может быть выполнен с возможностью выведения информации движения для текущего блока и без включения в битовый поток данных, указывающих информацию движения.

[0107] В некоторых случаях модуль 49 выведения (и/или модуль 40 выбора режима) может определять, выполнять ли выведение движения для конкретного блока (например, по сравнению с внутренним предсказанием или традиционным внешним предсказанием) на основе анализа скорость-искажение. Например, модуль 49 выведения может определить, следует ли выполнять выведение движения способом, подобным выбору стоимости скорость-искажение, который выполняется для кандидатов слияния в режиме слияния. В этом примере модуль 49 выведения может проверять каждый режим выведения информации движения из множества режимов выведения информации движения (например, режим двустороннего согласования, режим согласования с шаблоном или тому подобное), используя выбор стоимости скорость-искажение. Модуль 49 выведения может дополнительно сравнивать режим выведения информации движения, имеющий минимальную стоимость с другими режимами PU (например, режимы внутреннего предсказания, традиционный режим внешнего предсказания, режим кодирования палитры или тому подобное). В случаях, когда режим выведения движения является наиболее эффективным режимом с точки зрения эффективности кодирования, видеокодер 20 может кодировать один или несколько синтаксических элементов, указывающих, что для текущего блока информация движения выведена (а не сигнализирована). Видеокодер 20 также может кодировать один или несколько синтаксических элементов для указания режима выведения движения из множества режимов выведения информации движения.

[0108] В других примерах, в соответствии с аспектами настоящего раскрытия, модуль 49 выведения может интерполировать видеоданные, которые не включены в кодированный битовый поток для видеопоследовательности. Например, модуль 49 выведения может выполнять любую комбинацию способов выведения движения для интерполяции изображения, которое не включено в битовый поток, например, аналогично преобразованию с повышением частоты кадров. В некоторых случаях видеокодер 20 может использовать интерполированное изображение во время кодирования. Например, модуль 49 выведения может интерполировать изображение, а видеокодер 20 может кодировать данные для текущего изображения относительно интерполированного изображения. В этом примере видеокодер 20 может добавить интерполированное изображение в память 64 опорных изображений и кодировать данные других изображений на основе, по меньшей мере, части интерполированного изображения.

[0109] В других примерах модуль 49 выведения может интерполировать изображение, а видеокодер 20 может установить интерполированное изображение, равным текущему изображению. Например, модуль 49 выведения может интерполировать текущее изображение, а видеокодер 20 может кодировать синтаксические данные для текущего изображения, которое должно быть включено в битовый поток (например, данные заголовка фрагмента и т.п.), но может пропускать кодирование видеоданных для текущего изображения.

[0110] Хотя модуль 49 выведения может быть выполнен с возможностью выполнения определенных способов выведения и/или интерполяции, как описано в настоящем документе, следует понимать, что один или несколько других блоков видеокодера 20 могут также или альтернативно быть выполнены с возможностью интерполяции данных. Например, видеокодер 20 может включать в себя множество других интерполяторов или фильтров, например, для интерполяции пикселя в субпиксельном (подэлементном) местоположении во время компенсации движения.

[0111] Видеокодер 20 формирует остаточный видеоблок путем вычитания данных предсказания из блока 40 выбора режима из кодируемого исходного видеоблока. Сумматор 50 представляет компонент или компоненты, которые выполняют эту операцию вычитания. Модуль 52 обработки преобразования применяет преобразование, такое как дискретное косинусное преобразование (DCT) или концептуально подобное преобразование, к остаточному блоку, создавая видео-блок, содержащий значения коэффициента остаточного преобразования. Модуль 52 обработки преобразования может выполнять другие преобразования, которые концептуально похожи на DCT. Также можно использовать вейвлет-преобразования, целочисленные преобразования, субполосное преобразование или другие типы преобразований.