ОБЛАСТЬ ТЕХНИКИ

[0001] Изобретение относится к технической области обработки изображений и, в частности, относится к способу и устройству для синтеза объектов виртуальной реальности.

УРОВЕНЬ ТЕХНИКИ

[0002] Технология дополненной реальности (AR, Augmented Reality) - это технология, которая улучшает восприятие пользователем реального мира посредством информации, предоставляемой компьютерной системой. Она может применять виртуальную информацию к реальному миру и накладывать виртуальные объекты, создаваемые компьютерами, на реальные сцены, тем самым реализуя усовершенствование реальности.

[0003] Способ синтеза объектов виртуальной реальности на известном уровне техники может в некоторых случаях корректно управлять окклюзионными связями между виртуальными и реальными объектами, однако он имеет проблемы большого количества вычислений и непригоден для терминальных устройств, таких как мобильный телефон или планшетный компьютер.

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

[0004] Для преодоления проблем существующего уровня техники настоящее изобретение предлагает способ и устройство для синтеза объектов виртуальной реальности, которые могут корректно отображать виртуальный объект на изображении, захваченном терминальным устройством в реальном времени.

[0005] В соответствии с первым аспектом вариантов осуществления настоящего изобретения предлагается способ синтеза объектов виртуальной реальности, применяемый к терминальному устройству, причем способ включает в себя: обнаружение целевого объекта на изображении, захваченном терминальным устройством; получение информации о глубине для целевого объекта в режиме синтеза информации о глубине с помощью съемочного блока терминального устройства, причем режим синтеза информации о глубине используется для наложения виртуального объекта, генерируемого с помощью компьютерного моделирования, на изображение, а информация о глубине для целевого объекта используется для указания расстояния между целевым объектом и терминальным устройством; получение информации о глубине для виртуального объекта; и наложение виртуального объекта на изображение в соответствии с информацией о глубине для целевого объекта и информацией о глубине для виртуального объекта.

[0006] В возможном способе реализации наложение виртуального объекта на изображение на основе информации о глубине для целевого объекта и информации о глубине для виртуального объекта содержит: когда информация о глубине для целевого объекта меньше информации о глубине для виртуального объекта, наложение части виртуального объекта, которая не заслонена целевым объектом, на изображение.

[0007] В возможном способе реализации наложение виртуального объекта на изображение на основе информации о глубине для целевого объекта и информации о глубине для виртуального объекта содержит: когда информация о глубине для целевого объекта больше или равна информации о глубине для виртуального объекта, наложение виртуального объекта на изображение.

[0008] В возможном способе реализации съемочный блок терминального устройства содержит по меньшей мере две камеры, а получение информации о глубине для целевого объекта с помощью съемочного блока терминального устройства включает в себя: определение информации о глубине для целевого объекта в соответствии с позиционной связью между целевым объектом и по меньшей мере двумя камерами и расстоянием между по меньшей мере двумя камерами.

[0009] В возможном способе реализации получение информации о глубине для виртуального объекта включает в себя: получение информации о позиции для позиции виртуального объекта; и определение информации о глубине для виртуального объекта в соответствии с информацией о позиции.

[0010] В соответствии со вторым аспектом вариантов осуществления настоящего изобретения предлагается устройство для синтеза объектов виртуальной реальности, применяемое к терминальному устройству, причем упомянутое устройство содержит: модуль обнаружения объекта, выполненный с возможностью обнаруживать целевой объект на изображении, захваченном терминальным устройством; первый модуль получения информации, выполненный с возможностью получать информацию о глубине для целевого объекта с помощью съемочного блока терминального устройства в режиме синтеза информации о глубине, причем режим синтеза информации о глубине используется для наложения виртуального объекта, генерируемого с помощью компьютерного моделирования, на изображение; а информация о глубине для целевого объекта используется для указания расстояния между целевым объектом и терминальным устройством; второй модуль получения информации, выполненный с возможностью получать информацию о глубине для виртуального объекта; и модуль наложения, выполненный с возможностью накладывать виртуальный объект на изображение на основе информации о глубине для целевого объекта и информации о глубине для виртуального объекта.

[0011] В возможном способе реализации модуль наложения содержит: первый подмодуль наложения, выполненный с возможностью, когда информация о глубине для целевого объекта меньше информации о глубине для виртуального объекта, накладывать часть виртуального объекта, которая не заслонена целевым объектом, на изображение.

[0012] В возможном способе реализации модуль наложения дополнительно содержит: второй подмодуль наложения, выполненный с возможностью, когда информация о глубине для целевого объекта больше или равна информации о глубине для виртуального объекта, накладывать виртуальный объект на изображение.

[0013] В возможном способе реализации первый модуль получения информации содержит: первый подмодуль определения, выполненный с возможностью определять информацию о глубине для целевого объекта в соответствии с позиционной связью между целевым объектом и по меньшей мере двумя камерами и расстоянием между по меньшей мере двумя камерами.

[0014] В возможном варианте осуществления второй модуль получения информации содержит: подмодуль получения, выполненный с возможностью получать информацию о позиции для позиции виртуального объекта, и второй подмодуль определения, выполненный с возможностью определять информацию о глубине для виртуального объекта в соответствии с информацией о позиции.

[0015] В соответствии с третьим аспектом вариантов осуществления настоящего изобретения предлагается устройство для синтеза объектов виртуальной реальности, содержащее процессор и память для хранения команд, исполняемых процессором, причем процессор выполнен с возможностью выполнять описанный выше способ.

[0016] В соответствии с четвертым аспектом вариантов осуществления настоящего изобретения предлагается машиночитаемый носитель данных, содержащий сохраненные на нем команды, которые при выполнении процессором выполняют описанный выше способ.

[0017] Технические решения, предлагаемые вариантами осуществления настоящего изобретения, могут давать следующие положительные эффекты: объекты с различной информацией о глубине имеют различные окклюзионные связи, в вариантах осуществления настоящего изобретения после обнаружения целевого объекта терминальное устройство накладывает виртуальный объект на изображение, захваченное терминальным устройством, в соответствии с информацией о глубине для целевого объекта и информацией о глубине для виртуального объекта; таким образом, можно определить способ наложения на основе результата сравнения информации о глубине, когда обнаружен целевой объект. В сравнении с непосредственным наложением виртуального объекта без сравнения информации о глубине объекта и информации о глубине для виртуального объекта или наложением виртуального объекта после сравнения информации о глубине всех объектов и информации о глубине для виртуального объекта, технические решения в вариантах осуществления настоящего изобретения могут сократить объем вычислений во время процесса наложения и могут быть успешно применены к приложениям AR в терминальных устройствах. Кроме того, в вариантах осуществления настоящего изобретения используют съемочный блок терминального устройства для получения информации о глубине для целевого объекта, что является полезным для применения в терминальном устройстве. В результате, способ и устройство для синтеза объектов виртуальной реальности в соответствии с различными аспектами настоящего изобретения могут корректно отображать виртуальный объект на изображении, захваченном терминальным объектом в реальном времени.

[0018] Следует понимать, что как приведенное выше общее описание, так и последующее подробное описание являются только иллюстративными и не ограничивают настоящее изобретение.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

[0019] Сопроводительные чертежи, которые включены в это описание и составляют его часть, иллюстрируют варианты осуществления, соответствующие настоящему изобретению, и вместе с описанием служат для объяснения принципов настоящего изобретения.

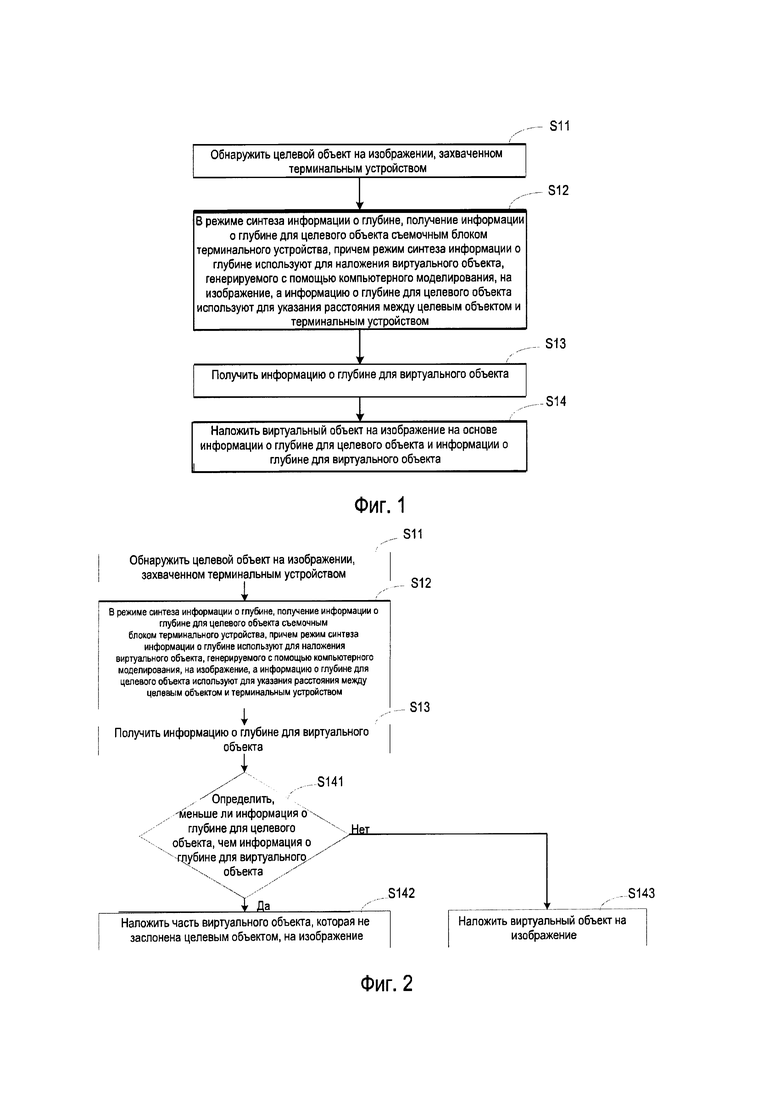

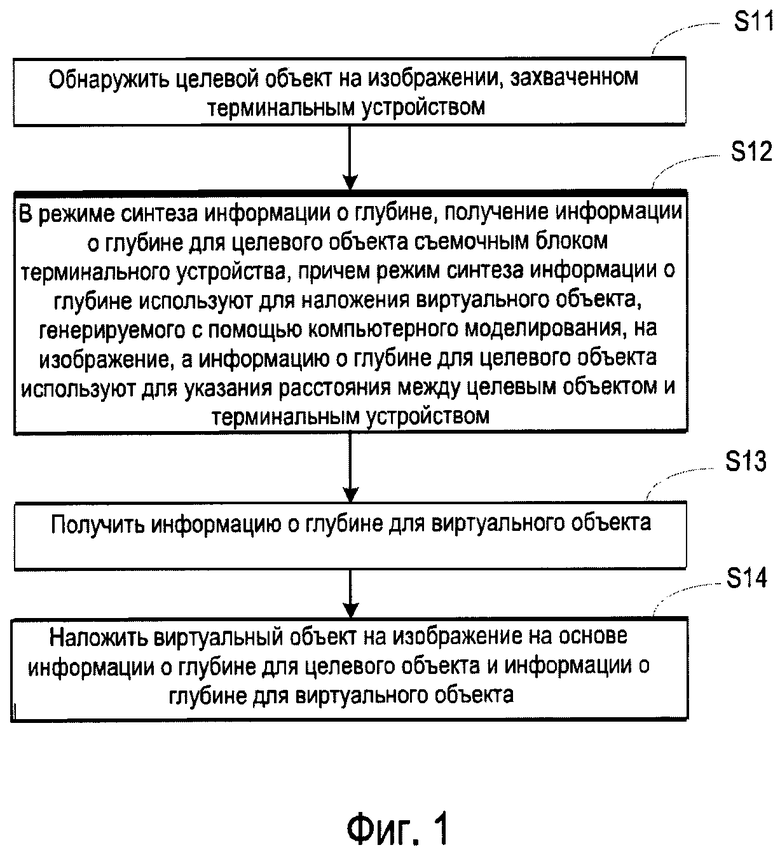

[0020] Фиг. 1 представляет блок-схему способа синтеза объектов виртуальной реальности в соответствии с примером осуществления.

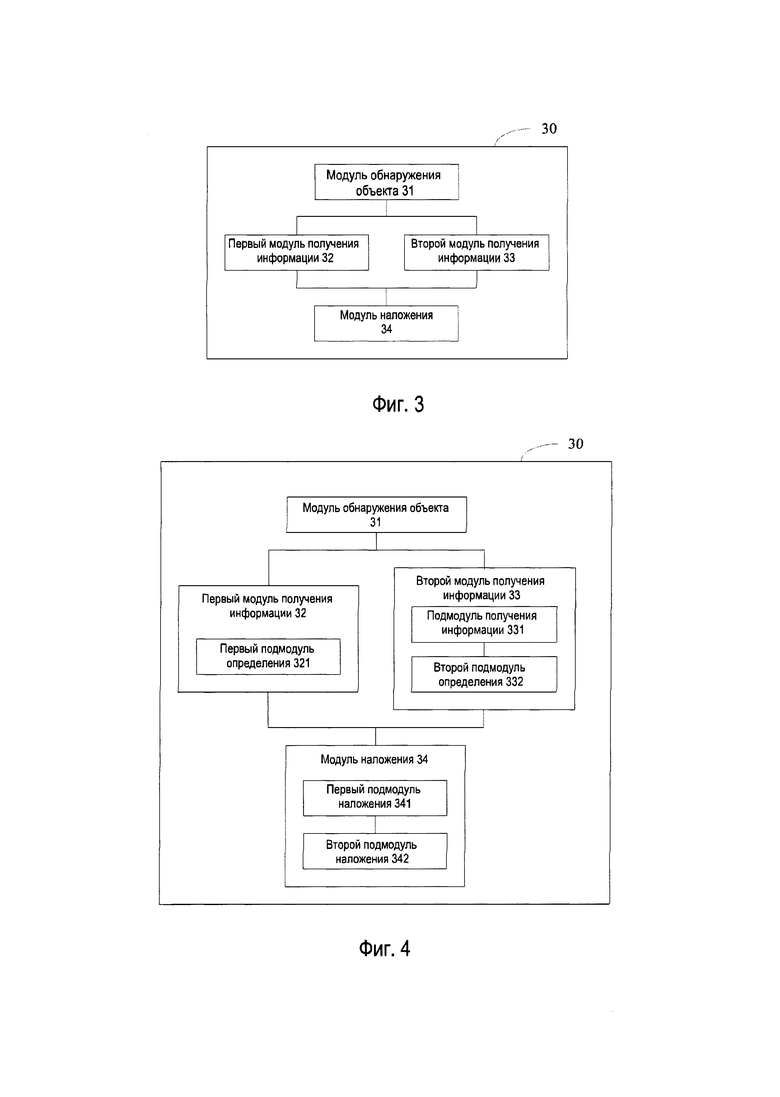

[0021] Фиг. 2 представляет блок-схему способа синтеза объектов виртуальной реальности в соответствии с примером осуществления.

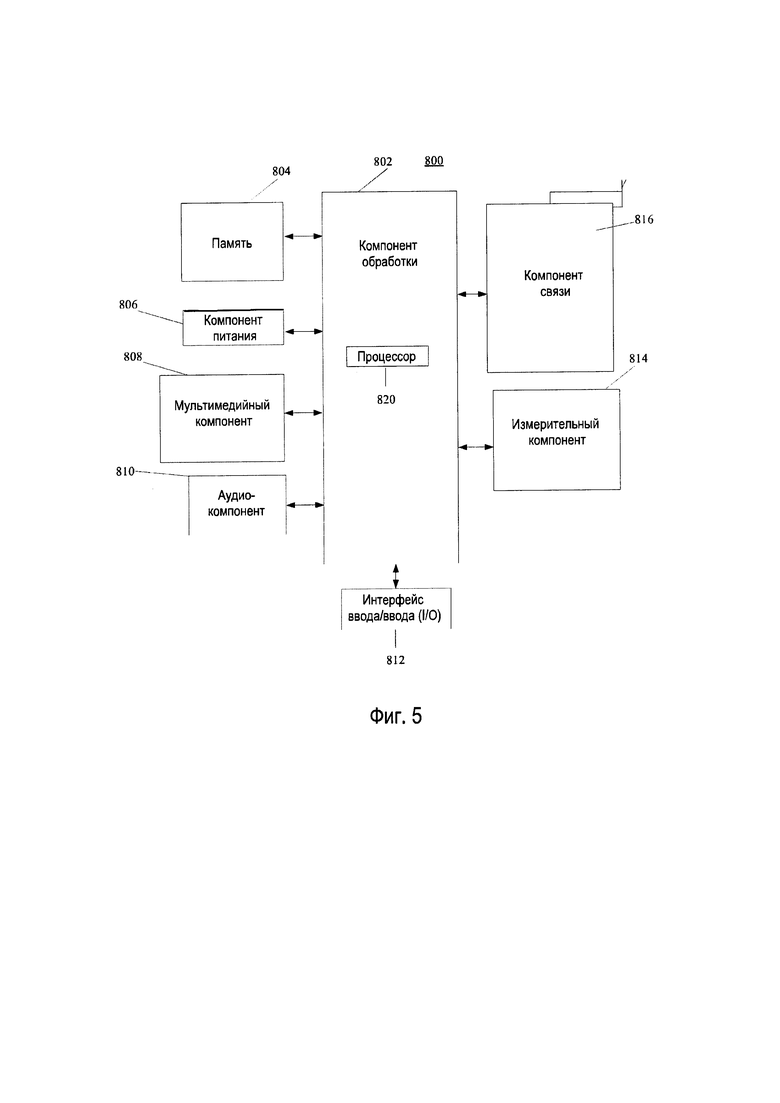

[0022] Фиг. 3 представляет структурную схему устройства для синтеза объектов виртуальной реальности в соответствии с примером осуществления.

[0023] Фиг. 4 представляет структурную схему устройства для синтеза объектов виртуальной реальности в соответствии с примером осуществления.

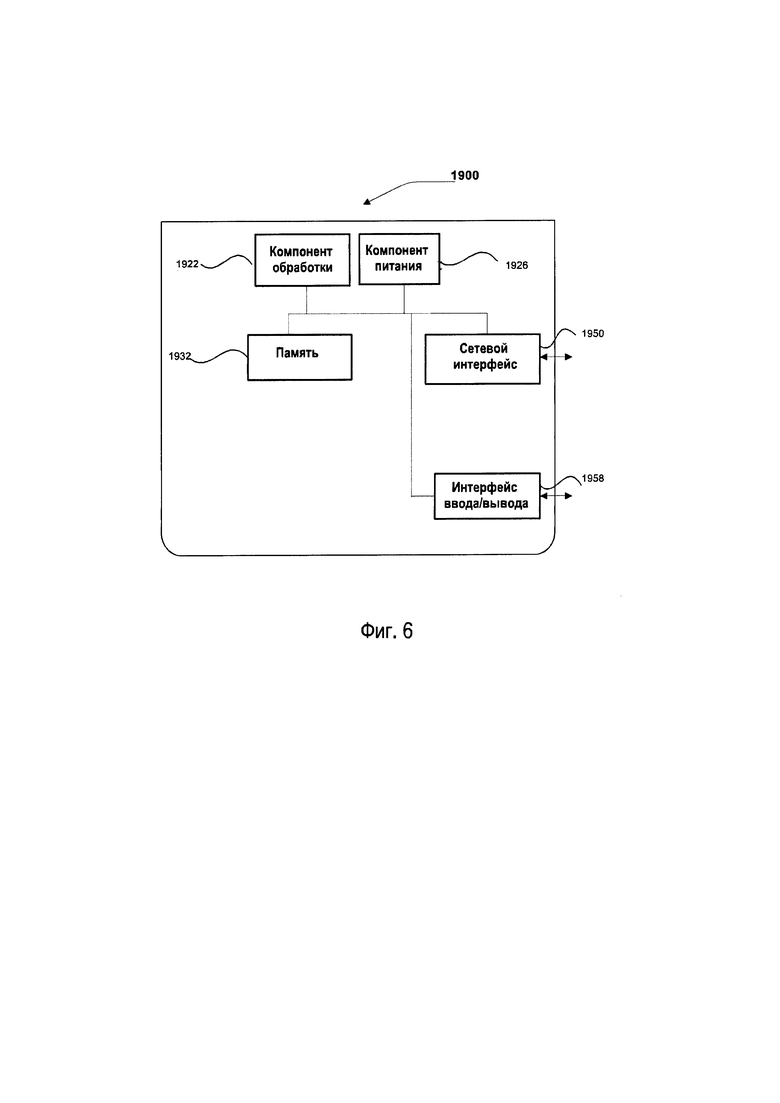

[0024] Фиг. 5 представляет структурную схему устройства для синтеза объектов виртуальной реальности в соответствии с примером осуществления.

[0025] Фиг. 6 представляет структурную схему устройства для синтеза объектов виртуальной реальности в соответствии с примером осуществления.

ПОДРОБНОЕ ОПИСАНИЕ ИЗОБРЕТЕНИЯ

[0026] Теперь будет сделана подробная ссылка на варианты осуществления, примеры которых проиллюстрированы на прилагаемых чертежах. Последующее описание относится к сопроводительным чертежам, на которых одинаковые номера на разных чертежах представляют одни и те же или аналогичные элементы, если не указано иное. Реализации, изложенные в последующем описании примеров осуществления, не представляют собой все реализации, соответствующие изобретению, а являются только примерами устройств и способов, соответствующих аспектам, которые относятся к изобретению, как оно описано в прилагаемой формуле изобретения.

[0027] Фиг. 1 представляет блок-схему способа синтеза объектов виртуальной реальности в соответствии с примером осуществления. Как показано на фиг. 1, способ синтеза объектов виртуальной реальности применяется к терминальному устройству, такому как мобильный телефон, планшетный компьютер и т.д. Способ синтеза объектов виртуальной реальности включает в себя следующие шаги.

[0028] На шаге S11 обнаруживают целевой объект на изображении, захваченном терминальным устройством.

[0029] Изображение, захваченное терминальным устройством, может быть изображением, соответствующим реальной сцене, и это изображение может быть захвачено съемочным блоком терминального устройства. В возможном способе реализации терминальное устройство может захватывать изображение в реальном времени или терминальное устройство может непрерывно захватывать множество изображений. Следует понимать, что множество изображений в реальном времени, непрерывно захватываемых терминальным устройством, может представлять собой видео.

[0030] Целевым объектом может быть реальный объект в реальной сцене, например, реальный человек или реальный объект. Целевым объектом может быть определенный конкретный объект в реальной сцене или определенный тип объектов в реальной сцене. Например, когда в реальной сцене присутствует множество людей, целевым объектом может быть определенный человек среди множества людей в реальной сцене, или им могут быть все люди в реальной сцене. В примере целевым объектом может быть объект, который имеет окклюзионную связь с реальным объектом. Целевой объект не ограничен в настоящем изобретении.

[0031] В возможном способе реализации терминальное устройство может распознавать и обнаруживать целевой объект на изображении с помощью технологии распознавания изображений известного уровня техники.

[0032] В возможном способе реализации целевой объект может перемещаться по изображению, захваченному терминальным устройством, например, человек может перемещаться в реальной сцене. В возможном способе реализации целевой объект может войти в изображение или выйти из него, например, человек входит в реальную сцену или покидает реальную сцену.

[0033] На шаге S12 в режиме синтеза информации о глубине получают информацию о глубине для целевого объекта с помощью съемочного блока терминального устройства, причем режим синтеза информации о глубине используют для наложения виртуального объекта, генерируемого с помощью компьютерного моделирования, на изображение, и информацию о глубине для целевого объекта используют для указания расстояния между целевым объектом и терминальным устройством.

[0034] Технология AR может накладывать виртуальные объекты на реальные сцены. Виртуальный объект может использоваться для указания объекта, генерируемого с помощью компьютерного моделирования, такого как виртуальные люди, объекты и т.д. Виртуальный объект может быть математической моделью, созданной компьютером, и эта математическая модель может включать в себя данные, представляющие особенности виртуального объекта, такие как контуры и текстуры. Такие данные могут быть извлечены на основе реальных объектов, таких как реальные люди, объекты и т.д., или могут быть искусственно созданы в соответствии с потребностью. Можно воспроизвести изображение на основе данных и представить виртуальный объект в реальной сцене. Позиция виртуального объекта может быть изменена терминальным устройством, так что виртуальный объект будет перемещаться по изображению в соответствии с реальной сценой. В настоящем раскрытии способы генерирования виртуальных объектов не ограничены.

[0035] В примере виртуальный объект может быть сгенерирован локально терминальным устройством или получен от других устройств. Терминальное устройство может настраивать виртуальный объект локально, после того как виртуальный объект получают от других устройств.

[0036] В примере терминальное устройство может непосредственно отображать виртуальный объект, когда целевой объект не обнаружен или перед отображением захваченного изображения. Например, терминальное устройство может отображать виртуальный объект выше уровня, на котором находится изображение. Таким образом, терминальное устройство может быстро и удобно накладывать виртуальный объект на реальную сцену. Настоящее изобретение не ограничивает работу, когда целевой объект не обнаружен.

[0037] В примере терминальное устройство может запустить режим синтеза информации о глубине, когда обнаружен целевой объект. Режим синтеза информации о глубине может использоваться для наложения виртуального объекта на изображение. Например, режим синтеза информации о глубине может определять окклюзионную связь между виртуальным объектом и целевым объектом на основе информации о глубине, а затем определять способ наложения виртуального объекта на изображение в соответствии с окклюзионной связью. В режиме синтеза информации о глубине синтез виртуальных объектов в терминальном устройстве является относительно более реалистичным. Когда целевой объект обнаружен, на изображении, захваченном терминальным устройством, может быть объект, который имеет окклюзионную связь с виртуальным объектом. В этом случае неправильная окклюзия может стать причиной плохого эффекта синтеза, и некоторые сценарии не могут быть реализованы. Поэтому терминальное устройство может начать режим синтеза информации о глубине для достижения относительно более реалистичного синтеза.

[0038] В примере целевым объектом является человек, а виртуальным объектом является стул. Когда получают информацию о человеке, может быть активирован режим синтеза информации о глубине, тем самым реализуя сцену, в которой человек стоит перед стулом или сидит на стуле и т.д.

[0039] Информация о глубине для целевого объекта используется для указания расстояния между целевым объектом и терминальным устройством. Реалистичный объективный мир представляет собой трехмерное пространство, и он может стать двухмерным изображением, которое теряет информацию о трехмерной глубине после формирования изображения съемочным блоком. Следовательно, терминальное устройство может получать информацию о глубине для целевого объекта посредством съемочного блока.

[0040] В возможном способе реализации съемочный блок терминального устройства содержит по меньшей мере две камеры, и терминальное устройство может определять информацию о глубине для целевого объекта в соответствии с позиционной связью между целевым объектом и по меньшей мере двумя камерами и расстоянием между по меньшей мере двумя камерами.

[0041] Если, в качестве примера, съемочный блок терминального устройства, содержит две камеры, терминальное устройство может определять информацию о глубине для целевого объекта в соответствии с углами между двумя соединительными линиями между целевым объектом и двумя камерами и соединительной линией между двумя камерами и расстоянием между двумя камерами. Вышеупомянутое является только одним примером определения информации о глубине для целевого объекта, и терминальное устройство может также определять информацию о глубине для целевого объекта в соответствии с другими способами известного уровня техники.

[0042] На шаге S13 получают информацию о глубине для виртуальной информации.

[0043] Терминальное устройство может размещать виртуальную модель, соответствующую виртуальному объекту, в различные позиции захваченного изображения и может перемещать позицию виртуальной модели. Виртуальный объект не является объектом, реально существующим на изображении, захваченном терминальным устройством, и он соответствует одной виртуальной модели. Виртуальная модель может быть названа виртуальным объектом при ее отображении на изображении.

[0044] В возможном способе реализации, информация о глубине для виртуального объекта может быть фиксированной. Если, в качестве примера, виртуальная модель генерирована локально терминальным устройством, терминальное устройство может записывать соответствующую связь между виртуальной моделью и информацией о глубине в процессе генерирования виртуальной модели. При этом, когда виртуальная модель перемещается на изображении, информация о глубине виртуальной модели остается неизменной. В возможном способе реализации терминальное устройство может получать информацию о глубине, соответствующую виртуальному объекту, в соответствии с соответствующей связью между виртуальной моделью и информацией о глубине.

[0045] В возможном способе реализации информация о глубине для виртуального объекта может изменяться при перемещении виртуальной модели на изображении. Если, в качестве примера, виртуальная модель генерирована локально терминальным устройством, терминальное устройство может записывать информацию о глубине в информацию о позиции виртуальной модели в процессе генерирования виртуальной модели и может использовать информацию о позиции виртуальной модели в качестве информации о позиции виртуального объекта. При этом, когда виртуальная модель перемещается на изображении, информация о глубине виртуальной модели связана с позицией виртуальной модели на изображении. В возможном способе реализации терминальное устройство может получать информацию о позиции виртуального объекта и определять информацию о глубине для виртуального объекта в соответствии с информацией о позиции.

[0046] На шаге S14 виртуальный объект накладывается на изображение на основе информации о глубине для целевого объекта и информации о глубине для виртуального объекта.

[0047] Понятно, что чем больше расстояние между объектом на изображении и съемочным блоком терминального устройства, тем больше информация о глубине. Объект с относительно большой информацией о глубине может быть заслонен объектом, имеющим относительно небольшую информацию о глубине, и только часть объекта, имеющую относительно большую информацию о глубине, может быть отображена на захваченном изображении терминального устройства.

[0048] Фиг. 2 представляет блок-схему способа синтеза объектов виртуальной реальности в соответствии с примером осуществления. Как показано на фиг. 2, шаг S14 включает в себя следующие шаги.

[0049] На шаге S141 определяют, меньше ли информация о глубине для целевого объекта, чем информация о глубине для виртуального объекта. Когда информация о глубине для целевого объекта меньше, чем информация о глубине для виртуального объекта, тогда выполняют шаг S142; в противном случае выполняют шаг S143.

[0050] На шаге S142 часть виртуального объекта, которая не заслонена целевым объектом, накладывается на изображение.

[0051] В возможном способе реализации может быть получена позиция пикселя для каждой пиксельной точки целевого объекта и позиция пикселя для каждой пиксельной точки виртуального объекта. Когда и пиксельная точка целевого объекта, и пиксельная точки виртуального объекта находятся в одной и той же позиции пикселя, пиксельная точка виртуального объекта может не отображаться в этой позиции. Когда в одной позиции пикселя отсутствует пиксельная точка целевого объекта, а пиксельная точка виртуального объекта присутствует, пиксельная точка виртуального объекта может быть нанесена в эту позицию.

[0052] В примере целевым объектом является человек, а виртуальным объектом является стул, и информация о глубине для человека меньше, чем информация о глубине для стула. Терминальное устройство может накладывать часть стула, которая не заслоняется человеком, на изображение. Таким образом, может быть представлена сцена, в которой человек стоит перед стулом или сидит на стуле.

[0053] На шаге S143 виртуальный объект накладывают на изображение.

[0054] В примере целевым объектом является человек, а виртуальным объектом является стул, и информация о глубине для человека больше или равна информации о глубине для стула. Терминальное устройство может накладывать стул на изображение. Таким образом, можно представить сцену, в которой человек стоит за стулом, и тому подобное.

[0055] Окклюзионные связи объектов, имеющих различную информацию о глубине, различны. В этом варианте осуществления, когда обнаружен целевой объект, терминальное устройство накладывает виртуальный объект на изображение, захваченное терминальным устройством, на основе информации о глубине для целевого объекта и информации о глубине для виртуального объекта. Способ наложения может быть определен в соответствии с результатом сравнения информации о глубине, когда обнаружен целевой объект, вместо непосредственного наложения без сравнения или наложения после сравнения информации о глубине всех объектов. Таким образом, способ может уменьшить объем вычислений во время процесса наложения и может быть лучше применим к приложениям AR в терминальных устройствах. Кроме того, в вариантах осуществления настоящего изобретения используют съемочный блок терминального устройства для получения информации о глубине для целевого объекта, что является полезным для применения в терминальном устройстве. Следовательно, способ синтеза объектов виртуальной реальности в соответствии с настоящим вариантом осуществления может корректно отображать виртуальный объект на изображении, захваченном терминальным устройством в реальном времени.

[0056] На фиг. 3 представлена структурная схема устройства для синтеза объектов виртуальной реальности в соответствии с примером осуществления. Как показано на фиг.3, устройство 30 для синтеза объектов виртуальной реальности применяют к терминальному устройству, и устройство 30 содержит модуль 31 обнаружения объекта, первый модуль 32 получения информации, второй модуль 33 получения информации и модуль 34 наложения.

[0057] Модуль 31 обнаружения объекта выполнен с возможностью обнаруживать целевой объект на изображении, захваченном терминальным устройством.

[0058] Первый модуль 32 получения информации выполнен с возможностью получать информацию о глубине для целевого объекта с помощью съемочного блока терминального устройства в режиме синтеза информации о глубине, причем режим синтеза информации о глубине используется для наложения виртуального объекта, сгенерированного с помощью компьютерного моделирования, на изображение, а информация о глубине для целевого объекта используется для указания расстояния между целевым объектом и терминальным устройством.

[0059] Второй модуль 33 получения информации выполнен с возможностью получать информацию о глубине для виртуального объекта.

[0060] Модуль 34 наложения выполнен с возможностью накладывать виртуальный объект на изображение в соответствии с информацией о глубине для целевого объекта и информацией о глубине для виртуального объекта.

[0061] Фиг. 4 представляет структурную схему устройства для синтеза объектов виртуальной реальности в соответствии с примером осуществления. Как показано на фиг. 4, в возможном способе реализации модуль 34 наложения содержит первый подмодуль 341 наложения.

[0062] Первый подмодуль 341 наложения выполнен с возможностью, когда информация о глубине для целевого объекта меньше информации о глубине для виртуального объекта, накладывать часть виртуального объекта, который не заслонен целевым объектом, на изображение.

[0063] В возможном способе реализации модуль наложения дополнительно содержит второй подмодуль 352 наложения.

[0064] Второй подмодуль 352 наложения выполнен с возможностью, когда информация о глубине для целевого объекта больше или равна информации о глубине для виртуального объекта, накладывать виртуальный объект на изображение.

[0065] В возможном способе реализации терминальное устройство содержит по меньшей мере две камеры, и первый модуль 32 получения информации содержит первый подмодуль 321 определения.

[0066] Первый подмодуль 321 определения выполнен с возможностью определять информацию о глубине для целевого объекта в соответствии с позиционной связью между целевым объектом и по меньшей мере двумя камерами и расстоянием между по меньшей мере двумя камерами.

[0067] В возможном способе реализации второй модуль 33 получения информации содержит подмодуль 331 получения информации и второй подмодуль 332 определения.

[0068] Подмодуль 331 получения выполнен с возможностью получать информацию о позиции виртуального объекта на изображении.

[0069] Второй подмодуль 332 определения выполнен с возможностью определять информацию о глубине для виртуального объекта в соответствии с информацией о позиции виртуального объекта.

[0070] Что касается устройств в вышеприведенных вариантах осуществления, то конкретные способы выполнения операций для отдельных модулей в них были подробно описаны в вариантах осуществления, относящихся к способам, и не будут рассматриваться здесь.

[0071] Фиг. 5 представляет структурную схему устройства 800 для синтеза объектов виртуальной реальности в соответствии с примером осуществления. Например, устройство 800 может быть мобильным телефоном, компьютером, цифровым вещательным терминалом, устройством обмена сообщениями, игровой консолью, планшетом, медицинским устройством, тренажером, персональным цифровым помощником и т.п.

[0072] Как показано на фиг. 5, устройство 800 может содержать один или более из следующих компонентов: компонент 802 обработки, память 804, компонент 806 питания, мультимедийный компонент 808, аудиокомпонент 810, интерфейс 812 ввода/вывода (I/O), измерительный компонент 814 и компонент 816 связи

[0073] Компонент 802 обработки, как правило, управляет всеми операциями устройства 800, например операциями, связанными с отображением, телефонными звонками, передачей данных, операциями с камерой и операциями записи. Компонент 802 обработки может содержать один или более процессоров 820 для исполнения команд с целью выполнения всех или части шагов вышеуказанных способов. Кроме того, компонент 802 обработки может содержать один или более модулей, которые обеспечивают взаимодействие между компонентом 802 обработки и другими компонентами. Например, компонент 802 обработки может содержать мультимедийный модуль для обеспечения взаимодействия между мультимедийным компонентом 808 и компонентом 802 обработки.

[0074] Память 804 выполнена с возможностью хранить различные виды данных для поддержки работы устройства 800. Примеры таких данных включают в себя команды для любых приложений или способов, реализуемых в устройстве 800, контактные данные, данные телефонной книги, сообщения, изображения, видео и т.д. Память 804 может быть выполнена с использованием любого вида энергозависимых или энергонезависимых запоминающих устройств или их комбинации, таких как статическое оперативное запоминающее устройство (static random access memory) (SRAM), электрически стираемое программируемое постоянное запоминающее устройство (electrically erasable programmable read-only memory) (EEPROM), стираемое программируемое постоянное запоминающее устройство (erasable programmable read-only memory) (EPROM), программируемое постоянное запоминающее устройство (programmable read-only memory) (PROM), постоянное запоминающее устройство (read-only memory) (ROM), магнитная память, флэш-память, магнитный или оптический диск.

[0075] Компонент 806 питания обеспечивает питанием различные компоненты устройства 800. Компонент 806 питания может включать в себя систему управления питанием, один или более источников питания и любые другие компоненты, связанные с производством, управлением и распределением энергии в устройстве 800.

[0076] Мультимедийный компонент 808 включает в себя экран, создающий выходной интерфейс между устройством 800 и пользователем. В некоторых вариантах осуществления экран может включать в себя жидкокристаллический дисплей (liquid crystal display) (LCD) и сенсорную панель (touch panel) (TP). Если экран включает в себя сенсорную панель, то этот экран может быть реализован в виде сенсорного экрана для приема входных сигналов от пользователя. Сенсорная панель содержит один или более датчиков касания для восприятия касаний, скольжений и жестов на сенсорной панели. Датчики касания могут не только воспринимать границу действия касания или скольжения, но и измерять период времени и давление, связанные с действием касания или скольжения. В некоторых вариантах осуществления мультимедийный компонент 808 содержит переднюю и/или заднюю камеру. Передняя камера и задняя камера могут принимать внешние мультимедийные данные, в то время как устройство 800 находится в рабочем режиме, например режиме фотографирования или видеорежиме. Каждая из передней камеры и задней камеры может быть системой с фиксированными оптическими линзами или может иметь способность к фокусировке и оптическому увеличению.

[0077] Аудиокомпонент 810 выполнен с возможностью выводить и/или вводить аудиосигналы. Например, аудиокомпонент 810 включает в себя микрофон ("MIC"), выполненный с возможностью принимать внешний аудиосигнал, когда устройство 800 находится в режиме работы, например режиме вызова, режиме записи и режиме распознавания голоса. Полученный аудиосигнал может быть далее запомнен в памяти 804 или передан посредством компонента 816 связи. В некоторых вариантах осуществления аудиокомпонент 810 дополнительно включает в себя динамик для вывода аудиосигналов.

[0078] Интерфейс 812 ввода/вывода предлагает интерфейс между компонентом 802 обработки и периферийными интерфейсными модулями, например клавиатурой, колесом прокрутки, кнопками и т.п. Кнопки могут включать в себя, но не ограничиваются этим, кнопку «домой», кнопку громкости, пусковую кнопку и кнопку блокировки.

[0079] Измерительный компонент 814 содержит один или более датчиков, выполненных с возможностью обеспечивать оценку состояния различных аспектов устройства 800. Например, измерительный компонент 814 может обнаруживать открытое/закрытое состояние устройства 800, относительное расположение компонентов, например дисплея и клавиатуры устройства 800, изменение в положении устройства 800 или компонента устройства 800, наличие или отсутствие контакта между пользователем и устройством 800, ориентацию или ускорение/замедление устройства 800, и изменение температуры устройства 800. Измерительный компонент 814 может представлять собой датчик близости, выполненный с возможностью обнаруживать присутствие близлежащих объектов без физического контакта. Измерительный компонент 814 может также представлять собой датчик света, например датчик изображения на структуре комплементарный металл-оксид-полупроводник (Complementary Metal Oxide Semiconductor) (CMOS, КМОП) или приборе с зарядовой связью (Charge Coupled Device) (CCD, ПЗС), для использования в применении, связанном с изображением. В некоторых вариантах осуществления измерительный компонент 814 может также представлять собой акселерометрический датчик, гироскопический датчик, магнитный датчик, датчик давления или датчик температуры.

[0080] Компонент 816 связи выполнен с возможностью обеспечения связи, проводной или беспроводной, между устройством 800 и другими устройствами. Устройство 800 может получать доступ к беспроводной сети на основе стандарта связи, например беспроводного интернета (WiFi), сети 2-го поколения (2G) или 3-го поколения (3G), или их комбинации. В одном примере осуществления компонент 816 связи принимает широковещательный сигнал или связанную с широковещанием информацию из внешней системы управления широковещанием через широковещательный канал. В одном примере осуществления компонент 816 связи дополнительно содержит модуль коммуникации ближнего поля (Near Field Communication) (NFC) для обеспечения коммуникации ближнего радиуса действия. Например, NFC-модуль может быть реализован на основе технологии радиочастотной идентификации (Radio Frequency Identification) (RFID), технологии Ассоциации по инфракрасной технологии передачи данных (Infrared Data Association) (IrDA), технологии сверхширокополосной передачи данных (Ultra-WideBand) (UWB), технологии Bluetooth (ВТ) и других технологий.

[0081] В примерах осуществления устройство 800 может быть реализовано с помощью одной или более специализированных интегральных схем (Application Specific Integrated Circuits) (ASIC), цифровых сигнальных процессоров (Digital Signal Processors) (DSP), устройств цифровой обработки сигналов (Digital Signal Processing Devices) (DSPD), программируемых логических устройств (Programmable Logic Devices) (PLD), программируемых вентильных матриц (Field Programmable Gate Arrays) (FPGA), контроллеров, микроконтроллеров, микропроцессоров или других электронных элементов для выполнения способов отображения интерфейса приложения, предлагаемых вышеописанными вариантами осуществления.

[0082] В примерах осуществления также предлагается машиночитаемый носитель данных, содержащий команды, такие как включенные в память 804, выполняемые процессором 820 в устройстве 800, для выполнения вышеописанных способов. Например, машиночитаемым носителем может быть ПЗУ (ROM), ОЗУ (RAM), компакт-диск (Compact Disc Read-Only Memory) (CD-ROM), магнитная лента, гибкий диск, оптическое устройство для хранения информации и тому подобное.

[0083] Фиг. 6 представляет структурную схему устройства 1900 для синтеза объектов виртуальной реальности в соответствии с примером осуществления. Например, устройство 1900 может быть представлено в виде сервера. Как показано на фиг. 6, устройство 1900 содержит компонент 1922 обработки, который также содержит один или более процессоров, и ресурсы памяти, представленные памятью 1932, для хранения команд, исполняемых компонентом 1922 обработки, например прикладных программ. Прикладные программы, хранящиеся в памяти 1932, могут включать в себя один или более модулей, каждый из которых соответствует набору команд. Кроме того, компонент 1922 обработки выполнен с возможностью выполнять команды для выполнения вышеописанного способа.

[0084] Устройство 1900 может также содержать компонент 1926 питания, выполненный с возможностью осуществлять управление питанием устройства 1900, проводной или беспроводной сетевой интерфейс (ы) 1950, выполненный с возможностью соединять устройство 1900 с сетью, и интерфейс 1958 ввода/вывода (I/O). Устройство 1900 может работать на основе операционной системы в памяти 1932, такой как Windows Server™, Mac OS X™, Unix™, Linux™, FreeBSD™ и т.п.

[0085] В примерах осуществления также предлагается машиночитаемый носитель данных для хранения команд, такой как память 1932, содержащая команды, исполняемые процессором 1922 в устройстве 1900. Например, машиночитаемым носителем может быть ПЗУ (ROM), ОЗУ (RAM), компакт-диск (Compact Disc Read-Only Memory) (CD-ROM), магнитная лента, гибкий диск, оптическое устройство для хранения информации и тому подобное.

[0086] Другие варианты осуществления изобретения будут очевидны специалистам в данной области из данного описания и практики использования изобретения, раскрытого в настоящем документе. Эта заявка предназначена для охвата любых вариантов, применений или адаптаций изобретения в соответствии с его общими принципами и включает в себя такие отклонения от настоящего раскрытия, которые входят в известную или обычную практику в данной области техники. Предполагается, что описание и примеры должны рассматриваться только как иллюстративные, при этом истинные объем и сущность представлены в формуле изобретения.

[0087] Очевидно, что настоящее изобретения не ограничено точной конструкцией, которая была описана выше и проиллюстрирована на прилагаемых чертежах, и могут быть сделаны различные модификации и изменения в рамках изобретения. Предполагается, что объем изобретения ограничивается только прилагаемой формулой изобретения.

Изобретение относится к способу и устройству для синтеза объектов виртуальной реальности. Технический результат заключается в уменьшении вычислений в процессе наложения виртуального объекта на изображение, захваченное терминальным устройством в реальном времени, получении при этом корректного отображения виртуального объекта. Обнаруживают целевой объект на изображении, захваченном терминальным устройством. В режиме синтеза информации о глубине получают информацию о глубине для целевого объекта съемочным блоком терминального устройства. Получают информацию о глубине для целевого объекта. Осуществляют наложение виртуального объекта на изображение на основе информации о глубине для целевого объекта и информации о глубине для виртуального объекта. Объекты с различной информацией о глубине имеют разные окклюзионные связи, после обнаружения целевого объекта виртуальный объект накладывают на изображение, захваченное терминальным устройством, в соответствии с информацией о глубине для целевого объекта и информацией о глубине для виртуального объекта. 2 н. и 8 з.п. ф-лы, 6 ил.

1. Способ объединения виртуальных и реальных объектов, применяемый к терминальному устройству, причем способ включает в себя:

обнаружение целевого объекта на изображении, захваченном терминальным устройством;

в режиме синтеза информации о глубине получение информации о глубине для целевого объекта с помощью съемочного блока терминального устройства, причем режим синтеза информации о глубине используют для наложения виртуального объекта, генерируемого с помощью компьютерного моделирования, на изображение, а информацию о глубине для целевого объекта используют для указания расстояния между целевым объектом и терминальным устройством;

получение информации о глубине для виртуального объекта; и

наложение виртуального объекта на изображение в соответствии с информацией о глубине для целевого объекта и информацией о глубине для виртуального объекта;

при этом виртуальный объект непосредственно отображают, когда целевой объект не обнаружен или перед отображением захваченного изображения.

2. Способ по п. 1, в котором наложение виртуального объекта на изображение в соответствии с информацией о глубине для целевого объекта и информацией о глубине для виртуального объекта содержит:

когда информация о глубине для целевого объекта меньше информации о глубине для виртуального объекта, наложение части виртуального объекта, которая не заслонена целевым объектом, на изображение.

3. Способ по п. 1, в котором наложение виртуального объекта на изображение в соответствии с информацией о глубине для целевого объекта и информацией о глубине для виртуального объекта содержит:

когда информация о глубине для целевого объекта больше или равна информации о глубине для виртуального объекта, наложение виртуального объекта на изображение.

4. Способ по любому из пп. 1-3, в котором съемочный блок терминального устройства содержит по меньшей мере две камеры и получение информации о глубине для целевого объекта с помощью съемочного блока терминального устройства содержит:

определение информации о глубине для целевого объекта в соответствии с позиционной связью между целевым объектом и по меньшей мере двумя камерами и расстоянием между по меньшей мере двумя камерами.

5. Способ по любому из пп. 1-3, в котором получение информации о глубине для виртуального объекта содержит:

получение информации о позиции, в которой размещается виртуальный объект; и

определение информации о глубине для виртуального объекта в соответствии с информацией о позиции.

6. Устройство для объединения виртуальных и реальных объектов, применяемое к терминальному устройству, причем терминальное устройство содержит:

модуль обнаружения объекта, выполненный с возможностью обнаруживать целевой объект на изображении, захваченном терминальным устройством;

первый модуль получения информации, выполненный с возможностью получать информацию о глубине для целевого объекта с помощью съемочного блока терминального устройства в режиме синтеза информации о глубине, причем режим синтеза информации о глубине используют для наложения виртуального объекта, генерируемого с помощью компьютерного моделирования, на изображение, а информацию о глубине для целевого объекта используют для указания расстояния между целевым объектом и терминальным устройством;

второй модуль получения информации, выполненный с возможностью получать информацию о глубине для виртуального объекта; и

модуль наложения, выполненный с возможностью накладывать виртуальный объект на изображение на основе информации о глубине для целевого объекта и информации о глубине для виртуального объекта;

при этом виртуальный объект непосредственно отображают, когда целевой объект не обнаружен или перед отображением захваченного изображения.

7. Устройство по п. 6, в котором модуль наложения содержит:

первый подмодуль наложения, выполненный с возможностью, когда информация о глубине для целевого объекта меньше информации о глубине для виртуального объекта, накладывать часть виртуального объекта, которая не заслонена целевым объектом, на изображение.

8. Устройство по п. 6, в котором модуль наложения дополнительно содержит:

второй подмодуль наложения, выполненный с возможностью, когда информация о глубине для целевого объекта больше или равна информации о глубине для виртуального объекта, накладывать виртуальный объект на изображение.

9. Устройство по любому из пп. 6-8, в котором съемочный блок терминального устройства содержит по меньшей мере две камеры, причем первый модуль получения информации содержит:

первый подмодуль определения, выполненный с возможностью определять информацию о глубине для целевого объекта в соответствии с позиционной связью между целевым объектом и по меньшей мере двумя камерами и расстоянием между по меньшей мере двумя камерами.

10. Устройство по любому из пп. 6-8, в котором второй модуль получения информации содержит:

подмодуль получения, выполненный с возможностью получать информацию о позиции для позиции, в которой размещается виртуальный объект; и

второй подмодуль определения, выполненный с возможностью определять информацию о глубине для виртуального объекта в соответствии с информацией о позиции.

| US 6166744 A, 26.12.2000 | |||

| Изложница с суживающимся книзу сечением и с вертикально перемещающимся днищем | 1924 |

|

SU2012A1 |

| US 20150356785 A1, 10.12.2015 | |||

| СПОСОБ УПРАВЛЕНИЯ УСТРОЙСТВОМ ФОРМИРОВАНИЯ СРЕДЫ ДОПОЛНЕННОЙ РЕАЛЬНОСТИ | 2015 |

|

RU2606874C1 |

Авторы

Даты

2020-03-03—Публикация

2018-08-20—Подача