Область техники, к которой относится изобретение

Варианты настоящего изобретения относятся к способу и устройству для отображения изображения на основе дополненной реальности и носителю для хранения информации.

Уровень техники

Технология дополненной реальности (augmented reality (AR)) представляет собой технологию, интегрирующую виртуальную информацию с реальным миром, а именно такую технологию, как мультимедиа, трехмерное моделирование, отслеживание и регистрация в реальном времени, интеллектуальное взаимодействие и восприятие, с целью симуляции генерируемой компьютером виртуальной информации, такой как текст, изображение, трехмерная модель, музыка и видео, и наложения этой генерируемой компьютером виртуальной информации на реальный мир. Эти два типа информации дополняют один другой, вследствие чего реализуется «дополнение» реального мира. По мере разработки технологии, она находила все более широкое применение в различных отраслях.

Применение технологии реальности AR в известной технике состоит в наложении виртуальной модели (например, модель рисованных персонажей, модель животных и т.п.) на реальный мир. Однако виртуальная модель в известной технике обычно является фиксированной и представляет собой изображение виртуальной модели, заранее построенное разработчиками, результатом чего является относительно единственное изображение виртуальной модели, что не может отвечать разнообразным потребностям пользователей, тем самым влияя на готовность пользователей использовать технологию реальности AR и на опыт использования.

Раскрытие сущности изобретения

Варианты настоящего изобретения предлагают способ и устройство для отображения изображений на основе дополненной реальности, а также носитель для хранения информации для решения проблемы, заключающейся в том, что изображение виртуальной модели является относительно одиночным и не может отвечать разнообразным потребностям пользователей.

Согласно первому аспекту, вариант настоящего изобретения предлагает способ отображения на основе дополненной реальности, содержащий этапы, на которых: выполняют сегментацию объектов для выделения целевого объекта на изображении сцены в реальном времени, захваченном модулем получения изображений, для получения изображения целевого объекта; генерируют виртуальное изображение, соответствующее целевому объекту, на основе изображения целевого объекта; и отображают виртуальное изображение на изображении сцены в реальном времени на основе технологии отображения дополненной реальности.

Согласно второму аспекту, вариант настоящего изобретения предлагает устройство отображения на основе дополненной реальности, содержащее: модуль определения целевого объекта, выполненный с возможностью выполнения сегментации объектов для выделения целевого объекта на изображении сцены в реальном времени, захваченном модулем для получения изображений, для получения изображения целевого объекта; модуль генерирования, выполненный с возможностью генерирования виртуального изображения, соответствующего целевому объекту, на основе изображения целевого объекта; и модуль отображения, выполненный с возможностью представления виртуального изображения на изображении сцены в реальном времени на основе технологии отображения дополненной реальности.

Согласно третьему аспекту, вариант настоящего изобретения предлагает электронное устройство, содержащее: по меньшей мере один процессор и запоминающее устройство; запоминающее устройство хранит исполняемые компьютером команды; указанный по меньшей мере один процессор исполняет исполняемые компьютером команды, хранящиеся в запоминающем устройстве, чтобы вызвать выполнение указанным по меньшей мере одним процессором способа, описанного в первом аспекте и в различных возможных вариантах реализации приведенного выше первого аспекта.

Согласно четвертому аспекту, вариант настоящего изобретения предлагает читаемый компьютером носитель для хранения информации, читаемый компьютером носитель для хранения информации хранит исполняемые компьютером команды, причем при исполнении процессором исполняемых компьютером команд процессор выполняет способ, описанные в первом аспекте и различных возможных вариантах реализации приведенного выше первого аспекта.

Варианты настоящего изобретения предлагают способ и устройство для отображения изображения на основе дополненной реальности и носитель для хранения информации. Способ позволяет получать изображение целевого объекта путем выполнения сегментации объектов для выделения целевого объекта на изображении сцены в реальном времени, захваченном модулем для получения изображений, генерировать виртуальное изображение, соответствующее целевому объекту, на основе изображения целевого объекта, и отображать виртуальное изображение на изображении сцены в реальном времени на основе технологии отображения дополненной реальности. Посредством получения изображения целевого объекта и генерирования виртуального изображения, соответствующего целевому объекту, на основе изображения целевого объекта можно избежать проблем, состоящих в том, что виртуальное изображение необходимо предварительно конструировать и что это изображение является одиночным и фиксированным. В вариантах настоящего изобретения можно генерировать различные виртуальные изображения в соответствии с потребностями пользователя и тем самым удовлетворять различным потребностям пользователей. Виртуальное изображение может быть улучшено и отображено на изображении сцены в реальном времени с использованием технологии дополненной реальности, так что можно увеличить степень готовности пользователя к использованию технологии реальности AR и улучшить опыт пользователя.

Краткое описание чертежей

Для более ясной иллюстрации технических решений в вариантах настоящего изобретения или технических решений известной технологии последующее кратко описывает прилагаемые чертежи, которые необходимо использовать в описаниях вариантов изобретения или известной технологии, для специалистов в рассматриваемой области очевидно, что прилагаемые чертежи в последующем описании представляют некоторые варианты настоящего изобретения, но в соответствии с этими чертежами могут быть без особых творческих усилий получены другие чертежи.

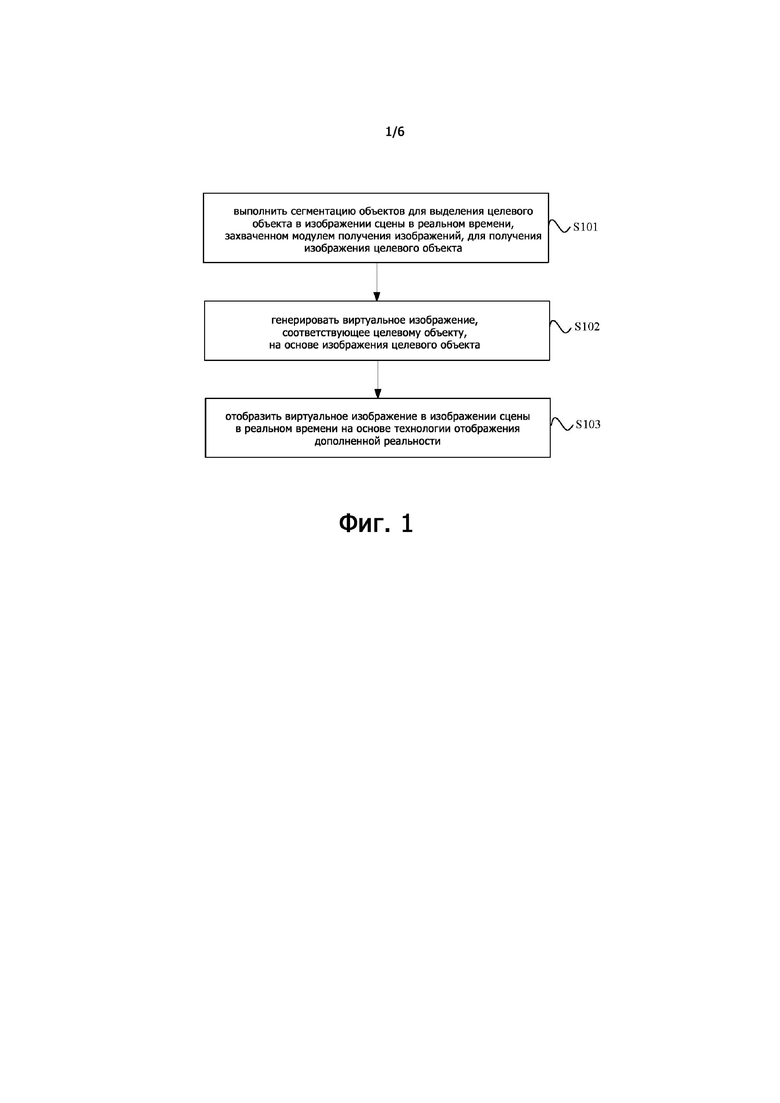

Фиг. 1 представляет упрощенную логическую схему способа отображения изображения на основе дополненной реальности согласно одному из вариантов настоящего изобретения;

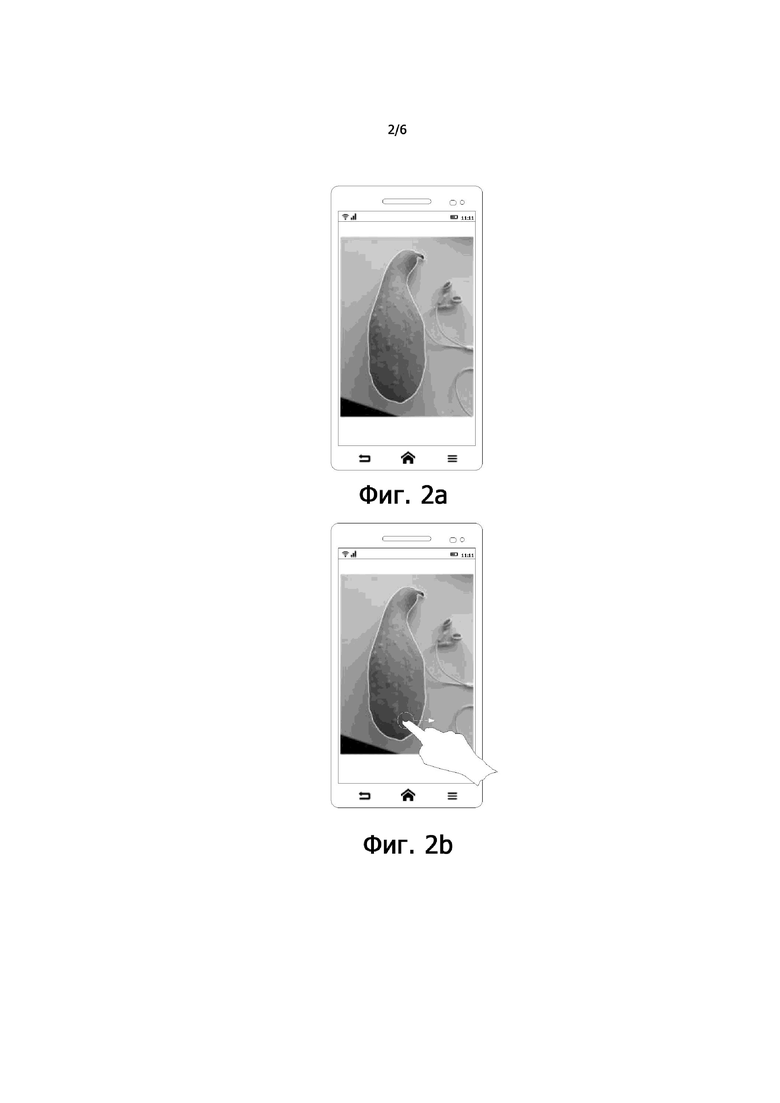

Фиг. 2a представляет упрощенное изображение, иллюстрирующее пример отображения контура изображения целевого объекта, согласно одному из вариантов настоящего изобретения;

Фиг. 2b представляет упрощенное изображение, иллюстрирующее пример выдачи пользователем первой команды и определения изображения целевого объекта согласно одному из вариантов настоящего изобретения;

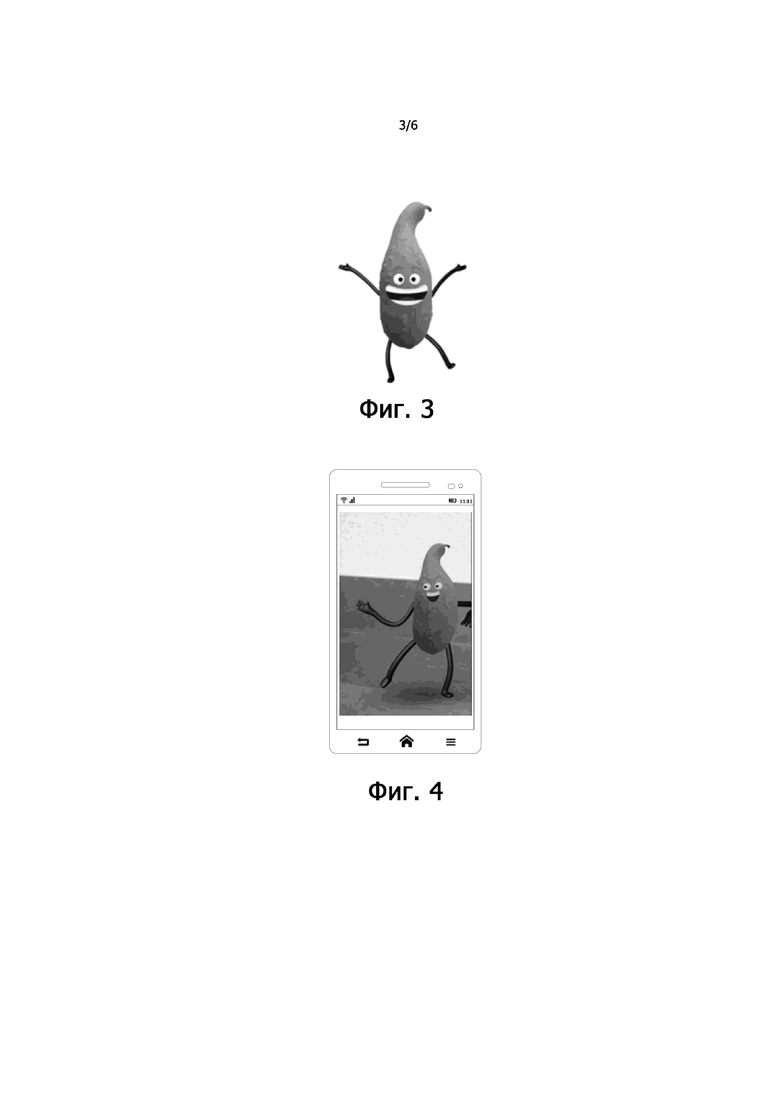

Фиг. 3 представляет упрощенное изображение, иллюстрирующее пример виртуального изображения, соответствующего изображению целевого объекта, согласно одному из вариантов настоящего изобретения;

Фиг. 4 представляет упрощенное изображение, иллюстрирующее пример виртуального изображения в изображении сцены в реальном времени согласно одному из вариантов настоящего изобретения;

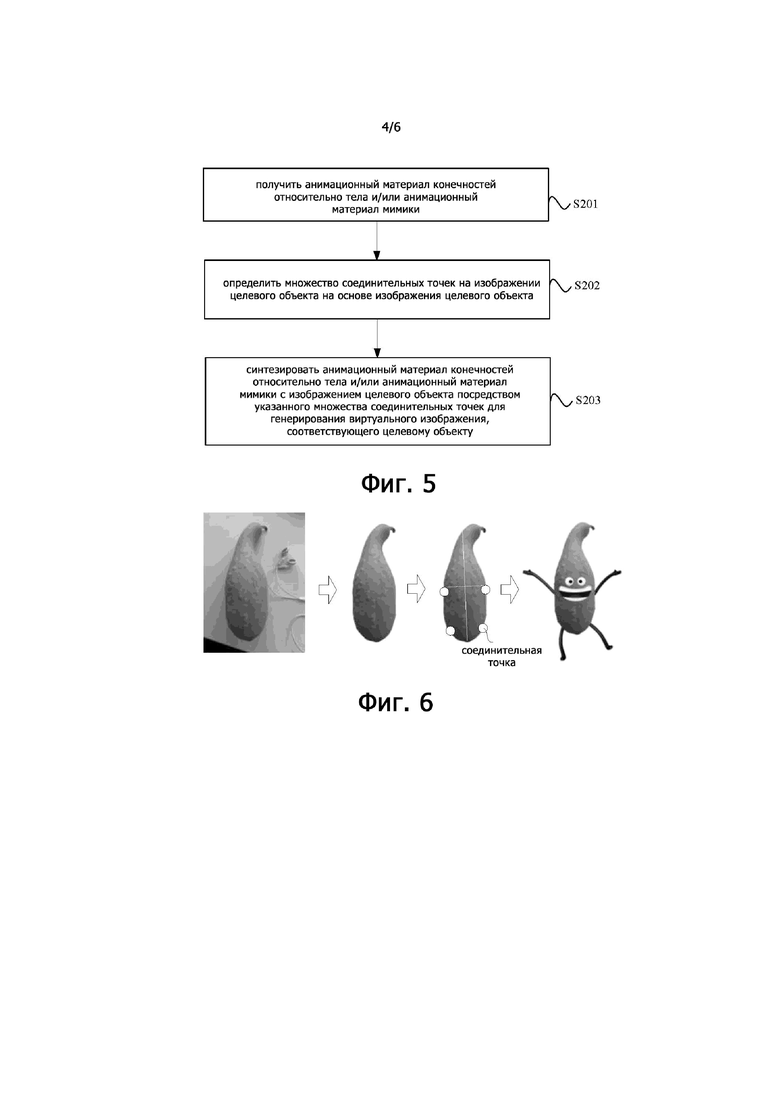

Фиг. 5 представляет упрощенную логическую схему способа отображения изображения на основе дополненной реальности согласно одному из вариантов настоящего изобретения;

Фиг. 6 представляет упрощенное изображение, иллюстрирующее пример процедуры генерирования виртуального изображения, соответствующего целевому объекту, согласно одному из вариантов настоящего изобретения;

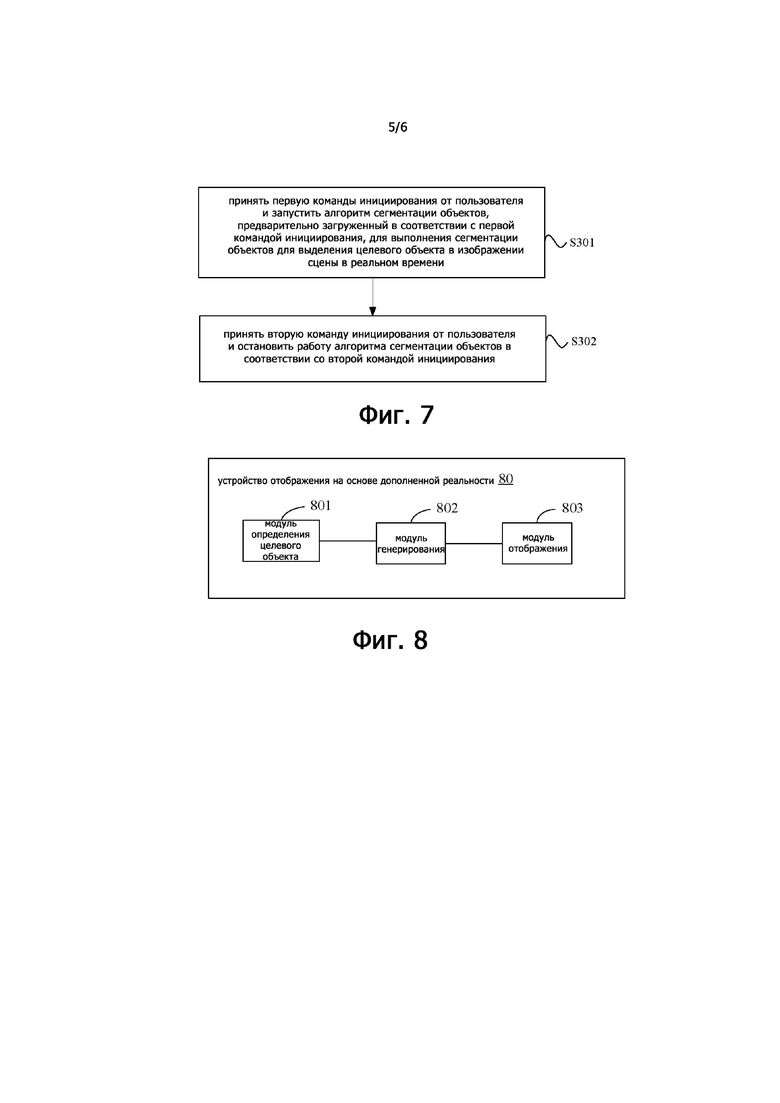

Фиг. 7 представляет упрощенную логическую схему способа отображения изображения на основе дополненной реальности согласно одному из вариантов настоящего изобретения;

Фиг. 8 представляет структурную блок-схему устройства отображения на основе дополненной реальности согласно одному из вариантов настоящего изобретения; и

Фиг. 9 представляет упрощенную схему, иллюстрирующую структуру аппаратуры электронного устройства согласно одному из вариантов настоящего изобретения.

Осуществление изобретения

Для того чтобы сделать цели, технические решения и преимущества настоящего изобретения более понятными, технические решения согласно вариантам настоящего изобретения будут четко и полностью описаны ниже со ссылками на прилагаемые чертежи вариантов настоящего изобретения. Очевидно, что описываемые здесь варианты составляют только часть, а не всю совокупность вариантов настоящего изобретения. На основе этих вариантов настоящего изобретения, специалисты в рассматриваемой области смогут без каких-либо изобретательских усилий получить другие варианты, которые все попадут в объем защиты настоящего изобретения.

Варианты настоящего изобретения могут быть применены к любому электронному устройству, имеющему функции реальности AR, такому как смартфон, планшетный компьютер, какое-либо носимое устройство и т.п., сценарии применения вариантов настоящего изобретения могут содержать, например, операции, в ходе которых электронное устройство захватывает изображение сцены в реальном времени посредством модуля для получения изображений в этом устройстве, генерирует соответствующее виртуальное изображение согласно целевому объекту в сцене реального времени, и, в конечном итоге, представляет сформированное им виртуальное изображение в изображении сцены в реальном времени посредством способа отображения изображения на основе дополненной реальности согласно различным вариантам настоящего изобретения. Например, целевой объект на изображении сцены в реальном времени представляет собой плод манго, а виртуальное изображение, соответствующее целевому объекту манго, генерируют с использованием способа генерирования виртуального изображения согласно вариантам настоящего изобретения. Виртуальное изображение, соответствующее этому плоду манго, может быть отображено в изображении сцены в реальном времени и далее может представляться динамически в форме анимации после того, как это виртуальное изображение будет обработано способом отображения изображения на основе дополненной реальности согласно различным вариантам настоящего изобретения. Более того, такое виртуальное изображение, соответствующее плоду манго, может иметь конечности (ручки и ножки) и/или мимику, причем эти конечности и/или выражения могут совершать определенные движения, так что виртуальное изображение, соответствующее плоду манго, движется в изображении реальной сцены.

На Фиг. 1 представлена упрощенная логическая схема способа отображения изображения на основе дополненной реальности согласно одному из вариантов настоящего изобретения. Способ согласно этому варианту может быть применен к электронному устройству или серверу, имеющему функцию реальности AR. Этот способ отображения изображения на основе дополненной реальности может содержать этапы, описываемые ниже.

Этап S101, осуществление сегментации объектов с целью выделения целевого объекта в изображении сцены в реальном времени, захваченном модулем для получения изображений с целью получения изображения целевого объекта.

В этом варианте, модуль для получения изображений, такой как видеокамера, в электронном устройстве может захватывать изображение сцены в реальном времени и представлять это изображение сцены в реальном времени на экране модуля отображения этого электронного устройства. Электронное устройство может получить изображение целевого объекта путем сегментации целевого объекта из изображения сцены в реальном времени. В частности, электронное устройство может выполнять алгоритм сегментации объектов, загруженный в это устройство заранее, для осуществления сегментации объектов на изображении сцены в реальном времени с целью получения изображения целевого объекта. Алгоритм сегментации объектов, используемый в рассматриваемом варианте настоящего изобретения, может представлять собой алгоритм сегментации выделяющихся объектов, при применении которого, в процессе сегментации, выделяющийся объект в изображении сцены в реальном времени может быть использован в качестве целевого объекта и сегментирован для получения изображения целевого объекта. Таким выделяющимся объектом может быть объект, значительно отличающийся по цвету от фона в изображении сцены в реальном времени, и может также быть объект, расположенный в центральной области изображения сцены в реальном времени, или объект, занимающий наибольшую площадь в изображении сцены в реальном времени, и т.п. Например, как показано на Фиг. 2a, плод манго в изображении изображение сцены в реальном времени расположен в центральной области этого изображения и занимает наибольшую площадь, так что этот плод может быть взят в качестве целевого объекта. Кроме того, присутствующая на изображении сцены в реальном времени пара наушников находится не в центральной области этого изображения и занимает намного меньшую площадь по сравнению с плодом, вследствие чего эта пара наушников не взята в качестве целевого объекта.

В одном из вариантов, когда пользователь хочет получить виртуальное изображение, соответствующее изображению определенного целевого объекта, присутствующего в изображении сцены в реальном времени, пользователь может дать первую команду, так что электронное устройство получит изображение целевого объекта в изображении сцены в реальном времени в соответствии с этой первой командой. В одном из вариантов, электронное устройство может, в соответствии с этой первой командой, реплицировать такое же изображение целевого объекта, как полученное изображение целевого объекта, на основе изображения целевого объекта и изображения сцены в реальном времени, захваченного модулем для получения изображений, и генерировать виртуальное изображение на основе реплицированного изображения целевого объекта.

В одном из вариантов, когда электронное устройство сегментирует целевой объект с целью получения изображения этого целевого объекта, это изображение целевого объекта может быть также помечено, например, электронное устройство может как-то выделить это изображение целевого объекта. Например, как показано на Фиг. 2a, электронное устройство может выделить контур изображения целевого объекта посредством штрихов, в качестве альтернативы, можно также высветить, сделать ярче изображение целевого объекта, в качестве альтернативы, можно отобразить область изображения, отличную от изображения целевого объекта, с меньшей яркостью, и т.п., что позволяет пользователю подтвердить, является ли целевой объект, сегментированный в текущий момент электронным устройством, тем объектом, который согласован с целевым объектом, какой требуется пользователю. Когда пользователь подтверждает, что выделенный целевой объект согласован с целевым объектом, требуемым пользователю, это пользователь может выдать первую команду, где эта первая команда может представлять собой, без ограничений, команду, подаваемую щелчком, команду, подаваемую перетаскиванием, или другую подобную команду относительно помеченного изображения целевого объекта, как показано на Фиг. 2b, пользователь может дать упомянутую выше команду операции перетаскивания путем перетаскивания в пределах очерченной контуром области изображения целевого объекта. Когда пользователь подтверждает, что выбранный целевой объект не согласован с целевым объектом, требуемым пользователю, этот пользователь может переместить электронное устройство, чтобы модуль для получения изображений в этом электронном устройстве изменил угол зрения для повторного захвата (съемки) изображения сцены в реальном времени, и затем снова запустить алгоритм сегментации объектов, чтобы сегментировать выделяющийся объект в изображении сцены в реальном времени в качестве целевого объекта и пометить полученное изображение целевого объекта. Таким образом, пользователь может заново подтвердить, что текущий целевой объект, найденный электронным устройством, согласован с целевым объектом, требуемым пользователю, и удовлетворяет ли эффект сегментации ожиданиям пользователя.

Этап S102, генерирование виртуального изображения, соответствующего целевому объекту, на основе изображения целевого объекта.

В рассматриваемом варианте, после получения изображения целевого объекта (например, изображения целевого объекта, полученного после репликации из исходного изображения целевого объекта), электронное устройство может генерировать виртуальное изображение, соответствующее целевому объекту, на основе изображения целевого объекта, где виртуальное изображение может иметь движения конечностей относительно тела и/или движения выражений. Например, когда изображение целевого объекта представляет собой изображение плода манго, соответствующее виртуальное изображение может иметь конечности (ручки-ножки) и мимику «лица» на изображении плода манго, как показано на Фиг. 3. Кроме того, конечности и выражения «лица» могут иметь определенные движения, побуждая виртуальное изображение плода манго перемещаться по экрану дисплея электронного устройства.

В качестве альтернативы, при генерировании виртуального изображения, соответствующего целевому объекту, на основе изображения целевого объекта, изображение этого целевого объекта может быть синтезировано с анимационным материалом для генерирования виртуального изображения, соответствующего целевому объекту, этот анимационный материал содержит анимационный материал конечностей относительно тела и/или анимационный материал мимики для виртуального изображения. Другими словами, в рассматриваемом варианте, движения конечностей относительно тела и/или движения мимики в виртуальном изображении, соответствующем целевому объекту, могут быть заданы заранее для генерирования соответствующего анимационного материала конечностей относительно тела и/или анимационного материала мимики для использования в последующей процедуре синтеза. Иными словами, анимационный материал конечностей относительно тела и/или анимационный материал мимики могут быть добавлены к изображению целевого объекта для получения виртуального изображения, соответствующего целевому объекту, а конечности и/или мимика на виртуальном изображении могут совершать определенные движения в соответствии с воспроизведением анимационного материала конечностей относительно тела и/или анимационного материала мимики.

Этап S103, отображение виртуального изображения в изображении сцены в реальном времени на основе технологии отображения дополненной реальности.

В рассматриваемом варианте, после получения виртуального изображения целевого объекта, электронное устройство может представлять виртуальное изображение целевого объекта в изображении сцены в реальном времени посредством технологии отображения дополненной реальности. Иными словами, виртуальное изображение может быть наложено на реалистичное изображение сцены в реальном времени посредством технологии отображения дополненной реальности с целью достижения эффекта дополненного отображения, как показано на Фиг. 4. В одном из вариантов, электронное устройство может динамически отображать виртуальное изображение целевого объекта в изображении сцены в реальном времени.

В одном из вариантов, электронное устройство может осуществить дополненное отображение виртуального изображения в изображении сцены в реальном времени в ответ на первую команду от пользователя, эта первая команда может представлять собой, не ограничиваясь этим, команду операции щелчка, команду операции перетаскивания, команду голосовой операции, команду операции, получаемой в результате распознавания мимики, или другую подобную команду, выданную пользователем, для изображения целевого объекта. В дополнение к этому, электронное устройство может, после определения положения на дисплее для виртуального изображения, автоматически осуществлять дополненное отображение виртуального изображения целевого объекта в указанном положении на дисплее в изображении сцены в реальном времени.

В альтернативном варианте, пользователь может перетаскивать полученное реплицированное изображение целевого объекта из первоначального положения исходного изображения целевого объекта в положение в изображении сцены в реальном времени. Далее, виртуальное изображение целевого объекта представляют в этом положении на основе технологии отображения дополненной реальности. В качестве альтернативы, сначала может быть отображено виртуальное изображение целевого объекта, генерируемое на основе реплицированного изображения целевого объекта, а затем это виртуальное изображение может быть отображено в некоем положении в изображении сцены в реальном времени на основе операции перетаскивания пользователем.

В качестве опции, пользователь может также поворачивать, увеличивать или уменьшать, или перемещать и т.п. отображенное виртуальное изображение. Например, пользователь может дать команду управления виртуальным изображением на интерфейс дисплея в электронном устройстве. Эта команда управления может представлять собой, не ограничиваясь этим, команду управления поворотом, команду управления уменьшением, команду управления перемещением, команду управления увеличением или другую подобную команду, а электронное устройство может осуществлять соответствующее управление виртуальным изображением в ответ на поступившую от пользователя команду управления для виртуального изображения. Необходимо отметить, что в рассматриваемом варианте поворот может содержать изменение угла виртуального изображения в любом случае, а перемещение может содержать изменение положения виртуального изображения в любом случае. Увеличение или уменьшение размера (масштабирование) может содержать изменение размера виртуального изображения в любом случае. Само собой разумеется, в рассматриваемом варианте, пользователь может также осуществлять больше других процедур взаимодействия с виртуальным изображением, что, для краткости, не будет здесь описано лишний раз одно за другим.

Способ отображения изображения на основе дополненной реальности, предлагаемый в рассматриваемом варианте, может содержать получение изображения целевого объекта посредством сегментации целевого объекта из изображения сцены в реальном времени, захваченного модулем для получения изображений, генерирование виртуального изображения, соответствующего целевому объекту, на основе изображения целевого объекта, и отображение виртуального изображения в изображении сцены в реальном времени на основе технологии отображения дополненной реальности. Благодаря получению изображения целевого объекта и генерированию виртуального изображения, соответствующего целевому объекту, на основе изображения целевого объекта, можно избежать проблем, связанных с тем, что виртуальное изображение необходимо предварительно сконструировать, а само это изображение является единственным и фиксированным. В рассматриваемом варианте, можно генерировать различные виртуальные изображения в соответствии с потребностями пользователей и тем самым удовлетворить разнообразным потребностям пользователей. Это виртуальное изображение может быть отображено в изображении сцены в реальном времени с использованием технологии дополненной реальности, так что можно повысить готовность пользователей использовать технологию реальности AR и улучшить опыт использования.

На основе любого из приведенных выше вариантов, при генерировании виртуального изображения соответствующего целевого объекта на основе изображения этого целевого объекта, изображение целевого объекта может быть синтезировано с использованием анимационного материала для генерирования виртуального изображения, соответствующего целевому объекту, этот анимационный материал представляет собой анимационный материал конечностей относительно тела и/или анимационный материал мимики для виртуального изображения.

В качестве опции, как показано на Фиг. 5, этап синтеза изображения целевого объекта с анимационным материалом может, в частности, содержать:

Этап S201, получение анимационного материала конечностей относительно тела и/или анимационного материала мимики;

Этап S202, определение нескольких соединительных точек на изображении целевого объекта на основе этого изображения целевого объекта; и

Этап S203, синтез анимационного материала конечностей относительно тела и/или анимационного материала мимики с изображением целевого объекта посредством нескольких соединительных точек для генерирования виртуального изображения, соответствующего целевому объекту.

В рассматриваемом варианте, электронное устройство может сначала получить анимационный материал конечностей относительно тела и/или анимационный материал мимики для виртуального изображения, этот анимационный материал конечностей относительно тела и/или the анимационный материал мимики может быть предварительно конфигурирован и сохранен в электронном устройстве. Когда требуется синтез, электронное устройство может извлечь анимационный материал конечностей относительно тела и/или анимационный материал мимики и затем определить несколько соединительных точек на изображении целевого объекта на основе свойств (например, формы, размера, текстуры) изображения целевого объекта, эти соединительные точки являются точками, в которых происходит комбинирование анимационного материала конечностей относительно тела и/или анимационного материала мимики с изображением целевого объекта. Например, электронное устройство может установить изображение целевого объекта в качестве «туловища» тела виртуального изображения и указанные несколько соединительных точек, выбранные на целевом изображении в качестве точек для присоединения конечностей. Таким образом, соединительные точки могут представлять собой позиции присоединения конечностей к «туловищу» тела, более того, электронное устройство может тогда синтезировать анимационный материал конечностей относительно тела с изображением целевого объекта посредством соединительных точек, так что изображение целевого объекта приобретает конечности (ручки-ножки). В дополнение к этому, электронное устройство может также определить, в соответствии с изображением целевого объекта, в качестве положения для помещения этого объекта, центр «туловища» тела, иными словами центральное положение изображения целевого объекта, для мимики «туловища» тела виртуального изображения на изображении целевого объекта, и синтезировать анимационный материал мимики с изображением целевого объекта, так что виртуальное изображение, соответствующее изображению целевого объекта, также имеет мимику. В дополнение к этому, конечности и/или мимика могут также иметь определенные анимационные эффекты, и вследствие этого, далее происходит генерирование имеющего анимационные эффекты виртуального изображения, соответствующего целевому объекту, как подробно показано на Фиг. 6.

На основе приведенного выше варианта, этап получения нескольких соединительных точек на изображении целевого объекта может, в частности, содержать: регулирование анимационного материала на основе изображения целевого объекта; и определение позиций нескольких соединительных точек на изображении целевого объекта.

В рассматриваемом варианте, поскольку изображения целевого объекта могут варьироваться по размеру, анимационный материал необходимо регулировать соответствующим образом на основе размера изображения целевого объекта, так что отрегулированный анимационный материал может быть согласован с изображением целевого объекта в масштабе. Далее, электронные устройства могут также определить позиции нескольких соединительных точек на изображении целевого объекта на основе таких факторов, как форма изображения целевого объекта, так что анимационный материал может быть присоединен к изображению целевого объекта в соединительных точках в соответствующих позициях для создания хорошего эстетичного внешнего вида. Иными словами, отрегулированный анимационный материал конечностей относительно тела может быть помещен в соответствующую позицию изображения целевого объекта, и отрегулированный анимационный материал мимики также может быть помещен в соответствующую позицию изображения целевого объекта.

Согласно способу, предлагаемому в рассматриваемом варианте настоящего изобретения, процедура осуществления электронным устройством сегментации объектов с целью выделения целевого объекта в изображении сцены в реальном времени, захваченном модулем для получения изображений, с целью получения изображения целевого объекта содержит: выполнение алгоритма сегментации объектов с целью осуществления сегментации объекта с целью выделения целевого объекта в изображении сцены в реальном времени, получая тем самым маску и ограничивающую рамку изображения целевого объекта и получая текстуру внутренней области маски.

В рассматриваемом варианте, при сегментации целевого объекта с использованием алгоритма сегментации объектов, могут быть получены маска Mask и ограничительная рамка Box целевого объекта, а также текстура внутренней области маски.

Соответственно, электронное устройство может регулировать размер анимационного материала на основе размера ограничительной рамки и регулировать позиции нескольких соединительных точек на изображении целевого объекта на основе оси симметрии и отношения длины к ширине для ограничительной рамки.

В рассматриваемом варианте, электронное устройство может регулировать размер анимационного материала на основе размера ограничительной рамки и затем регулировать позиции нескольких соединительных точек на изображении целевого объекта на основе оси симметрии и отношения длины к ширине для ограничительной рамки. Другими словами, если ограничительная рамка имеет большой размер, размер анимационного материала адаптивно увеличивается; если размер ограничительной рамки мал, размер анимационного материала адаптивно уменьшается. Электронное устройство может также определить позиции нескольких соединительных точек на изображении целевого объекта, например, определить позиции соединительных точек для верхних конечностей и позиции соединительных точек для нижних конечностей, на основе оси симметрии и отношения длины к ширине для ограничительной рамки, и определить позицию для помещения мимики «лица» в целевом изображении на основе этого целевого изображения и т.д. Соединительные точки для конечностей могут быть симметрично расположены по обе стороны от оси симметрия изображения целевого объекта, и конкретные позиции соединительных точек необходимо определить на основе отношения длины к ширине. Например, для очень вытянутого в длину, «долговязого» (т.е. ограничительная рамка с большим отношением длины к ширине) изображения целевого объекта, соединительные точки для верхних конечностей необходимо сдвинуть вверх, а соединительные точки для нижних конечностей необходимо сдвинуть вниз. Для относительно широкого, «коротышки» (т.е. ограничительная рамка с меньшим отношением длины к ширине) изображения целевого объекта, соединительные точки для верхних конечностей необходимо сдвинуть вниз, а соединительные точки для нижних конечностей необходимо сдвинуть вверх посредством описываемого выше регулирования, получаемое конечное виртуальное изображение может иметь более гармоничные и разумные пропорции тела.

На основе приведенного выше варианта, процедура синтеза анимационного материала конечностей относительно тела и/или анимационного материала мимики с изображением целевого объекта посредством нескольких соединительных точек для генерирования виртуального изображения, соответствующего целевому объекту, содержит: синтез анимационного материала конечностей относительно тела и/или анимационного материала мимики с текстурой внутренней области маски посредством нескольких соединительных точек для генерирования виртуального изображения, соответствующего целевому объекту.

В рассматриваемом варианте, электронное устройство может синтезировать анимационный материал конечностей относительно тела и/или анимационный материал мимики с текстурой внутренней области маски посредством соединительных точек для получения виртуального изображения, соответствующего целевому объекту, т.е. отобразить анимационный материал конечностей относительно тела и/или анимационный материал мимики на основе текстуры внутренней области маски. В одном из вариантов, после определения соединительных точек на изображении целевого объекта и регулирования размера анимационного материала, электронное устройство может синтезировать анимационный материал конечностей относительно тела и/или анимационный материал мимики с текстурой внутренней области маски посредством соединительных точек для получения виртуального изображения, соответствующего целевому объекту.

Далее, электронное устройство может также «проигрывать» анимационный материал, включая воспроизведение («проигрыш») анимационного материала конечностей относительно тела и/или анимационного материала мимики, и осуществлять, таким образом, управление движения и/или мимикой для виртуального изображения, т.е. позволяя конечностям и/или мимике на виртуальном изображении демонстрировать соответствующие движения.

В частности, электронное устройство может воспроизводить анимационные материалы в соответствии с предварительно заданными анимационными кадрами этих анимационных материалов для осуществления управления движениями и/или мимикой на виртуальном изображении, и/или генерировать и воспроизводить анимационные кадры анимационных материалов на основе движения конечностей пользователя относительно его тела и/или выражений пользователя для осуществления управления движениями и/или мимикой на виртуальном изображении, соответствующем целевому объекту. Другими словами, упомянутый выше анимационный материал может содержать предварительно заданные анимационные кадры и в этих предварительно заданных анимационных кадрах может быть предварительно задано, какие именно конкретные анимационные действия показаны для конечностей и/или мимики. В одном из вариантов, электронное устройство может также захватывать изображения пользователя в реальном времени и генерировать анимационные кадры из анимационного материала конечностей относительно тела и/или анимационного материала мимики в соответствии с движениями конечностей пользователя относительно его тела и/или движениями мимики пользователя, таким образом, обеспечивая для пользователя возможность управлять движениями на виртуальном изображении, соответствующем целевому объекту, через движения пользователя. Например, когда пользователь совершает некое движение конечностью относительно тела, виртуальное изображение соответственно показывает такое же движение конечностью относительно тела, и/или когда пользователя придает своему лицу некую мимику, виртуальное изображение соответственно показывает такое же выражение. Опыт работы и удовлетворение пользователя можно усилить путем приведения в действие и управления движениями виртуального изображения, соответствующего целевому объекту, с использованием движений пользователя.

На основе любого из рассматриваемых выше вариантов, этап отображения виртуального изображения в изображении сцены в реальном времени на основе технологии отображения дополненной реальности содержит следующие операции: создание виртуальной плоскости в изображении сцены в реальном времени; генерирование трехмерного (3D) пространства на этой виртуальной плоскости; и отображение виртуального изображения целевого объекта в этом 3D-пространстве, сформированном на основе технологии отображения дополненной реальности.

В рассматриваемом варианте, при осуществлении дополненного отображения виртуального изображения целевого объекта, для того, чтобы сделать движения на виртуальном изображении в изображении сцены в реальном времени более реалистичными и трехмерными, в изображении сцены в реальном времени может быть создано виртуальное 3D-пространство. В частности, электронное устройство сначала создает виртуальную плоскость в изображении сцены в реальном времени, а затем генерирует 3D-пространство на этой виртуальной плоскости и на основе этой виртуальной плоскости, и более того, усиливает и представляет виртуальное изображение в 3D-пространстве на основе технологии отображения дополненной реальности.

На основе приведенного выше варианта, процедура создания виртуальной плоскости в изображении сцены в реальном времени может, в частности, содержать: в случае обнаружения, что в изображении сцены в реальном времени существует целевая область плоскости, создание виртуальной плоскости на основе этой целевой области плоскости, где целевая область плоскости представляет собой область плоскости, имеющую расстояние до модуля для получения изображений в пределах первого заданного диапазона расстояний, и/или область плоскости, расположенную в центральной области изображения сцены в реальном времени; либо создание виртуальной плоскости в некой конкретной позиции в изображении сцены в реальном времени.

В рассматриваемом варианте, электронное устройство может обнаружить область плоскости, входящую в изображение сцены в реальном времени, на основе этого изображения сцены в реальном времени посредством, например, алгоритма одновременной локализации и отображения (simultaneous localization and mapping (SLAM)), и определения, существует ли область плоскости, имеющая расстояние до модуля для получения изображений в пределах первого заданного диапазона расстояний, и/или область плоскости в центральной области изображения сцены в реальном времени. Если такая область плоскости существует, эту найденную область плоскости можно использовать в качестве целевой области плоскости. Далее, создают виртуальную плоскость на основе целевой области плоскости, эта виртуальная плоскость может располагаться близко к целевой области плоскости или быть параллельной целевой область плоскости и поддерживать некоторое фиксированное расстояние до целевой области плоскости. Если электронное устройство не обнаружило целевой области плоскости, виртуальная плоскость может быть создана в некой конкретной позиции в изображении сцены в реальном времени. В качестве альтернативы, электронное устройство не осуществляет поиск целевой области плоскости, а виртуальную плоскость прямо создают в некой конкретной позиции в изображении сцены в реальном времени. Эта конкретная позиция в изображении сцены в реальном времени может представлять собой такие области, как центральная область или верхний левый угол изображения сцены в реальном времени, а положение, где именно указанная конкретная позиция находится в изображении сцены в реальном времени, может быть задано в соответствии с тем, как это нужно на практике.

На основе приведенного выше варианта, при представлении виртуального изображения целевого объекта в сформированном 3D-пространстве, поскольку это 3D-пространство может быть относительно большим, должно быть определено, что виртуальное изображение специально представляют в целевой позиции в этом 3D-пространстве. Иными словами, сначала может быть определена целевая позиция в 3D-пространстве, а затем виртуальное изображение целевого объекта может быть отображено в этой целевой позиции в 3D-пространстве на основе технологии отображения дополненной реальности.

На основе приведенного выше варианта, процедура определения целевой позиции в 3D-пространстве может содержать: прием команды, специфицирующей позицию, от пользователя, установление трехмерной анкерной точки в трехмерном пространстве на основе позиционной точки, обозначенной командой, специфицирующей позицию, от пользователя, и использование этой трехмерной анкерной точки в качестве целевой позиции.

В рассматриваемом варианте, пользователь может выдать команду, специфицирующую позицию, а электронное устройство может определить позиционную точку, обозначенную командой, специфицирующей позицию, от пользователя, после приема этой команды, специфицирующей позицию, от пользователя. От позиционной точки к 3D-пространству проводят прямую линию для образования точки пересечения этой прямой линии с 3D-пространством, и создают анкерную 3D-точку в 3D-пространстве на основе указанной точки пересечения. Анкерная 3D-точка представляется собой целевую позицию для представления виртуального изображения в 3D-пространстве, и тогда электронное устройство может осуществить дополненное отображение рассматриваемого виртуального изображения целевого объекта в анкерной 3D-точке в 3D-пространстве.

В качестве опции, команда, специфицирующая позицию, от пользователя может представлять собой конечную команду для выполняемой пользователем операции перетаскивания на виртуальном изображении, и позиция (т.е. точка, где операция перетаскивания пользователем завершается), обозначенная этой конечной командой перетаскивания является позиционной точкой, обозначенной командой, специфицирующей позицию, от пользователя. В дополнение к этому, команда, специфицирующая позицию, может не ограничиваться конечной командой операции перетаскивания пользователем по виртуальному изображению, а может также быть командой операции щелчка от пользователя, а позиционное точка (т.е. точка, по которой щелкнул пользователь), обозначенная командой операции щелчка, является позиционной точкой, обозначенной командой, специфицирующей позицию, от пользователя.

Безусловно, электронное устройство может также отображать виртуальную модель в любой позиции на изображении сцены в реальном времени, например, отображать в произвольной области плоскости, идентифицированной электронным устройством на изображении сцены в реальном времени. Безусловно, электронное устройство может определить позицию на дисплее для представления виртуальной модели и другими способами, что никак здесь не ограничивается.

На основе любого из рассмотренных выше вариантов, в процедуру дополнительно включен этап предварительного размещения, осуществляемый после генерирования виртуального изображения, соответствующего целевому объекту, на основе изображения этого целевого объекта и прежде осуществления дополненного отображения виртуального изображения целевого объекта в целевой позиции в изображении сцены в реальном времени. Иными словами, виртуальное изображение, соответствующее целевому объекту, может быть подвешено в заданном положении перед модулем для получения изображений, и это виртуальное изображение может быть затем представлено в целевой позиции, после того, как целевая позиция в изображение сцены в реальном времени будет подтверждена. На основе любого из рассмотренных выше вариантов, как показано на Фиг. 7, способ далее содержит:

Этап S301, прием первой команды управления от пользователя, и выполнение алгоритма сегментации объектов, предварительно загруженного в соответствии с этой первой командой управления, для осуществления сегментации объекта с целью выделения целевого объекта в изображении сцены в реальном времени; и

Этап S302, прием второй команды управления от указанного пользователя и остановку работы алгоритма сегментации объектов в соответствии с этой второй командой управления.

В рассматриваемом варианте, при получении изображения целевого объекта в изображении сцены в реальном времени, захваченном посредством модуля для получения изображений, для использования алгоритмом сегментации объектов, для предотвращения работы этого алгоритма сегментации объектов в течение продолжительного времени, когда он занимает вычислительные ресурсы в электронном устройстве, этим алгоритмом сегментации объектов можно управлять, чтобы запускать его в работу своевременно и останавливать работу. Когда нужно, чтобы алгоритм сегментации объектов работал, пользователь может выдать указанную первую команду управления. Эта первая команда управления может представлять собой команду управления для включения модуля для получения изображений, или команду управления, выдаваемую пользователем, когда этот пользователь нажимает пусковую кнопку на интерфейсе в ходе процедуры, когда модуль для получения изображений захватывает изображение сцены в реальном времени. Электронное устройство запускает и выполняет алгоритм сегментации объектов в ответ на команду управления от пользователя, тем самым начиная сегментацию целевого объекта из изображения сцены в реальном времени.

Далее, когда электронное устройство уже получило изображение целевого объекта в изображении сцены в реальном времени, в этот момент работа алгоритма сегментации объектов может быть остановлена. В качестве альтернативы, электронное устройство останавливает работу алгоритма сегментации объектов в ответ на вторую команду управления от пользователя. Например, пользователь закрывает модуль для получения изображений или нажимает кнопку остановки на интерфейсе. В качестве альтернативы, в ответ на первую команду от пользователя для выбора сегментированного изображения целевого объекта, электронное устройство останавливает работу алгоритма сегментации объектов в соответствии с этой первой командой, настоящее изобретение может быть в этом вопросе ничем не ограничено.

Например, электронное устройство запускает работу алгоритма сегментации объектов в алгоритмическом модуле. Когда принята первая команда управления (соответствующая команде запустить работу алгоритма), работа алгоритма сегментации объектов начинается. Когда принята вторая команда управления (соответствующая команде остановить работу алгоритма), работа алгоритма сегментации объектов останавливается.

В одном из вариантов, после того, как пользователь даст первую команду для выбора сегментированного изображения целевого объекта, электронное устройство получает изображение целевого объекта в изображении сцены в реальном времени в соответствии с этой первой командой, и тогда работа алгоритма сегментации объектов может быть в этот момент остановлена.

В одном из вариантов, пользователь может также управлять запуском алгоритма сегментации объектов в работу посредством операции продолжительного нажатия. Алгоритм сегментации объектов может продолжать работать, пока продолжается это нажатие. Когда продолжительное нажатие прекращается, работа алгоритма сегментации объектов может быть завершена.

Алгоритмом сегментации объектов управляют для своевременного запуска и остановки работы с использованием способа, описанного выше, вследствие чего можно избежать слишком продолжительной работы алгоритма сегментации объектов в электронном устройстве и сберечь вычислительные ресурсы этого электронного устройства.

В соответствии со способом отображения изображения на основе дополненной реальности из приведенных выше вариантов, на Фиг. 8 представлена структурная блок-схема устройства отображения на основе дополненной реальности согласно одному из вариантов настоящего изобретения. Для облегчения понимания здесь показаны только части, относящиеся к вариантам настоящего изобретения. Согласно Фиг. 8, устройство 80 отображения на основе дополненной реальности содержит модуль 801 определения целевого объекта, модуль 802 генерирования и модуль 803 отображения.

Модуль 801 определения целевого объекта конфигурирован для осуществления сегментации объекта с целью выделения целевого объекта в изображении сцены в реальном времени, захваченном модулем для получения изображений, для получения изображения целевого объекта.

Модуль 802 генерирования конфигурирован для генерирования виртуального изображения, соответствующего целевому объекту, на основе изображения целевого объекта.

Модуль 803 отображения конфигурирован для отображения виртуального изображения в изображении сцены в реальном времени на основе технологии отображения дополненной реальности.

Согласно одному или нескольким вариантам настоящего изобретения, модуль 802 генерирования, при генерировании виртуального изображения, соответствующего целевому объекту, на основе изображения целевого объекта, конфигурирован для: синтеза изображения целевого объекта с анимационным материалом с целью генерирования виртуального изображения, соответствующего целевому объекту.

Предварительно заданный анимационный материал содержит анимационный материал конечностей относительно тела и/или анимационный материал мимики для виртуального изображения.

Согласно одному или нескольким вариантам настоящего изобретения, модуль 802 генерирования, при синтезе изображения целевого объекта с анимационным материалом, конфигурирован для: получения анимационного материала конечностей относительно тела и/или анимационного материала мимики; определения нескольких соединительных точек на изображении целевого объекта на основе этого изображения целевого объекта; и синтеза анимационного материала конечностей относительно тела и/или анимационного материала мимики с изображением целевого объекта посредством указанных нескольких соединительных точек для генерирования виртуального изображения, соответствующего целевому объекту.

Согласно одному или нескольким вариантам настоящего изобретения, модуль 801 определения целевого объекта, при осуществлении сегментации объектов с целью выделения целевого объекта в изображении сцены в реальном времени, захваченном модулем для получения изображений, для получения изображения целевого объекта, конфигурирован для: выполнения алгоритма сегментации объектов для осуществления сегментации объектов с целью выделения целевого объекта в изображении сцены в реальном времени, получая тем самым маску и ограничивающую рамку изображения целевого объекта и получая текстуру внутренней области маски.

Согласно одному или нескольким вариантам настоящего изобретения, модуль 802 генерирования, при синтезе анимационного материала конечностей относительно тела и/или анимационного материала мимики с изображением целевого объекта посредством указанных нескольких соединительных точек для генерирования виртуального изображения, соответствующего целевому объекту, конфигурирован для: синтеза анимационного материала конечностей относительно тела и/или анимационного материала мимики с текстурой внутренней области маски посредством указанных нескольких соединительных точек для генерирования виртуального изображения, соответствующего целевому объекту.

Согласно одному или нескольким вариантам настоящего изобретения, модуль 802 генерирования далее конфигурирован для: регулирования размера анимационного материала на основе размера ограничительной рамки; и регулирования позиций нескольких соединительных точек на изображении целевого объекта на основе оси симметрии и отношения длины к ширине ограничительной рамки.

Согласно одному или нескольким вариантам настоящего изобретения, модуль 803 отображения далее конфигурирован для: воспроизведения анимационного материала с целью осуществления управления движениями и/или мимикой на виртуальном изображении.

Согласно одному или нескольким вариантам настоящего изобретения, модуль 803 отображения, при воспроизведении анимационного материала с целью осуществления управления движениями и/или мимикой на виртуальном изображении, конфигурирован для: воспроизведения анимационного материала в соответствии с предварительно заданными анимационными кадрами анимационного материала для осуществления управления движениями и/или мимикой на виртуальном изображении; и/или генерирования и воспроизведения анимационных кадров анимационного материала на основе движений конечностей относительно тела и/или мимики пользователя, с целью осуществления управления движениями и/или мимикой на виртуальном изображении.

Согласно одному или нескольким вариантам настоящего изобретения, модуль 803 отображения, при отображении виртуального изображения в изображении сцены в реальном времени на основе технологии отображения дополненной реальности, конфигурирован для: создания виртуальной плоскости в изображении сцены в реальном времени; генерирования 3D-пространства на этой виртуальной плоскости; и отображения виртуального изображения целевого объекта в сформированном 3D-пространстве на основе технологии отображения дополненной реальности.

Согласно одному или нескольким вариантам настоящего изобретения, модуль 803 отображения, при создании виртуальной плоскости на основе целевой области плоскости в изображении сцены в реальном времени, конфигурирован для: создания виртуальной плоскости на основе целевой области плоскости в случае обнаружения, что целевая область плоскости существует в изображении сцены в реальном времени, где эта целевая область плоскости представляет собой область плоскости, имеющую расстояние до модуля для получения изображений в пределах первого предварительно заданного диапазона расстояний, и/или область плоскости, расположенную в центральной области изображения сцены в реальном времени; или создания виртуальной плоскости в конкретной позиции в изображении сцены в реальном времени.

Согласно одному или нескольким вариантам настоящего изобретения, модуль 803 отображения, при отображении виртуального изображения целевого объекта в сформированном 3D-пространстве на основе технологии отображения дополненной реальности, конфигурирован для: определения целевой позиции в 3D-пространстве; и отображения виртуального изображения целевого объекта в целевой позиции в 3D-пространстве на основе технологии отображения дополненной реальности.

Согласно одному или нескольким вариантам настоящего изобретения, модуль 803 отображения, при определении целевой позиции в 3D-пространстве, конфигурирован для: приема команды, специфицирующей позицию, от пользователя, установления трехмерной анкерной точки в трехмерном пространстве на основе позиционной точки, обозначенной командой, специфицирующей позицию, от пользователя, и использования этой трехмерной анкерной точки в качестве целевой позиции.

Согласно одному или нескольким вариантам настоящего изобретения, модуль 801 определения целевого объекта далее конфигурирован для: приема первой команды управления от пользователя, и выполнения алгоритма сегментации объектов, предварительно загруженного в соответствии с этой первой командой управления, для осуществления сегментации объекта применительно к целевому объекту в изображении сцены в реальном времени; а также приема второй команды управления от указанного пользователя и остановки работы алгоритма сегментации объектов в соответствии с этой второй командой управления.

Согласно одному или нескольким вариантам настоящего изобретения, модуль отображения, при отображении виртуального изображения в изображении сцены в реальном времени, конфигурирован для: динамического отображения виртуального изображения в изображении сцены в реальном времени.

Устройство отображения на основе дополненной реальности, предлагаемое в рассматриваемом варианте, может быть использовано для осуществления технических решений способа отображения изображения на основе дополненной реальности в соответствии с вариантами способа, рассмотренными выше, принцип реализации и технический эффект устройства отображения на основе дополненной реальности аналогичны принципам и эффекту вариантов способа, так что в рассматриваемом варианте подробности повторно приведены не будут.

На Фиг. 9 приведена упрощенная схема, иллюстрирующая структуру, подходящую для реализации электронного устройства 900 согласно одному из вариантов настоящего изобретения. Это электронное устройство 900 может представлять собой терминал или сервер и может быть использовано для осуществления способа отображения изображения на основе дополненной реальности согласно вариантам способа, описываемым выше. В частности, терминал может представлять собой, не ограничиваясь этим, мобильный терминал, такой как мобильный телефон, компьютер ноутбук, приемник цифрового вещания, персональный цифровой помощник (personal digital assistant (PDA)), портативное устройство с системой Андроид (portable Android device (PAD)), портативный медиа плеер (portable media player (PMP)), устанавливаемый на автомобиле терминал (например, устанавливаемый на автомобиле навигационный терминал) или другое подобное устройство, либо фиксированный терминал, такой как цифровой телевизор, настольный компьютер или другое подобное устройство. Электронное устройство, показанное на Фиг. 9, представляет собой просто пример и не имеет целью накладывать какие-либо ограничения на функции и диапазон использования вариантов настоящего изобретения.

Как показано на Фиг. 9, электронное устройство 900 может содержать устройство 901 обработки (например, центральный процессор, графический процессор и т.п.), которое может осуществлять разнообразные подходящие действия и процедуры в соответствии с программой, сохраняемой в постоянном запоминающем устройстве (ПЗУ (read-only memory (ROM))) 902, или программой, загружаемой из запоминающего устройства 908 в запоминающее устройство с произвольной выборкой (ЗУПВ (random access memory (RAM))) 903. ЗУПВ (RAM) 903 далее сохраняет разнообразные программы и данные, требуемые для операций электронного устройства 900. устройство 901 обработки, ПЗУ (ROM) 902 и ЗУПВ (RAM) 903 соединены одни с другими по шине 904. Интерфейс 905 ввода/вывода (input/output (I/O)) также соединен с шиной 904.

Обычно с интерфейсом I/O могут быть соединены следующие устройства: устройство 906 ввода, представляющее собой, например, сенсорный экран, сенсорную панель (тачпад), клавиатуру, мышь, видеокамеру, микрофон, акселерометр, гироскоп и т.п.; устройство 907 вывода, представляющее собой, например, жидкокристаллический дисплей (liquid crystal display (LCD)), громкоговоритель, вибратор и т.п.; устройство 908 для хранения информации, представляющее собой, например, магнитную ленту, жесткий диск и т.п.; и устройство 909 связи. Устройство 909 связи может позволить электронному устройству 900 осуществлять связь беспроводным способом или по проводам с другими устройствами для обмена данными. Хотя Фиг. 9 иллюстрирует электронное устройство 900, имеющее различные устройства, следует понимать, что все иллюстрируемые устройства не обязательно реализуемы или включены в устройство 900. В качестве альтернативы могут быть реализованы или включены больше или меньше устройств.

В частности, согласно вариантам настоящего изобретения, процедура, описанная выше со ссылками на логическую схему, может быть реализована в виде программы компьютерного программного обеспечения. Например, один из вариантов настоящего изобретения содержит компьютерный программный продукт для осуществления способа отображения изображения на основе дополненной реальности согласно вариантам способа, описываемых выше. В таком варианте компьютерную программу можно скачать онлайн через устройство 909 связи и инсталлировать, либо ее можно инсталлировать из устройства 908 для хранения информации, либо инсталлировать из ПЗУ (ROM) 902. Когда эту компьютерную программу выполняет устройство 901 обработки, происходит осуществление описываемых выше функций, определяемых способом, предлагаемым вариантами настоящего изобретения.

Необходимо отметить, что читаемый компьютером носитель, описываемый выше в настоящем изобретении, может представлять собой читаемый компьютером носитель сигнала или читаемый компьютером носитель для хранения информации, либо какую-либо комбинацию таких носителей. Например, читаемый компьютером носитель для хранения информации может представлять собой, без ограничений, электрическую, магнитную, оптическую, электромагнитную, инфракрасную или полупроводниковую систему, аппаратуру или устройство, либо какую-либо комбинацию перечисленного. Более конкретные примеры читаемых компьютером носителей для хранения информации могут представлять собой, без ограничений: электрическое соединение, имеющее один или несколько проводов, портативный компьютерный диск, жесткий диск, запоминающее устройство с произвольной выборкой (RAM), постоянное запоминающее устройство (ROM), стираемое программируемое постоянное запоминающее устройство (СППЗУ (EPROM) или устройство флэш-памяти), волоконный световод, постоянное запоминающее устройство на портативном компакт-диске (CD-ROM), оптическое запоминающее устройство, магнитное запоминающее устройство, либо какую-либо подходящую комбинацию таких устройств. Согласно настоящему изобретению, читаемый компьютером носитель для хранения информации может представлять собой какой-либо материальный носитель, содержащий или сохраняющий программу, которая может быть использована посредством или в сочетании с системой, аппаратурой или устройством для выполнения команд. Согласно настоящему изобретению, читаемый компьютером носитель сигнала может содержать сигнал данных, который распространяется в видеодиапазоне, либо в качестве части несущей, и несет читаемые компьютером программные коды. Сигнал данных, распространяющийся таким способом, может принимать различные формы, включая, без ограничений, электромагнитный сигнал, оптический сигнал или какую-либо комбинацию этих сигналов. Читаемый компьютером носитель сигнала может также представлять собой какой-либо читаемый компьютером носитель, отличный от читаемого компьютером носителя для хранения информации. Читаемый компьютером носитель сигнала может посылать, распространять или передавать программу, используемую посредством или в сочетании с системой, аппаратурой или устройством для выполнения команд. Программный код, содержащийся на читаемом компьютером носителе, может быть передан с использованием какого-либо подходящего носителя, включая без ограничений, электрические провода, оптоволоконный кабель, высокочастотный сигнал (radio frequency (RF)), или другого подобного носителя, либо какой-либо подходящей комбинации носителя.

Упомянутый выше читаемый компьютером носитель может быть включен в электронное устройство, рассмотренное выше, или может существовать отдельно, без встраивания в электронное устройство.

Упомянутый выше читаемый компьютером носитель может нести одну или более программ, при выполнении которых электронным устройством, это электронное устройство осуществляет способ, иллюстрируемый в приведенных выше вариантах.

Компьютерные программные коды для осуществления операций согласно настоящему изобретению могут быть записаны на одном или нескольких языках программирования или комбинации таких языков. К указанным языкам программирования относятся объектно-ориентированные языки программирования, такие как Java, Smalltalk и C++, а также обычные языки процедурного программирования, такие как язык “C” или аналогичные языки программирования. Этот программный код может быть выполнен полностью на компьютере пользователя, выполнен частично на компьютере пользователя, выполнен в качестве независимого программного пакета, выполнен частично на компьютере пользователя и частично на удаленном компьютере, либо выполнен полностью на удаленном компьютере или сервере. В сценарии, использующем удаленный компьютер, этот удаленный компьютер может быть соединен с компьютером пользователя через сеть какого-либо типа, включая локальную сеть связи (local area network (LAN)) или широкомасштабную сеть связи (wide area network (WAN)), либо может быть соединен с внешним компьютером (например, соединен через Интернет от интернет-провайдера).

Логические схемы и блок-схемы на прилагаемых чертежах иллюстрируют системные архитектуры, функции и операции, которые могут быть реализованы посредством системы, способа и компьютерных программных продуктов в соответствии с различными вариантами настоящего изобретения. В этом отношении каждый блок в логических схемах или блок-схемах может представлять модуль, сегмент программы или часть кода, где эти модуль, сегмент программы или часть кода содержат одну или несколько выполняемых команд для осуществления специфицированных логических функций. Также следует отметить, что, в некоторых альтернативных вариантах реализации функции, маркированные в блоках, могут также осуществляться в порядке, отличном от порядка, обозначенного на прилагаемых чертежах. Например, два последовательных блока могут фактически быть выполнены по существу параллельно, а иногда могут выполняться в обратном порядке, что зависит от участвующих функций. Следует также отметить, что каждый блок в логических схемах и/или в блок-схемах и комбинации блоков в логических схемах и/или блок-схемах могут быть реализованы посредством системы на основе специализированной аппаратуры для выполнения специфицированных функций или операций, либо могут быть реализованы посредством комбинации специализированной аппаратуры и компьютерных команд.

Различные модули, описываемые в вариантах настоящего изобретения, могут быть реализованы посредством программного обеспечения или могут быть реализованы в аппаратуре. Название любого модуля не составляет ограничений для самого модуля. Например, первый модуль сбора данных может также быть описан как «модуль для получения по меньшей мере двух адресов Интернет-протокола».

Функции, описываемые выше для настоящего изобретения, могут быть осуществлены по меньшей мере частично посредством одного или нескольких аппаратных логических компонентов. Например, без ограничений, к примерам аппаратных логических компонентов, которые могут быть использованы, относятся: программируемая пользователем вентильная матрица (field programmable gate array (FPGA)), специализированная интегральная схема (application specific integrated circuit (ASIC)), стандартное изделие, ориентированное на приложения (application specific standard product (ASSP)), система на кристалле (system on chip (SOC)), комплексное программируемое логическое устройство (complex programmable logic device (CPLD)) и другие подобные компоненты.

В контексте настоящего изобретения, машиночитаемый носитель может представлять собой материальный носитель, который может содержать или сохранять программу для использования посредством или в сочетании с системой, аппаратурой или устройством для выполнения команд. Указанный машиночитаемый носитель может представлять собой машиночитаемый носитель сигнала или машиночитаемый носитель для хранения информации. Машиночитаемый носитель может представлять собой без ограничений электронную, магнитную, оптическую, электромагнитную, инфракрасную или полупроводниковую систему, аппаратуру или устройство, либо какую-либо подходящую комбинацию таких носителей. К более конкретным примерам машиночитаемых носителей для хранения информации могут относиться: электрическое соединение на основе одного или нескольких проводов, портативный компьютерный диск, жесткий диск, запоминающее устройство с произвольной выборкой (RAM), постоянное запоминающее устройство (ROM), стираемое программируемое постоянное запоминающее устройство (СППЗУ (EPROM) или устройство флэш-памяти), волоконный световод, постоянное запоминающее устройство на портативном компакт диске (CD-ROM), оптическое запоминающее устройство, магнитное запоминающее устройство, либо какая-либо подходящая комбинация таких устройств.

В первом аспекте, согласно одному или нескольким вариантам настоящего изобретения, предложен способ отображения изображения на основе дополненной реальности, содержащий: осуществление сегментации объектов с целью выделения целевого объекта в изображении сцены в реальном времени, захваченном модулем для получения изображений, чтобы получить изображение целевого объекта; генерирование виртуального изображения, соответствующего целевому объекту, на основе изображения целевого объекта; и отображение виртуального изображения в изображении сцены в реальном времени на основе технологии отображения дополненной реальности.

Согласно одному или нескольким вариантам настоящего изобретения, процедура генерирования виртуального изображения, соответствующего целевому объекту, на основе изображения целевого объекта содержит: синтез изображения целевого объекта с анимационным материалом для генерирования виртуального изображения, соответствующего целевому объекту. Предварительно заданный анимационный материал содержит анимационный материал конечностей относительно тела и/или анимационный материал мимики виртуального изображения.

Согласно одному или нескольким вариантам настоящего изобретения, процедура синтеза изображения целевого объекта с анимационным материалом содержит: получение анимационного материала конечностей относительно тела и/или анимационного материала мимики; определение нескольких соединительных точек на изображении целевого объекта на основе изображения целевого объекта; и синтез анимационного материала конечностей относительно тела и/или анимационного материала мимики с изображением целевого объекта посредством указанных нескольких соединительных точек для генерирования виртуального изображения, соответствующего целевому объекту.

Согласно одному или нескольким вариантам настоящего изобретения, процедура осуществления сегментации объектов с целью выделения целевого объекта в изображении сцены в реальном времени, захваченном модулем для получения изображений, чтобы получить изображение целевого объекта, содержит: выполнение алгоритма сегментации объектов для осуществления сегментации объектов с целью выделения целевого объекта в изображении сцены в реальном времени, получая тем самым маску и ограничивающую рамку изображения целевого объекта и получая текстуру внутренней области маски.

Согласно одному или нескольким вариантам настоящего изобретения, процедура синтеза анимационного материала конечностей относительно тела и/или анимационного материала мимики с изображением целевого объекта посредством указанных нескольких соединительных точек для генерирования виртуального изображения, соответствующего целевому объекту, содержит: синтез анимационного материала конечностей относительно тела и/или анимационного материала мимики с текстурой внутренней области маски посредством указанных нескольких соединительных точек для генерирования виртуального изображения, соответствующего целевому объекту.

Согласно одному или нескольким вариантам настоящего изобретения, способ далее содержит: регулирование размера анимационного материала на основе размера ограничительной рамки; и регулирование позиций указанных нескольких соединительных точек на изображении целевого объекта на основе оси симметрии и отношения длины к ширине ограничительной рамки.

Согласно одному или нескольким вариантам настоящего изобретения, способ далее содержит: воспроизведение анимационного материала для осуществления управления движениями и/или мимикой на виртуальном изображении.

Согласно одному или нескольким вариантам настоящего изобретения, процедура воспроизведения анимационного материала для осуществления управления движениями и/или мимикой на виртуальном изображении содержит: воспроизведение анимационного материала в соответствии с предварительно заданными анимационными кадрами анимационного материала для осуществления управления движениями и/или мимикой на виртуальном изображении; и/или генерирование и воспроизведение анимационных кадров анимационного материала на основе движений конечностей пользователя относительно тела и/или мимики пользователя, для осуществления управления движениями и/или мимикой на виртуальном изображении.

Согласно одному или нескольким вариантам настоящего изобретения, процедура отображения виртуального изображения в изображении сцены в реальном времени на основе технологии отображения дополненной реальности содержит: создание виртуальной плоскости в изображении сцены в реальном времени; генерирование трехмерного пространства на виртуальной плоскости; и отображение виртуального изображения целевого объекта в трехмерном пространстве, сформированном на основе технологии отображения дополненной реальности.

Согласно одному или нескольким вариантам настоящего изобретения, процедура создания виртуальной плоскости на основе целевой области плоскости в изображении сцены в реальном времени содержит: создание виртуальной плоскости на основе целевой области плоскости в случае обнаружения, что целевая область плоскости существует в изображении сцены в реальном времени, где эта целевая область плоскости представляет собой область плоскости, имеющую расстояние до модуля для получения изображений в пределах первого заданного диапазона расстояний, и/или область плоскости, расположенную в центральной области изображения сцены в реальном времени; либо создание виртуальной плоскости в конкретной позиции в изображении сцены в реальном времени.

Согласно одному или нескольким вариантам настоящего изобретения, процедура отображения виртуального изображения целевого объекта в трехмерном пространстве, сформированном на основе технологии отображения дополненной реальности, содержит: определение целевой позиции в трехмерном пространстве; и отображение виртуального изображения целевого объекта в целевой позиции в трехмерном пространстве на основе технологии отображения дополненной реальности.

Согласно одному или нескольким вариантам настоящего изобретения, процедура определения целевой позиции в трехмерном пространстве содержит: прием команды, специфицирующей позицию, от пользователя, установление трехмерной анкерной точки в трехмерном пространстве на основе позиционной точки, обозначенной командой, специфицирующей позицию, от пользователя, и использование этой трехмерной анкерной точки в качестве целевой позиции.

Согласно одному или нескольким вариантам настоящего изобретения, предлагаемый способ далее содержит: прием первой команды управления от пользователя, и выполнение алгоритма сегментации объектов, предварительно загруженного в соответствии с этой первой командой управления, для осуществления сегментации объектов с целью выделения целевого объекта в изображении сцены в реальном времени; а также прием второй команды управления от указанного пользователя и остановку работы алгоритма сегментации объектов в соответствии с этой второй командой управления.

Согласно одному или нескольким вариантам настоящего изобретения, процедура отображения виртуального изображения в изображении сцены в реальном времени содержит: динамическое отображение виртуального изображения в изображении сцены в реальном времени.

Во втором аспекте, согласно одному или нескольким вариантам настоящего изобретения, предложено устройство отображения на основе дополненной реальности, содержащее: модуль определения целевого объекта, конфигурированный для осуществления сегментации объектов с целью выделения целевого объекта в изображении сцены в реальном времени, захваченном модулем для получения изображений, для получения изображения целевого объекта; модуль генерирования, конфигурированный для генерирования виртуального изображения, соответствующего целевому объекту, на основе изображения целевого объекта; и модуль отображения, конфигурированный для отображения виртуального изображения в изображении сцены в реальном времени на основе технологии отображения дополненной реальности.

Согласно одному или нескольким вариантам настоящего изобретения, модуль генерирования, при генерировании виртуального изображения, соответствующего целевому объекту, на основе изображения целевого объекта, конфигурирован для: синтеза изображения целевого объекта с анимационным материалом с целью генерирования виртуального изображения, соответствующего целевому объекту.

Предварительно заданный анимационный материал представляет собой анимационный материал конечностей относительно тела и/или анимационный материал мимики для виртуального изображения.

Согласно одному или нескольким вариантам настоящего изобретения, модуль генерирования, при синтезе изображение целевого объекта с анимационным материалом, конфигурирован для: получения анимационного материала конечностей относительно тела и/или анимационного материала мимики; определения нескольких соединительных точек на изображении целевого объекта на основе изображения целевого объекта; и синтеза анимационного материала конечностей относительно тела и/или анимационного материала мимики с изображением целевого объекта посредством указанных нескольких соединительных точек для генерирования виртуального изображения, соответствующего целевому объекту.

Согласно одному или нескольким вариантам настоящего изобретения, модуль определения целевого объекта, при осуществлении сегментации объектов с целью выделения целевого объекта в изображении сцены в реальном времени, захваченном модулем для получения изображений, для получения изображения целевого объекта, конфигурирован для: выполнения алгоритма сегментации объектов для осуществления сегментации объектов с целью выделения целевого объекта в изображении сцены в реальном времени, получая тем самым маску и ограничивающую рамку изображения целевого объекта и получая текстуру внутренней области маски.

Согласно одному или нескольким вариантам настоящего изобретения, модуль генерирования, при синтезе анимационного материала конечностей относительно тела и/или анимационного материала мимики с изображением целевого объекта посредством нескольких соединительных точек для генерирования виртуального изображения, соответствующего целевому объекту, конфигурирован для: синтеза анимационного материала конечностей относительно тела и/или анимационного материала мимики с текстурой внутренней области маски посредством указанных нескольких соединительных точек для генерирования виртуального изображения, соответствующего целевому объекту.

Согласно одному или нескольким вариантам настоящего изобретения, модуль генерирования далее конфигурирован для: регулирования размера анимационного материала на основе размера ограничительной рамки; и регулирования позиций указанных нескольких соединительных точек на изображении целевого объекта на основе оси симметрии и отношения длины к ширине ограничительной рамки.

Согласно одному или нескольким вариантам настоящего изобретения, модуль отображения далее конфигурирован для: воспроизведения анимационного материала с целью осуществления управления движениями и/или мимикой на виртуальном изображении.

Согласно одному или нескольким вариантам настоящего изобретения, модуль отображения, при воспроизведении анимационного материала для осуществления управления движениями и/или мимикой на виртуальном изображении конфигурирован для: воспроизведения анимационного материала в соответствии с предварительно заданными анимационными кадрами анимационного материала для осуществления управления движениями и/или мимикой на виртуальном изображении; и/или генерирования и воспроизведения анимационных кадров анимационного материала на основе движений конечностей пользователя относительно его тела и/или мимики этого пользователя, для осуществления управления движениями и/или мимикой на виртуальном изображении.

Согласно одному или нескольким вариантам настоящего изобретения, модуль отображения, при отображении виртуального изображения в изображении сцены в реальном времени на основе технологии отображения дополненной реальности, конфигурирован для: создания виртуальной плоскости в изображении сцены в реальном времени; генерирования 3D-пространства на этой виртуальной плоскости; и отображения виртуального изображения целевого объекта в сформированном 3D-пространстве на основе технологии отображения дополненной реальности.

Согласно одному или нескольким вариантам настоящего изобретения, модуль отображения, при создании виртуальной плоскости на основе целевой области плоскости в изображении сцены в реальном времени, конфигурирован для: создания виртуальной плоскости на основе целевой области плоскости в случае обнаружения, что эта целевая область плоскости существует в изображении сцены в реальном времени, где эта целевая область плоскости представляет собой область плоскости, имеющую расстояние до модуля для получения изображений в пределах первого заданного диапазона расстояний, и/или область плоскости, расположенную в центральной области изображения сцены в реальном времени; либо создания виртуальной плоскости в конкретной позиции в изображении сцены в реальном времени.

Согласно одному или нескольким вариантам настоящего изобретения, модуль отображения, при отображении виртуального изображения целевого объекта в сформированном 3D-пространстве на основе технологии отображения дополненной реальности, конфигурирован для определения целевой позиции в 3D-пространстве; и отображения виртуального изображения целевого объекта в целевой позиции в 3D-пространстве на основе технологии отображения дополненной реальности.