Область техники

Изобретение относится к способам и устройствам автоматического переключения режимов работы камеры (далее, как переключения камеры) при фиксации камеры на объекте в зависимости от расстояния до объекта, и может использоваться, в частности, для фото- и видеосъемки камерами смартфонов, а также в планшетных компьютерах под управлением операционных сиcтем Android, iOS, HarmonyOS и подобных системах, а также в других подобных устройствах, в которых имеется потребность к обеспечению автоматического переключения режимов работы камеры.

Описание предшествующего уровня техники

В уровне техники известно множество способов переключения режимов работы камер, используемых в настоящее время известными производителями фото- и видеотехники, в частности переключение, например, режимов работы цифровой камеры может осуществляться вручную самим пользователем камеры. В ряде случае обеспечение автоматического переключения режима камеры требует наличия специализированного оборудования, такого как лазерные/инфракрасные/радио-датчики движения, радары, лидары. При этом необходимо учитывать время, требуемое для переключения режимов работы камеры, и потребляемую мощность.

При этом следует отметить, что для съемки целевого объекта, находящегося на расстоянии от пользователя камеры, используется мультикамерная система, куда входят несколько камер, которые могут переключаться между собой. Эти камеры могут быть с более близкими расстояниями для фокусировки (макрокамера, ближняя камера), т.е. камеры для работы на небольшом расстоянии от целевого объекта и с более дальними (дальняя камера, теле-фото камера), т.е. камера для работы на большом расстоянии от целевого объекта. Мы будем рассматривать мультикамерную систему с по меньшей мере двумя камерами, которые отличаются между собой расстояниями для фокусировки. Камеру с более близким расстоянием для фокусировки мы назовем ближней камерой. А с более далеким - дальней. Переключение между камерами (ближней и дальней) в мультикамерной системе назовем переключением режимов на режим ближней и дальней съемки, соответственно.

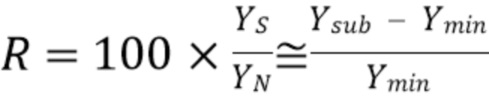

Для понимания проблемы, решаемой настоящим изобретением, рассмотрим типичные случаи переключения режимов работы камеры, таких как режим очень дальней съемки (телефото-камера), режим дальней съемки и режим ближней съемки, проиллюстрированные на фиг.1A, 1B, 2A, 2B и 3A, 3B:

1) переключение с режима дальней съемки (широкоугольная камера) на режим очень дальней съемки (телефото-камеру) и обратно при съемке объекта, находящегося на значительном расстоянии (см. фиг.1A, 1B),

2) переключение с режима дальней съемки (широкоугольная камера) на режим ближней съемки (сверхширокоугольная камера) и обратно при съемке объекта, находящегося на близком расстоянии, или при необходимости захвата большей части объекта или сцены целиком (см. фиг.2A, 2B),

3) переключение с режима очень дальней съемки (телефото-камеры) на режим дальней съемки (широкоугольная камера) и обратно, и с режима дальней съемки (широкоугольная камера) на режим ближней съемки (сверхширокоугольная камера) и обратно при съемке объекта, находящегося в фокусе или вне фокуса, на близком расстоянии или удаленно от пользователя в зависимости от требований пользователя (см. фиг.3A, 3B).

Следует отметить, что режим переключения с режима дальней съемки на режим ближней съемки и обратно наилучшим образом поддается автоматизации и более востребован у конечного пользователя.

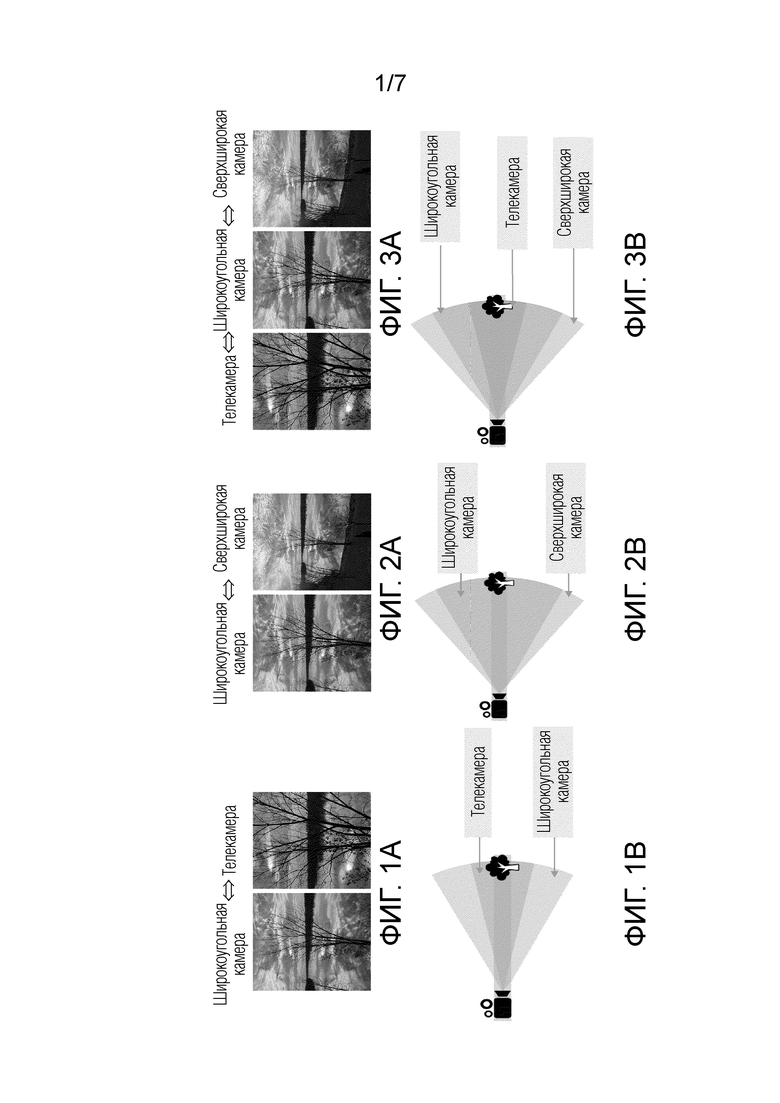

При этом решение об автоматическом переключении камеры в различных методах принимается путем использования дополнительной информации, полученной на основании расчетов и измерений, описанных ниже (1), (2) и (3).

(1) Одним из видов такой информации, на основании которого принимается решение о переключении камеры, является диспарантность (1), используемая для вычисления карты глубины сцены. При этом диспарантность (рассогласование или мера расфокусировки сцены), в общем виде, вычисляется на основании двух совпадающих изображений одной и той же сцены, снятых с двух разных углов, например, с помощью камеры по технологии dual pixel или стереокамеры. На фиг.4A представлена сцена, подлежащая съемке с помощью камеры, а на фиг.4B представлена карта глубины сцены с фиг.4A, на основании которой принимается решение о переключении камеры.

(2) Кроме того, для принятия решения о переключении камеры также используются данные движения (2) на сцене и последовательные изображения (кадры) с камеры, используемые для определения направлений целевого объекта и построения поля векторов, при этом по направлению и скорости объекта можно рассчитать необходимый момент времени для переключения линз камеры для повышения качества фото и/или видеосъемки. Кроме того, для компенсации движения камеры во время съемки на основании начального положения и направления камеры могут быть использованы данные текущего положения и направления камеры, получаемые, например, от акселерометра, гироскопа, магнитометра и других датчиков движения, как правило встроенных в смартфоны. На фиг.5A представлена сцена, подлежащая съемке с помощью камеры, а на фиг.5B представлено поле векторов движения сцены с фиг.5A, на основании которого принимается решение о переключении камеры.

(3) Для принятия решения о переключении камеры также могут быть использованы данные о глубине сцены (3), получаемые от лазерных, в том числе инфракрасных сенсоров, таких как времяпролетные (Time-of-Flight(ToF)) сенсоры или лидары (LiDAR), основанные на технологии измерения расстояния путем излучения света лазером или светодиодом и замера времени возвращения отраженного света на приемник. На фиг.6A представлена сцена, подлежащая съемке с помощью камеры, а на фиг.6B представлено дальностное изображение сцены, с фиг.6A, на основании которой принимается решение о переключении камеры.

Заявители изучили множество подобных решений на рынке и выявили основные проблемы, которые необходимо решить в новом способе и устройстве автоматического переключения режимов камеры.

Традиционные решения для автоматического переключения режимов камеры требуют значительное время для обработки и/или вычисления информации, вплоть до секунды, что приводит в свою очередь к задержке процесса инициализации переключения камеры и, соответственно, к снижению качества изображения, получаемого при съемке камерой.

Одной из задач заявленного изобретения является значительное сокращение времени на переключение камеры, которые должно быть практически мгновенным и занимать несколько миллисекунд, чтобы пользователь не заметил процесс переключения.

Кроме того, в известных решениях для автоматического переключения режимов камеры часто возникают ошибки переключения режимов при съемке объекта, например, при съемке объекта через оконное стекло или витрину, когда используемые сенсоры ошибочно распознают стекло в качестве объекта, что инициирует некорректное переключение камеры и приводит к снижению качества изображения, получаемого при съемке камерой. Авторы изобретения устраняют этот недостаток известного уровня техники посредством введения дополнительной информации об объекте в качестве входных данных, частности, карты глубины и поля векторов движения сцены, содержащей объект, для принятия решения о переключении режима камеры.

Кроме того, известные способы и устройства переключения камеры зачастую включают специальное оборудование, например, различные лазерные сенсоры, включая инфракрасные сенсоры, такие, как времяпролетные (ToF) сенсоры или лидары (LiDAR), которые встраиваются в камеры, что требует значительного расхода энергии и существенно повышает стоимость устройства. Однако такое энергопотребление совершенно неприемлемо для смартфонов. Задачей заявленного способа и устройства является также снижение энергопотребления.

Задачей заявленного способа и устройства является создание легкого, компактного, точного устройства, позволяющего автоматически переключать режимы работы камеры, предпочтительно переключать камеру между режимами дальней и ближней съемки, когда расстояние между камерой и целевым объектом превышает предварительно определенное пороговое значение, на основании информации о глубине и положении целевого объекта, полученной посредством определения диспарантности и данных отслеживания целевого объекта на сцене, а также данных, учитывающих движение на интересующей сцене, включающей целевой объект (в частности, поля векторов движения). Кроме того, в заявленном решении могут использоваться дополнительные данные о движении, полученные от акселерометра, гироскопа, датчиков глубины или других сенсоров для получения более точной оценки положения целевого объекта при принятии решения о переключении. В случае необходимости экономии или отсутствия таких сенсоров, или необходимости минимизации энергопотребления подобные сенсоры могут быть не использованы, а качество решения ухудшится незначительно. Таким образом, решение является гибким и устойчивым.

Из уровня техники известна система мобильной камеры US20160007008A1(патентообладатель Apple Inc.), IPC: G03B 13/34, H04N 13/02, опубл. 07.01.2016г., в которой раскрыт способ автофокусировки на основе данных о глубине и содержит получение двух изображений одной и той же сцены от двух различных камер с различными диапазонами фокусного расстояния, в частности, дальней камеры и телефото-камеры. После получения от пользователя информации о желаемом фокусе на сцене, например, при касании экрана, выполняется плавный переход путем совмещения кадров, полученных посредством линзы дальней камеры и телефото-линзы.

Недостатки указанного решения заключаются в необходимости непосредственного участия пользователя для управления камерой. При этом указанный способ съемки может использоваться только для фото- и видеосъемки в режиме приближения.

В публикации WO2020073959A1(патентообладатель Huawei Technologies Co Ltd.), IPC H04N 5/232, опубл. 16.04.2020 г., раскрыт способ и электронное устройство захвата изображения. Способ основан на получении информации о расстоянии от датчика расстояния (т. е. лазерного и/или инфракрасного датчика). Далее, полученная информация о расстоянии обрабатывается и анализируется для определения подходящего фокусного расстояния и последующего выбора одного из режимов: режим очень дальней съемки (телефото-камеры), режим дальней съемки или ближней съемки.

Недостатки данного решения заключаются в следующем: для работы необходим дополнительный датчик расстояния, включение которого в устройство значительно увеличивает стоимость его производства; кроме того, требуется непосредственное участие пользователя для установления фокуса на целевом объекте.

В US11218641B2 (патентообладатель Qualcomm Inc.), опубл.04.01.2022, IPC H04N 5/225, H04N 5/232 раскрыт способ и устройства захвата данных изображения. Способ основан на расчете коэффициента масштабирования и объединении пикселей.

Когда запрошенный пользователем коэффициент масштабирования изображения и/или необходимое для этого объединение пикселей превышает пороговое значение для переключения камеры, выполняется переключение между камерами с разными коэффициентами оптического масштабирования и/или разными фокусными расстояниями, т.е. между режимами очень дальней съемки, дальней съемки и ближней съемки. Этот способ выполняется вручную и не обеспечивает автоматическое переключение режима камеры, поскольку установление фокуса на целевом объекте выполняется по требованию пользователя и далее выполняется процесс переключения режима камеры.

Наиболее близким техническим решением заявленного изобретения является способ переключения фотокамеры и устройство цифровой фотокамеры, раскрытые в патенте US10,291,842B2 (патентообладатель Samsung Electronic Co Ltd), IPC G06T7/00; H04N 5/225, опубл. 14.05.2014г. Способ основан на получении изображений с помощью дальней камеры и очень дальней камеры (телекамеры), вычислении карты глубины путем сопоставления стереоданных, и использовании карты глубины для получения информации о движении. На основе полученной информации о движении и рассчитанной скорости целевого объекта инициируется переключение между дальней камерой и очень дальней камерой (телекамерой).

Недостатками данного решения является то, что способ может использоваться исключительно для фото- и видеосъемки в режиме приближения; кроме того, две камеры, работающие одновременно, увеличивают энергопотребление устройства в целом.

Все вышеуказанные решения не обеспечивают современные требования, диктуемые электронными портативными устройствами со встроенными камерами для захвата видео/фото. При этом в современных электронных устройствах очень трудно совместить требования к компактности устройства, позволяющие использовать его в мобильных телефонах, с одновременным сохранением качества захватываемого изображения в реальном времени, что обеспечивается автоматическим переключением режимов камеры.

Для наглядности преимуществ заявленного способа и устройства автоматического переключения режимов работы камеры далее приведен сопоставительный анализ функциональностей заявленного технического решения и известных технических решений, описанных выше.

Заявленное изобретение характеризуется следующим:

1) обеспечивает переключение камеры из режима дальней съемки в режим ближней съемки и обратно, также может быть использовано для автоматического переключения с режима теле-фотокамеры в режим дальней съемки при потере целевого объекта. Также изобретение может быть использовано для переключения из режима дальней и/или близкой съемки в режим очень близкой съемки (макросъемки) и обратно

2) требуются стереоданные и данные изображения,

3) управление камерой непосредственно пользователем не требуется,

4) способ, согласно изобретению, использует данные глубины и информацию поля векторов движения сцены, содержащей целевой объект.

5) другие данные, например, данные с различных сенсоров (ToF, LiDAR, UWB, акселерометр, гироскоп и другие), могут быть использованы для улучшения точности, но не являются необходимыми.

US 10,291,842 B2 (патентообладатель Samsung Electronics Co Ltd) (прототип)

1) обеспечивает переключение камеры из режима дальней съемки в режим телефото-камеры и обратно,

2) требуются стереоданные от режима дальней съемки и телефото-камеры,

3) управление камерой непосредственно пользователем не требуется,

4) в способе используется информация о движении целевого объекта, получаемая на основании данных глубины.

US20160007008A1(патентообладатель Apple Inc.)

1) обеспечивает переключения камеры из режима дальней съемки в режим телефото-камеры и обратно,

2) требуются стереоданные от режима дальней съемки и телефото-камеры,

3) управление камерой непосредственно пользователем требуется при инициировании переключения режима камеры,

4) в способе используются данные о глубине сцены.

WO2020073959A1(патентообладатель Huawei Technologies Co Ltd.)

1) обеспечивает переключения камеры из телефото-камеры в режим дальней съемки и в режим ближней съемки и обратно,

2) требуются данные от датчика расстояния до целевого объекта,

3) управление камерой непосредственно пользователем требуется при инициировании переключения режима камеры,

4) используются данные сенсоров (лазерные и/или инфракрасные сенсоры).

US11218641B2 (патентообладатель Qualcomm Inc.)

1) обеспечивает переключения камеры из телефото-камеры в режим дальней съемки (широкоугольная камера)и в режим ближней съемки (сверхширокоугольная камера) и обратно,

2) требуются стереоданные от широкоугольной камеры, сверхширокоугольной и телефото-камеры,

3) управление камерой непосредственно пользователем требуется при инициировании переключения режима камеры,

4) используются вычисления коэффициента масштабирования.

Сущность изобретения

Согласно первому аспекту изобретения предлагается способ автоматического переключения режимов работы камеры, содержащий следующие этапы, при которых:

- предварительно захватывают изображение сцены, включающей целевой объект, подлежащий отслеживанию, в одном из: режимов ближней, дальней съемки,

- по выбору, обеспечивают получение данных по меньшей мере одного из: сенсоров глубины, сенсоров движения,

- обеспечивают получение по меньшей мере одного из: стереоданных, данных изображения по меньшей мере в двух последовательных кадрах в одном из режима: ближней съемки, режима дальней съемки,

при получении стереоданных:

- определяют диспарантность Dk сцены, включающей целевой объект, захваченной камерой, на основании полученных стереоданных в определенный момент времени для каждого текущего кадра,

- определяют меру уверенности R1 полученной диспарантности Dk на основании полученных стерео данных,

- определяется расстояние d1 от камеры до целевого объекта на основании определенной диспарантности Dk для текущего кадра

при получении данных изображения:

- сравнивают данные изображения по меньшей мере двух последовательных кадров и на основании сравнения указанных данных изображения, вычисляют поле векторов движения на сцене, включающей целевой объект, захваченной камерой,

- вычисляют по меньшей мере один из: коэффициент сдвига, коэффициент поворота, коэффициент масштабирования сцены, на основании вычисленного поля векторов движения сцены,

- по выбору, инициализируют средство отслеживания для целевого объекта для текущего кадра, осуществляют отслеживание целевого объекта на последующих кадрах, и вычисляют коэффициент масштабирования ограничивающего прямоугольника камеры с находящимся в нем целевым объектом в процессе отслеживания для каждого кадра,

- определяют выход целевого объекта из кадра, и в случае если выход целевого объекта из кадра не выявлен:- определяют расстояние d2 от камеры до целевого объекта на основании коэффициента масштабирования, полученного на основании вычисленного поля векторов движения,

- определяют меру уверенности R2 расстояния d2 от камеры до целевого объекта,

- при получении данных с сенсоров глубины: определяют расстояние d3 от камеры до целевого объекта на основании данных глубины c помощью сенсоров глубины, и определяют меру уверенности R3 расстояния d3 на основании данных глубины c помощью сенсоров глубины,

- при получении данных с сенсоров движения: определяют расстояние d4 от камеры до целевого объекта на основании данных сенсоров движения и определяют меру уверенности R4 расстояния d4 на основании данных сенсоров движения,

- при инициализации средства отслеживания: определяют расстояние d5 от камеры до целевого объекта на основании вычисленного коэффициента масштабирования ограничивающего прямоугольника с находящимся в нем целевым объектом,

- при инициализации средства отслеживания: определяют меру уверенности R5 расстояния d5 от камеры до целевого объекта на основании вычисленного коэффициента масштабирования ограничивающего прямоугольника с находящимся в нем целевым объектом, и

- выполняют гибридную оценку расстояния от камеры до целевого объекта в текущем кадре на основании полученных значений расстояния d1, d2, d3, d4, d5 от камеры до целевого объекта и мер уверенности R1, R2, R3, R4, R5, и определяется скорректированное расстояние dh от камеры до целевого объекта в текущем кадре,

- принимают решение о переключении камеры в режим ближней съемки или в режим дальней съемки на основании скорректированного расстояния dh.

При этом, в заявленном способе, при нахождении камеры в режиме дальней съемки, если полученное скорректированное расстояние dh меньше предварительно определенного порогового значения принимают решение о переключении камеры в режим ближней съемки, а

при нахождении камеры в режиме в ближней съемки, если полученное скорректированное расстояние dh больше предварительно определенного порогового значения принимают решение о переключении камеры в режим дальней съемки.

При этом в способе данные изображения представляют собой одно из: RGB, YUV и CMYK данных, а стереоданные получают посредством PDAF сенсоров матрицы камеры с технологией Dual Pixel, при этом

значение диспарантности Dk для выбранного целевого объекта в текущем кадре определяется посредством PDAF данных, полученных матрицей сенсоров камеры, как локальный минимум SAD кривой, а

для определения диспарантности Dk для выбранного целевого объекта в текущем кадре на основе полученных PDAF данных, представляющих собой правое и левое изображение целевого объекта, полученных матрицей сенсоров камеры, рассчитывается сумма абсолютных различий, как абсолютная разность между пикселями левого и правого изображений, на основе которых строятся SAD кривые.

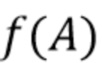

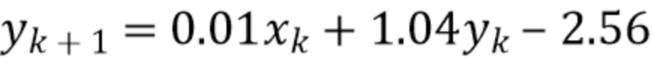

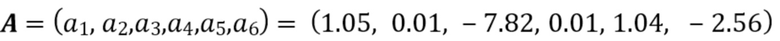

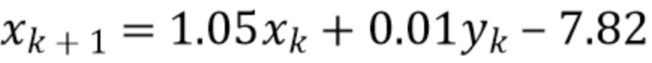

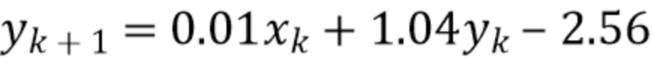

Согласно заявленному способу, скорректированное расстояние dh определяется на основании полученных значений расстояниЙ d1, d2, d3, d4, d5 от камеры до целевого объекта и мер уверенности R1, R2, R3, R4, R5 для текущего кадра из выражения согласно выражению:

dh=d1 * R1 + d2 * R2 + d3 * R3 + d4 * R4 + d5 * R5

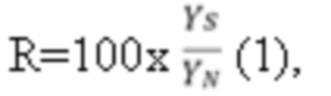

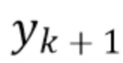

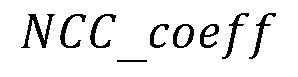

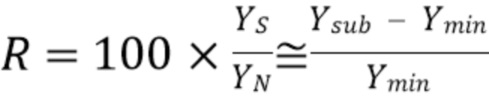

При этом мера уверенности R1 для текущего кадра рассчитывается на основании данных SAD кривых и определяется из выражения:

R1 ,

,

где  - уровень сигнала,

- уровень сигнала,  - уровень шума,

- уровень шума,  - глобальный минимум и

- глобальный минимум и  - подминимум SAD кривой.

- подминимум SAD кривой.

Кроме того, мера уверенности R2 для текущего кадра рассчитывается на основе данных поля векторов, и последующего аффинного преобразования поля векторов, а мера уверенности R3 для текущего кадра характеризует аппроксимацию соотношения сигнал/шум, полученного на основании данных сенсора глубины и определяется из выражения:

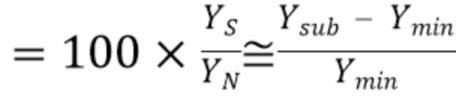

R3=100x ,

,

где R3 - мера уверенности, YS - уровень сигнала, YN - уровень шума.

Согласно способу, мера уверенности R4 для текущего кадра характеризует аппроксимацию соотношения сигнал/шум, полученного на основании данных по меньшей мере одного сенсора движения и

определяется из выражения:

R4=100x ,

,

где R4 - мера уверенности, YS - уровень сигнала, YN - уровень шума.

При этом, согласно способу, мера уверенности R5 рассчитывается на основе результатов работы средства отслеживания.

Кроме того, в заявленном способе:

- расстояние d1 от камеры до целевого объекта определяют на основании определенной диспарантности Dk для текущего кадра,

- расстояние d2 от камеры до целевого объекта определяют на основании определенного коэффициента масштабирования для текущего кадра,

- расстояние d3 от камеры до целевого объекта определяют на основании данных глубины c помощью сенсоров глубины, и расстояние d4 от камеры до целевого объекта определяют на основании данных движения c помощью сенсоров движения,

- расстояние d5 от камеры до целевого объекта определяется на основании коэффициента масштабирования ограничивающего прямоугольника с находящимся в нем целевым объектом.

При этом, согласно способу, вычисляют коэффициент масштабирования ограничивающего прямоугольника на экране камеры с находящейся в нем целевым объектом для текущего кадра k, как соотношение размеров ограничивающего прямоугольника текущего кадра и предыдущего кадра.

В заявленном способе, дополнительно, по выбору, определяют предварительно определенные случаи работы камеры, при захвате целевого объекта в текущем кадре, при этом к указанным случаям относятся по меньшей мере одно из: целевой объект представляет собой прозрачный объект, целевой объект представляет собой отражающий объект, съемка целевого объекта, находящегося за стеклом, низкая освещенность или эффект белой стены, когда камера смотрит на однородный фон, локальные перемещения объекта при неподвижном заднем фоне, поворот или дрожание камеры.

При работе камеры в режиме дальней съемки или в режиме ближней съемки, вычисление по меньшей мере одного из: коэффициента сдвига, коэффициента поворота, коэффициента масштабирования сцены, выполняется на основе аффинного преобразования вычисленного поля векторов движения сцены, кроме того, при работе камеры в режиме дальней съемки, определяют меру уверенности R2 расстояния d2 от камеры до целевого объекта на основании на основании вычисленного поля векторов движения сцены и аффинного преобразования этого поля векторов.

Кроме того, при работе камеры в режиме ближней съемки, при инициализации средства отслеживания, если ограничивающий прямоугольник, включающий целевой объект, выходит за границы текущего кадра, устанавливается потеря целевого объекта в текущем кадре, и при установлении потери целевого объекта в текущем кадре, принимается решение о переключении камеры в режим дальней съемки.

При этом, после установления потери целевого объекта в текущем кадре: дополнительно определяется расстояние d1 от камеры до целевого объекта на основании определенной диспарантности Dk для текущего кадра, и дополнительно определяют расстояние d3 от камеры до целевого объекта на основании данных глубины c помощью сенсоров глубины для текущего кадра.

Согласно первому аспекту изобретения в способе, при работе камеры в режиме ближней съемки, дополнительно определяют расстояние dh после установления потери целевого объекта в текущем кадре с учетом дополнительно определенных расстояний d1 и/или d3.

При этом, если полученное расстояние dh после установления потери целевого объекта в кадре меньше предварительно определенного порогового значения, принимается решение о сохранении режима ближней съемки и выполняют переход на следующий кадр, и, если полученное расстояние dh после установления потери целевого объекта в кадре больше или равно предварительно определенного порогового значения, принимается решение о переключении камеры в режим дальней съемки.

Кроме того, согласно способу, также вычисляют по меньшей мере один из: коэффициента сдвига, коэффициента поворота, коэффициент масштабирования сцены, посредством применения модели аффинного преобразования к вычисленному полю векторов.

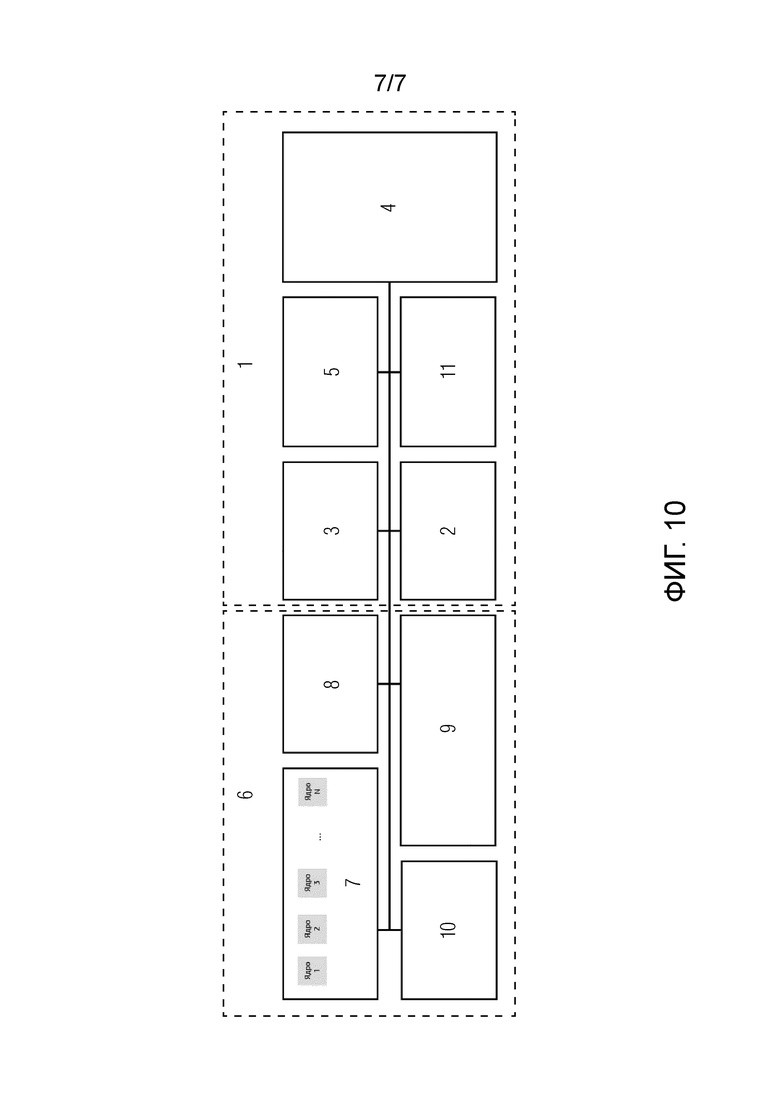

Согласно второму аспекту изобретения предлагается устройство автоматического переключения режимов работы камеры, содержащее:

- блок ввода-вывода, включающий графический процессор, дисплей, камеру, блок интерфейса ввода-вывода,

- блок вычислений, содержащий центральный процессор, контроллер памяти, системную память и накопитель,

при этом камера представляет собой мультикамерную систему, включающую фото и/или видеокамеру, и содержащую блок формирования изображения, содержащий линзу ближней съемки и линзу дальней съемки, и матрицу сенсоров, при этом камера выполнена с возможностью захвата целевого объекта и передачи данных изображения целевого объекта в системную память блока вычислений через блок интерфейса ввода-вывода,

блок вычислений выполнен с возможностью реализации этапов способа согласно первому аспекту изобретения, и вычисления расстояния до целевого объекта и принятия решения о переключении камеры в режим ближней съемки или в режим дальней съемки, при этом полученное расстояние до целевого объекта и решение о переключения камеры передается в системную память и через блок интерфейс ввода-вывода в камеру для осуществления переключения режима камеры.

камера выполнена с возможностью передачи графической информации через блок интерфейса ввода-вывода и графический процессор на дисплей устройства,

дисплей выполнен с возможностью визуализации целевого объекта в режиме реального времени.

При этом в заявленном устройстве, графический процессор выполнен с возможностью обработки графической информации, полученной с камеры, а котором матрица сенсоров представляет собой матрицу PDAF сенсоров, накопитель выполнен с возможностью хранения фото- и видеоизображений, полученных камерой устройства и представляет собой твердотельный накопитель(SSD).

При этом в заявленном устройстве блок ввода-вывода дополнительно содержит по меньшей мере один сенсор движения и сенсор глубины, при этом сенсор движения представляет собой по меньшей мере один из: акселерометр, гироскоп, магнитометр, а сенсор глубины представляет собой по меньшей мере один из: RaDAR, LiDAR ToF-сенсор, UWB-сенсор.

Кроме того, контроллер памяти выполнен с возможностью передачи данных из системной памяти на центральный процессор для вычислений.

Заявленное устройство выполнено с возможностью встраивания в одно из: смартфон, планшетный компьютер, фото- и видеокамера.

Краткое описание чертежей

Вышеописанные и другие признаки и преимущества настоящего изобретения поясняются в последующем описании, иллюстрируемом чертежами, на которых представлено следующее:

Фиг. 1A - представлено изображение сцены при переключении с режима дальней съемки на режим телефотокамеры и обратно при съемке объекта, находящегося на расстоянии, согласно известному уровню техники.

Фиг. 1B - схематично представлены углы обзора сцены при переключении с режима дальней съемки на режим телефотокамеры и обратно при съемке объекта, находящегося на расстоянии, согласно известному уровню техники.

Фиг. 2A - представлено изображение сцены при переключении с режима дальней съемки (широкоугольная камера) на режим ближней съемки (сверхширокоугольная камера) и обратно при съемке объекта, находящегося вблизи, или захвате всей сцены, согласно известному уровню техники.

Фиг. 2B - схематично представлены углы обзора сцены при переключении с режима дальней съемки (широкоугольная камера) на режим ближней съемки (сверхширокоугольная камера) и обратно при съемке объекта, находящегося вблизи, или захвате всей сцены, согласно известному уровню техники.

Фиг.3A - представлено изображение сцены при переключении с режима телефото-камеры на режим дальней съемки (широкоугольная камера) и обратно, и переключении камеры с режима дальней съемки на режим ближней съемки (сверхширокоугольная камера) и обратно при съемке сцены с изменением необходимого фокусного расстояния до объекта в зависимости от требований пользователя, согласно известному уровню техники.

Фиг.3B - схематично представлены углы обзора сцены при переключении с режима телефотокамеры на режим дальней съемки(широкоугольная камера) и обратно, и переключении режима дальней съемки в режим ближней съемки (сверхширокоугольная камера) и обратно при съемке сцены, с изменением необходимого фокусного расстояния до объекта в зависимости от требований пользователя, согласно известному уровню техники.

Фиг.4A - представлено изображение сцены, на основании которой рассчитывается диспарантность согласно известному уровню техники.

Фиг.4B - представлена карта глубины сцены, на основании полученной диспарантности сцены с фиг.4A согласно известному уровню техники.

Фиг.5A - представлено изображение сцены, на основании которой рассчитывается поле векторов движения сцены согласно известному уровню техники.

Фиг.5B - представлено поле векторов движения на основании данных движения на сцене с фиг.5A согласно известному уровню техники.

Фиг.6A - представлено изображение сцены, на основании которой генерируется карта глубины сцены на основании данных, получаемых от лазерных сенсоров согласно известному уровню техники.

Фиг.6B - представлено дальностное изображение сцены с фиг.6а, полученное на основании данных, получаемых от лазерных сенсоров согласно известному уровню техники.

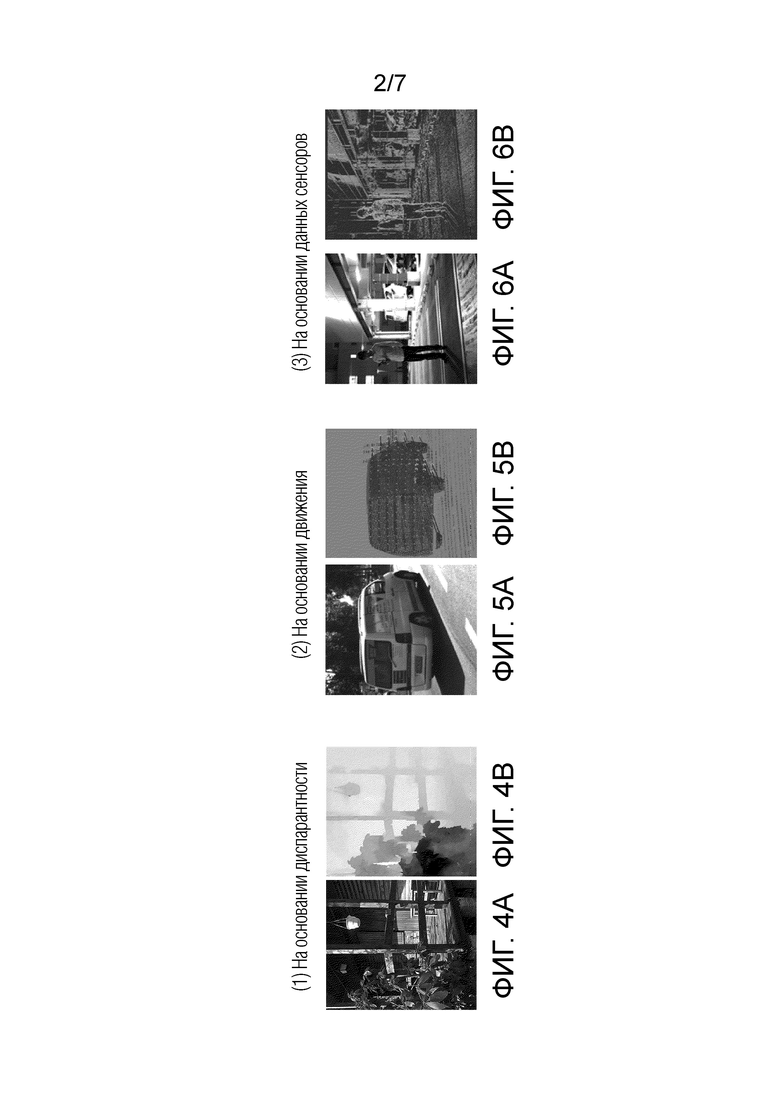

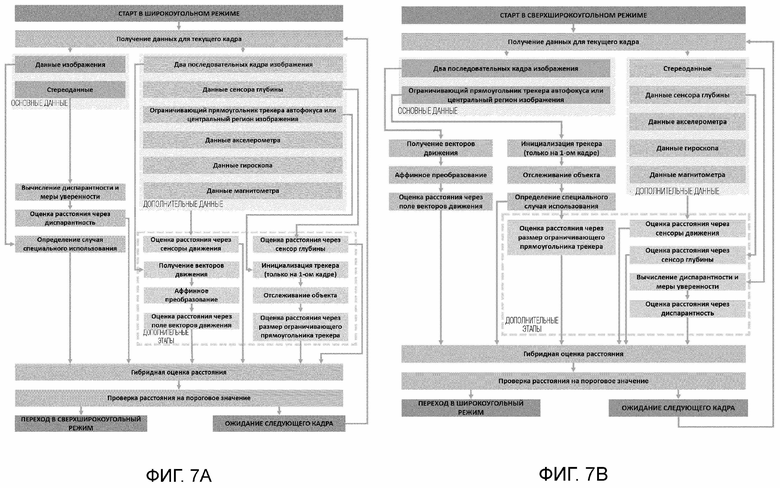

Фиг.7A - представлена блок-схема этапов способа автоматического переключения режимов работы камеры с режима дальней съемки (широкоугольная камера) на режим ближней съемки (сверхширокоугольная камера) согласно варианту реализации изобретения.

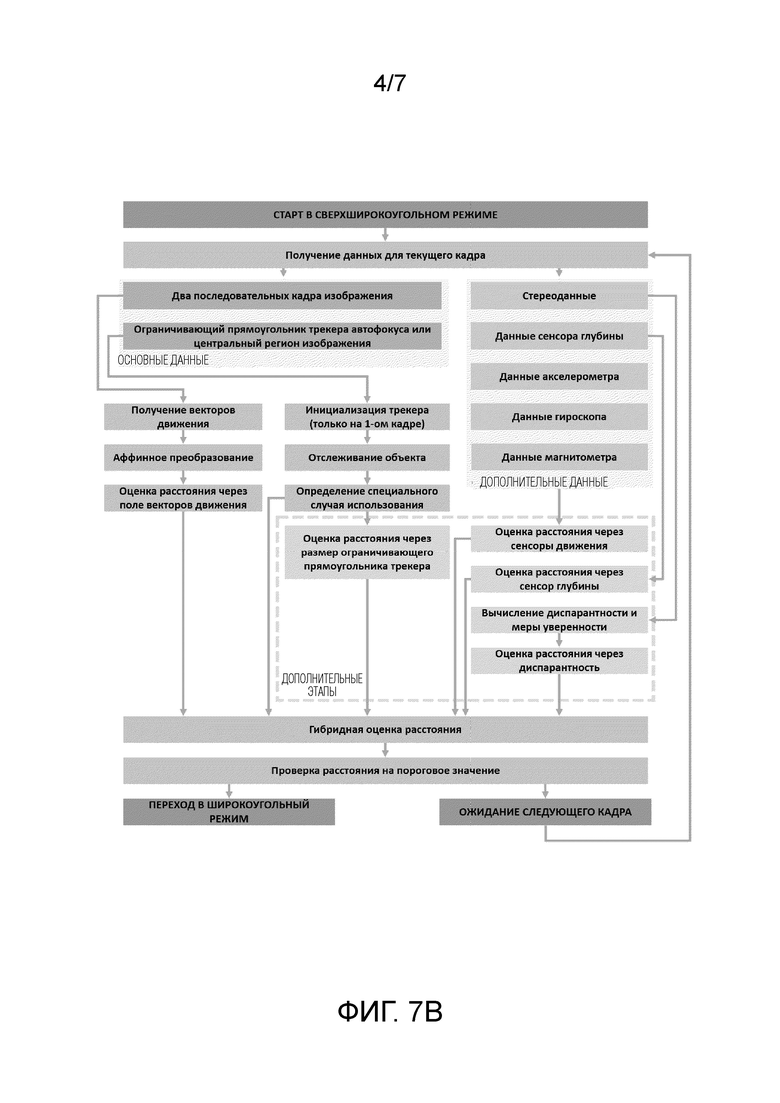

Фиг.7B - представлена блок-схема этапов способа автоматического переключения режимов работы камеры с режима ближней съемки (сверхширокоугольная камера) на режим дальней съемки(широкоугольная камера) согласно варианту реализации изобретения.

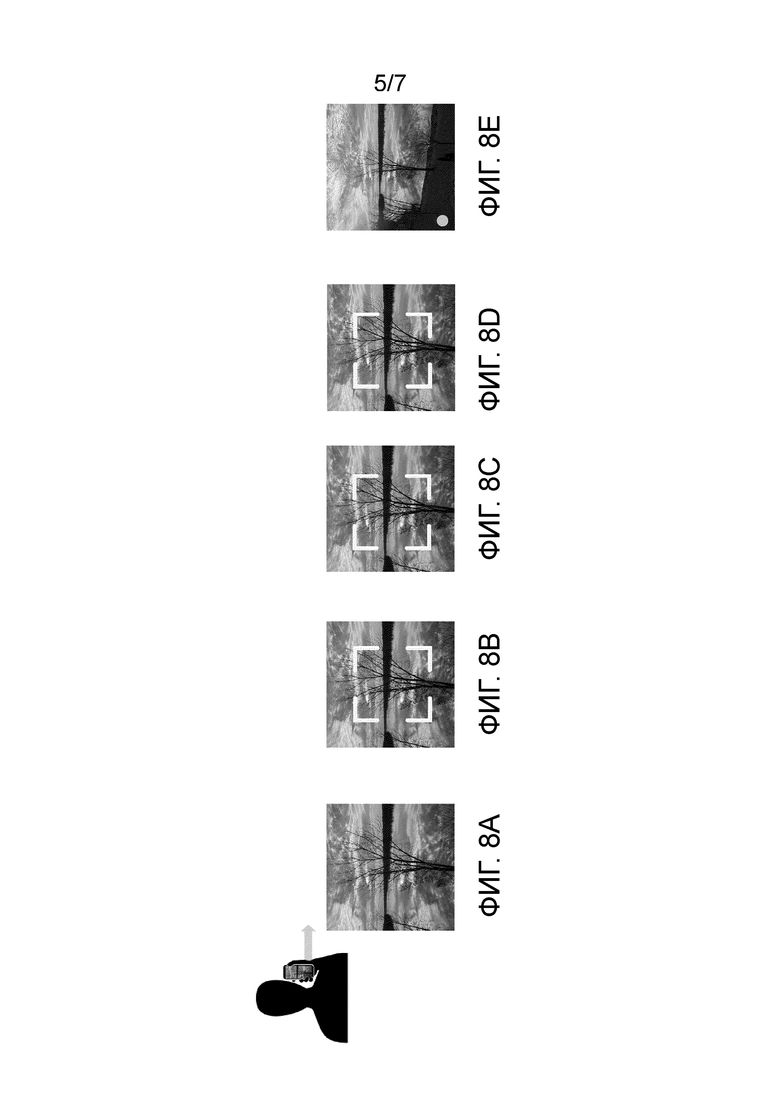

Фиг.8A - представлено изображение сцены при запуске приложения работы камеры в режиме дальней съемки.

Фиг.8B - представлена автоматическая оценка движения на сцене, как ее видит пользователь на камере.

Фиг.8C - представлена автоматическая оценка расстояния до целевого объекта, как ее видит пользователь на камере.

Фиг.8D - представлено изображение целевого объекта на этапе анализа оценки измерений с фиг.8B, 8C, как ее видит пользователь на камере.

Фиг.8E - представлено изображение сцены при переключении камеры, как ее видит пользователь на камере.

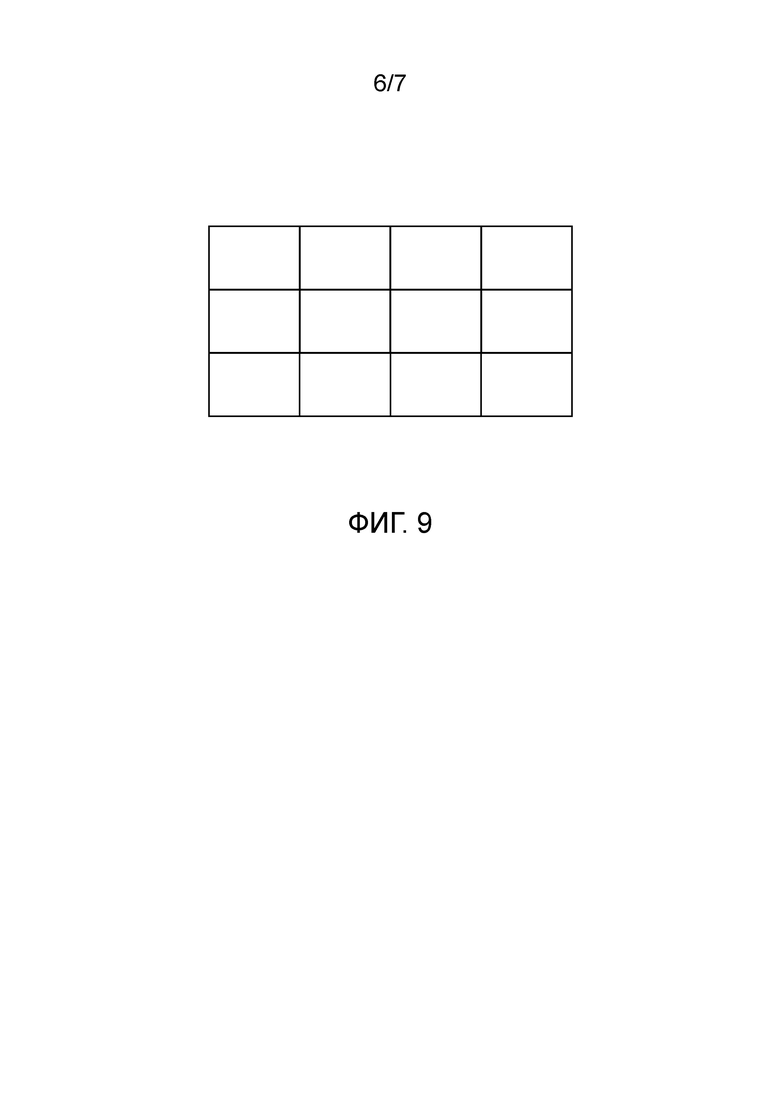

Фиг.9 - представлен пример ограничивающего прямоугольника в виде узлов 2D сетки.

Фиг. 10 - представлена блок-схема устройства автоматического переключения режимов работы камеры.

Предпочтительные варианты осуществления изобретения

Примеры вариантов осуществления настоящего раскрытия будут подробно описаны ниже. Примеры вариантов осуществления были проиллюстрированы на прилагаемых чертежах, на которых одинаковые или подобные ссылочные позиции относятся к одинаковым или подобным элементам, или элементам, имеющим одинаковые или подобные функции. Примерные варианты осуществления, описанные со ссылкой на прилагаемые чертежи, являются иллюстративными, используются только для объяснения настоящего раскрытия и не должны рассматриваться как какие-либо ограничения к нему.

В рамках настоящего изобретения будут использоваться следующие понятия и термины, толкование которых предоставляется ниже авторами изобретения:

Целевой объект - объект, выбранный пользователем и подлежащий съемке (захвату).

Сцена - область, выбранная пользователем, в которой находится целевой объект.

Регион интереса (ROI) - это определенная область (регион) экрана устройства, выбранная с помощью функциональности «сетка» в приложении для фото- и видеосъемки, присущей современным смартфонам под управлением операционных систем Android, iOS и т.д. Например, экран устройства может быть разделен на несколько равных или неравных прямоугольников или других фигур, образующих сетку. Одна ячейка или прямоугольник этой сетки, выбранный пользователем, называется регионом интереса (ROI). В качестве примера авторы изобретения рассматривали экран, разделенный на равные прямоугольники, образующие сетку 9×13, но этот пример не является ограничивающим. В данном случае на экране имеется 9×13 регионов интереса ROI.

Выбранный регион интереса (выбранный ROI) - это регион интереса, определенный на основе области, выбранной пользователем, который может содержать центр области, выбранной пользователем, ее большую часть или всю область, выбранную пользователем, в зависимости от требований пользователя при выполнении процесса автофокусировки на объекте. Если пользователь не выбирает регион сам, ROI может быть выбран автоматически. На фиг.2А показан выбранный ROI. Выбранный ROI, а также его координаты, рассматривается как входные данные для начала процесса отслеживания целевого объекта.

Текущий регион интереса (текущий ROI) - на первом кадре текущий ROI соответствует выбранному ROI, а на последующих кадрах текущим ROI является регион интереса, который для текущего кадра возвращает средство отслеживания. Пользователь выбирает ROI только в первый раз. Следует отметить, что каждый кадр делится условно на сетку ROI, например 13х9, при первой итерации ROI выбирается на основе пользовательского ввода (условно, пользователь показывает, где находится интересующий его объект), дальше эта информация передается в средство отслеживания (трекер), и для каждого последующего кадра предсказывается, в каком именно ROI из сетки целевой объект будет находиться.

Мультикамерная система - система, которая имеет по меньшей мере две камеры, которые могут переключаться между собой. В качестве камер могут использоваться: камера ближнего действия, например сверхширокоугольная камера; камера дальнего действия, например широкоугольная камера; камера очень ближнего действия, например макрокамера и камера очень дальнего действия, например телефотокамера

Режим ближней съемки - камера ближнего действия в мультикамерной системе. Эта камера не может сфокусироваться на дальнем расстоянии. Например, может фокусироваться на расстоянии менее 30 см, но характеристики могут быть и другие.

Режим дальней съемки - камера дальнего действия в мультикамерной системе. Эта камера не может сфокусироваться на ближнем расстоянии. Например, может фокусироваться на расстоянии более 30 см, но характеристики могут быть и другие.

Настоящее изобретение может быть использовано для разных камер в мультикамерной системе, но в рамках настоящего раскрытия авторами изобретения рассматривается переключение камеры с режима ближней съемки на режим дальней съемки и обратно.

Средство отслеживания(трекер) - последовательность этапов обработки данных, посредством которых на основании входных данных, в качестве которых задаются данные текущего ROI с объектом, подлежащим захвату, на выходе обеспечиваются данные (координаты) объекта на последующих кадрах.

PDAF данные - изображения, полученные путем отражения лучей света от объекта, находящегося в кадре, и попадания их на противоположные (левую и правую) стороны линзы камеры. Объект находится в фокусе, если два полученных изображения совпадают. Изображения, полученные таким образом, также называются левым и правым изображением соответственно.

Dual Pixel - технология фазовой автофокусировки, при которой каждый пиксель сенсора используется для определения фазы и для получения информации о цвете, что значительно повышает и скорость и точность автофокусировки по сравнению с обычными системами.

SAD кривая - кривая на 2D графике: оси X соответствует смещение в количестве пикселей левого изображения относительно правого, оси Y - соответствующая сумма попиксельных разностей между изображениями для выбранного фрагмента; SAD кривые авторы изобретения получают посредством сенсоров, встроенных в мобильный телефон, которые называются dual pixels и содержат информацию о двух картинках (левое и правое изображение объекта с телефона с небольшим сдвигом).

Диспарантность (рассогласование) - мера расфокусировки сцены, получаемая на основе анализа SAD кривой. Формально, диспарантность является точкой локального минимума SAD кривой, поэтому измеряется в количестве пикселей.

Специальный (предварительно определенный) случай использования камеры - это любые случаи использования камеры, которые отличаются от стандартных случаев использования камеры, и в которых переключение камеры может быть выполнено необоснованно, например, если имеет место прозрачный объект, отражающий объект, съемка за стеклом, повороты и движение камеры в режиме ближней съемки, очень маленькие объекты, безтекстурные объекты, безтекстурный фон без объекта (случай с белой стеной), сценарий прохода по комнате, убирание объекта из кадра, убирание камеры от объекта, движение объекта при неподвижной камере.

Стандартный случай использования камеры - в рамках настоящего раскрытия под стандартным случаем понимается сценарий, когда пользователь снимает не прозрачный и не отражающий двумерный или трехмерный целевой объект среднего размера (объект имеет какую-то текстуру), пользователь подходит с включенной камерой в режиме дальней съемки ближе к объекту, движение при этом не слишком быстрое или медленное, равномерное по скорости, может быть поворот камеры, поворота может не быть. При приближении к объекту на определенное расстояние, заданное порогом, происходит переключение в режим ближней съемки. Пользователь производит фото или видео съемку. Потом он отдаляется от целевого объекта, при отдалении на определенное расстояние, заданное порогом, происходит переключение в режим дальней съемки.

Дальностное изображение (карта глубины) - изображение, сформированное таким образом, что каждый пиксель вместо цвета кодирует информацию о расстоянии между соответствующей точкой на сцене и точкой обзора (камерой).

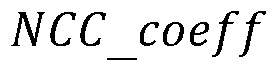

Мера уверенности - показатель, указывающий, в какой степени полученное измерение или вычисление (например, показатели сенсоров, вычисленные характеристики изображения) зависят от шума, и, следовательно, до какой степени на точность измерения можно положиться. В общем случае уверенность можно оценить, как соотношение сигнал/шум по выражению:

где R - мера уверенности, YS - уровень сигнала, YN - уровень шума.

Примеры расчета меры надежности для конкретных измерений или вычислений могут быть найдены в следующих работах, отражающих известный уровень техники:

[1]US8068543B2, IPC H04B 1/66, опубл.29.11.2011г.;

[2]Liu, Jun & Ye, Ping & Zhang, Xingchen & Xiao, Gang. (2021). Real-time long-term tracking with reliability assessment and object recovery. IET Image Processing. 10.1049/ipr2.12072.;

[3]J. Zhu, L. Wang, R. Yang, J. E. Davis and Z. pan, "Reliability Fusion of Time-of-Flight Depth and Stereo Geometry for High Quality Depth Maps," in IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 33, no. 7, pp. 1400-1414, July 2011, doi: 10.1109/TPAMI.2010.172.

Ограничивающий прямоугольник - прямоугольник, ограничивающий форму целевого объекта на плоскости сцены.

Коэффициент масштабирования - коэффициент, отражающий изменение размера целевого объекта между последовательными кадрами. В качестве примера, но не ограничения, коэффициент масштабирования может быть вычислен через отношение сторон соответствующих ограничивающих рамок целевого объекта; в известном уровне техники также описаны методы вычисления коэффициента масштабирования на основании оценки векторов движения, к ним относятся:

[4]WO2013106425A1, IPC H04N 7/26, опубл.18.07.2013г.;

[5]Wang H, Shen J, Chen Z, Shen J. A Fast Object Tracking Approach Based on the Motion Vector in a Compressed Domain. International Journal of Advanced Robotic Systems. 2013;10(1). doi:10.5772/55210;

[6]Alvar, Saeed & Bajic, Ivan. (2018). MV-YOLO: Motion Vector-Aided Tracking by Semantic Object Detection. 1-5. 10.1109/MMSP.2018.8547125.

Гибридная оценка расстояния до объекта - способ оценки расстояния от камеры до целевого объекта, использующий различные источники данных о глубине сцены для финальной оценки расстояния. В качестве примера, но не ограничения, гибридная оценка может использовать взвешенную комбинацию данных о глубине с разных источников (например, PDAF-данных, сенсоров глубины и векторов движения), а также может быть основана на выборе наиболее надежного источника данных о глубине посредством оценки уверенности (надежности).

Переключение режима съемки с режима дальней съемки на режим ближней съемки - процесс перехода от использования линзы камеры дальнего действия к использованию линзы камеры ближнего действия при захвате изображения, содержащего целевой объект, находящийся в движении, и изменении соответствующего оптимального диапазона фокусных расстояний линзы камеры.

Переключение режима съемки с режим ближней съемки на режим дальней съемки - процесс перехода от использования линзы камеры дальнего действия к использованию линзы камеры ближнего действия при захвате изображения, содержащего целевой объект, находящийся в движении, и изменении соответствующего оптимального диапазона фокусных расстояний линзы камеры.

На фиг.7A, фиг.7B представлены блок-схемы этапов автоматического переключения режимов камеры, а на фиг.8A-8E, представлены изображения на камере, которые наблюдает пользователь при съемке cцены и/или целевого объекта соответствующие последовательностям этапов с фиг.7A-7B.

Далее более детально будет раскрыта последовательность этапов автоматического переключения камеры со ссылкой на фиг.7A, фиг.7B, и соответствующие фиг.8A-8E:

1) Пользователь смартфона запускает приложение камеры, в котором режим дальней съемки камеры может быть выбран по умолчанию или установлен пользователем. Опционально, пользователь может вручную выбрать целевой объект, касаясь пальцем соответствующей области на экране, например смартфона. На основании данных, полученных с камеры смартфона, формируется само изображение и стереоданные к нему. В качестве примера, но не ограничения, стереоданные могут быть получены посредством PDAF сенсоров на матрице камеры с технологией Dual Pixel.

Следует отметить, что не обязательно начинать запуск приложения камеры в режиме дальней съемки, пользователь может быть и в режиме ближней съемки, если его настройки сохраняют последний режим съемки и он был ближним.

Этот этап ввода данных представлен на фиг.8A, где пользователь запускает камеру в режиме дальней съемки.

2) Построение с помощью полученных данных поля векторов движения и выполнение оценки диспарантности и меры уверенности.

На фиг.8B представлена автоматическая оценка движения на сцене, как ее видит пользователь на камере.

3) Выполнение оценки расстояния посредством векторов движения и выполнение оценки расстояния посредством стереоданных, при этом также на основе полученных данных могут быть выявлены специальные или предварительно определенные случаи использования для более стабильной работы и лучшего взаимодействия с пользователем. По выбору пользователя и при наличии соответствующих сенсоров, встроенных в смартфон или подобное устройство, оценка расстояния может быть выполнена на основании дополнительных данных движения на сцене, полученных от гироскопа, акселерометра, магнитометра, или любых других сенсоров (см. фиг.7A, фиг.7B)

При этом следует отметить, что оценка расстояния может выполняться разными, известными из уровня техники, методами, например посредством: векторов движения, стереоданных, данных сенсоров движения, данных сенсоров глубины, данных полученных с помощью алгоритма слежения, при этом используются разные типы данных. И все эти оценки расстояния, которые могут быть получены на этом этапе 3) объединяются в одну оценку расстояния на этапе 4 с помощью гибридной оценки расстояния

Автоматическая оценка расстояния до целевого объекта, которую наблюдает пользователь камеры, представлена на фиг.8C.4) Далее выполняется гибридная оценка расстояния, которая будет более детально описана далее в описании, на которой анализируют оценки и вычисления, полученные на этапах 2 и 3.

5) На основании данных о расстоянии до объекта, полученных на этапе гибридной оценки расстояния на этапе 4, осуществляют проверку пороговых значений для выбора линзы. На основании этой проверки и анализа пограничных случаев выбирают линзу для режима дальней съемки или режима ближней съемки работы камеры и выполняют автоматическое переключение камеры.

На фиг.8E представлена картинка, которую наблюдает пользователь при переключении камеры.

Далее остановимся на описании гибридного алгоритма, упомянутого со ссылкой на фиг.8C и фиг.7A, фиг.7B, на основании которого выполняется автоматическая оценка расстояния до целевого объекта, которую наблюдает пользователь камеры.

Ключевое положение 1: Гибридная оценка расстояния для определения расстояния до объекта(см. фиг.7A, фиг.7B).

1) Если пользователь находится в режиме дальней съемки камеры (широкоугольный режим) пользователь открывает (запускает) приложение камеры, посредством которого получает данные изображения в текущем кадре, при этом изображения могут быть закодированы цветовом пространстве, например, RGB, YUV или CMYK, и стереоданные, например, PDAF данные или согласованные данные изображения от двух камер на основании захвата целевого объекта.

2) Расстояние до целевого объекта определяется с помощью стереоданных. Методы и средства получения расстояния с помощью стереоданных раскрыты в следующих источниках информации: [7]RU2778355C2, опубл. 17.08.2022 г., САМСУНГ ЭЛЕКТРОНИКС КО., ЛТД., KR.

3) На основании полученных данных изображения целевого объекта инициируется отслеживание целевого объекта посредством средства отслеживания (трекера), и полученные данные отслеживания используются для определения коэффициента масштабирования ограничивающего прямоугольника средства отслеживания между последовательными кадрами захваченного изображения целевого объекта. На основании коэффициента масштабирования вычисляется расстояние до целевого объекта. Полученные данные отслеживания также используются для определения некоторых пограничных случаев, например потери целевого объекта в кадре. Процесс отслеживания целевого объекта детально описан в патенте [7] RU2778355C2, опубл. 17.08.2022 г., того же патентообладателя (САМСУНГ ЭЛЕКТРОНИКС КО., ЛТД., KR), что и патентообладатель заявленного изобретения.

4) На основании полученных двух последовательных изображений с камеры инициируется процесс оценки движения, который также используется для определения коэффициента масштабирования между последовательными кадрами захваченного изображения целевого объекта. Процесс оценки движения описан в следующих источниках информации:

[8] Pesquet-Popescu, B., Cagnazzo, M., & Dufaux, F. (2013). Motion Estimation Techniques;

[9] Qian, Xueming. (2012). Global Motion Estimation and Its Applications. 10.5772/34166.

На основании коэффициента масштабирования вычисляется расстояние до целевого объекта.

Коэффициент масштабирования в данном случае вычисляется через оценку векторов движения, например, как раскрыто в публикации [10]Lai, Lijun & Xu, Zhiyong. (2015). Global Motion Estimation Based on Fourier Mellin and Phase Correlation. 10.2991/cmes-15.2015.173.

5) Могут быть использованы другие данные и методы для определения расстояния до целевого объекта.

В качестве неограничивающего примера могут быть также использованы PDAF-данные, данные с сенсоров движения и глубины.

6) Определяются случаи специального использования, которые будут описаны далее.

7) Вычисляются меры уверенности R=100x (1),

(1),

где YS-уровень сигнала, YN-уровень шума для каждого используемого метода определения расстояния до целевого объекта.

8) Применение гибридной оценки расстояния при финальной оценке расстояния до целевого объекта характеризуется включением данных, полученных на этапах 2)-7). При этом подобные устройства известного уровня техники используют только один источник, т.е., например, только данные изображения, или только стереоданные для определения расстояния до целевого объекта, что вызывает некоторые ошибки при оценке расстояния до объекта и, соответственно, возникновение ошибок при переключении камеры с одного режима на другой.

Заявленное изобретение согласно первому варианту реализации использует несколько способов определения расстояния до целевого объекта. Например: с помощью отслеживания целевого объекта, с помощью векторов движения на сцене с целевым объектом, с помощью PDAF данных. Все эти оценки и их меры уверенности аккумулируются в одну единственную, более точную оценку расстояния до целевого объекта, что обеспечивает точное переключение камеры даже в случае отсутствия сенсоров глубины. Сенсоры глубины и другие сенсоры (например, сенсоры данных движения) также могут быть использованы для гибридной оценки для еще большего увеличения точности решения в случае наличия таких сенсоров.

Согласно первому варианту реализации, гибридный алгоритм оценки расстояния до целевого объекта описанный выше со ссылкой на фиг.7A, фиг.7B также может включать введение данных от сенсоров различных типов, например, акселерометра, гироскопа, магнитометра.

Данные движения, определяются на основании измерений, полученных от сенсоров различных типов, например акселерометров, гироскопов, магнитометров, а также различных сенсоров глубины, в частности, основанных на использовании радиоволн (RADAR), основанных на технологии измерения расстояний путем излучения света лазера и замера времени возвращения отраженного света на приемник (времяпролетные (ToF) сенсоры или лидары (LiDAR)), или сверхширокополосные (UWB) сенсоры, основанные на использовании сверхширокополосных сигналов в диапазоне от 6-8ГГц.

На основе полученных данных движений от различных сенсоров, определяется расстояние до целевого объекта, которые вводится в гибридный алгоритм для финальной оценки расстояния до целевого объекта.

Гибкость предлагаемого решения согласно первому варианту реализации позволяет включать различные данные о движении от различных сенсоров (например, акселерометра, гироскопа, ToF, LiDAR или UWB. Следует отметить, что в заявленном способе для каждого источника данных может быть посчитана отдельная оценка расстояния до объекта. Данные из сенсоров движения могут быть использованы все вместе или по отдельности. На основании их может быть сделана оценка расстояния до объекта, которая может быть преобразована вместе с остальными оценками, например, на основании данных глубины от сенсоров глубины, в общую единую оценку посредством гибридной оценки расстояния до объекта. Ключевую роль в проведении гибридной оценки играют определение меры уверенности, которые более детально будут описаны далее в настоящем, что позволяет объединить различные оценки расстояния в одну и тем самым обеспечить более точную оценку движения целевого объекта на сцене, и обеспечить более точное переключение камеры.

Ключевое положение 2: обработка специального( предварительно определенного) случая использования камеры.

1) Пользователь открывает (запускает) приложение камеры (режим дальней съемки камеры (широкоугольный режим) (см.фиг.7A) или режим ближней съемки камеры (сверхширокоугольный режим) (см. фиг.7B), посредством которого получает данные изображения, например RGB, YUV или CMYK данные, и стерео данные, например PDAF данные или согласованные данные изображения от двух камер на основании захвата целевого объекта.

2) Оценивается диспарантность и мера уверенности для кадра выбранных регионов интереса (ROI) посредством стерео данных.

3) Определяется положение линзы камеры на основе полученной диспарантности и меры уверенности выбранных ROI.

4) На основании полученных данных изображения целевого объекта инициируется процесс отслеживания целевого объекта посредством средства отслеживания (трекера).

5) Определяются вектора движения на сцене с целевым объектом на основании полученных данных изображения из последовательных кадров.

6) Определяются случаи специального использования на основании анализа данных, полученных на этапах 2-6 Ключевого положения 2. Например, в случае потери целевого объекта из кадра, которая была определена с помощью средства отслеживания, может быть принято решение о переключении режима съемки с ближнего на дальний режим. Также информация диспарантности и меры уверенности, полученные с стереоданных, а также самого изображения могут использованы для распознавания сцены, определения целевого объекта и фона (не объекта). Например, в случае распознавания отсутствия объекта (случай однородного фона), может быть принято решение о не переключении режима съемки с дальнего на ближний режим.

Следует отметить, что традиционные известные методы обработки данных расстояния целевого объекта не определяют случаев специального использования, например, захвата камерой сцены с целевым объектом через оконное стекло или витрину и т.п., при этом сенсоры ошибочно распознают стекло в качестве объекта, что инициирует некорректное переключение камеры и приводит к снижению качеству изображения, получаемого при съемке камерой.

Возможность выявления специальных (предварительно определенных) случаев использования для автоматического переключения режимов камеры повышает точность оценки движения целевого объекта на сцене, точность определения расстояния для целевого объекта и обеспечивает лучший пользовательский опыт. Использование только данных изображения для обработки специальных случаев использования делает необязательным использование дорогостоящего оборудования (например, сенсоров движения).

Эффекты, достигаемые при использовании способа и устройства автоматического переключения режимов работы камеры смартфона.

Общие эффекты:

- обеспечивается точное автоматическое переключение между режимами ближней и дальней съемки;

- обеспечивается легкое, компактное устройство

подходящее как для устройств премиум класса, так и для устройств массового рынка.

Эффекты, обеспечиваемые посредством гибридного процесса обработки данных для оценки расстояния до целевого объекта (Ключевое положение 1)

- обеспечивается использование различных источников информации о расстоянии для точной оценки расстояния до целевого объекта;

- обеспечивается соответствующее переключение камеры;

- заявленный способ и устройство могут использоваться для массового рынка.

Эффекты, обеспечиваемые включением данных сенсоров в гибридный процесс обработки данных для оценки расстояния до целевого объекта Ключевое положение 1, Вариант 1):

- обеспечивается гибкое решение, которое позволяет легко вводить данные глубины от других источников информации;

-обеспечивается возможность лучшего функционирования для устройств премиум класса.

Эффекты, обеспечиваемые от обработки специального случая использования (Ключевой момент 2):

- улучшенная точность работы устройства в специальных случаях использования

- более низкое энергопотребление за счет оперативного обнаружения специальных (предварительно определенных) случаев использования и их отдельной обработки.

Кроме того, авторы изобретения провели исследования конкретных эксплуатационных параметров известных на рынке флагманских решений, а также заявленного решения, которые наглядно демонстрируют преимущество заявленного устройства и способа автоматического переключения режимов работы камеры.

При этом в качестве основных эксплуатационных параметров выбирались: время работы текущего решения, энергопотребление, успешное переключение камеры в %, нежелательное переключение в %, задержка переключения в % и нестабильное расстояние переключения камеры в %.

Заявленное изобретение характеризуется следующим:

1) время работы ~9 мс,

2) энергопотребление 60 мА,

3) успешное переключение камеры ~97%,

4) нежелательное переключение ~0%,

5) задержка переключения ~2%,

6) нестабильное расстояние переключения камеры ~1%.

US10,291,842B2 (US20160381289А1)(патентообладатель Samsung Electronics Co Ltd), модель Galaxy S21ULTRA:

1) время работы ~15 мс,

2) энергопотребление 54 мА,

3) успешное переключение камеры ~60%,

4) нежелательное переключение 31%,

5) задержка переключения ~8%,

6) нестабильное расстояние переключения камеры ~1%.

US20160007008A1 (патентообладатель Apple Inc.), модель iPhone 13 Pro Max:

1) данные неизвестны из открытых источников,

2) данные неизвестны из открытых источников,

3) управление камерой непосредственно пользователем требуется при инициировании переключения режима камеры,

3) успешное переключение камеры 27%,

4) нежелательное переключение 33%,

5) задержка переключения ~7%,

6) нестабильное расстояние переключения камеры ~33%.

WO2020073959A1(патентообладатель Huawei Technologies Co Ltd.), модель P50Pro:

1) данные неизвестны из открытых источников,

2) данные неизвестны из открытых источников,

3) успешное переключение камеры 97%,

4) нежелательное переключение 15%,

5) задержка переключения ~66%,

6) нестабильное расстояние переключения камеры ~66%.

Представленный анализ эксплуатационных параметров известных смартфонов на рынке наглядно демонстрирует преимущества заявленного способа и устройства автоматического переключения режима работа камеры смартфона.

Кроме того, авторы изобретения провели исследования конкретных функциональностей известных на рынке флагманских решений, а также заявленного решения, которые наглядно демонстрируют преимущество заявленного устройства и способа автоматического переключения режимов работы камеры.

При этом в качестве основных функциональностей выбирались: наличие сенсора движения, схема переключения, автоматическое переключение, решение проблемы задержки переключения, решение проблемы нежелательного переключения, решение проблемы нестабильного поведения в случаях специального использования.

Заявленное изобретение характеризуется следующим:

1) не обязательно наличие сенсора движения,

2) схема переключения заключается в переключении камеры из режима дальней съемки в режим ближней съемки и обратно,

3) наличие автоматического переключения,

4) проблемы задержки переключения решены,

5) проблемы нежелательного переключения решены,

6) проблемы нестабильного поведения в случаях специального использования решены.

US10,291,842B2 (US20160381289А1)(патентообладатель Samsung Electronics Co Ltd), модель Galaxy S21ULTRA:

1) наличие сенсора движения,

2) схема переключения заключается в переключении камеры из режима дальней съемки в режим ближней съемки и обратно,

3) наличие автоматического переключения,

4) проблемы задержки переключения не решаются,

5) проблемы нежелательного переключения не решаются,

6) проблемы нестабильного поведения в случаях специального использования не решаются.

US20160007008A1 (патентообладатель Apple Inc.), модель iPhone 13 Pro Max:

1) наличие сенсора движения,

2) схема переключения заключается в переключении камеры из режима дальней съемки в режим ближней съемки и обратно,

3) наличие автоматического переключения,

4) проблемы задержки переключения не решаются,

5) проблемы нежелательного переключения не решаются,

6) проблемы нестабильного поведения в случаях специального использования не решаются.

WO2020073959A1 (патентообладатель Huawei Technologies Co Ltd.), модель P50Pro:

1) наличие сенсора движения,

2) схема переключения заключается в переключении камеры из режима дальней съемки в режим ближней съемки и обратно,

3) наличие автоматического переключения,

4) проблемы задержки переключения не решаются,

5) проблемы нежелательного переключения не решаются,

6) проблемы нестабильного поведения в случаях специального использования не решаются.

Представленный анализ функциональностей известных смартфонов наглядно демонстрирует преимущества заявленного способа и устройства автоматического переключения режимов работы камеры, например смартфона.

Далее будут описаны основные ключевые положения способа и устройства автоматического переключения режимов работы камеры. Как уже указывалось ранее, в рамках настоящего изобретения рассматривается возможность автоматического переключения режима камеры из режима дальней съемки в режим ближней съемки и наоборот.

При работе камеры в режиме дальней съемки (широкоугольный режим), см.фиг.7А, выполняются следующие этапы:

При захвате изображения сцены с целевым объектом в режиме дальней съемки работы камеры обеспечивается получение данных для текущего кадра, а именно обеспечиваются стереоданные текущего изображения k-ого кадра, включающие, например PDAF данные, полученные с помощью PDAF сенсоров на матрице камеры с технологией Dual Pixel или согласованные данные изображения от двух камер на основании захвата целевого объекта, а также, при необходимости, данные изображения. Каждый кадр полученного изображения рассматривается в виде пикселей или группы пикселей. По выбору: обеспечивают получение данных с сенсоров глубины и/или получение данных с сенсоров движения.

На основании полученных стерео данных с помощью левого и правого изображения из камеры по технологии Dual Pixel или другой пары изображений, например, из стереокамеры, вычисляется диспарантность, которая рассчитывается на основе кривых SAD (сумма абсолютных разностей) между левым и правым изображениями для захваченной сцены с целевым объектом, полученными с помощью камеры.

Следует отметить, что для определения диспарантности (Dk) для выбранного целевого объекта для k-ого кадра на основе полученных PDAF данных, представляющих собой правое и левое изображение целевого объекта, полученных матрицей сенсоров камеры, рассчитывается сумма абсолютных различий, как абсолютная разность между пикселями левого и правого изображений, на основе которых строятся SAD кривые. Формально, диспарантность является точкой локального минимума SAD кривой, поэтому измеряется в количестве пикселей. При этом, SAD кривая представляет собой кривую на 2D графике: оси X соответствует смещение в количестве пикселей левого изображения относительно правого, оси Y - соответствующая сумма попиксельных разностей между изображениями для выбранного фрагмента; SAD кривые авторы изобретения получают посредством сенсоров, встроенных в мобильный телефон, которые называются dual pixels и содержат информацию о двух картинках (левое и правое изображение объекта с телефона с небольшим сдвигом).

Публикации, в которых описывается оценка диспарантности через стереореконструкцию, представлены ниже:

[11] Raajan N, Ramkumar M, Monisha B, Jaiseeli C, venkatesan SP (2012) Disparity estimation from stereo images. In: International conference on modelling optimization and computing, Springer, vol 38, pp 462-472;

[12] S. Mukherjee and R. M. R. Guddeti, “A hybrid algorithm for disparity calculation from sparse disparity estimates based on stereo vision,” in Proceedings of IEEE International Conference on Signal Processing and Communications (SPCOM), (IEEE, 2014), pp. 1-6.

На основании полученных SAD кривых оценивают меру уверенности R1, полученной диспарантности Dk для захваченного целевого объекта для k-ого кадра.

Применительно к заявленному решению соотношение сигнал/шум может быть аппроксимировано с помощью двух минимальных значений SAD кривой - глобального минимума и подминимума, на основании указанного определяем мера уверенности R1:

где  - уровень сигнала,

- уровень сигнала,  - уровень шума,

- уровень шума,  - глобальный минимум и

- глобальный минимум и  - подминимум. Формула (2) характеризует аппроксимацию соотношения сигнал/шум с помощью глобального минимума и подминимума SAD-кривой.

- подминимум. Формула (2) характеризует аппроксимацию соотношения сигнал/шум с помощью глобального минимума и подминимума SAD-кривой.

Процесс обработки данных продолжается и определяется расстояние d1 до целевого объекта, захваченного камерой на основании полученных стерео данных.

По выбору:

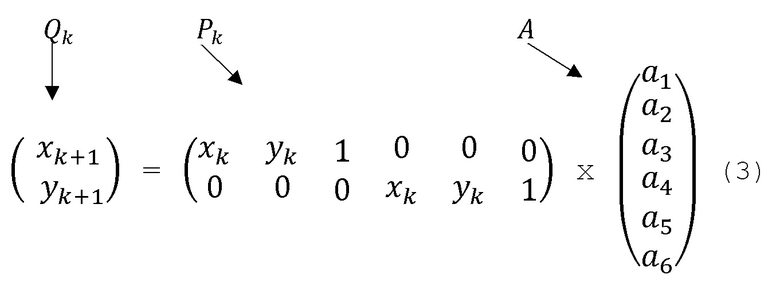

- Сравниваются данные изображения по меньшей мере двух последовательных кадров изображения и на основании сравнения указанных данных изображения, вычисляют поле векторов движения mvi, j на сцене, включающей целевой объект, захваченной камерой. Выбирается центральная область вычисленного поля векторов mvi, j к которой применяется модель аффинного преобразования и вычисляются коэффициенты сдвига, поворота, масштабирования. Все коэффициенты вычисляются одновременно. Основные принципы аффинного преобразования раскрыты в следующем источнике информации:

[13] И. М. Виноградов. Аффинное преобразование // Математическая энциклопедия. - М.: Советская энциклопедия. - 1977-1985.

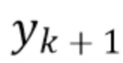

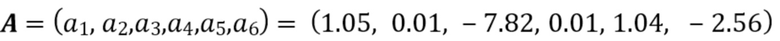

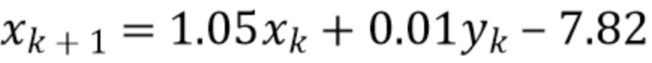

Каждый вектор mvij показывает движение одной точки от кадра к кадру, т.е. ( ,

, ) - координаты начала вектора на рассматриваемом кадре k, а (

) - координаты начала вектора на рассматриваемом кадре k, а ( ,

, ) - координаты конца вектора на кадре k+1. При этом (А i, j) - индексы обхода по полю векторов, т.е. векторов из множества точек на одном кадре. Вектор mvij описывает переход из точки начала вектора с координатами (

) - координаты конца вектора на кадре k+1. При этом (А i, j) - индексы обхода по полю векторов, т.е. векторов из множества точек на одном кадре. Вектор mvij описывает переход из точки начала вектора с координатами ( ,

, ) в текущем кадре k в точку конца вектора с координатами (

) в текущем кадре k в точку конца вектора с координатами ( ,

, ) в следующем кадре k+1 (т.е. самого вектора

) в следующем кадре k+1 (т.е. самого вектора  ). В матричном виде для одной пары координат

). В матричном виде для одной пары координат

( ,

, )->(

)->( ,

, ) аффинное преобразование выглядит следующим образом:

) аффинное преобразование выглядит следующим образом:

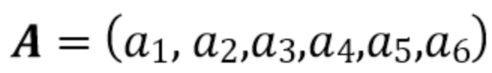

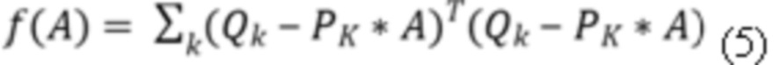

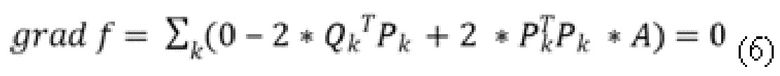

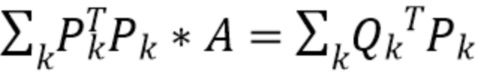

Т.е. аффинное преобразование представляет собой уравнение вида  (4) для каждого вектора из области, где Qk, Pk и A представляют собой компоненты в матричном виде, характеризующие вектора в текущем и последующих кадрах k и k+1, соответственно. Коэффициенты сдвига, поворота и масштабирования получаются из комбинаций искомых корней уравнения

(4) для каждого вектора из области, где Qk, Pk и A представляют собой компоненты в матричном виде, характеризующие вектора в текущем и последующих кадрах k и k+1, соответственно. Коэффициенты сдвига, поворота и масштабирования получаются из комбинаций искомых корней уравнения  , где

, где  -значения матрицы А.

-значения матрицы А.

Они вычисляются по методу наименьших квадратов (МНК)- поиску корней путем минимизации суммы квадратов разностей между левой и правой частью уравнений по каждому вектору, т.е. минимизации функции  , в матричном виде, где матрица

, в матричном виде, где матрица :

:

Раскрываем

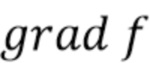

Для минимизации необходимо приравнять градиент функции  к 0.

к 0.

Получаем новое матричное уравнение:  (7). Наконец, корни уравнения (коэффициенты матрицы

(7). Наконец, корни уравнения (коэффициенты матрицы  ) можно найти методом Гаусса. При этом k обозначает текущий кадр, T-транспонированная матрица.

) можно найти методом Гаусса. При этом k обозначает текущий кадр, T-транспонированная матрица.

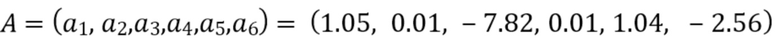

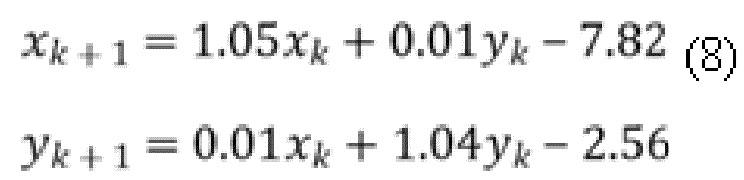

Пример для матрицы  искомое преобразование координат:

искомое преобразование координат:

Значения  - отвечают за сдвиг текущего кадра по осям X и Y, соответственно, относительно предыдущего кадра. Значения

- отвечают за сдвиг текущего кадра по осям X и Y, соответственно, относительно предыдущего кадра. Значения  отвечают за изменение масштаба, при этом коэффициент изменения масштаба подсчитывается, как:

отвечают за изменение масштаба, при этом коэффициент изменения масштаба подсчитывается, как:

где

ScaleChange k+1 - коэффициент изменения масштаба для кадра k+1,

ScaleChangek - коэффициент изменения масштаба для текущего кадра k,

max(α1,α5)- максимальное значение из α1 и α5.

Значение  - отвечает за горизонтальное растяжение целевого объекта на кадре( shear mapping) (пример, преобразование квадрата в параллелограмм), и рассматривается, как заведомо отсутствующий.

- отвечает за горизонтальное растяжение целевого объекта на кадре( shear mapping) (пример, преобразование квадрата в параллелограмм), и рассматривается, как заведомо отсутствующий.

Также с помощью модели аффинного преобразования вычисляется коэффициент поворота. Аффинная модель рассматривает поворот точек на кадре вокруг центра кадра, например поворот точки (x, y) на угол θ поворота в радианах. Таким образом, угол θ поворота из нашего преобразования координат можно вычислить следующим образом:

где

α1,α 4 - соответствующие значения матрицы А.

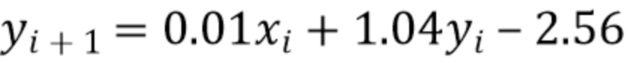

- Определяют расстояние d2 от камеры до целевого объекта на основании вычисленного коэффициента изменения масштаба, на текущем кадре k оно вычисляется следующим образом:

где  - начальное расстояние от камеры до целевого объекта при переходе в режим ближней съемки

- начальное расстояние от камеры до целевого объекта при переходе в режим ближней съемки

Следует отметить, что переход из режима дальней съемки в режим ближней съемки осуществляется по достижении определенного порога K, который предварительно определяется в зависимости от типа, используемой камеры, в качестве примера пороговое значение выбрано авторами изобретения равным 30 см, это расстояние и является начальным расстоянием для режима ближней съемки, но указанное значение приведено авторами только в качестве примера, и может варьироваться.

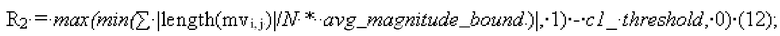

-Определяют меру уверенности R2 расстояния d2 от камеры до целевого объекта.

Например, мера уверенности R2 может быть рассчитана так:

где N - общее число векторов движения (mvi, j), length(mvi, j) - длина вектора mvi, j , avg_magnitude_bound - вручную задается, как параметр для среднего значения длины векторов из поля векторов, R2_threshold - вручную задается, как параметр для минимально допустимой меры уверенности. Таким образом, аномально длинные вектора приводят к низкой мере уверенности, что согласовывается с нашей подзадачей покадровой оценки изменения масштаба объекта.

- Определяют расстояние d3 от камеры до целевого объекта на основании данных глубины c помощью сенсоров глубины,

- Определяют меру уверенности R3 расстояния d3 на основании данных глубины c помощью сенсоров глубины,

Поскольку для вычисления мер уверенности R3 и R4 для расстояний d3 и d4, соответственно используются сенсоры глубины и сенсоры движения, то их показания можно оценить напрямую как сигнал/шум по выражению (1), представленному ранее.

В частности, оценку меры уверенности R3 можно выполнить способом, описанным в следующих источниках:

[3] J. Zhu, L. Wang, R. Yang, J. E. Davis and Z. pan, "Reliability Fusion of Time-of-Flight Depth and Stereo Geometry for High Quality Depth Maps," in IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 33, no. 7, pp. 1400-1414, July 2011, doi: 10.1109/TPAMI.2010.172.

- Определяют расстояние d4 от камеры до целевого объекта на основании данных сенсоров движения, согласно выражению (1). Определяют меру уверенности R4 расстояния d4 на основании данных сенсоров движения, как раскрыто в публикациях:

[14] Terra, R., Figueiredo, L., Barbosa, R.S., & Anacleto, R. (2014). Traveled Distance Estimation Algorithm for Indoor Localization. Procedia Technology, 17, 248-255.

[15] Shi, Yonglei & Fang, Liqing & Guo, Deqing & Qi, Ziyuan & Wang, Jinye & Che, Jinli. (2021). Research on distance measurement method based on micro-accelerometer. AIP Advances. 11. 055126. 10.1063/5.0054463.

Оценку меры уверенности R4 можно выполнить способом, описанным в следующих источниках (сенсоры объединены под названием IMU - Inertial Measurement Unit - можно рассчитать через RMSE), как раскрыто в публикации:

[16] Cho YS, Jang SH, Cho JS, Kim MJ, Lee HD, Lee SY, Moon SB. Evaluation of Validity and Reliability of Inertial Measurement Unit-Based Gait Analysis Systems. Ann Rehabil Med. 2018 Dec;42(6):872-883. doi: 10.5535/arm.2018.42.6.872. publ. 2018 Dec 28. PMID: 30613081; PMCID: PMC6325313.

- Инициализируют средство отслеживания (трекер) для целевого объекта только на первом кадре(начальном) посредством ограничивающего прямоугольника на экране камеры и осуществляют отслеживание целевого объекта на последующих кадрах, и вычисляют коэффициент масштабирования ограничивающего прямоугольника с находящейся в ней целевым объектом,

-Определяют расстояние d5 от камеры до целевого объекта на основании вычисленного коэффициента масштабирования ограничивающего прямоугольника с находящейся в ней целевым объектом при инициализации средства отслеживания,

-Определяют меру уверенности R5 расстояния d5 от камеры до целевого объекта на основании вычисленного коэффициента масштабирования ограничивающего прямоугольника с находящейся в ней целевым объектом при инициализации средства отслеживания

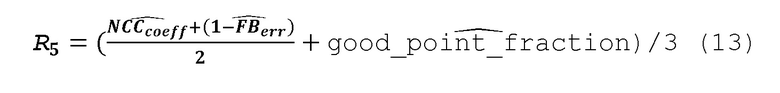

Например, меру уверенности R5 определяют, как:

На каждом кадре средством отслеживания сначала задается набор ключевых точек для отслеживания, в целях оптимизации - в нашем случае - он равномерно распределяется по ограничивающему прямоугольнику в виде узлов 2D сетки.

Пример ограничивающего прямоугольника в виде узлов 2D сетки представлен на фиг.9.

Затем средство отслеживания использует оптический поток, который выполняет отслеживание каждой точки. Таким образом, получается набор предсказанных векторов. Окончательный результат (изменение масштаба, смещение) извлекается посредством процедуры «голосования» с учетом каждого вектора.

Следует отметить, что более детально, методы и приемы получения меры уверенности при инициализации средства отслеживания раскрыты в публикации:

[17] Z. Kalal, K. Mikolajczyk and J. Matas, "Forward-Backward Error: Automatic Detection of Tracking Failures," 2010 20th International Conference on Pattern Recognition, Istanbul, Turkey, 2010, pp. 2756-2759, doi: 10.1109/ICPR.2010.675.

Далее, в настоящем описании приводится лишь краткое описание параметров получения выражения(13), которые, как уже указывалось, детально раскрыты в публикации[17]:

где:  - нормированные коэффициенты взаимной корреляции. Это мера сходства фрагментов изображения. Для каждого вектора она вычисляется для пары фрагментов (соответствующих ограничивающему прямоугольнику на кадре, см.фиг.9) из изображения i и изображения i+1 со смещенным центром согласно вектору

- нормированные коэффициенты взаимной корреляции. Это мера сходства фрагментов изображения. Для каждого вектора она вычисляется для пары фрагментов (соответствующих ограничивающему прямоугольнику на кадре, см.фиг.9) из изображения i и изображения i+1 со смещенным центром согласно вектору  . Значение меры сходства вычисляется для каждой пары фрагментов, полученной от одного из векторов движения

. Значение меры сходства вычисляется для каждой пары фрагментов, полученной от одного из векторов движения . Медиана по всем значениям меры сходства фрагментов изображения берется за финальную оценку.

. Медиана по всем значениям меры сходства фрагментов изображения берется за финальную оценку.

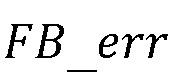

- ошибка прямого-обратного отслеживания: средство отслеживания применяется для каждой ключевой точки при переходе от кадра k к кадру k+1 (прямое отслеживание). Для подсчета ошибки необходимо также применить средство отслеживания для кадров изображений в обратном порядке, используя полученные при прямом отслеживании точки в качестве ключевых начальных точек. В результате расстояние между начальной точкой прямого отслеживания и конечной точкой обратного отслеживания определяет ошибку. Окончательное значение вычисляется на основании медианы по всем значениям ошибки для каждой ключевой точки

- ошибка прямого-обратного отслеживания: средство отслеживания применяется для каждой ключевой точки при переходе от кадра k к кадру k+1 (прямое отслеживание). Для подсчета ошибки необходимо также применить средство отслеживания для кадров изображений в обратном порядке, используя полученные при прямом отслеживании точки в качестве ключевых начальных точек. В результате расстояние между начальной точкой прямого отслеживания и конечной точкой обратного отслеживания определяет ошибку. Окончательное значение вычисляется на основании медианы по всем значениям ошибки для каждой ключевой точки

«good_point_fraction» - доля исходных ключевых точек после фильтрации. Фильтрация происходит следующим образом: указанные выше значения  и

и  подсчитываются для каждой ключевой точки, фильтруются (не учитываются в доле) те точки, на которых подсчет дал значения ниже пороговых (пороговые известны заранее и задаются вручную в результате предварительных экспериментов). Процесс фильтрации детально раскрыто в публикации[17]).

подсчитываются для каждой ключевой точки, фильтруются (не учитываются в доле) те точки, на которых подсчет дал значения ниже пороговых (пороговые известны заранее и задаются вручную в результате предварительных экспериментов). Процесс фильтрации детально раскрыто в публикации[17]).

Символ « ̂ »(hat) над каждым выражением - означает нормализованное значение - в диапазоне [0,1]. Его получают каждый раз путем сравнения с пороговым значением (настроенным вручную). Таким образом, также гарантируется, что R5 находится в диапазоне [0,1]. А если средство отслеживания теряет объект - значение меры уверенности R5 устанавливается в 0 до повторной инициализации средства отслеживания(см. публикацию [17]).