Область техники, к которой относится изобретение

[0001] Данное раскрытие сущности относится к кодированию видео и, в частности, к системам, компонентам и способам кодирования и декодирования видео при кодировании и декодировании видео, к примеру, для выполнения процесса CCALF (кросскомпонентной адаптивной контурной фильтрации).

Уровень техники

[0002] В силу совершенствований в технологии кодирования видео, из (H.261 и MPEG-1 в (H.264/AVC (стандарт усовершенствованного кодирования видео), MPEG-LA, (H.265/HEVC (стандарт высокоэффективного кодирования видео) и (H.266/VVC (универсальный видеокодек), остается постоянная потребность в том, чтобы предоставлять улучшения и оптимизации для технологии кодирования видео, с тем чтобы обрабатывать постоянно увеличивающийся объем цифровых видеоданных в различных вариантах применения. Данное раскрытие сущности относится к дополнительным усовершенствованиям, улучшениям и оптимизациям при кодировании видео, в частности, в процессе CCALF (кросскомпонентной адаптивной контурной фильтрации).

Сущность изобретения

[0003] Согласно одному аспекту, предоставляется кодер, который включает в себя схему и запоминающее устройство, соединенное со схемой. Схема, при работе, формирует первое значение коэффициента посредством применения процесса CCALF (кросскомпонентной адаптивной контурной фильтрации) к первой восстановленной выборке изображений компонента сигнала яркости. Схема формирует второе значение коэффициента посредством применения процесса ALF (адаптивной контурной фильтрации) ко второй восстановленной выборке изображений компонента сигнала цветности и отсекает второе значение коэффициента. Схема формирует третье значение коэффициента посредством суммирования первого значения коэффициента с отсеченным вторым значением коэффициента и отсекает третье значение коэффициента. Схема кодирует третью восстановленную выборку изображений компонента сигнала цветности с использованием отсеченного третьего значения коэффициента.

[0004] Согласно дополнительному аспекту, первая восстановленная выборка изображений расположена рядом со второй восстановленной выборкой изображений.

[0005] Согласно другому аспекту, схема, при работе, задает первое значение коэффициента равным нулю в ответ на первое значение коэффициента, меньшее 64.

[0006] Согласно другому аспекту, предоставляется кодер, который включает в себя: модуль разбиения блоков, который, при работе, разбивает первое изображение на множество блоков; модуль внутреннего прогнозирования, который, при работе, прогнозирует блоки, включенные в первое изображение, с использованием опорных блоков, включенных в первое изображение; модуль взаимного прогнозирования, который, при работе, прогнозирует блоки, включенные в первое изображение, с использованием опорных блоков, включенных во второе изображение, отличающееся от первого изображения; контурный фильтр, который, при работе, фильтрует блоки, включенные в первое изображение; преобразователь, который, при работе, преобразует ошибку прогнозирования между исходным сигналом и прогнозным сигналом, сформированным посредством модуля внутреннего прогнозирования или модуля взаимного прогнозирования, чтобы формировать коэффициенты преобразования; квантователь, который, при работе, квантует коэффициенты преобразования, чтобы формировать квантованные коэффициенты; и энтропийный кодер, который, при работе, переменно кодирует квантованные коэффициенты, чтобы формировать кодированный поток битов, включающий в себя кодированные квантованные коэффициенты и управляющую информацию. Контурный фильтр выполняет следующее:

- формирование первого значения коэффициента посредством применения процесса CCALF (кросскомпонентной адаптивной контурной фильтрации) к первой восстановленной выборке изображений компонента сигнала яркости;

- формирование второго значения коэффициента посредством применения процесса ALF (адаптивной контурной фильтрации) ко второй восстановленной выборке изображений компонента сигнала цветности;

- отсечение второго значения коэффициента;

- формирование третьего значения коэффициента посредством суммирования первого значения коэффициента с отсеченным вторым значением коэффициента; и

- отсечение третьего значения коэффициента; и

- кодирование третьей восстановленной выборки изображений компонента сигнала цветности с использованием отсеченного третьего значения коэффициента.

[0007] Согласно дополнительному аспекту, предоставляется декодер, который включает в себя схему и запоминающее устройство, соединенное со схемой. Схема, при работе, формирует первое значение коэффициента посредством применения процесса CCALF (кросскомпонентной адаптивной контурной фильтрации) к первой восстановленной выборке изображений компонента сигнала яркости. Схема формирует второе значение коэффициента посредством применения процесса ALF (адаптивной контурной фильтрации) ко второй восстановленной выборке изображений компонента сигнала цветности и отсекает второе значение коэффициента. Схема формирует третье значение коэффициента посредством суммирования первого значения коэффициента с отсеченным вторым значением коэффициента и отсекает третье значение коэффициента. Схема декодирует третью восстановленную выборку изображений компонента сигнала цветности с использованием отсеченного третьего значения коэффициента.

[0008] Согласно другому аспекту, предоставляется оборудование декодирования, которое включает в себя: декодер, который, при работе, декодирует кодированный поток битов, чтобы выводить квантованные коэффициенты; обратный квантователь, который, при работе, обратно квантует квантованные коэффициенты, чтобы выводить коэффициенты преобразования; обратный преобразователь, который, при работе, обратно преобразует коэффициенты преобразования, чтобы выводить ошибку прогнозирования; модуль внутреннего прогнозирования, который, при работе, прогнозирует блоки, включенные в первое изображение, с использованием опорных блоков, включенных в первое изображение; модуль взаимного прогнозирования, который, при работе, прогнозирует блоки, включенные в первое изображение, с использованием опорных блоков, включенных во второе изображение, отличающееся от первого изображения; контурный фильтр, который, при работе, фильтрует блоки, включенные в первое изображение; и вывод, который, при работе, выводит кадр, включающий в себя первое изображение. Контурный фильтр выполняет следующее:

- формирование первого значения коэффициента посредством применения процесса CCALF (кросскомпонентной адаптивной контурной фильтрации) к первой восстановленной выборке изображений компонента сигнала яркости;

- формирование второго значения коэффициента посредством применения процесса ALF (адаптивной контурной фильтрации) ко второй восстановленной выборке изображений компонента сигнала цветности;

- отсечение второго значения коэффициента;

- формирование третьего значения коэффициента посредством суммирования первого значения коэффициента с отсеченным вторым значением коэффициента; и

- отсечение третьего значения коэффициента; и

- декодирование третьей восстановленной выборки изображений компонента сигнала цветности с использованием отсеченного третьего значения коэффициента.

[0009] Согласно другому аспекту, предоставляется способ кодирования, который включает в себя:

- формирование первого значения коэффициента посредством применения процесса CCALF (кросскомпонентной адаптивной контурной фильтрации) к первой восстановленной выборке изображений компонента сигнала яркости;

- формирование второго значения коэффициента посредством применения процесса ALF (адаптивной контурной фильтрации) ко второй восстановленной выборке изображений компонента сигнала цветности;

- отсечение второго значения коэффициента;

- формирование третьего значения коэффициента посредством суммирования первого значения коэффициента с отсеченным вторым значением коэффициента; и

- отсечение третьего значения коэффициента; и

- кодирование третьей восстановленной выборки изображений компонента сигнала цветности с использованием отсеченного третьего значения коэффициента.

[0010] Согласно дополнительному аспекту, предоставляется способ декодирования, который включает в себя:

- формирование первого значения коэффициента посредством применения процесса CCALF (кросскомпонентной адаптивной контурной фильтрации) к первой восстановленной выборке изображений компонента сигнала яркости;

- формирование второго значения коэффициента посредством применения процесса ALF (адаптивной контурной фильтрации) ко второй восстановленной выборке изображений компонента сигнала цветности;

- отсечение второго значения коэффициента;

- формирование третьего значения коэффициента посредством суммирования первого значения коэффициента с отсеченным вторым значением коэффициента; и

- отсечение третьего значения коэффициента; и

- декодирование третьей восстановленной выборки изображений компонента сигнала цветности с использованием отсеченного третьего значения коэффициента.

[0011] В технологии кодирования видео, желательно предлагать новые способы для того, чтобы повышать эффективность кодирования, повышать качество изображений и уменьшать размер схем. Некоторые реализации вариантов осуществления настоящего раскрытия сущности, включающие в себя составляющие элементы вариантов осуществления настоящего раскрытия сущности, рассматриваемые отдельно или в различных комбинациях, могут упрощать одно или более из следующего: повышение эффективности кодирования, повышение качества изображений, уменьшение степени использования ресурсов обработки, ассоциированных с кодированием/декодированием, уменьшение размера схем, повышение скорости обработки кодирования/декодирования и т.д.

[0012] Помимо этого, некоторые реализации вариантов осуществления настоящего раскрытия сущности, включающие в себя составляющие элементы вариантов осуществления настоящего раскрытия сущности, рассматриваемые отдельно или в различных комбинациях, могут упрощать, при кодировании и декодировании, соответствующий выбор одного или более элементов, таких как фильтр, блок, размер, вектор движения, опорный кадр, опорный блок или операция. Следует отметить, что настоящее раскрытие сущности включает в себя раскрытие сущности относительно конфигураций и способов, которые могут предоставлять преимущества, отличные от вышеописанных преимуществ. Примеры таких конфигураций и способов включают в себя конфигурацию или способ для повышения эффективности кодирования при уменьшении роста использования ресурсов обработки.

[0013] Дополнительные выгоды и преимущества раскрытых вариантов осуществления должны становиться очевидными из подробного описания и чертежей. Выгоды и/или преимущества могут отдельно получаться посредством различных вариантов осуществления и признаков подробного описания и чертежей, не все из которых должны обязательно предоставляться для того, чтобы получать одну или более таких выгод и/или преимуществ.

[0014] Следует отметить, что общие или конкретные варианты осуществления могут реализовываться как система, способ, интегральная схема, компьютерная программа, носитель хранения данных или любая избирательная комбинация вышеозначенного.

Краткое описание чертежей

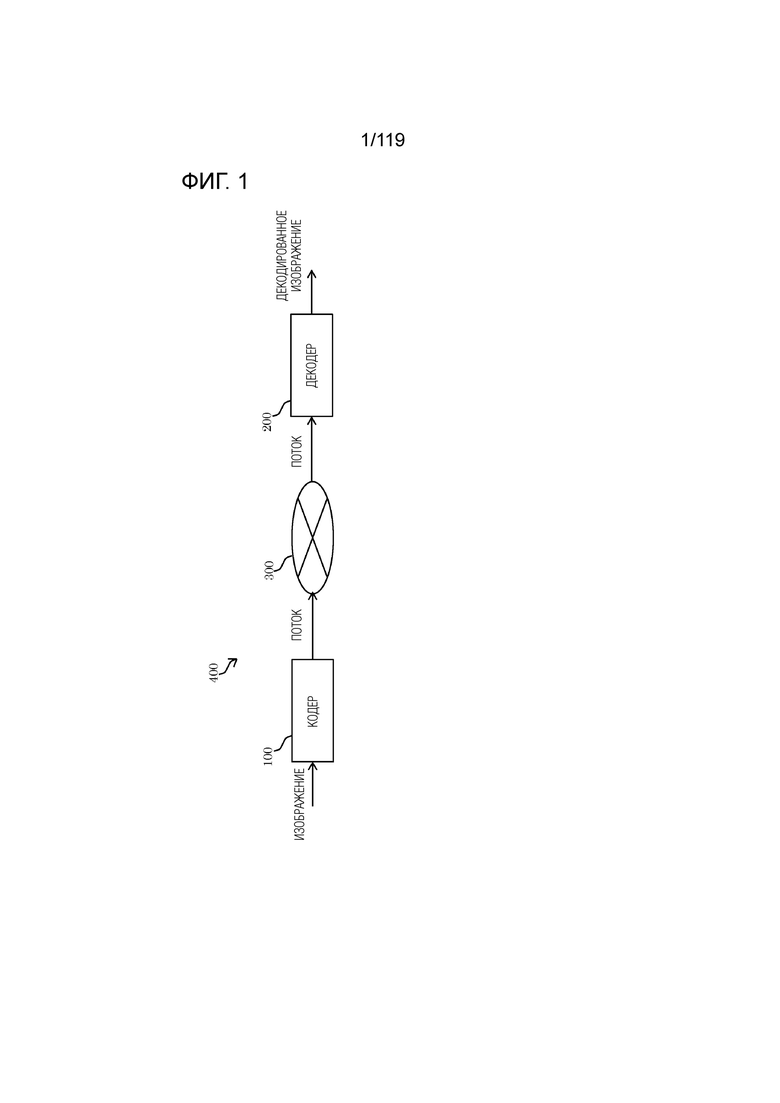

[0015] Фиг. 1 является принципиальной схемой, иллюстрирующей один пример функциональной конфигурации системы передачи согласно варианту осуществления.

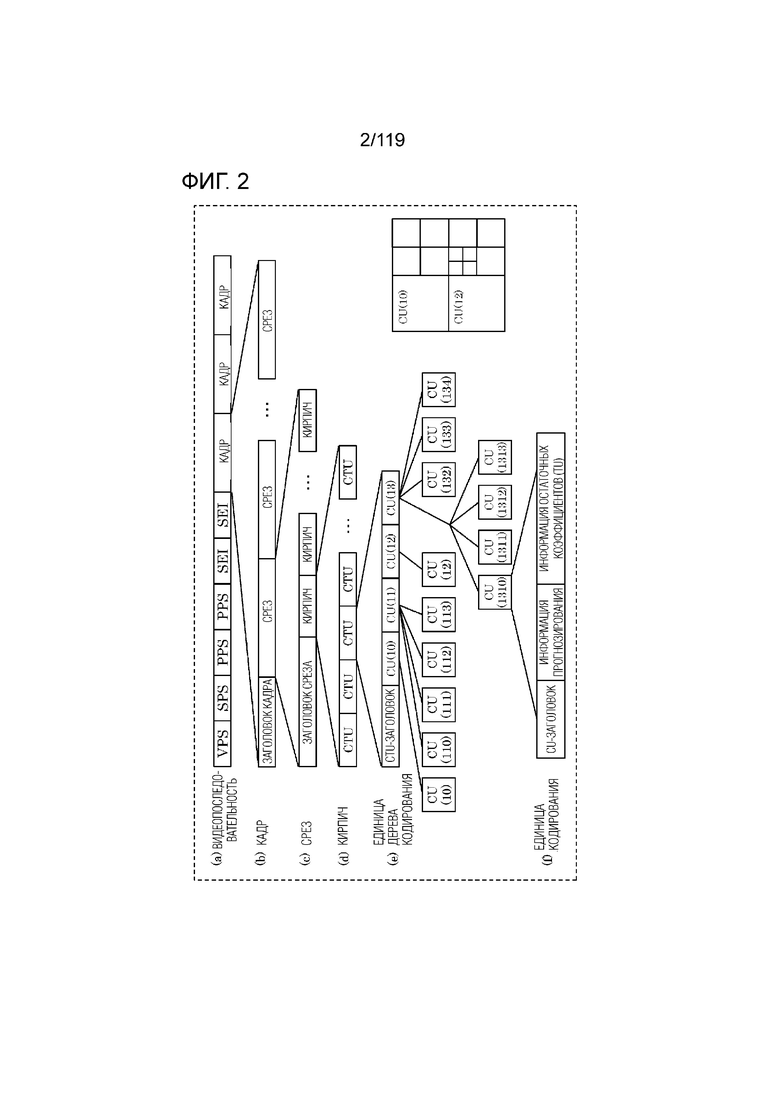

Фиг. 2 является концептуальной схемой для иллюстрации одного примера иерархической структуры данных в потоке.

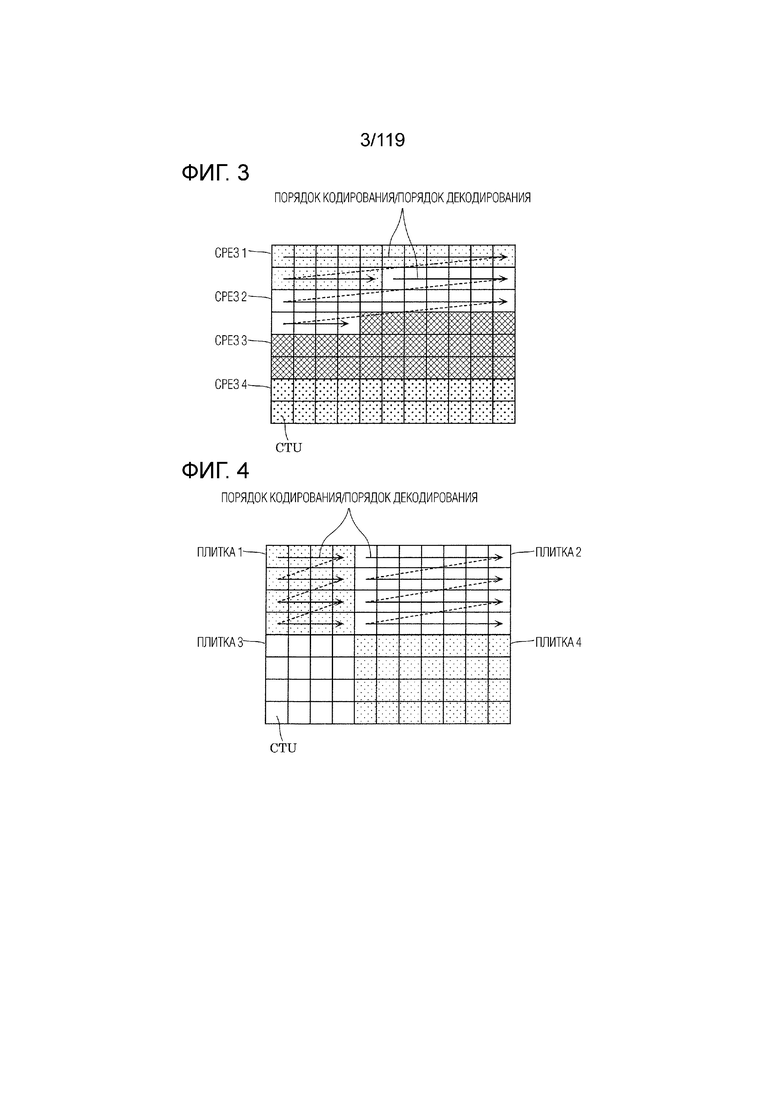

Фиг. 3 является концептуальной схемой для иллюстрации одного примера конфигурации срезов.

Фиг. 4 является концептуальной схемой для иллюстрации одного примера конфигурации плиток.

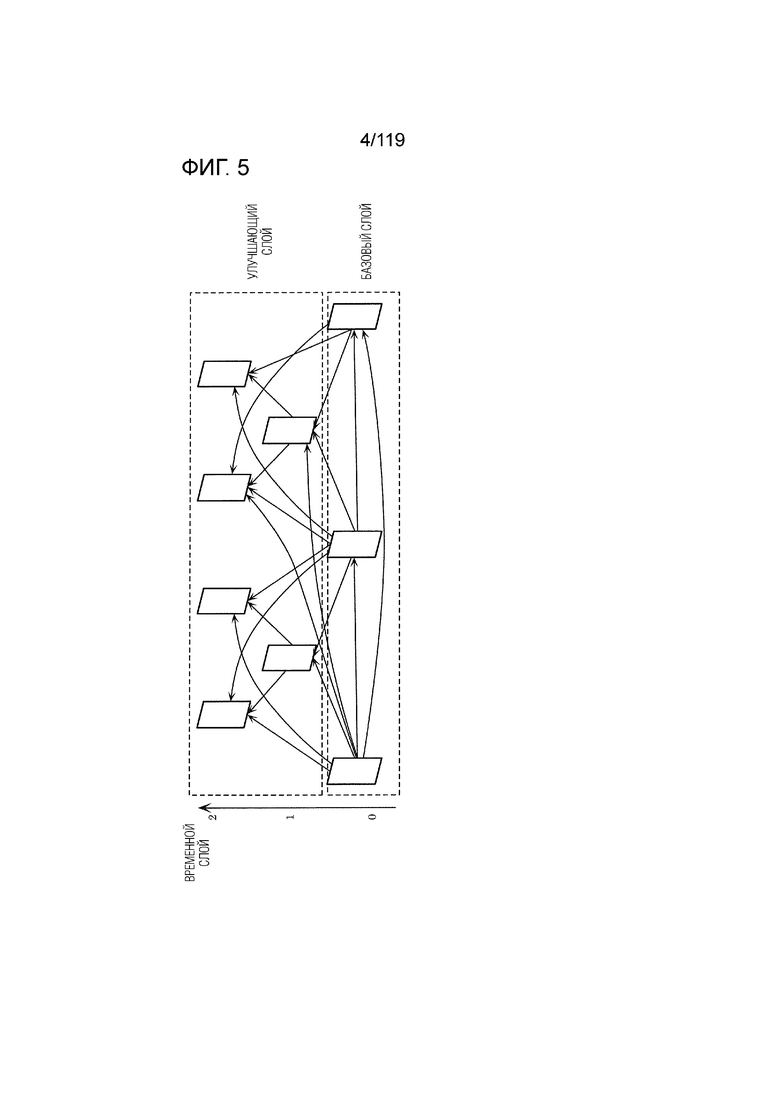

Фиг. 5 является концептуальной схемой для иллюстрации одного примера структуры кодирования при масштабируемом кодировании.

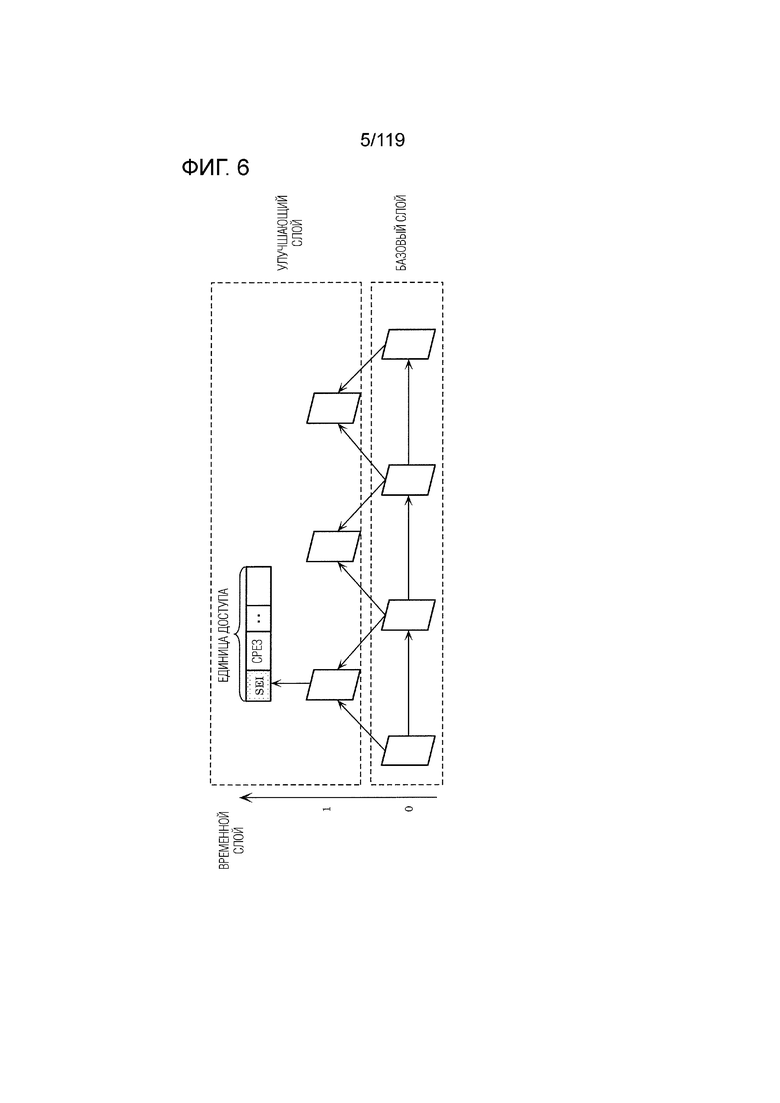

Фиг. 6 является концептуальной схемой для иллюстрации одного примера структуры кодирования при масштабируемом кодировании.

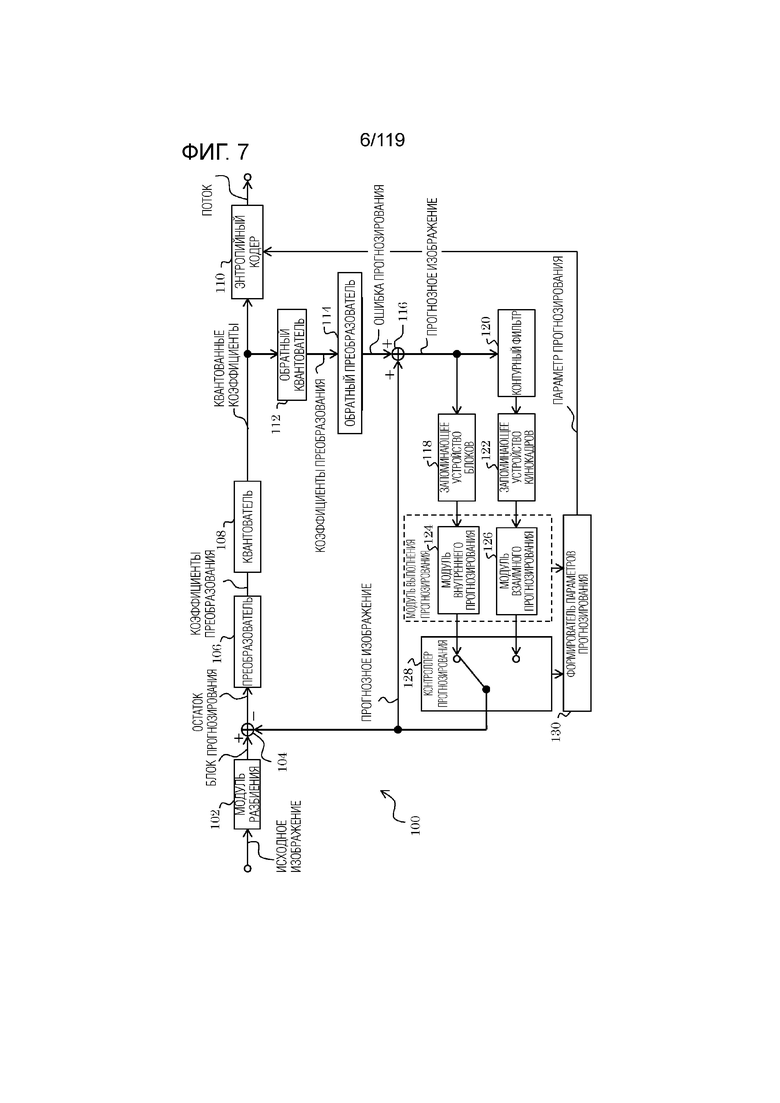

Фиг. 7 является блок-схемой, иллюстрирующей функциональную конфигурацию кодера согласно варианту осуществления.

Фиг. 8 является функциональной блок-схемой, иллюстрирующей пример монтажа кодера.

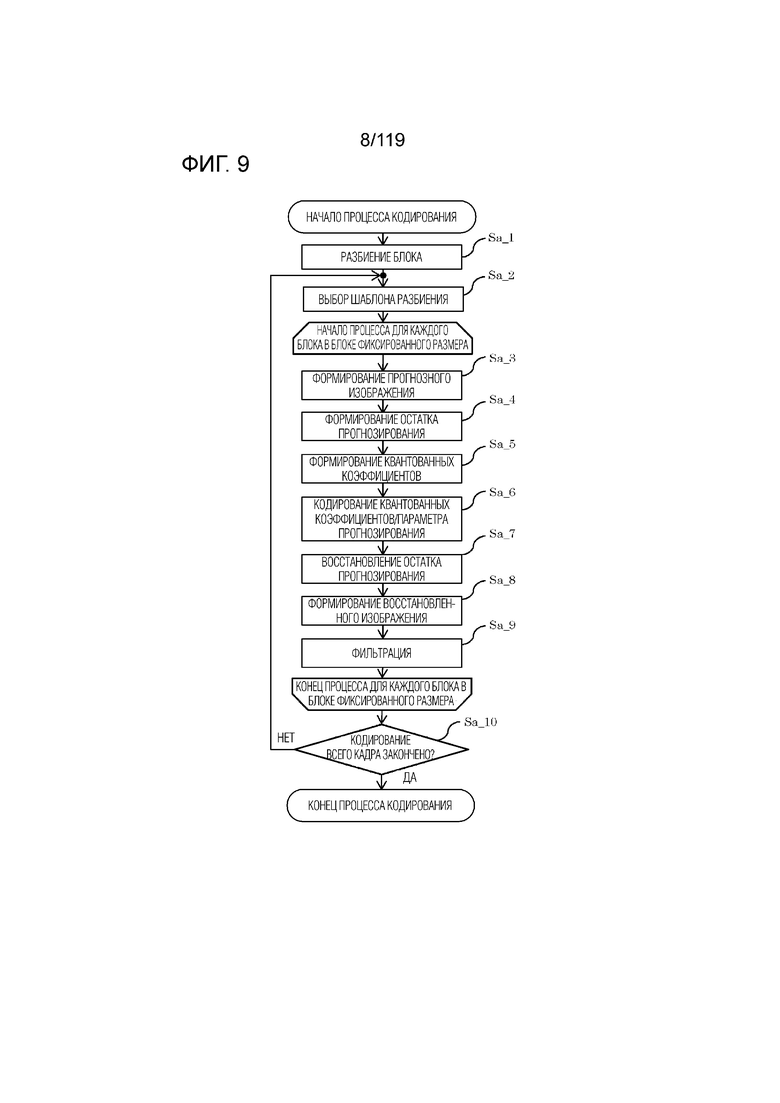

Фиг. 9 является блок-схемой последовательности операций способа, указывающей один пример полного процесса декодирования, выполняемого посредством кодера.

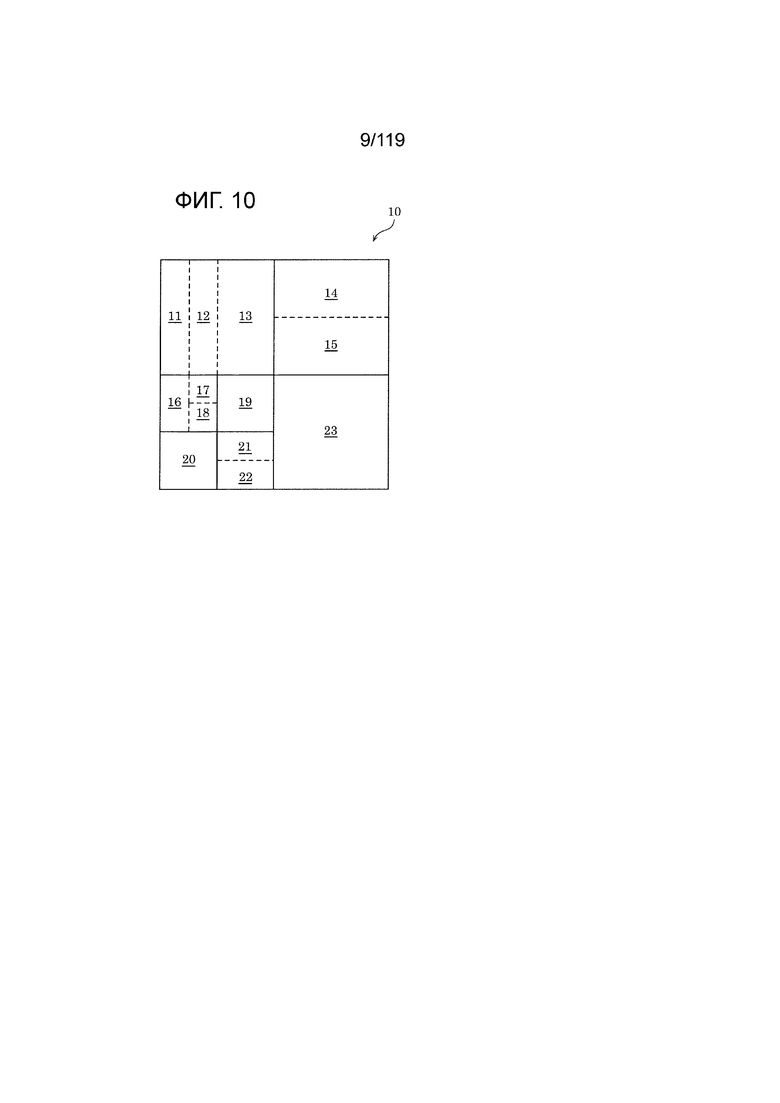

Фиг. 10 является концептуальной схемой для иллюстрации одного примера разбиения блоков.

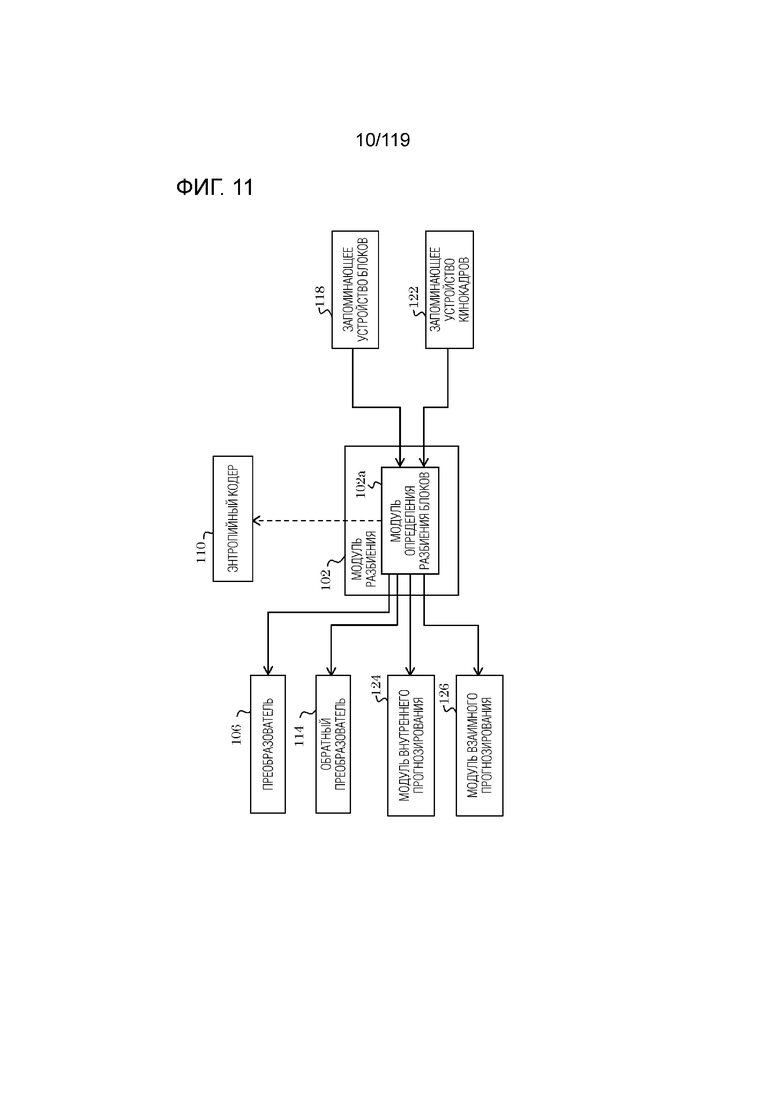

Фиг. 11 является блок-схемой, иллюстрирующей один пример функциональной конфигурации модуля разбиения согласно варианту осуществления.

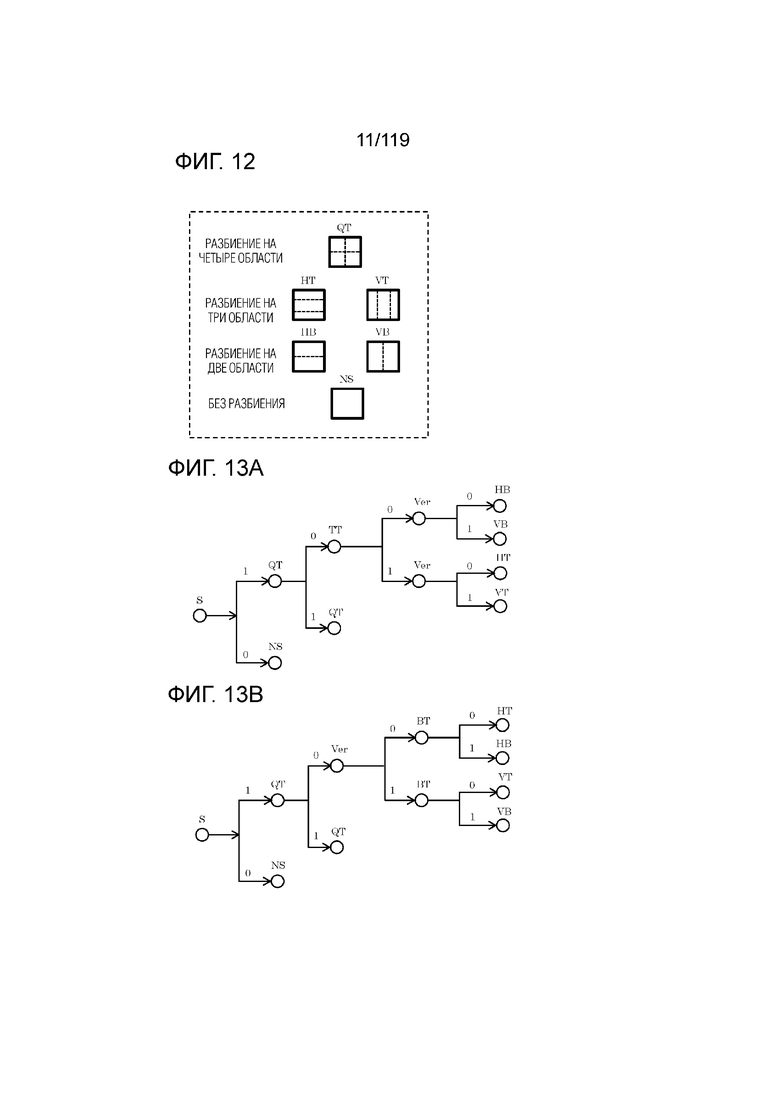

Фиг. 12 является концептуальной схемой для иллюстрации примеров шаблонов разбиения.

Фиг. 13A является концептуальной схемой для иллюстрации одного примера синтаксического дерева шаблона разбиения.

Фиг. 13B является концептуальной схемой для иллюстрации другого примера синтаксического дерева шаблона разбиения.

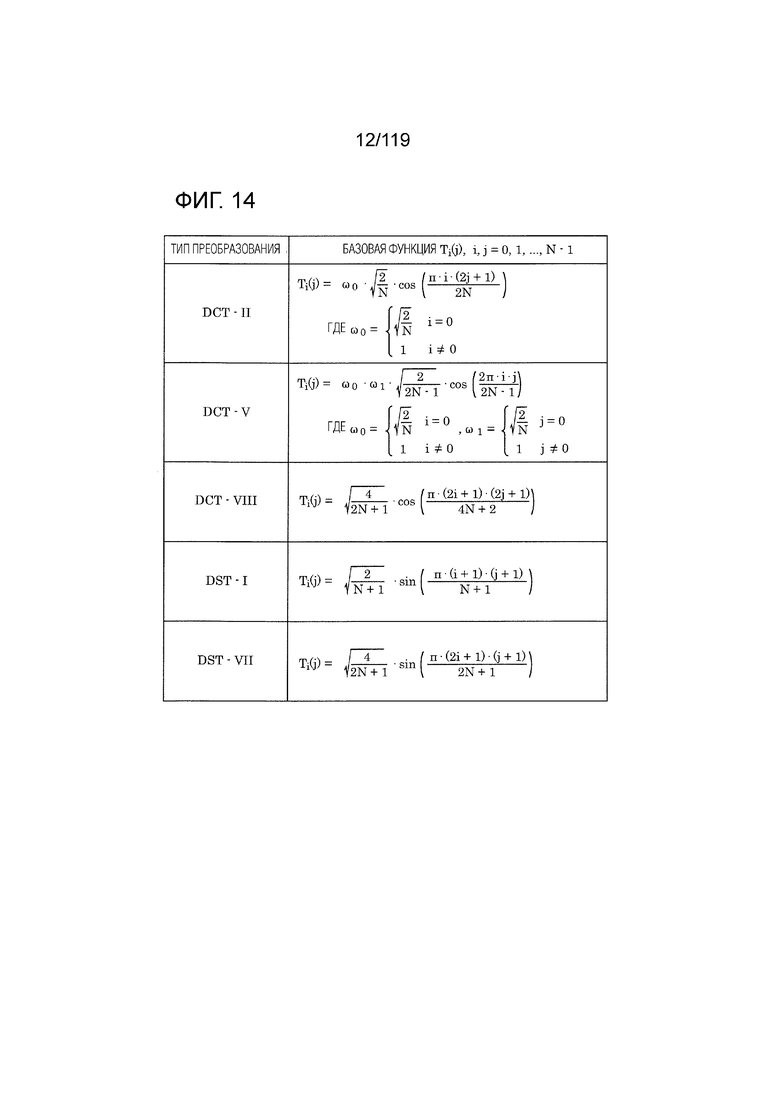

Фиг. 14 является диаграммой, указывающей примерные базисные функции преобразования для различных типов преобразования.

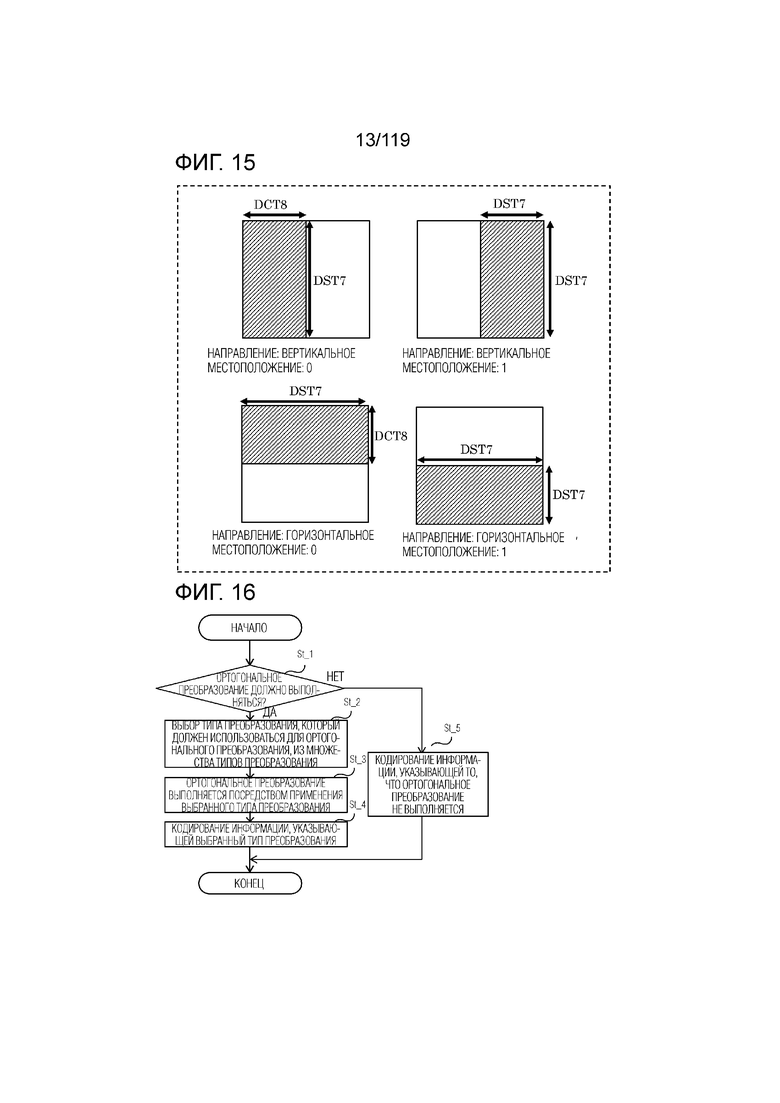

Фиг. 15 является концептуальной схемой для иллюстрации примерных пространственно варьирующихся преобразований (SVT).

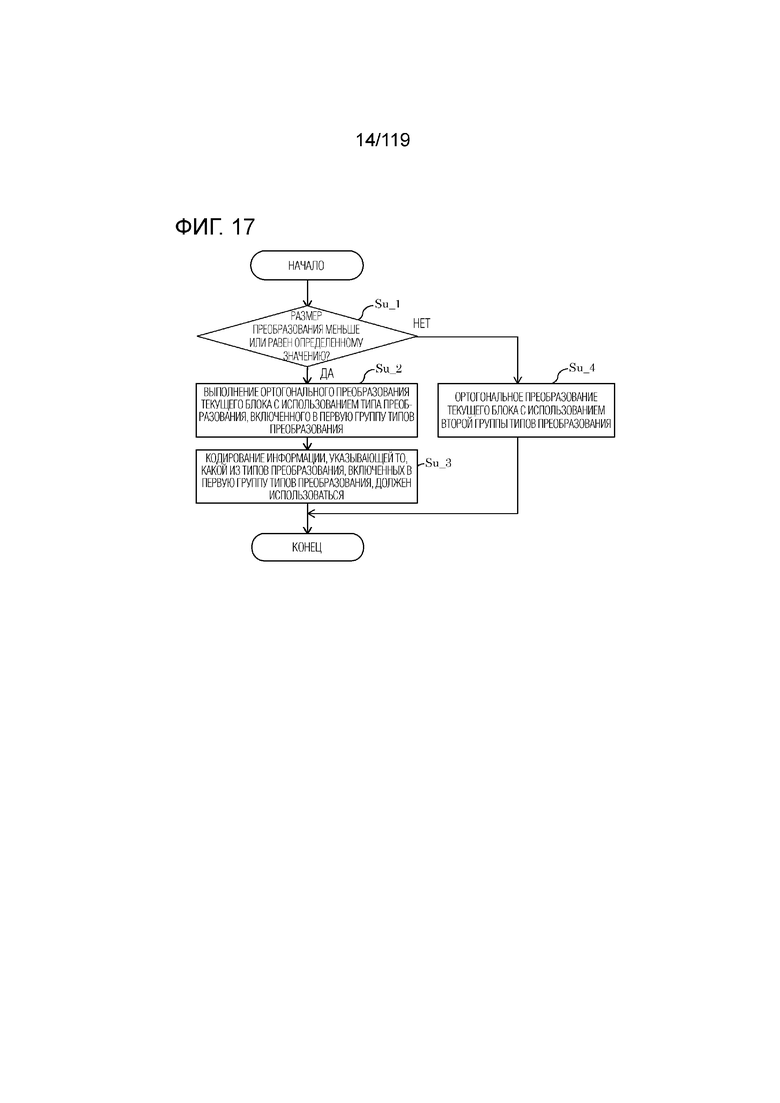

Фиг. 16 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса, выполняемого посредством преобразователя.

Фиг. 17 является блок-схемой последовательности операций способа, иллюстрирующей другой пример процесса, выполняемого посредством преобразователя.

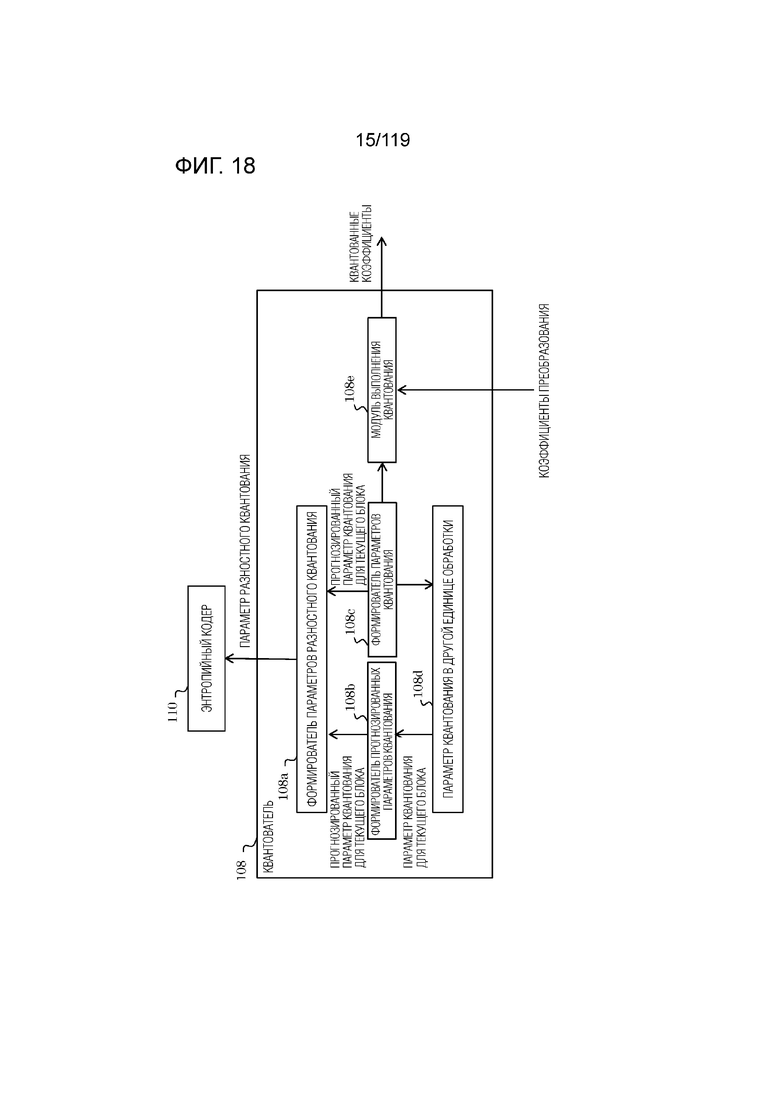

Фиг. 18 является блок-схемой, иллюстрирующей один пример функциональной конфигурации квантователя согласно варианту осуществления.

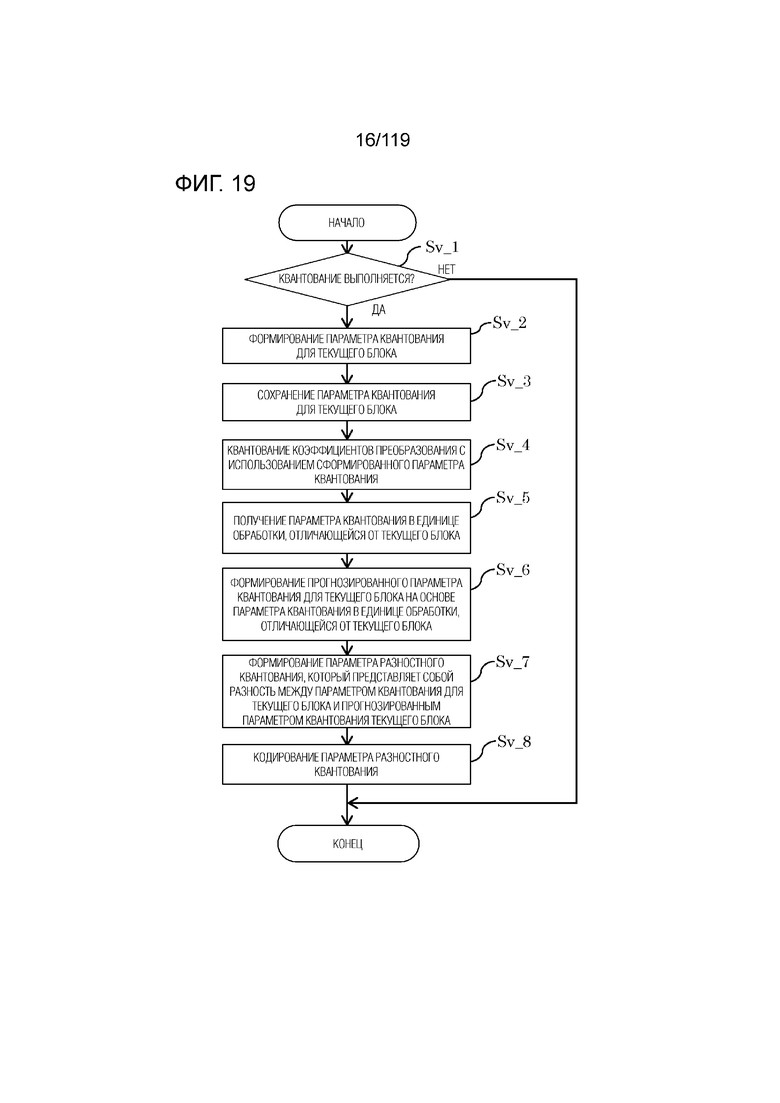

Фиг. 19 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса квантования, выполняемого посредством квантователя.

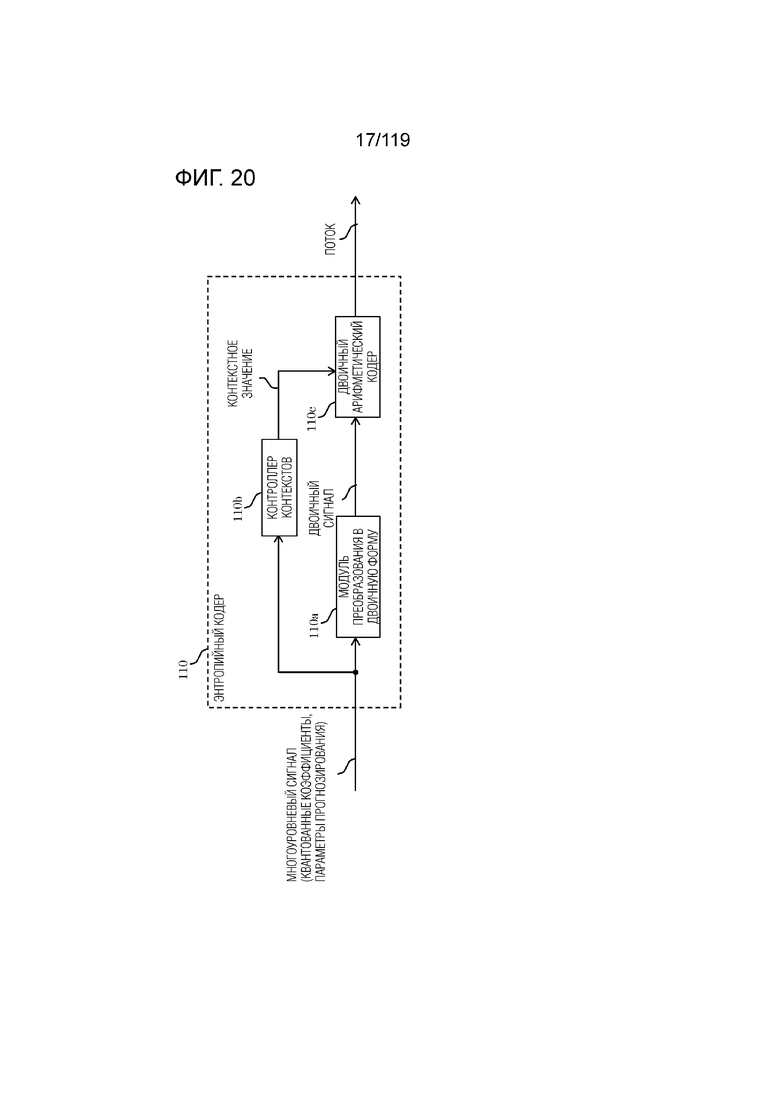

Фиг. 20 является блок-схемой, иллюстрирующей один пример функциональной конфигурации энтропийного кодера согласно варианту осуществления.

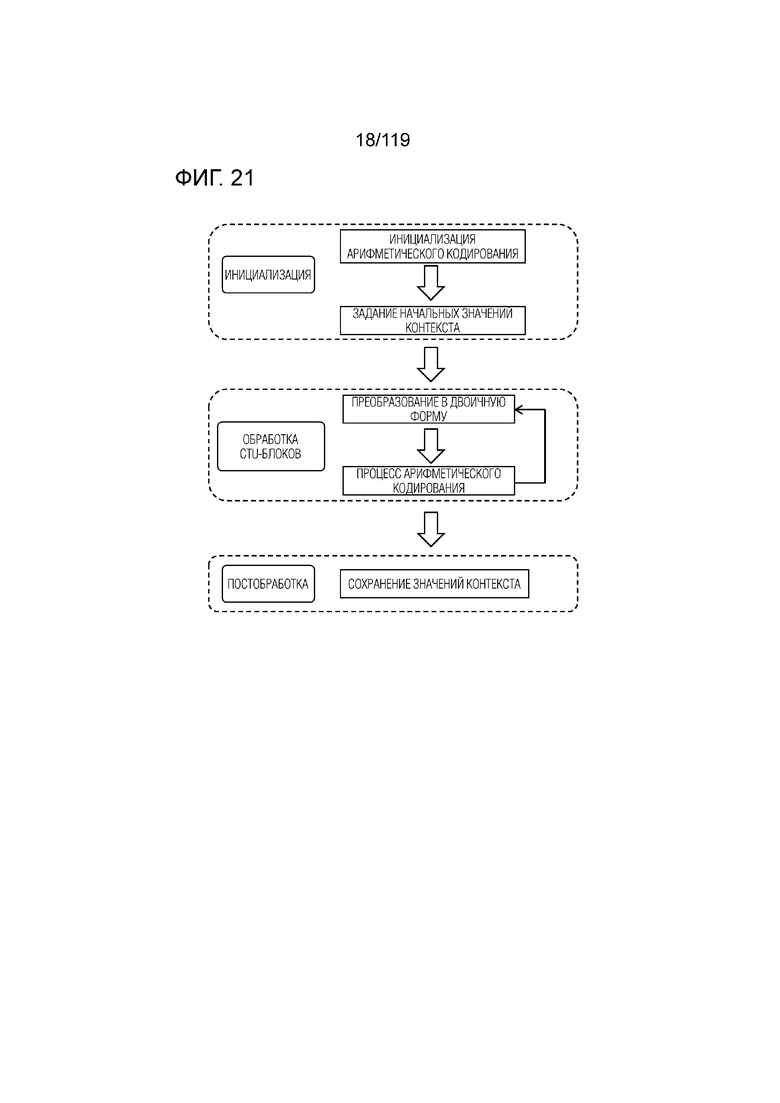

Фиг. 21 является концептуальной схемой для иллюстрации примерной последовательности операций процесса контекстно-адаптивного двоичного арифметического кодирования (CABAC) в энтропийном кодере.

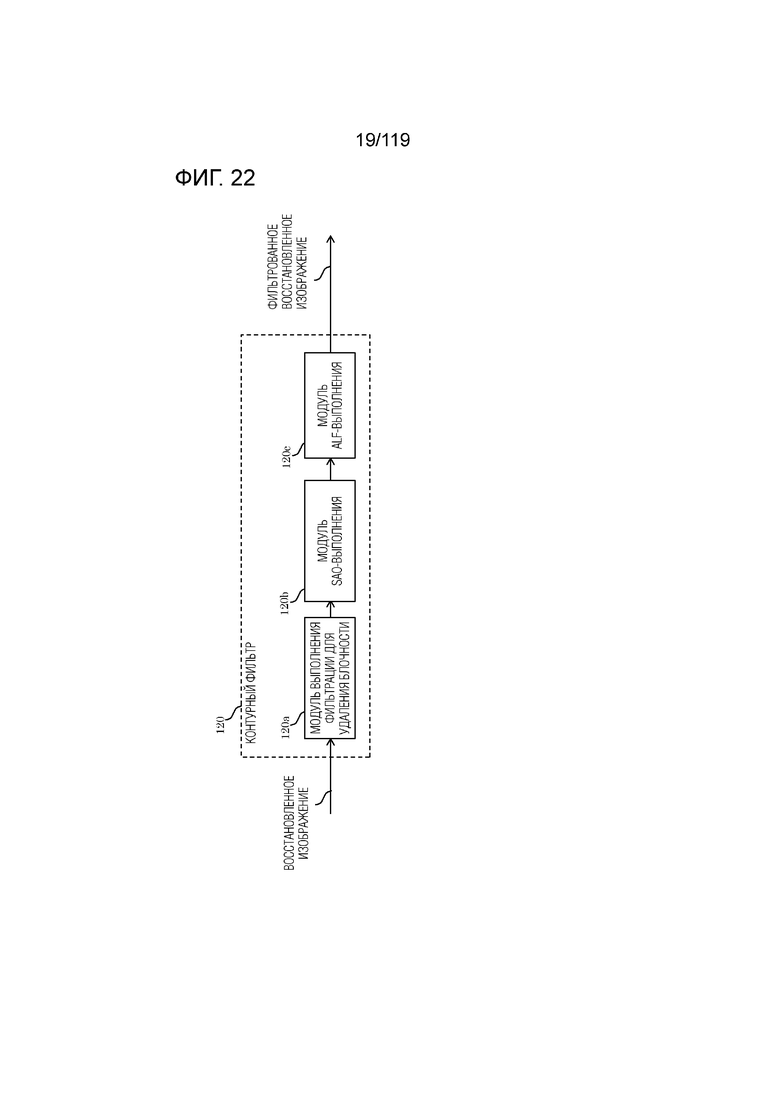

Фиг. 22 является блок-схемой, иллюстрирующей один пример функциональной конфигурации контурного фильтра согласно варианту осуществления.

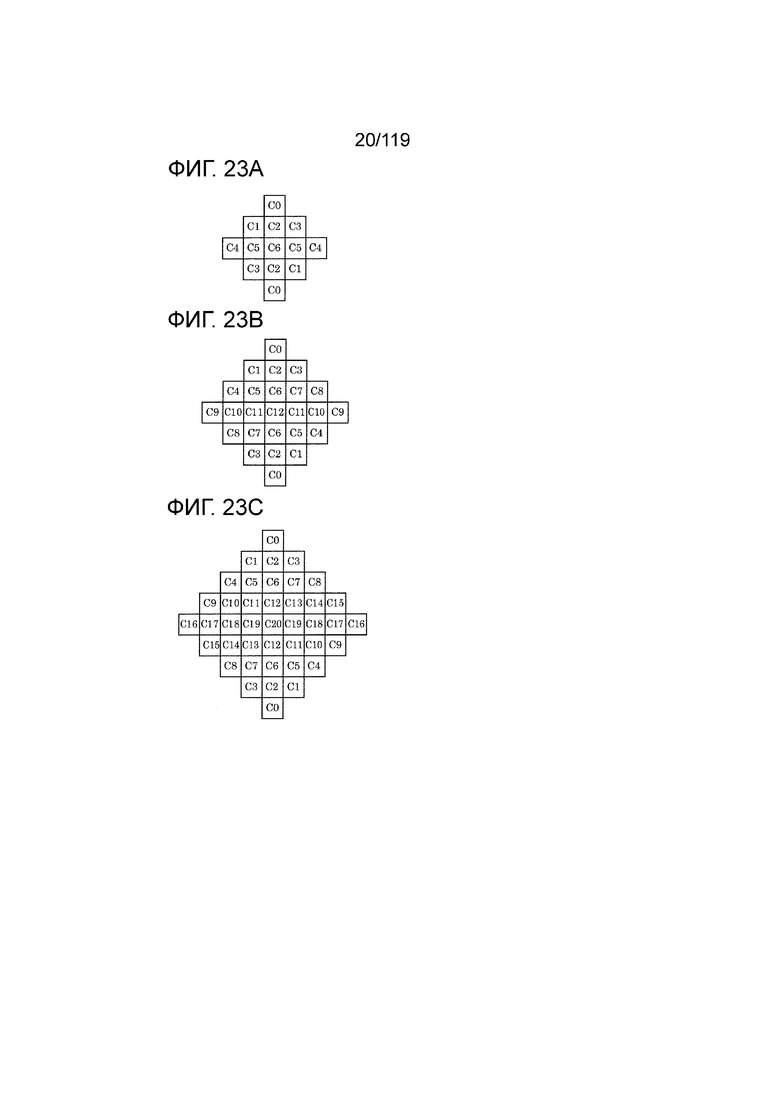

Фиг. 23A является концептуальной схемой, иллюстрирующей один пример формы фильтра, используемой в адаптивном контурном фильтре (ALF).

Фиг. 23B является концептуальной схемой для иллюстрации другого примера формы фильтра, используемой в ALF.

Фиг. 23C является концептуальной схемой для иллюстрации другого примера формы фильтра, используемой в ALF.

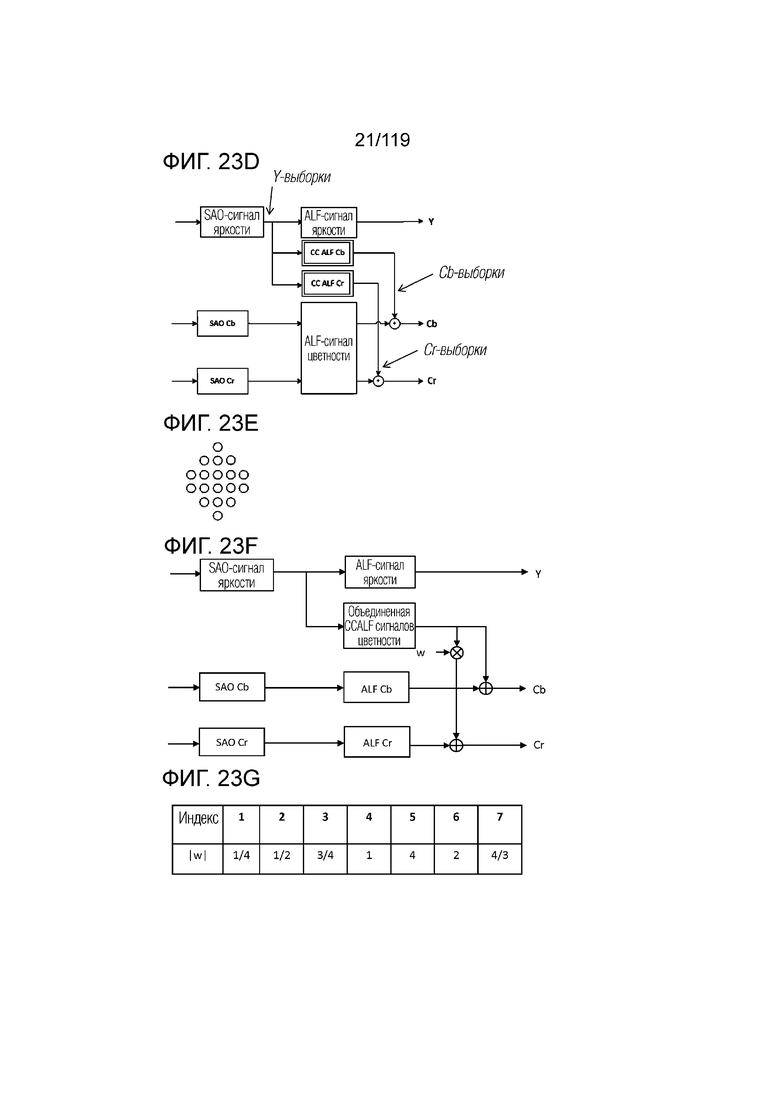

Фиг. 23D является концептуальной схемой для иллюстрации примерной последовательности операций кросскомпонентной ALF (CCALF).

Фиг. 23E является концептуальной схемой для иллюстрации примера формы фильтра, используемой в CCALF.

Фиг. 23F является концептуальной схемой для иллюстрации примерной последовательности операций объединенной CCALF сигналов цветности (JC-CCALF).

Фиг. 23G является таблицей, иллюстрирующей примерные возможные варианты весовых индексов, которые могут использоваться в JC-CCALF.

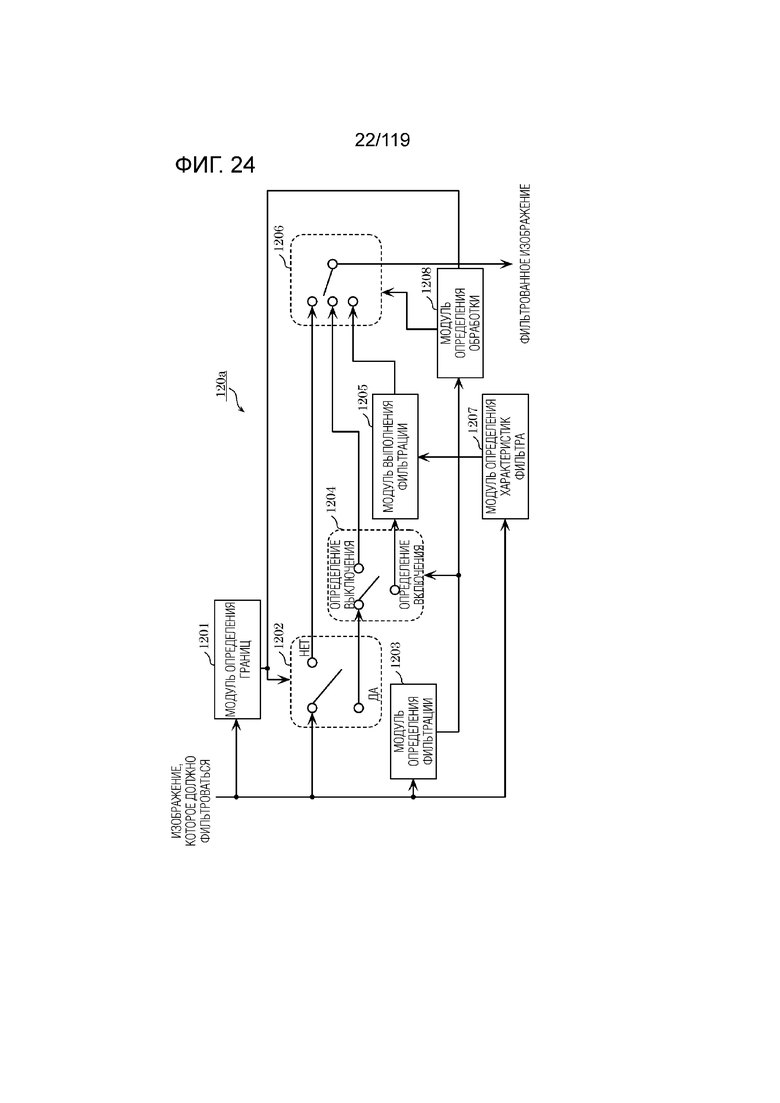

Фиг. 24 является блок-схемой, указывающей один пример конкретной конфигурации контурного фильтра, который функционирует в качестве фильтра удаления блочности (DBF).

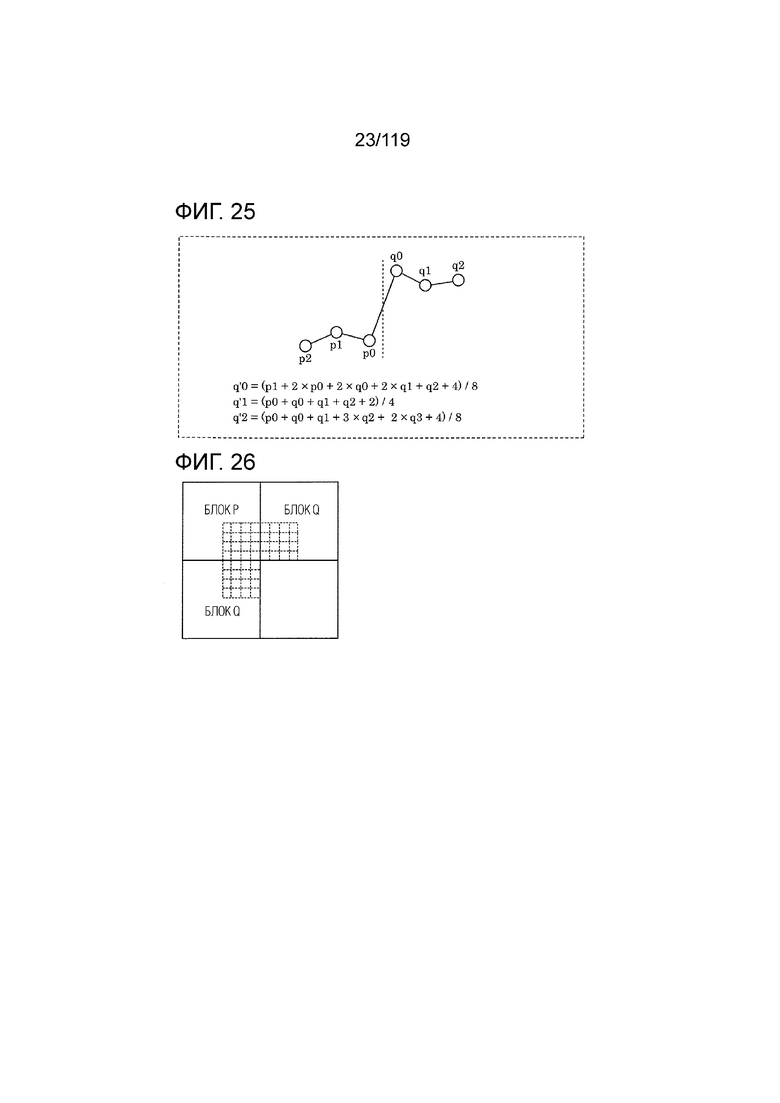

Фиг. 25 является концептуальной схемой для иллюстрации примера фильтра удаления блочности, имеющего симметричную характеристику фильтрации относительно границы блока.

Фиг. 26 является концептуальной схемой для иллюстрации границы блока, для которой выполняется процесс фильтрации для удаления блочности.

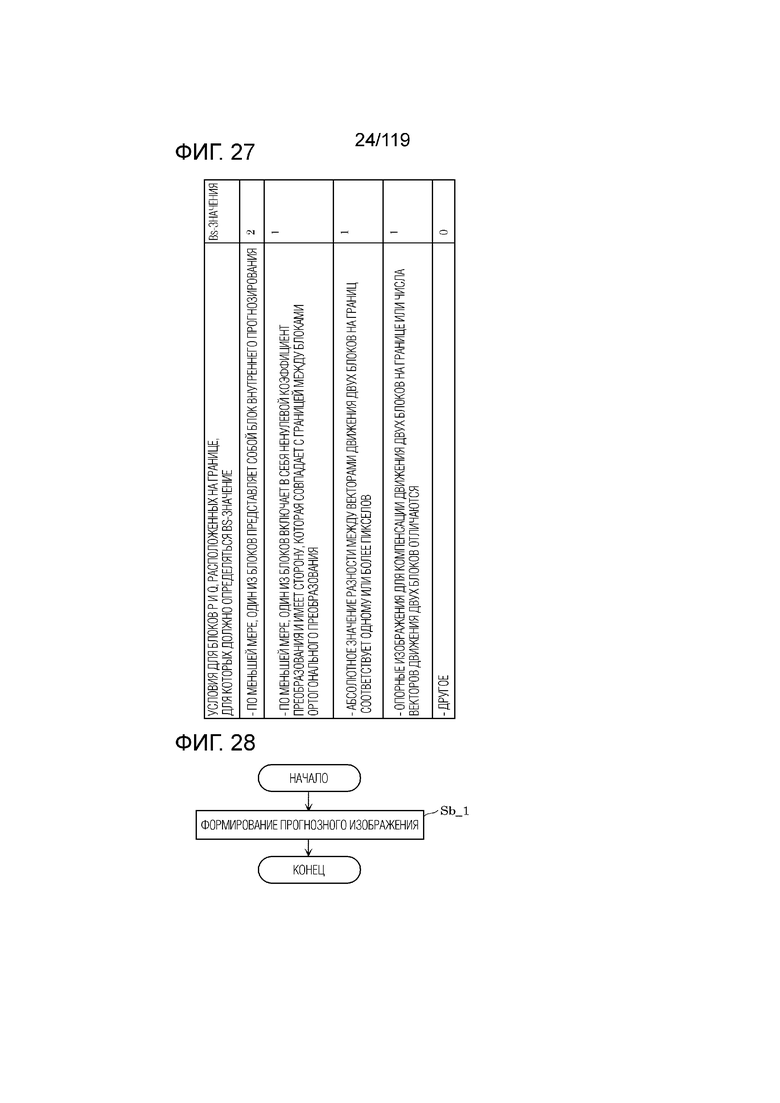

Фиг. 27 является концептуальной схемой для иллюстрации примеров значений граничной интенсивности (Bs).

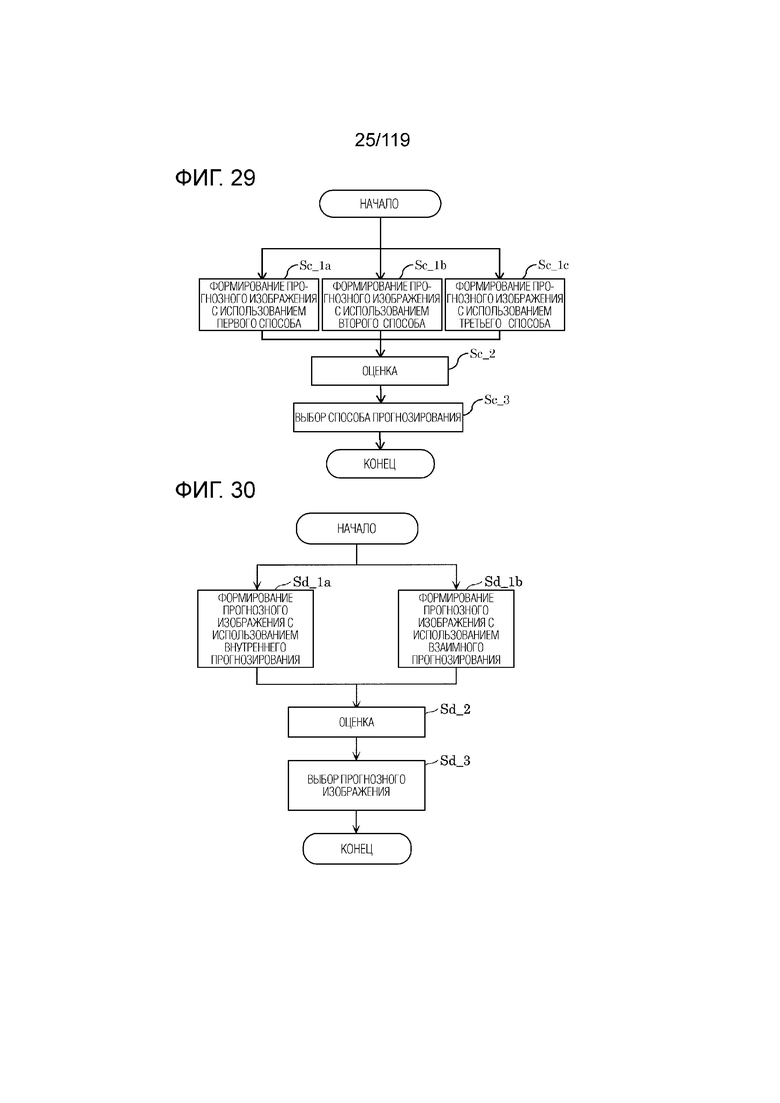

Фиг. 28 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса, выполняемого посредством модуля прогнозирования кодера.

Фиг. 29 является блок-схемой последовательности операций способа, иллюстрирующей другой пример процесса, выполняемого посредством модуля прогнозирования кодера.

Фиг. 30 является блок-схемой последовательности операций способа, иллюстрирующей другой пример процесса, выполняемого посредством модуля прогнозирования кодера.

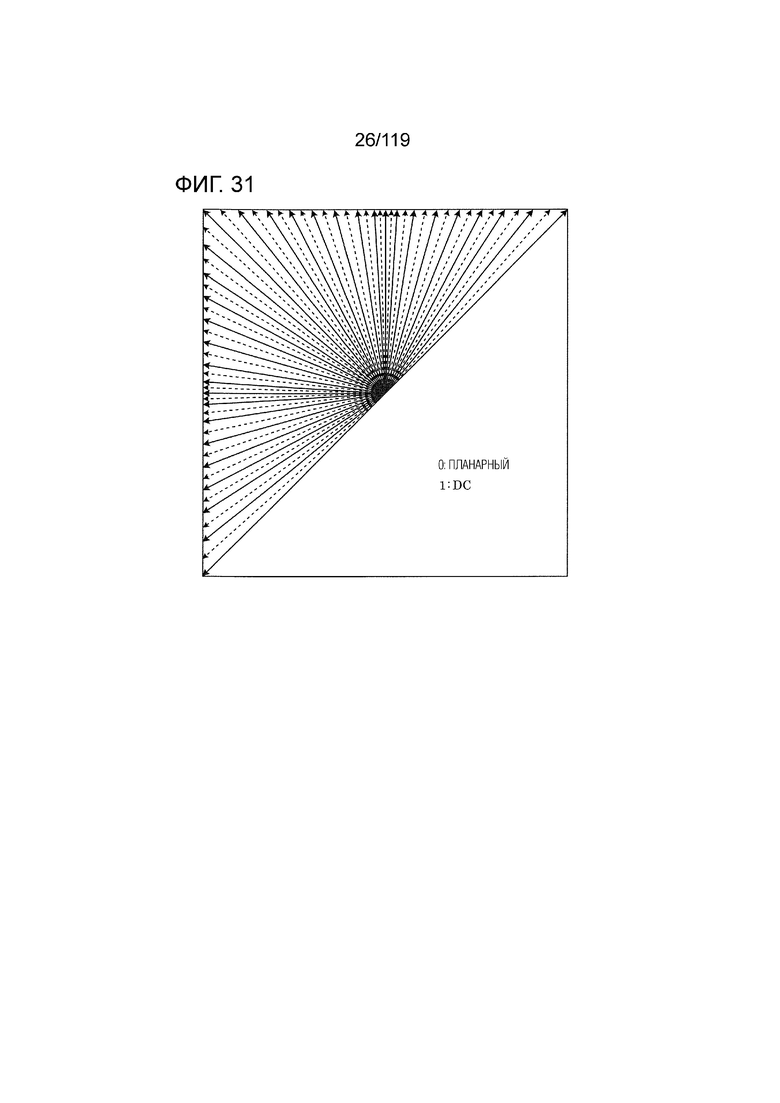

Фиг. 31 является концептуальной схемой для иллюстрации шестьдесят семи режимов внутреннего прогнозирования, используемых при внутреннем прогнозировании в варианте осуществления.

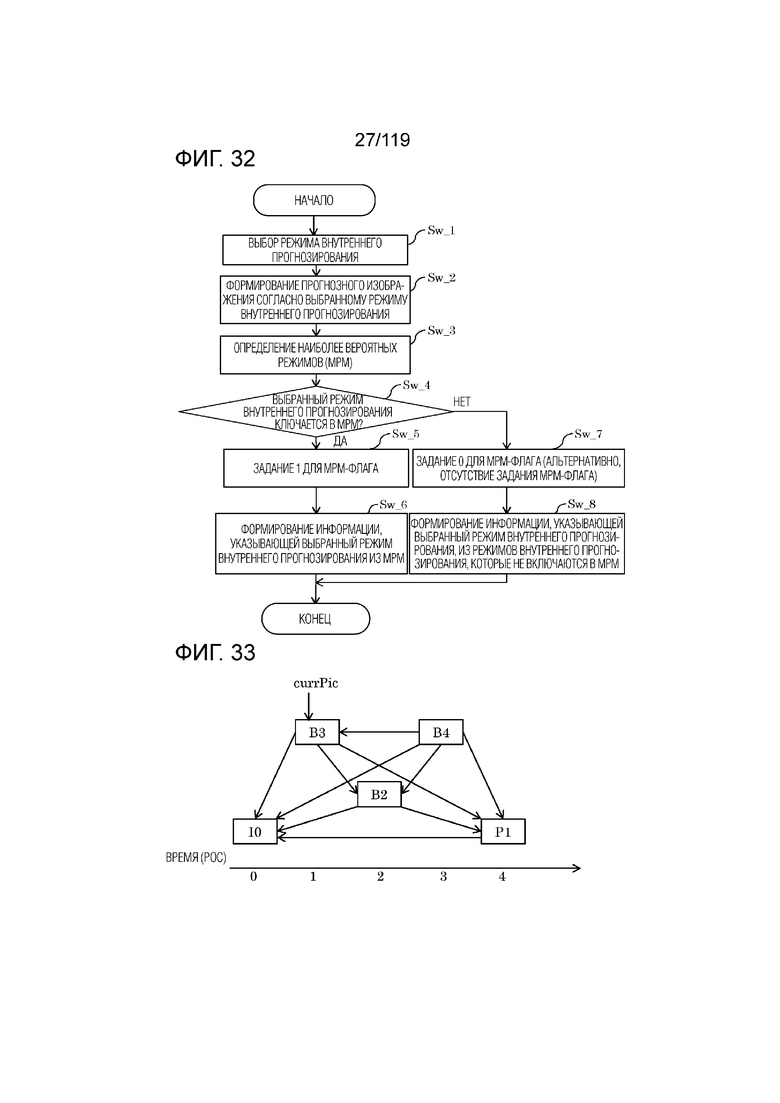

Фиг. 32 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса, выполняемого посредством модуля внутреннего прогнозирования.

Фиг. 33 является концептуальной схемой для иллюстрации примеров опорных кадров.

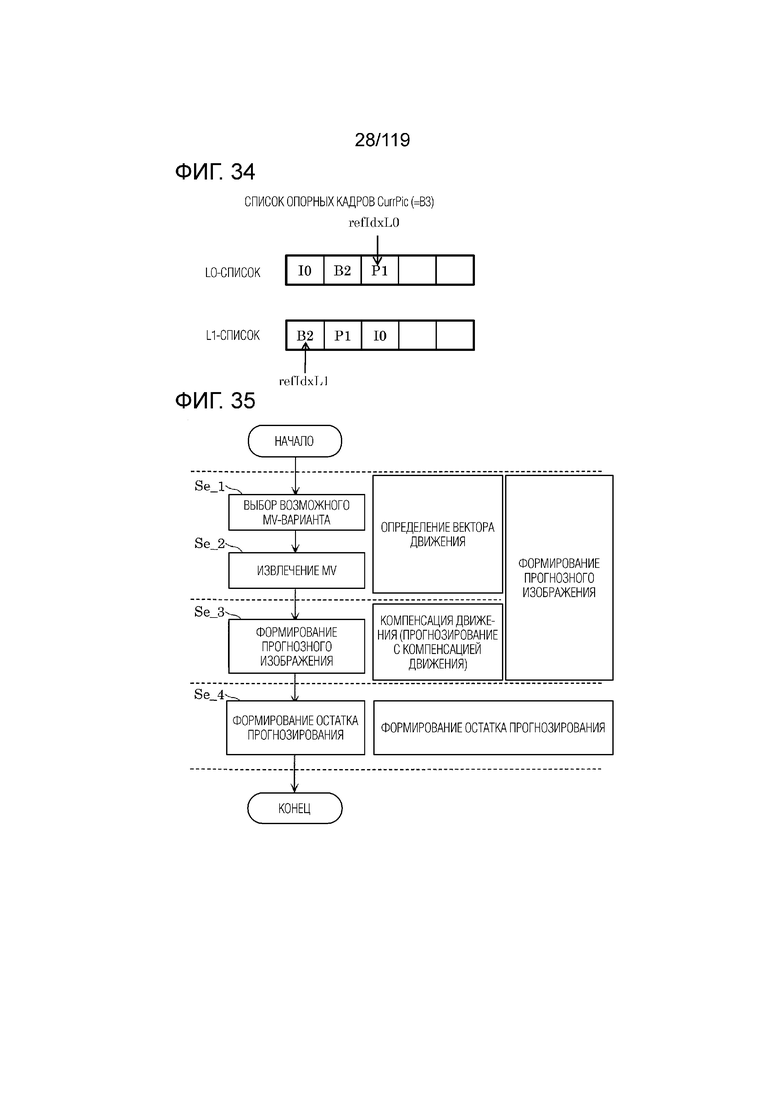

Фиг. 34 является концептуальной схемой для иллюстрации примеров списков опорных кадров.

Фиг. 35 является блок-схемой последовательности операций способа, иллюстрирующей примерную базовую последовательность операций обработки взаимного прогнозирования.

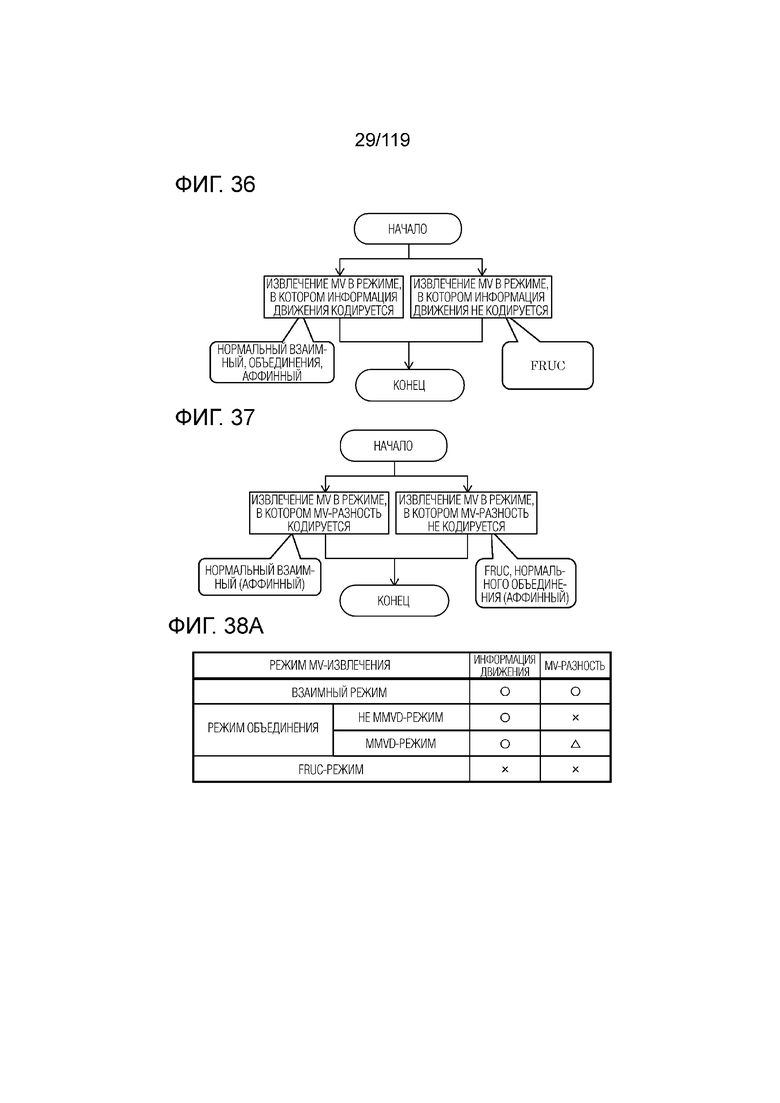

Фиг. 36 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса извлечения векторов движения.

Фиг. 37 является блок-схемой последовательности операций способа, иллюстрирующей другой пример процесса извлечения векторов движения.

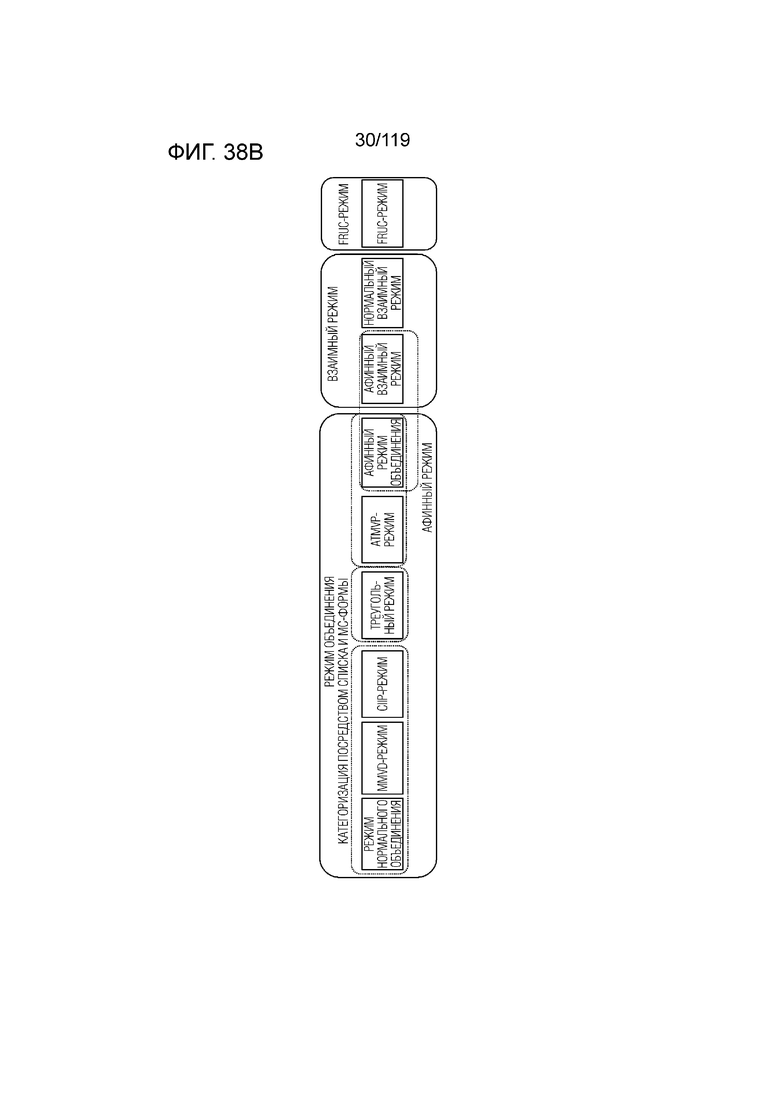

Фиг. 38A является концептуальной схемой для иллюстрации примерных характеризаций режимов для MV-извлечения.

Фиг. 38B является концептуальной схемой для иллюстрации примерных характеризаций режимов для MV-извлечения.

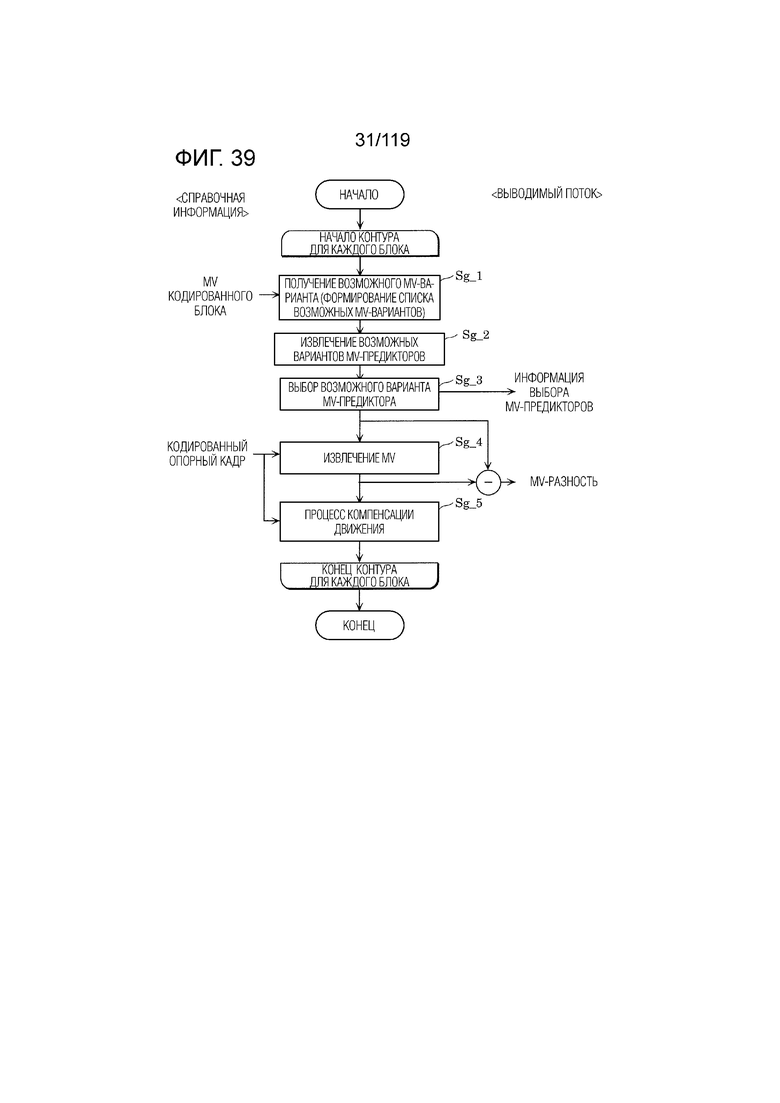

Фиг. 39 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса взаимного прогнозирования в нормальном взаимном режиме.

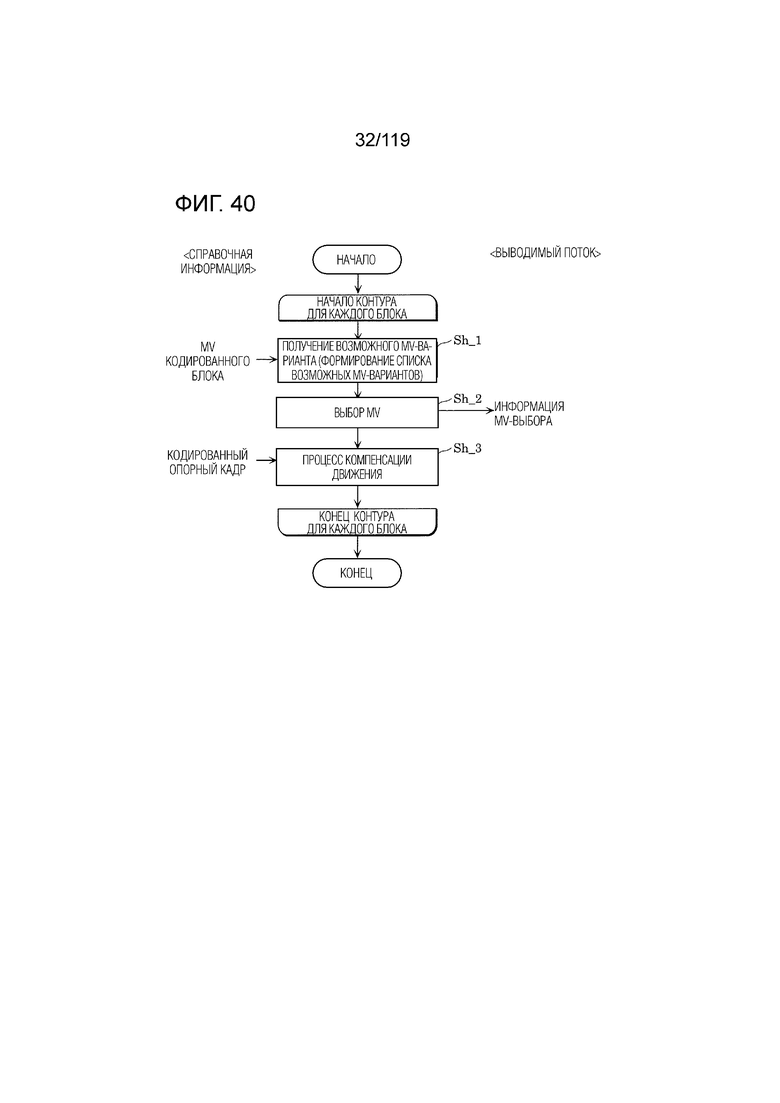

Фиг. 40 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса взаимного прогнозирования в режиме нормального объединения.

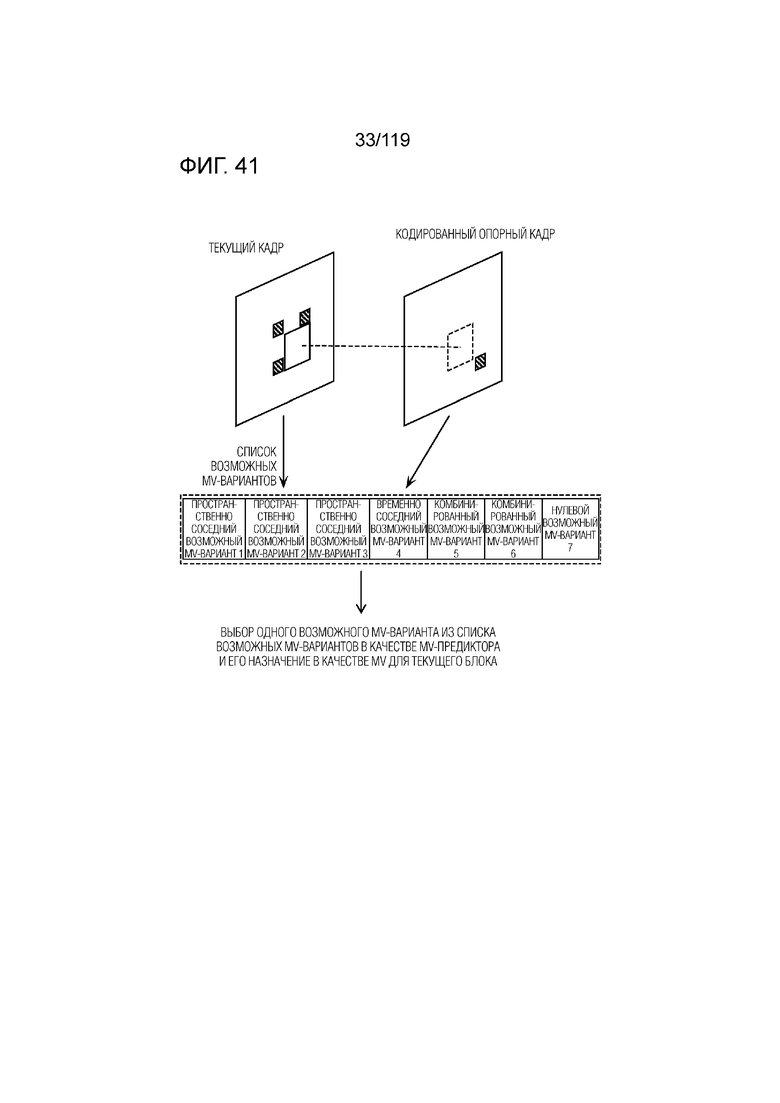

Фиг. 41 является концептуальной схемой для иллюстрации одного примера процесса извлечения векторов движения в режиме объединения.

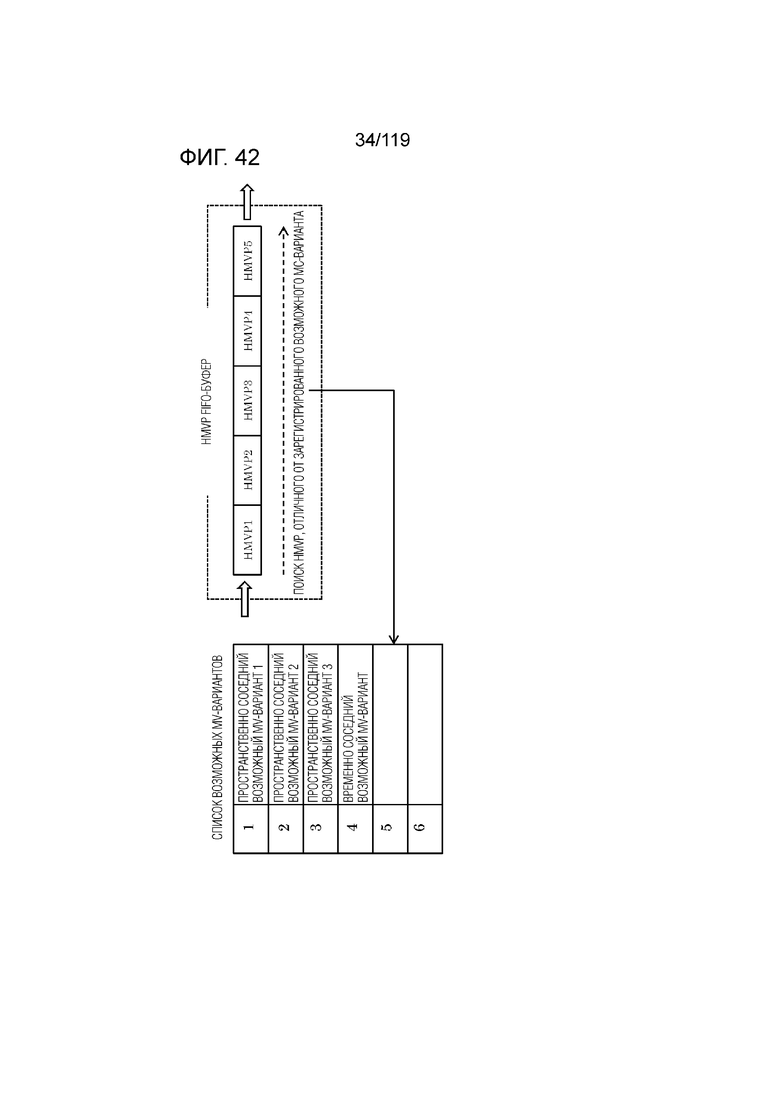

Фиг. 42 является концептуальной схемой для иллюстрации одного примера процесса MV-извлечения для текущего кадра посредством HMVP-режима объединения.

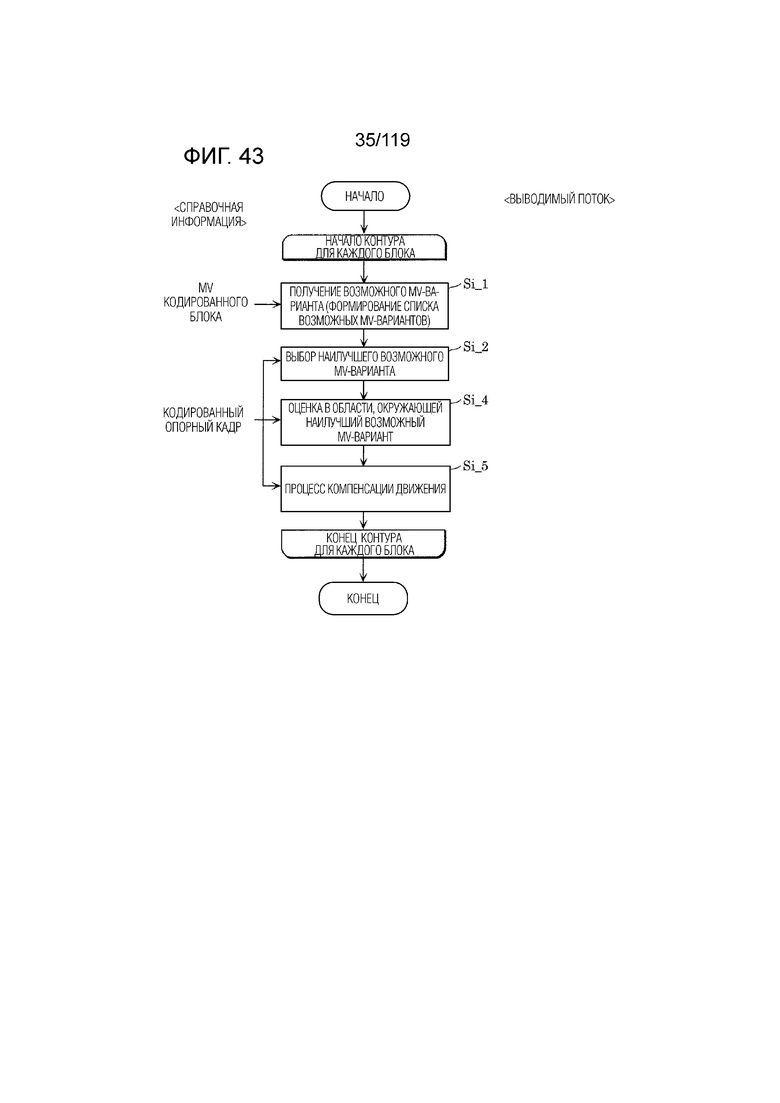

Фиг. 43 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса преобразования с повышением частоты кинокадров (FRUC).

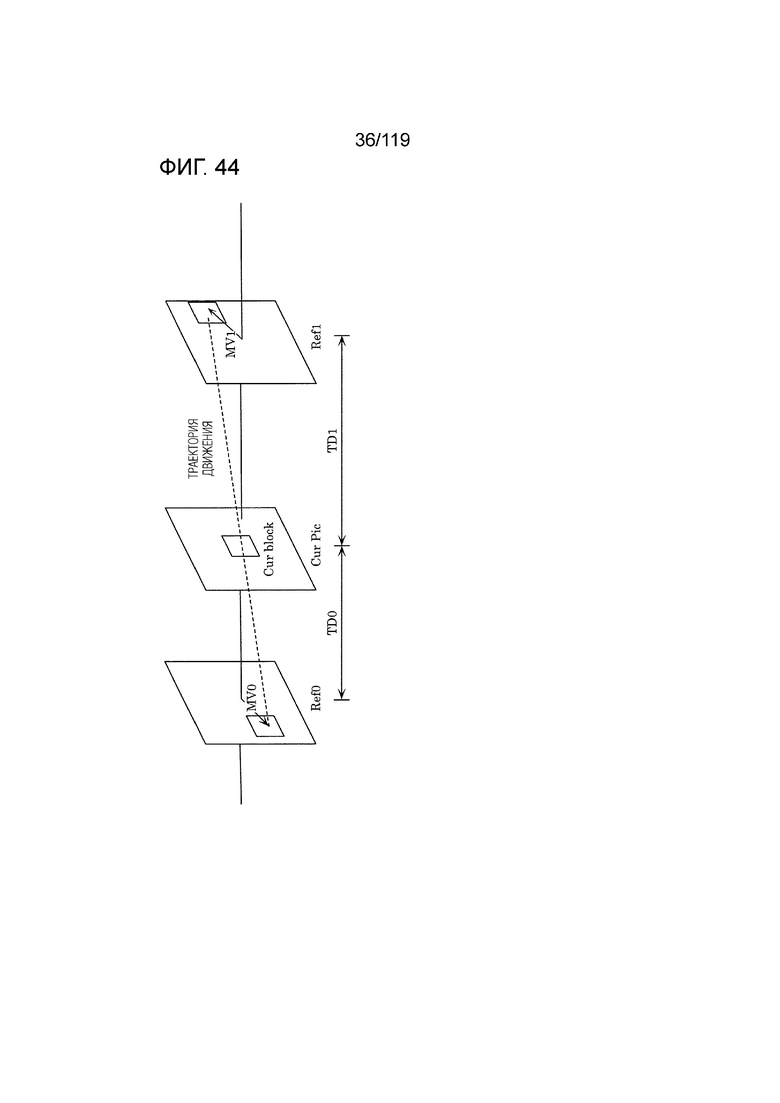

Фиг. 44 является концептуальной схемой для иллюстрации одного примера сопоставления с шаблоном (билатерального сопоставления) между двумя блоками вдоль траектории движения.

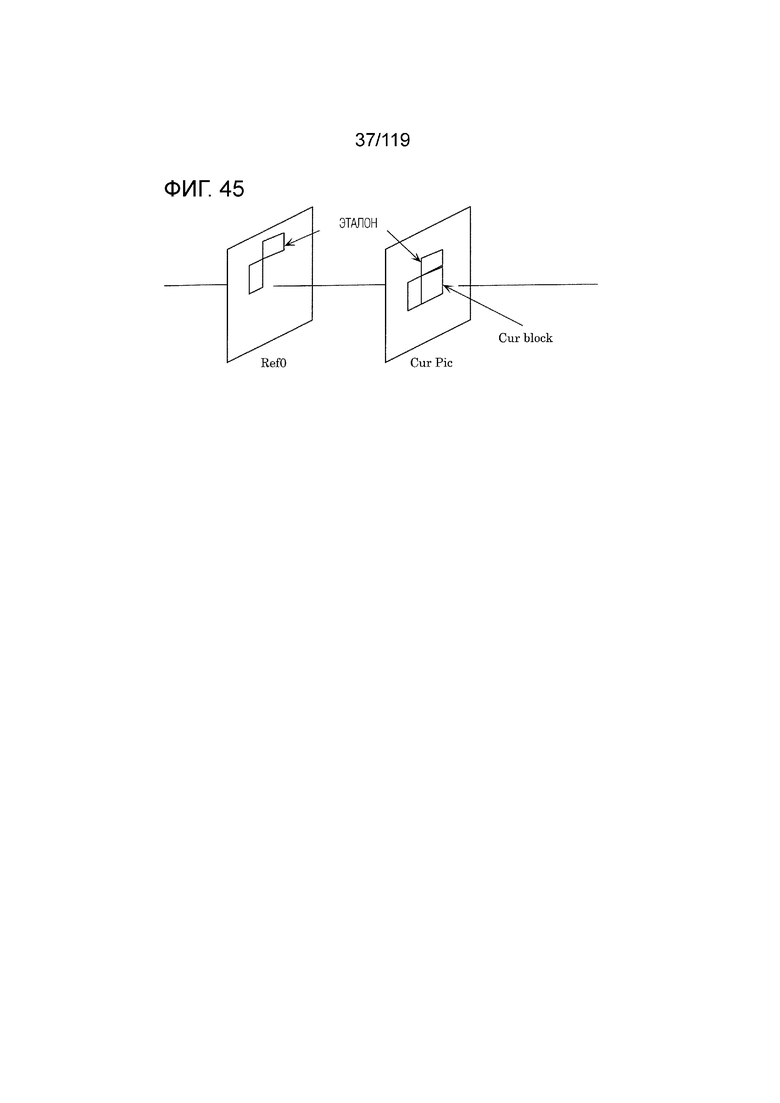

Фиг. 45 является концептуальной схемой для иллюстрации одного примера сопоставления с шаблоном (сопоставления с эталоном) между эталоном в текущем кадре и блоком в опорном кадре.

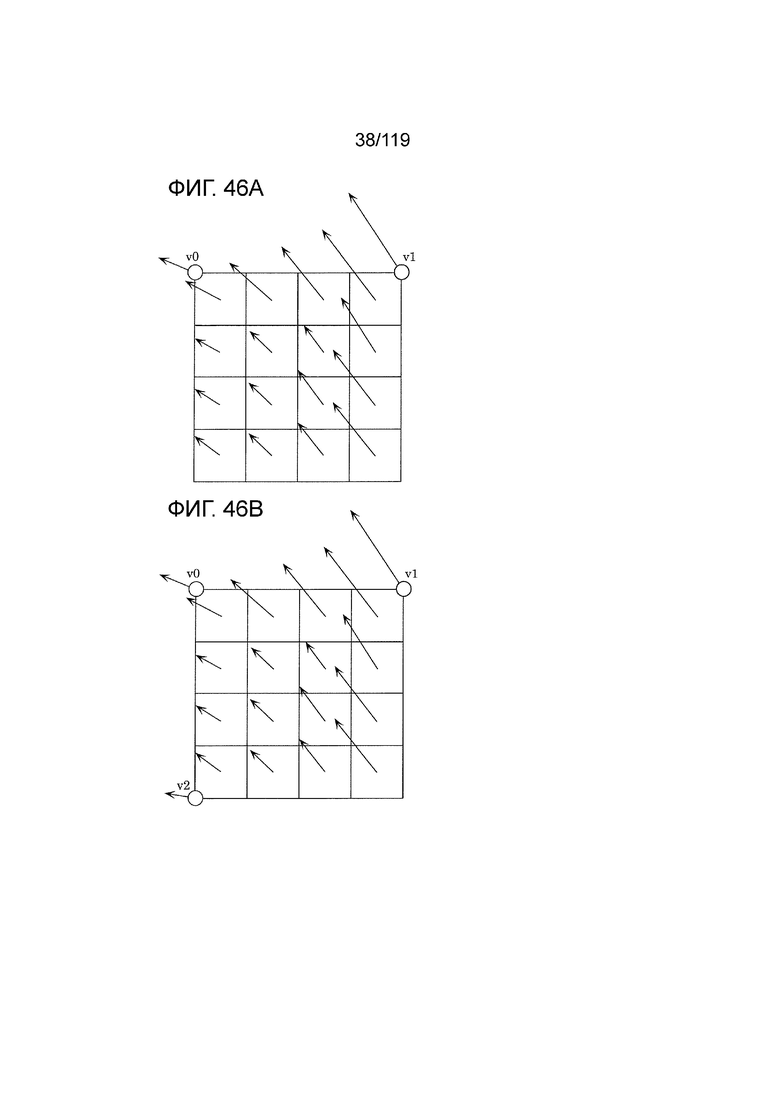

Фиг. 46A является концептуальной схемой для иллюстрации одного примера извлечения вектора движения каждого субблока на основе векторов движения множества соседних блоков.

Фиг. 46B является концептуальной схемой для иллюстрации одного примера извлечения вектора движения каждого субблока в аффинном режиме, в котором используются три управляющих точки.

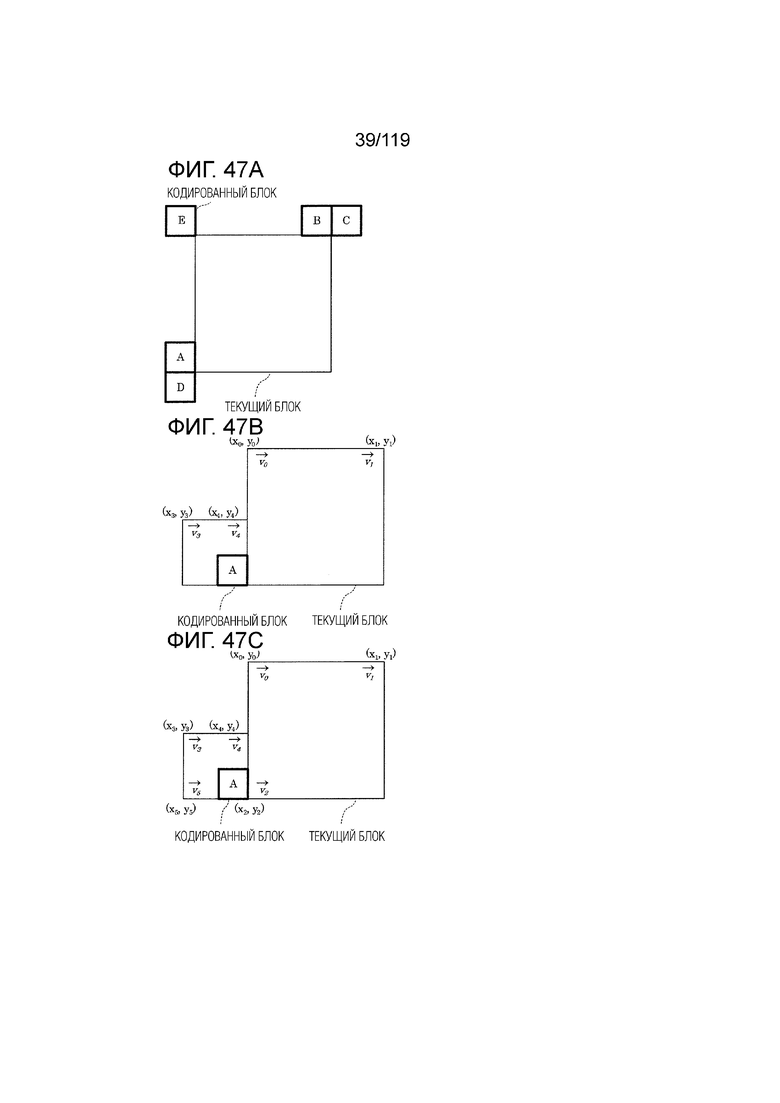

Фиг. 47A является концептуальной схемой для иллюстрации примерного MV-извлечения в управляющих точках в аффинном режиме.

Фиг. 47B является концептуальной схемой для иллюстрации примерного MV-извлечения в управляющих точках в аффинном режиме.

Фиг. 47C является концептуальной схемой для иллюстрации примерного MV-извлечения в управляющих точках в аффинном режиме.

Фиг. 48A является концептуальной схемой для иллюстрации аффинного режима, в котором используются две управляющих точки.

Фиг. 48B является концептуальной схемой для иллюстрации аффинного режима, в котором используются три управляющих точки.

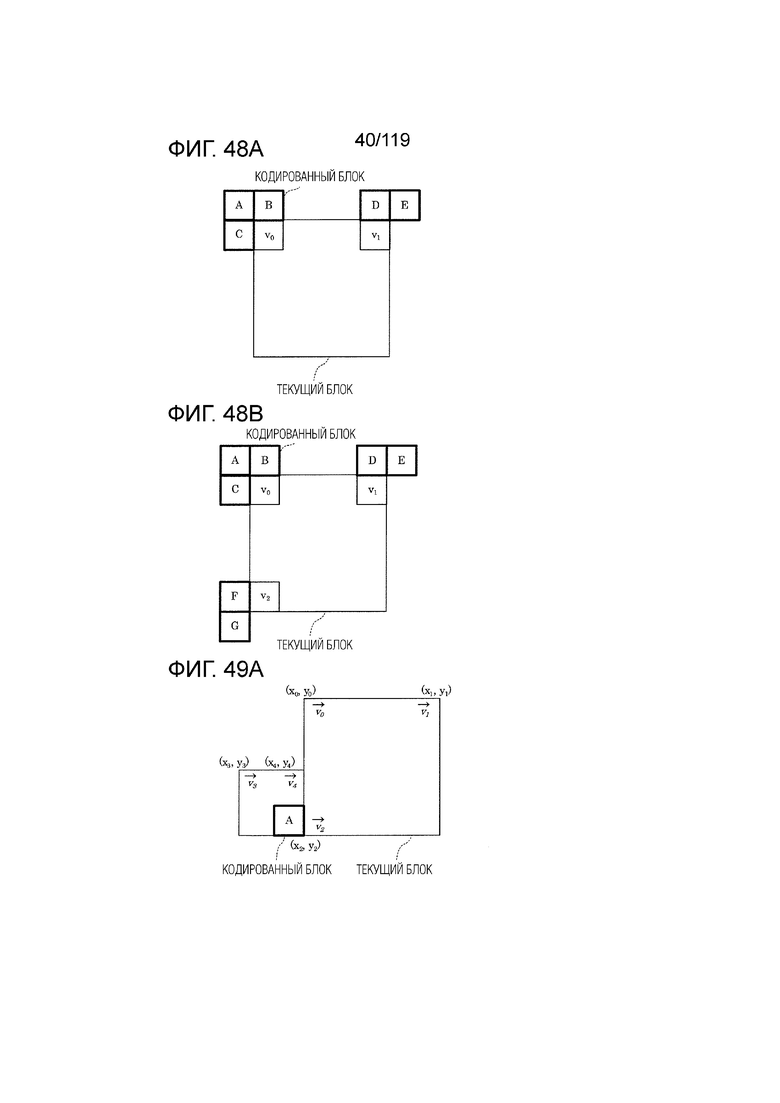

Фиг. 49A является концептуальной схемой для иллюстрации одного примера способа для MV-извлечения в управляющих точках, когда число управляющих точек для кодированного блока и число управляющих точек для текущего блока отличаются друг от друга.

Фиг. 49B является концептуальной схемой для иллюстрации другого примера способа для MV-извлечения в управляющих точках, когда число управляющих точек для кодированного блока и число управляющих точек для текущего блока отличаются друг от друга.

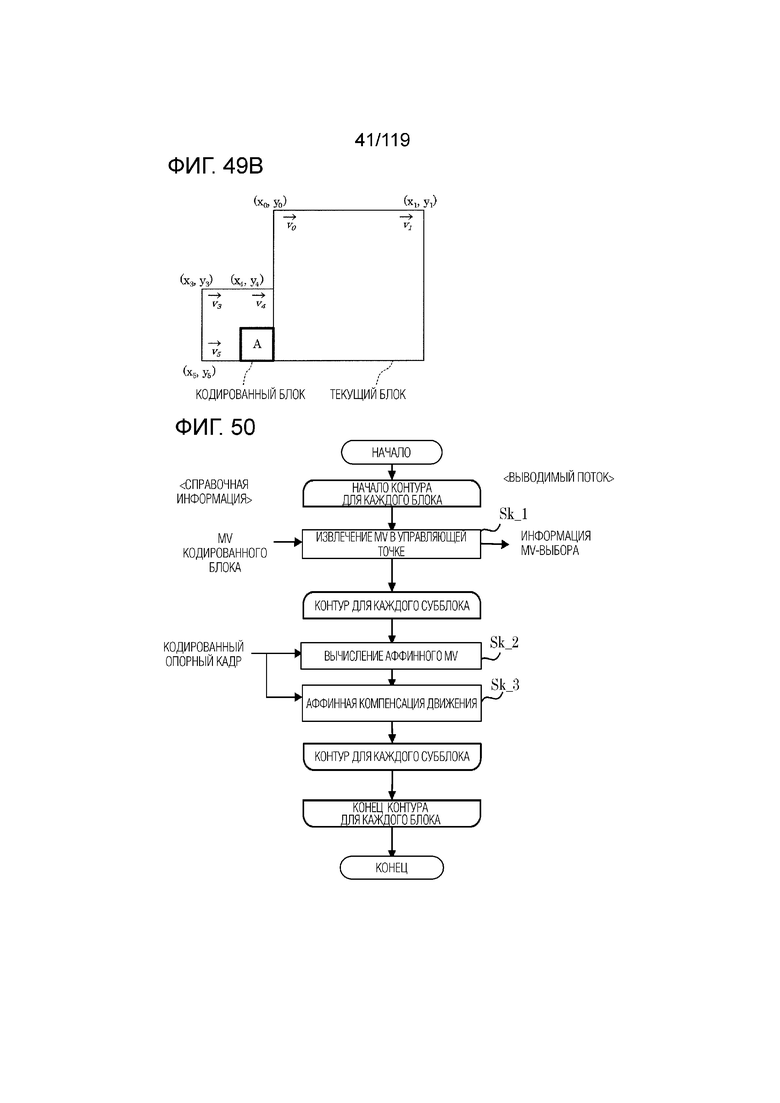

Фиг. 50 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса в аффинном режиме объединения.

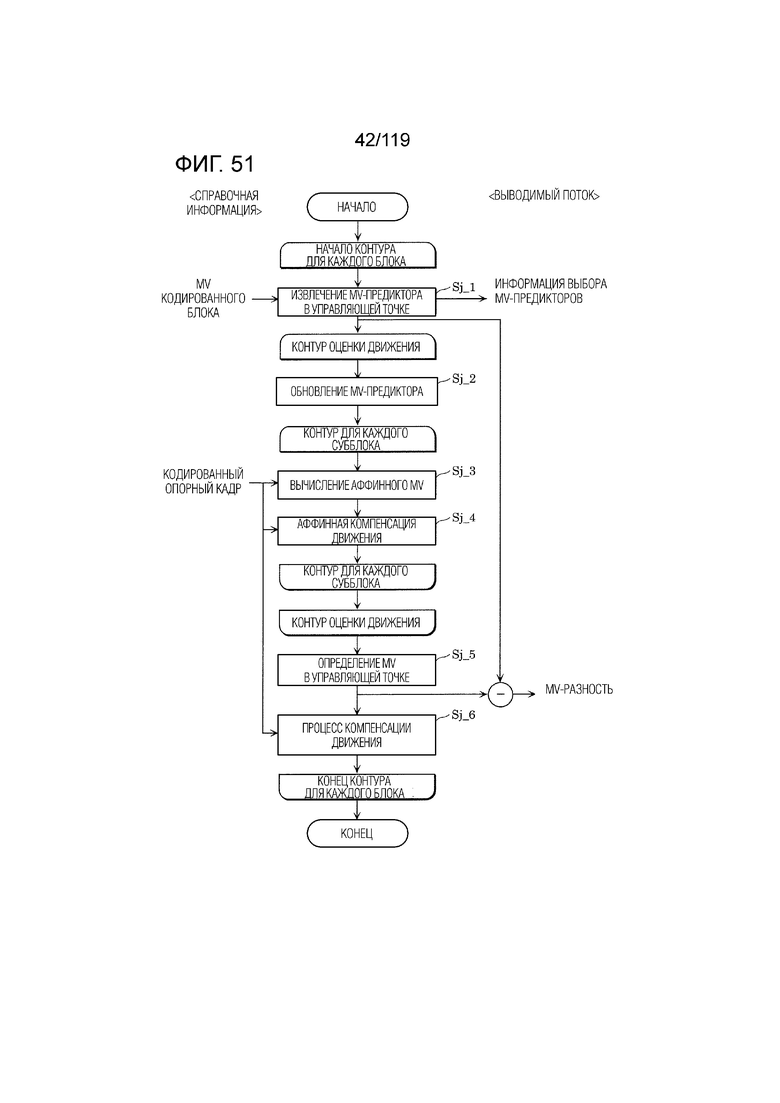

Фиг. 51 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса в аффинном взаимном режиме.

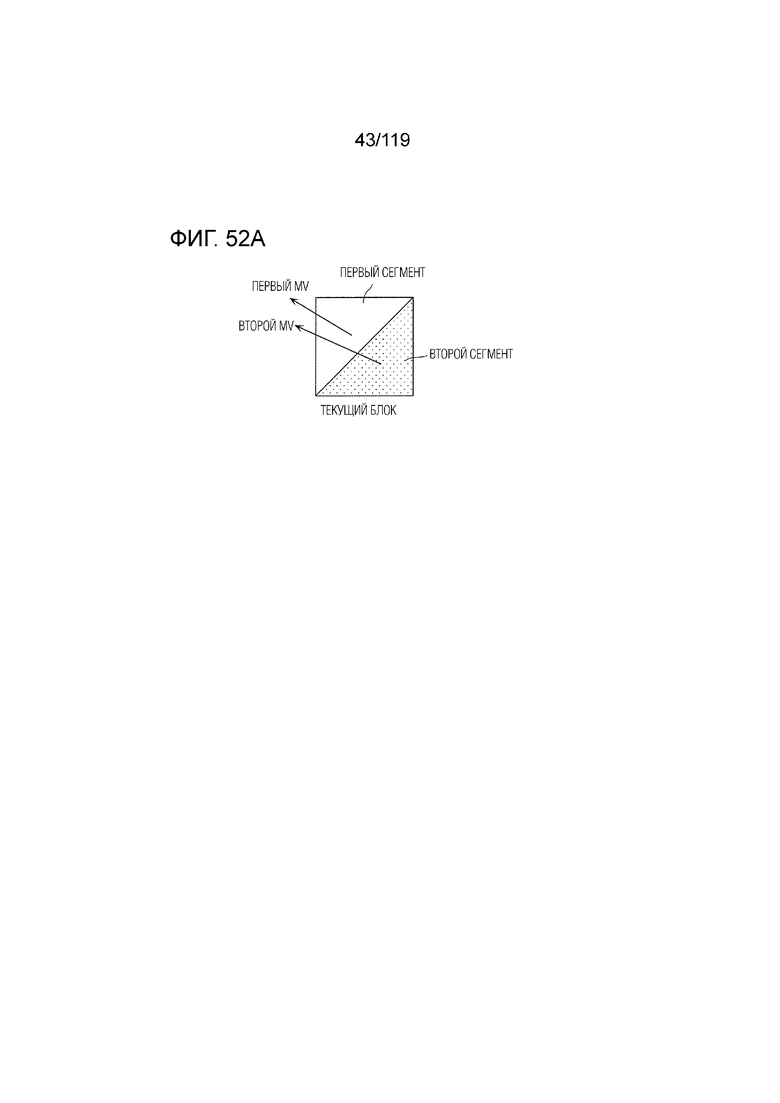

Фиг. 52A является концептуальной схемой для иллюстрации формирования двух треугольных прогнозных изображений.

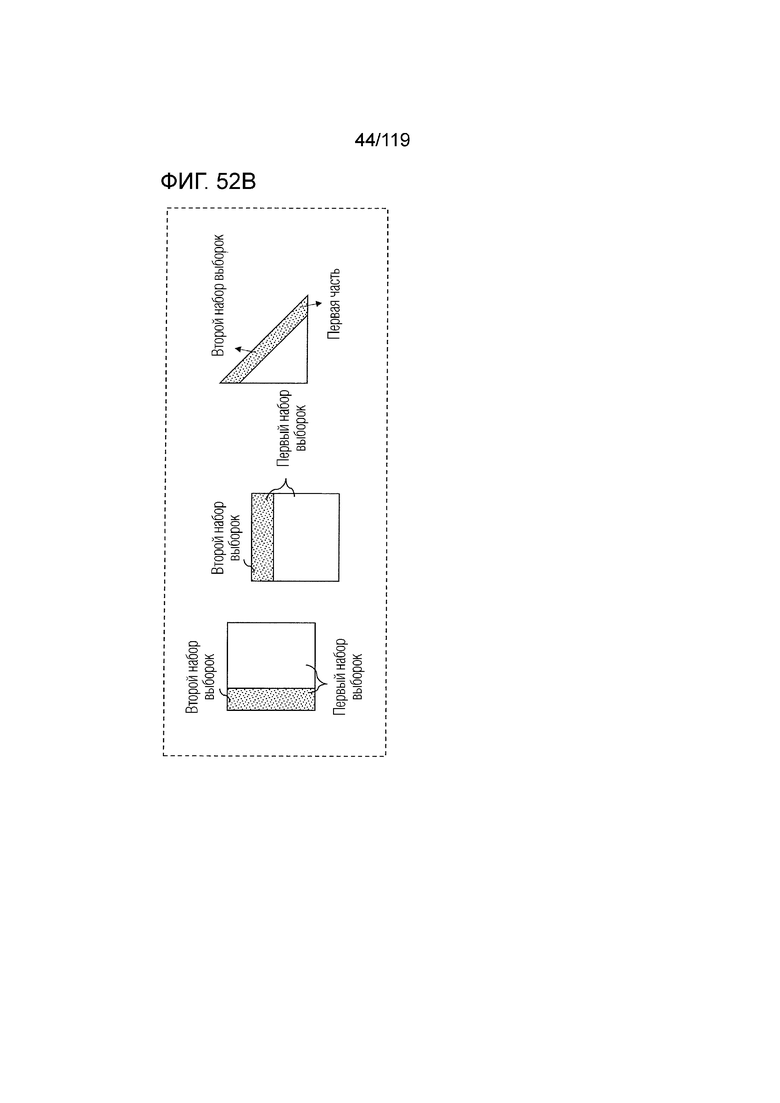

Фиг. 52B является концептуальной схемой для иллюстрации примеров первой части первого сегмента, которая перекрывается со вторым сегментом, и первого и второго наборов выборок, которые могут взвешиваться в качестве части процесса коррекции.

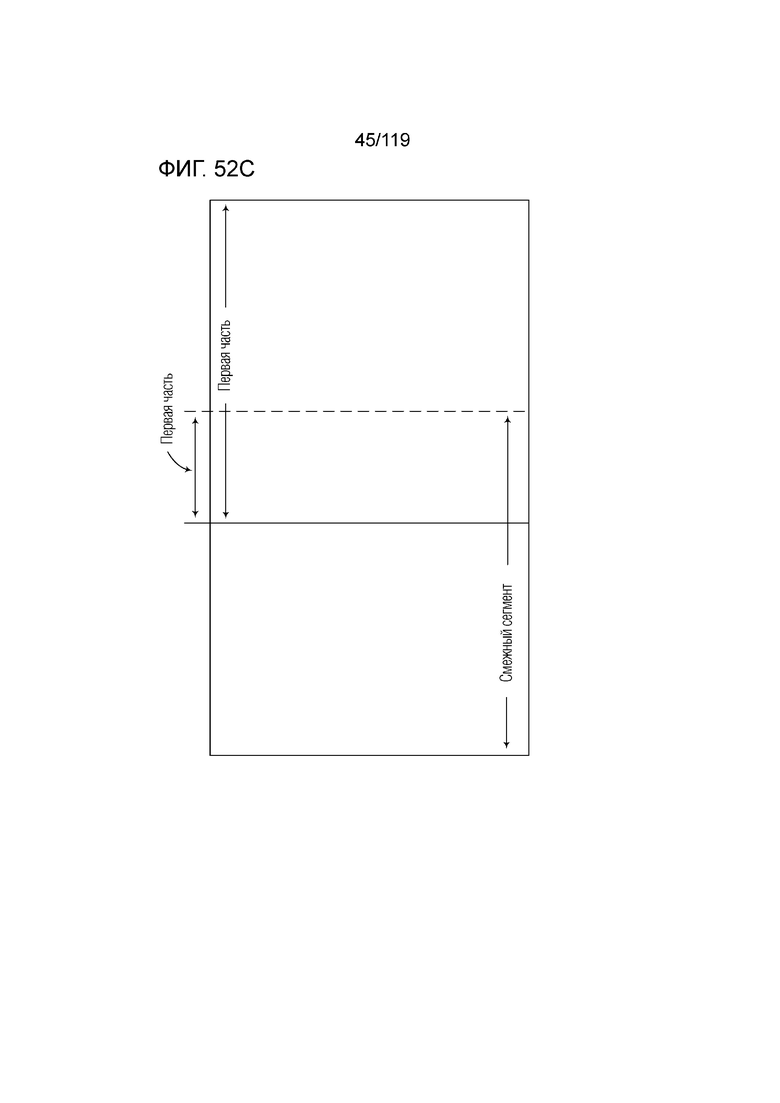

Фиг. 52C является концептуальной схемой для иллюстрации первой части первого сегмента, которая составляет часть первого сегмента, которая перекрывается с частью смежного сегмента.

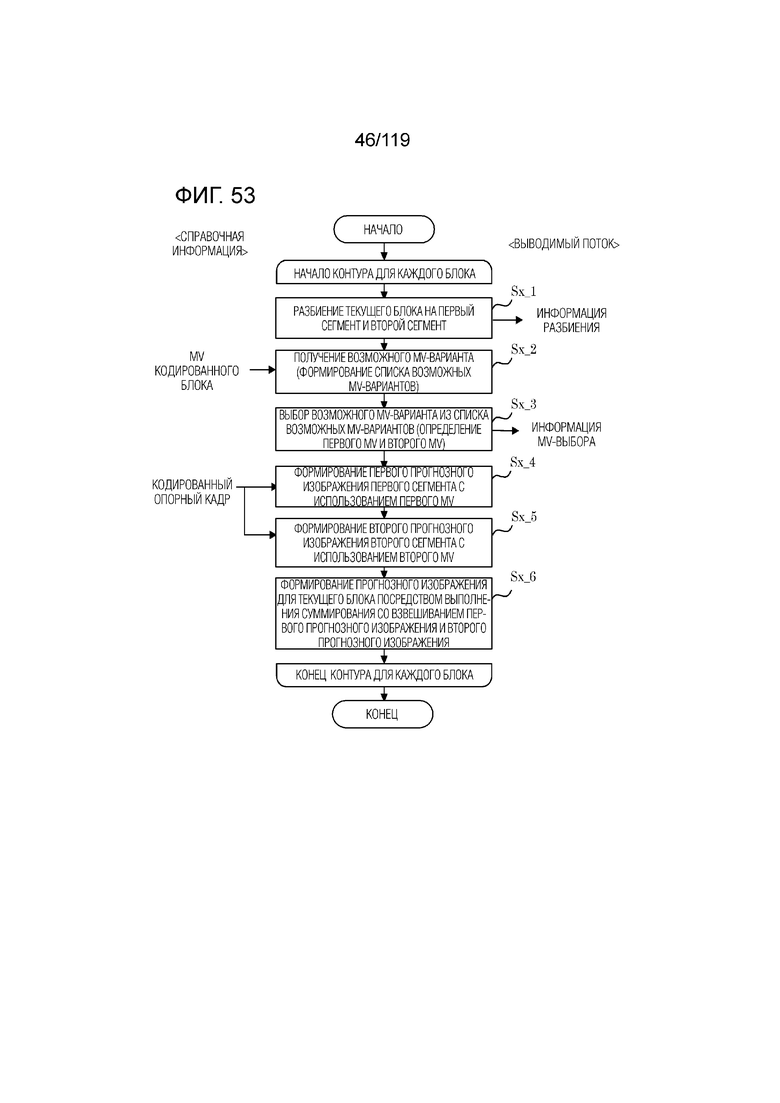

Фиг. 53 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса в треугольном режиме.

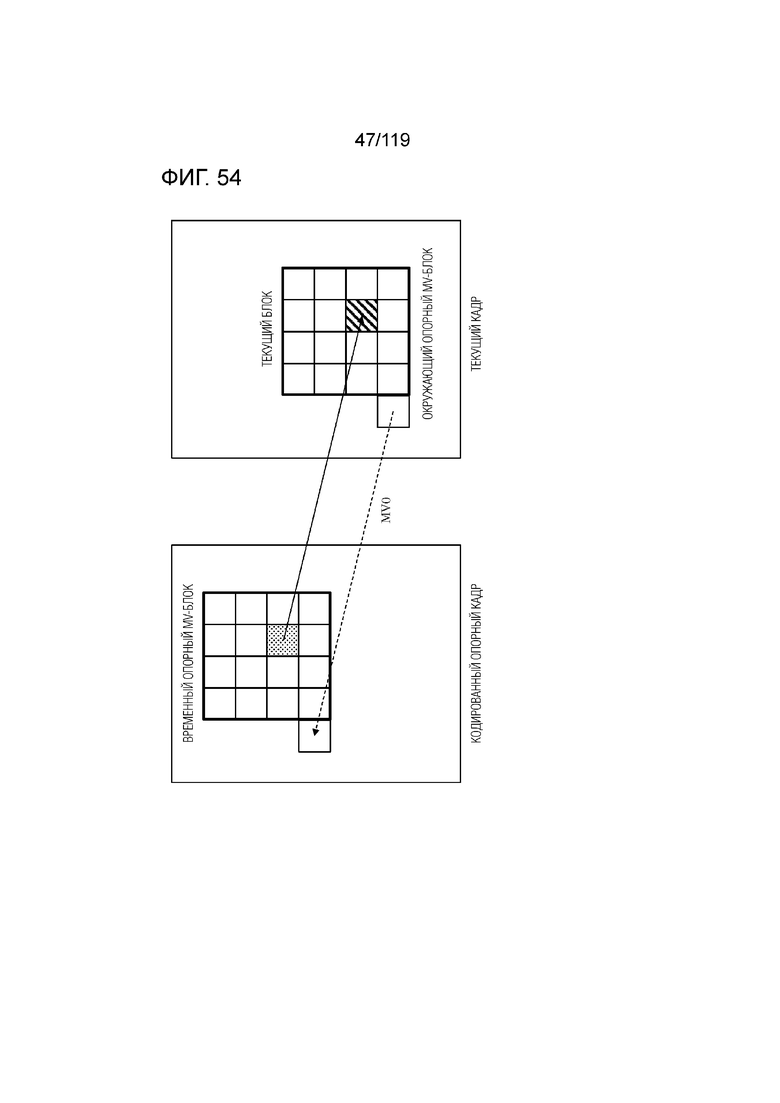

Фиг. 54 является концептуальной схемой для иллюстрации одного примера режима усовершенствованного временного прогнозирования векторов движения (ATMVP), в котором MV извлекается в единицах субблоков.

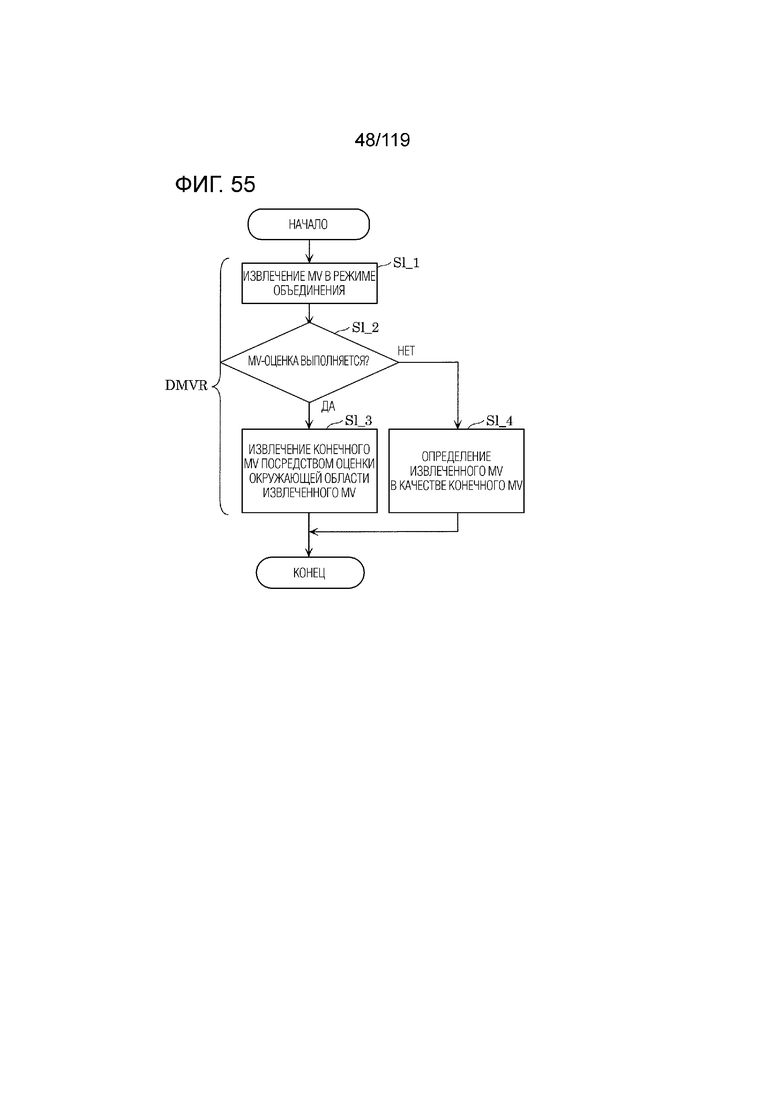

Фиг. 55 является блок-схемой последовательности операций способа, иллюстрирующей взаимосвязь между режимом объединения и динамическим обновлением векторов движения (DMVR).

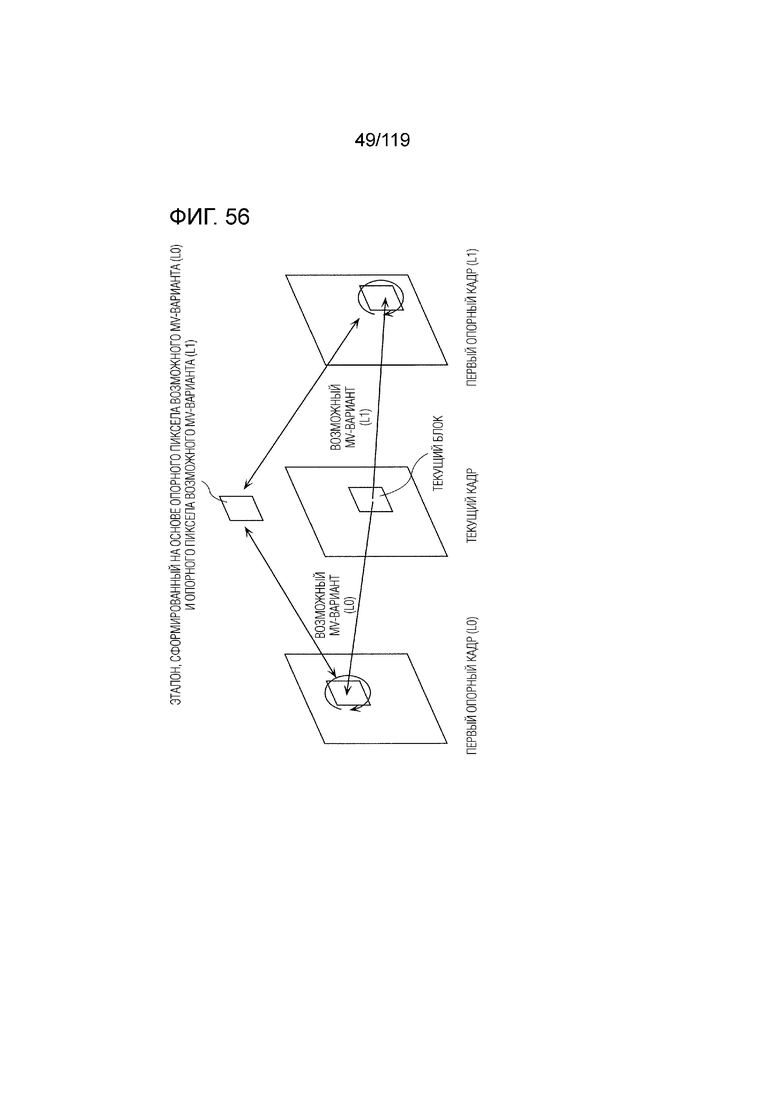

Фиг. 56 является концептуальной схемой для иллюстрации одного примера DMVR.

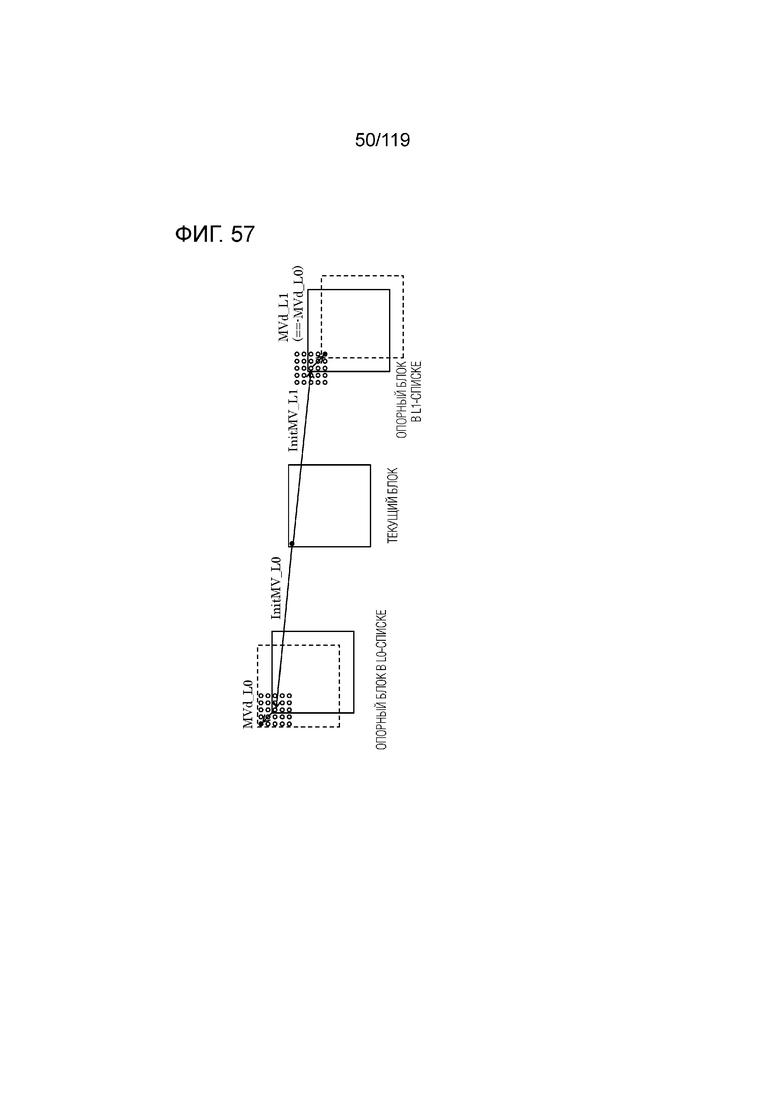

Фиг. 57 является концептуальной схемой для иллюстрации другого примера DMVR для определения MV.

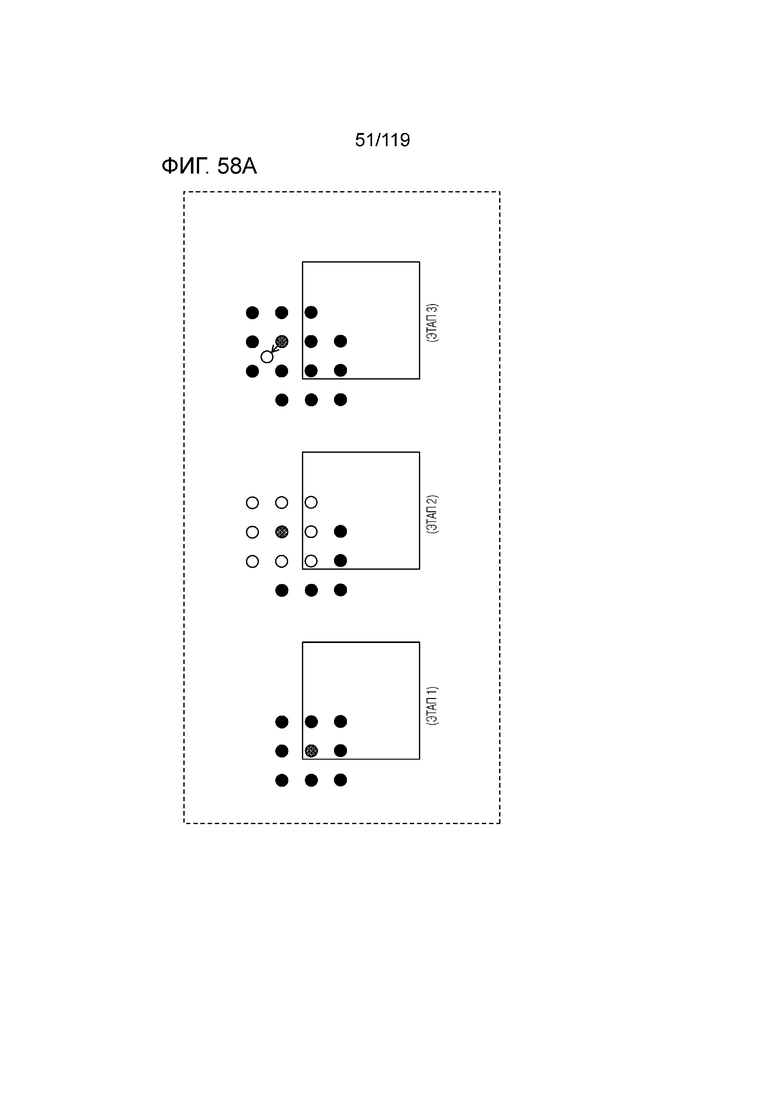

Фиг. 58A является концептуальной схемой для иллюстрации одного примера оценки движения в DMVR.

Фиг. 58B является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса оценки движения в DMVR.

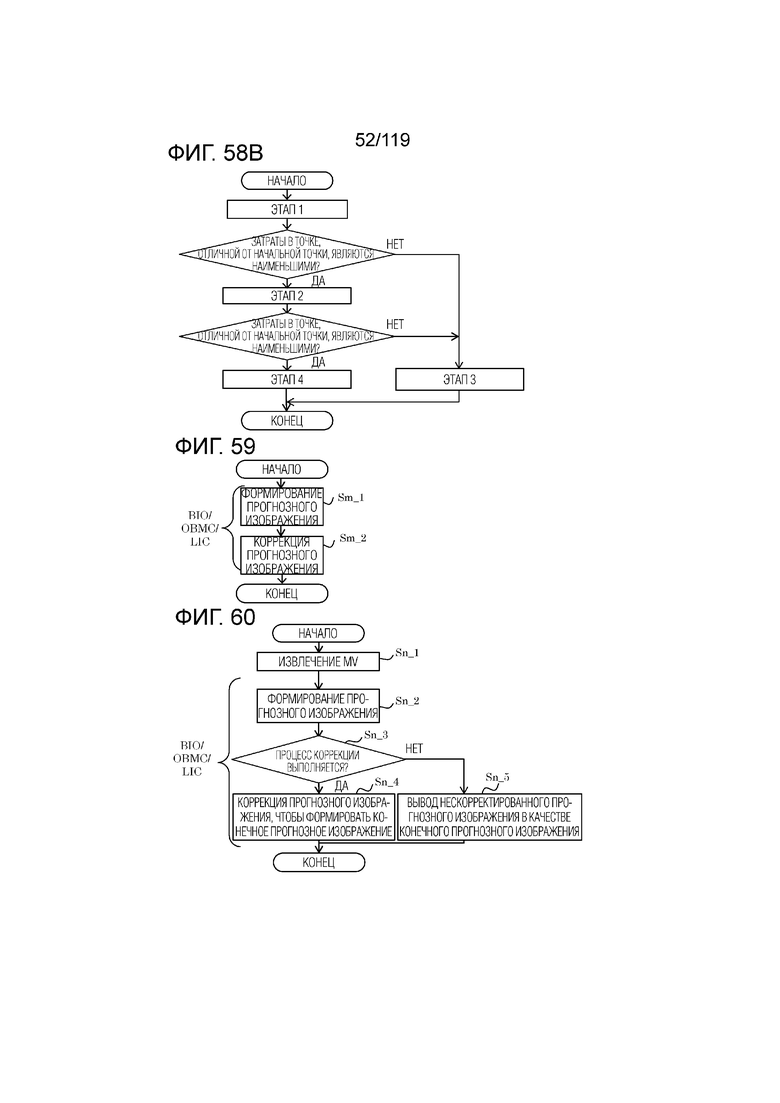

Фиг. 59 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса формирования прогнозного изображения.

Фиг. 60 является блок-схемой последовательности операций способа, иллюстрирующей другой пример процесса формирования прогнозного изображения.

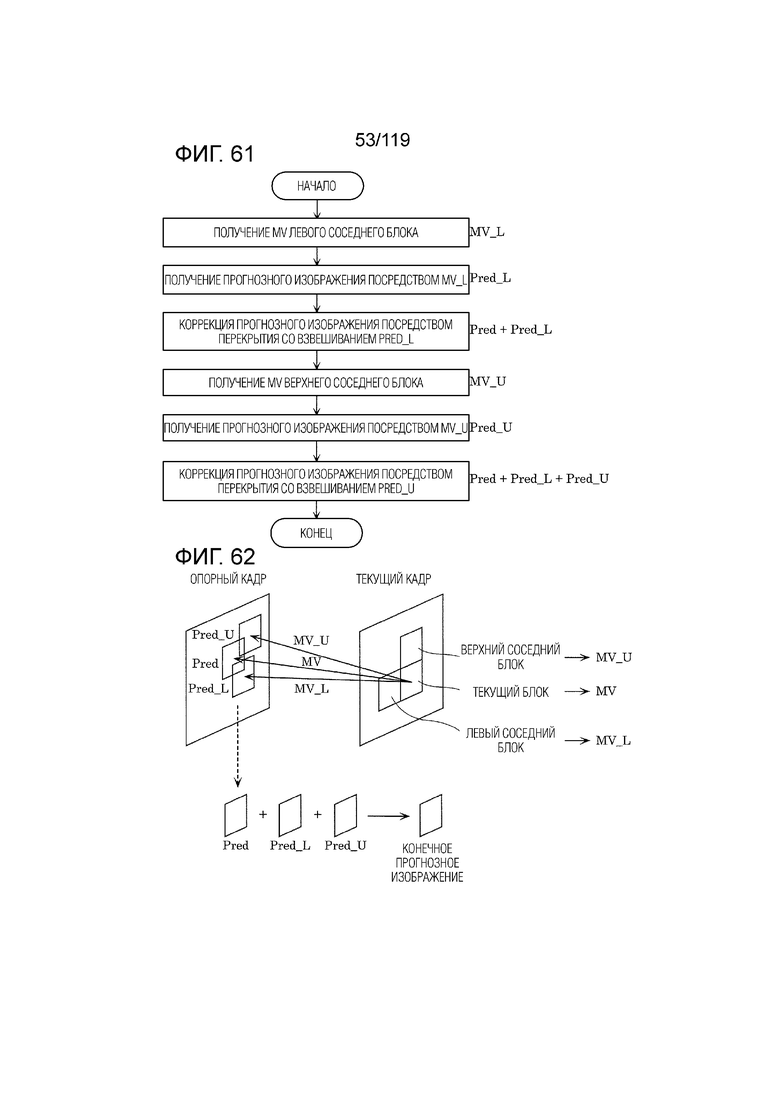

Фиг. 61 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса коррекции прогнозного изображения посредством перекрывающейся блочной компенсации движения (OBMC).

Фиг. 62 является концептуальной схемой для иллюстрации одного примера процесса коррекции прогнозных изображений посредством OBMC.

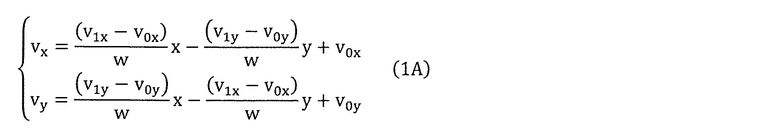

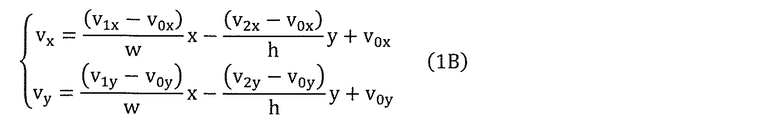

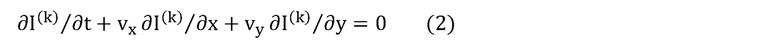

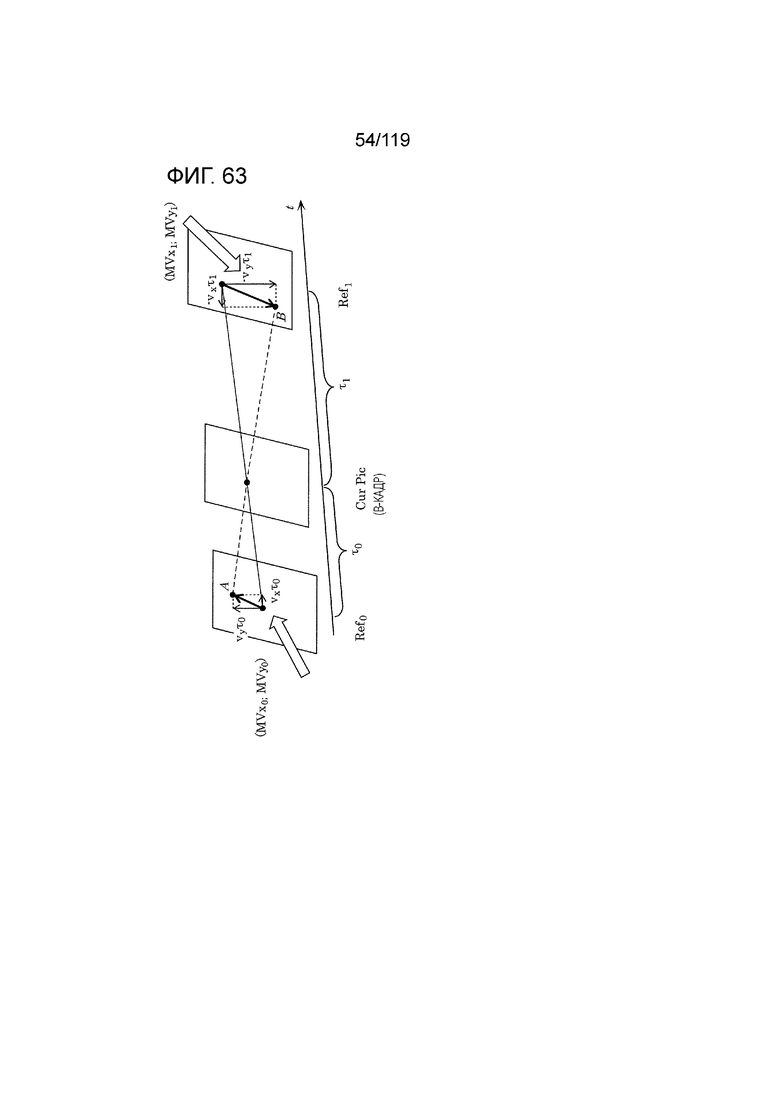

Фиг. 63 является концептуальной схемой для иллюстрации модели при условии равномерного прямолинейного движения.

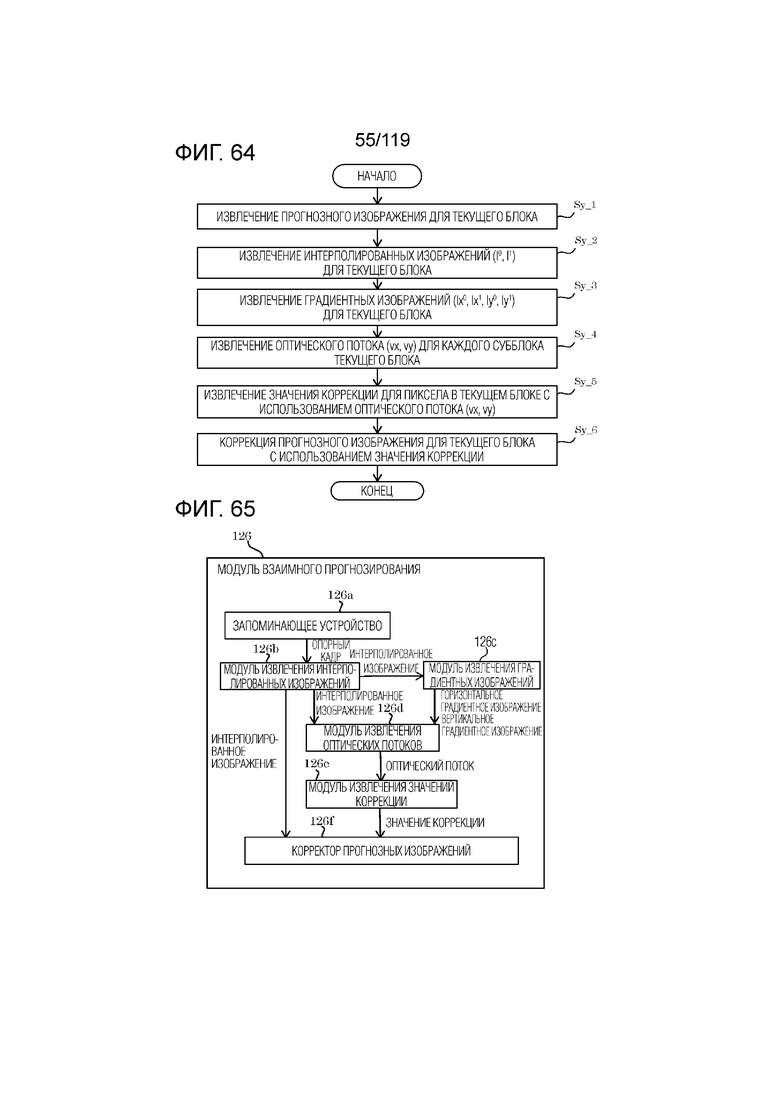

Фиг. 64 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса взаимного прогнозирования согласно BIO.

Фиг. 65 является функциональной блок-схемой, иллюстрирующей один пример функциональной конфигурации модуля взаимного прогнозирования, который может выполнять взаимное прогнозирование согласно BIO.

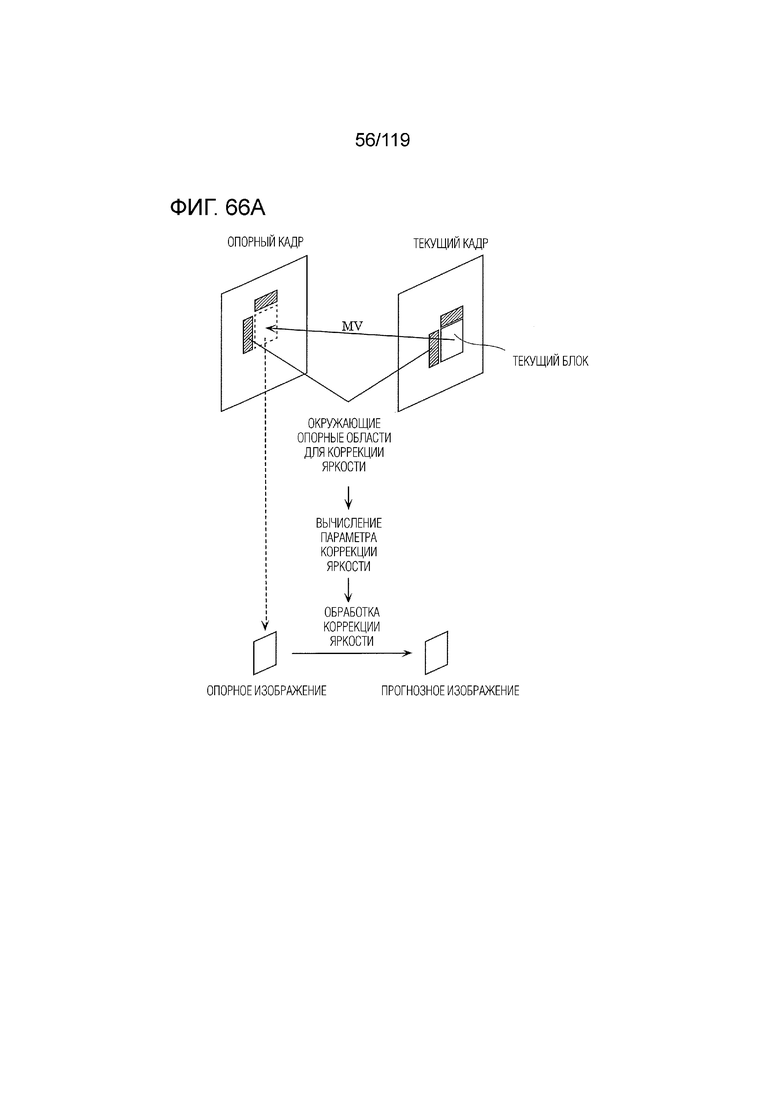

Фиг. 66A является концептуальной схемой для иллюстрации одного примера процесса для способа формирования прогнозных изображений с использованием процесса коррекции яркости, выполняемого посредством LIC.

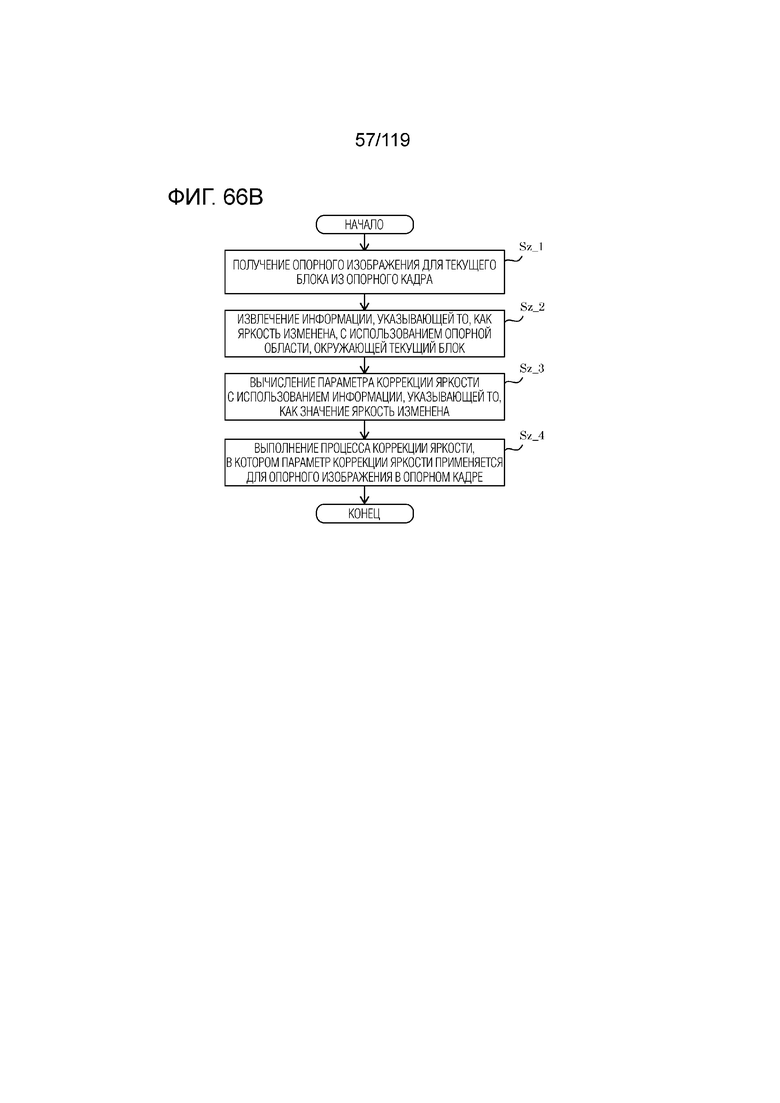

Фиг. 66B является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса для способа формирования прогнозных изображений с использованием LIC.

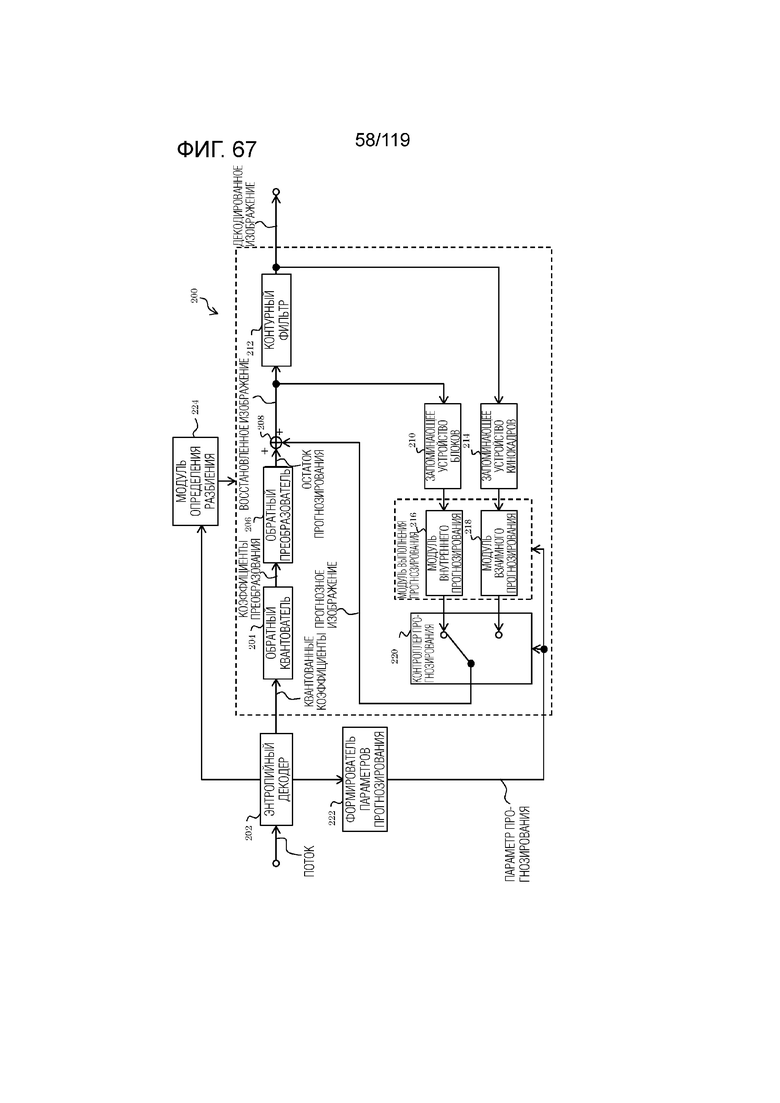

Фиг. 67 является блок-схемой, иллюстрирующей функциональную конфигурацию декодера согласно варианту осуществления.

Фиг. 68 является функциональной блок-схемой, иллюстрирующей пример монтажа декодера.

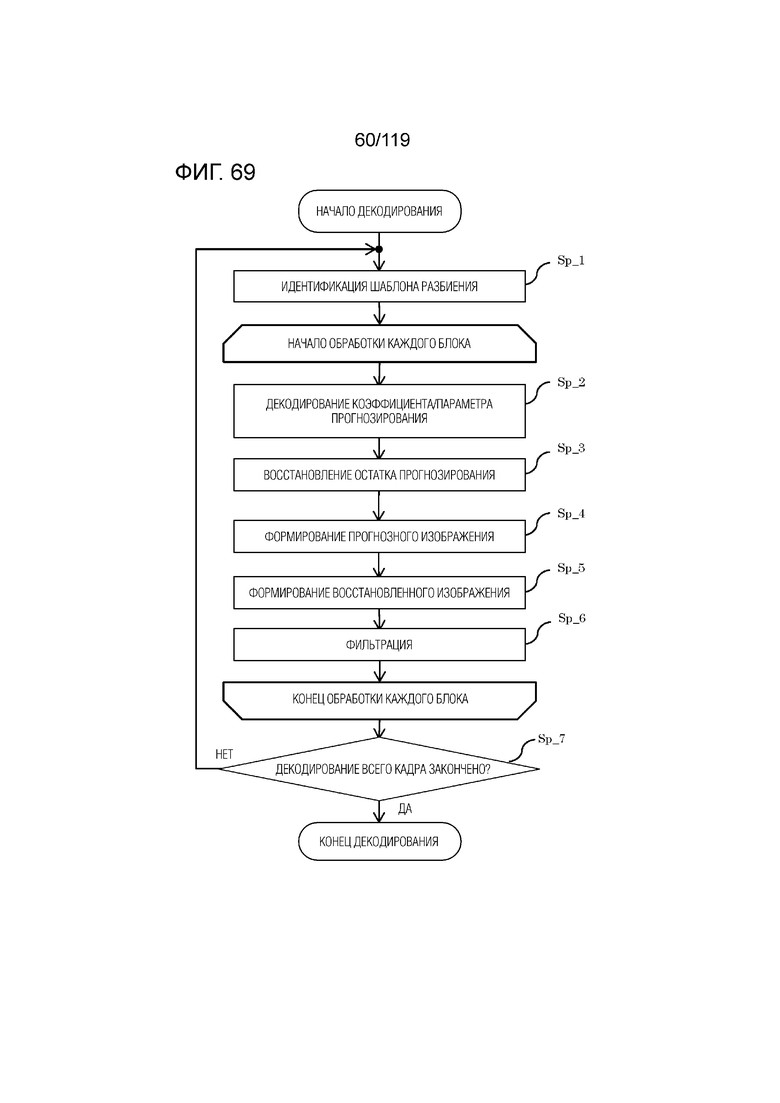

Фиг. 69 является блок-схемой последовательности операций способа, иллюстрирующей один пример полного процесса декодирования, выполняемого посредством декодера.

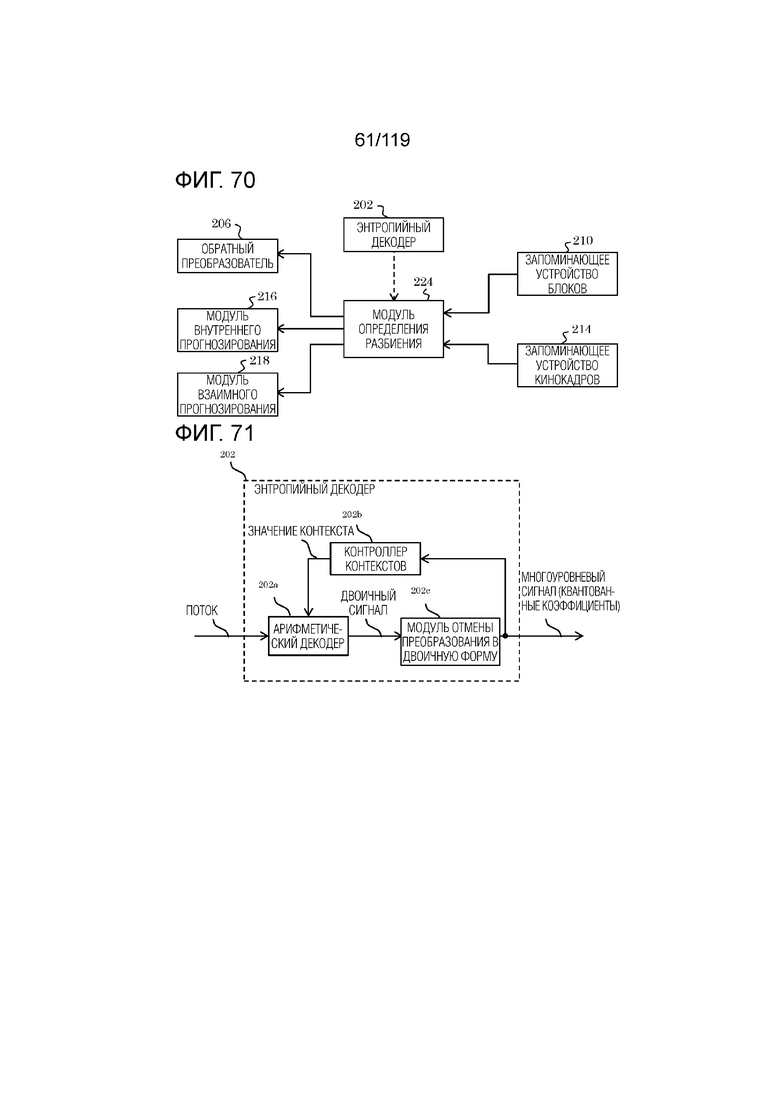

Фиг. 70 является концептуальной схемой для иллюстрации взаимосвязи между модулем определения разбиения и другими составляющими элементами.

Фиг. 71 является блок-схемой, иллюстрирующей один пример функциональной конфигурации энтропийного декодера.

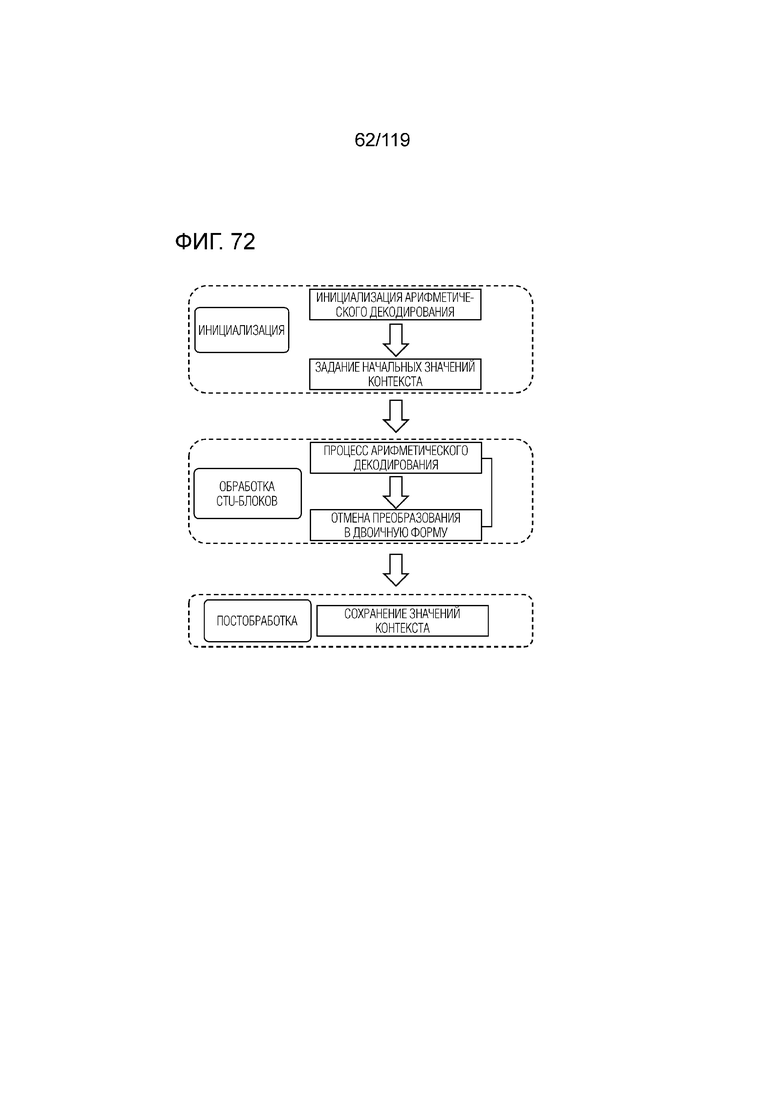

Фиг. 72 является концептуальной схемой для иллюстрации примерной последовательности операций CABAC-процесса в энтропийном декодере.

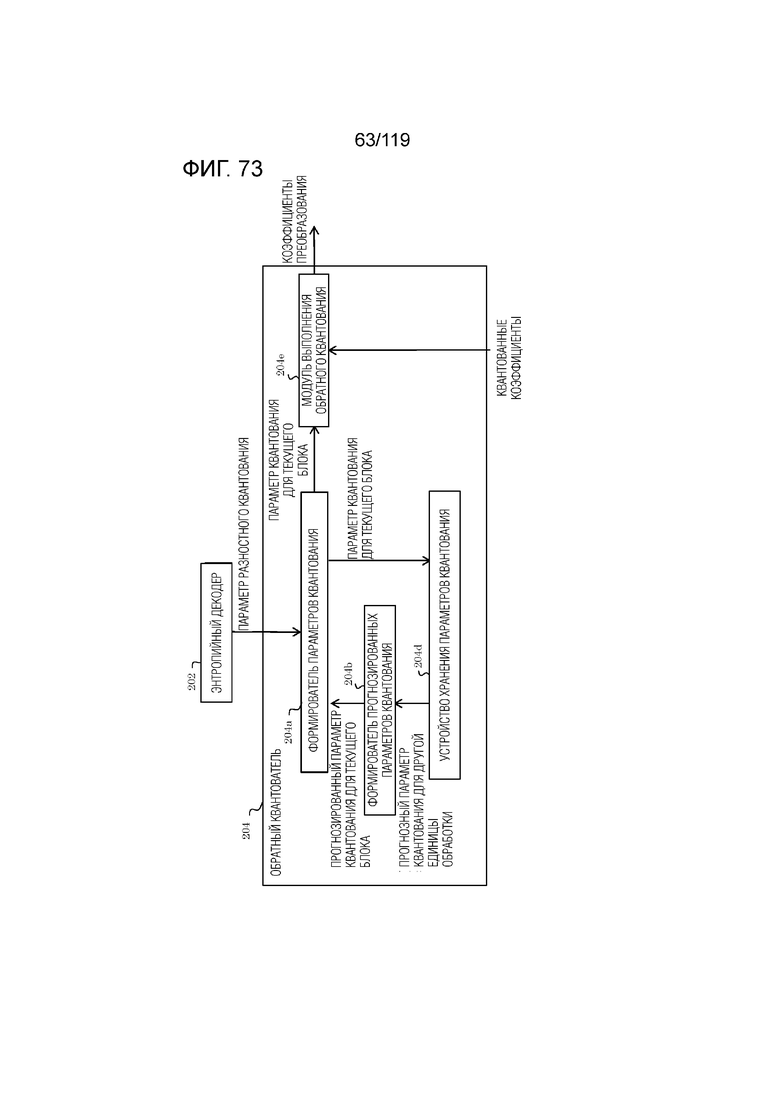

Фиг. 73 является блок-схемой, иллюстрирующей один пример функциональной конфигурации обратного квантователя.

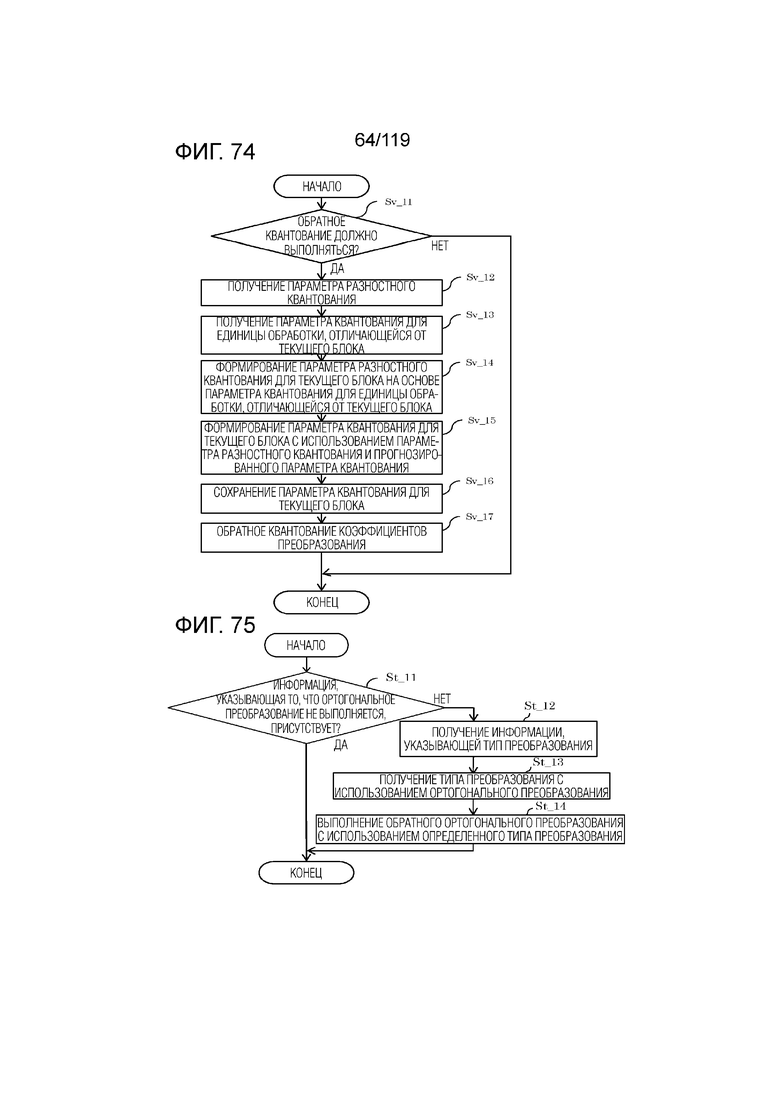

Фиг. 74 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса обратного квантования, выполняемого посредством обратного квантователя.

Фиг. 75 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса, выполняемого посредством обратного преобразователя.

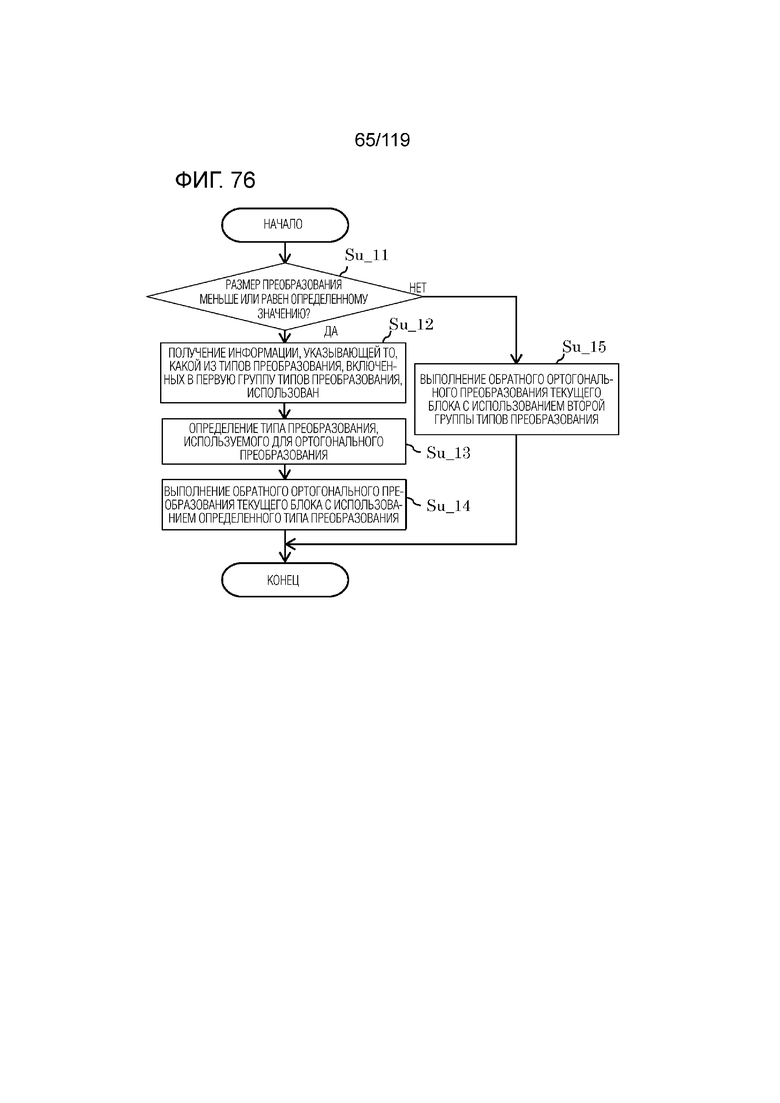

Фиг. 76 является блок-схемой последовательности операций способа, иллюстрирующей другой пример процесса, выполняемого посредством обратного преобразователя.

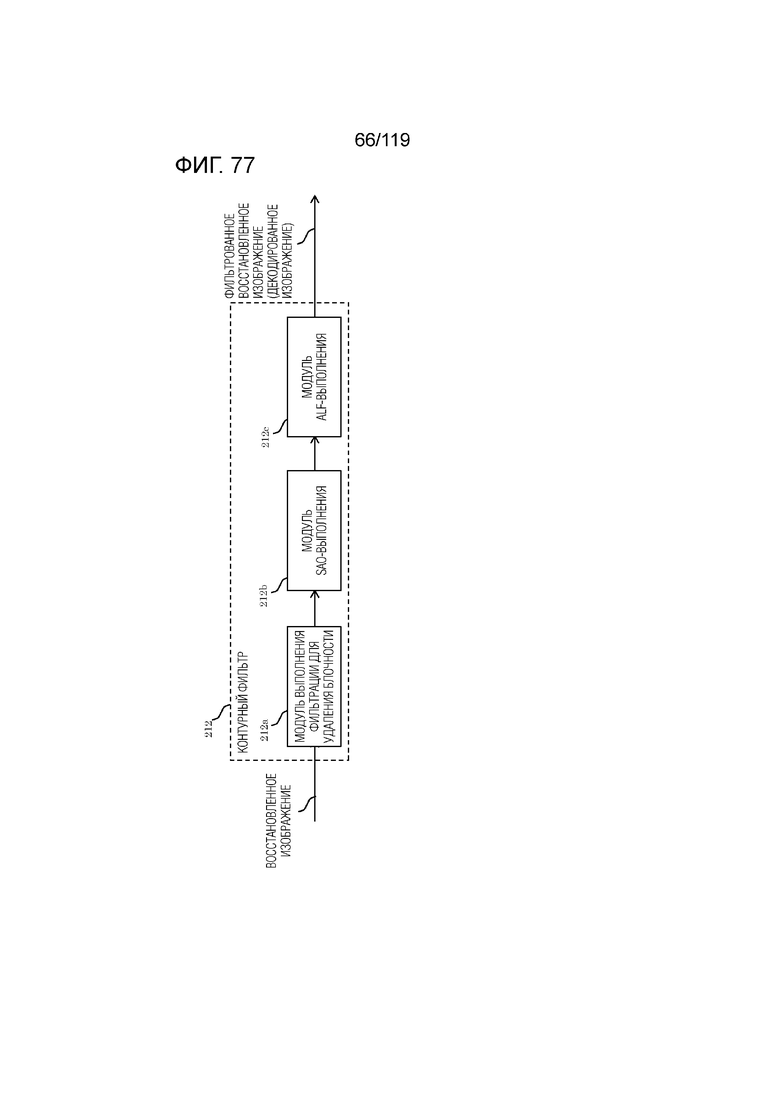

Фиг. 77 является блок-схемой, иллюстрирующей один пример функциональной конфигурации контурного фильтра.

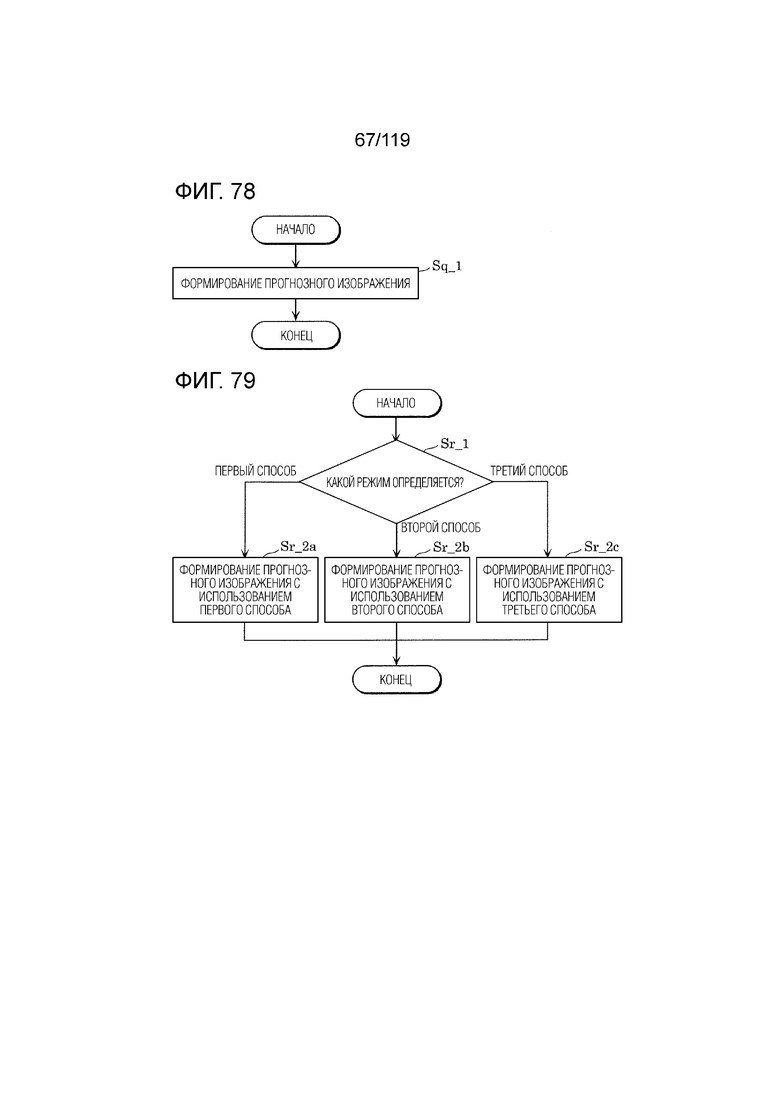

Фиг. 78 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса, выполняемого посредством модуля прогнозирования декодера.

Фиг. 79 является блок-схемой последовательности операций способа, иллюстрирующей другой пример процесса, выполняемого посредством модуля прогнозирования декодера.

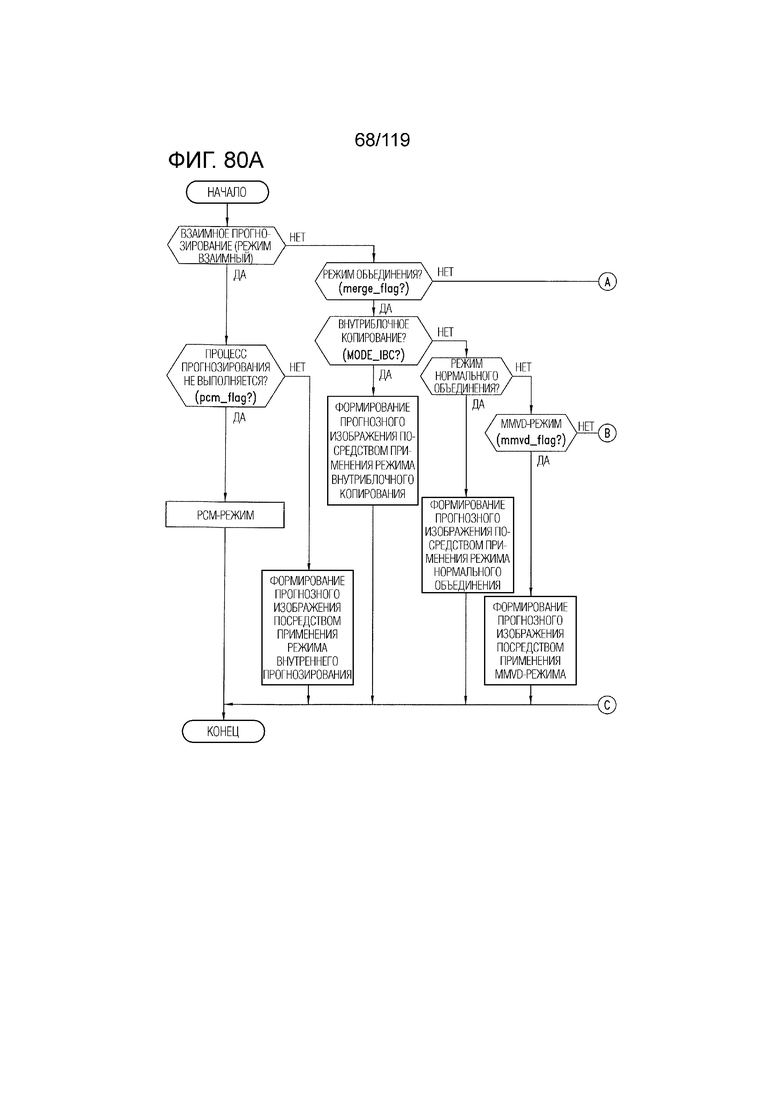

Фиг. 80A является блок-схемой последовательности операций способа, иллюстрирующей другой пример процесса, выполняемого посредством модуля прогнозирования декодера.

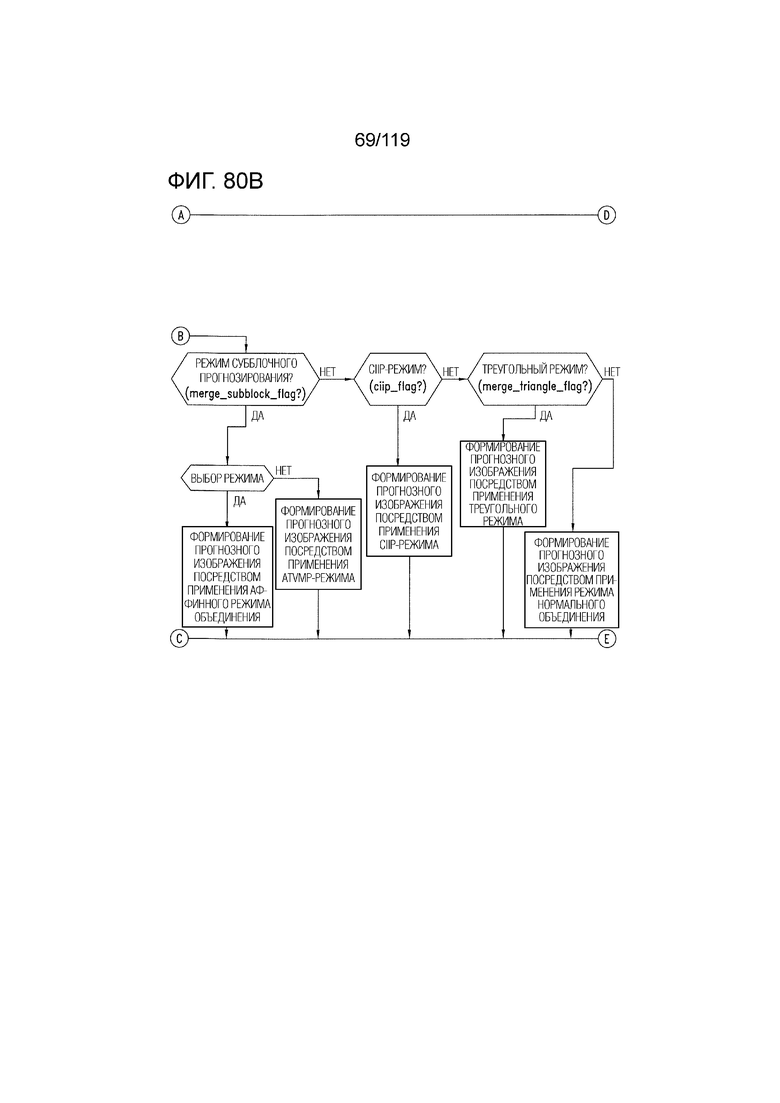

Фиг. 80B является блок-схемой последовательности операций способа, иллюстрирующей другой пример процесса, выполняемого посредством модуля прогнозирования декодера.

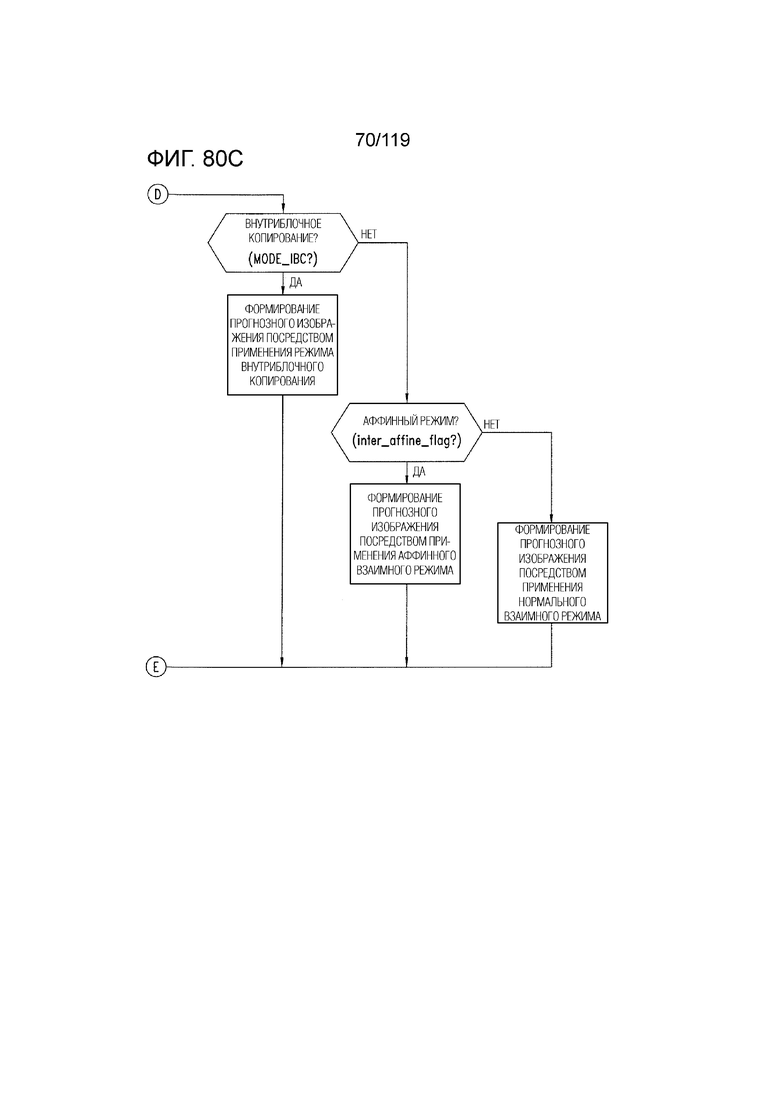

Фиг. 80C является блок-схемой последовательности операций способа, иллюстрирующей другой пример процесса, выполняемого посредством модуля прогнозирования декодера.

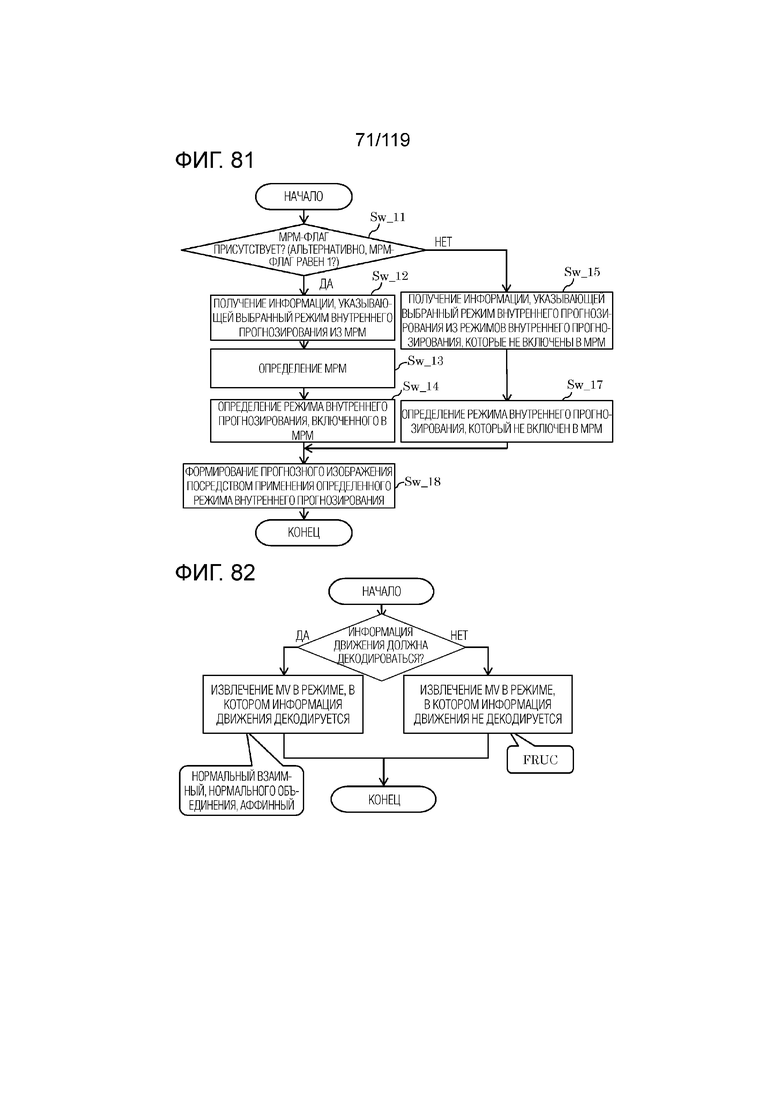

Фиг. 81 является схемой, иллюстрирующей один пример процесса, выполняемого посредством модуля внутреннего прогнозирования декодера.

Фиг. 82 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса MV-извлечения в декодере.

Фиг. 83 является блок-схемой последовательности операций способа, иллюстрирующей другой пример процесса MV-извлечения в декодере.

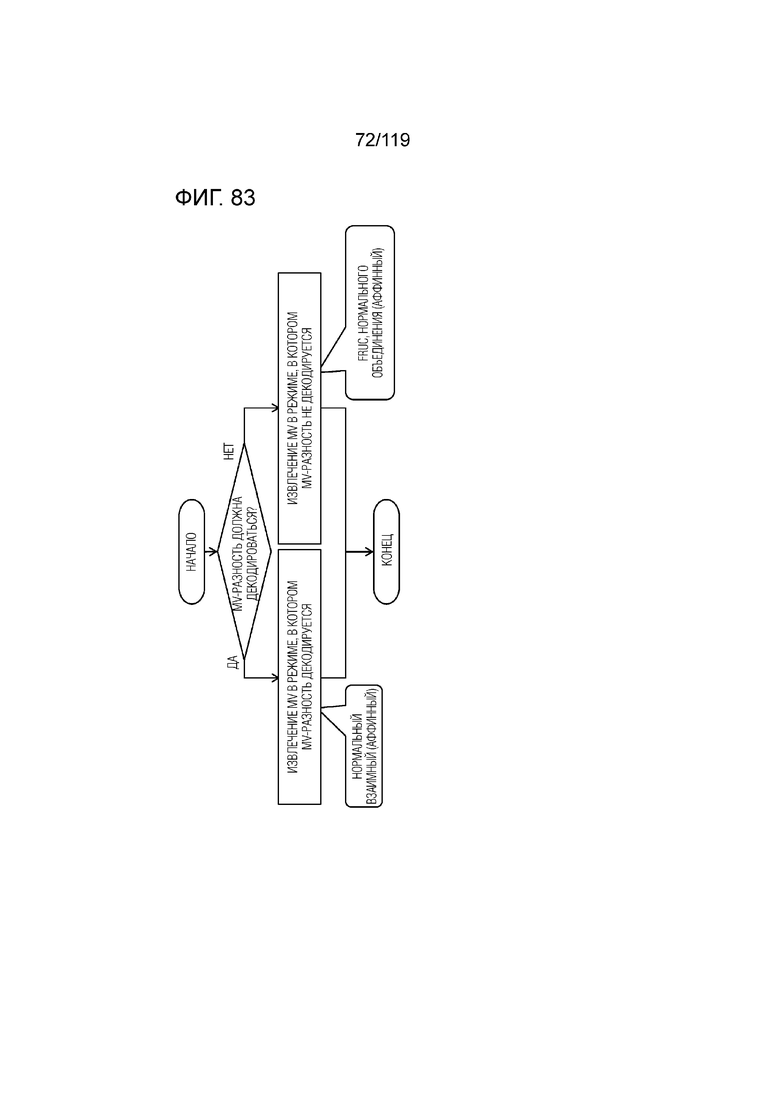

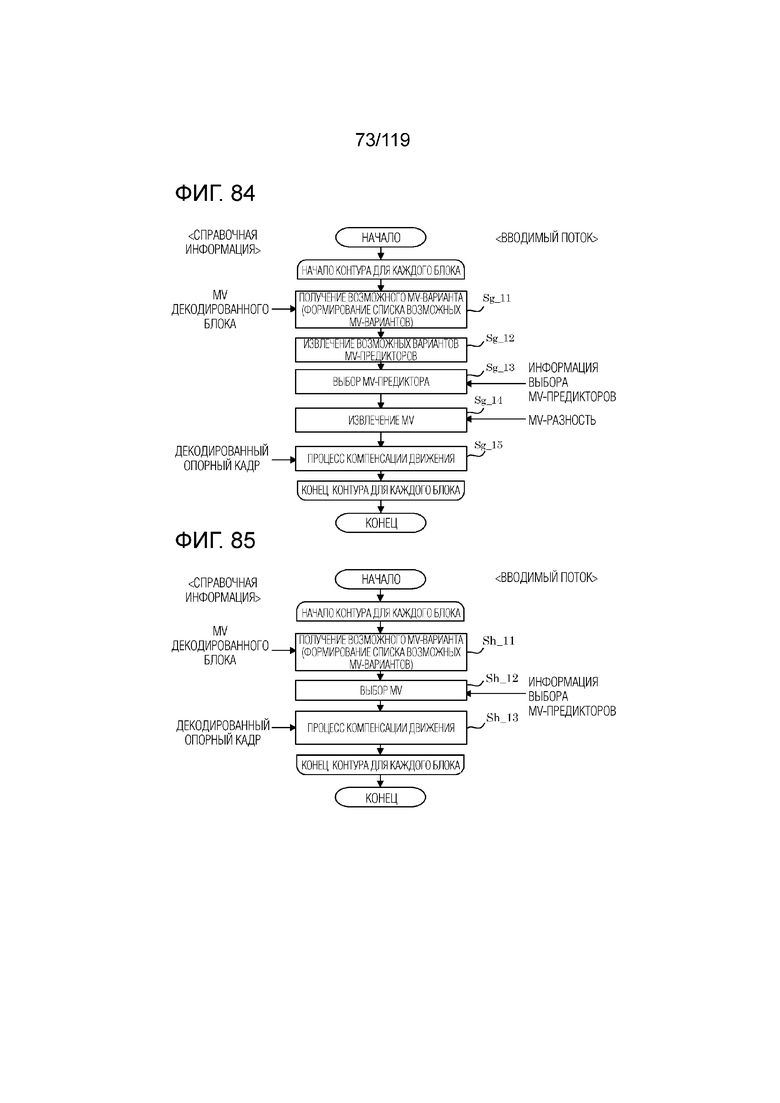

Фиг. 84 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса взаимного прогнозирования посредством нормального взаимного режима в декодере.

Фиг. 85 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса взаимного прогнозирования посредством режима нормального объединения в декодере.

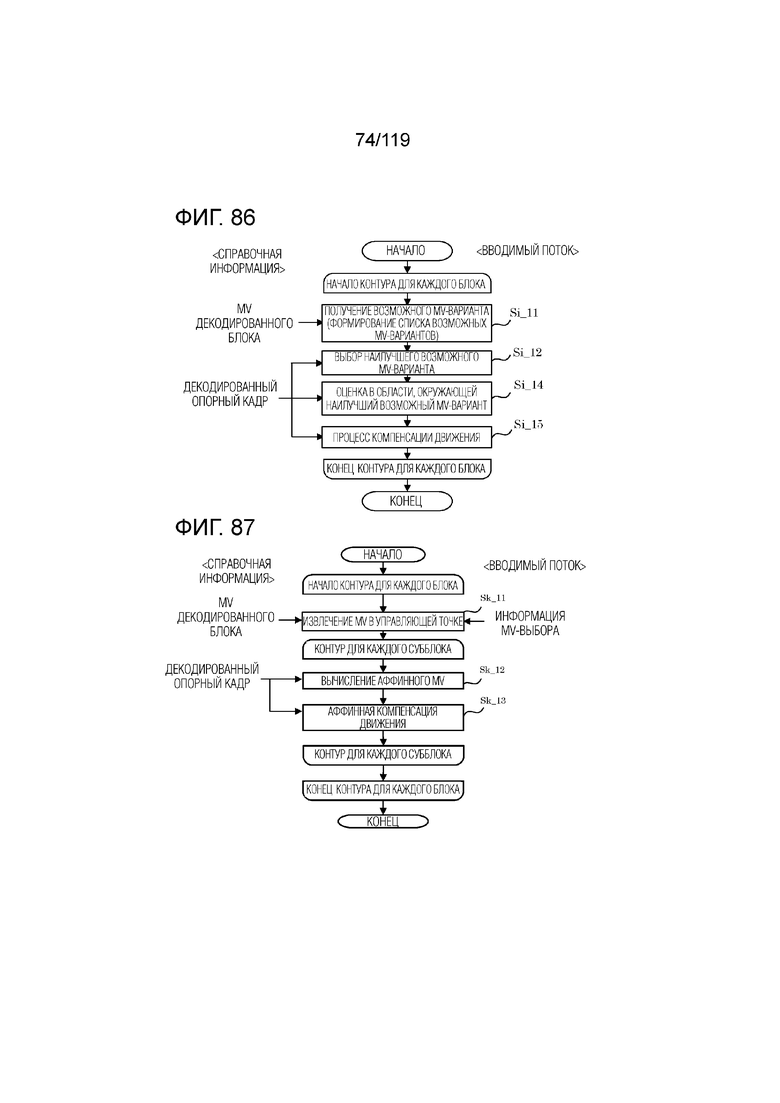

Фиг. 86 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса взаимного прогнозирования посредством FRUC-режима в декодере.

Фиг. 87 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса взаимного прогнозирования посредством аффинного режима объединения в декодере.

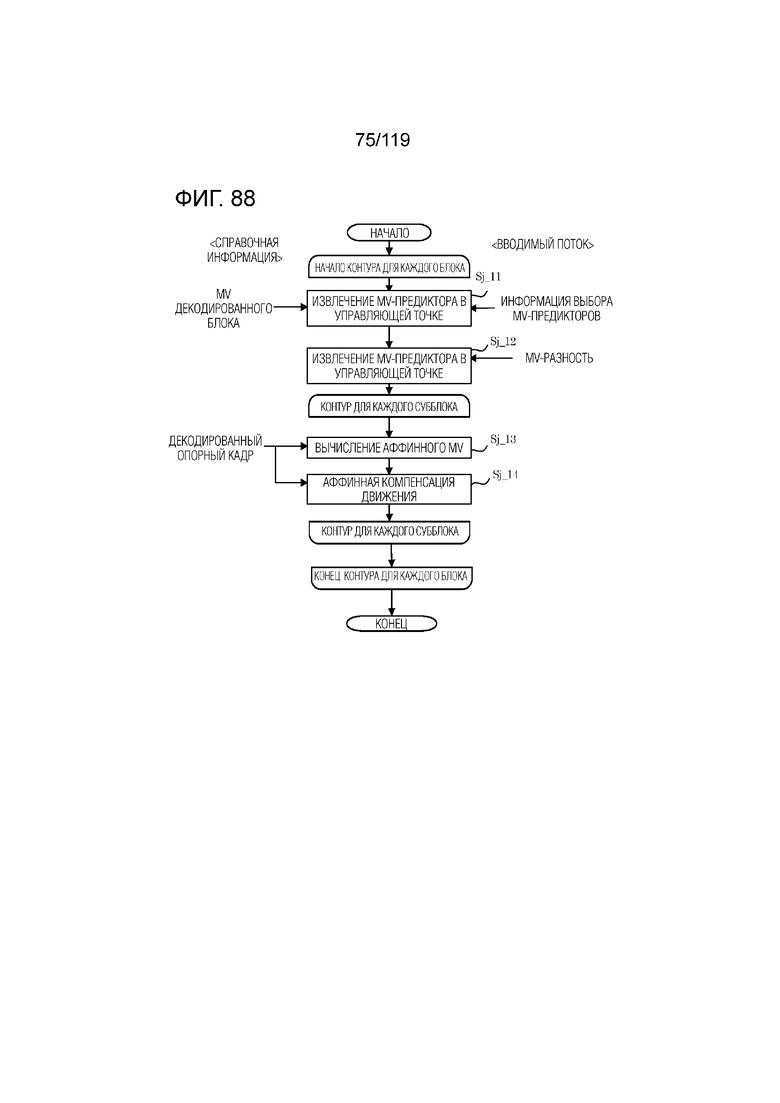

Фиг. 88 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса взаимного прогнозирования посредством аффинного взаимного режима в декодере.

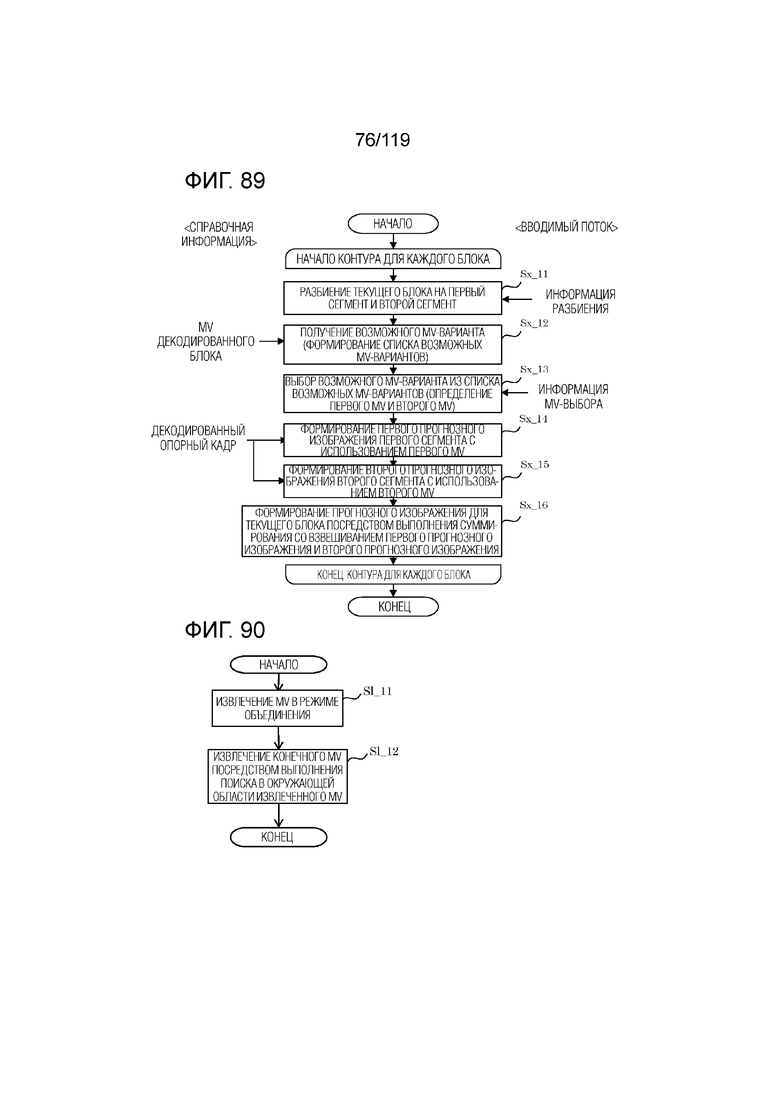

Фиг. 89 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса взаимного прогнозирования посредством треугольного режима в декодере.

Фиг. 90 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса оценки движения посредством DMVR в декодере.

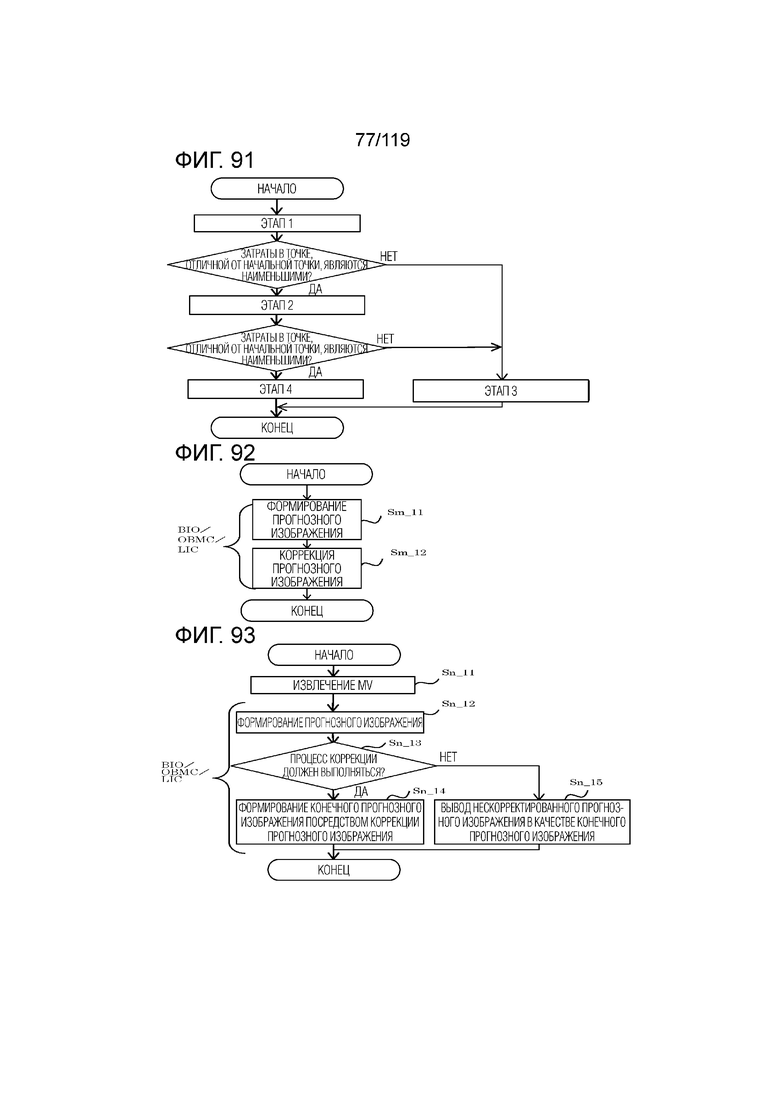

Фиг. 91 является блок-схемой последовательности операций способа, иллюстрирующей один примерный процесс оценки движения посредством DMVR в декодере.

Фиг. 92 является блок-схемой последовательности операций способа, иллюстрирующей один пример процесса формирования прогнозного изображения в декодере.

Фиг. 93 является блок-схемой последовательности операций способа, иллюстрирующей другой пример процесса формирования прогнозного изображения в декодере.

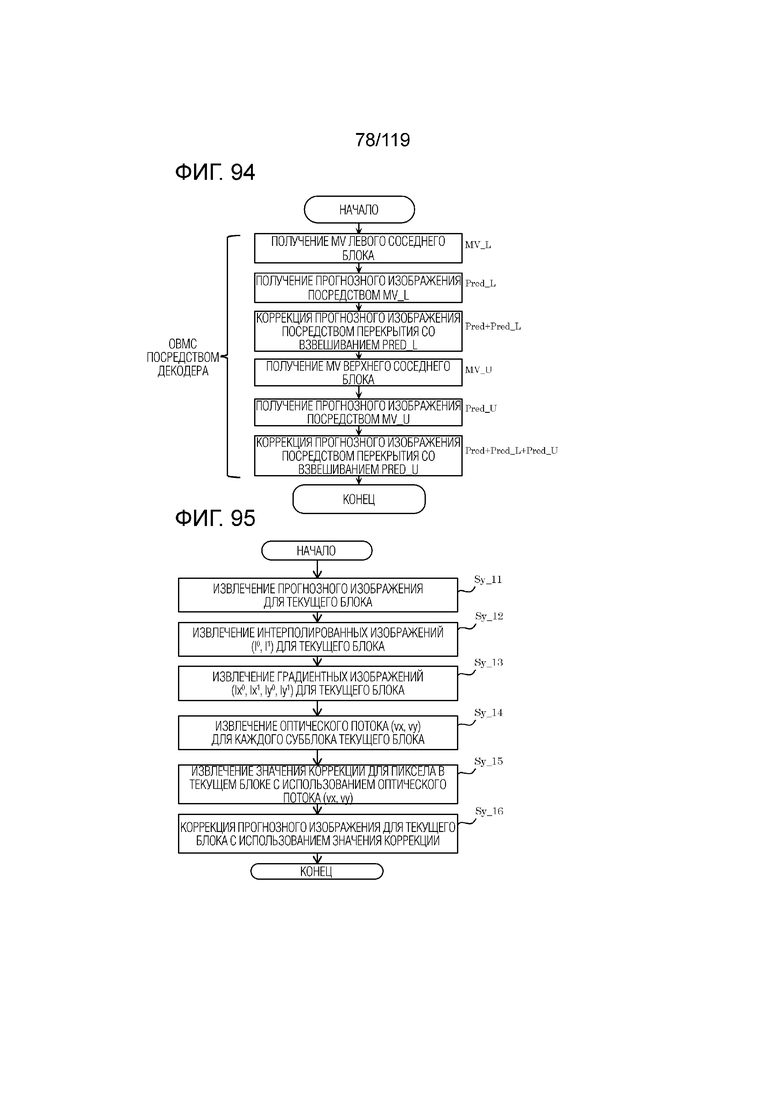

Фиг. 94 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса коррекции прогнозного изображения посредством OBMC в декодере.

Фиг. 95 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса коррекции прогнозного изображения посредством BIO в декодере.

Фиг. 96 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса коррекции прогнозного изображения посредством LIC в декодере.

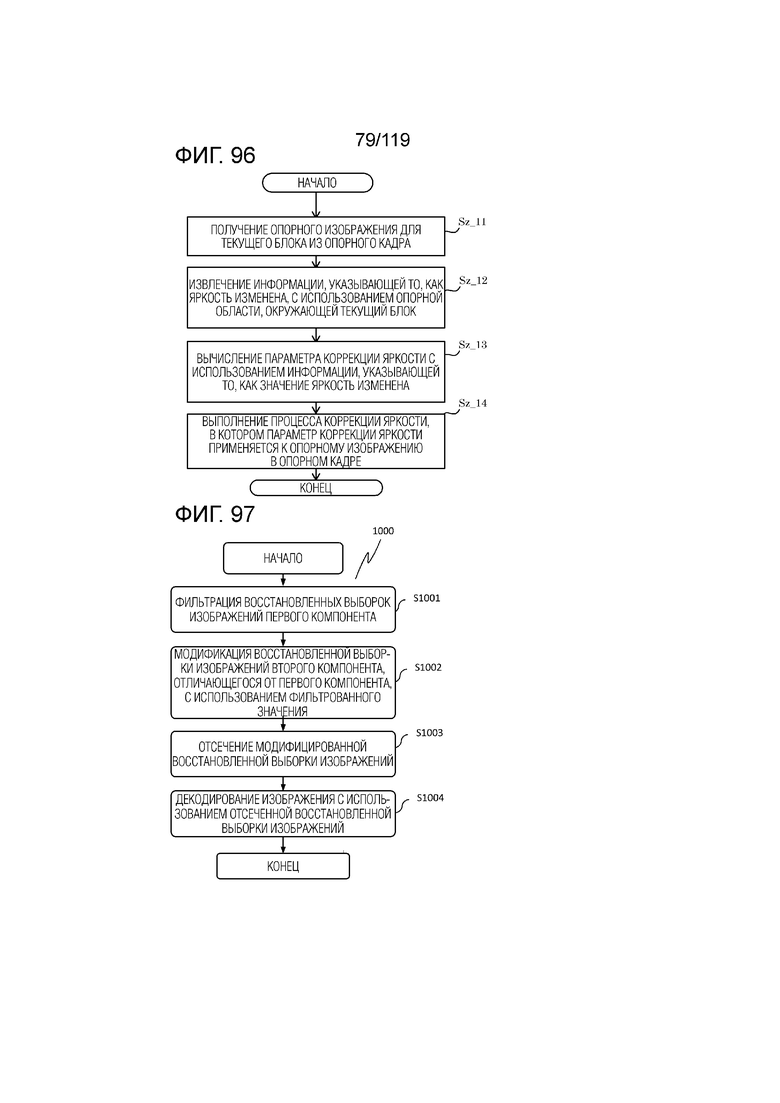

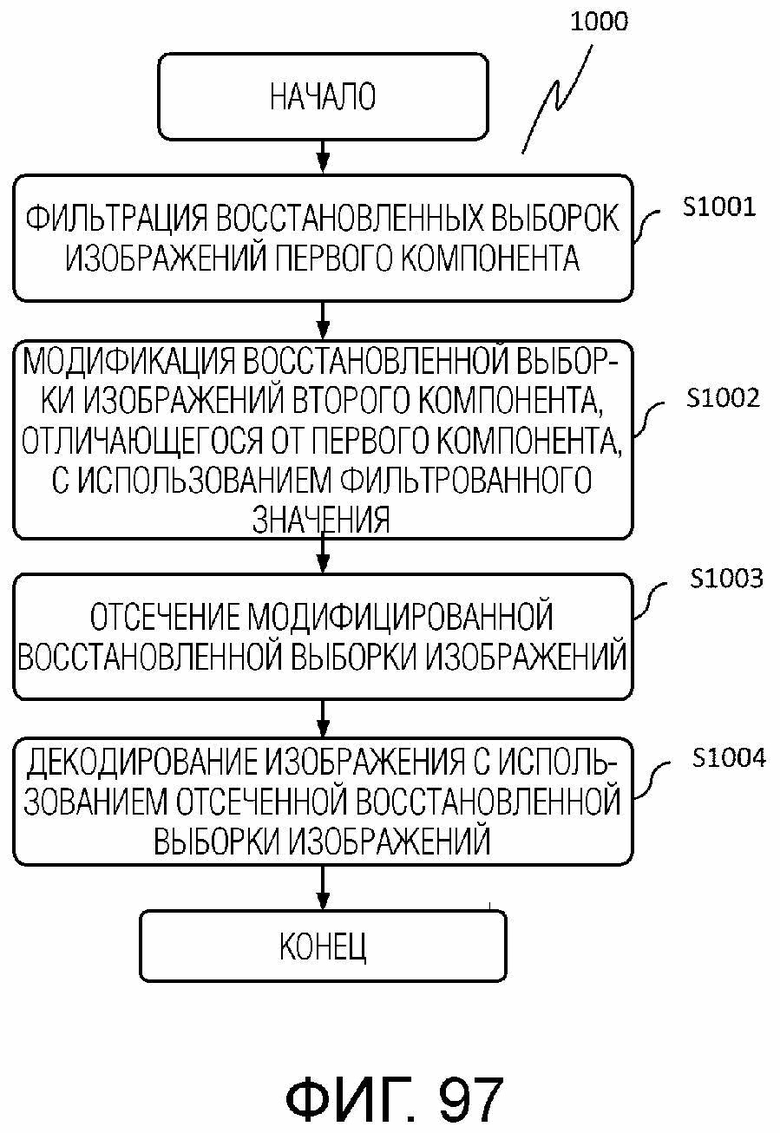

Фиг. 97 является блок-схемой последовательности операций способа для примерной последовательности операций обработки для декодирования изображения, применяющего процесс CCALF (кросскомпонентной адаптивной контурной фильтрации) согласно первому аспекту.

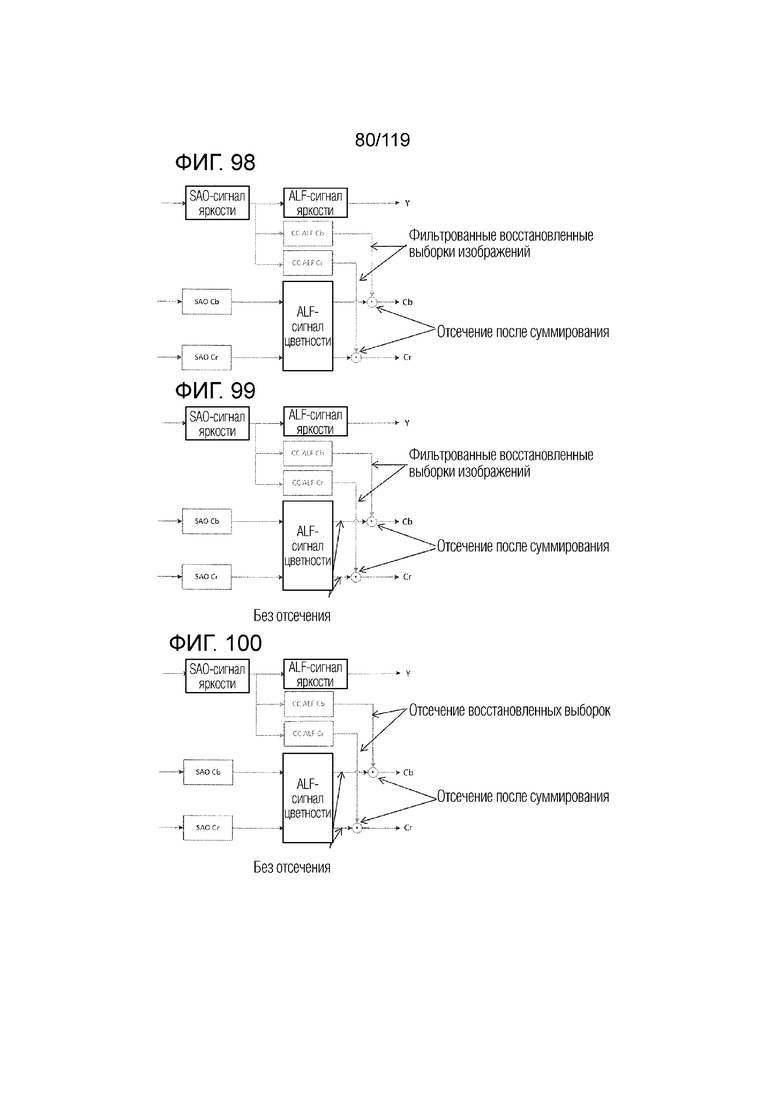

Фиг. 98 является блок-схемой, иллюстрирующей функциональную конфигурацию кодера и декодера согласно варианту осуществления.

Фиг. 99 является блок-схемой, иллюстрирующей функциональную конфигурацию кодера и декодера согласно варианту осуществления.

Фиг. 100 является блок-схемой, иллюстрирующей функциональную конфигурацию кодера и декодера согласно варианту осуществления.

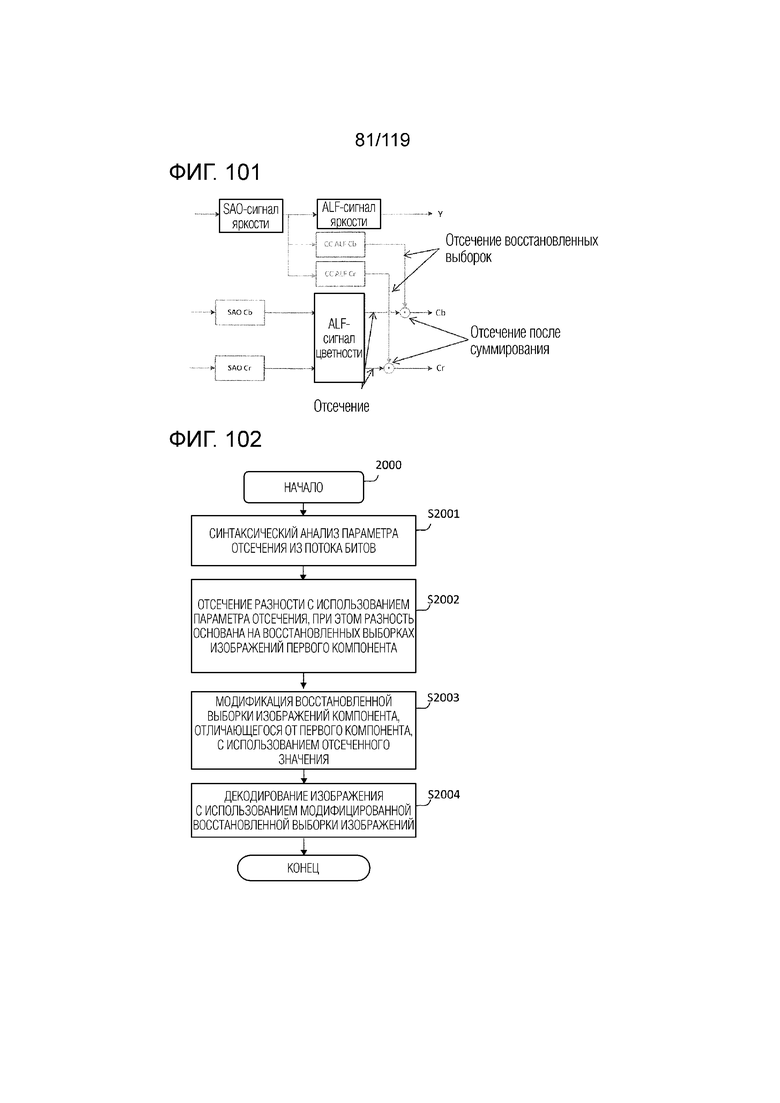

Фиг. 101 является блок-схемой, иллюстрирующей функциональную конфигурацию кодера и декодера согласно варианту осуществления.

Фиг. 102 является блок-схемой последовательности операций способа для примерной последовательности операций обработки для декодирования изображения, применяющего CCALF-процесс согласно второму аспекту.

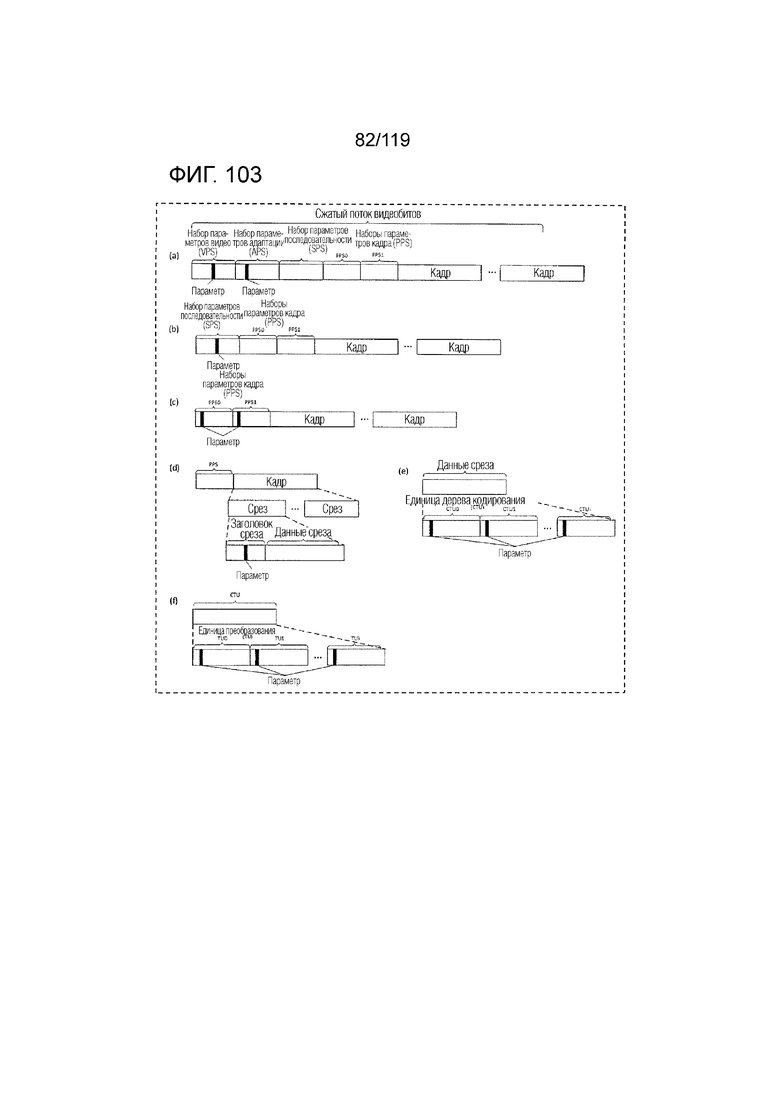

Фиг. 103 иллюстрирует выборочные местоположения параметров отсечения, которые должны синтаксически анализироваться, например, из VPS, APS, SPS, PPS, заголовка среза, CTU или TU потока битов.

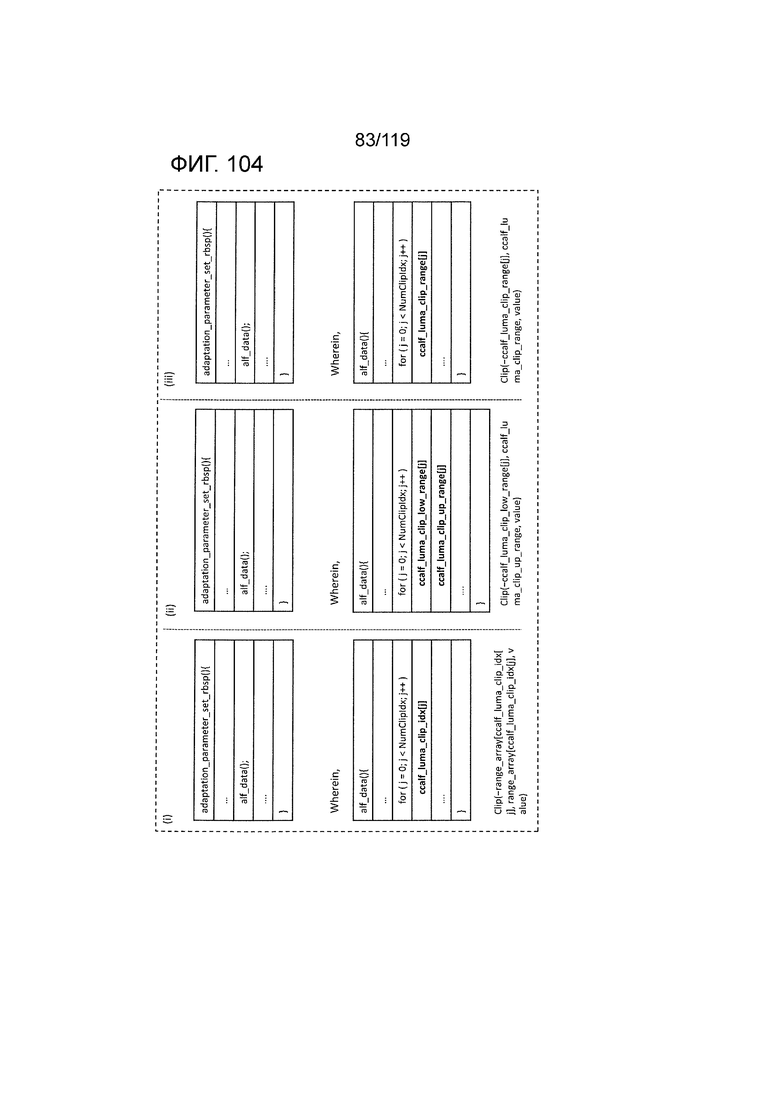

Фиг. 104 иллюстрирует примеры параметров отсечения.

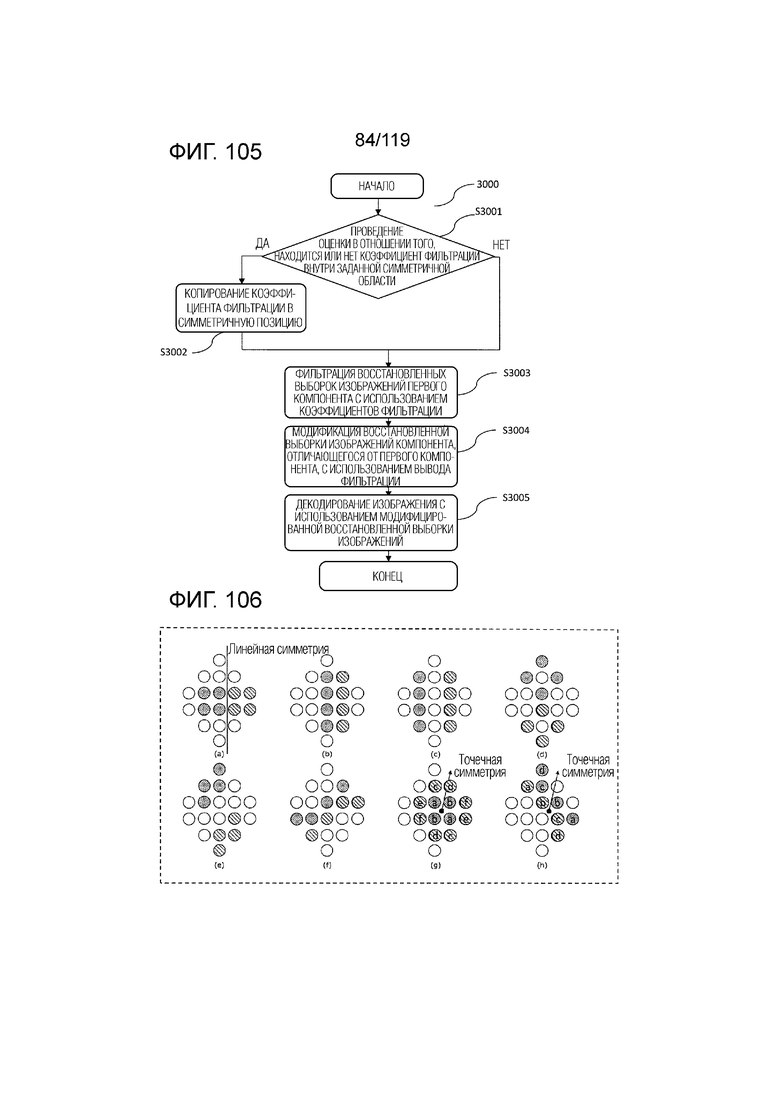

Фиг. 105 является блок-схемой последовательности операций способа для примерной последовательности операций обработки для декодирования изображения, применяющего CCALF-процесс с использованием коэффициента фильтрации согласно третьему аспекту.

Фиг. 106 является концептуальной схемой примера, указывающего местоположения коэффициентов фильтрации, которые должны использоваться в CCALF-процессе.

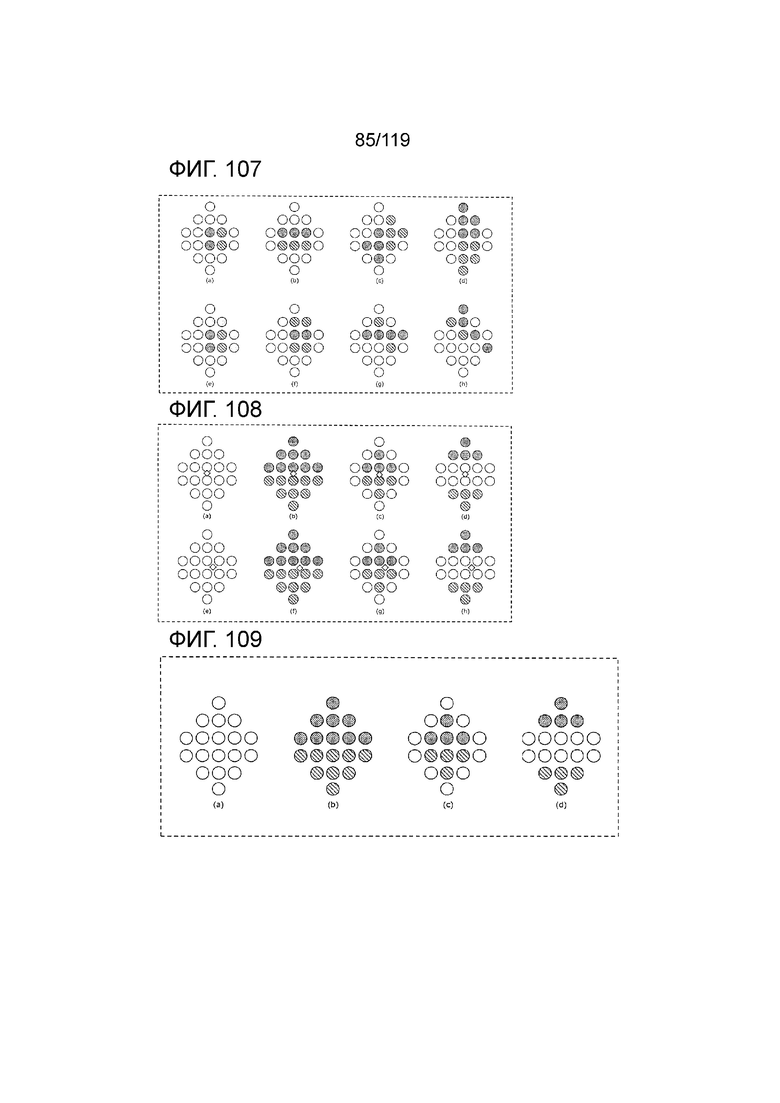

Фиг. 107 является концептуальной схемой примера, указывающего местоположения коэффициентов фильтрации, которые должны использоваться в CCALF-процессе.

Фиг. 108 является концептуальной схемой примера, указывающего местоположения коэффициентов фильтрации, которые должны использоваться в CCALF-процессе.

Фиг. 109 является концептуальной схемой примера, указывающего местоположения коэффициентов фильтрации, которые должны использоваться в CCALF-процессе.

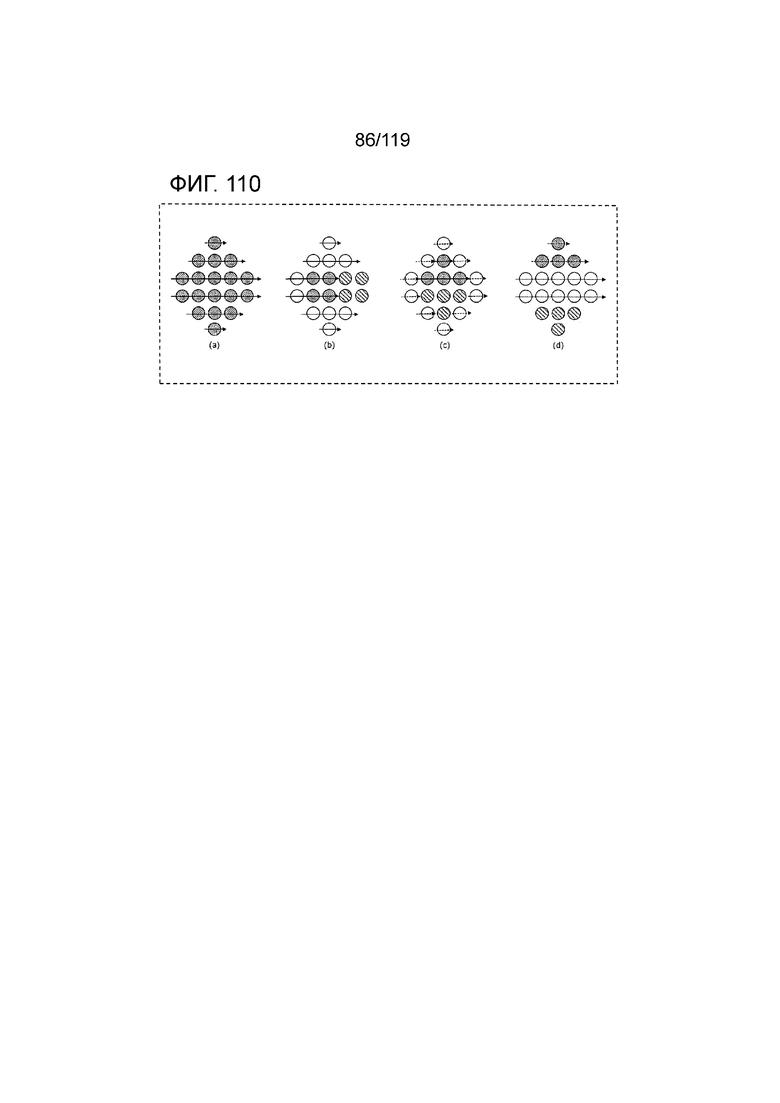

Фиг. 110 является концептуальной схемой примера, указывающего местоположения коэффициентов фильтрации, которые должны использоваться в CCALF-процессе.

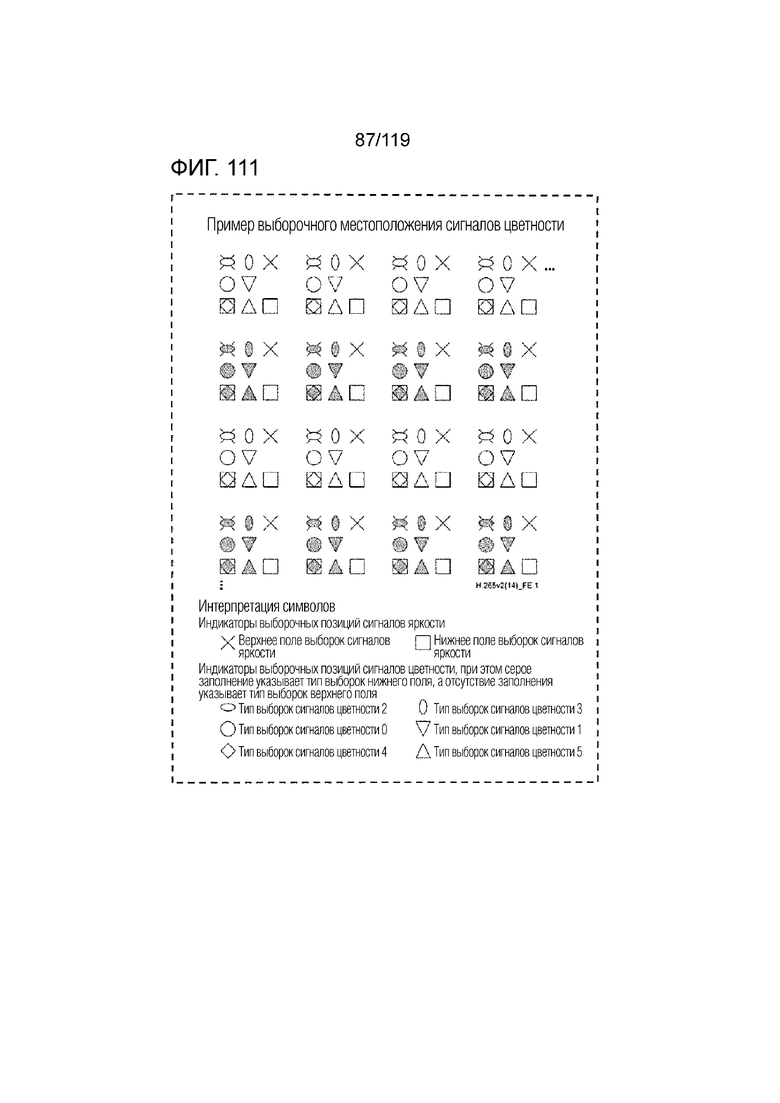

Фиг. 111 является концептуальной схемой дополнительного примера, указывающего местоположения коэффициентов фильтрации, которые должны использоваться в CCALF-процессе.

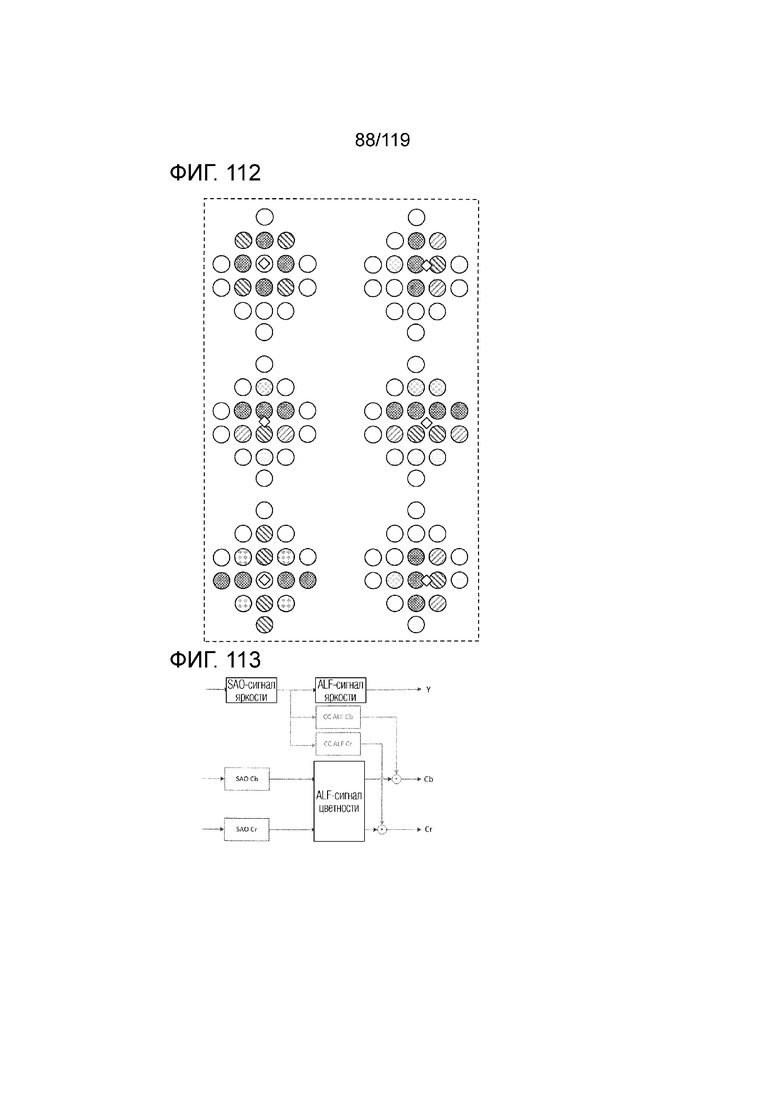

Фиг. 112 является концептуальной схемой дополнительного примера, указывающего местоположения коэффициентов фильтрации, которые должны использоваться в CCALF-процессе.

Фиг. 113 является блок-схемой, иллюстрирующей функциональную конфигурацию CCALF-процесса, выполняемого посредством кодера и декодера согласно варианту осуществления.

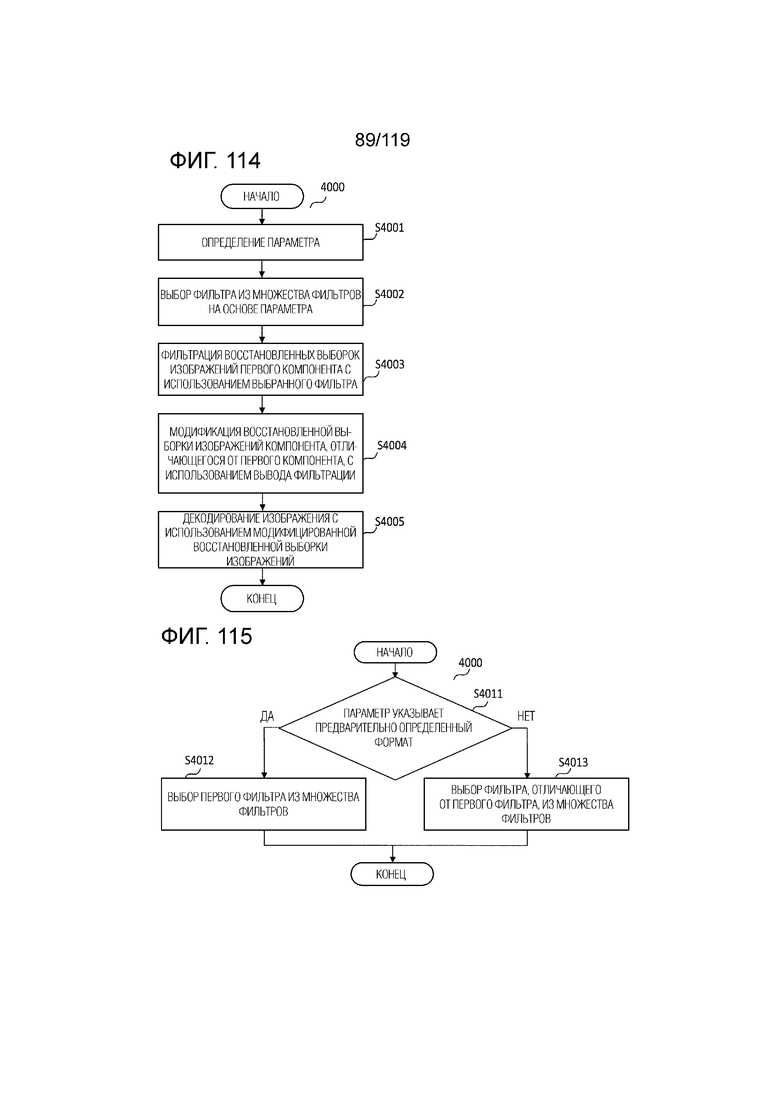

Фиг. 114 является блок-схемой последовательности операций способа для примерной последовательности операций обработки для декодирования изображения, применяющего CCALF-процесс с использованием фильтра, выбранного из множества фильтров согласно четвертому аспекту.

Фиг. 115 иллюстрирует пример последовательности операций обработки выбора фильтра.

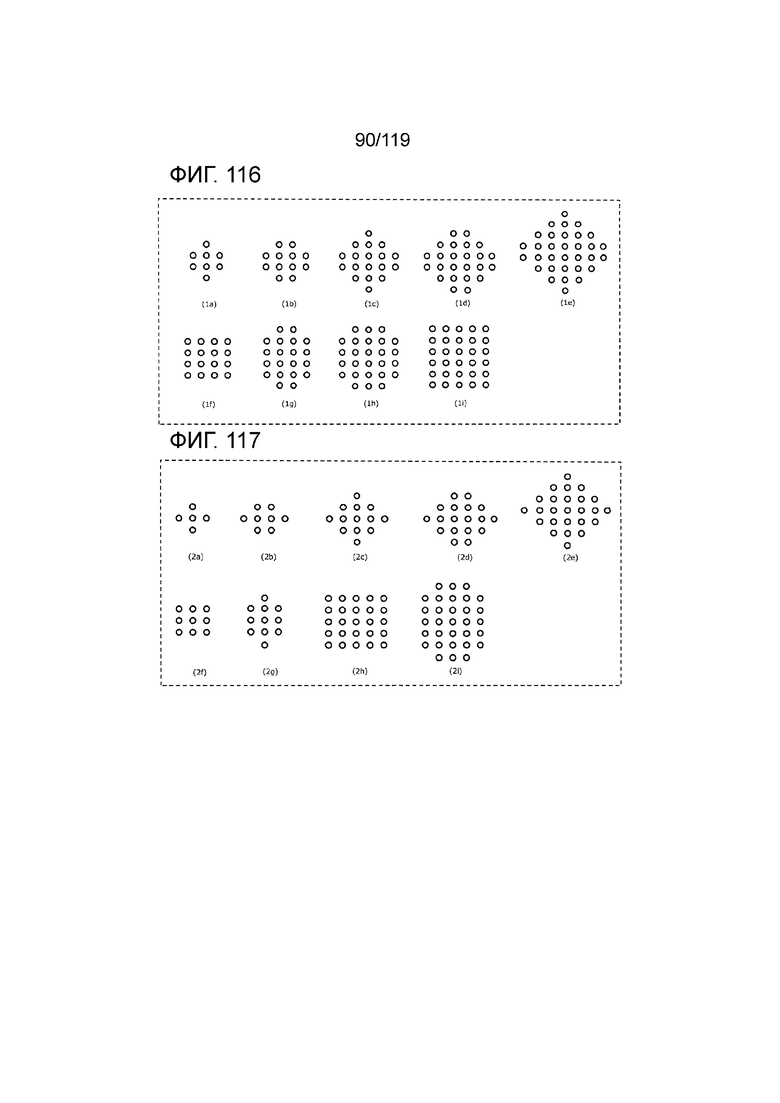

Фиг. 116 иллюстрирует примеры фильтров.

Фиг. 117 иллюстрирует примеры фильтров.

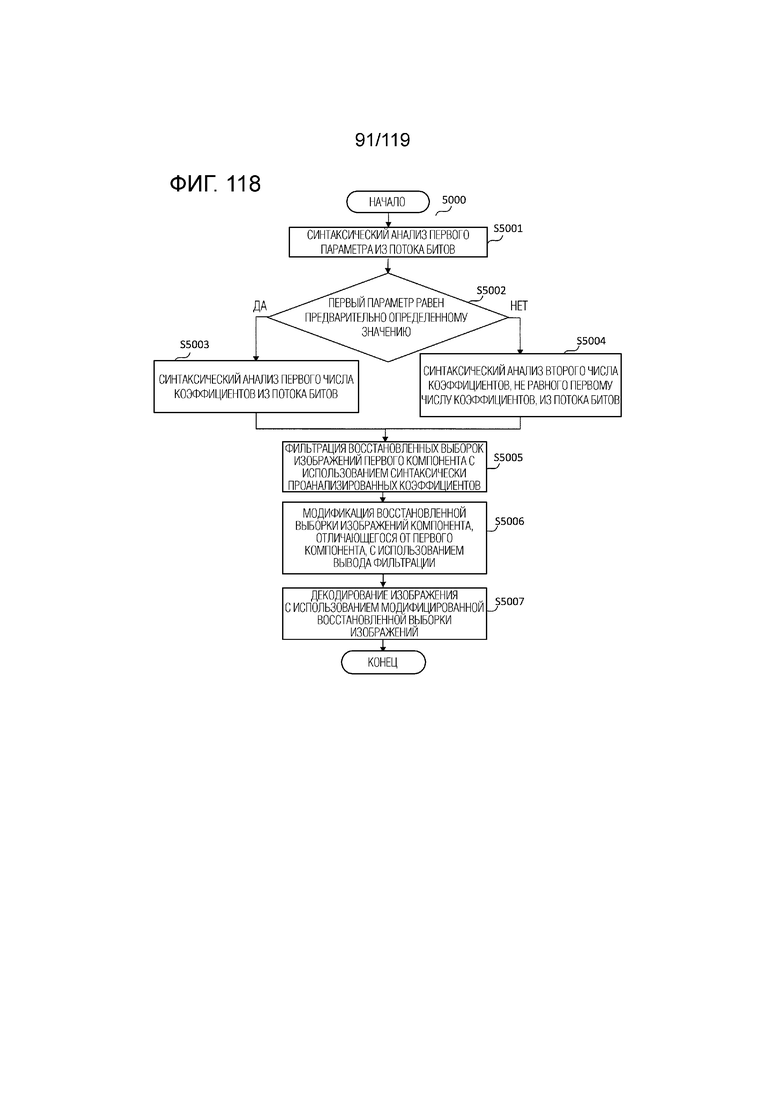

Фиг. 118 является блок-схемой последовательности операций способа для примерной последовательности операций обработки для декодирования изображения, применяющего CCALF-процесс с использованием параметра согласно пятому аспекту.

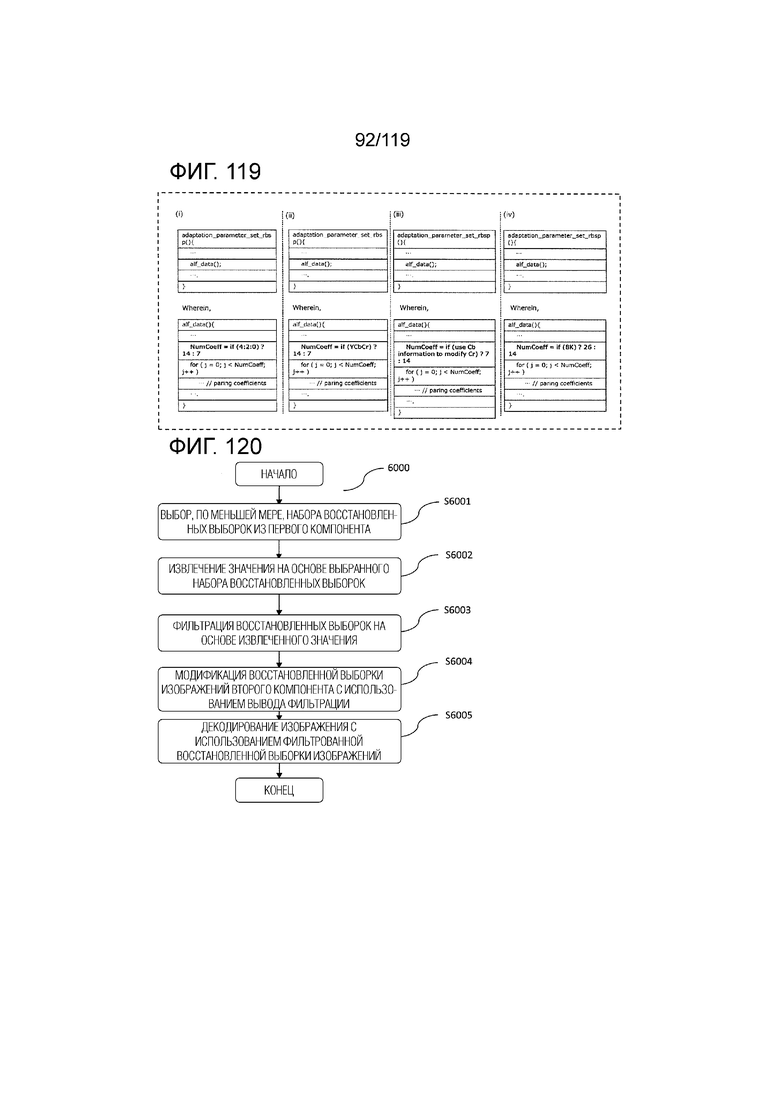

Фиг. 119 иллюстрирует примеры числа коэффициентов, которые должны синтаксически анализироваться из потока битов.

Фиг. 120 является блок-схемой последовательности операций способа для примерной последовательности операций обработки для декодирования изображения, применяющего CCALF-процесс с использованием параметра согласно шестому аспекту.

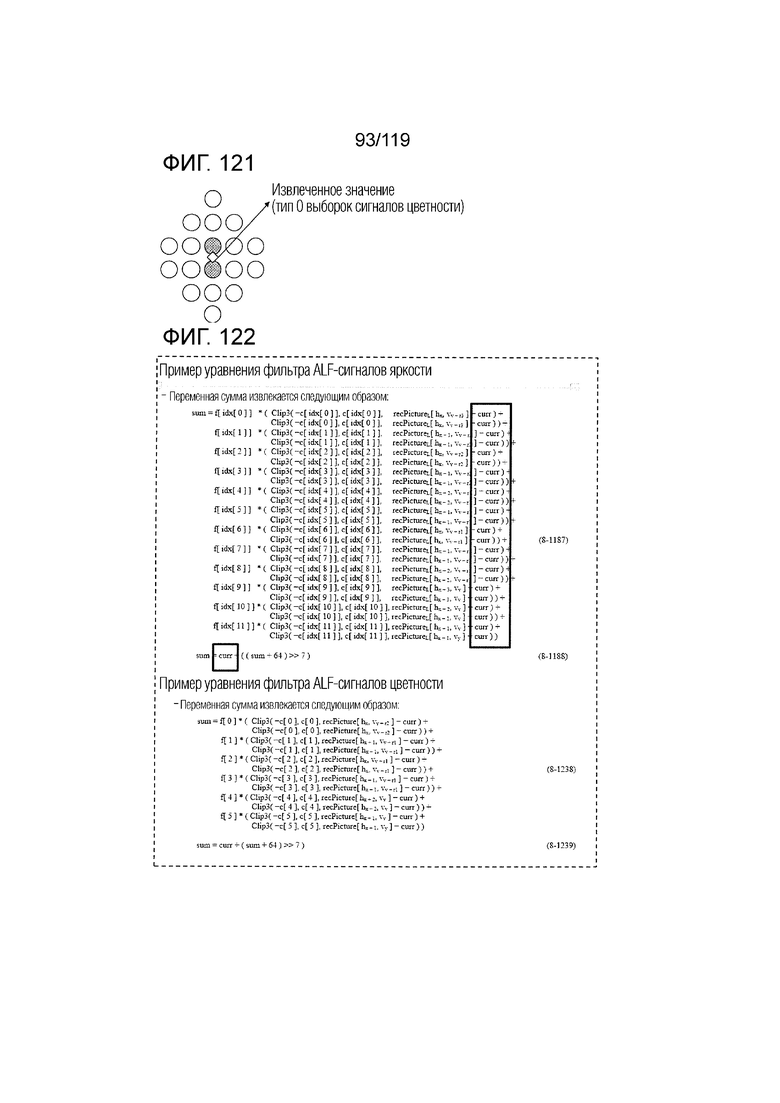

Фиг. 121 является концептуальной схемой, иллюстрирующей пример формирования CCALF-значения компонента сигнала яркости для текущей выборки сигналов цветности посредством вычисления средневзвешенного значения соседних выборок.

Фиг. 122 является концептуальной схемой, иллюстрирующей пример формирования CCALF-значения компонента сигнала яркости для текущей выборки сигналов цветности посредством вычисления средневзвешенного значения соседних выборок.

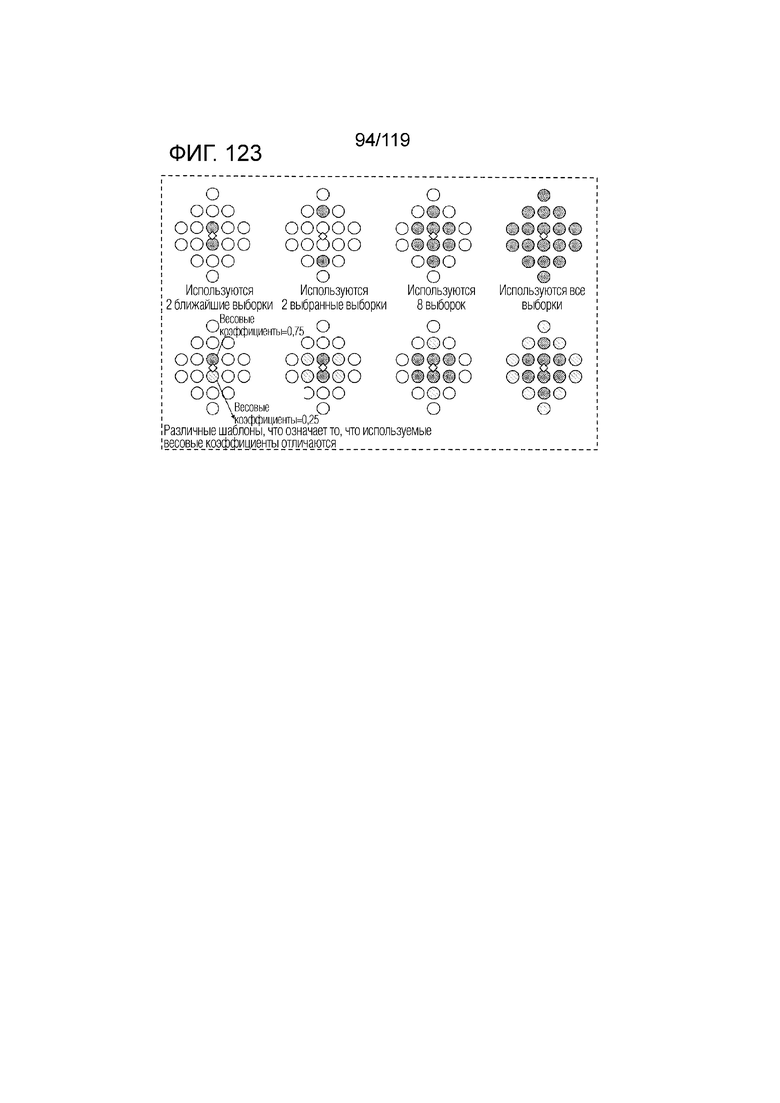

Фиг. 123 является концептуальной схемой, иллюстрирующей пример формирования CCALF-значения компонента сигнала яркости для текущей выборки сигналов цветности посредством вычисления средневзвешенного значения соседних выборок.

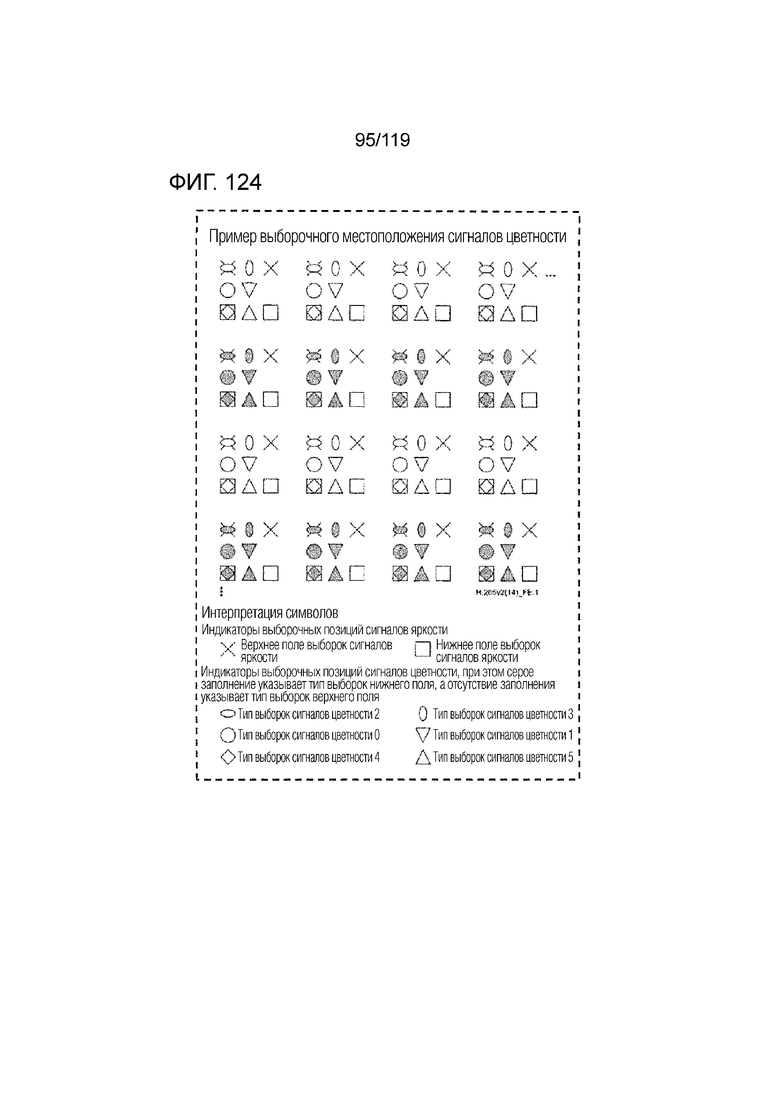

Фиг. 124 является концептуальной схемой, иллюстрирующей пример формирования CCALF-значения компонента сигнала яркости для текущей выборки посредством вычисления средневзвешенного значения соседних выборок, при этом местоположения соседних выборок определяются адаптивно относительно типа сигналов цветности.

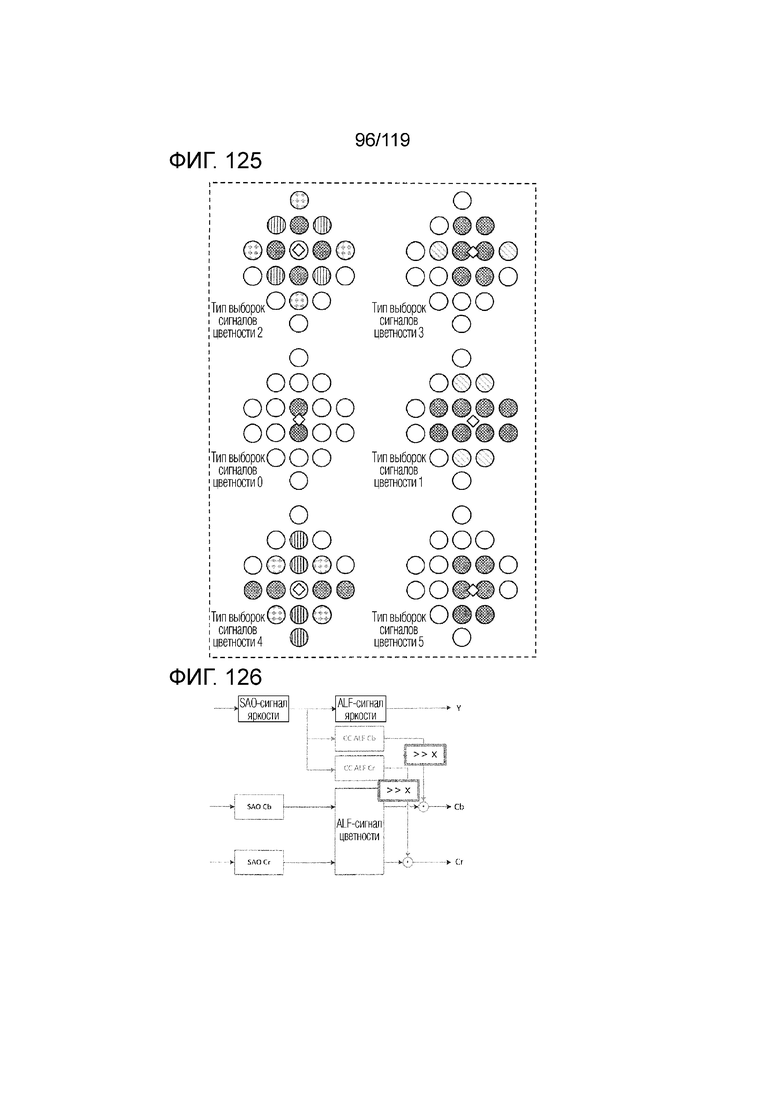

Фиг. 125 является концептуальной схемой, иллюстрирующей пример формирования CCALF-значения компонента сигнала яркости для текущей выборки посредством вычисления средневзвешенного значения соседних выборок, при этом местоположения соседних выборок определяются адаптивно относительно типа сигналов цветности.

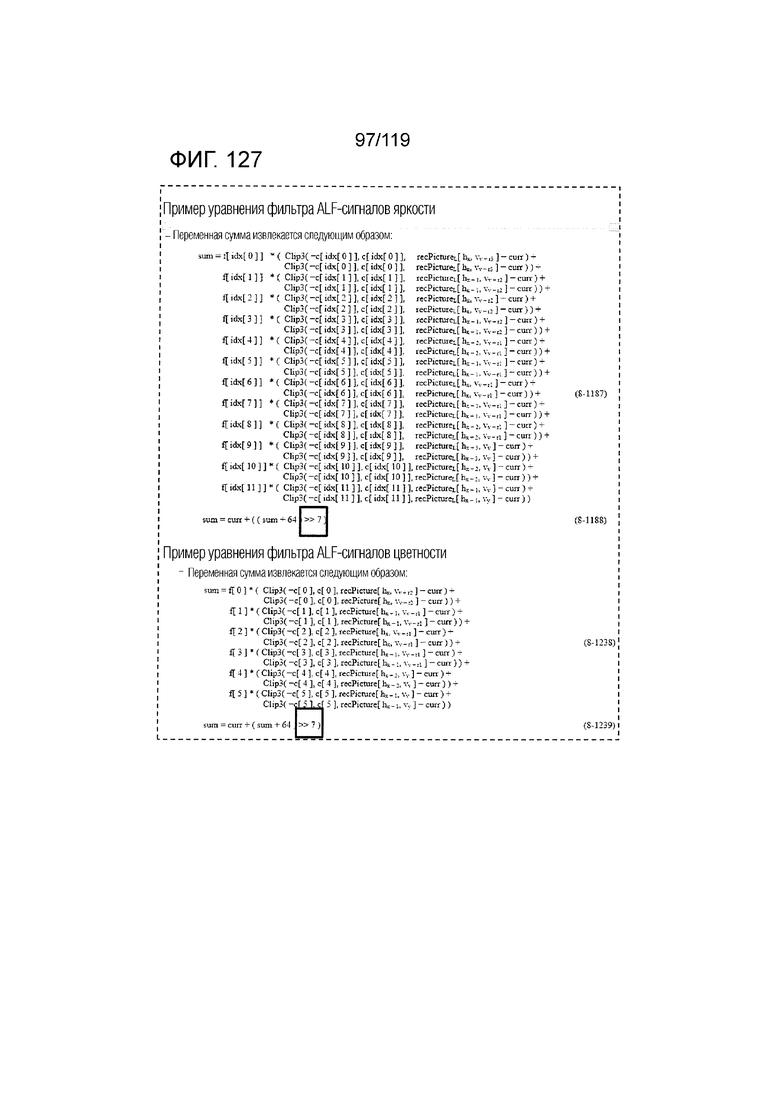

Фиг. 126 является концептуальной схемой, иллюстрирующей пример формирования CCALF-значения компонента сигнала яркости посредством применения побитового сдвига к выходному значению вычисления со взвешиванием.

Фиг. 127 является концептуальной схемой, иллюстрирующей пример формирования CCALF-значения компонента сигнала яркости посредством применения побитового сдвига к выходному значению вычисления со взвешиванием.

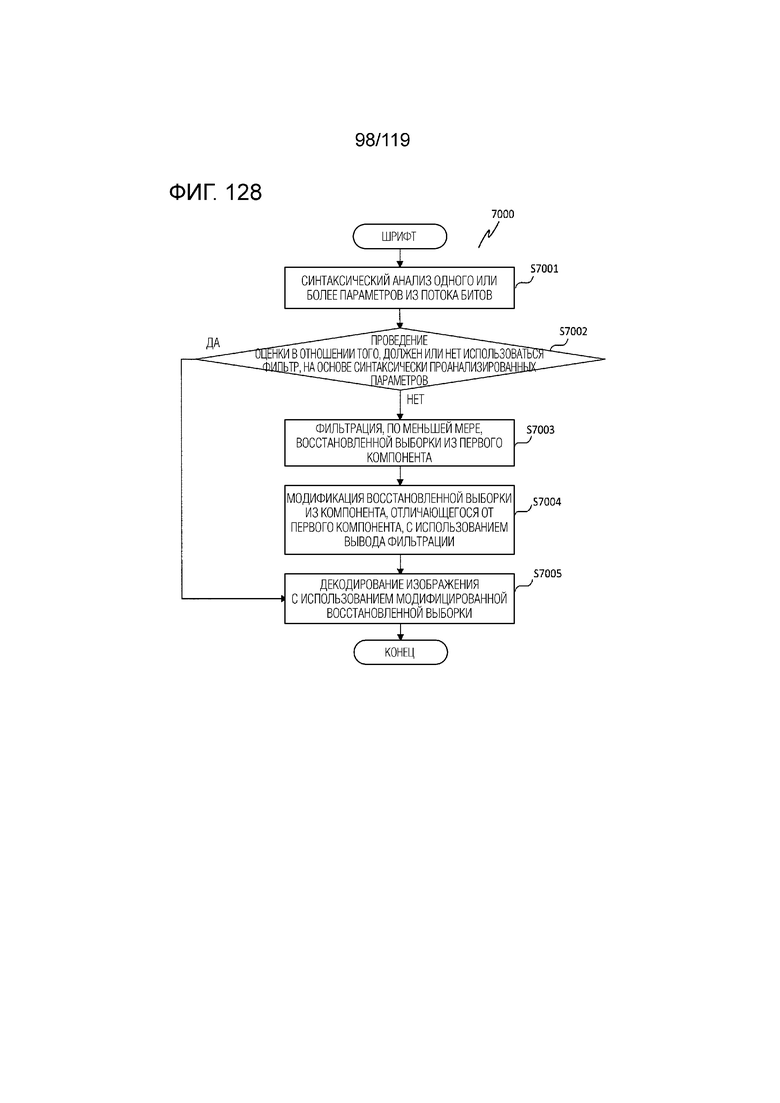

Фиг. 128 является блок-схемой последовательности операций способа для примерной последовательности операций обработки для декодирования изображения, применяющего CCALF-процесс с использованием параметра согласно седьмому аспекту.

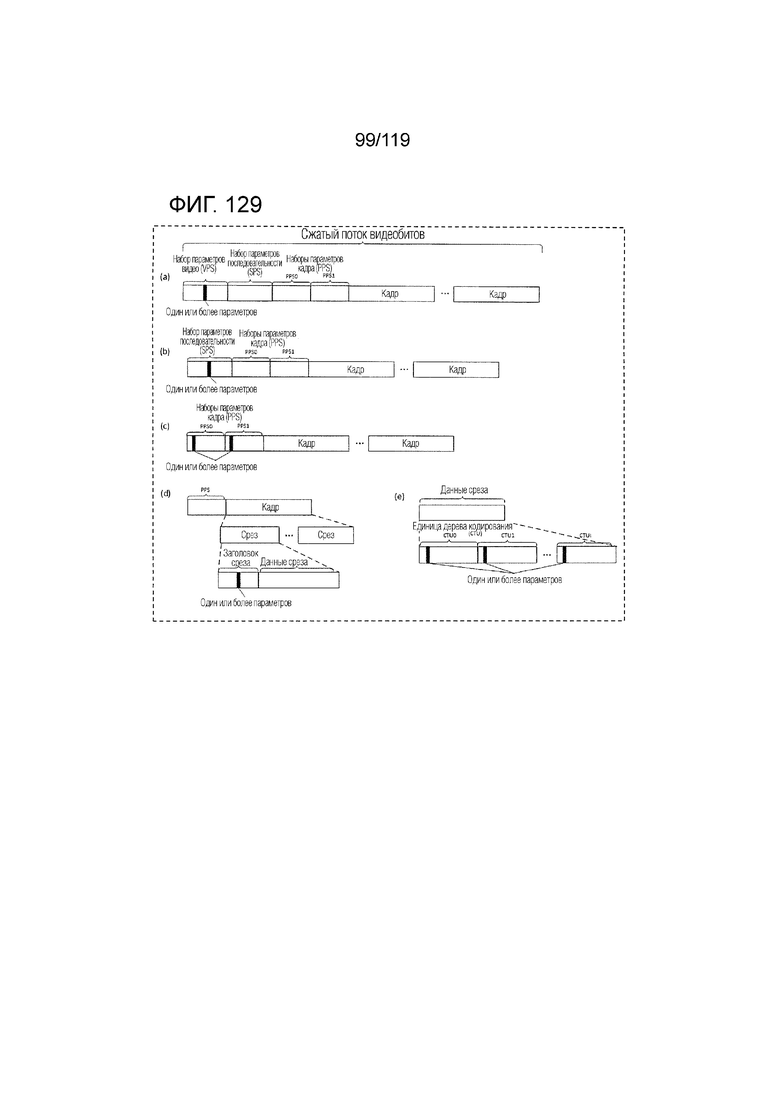

Фиг. 129 иллюстрирует выборочные местоположения одного или более параметров, которые должны синтаксически анализироваться из потока битов.

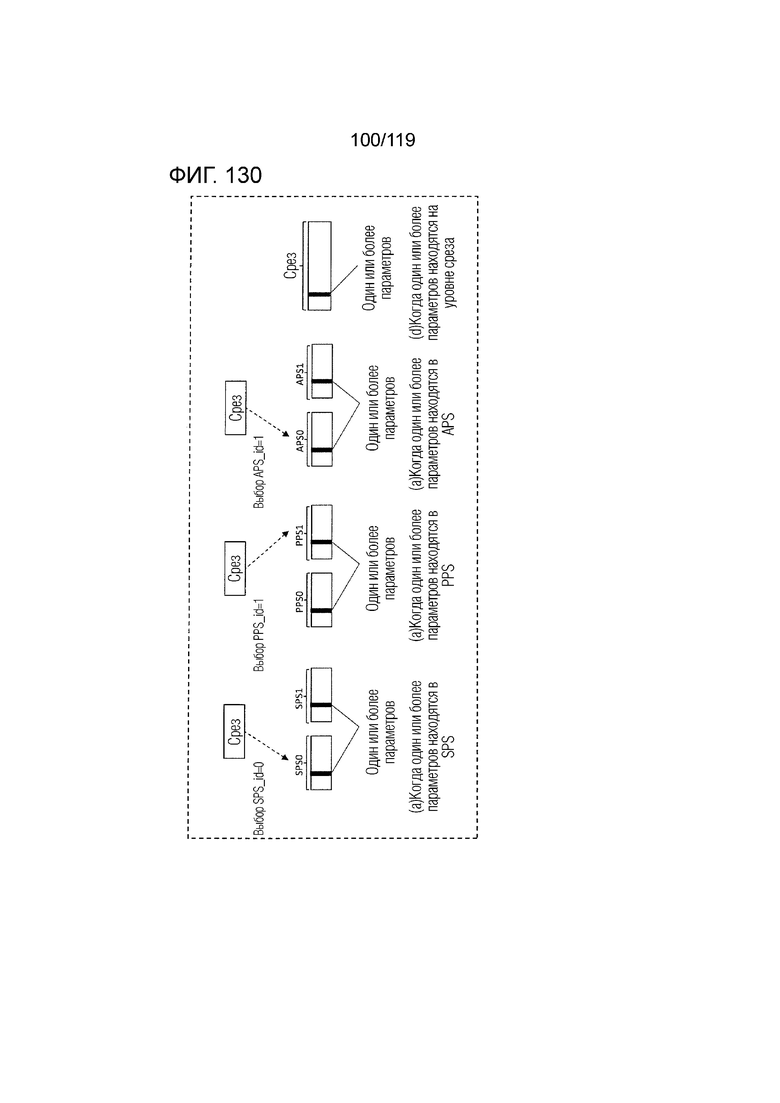

Фиг. 130 показывает примерные процессы извлечения одного или более параметров.

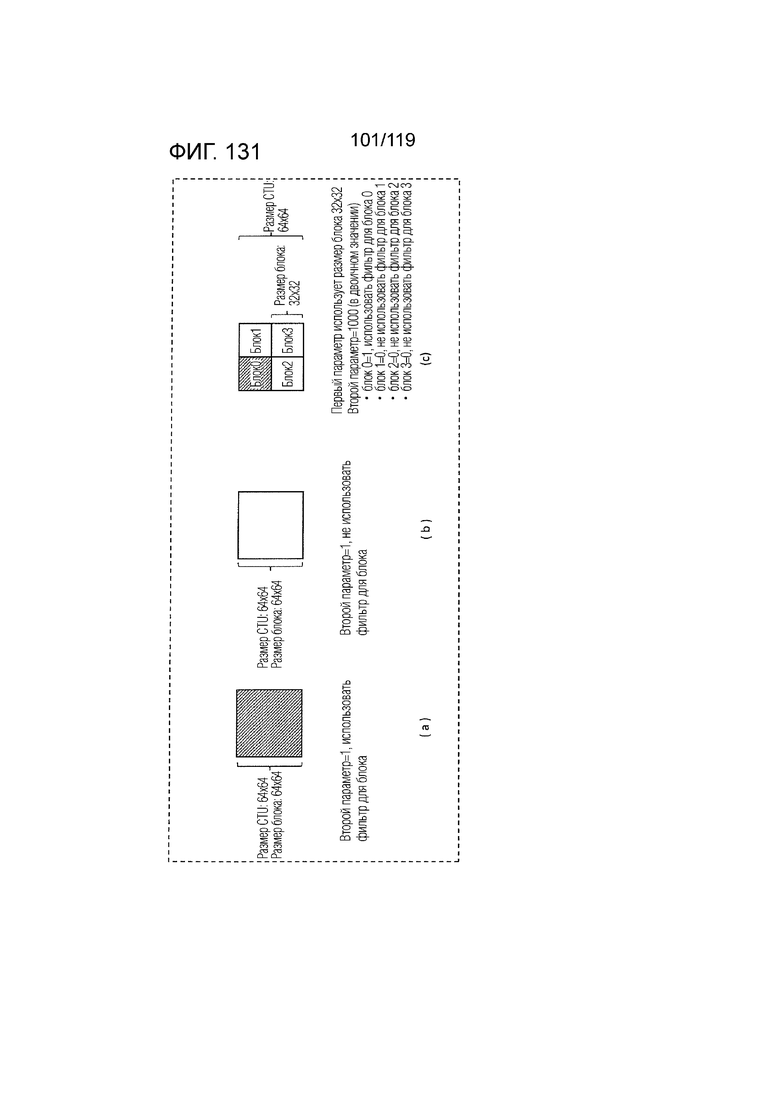

Фиг. 131 показывает выборочные значения второго параметра.

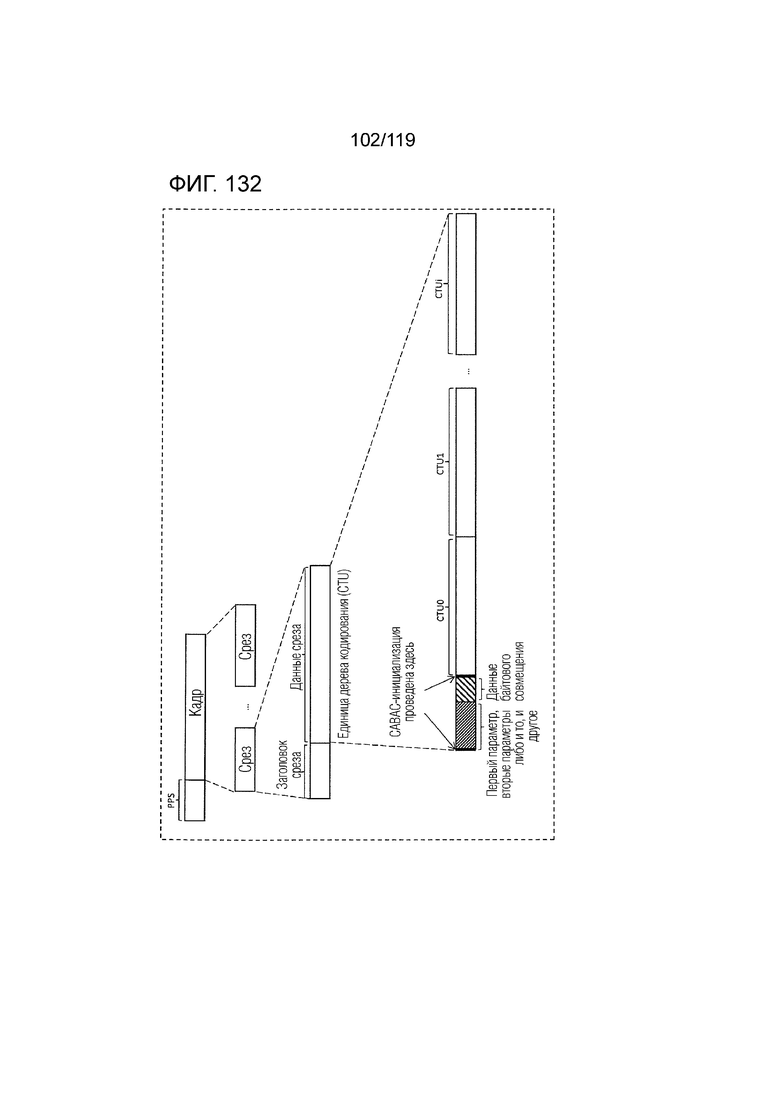

Фиг. 132 показывает пример синтаксического анализа второго параметра с использованием арифметического кодирования.

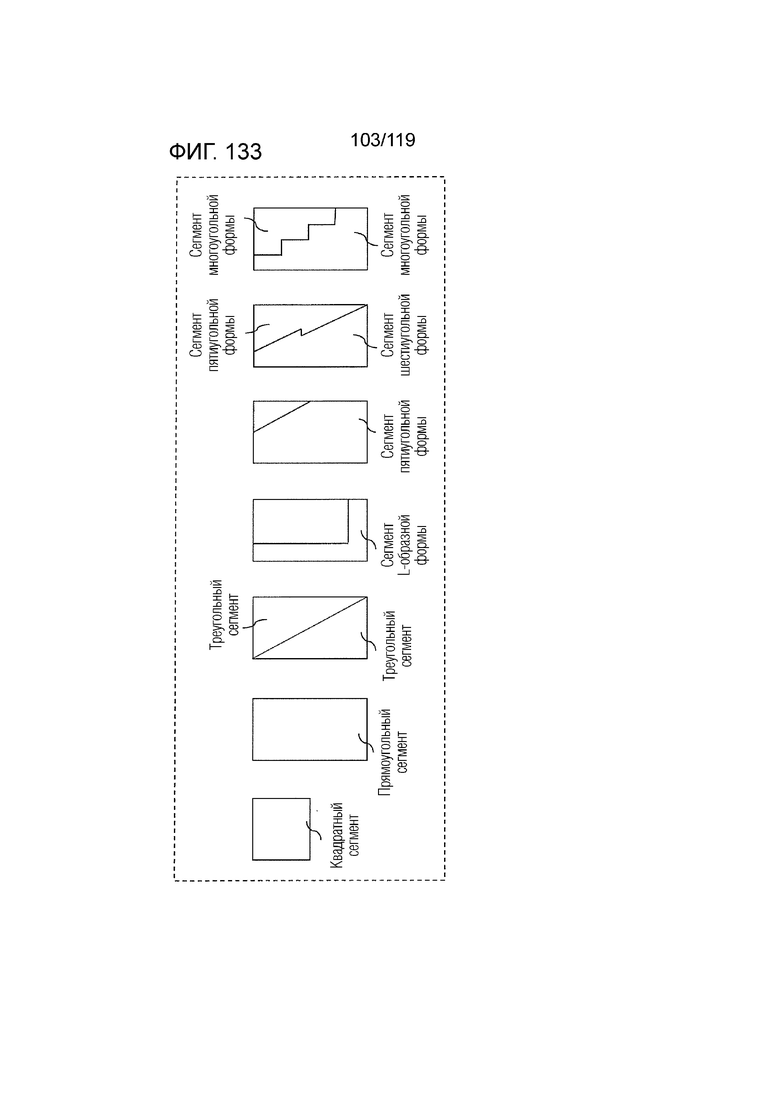

Фиг. 133 является концептуальной схемой варьирования этого варианта осуществления, применяемого к прямоугольным сегментам и непрямоугольным сегментам, таким как треугольные сегменты.

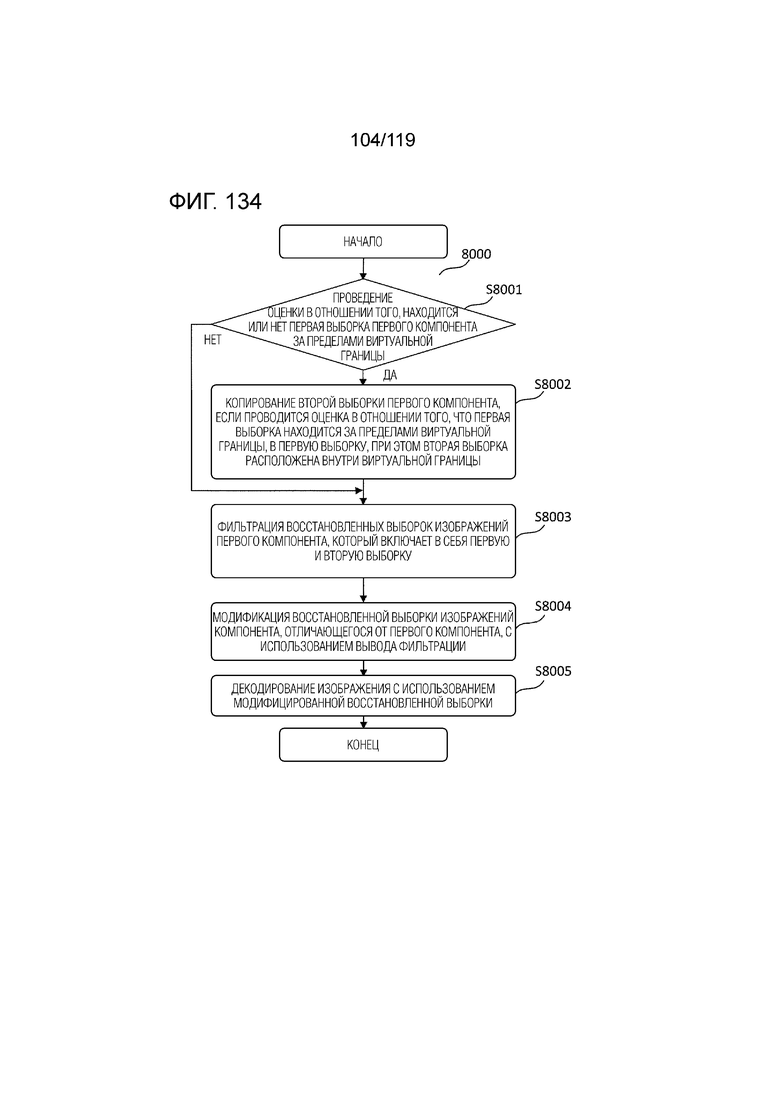

Фиг. 134 является блок-схемой последовательности операций способа для примерной последовательности операций обработки для декодирования изображения, применяющего CCALF-процесс с использованием параметра согласно восьми аспектам.

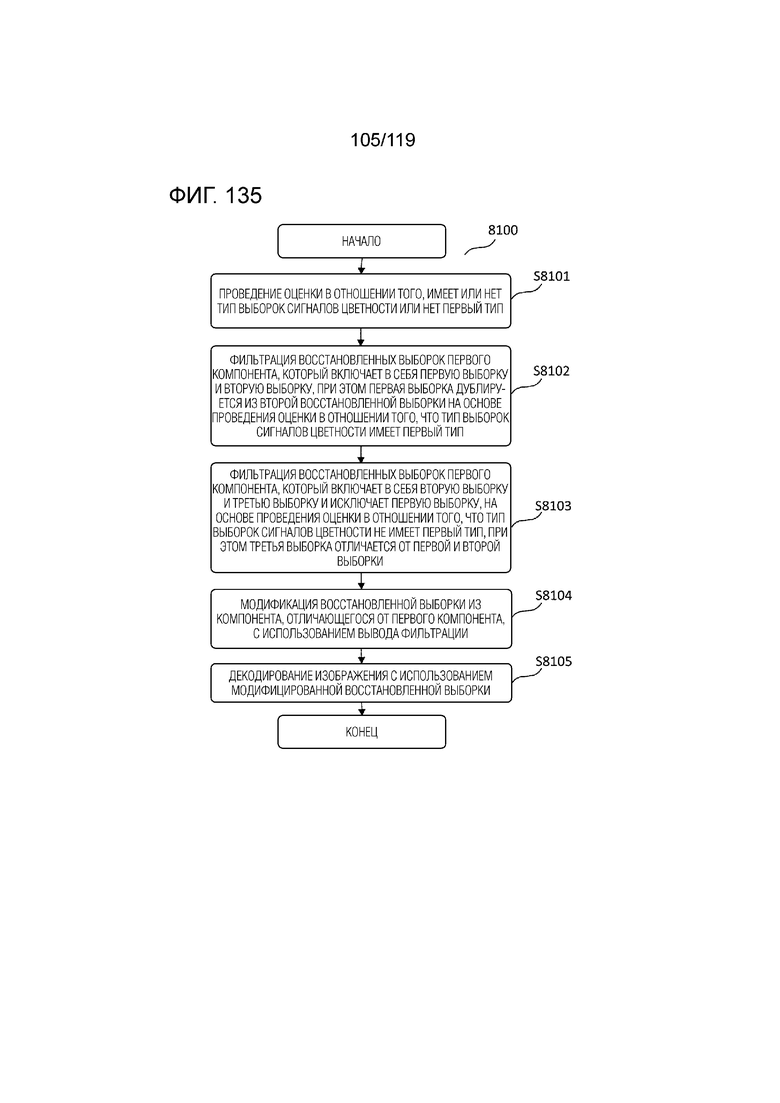

Фиг. 135 является блок-схемой последовательности операций способа для примерной последовательности операций обработки для декодирования изображения, применяющего CCALF-процесс с использованием параметра согласно восьмому аспекту.

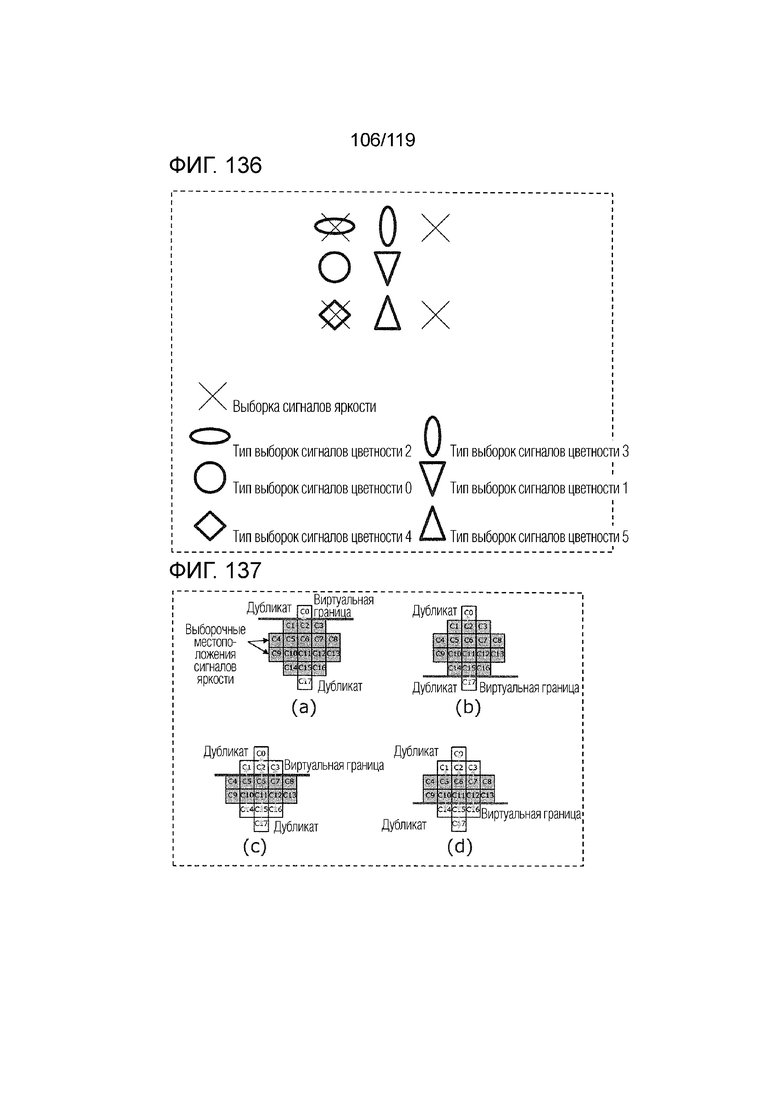

Фиг. 136 показывает примерные местоположения типов 0-5 выборок сигналов цветности.

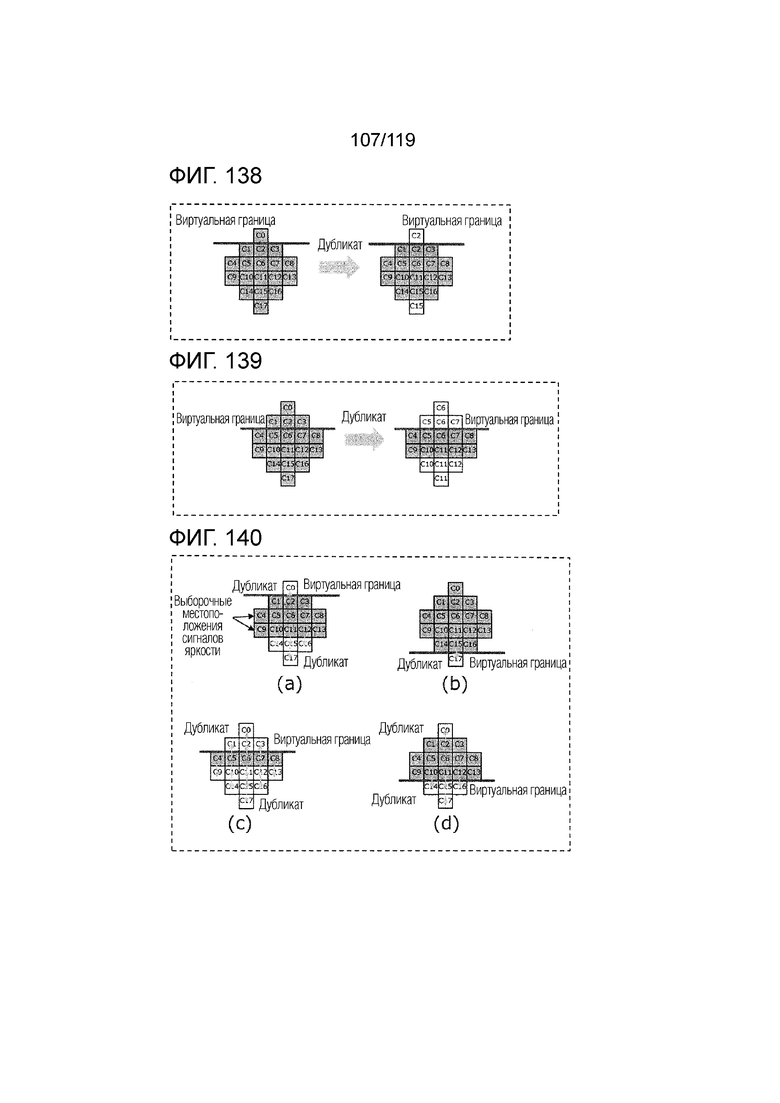

Фиг. 137 является концептуальной схемой, иллюстрирующей выборочное симметричное дополнение.

Фиг. 138 является концептуальной схемой, иллюстрирующей выборочное симметричное дополнение.

Фиг. 139 является концептуальной схемой, иллюстрирующей выборочное симметричное дополнение.

Фиг. 140 является концептуальной схемой, иллюстрирующей выборочное несимметричное дополнение.

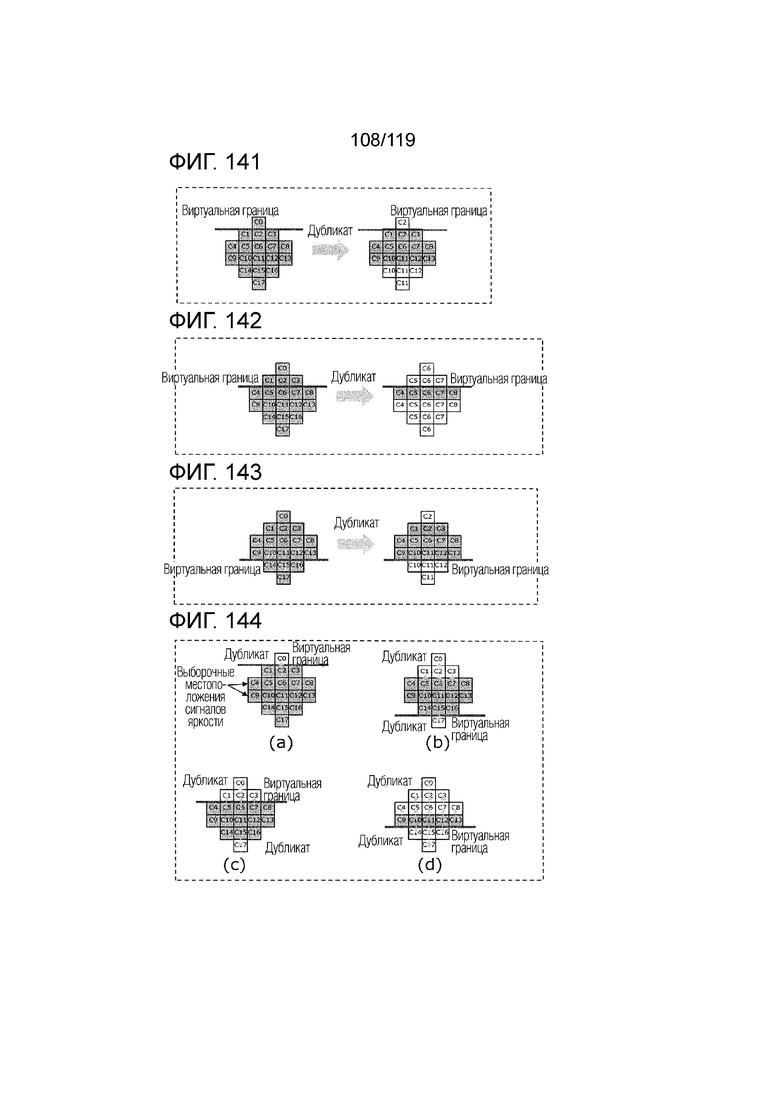

Фиг. 141 является концептуальной схемой, иллюстрирующей выборочное несимметричное дополнение.

Фиг. 142 является концептуальной схемой, иллюстрирующей выборочное несимметричное дополнение.

Фиг. 143 является концептуальной схемой, иллюстрирующей выборочное несимметричное дополнение.

Фиг. 144 является концептуальной схемой, иллюстрирующей дополнительное выборочное несимметричное дополнение.

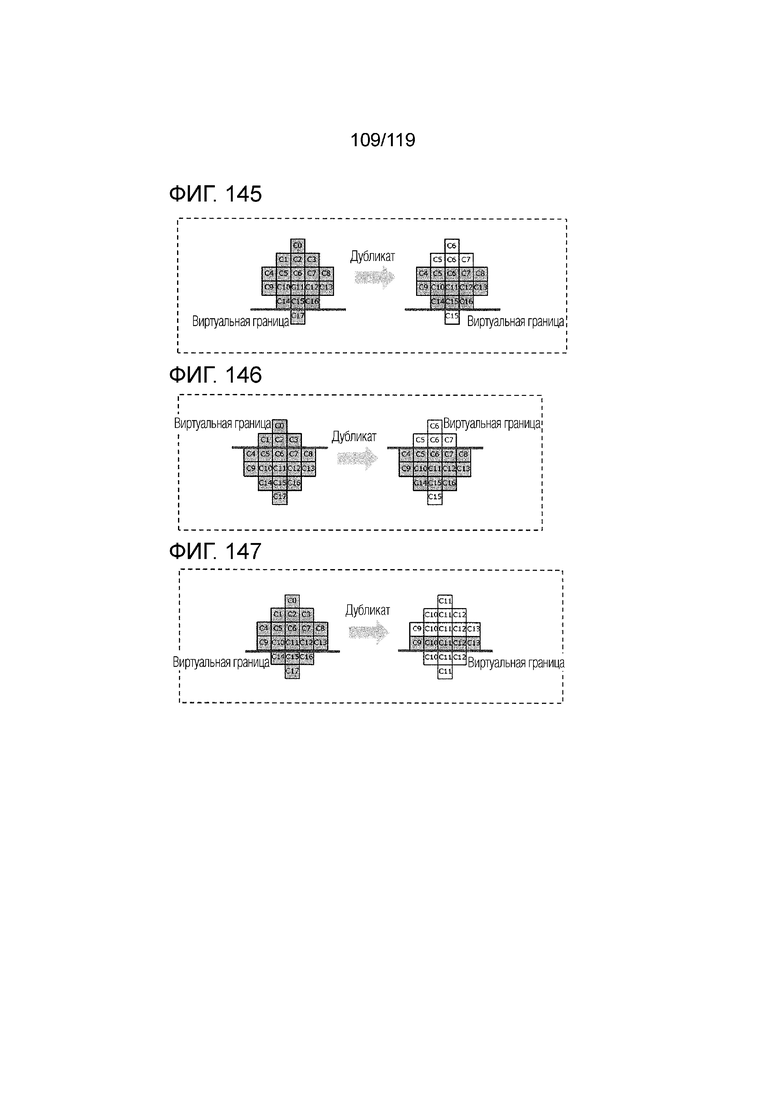

Фиг. 145 является концептуальной схемой, иллюстрирующей дополнительное выборочное несимметричное дополнение.

Фиг. 146 является концептуальной схемой, иллюстрирующей дополнительное выборочное несимметричное дополнение.

Фиг. 147 является концептуальной схемой, иллюстрирующей дополнительное выборочное несимметричное дополнение.

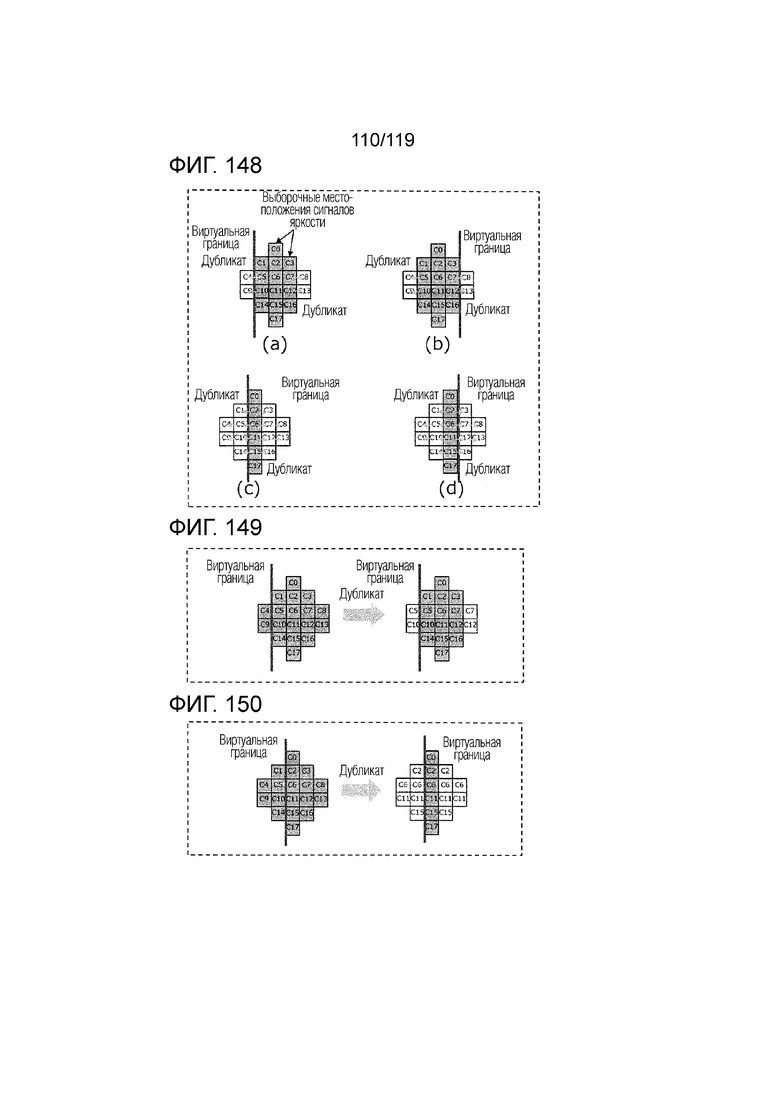

Фиг. 148 является концептуальной схемой, иллюстрирующей дополнительное выборочное симметричное дополнение.

Фиг. 149 является концептуальной схемой, иллюстрирующей дополнительное выборочное симметричное дополнение.

Фиг. 150 является концептуальной схемой, иллюстрирующей дополнительное выборочное симметричное дополнение.

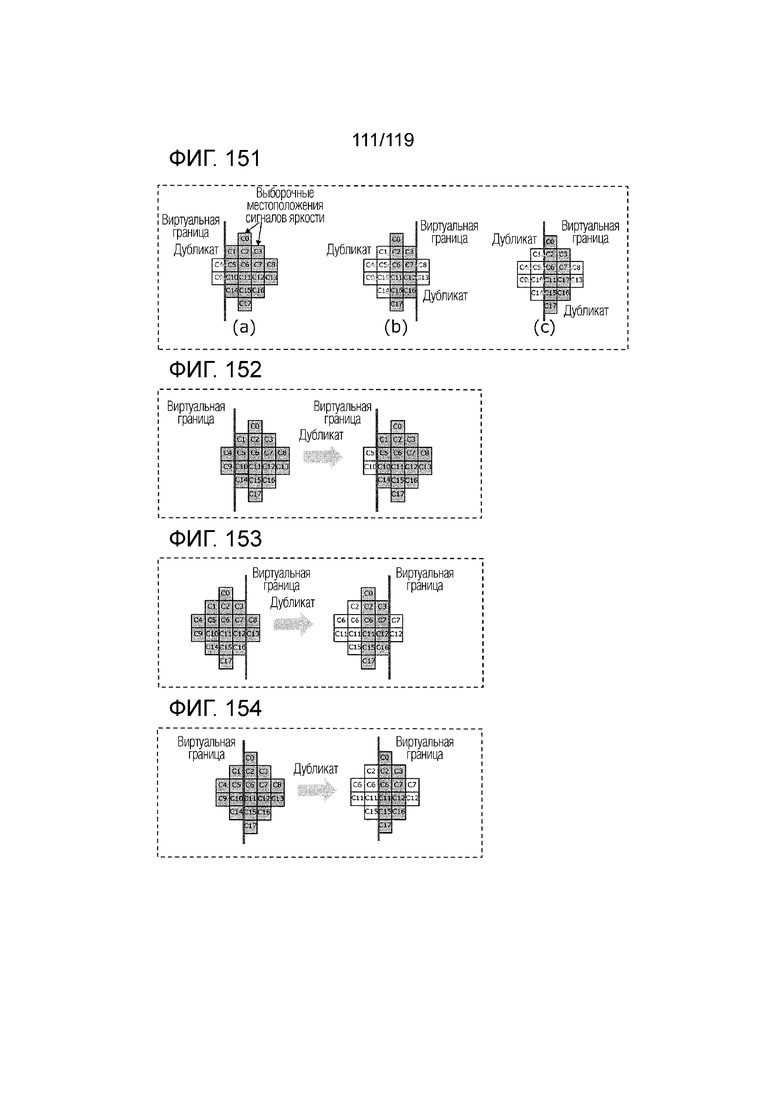

Фиг. 151 является концептуальной схемой, иллюстрирующей дополнительное выборочное несимметричное дополнение.

Фиг. 152 является концептуальной схемой, иллюстрирующей дополнительное выборочное несимметричное дополнение.

Фиг. 153 является концептуальной схемой, иллюстрирующей дополнительное выборочное несимметричное дополнение.

Фиг. 154 является концептуальной схемой, иллюстрирующей дополнительное выборочное несимметричное дополнение.

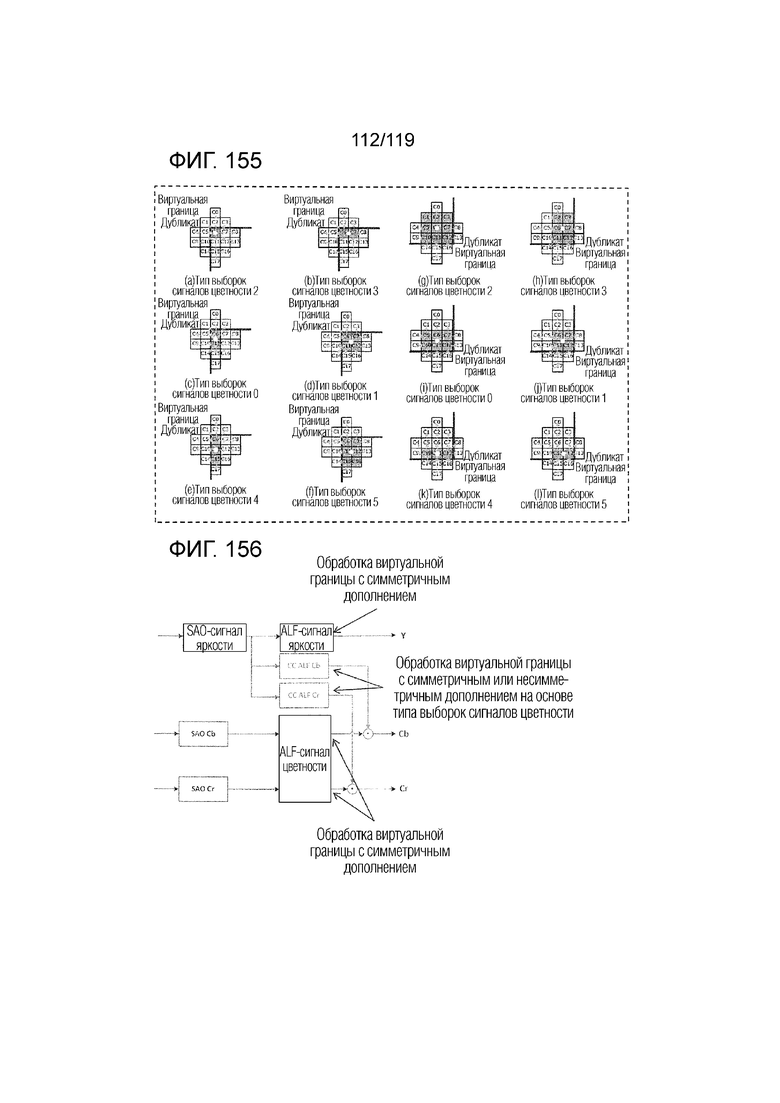

Фиг. 155 иллюстрирует дополнительные примеры дополнения с горизонтальной и вертикальной виртуальной границей.

Фиг. 156 является блок-схемой, иллюстрирующей функциональную конфигурацию кодера и декодера согласно примеру, в котором симметричное дополнение используется в виртуальных граничных местоположениях в виртуальных граничных местоположениях для ALF, и симметричное или несимметричное дополнение используется в виртуальных граничных местоположениях для CCALF.

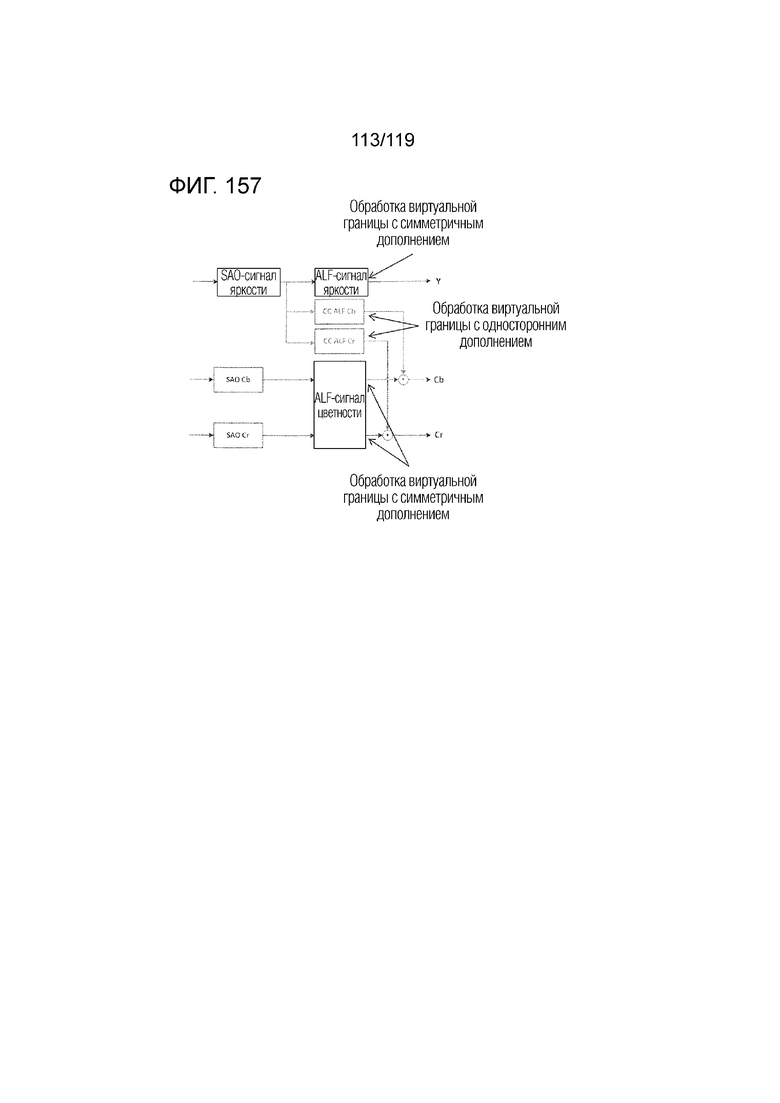

Фиг. 157 является блок-схемой, иллюстрирующей функциональную конфигурацию кодера и декодера согласно примеру, в котором другое симметричное дополнение используется в виртуальных граничных местоположениях для ALF, и одностороннее дополнение используется в виртуальных граничных местоположениях для CCALF.

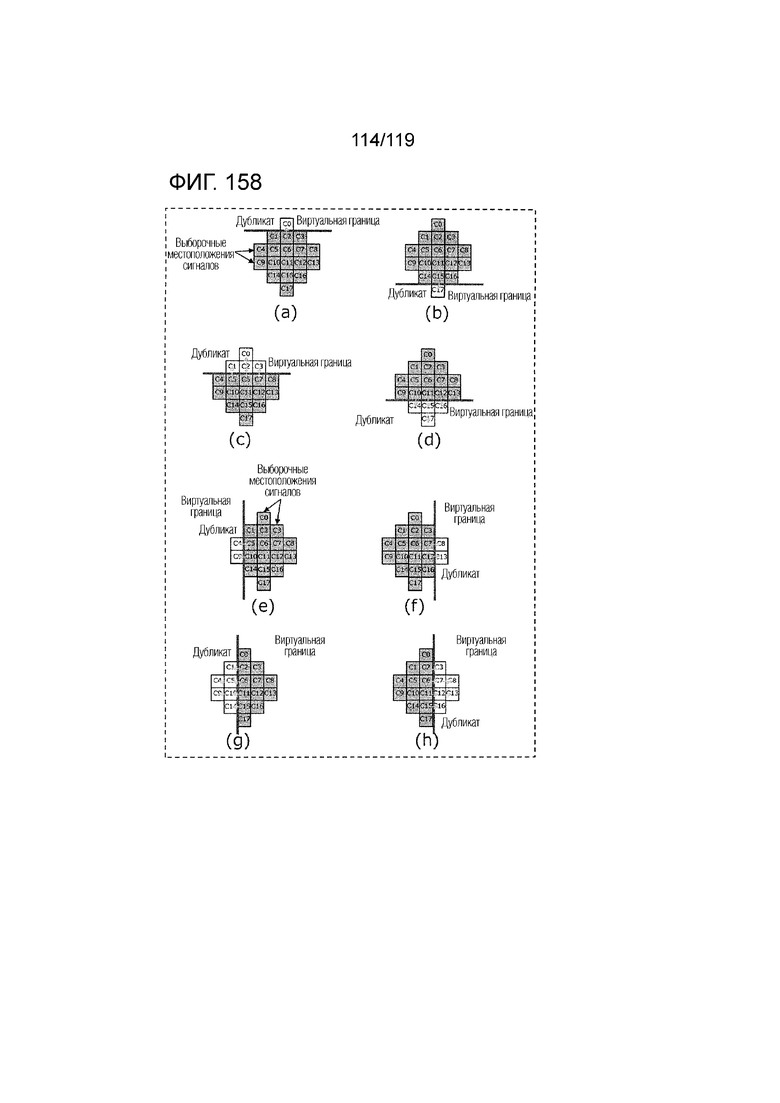

Фиг. 158 является концептуальной схемой, иллюстрирующей пример одностороннего дополнения с горизонтальной или вертикальной виртуальной границей.

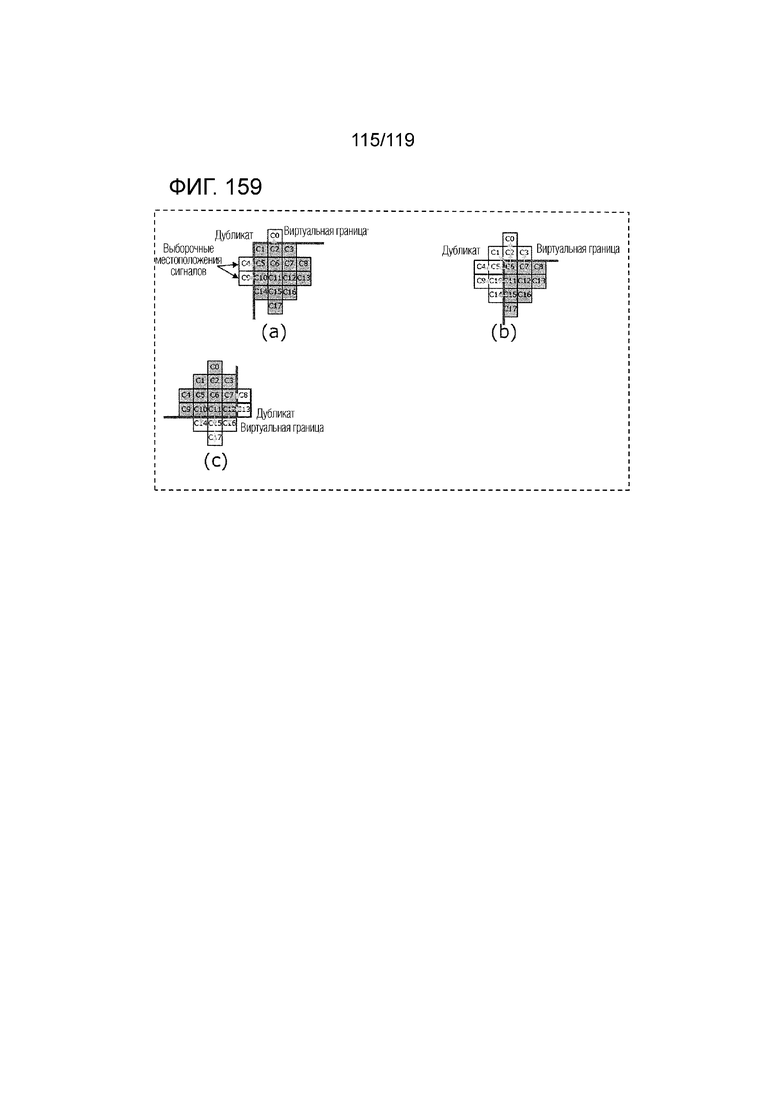

Фиг. 159 является концептуальной схемой, иллюстрирующей пример одностороннего дополнения с горизонтальной и вертикальной виртуальной границей.

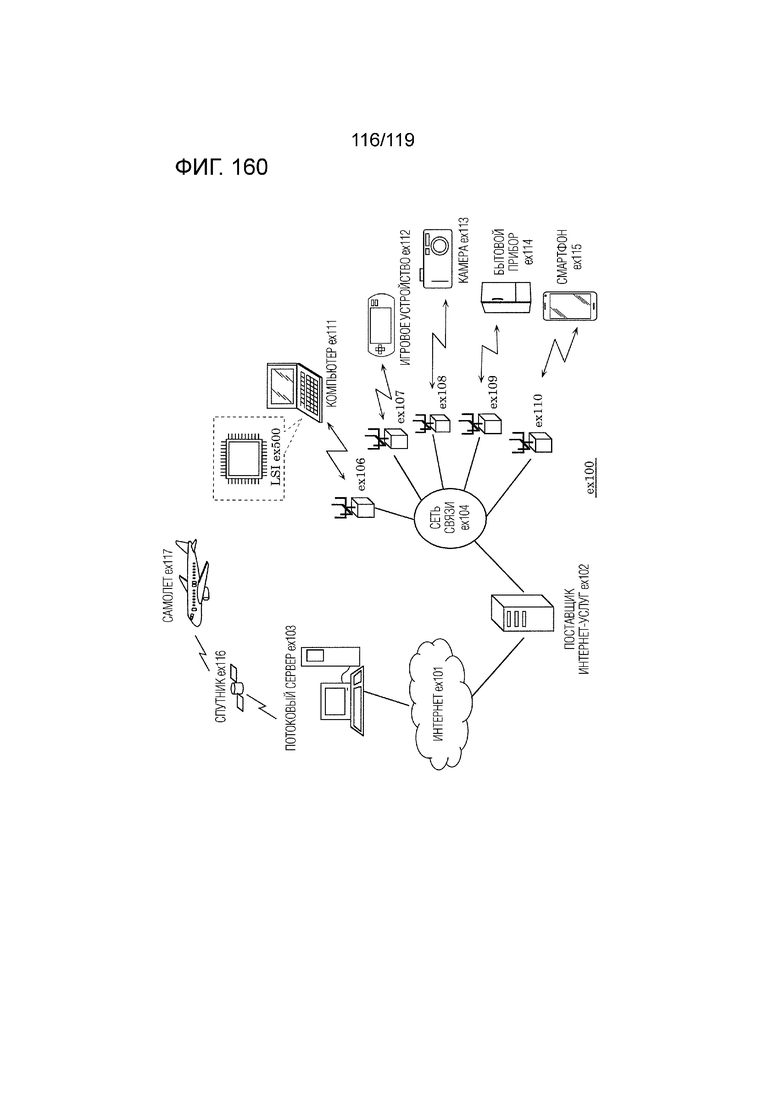

Фиг. 160 является схемой, иллюстрирующей примерную общую конфигурацию системы предоставления контента для реализации услуги распространения контента.

Фиг. 161 является концептуальной схемой, иллюстрирующей пример экрана отображения веб-страницы.

Фиг. 162 является концептуальной схемой, иллюстрирующей пример экрана отображения веб-страницы.

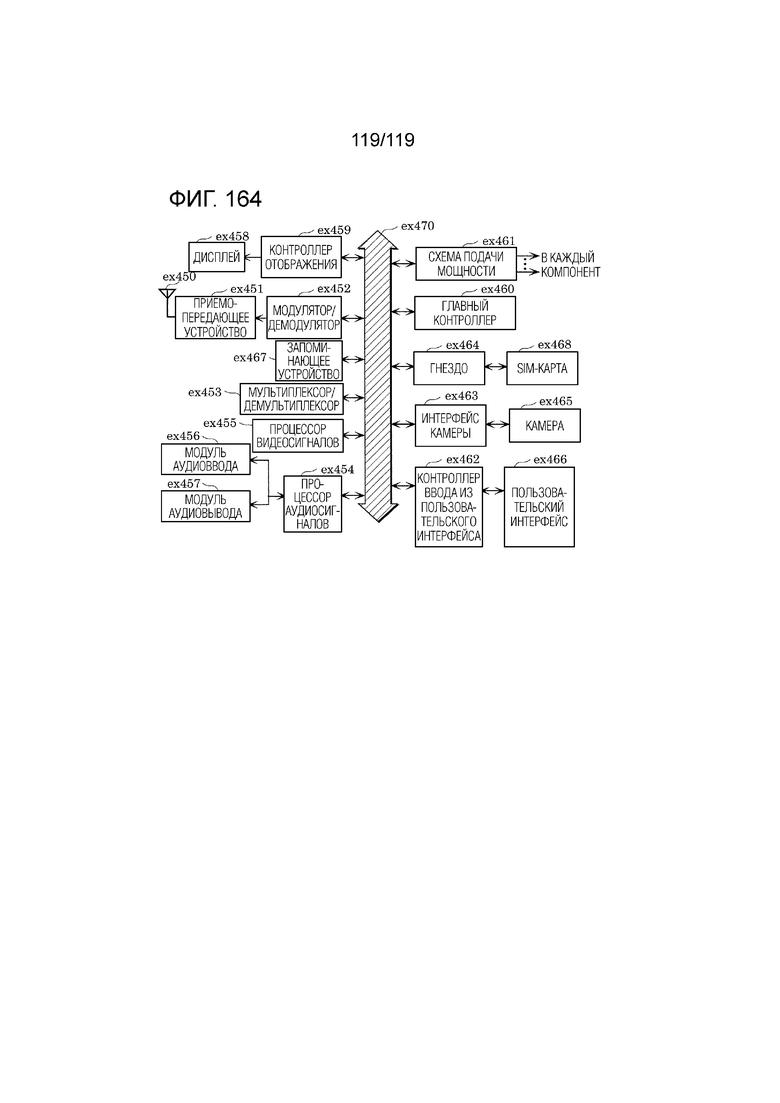

Фиг. 163 является блок-схемой, иллюстрирующей один пример смартфона.

Фиг. 164 является блок-схемой, иллюстрирующей пример функциональной конфигурации смартфона.

Подробное описание вариантов осуществления

[0016] На чертежах, идентичные ссылки с номерами идентифицируют аналогичные элементы, если контекст не указывает иное. Размеры и относительные позиции элементов на чертежах не обязательно чертятся в масштабе.

[0017] В дальнейшем в этом документе описываются варианты осуществления со ссылкой на чертежи. Следует отметить, что варианты осуществления, описанные ниже, показывают общий или конкретный пример. Числовые значения, формы, материалы, компоненты, компоновка и соединение компонентов, этапов, взаимосвязь и порядок этапов и т.д., указываемых в нижеприведенных вариантах осуществления, представляют собой просто примеры и в силу этого не имеют намерение ограничивать объем формулы изобретения.

[0018] Ниже описываются варианты осуществления кодера и декодера. Варианты осуществления представляют собой примеры кодера и декодера, к которым являются применимыми процессы и/или конфигурации, представленные в описании аспектов настоящего раскрытия сущности. Процессы и/или конфигурации также могут реализовываться в кодере и декодере, отличающихся от кодера и декодера согласно вариантам осуществления. Например, относительно процессов и/или конфигураций, применяемых к вариантам осуществления, может реализовываться любое из следующего:

[0019] (1) Любой из компонентов кодера или декодера согласно вариантам осуществления, представленным в описании аспектов настоящего раскрытия сущности, может заменяться или комбинироваться с другим компонентом, представленным в любом месте в описании аспектов настоящего раскрытия сущности.

[0020] (2) В кодере или декодере согласно вариантам осуществления, дискреционные изменения могут вноситься в функции или процессы, выполняемые посредством одного или более компонентов кодера или декодера, такие как добавление, замена, удаление и т.д. функций или процессов. Например, любая функция или процесс может заменяться или комбинироваться с другой функцией или процессом, представленным в любом месте в описании аспектов настоящего раскрытия сущности.

[0021] (3) В способах, реализованных посредством кодера или декодера согласно вариантам осуществления, могут вноситься дискреционные изменения, такие как добавление, замена и удаление одного или более процессов, включенных в способ. Например, любой процесс в способе может заменяться или комбинироваться с другим процессом, представленным в любом месте в описании аспектов настоящего раскрытия сущности.

[0022] (4) Один или более компонентов, включенных в кодер или декодер согласно вариантам осуществления, могут комбинироваться с компонентом, представленным в любом месте в описании аспектов настоящего раскрытия сущности, могут комбинироваться с компонентом, включающим в себя одну или более функций, представленных в любом месте в описании аспектов настоящего раскрытия сущности, и могут комбинироваться с компонентом, который реализует один или более процессов, реализованных посредством компонента, представленного в описании аспектов настоящего раскрытия сущности.

[0023] (5) Компонент, включающий в себя одну или более функций кодера или декодера согласно вариантам осуществления, либо компонент, который реализует один или более процессов кодера или декодера согласно вариантам осуществления, может комбинироваться или заменяться компонентом, представленным в любом месте в описании аспектов настоящего раскрытия сущности, компонентом, включающим в себя одну или более функций, представленных в любом месте в описании аспектов настоящего раскрытия сущности, либо компонентом, который реализует один или более процессов, представленных в любом месте в описании аспектов настоящего раскрытия сущности.

[0024] (6) В способах, реализованных посредством кодера или декодера согласно вариантам осуществления, любой из процессов, включенных в способ, может заменяться или комбинироваться с процессом, представленным в любом месте в описании аспектов настоящего раскрытия сущности, либо с любым соответствующим или эквивалентным процессом.

[0025] (7) Один или более процессов, включенных в способы, реализованные посредством кодера или декодера согласно вариантам осуществления, могут комбинироваться с процессом, представленным в любом месте в описании аспектов настоящего раскрытия сущности.

[0026] (8) Реализация процессов и/или конфигураций, представленных в описании аспектов настоящего раскрытия сущности, не ограничена кодером или декодером согласно вариантам осуществления. Например, процессы и/или конфигурации могут реализовываться в устройстве, используемом для цели, отличающейся от кодера движущихся кадров или декодера движущихся кадров, раскрытого в вариантах осуществления.

[0027] Определения терминов

Соответствующие термины могут задаваться так, как указано ниже в качестве примеров.

[0028] Изображение представляет собой единицу данных, сконфигурированную с набором пикселов, представляет собой кадр или включает в себя блоки, меньшие пиксела. Изображения включают в себя неподвижное изображение в дополнение к видео.

[0029] Кадр представляет собой единицу обработки изображений, сконфигурированную с набором пикселов, и также может называться "кадром" или "полем". Кадр, например, может принимать форму массива выборок сигналов яркости в монохромном формате или массива выборок сигналов яркости и двух соответствующих массивов выборок сигналов цветности в цветовом формате 4:2:0, 4:2:2 и 4:4:4.

[0030] Блок представляет собой единицу обработки, которая представляет собой набор определенного числа пикселов. Блоки могут иметь любое число различных форм. Например, блок может иметь прямоугольную форму в MxN (M столбцов на N строк) пикселов, квадратную форму в MxM пикселов, треугольную форму, круглую форму и т.д. Примеры блоков включают в себя срезы, плитки, кирпичи, CTU, суперблоки, базовые единицы разбиения, VPDU, единицы разбиения для обработки для аппаратных средств, CU, блочные единицы для обработки, блочные единицы прогнозирования (PU), блочные единицы ортогонального преобразования (TU), единицы и субблоки. Блок может принимать форму массива MxN выборок или массива MxN коэффициентов преобразования. Например, блок может представлять собой квадратную или прямоугольную область пикселов, включающую в себя одну матрицу сигналов яркости и две матрицы сигналов цветности.

[0031] Пиксел или выборка представляет собой наименьшую точку изображения. Пикселы или выборки включают в себя пиксел в целочисленной позиции, а также пикселы в субпиксельных позициях, например, сформированных на основе пиксела в целочисленной позиции.

[0032] Пиксельное значение или выборочное значение представляет собой собственное значение пиксела. Пиксельные значения или выборочные значения могут включать в себя одно или более из значения сигнала яркости, значения сигнала цветности, уровня RGB-градации, значения глубины, двоичных значений в нуль или 1 и т.д.

[0033] Сигнал цветности или цветность представляют собой интенсивность цвета, типично представленную посредством символов Cb и Cr, которые указывают то, что значения массива выборок или одно выборочное значение представляют значения одного из двух цветоразностных сигналов, связанных с первичными цветами.

[0034] Сигнал яркости или яркость представляет собой яркость изображения, типично представленную посредством символа или подстрочного индекса Y или L, которые указывают то, что значения массива выборок или одно выборочное значение представляют значения монохромного сигнала, связанные с первичными цветами.

[0035] Флаг содержит один или более битов, которые указывают значение, например, параметра или индекса. Флаг может представлять собой двоичный флаг, который указывает двоичное значение флага, который также может указывать недвоичное значение параметра.

[0036] Сигнал передает информацию, которая преобразуется в символьную форму посредством или кодируется в сигнал. Сигналы включают в себя дискретные цифровые сигналы и непрерывные аналоговые сигналы.

[0037] Поток или поток битов представляет собой строку цифровых данных потока цифровых данных. Поток или поток битов может представлять собой один поток либо может быть сконфигурирован с множеством потоков, имеющих множество иерархических слоев. Поток или поток битов может передаваться при последовательной связи с использованием одного тракта передачи либо может передаваться при связи с коммутацией пакетов с использованием множества трактов передачи.

[0038] Разность означает различные математические разности, к примеру, простую разность (x-y), абсолютное значение разности (|x-y|), квадрат разности (x^2-y^2), квадратный корень разности (√(x-y)), взвешенную разность (ax-by: a и b являются константами), разность смещения (x-y+a: a является смещением) и т.д. В случае скалярной величины, простая разность может быть достаточной, и вычисление разности может включаться.

[0039] Сумма означает различные математические суммы, к примеру, простую сумму (x+y), абсолютное значение суммы (|x+y|), возведенную в квадрат сумму (x^2+y^2), квадратный корень суммы (√(x+y)), взвешенную разность (ax+by: a и b являются константами), сумму смещения (x+y+a: a является смещением) и т.д. В случае скалярной величины, простая сумма может быть достаточной, и вычисление сумм может включаться.

[0040] Кадр представляет собой композицию верхнего поля и нижнего поля, при этом строки 0, 2, 4, ..., выборок инициируются из верхнего поля, и строки 1, 3, 5, ..., выборок инициируются из нижнего поля.

[0041] Срез представляет собой целое число единиц дерева кодирования, содержащихся в одном независимом сегменте срезов и во всех последующих зависимых сегментах срезов (если таковые имеются), которые предшествуют следующему независимому сегменту срезов (если таковые имеются) в идентичной единице доступа.

[0042] Плитка представляет собой прямоугольную область блоков дерева кодирования в конкретном столбце плиток и конкретной строке плиток в кадре. Плитка может представлять собой прямоугольную область кинокадра, которая должна иметь возможность декодироваться и кодироваться независимо, хотя по-прежнему может применяться контурная фильтрация по краям плиток.

[0043] Единица дерева кодирования (CTU) может представлять собой блок дерева кодирования выборок сигнала яркости кадра, который имеет три массива выборок, или два соответствующих блока дерева кодирования выборок сигнала цветности. Альтернативно, CTU может представлять собой блок дерева кодирования выборок одного из монохромного кадра и кадра, который кодируется с использованием трех отдельных цветовых плоскостей и синтаксических структур, используемых для того, чтобы кодировать выборки. Суперблок может представлять собой квадратный блок в 64×64 пикселов, который состоит из или 1 или 2 блоков информации режима или рекурсивно сегментируется на четыре блока 32×32, которые сами дополнительно могут сегментироваться.

[0044] Конфигурация системы

Во-первых, описывается система передачи согласно варианту осуществления. Фиг. 1 является принципиальной схемой, иллюстрирующей один пример конфигурации системы 400 передачи согласно варианту осуществления.

[0045] Система 400 передачи представляет собой систему, которая передает поток, сформированный посредством кодирования изображения, и декодирует передаваемый поток. Как проиллюстрировано, система 400 передачи включает в себя кодер 100, сеть 300 и декодер 200, как проиллюстрировано на фиг. 1.

[0046] Изображение вводится в кодер 100. Кодер 100 формирует поток посредством кодирования входного изображения и выводит поток в сеть 300. Поток включает в себя, например, кодированную информацию изображений и управляющую информацию для декодирования кодированного изображения. Изображение сжимается посредством кодирования.

[0047] Следует отметить, что изображение до кодирования посредством кодера 100 также называется "исходным изображением", "исходным сигналом" или "исходной выборкой". Изображение может представлять собой видео или неподвижное изображение. Изображение представляет собой общий принцип последовательности, кадра и блока и в силу этого не ограничено пространственной областью, имеющей конкретный размер, и временной областью, имеющей конкретный размер, если не указано иное. Изображение представляет собой массив пикселов или пиксельных значений, и сигнал, представляющий изображение или пиксельные значения, также называется "выборками". Поток может называться "потоком битов", "кодированным потоком битов", "сжатым потоком битов" или "кодированным сигналом". Кроме того, кодер 100 может называться "кодером изображений" или "видеокодером". Способ кодирования, выполняемый посредством кодера 100, может называться "способом кодирования", "способом кодирования изображений" или "способом кодирования видео".

[0048] Сеть 300 передает поток, сформированный посредством кодера 100, в декодер 200. Сеть 200 может представлять собой Интернет, глобальную вычислительную сеть (WAN), локальную вычислительную сеть (LAN) либо любую комбинацию сетей. Сеть 300 не ограничена сетью двунаправленной связи и может представлять собой сеть однонаправленной связи, которая передает широковещательные волны цифровой наземной широковещательной передачи, спутниковой широковещательной передачи и т.п. Альтернативно, сеть 300 может заменяться посредством носителя записи, такого как универсальный цифровой диск (DVD) и Blu-Ray-диск (BD) и т.д., на который записывается поток.

[0049] Декодер 200 формирует, для примера, декодированное изображение, которое представляет собой несжатое изображение, посредством декодирования потока, передаваемого посредством сети 300. Например, декодер декодирует поток согласно способу декодирования, соответствующему способу кодирования, используемому посредством кодера 100.

[0050] Следует отметить, что декодер 200 также может называться "декодером изображений" или "видеодекодером", и что способ декодирования, выполняемый посредством декодера 200, также может называться "способом декодирования", "способом декодирования изображений" или "способом декодирования видео".

[0051] Структура данных

Фиг. 2 является концептуальной схемой для иллюстрации одного примера иерархической структуры данных в потоке. Для удобства, фиг. 2 описывается со ссылкой на систему 400 передачи по фиг. 1. Поток включает в себя, например, видеопоследовательность. Как проиллюстрировано в (a) по фиг. 2, видеопоследовательность включает в себя один или более наборов параметров видео (VPS), один или более наборов параметров последовательности (SPS), один или более наборов параметров кадра (PPS), дополнительную улучшающую информацию (SEI) и множество кадров.

[0052] В видео, имеющем множество слоев, VPS может включать в себя параметр кодирования, который является общим между некоторыми из множества слоев, и параметр кодирования, связанный с некоторыми из множества слоев, включенных в видео, или с отдельным слоем.

[0053] SPS включает в себя параметр, который используется для последовательности, т.е. параметр кодирования, к которому обращается декодер 200 для того, чтобы декодировать последовательность. Например, параметр кодирования может указывать ширину или высоту кадра. Следует отметить, что множество SPS могут присутствовать.

[0054] PPS включает в себя параметр, который используется для кадра, т.е. параметр кодирования, к которому обращается декодер 200 для того, чтобы декодировать каждый из кадров в последовательности. Например, параметр кодирования может включать в себя опорное значение для ширины квантования, которая используется для того, чтобы декодировать кадр, и флаг, указывающий применение прогнозирования со взвешиванием. Следует отметить, что множество PPS могут присутствовать. Каждый из SPS и PPS может называться просто "набором параметров".

[0055] Как проиллюстрировано в (b) по фиг. 2, кадр может включать в себя заголовок кадра и один или более срезов. Заголовок кадра включает в себя параметр кодирования, к которому обращается декодер 200 для того, чтобы декодировать один или более срезов.

[0056] Как проиллюстрировано в (c) по фиг. 2, срез включает в себя заголовок среза и один или более кирпичей. Заголовок среза включает в себя параметр кодирования, к которому обращается декодер 200 для того, чтобы декодировать один или более кирпичей.

[0057] Как проиллюстрировано в (d) по фиг. 2, кирпич включает в себя одну или более единиц дерева кодирования (CTU).

[0058] Следует отметить, что кадр может не включать в себя срез и может включать в себя группу плиток вместо среза. В этом случае, группа плиток включает в себя, по меньшей мере, одну плитку. Помимо этого, кирпич может включать в себя срез.

[0059] CTU также называется "суперблоком" или "базисной единицей разбиения". Как проиллюстрировано в (e) по фиг. 2, CTU включает в себя CTU-заголовок и, по меньшей мере, одну единицу кодирования (CU). Как проиллюстрировано, CTU включает в себя четыре единицы кодирования CU(10), CU(11), (CU(12) и CU(13). CTU-заголовок включает в себя параметр кодирования, к которому обращается декодер 200 для того, чтобы декодировать, по меньшей мере, одну CU.

[0060] CU может разбиваться на множество меньших CU. Как показано, CU(10) не разбивается на меньшие единицы кодирования; CU(11) разбивается на четыре меньших единицы кодирования CU(110), CU(111), CU(112) и CU(113); CU(12) не разбивается на меньшие единицы кодирования; и CU(13) разбивается на семь меньших единиц кодирования CU(1310), CU(1311), CU(1312), CU(1313), CU(132), CU(133) и CU(134), как проиллюстрировано в(f) по фиг. 2, CU включает в себя заголовок CU, информацию прогнозирования и информацию остаточных коэффициентов. Информация прогнозирования представляет собой информацию для прогнозирования CU, и информация остаточных коэффициентов представляет собой информацию, указывающую остаток прогнозирования, который описывается ниже. Хотя CU является по существу идентичной единице прогнозирования (PU) и единице преобразования (TU), следует отметить, что, например, субблочное преобразование (SBT), которое описывается ниже, может включать в себя множество TU, меньших CU. Помимо этого, CU может обрабатываться для каждой виртуальной конвейерной единицы декодирования (VPDU), включенной в CU. VPDU, например, представляет собой фиксированную единицу, которая может обрабатываться однократно, когда конвейерная обработка выполняется в аппаратных средствах.

[0061] Следует отметить, что поток может не включать в себя все иерархические слои, проиллюстрированные на фиг. 2. Порядок иерархических слоев может меняться, или любой из иерархических слоев может заменяться посредством другого иерархического слоя. Здесь, кадр, который представляет собой цель для процесса, который должен выполняться посредством устройства, такого как кодер 100 или декодер 200, называется "текущим кадром". Текущий кадр означает текущий кадр, который должен кодироваться, когда процесс представляет собой процесс кодирования, и текущий кадр означает текущий кадр, который должен декодироваться, когда процесс представляет собой процесс декодирования. Аналогично, например, CU или блок CU, который представляет собой цель для процесса, который должен выполняться посредством устройства, такого как кодер 100 или декодер 200, называется "текущим блоком". Текущий блок означает текущий блок, который должен кодироваться, когда процесс представляет собой процесс кодирования, и текущий блок означает текущий блок, который должен декодироваться, когда процесс представляет собой процесс декодирования.

[0062] Структура кадра: срез/плитка

Кадр может быть сконфигурирован с одной или более единиц срезов или одной или более единиц плиток, чтобы упрощать параллельное кодирование/декодирование кадра.

[0063] Срезы представляют собой базовые единицы кодирования, включенные в кадр. Кадр может включать в себя, например, один или более срезов. Помимо этого, срез включает в себя одну или боле единиц дерева кодирования (CTU).

[0064] Фиг. 3 является концептуальной схемой для иллюстрации одного примера конфигурации срезов. Например, на фиг. 3, кадр включает в себя CTU 11×8 и разбивается на четыре среза (срезы 1-4). Срез 1 включает в себя шестнадцать CTU, срез 2 включает в себя двадцать одну CTU, срез 3 включает в себя двадцать девять CTU, и срез 4 включает в себя двадцать две CTU. Здесь, каждая CTU в кадре принадлежит одному из срезов. Форма каждого среза представляет собой форму, полученную посредством разбиения кадра горизонтально. Граница каждого среза не должна обязательно совпадать с концом изображения и может совпадать с любой из границ между CTU в изображении. Порядок обработки CTU в срезе (порядок кодирования или порядок декодирования), например, представляет собой порядок растрового сканирования. Срез включает в себя заголовок среза и кодированные данные. Признаки среза могут записываться в заголовок среза. Признаки могут включать в себя CTU-адрес верхней CTU в срезе, тип среза и т.д.

[0065] Плитка представляет собой единицу прямоугольной области, включенной в кадр. Плиткам кадра может назначаться номер, называемый "TileId" в порядке растрового сканирования.

[0066] Фиг. 4 является концептуальной схемой для иллюстрации одного примера конфигурации плиток. Например, на фиг. 4, кадр включает в себя CTU 11×8 и разбивается на четыре плитки прямоугольных областей (плитки 1-4). Когда плитки используются, порядок обработки CTU может отличаться от порядка обработки в случае, если плитки не используются. Когда плитки не используются, множество CTU в кадре, в общем, обрабатываются в порядке растрового сканирования. Когда множество плиток используются, по меньшей мере, одна CTU в каждой из множества плиток обрабатывается в порядке растрового сканирования. Например, как проиллюстрировано на фиг. 4 порядок обработки CTU, включенных в плитку 1, с левого конца первого столбца плитки 1 к правому концу первого столбца плитки 1, а затем продолжается с левого конца второго столбца плитки 1 к правому концу второго столбца плитки 1.

[0067] Следует отметить, что одна плитка может включать в себя один или более срезов, и один срез может включать в себя одну или более плиток.

[0068] Следует отметить, что кадр может быть сконфигурирован с одним или более наборов плиток. Набор плиток может включать в себя одну или более групп плиток или одну или более плиток. Кадр может быть сконфигурирован с одним из набора плиток, группы плиток и плитки. Например, порядок для сканирования множества плиток для каждого набора плиток в порядке растрового сканирования предположительно представляет собой базовый порядок кодирования плиток. Набор из одной или более плиток, которые являются непрерывными в базовом порядке кодирования в каждом наборе плиток, предположительно представляет собой группу плиток. Такой кадр может быть сконфигурирован посредством модуля 102 разбиения (см. фиг. 7), который описывается ниже.

[0069] Масштабируемое кодирование

Фиг. 5 и 6 являются концептуальными схемами, иллюстрирующими примеры масштабируемых структур потока, и описываются для удобства со ссылкой на фиг. 1.

[0070] Как проиллюстрировано на фиг. 5, кодер 100 может формировать временно/пространственно масштабируемый поток посредством разделения каждого из множества кадров на любые из множества слоев и кодирования кадра в слое. Например, кодер 100 кодирует кадр для каждого слоя, за счет этого достигая масштабируемости, при которой улучшающий слой присутствует выше базового слоя. Такое кодирование каждого кадра также называется "масштабируемым кодированием". Таким образом, декодер 200 допускает переключение качества изображений для изображения, которое отображается посредством декодирования потока. Другими словами, декодер 200 может определять то, какой слой следует декодировать, на основе внутренних факторов, таких как характеристики обработки декодера 200, и внешних факторов, таких как состояние полосы пропускания линий связи. Как результат, декодер 200 допускает декодирование контента при свободном переключении между низким разрешением и высоким разрешением. Например, пользователь потока просматривает видео потока наполовину с использованием смартфона по пути домой и продолжает просмотр ролика дома на таком устройстве, как телевизор, соединенный с Интернетом. Следует отметить, что каждое из смартфона и устройства, описанных выше, включает в себя декодер 200, имеющий идентичную или различную производительность. В этом случае, когда устройство декодирует слои вплоть до верхнего слоя в потоке, пользователь может просматривать видео в высоком качестве дома. Таким образом, кодер 100 не должен формировать множество потоков, имеющих различные качества изображений идентичного контента, и в силу этого нагрузка по обработке может уменьшаться.

[0071] Кроме того, улучшающий слой может включать в себя метаинформацию на основе статистической информации относительно изображения. Декодер 200 может формировать видео, качество изображений которого повышено посредством выполнения формирования изображений со сверхразрешением на кадре в базовом слое на основе метаданных. Формирование изображений со сверхразрешением может включать в себя, например, улучшение SN-отношения при идентичном разрешении, увеличение разрешения и т.д. Метаданные могут включать в себя, например, информацию для идентификации коэффициента линейной или нелинейной фильтрации, используемой в процессе на основе сверхразрешения, либо информацию, идентифицирующую значение параметра в процессе фильтрации, при машинном обучении или в методе наименьших квадратов, используемом в обработке на основе сверхразрешения и т.д.

[0072] В варианте осуществления, может предоставляться конфигурация, в которой кадр разделяется, например, на плитки, например, в соответствии со смысловым значением объекта в кадре. В этом случае, декодер 200 может декодировать только частичную область в кадре посредством выбора плитки, которая должна декодироваться. Помимо этого, атрибут объекта (человека, автомобиля, шара и т.д.) и позиция объекта в кадре (координаты в идентичных изображениях) могут сохраняться в качестве метаданных. В этом случае, декодер 200 допускает идентификацию позиции требуемого объекта на основе метаданных и определение плитки, включающей в себя объект. Например, как проиллюстрировано на фиг. 6, метаданные могут сохраняться с использованием структуры хранения данных, отличающейся от данных изображений, такой как сообщение с SEI (дополнительной улучшающей информацией) в HEVC. Эти метаданные указывают, например, позицию, размер или цвет основного объекта.

[0073] Метаданные могут сохраняться в единицах множества кадров, к примеру, как поток, последовательность или единица произвольного доступа. Таким образом, декодер 200 допускает получение, например, времени, в которое конкретный человек появляется в видео, и посредством подгонки информации времени к информации единицы кадров, допускает идентификацию кадра, в котором объект (человек) присутствует, и определение позиции объекта в кадре.

[0074] Кодер

В дальнейшем описывается кодер согласно варианту осуществления. Фиг. 7 является блок-схемой, иллюстрирующей функциональную конфигурацию кодера 100 согласно варианту осуществления. Кодер 100 представляет собой видеокодер, который кодирует видео в единицах блоков.

[0075] Как проиллюстрировано на фиг. 7, кодер 100 представляет собой оборудование, которое кодирует изображение в единицах блоков, и включает в себя модуль 102 разбиения, вычитатель 104, преобразователь 106, квантователь 108, энтропийный кодер 110, обратный квантователь 112, обратный преобразователь 114, сумматор 116, запоминающее устройство 118 блоков, контурный фильтр 120, запоминающее устройство 122 кинокадров, модуль 124 внутреннего прогнозирования, модуль 126 взаимного прогнозирования, контроллер 128 прогнозирования и формирователь 130 параметров прогнозирования. Как проиллюстрировано, модуль 124 внутреннего прогнозирования и модуль 126 взаимного прогнозирования представляют собой часть контроллера прогнозирования.

[0076] Кодер 100 реализуется, например, в качестве общего процессора и запоминающего устройства. В этом случае, когда программно-реализованная программа, сохраненная в запоминающем устройстве, выполняется посредством процессора, процессор функционирует в качестве модуля 102 разбиения, вычитателя 104, преобразователя 106, квантователя 108, энтропийного кодера 110, обратного квантователя 112, обратного преобразователя 114, сумматора 116, контурного фильтра 120, модуля 124 внутреннего прогнозирования, модуля 126 взаимного прогнозирования и контроллера 128 прогнозирования. Альтернативно, кодер 100 может реализовываться в качестве одной или более специализированных электронных схем, соответствующих модулю 102 разбиения, вычитателю 104, преобразователю 106, квантователю 108, энтропийному кодеру 110, обратному квантователю 112, обратному преобразователю 114, сумматору 116, контурному фильтру 120, модулю 124 внутреннего прогнозирования, модулю 126 взаимного прогнозирования и контроллеру 128 прогнозирования.

[0077] Пример монтажа кодера

Фиг. 8 является функциональной блок-схемой, иллюстрирующей пример монтажа кодера 100. Кодер 100 включает в себя процессор a1 и запоминающее устройство a2. Например, множество составляющих элементов кодера 100, проиллюстрированного на фиг. 7, смонтированы в процессоре a1 и запоминающем устройстве a2, проиллюстрированных на фиг. 8.

[0078] Процессор a1 представляет собой схему, которая выполняет обработку информации, и соединяется с запоминающим устройством a2. Например, процессор a1 представляет собой специализированную или общую электронную схему, которая кодирует изображение. Процессор a1 может представлять собой процессор, такой как CPU. Помимо этого, процессор a1 может представлять собой совокупность множества электронных схем. Помимо этого, например, процессор a1 может выполнять роли двух или более составляющих элементов из множества составляющих элементов кодера 100, проиллюстрированного на фиг. 7, и т.д.

[0079] Запоминающее устройство a2 представляет собой специализированное или общее запоминающее устройство для сохранения информации, которая используется посредством процессора a1 для того, чтобы кодировать изображение. Запоминающее устройство a2 может представлять собой электронную схему и может соединяться с процессором a1. Помимо этого, запоминающее устройство a2 может включаться в процессор a1. Помимо этого, запоминающее устройство a2 может представлять собой совокупность множества электронных схем. Помимо этого, запоминающее устройство a2 может представлять собой магнитный диск, оптический диск и т.п. либо может представляться как устройство хранения данных, носитель записи и т.п. Помимо этого, запоминающее устройство a2 может представлять собой энергонезависимое запоминающее устройство или энергозависимое запоминающее устройство.

[0080] Например, запоминающее устройство a2 может сохранять изображение, которое должно кодироваться, или поток битов, соответствующий кодированному изображению. Помимо этого, запоминающее устройство a2 может сохранять программу для инструктирования процессору a1 кодировать изображение.

[0081] Помимо этого, например, запоминающее устройство a2 может выполнять роли двух или более составляющих элементов для сохранения информации из множества составляющих элементов кодера 100, проиллюстрированного на фиг. 7, и т.д. Например, запоминающее устройство a2 может выполнять роли запоминающего устройства 118 блоков и запоминающего устройства 122 кинокадров, проиллюстрированных на фиг. 7. Более конкретно, запоминающее устройство a2 может сохранять восстановленный блок, восстановленный кадр и т.д.

[0082] Следует отметить, что, в кодере 100, все из множества составляющих элементов, указываемых на фиг. 7 и т.д., могут не реализовываться, и все процессы, описанные в данном документе, могут не выполняться. Часть составляющих элементов, указываемых на фиг. 7 и т.д., может включаться в другое устройство, или часть процессов, описанных в данном документе, может выполняться посредством другого устройства.

[0083] В дальнейшем в этом документе описывается полная последовательность операций процессов, выполняемых посредством кодера 100, и после этого описывается каждый из составляющих элементов, включенных в кодер 100.

[0084] Общая последовательность операций процесса кодирования

Фиг. 9 является блок-схемой последовательности операций способа, указывающей один пример полного процесса декодирования, выполняемого посредством кодера 100, и для удобства описывается со ссылкой на фиг. 7.

[0085] Во-первых, модуль 102 разбиения кодера 100 разбивает каждый из кадров, включенных во входное изображение, на множество блоков, имеющих фиксированный размер (например, 128×128 пикселов) (этап Sa_1). Модуль 102 разбиения затем выбирает шаблон разбиения для блока фиксированного размера (также называется "формой блока") (этап Sa_2). Другими словами, модуль 102 разбиения дополнительно разбивает блок фиксированного размера на множество блоков, которые формируют выбранный шаблон разбиения. Кодер 100 выполняет, для каждого из множества блоков, этапы Sa_3-Sa_9 для блока (который представляет собой текущий блок, который должен кодироваться).

[0086] Контроллер 128 прогнозирования и модуль выполнения прогнозирования (который включает в себя модуль 124 внутреннего прогнозирования и модуль 126 взаимного прогнозирования) формируют прогнозное изображение текущего блока (этап Sa 3). Прогнозное изображение также может называться "прогнозным сигналом", "блоком прогнозирования" или "прогнозными выборками".

[0087] Затем, вычитатель 104 формирует разность между текущим блоком и прогнозным изображением в качестве остатка прогнозирования (этап Sa_4). Остаток прогнозирования также может называться "ошибкой прогнозирования".

[0088] Затем, преобразователь 106 преобразует прогнозное изображение, и квантователь 108 квантует результат для того, чтобы формировать множество квантованных коэффициентов (этап Sa_5). Множество квантованных коэффициентов иногда могут называться "блоком коэффициентов".

[0089] Затем, энтропийный кодер 110 кодирует (в частности, энтропийно кодирует) множество квантованных коэффициентов и параметр прогнозирования, связанный с формированием прогнозного изображения, чтобы формировать поток (этап Sa_6). Поток может иногда называться "кодированным потоком битов" или "сжатым потоком битов".

[0090] Затем, обратный квантователь 112 выполняет обратное квантование множества квантованных коэффициентов, и обратный преобразователь 114 выполняет обратное преобразование результата, чтобы восстанавливать остаток прогнозирования (этап Sa_7).

[0091] Затем, сумматор 116 суммирует прогнозное изображение с восстановленным остатком прогнозирования, чтобы восстанавливать текущий блок (этап Sa_8). Таким образом, восстановленное изображение формируется. Восстановленное изображение также может называться "восстановленным блоком" или "декодированным блоком изображений".

[0092] Когда восстановленное изображение формируется, контурный фильтр 120 выполняет фильтрацию восстановленного изображения при необходимости (этап Sa_9).

[0093] Кодер 100 затем определяет то, закончено или нет кодирование всего кадра (этап Sa_10). При определении того, что кодирование еще не закончено ("Нет" на этапе Sa_10), выполнение процессов с этапа Sa_2 повторяется для следующего блока кадра.

[0094] Хотя кодер 100 выбирает один шаблон разбиения для блока фиксированного размера и кодирует каждый блок согласно шаблону разбиения в вышеописанном примере, следует отметить, что каждый блок может кодироваться согласно соответствующему одному из множества шаблонов разбиения. В этом случае, кодер 100 может оценивать затраты для каждого из множества шаблонов разбиения и, например, может выбирать поток, получаемый посредством кодирования согласно шаблону разбиения, который дает в результате наименьшие затраты, в качестве потока, который выводится.

[0095] Как проиллюстрировано, процессы на этапах Sa_1-Sa_10 выполняются последовательно посредством кодера 100. Альтернативно, два или более процессов могут выполняться параллельно, процессы могут переупорядочиваться и т.д.

[0096] Процесс кодирования, используемый посредством кодера 100, представляет собой гибридное кодирование с использованием прогнозного кодирования и кодирования с преобразованием. Помимо этого, прогнозное кодирование выполняется посредством контура кодирования, сконфигурированного с вычитателем 104, преобразователем 106, квантователем 108, обратным квантователем 112, обратным преобразователем 114, сумматором 116, контурным фильтром 120, запоминающим устройством 118 блоков, запоминающим устройством 122 кинокадров, модулем 124 внутреннего прогнозирования, модулем 126 взаимного прогнозирования и контроллером 128 прогнозирования. Другими словами, модуль выполнения прогнозирования, сконфигурированный с модулем 124 внутреннего прогнозирования и модулем 126 взаимного прогнозирования, представляет собой часть контура кодирования.

[0097] Модуль разбиения

Модуль 102 разбиения разбивает каждый кадр, включенный в исходное изображение, на множество блоков, и выводит каждый блок в вычитатель 104. Например, модуль 102 разбиения сначала разбивает кадр на блоки фиксированного размера (например, 128×128 пикселов). Могут использоваться другие фиксированные размеры блоков. Блок фиксированного размера также называется "единицей дерева кодирования (CTU)". Модуль 102 разбиения затем разбивает каждый блок фиксированного размера на блоки переменных размеров (например, 64×64 пикселов или меньше), на основе рекурсивного разбиения на блоки дерева квадрантов и/или двоичного дерева. Другими словами, модуль 102 разбиения выбирает шаблон разбиения. Блок переменного размера также может называться "единицей кодирования (CU)", "единицей прогнозирования (PU)" или "единицей преобразования (TU)". Следует отметить, что, в различных видах примеров обработки, нет необходимости различать между CU, PU и TU; все или некоторые блоки в кадре могут обрабатываться в единицах CU, PU или TU.

[0098] Фиг. 10 является концептуальной схемой для иллюстрации одного примера разбиения на блоки согласно варианту осуществления. На фиг. 10, сплошные линии представляют границы блоков для блоков, разбитых посредством разбиения на блоки дерева квадрантов, и пунктирные линии представляют границы блоков для блоков, разбитых посредством разбиения на блоки двоичного дерева.

[0099] Здесь, блок 10 представляет собой квадратный блок, имеющий 128×128 пикселов (блок 128×128). Это блок 10 128×128 сначала разбивается на четыре квадратных 64×64-пиксельных блока (разбиение на блоки дерева квадрантов).

[0100] Верхний левый 64×64-пиксельный блок дополнительно вертикально разбивается на два прямоугольных 32×64-пиксельных блока, и левый 32×64-пиксельный блок дополнительно вертикально разбивается на два прямоугольных 16×64-пиксельных блока (разбиение на блоки двоичного дерева). Как результат, верхний левый 64×64-пиксельный блок разбивается на два 16×64-пиксельных блока 11 и 12 и один 32×64-писелный блок 13.

[0101] Верхний правый 64×64-пиксельный блок горизонтально разбивается на два прямоугольных 64×32-пиксельных блока 14 и 15 (разбиение на блоки двоичного дерева).

[0102] Левый нижний квадратный 64×64-пиксельный блок сначала разбивается на четыре квадратных 32×32-пиксельных блока (разбиение на блоки дерева квадрантов). Верхний левый блок и нижний правый блок из четырех квадратных 32×32-пиксельных блоков дополнительно разбиваются. Верхний левый квадратный 32×32-пиксельный блок вертикально разбивается на два прямоугольных 16×32-пиксельных блока, и правый 16×32-пиксельный блок дополнительно горизонтально разбивается на два 16×16-пиксельных блока (разбиение на блоки двоичного дерева). Правый нижний 32×32-пиксельный блок горизонтально разбивается на два 32×16-пиксельных блока (разбиение на блоки двоичного дерева). Верхний правый квадратный 32×32-пиксельный блок горизонтально разбивается на два прямоугольных 32×16-пиксельных блока (разбиение на блоки двоичного дерева). Как результат, левый нижний квадратный 64×64-пиксельный блок разбивается на прямоугольный 16×32-пиксельный блок 16, два квадратных 16×16-пиксельных блока 17 и 18, два квадратных 32×32-пиксельных блока 19 и 20 и два прямоугольных 32×16-пиксельных блока 21 и 22.

[0103] Правый нижний 64×64-пиксельный блок 23 не разбивается.

[0104] Как описано выше, на фиг. 10, блок 10 разбивается на тринадцать блоков 11-23 переменного размера на основе рекурсивного разбиения на блоки дерева квадрантов и двоичного дерева. Этот тип разбиения также называется "разбиением на дерево квадрантов плюс двоичное дерево (QTBT)".

[0105] Следует отметить, что, на фиг. 10, один блок разбивается на четыре или два блока (разбиение на блоки дерева квадрантов или двоичного дерева), но разбиение не ограничено этими примерами. Например, один блок может разбиваться на три блока (разбиение на троичные блоки). Разбиение, включающее в себя такое разбиение на троичные блоки, также называется "разбиением на многотипное дерево (MBT)".