Область техники, к которой относится изобретение

Настоящее изобретение относится к информационному процессору, способу обработки и программе. Более конкретно, настоящее изобретение относится к информационному процессору, способу обработки и программе для обработки данных с использованием технологии смешанной реальности (MR), который объединяет реальные объекты реального мира и электронное отображение.

Уровень техники

Например, если пользователь обрабатывает данные, используя персональный компьютер (PC), он обрабатывает данные отображения в секции дисплея (на дисплее) PC. Однако обработка данных только в секции дисплея, то есть в ограниченной области, имеет следующую проблему.

(1) При работе с мышью курсор мыши, появляющийся в секции дисплея PC или другого устройства, останавливается на краю области экрана секции дисплея. Это делает невозможным перемещать объект или окно, расположенное в области дисплея, в область, расположенную вне секции дисплея, используя курсор мыши.

(2) Если окна и другие объекты, используемые пользователем, заполняют область экрана секции дисплея PC или другого устройства, многочисленные окна отображаются так, что накладываются друг на друга. Чтобы просмотреть нижележащее окно, пользователь должен, например, выбрать нижележащее окно, чтобы оно отображалось сверху, или превратить перекрывающиеся окна в значки. Однако первый процесс делает невозможным просматривать окна, которые были передвинуты за другие окна. С другой стороны, последний процесс делает невозможным просматривать подробности окон, превращенных в значки.

Указанное выше является проблемами. Следует заметить, что нижеследующий процесс может выполняться, чтобы использовать площадь, большую, чем размер секции дисплея PC или другого устройства.

(a) Можно иметь наготове новый физический дисплей и подключить дисплей к компьютеру, управляемому пользователем, так чтобы для использования было доступно множество дисплеев.

(b) Можно установить виртуальный рабочий стол на одном участке дисплея. Однако первое решение (а) требует не только затрат на добавление дисплея, но также и пространства. С другой стороны, второе решение (b) требует от пользователя вводить команду или манипулировать значком, появляющимся, например, в строке для доступа к области, отличной от той, которая фактически отображается в секции дисплея.

Настоящее изобретение предназначено решить эти проблемы, используя, например, обработки данных на основе смешанной реальности (MR). Следует заметить, что патентный документ 1 (японский выложенный патент №2008-304268) и патентный документ 2 (японский выложенный патент №2008-304269) являются примерами предшествующего уровня техники, описывающими смешанную реальность. Эти документы описывают процесс, адаптированный для подготовки трехмерной карты реального мира, используя изображения, полученные фотокамерой.

Документы предшествующего уровня изобретения

Патентные документы

Патентный документ 1: Японский выложенный патент №2008-304268

Патентный документ 2: Японский выложенный патент №2008-304269

Раскрытие изобретения

Техническая проблема

Задача настоящего изобретения состоит в обеспечении информационного процессора, способа и программы обработки информации, которые эффективно используют площадь пространства, отличную от секции дисплея (дисплея) PC или другого устройства вместо использования только секции дисплея для обработки данных благодаря обработке данных, основанной на смешанной реальности (MR).

Техническое решение

Первым вариантом настоящего изобретения является информационный процессор, содержащий модуль обработки координат, фотокамеру, секцию анализа трехмерной информации, вторую секцию дисплея и секцию управления виртуальными объектами. Модуль обработки координат определяет, находится ли положение курсора, то есть индикатора положения, отображаемого на первой секции дисплея, внутри или вне области первой секции дисплея и выводит информацию о положении курсора в секцию управления виртуальными объектами, если курсор располагается вне области первой секции дисплея. Фотокамера получает изображение реального объекта, в том числе первой секции дисплея. Секция анализа трехмерной информации анализирует трехмерное положение реального объекта, содержащегося в полученном фотокамерой изображении. Вторая секция дисплея отображает изображение, полученное фотокамерой. Секция управления виртуальными объектами создает виртуальный объект, отличный от реального объекта, содержащегося в изображении, полученном фотокамерой, и создает составное изображение, содержащее созданный виртуальный объект и реальный объект, чтобы отобразить составное изображение во второй секции дисплея. Секция управления виртуальными объектами вычисляет трехмерное положение курсора на основе информации о положении курсора, предоставленной модулем обработки координат, чтобы отобразить во второй секции дисплея составное изображение, в котором объект помещается в вычисленное положение в качестве виртуального объекта.

Дополнительно, в варианте осуществления информационного процессора, соответствующего настоящему изобретению, информационный процессор содержит секцию исполнения приложений, выполненную с возможностью обработки конкретного объекта, указанного индикатором положения. Секция исполнения приложений определяет, располагается ли указанный объект внутри или вне области первой секции дисплея, и выводит информацию о положении объекта в секцию управления виртуальными объектами, если указанный объект располагается вне области первой секции дисплея. Секция управления виртуальными объектами вычисляет трехмерное положение объекта на основе информации о положении объекта, предоставленной модулем обработки координат, чтобы отобразить во второй секции дисплея составное изображение, в котором объект размещается в вычисленном положении в качестве виртуального объекта.

Дополнительно, в другом варианте осуществления информационного процессора, соответствующего настоящему изобретению, если трехмерное положение объекта, вычисленное на основе информации о положении объекта, предоставленной модулем обработки координат, содержит область отображения первой секции дисплея, секция управления виртуальными объектами отображает во второй секции дисплея составное изображение с удаленным изображением области объекта, перекрывающим область отображения первой секции.

Дополнительно, еще в одном варианте осуществления информационного процессора, соответствующего настоящему изобретению, информационный процессор дополнительно содержит секцию получения информации об объекте. Секция получения информации об объекте получает данные изображения для реального объекта, указанного курсором, помещенным в качестве виртуального объекта, и ищет данные на основе полученных данных изображения для получения информации об объекте. Секция получения информации об объекте выводит полученную информацию об объекте в первую секцию дисплея в качестве данных отображения.

Дополнительно, в еще одном варианте осуществления информационного процессора, соответствующем настоящему изобретению, секция получения информации об объекте обращается к базе данных, в которой данные изображения реального объекта и информация об объекте связаны друг с другом, или к серверу для получения информации об объекте посредством поиска на основе данных изображения реального объекта.

Дополнительно, в еще одном варианте осуществления информационного процессора, соответствующего настоящему изобретению, секция управления виртуальными объектами вычисляет плоскость, содержащую поверхность отображения первой секции дисплея, на основе трехмерной информации о положении компонентов, составляющих первую секцию дисплея, содержащихся в изображении, полученном фотокамерой, и вычисляет трехмерное положение курсора, так чтобы положение курсора находилось на плоскости.

Дополнительно, в еще одном другом варианте осуществления информационного процессора, соответствующего настоящему изобретению, курсор является курсором мыши, который перемещается при операции с мышью. Модуль обработки координат принимает информацию о перемещении курсора мыши в результате операции с мышью и определяет, находится ли курсор мыши внутри или вне области первой секции дисплея.

Дополнительно, вторым вариантом настоящего изобретения является способ обработки информации, выполняемый информационным процессором. Способ обработки информации содержит этап обработки координат, выполняемый модулем обработки координат, определяющим, находится ли положение курсора, то есть, индикатора положения, выведенного на экран в первой секции дисплея, внутри или вне области первой секции дисплея, и выводящим информацию о положении курсора в секцию управления виртуальными объектами, если курсор располагается вне области первой секции дисплея. Способ обработки информации дополнительно содержит этап получения изображения камерой, получающей изображение реального объекта, содержащее первую секцию дисплея. Дополнительно способ обработки информации содержит этап анализа трехмерной информации секцией анализа трехмерной информации, анализирующей трехмерное положение реального объекта, содержащегося в изображении, полученном камерой. Способ обработки информации дополнительно содержит этап управления виртуальными объектами, выполняемый секцией управления виртуальными объектами, создающей виртуальный объект, отличающийся от реального объекта, содержащегося в изображении, полученном камерой, и создающей составное изображение, содержащее созданный виртуальный объект и реальный объект для отображения составного изображения на второй секции дисплея.

Этап управления виртуальными объектами является этапом вычисления трехмерного положения курсора на основе информации о положении курсора, поступающей от модуля обработки координат, для отображения на второй секции дисплея составного изображения, в котором курсор помещается в вычисленном положении в качестве виртуального объекта.

Дополнительно, третьим вариантом настоящего изобретения является программа, вызывающая обработку информации информационным процессором. Программа содержит этап обработки координат, на котором вызывает определение модулем обработки координат, находится ли положение курсора, то есть индикатора положения, отображаемого на первой секции дисплея, внутри или вне области первой секции дисплея, и вывод информации о положении курсора в секцию управления виртуальными объектами, если курсор располагается вне области первой секции дисплея. Дополнительно, программа содержит этап получения изображения, на котором вызывает получение камерой изображения реального объекта, содержащего первую секцию дисплея. Программа также дополнительно содержит этап анализа трехмерной информации, на котором вызывает анализ секцией анализа трехмерной информации трехмерного положения реального объекта, содержащегося в изображении, полученном камерой. Программа также дополнительно содержит этап управления виртуальными объектами, на котором вызывает создание секцией управления виртуальными объектами виртуального объекта, отличающегося от реального объекта, содержащегося в изображении, полученном камерой, и создание составного изображения, содержащего созданный виртуальный объект и реальный объект, для отображения составного изображения на второй секции дисплея.

Этап управления виртуальными объектами является этапом, на котором вызывают вычисление секцией управления виртуальными объектами трехмерного положения курсора на основе информации о положении курсора, предоставленной модулем обработки координат, для отображения на второй секции дисплея составного изображения, в котором курсор размещается в вычисленном положении в качестве виртуального объекта.

Следует заметить, что программа, соответствующая настоящему изобретению, может быть предоставлена, например, через носитель записи или среду связи, выполненную с возможностью предоставления программы в машиночитаемом виде, процессору изображений или компьютерной системе, выполненным с возможностью исполнения множества управляющих программ. Если такая программа предоставляется в машиночитаемом виде, процессы, соответствующие программе, осуществляются в процессоре изображений или в компьютерной системе.

Другие объекты, признаки и преимущества настоящего изобретения станут очевидны из подробного описания, основанного на вариантах осуществления, которые будут описаны позже, и на сопроводительных чертежах. Следует заметить, что термин "система" в настоящем описании относится к логическому набору множества устройств и что входящие устройства не обязательно обеспечиваются в общем корпусе.

Полезный результат

В конфигурации, соответствующей варианту осуществления настоящего изобретения, курсор или объект, лежащий внутри области, находящейся за пределами области секции дисплея PC или другого устройства, отображается как виртуальный объект. Например, дисплей в виде очков, которые носит пользователь, отображает дисплей, такой как PC, и область вне дисплея. Трехмерное положение курсора или объекта, который, вероятно, перемещается в ответ на действия пользователя, вычисляется, после чего курсор или объект выводится на экран в качестве виртуального объекта в вычисленном положении. Дополнительно, информация об объекте для объекта, определенного курсором, получается и представляется. Настоящая конфигурация позволяет постоянно наблюдать и проверять данные, которые переместились за пределы секции дисплея, обеспечивая, таким образом, повышенную эффективность обработки данных.

Краткое описание чертежей

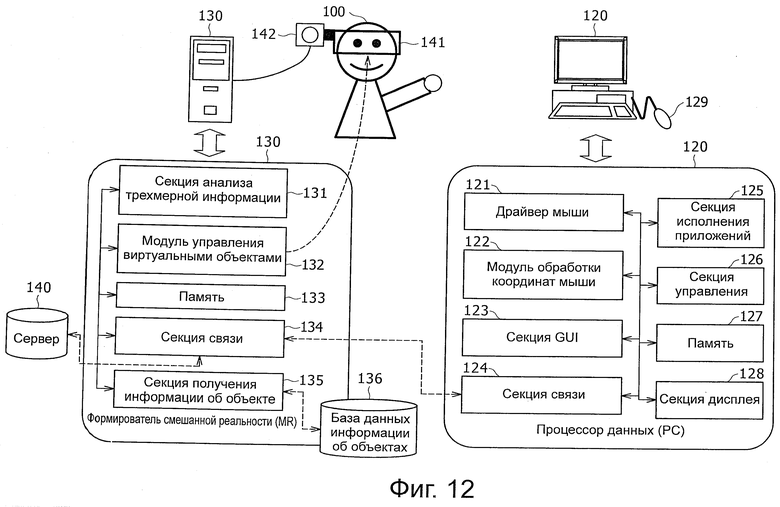

Фиг.1 - пример процесса, выполняемого информационным процессором, соответствующим настоящему изобретению.

Фиг.2 - пример процесса, выполняемого информационным процессором, соответствующим настоящему изобретению.

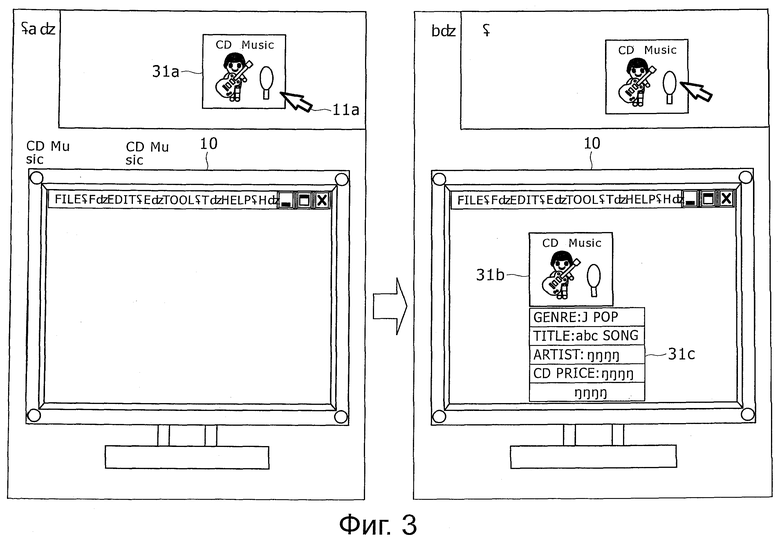

Фиг.3 - пример процесса, выполняемого информационным процессором, соответствующим настоящему изобретению.

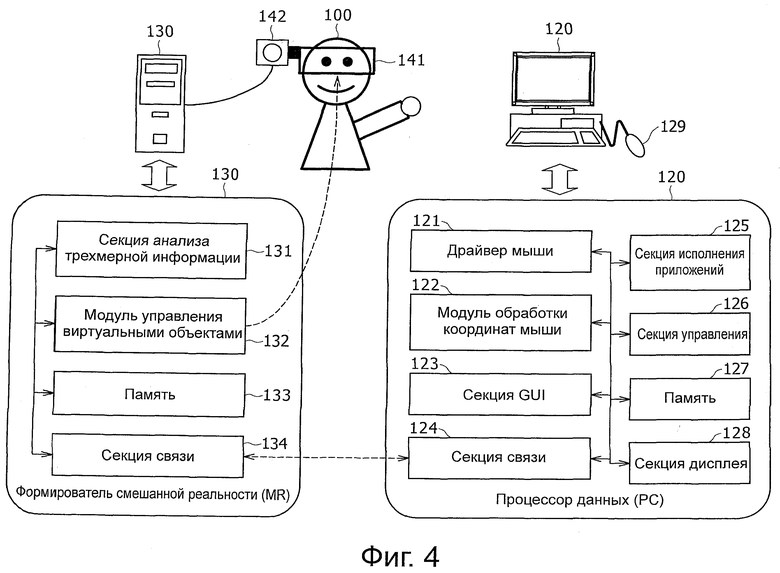

Фиг.4 - пример конфигурации информационного процессора, соответствующего настоящему изобретению.

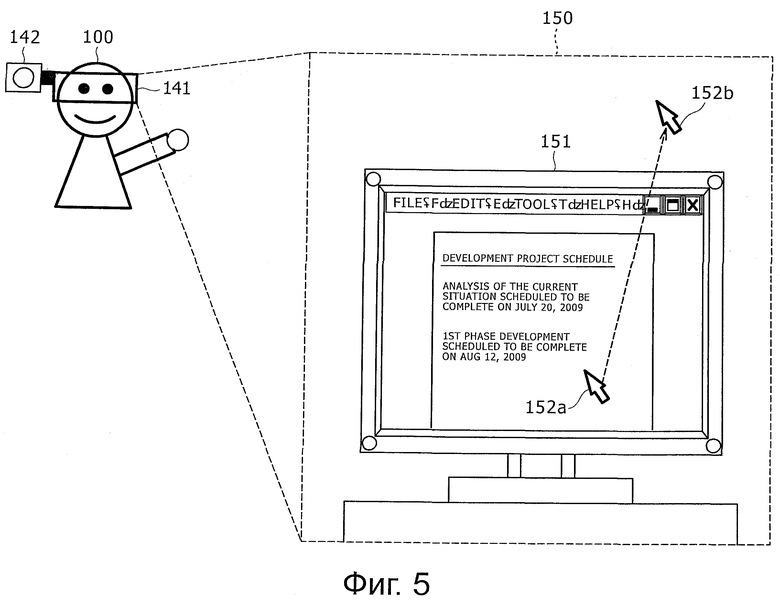

Фиг.5 - пример данных дисплея, отображаемых на дисплее очков, которые носит пользователь, в результате процесса, выполняемого информационным процессором, соответствующим настоящему изобретению.

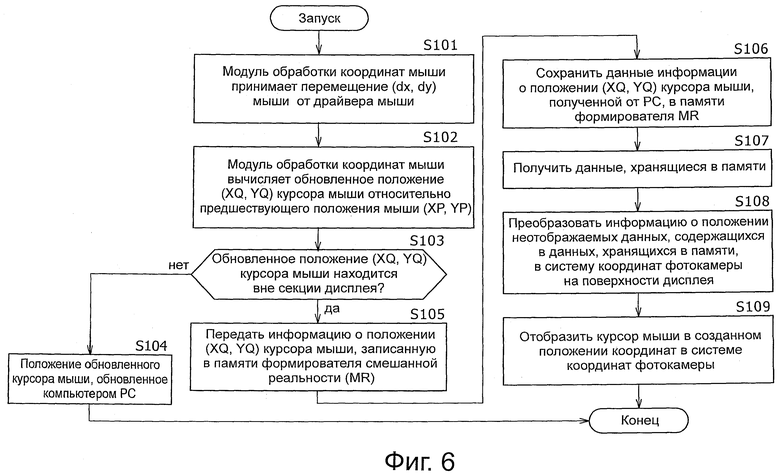

Фиг.6 - блок-схема последовательности выполнения операций процесса, выполняемого информационным процессором, соответствующим настоящему изобретению.

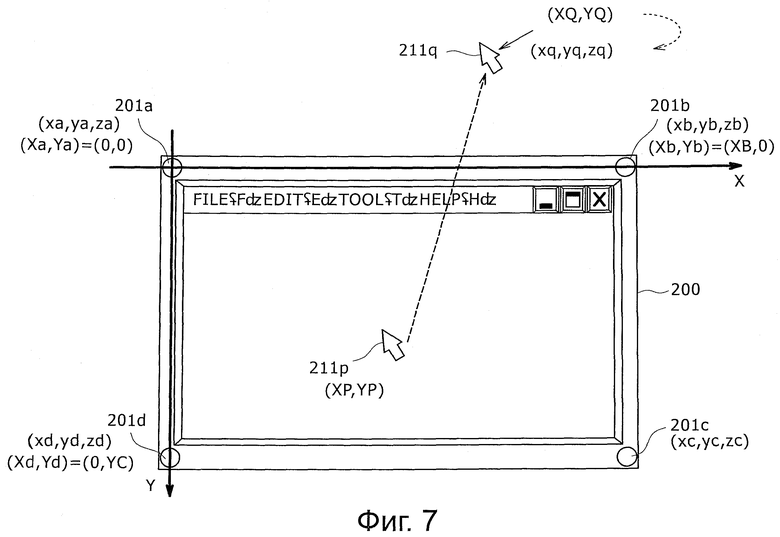

Фиг.7 - конкретный пример процесса, демонстрирующего пример процесса, выполняемого информационным процессором, соответствующим настоящему изобретению.

Фиг.8 - пример данных дисплея, отображаемых на дисплее очков, которые носит пользователь, в результате процесса, выполняемого информационным процессором, соответствующим настоящему изобретению.

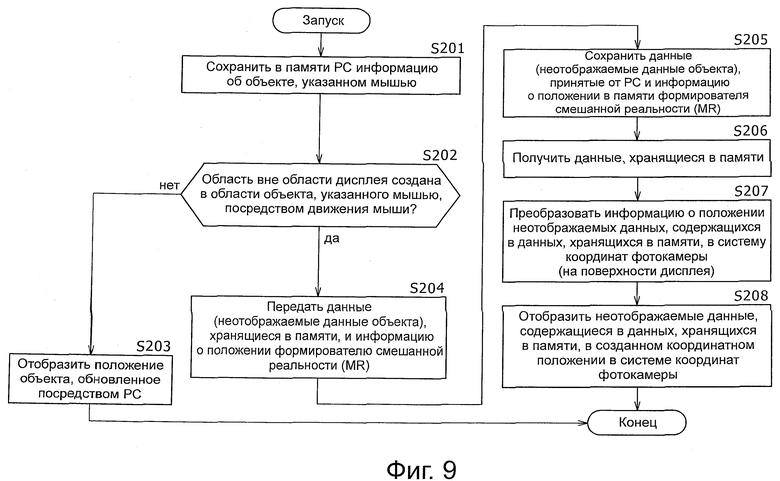

Фиг.9 - блок-схема последовательности выполнения операций процесса, выполняемого информационным процессором, соответствующим настоящему изобретению.

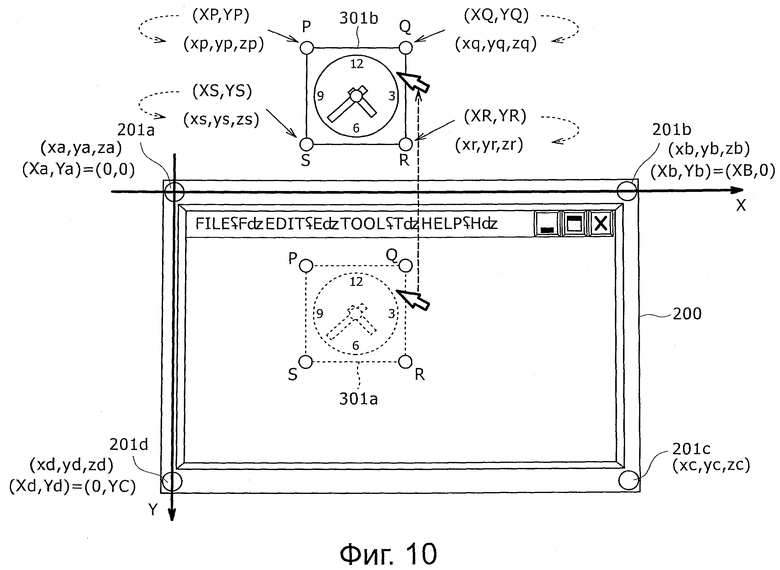

Фиг.10 - конкретный пример процесса, демонстрирующего пример процесса, выполняемого информационным процессором, соответствующим настоящему изобретению.

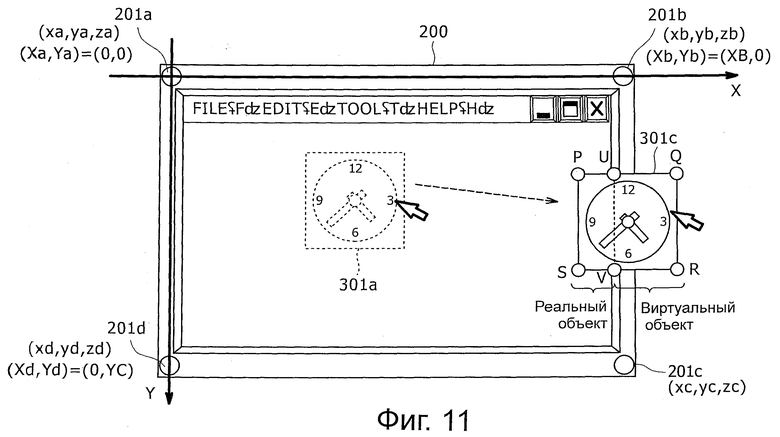

Фиг.11 - конкретный пример процесса, демонстрирующего пример процесса, выполняемого информационным процессором, соответствующим настоящему изобретению.

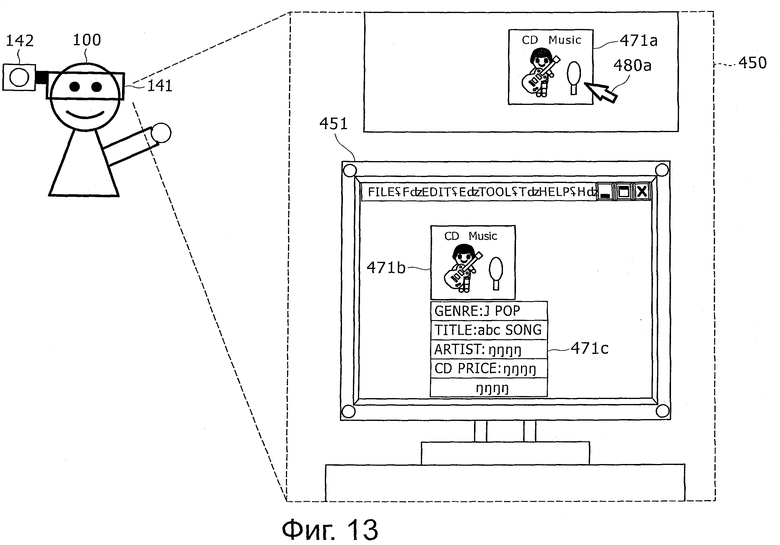

Фиг.12 - пример конфигурации информационного процессора, соответствующего настоящему изобретению.

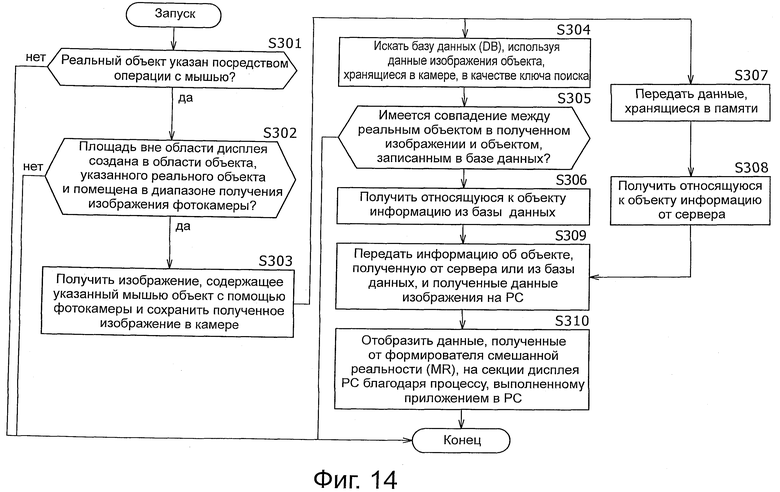

Фиг.13 - пример данных дисплея, отображаемых на дисплее очков, которые носит пользователь, в результате процесса, выполняемого информационным процессором, соответствующим настоящему изобретению.

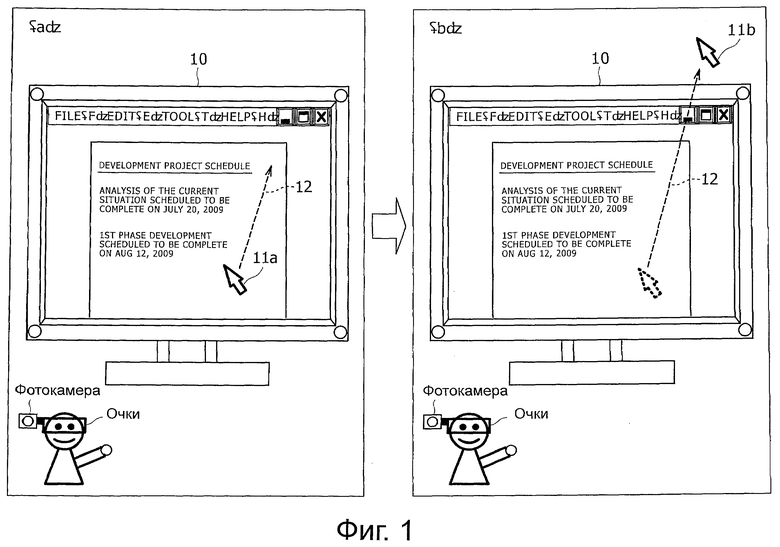

Фиг.14 - блок-схема последовательности выполнения операций процесса, выполняемого информационным процессором, соответствующим настоящему изобретению.

Осуществление изобретения

Ниже будет дано подробное описание информационного процессора, способа обработки и программы, соответствующих настоящему изобретению, со ссылкой на сопроводительные чертежи.

Настоящее изобретение будет описано последовательно по следующим позициям:

1. Краткое содержание процессов, выполняемых информационным процессором, соответствующим настоящему изобретению.

2. Конфигурация и процессы, выполняемые в соответствии с первым вариантом осуществления информационного процессора, соответствующего первому варианту осуществления настоящего изобретения.

3. Конфигурация и процессы, выполняемые информационным процессором, соответствующим второму варианту осуществления настоящего изобретения.

4. Конфигурация и процессы, выполняемые информационным процессором, соответствующим третьему варианту осуществления настоящего изобретения.

1. Краткое содержание процессов, выполняемых информационным процессором, соответствующим настоящему изобретению

Сначала, со ссылкой на фиг.1-3, будет приведено краткое содержание процессов, выполняемых информационным процессором, соответствующим настоящему изобретению. Настоящее изобретение предназначено для эффективного использования области пространства, отличной от секции дисплея (дисплея) PC или другого устройства обработки данных, благодаря процессу обработки данных, основанному на смешанной реальности (MR).

На фиг.1 представлено несколько рисунков, демонстрирующих пример процесса, выполняемого информационным процессором, соответствующим настоящему изобретению. На фиг.1 показана секция 10 дисплея персонального компьютера или другого устройства, используемого пользователем. Следует заметить, хотя подробная конфигурация будет описана позже, пользователь работает с персональным компьютером в очках. Очки имеют дисплей, выполненный с возможностью отображения изображения, созданного формирователем смешанной реальности (MR).

Очки имеют фотокамеру, выполненную с возможностью получения изображения окружающей среды. Дисплей очков отображает составное изображение, состоящее из полученного камерой изображения и виртуального объекта, созданного формирователем смешанной реальности (MR). На каждом из фиг.1(а) и (b) показано изображение, появляющееся на дисплее очков, которые носит пользователь для наблюдения.

Пользователь готовит документ путем отображения документа на секции 10 дисплея, как показано, например, на фиг.1(а). Этот процесс является обычной работой с PC. Секция 10 дисплея, показанная на фиг.1(а), отображает курсор 11 мыши в качестве индикатора положения, выполненного с возможностью перемещения в ответ на перемещение мыши, управляемой пользователем.

Пользователь может перемещать курсор 11 мыши, управляя мышью. В обычном информационном процессоре курсор мыши перемещается в пределах области отображения секции 10 дисплея. Однако при применении настоящего изобретения перемещение курсора мыши не ограничивается пределами области дисплея секции 10 дисплея.

Например, если за счет действия пользователя движение происходит вдоль линии 12 перемещения, показанной на фиг.1(а), курсор мыши может перемещаться в пространство за пределами секции 10 дисплея, как показано на фиг.1(b). Это тот курсор 11b мыши, который показан на фиг.1(b). Курсор 11b мыши, показанный на фиг.1(b), является виртуальным объектом, созданным формирователем смешанной реальности (MR). Пользователь наблюдает курсор 11b мыши, который является виртуальным объектом, отображаемым на дисплее очков, которые носит пользователь. Как описано выше, конфигурация, соответствующая настоящему изобретению, позволяет перемещать курсор 11 мыши по желанию вне или внутри секции 10 дисплея.

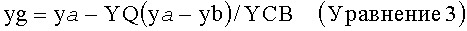

На фиг.2 также представлено несколько схем, демонстрирующих пример процесса, выполняемого информационным процессором, соответствующим настоящему изобретению. Как и на фиг.1, на фиг.2 также показана секция 10 дисплея PC или другого устройства, с которым работает пользователь. Пользователь носит очки, имеющие дисплей, выполненный с возможностью отображения изображения, созданного формирователем смешанной реальности (MR). Каждый из фиг.2(а) и 2(b) показывает изображение, появляющееся на дисплее очков, которые носит пользователь для наблюдения.

Секция 10 дисплея, показанная на фиг.2(а), отображает курсор 11 мыши и объект 21 а, указанный курсором 11 мыши. В этом примере объект 21 а является объектом, отображаемым на секции 10 дисплея в результате выполнения в PC приложения с изображением часов.

Пользователь помещает курсор 11 мыши на объект 21а, указывает объект, управляя мышью, и дополнительно перемещает курсор 11 мыши вдоль линии 22 перемещения, показанный на фиг.2(а).

Этот процесс позволяет курсору мыши и указанному объекту 21 перемещаться в пространстве за пределами секции 10 дисплея. Объект 21 является объектом 21b, показанным на фиг.2(b). Объект 21b, показанный на фиг.2(b), является виртуальным объектом, созданным формирователем смешанной реальности (MR). Пользователь наблюдает объект 21b, отображаемый на дисплее очков, которые носит пользователь. Как описано выше, конфигурация, соответствующая настоящему изобретению, позволяет по желанию перемещать не только курсор мыши, но также и объект, отображаемый на секции 10 дисплея.

На фиг.3 представлен набор рисунков, демонстрирующих пример процесса, выполняемого информационным процессором, соответствующим настоящему изобретению. Как и на фиг.1 и фиг.2, на фиг.3 также показана секция 10 дисплея PC или другого устройства, с которым работает пользователь. Пользователь носит очки, имеющие дисплей, выполненный с возможностью отображения изображения, созданного формирователем смешанной реальности (MR). Каждая из фиг.3(а) и 3(b) показывает изображение, появляющееся на дисплее очков, которые носит пользователь для наблюдения.

На фиг.3(а) показаны курсор 11 мыши, помещенный за пределами секции 10 дисплея за счет операции, описанной ранее со ссылкой на фиг.1, и реальный объект 31а, указанный курсором 11 мыши. В этом примере объект 31а является реальным объектом, фактически существующим в пространстве. В этом примере объектом 31а является фотография конверта для компакт-диска, то есть диска, на котором хранятся музыкальные данные.

Пользователь помещает курсор 11 мыши на объекте 31 а за счет операции с мышью и указывает объект за счет операции с мышью Информацию об указанном объекте, то есть информацию об объекте, получают из базы данных или от сервера, указывая объект. Полученная информация об объекте отображается на секции 10 дисплея. Изображение 31b объекта и информация 31 с об объекте, показанные на фиг.3 (b), являются информацией об объекте.

Как описано выше, конфигурация, соответствующая настоящему изобретению, позволяет указать множество реальных объектов в реальном пространстве с помощью курсора мыши, то есть виртуального объекта, чтобы получить информацию, связанную с указанным объектом, загрузить полученные данные в информационный процессор, такой как PC, для обработки и отобразить полученные данные на секции 10 дисплея в результате исполнения приложения на персональном компьютере.

2. Конфигурация и процессы, выполняемые информационным процессором, соответствующим первому варианту осуществления настоящего изобретения

Далее будет представлено подробное описание конфигурации и процессов, осуществляемых информационным процессором, выполненным с возможностью реализации процесса, описанного со ссылкой на фиг.1, в качестве первого варианта осуществления настоящего изобретения. Как показано на фиг.1, вариант 1 осуществления является примером конфигурации, в котором курсор мыши перемещается в пространство за пределами секции 10 дисплея, как показано на фиг.1(b), перемещая курсор 11 мыши вдоль линии 12 перемещения, показанной на фиг.1(а), в результате операции с мышью, выполняемой пользователем.

На фиг.4 представлена диаграмма, демонстрирующая конфигурацию информационного процессора, соответствующего варианту осуществления настоящего изобретения, выполненного с возможностью реализации описанного выше процесса. Пользователь 100 обрабатывает множество данных, управляя PC (персональным компьютером) 120. PC 120 содержит драйвер 121 мыши, модуль 122 обработки координат мыши, секцию графического интерфейса пользователя (GUI) 123, секцию 124 связи, секцию 125 исполнения приложений, секцию 126 управления, память 127 и секцию 128 дисплея, как показано на фиг.4. PC 120 дополнительно содержит мышь 129, показанную в верхней части на фиг.4.

Драйвер 121 мыши принимает информацию о положении и информацию об операции от мыши 129 в качестве входной информации. Модуль 122 обработки координат мыши определяет положение отображения курсора мыши в соответствии с информацией о положении мыши 129, принятой через драйвер 121 мыши. Следует заметить, что положение отображения курсора мыши не ограничивается областью отображения секции 128 дисплея в конфигурации, соответствующей настоящему изобретению.

Секция 123 GUI является интерфейсом пользователя, выполненным, например, с возможностью обработки информации, принятой от пользователя, и вывода информации пользователю. Секция 124 связи осуществляет связь с формирователем 130 смешанной реальности (MR).

Секция 125 исполнения приложений исполняет приложение, соответствующее обработке данных, выполняемой PC 120. Секция 126 управления осуществляет управление процессами, выполняемыми PC 120. Память 127 содержит RAM, ROM и другие устройства хранения, выполненные с возможностью хранения, например, программ, и параметры обработки данных. Секция 128 дисплея является секцией отображения, содержащей, например, жидкокристаллический дисплей.

Пользователь 100 носит очки 141, имеющие дисплей, выполненный с возможностью отображения виртуальных объектов. Очки 141 имеют фотокамеру 142, выполненную с возможностью получения изображения окружающей среды. Очки 141 и фотокамера 142 соединяются с формирователем 30 смешанной реальности (MR). Пользователь 100 выполняет свои задачи, наблюдая изображение, появляющееся на дисплее, обеспеченном на очках 141.

Дисплей очков 141 отображает реальное изображение, то есть, изображение, полученное фотокамерой 142. Дисплей очков 141 дополнительно отображает виртуальный объект, созданный формирователем 130 смешанной реальности (MR), вместе с реальным изображением.

В примере, показанном на фиг.4, пользователь 100 управляет PC (персональным компьютером) 120, и фотокамера 142 получает изображение PC (персонального компьютера) 120, управляемого пользователем 100. Поэтому дисплей очков 141 отображает в качестве реального изображения такое изображение, которое содержит, например, дисплей (секцию 128 дисплея) PC (персонального компьютера) 120, управляемого пользователем 100, и множество реальных объектов вокруг дисплея PC 120. Дополнительно, на реальном изображении появляется наложенный виртуальный объект, созданный формирователем 130 смешанной реальности (MR). Ориентация фотокамеры 142 изменяется в соответствии с перемещением пользователя 100.

Если пользователь 100 обращен лицом к экрану PC 120, когда выполняет свои задачи, фотокамера 142 получает изображение, центрованное вокруг изображения на экране PC 120. В результате, данные 150 дисплея, как показано, например, на фиг.5, показываются на дисплее 141 очков, которые носит пользователь 100. Данные 150 дисплея, показанные на фиг.5, являются составным изображением, содержащим изображение реального и виртуального объектов.

Далее будет приведено описание конфигурации формирователя 130 смешанной реальности (MR), показанного на фиг.4. Формирователь 130 смешанной реальности (MR) содержит секцию 131 анализа трехмерной информации, модуль 132 управления виртуальными объектами, память 133 и секцию 134 связи, как показано на фиг.4.

Секция 131 анализа трехмерной информации принимает изображение, полученное фотокамерой 142, которую носит пользователем, и анализирует трехмерные положения объектов, содержащихся в полученном изображении. Этот анализ трехмерного положения выполняется, например, используя процесс SLAM (одновременные локализация и отображение). SLAM предназначен выбирать характерные точки множества реальных объектов, содержащихся в полученном фотокамерой изображении, и обнаруживать положения выбранных характерных точек и местоположение и положение фотокамеры. Следует заметить, что SLAM описывается в патентном документе 1 (японский выложенный патент №2008-304268) и в патентном документе 2 (японский выложенный патент №2008-304269), упомянутых ранее. Следует заметить, что базовый процесс SLAM описывается в документе Andrew J. Davison, "Real-time simultaneous localisation and mapping with a single camera," Proceedings of the 9th International Conference on Computer Vision, Ninth, (2003).

Секция 131 анализа трехмерной информации вычисляет трехмерные положения реальных объектов, содержащихся в изображении, полученном фотокамерой 142, которую носит пользователь, используя, например, процесс SLAM, описанный выше. Следует заметить, однако, что секция 131 анализа трехмерной информации может обнаруживать трехмерные положения реальных объектов, содержащихся в полученном фотокамерой изображении, при использовании способа, отличного от процесса SLAM, описанного выше.

Модуль 132 управления виртуальными объектами управляет виртуальными объектами, появляющимися на дисплее очков 141, которые носит пользователь. Виртуальные объекты являются данными, хранящимися в памяти 133. Более конкретно, дисплей 141 очков, которые носит пользователь, отображает, например, данные 150 дисплея, показанные на фиг.5. Изображение 151 PC, содержащееся в данных 150 дисплея, является реальным изображением (реальным объектом), полученным фотокамерой 142.

Например, если пользователь перемещает мышь 129 PC 120, курсор 152а мыши, появляющийся на изображении 151 PC, показанном на фиг.5, перемещается за пределы изображения 151 PC, отображая, таким образом, курсор 152b мыши как виртуальный объект.

Пользователь 100, показанный на фиг.4, может наблюдать составное изображение, содержащее, например, реальный и виртуальный объекты, показанные на фиг.5, на дисплее очков 141. Изображение 151 PC, показанное на фиг.5, является реальным объектом, полученным фотокамерой 142. Курсор 152а мыши в изображении 151 PC также является информацией, то есть реальным объектом, фактически появляющимся в изображении 151 PC. Следует заметить, что объект, который существует в реальности как полученный фотокамерой 142 и чье изображение может быть получено фотокамерой, описывается здесь как реальный объект.

Курсор 152b мыши вне изображения 151 PC, показанный на фиг.5, не является объектом реального мира (реальным объектом). Курсор 152b мыши является виртуальным объектом, созданным формирователем 130 смешанной реальности (MR). Курсор 152b мыши является объектом, который не существует в реальном мире, но появляется на дисплее очков 141, которые носит пользователь.

Ниже будет дано описание последовательности процесса, выполняемого с возможностью отображения курсоров мыши, как описано выше со ссылкой на блок-схему последовательности выполнения операций, показанную на фиг.6. Следует заметить, что мы предполагаем, что пользователь управляет мышью 129, соединенной с PC 120, показанным на фиг.4. Информация об операции подается на драйвер мыши. Далее после этого процесса выполняется процесс, начинающийся с этапа S101 блок-схемы последовательности выполнения операций, показанной на фиг.6.

Этапы процесса от этапа S101 до этапа S105 на блок-схеме последовательности выполнения операций, показанной на фиг.6, выполняет PC 120, показанный на фиг.4.

Этапы процесса от этапа S106 до этапа S109 выполняются с помощью формирователя 130 смешанной реальности (MR), показанного на фиг.4.

На этапе S101 модуль 122 обработки координат мыши PC 120 принимает информацию перемещения (dX, dY) мыши от драйвера 121 мыши.

На этапе S102 модуль 122 обработки координат мыши вычисляет обновленное положение (XQ, YQ) курсора мыши относительно информации о предыдущем положении (ХР, YP) курсора мыши и смещении (dX, dY) мыши.

На этапе S103 модуль 122 обработки координат мыши определяет, находится ли обновленное положение (XQ, YQ) курсора мыши за пределами секции дисплея. Процесс переходит к этапу S104, когда обновленное положение (XQ, YQ) курсора мыши находится в области секции дисплея. В этом случае PC обновляет дисплей курсора мыши, как это делается обычно. Процесс переходит к этапу S105, если обновленное положение (XQ, YQ) курсора мыши находится за пределами области секции дисплея.

На этапе S105 информация о положении (XQ, YQ) курсора мыши, хранящаяся в памяти, передается формирователю 130 смешанной реальности (MR) через секцию связи. Следует заметить, что в настоящем варианте осуществления информация о положении, переданная от PC 120 к формирователю 130 смешанной реальности (MR), является только информацией о положении курсора мыши и что формирователь 130 смешанной реальности (MR) подтверждает заранее, что переданная информация о положении является информацией о положении курсора мыши. Чтобы передать информацию о положении или другую информацию других объектов, необходимо передать идентификационную информацию каждого объекта или данных чертежа объекта.

Этапы процесса от этапа S106 и далее выполняются формирователем 130 смешанной реальности (MR).

Сначала, на этапе S106, формирователь 130 смешанной реальности (MR) сохраняет информацию о положении (XQ, YQ) курсора мыши, переданной от PC 120 в его память 133. Если формирователь 130 смешанной реальности (MR) принимает данные, не относящиеся к отображению, (данные чертежа курсора мыши) или его идентификатор от PC 120, принятые данные также сохраняются в памяти 133 формирователя 130 смешанной реальности (MR).

Затем, на этапе S107, модуль 132 управления виртуальными объектами формирователя 130 смешанной реальности (MR) получает данные, хранящиеся в памяти 133, то есть данные, не относящиеся к отображению (данные чертежа курсора мыши), и информацию о положении (XQ, YQ).

На этапе S108 модуль 132 управления виртуальными объектами преобразует информацию о положении неотображаемых данных (курсора мыши) в систему координат фотокамеры для изображения, полученного фотокамерой, полученного от секции 131 анализа трехмерной информации.

Описание этого процесса будет дано со ссылкой на фиг.7. Секция 131 анализа трехмерной информации уже получила информацию о трехмерном положении маркеров 201a-201d в четырех углах секции 200 дисплея PC, введенную в изображение, полученное фотокамерой. Как показано на фиг.7, получены следующие фрагменты информации о положении:

Маркер 201a=(xa, ya, za)

Маркер 201b=(xb, yb, zb)

Маркер 201с=(xc, ус, zc)

Маркер 201d=(xd, yd, zd)

Следует заметить, что эти фрагменты информации о положении находятся в системе (x, y, z) координат фотокамеры.

С другой стороны, информация о положении (XQ, YQ) курсора мыши, принятая от PC 120, находится в системе координат плоскости секции дисплея PC. Как показано на фиг.7, информация о положении курсора мыши является той, которая имеет, например, верхний левый угол секции дисплея в качестве его начала координат (X, Y)=(0, 0) с горизонтальным направлением, обозначенным X, и вертикальным направлением, обозначенным Y.

Модуль 132 отображения управления виртуальными объектами вычисляет плоскость секции дисплея в системе координат фотокамеры, основываясь на информации о трехмерном положении маркеров 201a-201d, определяя положение, в котором неотображаемые данные (данные чертежа курсора мыши), полученные от PC 120, должны быть помещены на вычисленной плоскости. Чтобы выполнить этот процесс, информация (XQ, YQ) о положении, представленная в системе координат (X, Y) плоскости секции дисплея, полученная от PC 120, преобразуется, вычисляя, таким образом, положение отображения (xq, yq, zq) курсора 211q мыши (x, y, z) в системе координат фотокамеры (х, y.z).

Положение (xq, yq, zq) отображения курсора 211q мыши устанавливается на плоскости поверхности отображения, образованной маркерами 201a-201d, в четырех углах секции 200 дисплея, показанных на фиг.7. Сначала находится поверхность отображения, образованная маркерами 201a-201d в четырех углах секции 200 дисплея.

Эта поверхность отображения может быть определена, используя произвольные трех из четырех координат маркеров 201a-201d в четырех углах секции 100 дисплея. Например, поверхность отображения может определяться, используя координаты следующих трех точек:

Маркер 201a=(xa, ya, za)

Маркер 201b=(xb, yb, zb)

Маркер 201с=(xc, yс, zc)

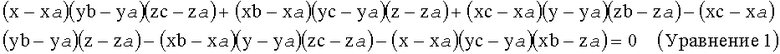

Плоскость xyz (плоскость в системе (x, y, z) координат фотокамеры, проходящая через поверхность отображения) может быть выражена согласно уравнению 1, показанному ниже, используя координаты упомянутых выше трех точек.

Модуль 132 управления виртуальными объектами преобразует информацию о положении (XQ, YQ), представленную в системе координат (X, Y) плоскости секции дисплея, полученную от PC 120, в координаты (xq, yq, zq) положения на плоскости xyz в системе координат (x, y, z) фотокамеры.

Мы предполагаем, что координаты, которые должны быть найдены, являются координатами (xq, yq, zq) положения в системе координат (x, y, z) фотокамеры курсора 211q мыши, показанного на фиг.7.

Маркер 201а=(ха, yа, za)

Маркер 201b=(xb, yb, zb)

Маркер 201с=(хс, yс, zc)

Дополнительно, положения вышеупомянутых трех точек в системе координат (X, Y) плоскости секции дисплея, соответственно, предполагаются следующими:

Маркер 201а=(0,0)

Маркер 201b=(XB, 0)

Маркер201с=(0, УС)

Позиционное соотношение между следующими наборами координат в системе координатной плоскости (X, Y) секции дисплей, а именно:

Маркер 201а=(0,0)

Маркер 201b=(XB, 0)

Маркер 201с=(0, УС)

Положение курсора 211p мыши (ХР, YP)

Положение курсора 211q мыши (XQ, YQ)

является тем же самым, что и между следующими наборами координат в системе (z, y, z) координат фотокамеры, а именно:

Маркер 201b=(xb, yb, zb)

Маркер 201с=(хс, yс, zc)

Положение курсора 211р мыши (xр, yр, zp)

Положение курсора 211q мыши (xq, yq, zq).

Следовательно, следующие уравнения содержат:

(0-XQ)/(0-ХВ)=(xa-xq)/(xa-xb)

(0-YQ)/(0-YC)=(ya-yq)/(ya-yc)

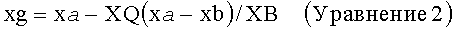

От вышеупомянутого могут быть выведены следующие уравнения связи (Уравнения 2 и 3):

Подставляя вышеупомянутые уравнения связи (Уравнения 2 и 3) в уравнение (Уравнение 1), описанное ранее, можно получить zq. Положение (xq, yq, zq) курсора 211q мыши вычисляется, как описано выше.

На этапе S108, показанном в блок-схеме последовательности выполнения операций на фиг.6, модуль 132 управления виртуальными объектами преобразует информацию (XQ, YQ) о положении неотображаемых данных, полученных из памяти 133, в положение (xq, yq, zq) в системе координат фотокамеры для изображения, полученного фотокамерой от секции анализа трехмерной информации, как описано выше.

Далее, на этапе S109 модуль 132 управления виртуальными объектами отображает курсор мыши в созданном координатном положении (xq, yq, zq) в системе координат фотокамеры. Следует заметить, что если данные чертежа для курсора мыши были приняты от PC 120 и хранятся в памяти 133, неотображаемые данные, содержащиеся в данных, хранящихся в памяти 133, то есть неотображаемые данные (данные чертежа для курсора мыши), переданные от PC 120, отображаются в созданном координатном положении (xq, yq, zq) в системе координат фотокамеры.

В результате этого процесса данные 150 дисплея, показанные на фиг.5, появляются на дисплее очков 141, которые носит пользователь 100. Данные 150 дисплея, показанные на фиг.5, являются составным изображением, показывающим изображение 151 PC как реальный объект, вместе с курсором 152b мыши как виртуальным объектом. Модуль 132 управления виртуальными объектами устанавливает положение отображения виртуального объекта в пространстве за пределами секции дисплея PC, как показано на фиг.5. Этот процесс отображения позволяет пользователю перемещать курсор мыши за пределами секции дисплея PC, а не только внутри секции дисплея PC, делая, таким образом, возможным использовать большую рабочую область для обработки данных.

Следует заметить, что процесс, описанный со ссылкой на блок-схему последовательности выполнения операций, показанную на фиг.6, выполняется каждый раз при изменении положения курсора мыши в результате операции пользователя с мышью 129 PC 120. Модуль 122 обработки координат мыши передает обновленные данные на формирователь 130 смешанной реальности (MR) каждый раз, когда изменяется положение курсора мыши. Формирователь 130 смешанной реальности (MR) изменяет положение отображения виртуального объекта (курсора мыши), основываясь на обновленных данных как процессе в реальном времени.

3. Конфигурация и процессы, выполняемые информационным процессором в соответствии со вторым вариантом осуществления настоящего изобретения

Далее, со ссылкой на фиг.2 будет дано подробное описание конфигурации и процессов, осуществляемых информационным процессором, выполненным с возможностью осуществления процесса, описанного ранее, как второго варианта осуществления настоящего изобретения. Как описано со ссылкой на фиг.2, вариант 2 осуществления 2 является примером конфигурации, в которой объект 21 перемещается в пространстве за пределами секции 10 дисплея, как показано на фиг.2(b), указывая объект 21 и перемещая курсор 11 мыши вдоль линии 22 перемещения, показанной на фиг.2(а) и 2(b) в результате операции пользователя с мышью.

Настоящий вариант осуществления выполняется устройствами, конфигурированными в соответствии с фиг.4, как в первом варианте осуществления. В примере, показанном на фиг.4, пользователь 100 работает с PC (персональным компьютером) 120 и фотокамера 142 получает изображение PC (персонального компьютера) 120, управляемого пользователем 100. Поэтому дисплей очков 141, которые носит пользователь 100, отображает в качестве реального изображения такое изображение, которое содержит, например, дисплей (секцию 128 дисплея) PC (персонального компьютера) 120, управляемого пользователем 100, и множество реальных объектов вокруг дисплея PC 120. Дополнительно, виртуальный объект, созданный формирователем 130 смешанной реальности (MR) оказывается наложенным на реальное изображение. Ориентация фотокамеры 142 изменяется в соответствии с перемещением пользователя 100.

Если пользователь 100 обращен лицом к экрану PC 120, когда выполняет свои задачи, фотокамера 142 получает изображение, центрованное вокруг изображения на экране PC 120. В результате, данные 250 дисплея, как показано, например, на фиг.8, появляются на дисплее очков 141, которые носит пользователь 100. Данные 250 дисплея, показанные на фиг.8, являются составным изображением, содержащим реальные и виртуальные объекты.

Изображение 251 PC, содержащееся в данных 250 дисплея, является реальным изображением (реальным объектом), полученным фотокамерой 142. Например, на фиг.8 показан процесс, в котором пользователь перемещает мышь 129 персонального компьютера PC 120, показанного на фиг.4. Если объект 252а, появляющийся в изображении 251 PC, показанном на фиг.8, перемещается за пределами изображения 251 PC после того, как он указан курсором 271 а мыши, объект 252 и курсор 271 мыши движутся вместе. Если объект 252 и курсор 271 мыши продолжают перемещаться, объект 252b и курсор 27 lb мыши отображаются за пределами изображения 251 PC как виртуальные объекты.

Пользователь 100, показанный на фиг.4, может наблюдать составное изображение, содержащее, например, реальные и виртуальные объекты, показанные на фиг.8, на дисплее очков 141. Изображение 251 PC, показанное на фиг.8, является реальным объектом, полученным фотокамерой 142. Как объект 252а в изображении 251 PC, так и курсор 271 а мыши являются информацией и реальными объектами, фактически отображаемыми в изображении 151 PC. С другой стороны, объект 252b и курсор 271b мыши за пределами изображения 251 PC, показанного на фиг.8, не являются объектами реального мира (реальными объектами). Объект 252b и курсор 271b мыши является виртуальными объектами, созданными формирователем 130 смешанной реальности (MR). Объект 252b и курсор 271b мыши является объектами, которые не существуют в реальном мире, но представляются на дисплее очков 141, которые носит пользователь.

Ниже будет приведено описание последовательности процесса, выполняемого с возможностью отображения виртуальных объектов, как описано выше, со ссылкой на блок-схему последовательности выполнения операций, показанную на фиг.9. Следует заметить, что мы предполагаем, что пользователь управляет мышью 129, соединенной с PC 120, показанным на фиг.4.

Следует заметить, что, как можно понять из данных 250 дисплея, показанных на фиг.8, курсор 271b мыши в настоящем варианте осуществления, как и в первом варианте осуществления, отображается как виртуальный объект. Последовательность, адаптированная для отображения курсора 271b мыши, выполняется тем же самым способом, что и последовательность, описанная со ссылкой на фиг.6.

В настоящем варианте 2 осуществления дополнительно добавлен процесс, выполненный с возможностью отображения объекта 252, указанного мышью. Блок-схема последовательности выполнения операций, показанная на фиг.9, является блок-схемой, описывающей только последовательность, выполненную с возможностью отображения этого объекта, указанного мышью. То есть, если данные 250 дисплея, показанные на фиг.8, созданы и отображаются, два процесса, один - в соответствии с блок-схемой, показанной на фиг.6, и другой - в соответствии с блок-схемой, показанной на фиг.9, выполняются вместе.

Этапы процесса от этапа S201 до этапа S204 на блок-схеме последовательности выполнения операций, показанной на фиг.9, выполняются PC 120, показанным на фиг.4.

Этапы процесса от этапа S205 до этапа S208 выполняются формирователем 130 смешанной реальности (MR), показанным на фиг.4.

На этапе S201 информация об объекте, указанная мышью 129 персонального компьютера 120, сохраняется в памяти 127 персонального компьютера 120. Следует заметить, что информация об объекте, хранящаяся в памяти 127, содержит данные чертежа и информацию о положении для объекта. Информацией о положении являются, например, координаты положения центра, служащего в качестве точки отсчета объекта, или множество фрагментов информации о положении, определяющей общие контуры.

В случае данных прямоугольного объекта, такого как объект 301а, показанный, например, на фиг.10, информация о координатах каждой из четырех вершин Р, Q, R и S хранится в памяти как элементы, составляющие информацию об объекте. Следует заметить, что информация о положении должна быть только такой, чтобы она позволила представить объект в определенном положении. Поэтому в памяти может храниться информация о координатах только одной точки, то есть Р, из всех этих четырех вершин Р, Q, R и S. Данные для вычерчивания объекта, представляющие форму объекта, также хранятся в памяти. Поэтому, даже если информация о координатах только одной точки, то есть Р, хранится в памяти как информация о положении, можно вычертить (отобразить) объект, используя Р в качестве начальной точки.

На этапе S202 определяется, была ли в результате перемещения мыши 129 персонального компьютера 120 действием пользователя в области вне секции дисплея создана область объекта, указанная мышью. В этом процессе секция 125 исполнения приложений персонального компьютера 120 выполняет такое определение, основываясь на новом положении курсора мыши и форме объекта, полученной от модуля 122 обработки координат мыши.

Если при определении на этапе S202 ответ "Нет" (No), то есть, если никакая область вне секции дисплея не была создана в области объекта, указанного мышью, процесс переходит к этапу S203, где секция 125 исполнения приложений персонального компьютера 120 отображает указанный мышью объект в секции дисплея.

С другой стороны, если при определении на этапе S202 ответ "Да" (Yes), то есть, когда в области объекта, указанного мышью, создана область вне секции дисплея, процесс переходит к этапу S204. В этом случае, например, за счет действия пользователя объект перемещается в положение объекта 301b, показанного на фиг.10, или в положение объекта 301с, показанного на фиг.11. Это можно видеть на фиг.10 и 11, демонстрирующих примеры, на которых объекты 301b и 301с, показанные на фиг.10 и 11, появляются, по меньшей мере, частично как виртуальные объекты на дисплее очков, которые носит пользователь.

На этапе S204 данные (неотображаемые данные (данные вычерчивания объекта)) и информация о положении, хранящаяся в памяти, передаются на формирователь 130 смешанной реальности (MR). В примере, показанном на фиг.10, например, данные вычерчивания часов, то есть объекта 301b, и данные координат каждой из четырех вершин Р, Q, R и S объекта 301b, получаются из памяти 127 PC 120 и передаются на формирователь 130 смешанной реальности (MR).

Следует заметить, что переданная информация о положении является такой, что в плоской системе координат секции дисплея персонального компьютера, как в варианте 1 осуществления, она является информацией о положении, например, верхнего левого угла секции дисплея в качестве его начала координат (X, Y)=(0, 0) с горизонтальным направлением, обозначенным X, и вертикальным направлением, обозначенным Y, как показано на фиг.10. В примере, показанном на фиг.10, передается информация о координатах следующих четырех вершин:

Р=(ХР, YP)

Q=(XQ, YQ)

R=(XR, YR)

S=(XS, YS)

Этапы процесса от этапа S205 и далее выполняются формирователем 130 смешанной реальности (MR).

Сначала, на этапе S205, формирователь 130 смешанной реальности (MR) сохраняет данные, полученные от персонального компьютера 120, то есть неотображаемые данные (данные вычерчивания объекта) и информацию о положении (информацию о координатах Р, Q, R и S), в памяти 133 формирователя 130 смешанной реальности (MR).

Затем, на этапе S206, модуль 132 управления виртуальными объектами формирователя 130 смешанной реальности (MR) получает данные, хранящиеся в памяти 133, то есть неотображаемые данные (данные вычерчивания объекта) и информацию о положении (информацию о координатах Р, Q, R и S).

Далее, на этапе S207 модуль 132 управления виртуальными объектами преобразует информацию о положении точек Р, Q, R, и S, полученную из памяти 133, в положении в системе координат фотокамеры для полученного фотокамерой изображения, переданного от секции 131 анализа трехмерной информации.

Это преобразование координат выполняется тем же самым способом, что и преобразование координат курсора мыши, описанное в первом варианте осуществления. Поэтому его подробное описание опускается.

В примере, показанном на фиг.10, например, координаты каждой из точек Р, Q, R и S объекта 301b в плоской системе координат (X, Y) секции дисплея преобразуются в следующие координаты в системе (х, у, z) координат фотокамеры:

P=(XP, YP)→(xp, yp, zp)

Q=(XQ, YQ)→(xq, yq, zq)

R=(XR, YR)→(xr, yr, zr)

S=(XS, YS)→(xs, ys, zs)

Как описано выше, модуль 132 управления виртуальными объектами на этапе S270, показанном на блок-схеме последовательности выполнения операций на фиг.9, преобразует информацию о положении неотображаемых данных, полученных из памяти 133, в положения (xq, yq, zq) в системе координат фотокамеры для полученного фотокамерой изображения, полученного от секции анализа трехмерной информации.

Затем на этапе S208 модуль 132 управления виртуальными объектами получает неотображаемые данные (данные вычерчивания объекта), содержащиеся в данных, хранящихся в памяти 133, вычерчивает или отображает объекты в созданных положениях координат в системе координат фотокамеры, как представлено на фиг.10.

В результате этого процесса данные 250 дисплея, показанные на фиг.8, представляются на дисплее очков 141, которые носит пользователь 100. Данные 250 дисплея, показанные на фиг.8, являются составным изображением, показывающим изображение 251 персонального компьютера как реальный объект вместе с объектом 252b и курсором 271b мыши в качестве виртуальных объектов. Модуль 132 управления виртуальными объектами устанавливает положения отображения виртуальных объектов в пространстве за пределами секции дисплея персонального компьютера, как показано на фиг.8. Этот процесс отображения позволяет пользователю отображать множество объектов в пространстве за пределами секции дисплея персонального компьютера, а не только в секции дисплея персонального компьютера, позволяя, таким образом, использовать большую рабочую область для обработки данных.

Следует заметить, что процесс, описанный со ссылкой на блок-схему последовательности выполнения операций, показанную на фиг.9, выполняется каждый раз, когда в результате действий пользователя, управляющего мышью 129 PC 120, изменяется положение курсора мыши. Секция 125 исполнения приложений передает обновленные данные на формирователь 130 смешанной реальности (MR) каждых раз при изменении положения курсора мыши. Формирователь 130 смешанной реальности (MR) изменяет положение отображения виртуального объекта (часов), основываясь на обновленных данных как процессе в реальном времени.

Заметим, что случай, в котором на блок-схеме последовательности выполнения операций, показанной на фиг.9, при определении на этапе S202 ответом является "Да" (Yes), то же самое происходит, например, в положении объекта 301с, показанном на фиг.11. То есть определение на этапе S202 дает ответ "Да", если даже только часть указанного мышью объекта располагается вне области дисплея секции дисплея персонального компьютера.

В этом случае информация о положении точек Р, Q, R и S, показанных на фиг.11, также передается от PC 120 на формирователь 130 смешанной реальности (MR) как информация о положении объекта 301с.Формирователь 130 смешанной реальности (MR) необходимо отображать объект 301с таким способом, что часть объекта 301с представляется наложенной на секцию дисплея PC.

Следует заметить, что в этом случае только область секции за пределами раздела дисплея объекта 301с, показанного на фиг.11, ограниченного точками U, Q, R и V, может представляться как виртуальный объект и что в отношении части объекта, ограниченной точками Р, U, V и S, не виртуальный, а реальный объект появляется в секции дисплея PC, то есть полученное фотокамерой изображение само может отображаться на дисплее очков, которые носит пользователь.

Чтобы выполнить этот процесс, модуль 132 управления виртуальными объектами формирователя 130 смешанной реальности (MR) создает виртуальные данные отображения виртуального объекта, состоящие только из данных части, ограниченной точками U, Q, R и V, как показано на фиг.11, и отображает эти данные дисплея во время процесса отображения виртуального объекта. То есть данные части, ограниченной точками Р, U, V и S данных чертежа объекта, принятые от PC, делаются кажущимися прозрачными.

4. Конфигурация и процессы, выполняемые информационным процессором в соответствии с третьим вариантом осуществления настоящего изобретения

Далее будет приведено подробное описание конфигурации и процессы, выполняемые информационным процессором, выполненным с возможностью осуществления процесса, описанного ранее как третий вариант осуществления настоящего изобретения со ссылкой на фиг.3. Как описано со ссылкой на фиг.3, вариант 3 осуществления является примером конфигурации, в которой информация 31 с об объекте отображается, как показано на фиг.3(b), указывая объект 31 в реальном пространстве за пределами секции дисплея PC в результате действий пользователя с мышью.

Настоящий вариант осуществления выполняется устройствами, конфигурированными так, как показано на фиг.12. PC 120 конфигурируется тем же самым способом, как было описано ранее со ссылкой на фиг.4 в варианте 1 осуществления. Формирователь 130 смешанной реальности (MR) содержит секцию 131 анализа трехмерной информации, модуль 132 управления виртуальными объектами, память 133, секцию 134 связи, секцию 135 получения информации об объекте и базу 136 данных информации об объекте. Следует заметить, что база 136 данных информации об объекте, по существу, не является обязательной в формирователе 130 смешанной реальности (MR). Базе 136 данных информации об объекте необходимо быть только, например, подключаемой к сети базой данных, к которой можно получать доступ через секцию связи формирователя 130 смешанной реальности (MR).

Секция 131 анализа трехмерной информации, модуль 132 управления виртуальными объектами, память 133 и секция 134 связи выполняются таким же способом, как описано ранее со ссылкой на фиг.4 в первом варианте осуществления. Следует заметить, однако, что секция 134 связи осуществляет связь с внешним сервером 140 или с базой 136 данных информации об объектах через сеть.

Секция 135 получения информации об объекте получает множество изображений реальных объектов из изображения, полученного фотокамерой 142, которую носит пользователь 100, и сравнивает изображения с данными, хранящимися в базе 136 данных информации об объектах, выбирая схожие изображения и получая информацию об объекте, связанную с выбранными изображениями.

Например, если изображением реального объекта является фотография конверта компакт-диска, информацией об объекте является многочисленная информация, такая как заголовок песни и жанр, исполнитель и цена. Эти части информации об объекте связываются с изображением объекта и сохраняются в базе 136 данных информации об объекте.

Следует заметить, что сервер 140 также хранит ту же самую информацию, которая хранится в базе 136 данных информации об объектах. Формирователь 130 смешанной реальности (MR) передает изображение, полученное фотокамерой 142, которую носит пользователь 100, или изображение реального объекта (например, изображение конверта компакт-диска), выбранное из полученного изображения, на сервер через секцию 134 передачи. Сервер извлекает соответствующую информацию об объекте из принятого изображения, предоставляя информацию об объекте на формирователь 130 смешанной реальности (MR).

Как описано выше, формирователь 130 смешанной реальности (MR) получает информацию об объекте от базы 136 данных информации об объектах или от сервера 140 и подает полученную информацию на PC 120 вместе с данными изображения реального объекта, полученного фотокамерой 142. PC 120 отображает полученную информацию на своей секции дисплея, используя полученную информацию.

В результате, данные 450 дисплея, как показано, например, на фиг.13, представляются на дисплее очков 14, которые носит пользователь 100. Изображение 451 PC, содержащееся в данных 450 дисплея, является реальным изображением (реального объекта), полученным фотокамерой 142. Объект 471а, расположенный за пределами изображения 451 PC, также является реальным объектом. Курсор 480а мыши является виртуальным объектом.

Изображение 471b объекта и информация 471 с об объекте, появляющиеся на изображении 451 PC, являются данными, отображаемыми в секции 128 дисплея секцией 125 исполнения приложений персонального компьютера PC 120. Из данных 450 дисплея, показанных на фиг.13, поэтому, информация, кроме курсора 480а мыши, является изображением, появляющимся на дисплее очков 141, которые носит пользователь 100. Это изображение может также наблюдаться теми пользователями, которые не носят никакие очки.

То есть изображение 471b об объекте и информация 471 с об объекте, появляющиеся в изображении 451 PC, являются данными дисплея в секции дисплея PC 120, которые могут наблюдаться любым человеком.

Ниже будет приведено описание последовательности процесса, выполняемого с возможностью обработки данных, как описано выше со ссылкой на блок-схему последовательности выполнения операций, показанную на фиг.14. Следует заметить, что мы предполагаем, что пользователь управляет мышью 129, соединенной с PC 120, показанным на фиг.12.

Следует заметить, что, как можно понять из данных 450 дисплея, показанных на фиг.13, курсор 480а мыши в настоящем варианте осуществления отображается как виртуальный объект, как в первом и втором вариантах осуществления. Последовательность, выполненная с возможностью отображения курсора 480а мыши, выполняется тем же самым способом, что и последовательность, описанная со ссылкой на фиг.6.

В настоящем варианте 3 осуществления дополнительно добавлен процесс для реального объекта, указанного мышью. Блок-схема последовательности выполнения операций, показанная на фиг.14, является последовательностью операций, которая описывает только последовательность для этого указанного мышью объекта. Таким образом, если данные 450 дисплея, показанные на фиг.13, созданы и отображаются, два процесса, один - соответствующий последовательности выполнения операций, показанной на фиг.6, и другой - соответствующий последовательности выполнения операций, показанной на фиг.14, выполняются вместе.

Процесс на этапе S3 01, показанном на блок-схеме последовательности выполнения операций на фиг.14, выполняется вместе как PC 120, так и формирователем 130 смешанной реальности (MR), показанными на фиг.12. Этапы обработки от этапа S302 до этапа S309 выполняются формирователем 130 смешанной реальности (MR), показанным на фиг.12. Этап обработки, показанный на этапе S310, выполняется PC 120, показанным на фиг.12.

Перед этапом обработки на этапе S301 выполняется процесс, соответствующий последовательности операций, показанной на фиг.6, описанный в первом варианте осуществления, помещая, таким образом, курсор мыши в область вне секции дисплея. Мы предполагаем, например, что курсор мыши располагается в положении курсора 480а мыши, показанном на фиг.13.

На этапе S301 определяется, был ли реальный объект указан операцией с мышью. Когда реальный объект был указан, процесс переходит к этапу S302. Если реальный объект не был указан, процесс завершается. Следующий процесс выполняется, когда указан реальный объект. Сначала, когда информация о щелчке мышью подается в секцию 125 исполнения приложений через драйвер 121 мыши от PC 120, секция 125 исполнения приложений сообщает информацию об операции с мышью (щелчке) формирователю 130 смешанной реальности (MR) через секцию 124 связи. Формирователь 130 смешанной реальности (MR) принимает информацию о работе мыши через секцию 134 связи и сообщает ту же самую информацию модулю 132 управления виртуальными объектами.

На этапе S302 модуль 132 управления виртуальными объектами определяет, содержится ли область, находящаяся за пределами секции дисплея PC, в области объекта указанного реального объекта и расположена ли она в диапазоне получения изображений фотокамеры. Фотокамера является фотокамерой 142, которую носит пользователь 100. Если результатом определения на этапе S302 является "Нет" (No), процесс завершается. Если результатом определения на этапе S302 является "Да" (Yes), процесс переходит к этапу S3 03.

На этапе S303 изображение, содержащее указанный мышью объект, принимается фотокамерой 142, которую носит пользователь 100, и полученное изображение сохраняется в памяти. Этот процесс выполняется под управлением модуля 132 управления виртуальными объектами.

Этапы процесса от этапа S304 до S306 предназначены для получения информации об объекте из базы 136 данных информации об объекте. Этапы процесса от этапа S307 до S308 предназначены для получения информации об объекте от сервера 140. Выполняться может любой из этих процессов. Альтернативно, могут выполняться оба процесса.

Сначала будет дано описание этапов процесса от этапа S304 до S306, которые выполняются с возможностью получения информации об объекте от базы 136 данных информации об объекте.

На этапе S304 ведется поиск базы 136 данных (DB) информации об объекте, используя указанное мышью изображение объекта, хранящееся в памяти в качестве ключа поиска. Этот процесс выполняется секцией 135 поиска информации об объекте.

Данные изображения множества реальных объектов и информации об объектах для этих объектов для данных изображения записываются в базе 136 данных (DB) информации об объектах. Среди такой информации об объектах находятся фотографии конвертов компакт-дисков и заголовки песен и цены на компакт-диски.

На этапе S305 секция 135 получения информации об объекте ищет базу 136 данных (DB) информации об объектах. Таким образом, та же самая секция 135 определяет, совпадают или подобны ли какие-либо данные изображения, зарегистрированные в базе 136 данных (DB) информации об объектах, изображению объекта, указанному мышью. Процесс завершается, если никакое совпадающее или подобное зарегистрированное изображение не обнаружено. Процесс переходит к этапу S306, когда совпадающее или подобное зарегистрированное изображение обнаружено.

На этапе S306 секция 135 получения информации об объекте получает от базы 136 данных (DB) информации об объектах зарегистрированные данные для зарегистрированного изображения, совпадающего или подобного изображению указанного мышью объекта, то есть изображение и информацию об объекте.

Далее будет дано описание этапов процесса от этапа S307 до этапа S308, использующих сервер 140. На этапе S307 секция 135 получения информации об объекте передает изображение указанного мышью объекта, хранящееся в памяти, серверу 140 через секцию 134 связи.

На этапе S308 секция 135 получения информации об объекте получает от сервера 140 изображение объекта и информацию об объекте, выбранные, основываясь на информации, записанной в сервере. Сервер 140 выполняет тот же самый процесс, что и секция 135 получения информации об объекте, осуществляя поиск базы данных сервера 140, используя изображение указанного мышью объекта в качестве ключа поиска и извлекая информацию об объекте. Следует заметить, что если информация об объекте не может быть извлечена, передается сообщение об ошибке.

На этапе S309 формирователь 130 смешанной реальности (MR) передает на PC 120 информацию об объекте и данные изображения объекта, полученные от сервера или от базы данных. Следует заметить, что данные изображения объекта могут быть теми, которые получены от сервера или от базы данных, или изображением, полученным фотокамерой 142.

Обработка на конечном этапе S310 выполняется персональным компьютером 120. На этапе S310 данные, полученные от формирователя 130 смешанной реальности (MR), отображаются на секции дисплея PC благодаря процессу, выполняемому приложением в PC.

В результате, данные 450 дисплея, показанные на фиг.13, появляются на дисплее очков 14, которые носит пользователь 100. Как описано ранее, изображение 471b объекта и информация 471с объекта, появляющиеся в изображении 451 PC, являются данными, отображаемыми на секции 128 дисплея секцией 125 исполнения приложений персонального компьютера 120. Поэтому данные 450 дисплея, кроме курсора 480а мыши, показанного на фиг.13, являются информацией, которая может также наблюдаться теми пользователями, которые не носят очки.

Настоящее изобретение выше было описано подробно со ссылкой на конкретные варианты осуществления. Однако очевидно, что специалисты в данной области техники могут модифицировать или заменить варианты осуществления на другие, не отступая от сущности настоящего изобретения. То есть настоящее изобретение было раскрыто посредством иллюстрации и не должно интерпретироваться ограниченным способом. Приложенная формула изобретения должна учитываться при оценке сущности настоящего изобретения.

С другой стороны, ряд процессов, представленных в описании, может быть выполнен аппаратурными средствами, или программным обеспечением, или комбинацией их обоих. Если программным обеспечением выполняется ряд процессов, программа, содержащая последовательность процессов, устанавливается в память компьютера, введенного в состав выделенных аппаратурных средств для ее выполнения, или в универсальный персональный компьютер, способный выполнять различные процессы, для ее выполнения. Например, программа может быть заранее сохранена на носители записи. В дополнение к установке с носители записи в компьютер программа может быть установлена на носитель записи, такой как встроенный жесткий диск, принимая программу через сеть, такую как LAN (локальная сеть) или Интернет.

Следует заметить, что каждый из процессов, представленных в описании, может быть выполнен не только в хронологическом соответствии с описанием, но также и параллельно или индивидуально в соответствии с возможностями обработки устройства, выполняющего процесс, или по мере необходимости. С другой стороны, термин "система" в настоящем описании относится к логическому набору множества устройств и входящие в нее устройства не обязательно обеспечиваются в одном и том же корпусе.

Промышленная применимость

Как описано выше, в конфигурации, соответствующей варианту осуществления настоящего изобретения, курсор или объект, лежащие в области за пределами секции дисплея PC или другого устройства, отображаются как виртуальный объект. Например, дисплей очков, которые носит пользователь, отображает дисплей, такой как PC, и область вне дисплея. Трехмерное положение курсора или объекта, который, вероятно, переместился в ответ на действие пользователя, вычисляется, после чего курсор или объект отображается как виртуальный объект в вычисленном положении. Дополнительно, получается и представляется информация об объекте для объекта, указанного курсором. Настоящая конфигурация позволяет постоянно наблюдать и проверять данные, которые переместились за пределы секции дисплея, обеспечивая, таким образом, повышенную эффективность обработки данных.

Описание ссылочных позиций

10 Секция дисплея

11 Курсор мыши

12 Линия перемещения

21 Объект

22 Линия перемещения

31а, 31b Объекты

31с Информация об объекте

100 Пользователь

120 PC (персональный компьютер)

121 Драйвер мыши

122 Модуль обработки координат мыши

123 Секция GUI

124 Секция связи

125 Секция исполнения приложений

126 Секция управления

127 Память

128 Секция дисплея

129 Мышь

130 Формирователь смешанной реальности (MR)

131 Секция анализа трехмерной информации

132 Модуль управления виртуальными объектами

133 Память

134 Секция связи

135 Секция получения информации об объекте

136 База данных информации об объектах

140 Сервер

141 Очки

142 Фотокамера

150 Данные дисплея

151 Изображение PC

152 Курсор мыши

200 Секция дисплея

201 Маркер

211 Курсор мыши

250 Данные дисплея

251 Изображение PC

252 Объект

271 Курсор мыши

301 Объект

450 Данные дисплея

451 Изображение PC

471a, 471b Объекты

471c Информация об объекте

| название | год | авторы | номер документа |

|---|---|---|---|

| УСТРОЙСТВО ОБРАБОТКИ ИНФОРМАЦИИ, СПОСОБ ОБРАБОТКИ ИНФОРМАЦИИ И ПРОГРАММА | 2010 |

|

RU2536363C2 |

| СПОСОБ И СИСТЕМА СБОРА ИНФОРМАЦИИ ДЛЯ УСТРОЙСТВА СОВМЕЩЕННОЙ РЕАЛЬНОСТИ В РЕЖИМЕ РЕАЛЬНОГО ВРЕМЕНИ | 2019 |

|

RU2702495C1 |

| СИСТЕМА ТРЕХМЕРНОЙ ВИДЕОИГРЫ | 2003 |

|

RU2339083C2 |

| СПОСОБ ВИЗУАЛИЗАЦИИ ДИНАМИЧЕСКОЙ АНАТОМИЧЕСКОЙ СТРУКТУРЫ | 2020 |

|

RU2808612C2 |

| АВТОСТЕРЕОСКОПИЧЕСКИЙ ДИСПЛЕЙ РАСШИРЕННОЙ РЕАЛЬНОСТИ | 2013 |

|

RU2651611C2 |

| ОРИЕНТАЦИЯ И ВИЗУАЛИЗАЦИЯ ВИРТУАЛЬНОГО ОБЪЕКТА | 2014 |

|

RU2670784C9 |

| СИСТЕМА ПРОЕКТИРОВАНИЯ ОБЪЕКТОВ В СРЕДЕ ВИРТУАЛЬНОЙ РЕАЛЬНОСТИ В РЕАЛЬНОМ ВРЕМЕНИ | 2017 |

|

RU2656584C1 |

| СПОСОБ ВОЗДЕЙСТВИЯ НА ВИРТУАЛЬНЫЕ ОБЪЕКТЫ | 2008 |

|

RU2451982C1 |

| ВЗАИМОДЕЙСТВИЕ С ТРЕХМЕРНЫМ ВИРТУАЛЬНЫМ ДИНАМИЧЕСКИМ ОТОБРАЖЕНИЕМ | 2012 |

|

RU2604430C2 |

| СПОСОБ И СИСТЕМА ДЛЯ ФОРМИРОВАНИЯ ИЗОБРАЖЕНИЙ СОВМЕЩЕННОЙ РЕАЛЬНОСТИ | 2017 |

|

RU2660631C1 |

Изобретение относится к информационному процессору, способу обработки и носителю записи. Техническим результатом является обеспечение возможности использования площади пространства, отличной от секции дисплея (дисплея) PC или другого устройства вместо использования только секции дисплея для обработки данных на основе технологии смешанной реальности. Информационный процессор содержит модуль обработки координат для определения положения курсора внутри или вне области первой секции дисплея и вывода информации о его положении на секцию управления виртуальными объектами, если он расположен вне области первой секции дисплея; фотокамеру для получения изображения, состоящего из реального объекта, содержащего первую секцию дисплея; секцию анализа трехмерной информации положения реального объекта, содержащегося в этом изображении; вторую секцию дисплея для отображения полученного изображения; и секцию управления виртуальными объектами для создания виртуального объекта, отличного от реального объекта, и создания составного изображения, содержащего созданный виртуальный объект и реальный объект, отображаемого на второй секции дисплея, при этом секция управления виртуальными объектами выполнена с возможностью вычисления трехмерного положения курсора на основе информации о положении курсора, предоставляемой от модуля обработки координат для отображения на второй секции дисплея составного изображения, на котором объект помещен в вычисленное положение в качестве виртуального объекта. 3 н. и 6 з.п. ф-лы, 14 ил.

1. Информационный процессор, содержащий:

модуль обработки координат, выполненный с возможностью определения, находится ли положение курсора, то есть индикатора положения, отображаемого на первой секции дисплея, внутри или вне области первой секции дисплея, и вывода информации о положении курсора на секцию управления виртуальными объектами, если курсор расположен вне области первой секции дисплея;

фотокамеру, выполненную с возможностью получения изображения, состоящего из реального объекта, содержащего первую секцию дисплея;

секцию анализа трехмерной информации, выполненную с возможностью анализа трехмерного положения реального объекта, содержащегося в полученном фотокамерой изображении;

вторую секцию дисплея, выполненную с возможностью отображения изображения, полученного фотокамерой; и

секцию управления виртуальными объектами, выполненную с возможностью создания виртуального объекта, отличного от реального объекта, содержащегося в полученном фотокамерой изображении, и создания составного изображения, содержащего созданный виртуальный объект и реальный объект, для отображения составного изображения на второй секции дисплея,

при этом секция управления виртуальными объектами выполнена с возможностью вычисления трехмерного положения курсора на основе информации о положении курсора, предоставляемой от модуля обработки координат, для отображения на второй секции дисплея составного изображения, на котором объект помещен в вычисленное положение в качестве виртуального объекта.

2. Информационный процессор по п.1, содержащий:

секцию исполнения приложений, выполненную с возможностью обработки конкретного объекта, указанного индикатором положения, при этом

секция исполнения приложений выполнена с возможностью определять, расположен ли указанный конкретный объект внутри или вне области первой секции дисплея, и выводить информацию о положении объекта в секцию управления виртуальными объектами, если указанный объект расположен вне области первой секции дисплея, а

секция управления виртуальными объектами выполнена с возможностью вычислять трехмерное положение объекта на основе информации о положении объекта, предоставляемой от модуля обработки координат, для отображения на второй секции дисплея составного изображения, в котором указанный объект помещен в вычисленное положение в качестве виртуального объекта.

3. Информационный процессор по п.2, в котором,

если трехмерное положение объекта, вычисляемое на основе информации о положении объекта, предоставляемой от модуля обработки координат, содержит область отображения первой секции дисплея, секция управления виртуальными объектами выполнена с возможностью отображать на второй секции дисплея составное изображение с удаленным изображением области объекта, накладывающейся на область отображения первой секции дисплея.

4. Информационный процессор по п.1, дополнительно содержащий:

секцию получения информации об объекте, выполненную с возможностью получения данных изображения для реального объекта, указываемого курсором, помещенным в качестве виртуального объекта, и поиска данных на основе получаемых данных изображения для получения информации об объекте, при этом

секция получения информации об объекте выполнена с возможностью выводить полученную информацию об объекте в первую секцию дисплея в качестве данных отображения.

5. Информационный процессор по п.4, в котором

секция получения информации об объекте выполнена с возможностью обращения к базе данных, в которой данные изображения реального объекта и информация об объекте связаны друг с другом, или к серверу для получения информации об объекте посредством поиска на основе данных изображения для реального объекта.

6. Информационный процессор по п.1, в котором

секция управления виртуальными объектами выполнена с возможностью вычисления плоскости, содержащей поверхность отображения для первой секции дисплея, на основе информации о трехмерном положении компонентов, составляющих первую секцию дисплея, содержащуюся в полученном фотокамерой изображении, и вычисления трехмерного положения курсора, так чтобы положение курсора располагалось на указанной плоскости.

7. Информационный процессор по п.1, в котором

курсор является курсором мыши, перемещаемым при операциях с мышью, при этом

модуль обработки координат выполнен с возможностью приема информации о перемещении курсора мыши в результате операции с мышью и определения, находится ли курсор мыши внутри или вне области первой секции дисплея.

8. Способ обработки информации, выполняемый информационным процессором, содержащий:

этап обработки координат, на котором посредством модуля обработки координат определяют, находится ли положение курсора, то есть индикатора положения, отображаемого на первой секции дисплея, внутри или вне области первой секции дисплея, и выводят информацию о положении курсора в секцию управления виртуальными объектами, если курсор расположен вне области первой секции дисплея;

этап получения изображения, на котором посредством фотокамеры получают изображение реального объекта, содержащее первую секцию дисплея;

этап анализа трехмерной информации, на котором посредством секции анализа трехмерной информации анализируют трехмерное положение реального объекта, содержащегося в полученном фотокамерой изображении; и

этап управления виртуальным объектом, на котором посредством секции управления виртуальными объектами создают виртуальный объект, отличный от реального объекта, содержащегося в полученном фотокамерой изображении, и создают составное изображение, содержащее созданный виртуальный объект и реальный объект, для отображения составного изображения на второй секции дисплея, при этом

на этапе управления виртуальными объектами вычисляют трехмерное положение курсора на основе информации о положении курсора, предоставленной модулем обработки координат, для отображения на второй секции дисплея составного изображения, в котором курсор помещен в вычисленное положение в качестве виртуального объекта.

9. Носитель записи, содержащий программу, вызывающую выполнение информационным процессором обработки информации, содержащей:

этап обработки координат, на котором посредством модуля обработки координат определяют, располагается ли положение курсора, то есть индикатора положения, отображаемого на первой секции дисплея, внутри или вне области первой секции дисплея, и выводят информацию о положении курсора на секцию управления виртуальными объектами, если курсор расположен вне области первой секции дисплея;