Область техники, к которой относится изобретение

Настоящее изобретение относится к устройству обработки информации, способу обработки информации и программе. Конкретнее, настоящее изобретение относится к устройству обработки информации, способу обработки информации и программе, которые выполняют обработку данных с помощью смешанной реальности (Mixed Reality, MR), которая объединяет реальный объект в реальном мире с электронным отображением.

Уровень техники

Например, в случае, когда пользователь выполняет обработку данных с помощью персонального компьютера (ПК) (PC), этот пользователь выполняет обработку данных, отображенных на дисплейной секции (дисплее) этого ПК. Однако, например, в случае выполнения создания документа, если дисплейный размер листа, примененного для создания документа, становится больше, нежели размер (к примеру, размер окна) дисплейной секции ПК, невозможно отобразить весь лист на экране ПК, что заставляет выполнять работу, отображая только часть этого листа на экране.

То есть информация, которая выходит за экран, больше не отображается на экране ПК. При отображении области, которая выходит за экран ПК, хотя и возможно отображать эту область, выполняя обработку прокрутки, возникает проблема в том, что область, которая отображена до этого, становится скрытой в результате прокрутки. Хотя и возможно для отображения всего листа выполнять такую обработку как уменьшение масштаба всего листа или разделение экрана на два, но когда выполняется такая обработка, возникает проблема в том, что становится малым размер знаков, затрудняя выполнение работы.

Настоящее изобретение разрешает такую проблему с помощью такой обработки данных, которая использует, например, смешанную реальность. Следует отметить, что в качестве известного источника, описывающего смешанную реальность, существует, например, PTL1 (публикация выложенной заявки на патент Японии №2008-304268) и PTL2 (публикация выложенной заявки на патент Японии №2008-304269). Эти источники описывают процесс создания трехмерной карты реального мира с помощью заснятого фотокамерой изображения.

Список ссылок

Патентная литература

PTL1: публикация выложенной заявки на патент Японии №2008-304268.

PTL2: публикация выложенной заявки на патент Японии №2008-304269.

Сущность изобретения

Техническая проблема

Цель настоящего изобретения состоит в обеспечении устройства обработки информации, способа обработки информации и программы, которые генерируют составное изображение, в котором различные порции данных электронным образом прикрепляются к областям вне дисплейной секции (дисплея) в ПК или тому подобному, например, посредством обработки данных с помощью смешанной реальности (MR) и делает это составное изображение наблюдаемым, благодаря чему обеспечивается эффективное использование пространственной области вне дисплейной секции, которая используется в качестве основной рабочей области.

Решение проблемы

Первый объект настоящего изобретения относится к устройству обработки информации, включающему в себя:

- исполняющую приложение секцию, которая сохраняет неотображаемые данные и позиционную информацию этих неотображаемых данных в памяти при обработке данных с помощью первой дисплейной секции, причем неотображаемые данные граничат с отображенными данными первой дисплейной секции;

- секцию анализа трехмерной информации, которая анализирует трехмерную позицию реального объекта, включающего в себя первую дисплейную секцию, включенную в заснятое фотокамерой изображение;

- секцию управления виртуальным объектом, которая принимает ввод неотображаемых данных и позиционную информацию этих неотображаемых данных, которые сохранены в памяти, и трехмерную позиционную информацию первой дисплейной секции, проанализированную секцией анализа трехмерной информации, генерирует составное изображение, образованное реальным объектом, включенным в заснятое фотокамерой изображение, и виртуальным объектом, образованным неотображаемыми данными, и отображает это составное изображение на второй дисплейной секции,

при этом секция управления виртуальным объектом устанавливает дисплейную позицию виртуального объекта на второй дисплейной секции в позицию, расположенную в направлении распространения от границы отображаемых данных первой дисплейной секции, отображенной на второй дисплейной секции, наружу от первой дисплейной секции.

Далее, в варианте осуществления устройства обработки информации согласно настоящему изобретению секция управления виртуальным объектом преобразует координатные данные, которые являются позиционной информацией неотображаемых данных, сохраненной в памяти, "в координатную систему фотокамеры, служащую в качестве индикатора дисплейной позиции в дисплейном изображении второй дисплейной секции, и находит дисплейную позицию виртуального объекта за счет применения преобразованных координатных данных.

Далее, в варианте осуществления устройства обработки информации согласно настоящему изобретению секция управления виртуальным объектом решает, происходит ли пересечение между дисплейной позицией виртуального объекта, преобразованной в координатную систему фотокамеры, и плоскостью, формирующей реальный объект, включенный в заснятое фотокамерой изображение, и если это пересечение происходит, исполняет процесс повторного преобразования, чтобы позиционировать преобразованные координатные данные в плоскость, формирующую реальный объект, и находит дисплейную позицию виртуального объекта за счет применения повторно преобразованных координатных данных.

Далее, в варианте осуществления устройства обработки информации согласно настоящему изобретению устройство обработки информации включает в себя первое устройство, имеющее исполняющую приложение секцию, и второе устройство, имеющее секцию анализа трехмерной информации и секцию управления виртуальным объектом, и данные, сохраненные в первой памяти в первом устройстве, исполняющей приложение секцией, передаются во второе устройство посредством секции связи, а во втором устройстве секция анализа трехмерной информации и секция управления виртуальным объектом выполняют обработку, используя принятые данные.

Далее второй объект настоящего изобретения относится к способу обработки информации, который исполняется в устройстве обработки информации и включает в себя:

- этап исполнения приложения исполняющей приложение секции, сохраняющей неотображаемые данные и позиционную информацию этих неотображаемых данных в памяти при обработке данных с помощью первой дисплейной секции, причем неотображаемые данные граничат с отображенными данными первой дисплейной секции;

- этап анализа трехмерной информации секции анализа трехмерной информации, анализирующей трехмерную позицию реального объекта, включающего в себя первую дисплейную секцию, включенную в заснятое фотокамерой изображение; и

- этап управления виртуальным объектом секции управления виртуальным объектом, принимающей ввод неотображаемых данных и позиционную информацию этих неотображаемых данных, которые сохранены в памяти, и трехмерную позиционную информацию первой дисплейной секции, проанализированную секцией анализа трехмерной информации, генерирующей составное изображение, образованное реальным объектом, включенным в заснятое фотокамерой изображение, и виртуальным объектом, образованным неотображаемыми данными, и отображающей это составное изображение на второй дисплейной секции,

при этом этап управления виртуальным объектом имеет этап установления дисплейной позиции виртуального объекта на второй дисплейной секции в позиции, расположенной в направлении распространения от границы отображаемых данных первой дисплейной секции, отображенной на второй дисплейной секции, наружу от первой дисплейной секции.

Далее, третий объект настоящего изобретения относится к программе, вызывающей исполнение обработки информации в устройстве обработки информации, включающей в себя:

- этап исполнения приложения, заставляющий исполняющую приложение секцию сохранять неотображаемые данные и позиционную информацию этих неотображаемых данных в памяти при обработке данных с помощью первой дисплейной секции, причем неотображаемые данные граничат с отображенными данными первой дисплейной секции;

- этап анализа трехмерной информации, заставляющий секцию анализа трехмерной информации анализировать трехмерную позицию реального объекта, включающего в себя первую дисплейную секцию, включенную в заснятое фотокамерой изображение; и

- этап управления виртуальным объектом, заставляющий секцию управления виртуальным объектом принимать ввод неотображаемых данных и позиционную информацию этих неотображаемых данных, которые сохранены в памяти, и трехмерную позиционную информацию первой дисплейной секции, проанализированную секцией анализа трехмерной информации, генерировать составное изображение, образованное реальным объектом, включенным в заснятое фотокамерой изображение, и виртуальным объектом, образованным неотображаемыми данными, и отображать это составное изображение на второй дисплейной секции,

при этом этап управления виртуальным объектом имеет этап, заставляющий устанавливать дисплейную позицию виртуального объекта на второй дисплейной секции в позиции, расположенной в направлении распространения от границы отображаемых данных первой дисплейной секции, отображенной на второй дисплейной секции, наружу от первой дисплейной секции.

Следует отметить, что программа согласно настоящему изобретению представляет собой, например, программу, которая может быть представлена носителем данных или сетью передачи данных и которая предоставляется в машиночитаемом формате в устройство обработки информации или компьютерную систему, способные исполнять различные программные коды. Благодаря предоставлению такой программы в машиночитаемом формате обработки по этой программе могут быть реализованы в устройстве обработки информации или компьютерной системе.

Прочие цели, признаки и преимущества настоящего изобретения станут понятны из нижеследующего подробного описания вариантов осуществления настоящего изобретения и сопровождающих чертежей. Следует отметить, что выражение «система», как используется в данном описании, относится к логическому соединению множества устройств и не ограничивается тем, что составляющие устройства расположены в одном и том же корпусе.

Преимущественные эффекты изобретения

Согласно конфигурации варианта осуществления настоящего изобретения реализуется выполнение, при котором в различных видах дисплейных устройств, таких как персональный компьютер (ПК) (PC) и портативный телефон с дисплейной секцией, неотображаемые данные, которые выходят за область дисплейной секции, отображаются как виртуальный объект в позиции, граничащей с отображенными данными первой дисплейной секции. Это выполнение позволяет пользователю всегда наблюдать и просматривать не только данные, отображенные в ограниченной дисплейной области ПК или тому подобного, но также и данные, которые вышли за дисплейную секцию, благодаря чему улучшается эффективность обработки.

Краткое описание чертежей

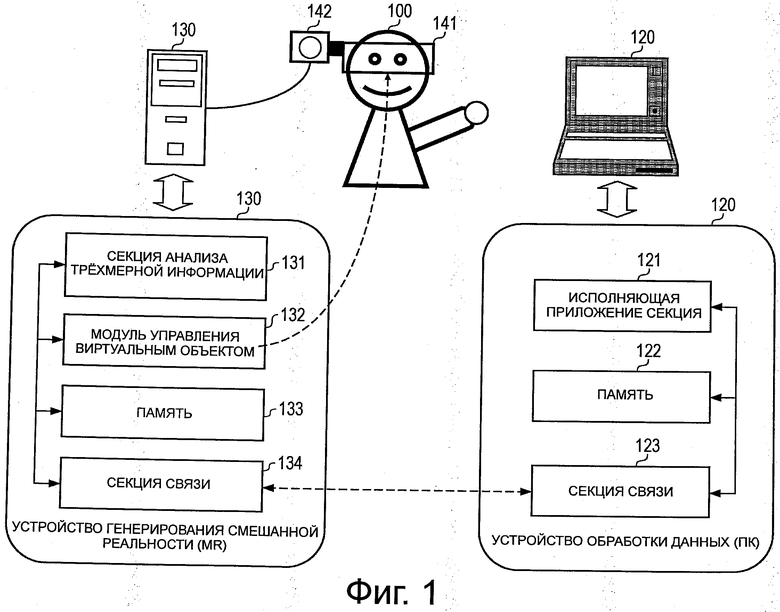

Фиг.1 является схемой, поясняющей конфигурацию варианта осуществления устройства обработки информации согласно настоящему изобретению.

Фиг.2 является схемой, поясняющей пример отображения виртуального объекта, исполняемого устройством обработки информации согласно настоящему изобретению.

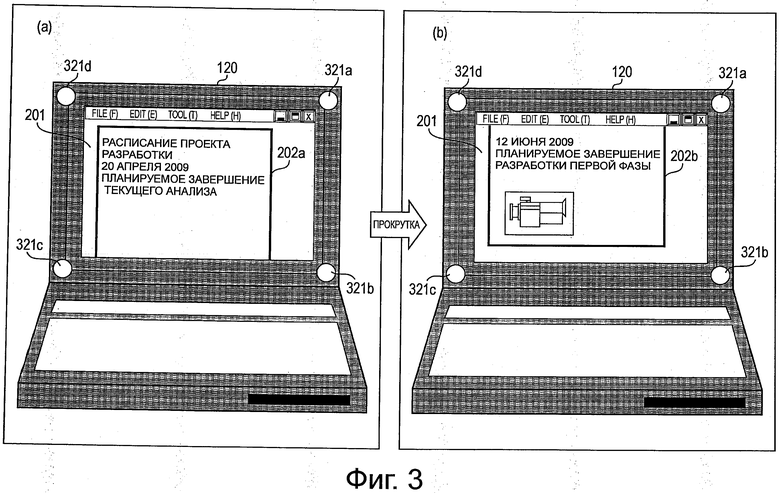

Фиг.3 является схемой, поясняющей пример обработки, исполняемый устройством обработки информации согласно настоящему изобретению.

Фиг.4 является схемой, поясняющей пример конкретной обработки, иллюстрирующий пример обработки, исполняемой устройством обработки информации согласно настоящему изобретению.

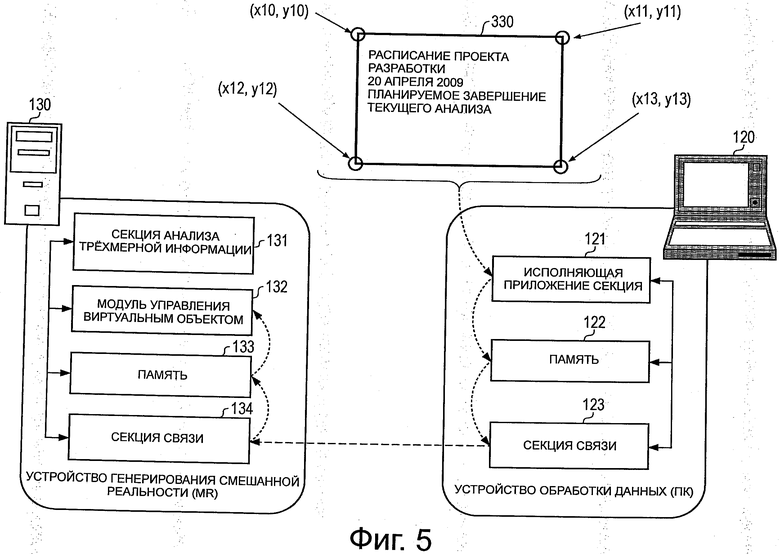

Фиг.5 является схемой, поясняющей пример конкретной обработки, иллюстрирующий пример обработки, исполняемой устройством обработки информации согласно настоящему изобретению.

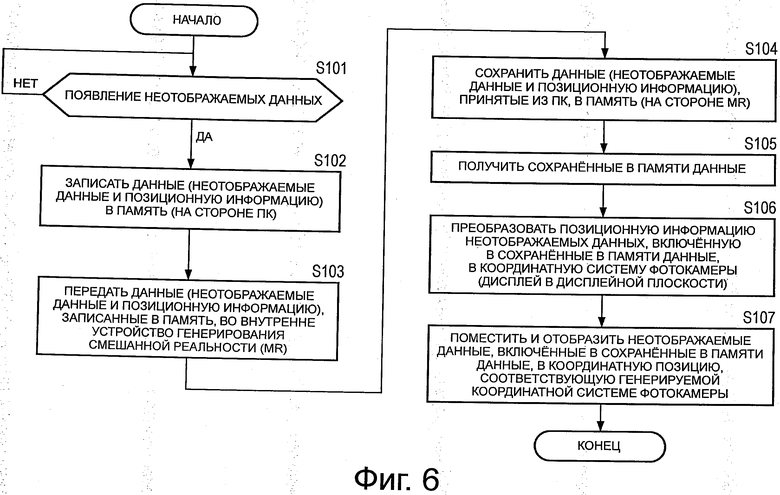

Фиг.6 является схемой, иллюстрирующей блок-схему алгоритма, поясняющую последовательность обработки, исполняемую устройством обработки информации согласно настоящему изобретению.

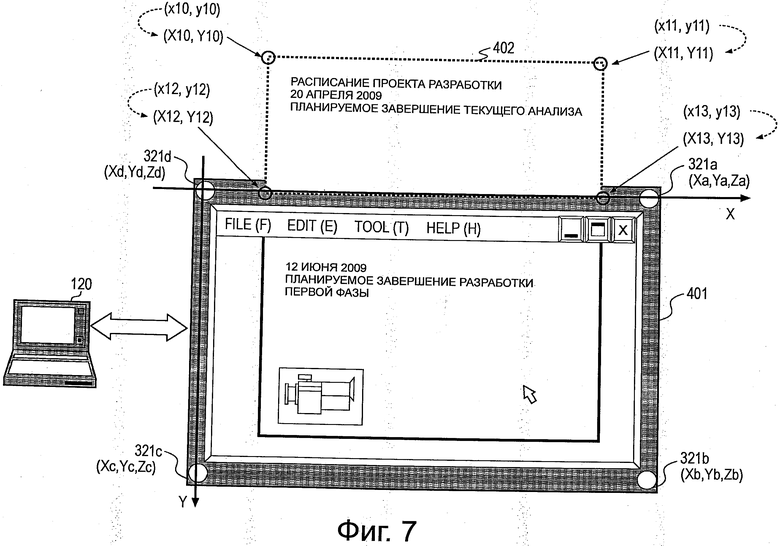

Фиг.7 является схемой, поясняющей пример конкретной обработки, иллюстрирующий пример обработки, исполняемой устройством обработки информации согласно настоящему изобретению.

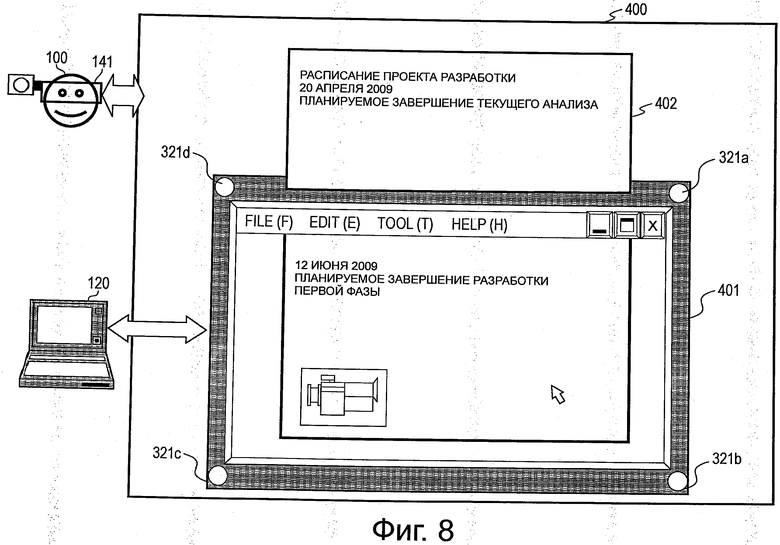

Фиг.8 является схемой, поясняющей пример конкретной обработки, иллюстрирующий пример обработки, исполняемой устройством обработки информации согласно настоящему изобретению.

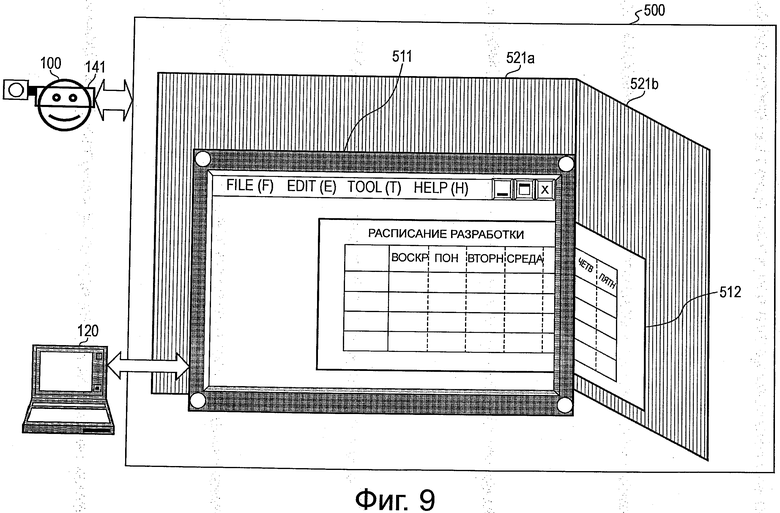

Фиг.9 является схемой, поясняющей пример конкретной обработки, иллюстрирующий пример обработки, исполняемой устройством обработки информации согласно настоящему изобретению.

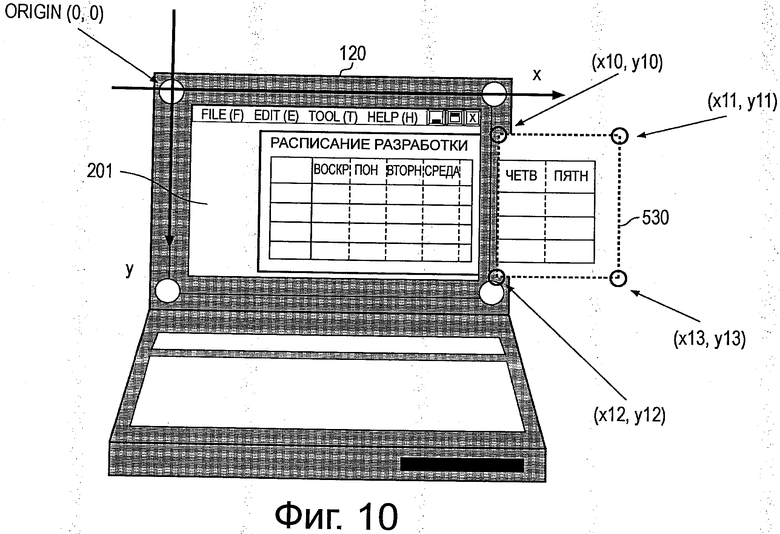

Фиг.10 является схемой, поясняющей пример конкретной обработки, иллюстрирующий пример обработки, исполняемой устройством обработки информации согласно настоящему изобретению.

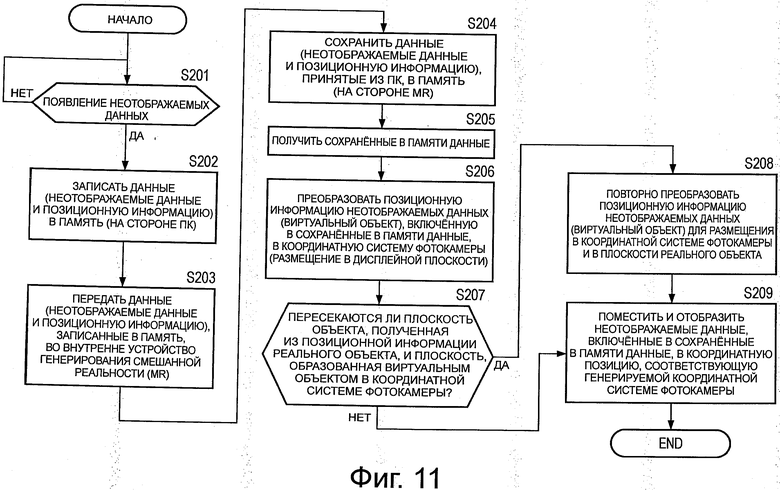

Фиг.11 является схемой, иллюстрирующей блок-схему алгоритма, поясняющую последовательность обработки, исполняемую устройством обработки информации согласно настоящему изобретению.

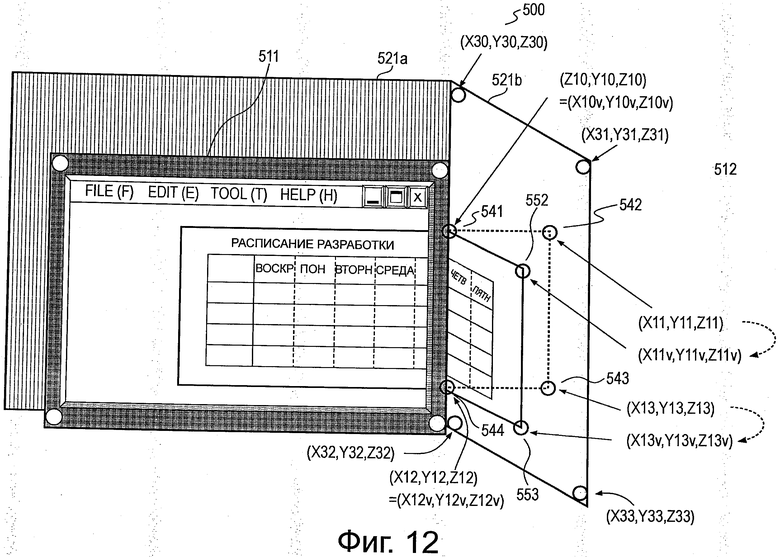

Фиг.12 является схемой, поясняющей пример конкретной обработки, иллюстрирующий пример обработки, исполняемой устройством обработки информации согласно настоящему изобретению.

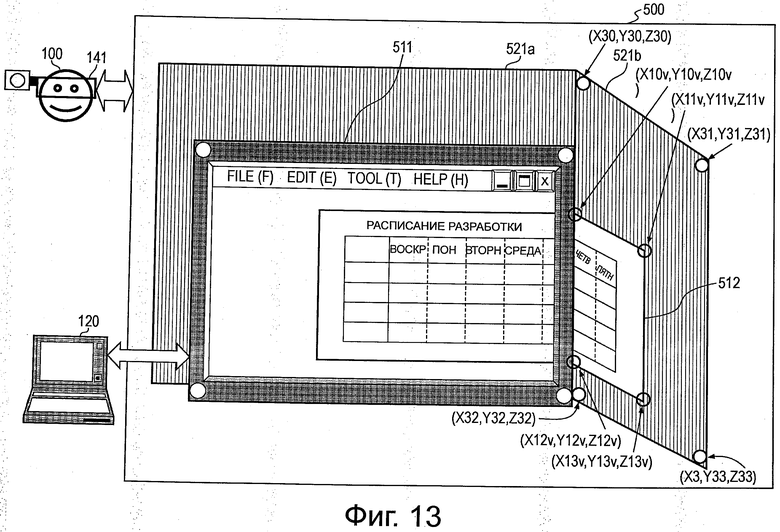

Фиг.13 является схемой, поясняющей пример конкретной обработки, иллюстрирующий пример обработки, исполняемой устройством обработки информации согласно настоящему изобретению.

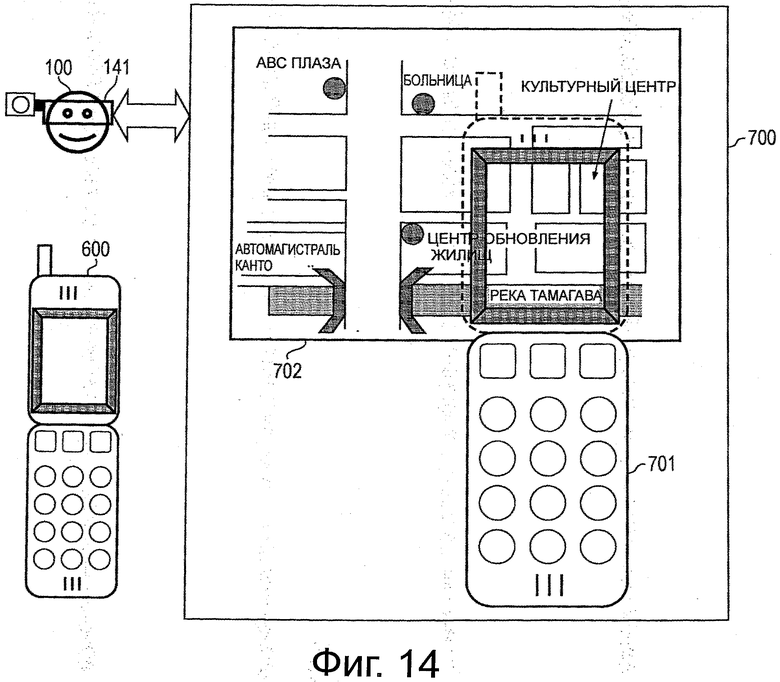

Фиг.14 является схемой, поясняющей пример конкретной обработки, иллюстрирующий пример обработки, исполняемой устройством обработки информации согласно настоящему изобретению.

Подробное описание изобретения

Ниже со ссылками на чертежи будут подробно описаны устройство обработки информации, способ обработки информации и программа согласно настоящему изобретению.

Настоящее изобретение будет описано по порядку в соответствии со следующими предметами:

1. В отношении примера выполнения и примера обработки устройства обработки информации согласно настоящему изобретению (Вариант осуществления 1).

2. Процесс отображения виртуального объекта, подогнанного к форме объекта в реальном мире (Вариант осуществления 2).

3. Пример обработки с помощью иного устройства отображения.

1. В отношении примера выполнения и примера обработки устройства обработки информации согласно настоящему изобретению

Пример выполнения и пример обработки устройства обработки информации согласно настоящему изобретению будут далее описаны со ссылкой на фиг.1. Фиг.1 является схемой, показывающей пример выполнения устройства обработки информации согласно настоящему изобретению.

Пользователь 100 выполняет различные виды обработки данных благодаря работе ПК (персонального компьютера) 120. Как показано на чертеже, ПК 120 имеет исполняющую приложение секцию 121, память 122 и секцию 123 связи. В исполняющей приложение секции 121 исполняется выбранная пользователем прикладная программа. Например, эта прикладная программа представляет собой создающее документ приложение или визуализирующее приложение. Память 122 образуется ОЗУ (RAM), ПЗУ (ROM) или тому подобным и используется в качестве области хранения или рабочей области для прикладной программы. Память 122 используется также, например, в качестве области хранения для неотображаемых данных, которые больше не отображаются на дисплейной секции (дисплее) ПК вследствие обработки прокрутки или тому подобного, что будет описано позже, и позиционной информации этих неотображаемых данных или тому подобного. Секция 123 связи выполняет обработку связи с внутренним устройством 130 генерирования смешанной реальности (MR).

Пользователь 100 носит очки 141, имеющие дисплей, который отображает виртуальный объект. Очки 1241 снабжены фотокамерой 142, которая снимает окружающую среду. Очки 141 и фотокамера 142 соединены с внутренним устройством 130 генерирования смешанной реальности. Пользователь 100 совершает работу, наблюдая изображение, отображенное на дисплее, предусмотренном на очках 141.

На дисплее очков 141 отображается изображение реального мира, которое представляет собой изображение, заснятое фотокамерой 141, а кроме того, виртуальный объект, генерируемый устройством 130 генерирования смешанной реальности, отображается вместе с изображением реального мира.

В примере по фиг.1 пользователь 100 работает на ПК (персональном компьютере) 120, и фотокамера 142 снимает ПК (персональный компьютер) 120, на котором работает пользователь 100, и отображаются разнообразные реальные объекты в его окружении. Далее, и виртуальный объект, генерируемый устройством 130 генерирования смешанной реальности, отображается наложенным на это изображение реального мира. По мере перемещения пользователя 100 изменяется и ориентация фотокамеры 142. Например, когда пользователь смотрит на свою собственную руку, изображение этой руки отображается как объект реального мира на дисплее очков 141, и вместе с изображением реального мира отображается виртуальный объект.

Когда пользователь 100 выполняет обработку, глядя на экран ПК 120, фотокамера 142 снимает изображение с центром на изображении экрана этого ПК 120. В результате, например, дисплейное изображение 150 дисплея, как показано на фиг.2, отображается на дисплее очков 141, которые носит пользователь 100. Дисплейное изображение 150 дисплея, показанное на фиг.2, является составным изображением реального объекта и виртуального объекта.

Перед тем как перейти к описанию фиг.2, будет описана конфигурация устройства 130 генерирования смешанной реальности (MR), показанного на фиг.1. Как показано на фиг.1, устройство 130 генерирования смешанной реальности (MR) имеет секцию 131 анализа трехмерной информации, модуль 132 управления виртуальным объектом, память 133 и секцию 134 связи.

Секция 131 анализа трехмерной информации выполняет процесс приема ввода изображения, заснятого фотокамерой 142, которую носит пользователь, и анализирования трехмерной позиции объекта, включенного в это заснятое изображение. Данный процесс анализирования трехмерной позиции исполняется как процесс, который применяет, например, SLAM (одновременная локализация и картографирование). SLAM представляет собой обработку, которая выбирает характерные точки из различных реальных объектов, включенных в заснятое фотокамерой изображение, и обнаруживает позиции выбранных характерных точек вместе с позицией (пространственным положением) фотокамеры. Следует отметить, что SLAM описана в PTL1 (публикация выложенной заявки на патент Японии №2008-304268) и PTL2 (публикация выложенной заявки на патент Японии №2008-304269), описанных выше. Следует отметить, что основная обработка SLAM описана в тезисах [Andrew J. Davidson, “Real-time simultaneous localization and mapping with a single camera” (Одновременная локализация и картографирование в реальном времени одной фотокамерой). Proceedings of the 9th International Conference on Computer Vision, Ninth, (2003)].

Секция 131 анализа трехмерной информации подсчитывает трехмерную позицию реального объекта, включенного в изображение, заснятое фотокамерой 142, которую носит пользователь, например, за счет применения вышеупомянутой SLAM. Следует, однако, отметить, что секция 131 анализа трехмерной информации может быть установлена для получения трехмерной позиции объекта, включенного в заснятое фотокамерой изображение, не только посредством вышеупомянутой SLAM, но также и иными способами.

Модуль 132 управления виртуальным объектом выполняет управление виртуальным объектом, подлежащим отображению на дисплее очков 141, которые носит пользователь. Виртуальный объект представляет собой данные, хранящиеся в памяти 133. Конкретно, например, дисплейное отображение 150 дисплея, показанное на фиг.2, отображается на дисплее очков 141, которые носит пользователь. Изображение 151 ПК, включенное в дисплейное изображение 150 дисплея, является реальным изображением, заснятым фотокамерой 142. Виртуальный объект 161, показанный на фиг.2, отображается вместе с реальным изображением (реальным объектом).

Пользователь 100, показанный на фиг.1, может наблюдать, например, составное изображение реального объекта и виртуального объекта, показанных на фиг.2, на дисплее очков 141. Изображение 151 ПК, показанное на фиг.2, представляет собой реальный объект, заснятый фотокамерой 142. Дисплейная секция 152 ПК в изображении 151 ПК также является реальным изображением. Часть документа, созданного пользователем, отображается на дисплейной секции 152 ПК.

С другой стороны, виртуальный объект, включенный в дисплейное изображение 150, показанное на фиг.2, не является объектом реального мира (реальным объектом). Виртуальный объект 161, показанный на фиг.2, является частью листа, обрабатываемого пользователем, который отображается в дисплейной секции 152 ПК в изображении 151 ПК.

Хотя пользователь оперирует ПК 120, показанным на фиг.1 для установления размера листа, и вводит знаки или тому подобное на лист установленного размера, размер листа такой большой, что лист выходит за дисплейную область ПК 120, и весь лист не отображается на дисплее этого ПК. Виртуальный объект 221, показанный на фиг.2, представляет собой неотображаемые данные, которые выходят за дисплейную область ПК 120. При обнаружении появления неотображаемых данных исполняющая приложение секция 121 в ПК 120 сохраняет эти неотображаемые данные и их позиционную информацию в памяти 122 внутри ПК 120.

Данные, сохраненные в памяти 122, передаются в устройство 130 генерирования смешанной реальности (MR) по связи между секцией 123 связи в ПК 120 и секцией 134 связи в устройстве 130 генерирования смешанной реальности (MR). Устройство 130 генерирования смешанной реальности (MR) сохраняет данные, принятые от ПК 120, память 133 внутри устройства 130 генерирования смешанной реальности (MR).

Модуль 132 управления виртуальным объектом устройства 130 генерирования смешанной реальности (MR) выполняет процесс отображения данных, сохраненных в памяти 133, в качестве виртуального объекта на дисплее очков 141, которые носит пользователь. Конкретно, например, модуль 132 управления виртуальным объектом выполняет процесс нахождения дисплейной позиции виртуального объекта и отображения виртуального объекта на найденной дисплейной позиции.

Пример, показанный на фиг.2, показывает случай, в котором виртуальный объект 161 отображается над дисплейной секцией 152 ПК в изображении 151 ПК, которое отображается в качестве реального объекта. Эта дисплейная позиция находится модулем 132 управления виртуальным объектом за счет применения позиционной информации, которая сохранена в памяти 122 вместе с неотображаемыми данными исполняющей приложение секцией 121 в ПК 120. Данная позиционная информация передается также из ПК 120 в устройство 130 генерирования смешанной реальности (MR) посредством связи.

Виртуальный объект 161, показанный на фиг.2, представляет собой неотображаемые данные, которые вышли за область дисплейной секции (дисплея) в ПК 120 вследствие режима работы пользователя 100 на ПК 120. Эти неотображаемые данные передаются в устройство 130 генерирования смешанной реальности (MR) посредством связи вместе с позиционной информацией и сохраняются в памяти 133 устройства 130 генерирования смешанной реальности (MR). С этими данными, сохраненными в памяти 133 в качестве виртуального объекта, устройство 130 генерирования смешанной реальности (MR) выполняет процесс нахождения дисплейной позиции виртуального объекта и отображает виртуальный объект на дисплее очков 141, которые носит пользователь.

Следует отметить, что в случае устройства, показанного на фиг.1, ПК 120 и устройство 130 генерирования смешанной реальности (MR) выполнены как два раздельных устройства, и передача данных выполняется между этими двумя устройствами. Однако возможно также выполнить ПК 120 и устройство 130 генерирования смешанной реальности (MR) как единое устройство, и в этом случае секцию связи каждого из устройств, показанных на фиг.1, можно опустить. Например, возможно также выполнить обработку в единственном ПК путем установки секции 131 анализа трехмерной информации и модуля 132 управления виртуальным объектом устройства 130 генерирования смешанной реальности (MR) в ПК 120.

То есть, хотя на фиг.1 ПК (персональный компьютер) 120 и устройство 130 генерирования смешанной реальности (MR) показаны как два отдельных устройства, устройство обработки информации согласно настоящему изобретению может быть устройством, выполненным исключительно посредством внутреннего устройства 130 генерирования смешанной реальности (MR) либо может быть устройством, выполненным двумя устройствами, составленными устройством 130 генерирования смешанной реальности (MR) и ПК 120. Альтернативно, устройство обработки информации может быть также выполнено посредством единственного устройства, которое объединяет функции этих двух устройств.

Далее со ссылкой на фиг.3 будет приведено описание примера конкретной обработки, к которому применено выполнение по фиг.1. Пользователь 100 исполняет создающее документ приложение в исполняющей приложение секции 121 в ПК 120 и создает документ с создаваемым документом, отображенным на дисплейной секции 201 в ПК 120, как показано на фиг.3(а). Лист 202а подлежащего созданию документа отображается на дисплейной секции 121 в ПК 120, и пользователь вводит символы или тому подобное в лист 202а. На дисплейной секции 201 отображается примерно половина листа 202а, а остальное скрыто.

По мере прохождения создания документа пользователь перемещает (прокручивает) лист 202а и продолжает работу по вводу, отображая нижнюю половину. То есть, как показано на фиг.3(b), отображается нижний край листа 202а подлежащего созданию документа, и пользователь может вводить символы или тому подобное в лист 202а документа. Однако в состоянии, показанном на фиг.3(b), на дисплейной секции 201 отображается только нижняя половина листа 202b, а остальная часть области на верхнем краю лежит вне области дисплейной секции 201 и не видна пользователю.

В устройстве согласно настоящему изобретению данные, которые выходят за область дисплейной секции 201, то есть неотображаемые данные, временно сохраняются в памяти 122 в ПК 120 вместе с позиционной информацией. Затем эти неотображаемые данные передаются в устройство 130 генерирования смешанной реальности (MR) посредством секции 123 связи вместе с позиционной информацией. Устройство 130 генерирования смешанной реальности (MR) сохраняет данные, принятые из ПК 120, то есть неотображаемые данные и позиционную информацию, в памяти 133 внутри устройства 130 генерирования смешанной реальности (MR).

Секция 131 анализа трехмерной информации в устройстве 130 генерирования смешанной реальности (MR) принимает ввод изображения, заснятого фотокамерой 142, которую носит пользователь 100, и вычисляет трехмерную позицию объекта, включенного в заснятое изображение путем применения, например, вышеописанной SLAM. Например, секция 131 анализа трехмерной информации выбирает маркеры 321а-321d, которые установлены в четырех углах дисплея ПК, показанного на фиг.3, в качестве характерных точек и подсчитывает трехмерные позиции этих характерных точек.

Следует отметить, что хотя пример, показанный на фиг.3, иллюстрирует пример, в котором маркеры 321а-321d установлены для идентификации характерных точек, устанавливать такие маркеры необязательно. Возможно также обнаруживать форму реального объекта, например угловую часть (угол) реального объекта, включенного в изображение, выбирать обнаруженную угловую часть (угол) в качестве характерной точки и оценивать трехмерную позицию этой характерной точки. Следует отметить, что процесс обнаружения угловой части (угла) может исполняться за счет процесса выделения характерных точек с помощью существующего детектора углов Харриса.

Следует отметить, что секция 131 анализа трехмерной информации может быть выполнена с возможностью иметь функцию обнаружения конкретного объекта из заснятого изображения. Конкретно, например, если форма ПК и информация признаков регистрируются заранее и экранная область ПК определяется применением этой зарегистрированной информации, экранную область ПК возможно определить из заснятого изображения точно и быстро.

Модуль 132 управления виртуальным объектом получает трехмерную позиционную информацию реального объекта, включенного в заснятое фотокамерой изображение, из секции 131 анализа трехмерной информации. Например, модуль 312 анализа трехмерной информации получает позиционную информацию четырех точек вокруг дисплейной секции ПК. Далее модель 132 управления виртуальным объектом получает неотображаемые данные, сохраненные в памяти 133, то есть неотображаемые данные, которые вышли за экран ПК во время работы ПК 120, и отображает полученные данные как виртуальный объект на дисплее очков 141 пользователя 100.

Дисплейная позиция виртуального объекта находится модулем 132 управления виртуальным объектом. Дисплейную позицию находят применением позиционной информации неотображаемых данных, принятых из ПК 120, и трехмерной позиционной информации реального объекта в заснятом фотокамерой изображении, полученном из секции 131 анализа трехмерной информации.

Модуль 132 управления виртуальным объектом устанавливает дисплейную позицию виртуального объекта по отношению к дисплею очков 141 пользователя 100 в направлении распространения от границы отображаемых данных дисплейной секции ПК, отображенной на дисплее очков 141, наружу от дисплейной секции ПК. То есть, модуль 312 управления виртуальным объектом генерирует и отображает составное изображение, в котором виртуальный объект 161 устанавливается в такой позиции, что и позиция в отображаемых данных 150 на фиг.2. За счет такого процесса отображения пользователь способен наблюдать весь подлежащий обработке лист без ощущения чувства диссонанса.

Со ссылкой на фиг.4 будет дано описание позиционной информации неотображаемых данных, которые сохранены в памяти 122 исполняющей приложение секцией 121 в ПК 120.

Когда появляются неотображаемые данные, которые больше не отображаются на экране вследствие, например, операции прокрутки, исполняющая приложение секция 121 в ПК 120 сохраняет эти неотображаемые в памяти 122. В примере по фиг.4 содержимое 330 данных в неотображаемых данных, обозначенное пунктирным прямоугольником, сохраняется в памяти 122 в ПК 120.

Далее, исполняющая приложение секция 121 в ПК 120 устанавливает конкретное положение в качестве исходного в плоскости, определяющей дисплейную секцию 201 ПК, принятой в качестве плоскости х-у. В примере, показанном на чертеже, точка вверху слева дисплейной секции 201 принята в качестве исходной точки 350.

Плоскость, параллельная дисплейной секции 201, устанавливается принятием горизонтального направления в качестве оси х и вертикального направления в качестве оси у. Эта система координат устанавливается в качестве системы координат, соответствующей дисплейной секции ПК. Исполняющая приложение секция 121 получает позицию неотображаемых данных 330 в этой системе координат, соответствующей дисплейной секции ПК.

Координаты четырех углов неотображаемых данных 330, показанных на фиг.4, являются, как показано на чертеже, координатами следующих четырех точек:

(х10, у10),

(x11, y11),

(х12, у12),

(х13, у13).

Следует отметить, что, хотя в примере, показанном на фиг.4, позиционная информация неотображаемых данных представлена координатами четырех углов неотображаемых данных, требуемая позиционная информация меняется с формой неотображаемых данных. Исполняющая приложение секция 121 исполняет процесс получения позиционной информации согласно форме неотображаемых данных, которая становится необходимой при отображении неотображаемых данных в качестве виртуальных данных, и сохранения позиционной информации в памяти 122.

В случае неотображаемых данных 330 в прямоугольной форме, как показано на фиг.4, координатные данные каждого из четырех углов получаются в качестве позиционной информации неотображаемых данных. Последующая обработка будет описана со ссылкой на фиг.5. Как показано на фиг.5, исполняющая приложение секция 121 сохраняет эти четыре фрагмента координатных данных в качестве позиционной информации неотображаемых данных в памяти 122 вместе с сущностными данными неотображаемых данных.

Неотображаемые данные, сохраненные в памяти 122 на стороне ПК 120, и их позиционная информация передаются в устройство 130 генерирования смешанной реальности (MR) через секцию связи и сохраняются в памяти 133 устройства 130 генерирования смешанной реальности (MR).

Модуль 132 управления виртуальным объектом в устройстве 130 генерирования смешанной реальности (MR) находит дисплейную позицию виртуального объекта (неотображаемых данных) за счет применения позиционной информации неотображаемых данных, принятой таким образом из ПК 120, и трехмерной позиционной информации реального объекта в заснятом фотокамерой изображении, полученном из секции 131 анализа трехмерной информации. Посредством этого процесса отображаемые данные 150, описанные ранее со ссылкой на фиг.2, генерируются и отображаются на дисплее, установленном в очках 141 пользователя 100.

Со ссылкой на блок-схему алгоритма, показанную на фиг.6, будет описана последовательность обработки в устройстве обработки информации согласно настоящему изобретению.

Процессы на этапах S101-S103 на блок-схеме алгоритма, показанной на фиг.6, являются процессами в ПК 120, показанном на фиг.1.

Процессы на этапах S104-S107 являются процессами в устройстве 130 генерирования смешанной реальности (MR), показанном на фиг.1.

Сначала, когда на этапе S101 исполняющая приложение секция 121 в ПК 120 обнаруживает появление неотображаемых данных, которые выходят за область дисплейной секции ПК, на этапе S102 исполняющая приложение секция 121 сохраняет сущностные данные неотображаемых данных и их позиционную информацию в памяти 122 в ПК 120. Этот процесс представляет собой процесс, описанный со ссылкой на фиг.4 и фиг.5. Позиционная информация неотображаемых данных представляет собой, например, координатные данные каждого из четырех углов неотображаемых данных в плоскости дисплейной секции ПК.

Затем на этапе S103 неотображаемые данные и позиционная информация, сохраненные в памяти, переносятся в устройство 130 генерирования смешанной реальности (MR) посредством секции связи.

Процессы на этапе S104 и далее выполняются как процессы в устройстве 130 генерирования смешанной реальности (MR).

Сначала на этапе S104 устройство 130 генерирования смешанной реальности (MR) сохраняет неотображаемые данные и их позиционную информацию, переданные из ПК 120, в памяти 133 на стороне устройства 130 генерирования смешанной реальности (MR).

Затем на этапе S105 модуль 132 управления виртуальным объектом в устройстве 130 генерирования смешанной реальности (MR) получает данные, сохраненные в памяти 133, то есть неотображаемые данные и их позиционную информацию.

На этапе S106 модуль 132 управления виртуальным объектом выполняет процесс передачи позиционной информации неотображаемых данных, полученных из памяти 133, в координатную систему фотокамеры, соответствующую заснятому фотокамерой изображению, полученному из секции 131 анализа трехмерной информации.

Этот процесс будет описан со ссылкой на фиг.7. Секция 131 анализа трехмерной информации имеет ранее полученную трехмерную позиционную информацию каждого из маркеров 321a-321d в четырех углах дисплейной секции ПК 120, включенной в заснятое фотокамерой изображение. Как показано на фиг.7, получены следующие фрагменты позиционной информации:

Маркер 321a=(Ха, Ya, Za),

Маркер 321b=(Xb, Yb, Zb),

Маркер 321с=(Хс, Yc, Zc),

Маркер 321d=(Xd, Yd, Zd).

На основе этой трехмерной информации модуль 132 управления виртуальным объектом вычисляет плоскость дисплейной секции ПК, которая является реальным объектом в координатной системе фотокамеры, и исполняет преобразование координат, чтобы установить неотображаемые данные 330, полученные из ПК 120, в вычисленной плоскости. Позиция листа в дисплейной секции ПК также включается в заснятое фотокамерой изображение, и преобразование координат исполняется так, чтобы установить неотображаемые данные 330, полученные из ПК 120, в соответствии с позицией листа в дисплейной секции ПК, полученной из фотокамеры. Следует отметить, что когда координатная система фотокамеры устанавливается таким образом, что плоскость дисплейной секции ПК в заснятом фотокамерой изображении принимается в качестве плоскости XY, а направление, перпендикулярное дисплейной секции ПК, принимается в качестве оси Z, координаты по оси Z для четырех маркеров становятся все равны 0, тем самым давая возможность установки, которая не использует координату по оси Z.

Преобразование координат может исполняться таким путем, что координаты четырех углов неотображаемых данных, ранее принятых из ПК 120, устанавливаются в плоскости XY, определяемой плоскостью дисплейной секции ПК, показанной на фиг.7. Как показано на фиг.7, позиционные координаты четырех углов неотображаемых данных 330 в координатной системе (х, у), соответствующей дисплейной секции ПК, преобразуются следующим образом в координаты в координатной системе (X, Y) фотокамеры:

(x10, y10)→(X10, Y10),

(x11, y11)→(X11, Y11),

(х12, у12)→(Х12, Y12),

(x13, y13)→(X13, Y13).

Модуль 132 управления виртуальным объектом устанавливает эти координаты в качестве дисплейной позиции виртуального объекта. При этом на этапе S106 блок-схемы алгоритма, показанной на фиг.6, модуль 132 управления виртуальным объектом выполняет процесс преобразования позиционной информации неотображаемых данных, полученных из памяти 133, в координатную систему фотокамеры, соответствующую заснятому фотокамерой изображению, полученному из секции 131 анализа трехмерной информации.

На этапе S107 модуль 132 управления виртуальным объектом исполняет процесс отображения неотображаемых данных, полученных из памяти 133, в качестве виртуального объекта в дисплейной позиции виртуального объекта, вычисленной на этапе S106.

Посредством этого процесса отображаемые данные 400, показанные на фиг.8, отображаются на дисплее очков 141, которые носит пользователь 100. Отображаемые данные 400, показанные на фиг.8, представляют составное изображение, в котором ПК 401 в качестве реального объекта и виртуальный объект 402 отображаются вместе. Как показано на фиг.8, модуль 132 управления виртуальным объектом устанавливает дисплейную позицию виртуального объекта в направлении распространения от границы отображаемых данных дисплейной секции ПК наружу от дисплейной секции ПК. За счет такого процесса отображения пользователь способен наблюдать весь подлежащий обработке лист без ощущения чувства диссонанса.

Посредством этого процесса для пользователя 100 возможно всегда видеть также неотображаемые данные, которые выходят за дисплейную секцию в ПК, в качестве виртуального объекта вместе с данными, отображенными на дисплейной секции в ПК.

Следует отметить, что обработка, описанная со ссылкой на блок-схему алгоритма, показанную на фиг.6, выполняется каждый раз, когда пользователь оперирует с ПК 120 и диапазон неотображаемых данных изменяется, например, вследствие процесса прокрутки или тому подобного. Исполняющая приложение секция 121 исполняет обновление данных, сохраненных в памяти 122, каждый раз, когда происходит изменение в области или содержании неотображаемых данных. Обновленные данные передаются в устройство 130 генерирования смешанной реальности (MR). Устройство 130 генерирования смешанной реальности (MR) в качестве процесса обновления в реальном времени исполняет процесс изменения вида отображения виртуального объекта на основе этих обновленных данных.

2. Процесс отображения виртуального объекта, подогнанного к форме объекта в реальном мире

Далее в качестве второго варианта осуществления настоящего изобретения будет дано описание процесса отображения виртуального объекта, подогнанного к форме объекта в реальном мире.

В описанном выше варианте осуществления отображение виртуального объекта выполняется укрупнением плоскости, соответствующей экрану ПК. Однако, например, как показано на фиг.9, имеются случаи, в которых плоскость дисплейной секции ПК загораживается стенкой 521 в реальном мире. Если в таких случаях исполняется описанный выше процесс отображения виртуального объекта, этот виртуальный объект отображается проникающим через эту стенку, и в результате пользователь наблюдает данные, которые вызывают чувство диссонанса.

Ниже, как показано на фиг.9, отображаемые данные 500 генерируются и представляются пользователю. То есть виртуальный объект 512 отображается в соответствии с формой реального объекта (например, стенки 521а и 521b, показанные на фиг.9) в реальном мире.

Данный вариант осуществления представляет собой вариант осуществления, который дает возможность отображать виртуальный объект 512 параллельно объекту реального мира. Например, как показано на фиг.9, возможно отображать виртуальный объект 512 параллельно поверхности стенки 521b, которая является реальным объектом. Следует отметить, что и в данном варианте осуществления в качестве аппаратного выполнения применяется конфигурация, описанная со ссылкой на фиг.1.

Со ссылкой на фиг.10 будет приведено описание позиционной информации неотображаемых данных, которая сохраняется в памяти 122 исполняющей приложение секцией 121 в ПК 120 в данном варианте осуществления. Когда неотображаемые данные, которые больше не отображаются на экране, появляются вследствие, например, операции прокрутки, исполняющая приложение секция 121 в ПК 120 сохраняет эти неотображаемые данные в памяти 122. В примере по фиг.10 содержание данных неотображаемых данных 530, обозначенных пунктирным прямоугольником, сохраняется в памяти 122 в ПК 120.

Далее, как и в ранее описанном варианте осуществления, исполняющая приложение секция 121 в ПК 120 устанавливает плоскость, параллельную дисплейной секции 201 принятием точки вверху слева дисплейной секции 201 в качестве исходной, горизонтальное направление в качестве оси х, а вертикальное направление в качестве оси у. Эту координатную систему устанавливают в качестве координатной системы, соответствующей дисплейной секции ПК. Исполняющая приложение секция 121 получает позицию неотображаемых данных 530 в данной координатной системе, соответствующей дисплейной секции ПК.

Координатами четырех углов неотображаемых данных 530, показанных на фиг.10, являются, как показано на чертеже, координаты следующих четырех точек:

(х10, у10),

(х11, у11),

(х12, у12),

(х13, у13).

Неотображаемые данные, сохраненные в памяти 122 на стороне ПК 120, и их позиционная информация передаются в устройство 130 генерирования смешанной реальности (MR) через секцию связи и сохраняются в памяти 133 устройства 130 генерирования смешанной реальности (MR).

Модуль 132 управления виртуальным объектом в устройстве 130 генерирования смешанной реальности (MR) находит дисплейную позицию виртуального объекта (неотображаемых данных) за счет применения позиционной информации неотображаемых данных, принятых таким образом из ПК 120, и трехмерной позиционной информации реального объекта в заснятом фотокамерой изображении, полученном из секции 131 анализа трехмерной информации.

В данном варианте осуществления генерируются отображаемые данные 500, описанные со ссылкой на фиг.9. То есть дисплейная позиция виртуального объекта находится таким образом, что виртуальный объект отображается параллельно поверхности реального объекта.

Со ссылкой на блок-схему алгоритма, показанную на фиг.11, будет описана последовательность обработки в устройстве обработки информации согласно настоящему изобретению.

Обработка на этапах S201-S203 в блок-схеме алгоритма, показанной на фиг.11, представляет собой обработку в ПК 120, показанном на фиг.1.

Обработка на этапах S204-S209 представляет собой обработку в устройстве 130 генерирования смешанной реальности (MR), показанном на фиг.1.

Сначала, когда на этапе S201 исполняющая приложение секция 121 в ПК 120 обнаруживает появление неотображаемых данных, которые выходят за область дисплейной секции ПК, на этапе S202 исполняющая приложение секция 121 сохраняет сущностные данные неотображаемых данных и их позиционную информацию в памяти 122 в ПК 120. Данный процесс представляет собой процесс, описанный со ссылкой на фиг.10. Позиционная информация неотображаемых данных представляет собой, например, координатные данные каждого из четырех углов неотображаемых данных в плоскости дисплейной секции ПК.

Затем на этапе S203 неотображаемые данные и позиционная информация, сохраненные в памяти, передаются в устройство 130 генерирования смешанной реальности (MR) через секцию связи.

Обработка от этапа S204 и далее выполняется как обработка в устройстве 130 генерирования смешанной реальности (MR).

Сначала на этапе S204 устройство 130 генерирования смешанной реальности (MR) сохраняет неотображаемые данные и их позиционные данные, переданные из ПК 120, в памяти 133 на стороне устройства 130 генерирования смешанной реальности (MR).

Затем на этапе S205 модуль 132 управления виртуальным объектом в устройстве 130 генерирования смешанной реальности (MR) получает данные, сохраненные в памяти 133, то есть неотображаемые данные и их позиционную информацию.

На этапе S206 модуль 132 управления виртуальным объектом выполняет процесс преобразования позиционной информации неотображаемых данных, полученной из памяти 133, в координатную систему фотокамеры, соответствующую заснятому фотокамерой изображению, полученному из секции 131 анализа трехмерной информации.

Этот процесс является таким же процессом, как и процесс на этапе S106 блок-схемы алгоритма, показанной на фиг.6, описанный ранее как процесс согласно первому варианту осуществления.

То есть секция 131 анализа трехмерной информации получает трехмерную позиционную информацию каждого из маркеров 321a-321d в четырех углах дисплейной секции ПК 120, включенной в заснятое фотокамерой изображение. Как описано ранее со ссылкой на фиг.7, получают следующие фрагменты позиционной информации:

Маркер 321а=(Ха, Ya, Za).

Маркер 321b=(Xb, Yb, Zb).

Маркер 321с=(Xc, Yc, Zc).

Маркер 321d=(Xd, Yd, Zd).

На основе этой трехмерной позиционной информации модуль 132 управления виртуальным объектом вычисляет плоскость дисплейной секции ПК, которая является реальным объектом, в координатной системе фотокамеры и исполняет преобразование координат, чтобы установить неотображаемые данные 530, полученные из ПК 120, в вычисленной плоскости. Позиция листа в дисплейной секции ПК также включается в заснятое фотокамерой изображение, и преобразование координат исполняется так, чтобы установить неотображаемые данные 330, полученные из ПК 120, в соответствии с позицией листа в дисплейной секции ПК, полученной из фотокамеры.

При данном преобразовании координат преобразование координат осуществляется таким образом, что координаты четырех углов неотображаемых данных, принятых ранее из ПК 120, устанавливаются в плоскости XY, определяемой плоскостью дисплейной секции ПК. Позиционные координаты четырех углов неотображаемых данных 330 в координатной системе (х, у, z), соответствующей дисплейной секции ПК, преобразуются в координаты в координатной системе (X, Y, Z) фотокамеры следующим образом:

(х10, у10, z10)→(X10, Y10, Z10),

(x11, y11, z11)→(X11, Y11, Z11),

(х12, у12, z12)→(X12, Y12, Z12),

(х13, у13, z13)→(X13, Y13, Z13).

Следует отметить, что в данном варианте осуществления в отличие от предыдущего варианта осуществления обработка выполняется за счет принятия во внимание также и направления по оси Z.

На этапе S207 модуль 132 управления виртуальным объектом решает, пересекается ли плоскость реального объекта плоскостью, полученной четырьмя координатами в координатной системе фотокамеры, указывающими дисплейную позицию виртуального объекта, полученную процессом преобразования на этапе S206. Плоскость реального объекта получена из трехмерной позиционной информации реального объекта, полученной секцией 131 анализа трехмерной информации.

Если дисплейная плоскость виртуального объекта не пересекает плоскости реального объекта, на этапе S207 принимается решение «Нет». В этом случае обработка переходит к этапу S209 и виртуальный объект отображается за счет применения преобразованных координат, вычисленных на этапе S206. Этот процесс является таким же процессом, как и в ранее описанном первом варианте осуществления, в котором виртуальный объект отображается в плоскости, полученной укрупнением плоскости дисплейной секции ПК.

С другой стороны, если на этапе S207 принято решение, что плоскость, полученная четырьмя координатами в координатной системе фотокамеры, указывающей дисплейную позицию виртуального объекта, полученную посредством процесса преобразования на этапе S206, пересекает плоскость реального объекта, обработка переходит к этапу S208.

То есть это соответствует случаю состояния, как показано на фиг.9. В этом случае на этапе S208 выполняется процесс повторного преобразования координат, указывающих дисплейную позицию виртуального объекта. То есть выполняется процесс повторного преобразования координат, указывающих дисплейную позицию виртуального объекта, вычисленную на этапе S206.

Этот процесс преобразования выполняется как процесс такого преобразования четырех координат, указывающих дисплейную позицию виртуального объекта, что координаты устанавливаются в плоскости, образующей реальный объект. Данный процесс будет описан со ссылкой на фиг.12.

На этапе S206 координаты четырех углов, указывающие вычисленную дисплейную позицию виртуального объекта, представляют собой точки 541-544, показанные на фиг.12. Как показано на чертеже, эти координаты являются следующими координатами:

Точка 541=(X10, Y10, Z10).

Точка 542=(X11, Y11, Z11).

Точка 543=(Х12, Y12, Z12).

Точка 544=(Х13, Y13, Z13).

Однако плоскость, представленная этими четырьмя точками, пересекает плоскость стенки 521, которая является реальным объектом. Следует отметить, что плоскость, образующая стенку 521 в качестве реального объекта, получается посредством анализа секцией 131 анализа трехмерной информации. Например, в точках в четырех углах стенки, показанной на фиг.12, обнаруживаются в качестве характерных точек, и о плоскости, образованной этими четырьмя точками, принимается решение как о плоскости, образующей стенку 521, которая является реальным объектом.

В примере, показанном на фиг.12, плоскость стенки 521b определяется следующими четырьмя координатами, представляющими координаты четырех углов:

(Х30, Y30, Z30).

(X31, Y31, Z31).

(Х32, Y32, Z32).

(Х33, Y33, Z33).

Модуль 132 управления виртуальным объектом преобразует координаты четырех точек 541-544 виртуального объекта, чтобы развернуть четыре точки 541-544 виртуального объекта, показанного на фиг.12, в плоскости, образующей упомянутую выше стенку 521b. В результате этого получается преобразование координат, как показано на чертеже.

Точка 541 (Х10, Y10, Z10)→После преобразования (X10v, Y10v, Z10v) (=точка 541)

Точка 542 (X11, Y11, Z11)→После преобразования (X11v, Y11v, Z11v) (=точка 552)

Точка 543 (Х12, Y12, Z12)→После преобразования (X12v, Y12v, Z12v) (=точка 553)

Точка 544 (Х13, Y13, Z13)→После преобразования (X13v, Y13v, Z13v) (=точка 544)

Таким образом вычисляются четыре преобразованных координаты. Следует отметить, что, как понятно из чертежа, точка 541 и точка 544 остаются неизменными координатной позиции до и после этого преобразования.

Что же касается точки 542 и точки 543, расположенных в позициях, проникающих стенку 521b, то выполняется процесс преобразования этих точек в позиции в плоскости стенки 521b.

После такого процесса преобразования координат на этапе S208 обработка переходит к этапу S209. На этапе S209 за счет принятия неотображаемых данных, полученных из памяти 133, в качестве виртуального объекта модуль 132 управления виртуальным объектом исполняет процесс отображения виртуального объекта в дисплейной позиции виртуального объекта, вычисленной на этапе S208.

Посредством этого процесса, например, отображаемые данные 500, показанные на фиг.13, отображаются на дисплее очков 141, которые носит пользователь 100. Отображаемые данные 500, показанные на фиг.13, представляют составное изображение, в котором вместе отображаются ПК 511 в качестве реального объекта и виртуальный объект 512.

Пользователь 100 всегда может видеть также неотображаемые данные, которые выходят за дисплейную секцию ПК в качестве виртуального объекта, вместе с отображаемыми данными дисплейной секции ПК.

Следует отметить, что обработка, описанная со ссылкой на блок-схему алгоритма, показанную на фиг.11, выполняется каждый раз, когда пользователь оперирует с ПК 120 и диапазон неотображаемых данных изменяется, например, вследствие процесса прокрутки или тому подобного. Исполняющая приложение секция 121 исполняет обновление данных, сохраненных в памяти 122, каждый раз, когда происходит изменение в области или содержании неотображаемых данных. Обновленные данные передаются в устройство 130 генерирования смешанной реальности (MR). Устройство 130 генерирования смешанной реальности (MR) в качестве процесса обновления в реальном времени исполняет процесс изменения вида отображения виртуального объекта на основе этих обновленных данных.

3. Пример обработки с помощью иного устройства отображения

В описанных выше вариантах осуществления описание направлено на выполнение, которое позволяет пользователю наблюдать в качестве виртуального объекта данные, которые больше не отображаются на дисплейном экране ПК при работе с ПК.

Однако обработка, к которой применяется настоящее изобретение, то есть процесс отображения виртуального объекта, может использоваться не только для данных, подлежащих обработке в ПК, но также в различных видах устройств, имеющих дисплейную секцию. Например, и в случае наблюдения части, которая лежит вне дисплейной области данных, подлежащих отображению на дисплейной секции портативного телефона 600, как показано на фиг.14, за счет выполнения описанного выше процесса отображения виртуального объекта отображаемые данные 700, как показано на фиг.14, могут отображаться на дисплее очков 141, которые носит пользователь 100.

Изображение 701 в портативном телефоне в качестве реального объекта, которым обладает пользователь, и виртуальный объект 702 в качестве картографических данных отображаются вместе в качестве отображаемых данных 700, позволяя пользователю просматривать широкую картографическую информацию в части вне дисплейной секции портативного телефона.

Согласно выполнению настоящего изобретения, например, поскольку информация, которую «прокрутили» с экрана дисплейной секции в ПК или тому подобном, отображается в реальном мире как таковая, нет необходимости оперировать с полосой прокрутки для отображения информации, давая возможность всегда просматривать данные по широкой области. Кроме того, поскольку виртуальный объект отображается вне экрана в некотором смысле граничащим с экраном, на котором работает пользователь, возможно всегда просматривать информацию по широкой области, не вызывая ощущения чувства диссонанса.

Выше настоящее изобретение подробно описано со ссылкой на конкретные варианты осуществления. Однако очевидно, что специалист может сделать различные модификации и замены в вариантах осуществления без отхода от объема настоящего изобретения. То есть настоящее изобретение раскрыто посредством примеров и не должно толковаться в ограничительном смысле. Объем настоящего изобретения следует определять со ссылкой на приложенную формулу изобретения.

Кроме того, ряд процессов, приведенных в описании, может исполняться аппаратно, программно или объединенной конфигурацией обоих. Если обработка должна осуществляться программно, эту обработку можно исполнять путем установки программы, записывающей последовательность обработки в памяти в компьютере, встроенном в выделенное аппаратное обеспечение либо путем установки программы в универсальный компьютер, способный исполнять различные виды обработки. Например, программа может быть заранее записана на носителе записи. В отличие от установки в компьютер с записывающего носителя, программа может приниматься по сети, такой как локальная сеть (LAN) или Интернет, и устанавливаться во встроенный записывающий носитель, такой как жесткий диск.

Следует отметить, что различные процессы, приведенные в описании, могут исполняться не только во временной последовательности в порядке, как описано, но могут исполняться параллельно или независимо в зависимости от производительности устройства, исполняющего эти процессы. Кроме того, выражение «система», как оно используется в данном описании, относится к логической совокупности из множества устройств и не ограничено совокупностью, в которой составляющие устройства расположены в одном и том же корпусе.

Промышленная применимость

Как описано выше, согласно выполнению варианта осуществления настоящего изобретения реализуется конфигурация, при которой в различных видах такого дисплейного устройства как ПК и портативный телефон, имеющие дисплейную секцию, неотображаемые данные, которые выходят за область дисплейной секции, отображаются как виртуальный объект в позиции, граничащей с отображаемыми данными дисплейной секции. Эта конфигурация позволяет пользователю всегда наблюдать и просматривать не только данные, отображенные на ограниченной дисплейной области ПК или тому подобного, но также и данные, которые вышли за дисплейную секцию, благодаря чему улучшается эффективность обработки данных.

Перечень ссылочных позиций

100 - Пользователь

120 - ПК (персональный компьютер)

121 - Исполняющая приложение секция

122 - Память

123 - Секция связи

130 - Устройство генерирования смешанной реальности (MR)

131 - Секция анализа трехмерной информации

132 - Модуль управления виртуальным объектом

133 - Память

134 - Секция связи

141 - Очки

142 - Фотокамера

150 - Дисплейное изображение дисплея

151 - Изображение ПК

152 - Дисплейная секция ПК

161 - Виртуальный объект

201 - Дисплейная секция

202 - Лист

321a-321d - Маркер

330 - Неотображаемые данные

350 - Исходная точка

401 - ПК

402 - Виртуальный объект

500 - Отображаемые данные

511 - ПК

512 - Виртуальный объект

521 - Стенка

530 - Неотображаемые данные

600 - Портативный телефон

700 - Отображаемые данные

701 - Изображение портативного телефона (реальный объект)

702 - Виртуальный объект

Изобретение относится к устройствам обработки информации. Технический результат заключается в обеспечении возможности одновременного просмотра данных, выходящих за дисплейную секцию. Устройство содержит исполняющую приложение секцию, которая сохраняет неотображаемые данные и позиционную информацию этих неотображаемых данных в памяти при обработке данных с помощью первой дисплейной секции, причем неотображаемые данные граничат с отображенными данными первой дисплейной секции, секцию анализа трехмерной информации, которая анализирует трехмерную позицию реального объекта, включающего в себя первую дисплейную секцию, секцию управления виртуальным объектом, которая принимает ввод неотображаемых данных и позиционную информацию этих неотображаемых данных, и трехмерную позиционную информацию первой дисплейной секции, генерирует составное изображение, образованное реальным объектом, и отображает это составное изображение на второй дисплейной секции. 3 н. и 3 з.п. ф-лы, 14 ил.

1. Устройство обработки информации, содержащее:

- исполняющую приложение секцию, которая сохраняет неотображаемые данные и позиционную информацию этих неотображаемых данных в память при обработке данных с помощью первой дисплейной секции, причем неотображаемые данные граничат с отображенными данными первой дисплейной секции;

- секцию анализа трехмерной информации, которая анализирует трехмерную позицию реального объекта, включающего в себя первую дисплейную секцию, включенную в заснятое фотокамерой изображение;

- секцию управления виртуальным объектом, которая принимает ввод неотображаемых данных и позиционную информацию этих неотображаемых данных, которые сохранены в памяти, и трехмерную позиционную информацию первой дисплейной секции, проанализированную секцией анализа трехмерной информации, генерирует составное изображение, образованное реальным объектом, включенным в заснятое фотокамерой изображение, и виртуальным объектом, образованным неотображаемыми данными, и отображает это составное изображение на второй дисплейной секции,

при этом секция управления виртуальным объектом устанавливает дисплейную позицию виртуального объекта на второй дисплейной секции в позицию, расположенную в направлении распространения от границы отображаемых данных первой дисплейной секции, отображенной на второй дисплейной секции, наружу от первой дисплейной секции, и отображает данные, граничащие с отображенными данными первой дисплейной секции как упомянутый виртуальный объект.

2. Устройство обработки информации по п.1, в котором секция управления виртуальным объектом преобразует координатные данные, которые являются позиционной информацией неотображаемых данных, сохраненной в памяти, в координатную систему фотокамеры, служащую в качестве индикатора дисплейной позиции в дисплейном изображении второй дисплейной секции, и находит дисплейную позицию виртуального объекта за счет применения преобразованных координатных данных.

3. Устройство обработки информации по п.2, в котором секция управления виртуальным объектом решает, происходит ли пересечение между дисплейной позицией виртуального объекта, преобразованной в координатную систему фотокамеры, и плоскостью, формирующей реальный объект, включенный в заснятое фотокамерой изображение, и если это пересечение происходит, исполняет процесс повторного преобразования, чтобы позиционировать преобразованные координатные данные в плоскость, формирующую реальный объект, и находит дисплейную позицию виртуального объекта за счет применения повторно преобразованных координатных данных.

4. Устройство обработки информации по любому из пп.1-3, в котором:

устройство обработки информации включает в себя:

- первое устройство, имеющее исполняющую приложение секцию, и

- второе устройство, имеющее секцию анализа трехмерной информации и секцию управления виртуальным объектом, и

- данные, сохраненные в первой памяти в первом устройстве исполняющей приложение секцией, передаются во второе устройство посредством секции связи, а во втором устройстве секция анализа трехмерной информации и секция управления виртуальным объектом выполняют обработку, используя принятые данные.

5. Способ обработки информации, который исполняется в устройстве обработки информации, содержащий:

- этап исполнения приложения исполняющей приложение секции, сохраняющей неотображаемые данные и позиционную информацию этих неотображаемых данных в памяти при обработке данных с помощью первой дисплейной секции, причем неотображаемые данные граничат с отображенными данными первой дисплейной секции;

- этап анализа трехмерной информации секции анализа трехмерной информации, анализирующей трехмерную позицию реального объекта, включающего в себя первую дисплейную секцию, включенную в заснятое фотокамерой изображение; и

- этап управления виртуальным объектом секции управления виртуальным объектом, принимающей ввод неотображаемых данных и позиционную информацию этих неотображаемых данных, которые сохранены в памяти, и трехмерную позиционную информацию первой дисплейной секции, проанализированную секцией анализа трехмерной информации, генерирующей составное изображение, образованное реальным объектом, включенным в заснятое фотокамерой изображение, и виртуальным объектом, образованным неотображаемыми данными, и отображающий это составное изображение на второй дисплейной секции,

при этом этап управления виртуальным объектом имеет этап установления дисплейной позиции виртуального объекта на второй дисплейной секции в позиции, расположенной в направлении распространения от границы отображаемых данных первой дисплейной секции, отображенной на второй дисплейной секции, наружу от первой дисплейной секции, и отображает данные, граничащие с отображенными данными первой дисплейной секции как упомянутый виртуальный объект.

6. Носитель записи, содержащий записанную на нем программу, вызывающую исполнение обработки информации в устройстве обработки информации, содержащую:

- этап исполнения приложения, заставляющий исполняющую приложение секцию сохранять неотображаемые данные и позиционную информацию этих неотображаемых данных в памяти при обработке данных с помощью первой дисплейной секции, причем неотображаемые данные граничат с отображенными данными первой дисплейной секции;

- этап анализа трехмерной информации, заставляющий секцию анализа трехмерной информации анализировать трехмерную позицию реального объекта, включающего в себя первую дисплейную секцию, включенную в заснятое фотокамерой изображение; и

- этап управления виртуальным объектом, заставляющий секцию управления виртуальным объектом принимать ввод неотображаемых данных и позиционную информацию этих неотображаемых данных, которые сохранены в памяти, и трехмерную позиционную информацию первой дисплейной секции, проанализированную секцией анализа трехмерной информации, генерировать составное изображение, образованное реальным объектом, включенным в заснятое фотокамерой изображение, и виртуальным объектом, образованным неотображаемыми данными, и отображать это составное изображение на второй дисплейной секции,

при этом этап управления виртуальным объектом имеет этап, заставляющий устанавливать дисплейную позицию виртуального объекта на второй дисплейной секции в позиции, расположенной в направлении распространения от границы отображаемых данных первой дисплейной секции, отображенной на второй дисплейной секции, наружу от первой дисплейной секции.

| Пломбировальные щипцы | 1923 |

|

SU2006A1 |

| Способ обработки целлюлозных материалов, с целью тонкого измельчения или переведения в коллоидальный раствор | 1923 |

|

SU2005A1 |

| JP 2006154902 A, 15.06.2006 | |||

| US 6674534 B2, 06.01.2004 | |||

| СПОСОБ И УСТРОЙСТВО ДЛЯ ПРОСМОТРА ИНФОРМАЦИИ НА ДИСПЛЕЕ | 2002 |

|

RU2288512C2 |

Авторы

Даты

2014-12-20—Публикация

2010-03-17—Подача