ОБЛАСТЬ ТЕХНИКИ

Настоящее изобретение относится к устройству, способу и компьютерной программе для кодирования и декодирования видеосигналов.

УРОВЕНЬ ТЕХНИКИ

В настоящее время исследуются и разрабатываются различные технологии реализации трехмерного (3D) видеоконтента. Главным образом, серьезные исследования были сфокусированы на различных многоракурсных применениях, в которых наблюдатель с одной точки обзора способен видеть только одну пару стереоскопических видеоизображений, а другую пару - с другой точки обзора. Один из наиболее осуществимых подходов для таких многоракурсных применений заключается в том, что на сторону декодера подается только ограниченное количество входных ракурсов, например моноизображений или стереоскопических изображений, совместно с некоторыми дополнительными данными, и затем все требуемые ракурсы для отображения на дисплее локально визуализируются (то есть, синтезируются) декодером.

Существуют несколько технологий для визуализации ракурсов, и, например, свою конкурентоспособность показал способ визуализации на основе глубины изображения (DIBR, depth image-based rendering). Согласно типовому применению DIBR, в качестве входных данных выбирается стереоскопическое видеоизображение и соответствующая информация о глубине со стереоскопическим базисом, и выполняется синтез ряда виртуальных ракурсов между двумя входными ракурсами. Таким образом, алгоритмы DIBR также позволяют экстраполировать ракурсы, расположенные вне двух входных ракурсов, а не только между ними. Подобным образом, алгоритмы DIBR позволяют выполнять синтез на основе одного ракурса текстуры и соответствующего ракурса глубины.

При кодировании трехмерного видеоконтента могут использоваться системы сжатия видеоинформации, такие как стандарт H.264/AVC (Advanced Video Coding, усовершенствованное кодирование видеосигнала) или кодирование MVC (Multiview Video Coding, многоракурсное кодирование видеосигнала), определенные в качестве дополнения к стандарту H.264/AVC. Однако способ предсказания вектора движения, приведенный в H.264/AVC/MVC, может быть не оптимальным для систем кодирования видеосигнала, использующих межракурсное (inter-view) предсказание и/или предсказание синтеза ракурса (VSP, view synthesis prediction) совместно со взаимным предсказанием (inter prediction).

Таким образом, существует необходимость в улучшении способа предсказания вектора движения (MVP, motion vector prediction) с целью многоракурсного кодирования (MVC), кодирования видеосигнала с улучшенной глубиной, многоракурсного кодирования+кодирования по глубине (MVD, multiview+depth) и/или многоракурсного кодирования с цикличным синтезом ракурсов (MVC-VSP, multi-view with in-loop view synthesis).

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

Это изобретение основано на том, что информация о глубине или диспаратности (Di, disparity information) для текущего блока (cb, current block) данных текстуры становится доступной посредством декодирования кодированной информации о глубине или диспаратности либо может оцениваться на стороне декодера перед декодированием текущего блока cb текстуры, благодаря чему возможно использовать информацию о глубине или диспаратности в процессе MVP. Использование информации о глубине или диспаратности (Di) в MVP повышает степень сжатия в системах многоракурсного кодирования, многоракурсного кодирования + кодирования по глубине и в системах кодирования MVC-VSP.

Ниже в этом описании применяется следующее соглашение о наименованиях. Термин cb используется для обозначения текущего блока данных текстуры, а связанная с cb информация о глубине или диспаратности обозначается как d(cb). Текущий блок данных текстуры определяется как блок текстуры, кодируемый кодером или посредством способа кодирования, либо декодируемый декодером или посредством способа декодирования.

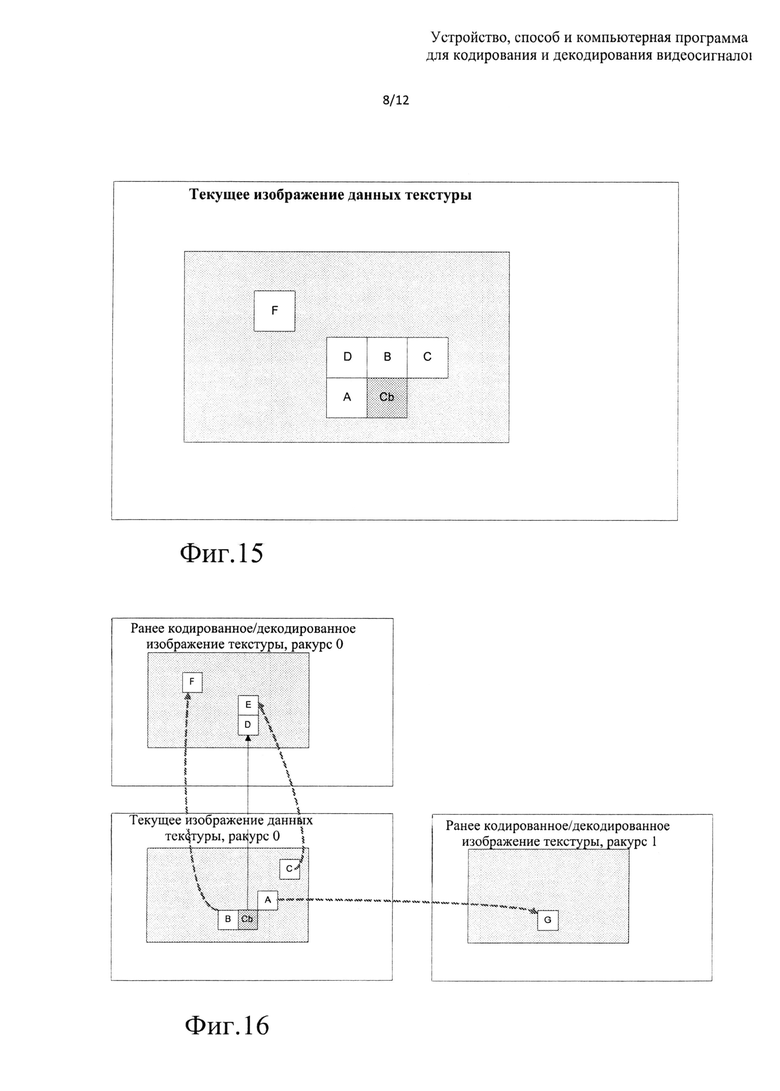

В процессе предсказания вектора движения (MVP) для cb кодер/декодер может использовать двумерные блоки данных текстуры (А, В, С и т.д.). Эти блоки называются смежными блоками, и они пространственно прилегают к области изображения cb (двумерные фрагменты изображения, прилегающего к блоку cb или окружающего этот блок), и, как предполагается, доступны перед выполнением кодирования/декодирования cb. См. фиг. 15, на котором серым цветом показан фрагмент двумерного изображения, смежного с cb и используемого в процессе MVP.

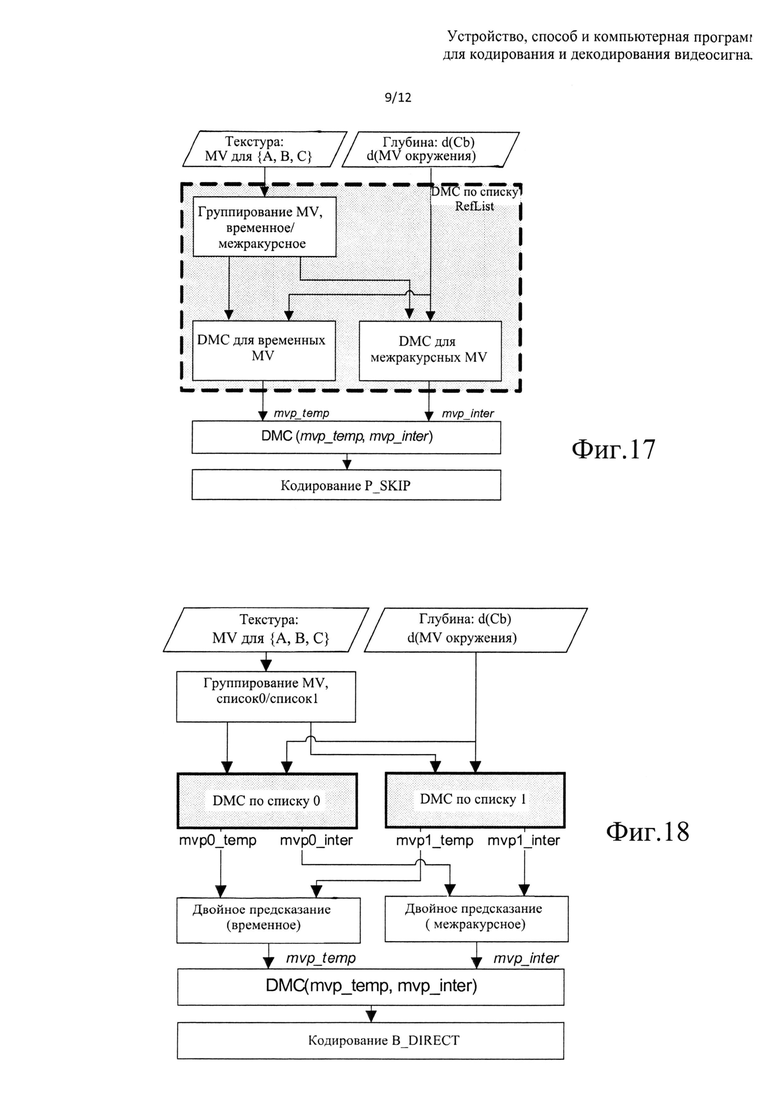

В некоторых случаях в процессе MVP для cb могут использоваться смежные двумерные блоки данных текстуры (А, В, С и т.д.), которые расположены в двумерных фрагментах других изображений в пределах той же видеоинформации (фрагмента видеосигнала), прилегающей к блоку cb, см. фиг. 16. Предполагается, что этот фрагмент видеоинформации должен быть доступен (в кодированном/декодированном виде) до выполнения процесса кодирования/декодирования cb.

В некоторых случаях в процессе MVP для cb могут использоваться смежные двумерные блоки данных текстуры (А, В, С и т.д.), которые расположены в двумерных фрагментах других изображений, размещенных в других ракурсах в пределах той же многоракурсной видеоинформации (во фрагменте многоракурсного видеосигнала), прилегающей к блоку cb, см. фиг. 16. Предполагается, что этот многоракурсный фрагмент видеосигнала должен быть доступен (в кодированном/декодированном виде) до выполнения процесса кодирования/декодирования cb.

Другими словами, смежные блоки А, В, С и т.д. могут быть расположены в пространственной/временной/межракурсной близости от блока cb в нескольких двумерных изображениях, которые доступны (в кодированном/декодированном виде) перед выполнением процесса кодирования текущего изображения.

Кодер/декодер может использовать информацию о движении (такую как компонент mv_x вектора горизонтального движения, компонент mv_y вектора вертикального движения и опорные кадры, которые могут идентифицироваться, например, с использованием индексов refldx, указывающих на один ли более списков опорных изображений), связанную с блоками MV(A), MV(B), MV(C), а также с информацией о глубине/диспаратности, связанной с этими блоками - d(A), d(B), d(C) - в предположении, что они доступны перед кодированием/декодированием cb. Для простоты описания следующие термины эквивалентны и их использование относится к одним и тем же объектам: cb и cb_t, Di(cb_t) и d(cb), Di(cb_t) и cb_d, mvX и MV(X), "соседний блок" и "смежный блок".

Пространственное разрешение изображения определяется как количество пикселей (дискретных элементов изображения), представляющих изображение в горизонтальном и вертикальном направлении. Ниже в этом документе выражение "изображения с разным разрешением" может интерпретироваться как описание двух изображений, для воспроизведения которых используется различное количество пикселей либо в горизонтальном, либо в вертикальном направлении, либо в обоих направлениях.

Информация о движении может предоставляться с определенной точностью или достоверностью MV(A), соответствующей определенному разрешению. Например, в стандарте кодирования H.264/AVC используется точность вектора движения, соответствующая ¼ пикселя, которая во многих применениях требует, чтобы к опорному изображению применялась повышающая дискретизация с коэффициентом 4х по отношению к разрешению исходного изображения по обеим координатным осям.

Ниже в рамках раскрытия изобретения под разрешением вектора движения понимается разрешение опорного изображения, в котором находится этот вектор движения в процессе выполнения процедуры оценки движения. Например, разрешение вектора движения составляет 4х относительно разрешения исходного изображения по обеим координатным осям, если используется точность вектора движения, соответствующая ЛА пикселя. Согласно множеству схем кодирования точность вектора движения определяется предварительно, хотя также описаны схемы кодирования с адаптивной точностью вектора движения, в которых вектор движения выбирается кодером. Кодер может выбрать точность вектора движения, то есть определить, каким образом фактически следует оценивать движение, уменьшить или оставить на прежнем уровне точности, в процессе многократного использования кодерами заданной точности вектора движения. Например, векторы движения в схеме кодирования представлены с точностью до ¼ пикселя в битовом потоке, однако кодер может выбрать способ оценки движения с точностью до ½ пикселя, то есть выполнять поиск только целого или половинного пикселя. Далее в этом описании термины точность и погрешность вектора движения могут использоваться взаимозаменяемо как синонимы.

В соответствии с первым аспектом настоящего изобретения предлагается способ, включающий декодирование из битового потока первого кодированного блока текстуры первого кодированного изображения текстуры в первый блок cb текстуры, при этом процедура декодирования первого кодированного блока текстуры включает: выбор первого смежного блока А текстуры и второго смежного блока В текстуры; получение первого смежного блока d(A) глубины/диспаратности и второго смежного блока d(B) глубины/диспаратности; получение первого блока d(cb) глубины/диспаратности, пространственно совмещенного с первым блоком cb текстуры; сравнение первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/диспаратности и вторым смежным блоком d(B) глубины/диспаратности; выбор одного или обоих из первого смежного блока А текстуры и второго смежного блока В текстуры на основе значения подобия, вычисленного посредством указанного сравнения; получение одного или более параметров предсказания для декодирования первого кодированного блока cb текстуры на основе значений, связанных с выбранными первым смежным блоком А текстуры и/или вторым смежным блоком В текстуры; и декодирование первого кодированного блока cb текстуры с использованием полученных одного или более параметров предсказания.

В соответствии со способом, реализуемым согласно первому варианту осуществления настоящего изобретения, к указанным параметрам предсказания могут относиться одна или более следующих величин: количество блоков предсказания, например однонаправленного и двунаправленного предсказания; тип одного или более используемых базовых способов предсказания, таких как межкадровое, межракурсное и синтез ракурсов; одно или более используемых опорных изображений; применяемые предсказатели вектора движения или векторы движения; применяемый способ предсказания вектора движения; результирующий сигнал ошибки предсказания с нулевым значением.

Способ в соответствии с первым вариантом осуществления настоящего изобретения может также включать создание условий для выбора первого смежного блока А текстуры и/или второго смежного блока В текстуры на основе значения подобия, полученного в результате указанного сравнения с одним или более пороговыми значениями, полученными из битового потока.

Способ в соответствии с первым вариантом осуществления настоящего изобретения может также включать получение первого блока d(cb) глубины/диспаратности посредством декодирования из битового потока или путем оценки.

В соответствии с первым вариантом осуществления настоящего изобретения, если предсказатель вектора движения недоступен для кодированного блока cb текстуры, и указанным типом предсказания для кодированного блока текстуры является межракурсное предсказание, то способ может также включать установку для предсказателя вектора движения величины, полученной на основе информации о глубине/диспаратности для текущего блока данных d(cb) текстуры.

В соответствии с первым вариантом осуществления настоящего изобретения при выполнении способа процедура декодирования первого кодированного блока cb текстуры может включать обработку более двух смежных блоков.

В соответствии с первым вариантом осуществления настоящего изобретения при выполнении способа указанная процедура выбора первого смежного блока А текстуры и второго смежного блока В текстуры для первого блока cb текстуры может включать выполнение следующих операций: выбор первого смежного блока А текстуры и второго смежного блока В текстуры, расположенных в двумерном фрагменте изображения (набор пикселей, принадлежащий одному изображению), смежном или окружающем cb; выбор первого смежного блока А текстуры и второго смежного блока В текстуры, расположенных в видеофрагменте (набор пикселей, принадлежащий различным изображениям тех же видеоданных) или в многоракурсном видеофрагменте (набор пикселей, принадлежащий различным изображениям тех же многоракурсных видеоданных), смежном с блоком cb.

В соответствии с первым вариантом осуществления настоящего изобретения, при выполнении способа указанная процедура получения блока глубины/диспаратности, связанного со смежным блоком текстуры, может включать выполнение следующих операций: выбор первого смежного блока Ζ текстуры и второго смежного блока Υ текстуры; получение информации MV(Z) о движении, используемой для декодирования блока Ζ текстуры, и информации MV(Y) о движении, используемой для декодирования второго смежного блока Υ текстуры; получение одного или более подходящих элементов информации MV(X), извлеченных из информации MV(Z) о движении и/или из информации MV(Y) о движении; получение одного или более подходящих элементов информации MV(d(cb)) о движении, извлеченных из информации d(cb) о глубине/диспаратности, связанной с первым блоком cb текстуры; получение блока А текстуры путем применения информации MV(Z) о движении и отсчитанного от местоположения первого блока cb текстуры; получение блока В текстуры путем применения информации MV(Y) о движении и отсчитанного от местоположения второго блока cb текстуры; получение одного или более блоков текстуры путем применения информации MV(X) о движении и отсчитанных от местоположения первого блока cb текстуры; получение одного или более блоков текстуры путем применения информации MV(d(cb)) о движении и отсчитанных от местоположения первого блока cb текстуры; получение блоков d(A), d(B) глубины/диспаратности и остальных блоков, связанных с полученными блоками А, В текстуры и остальными блоками.

В соответствии с первым вариантом осуществления настоящего изобретения, при выполнении способа указанная процедура выбора первого смежного блока А текстуры и второго смежного блока В текстуры для первого блока cb текстуры может включать выполнение следующих операций: выбор совмещенного блока в первом опорном изображении в качестве первого смежного блока А текстуры и выбор второго смежного блока В текстуры на основе информации MV(A) и/или d(A) о движении или информации о глубине, связанной с первым смежным блоком текстуры; использование первого блока d(cb) глубины/диспаратности для выбора блока во втором опорном изображении в качестве первого смежного блока А текстуры и выбор второго смежного блока В текстуры на основе значений, связанных с первым смежным блоком А текстуры; использование первого блока d(cb) глубины/диспаратности для выбора блока в третьем опорном изображении в качестве первого смежного блока А текстуры и выбор второго смежного блока В текстуры, который расположен в двумерном фрагменте изображения или в видеофрагменте, или в многоракурсном видеофрагменте, смежном с первым совмещенным блоком А текстуры.

В соответствии с первым вариантом осуществления настоящего изобретения, если изображение текстуры и изображение глубины, связанное с указанным изображением текстуры, представлены с различным пространственным разрешением, способ может также включать выполнение следующих операций: нормализация пространственных разрешений изображений текстуры и глубины путем повторной дискретизации любого из двух компонентов (текстуры или глубины) до уровня разрешения другого компонента (глубины или текстуры), либо повторная дискретизация обоих компонентов до одного уровня пространственного разрешения.

В соответствии с первым вариантом осуществления настоящего изобретения, если изображение текстуры и изображение глубины, связанное с указанным изображением текстуры, представлены с различным пространственным разрешением, и разрешение изображения глубины отличается от разрешения изображения текстуры, способ может также включать выполнение следующих операций: изменение масштаба соответственно информации MV(A) и MV(B) о движении смежных блоков А и В текстуры с целью достижения требуемого уровня пространственного разрешения изображения глубины вместо повторной дискретизации изображения глубины. В состав указанной информации о движении могут входить компоненты вектора движения, размеры разделов движения и т.д.

В соответствии с первым вариантом осуществления настоящего изобретения, если изображение текстуры и изображение глубины, связанное с указанным изображением текстуры, представлены с различным пространственным разрешением и разрешение изображения глубины отличается от разрешения изображения текстуры, способ может также включать выполнение следующих операций: корректировка указанной операции сравнения, посредством которой формируются показатели подобия, путем применения информации о движении смежных блоков MV(A), MV(B) текстуры к изображению глубины, для отражения различия уровней разрешения изображений текстуры и глубины. Указанная процедура корректировки может включать прореживание, субдискретизацию, интерполяцию или повышающую дискретизацию информации d(MV(A), d(cb)) и d(MV(B), d(cb)) о глубине для согласования с разрешением информации о движении, полученной на основе смежных блоков А, В текстуры и т.д.

В соответствии с первым вариантом осуществления настоящего изобретения, если изображение текстуры и изображение глубины, связанное с указанным изображением текстуры, представлены с различным разрешением, и/или данные о глубине представлены в формате неравномерной дискретизации или с использованием способа дискретизации, отличающегося от способа дискретизации, применяемого для представления данных текстуры, то способ может также включать выполнение следующих операций: корректировка указанной операции сравнения, посредством которой формируются показатели подобия, путем применения информации о движении смежных блоков MV(A), MV(B) текстуры к нерегулярно дискретизированной информации о глубине, для отражения различия в представлении или способе дискретизации, используемом для данных текстуры и глубины. Указанная процедура корректировки может включать повторную дискретизацию (понижающую дискретизацию, повышающую дискретизацию, изменение масштабирования) информации о глубине, текстуре или движении, а также линейные и нелинейные операции объединения или агрегирования информации о глубине, представленной в результате выполнения способа неоднородной дискретизации.

В соответствии с первым вариантом осуществления настоящего изобретения, если изображение текстуры и изображение глубины, связанное с указанным изображением текстуры, представлены с различным пространственным разрешением и/или данные о глубине представлены в формате неоднородной дискретизации или с использованием способа дискретизации, отличающегося от способа дискретизации, применяемого для представления данных текстуры, то способ может также включать выполнение следующих операций: передача декодеру через битовый поток информации, требуемой для операции декодирования. В состав указанной информации могут входить данные сигнализации о способе, используемом для нормализации пространственного разрешения изображений текстуры и/или глубины, или данные сигнализации о способах, применяемых для изменения масштаба информации о движении (например, об округлении, коэффициенте понижающей/повышающей дискретизации и т.д.), или данные сигнализации о способе, используемом для корректировки сравнения (изменение масштабирования, повторная дискретизация либо нелинейные операции объединения или агрегирования).

В соответствии со вторым аспектом настоящего изобретения, предлагается устройство, содержащее видеодекодер, сконфигурированный для декодирования из битового потока первого кодированного блока текстуры первого кодированного изображения текстуры в первый блок cb текстуры, при этом процедура декодирования первого кодированного блока текстуры включает: выбор первого смежного блока А текстуры и второго смежного блока В текстуры; получение первого смежного блока d(A) глубины/диспаратности и второго смежного блока d(B) глубины/диспаратности; получение первого блока d(cb) глубины/диспаратности, пространственно совмещенного с первым блоком cb текстуры; сравнение первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/диспаратности и вторым смежным блоком d(B) глубины/диспаратности; выбор первого смежного блока текстуры и/или второго смежного блока текстуры (А и/или В) на основе значения подобия, вычисленного посредством указанного сравнения первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/диспаратности и вторым смежным блоком d(B) глубины/диспаратности; получение одного или более параметров предсказания для декодирования первого кодированного блока cb текстуры на основе значений, связанных с выбранными первым смежным блоком А текстуры и/или вторым смежным блоком В текстуры; и декодирование первого кодированного блока cb текстуры с использованием полученных одного или более параметров предсказания.

В соответствии со вторым вариантом осуществления настоящего изобретения, если изображение текстуры и изображение глубины, связанное с указанным изображением текстуры, представлены с различным пространственным разрешением, устройство может также выполнять следующие операции: нормализация пространственных разрешений изображений текстуры и глубины путем цикличной повторной дискретизации любого из двух компонентов (текстуры или глубины) до уровня разрешения другого компонента (глубины или текстуры), либо повторная дискретизация обоих компонентов до одного уровня пространственного разрешения.

В соответствии со вторым вариантом осуществления настоящего изобретения, устройство сконфигурировано таким образом, что если изображение текстуры и изображение глубины, связанное с указанным изображением текстуры, представлены с различным пространственным разрешением, и разрешение изображения глубины отличается от разрешения изображения текстуры, способ может также включать выполнение следующих операций: изменение масштаба соответственно информации MV(A) и MV(B) о движении смежных блоков А и В текстуры с целью достижения требуемого уровня пространственного разрешения изображения глубины вместо повторной дискретизации изображения глубины. В состав указанной информации о движении могут входить компоненты вектора движения, размеры разделов движения и т.д.

В соответствии со вторым вариантом осуществления настоящего изобретения, устройство сконфигурировано таким образом, что если изображение текстуры и изображение глубины, связанное с указанным изображением текстуры, представлены с различным пространственным разрешением, и разрешение изображения глубины отличается от разрешения изображения текстуры, способ может также включать выполнение следующих операций: корректировка указанной операции сравнения, посредством которой формируются показатели подобия путем применения информации MV(A), MV(B) о движении смежных блоков текстуры к изображению глубины, для отражения различия уровней разрешения изображений текстуры и глубины. Указанная процедура корректировки может включать прореживание, субдискретиизацию, интерполяцию или повышающую дискретизацию информации d(MV(A), d(cb)) and d(MV(B), d(cb)) о глубине для согласования с разрешением информации о движении, полученной на основе смежных блоков А, В текстуры и т.д.

В соответствии со вторым вариантом осуществления настоящего изобретения, устройство сконфигурировано таким образом, что если изображение текстуры и изображение глубины, связанное с указанным изображением текстуры, представлены с различным разрешением, и/или данные о глубине представлены в формате неоднородной дискретизации или с использованием способа дискретизации, отличающегося от способа дискретизации, применяемого для представления данных текстуры, то способ может также включать выполнение следующих операций: корректировка указанной операции сравнения, посредством которой формируются показатели подобия, путем применения информации о движении смежных блоков MV(A), MV(B) текстуры к нерегулярно дискретизированной информации о глубине, для отражения различия в представлении или способе дискретизации, используемом для данных текстуры и глубине. Указанная процедура корректировки может включать повторную дискретизацию (понижающую дискретизацию, повышающую дискретизацию, изменение масштабирования) информации о глубине, текстуре или движении, а также линейные и нелинейные операции объединения или агрегирования информации о глубине, представленной в результате выполнения способа неоднородной дискретизации.

В соответствии со вторым вариантом осуществления настоящего изобретения, если изображение текстуры и изображение глубины, связанное с указанным изображением текстуры, представлены с различным пространственным разрешением, и/или данные о глубине представлены в формате неоднородной дискретизации или с использованием способа дискретизации, отличающегося от способа дискретизации, применяемого для представления данных текстуры, то способ может также включать выполнение следующих операций: декодирование из битового потока информации, требуемой для операции декодирования. В состав указанной информации могут входить индексы декодирования для способа, используемого для нормализации пространственного разрешения изображений текстуры и/или глубиной, или индексы декодирования для способов, применяемых для изменения масштаба информации о движении (например, для округления, коэффициент понижающей/повышающей дискретизации и т.д.), или индексы декодирования для способа, используемого для корректировки сравнения (для изменения масштабирования, повторной дискретизации или нелинейных операций объединения или агрегирования).

Согласно третьему аспекту настоящего изобретения, предлагается компьютерный машиночитаемый носитель информации, на котором хранится используемый устройством код, при исполнении которого процессором устройство выполняет следующие операции: декодирование из битового потока первого кодированного блока текстуры первого кодированного изображения текстуры в первый блок cb текстуры, при этом процедура декодирования первого кодированного блока текстуры включает: выбор первого смежного блока А текстуры и второго смежного блока В текстуры; получение первого смежного блока d(A) глубины/диспаратности и второго смежного блока d(B) глубины/диспаратности; получение первого блока d(cb) глубины/диспаратности, пространственно совмещенного с первым блоком cb текстуры; сравнение первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/диспаратности и вторым смежным блоком d(B) глубины/диспаратности; выбор первого смежного блока текстуры и/или второго смежного блока текстуры (А и/или В) на основе значения подобия, вычисленного посредством указанного сравнения первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/ диспаратности и вторым смежным блоком d(B) глубины/диспаратности; получение одного или более параметров предсказания для декодирования первого кодированного блока cb текстуры на основе значений, связанных с выбранным первым смежным блоком А текстуры и/или вторым смежным блоком В текстуры; и декодирование первого кодированного блока cb текстуры с использованием полученных одного или более параметров предсказания.

В соответствии с четвертым аспектом настоящего изобретения предлагается устройство, содержащее по меньшей мере один процессор и по меньшей мере один модуль памяти, в котором хранится код, при исполнении которого по меньшей мере одним указанным процессором устройство выполняет следующие операции: декодирование из битового потока первого кодированного блока текстуры первого кодированного изображения текстуры в первый блок cb текстуры, при этом процедура декодирования первого кодированного блока текстуры включает: выбор первого смежного блока А текстуры и второго смежного блока В текстуры; получение первого смежного блока d(A) глубины/диспаратности и второго смежного блока d(B) глубины/диспаратности; получение первого блока d(cb) глубины/диспаратности, пространственно совмещенного с первым блоком cb текстуры; сравнение первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/диспаратности и вторым смежным блоком d(B) глубины/диспаратности; выбор первого смежного блока текстуры и/или второго смежного блока текстуры (А и/или В) на основе значения подобия, вычисленного посредством указанного сравнения первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/ диспаратности и вторым смежным блоком d(B) глубины/диспаратности; получение одного или более параметров предсказания для декодирования первого кодированного блока cb текстуры на основе значений, связанных с выбранным первым смежным блоком А текстуры и/или вторым смежным блоком В текстуры; и декодирование первого кодированного блока cb текстуры с использованием полученных одного или более параметров предсказания.

В соответствии с пятым аспектом настоящего изобретения предлагается видеодекодер, сконфигурированный для декодирования на основе битового потока первого кодированного блока текстуры первого кодированного изображения текстуры в первый блок cb текстуры, при этом процедура декодирования первого кодированного блока текстуры включает: выбор первого смежного блока А текстуры и второго смежного блока В текстуры; получение первого смежного блока d(A) глубины/диспаратности и второго смежного блока d(B) глубины/диспаратности; получение первого блока d(cb) глубины/диспаратности, пространственно совмещенного с первым блоком cb текстуры; сравнение первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/ диспаратности и вторым смежным блоком d(B) глубины/диспаратности; выбор первого смежного блока А текстуры и/или второго смежного блока В текстуры на основе значения подобия, вычисленного посредством указанного сравнения первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/диспаратности и вторым смежным блоком d(B) глубины/диспаратности; получение одного или более параметров предсказания для декодирования первого кодированного блока cb текстуры на основе значений, связанных с выбранным первым смежным блоком А текстуры и/или вторым смежным блоком В текстуры; и кодирование/декодирование первого кодированного блока cb текстуры с использованием полученных одного или более параметров предсказания.

В соответствии с шестым аспектом настоящего изобретения, предлагается способ, включающий кодирование первого несжатого блока cb текстуры первого несжатого изображения текстуры в первый кодированный блок текстуры первого кодированного изображения текстуры в битовом потоке, при этом процедура кодирования первого несжатого блока cb текстуры включает: выбор первого смежного блока А текстуры и второго смежного блока В текстуры; получение первого смежного блока d(A) глубины/диспаратности и второго смежного блока d(B) глубины/ диспаратности; получение первого блока d(cb) глубины/диспаратности, пространственно совмещенного с первым блоком cb текстуры; сравнение первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/диспаратности и вторым смежным блоком d(B) глубины/диспаратности; выбор первого смежного блока А текстуры и/или второго смежного блока В текстуры на основе значения подобия, вычисленного посредством указанного сравнения первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/ диспаратности и вторым смежным блоком d(B) глубины/диспаратности; получение одного или более параметров предсказания для кодирования первого кодируемого блока cb текстуры на основе значений, связанных с выбранным первым смежным блоком А текстуры и/или вторым смежным блоком В текстуры; и кодирование первого несжатого блока cb текстуры в первый кодированный блок текстуры с использованием полученных одного или более параметров предсказания.

В соответствии с седьмым аспектом настоящего изобретения предлагается устройство, содержащее видеокодер, сконфигурированный для кодирования первого несжатого блока cb текстуры первого несжатого изображения текстуры в первый кодированный блок текстуры первого кодированного изображения текстуры в битовом потоке, при этом процедура кодирования первого несжатого блока cb текстуры включает: выбор первого смежного блока А текстуры и второго смежного блока В текстуры; получение первого смежного блока d(A) глубины/диспаратности и второго смежного блока d(B) глубины/диспаратности; получение первого блока d(cb) глубины/диспаратности, пространственно совмещенного с первым блоком cb текстуры; сравнение первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/диспаратности и вторым смежным блоком d(B) глубины/диспаратности; выбор первого смежного блока А текстуры и/или второго смежного блока В текстуры на основе значения подобия, вычисленного посредством указанного сравнения первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/ диспаратности и вторым смежным блоком d(B) глубины/диспаратности; получение одного или более параметров предсказания для кодирования первого кодируемого блока cb текстуры на основе значений, связанных с выбранным первым смежным блоком А текстуры и/или вторым смежным блоком В текстуры; и кодирование первого несжатого блока cb текстуры в первый кодированный блок текстуры с использованием полученных одного или более параметров предсказания.

Согласно восьмому аспекту настоящего изобретения предлагается компьютерный машиночитаемый носитель информации, на котором хранится используемый устройством код, при исполнении которого процессором устройство выполняет следующие операции: кодирование первого несжатого блока cb текстуры первого несжатого изображения текстуры в первый кодированный блок текстуры первого кодированного изображения текстуры в битовом потоке, при этом процедура кодирования первого несжатого блока cb текстуры включает: выбор первого смежного блока А текстуры и второго смежного блока В текстуры; получение первого смежного блока d(A) глубины/диспаратности и второго смежного блока d(B) глубины/диспаратности; получение первого блока d(cb) глубины/диспаратности, пространственно совмещенного с первым блоком cb текстуры; сравнение первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/диспаратности и вторым смежным блоком d(B) глубины/диспаратности; выбор первого смежного блока А текстуры и/или второго смежного блока В текстуры на основе значения подобия, вычисленного посредством указанного сравнения первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/ диспаратности и вторым смежным блоком d(B) глубины/диспаратности; получение одного или более параметров предсказания для кодирования первого кодируемого блока cb текстуры на основе значений, связанных с выбранным первым смежным блоком А текстуры и/или вторым смежным блоком В текстуры; и кодирование первого несжатого блока cb текстуры в первый кодированный блок текстуры с использованием полученных одного или более параметров предсказания.

В соответствии с девятым аспектом настоящего изобретения, предлагается по меньшей мере один процессор и по меньшей мере один модуль памяти, в котором хранится код, при исполнении которого по меньшей мере одним указанным процессором устройство выполняет следующие операции: кодирование первого несжатого блока cb текстуры первого несжатого изображения текстуры в первый кодированный блок текстуры первого кодированного изображения текстуры в битовом потоке, при этом процедура кодирования первого несжатого блока cb текстуры включает: выбор первого смежного блока А текстуры и второго смежного блока В текстуры; получение первого смежного блока d(A) глубины/диспаратности и второго смежного блока d(B) глубины/ диспаратности; получение первого блока d(cb) глубины/диспаратности, пространственно совмещенного с первым блоком cb текстуры; сравнение первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/диспаратности и вторым смежным блоком d(B) глубины/диспаратности; выбор первого смежного блока А текстуры и/или второго смежного блока В текстуры на основе значения подобия, вычисленного посредством указанного сравнения первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/ диспаратности и вторым смежным блоком d(B) глубины/диспаратности; получение одного или более параметров предсказания для кодирования первого кодируемого блока cb текстуры на основе значений, связанных с выбранным первым смежным блоком А текстуры и/или вторым смежным блоком В текстуры; и кодирование первого несжатого блока cb текстуры в первый кодированный блок текстуры с использованием полученных одного или более параметров предсказания.

В соответствии с десятым аспектом настоящего изобретения, предлагается устройство, содержащее видеодекодер, сконфигурированный для кодирования первого несжатого блока cb текстуры первого несжатого изображения текстуры в первый кодированный блок текстуры первого кодированного изображения текстуры в битовом потоке, при этом процедура кодирования первого несжатого блока cb текстуры включает: выбор первого смежного блока А текстуры и второго смежного блока В текстуры; получение первого смежного блока d(A) глубины/диспаратности и второго смежного блока d(B) глубины/диспаратности; получение первого блока d(cb) глубины/диспаратности, пространственно совмещенного с первым блоком cb текстуры; сравнение первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/диспаратности и вторым смежным блоком d(B) глубины/диспаратности; выбор первого смежного блока А текстуры и/или второго смежного блока В текстуры на основе значения подобия, вычисленного посредством указанного сравнения первого блока d(cb) глубины/диспаратности с первым смежным блоком d(A) глубины/ диспаратности и вторым смежным блоком d(B) глубины/диспаратности; получение одного или более параметров предсказания для кодирования первого кодируемого блока cb текстуры на основе значений, связанных с выбранным первым смежным блоком А текстуры и/или вторым смежным блоком В текстуры; и кодирование первого несжатого блока cb текстуры в первый кодированный блок текстуры с использованием полученных одного или более параметров предсказания.

Согласно одиннадцатому аспекту настоящего изобретения, способ включает кодирование первого элемента данных с использованием первого способа, соответствующего первому варианту осуществления настоящего изобретения; вычисление первой метрики Costl оценки для кодированного первого элемента данных; кодирование второго элемента данных с использованием второго способа, являющегося способом предсказания вектора движения, альтернативным первому способу; вычисление второй метрики Cost2 оценки для кодированного второго элемента данных; выбор из первого и второго способа такого способа, который определяется в качестве оптимального с учетом первой и второй метрик, Cost1 и Cost2, оценки; кодирование первого и второго элементов данных с использованием выбранного способа; передача в битовом потоке индекса, указывающего выбранный способ.

Согласно способу, соответствующему одиннадцатому варианту осуществления настоящего изобретения, первый элемент данных может включать в свой состав либо отдельный блок Cb текстуры, либо набор кодированных блоков (секция, изображение, группа изображений).

Согласно способу, соответствующему одиннадцатому варианту осуществления настоящего изобретения, второй элемент данных может включать в свой состав набор блоков (А, В) текстуры.

Согласно способу, соответствующему одиннадцатому варианту осуществления настоящего изобретения, указанная метрика оценки может формироваться на основе метрики зависимости искажений от скорости передачи или других метрик оценки, например метрики сложности алгоритма вычисления и зависимости искажений от скорости передачи.

Согласно способу, соответствующему одиннадцатому варианту осуществления настоящего изобретения, указанная процедура передачи индекса выполняется на различных уровнях представления кодированных данных.

Согласно способу, соответствующему одиннадцатому варианту осуществления настоящего изобретения, индекс передается по меньшей мере в одном из следующих компонентов: в наборе параметров последовательности, в наборе параметров изображения, в заголовке секции (слайса) или совместно с информацией о движении для конкретного раздела блока.

В соответствии с двенадцатым аспектом настоящего изобретения, способ включает декодирование из битового потока индекса, указывающего способ, используемый для декодирования набора данных; декодирование из битового потока характеристик декодируемого набора данных, к которому применим указанный способ, обозначенный индексом; применение первого способа по п.1 формулы изобретения, если указано, что декодирование битового потока должно выполняться таким способом; применение второго способа, являющегося способом предсказания вектора движения, альтернативным первому способу, если указано, что декодирование битового потока должно выполняться таким способом.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

Для лучшего понимания сути настоящего изобретения далее в примерах приводятся ссылки на прилагаемые чертежи, на которых:

на фиг. 1 показана упрощенная двумерная модель устройства стереоскопических камер;

на фиг. 2 показана упрощенная модель устройства многоракурсной камеры;

на фиг. 3 показана упрощенная модель многоракурсного автостереоскопического дисплея (ASD);

на фиг. 4 показана упрощенная модель системы 3DV, основанной на технологии DIBR;

на фиг. 5 и 6 показан пример системы оценки глубины на основе TOF;

на фиг. 7а и 7b показано пространственное и временное окружение текущего кодируемого блока, служащего в качестве подходящего образца для MVP согласно H.264/AVC;

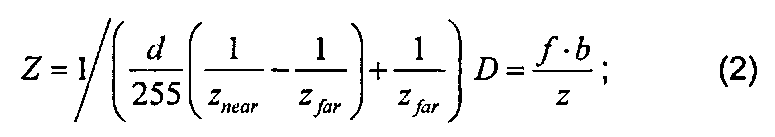

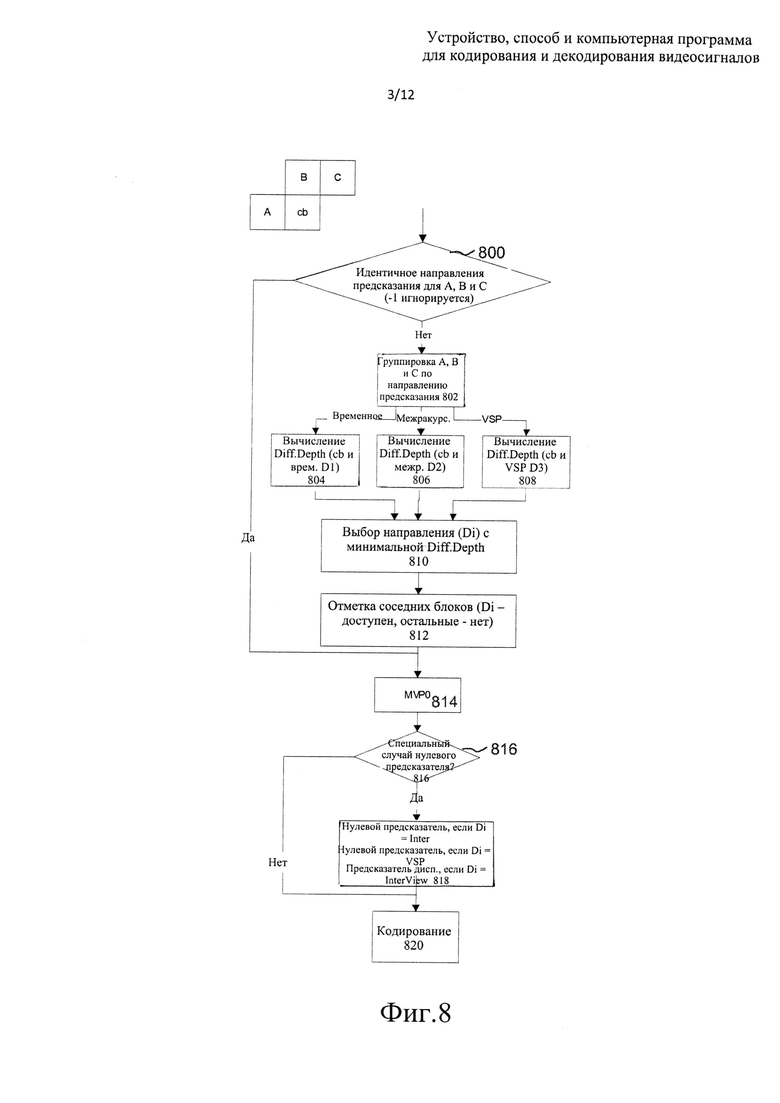

на фиг. 8 показан алгоритм MVP, выполняемый на основе информации о глубине/диспаратности, в соответствии с вариантом осуществления настоящего изобретения;

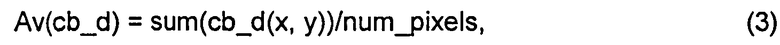

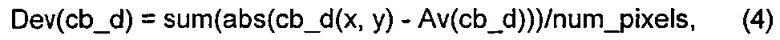

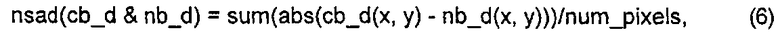

на фиг. 9 показан алгоритм MVP, выполняемый на основе информации о глубине/диспаратности, в соответствии с другим вариантом осуществления настоящего изобретения;

на фиг. 10 схематично показан электронный прибор, подходящий для использования в некоторых вариантах осуществления настоящего изобретения;

на фиг. 11 схематично показано пользовательское оборудование, подходящее для использования в некоторых вариантах осуществления настоящего изобретения;

на фиг. 12 схематично показаны другие электронные приборы, использующие варианты осуществления настоящего изобретения и подключенные с помощью соединений беспроводной и проводной сетей;

на фиг. 13 показан пример структуры блоков cb, А, В, С, D;

на фиг. 14 показаны блоки данных текстуры (cb, S, Τ, U) и блоки d(cb), d(S), d(T) и d(U) данных о глубине/диспаратности, связанные соответственно с этими блоками;

на фиг. 15 показана концепция пространственно смежных блоков данных текстуры;

на фиг. 16 показана концепция смежных блоков в данных двумерной или многоракурсной текстуры;

на фиг. 17 показан алгоритм примера реализации процесса отбора вектора движения на основе глубины в режиме Skip для Р-секций;

на фиг. 18 показан алгоритм примера реализации процесса отбора вектора движения на основе глубины в режиме Direct для В-секций;

на фиг. 19 показан алгоритм выполнения процесса предсказания возможного вектора движения (MVP);

на фиг. 20 показаны опорное неоднородно дискретизированное изображение глубины и опорное однородно дискретизированное изображение текстуры;

на фиг. 21 показан пример отображения карты глубины на другой ракурс;

на фиг. 22 показан пример генерации начальной оценки карты глубины после кодирования первого зависимого ракурса блока произвольного доступа;

на фиг. 23 показан пример получения оценки карты глубины для текущего изображения с использованием параметров движения уже кодированного ракурса того же блока доступа; и

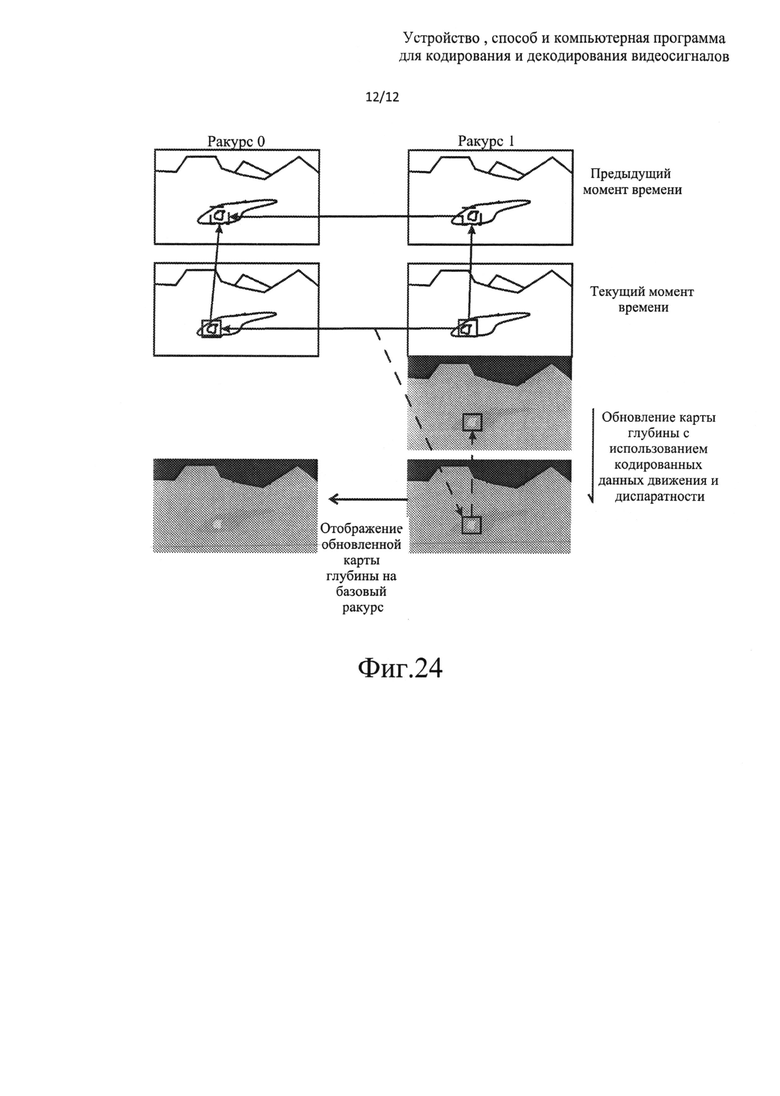

на фиг. 24 показан пример обновления оценки карты глубины для зависимого ракурса на основе кодированных векторов движения и диспаратности.

ПОДРОБНОЕ ОПИСАНИЕ НЕКОТОРЫХ ВАРИАНТОВ ОСУЩЕСТВЛЕНИЯ ИЗОБРЕТЕНИЯ

Для понимания различных аспектов настоящего изобретения и вариантов его осуществления ниже кратко описываются некоторые тесно связанные с ним аспекты процесса кодирования видеосигнала.

В этом разделе приводятся некоторые ключевые определения, описываются структуры битового потока и кодирования, а также концепции стандарта H.264/AVC в виде примеров видеокодера, декодера, способа кодирования, способа декодирования и структуры битового потока, согласно которым может быть реализовано настоящее изобретение. Аспекты изобретения не ограничены стандартом H.264/AVC, однако описание приводится для одного из возможных вариантов, на основе которого частично или полностью может быть реализовано настоящее изобретение.

Стандарт H.264/AVC разработан объединенным коллективом видеоэкспертов (JVT, Joint Video Team) в составе группы экспертов по кодированию видеосигналов (VCEG, Video Coding Experts Group) сектора стандартизации электросвязи международного телекоммуникационного союза (ITU-T, International Telecommunication Union) и группы по движущемуся изображению (MPEG, Moving Picture Experts Group) международной организации по стандартизации (ISO, International Standardisation Organisation) / международной электротехнической комиссии (IEC, International Electrotechnical Commission). Стандарт H.264/AVC опубликован обеими организациями, занимавшимися его разработкой, и известен как рекомендация ITU-T Н.264 и международный стандарт ISO/IEC 14496-10, а также известен под названием "усовершенствованное кодирование видеосигналов MPEG-4, часть 10" (AVC, MPEG-4 Part 10 Advanced Video Coding). Было разработано несколько версий стандарта H.264/AVC, в спецификации каждой из которых включены новые дополнения и возможности. К этим дополнениям относятся алгоритмы масштабируемого кодирования видеосигнала (SVC, Scalable Video Coding) и многоракурсного кодирования видеосигнала (MVC, Multiview Video Coding).

Высокоэффективное кодирование видеосигнала (HEVC, High Efficiency Video Coding) является примером другой недавней разработки, направленной на развитие технологии кодирования видеосигнала и выполненной объединенным коллективом по кодированию видеосигналов (JCT-VC, Joint Collaborative Team - Video Coding), входящим в состав групп VCEG и MPEG.

В этом разделе приводятся некоторые ключевые определения, описываются структуры битового потока и кодирования, а также концепции стандартов H.264/AVC и HEVC в виде примеров видеокодера, декодера, способа кодирования, способа декодирования и структуры битового потока, согласно которым может быть реализовано настоящее изобретение. Некоторые ключевые определения, структуры битового потока и кодирования, а также концепции стандарта H.264/AVC и рабочей версии стандарта HEVC совпадают и поэтому ниже описываются совместно. Аспекты настоящего изобретения не ограничены стандартом H.264/AVC или HEVC, однако описание приводится для одного из возможных вариантов, на основе которого частично или полностью может быть реализовано настоящее изобретение.

Подобно многим ранее разработанным стандартам кодирования видеосигналов, в стандартах H.264/AVC и HEVC определен синтаксис и семантика битового потока, а также процесс декодирования для безошибочной передачи битовых потоков. Процесс кодирования не определен в стандарте, однако кодеры должны генерировать согласованные битовые потоки. Соответствие характеристик битового потока и декодера может быть проверены с помощью гипотетического эталонного декодера (HRD, Hypothetical Reference Decoder), определенного в приложении С стандарта H.264/AVC. В стандарте описаны средства кодирования, позволяющие избежать ошибок и потери данных при передаче, однако использование таких средств при кодировании является необязательным, и процесс декодирования не определен для битовых потоков с ошибками.

Элементарным блоком на входе кодера H.264/AVC или HEVC и на выходе декодера H.264/AVC или HEVC является изображение (picture). Изображение может представлять собой кадр или поле. Кадр содержит матрицу отсчетов яркости и соответствующих отсчетов цветности. Поле представляет собой набор чередующихся строк выборки кадра и может использоваться в качестве входных данных кодера в случае чересстрочного исходного сигнала. Цветовые изображения могут подвергаться субдискретизации по сравнению с яркостными изображениями. Например, при использовании шаблона выборки вида 4:2:0 пространственное разрешение цветовых изображений в два раза меньше разрешения яркостных изображений по обеим осям координат, и соответственно макроблок содержит один блок размером 8x8 выборок цветности на каждый компонент цветности. Изображение разделяется на одну или более групп секций (слайсов), и каждая группа секций содержит одну или более секций. Секция содержит целое число макроблоков, последовательно упорядоченных в процессе растрового сканирования в пределах определенной группы секций.

Согласно H.264/AVC, макроблок представляет собой блок размером 16×16, содержащий яркостные выборки и соответствующие блоки цветовых выборок. Например, при использовании шаблона выборки вида 4:2:0 макроблок содержит один блок размером 8×8 цветовых выборок для каждого компонента цветности. Согласно H.264/AVC, изображение разделяется на одну или более групп секций, и каждая группа секций содержит одну или более секций. В соответствии с H.264/AVC секция содержит целое число макроблоков, последовательно упорядоченных в процессе растрового сканирования в пределах определенной группы секций.

Согласно рабочей версии стандарта HEVC, видеоизображения разделены на блоки кодирования (CU, coding unit), перекрывающие область изображения. CU содержит один или более блоков предсказания (PU, prediction unit), определяющих процесс предсказания для выборок в пределах CU, и один или более блоков преобразования (TU, transform unit), определяющих процесс кодирования ошибки предсказания для выборок в указанном CU. Обычно CU содержит квадратный блок выборок, размер которого выбирается из предварительно определенного множества возможных размеров CU. Блок CU с максимально допустимым размером обычно называется LCU (largest coding unit, наибольший блок кодирования), и видеоизображение разделяется на неперекрывающиеся LCU. LCU также можно разбить на комбинацию меньших по размеру CU, например, путем рекурсивного разбиения LCU и результирующих CU. Каждый результирующий CU обычно содержит по меньшей мере один PU и по меньшей мере один связанный с ним TU. Каждый PU и TU далее можно разбить на меньшие PU и TU для увеличения, соответственно, степени детализации процессов предсказания и кодирования ошибки предсказания. Разбиение PU можно выполнить путем разбиения CU на четыре одинаковых по размеру квадратных PU или путем разбиения CU на два прямоугольных PU по вертикали или горизонтали симметричным или асимметричным образом. Способ разделения изображения на CU и разделения CU на PU и TU обычно сообщается в битовом потоке, что позволяет декодеру воспроизвести требуемую структуру этих блоков.

Согласно рабочей версии стандарта HEVC изображение может разделяться на мозаичные прямоугольные элементы, содержащие целое число LCU. В соответствии с текущей рабочей версией HEVC при разделении на мозаичные элементы формируется регулярная сетка, при этом значения высоты и ширины мозаичных элементов отличаются друг от друга максимум на один LCU. Согласно рабочей версии HEVC секция состоит из целого числа CU. CU сканируются в порядке растрового сканирования блоков LCU в мозаичных элементах или в пределах изображения, если мозаичные элементы не используются. В пределах LCU используется специфический порядок сканирования CU.

Далее описываются некоторые ключевые определения и концепции разделения изображения согласно рабочей версии (WD, Working Draft) 5 HEVC. Разделение определяется как деление множества на подмножества таким образом, чтобы каждый элемент множества находился в точности в одном подмножестве.

Базовый блок кодирования в WD5 HEVC представляет собой древовидный блок. Древовидный блок представляет собой блок размерностью Ν×N выборок яркости и два соответствующих блока выборок цветности изображения, который содержит три массива выборок, или блок размерностью Ν×N выборок монохромного изображения или изображения, который кодирован с использованием трех отдельных цветовых плоскостей. Древовидный блок может разделяться для различных процессов кодирования и декодирования. Раздел древовидного блока представляет собой совокупность блока выборок яркости и двух соответствующих блоков выборок цветности, полученных в результате разделения древовидного блока для изображения, которое содержит три массива выборок, или блок выборок яркости, полученный в результате разделения древовидного блока для монохромного изображения или изображения, кодированного с использованием трех отдельных цветовых плоскостей. Каждому древовидному блоку назначаются данные сигнализации о разделении для идентификации размеров блока с целью внутреннего или взаимного предсказания, а также для кодирования с преобразованием. Разделение выполняется рекурсивно путем разбиения на дерево квадрантов. Корень дерева квадрантов связан с древовидным блоком. Дерево квадрантов разбивается до тех пор, пока не достигается лист дерева, который называется узлом кодирования. Узел кодирования является корневым узлом двух деревьев - дерева предсказания и дерева преобразования. Дерево предсказания указывает позицию и размер блоков предсказания. Дерево предсказания и связанные с ним данные предсказания называются блоком предсказания. Дерево преобразования указывает позицию и размер блоков преобразования. Дерево преобразования и связанные с ним данные преобразования называются блоком преобразования. Разбиение информации о яркости и цветности выполняется идентично для дерева предсказания и может выполняться идентично или по-разному для дерева преобразования. Узел кодирования и связанные с ним блоки предсказания и преобразования совместно формируют блок кодирования.

Согласно WD5 HEVC изображения разделяются на секции и мозаичные элементы. Секция может представлять собой последовательность древовидных блоков, а также (если имеется в виду так называемая мелкозернистая секция) может быть ограничена древовидным блоком в местоположении, в котором блоки преобразования и предсказания совпадают. Древовидные блоки в пределах секции кодируются и декодируются в порядке растрового сканирования. Для первично кодированного изображения процесс разделения представляет собой деление каждого изображения на секции.

Согласно WD5 HEVC мозаичный элемент определяется как целое число древовидных блоков, совместно входящих в один столбец и одну строку, последовательно упорядоченных в процессе растрового сканирования в пределах мозаичного элемента. Для первично кодированного изображения процесс деления каждого изображения на мозаичные элементы представляет собой разделение. Мозаичные элементы упорядочиваются последовательно в процессе растрового сканирования в пределах изображения. Хотя секция содержит древовидные блоки, последовательные при растровом сканировании в пределах секции, эти древовидные блоки не обязательно должны быть последовательны при растровом сканировании в пределах изображения. Секции и мозаичные элементы не должны содержать одинаковую последовательность древовидных блоков. Мозаичный элемент может содержать древовидные блоки, входящие в несколько секций. Таким же образом, секция может содержать древовидные блоки, входящие в несколько мозаичных элементов.

Согласно H.264/AVC и HEVC предсказание в изображении может быть запрещено при переходе границ секции. Таким образом, секции можно рассматривать в качестве средства для разбиения кодированного изображения на независимо декодируемые фрагменты, и, следовательно, секции часто рассматриваются как элементарные блоки для передачи. Во многих случаях кодеры могут указывать в битовом потоке, какие типы предсказания в изображении отключаются на границах секции, и при функционировании декодера эта информация принимается во внимание, например, в случае принятия решения о том, какие источники предсказания доступны. Например, выборки из соседних макроблоков или CU можно рассматривать в качестве недоступных для внутреннего предсказания, если соседний макроблок или CU располагается в другой секции.

Элементарным блоком на выходе кодера H.264/AVC или HEVC и на входе декодера H.264/AVC или HEVC является блок уровня абстракции сети (NAL, Network Abstraction Layer). Декодирование частично потерянных или искаженных блоков NAL обычно является достаточно трудным процессом. Для транспортировки по пакетно-ориентированным сетям или для сохранения в структурированных файлах блоки NAL обычно инкапсулируются в пакетах или в подобных структурах данных. Формат байтового потока определен стандартом H.264/AVC или HEVC для сред передачи или хранения данных, которые не поддерживают кадровые структуры. В формате байтового потока блоки NAL отделяются друг от друга с помощью начального кода, который присоединяется в начале каждого блока NAL. Во избежание ложного обнаружения границ блока NAL кодеры выполняют побайтовый алгоритм предотвращения эмуляции начального кода, с помощью которого в полезную нагрузку блока NAL добавляется байт предотвращения эмуляции на тот случай, если начальный код все же появится. Для того чтобы инициировать непосредственную шлюзовую передачу данных между пакетными и потоковыми системами, всегда выполняется процедура предотвращения эмуляции начального кода, вне зависимости от того, используется ли формат байтового потока.

Некоторые профили H.264/AVC позволяют использовать до восьми групп секций для кодированного изображения. Если используются несколько групп секций, изображение разделяется на блоки карты групп секций, которые равны двум вертикальным последовательным макроблокам в случае адаптивного к макроблокам кодирования кадров-полей (MBAFF, macroblock-adaptive frame-field), и равны макроблоку в противном случае. Набор параметров изображения содержит данные, основанные на том, какой из блоков карты группы секций изображения связан с конкретной группой секций. Группа секций может содержать любые блоки карты группы секций, включая несмежные блоки карты. Если для изображения указано несколько групп секций, используется функция гибкого упорядочивания макроблоков (FMO, flexible macroblock ordering), определенная в стандарте.

В соответствии с H.264/AVC секция содержит один или более последовательных макроблоков (или пар макроблоков, если используется MBAFF) в пределах определенной группы секций, упорядоченных в порядке растрового сканирования. Если используется только одна группа секций, то согласно H.264/AVC секции содержат последовательные макроблоки в порядке растрового сканирования, и, таким образом, они схожи с секциями, определенными в множестве предшествующих стандартов кодирования. В некоторых профилях стандарта H.264/AVC секции кодированного изображения могут появляться в любом порядке по отношению друг к другу в битовом потоке, и такая структура называется произвольным упорядочиванием секций (ASO, arbitrary slice ordering). В противном случае секции в битовом потоке должны быть упорядочены в соответствии с растровым кодированием.

Блоки NAL содержат заголовок и полезную нагрузку. Заголовок блока NAL указывает тип этого блока, а также указывает на то, является ли кодированная секция, содержащаяся в блоке NAL, частью опорного изображения или изображения, отличного от опорного. Согласно H.264/AVC и HEVC заголовок блока NAL указывает тип этого блока, а также указывает на то, является ли кодированная секция, содержащаяся в блоке NAL, частью опорного изображения или изображения, отличного от опорного. В стандарт H.264/AVC включен 2-битовый синтаксический элемент nal_ref_idc, значение 0 которого указывает на то, что кодированная секция, содержащаяся в блоке NAL, является частью изображения, отличного от опорного, в то время как значение, большее 0, указывает на то, что кодированная секция, содержащаяся в блоке NAL, является частью опорного изображения. В рабочую версию стандарта HEVC включен 1-битовый синтаксический элемент nal_ref_idc, также обозначаемый nal_ref_flag, значение 0 которого указывает на то, что кодированная секция, содержащаяся в блоке NAL, является частью изображения, отличного от опорного, в то время как значение, равное 1, указывает на то, что кодированная секция, содержащаяся в блоке NAL, является частью опорного изображения. Заголовок блоков NAL для SVC и MVC дополнительно содержит различные индикаторы, связанные со стабильностью и многоракурсной иерархией.

Согласно стандартам H.264/AVC и HEVC блоки NAL могут быть классифицированы как NAL уровня кодирования видеосигнала (VCL, Video Coding Layer) и блоки NAL, отличные от VCL.

Блоки NAL VCL в H.264/AVC представляют собой либо блоки NAL кодированной секции, либо блоки NAL раздела данных кодированной секции, либо блоки NAL префикса VCL. Блоки NAL кодированной секции содержат синтаксические элементы, представляющие один или более кодированных макроблоков, каждый из которых соответствует блоку выборок в несжатом изображении. Существует четыре типа блоков NAL кодированной секции: кодированная секция в изображении с мгновенным обновлением декодирования (IDR, Instantaneous Decoding Refresh), кодированная секция в изображении, отличном от IDR, кодированная секция во вспомогательном кодированном изображении (таком, как альфа-плоскость) и расширение кодированной секции (для секций SVC, находящихся на уровне, отличном от базового, или для секций MVC, расположенных в ракурсе, отличном от базового). Набор из трех блоков NAL раздела данных кодированной секции содержит те же синтаксические элементы, что и кодированная секция. Раздел А данных кодированной секции содержит заголовки макроблоков и векторы движения секции, в то время как разделы В и С данных кодированной секции содержат кодированные остаточные данные соответственно для интра- и интер- макроблоков. Следует отметить, что поддержка разделов данных секции предусмотрена только в некоторых профилях H.264/AVC. Блок NAL префикса VCL предшествует кодированной секции базового уровня в битовых потоках SVC и MVC и содержит индикаторы иерархии масштабирования связанной кодированной секции.

Согласно HEVC блоки NAL кодированной секции содержат синтаксические элементы, представляющие один или более CU. Согласно HEVC блоки NAL кодированной секции могут идентифицироваться как кодированная секция в изображении с мгновенным обновлением декодирования (IDR) или кодированная секция в изображении, отличном от IDR. В соответствии с HEVC, блок NAL кодированной секции может идентифицироваться как кодированная секция в изображении с полным обновлением декодирования (CDR, Clean Decoding Refresh) (который может также называться изображением с полным произвольным доступом (Clean Random Access picture)).

Блок NAL, отличный от VCL, может представлять собой пример блока одного из следующих типов: набор параметров последовательности, набор параметров изображения, блок NAL дополнительной информации уровня расширения (SEI, supplemental enhancement information), разделитель блока доступа, блок NAL завершения последовательности, блок NAL завершения потока или блок NAL данных заполнения. Наборы параметров играют существенную роль в процессе реконструкции декодируемых изображений, в то время как другие блоки NAL, отличные от VCL, не обязательно предназначены для реконструкции значений декодируемых выборок и служат для иных целей, описываемых ниже. Параметры, остающиеся неизменными в кодированной последовательности видеоинформации, включаются в набор параметров последовательности. Помимо параметров, существенных для процесса декодирования, набор параметров последовательности может дополнительно содержать информацию о применимости видеосигнала (VUI, video usability information), в состав которой входят параметры, имеющие важное значение для буферизации, синхронизации вывода изображения, визуализации и резервирования ресурсов. Набор параметров изображения содержит такие параметры, которые, скорее всего, не будут изменяться в нескольких кодированных изображениях. В битовых потоках H.264/AVC отсутствует заголовок изображения, однако часто изменяющиеся данные уровня изображения повторяются в каждом заголовке секции, а наборы параметров изображения переносят оставшиеся параметры уровня изображения. Синтаксис H.264/AVC допускает наличие множества экземпляров наборов параметров последовательности и изображения, при этом каждый экземпляр идентифицируется уникальным идентификатором. Каждый заголовок секции содержит идентификатор набора параметров изображения, который является активным для декодирования изображения, содержащего секцию, и каждый набор параметров изображения содержит идентификатор активного набора параметров последовательности. Следовательно, передача наборов параметров изображения и последовательности не должна быть точно синхронизирована с передачей секций. Вместо этого достаточно, чтобы активные наборы параметров последовательности и изображения принимались в любой момент перед тем, как к ним будет осуществляться обращение, благодаря чему передача наборов параметров может выполняться с помощью более надежного механизма передачи по сравнению с протоколами, используемыми для данных секции. Например, для сеансов транспортного протокола реального времени (RTP, Real-time Transport Protocol) H.264/AVC наборы параметров могут включаться в качестве параметра в описание сеанса. Если для передачи наборов параметров используется внутриполосный механизм, эти наборы могут повторяться для повышения уровня устойчивости к ошибкам.

Согласно рабочей версии HEVC существует также третий тип наборов параметров, называемый в этом описании набором параметров адаптации (APS, Adaptation Parameter Set), в состав которого входят параметры, которые, скорей всего, не должны изменяться в нескольких кодированных секциях. Согласно рабочей версии HEVC структура синтаксиса APS предполагает включение параметров или синтаксических элементов, связанных с адаптивным бинарным арифметическим кодированием, основанным на контексте (САВАС, context-based adaptive binary arithmetic coding), сдвигом адаптивной выборки, адаптивной кольцевой фильтрацией и фильтрацией разблокирования. В соответствии с рабочей версией HEVC набор APS представляет собой блок NAL, кодированный без использования ссылки или предсказания, полученного из какого-либо иного блока NAL. Идентификатор, обозначаемый как синтаксический элемент aps_id, включается в блок APS NAL, а также включается и используется в заголовке секции для ссылки на конкретный набор APS.

Блок NAL SEI содержит одно или более сообщений SEI, которые не требуются для декодирования выходных изображений, но помогают выполнять соответствующие процессы, такие как синхронизация вывода изображений, визуализация, обнаружение ошибок, маскирование ошибок и резервирование ресурсов. В H.264/AVC и HEVC определены несколько сообщений SEI, и сообщения SEI с пользовательскими данными позволяют организациям и компаниям указывать сообщения SEI для собственного использования. В H.264/AVC и HEVC определяется синтаксис и семантика указанных сообщений SEI, однако не определен процесс для обработки сообщений на стороне приема. Следовательно, требуется, чтобы кодеры удовлетворяли стандарту H.264/AVC или HEVC при создании сообщений SEI, а для обработки сообщений SEI для согласования порядка вывода декодеры, соответствующие стандарту H.264/AVC или HEVC, не требуются. Одной из причин включения синтаксиса и семантики сообщений SEI в H.264/AVC и HEVC является предоставление возможности формирования спецификаций различных систем для идентичной интерпретации дополнительной информации и, таким образом, для поддержки взаимодействия систем. Предполагается, что для спецификаций системы может потребоваться использование конкретных сообщений SEI как в конце процесса кодирования, так и в конце процесса декодирования, а также может быть определен процесс обработки конкретных сообщений SEI на приемной стороне.

Согласно H.264/AVC кодированное изображение содержит блоки NAL VCL, которые требуются для декодирования изображения. Кодированное изображение может представлять собой первично кодированное изображение либо изображение, кодированное с избыточностью. Первично кодированное изображение используется в процессе декодирования действительных битовых потоков. Согласно H.264/AVC изображение, кодированное с избыточностью, представляет собой избыточное представление, которое должно декодироваться только в том случае, если не удается успешно декодировать первично кодированное изображение.

Блок доступа в H.264/AVC содержит первичное кодированное изображение и связанные с ним блоки NAL. Порядок появления блоков NAL в блоке доступа устанавливается следующим образом. Дополнительный блок NAL разделителя блока доступа может указывать на начало блока доступа. За ним может следовать несколько блоков NAL SEI либо ни одного из таких блоков. Далее располагаются кодированные секции или разделы данных секций первичного кодированного изображения, за которыми следуют кодированные секции для нуля или более изображений, кодированных с избыточностью.

Блок доступа в MVC определен как набор блоков NAL, которые последовательно расположены в порядке декодирования и содержат в точности одно первичное кодированное изображение, состоящее из одного или более компонентов ракурса. Помимо первичного кодированного изображения, блок доступа также может содержать одно или более изображений, кодированных с избыточностью, одно дополнительно кодированное изображение или другие блоки NAL, не содержащие секции или разделы данных секций кодированного изображения. В результате декодирования блока доступа всегда формируется одно декодированное изображение, содержащее один или более декодированных компонентов ракурса. Другими словами, блок доступа в MVC содержит компоненты ракурсов одного выходного временного экземпляра.

Компонент ракурса в MVC называется кодированным представлением ракурса в отдельном блоке доступа. Изображение привязки (якорное изображение) представляет собой кодированное изображение, в котором все секции могут ссылаться только на секции в том же блоке доступа, то есть может использоваться межракурсное, но не межкадровое предсказание, и все последующие изображения в порядке вывода не используют межкадровое предсказание на основе любого изображения, предшествующего кодированному изображению в порядке декодирования. Межракурсное предсказание может использоваться для компонентов ракурса IDR, являющихся частью ракурса, отличного от базового. Базовый ракурс согласно MVC представляет собой ракурс с минимальным значением порядкового индекса ракурса в кодированной последовательности видеосигнала. Базовый ракурс может декодироваться независимо от других ракурсов без использования межракурсного предсказания. Базовый ракурс может декодироваться декодерами H.264/AVC, поддерживающими только профили одного ракурса, такие как базисный профиль (Baseline Profile) или профиль высокой четкости (High Profile), определенные стандартом H.264/AVC.

Согласно стандарту MVC множество подпроцессов процесса декодирования MVC используют соответствующие подпроцессы стандарта H.264/AVC путем замены в спецификациях этого стандарта терминов "изображение", "кадр" и "поле" на термины "компонент ракурса", "компонент ракурса кадра" и "компонент ракурса поля", соответственно. Таким же образом, далее термины "изображение", "кадр" и "поле" часто используются для замены терминов "компонент ракурса", "компонент ракурса кадра" и "компонент ракурса поля", соответственно.

Кодированная видеопоследовательность определяется как последовательность следующих друг за другом блоков доступа в порядке декодирования, начиная с блока доступа IDR (включительно) и заканчивая следующим блоком доступа IDR (не включаемым в текущую последовательность) либо блоком завершения битового потока, в зависимости от того, какой из последних двух блоков появляется раньше.

Группа изображений (GOP, group of pictures), а также характеристики этой группы могут быть определены следующим образом. GOP может декодироваться вне зависимости от того, были ли декодированы предшествующие изображения. Открытая группа GOP представляет собой такую группу изображений, в которой изображения, предшествующие в порядке вывода начальному внутреннему изображению, могут быть декодированы некорректно, если процесс декодирования начинается от начального внутреннего изображения открытой группы GOP. Другими словами, изображения открытой группы GOP могут ссылаться (в процессе взаимного предсказания) на изображения, входящие в предшествующую группу GOP. Декодер H.264/AVC может распознавать внутреннее изображение, с которого начинается открытая GOP, с помощью сообщения SEI о точке восстановления, передаваемого в битовом потоке H.264/AVC. Закрытая GOP представляет собой группу изображений, в которой все изображения могут быть корректно декодированы, если процесс декодирования начинается с начального внутреннего изображения закрытой GOP. Другими словами, в закрытой GOP отсутствуют изображения, ссылающиеся на изображения в предшествующих GOP. В стандарте H.264/AVC определено, что закрытая группа GOP начинается блоком доступа IDR. В результате структура закрытой GOP потенциально в большей степени устойчива к ошибкам по сравнению со структурой открытой GOP, однако при этом эффективность сжатия уменьшается. Структура кодирования открытой GOP потенциально более эффективна с точки зрения сжатия, поскольку в этом случае выбор опорных изображений осуществляется более гибко.

В синтаксисе битового потока, определенном в стандарте H.264/AVC, указывается, является ли конкретное изображение опорным для взаимного предсказания любого другого изображения. Изображения любого типа кодирования (I, Р, В) в рамках стандарта H.264/AVC могут являться опорными или отличными от опорных. Заголовок блока NAL указывает тип этого блока, а также указывает на то, является ли кодированная секция, содержащаяся в блоке NAL, частью опорного изображения или изображения, отличного от опорного. Множество гибридных видеокодеков, включая те, что соответствуют стандартам H.264/AVC и HEVC, кодируют видеоинформацию с использованием двух фаз. На первой фазе выполняется предсказание значений пикселей или выборок в определенной области изображения или в "блоке". Эти значения пикселей или выборок могут быть предсказаны, например, с помощью механизмов компенсации движения, в которых задействованы процессы обнаружения и индикации области в одном из ранее кодированных видеокадров, которая наиболее точно соответствует кодируемому блоку. Кроме того, значения пикселей или выборок могут быть предсказаны путем пространственных механизмов, в которых задействованы процессы обнаружения и индикации взаимосвязи пространственных областей.

Принципы предсказания с использованием информации об изображении на основе предварительно кодированного изображения также могут называться способами взаимного предсказания, временного предсказания и компенсации движения. Принципы предсказания с использованием информации об изображении на основе одного изображения также могут называться способами внутреннего предсказания.

На второй фазе выполняется кодирование ошибки между предсказанным блоком пикселей или выборок и исходным блоком пикселей или выборок. Эта процедура может выполняться путем преобразования разности в значениях пикселей или выборок посредством указанного вида преобразования. Для этого может использоваться дискретное косинусное преобразование (DCT, Discrete Cosine Transform) или различные его варианты. После преобразования разности выполняется квантование и энтропийное кодирование этой преобразованной разности.

Путем изменения точности процесса квантования кодер может управлять балансом между точностью представления пикселей или выборок (другими словами, визуальным качеством изображения) и размером результирующего кодированного видеопредставления (то есть, размером файла или величиной битовой скорости передачи).

Декодер реконструирует выходной видеосигнал путем применения механизма предсказания, сходного с тем, что использовался кодером, для того чтобы сформировать предсказанное представление блоков пикселей или выборок (с помощью информации о движении или пространственной области, созданной кодером и хранимой в сжатом представлении изображения), и декодирования ошибки предсказания (операция, обратная кодированию ошибки предсказания, выполняемая для восстановления квантованного сигнала ошибки предсказания в пространственной области).

После применения процессов предсказания пикселей или выборок и декодирования ошибки декодер объединяет сигналы предсказания и ошибки предсказания (значения пикселей или выборок) для формирования выходного видеокадра.

Декодер (и кодер) может также выполнять дополнительный процесс фильтрации, для того чтобы повысить качество выходного видеосигнала перед выводом его для отображения и/или сохранения в качестве опорного сигнала предсказания для последующих изображений в видеопоследовательности.

В большинстве видеокодеков, включая кодеки, соответствующие стандартам H.264/AVC и HEVC, информация о движении указывается векторами движения, связанными с каждым блоком изображения с компенсацией движения. Каждый из этих векторов движения представляет смещение блока изображения в изображении, подлежащем кодированию (в кодере) или декодированию (в декодере), и исходного блока предсказания в одном из ранее кодированных или декодированных изображений (или кадров).

Согласно H.264/AVC и HEVC и множеству других стандартов сжатия видеосигналов, выполняется разделение изображения на сетку прямоугольников, для каждого из которых с целью внутреннего предсказания указывается подобный блок в одном из опорных изображений. Местоположение блока предсказания кодируется в виде вектора движения, который указывает позицию блока предсказания по отношению к блоку, подлежащему кодированию.

Процесс внутреннего предсказания можно охарактеризовать с использованием одного или более следующих факторов.

Точность представления вектора движения. Точность вектора движения, например, может определяться четвертью пикселя, и значения выборок в позициях частей пикселей определяются с использованием фильтра с конечной импульсной характеристикой (FIR, finite impulse response).

Разделение на блоки для взаимного предсказания. Множество стандартов кодирования, включая H.264/AVC и HEVC, позволяют выбирать размер и форму блока, для которого применяется вектор движения, с целью компенсации движения в кодере, при этом выбранные размер и форма указываются в битовом потоке таким образом, чтобы декодеры могли воспроизвести способ предсказания с компенсацией движения, выполненный в кодере.

Базовый блок для взаимного предсказания во многих стандартах кодирования, включая H.264/AVC, представляет собой макроблок, соответствующий блоку размером 16×16 выборок яркости и соответствующих выборок цветности. В соответствии с H.264/AVC макроблок также может разбиваться на разделы макроблока размером 16×8, 8×16 или 8×8, а раздел 8×8 может также разбиваться на разделы частей макроблока размером 4×4, 4×8 или 8×4, и при этом вектор движения кодируется для каждого раздела. Далее понятие "блок" используется для ссылки на элемент для взаимного предсказания, который может характеризоваться разными уровнями в структуре разделения. Например, в случае применения H.264/AVC далее блок может обозначать макроблок, раздел макроблока или раздел части макроблока, в зависимости от того, какой из этих компонентов используется в качестве элемента для взаимного предсказания.