Изобретение относится к системам и способам обработки данных антропометрии тела человека, предназначенным для использования в торговле одеждой, обувью, и в частности при электронной торговле, а также при изготовлении ортопедических изделий.

С развитием Интернета все большее распространение получает дистанционный заказ предметов одежды и обуви без предварительной примерки. При этом поставщики вынуждены оплачивать возврат одежды и обуви покупателями при несоответствии характеристик тела и/или ноги/стопы покупателя, с одной стороны, и точных размеров поставляемых предметов одежды и обуви, с другой стороны. Возврат заказанных дистанционно через Интернет товаров достигает 30% от общего оборота магазинов дистанционной торговли и значительно превышает возврат предварительно примеренных товаров в стационарных магазинах. Таким образом, дистанционная торговля, экономя на аренде помещений, несет значительные издержки, связанные с возвратом неподходящего по размеру товара.

Известны различные способы решения указанной проблемы, связанные с получением оцифрованных данных тела конкретного человека и последующим использованием этих данных для подбора и изготовления одежды и обуви, в том числе и при электронной торговле. Так, известен способ проектирования одежды на основе бесконтактной антропометрии (см., например, патент РФ №2358628), включающий измерение поверхности тела потребителя с помощью системы технического зрения путем одновременного фотографирования потребителя с разных ракурсов, передачу данных измерений в компьютер, формирование из снимков стереопар, декодирование каждой стереопары с построением поверхности, соответствующей части тела измеряемого, формирование поверхности виртуального манекена, передачу данных в САПР одежды, выделение на поверхности виртуального манекена выбранных опорных точек, соответствующих предмету одежды. При этом в дальнейшем в данных точках задают величины зазоров, получают трехмерную конструкцию проектируемого изделия, наносят линии членения, рисунок и фактуру материала. Таким образом, осуществляют развертывание трехмерной конструкции на плоскость с учетом свойств материалов и подготавливают лекала модели швейного изделия, после чего передают их на автоматический раскрой. Однако указанный способ бесконтактного измерения антропометрических данных для изготовления одежды/обуви на основе фотографического моделирования характеризуется невысокой точностью измерений, требует полного обнажения или фотографирования в специализированной, обтягивающей одежде, что создает неудобство для потребителя.

Известен способ (см., например, заявку на выдачу патента CN №10513935), при котором предлагается ставить человека на вращающуюся базу напротив фотосканера и, вращая его, получать сканируемое изображение, создавать 3D-модель тела человека, а затем, используя полученные данные, с помощью компьютера подбирать подходящие модели одежды.

Известен также способ дистанционного подбора одежды (см., например, заявку на выдачу патента CN №10513935), при котором связывают подсистему покупателя с подсистемой продавца, при этом на стороне покупателя имеется сканер, позволяющий получить объемные данные о покупателе, а на стороне продавца должен быть 3D-принтер, с помощью которого печатают модели из пены или надувные куклы, соответствующие размерам покупателя и которые в дальнейшем помогают в подборке одежды.

В то же время существуют объемные сканеры, используемые, например, в целях безопасности в аэропортах для сканирования точных размеров тела человека в целях безопасности (см., например, http://avia.travel.ru/airports/185242.html).

Технический результат заявляемого изобретения заключается в обеспечении получения оцифрованных точных объемных параметров тела человека, включая ногу/стопу без необходимости раздевания, в их обработке и сохранении полученных трехмерных изображений, а также в обеспечении использования этих сохраненных оцифрованных точных объемных параметров тела человека при автоматическом подборе подходящей модели из базы данных существующих моделей одежды и обуви, при примерке одежды и обуви с использованием пространственно-изменяемого робоманекена и при индивидуальном изготовлении одежды, обуви, ортопедических средств.

Указанный технический результат достигают тем, что при комплексном способе подбора и проектирования индивидуально-эргономических физических предметов на основе бесконтактной антропометрии, содержащем процессы сканирования тела, обработки и сохранения полученных данных и их использования для подбора и изготовления одежды, обуви и ортопедических средств, сначала создают базу данных параметров соответствующего тела, осуществляя при этом сканирование его под одеждой или внутри обуви с помощью 3D микроволнового или рентгеновского сканера, и в последующем, обрабатывая и сохраненяя полученное трехмерное изображение в базе подобных изображений с присвоением каждому трехмерному изображению соответствующего идентификационного кода-номера, подбирают подходящую модель путем сравнения данных из базы данных сохраненного трехмерного изображения, имеющего соответствующий идентификационный код-номер, с данными уже существующих оцифрованных лекал и колодок одежды и обуви, а также с данными моделей одежды, обуви и ортопедических средств, предварительно отсканированных при помощи 3D-сканера, при этом примерку конкретных экземпляров одежды и обуви осуществляют при помощи пространственно-изменяемого робоманекена, используя при этом и данные о традиционных размерах одежды и обуви, и, кроме того, в случае индивидуального изготовления экземпляров одежды, обуви и ортопедических средств это делают либо путем подбора точных лекал и колодок или их изготовления в соответствии с данными из базы данных сохраненного трехмерного изображения с соответствующим идентификационным кодом-номером, либо путем изготовления экземпляров индивидуальной одежды, обуви и ортопедических средств на 3D-принтере. При этом в качестве робоманекена используют пространственно-изменяемый манекен, внешние параметры которого могут видоизменяться при помощи механического, или пневматического, или гидравлического привода для соответствия его заданным антропометрическим данным (см., например, http://zoom.cnews.ru/rnd/news/line/robotymanekeny_kupit_odezhdu_onlayn_stanovitsya_proshhe).

Данное техническое решение состоит в использовании существующих объемных микроволновых или рентгеновских сканеров вместе с соответствующим программным обеспечением, в рамках которого можно определить и оцифровать точные объемные параметры тела человека, включая ногу/стопу человека, без необходимости раздевания. Такие сканеры могут быть установлены в доступных местах, таких как торговые моллы, могут быть даже использованы существующие сканеры в аэропортах, при прохождении через которые параметры тела человека будут занесены в соответствующую базу данных, в которой каждому трехмерному изображению данного лица присваивают уникальный идентификационный код-номер в такой базе. Этот уникальный номер указанное лицо может сообщать изготовителям/поставщикам одежды, обуви, ортопедических средств, которые при обращении к базе получат доступ к точным объемным характеристикам тела человека.

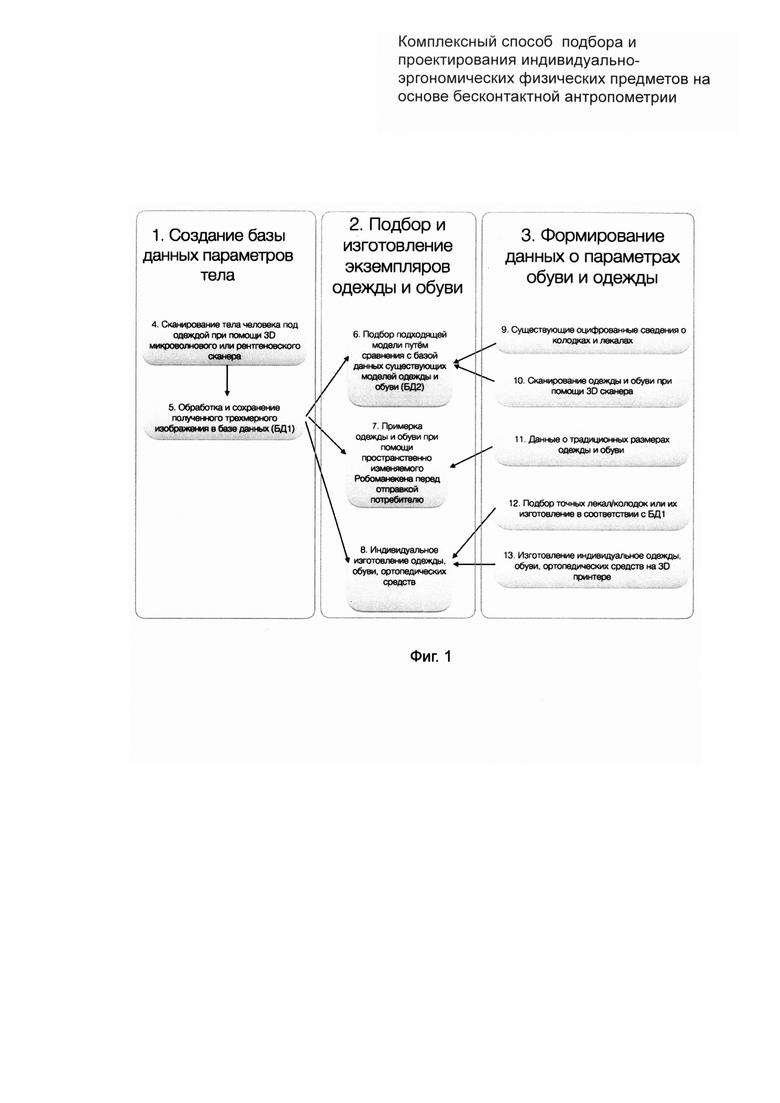

На прилагаемой фиг. 1 изображена схема функционирования и взаимодействия процессов, входящих в состав комплексного способа подбора и проектирования индивидуально-эргономических физических предметов на основе бесконтактной антропометрии.

На приведенной схеме использованы следующие обозначения:

1 - создание базы данных параметров тела;

2 - подбор и изготовление экземпляров одежды и обуви;

3 - формирование данных о параметрах обуви и одежды;

4 - сканирование тела при помощи 3D объемного сканера: микроволнового или рентгеновского;

5 - обработка и сохранение полученного трехмерного изображения в базе данных;

6 - подбор подходящей модели путем сравнения данных из базы данных сохраненного трехмерного изображения, имеющего соответствующий идентификационный код-номер, с данными уже существующих оцифрованных лекал и колодок одежды и обуви;

7 - примерка одежды и обуви при помощи пространственно-изменяемого робоманекена перед отправкой потребителю;

8 - индивидуальное изготовление экземпляров одежды, обуви, ортопедических средств;

9 - данные о существующих оцифрованных лекалах и колодках одежды и обуви;

10 - данные моделей одежды, обуви и ортопедических средств, предварительно отсканированных при помощи 3D-сканера;

11 - данные о традиционных размерах одежды и обуви;

12 - подбор точных лекал и колодок или их изготовление в соответствии с данными из базы данных сохраненного трехмерного изображения с соответствующим идентификационным кодом-номером;

13 - изготовление экземпляров индивидуальной одежды, обуви и ортопедических средств на 3D принтере.

При заявляемом способе, поз. 1, 2, 3, со стороны изготовителей/поставщиков одежды точные параметры тела человека, поз. 4, 5, могут быть использованы следующим образом: подбора наиболее подходящих по размерам одежды/обуви из существующего ассортимента путем сравнения антропометрических данных человека, полученных из базы изображений с присвоением каждому трехмерному изображению соответствующего идентификационного кода-номера, поз. 5, с размерами лекал/колодок в собственной базе поставщика/производителя, поз. 9. Данное сравнение может осуществляться мгновенно программным образом при подборе покупателем на Интернет-сайте интересующих его/ее фасонов одежды/обуви. Специальное программное обеспечение, установленное на сайте, может также демонстрировать виртуальную модель посадки данной модели одежды/обуви на тело данного покупателя с разных сторон, поз. 6. Кроме того, для подбора наиболее подходящих по размерам одежды/обуви из существующего ассортимента, путем ручной примерки одежды/обуви с использованием специального робота-менекена поз. 7, объемно-пространственные параметры которого меняются в соответствии с заданными параметрами из изображений с присвоением каждому трехмерному изображению соответствующего идентификационного кода-номера, поз. 5. Использование робоманекена, поз. 7, может потребоваться в случае, если отсутствует оцифрованная база данных параметров существующего ассортимента одежды/обуви, поз. 11. Кроме того, для изготовления одежды и обуви по точным антропометрическим данным клиента (на заказ), поз. 8, с использованием следующих вариантов: либо как подбор наиболее подходящих лекал/колодок, либо изготовление точных лекал/колодок с использованием станка с программным управлением, или 3D-принтера, поз. 12, или распечатка на 3D-принтере одежды и обуви в соответствии с выбранным фасоном, на основании точных полученных антропометрических данных клиента, поз. 5, поз. 13, или изготовление индивидуальной одежды/обуви с примеркой на робоманекене, поз. 7. При этом в качестве робоманекена, поз. 7, используют пространственно-изменяемый манекен, внешние параметры которого могут видоизменять при помощи механического, или пневматического, или гидравлического привода для соответствия его заданным антропометрическим данным.

Для оцифровки параметров ассортимента обуви может быть также использован рентгеновский аппарат с программным комплексом на стороне поставщика/изготовителя обуви. Данный рентгеновский аппарат сканирует обувь, в том числе внутри упаковочной коробки, программный комплекс оцифровывает внутреннюю поверхность обуви в той же системе, что и данные с соответствующим идентификационным кодом-номером, поз. 5, для их сопоставления.

В качестве дополнительного решения может быть использован рентгеновский или микроволновой сканер на стороне изготовителя/поставщика для оцифровки предметов одежды, однако для этого одежда должна быть одета на специальные манекены, прозрачные для сканирующих лучей.

Вышеперечисленные признаки изобретения, применимые и к изготовлению, и подбору одежды и обуви, также применимы к изготовлению и подбору ортопедических предметов.

| название | год | авторы | номер документа |

|---|---|---|---|

| КОМПЬЮТЕРНО-РЕАЛИЗУЕМЫЙ СПОСОБ ОБЕСПЕЧЕНИЯ УДАЛЕННОЙ АВТОМАТИЗИРОВАННОЙ ПРИМЕРКИ И/ИЛИ ВЫБОРА ИЗДЕЛИЙ | 2018 |

|

RU2730044C2 |

| СПОСОБ И СИСТЕМА ПОСТРОЕНИЯ РЕАЛИСТИЧНОГО 3D АВАТАРА ПОКУПАТЕЛЯ ДЛЯ ВИРТУАЛЬНОЙ ПРИМЕРОЧНОЙ | 2015 |

|

RU2615911C1 |

| СПОСОБ ВИРТУАЛЬНОГО ПОДБОРА ОДЕЖДЫ | 2014 |

|

RU2551731C1 |

| СПОСОБ ИЗГОТОВЛЕНИЯ ИНДИВИДУАЛЬНОЙ ОРТОПЕДИЧЕСКОЙ КОЛОДКИ С МЕЖСТЕЛЕЧНЫМ СЛОЕМ | 2015 |

|

RU2596107C1 |

| СПОСОБ ПРОЕКТИРОВАНИЯ ОДЕЖДЫ НА ОСНОВЕ БЕСКОНТАКТНОЙ АНТРОПОМЕТРИИ | 2007 |

|

RU2358628C2 |

| СПОСОБ И СИСТЕМА ДЛЯ ДИСТАНЦИОННОГО ВЫБОРА ОДЕЖДЫ | 2020 |

|

RU2805003C2 |

| СПОСОБ И СИСТЕМА ИНТЕРАКТИВНОГО СОЗДАНИЯ ПРЕДМЕТОВ ОДЕЖДЫ | 2016 |

|

RU2635294C1 |

| Контактное устройство для измерения конфигурации и размеров объемного тела, система измерения конфигурации и размеров объемного тела, способ измерения конфигурации и размеров объемного тела | 2017 |

|

RU2663387C1 |

| СПОСОБ ОБЕСПЕЧЕНИЯ УДАЛЕННОЙ ПРИМЕРКИ И/ИЛИ ВЫБОРА ОДЕЖДЫ | 2012 |

|

RU2504009C1 |

| СПОСОБ ПРОЕКТИРОВАНИЯ КОНСТРУКЦИЙ ОДЕЖДЫ НА ОСНОВЕ СОВМЕЩЕНИЯ ВИРТУАЛЬНЫХ ОБРАЗОВ ТИПОВОЙ И ИНДИВИДУАЛЬНОЙ ФИГУР | 2017 |

|

RU2669688C2 |

Изобретение относится к системам и способам обработки данных антропометрии тела человека, предназначенным для использования в торговле одеждой, обувью, при электронной торговле, а также при изготовлении ортопедических изделий. Изобретение заключается в получении оцифрованных точных объемных параметров тела человека, включая ногу/стопу, без необходимости раздевания, в их обработке и сохранении полученных трехмерных изображений, а также в обеспечении использования этих сохраненных оцифрованных точных объемных параметров тела человека при автоматическом подборе подходящей модели из базы данных существующих моделей одежды и обуви, при примерке одежды и обуви с использованием пространственно-изменяемого робоманекена и при индивидуальном изготовлении одежды, обуви, ортопедических средств. 3 з.п. ф-лы, 1 ил.

1. Комплексный способ подбора и проектирования индивидуально-эргономических физических предметов на основе бесконтактной антропометрии, содержащий процессы сканирования тела, обработки, сохранения полученных данных и их использования для подбора и изготовления одежды, обуви и ортопедических средств, отличающийся тем, что сначала создают базу данных параметров соответствующего тела, осуществляя при этом сканирование его под одеждой или внутри обуви с помощью 3D-микроволнового или рентгеновского сканера, и в последующем, обрабатывая и сохраняя полученное трехмерное изображение в базе подобных изображений с присвоением каждому трехмерному изображению соответствующего идентификационного кода-номера, подбирают подходящую модель путем сравнения данных из базы данных сохраненного трехмерного изображения, имеющего соответствующий идентификационный код-номер, с данными уже существующих оцифрованных лекал и колодок одежды и обуви, а также с данными моделей одежды, обуви и ортопедических средств, предварительно отсканированных при помощи 3D-сканера, при этом примерку конкретных экземпляров одежды и обуви осуществляют при помощи пространственно-изменяемого робоманекена, используя при этом и данные о традиционных размерах одежды и обуви, и, кроме того, в случае индивидуального изготовления экземпляров одежды, обуви и ортопедических средств это делают либо путем подбора точных лекал и колодок или их изготовления в соответствии с данными из базы данных сохраненного трехмерного изображения с соответствующим идентификационным кодом-номером, либо путем изготовления экземпляров индивидуальной одежды, обуви и ортопедических средств на 3D-принтере.

2. Комплексный способ по п. 1, отличающийся тем, что в качестве робоманекена используют пространственно-изменяемый манекен, внешние параметры которого видоизменяют при помощи механического привода для соответствия его заданным антропометрическим данным.

3. Комплексный способ по п. 1, отличающийся тем, что в качестве робоманекена используют пространственно-изменяемый манекен, внешние параметры которого видоизменяют при помощи пневматического привода для соответствия его заданным антропометрическим данным.

4. Комплексный способ по п. 1, отличающийся тем, что в качестве робоманекена используют пространственно-изменяемый манекен, внешние параметры которого видоизменяют при помощи гидравлического привода для соответствия его заданным антропометрическим данным.

| US 9460557 B1, 04.10.2016 | |||

| US 20160219265 A1, 28.07.2016 | |||

| WO 2016140590 A2, 09.09.2016 | |||

| US 8650096 B2, 11.02.2014 | |||

| US 20170011452 A1, 12.01.2017. |

Авторы

Даты

2017-12-08—Публикация

2017-03-01—Подача