Настоящее изобретение относится к обработке аудиосигнала и, в частности, к системе, устройству и способу для согласованного воспроизведения акустической сцены на основании информированной пространственной фильтрации.

При воспроизведении пространственного звука звук в местоположении записи (на стороне ближнего конца) захватывается множеством микрофонов и затем воспроизводится на стороне воспроизведения (стороне дальнего конца) с использованием множества громкоговорителей или головных наушников. Во многих применениях, желательно воспроизводить записанный звук таким образом, чтобы пространственное изображение, воссоздаваемое на стороне дальнего конца, согласовывалось с первоначальным пространственным изображением на стороне ближнего конца. Это означает, например, что звук источников звука воспроизводится с направлений, где источники присутствовали в первоначальном сценарии записи. Альтернативно, когда, например, видео дополняет записанное аудио, желательно, чтобы звук воспроизводился таким образом, чтобы воссоздаваемое акустическое изображение согласовывалось с видеоизображением. Это означает, например, что звук источника звука воспроизводится с направления, в котором источник наблюдается в видео. Дополнительно, видеокамера может быть снабжена функцией визуального масштабирования, или пользователь на стороне дальнего конца может применять к видео цифровое масштабирование, которое будет изменять визуальное изображение. В этом случае, должно соответственно изменяться акустическое изображение воспроизводимого пространственного звука. Во многих случаях, сторона дальнего конца определяет пространственное изображение, с которым нужно согласовывать воспроизводимый звук, определяется либо на стороне дальнего конца, либо в ходе воспроизведения, например, когда используется видеоизображение. В результате, пространственный звук на стороне ближнего конца нужно записывать, обрабатывать и передавать таким образом, чтобы на стороне дальнего конца все же можно было управлять воссоздаваемым акустическим изображением.

Возможность воспроизведения записанной акустической сцены в согласовании с желаемым пространственным изображением требуется во многих современных областях применения. Например, такие современные бытовые устройства, как цифровые камеры или мобильные телефоны часто снабжены видеокамерой и множественными микрофонами. Это позволяет записывать видео совместно с пространственным звуком, например, стереозвуком. При воспроизведении записанного аудио совместно с видео, желательно, чтобы визуальное и акустическое изображения были согласованы. Когда пользователь осуществляет масштабирование приближения с помощью камеры, желательно воссоздавать эффект визуального масштабирования акустически таким образом, чтобы визуальные и акустические изображения выравнивались при просмотре видео. Например, когда пользователь осуществляет масштабирование приближения на человеке, голос этого человека должен становиться менее реверберирующим по мере приближения человека к камере. Кроме того, голос человека должен воспроизводиться с того же направления, где находится человек в визуальном изображении. Акустическая имитация визуального масштабирования камеры в дальнейшем именуется акустическим масштабированием и представляет один пример согласованного аудио-видео-воспроизведения. Согласованное аудио-видеовоспроизведение, в котором может применяться акустическая масштабирование, также полезно в телеконференцсвязи, где пространственный звук на стороне ближнего конца воспроизводится на стороне дальнего конца совместно с визуальным изображением. Кроме того, желательно акустически воссоздавать эффект визуального масштабирования таким образом, чтобы визуальные и акустические изображения выравнивались.

Первая реализация акустического масштабирования представлена в [1], где эффект масштабирования получен путем увеличения направленности направленного микрофона второго порядка, сигнал которого сгенерирован на основании сигналов линейной микрофонной решетки. Этот подход получил развитие в [2] до стереомасштабирования. В [3] представлен более недавний подход к моно- или стереомасштабированию, который состоит в изменение уровней источников звука таким образом, что источник с фронтального направления сохраняется, тогда как источники, поступающие с других направлений, и диффузный звук ослабляются. Подходы, предложенные в [1,2] приводят к увеличению отношения прямого звука к реверберации (DRR), и подход в [3] дополнительно позволяет подавлять нежелательные источники. Вышеупомянутые подходы предполагают, что источник звука располагается перед камерой, и не предполагают захват акустического изображения которое согласуется с видеоизображением.

Общеизвестный подход к адаптивным записи и воспроизведению пространственного звука представлен направленным аудиокодированием (DirAC) [4]. В DirAC, пространственный звук на стороне ближнего конца описывается посредством аудиосигнала и параметрической вспомогательной информации, а именно, направления прихода (DOA) и диффузности звука. Параметрическое описание позволяет воспроизводить первоначальное пространственное изображение с произвольными конфигурациями громкоговорителей. Это означает, что воссоздаваемое пространственное изображение на стороне дальнего конца согласуется с пространственным изображением в ходе записи на стороне ближнего конца. Если же, например, видео дополняет записанное аудио, то воспроизводимый пространственный звук не обязательно выравнивать с видеоизображением. Кроме того, воссоздаваемое акустическое изображение невозможно регулировать при изменении визуальных изображений, например, когда изменяется направление наведения и масштабирование камеры. Это означает, что DirAC не позволяет регулировать воссоздаваемое акустическое изображение до произвольного желаемого пространственного изображения.

В [5] акустическое масштабирование реализовано на основании DirAC. DirAC представляет приемлемую основу для реализации акустического масштабирования, поскольку оно основано на простой, но эффективной модели сигнала, предполагающей, что звуковое поле в частотно-временной области состоит из одиночной плоской волны плюс диффузный звук. Основные параметры модели, например, DOA и диффузность, используются для разделения прямого звука и диффузного звука и для создания эффекта акустического масштабирования. Параметрическое описание пространственного звука позволяет эффективно передавать звуковую сцену стороне дальнего конца, предоставляя при этом пользователю полное управление эффектом масштабирования и воспроизведением пространственного звука. Хотя DirAC использует множественные микрофоны для оценивания параметров модели, для выделения прямого звука и диффузного звука применяются только одноканальные фильтры, ограничивающие качество воспроизводимого звука. Кроме того, предполагается, что все источники в звуковой сцене располагаются на окружности, и воспроизведение пространственного звука осуществляется согласно изменению положения аудиовизуальной камеры, которое не согласуется с визуальным масштабированием. Фактически, масштабирование изменяет угол зрения камеры, в то время как расстояние до визуальных объектов и их относительные положения в изображении остаются неизменными, в отличие от движения камеры.

Родственным подходом является так называемый метод виртуальных микрофонов (VM) [6,7], который опирается на ту же модель сигнала, что и DirAC, но позволяет синтезировать сигнал несуществующего (виртуального) микрофона в произвольном положении в звуковой сцене. Движение VM к источнику звука аналогично перемещению камеры в новое положение. VM реализован с использованием многоканальных фильтров для повышения качества звука, но требует несколько распределенных микрофонных решеток для оценивания параметров модели.

Однако очевидно, что можно предложить дополнительно усовершенствованные принципы обработки аудиосигнала.

Таким образом, задачей настоящего изобретения является обеспечение усовершенствованных принципов обработки аудиосигнала. Задача настоящего изобретения решается путем обеспечения системы по п. 1, устройства по п. 13, способа по п. 14, способа по п. 15 и компьютерной программы по п. 16.

Предусмотрена система для генерации одного или более выходных аудиосигналов. Система содержит модуль разложения, процессор сигналов и выходной интерфейс. Модуль разложения выполнен с возможностью приема двух или более входных аудиосигналов, причем модуль разложения выполнен с возможностью генерации прямого компонентного сигнала, содержащего прямые составляющие сигнала двух или более входных аудиосигналов, и модуль разложения выполнен с возможностью генерации диффузного компонентного сигнала, содержащего диффузные составляющие сигнала двух или более входных аудиосигналов. Процессор сигналов выполнен с возможностью приема прямого компонентного сигнала, диффузного компонентного сигнала и информации направления, причем упомянутая информация направления зависит от направления прихода прямых составляющих сигнала двух или более входных аудиосигналов. Кроме того, процессор сигналов выполнен с возможностью генерации одного или более обработанных диффузных сигналов в зависимости от диффузного компонентного сигнала. Для каждого выходного аудиосигнала из одного или более выходных аудиосигналов, процессор сигналов выполнен с возможностью определения, в зависимости от направления прихода, прямого коэффициента усиления, процессор сигналов выполнен с возможностью применения упомянутого прямого коэффициента усиления к прямому компонентному сигналу для получения обработанного прямого сигнала, и процессор сигналов выполнен с возможностью объединения упомянутого обработанного прямого сигнала и одного из одного или более обработанных диффузных сигналов для генерации упомянутого выходного аудиосигнала. Выходной интерфейс выполнен с возможностью вывода одного или более выходных аудиосигналов.

Согласно вариантам осуществления, предусмотрены принципы обеспечения записи и воспроизведения пространственного звука, позволяющие, например, согласовывать воссоздаваемое акустическое изображение с желаемым пространственным изображением, которое, например, определяется пользователем на стороне дальнего конца или видеоизображением. Предложенный подход предусматривает использование микрофонной решетки на стороне ближнего конца, которая позволяет разлагать захваченный звук на составляющие прямого звука и составляющую диффузного звука. Затем выделенные составляющие звука передаются стороне дальнего конца. Согласованное воспроизведение пространственного звука можно реализовать, например, посредством взвешенной суммы выделенного прямого звука и диффузного звука, где весовые коэффициенты зависят от желаемого пространственного изображения, с которым нужно согласовывать воспроизводимый звук, например, весовые коэффициенты зависят от направления наведения и коэффициента масштабирования видеокамеры, которые могут, например, дополнять аудиозапись. Предусмотрены принципы использования информированных многоканальных фильтров для выделения прямого звука и диффузного звука.

Согласно варианту осуществления, процессор сигналов может, например, быть выполнен с возможностью определения двух или более выходных аудиосигналов, причем для каждого выходного аудиосигнала из двух или более выходных аудиосигналов панорамирующая функция усиления может, например, присваиваться упомянутому выходному аудиосигналу, причем панорамирующая функция усиления каждого из двух или более выходных аудиосигналов содержит множество значений аргумента панорамирующей функции, причем возвращаемое значение панорамирующей функции может, например, присваиваться каждому из упомянутых значений аргумента панорамирующей функции, причем, когда упомянутая панорамирующая функция усиления принимает одно из упомянутых значений аргумента панорамирующей функции, упомянутая панорамирующая функция усиления может, например, быть выполнена с возможностью возвращения возвращаемого значения панорамирующей функции, присваиваемого упомянутому одному из упомянутых значений аргумента панорамирующей функции, и при этом процессор сигналов может, например, быть выполнен с возможностью определения каждого из двух или более выходных аудиосигналов в зависимости от зависящего от направления значения аргумента из значений аргумента панорамирующей функции панорамирующей функции усиления, присваиваемой упомянутому выходному аудиосигналу, причем упомянутое зависящее от направления значение аргумента зависит от направления прихода.

Согласно варианту осуществления, панорамирующая функция усиления каждого из двух или более выходных аудиосигналов имеет один или более глобальных максимумов, являющихся одним из значений аргумента панорамирующей функции, причем для каждого из одного или более глобальных максимумов каждой панорамирующей функции усиления, не существует других значений аргумента панорамирующей функции, для которых упомянутая панорамирующая функция усиления возвращает более высокое возвращаемое значение панорамирующей функции, чем для упомянутых глобальных максимумов, и при этом, для каждой пары первого выходного аудиосигнала и второго выходного аудиосигнала из двух или более выходных аудиосигналов, по меньшей мере, один из одного или более глобальных максимумов панорамирующей функции усиления первого выходного аудиосигнала может, например, отличаться от любого из одного или более глобальных максимумов панорамирующей функции усиления второго выходного аудиосигнала.

Согласно варианту осуществления, процессор сигналов может, например, быть выполнен с возможностью генерации каждого выходного аудиосигнала из одного или более выходных аудиосигналов в зависимости от функции окна усиления, причем функция окна усиления может, например, быть выполнена с возможностью возвращения возвращаемого значения функции окна при приеме значения аргумента функции окна, причем, если значение аргумента функции окна может, например, быть больше нижнего порога окна и меньше верхнего порога окна, функция окна усиления может, например, быть выполнена с возможностью возвращения возвращаемого значения функции окна, которое больше любого возвращаемого значения функции окна, возвращаемого функцией окна усиления, если значение аргумента функции окна может, например, быть меньше нижнего порога или больше верхнего порога.

Согласно варианту осуществления, процессор сигналов может, например, быть выполнен с дополнительной возможностью приема информации ориентации, указывающей угловой сдвиг направления наведения относительно направления прихода, и при этом, по меньшей мере, одна из панорамирующей функции усиления и функции окна усиления зависит от информации ориентации; или модуль вычисления функции усиления может, например, быть выполнен с дополнительной возможностью приема информации масштабирования, причем информация масштабирования указывает угол раствора камеры, и при этом, по меньшей мере, одна из панорамирующей функции усиления и функции окна усиления зависит от информации масштабирования; или модуль вычисления функции усиления может, например, быть выполнен с дополнительной возможностью приема параметра калибровки, и при этом, по меньшей мере, одна из панорамирующей функции усиления и функции окна усиления зависит от параметра калибровки.

Согласно варианту осуществления, процессор сигналов может, например, быть выполнен с возможностью приема информации расстояния, причем процессор сигналов может, например, быть выполнен с возможностью генерации каждого выходного аудиосигнала из одного или более выходных аудиосигналов в зависимости от информации расстояния.

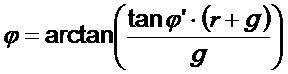

Согласно варианту осуществления, процессор сигналов может, например, быть выполнен с возможностью приема первоначального значения угла в зависимости от первоначального направления прихода, которое является направлением прихода прямых составляющих сигнала двух или более входных аудиосигналов, и может, например, быть выполнен с возможностью приема информации расстояния, причем процессор сигналов может, например, быть выполнен с возможностью вычисления измененного значения угла в зависимости от первоначального значения угла и в зависимости от информации расстояния, и при этом процессор сигналов может, например, быть выполнен с возможностью генерации каждого выходного аудиосигнала из одного или более выходных аудиосигналов в зависимости от измененного значения угла.

Согласно варианту осуществления, процессор сигналов может, например, быть выполнен с возможностью генерации одного или более выходных аудиосигналов путем проведения низкочастотной фильтрации, или путем прибавления задержанного прямого звука, или путем проведения ослабления прямого звука, или путем проведения временного сглаживания, или путем проведения расширения направления прихода, или путем проведения декорреляции.

Согласно варианту осуществления, процессор сигналов может, например, быть выполнен с возможностью генерации двух или более выходных аудиоканалов, причем процессор сигналов может, например, быть выполнен с возможностью применения диффузного коэффициента усиления к диффузному компонентному сигналу для получения промежуточного диффузного сигнала, и при этом процессор сигналов может, например, быть выполнен с возможностью генерации одного или более декоррелированных сигналов из промежуточного диффузного сигнала путем проведения декорреляции, причем один или более декоррелированных сигналов образуют один или более обработанных диффузных сигналов, или промежуточный диффузный сигнал и один или более декоррелированных сигналов образуют один или более обработанных диффузных сигналов.

Согласно варианту осуществления, прямой компонентный сигнал и один или более дополнительных прямых компонентных сигналов образуют группу из двух или более прямых компонентных сигналов, причем модуль разложения может, например, быть выполнен с возможностью генерации одного или более дополнительных прямых компонентных сигналов, содержащих дополнительные прямые составляющие сигнала двух или более входных аудиосигналов, причем направление прихода и одно или более дополнительных направлений прихода образуют группу из двух или более направлений прихода, причем каждое направление прихода из группы из двух или более направлений прихода может, например, присваиваться в точности одному прямому компонентному сигналу из группы из двух или более прямых компонентных сигналов, причем количество прямых компонентных сигналов из двух или более прямых компонентных сигналов, и количество направлений прихода двух направлений прихода может, например, быть равным, причем процессор сигналов может, например, быть выполнен с возможностью приема группы из двух или более прямых компонентных сигналов и группы из двух или более направлений прихода, и при этом, для каждого выходного аудиосигнала из одного или более выходных аудиосигналов, процессор сигналов может, например, быть выполнен с возможностью определения, для каждого прямого компонентного сигнала из группы из двух или более прямых компонентных сигналов, прямого коэффициента усиления в зависимости от направления прихода упомянутого прямого компонентного сигнала, процессор сигналов может, например, быть выполнен с возможностью генерации группы из двух или более обработанных прямых сигналов путем применения, для каждого прямого компонентного сигнала из группы из двух или более прямых компонентных сигналов, прямого коэффициента усиления упомянутого прямого компонентного сигнала к упомянутому прямому компонентному сигналу, и процессор сигналов может, например, быть выполнен с возможностью объединения одного из одного или более обработанных диффузных сигналов и каждого обработанного сигнала из группы из двух или более обработанных сигналов для генерации упомянутого выходного аудиосигнала.

Согласно варианту осуществления, количество прямых компонентных сигналов из группы из двух или более прямых компонентных сигналов плюс 1 может, например, быть меньше количества входных аудиосигналов, принимаемых приемным интерфейсом.

Кроме того, может, например, быть предусмотрен слуховой аппарат или вспомогательное слуховое устройство, содержащее вышеописанную систему.

Кроме того, предусмотрено устройство для генерации одного или более выходных аудиосигналов. Устройство содержит процессор сигналов и выходной интерфейс. Процессор сигналов выполнен с возможностью приема прямого компонентного сигнала, содержащего прямые составляющие сигнала двух или более первоначальных аудиосигналов, причем процессор сигналов выполнен с возможностью приема диффузного компонентного сигнала, содержащего диффузные составляющие сигнала двух или более первоначальных аудиосигналов, и при этом процессор сигналов выполнен с возможностью приема информации направления, причем упомянутая информация направления зависит от направления прихода прямых составляющих сигнала двух или более входных аудиосигналов. Кроме того, процессор сигналов выполнен с возможностью генерации одного или более обработанных диффузных сигналов в зависимости от диффузного компонентного сигнала. Для каждого выходного аудиосигнала из одного или более выходных аудиосигналов, процессор сигналов выполнен с возможностью определения, в зависимости от направления прихода, прямого коэффициента усиления, процессор сигналов выполнен с возможностью применения упомянутого прямого коэффициента усиления к прямому компонентному сигналу для получения обработанного прямого сигнала, и процессор сигналов выполнен с возможностью объединения упомянутого обработанного прямого сигнала и одного из одного или более обработанных диффузных сигналов для генерации упомянутого выходного аудиосигнала. Выходной интерфейс выполнен с возможностью вывода одного или более выходных аудиосигналов.

Кроме того, предусмотрен способ генерации одного или более выходных аудиосигналов. Способ содержит:

- прием двух или более входных аудиосигналов.

- генерацию прямого компонентного сигнала, содержащего прямые составляющие сигнала двух или более входных аудиосигналов.

- генерацию диффузного компонентного сигнала, содержащего диффузные составляющие сигнала двух или более входных аудиосигналов.

- прием информации направления в зависимости от направления прихода прямых составляющих сигнала двух или более входных аудиосигналов.

- генерацию одного или более обработанных диффузных сигналов в зависимости от диффузного компонентного сигнала.

- для каждого выходного аудиосигнала из одного или более выходных аудиосигналов, определение, в зависимости от направления прихода, прямого коэффициента усиления, применение упомянутого прямого коэффициента усиления к прямому компонентному сигналу для получения обработанного прямого сигнала, и объединение упомянутого обработанного прямого сигнала и одного из одного или более обработанных диффузных сигналов для генерации упомянутого выходного аудиосигнала, и

- вывод одного или более выходных аудиосигналов.

Кроме того, предусмотрен способ генерации одного или более выходных аудиосигналов. Способ содержит:

- прием прямого компонентного сигнала, содержащего прямые составляющие сигнала двух или более первоначальных аудиосигналов.

- прием диффузного компонентного сигнала, содержащего диффузные составляющие сигнала двух или более первоначальных аудиосигналов.

- прием информации направления, причем упомянутая информация направления зависит от направления прихода прямых составляющих сигнала двух или более входных аудиосигналов.

- генерацию одного или более обработанных диффузных сигналов в зависимости от диффузного компонентного сигнала.

- для каждого выходного аудиосигнала из одного или более выходных аудиосигналов, определение, в зависимости от направления прихода, прямого коэффициента усиления, применение упомянутого прямого коэффициента усиления к прямому компонентному сигналу для получения обработанного прямого сигнала, и объединение упомянутого обработанного прямого сигнала и одного из одного или более обработанных диффузных сигналов для генерации упомянутого выходного аудиосигнала, и

- вывод одного или более выходных аудиосигналов.

Кроме того, предусмотрены компьютерные программы, причем каждая из компьютерных программ выполнена с возможностью осуществления одного из вышеописанных способов при выполнении на компьютере или процессоре сигналов, таким образом, что каждый из вышеописанных способов осуществляется одной из компьютерных программ.

Кроме того, предусмотрена система для генерации одного или более выходных аудиосигналов. Система содержит модуль разложения, процессор сигналов и выходной интерфейс. Модуль разложения выполнен с возможностью приема двух или более входных аудиосигналов, причем модуль разложения выполнен с возможностью генерации прямого компонентного сигнала, содержащего прямые составляющие сигнала двух или более входных аудиосигналов, и модуль разложения выполнен с возможностью генерации диффузного компонентного сигнала, содержащего диффузные составляющие сигнала двух или более входных аудиосигналов. Процессор сигналов выполнен с возможностью приема прямого компонентного сигнала, диффузного компонентного сигнала и информации направления, причем упомянутая информация направления зависит от направления прихода прямых составляющих сигнала двух или более входных аудиосигналов. Кроме того, процессор сигналов выполнен с возможностью генерации одного или более обработанных диффузных сигналов в зависимости от диффузного компонентного сигнала. Для каждого выходного аудиосигнала из одного или более выходных аудиосигналов, процессор сигналов выполнен с возможностью определения, в зависимости от направления прихода, прямого коэффициента усиления, процессор сигналов выполнен с возможностью применения упомянутого прямого коэффициента усиления к прямому компонентному сигналу для получения обработанного прямого сигнала, и процессор сигналов выполнен с возможностью объединения упомянутого обработанного прямого сигнала и одного из одного или более обработанных диффузных сигналов для генерации упомянутого выходного аудиосигнала. Выходной интерфейс выполнен с возможностью вывода одного или более выходных аудиосигналов. Процессор сигналов содержит модуль вычисления функции усиления для вычисления одной или более функций усиления, причем каждая функция усиления из одной или более функций усиления, содержит множество значений аргумента функции усиления, причем возвращаемое значение функции усиления присваивается каждому из упомянутых значений аргумента функции усиления, причем, когда упомянутая функция усиления принимает одно из упомянутых значений аргумента функции усиления, упомянутая функция усиления выполнена с возможностью возвращения возвращаемого значения функции усиления, присваиваемого упомянутому одному из упомянутых значений аргумента функции усиления. Кроме того, процессор сигналов дополнительно содержит модификатор сигнала для выбора, в зависимости от направления прихода, зависящего от направления значения аргумента из значений аргумента функции усиления функции усиления из одной или более функций усиления, для получения возвращаемого значения функции усиления, присваиваемого упомянутому зависящему от направления значению аргумента из упомянутой функции усиления, и для определения значения коэффициента усиления, по меньшей мере, одного из одного или более выходных аудиосигналов в зависимости от упомянутого возвращаемого значения функции усиления, полученного из упомянутой функции усиления.

Согласно варианту осуществления, модуль вычисления функции усиления может, например, быть выполнен с возможностью генерации поисковой таблицы для каждой функции усиления из одной или более функций усиления, причем поисковая таблица содержит множество записей, причем каждая из записей поисковой таблицы содержит одно из значений аргумента функции усиления и возвращаемого значения функции усиления, присваиваемого упомянутому значению аргумента функции усиления, причем модуль вычисления функции усиления может, например, быть выполнен с возможностью сохранения поисковой таблицы каждой функции усиления в постоянной или непостоянной памяти, и при этом модификатор сигнала может, например, быть выполнен с возможностью получения возвращаемого значения функции усиления, присваиваемого упомянутому зависящему от направления значению аргумента, путем считывания упомянутого возвращаемого значения функции усиления из одной из одной или более поисковых таблиц, хранящихся в памяти.

Согласно варианту осуществления, процессор сигналов может, например, быть выполнен с возможностью определения двух или более выходных аудиосигналов, причем модуль вычисления функции усиления может, например, быть выполнен с возможностью вычисления двух или более функций усиления, причем, для каждого выходного аудиосигнала из двух или более выходных аудиосигналов, модуль вычисления функции усиления может, например, быть выполнен с возможностью вычисления панорамирующей функции усиления, присваиваемой упомянутому выходному аудиосигналу в качестве одной из двух или более функций усиления, причем модификатор сигнала может, например, быть выполнен с возможностью генерации упомянутого выходного аудиосигнала в зависимости от упомянутой панорамирующей функции усиления.

Согласно варианту осуществления, панорамирующая функция усиления каждого из двух или более выходных аудиосигналов может, например, иметь один или более глобальных максимумов, являющихся одним из значений аргумента функции усиления упомянутой панорамирующей функции усиления, причем для каждого из одного или более глобальных максимумов упомянутой панорамирующей функции усиления, не существует других значений аргумента функции усиления, для которых упомянутая панорамирующая функция усиления возвращает более высокое возвращаемое значение функции усиления, чем для упомянутых глобальных максимумов, и при этом, для каждой пары первого выходного аудиосигнала и второго выходного аудиосигнала из двух или более выходных аудиосигналов, по меньшей мере, один из одного или более глобальных максимумов панорамирующей функции усиления первого выходного аудиосигнала может, например, отличаться от любого из одного или более глобальных максимумов панорамирующей функции усиления второго выходного аудиосигнала.

Согласно варианту осуществления, для каждого выходного аудиосигнала из двух или более выходных аудиосигналов, модуль вычисления функции усиления может, например, быть выполнен с возможностью вычисления функции окна усиления, присваиваемой упомянутому выходному аудиосигналу в качестве одной из двух или более функций усиления, причем модификатор сигнала может, например, быть выполнен с возможностью генерации упомянутого выходного аудиосигнала в зависимости от упомянутой функции окна усиления, и при этом, если значение аргумента упомянутой функции окна усиления больше нижнего порога окна и меньше верхнего порога окна, функция окна усиления выполнена с возможностью возвращения возвращаемого значения функции усиления, которое больше любого возвращаемого значения функции усиления, возвращаемого упомянутой функцией окна усиления, если значение аргумента функции окна меньше нижнего порога или больше верхнего порога.

Согласно варианту осуществления, функция окна усиления каждого из двух или более выходных аудиосигналов имеет один или более глобальных максимумов, являющихся одним из значений аргумента функции усиления упомянутой функции окна усиления, причем для каждого из одного или более глобальных максимумов упомянутой функции окна усиления, не существует других значений аргумента функции усиления, для которых упомянутая функция окна усиления возвращает более высокое возвращаемое значение функции усиления, чем для упомянутых глобальных максимумов, и при этом, для каждой пары первого выходного аудиосигнала и второго выходного аудиосигнала из двух или более выходных аудиосигналов, по меньшей мере, один из одного или более глобальных максимумов функции окна усиления первого выходного аудиосигнала может, например, быть равен одному из одного или более глобальных максимумов функции окна усиления второго выходного аудиосигнала.

Согласно варианту осуществления, модуль вычисления функции усиления может, например, быть выполнен с дополнительной возможностью приема информации ориентации, указывающей угловой сдвиг направления наведения относительно направления прихода, и модуль вычисления функции усиления может, например, быть выполнен с возможностью генерации панорамирующей функции усиления каждого из выходных аудиосигналов в зависимости от информации ориентации.

Согласно варианту осуществления, модуль вычисления функции усиления может, например, быть выполнен с возможностью генерации функции окна усиления каждого из выходных аудиосигналов в зависимости от информации ориентации.

Согласно варианту осуществления, модуль вычисления функции усиления может, например, быть выполнен с дополнительной возможностью приема информации масштабирования, причем информация масштабирования указывает угол раствора камеры, и модуль вычисления функции усиления может, например, быть выполнен с возможностью генерации панорамирующей функции усиления каждого из выходных аудиосигналов в зависимости от информации масштабирования.

Согласно варианту осуществления, модуль вычисления функции усиления может, например, быть выполнен с возможностью генерации функции окна усиления каждого из выходных аудиосигналов в зависимости от информации масштабирования.

Согласно варианту осуществления, модуль вычисления функции усиления может, например, быть выполнен с дополнительной возможностью приема параметра калибровки для выравнивания визуального изображения и акустического изображения, и модуль вычисления функции усиления может, например, быть выполнен с возможностью генерации панорамирующей функции усиления каждого из выходных аудиосигналов в зависимости от параметра калибровки.

Согласно варианту осуществления, модуль вычисления функции усиления может, например, быть выполнен с возможностью генерации функции окна усиления каждого из выходных аудиосигналов в зависимости от параметра калибровки.

Система по любому из предыдущих пунктов, модуль вычисления функции усиления может, например, быть выполнен с возможностью приема информации в визуальном изображении, и модуль вычисления функции усиления может, например, быть выполнен с возможностью генерации, в зависимости от информации в визуальном изображении, размывающей функции, возвращающей комплексные коэффициенты усиления для реализации перцептивного расширения источника звука.

Кроме того, предусмотрено устройство для генерации одного или более выходных аудиосигналов. Устройство содержит процессор сигналов и выходной интерфейс. Процессор сигналов выполнен с возможностью приема прямого компонентного сигнала, содержащего прямые составляющие сигнала двух или более первоначальных аудиосигналов, причем процессор сигналов выполнен с возможностью приема диффузного компонентного сигнала, содержащего диффузные составляющие сигнала двух или более первоначальных аудиосигналов, и при этом процессор сигналов выполнен с возможностью приема информации направления, причем упомянутая информация направления зависит от направления прихода прямых составляющих сигнала двух или более входных аудиосигналов. Кроме того, процессор сигналов выполнен с возможностью генерации одного или более обработанных диффузных сигналов в зависимости от диффузного компонентного сигнала. Для каждого выходного аудиосигнала из одного или более выходных аудиосигналов, процессор сигналов выполнен с возможностью определения, в зависимости от направления прихода, прямого коэффициента усиления, процессор сигналов выполнен с возможностью применения упомянутого прямого коэффициента усиления к прямому компонентному сигналу для получения обработанного прямого сигнала, и процессор сигналов выполнен с возможностью объединения упомянутого обработанного прямого сигнала и одного из одного или более обработанных диффузных сигналов для генерации упомянутого выходного аудиосигнала. Выходной интерфейс выполнен с возможностью вывода одного или более выходных аудиосигналов. Процессор сигналов содержит модуль вычисления функции усиления для вычисления одной или более функций усиления, причем каждая функция усиления из одной или более функций усиления, содержит множество значений аргумента функции усиления, причем возвращаемое значение функции усиления присваивается каждому из упомянутых значений аргумента функции усиления, причем, когда упомянутая функция усиления принимает одно из упомянутых значений аргумента функции усиления, упомянутая функция усиления выполнена с возможностью возвращения возвращаемого значения функции усиления, присваиваемого упомянутому одному из упомянутых значений аргумента функции усиления. Кроме того, процессор сигналов дополнительно содержит модификатор сигнала для выбора, в зависимости от направления прихода, зависящего от направления значения аргумента из значений аргумента функции усиления функции усиления из одной или более функций усиления, для получения возвращаемого значения функции усиления, присваиваемого упомянутому зависящему от направления значению аргумента из упомянутой функции усиления, и для определения значения коэффициента усиления, по меньшей мере, одного из одного или более выходных аудиосигналов в зависимости от упомянутого возвращаемого значения функции усиления, полученного из упомянутой функции усиления.

Кроме того, предусмотрен способ генерации одного или более выходных аудиосигналов. Способ содержит:

- прием двух или более входных аудиосигналов,

- генерацию прямого компонентного сигнала, содержащего прямые составляющие сигнала двух или более входных аудиосигналов,

- генерацию диффузного компонентного сигнала, содержащего диффузные составляющие сигнала двух или более входных аудиосигналов,

- прием информации направления в зависимости от направления прихода прямых составляющих сигнала двух или более входных аудиосигналов,

- генерацию одного или более обработанных диффузных сигналов в зависимости от диффузного компонентного сигнала,

- для каждого выходного аудиосигнала из одного или более выходных аудиосигналов, определение, в зависимости от направления прихода, прямого коэффициента усиления, применение упомянутого прямого коэффициента усиления к прямому компонентному сигналу для получения обработанного прямого сигнала, и объединение упомянутого обработанного прямого сигнала и одного из одного или более обработанных диффузных сигналов для генерации упомянутого выходного аудиосигнала, и

- вывод одного или более выходных аудиосигналов.

Генерация одного или более выходных аудиосигналов содержит вычисление одной или более функций усиления, причем каждая функция усиления из одной или более функций усиления, содержит множество значений аргумента функции усиления, причем возвращаемое значение функции усиления присваивается каждому из упомянутых значений аргумента функции усиления, причем, когда упомянутая функция усиления принимает одно из упомянутых значений аргумента функции усиления, упомянутая функция усиления выполнена с возможностью возвращения возвращаемого значения функции усиления, присваиваемого упомянутому одному из упомянутых значений аргумента функции усиления. Кроме того, генерация одного или более выходных аудиосигналов содержит выбор, в зависимости от направления прихода, зависящего от направления значения аргумента из значений аргумента функции усиления функции усиления из одной или более функций усиления, для получения возвращаемого значения функции усиления, присваиваемого упомянутому зависящему от направления значению аргумента из упомянутой функции усиления, и для определения значения коэффициента усиления, по меньшей мере, одного из одного или более выходных аудиосигналов в зависимости от упомянутого возвращаемого значения функции усиления, полученного из упомянутой функции усиления.

Кроме того, предусмотрен способ генерации одного или более выходных аудиосигналов. Способ содержит:

- прием прямого компонентного сигнала, содержащего прямые составляющие сигнала двух или более первоначальных аудиосигналов,

- прием диффузного компонентного сигнала, содержащего диффузные составляющие сигнала двух или более первоначальных аудиосигналов,

- прием информации направления, причем упомянутая информация направления зависит от направления прихода прямых составляющих сигнала двух или более входных аудиосигналов,

- генерацию одного или более обработанных диффузных сигналов в зависимости от диффузного компонентного сигнала,

- для каждого выходного аудиосигнала из одного или более выходных аудиосигналов, определение, в зависимости от направления прихода, прямого коэффициента усиления, применение упомянутого прямого коэффициента усиления к прямому компонентному сигналу для получения обработанного прямого сигнала, и объединение упомянутого обработанного прямого сигнала и одного из одного или более обработанных диффузных сигналов для генерации упомянутого выходного аудиосигнала, и

- вывод одного или более выходных аудиосигналов.

Генерация одного или более выходных аудиосигналов содержит вычисление одной или более функций усиления, причем каждая функция усиления из одной или более функций усиления, содержит множество значений аргумента функции усиления, причем возвращаемое значение функции усиления присваивается каждому из упомянутых значений аргумента функции усиления, причем, когда упомянутая функция усиления принимает одно из упомянутых значений аргумента функции усиления, упомянутая функция усиления выполнена с возможностью возвращения возвращаемого значения функции усиления, присваиваемого упомянутому одному из упомянутых значений аргумента функции усиления. Кроме того, генерация одного или более выходных аудиосигналов содержит выбор, в зависимости от направления прихода, зависящего от направления значения аргумента из значений аргумента функции усиления функции усиления из одной или более функций усиления, для получения возвращаемого значения функции усиления, присваиваемого упомянутому зависящему от направления значению аргумента из упомянутой функции усиления, и для определения значения коэффициента усиления, по меньшей мере, одного из одного или более выходных аудиосигналов в зависимости от упомянутого возвращаемого значения функции усиления, полученного из упомянутой функции усиления.

Кроме того, предусмотрены компьютерные программы, причем каждая из компьютерных программ выполнена с возможностью осуществления одного из вышеописанных способов при выполнении на компьютере или процессоре сигналов, таким образом, что каждый из вышеописанных способов осуществляется одной из компьютерных программ.

Далее, более подробно описаны варианты осуществления настоящего изобретения со ссылкой на чертежи, в которых:

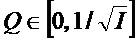

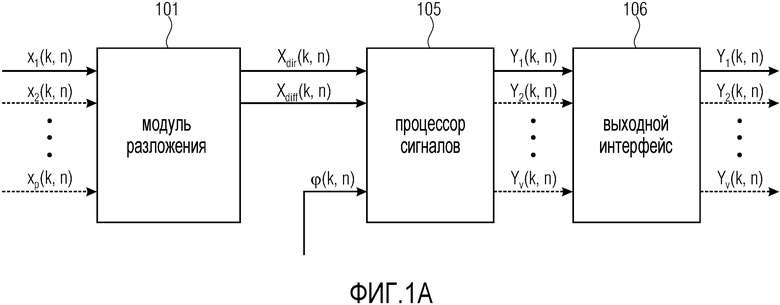

фиг. 1a - система согласно варианту осуществления,

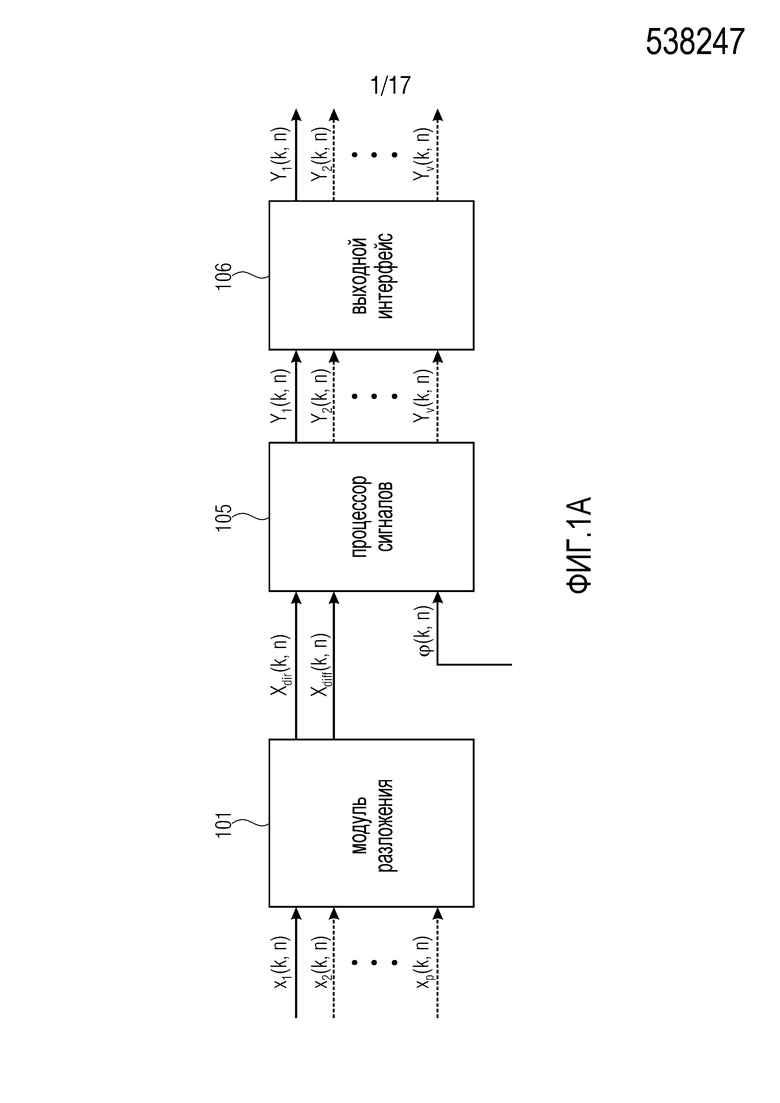

фиг. 1b - устройство согласно варианту осуществления,

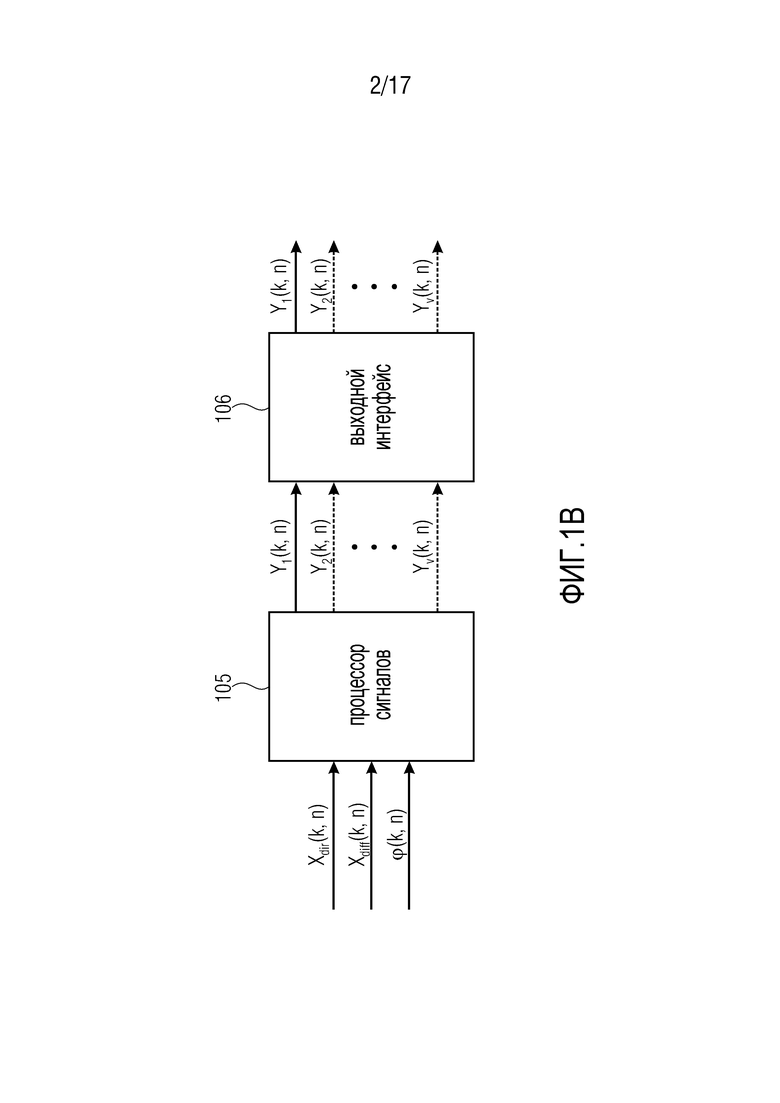

фиг. 1c - система согласно другому варианту осуществления,

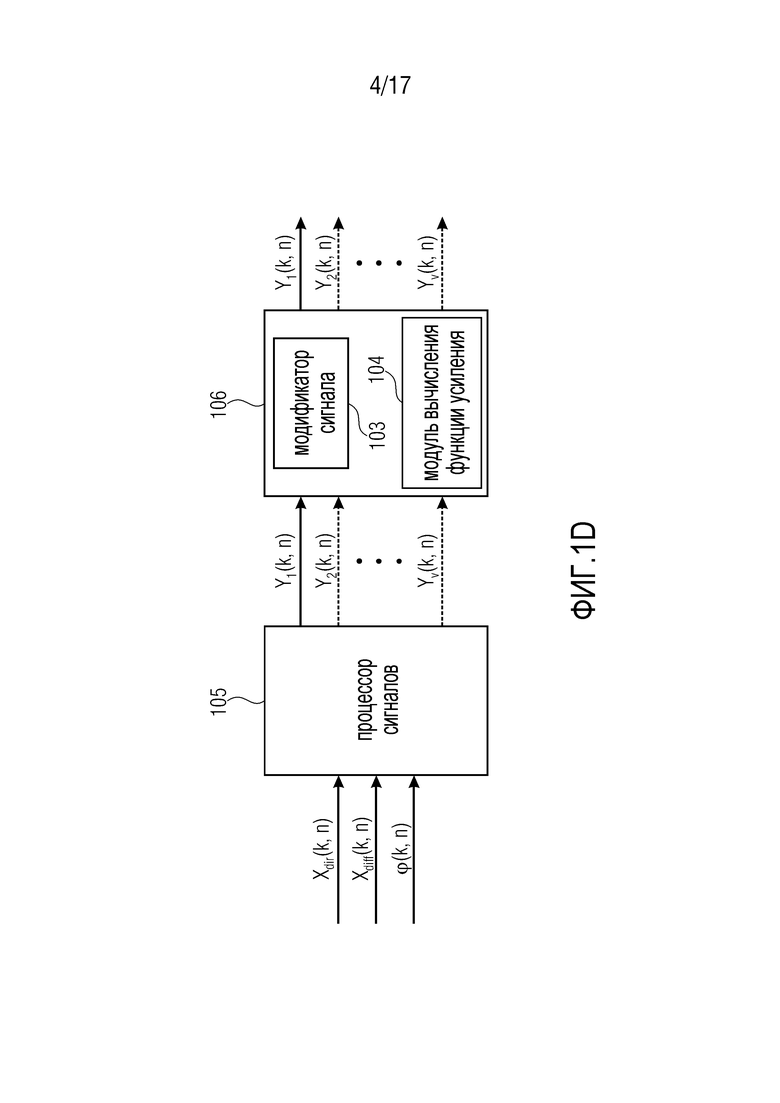

фиг. 1d - устройство согласно другому варианту осуществления,

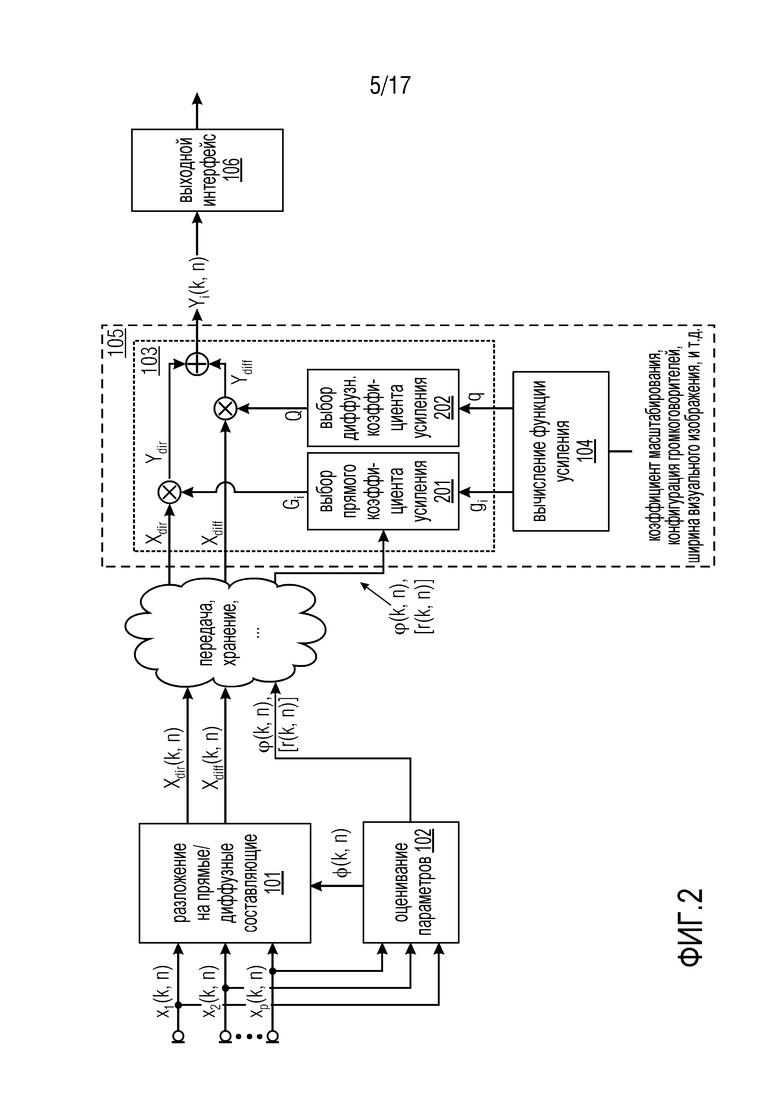

фиг. 2 - система согласно другому варианту осуществления,

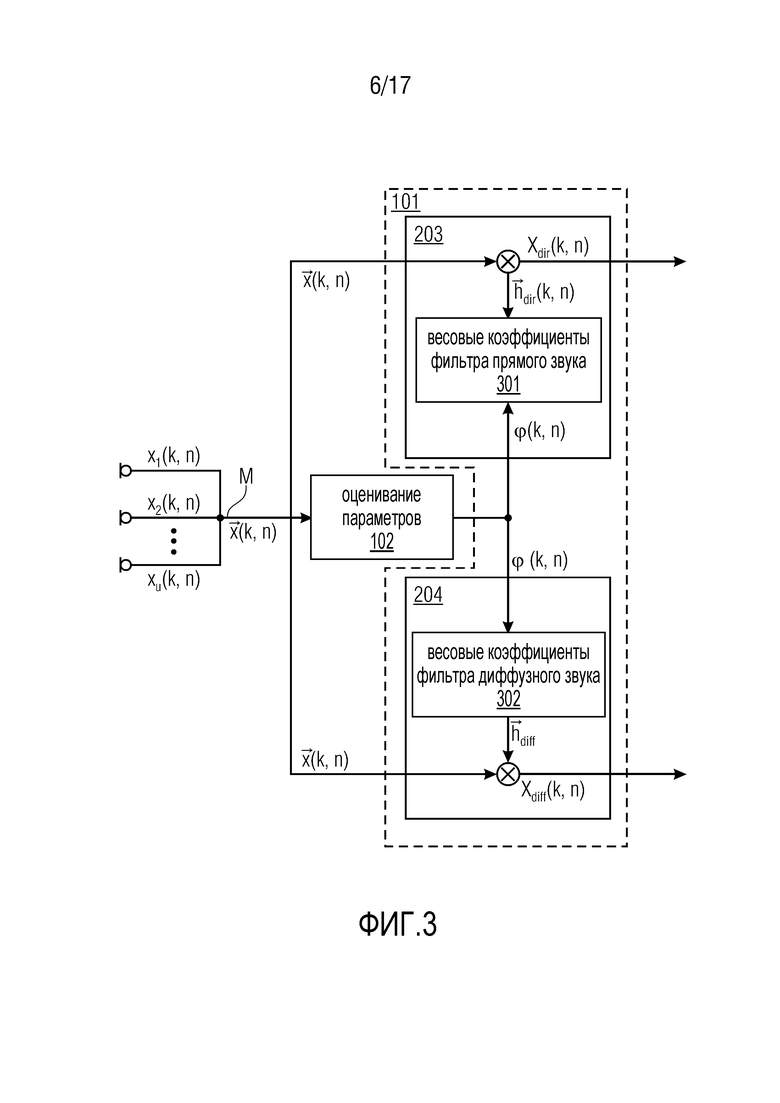

фиг. 3 - модули для разложения на прямые/диффузные составляющие и для параметра оценивания системы согласно варианту осуществления,

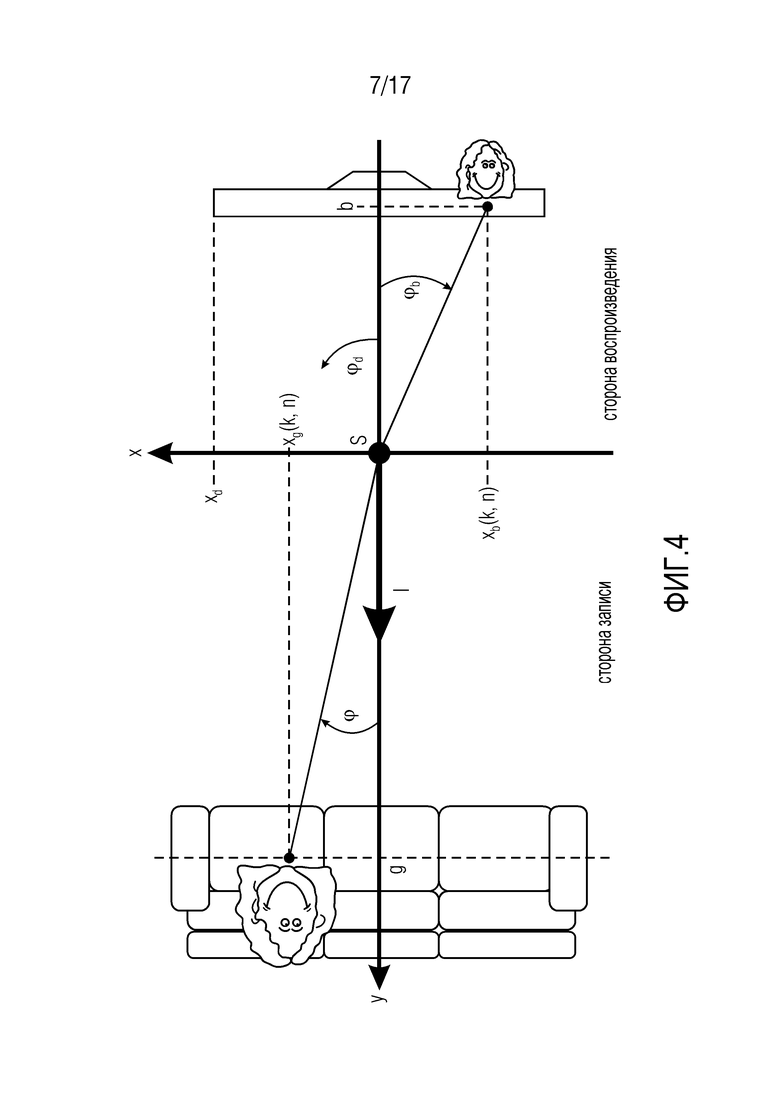

фиг. 4 - первая геометрия для воспроизведения акустической сцены с акустическим масштабированием согласно варианту осуществления, где источник звука располагается в фокальной плоскости,

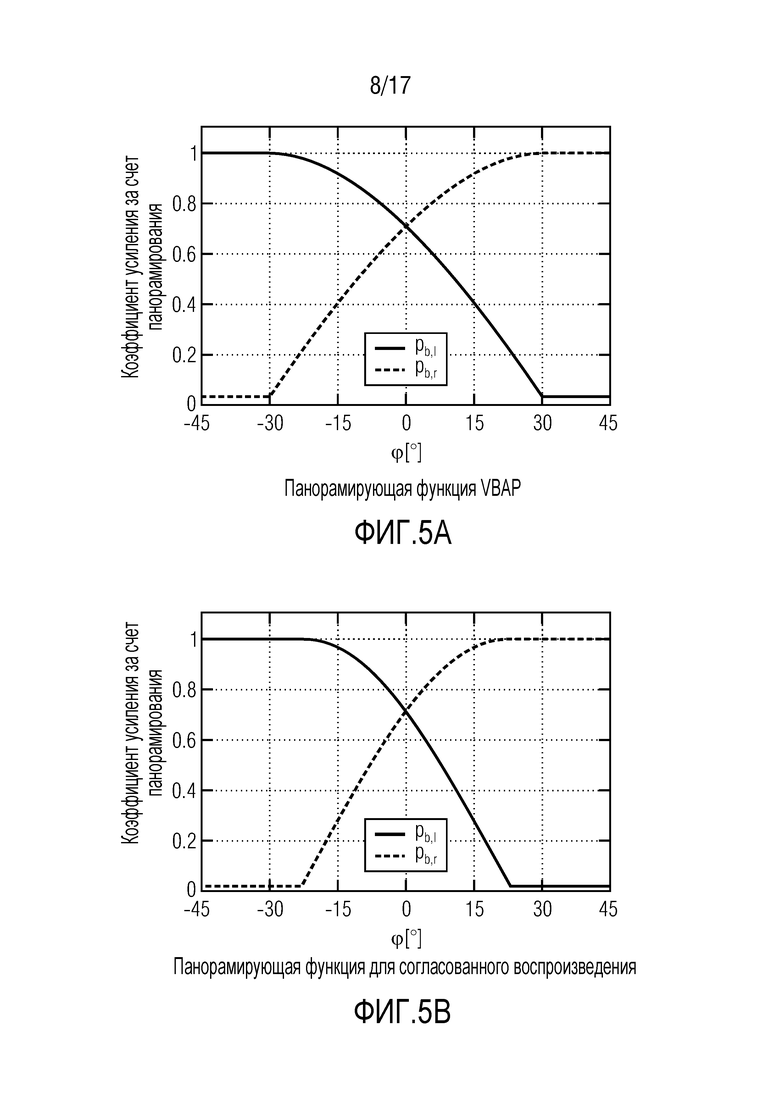

фиг. 5 - панорамирующие функции для согласованного воспроизведения сцены и для акустической масштабирования,

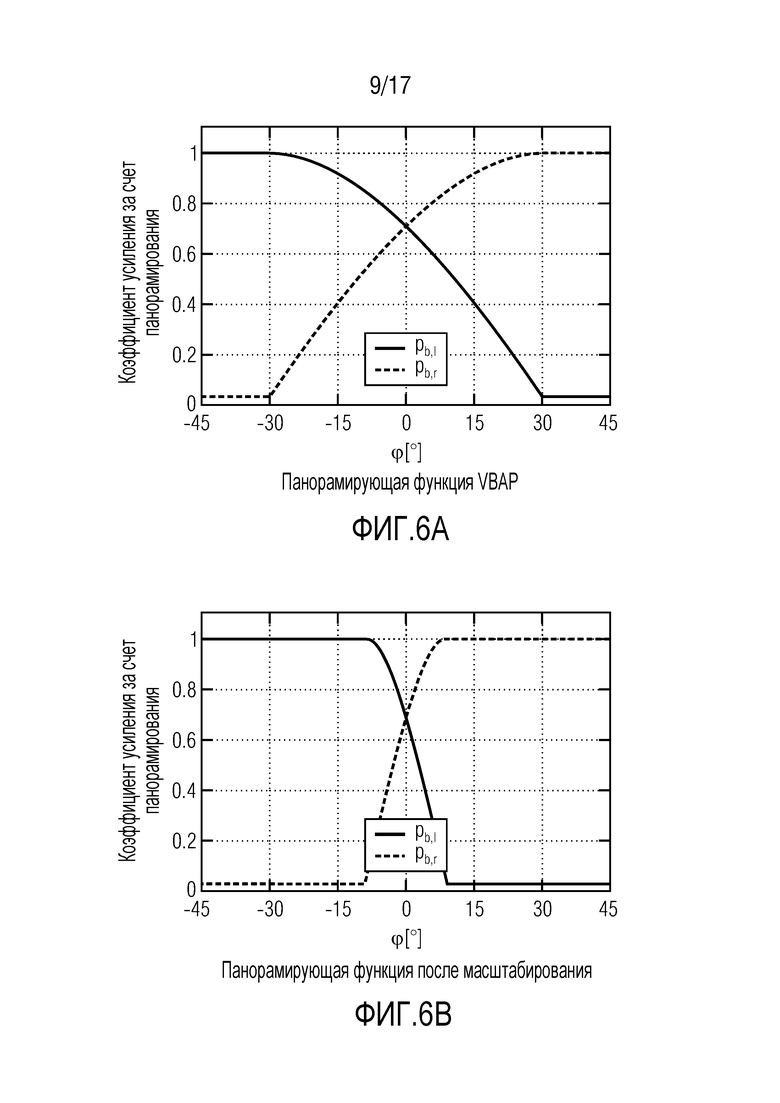

фиг. 6 - дополнительные панорамирующие функции для согласованного воспроизведения сцены и для акустической масштабирования согласно вариантам осуществления,

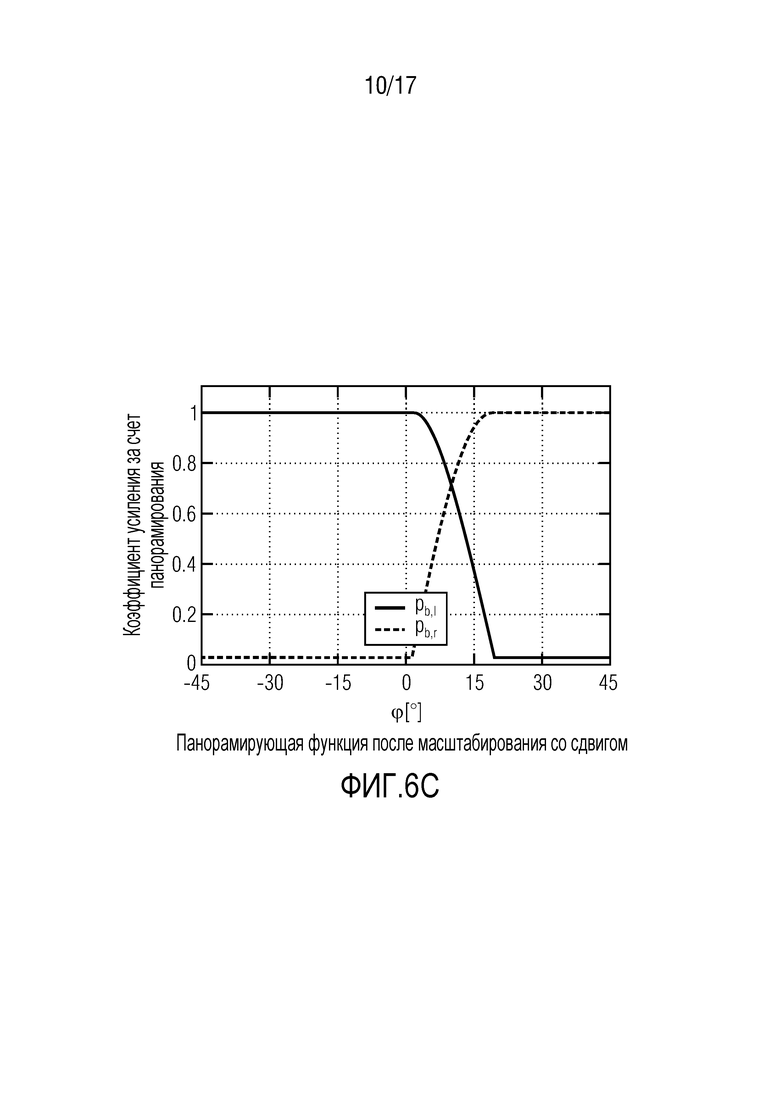

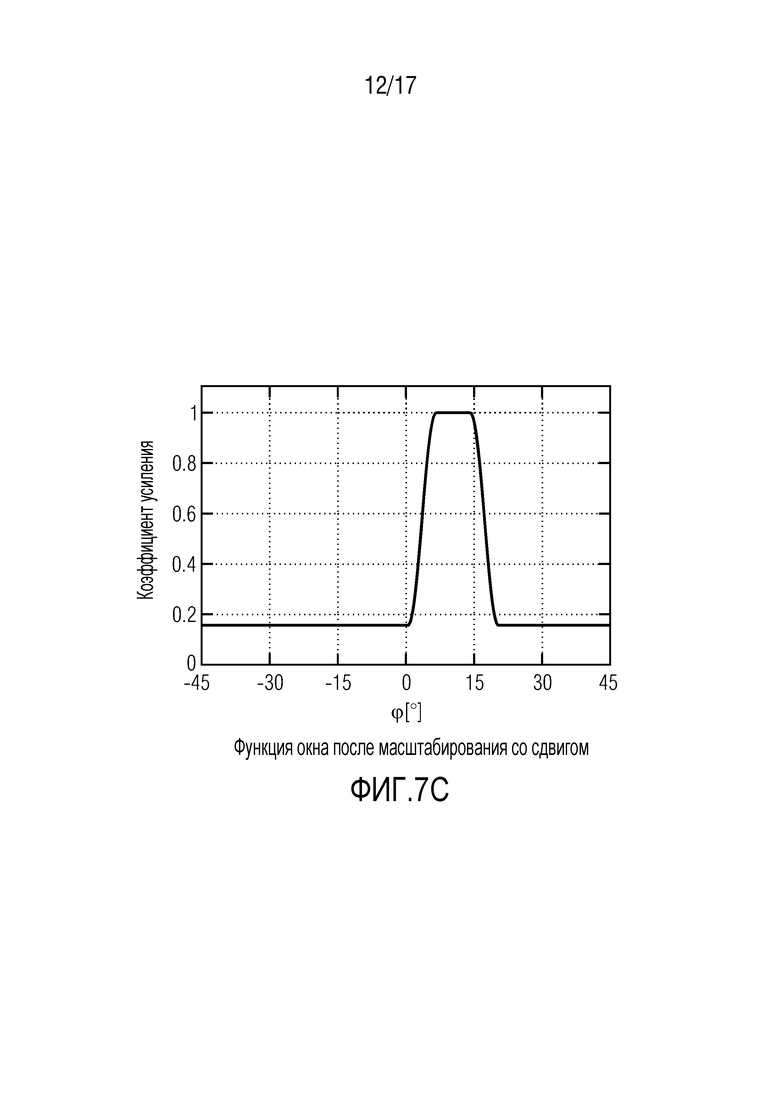

фиг. 7 - иллюстративные функции окна усиления для различных ситуации согласно вариантам осуществления,

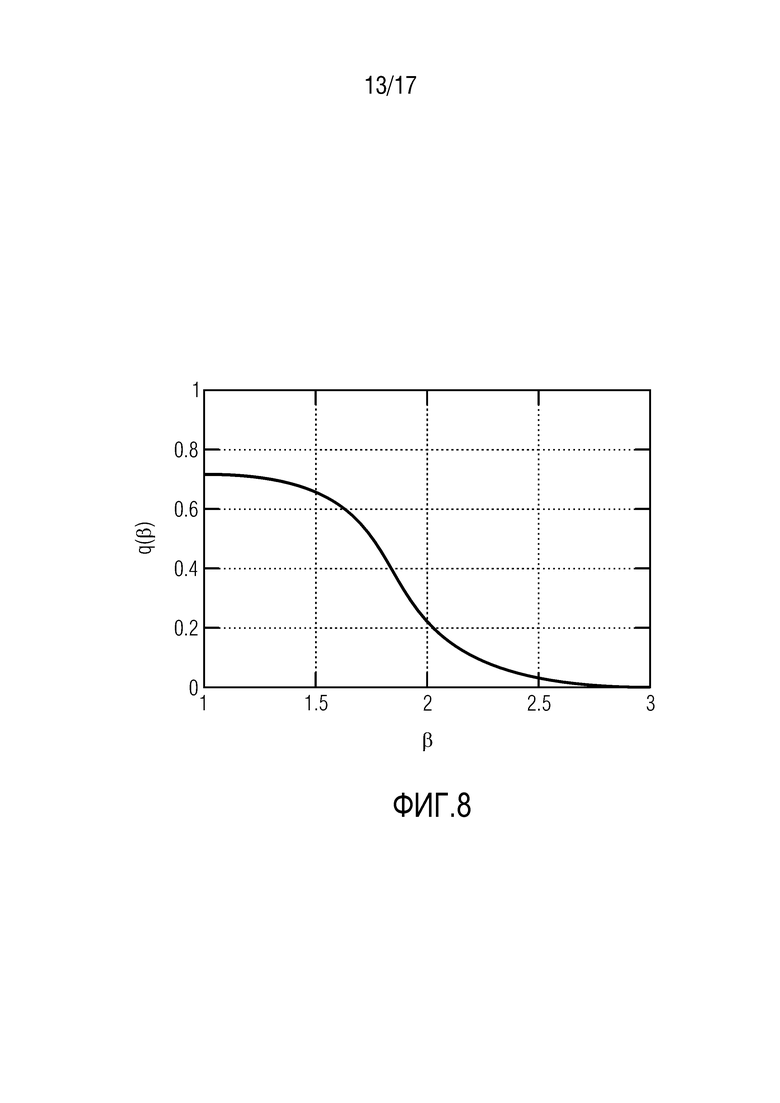

фиг. 8 - функция диффузного усиления согласно варианту осуществления,

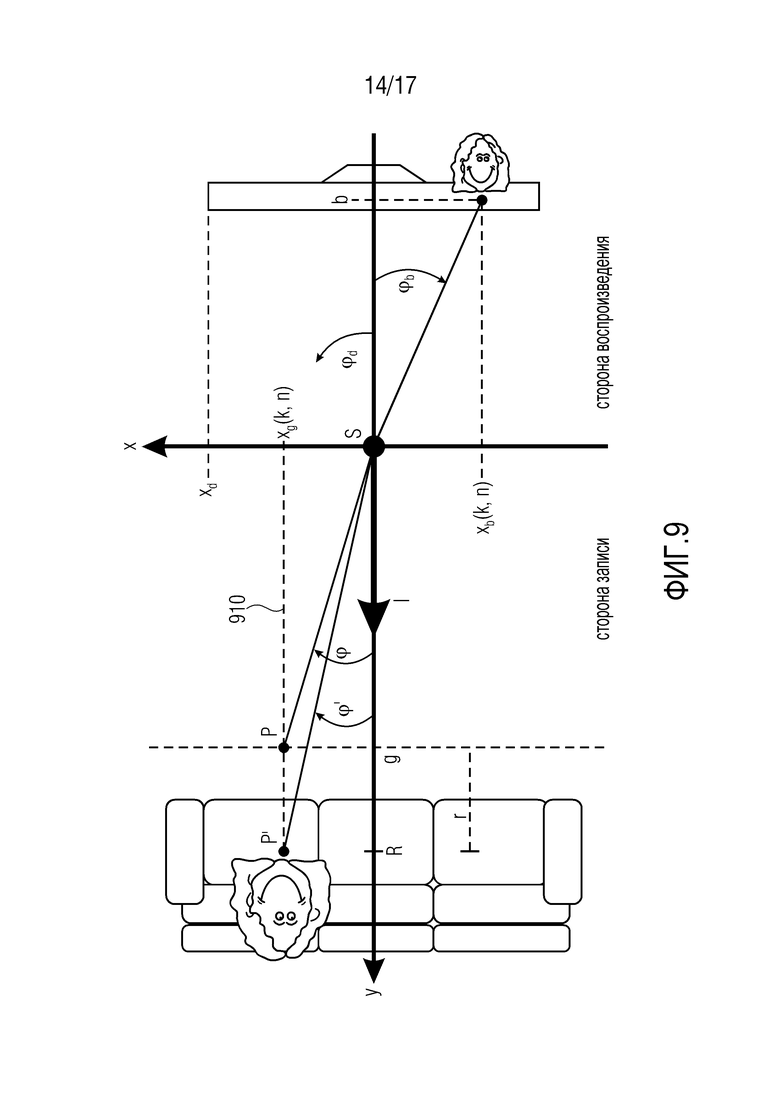

фиг. 9 - вторая геометрия для воспроизведения акустической сцены с акустическим масштабированием согласно варианту осуществления, где источник звука не располагается в фокальной плоскости,

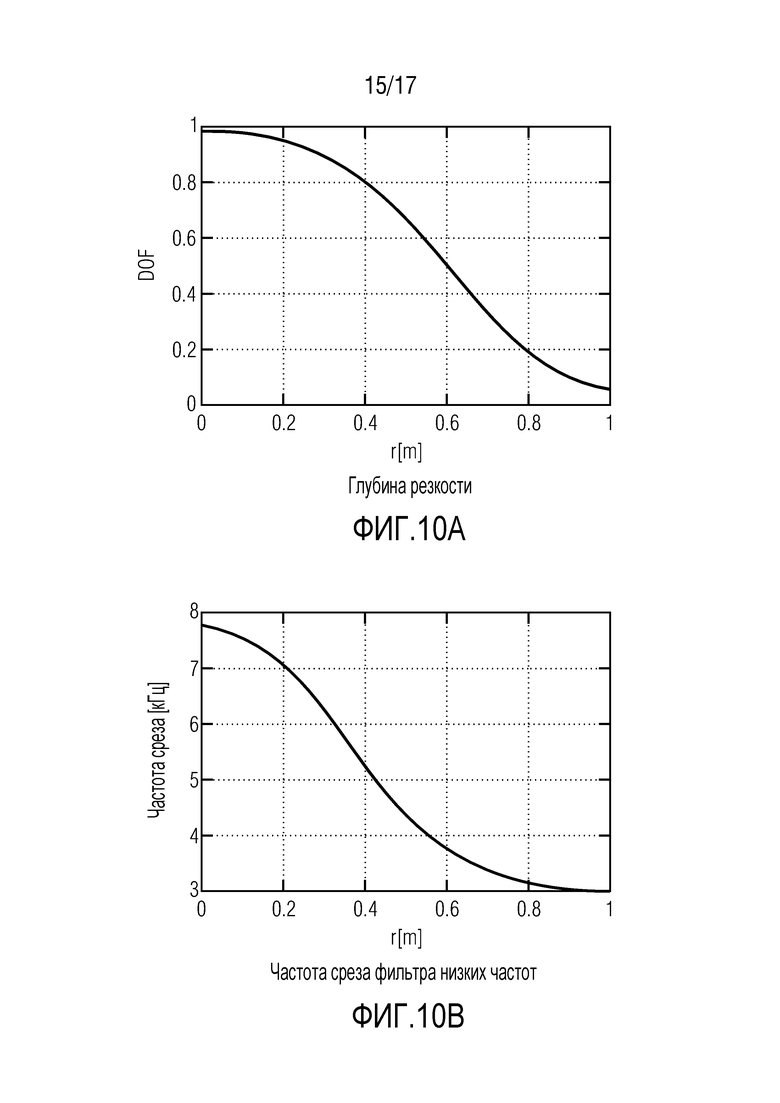

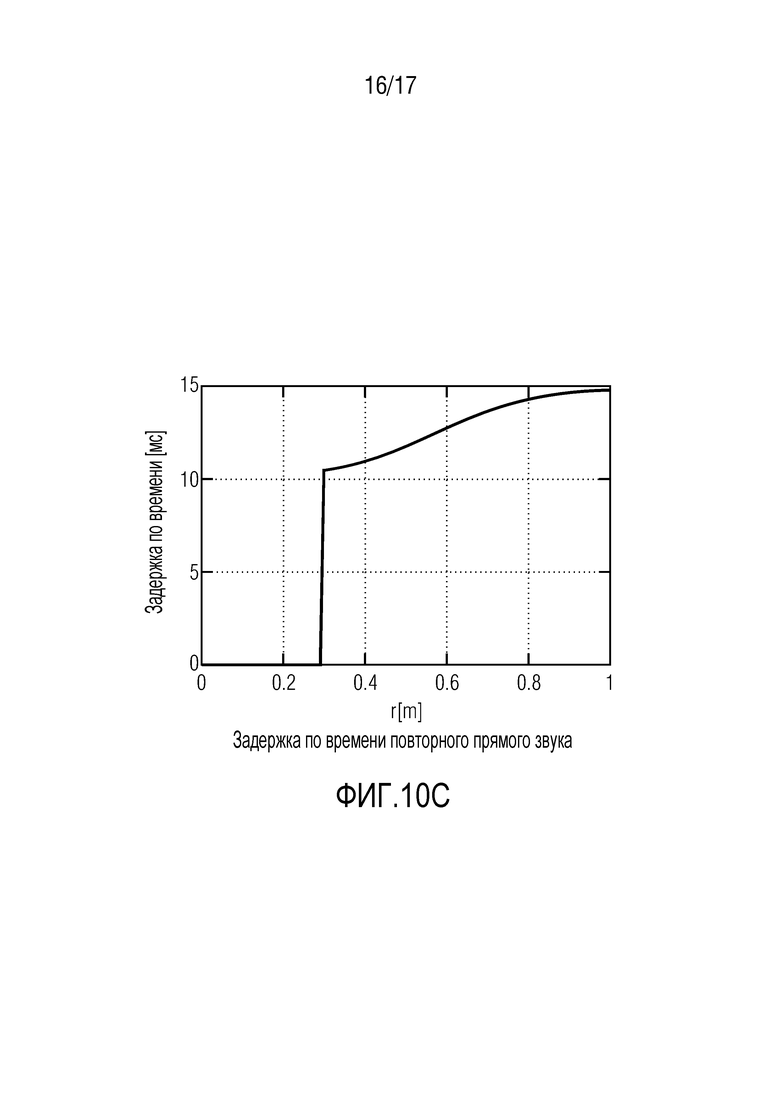

фиг. 10 - функции для объяснения размывания прямого звука, и

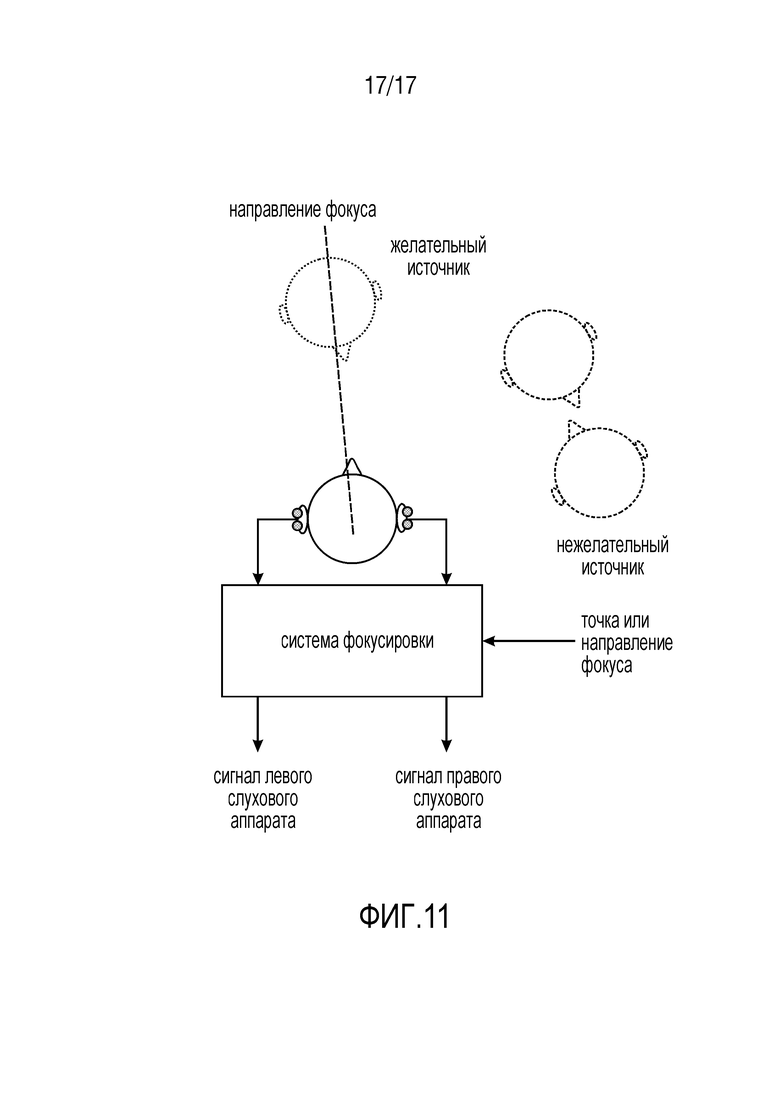

фиг. 11 - слуховые аппараты согласно вариантам осуществления.

На фиг. 1a показана система для генерации одного или более выходных аудиосигналов. Система содержит модуль 101 разложения, процессор 105 сигнала и выходной 106 интерфейс.

Модуль 101 разложения выполнен с возможностью генерации прямого компонентного сигнала Xdir(k,n), содержащего прямые составляющие сигнала двух или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n). Кроме того, модуль 101 разложения выполнен с возможностью генерации диффузного компонентного сигнала Xdiff(k,n), содержащего диффузные составляющие сигнала двух или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n).

Процессор 105 сигнала выполнен с возможностью приема прямого компонентного сигнала Xdir(k,n), диффузного компонентного сигнала Xdiff(k,n) и информации направления, причем упомянутая информация направления зависит от направления прихода прямых составляющих сигнала двух или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n).

Кроме того, процессор 105 сигнала выполнен с возможностью генерации одного или более обработанных диффузных сигналов Ydiff,1(k,n), Ydiff,2(k,n), …, Ydiff,v(k,n) в зависимости от диффузного компонентного сигнала Xdiff(k,n).

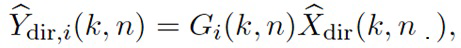

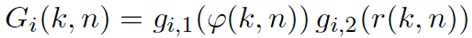

Для каждого выходного аудиосигнала Yi(k,n) из одного или более выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n), процессор 105 сигнала выполнен с возможностью определения, в зависимости от направления прихода, прямого коэффициента усиления Gi(k,n), процессор 105 сигнала выполнен с возможностью применения упомянутого прямого коэффициента усиления Gi(k,n) к прямому компонентному сигналу Xdir(k,n) для получения обработанного прямого сигнала Ydir,i(k,n), и процессор 105 сигнала выполнен с возможностью объединения упомянутого обработанного прямого сигнала Ydir,i(k,n) и одного Ydiff,i(k,n) из одного или более обработанных диффузных сигналов Ydiff,1(k,n), Ydiff,2(k,n), …, Ydiff,v(k,n) для генерации упомянутого выходного аудиосигнала Yi(k,n).

Выходной 106 интерфейс выполнен с возможностью вывода одного или более выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n).

Как описано, информация направления зависит от направления прихода ϕ(k,n) прямых составляющих сигнала двух или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n). Например, направление прихода прямых составляющих сигнала двух или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n) может, например, само быть информацией направления. Или, например, информация направления, может, например, быть направлением распространения прямых составляющих сигнала двух или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n). Направление прихода указывает от принимающей микрофонной решетки к источнику звука, направление распространения указывает от источника звука к принимающей микрофонной решетке. Таким образом, направление распространения в точности противоположно направлению прихода и поэтому зависит от направления прихода.

Для генерации одного Yi(k,n) из одного или более выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n), процессор 105 сигнала

- определяет, в зависимости от направления прихода, прямой коэффициент усиления Gi(k,n),

- применяет упомянутый прямой коэффициент усиления Gi(k,n) к прямому компонентному сигналу Xdir(k,n) для получения обработанного прямого сигнала Ydir,i(k,n), и

- объединяет упомянутый обработанный прямой сигнал Ydir,i(k,n) и один Ydiff,i(k,n) из одного или более обработанных диффузных сигналов Ydiff,1(k,n), Ydiff,2(k,n), …, Ydiff,v(k,n) для генерации упомянутого выходного аудиосигнала Yi(k,n).

Это осуществляется для каждого из одного или более выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n), которые должны быть сгенерированными Y1(k,n), Y2(k,n), …, Yv(k,n). Процессор сигналов может, например, быть выполнен с возможностью генерации одного, двух, трех или более выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n).

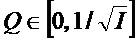

В отношении одного или более обработанных диффузных сигналов Ydiff,1(k,n), Ydiff,2(k,n), …, Ydiff,v(k,n), согласно варианту осуществления, процессор 105 сигнала может, например, быть выполнен с возможностью генерации одного или более обработанных диффузных сигналов Ydiff,1(k,n), Ydiff,2(k,n), …, Ydiff,v(k,n) путем применения диффузного коэффициента усиления Q(k,n) к диффузному компонентному сигналу Xdiff(k,n).

Модуль 101 разложения выполнен с возможностью, например, генерации прямого компонентного сигнал Xdir(k,n), содержащего прямые составляющие сигнала двух или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n), и диффузного компонентного сигнала Xdiff(k,n), содержащего диффузные составляющие сигнала двух или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n), путем разложения одного или более входных аудиосигналов на прямой компонентный сигнал и диффузный компонентный сигнал.

В конкретном варианте осуществления, процессор 105 сигнала может, например, быть выполнен с возможностью генерации двух или более выходных аудиоканалов Y1(k,n), Y2(k,n), …, Yv(k,n). Процессор 105 сигнала может, например, быть выполнен с возможностью применения диффузного коэффициента усиления Q(k,n) к диффузному компонентному сигналу Xdiff(k,n) для получения промежуточного диффузного сигнала. Кроме того, процессор 105 сигнала может, например, быть выполнен с возможностью генерации одного или более декоррелированных сигналов из промежуточного диффузного сигнала путем проведения декорреляции, причем один или более декоррелированных сигналов образуют один или более обработанных диффузных сигналов Ydiff,1(k,n), Ydiff,2(k,n), …, Ydiff,v(k,n), или промежуточный диффузный сигнал и один или более декоррелированных сигналов образуют один или более обработанных диффузных сигналов Ydiff,1(k,n), Ydiff,2(k,n), …, Ydiff,v(k,n).

Например, количество обработанных диффузных сигналов Ydiff,1(k,n), Ydiff,2(k,n), …, Ydiff,v(k,n) и количество выходных аудиосигналов может, например, быть равно Y1(k,n), Y2(k,n), …, Yv(k,n).

Генерация одного или более декоррелированных сигналов из промежуточного диффузного сигнала может, например, проводиться путем применения задержек к промежуточному диффузному сигналу, или, например, путем осуществления свертки промежуточного диффузного сигнала с шумовым импульсом или, например, путем осуществления свертки промежуточного диффузного сигнала с импульсным откликом и т.д. Альтернативно или дополнительно, можно применять, например, любой другой традиционный метод декорреляции.

Для получения v выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n), v определений v прямых коэффициентов усиления G1(k,n), G2(k,n), …, Gv(k,n) и v применений соответствующего коэффициента усиления к одному или более прямым компонентным сигналам Xdir(k,n) можно, например, использовать для получения v выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n).

Для получения v выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n) может, например, потребоваться один-единственный диффузный компонентный сигнал Xdiff(k,n), одно-единственное определение одиночного диффузного коэффициента усиления Q(k,n) и одно-единственное применение диффузного коэффициента усиления Q(k,n) к диффузному компонентному сигналу Xdiff(k,n). Для обеспечения декорреляции, методы декорреляции можно применять только после применения диффузного коэффициента усиления к диффузному компонентному сигналу.

Согласно варианту осуществления, показанному на фиг. 1a, тот же обработанный диффузный сигнал Ydiff(k,n) затем объединяется с соответствующим одним (Ydir,i(k,n)) из обработанных прямых сигналов для получения соответствующего одного (Yi(k,n)) из выходных аудиосигналов.

Согласно варианту осуществления, показанному на фиг. 1a, учитывается направление прихода прямых составляющих сигнала двух или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n). Таким образом, выходные аудиосигналы Y1(k,n), Y2(k,n), …, Yv(k,n) можно генерировать, гибко регулируя прямые компонентные сигналы Xdir(k,n) и диффузные компонентные сигналы Xdiff(k,n) в зависимости от направления прихода. Достигаются улучшенные возможности адаптации.

Согласно вариантам осуществления выходные аудиосигналы Y1(k,n), Y2(k,n), …, Yv(k,n) можно, например, определять для каждого частотно-временного бина (k,n) частотно-временной области.

Согласно варианту осуществления, модуль 101 разложения может, например, быть выполнен с возможностью приема двух или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n). В другом варианте осуществления, модуль 101 разложения может, например, быть выполнен с возможностью приема трех или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n). Модуль 101 разложения может, например, быть выполнен с возможностью разложения двух или более (или трех или более входных аудиосигналов) x1(k,n), x2(k,n), … xp(k,n) на диффузный компонентный сигнал Xdiff(k,n), который не является многоканальным сигналом, и один или более прямых компонентных сигналов Xdir(k,n). То, что аудиосигнал не является многоканальным сигналом, означает, что аудиосигнал сам по себе не содержит более одного аудиоканала. Таким образом, аудиоинформация множества входных аудиосигналов передается в двух компонентных сигналах (Xdir(k,n), Xdiff(k,n)) (и, возможно, в дополнительной вспомогательной информации), что способствует эффективной передаче.

Процессор 105 сигнала, может, например, быть выполнен с возможностью генерации каждого выходного аудиосигнала Yi(k,n) из двух или более выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n) путем определения прямого коэффициента усиления Gi(k,n) для упомянутого выходного аудиосигнала Yi(k,n), путем применения упомянутого прямого коэффициента усиления Gi(k,n) к одному или более прямым компонентным сигналам Xdir(k,n) для получения обработанного прямого сигнала Ydir,i(k,n) для упомянутого выходного аудиосигнала Yi(k,n), и путем объединения упомянутого обработанного прямого сигнала Ydir,i(k,n) для упомянутого выходного аудиосигнала Yi(k,n) и обработанного диффузного сигнала Ydiff(k,n) для генерации упомянутого выходного аудиосигнала Yi(k,n). Выходной 106 интерфейс выполнен с возможностью вывода двух или более выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n). Особенно предпочтительна генерация два или более выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n) путем определения одного-единственного обработанного диффузного сигнала Ydiff(k,n).

На фиг. 1b показано устройство для генерации одного или более выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n) согласно варианту осуществления. Устройство реализует так называемую сторону ʺдальнего концаʺ системы, показанной на фиг. 1a.

Устройство, показанное на фиг. 1b, содержит процессор 105 сигнала и выходной 106 интерфейс.

Процессор 105 сигнала выполнен с возможностью приема прямого компонентного сигнала Xdir(k,n), содержащего прямые составляющие сигнала двух или более первоначальных аудиосигналов x1(k,n), x2(k,n), … xp(k,n) (например, входных аудиосигналов, показанных на фиг. 1a). Кроме того, процессор 105 сигнала выполнен с возможностью приема диффузного компонентного сигнала Xdiff(k,n), содержащего диффузные составляющие сигнала двух или более первоначальных аудиосигналов x1(k,n), x2(k,n), … xp(k,n). Кроме того, процессор 105 сигнала выполнен с возможностью приема информации направления, причем упомянутая информация направления зависит от направления прихода прямых составляющих сигнала двух или более входных аудиосигналов.

Процессор 105 сигнала выполнен с возможностью генерации одного или более обработанных диффузных сигналов Ydiff,1(k,n), Ydiff,2(k,n), …, Ydiff,v(k,n) в зависимости от диффузного компонентного сигнала Xdiff(k,n).

Для каждого выходного аудиосигнала Yi(k,n) из одного или более выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n), процессор 105 сигнала выполнен с возможностью определения, в зависимости от направления прихода, прямого коэффициента усиления Gi(k,n), процессор 105 сигнала выполнен с возможностью применения упомянутого прямого коэффициента усиления Gi(k,n) к прямому компонентному сигналу Xdir(k,n) для получения обработанного прямого сигнала Ydir,i(k,n), и процессор 105 сигнала выполнен с возможностью объединения упомянутого обработанного прямого сигнала Ydir,i(k,n) и одного Ydiff,i(k,n) из одного или более обработанных диффузных сигналов Ydiff,1(k,n), Ydiff,2(k,n), …, Ydiff,v(k,n) для генерации упомянутого выходного аудиосигнала Yi(k,n).

Выходной 106 интерфейс выполнен с возможностью вывода одного или более выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n).

Все конфигурации процессора 105 сигнала, описанного в дальнейшем со ссылкой на систему, также могут быть реализованы в устройстве согласно фиг. 1b. Это относится, в частности, к различным конфигурациям модификатора 103 сигнала и модуля 104 вычисления функции усиления, которые описаны ниже. То же самое применимо к различных примерам применения описанных ниже принципов.

На фиг. 1c показана система согласно другому варианту осуществления. Согласно фиг. 1c, генератор 105 сигнала, показанный на фиг. 1a, дополнительно содержит модуль 104 вычисления функции усиления для вычисления одной или более функций усиления, причем каждая функция усиления из одной или более функций усиления, содержит множество значений аргумента функции усиления, причем возвращаемое значение функции усиления присваивается каждому из упомянутых значений аргумента функции усиления, причем, когда упомянутая функция усиления принимает одно из упомянутых значений аргумента функции усиления, упомянутая функция усиления выполнена с возможностью возвращения возвращаемого значения функции усиления, присваиваемого упомянутому одному из упомянутых значений аргумента функции усиления.

Кроме того, процессор 105 сигнала дополнительно содержит модификатор 103 сигнала для выбора, в зависимости от направления прихода, зависящего от направления значения аргумента из значений аргумента функции усиления функции усиления из одной или более функций усиления, для получения возвращаемого значения функции усиления, присваиваемого упомянутому зависящему от направления значению аргумента из упомянутой функции усиления, и для определения значения коэффициента усиления, по меньшей мере, одного из одного или более выходных аудиосигналов в зависимости от упомянутого возвращаемого значения функции усиления, полученного из упомянутой функции усиления.

На фиг. 1d показана система согласно другому варианту осуществления. Согласно фиг. 1d, генератор 105 сигнала, показанный на фиг. 1b, дополнительно содержит модуль 104 вычисления функции усиления для вычисления одной или более функций усиления, причем каждая функция усиления из одной или более функций усиления, содержит множество значений аргумента функции усиления, причем возвращаемое значение функции усиления присваивается каждому из упомянутых значений аргумента функции усиления, причем, когда упомянутая функция усиления принимает одно из упомянутых значений аргумента функции усиления, упомянутая функция усиления выполнена с возможностью возвращения возвращаемого значения функции усиления, присваиваемого упомянутому одному из упомянутых значений аргумента функции усиления.

Кроме того, процессор 105 сигнала дополнительно содержит модификатор 103 сигнала для выбора, в зависимости от направления прихода, зависящего от направления значения аргумента из значений аргумента функции усиления функции усиления из одной или более функций усиления, для получения возвращаемого значения функции усиления, присваиваемого упомянутому зависящему от направления значению аргумента из упомянутой функции усиления, и для определения значения коэффициента усиления, по меньшей мере, одного из одного или более выходных аудиосигналов в зависимости от упомянутого возвращаемого значения функции усиления, полученного из упомянутой функции усиления.

Варианты осуществления предусматривают запись и воспроизведение пространственного звука таким образом, что акустическое изображение согласуется с желаемым пространственным изображением, которое определяется, например, видео, дополняющим аудио, на стороне дальнего конца. Некоторые варианты осуществления базируются на записях, сделанных с помощью микрофонной решетки, расположенной на реверберирующей стороне ближнего конца. Варианты осуществления предусматривают, например, акустическое масштабирование, согласованное с визуальным масштабированием камеры. Например, при приближении, прямой звук громкоговорителей воспроизводится с направления, где располагались бы громкоговорители в приближенном визуальном изображении, благодаря чему, визуальное и акустическое изображения выравниваются. Если после приближения громкоговорители располагаются за пределами визуального изображения (или за пределами желаемой пространственной области), прямой звук этих громкоговорителей можно ослаблять, поскольку эти громкоговорители больше не видны, или, например, поскольку прямой звук от этих громкоговорителей не желателен. Кроме того, отношение прямого звука к реверберации можно, например, увеличивать при приближении для имитации меньшего угла раствора визуальной камеры.

Варианты осуществления базируются на принципе разделения записанных сигналов микрофонов на прямой звук источников звука и диффузный звук, например, реверберирующий звук, путем недавнего применения двух многоканальных фильтров на стороне ближнего конца. Эти многоканальные фильтры могут, например, опираться на параметрическую информацию звукового поля, например, DOA прямого звука. В некоторых вариантах осуществления, разделенные прямой звук и диффузный звук могут, например, передаваться стороне дальнего конца совместно с параметрической информацией.

Например, на стороне дальнего конца, конкретные весовые коэффициенты можно, например, применять к выделенным прямому звуку и диффузному звуку, которые регулируют воспроизводимое акустическое изображение таким образом, что полученные выходные аудиосигналы согласуются с желаемым пространственным изображением. Эти весовые коэффициенты моделируют, например, эффект акустической масштабирования, и зависят, например, от направления прихода (DOA) прямого звука и, например, от коэффициента масштабирования и/или направления наведения камеры. Затем окончательные выходные аудиосигналы можно, например, получать путем суммирования взвешенных прямого звука и диффузного звука.

Изложенные принципы реализуют эффективное использование в вышеупомянутом сценарии видеозаписи с помощью бытовых устройств или в сценарии телеконференцсвязи: например, в сценарии видеозаписи, может быть, например, достаточно сохранять или передавать выделенные прямой звук и диффузный звук (вместо сигналов всех микрофонов), сохраняя при этом возможность управления воссоздаваемым пространственным изображением.

Это означает, что если, например, визуальная масштабирование применяется на этапе последующей обработки (цифровой масштабирования), акустическое изображение все еще можно соответственно изменять без необходимости в сохранении первоначальных сигналов микрофонов и доступе к ним. В сценарии телеконференцсвязи, предложенные принципы также можно эффективно использовать, поскольку выделение прямого и диффузного звука можно осуществлять на стороне ближнего конца, сохраняя способность управления воспроизведением пространственного звука (например, изменения конфигурации громкоговорителей) на стороне дальнего конца и выравнивания акустического и визуального изображений. Таким образом, необходимо передавать только несколько аудиосигналов и оцененных DOA в качестве вспомогательной информации, при низкой вычислительной сложности на стороне дальнего конца.

На фиг. 2 показана система согласно варианту осуществления. Сторона ближнего конца содержит модули 101 и 102. Сторона дальнего конца содержит модули 105 и 106. Модуль 105 сам содержит модули 103 и 104. Рассматривая сторону ближнего конца и сторону дальнего конца, следует понимать, что в некоторых вариантах осуществления, первое устройство может реализовать сторону ближнего конца (например, содержащую модули 101 и 102), и второе устройство может реализовать сторону дальнего конца (например, содержащую модули 103 и 104), тогда как в других вариантах осуществления, единое устройство реализует, как сторону ближнего конца, так и сторону дальнего конца, причем такое единое устройство, например, содержит модули 101, 102, 103 и 104.

В частности, на фиг. 2 показана система согласно варианту осуществления содержащая модуль 101 разложения, модуль 102 оценивания параметров, процессор 105 сигнала и выходной 106 интерфейс. Согласно фиг. 2, процессор 105 сигнала содержит модуль 104 вычисления функции усиления и модификатор 103 сигнала. Процессор 105 сигнала и выходной 106 интерфейс могут, например, реализовать устройство, показанное на фиг. 1b.

Кроме того, модуль 102 оценивания параметров, показанный на фиг. 2, может, например, быть выполнен с возможностью приема двух или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n). Кроме того, модуль 102 оценивания параметров может, например, быть выполнен с возможностью оценивания направления прихода прямых составляющих сигнала двух или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n) в зависимости от двух или более входных аудиосигналов. Процессор 105 сигнала может, например, быть выполнен с возможностью приема информации направления прихода, содержащей направление прихода прямых составляющих сигнала двух или более входных аудиосигналов, от модуля 102 оценивания параметров.

Вход системы, показанной на фиг. 2, состоит из M сигналов микрофонов X1...M(k,n) в частотно-временной области (частотный индекс k, временной индекс n). Например, можно предположить, что звуковое поле, захватываемое микрофонами, состоит для каждого (k,n) из плоской волны, распространяющейся в изотропном диффузном поле. Плоская волна моделирует прямой звук источников звука (например, громкоговорителей), тогда как диффузный звук моделирует реверберацию.

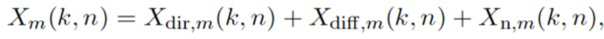

Согласно такой модели, сигнал m-го микрофона можно выразить в виде

(1)

(1)

где Xdir,m(k,n) - измеренный прямой звук (плоская волна), Xdiff,m(k,n) - измеренный диффузный звук, и Xn,m(k,n) - шумовая составляющая (например, собственный шум микрофона).

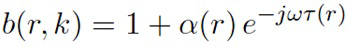

В модуле 101 разложения, показанном на фиг. 2 (разложения на прямые/диффузные составляющие), прямой звук Xdir(k,n) и диффузный звук Xdiff(k,n) выделяется из сигналов микрофонов. С этой целью можно применять, например, информированные многоканальные фильтры, описанные ниже. Для разложения на прямые/диффузные составляющие, можно, например, использовать конкретную параметрическую информацию о звуковое поле, например, DOA прямого звука ϕ(k,n). Эту параметрическую информацию можно, например, оценивать из сигналов микрофонов в модуле 102 оценивания параметров. Помимо DOA ϕ(k,n) прямого звука, в некоторых вариантах осуществления, можно, например, оценивать информацию расстояния r(k,n). Эта информация расстояния может, например, описывать расстояние между микрофонной решеткой и источником звука, который испускает плоскую волну. Для оценивания параметров, можно, например, использовать блоки оценивания расстояния и/или традиционные блоки оценивания DOA,. Соответствующие блоки оценивания могут быть, например, описаны ниже.

Выделенный прямой звук Xdir(k,n), выделенный диффузный звук Xdiff(k,n) и оцененная параметрическая информация прямого звука, например, DOA ϕ(k,n) и/или расстояние r(k,n), могут, например, затем сохраняться, передаваться стороне дальнего конца, или сразу использоваться для генерации пространственного звука с желаемым пространственным изображением, например, для создания эффекта акустической масштабирования.

Желаемое акустическое изображение, например, эффект акустической масштабирования, генерируется в модификаторе 103 сигнала с использованием выделенного прямого звука Xdir(k,n), выделенного диффузного звука Xdiff(k,n) и оцененной параметрической информации ϕ(k,n) и/или r(k,n).

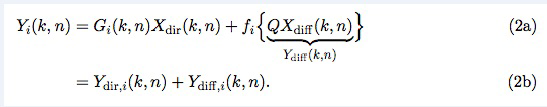

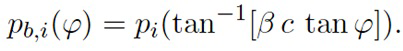

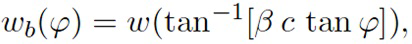

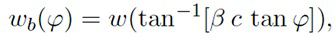

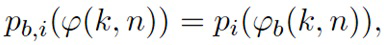

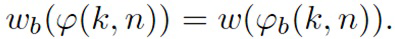

Модификатор 103 сигнала может, например, вычислять один или более выходных сигналов Yi(k,n) в частотно-временной области, которые воссоздают акустическое изображение таким образом, что оно согласуется с желаемым пространственным изображением. Например, выходные сигналы Yi(k,n) имитируют эффект акустической масштабирования. Наконец, эти сигналы могут преобразовываться обратно во временную область и воспроизводиться, например, через громкоговорители или головные наушники. i-й выходной сигнал Yi(k,n) вычисляется как взвешенная сумма выделенного прямого звука Xdir(k,n) и диффузного звука Xdiff(k,n), например,

В формулах (2a) и (2b), весовые коэффициенты Gi(k,n) и Q являются параметрами, которые используются для создания желаемого акустического изображения, например, эффекта акустической масштабирования. Например, при приближении, параметр Q можно уменьшать таким образом, чтобы ослаблять воспроизводимый диффузный звук.

Кроме того, с помощью весовых коэффициентов Gi(k,n) можно управлять, с какого направления воспроизводить прямой звук, благодаря чему, визуальное и акустическое изображения выравниваются. Кроме того, эффект акустического размывания можно выравнивать с прямым звуком.

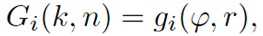

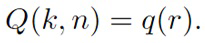

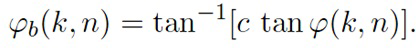

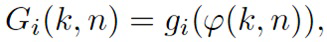

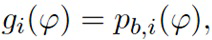

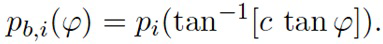

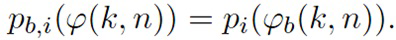

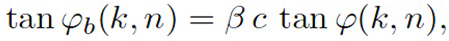

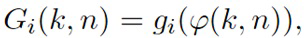

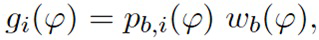

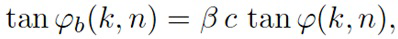

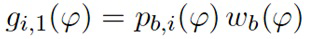

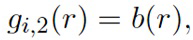

В некоторых вариантах осуществления, весовые коэффициенты Gi(k,n) и Q могут, например, определяться в блоках 201 и 202 выбора коэффициента усиления. Эти блоки могут, например, выбирать надлежащие весовые коэффициенты Gi(k,n) и Q из двух функций усиления, обозначенных gi и q, в зависимости от оцененной параметрической информации ϕ(k,n) и r(k,n). В математическом выражении,

(3a)

(3a)

(3b)

(3b)

В некоторых вариантах осуществления, функции усиления gi и q могут зависеть от применения и могут, например, генерироваться в модуле 104 вычисления функции усиления. Функции усиления описывают, какие весовые коэффициенты Gi(k,n) и Q следует использовать в (2a) для данной параметрической информации ϕ(k,n) и/или r(k,n), чтобы получить желаемое согласованное пространственное изображение.

Например, при приближении с помощью визуальной камеры, функции усиления регулируются таким образом, чтобы звук воспроизводился с направлений, где источники наблюдаются в видео. Весовые коэффициенты Gi(k,n) и Q и лежащие в основе функции усиления gi и q дополнительно описаны ниже. Следует отметить, что весовые коэффициенты Gi(k,n) и Q и лежащие в основе функции усиления gi и q могут, например, быть комплекснозначными. Вычисление функций усиления требует такой информации, как коэффициент масштабирования, ширина визуального изображения, желаемое направление наведения и конфигурация громкоговорителей.

В других вариантах осуществления, весовые коэффициенты Gi(k,n) и Q вычисляются непосредственно в модификаторе 103 сигнала, вместо того, чтобы сначала вычислять функции усиления в модуле 104 и затем выбирать весовые коэффициенты Gi(k,n) и Q из вычисленных функций усиления в блоках 201 и 202 выбора коэффициента усиления.

Согласно вариантам осуществления, более одной плоской волны на частотно-временной можно, например, подвергаться конкретной обработке. Например, две или более плоских волн в одном и том же частотном диапазоне могут, например, приходить с двух разных направлений и записываться микрофонной решеткой в один и тот же момент времени. Эти две плоские волны могут приходить с разных направлений. В таких сценариях, прямые составляющие сигнала двух или более плоских волн и их направление прихода можно, например, рассматривать по отдельности.

Согласно вариантам осуществления, прямой компонентный сигнал Xdir1(k,n) и один или более дополнительных прямых компонентных сигналов Xdir2(k,n), …, Xdir q(k,n) могут, например, образовывать группу из двух или более прямых компонентных сигналов Xdir1(k,n), Xdir2(k,n), …, Xdir q(k,n), причем модуль 101 разложения может, например, быть выполнен с возможностью генерации одного или более дополнительных прямых компонентных сигналов Xdir2(k,n), …, Xdir q(k,n), содержащих дополнительные прямые составляющие сигнала двух или более входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n).

Направление прихода и одно или более дополнительных направлений прихода образуют группу из двух или более направлений прихода, причем каждое направление прихода из группы из двух или более направлений прихода присваивается в точности одному прямому компонентному сигналу Xdir j(k,n) группы из двух или более прямых компонентных сигналов Xdir1(k,n), Xdir2(k,n), …, Xdir q,m(k,n), причем количество прямых компонентных сигналов из двух или более прямых компонентных сигналов, и количество направлений прихода двух направлений прихода равны.

Процессор 105 сигнала может, например, быть выполнен с возможностью приема группы из двух или более прямых компонентных сигналов Xdir1(k,n), Xdir2(k,n), …, Xdir q(k,n) и группы из двух или более направлений прихода.

Для каждого выходного аудиосигнала Yi(k,n) из одного или более выходных аудиосигналов Y1(k,n), Y2(k,n), …, Yv(k,n),

- процессор 105 сигнала может, например, быть выполнен с возможностью определения, для каждого прямого компонентного сигнала Xdir j(k,n) из группы из двух или более прямых компонентных сигналов Xdir1(k,n), Xdir2(k,n), …, Xdir q(k,n), прямого коэффициента усиления Gj,i(k,n) в зависимости от направления прихода упомянутого прямого компонентного сигнала Xdir j(k,n),

- процессор 105 сигнала может, например, быть выполнен с возможностью генерации группы из двух или более обработанных прямых сигналов Ydir1,i(k,n), Ydir2,i(k,n), …, Ydir q,i(k,n) путем применения, для каждого прямого компонентного сигнала Xdir j(k,n) из группы из двух или более прямых компонентных сигналов Xdir1(k,n), Xdir2(k,n), …, Xdir q(k,n), прямого коэффициента усиления Gj,i(k,n) упомянутого прямого компонентного сигнала Xdir j(k,n) к упомянутому прямому компонентному сигналу Xdir j(k,n), и

- процессор 105 сигнала может, например, быть выполнен с возможностью объединения одного Ydiff,i(k,n) из одного или более обработанных диффузных сигналов Ydiff,1(k,n), Ydiff,2(k,n), …, Ydiff,v(k,n) и каждого обработанного сигнала Ydir j,i(k,n) из группы из двух или более обработанных сигналов Ydir1,i(k,n), Ydir2,i(k,n), …, Ydir q,i(k,n) для генерации упомянутого выходного аудиосигнала Yi(k,n).

Таким образом, если рассматривать по отдельности две или более плоских волн, модель, выраженная формулой (1), приобретет вид:

Xm(k,n)=Xdir1,m(k,n)+Xdir2,m(k,n)+…+Xdir q,m(k,n)+Xdiff,m(k,n)+Xn,m(k,n)

и весовые коэффициенты можно, например, вычислять аналогично формулам (2a) и (2b) согласно:

Yi(k,n)=G1,i(k,n) Xdir1(k,n)+G2,i(k,n) Xdir2(k,n) +…+Gq,i(k,n) Xdir q(k,n)+Q Xdiff,m(k,n)=Ydir1,i(k,n)+Ydir2,i(k,n) +…+ Ydir q,i(k,n)+Ydiff,i(k,n)

Если достаточно лишь нескольких прямых компонентных сигналов, диффузный компонентный сигнал и вспомогательная информация передаются от стороны ближнего конца стороне дальнего конца. Согласно варианту осуществления, количество прямых компонентных сигналов группы из двух или более прямых компонентных сигналов Xdir1(k,n), Xdir2(k,n), …, Xdir q(k,n) плюс 1 меньше количества входных аудиосигналов x1(k,n), x2(k,n), … xp(k,n), принимаемых приемным интерфейсом 101. (использование индексов: q+1<p) ʺплюс 1ʺ представляет необходимый диффузный компонентный сигнал Xdiff(k,n).

Далее приведены объяснения одиночной плоской волны, одиночного направления прихода и одиночного прямого компонентного сигнала, но следует понимать, что объясненные принципы одинаково применимы к более чем одной плоской волне, более чем одному направлению прихода и более чем одному прямому компонентному сигналу.

Далее описано выделение прямого и диффузного звука. Обеспечены практические реализации модуля 101 разложения, показанного на фиг. 2, который осуществляет разложение на прямые/диффузные составляющие.

Согласно вариантам осуществления, для осуществления согласованного воспроизведения пространственного звука, выходные сигналы двух недавно предложенных информированных фильтров линейно ограниченной минимальной дисперсии (LCMV), описанных в [8] и [9], объединяются, что обеспечивает точное многоканальное выделение прямого звука и диффузного звука с желаемым произвольным откликом, предполагая аналогичную модель звукового поля, как в DirAC (направленном аудиокодировании). Далее описан конкретный способ объединения этих фильтров согласно варианту осуществления.

Сначала опишем выделение прямого звука согласно варианту осуществления.

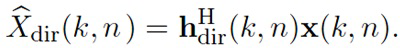

Прямой звук выделяется с использованием недавно предложенного информированного пространственного фильтра, описанного в [8]. Этот фильтр кратко описан ниже и затем выражен таким образом, чтобы его можно было использовать согласно вариантам осуществления, представленным фиг. 2.

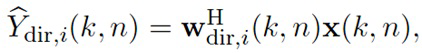

Оцененный желаемый прямой сигнал

(4)

(4)

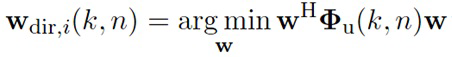

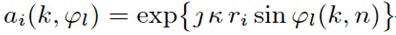

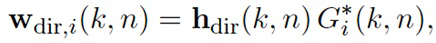

где вектор x(k,n)=[X1(k,n),…,XM(k,n)]T содержит M сигналов микрофонов, и wdir,i - вектор комплекснозначных весовых коэффициентов. Здесь, весовые коэффициенты фильтра минимизируют шум и диффузный звук, содержащийся микрофонами при захвате прямого звука с желаемым коэффициентом усиления Gi(k,n). В математическом выражении, весовые коэффициенты можно, например, вычислять как

(5)

(5)

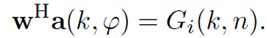

при условии линейного ограничения

(6)

(6)

Здесь, a(k,ϕ) - так называемый вектор распространения решетки. m-й элемент этого вектора является относительной передаточной функцией прямого звука между m-ым микрофоном и опорным микрофоном решетки (без потери общности, в нижеследующем описании используется первый микрофон в положении d1). Этот вектор зависит от DOA ϕ(k,n) прямого звука.

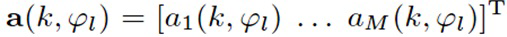

Вектор распространения решетки определен, например, в [8]. В формуле (6) документа [8], вектор распространения решетки определяется согласно

где ϕl - азимутальный угол направления прихода l-ой плоской волны. Таким образом, вектор распространения решетки зависит от направления прихода. Если существует или рассматривается одна-единственная плоская волна, индекс l можно исключить.

Согласно формуле (6) в [8], i-й элемент ai вектора распространения решетки a, описывающий сдвиг фазы l-ой плоской волны микрофонов с первого по i-й, определяется согласно

Например, ri равно расстоянию между первым и i-ым микрофонами, κ указывает волновое число плоской волны, и j - мнимая единица.

Дополнительную информацию о векторе распространения решетки a и его элементах ai можно найти в [8], которое в явном виде включено в данное описание в порядке ссылки.

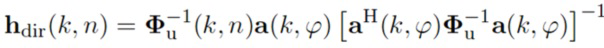

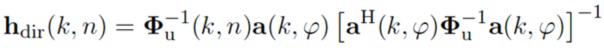

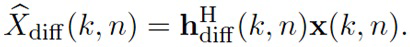

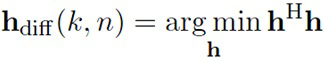

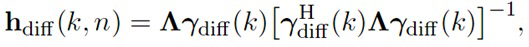

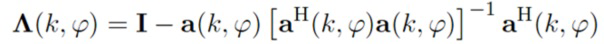

Матрица M×M Фu(k,n) в (5) является матрицей спектральной плотности мощности (PSD) шума и диффузного звука, которую можно определить, как объяснено в [8]. Решение (5) задается согласно

(7)

(7)

где

(8)

(8)

Расчет фильтра требует вектора распространения решетки a(k, ϕ), который можно определить после оценивания DOA ϕ(k,n) прямого звука [8]. Как объяснено выше, вектор распространения решетки и, таким образом, фильтр зависит от DOA. DOA можно оценивать, как объяснено ниже.

Информированный пространственный фильтр, предложенный в [8], например, выделение прямого звука с использованием (4) и (7), нельзя непосредственно использовать согласно варианту осуществления, представленному на фиг. 2. Фактически, для расчета требуются сигналы микрофонов x(k,n) а также коэффициент усиления прямого звука Gi(k,n). Как следует из фиг. 2, сигналы микрофонов x(k,n) доступны только на стороне ближнего конца, тогда как коэффициент усиления прямого звука Gi(k,n) доступен только на стороне дальнего конца.

Чтобы использовать информированный пространственный фильтр согласно вариантам осуществления изобретения, предусмотрено изменение, в которой (7) заменяется на (4), что дает

(9)

(9)

где

(10)

(10)

Этот измененный фильтр hdir(k,n) не зависит от весовых коэффициентов Gi(k,n). Таким образом, фильтр можно применять на стороне ближнего конца для получения прямого звука

(10a)

(10a)