Область техники, к которой относится изобретение

Настоящее изобретение относится к обработке аудиоданных и, в частности, касается устройств и способа для приема звука посредством выделения геометрической информации из оценок направления его поступления.

Уровень техники

Традиционная запись пространственного звука ставит своей целью зафиксировать звуковое поле с помощью множества микрофонов, так чтобы на стороне воспроизведения слушатель смог воспринимать звуковое изображение, каким оно было в месте записи. В стандартных подходах к записи пространственного звука обычно используются разнесенные всенаправленные микрофоны, например, как в AB-стереофонии, или совмещенные направленные микрофоны, например, как в интенсивной стереофонии, либо более сложные микрофоны, такие как микрофон B-формата, например, как в системе Ambisonics (смотри, например,

[1] R. K. Furness, "Ambisonics - An overview," in AES 8th International Conference, April 1990, pp. 181-189).

Для воспроизведения звука согласно этим непараметрическим подходам необходимые аудиосигналы воспроизведения (например, сигналы, посылаемые на громкоговорители) получают непосредственно из записанных микрофонных сигналов.

В качестве альтернативы могут применяться способы на основе параметрического представления звуковых полей, которые предполагают использование так называемых параметрических пространственных аудиокодеров. Эти способы части предусматривают использование микрофонных матриц для определения одного или нескольких аудиосигналов понижающего микширования вместе с дополнительной пространственной информацией, описывающей пространственный звук. Примерами этого являются прямое аудиокодирование (DirAC) или подход на основе использования так называемых пространственных микрофонов (SAM). Более подробное описание DirAC можно найти в

[2] Pulkki, V., "Directional audio coding in spatial sound reproduction and stereo upmixing," in Proceedings of the AES 28th International Conference, pp. 251-258, Pitea, Sweden, June 30 - July 2, 2006,

[3] V. Pulkki, "Spatial sound reproduction with directional audio coding," J. Audio Eng. Soc, vol. 55, no. 6, pp. 503-516, June 2007.

Более подробное описание использования пространственных микрофонов можно найти в

[4] C. Fallen "Microphone Front-Ends for Spatial Audio Coders", in Proceedings of the AES 125th International Convention, San Francisco, Oct. 2008. [5] M. Kallinger, H. Ochsenfeld, G. Del Galdo, F. Kuch, D. Mahne, R. Schultz-Amling. and O. Thiergart, "A spatial filtering approach for directional audio coding," in Audio Engineering Society Convention 126, Munich, Germany, May 2009.

В способе DirAC информация в пространственном акустическом сигнале содержит направление поступления (DOA) звука и диффузность звукового поля, вычисленные в частотно-временной области. Аудиосигналы для воспроизведения звука могут быть получены на основе их параметрического описания. В некоторых приложениях прием пространственного звука ставит своей целью фиксацию всей звуковой сцены в целом. В других приложениях прием пространственного звука ставит своей целью фиксацию лишь некоторых необходимых компонент. Для записи отдельных источников звука с высоким отношением сигнал-шум и низкой реверберацией часто используют микрофоны ближнего действия, в то время как в дистанционные конфигурации, рассчитанные на большие расстояния, такие как XY-стереофония, обеспечивают механизм для фиксации пространственного представления всей звуковой сцены. Повышенная гибкость с точки зрения направленности может быть достигнута при использовании формирования луча, где для реализации управляемых диаграмм направленности съема звука может быть использована микрофонная матрица. Еще большая гибкость обеспечивается вышеупомянутыми способами, такими как прямое аудиокодирование (DirAC) (смотри [2], [3]), где можно реализовать пространственные фильтры с произвольными диаграммами направленности съема звука, как это описано в

[5] M. Kallinger, H. Ochsenfeld, G. Del Galdo, F. Kuch, D. Mahne, R. Schultz-Amling. and O. Thiergart, "A spatial filtering approach for directional audio coding," in Audio Engineering Society Convention 126, Munich, Germany, May 2009,

а также другие манипуляции для обработки сигналов звуковой сцены (смотри, например,

[6] R. Schultz-Amling, F. Kiich, O. Thiergart, and M. Kallinger, "Acoustical zooming based on a parametric sound field representation," in Audio Engineering Society Convention 128, London UK, May 2010,

[7] J. Herre, C. Falch, D. Mahne, G. Del Galdo, M. Kallinger, and O. Thiergart, "Interactive teleconferencing combining spatial audio object coding and DirAC technology," in Audio Engineering Society Convention 128, London UK, May 2010).

Общим во всех вышеупомянутых концепциях является то, что микрофоны скомпонованы с известными фиксированными геометрическими характеристиками. Интервалы между микрофонами минимальны, насколько это возможно, в случае использования совмещенных микрофонов, в то время как в других способах они обычно составляют несколько сантиметров. Далее любое устройство для записи пространственного звука, способное определять направление поступления звука (например, комбинация направленных микрофонов или микрофонная матрица и т.д.), называется пространственным микрофоном.

Кроме того, общим для всех вышеупомянутых способов является то, что они ограничены представлением звукового поля относительно только одной точки, а именно, места измерения. Таким образом, необходимые микрофоны должны быть размещены в совершенно конкретных, тщательно выбранных местах, например, рядом с источниками звука, или так, чтобы можно было зафиксировать пространственное изображение оптимальным образом.

Однако во многих приложениях это физически невозможно, и, следовательно, выгодно разместить несколько микрофонов подальше от источников звука без потери требуемой способности фиксации звука.

На сегодняшний день существует несколько способов восстановления для оценки звукового поля в точке пространства, отличной от точки, где выполнялось измерение. Одним из таких способов является акустическая голография, описанная в

[8] E. G. Williams, Fourier Acoustics: Sound Radiation and Nearfield Acoustical Holography, Academic Press, 1999.

Акустическая голография позволяет вычислить звуковое поле в любой точке при произвольном объеме при условии, что известны звуковое давление и акустическая скорость частиц на всей поверхности. Следовательно, когда объем велик, потребуется нереально большое количество датчиков. Кроме того, этот способ предполагает, что внутри данного объема отсутствуют источники звука, что делает данный алгоритм неприемлемым для сформулированных потребностей. Соответствующая экстраполяция волнового поля (смотри также [8]) ставит своей целью экстраполяцию известного звукового поля на поверхности объема на внешние области. Однако точность экстраполяции быстро падает с возрастанием расстояния, а также в случае экстраполяций в направлениях, перпендикулярных направлению распространения звука (смотри

[9] A. Kuntz and R. Rabenstein, "Limitations in the extrapolation of wave fields from circular measurements," in 15th European Signal Processing Conference (EUSIPCO 2007), 2007.

[10] A. Walther and C. Faller, "Linear simulation of spaced microphone arrays using b-format recordings," in Audio Engineering Society Convention 128, London UK, May 2010,

где описана модель плоской волны и где экстраполяция поля возможна только в точках, отдаленных от реальных источников звука, например, рядом с точкой измерения.

Главным недостатком традиционных подходов является то, что записанное пространственное изображение всегда связано с используемым пространственным микрофоном. Во многих приложениях нельзя или физически невозможно разместить пространственный микрофон в требуемом месте, например, рядом с источниками звука. В этом случае было бы выгодно разместить множество пространственных микрофонов вдали от звуковой сцены без потери способности требуемой фиксации звука.

В [11] US61/287596: An Apparatus and a Method for Converting a First Parametric Spatial Audio Signal into a Second Parametric Spatial Audio Signal,

предложен способ для виртуального перемещения реального местоположения записи в другое место при воспроизведении через громкоговорители или наушники. Однако этот подход применим лишь к простой звуковой сцене, в которой, как предполагается, все звуковые объекты расположены на одинаковом расстоянии по отношению к реальному пространственному микрофону, используемому для записи. Кроме того, этот способ может дать преимущества только в случае одного пространственного микрофона.

Сущность изобретения

Цель настоящего изобретения состоит в усовершенствовании концепций приема звука посредством извлечения геометрической информации. Цель настоящего изобретения достигается с помощью устройства согласно пункту 1 формулы изобретения, способа согласно пункту 17 формулы изобретения и машиночитаемого носителя согласно пункту 18 изобретения.

Согласно одному варианту обеспечено устройство для создания выходного аудиосигнала для имитации записи, осуществляемой виртуальным микрофоном, находящимся в конфигурируемом виртуальном местоположении в окружающей среде. Устройство содержит блок оценки местоположения звуковых событий и модуль вычисления информации. Блок оценки местоположения звуковых событий приспособлен для оценки местоположения источника звука, указывающего местоположение источника звука в окружающей среде, причем этот блок оценки местоположения звуковых событий приспособлен для оценки местоположения источника звука на основе информации о первом направлении, обеспечиваемой первым реальным пространственным микрофоном, который находится в месте расположения первого реального микрофона в окружающей среде, и основан на информации о втором направлении, обеспечиваемой вторым реальным пространственным микрофоном, который находится в месте расположения второго реального микрофона в упомянутой окружающей среде.

Модуль вычисления информации приспособлен для создания выходного аудиосигнала на основе первого записанного входного аудиосигнала, который записывается первым реальным пространственным микрофоном, на основе местоположения первого реального микрофона, на основе виртуального местоположения виртуального микрофона и на основе местоположения источника звука, где первый реальный пространственный микрофон сконфигурирован для записи первого записанного входного аудиосигнала, или где третий микрофон сконфигурирован для записи первого записанного входного аудиосигнала.

В одном варианте модуль вычисления информации содержит компенсатор распространения, где компенсатор распространения приспособлен для создания первого модифицированного аудиосигнала путем модификации первого записанного входного аудиосигнала на основе первого затухания амплитуды между источником звука и первым реальным пространственным микрофоном и на основе второго затухания амплитуды между источником звука и виртуальным микрофоном, путем регулировки значения амплитуды, значения магнитуды или значения фазы первого записанного входного аудиосигнала, для получения выходного аудиосигнала. В одном варианте первое затухание амплитуды может представлять собой затухание амплитуды звуковой волны, излучаемой источником звука, и второе затухание амплитуды может представлять собой затухание амплитуды звуковой волны, излучаемой источником звука.

Кроме того, компенсатор распространения адаптирован для создания третьего модифицированного аудиосигнала путем модификации третьего записанного входного аудиосигнала, записанного четвертым микрофоном, путем компенсации третьей временной задержки или третьего затухания амплитуды между поступлением звуковой волны, излучаемой звуковым событием, у четвертого микрофона, и поступлением звуковой волны у виртуального микрофона, путем регулировки значения амплитуды, значения магнитуды или значения фазы третьего записанного входного аудиосигнала для получения выходного аудиосигнала.

Согласно другому варианту модуль вычисления информации содержит компенсатор распространения, где компенсатор распространения приспособлен для создания первого модифицированного аудиосигнала путем модификации первого записанного входного аудиосигнала путем компенсации первого затухания между поступлением звуковой волны, излучаемой источником звука, у первого реального пространственного микрофона, и поступлением звуковой волны у виртуального микрофона путем регулировки значения амплитуды, значения магнитуды или значения фазы первого записанного входного аудиосигнала для получения выходного аудиосигнала.

Согласно одному варианту предполагается использовать два или более пространственных микрофона, которые далее называют реальными пространственными микрофонами. Для каждого реального пространственного микрофона можно оценить DOA звука в частотно-временной области. Из информации, собранной реальными пространственными микрофонами, зная их относительное местоположение, можно сформировать выходной сигнал произвольного пространственного микрофона, виртуально размещенного в указанной окружающей среде. Этот пространственный микрофон называют далее виртуальным пространственным микрофоном.

Заметим, что направление поступления (DOA) можно выразить в виде азимутального угла, если речь идет о двумерном пространстве, или в виде пары, состоящей из азимутального угла и угла места, в трехмерном пространстве. В качестве эквивалента можно использовать единичный нормальный вектор, указанный в DOA.

В ряде вариантов обеспечены средства для избирательной пространственной фиксации звука; например, звук, исходящий из конкретного заданного места, может быть зафиксирован, как если бы в этом месте был установлен близлежащий «точечный микрофон». Однако вместо реальной установки этого точечного микрофона можно имитировать его выходной сигнал путем использования двух или более пространственных микрофонов, расположенных в других удаленных местах.

Термин «пространственный микрофон» относится к любому устройству для приема пространственного звука, способному извлекать направление поступления звука (например, комбинация направленных микрофонов, микрофонные матрицы и т.д.).

Термин «непространственный микрофон» относится к любому устройству, которое не приспособлено для извлечения направления поступления звука, например, один всенаправленный или направленный микрофон.

Следует заметить, что термин «реальный пространственный микрофон» относится к пространственному микрофону, определенному выше, который физически существует.

Что касается виртуального пространственного микрофона, то следует заметить, что виртуальный пространственный микрофон может представлять собой микрофон любого требуемого типа или их комбинацию, например, это может быть единичный всенаправленный микрофон, направленный микрофон, пару направленных микрофонов, используемых в обычных стереомикрофонах, но также и микрофонную матрицу.

Настоящее изобретение основано на установленном положении, заключающемся в том, что при использовании двух или более реальных пространственных микрофонов можно оценить местоположение звуковых событий в двухмерном или трехмерном пространстве, что позволяет обеспечить локализацию местоположения. Используя определенные местоположения звуковых событий, можно вычислить звуковой сигнал, который мог бы быть записан виртуальным пространственным микрофоном, произвольно расположенным и ориентированным в пространстве, а также соответствующую дополнительную пространственную информацию, такую как направление поступления из точки обзора виртуального пространственного микрофона.

С этой целью можно предположить, что каждое звуковое событие представляет точечный источник звука, например, изотропный точечный источник звука. Используемый далее термин «реальный источник звука» относится к действительному источнику звука, физически существующему в среде записи, например, собеседники или музыкальные инструменты и т.д. С другой стороны, термины «источник звука» или «звуковое событие» относятся далее к действующему источнику звука, который активен в определенный момент времени или в определенном частотно-временном бине, где источники звука могут представлять, например, реальные источники звука или источники зеркальных изображений. Согласно одному варианту предположим в неявном виде, что звуковую сцену можно смоделировать в виде интенсивности указанных звуковых событий или точечных источников звука. Кроме того, можно предположить, что каждый источник может быть активен только в течение конкретного временного интервала и на частотном слоте в заранее определенном частотно-временном представлении. Расстояние между реальными пространственными микрофонами может быть таким, что результирующее различие между временами распространения будет меньше, чем временное разрешение частотно-временного представления. Последнее предположение гарантирует, что конкретное звуковое событие будет фиксироваться всеми пространственными микрофонами в одном и том же временном слоте. Это означает, что направления DOA, оцененные разными пространственными микрофонами для одного и того же частотно-временного слота, будут действительно соответствовать одному и тому же звуковому событию. Это предположение нетрудно удовлетворить, используя реальные пространственные микрофоны, размещенные в нескольких метрах друг от друга даже в больших помещениях (таких как жилые комнаты или конференц-залы) при временном разрешении, составляющем вплоть до нескольких миллисекунд.

Для локализации источников звука можно использовать микрофонные матрицы. Локализованные источники звука можно по-разному физически интерпретировать в зависимости от их природы. Когда микрофонные матрицы воспринимают звук напрямую, они способны локализовать местоположение действительного источника звука (например, собеседников). Когда микрофонные матрицы принимают отраженные сигналы, они могут локализовать местоположение источника зеркального отражения. Источники зеркального отражения также считаются источниками звука.

Обеспечен параметрический способ, способный оценить звуковой сигнал виртуального микрофона, имеющего произвольное местоположение. В отличие от ранее описанных способов, предложенный способ не ставит своей целью непосредственное восстановление звукового поля, а скорее имеет своей целью обеспечение звука, воспринимаемого подобно звуку, который был бы зафиксирован микрофоном, физически размещенным в этом месте. Это можно обеспечить, используя параметрическую модель звукового поля на основе точечных источников звука, например, изотропных точечных источников звука (IPLS). Необходимую геометрическую информацию, а именно, мгновенное местоположение всех IPLS, можно получить путем выполнения триангуляции направлений поступления, оцененных двумя или более распределенными микрофонными матрицами. Это можно достичь, получив информацию об относительном местоположении и ориентации этих матриц. При этом количество и местоположение действительных источников звука (например, собеседников) заранее знать не обязательно. При заданных параметрических особенностях предложенных концепций, например, касающихся предложенного устройства или способа, виртуальный микрофон может иметь произвольную диаграмму направленности, а также произвольные физические или нефизические свойства, например, в отношении снижения звукового давления с расстоянием. Представленный здесь подход был верифицирован путем исследования точности оценки параметров на основе измерений в реверберирующей среде.

В то время как традиционные способы записи для пространственного аудио ограничены, поскольку полученное пространственное изображение всегда соотнесено с местом, в котором физически размещены микрофоны, варианты настоящего изобретения учитывают, что во многих приложениях микрофоны желательно размещать вне звуковой сцены, причем они еще должны быть способны при этом фиксировать звук с произвольного ракурса. Согласно вариантам изобретения предложены концепции, которые позволяют виртуально разместить виртуальный микрофон в произвольной точке пространства путем вычисления сигнала, воспринимаемого подобно сигналу, который был бы зафиксирован в том случае, если бы микрофон был физически размещен в звуковой сцене. Варианты изобретения позволяют реализовать концепции, которые предполагают использование параметрической модели звукового поля на основе точечных источников звука, например, изотропных точечных источников звука. Необходимую геометрическую информацию можно получить, используя две или более распределенных микрофонных матрицы.

Согласно одному варианту изобретения блок оценки местоположения звуковых событий можно адаптировать для оценки местоположения источника звука на основе первого направления поступления звуковой волны, излучаемой источником звука, в месте расположения первого реального микрофона, в качестве информации о первом направлении, и на основе второго направления поступления звуковой волны в месте расположения второго реального микрофона, в качестве информации о втором направлении.

В других вариантах модуль вычисления информации может содержать модуль вычисления дополнительной пространственной информации для вычисления дополнительной пространственной информации. Модуль вычисления информации может быть адаптирован для оценки направления поступления или интенсивности активизированного звука у виртуального микрофона, в качестве дополнительной пространственной информации на основе вектора местоположения виртуального микрофона и на основе вектора местоположения звукового события.

Согласно еще одному варианту изобретения компенсатор распространения можно адаптировать для создания первого модифицированного аудиосигнала в частотно-временной области путем компенсации первой задержки или затухания амплитуды между поступлением второй волны, излучаемой вторым источником, у первого реального пространственного микрофона, и поступлением звуковой волны у виртуального микрофона путем регулировки значения указанной интенсивности первого записанного входного аудиосигнала, представленного в частотно-временной области.

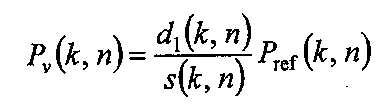

В одном варианте компенсатор распространения может быть адаптирован для выполнения компенсации распространения путем создания модифицированного значения магнитуды первого модифицированного аудиосигнала с применением формулы:

где d1(k,n) представляет собой расстояние между местоположением первого реального пространственного микрофона и местоположением звукового события, где s(k,n) - расстояние между виртуальным местоположением виртуального микрофона и местоположением источника звука для данного звукового события, где Pref(k,n) - значение магнитуды первого записанного входного аудиосигнала, представляемого в частотно-временной области, и где Pv(k,n) - модифицированное значение магнитуды.

В дополнительном варианте модуль вычисления информации кроме того может содержать объединитель, причем компенсатор распространения кроме того может быть адаптирован для модификации второго записанного входного аудиосигнала, записываемого вторым реальным пространственным микрофоном, посредством компенсации второй задержки или затухания амплитуды между моментом поступления звуковой волны, излучаемой источником звука, на второй реальный пространственный микрофон, и моментом поступления звуковой волны на виртуальный микрофон путем регулировки значения амплитуды, значения магнитуды или значения фазы второго записанного входного аудиосигнала, чтобы получить второй модифицированный аудиосигнал, и где объединитель может быть адаптирован для создания объединенного сигнала путем объединения первого модифицированного аудиосигнала и второго модифицированного аудиосигнала, для получения выходного аудиосигнала.

Согласно еще одному варианту компенсатор распространения кроме того можно адаптировать для модификации одного или нескольких дополнительно записанных входных аудиосигналов, записываемых одним или несколькими дополнительными реальными пространственными микрофонами, посредством компенсации задержек между моментом поступления звуковой волны на виртуальный микрофон и моментом поступления звуковой волны, излучаемой источником звука, на каждый из дополнительных реальных пространственных микрофонов. Каждую задержку или затухание амплитуды можно компенсировать посредством регулировки значения амплитуды, значения магнитуды или значения фазы каждого из дополнительно записанных входных аудиосигналов, чтобы получить множество третьих модифицированных аудиосигналов. Упомянутый объединитель можно адаптировать для создания объединенного сигнала посредством объединения первого модифицированного аудиосигнала и второго модифицированного аудиосигнала и множества третьих модифицированных аудиосигналов для получения выходного аудиосигнала.

В следующем варианте модуль вычисления информации может содержать блок спектрального взвешивания для создания взвешенного аудиосигнала путем модификации первого модифицированного аудиосигнала в зависимости от направления поступления звуковой волны в виртуальном местоположении виртуального микрофона, а также в зависимости от виртуальной ориентации виртуального микрофона для получения выходного аудиосигнала, где первый модифицированный аудиосигнал может быть модифицирован в частотно-временной области.

Кроме того, модуль вычисления информации может содержать блок спектрального взвешивания для создания взвешенного аудиосигнала путем модификации объединенного сигнала в зависимости от направления поступления звуковой волны в виртуальное место нахождения виртуального микрофона, а также в зависимости от виртуальной ориентации виртуального микрофона для получения выходного аудиосигнала, где объединенный сигнал может быть модифицирован в частотно-временной области.

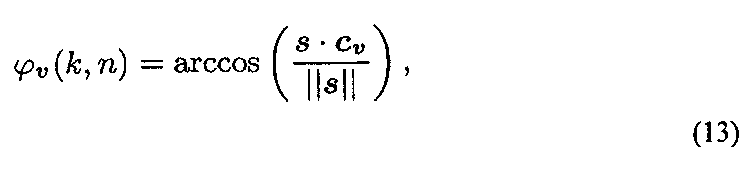

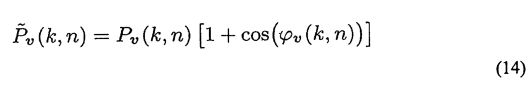

Согласно еще одному варианту блок спектрального взвешивания может быть адаптирован для применения весового коэффициента

α+(1-α)cos(φv(k,n)), или весового коэффициента

0,5+0,5cos(φv (k,n))

для взвешенного аудиосигнала,

где φv(k,n) указывает вектор направления поступления звуковой волны, излучаемой источником звука, в виртуальное место расположения виртуального микрофона.

В одном варианте компенсатор распространения кроме того адаптирован для создания третьего модифицированного аудиосигнала посредством модификации третьего записанного входного аудиосигнала, записываемого всенаправленным микрофоном, путем компенсации третьей задержки или затухания амплитуды между моментом поступления звуковой волны, излучаемой вторым источником звука, на всенаправленный микрофон, и моментом поступления звуковой волны на виртуальный микрофон, путем регулировки значения амплитуды, значения магнитуды или значения фазы третьего записанного входного аудиосигнала, чтобы получить выходной аудиосигнал.

В следующем варианте блок оценки местоположения звуковых событий может быть адаптирован для оценки местоположения источника звука в трехмерной окружающей среде.

Кроме того, согласно еще одному варианту модуль вычисления информации, кроме того, может содержать блок вычисления диффузности, адаптируемый для оценки энергии диффузного звука у виртуального микрофона или энергии прямого звука у виртуального микрофона.

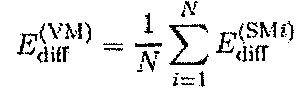

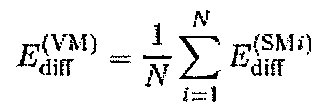

Блок вычисления диффузности согласно следующему варианту может быть адаптирован для оценки энергии  диффузного звука у виртуального микрофона путем применения формулы:

диффузного звука у виртуального микрофона путем применения формулы:

где N - количество реальных пространственных микрофонов из множества реальных пространственных микрофонов, содержащее первый и второй реальный пространственный микрофон, и где  - энергия диффузного звука у i-го реального пространственного микрофона.

- энергия диффузного звука у i-го реального пространственного микрофона.

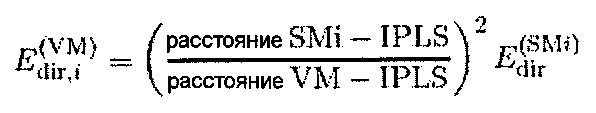

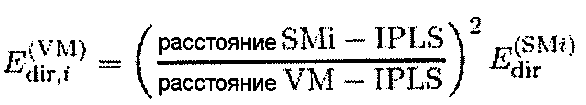

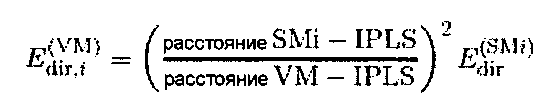

В следующем варианте блок вычисления диффузности можно адаптировать для оценки энергии прямого звука путем применения формулы:

где «расстояние SMi-IPLS» - расстояние между местоположением i-го реального микрофона и местоположением источника звука, где «расстояние VM-IPLS» - расстояние между виртуальным местоположением и местоположением источника звука и где  - прямая энергия у i-го реального пространственного микрофона.

- прямая энергия у i-го реального пространственного микрофона.

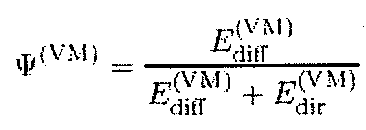

Кроме того, согласно еще одному варианту блок вычисления диффузности может, кроме того, быть адаптирован для оценки диффузности у виртуального микрофона путем оценки энергии диффузного звука у виртуального микрофона и энергии прямого звука у виртуального микрофона с применением формулы:

где  указывает оцениваемую диффузность у виртуального микрофона, где

указывает оцениваемую диффузность у виртуального микрофона, где  указывает оцениваемую энергию диффузного звука и где

указывает оцениваемую энергию диффузного звука и где  указывает оцениваемую энергию прямого звука.

указывает оцениваемую энергию прямого звука.

Краткое описание чертежей

Далее описываются предпочтительные варианты настоящего изобретения со ссылками на чертежи, на которых:

фиг. 1 - устройство для создания выходного сигнала согласно одному варианту настоящего изобретения;

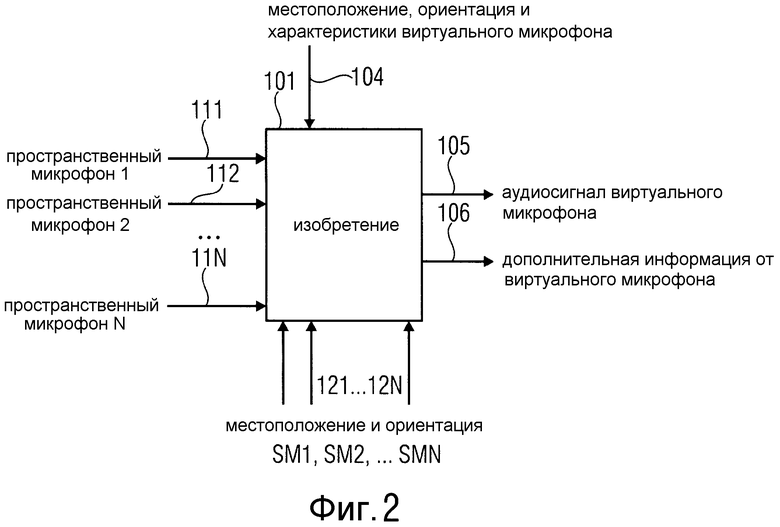

фиг. 2 - входы и выходы устройства и способ создания выходного аудиосигнала согласно настоящему изобретению;

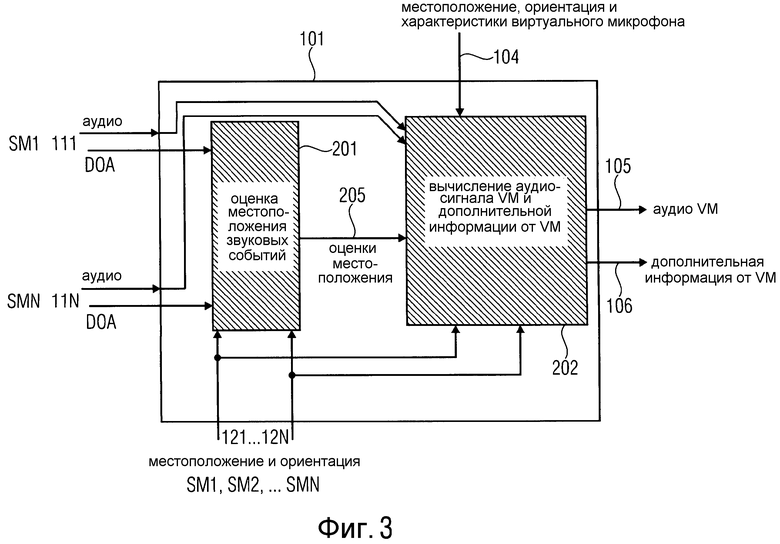

фиг. 3 - базовая структура устройства согласно одному варианту, которая содержит блок оценки местоположения звуковых событий, и модуль вычисления информации;

фиг. 4 - иллюстрация примерного сценария, где реальные пространственные микрофоны изображены в виде однородных линейных матриц из 3 микрофонов каждая;

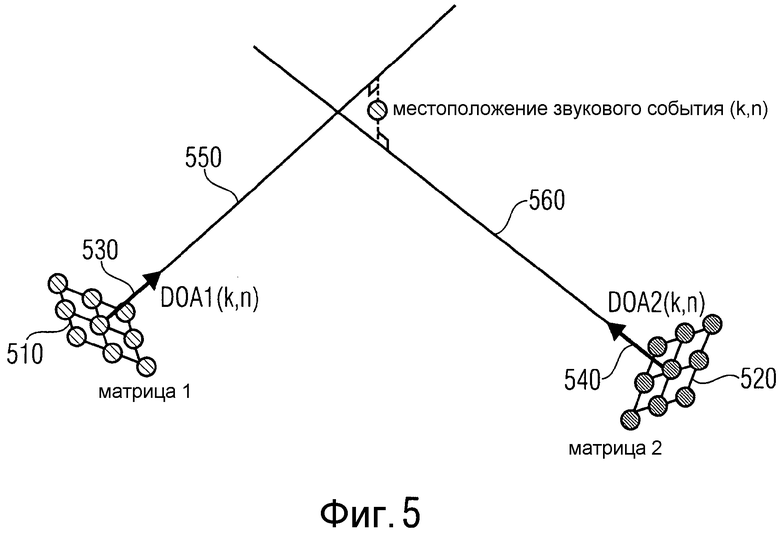

фиг. 5 - два пространственных микрофона в трехмерном (3D) пространстве для оценки направления поступления звука в 3D пространстве;

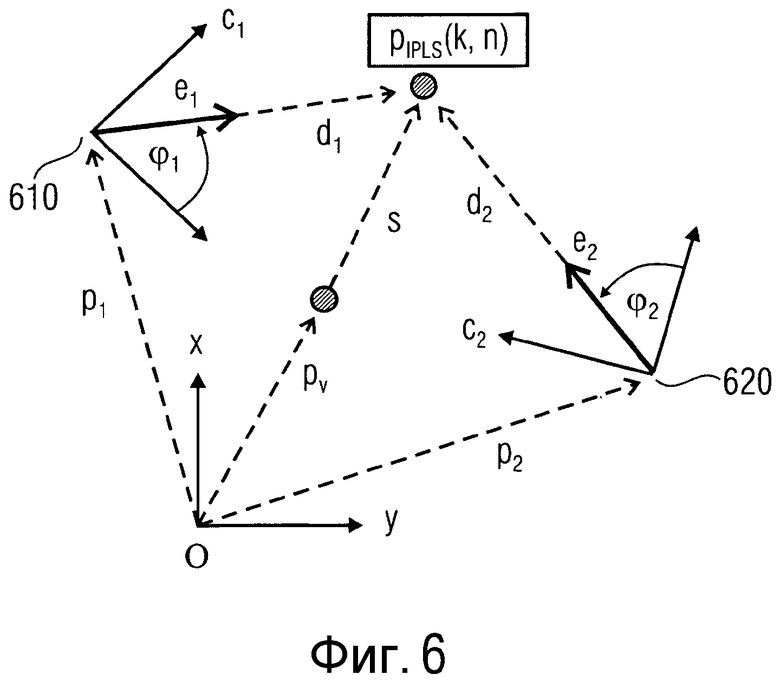

фиг. 6 - геометрическая схема, где изотропный точечный источник звука для текущего частотно-временного бина (k,n) расположен у места расположения piPLs(k,n);

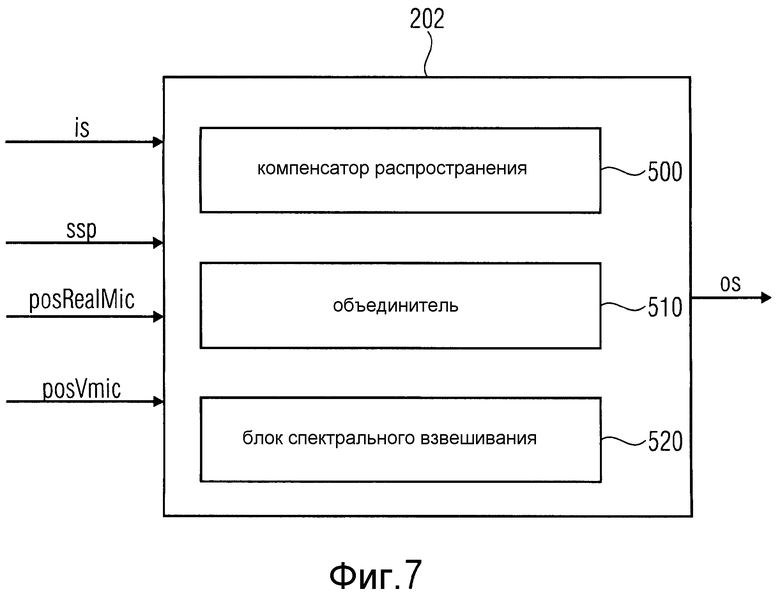

фиг. 7 - модуль вычисления информации согласно одному варианту настоящего изобретения;

фиг. 8 - модуль вычисления информации согласно другому варианту настоящего изобретения;

фиг. 9 - два реальных пространственных микрофона, локализованное звуковое событие и местоположение виртуального пространственного микрофона вместе с соответствующими задержками и затуханиями амплитуды;

фиг. 10 - иллюстрация способа получения направления поступления по отношению к виртуальному микрофону согласно одному варианту настоящего изобретения;

фиг. 11 - возможный способ получения DOA звука из точки обзора виртуального микрофона согласно одному варианту настоящего изобретения;

фиг. 12 - блок вычисления информации, дополнительно содержащий блок вычисления диффузности согласно одному варианту настоящего изобретения;

фиг. 13 - блок вычисления диффузности согласно одному варианту настоящего изобретения;

фиг. 14 - пример сценария, в котором невозможна оценка местоположения звуковых событий; и

фиг. 15а-15с - примеры сценариев, где две микрофонные матрицы принимают прямой звук, звук, отраженный стеной, и диффузный звук.

Подробное описание вариантов изобретения

На фиг. 1 показано устройство для создания выходного аудиосигнала с целью имитации записи, выполняющейся виртуальным микрофоном у конфигурируемого виртуального места posVmic его расположения в окружающей среде. Устройство содержит блок 110 оценки местоположения звуковых событий и модуль 120 вычисления информации. Блок 110 оценки местоположения звуковых событий получает информацию di1 о первом направлении от первого реального пространственного микрофона и информацию di2 о втором направлении от второго реального пространственного микрофона. Блок 110 оценки местоположения звуковых событий адаптирован для оценки ssp местоположения звукового события, указывающей местоположение источника звука в окружающей среде, где источник звука излучает звуковую волну, и где блок 110 оценки местоположения звуковых событий адаптирован для оценки ssp местоположения источника звука на основе информации di1 о первом направлении, обеспечиваемой первым реальным пространственным микрофоном, находящимся в месте pos1mic первого реального микрофона в данной окружающей среде, и на основании информации di2 о втором направлении, обеспечиваемой вторым реальным пространственным микрофоном, находящимся в окрестности места расположения второго реального микрофона в данной окружающей среде. Модуль 120 вычисления информации адаптирован для создания выходного аудиосигнала на основе первого записанного входного аудиосигнала is1, записываемого первым реальным пространственным микрофоном, на основе местоположения pos1mic первого реального микрофона и на основе виртуального местоположения posVmic виртуального микрофона. Модуль 120 вычисления информации содержит компенсатор распространения, адаптируемый для создания первого модифицированного аудиосигнала посредством модификации первого записанного входного аудиосигнала is1 посредством компенсации первой задержки или затухания амплитуды между моментом поступления звуковой волны, излучаемой источником звука, у первого реального пространственного микрофона и моментом поступления звуковой волны у виртуального микрофона путем регулировки значения амплитуды, значения магнитуды или значения фазы первого записанного входного аудиосигнала is1, чтобы получить выходной аудиосигнал.

На фиг. 2 показаны входы и выходы устройства и способа согласно одному варианту изобретения. Информация от двух или более реальных пространственных микрофонов 111, 112,… 11N подается в устройство/обрабатывается с использованием упомянутого способа. Эта информация содержит аудиосигналы, зафиксированные реальными пространственными микрофонами, а также информацию о направлении от реальных пространственных микрофонов, например, оценки направления поступления (DOA). Аудиосигналы и информация о направлении, например, оценки управления поступления, могут быть представлены в частотно-временной области. Например, если требуется восстановление в 2D геометрии, и для представления сигналов выбрана область традиционного кратковременного преобразования Фурье (STFT), то DOA можно выразить в виде азимутальных улов, зависящих от k и n, а именно от индексов частоты и времени.

В вариантах настоящего изобретения локализация звукового события в пространстве, а также описание местоположения могут быть выполнены на основе местоположений и ориентаций реальных и виртуальных пространственных микрофонов в общей системе координат. Эта информация может быть представлена входами 121,… 12N и входом 104 на фиг. 2. Вход 104 может дополнительно задать некоторую характеристику виртуального пространственного микрофона, например, его местоположение и диаграмму направленности приема звука, что обсуждается далее. Если виртуальный пространственный микрофон содержит множество виртуальных датчиков, то можно будет учесть их местоположение и соответствующие различные диаграммы направленности приема.

Выходом устройства или соответствующего способа может быть, когда это требуется, один или несколько пространственных сигналов 105, которые были зафиксированы пространственным микрофоном, определенным и размещенным так, как это задано ссылочной позицией 104. Кроме того, устройство (или, скорее, способ) в качестве выхода может предоставить дополнительную пространственную информацию 106, которую можно оценить, используя виртуальный пространственный микрофон.

На фиг. 3 показано устройство согласно одному варианту, которое содержит два основных обрабатывающих блока, блок 201 оценки местоположения звуковых событий и модуль 202 вычисления информации. Блок 201 оценки местоположения звуковых событий может выполнять геометрическое восстановление на основе направлений (DOA), содержащихся во входных сигналах 111,… 11N, и на основе известно местоположения и известной ориентации реальных пространственных микрофонов, где были вычислены направления DOA. Выход блока 205 оценки местоположения звуковых событий содержит оценки местоположения (в 2D или 3D пространстве) источников звука, где звуковые события появляются для каждого частотно-временного бина. Второй обрабатывающий блок 202 является модулем вычисления информации. Согласно варианту изобретения по фиг. 3 второй обрабатывающий блок 202 вычисляет сигнал виртуального микрофона и дополнительную пространственную информацию. Следовательно, это также относится к сигналу виртуального микрофона и блоку 202 вычисления информации. Сигнал виртуального микрофона и блок 202 вычисления дополнительной информации используют местоположения 205 звуковых событий для обработки аудиосигналов, содержащихся в 111,… 11N, для вывода аудиосигнала 105 виртуального микрофона. Если это необходимо, то блок 202 также может вычислить дополнительную пространственную информацию 106, соответствующую виртуальному пространственному микрофону. Изложенные ниже варианты иллюстрируют, как могут функционировать блоки 201 и 202.

Далее подробно описывается операция оценки местоположения, выполняемая блоком оценки местоположения звуковых событий, согласно одному варианту настоящего изобретения.

В зависимости от размерности задачи (2D или 3D) и количества пространственных микрофонов возможно несколько решений задачи оценки местоположения.

Если в 2D пространстве существует два пространственных микрофона (простейший случай из всех возможных), то можно использовать простую триангуляцию. На фиг. 4 показан примерный сценарий, в котором реальные пространственные микрофоны представлены в виде однородных линейных матриц (ULA) из 3 микрофонов каждая. Для частотно-временного бина (k,n) вычисляют направление DOA, выраженное в виде азимутальных углов a1(k,n) и a2(k,n). Это достигается посредством использования блока оценки правильного DOA, такого как ESPRIT (смотри

[13] R. Roy, A. Paulraj, and Т. ailath, "Direction-of-arrival estimation by subspace rotation methods - ESPRIT," in IEEE International Conference on Acoustics, Speech, and Signal Processing (ICASSP), Stanford, CA, USA, April 1986),

или (основного) MUSIC (смотри

[14] R. Schmidt, "Multiple emitter location and signal parameter estimation," IEEE Transactions on Antennas and Propagation, vol. 34, no. 3, pp. 276-280, 1986)

для сигналов давления, преобразованных в частотно-временной области.

На фиг. 4 показаны два реальных пространственных микрофона (здесь это две реальных пространственных микрофонных матрицы 410, 420). Два оцененных направления DOA, a1(k,n) и a2(k,n), представлены двумя линиями, где первая линия 430 представляет DOA направление a1(k,n), а вторая линия 440 представляет DOA направление a2(k,n). Применение триангуляции возможно на основе простых геометрических рассуждений при известном местоположении и известной ориентации каждой матрицы.

Триангуляцию применить невозможно, если эти две линии 430, 440 в точности параллельны. Однако в реальных приложениях это крайне маловероятно. Однако не все результаты триангуляции соответствуют физическому или возможному местоположению звукового события в данном рассматриваемом пространстве. Например, полученное в результате оценки местоположение звукового события может оказаться слишком далеким или даже вне предполагаемого пространства, что указывает на несоответствие направлений DOA звуковому событию, которое можно физически интерпретировать с помощью этой используемой модели. Причиной таких результатов может быть шум датчика или слишком сильная реверберация в помещении. Следовательно, согласно одному варианту изобретения указанные нежелательные результаты корректируются так, чтобы модуль 202 вычисления информации смог правильно их трактовать.

На фиг. 5 показан сценарий, где выполняется оценка местоположения звукового события в 3D пространстве. Здесь использованы соответствующие пространственные микрофоны, например, планарная микрофонная матрица или 3D микрофонная матрица. На фиг. 5 показаны первый пространственный микрофон 510, например, первая 3D микрофонная матрица, и второй пространственный микрофон 520, например, вторая 3D микрофонная матрица. Направление DOA в 3D пространстве можно представить, например, в виде азимута и высоты. Для представления направлений DOA можно использовать единичные векторы 530, 540. В соответствии с направлениями DOA построены две линии 550, 560. В 3D пространстве даже при очень надежных оценках две линии 550, 560, построенные согласно указанным направлениям DOA, могут не пересекаться. Однако триангуляцию все же можно выполнить, выбрав, например, среднюю точку минимального отрезка, соединяющего эти две линии.

Аналогичным образом в случае 2D пространства триангуляция может оказаться невыполнимой или может дать физически невозможные результаты для некоторых комбинаций направлений, которые затем также могут быть скорректированы, например, для модуля 202 вычисления информации по фиг. 3.

При наличии более двух пространственных микрофонов возможно несколько решений. Например, объясненную выше триангуляцию можно осуществить для всех пар реальных пространственных микрофонов (если N=3, то 1 с 2, 1 с 3 и 2 с 3). Затем результирующие места расположения можно усреднить (по х и у, а если рассматривается 3D пространство, то и по z). В качестве альтернативы могут быть использованы более сложные концепции. Например, можно применить вероятностные подходы, описанные в

[15] J. Michael Steele, "Optimal Triangulation of Random Samples in the Plane", The Annals of Probability, Vol. 10, No. 3

(Aug., 1982), pp.548-553.

Согласно одному варианту изобретения можно проанализировать звуковое поле в частотно-временной области, полученное, например, посредством кратковременного преобразования Фурье (STFT), где k и n обозначают индекс k частоты и индекс n времени соответственно. Комплексное давление Pv(k,n) в произвольном местоположении pv для определенных кип моделируется в виде одной сферической волны, излучаемой узкополосным изотропным точечным источником, например, с использованием следующей формулы:

где PIPLS(k,n) - сигнал, излучаемый источником IPLS, находящимся в положении pIPLS(k,n). Комплексный коэффициент γ(k, pIPLS(k, n, pv) представляет распространение от pIPLS(k,n) до pv, например, он вводит соответствующие модификации фазы и величины аудиосигнала. Здесь можно предположить, что в каждом частотно-временном бине активен только один IPLS. Тем не менее, в один момент времени также могут быть активными множество узкополосных IPLS, имеющих различное местоположение.

Каждый IPLS моделирует либо прямой звук, либо удаленное отражение в помещении. Местоположение pIPLS(k,n) может идеально соответствовать действительному источнику звука, находящемуся внутри данного помещения, или источнику зеркального отражения, находящемуся вне помещения соответственно. Таким образом, местоположение pIPLS(k,n) также может указывать местоположение источника звука. Следует обратить внимание на то, что термин «реальные источники звука» обозначает действительные источники звука, физически существующие в среде записи, такие как собеседники или музыкальные инструменты. С другой стороны, термины «источники звука», «звуковые события» или «IPLS относятся к эффективным источникам звука, активным в определенные моменты времени или на определенных частотно-временных бинах, где эти источники звука могут, например, представлять реальные источники звука или источники зеркального отражения.

На фиг. 15а-15b показаны микрофонные матрицы, локализующие источники звука. Локализованные источники звука могут быть по-разному физически интерпретированы в зависимости от их природы. Когда микрофонные матрицы воспринимают прямой звук, они способны локализовать местоположение действительного источника звука (например, собеседников). Когда микрофонные матрицы воспринимают отраженные звуки, они могут локализовать местоположение источника зеркального отражения. Источники зеркального отражения также являются источниками звука.

На фиг. 15а показан сценарий, где две микрофонные матрицы 151 и 152 воспринимают прямой звук от действительного источника звука (физически существующего источника звука).

На фиг. 15b показан сценарий, где две микрофонные матрицы 161, 162 принимают отраженный звук, который был отражен стеной. По причине отражения микрофонные матрицы 161, 162 определяют место появления звука как место расположения источника 165 зеркального отражения, которое отличается от местоположения собеседника 163.

Действительный источник 153 звука по фиг. 15а, а также источник 165 зеркального отражения являются оба источниками звука.

На фиг. 15с показан сценарий, где две микрофонные матрицы 171, 172 принимают диффузный звук и не способны локализовать источник звука.

Эта одноволновая модель дает точные результаты только для сред с умеренной реверберацией при условии, что сигналы источника достаточно хорошо удовлетворяют условию отсутствия их частотно-временного перекрытия (WDO-ортогональность). Обычно это действительно для речевых сигналов (смотри, например

[12] S. Rickard and Z. Yilmaz, "On the approximate W-disjoint orthogonality of speech," in Acoustics, Speech and Signal Processing, 2002. ICASSP 2002. IEEE International Conference on, April 2002, vol. 1).

Однако эта модель также обеспечивает хорошую оценку для других сред и поэтому также может найти в них свое применение.

Далее объясняется, как выполняется оценка местоположений pIPLS(k,n) согласно одному варианту изобретения. Местоположение pIPLS(k,n) активного источника IPLS в конкретном частотно-временном бине и, следовательно, оценку звукового события в частотно-временном бине получают с помощью триангуляции на основе направления поступления (DOA) звука, измеренного по меньшей мере в двух разных точках наблюдения.

На фиг. 6 показана геометрическая структура, где источник IPLS текущего частотно-временного слота (k,n) находится в неизвестном положении pIPLS(k,n). Чтобы определить необходимую информацию о DOA, используют два реальных пространственных микрофона, здесь это две микрофонные матрицы, имеющие известную геометрию, местоположение и ориентацию, причем местоположения этих матриц обозначены ссылочными позициями 610 и 620 соответственно. Векторы р1 и р2 указывают на местоположения 610, 620 соответственно. Ориентация матриц определяется единичными векторами с1 и с2. Направление DOA звука определяют в местах 610 и 620 для каждого (k,n), используя алгоритм оценки DOA, например, как это обеспечивается при использовании анализа DirAC (смотри [2], [3]). Таким образом, в качестве выходного результата анализа DirAC могут быть получены единичный вектор  (k,n) первой точки обзора и единичный вектор

(k,n) первой точки обзора и единичный вектор  (k,n) второй точки обзора относительно точки обзора микрофонных матриц (на фиг. 6 они не показаны). Например, при функционировании в 2D пространстве единичный вектор первой точки обзора будет представлен как:

(k,n) второй точки обзора относительно точки обзора микрофонных матриц (на фиг. 6 они не показаны). Например, при функционировании в 2D пространстве единичный вектор первой точки обзора будет представлен как:

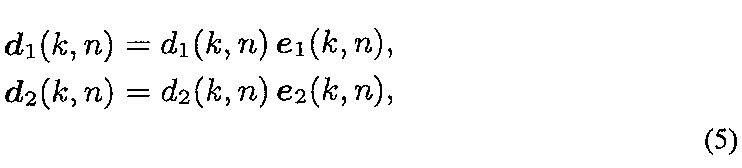

Здесь φ1(k,n) представляет азимут DOA, оцененный у первой микрофонной матрицы, показанной на фиг. 6. Соответствующие единичные векторы е1(k,n) и е2(k,n) применительно к глобальной системе координат можно вычислить, применив следующие формулы:

где R - матрицы координатного преобразования, например,

при работе в 2D пространстве и с1=[c1,x c1,y)T. Для выполнения триангуляции d1(k,n) и d2 (k,n) направления можно вычислить как

где d1(k,n)=||d1(k,n)|| и d2(k,n)=||d2(k,n)|| - неизвестные расстояния между IPLS и двумя микрофонными матрицами. Следующее уравнение

может быть решено для d1(k,n). Наконец, местоположение pIPLS(k,n) источника IPLS задается как

В другом варианте уравнение (6) можно решить для d2(k,n), и pIPLS(k,n) вычисляют аналогичным образом, используя d2(k,n).

Уравнение (6) всегда обеспечивает решение при работе в 2D пространстве, если e1(k,n) и e2(k,n) непараллельны. Однако при использовании более двух микрофонных матриц и при работе в 3D пространстве решение получить невозможно, когда векторы d направлений не пересекаются. Согласно одному варианту в этом случае будет вычисляться точка, ближайшая ко всем векторам d направления, и полученный результат можно использовать в качестве местоположения IPLS.

В одном варианте все точки p1, р2, обзора следует расположить таким образом, чтобы звук, излучаемый источником IPLS, попадал в один и тот же временной блок п. Это требование можно простым образом удовлетворить, когда расстояние Л между любыми двумя точками обзора меньше, чем

где nFFT - длина окна STFT, 0≤R<1 задает перекрытие между последовательными временными кадрами, a fs - частота дискретизации. Например, для 1024-точечного преобразования STFT при частоте 48 кГц с 50% перекрытием (R=0,5) максимальный интервал между матрицами, удовлетворяющий вышеупомянутому требованию, составит Δ=3,65 м.

Далее подробно описывается модуль 202 вычисления информации, например, модуль вычисления сигнала виртуального микрофона и дополнительной информации, согласно одному варианту изобретения.

На фиг. 7 схематически показан модуль 202 вычисления информации согласно одному варианту. Блок вычисления информации содержит компенсатор 500 распространения, объединитель 510 и блок 520 спектрального взвешивания. Модуль 202 вычисления информации получает оценки ssp местоположения источников звука, выполненные блоком оценки местоположения звуковых событий, один или более входных аудиосигналов is, записанных одним или несколькими реальными пространственными микрофонами, местоположение posRealMic одного или нескольких реальных пространственных микрофонов и виртуальное местоположение posVmic виртуального микрофона. Модуль 202 выдает выходной аудиосигнал os, представляющий аудиосигнал виртуального микрофона.

На фиг. 8 показан модуль вычисления информации согласно другому варианту. Модуль вычисления информации по фиг. 8 содержит компенсатор 500 распространения, объединитель 510 и блок 520 спектрального взвешивания. Компенсатор 500 распространения содержит модуль 501 вычисления параметров распространения и модуль 504 компенсации распространения. Объединитель 510 содержит модуль 502 вычисления коэффициентов объединения и модуль 505 объединения. Модуль 520 спектрального взвешивания содержит блок 503 вычисления спектральных весов, модуль 506 применения спектрального взвешивания и модуль 507 вычисления дополнительной информации о спектре.

Для вычисления аудиосигнала виртуального микрофона в модуль 202 вычисления информации, в частности, в модуль 501 вычисления параметров распространения, входящий в состав компенсатора 500 распространения, в модуль 502 вычисления коэффициентов объединения, входящий в состав объединителя 510, и в блок 503 вычисления спектральных весов, входящий в состав блока 520 спектрального взвешивания, подают геометрическую информацию, например, местоположения и ориентацию реальных пространственных микрофонов 121,…, 12N, местоположение, ориентацию и характеристики виртуального пространственного микрофона 104 и оценки местоположения звуковых событий 205. Модуль 501 вычисления параметров распространения, модуль 502 вычисления коэффициентов объединения и блок 503 вычисления спектральных весов вычисляют параметры, используемые при модификации аудиосигналов 111,…, 11N в модуле 504 компенсации распространения, модуле 505 объединения и модуле 506 применения спектрального взвешивания.

В модуле 202 вычисления информации аудиосигналы 111,…, 11N сначала могут быть модифицированы для компенсации эффектов, обусловленных разной длиной траекторий распространения сигнала между местами появления звуковых событий и реальными пространственными микрофонами. Затем эти сигналы могут быть объединены, например, для улучшения отношения сигнал-шум (SNR). Наконец, может быть выполнено спектральное взвешивание результирующего сигнала для учета направленного характера фиксации звука, выполняемой виртуальным микрофоном, а также зависимости усиления от расстояния. Эти три шага боле подробно обсуждаются ниже.

Теперь более подробно объясним, как выполняется компенсация распространения. В верхней части фиг. 9 показаны два реальных пространственных микрофона (первая микрофонная матрица 910 и вторая микрофонная матрица 920), местоположение локализованного звукового события 930 для частотно-временного бина (k,n) и местоположение виртуального пространственного микрофона 940.

В нижней части фиг. 9 показана ось времени. Здесь предполагается, что звуковое событие происходит в момент to, после чего звук распространяется к реальному и виртуальному пространственным микрофонам. Временные задержки поступления, а также амплитуды изменяются с изменением расстояния, так что чем больше длина распространения, тем слабее амплитуда и тем больше время задержки поступления сигнала.

Сигналы у двух реальных матриц можно сравнить только в том случае, если относительная задержка Dt12 между ними мала. В противном случае, один из двух сигналов необходимо временно скорректировать для компенсации относительной задержки Dt12, а возможно и масштабировать для компенсации различных затуханий.

Компенсация задержки между поступлением звука на виртуальный микрофон и поступлением звука на реальные микрофонные матрицы (на один из реальных пространственных микрофонов) изменяет задержку независимо от локализации звукового события, что более чем достаточно для большинства приложений.

Обратимся к фиг. 8, где модуль 501 вычисления параметров распространения адаптирован для вычисления задержек, подлежащих коррекции для каждого реального пространственного микрофона и для каждого звукового события. Если это необходимо, то модуль 501 также вычисляет коэффициенты усиления, необходимые для компенсации разных затуханий амплитуды.

Модуль 504 компенсации распространения сконфигурирован для использования вышеупомянутой информации для модификации соответствующих аудиосигналов. Если сигналы должны быть смещены во времени на небольшую величину (по сравнению с временным окном набора фильтров), то тогда достаточно использовать простое фазовращение. Если задержки большие, то тогда необходимы более сложные варианты. Выходом модуля 504 компенсации распространения являются модифицированные аудиосигналы, представленные в исходной частотно-временной области.

Далее со ссылками на фиг. 6 описывается, как выполняется конкретная оценка компенсации распространения для виртуального микрофона согласно одному варианту изобретения, причем на фиг. 6, в частности, показано местоположение 610 первого реального пространственного микрофона и местоположение 620 второго реального пространственного микрофона.

В разъясняемом в данный момент варианте предполагается, что имеется по меньшей мере первый записанный входной аудиосигнал, например, сигнал давления по меньшей мере у одного из реальных пространственных микрофонов (например, микрофонные матрицы), например, сигнал давления у первого реального пространственного микрофона. Рассматриваемый микрофон считается опорным микрофоном, его местоположение опорным местоположением pref, а сигнал давления опорным сигналом давления Pref(k,n). Однако компенсацию распространения можно выполнить не только по отношению к одному сигналу давления, но также по отношению к сигналам давления от множества (или всех) реальных пространственных микрофонов.

Соотношение между сигналом PIPLS(k,n) давления, излучаемым источником IPLS, и опорным сигналом Pref(k,n) опорного микрофона, расположенного в pref, можно представить формулой (9):

В общем случае комплексный коэффициент γ(k,pa,pb) представляет вращение фазы и затухание амплитуды, внесенные распространением сферической волны из точки ра ее возникновения в точку pb. Однако проведенные на практике испытания показали, что учет только затухания амплитуды в коэффициенте у приводит к приемлемым представлениям сигнала виртуального микрофона со значительно меньшим количеством артефактов по сравнению с учетом также и вращения фазы.

Звуковая энергия, которую можно измерить в конкретной точке пространства, сильно зависит от расстояния r от источника звука (на фиг. 6 от местоположения pIPLS источника звука). Во многих ситуациях эту зависимость можно смоделировать с достаточной точностью, используя хорошо известные физические принципы, например, 1/r затухание звукового давления в дальнем поле точечного источника. Когда расстояние опорного микрофона, например, первого реального микрофона, от источника звука известно, и когда также известно расстояние виртуального микрофона от источника звука, звуковую энергию в месте расположения виртуального микрофона можно оценить исходя из упомянутого сигнала и энергии опорного микрофона, например, первого реального пространственного микрофона. Это означает, что выходной сигнал виртуального микрофона можно получить путем применения правильно определенных коэффициентов усиления к эталонному сигналу давления.

Предположим, что первый реальный пространственный микрофон является опорным микрофоном, и что pref=p1- На фиг. 6 виртуальный микрофон находится в pv. Поскольку геометрия на фиг. 6 известна во всех подробностях, расстояние d1(k,n)=||d1(k,n) || между опорным микрофоном (на фиг. 6 это первый реальный пространственный микрофон) и источником IPLS можно легко определить, также как расстояние s(k,n)=||s(k,n)|| между виртуальным микрофоном и IPLS, а именно

Звуковое давление Pv(k,n) в месте нахождения виртуального микрофона вычисляют, объединив формулы (1) и (9), что приводит к

Как упоминалось выше, в некоторых вариантах коэффициенты γ могут только учитывать затухание амплитуды из-за распространения. Положим, например, что звуковое давление уменьшается с увеличением 1/r, и тогда

Когда указанная модель поддерживается согласно формуле (1), например, когда присутствует только прямой звук, формула (12) позволяет точно восстановить информацию о величине аудиосигнала. Однако в случае чисто диффузных звуковых полей, например, когда предположения, лежащие в основе модели, не удовлетворяются, представленный способ вызывает подавление реверберации сигнала в явном виде при перемещении виртуального микрофона от мест расположения сенсорных матриц. В действительности, как обсуждалось выше, в диффузных звуковых полях следует ожидать, что большинство источников IPLS будут находиться рядом с двумя сенсорными матрицами. Таким образом, при перемещении виртуального микрофона в направлении от этих мест скорее всего увеличится расстояние s=||s|| на фиг. 6. Следовательно, величина опорного давления уменьшается при использовании взвешивания согласно формуле (11). Соответственно, при перемещении виртуального микрофона ближе к действительному источнику звука частотно-временные бины, соответствующие прямому звуку, будут усилены, так что весь аудиосигнал будет восприниматься без диффузии. Путем настройки правила, лежащего в основе формулы (12), можно по желанию обеспечить управление усилением прямого звука и подавлением диффузного звука.

В результате выполнения компенсации для записанного входного аудиосигнала (например, сигнала давления) первого реального пространственного микрофона получают первый модифицированный аудиосигнал. В вариантах изобретения второй модифицированный аудиосигнал можно получить посредством компенсации распространения для записанного второго входного аудиосигнала (второй сигнал давления) второго реального пространственного микрофона.

В других вариантах можно получить дополнительные аудиосигналы путем выполнения компенсации распространения для записанных дополнительных входных аудиосигналов (дополнительные сигналы давления) дополнительных реальных пространственных микрофонов.

Далее более подробно объясняется, как выполняется объединение в блоках 502 и 505 на фиг. 8 согласно одному варианту изобретения. Предположим, что для компенсации различных путей распространения для получения двух или более модифицированных аудиосигналов было модифицировано два или более аудиосигналов из множества различных реальных пространственных микрофонов.

Поскольку аудиосигналы от различных реальных пространственных микрофонов были модифицированы для компенсации различных путей распространения, их можно объединить для повышения качества аудио. Выполнив это, можно, например, увеличить SNR или уменьшить реверберацию.

Возможные решения для объединения содержат:

усреднение с взвешиванием, например, учет SNR или расстояния до виртуального микрофона либо диффузии, которая была оценена реальными пространственными микрофонами. Например, могут быть использованы традиционные решения, такие как объединение при максимальном отношении (MRC) или объединение с равным усилением (EQC); или

линейное объединение некоторых или всех модифицированных аудиосигналов для получения объединенного сигнала. Модифицированные аудиосигналы могут быть взвешены в линейном объединении для получения объединенного сигнала; или

выбор для использования, например, только одного сигнала, например, в зависимости от SNR или расстояния либо диффузности.

Задачей модуля 502, если он применяется, является вычисление параметров для объединения, которое выполняется в модуле 505.

Далее более подробно описывается спектральное взвешивание согласно варианту изобретения. Для этого обратимся к блокам 503 и 506 на фиг. 8. На этом финальном шаге аудиосигнал, являющийся результатом объединения или компенсации распространения входных аудиосигналов, взвешивают в частотно-временной области в соответствии с пространственными характеристиками виртуального пространственного микрофона, заданных входными данными 104, и/или согласно восстановленной геометрии (представленной под ссылочной позицией 205). Для каждого частотно-временного бина геометрическое восстановление позволяет легко получить направление DOA относительно виртуального микрофона, как показано на фиг. 10. Кроме того, также легко вычислить расстояние между виртуальным микрофоном и местоположением звукового события.

Затем с учетом типа требуемого виртуального микрофона вычисляют вес для данного частотно-временного бина.

В случае направленных микрофонов спектральные веса можно вычислить в соответствии с заранее определенной диаграммой направленности приема звука. Например, согласно одному варианту кардиоидный микрофон может иметь диаграмму направленности приема звука, определенную следующей функцией g(тета),

где «тета» - угол между линией визирования виртуального пространственного микрофона и направлением DOA звука из точки обзора виртуального микрофона.

Другой возможностью является использование функций искусственного (нефизического) затухания. В некоторых приложениях может потребоваться подавление звуковых событий далеко от виртуального микрофона с коэффициентом, превышающим коэффициент, характеризующий распространение в ближнем поле. С этой целью некоторые варианты изобретения вводят дополнительную весовую функцию, которая зависит от расстояния между виртуальным микрофоном и звуковым событием. В одном варианте изобретения должны фиксироваться только звуковые события в пределах конкретного расстояния (например, в метрах) от виртуального микрофона.

Что касается направленности виртуального микрофона, то для данного виртуального микрофона можно использовать произвольно выбранные диаграммы направленности. Это позволяет, например, выделить источник из сложной звуковой сцены.

Поскольку направление DOA звука можно вычислить в месте pv расположения виртуального микрофона, а именно

где cv - единичный вектор, описывающий ориентацию виртуального микрофона, можно реализовать произвольную направленность для виртуального микрофона. Например, если предположить, что Pv(k,n) указывает объединенный сигнал или модифицированный аудиосигнал с компенсированным

распространением, то тогда формула:

вычисляет выходной сигнал виртуального микрофона с кардиоидной направленностью. Направленные диаграммы, которые можно создать таким путем, зависят от точности оценки местоположения. В вариантах изобретения один или несколько реальных, непространственных микрофонов, например, всенаправленный микрофон или направленный микрофон, такой как кардиоид, размещены в звуковой сцене вдобавок к реальным пространственным микрофонам для дальнейшего повышения качества звука в виртуальных микрофонных сигналах 105 на фиг. 8. Эти микрофоны не используются для сбора какой-либо геометрической информации, а скорее только для обеспечения более чистого аудиосигнала. Эти микрофоны можно размещать ближе к источникам звука, чем пространственные микрофоны. В этом случае согласно одному варианту изобретения аудиосигналы реальных непространственных микрофонов и данные об их местоположениях подают просто в модуль 504 компенсации распространения по фиг. 8 для обработки вместо аудиосигнала реальных пространственных микрофонов. Затем выполняют компенсацию распространения для одного или нескольких записанных аудиосигналов непространственных микрофонов относительно местоположения одного или нескольких непространственных микрофонов. Таким образом, реализуется вариант изобретения, где используются дополнительные непространственные микрофоны.

В следующем варианте изобретения реализуется вычисление дополнительной пространственной информации от виртуального микрофона. Для вычисления дополнительной пространственной информации 106 от микрофона модуль 202 вычисления информации по фиг. 8 содержит модуль 507 вычисления дополнительной пространственной информации, который адаптирован для приема в качестве входных данных мест 205 расположения источников звука, а также местоположения, ориентации и характеристик 104 виртуального микрофона. В некоторых вариантах в соответствии с дополнительной информацией 106, которую необходимо вычислить, в качестве входного сигнала в модуль 507 вычисления дополнительной пространственной информации также может быть учтен аудиосигнал виртуального микрофона 105.

Выходом модуля 507 вычисления дополнительной пространственной информации является дополнительная информация от виртуального микрофона 106. Этой дополнительной информацией может быть, например, направление DOA или диффузность звука для каждого частотно-временного бина (k,n) от точки обзора виртуального микрофона. Другой возможной дополнительной информацией может быть, например, вектор Iа(k,n) интенсивности активного звука, которую можно измерить в месте расположения виртуального микрофона. Далее описывается, как можно получить эти параметры.

Согласно одному варианту изобретения реализуют оценку DOA для виртуального пространственного микрофона. Модуль 120 вычисления информации адаптирован для оценки, в качестве дополнительной пространственной информации, направления поступления у виртуального микрофона на основе вектора местоположения виртуального микрофона и на основе вектора местоположения звукового события, как показано на фиг. 11.

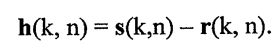

На фиг. 11 показан возможный способ получения DOA звука из точки обзора виртуального микрофона. Местоположение звукового события, обеспечиваемое блоком 205 на фиг. 8, можно описать для каждого частотно-временного бина (k,n) с помощью вектора r(k,n) местоположения, вектора местоположения звукового события. Аналогичным образом местоположение виртуального микрофона, предоставляемое в виде входа 104 на фиг. 8, можно описать с помощью вектора s(k,n) местоположения, вектора местоположения виртуального микрофона. Кажущееся направление виртуального микрофона можно описать вектором v(k,n). Направление DOA относительно виртуального микрофона задается как a(k,n). Оно представляет угол между v и путем h(k,n) распространения звука. Путь h(k,n) можно вычислить по формуле:

Теперь для каждого (k,n) можно вычислить требуемое направление DOA a(k,n), например, путем определения векторного произведения h(k,n) и v(k,n), а именно

В другом варианте модуль 120 вычисления информации можно адаптировать для оценки интенсивности активного звука у виртуального микрофона в качестве дополнительной

пространственной информации на основе вектора местоположения виртуального микрофона и на основе вектора местоположения звукового события, как показано на фиг. 11.

Исходя из DOA a(k,n), определенного выше, можно получить интенсивность Iа(k,n) активного звука в месте расположения виртуального микрофона. Для этого предполагается, что аудиосигнал 105 виртуального микрофона по фиг. 8 соответствует выходу всенаправленного микрофона, например, предполагается, что виртуальный микрофон является всенаправленным микрофоном. Кроме того, предполагается, что кажущееся направление v на фиг. 11 параллельно оси х системы координат. Поскольку требуемый вектор Ia(k,n) интенсивности активного звука описывает чистый поток энергии через место расположения виртуального микрофона, можно вычислить Ia(k,n), например, по следующей формуле:

где []т обозначает транспонированный вектор, rho - плотность воздуха, a Pv(k,n) - звуковое давление, измеренное виртуальным пространственным микрофоном, например выход 105 блока 506 на фиг. 8.

Если вектор интенсивности активного звука должен вычисляться в общей системе координат, но при этом по месту расположения виртуального микрофона, то можно использовать следующую формулу:

Диффузность звука выражает диффузию звукового поля в данном частотно-временном слоте (смотри, например, [2]). Диффузность выражается значением ψ где 0≤ψ≤1. Диффузность, равная 1, указывает на то, что общая энергия звукового поля является полностью диффузной. Эта информация важна, например, при восстановлении пространственного звука. Традиционно диффузность вычисляют в определенной точке пространства, в которой расположена микрофонная матрица.

Согласно одному варианту диффузность можно вычислить в качестве дополнительного параметра к дополнительной информации, созданной для виртуального микрофона (VM), который по желанию можно разместить в произвольно выбранной точке в звуковой сцене. В этом случае устройство, которое помимо аудиосигнала у виртуального места расположения виртуального микрофона также вычисляет диффузность, можно рассматривать как виртуальный интерфейс DirAC, поскольку можно создать поток DirAC, а именно, аудиосигнал, направление поступления и диффузность для произвольной точки в звуковой сцене. Поток DirAC можно дополнительно обработать, запомнить, передать и воспроизвести на любой произвольно выбранной установке с множеством громкоговорителей. В этом случае слушатель воспринимает звуковую сцену, как будто он находится в месте, определенном виртуальным микрофоном, и ориентирован в направлении, определенном ориентацией виртуального микрофона.

На фиг. 12 показан блок вычисления информации согласно одному варианту изобретения, содержащий блок 801 вычисления диффузности для вычисления диффузности у виртуального микрофона. Блок 202 вычисления информации адаптирован для приема входных данных 111-11N, которые, вдобавок к входам по фиг. 3, также включают в себя диффузность у реальных пространственных микрофонов. Обозначим эти значения как  . Эти дополнительные входные данные подаются в модуль 202 вычисления информации. Выходом 103 блока 801 вычисления диффузности является параметр диффузности, вычисленный в месте расположения виртуального микрофона.

. Эти дополнительные входные данные подаются в модуль 202 вычисления информации. Выходом 103 блока 801 вычисления диффузности является параметр диффузности, вычисленный в месте расположения виртуального микрофона.

Блок 801 вычисления диффузности согласно одному варианту более подробно показан на фиг. 13. Согласно одному варианту оценивается энергия прямого и диффузного звука у каждого из N пространственных микрофонов. Затем, используя информацию о местах расположения источников IPLS и информацию о местах расположения пространственных и виртуальных микрофонов, получают N оценок этих энергий в месте расположения виртуального микрофона. Наконец, эти оценки можно объединить для повышения точности оценки, после чего можно легко вычислить параметр диффузности у виртуального микрофона.

Пусть  и

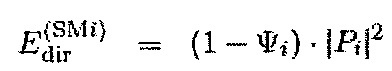

и  обозначают оценки энергий прямого и диффузного звука для N пространственных микрофонов, вычисленных блоком 810 анализа энергии. Если Pi является комплексным сигналом давления, a ψi диффузность для i-го пространственного микрофона, то тогда значения энергии можно вычислить, например, по формуле:

обозначают оценки энергий прямого и диффузного звука для N пространственных микрофонов, вычисленных блоком 810 анализа энергии. Если Pi является комплексным сигналом давления, a ψi диффузность для i-го пространственного микрофона, то тогда значения энергии можно вычислить, например, по формуле:

Энергия диффузного звука должна быть одинаковой во всех точках; следовательно, оценку энергии  диффузного звука у виртуального микрофона можно вычислить, просто усреднив

диффузного звука у виртуального микрофона можно вычислить, просто усреднив

, например, в блоке 820 объединения диффузности, согласно формуле:

, например, в блоке 820 объединения диффузности, согласно формуле:

Более эффективную комбинацию оценок  можно выполнить, если учесть разброс оценок, выполняемых блоками оценки, например, посредством учета SNR.

можно выполнить, если учесть разброс оценок, выполняемых блоками оценки, например, посредством учета SNR.

Энергия прямого звука в результате его распространения зависит от расстояния до источника. Следовательно,  можно модифицировать с учетом распространения звука. Это можно выполнить, например, с помощью блока 830 регулировки распространения прямого звука. Например, если предположить, что энергия прямого звукового поля затухает пропорционально квадрату расстояния, то тогда оценку для прямого звука у вертикального микрофона для i-го пространственного микрофона можно вычислить по формуле:

можно модифицировать с учетом распространения звука. Это можно выполнить, например, с помощью блока 830 регулировки распространения прямого звука. Например, если предположить, что энергия прямого звукового поля затухает пропорционально квадрату расстояния, то тогда оценку для прямого звука у вертикального микрофона для i-го пространственного микрофона можно вычислить по формуле:

По аналогии с блоком 820 объединения диффузности можно объединить оценки энергии прямого звука, полученные у разных пространственных микрофонов, например, с помощью блока 840 объединения прямого звука. Результатом будет  , например, оценка для энергии прямого звука у виртуального микрофона. Диффузность

, например, оценка для энергии прямого звука у виртуального микрофона. Диффузность  можно вычислить, например, с помощью субвычислителя 850 диффузности, например, по формуле:

можно вычислить, например, с помощью субвычислителя 850 диффузности, например, по формуле:

Как упоминалось выше, в некоторых случаях оценка местоположения звуковых событий, выполняемая блоком оценки местоположения звуковых событий, невозможна, например, в случае ошибочной оценки направления поступления звука. Указанный сценарий показан на фиг. 14. В этих случаях независимо от параметров диффузности, оцененных у разных пространственных микрофонов, и полученных в виде входов 111-11N, диффузность для виртуального микрофона 103 можно установить равной 1 (то есть полная диффузность), так как пространственное когерентное восстановление невозможно.

Вдобавок можно учесть надежность оценок направлений DOA у N пространственных микрофонов. Это можно представить, например, исходя из разброса результатов блока оценки DOA или SNR. Указанная информация может быть также учтена субвычислителем 850 диффузности, так что диффузность 103 виртуального микрофона можно искусственно увеличить в том случае, когда оценки DOA ненадежны. В действительности вследствие вышесказанного оценки 205 местоположения также могут оказаться ненадежными.

Хотя некоторые аспекты изобретения были описаны здесь в контексте устройства, очевидно, что эти аспекты также представляют описание соответствующего способа, где блок или устройство соответствует шагу способа или отличительному признаку шага способа. Аналогичным образом аспекты, описанные в контексте шага способа, также представляют описание соответствующего блока, элемента или отличительного признака соответствующего устройства.

Предложенный в изобретении составной сигнал можно запомнить на носителе цифровых данных или можно передать через среду передачи, такую как среда беспроводной передачи или среда проводной передачи, например, Интернет.

В зависимости от конкретных требований к реализации варианты данного изобретения можно реализовать аппаратными средствами или программными средствами. Указанная реализация может быть выполнена с использованием носителя цифровых данных, например, гибкого диска, DVD, CD, ROM (ПЗУ), PROM (программируемое ПЗУ), EPROM (стираемое программируемое ПЗУ), EEPROM (электрически стираемое программируемое ПЗУ) или флэш-памяти, содержащий считываемые электронным путем, записанные на нем сигналы управления, которые действуют (или способны к совместному действию) с программируемой компьютерной системой, с тем чтобы реализовать соответствующий способ.

Некоторые варианты согласно настоящему изобретению содержат носитель данных, содержащий считываемые электронным путем управляющие сигналы, которые способны функционировать совместно с программируемой компьютерной системой, с тем чтобы реализовать один из описанных здесь способов.

В общем случае варианты настоящего изобретения можно реализовать в виде компьютерного программного продукта с программным кодом, причем этот программный код предназначен для выполнения одного из способов, когда этот компьютерный программный продукт выполняется на компьютере. Программный код может храниться, например, на считываемом машиной носителе.

Другие варианты содержат компьютерную программу для выполнения описанных здесь способов, которая запомнена на считываемом компьютером носителе.

Другими словами, вариант нового способа представляет собой компьютерную программу, содержащую программный код для выполнения одного из описанных здесь способов, когда эта компьютерная программа выполняется на компьютере.

Таким образом, следующий вариант из числа предложенных новых способов представляет собой носитель данных (или носитель цифровых данных или считываемый компьютером носитель), содержащий записанную на нем компьютерную программу для выполнения одного из описанных здесь способов.

Еще один вариант предложенного здесь оригинального способа представляет собой поток данных или последовательность сигналов, представляющую компьютерную программу для выполнения одного из описанных здесь способов. Этот поток данных или последовательность сигналов может быть сконфигурирована для пересылки через соединение для передачи данных, например через Интернет.

Следующий вариант содержит средство обработки, например компьютер или программируемое логическое устройство, сконфигурированное для или адаптированное к выполнению одного из описанных здесь способов.

Еще один вариант изобретения содержит компьютер с установленной в нем программой для выполнения одного из описанных здесь способов.

В некоторых вариантах для выполнения некоторых или всех функций описанных здесь способов можно использовать программируемое логическое устройство (например, вентильную матрицу, программируемую пользователем). В некоторых вариантах вентильная матрица, программируемая пользователем, может работать совместно с микропроцессором для выполнения одного из описанных здесь способов. В общем случае эти способы предпочтительно выполняются каким-либо аппаратным устройством.