ОБЛАСТЬ ТЕХНИКИ

Техническое решение относится к области вычислительной техники, в частности к способам человеко-компьютерного взаимодействия (англ. human-computer interaction, HCI) и может применяться в системах виртуальной и дополненной реальности (AR/VR) для управления виртуальными объектами.

УРОВЕНЬ ТЕХНИКИ

Трекинг положения - одна из базовых технологий AR/VR, лежащая в основе взаимодействия человека с виртуальным миром. Полная информация (6 степеней свободы, англ. 6 Degrees of Freedom, 6DoF) о положении пользователя и элементов управления складывается из физических координат объекта в пространстве и из углов наклона, задающих ориентацию объекта.

При этом для эффективного и интуитивного взаимодействия человека с виртуальным миром следует решать в комплексе задачи по реалистичному отображению объектов 3D-сцены в пространстве перед пользователем и по интуитивному управлению объектами, отображаемых не в плоскости, а в 3D-пространстве. Ситуация осложняется, когда нужно построить коллаборативную среду, где необходимо обеспечить взаимодействие нескольких пользователей в едином пространстве.

В последнее время активно развиваются технологии отображения для систем виртуальной и дополненной реальности: стереоскопические 3D-экраны, шлемы виртуальной реальности, шлемы дополненной реальности. Для обеспечения реалистичности трехмерного изображения одновременно используют эффекты бинокулярного параллакса и параллакса движения. Для получения эффекта параллакса движения необходимо реализовать изменение изображения на экране в соответствии с изменением положения наблюдателя: в каждом кадре на поверхность экрана дисплея должна выводиться проекция 3D-сцены, как она видна из текущей точки положения глаз зрителя.

При этом вопрос интуитивного управления объектами, отображаемыми в 3D-пространстве, во многом остается открытым. Очевидно, что традиционные манипуляторы типа мышь или клавиатура, позволяющие эффективно управлять объектами на плоскости, в случае с пространственной манипуляцией объектами 3D-сцены неэффективны. Хотя производители шлемов виртуальной/дополненной реальности в комплект поставки своих систем включают специализированные манипуляторы, данные манипуляторы, как правило, предназначены для индивидуальной работы, а не для коллаборативной среды. Так, если несколько таких манипуляторов окажутся в одном пространстве, между ними могут возникнуть коллизии, что порождает задачу идентификации манипуляторов в многопользовательской системе. Кроме того, поскольку пользователи шлемов виртуальной реальности отделены от реального мира, они не видят друг друга, и для построения коллаборативной среды необходимо обеспечить сетевое взаимодействие между шлемами и дорисовывать аватары других пользователей.

Одним из более эффективных подходов для построения коллаборативной среды, относительно шлемов виртуальной реальности, являются экраны смешанной реальности, на которых виртуальные объекты дорисовываются в пространстве между пользователями и экраном. В таких системах пользователи помимо виртуальных объектов видят окружающий мир и друг друга, что упрощает взаимодействие.

Авторами изобретения разработан способ отслеживания множества пространственных манипуляторов перед экраном отображения объектов 3D-сцены с миллиметровой точностью, при этом добавление дополнительных манипуляторов или пользователей системы не усложняет конструкцию манипуляторов и не приводит к существенному снижению производительности системы. Для отслеживания положения глаз пользователей в пространстве применим тот же способ отслеживания, что и для отслеживания манипуляторов.

Из патента US9529454B1 известен способ управления объектами 3D-сценами. Данное решение предполагает отслеживание жестов рук пользователя. Подобное решение является довольно интуитивным для пользователя, но не обеспечивает высокой точности отслеживания, что делает его неэффективным при работе с большим количеством мелких объектов 3D-сцены. Указание на многопользовательский режим и решение задачи идентификации рук конкретных пользователей при многопользовательском режиме в патенте отсутствует.

Из патента US20120162384A1 известен способ построения коллаборативной среды с использованием экранов смешанной реальности. Данное решение предполагает наличие отдельного экрана у каждого пользователя коллаборативной среды, что усложняет взаимодействие между ними и приводит к возникновению задержек при сетевом взаимодействии пользователей.

Из патента US9829996B2 известен способ и устройство управления объектами 3D-сцены при помощи пространственного стилуса. Данное решение предполагает отслеживание стилуса относительно экрана отображения 3D-сцены. При этом патент не затрагивает вопросов реалистичного отображения объектов 3D-сцены с задействованием эффекта параллакса движения. Указание на многопользовательский режим и наличие нескольких манипуляторов в патенте отсутствует.

Из патента US20130154913A1 известен способ устройство отслеживания взгляда и жестов пользователя при отображении объектов 3D-сцены. Данное решение предполагает отслеживание взгляда пользователя с помощью датчиков, размещенных на голове пользователя. Указание на многопользовательский режим и решение задачи идентификации рук конкретных пользователей при многопользовательском режиме в патенте отсутствует.

СУЩНОСТЬ ТЕХНИЧЕСКОГО РЕШЕНИЯ

Технический результат, обеспечиваемый заявленным техническим решением, заключается в отслеживании множества пространственных манипуляторов перед экраном отображения объектов 3D-сцены, при этом добавление дополнительных манипуляторов или пользователей системы не усложняет конструкцию манипуляторов и не приводит к существенному снижению производительности системы.

В общем виде, решение задачи, на которую направлено заявленное техническое решение, достигается за счет применения оптико-инерциальных устройств отслеживания, ориентирующихся, в том числе, по единому для всех оптическому паттерну, и работающих независимо друг от друга, что позволяет устранить коллизии при определении положения нескольких устройств отслеживания. Система 3D-визуализации отслеживает также положение глаз пользователей системы и выводит объекты 3D-сцены на экран с учетом информации о 3D-объектах, с которыми взаимодействуют манипуляторы.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

Признаки и преимущества заявленного технического решения станут очевидными из приводимого ниже подробного описания и прилагаемых чертежей, на которых:

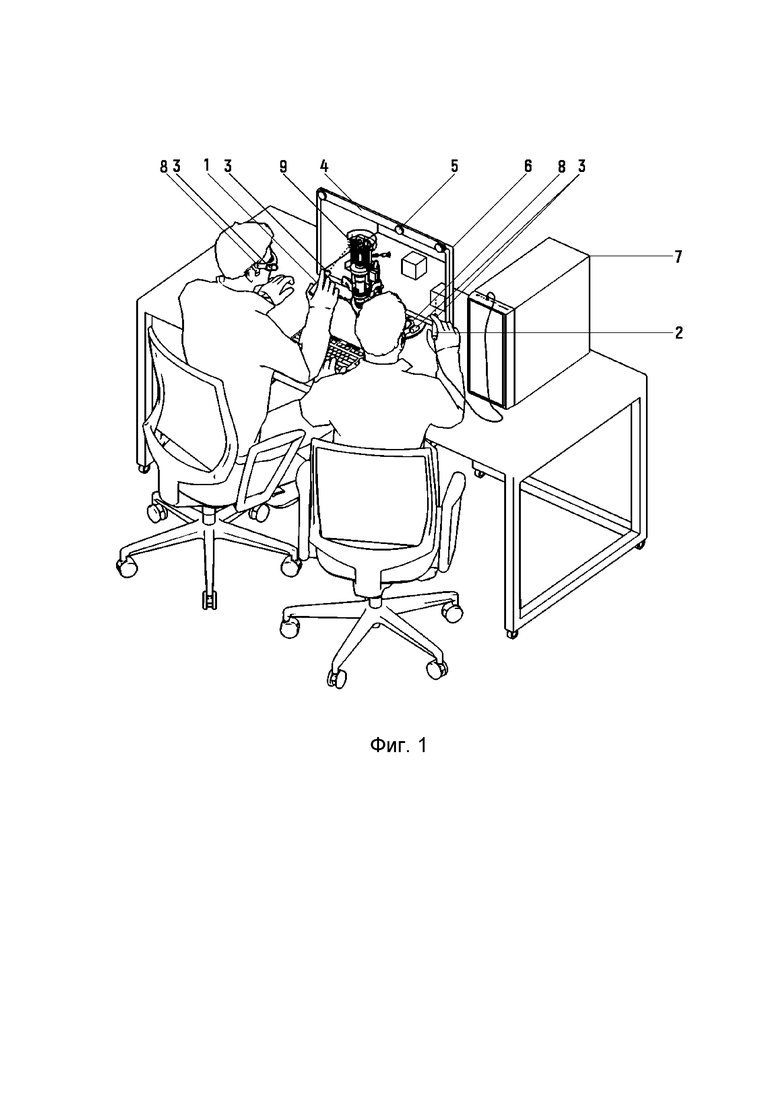

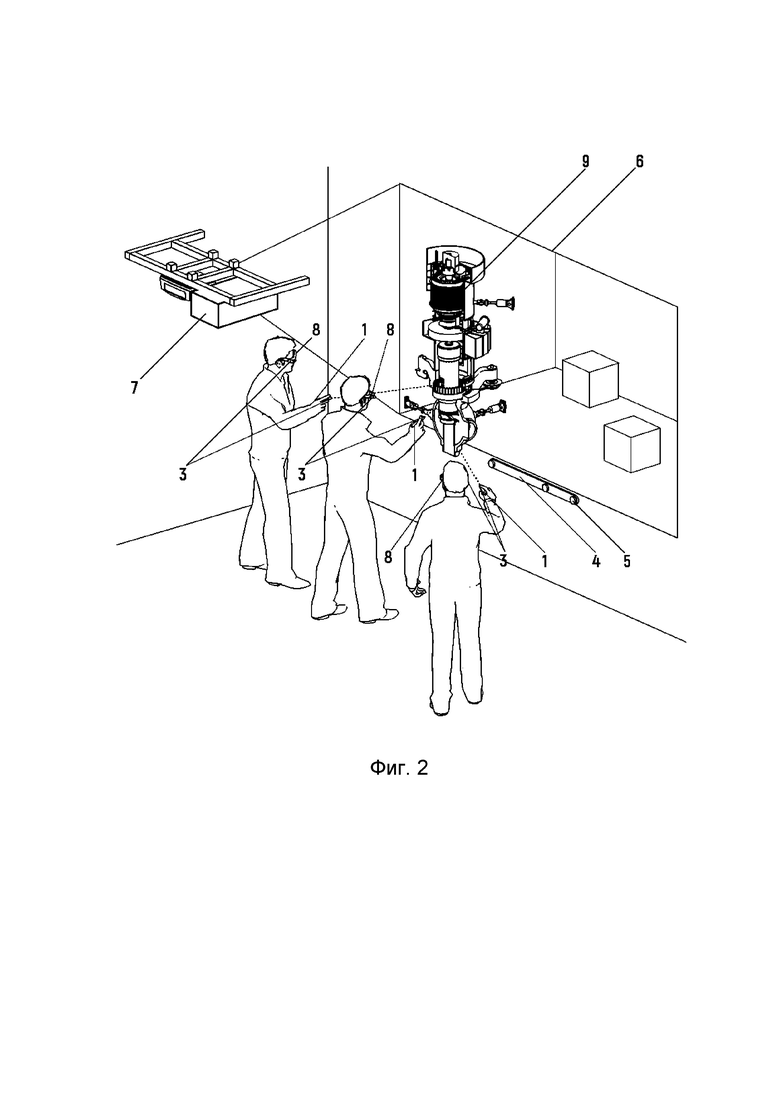

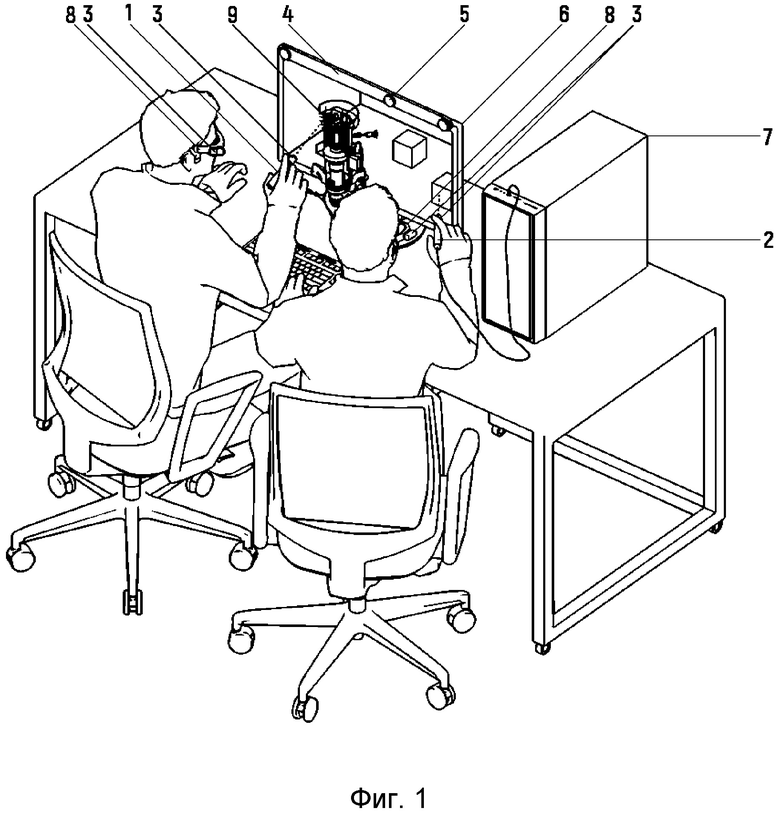

На Фиг. 1 и Фиг. 2 показаны примеры реализации систем дополненной реальности в соответствии с изобретением.

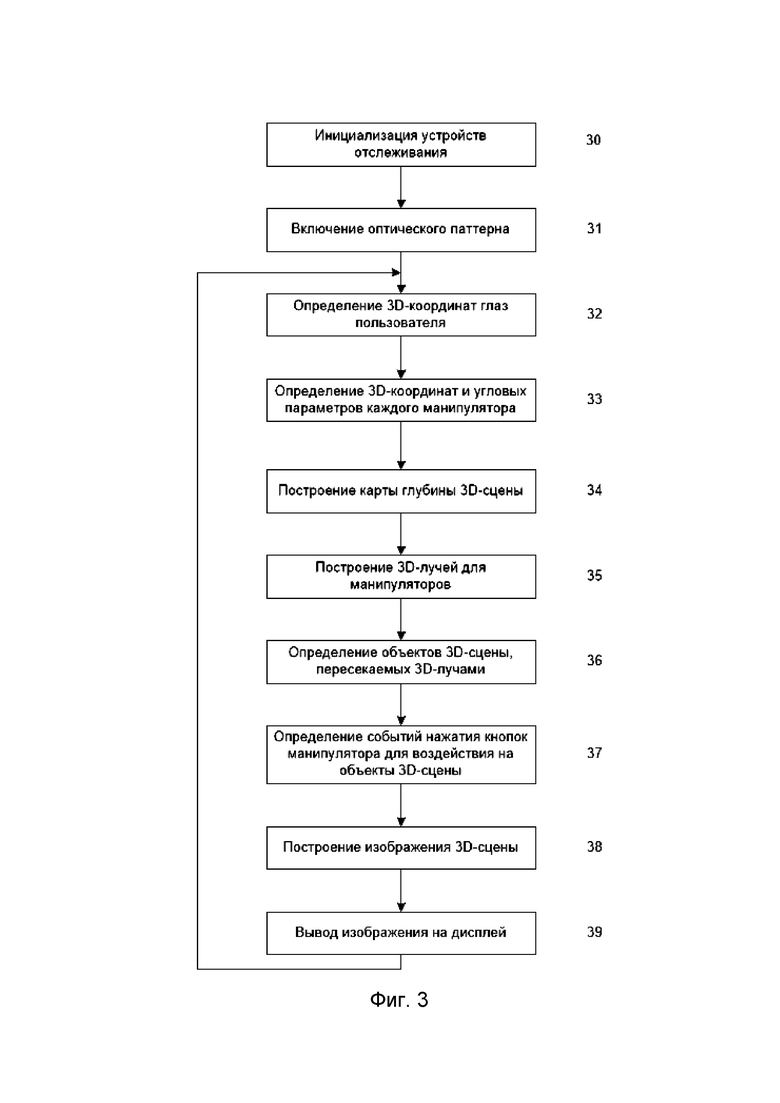

На Фиг. 3 показана блок-схема алгоритма работы системы смешенной реальности.

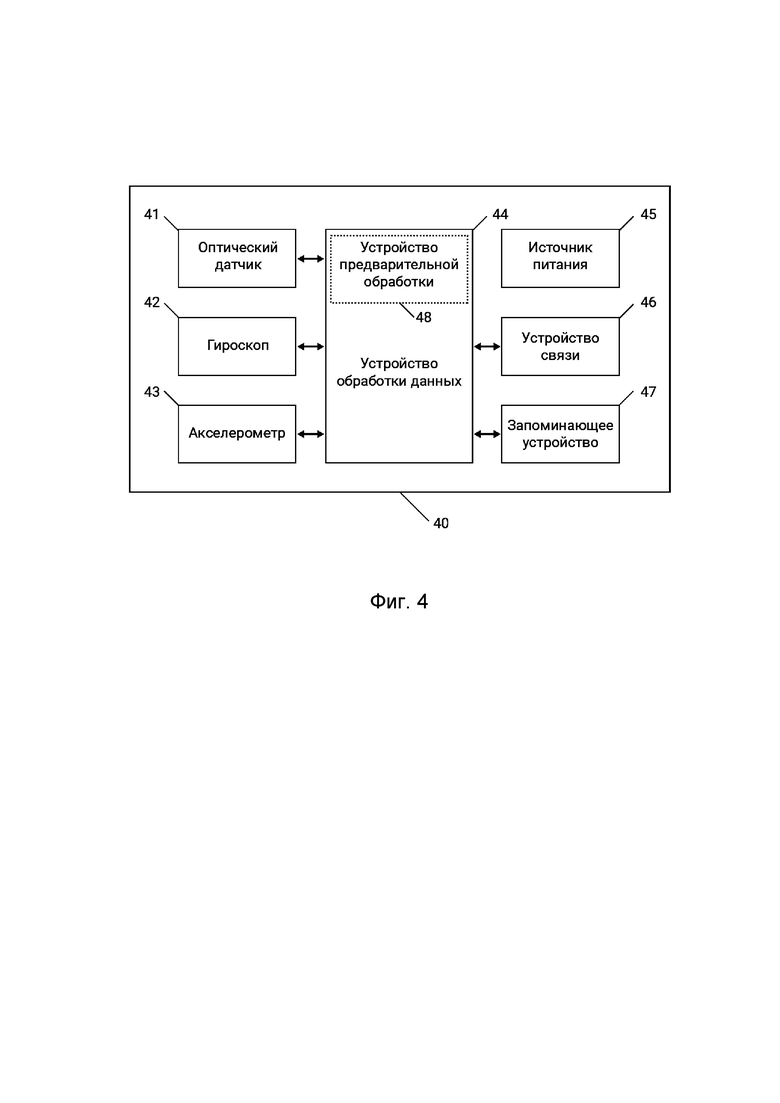

На Фиг. 4 показана структурная схема устройства отслеживания манипулятора.

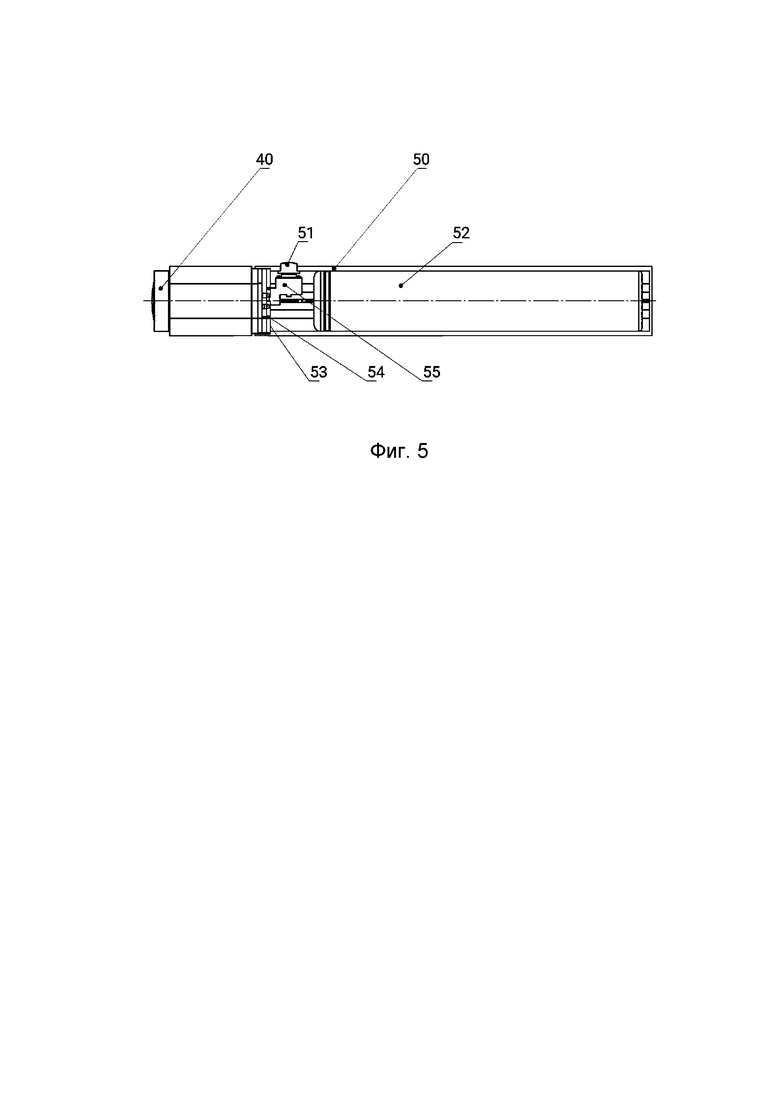

На Фиг. 5 показан пример манипулятора, сопрягаемого с устройством отслеживания.

ПОДРОБНОЕ ОПИСАНИЕ ТЕХНИЧЕСКОГО РЕШЕНИЯ

Далее изобретение описано на примере использования оптико-инерциальных устройств отслеживания в системе смешанной реальности.

Изобретение реализует способ обратного оптико-инерциального трекинга, в котором устройство отслеживания (трекер) расположено на подвижном объекте отслеживания, а источники света (маркеры), образующие оптический паттерн, неподвижны и расположены в пространстве рабочей зоны системы смешанной реальности. Система смешанной реальности может содержать неограниченное количество устройств отслеживания, при этом каждый трекер позволяет определять положение и ориентацию соответствующего подвижного объекта (или его части) независимо от других трекеров.

На фиг. 1 и фиг. 2 показан пример реализации изобретения, в котором система смешанной реальности содержит экран 6, манипуляторы 1 и 2 с устройствами отслеживания 3, вычислительный блок 7, 3D-очки пользователей 8 с размещенными на них устройствами отслеживания 3, виртуальный объект 3D-сцены 9, а также маркерную полосу 4, содержащую активные маркеры 5. Данные трекинга, формируемые устройствами отслеживания 3, содержат данные о местоположении трекеров и, следовательно, соответствующих частей тела пользователя, об их ориентации в пространстве, и о параметрах их движения – направлении, скорости и ускорении. Эти данные сохраняются в системе и используются для определения текущего положения, ориентации и (при необходимости) параметров движения манипуляторов и частей тела пользователя. Манипуляторы могут быть беспроводными манипуляторами 1 или проводными манипуляторами 2. Манипуляторы (1 и 2) могут содержать органы управления (например, кнопки, кнюпельные механизмы (джойстики), шарово-кнюпельные механизмы (трекболы), сенсорные поверхности (тачскины) и т.п.), которые хорошо известны в данной области техники и их описание опущено.

Экран 6 может быть выполнен в виде монитора (фиг. 1) или проекционного экрана (фиг. 2). Экран 6 обеспечивает демонстрацию пользователям изображения 3D-сцены, формируемого с учетом данных устройств отслеживания. Изображение, демонстрируемое пользователю, может быть 3D-изображением дополненной реальности. Следует отметить, что экран 6 с частотой обновления 120 Гц обеспечивает хорошее качество стереоскопического изображения для одного наблюдателя (с частотой смены кадров 60 Гц и скважностью 2 для каждого глаза наблюдателя). Если использовать экран с частотой 240 кадров в секунду, то он обеспечит хорошее качество стереоскопического изображения для двух наблюдателей. При этом, если необходимо вывести изображение для большего количества наблюдателей, то можно производить построение изображения 3D-сцены без учета информации о положении глаз пользователей.

Заявленное техническое решение работает следующим образом (фиг. 3).

На шаге (30) выполняется включение и инициализация устройств отслеживания.

На шаге (31) выполняется включение активных маркеров, образующих устойчивый оптический паттерн.

На шаге (32) на основе данных устройств отслеживания, расположенных на пользователе, выполняется определение 3D-координат глаз пользователя.

На шаге (33) на основе данных устройств отслеживания, расположенных на манипуляторах, выполняется определение 3D-координат и угловых параметров каждого манипулятора.

На шаге (34) выполняется построение карты глубины 3D-сцены.

На шаге (35) на основе 3D-координат и угловых манипуляторов выполняется построение 3D-лучей для манипуляторов.

На шаге (36) для каждого 3D-луча определяют объект 3D-сцены ближайший к пользователю, который пересекает данный 3D-луч.

На шаге (37) происходит опрос событий нажатия кнопок манипулятора для определения необходимого воздействия на объекты 3D-сцены.

На шаге (38) выполняется построение 3D-сцены, т.е. формирование изображения для каждого глаза пользователя. За построение 3D-сцены отвечает специализированное программное обеспечение (т.н. «3D-движок»), например, Unity или Unreal.

На шаге (39) выполняется вывод изображения на дисплей. При этом обеспечивается вывод изображения для каждого глаза пользователя в требуемом порядке и синхронизация стереоскопических очков. При необходимости на дисплее отображается также и 3D-луч.

Устройство отслеживания 40 (фиг. 4) содержит оптический датчик 41, гироскоп 42 и акселерометр 43. Данные с оптического датчика характеризуются высокой точностью при определении положения в пространстве и ориентации устройства, однако частота получения данных с оптического датчика сильно уступает частоте получения данных с инерциальных датчиков – гироскопа и акселерометра. В частности, частота получения данных с оптического датчика обычно составляет 60 кадров в секунду при полном кадре и может быть увеличена до 400 кадров в секунду при применении техник ROI (region of interest) и уменьшении размера кадра (принцип «следящего окна»), а частота получения данных с акселерометра и гироскопа обычно составляет порядка 2000 выборок в секунду. Однако при использовании данных только гироскопа и акселерометра быстро накапливается абсолютная ошибка позиционирования вследствие зашумленности и дрейфа этих данных.

В данной системе точность оптических данных в сочетании с высокой частотой и малой задержкой данных инерциальных датчиков позволяет получить объединенный поток данных трекинга, пригодный для реализации алгоритма определения текущих и предсказания будущих данных позиционирования – положения, ориентации и параметров движения пользователя, обеспечивающего высокие характеристики системы VR/AR.

Передача изображения с оптического датчика целиком требует высокой пропускной способности канала связи между трекером и хостом и неизбежно вносит дополнительную задержку, связанную с передачей изображения. Для минимизации задержек обработки данных трекинга, связанных с передачей и обработкой изображения, изображение с оптического датчика обрабатывается непосредственно в трекере и на хост передаются вычисленные координаты и размеры изображений маркеров, обнаруженных на изображении.

Для обработки данных трекинга трекер 40 содержит устройство 44 обработки данных. Устройство 44 обработки данных обеспечивает синхронизацию всех датчиков, получение данных с оптического датчика, гироскопа и акселерометра, обработку данных с оптического датчика для получения информации о маркерах, содержащихся в кадре, формирование объединенного потока данных с гироскопа, данных с акселерометра и данных о маркерах.

Кроме того, устройство 44 обработки данных содержит устройство предварительной обработки данных с оптического датчика на основе ПЛИС, что позволяет применять высокоскоростные алгоритмы для параллельной обработки строк изображения и поиска в нем групп пикселей, предположительно соответствующих маркерам. В этом случае обработка изображения производится в один проход на шаге считывания данных с оптического датчика без необходимости хранения всего кадра в запоминающем устройстве 47 трекера, что существенно снижает вычислительную сложность последующей обработки данных трекинга в устройстве 44 обработки данных и позволяет дополнительно сократить задержки в системе VR/AR. Кроме того, такое решение позволяет снизить требования к объему памяти запоминающего устройства 47.

Объединение всех датчиков в одном устройстве обеспечивает решение проблемы синхронизации датчиков. Такая архитектура позволяет использовать точные временные метки получения данных с каждого из датчиков. Кроме того, поскольку съемка кадра в оптическом датчике и его обработка занимает определенное время, зависящее от времени экспозиции, которое, в свою очередь, зависит от внешних условий (в частности, от освещенности рабочей зоны), в объединенном потоке данных фиксируется время начала съемки кадра и содержится уведомление об окончании обработки кадра и появлении новых оптических данных.

Трекер 40 имеет модульную конструкцию (фиг. 5). Сопряжение между модулями осуществляется посредством магнитного соединителя. В частности, трекер 40 может содержать базовый модуль, содержащий оптический датчик 41, гироскоп 42, акселерометр 43, устройство 44 обработки данных и устройство 46 связи, обеспечивающее проводную и/или беспроводную связь, и сменный модуль, содержащий дополнительные устройства, обеспечивающие выполнение необходимых функций в соответствии с назначением системы VR/AR. В случае данного изобретения сменным модулем является тело манипулятора 50. Тело манипулятора 50 содержит кнопку 55 с толкателем 51, аккумулятор 52, магнитный соединитель 53 для соединения с модулем отслеживания, печатная плата 54.

Заявленное техническое решение является промышленно применимым, поскольку для его реализации используют промышленно изготовленные и промышленно применимые ресурсы.

Устройства, средства, способы и их части, упомянутые в настоящем документе, относятся к одному или нескольким определенным вариантам осуществления изобретения, если они упоминаются со ссылкой на числовое позиционное обозначение, или ко всем вариантам осуществления изобретения, в которых возможно их применение, если они упоминаются без ссылки на числовое позиционное обозначение.

Устройства, упомянутые в формуле изобретения, представляют собой программно-аппаратные средства, при этом аппаратные части одних устройств могут отличаться, частично совпадать или полностью совпадать с аппаратными частями других устройств, если иное не указано в явном виде. Аппаратные части устройств могут располагаться в различных частях других устройств, средств, если иное не указано в явном виде.

Последовательность действий в описании способа в настоящем документе носит иллюстративный характер и в различных вариантах осуществления изобретения эта последовательность может отличаться от описанной при условии сохранения выполняемой функции и достигаемого результата.

Части и признаки настоящего изобретения могут сочетаться в различных вариантах осуществления изобретения, если они не противоречат друг другу. Описанные выше варианты осуществления изобретения приведены исключительно с иллюстративной целью и не предназначены для ограничения объема настоящего изобретения, определяемого формулой изобретения. Все разумные модификации, модернизации и эквивалентные замены в конструкции, составе и принципе действия, выполненные в пределах сущности настоящего изобретения, входят в объем настоящего изобретения.

| название | год | авторы | номер документа |

|---|---|---|---|

| СПОСОБ И СИСТЕМА ДЛЯ ОПТИКО-ИНЕРЦИАЛЬНОГО ТРЕКИНГА ПОДВИЖНОГО ОБЪЕКТА | 2017 |

|

RU2758036C1 |

| СПОСОБ И СИСТЕМА ДЛЯ ОПТИКО-ИНЕРЦИАЛЬНОГО ТРЕКИНГА ПОДВИЖНОГО ОБЪЕКТА | 2021 |

|

RU2772407C1 |

| СПОСОБ И СИСТЕМА ОБРАТНОГО ОПТИЧЕСКОГО ТРЕКИНГА ПОДВИЖНОГО ОБЪЕКТА | 2018 |

|

RU2697942C1 |

| Система калибровки набора камер для задач оптического трекинга объектов в пространстве | 2023 |

|

RU2811363C1 |

| СПОСОБ И СИСТЕМА ДЛЯ ВЕДЕНИЯ ДИАЛОГОВ С ВИРТУАЛЬНЫМИ ПЕРСОНАЖАМИ В ВИРТУАЛЬНОЙ СРЕДЕ | 2020 |

|

RU2747861C1 |

| СПОСОБ И СИСТЕМА СБОРА ИНФОРМАЦИИ ДЛЯ УСТРОЙСТВА СОВМЕЩЕННОЙ РЕАЛЬНОСТИ В РЕЖИМЕ РЕАЛЬНОГО ВРЕМЕНИ | 2019 |

|

RU2702495C1 |

| СИМУЛЯЦИОННЫЙ КОМПЛЕКС ДЛЯ БЕЗПАСНОГО ОБУЧЕНИЯ МЕДИЦИНСКОГО ПЕРСОНАЛА В УСЛОВИЯХ ПАНДЕМИИ | 2020 |

|

RU2748960C1 |

| СПОСОБ ВИЗУАЛИЗАЦИИ ДИНАМИЧЕСКОЙ АНАТОМИЧЕСКОЙ СТРУКТУРЫ | 2020 |

|

RU2808612C2 |

| СПОСОБ И СИСТЕМА УПРАВЛЕНИЯ ОТОБРАЖЕНИЕМ ВИРТУАЛЬНЫХ ТУРОВ В МНОГОПОЛЬЗОВАТЕЛЬСКОМ РЕЖИМЕ | 2022 |

|

RU2783218C1 |

| Устройство для формирования объёмного изображения в трёхмерном пространстве с реальными объектами | 2017 |

|

RU2664781C1 |

Изобретение относится к вычислительной технике. Технический результат – обеспечение отслеживания пространственных манипуляторов перед экраном отображения объектов 3D-сцены. Способ управления трехмерными объектами в виртуальном пространстве содержит: получение 3D-координат глаз пользователя с помощью устройства отслеживания; получение 3D-координат и угловых параметров манипулятора с помощью устройства отслеживания, расположенного в каждом манипуляторе; определение действий, которые следует выполнить с объектом 3D-сцены, путем определения воздействия на органы управления манипулятора; построение карты глубины 3D-сцены с учетом 3D-координат глаз пользователя; построение 3D-луча от каждого манипулятора и определение ближайшего к пользователю объекта 3D-сцены, пересекаемого 3D-лучом; построение 3D-сцены с учетом информации о ближайших к пользователю объектах 3D-сцены, пересекаемых 3D-лучами с обеспечением эффекта параллакса движения и/или эффекта бинокулярного параллакса; вывод изображения 3D-сцены в стереоскопическом формате. 2 н. и 7 з.п. ф-лы, 5 ил.

1. Способ управления трехмерными объектами в виртуальном пространстве, содержащий этапы, на которых:

получают 3D-координаты глаз пользователя с помощью, по меньшей мере, одного устройства отслеживания;

получают 3D-координаты и угловые параметры, по меньшей мере, одного манипулятора с помощью, по меньшей мере, одного устройства отслеживания, расположенного в каждом манипуляторе;

определяют действия, которые следует выполнить с объектом 3D-сцены, путем определения воздействия на орган(ы) управления манипулятора;

выполняют построение карты глубины 3D-сцены с учетом 3D-координат глаз пользователя;

выполняют построение 3D-луча от каждого манипулятора и определяют ближайший к пользователю объект 3D-сцены, пересекаемый данным 3D-лучом;

выполняют построение 3D-сцены с учетом информации о ближайших к пользователю объектах 3D-сцены, пересекаемых 3D-лучами, и с обеспечением эффекта параллакса движения и/или эффекта бинокулярного параллакса;

выводят изображения 3D-сцены в стереоскопическом формате на, по меньшей мере, одно устройство отображения.

2. Способ по п. 1, в котором данные о воздействии на орган(ы) управления манипулятора передают по каналу связи, предназначенному для передачи 3D-координат и угловых параметров манипулятора.

3. Способ по п. 1, в котором построение 3D-сцены выполняют с учетом 3D-координат глаз пользователя.

4. Способ по п. 1, в котором 3D-координаты глаз пользователя и 3D-координаты и угловые параметры, по меньшей мере, одного манипулятора получают с помощью одинаковых устройств отслеживания, работающих независимо друг от друга.

5. Способ по п. 1, в котором на этапе вывода 3D-сцены выполняют отображение 3D-лучей для каждого манипулятора.

6. Устройство для управления трехмерными объектами в виртуальном пространстве, обеспечивающее отображение объектов 3D-сцены и управление объектами 3D-сцены, содержащее:

по меньшей мере, одно устройство отображения, выполненное с

возможностью отображения последовательности изображений 3D-сцены;

по меньшей мере, одни очки, выполненные с возможностью стереоскопической сепарации изображений 3D-сцены и содержащие, по меньшей мере, одно устройство отслеживания;

по меньшей мере, один оптический паттерн, состоящий из маркеров, расположенных заранее известным образом;

по меньше мере, один манипулятор, содержащий орган(ы) управления и, по меньшей мере, одно устройство отслеживания;

устройство построения 3D-сцены, выполненное с возможностью построения карты глубины 3D-сцены и 3D-лучей от манипулятора и отображения объектов 3D-сцены с эффектом параллакса движения и/или с эффектом бинокулярного параллакса;

по меньшей мере, одно устройство вывода изображения, выполненное с возможностью вывода изображения 3D-сцены на, по меньшей мере, одно устройство отображения.

7. Устройство по п. 6, в котором устройство отслеживания содержит набор оптических и инерциальных датчиков, устройство вычисления 3D-координат, выполненное с возможностью вычисления 3D-координат на основе комбинации инерциальных данных и координат, определенных относительно оптического паттерна.

8. Устройство по п. 6, выполненное с возможностью передачи данных о воздействии на орган(ы) управления манипулятора по каналу связи, предназначенному для передачи 3D-координат и угловых параметров манипулятора.

9. Устройство по п. 7, в котором канал связи, предназначенный для передачи 3D-координат и угловых параметров манипулятора, представляет собой канал беспроводной связи, канал проводной связи или канал оптической связи.

| Многоступенчатая активно-реактивная турбина | 1924 |

|

SU2013A1 |

| Многоступенчатая активно-реактивная турбина | 1924 |

|

SU2013A1 |

| Токарный резец | 1924 |

|

SU2016A1 |

| Устройство для закрепления лыж на раме мотоциклов и велосипедов взамен переднего колеса | 1924 |

|

SU2015A1 |

| СПОСОБ И УСТРОЙСТВО ДЛЯ ВЗАИМОДЕЙСТВИЯ С ВИРТУАЛЬНЫМИ ОБЪЕКТАМИ | 2015 |

|

RU2601169C1 |

| СИСТЕМА ПРОЕКТИРОВАНИЯ ОБЪЕКТОВ В СРЕДЕ ВИРТУАЛЬНОЙ РЕАЛЬНОСТИ В РЕАЛЬНОМ ВРЕМЕНИ | 2017 |

|

RU2656584C1 |

| СПОСОБ УПРАВЛЕНИЯ УСТРОЙСТВОМ С ПОМОЩЬЮ ЖЕСТОВ И 3D-СЕНСОР ДЛЯ ЕГО ОСУЩЕСТВЛЕНИЯ | 2011 |

|

RU2455676C2 |

Авторы

Даты

2019-07-18—Публикация

2018-09-18—Подача