ОБЛАСТЬ ТЕХНИКИ

[0001] Представленное техническое решение относится, в общем, к области анализа видеоизображений для выявления тревожных событий при взаимодействии с устройствами самообслуживания (далее - «УС»), а в частности к способам и системам выявления тревожных событий при взаимодействии с банкоматами.

УРОВЕНЬ ТЕХНИКИ

[0002] В настоящее время существует проблема оперативной и качественной обработки видеоданных на предмет анализа совершения противоправных действий в отношении банковского имущества или с целью совершения мошеннических действий, в частности при взаимодействии с банкоматами или платежными терминалами.

[0003] Широкое распространение в свое время получил принцип использования внешних вычислительных устройств, устанавливаемых в отсек для приема карт банкоматов для считывания данных платежных карт. Также, существуют методы физического воздействия на банкоматы с целью доступа к содержимому кассет с наличностью. Так или иначе, все данные события обуславливаются соответствующими характерными действиями, совершаемыми злоумышленникам, которые попадают в объект камер наблюдения, однако при осуществлении мониторинга с помощью сотрудников службы безопасности подчас бывает недостаточно, чтобы оперативно и точно выявить факт совершения того или иного тревожного события, которые с большой долей вероятности приведет к порче или краже ценного имущества.

[0004] Существуют различные методы анализа видеоданных, например, внутри отделений банка, которые позволяют выявить нестандартное и/или опасное поведение посетителей, которое может свидетельствовать о вероятности наступления тревожных или критических событий. Такие подходы, как правило, основываются на распознавании поз посетителей, а также их перемещении, чтобы классифицировать на основании существующих моделей поведения фактор наступления того или иного события, тревожного или критического.

[0005] Из уровня техники известно решение для анализа поведения посетителей на основании применения моделей машинного обучения, которая осуществляет определение отклонения от нормы поведения, например, выявление нестандартного или противозаконных действий на основании обработки изображений, получаемых с камер видеонаблюдения (US 20160005050, дата публикации: 07.01.2016).

[0006] Из другого решения известна система наблюдения за положением рук пользователя, осуществляющего взаимодействие с банкоматом, на предмет выявления различного рода противоправных действий (WO 2012178202, дата публикации: 27.12.2012). Анализ положения и перемещения рук осуществляется на основании построения цифровой скелетной модели кистей, что позволяет построить и отследить перемещение пальцев для анализа того или иного события.

[0007] Существенным недостатком известных решений является недостаточная точность определения определенного типа положений фигуры человека, в частности, когда человек находится в согнутом, сидячем или полусидячем положении в определенный временной диапазон вблизи УС, что позволяет явно осуществить классификацию события как тревожного.

РАСКРЫТИЕ ИЗОБРЕТЕНИЯ

[0008] Решаемой технической проблемой или технической проблемой с помощью предлагаемого подхода является создание нового эффективного метода выявления тревожных событий при взаимодействии пользователей с УС, например, в банке.

[0009] Техническим результатом является повышение точности выявления тревожных событий, который достигается за счет применения моделей машинного обучения для анализа поз человека при его взаимодействии с УС в заданный временной промежуток.

[0010] Дополнительным техническим результатом является повышение эффективности реагирования системы на факт возникновения тревожного события.

[0011] В предпочтительном варианте осуществления заявлен способ выявления тревожных событий при взаимодействии с УС, выполняемый с помощью по меньшей мере одного вычислительного устройства, содержащий этапы, на которых:

получают данные с по меньшей мере одной камеры видеонаблюдения, характеризующие изображение по меньшей мере одной фигуры человека, находящего вблизи УС;

выполняют анализ полученных данных с помощью модели машинного обучения, в ходе которого осуществляют обработку полученных изображений для выявления ключевых точек фигуры человека;

выполняют анализ ключевых точек для определения позы, принятой фигурой человека; осуществляют определение позы фигуры человека, находящейся в сидячем, согнутом или присевшем положении;

выполняют анализ наличия взаимодействия фигуры человека в выявленном положении с УС;

определяют временной интервал выявленного взаимодействия; и

если временной интервал больше установленного порогового значения, то идентифицируют наличие тревожного события при работе с УС.

[0012] В одном из частных вариантов осуществления способа дополнительно фиксируется изображение, получаемое с камеры УС.

[0013] В другом частном варианте осуществления способа дополнительно фиксируются данные, получаемые от датчиков УС.

[0014] В другом частном варианте осуществления способа получаемое изображение с камер видеонаблюдения анализируется на предмет распознавания личности человека, находящегося вблизи УС.

[0015] В другом частном варианте осуществления способа получаемое изображение с камер видеонаблюдения анализируется на предмет наличия элементов, закрывающих лицо человека, осуществляющего взаимодействие с УС.

[0016] В другом частном варианте осуществления способа анализ позы человека осуществляется с помощью построения графического скелета фигуры человека с помощью модели машинного обучения.

[0017] В другом частном варианте осуществления способа определение позы осуществляются с помощью анализа углов между ключевыми точками цифрового скелета фигуры человека.

[0018] В другом частном варианте осуществления способа выполняется построение векторов между ключевыми точками для осуществления анализа углов между ними.

[0019] В другом частном варианте осуществления способа при выявлении тревожного события осуществляет его передачу по каналу связи на пульт оперативного реагирования и/или активацию сигнализации.

[0020] В другом частном варианте осуществления способа дополнительно осуществляется блокировка доступа в помещение, в котором установлено УС.

[0021] В другом частном варианте осуществления способа при идентификации тревожного события формируется уведомление, содержащее по меньшей мере изображение фигуры человека вблизи УС, время и адрес фиксации события.

[0022] В другом частном варианте осуществления способа уведомление передается по каналам передачи данных на по меньшей мере одно удаленное устройство.

[0023] Указанный технический результат также достигается за счет осуществления системы выявления тревожных событий при взаимодействии с УС, которая содержит по меньшей мере один процессор и средство хранения данных, содержащее машиночитаемые команды, которые при их исполнении по меньшей мере одним процессором, обеспечивают:

получение данных от по меньшей мере одной камеры видеонаблюдения, характеризующие изображение по меньшей мере одной фигуры человека, находящего вблизи УС;

выполнение анализа полученных данных с помощью модели машинного обучения, в ходе которого осуществляют обработку полученных изображений для выявления ключевых точек фигуры человека;

выполнения анализа ключевых точек для определения позы, принятой фигурой человека; осуществление определения позы фигуры человека, находящейся в сидячем, согнутом или присевшем положении;

выполнение анализа наличия взаимодействия фигуры человека в выявленном положении с УС;

определение временного интервала выявленного взаимодействия; и

если временной интервал больше установленного порогового значения, то идентификации наличия тревожного события при работе с УС.

[0024] В одном из частных вариантов реализации системы при идентификации тревожного события формируется уведомление, содержащее по меньшей мере изображение фигуры человека вблизи УС, время и адрес фиксации события.

[0025] В другом частном варианте реализации системы уведомление передается по каналам передачи данных на по меньшей мере одно удаленное устройство.

ОПИСАНИЕ ЧЕРТЕЖЕЙ

[0026] Признаки и преимущества настоящего технического решения станут очевидными из приводимого ниже подробного описания изобретения и прилагаемых чертежей, на которых:

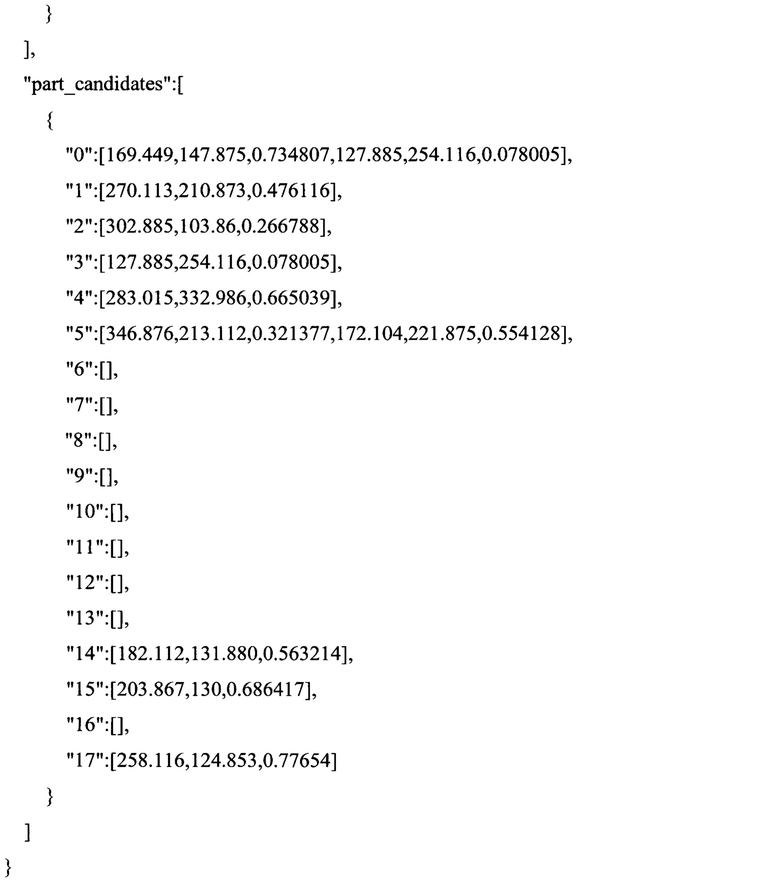

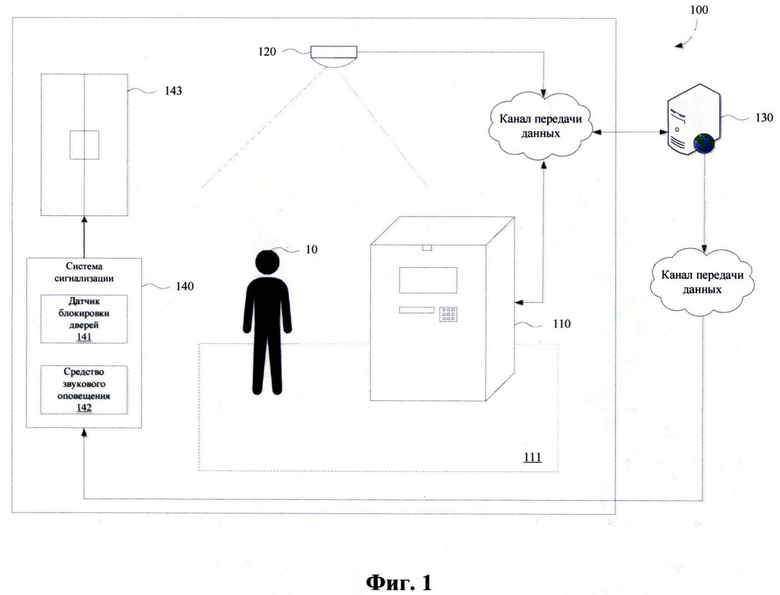

[0027] Фиг. 1 иллюстрирует общую схему взаимодействия элементов заявленного решения.

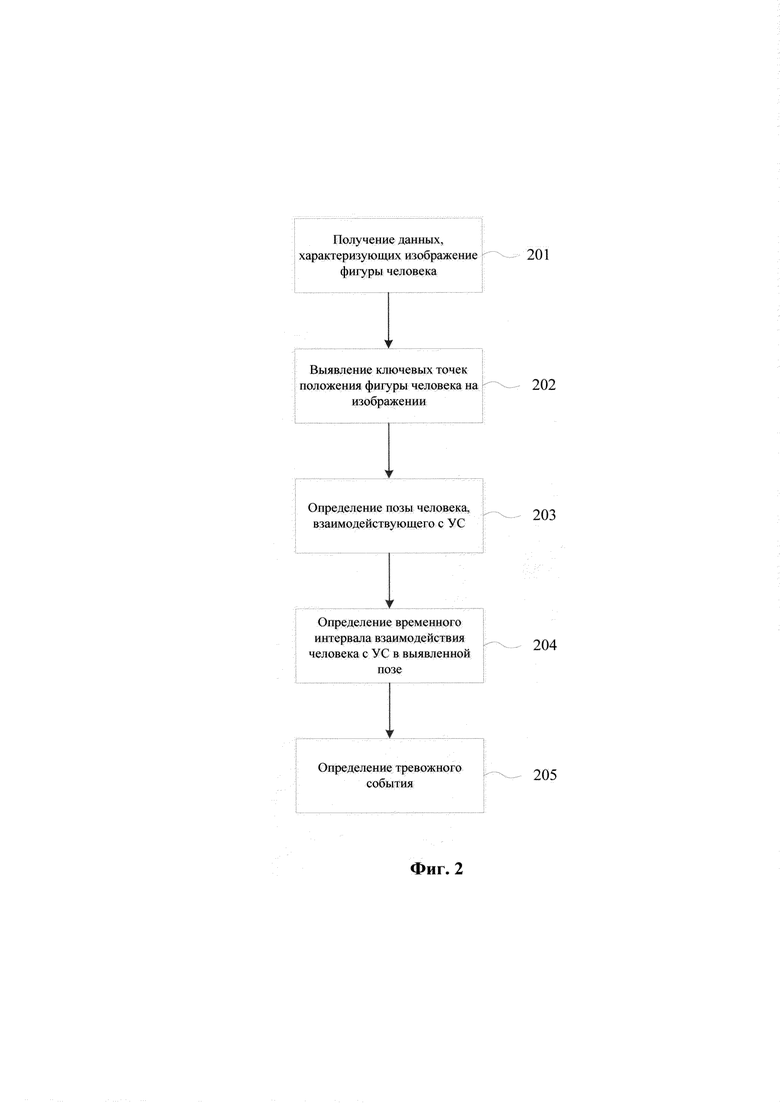

[0028] Фиг. 2 иллюстрирует процесс выполнения заявленного способа.

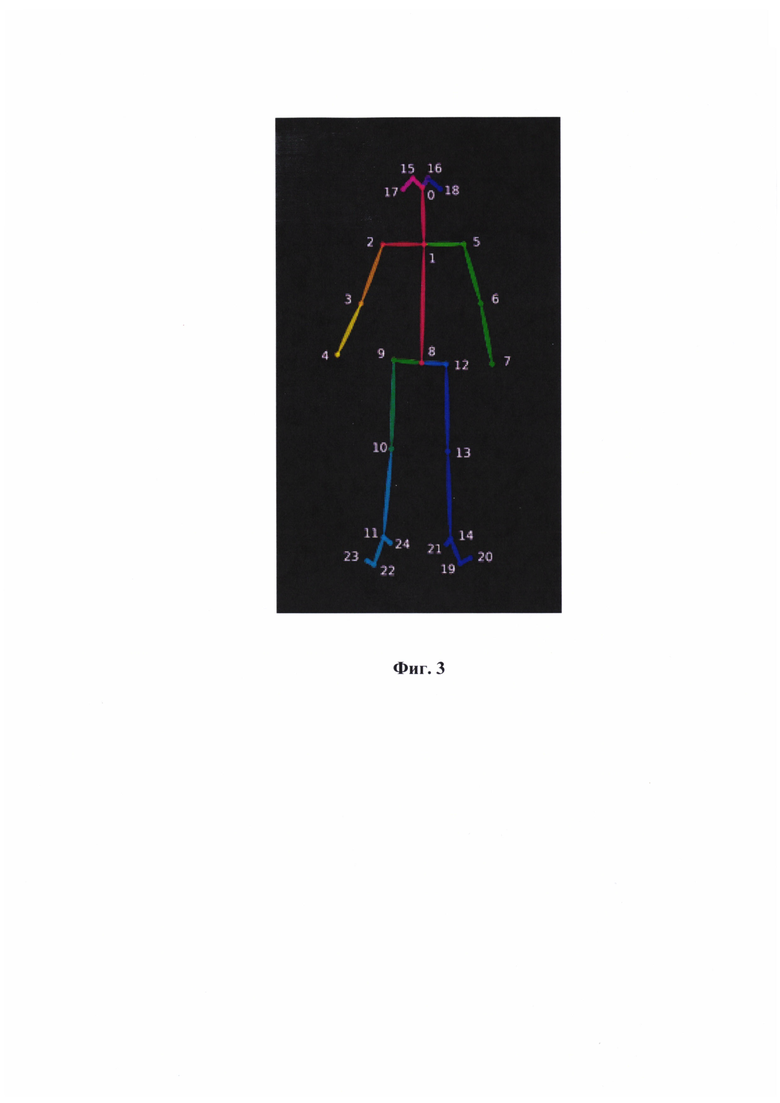

[0029] Фиг. 3 иллюстрирует модель цифрового скелета.

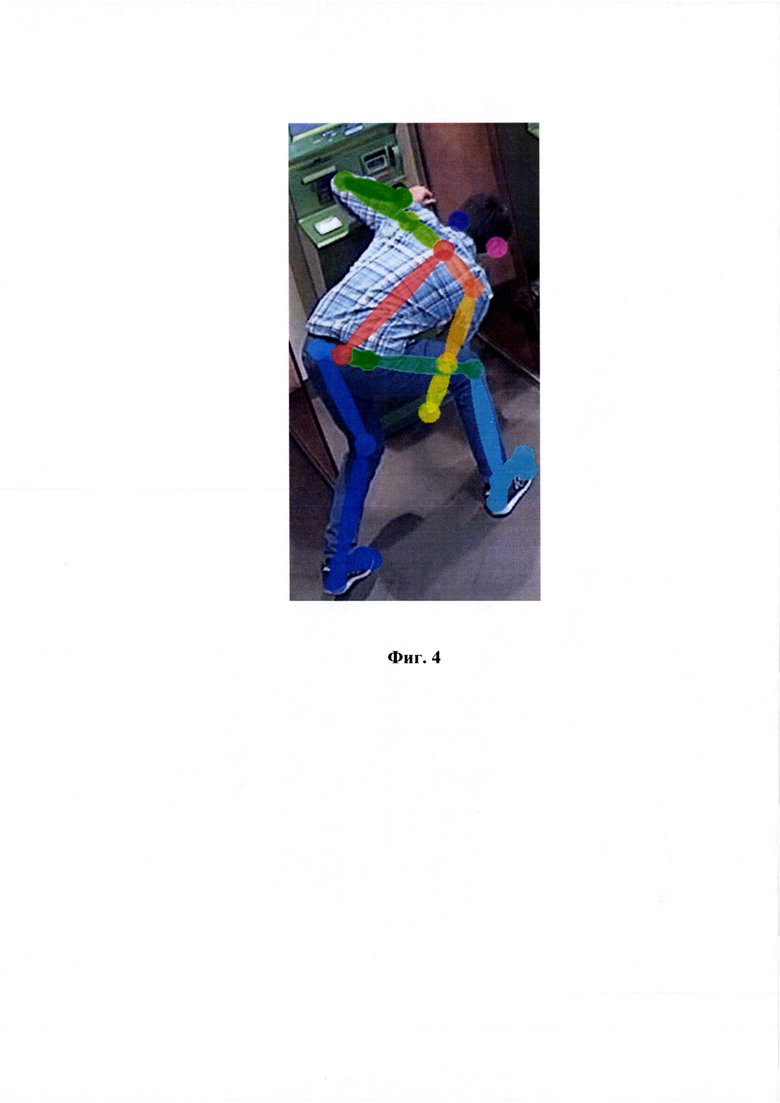

[0030] Фиг. 4 иллюстрирует построение цифрового скелета на основе реального изображения.

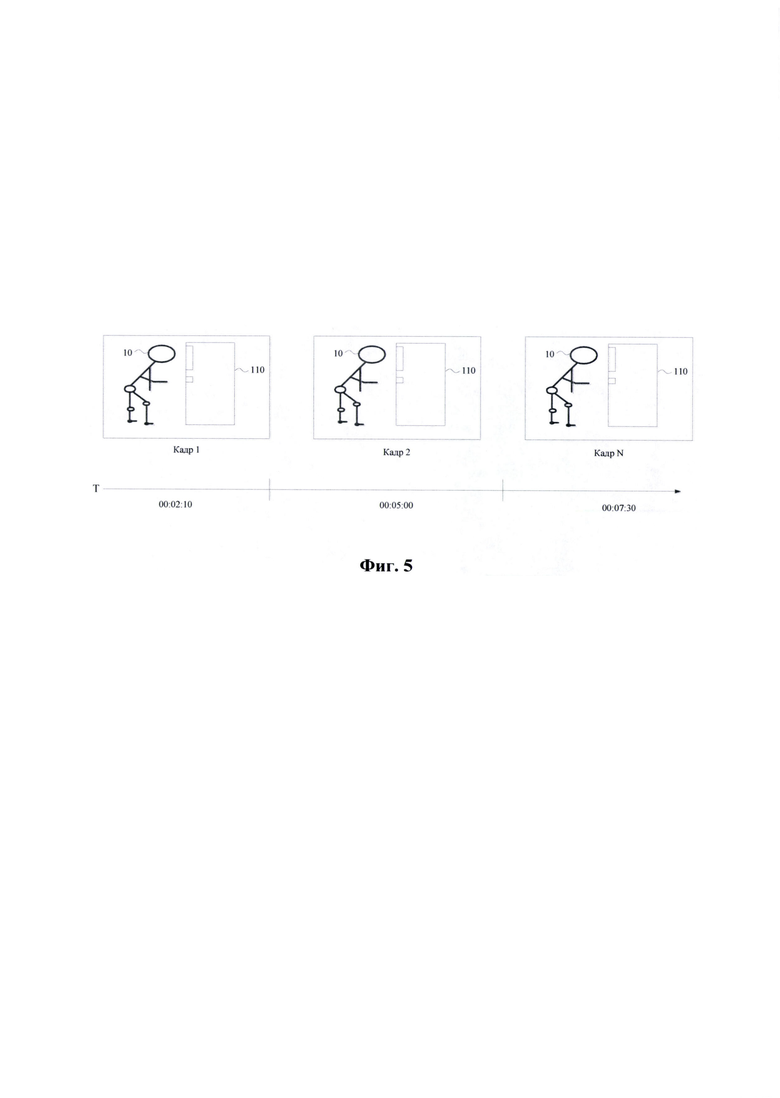

[0031] Фиг. 5 иллюстрирует схематичный пример анализа времени нахождения человека в выявленной позе при работе с УС.

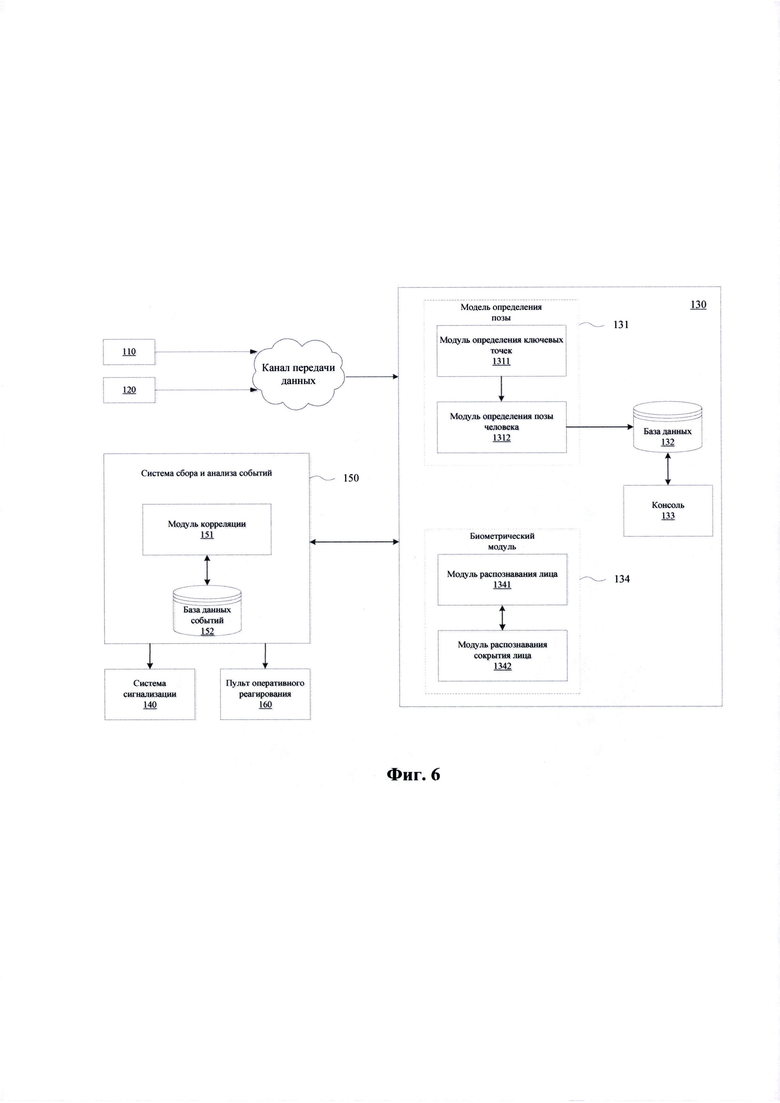

[0032] Фиг. 6 иллюстрирует пример работы обмена данными между элементами системы.

ОСУЩЕСТВЛЕНИЕ ИЗОБРЕТЕНИЯ

[0033] Ниже будут описаны понятия и термины, необходимые для понимания данного технического решения.

[0034] В данном техническом решении под системой подразумевается, в том числе компьютерная система, ЭВМ (электронно-вычислительная машина), ЧПУ (числовое программное управление), ПЛК (программируемый логический контроллер), компьютеризированные системы управления и любые другие устройства, способные выполнять заданную, четко определенную последовательность операций (действий, инструкций).

[0035] Под устройством обработки команд подразумевается электронный блок либо интегральная схема (микропроцессор), исполняющая машинные инструкции (программы).

[0036] Устройство обработки команд считывает и выполняет машинные инструкции (программы) с одного или более устройств хранения данных. В роли устройства хранения данных могут выступать, но не ограничиваясь, жесткие диски (HDD), флеш-память, ПЗУ (постоянное запоминающее устройство), твердотельные накопители (SSD), оптические приводы.

[0037] Программа - последовательность инструкций, предназначенных для исполнения устройством управления вычислительной машины или устройством обработки команд.

[0038] Как представлено на Фиг. 1, в общем случае автоматизированная система (100) включает в себя установленное УС (110), которое находится в зоне работы одной или нескольких видеокамер (120). Информация, в частности видеопоток, получаемый от камеры (120) передается на удаленный сервер (130) с помощью выбранного протокола передачи данных, например, TCP/IP, WLAN, или другой пригодный тип связи, не ограничиваясь. В качестве камер видеонаблюдения (иногда - видеокамер) могут применяться различные типы камер, в частности PTZ-камеры, IP-камеры, стационарные антивандальные камеры, камера кругового обзора и т.п., не ограничиваясь.

[0039] На сервер (130) информация может также передаваться от систем мониторинга состояния УС, например, от встроенных в УС датчиков вибрации, температуры, гироскопа, а также данные с биометрической системы УС (встроенная камера, сканер сетчатки глаза, микрофон и т.п.). Данная информация может использоваться для дополнительного анализа ситуации, возникающей вблизи УС (110).

[0040] Также, система (100) включает в себя систему сигнализации (140), которая в общем случае включает в себя датчик блокировки дверей (141) в помещение, где установлено УС (110) и/или средство звукового оповещения (142). Дополнительно система сигнализации (140) может включать в себя другие устройства, которые будут использоваться в случае наступления тревожного события. Датчик блокировки дверей (141) связывается соответствующим каналом передачи данных непосредственно с дверью (143), установленной в зоне размещения УС (110).

[0041] Работа системы (100) заключается в получении изображений фигур людей, находящихся в области (111) взаимодействия с УС (110), которая впоследствии обрабатывается с помощью аналитического модуля, построенного на базе одной или нескольких моделей машинного обучения, для обеспечения процесса распознавания позы, принимаемой человеком (10), взаимодействующим с УС (110), для вынесения суждения о вероятности совершения того или иного противоправного действия.

[0042] Способ выявления тревожного события (200), реализуемый в ходе осуществления представленного решения, заключается в выполнении следующих последовательных вычислительных этапов. На первом этапе (201) с одной или нескольких камер видеонаблюдения (120) получается видеопоток, который характеризует наличие одной или нескольких фигур людей (10), находящихся в зоне (111) расположения УС (110).

[0043] Полученный видеопоток с камеры (120) передается на сервер (130) для его дальнейшей обработки. На сервере (130) с помощью аналитического модуля выполняется покадровый разбор полученного видеопотока для целей анализа поз людей (10), осуществляющих взаимодействие с УС (110). Анализ видеопотока осуществляется с помощью модели машинного обучения, например, с помощью модели OpenPose.

[0044] С помощью модели OpenPose на этапе (202) осуществляется определение ключевых точек на полученных изображениях (кадрах), извлеченных из видеопотока. Модель машинного обучения OpenPose выполняет обработку полученных кадров и на выходе формирует JSON-файл с координатами х/у в пикселях, а также вероятностную характеристику для каждой ключевой точки. В качестве вероятностной характеристики понимается вероятность корректного нахождения ключевых точек относительно их принадлежности цифровому скелету. Пример такого алгоритма раскрыт в статье Cao et al. OpenPose: Realtime Multi-Person 2D Pose Estimation using Part Affinity Fields опубликовано: 18.12.2018).

[0045] Этап (202) осуществляется с помощью построения цифрового скелета человека по каждому входному изображению. Пример общего вида цифрового скелета представлен на Фиг. 3. На основании алгоритма модели OpenPose осуществляется построение пиксельных координат для каждой фигуры человека (10) на кадрах, полученных с камер наблюдения (120). Дополнительно, OpenPose использует фреймворк глубокого обучения Caffe, который способен переключаться во время вычислений между графическим и центральным процессором, что дает прирост в производительности. В основе работы OpenPose лежит обучение моделей с помощью сверточной нейронной сети (СНС - англ. Convolutional Neural Network, CNN).

[0046] Модель принимает на вход цветное изображение размером  а на выходе выдает расположения ключевых точек каждого объекта наблюдения. Определение ключевых точек происходит в три этапа. Первые 10 слоев обучающей выборки (VGGNet) используются для создания карты особенных точек для исходного изображения. СНС использует две ветви: первая предсказывает карту (S) множества точек на человеческом теле (плечо, рука, и т.д.), вторая множество векторов (L), которые содержат степень разницы между частями тела. (S)-карта и (L)-вектора анализируются для создания ключевых точек для всех людей (10) на изображении.

а на выходе выдает расположения ключевых точек каждого объекта наблюдения. Определение ключевых точек происходит в три этапа. Первые 10 слоев обучающей выборки (VGGNet) используются для создания карты особенных точек для исходного изображения. СНС использует две ветви: первая предсказывает карту (S) множества точек на человеческом теле (плечо, рука, и т.д.), вторая множество векторов (L), которые содержат степень разницы между частями тела. (S)-карта и (L)-вектора анализируются для создания ключевых точек для всех людей (10) на изображении.

[0047] Далее на этап (203) по координатам фигуры человека (10) на полученных кадрах с помощью модели OpenPose выполняется определение ключевых точек тела для распознавания позы, принимаемой человеком (10). По координатам ключевых точек строится вектор, на основании которого производится расчет угла между векторами бедро-голень и бедро-позвоночник, и если упомянутый угол меньше заданного, и при этом человек (10) в данной позе находится вблизи УС (110), то формируется оповещение о наличии тревожного события, факт наличия которого также записывается в хранилище данных, например, базу данных.

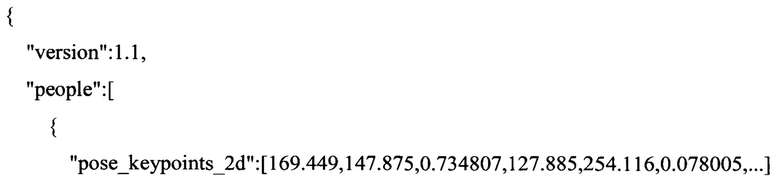

[0048] Входными данными для анализа наличия тревожного события по анализируемым данным является кадр в формате.PNG и JSON файл, содержащий двумерные координаты всех ключевых точек фигур людей (10), обнаруженных OpenPose на базе цифрового скелета, а также вероятностную характеристику для каждой ключевой координаты в диапазоне от 0 до 1.

[0049] Пример структуры JSON-файла:

[0050] Новые файлы OpenPose обрабатывают поступающие данные в итеративном режиме. В случае появления нового *.json файла алгоритмом распознавания осуществляет считывание из него результатов работы OpenPose - если фигур людей обнаружено не было, файл и соответствующий кадр удаляются, в противном случае начинается обработка, представляющая собой несколько этапов.

[0051] Для задействованных ключевых точек обнаруженных фигур (10) проверяется, чтобы значение вероятности превышало установленное пороговое значение, например, 0.4, что позволяет отсекать подавляющее количество ложных срабатываний. При этом пороговое значение может варьироваться в зависимости от освещенности зоны обзора камер (120), места установки камер (120), а также пороговое значение может задаваться отдельно для конкретной обрабатываемой координаты. Поскольку в захватываемых камерами (120) областях могут присутствовать окна, то алгоритм проверяет, что каждая попавшая в кадр фигура (10) не находится за территорией места установки УС (110), например, за территорией отделения банка. На Фиг. 4 представлен пример построения цифрового скелета на основании полученного изображения.

[0052] Далее вычисляются углы между ключевыми точками цифрового скелета (ЛБедро, ЛКолено, ЛЩиколотка), (ПБедро, ПКолено, ПЩиколотка), (Шея, СредняяЧастьБедра, ПКолено) и (Шея, СредняяЧастьБедра, ЛКолено). Если все четыре угла находятся в промежутке от 0 до 120 градусов, то алгоритм определяет, что фигура находится в сидячем, присевшем или согнутом положении.

[0053] Дополнительно может фиксироваться иное положение фигур, которые может являться нестандартным и также фиксироваться с помощью заявленного решения. Для обнаружения лежачих фигур задаются области кадра, соответствующие полу места расположения (111) УС (110), а также определяются векторы, задающие плоскость пола (предполагается, что лежащий человек будет стараться расположиться вдоль стен, а не под произвольным углом - последний случай сложно определим в двумерных координатах). Фигура считается находящейся в лежачем положении, если обе точки СредняяЧастьБедра и Шея находятся в пределах области (111), и угол между указанными точками и одним из векторов (2) не превышает 10 градусов. Также фигура считается лежащей, если точки ЛЩиколотка и ПЩиколотка расположены выше точки Шея.

[0054] После определения позы на этапе (203) далее осуществляется анализ временного интервала (204), в течение которого человек (10) в выявленной позе осуществляет взаимодействие с УС (110). На Фиг. 5 представлен схематичный пример анализа кадров с выявленной позой человека (10) в течение определенного временного интервала Т. Если происходит определение того, что человек (10) в установленной позе осуществляет взаимодействие с УС (110) более заданного временного промежутка Т (временного порога), то на этапе (205) алгоритм выносит суждение о наличии тревожного события.

[0055] По факту фиксации тревожного события на этапе (205) на сервере (130) осуществляется формирование соответствующей записи, которая может включать: идентификатор (ID) события, номер учреждения установки УС, номер видеокамеры, зафиксировавшей событие, время/дату инцидента, наименование тревожного события, изображение, зафиксированное видеокамерой наблюдения.

[0056] Далее более детально будет рассмотрена программно-аппаратная составляющая заявленного решения, представленная на Фиг. 6. Как указывалось, выше, помимо информации, получаемой от камеры или камер наблюдения (120), также на сервер может передаваться информация, получаемая непосредственно от устройств, установленных в УС (110). В качестве таких устройств могут быть различные типы датчиков и сенсоров, реагирующих на возникающее внешнее воздействие. Также может анализироваться биометрическая информация лиц, взаимодействующих с УС (110), в частности их изображение, получаемое от видеокамеры, встроенной в УС (110).

[0057] Данные, полученные от УС (110) и видеокамеры (120), передаются по каналу передачи данных на сервер (130). Поступившая от устройств (110, 120) информация передается для дальнейшего анализа графической информации (видеопотока) в аналитический модуль для определения позы (131). Аналитический модуль (131), построенный на базе алгоритмов машинного обучения, содержит модуль определения ключевых точек (1311) и модуль определения позы (1312) фигуры человека на кадрах с камеры наблюдения.

[0058] Модуль (1311) может осуществлять свою работу с помощью алгоритма модели OpenPose. Данные с камеры наблюдения (120) могут передаваться с помощью известных протоколов передачи потокового видео, например, RTSP, RTMP. Модуль (1312) выполняет классификацию позы фигуры человека (10), а также анализирует время нахождения человека (10) в данной позе при работе с УС (110). Так же модуль (1312) учитывает разметку зон нахождения (111) УС (110) с привязкой к номеру УС 110), а также дополнительно может учитываться номер отделения, в котором оно установлено.

[0059] Отдельно выделяются зеркальные области и прозрачные объекты, находящиеся вне контролируемой зоны, например, окна, стеклянные двери, чтобы исключить данные области из анализа для снижения ложноположительных инцидентов. Разметка зон выполняется в пикселях по двум осям X и Y. Точкой отсчета с координатами (0,0) считается левый верхний угол кадров, транслируемых с камер (120). Околобанкоматные зоны (111) учитываются при подсчете времени Т нахождения в них человека (10) и коррелируются с событиями с других источников в модуле корреляции (151) системы сбора и анализа событий (150) (ССАС).

[0060] Из аналитического модуля (131) обработанные данные о выявленных тревожных событиях совместно с идентифицирующей их информацией передаются в базу данных (132) (Время/дата, номер отделения, номер банкомата, тип тревожного события, изображение), которая выполняет долгосрочное хранение выявленных инцидентов и служит источником данных для консоли (133).

[0061] Консоль (133) представляет собой программное решение для работы с выявленными инцидентами. Логика агрегации инцидентов в консоли (133) подразумевает объединение нескольких тревожных событий в один инцидент (только для отображения), который будет включать данные самого первого тревожного события при объединении, а фотографии всех объединенных событий. Для агрегации предусмотрены различные временные интервалы. При появлении нового тревожного события оно будет проверено на возможность объединения с уже существующими элементами за выбранный период.

[0062] Модуль (131) также осуществляет отправку упомянутых данных в ССАС (150) (англ. SIEM - Security information and event management). Отправка осуществляется по протоколу syslog. ССАС (150) может выполняться на базе отдельного сервера, связанного с сервером (130).

[0063] Дополнительно с помощью анализа изображений может также анализироваться дополнительный тип информации, попадающий в поле зрения камер (120). Например, может анализироваться наличие в кадре посторонних предметов и/или инструментов, с помощью которых могут быть совершены противоправные действия, например, режущее оборудование, баллоны, провода и т.п. Также может происходить фиксация посторонних действий непосредственно с УС (110) или в его близости, например, наличие дыма, искр, открытого пламени и т.п.

[0064] Система (150) представляет собой типовое решение и состоит, как правило, из трех модулей - коннекторы (осуществляющие сбор данных), менеджер (выполняет прием и корреляцию событий) и база данных (осуществляет долгосрочное хранение). В представленном решении в модуль корреляции (151) ССАС (150) поступают события из следующих источников информации: датчиков УС (110), модели анализа позы фигуры человека (130) и от биометрического модуля (134).

[0065] Биометрический модуль (134) представляет собой платформу для анализа биометрических признаков, получаемых с помощью средств УС (110), например, камеры или микрофона. Модуль (134) включает в себя модуль распознавания лица (1341) и модуль распознавания сокрытия лица (1342). Модули (1341, 1342) могут выполняться на базе одной или нескольких моделей машинного обучения, например, представлять собой искусственную нейронную сеть, алгоритм случайного леса и т.п.

[0066] С помощью модуля (1341) выполняется распознавание личности человека (10), находящегося в зоне фиксации камеры УС (110). Такой подход позволяет получить дополнительную информацию для прогнозирования возможности наступления тревожного события. Например, при выявлении лица, которое находится в розыске, или лица, который был уличен/осужден в противоправных действиях по отношению к имуществу банка. Анализ и реагирование на данный вид информации может осуществляться с помощью сравнения получаемых данных с данными, хранящимися во внешней или внутренней базе данных, например, с помощью оперативной отправки через систему ССАС (150) биометрических данных на пульт (160) для осуществления реагирования на факт распознавания той или иной личности человека (10) около УС (110).

[0067] Модуль (1342) предназначен для анализа наличия людей возле УС (110) в скрывающих лицо элементах, например, шарфы, маски, шлем и т.п. Фиксация данной информации может являться дополнительным параметром для принятия оперативного решения при анализе возможности наступления тревожного события.

[0068] После обработки событий, модуль корреляции (151) передает информацию о событиях в БД событий (152) для долгосрочного хранения и построения отчетности. При возникновении тревожного события ССАС (150) отправляет оповещение ответственным лицам, например, на пульт оперативного реагирования (160) внутренних служб, или в систему сигнализации (140), которая связана с управлением контроля доступа в помещение, в частности датчиком блокировки дверей (141).

[0069] Например, событие является тревожным, когда в модуль корреляции (151) поступает событие от датчика вибрации, установленного в УС (110), и событие от модели анализа позы (131), зафиксировавшей, что человек сидит около УС (110) продолжительное время. При этом идентификаторы такого события, как: время, номер банкомата и номер отделения установки банкомата должны совпадать, что необходимо для целей однозначной корреляции поступающих данных для фиксации действительности возникновения тревожного события.

[0070] Правила корреляции для идентификации тревожных событий могут устанавливаться для каждого УС (110) отдельно. Например, можно установить список заданных идентификаторов тревожного события, которые при их возникновении и совпадении с заданным шаблоном будут явно идентифицировать факт его возникновения. Таким идентификаторами могут быть: тип позы человека (10) около УС (110) или номер зоны около УС (111), сигналы от конкретных датчиков УС (110), либо наличие посторонних предметов в кадре, получаемых с камер наблюдения (120), временной интервал фиксации человека (10) в заданной позе и т.п.

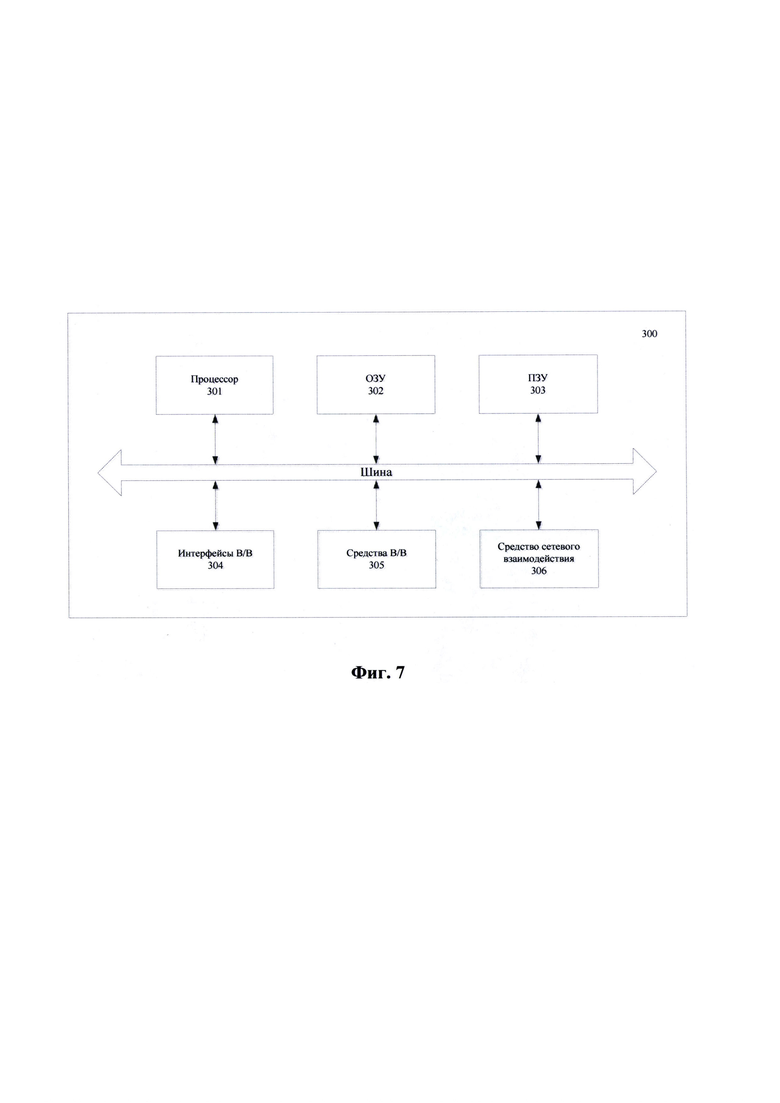

[0071] На Фиг. 7 представлен пример общего вида вычислительного устройства (300), которое обеспечивает реализацию представленного решения. Например, сервер (130), ССАС (150) и программно-аппаратная составляющая УС (110) могут быть сформированы на базе вычислительного устройства (300).

[0072] В общем виде устройство (300) содержит объединенные общей шиной информационного обмена один или несколько процессоров (301), средства памяти, такие как ОЗУ (302) и ПЗУ (303), интерфейсы ввода/вывода (304), устройства ввода/вывода (305), и устройство для сетевого взаимодействия (306).

[0073] Процессор (301) (или несколько процессоров, многоядерный процессор и т.п.) может выбираться из ассортимента устройств, широко применяемых в настоящее время, например, таких производителей, как: Intel™, AMD™, Apple™, Samsung Exynos™, MediaTEK™, Qualcomm Snapdragon™ и т.п. Под процессором или одним из используемых процессоров в системе (300) также необходимо учитывать графический процессор, например, GPU NVIDIA или Graphcore, тип которых также является пригодным для полного или частичного выполнения способа (100), а также может применяться для обучения и применения моделей машинного обучения в различных информационных системах.

[0074] ОЗУ (302) представляет собой оперативную память и предназначено для хранения исполняемых процессором (301) машиночитаемых инструкций для выполнения необходимых операций по логической обработке данных. ОЗУ (302), как правило, содержит исполняемые инструкции операционной системы и соответствующих программных компонент (приложения, программные модули и т.п.). При этом в качестве ОЗУ (302) может выступать доступный объем памяти графической карты или графического процессора.

[0075] ПЗУ (303) представляет собой одно или более устройств постоянного хранения данных, например, жесткий диск (HDD), твердотельный накопитель данных (SSD), флэш-память (EEPROM, NAND и т.п.), оптические носители информации (CD-R/RW, DVD-R/RW, BlueRay Disc, MD) и др.

[0076] Для организации работы компонентов системы (300) и организации работы внешних подключаемых устройств применяются различные виды интерфейсов В/В (304). Выбор соответствующих интерфейсов зависит от конкретного исполнения вычислительного устройства, которые могут представлять собой, не ограничиваясь: PCI, AGP, PS/2, IrDa, FireWire, LPT, COM, SATA, IDE, Lightning, USB (2.0, 3.0, 3.1, micro, mini, type C), TRS/Audio jack (2.5, 3.5, 6.35), HDMI, DVI, VGA, Display Port, RJ45, RS232 и т.п.

[0077] Для обеспечения взаимодействия пользователя с вычислительной системой (300) применяются различные средства (305) В/В информации, например, клавиатура, дисплей (монитор), сенсорный дисплей, тач-пад, джойстик, манипулятор мышь, световое перо, стилус, сенсорная панель, трекбол, динамики, микрофон, средства дополненной реальности, оптические сенсоры, планшет, световые индикаторы, проектор, камера, средства биометрической идентификации (сканер сетчатки глаза, сканер отпечатков пальцев, модуль распознавания голоса) и т.п.

[0078] Средство сетевого взаимодействия (306) обеспечивает передачу данных посредством внутренней или внешней вычислительной сети, например, Интранет, Интернет, ЛВС и т.п. В качестве одного или более средств (306) может использоваться, но не ограничиваться: Ethernet карта, GSM модем, GPRS модем, LTE модем, 5G модем, модуль спутниковой связи, NFC модуль, Bluetooth и/или BLE модуль, Wi-Fi модуль и др.

[0079] Дополнительно могут применяться также средства спутниковой навигации в составе системы (300), например, GPS, ГЛОНАСС, BeiDou, Galileo.

[0080] Конкретный выбор элементов устройства (300) для реализации различных программно-аппаратных архитектурных решений может варьироваться с сохранением обеспечиваемого требуемого функционала.

Представленные материалы заявки раскрывают предпочтительные примеры реализации технического решения и не должны трактоваться как ограничивающие иные, частные примеры его воплощения, не выходящие за пределы испрашиваемой правовой охраны, которые являются очевидными для специалистов соответствующей области техники.

| название | год | авторы | номер документа |

|---|---|---|---|

| СПОСОБ И СИСТЕМА ДЕТЕКТИРОВАНИЯ ТРЕВОЖНЫХ СОБЫТИЙ, ПРОИСХОДЯЩИХ НА ТРАНСПОРТНОМ СРЕДСТВЕ ВО ВРЕМЯ ПЕРЕВОЗКИ ГРУЗОВ, В РЕЖИМЕ РЕАЛЬНОГО ВРЕМЕНИ | 2020 |

|

RU2748780C1 |

| СПОСОБ И УСТРОЙСТВО ФИКСАЦИИ ТРЕВОЖНЫХ СОБЫТИЙ НА СЛУЖЕБНОМ ТРАНСПОРТНОМ СРЕДСТВЕ | 2021 |

|

RU2770862C1 |

| СИСТЕМА И СПОСОБ ОПРЕДЕЛЕНИЯ ПОТЕНЦИАЛЬНО ОПАСНЫХ СИТУАЦИЙ ПО ВИДЕОДАННЫМ | 2019 |

|

RU2718223C1 |

| СПОСОБ И КОГНИТИВНАЯ СИСТЕМА ВИДЕОАНАЛИЗА, МОНИТОРИНГА, КОНТРОЛЯ СОСТОЯНИЯ ВОДИТЕЛЯ И ТРАНСПОРТНОГО СРЕДСТВА В РЕЖИМЕ РЕАЛЬНОГО ВРЕМЕНИ | 2018 |

|

RU2684484C1 |

| СПОСОБ И СИСТЕМА АНАЛИЗА СТАТИЧНЫХ ОБЪЕКТОВ В ВИДЕОПОТОКЕ | 2020 |

|

RU2723900C1 |

| СПОСОБ ДИАГНОСТИКИ БОЛЕЗНИ ПАРКИНСОНА НА ОСНОВЕ АНАЛИЗА ВИДЕОДАННЫХ С ПРИМЕНЕНИЕМ МАШИННОГО ОБУЧЕНИЯ | 2021 |

|

RU2764568C1 |

| СПОСОБ ПЕРЕДАЧИ ДВИЖЕНИЯ СУБЪЕКТА ИЗ ВИДЕО НА АНИМИРОВАННОГО ПЕРСОНАЖА | 2019 |

|

RU2708027C1 |

| СПОСОБ И УСТРОЙСТВО ДЛЯ ОПРЕДЕЛЕНИЯ ПОЗЫ ЧЕЛОВЕКА, УСТРОЙСТВО И НОСИТЕЛЬ ДАННЫХ | 2019 |

|

RU2773232C1 |

| СПОСОБ И СИСТЕМА ДЛЯ ОБНАРУЖЕНИЯ ЧЕЛОВЕКА В ОПАСНОЙ ЗОНЕ И ПРЕДУПРЕЖДЕНИЯ ЕГО ОБ ОПАСНОСТИ | 2021 |

|

RU2781356C1 |

| Способ автоматического контроля технологического процесса и безопасности и интеллектуальная видеосистема для его реализации | 2022 |

|

RU2788432C1 |

Изобретение относится к области анализа видеоизображений для выявления тревожных событий при взаимодействии с устройствами самообслуживания (далее - УС). Технический результат заключается в повышении точности выявления тревожных событий. Такой результат достигается за счет получения данных с по меньшей мере одной камеры видеонаблюдения, характеризующих изображение по меньшей мере одной фигуры человека, находящего вблизи УС; выполнения анализа полученных данных с помощью модели машинного обучения, в ходе которого осуществляют обработку полученных изображений для выявления ключевых точек фигуры человека; выполнения анализа ключевых точек, выявленных на предыдущем шаге, для определения позы, принятой фигурой человека, с помощью построения графического скелета фигуры человека с применением модели машинного обучения и анализа углов между ключевыми точками упомянутого графического скелета; осуществления расчета углов между упомянутыми ключевыми точками, причем при значении углов в диапазоне от 0 до 120 градусов фиксируют нестандартную позу человека рядом с УС; выполнения анализа наличия взаимодействия фигуры человека в выявленной нестандартной позе с УС; определения временного интервала выявленного взаимодействия, причем если временной интервал больше установленного заранее порогового значения, то идентифицируют наличие тревожного события при работе с УС. 2 н. и 11 з.п. ф-лы, 7 ил.

1. Способ выявления тревожных событий при взаимодействии с устройством самообслуживания (УС), выполняемый с помощью по меньшей мере одного вычислительного устройства, содержащий этапы, на которых:

- получают данные с по меньшей мере одной камеры видеонаблюдения, характеризующие изображение по меньшей мере одной фигуры человека, находящего вблизи УС;

- выполняют анализ полученных данных с помощью модели машинного обучения, в ходе которого осуществляют обработку полученных изображений для выявления ключевых точек фигуры человека;

- выполняют анализ ключевых точек, выявленных на предыдущем шаге, для определения позы, принятой фигурой человека, с помощью построения графического скелета фигуры человека с применением модели машинного обучения и анализа углов между ключевыми точками упомянутого графического скелета;

- осуществляют расчет углов между упомянутыми ключевыми точками, причем при значении углов в диапазоне от 0 до 120 градусов фиксируют нестандартную позу человека рядом с УС;

- выполняют анализ наличия взаимодействия фигуры человека в выявленной нестандартной позе с УС;

- определяют временной интервал выявленного взаимодействия, причем

если временной интервал больше установленного заранее порогового значения, то идентифицируют наличие тревожного события при работе с УС.

если временной интервал больше установленного заранее порогового значения, то идентифицируют наличие тревожного события при работе с УС.

2. Способ по п. 1, характеризующийся тем, что дополнительно фиксируется изображение, получаемое с камеры УС.

3. Способ по п. 2, характеризующийся тем, что дополнительно фиксируются данные, получаемые от датчиков УС.

4. Способ по п. 1, характеризующийся тем, что получаемое изображение с камер видеонаблюдения анализируется на предмет распознавания личности человека, находящегося вблизи УС.

5. Способ по п. 1, характеризующийся тем, что получаемое изображение с камер видеонаблюдения анализируется на предмет наличия элементов, закрывающих лицо человека, осуществляющего взаимодействие с УС.

6. Способ по п. 1, характеризующийся тем, что выполняется построение векторов между ключевыми точками для осуществления анализа углов между ними.

7. Способ по п. 1, характеризующийся тем, что при выявлении тревожного события осуществляет его передачу по каналу связи на пульт оперативного реагирования и/или активацию сигнализации.

8. Способ по п. 7, характеризующийся тем, что дополнительно осуществляется блокировка доступа в помещение, в котором установлено УС.

9. Способ по п. 1, характеризующийся тем, что при идентификации тревожного события формируется уведомление, содержащее по меньшей мере изображение фигуры человека вблизи УС, время и адрес фиксации события.

10. Способ по п. 9, характеризующийся тем, что уведомление передается по каналам передачи данных на по меньшей мере одно удаленное устройство.

11. Система выявления тревожных событий при взаимодействии с устройством самообслуживания (УС), содержащая по меньшей мере один процессор и средство хранения данных, содержащее машиночитаемые команды, которые при их исполнении по меньшей мере одним процессором, обеспечивают:

- получение данных от по меньшей мере одной камеры видеонаблюдения, характеризующие изображение по меньшей мере одной фигуры человека, находящего вблизи УС;

- выполнение анализа полученных данных с помощью модели машинного обучения, в ходе которого осуществляют обработку полученных изображений для выявления ключевых точек фигуры человека;

- выполнения анализа ключевых точек для определения позы, принятой фигурой человека, с помощью построения графического скелета фигуры человека с применением модели машинного обучения и анализа углов между ключевыми точками упомянутого графического скелета;

- осуществление расчет углов между упомянутыми ключевыми точками, причем при значении углов в диапазоне от 0 до 120 градусов фиксируют нестандартную позу человека рядом с УС;

- выполнение анализа наличия взаимодействия фигуры человека в выявленной нестандартной позе с УС;

- определение временного интервала выявленного взаимодействия; и

- если временной интервал больше установленного порогового значения, то идентификации наличия тревожного события при работе с УС.

12. Система по п. 11, характеризующаяся тем, что при идентификации тревожного события формируется уведомление, содержащее по меньшей мере изображение фигуры человека вблизи УС, время и адрес фиксации события.

13. Система по п. 12, характеризующаяся тем, что уведомление передается по каналам передачи данных на по меньшей мере одно удаленное устройство.

| CN 105913559 A, 31.08.2016 | |||

| US 20120075464 A1, 29.03.2012 | |||

| Автомобиль-сани, движущиеся на полозьях посредством устанавливающихся по высоте колес с шинами | 1924 |

|

SU2017A1 |

| CN 103873825 A, 18.06.2014 | |||

| CN 101609581 A, 23.12.2009 | |||

| Станок для изготовления деревянных ниточных катушек из цилиндрических, снабженных осевым отверстием, заготовок | 1923 |

|

SU2008A1 |

| СИСТЕМА И СПОСОБ АВТОМАТИЗИРОВАННОГО ВИДЕОНАБЛЮДЕНИЯ И РАСПОЗНАВАНИЯ ОБЪЕКТОВ И СИТУАЦИЙ | 2003 |

|

RU2268497C2 |

Авторы

Даты

2020-02-07—Публикация

2019-02-12—Подача