Область техники, к которой относится изобретение

Варианты осуществления настоящего изобретения относятся к области технологий кодирования видео и, в частности, к способу и устройству внешнего предсказания.

Уровень техники

Технологии цифрового видео могут широко использоваться в различных цифровых видеоустройствах. Цифровое видеоустройство может реализовывать технологии кодирования видео, например, стандарты, определенные в MPEG-2, MPEG-4, ITU-T H.263, ITU-T H.264/MPEG-4 часть 10 Advanced Video Coding (AVC), ITU-T H.265 (также называемый высокоэффективным кодированием видео HEVC) и технологии кодирования видео, описанные в расширениях этих стандартов. Цифровое видеоустройство отправляет, принимает, кодирует, декодирует и/или сохраняет цифровую видеоинформацию более эффективно за счет реализации этих технологий кодирования видео.

В настоящее время технологии внешнего предсказания и внутреннего предсказания в основном используются при кодировании видео для устранения временной избыточности и пространственной избыточности в видео. В технологии внешнего предсказания учитывается только временная корреляция между одними и теми же объектами в соседних кадрах изображений, но пространственная корреляция не учитывается. Следовательно, выборки предсказания, полученные в существующем режиме внешнего предсказания, являются пространственно прерывистыми. Кроме того, это влияет на эффективность предсказания, и остаточная энергия предсказания является относительно высокой.

Сущность изобретения

Варианты осуществления настоящего изобретения предоставляют способ и устройство внешнего предсказания для выполнения пространственной фильтрации внешне закодированного блока предсказания и повышения эффективности кодирования.

Для решения технических задач в вариантах осуществления настоящего изобретения используются следующие технические решения.

Согласно первому аспекту вариантов осуществления настоящего изобретения предоставляется способ внешнего предсказания. Способ включает в себя: синтаксический анализ битового потока для получения информации движения блока изображения, подлежащего обработке; выполнение компенсации движения на блоке изображения, подлежащего обработке, на основании информации движения, для получения блока предсказания блока изображения, подлежащего обработке, где блок предсказания блока изображения, подлежащего обработке, включает в себя значение предсказания целевой выборки; и выполнение вычисления взвешивания для одного или нескольких восстановленных значений одной или нескольких опорных выборок и значения предсказания целевой выборки, для обновления значения предсказания целевой выборки, где опорная выборка имеет заданную взаимосвязь пространственной позиции с целевой выборкой.

На основании этого решения выполняется обработка пространственной фильтрации для значения предсказания целевой выборки с использованием соседней восстановленной выборки для повышения эффективности кодирования со сжатием.

Со ссылкой на первый аспект, в возможной реализации одна или несколько опорных выборок включают в себя восстановленную выборку, которая имеет ту же горизонтальную координату, что и целевая выборка, и имеет заданную разность вертикальной координаты с целевой выборкой, или восстановленную выборку, которая имеет ту же вертикальную координату, что и целевая выборка, и имеет заданную разницу горизонтальной координаты с целевой выборкой.

На основании этого решения выполняется обработка фильтрации на целевой выборке с использованием опорной выборки, которая имеет заданное отношение пространственной позиции с целевой выборкой. По сравнению с традиционной технологией повышается эффективность кодирования.

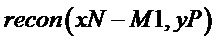

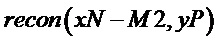

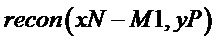

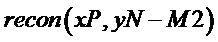

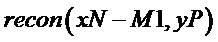

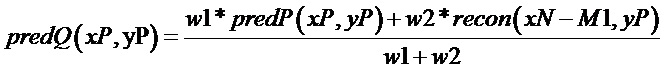

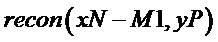

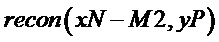

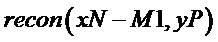

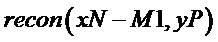

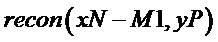

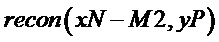

Со ссылкой на первый аспект и вышеупомянутую возможную реализацию, в другой возможной реализации, обновление значения предсказания целевой выборки включает в себя: выполнение вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленного значения опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

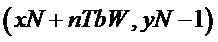

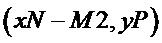

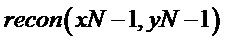

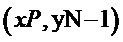

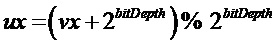

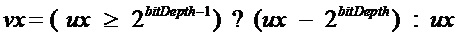

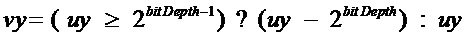

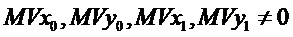

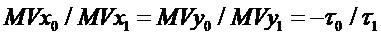

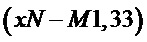

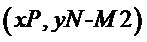

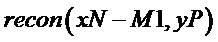

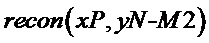

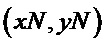

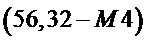

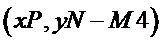

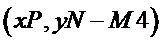

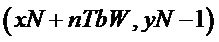

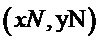

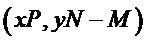

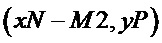

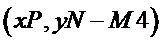

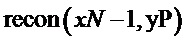

где координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, являются

, координаты верхней левой выборки блока изображения, подлежащего обработке, являются  ,

,  представляют собой значение предсказания целевой выборки перед обновлением,

представляют собой значение предсказания целевой выборки перед обновлением,  представляет обновленное значение предсказания целевой выборки

представляет обновленное значение предсказания целевой выборки  и

и  представляют восстановленные значения опорных выборок на позициях

представляют восстановленные значения опорных выборок на позициях  координат и

координат и  , соответственно, w1, w2, w3, w4, w5 и w6 являются заданными константами, и M1 и M2 являются заданными положительными целыми числами.

, соответственно, w1, w2, w3, w4, w5 и w6 являются заданными константами, и M1 и M2 являются заданными положительными целыми числами.

На основании этого решения обновленное значение предсказания целевой выборки может быть получено посредством обработки фильтрации.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации, w1 + w2 = R1, w3 + w4 = R2 или w5 + w6 + w7 = R3, где R1, R2 и R3 каждый являются 2 в степени n, и n являются целым неотрицательным числом.

На основании этого решения дополнительно может быть улучшена эффективность кодирования.

Следует понимать, что каждый из R1, R2 и R3 равен 2 в степени n. R1, R2 и R3 одинаковые или разные, и это не ограничивается. Например, R1, R2 и R3 могут быть 8 или R1, R2 и R3 могут быть 2, 4 и 16, соответственно.

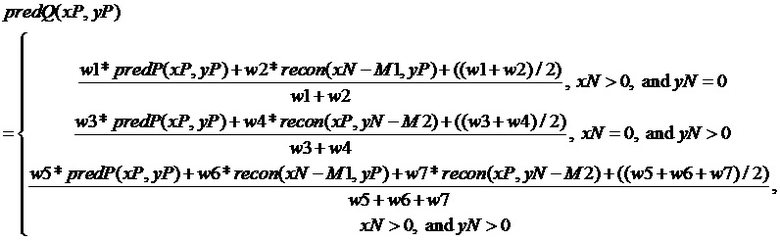

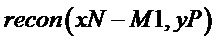

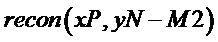

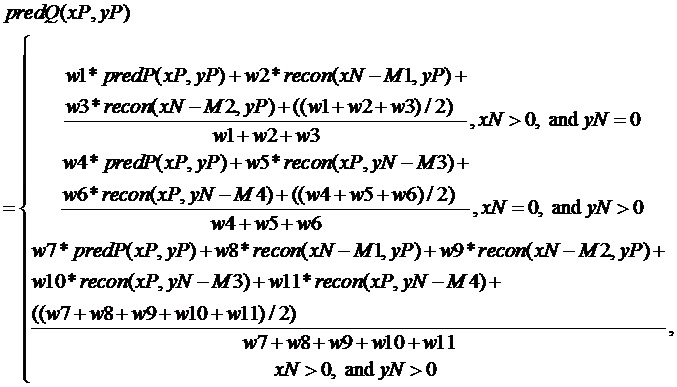

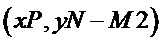

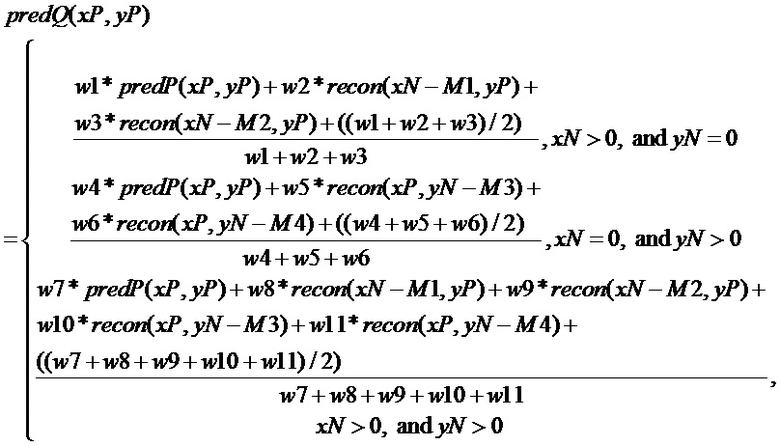

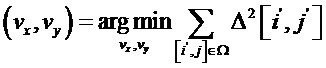

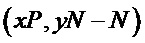

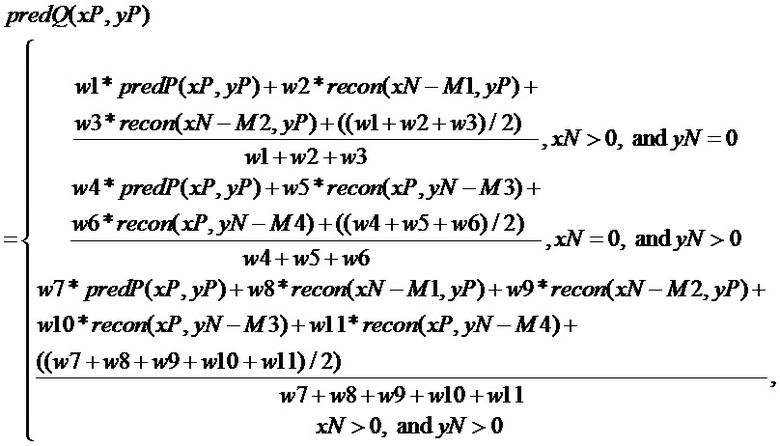

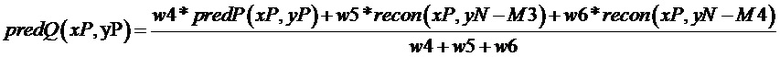

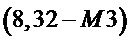

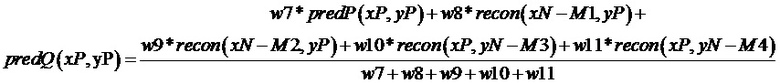

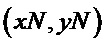

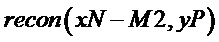

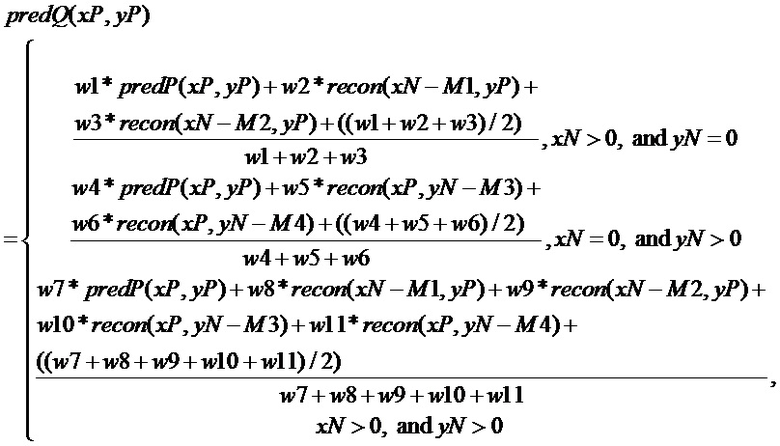

Со ссылкой на первый аспект и вышеупомянутую возможную реализацию, в другой возможной реализации, обновление значения предсказания целевой выборки включает в себя: выполнение вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленного значения опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

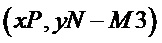

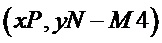

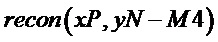

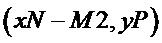

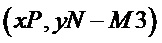

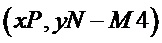

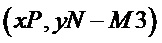

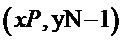

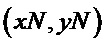

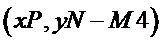

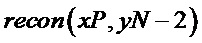

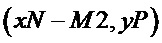

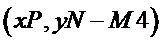

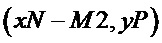

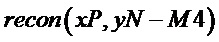

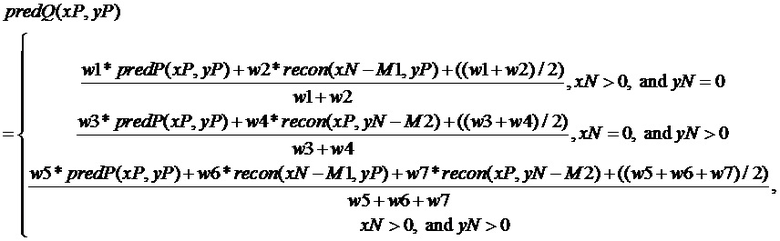

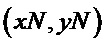

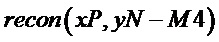

где координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, являются

, координаты верхней левой выборки блока изображения, подлежащего обработке, являются  ,

,  представляет собой значение предсказания целевой выборки перед обновлением,

представляет собой значение предсказания целевой выборки перед обновлением,  представляет обновленное значение предсказания целевой выборки,

представляет обновленное значение предсказания целевой выборки,  ,

,  ,

,  и

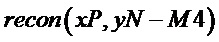

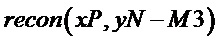

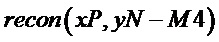

и  представляют восстановленные значения опорных выборок на координатах

представляют восстановленные значения опорных выборок на координатах  ,

,  ,

,  и

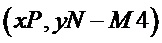

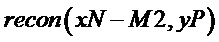

и  позиций, соответственно, w1, w2, w3, w4, w5, w6, w7, w8, w9, w10 и w11 являются заданными константами, и M1, M2, M3 и M4 являются заданными положительными целыми числами.

позиций, соответственно, w1, w2, w3, w4, w5, w6, w7, w8, w9, w10 и w11 являются заданными константами, и M1, M2, M3 и M4 являются заданными положительными целыми числами.

На основании этого решения обновленное значение предсказания целевой выборки может быть получено посредством обработки фильтрации.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации, w1 + w2 + w3 = S1, w4 + w5 + w6 = S2 или w7 + w8 + w9 + w10 + w11 = S3, где S1, S2 и S3 равны 2 в степени n, и n является неотрицательным целым числом.

На основании этого решения эффективность кодирования может быть дополнительно улучшена.

Следует понимать, что каждое из S1, S2 и S3 равно 2 в степени n. S1, S2 и S3 одинаковые или разные, и это не ограничивается. Например, S1, S2 и S3 могут быть 8 или S1, S2 и S3 могут быть 2, 4 и 16 соответственно.

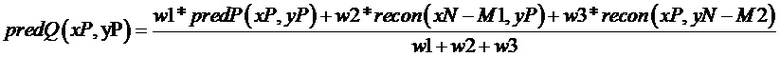

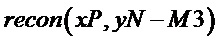

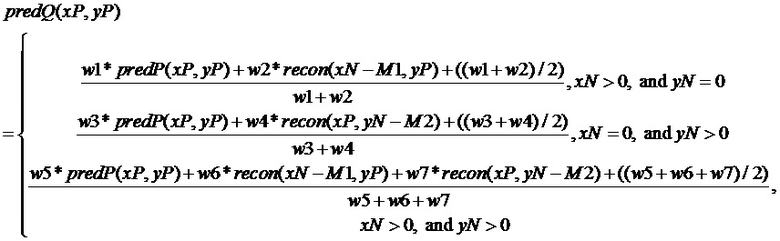

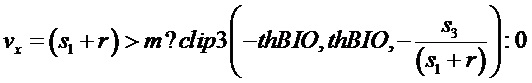

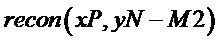

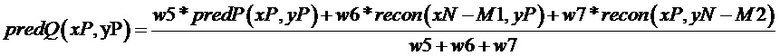

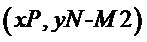

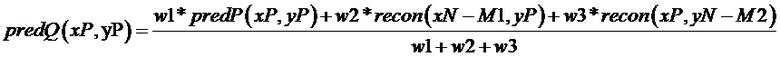

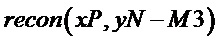

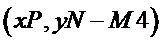

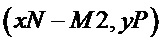

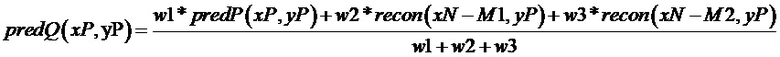

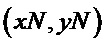

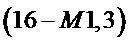

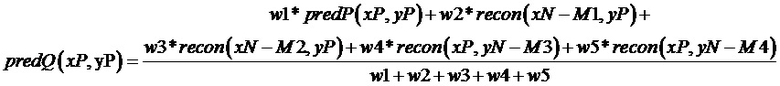

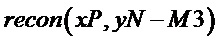

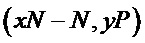

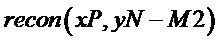

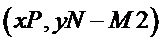

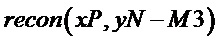

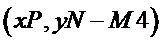

Со ссылкой на первый аспект и вышеупомянутую возможную реализацию, в другой возможной реализации, обновление значения предсказания целевой выборки включает в себя: выполнение вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленного значения опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

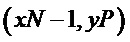

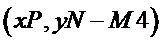

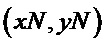

где координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, равны

, координаты верхней левой выборки блока изображения, подлежащего обработке, равны  ,

,  представляют собой значение предсказания целевой выборки перед обновлением,

представляют собой значение предсказания целевой выборки перед обновлением,  представляют обновленное значение предсказания целевой выборки

представляют обновленное значение предсказания целевой выборки  и

и  представляют восстановленные значения опорных выборок на позициях

представляют восстановленные значения опорных выборок на позициях  координат и

координат и  , соответственно, w1, w2 и w3 являются заданными константами и M1 и M2 являются заданными положительными целыми числами.

, соответственно, w1, w2 и w3 являются заданными константами и M1 и M2 являются заданными положительными целыми числами.

На основании этого решения обновленное значение предсказания целевой выборки может быть получено посредством обработки фильтрации.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации w1 + w2 + w3 = R, где R равно 2 в степени n, и n является неотрицательным целым числом.

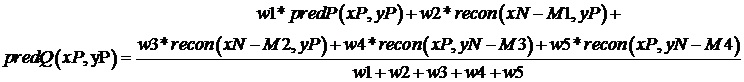

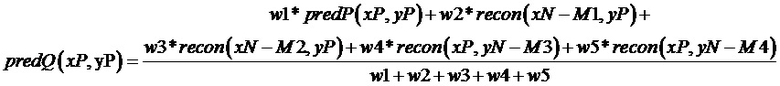

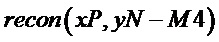

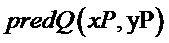

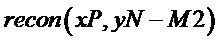

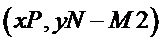

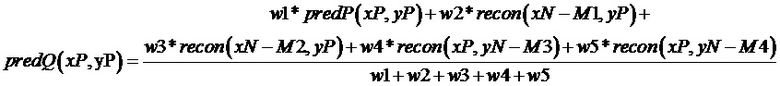

Со ссылкой на первый аспект и вышеупомянутую возможную реализацию, в другой возможной реализации, обновление значения предсказания целевой выборки включает в себя: выполнение вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленного значения опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

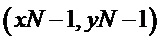

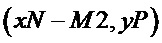

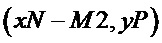

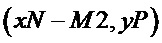

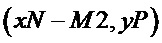

где координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, равны

, координаты верхней левой выборки блока изображения, подлежащего обработке, равны

представляет собой значение предсказания целевой выборки перед обновлением,

представляет собой значение предсказания целевой выборки перед обновлением,  представляет обновленное значение предсказания целевой выборки,

представляет обновленное значение предсказания целевой выборки,  ,

,  ,

,  и

и  представляют восстановленные значения опорных выборок на позициях

представляют восстановленные значения опорных выборок на позициях  ,

,  ,

,  и

и  координат, соответственно, w1, w2, w3, w4 и w5 являются заданными константы и M1, M2, M3 и M4 являются заданными положительными целыми числами.

координат, соответственно, w1, w2, w3, w4 и w5 являются заданными константы и M1, M2, M3 и M4 являются заданными положительными целыми числами.

На основании этого решения обновленное значение предсказания целевой выборки может быть получено посредством обработки фильтрации.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации, w1 + w2 + w3 + w4 + w5 = S, где S равно 2 в степени n, и n является неотрицательным целым числом.

На основании этого решения эффективность кодирования может быть дополнительно улучшена.

Со ссылкой на первый аспект и вышеупомянутой возможной реализации, в другой возможной реализации одна или несколько опорных выборок включают в себя одну или несколько из следующих выборок: восстановленная выборка, которая имеет ту же горизонтальную координату, что и целевая выборка, и которая находится рядом с верхней стороной блока изображения, подлежащего обработке, восстановленная выборка, которая имеет ту же вертикальную координату, что и целевая выборка, и которая находится рядом с левой стороной блока изображения, подлежащего обработке, верхняя правая восстановленная выборка блока изображения, подлежащего обработке, нижняя левая восстановленная выборка блока изображения, подлежащего обработке, или верхняя левая восстановленная выборка блока изображения, подлежащего обработке.

На основании этого решения выполняется обработка фильтрации на целевой выборке с использованием опорной выборки, который имеет заданное отношение пространственной позиции с целевой выборкой. По сравнению с традиционной технологией эффективность кодирования повышается.

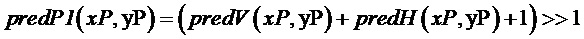

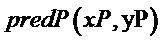

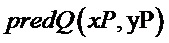

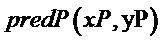

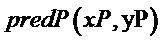

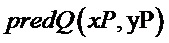

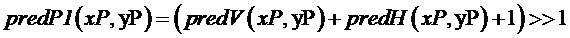

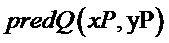

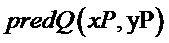

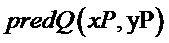

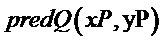

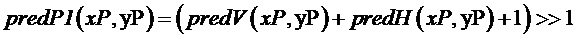

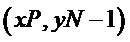

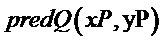

Со ссылкой на первый аспект и вышеупомянутую возможную реализацию, в другой возможной реализации, обновление значения предсказания целевой выборки включает в себя: выполнение вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленного значения опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

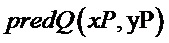

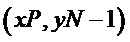

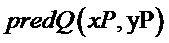

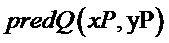

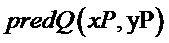

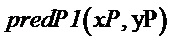

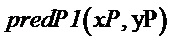

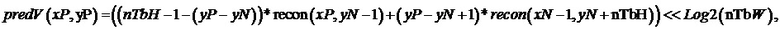

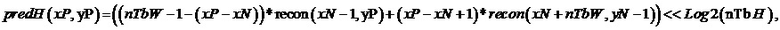

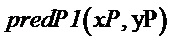

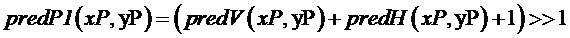

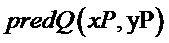

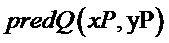

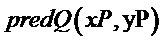

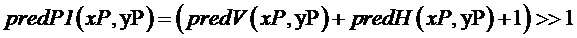

predQ(xP, yP) = (w1 * predP(xP, yP) + w2 * predP1(xP, yP) + ((w1 + w2)/2))/(w1 + w2)

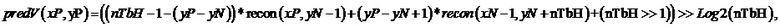

где predP1(xP, yP) = (predV(xP, yP) + predH(xP, yP) + nTbW * nTbH) >> (Log2(nTbW) + Log2(nTbH) + 1), predV(xP, yP) = ((nTbH – 1 – yP) * p(xP, –1) + (yP + 1) * p(–1, nTbH)) << Log2(nTbW), predH(xP, yP) = ((nTbW – 1 – xP) * p(–1, yP) + (xP + 1) * p(nTbW, –1)) << Log2(nTbH), координаты целевой выборки равны (xP, yP), координаты верхней левой выборки блока изображения, подлежащего обработке, равны (0, 0), predP (xP, yP) представляет значение предсказания целевой выборки перед обновлением, predQ (xP, yP) представляет обновленное значение предсказания целевой выборки, p (xP, –1), p (–1, nTbH), p (–1, yP) и p (nTbW, –1) представляют восстановленные значения опорных выборок на позициях (xP, –1), (–1, nTbH), (–1, yP) и (nTbW, –1) координат, соответственно, w1 и w2 являются заданными константами и nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке.

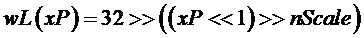

В возможной реализации первого аспекта значение предсказания целевой выборки обновляется согласно следующей формуле:

predQ(xP, yP) = (w1 * predP(xP, yP) + w2 * predV(xP, yP) + w3 * predH(xP, yP) + ((w1 + w2 + w3)/2))/(w1 + w2 + w3)

где predV (xP, yP) = ((nTbH - 1 - yP) * p (xP, –1) + (yP + 1) * p (–1, nTbH) + nTbH / 2) >> Log2 (nTbH), predH (xP, yP) = ((nTbW - 1 - xP) * p (–1, yP) + (xP + 1) * p (nTbW, –1) + nTbW / 2) >> Log2 (nTbW), координаты целевой выборки являются (xP, yP), координаты верхней левой выборки блока изображения, подлежащего обработке, равны (0, 0), predP (xP, yP) представляет значение предсказания целевой выборки до обновления, predQ (xP, yP) представляет обновленное значение предсказания целевой выборки, p (xP, –1), p (–1, nTbH), p (–1, yP) и p (nTbW, –1) представляют восстановленные значения опорных выборок на позициях (xP, –1), (–1, nTbH), (–1, yP) и (nTbW, –1) координат, соответственно, w1, w2 и w3 представляют собой заданные константы, и nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке.

В возможной реализации первого аспекта значение предсказания целевой выборки обновляется согласно следующей формуле:

predQ(xP, yP) = (((w1 * predP(xP, yP)) << (Log2(nTbW) + Log2(nTbH) + 1)) + w2 * predV(xP, yP) +w3 * predH(xP, yP) + (((w1 + w2 + w3)/2) << (Log2(nTbW) + Log2(nTbH) + 1)))/(((w1 + w2 + w3) << (Log2(nTbW) + Log2(nTbH) + 1)))

где predV (xP, yP) = ((nTbH - 1 - yP) * p (xP, –1) + (yP + 1) * p (–1, nTbH)) << Log2 (nTbW), predH (xP, yP) = ((nTbW - 1 - xP) * p (–1, yP) + (xP + 1) * p (nTbW, –1)) << Log2 (nTbH), координаты целевой выборки равны (xP, yP), координаты верхней левой выборки блока изображения, подлежащего обработке, равны (0, 0), predP (xP, yP) представляет значение предсказания целевой выборки до обновления, predQ (xP, yP) представляет обновленное значение предсказания целевой выборки, p (xP, –1), p (–1, nTbH), p (–1, yP) и p (nTbW, –1) представляют восстановленные значения опорных выборок на позициях (xP, –1), (–1, nTbH), (–1, yP) и (nTbW, –1) координат, соответственно, w1 и w2 являются заданными константами и nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке.

На основании этого решения обновленное значение предсказания целевой выборки может быть получено посредством обработки фильтрации.

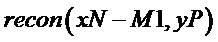

Со ссылкой на первый аспект и вышеупомянутую возможную реализацию, в другой возможной реализации, обновление значения предсказания целевой выборки включает в себя: выполнение вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленного значения опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

predQ(xP, yP) = (w1 * predP(xP, yP) + w2 * predP1(xP, yP) + ((w1 + w2)/2))/(w1 + w2)

где

координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, равны

, координаты верхней левой выборки блока изображения, подлежащего обработке, равны  ,

,  представляет значение предсказания целевой выборки перед обновлением,

представляет значение предсказания целевой выборки перед обновлением,  представляет обновленное значение предсказания целевой выборки,

представляет обновленное значение предсказания целевой выборки,  ,

,  ,

,  и

и  представляют восстановленные значения опорных выборок на позициях

представляют восстановленные значения опорных выборок на позициях  ,

,  ,

,  и

и  координат, соответственно, w1 и w2 являются заданными константами и nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке.

координат, соответственно, w1 и w2 являются заданными константами и nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке.

На основании этого решения обновленное значение предсказания целевой выборки может быть получено посредством обработки фильтрации.

Со ссылкой на первый аспект и вышеупомянутых возможных реализаций, в другой возможной реализации сумма w1 и w2 равна 2, возведенной в степень n, и n является неотрицательным целым числом.

На основании этого решения эффективность кодирования может быть дополнительно улучшена.

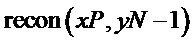

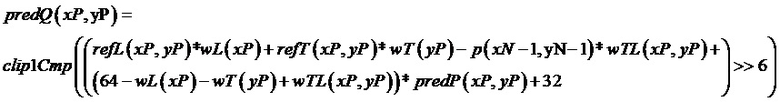

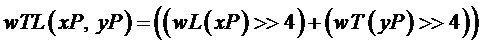

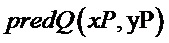

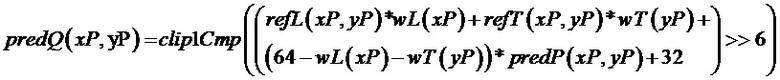

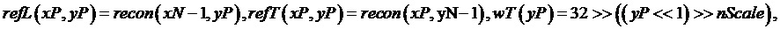

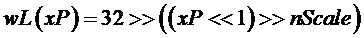

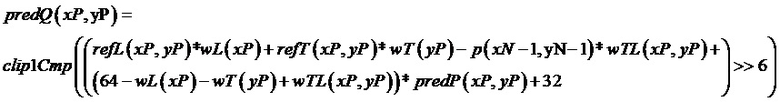

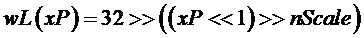

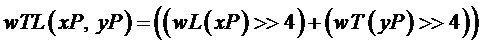

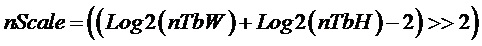

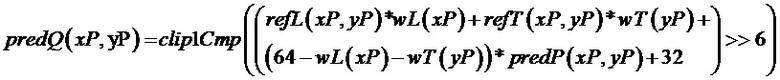

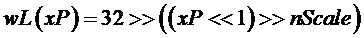

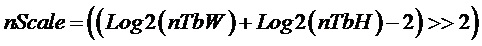

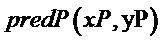

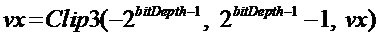

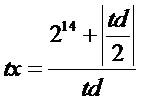

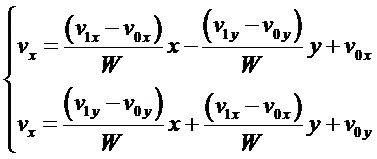

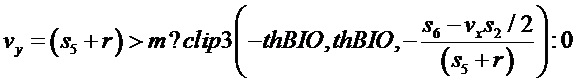

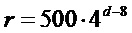

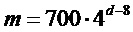

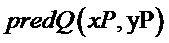

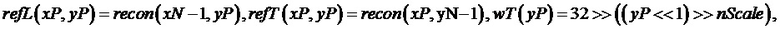

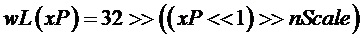

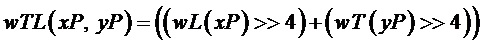

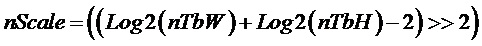

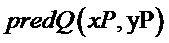

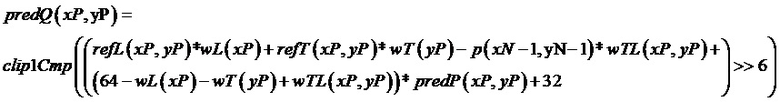

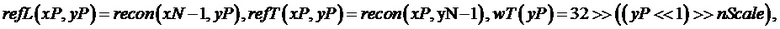

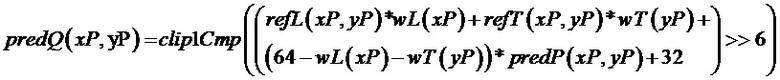

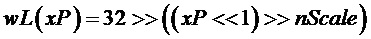

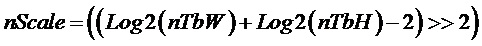

Со ссылкой на первый аспект и вышеупомянутую возможную реализацию, в другой возможной реализации обновление значения предсказания целевой выборки включает в себя: выполнение вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленного значения опорной выборки, для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

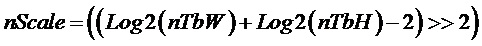

где

,

, ,

,

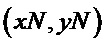

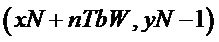

, координаты целевой выборки равны

, координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, равны

, координаты верхней левой выборки блока изображения, подлежащего обработке, равны  ,

,  представляет значение предсказания целевой выборки перед обновлением,

представляет значение предсказания целевой выборки перед обновлением,  представляет обновленное значение предсказания целевой выборки,

представляет обновленное значение предсказания целевой выборки,  ,

,  и

и  представляют восстановленные значения опорных выборок на позициях

представляют восстановленные значения опорных выборок на позициях  ,

,  и

и  координат, соответственно, nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке, и clip1Cmp представляет операцию отсечения.

координат, соответственно, nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке, и clip1Cmp представляет операцию отсечения.

На основании этого решения обновленное значение предсказания целевой выборки может быть получено посредством обработки фильтрации.

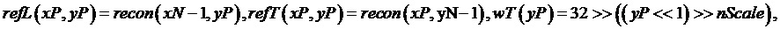

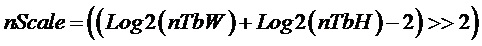

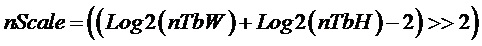

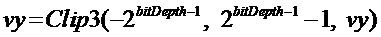

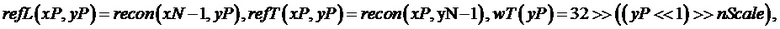

Со ссылкой на первый аспект и вышеупомянутую возможную реализацию, в другой возможной реализации, обновление значения предсказания целевой выборки включает в себя: выполнение вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленного значения опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

где

,

,  ,

,

координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, равны

, координаты верхней левой выборки блока изображения, подлежащего обработке, равны  ,

,  представляет значение предсказания целевой выборки перед обновлением,

представляет значение предсказания целевой выборки перед обновлением,  представляет обновленное значение предсказания целевой выборки,

представляет обновленное значение предсказания целевой выборки,  и

и  представляют восстановленные значения опорных выборок на позициях

представляют восстановленные значения опорных выборок на позициях  и

и  координат, соответственно, nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке, clip1Cmp представляет операцию отсечения.

координат, соответственно, nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке, clip1Cmp представляет операцию отсечения.

На основании этого решения обновленное значение предсказания целевой выборки может быть получено посредством обработки фильтрации.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации, выполнение вычисления взвешивания для одного или нескольких восстановленных значений одной или нескольких опорных выборок и значения предсказания целевой выборки включает в себя: когда восстановленное значение опорной выборки недоступно, определение в заданном порядке доступности выборок, смежных с верхней и левой стороной блока изображения, подлежащего обработке, до тех пор, пока не будет получено заданное количество доступных опорных выборок; и выполнение вычисления взвешивания для восстановленного значения доступной опорной выборки и значения предсказания целевой выборки.

На основании этого решения, когда восстановленное значение опорной выборки недоступно, опорные выборки, которые расположены слева и над блоком изображения, подлежащего обработке, и чьи восстановленные значения доступны, могут быть найдены в заданном порядке. Таким образом, значение предсказания целевой выборки может быть обновлено с использованием восстановленных значений доступных опорных выборок.

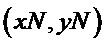

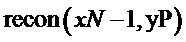

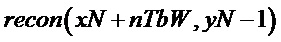

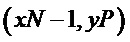

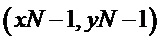

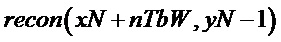

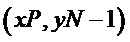

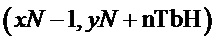

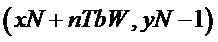

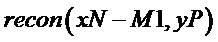

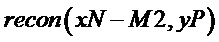

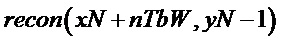

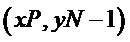

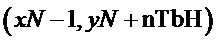

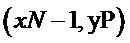

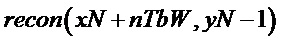

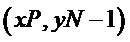

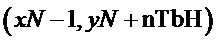

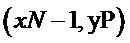

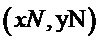

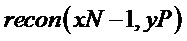

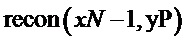

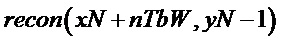

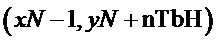

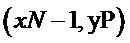

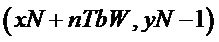

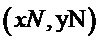

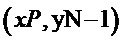

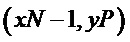

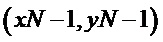

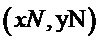

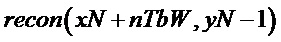

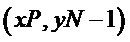

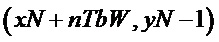

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации определение в заданном порядке доступности выборок, смежных с верхней и левой стороной блока изображения, подлежащего обработке, до получения заданного количества доступных опорных выборок включает в себя: получение доступных опорных выборок в порядке от координат (xN - 1, yN + nTbH - 1) до координат (xN - 1, yN - 1) и затем от координат (xN, yN - 1) до координат (xN + nTbW - 1, yN - 1).

На основании этого решения могут быть получены восстановленные значения доступных опорных выборок.

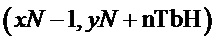

Со ссылкой на первый аспект и вышеупомянутых возможных реализаций, в другой возможной реализации, при наличии, по меньшей мере, одной доступной опорной выборки во всех опорных выборках, если восстановленное значение опорной выборки (xN - 1, yN + nTbH - 1) недоступно, выполняется поиск доступной выборки в заданном порядке от координат (xN - 1, yN + nTbH - 1) до координат (xN - 1, yN - 1) и затем от координатам (xN, yN - 1) до координат (xN + nTbW - 1, yN - 1). Как только доступная выборка найдена, поиск заканчивается. Если доступная выборка является (x, y), восстановленное значение опорной выборки (xN - 1, yN + nTbH - 1) устанавливается равным восстановленному значению выборки (x, y). Если восстановленное значение опорной выборки (x, y) недоступно в наборе, включающем в себя опорную выборку (xN - 1, yN + nTbH - M), восстановленное значение опорной выборки (x, y) устанавливается на восстановленное значение выборки (x, y + 1), где M больше или равно 2 и меньше или равно nTbH + 1. Если восстановленное значение опорной выборки (x, y) недоступно в наборе, включающий в себя опорную выборку (xN + N, yN - 1), восстановленное значение опорной выборки (x, y) устанавливается равным восстановленному значению опорной выборки (x - 1, y), где N больше или равно 0 и меньше или равно nTbW - 1.

На основании этого решения могут быть получены восстановленные значения доступных опорных выборок.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации, если восстановленное значение опорной выборки (xN - 1, yN + nTbH - M) недоступно, доступная опорная выборка может быть найдена в заданном порядке, начиная с координат (xN - 1, yN + nTbH - M), где M больше или равно 1 и меньше или равно nTbH + 1. Если доступная опорная выборка является B, восстановленное значение опорной выборки (xN - 1, yN + nTbH - M) может быть установлено на восстановленное значение опорной выборки B. Если восстановленное значение опорной выборки с координатами (xN + N, yN - 1) недоступно, доступная опорная выборка может быть найдена в заданном порядке, начиная с координат (xN + N, yN - 1), где N больше или равно 0 и меньше или равно nTbW - 1. Если доступная опорная выборка равно C, восстановленное значение опорной выборки (xN + N, yN - 1) может быть установлено на восстановление измененное значение опорной выборки C.

На основании этого решения могут быть получены восстановленные значения доступных опорных выборок.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации, если восстановленное значение опорной выборки (xN - 1, yN + nTbH - 1) недоступно, доступная выборка ищется в заданном порядке от координат (xN - 1, yN + nTbH - 1) к координатам (xN - 1, yN - 1) и затем от координат (xN, yN - 1) к координатам (xN + nTbW - 1, yN - 1). Как только доступная выборка найдена, поиск заканчивается. Если доступная выборка является (x, y), восстановленное значение опорной выборки (xN - 1, yN + nTbH - 1) устанавливается равным восстановленному значению выборки (x, y). Если восстановленное значение опорной выборки (xN - 1, yN + nTbH - M) недоступно, можно искать доступную опорную выборку в порядке, обратном заданному, начиная с координат (xN - 1, yN + nTbH - M), где M больше 1 и меньше или равно nTbH + 1. Если доступной опорной выборкой является C, восстановленное значение опорной выборки (xN - 1, yN + nTbH - M) может быть установлено на восстановленное значение опорной выборки C. Если восстановленное значение опорной выборки с координатами (xN + N, yN - 1) недоступно, доступная опорная выборка может быть найдена в порядке, обратном заданному, начиная с координат (xN + N, yN - 1), где N больше или равно 0 и меньше или равно nTbW - 1. Если доступная опорная выборка является D, восстановленное значение опорной выборки (xN + N, yN - 1) может быть установлено равным восстановленному значению опорной выборки D.

На основании этого решения могут быть получены восстановленные значения доступных опорных выборок.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации в другой возможной реализации, если определено, что все выборки, смежные с верхней стороной и левой стороной блока изображения, подлежащего обработке, недоступны, восстановленное значение опорной выборки устанавливается равным 1 << (bitDepth - 1), где bitDepth представляет битовую глубину значения выборки опорной выборки.

На основании этого решения восстановленное значение опорной выборки может быть установлено на основании битовой глубины, когда как восстановленное значение опорной выборки, так и восстановленное значение новой опорной выборки недоступны.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации, перед выполнением вычисления взвешивания для одного или нескольких восстановленных значений одной или нескольких опорных выборок и значения предсказания целевой выборки, способ включает в себя: когда опорная выборка находится выше блока изображения, подлежащего обработке, выполнение вычисления взвешивания на восстановленном значении опорной выборки и восстановленных значений левой соседней выборки и правой соседней выборки опорной выборки; когда опорная выборка находится слева блока изображения, подлежащего обработке, выполнение вычисления взвешивания на восстановленном значении опорной выборки и восстановленных значений верхней соседней выборки и нижней соседней выборки опорной выборки; и обновление восстановленного значения опорной выборки с использованием результата вычисления взвешивания.

На основании этого решения перед тем, как обработка фильтрации будет выполнена для целевой выборки, выполняется обработка фильтрации для восстановленного значения опорной выборки. Таким образом, эффективность кодирования может быть дополнительно улучшена, и остаток предсказания может быть уменьшен.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации, перед выполнением компенсации движения на блоке изображения, подлежащего обработке, на основании информации движения, способ дополнительно включает в себя: первоначальное обновление информации движения с использованием первого заданного алгоритма; и, соответственно, выполнение компенсации движения над подлежащим обработке блоком изображения на основании информации движения, включает в себя: выполнение компенсации движения на блоке изображения, подлежащего обработке, на основании изначально обновленной информации движения.

На основании этого решения обновляется информация движения до того, как компенсация движения выполняется для текущего блока, и компенсация движения выполняется на основании обновленной информации движения. Таким образом можно уменьшить остаток предсказания.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации, после получения блока предсказания блока изображения, подлежащего обработке, способ дополнительно включает в себя: предварительное обновление блока предсказания с использованием второго заданного алгоритма; и, соответственно, выполнение вычисления взвешивания для одного или нескольких восстановленных значений одной или нескольких опорных выборок и значения предсказания целевой выборки включает в себя: выполнение вычисления взвешивания для одного или нескольких восстановленных значений одной или нескольких опорных выборок и предварительного обновленного значения предсказания целевой выборки.

На основании данного решения, блок предсказания текущего блока предварительно обновляются, и выполняется вычисление взвешивания на основании предварительно обновленного значения предсказания и восстановленного значения опорной выборки. Таким образом можно уменьшить остаток предсказания.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации, после выполнения вычисления взвешивания для одного или нескольких восстановленных значений одной или нескольких опорных выборок и значения предсказания целевой выборки для обновления значения предсказания целевой выборки, способ дополнительно включает в себя: обновление значения предсказания целевой выборки с использованием второго заданного алгоритма.

На основании этого решения значение предсказания, которое относится к целевой выборке и которое подверглось обработке пространственной фильтрации, может быть обновлено с использованием заданного алгоритма. Таким образом можно уменьшить остаток предсказания.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации, перед выполнением вычисления взвешивания для одного или нескольких восстановленных значений одной или нескольких опорных выборок и значения предсказания целевой выборки, способ дополнительно включает в себя: синтаксический анализ битового потока для получения режима предсказания, соответствующего блоку изображения, подлежащего обработке; и определение, что режим предсказания является режимом слияния (merge) и/или усовершенствованным режимом внешнего предсказания вектора движения (inter-AMVP). Можно понять, что усовершенствованный режим внешнего предсказания вектора движения (inter-AMVP) также может называться режимом внешнего предсказания вектора движения (inter-MVP).

На основании этого решения перед обработкой фильтрации может быть определен режим предсказания, соответствующий блоку изображения, подлежащего обработке.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации, перед выполнением вычисления взвешивания для одного или нескольких восстановленных значений одной или нескольких опорных выборок и значения предсказания целевой выборки, способ дополнительно включает в себя: синтаксический анализ битового потока для получения информации указания определения обновления блока изображения, подлежащего обработке; и определение, что информация указания определения обновления используется для указания обновить блок предсказания блока изображения, подлежащего обработке.

На основании этого решения информация указания определении обновления блока изображения, подлежащего обработке, может быть получена путем синтаксического анализа битового потока, и определяется, что блок предсказания блока изображения, подлежащего обработке, должен быть обновлен.

Со ссылкой на первый аспект и вышеупомянутые возможные реализации, в другой возможной реализации, перед выполнением вычисления взвешивания для одного или нескольких восстановленных значений одной или нескольких опорных выборок и значения предсказания целевой выборки, способ дополнительно включает в себя: получение заданной информации указания определения обновления блока изображения, подлежащего обработке; и определение, что информация указания определения обновления используется для указания обновить блок предсказания блока изображения, подлежащего обработке.

На основании этого решения может быть получена информация указания определения обновления блока изображения, подлежащего обработке, и на основании информации указания определения обновления определяется, что блок предсказания блока изображения, подлежащего обработке, подлежит обновлению.

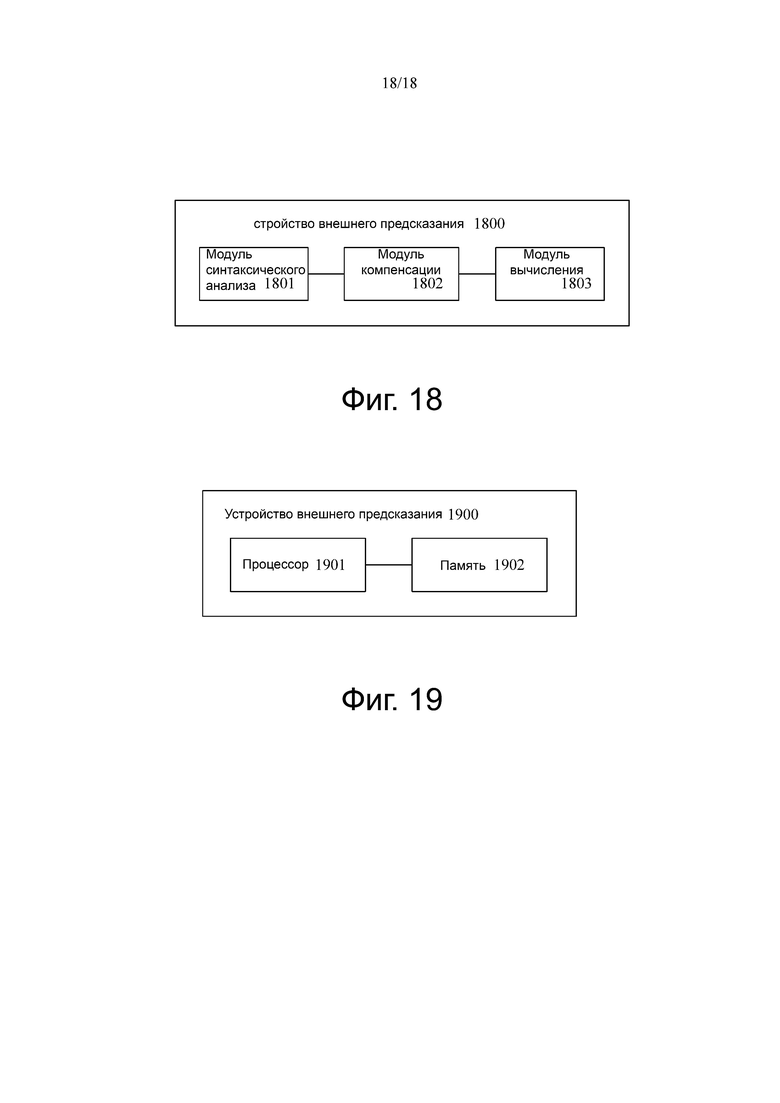

Согласно второму аспекту вариантов осуществления настоящего изобретения предоставляется устройство внешнего предсказания, включающее в себя: модуль синтаксического анализа, выполненный с возможностью выполнять синтаксический анализ битового потока для получения информации движения блока изображения, подлежащего обработке; модуль компенсации, выполненный с возможностью выполнять компенсацию движения над блоком изображения, подлежащего обработке, на основании информации движения для получения блока предсказания блока изображения, подлежащего обработке, где блок предсказания блока изображения, подлежащего обработке, включает в себя значение предсказания целевой выборки; и модуль вычислений, выполненный с возможностью выполнять вычисления взвешивания для одного или нескольких восстановленных значений одной или нескольких опорных выборок и значения предсказания целевой выборки для обновления значения предсказания целевой выборки, где опорная выборка имеет заданное отношение пространственной позиции с целевой выборкой.

Со ссылкой на второй аспект и вышеупомянутую возможную реализацию, в другой возможной реализации одна или несколько опорных выборок включают в себя восстановленную выборку, которая имеет ту же горизонтальную координату, что и целевая выборка, и имеет заданную разность вертикальной координаты с целевой выборкой, или восстановленную выборку, которая имеет ту же вертикальную координату, что и целевая выборка, и имеет заданную разность горизонтальной координаты с целевой выборкой.

Со ссылкой на второй аспект и вышеизложенное возможным осуществление, в другом возможном варианте реализации модуль вычисления специально выполнен с возможностью выполнять вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленным значением опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

где координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, равны

, координаты верхней левой выборки блока изображения, подлежащего обработке, равны  ,

,  представляет собой значение предсказания целевой выборки перед обновлением,

представляет собой значение предсказания целевой выборки перед обновлением,  представляет обновленное значение предсказания целевой выборки,

представляет обновленное значение предсказания целевой выборки,  и

и  представляют восстановленные значения опорных выборок на позициях

представляют восстановленные значения опорных выборок на позициях  и

и  координат, соответственно, w1, w2, w3, w4, w5 и w6 являются заданными константами и M1 и M2 являются заданными положительными целыми числами.

координат, соответственно, w1, w2, w3, w4, w5 и w6 являются заданными константами и M1 и M2 являются заданными положительными целыми числами.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации, w1 + w2 = R1, w3 + w4 = R2 или w5 + w6 + w7 = R3, где R1, R2 и R3 каждый являются 2 в степени n, и n представляет собой целое неотрицательное число.

Со ссылкой на второй аспект и вышеупомянутую возможную реализацию, в другой возможной реализации модуль вычисления дополнительно специально выполнен с возможностью выполнять вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленным значением опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

где координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, равны

, координаты верхней левой выборки блока изображения, подлежащего обработке, равны  ,

,  представляет собой значение предсказания целевой выборки перед обновлением,

представляет собой значение предсказания целевой выборки перед обновлением,  представляет обновленное значение предсказания целевой выборки,

представляет обновленное значение предсказания целевой выборки,  ,

,  ,

,  и

и  представляют восстановленные значения опорных выборок на позициях

представляют восстановленные значения опорных выборок на позициях  ,

,  ,

,  и

и  координат, соответственно, w1, w2, w3, w4, w5, w6, w7, w8, w9, w10 и w11 являются заданными константами и M1, M2, M3 и M4 являются заданными положительными целыми числами.

координат, соответственно, w1, w2, w3, w4, w5, w6, w7, w8, w9, w10 и w11 являются заданными константами и M1, M2, M3 и M4 являются заданными положительными целыми числами.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации, w1 + w2 + w3 = S1, w4 + w5 + w6 = S2 или w7 + w8 + w9 + w10 + w11 = S3, где S1, S2 и S3 равны 2 в степени n, и n представляет собой неотрицательное целое число.

Со ссылкой на второй аспект и вышеупомянутую возможную реализацию, в другой возможной реализации модуль вычисления дополнительно специально выполнен с возможностью выполнять вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленным значением опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

где координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, равны

, координаты верхней левой выборки блока изображения, подлежащего обработке, равны  ,

,  представляет собой значение предсказания целевой выборки перед обновлением,

представляет собой значение предсказания целевой выборки перед обновлением,  представляет обновленное значение предсказания целевой выборки,

представляет обновленное значение предсказания целевой выборки,  и

и  представляют восстановленные значения опорных выборок на позициях

представляют восстановленные значения опорных выборок на позициях  и

и  координат, соответственно, w1, w2 и w3 являются заданными константами и M1 и M2 являются заданными положительными целыми числами.

координат, соответственно, w1, w2 и w3 являются заданными константами и M1 и M2 являются заданными положительными целыми числами.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации w1 + w2 + w3 = R, где R равно 2 в степени n, и n представляет собой неотрицательное целое число.

Со ссылкой на второй аспект и вышеупомянутую возможную реализацию, в другой возможной реализации модуль вычисления дополнительно специально выполнен с возможностью выполнять вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленным значением опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

где координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, равны

, координаты верхней левой выборки блока изображения, подлежащего обработке, равны  ,

,  представляет собой значение предсказания целевой выборки перед обновлением,

представляет собой значение предсказания целевой выборки перед обновлением,  представляет обновленное значение предсказания целевой выборки,

представляет обновленное значение предсказания целевой выборки,  ,

,  ,

,  и

и  представляют восстановленные значения опорных выборок на позициях

представляют восстановленные значения опорных выборок на позициях  ,

,  ,

,  и

и  координат, соответственно, w1, w2, w3, w4 и w5 являются заданными константами и M1, M2, M3 и M4 являются заданными положительными целыми числами.

координат, соответственно, w1, w2, w3, w4 и w5 являются заданными константами и M1, M2, M3 и M4 являются заданными положительными целыми числами.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации, w1 + w2 + w3 + w4 + w5 = S, где S равно 2 в степени n, и n является неотрицательным целым числом.

Со ссылкой на второй аспект и вышеупомянутой возможной реализации, в другой возможной реализации одна или несколько опорных выборок включают в себя одну или несколько из следующих выборок: восстановленная выборка, которая имеет ту же горизонтальную координату, что и целевая выборка, и которая находится рядом с верхней стороной блока изображения, подлежащего обработке, восстановленная выборка, которая имеет ту же вертикальную координату, что и целевая выборка, и которая находится рядом с левой стороной блока изображения, подлежащего обработке, восстановленной выборкой рядом с верхней правой стороной блока изображения, подлежащего обработке, восстановленной выборкой с нижней левой стороны блока изображения, подлежащего обработке, или восстановленной выборкой верхней левой стороны блока изображения, подлежащего обработке.

Со ссылкой на второй аспект и вышеупомянутую возможную реализацию, в другой возможной реализации модуль вычисления дополнительно специально выполнен с возможностью выполнять вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленного значения опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

predQ (xP, yP) = (w1 * predP (xP, yP) + w2 * predP1 (xP, yP) + ((w1 + w2) / 2)) / (w1 + w2)

где predP1 (xP, yP) = (predV (xP, yP) + predH (xP, yP) + nTbW * nTbH) >> (Log2 (nTbW) + Log2 (nTbH) + 1), predV (xP, yP) = ((nTbH - 1 - yP) * p (xP, –1) + (yP + 1) * p (–1, nTbH)) << Log2 (nTbW), predH (xP, yP) = ((nTbW - 1 - xP) * p (–1, yP) + (xP + 1) * p (nTbW, –1)) << Log2 (nTbH), координаты целевой выборки равны (xP, yP), координаты верхней левой выборки блока изображения, подлежащего обработке, равны (0, 0), predP (xP, yP) представляет значение предсказания целевой выборки перед обновлением, predQ (xP, yP) представляет обновленное значение предсказания целевой выборки, p (xP, –1), p (–1, nTbH), p (–1, yP) и p (nTbW, –1) представляют восстановленные значения опорных выборок в координатах (xP, –1), (–1, nTbH), (–1, yP) и (nTbW, –1), соответственно, w1 и w2 являются заданными константами и nTbW и nTbH представляют ширину и высоту блока изображения, подлежащий обработке.

В возможной реализации второго аспекта значение предсказания целевой выборки обновляется согласно следующей формуле:

predQ (xP, yP) = (w1 * predP (xP, yP) + w2 * predV (xP, yP) + w3 * predH (xP, yP) + ((w1 + w2 + w3) / 2)) / (w1 + w2 + w3)

где predV (xP, yP) = ((nTbH - 1 - yP) * p (xP, –1) + (yP + 1) * p (–1, nTbH) + nTbH / 2) >> Log2 (nTbH), predH (xP, yP) = ((nTbW - 1 - xP) * p (–1, yP) + (xP + 1) * p (nTbW, –1) + nTbW / 2) >> Log2 (nTbW), координаты целевой выборки равны (xP, yP), координаты верхней левой выборки блока изображения, подлежащего обработке, равны (0, 0), predP (xP, yP) представляет значение предсказания целевой выборки перед обновлением, predQ (xP, yP) представляет обновленное значение предсказания целевой выборки, p (xP, –1), p (–1, nTbH), p (–1, yP) и p (nTbW, –1) представляют восстановленные значения опорных выборок в координатах (xP, –1), (–1, nTbH), (–1, yP) и (nTbW, –1), соответственно, w1, w2 и w3 являются заданными константами и nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке.

В возможной реализации второго аспекта значение предсказания целевой выборки обновляется согласно следующей формуле:

predQ (xP, yP) = (((w1 * predP (xP, yP)) << (Log2 (nTbW) + Log2 (nTbH) + 1)) + w2 * predV (xP, yP) + w3 * predH (xP, yP) + (((w1 + w2 + w3) / 2) << (Log2 (nTbW) + Log2 (nTbH) + 1))) / (((w1 + w2 + w3) << (Log2 (nTbW) + Log2 (nTbH) + 1)))

где predV (xP, yP) = ((nTbH - 1 - yP) * p (xP, –1) + (yP + 1) * p (–1, nTbH)) << Log2 (nTbW), predH (xP, yP) = ((nTbW - 1 - xP) * p (–1, yP) + (xP + 1) * p (nTbW, –1)) << Log2 (nTbH), координаты целевой выборки равны (xP, yP), координаты верхней левой выборки блока изображения, подлежащего обработке, равны (0, 0), predP (xP, yP) представляет значение предсказания целевой выборки до обновления, predQ (xP, yP) представляет обновленное значение предсказания целевой выборки, p (xP, –1), p (–1, nTbH), p (–1, yP) и p (nTbW, –1) представляют восстановленные значения опорных выборок на позициях (xP, –1), (–1, nTbH), (–1, yP) и (nTbW, –1) координат, соответственно, w1 и w2 являются заданными константами и nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке.

Со ссылкой на второй аспект и вышеупомянутую возможную реализацию, в другой возможной реализации модуль вычисления дополнительно специально выполнен с возможностью выполнять вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленного значения опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

predQ (xP, yP) = (w1 * predP (xP, yP) + w2 * predP1 (xP, yP) + ((w1 + w2) / 2)) / (w1 + w2)

где

координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, равны

, координаты верхней левой выборки блока изображения, подлежащего обработке, равны  ,

,  представляет значение предсказания целевой выборки перед обновлением,

представляет значение предсказания целевой выборки перед обновлением,  представляет обновленное значение предсказания целевой выборки,

представляет обновленное значение предсказания целевой выборки,  ,

,  ,

,  и

и  представляют восстановленные значения опорных выборок на позициях

представляют восстановленные значения опорных выборок на позициях  ,

,  ,

,  и

и  координат, соответственно, w1 и w2 являются заданными константами и nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке.

координат, соответственно, w1 и w2 являются заданными константами и nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации сумма w1 и w2 равна 2, возведенной в степень n, и n является неотрицательным целым числом.

Со ссылкой на второй аспект и вышеупомянутую возможную реализацию, в другой возможной реализации модуль вычисления дополнительно специально выполнен с возможностью выполнять вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленного значения опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

где

,

,  ,

,

координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, равны

, координаты верхней левой выборки блока изображения, подлежащего обработке, равны  ,

,  представляет значение предсказания целевой выборки перед обновлением,

представляет значение предсказания целевой выборки перед обновлением,  представляет обновленное значение предсказания целевой выборки,

представляет обновленное значение предсказания целевой выборки,  ,

,  и

и  представляют восстановленные значения опорных выборок на позициях

представляют восстановленные значения опорных выборок на позициях  ,

,  и

и  координат, соответственно, nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке, и clip1Cmp представляет операцию отсечения.

координат, соответственно, nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке, и clip1Cmp представляет операцию отсечения.

Со ссылкой на второй аспект и вышеупомянутую возможную реализацию, в другой возможной реализации модуль вычисления дополнительно специально выполнен с возможностью выполнять вычисления взвешивания на основании значения предсказания целевой выборки перед обновлением и восстановленного значения опорной выборки для получения обновленного значения предсказания целевой выборки, где обновленное значение предсказания целевой выборки получается в соответствии со следующей формулой:

где

,

,  ,

,

координаты целевой выборки равны  , координаты верхней левой выборки блока изображения, подлежащего обработке, равны

, координаты верхней левой выборки блока изображения, подлежащего обработке, равны  ,

,  представляет значение предсказания целевой выборки перед обновлением,

представляет значение предсказания целевой выборки перед обновлением,  представляет обновленное значение предсказания целевой выборки,

представляет обновленное значение предсказания целевой выборки,  и

и  представляют восстановленные значения опорных выборок на позициях

представляют восстановленные значения опорных выборок на позициях  и

и  координат, соответственно, nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке и clip1Cmp представляет операцию отсечения.

координат, соответственно, nTbW и nTbH представляют ширину и высоту блока изображения, подлежащего обработке и clip1Cmp представляет операцию отсечения.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации модуль вычислений дополнительно выполнен с возможностью: когда восстановленное значение опорной выборки недоступно, определять в заданном порядке доступность выборок соседних к верхней и левой сторонам блока изображения, подлежащего обработке, до тех пор, пока не будет получено заданное количество доступных опорных выборок; и выполнить вычисление взвешивания восстановленного значения доступной опорной выборки и значения предсказания целевой выборки.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации модуль вычисления специально выполнен с возможностью получать восстановленное значение доступной опорной выборки в порядке от координат (xN - 1, yN + nTbH - 1) до координат (xN - 1, yN - 1) и затем из координат (xN, yN - 1) в координаты (xN + nTbW - 1, yN - 1).

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации, когда есть, по меньшей мере, одна доступная опорная выборка во всех опорных выборках, если восстановленное значение опорной выборки (xN - 1, yN + nTbH - 1) недоступно, доступная выборка ищется в заданном порядке от координат (xN - 1, yN + nTbH - 1) до координат (xN - 1, yN - 1) и затем от координат (xN, yN - 1) до координат (xN + nTbW - 1, yN - 1). Как только доступная выборка найдена, поиск заканчивается. Если доступная выборка является (x, y), восстановленное значение опорной выборки (xN - 1, yN + nTbH - 1) устанавливается равной восстановленному значению выборки (x, y). Если восстановленное значение опорной выборки (x, y) недоступно в наборе, включающем в себя опорную выборку (xN - 1, yN + nTbH - M), восстановленное значение опорной выборки (x, y) устанавливается на восстановленное значение выборки (x, y + 1), где M больше или равно 2 и меньше или равно nTbH + 1. Если восстановленное значение опорной выборки (x, y) недоступно в наборе включающий в себя опорную выборку (xN + N, yN - 1), восстановленное значение опорной выборки (x, y) устанавливается равным восстановленному значению опорной выборки (x - 1, y), где N больше или равно 0 и меньше или равно nTbW - 1.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации модуль вычислений специально выполнен с возможностью: если восстановленное значение опорной выборки (xN - 1, yN + nTbH - M) недоступно, поиск доступного опорной выборки в заданном порядке начинается с координат (xN - 1, yN + nTbH - M), где M больше или равно 1 и меньше или равно nTbH + 1. Если доступная опорная выборка равна B, восстановленное значение опорной выборки (xN - 1, yN + nTbH - M) может быть установлено на восстановленное значение опорной выборки B. Если восстановленное значение опорной выборки с координатами (xN + N, yN - 1) недоступно, доступную опорную выборку можно искать в заданном порядке, начиная с координат (xN + N, yN - 1), где N больше или равно 0 и меньше или равно nTbW - 1 .Если доступная опорная выборка равна C, восстановленное значение опорной выборки (xN + N, yN - 1) может быть установлено на восстановленное значение опорной выборки C.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации, если восстановленное значение опорной выборки (xN - 1, yN + nTbH - 1) недоступно, доступная выборка ищется в заданном порядке с координат (xN - 1, yN + nTbH - 1) до координат (xN - 1, yN - 1) и затем от координат (xN, yN - 1) к координатам (xN + nTbW - 1, yN - 1). Как только доступная выборка найдена, поиск заканчивается. Если доступная выборка равна (x, y), восстановленное значение опорной выборки (xN - 1, yN + nTbH - 1) устанавливается равным восстановленному значению выборки (x, y). Если восстановленное значение опорной выборки (xN - 1, yN + nTbH - M) недоступно, можно искать доступную опорную выборку в порядке, обратном заданному, начиная с координат (xN - 1, yN + nTbH - M), где M больше 1 и меньше или равно nTbH + 1. Если доступная опорная выборка является C, восстановленное значение опорной выборки (xN - 1, yN + nTbH - M) может быть установить на восстановленное значение опорной выборки C. Если восстановленное значение опорной выборки с координатами (xN + N, yN - 1) недоступно, доступная опорная выборка может быть найдена в порядке, обратном заданному, начиная с координат (xN + N, yN - 1), где N больше или равно 0 и меньше или равно nTbW - 1. Если доступная опорная выборка является D, восстановленное значение опорной выборки (xN + N, yN - 1) может быть установлено равным восстановленному значению опорной выборки D.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации, если определено, что все выборки, смежные с верхней стороной и левой стороной блока изображения, подлежащего обработке, недоступны, восстановленное значение опорной выборки устанавливается равным 1 << (bitDepth - 1), где bitDepth представляет битовую глубину значения выборки опорной выборки.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации модуль вычислений дополнительно выполнен с возможностью: когда опорная выборка расположена над блоком изображения, подлежащий обработке, выполнять вычисление взвешивания для восстановленного значения опорной выборки и восстановленных значений соседней слева выборки и правой соседней выборки опорной выборки; когда опорная выборка расположена слева от блока изображения, подлежащего обработке, выполнить вычисление взвешивания для восстановленного значения опорной выборки и восстановленных значений верхней соседней выборки и нижней соседней выборки опорной выборки; и обновить восстановленное значение опорной выборки, используя результат вычисления взвешивания.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации модуль вычислений дополнительно выполнен с возможностью первоначального обновлять информацию движения с использованием первого заданного алгоритма; и, соответственно, модуль компенсации специально выполнен с возможностью выполнять компенсацию движения блока изображения, подлежащего обработке, на основании первоначально обновленной информации движения.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации модуль вычислений дополнительно выполнен с возможностью предварительно обновлять блок предсказания с использованием второго заданного алгоритма; и, соответственно, модуль вычисления специально выполнен с возможностью выполнять вычисление взвешивания одного или нескольких восстановленных значений одной или нескольких опорных выборок и предварительно обновленного значения предсказания целевой выборки.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации модуль вычислений дополнительно выполнен с возможностью обновлять значения предсказания целевой выборки с использованием второго заданного алгоритма.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации модуль синтаксического анализа дополнительно выполнен с возможностью: выполнять синтаксический анализ битового потока для получения режима предсказания, соответствующего блоку изображения, подлежащего обработке; и определять, что режим предсказания является режимом слияния (merge) и/или усовершенствованным режимом внешнего предсказания вектора движения (inter-AMVP). Можно понять, что усовершенствованным режимом внешнего предсказания вектора движения (inter-AMVP) также может называться режим внешнего предсказания вектора движения (inter-MVP).

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации модуль синтаксического анализа дополнительно выполнен с возможностью: выполнять синтаксический анализ битового потока для получения информации указания определения обновления блока изображения, подлежащего обработке; и определять, что информация указания определения обновления используется для указания обновить блок предсказания блока изображения, подлежащего обработке.

Со ссылкой на второй аспект и вышеупомянутые возможные реализации, в другой возможной реализации модуль вычислений дополнительно выполнен с возможностью: получать заданную информацию определения обновления блока изображения, подлежащего обработке; и определять, что информация указания определения обновления используется для указания обновить блок предсказания блока изображения, подлежащего обработке.

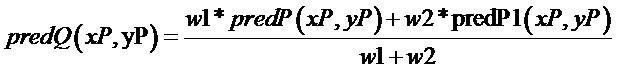

Согласно третьему аспекту настоящего изобретения, предоставляется устройство предсказания информации движения, включающее в себя процессор и память, которая связана с процессором. Процессор выполнен с возможностью выполнять способ согласно первому аспекту.

Согласно четвертому аспекту настоящего изобретения предоставляется машиночитаемый носитель данных. Машиночитаемый носитель данных хранит инструкцию. Когда инструкция выполняется на компьютере, компьютер получает возможность выполнять способ в соответствии с первым аспектом.

Согласно пятому аспекту настоящего изобретения предоставляется компьютерный программный продукт, включающий в себя инструкцию. Когда инструкция выполняется на компьютере, компьютер получает возможность выполнять способ в соответствии с первым аспектом.

Следует понимать, что технические решения в аспектах со второго по пятый настоящего изобретения согласуются с решениями в первом аспекте настоящего изобретения. Достигаемые положительные эффекты во всех аспектах и соответствующие возможные реализации всех аспектов аналогичны. Поэтому подробности снова не описываются.

Краткое описание чертежей

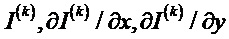

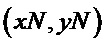

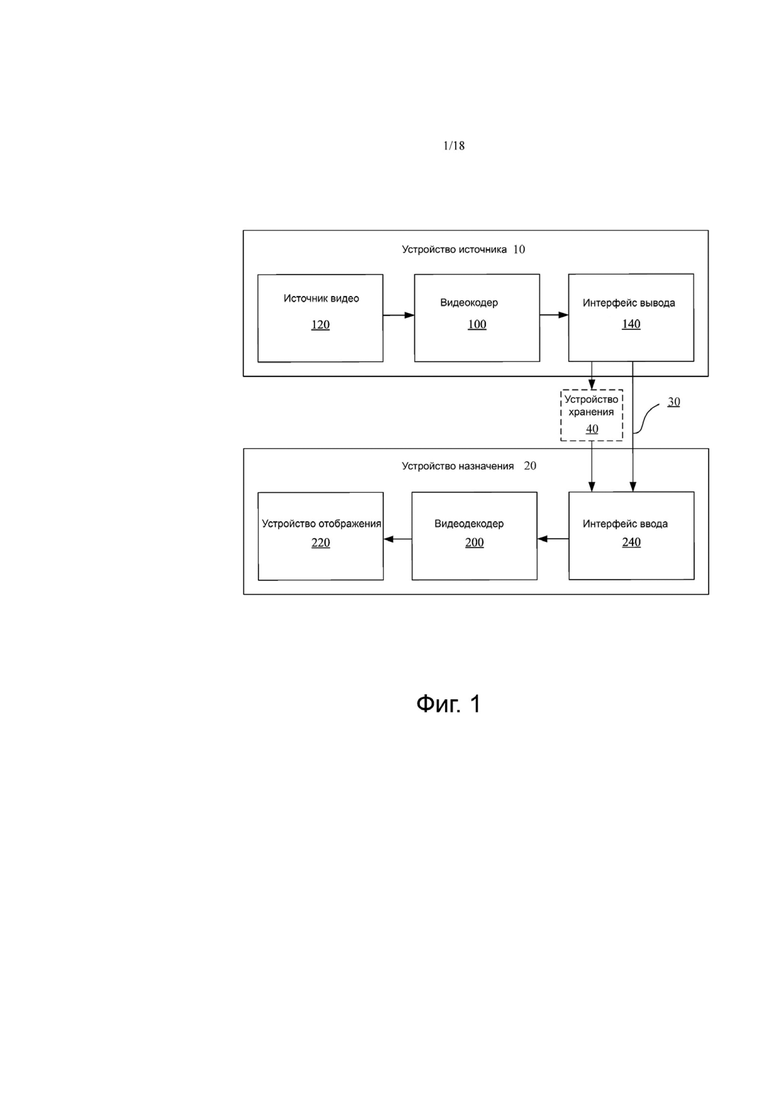

Фиг. 1 является блок-схемой примера системы кодирования видео, которая может быть выполнена с возможностью использовать в варианте осуществления настоящего изобретения;

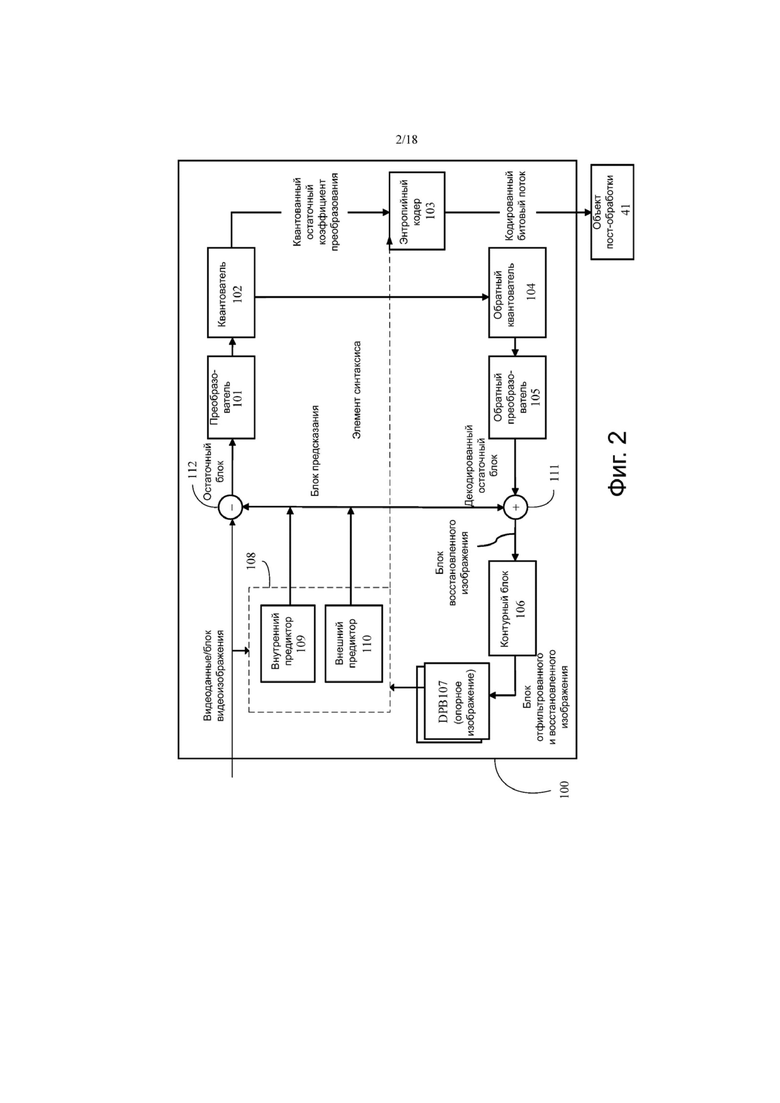

фиг. 2 является блок-схемой примера видеокодера, который может быть выполнен с возможностью использовать в варианте осуществления настоящего изобретения;

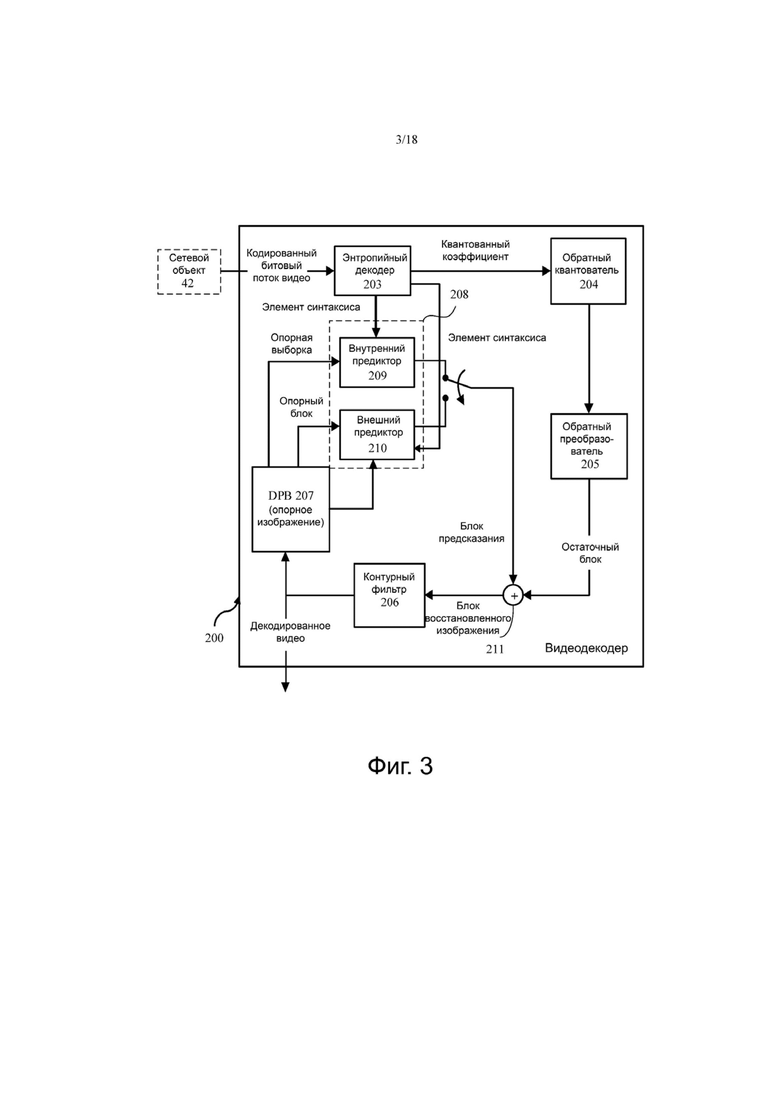

фиг. 3 является блок-схемой примера видеодекодера, который может быть выполнен с возможностью использовать в варианте осуществления настоящего изобретения;

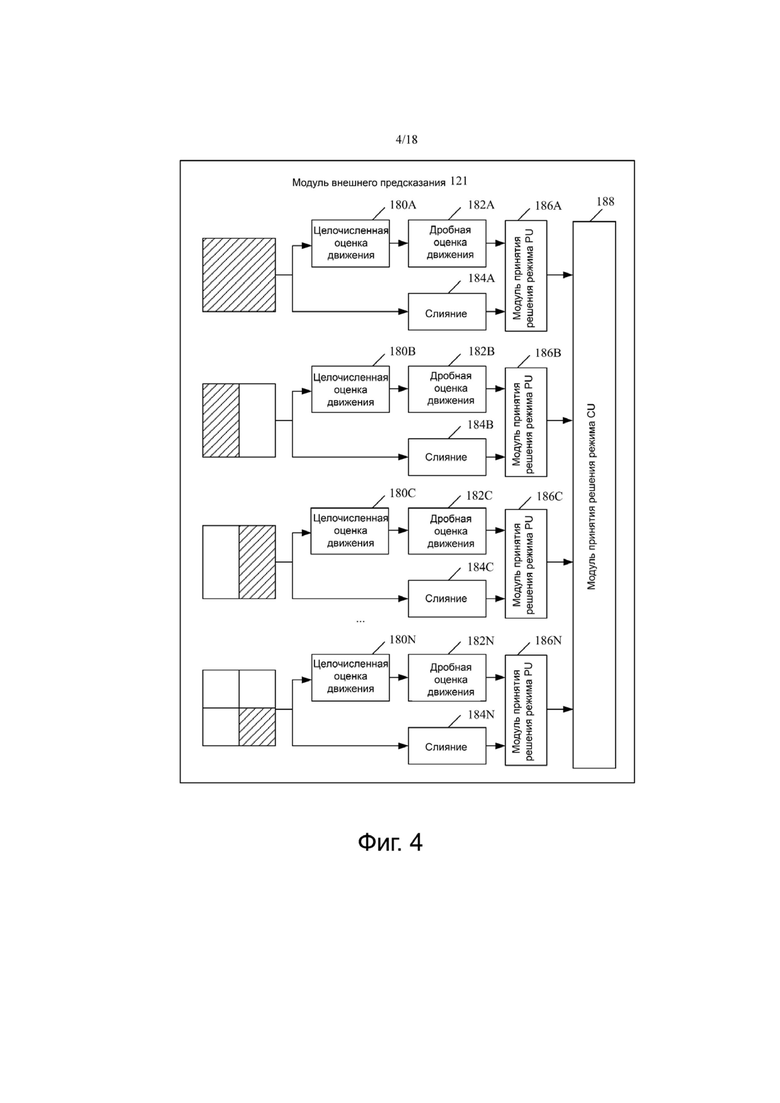

фиг. 4 является блок-схемой примера модуля внешнего предсказания, который может быть выполнен с возможностью использования в варианте осуществления настоящего изобретения;

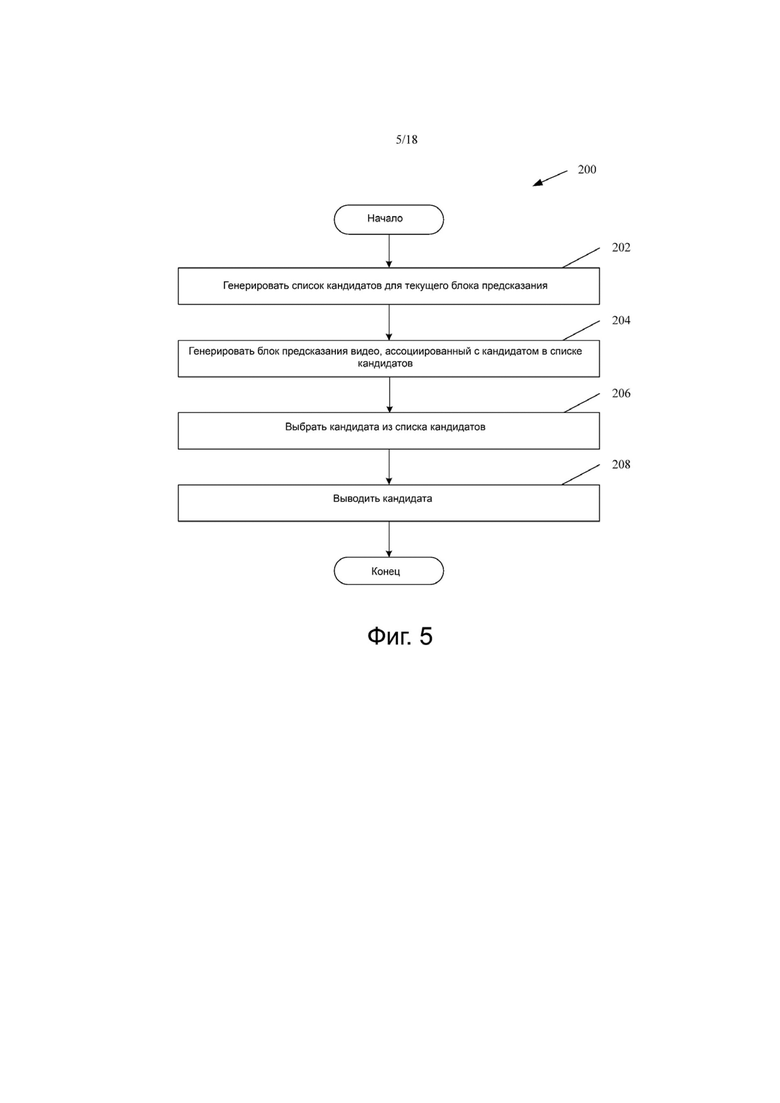

фиг. 5 является блок-схемой алгоритма примерной реализации режима предсказания слияния;

фиг. 6 является блок-схемой алгоритма примерной реализации усовершенствованного режима предсказания вектора движения;

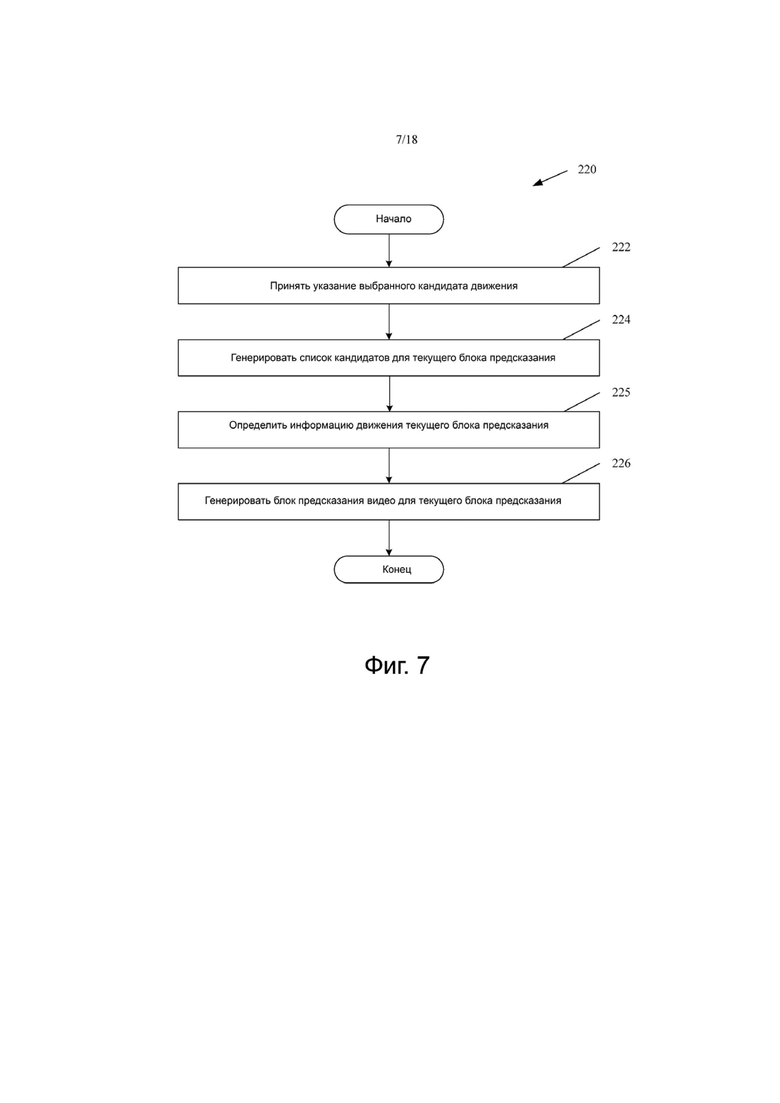

фиг. 7 является блок-схемой алгоритма примерной реализации компенсации движения, выполняемой видеодекодером, который может быть выполнен с возможностью использования в варианте осуществления настоящего изобретения;

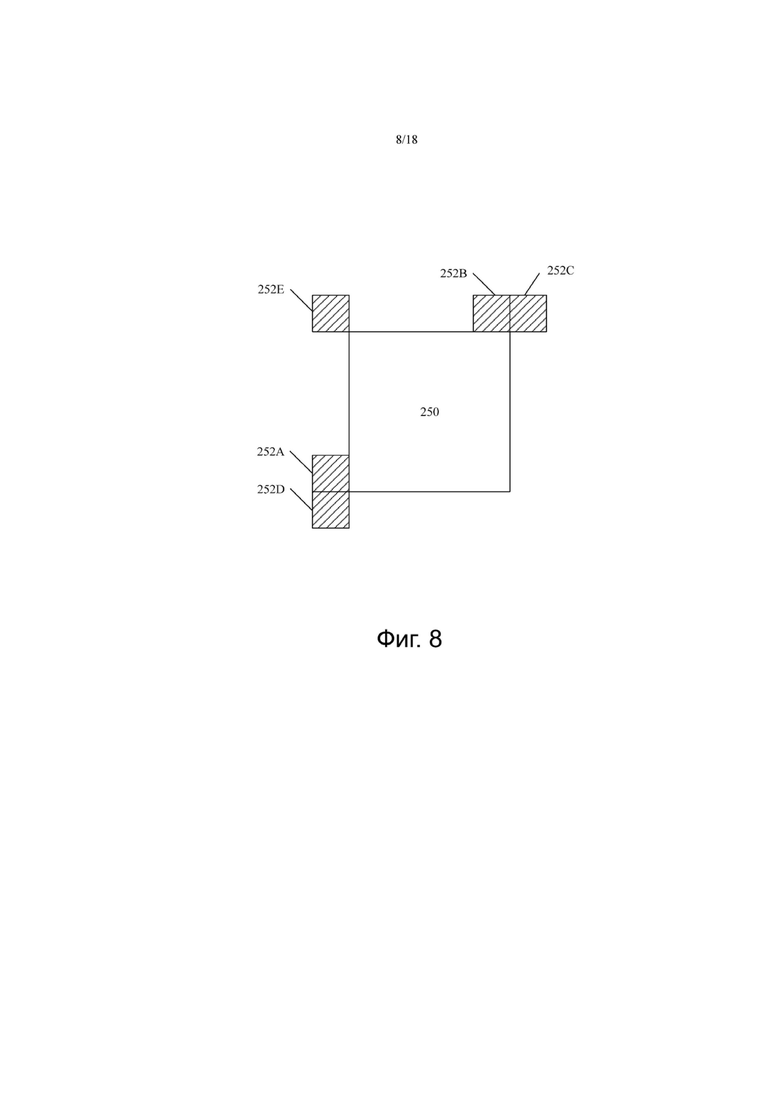

фиг. 8 является схемой примера блока кодирования и соседнего блока изображения, ассоциированного с блоком кодирования;

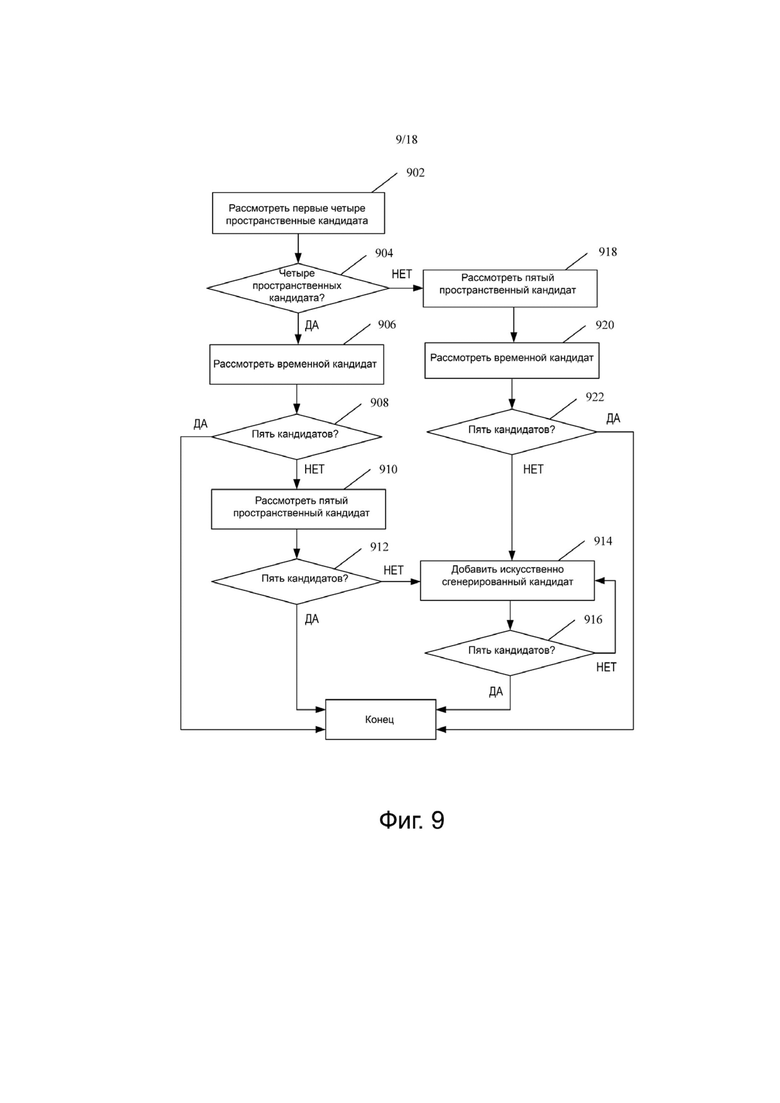

фиг. 9 является блок-схемой алгоритма примерной реализации составления списка кандидатов предсказанного вектора движения;

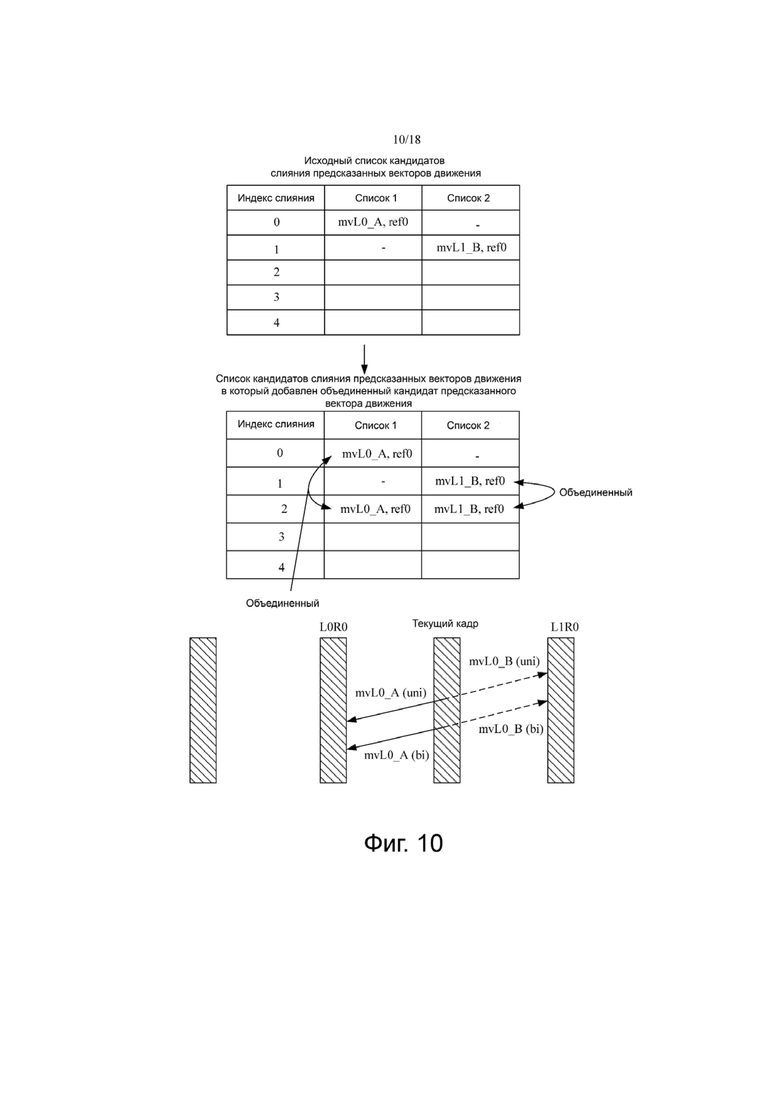

фиг. 10 является схемой примерной реализации добавления объединенного кандидата вектора движения в список кандидатов предсказанного вектора движения в режиме слияния;

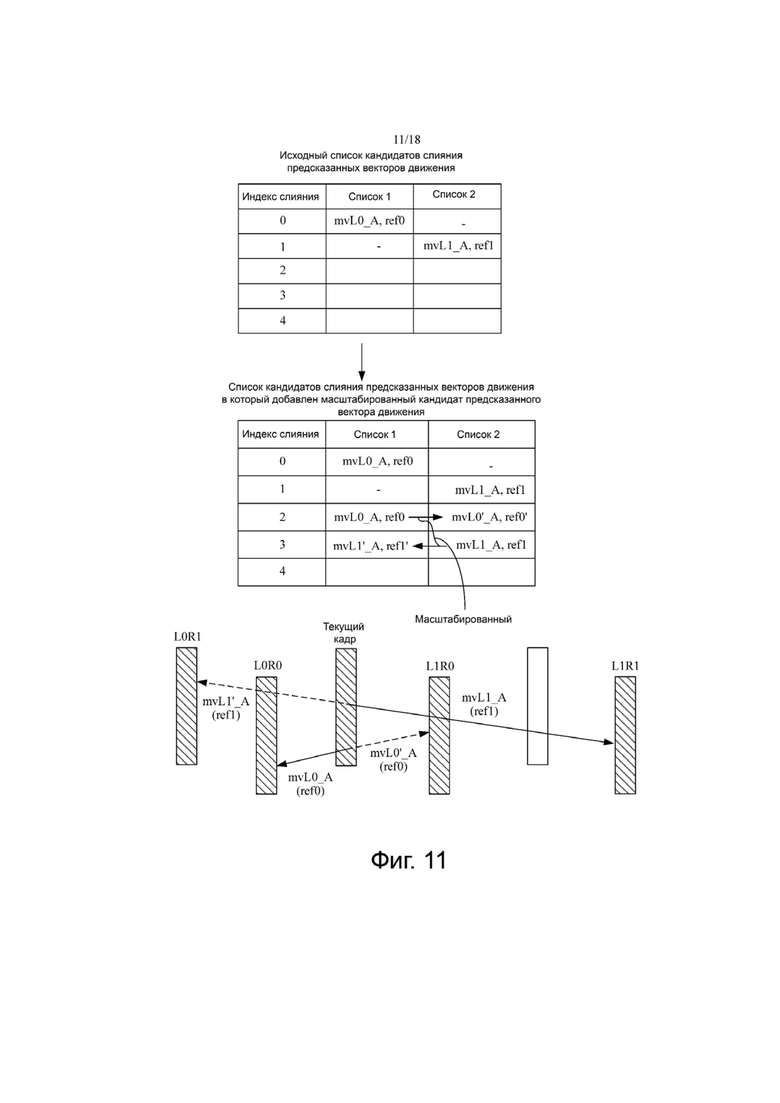

фиг. 11 является схемой примерной реализации добавления масштабированного кандидата вектора движения в список кандидатов предсказанного вектора движения в режиме слияния;

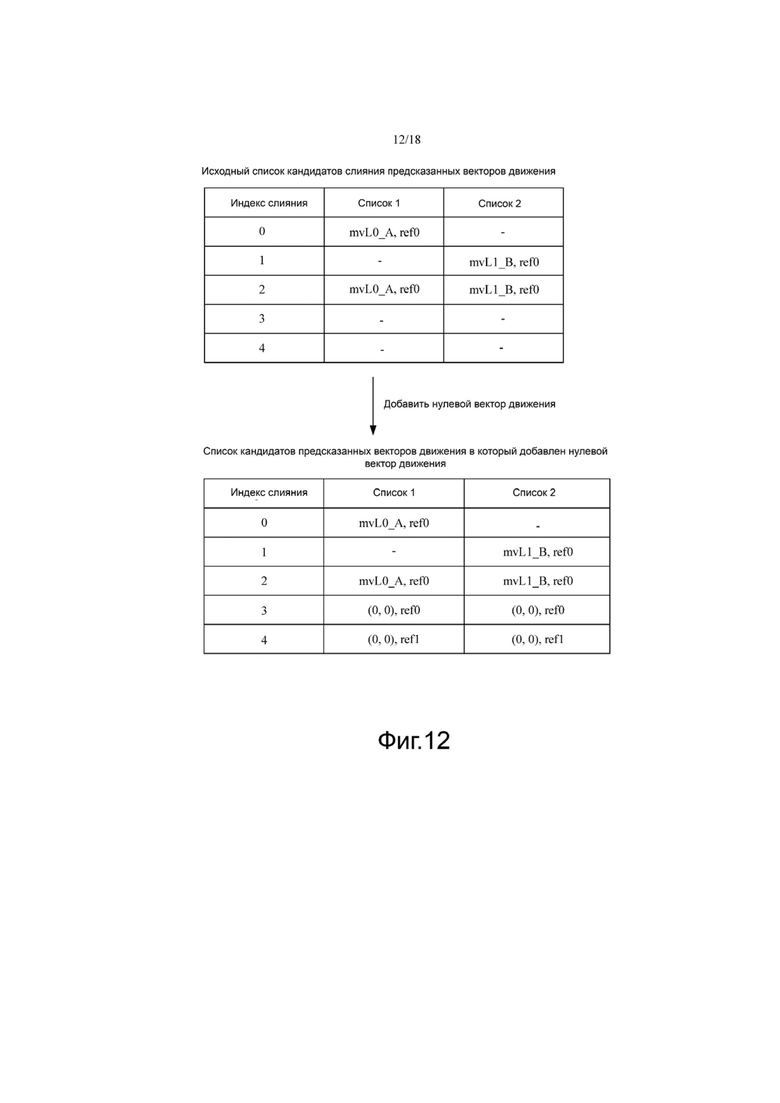

фиг. 12 является схемой примерной реализации добавления нулевого вектора движения к списку кандидатов предсказанного вектора движения в режиме слияния;

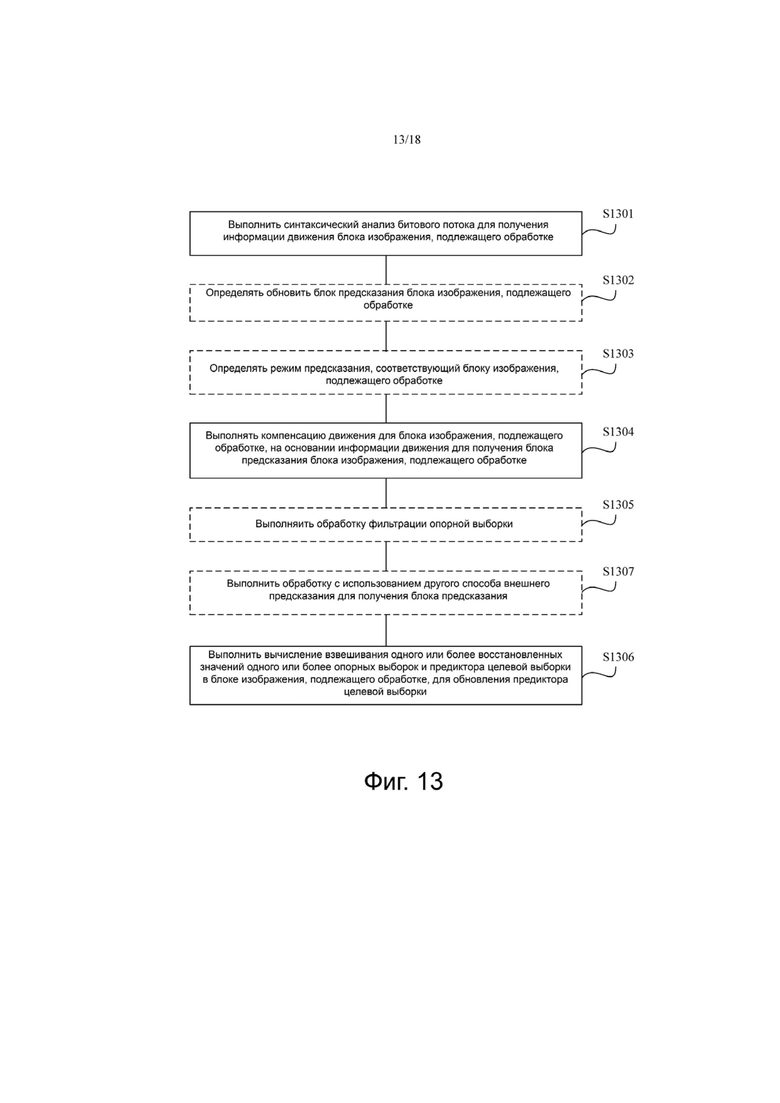

фиг. 13 является блок-схемой алгоритма способа внешнего предсказания согласно варианту осуществления настоящего изобретения;

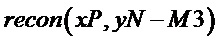

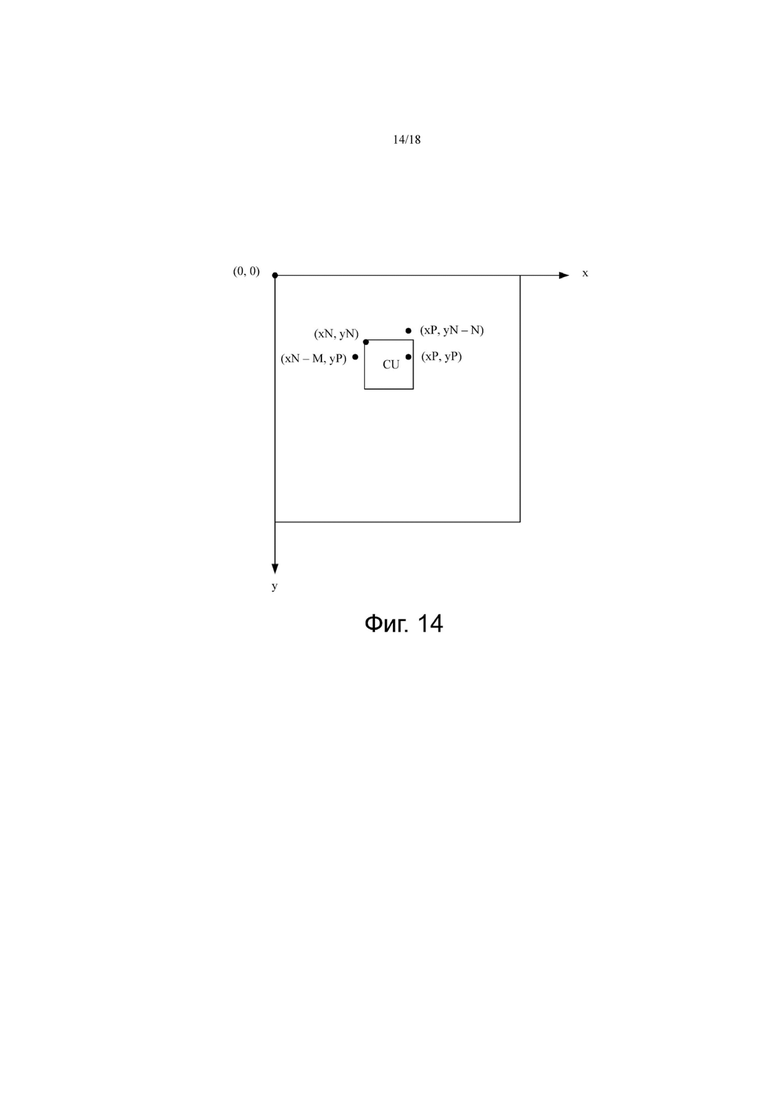

фиг. 14 является схемой 1 применения способа внешнего предсказания согласно варианту осуществления настоящего изобретения;

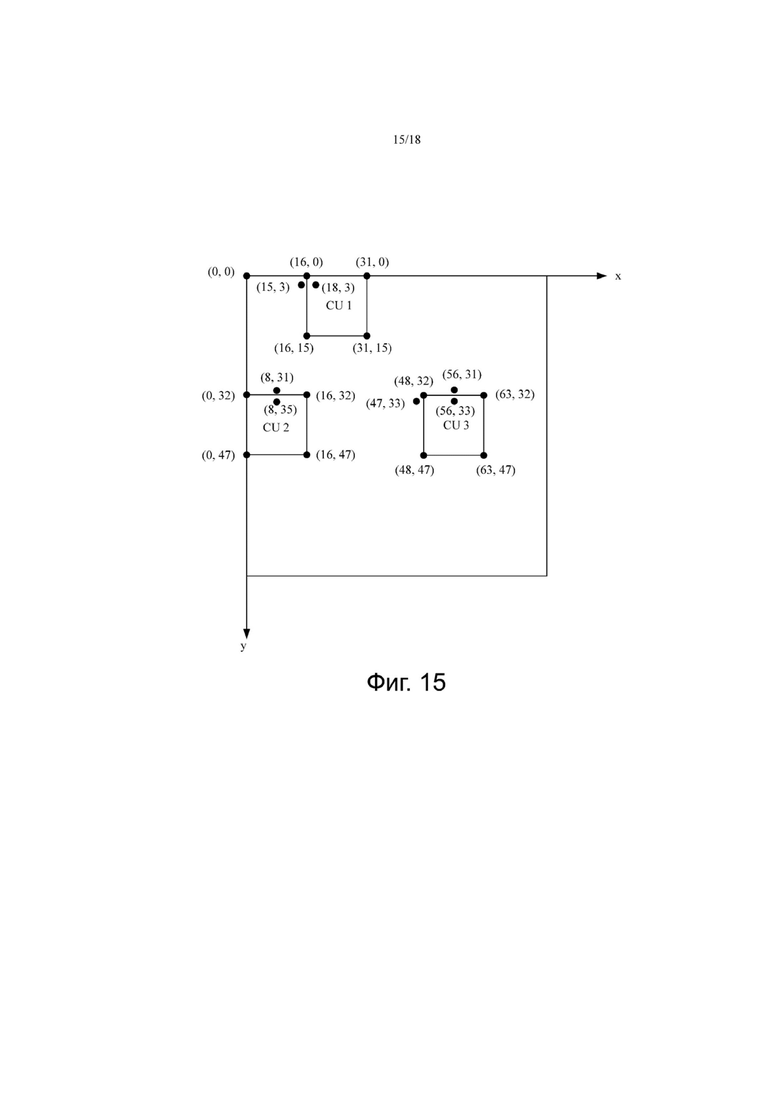

фиг. 15 является схемой 2 применения способа внешнего предсказания согласно варианту осуществления настоящего изобретения;

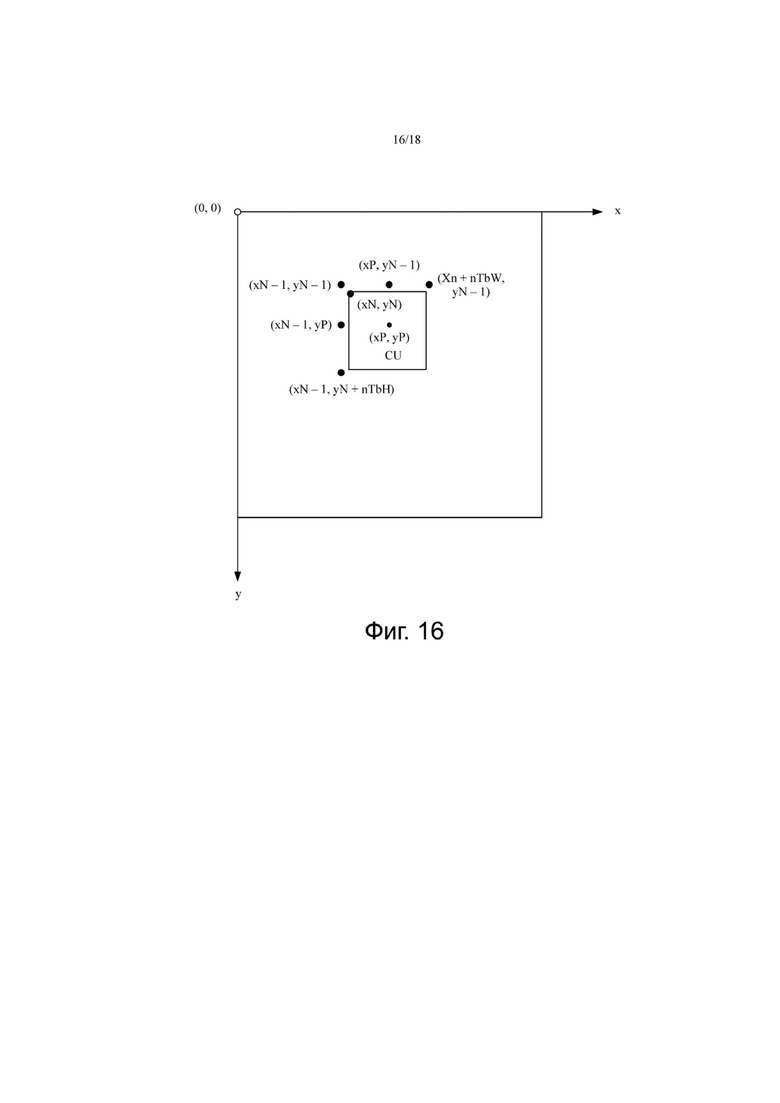

фиг. 16 является схемой 3 применения способа внешнего предсказания согласно варианту осуществления настоящего изобретения;

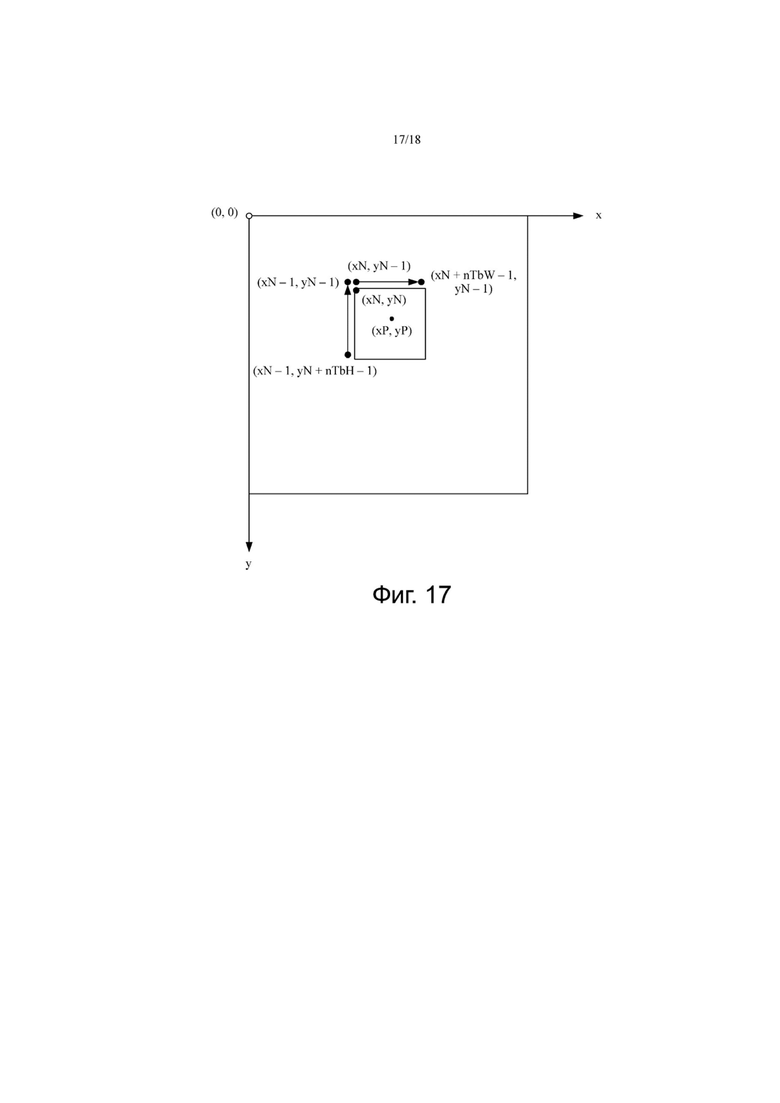

фиг. 17 является схемой 4 применения способа внешнего предсказания согласно варианту осуществления настоящего изобретения;

фиг. 18 является схемой устройства внешнего предсказания согласно варианту осуществления настоящего изобретения; и

фиг. 19 является схемой другого устройства внешнего предсказания согласно варианту осуществления настоящего изобретения.

Описание вариантов осуществления

Нижеследующее ясно и полностью описывает технические решения в вариантах осуществления настоящего изобретения со ссылкой на сопроводительные чертежи в вариантах осуществления настоящего изобретения.

Фиг. 1 является блок-схемой примера системы кодирования видео согласно варианту осуществления настоящего изобретения. Как описано здесь, термин «видеокодер» обычно относится как к видеокодеру, так и к видеодекодеру. В настоящем изобретении термин «кодирование видео» или «кодирование» обычно может относиться к кодированию видео или декодированию видео. Видеокодер 100 и видеодекодер 200 в системе кодирования видео выполнены с возможностью предсказывать информацию движения, например, вектор движения, текущего кодированного блока изображения или подблока текущего кодированного блока изображения согласно различным примерам способа, описанным на основании любого из множества новых режимов внешнего предсказания, предоставленных в настоящем изобретении, так что предсказанный вектор движения в наибольшей степени приближается к вектору движения, полученному с помощью способа оценки движения, и нет необходимости передавать разность векторов движения во время кодирования. Кроме того, это повышает производительность кодирования.

Как показано на фиг. 1, система кодирования видео включает в себя устройство 10 источника и устройство 20 назначения. Устройство 10 источника генерирует кодированные видеоданные. Следовательно, устройство 10 источника может называться устройством кодирования видео. Устройство 20 назначения может декодировать кодированные видеоданные, генерируемые устройством 10 источника. Следовательно, устройство 20 назначения может называться устройством декодирования видео. В различных решениях реализации устройство 10 источника, устройство 20 назначения или как устройство 10 источника, так и устройство 20 назначения могут включать в себя один или несколько процессоров и память, соединенную с одним или несколькими процессорами. Память может включать в себя, но не ограничивается, RAM, ROM, EEPROM, флэш-память или любой другой носитель, который может использоваться для хранения необходимого программного кода в форме инструкции или структуры данных и к которому можно получить доступ с помощью компьютера, как описано в этой спецификации.

Устройство 10 источника и устройство 20 назначения могут включать в себя различные устройства, включающие в себя настольный компьютер, мобильное вычислительное устройство, портативный компьютер (например, портативный компьютер), планшетный компьютер, телеприставку, портативный телефонный аппарат. такой как «умный» телефон, телевизор, фотоаппарат, устройство отображения, цифровой медиаплеер, игровая приставка, бортовой компьютер и т.п.

Устройство 20 назначения может принимать кодированные видеоданные от устройства 10 источника по линии 30 связи. Линия 30 связи может включать в себя один или несколько носителей или устройств, которые могут передавать кодированные видеоданные от устройства 10 источника в устройство назначения 20. В одном примере линия 30 связи может включать в себя одну или несколько сред передачи данных, которые позволяют устройству 10 источника напрямую передавать кодированные видеоданные в устройство 20 назначения в реальном времени. В этом примере устройство 10 источника может модулировать закодированные видеоданные в соответствии со стандартом связи (например, протоколом беспроводной связи) и может передавать модулированные видеоданные в устройство 20 назначения. Одна или несколько сред связи могут включать в себя беспроводная и/или проводная среда связи, например, радиочастотный (radio frequency, RF) спектр или одну или несколько физических линий передачи. Одна или несколько сред связи могут составлять часть сети с пакетной передачей данных, и сеть с пакетной передачей данных представляет собой, например, локальную сеть, региональную сеть или глобальную сеть (например, интернет). Одна или несколько сред связи могут включать в себя маршрутизатор, коммутатор, базовую станцию или другое устройство, обеспечивающее связь от устройства 10 источника к устройству 20 назначения.

В другом примере, закодированные данные могут быть выведены в устройство 40 хранения через интерфейс 140 вывода. Аналогичным образом, к кодированным данным можно получить доступ из устройства 40 хранения через интерфейс 240 ввода. Устройство 40 хранения может включать в себя любой один из множества распределенных носителей для хранения данных или локально доступных носителей для хранения данных, например, жесткий диск, диск Blu-ray, цифровой видеодиск (digital video disc, DVD), компакт-диск, постоянное запоминающее устройство (compact disk read-only memory, CD-ROM), флэш-памятью, энергозависимой или энергонезависимой памятью или любым другим подходящим цифровым запоминающим устройством, выполненным с возможностью хранить кодированные видеоданные.

В другом примере устройство 40 хранения может соответствовать файловому серверу или другому промежуточному устройству хранения, выполненному с возможностью хранить кодированное видео, сгенерированное устройством 10 источника. Устройство 20 назначения может осуществлять доступ к сохраненным видеоданным из устройства 40 хранения посредством потоковой передачи или загрузки. Файловый сервер может быть сервером любого типа, который может хранить закодированные видеоданные и передавать закодированные видеоданные в устройство 20 назначения. В одном примере файловый сервер включает в себя сетевой сервер (например, используемый для веб-сайта), протокол передачи файлов (file transfer protocol, FTP), устройство сетевого хранилища (network-attached storage, NAS) или локальный диск. Устройство 20 назначения может получить доступ к закодированным видеоданным через любое стандартное соединение для передачи данных (включающее в себя соединение с интернетом). Стандартное соединение для передачи данных может включать в себя беспроводной канал (например, соединение достоверностью беспроводной связи (wireless-fidelity, Wi-Fi)), проводное соединение (например, цифровую абонентскую линию (digital subscriber line, DSL) или кабельному модему) или комбинацию беспроводного канала и проводного соединения, где комбинация подходит для доступа к кодированным видеоданным, хранящимся на файловом сервере. Кодированные видеоданные могут передаваться из устройства 40 хранения посредством потоковой передачи, загрузки с загрузкой или их комбинации.

Технология предсказания вектора движения в настоящем изобретении применима к кодированию видео для поддержки множества мультимедийных приложений, например, эфирного телевещания, передачи кабельного телевидения, передачи спутникового телевидения, передачи потокового видео (например, через интернет), кодирование видеоданных, хранящихся на носителе данных, декодирование видеоданных, хранящихся на носителе данных, или другое приложение. В некоторых примерах система кодирования видео может быть выполнена с возможностью поддерживать однонаправленную или двунаправленную передачи видео для поддержки таких приложений, как потоковая передача видео, воспроизведение видео, широковещательная передача видео и/или видеотелефония.

Система кодирования видео, описанная на фиг. 1, является просто примером, и технология настоящего изобретения применимы к настройкам кодирования видео (например, кодирование видео или декодирование видео), которые не обязательно включают в себя обмен данными между устройством кодирования и устройством декодирования. В другом примере данные извлекаются из локальной памяти, передаются в потоковом режиме по сети и т.п. Устройство кодирования видео может кодировать данные и сохранять данные в памяти, и/или устройство декодирования видео может извлекать данные из памяти и декодировать данные. Во многих примерах кодирование и декодирование выполняются устройствами, которые не обмениваются данными друг с другом, и просто кодируют данные и сохраняют данные в памяти и/или извлекают данные из памяти и декодируют данные.

В примере на фиг. 1, устройство 10 источника включает в себя источник 120 видео, видеокодер 100 и интерфейс 140 вывода. В некоторых примерах интерфейс 140 вывода может включать в себя модулятор/демодулятор (модем) и/или передатчик. Источник 120 видео может включать в себя устройство захвата видео (например, видеокамеру), видеоархив, включающий в себя ранее захваченные видеоданные, интерфейс подачи видео для приема видеоданных от поставщика видеоконтента и/или компьютерную графическую систему для генерирования видеоданных или комбинаций вышеупомянутых источников видеоданных.

Видеокодер 100 может кодировать видеоданные из источника 120 видео. В некоторых примерах устройство 10 источника напрямую передает закодированные видеоданные в устройство 20 назначения через интерфейс 140 вывода. В других примерах кодированные видеоданные могут быть дополнительно сохранены в устройстве 40 хранения, так что устройство 20 назначения впоследствии получает доступ к кодированным видеоданным для декодирования и/или воспроизведения.

В примере на фиг. 1, устройство 20 назначения включает в себя интерфейс 240 ввода, видеодекодер 200 и устройство 220 отображения. В некоторых примерах интерфейс 240 ввода включает в себя приемник и/или модем. Интерфейс 240 ввода может принимать закодированные видеоданные по линии 30 связи и/или от устройства 40 хранения. Устройство 220 отображения может быть интегрировано с устройством 20 назначения или может быть расположено вне устройства 20 назначения. Как правило, устройство 220 отображения отображает декодированные видеоданные. Устройство 220 отображения может включать в себя множество типов устройств отображения, например, жидкокристаллический дисплей (liquid crystal display, LCD), плазменный дисплей, дисплей на органических светодиодах (organic light-emitting diode, OLED), или другой тип устройства отображения.

В некоторых аспектах, хотя это не показано на фиг. 1, видеокодер 100 и видеодекодер 200 могут быть интегрированы с аудиокодером и аудиодекодером соответственно и могут включать в себя соответствующий блок мультиплексора-демультиплексора или другое аппаратное и программное обеспечение для кодирования как звука, так и видео в одном и том же потоке данных или отдельных потоках данных. В некоторых примерах, если применимо, блок демультиплексора (MUX-DEMUX) может соответствовать протоколу мультиплексора H.223 международного союза электросвязи (International Telecommunication Union, ITU) или другому протоколу, например, протоколу дейтаграмм пользователя (user datagram protocol, UDP).

Видеокодер 100 и видеодекодер 200 каждый может быть реализован в виде любой из множества схем, например, одного или нескольких микропроцессоров, процессоров цифровых сигналов (digital signal processor, DSP), специализированной интегральной схемой (application-specific integrated circuit, ASIC), программируемые пользователем вентильные матрицы (field programmable gate array, FPGA), дискретная логика, аппаратное обеспечение или любая их комбинация. Если настоящее изобретение реализовано частично с использованием программного обеспечения, устройство может хранить инструкцию для программного обеспечения на соответствующем постоянном машиночитаемом носителе данных и может использовать один или несколько процессоров для выполнения инструкции в аппаратном обеспечении для реализации технологии в настоящем изобретении. Любое из вышеупомянутого (включающее в себя оборудование, программное обеспечение, комбинацию аппаратного и программного обеспечения и т.п.) может рассматриваться как один или несколько процессоров. Видеокодер 100 и видеодекодер 200 каждый может быть использован в одном или нескольких кодеров или декодеров. Кодер или декодер могут быть интегрированы как часть комбинированного кодера/декодера (кодека) в соответствующее устройство.

В настоящем изобретении видеокодер 100 может, в целом, называться устройством, которое «сигнализирует» или «отправляет» некоторую информацию на другое устройство, такое как видеодекодер 200. Термин «сигнализация» или «отправка» может обычно относиться к передаче элемента синтаксиса и/или других данных, используемых для декодирования сжатых видеоданных. Передача может осуществляться в реальном времени или почти в реальном времени. В качестве альтернативы связь может выполняться по истечении определенного периода времени, например, когда элемент синтаксиса в закодированном битовой потоке сохраняется на машиночитаемом носителе данных во время кодирования. Затем устройство декодирования может извлекать элемент синтаксиса в любое время после того, как элемент синтаксиса, сохраненный на носителе.

JCT-VC разработал стандарт высокоэффективного видеокодирования H.265 (high efficiency video coding, HEVC). Стандартизация HEVC основана на развитой модели устройства декодирования видео, где модель называется тестовой моделью HEVC (HEVC model, HM). Последний стандартный документ H.265 доступен по адресу http://www.itu.int/rec/T-REC-H.265. Последней версией стандартного документа является H.265 (12/16), и стандартный документ полностью включен в настоящее описание посредством ссылки. В HM предполагается, что устройство декодирования видео имеет несколько дополнительных возможностей по сравнению с существующим алгоритмом в ITU-TH.264/AVC. Например, H.264 обеспечивает девять режимов кодирования с внутренним предсказанием, тогда как HM может обеспечивать до 35 режимов кодирования с внутренним предсказанием.

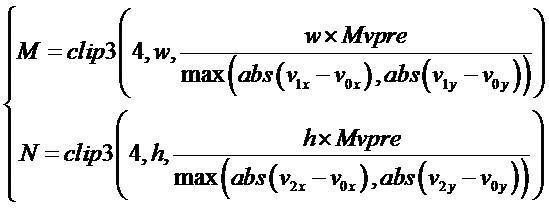

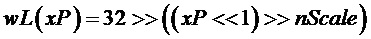

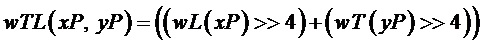

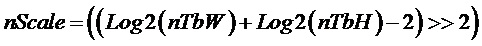

JVET разрабатывает стандарт H.266. Процесс стандартизации H.266 основан на усовершенствованной модели устройства декодирования видео, где модель упоминается как тестовая модель H.266. Описания алгоритмов H.266 доступны на http://phenix.int-evry.fr/jvet, и последние описания алгоритмов содержаться в JVET-F1001-v2. Документ с описанием алгоритма полностью включен в настоящий документ посредством ссылки. Кроме того, справочное программное обеспечение для тестовой модели JEM доступно по адресу https://jvet.hhi.fraunhofer.de/svn/svn_HMJEMSoftware/, и оно также полностью включено в настоящий документ посредством ссылки.