Заявляемое изобретение относится к технологии обработки видео, а более конкретно - к устройствам и способам для автоматического извлечения ключевых кадров из видео для дополнения видео с помощью оператора такой информацией, как назначение глубины для последующего преобразования монокулярной видео последовательности в стерео последовательность или для назначения цветовой информации для последующего преобразования черно-белой видео последовательности в цветную видео последовательность.

В последние годы разные производители активно разрабатывали стереоскопические устройства отображения (дисплеи), способные воспроизводить стерео изображения. Для получения ощущения трехмерности (стерео), требуется применение видео последовательности в особом формате. Этот формат включает видео, записанное с разных ракурсов, отдельно для левого и правого глаза. Для формирования изображений с различных ракурсов применяют большое число способов. Например, может использоваться съемка несколькими камерами, или видео на основе трехмерной модели.

Большинство видео изображений, полученных в эпоху синематографа, предназначены для обычных монодисплеев. Чтобы получить ощущение трехмерности на основе старых кинопленок, необходимо преобразовать эти видео изображения в стереоскопическое видео. Это достигается за счет назначения карты глубины для каждого видео кадра, и получения левого и правого ракурсов на основе использования видео кадров и карты глубины.

Системы для преобразования видео могут быть или полностью автоматическими, действующими без вмешательства оператора, или полуавтоматическими, где преобразование выполняется с участием оператора. В последнем варианте, оператор, как правило, выбирает ключевые кадры видео последовательности и вручную назначает (рисует) карты глубины, в ряде случаев используя некоторые специальные вспомогательные способы (см., например, патентную заявку США 2002/0048395)[1]. Такие карты глубины распространяют на остальные части видео кадров (такими, например, способами, как в американских патентных заявках 2010/0194856 [2] и 2009/0116732 [3]). Полуавтоматические системы обеспечивают намного более высокое качество, чем полностью автоматизированные системы.

В последние годы многие старые черно-белые кинофильмы были преобразованы в цветные. В настоящее время потребителю хочется более полных ощущений от просмотра кинофильма, в том числе получения полноценной цветовой видео информации. Однако большое число кино шедевров записывались на черно-белой пленке, в связи с чем была утрачена цветовая информация. Восстановление такого драгоценного наследия в цвете является утомительной и дорогостоящей процедурой. Обычно пленку обрабатывают следующим образом: одному из кадров (ключевому кадру) в видео последовательности добавляют (назначают) информацию, касающуюся цвета (раскрашивание), и эту информацию далее распространяют на соседние кадры, как это описано, например, в патенте США 4755870 [4]. В этом изобретении, однако, такие ключевые кадры выбираются вручную.

Способ выбора ключевых кадров играет важную роль в конвертации видео последовательностей.

В американской патентной заявке 2011/0110649 [5] ключевые кадры выбираются автоматически, но они скорее предназначены для видео резюмирования, то есть для выбора наиболее визуально представительных видео кадров. В американском патенте 7046731 [6] ключевые кадры выбирают автоматически на основе определения направления глобального движения и кластеризации глобального движения, но этот способ выбора ключевых кадров предназначен для эффективного представления и резюмирования видео. В американской патентной заявке 2007/0263128 [7] представлены методики, которые позволяют осуществлять адаптивный процесс извлечения ключевых кадров из видео. Процесс выбора включает оценку качества кадров для отбора кадров с наивысшим качеством на роль ключевых кадров. Ключевые кадры выбираются на основе значений энтропии, четкости и контрастности кадров. Однако в этом подходе рассматривается кадр в целом, т. е. не принимаются во внимание объекты в кадре. В американском патенте 7843512 [8] определяют скорость изменения содержимого кадра (по сравнению со смежным видео кадром), и выбирают видео кадр в качестве ключевого видео кадра, если скорость превышает некое пороговое значение. В американской патентной заявке [3] ключевые кадры выбираются автоматически на основе анализа поля движения объектов. В американском патенте 7158676 [9] ключевые кадры и объекты, представляющих интерес, выбираются вручную. Данные интерактивного содержимого встраиваются вместе с объектом, и объект отслеживается через всю последовательность кадров, и данные интерактивного содержимого встраиваются в каждый из кадров. В целом, современные технологии для выбора ключевых кадров предназначены для визуального резюмирования видео последовательностей, для лучшего визуального понимания.

Американский патент [9] и американскую патентную заявку [3] можно рассматривать в качестве прототипов.

Заявляемый способ предназначен для решения конкретной задачи преобразования видео из монокулярного в стереоскопическое и из черно-белого - в цветное в полуавтоматическом режиме. Заявляемый способ учитывает конкретные характеристики видео последовательностей, такие, как данные о главных персонажах (ключевых кадрах) видеопоследовательности. Это позволяет добиться более целенаправленного выбора видео кадров.

Технический результат достигается за счет разработки усовершенствованного способа выделения ключевого кадра в процессе полуавтоматического дополнения видео последовательности информацией о глубине или цвете, причем заявленный способ предусматривает выполнение следующих операций:

• выявляют смены сцены во входной видео последовательности и осуществляют разбиение видео последовательности на сцены;

• для каждой сцены на модуль анализа видеоданных подают данные об инициализации объектов, выявляют действия каждого объекта и данные GM (глобального движения) на всех кадрах сцены и записывают в накопителе результаты видеоанализа;

• после обработки всех кадров видео сцены с помощью модуля анализа видеоданных сначала анализируют сохраненные данные о деятельности каждого объекта, извлекают ключевые кадры объекта, затем анализируют данные GM и ключевые кадры объекта, извлекают и выводят ключевые кадры; после чего накопитель результатов видеоанализа очищают и загружают модуль анализа видеоданных следующей сценой входной видео последовательности.

Как правило, ключевые кадры выбирают для резюмирования видео визуальной информации. Новизна заявляемого изобретения подтверждается следующими отличительными признаками:

• ключевые кадры выбирают на основе вводимой пользователем информации о содержимом сцены;

• каждый ключевой объект выбирают на одном или нескольких кадрах;

• каждый ключевой объект отслеживают во всех кадрах в вырезанной сцене;

• оценивают качество участков кадра, содержащих ключевой объект;

• анализируют траекторию движения каждого ключевого объекта;

• выбирают ключевые кадры на основе анализа участков кадров и/или точек качества траектории.

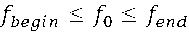

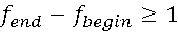

В заявляемом способе данные для инициализации объекта включают в себя координаты RBB, а именно координаты {x, y} левого верхнего угла, ширина и высота, кадр для этого RBB f

0 и два кадра f

begin и f

end для отслеживания промежутка RBB между ними таким образом, что  и

и  .

.

В заявляемом способе для выявления действий объекта RBB объекта отслеживают по всем кадрам в видео сцене, а именно, определяют координаты RBB в видео кадре таким образом, чтобы сравнение областей видео кадров, содержащихся внутри RBB, на текущем и на следующем кадре, давало максимальное значение в терминах предопределенных метрик, и вычисляют параметры объекта, представляющие собой особенности изображения области видео кадра, содержащейся внутри RBB.

В заявляемом способе дополнительные ключевые кадры выбирают в промежутке между ключевыми кадрами объектов, основываясь на анализе данных глобального движения (GM).

В заявляемом способе отслеживают RBB из кадра f 0 инициализации объекта вперед, из кадра f 0 до кадра f end , после чего в обратном направлении, из кадра f 0 до кадра f begin , для получения отслеженных координат RBB.

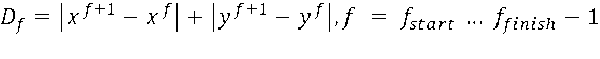

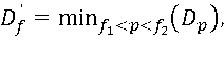

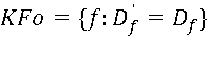

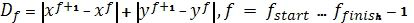

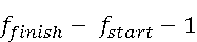

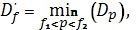

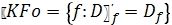

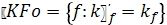

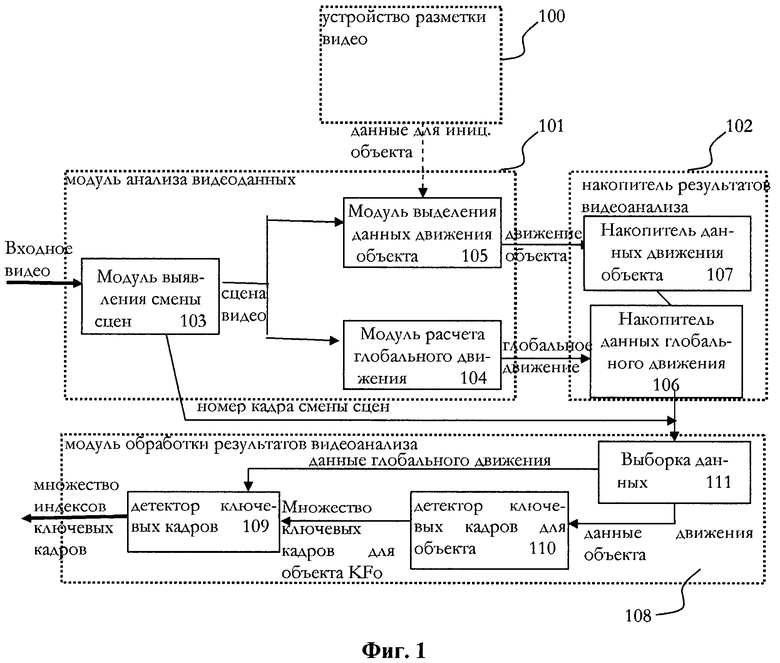

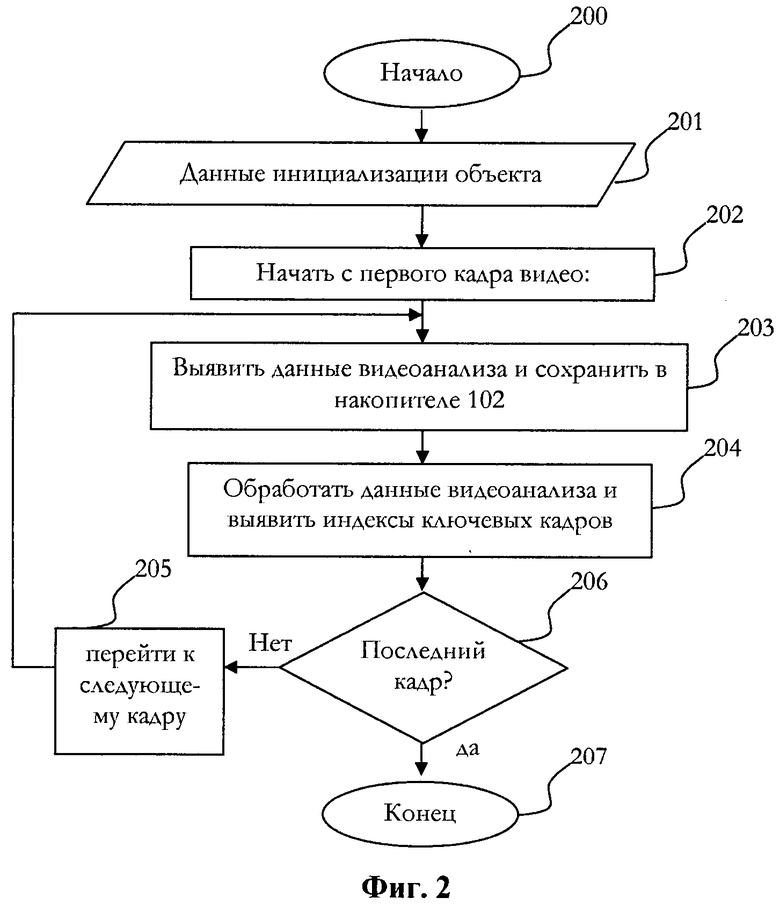

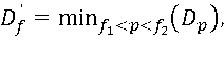

В заявляемом способе в модуле обработки результатов видеоанализа сравнивают аккумулированные координаты RBB и параметры объекта и выводят ряд ключевых кадров KFo:

,

,

где f start и f finish - последовательные кадры сцены, для которой вычисляют данные о действиях объекта,

где ƒ1 = max(ƒ-T, ƒstart), ƒ2 = min (ƒ+T, ƒfinish), T - предопределенный порог,

.

.

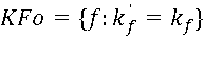

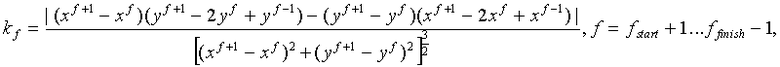

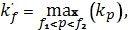

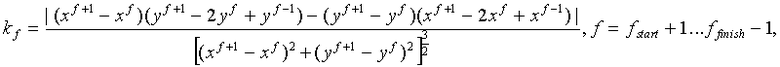

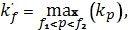

В заявляемом способе в модуле обработки результатов видеоанализа анализируют кривизну траектории объекта  в видео кадрах и получают на выходе ряд ключевых кадров KFo

в видео кадрах и получают на выходе ряд ключевых кадров KFo

где

ƒ1 = max(ƒ-T, ƒstart+1), ƒ2 = min(ƒ+T, ƒfinish-1), T - предопределенный порог,  .

.

В заявляемом способе параметры объектов включают оценку резкости и контрастности.

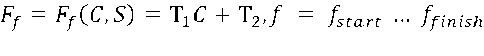

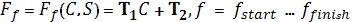

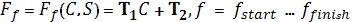

В заявляемом способе анализируют параметры объекта, такие как контраст C и резкость S, вычисляют функции F и F' C, и S, а T1 и T2 являются предопределенными реальными значениями:

,

,

где ƒ1 = max(ƒ-T, ƒstart+1), ƒ2 = min(ƒ+T, ƒfinish-1), T - предопределенный порог

.

.

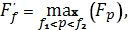

Кроме того, в заявленном изобретении предлагается система для реализации способа выделения ключевых кадров в процессе полуавтоматического дополнения видео последовательности информацией о глубине или цвете, отличающаяся тем, что состоит из трех основных частей:

модуля анализа видеоданных, выполненного с возможностью извлечения данных из входного видео потока и получения множества инициализационных данных для ключевых объектов в видео через устройство разметки видео;

накопителя результатов видеоанализа, выполненного с возможностью запоминания аккумулированных данных видеоанализа, обнаруженных модулем анализа;

и модуля обработки результатов видеоанализа, выполненного с возможностью проведения анализа аккумулированных данных.

В заявляемой системе модуль анализа видеоданных выполнен с возможностью получения множества координат прямоугольных рамок (RBB), индексов кадра и числа кадров, через устройство разметки видео.

В заявляемой системе модуль анализа видеоданных включает детектор смены кадров, детектор данных глобального движения, детектор действий объекта.

В заявляемой системе накопитель результатов видеоанализа состоит из аккумулятора данных о действиях объекта, запоминающего аккумулированные данные о действиях объекта, и аккумулятора данных глобального движения, запоминающего параметры, описывающие относительное смещение статичных объектов в двух последовательных видео кадрах.

В заявляемой системе модуль обработки результатов видеоанализа включает в себя выделитель данных, детектор ключевых кадров объекта и детектор ключевых кадров.

Для лучшего понимания сущности заявляемого изобретения ниже приводится подробное описание с чертежами.

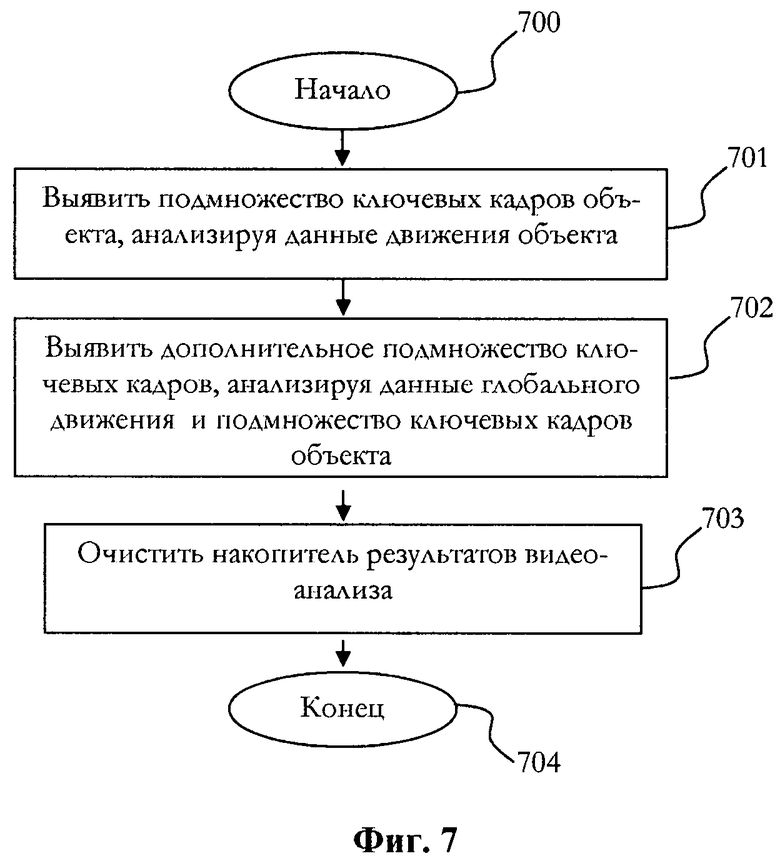

Фиг. 1. Описывает основные части системы, с помощью которой реализуется способ для выделения ключевых кадров.

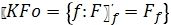

Фиг. 2. Иллюстрирует основные шаги видео анализа для выбора ключевых кадров.

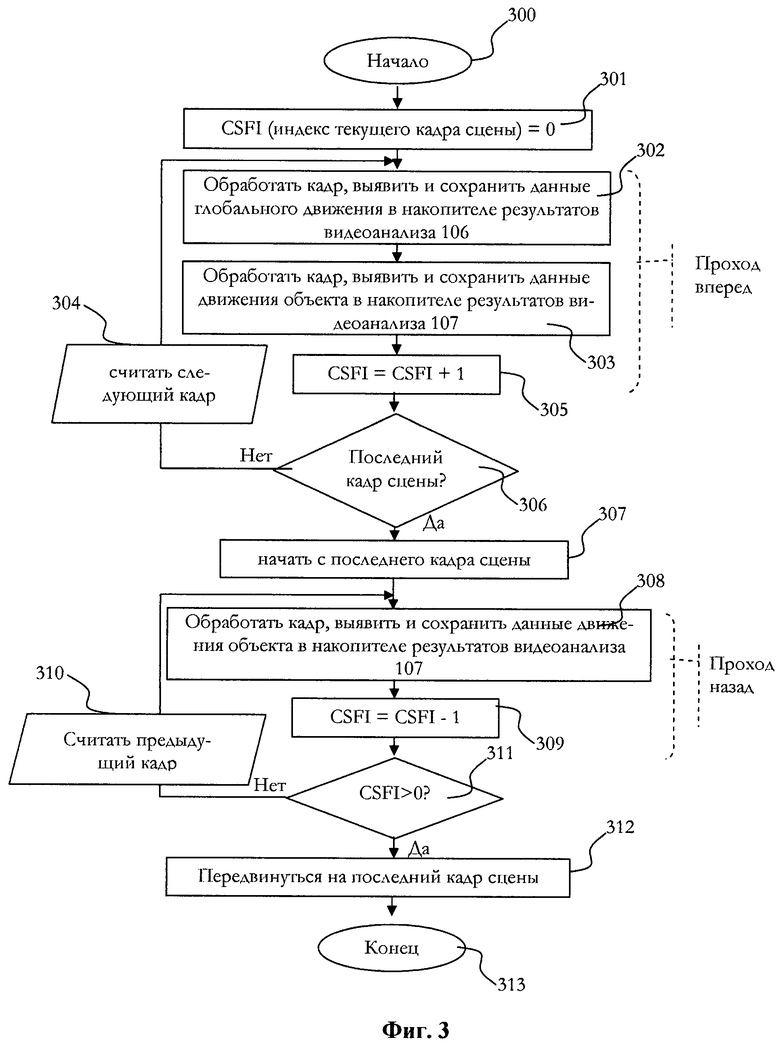

Фиг. 3. Объясняет в подробностях этап 203, касающийся обнаружения данных видео анализа в видео сцене.

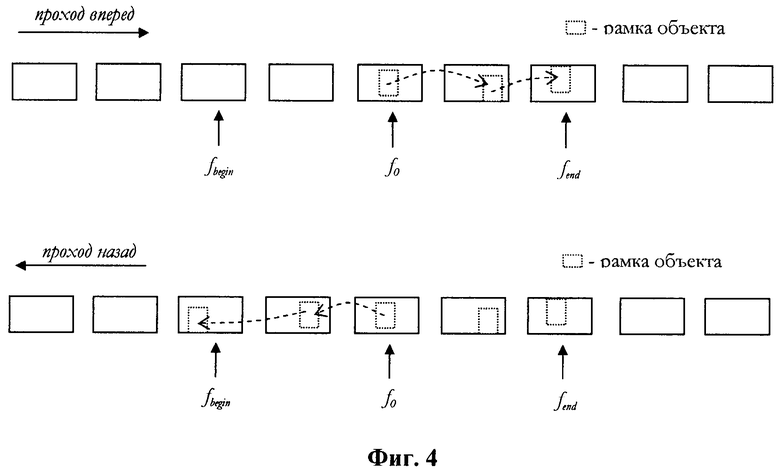

Фиг. 4. Иллюстрирует процесс выполнения анализа видео последовательности.

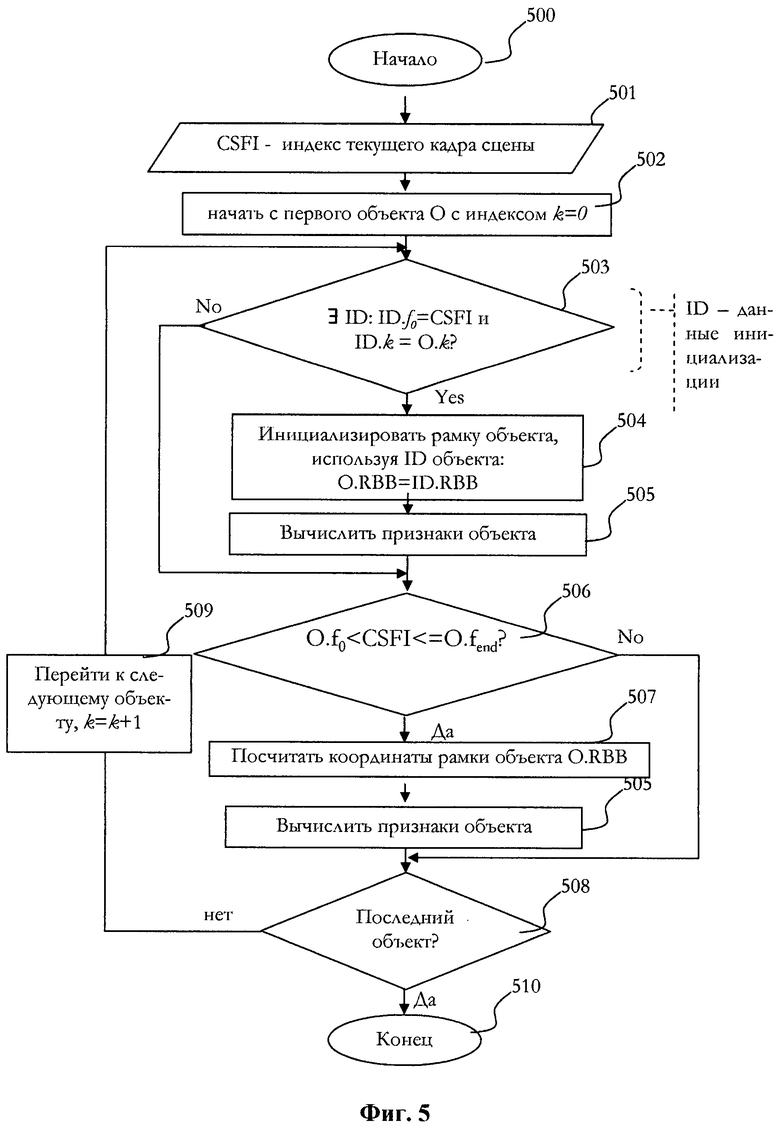

Фиг. 5. Объясняет в подробностях этап 303, касающийся обработки конкретного видео кадра и извлечения данных о действиях объекта во время прохождения через видео кадр «вперед».

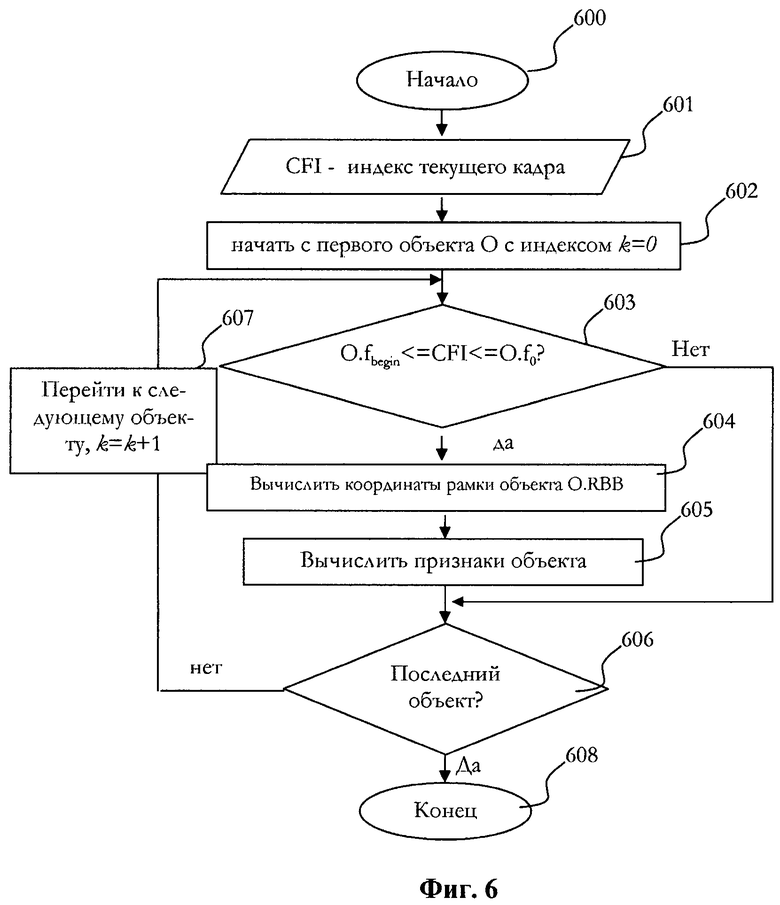

Фиг. 6. Объясняет в подробностях этап 308, касающийся обработки конкретного видео кадра и извлечения данных о действиях объекта во время прохода через видео кадр «назад».

Фиг. 7. Объясняет в подробностях этап 204, касающийся обработки данных видео анализа, извлечения ключевых кадров и очистки накопителя.

Система, реализующая способ для выделения ключевых кадров в процессе дополнения монокулярного видео глубиной (преобразование из 2D в 3D) или черно-белого видео цветом состоит из трех основных частей: модуль анализа видеоданных, который извлекает данные из входного видео потока и который может получить множество данных для инициализации для ключевых объектов в видео через устройство разметки видео; накопитель результатов видеоанализа, который запоминает аккумулированные данные видеоанализа, обнаруженные модулем анализа; и модуль обработки результатов видеоанализа, который выполняет анализ аккумулированных данных.

Модуль анализа видеоданных может получать множество координат прямоугольных рамок (RBB) и кадров от устройства разметки видео. Накопитель результатов видеоанализа сохраняет данные о деятельности объекта в аккумуляторе данных о деятельности объекта, сохраняет данные глобального движения (GM данные) (параметры, описывающие относительное смещение неподвижных объектов в двух последовательных видео кадрах) в аккумуляторе данных глобального движения. Модуль обработки результатов видеоанализа анализирует аккумулированные данные и выделяет ключевые кадры для дальнейшего дополнения видео с помощью оператора.

Способ выделения ключевых кадров в процессе полуавтоматического дополнения видео включает следующие шаги:

получают данные для инициализации объектов каждого ключевого объекта в каждом кадре;

выявляют смены сцен во входной видео последовательности и разбивают видео последовательность на сцены;

для каждой сцены выявляют данные о деятельности каждого объекта посредством модуля анализа видеоданных и данных GM по всем кадрам сцены и сохраняют эти данные в накопителе результатов видеоанализа;

после обработки видео сцены, сначала анализируют сохраненные данные о деятельности каждого объекта, выделяют ключевые кадры, затем анализируют данные GM и ключевых кадров объекта, и извлекают и выводят ключевые кадры посредством модуля анализа видеоданных; после чего очищают накопитель результатов видеоанализа и переходят к следующей сцене входной видео последовательности до достижения конца видео последовательности.

Фиг. 1 показывает схему функционирования основных компонентов системы, которая осуществляет заявляемый способ. Входное видео обрабатывается Модулем 101 анализа видеоданных, который получает данные для инициализации каждого объекта, который необходимо принять во внимание.

Данные для инициализации (идентификатор) конкретного объекта k даны для одного или нескольких видео кадров как {k, RBB, ƒ0, ƒbegin, ƒend}, где:

k - индекс объекта,

RBB - прямоугольная рамка, отмечающая позицию объекта в видео кадре,

ƒ0 - кадр, в котором объект отмечен,

ƒbegin - кадр, от которого начинают вычислять данные о действиях объекта (отслеживание объекта),

ƒend - кадр, на котором заканчивают вычисление данных о действиях объекта (отслеживание объекта).

Такая информация предоставляется оператором вместе с видео последовательностью посредством устройства 100 разметки видео, который может включать, по меньшей мере, устройство отображения (дисплей) и манипулятор, такой как компьютерная мышь. Число объектов оставляют на усмотрение оператора. Модуль 101 анализа видеоданных в процессе обработки видео последовательности дает на выходе данные видеоанализа, такие как действия объекта и данные о глобальном движении (GM). Данные GM включают параметры, описывающие относительное смещение неподвижных (статичных) объектов в двух последовательных видео кадрах. Данные видео анализа аккумулируются в накопителе 102 результатов видеоанализа. Когда модуль 101 анализа видеоданных обнаруживает смену сцены, модуль 108 обработки результатов видеоанализа выделяет и анализирует аккумулированные данные и дает на выходе выявленные ключевые кадры. Модуль 101 анализа видеоданных включает детектор 103 смены кадров, детектор 104 данных GM и детектор 105 действий объекта. Накопитель 102 результатов видеоанализа сохраняет данные о действиях объекта в аккумуляторе 107 данных о действиях объекта и данные GM в аккумуляторе 106 данных глобального движения. Модуль 108 обработки результатов видеоанализа включает в себя выделитель 111 данных, детектор 110 ключевых кадров объекта и детектор 109 ключевых кадров.

Все компоненты данной системы могут быть изготовлены путем применения современных систем проектирования электрических цепей, дополненных исполняемыми программами.

Фиг. 2 описывает основные шаги заявляемого способа. На шаге 201 данные для инициализации вводят для всех объектов. Видео обработка начинается с анализа видео сцена за сценой начиная с первого кадра 202. В каждой видео сцене выявляют данные видеоанализа и заносят их в накопитель результатов видеоанализа, шаг 203. После завершения анализа сцены данные видеоанализа обрабатываются, выделяются ключевые кадры и накопитель результатов видеоанализа очищается, шаг 204. Затем, проверяют выполнение условия 206, в случае если последний обработанный кадр не был последним кадром видео последовательности, процесс переходит к следующему видео кадру, шаг 205. В ином случае обработка продолжается до завершения на шаге 207.

Фиг. 3 объясняет в подробностях процесс обнаружения данных видеоанализа во время обработки сцены, шаг 203. Начиная с первого кадра сцены (CSFI, т. е. кадр текущей сцены, = 0), сцена обрабатывается кадр за кадром, шаг 301. Два прохода выполняют по сцене (см. также Фиг. 4). Сначала сцена обрабатывается в прямом направлении («вперед»), то есть с увеличением CSFI. После достижения конца сцены кадры обрабатываются в обратном порядке («назад»), то есть с CSFI. В каждом кадре извлекаются данные GM, шаг 302. Как было упомянуто выше, данные GM включают параметры, описывающие относительное смещение неподвижных (статичных) объектов в двух последовательных видео кадрах. Есть много способов, известных из уровня техники, для обнаружения такого смещения, например, в американском патенте 7312819 [10]. На шаге 303 данные о действиях объекта извлекают из видео кадра, подробности этого процесса объяснены ниже, на Фиг. 5. На шаге 305 CSFI увеличивается на 1. В случае если условие 306 не выполняется, процесс продолжается в отношении следующего кадра, шаг 304. Условие 306 проверяют с помощью детектора смены сцен, то есть сравнивая текущий кадр со следующим кадром. Есть много способов, известных из уровня техники, для выявления смены сцен, например, в американском патенте 7123769 [11]. В случае если обнаружена смена сцены, текущий кадр определяют как последний кадр сцены. Потом данная сцена анализируется в обратном направлении («назад») начиная с последнего кадра сцены, шаг 307. На шаге 308 извлекают данные о действиях объекта из видео кадра, подробности этого процесса объяснены ниже, на Фиг. 6. Затем CSFI уменьшают на 1, шаг 309. Когда достигается первый кадр сцены, CSFI = 0, то есть тот же самый кадр в видео, как на шаге 301, и обработка видео последовательности продолжается с последнего кадра сцены, как на шаге 307. В ином случае, если условие на шаге 311 не соблюдено, обрабатывают следующий кадр, шаг 310. На шаге 312 индекс текущего видео кадра устанавливается на последнем кадре сцены для того, чтобы начать обработку следующей сцены (шаги 205 и далее).

Фиг. 5 описывает процесс обнаружения данных о действиях объекта. Процесс выполняется в отношении конкретного кадра в сцене, с индексом CSFI, индексом кадра текущей сцены, шаг 501, для всех объектов начиная с объекта с индексом k=0, шаг 502. Данные о действиях объекта могут состоять из, но не ограничиваются, {k, {RBB f }|ƒ, ƒ0, ƒbegin, ƒend, {featuresƒ}}, где:

k - индекс объекта,

{RBBƒ} - множество прямоугольных рамок, отмечающих положение (позицию) объекта в видео кадре с индексом ƒ, 0 <ƒ <N, где N - индекс последнего кадра в сцене.

ƒ0 - кадр, в котором отмечен объект,

ƒbegin - кадр, с которого начинают вычисление данных о действиях объекта (отслеживание объекта),

ƒend - кадр, в котором завершают вычисление данных о действиях объекта (отслеживание объекта),

{featuresƒ} - набор параметров, связанных с кадром ƒ и RBBƒ, таких как особенности изображения, вычисленного для заплаты изображения, содержавшейся в соответствующей RBBƒ. Параметры изображения могут включать резкость, контраст, или тому подобные.

RBB = {x, y, w, h}, где {x, y} - координаты верхнего левого угла, w и h - ширина и высота соответственно.

На шаге 503 инициализационные данные (ID) анализируют на предмет того, присутствуют ли там данные с ƒ0, равным CSFI, и индексом объекта, равным k. В случае если эти данные присутствуют, объект инициализируют, то есть его RBB инициализируют на основе RBB данных для инициализации, шаг 504, и затем параметры объекта вычисляются, шаг 505 (будет объяснено ниже). В случае если условие 503 не выполняется, шаги 504 и 505 пропускают. На шаге 506 проверяют выполнение условия, находится ли кадр текущей сцены (CSFI) между ƒ0 объекта и ƒend объекта. В случае положительного результата на шаге 507 вычисляют координаты объекта RBB, используя координаты этого RBB на предыдущем кадре, CSFI-1. Есть много способов, известных из уровня техники, для вычисления таких координат, например, американские патенты 5099324 [12] и 7620204 [13]. На шаге 505 вычисляют параметры области изображения, содержащей объект, для оценки параметров объекта. На шаге 508 проверяют, имеются ли еще необработанные объекты. В случае если таких объектов больше нет, процесс завершают, шаг 510. В ином случае индекс k объекта увеличивают на 1 (шаг 509) и шаги 503 и последующие повторяют.

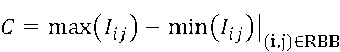

Следующие параметры вычисляют на шаге 505: контраст и резкость. Контраст вычисляют как разность между максимальными и минимальными значениями в области изображения, содержащейся в RBB:

Резкость S вычисляют, например, так, как это описано в статье Safonov, I. V.; Rychagov, М. N.; Kang, KiMin; Ким, Sang Ho; “Adaptive sharpening of photos”, Proceedings of the SPIE, Volume 6807, pp. 68070U-68070U-12 (2008) [14].

Фиг. 6 описывает в подробностях процесс выявления данных о действиях объекта во время обратного прохода («назад») через кадр, шаг 308. Процесс выполняют для конкретного кадра в сцене, с индексом CSFI, индекс кадра текущей сцены, шаг 601, для всех объектов начиная с объекта с индексом k=0, шаг 602. Если CSFI оказывается между ƒbegin текущего объекта и ƒ0 текущего объекта, то координаты RBB объекта вычисляют используя координаты этого RBB на предыдущем обработанном кадре, CSFI+1 (поскольку это обратный проход) таким же способом, как это было сделано на шаге 507. На шаге 605 параметры объекта вычисляют тем же способом, как это было сделано на шаге 505. В случае если текущий объект является последним (условие 606), процесс заканчивается, в ином случае он продолжается в отношении следующего объекта, шаг 607, и индекс объекта увеличивают на 1.

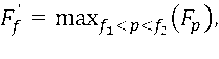

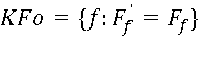

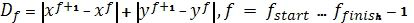

Фиг. 7 объясняет более детально шаг 204, касающийся обработки данных видеоанализа, выделения ключевых кадров и очистки накопителя. На шаге 701 выбирают набор ключевых кадров KFo исходя из выявленных данных о действиях объекта, подробности этого процесса объяснены далее. На шаге 702 вводят дополнительные ключевые кадры, если необходимо, между кадрами, которые присутствуют в наборе KFo. Из уровня техники известны способы для этого, например, S. V. Porter, M. Mirmehdi, and B. T. Thomas. A shortest path representation for video summarization. In Proc. of 12th ICIAP, pp. 460-465. IEEE Comp. Soc., Sept. 2003 [15], где данные глобального движения используют для выявления ключевых кадров. Полученный набор ключевых кадров подается на выход, и накопитель результатов видеоанализа очищают для использования при дальнейшей обработке следующей видео сцены, шаг 703. Набор ключевых кадров KFo выбирают на основе данных о действиях обнаруженного объекта, шаг 701, следующим образом. В одном из предложенных вариантов реализации заявляемого изобретения ключевые кадры выбирают на основе скорости движения объекта. Модуль обработки результатов видеоанализа сравнивает аккумулированные координаты RBB и параметры объекта.

,

,

где ƒstart и ƒfinish - последовательные кадры сцены, для которых вычисляют данные о действиях объекта. Пусть T является заранее заданным порогом,

0<T<

где

ƒ1 = max(ƒ-T, ƒstart), ƒ2 = min(ƒ+T, ƒfinish)

где

ƒ1 = max(ƒ-T, ƒstart), ƒ2 = min(ƒ+T, ƒfinish)

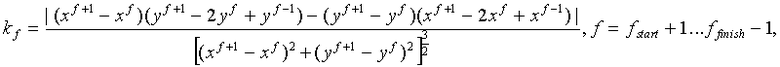

В другом варианте реализации заявляемого изобретения выполняют анализ кривизны траектории объекта  в видео кадрах.

в видео кадрах.

где

ƒ1 = max(ƒ-T, ƒstart+1), ƒ2 = min(ƒ+T, ƒfinish-1)

где

ƒ1 = max(ƒ-T, ƒstart+1), ƒ2 = min(ƒ+T, ƒfinish-1)

В еще одном варианте реализации заявленного изобретения проводят анализ параметров изображения, таких, как контраст C и резкость S. Пусть F является функцией C и S, а T1 и T2 являются предопределенными реальными значениями.

,

,

где

ƒ1 = max(ƒ-T, ƒstart+1), ƒ2 = min(ƒ+T, ƒfinish-1),

где

ƒ1 = max(ƒ-T, ƒstart+1), ƒ2 = min(ƒ+T, ƒfinish-1),

Специалист в данной области техники поймет, что возможны также и другие варианты реализации данного изобретения и что элементы изобретения могут быть изменены различным образом не выходя за рамки концепции данного изобретения. Поэтому чертежи и описание следует рассматривать лишь в качестве иллюстрации, которая не имеет ограничительного характера.

Заявляемый способ предназначен для реализации в программном обеспечении полуавтоматических систем преобразования "моно-в-стерео" или «черно/белое-в-цветное», используя современное вычислительное оборудование (персональные компьютеры, рабочие станции, компьютерные кластеры или тому подобное). Способ применим для систем преобразования видео "моно-в-стерео" или «черно/белое-в-цветное», оборудованных процессором, памятью, устройствами ввода - вывода и шиной передачи данных.

| название | год | авторы | номер документа |

|---|---|---|---|

| СПОСОБ АВТОМАТИЧЕСКОГО ВОССТАНОВЛЕНИЯ 3D СЦЕНЫ ПРОИСХОДЯЩЕГО НА СПОРТИВНОМ СООРУЖЕНИИ И СИСТЕМА ДЛЯ ОСУЩЕСТВЛЕНИЯ СПОСОБА | 2020 |

|

RU2763270C1 |

| СПОСОБ ПОДСЧЕТА ИЗВЛЕЧЕНИЯ ШТАНГ НА ВИДЕОЗАПИСЯХ БУРЕНИЯ НА ОСНОВЕ РАСПОЗНАВАНИЯ ЖЕСТОВ ЧЕЛОВЕЧЕСКОГО ТЕЛА | 2021 |

|

RU2802411C1 |

| СПОСОБ АВТОМАТИЧЕСКОГО ИЗВЛЕЧЕНИЯ ИНДЕКСОВ КЛЮЧЕВЫХ КАДРОВ ДЛЯ РАСШИРЕНИЯ ВИДЕОДАННЫХ | 2014 |

|

RU2577486C2 |

| СИСТЕМА РАСПОЗНАВАНИЯ ПОВЕДЕНИЯ | 2008 |

|

RU2475853C2 |

| УСТРОЙСТВО УПРАВЛЕНИЯ ВЫСОКОАДАПТИВНЫМ АВТОНОМНЫМ МОБИЛЬНЫМ РОБОТОМ | 2019 |

|

RU2705049C1 |

| СПОСОБ ВЫЯВЛЕНИЯ ТЕХНИЧЕСКИХ ОШИБОК СПОРТСМЕНА И СИСТЕМА ДЛЯ ЕГО ОСУЩЕСТВЛЕНИЯ | 2020 |

|

RU2763127C1 |

| СИСТЕМА И СПОСОБ ОТСЛЕЖИВАНИЯ ДВИЖУЩИХСЯ ОБЪЕКТОВ ПО ВИДЕОДАННЫМ | 2021 |

|

RU2775162C1 |

| СПОСОБ И СИСТЕМА ДЛЯ ПРЕОБРАЗОВАНИЯ ДВУХМЕРНОГО ВИДЕО В ТРЕХМЕРНОЕ ВИДЕО | 2007 |

|

RU2454025C2 |

| СПОСОБ И СИСТЕМА ДЕТЕКТИРОВАНИЯ ТРЕВОЖНЫХ СОБЫТИЙ, ПРОИСХОДЯЩИХ НА ТРАНСПОРТНОМ СРЕДСТВЕ ВО ВРЕМЯ ПЕРЕВОЗКИ ГРУЗОВ, В РЕЖИМЕ РЕАЛЬНОГО ВРЕМЕНИ | 2020 |

|

RU2748780C1 |

| СПОСОБ И СИСТЕМА ОТОБРАЖЕНИЯ ДАННЫХ С ВИДЕОКАМЕРЫ | 2018 |

|

RU2679200C1 |

Изобретение относится к технологии обработки видео. Заявлены способ и система для решения конкретной задачи преобразования видео из монокулярного в стереоскопическое и из черно-белого - в цветное в полуавтоматическом режиме. При этом способ выделения ключевых кадров и дополнения видео последовательности информацией о глубине или цвете включает в себя следующие операции: получают данные для инициализации объектов каждого ключевого объекта в каждом кадре; выявляют смены сцен во входной видео последовательности и разбивают видео последовательность на сцены; для каждой сцены выявляют данные о деятельности каждого объекта посредством модуля анализа видеоданных и данных глобального движения (GM) по всем кадрам сцены и сохраняют эти данные в накопителе результатов видеоанализа; причем после обработки видео сцены сначала анализируют сохраненные данные о деятельности каждого объекта, выделяют ключевые кадры, затем анализируют данные GM и ключевых кадров объекта, извлекают и выводят ключевые кадры посредством модуля анализа видеоданных; после чего очищают накопитель результатов видеоанализа и переходят к следующей сцене входной видео последовательности до достижения конца видео последовательности. Система состоит из трех основных частей: модуля анализа видеоданных; накопителя результатов видеоанализа; модуля обработки результатов видеоанализа. Технический результат - преобразование видео из монокулярного в стереоскопическое и из черно-белого - в цветное в полуавтоматическом режиме. 2 н. и 19 з.п. ф-лы, 7 ил.

1. Способ выделения ключевых кадров в процессе полуавтоматического дополнения видео последовательности информацией о глубине или цвете, отличающийся тем, что включает в себя следующие операции:

получают данные для инициализации объектов каждого ключевого объекта в каждом кадре;

выявляют смены сцен во входной видео последовательности и разбивают видео последовательность на сцены;

для каждой сцены выявляют данные о деятельности каждого объекта посредством модуля анализа видеоданных и данных глобального движения (GM) по всем кадрам сцены и сохраняют эти данные в накопителе результатов видеоанализа;

причем после обработки видео сцены, сначала анализируют сохраненные данные о деятельности каждого объекта, выделяют ключевые кадры, затем анализируют данные глобального движения (GM) и ключевых кадров объекта, извлекают и выводят ключевые кадры посредством модуля анализа видеоданных; после чего очищают накопитель результатов видеоанализа и переходят к следующей сцене входной видео последовательности до достижения конца видео последовательности.

2. Способ по п. 1, отличающийся тем, что ключевые кадры выбирают на основе вводимой пользователем информации о содержимом сцены.

3. Способ по п. 1, отличающийся тем, что каждый ключевой объект выбирают на одном или нескольких кадрах.

4. Способ по п. 1, отличающийся тем, что каждый ключевой объект отслеживают во всех кадрах в вырезанной сцене.

5. Способ по п. 1, отличающийся тем, что оценивают качество участков кадра, содержащих ключевой объект.

6. Способ по п. 1, отличающийся тем, что анализируют траекторию движения каждого ключевого объекта.

7. Способ по п. 1, отличающийся тем, что выбирают ключевые кадры на основе анализа участков кадров и/или точек качества траектории.

8. Способ по п. 1, отличающийся тем, что смену сцены выявляют посредством сравнений гистограмм, вычисленных в блоках изображения.

9. Способ по п. 1, отличающийся тем, что данные для инициализации объекта включают в себя координаты RBB, а именно координаты {x, y} левого верхнего угла, ширина и высота, кадр для этого RBB f

0, и два кадра, f

begin и f

end для отслеживания промежутка RBB между ними, таким образом что  и

и  .

.

10. Способ по п. 9, отличающийся тем, что отслеживают RBB из кадра f 0 инициализации объекта вперед, из кадра f 0 до кадра f end, после чего в обратном направлении из кадра f 0 до кадра f begin, для получения отслеженных координат RBB.

11. Способ по п. 1, отличающийся тем, что для выявления действий объекта, RBB объекта отслеживают по всем кадрам в видео сцене, а именно, определяют координаты RBB в видео кадре таким образом, чтобы сравнение областей видео кадров, содержащихся внутри RBB, на текущем и на следующем кадре давало максимальное значение в терминах предопределенных метрик, и вычисляют параметры объекта, представляющие собой особенности изображения области видео кадра, содержащейся внутри RBB.

12. Способ по п. 1, отличающийся тем, что дополнительные ключевые кадры выбирают в промежутке между ключевыми кадрами объектов, основываясь на анализе данных глобального движения GM.

13. Способ по п. 1 отличающийся тем, что в модуле обработки результатов видеоанализа сравнивают аккумулированные координаты RBB и параметры объекта и выводят ряд ключевых кадров KFo:

,

,

где f

start и f

finish - последовательные кадры сцены, для которой вычисляют данные о действиях объекта,

где f

1 = max(f-T, f

start), f

2 = min (f+T, f

finish), T - предопределенный порог,

KFo = {f: D

' f

= D

f

}

14. Способ по п. 1, отличающийся тем, что в модуле обработки результатов видеоанализа анализируют кривизну траектории объекта  в видео кадрах и получают на выходе ряд ключевых кадров KFo

в видео кадрах и получают на выходе ряд ключевых кадров KFo

где f

1 = max(f-T, f

start+1), f

2 = min(f+T, f

finish-1), T - предопределенный порог,

KFo = {f: k

' f

= k

f

}

15. Способ по п. 1, отличающийся тем, что параметры объектов включают оценку резкости и контрастности.

16. Способ по п. 15, отличающийся тем, что анализируют параметры объекта, такие как контраст C и резкость S, вычисляют функции F и F' C, и S, а T1 и T2 являются предопределенными реальными значениями:

,

,

где f

1 = max(f-T, f

start+1), f

2 = min(f+T, f

finish-1), T - предопределенный порог

KFo = {f: F

' f

= F

f

}

17. Система для реализации способа выделения ключевых кадров в процессе полуавтоматического дополнения видео последовательности информацией о глубине или цвете, отличающаяся тем, что состоит из трех основных частей:

модуля анализа видеоданных, выполненного с возможностью извлечения данных из входного видео потока и получения множества инициализационных данных для ключевых объектов в видео через устройство разметки видео;

накопителя результатов видеоанализа, выполненного с возможностью запоминания аккумулированных данных видеоанализа, обнаруженных модулем анализа;

и модуля обработки результатов видеоанализа, выполненного с возможностью проведения анализа аккумулированных данных.

18. Система по п. 17, отличающаяся тем, что модуль анализа видеоданных выполнен с возможностью получения множества координат прямоугольных рамок (RBB), индексов кадра и числа кадров, через устройство разметки видео.

19. Система по п. 17, отличающаяся тем, что модуль анализа видеоданных включает детектор смены кадров, детектор данных глобального движения, детектор действий объекта.

20. Система по п. 17, отличающаяся тем, что накопитель результатов видеоанализа состоит из аккумулятора данных о действиях объекта, выполненного с возможностью запоминания аккумулированных данных о действиях объекта, и аккумулятора данных глобального движения, выполненного с возможностью запоминания параметров, описывающих относительное смещение статичных объектов в двух последовательных видео кадрах.

21. Система по п. 17, отличающаяся тем, что модуль обработки результатов видеоанализа включает в себя выделитель данных, детектор ключевых кадров объекта и детектор ключевых кадров.

| RU 2003104786 A, 10.06.2004 | |||

| RU 2007128309 A, 27.01.2009 | |||

| СПОСОБ ОБРАБОТКИ ИЗОБРАЖЕНИЙ | 1998 |

|

RU2193798C2 |

| СПОСОБ И СИСТЕМА ДЛЯ ПРЕОБРАЗОВАНИЯ СТЕРЕОКОНТЕНТА | 2009 |

|

RU2423018C2 |

| Колосоуборка | 1923 |

|

SU2009A1 |

| US 7158676 B1, 02.01.2007 | |||

| WO 2002013141 A1, 14.02.2002 | |||

| АМИДЫ АЛЬФА-АМИНОКИСЛОТ, ИХ ПОЛУЧЕНИЕ И ТЕРАПЕВТИЧЕСКОЕ ПРИМЕНЕНИЕ | 1997 |

|

RU2174511C2 |

| Устройство для измерения объема жидкости | 1984 |

|

SU1229583A2 |

| AU 762791 B2, 03.07.2003. | |||

Авторы

Даты

2013-09-20—Публикация

2012-08-10—Подача