УРОВЕНЬ ТЕХНИКИ

ОБЛАСТЬ ТЕХНИКИ, К КОТОРОЙ ОТНОСИТСЯ ИЗОБРЕТЕНИЕ

[0001] Конкретные аспекты настоящего раскрытия сущности, в общем, относятся к разработке нейронных систем, а более конкретно, к способу и устройству нейронного временного кодирования, обучения и распознавания.

УРОВЕНЬ ТЕХНИКИ

[0002] Нейроны в нейронной системе могут передавать информацию временно с использованием так называемых временных кодов в форме синхронизированных спайков (пиковых потенциалов). Вследствие этого, основной интерес представляют способы кодирования и декодирования и способы изучения такой временной информации.

[0003] В частности, требуется отличать временные шаблоны, а (в отличие от других способов на основе временных шаблонов) не просто совпадение вводов или порядок вводов. Настоящее раскрытие сущности предоставляет способы, которые являются биотехнологическими/согласованными, но имеют меньшую сложность и допускают кодирование, декодирование, распознавание и изучение временных шаблонов спайковых (пиковых) сигналов.

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

[0004] Конкретные аспекты настоящего раскрытия сущности предоставляют способ нейронного временного кодирования. Способ, в общем, включает в себя использование абстракции линии относительной задержки, которая задерживает один или более синаптических вводов в нейронную схему посредством временных задержек, применение динамической спайковой модели для того, чтобы определять спайковое поведение нейронной схемы на основе взвешенных и задержанных синаптических вводов нейронной схемы, и регулирование, согласно правилу неконтролируемого обучения, весовых коэффициентов, ассоциированных с синаптическими вводами, в зависимости от взаимосвязи по синхронизации образования спайков в нейронных схемах и задержанных синаптических вводов.

[0005] Конкретные аспекты настоящего раскрытия сущности предоставляют устройство для нейронного временного кодирования. Устройство, в общем, включает в себя первую схему, выполненную с возможностью использовать абстракцию линии относительной задержки, которая задерживает один или более синаптических вводов в нейронную схему посредством временных задержек, вторую схему, выполненную с возможностью применять динамическую спайковую модель для того, чтобы определять спайковое поведение нейронной схемы на основе взвешенных и задержанных синаптических вводов нейронной схемы, и третью схему, выполненную с возможностью регулировать, согласно правилу неконтролируемого обучения, весовые коэффициенты, ассоциированные с синаптическими вводами, в зависимости от взаимосвязи по синхронизации образования спайков в нейронных схемах и задержанных синаптических вводов.

[0006] Конкретные аспекты настоящего раскрытия сущности предоставляют устройство для нейронного временного кодирования. Устройство, в общем, включает в себя средство для использования абстракции линии относительной задержки, которая задерживает один или более синаптических вводов в нейронную схему посредством временных задержек, средство для применения динамической спайковой модели для того, чтобы определять спайковое поведение нейронной схемы на основе взвешенных и задержанных синаптических вводов нейронной схемы, и средство для регулирования, согласно правилу неконтролируемого обучения, весовых коэффициентов, ассоциированных с синаптическими вводами, в зависимости от взаимосвязи по синхронизации образования спайков в нейронных схемах и задержанных синаптических вводов.

[0007] Конкретные аспекты настоящего раскрытия сущности предоставляют компьютерный программный продукт для нейронного временного кодирования. Компьютерный программный продукт, в общем, включает в себя машиночитаемый носитель, содержащий код для использования абстракции линии относительной задержки, которая задерживает один или более синаптических вводов в нейронную схему посредством временных задержек, применения динамической спайковой модели для того, чтобы определять спайковое поведение нейронной схемы на основе взвешенных и задержанных синаптических вводов нейронной схемы, и регулирования, согласно правилу неконтролируемого обучения, весовых коэффициентов, ассоциированных с синаптическими вводами, в зависимости от взаимосвязи по синхронизации образования спайков в нейронных схемах и задержанных синаптических вводов.

[0008] Конкретные аспекты настоящего раскрытия сущности предоставляют способ нейронного временного кодирования длинных и больших пространственно-временных шаблонов. Способ, в общем, включает в себя соединение каждого уровня нейронных схем в иерархической многоуровневой нейронной сети с вводом и с другим уровнем нейронных схем в многоуровневой нейронной сети, и согласование первого уровня нейронных схем в многоуровневой нейронной сети с первой подсекцией входного шаблона, при этом этот соединенный уровень согласует комбинацию возбуждения нейронных схем другого уровня в результате согласования подсекции входного шаблона и другой подсекции входного шаблона.

[0009] Конкретные аспекты настоящего раскрытия сущности предоставляют устройство для нейронного временного кодирования длинных и больших пространственно-временных шаблонов. Устройство, в общем, включает в себя первую схему, выполненную с возможностью соединять каждый уровень нейронных схем в иерархической многоуровневой нейронной сети с вводом и с другим уровнем нейронных схем в многоуровневой нейронной сети, и вторую схему, выполненную с возможностью согласовывать первый уровень нейронных схем в многоуровневой нейронной сети с первой подсекцией входного шаблона, при этом этот соединенный уровень согласует комбинацию возбуждения нейронных схем другого уровня в результате согласования подсекции входного шаблона и другой подсекции входного шаблона.

[0010] Конкретные аспекты настоящего раскрытия сущности предоставляют устройство для нейронного временного кодирования длинных и больших пространственно-временных шаблонов. Устройство, в общем, включает в себя средство для соединения каждого уровня нейронных схем в иерархической многоуровневой нейронной сети с вводом и с другим уровнем нейронных схем в многоуровневой нейронной сети, и средство для согласования первого уровня нейронных схем в многоуровневой нейронной сети с первой подсекцией входного шаблона, при этом этот соединенный уровень согласует комбинацию возбуждения нейронных схем другого уровня в результате согласования подсекции входного шаблона и другой подсекции входного шаблона.

[0011] Конкретные аспекты настоящего раскрытия сущности предоставляют компьютерный программный продукт для нейронного временного кодирования длинных и больших пространственно-временных шаблонов. Компьютерный программный продукт, в общем, включает в себя машиночитаемый носитель, содержащий код для соединения каждого уровня нейронных схем в иерархической многоуровневой нейронной сети с вводом и с другим уровнем нейронных схем в многоуровневой нейронной сети и согласования первого уровня нейронных схем в многоуровневой нейронной сети с первой подсекцией входного шаблона, при этом этот соединенный уровень согласует комбинацию возбуждения нейронных схем другого уровня в результате согласования подсекции входного шаблона и другой подсекции входного шаблона.

[0012] Конкретные аспекты настоящего раскрытия сущности предоставляют способ нейронного временного кодирования длинных и больших пространственно-временных шаблонов. Способ, в общем, включает в себя предоставление, через синапсы с ассоциированными задержками, синаптических вводов в нейронную схему, при этом, по меньшей мере, один из синаптических вводов ассоциирован, по меньшей мере, с одним из самосоединяемых синапсов, причем синапсы принадлежат множеству наборов, и, по меньшей мере, один из наборов содержит комбинацию задержек, чтобы согласовывать первую часть шаблона синаптических вводов, не содержащих рекурсивное самосоединение.

[0013] Конкретные аспекты настоящего раскрытия сущности предоставляют устройство для нейронного временного кодирования длинных и больших пространственно-временных шаблонов. Устройство, в общем, включает в себя первую схему, выполненную с возможностью предоставлять, через синапсы с ассоциированными задержками, синаптические вводы в нейронную схему, при этом, по меньшей мере, один из синаптических вводов ассоциирован, по меньшей мере, с одним из самосоединяемых синапсов, причем синапсы принадлежат множеству наборов, и, по меньшей мере, один из наборов содержит комбинацию задержек, чтобы согласовывать первую часть шаблона синаптических вводов, не содержащих рекурсивное самосоединение.

[0014] Конкретные аспекты настоящего раскрытия сущности предоставляют устройство для нейронного временного кодирования длинных и больших пространственно-временных шаблонов. Устройство, в общем, включает в себя средство для предоставления, через синапсы с ассоциированными задержками, синаптических вводов в нейронную схему, при этом, по меньшей мере, один из синаптических вводов ассоциирован, по меньшей мере, с одним из самосоединяемых синапсов, причем синапсы принадлежат множеству наборов, и, по меньшей мере, один из наборов содержит комбинацию задержек, чтобы согласовывать первую часть шаблона синаптических вводов, не содержащих рекурсивное самосоединение.

[0015] Конкретные аспекты настоящего раскрытия сущности предоставляют компьютерный программный продукт для нейронного временного кодирования длинных и больших пространственно-временных шаблонов. Компьютерный программный продукт, в общем, включает в себя машиночитаемый носитель, содержащий код для предоставления, через синапсы с ассоциированными задержками, синаптических вводов в нейронную схему, при этом, по меньшей мере, один из синаптических вводов ассоциирован, по меньшей мере, с одним из самосоединяемых синапсов, причем синапсы принадлежат множеству наборов, и, по меньшей мере, один из наборов содержит комбинацию задержек, чтобы согласовывать первую часть шаблона синаптических вводов, не содержащих рекурсивное самосоединение.

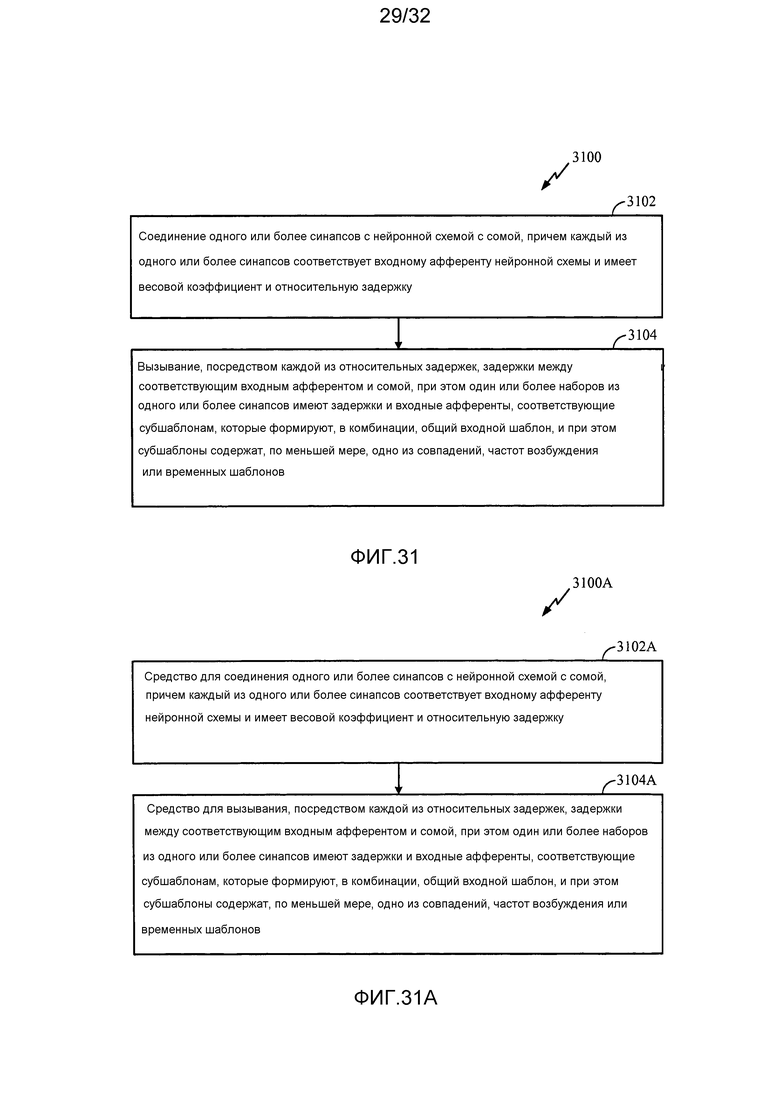

[0016] Конкретные аспекты настоящего раскрытия сущности предоставляют способ нейронного кодирования для общих входных шаблонов. Способ, в общем, включает в себя соединение одного или более синапсов с нейронной схемой с сомой, причем каждый из одного или более синапсов соответствует входному афференту нейронной схемы и имеет весовой коэффициент и относительную задержку, и вызывание, посредством каждой из относительных задержек, задержки между соответствующим входным афферентом и сомой, при этом один или более наборов из одного или более синапсов имеют задержки и входные афференты, соответствующие субшаблонам, которые формируют, в комбинации, один из общих входных шаблонов, и субшаблоны содержат, по меньшей мере, одно из совпадений, частот возбуждения или временных шаблонов.

[0017] Конкретные аспекты настоящего раскрытия сущности предоставляют устройство для нейронного кодирования для общих входных шаблонов. Устройство, в общем, включает в себя первую схему, выполненную с возможностью соединять один или более синапсов с нейронной схемой с сомой, причем каждый из одного или более синапсов соответствует входному афференту нейронной схемы и имеет весовой коэффициент и относительную задержку, и вторую схему, выполненную с возможностью вызывать, посредством каждой из относительных задержек, задержку между соответствующим входным афферентом и сомой, при этом один или более наборов из одного или более синапсов имеют задержки и входные афференты, соответствующие субшаблонам, которые формируют, в комбинации, один из общих входных шаблонов, и субшаблоны содержат, по меньшей мере, одно из совпадений, частот возбуждения или временных шаблонов.

[0018] Конкретные аспекты настоящего раскрытия сущности предоставляют устройство для нейронного кодирования для общих входных шаблонов. Устройство, в общем, включает в себя средство для соединения одного или более синапсов с нейронной схемой с сомой, причем каждый из одного или более синапсов соответствует входному афференту нейронной схемы и имеет весовой коэффициент и относительную задержку, и средство для вызывания, посредством каждой из относительных задержек, задержки между соответствующим входным афферентом и сомой, при этом один или более наборов из одного или более синапсов имеют задержки и входные афференты, соответствующие субшаблонам, которые формируют, в комбинации, один из общих входных шаблонов, и субшаблоны содержат, по меньшей мере, одно из совпадений, частот возбуждения или временных шаблонов.

[0019] Конкретные аспекты настоящего раскрытия сущности предоставляют компьютерный программный продукт для нейронного кодирования для общих входных шаблонов. Компьютерный программный продукт, в общем, включает в себя машиночитаемый носитель, содержащий код для соединения одного или более синапсов с нейронной схемой с сомой, причем каждый из одного или более синапсов соответствует входному афференту нейронной схемы и имеет весовой коэффициент и относительную задержку, и вызывания, посредством каждой из относительных задержек, задержки между соответствующим входным афферентом и сомой, при этом один или более наборов из одного или более синапсов имеют задержки и входные афференты, соответствующие субшаблонам, которые формируют, в комбинации, один из общих входных шаблонов, и субшаблоны содержат, по меньшей мере, одно из совпадений, частот возбуждения или временных шаблонов.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

[0020] В качестве способа, которым вышеизложенные признаки настоящего раскрытия сущности могут подробно пониматься, более подробное описание, сущность которого вкратце приведена выше, может предоставляться в отношении аспектов, некоторые из которых проиллюстрированы на прилагаемых чертежах. Тем не менее, следует отметить, что прилагаемые чертежи иллюстрируют только конкретные типичные аспекты этого раскрытия сущности, и, следовательно, не должны считаться ограничением его объема, и описание может признавать другие в равной мере эффективные аспекты.

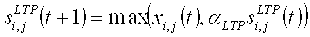

[0021] Фиг. 1 иллюстрирует примерную сеть нейронов в соответствии с конкретными аспектами настоящего раскрытия сущности.

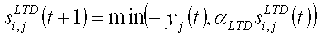

[0022] Фиг. 2 иллюстрирует пример компонента и признаков способа в соответствии с конкретными аспектами настоящего раскрытия сущности.

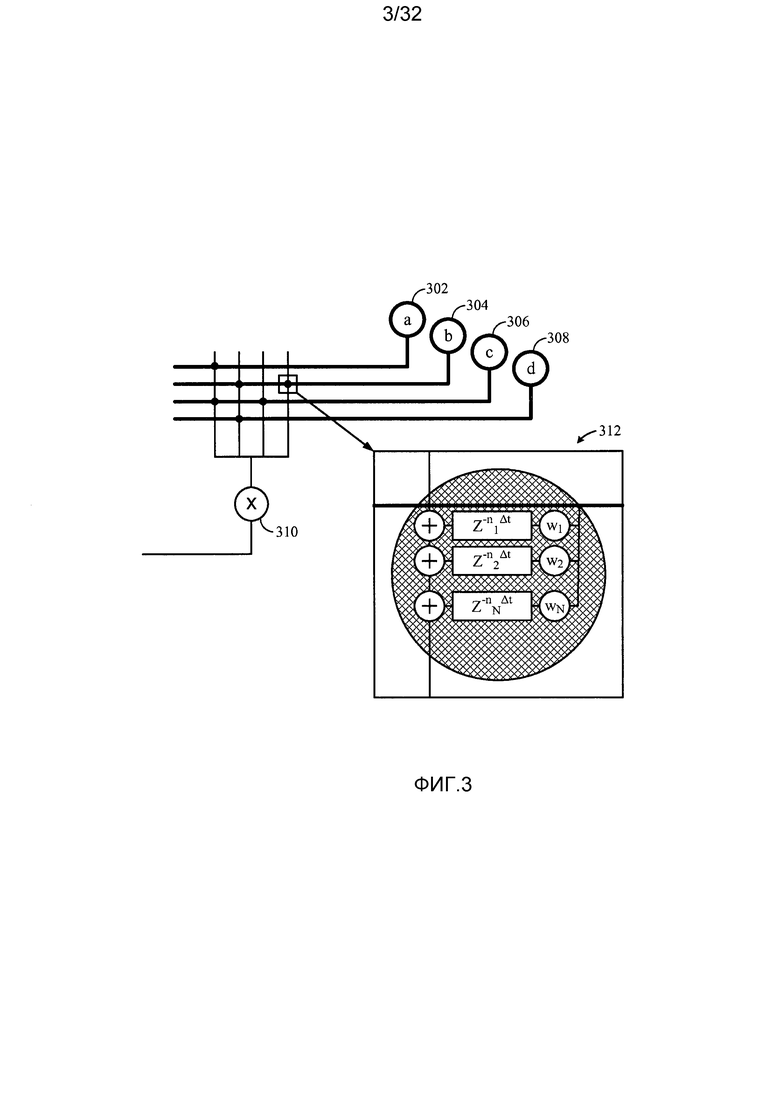

[0023] Фиг. 3 иллюстрирует примерную нейронную модель с относительной задержкой в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0024] Фиг. 4 иллюстрирует примерное повторное совмещение вводов относительной задержки посредством дендритной модели в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0025] Фиг. 5 иллюстрирует пример типичных кривых обучения на основе зависимой от синхронизации спайков пластичности (STDP) в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0026] Фиг. 6 иллюстрирует пример изменений временной чувствительности STDP-кривых обучения в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0027] Фиг. 7 иллюстрирует примерные изменения баланса усиления/ослабления STDP-кривых обучения в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0028] Фиг. 8 иллюстрирует пример точности и устойчивости реакции нейронов на временной входной шаблон в соответствии с конкретными аспектами настоящего раскрытия сущности.

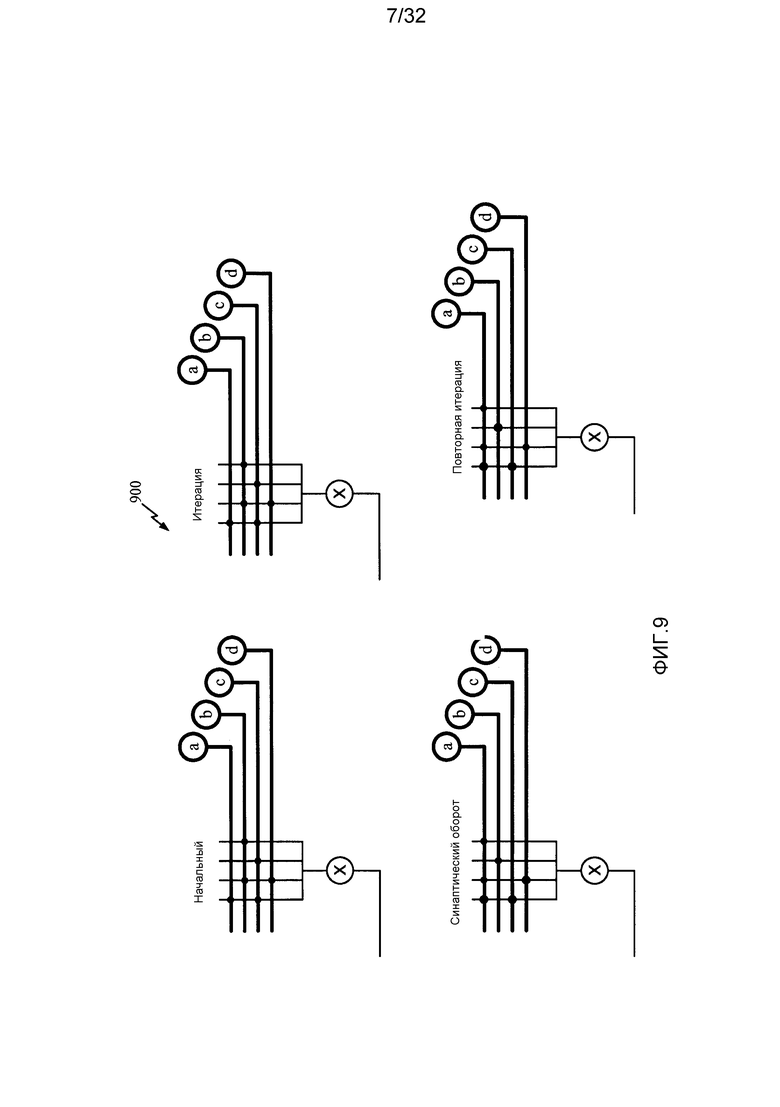

[0029] Фиг. 9 иллюстрирует примерный синаптический оборот в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0030] Фиг. 10 иллюстрирует примерные эффекты частоты возбуждения для обучения на основе временных шаблонов в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0031] Фиг. 11 иллюстрирует примерные операции, которые могут выполняться посредством нейронной схемы нейронной сети для нейронного временного кодирования в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0032] Фиг. 11A иллюстрирует примерные компоненты, допускающие выполнение операций, проиллюстрированных на фиг. 11.

[0033] Фиг. 12 иллюстрирует пример длинного большого пространственно-временного шаблона в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0034] Фиг. 13 иллюстрирует пример многоуровневой сети для кодирования на основе более длинных и/или больших пространственно-временных шаблонов в соответствии с конкретными аспектами настоящего раскрытия сущности.

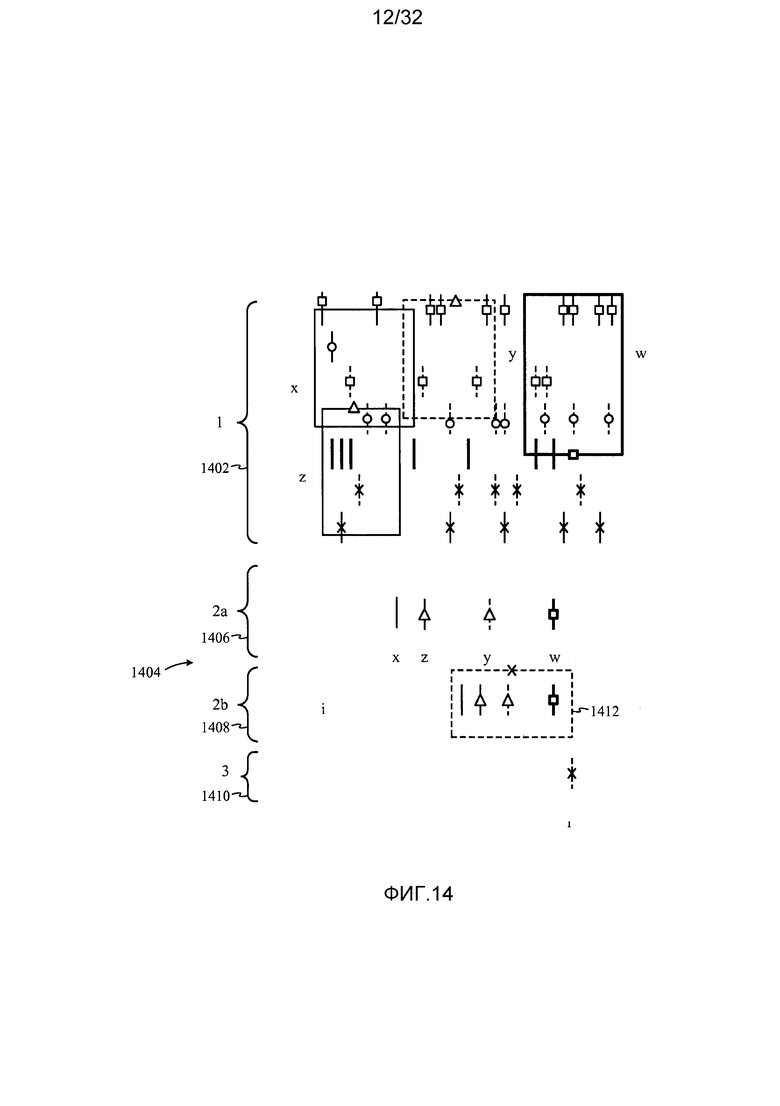

[0035] Фиг. 14 иллюстрирует пример многоуровневой сети для кодирования на основе более длинных пространственно-временных шаблонов с аксональной задержкой в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0036] Фиг. 15 иллюстрирует примерную масштабируемую сеть для кодирования на основе более длинных и/или больших пространственно-временных шаблонов в соответствии с конкретными аспектами настоящего раскрытия сущности.

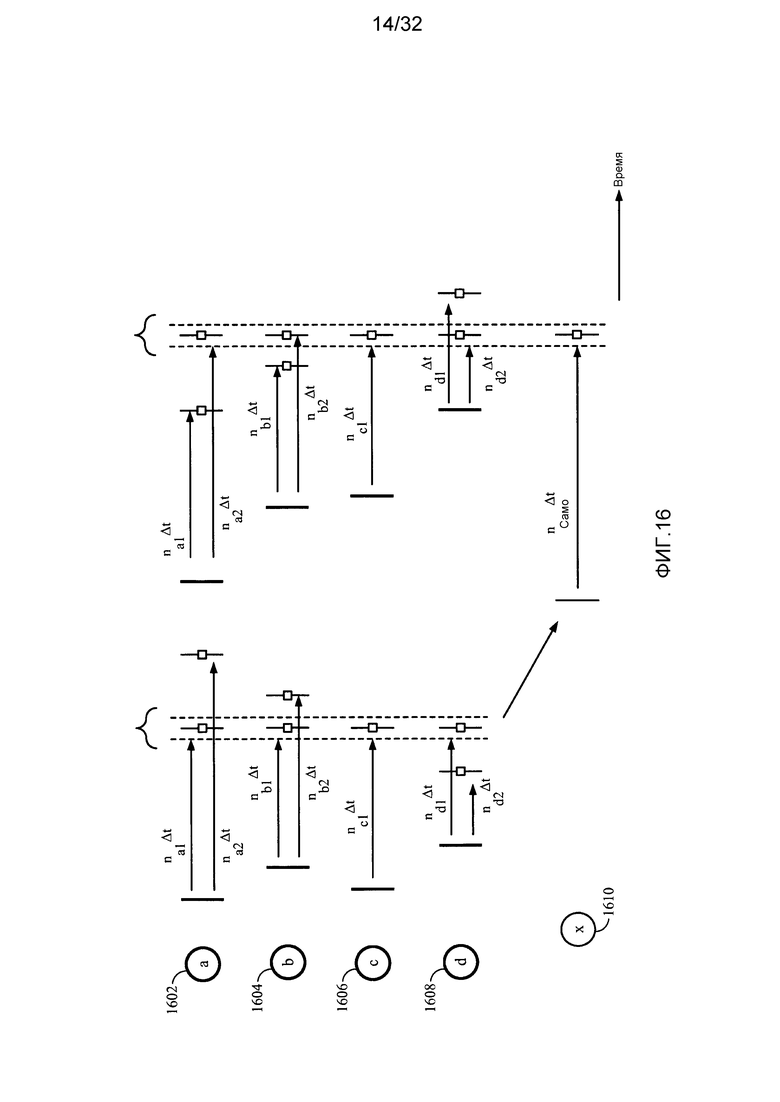

[0037] Фиг. 16 иллюстрирует примерное кодирование на основе рекурсивных масштабируемых пространственно-временных шаблонов в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0038] Фиг. 17 иллюстрирует примерные графики адаптации весовых коэффициентов в каждом нейроне в соответствии с конкретными аспектами настоящего раскрытия сущности.

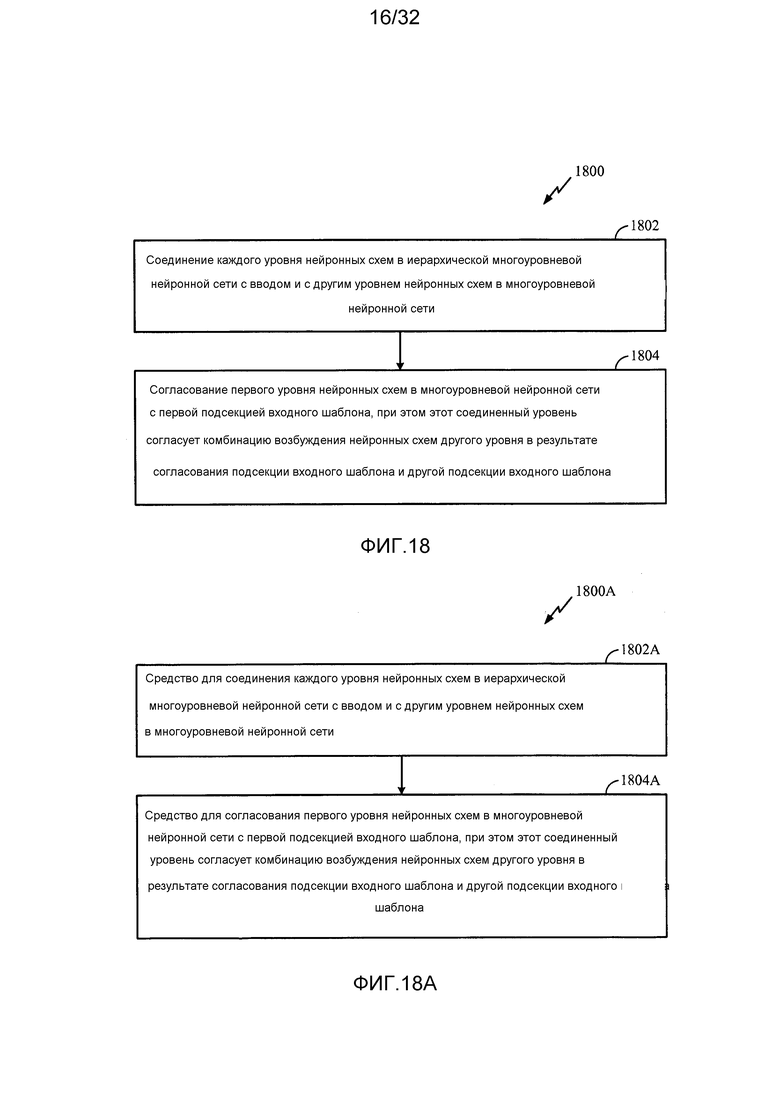

[0039] Фиг. 18 иллюстрирует примерные операции, которые могут выполняться в многоуровневой нейронной сети для нейронного временного кодирования длинных и больших пространственно-временных шаблонов в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0040] Фиг. 18A иллюстрирует примерные компоненты, допускающие выполнение операций, проиллюстрированных на фиг. 18.

[0041] Фиг. 19 иллюстрирует другие примерные операции, которые могут выполняться в нейронной схеме нейронной сети для нейронного временного кодирования длинных и больших пространственно-временных шаблонов в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0042] Фиг. 19A иллюстрирует примерные компоненты, допускающие выполнение операций, проиллюстрированных на фиг. 19.

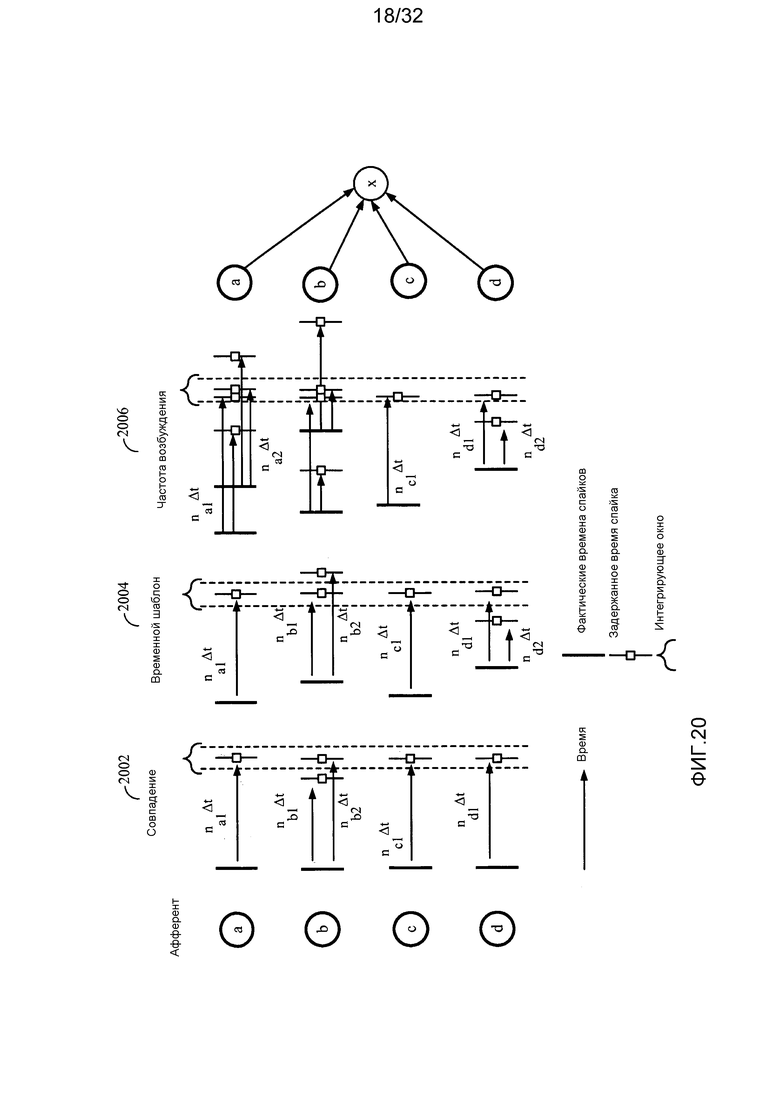

[0043] Фиг. 20 иллюстрирует пример декодирования различных схем нейронного кодирования посредством совмещения синхронизации спайков в соответствии с конкретными аспектами настоящего раскрытия сущности.

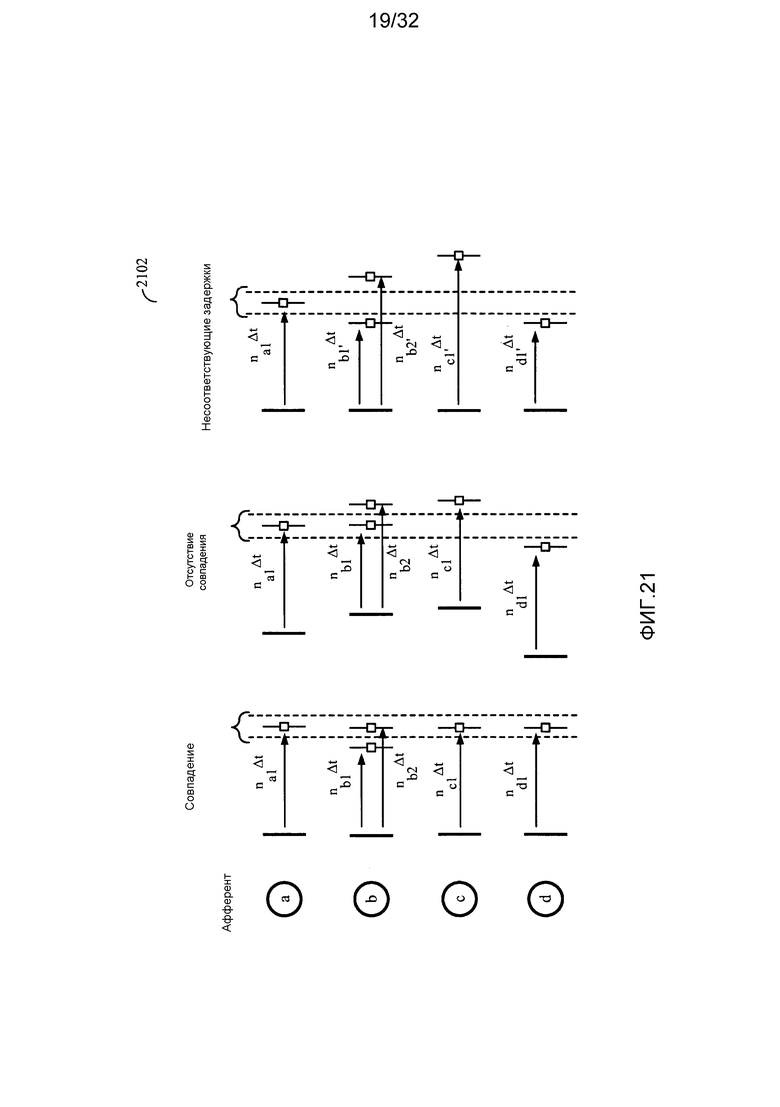

[0044] Фиг. 21 иллюстрирует пример декодирования на основе совпадений с зависимостью от относительных задержек в соответствии с конкретными аспектами настоящего раскрытия сущности.

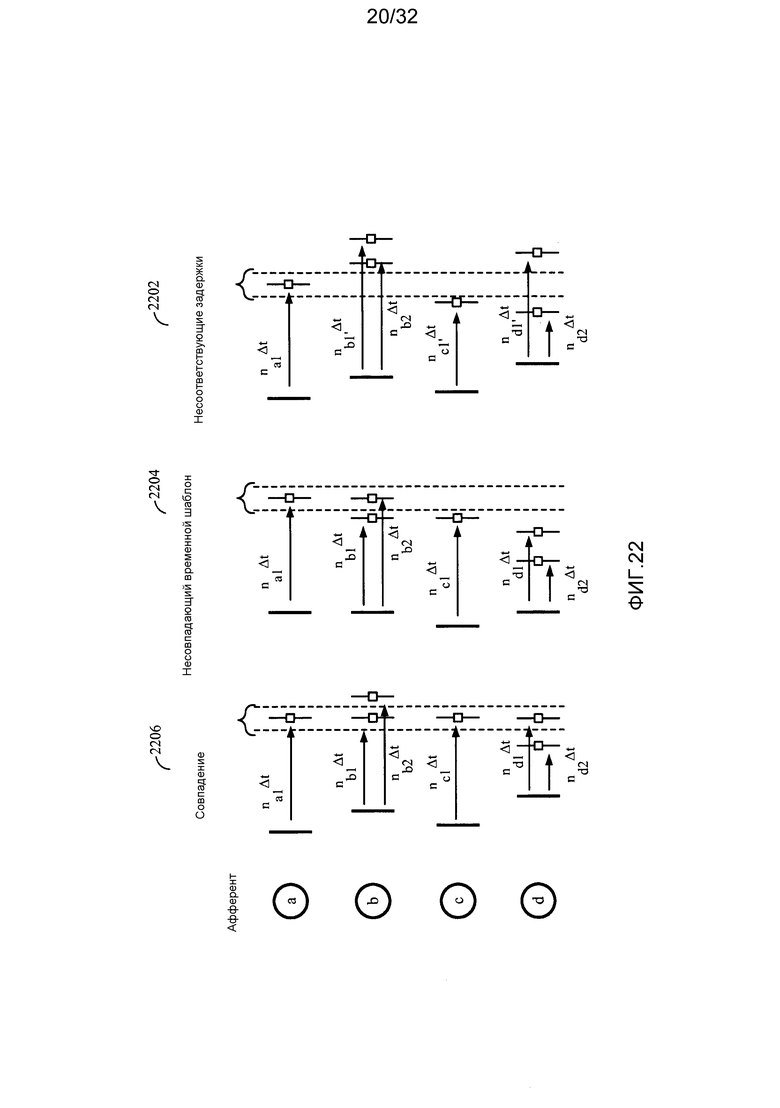

[0045] Фиг. 22 иллюстрирует пример декодирования на основе временных шаблонов с зависимостью от относительных задержек в соответствии с конкретными аспектами настоящего раскрытия сущности.

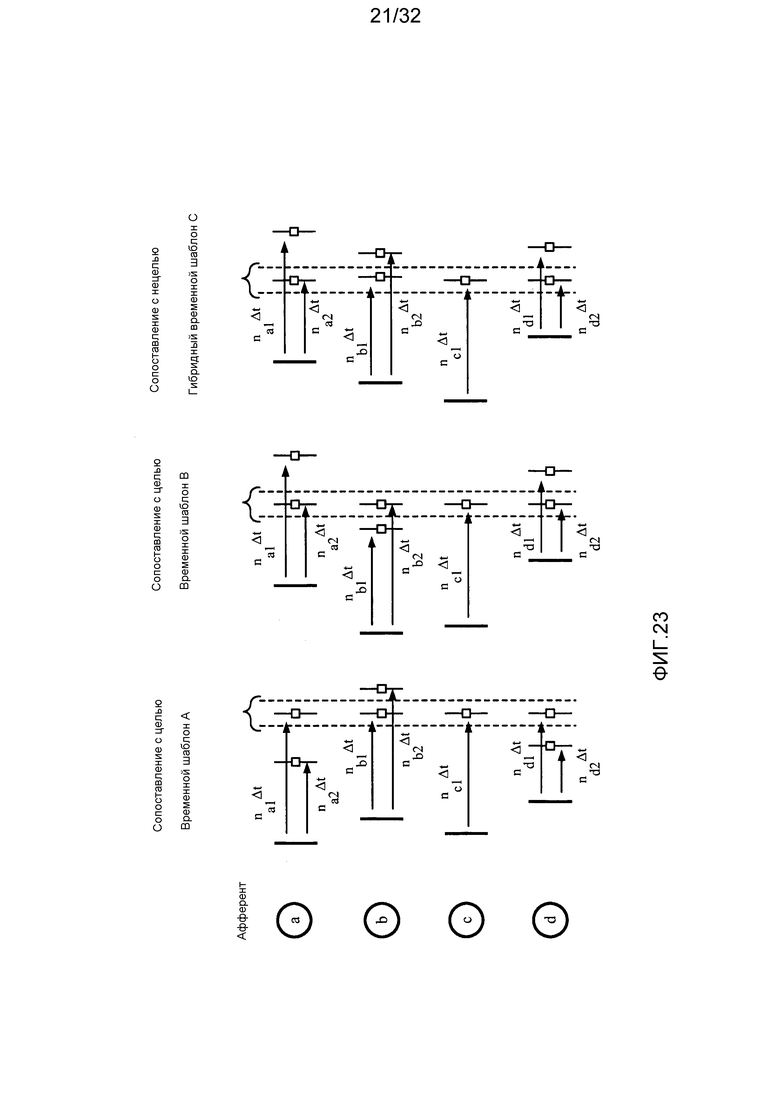

[0046] Фиг. 23 иллюстрирует пример сопоставления с временным шаблоном на основе логического "ИЛИ" в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0047] Фиг. 24 иллюстрирует пример декодирования на основе частоты возбуждения с зависимостью от относительных задержек в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0048] Фиг. 25 иллюстрирует пример декодирования на основе частоты возбуждения, при этом частота возбуждения является целевой частотой для декодирования, в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0049] Фиг. 26 иллюстрирует пример декодирования на основе частоты возбуждения с преобразованием частоты в совпадение в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0050] Фиг. 27 иллюстрирует пример декодирования на основе частоты возбуждения с инвариантностью выходной частоты возбуждения в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0051] Фиг. 28 иллюстрирует пример изображения временной фазы простой спайковой модели согласно различной входной синхронизации в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0052] Фиг. 29 иллюстрирует пример изображения временной фазы простой спайковой модели согласно различной номинальной постоянной времени в соответствии с конкретными аспектами настоящего раскрытия сущности.

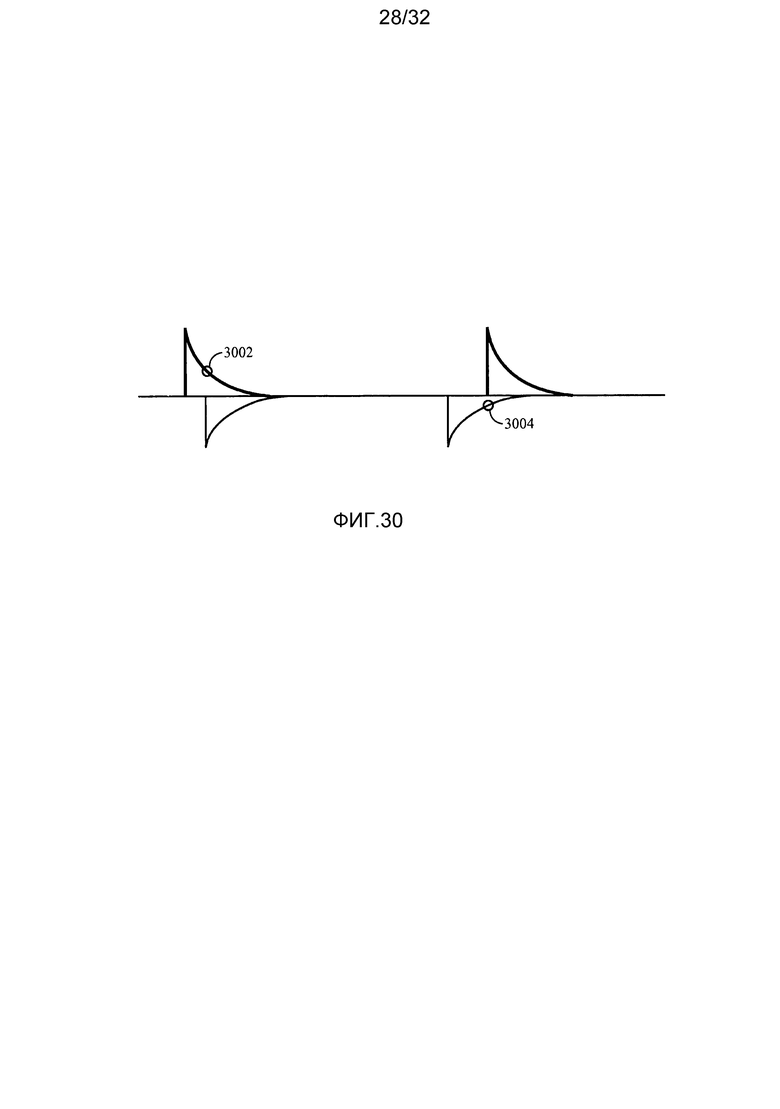

[0053] Фиг. 30 иллюстрирует примерную STDP-реализацию в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0054] Фиг. 31 иллюстрирует примерные операции нейронного кодирования для общих входных шаблонов в соответствии с конкретными аспектами настоящего раскрытия сущности.

[0055] Фиг. 31A иллюстрирует примерные компоненты, допускающие выполнение операций, проиллюстрированных на фиг. 31.

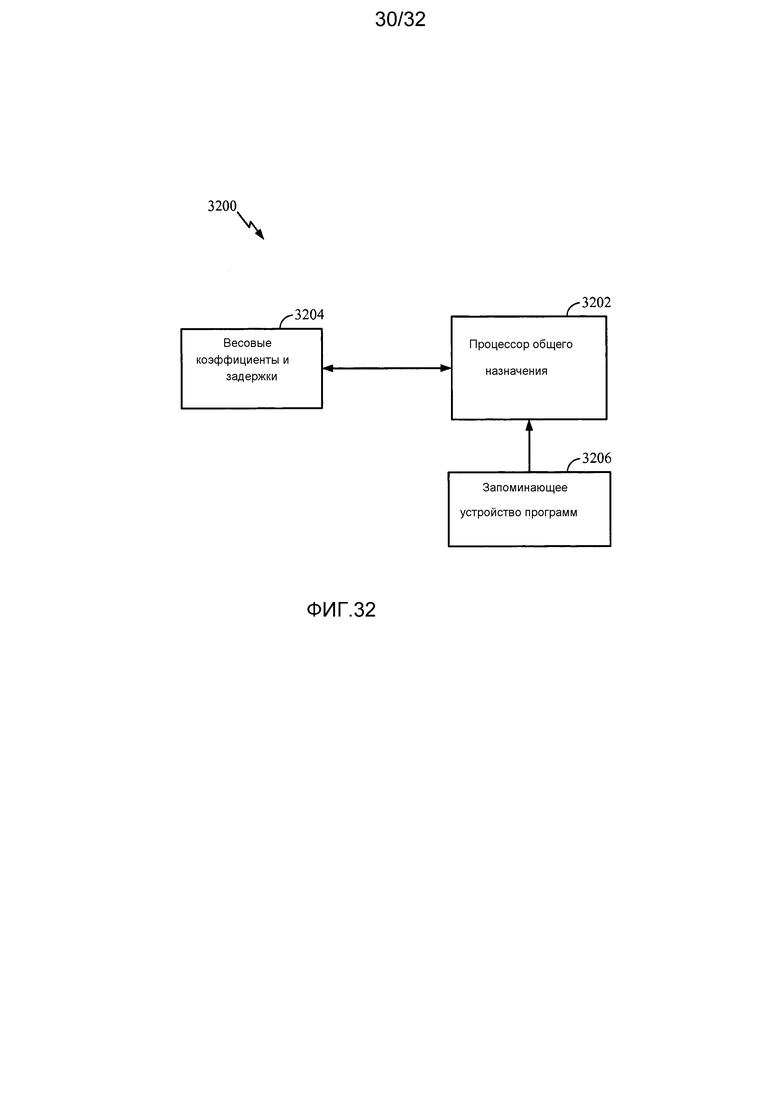

[0056] Фиг. 32 иллюстрирует примерную программную реализацию нейронного кодирования с использованием процессора общего назначения в соответствии с конкретными аспектами настоящего раскрытия сущности.

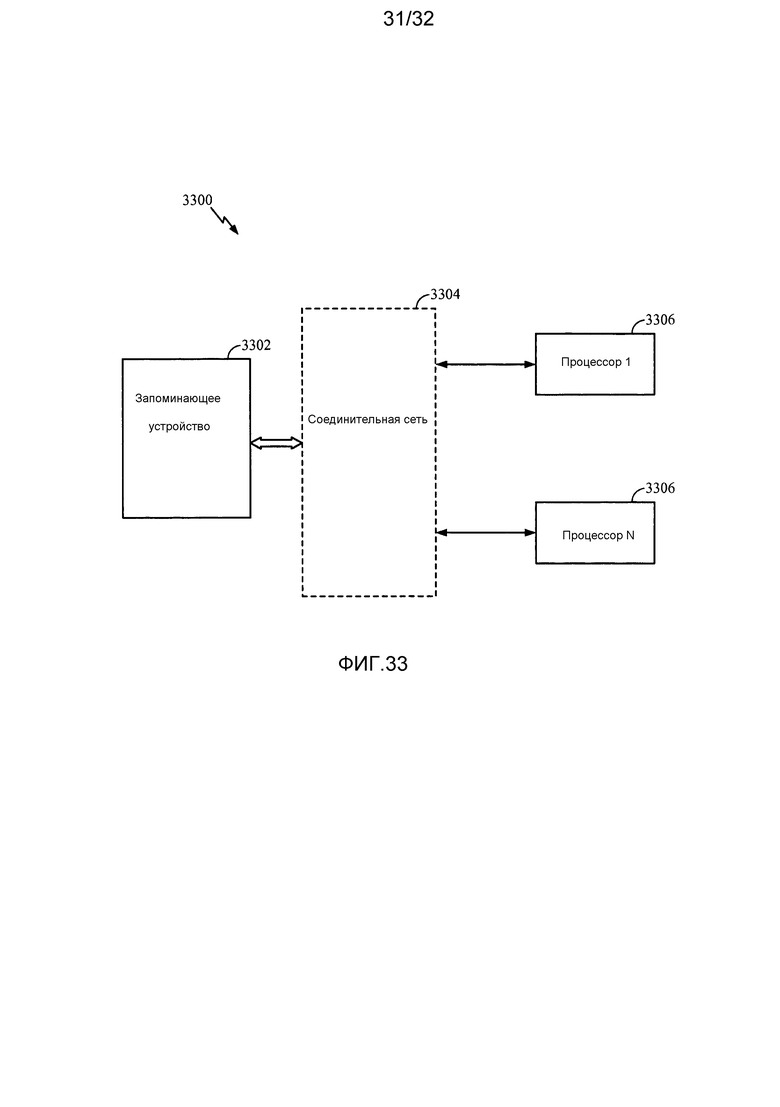

[0057] Фиг. 33 иллюстрирует примерную реализацию нейронного кодирования, в которой запоминающее устройство может взаимодействовать с отдельными распределенными процессорами в соответствии с конкретными аспектами настоящего раскрытия сущности.

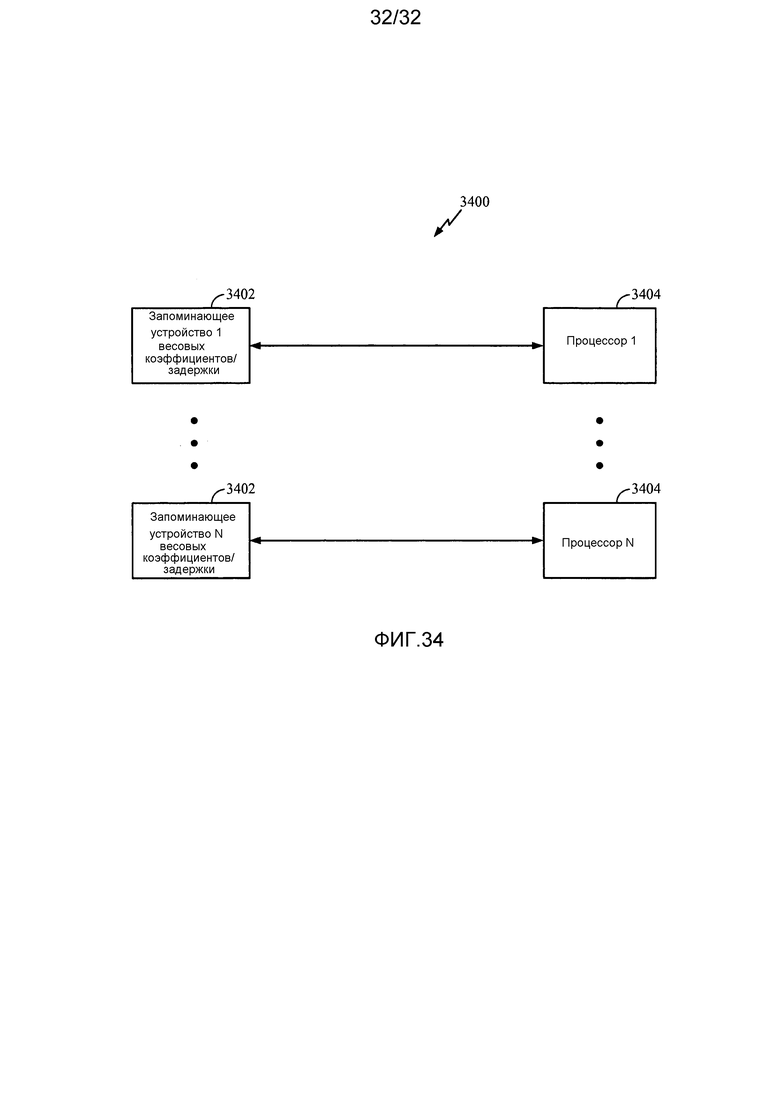

[0058] Фиг. 34 иллюстрирует примерную реализацию нейронного кодирования на основе распределенных запоминающих устройств и распределенных процессоров в соответствии с конкретными аспектами настоящего раскрытия сущности.

ПОДРОБНОЕ ОПИСАНИЕ ИЗОБРЕТЕНИЯ

[0059] Далее подробно описываются различные аспекты раскрытия сущности со ссылкой на прилагаемые чертежи. Тем не менее, это раскрытие сущности может осуществляться во множестве различных форм и не должно рассматриваться как ограниченное какой-либо конкретной структурой или функцией, представленной в этом раскрытии сущности. Наоборот, эти аспекты предоставляются таким образом, что это раскрытие сущности является всеобъемлющим и завершенным и полностью передает объем раскрытия сущности для специалистов в данной области техники. На основе идей в данном документе специалисты в данной области техники должны принимать во внимание, что объем раскрытия сущности имеет намерение охватывать любой аспект раскрытия сущности, раскрытый в данном документе, реализованный независимо или комбинированный с любым другим аспектом раскрытия сущности. Например, устройство может быть реализовано или способ может быть использован на практике с помощью любого числа аспектов, изложенных в данном документе. Помимо этого, объем раскрытия сущности имеет намерение охватывать такое устройство или способ, который осуществляется на практике с использованием другой структуры, функциональности либо структуры и функциональности в дополнение или помимо различных аспектов раскрытия сущности, изложенных в данном документе. Следует понимать, что любой аспект раскрытия сущности, раскрытый в данном документе, может осуществляться посредством одного или более элементов формулы изобретения.

[0060] Слово "примерный" используется в данном документе для того, чтобы означать "служащий в качестве примера, отдельного случая или иллюстрации". Любой аспект, описанный в данном документе как "примерный", не обязательно должен быть истолкован как предпочтительный или выгодный по сравнению с другими аспектами.

[0061] Хотя в данном документе описаны конкретные аспекты, множество изменений и перестановок этих аспектов попадают в пределы объема раскрытия сущности. Хотя упоминаются некоторые выгоды и преимущества предпочтительных аспектов, объем раскрытия сущности не имеет намерение быть ограниченным конкретными выгодами, вариантами использования или целями. Наоборот, аспекты раскрытия сущности имеют намерение широкого применения к различным технологиям, конфигурациям систем, сетям и протоколам, некоторые из которых проиллюстрированы в качестве примера на чертежах и в нижеприведенном описании предпочтительных аспектов. Подробное описание и чертежи являются просто иллюстративными, а не ограничивающими раскрытие сущности, при этом объем раскрытия сущности задается посредством прилагаемой формулы изобретения и ее эквивалентов.

ПРИМЕРНАЯ НЕЙРОННАЯ СИСТЕМА

[0062] Фиг. 1 иллюстрирует примерную нейронную систему 100 с несколькими уровнями нейронов в соответствии с конкретными аспектами настоящего раскрытия сущности. Нейронная система 100 может содержать уровень нейронов 102, соединенный с другим уровнем нейронов 106 через сеть синаптических соединений 104. Для простоты, только два уровня нейронов проиллюстрированы на фиг. 1, хотя меньшее или большее число уровней нейронов может существовать в типичной нейронной системе.

[0063] Как проиллюстрировано на фиг. 1, каждый нейрон на уровне 102 может принимать входной сигнал 108, который может быть сформирован посредством множества нейронов предыдущего уровня (не показан на фиг. 1). Сигнал 108 может представлять входной ток нейрона уровня 102. Этот ток может накапливаться на мембране нейрона, чтобы заряжать мембранный потенциал. Когда мембранный потенциал достигает своего порогового значения, нейрон может возбуждать и формировать выходной спайк, который должен переноситься на следующий уровень нейронов (например, уровень 106).

[0064] Перенос спайков с одного уровня нейронов на другой может осуществляться через сеть синаптических соединений (или просто "синапсов") 104, как проиллюстрировано на фиг. 1. Синапсы 104 могут принимать выходные сигналы (т.е. спайки) из нейронов уровня 102, масштабировать эти сигналы согласно регулируемым синаптическим весовым коэффициентам

[0065] Нейронная система 100 может моделироваться посредством электрической схемы и использоваться в большом спектре вариантов применения, таких как распознавание изображений и шаблонов, машинное обучение, управление моторами и т.п. Каждый нейрон в нейронной системе 100 может быть реализован как нейронная схема. Мембрана нейрона, заряженная до порогового значения, инициирующего выходной спайк, может быть реализована, например, в качестве конденсатора, который интегрирует электрический ток, протекающий через нее.

[0066] В аспекте, конденсатор может исключаться в качестве устройства интеграции электрического тока нейронной схемы, и вместо него может использоваться меньший мемристорный элемент. Этот подход может применяться в нейронных схемах, а также в различных других вариантах применения, в которых большие конденсаторы используются в качестве интеграторов электрического тока. Помимо этого, каждый из синапсов 104 может быть реализован на основе мемристорного элемента, при этом изменения синаптических весовых коэффициентов могут быть связаны с изменениями сопротивления мемристора. За счет мемристоров с нанометровым размером элементов может быть существенно уменьшена площадь нейронной схемы и синапсов, что позволяет обеспечивать практичность реализации очень крупномасштабной аппаратной реализации нейронной системы.

СПОСОБ НЕЙРОННОГО КОДИРОВАНИЯ, ОБУЧЕНИЯ И РАСПОЗНАВАНИЯ НА ОСНОВЕ ВРЕМЕННЫХ ШАБЛОНОВ

[0067] Поскольку нейронные схемы нейронной системы 100 могут передавать информацию временно с использованием так называемых временных кодов в форме синхронизированных спайков, основной интерес представляют способы кодирования и декодирования, а также способы изучения такой временной информации. Конкретные аспекты настоящего раскрытия сущности поддерживают способы для различения временных шаблонов, а (в отличие от других способов "на основе временных шаблонов") не просто совпадения вводов или порядка вводов. Кроме того, настоящее раскрытие сущности предлагает практические способы, которые являются биотехнологическими/согласованными, но имеют меньшую сложность и допускают кодирование, декодирование, распознавание и изучение временных шаблонов спайковых сигналов.

[0068] Система, предложенная в настоящем раскрытии сущности, может содержать комбинацию взаимозависимых признаков, проиллюстрированных на фиг. 2. В общем, система 200 может быть нацелена на аспект обучения (например, хеббиановского обучения) и аспект выполнения (динамическую спайковую модель). Относительная входная синхронизация для спайковой модели может быть определена посредством аспекта линии(й) дендритной задержки, на которую может оказывать влияние синаптический оборот и другие аспекты. Обучение может определять синаптические весовые коэффициенты, а также влияние на другие аспекты, и на него может оказывать влияние регулирование (нормализация), совмещение, отжиг, а также другие аспекты. Каждый из этих аспектов поясняется в настоящем раскрытии сущности наряду с взаимосвязью с другими аспектами, а также их значимостью, параметрами и преимуществами.

ЛИНИИ ОТНОСИТЕЛЬНОЙ ЗАДЕРЖКИ И ДЕНДРИТНОЙ ЗАДЕРЖКИ

[0069] В настоящем раскрытии сущности предлагается способ, в котором поведение нейрона может быть определено на основе относительной задержки между вводами в синапсах, относительной задержки между вводами в синапсах и опорным вводом либо и того, и другого. Базовый аспект модели временного кодирования проиллюстрирован на фиг. 3. Пространственно-временной шаблон спайков, выводимых из нейронов 302, 304, 306, 308 (т.е. входных нейронов), может составлять вводы спайков для нейрона 310 (т.е. выходного нейрона). Каждый входной нейрон может соединяться с нейроном 310 через один или более синапсов на одном или более дендритов нейрона 310. Каждый синапс может иметь ассоциированную задержку, которая характеризует временную задержку, которой подвергается спайк из входного нейрона до достижения сомы нейрона 310, как проиллюстрировано на фиг. 3 для синапсов 312, соединяющих нейрон 304 с нейроном 310. Как проиллюстрировано на фиг. 3, вводы могут подвергаться масштабированию перед задержкой и интеграцией. Альтернативно, вводы могут подвергаться задержке перед масштабированием для сокращения объема обработки в крупномасштабных нейронных сетях.

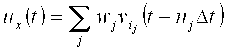

[0070] С использованием этого способа нейрон может распознавать пространственно-временные шаблоны в выводах входных нейронов (пространственные в смысле входных нейронов, временные в смысле относительной синхронизации спайков или временных разностей между спайками). Это проиллюстрировано на фиг. 4, на котором входные нейроны 402, 404, 406, 408 могут образовывать спайк в различные моменты времени. Тем не менее, вследствие задержек в дендрите(ах), сигналы из входных нейронов могут достигать сомы выходного нейрона x, совмещенного во времени. Ввод в выходной нейрон x во время t в силу этого может выражаться как функция от задержанных выводов входных нейронов, т.е.:

где j является индексом синапса,

[0071] Фактическая синхронизация возбуждения нейронов 402, 404, 406, 408 помечается в качестве 410 на фиг. 4. Вследствие конкретных задержек, соответствующих синапсам (обозначаются посредством кратных чисел разрешения

[0072] В предпочтительном аспекте настоящего раскрытия сущности, могут использоваться дискретные временные задержки в целочисленное число миллисекунд (т.е. задержки в кратных числах разрешения временной задержки

[0073] Данные зависимой от синхронизации спайков пластичности (STDP) могут экспериментально измеряться и сообщаться. Типичные иллюстрации таких обучающих взаимосвязей проиллюстрированы на фиг. 5 с помощью кривой 502 долговременной потенциации (LTP) и кривой 504 долговременного подавления (LTD). Типично, ось X указывает разность времен между вводом и выводом (причем причинная предусмотрена для кривой 502, а непричинная предусмотрена для кривой 504). Следует отметить, что предложенный способ может обуславливать задержки в дендритах. Таким образом, ось X может рассматриваться на кривых обучения в качестве задержки между возбуждением нейрона и повторно совмещенными вводами. В настоящем раскрытии сущности,

[0074] Кроме того, может предлагаться множество изменений для того, чтобы отражать варьирование чувствительности к разностям времен, а также просто усиление или ослабление взаимосвязей, масштабирование и изменения означенного. Следует отметить, что, в общем, горизонтальные расширения в причинных и непричинных направлениях не обязательно могут быть идентичным. Аналогично, пиковые отрицательные и положительные абсолютные величины могут отличаться, чтобы неравномерно выделять/ослаблять обучение. Фиг. 6 иллюстрирует примеры 602, 604 изменения в чувствительности к разности времен в соответствии с конкретными аспектами настоящего раскрытия сущности. Фиг. 7 иллюстрирует пример 702 чистого усиления и пример 704 чистого ослабления в соответствии с конкретными аспектами настоящего раскрытия сущности.

СРЕДСТВО УПРАВЛЕНИЯ ДЛЯ СОПОСТАВЛЕНИЯ С ПРОСТРАНСТВЕННО-ВРЕМЕННЫМ ШАБЛОНОМ

[0075] Чтобы нейрон имел возможность распознавать временной шаблон спайков данной длительности, набор синапсов, возможно, должен иметь ненулевые (или не пренебрежимо малые) весовые коэффициенты с промежутком дендритных задержек, соответствующим длительности шаблона. Таким образом, несколько факторов могут быть релевантными для определения разрешимой длительности шаблона (промежутка временного окна), размера (спайков в окне) и разрешимой точности синхронизации. Согласно конкретным аспектам настоящего раскрытия сущности, эти факторы могут содержать, по меньшей мере, одно из следующего: длина дендрита (максимальная задержка), блочное запоминающее устройство (постоянная времени мембран в дендрите или соме), предсинаптическая мембранная чувствительность (постоянная времени предсинаптических эффектов фильтрации; определение ширины AP), постоянные времени синаптических проводимостей, или функциональная операция в дендрите (например, логическое "ИЛИ" в сравнении с логическим "И").

[0076] Следует отметить, что большая постоянная времени может уменьшать временное разрешение, поскольку эффект фильтрации нижних частот мембраны может уменьшать дифференцирование реакции спайков при различных задержках и при этом обеспечивать возможность рассмотрения более длинного шаблона. Другими словами, различные нейроны могут быть выполнены с различными временными шкалами, или временная шкала данного нейрона может быть изменена, или различные нейронные матрицы могут работать на различных (возможно перекрывающихся) временных шкалах. Кроме того, разрешимая сложность шаблона (в дополнение к длительности) также может быть ограничена посредством следующих факторов: число синапсов (при условии идентичного весового коэффициента, порогового значения), распределение весовых коэффициентов (при условии идентичного порогового значения, числа синапсов), пороговое значение (и уровень относительного покоя) (при условии идентичного числа синапсов, весового коэффициента).

[0077] Согласно конкретным аспектам настоящего раскрытия сущности, баланс может быть важным, поскольку, учитывая ограничение на одно или более вышеуказанного, шаблон может иметь слишком мало спайков для возбуждения нейрона (пересечение порогового значения) или слишком много спайков для различения посредством отдельного нейрона конкретного шаблона из изменений. Эти аспекты демонстрируются на фиг. 8, который содержит весовые коэффициенты каждого синапса.

[0078] Чтобы превышать пороговое значение 802 возбуждения, комбинированный совпадающий ввод, возможно, должен превышать пороговое значение (относительно потенциала покоя). Доля весовых коэффициентов, порогового значения и числа синапсов проиллюстрирована на фиг. 8. В случае 804, может быть слишком мало совпадающих синапсов (или слишком мало весовых коэффициентов, или пороговое значение 804 может быть слишком высоким). В случае 806, может быть истинным противоположное. Только в случае 808 совпадение может быть идеальным. Случай 806 может считаться либо нестрогим (избыточным), либо устойчивым в зависимости от точки зрения, в зависимости от контекста или уровня шума. Аналогично, случай 808 может считаться идеальным (точным или эффективным) либо чувствительным (нестабильным, неустойчивым).

[0079] Следует отметить, что для данного возбуждения, полная доля одного входного нейрона может быть определена посредством суммы синапсов с совпадающей задержкой (не просто относительно друг друга, а относительно комбинации с другими вводами) и их весовых коэффициентов. Если полный совпадающий ввод для входных нейронов для этих синапсов ниже порогового значения, то возбуждение может не возникать. Если полный совпадающий ввод для входных нейронов для этих синапсов выше порогового значения, то возбуждение может возникать. Это может быть проблематичным в связи с тем, что как проиллюстрировано в качестве случая 806 на фиг. 8, некоторые части шаблона 810 могут не требоваться для возбуждения, к примеру, шаблон ввода a (т.е. шаблон 812).

[0080] Способы для разрешения этой проблемы могут содержать нейронное регулирование, т.е. управление или нормализацию полной доли составляющих вводов, с точки зрения числа, весового коэффициента, частоты возбуждения и т.п.

СИНАПТИЧЕСКИЙ ОБОРОТ

[0081] Согласно конкретным аспектам настоящего раскрытия сущности, синаптический оборот также может быть важным для того, чтобы разрешать проблемы, описанные выше. Фактически, синаптический оборот может требоваться для того, чтобы разрешать вышеизложенные проблемы, если ограничено число синапсов или весовых коэффициентов (либо и то, и другое). Синаптический оборот может содержать многократное использование синаптического ресурса для другой временной задержки или другого ввода. Это может быть критически важным, если ресурсы являются ограниченными, или соединения являются ограниченными.

[0082] Поскольку местоположение синапса на дендрите может неявно кодировать синхронизацию спайков, если конкретное местоположение синапса (и следовательно, относительное время задержки) занимается посредством, в частности, ввода a, то идентичное дендритное время задержки не может быть использовано посредством другого ввода b в идентичном дендрите. Тем не менее, если ввод b должен использовать идентичное относительное время задержки, он, возможно, должен использовать синапс (с согласованием относительного времени задержки) на другом дендрите. В результате может требоваться экономия числа синапсов, используемых для того, чтобы представлять конкретный шаблон спайков, и связанной эффективности при многократном использовании синапсов (относительных времен задержки), которые имеют минимальные корреляции с конкретными вводами, так что идентичное время задержки может быть использовано посредством других вводов. В модели, используемой в настоящем раскрытии сущности, дендриты могут быть абстрагированы таким образом, что ограничений на это нет. Тем не менее, может быть стимул ограничивать общее число синапсов и многократно использовать ресурсы. Это может относиться к аппаратным или программным ресурсам, а также к нейронному регулированию.

[0083] Аспект синаптического оборота, в контексте системы, проиллюстрирован на фиг. 9. Следует отметить, что процесс синаптического оборота может эффективно выполняться периодически (не каждый временной шаг динамической спайковой модели или разрешения линии задержки) между одной или более итераций других аспектов модели. Можно предположить, что нейрон x на фиг. 9 инициализируется со случайными или равномерными весовыми коэффициентами в случайных вводах со случайными задержками, как проиллюстрировано на фиг. 9. По мере итеративного прохождения по модели механизм обучения зачастую может увеличивать некоторые весовые коэффициенты и снижать другие. В предложенной модели, будь то посредством кривой обучения или посредством хеббиановского правила, зачастую это может приводить к тому, что весовые коэффициенты достигают нуля или своего максимума (либо некоторого нормализованного максимума). Тем не менее, это может, в общем, не иметь место. Синапсы, которые имеют весовые коэффициенты около нуля (используется низкое пороговое значение), могут повторно оборачиваться посредством синаптического оборота, что позволяет получать, по меньшей мере, одно из следующего: новую задержку, новый ввод или новый весовой коэффициент. Каждое из означенного может быть произвольно или детерминированно определено и может быть ограничено (например, число синапсов в расчете на ввод или диапазон значения весового коэффициента). Затем, система может продолжать итеративное прохождение по другим аспектам, включающим в себя обучение, и весовые коэффициенты могут дополнительно адаптироваться.

[0084] Следует отметить, что, в общем, для нового синапса может предоставляться "испытательный срок", в течение которого он не может повторно оборачиваться, даже если его весовой коэффициент опускается ниже порогового значения.

[0085] После итеративного прохождения по способу обучения весовые коэффициенты могут падать или расти. Если число синапсов является ограниченным (для чего существует стимул), и весовые коэффициенты являются ограниченными (для чего также существует стимул - для нейронного регулирования), характеристики распознавания шаблонов могут быть ограничены, если только некоторые синапсы с более низкими (или относительно пренебрежимо малыми) весовыми коэффициентами не используются многократно. Синаптический оборот может содержать переконфигурирование синапса с другой задержкой и/или весовым коэффициентом и/или связностью (другим входным нейроном). За счет этого, синаптический шаблон нейрона может развиваться в направлении критической массы для конкретного входного шаблона (т.е. требовать конкретного числа синапсов для обеспечения соответствия конкретному числу спайков в шаблоне). Затем, если эта последовательность оборота и повторной итерации повторяется, то весовые коэффициенты могут изучаться прогрессивно, чтобы улучшать совпадение с шаблоном(ами).

ИНИЦИАЛИЗАЦИЯ НЕЙРОННОГО ОБУЧЕНИЯ

[0086] Следует отметить, что при STDP или других механизмах хеббиановского обучения, обучение может требовать возбуждения. Нейрон, который не возбуждается, не обучается. В настоящем раскрытии сущности предлагаются определенные способы для того, чтобы помогать обеспечивать что, изучение начинается эффективно без ограничения нейронной сети другими способами. Возбуждение нейрона может обеспечиваться посредством конфигурирования, по меньшей мере, одного из следующего: больших весовых коэффициентов, большого числа синапсов, больших постоянных времени, низкого порогового значения (состояния высокого относительного покоя), меньшего торможения в начале или большего входного шума.

[0087] Таким образом, в одном аспекте, для начала возбуждения посредством нейрона, колебание может быть использовано при вводе нейрона. В другом аспекте, синаптические весовые коэффициенты, ассоциированные с нейроном, могут задаваться высокими. В еще одном аспекте, число синапсов может задаваться высоким. Фиг. 10 иллюстрирует пример 1000 относительно того, как нейроны, которые являются первоначально более легковозбудимыми, могут обучаться намного быстрее, поскольку они возбуждаются больше и в силу этого их весовые коэффициенты регулируются быстрее. Например, в примере 1000, нейрон 1002 может возбуждаться редко. Этот нейрон может выступать в большей степени в качестве счетчика спайков, а не распознавателя временных шаблонов. Поскольку он возбуждается достаточно редко, он может иметь небольшую вероятность изучения весовых коэффициентов для временного кода. Аналогично, нейрон 1004 может оказываться просто счетчиком спайков из меньшего числа спайков (например, из четырех спайков). Нейрон 1004 может адаптироваться, но это может быть медленным процессом, поскольку он может возбуждаться только один раз в расчете на шаблон из четырех спайков.

[0088] Напротив, нейроны 1006, 1008 могут первоначально возбуждаться очень быстро и не оказываются допускающими распознавание временного шаблона. Тем не менее, может быть истинным совершенно противоположное. Поскольку эти нейроны могут возбуждаться настолько часто, их весовые коэффициенты могут быстро адаптироваться и, в зависимости от предыстории, могут фиксироваться на различных шаблонах, как проиллюстрировано на фиг. 10. По мере того, как адаптируются весовые коэффициенты, частота возбуждения может замедляться и фиксироваться на конкретном временном окне/задержке. Если этот процесс выполняется плавно, эти нейроны могут изучать временные коды намного лучше/быстрее, чем нейроны с медленным возбуждением. Затем, когда эти шаблоны снова возникают позднее, эти нейроны могут хорошо реагировать с возможностью согласовывать различные шаблоны или различные части шаблонов.

[0089] Касательно этого подхода может быть предусмотрено дополнительное временное преимущество. Нейроны могут первоначально возбуждаться на высокой частоте, что приводит к латеральному торможению для широких временных окон. Затем, нейроны могут начинать диверсификацию в зависимости от различных входных комбинаций и нейронного регулирования. После этого, нейроны могут начинать замедлять свои частоты возбуждения и в силу этого могут становиться более чувствительными к более точным задержкам и смещениям задержки на обучение. В аспекте, нейроны могут возбуждаться в моменты времени смещения, и латеральное торможение может уменьшаться через временные задержки. Теперь, нейроны с похожими, но различными шаблонами могут повышать частоту возбуждения и улучшать диверсификацию.

[0090] Переходы между уровнями активности могут быть крайне важными для диверсификации. Это может быть обусловлено тем, что нейроны с медленным возбуждением могут уменьшать свое тормозящее действие на другие. Дополнительно, нейроны, которые принимают меньшее торможение, могут повышать свою частоту возбуждения и тормозящее действие. Согласно вышеуказанному, уровень активности может влиять на способность к временному обучению, так что в комбинации с варьированием частот возбуждения обучение может продолжаться эффективным распределенным способом комбинаторного исследования с варьированием временной чувствительности от низкой к высокой в последовательности стадий до сходимости. В аспекте, характеристики запоминающего устройства сети могут зависеть от торможения, а также связности и отдельных нейронных аспектов и могут предоставляться в эффективном распределенном многоуровневом процессе.

МЕТОД ИМИТАЦИИ ОТЖИГА

[0091] Посредством уменьшения частоты регулирования весовых коэффициентов на основе счетчика возбуждений (предыстории активности), темп обучения нейрона может быть "охлажден", так что он может замораживаться, как только шаблон изучен. Это может быть, в частности, полезным при временном кодировании вследствие проблем, описанных выше. Например, использование STDP или других правил зачастую может пытаться сдвигать окна шаблона до тех пор, пока они не перекроются, и в силу этого может избыточным. Если весовые коэффициенты "охлаждаются", это может исключаться.

[0092] В завершение, следует отметить, что хотя некритично, если дендритная обработка является полностью интегративной (логическое "И"), должен быть некоторый компонент сложения, выше порогового значения, для функционирования временной системы. Другими словами, может быть возможным моделировать только дендриты в качестве операций логического "ИЛИ" при условии, что может быть предусмотрен интегративный компонент для дендритов или в соме.

[0093] Фиг. 11 иллюстрирует примерные операции 1100, которые могут выполняться посредством нейронной схемы нейронной сети для нейронного временного кодирования в соответствии с конкретными аспектами настоящего раскрытия сущности. На этапе 1102 может быть использована абстракция линии относительной задержки, которая может задерживать один или более синаптических вводов в нейронную схему посредством временных задержек. На этапе 1104 может применяться динамическая спайковая модель для того, чтобы определять спайковое поведение нейронной схемы на основе взвешенных и задержанных синаптических вводов нейронной схемы. На этапе 1106 весовые коэффициенты, ассоциированные с синаптическими вводами, могут регулироваться согласно правилу неконтролируемого обучения в зависимости от взаимосвязи по синхронизации образования спайков в нейронных схемах и задержанных синаптических вводов.

[0094] В аспекте настоящего раскрытия сущности, по меньшей мере, одно из: весовых коэффициентов, числа синапсов, ассоциированных с нейронной схемой, постоянных времени синапсов, порогового значения возбуждения нейронной схемы, степени торможения нейронной схемы или шума, ассоциированного с нейронной схемой, может управляться с возможностью обуславливать начальные частоты возбуждения нейронной схемы. Дополнительно, метод имитации отжига может применяться посредством правила неконтролируемого обучения для регулирования весовых коэффициентов.

[0095] В аспекте настоящего раскрытия сущности, допускающий повторное использование синапс, ассоциированный с нейронной схемой, может быть выбран, и, по меньшей мере, одно из весового коэффициента, задержки или афферента допускающего повторное использование синапса может быть модифицировано. Выбор допускающего повторное использование синапса может быть основан на уменьшении весового коэффициента допускающего повторное использование синапса посредством правила неконтролируемого обучения до значения ниже порогового значения. Дополнительно, выбор допускающего повторное использование синапса может быть обусловлен истекшим временем с момента, когда синапс был повторно использован.

СПОСОБ НЕЙРОННОГО КОДИРОВАНИЯ БОЛЬШИХ ИЛИ ДЛИННЫХ ПРОСТРАНСТВЕННО-ВРЕМЕННЫХ ШАБЛОНОВ

[0096] Предложенный способ на основе временных шаблонов может быть использован для того, чтобы разрабатывать нейрон, допускающий сопоставление с временным шаблоном с учетом длительности и размера (числа вводов) шаблона. Тем не менее, дополнительно может требоваться согласовывать больший шаблон. Фиг. 12 иллюстрирует график 1200 столбцов, указывающих вводы (спайки). Вертикальная позиция спайка указывает входной индекс или пространственную размерность, при этом горизонтальное направление представляет время. Как проиллюстрировано на фиг. 12, может быть предусмотрено три нейрона x, y и z для сопоставления с шаблоном, которые могут иметь возможность распознавать пространственно-временные части полного шаблона, указываемого посредством соответствующих прямоугольников 1202, 1204, 1206. Каждый из нейронов для сопоставления с шаблоном может рассматривать вводы в различном пространственно-временном кадре, которые могут перекрываться.

[0097] Настоящее раскрытие сущности предлагает решение относительно того, как распознавать весь шаблон, когда он возникает. Возможно, это потребуется выполнять эффективно (т.е. без слишком большого числа уровней нейрона). Дополнительно, предложенное решение может позволять предотвращать ложное распознавание шаблона, который содержит части, переупорядоченные или подставленные из требуемого шаблона.

[0098] Отдельные нейроны могут иметь ограниченные (или управляемые) характеристики с точки зрения разрешающей способности пространственных (числа рассматриваемых входных нейронов или синапсов) или временных (например, точности или окна) шаблонов, как описано выше. Тем не менее, изучение и распознавание более длинных временных шаблонов или больших пространственных шаблонов (либо и того, и другого) может осуществляться с использованием нескольких нейронов или нескольких уровней нейронов.

СЕТЬ ДЛЯ КОДИРОВАНИЯ БОЛЕЕ ДЛИННЫХ И БОЛЬШИХ ПРОСТРАНСТВЕННО-ВРЕМЕННЫХ ШАБЛОНОВ

[0099] В примере 1200, проиллюстрированном на фиг. 12, большая часть полного шаблона может согласовываться, если нейроны x, y и z возбуждаются. Тем не менее, в пространственно-временной инфраструктуре, это может требовать не только комбинирования выводов пространственно, но также и их комбинирования временно. Таким образом, нейрон i следующего уровня может иметь совпадающие задержки, как проиллюстрировано на фиг. 13. На фиг. 13, три уровня 1302, 1304, 1306 проиллюстрированы с вводами на уровне 1302, нейронами x, y, z с небольшим шаблоном на уровне 1304 и нейроном i с длинным/большим шаблоном на уровне 1306. Из фиг. 13 можно наблюдать, что выводы обоих уровней 1304 и 1306 могут формировать пространственно-временные шаблоны. Нейрон i уровня 1306 может содержать весовые коэффициенты и задержки для синапсов, которые совпадают с шаблоном спайков нейронов x, y, z. В примере, проиллюстрированном на фиг. 13, нейрон i может комбинировать результаты для смежных временных окон (x/z и y), но это может быть просто примером, поскольку этот структурный стандартный блок может собираться в иерархическую сетевую архитектуру, в которой последующие уровни кодируют/декодируют/реагируют на еще более длинные или большие пространственно-временные шаблоны.

[00100] Тем не менее, может быть необязательным добавлять все большее число уровней для того, чтобы распознавать/декодировать все более длинные временные шаблоны, поскольку временные окна отдельного нейрона могут управляться так, как описано выше (и за счет этого могут управляться сетевые временные окна).

МАСШТАБИРУЕМЫЕ ПРОСТРАНСТВЕННО-ВРЕМЕННЫЕ СЕТЕВЫЕ РЕШЕНИЯ

[00101] Кроме того, в комбинации с аксональными задержками или задержками вследствие сетевой архитектуры (различных трактов), более длинные шаблоны также могут сопоставляться с небольшим числом уровней. Это может быть продемонстрировано на фиг. 14. Нейроны w, x, y, и z уровня 1404 могут распознавать субшаблоны пространственно-временного шаблона в афферентах уровня 1402. Время возбуждения уровня 1404 (время возникновения потенциала действия (AP)) указывается на уровне 1406. Тем не менее, может потребоваться некоторое время для распространения AP вдоль соответствующих аксонов и достижения синапса(ов) для нейрона i, который находится на уровне 1410. Кроме того, в зависимости от свойств аксонального кабеля (длины, проводимости, мембранной проводимости и т.д.), это может отнимать различное количество времени в зависимости из нейрона. В этом случае, нейроны x, y, и z могут иметь большее аксональное расстояние (либо меньшую скорость (более тонкий миелин), либо больший сетевой тракт перескока) от сомы до предсинаптической точки в синаптическом переходе с нейроном i, чем нейрон w. AP-синхронизация в предсинаптической точке проиллюстрирована на уровне 1408. Синхронизация в этот момент может быть в пределах временного окна 1412, которое может разрешать нейрон i (т.е. они намного ближе во времени, чем в начале координат). Нейрон i может распознавать этот шаблон и в силу этого весь шаблон уровня 1402, и он может возбуждаться соответствующим образом. Фактически, аксональная задержка сжимает распознавание шаблонов произвольно длинного шаблона до окна для распознавания посредством нейрона i.

[00102] Другой способ для того, чтобы масштабировать характеристики временных шаблонов, может быть реализован с помощью рекуррентных соединений или саморекуррентных соединений. Нейрон или множество нейронов могут быть соединены таким образом, что частичное совпадение с шаблоном может быть подано в нейрон, который согласует последующую часть шаблона в комбинации с предыдущей частью, как проиллюстрировано на фиг. 15.

[00103] Этот принцип может быть дополнен несколькими способами. В одном аспекте настоящего раскрытия сущности, могут добавляться нейроны для того, чтобы изучать более длинные шаблоны. В другом аспекте, нейроны могут компилировать смежные или несмежные части шаблона. В еще одном аспекте, нейроны могут распознавать различные части шаблона с различной точностью или общностью или иметь различную чувствительность в зависимости от того, насколько критически важной является часть шаблона, или насколько переменным может быть ввод в этой части шаблона (пространственно или временно).

[00104] Следует отметить, что биологически аксональная задержка для предсинаптического нейрона типично может характеризоваться как равная для всех синапсов с этим нейроном (т.е. как общая аксональная задержка). Хотя это может быть полезным механизмом для совмещения/сжатия, как описано выше, способы, предложенные в настоящем раскрытии сущности, могут не требовать этого строго, поскольку аспекты обработки задержки могут быть абстрагированы. Независимо от того, входит первый нейрон в нейрон следующего уровня с различными дендритными задержками либо входят два нейрона с совершенно идентичной обработкой, но с различными аксональными задержками в нейрон следующего уровня, с вычислительной точки зрения может моделироваться эквивалентное представление задержки.

КОДИРОВАНИЕ НА ОСНОВЕ СУПЕРМАСШТАБИРУЕМЫХ/РЕКУРСИВНЫХ ВРЕМЕННЫХ ШАБЛОНОВ

[00105] Кроме того, сопоставление с еще более длинным временным шаблоном может осуществляться с использованием одного нейрона. Следует отметить, что один нейрон может быть выполнен с возможностью распознавать несколько шаблонов. Это может быть возможным, поскольку различные синапсы могут быть совпадающими в зависимости от входного шаблона (части). На фиг. 16, проиллюстрированы две части шаблона из идентичных четырех входных нейронов 1602, 1604, 1606, 1608. Следует отметить, что для первой части (половины), некоторые задержки могут приводить к совпадающему совмещению, тогда как другие могут не приводить к нему. Тем не менее, могут быть другие задержки (синапсы), которые совмещаются во второй части (половине) шаблона. Если весовые коэффициенты (и число) синапсов являются такими, что нейрон 1610 возбуждается при распознавании первой части шаблона, то они могут возвращаться себе (также с задержкой) и использоваться для того, чтобы сопоставлять со второй частью шаблона. Конечно, это может быть обобщено для любой длины шаблона. Следовательно, этот всего один рекуррентный нейрон 1610 может распознавать длинные шаблоны и/или большие пространственные шаблоны.

[00106] В дополнение к наличию механизмов для того, чтобы кодировать такие большие или более длинные временные шаблоны, дополнительно предлагаются способы обучения сети, которые могут эффективно разделять задачу кодирования на основе временных шаблонов между несколькими нейронами.

СПОСОБЫ ДЛЯ ДИФФЕРЕНЦИРОВАНИЯ ПРИ ИЗУЧЕНИИ ПРОСТРАНСТВЕННО-ВРЕМЕННЫХ ШАБЛОНОВ

[00107] Различные шаблоны могут быть распознаны с различными нейронами. При неконтролируемом обучении, может быть желательным для нейронов автономно изучать/выбирать различные шаблоны. Тем не менее, зависимая от синхронизации спайков пластичность (STDP), как типично представляется, может не допускать различение нейронов. Это также может быть важным при изучении более длинных шаблонов с использованием отдельных нейронов для различных частей. Если отсутствует дифференцирование (между частями), то может не допускаться полное соответствие (согласование/изучение) шаблонов.

[00108] Причина, по которой STDP может быть проблематичной, состоит в том, что она может приводить к временному уходу, так что безотносительно части шаблона, с которой нейрон начинает обучение, нейрон может сдвигаться к самой первой части шаблона. Чтобы разрешать эту проблему, может предлагаться несколько способов, такие как разделяющая нормализация (выходное торможение) или латеральное торможение (т.е. по принципу "победитель получает все").

[00109] Латеральное торможение или принцип "победитель получает все" позволяет повышать диверсификацию посредством введения конкуренции между временными шаблонами, предпочтения нейронов, которые возбуждаются в другое время, в силу этого потенциально расширяя покрытие шаблона. Влияние латерального торможения можно отметить на фиг. 17. Графики 1702, 1704 представляют адаптацию весовых коэффициентов в каждом нейроне с и без латерального торможения, соответственно.

[00110] Согласно наблюдаемым эффектам STDP, весовые коэффициенты могут стремиться к полюсам (биполярные весовые коэффициенты), либо вырастая до максимума, либо уменьшаясь практически до нуля. На графике 1702, без латерального торможения все нейроны могут изучать идентичный шаблон (неэффективный и ограниченный). На графике 1704, при латеральном торможении нейроны 1706, 1708 могут изучать различные части шаблона, в то время как нейроны 1710, 1712 могут оставаться неиспользуемыми (свободное запоминающее устройство).

[00111] Фиг. 18 иллюстрирует примерные операции 1800, которые могут выполняться в многоуровневой нейронной сети для нейронного временного кодирования длинных и больших пространственно-временных шаблонов в соответствии с конкретными аспектами настоящего раскрытия сущности. На этапе 1802 каждый уровень нейронных схем в иерархической многоуровневой нейронной сети может соединяться с вводом и с другим уровнем нейронных схем в многоуровневой нейронной сети. На этапе 1804, первый уровень нейронных схем в многоуровневой нейронной сети может сопоставляться с первой подсекцией входного шаблона, при этом этот соединенный уровень может согласовывать комбинацию возбуждения нейронных схем другого уровня в результате согласования подсекции входного шаблона и другой подсекции входного шаблона. В аспекте, другая подсекция входного шаблона может быть последовательной для подсекции входного шаблона.

[00112] Согласно конкретным аспектам настоящего раскрытия сущности, первый уровень может содержать сеть рекуррентных нейронных схем, возбужденных посредством первой подсекции входного шаблона, поддерживающего запоминающее устройство во временном коде, посредством воспроизведения полихронной волны возбуждения. Другая сеть рекуррентных нейронных схем многоуровневой нейронной сети может быть возбуждена посредством комбинации второй подсекции входного шаблона и полихронной волны возбуждения. В аспекте настоящего раскрытия сущности, аксональная задержка между уровнями иерархической многоуровневой нейронной сети может задерживать реакцию на согласование первой части входного шаблона таким образом, что реакция попадает в окно времени, соответствующее второй части входного шаблона.

[00113] Фиг. 19 иллюстрирует примерные операции 1900, которые могут выполняться в нейронной схеме нейронной сети для нейронного временного кодирования длинных и больших пространственно-временных шаблонов в соответствии с конкретными аспектами настоящего раскрытия сущности. На этапе 1902 синаптические вводы могут предоставляться, через синапсы с ассоциированными задержками, в нейронную схему, при этом, по меньшей мере, один из синаптических вводов может быть ассоциирован, по меньшей мере, с одним из самосоединяемых синапсов, синапсы могут принадлежать множеству наборов, и, по меньшей мере, один из наборов может содержать комбинацию задержек, чтобы согласовывать первую часть шаблона синаптических вводов, не содержащих рекурсивное самосоединение.

[00114] Согласно конкретным аспектам настоящего раскрытия сущности, по меньшей мере, один другой набор из множества наборов может содержать другую комбинацию задержек, чтобы согласовывать вторую часть шаблона и, по меньшей мере, самосоединяемый один синапс, имеющий задержку, чтобы коррелировать первую часть шаблона со второй частью шаблона, согласующейся с другой комбинацией задержек. В аспекте, аксональная задержка, ассоциированная, по меньшей мере, с одним самосоединяемым синапсом, может задерживать реакцию на согласование первой части шаблона таким образом, что реакция может попадать в окно времени, соответствующее второй части шаблона.

СПОСОБ ОБОБЩЕННОГО НЕЙРОННОГО КОДИРОВАНИЯ И ОБУЧЕНИЯ: ВРЕМЕННОЕ КОДИРОВАНИЕ И КОДИРОВАНИЕ НА ОСНОВЕ ЧАСТОТЫ

[00115] Традиционно, нейронная связь в теории должна кодироваться на частотах возбуждения (образования спайков) нейронов. Тем не менее, предполагается такая значимость синхронизации спайков, что связь может быть кодирована во временном совпадении спайков. Кроме того, предлагается, что временные шаблоны в синхронизации спайков могут кодировать информацию, и предлагается способ, посредством которого декодирование и изучение таких временных шаблонов может осуществляться биологически вероятным способом. В настоящем раскрытии сущности, дополнительно предлагается то, как одна модель может кодировать/декодировать спектр схем кодирования информации от частоты возбуждения (спайков) до совпадения спайков, чтобы обеспечивать спайк временных шаблонов, и то, как такая модель может динамически адаптировать способ декодирования через такой спектр или даже одновременно универсально работать в нескольких несколькими формах кода. Кроме того, предлагаются практические способы, которые являются биотехнологическими/согласованными, но имеют меньшую вычислительную сложность.

УНИВЕРСАЛЬНОЕ НЕЙРОННОЕ КОДИРОВАНИЕ - СОВПАДЕНИЕ, ВРЕМЕННОЕ И КОМБИНАЦИИ ЧАСТОТ ВОЗБУЖДЕНИЯ - СПЕКТР КОДОВ

[00116] Ключевое преимущество способа, предложенного в настоящем раскрытии сущности, заключается в том, что информация, кодированная согласно частоте возбуждения, совпадению синхронизации спайков или пространственно-временным шаблонам спайков, может быть декодирована посредством идентичной нейронной модели. В примерном случае, может рассматриваться нейрон x с афферентами (вводами) из нейронов a-d, как проиллюстрировано на фиг. 20. Дополнительно, можно предположить, что входная информация этих афферентов в нейрон x может быть кодирована в форме совпадения, временного шаблона или частоты возбуждения (либо комбинации частот возбуждения). Фиг. 20 иллюстрирует три характерных примера 2002, 2004, 2006 декодирования таких форм, в которых может быть предусмотрено произвольное временное разрешение, обозначаемое посредством

[00117] Фактические времена входных спайков могут быть задержаны посредством одной или более задержек, ассоциированных с одним или более соединений с этим вводом. Задержанные вводы, которые поступают во временном окне (интегративном окне), примерно соответствующем постоянной времени нейрона x, могут быть комбинированы, потенциально деполяризуя нейрон и в силу этого приводя к выходному спайку (потенциально после задержки в зависимости от этой деполяризации или уровня активности или возбудимости нейрона).

[00118] Совпадение синхронизации входных спайков (пример 2002 на фиг. 20) может быть декодировано с любыми задержками, которые равны (т.е. nai=nbi) или являются достаточно близкими таким образом, что результирующие задержанные спайки могут попадать в окно интеграции для нейрона x, так что комбинирование (интеграция) совпадающих задержанных афферентов может превышать пороговое значение, инструктирующее нейрону x возбуждаться с синхронизацией, передающей ненулевую взаимную информацию, ассоциированную с входным совпадением. Другими словами, тот факт, что нейрон x возбуждается, а также синхронизация выходного спайка нейрона x позволяют передавать информацию относительно совпадения вводов. Если нейрон x не возбуждается, он может передавать информацию, связанную с недостатком или отсутствием входного совпадения.

[00119] Нейрон может содержать несколько соединений с афферентами и различными задержками, ассоциированными с этими соединениями, как проиллюстрировано в примере 2002 на фиг. 20 для афферента b. Следует отметить, что может не требоваться, чтобы все такие задержки соответствовали друг другу (например, задержка на фиг. 20). Кроме того, как проиллюстрировано в примере 2004 на фиг. 20, если сравнивается недостаточное число задержек, не так много совпадающих фактических спайков может совмещаться после задержки и в силу этого может приводить к тому, что нейрон x не образует спайк (либо приводить к тому, что он образует спайк в другое время, например, позднее).

[00120] Кроме того, если задержки конфигурируются по-иному, совпадение во вводах не может быть распознано посредством нейрона x (см. пример 2102 на фиг. 21). Другими словами, нейрон может быть выполнен с возможностью распознавать (возбуждаться при применении к нему) совпадение вводов или нет. Чтобы идентифицировать тот факт, что несколько из задержек (но не все) отличаются, эти задержки указываются посредством простого обозначения (например, задержка nb1' на фиг. 21).

[00121] Временные шаблоны синхронизации входных спайков (например, пример 2004 на фиг. 20) могут быть декодированы с помощью профиля задержек, имеющих относительные различия, соответствующие разностям времен между спайками во временном шаблоне. В частности, может быть предусмотрена, по меньшей мере, одна задержка

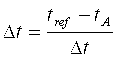

[00122] Следует отметить, что начало отсчета времени может означать опорный афферент (например, афферент a) либо абсолютную привязку ко времени или относительную привязку ко времени, отличную от афферентов (например, колебание), и синхронизация

[00123] Одна точка зрения этого может заключаться в том, что временные задержки могут эффективно преобразовывать шаблон задержки в совпадение, которое декодируется, как описано выше. Если достаточного числа требуемых задержек не существует (простые индикаторы задержек на фиг. 20-21, указывающие то, что они отличаются), задержанные спайки могут быть в большей степени распределены во времени, а не совмещены (см. пример 2202 на фиг. 22). Это может либо приводить к тому, что нейрон x не образует спайк (либо приводить к тому, что он образует спайк в другое время, например, позднее). Это может отличаться от случая, когда требуемый шаблон не предоставляется в качестве ввода (см. пример 2204 на фиг. 22), при этом может обеспечиваться аналогичный результат (отсутствие возбуждения), но поскольку нейрон может не быть выполнен с возможностью распознавать этот шаблон.

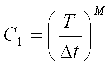

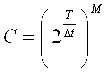

[00124] Можно снова отметить, что может не требоваться, чтобы все такие задержки соответствовали временному шаблону, например, как и в случае задержкой nb2 в примере 2004 на фиг. 20 или в примере 2206 на фиг. 22. Фактически, нейрон может иметь значительно большее число несоответствующих задержек для вводов, чем соответствующих задержек, и по-прежнему допускать различение требуемого временного шаблона для очень большого числа возможных вводов. Если предусмотрено M афферентов, разрешимое временное разрешение может составлять

[00125] Число возможных входных временных шаблонов с любым числом спайков в расчете на афферент может составлять:

[00126] Безусловно, число возможных шаблонов может становиться очень большим даже для относительно небольшого числа афферентов и диапазона задержки. Таким образом, если один нейрон имеет задержки, соответствующие, например, двум временным шаблонам, вероятность распознавания третьего нежелательного шаблона может быть исчезающее небольшой (т.е. 1/(C1-2)) и может быть ассоциирована с временным шаблоном, который является гибридом целевых шаблонов задержки. Другими словами, операция логического "ИЛИ" может быть реализована для входных шаблонов с высокой эффективностью, как проиллюстрировано на фиг. 23 (шаблон C может быть гибридом шаблонов A и B). При необходимости такие нецелевые шаблоны могут быть отклонены посредством архитектур с торможением или посредством отдельных нейронов, чтобы отличать шаблоны, или задержки могут быть сгруппированы в "дендритной ветви", так что задержки, соответствующие конкретным шаблонам, могут быть суммированы сверхлинейно в пределах ветви, но не между ветвями. Другой способ осуществлять это может состоять в том, чтобы применять пороговое значение возбуждения в расчете на дендритную ветвь нейрона x. Также следует отметить, что может не быть необходимости удваивать число соединений, чтобы согласовывать два различных шаблона, поскольку, по меньшей мере, одна задержка может быть многократно использована (см., например, задержку nc1 на фиг. 23).

[00127] Дополнительно можно отметить, что хотя шаблоны A и B проиллюстрированы в качестве временных шаблонов на фиг. 23, нет основания для того, что один или оба из них не могут частично или полностью представлять собой шаблон совпадения (с равными задержками). Другими словами, один нейрон может быть выполнен с возможностью распознавать смешивание временных шаблонов и совпадений.

[00128] В настоящем раскрытии сущности дополнительно предлагается то, что частоты возбуждения (спайков) вводов (пример 2002 на фиг. 20), также могут быть декодированы таким способом, если две или более задержек предоставляются в расчете на ввод (афферент), причем задержки могут соответствовать межспайковому интервалу афферента (обратной величине целевой входной частоты fA возбуждения для афферента A), т.е.:

[00129] Поскольку спайки одного ввода могут быть повторно совмещены в окне интеграции, нейрон x может декодировать частоту возбуждения и возбуждаться, когда комбинирование (интеграция) совпадающих задержанных вводов превышает пороговое значение. Аналогично совпадению и сопоставлению с временным шаблоном, как проиллюстрировано на фиг. 24, может быть необязательным, чтобы все задержки соответствовали друг другу (например, задержка nd2 в примере 2402 на фиг. 24 и в примере 2006 на фиг. 20). Кроме того, можно ожидать, что задержки, которые обеспечивают совмещение спайков из одного ввода, также могут формировать избыточные вспомогательные задержанные спайки, которые могут не совмещаться (например, задержка na1, применяемая ко второму входному спайку из афферента a на фиг. 24), но они могут быть подпороговыми и в силу этого могут не снижать производительность сопоставления с шаблоном.

[00130] Кроме того, задержки, соответствующие частоте, отличной от частоты, предоставляемой нейрону, могут не приводить к возбуждению при условии отличающегося порогового значения (т.е. следует сравнить предоставление идентичного шаблона в примерах 2402, 2404 на фиг. 24 с различными задержками; и следует сравнить предоставление различного шаблона в примере 2406 с идентичной конфигурацией задержки). Например, на фиг. 24, пороговое значение может быть выполнено равным 6, так что возбуждение нейрона x может выполняться, когда возникают комбинации частот возбуждения, показанные в примере 2402 (комбинация целевых частот возбуждения), а не другие.

[00131] Фиг. 25 иллюстрирует пример 2500, в котором две различных частоты возбуждения могут предоставляться для афферента a с нейроном x, выполненным с идентичной парой задержек для афферента a. Пара задержек может быть выполнена для целевой частоты A, т.е. так, чтобы приводить к почти полному совпадению изображений исходных спайков.

[00132] Фиг. 26 иллюстрирует пример 2600 относительно того, как две задержки в расчете на афферент (в этом случае для афферентов a и b) могут быть использованы для того, чтобы совмещать изображения исходного спайка. Посредством установления порогового значения нейрона x равным уровню, соответствующему числу совпадающих изображений (например, двум на фиг. 26), может согласовываться частота возбуждения одного афферента. Тем не менее, при попытке согласовывать комбинацию частот (одну частоту из A и одну частоту из B), если только пара задержек используется в расчете на афферент, в зависимости от совмещения последовательностей афферентных частот возбуждения, может потребоваться некоторое время до того, как изображения (спайки задержек) из обоих афферентов могут совмещаться в окне интеграции (следует сравнить изображения для афферента a с изображениями случая 1 для афферента b).

[00133] Тем не менее, ожидаемая задержка может быть сокращена посредством добавления дополнительных задержек (например, в случае 2 афферента b, существует три задержки, и более вероятно, что изображения афферентов a и b попадают в окно). Может рассматриваться конфигурирование нейрона x больше чем с двумя отводами задержки в расчете на афферент, чтобы согласовывать не просто пару входных спайков, возникающих на целевой входной частоте возбуждения, а вместо этого последовательность спайков на целевой входной частоте возбуждения (например, для устойчивости). Тем не менее, следует отметить, что может возникать наложение спектров, если используется более одной пары задержек в расчете на афферент, и они выполнены для последовательных спайков, если пороговое значение не задается достаточно высоким для того, чтобы согласовывать только полную последовательность. Таким образом, может требоваться конфигурировать задержки (если их больше двух) в разреженной временной компоновке. Например, чтобы согласовывать частоту в 1, это может предлагаться при задержках в 0 и 1. Если требуется большее временное окно, задержки могут добавляться для идентичного афферента в 3, 4 единицах разрешения задержки. Тем не менее, если пороговое значение увеличивается так, что оно требует четырех входных единиц, то время может быть задержано для обеспечения совпадения (что составляет, по меньшей мере, максимальную задержку).

[00134] Другой способ осуществлять это может состоять в том, чтобы инструктировать отдельным нейронам декодировать частоту возбуждения для каждого афферента. В аспекте, нейроны x, y, z, и w могут декодировать целевые частоты возбуждения для афферентов a, b, c, и d, соответственно. Затем, другой нейрон, выполненный с большой постоянной времени, может быть использован для того, чтобы согласовывать совпадение всех четырех из них, чтобы распознавать комбинацию целевых частот возбуждения. Тем не менее, это также может осуществляться с одним нейроном, который декодирует каждую частоту возбуждения на отдельных дендритных ветвях, выполненных с различными задержками, чтобы согласовывать различные частоты возбуждения. Еще один другой способ осуществлять распознавание частоты возбуждения может заключаться в использовании рекурсии. Тем не менее, это может требовать, чтобы вывод кодировался на основе частоты (подсчета спайков), а не общим способом.

[00135] Тем не менее, предлагается, что ни одна из этих технологий может не требоваться, когда входные частоты возбуждения находятся в пределах обоснованного диапазона относительно друг друга, поскольку кодирование информации в форме частоты возбуждения по сути медленнее (при условии идентичного числа афферентов) в качестве кодирования на основе временных шаблонов. Таким образом, декодирование частот возбуждения, возможно, не обязательно должно быть быстрым. Тем не менее, из этого можно вынести потенциально интересное наблюдение: частота возбуждения афферента x может просто быть функцией от периодичностей афферентов (а не от их относительных смещений), тогда как задержка для начала возбуждения посредством афферента x может быть функцией от их смещений. Другими словами, при декодировании комбинации афферентных частот возбуждения, нейрон x может возбуждаться на частоте, которая является постоянной независимо от смещений отдельных афферентных частот возбуждения, как проиллюстрировано на фиг. 27. Это может быть применимо для двух афферентов и может быть вероятностно применимо для множества афферентов. Тем не менее, частота возбуждения может изменяться, если предусмотрено более двух афферентов в зависимости от вероятности перекрытия изображений. Кроме того, может быть возможно то, что обучение может применяться способом, который приводит к идентичной частоте возбуждения независимо от смещений комбинаций частот возбуждения, поскольку несколько пар задержек могут быть использованы, и временное окно интеграции нейрона может быть модифицировано.

[00136] В вышеуказанных трех случаях кодирования (совпадение, временное, частота возбуждения/комбинация частот), можно отметить, что не все задержки должны совмещать целевую входную синхронизацию. Следовательно, один нейрон может быть выполнен с возможностью декодировать (распознавать) несколько совпадений разностей, несколько различных временных шаблонов либо несколько частот возбуждения или комбинаций частот. Кроме того, один нейрон может быть выполнен с возможностью декодировать смесь шаблонов совпадения, временных шаблонов и частот возбуждения или комбинаций частот. Вышеописанные способы могут быть обобщены, и способы на основе архитектурных или дендритных ветвей могут применяться к этим комбинациям с тем, чтобы уменьшать вероятность совпадения гибридного или нецелевого шаблона.

УНИВЕРСАЛЬНОЕ ОБУЧЕНИЕ - ОДИН СПОСОБ ДЛЯ ВСЕХ КОДОВ: СОВПАДЕНИЕ, ВРЕМЕННОЕ И КОМБИНАЦИИ ЧАСТОТ ВОЗБУЖДЕНИЯ