Область техники, к которой относится изобретение

Изобретение относится к средствам обработки цифровых видеопотоков, а именно к способам автоматического анализа видеопотоков растровых кадров и может использоваться в системах IP-видеонаблюдения.

Уровень техники

В качестве наиболее близкого аналога выбран известный способ анализа видеопотока, состоящий в определении тени от движущихся объектов на основе анализа данных о цвете, яркости и других параметрах пикселей (CN 104899881 (A), G06T 7/00, опубликовано 09.09.2015). Данный известный способ использует сложный алгоритм определения градиентов областей кадра и не исключает ошибок при классификации областей кадра.

Сущность изобретения

Задачей, на решение которой направлено настоящее изобретение, является создание способа анализа видеопотока, обеспечивающего качественное обнаружение и сопровождение движущихся объектов.

Настоящее изобретение обеспечивает достижение следующей совокупности технических результатов: повышение точности обнаружения и сопровождения подвижных объектов за счет эффективного идентифицирования теневых зон, схожих по характеристикам с движущимися объектами; уменьшение количества ложных обнаружений (как ложно положительных, так и ложноотрицательных); упрощение способа за счет совместного использования комплекса параметров пикселей.

Указанная совокупность технических результатов достигается тем, что способ анализа видеопотока состоит в том, что

- получают первый кадр видеопотока, для каждого пикселя которого определяют значение следующих компонент: компоненты Y яркости, компоненты цветоразности U и компоненты цветоразности V;

- на основе полученных параметров YUV формируют попиксельное предсказание кадра;

- получают следующий кадр видеопотока и осуществляют цикл анализа, а именно определяют пиксели, относящиеся к объекту, и формируют бинарную маску обнаруженного объекта;

- для упомянутых пикселей, относящихся к объекту, определяют, по крайней мере, один параметр цветовой схожести и параметр текстурной схожести;

- осуществляют сравнение упомянутых параметров цветовой схожести и текстурной схожести с их пороговыми значениями и классифицируют каждый пиксель как «тень/не тень» следующим образом: если значение параметра цветовой схожести не превышает порогового значения, то пиксель относят к классу «тень», если значение параметра цветовой схожести превышает пороговое значение, а значение параметра текстурной схожести не меньше порогового значения, то пиксель относят к классу «тень», в остальных случаях пиксель классифицируют как «не тень»;

- пиксели, классифицированные как «тень», относят к фоновой составляющей кадра, после чего уточняют попиксельное предсказание следующего кадра и повторяют цикл.

Указанная совокупность технических результатов достигается также тем, что упомянутую бинарную маску формируют на основе значений только компоненты Y.

Указанная совокупность технических результатов достигается также тем, что упомянутый параметр цветовой схожести определяют на основе компоненты U и дополнительно к нему определяют второй параметр цветовой схожести на основе компоненты V.

Отличительной особенностью настоящего изобретения является использование комбинации параметров пикселей в рамках цветовой модели YUV каждого кадра для идентифицирования теневых зон и постоянное обновление фоновой составляющей кадров.

Краткое описание фигур чертежей

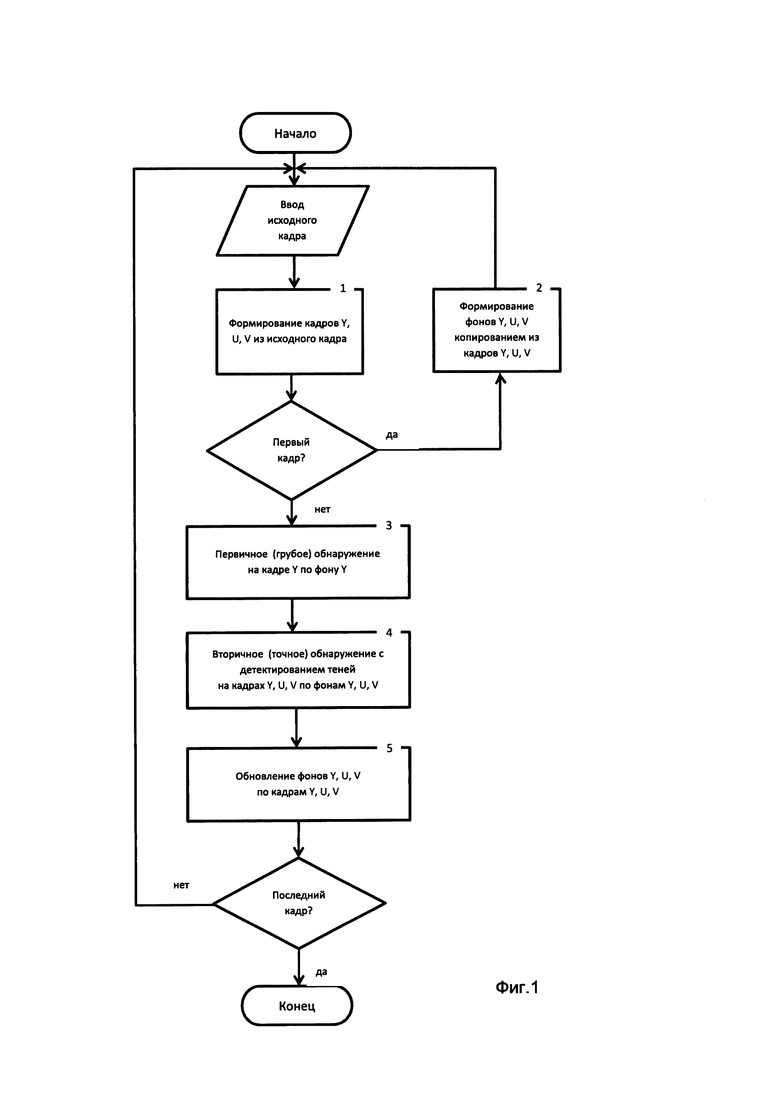

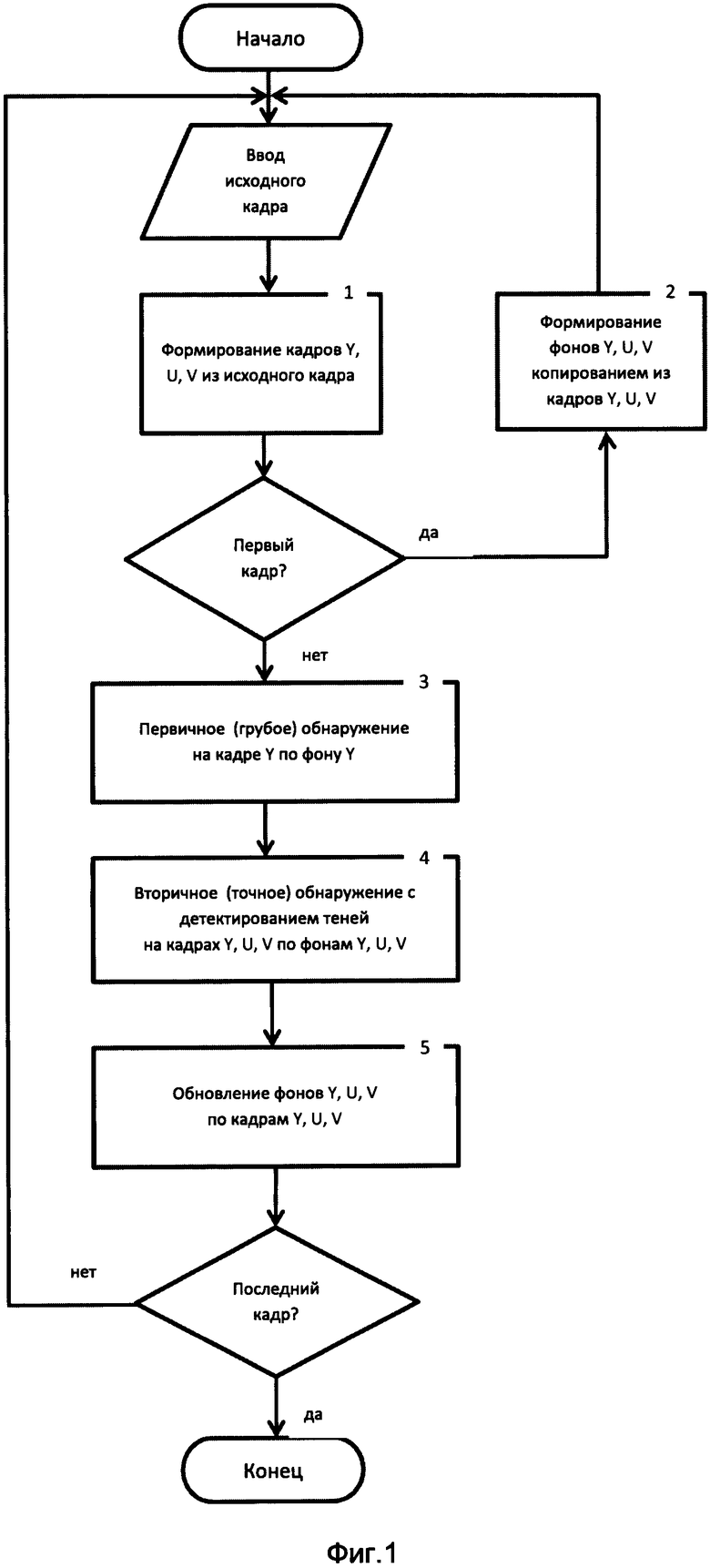

На Фиг. 1 показана блок-схема реализации способа.

На Фиг. 2-Фиг. 4 показаны, соответственно, исходный кадр, первичная бинарная маска обнаружения объекта и уточненная бинарная маска на этапе вторичного обнаружения подвижного объекта.

Сведения, подтверждающие возможность осуществления изобретения

Современные стационарные системы 1Р-видеонаблюдения обычно оснащаются подсистемами видеоаналитики для автоматического анализа видеопотока с целью обнаружения движущихся объектов. Видеопоток с видеокамеры наблюдения поступает по сетевому интерфейсу на сервер видеоаналитики для автоматического анализа либо анализируется непосредственно на камере, если камера оснащена встроенным сервером. Сервер выполняет анализ видеопотока с помощью программного обеспечения видеоаналитики и формирует описание видеопотока, как набора объектов. Исходный видеопоток и поток метаданных с формальным описанием объектов поступают по сетевому интерфейсу в центр мониторинга.

Существуют проблемы подсистемы видеоанэлитики, связанные: с ошибками первого рода (ложноположительные срабатывания), когда подсистема обнаруживает несуществующие объекты в сложных условиях наблюдения;

- с ошибками второго рода (ложноотрицательные срабатывания), когда подсистема в условиях плохой видимости не обнаруживает существующие объекты, в первую очередь малоконтрастные и замаскированные.

В общем случае качество работы подсистемы видеоаналитики определяется компромиссом между значениями вероятностей ошибок первого и второго рода. Общепринятым считается подход, когда задается допустимый уровень вероятности ложного обнаружения, то есть ошибки первого рода, и качество работы подсистемы видеоаналитики определяется вероятностью пропуска объекта, то есть ошибкой второго рода при заданном значении вероятности ошибки первого рода. При недостаточно строгом ограничении вероятности ошибки первого рода снижается вероятность пропуска объекта, но ложные срабатывания становятся массовыми, и подсистема видеоаналитики теряет работоспособность. При излишне строгом ограничении вероятности ошибки первого рода ложные срабатывания случаются реже, но повышается вероятность пропуска объекта.

Описанная проблема решается настоящим изобретением следующим образом.

Видеопоток формируют в виде последовательности растровых кадров с последующим двухэтапным обнаружением на каждом кадре движущихся объектов. Под объектами подразумеваются связные множества пикселей, имеющие сходные характеристики при переходе от кадра к кадру и перемещающиеся (перемещавшиеся в известной истории наблюдений) в системе координат кадра.

Суть способа состоит в том, что обнаружение подвижного объекта осуществляют в два этапа.

На этапе первичного обнаружения алгоритм настраивается на гарантированное выявление связных множеств пикселей, иначе говоря, потенциальных объектов, на заданной площади кадра. В основе процедуры первичного обнаружения лежит, например, механизм адаптивного порога: пороговое значение градиента яркости пикселя, при превышении которого пиксель предварительно включается в состав объекта, не является фиксированным, а изменяется от кадра к кадру. Используется следующее обобщенное правило. Если общее количество обнаруженных пикселей меньше заданной в настройках площади кадра, обязательной для обнаружения, порог уменьшается, чувствительность алгоритма повышается. Если общее количество обнаруженных пикселей больше обязательной доли площади кадра, порог увеличивается, чувствительность алгоритма уменьшается. Описанный подход гарантирует выявление наиболее заметных аномалий яркости множества пикселей, объемом равным или большим заданной доли площади кадра. Обнаруженные множества пикселей потенциально являются объектами и могут содержать только существующие объекты, или только ложные объекты (случайные флуктуации яркости кадра), или существующие и ложные объекты в неизвестной пропорции.

На этапе вторичного обнаружения производится фильтрация выявленных на первом этапе множеств пикселей с целью выявления заведомо ложных срабатываний за счет идентифицирования теневых зон. На этапе вторичного обнаружения одной из наиболее сложных проблем является выявление ложных срабатываний, обусловленных появлением теней в сцене, так как формально тень имеет все признаки существующего объекта. Происхождение тени с точки зрения подсистемы видеоаналитики не играет существенной роли. При изменении условий освещения тень может появляться и исчезать на близких по времени кадрах, то есть являться подвижной хотя бы одномоментно в смысле градиента яркости с фоном. Тень от неподвижных элементов сцены может перемещаться, менять пропорции и размеры, если перемещаются источники освещения, находящиеся за кадром. Тень может сопровождать подвижные объекты, пересекаясь или не пересекаясь с ними попиксельно.

Технический результат достигается за счет введения в алгоритм вторичного обнаружения дополнительной процедуры классификации «тень/не тень» каждого пикселя в составе потенциального объекта. В ситуации, когда все или значительное количество пикселей в составе объекта классифицированы как тень, обнаружение не производится. В ситуации, когда незначительное количество пикселей в составе объекта классифицированы как тень, производится уточнение границ объекта путем игнорирования классифицированных как тень пикселей, а затем обнаружение объекта с уточненными границами.

В настоящем изобретении используется цветовая модель YUV, в которой цвет представляется как 3 компонента - яркость (Y) и две цветоразностных (U и V). Данная модель широко применяется в телевещании и хранении/обработке видеоданных. Яркостная компонента содержит «черно-белое» (в оттенках серого) изображение, а оставшиеся две компоненты содержат информацию для восстановления требуемого цвета. В цветовом пространстве YUV есть один компонент, который представляет яркость (сигнал яркости), и два других компонента, которые представляют цвет (сигнал цветности). В то время как яркость передается со всеми деталями, некоторые детали в компонентах цветоразностного сигнала, лишенного информации о яркости, могут быть удалены путем понижения разрешения отсчетов (фильтрация или усреднение), что может быть сделано несколькими способами (то есть много форматов для сохранения изображения в цветовом пространстве YUV).

Таким образом, в настоящем изобретении каждый цветной кадр в видеопотоке приводится к цветовому пространству YUV, иначе говоря, раскладывается на три компоненты:

- яркостную компоненту Y - массив одноцветных пикселей, содержащих информацию об усредненной яркости по красной, зеленой и синей составляющим исходного цветного пиксела;

- цветоразностную компоненту U - массив одноцветных пикселей, содержащих информацию о нормированной разности красной и зеленой составляющих исходного цветного пиксела;

- цветоразностную компоненту V - массив одноцветных пикселей, содержащих информацию о нормированной разности синей и зеленой составляющих исходного цветного пиксела.

Исходный кадр видеопотока (Фиг. 2) попиксельно приводится к цветовой модели YUV. Компоненты Y, U, V копируются в отдельные однокомпонентные кадры, которые в дальнейшем обрабатываются независимо.

Для первого в истории наблюдений кадра выполняется попиксельная инициализация фона Y, иначе говоря, статичной составляющей компоненты Y, текущими значениями кадра Y, фона U -текущими значениями кадра U, фона V - текущими значениями кадра V. Для второго и последующих кадров этот шаг не выполняется, обновление фона производится на шаге 5. Таким образом, для каждого пиксела компонент Y, U и V по результатам статистических наблюдений по предыдущим кадрам строится предсказание значения на текущем кадре. Предсказанное значение считается фоновым, то есть в данном случае наиболее вероятным значением пиксела, а массивы предсказанных значений считаются фоновыми кадрами для каждой из компонент Y, U, V.

Далее на текущем кадре любыми известными методами производится первичное обнаружение, иначе говоря, выделяются области кадра, в которых вероятно присутствует движущийся объект. Это осуществляется следующим образом. Формируется грубый бинарный кадр маски обнаружения (Фиг. З) каждый пиксель которого принимает значение «0» (фон), если разница между значением пикселя текущего кадра Y и значением пикселя фонового кадра Y не превышает текущее значение адаптивного порога, и значение «1» (передний план) в другом случае. Кадры U и V на этапе первичного обнаружения игнорируются. Производится подстройка адаптивного порога для кадра Y: если количество пикселей переднего плана выше заданной доли от общего числа пикселей (настраиваемый параметр), порог повышается на единицу; если ниже, порог понижается на единицу; если равен, порог остается без изменений. Также допустимо использование любого другого алгоритма первичного обнаружения для формирования бинарного кадра маски обнаружения.

После этого производится вторичное обнаружение (фильтрация кандидатов в объекты) по пикселям, отнесенным на этапе первичного обнаружения к переднему плану. Пиксели, отнесенные на этапе первичного обнаружения к фону, игнорируются. Затем в выделенных областях, в пространственной окрестности (локальном плавающем окне) каждого пиксела вычисляются следующие параметры:

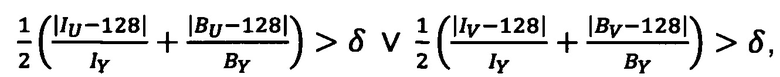

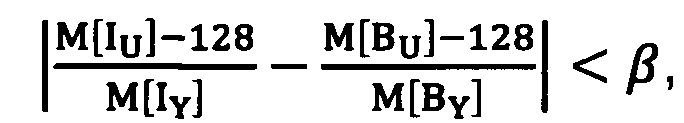

Определяется комплексный параметр №1, инвариантный к яркости и содержащий информацию о схожести цветовой составляющей U пикселей текущего кадра с цветовой составляющей пикселей U фонового кадра. Вычисляется как разность между отношением усредненного значения компоненты U к усредненному значению компоненты Y на текущем кадре и отношением значения усредненной компоненты U к значению усредненной компоненты Y на фоновом кадре. Под усредненным значением следует понимать среднее арифметическое по пространственной окрестности 3x3 каждого исследуемого пикселя текущего кадра U, текущего кадра Y, фонового кадра U, фонового кадра Y.

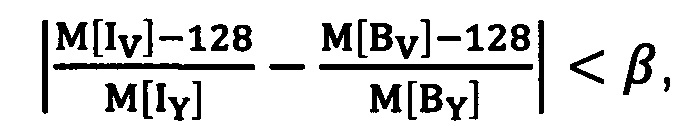

Дополнительно к параметру №1 может определяться параметр №2, инвариантный к яркости и содержащий информацию о схожести цветовой составляющей V пикселей текущего кадра с цветовой составляющей V пикселей фонового кадра. Вычисляется как разность между отношением усредненного значения компоненты V к усредненному значению компоненты Y на текущем кадре и отношением усредненного значения компоненты V к усредненному значению компоненты Y на фоновом кадре. Под усредненным значением следует понимать среднее арифметическое по пространственной окрестности 3x3 каждого исследуемого пикселя текущего кадра V, текущего кадра Y, фонового кадра V, фонового кадра Y.

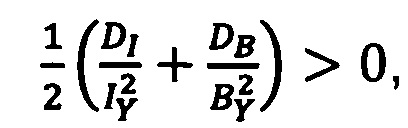

Далее определяется параметр №3, инвариантный к цвету и содержащий информацию о текстурной схожести пикселей текущего кадра с пикселями фонового кадра, а также ковариация компоненты Y текущего кадра и компоненты Y фонового кадра.

Указанные выше параметры могут определяться на основе следующих зависимостей:

а также:

где IY, IU, IV - значения компонент Y, U, V пикселя; BY, BU, BV - значения компонент Y, U, V пикселя на фоне;  - оператор среднего арифметического по пространственной окрестности; DI - дисперсия компоненты IY в пространственной окрестности; DB - дисперсия BY в пространственной окрестности; δ - порог наличия цвета; (β - порог сходства по цвету; ρY_max _ порог сходства по текстуре.

- оператор среднего арифметического по пространственной окрестности; DI - дисперсия компоненты IY в пространственной окрестности; DB - дисперсия BY в пространственной окрестности; δ - порог наличия цвета; (β - порог сходства по цвету; ρY_max _ порог сходства по текстуре.

Далее осуществляется выбор бинарного признака «тень/не тень» для каждого пикселя текущего кадра путем сравнения параметров №1 и №3 (при наличии и параметра №2) с экспериментально установленными пороговыми значениями. Проведенные исследования алгоритма в соответствии с настоящим изобретением на большой выборке эталонных видеозаписей показали, что экспериментально полученные пороговые значения в высокой степени инвариантны к условиям наблюдения, применимы к широкому классу изображений и требуют ручной подстройки только в особых случаях. Если параметры №1 и №2 (схожесть по цвету) не превышают порогового значения, пиксель относится к классу «тень», и параметр №3 не вычисляется и не анализируется. Если параметры №1 и №2 превышают пороговое значение, или цветовая информация отсутствует в связи с условиями наблюдения, пиксель не классифицируется, а вычисляется и анализируется параметр №3. Если параметр №3 (схожесть по текстуре) не меньше порогового значения, пиксель классифицируется как «тень». В любом другом случае пиксель классифицируется как «не тень».

Пиксели, имеющие признак «тень», помечаются в бинарной маске обнаружения, сформированной на этапе первичного обнаружения, значением «0», то есть относятся к фоновой составляющей кадра и не становятся частью объекта (Фиг. 4).

Далее для кадров Y, U, V выполняется обновление фонов Y, U, V путем адаптивного приближения к медианному значению в каждом пикселе за историю наблюдения. Допустимо использование и иных алгоритмов формирования фоновой составляющей кадра.

После проведенного цикла выполняется переход к обработке следующего кадра и цикл повторяется.

Таким образом, последовательность существенных действий в способе, состоящая в том, что

- получают первый кадр видеопотока, для каждого пикселя которого определяют значение следующих компонент: компоненты Y яркости, компоненты цветоразности U и компоненты цветоразности V;

- на основе полученных параметров YUV формируют попиксельное предсказание кадра;

- получают следующий кадр видеопотока и осуществляют цикл анализа, а именно определяют пиксели, относящиеся к объекту, и формируют бинарную маску обнаруженного объекта;

- для упомянутых пикселей, относящихся к объекту, определяют, по крайней мере, один параметр цветовой схожести и параметр текстурной схожести;

- осуществляют сравнение упомянутых параметров цветовой схожести и текстурной схожести с их пороговыми значениями и классифицируют каждый пиксель как «тень/не тень» следующим образом: если значение параметра цветовой схожести не превышает порогового значения, то пиксель относят к классу «тень», если значение параметра цветовой схожести превышает пороговое значение, а значение параметра текстурной схожести не меньше порогового значения, то пиксель относят к классу «тень», в остальных случаях пиксель классифицируют как «не тень»;

- пиксели, классифицированные как «тень», относят к фоновой составляющей кадра, после чего уточняют попиксельное предсказание следующего кадра и повторяют цикл,

обеспечивает применение дополнительной процедуры классификации «тень/не тень» каждого пиксела в составе предположительно движущегося объекта. ситуации, когда незначительное количество пикселей в составе объекта классифицированы как тень, производится уточнение границ объекта путем игнорирования классифицированных как тень пикселей, а затем обнаружение и сопровождение объекта с уточненными границами.

Реализация описанного способа может быть осуществлена программно-аппаратным способом на вычислительном комплексе общего назначения или специального назначения, располагающим аппаратным ускорителем операций цифровой обработки сигналов.

| название | год | авторы | номер документа |

|---|---|---|---|

| Способ идентификации объекта в видеопотоке | 2018 |

|

RU2676029C1 |

| Способ обнаружения оставленного предмета в видеопотоке | 2018 |

|

RU2676028C1 |

| СПОСОБ ОБНАРУЖЕНИЯ ОБЪЕКТОВ | 2008 |

|

RU2395787C2 |

| СПОСОБ КОРРЕКТИРОВКИ ОСВЕЩЕННОСТИ ОБЪЕКТА НА ИЗОБРАЖЕНИИ В ПОСЛЕДОВАТЕЛЬНОСТИ ИЗОБРАЖЕНИЙ И ВЫЧИСЛИТЕЛЬНОЕ УСТРОЙСТВО ПОЛЬЗОВАТЕЛЯ, РЕАЛИЗУЮЩЕЕ УПОМЯНУТЫЙ СПОСОБ | 2018 |

|

RU2697627C1 |

| УСТРОЙСТВО ОБРАБОТКИ ВИДЕОИНФОРМАЦИИ СИСТЕМЫ ОХРАННОЙ СИГНАЛИЗАЦИИ | 2009 |

|

RU2484531C2 |

| СПОСОБ И СИСТЕМА АНАЛИЗА СТАТИЧНЫХ ОБЪЕКТОВ В ВИДЕОПОТОКЕ | 2020 |

|

RU2723900C1 |

| СПОСОБ И УСТРОЙСТВО ДЕТЕКТИРОВАНИЯ ЛОКАЛЬНЫХ ОСОБЕННОСТЕЙ НА ИЗОБРАЖЕНИИ | 2013 |

|

RU2535184C2 |

| Способ детекции протяженных линейных объектов на изображении | 2022 |

|

RU2802991C1 |

| ОБРАБОТКА ДАННЫХ ДЛЯ СВЕРХРАЗРЕШЕНИЯ | 2017 |

|

RU2652722C1 |

| СПОСОБ КОМПЕНСАЦИИ ДВИЖЕНИЯ В ЦИФРОВЫХ ДИНАМИЧЕСКИХ ВИДЕОИЗОБРАЖЕНИЯХ | 2013 |

|

RU2552139C1 |

Изобретение относится к средствам обработки растровых изображений. Технический результат заключается в повышении точности определения подвижных объектов. В способе: получают первый кадр видеопотока, для каждого пикселя которого определяют значение следующих компонент: компоненты Y яркости, компоненты цветоразности U и компоненты цветоразности V; на основе полученных параметров YUV формируют попиксельное предсказание кадра; получают следующий кадр видеопотока и осуществляют цикл анализа, а именно определяют пиксели, относящиеся к объекту, и формируют бинарную маску обнаруженного объекта; для упомянутых пикселей, относящихся к объекту, определяют, по крайней мере, один параметр цветовой схожести и параметр текстурной схожести; осуществляют сравнение упомянутых параметров цветовой схожести и текстурной схожести с их пороговыми значениями и классифицируют каждый пиксель как «тень/не тень», после чего уточняют попиксельное предсказание следующего кадра и повторяют цикл. 2 з.п. ф-лы, 4 ил.

1. Способ анализа видеопотока, состоящий в том, что

- получают первый кадр видеопотока, для каждого пикселя которого определяют значение следующих компонент: компоненты Y яркости, компоненты цветоразности U и компоненты цветоразности V;

- на основе полученных параметров YUV формируют попиксельное предсказание кадра;

- получают следующий кадр видеопотока и осуществляют цикл анализа, а именно определяют пиксели, относящиеся к объекту, и формируют бинарную маску обнаруженного объекта;

- для упомянутых пикселей, относящихся к объекту, определяют, по крайней мере, один параметр цветовой схожести и параметр текстурной схожести;

- осуществляют сравнение упомянутых параметров цветовой схожести и текстурной схожести с их пороговыми значениями и классифицируют каждый пиксель как «тень/не тень» следующим образом: если значение параметра цветовой схожести не превышает порогового значения, то пиксель относят к классу «тень», если значение параметра цветовой схожести превышает пороговое значение, а значение параметра текстурной схожести не меньше порогового значения, то пиксель относят к классу «тень», в остальных случаях пиксель классифицируют как «не тень»;

- пиксели, классифицированные как «тень», относят к фоновой составляющей кадра, после чего уточняют попиксельное предсказание следующего кадра и повторяют цикл.

2. Способ по п. 1, отличающийся тем, что упомянутую бинарную маску формируют на основе значений только компоненты Y.

3. Способ по п. 1, отличающийся тем, что упомянутый параметр цветовой схожести определяют на основе компоненты U и дополнительно к нему определяют второй параметр цветовой схожести на основе компоненты V.

| CN 104899881, 09.09.2015 | |||

| US 20140015964 A1, 16.01.2014 | |||

| СПОСОБ ОБМЕНА ДАННЫМИ МЕЖДУ IP ВИДЕОКАМЕРОЙ И СЕРВЕРОМ (ВАРИАНТЫ) | 2016 |

|

RU2632473C1 |

| US 20140333777 A1, 13.11.2014. | |||

Авторы

Даты

2018-12-25—Публикация

2018-03-23—Подача