ОБЛАСТЬ ТЕХНИКИ

[001] Данное техническое решение, в общем, относится к области вычислительной техники, а в частности к способам и системам для распознавания лиц с помощью очков дополненной реальности с интегрированной камерой или с использованием комплекса систем, обеспечивающих видеонаблюдение.

УРОВЕНЬ ТЕХНИКИ

[002] В настоящее время существует проблема идентификации преступников среди массового скопления людей, например, в общественных местах или на публичных мероприятиях. Сотрудники охраны не всегда способны без использования дополнительной техники идентифицировать преступника. Это может быть связано с различными факторами, например, визуально внешность человека с течением времени может сильно изменяться из-за отращивания/сбривания бороды, изменения прически или цвета глаз и т.д. Так же может присутствовать человеческий фактор - утомляемость, приводящая к рассеиванию внимания.

[003] Системы биометрической идентификации по лицу позволяют распознать лицо человека, несмотря на вышеперечисленные возможные изменения внешности. Существуют системы, включающие в себя очки дополненной реальности со встроенной камерой, интегрированные с системой идентификации по биометрии лица, но такая система позволяет решить проблему локально, только в месте нахождения сотрудника охраны. В помещениях с большой площадью, например, на стадионах, такое решение не является эффективным. Анализ предшествующего уровня техники позволяет сделать вывод о неэффективности и в некоторых случаях о невозможности применения предшествующих технологий, недостатки которых решаются настоящим изобретением.

СУЩНОСТЬ ТЕХНИЧЕСКОГО РЕШЕНИЯ

[004] Технической проблемой или задачей, поставленной в данном техническом решении, является создание надежного способа биометрического распознавания лиц с помощью средств дополненной реальности, а также системы для реализации способа. Дополнительной задачей является визуальное отображение классифицированных людей на дисплее очков дополненной реальности и построение маршрута до детектированного объекта с использованием технологий indoor-навигации.

[005] Техническим результатом, достигаемым при решении вышеуказанной технической задачи, является снижение времени поиска людей в местах массового скопления людей или больших многоэтажных зданий, в которых данные люди не должны находиться, и повышение точности идентификации лиц. После детектирования таких людей заявленная система позволяет построить маршрут до сегмента внутри помещения, в котором находится зафиксированное лицо, что сокращает время задержания.

[006] Указанный технический результат достигается благодаря осуществлению способа распознавания лиц в видеопотоке, выполняемый по меньшей мере одним вычислительным устройством, содержащего этапы, на которых: получают видеопоток от по меньшей мере одного источника видеопотока с изображением области пространства;

- захватывают кадры видеопотока при обнаружении на них изображения по меньшей мере одного лица;

- определяют положение и размер изображения лица на каждом захваченном кадре;

- определяют показатели качества изображения лица на захваченных кадрах, на которых размер изображения лица выше заранее заданных пороговых значений;

- выбирают изображение лица с максимальным показателем качества изображения лица;

- рассчитывают вектор, характеризующий признаки изображения лица, на основе выбранного изображения лица;

- сравнивают рассчитанный вектор с сохраненными векторами изображений в базе данных (БД);

- на основе результатов сравнения рассчитанного вектора с сохраненными векторами присваивают лицу параметр доступа, определяющий разрешение на нахождение в области пространства;

- выводят параметр доступа на устройство отображения изображения.

[007] В одном из частных примеров осуществления способа устройство отображения изображения представляет собой устройство дополненной реальности, причем параметр доступа выводят в режиме дополненной реальности.

[008] В другом частном примере осуществления способа дополнительно задают область интереса для поступающих кадров видеопотока, при этом захватывают только те кадры видеопотока, на которых изображение лица попадает в заданную область интереса.

[009] В другом частном примере осуществления способа после захвата кадров видеопотока при обнаружении на них изображения по меньшей мере одного лица дополнительно выполняют этап, на котором:

- определяют наличие изображения человека в кадре, изображение лица которого было обнаружено, причем для определения наличия изображения человека в кадре определяют наличие в кадре: изображения плеч в соответствующей изображению лица области или изображения тела человека.

[0010] В другом частном примере осуществления способа показатели качества изображения лица определяются на основе по меньшей мере одного параметра лица:

- поворота головы (в градусах) по каждой из трех осей вращения наклон вверх/вниз относительно горизонтальной оси;

- наклона влево/вправо относительно вертикальной оси;

- поворота относительно вертикальной оси.

[0011] В другом частном примере осуществления способа дополнительно выполняют этапы, на которых:

- определяют местоположение лица с назначенным параметром доступа, указывающим на то, что у лица нет разрешения находиться в области пространства;

- определяют по меньшей мере одно устройство дополненной реальности, расположенное наиболее близко к упомянутой области пространства;

- формируют маршрут из области пространства, в которой размещено данное устройство дополненной реальности, до области пространства, в которой находится упомянутое лицо;

- отображают маршрут на устройстве дополненной реальности в режиме дополненной реальности.

[0012] В другом частном примере осуществления способа дополнительно выполняют этапы, на которых:

- отслеживают перемещение устройства дополненной реальности в режиме реального времени;

- корректируют маршрут в случае отклонения траектории движения устройства дополненной реальности от сформированного ранее маршрута.

[0013] В другом частном примере осуществления способа дополнительно выполняют этапы, на которых:

- при достижении устройства дополненной реальности области пространства, в которой находится упомянутое лицо, анализирует в реальном времени входящий видеопоток от камеры устройства дополненной реальности для определения наличия в кадрах видеопотока по меньшей мере одного лица;

- выводят в заданную область дисплея устройства дополненной реальности в режиме дополненной реальности информацию о том, что у лица, находящегося в поле зрения сотрудника в AR-очках, нет разрешения находиться в области пространства в соответствии с присвоенным параметром доступа.

[0014] В другом частном примере осуществления способа дополнительно выполняют этапы, на которых:

- определяют местоположение лица в области пространства и местоположение по меньшей мере одного устройства дополненной реальности;

- преобразуют данные о местоположениях лица и устройства дополненной реальности в координаты в 3D модели пространства;

- определяют маршрут в 3D модели пространства от местоположения устройства дополненной реальности до упомянутого лица;

- формируют указатель траектории движения по маршруту в 3D модели пространства и выводят его на дисплей устройства дополненной реальности в режиме дополненной реальности для навигации сотрудника с устройством дополненной реальности до области, пространства, в котором находится упомянутое лицо, по маршруту, сформированному в 3D модели пространства.

[0015] В другом частном примере осуществления способа дополнительно выполняют этапы, на которых формируют в 3D модели пространства указатель лица в соответствии с его расположением в 3D модели пространства и выводят упомянутый указатель на дисплей устройства дополненной реальности в режиме дополненной реальности, когда лицо находится в области видимости сотрудника с устройством дополненной реальности, для указания на лицо в области пространства.

[0016] В другом предпочтительном варианте осуществления заявленного решения представлена система распознавания лиц в видеопотоке, содержащая по меньшей мере одно вычислительное устройство и по меньшей мере одну память, содержащую машиночитаемые инструкции, которые при их исполнении по меньшей мере одним вычислительным устройством выполняют вышеуказанный способ.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

[0017] Признаки и преимущества настоящего изобретения станут очевидными из приводимого ниже подробного описания изобретения и прилагаемых чертежей, на которых:

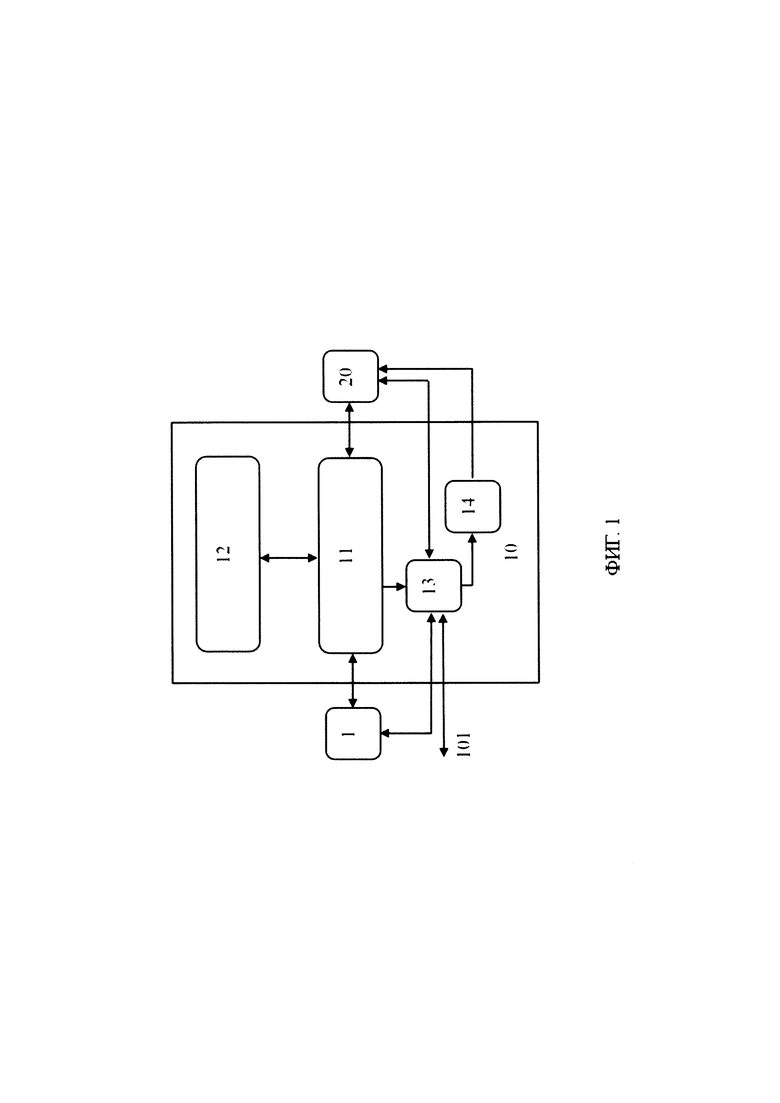

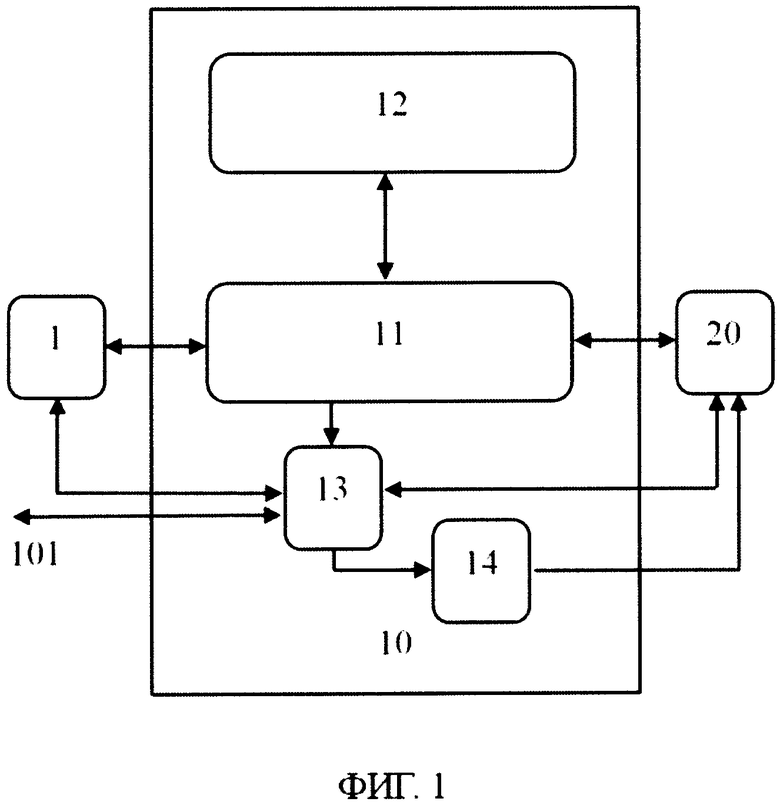

[0018] На Фиг. 1 представлен пример реализации устройства распознавания лиц.

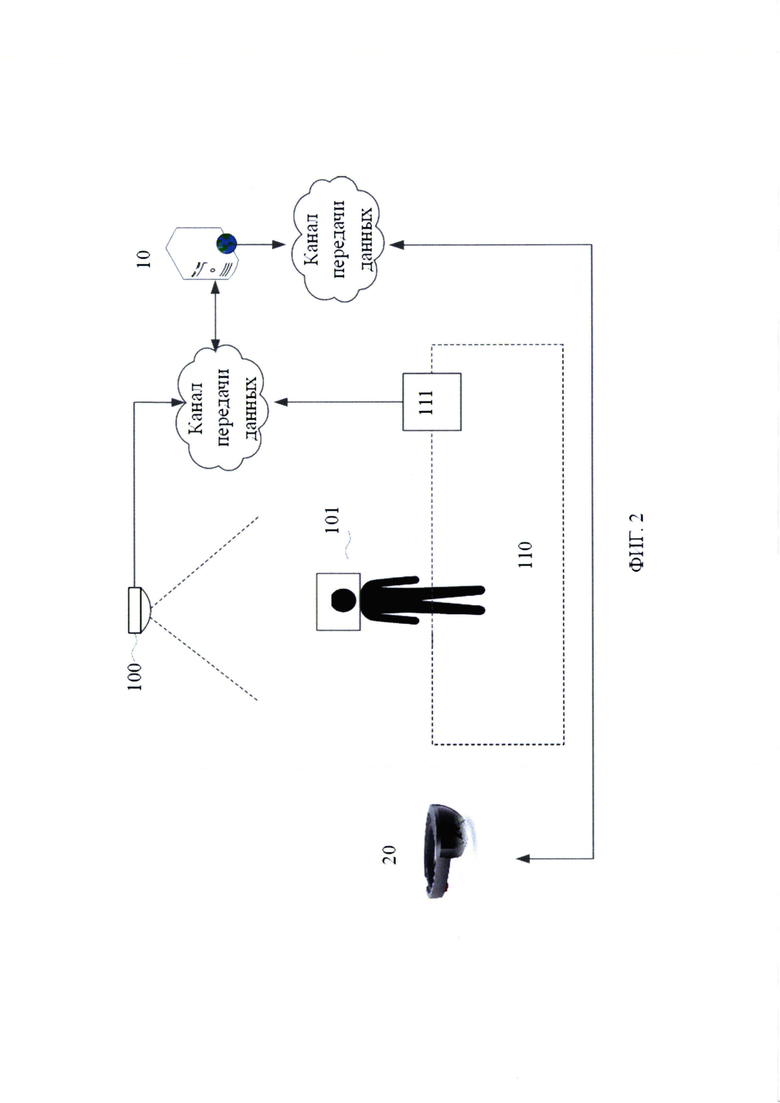

[0019] На Фиг. 2 представлен пример реализации системы для распознавания лиц с помощью средства дополненной реальности.

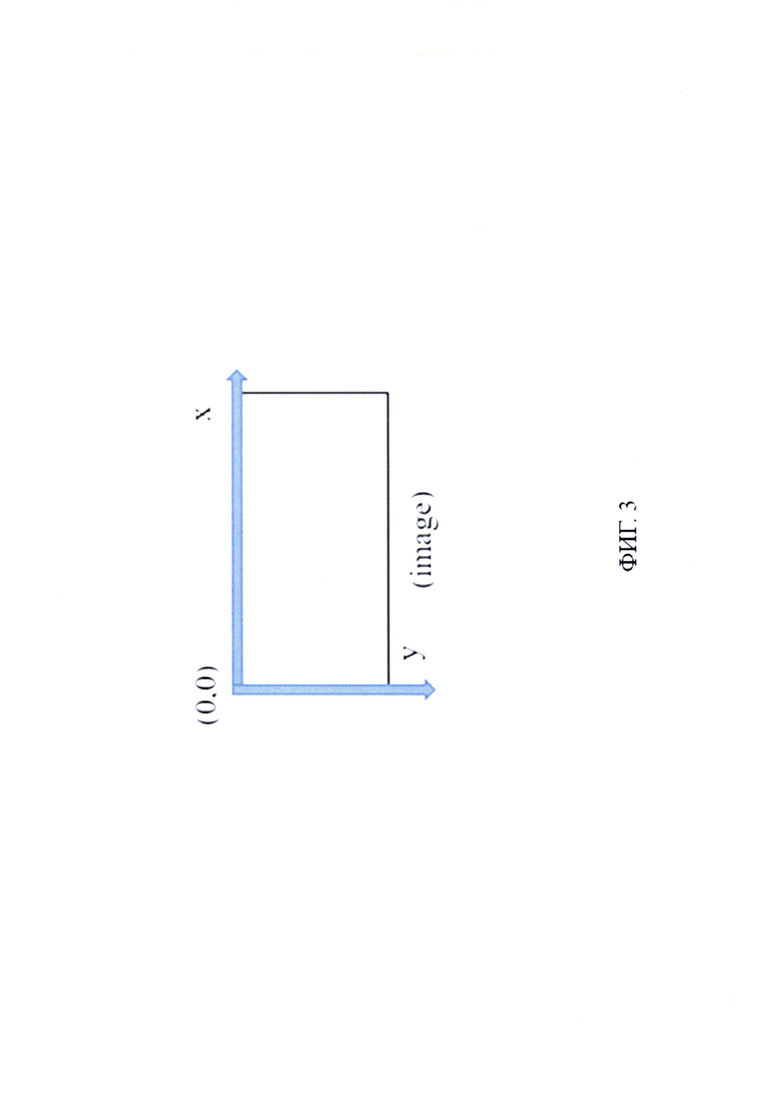

[0020] На Фиг. 3 представлен пример области интереса на изображении.

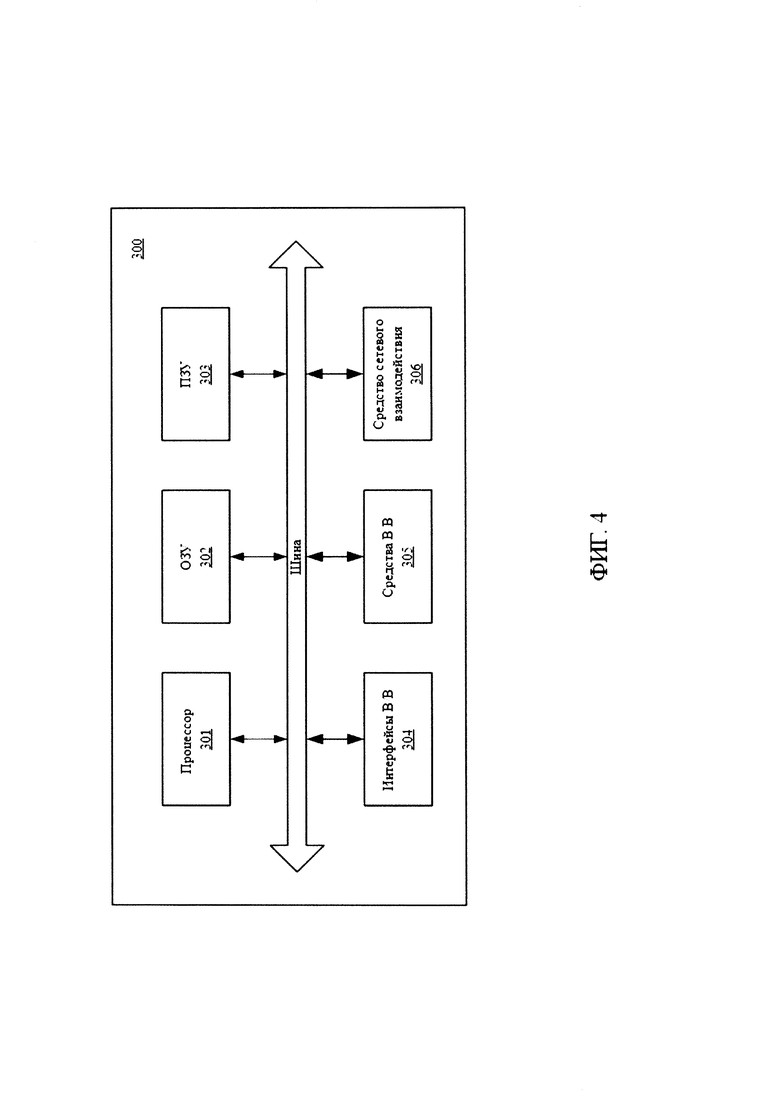

[0021] На Фиг. 4 представлен пример общего вида вычислительного устройства распознавания лиц.

ПОДРОБНОЕ ОПИСАНИЕ ИЗОБРЕТЕНИЯ

[0022] Ниже будут описаны понятия и термины, необходимые для понимания данного технического решения.

[0023] В данном техническом решении под системой подразумевается, в том числе компьютерная система, ЭВМ (электронно-вычислительная машина), ЧПУ (числовое программное управление), ПЛК (программируемый логический контроллер), компьютеризированные системы управления и любые другие устройства, способные выполнять заданную, четко определенную последовательность операций (действий, инструкций).

[0024] Под устройством обработки команд подразумевается электронный блок либо интегральная схема (микропроцессор), исполняющая машинные инструкции (программы).

[0025] Устройство обработки команд считывает и выполняет машинные инструкции (программы) с одного или более устройств хранения данных. В роли устройства хранения данных могут выступать, но не ограничиваясь, жесткие диски (HDD), флеш-память, ПЗУ (постоянное запоминающее устройство), твердотельные накопители (SSD), оптические приводы.

[0026] Программа - последовательность инструкций, предназначенных для исполнения устройством управления вычислительной машины или устройством обработки команд.

[0027] В соответствии со схемой, приведенной на Фиг. 1, система распознавания лиц с помощью средства дополненной реальности содержит источник видеопотока 1, устройство распознавания лиц 10 и устройство дополненной реальности 20.

[0028] Источником видеопотока 1 может являться внешняя камера видеонаблюдения (USB или IP) или интегрированная в устройство дополненной реальности камера. В качестве камер видеонаблюдения (иногда - видеокамер) могут применяться различные типы камер, в частности PTZ-камеры, IP-камеры, стационарные антивандальные камеры, камера кругового обзора и т.п., не ограничиваясь. Камера должна быть настроена на передачу видеопотока в устройство распознавания лиц 10, выполненное на базе по меньшей мере одного вычислительного устройства, например, сервера, который может находиться в облаке данных с развернутой платформой биометрической идентификации 11. Источник видеопотока 1, в частности камера видеонаблюдения или AR-очки, и устройство распознавания лиц 10 могут взаимодействовать для передачи данных по проводной и/или беспроводной связи с использованием протоколов передачи данных Socket и/или WebSocket, и/или WCF, и/или REST, и/или HTTP и WebSocket и пр.

[0029] В общем виде (см. Фиг. 4) устройство (300) распознавания лиц содержит объединенные общей шиной информационного обмена один или несколько процессоров (301), средства памяти, такие как ОЗУ (302) и ПЗУ (303), интерфейсы ввода/вывода (304), устройства ввода/вывода (305), и устройство для сетевого взаимодействия (306).

[0030] Процессор (301) (или несколько процессоров, многоядерный процессор и т.п.) может выбираться из ассортимента устройств, широко применяемых в настоящее время, например, таких производителей, как: Intel™, AMD™, Apple™, Samsung Exynos™, MediaTEK™, Qualcomm Snapdragon™ и т.п. Под процессором или одним из используемых процессоров в системе (300) также необходимо учитывать графический процессор, например, GPU NVIDIA или Graphcore, тип которых также является пригодным для полного или частичного выполнения способа (100), а также может применяться для обучения и применения моделей машинного обучения в различных информационных системах.

[0031] ОЗУ (302) представляет собой оперативную память и предназначено для хранения исполняемых процессором (301) машиночитаемых инструкций для выполнения необходимых операций по логической обработке данных. ОЗУ (302), как правило, содержит исполняемые инструкции операционной системы и соответствующих программных компонент (приложения, программные модули и т.п.). При этом в качестве ОЗУ (302) может выступать доступный объем памяти графической карты или графического процессора.

[0032] ПЗУ (303) представляет собой одно или более устройств постоянного хранения данных, например, жесткий диск (HDD), твердотельный накопитель данных (SSD), флэш-память (EEPROM, NAND и т.п.), оптические носители информации (CD-R/RW, DVD-R/RW, BlueRay Disc, MD) и др.

[0033] Для организации работы компонентов системы (300) и организации работы внешних подключаемых устройств применяются различные виды интерфейсов ввода/вывода (304). Выбор соответствующих интерфейсов зависит от конкретного исполнения вычислительного устройства, которые могут представлять собой, не ограничиваясь: PCI, AGP, PS/2, IrDa, FireWire, LPT, COM, SATA, IDE, Lightning, USB (2.0, 3.0, 3.1, micro, mini, type C), TRS/Audio jack (2.5, 3.5, 6.35), HDMI, DVI, VGA, Display Port, RJ45, RS232 и т.п.

[0034] Для обеспечения взаимодействия пользователя с вычислительной системой (300) применяются различные средства (305) ввода/вывода информации, например, клавиатура, дисплей (монитор), сенсорный дисплей, тач-пад, джойстик, манипулятор мышь, световое перо, стилус, сенсорная панель, трекбол, динамики, микрофон, средства дополненной реальности, оптические сенсоры, планшет, световые индикаторы, проектор, камера, средства биометрической идентификации (сканер сетчатки глаза, сканер отпечатков пальцев, модуль распознавания голоса) и т.п.

[0035] Средство сетевого взаимодействия (306) обеспечивает передачу данных посредством внутренней или внешней вычислительной сети, например, Интранет, Интернет, ЛВС и т.п.В качестве одного или более средств (306) может использоваться, но не ограничиваться: Ethernet карта, GSM модем, GPRS модем, LTE модем, 5G модем, модуль спутниковой связи, NFC модуль, Bluetooth и/или BLE модуль, Wi-Fi модуль и др.

[0036] Дополнительно могут применяться также средства спутниковой навигации в составе системы (300), например, GPS, ГЛОНАСС, BeiDou, Galileo.

[0037] Конкретный выбор элементов устройства (300) для реализации различных программно-аппаратных решений может варьироваться с сохранением обеспечиваемого требуемого функционала.

[0038] Устройство распознавания лиц 10, в частном варианте его реализации, также включает платформу биометрической идентификации 11, базу данных (БД) дескрипторов идентифицируемых лиц 12, модуль 13 построения маршрута и модуль 14 формирования уведомлений. Платформа биометрической идентификации 11 определяет положение и размер всех лиц, присутствующих на входном видеопотоке. Каждому зафиксированному лицу присваивается показатель качества изображения, на основе которого автоматически выбирают лучшие изображения для дальнейшей обработки. Показатель соответствия для любой пары изображений лиц определяется евклидовым расстоянием соответствующих дескрипторов лиц. Низкие значения евклидова расстояния указывают на высокую схожесть двух изображений одного и того же человека. В этом случае приложению, установленному на AR-очках, отправляется ответ в формате JSON с информацией о распознанном человеке в следующем виде:

{"name": "Иванов О.В.", "color": "red", "article": 191.5, "info": "Особо опасен"}

[0039] Под показателем соответствия понимается сравнение «один ко многим», т.е. изображение с камеры сравнивается со множеством изображений в БД 12. Каждое выравненное изображение лица далее обрабатывается для получения дескриптора лица при помощи глубинных нейронных сетей (Deep Neural Networks или DNN). Дескрипторы лиц - это числовые векторы, суммирующие характерные признаки лица. Ключевым свойством дескрипторов является их близкое сходство для изображений одного и того же человека, и сильное различие для изображений разных людей. Таким образом, дескрипторы лиц зависят только от индивидуальных особенностей конкретного человека, изменения изображений из-за смены точек съемки, освещения, прически и возраста игнорируются. Каждый дескриптор имеет множество точек, которое может быть облаком точек. Измеряется расстояние между соответствующими точками в разных дескрипторах, затем суммируются для получения числового вектора -дескриптора лица.

[0040] Модуль 13 построения маршрута и модуль 14 формирования уведомлений могут быть реализованы на базе по меньшей мере одного устройства обработки команд, такого как процессор или микроконтроллер, выполненные в программно-аппаратной части таким образом, чтобы выполнять приписанные данным модулям ниже функций. Также модуль 13 построения маршрута может быть реализован на базе программно-аппаратных вычислительных средств устройства дополненной реальности 20 и размещаться непосредственно в архитектуре устройства дополненной реальности 20.

[0041] Web-интерфейс устройства распознавания лиц 10 позволяет редактировать описание и добавлять новые лица в базу данных 12, а также метки черного списка (стоп-листа), указывающие на то, что данный человек находится в «черном списке». Взаимодействие клиента с серверной частью устройства распознавания лиц 10 осуществляется по протоколу HTTP или HTTPS.

[0042] Устройство дополненной реальности 20 является средством вывода информации, в качестве которого может использоваться любое известное устройство, выполненное с возможностью отображения информации о физический и цифровых объектах в реальном времени, в том числе: очки дополненной реальности (или AR-очки) (например, Hololens или Magic Leap), гарнитура mixed reality (MR) или вычислительное устройство (смартфон/планшет/фаблет/ноутбук и пр.) с соответствующим ПО, позволяющим накладывать изображения цифровых объектов на изображения реального мира или виртуальной модели реального мира. В окне запущенного приложения отображается исходная фотография лица, находящаяся в БД, фотография лица с захваченного кадра и информация об идентифицированном человеке. Так же может отображаться маршрут до зоны, в которой было зафиксировано распознанное лицо.

[0043] По результатам исследования были сформулированы возможные векторы развития прототипа, позволяющие устранить выявленные недостатки и ограничения, усовершенствовать прототип, сделав его более функциональным и удобным в использовании.

[0044] Первый вектор предполагает преодоление основного ограничения -расстояния до объекта распознавания и низкое быстродействие вычислительных устройств без пересмотра архитектуры решения. Для увеличения расстояния до объекта распознавания можно использовать длиннофокусные камеры с высоким разрешением. В случае использования камер с длиннофокусными объективами (телеобъективами) архитектура системы следующая. Камера с телеобъективом передает изображение на вычислительное устройство (компьютер, сервер и т.п.).

[0045] На вычислительном устройстве установлено приложение, позволяющее находить лица в захваченных кадрах и перенаправлять данные в реальном времени на устройство с биометрической платформой идентификации по лицу. AR-очки дополненной реальности с запущенным приложением отображают информацию о распознанных лицах и прокладывают маршрут до распознанного человека.

[0046] Для решения проблемы с производительностью необходима оптимизация ОС устройств. Так же возможно увеличение производительности за счет добавления/замены аппаратных составляющих очков.

[0047] В данном техническом решении возможна реализация нескольких вариантов для повышения производительности за счет аппаратной части:

- использование интегральной схемы специального назначения (например, интегральная схема специального назначения ASIC), которая предназначена для решения конкретной задачи.

- увеличение вычислительной мощности устройства дополненной реальности за счет увеличения количества RAM (возможно использование более быстрой), использования более производительных CPU или GPU. Второй вектор позволяет помимо основной проблемы также оптимизировать UX и упростить задачи сотрудников силовых органов при работе в местах массового скопления людей. Выявление злоумышленников в массовых скоплениях людей доставляет большие трудности, даже если нарушитель был замечен, отследить его перемещение среди массы людей является сложной задачей.

[0048] Эту проблему позволяет решить построение интегрированной AR+CCTV системы, включающей:

идентификацию лиц в местах скопления людей длиннофокусными камерами CCTV и системой видеоаналитики;

идентификацию лиц в местах скопления людей длиннофокусными камерами CCTV и системой видеоаналитики;

оповещение сотрудников в очках AR о выявлении нарушителя и указание направления к нему (навигация по GPS и/или маякам);

оповещение сотрудников в очках AR о выявлении нарушителя и указание направления к нему (навигация по GPS и/или маякам);

быструю идентификацию личности с использованием устройства дополненной реальности.

быструю идентификацию личности с использованием устройства дополненной реальности.

[0049] Closed Circuit Television (CCTV) расшифровывается как «система телевидения замкнутого контура» и под этим термином подразумевается комплекс устройств, обеспечивающих видеонаблюдение. CCTV система, может состоять из множества камер, направленных в различные области пространства контролируемой зоны, при этом передавая изображения на сервер с установленным приложением face stream, где происходит поиск лиц в захваченных кадрах и передача их на сервер распознавания.

[0050] Каждой области, покрываемой камерами CCTV, ставятся в однозначное соответствие географические координаты этой зоны для последующего построения маршрута.

[0051] На открытых площадках может использоваться GPS-навигация. Для создания системы навигации на очках дополненной реальности, работающих на базе ОС Android может использоваться GooglePlayserviceslocationAPIs, который позволяет получить доступ к встроенной в вычислительный модуль очков GPS системе. Затем проложить маршрут от места нахождения пользователя очков до зоны, в которой находится идентифицированный объект.

[0052] Для построения маршрута внутри помещения могут использоваться системы indoor-навигации, например, способ навигации по Bluetooth-маячкам. Этот способ заключается в размещении на периметре помещения специальных датчиков, которые и обеспечивают получение данных о месторасположении пользователя очков относительно зоны, в которой зафиксирован объект. Местоположение вычисляется путем сравнения измеряемых в реальном времени мощностей сигнала от окружающих Bluetooth точек с заранее измеренными значениями, привязанными к карте помещения. Более плотное размещение датчиков, позволяет повысить точность локализации пользователя очков и место нахождения объекта. Пример реализации навигации, базирующейся на этой технологии - система iBeacon от компании Apple.

[0053] Также для построения маршрута внутри помещения может использоваться indoor-навигации по QR-кодам. При таком способе навигации строится 3D модель помещения, в которой закрепляется QR-код в определенном месте этой модели и в помещении. Для того, чтобы пользователю очков локализоваться в 3D модели помещения, ему нужно отсканировать QR-код камерой очков в помещении.

[0054] Далее будет описана работа устройства распознавания лиц 10 со ссылкой на Фиг. 2 на примере AR-очков в качестве устройства дополненной реальности.

[0055] В соответствии с заложенным программно-аппаратным алгоритмом по меньшей мере одна камера 100, которая является источником видеопотока 1 и входит в состав CCTV, осуществляет съемку заданной ей области пространства 110. Камера 100 может быть расположения в любом удобном для обзора области пространства 110, например, установлена на потолке, стене и пр.

[0056] Изображение области пространства с камеры 100 в виде видеопотока поступает в устройство распознавания лиц 10, которое анализирует в реальном времени входящий видеопоток для определения наличия в кадрах видеопотока изображения по меньшей мере одного лица 101. Вместе с изображение от камеры 100 в устройство 10 также может поступать идентификатор камеры 100. Дополнительно в устройство распознавания лиц 10 также может поступать видеопоток от камеры AR-очков 20 и их идентификатор, например, МАС-адрес.

[0057] При обнаружении на поступающих кадрах видеопотока изображения по меньшей мере одного лица 101 устройство распознавания лиц 10 захватывает данные кадры видеопотока и направляет их в виде последовательности n кадров в платформу биометрической идентификации 11 для идентификации лица 101.

[0058] В устройстве распознавания лиц 10 может быть задана область интереса на поступающих кадрах видеопотока. Область интереса задается в пикселях как массив вида [х, у, ширина, высота], где (х, у) - координаты верхней левой точки области интереса. Система координат на изображении задается аналогично рисунку на Фиг. 3. При значениях ширины и высоты, равных '0', областью интереса считается весь кадр. Соответственно, в такой реализации заявленного решения устройство распознавания лиц 10 будет осуществлять захват только тех кадров видеопотока, на которых изображение лица 101 попадает в заданную область интереса. Например, в качестве области интереса может быть выбрана область размещения турникетов. Таким образом, захват будет осуществляться только тех изображений лиц, которые находятся в области размещения турникетов.

[0059] Также дополнительно устройство распознавания лиц 10 может быть выполнено с возможностью определения наличия изображения человека в кадре, изображение лица 101 которого было обнаружено. Для определения наличия изображения человека в кадре устройство 10 после обнаружения изображения лица определяет наличие в кадре изображения плеч в соответствующей изображению лица области или изображения тела человека. После того, как устройство 10 определило наличие человека в кадре, изображение лица 101 которого было определено, осуществляется захват кадров видеопотока для их передачи в виде последовательности n кадров в платформу биометрической идентификации 11 для идентификации человека в кадре.

[0060] Платформа биометрической идентификации 11 определяет положение и размер изображения лица 101 на каждом входном захваченном кадре в последовательности n кадров, на котором данное изображение лица 101 распознано. Если на захваченных n кадрах определены дополнительные изображения лиц, то платформа 11 также может определять размеры и положение всех изображений лиц описанным ниже образом. На основе данных о положении лиц платформа 11 отслеживает изображение лица 101 на захваченных n кадрах.

[0061] Размеры изображений лиц 101 на захваченных n кадрах платформа биометрической идентификации 11 сравнивает с заранее заданными пользователем пороговыми значениями размеров изображений лиц и если размеры изображения лица 101 на захваченном кадре больше заранее заданного порогового значения, то упомянутая платформа 11 переходит к этапу определения параметров лица на основе изображения лица на захваченном кадре, в частности, параметров: поворота головы (в градусах) по каждой из трех осей вращения наклон вверх/вниз относительно горизонтальной оси; наклона влево/вправо относительно вертикальной оси; поворота относительно вертикальной оси. Для изображений лиц, размер которых меньше заранее заданного порогового значения, упомянутые параметры не определяются.

[0062] Определенные платформой 11 параметры изображения лица 101 на захваченном кадре сравниваются с заранее заданными пороговыми значениями параметров лиц и на основе величины отклонения определенных на предыдущем шаге параметров изображения лица от заданных пороговыми значений параметров платформа 11 присваивает изображению лица 101 показатель качества изображения лица, причем чем ниже величина отклонения, тем выше показатель качества изображения лица. Для повышения точности идентификации лица 101 для дальнейшего анализа платформа 11 выбирает то изображение лица 101, у которого показатель качества является максимальным.

[0063] Соответственно, если в видеопотоке обнаружены дополнительные изображения лиц, помимо изображения лица 101, попадающие в область интереса, то они могут быть также обработаны описанным выше способом для определения дополнительных изображений лиц, у которых показатель качества будет являться максимальным.

[0064] Далее на основе изображения лица 101, у которого показатель качества является максимальным, платформа биометрической идентификации 11 известными из уровня техники методами осуществляет построение облака точек лица и рассчитывает вектор, характеризующий признаки изображения лица 101 (далее вектор лица 101). Полученный вектор платформа 11 сравнивает с заранее сохраненными векторами изображений в БД 12. Каждому заранее сохраненному вектору изображения в БД 12 назначена соответствующая идентификационная информация личности человека, на основе изображения лица, которого данный вектор изображения был рассчитан. Идентификационной информацией может быть, например, данные паспорта, фотография лица и т.д. Также БД 12 может содержать информацию, например, метку черного списка (стоп-листа), указывающую на то, что данный человек находится в «черном списке» (стоп-листе), например, в связи с тем, что он является злоумышленником или нарушителем.

[0065] Если вектор, характеризующий признаки изображения лица 101, совпал с вектором изображения, сохранным в БД 12, то платформа биометрической идентификации 11 определяет изображение лица 101 как распознанное/идентифицированное. Далее платформа 11 обращается к БД 12 для извлечения идентификационной информации личности человека 101 в соответствии с вектором изображения из БД 12, с которым вектор лица 101 совпал, и проверки наличия метки черного списка для определения параметров доступа человека 101 в область пространства 110, снимаемой камерой, в соответствии с заранее заданным классификатором.

[0066] Если метка черного списка содержится в БД 12, то платформа 11 назначает лицу 101 параметр доступа, указывающий на то, что у лица 101 нет разрешения находиться в области пространства 110, в частности, классификатор «черного списка». Если метка черного списка в БД 12 отсутствует, то платформа 11 назначает лицу 101 параметр доступа, указывающий на то, что у лица 101 есть разрешение находиться в области пространства 110, в частности, классификатор белого списка. Таким образом, устройство распознавания лиц 10 присваивает лицу 101 параметры доступа, определяющие разрешение на нахождение в области пространства 110, на основе полученного с камеры 100 изображения лица 101.

[0067] Результаты сравнения векторов, в частности идентификационная информация и параметры доступа могут быть выведены устройством 10 на средства вывода изображений, например, на дисплей пользователя устройство распознавания лиц 10 вместе с указателем на изображение лица 101 на выводимых в реальном времени кадрах видеопотока, например, в формате JSON с информацией о распознанном человеке.

[0068] Если вектор, характеризующий признаки изображения лица 101, не совпал ни с одним вектором изображения, сохранным в БД 12, то платформа биометрической идентификации 11 определяет изображение лица 101 как нераспознанное/неидентифицированное и назначает лицу 101 параметр доступа, указывающий на то, что у лица 101 нет разрешения находиться в области пространства 110. Результаты сравнения векторов, в частности информация о том, что изображение лица 101 не распознано, и параметр доступа также могут быть выведены на устройство отображения изображения, например, дисплей пользователя устройства распознавания лиц 10 или устройства дополненной реальности, в частности, на стекла AR-очков 20, в формате JSON с информацией о распознанном человеке.

[0069] Таким образом, поскольку для формирования вектора, характеризующего признаки изображения лица 101, используют только лишь изображение лица 101, у которого показатель качества является максимальным, а не весь кадр видеопотока, повышается скорость обработки изображения лица 101, снижается время и повышается точность идентификации лиц и их классификации для определения параметров доступа.

[0070] Далее устройство распознавания лиц 10 переходит к этапам определения местоположения лица 101 с назначенным параметром доступа, указывающим на то, что у лица 101 нет разрешения находиться в области пространства 110 (т.е. изображение лица которого не было распознано или было определено, что лицо на распознанном изображении находится в «черном списке»), и построению до данного лица 101 маршрута. Для построения маршрута устройство распознавания лиц 10 может быть дополнительно оснащена модулем 13 построения маршрута до лица 101, который идентифицирует камеру 100, посредством которой было получено изображение лица 101, и извлекает географические координаты области пространства 110, находящейся в зоне съемки камеры 100. Географические координаты области пространства 110 могут быть извлечены модулем 13 из БД 12 на основе идентификатора камеры, либо запрошены известными из уровня техники методами у соответствующей камеры 100, от которой поступил кадр с изображением лица 101.

[0071] Также для построения маршрута устройство распознавания лиц 10 может быть выполнено с возможностью определения местоположения лица 101, изображение лица которого было распознано. Например, команда на построение такого маршрута может быть направлена от пользователя на устройство 10, который посредством устройства ввода/вывода информации выбирает лицо, которое было распознано на изображении для построения до него маршрута.

[0072] Далее модуль 13 построения маршрута определяет, находится ли по меньшей мере один сотрудник в AR-очках 20 в области пространства 110 на основе информации о местоположении AR-очков 20, полученной с помощью датчика системы навигации, например, GPS приемо-передатчика, или Bluetooth-маячка, встроенного в очки AR-очки 20. Считывание Bluetooth-маячка может осуществляться посредством устройства считывания Bluetooth-маячков 111, установленного в области пространства 110 или в области пространства, в которой находится сотрудник в AR-очках 20.

[0073] Определять местоположение AR-очков 20 модуль 13 построения маршрута может также посредством считывания с помощью камеры AR-очков 20 размещенных в различных областях пространства QR-коды. Информация QR-кода поступает в модуль 13 построения маршрута, который на основе поступившей информации определяет местоположении AR-очков 20.

[0074] Если по меньшей мере одни AR-очки 20 находятся в области пространства 110, то модуль 13 построения маршрута направляет команду на модуль 14 формирования уведомлений, в соответствии с которой модуль 14 формирует уведомление для AR-очков 20, находящихся в области пространства 110, содержащее информацию о том, что в данной области расположения AR-очков 20 находится лицо с назначенным параметром доступа, указывающим на то, что у лица нет разрешения находиться в области пространства 110 в связи с тем, что оно нераспознанно или находится в «черном списке». Дополнительно упомянутое уведомление может включать указание на сканирование с помощью камеры AR-очков 20 области пространства 110 для захвата изображения упомянутого лица 101. Сформированное уведомление, например, в формате JSON с информацией о распознанном человеке, направляется модулем 14 на AR-очки 20 для вывода уведомления на стекла AR-очков в режиме дополненной реальности известными из уровня техники методами.

[0075] Если модуль 13 построения маршрута определил, что в области пространства 110 нет сотрудника в AR-очках 20, то модуль 13 по поступающим на него данным о местоположении от всех AR-очков определяет по меньшей мере одни AR-очки, расположенные наиболее близко к области пространства 110. На основе данных о местоположении AR-очков модуль 13 формирует маршрут из области пространства, в которой размещены данные AR-очки, до области пространства 110, в которой находится нераспознанное или находящееся в черном списке лицо 101, и передает его в модуль 14 формирования уведомлений, который формирует уведомление о том, что в области пространства 110 находится лицо 101. Сформированные уведомление и маршрут также направляются модулем 14 на AR-очки для их отображения на стеклах AR

- очков (т.е. дисплей устройства дополненной реальности) в режиме дополненной реальности известными из уровня техники методами.

[0076] Размещение модуля 13 формирования маршрута и модуля 14 формирования уведомлений в устройстве распознавания лиц 10 позволяет снизить вычислительную нагрузку на вычислительные средства AR-очков 20. Однако в альтернативном варианте реализации заявленного решения для снижения вычислительной нагрузки на устройство распознавания лиц 10 модуль 13 формирования маршрута и модуль 14 формирования уведомлений могут быть размещены в архитектуре AR-очков 20. Соответственно, устройство распознавания лиц 10: идентифицирует камеру 100, посредством которой было получено изображение лица 101; извлекает географические координаты области пространства 110 на основе идентификатора камеры 100; определяет по меньшей мере одни AR-очки, расположенные наиболее близко к области пространства 110; и направляет упомянутые координаты в модуль 13 формирования маршрута, размещенный в архитектуре AR-очков 20. Также поскольку по каналу связи между модулем 13 и устройством 10 передаются только лишь координаты, а не маршрут целиком, то увеличивается пропуская способность канала связи между AR-очками 20 и устройство распознавания лиц 10.

[0077] При получении географических координат области пространства 110 модуль 13 формирования маршрута определяет местоположение AR-очков 20 с помощью датчика системы навигации, Bluetooth-маячка или с помощью считанных посредством AR-очков QR-кода и направляет команды на модуль 14 формирования уведомлений для вывода на стекла AR-очков, находящихся в области пространства 110, уведомления, содержащего информацию о том, что в данной области расположения AR-очков 20 находится нераспознанное или находящееся в «черном списке» лицо 101, либо вывода на стекла AR-очков (т.е. дисплей устройства дополненной реальности) уведомления о том, что в области пространства 110 находится лицо 101, если AR-очки 20 не располагаются в области пространства 110, и информацию о маршруте из области пространства, в которой размещены данные AR-очки, до области пространства 110, в которой находится нераспознанное или находящееся в черном списке лицо 101.

[0078] В процессе перемещения сотрудника в AR-очках по маршруту следования до области пространства 110 модуль 13 построения маршрута может быть выполнен с возможностью отслеживать траекторию движения устройства дополненной реальности, в частности перемещение AR-очков, в режиме реального времени по поступающей от них информации о местоположении и корректировать маршрут в случае отклонения траектории движения устройства дополненной реальности от сформированного ранее маршрута.

[0079] При достижении данного сотрудника конечной точки маршрута - области пространства 110 модуль 14 направляет на AR-очки уведомление, содержащее информацию о том, что в данной области расположения AR-очков находится нераспознанное или находящееся в черном списке лицо 101, а также, при необходимости, указание на сканирование с помощью камеры AR-очков области пространства 110.

[0080] После того, как модуль 13 построения маршрута направил уведомление на AR-очки 20, указывающее на то, что в данной области расположения AR-очков 20 находится лицо 101, устройство распознавания лиц 10 анализирует в реальном времени входящий видеопоток от камеры AR-очков 20 для определения наличия в кадрах видеопотока по меньшей мере одного лица 101 описанным ранее способом.

[0081] При обнаружении на кадрах видеопотока от камеры AR-очков 20 изображения по меньшей мере одного лица система распознавания лиц 10 захватывает данные кадры видеопотока и направляет их в виде последовательности n кадров в платформу биометрической идентификации 11. Платформа биометрической идентификации 11 обрабатывает поступившие кадры описанным ранее способом для расчета вектора, характеризующего признаки изображения лица 101.

[0082] При обнаружении на кадрах видеопотока от камеры AR-очков 20 изображения по меньшей мере одного лица система распознавания лиц 10 захватывает данные кадры видеопотока и направляет их в виде последовательности n кадров в платформу биометрической идентификации 11. Платформа биометрической идентификации 11 обрабатывает поступившие кадры описанным ранее способом для расчета вектора, характеризующего признаки изображения лица 101. Полученный на предыдущем этапе вектор платформа 11 сравнивает с ранее полученным вектором, характеризующим признаки изображения лица 101. При совпадении векторов платформа биометрической идентификации 11 направляет соответствующую команду в модуль 14 формирования уведомлений для формирования и вывода на стекла AR-очков 20 уведомления о том, что лицо 101 является нераспознанным или находящимся в черном списке лицом. Уведомление выводится известными из уровня техники методами в заданную область стекол AR-очков 20 (т.е. дисплея устройства дополненной реальности) в режиме дополненной реальности вместе с информацией о том, что лицо, находящееся в поле зрения сотрудника в AR-очках 20, является нераспознанным лицом 101 или лицом, находящимся в «черном списке».

[0083] Дополнительно устройство распознавания лиц 10 может быть выполнено с возможностью определения местоположения лица 101 в области пространства 110. Соответственно, после того, как устройство распознавания лиц 10 определило наличие в области пространства 110 лица 101, у которого нет разрешения находиться в области пространства 110, устройство 10 посредством платформы биометрической идентификации 11 определяет известными из уровня техники методами местоположение лица 101 в области пространства 110, например, посредством определения расположения изображения лица 101 относительно по меньшей мере одного объекта на изображении, местоположение которого в области пространства 110 заранее известны и заданы в устройстве распознавания лиц 10. Полученные данные местоположения лица 101 в области пространства 110 преобразуются в координаты лица 101 в 3D модели пространства, модель которого заранее создана и сохранена в БД 12.

[0084] Также определение местоположения лица 101 в области пространства 110 может осуществляться следующим образом. После того, как устройство распознавания лиц 10 определило наличие в области пространства 110 лица 101, у которого нет разрешения находиться в области пространства 110, модуль 13 построения маршрута на основе идентификатора камеры извлекает из БД 12 информацию о местоположении камеры и покрываемой ей области пространства 110. На основе информации о местоположении камеры модуль 13 определяет координаты камеры в 3D-модели пространства и проецирует покрываемую камеру область пространства в точку на 3D-модели. Координаты полученной точки на 3D-модели определяются модулем 13 как координаты лица 101 в 3D модели пространства.

[0085] Полученные координаты лица 101 в 3D модели пространства передаются в модуль 13 построения маршрута, который также преобразует данные о местоположении AR-очков 20 в координаты очков в 3D модели пространства для локализации AR-очков 20 в 3D модели пространства. Далее модуль 13 построения маршрута на основе полученных координат лица 101 и координат очков в 3D модели пространства определяет маршрут в 3D модели пространства от местоположения AR-очков 20 до лица 101 и формирует указатель траектории движения по маршруту в 3D модели пространства. Сформированный указатель траектории движения по маршруту в 3D модели пространства направляется в модуль 14 формирования уведомлений и выводится на стекла AR-очков 20 (т.е. дисплея устройства дополненной реальности) в режиме дополненной реальности в соответствии с местоположением AR-очков 20 для навигации сотрудника в AR-очках 20 до области пространства 110 по маршруту, сформированному в 3D модели пространства.

[0086] Также модуль 14 формирования уведомлений может быть выполнен с возможностью формирования в 3D модели пространства 2D или 3D указателя лица 101 в соответствии с его расположением в 3D модели пространства. Указатель лица 101 размещается согласно определенным ранее координатам лица 101 в 3D модели пространства и выводится модулем 14 на стекла AR-очков 20 в режиме дополненной реальности, когда лицо 101 находится в области видимости сотрудника в AR-очках 20, для указания на лицо 101 в области пространства 110.

[0087] Таким образом, за счет того, что заявленная система выполнена с возможность формирования маршрута до места фиксации камерами лица 101, у которого нет разрешения находиться в области пространства 110, обеспечивается оперативное детектирование и идентификацию человека, и повышается скорость задержания нарушителей. Также представленная система обладает простой конструкцией, вследствие которой повышается надежность работы системы.

[0088] Модификации и улучшения вышеописанных вариантов осуществления настоящего технического решения будут ясны специалистам в данной области техники. Предшествующее описание представлено только в качестве примера и не несет никаких ограничений. Таким образом, объем настоящего технического решения ограничен только объемом прилагаемой формулы изобретения.

| название | год | авторы | номер документа |

|---|---|---|---|

| СПОСОБ И СИСТЕМА ВЫЯВЛЕНИЯ ТРЕВОЖНЫХ СОБЫТИЙ ПРИ ВЗАИМОДЕЙСТВИИ С УСТРОЙСТВОМ САМООБСЛУЖИВАНИЯ | 2019 |

|

RU2713876C1 |

| СПОСОБ АУДИОВИЗУАЛЬНОГО РАСПОЗНАВАНИЯ СРЕДСТВ ИНДИВИДУАЛЬНОЙ ЗАЩИТЫ НА ЛИЦЕ ЧЕЛОВЕКА | 2022 |

|

RU2791415C1 |

| СПОСОБ, УСТРОЙСТВО И СИСТЕМА ОТОБРАЖЕНИЯ ИНФОРМАЦИИ | 2017 |

|

RU2735617C2 |

| СПОСОБ И УСТРОЙСТВО ФИКСАЦИИ ТРЕВОЖНЫХ СОБЫТИЙ НА СЛУЖЕБНОМ ТРАНСПОРТНОМ СРЕДСТВЕ | 2021 |

|

RU2770862C1 |

| СИСТЕМА И СПОСОБ ДЛЯ ВИДЕОКОНФЕРЕНЦ-СВЯЗИ | 2023 |

|

RU2827057C1 |

| СПОСОБ ОТСЛЕЖИВАНИЯ, ОБНАРУЖЕНИЯ И ИДЕНТИФИКАЦИИ ИНТЕРЕСУЮЩИХ ОБЪЕКТОВ И АВТОНОМНОЕ УСТРОЙСТВО C ЗАЩИТОЙ ОТ КОПИРОВАНИЯ И ВЗЛОМА ДЛЯ ИХ ОСУЩЕСТВЛЕНИЯ | 2021 |

|

RU2789609C1 |

| СПОСОБ И СИСТЕМА ОПРЕДЕЛЕНИЯ СИНТЕТИЧЕСКИХ ИЗМЕНЕНИЙ ЛИЦ В ВИДЕО | 2021 |

|

RU2774624C1 |

| СИСТЕМА И СПОСОБ ДЛЯ ВИДЕОКОНФЕРЕНЦСВЯЗИ | 2022 |

|

RU2795506C1 |

| СПОСОБ И СИСТЕМА ДЛЯ ОПРЕДЕЛЕНИЯ СИНТЕТИЧЕСКИ ИЗМЕНЕННЫХ ИЗОБРАЖЕНИЙ ЛИЦ НА ВИДЕО | 2021 |

|

RU2768797C1 |

| СИСТЕМА И СПОСОБ ОТСЛЕЖИВАНИЯ ОБЪЕКТА | 2004 |

|

RU2370817C2 |

Данное техническое решение, в общем, относится к области вычислительной техники. Техническим результатом является снижение времени поиска людей в местах массового скопления людей или больших многоэтажных зданий, в которых данные люди не должны находиться, и повышение точности идентификации лиц. Способ содержит этапы: получают видеопоток от одного источника видеопотока с изображением области пространства; захватывают кадры видеопотока при обнаружении на них изображения одного лица; определяют положение и размер изображения лица на каждом захваченном кадре; определяют показатели качества изображения лица на захваченных кадрах, на которых размер изображения лица выше заранее заданных пороговых значений; выбирают изображение лица с максимальным показателем качества изображения лица; рассчитывают вектор, характеризующий признаки изображения лица, на основе выбранного изображения лица; сравнивают рассчитанный вектор с сохраненными векторами изображений в базе данных (БД); на основе результатов сравнения рассчитанного вектора с сохраненными векторами присваивают лицу параметр доступа, определяющий разрешение на нахождение в области пространства; выводят параметр доступа на устройство отображения изображения. 2 н. и 9 з.п. ф-лы, 4 ил.

1. Способ распознавания лиц в видеопотоке, выполняемый по меньшей мере одним вычислительным устройством, содержащий этапы, на которых:

- получают видеопоток от по меньшей мере одного источника видеопотока с изображением области пространства;

- захватывают кадры видеопотока при обнаружении на них изображения по меньшей мере одного лица;

- определяют положение и размер изображения лица на каждом захваченном кадре;

- определяют показатели качества изображения лица на захваченных кадрах, на которых размер изображения лица выше заранее заданных пороговых значений;

- выбирают изображение лица с максимальным показателем качества изображения лица;

- рассчитывают вектор, характеризующий признаки изображения лица, на основе выбранного изображения лица;

- сравнивают рассчитанный вектор с сохраненными векторами изображений в базе данных (БД);

- на основе результатов сравнения рассчитанного вектора с сохраненными векторами присваивают лицу параметр доступа, определяющий разрешение на нахождение в области пространства;

- выводят параметр доступа на устройство отображения изображения.

2. Способ по п. 1, отличающийся тем, что устройство отображения изображения представляет собой устройство дополненной реальности, причем параметр доступа выводят в режиме дополненной реальности в формате JSON с информацией о распознанном или нераспознанном человеке.

3. Способ по п. 1, отличающийся тем, что дополнительно содержит этап, на котором задают область интереса для поступающих кадров видеопотока, при этом захватывают только те кадры видеопотока, на которых изображение лица попадает в заданную область интереса.

4. Способ по п. 1, отличающийся тем, что после захвата кадров видеопотока при обнаружении на них изображения по меньшей мере одного лица дополнительно выполняют этап, на котором:

- определяют наличие изображения человека в кадре, изображение лица которого было обнаружено, причем для определения наличия изображения человека в кадре определяют наличие в кадре: изображения плеч в соответствующей изображению лица области или изображения тела человека.

5. Способ по п. 1, отличающийся тем, что показатели качества изображения лица определяются на основе по меньшей мере одного параметра лица:

- поворота головы (в градусах) по каждой из трех осей вращения наклон вверх/вниз относительно горизонтальной оси;

- наклона влево/вправо относительно вертикальной оси;

- поворота относительно вертикальной оси.

6. Способ по п. 1, отличающийся тем, что дополнительно содержит этапы, на которых:

- определяют местоположение лица с назначенным параметром доступа, указывающим на то, что у лица нет разрешения находиться в области пространства;

- определяют по меньшей мере одно устройство дополненной реальности, расположенное наиболее близко к упомянутой области пространства;

- формируют маршрут из области пространства, в которой размещено данное устройство дополненной реальности, до области пространства, в которой находится упомянутое лицо;

- отображают маршрут на устройстве дополненной реальности в режиме дополненной реальности.

7. Способ по п. 6, отличающийся тем, что дополнительно содержит этапы, на которых:

- отслеживают перемещение устройства дополненной реальности в режиме реального времени;

- корректируют маршрут в случае отклонения траектории движения устройства дополненной реальности от сформированного ранее маршрута.

8. Способ по п. 6, отличающийся тем, что дополнительно содержит этапы, на которых:

- при достижении устройства дополненной реальности области пространства, в которой находится упомянутое лицо, анализируют в реальном времени входящий видеопоток от камеры устройства дополненной реальности для определения наличия в кадрах видеопотока по меньшей мере одного лица;

- выводят в заданную область дисплея устройства дополненной реальности в режиме дополненной реальности информацию о том, что у лица, находящегося в поле зрения сотрудника в AR-очках, нет разрешения находиться в области пространства в соответствии с присвоенным параметром доступа.

9. Способ по п. 1, отличающийся тем, что дополнительно содержит этапы, на которых:

- определяют местоположение лица в области пространства и местоположение по меньшей мере одного устройства дополненной реальности;

- преобразуют данные о местоположениях лица и устройства дополненной реальности в координаты в 3D модели пространства;

- определяют маршрут в 3D модели пространства от местоположения устройства дополненной реальности до упомянутого лица;

- формируют указатель траектории движения по маршруту в 3D модели пространства и выводят его на дисплей устройства дополненной реальности в режиме дополненной реальности для навигации сотрудника с устройством дополненной реальности до области пространства, в котором находится упомянутое лицо, по маршруту, сформированному в 3D модели пространства.

10. Способ по п. 9, отличающийся тем, что дополнительно содержит этапы, на которых:

- формируют в 3D модели пространства указатель лица в соответствии с его расположением в 3D модели пространства и выводят упомянутый указатель на дисплей устройства дополненной реальности в режиме дополненной реальности, когда лицо находится в области видимости сотрудника с устройством дополненной реальности, для указания на лицо в области пространства.

11. Система распознавания лиц в видеопотоке, содержащая по меньшей мере одно вычислительное устройство и по меньшей мере одну память, содержащую машиночитаемые инструкции, которые при их исполнении по меньшей мере одним вычислительным устройством выполняют способ по любому из пп. 1-10.

| US 2005063566 A1, 24.03.2005 | |||

| US 2015023602 А1, 22.01.2015 | |||

| CN 102360421 B, 28.05.2014 | |||

| US 2003215114 A1, 20.11.2003 | |||

| СПОСОБ ИДЕНТИФИКАЦИИ ЛИЧНОСТИ ЧЕЛОВЕКА ПО ЦИФРОВОМУ ИЗОБРАЖЕНИЮ ЛИЦА | 2009 |

|

RU2431191C2 |

| СИСТЕМА И СПОСОБ ДЛЯ ДОПОЛНЕННОЙ И ВИРТУАЛЬНОЙ РЕАЛЬНОСТИ | 2012 |

|

RU2621633C2 |

Авторы

Даты

2020-01-28—Публикация

2019-02-28—Подача