ОБЛАСТЬ ТЕХНИКИ

[0001] Настоящее техническое решение относится к области компьютерных технологий, применяемых в области обработки данных, в частности к способу и системе для определения синтетически измененных изображений лиц на видео.

УРОВЕНЬ ТЕХНИКИ

[0002] На сегодняшний день применение технологий для формирования синтетических изображений, накладываемых на изображения лиц реальных людей, основано, как правило, на применении алгоритмов машинного обучения, например, искусственных нейронных сетей (ИНС). Такие подходы направлены на наложение цифровых масок, имитирующих лица людей. Примером такой технологии является методика DeepFake, основанная на искусственном интеллекте и применяемая для синтеза изображений (см. https://ru.wikipedia.org/wiki/Deepfake).

[0003] Известен способ распознавания синтетически измененных изображений лиц людей, в частности DeepFake изображений (Tolosana et al. DeepFakes Evolution: Analysis of Facial Regionsand Fake Detection Performance // Biometrics and Data Pattern Analytics - BiDA Lab, Universidad Autonoma de Madrid. 2020), который основан на анализе сегментов, формирующих изображения лица. Анализ осуществляется с помощью ИНС, обученной на реальных и синтетических изображениях лиц людей, в частности, знаменитостей, что может применяться для выявления подложных (фейковых) видео. Способ позволяет анализировать сегменты лица, на основании которых выдается классификация соответствующего изображения как содержащего синтетические изменения или нет.

[0004] В уровне техники также известен алгоритм усиления Эйлера (Eulerian Video Magnification, сокр. EVM // http://people.csail.mit.edu/mrub/evm/), который основывается на усилении компонента R цветового спектра палитры RGB, что позволяет наблюдать на видео биологические изменения людей, в частности, проводить анализ за счет визуализации пульсации крови в венах. Данный подход на сегодняшний день не применяется для выявления синтетических изменений лиц в видео, что ограничивает существующий спектр методов определение синтетических изменений видеоизображений.

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

[0005] Заявленное техническое решение направлено на создание нового подхода по выявлению синтетических изменений лиц людей в видео.

[0006] Техническим результатом является обеспечение возможности выявления синтетически измененных изображений лиц в видео с помощью пиксельного анализа динамики изменений цвета на кадрах.

[0007] Заявленный технический результат достигается за счет способа определения синтетических изменений лиц в видео, выполняемого с помощью процессора и содержащего этапы, на которых:

a) получают видео, содержащее по меньшей мере одно изображение лица;

b) разбивают полученное видео на множество фреймов F = {F1, F2, …, Fn}, при этом каждый фрейм содержит область кадра с изображением лица;

c) извлекают компоненту R палитры RGB каждого пикселя в каждом фрейме из множества F;

d) составляют массив значений красного спектра для каждого пикселя в каждом фрейме из множества F;

e) рассчитывают ΔR компонент R между текущим и следующим фреймом для каждого пикселя и формируют массив ArrΔR = {|R1 - R2|, |R2 - R3|, …, |Rn-2 - Rn-1|} отображающую интенсивность изменения пикселей;

f) рассчитывают параметр усиления β между текущим и следующим фреймом на основании массива ArrΔR и формируют массив Arrβ для каждого пикселя;

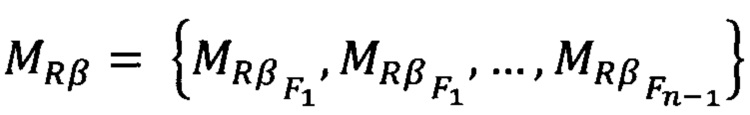

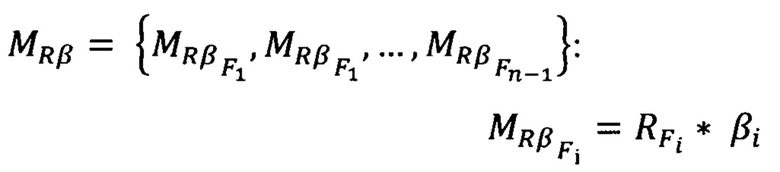

g) формируют массив матриц  на основании массивов каждого пикселя Arrβ и значений компоненты R во фреймах F;

на основании массивов каждого пикселя Arrβ и значений компоненты R во фреймах F;

h) формируют новые фреймы Fr = {Fr1, Fr2, …, Frn-1} на основании MRβ замены в компоненты R палитры RGB в каждом фрейме F;

i) осуществляют анализ каждого фрейма из Fr, полученного на этапе h) с помощью модели машинного обучения, выполненной с возможностью выявления наличия динамики пикселей в компоненте R палитры RGB;

j) определяют синтетические изменения изображений лиц в видео на основании анализа фреймов на этапе i).

[0008] В одном из частных примеров реализации способа фреймы лиц на этапе b) определяются с помощью алгоритма библиотеки OpenCV, обеспечивающего определение местоположений лиц на кадрах видео.

[0009] В другом частном примере реализации способа этапы с)- h) выполняются с помощью алгоритма библиотеки EVM (Алгоритм усиления Эйлера).

[0010] В другом частном примере реализации способа фреймы определяются с помощью обрезки области кадра видео, содержащего изображение лица.

[0011] В другом частном примере реализации способа при выявлении синтетически измененного лица формируется уведомление.

[0012] В другом частном примере реализации способа уведомление отображается в графическом интерфейсе пользователя.

[0013] В другом частном примере реализации способа выполняется маркировка области изображения с синтетически измененным изображением лица.

[0014] Заявленное решение также осуществляется с помощью системы определения синтетических изменений лиц в видео, содержащей по меньшей мере один процессор и по меньшей мере одну память, в которой хранятся машиночитаемые инструкции, которые при их выполнении процессором реализуют вышеописанный способ.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

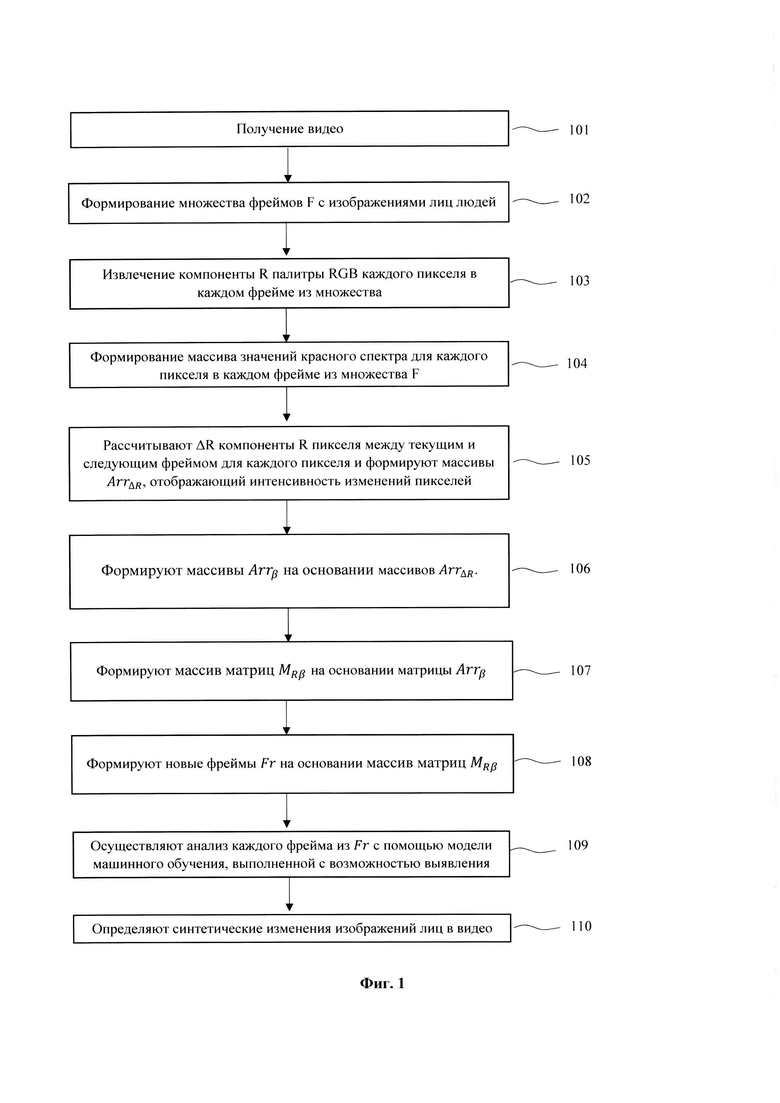

[0015] Фиг. 1 иллюстрирует блок-схему заявленного способа.

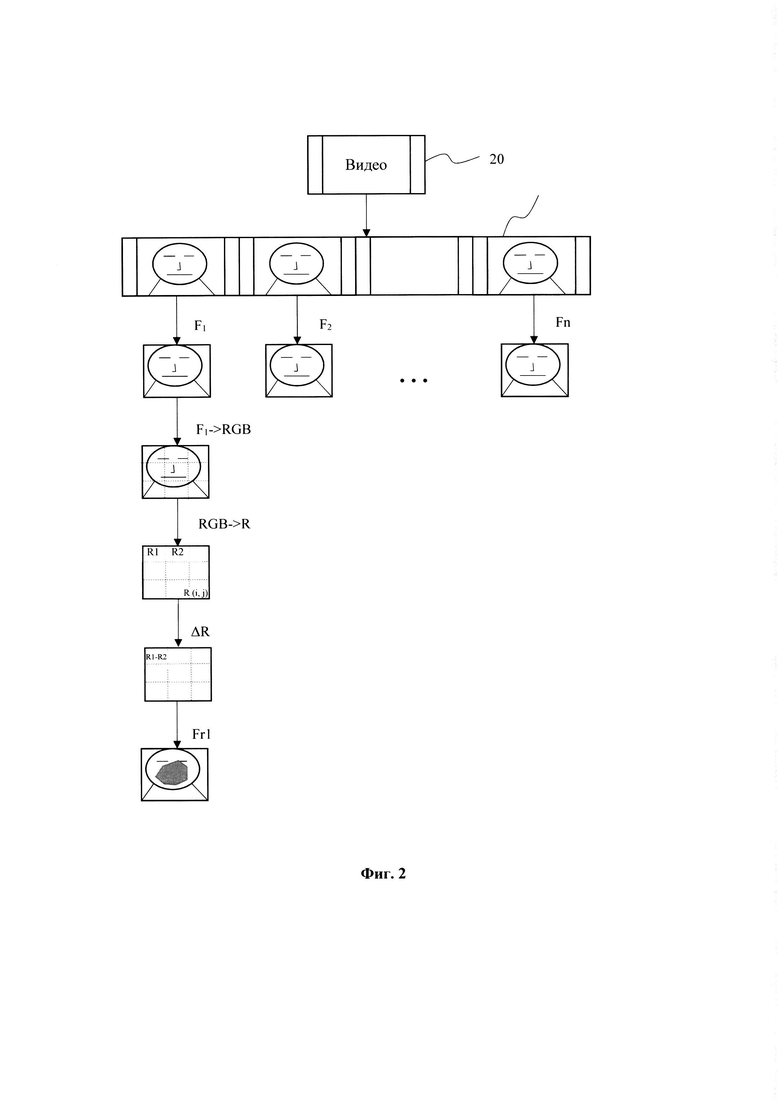

[0016] Фиг. 2 иллюстрирует пример формирования фреймов из кадров видео.

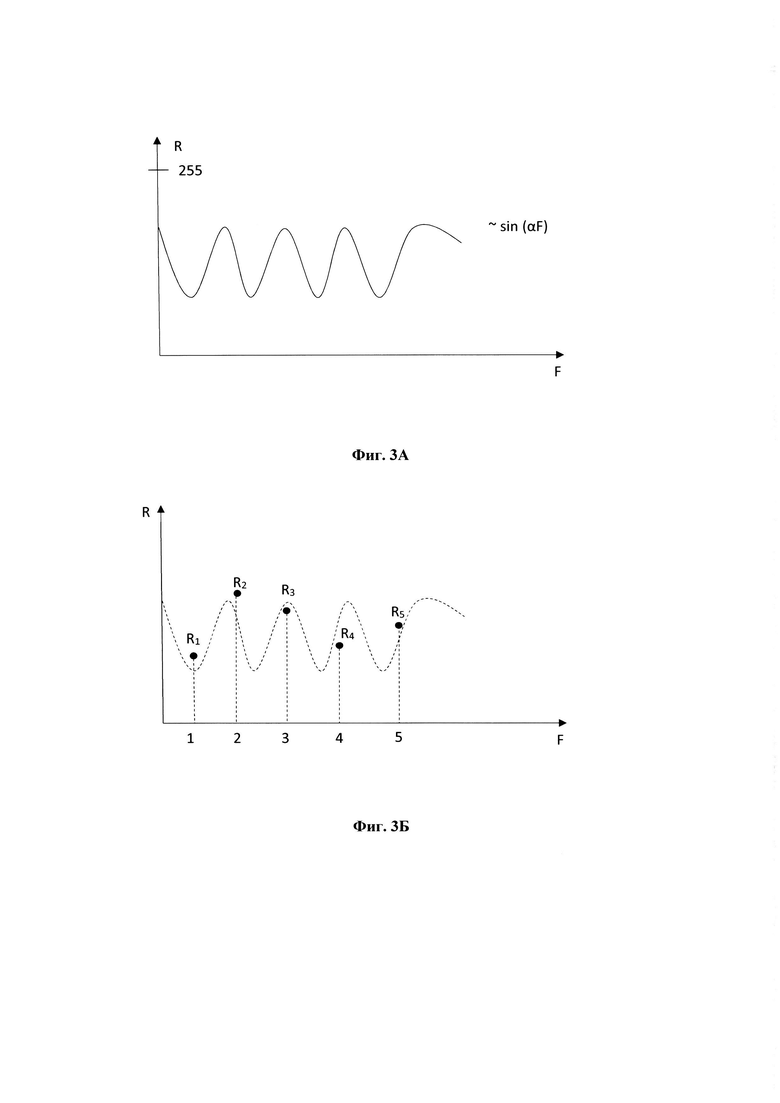

[0017] Фиг. 3А иллюстрирует общее представление периодического закона изменения

красного спектра пикселя сквозь фреймы.

[0018] Фиг. 3Б иллюстрирует значение красного спектра пикселя сквозь фреймы F в случае, если видеоролик оригинальный.

[0019] Фиг. 3В иллюстрирует значение красного спектра пикселя сквозь фреймы F в случае, если видеоролик с наложением DeepFake.

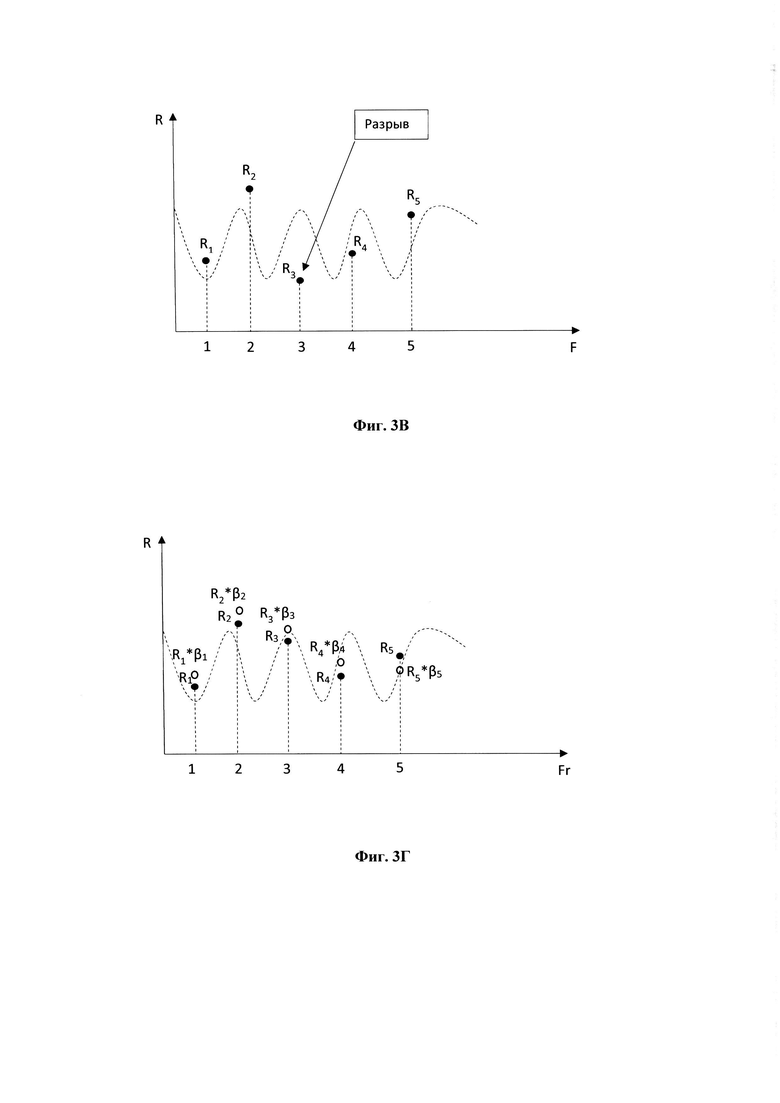

[0020] Фиг. 3Г иллюстрирует создание нового ряда пикселей сквозь фреймы Fr, если видеоролик был оригинальный.

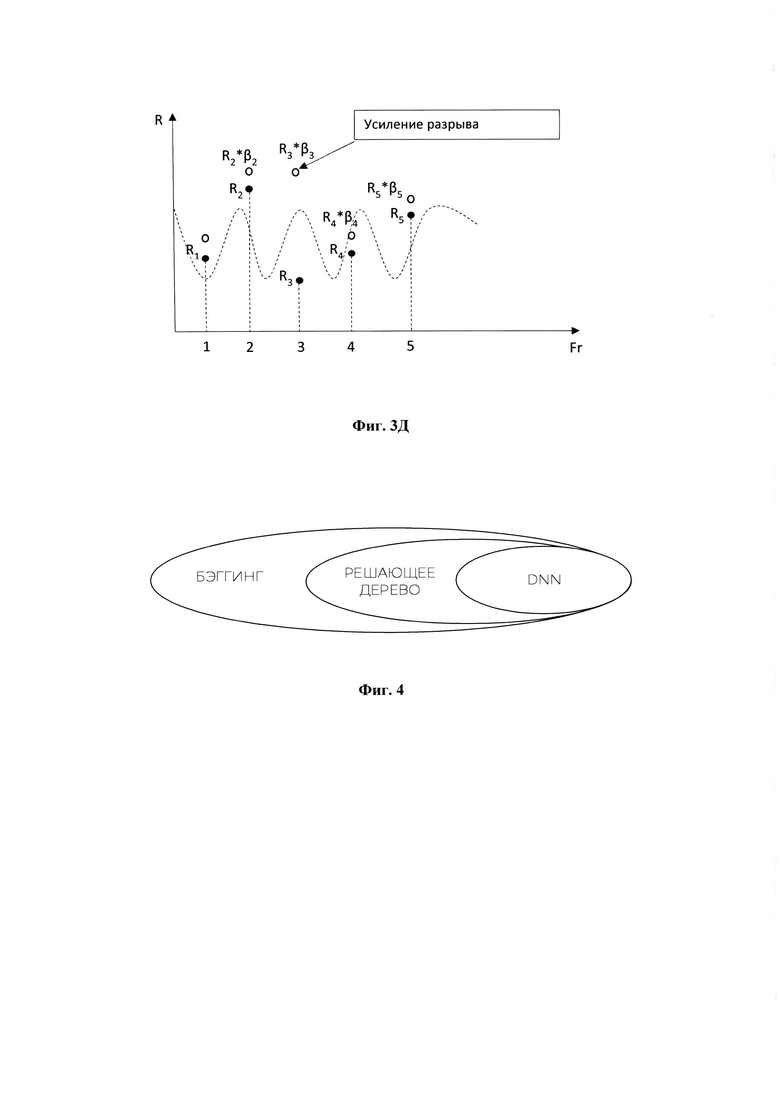

[0021] Фиг. 3Д иллюстрирует создание нового ряда пикселей сквозь фреймы Fr, если видеоролик был с наложением DeepFake.

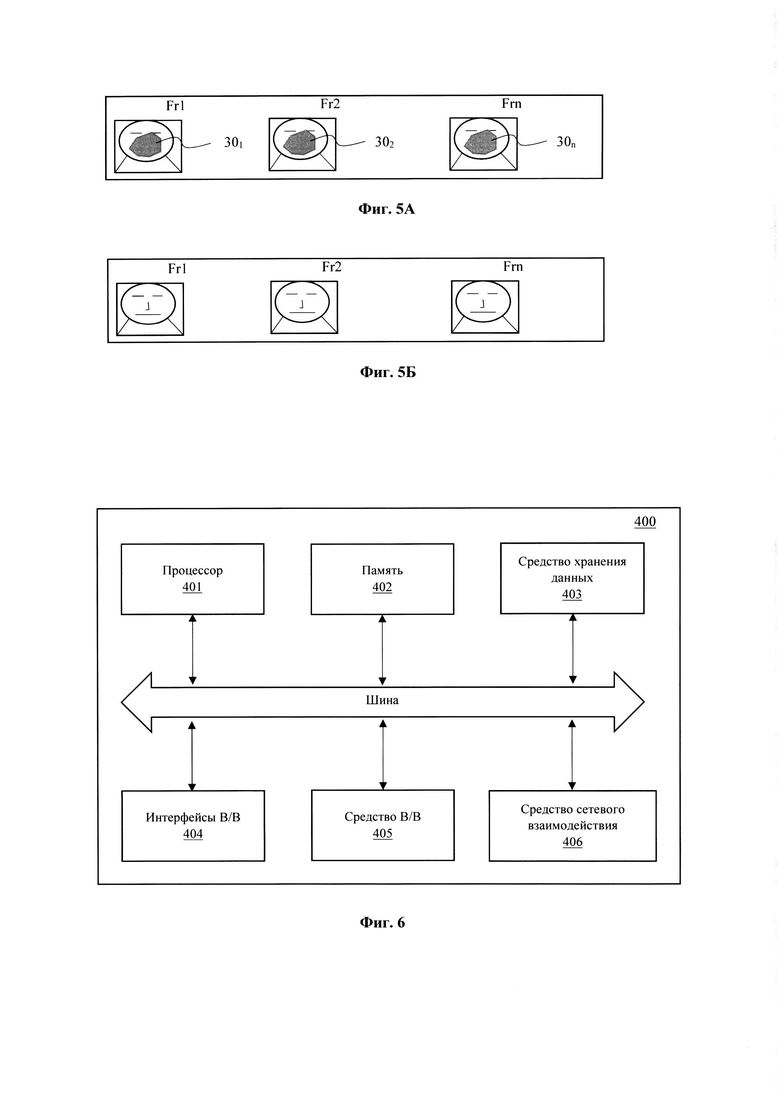

[0022] Фиг. 4 иллюстрирует общую архитектуру модели машинного обучения.

[0023] Фиг. 5А - 5Б иллюстрируют пример анализа фреймов для определения синтетических изменений в видео.

[0024] Фиг. 6 иллюстрирует общий вид вычислительного устройства.

ОСУЩЕСТВЛЕНИЕ ИЗОБРЕТЕНИЯ

[0025] Как представлено на Фиг. 1, реализация заявленного способа (100) определения синтетически измененных изображений лиц в видео заключается в выполнении вычислительным компьютерным устройством, в частности, с помощью одного или нескольких процессоров в автоматизированном режиме программного алгоритма, представленного в виде последовательности этапов, обеспечивающих выполнение материальных действий в виде обработки электронных сигналов, порождаемых при исполнении процессором вычислительного устройства своих функций в целях реализации выполнения обработки данных в рамках исполнения способа (100).

[0026] В настоящем решении под термином «синтетически измененное изображения лица» здесь и далее по тексту будет пониматься любой тип формирования цифрового изображения, имитирующего лицо или часть лица другого человека, в том числе путем наложения цифровых масок, искажение/изменение частей лица и т.п. Под синтетически измененным изображением лица следует понимать, как полностью сгенерированные изображения, например, масок с помощью технологии DeepFake, накладываемых на лицо реального человека в кадре с сохранением мимической активности изображения, так и формирование частичного изменения отдельных частей лица (глаз, носа, губ, ушей и т.п.).

[0027] На первом этапе (101) осуществляется получение и сохранение в память вычислительного устройства, выполняющего способ (100), одного или нескольких изображений, получаемых из видео. В настоящих материалах заявки под термином «видео» будет пониматься видеоизображение, видеопоток (например, с ip-камеры, камеры электронного устройства, виртуальной камеры, с Интернет-приложения), упорядоченная последовательность кадров (изображений), подвыборка кадров, в том числе вплоть и до одного изображения.

[0028] Как представлено на Фиг. 2, из полученных на этапе (101) кадров (201) видео (20) на этапе (102) формируются фреймы F = {F1, F2, …, Fn}, где каждый фрейм содержит область кадра с изображением лица. Разбиение на фреймы выполняются с помощью библиотек, таких как OpenCV, EmguCV, AForge, Accord и других подобных библиотек для выявления лиц на видеокадрах. Данные классификаторы способны выявлять лица на статическом изображениях (кадрах).

[0029] Каждый фрейм из множества F = {F1, F2, …, Fn} содержит изображение лица в цветовой палитре RGB, что позволяет на этапе (103) выполнить извлечение компоненты R палитры RGB каждого пикселя. Как представлено на Фиг. 2 на примере фрейма F1 компоненты пикселей R1, R2 извлекаются для последующей обработки, чтобы на этапе (104) сформировать массива значений красного спектра R для каждого пикселя в каждом фрейме из множества F.

[0030] На Фиг. 3А приведен пример анализа интенсивности изменения пикселей изображения на примере динамики пульса человека, который обычно подчиняется периодическому закону распределения ~ sin(at). По изменениям во времени пульсации красного спектра R формируется распределение массива значений на кадрах F (Фиг. 3Б), который соответствуют изображению реального человека на кадрах видео. На Фиг. 3В приведен пример распределения компонент R, который свидетельствует о возможной аномалии, связанной со значительным разрывом между точками R, в которых обычно происходит изменение в красном спектре в связи с пульсацией крови.

[0031] На основании сформированного массива компонент R на этапе (105) для каждого фрейма выполняется расчет ΔR компоненты (например, R1 - R2 для пикселя на фрейме F1) пикселя между текущим и следующим фреймом, что позволяет сформировать массив ArrΔβ для, отображающий интенсивность изменения пикселей для каждого фрейма в области изображения лица.

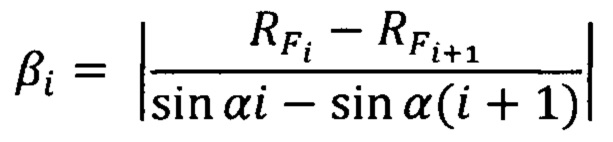

[0032] На основании сформированного массива ArrΔβ на этапе (106) рассчитывают параметр усиления β между текущим и следующим фреймом и формируют массив Arrβ для каждого пикселя. Параметр усиления β определяется следующим образом. Для каждого Рх(х, у)-пикселя фрейма F с координатами (х, у):

где:

i - порядковый номер фрейма F видеоролика, i - целое неотрицательное число, i ≤ n, n - количество фреймов;

- значение красной компоненты яркости пикселя в i-ом фрейме;

- значение красной компоненты яркости пикселя в i-ом фрейме;

α - частота пульса человека (например, 0,5 - 1 Гц).

[0033] На основании сформированного массива Arrβ на этапе (107) формируют массив матриц

[0034] Далее на этапе (108) с помощью сформированной матриц MRβ выполняется формирование новых фреймов Fr = {Fr1, Fr2, …, Frn-1} с помощью замены в компоненты R палитры RGB в каждом фрейме F.

[0035] На этапе (109) каждый полученный новый фрейм из множества Fr обрабатывается с помощью модели машинного обучения, которая выполнена с возможностью выявления наличия динамики пикселей в компоненте R палитры RGB. Так как анализ EVM дает огромное количество сочетаний цветов, их прямой анализ перебором не возможен алгоритмическими средствами. Для этого применяется модель машинного обучения, которая построена на базе нейронной сети глубокого обучения (DNN).

[0036] На Фиг. 3Г показан принцип формирования новых фреймов Fr с помощью умножения компонент R на параметр усиления β. Если полученные фреймы Fr в части отображения изменений R компонент является идентичной или близкой к фреймам R, то это свидетельствует о живом человеке в кадрах видео. Если же определяется значительный разрыв между отображением пикселей в красном спектре, то это говорит о наложении синтетических изменений и представленное изображение лица является подменным.

[0037] Задача, которую выполняет настоящая модель машинного обучения, относится к задаче бинарной классификации изображения, осложненной тем, что необходимо распознать не объект в изображении, а на основе сочетаний цветов в изображении, дать ответ, содержит ли данное изображение синтетическое изменение лица или нет. В предлагаемой модели могут использоваться библиотеки MS.ML, TensorFlow, Torch, Accord и т.п. Общий вид структуры модели приведен на Фиг. 4.

[0038] Модель представляет собой бэггинг из решающих деревьев (например, https://www.geeksforgeeks.org/ml-bagging-classifier/), в каждой из которых результат работы DNN текущей итерации сравнивается с результатом работы DNN предыдущей итерации. И, если результат лучше, результат работы текущей DNN передается в следующую итерацию, иначе следующая итерация заново отрабатывает по старым данным. Таким образом достигается качество работы DNN, при которой результат предсказания приближается к результату работы нейронной сети.

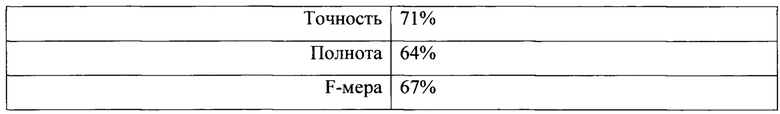

[0039] Сама нейросеть представляет собой сложную сверточную глубинную нейросеть со внутренними деревьями созданной на TF (Tensor Flow).

[0040] Модель была обучена на базе видеороликов из Deepfake Detection Challenge (DFDC), организованной AWS, Facebook, Microsoft. Из 70% всех скачанных видеороликов (~250 Гб) использовалось ~2 300 из 6 000 оригинальных видеороликов (real) и ~2 300 из 33 000 видеороликов с нанесенными дипфейками (fake). Из оставшихся 30% видеороликов была проведена проверка на ~300 видеороликах из real и ~300 видеороликов из категории fake. Алгоритм показал следующие результаты:

[0041] При этом необходимо отметить, что видеоролики DFDC имеют следующие свойства:

• разное качество видеороликов, наличие зернистости, квадратности, обусловленное работой камеры;

• разные скорости воспроизведения видеороликов;

• наличие нескольких человек в кадре;

• наличие посторонних предметов в кадре, имитирующих человеческое лицо (значки - смайлики, постеры);

• лица людей не всегда смотрят в кадр, съемка ведется сбоку;

• в видеороликах присутствуют люди разных полов, рас;

• алгоритмы нанесения дипфейков заранее неизвестны.

[0042] По итогам анализа модели на этапе (109) алгоритм определения выявляет по сформированным фреймам Fr наличие пиксельной активности (301 - 30n) в области отображения лица и выдает итог проверки на этапе (110). Как показано на Фиг. 5А, в случае наличия динамики изменения пикселей в R компоненте на фреймах Fr, то это свидетельствует о наложении синтетического изменения на изображение лица. В противном случае, как показано на Фиг. 5Б, если изменений пикселей в R компоненте нет, то это свидетельствует об отсутствии синтетических изменений лиц в видео. По завершению этапа (110) генерируется уведомление о наличии синтетически измененного лица в видео.

[0043] Уведомление может отображаться непосредственно в графическом интерфейсе пользователя, например, при проведении онлайн-конференции (Zoom, Skype, MS Teams). Также, уведомление может отображаться непосредственно в области выявления синтетического изменения лица, например, в области с изображением лица человека. Дополнительным эффектом от применения изобретения может являться его использование в системах биометрического контроля, например, при получении услуг (например, банковских услуг) или доступа (система контроля доступа, турникет с биометрическим сенсором). При выявлении синтетически измененного изображения лица осуществляется блокировка доступа или запрашиваемого действия со стороны пользователя. В этом случае может дополнительно запрашиваться данные аутентификации пользователя, выбираемые из группы: логин, код, пароль, двухфакторная аутентификация или их сочетания.

[0044] Заявленное решение может применяться в системах мониторинга медиапространства и анализа социальных медиа и СМИ, для выявления публичных известных людей (первые лица государства, медийные личности, известные люди и т.п.), на которых может производиться попытка их компрометации. Такие системы будут являться источником получаемого видео для его последующего анализа, и, в случае выявления синтетических изменений изображений лиц таких людей, им или соответствующей службе может быть направлено уведомление о подложно сформированной информации. Для такого вида уведомления может также сохраняться информация о времени выявленного события, источнике события.

[0045] На Фиг. 6 представлен общий вид вычислительного устройства (400), пригодного для выполнения заявленного способа (100). Устройство (400) может представлять собой, например, сервер или иной тип вычислительного устройства, который может применяться для реализации заявленного технического решения. В том числе входить в состав облачной вычислительной платформы.

[0046] В общем случае вычислительное устройство (400) содержит объединенные общей шиной информационного обмена один или несколько процессоров (401), средства памяти, такие как ОЗУ (402) и ПЗУ (403), интерфейсы ввода/вывода (404), устройства ввода/вывода (405), и устройство для сетевого взаимодействия (406).

[0047] Процессор (401) (или несколько процессоров, многоядерный процессор) могут выбираться из ассортимента устройств, широко применяемых в текущее время, например, компаний Intel™, AMD™, Apple™, Samsung Exynos™, MediaTEK™, Qualcomm Snapdragon™ и т.п. В качестве процессора (501) может также применяться графический процессор, например, Nvidia, AMD, Graphcore и пр.

[0048] ОЗУ (402) представляет собой оперативную память и предназначено для хранения исполняемых процессором (401) машиночитаемых инструкций для выполнения необходимых операций по логической обработке данных. ОЗУ (402), как правило, содержит исполняемые инструкции операционной системы и соответствующих программных компонент (приложения, программные модули и т.п.).

[0049] ПЗУ (403) представляет собой одно или более устройств постоянного хранения данных, например, жесткий диск (HDD), твердотельный накопитель данных (SSD), флэш-память (EEPROM, NAND и т.п.), оптические носители информации (CD-R/RW, DVD-R/RW, BlueRay Disc, MD) и др.

[0050] Для организации работы компонентов устройства (400) и организации работы внешних подключаемых устройств применяются различные виды интерфейсов В/В (404). Выбор соответствующих интерфейсов зависит от конкретного исполнения вычислительного устройства, которые могут представлять собой, не ограничиваясь: PCI, AGP, PS/2, IrDa, FireWire, LPT, COM, SATA, IDE, Lightning, USB (2.0, 3.0, 3.1, micro, mini, type C), TRS/Audio jack (2.5, 3.5, 6.35), HDMI, DVI, VGA, Display Port, RJ45, RS232 и т.п.

[0051] Для обеспечения взаимодействия пользователя с вычислительным устройством (400) применяются различные средства (405) В/В информации, например, клавиатура, дисплей (монитор), сенсорный дисплей, тач-пад, джойстик, манипулятор мышь, световое перо, стилус, сенсорная панель, трекбол, динамики, микрофон, средства дополненной реальности, оптические сенсоры, планшет, световые индикаторы, проектор, камера, средства биометрической идентификации (сканер сетчатки глаза, сканер отпечатков пальцев, модуль распознавания голоса) и т.п.

[0052] Средство сетевого взаимодействия (406) обеспечивает передачу данных устройством (400) посредством внутренней или внешней вычислительной сети, например, Интранет, Интернет, ЛВС и т.п. В качестве одного или более средств (406) может использоваться, но не ограничиваться: Ethernet карта, GSM модем, GPRS модем, LTE модем, 5G модем, модуль спутниковой связи, NFC модуль, Bluetooth и/или BLE модуль, Wi-Fi модуль и др.

[0053] Дополнительно могут применяться также средства спутниковой навигации в составе устройства (400), например, GPS, ГЛОНАСС, BeiDou, Galileo.

[0054] Представленные материалы заявки раскрывают предпочтительные примеры реализации технического решения и не должны трактоваться как ограничивающие иные, частные примеры его воплощения, не выходящие за пределы испрашиваемой правовой охраны, которые являются очевидными для специалистов соответствующей области техники.

Настоящее техническое решение относится к области компьютерных технологий, применяемых в области обработки данных, в частности к способу и системе для определения синтетически измененных изображений лиц на видео. Техническим результатом является обеспечение возможности выявления синтетически измененных изображений лиц в видео. Заявленный технический результат достигается за счет способа определения синтетических изменений лиц в видео, выполняемого с помощью процессора и содержащего этапы, на которых: получают видео, содержащее по меньшей мере одно изображение лица; разбивают полученное видео на множество фреймов, при этом каждый фрейм содержит область кадра с изображением лица; извлекают компоненту R палитры RGB каждого пикселя в каждом фрейме из множества F; составляют массив значений красного спектра для каждого пикселя; рассчитывают ΔR компонент R между текущим и следующим фреймом для каждого пикселя и формируют массив, отображающий интенсивность изменения пикселей; рассчитывают параметр усиления между текущим и следующим фреймом на основании массива и формируют массив для каждого пикселя. 2 н. и 6 з.п. ф-лы, 11 ил.

1. Способ определения синтетических изменений лиц в видео, выполняемый с помощью процессора и содержащий этапы, на которых:

a) получают видео, содержащее по меньшей мере одно изображение лица;

b) разбивают полученное видео на множество фреймов F = {F1, F2, …, Fn}, при этом каждый фрейм содержит область кадра с изображением лица;

c) извлекают компоненту R палитры RGB каждого пикселя в каждом фрейме из множества F;

d) составляют массив значений красного спектра для каждого пикселя в каждом фрейме из множества F;

e) рассчитывают ΔR компоненты R пикселя между текущим и следующим фреймом для каждого пикселя и формируют массивы ArrΔR, отображающие интенсивности изменений пикселей сквозь F;

f) рассчитывают параметры усиления β и формируют массивы Arrβ между текущим и следующим фреймом и для каждого пикселя на основании массивов ArrΔR, полученных на этапе е);

g) формируют массив матриц MRβ на основании массива Arrβ, полученного на этапе f);

h) формируют фреймы Fr = {Fr1, Fr2, …, Frn} на основании массива матриц MRβ, полученных на этапе g) путем замены красного спектра каждого пикселя R во множестве F, полученного на этапе b);

i) осуществляют анализ каждого фрейма из Fr, полученного на этапе h) с помощью модели машинного обучения, выполненной с возможностью выявления наличия динамики пикселей в компоненте R палитры RGB;

j) определяют синтетические изменения изображений лиц в видео на основании анализа фреймов на этапе g).

2. Способ по п. 1, в котором фреймы лиц на этапе b) определяются с помощью алгоритма библиотеки OpenCV, обеспечивающего определение местоположений лиц на кадрах видео.

3. Способ по п. 1, в котором этапы с)- h) выполняются с помощью алгоритма библиотеки EVM (Алгоритм усиления Эйлера).

4. Способ по п. 2, в котором фреймы определяются с помощью обрезки области кадра видео, содержащего изображение лица.

5. Способ по п. 1, в котором при выявлении синтетически измененного лица формируется уведомление.

6. Способ по п. 5, в котором уведомление отображается в графическом интерфейсе пользователя.

7. Способ по п. 6, в котором выполняется маркировка области изображения с синтетически измененным изображением лица.

8. Система определения синтетических изменений лиц в видео, содержащая по меньшей мере один процессор и по меньшей мере одну память, в которой хранятся машиночитаемые инструкции, которые при их выполнении процессором реализуют способ по пп. 1-7.

| CN113435292A, 24.09.2021 | |||

| Способ регенерирования сульфо-кислот, употребленных при гидролизе жиров | 1924 |

|

SU2021A1 |

| JOHN K | |||

| LEWIS et al: "Deepfake Video Detection Based on Spatial, Spectral, and Temporal Inconsistencies Using Multimodal Deep Learning", 10.05.2021, [найдено: 29.04.2022] Найдено в: | |||

Авторы

Даты

2022-06-21—Публикация

2021-12-01—Подача