Область техники

Изобретение относится к технологиям обеспечения информационной безопасности, а более конкретно к системам и способам авторизации пользователя на вычислительном устройстве.

Уровень техники

Бурное развитие компьютерных технологий в последнее десятилетие, а также широкое распространение разнообразных вычислительных устройств (персональных компьютеров, ноутбуков, планшетов, смартфонов и т.д.) стали мощным стимулом для использования упомянутых устройств в разнообразных сферах деятельности и для огромного количества задач (от интернет-серфинга до банковских переводов и ведения электронного документооборота). Параллельно с ростом количества вычислительных устройств и объемом программного обеспечения, работающего на этих устройствах, быстрыми темпами росло и количество вредоносных программ, а также способов несанкционированного доступа к данным, обрабатываемых указанными устройствами, и мошеннических способов использования этих данных. Таким образом особенно важным становятся вопросы информационной безопасности.

В настоящий момент существует огромное количество разновидностей вредоносных программ. Одни крадут с устройств пользователей их персональные и конфиденциальные данные (например, логины и пароли, банковские реквизиты, электронные документы). Другие формируют из устройств пользователей так называемые бот-сети (англ. botnet) для таких атак, как отказ в обслуживании (англ. DDoS - Distributed Denial of Service) или для перебора паролей методом грубой силы (англ. bruteforce) на другие компьютеры или компьютерные сети. Третьи предлагают пользователям платный контент через навязчивую рекламу, платные подписки, отправку CMC на платные номера и т.д.

С описанными выше угрозами хорошо справляются специальные программы - антивирусы. Однако в некоторых ситуациях упомянутые антивирусы практически бесполезны, например при целевых кибератаках на компьютерные системы (англ. APT - advanced persistent threat), а также, когда при заражении компьютерных систем упомянутые антивирусы на этих компьютерных системах не функционировали (например, не были установлены или отключены).

Для более надежной защиты вместе с описанными выше автоматическими средствами зачастую приходится использовать экспертизу пользователя, которая заключается в том, чтобы корректировать работу системы (принимать решение о выборе того или иного способа решения задач), вводить в системы данные, на основании которых система может продолжить дальнейшую работу (например, для задач выявления несанкционированного доступа, целевых кибератак или исполнения неизвестных программ). С этой целью используются такие средства, как авторизация (логины и пароли), определение действий пользователя, а также автоматизированные публичные тесты Тьюринга, т.е. активная работа пользователя с элементами системы безопасности системы.

Известные автоматизированные публичные тесты Тьюринга хорошо справляются с задачами определения присутствия человека в системах и блокировки автоматического выполнения критически важных задач, однако они не устойчивы к целевым кибератакам, а также к возможности их прохождения узкоспециализированными автоматическими средствами, создаными для того, чтобы проходить заранее заданные и хорошо известные тесты (например, распознавание текста). Работа подобных автоматических средств возможна из-за статичности тестов, в результате чего у злоумышленников появляется время их досконально изучить и разработать алгоритмы их прохождения.

В публикации US 20150039315 A1 описана технология получения доступа к вычислительным ресурсам с использованием устных полностью автоматических публичных тестов Тьюринга (капчи). Пользователь, желающий получить доступ к вычислительным ресурсам прослушивает звуковой фрагмент, после чего голосом проговаривает, что услышал, в зависимости от точности воспроизведения определяется предоставлять ли ему доступ к вычислительным ресурсам или нет.

Описанная выше технология хорошо справляется с предоставлением пользовательского доступа для заданных пользователей по запросу, но она уязвима к современным автоматическим средствам обхода запросов на выполнение задач (например, статичные автоматические публичные тесты Тюринга).

Настоящее изобретение позволяет решать задачу предоставления санкционированного доступа к вычислительным ресурсам и выполнение критических для информационной безопасности действий на вычислительном устройстве.

Раскрытие изобретения

Изобретение предназначено для обеспечения информационной безопасности данных.

Технический результат настоящего изобретения заключается в авторизации пользователя на вычислительном устройстве в зависимости от действий, выполняемых указанным пользователем на вычислительном устройстве.

Краткое описание чертежей

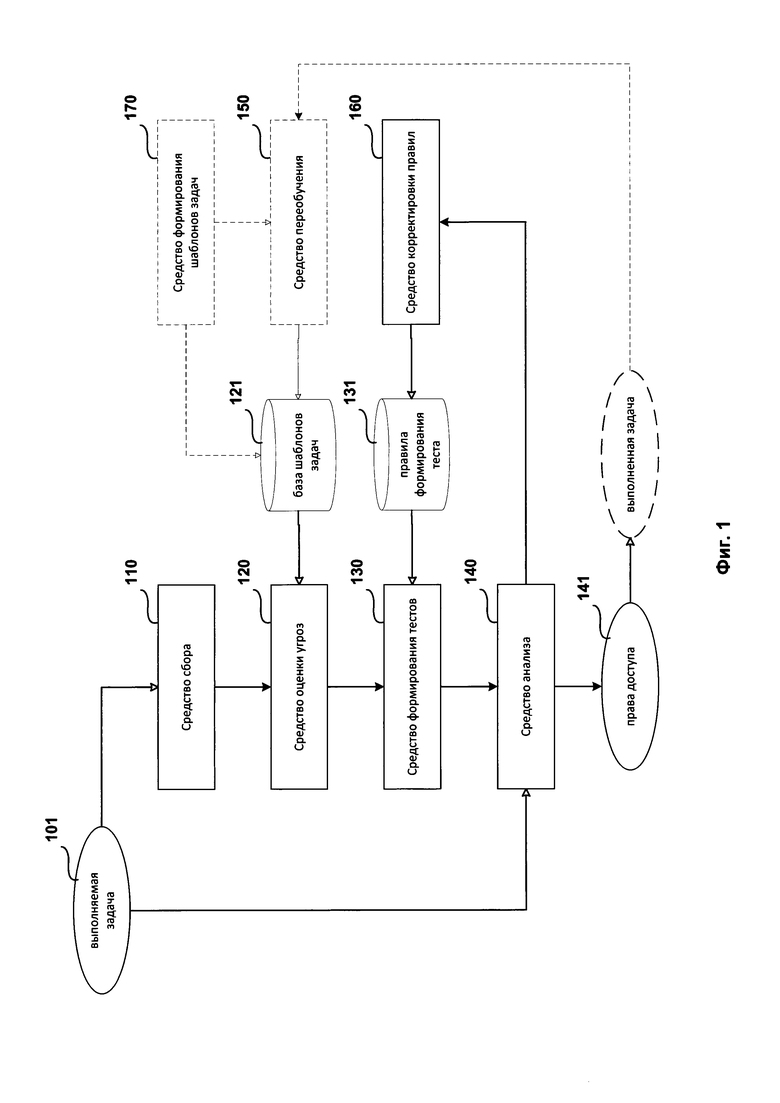

Фиг. 1 представляет пример структурной схемы системы выполнения задачи на вычислительном устройстве.

Фиг. 2 представляет пример структурной схемы способа выполнения задачи на вычислительном устройстве.

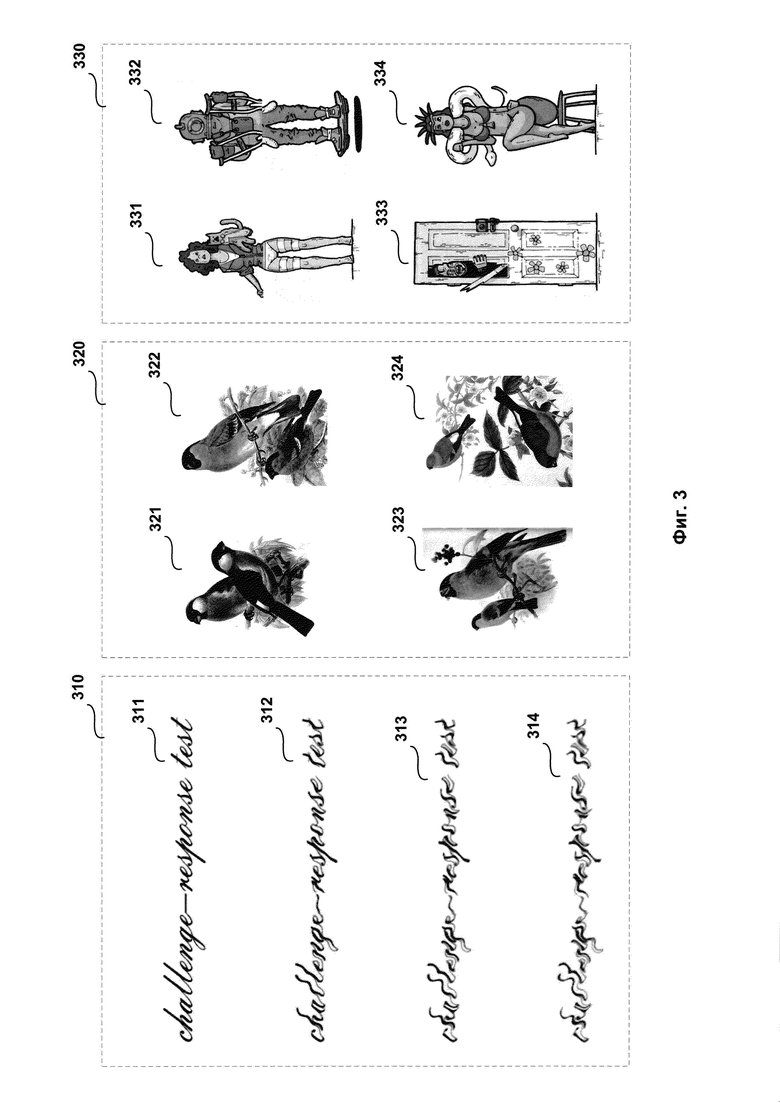

Фиг. 3 представляет примеры вариантов корректируемого автоматизированного публичного теста Тьюринга.

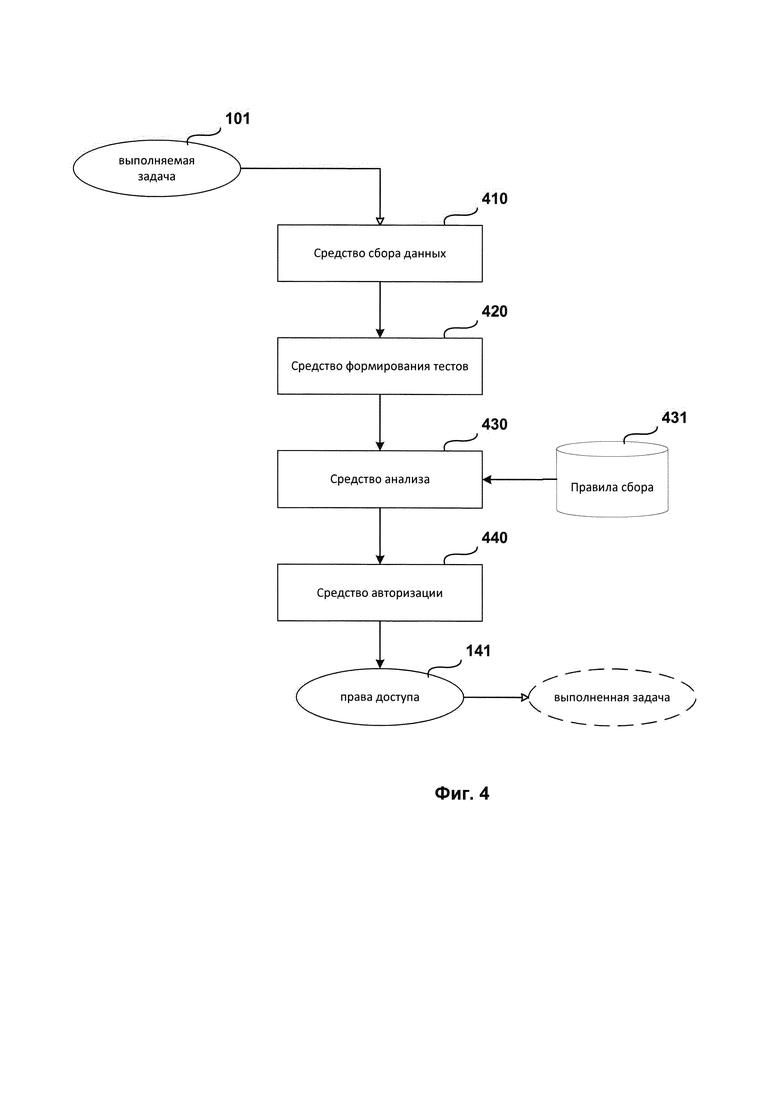

Фиг. 4 представляет пример структурной схемы системы авторизации пользователя на вычислительном устройстве.

Фиг. 5 представляет пример структурной схемы способа авторизации пользователя на вычислительном устройстве.

Фиг. 6 представляет пример компьютерной системы общего назначения, персональный компьютер или сервер.

Хотя изобретение может иметь различные модификации и альтернативные формы, характерные признаки, показанные в качестве примера на чертежах, будут описаны подробно. Следует понимать, однако, что цель описания заключается не в ограничении изобретения конкретным его воплощением. Наоборот, целью описания является охват всех изменений, модификаций, входящих в рамки данного изобретения, как это определено приложенной формуле.

Описание вариантов осуществления изобретения

Объекты и признаки настоящего изобретения, способы для достижения этих объектов и признаков станут очевидными посредством отсылки к примерным вариантам осуществления. Однако настоящее изобретение не ограничивается примерными вариантами осуществления, раскрытыми ниже, оно может воплощаться в различных видах. Сущность, приведенная в описании, является ничем иным, как конкретными деталями, необходимыми для помощи специалисту в области техники в исчерпывающем понимании изобретения, и настоящее изобретение определяется в объеме приложенной формулы.

Введем ряд определений и понятий, которые будут использоваться при описании вариантов осуществления изобретения.

Автоматизированный публичный тест Тьюринга (САРТСНА - англ. Completely Automated Public Turing test to tell Computers and Humans Apart) - компьютерный тест, используемый для того, чтобы определить, кем является пользователь системы: человеком или компьютером.

Защищаемая информация - информация, являющаяся предметом собственности и подлежащая защите в соответствии с требованиями правовых документов или требованиями, устанавливаемыми собственником информации.

Критические данные пользователя - данные, использование которых (модификация, удаление, копирование) может нанести значительный ущерб физическому лицу (субъекту критических данных) или системе, на которой работает физическое лицо.

Персональные данные - любая информация, относящаяся к определенному или определяемому на основании такой информации физическому лицу (субъекту персональных данных), в том числе его фамилия, имя, отчество, год, месяц, дата и место рождения, адрес, семейное, социальное, имущественное положение, образование, профессия, доходы, другая информация.

Правило доступа - совокупность правил, устанавливающих порядок и условия доступа субъекта (пользователя) к защищаемой информации (например, персональным данным) и ее носителям.

Право доступа - совокупность правил доступа к защищаемой информации, установленных правовыми документами или собственником информации.

Целевая кибератака (APT - англ. Advanced Persistent Threat) - вид кибератаки, процесс которой контролируется вручную в реальном времени человеком, являющимся центром атаки. Целью данной атаки является хищение защищаемой информации из информационной системы конкретной компании, организации или государственной службы. Важными отличительными особенностями целевых атак можно назвать их продолжительность, длительный и ресурсозатратный период подготовки, а также использование не только технических и компьютерных средств для ее осуществления. Комплексный подход к построению атаки может включать активное воздействие на людей с помощью психологии и методов социальной инженерии, совместно с атаками нулевого дня (англ. zero-day exploits) на оборудование.

В основе автоматизированных публичных тестов Тьюринга лежит сугубо человеческий способ решения абстрактных задач, при этом каждый пользователь, решающий упомянутые тесты Тьюринга, будет решать их индивидуально присущими только этому пользователю способами (сюда можно отнести и скорость прохождения теста, действия, выполняемые пользователем при прохождении теста, а также возможность обучаться на своем опыте и корректировать применяемые для прохождения теста способы). Например, самым простым случаем такого индивидуального способа решения теста, является перемещение объекта на рабочем столе из одного места в другое или осуществление выбора между многими элементами, расположенными слева направо и т.д. Таким образом, упомянутые тесты Тьюринга позволяют не только определить, человек проходит указанные тесты, или применяются автоматические средства, но и кто именно из ранее проходивших данные тесты людей проходит их в текущий момент. Эти принципы и лежат в основе повышения информационной безопасности вычислительных устройств посредством подтверждения человеком выполняемых на упомянутых устройствах критически важных задач.

Фиг. 1 представляет пример структурную схему системы выполнения задачи на вычислительном устройстве.

Структурная схема системы выполнения задачи на вычислительном устройстве содержит средство сбора 110, средство оценки угроз 120, средство формирования тестов 130, средство анализа 140, средство переобучения 150, средство корректировки правил 160, средство формирования шаблонов задач 170.

Средство сбора 110 предназначено для:

сбора данных, характеризующих задачу управления вычислительным устройством (далее, задача 101);

сбора данных, характеризующих задачу управления вычислительным устройством (далее, задача 101);

передачи собранных данных средству оценки угроз 120.

передачи собранных данных средству оценки угроз 120.

В одном из вариантов реализации системы задача управления вычислительным устройством 101 может включать в себя задачи создания, модификации, удаления или передачи по компьютерной сети данных (например, файлов).

Еще в одном из вариантов реализации системы до определения права доступа указанной задачи 101 средством анализа 140, описанного ниже, выполнение задачи 101 на вычислительном устройстве приостанавливается.

Например, такие задачи 101 как удаление файла, запись на жесткий диск или передача данных по компьютерной сети, если такие задачи 101 признаны критическими для безопасности вычислительного устройства (например, на основании собранной ранее и проанализированной любым известным из уровня техники способом статистики кибератак на различные вычислительные устройства) временно (до вынесения решения средством анализа 140) блокируются для выполнения на вычислительном устройстве. По указанным задачам 101 собираются данные, характеризующие указанные задачи 101, а после успешного прохождения пользователем вычислительного устройства автоматизированного публичного теста Тьюринга, сформированного средством формирования тестов 130, выдают разрешение на выполнение описанных выше задач 101 (удаление файла, запись на жесткий диск или передача данных по компьютерной сети) на вычислительном устройстве с определенными правами доступа 141 (например, выдают соответствующие команды операционной системе, используют API для блокировки и разблокировки процессов, выполняющих указанные задачи 101, и т.д.).

Еще в одном из вариантов реализации системы сбор данных, характеризующих задачу 101, осуществляется путем перехвата с помощью специализированного драйвера выполнения указанной задачи 101.

Например, с помощью специализированного драйвера перехватывают вызовы API функций, используемых для выполнения задачи 101. К примеру задача передачи данных ко компьютерной сети, выполняемые в операционной системе Windows, используют функции socket, recv, send и т.д., которые перехватываются сетевым драйвером.

Еще в одном примере, если выполняемая задача 101 состоит из нескольких подзадач, могут совместно использоваться различные способы сбора данных. К примеру задача установки программного обеспечения состоит из таких подзадач, как работа с файловой системой для записи устанавливаемых файлов на диск, работа с памятью для выделения больших объемов данных для выполнения операций разархивирования устанавливаемых файлов, работа с реестром для записи параметров устанавливаемого программного обеспечения и т.д. В этом случае с помощью драйвера файловой системы отслеживается выполнение таких функций, как CreateFile, ReadFile, WriteFile и т.д., с помощью установки перехватчиков (hooks), отслеживается выполнение таких функций, как HeapAlloc, VirtualAlloc, CreateFileMapping и т.д., с помощью анализа журналов установки программного обеспечения, файлов настроек программного обеспечения и т.д. отслеживают параметры, влияющие на работу указанного программного обеспечение.

Еще в одном примере после того как происходит перехват выполнения функций, описанными выше способами операционной системе подается запрос на временное прекращение или прерывания выполнения перехваченных функций. К примеру, с помощью технологии сплайсинга (англ. splicing) отслеживаемое приложение при вызове WinAPI функции (например, CreateFile) сначала обращается к отслеживающему приложению (например, драйверу) и лишь затем драйвер переправляет вызов перехваченной функции для выполнение операционной системе. Если логика работы драйвера требует иного, то перехваченная функция не будет передана операционной системе, при этом отслеживаемому приложению, вызвавшему перехваченную функцию, будут отправлены необходимые данные, чтобы указанное приложение «посчитало», что вызываемая функция была корректно выполнена.

Еще в одном из вариантов реализации системы задача 101 представляет собой по меньшей мере:

управление процессом, исполняемом в операционной системе на вычислительном устройстве, отвечающий за обработку критических для информационной безопасности данных, в том числе персональных или конфиденциальных данных пользователя или юридического лица (например, создание, изменение или удаление файлов, установка программного обеспечения на вычислительном устройстве, архивирование данных и т.д.), с которыми непосредственно работает пользователь (например, электронные документы Microsoft Office);

управление процессом, исполняемом в операционной системе на вычислительном устройстве, отвечающий за обработку критических для информационной безопасности данных, в том числе персональных или конфиденциальных данных пользователя или юридического лица (например, создание, изменение или удаление файлов, установка программного обеспечения на вычислительном устройстве, архивирование данных и т.д.), с которыми непосредственно работает пользователь (например, электронные документы Microsoft Office);

управление процессом, исполняемом в операционной системе на указанном вычислительном устройстве или иных вычислительных устройствах, связанных с указанным устройством по компьютерной сети в рамках клиент-серверной архитектуры (например, взаимодействие с сайтами с помощью браузера), при этом средство сбора 110 и средство анализа 140 могут функционировать на разных клиентах и серверах;

управление процессом, исполняемом в операционной системе на указанном вычислительном устройстве или иных вычислительных устройствах, связанных с указанным устройством по компьютерной сети в рамках клиент-серверной архитектуры (например, взаимодействие с сайтами с помощью браузера), при этом средство сбора 110 и средство анализа 140 могут функционировать на разных клиентах и серверах;

управление приложением с помощью графического интерфейса приложения, в том числе ввод данных пользователем или управление анализом упомянутых данных (например, в качестве задачи 101 может выступать ввод конфиденциальных данных пользователя, таких как логин и пароль с помощью административных утилит, при этом важно не только, какие данные указываются, но и какими средствами выполняется данная задача, еще в одном примере собирается информация о том какие действия в системе выполнял пользователь, какие элементы графического интерфейса приложения использовал, как перемещал мышь, какие кнопки нажимал и т.д.);

управление приложением с помощью графического интерфейса приложения, в том числе ввод данных пользователем или управление анализом упомянутых данных (например, в качестве задачи 101 может выступать ввод конфиденциальных данных пользователя, таких как логин и пароль с помощью административных утилит, при этом важно не только, какие данные указываются, но и какими средствами выполняется данная задача, еще в одном примере собирается информация о том какие действия в системе выполнял пользователь, какие элементы графического интерфейса приложения использовал, как перемещал мышь, какие кнопки нажимал и т.д.);

изменения параметров работы операционной системы (например, управление административными правами, правами доступа приложений и пользователей и т.д.), в том числе изменение режима работы операционной системы (т.е. как операционная система реагирует на действия, выполняемые пользователями и приложениями, работающими в операционной системе, например, управления правами доступа 141 и т.д.).

изменения параметров работы операционной системы (например, управление административными правами, правами доступа приложений и пользователей и т.д.), в том числе изменение режима работы операционной системы (т.е. как операционная система реагирует на действия, выполняемые пользователями и приложениями, работающими в операционной системе, например, управления правами доступа 141 и т.д.).

Например, при использовании клиент-серверной архитектуры данных хранятся в облаке (на одном удаленном ресурсе), обрабатываются на сервере (на другом удаленном ресурсе) и передаются сервером клиенту (локальному ресурсу) по запросу упомянутого клиента. При этом задачи 101 выполняются на сервере, но для разрешения их выполнения данных запрашиваются у клиента, таким образом средство сбора 110, средство оценки угроз 120, средство формирования тестов 130 функционирует на сервере, а средство анализа 140 на клиенте. С другой стороны, возможна и обратная ситуация, когда средство сбора 110, средство оценки угроз 120, средство формирования тестов 130 функционирует на клиенте, а средство анализа 140 на сервере. В зависимости от того, какая схема работы в клиент-серверной архитектуре выбрана, осуществляется информационная безопасность клиента (первый случай) или сервера (второй случай).

Еще в одном из вариантов реализации системы задача 101 может представлять собой совокупность нескольких задач 101 (например, задача модификации электронного документа Adobe PDF может подразумевать несколько задач, от получения архива с сайта, разархивирования требуемого документа и последующей модификации разархивированного документа).

Например, при перехвате данных задача 101 откладывается и не выполняется (операционной системе передаются команды на отказ в выполнении задачи), и только после успешного прохождения пользователем вычислительного устройства автоматизированного публичного теста Тьюринга, сформированного средством формирования тестов 130, выполняется с определенными правами доступа 141 средством анализа 140 на основании данных, собранных средством сбора 110.

Еще в одном примере все задачи 101 на вычислительном устройстве виртуализируются (т.е. выполняются в виртуальной среде, англ. virtual machine) и лишь после успешного прохождения пользователем теста указанные задачи 101 выполняются и выполненные ими изменения применяются на физическом устройстве. В определенных случаях могут виртуализироваться не все задачи 101, а лишь с уровнями задачи, определяемыми средством оценки угроз, более заданного порогового значения.

Еще в одном примере средство анализа 140 является компонентом гипервизора, все задачи 100, выполняются на виртуальной машине, управляемой указанным гипервизором (англ. hypervisor) и в случае, если пользователь не проходил сформированный тест, то выполнение указанных задач 101 блокируется, а виртуальная машина возвращается в состояние, которое предшествовало запуску указанных задач 101.

Еще в одном из вариантов реализации системы средство анализа 140 выполняет задачу 101 посредством по меньшей мере:

взаимодействия с операционной системой (например, через предоставляемый системой API);

взаимодействия с операционной системой (например, через предоставляемый системой API);

взаимодействия с процессами приложений, обрабатывающих задачи 101 (например, приостанавливая или запуская указанные процессы, внедрение в процессы и т.д.).

взаимодействия с процессами приложений, обрабатывающих задачи 101 (например, приостанавливая или запуская указанные процессы, внедрение в процессы и т.д.).

Еще в одном из вариантов реализации системы в качестве задачи 101 выступает по меньшей мере:

задачи, заключающиеся в создании, модификации или удалении персональных или конфиденциальных данных пользователя на вычислительном устройстве;

задачи, заключающиеся в создании, модификации или удалении персональных или конфиденциальных данных пользователя на вычислительном устройстве;

задачи, заключающиеся в передаче данных по компьютерной сети;

задачи, заключающиеся в передаче данных по компьютерной сети;

задачи, заключающиеся в создании и модификации электронных документов;

задачи, заключающиеся в создании и модификации электронных документов;

задачи, заключающиеся в управлении вычислительным устройством, которые в свою очередь заключаются по меньшей мере в:

задачи, заключающиеся в управлении вычислительным устройством, которые в свою очередь заключаются по меньшей мере в:

работа с объектами файловой системы (создание, удаление, модификация файлов и их атрибутов),

работа с объектами файловой системы (создание, удаление, модификация файлов и их атрибутов),

работа с правами объектов операционной системы (модификация прав доступа объектов файловой системы и системы памяти, в том числе, исполняемых процессов);

работа с правами объектов операционной системы (модификация прав доступа объектов файловой системы и системы памяти, в том числе, исполняемых процессов);

работа с элементами графического интерфейса приложения;

работа с элементами графического интерфейса приложения;

управление режимами работы оборудования вычислительного устройства (например, работа с сетевым оборудованием, видеосистемой, со звуковой системой и т.д.);

управление режимами работы оборудования вычислительного устройства (например, работа с сетевым оборудованием, видеосистемой, со звуковой системой и т.д.);

задачи, заключающиеся в управлении программным обеспечением, работающего на вычислительном устройстве.

задачи, заключающиеся в управлении программным обеспечением, работающего на вычислительном устройстве.

Например, к указанным выше задачам 101 могут относиться создание, модификация или удаление файлов, передача данных по компьютерной сети, изменения прав на работу с объектами вычислительного устройства (например, с файлами), изменения состояния вычислительного устройства, изменения привилегий работы на вычислительном устройстве, управление приложениями с помощью графических интерфейсов, предоставляемых работающими на вычислительном устройстве приложениями и т.д.

Еще в одном из вариантов реализации системы в качестве данных, характеризующих задачу 101 выступают по меньшей мере:

параметры и свойства, однозначно идентифицирующие указанную задачу 101 среди прочих задач;

параметры и свойства, однозначно идентифицирующие указанную задачу 101 среди прочих задач;

параметры и свойства вычислительного устройства, необходимые для выполнения указанной задачи 101, в том числе вычислительных ресурсов.

параметры и свойства вычислительного устройства, необходимые для выполнения указанной задачи 101, в том числе вычислительных ресурсов.

Например, для задачи 101 «удаление файла» в качестве параметров будут выступать имя файла, предназначенного для удаления, идентификатор процесса или пользователя, который инициировал указанную задачу 101 и т.д.

Еще в одном примере, для задачи 101 «передача данных по компьютерной сети» в качестве параметров будут выступать указатель на передаваемые данные (например, контрольная сумма передаваемых данных), идентификатор процесса, передающего указанные данные, адрес приемника передаваемых данных. В качестве свойств могут выступать тип данных (например, текст, изображения, медиа-данные, исполняемые приложения, базы данных, архивы и т.д.), права работы с передаваемыми данными и т.д.

Средство оценки угроз 120 предназначено для:

определения уровня опасности задачи 101 на основании полученных данных о задаче 101, при этом уровень опасности задачи характеризует степень угрозы информационной безопасности вычислительного устройства в случае выполнения указанной задачи;

определения уровня опасности задачи 101 на основании полученных данных о задаче 101, при этом уровень опасности задачи характеризует степень угрозы информационной безопасности вычислительного устройства в случае выполнения указанной задачи;

передачи определенного уровня опасности задачи 101 средству формирования тестов 130.

передачи определенного уровня опасности задачи 101 средству формирования тестов 130.

В одном из вариантов реализации системы степень угрозы задачи вычислительному устройству представляет собой численное значение, характеризующее вероятность того, что выполнение упомянутой задачи нанесет урон информационной безопасности вычислительного устройства, и вычисляется на основании собранных данных, характеризующих упомянутую задачу, на основании схожести упомянутой задачи с по меньшей мере одной заранее заданной задачей, для которой заранее была определена степень угрозы вычислительному устройству.

Степень опасности устройства может вычисляться любым известным из уровня техники способом, в том числе способом оценки степени уязвимости приложений CVE (англ. Common Vulnerabilities and Exposures) (https://www.cvedetails.com), при которой оценка степень уязвимости представляет собой числовое значение от 0 (уязвимость отсутствует) до 10 (опасная уязвимость, представляющая реальную опасность информационной безопасности), где в некоторых системах управления информационной безопасностью при значении равном 4 использование приложений не рекомендуется, а свыше 8 - запрещено.

Еще в одном из вариантов реализации системы уровень опасности последующей задачи 101 определяется в зависимости от уровня опасности более ранней задачи 101.

Например, в задаче установки приложения и настройка его работы в операционной системе может содержать в себе несколько независимых задач, каждая из которых обладает своим уровнем опасности, при этом каждая следующая задача при условии выполнения предыдущей задачи может обладать более высоким уровнем опасности, чем если бы предыдущая задача не была выполнена. К примеру, задача установки службы резервирования пользовательских данных может содержать в себе следующие подзадачи: 1) разархивирование установочного пакета, 2) выполнение установочного пакета, 3) запись файлов устанавливаемой службы в системную папку операционной системы, 4) изменение ключей реестра операционной системы (в том числе замены старых значений ключей новыми, к примеру, путь к файлам устанавливаемой службы), 5) запуск службы (загрузка файла службы в память, передачи управления загруженной службе и т.д.), 6) соединение с внешним адресом по компьютерной сети, 7) получение заданий по компьютерной сети (например, обновление). Каждый из описанных этапов может иметь небольшой уровень опасности, поскольку не представляет опасности информационной безопасности вычислительного устройства (например, этап 1) или этап 7) сами по себе никак не влияют на информационную безопасность), однако если некоторые этапы выполняются один за другим и используют результаты, полученные на предыдущих этапах, они могут нести угрозу информационной безопасности вычислительного устройства (например, этапы 6), 7) и 5) позволяют выполнять вредоносный код, полученный по компьютерной сети, или передавать злоумышленникам персональные или конфиденциальные данные пользователя и, как следствие, уровень опасности такой комбинации этапов будет значительно выше, чем уровень опасности каждого этапа по отдельности). Кроме того, на уровень опасности каждого этапа может влиять не только уровень опасности предыдущего этапа, но и данные, которые были на предыдущем этапе получены.

Еще в одном из вариантов реализации системы степень угрозы вычислительному устройству тем больше, чем больше вероятность того, что анализируемая задача может оказаться элементом целевой кибератаки. Степень угрозы определяется средством оценки угроз 120 на основании базы шаблонов задач 121, которая формируется в том числе с помощью методов машинного обучения средством переобучения 150. Параметры задачи 101 сравниваются с указанными шаблонами из базы шаблонов задач 121 с помощью заранее обученной модели, сформированной и обновляемой средством переобучения 150. В результате определяется схожесть упомянутой задачи 101 с по меньшей мере одним из шаблонов задач, и по степени схожести с указанными шаблонами и степенью угрозы указанного шаблона определяется степень угрозы задачи.

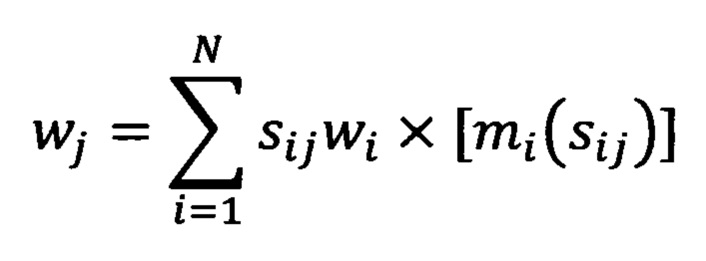

Например, в описанном выше случае степень угрозы задачи 101 может определяться по формуле:

где

wj - степень опасности j-ой задачи 101,

N - кол-во найденных шаблонов с помощью обученной модели,

sij - степень схожести между j-ой задачи 101 и i-ым шаблоном задачи,

wi - степень опасности i-ого шаблона задачи,

mi(sij) - корректировочный член (коэффициент), учитывающий насколько обучена упомянутая модель для работы с заданной j-ой задачей 101.

Например, скачивание архива из компьютерной сети по адресу, на который до этого не было ни одного обращения с указанного вычислительного устройства, извлечение из скаченного архива установочного файла с именем, обладающим высокой энтропией символов (т.е. с большой вероятностью сформированного случайно), и запуск указанного файла совокупно могут считаться задачей №1 101 внедрения на вычислительное устройство вредоносного программного обеспечения, методами, характерными для целевой кибератаки. С другой стороны, скачивание из компьютерной сети по адресу, на который до этого уже были обращения с указанного вычислительного устройства, исполняемого приложения, имеющего имя из списка разрешенных имен, и исполнение указанного приложения могут считаться задачей №2 101 установки на вычислительном устройстве безопасного (хотя и непроверенного) программного обеспечения. В первом случае задача №1 101 как представляющая большую угрозу безопасности вычислительному устройству будет иметь более высокий уровень опасности задачи (например, 0,80), чем задача №2 101 из второго случая (например, 0,30).

Еще в одном примере степень угрозы может зависеть от времени выполнения задачи 101 или длительности выполняемой задачи 101.

Еще в одном из вариантов реализации системы уровень опасности задачи представляет собой численное значение, характеризующее вероятность того, что указанная задача 101 может нести угрозу информационной безопасности вычислительному устройству, а также степень указанной угрозы.

Например, уровень опасности задачи 101 может находиться в диапазоне от 0,0 (выполнение задачи 101 гарантированно не представляет угрозы для информационной безопасности вычислительного устройства) до 1,0 (выполнение задачи 101 гарантированно представляет угрозу для информационной безопасности вычислительного устройства, например, передача конфиденциальных данных пользователя по компьютерной сети).

Еще в одном из вариантов реализации системы определение уровня опасности задачи осуществляется на основании заранее определенных шаблонов задач из базы шаблонов задач 121, при этом шаблон задачи представляет собой одну или несколько задач, характеризуемых параметрами и свойствами в заданных диапазонах, где параметры и свойства задач представляют собой характеристики на основании которых можно производить сравнения задач между собой и определять степень схожести упомянутой задачи и задач из базы шаблонов 121, а каждому шаблону задачи из базы шаблонов задач 121 поставлен в соответствие уровень опасности задачи.

В одном из вариантов реализации системы база шаблонов задач 121 формируется предварительно на основании накопленной статистики по выполненным задачам 101 на разнообразных вычислительных устройствах, а сами шаблоны задач созданы таким образом, чтобы для всех упомянутых задач 101 корректно определялись уровни угрозы на основании упомянутых шаблонов.

Например, зная, как именно работал приложения Microsoft Office, можно выявить все выполняемые упомянутыми приложениями задачи 101, а зная результаты работы упомянутых приложений - рассчитать уровни угрозы для каждой задачи 101 и сформировать соответствующие шаблоны задач, которые в дальнейшем будут использоваться при работе описанной системы.

Еще в одном примере, зная, как устроено вычислительное устройство, какие задачи оно выполняет, работа с какими данными являются критической для информационной безопасности вычислительного устройства, можно заранее сформировать базу шаблонов задач 121, где каждому действию назначить свой уровень опасности в зависимости от возможности нанести вред вычислительному устройству или данным на указанном вычислительной устройстве.

К примеру на основе собранной на большой выборке пользователей статистики работы с электронными документами известно, что цикл работы с указанными электронными документами можно представить в виде шаблона [создать] [изменить]

[изменить] …

… [изменить]

[изменить] [сохранить/заархивировать]

[сохранить/заархивировать] [передать по электронной почте]. На основании другой собранной на большой выборке вредоносных программ статистики известно, как вредоносные программы работают с электронными документами. В зависимости от того, насколько указанная работа отличается от эталонной, полученной на основании анализа статистики работы пользователей тем или иным действиям работы с электронными документами назначается степень угрозы. К таким отклонениям могут относиться:

[передать по электронной почте]. На основании другой собранной на большой выборке вредоносных программ статистики известно, как вредоносные программы работают с электронными документами. В зависимости от того, насколько указанная работа отличается от эталонной, полученной на основании анализа статистики работы пользователей тем или иным действиям работы с электронными документами назначается степень угрозы. К таким отклонениям могут относиться:

создание электронного документа с именем, имеющим большую энтропию использованных в имени символов, что может указывать на сгенерированный автоматикой (в том числе и вредоносной программой файл),

создание электронного документа с именем, имеющим большую энтропию использованных в имени символов, что может указывать на сгенерированный автоматикой (в том числе и вредоносной программой файл),

переименование электронного документа со свойствами имени, описанными выше,

переименование электронного документа со свойствами имени, описанными выше,

передача электронного документа не по электронной почте, а иными способами (например, через Р2Р сети);

передача электронного документа не по электронной почте, а иными способами (например, через Р2Р сети);

архивирование электронного документа в разные архивы;

архивирование электронного документа в разные архивы;

архивирование электронного документа в который не вносились изменения.

архивирование электронного документа в который не вносились изменения.

Еще в одном примере на основании ранее собранной статистики с разнообразных вычислительных устройств, включая описываемое, по работе пользователей на указанных вычислительных устройствах и по работе известных из уровня техники автоматических средств (в том числе автоматических средств решения полностью автоматизированных публичных тестов Тьюринга) определяется любым известным из уровня техники способом последовательность задач, приводящих к одинаковому результату, но при этом с помощью использования разных средств (человеком и автоматическими средствами). К примеру передача данных по компьютерной сети для пользователя и автоматических средств отличается временем реакции на установление соединение, выбора способа передачи данных, возможности шифрования данных и т.д. Различия в последовательностях используются для вычисления уровня опасности задачи с помощью любого метода определения схожести. Таким образом даже если тест оказывается успешно решенным, но при этом обнаруживается, что способ решения более типичен для автоматических средств, такой тест (для некоторых критически важных для информационной безопасности задач) считается проваленным и как следствие задача 101, на подтверждения которой был сформирован указанный тест, не выполняется.

Например, с помощью анализа движения курсора мышки (отклонение от прямолинейных равномерных движений, определение гармоник и т.д.) можно определить, что движение курсором осуществляет человек, а не автоматическое средство.

Еще в одном из вариантов реализации системы уровень опасности задачи определяется по степени схожести указанной задачи с по меньшей мере одним шаблоном задачи из базы шаблонов задач 121 с учетом заданным указанным шаблоном уровнем опасности задач.

Например, шаблон задачи описывает запись данных в электронный документ Microsoft Word, а на вычислительном устройстве происходит запись данных в электронный документ Microsoft Excel. На основании того, что записываемые данных представляются в одинаковом XML виде, запись осуществляется в электронные документы единого программного продукта Microsoft Office и т.д. в средстве оценки угроз 120 выносится решение о схожести этой задачи и задачи записи в электронный документ Microsoft Excel получает такой же уровень опасности задачи как назначенный записи в электронный документ Microsoft Word. При этом при сравнении задач 101 может использоваться любой известный из уровня техники способ.

Например, при сравнении задач 101 может использоваться следующий алгоритм сравнения:

1) каждая задача разбивается на элементарные действия, характеризуемые минимальным количеством параметров;

2) каждому действию ставится в соответствие свой уникальный хэш (в самом простом случае - уникальный числовой идентификатор), который совместно с указанными выше параметрами образует байт-код (промежуточный код, англ. bytecode);

3) для совокупности сформированных байт-кодов для каждой из вычисляют степень схожести с помощью алгоритмов вычисления редакционного расстояния, например, расстояния Левенштейна;

4) если вычисленное расстояние не превышает заданного порогового значения, сравниваемые задачи 101 считаются схожими.

Еще в одном из вариантов реализации системы уровень опасности задачи имеет схожий характер (используются схожие технологии, способы определения и интерпретации) со степенью вредоносности объектов вычислительного устройства, определяемой при осуществлении антивирусной проверки любым известным из уровня техники способом, в том числе способами, используемыми для выявления целевых кибератак.

Например, при выполнении антивирусной проверки антивирус определяет степень вредоносности анализируемых объектов - вероятность того, что анализируемый объект может оказаться вредоносным (особенно это показательно для эвристического анализа или проактивной защиты) и в зависимости от того, насколько определенная степень вредоносности велика выносит вердикт о том, что анализируемый объект является безопасным, подозрительным или вредоносным. В зависимости от того, сколько проанализированных объектов на вычислительном устройстве является соответственно безопасными, подозрительными или вредоносными (или какое значение итоговой степени вредоносности всех проанализированных объектов получается) антивирус выносит решение о степени вредоносности вычислительного устройства целиком.

Еще в одном примере на степень вредоносности системы может влиять состояние описанного выше антивируса - состояние антивирусных баз (объем, последнее обновление), подключенные модули антивируса (например, модуль эвристического анализа или проактивной защиты, модуль поиска руткитов и т.д.), наличие файлов в карантине и т.п. В зависимости от всех этих факторов система может иметь меньшую или большую степень вредоносности.

Еще в одном примере могут использоваться способы, применяемые в сигнатурном и эвристическом анализе файлов при проверки их на вредоносность на основании базы антивирусных записей.

Еще в одном из вариантов реализации системы уровень опасности задачи определяется с помощью обученной модели, формируемой средством переобучения 150 на основании ранее выполненных задач 101.

Например, использование обученной модели, с помощью которой осуществляется определение уровня опасности задачи 101, позволяет в базе шаблонов задач 121 содержать не сами шаблоны действий, а модели, обученные на этих шаблонах, что в свою очередь повышает скорость и точность определения уровня опасности действий и снижает требования к вычислительным ресурсам вычислительного устройства. В некоторых случаях использование шаблонов задач 121 становится менее эффективно, чем использование моделей, обученных на этих шаблонах, частности, когда для определения уровня опасности задачи 101 требуется использовать большое кол-во шаблонов задач 121 - в этом случае становится целесообразно использовать обученные модели.

Еще в одном примере обученные модели могут применяться для определения уровня опасности задачи 101 в случае, если задача содержит большого количество более мелких (и простых) задач, которые в свою очередь также содержат задачи. В этом случае для определения уровня опасности задачи 101 (и всех ее подзадач) может применяться большое количество шаблонов задач 121, что негативно влияет на использование вычислительных ресурсов вычислительного устройства и время вычисления степени опасности задачи 101, поэтому целесообразнее использовать обученную на основании упомянутых шаблонов задач 121 модель.

Средство формирования тестов 130 предназначено для:

формирования автоматизированного публичного теста Тьюринга (далее, тест) в зависимости от полученного уровня опасности задачи на основании заданных правил формирования теста 131;

формирования автоматизированного публичного теста Тьюринга (далее, тест) в зависимости от полученного уровня опасности задачи на основании заданных правил формирования теста 131;

передачи сформированного теста средству анализа 140.

передачи сформированного теста средству анализа 140.

В одном из вариантов реализации системы тест формируют таким образом, чтобы для задач с более высоким уровнем опасности задачи вероятность коллизии теста была более низкой, при этом в качестве коллизии теста выступает по меньшей мере:

успешное прохождение теста человеком, не являющимся авторизованным пользователем вычислительного устройства;

успешное прохождение теста человеком, не являющимся авторизованным пользователем вычислительного устройства;

успешное прохождение теста с помощью автоматических средств.

успешное прохождение теста с помощью автоматических средств.

Например, тест для подтверждения задачи 101 с низким уровнем опасности (к примеру передача данных по компьютерной сети) может представлять собой задачу распознавания текста 312, созданного с незначительными искажениями относительно эталонного текста 311, а тест для подтверждения задачи 101 с высоким уровнем опасности (к примеру форматирование жесткого диска) может представлять собой задачу распознавания текста 314, созданного со значительными искажениями относительно эталонного текста 311.

Еще в одном примере тест для подтверждения задачи 101 с низким уровнем опасности может представлять собой более простой тип задач (распознавание текста 310), а тест для подтверждения задачи 101 с высоким уровнем опасности может представлять более сложный тип задач (классификация объектов 320).

Еще в одном из вариантов реализации системы в случае, если вероятность осуществления целевой кибератаки выше заданного порогового значения тест формируется таким образом, чтобы исключить прохождение указанного теста используемыми при целевой кибератаки автоматическими средствами, при этом вероятность осуществления целевой кибератаки представляет собой численную характеристику, выражающую вероятность того, что выполняемые на вычислительном устройстве задачи 101 выполняются не авторизированным пользователем вычислительного устройства, а злоумышленником или автоматическими средствами, принадлежащие злоумышленнику, а сам способ вычислений указанной вероятности выполняется любым известным из уровня техники способом (например, способами, используемыми при выполнении антивирусных проактивных проверок).

Например, автоматические средства с большой вероятностью могут решить задачи распознавания текста 310 (к примеру, распознать искаженный текст «challenge-response test» 311-314), с низкой или средней вероятностью - задачи классификации 320 (к примеру, определить виды снегирей 321-324), но практически не в состоянии решить задачи, требующие ассоциативного мышления и работы с нечеткими правилами как в графических головоломках 330 (к примеру, определить фильмы по тематическим изображениям 331-334).

Еще в одном из вариантов реализации системы тест формируют на основании данных о по меньшей мере:

действиях пользователя на вычислительном устройстве, в том числе классификации информации пользователя на вычислительном устройстве, запускаемых приложениях и т.д.;

действиях пользователя на вычислительном устройстве, в том числе классификации информации пользователя на вычислительном устройстве, запускаемых приложениях и т.д.;

информации, запрашиваемой пользователем на вычислительном устройстве, в том числе данных, полученных из журнала истории запросов пользователя в браузере, данных, полученных их профиля пользователя в социальных сетях и т.д.

информации, запрашиваемой пользователем на вычислительном устройстве, в том числе данных, полученных из журнала истории запросов пользователя в браузере, данных, полученных их профиля пользователя в социальных сетях и т.д.

Например, если пользователь вычислительного устройства быстро и корректно проходит все тесты на распознавания изображений 312, последующие тесты на распознавание изображений могут усложняться (за счет внесения больших искажений изображения текста) - 313. Если время успешного прохождения теста начинает превышать заданной длительности дальнейшее усложнение теста прекращается 314.

Еще в одном примере с целью обойти автоматические средства классификации могут подбираться изображения так, чтобы они могли относиться к нескольким классам. Например, на 321 изображен два снегиря одного вида, а на 322 - один снегирь другого вида, в результате классификация может проводиться как по кол-ву птиц, так и по принадлежности их к разным видам.

Еще в одном из вариантов реализации системы формируемый тест может представлять собой по меньшей мере:

задачу на распознание изображений, которая включает по меньшей мере:

задачу на распознание изображений, которая включает по меньшей мере:

задачу на распознание текста 310,

задачу на распознание текста 310,

задачу на классификацию образов 320,

задачу на классификацию образов 320,

задачу на смысловые головоломки 330;

задачу на смысловые головоломки 330;

задачу на распознание аудио-фрагментов;

задачу на распознание аудио-фрагментов;

задачу на распознавание медиа-данных.

задачу на распознавание медиа-данных.

Еще в одном из вариантов реализации системы заданные правила формирования теста 131 устанавливаются авторизованным пользователем вычислительного устройства (в том числе в зависимости от навыков, знаний или предпочтений указанного пользователя).

Еще в одном примере пользователь на основании своих знаний и навыков может установить вид и содержимое теста, таким образом подобные тесты он будет проходить лучше других пользователей и автоматических средств. Например, если пользователь вычислительного устройства является орнитологом он в качестве теста может выбрать задачу классификации видов птиц 320, а сложность теста будет заключаться в увеличении кол-ва классов изображений или увеличение схожести изображений между собой.

Еще в одном из вариантов реализации системы в зависимости от уровня опасности задачи сложность теста изменяется по меньшей мере:

в случае использования задач распознавания теста степень искажения теста увеличивается с увеличением уровня опасности задачи (Фиг. 3: 311-314);

в случае использования задач распознавания теста степень искажения теста увеличивается с увеличением уровня опасности задачи (Фиг. 3: 311-314);

в случае использования задач классификации образов кол-во возможных классов увеличивается (Фиг. 3: 321-324);

в случае использования задач классификации образов кол-во возможных классов увеличивается (Фиг. 3: 321-324);

с увеличением уровня опасности в формируемую задачу добавляются дополнительные смысловые элементы (например, математические тесты на решение примеров, замена числовых задач текстовыми и т.д.).

с увеличением уровня опасности в формируемую задачу добавляются дополнительные смысловые элементы (например, математические тесты на решение примеров, замена числовых задач текстовыми и т.д.).

Еще в одном из вариантов реализации системы в качестве прав формирования теста 131 могут выступать по меньшей мере:

готовые тесты, не зависящие от внешних параметров;

готовые тесты, не зависящие от внешних параметров;

шаблоны тестов, содержащие информацию о тесте, на основании которых в зависимости от внешних параметров формируется непосредственно тест;

шаблоны тестов, содержащие информацию о тесте, на основании которых в зависимости от внешних параметров формируется непосредственно тест;

логические, лексические или семантические правила формирования тестов или шаблонов тестов.

логические, лексические или семантические правила формирования тестов или шаблонов тестов.

Например, для задач классификации 320 могут быть заранее задана совокупность изображений, из которой в случайном порядке для теста выбирается изображение.

Еще в одном примере задачи со смысловыми головоломками могут формироваться на основании заранее заданной совокупности изображений, но с меняющимися ассоциативными правилами. Например, на 330 изображены 8 изображений для задачи определения фильмов, скомбинированные между собой так, что каждое скомбинированное изображение содержит элементы из двух разных фильмов и, не зная, какой элемент является ключевым, нельзя корректно решить задачу.

Еще в одном из вариантов реализации системы после формирования теста с помощью средства формирования тестов 130:

указанный тест предоставляется для прохождения пользователю;

указанный тест предоставляется для прохождения пользователю;

производится получение от пользователя данных о прохождении теста (решении поставленной в тесте задачи);

производится получение от пользователя данных о прохождении теста (решении поставленной в тесте задачи);

определяются параметры, описывающие прохождение теста пользователем;

определяются параметры, описывающие прохождение теста пользователем;

полученные результаты прохождения теста и определенные параметры передаются средству анализа 140.

полученные результаты прохождения теста и определенные параметры передаются средству анализа 140.

Например, при прохождении теста собираются данные по времени прохождения теста, действиям пользователя (запускает ли вспомогательные приложения, какие элементы теста, если есть такая возможность, использует первыми и т.д.). Эти данные впоследствии могут использоваться для корректировки правил формирования теста и для оценки успешности выполнения теста.

Еще в одном из вариантов реализации системы пользователь сам предварительно настраивает средство формирования тестов, т.е. задает правила по которым в дальнейшем будут формироваться тесты, в том числе:

добавляет по шаблонам изображения, текст, аудио-фрагменты и т.д.;

добавляет по шаблонам изображения, текст, аудио-фрагменты и т.д.;

задает сложность теста;

задает сложность теста;

выбирает способы искажения теста в зависимости от задаваемой сложности.

выбирает способы искажения теста в зависимости от задаваемой сложности.

Затем тест сериализуется и сохраняется (в том числе с применением шифрования) как одно из правил формирования теста 131.

При формировании теста предварительно определяется для какого пользователя требуется сформировать тест (например, в зависимости от аккаунта пользователя) и формируется тест по тем правилам, которые указал конкретный пользователь «под себя».

Средство анализа 140 предназначено для:

в зависимости от результата выполнения сформированного теста пользователем вычислительного устройства определения права доступа задачи 141;

в зависимости от результата выполнения сформированного теста пользователем вычислительного устройства определения права доступа задачи 141;

выполнения указанной задачи 101 с определенными правами доступа 141.

выполнения указанной задачи 101 с определенными правами доступа 141.

В одном из вариантов реализации системы во время анализа успешности выполнения теста пользователем вычислительного устройства определяется степень схожести указанного результата с эталонным результатом, определяемым средством формирования тестов 130 на этапе формирования теста.

Например, в тесте, где надо выбрать несколько изображений определяется сколько изображений совпадает с изображениями из эталонного результата, а точность прохождения теста определяется как кол-во неверно выбранных изображений, отнесенное к кол-ву верно выбранных изображений.

Еще в одном из вариантов реализации системы в анализе успешности выполнения полеченного теста пользователем вычислительного устройства используются параметры прохождения теста, полученные средством формирования тестов 130.

Например, если пользователь верно прошел тест, но затратил на это значительное время (более заданного значения), то тест признается не пройденным.

Еще в одном из вариантов реализации системы успешность выполнения теста пользователем вычислительного устройства оценивается через вычисление степени успешности выполнения теста, представляющего собой численное значение, где минимальное соответствует тому, что тест гарантированно провален, а максимальное - тому, что тест гарантированно успешно пройден.

Например, вместо бинарной оценки успешности выполнения теста («пройден» или «не пройден»), оценивается (любым известным из уровня техники способом, в том числе способами, оценивающими в задачах, содержащих возможность дачи нескольких вариантов ответов, отношение неверных ответов к верным) степень успешности прохождения теста от 0,0 (тест гарантированно не пройден) до 1,0 (тест гарантированно пройден) и, если степень успешности прохождения теста выше заданного значения (например, 0,75) тест считается пройденным. Так же может использоваться и нижняя оценка степени успешности прохождения теста (например, 0,25), такая, что если вычисленная степень успешности прохождения теста ниже заданного значения, то тест считается не пройденным, а если вычисленная степень успешности прохождения теста выше нижнего заданного значения (0,25), но ниже верхнего заданного значения (0,75), успешность прохождения теста считается неопределенной и для пользователя формируется следующий тест, при этом нижняя и верхняя граница могут устанавливаться уже более жесткими (например, 0,10 и 0,90 соответственно).

Еще в одном из вариантов реализации системы в зависимости от значения степени успешности выполнения теста определяются права доступа на выполнение задачи 101.

Например, если в качестве задачи выступает получение доступа к файлу, то при успешном прохождении теста со степенью успешности выше заданного значения (например, 0,95) пользователю вычислительного устройства предоставляются полные права на работу с файлом, если выше другого заданного значения (например, 0,75) - то только права на чтение данных, в противном случае доступ к файлу не предоставляется вовсе.

Еще в одном из вариантов реализации системы в качестве права доступа 141 на выполнение задачи 101 выступают право #1 запретить выполнение задачи 101 и право #2 разрешить выполнение задачи 101.

Например, при удалении файла данная операция может для указанного пользователя только или запрещена к выполнению или разрешена к выполнению. С другой стороны, операция открытия файла может иметь несколько прав доступа 141 - право на чтение, право на запись (в том числе, право на удаление), право на исполнение.

Средство переобучения 150 предназначено для переобучения модели, используемой для определения уровня опасности задачи в зависимости от того, какая задача 101 была разрешена для выполнения (после прохождения пользователем теста), с какими правами указанная задача 101 была выполнена и к каким последствиям для безопасности вычислительного устройства это привело.

Еще в одном из вариантов реализации системы переобучение модели и формирования базы шаблонов задач 121 осуществляется на основании анализа состояния вычислительного устройства, степени ее информационной безопасности любым известным из уровня техники способом.

Средство корректировки правил 160 предназначено для корректировки правила формирования теста 131 путем по меньшей мере:

изменения входных параметров, на основании которых формируется правило;

изменения входных параметров, на основании которых формируется правило;

формирования нового правила на основании выделенных компонент старых правил (сборка, компиляция);

формирования нового правила на основании выделенных компонент старых правил (сборка, компиляция);

формирования новых правил на основании заранее заданных компонент;

формирования новых правил на основании заранее заданных компонент;

таким образом, чтобы вероятность успешного прохождения указанного теста, сформированного на основании скорректированных правил 131, пользователем вычислительного устройства была выше, чем теста, сформированного на основании нескорректированных правил 131 (т.е. происходит упрощение теста для конкретного авторизированного пользователя).

Например, в задачах распознавания текста 310 с каждым успешным прохождением теста применяются все большие искажение текста 311-313, но не более заданного значения, чтобы текст не стал совершенно нераспознаваемым для пользователя 314.

В одном из вариантов реализации системы корректировка правил формирования теста 131 заключается в изменении степени сложности тестов, формируемого средством формирования тестов 130, при этом степень сложности теста изменяется в зависимости от степени успешности выполнения теста, вычисляемой средством анализа 140.

Еще в одном из вариантов реализации системы степень сложности теста представляет собой численное значение, характеризующее вероятность пройти тест пользователем вычислительного устройства.

Например, степень сложности теста может измеряться от 0,0 (минимальная сложность - пользователь может успешно пройти тест без дополнительной подготовки или дополнительных усилий) до 1,0 (максимальная сложность - для успешного прохождения теста требуется значительное время или дополнительная подготовка пользователя).

Еще в одном из вариантов реализации системы, при условии, что при минимальной степени сложности теста, сформированный тест считается эталонным, усложнение теста (т.е. отличие от эталонного теста) заключается по меньшей мере:

во внесении искажений (графических в случае теста для работы с изображениями, акустических - в случае аудио-теста и т.д.) - 3.11-3.14 (для графического теста);

во внесении искажений (графических в случае теста для работы с изображениями, акустических - в случае аудио-теста и т.д.) - 3.11-3.14 (для графического теста);

в увеличении классов при классификации объектов или увеличения схожести между собой объектов различных классов - 3.21-3.24.

в увеличении классов при классификации объектов или увеличения схожести между собой объектов различных классов - 3.21-3.24.

Еще в одном из вариантов реализации системы корректировка правил осуществляется с той целью, чтобы в последствии при создании новых тестов время их прохождения уменьшалось заданным пользователем вычислительного устройства и увеличивалось иными пользователями или автоматическими средствами. С этой целью отслеживается время прохождения теста конкретным пользователем, для того, чтобы корректировать (например, упрощать тест для конкретного пользователя) тест с целью увеличения скорость прохождения теста, отслеживаются действия пользователя на вычислительном устройстве, анализируются выполняемые пользователем задачи с целью подбора типа и тематики тестов (например, при длительной работе пользователя с числами формируется числовой тест, с изображениями - графический, с текстами - текстовой и т.д.).

Например, если пользователь хорошо распознает изображения птиц, то в тестах используются чаще изображения редких или похожих на известные виды птиц).

Еще в одном из вариантов реализации системы при формировании каждого последующего теста учитываются внешние параметры ранее сформированного теста и результаты его прохождения таким образом, чтобы результаты прохождения нового теста заданным пользователем (пользователем, который проходил созданные ранее тесты) были лучше результатов прохождения пользователем более ранних тестов, в частном случае, чтобы прохождение сформированного теста было возможным только при условии знания результатов прохождения созданного ранее теста пользователем вычислительного устройства.

Например, решение ранее сформированного теста является условием классификации следующего теста, а без знания условия классификации выполнить классификацию невозможно.

Еще в одном из вариантов реализации системы тест формируется таким образом, чтобы он мог быть пройден только автоматическими средствами, а не пользователем вычислительного устройства, т.е. тест формируется на основании результатов прохождения сформированных ранее тестов таким образом, чтобы уменьшать (ухудшать) результаты прохождения новых тестов. Таким образом прохождение такого теста будет в противовес описанному выше означать компрометацию действия 101 и запрет на его выполнение. Например, подобная схема может использоваться для вычислительных устройств, которые могут быть атакованными (например, с помощью целевых кибератак) и которые служат для оперативного определения начала атаки (например, honeypots - ресурс, представляющий собой приманку для злоумышленников), а описанная выше схема защиты нужна для того, чтобы атака через «приманку» не смогла нанести угрозу иным вычислительным устройства, связанным с «приманкой» (к примеру, в единую компьютерную локальную сеть).

Например, задача распознавания текста может содержат настолько искаженный текст 314, что его распознавание возможно только автоматическими средствами при условии, что известны алгоритмы искажения изображения текста при формировании теста.

Средство формирования шаблонов задач 170 предназначено для:

сбора данных, характеризующих по меньшей мере:

сбора данных, характеризующих по меньшей мере:

вычислительное устройство, на котором функционирует описываемая система выполнения задачи;

вычислительное устройство, на котором функционирует описываемая система выполнения задачи;

программное обеспечение, работающее на вычислительном устройстве;

программное обеспечение, работающее на вычислительном устройстве;

задачи, выполняемые работающим программным обеспечением;

задачи, выполняемые работающим программным обеспечением;

формирование на основании собранных данных по меньшей мере одного шаблона задачи;

формирование на основании собранных данных по меньшей мере одного шаблона задачи;

записи сформированного шаблона задачи в базу шаблонов задач 121.

записи сформированного шаблона задачи в базу шаблонов задач 121.

Фиг. 2 представляет пример структурной схемы способа выполнения задачи на вычислительном устройстве.

Структурная схема способа выполнения задачи на вычислительном устройстве содержит этап 210, на котором собирают данные о действии, этап 220, на котором определяют уровень опасности задачи, этап 230, на котором формируют тест, этап 240, на котором анализируют данные пользователя, этап 250, на котором выполняют действие, этап 260, на котором переобучают модель, этап 270, на котором корректируют правила формирования теста, этап 280, на котором формируют шаблоны задач.

На этапе 210 собирают данные, характеризующие задачу управления вычислительным устройством (далее, задача).

На этапе 220 определяют уровень опасности задачи на основании собранных на этапе 210 данных, при этом уровень опасности задачи характеризует степень угрозы информационной безопасности вычислительного устройства в случае выполнение указанной задачи.

На этапе 230 формируют автоматизированный публичный тест Тьюринга (далее, тест) в зависимости от определенного на этапе 220 уровня опасности задачи на основании заданных правил формирования теста 131.

На этапе 240 в зависимости от результата выполнения сформированного на этапе 230 теста пользователем вычислительного устройства определяют права доступа задачи 101.

На этапе 250 выполняют указанную задачу 101 с определенными правами доступа.

На этапе 260 дополнительно переобучают модель, используемую для определения уровня опасности задачи в зависимости от того, какое действие было разрешено для выполнения (после прохождения пользователем теста), с какими правами указанное действие было выполнено и к каким последствиям для безопасности вычислительного устройства это привело.

На этапе 270 дополнительно корректируют правила формирования теста 131 таким образом, чтобы вероятность успешного прохождения указанного теста, сформированного на основании скорректированных правил 131, пользователем вычислительного устройства была выше, чем теста, сформированного на основании нескорректированных правил 131.

На этапе 280 дополнительно:

собирают данные, характеризующих по меньшей мере:

собирают данные, характеризующих по меньшей мере:

вычислительное устройство, на котором функционирует описываемая система выполнения задачи;

вычислительное устройство, на котором функционирует описываемая система выполнения задачи;

программное обеспечение, работающее на вычислительном устройстве;

программное обеспечение, работающее на вычислительном устройстве;

задачи, выполняемые работающим программным обеспечением;

задачи, выполняемые работающим программным обеспечением;

формируют на основании собранных данных по меньшей мере один шаблон задачи;

формируют на основании собранных данных по меньшей мере один шаблон задачи;

записывают сформированный шаблон задачи в базу шаблонов задач 121.

записывают сформированный шаблон задачи в базу шаблонов задач 121.

Фиг. 4 представляет пример структурной схемы системы авторизации пользователя на вычислительном устройстве.

Структурная схема системы авторизации пользователя на вычислительном устройстве содержит средство сбора данных 410, средство формирования тестов 420, средство анализа 430, средство авторизации 440.

Средство сбора данных 410 предназначено для:

сбора данных, характеризующие по меньшей мере две задачи управления вычислительным устройством (далее, задача) 101, выполняемые пользователем, неавторизованным на вычислительном устройстве,

сбора данных, характеризующие по меньшей мере две задачи управления вычислительным устройством (далее, задача) 101, выполняемые пользователем, неавторизованным на вычислительном устройстве,

передачи собранных данных средству формирования тестов 420.

передачи собранных данных средству формирования тестов 420.

В одном из вариантов реализации системы сбор данных осуществляется способом, описанным выше в раскрытии системы (Фиг. 1) и способа (Фиг. 2) выполнения задачи на вычислительном устройстве.

Еще в одном из вариантов реализации системы для неавторизованного пользователя предоставляется возможность выполнения задач с частичным ограничением правами на исполнение упомянутых задач, а после принятия решения об авторизации пользователя на вычислительном устройстве - последующего выполнения задач без ограничения прав исполнения упомянутых задач.

Например, неавторизированный пользователь может выполнять операции считывания данных с вычислительного устройства, но при этом лишен права записи на вычислительное устройство.

Еще в одном примере вместо авторизации как бинарной операции (авторизированный и неавторизированный пользователь) может использоваться некоторый численный коэффициент права доступа, который характеризует какими правами и привилегиями обладает пользователь для выполнения тех или иных задач на вычислительном устройстве. При этом в зависимости от действий пользователя упомянутый коэффициент может пересчитываться, что в свою очередь позволит пользователю выполнять новые, ранее запрещенные для него задачи или наоборот ограничит права на выполнения ранее выполняемых задач.

Средство формирования тестов 420 предназначено для:

формирования для каждой задачи 101 автоматизированного публичного теста Тьюринга (далее тест) на основании полученных от средства сбора данных 410, характеризующих указанную задачу 101, с помощью правил формирования теста 131 с последующим получением результатов выполнения сформированного теста, при этом для каждой последующей задачи 101 правила формирования теста 131 корректируют согласно результатам выполнения сформированного теста 131 для предыдущей задачи 101.

формирования для каждой задачи 101 автоматизированного публичного теста Тьюринга (далее тест) на основании полученных от средства сбора данных 410, характеризующих указанную задачу 101, с помощью правил формирования теста 131 с последующим получением результатов выполнения сформированного теста, при этом для каждой последующей задачи 101 правила формирования теста 131 корректируют согласно результатам выполнения сформированного теста 131 для предыдущей задачи 101.

Например, есть пользователь эффективно выполняет графические тесты и плохо выполняет лингвистические (словесные) тесты, то в последующем для такого пользователя больше формируется графических тестов.

Еще в одном примере сложность тестов для заданного пользователя поддерживается на одном уровне, поэтому если пользователь начинает быстро проходить сформированные для него тесты, то сложность тестов начинает увеличиваться (или же меняются типы тестов).

Средство анализа 430 предназначено для:

определения степени достоверности пользователя на основании результатов выполнения по меньшей мере двух тестов 131, сформированных средством формирования тестов 420, при этом степень достоверности пользователя указывает на вероятность того, что пользователь является легитимным на вычислительном устройстве;

определения степени достоверности пользователя на основании результатов выполнения по меньшей мере двух тестов 131, сформированных средством формирования тестов 420, при этом степень достоверности пользователя указывает на вероятность того, что пользователь является легитимным на вычислительном устройстве;

вычисления итоговой степени достоверности пользователя на основании определенных степеней достоверности пользователя, полученных в течении заданного правилом сбора 431 времени.

вычисления итоговой степени достоверности пользователя на основании определенных степеней достоверности пользователя, полученных в течении заданного правилом сбора 431 времени.

Например, степень достоверности пользователя может представлять собой численное значение от 0% до 100%, где 0% означает, что пользователь гарантированно нелегитимный (не имеющий право выполнять ту или иную задачу на вычислительном устройстве), а 100% - что пользователь легитимный, что автоматически означает его авторизацию на вычислительном устройстве.

Еще в одном примере пользователь может считаться легитимным в случае, если степень достоверности пользователя превышает некоторое заранее заданное пороговое значение (например, 85% в описанном выше примере).

В одном из вариантов реализации системы степень достоверности пользователя определяется на основании шаблонов пользователя, которые представляют собой совокупность правил, связывающих между собой тест, 131 предоставленный пользователю, результат теста 131, выполненного пользователем, и численное значение, характеризующее вероятность того, что указанный результат окажется правильным для указанного теста 131.

Еще в одном из вариантов реализации системы изменение значений последовательно вычисленных степеней достоверности пользователя имело монотонный характер.

Еще в одном из вариантов реализации системы для каждой последующей задачи правила формирования теста корректируются на основании результатов выполнения сформированного теста для предыдущей задачи таким образом, чтобы вероятность прохождения указанного теста для пользователя, для которого авторизация разрешена, возрастала бы, а для пользователя, для которого авторизация запрещена, убывала бы.

Средство авторизации 440 предназначено для:

принятия решения об авторизации пользователя на вычислительном устройстве в случае, когда итоговая степень достоверности пользователя превышает заданное пороговое значение.

принятия решения об авторизации пользователя на вычислительном устройстве в случае, когда итоговая степень достоверности пользователя превышает заданное пороговое значение.

В одном из вариантов реализации системы под авторизацией системы может пониматься предоставление пользователю прав на выполнение определенных задач. Таким образом авторизация пользователя может представлять не бинарную (авторизован/не авторизован), а более сложную дискретную систему.

Например, для выполнения задачи считывания из файла *.docx требуются права А (которые пользователь получает от средства авторизации 440 после успешного прохождения М тестов), а для выполнения задачи записи в файл *.docx требуются права В (которые пользователь получает от средства авторизации 440 после успешного прохождения N тестов, при этом N>М).

Еще в одном из вариантов реализации системы средства авторизации назначает пользователю некоторый индекс доверия, представляющий собой численное значение и характеризующий к каким задачам пользователь имеет доступ (например, в случае, если индекс доверия пользователя выше некоторого заданного значения для указанной задачи).

Например, для работы с системными файлами требуется индекс свыше Pmin>1000, а для работы с документами Microsoft Office - свыше Pmin>300, при этом при однократном прохождении теста пользователю назначается дополнительно индекс доверия Р+75.

Фиг. 5 представляет пример структурной схемы способа авторизации пользователя на вычислительном устройстве.

Структурная схема способа авторизации пользователя на вычислительном устройстве содержит этап 510, на котором собирают данные, этап 520, на котором формируют тест, этап 530, на котором определяют степень достоверности пользователя, этап 540, на котором принимают решение об авторизации пользователя.

На этапе 510 с помощью средства сбора данных 410 собирают данные, характеризующие по меньшей мере две задачи 101 управления вычислительным устройством (далее, задача), выполняемые пользователем, неавторизованным на вычислительном устройстве.

На этапе 520 с помощью средства формирования тестов 420 для каждой задачи 101 формируют автоматизированный публичный тест Тьюринга (далее тест) 131 на основании собранных данных, характеризующих указанную задачу 101, с помощью правил формирования теста 131 с последующим получением результатов выполнения сформированного теста, при этом для каждой последующей задачи правила формирования теста корректируют согласно результатам выполнения сформированного теста для предыдущей задачи.

На этапе 530 с помощью средства анализа 430 определяют степень достоверности пользователя на основании результатов выполнения по меньшей мере двух сформированных тестов, при этом степень достоверности пользователя указывает на вероятность того, что пользователь является легитимным на вычислительном устройстве.

На этапе 540 с помощью средства авторизации 440 принимают решение об авторизации пользователя на вычислительном устройстве в случае, когда итоговая степень достоверности пользователя превышает заданное пороговое значение, при этом итоговая степень достоверности пользователя вычисляется на основании определенных степеням достоверности пользователя, полученных в течении заданного правилом сбора времени исполнения шагов 520-530.

Фиг. 6 представляет пример компьютерной системы общего назначения, персональный компьютер или сервер 20, содержащий центральный процессор 21, системную память 22 и системную шину 23, которая содержит разные системные компоненты, в том числе память, связанную с центральным процессором 21. Системная шина 23 реализована, как любая известная из уровня техники шинная структура, содержащая в свою очередь память шины или контроллер памяти шины, периферийную шину и локальную шину, которая способна взаимодействовать с любой другой шинной архитектурой. Системная память содержит постоянное запоминающее устройство (ПЗУ) 24, память с произвольным доступом (ОЗУ) 25. Основная система ввода/вывода (BIOS) 26, содержит основные процедуры, которые обеспечивают передачу информации между элементами персонального компьютера 20, например, в момент загрузки операционной системы с использованием ПЗУ 24.

Персональный компьютер 20 в свою очередь содержит жесткий диск 27 для чтения и записи данных, привод магнитных дисков 28 для чтения и записи на сменные магнитные диски 29 и оптический привод 30 для чтения и записи на сменные оптические диски 31, такие как CD-ROM, DVD-ROM и иные оптические носители информации. Жесткий диск 27, привод магнитных дисков 28, оптический привод 30 соединены с системной шиной 23 через интерфейс жесткого диска 32, интерфейс магнитных дисков 33 и интерфейс оптического привода 34 соответственно. Приводы и соответствующие компьютерные носители информации представляют собой энергонезависимые средства хранения компьютерных инструкций, структур данных, программных модулей и прочих данных персонального компьютера 20.