Область техники, к которой относится изобретение

Настоящее описание относится к области технологий оконечных устройств и, в частности, к устройству и способу обработки изображения и оборудованию.

Уровень техники

Фотографирование предполагает использование камеры или видеорегистратор для записи изображения человека или объекта. В настоящее время используются различные навыки фотографирования для разных сцен, таких как фотографирование ночной сцены, фотографирование дождевой сцены, фотографирование зданий и фотографирование портрета. Динамическое фотографирование для кинематографа также является типом фотографирования, но должно соответствовать конкретному принципу. С развитием науки и техники фотографирование стало проще и популярнее.

С увеличением пропускной способности сети и повышением возможности обработки оконечных устройств, видео и фотографирование и совместное использование видео и изображения становятся более удобными, и использование видео стало новой повседневной потребностью для всех людей. Видео быстро становятся интенсивной услугой в сетевой трафике и, как ожидается, в ближайшие годы на него будет приходиться от 80% до 90% от общего объема трафика.

В повседневной жизни фотографирование стало главным способом иллюстрации самого себя для пользователей и получения удовольствия от красоты вещей. Люди хотят фотографировать с использованием более примечательных стилей. Например, использование во время фотографирования специального эффекта обработки изображений или видео для передачи впечатления от фотографирования «Что вы видите, это то, что вы получаете». Поэтому для непрофессиональных пользователей оконечного устройства необходимо внедрить новые технологии обработки изображения.

В настоящее время функция записи видео оконечного устройства является монотонной. В настоящее время может быть предоставлен только обычный способ фотографирования, не имеющий некоторые персонализированные эффекты.

Раскрытие сущности изобретения

Настоящее описание предлагает способ обработки изображений. В изображении определяются целевая область и область фона посредством выполнения сегментации маски (шаблона) на изображении. К целевой области и области фона применяются различные режимы обработки цвета, так что яркость целевой области выше, чем яркость области фона, или цветность целевой области больше, чем цветности области фона, и основной объект, соответствующий целевой области, более заметно выделен. Это позволяет пользователю оконечного устройства получить эффект видеоклипа во время фотографирования или съемки видео и улучшает передачу впечатления от фотографирования пользователя.

Конкретные технические решения, предусмотренные в вариантах осуществления настоящего описания, заключаются в следующем.

Согласно первому аспекту вариант осуществления настоящего описания обеспечивает способ обработки изображений. Способ применяется к процессу записи видео, и способ включает в себя: захват N1 изображений в первый временной период; захват N2 изображений во второй период времени, где первый период времени и второй период времени являются смежными периодами времени, и N1, так и N2 являются положительными целыми числами; определение первой целевой области и первой области фона из каждого из N1 изображений, где первая область фона представляет собой область изображения, отличную от первой целевой области, и первая целевая область в каждом из N1 изображениях соответствует первому объекту; определение второй целевой области и второй области фона из каждого из N2 изображений, где вторая область фона является областью изображения, отличной от второй целевой области, и вторая целевая область в каждом из N2 изображениях соответствует второму объекту; и обработку первой целевой области в первом режиме обработки цвета, обработку первой фоновой области во втором режиме обработки цвета, обработку второй целевой области в третьем режиме обработки и обработку второй области фона в четвертом режиме обработки цвета для получения целевого видео. В целевом видео цветность первой целевой области выше, чем цветность первой области фона, или яркость первой целевой области выше, чем яркость первой области фона. Дополнительно, цветность второй целевой области больше, чем цветность второй области фона, или яркость второй целевой области больше, чем яркость второй области фона.

Согласно второму аспекту, вариант осуществления настоящего описания обеспечивает устройство обработки изображения. Устройство используется в процессе съемки видео и устройство включает в себя: модуль фотографирования, выполненный с возможностью захватывать N1 изображения в первый период времени и захватывать N2 изображения во второй период времени, где первый период времени и второй период времени являются смежными периодами времени, и N1, так и N2 являются положительными целыми числами; модуль определения, выполненный с возможностью: определять первую целевую область и первую область фона из каждого N1 изображений, где первая область фона представляет собой область изображения, отличную от первой целевой области и первая целевая область в каждом N1 изображении соответствуют первому объекту; и определять вторую целевую область и вторую область фона из каждого N2 изображений, где вторая область фона представляет собой область изображения, отличную от второй целевой области и вторая целевая область в каждом N2 изображении соответствует второму объекту; и модуль обработки цвета, выполненный с возможностью обрабатывать первую целевую область в первом режиме обработки цвета, обрабатывать первую область фона во втором режиме обработки цвета, обрабатывать вторую целевую область в третьем режиме обработки цвета и обрабатывать вторую область фона в четвертом режиме обработки цвета для получения целевого видео. В целевом видео цветность первой целевой области больше, чем цветность первой области фона, или яркость первой целевой области выше, чем яркость первой области фона. Дополнительно, цветность второй целевой области больше, чем цветность второй области фона, или яркость второй целевой области выше, чем яркость второй области фона.

Согласно первому аспекту или второму аспекту, в возможной реализации, первый объект и второй объект являются одним и тем же объектом.

Согласно первому аспекту или второму аспекту, в возможной реализации, первый объект и второй объект являются разными объектами.

Согласно первому аспекту или второму аспекту, в возможной реализации, первый объект или второй объект включает в себя, по меньшей мере, один отдельный предмет категории объекта (например, человек, животное или растение).

Согласно первому аспекту или второму аспекту, в возможной реализации, первый объект и второй объект определяются в соответствии с инструкцией выбора пользователя.

В частности, например, первый объект определяется из первого изображения в первый период времени в соответствии с инструкцией выбора пользователя, и первый объект используется в качестве целевого объекта во всех изображениях в первый период времени. Аналогичным образом, второй объект определяется из первого изображения во втором периоде времени в соответствии с инструкцией выбора пользователя, и второй объект используется в качестве целевого объекта во всех изображениях во второй период времени. Например, для получения k масок на изображении может быть выполнена сегментирование семантики. k маски соответствуют разным категориям объекта, инструкция выбора, введенная пользователем, соответствует конкретной маске или конкретным маскам и объект, соответствующий конкретной маске или конкретным маскам, является целевым объектом.

Согласно первому аспекту или второму аспекту, в возможной реализации, первый объект и второй объект отдельно определяются оконечным устройством на основании контента двух изображений в заданном интервале времени.

В частности, например, первый объект определяется из первого изображения в первый период времени, и первый объект используется в качестве целевого объекта во всех изображениях в первый период времени. Аналогичным образом, второй объект определяется из первого изображения во втором периоде времени и второй объект используется в качестве целевого объекта во всех изображениях во второй период времени. Способ, в котором первый объект определяется из первого изображения в первый период времени и второй объект определяется из первого изображения во второй период времени, включает в себя, но не ограничивается, один из следующих способов:

выполнение сегментирования семантики на изображении для получения k масок, где k маски соответствуют различным категориям объекта; и

если k=2, и две маски включают в себя одну маску объекта и одну маску фона, определение области изображения, соответствующей маске объекта, в качестве целевой области, и определение области, соответствующей маске фона, в качестве области фона, где объект, соответствующий маске объекта, является первым объектом или вторым объектом;

если k превышает 2, и количество пикселей, включенных в k0 маски объекта в k масках, превышает заданное пороговое значение, определение области изображения, соответствующей k0 маскам объекта в качестве целевой области, и определение области изображения, соответствующей оставшимся маскам как область фона, где объект, соответствующий маске объекта, является первым объектом или вторым объектом, и k0 является неотрицательным целым числом меньше k;

если k превышает 2, определение, в качестве целевой области, области изображения, соответствующей маске, которая включает в себя наибольшее количество пикселей, то есть, в k масках, и определение области изображения, соответствующей оставшимся маскам, в качестве области фона, где объект, соответствующий маске объекта, является первым объектом или вторым объектом;

если k больше 2, определение целевой маски из k масок на основании заданных приоритетов категорий объектов; и определение области изображения, соответствующей целевой маске, в качестве целевой области, и определение области изображения, соответствующей оставшимся маскам, в качестве области фона, где объект, соответствующий маске объекта, является первым объектом или вторым объектом; или

если k больше 2, определение целевой маски из k масок в соответствии с инструкцией выбора пользователя; и определение области изображения, соответствующей целевой маске, в качестве целевой области, и определение области изображения, соответствующей оставшимся маскам, в качестве области фона, где объект, соответствующий маске объекта, является первым объектом или вторым объектом. Способ может быть специально выполнен модулем определения.

Согласно первому аспекту или второму аспекту, в возможной реализации, первый режим обработки цвета является таким же, как третий режим обработки цвета, и второй режим обработки цвета является таким же, как и четвертый режим обработки цвета.

Согласно первому аспекту или второму аспекту, в возможной реализации, первый режим обработки цвета является таким же, как третий режим обработки цвета, и второй режим обработки цвета отличается от первого режима обработки цвета.

В соответствии с первым аспектом или вторым аспектом, в возможной реализации, первый режим обработки цвета отличается от третьего режима обработки цвета, и второй режим обработки цвета является таким же, как и четвертый режим обработки цвета.

Согласно первому аспекту или второму аспекту, в возможной реализации, первый режим обработки цвета отличается от третьего режима обработки цвета, и второй режим обработки цвета отличается от четвертого режима обработки цвета.

В соответствии с первым аспектом или вторым аспектом, в возможной реализации, первый режим обработки цвета или третий режим обработки цвета включает в себя удерживание цвета или улучшение цвета.

Согласно первому аспекту или второму аспекту, в возможной реализации, второй режим обработки цвета или четвертый режим обработки цвета включает в себя режим обработки черно-белого цвета, затемнения, размытия или ретро режим.

В соответствии с третьим аспектом вариант осуществления настоящего описания обеспечивает оконечное устройство, включающее в себя камеру, память, процессор и шину. Камера, память и процессор подключены через шину. Камера выполнена с возможностью захватывать изображение и память выполнена с возможностью хранить компьютерную программу и инструкцию. Процессор выполнен с возможностью вызывать компьютерную программу, инструкцию и захваченное изображение, которое хранится в памяти, и дополнительно специально выполнен с возможностью обеспечивать возможность оконечному устройству выполнять любые предшествующие возможные способы.

В соответствии с третьим аспектом, в возможной реализации, оконечное устройство дополнительно включает в себя антенную систему. Антенная система принимает и передает сигнал беспроводной связи под управлением процессора для реализации беспроводной связи с сетью мобильной связи. Сеть мобильной связи включает в себя одно или несколько следующих: GSM сеть, CDMA сеть, 3G сеть, 4G сеть, 5G сеть, FDMA сеть, TDMA сеть, PDC сеть, TACS сеть, AMPS сеть, WCDMA сеть, TDSCDMA сеть, Wi-Fi сеть и LTE сеть.

Технические решения в вышеуказанных возможных реализациях могут быть объединены в рамках объема настоящего описания.

В обычной технологии фотографирования изображения отсутствует возможность получения специального эффекта, не различая отдельные предметы или цвета в любом изображении. Согласно настоящему изобретению различные области в изображении могут отличаться между собой посредством использования цвета, что позволят обеспечить особый эффект фото или видео, и основной объект и цель на изображении могут быть выделены более четко. Таким образом, основные объекты являются более заметными. Дополнительно, настоящее описание может дополнительно обеспечить больше изменений цвета и изменений основных объектов для расширения возможностей для пользователя.

Краткое описание чертежей

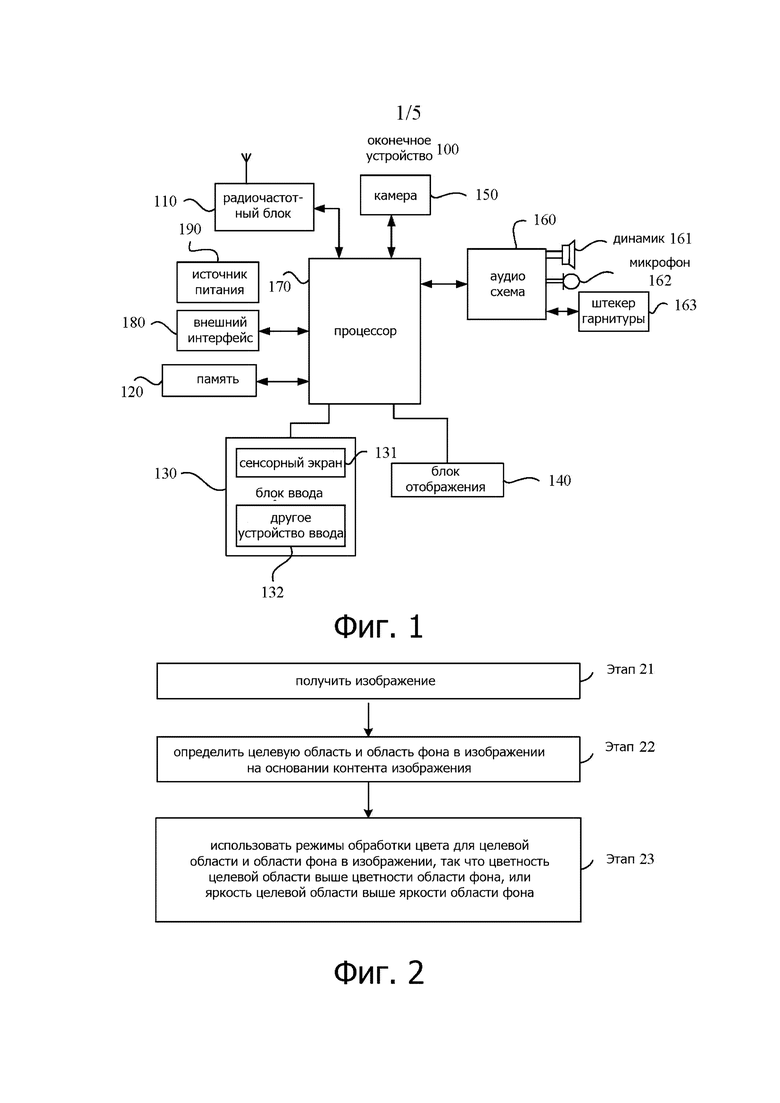

Фиг. 1 представляет собой схему структуры оконечного устройства в соответствии с вариантом осуществления настоящего описания;

Фиг. 2 является блок-схемой последовательности операций способа обработки изображения в соответствии с вариантом осуществления настоящего описания;

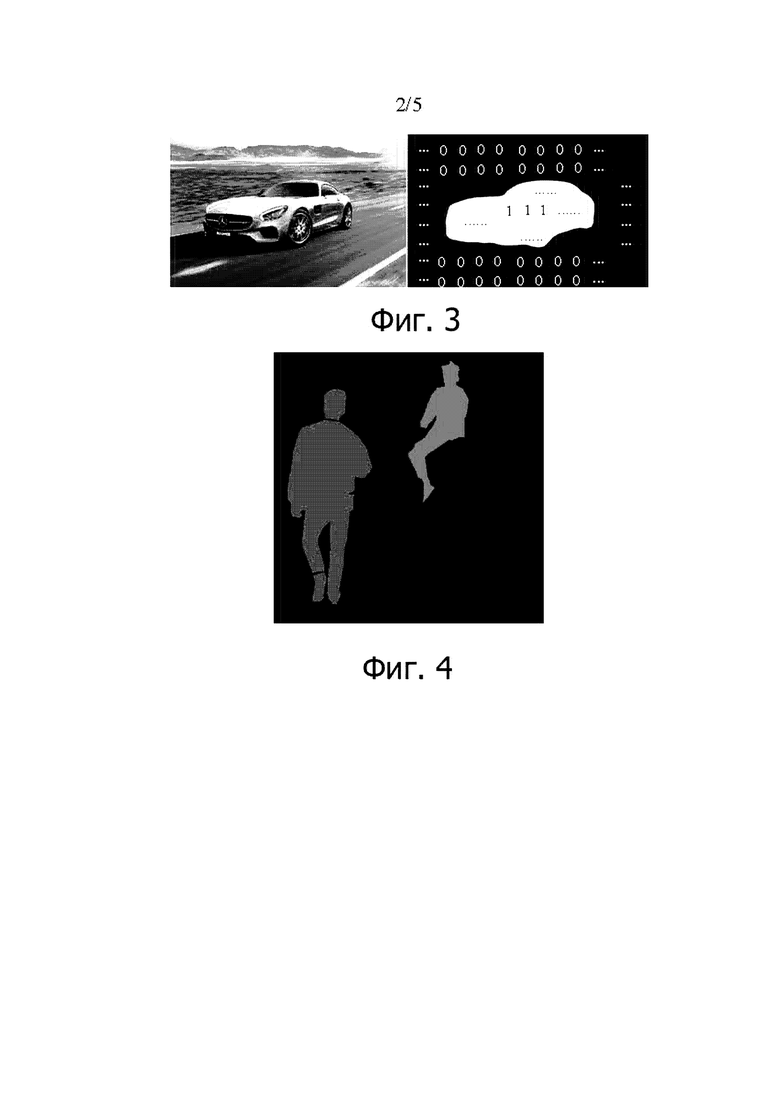

Фиг. 3 показывает пример идентификатора маски в соответствии с вариантом осуществления настоящего описания;

Фиг. 4 показывает другой пример идентификатора маски в соответствии с вариантом осуществления настоящего описания;

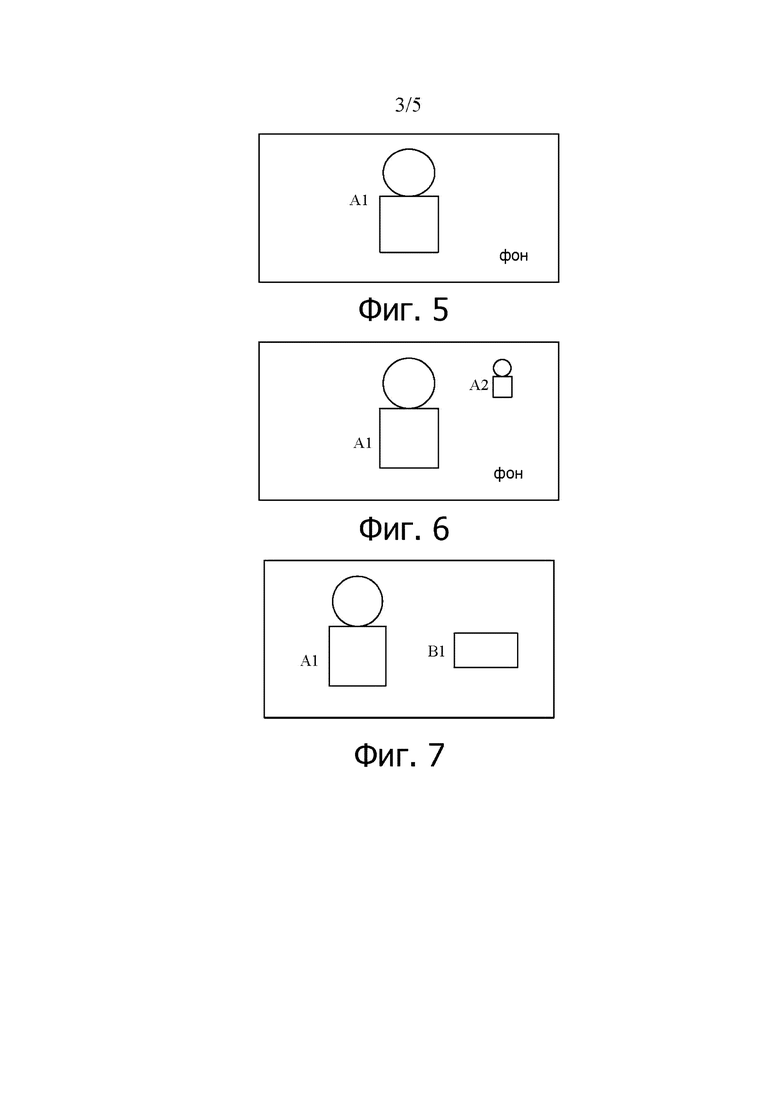

Фиг. 5 является схемой определения целевой маски в соответствии с вариантом осуществления настоящего описания;

Фиг. 6 является еще одной схемой определения целевой маски в соответствии с вариантом осуществления настоящего описания;

Фиг. 7 является еще одной схемой определения целевой маски в соответствии с вариантом осуществления настоящего описания;

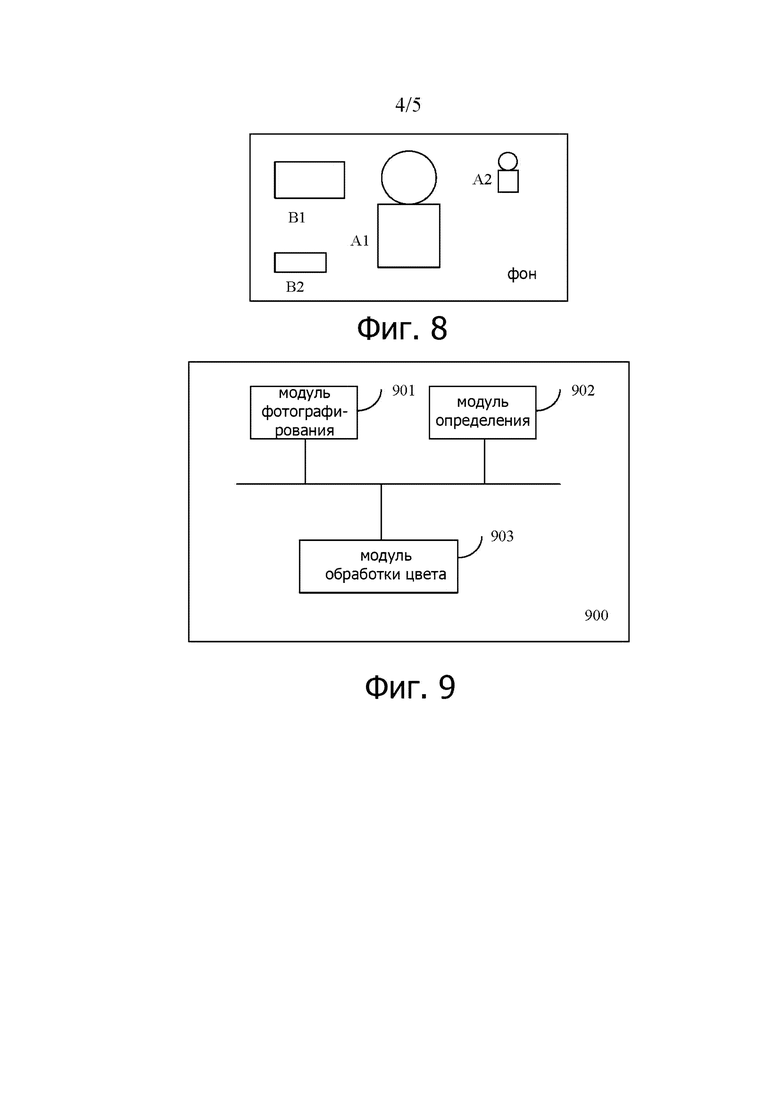

Фиг. 8 является еще одной схемой определения целевой маски в соответствии с вариантом осуществления настоящего описания;

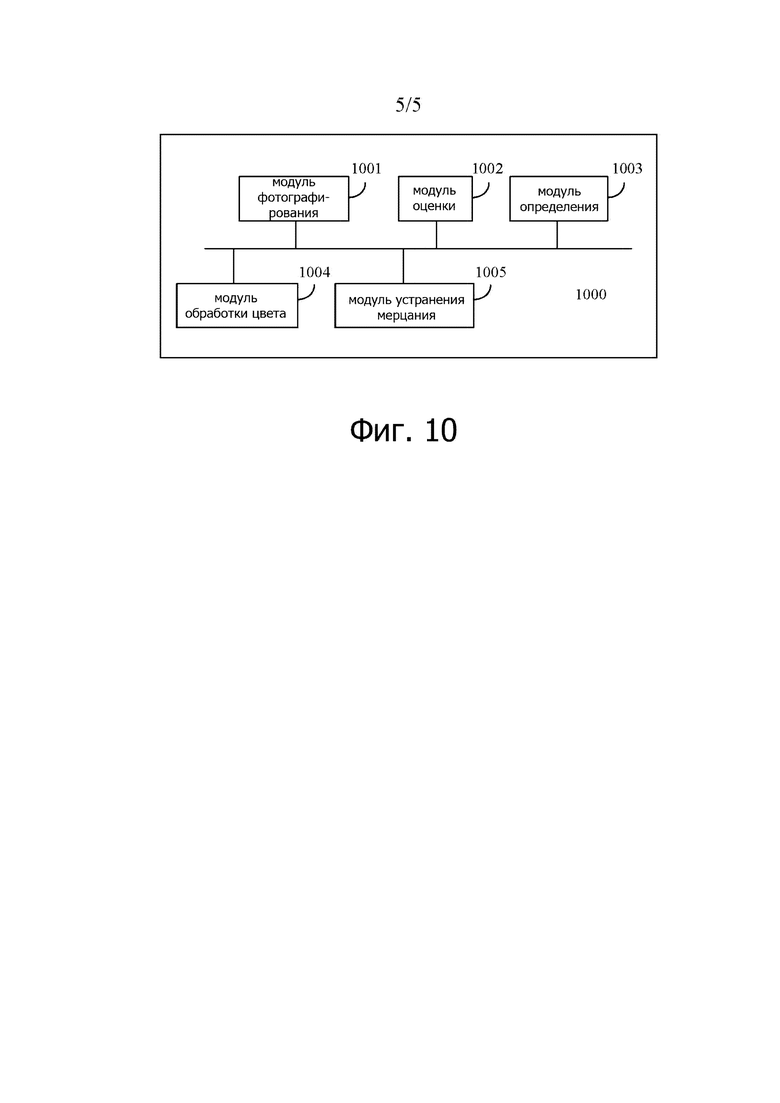

Фиг. 9 представляет собой схему устройства обработки изображения в соответствии с вариантом осуществления настоящего описания; и

Фиг. 10 является еще одной схемой устройства обработки изображения в соответствии с вариантом осуществления настоящего описания.

Осуществление изобретения

Ниже ясно и полностью приведено описание технических решений в вариантах осуществления настоящего описания со ссылкой на прилагаемые чертежи в вариантах осуществления настоящего описания. Определенно, описанные варианты осуществления являются просто некоторыми, но не всеми вариантами осуществления настоящего описания. Все остальные варианты осуществления, полученные специалистом в данной области техники, основанные на вариантах осуществления настоящего описания без творческих усилий, должны находиться в рамках области охраны настоящего описания.

В вариантах осуществления настоящего описания оконечное устройство может представлять собой устройство, которое обеспечивает пользователю функцию съемки видео и/или подключение к передаче данных, портативное устройство, имеющее функцию беспроводного соединения, или другое устройство обработки, подключенное к беспроводному модему, например, цифровая камера, однолинзовая рефлекторная камера, мобильный телефон (или называется «сотовый» телефон) или смартфон. Оконечное устройство может быть портативным, карманным, переносным или носимым устройством (например, SmartWatch), планшетным компьютером, персональным компьютером (PC), PDA (персональный цифровой помощник), компьютером, установленным на транспортном средстве, дроном, летательным аппаратом или тому подобным.

Фиг. 1 является схемой дополнительной возможной аппаратной структуры оконечного устройства 100.

Как показано на фиг. 1, оконечное устройство 100 может включать в себя такие компоненты, как радиочастотный блок 110, память 120, входной блок 130, блок 140 отображения, камера 150, аудиосхема 160 (включающая в себя динамик 161 и микрофон 162), процессор 170, внешний интерфейс 180 и источник питания 190. Специалист в данной области может понять, что фиг. 1 является просто примером интеллектуального оконечного устройства или многофункционального устройства и не является ограничением интеллектуального оконечного устройства или многофункционального устройства. Интеллектуальное оконечное устройство или многофункциональное устройство могут включать в себя больше или меньше компонентов, чем показанные на чертеже, или сочетают в себе некоторые компоненты или включают в себя различные компоненты. Например, интеллектуальное оконечное устройство или многофункциональное устройство включает в себя, по меньшей мере, память 120, процессор 170 и камеру 150.

Камера 150 выполнена с возможностью захватывать изображения или видео, и может быть использована в соответствии с инструкцией прикладной программы для реализации функции фотографирования или функции съемки видео. Камера может включать в себя такие компоненты, как линза, формирующая изображение, световой фильтр и датчик изображения. Световые лучи, испускаемые или отраженные объектом, поступают в линзу, формирующую изображение, проходят через световой фильтр и, наконец, сходятся на датчике изображения. Линза, формирующая изображение, в основном выполнена с возможностью обеспечивать сходимость в изображении света, испускаемого или отраженного всеми объектами (которые также могут быть упомянуты как фотографируемый сценарий, фотографируемые объекты, целевой сценарий или целевые объекты, и также может упоминаться, как сценарий изображения, которое пользователь фотографирует) в углу обзора фотографирования. Световой фильтр, в основном, выполнен с возможностью фильтрации избыточной световой волны (например, световая волна, отличная от видимого света, например, инфракрасного света) в световых лучах. Датчик изображения, в основном, выполнен с возможностью: выполнять оптико-электрическое преобразование принятого оптического сигнала, преобразование оптического сигнала в электрический сигнал и подавать электрический сигнал в процессор 170 для последующей обработки. Камера может быть расположена во фронтальной части оконечного устройства или может быть расположена на задней панели оконечного устройства. Конкретное количество и специфическое расположение камер может быть гибко определено на основании требования конструктора или поставщика. Это не ограничено в настоящем изобретении.

Входной блок 130 может быть выполнен с возможностью принимать входную цифровую или символьную информацию и генерировать входной сигнал управления, относящийся к установкам пользователя и функциям управления многофункционального устройства. В частности, входной блок 130 может включать в себя сенсорный экран 131 и/или другое устройство 132 ввода. Сенсорный экран 131 может воспринимать операцию касания (например, операцию, выполняемую пользователем на сенсорном экране или рядом с сенсорным экраном, используя любой подходящий предмет, например, палец, соединение или стилус) пользователя на или рядом с сенсорным экраном 131 и управлять соответствующими подключенными устройствами на основании заданной программы. Сенсорный экран может обнаружить сенсорное действие пользователя на сенсорном экране, преобразуя действие касания в сенсорный сигнал, отправлять сенсорный сигнал в процессор 170 и может принимать и выполнить команду, отправленную процессором 170. Сенсорный сигнал включает в себя, по меньшей мере, контактную координатную информацию. Сенсорный экран 131 может обеспечить интерфейс ввода и выходной интерфейс между оконечным устройством 100 и пользователем. Дополнительно, сенсорный экран может быть реализован в различных типах, таких как резистивный тип, емкостный тип, инфракрасный тип и тип поверхностной акустической волны. В дополнение к сенсорному экрану 131, входной блок 130 может дополнительно включать в себя другое устройство ввода. В частности, другое устройство 132 ввода может включать в себя, но не ограничивается, одну или несколько физических клавиатур, функциональную клавишу (например, клавиша управления громкостью или клавиша 133 включения/выключения), трекбол, мышь, джойстик и тому подобное.

Блок 140 отображения может быть выполнен с возможностью отображать информацию, введенную пользователем или информацию, предоставленную для пользователя, различные меню оконечного устройства 100, интерфейс взаимодействия, файл и/или воспроизведение любого мультимедийного файла. В этом варианте осуществления настоящего описания блок отображения дополнительно выполнен с возможностью отображать изображение/видео, полученное оконечным устройством с помощью камеры 150. Изображение/видео может включать в себя изображение/видео для предварительного просмотра в некоторых режимах фотографирования, фотографированное начальное изображение/видео и целевое изображение/видео на котором выполняется конкретный алгоритм обработки после выполнения фотографирования.

Кроме того, сенсорное экран 131 может покрывать панель 141 дисплея. После обнаружения операции касания на или рядом с сенсорным экраном 131, сенсорный экран 131 передает в процессор 170 данные операции касания для определения типа сенсорного события. Затем процессор 170 обеспечивает соответствующий визуальный вывод на панели 141 дисплея на основании типа сенсорного события. В этом варианте осуществления сенсорный экран и блок отображения могут быть интегрированы в один компонент для реализации функций ввода, вывода и отображения оконечного устройства 100. Для простоты описания в этом варианте осуществления настоящего описания экран сенсорного дисплея представляет собой комбинацию сенсорного экрана и блока отображения. В некоторых вариантах осуществления сенсорный экран и блок отображения могут быть альтернативно использованы в качестве двух независимых компонентов.

Память 120 может быть выполнена с возможностью хранить инструкцию и данные. Память 120, в основном, может включать в себя область хранения инструкции и область хранения данных. Область хранения данных может хранить такие данные, как мультимедийный файл и текст. Область хранения инструкции может хранить такие программные блоки, как операционная система, приложение и инструкция, требуемая, по меньшей мере, одной функцией, их подмножество или его расширение. Память 120 может дополнительно включать в себя постоянную память произвольного доступа и предоставить процессору 170 функции, включающие в себя управление аппаратным обеспечением, программным обеспечением и ресурсами данных в вычислительном устройстве обработки, и поддерживающие управление программным обеспечением и приложением. Память 120 дополнительно выполнена с возможностью хранить мультимедийный файл и хранить программу выполнения и приложение.

Процессор 170 представляет собой центр управления оконечным устройством 100 и подключен к различным частям всего оконечного устройства через различные интерфейсы и линии связи. Процессор 170 выполняет различные функции оконечного устройства 100 и обрабатывают данные посредством выполнения инструкции, хранящиеся в памяти 120, и вызывает данные, хранящиеся в памяти 120, для выполнения общего управления оконечного устройства. В качестве варианта, процессор 170 может включать в себя одно или несколько блоков обработки. Предпочтительно, процессор 170 может быть интегрирован с прикладным процессором и модемным процессором. Прикладной процессор, в основном, обрабатывает операционную систему, пользовательский интерфейс, прикладную программу и тому подобное. Модемный процессор, в основном, обрабатывает данные беспроводной связи. Очевидно, что модемный процессор может альтернативно не быть интегрирован в процессор 170. В некоторых вариантах осуществления процессор и память могут альтернативно быть реализованы на одной микросхеме. В некоторых вариантах осуществления процессор и память могут быть соответственно реализованы на независимых микросхемах. Процессор 170 может быть дополнительно выполнен с возможностью: генерировать соответствующий управляющий сигнал управления, отправлять управляющий сигнал в соответствующий компонент в вычислительном устройстве обработки и считывать и обрабатывать данные в программном обеспечении, в частности, считывать и обрабатывать данные и программу в памяти 120, так что функциональные модули в процессоре 170 выполняют соответствующие функции для управления соответствующими компонентами для выполнения действий, как требуется инструкциями.

Радиочастотный блок 110 может быть выполнен с возможностью принимать и отправлять информацию или принимать и отправить сигнал в процессе вызова. Например, радиочастотный блок 110 принимает информацию нисходящей линии связи из базовой станции, затем доставляет информацию нисходящей линии связи в процессор 170 для обработки и передает связанные данные восходящей линии связи в базовую станцию. Как правило, радиочастотный блок включает в себя, но не ограничивается, антенну, по меньшей мере, один усилитель, приемопередатчик, соединитель, малошумящий усилитель (Low Noise Amplifier, LNA), дуплексер и тому подобное. Дополнительно, радиочастотный блок 110 может дополнительно взаимодействовать с сетевым устройством и другим устройством через беспроводную связь. Беспроводная связь может использовать любой стандарт связи или протокол, включающий в себя, но не ограничиваясь, глобальную систему мобильной связи (Global System for Mobile Communications, GSM), общую услугу пакетной радиопередачи (General Packet Radio Service, GPRS), множественный доступ с кодовым разделением (Code Division Multiple Access, CDMA), широкополосный множественный доступ с кодовым разделением (Wideband Code Division Multiple Access, WCDMA), «Долгосрочное развитие» (Long Term Evolution, LTE), электронная почта, служба короткого сообщения (Short Message Service, SMS) и тому подобное.

Аудиосхема 160, динамик 161 и микрофон 162 могут обеспечить аудио интерфейс между пользователем и оконечным устройством 100. Аудиосхема 160 может передавать в динамик 161 электрический сигнал, преобразованный из принятых аудиоданных, и динамик 161 преобразует электрический сигнал в звуковой сигнал для вывода. Дополнительно, микрофон 162 выполнен с возможностью сбора звукового сигнала и может дополнительно преобразовать собранный звуковой сигнал в электрический сигнал. Аудиосхема 160 принимает электрический сигнал, преобразует электрический сигнал в аудиоданные, выводит аудиоданные в процессор 170 для обработки и затем передает обработанные аудиоданные, например, в другое оконечное устройство через радиочастотный блок 110 или выводит обработанные аудиоданные в память 120 для дополнительной обработки. Аудиосхема также может включать в себя гнездо 163 гарнитуры, выполненное с возможностью обеспечивать интерфейс подключения между аудиосхемой и гарнитурой. Конкретное количество и конкретные компоновки динамиков и микрофонов могут быть гибко определены на основании требования конструктора или поставщика. Это не ограничено в настоящем изобретении.

Оконечное устройство 100 дополнительно включает в себя источник питания 190 (например, аккумуляторную батарею), которая обеспечивает питание каждого компонента. Предпочтительно источник питания может быть логически подключен к процессору 170 с использованием системы управления питанием, для реализации таких функций, как зарядка, разгрузка и управление потреблением энергии, используя систему управления питанием.

Оконечное устройство 100 дополнительно включает в себя внешний интерфейс 180. Внешний интерфейс может представлять собой стандартный порт MICRO-USB или может быть многоштыревым разъемом. Внешний интерфейс может быть выполнен с возможностью подключения оконечного устройства 100 к другому устройству для связи или может быть выполнен с возможностью подключения к зарядному устройству для зарядки оконечного устройства 100.

Хотя не показано, оконечное устройство 100 может дополнительно включать в себя вспышку, модуль беспроводная достоверность (wireless fidelity, Wi-Fi), модуль Bluetooth, датчики с различными функциями и тому подобное. Детали не описаны. Некоторые или все способы, описанные ниже, могут быть применены к оконечному устройству, показанному на фиг. 1.

Настоящее описание может быть применено к оконечному устройству, имеющее функцию фотографирования (включающую в себя, по меньшей мере, одну из функцию фотографирования или функцию съемки видео), и устройство может быть реализовано в форме интеллектуального оконечного устройства, например, устройство, на котором установлена камера, например, мобильный телефон, планшет, DV, видеокамера, камера, портативный компьютер, ноутбук, интеллектуальный робот, телевизор, система защиты безопасности или дрон. В частности, функциональные модули по настоящему изобретению могут быть развернуты на DSP микросхеме соответствующего устройства и могут быть специально прикладной программой или программным обеспечением в DSP микросхеме. В настоящем изобретении функциональные модули развернуты на оконечном устройстве для обеспечения функции обработки изображений с помощью установки программного обеспечения или обновления и использования аппаратного обеспечения.

Настоящее описание в основном применяется к сценарию, в котором изображение или видео сфотографируются с помощью оконечного устройства. Пользователи предъявляют все более высокие требования к съемке видео и получать специальный эффект обработки видео во время фотографирования для передачи эмоций при съемке видео «Что вы видите, это то, что вы получаете». Согласно настоящему изобретению может быть выполнена сегментация основного объекта на изображении или видео, и цвета различных областей могут быть регулированы для реализации специального эффекта изображения в реальном времени.

Далее настоящее описание будет описано с помощью примеров.

Пример 1

Подробное описание приведено со ссылкой на фиг. 2. Фиг. 2 является блок-схемой последовательности операций способа обработки изображения в соответствии с вариантом осуществления настоящего описания. Способ выполняется в процессе фотографирования изображения. В конкретном процессе реализации оконечное устройство может настроить режим фотографирования. В режиме фотографирования способ может включать в себя следующие этапы.

Этап 21: получить (которое также может быть понято как фотография или захват) изображение.

В частности, когда пользователь фотографирует изображение, на экране также отображается соответствующий поток предварительного просмотра. Изображение предварительного просмотра, как правило, может относиться к одному изображению в потоке предварительного просмотра. При нажатии затвора пользователь получает сфотографированное изображение. Размер сфотографированного изображения, например, равен, но не ограничен, 1920 x 1080.

Этап 22: определить целевую область и область фона на изображении на основании контента (который может быть рассмотрен, как семантика сцены) в сфотографированном изображении. Более конкретно, целевая область и область фона могут быть определены на изображении на основании категории объекта на изображении. Область фона представляет собой область изображения, отличную от целевой области. Целевая область соответствует целевому объекту в изображении, а именно, объект, который пользователь выделяет в изображении, и может быть связан с интерактивным выбором пользователя или настройки системы. В частности, этап 22 может включать в себя S221 до S224.

S221: предварительно обработать изображение.

Cфотографированное изображение оригинального размера подвергается понижающей дискретизации и преобразуется в изображение меньшего разрешения. При осуществлении вычислений объем вычислений может быть уменьшен на основании небольшого изображения. В конкретном процессе реализации исходный размер (например, m0 x n0) может быть подвержен понижающей дискретизации до размера m x n. Меньшие значения m и n указывают меньшее количество последующих вычислений. Однако, если значения m и n являются чрезмерно небольшими, разрешение пикселей впоследствии уменьшается. Эксперименты показали, что соответствующие диапазоны значения m и n представляют собой [128, 512] и, более конкретно [256, 300]. Дополнительно, m и n могут быть равными или неравными. Например, изображение 1920x1080 может быть подвержено понижающей дискретизации до 256х256.

S222: ввести изображение mxn изображение с понижающей дискретизацией в нейронную сеть для выполнения семантической сегментации для определения маски изображения (Mask).

Семантическая сегментация относится к сегментации уровня пикселя, выполненной на объекте в изображении, и категория объекта отмечена для каждого пикселя. Область без категории объекта отмечена как «фон».

В частности, семантическая сегментация может использовать алгоритм глубокого обучения на основании CNN (сверточная нейронная сеть). Сетевая модель на основании CNN специально описывается следующим образом:

(1) на изображении m x n выполняется понижающая дискретизация и свертка для получения изображения m1 x n1, изображения m2 x n2, … и изображения mz x nz, и послойно извлекаются семантические признаки изображения для получения m1 x n1 карты признака, m2 x n2 карты признака, … и mz x nz карты признака, а именно, многомасштабные семантические признаки, где m1, m2, … и mz находятся во множественных отношениях и меньше чем m, и n1, n2, …, nZ находятся во множественных отношениях и меньше, чем n. Например, m=2m1=4m2=, …, =2zxmz, и n=2n1=4n2=, …, =2zxnz. Значение z и множественные отношения могут быть определены на основании производительности алгоритма и требования к структуре.

(2) на m1xn1 карте признака, m2xn2 карте признака, … и mzxnz карте признака выполняется повышающая дискретизация и свертка для объединения многомасштабных семантических признаков.

Упомянутая выше свертка, понижающая дискретизация и повышающая дискретизация могут использовать технологии, хорошо известные в данной области техники, и не ограничены и перечислены в настоящем изобретении.

(3) определить категорию объекта, которая должна быть идентифицирована на изображении, вычислить оценку каждой категории объектов на каждом пикселе, категория объекта (которая может быть категорией для краткости) с наивысшей оценкой используется в качестве результата классификации пикселя, и окончательно получить граф маски, а именно, маску.

Например, если оконечное устройство может идентифицировать категории k объектов (например, по меньшей мере, один из человек, животное, растение, другой предустановленный объект или фон), то могут быть получены k изображения. Каждый пиксель в изображении получает оценку, принадлежащую категории объекта. Более высокая оценка указывает на более высокую вероятность того, что пиксель принадлежит категории объекта.

После определения категории объекта любого пикселя, пиксель может быть идентифицирован. Например, 1 используется для обозначения человека, 2 используется для обозначения транспортного средства, 3 используется для обозначения животного, 4 используется для обозначения растения и 0 используется для обозначения фона. Это просто пример, и не представляет никаких ограничений. Пользователь может произвольно установить количество категорий, категории и способ идентификации на основании требований. На фиг. 3 показан конкретный пример. Все области пикселей, в которых находится транспортное средство, классифицируется как транспортное средство нейронной сетью, и идентифицируется как 1. Все области пикселей в окружающей фоновой части классифицируются как фон нейронной сетью и идентифицированы как 0. Для другого примера, в маске, выводимой нейронной сетью, области объектов одной и той же категории имеют одинаковое обозначение. Например, обозначение фона равно 0, обозначение кота 1 и обозначение скейтборда равно 2. В маске, показанной на фиг. 4, может дополнительно использоваться тот же цвет для представления обозначений одинаковой категории объекта. Например, человек, лошадь и фон соответственно идентифицируются с помощью разных цветов.

Маска является результатом выполнения алгоритма семантической сегментации. На изображении все пиксели, принадлежащие к категории объектов, обозначаются как цветом или идентификатором, так и фон также обозначается цветом или идентификатором. Изображение, полученное после обработки, относится к маске, так что результат сегментации отображается интуитивно.

Содержание изображения может включать в себя основной объект и фон. Для простоты описания, соответственно, маска изображения может включать в себя маску основного объекта и маску фона. Маска основного объекта может соответствовать основному объекту, идентифицированному с использованием способа сегментации, включающий в себя предмет, который пользователь выделяет в изображении или в фотографированном изображении, например, человека, животное, растение или конкретный объект (чашка, стол, одежда, украшение …). Маска фона соответствует другой области, которая находится в изображении, и не идентифицируется как маска основного объекта. Маска изображения соответствует всему изображению. Возможность идентификации маски основного объекта связана с функционированием нейронной сети. Например, некоторые нейронные сети могут идентифицировать только человека и фон. Некоторые нейронные сети могут идентифицировать человека, транспортное средство и фон. Некоторые нейронные сети могут идентифицировать только транспортное средство и фон. Некоторые нейронные сети могут идентифицировать человека, животное и фон. Некоторые нейронные сети могут идентифицировать только животное и фон. Некоторые нейронные сети могут идентифицировать животное, растение, фон …

Следует понимать, что изображение может в качестве альтернативы включать в себя только основной объект или может включать в себя только фоном. Когда изображение включает в себя только основной объект, основной объект также может быть идентифицирован как фон. Эти установки основного объекта и фона на изображении могут быть гибко спроектированы и определены конструктором.

Большое количество данных обучения сегментации необходимо использовать для обучения глубокой нейронной сети, и набор данных обучения включает в себя большое количество изображений, включающие в себя категории объектов сегментации, входные изображения и графы маски. Набор данных обучения может охватывать различные типичные сценарии приложений объекта сегментации и имеет разнообразные данные. Входные изображения и графы маски в наборе данных обучения используются для обучения сети для получения отличного сетевого параметра, другими словами, для получения производительности сегментации, удовлетворяющая пользователя. Полученный сетевой параметр используется в качестве окончательного использованного параметра вычисления нейронной сети.

S223: определить целевую маску на основании масок.

Для различных изображений и нейронных сетей с различными возможностями могут быть получены различные маски. Оконечное устройство может дополнительно определить маску, которая находится в масках, и которая соответствует объекту, который необходимо выделить и заметно отобразить. То есть, должна быть определена целевая маска. Определение целевой маски включает в себя, но не ограничивается, следующие несколько способов.

Способ 1: если маска включает в себя только одну маску основного объекта и одну маску фона, то маска основного объекта определяется как целевая маска.

В частности, предполагается, что для получения k масок на изображении выполняется сегментация. K маски соответствуют различным категориям объекта. Если k=2 и две маски включают в себя одну маску объекта и одну маску фона, то область изображения, соответствующая маске объекта, определяется как целевая область, и область, соответствующая маске фона, определяется как область фона.

Как показано на фиг. 5, маски изображения, выведенные нейронной сетью, включают в себя только маску A1 основного объекта и маску фона. В этом случае A1 может быть определена как целевая маска.

Способ 2: когда маска включает в себя множество масок основного объекта и маску фона, если количество пикселей, включенных в любую маску основного объекта, превышает конкретное пороговое значение, то маска основного объекта определяется как целевой основной объект; или, если количество пикселей, включенных в любую маску основного объекта, меньше конкретного порогового значения, то маска основного объекта повторно обозначается и также обозначается как фон. Количество пикселей, включенных в маску основного объекта, может быть количеством пикселей, включенных в область отдельного предмета на изображении.

В частности, предполагается, что для получения k масок на изображении выполняется семантическая сегментация. k маски соответствуют различным категориям объекта. Если k больше 2, и количество пикселей, включенных в k0 маски в k масках, превышает заданное пороговое значение, то область изображения, соответствующая k0 маскам объекта, определяется как целевая область, и область изображения, соответствующая оставшейся маске, определяется как область фона, где k0 является неотрицательным целым числом меньше k.

Как показано на фиг. 6, маски вывода изображения нейронной сетью включают в себя маску A1 основного объекта, маску A2 основного объекта и маску фона. Если количество пикселей, включенных в A1, больше заданного порогового значения и количество пикселей, включенных в A2, не превышает заданное пороговое значение, A1 определяется как целевая маска и маска A2 основного объекта повторно обозначается как маска фона. На фиг. 5 показана повторно обозначенная маска. Если количество пикселей, включенных в A1, больше заданного порогового значения, и количество пикселей, входящих в A2, также больше, чем заданного пороговое значение, как A1, так и A2 определяются как целевая маска. Если ни количество пикселей, включенных в A1, ни количество пикселей, входящих в A2, не превышает заданное пороговое значение, A1 и A2 повторно идентифицируются в качестве масок фона. Другими словами, изображение не включает в себя маску основного объекта.

Следует понимать, что в конкретном процессе реализации A1 и A2 могут иметь одну категорию объекта или разные категории объектов.

Способ 3: когда маска включает в себя множество масок основного объекта и маску фона, маска основного объекта, включающая в себя наибольшее количество пикселей, выбирается в качестве целевой маски, и другие маски основного объекта также повторно обозначены как маска фона.

В частности, предполагается, что для получения k масок на изображении выполняется семантическая сегментация. k маски соответствуют различным категориям объекта. Если k больше 2, область изображения, соответствующая маске, которая включает в себя наибольшее количество пикселей, и, то есть, в k масках, определяется как целевая область, и область изображения, соответствующая оставшимся маскам, определяется как область фона.

Как показано на фиг. 6, маски вывода изображения нейронной сети включают в себя маску A1 основного объекта, маску A2 основного объекта и маску фона. A1, которая включает в себя наибольшее количество пикселей, определяется как целевая маска и маска A2 основного объекта повторно обозначается как маска фона. На фиг. 5 показана повторно обозначенная маска.

Следует понимать, что в конкретном процессе реализации A1 и A2 могут иметь одну категорию объекта или различные категории объектов.

Способ 4: когда маска включает в себя множество масок основного объекта и маску фона, и множество масок основного объекта включает в себя множество категорий объектов, целевая маска определяется на основании приоритетов категорий объектов. Например, если приоритет маски человека выше, чем приоритет маски транспортного средства, то маска человека является целевой маской, и маска транспортного средства может быть повторного обозначена в качестве фона. Например, если приоритет маски человека выше, чем приоритет маски животного и является выше, чем приоритет маски растений, и приоритет, установленный системой, является то, что все маски, приоритеты которых выше, чем приоритет маски растений, являются масками основного объекта, то, как маска человека, так и маска животного являются целевыми масками, и маска растений может быть повторного обозначена в качестве фона. Следует понимать, что один или несколько предметов принадлежат к той же маске категории объектов.

В частности, предполагается, что для получения k масок на изображении выполняется семантическая сегментация. k маски соответствуют различным категориям объекта. Если k больше 2, целевая маска определяется из k масок на основании заданных приоритетов категорий объектов. Область изображения, соответствующая целевой маске, определяется как целевая область, и область изображения, соответствующая оставшимся маскам, определяется как область фона.

Как показано на фиг. 7, маски изображения, выводимого нейронной сетью, включают в себя маску A1 основного объекта, маску B1 основного объекта и маску фона. A1 и B1 имеют разные категории объекта, и приоритет A1 выше, чем приоритет B1. Если система устанавливает, что любая маска основного объекта, приоритет которой выше, чем или равна, что B1, может использоваться в качестве целевой маски, как A1, так и B1 являются целевыми масками. Если система устанавливает, что маска основного объекта, приоритет которой выше, чем B1, может использоваться в качестве целевой маски, A1 определяется как целевая маска, и B1 повторно обозначена как маска фона.

Способ 5: если маска включает в себя множество масок основного объекта и маски фона, целевая маска может быть определена в соответствии с операцией выбора пользователем. Входной режим включает в себя, но не ограничен инструкциями выбора, такими как касание экрана и голос. Маска основного объекта, соответствующая предмету, выбранного пользователем, является целевой маской.

В частности, предполагается, что для получения k масок на изображении выполняется семантическая сегментация. k маски соответствуют различным категориям объекта. Если k превышает 2, целевая маска определяется из k масок в соответствии с инструкцией выбора пользователя. Область изображения, соответствующая целевой маске, определяется как целевая область, и область изображения, соответствующая оставшимся маскам, определяется как область фона.

Как показано на фиг.7, маски изображения, выведенные нейронной сетью, включают в себя маску A1 основного объекта, маску B1 основного объекта и маску фона. Если ввод пользователя в процессе фотографирования соответствует A1 на сенсорном экране, то A1 определяется как целевая маска и B1 повторно обозначена как маска фона. Если ввод пользователя в процессе фотографирования соответствует B1 на сенсорном экране, то B1 определяется как целевая маска и A1 повторно обозначается как маска фона.

Способ 6: если маска включает в себя множество масок основных объектов и маски фона, и множество масок основных объектов включает в себя множество категорий объекта, целевая маска может быть определена на основании ввода операции выбора пользователем. Входной режим включает в себя, но не ограничен инструкциями выбора, такими как касание экрана и голос. Все маски основных объектов категории объекта, соответствующие предмету, выбранному пользователем, являются целевыми масками.

В частности, предполагается, что для получения k масок на изображении выполняется семантическая сегментация. k маски соответствуют различным категориям объекта. Если k превышает 2, целевая маска определяется из k масок в соответствии с инструкцией выбора пользователя. Область изображения, соответствующая целевой маске, определяется как целевая область и область изображения, соответствующая оставшимся маскам, определяется как область фона.

Как показано на фиг. 8, маски изображения, выводимые нейронной сетью, включают в себя маски A1, A2, B1 и B2 основного объекта и маску фона. A1 и A2 имеют одну и ту же категорию объекта, B1 и B2 имеют одну категорию объекта. Если ввод пользователя в процессе фотографирования соответствует A1 на сенсорном экране, A1 и A2, которые имеют одинаковую категорию объекта, определяются как целевые маски, и B1 и B2 повторно обозначены как маски фона. Если ввод пользователя в процессе фотографирования соответствует B2 на сенсорном экране, B1 и B2 одной и той же категории объекта, определяется как целевые маски и A1 и A2 повторно обозначены как маски фона.

Следует понимать, что вышеуказанные конкретные реализации или варианты осуществления являются просто примерами и не должны представлять собой ограничения. Вышеуказанные конкретные реализации или варианты осуществления могут быть свободно объединены без нарушения логики. Следовательно, после выполнения сегментации маски на изображении могут быть получены одна или несколько целевых масок. Эти целевые маски могут иметь одну или несколько категорий объектов, и каждая категория объектов целевых масок может дополнительно включать в себя один или несколько отдельных предметов. Результат относится к правилу, которое устанавливается в оконечном устройстве для определения целевой маски и ввода пользователя. В некоторых сценариях изображение может альтернативно включать в себя только маску фона.

S224: определить целевую область и область фона в исходном изображении.

Из маски осуществляют выборку сфотографированного изображения исходного размера, и целевая маска и маска фона в маске также подвержена повышающей дискретизации. Область, составленная всеми пикселями, которые представляют собой целевую маску после повышающей дискретизации, и которые соответствуют исходному изображению, является целевой областью, и область, составленная всеми пикселями, которые представляют собой маску фона после повышающей дискретизации, и которые соответствуют исходному изображению, является областью фона.

Этап 23: обработать целевую область и область фона на изображении в разных режимах обработки цвета для получения целевого изображения. Для обработки используются различные режимы обработки цвета, так что цветность целевой области больше, чем цветность области фона или яркость целевой области больше, чем яркость области фона. Другими словами, цветность целевой области в целевом изображении больше, чем цветность области фона в целевом изображении, или яркость целевой области в целевом изображении больше, чем яркость области фона в целевом изображении.

В частности, первый режим обработки цвета и второй режим обработки цвета соответственно используются для целевой области и области фона на изображении. Первый режим обработки цвета и второй режим обработки цвета включают в себя, но не ограничиваются ими, следующие способы.

Способ 1: первый режим обработки цвета сохраняет цвет и второй режим обработки цвета использует фильтр, например, преобразование цвета области фона в черный и белый цвет. Типичные фильтры дополнительно включают в себя любой фильтр черного и белого цвета, фильтр затемнения, ретро фильтр, пленочный фильтр, фильтр размытия, фильтр эффекта боке и тому подобное.

Например, операция фильтрации черного и белого цвета состоит в отображении каждого значения пикселя на значение серого цвета для реализации эффекта фильтра черного-белого цвета. В качестве другого примера фильтр затемнения осуществляет затемнение яркости каждого значения пикселя для достижения особого эффекта затемнения.

Способ 2: первый режим обработки цвета представляет собой первый способ фильтрации, второй режим обработки цвета представляет собой второй способ фильтрации, и первый способ фильтрации отличается от второго способа фильтрации. Для одного и того же изображения цветность изображения, полученного в первом способе фильтрации, больше, чем цветность изображения, полученного во втором способе фильтрации.

Способ 3: первый режим обработки цвета представляет собой третий способ фильтрации, второй режим обработки цвета представляет собой четвертый способ фильтрации, и третий способ фильтрации отличается от четвертого способа фильтрации. Для одного и того же изображения яркость изображения, полученного в третьем способе фильтрации, больше, чем яркость изображения, полученного в четвертом способе фильтрации.

Следует понимать, что цвет представляется как яркостью, так и цветностью. Цветность является свойством цвета, который не включает в себя яркость и отражает тон и насыщение цвета, и яркость относится к яркости цвета. Следовательно, обработка цвета включает в себя обработку яркости и/или обработка цветности.

В частности, фильтр может включать в себя регулировку цветности, яркости и оттенок и может дополнительно включать в себя наложенную текстуру и тому подобное. Цветовая система может регулироваться в целевом способе посредством регулировки цветности и оттенка, так что цветовая система становится насыщеннее или бледнее, или тон может быть изменен и другая цветовая система остается неизменной. Фильтр также может быть рассмотрен как отображение пикселей на пиксели. Значение пикселя входного изображения отображается на значение пикселя целевого пикселя, используя таблицу заданного отображения, для достижения особого эффекта. Следует понимать, что фильтр может быть заданным параметром маски. Эти параметры, связанные с цветом, могут быть параметрами в маске фильтра, которые хорошо известны в данной области техники, или могут быть параметрами, независимо разработанными пользователем.

Дополнительно, после этапа 23 способ дополнительно включает в себя этап 24 хранения изображения, обработанного на этапе 23.

Согласно настоящему изобретению, в процессе фотографирования оконечное устройство может определить целевой предмет и фон на основании контента изображения и выполнять различную обработку цвета на целевом предмете и на фоне, так что основной объект в изображении, сфотографированного пользователем, может быть более заметным, а сфотографированное изображение похоже на фильм.

Пример 2

В частности, в настоящем изобретении способ обработки изображения для записи видео аналогичен способу обработки изображения для фотографирования, и разница заключается в том, что объект, обработанный в фотографии, является одним изображением, когда как объект, обработанный в записи видео, является последовательными кадрами видео, а именно, множеством последовательных изображений. Объект, обработанный в записи видео, может быть завершенным видео или может быть сегментом в завершенном видео, или пользовательским видеоклипом в диапазоне периода времени. Для процедуры обработки каждого изображения в видео или видеоклипа, обратитесь к способу обработки в примере 1.

В частности, способ обработки изображения для съемки видео может включать в себя следующие этапы.

Этап 31: получить N сфотографированных изображений, где N является положительным целым числом; и выполнить операции этапов 32 и 33 на каждом изображении, где N изображений могут быть соседними видеокадрами и сумма N изображений может быть рассмотрена как видео. Альтернативно, N изображений могут не быть соседними.

Возможная реализация этапа 32 может быть такой же, как и этапа 22.

Возможная реализация этапа 33 может быть такой же, как и этапа 23.

Дополнительно, поскольку видео включает в себя последовательные изображения, способ определения предмета также относится к временной последовательности. Следовательно, в дополнение к этапу 23, на этапе 33 могут быть выполнены больше операций. В качестве варианта, любой способ определения основного объекта в S223 может иметь задержку. Например, человек и фон определяются в L1 кадре, и он все еще может быть определен от (L1+1) кадра изображения до (L1+L0) кадра изображения с помощью маркировки пикселя и сравнения маски, что человек в этих изображениях является основным объектом, и область, соответствующая человеку в этих изображениях, является целевой областью 0. Основной объект и фон не нужно определять для каждого кадра. Момент, в котором основной объект определяется каждый раз, может быть определен пользователем, или основной объект может периодически определяться, например, но не ограничиваться, каждые 2s или каждые 10s. Способ определения основного объекта каждый раз включает в себя, но не ограничивается, шесть способов в S223.

Этап 34: хранить видео, составленное N изображениями, на которых выполняется обработка цвета.

Согласно настоящему изобретению, в процессе, в котором пользователь записывает видео, оконечное устройство может определить целевой предмет и фон на основании видеоконтента и выполнять различную обработку цвета на целевом предмете и на фоне, так что основной объект видео, сфотографированный пользователем, может быть более заметным, сфотографированное видео является таким же привлекательным, как фильм, и взаимодействие с пользователем улучшено.

Пример 3

В настоящем изобретении способ обработки изображений для записи видео аналогичен способу обработки изображения для фотографирования, и различие заключается в том, что объект, обрабатываемый в фотографии, является одним изображением, когда объект, обработанный в записи видео, является последовательными видеокадрами, а именно, множеством последовательных изображений. Следовательно, для процедуры обработки каждого изображения обратитесь к способу обработки в примере 1. В некоторых сложных сценариях съемки видео некоторые области в изображении могут быть определены неправильно. Если та же область, обозначенная отдельно как цель или фон в соседних кадрах, одна и та же область обрабатывается в разные цвета в соответствии с вышеупомянутым примером способа обработки цвета, и изменения цветов той же области в соседних кадрах вызывают мерцание. Следовательно, мерцание должно быть определено и устранено во время обработки. Мерцание может быть ошибкой определения категории объекта.

В способе определения при наличии мерцающего видео, маска предшествующего кадра может быть обработана на основании оптического потока для получения оптической маски на основании потока, и сравнивается различие между маской на основании оптического потока и маской текущего кадра. Когда степень совпадения или степень сходства превышает конкретную пропорцию, определяется отсутствие мерцания. Когда степень совпадения или степень сходства не превышает конкретной пропорции, определяется наличие мерцания. Дополнительно, следует понимать, что определение мерцания является непрерывным процессом. В качестве варианта, конкретный способ определения наличия мерцания заключается в следующем:

(1) Во-первых, вычисляется оптический поток соседних кадров, где оптический поток указывает взаимосвязь смещения между пикселями в соседних кадрах ((t-1) кадр и t кадр).

(2) получить маску (t-1), вычислить маску F оптического потока на основании маски (t-1) кадра и информации оптического потока (t-1) кадра и t кадра, где маска оптического потока получается путем вычисления на основании оптического потока.

(3) получить маску S t кадра.

(4) вычислить набор SF пикселей основного объекта в маске F оптического потока и подсчитать набор SS пикселей основного объекта в маске S. Количество пикселей в наборе объединения и наборе пересечения SF и SS соответственно являются Nu и Ni. Когда (Nu-Ni)/Nu превышает конкретное пороговое значение, определяется наличие относительно большой разницы между масками соседних кадров (t-1) и t, и определяется наличие мерцания между (t-1) кадром и t кадром, или, очевидно, что мерцание происходит в t кадре. Относительно большая разница указывает на то, что один и тот же объект может быть неверно оценен как относящийся к разным категориям объектов. Например, один и тот же предмет в кадрах (t-1) и t отдельно определяется как человек и обезьяна.

В качестве варианта, если в первых N0 (положительное целое число больше 2) изображениях текущего изображения, количество групп соседних изображений с одним и тем же объектом, определенным как разные категории объекта, больше, чем заданное пороговое значение, это может быть определено, что на текущем кадре должна быть выполнена обработка исключения мерцания. Если определено, что количество групп соседних изображений с таким же объектом, определенным как разные категории объектов, не превышает заданное пороговое значение, может быть определено, что на текущем кадре не должна быть выполнена обработка исключения мерцания.

В качестве варианта, например, для заданного количества исторических соседних кадров или заданного количества исторических кадров, если определяется наличие мерцания в более чем половине кадров (например, определено, что мерцание происходит в трех кадрах видео в первых пяти соседних кадрах текущего видеокадра) может быть определено, что на текущем кадре должна быть выполнена обработка исключения мерцания. Если определено наличие мерцания менее чем половины кадров (например, определено, что мерцание происходит в одном из первых пяти соседних кадров текущего видеокадра), может быть определено, что на текущем кадре не должна быть выполнена обработка исключения мерцания.

Следует понимать, что текущее видеоизображение может быть рассмотрено как изображение, которое записывается в данный момент. Момент может быть понят как общий момент в некоторых сценариях, или может быть понят как какой-то конкретный момент в некоторых сценариях, например, последний момент или момент, в котором заинтересован пользователь.

В частности, способ обработки изображения для съемки видео в этом примере может включать в себя следующие этапы.

Этап 41: получить N сфотографированных изображений, где N является положительным целым числом; и выполнить операции этапов 32 и 33 на каждом изображении, где N изображений могут быть соседними видеокадрами и сумма N изображений может быть понята как видео; или N изображений могут не быть соседними кадрами.

Этап 42: определить, превышает ли количество групп соседних изображений, в которых происходит мерцание в первых N0 кадрах текущего кадра (текущее изображение) заданное пороговое значение. Здесь N0 и пороговое значение могут быть установлены пользователем. Например, N0 представляет собой выбранное количество исторических выборок видеокадра и пороговое значение может составлять 1/2, 2/3 или тому подобное N0. Это просто пример и этим не ограничивается.

Если результатом определения является не превышение заданного порогового значения, то операции этапов 43 и 44 выполняются на текущем сфотографированном или захваченном изображении.

Возможная реализация этапа 43 может быть такой же, как и этапа 32.

Возможная реализация этапа 44 может быть такой же, как и этапа 33.

Если результат определения является превышением заданного порогового значения, то операция этапа 45 выполняется на текущем сфотографированном или захваченном изображении.

Этап 45: обработать все области изображения текущего кадра, используя тот же способ обработки цвета для получения целевого изображения. Тот же способ обработки цвета может быть таким же, как способ обработки цвета области фона в предшествующем кадре, или может быть таким же, как способ обработки цвета целевой области в предшествующем кадре, или может быть таким же, как способ обработки цвета всего изображения в предшествующем кадре. Например, способ обработки цвета, который является таким же, как и для области фона на этапе 33 (23), может использоваться для всего изображения. Альтернативно, способ обработки цвета, который является таким же, как и для целевой области на этапе 33 (23), может использоваться для всего изображения. Например, все изображение остается цветным или все изображение является черно-белым, или первый или второй режим обработки цвета (включающий в себя, но не ограничиваясь, режимы обработки цвета в примере 1), используется для всего изображения.

В этом случае для текущего кадра может быть выполнена или опущена процедура сегментации маски аналогичной этапу 22. Это не ограничено в этом примере.

После этапа 45 этап 46 хранения видео, составленного N изображений, на которых выполняется обработка цвета. N является положительным целым числом.

Согласно настоящему изобретению, в процессе, в котором пользователь записывает видео, оконечное устройство может определить целевой предмет и фон на основании видеоконтента и выполнять различную обработку цвета на целевом предмете и фоне, так что основной объект видео, сфотографированного пользователем, может быть более заметным, сфотографированное видео является таким же привлекательным, как фильм, и взаимодействие с пользователем улучшено.

Пример 4

В некоторых сценариях применения содержание изображения, сфотографированного пользователем обычно меняется. Следовательно, основной объект изображения обычно меняется. Пользователь также может свободно выбирать режим обработки цвета основного объекта на разных изображениях, чтобы самостоятельно контролировать стиль видео.

Способ обработки изображения в процессе съемки видео может включать в себя следующие этапы.

Этап 51: оконечное устройство получает видеокадр.

Этап 52: оконечное устройство определяет область основного объекта и область фона в любом кадре видео, полученном из видео.

Этап 53: оконечное устройство использует любой режим обработки цвета в любое время для области основного объекта и использует любой режим обработки цвета в любое время для области фона. Однако необходимо обеспечить для любого изображения, чтобы яркость или цветность области основного объекта после обработки цвета была больше, чем яркость или цветность области фона после обработки цвета. В качестве альтернативы, для любого изображения цветность или яркость изображения, полученного в режиме обработки цвета, используемым для области основного объекта, была больше, чем цветность или яркость изображения, полученного в режиме обработки цвета, используемым для области фона.

Пример 5

В некоторых сценариях использования содержание изображения, сфотографированного пользователем обычно меняется. Следовательно, основной объект изображения обычно меняется. Пользователь также может свободно выбирать режим обработки цвета основного объекта на разных изображениях, чтобы самостоятельно контролировать стиль видео. Особенно, цвет изменяется в период времени.

Способ обработки изображения в процессе съемки видео может включать в себя следующие этапы.

Этап 61: захватить N1 изображения в первый период времени и захватить N2 изображения во второй период времени, когда первый период времени и второй период времени являются соседними периодами времени, и как N1, так и N2 являются положительными целыми числами, первый период времени и второй период времени могут быть продолжительностью, в котором пользователь может идентифицировать изменение изображения невооруженным взглядом, и N1 и N2 определяются частотой кадров и продолжительностью периодов времени во время записи видео. Это не ограничено в настоящем изобретении.

Этап 62: определить первую целевую область и первую область фона в каждом из N1 изображений, где первая область фона представляет собой область изображения, отличной от первой целевой области, и первая целевая область в каждом из N1 изображений соответствуют первому объекту (который может включать в себя, по меньшей мере, один объект); и определить вторую целевую область и вторую область фона в каждом из N2 изображений, где вторая область фона представляет собой область изображения, отличной от второй целевой области, и вторая целевая область в каждом из N2 изображений соответствует второму объекту (который может включать в себя, по меньшей мере, один объект).

Этап 63: обрабатывать первую целевую область в первом режиме обработки цвета, обрабатывать первую область фона во втором режиме обработки цвета, обрабатывать вторую целевую область в третьем режиме обработки цвета и обрабатывать вторую область фона в четвертом режиме обработки цвета, чтобы получить целевое видео, где в целевом видео, цветность первой целевой области больше, чем цветность первой области фона, или яркость первой целевой области больше, чем яркость первой области фона; и цветность второй целевой области больше, чем цветность второй области фона, или яркость второй целевой области больше, чем яркость второй области фона.

Пример 6

В некоторых сценариях реализации содержание изображения, сфотографированного пользователем обычно меняется. Следовательно, основной объект изображения обычно меняется. Пользователь также может свободно выбирать основной целевой объект, который пользователь хочет выделить в разных изображениях. Например, область изображения, соответствующая первому объекту, определяется в качестве целевой области в первый период времени, область изображения, соответствующая второму объекту, определяется как целевая область во второй период времени и первый объект и второй объект являются разными объектами, предметами или категориями объектов.

В этом сценарии способ обработки изображения в процессе съемки видео может включать в себя следующие этапы.

Дополнительная реализация этапа 71 может быть такой же, как и этапа 61.

Этап 72: определить первую целевую область и первую область фона в любом из N1 изображений на основании содержимого изображения и определить вторую целевую область и вторую область фона в любом из N2 изображений на основании содержимого изображения, где объект или категория объекта, соответствующие второй целевой области, отличается от объекта или категории объекта, соответствующей первой целевой области, так что система и пользователь могут самостоятельно выбирать целевой основной объект и целевую область изображения. Изображение включает в себя основной объект и фон, и соответственно, изображение включает в себя целевую область и область фона.

Например, первый объект является человеком и второй объект является животным. Например, первый объект является человеком A и второй объект является человеком B. Например, первый объект является двумя человеками и второй объект является собакой и двумя кошками. Оставшаяся область, которая не идентифицирована, обозначена как фон.

В этом способе маска изображения может быть определена путем использования вышеупомянутых способов в S221 и S222. Однако последующий способ не ограничивается определением целевого объекта в маске для каждого изображения.

Возможно в маске изображения пользователь может свободно вводить первый объект и второй объект, и первый объект, и второй объект определяется в соответствии с инструкцией выбора пользователем. Например, если пользователь выбирает предмет, система идентифицирует пиксель, соответствующий инструкции, введенной пользователем, дополнительно идентифицирует конкретный (/некоторый) предмет (/предметы) (/может быть, по меньшей мере, один предмет) или конкретную (/некоторую) категорию объекта (/категории объекта) (/может быть, по меньшей мере, одна категория объекта) маски, выбранной пользователем, дополнительно определяет конкретный (/ некоторый) предметы (/предметы) или все предметы в конкретной (/некоторой) категории объекта (/категории объекта), как первый объект, и определяет первый объект или область изображения, соответствующую первому объекту, как первая целевая область. Эта ситуация может поддерживаться в течение определенного периода времени. Другими словами, в последующих нескольких кадрах область, соответствующая маске, соответствующей первому объекту, является первой целевой областью, пока пользователь не выберет другой предмет в следующий момент, и область, соответствующая новому предмету, определяется как вторая целевая область в соответствии со способом, аналогичным вышеуказанному способу. На изображении область изображения, отличная от первой целевой области или второй целевой площади, является областью фона. Конкретно, область, соответствующая маске, соответствующей первому объекту в первый период времени, представляет собой первую целевую область, и область, соответствующая маске, соответствующей второму объекту во втором периоде времени, является второй целевой областью.

В качестве варианта, в маске изображения система может определить целевую маску изображения в период времени в маске изображения на основании заданного интервала времени (например, но не ограничиваясь, 1s или 2s) или заданного количества кадров (например, но не ограничены, 50 кадрами или 100 кадрами). Например, первая целевая маска определяется в 101-м кадре, и маска, которая имеет одну и туже категорию объекта или предмет, как первая целевая маска в 101-ом кадре, используется в качестве первой целевой маски для каждого следующих 102 кадров до 200 кадров до определения второй целевой маски в 201-ом кадре. Для каждого из следующих 202 кадров до 300 кадров маска, которая имеет такую же категорию объекта или предмет как вторая целевая маска в 201-ом кадре, используется в качестве второй целевой маски. Следует понимать, что число вышеперечисленного примера может быть задано пользователем или системой. Конкретно, в момент времени определяется целевая маска и маска этого типа или маска этого предмета постоянно используется в течение периода времени.

Для описания способа определения первой целевой маски, принадлежащей к первой категории, и второй целевой маски, принадлежащей к первой категории, без ограничения, может быть сделана ссылка на любой из шести способов на этапе S223. Следовательно, первая целевая маска и вторая целевая маска могут иметь одну категорию объекта или тот же предмет, или могут быть различными категориями объектов или разных предметов. Данный аспект относится к идентификационным возможностями сети, изменению изображения сцены или входной команды пользователя.

Дополнительно, первая целевая область, первая область фона, вторая целевая область и вторая область фона дополнительно определяются в соответствии со способом на S224. Детали не описаны в этом примере.

Возможная реализация этапа 73 может быть такой же, как и этапа 63.

Дополнительно, поскольку этот пример может варьироваться в зависимости от периода времени, может быть множество комбинаций способов обработки цвета.

Например, первый режим обработки цвета является таким же, как третий режим обработки цвета, и второй режим обработки цвета является таким же, как и четвертый режим обработки цвета. Этот режим обработки цвета имеет хорошую согласованность.

Например, первый режим обработки цвета является таким же, как третий режим обработки цвета, и второй режим обработки цвета отличается от четвертого режима обработки цвета. В этом режиме обработки цвета целевого основного объекта являются согласующимися и цвета фона изменяются так, чтобы общий визуальный эффект был более ошеломляющим.

Например, первый режим обработки цвета отличается от третьего режима обработки цвета, и второй режим обработки цвета является таким же, как и четвертый режим обработки цвета. В этом режиме обработки цвета фона являются согласующимися, и цвета целевого основного объекта изменяются, так что основной целевой объект является более заметным.

Например, первый режим обработки цвета отличается от третьего режима обработки цвета, и второй режим обработки цвета отличается от четвертого режима обработки цвета. В этом режиме обработки цвета могут быть предоставлены больше способов трансформаций цветов и можно обеспечить более значительного уровня согласования цветов на основании требований различных сценариев.

Первый режим обработки цвета или третий режим обработки цвета включает в себя фильтр, например, удерживающий цвет или улучшающий цвет. Второй режим обработки цвета или четвертый режим обработки цвета включает в себя фильтры, такие как фильтр черного и белого цвета, фильтр затемнения, ретро фильтр, пленочный фильтр, фильтр размытия и фильтр эффекта боке.

В частности, для способов обработки цвета для целевой области и области фона одного и того же изображения, обратитесь к этапу 23. Для N2 изображений третий режим обработки цвета и четвертый режим обработки цвета соответственно аналогичны первому режиму обработки цвета и второму режиму обработки цвета.

Согласно вышеуказанным решениям, в некоторых сценариях для выделения различного фона пользователь может свободно выбирать режим обработки цвета фона на разных изображениях. В некоторых сценариях пользователь может свободно выбирать режим обработки цвета основного объекта на разных изображениях, чтобы выделить основной объект в разных формах и различных пропорциях.

Следует понимать, что в разных примерах настоящего описания сигналы, указанные одной и той же маркировкой, могут иметь разные источники или могут быть получены разными способами. Это не является ограничением. Дополнительно, ссылки на этап разных примеров «то же самое, что и этап XX» указывают больше на общую логику обработки сигналов двух этапов. Это не ограничено тем, что как ввод, так и вывод двух этапов должны быть полностью одинаковыми, и что две процедуры способа полностью эквивалентны. Соответствующие ссылки и вариации, которые могут быть использованы специалистом в данной области техники, должны находиться в рамках области защиты настоящего описания.

Настоящее описание относится к способу обработки изображения. Целевая область и область фона определяются на изображении посредством выполнения сегментации маски на изображении. Различные режимы обработки цвета применяются к целевой области и области фона, так что яркость целевой области больше, чем яркость области фона, или цветность целевой области больше, чем цветность области фона и основной объект, соответствующий целевой области, более заметно выделен. Это реализует особый эффект фильма.

На основании способа обработки изображения, предусмотренного в вышеупомянутом варианте осуществления, вариант осуществления настоящего описания обеспечивает устройство 900 обработки изображения. Устройство может быть использовано во множестве оконечных устройств и может иметь любую форму реализации оконечного устройства 100, например, оконечное устройство, имеющее функцию фотографирования видео. Ссылаясь на фиг.9, устройство включает в себя:

модуль 901 фотографирования, выполненный с возможностью получать изображение, который может быть фотографировать или съемки видео, где модуль специально выполнен с возможностью выполнять способ на этапе 21, этапе 31, этапе 51, этапе 61 или этапе 71 в вышеупомянутом примере и способ, который может быть эквивалентен способу, и модуль может быть реализован процессором, вызывая соответствующую программную инструкцию в памяти для управления камерой для захвата изображения;

модуль 902 определения, выполненный с возможностью определять целевую область и область фона на изображении на основании содержимого изображения, где модуль специально выполнен с возможностью выполнять способ на этапе 22, этапе 32, этапе 52, этапе 62 или этапе 72 в вышеупомянутом примере и способ, который может быть эквивалентен способу, и модуль, может быть реализован процессором, вызывая соответствующую программную инструкцию в памяти для реализации соответствующего алгоритма; и