Область техники, к которой относится изобретение

Настоящее изобретение относится к области технологий, применяемых в терминалах, и в частности, к способу, аппаратуре и устройству для обработки изображений.

Уровень техники

Фотографирование представляет собой использование фото или видеокамеры, либо видеомагнитофона для записи изображения человека или объекта. Для различных сцен применяются разные способы фотографирования, такие как ночное фотографирование, фотографирования при дожде, фотографирование в здании и портретное фотографирование. Динамическое фотографирование для съемки движущихся объектов также является одним из видов фотографирования, но должно соответствовать конкретному, специальному принципу. По мере продвижения и развития науки фотографирование становилось проще и более популярным.

В связи с расширением полосы пропускания сети связи и увеличением процессорных возможностей терминала фотографирование и совместное использование видео и изображений стало более удобным, а потребление видео стало новым образом жизни для всех людей. Видео быстро стало сервисом, требующим передачи больших объемов трафика в сети связи, и ожидается, что в следующие несколько лет трафик видео составит от 80% до 90% общего трафика в сети.

В повседневной жизни фотографирование стало основным способом для людей показать себя и выявлять красоту вещей. Люди хотят фотографировать более интересными способами. Например, во время фотографирования осуществляются специальные эффекты обработки изображений или видео, чтобы добиться такого восприятия фотографии, когда «что Вы видите, то и получаете». Поэтому, для непрофессионала, в терминал необходимо интегрировать все больше новых технологий обработки изображения.

На текущий момент, функция видеозаписи в аппаратуре терминала является монотонной. На сегодня, может осуществляться только обычное фотографирование видео, без некоторых персонализированных эффектов.

Сущность изобретения

Настоящее изобретение предлагает способ обработки изображения. На изображении определяют целевую область и фоновую область путем осуществления сегментации изображения с применением маски (шаблона). К этим целевой области и фоновой области применяют различные режимы обработки цвета, так что яркость целевой области становится больше яркости фоновой области, либо насыщенность цвета в целевой области становится больше насыщенности цвета в фоновой области, так что главный объект, соответствующий целевой области, оказывается сильнее выделен. Это позволяет пользователю иметь специальные эффекты движущегося изображения в процессе фотографирования или видео фотографирования (видео съемки) и улучшить результаты фотографирования для пользователя.

В вариантах настоящего изобретения предложены следующие технические решения.

Согласно первому аспекту один из вариантов настоящего изобретения предлагает способ обработки изображения. Это способ применяется к процедуре видеозаписи и содержит: получение N изображений; и осуществление этапа 1 и этапа 2 применительно к каждому из N изображений для получения целевого видео:

этап 1: определение целевой области и фоновой области изображения на основе категории объекта на изображении, где фоновая область является областью изображения, отличной от целевой области; и

этап 2: обработка целевой области и фоновой области в разных режимах обработки цвета для получения целевого изображения, где насыщенность цвета в целевой области в целевом изображении выше насыщенности цвета в фоновой области в этом целевом изображении, либо яркость целевой области в целевом изображении выше яркости фоновой области в этом целевом изображении.

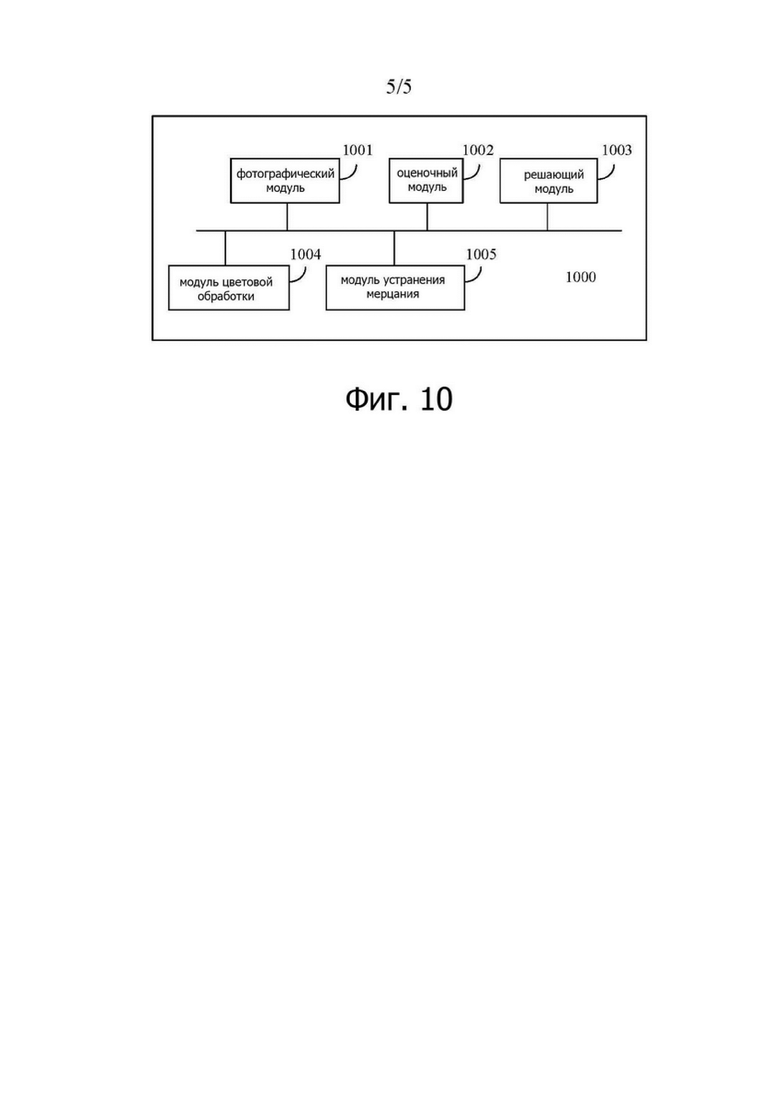

Согласно второму аспекту, один из вариантов настоящего изобретения предлагает аппаратуру для обработки изображения. Эта аппаратура применяется к процедуре видео фотографирования и содержит: фотографический модуль, конфигурированный для получения N изображений; решающий модуль, конфигурированный для определения целевой области и фоновой области в каждом из N изображений на основе категории объекта в этом изображении, где фоновая область является областью изображения, отличной от целевой области; и модуль цветовой обработки, конфигурированный для обработки целевой области и фоновой области в различных режимах цветовой обработки с целью получения целевого изображения, где насыщенность цвета в целевой области на целевом изображении больше насыщенности цвета в фоновой области в целевом изображении, или яркость целевой области в целевом изображении больше яркости фоновой области в целевом изображении.

Согласно третьему аспекту, один из вариантов настоящего изобретения предлагает способ обработки изображения. Этот способ применяется к процессу фотографирования и содержит:

получение изображения; определение целевой области и фоновой области в этом изображении на основе категории объекта, имеющегося на изображении, где фоновая область представляет собой область изображения, отличную от целевой области; и обработку найденных целевой области и фоновой области с применением разных режимов цветовой обработки для получения целевого изображения, где насыщенность цвета в целевой области целевого изображения больше насыщенности цвета в фоновой области этого целевого изображения, либо яркость целевой области целевого изображения больше яркости фоновой области этого целевого изображения.

Согласно четвертому аспекту, один из вариантов настоящего изобретения предлагает аппаратуру для обработки изображения. Аппаратура содержит:

фотографический модуль, конфигурированный для получения изображения; решающий модуль, конфигурированный для определения целевой области и фоновой области рассматриваемого изображения на основе категории объекта на этом изображении, где фоновая область представляет собой область изображения, отличную от целевой области; и модуль цветовой обработки, конфигурированный для обработки целевой области и фоновой области с применением разных режимов цветовой обработки для получения целевого изображения, где насыщенность цвета в целевой области целевого изображения больше насыщенности цвета в фоновой области этого целевого изображения, либо яркость целевой области целевого изображения больше яркости фоновой области этого целевого изображения.

Согласно первому аспекту, второму аспекту, третьему аспекту или четвертому аспекту в одном из возможных вариантов, процедура определения целевой области и фоновой области в изображении на основе категории объекта на этом изображении содержит: осуществление семантической сегментации изображения для получения k масок, где эти k масок соответствует различным категориям объектов; и

если k = 2 и совокупность этих двух масок содержит одну маску для главного объекта и одну фоновую маску, определяют область изображения, соответствующую маске для главного объекта, в качестве целевой области, и определяют область, соответствующую фоновой маске, в качестве фоновой области;

если k больше 2 и количество пикселей, входящих в k0 масок для главных объектов из совокупности указанных k масок, больше заданной пороговой величины, определяют область изображения, соответствующую этим k0 маскам для главных объектов, в качестве целевой области, и определяют область изображения, соответствующую одной из остальных масок, в качестве фоновой области, где k0 является неотрицательным целым числом меньше k;

если k больше 2, определяют, в качестве целевой области, область изображения, соответствующую маске, содержащей наибольшее количество пикселей и входящей в указанную совокупность k масок, и определяют область изображения, соответствующую остальным маскам, в качестве фоновой области;

если k больше 2, определяют целевую маску из совокупности k масок на основе заданных приоритетов категорий объектов, и определяют область изображения, соответствующую целевой маске, в качестве целевой области и определяют область изображения, соответствующую остальным маскам, в качестве фоновой области; или

если k больше 2, определяют целевую маску из совокупности k масок в соответствии с командой выбора от пользователя; и определяют область изображения, соответствующую целевой маске, в качестве целевой области, и определяют область изображения, соответствующую остальным маскам, в качестве фоновой области. Этот способ может быть конкретно выполнен решающим модулем.

Согласно первому аспекту, второму аспекту, третьему аспекту или четвертому аспекту в одном из возможных вариантов, процедура обработки целевой области и фоновой области с применением разных режимов цветовой обработки содержит, но не ограничивается этим:

сохранение цвета целевой области, и осуществление черно-белой обработки фоновой области;

сохранение цвета целевой области, и осуществление затемняющей обработки фоновой области;

сохранение цвета целевой области, и осуществление «размывающей» обработки фоновой области;

усиление цвета целевой области, и осуществление черно-белой обработки фоновой области;

усиление цвета целевой области, и осуществление затемняющей обработки фоновой области; или

усиление цвета целевой области, и осуществление «размывающей» обработки фоновой области.

В дополнение к этому, способ обработки фоновой области может далее содержать способ фильтрации темных тонов, например, способ ретро фильтрации или способ пленочной фильтрации. Этот способ, в частности, осуществляется модулем цветовой обработки.

Согласно первому аспекту, второму аспекту, третьему аспекту или четвертому аспекту в одном из возможных вариантов, категория объекта может представлять собой по меньшей мере одно из списка – человек, животное, растительность, заданный объект или фон.

Более конкретно, в упомянутых выше возможных вариантах технической реализации, процессор может вызвать программу и команду из запоминающего устройства для осуществления соответствующей обработки данных, такой как реализация алгоритмов и/или получение сигналов.

Согласно пятому аспекту, один из вариантов настоящего изобретения предлагает способ обработки изображения. Этот способ применяется к процедуре видеозаписи и, в частности, содержит: определение категории объекта, входящего в каждое полученное изображение; если в первых N0 изображениях относительно текущего изображения число групп соседних изображений с одним и тем же объектом, определяемых как разные категории объектов, не больше заданной пороговой величины, определение целевой области и фоновой области в текущем изображении на основе категории указанного объекта на изображении, где фоновая область представляет собой область текущего изобретения, отличную от целевой области; и обработку целевой области и фоновой области в первом режиме цветовой обработки и во втором режиме цветовой обработки, соответственно, для получения целевого изображения, где насыщенность цвета в целевой области целевого изображения больше насыщенности цвета в фоновой области этого целевого изображения, либо яркость целевой области целевого изображения больше яркости фоновой области этого целевого изображения; или если в первых N0 изображениях текущей съемки (текущего изображения), число групп соседних изображений с одним и тем же объектом, определяемых как разные категории объектов, больше заданной пороговой величины, обработку этого текущего изображения в первом режиме цветовой обработки или во втором режиме цветовой обработки для получения целевого изображения.

Согласно шестому аспекту, один из вариантов настоящего изобретения предлагает аппаратуру для обработки изображения. Эта аппаратура для обработки изображения используется в процессе видеозаписи и, в частности, содержит: фотографический модуль, конфигурированный для получения изображения; решающий модуль, конфигурированный для определения категории объекта, входящего в каждое полученное изображение; оценочный модуль, конфигурированный для того, чтобы: если в первых N0 изображениях относительно текущего изображения число групп соседних изображений с одним и тем же объектом, определяемых как разные категории объектов, не больше заданной пороговой величины, управлять решающим модулем для определения целевой области и фоновой области в текущем изображении на основе категории указанного объекта на изображении, где фоновая область представляет собой область текущего изображения, отличную от целевой области; и управлять модулем цветовой обработки для обработки целевой области и фоновой области в первом режиме цветовой обработки и во втором режиме цветовой обработки, соответственно, для получения целевого изображения, где насыщенность цвета в целевой области целевого изображения становится больше насыщенности цвета в фоновой области этого целевого изображения, либо яркость целевой области целевого изображения становится больше яркости фоновой области этого целевого изображения; или если в первых N0 изображениях относительно текущего изображения, число групп соседних изображений с одним и тем же объектом, определяемых как разные категории объектов, больше заданной пороговой величины, управлять модулем устранения мерцания с целью обработки текущего изображения в первом режиме цветовой обработки или во втором режиме цветовой обработки для получения целевого изображения.

Следует понимать, что текущее видео изображение может рассматриваться как изображение, записываемое в некоторый момент времени. В некоторых сценариях этот момент может считаться некоторым обобщенным моментом, либо в некоторых других сценариях это может быть какой-то конкретный момент, например, самый последний по времени момент, либо момент, которым интересуется пользователь.

Согласно пятому аспекту или шестому аспекту, в одном из возможных вариантов, процедура определения целевой области и фоновой области в текущем изображении на основе категории объекта в этом изображении содержит: осуществление семантической сегментации изображения с целью получения k масок, где эти k масок соответствуют разным категориям объектов; и

если k = 2 и совокупность этих двух масок содержит одну маску для главного объекта и одну фоновую маску, определяют область изображения, соответствующую маске для главного объекта, в качестве целевой области, и определяют область, соответствующую фоновой маске, в качестве фоновой области;

если k больше 2 и количество пикселей, входящих в k0 масок для главных объектов из совокупности указанных k масок, больше заданной пороговой величины, определяют область изображения, соответствующую этим k0 маскам для главных объектов, в качестве целевой области, и определяют область изображения, соответствующую одной из остальных масок, в качестве фоновой области, где k0 является неотрицательным целым числом меньше k;

если k больше 2, определяют, в качестве целевой области, область изображения, соответствующую маске, содержащей наибольшее количество пикселей и входящей в указанную совокупность k масок, и определяют область изображения, соответствующую остальным маскам, в качестве фоновой области;

если k больше 2, определяют целевую маску из совокупности k масок на основе заданных приоритетов категорий объектов, и определяют область изображения, соответствующую целевой маске, в качестве целевой области и определяют область изображения, соответствующую остальным маскам, в качестве фоновой области; или

если k больше 2, определяют целевую маску из совокупности k масок в соответствии с командой выбора от пользователя; и определяют область изображения, соответствующую целевой маске, в качестве целевой области, и определяют область изображения, соответствующую остальным маскам, в качестве фоновой области. Этот способ может быть, в частности, выполнен решающим модулем.

Согласно пятому аспекту или шестому аспекту, в одном из возможных вариантов, процедура обработки целевой области и фоновой области в разных режимах цветовой обработки содержит, но не ограничивается этим:

сохранение цвета целевой области, и осуществление черно-белой обработки фоновой области;

сохранение цвета целевой области, и осуществление затемняющей обработки фоновой области;

сохранение цвета целевой области, и осуществление «размывающей» обработки фоновой области;

усиление цвета целевой области, и осуществление черно-белой обработки фоновой области;

усиление цвета целевой области, и осуществление затемняющей обработки фоновой области; или

усиление цвета целевой области, и осуществление «размывающей» обработки фоновой области.

В дополнение к этому, способ обработки фоновой области может далее содержать способ фильтрации темных тонов, например, способ ретро фильтрации или способ пленочной фильтрации. Этот способ, в частности, осуществляется модулем цветовой обработки.

Согласно пятому аспекту или шестому аспекту, в одном из возможных вариантов, категория объекта может представлять собой по меньшей мере одно из списка – человек, животное, растительность, заданный объект или фон.

Более конкретно, в перечисленных выше возможных вариантах технической реализации в упомянутых выше возможных вариантах технической реализации, процессор может вызвать программу и команду из запоминающего устройства для осуществления соответствующей обработки данных, такой как реализация алгоритмов и/или получение сигналов.

Согласно седьмому аспекту, один из вариантов настоящего изобретения предлагает терминал, содержащий видеокамеру, запоминающее устройство, процессор и шину. Эти видеокамера, запоминающее устройство и процессор соединены одно с другим посредством шины. Видеокамера конфигурирована для захвата изображения, а запоминающее устройство конфигурировано для сохранения компьютерной программы и команд. Процессор конфигурирован для вызова компьютерной программы, команд и захваченного изображения, сохраняемых в запоминающем устройстве, и далее специально конфигурирован с целью позволить терминалу осуществить какой-либо один из указанных выше возможных вариантов способов.

Согласно седьмому аспекту, в одном из возможных вариантов этот терминал дополнительно содержит антенную систему. Эта антенная система принимает/передает сигнал радиосвязи под управлением процессора с целью осуществления радиосвязи с сетью мобильной связи. Сеть мобильной связи может представлять собой одну или более из следующих сетей: сеть GSM, сеть CDMA, сеть 3G, сеть 4G, сеть 5G, сеть FDMA, сеть TDMA, сеть PDC, сеть TACS, сеть AMPS, сеть WCDMA, сеть TDSCDMA, сеть Wi-Fi и сеть LTE.

Технические решения приведенных выше возможных вариантов могут быть скомбинированы, не вступая в противоречия с природой настоящего изобретения.

При использовании обычной технологии при фотографировании видео или изображений специальные эффекты оказываются недостаточно богатыми без различения между индивидуальными объектами или цветами в любом изображении. Согласно настоящему изобретению разные области изображения можно отличать одну от другой с использованием цветов, так что специальные эффекты фото или видео съемки оказываются усилены, вследствие чего главный объект и цель могут быть лучше выделены на изображении. Таким образом, главные роли становятся более заметными.

Краткое описание чертежей

Фиг. 1 представляет упрощенную схему структуры терминала согласно одному из вариантов настоящего изобретения;

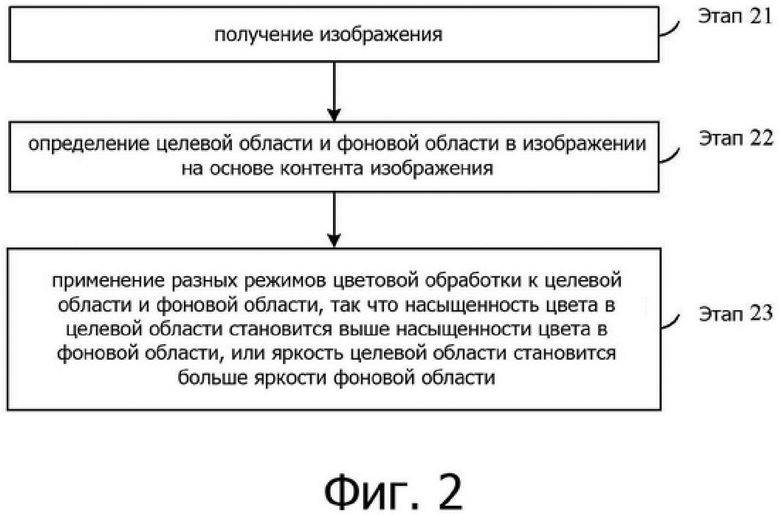

Фиг. 2 представляет логическую схему способа обработки изображения согласно одному из вариантов настоящего изобретения;

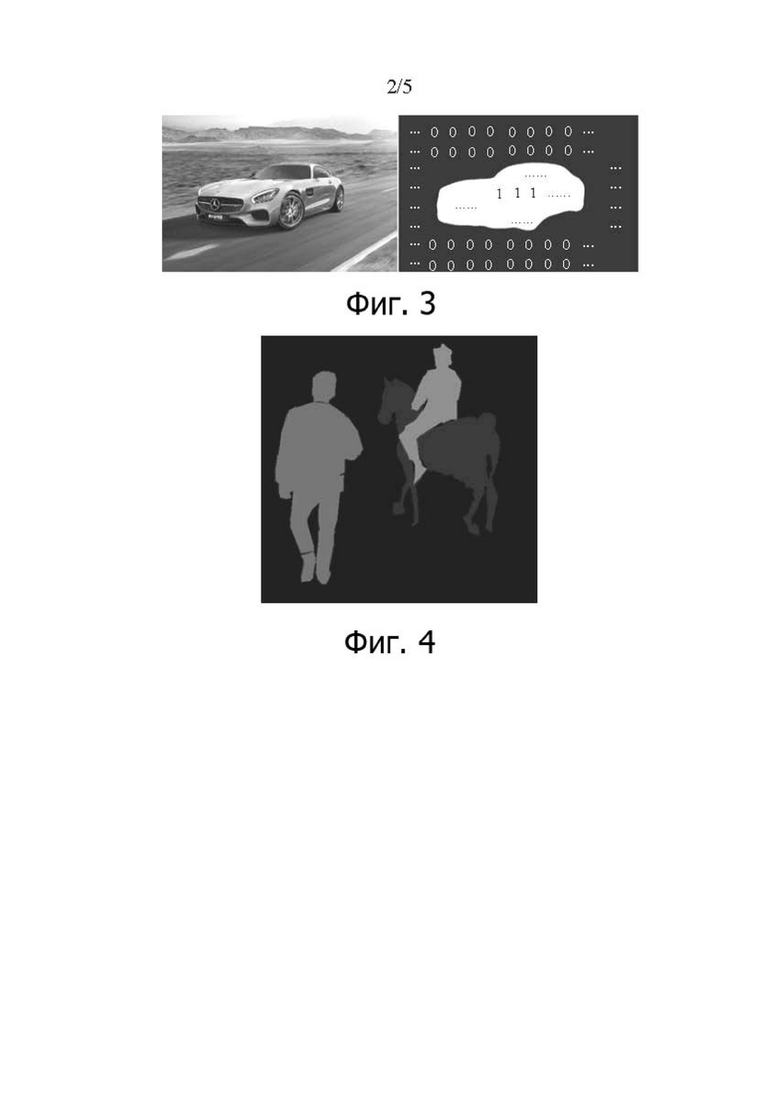

Фиг. 3 показывает пример идентификатора маски согласно одному из вариантов настоящего изобретения;

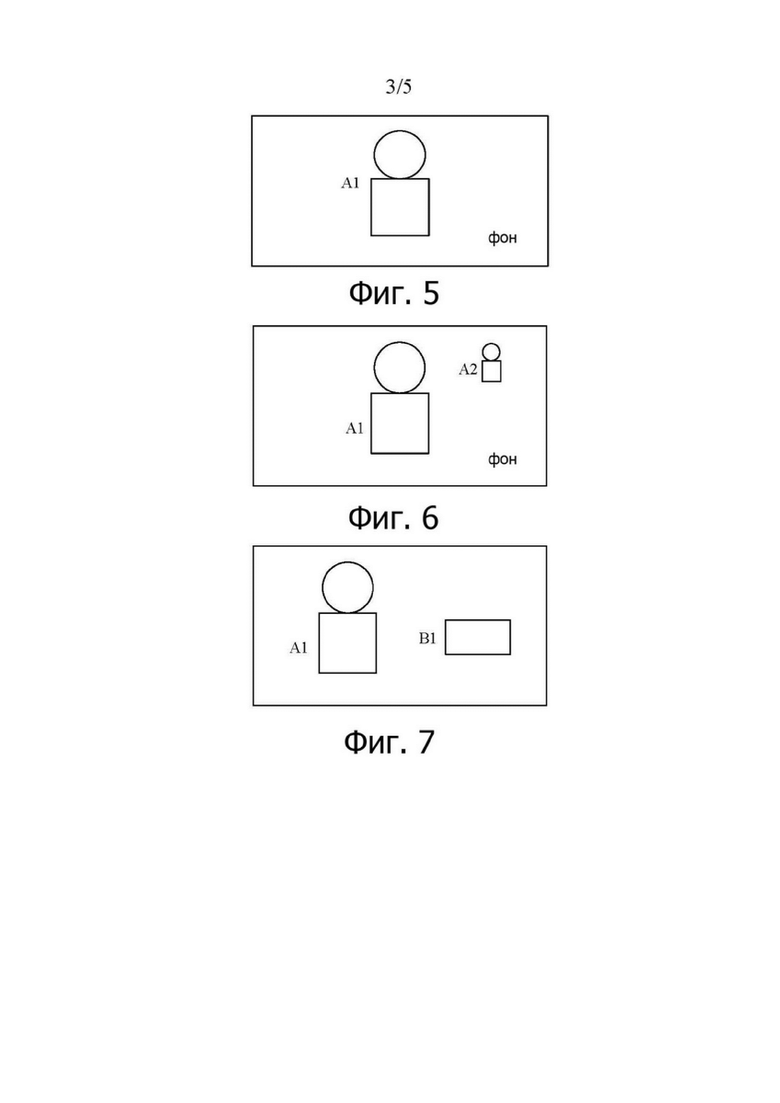

Фиг. 4 показывает другой пример идентификатора маски согласно одному из вариантов настоящего изобретения;

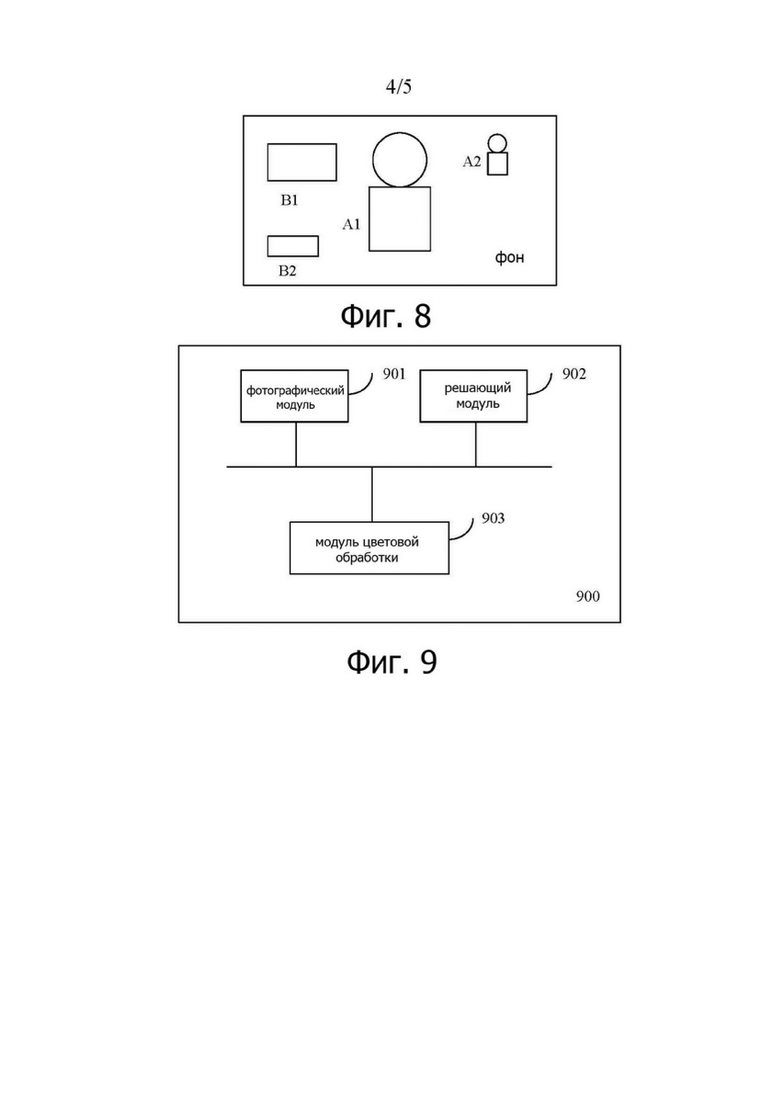

Фиг. 5 показывает упрощенную схему определения целевой маски согласно одному из вариантов настоящего изобретения;

Фиг. 6 показывает другую упрощенную схему определения целевой маски согласно одному из вариантов настоящего изобретения;

Фиг. 7 показывает другую упрощенную схему определения целевой маски согласно одному из вариантов настоящего изобретения;

Фиг. 8 показывает другую упрощенную схему определения целевой маски согласно одному из вариантов настоящего изобретения;

Фиг. 9 представляет упрощенную схему аппаратуры для обработки изображения согласно одному из вариантов настоящего изобретения; и

Фиг. 10 представляет другую упрощенную схему аппаратуры для обработки изображения согласно одному из вариантов настоящего изобретения.

Описание вариантов

Последующее четко и полностью описывает технические решения настоящего изобретения со ссылками на прилагаемые чертежи этих вариантов настоящего изобретения. Очевидно, что описываемые варианты представляют всего лишь некоторые, но не все, варианты настоящего изобретения. Все другие варианты, получаемые даже рядовыми специалистами в рассматриваемой области на основе представленных здесь вариантов настоящего изобретения без каких-либо особых творческих усилий, попадают в объем защиты настоящего изобретения.

В одном из вариантов настоящего изобретения терминал может представлять собой устройство, предоставляющее пользователю возможности для фотографирования и видеосъемки и/или соединение для передачи данных, ручное устройство, имеющее функцию беспроводного (радио) соединения, либо другое процессорное устройство, соединенное с беспроводным (радио) модемом, например, цифровую видеокамеру, зеркальную видеокамеру с одним объективом, мобильный телефон (или называемый также «сотовым телефоном») или смартфон. Терминал может представлять собой портативное, карманное, ручное или носимое устройство (например, интеллектуальные наручные часы), планшетный компьютер, персональный компьютер (personal computer (PC)), персональный цифровой помощник (PDA (Personal Digital Assistant)), автомобильный компьютер, дрон (беспилотный летательный аппарат), летательный аппарат или другой подобный объект.

Фиг. 1 представляет упрощенную схему одного из вариантов структуры аппаратуры терминала 100.

Как показано на Фиг. 1, терминал 100 может содержать компоненты, такие как высокочастотный модуль 110, запоминающее устройство 120, модуль 130 ввода, дисплейный модуль 140, видеокамеру 150, аудио схему 160 (содержащую громкоговоритель 161 и микрофон 162), процессор 170, внешний интерфейс 180 и источник 190 питания. Специалист в рассматриваемой области может понять, что на Фиг. 1 представлен всего лишь пример интеллектуального терминала или многофункционального устройства, который не накладывает каких-либо ограничений на интеллектуальный терминал или на многофункциональное устройство. Такой интеллектуальный терминал или многофункциональное устройство может содержать больше или меньше компонентов, чем показано на чертеже, либо комбинации таких компонентов, либо содержать другие компоненты. Например, такой интеллектуальный терминал или многофункциональное устройство содержит по меньшей мере запоминающее устройство 120, процессор 170 и видеокамеру 150.

Видеокамера 150 конфигурирована для захвата изображения или видео и может быть включена в работу в соответствии с командой от прикладной программы для осуществления функции фотографирования или функции фотографирования (съемки) видео. Видеокамера может содержать такие компоненты, как видео объектив, светофильтр и формирователь сигналов изображения. Световые лучи, испускаемые или отраженные объектом, входят в объектив, проходят сквозь светофильтр и, в конечном итоге, сходятся на формирователе сигналов изображения. Объектив конфигурирован главным образом для сведения, в изображение, света, излученного или отраженного всеми объектами (которые могут также называться сценарием, подлежащим фотографированию, объектами, подлежащими фотографированию, целевым сценарием или целевыми объектами и могут также рассматриваться как изображение сценария, которые пользователь желает фотографировать) в пределах угла зрения для фотографирования. Светофильтр конфигурирован главным образом для отфильтровывания избыточных световых волн (например, световых волн, отличных от видимого света, например, инфракрасного излучения) из световых лучей. Формирователь сигналов изображения конфигурирован главным образом для того, чтобы: осуществлять оптоэлектрическое преобразование принимаемого оптического сигнала, преобразование этого оптического сигнала в электрический сигнал и ввод полученного электрического сигнала в процессор 170 для последующей обработки. Видеокамера может быть расположена на передней стороне терминала или на задней стороне терминала. Конкретное число и конкретное расположение видеокамер можно определять гибко на основе требований конструктора или политики поставщика. В настоящей заявке это никак не ограничено.

Модуль 130 ввода может быть конфигурирован для приема вводимой цифровой или символьной информации и генерации введенного клавишами сигнала, относящегося к установкам пользователя и управлению функциями многофункциональной аппаратуры. В частности, модуль 130 ввода может содержать сенсорный экран 131 и/или другое устройство 132 ввода. Сенсорный экран 131 может собирать операцию прикосновения (например, операцию, осуществляемую пользователем на сенсорном экране или поблизости от сенсорного экрана с использованием какого-либо подходящего объекта, например, пальца, шарнира или стилуса) и управлять работой соответствующей аппаратуры связи на основе заданной программы. Сенсорный экран может обнаружить прикосновение пользователя к этому сенсорному экрану, преобразовать это прикосновение в соответствующий сигнал касания, передать этот сигнал касания процессору 170, а также может принять и выполнить команду, переданную процессором 170. Сигнал касания содержит по меньшей мере информацию о координатах точки контакта. Этот сенсорный экран 131 может создать интерфейс ввода и интерфейс вывода между терминалом 100 и пользователем. В дополнение к этому, сенсорный экран может быть реализован в виде устройств различного типа, таких как экраны резистивного типа, емкостного типа, инфракрасного типа или экраны с использованием поверхностной акустической волны. В дополнение к сенсорному экрану 131 модуль 130 ввода может также содержать другое устройство ввода. В частности, это другое устройство 132 ввода может представлять собой, без ограничений, одно или несколько из следующих устройств – физическую клавиатуру, функциональную клавишу (например, клавишу регулировки громкости и/или клавишу 133 включения/выключения), трекбол, мышь, джойстик или другое подобное устройство.

Дисплейный модуль 140 может быть конфигурирован для представления на дисплее информации, вводимой пользователем, или информации, предназначенной для пользователя, различных меню, используемых терминалом 100, интерактивного интерфейса, файла и/или воспроизведения какого-либо мультимедийного файла. В этом варианте настоящего изобретения дисплейный модуль дополнительно конфигурирован для представления изображения/видео, получаемого терминалом с использованием видеокамеры 150. Это изображение/видео может представлять собой изображение/видео для предварительного просмотра в некоторых режимах фотографирования, сфотографированное первоначальное изображение/видео и целевое изображение/видео к которому была применена обработка в соответствии со специальным алгоритмом после фотографирования.

Далее, сенсорный экран 131 может закрывать панель 141 дисплея. После обнаружения операции прикосновения на поверхности сенсорного экрана 131 или рядом с ним этот сенсорный экран 131 передает обнаруженную операцию прикосновения процессору 170 для определения типа события прикосновения. Затем процессор 170 создает соответствующий визуальный выходной сигнал на панели 141 дисплея на основе найденного типа события прикосновения. В этом варианте сенсорный экран и дисплейный модуль могут быть интегрированы в одном компоненте для осуществления функций ввода, вывода и дисплейных функций терминала 100. Для простоты описания, в этом варианте настоящего изобретения, сенсорный экран дисплея представляет множество функций сенсорного экрана и дисплейного модуля. В некоторых вариантах сенсорный экран и дисплейный модуль могут, в качестве альтернативы, использоваться как два независимых компонента.

Запоминающее устройство 120 может быть конфигурировано для сохранения команд и данных. Это запоминающее устройство 120 может в основном содержать область для хранения команд и область для хранения данных. Область для хранения данных может сохранять данные, такие как мультимедийный файл и текст. Область для хранения команд может содержать блоки программного обеспечения, такие как операционная система, приложение и команда, требуемая по меньшей мере для одной функции, подмножества функций или расширенного множества функций. Запоминающее устройство 120 может далее содержать энергонезависимое запоминающее устройство с произвольной выборкой и предоставлять процессору 170 ряд функций, включая, в том числе, управление аппаратурой, программным обеспечением и ресурсами данных в компьютерном процессорном устройстве и поддержку управления программным обеспечением и приложением. Запоминающее устройство 120 далее конфигурировано для хранения мультимедийного файла и хранения выполняемой программы и приложения.

Процессор 170 представляет собой центр управления терминалом 100 и соединен с разными частями всего терминала через различные интерфейсы и линии. Этот процессор 170 осуществляет различные функции терминала 100 и обрабатывает данные посредством выполнения команд, сохраняемых в запоминающем устройстве 120, и вызова данных, сохраняемых в этом запоминающем устройстве 120, с целью осуществления общего управления терминалом. В качестве опции, процессор 170 может содержать один или несколько процессорных модулей. Предпочтительно, этот процессор 170 может быть интегрирован с процессором приложений и процессором модема. Процессор приложений главным образом исполняет операционную систему, выполняет функции интерфейса пользователя, выполняет программу приложения и другие подобные программы. Процессор модема главным образом обрабатывает функции радиосвязи. Можно понять, что в альтернативном варианте процессор модема может не быть интегрирован в процессор 170. В некоторых вариантах процессор и запоминающее устройство могут быть, в качестве альтернативы, реализованы в одном кристалле интегральной схемы. В некоторых вариантах, процессор и запоминающее устройство могут быть, соответственно, реализованы на независимых кристаллах интегральных схем. Процессор 170 может быть далее конфигурирован для того, чтобы: генерировать соответствующий сигнал управления работой, передавать этот сигнал управления работой соответствующему компоненту в компьютерном процессорном устройстве и считывать и обрабатывать данные посредством программного обеспечения, и, в частности, считывать и обрабатывать данные и программы в запоминающем устройстве 120, так что функциональные модули в процессоре 170 осуществляют соответствующие функции для управления соответствующими компонентами с целью выполнения действий, как этого требуют команды.

Высокочастотный модуль 110 может быть конфигурирован для приема и передачи информации или для приема и передачи сигнала в процессе вызова. Например, высокочастотный модуль 110 принимает информацию нисходящей линии от базовой станции, затем передает эту информацию нисходящей линии процессору 170 для обработки и передает соответствующие данные восходящей линии в адрес базовой станции. Обычно, высокочастотный модуль содержит, не ограничиваясь этим, антенну, по меньшей мере один усилитель, приемопередатчик, направленный ответвитель (элемент связи), малошумящий усилитель (МШУ (Low Noise Amplifier, LNA)), дуплексер и другие подобные компоненты. В дополнение к этому, высокочастотный модуль 110 может далее осуществлять связь с сетевым устройством и с другим устройством посредством радиосвязи. Такая радиосвязь может использовать какой-либо стандарт или протокол связи, включая без ограничений, стандарт глобальной системы мобильной связи (Global System for Mobile Communications, GSM), стандарт системы пакетной радиосвязи общего пользования (General Packet Radio Service, GPRS), стандарт многостанционного доступа с кодовым уплотнением (Code Division Multiple Access, CDMA), стандарт широкополосного многостанционного доступа с кодовым уплотнением (Wideband Code Division Multiple Access, WCDMA), стандарт долговременной эволюции (Long Term Evolution, LTE), электронную почту, сервис коротких сообщений (Short Message Service, SMS) и другие подобные стандарты.

Аудио схема 160, громкоговоритель 161 и микрофон 162 могут создать аудио интерфейс между пользователем и терминалом 100. Аудио схема 160 может передавать громкоговорителю 161 электрический сигнал, преобразованный из принятых аудиоданных, а громкоговоритель 161 преобразует этот электрический сигнал в звуковой сигнал для излучения звука. В дополнение к этому, микрофон 162 конфигурирован для сбора звукового сигнала и может далее преобразовывать собранный звуковой сигнал в электрический сигнал. Аудио схема 160 принимает этот электрический сигнал, преобразует электрический сигнал в аудиоданные, передает эти аудиоданные процессору r 170 для обработки и затем передает обработанные аудиоданные, например, другому терминалу через высокочастотный модуль 110 или передает эти обработанные аудиоданные в запоминающее устройство 120 для дальнейшей обработки. Аудио схема может содержать гнездо 163 для подключения наушников (головных телефонов), конфигурированное для создания соединительного интерфейса между аудио схемой и наушниками. Конкретное количество и конкретные схемы расположения громкоговорителей и микрофонов можно гибко определять на основе требований конструктора или политики поставщика. В настоящей заявке это никак не ограничено.

Терминал 100 далее содержит источник 190 питания (например, аккумулятор), который обеспечивает энергией каждый компонент. Предпочтительно, этот источник питания может быть логически соединен с процессором 170 с использованием системы управления питанием для реализации таких функций, как заряд, разряд и управление потреблением энергии с применением этой системы управления питания.

Терминал 100 далее содержит внешний интерфейс 180. Этот внешний интерфейс может представлять собой стандартный микро-USB порт, либо может быть выполнен в виде многоштырькового разъема. Этот внешний интерфейс может быть конфигурирован для соединения терминала 100 с другой аппаратурой для связи, либо может быть конфигурирован для присоединения к зарядному устройству с целью заряда аккумулятора терминала 100.

Хотя это не показано, терминал 100 может далее содержать лампу-вспышку, модуль «беспроводной достоверности» (wireless fidelity, Wi-Fi), модуль Bluetooth, датчики с различными функциями и другие подобные компоненты. Подробности здесь не описаны. К терминалу, показанному на Фиг. 1, могут быть применены некоторые или все способы, описываемые ниже.

Настоящее изобретение может быть применено к терминалу, имеющему функцию фотографирования (включая по меньшей мере одну из функций – функцию обычного фотографирования или функцию фотографирования видео), так что реализованный продукт может иметь форму интеллектуального терминала, например, это может быть продукт, в котором установлена видеокамера, например, мобильный телефон, планшет, камера прямого видения (DV), видеокамера, фотокамера, портативный компьютер, компьютер ноутбук, интеллектуальный робот, телевизор, система обеспечения безопасности или дрон (беспилотный летательный аппарат). В частности, функциональные модули настоящего изобретения могут быть развернуты на кристалле интегральной схемы цифрового процессора сигнала (DSP) соответствующего устройства и могут, в частности, представлять собой прикладную программу или программное обеспечение кристалла процессора DSP. Согласно настоящему изобретению эти функциональные модули развернуты в терминале для реализации функции обработки изображения посредством инсталлированного или обновленного программного обеспечения во взаимодействии с соответствующей аппаратурой.

Настоящее изобретение применяется главным образом к сценарию, в котором фотографирование изображения или видео осуществляется с использованием терминала. Люди имеют все более и более высокие требования к фотографированию видео и ожидают достижения полного спектра специальных эффектов при обработке видео в процессе фотографирования для получения при фотографировании видео типа «что Вы видите, то и получаете». Согласно настоящему изобретению, применительно к изображению или видео может быть осуществлено сегментирование главного объекта, а также могут быть скорректированы цвета различных областей для реализации специальных эффектов изображения в реальном времени.

Подробнее см. Фиг. 2. На Фиг. 2 представлена логическая схема способа обработки изображения согласно одному из вариантов настоящего изобретения. Способ этот может быть осуществлен в процессе фотографирования или видео. В последующем настоящее изобретение будет описано с использованием примеров.

Пример 1: фотографирование изображения (режим фотографирования)

Для этого примера, в процессе конкретной реализации, терминал может конфигурировать режим фотографирования. В этом режиме фотографирования способ может содержать следующие этапы.

Этап 21: Получение (что также можно понимать как фотографирование или захват) изображения.

В частности, когда пользователь осуществляет съемку изображения, на экране дисплея также представляется соответствующий поток предварительного просмотра. Термин «изображение для предварительного просмотра» в общем случае относится к одному из изображений в потоке для предварительного просмотра. Когда пользователь нажимает на спуск затвора, получается фотографическое изображение. Сфотографированное изображение имеет размер, например, но не ограничиваясь этим, 1920 x 1080.

Этап 22: Определение целевой области и фоновой области в изображении на основе контента (что можно понимать как семантику сцены) сфотографированного изображения. Более конкретно, целевая область и фоновая область в изображении могут быть определены на основе категории объекта на этом изображении. Фоновая область представляет собой область изображения, отличную от целевой области. Целевая область соответствует целевому объекту или целевому телу на изображении, а именно, объекту, который пользователь ожидает выделить (подчеркнуть) на изображении и который может быть связан с интерактивным выбором пользователя или с настройками системы. В частности, этап 22 может содержать шаги с S221 по S224.

S221: Предварительная обработка изображения.

Сфотографированное изображение первоначального размера подвергают понижающей дискретизации (субдискретизации) и преобразуют в изображение с меньшим разрешением. Объем вычислений может быть уменьшен, когда вычисления осуществляются на основе небольшого изображения. В процессе конкретной реализации первоначальный размер (например, m0 x n0) может быть подвергнут понижающей дискретизации до размера m x n. Меньшие величины m и n указывают на меньший объем последующих вычислений. Однако если величины m и n будут слишком маленькими, разрешение пикселей в последующем уменьшается. Эксперименты показали, что подходящими диапазонами значений m и n являются [128, 512], и более конкретно [256, 300]. В дополнение к этому, величины m и n могут быть равны или неравны одна к другой. Например, изображение 1920 x 1080 может посредством понижающей дискретизации быть преобразовано к размеру 256 x 256.

S222: Ввод подвергнутого понижающей дискретизации изображения размером m x n в нейронную сеть для осуществления семантической сегментации с целью определения маски изображения (Mask).

Под семантической сегментацией понимают сегментацию на уровне пикселей, осуществляемую применительно к объекту на изображении, и маркируют категорию объекта для каждого пикселя. Область, которая не маркирована категорией объекта, маркируется как «фон».

В частности, семантическая сегментация может использовать алгоритм глубокого обучения на основе сверточной нейронной сети (CNN (Convolutional Neural Network)). В частности, модель сети на основе CNN описана следующим образом:

(1) Осуществляются понижающая дискретизация и свертка применительно к изображению размером m x n для получения изображения m1 x n1, изображения m2 x n2, ..., и изображения mz x nz, и затем выделяют семантические признаки изображения слой за слоем для получения карты признаков m1 x n1, карты признаков m2 x n2, ..., и карты признаков mz x nz, а именно многоуровневые семантические признаки, где m1, m2, ..., и mz находятся в кратном соотношении с числом m и меньше этого числа, и где n1, n2, ..., nz находятся в кратном соотношении с числом n и меньше этого числа. Например, m = 2m1 = 4m2 =, ..., = x mz, и n = 2n1 = 4n2 =, ..., =

x mz, и n = 2n1 = 4n2 =, ..., = x nz. Величина z и соотношение кратности могут быть определены на основе характеристик алгоритма и проектных требований.

x nz. Величина z и соотношение кратности могут быть определены на основе характеристик алгоритма и проектных требований.

(2) К карте признаков m1 x n1, карте признаков m2 x n2, ..., и карте признаков mz x nz применяют повышающую дискретизацию (передискретизацию) и свертку для слияния многоуровневых семантических признаков.

Способы свертки, понижающей дискретизации и повышающей дискретизации, упомянутые выше, могут использовать технологии, которые хорошо известны в промышленности и не исчерпываются тем, что перечислено в настоящем описании.

(3) Определяют категорию объекта, которую нужно идентифицировать в изображении, вычисляют балл для каждой категории объекта на каждом пикселе, категорию объекта (которая может для краткости называться «категорией») с наивысшим баллом используют в качестве результата классификации для рассматриваемого пикселя, и в конечном итоге получают граф маски, а именно маску.

Например, если терминал может идентифицировать k категорий объектов (например, по меньшей мере одну категорию из списка – человек, животное, растительность, другой заданный объект или фон), можно получить k изображений. Каждый пиксель изображения получает балл, принадлежащий какой-либо категории объекта. Более высокий балл обозначает более высокую вероятность, что пиксель принадлежит соответствующей категории объекта.

После того, как будет определена категория объекта для какого-либо пикселя, этот пиксель может быть идентифицирован. Например, 1 используется для обозначения человека, 2 используется для обозначения транспортного средства (автомобиля), 3 используется для обозначения животного, 4 используется для обозначения растительности, и 0 используется для обозначения фона. Это всего лишь пример и не составляет каких-либо ограничений. Пользователь может случайным образом установить число категорий, сами категории и способ идентификации на основе проектных требований. Конкретный пример может быть показан на Фиг. 3. Нейронная сеть классифицирует все области пикселей, где находится автомобиль, в качестве автомобиля и присваивает им идентификатор 1. Все области пикселей в окружающей фоновой части нейронная сеть классифицирует в качестве фона и присваивает им идентификатор 0. Для другого примера, в маске, передаваемой нейронной сетью на выход, области объектов одинаковой категории имеют одинаковую маркировку. Например, маркер для фона равен 0, маркер для кошки равен 1 и маркер для скейтборда равен 2. В маске, показанной на Фиг. 4, один и тот же цвет может быть далее использован для представления маркеров объектов одинаковой категории. Например, человека, лошадь и фон соответственно идентифицируют с использованием различных цветов.

Маска является результатом работы алгоритма семантической сегментации. На изображении, все пиксели, принадлежащие какой-либо категории объекта, маркированы цветом или идентификатором, и фон также маркируют цветом или идентификатором. Изображение, полученное после обработки, называют маской, так что результат сегментации представляют на дисплее интуитивно.

Контент изображения может содержать главный объект и фон. Для простоты описания, соответственно, маска изображения может представлять собой маску для главного объекта или фоновую маску. Маска для главного объекта может соответствовать главному объекту, идентифицированному с использованием способа сегментации, включая индивидуальные объекты, которые пользователь ожидает увидеть выделенными («подчеркнутыми») на изображении или на сфотографированном изображении, например, человека, животное, растительность или конкретный объект (чашку, стол, одежду, декорацию…). Фоновая маска соответствует другой области, которая имеется на изображении и которая не идентифицирован в качестве маски для главного объекта. Маска изображения соответствует полному изображению. Способность идентификации маски для главного объекта связана с характеристиками нейронной сети. Например, некоторые нейронные сети могут идентифицировать только человека и фон. Некоторые нейронные сети могут идентифицировать человека, автомобиль и фон. Некоторые нейронные сети могут идентифицировать человека, животное и фон. Некоторые нейронные сети могут идентифицировать только животное и фон. Некоторые нейронные сети могут идентифицировать животное, растительность и фон...

Следует понимать, что изображение может, в качестве альтернативы, содержать только главный объект или может содержать только фон. Когда изображение содержит только главный объект, этот главный объект может быть идентифицирован в качестве фона. Эти настройки относительно главного объекта и фона в изображении могут быть гибко сконструированы и определены проектировщиком.

Для обучения глубокой нейронной сети может потребоваться большой объем настроечных данных сегментации, где множество настроечных данных содержит большое число изображений, включая категории сегментации объектов, входные изображения и графы масок. Множество настроечных данных может охватывать разнообразные типовые сценарии приложений для сегментации объекта и содержать разнообразные данные. Входные изображения и графы масок в составе множества настроечных данных используются для обучения (настройки) сети с целью получения превосходного параметра сети, другими словами, получения характеристик сегментации, удовлетворяющих пользователя. Полученный параметр сети применяется в качестве окончательно используемого вычислительного параметра для нейронной сети.

S223: Определение целевой маски на основе совокупности масок.

Для различных изображений и нейронных сетей с различными возможностями могут быть получены разнообразные маски. Терминал может далее определить из совокупности масок одну маску, соответствующую объекту, который в наибольшей степени необходимо выделить и сделать заметным на дисплее. Иными словами, нужно определить целевую маску. Процедура определения целевой маски содержит, не ограничиваясь этим, следующие несколько способов.

Способ 1: Если совокупность масок содержит только одну маску для главного объекта и одну фоновую маску, маску для главного объекта определяют в качестве целевой маски.

В частности, предположим, что на изображении осуществляется семантическая сегментация для получения k масок. Эти k масок соответствуют различным категориям объектов. Если k = 2 и совокупность этих двух масок содержит одну маску для главного объекта и одну фоновую маску, определяют область изображения, соответствующую маске для главного объекта, в качестве целевой области, и определяют область, соответствующую фоновой маске, в качестве фоновой области;

Как показано на Фиг. 5, совокупность масок для изображения на выходе нейронной сети содержит только одну маску A1 для главного объекта и одну фоновую маску. В этом случае, маска A1 может быть определена в качестве целевой маски.

Способ 2: Когда совокупность масок содержит несколько масок для главных объектов и одну фоновую маску, если количество пикселей, входящих в какую-либо маску для главного объекта, больше конкретной пороговой величины, эту маску для главного объекта определяют в качестве маски для целевого главного объекта; или если количество пикселей, входящих в какую-либо маску для главного объекта, меньше конкретной пороговой величины, изменяют маркировку этой маски для главного объекта и также маркируют ее в качестве фона. Количество пикселей, входящих в маску для главного объекта, может представлять собой количество пикселей, входящих в область индивидуального объекта на изображении.

В частности, предположим, что на изображении осуществляется семантическая сегментация для получения k масок. Эти k масок соответствуют различным категориям объектов. Если k больше 2 и количество пикселей, входящих в k0 масок для главных объектов из совокупности k масок, больше заданной пороговой величины, область изображения, соответствующую этим k0 маскам для главных объектов, определяют в качестве целевой области, а область изображения, соответствующую остальным маскам, определяют в качестве фоновой области, где k0 представляет собой неотрицательное целое число меньше k.

Как показано на Фиг. 6, совокупность масок для изображения на выходе нейронной сети содержит маску A1 для главного объекта, маску A2 для главного объекта, и фоновую маску. Если количество пикселей, входящих в маску A1, больше заданной пороговой величины и количество пикселей, входящих в маску A2, не больше заданной пороговой величины, маску A1 определяют в качестве целевой маски, а маркировку маски A2 для главного объекта изменяют и заново маркируют ее в качестве фоновой маски. Маска с измененной маркировкой может быть показана на Фиг. 5. Если количество пикселей, входящих в маску A1, больше заданной пороговой величины и количество пикселей, входящих в маску A2, также больше заданной пороговой величины, обе маски A1 и A2 определяют в качестве целевых масок. Если ни количество пикселей, входящих в маску A1, ни количество пикселей, входящих в маску A2, не больше заданной пороговой величины, эти маски A1 и A2 заново идентифицируют в качестве фоновых масок. Другими словами, рассматриваемое изображение не содержит маски для главного объекта.

Должно быть понятно, что в какой-либо конкретной процедуре реализации обе маски A1 и A2 могут быть отнесены к одной и той же категории объекта или к разным категориям объектов.

Способ 3: Когда совокупность масок содержит несколько масок для главных объектов и одну фоновую маску, маску для главного объекта, содержащую наибольшее количество пикселей, выбирают в качестве целевой маски, маркировку других масок для главных объектов изменяют и заново маркируют их в качестве фоновых масок.

В частности, предположим, что на изображении осуществляется семантическая сегментация для получения k масок. Эти k масок соответствуют различным категориям объектов. Если k больше 2, область изображения, соответствующую маске для главного объекта, содержащей наибольшее количество пикселей и входящей в совокупность k масок, определяют в качестве целевой области, а область изображения, соответствующую остальным маскам, определяют в качестве фоновой области.

Как показано на Фиг. 6, совокупность масок для изображения на выходе нейронной сети содержит маску A1 для главного объекта, маску A2 для главного объекта и фоновую маску. Маску A1, содержащую наибольшее количество пикселей, определяют в качестве целевой маска, а маркировку маски A2 для главного объекта изменяют и заново маркируют ее в качестве фоновой маски. Эта заново маркированная маска может быть показана на Фиг. 5.

Должно быть понятно, что в какой-либо конкретной процедуре реализации обе маски A1 и A2 могут быть отнесены к одной и той же категории объекта или к разным категориям объектов.

Способ 4: Когда совокупность масок содержит несколько масок для главных объектов и одну фоновую маску, а в число нескольких масок для главных объектов входят маски для нескольких категорий объектов, целевую маску определяют на основе приоритетов этих категорий объектов. Например, если приоритет маски для человека выше приоритета маски для автомобиля, маска для человека является целевой маской, а маркировка маски для автомобиля может быть изменена и эта маска может быть заново маркирована в качестве фона. Например, если приоритет маски для человека выше приоритета маски для животного и выше приоритета маски для растительности, а система установила приоритеты таким образом, что все маски с приоритетами выше приоритета маски для растительности являются масками для главных объектов, обе маски – и маска для человека, и маска для животного, считаются целевыми масками, а маркировка маски для растительности может быть изменена, и эта маска может быть маркирована заново в качестве фона. Должно быть понятно, что один или несколько индивидуальных объектов могут принадлежать к одной и той же категории объектов.

В частности, предположим, что на изображении осуществляется семантическая сегментация для получения k масок. Эти k масок соответствуют различным категориям объектов. Если k больше 2, целевую маску определяют из этих k масок на основе заданных приоритетов категорий объектов. Область изображения, соответствующую целевой маске, определяют в качестве целевой области, а область изображения, соответствующую остальным маскам определяют в качестве фоновой области.

Как показано на Фиг. 7, совокупность масок для изображения на выходе нейронной сети содержит маску A1 для главного объекта, маску B1 для главного объекта и фоновую маску. Маски A1 и B1 относятся к различным категориям объектов, причем приоритет маски A1 выше приоритета маски B1. Если система устанавливает, что любая маска для главного объекта, приоритет которой не ниже приоритета маски B1, может быть использована в качестве целевой маски, обе маски A1 и B1 являются целевыми масками. Если система устанавливает, что маска для главного объекта, приоритет которой выше приоритета маски B1, может быть использована в качестве целевой маски, маску A1 определяют в качестве целевой маски, а маркировку маски B1 изменяют и заново маркируют эту маску в качестве фоновой маски.

Способ 5: Если совокупность масок содержит несколько масок для главных объектов и одну фоновую маску, целевая маска может быть определена в соответствии с введенной пользователем операцией выбора. Режим ввода содержит, не ограничиваясь, команду выбора, такую как прикосновение к экрану или голосовая команда. Маска для главного объекта, соответствующая индивидуальному объекту, выбранному пользователем, является целевой маской.

В частности, предположим, что на изображении осуществляется семантическая сегментация для получения k масок. Эти k масок соответствуют различным категориям объектов. Если k больше 2, целевую маску определяют из совокупности k масок в соответствии с командой выбора от пользователя. Область изображения, соответствующую целевой маске, определяют в качестве целевой области, а область изображения, соответствующую остальным маскам, определяют в качестве фоновой области.

Как показано на Фиг. 7, совокупность масок для изображения на выходе нейронной сети содержит маску A1 для главного объекта, маску B1 для главного объекта и фоновую маску. Если пользователь нажмет, в процессе фотографирования, на индивидуальный объект, соответствующий маске A1, на сенсорном экране, эту маску A1 определяют в качестве целевой маски, и изменяют маркировку маски B1, заново маркируя ее в качестве фоновой маски. Если пользователь нажмет, в процессе фотографирования, на индивидуальный объект, соответствующий маске B1 на сенсорном экране, эту маску B1 определяют в качестве целевой маски, и изменяют маркировку маски A1, заново маркируя ее в качестве фоновой маски.

Способ 6: Если совокупность масок содержит несколько масок для главных объектов и одну фоновую маску, а в число нескольких масок для главных объектов входят маски для нескольких категорий объектов, целевая маска может быть определена на основе введенной пользователем операции выбора. Режим ввода содержит, не ограничиваясь, команду выбора, такую как прикосновение к экрану или голосовая команда. Все маски для главных объектов, имеющие категорию объекта, соответствующую индивидуальному объекту, выбранному пользователем, являются целевыми масками.

В частности, предположим, что на изображении осуществляется семантическая сегментация для получения k масок. Эти k масок соответствуют различным категориям объектов. Если k больше 2, целевую маску определяют из совокупности этих k масок в соответствии с командой выбора от пользователя. Область изображения, соответствующую целевой маске, определяют в качестве целевой области, а область изображения, соответствующую остальным маскам, определяют в качестве фоновой области.

Как показано на Фиг. 8, совокупность масок для изображения на выходе нейронной сети содержит маски A1, A2, B1 и B2 для главных объектов и одну фоновую маску. Маски A1 и A2 относятся к одной и той же категории объектов, и маски B1 и B2 также относятся к одной и той же категории объектов. Если пользователь нажмет, в процессе фотографирования, на индивидуальный объект, соответствующий маске A1, на сенсорном экране, маски A1 и A2, относящиеся к одной и той же категории объектов, определяют в качестве целевых масок, а маркировку масок B1 и B2 изменяют и заново маркируют эти маски в качестве фоновых масок. Если пользователь нажмет, в процессе фотографирования, на индивидуальный объект, соответствующий маске B2, на сенсорном экране, маски B1 и B2, относящиеся к одной и той же категории объектов, определяют в качестве целевых масок, а маркировку масок A1 и A2 изменяют и заново маркируют эти маски в качестве фоновых масок.

Следует понимать, что приведенные выше конкретные варианты реализации изобретения являются всего лишь примерами и не должны составлять ограничения. Эти приведенные выше конкретные варианты реализации изобретения можно свободно комбинировать, не нарушая логики изобретения. Поэтому, после осуществления сегментации масок применительно к изображению могут быть получены несколько целевых масок. Эти целевые маски могут относиться к одной или нескольким категориям объектов, и каждая категория объектов для этих целевых масок может далее охватывать один или несколько индивидуальных объектов. Представленный на дисплее результат относится к правилу, которое устанавливается в системе терминала и которое предназначено для определения целевой маски и для ввода от пользователя. В некоторых сценариях изображение может, в качестве альтернативы, содержать только одну фоновую маску.

s224: Определение целевой области и фоновой области в первоначальном изображении.

Первоначальный размер сфотографированного изображения получают из совокупности масок, при этом целевую маску и фоновую маску из этой совокупности масок также подвергают повышающей дискретизации. Область, составленная всеми пикселями подвергнутой повышающей дискретизации целевой маски и соответствующая первоначальному изображению, является целевой областью, а область, составленная всеми пикселями подвергнутой повышающей дискретизации фоновой маски и соответствующая первоначальному изображению, является фоновой областью.

Этап 23: Обработка целевой области и фоновой области в изображении в разных режимах цветовой обработки с целью получения целевого изображения. Для обработки используются разные режимы цветовой обработки, так что насыщенность цвета в целевой области оказывается больше насыщенности цвета в фоновой области, либо яркость в целевой области становится больше яркости в фоновой области. Другими словами, насыщенность цвета в целевой области целевого изображения больше насыщенности цвета в фоновой области, либо яркость в целевой области целевого изображения, больше яркости в фоновой области целевого изображения.

В частности, первый режим цветовой обработки и второй режим цветовой обработки используются соответственно для целевой области и фоновой области в изображении. Эти первый режим цветовой обработки и второй режим цветовой обработки содержат, не ограничиваясь этим, следующие способы.

Способ 1: Первый режим цветовой обработки сохраняет цвет, а второй режим цветовой обработки использует фильтр, например, преобразующий цвет фоновой области в черно-белую окраску. К типовым фильтрам относятся черно-белый фильтр, затемняющий фильтр, ретро фильтр, пленочный фильтр, фильтр размытости, фильтр бликов (фильтр боке) и другие подобные фильтры.

Например, черно-белый фильтр предназначен для отображения каждой величины пикселя в полутоновую величину с целью реализации эффекта черно-белого фильтра. В качестве другого примера, затемняющий фильтр предназначен для снижения яркости величины каждого пикселя с целью достижения специального затемняющего эффекта.

Способ 2: Первый режим цветовой обработки представляет собой первый способ фильтрации, второй режим цветовой обработки представляет собой второй способ фильтрации, причем первый способ фильтрации отличается от второго способа фильтрации. Для одного и того же изображения, насыщенность цвета изображения, полученного с использованием первого способа фильтрации, больше насыщенности цвета изображения, полученного с использованием второго способа фильтрации.

Способ 3: Первый режим цветовой обработки представляет собой третий способ фильтрации, второй режим цветовой обработки представляет собой четвертый способ фильтрации. Для одного и того же изображения, насыщенность цвета изображения, полученного с использованием третьего способа фильтрации, больше насыщенности цвета изображения, полученного с использованием четвертого способа фильтрации.

Должно быть понятно, что цвет представлен обоими параметрами – яркостью и насыщенностью цвета. Насыщенность цвета представляет собой свойство цвета, которое не охватывает яркость, а отражает тон и собственно насыщенность цвета, а яркостью называется свечение или степень светлоты цвета. Поэтому, цветовая обработка содержит обработку яркости и/или обработку насыщенности цвета.

В частности, фильтрация может содержать регулирование насыщенности цвета, яркости и цветового тона и может далее содержать наложенную текстуру и другие подобные факторы. Цветовую систему можно регулировать целевым образом путем регулирования насыщенности цвета и цветового тона, так что цветовая система становится более плотной или более светлой, либо изменяется цветовой тон, а другая цветовая система остается неизменной. Процесс фильтрации можно также понимать как отображения пикселя-в-пиксель. Величину пикселя входного изображения отображают в величину целевого пикселя с использованием заданной таблицы отображения с целью достижения специального эффекта. Следует понимать, что фильтр может представлять собой заданную параметрическую маску. Такими относящимися к цвету параметрами могут быть параметры фильтрующей маски, хорошо известные в промышленности, либо это могут быть параметры, независимо назначаемые пользователем.

В дополнение к этому, после этапа 23, способ далее содержит этап 24 для сохранения изображения, обработанного на этапе 23.

Согласно настоящему изобретению, в процессе фотографирования, терминал может определить целевой индивидуальный объект и фон на основе содержания изображения и осуществить различную цветовую обработку применительно к целевому индивидуальному объекту и к фону, так что главный объект на изображении, сфотографированном пользователем, может быть более выделенным, а само сфотографированное изображение выглядит как пленка.

Пример 2: фотографирование видео (режим видеозаписи)

В частности, согласно настоящему изобретению, способ обработки изображения для видеозаписи аналогичен способу обработки изображения для фотографирования, а разница состоит в том, что объект, обрабатываемый при фотографировании, представляет собой одно изображение, тогда как объект, обрабатываемый при видеозаписи, представляет собой последовательные видео кадры, а именно несколько последовательных изображений. Объект, обрабатываемый при видеозаписи, может представлять собой полное видео или сегмент полного видео, либо определяемый пользователем видео клип в пределах некоторого периода времени. Для информации о процедуре обработки каждого изображения в составе видео или видео клипа можно обратиться к способу обработки согласно Примеру 1.

В частности, способ обработки изображения для фотографирования видео может содержать следующие этапы.

Этап 31: Получение N сфотографированных изображений, где N – положительное целое число; и осуществление операций этапа 32 и 33 применительно к каждому изображению, где эти N изображений могут представлять собой соседние видео кадры, так что сумму этих N изображений можно рассматривать в качестве видео. В альтернативном варианте, эти N изображений могут быть несоседними.

Одна из опций реализации этапа 32 может быть такой же, как этап 22.

Одна из опций реализации этапа 33 может быть такой же, как этап 23.

В качестве дополнения, поскольку видео содержит последовательные изображения, способ определения индивидуального объекта также относится к временной последовательности. Поэтому, в дополнение к этапу 23, могут быть больше вариантов реализации на этапе 33. В качестве опции, любой способ определения главного объекта на шаге S223 может иметь задержку. Например, в L1-ом кадре определены человек и фон, и они могут быть по-прежнему определены в кадрах от (L1 + 1)-го кадра по (L1 + L0)-ый кадр изображения посредством маркировки пикселей и сравнения масок, при этом человек на этих изображениях является главным объектом, а область, соответствующая этому человеку на рассматриваемых изображениях, является целевой областью 0. Нет необходимости определять главный объект и фон для каждого кадра. Момент, в который определяют главный объект, может быть каждый раз задан пользователем, либо главный объект можно определять периодически, например, не ограничиваясь этим, каждые 2 с или каждые 10 с. Метод определения главного объекта на шаге S223 содержит, но не ограничивается этим, до шести способов.

Этап 34: Сохранение видео, составленного из N изображений, к которым применена цветовая обработка.

Согласно настоящему изобретению, в процессе записи видео пользователем терминал может определить целевой индивидуальный объект и фон на основе контента видео, и осуществить различную цветовую обработку применительно к целевому индивидуальному объекту и к фону, так что главный объект на видео, сфотографированном пользователем, может быть более выделенным, само сфотографированное видео может быть таким же «крутым», как и кинофильм, а впечатление для пользователя может быть улучшено.

Пример 3: фотографирование видео (режим видеозаписи)

Согласно настоящему изобретению, способ обработки изображения для видеозаписи аналогичен способу обработки изображения для фотографирования, а разница состоит в том, что объект, обрабатываемый при фотографировании, представляет собой одно изображение, тогда как объект, обрабатываемый при видеозаписи, представляет собой последовательные видео кадры, а именно несколько последовательных изображений. Поэтому, для информации о процедуре обработки каждого изображения в составе видео или видео клипа можно обратиться к способу обработки согласно Примеру 1. В некоторых сложных сценариях фотографирования видео, некоторые области изображения могут быть приняты неправильно. Если одна и та же область по отдельности маркирована в соседних кадрах в качестве целевой области и фона, эту одну и ту же область обрабатывают в разных цветах в соответствии с приведенным выше способом цветовой обработки, а изменения цветов одной и той же области в соседних кадрах вызывает «сенсорное мерцание». Поэтому, такое мерцание необходимо обнаружить и исключить в процессе обработки. Это мерцание можно понимать в качестве ошибки определения категории объекта.

Согласно способу определения факта мерцания видео, маску для предшествующего кадра можно обрабатывать на основе оптического потока для получения маски на основе оптического потока и сравнивать маску на основе оптического потока с маской текущего кадра. Когда степень совпадения или степень подобия превосходит заданную конкретную пропорцию, определяют, что мерцание не возникает. Когда степень совпадения или степень подобия не превосходит заданную конкретную пропорцию, определяют, что возникло мерцание. В дополнение к этому, следует понимать, что определение мерцания является непрерывным процессом. В качестве опции, конкретный способ для определения, присутствует ли мерцание, выглядит следующим образом:

(1) Сначала вычисляют оптический поток соседних кадров, где оптический поток служит индикатором соотношения смещения между пикселями в соседних кадрах (в (t – 1)-ом кадре и в t-ом кадре).

(2) Получают маску для (t – 1)-го кадра и вычисляют маску F для оптического потока для t-го кадра на основе маски для (t – 1)-го кадра и информации об оптическом потоке для (t – 1)-го кадра и t-го кадра, где маску для оптического потока получают посредством вычислений на основе оптического потока.

(3) Получают маску S для t-го кадра.

(4) Подсчитывают множество SF пикселей главного объекта в маске F для оптического потока, и подсчитывают множество SS пикселей главного объекта в маске S. Количества пикселей в объединенном множестве и во множестве пересечения масок SF и SS обозначены соответственно Nu и Ni. Когда (Nu – Ni)/Nu больше заданной пороговой величины, считается, что имеет место относительно большая разница между масками соседних кадров (t – 1)-го и t-го, и определяют, что возникает мерцание между (t – 1)-ым кадров и t-ым кадром, либо можно понять, что t-ом кадре возникает мерцание. Относительно большая разность обозначает, что один и тот же объект может быть ошибочно отнесен к разным категориям объектов. Например, один и тот же индивидуальный объект в (t – 1)-ом кадре и t-ом кадре может быть по отдельности определен как человек и как обезьяна.

В качестве опции, если в первых N0 (положительное целое число больше 2) изображениях текущей съемки (текущего изображения), число групп соседних изображений с одним и тем же объектом, определяемым на этих изображениях как относящийся к разным категориям объектов, больше заданной пороговой величины, может быть установлено, что необходимо выполнить процедуру устранения мерцания применительно к текущему кадру. Если установлено, что число групп соседних изображений, в которых один и тот же объект определен как относящийся к разным категориям объектов, не превышает заданной пороговой величины, может быть решено, что нет необходимости выполнять процедуру устранения мерцания применительно к текущему кадру.

В качестве опции, например, для заданного количества исторически соседних кадров или заданного количества исторических кадров, если определено, что мерцание возникает более чем в половине этих кадров, (например, если определено, что мерцание возникает в трех видео кадрах из первых пяти соседних кадров относительно текущего видео кадра) может быть установлено, что необходимо выполнить процедуру устранения мерцания применительно к текущему кадру. Если же определено, что мерцание возникает менее чем в половине этих кадров, (например, если определено, что мерцание возникает в одном из первых пяти соседних кадров относительно текущего видео кадра) может быть установлено, что нет необходимости выполнять процедуру устранения мерцания применительно к текущему кадру.

Должно быть понятно, что текущее видео изображение можно рассматривать как изображение, записанное в некий момент времени. Под этим моментом можно понимать некий обобщенный момент в некоторых сценариях, либо можно понимать некий конкретный момент в некоторых сценариях, например, самый последний момент или момент, который интересует пользователя.

В частности, способ обработки изображения для фотографирования видео в этом примере может содержать следующие этапы.

Этап 41: Получение N сфотографированных изображений, где N представляет собой положительное целое число; и осуществление операций этапов 32 и 33 применительно к каждому изображению, где эти N изображений могут быть соседними видео кадрами, и тогда сумму этих N изображений можно рассматривать в качестве видео; либо эти N изображений могут быть не соседними.

Этап 42: Определение, является ли число групп соседних изображений, в которых возникает мерцание, в первых N0 кадрах относительно текущего кадра (текущего изображения) больше заданной пороговой величины. Здесь, число N0 и пороговая величина могут быть заданы пользователем. Например, число N0 представляет выбранное число отсчетов исторических видео кадров, а пороговая величина может составлять 1/2, 2/3 или другую подобную долю от числа N0. Это представляет собой всего лишь пример и не является ограничением.

Если результат такого определения не больше заданной пороговой величины, выполняют операции этапов 42 и 43 применительно к сфотографированному или захваченному в текущий момент изображению.

Один из вариантов реализации этапа 43 может быть таким же, как этап 32.

Один из вариантов реализации этапа 44 может быть таким же, как этап 33.

Если результат определения больше заданной пороговой величины, выполняют операцию этапа 44 применительно к сфотографированному или захваченному в текущий момент изображению.

Этап 45: Обработка всех областей изображения в текущем кадре с использованием одного и того же способа цветовой обработки для получения целевого изображения. Этот один и тот же способ цветовой обработки может быть таким же, как способ цветовой обработки фоновой области в предшествующем кадре, или может быть таким же, как способ цветовой обработки целевой области в предшествующем кадре, или может быть таким же, как способ цветовой обработки всего изображения в предшествующем кадре. Например, способ цветовой обработки, который является таким же, как способ, использованный для фоновой области на этапе 33 (23), может быть применен ко всему изображению. В альтернативном варианте, способ цветовой обработки, который является таким же, как способ, использованный для целевой области на этапе 33 (23), может быть использован для всего изображения. Например, все изображение остается цветным, либо все изображение являет черно-белым, либо первый или второй режим цветовой обработки (включая, но не ограничиваясь, режимами цветовой обработки, указанными в Примере 1) используется для всего изображения.

В таком случае, для текущего кадра, может быть осуществлена или может быть исключена процедура сегментации маски, аналогичная процедуре, применяемой на этапе 22. В рассматриваемом примере это никак не ограничено.

После этапа 45, осуществляется этап 46 сохранения видео, состоящего из N изображений, к которым применена цветовая обработка. Здесь N представляет собой положительное целое число.

Согласно настоящему изобретению в ходе процедуры записи видео пользователем терминал может определить целевой индивидуальный объект и фон на основе контента этого видео и осуществить различную цветовую обработку целевого индивидуального объекта и фона таким образом, чтобы главный объект на видео, сфотографированном пользователем, мог быть более выделенным, само сфотографированное видео могло быть таким же «крутым», как и кинофильм, а впечатление для пользователя могло быть улучшено.

Пример 4: фотографирование видео (режим видеозаписи)

В некоторых сценариях приложений контент изображения, сфотографированного пользователем, обычно изменяется. Поэтому обычно изменяется главный объект изображения. Пользователь также ожидает возможности свободного выбора режима цветовой обработки главного объекта в различных изображениях, чтобы независимо управлять стилем видео.

Способ обработки изображения в процессе фотографирования видео может содержать следующие этапы.

Этап 51: Терминал получает видео кадр.

Этап 52: Терминал определяет область главного объекта и фоновую область в каком-либо видео кадре, полученном из видео.

Этап 53: Терминал использует какой-либо режим цветовой обработки в какой-либо момент времени для области главного объекта, и этот терминал использует какой-либо режим цветовой обработки в какой-либо момент времени для фоновой области. Однако необходимо быть уверенным, что для любого изображения яркость или насыщенность цвета области главного объекта после цветовой обработки будет больше яркости или насыщенности цвета фоновой области после цветовой обработки. В качестве альтернативы, для любого изображения, насыщенность цвета или яркость изображения, получаемого в режиме цветовой обработки, используемом для области главного объекта, больше насыщенности цвета или яркости изображения, получаемого в режиме цветовой обработки, используемом для фоновой области.

Пример 5: фотографирование видео (режим видеозаписи)

В некоторых сценариях приложений контент изображения, сфотографированного пользователем, обычно изменяется. Поэтому обычно изменяется главный объект изображения. Пользователь также ожидает возможности свободного выбора режима цветовой обработки главного объекта в различных изображениях, чтобы независимо управлять стилем видео. В частности, цвет, изменяется по истечении периода времени.

Способ обработки изображения в процессе фотографирования видео может содержать следующие этапы.

Этап 61: Захват N1 изображений в течение первого периода времени и захват N2 изображений в течение второго периода времени, где эти первый период времени и второй период времени представляют собой соседние периоды времени, и оба числа N1 и N2 представляют собой положительные целые числа, эти первый период времени и второй период времени могут иметь такую продолжительность, чтобы пользователь мог идентифицировать изменения изображения невооруженным глазом, и числа N1 и N2 определены частотами кадров и продолжительностями периодов времени в процессе видеозаписи. В рассматриваемом примере это никак не ограничено.

Этап 62: Определение первой целевой области и первой фоновой области в каждом из N1 изображений, где первая фоновая область представляет собой область изображения, отличную от первой целевой области, и первая целевая область в каждом из N1 изображений соответствует первому объекту (который может представлять собой по меньшей мере один объект); и определение второй целевой области и второй фоновой области в каждом из N2 изображений, где вторая фоновая область представляет собой область изображения, отличную от второй целевой области, и вторая целевая область в каждом из N2 изображений соответствует второму объекту (который может представлять собой по меньшей мере один объект).

Этап 63: Обработка первой целевой области в первом режиме цветовой обработки, обработка первой фоновой области во втором режиме цветовой обработки, обработка второй целевой области в третьем режиме цветовой обработки, и обработка второй фоновой области в четвертом режиме цветовой обработки, для получения целевого видео, где в этом целевом видео насыщенность цвета в первой целевой области больше насыщенности цвета в первой фоновой области, или яркость первой целевой области больше яркости первой фоновой области; и насыщенность цвета во второй целевой области больше насыщенности цвета во второй фоновой области или яркость второй целевой области больше яркости второй фоновой области.

Пример 6: фотографирование видео (режим видеозаписи)

В некоторых сценариях приложений контент изображения, сфотографированного пользователем, обычно изменяется. Поэтому обычно изменяется главный объект изображения. Пользователь также ожидает возможности свободного выбора целевого главного объекта, который пользователь ожидает выделить на разных изображениях. Например, область изображения, соответствующую первому объекту, определяют в качестве целевой области в первый период времени, область изображения, соответствующую второму объекту, определяют в качестве целевой области во второй период времени, при этом первый объект и второй объект представляют собой различные объекты, различные индивидуальные объекты или относятся к разным категориям объектов.