Предлагаемая система сопровождения подвижных объектов относится к области обработки изображений, компьютерного зрения и анализа видеоданных и предназначена для отслеживания объектов в видеопотоке или последовательности кадров, для определения характеристик объектов, проверки истинности сопровождаемого объекта по статистическим критериям и сброса сопровождения ложного объекта. Предложенная система позволяет повысить точность сопровождения движущихся объектов в следствие применения нейросетевого подхода при определении метода сопровождения объекта на основе данных видеопоследовательности, уменьшить время обработки за счет применяемых математических методов обработки информации в режиме реального времени. Данная система может быть использована для охраны помещений, обнаружений посторонних людей на территории предприятий.

Известен патент РФ «Система и способ сопровождении движущихся объектов» №2701092, G06T 7/80, опубл. 24.09.2019, который может быть использован в системах сопровождения движущихся объектов, применяющий обзорную и поворотную видеокамеры.

Сущность изобретения №2701092 заключается в том, что в системе реализовано обнаружение объектов, слежение за их движением и их сопровождение, позволяющее анализировать видео без прямого участия человека. Основная идея данного изобретения заключается в применении поворотной камеры, а также возможности оператора выбирать конкретную обзорную видеокамеру из имеющихся в системе. Происходит обнаружение в кадре всех движущихся объектов и определение их пространственных координат. Данная система имеет как «автоматический», так и «ручной» режимы работы. Объект для сопровождения может быть выбран автоматически - осуществляется обнаружение подвижных объектов или быть выбран пользователем вручную.

Применение нескольких камер увеличивает аппаратные затраты на реализацию системы сопровождения подвижных объектов, требует от пользователя периодического контроля в выборе камеры в «ручном режиме» работы для сопровождения.

В патенте «Способ обработки последовательности изображений для обнаружения и слежения за воздушными объектами» №2419150С1, G06K 9/54, опубл. 20.05.2011, техническим результатом является повышение точности обнаружения и слежения как за малоразмерными, так и протяженными воздушными объектами, наблюдаемыми на фоне ясного или облачного неба датчиками телевизионного (ТВ) и инфракрасного (ИК) диапазонов. Суть изобретения заключается в алгоритме траекторного анализа, который осуществляет слежение за одним объектом.

Изобретение «Способ обработки последовательности изображений для распознавания воздушных объектов» - патент РФ №2664411С2, G06K 9/46, опубл. 06.06.2018, предназначено для повышения точности определения класса наблюдаемого воздушного судна.

Основные отличительные особенности изобретения:

- генерация на основе 3D-моделей эталонных бинарных изображений воздушных объектов;

- использование базы данных эталонных дескрипторов внешнего контура объекта;

- применение бинарного изображения.

Патент №2311684С1 «Способ обработки сигналов для выделения движущихся объектов в последовательности телевизионных изображений», G06T 7/00, опубл. 27.11.2007 относится к области обработки сигналов для выделения движущихся объектов в последовательности телевизионных изображений. Алгоритм, примененный в изобретении, использует сдвиг изображения текущего кадра относительно эталонного изображения с учетом оценки параметров сдвига.

Недостатком рассмотренных ранее изобретений является использование дополнительной информации, помимо видеопоследовательности, таких как 3D-модели и датчик ИК, что приводит к увеличению аппаратных затрат. Еще одним недостатком является возможность сопровождения одного объекта на видеопоследовательности, предложенная система позволяет сопровождать несколько объектов одновременно. Изобретения №2664411С2 и №2419150С1 осуществляют сопровождение только воздушных объектов, предложенная система позволяет сопровождать объекты на видео как в воздушном, так и в наземном пространстве.

Задача предложенного изобретения - повышение точности сопровождения подвижных наземных и воздушных объектов за счет применения нейросетевого подхода при определении метода сопровождения объекта на основе данных видеопоследовательности, обеспечение скорости обработки до 25 кадров в секунду для размеров изображения 1920x1080 точек, а также одновременное сопровождение нескольких подвижных объектов.

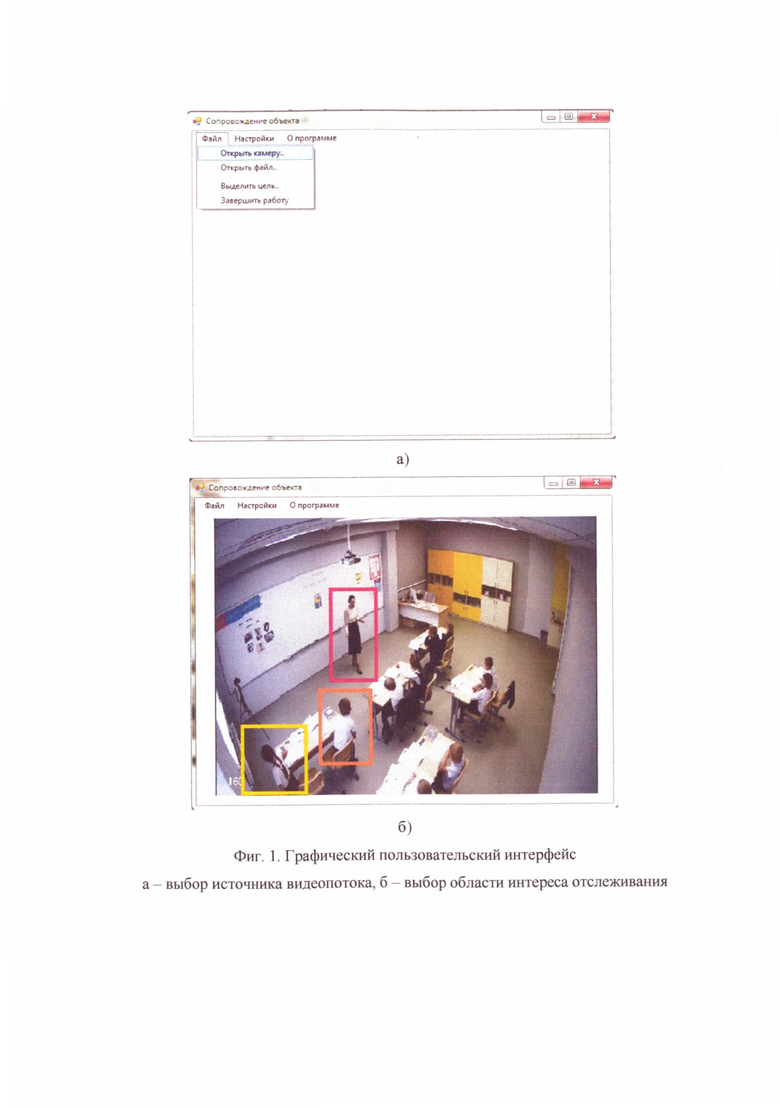

На фиг. 1 представлен графический пользовательский интерфейс (ГПИ), который реализует выбор видеопоследовательности и выбор области интереса для отслеживания. На фиг. l.a приведена возможность выбора источника видеопотока. После того, как будет выбрана видеопоследовательность, пользователь должен указать область интереса для отслеживания, как изображено на фиг. 1б. После того, как область интереса была выделена, за данным объектом начинается наблюдение. Для области интереса также вычисляются характеристики (двумерное вейвлет-преобразование Хаара; сегментирование, основанное на распределении Гиббса), рассмотренные в блоке 4.

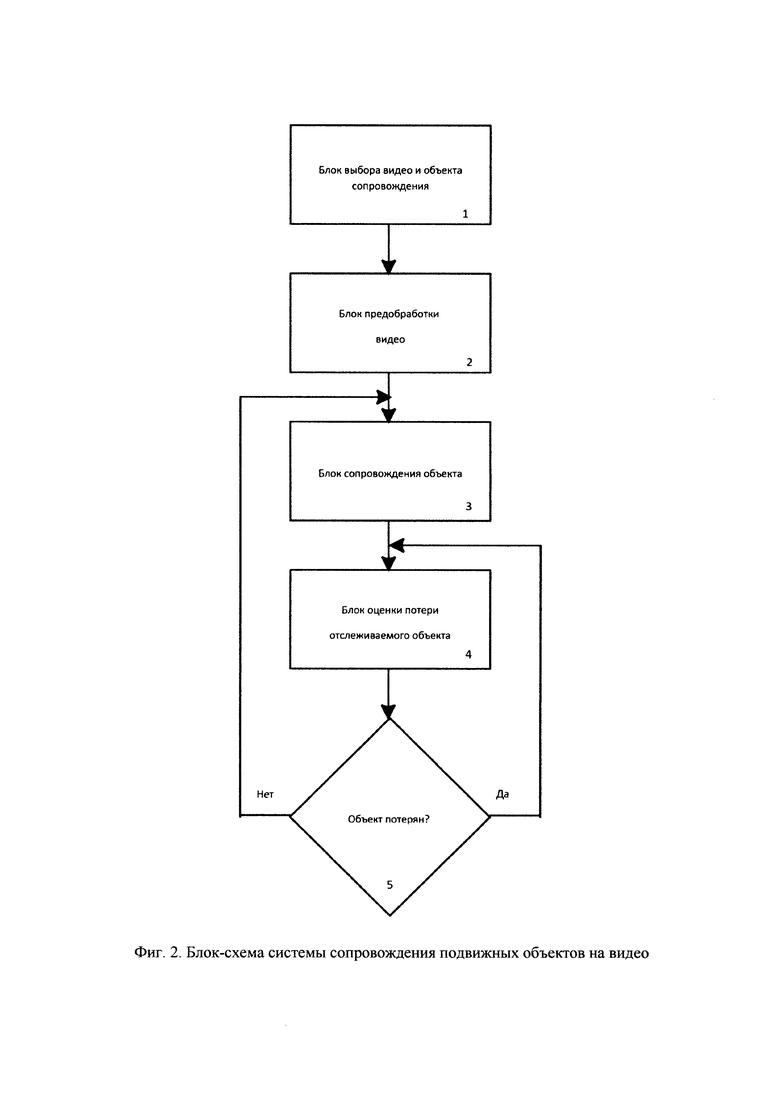

На фиг. 2 изображена блок-схема системы сопровождения подвижных объектов на видео, состоящая из: 1 - блока выбора видео и объекта сопровождения, 2 - блока предобработки видео, 3 - блока сопровождения объекта, 4 - блока оценки отслеживаемого объекта, 5 - блока проверки.

Блок 1 реализован при помощи ГПИ; пользователь выбирает источник видеопоследовательности, затем выделяет область интереса.

Блок 2 включает в себя нормировку цветовой составляющей и баланса белого в окрестностях выбранного в блоке t объекта, устранение шумовой составляющей, устранение влияния движения видеокамеры. Блок нормировки цветовой составляющей состоит из двух частей: эквализатор гистограммы изображения и преобразователь изображения в цветовое пространство YIQ [1]. Устранение шумовой составляющей осуществляется при помощи фильтрации и позволяет убрать шумы оптической системы и дефектные пиксели на изображении. Для устранения влияния движения камеры применяются аффинные преобразования:

- перемещение изображения

здесь Δх - перемещение по оси абсцисс, Δу - перемещение по оси ординат, m,n - размерность изображения, i,j - итерируемые переменные, OFij[x] - вектор перемещения оптического потока по оси х, OFij[у] - вектор перемещения оптического потока по оси у.

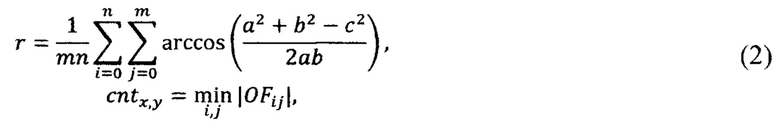

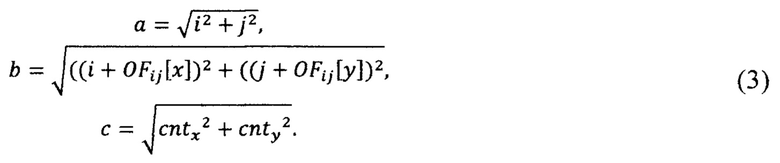

- поворот изображения

здесь r - угол поворота, cntx,y - координата центра поворота, а, b, с рассчитываются следующим образом:

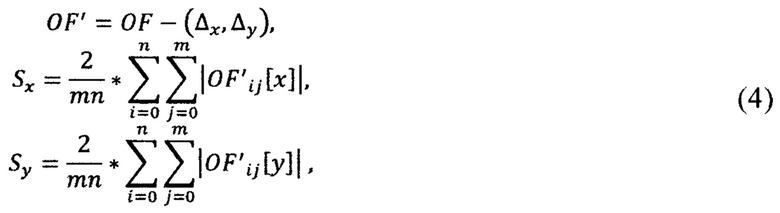

- масштабирование изображения

здесь Sx - коэффициент масштабирования по ширине, Sy - коэффициент масштабирования по длине, OF'ij[x] - оптический поток после устранения перемещения по оси х, OF'ij[y] - оптический поток после устранения перемещения по оси у [2].

После стабилизации видео система вычисляет направление движения фона по следующему алгоритму:

- используется 1 точка в квадрате 10x10. Ее значение определяют остальные вектора в квадрате;

- точка внутри блока выбирается при помощи FAST-детектора ключевых точек [3];

- для просчета оптического потока применяется метод Лукаса-Канаде [4, 5].

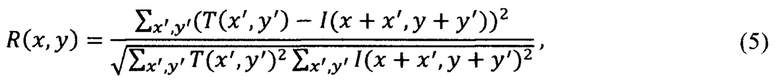

Блок 3 состоит из нескольких методов сопровождения: корреляционный поиск на основе метода Мультистарт, вычисление оптического потока Лукаса-Канаде, сопоставление ключевых точек, Y-Net нейронная сеть, линейная регрессия, экспертная система выбора на основе нейросетевого подхода [6, 7]. Корреляционный поиск основан на сравнении некоторого эталонного фрагмента (области интереса с предыдущего кадра) с текущим изображением:

здесь R(x, у) - значение корреляционной функции в точке (х, у), х', у' - смещение объекта относительно начала координат, Т(х', у') - фрагмент с объектом сопровождения, I(х, у) - исходное изображение [8].

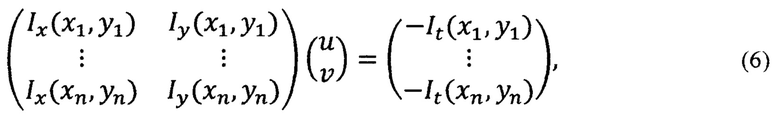

Локальный оптический поток:

здесь u, v - вычисляемые переменные, вектор оптического потока, Ix(xi, yi), Iy(xi, yi), It(xi, yi) - частные производные изображения 1 по координатам х, у и времени t, вычисленные в точке (xi,yi) [9].

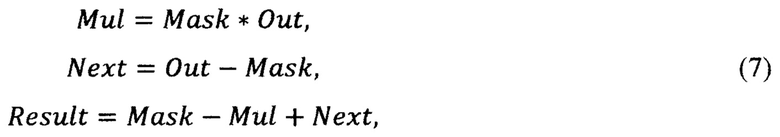

Сопровождение с использованием детектора движения Y-Net:

здесь Mask - маска по расположению объекта в предыдущем кадре, Out - выход с нейронной сети, Mul - результат произведения, Next - результат вычитания, Result - результат расположения сопровождаемого объекта.

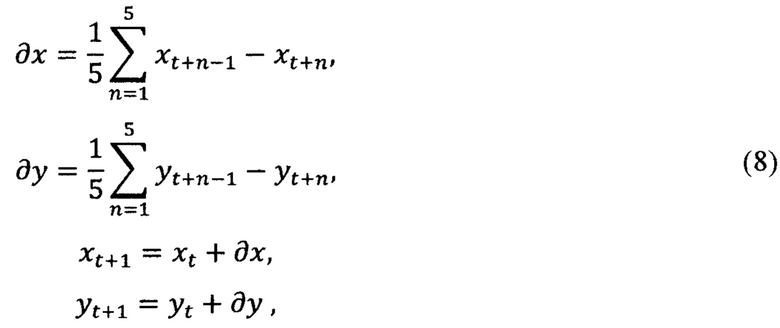

Новое расположение объекта оценивается исключительно исходя из его перемещений за последние 5 кадров.

Метод сопоставление на основе линейной регрессии:

здесь gx, gy - предполагаемое смещение объекта по оси х, у, xt,yt - расположение объекта в момент времени t по оси х, у, xt+n-1, yt+n-1 - расположение объекта в момент времени t+n-1 по оси х, у.

Блок 4 содержит расчет характеристик сопровождаемого объекта в текущем кадре и сравнение вычисленных характеристик с характеристиками, полученными в блоке 1. При сопоставлении объектов из области интереса за последние 5 кадров учитываются следующие характеристики:

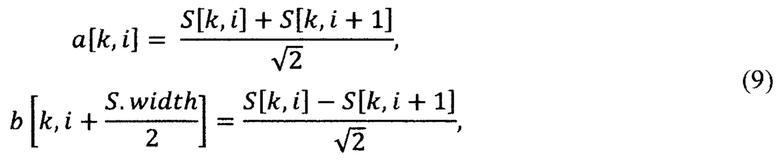

- двумерное вейвлет-преобразование Хаара

здесь a, b - полусумма и полуразность, k, i - итерируемые переменные, S - изображение области интереса, width - ширина области интереса.

- сегментирование, основанное на распределении Гиббса

здесь img [х, у] - изображение из области интереса, variance - дисперсия, mean - среднее значение, click - вычисляемое значение [10].

Блок 5 осуществляет переход либо в блок 3 к сопровождению за объектом в случае сходных характеристик, либо в блок 4 для перерасчета сопровождаемых характеристик. В том случае, если за последние 5 кадров сопровождаемый объект считается «потерянным», сопровождение за объектом прекращается.

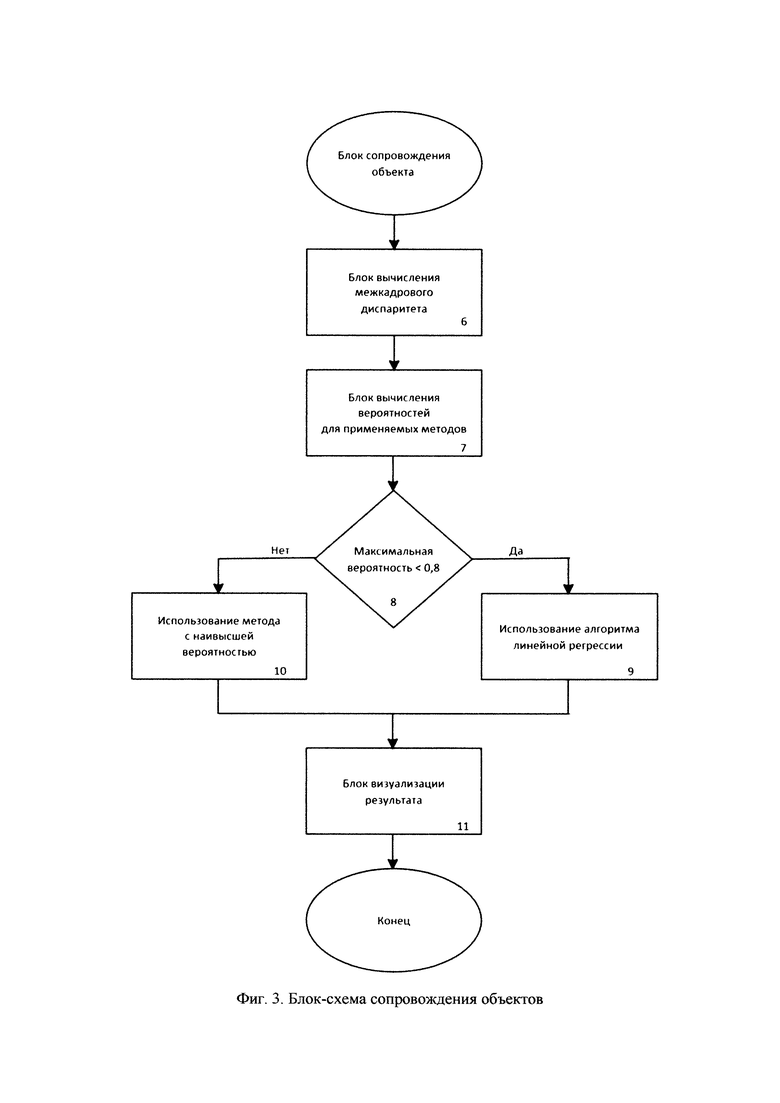

На фиг. 3 приведена блок-схема сопровождения объектов. На первоначальном этапе осуществляется блок вычисления межкадрового диспаритета (6). Вычисление межкадрового диспаритета заключается в вычитании значений пикселей двух соседних кадров и порогового значения вычитаемого изображения для выделенной области движения на изображении [11].

Далее выполняется блок вычисления вероятностей для различных методов сопровождения объектов (7) при помощи экспертной системы на основе нейросетевого подхода. В том случае, если максимальная вероятность <0,8 применяется алгоритм линейной регрессии (9), в противном случае - использование метода с наивысшей вероятностью (10). Цифрами с 8 по 10 отмечен блок выбора метода сопровождения объекта.

На заключительном этапе применяется блок визуализации результата (11), который осуществляется путем перемещения (перерисовки) области интереса поверх видеопоследовательности.

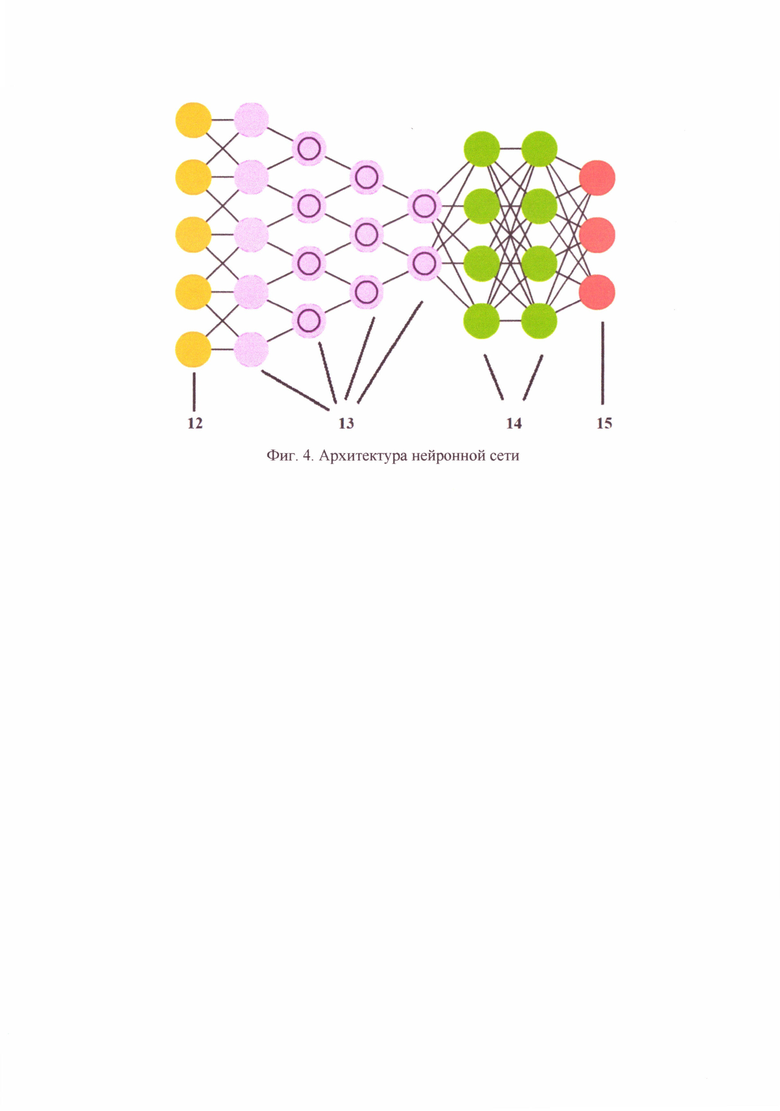

На фиг. 4 приведена архитектура нейронной сети для определения метода сопровождения на основе видеокадра. Цифрами обозначены следующие элементы: 12 - входной слой, 13 - слои свертки и подвыборки, 14 - полносвязные слои, 15 - выходной слой. При помощи сверточной нейронной сети и фрагмента с объектом области интереса в текущем кадре оценивается какой из методов может предоставить наивысшую точность сопровождения. Этот метод и будет использован для данного кадра. Обучающая выборка составлялась на основе набора данных Visual Object Tracking 2014. Для каждого случая каждым методом выполнялось прогнозирование расположения объекта. Далее, это расположение сравнивалось с эталонным. Разница между центрами масок объектов является величиной, обратной целесообразности и определяется следующим образом:

Выбором метода руководит экспертная система под управлением нейронной сети:

- вход (256х256хС) - оцениваемое изображение;

- выход (N) - прогноз для каждого из представленных методов сопровождения.

Отдельно рассматривается ситуация, когда все метрики меньше 0,8. В этом случае применяется алгоритм линейной регрессии для прогнозирования нового расположения объекта. Применение экспертной системы позволило снизить вероятность потери объекта до 40%.

Список литературы

1. A. Tarasov, V. Potapova, P. Belyakov, О. Melnik. The developing of targets tracking complex (Разработка комплекса сопровождения целей) В сборнике: Proceedings of 2018 IEEE East-West Design and Test Symposium, EWDTS 2018. electronic publication. 2018. C. 8524751.

2. А.С.Тарасов, M.Б. Никифоров Разработка видеосистемы сопровождения объектов // в сборнике Известия ТулГУ. Технические науки 2019. Выпуск 2. стр. 888-892

3. Bolme D.S., Beveridge R.J., Draper В.A., Lui Y.M. Visual Object Tracking using Adaptive Correlation Filters // Conference on Computer Vision and Pattern Recognition (CVPR), 2010. - 2544-2550 pp.

4. Kim S., Jay Kuo C.-C. A Stochastic Approach for Motion Vector Estimation in Video Coding // Proc. of SPIE, Vol. 2304, Neural and Stochastic Methods in Image and Signal Processing III. - 1994, pp. 111-122.

5. M.B. Акинин, М.Б. Никифоров, А.И. Таганов Нейросетевые системы искусственного интеллекта в задачах обработки изображений: монография. М.: Научно-техническое издательство «Горячая линия - Телком», 2016. 152 с.

6. A. Tarasov, Y. Muratov, М. Nikiforov, A. Baranchikov Intelligent video computer tracking system (Интеллектуальная видео компьютерная система слежения) В сборнике: 13th International Conference ELEKTRO 2020, ELEKTRO 2020 - Proceedings. 13. 2020. C. 9130254.

7. A.C. Тарасов, М.Б. Никифоров, В.Ю. Тарасова. Применение возможностей нейронных сетей в задачах сопровождения подвижных объектов // в сборнике: Нейроинформатика-2020. Сборник научных трудов. XXII Международная научно-техническая конференция. Москва, 2020. С. 277-285.

8. Блохин А.Н. "Разработка алгоритмов функционирования и архитектуры автомата сопровождения объектов по данным видеонаблюдения" // [Электронный ресурс] https://new-disser.ru/_avtoreferats/01005427371.pdf (дата обращения 01.03.2019)

9. П.В. Беляков, М.Б. Никифоров Вариационный метод вычисления оптического потока в системе-на-кристалле // Цифровая обработка сигналов. 2018. №3. С. 76-82.

10. V. Potapova, A. Tarasov, N. Grinchenko Image search by content system development (Разработка системы поиска изображений по содержанию) в сборнике Proceedings of IEEE East-West Design&Test Symposium (EWDTS2018) стр. 625-629

11. Алпатов Б.А., Бабаян П.В., Балашов О.Е., Степашкин А.И. Системы автоматического обнаружения и сопровождения объектов. - М.: Радиотехника, 2008. - 175 с.

| название | год | авторы | номер документа |

|---|---|---|---|

| Способ и устройство для коррекции карт глубины для множества видов | 2023 |

|

RU2827434C1 |

| СПОСОБ АУДИОВИЗУАЛЬНОГО РАСПОЗНАВАНИЯ СРЕДСТВ ИНДИВИДУАЛЬНОЙ ЗАЩИТЫ НА ЛИЦЕ ЧЕЛОВЕКА | 2022 |

|

RU2791415C1 |

| СПОСОБ И СИСТЕМА СВЕРХРАЗРЕШЕНИЯ С ПОМОЩЬЮ КОМБИНИРОВАННОЙ РАЗРЕЖЕННОЙ АППРОКСИМАЦИИ | 2016 |

|

RU2661537C2 |

| АВИАЦИОННАЯ СИСТЕМА ОБРАБОТКИ ДАННЫХ АЭРОСЪЕМКИ ДЛЯ ОПРЕДЕЛЕНИЯ ОПТИМАЛЬНЫХ ЗОН И УПРАВЛЕНИЯ РЕЖИМАМИ РАБОТЫ ЦЕЛЕВЫХ НАГРУЗОК БЕСПИЛОТНОГО ЛЕТАТЕЛЬНОГО АППАРАТА | 2024 |

|

RU2840814C1 |

| Способ и устройство для видеокодирования | 2020 |

|

RU2789146C1 |

| Программно-аппаратный комплекс, предназначенный для обучения и (или) дообучения алгоритмов обработки аэрокосмических изображений местности с целью обнаружения, локализации и классификации до типа авиационной и сухопутной техники | 2020 |

|

RU2747044C1 |

| СПОСОБ СИНТЕЗА ВИДЕО ИЗ ВХОДНОГО КАДРА АВТОРЕГРЕССИОННЫМ МЕТОДОМ, ПОЛЬЗОВАТЕЛЬСКОЕ ЭЛЕКТРОННОЕ УСТРОЙСТВО И СЧИТЫВАЕМЫЙ КОМПЬЮТЕРОМ НОСИТЕЛЬ ДЛЯ ЕГО РЕАЛИЗАЦИИ | 2023 |

|

RU2829010C1 |

| СПОСОБ И УСТРОЙСТВО ДЛЯ АЛГОРИТМОВ ПРОТИВОСТОЯНИЯ ОШИБКАМ ПРИ БЕСПРОВОДНОЙ ПЕРЕДАЧЕ ВИДЕО | 2007 |

|

RU2404536C2 |

| СИСТЕМА И СПОСОБ ОБНАРУЖЕНИЯ И КЛАССИФИКАЦИИ КОЛОНИЙ МИКРООРГАНИЗМОВ НА ИЗОБРАЖЕНИЯХ НА ОСНОВЕ ТЕХНОЛОГИЙ ИСКУССТВЕННОГО ИНТЕЛЛЕКТА И КОМПЬЮТЕРНОГО ЗРЕНИЯ | 2022 |

|

RU2791813C1 |

| СПОСОБ ВИДЕОСОПРОВОЖДЕНИЯ С УЛУЧШЕННЫМИ ДИНАМИЧЕСКИМИ ХАРАКТЕРИСТИКАМИ И УСТРОЙСТВО ДЛЯ ЕГО ОСУЩЕСТВЛЕНИЯ | 2018 |

|

RU2716005C2 |

Изобретение относится к области компьютерного зрения. Техническим результатом является повышение точности сопровождения подвижных наземных и воздушных объектов. Технический результат достигается тем, что в заявленном решении предусмотрены блок выбора видео и объекта сопровождения, блок предобработки видео, состоящий из подблока нормировки цветовой составляющей, подблока нормировки баланса белого в окрестностях выбранного объекта, подблока устранения шумовой составляющей, подблока устранения влияния движения камеры, а также блок сопровождения отслеживаемого объекта, состоящий из подблока вычисления межкадрового диспаритета, подблока вычисления вероятностей, экспертная система выбора на основе нейросетевого подхода, подблока визуализации результата, блок оценки потери отслеживаемого объекта, блок выбора метода сопровождения объекта на основе анализа сюжета кадра в последовательности видеофрагментов, содержащий нейронную сеть, которая оценивает, какой из методов может предоставить наивысшую точность сопровождения, и прогнозирует расположение объекта каждым методом. 4 ил.

Система сопровождения подвижных объектов на видео, состоящая из блока выбора видео и объекта сопровождения (1), блока предобработки видео (2), состоящего из подблока нормировки цветовой составляющей (2.1), подблока нормировки баланса белого в окрестностях выбранного объекта (2.2), подблока устранения шумовой составляющей, реализующего функцию устранения шумов оптической системы и дефектных пикселей на изображении (2.3), подблока устранения влияния движения камеры (2.4), блока сопровождения отслеживаемого объекта (3), состоящего из подблока вычисления межкадрового диспаритета, реализующего функцию подготовки входных данных для экспертной системы (3.1), подблока вычисления вероятностей для применяемых методов, таких как: корреляционный поиск на основе метода Мультистарт, вычисление оптического потока Лукаса-Канаде, сопоставление ключевых точек, Y-Net нейронная сеть, линейная регрессия, экспертная система выбора на основе нейросетевого подхода (3.2), подблока визуализации результата, реализующего функцию перерисовки области интереса поверх видеопоследовательности (3.3), блока оценки потери отслеживаемого объекта (4), вследствие его выхода из поля зрения камеры или перекрытия другим объектом, отличающаяся тем, что в ней реализован блок выбора метода сопровождения объекта на основе анализа сюжета кадра в последовательности видеофрагментов, содержащий нейронную сеть, состоящую из 4 сверточных слоев, которая оценивает, какой из методов может предоставить наивысшую точность сопровождения, и прогнозирует расположение объекта каждым методом, сравнивая с эталонным значением, позволяющая сопровождать подвижные объекты любой физической природы и формы.

| ШАЛЬНОВ Е.В: "Исследование и разработка методов сопровождения людей и частей их тела в видеопоследовательности", 2017 [найдено: 23.01.2023] Найдено в: https://www.keldysh.ru/council/1/2018-shalnov/diss.pdf | |||

| TARASOV A | |||

| et al.: "Intelligent Video Computer Tracking System", 15.05.2021 [найдено: 23.01.2023] | |||

| Найдено в: |

Авторы

Даты

2023-11-21—Публикация

2022-05-30—Подача