Область техники, к которой относится изобретение

Данный патентный документ относится к технологиям, устройствам и системам кодирования видео.

Уровень техники

Несмотря на достижения в области сжатия видео, на цифровое видео по-прежнему приходится наибольшая пропускная способность в Интернете и других сетях цифровой связи. Ожидается, что по мере увеличения количества подключенных пользовательских устройств, способных принимать и отображать видео, будет продолжать расти потребность в полосе пропускания для использования цифрового видео.

Раскрытие сущности изобретения

Устройства, система и способы, которые относятся к кодированию цифрового видео, и, в частности, для гармонизации режима линейного предсказания для кодирования видео. Описанные способы могут применяться как к существующим стандартам кодирования видео (например, к высокоэффективному кодированию видео (HEVC)), так и к будущим стандартам кодирования видео или видеокодекам.

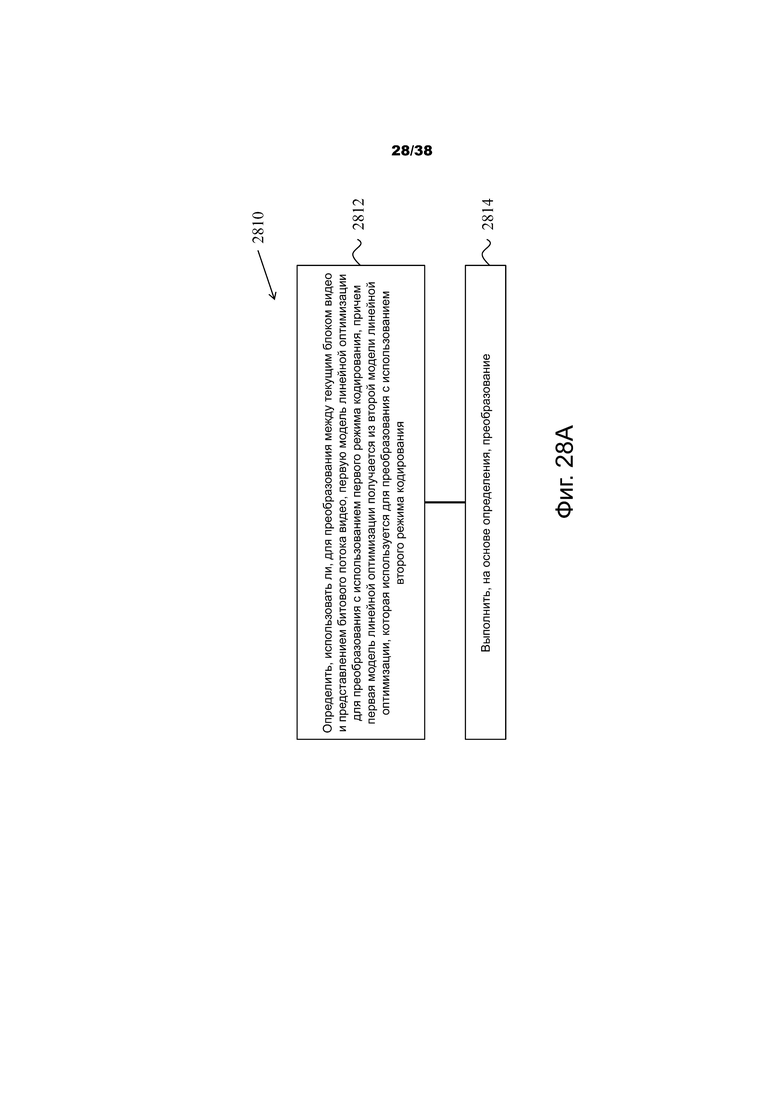

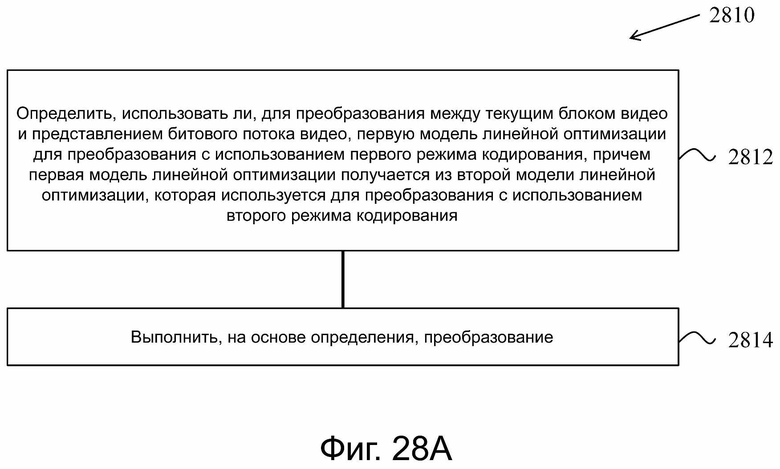

В одном характерном аспекте раскрытая технология может быть использована для выполнения способа обработки видео. Этот способ включает в себя определение относительно того, использовать ли, для преобразования между текущим блоком видео и представлением битового потока видео, первую линейную модель оптимизации для преобразования с использованием первого режима кодирования, причем первая модель линейной оптимизации получается из второй модели линейной оптимизации, которая используется для преобразования с использованием второго режима кодирования; и выполнение, на основе определения, преобразования.

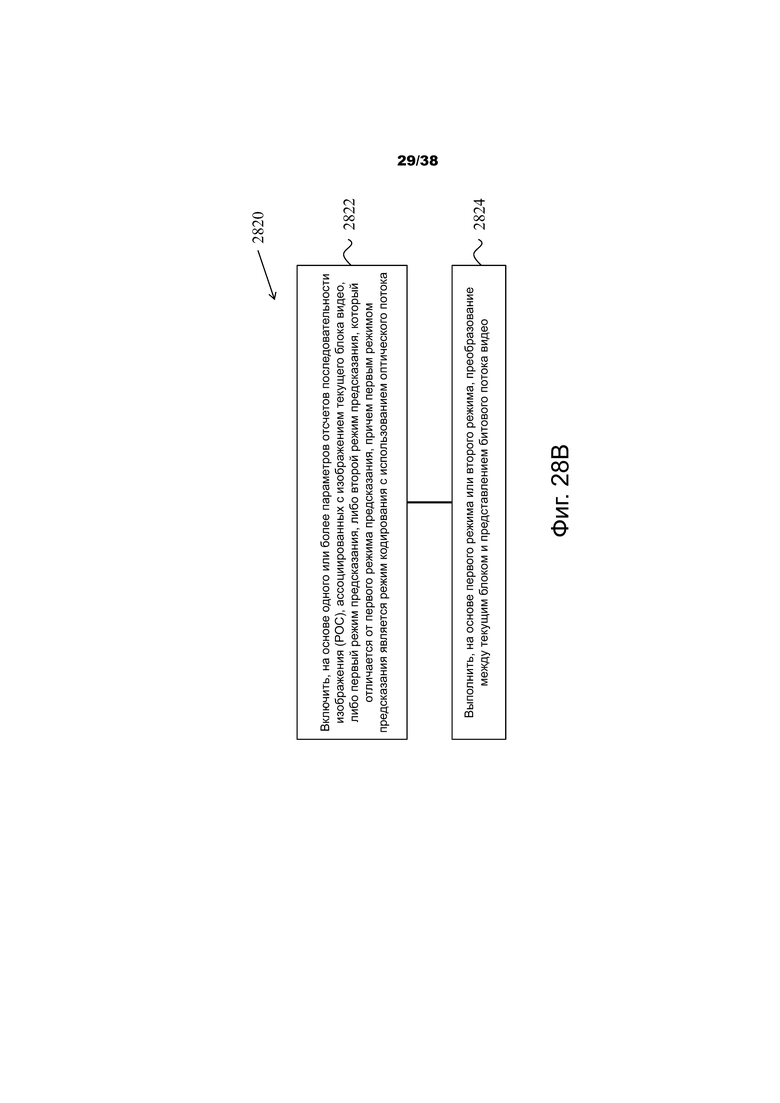

В другом характерном аспекте раскрытая технология может быть использована для выполнения способа обработки видео. Этот способ включает в себя включение, на основе одного или более параметров подсчета порядка изображений (POC), ассоциированных с изображением текущего блока видео, либо первого режима предсказания, либо второго режима предсказания, отличного от первого режима предсказания, причем первым режимом предсказания является режим кодирования с использованием оптического потока; и выполнение, на основе первого режима или второго режима, преобразования между текущим блоком и представлением битового потока видео.

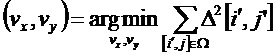

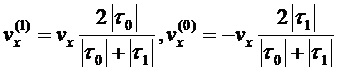

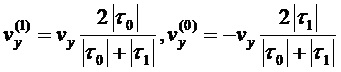

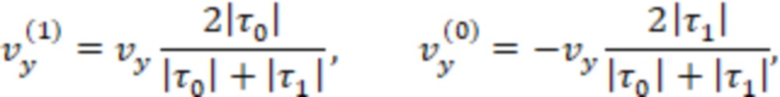

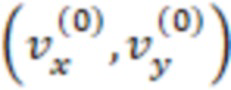

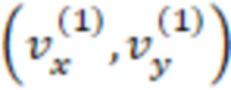

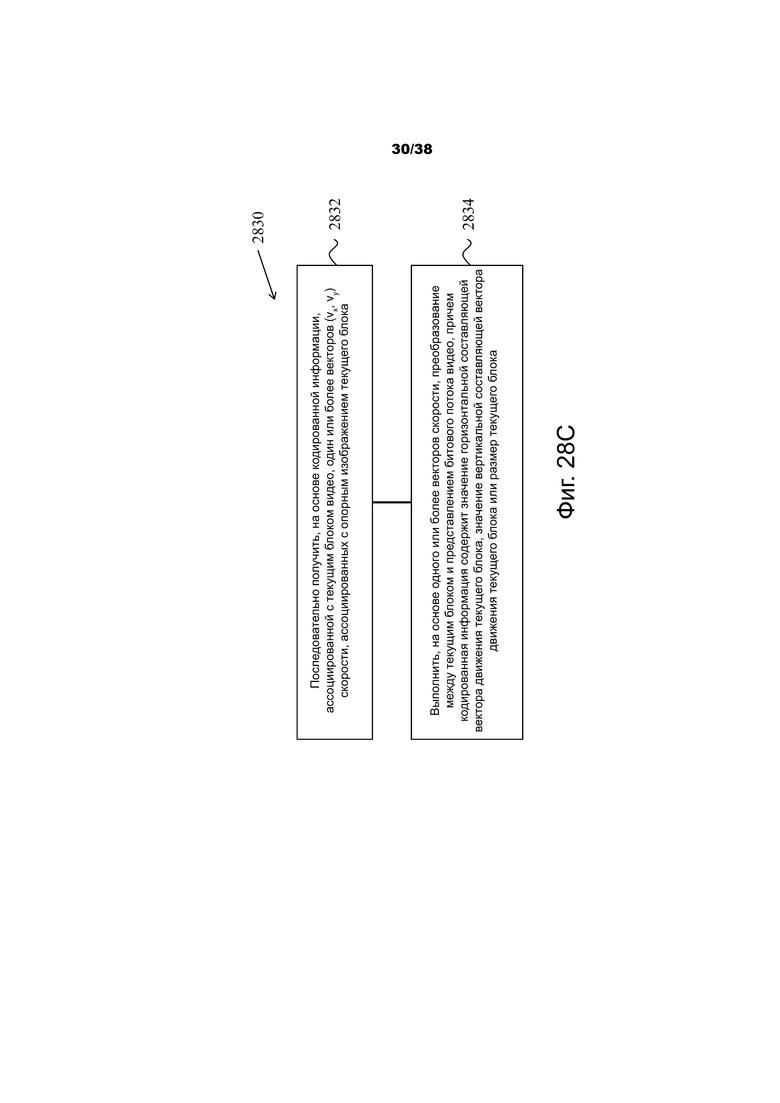

В еще одном характерном аспекте раскрытая технология может быть использована для выполнения способа обработки видео. Этот способ включает в себя последовательное получение, на основе кодированной информации, ассоциированной с текущим блоком видео, одного или более векторов (vx, vy) скорости, ассоциированных с опорным изображением текущего блока; и выполнение, на основе одного или более векторов скорости, преобразования между текущим блоком и представлением битового потока видео, причем кодированная информация содержит значение горизонтальной составляющей вектора движения текущего блока, значение вертикальной составляющей вектора движения текущего блока или размер текущего блока.

В еще одном характерном аспекте раскрытая технология может быть использована для выполнения способа обработки видео. Этот способ включает в себя выполнение, после определения того, что режим кодирования с использованием оптического потока был включен для текущего блока видео, операции фильтрации с использованием интерполяционного фильтра одного типа для каждого цветового компонента текущего блока; и выполнение, на основе операции фильтрации, преобразования между текущим блоком и представлением битового потока видео.

В еще одном характерном аспекте раскрытая технология может быть использована для выполнения способа обработки видео. Этот способ включает в себя выполнение, после определения того, что режим кодирования с использованием оптического потока был включен для текущего блока видео, операции фильтрации с использованием интерполяционного фильтра одного типа для каждого цветового компонента текущего блока; выполнение, после определения того, что по меньшей мере одна выборка текущего блока находится за пределами заданного диапазона, операции заполнения; и выполнение, на основе операции фильтрации и операции заполнения, преобразования между текущим блоком и представлением битового потока видео.

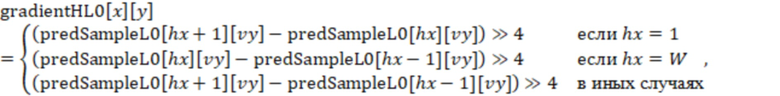

В еще одном характерном аспекте раскрытая технология может быть использована для выполнения способа обработки видео. Этот способ включает в себя определение относительно того, чтобы использовать, для преобразования между текущим блоком видео и представлением битового потока видео, алгоритм вычисления значения градиента для инструмента оптического потока; и выполнение, на основе определения, преобразования.

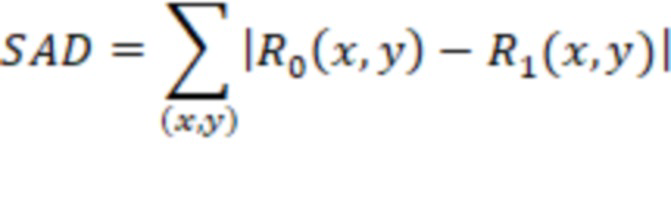

В еще одном характерном аспекте раскрытая технология может быть использована для выполнения способа обработки видео. Этот способ включает в себя принятие решения, на основе одного или более вычислений суммы абсолютной разности (SAD) для подблока текущего блока видео, относительно выборочного включения режима кодирования с использованием оптического потока для текущего блока; и выполнение, на основе принятого решения, преобразования между текущим блоком и представлением битового потока текущего блока.

В еще одном характерном аспекте раскрытая технология может быть использована для выполнения способа обработки видео. Этот способ включает в себя получение, на основе выборочного включения процесса улучшения обобщенного би-предсказания (GBi) для текущего блока видео, одного или более параметров режима кодирования с использованием оптического потока для текущего блока; и выполнение, на основе одного или более параметров режима кодирования с использованием оптического потока, преобразования между текущим блоком и представлением битового потока видео.

В еще одном характерном аспекте раскрытая технология может быть использована для выполнения способа обработки видео. Этот способ включает в себя выполнение, для текущего блока видео, кодированного с использованием оптического потока, операции ограничения над окончательным результатом предсказания режима кодирования с использованием оптического потока; и выполнение, на основе окончательного результата предсказания, преобразования между текущим блоком и представлением битового потока видео.

В еще одном характерном аспекте вышеописанный способ воплощен в виде кода, исполняемого процессором, и сохранен на машиночитаемом носителе информации, хранящем компьютерную программу.

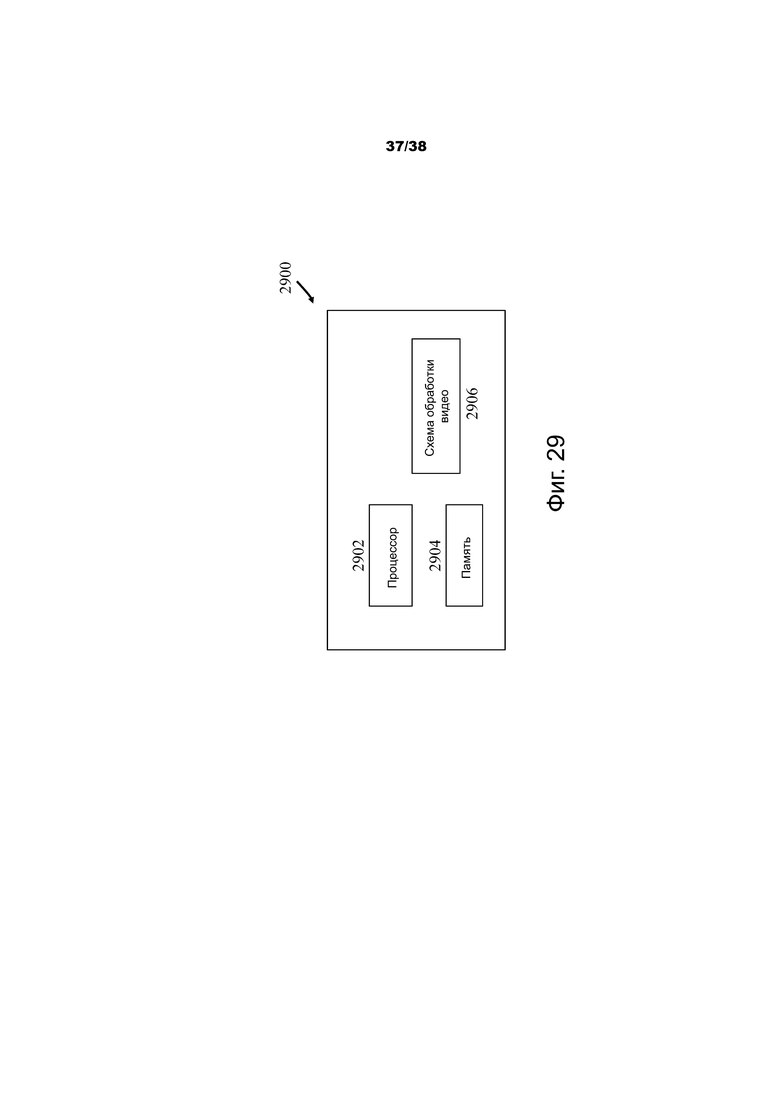

В еще одном характерном аспекте раскрыто устройство, которое сконфигурировано или выполнено с возможностью выполнения вышеописанного способа. Устройство может включать в себя процессор, который запрограммирован для реализации этого способа.

В еще одном характерном аспекте устройство видеодекодера может реализовать способ, как описано в данном документе.

Вышеупомянутые и другие аспекты и особенности раскрытой технологии описаны более подробно на чертежах, в описании и в формуле изобретения.

Краткое описание чертежей

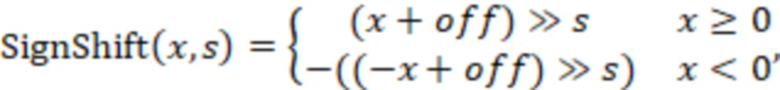

Фиг.1 – пример построения списка кандидатов слияния.

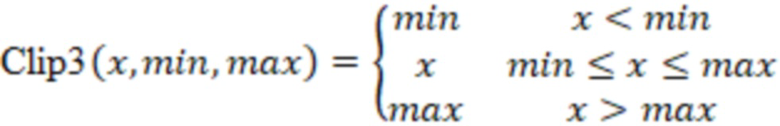

Фиг.2 – пример позиций пространственных кандидатов.

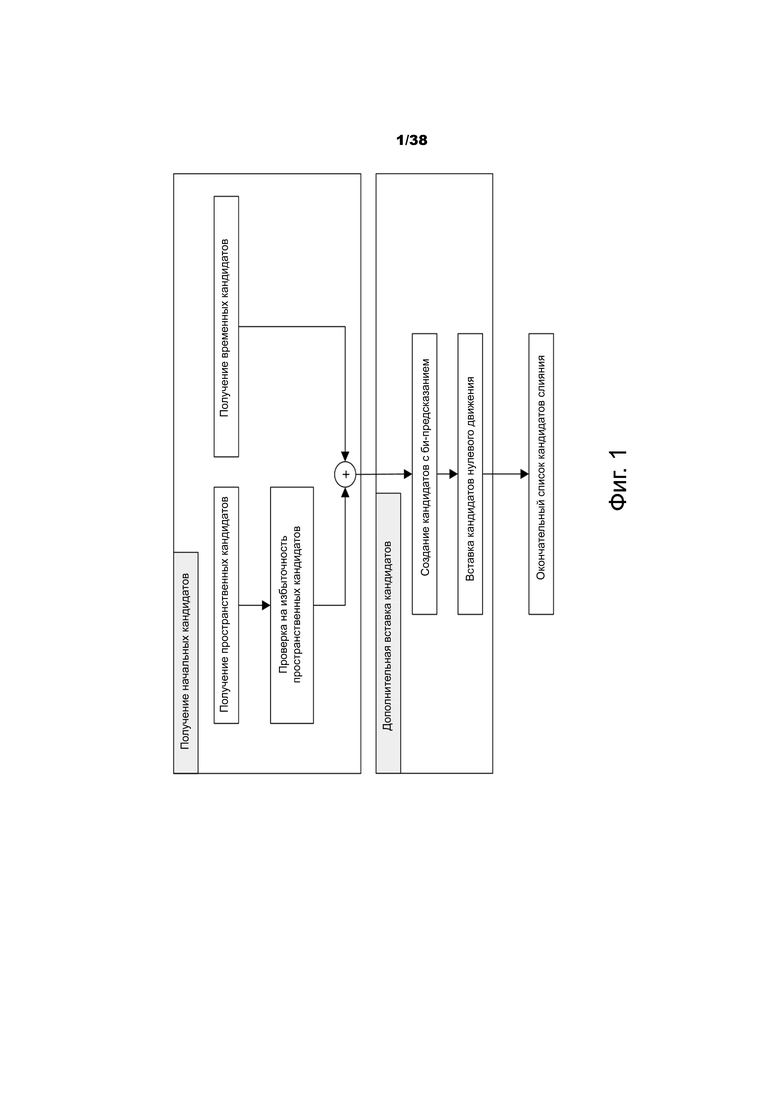

Фиг.3 – пример пар кандидатов, подлежащих проверке избыточности пространственных кандидатов слияния.

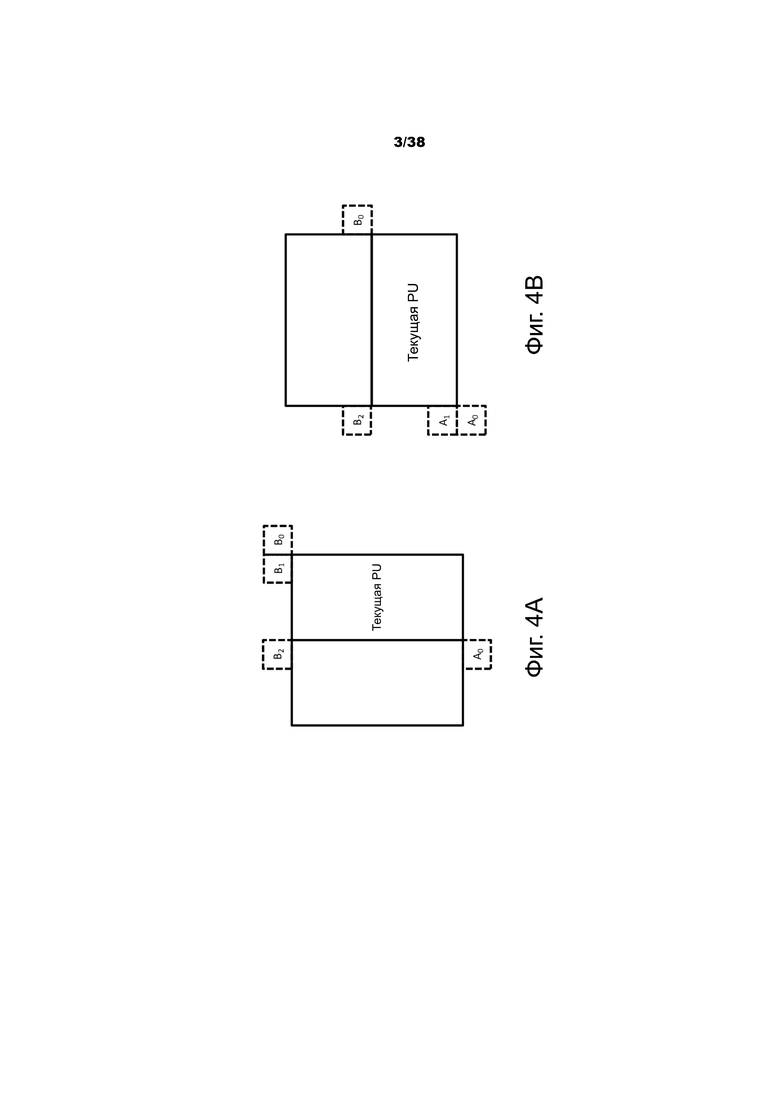

Фиг.4A и 4B – примеры позиции второй единицы предсказания (PU) на основе размера и формы текущего блока.

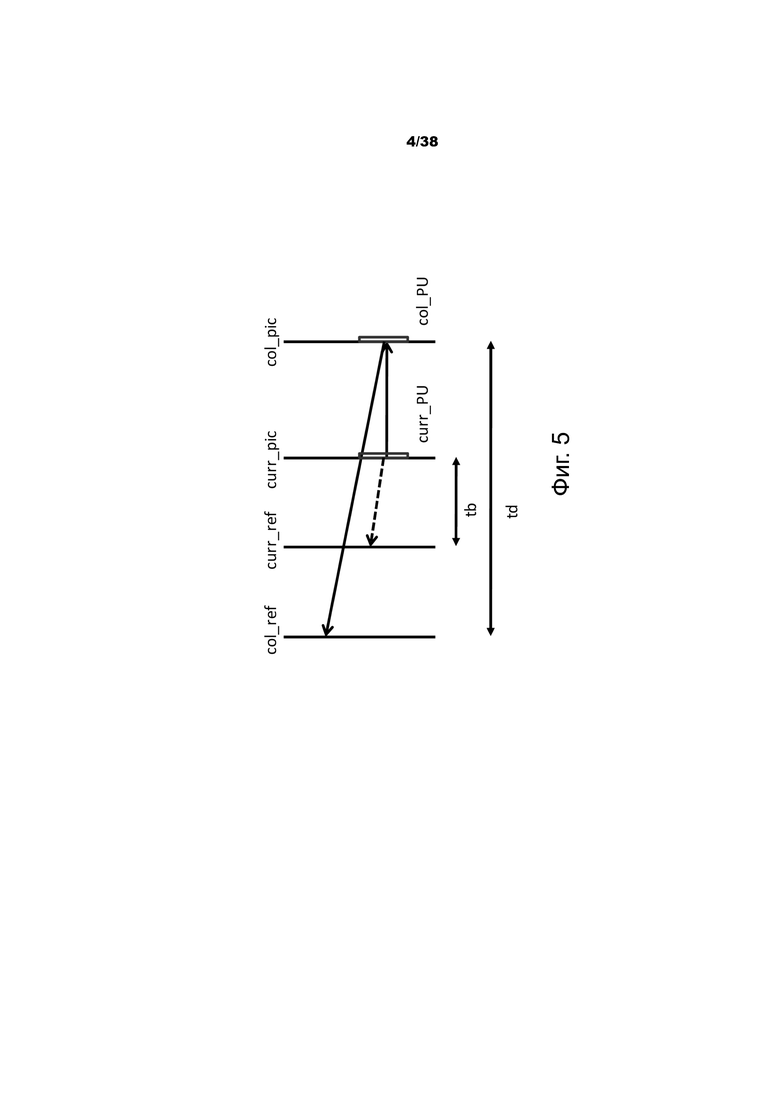

Фиг.5 – пример масштабирования вектора движения для временных кандидатов слияния.

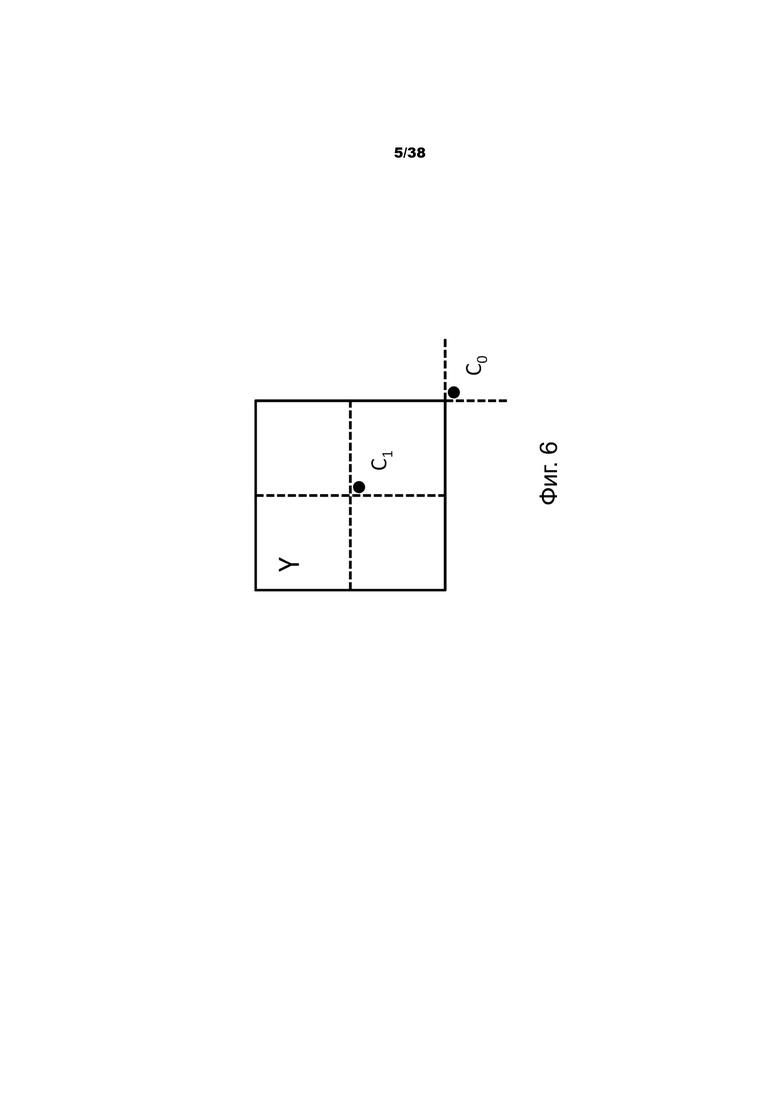

Фиг.6 – пример позиций кандидатов для временных кандидатов слияния.

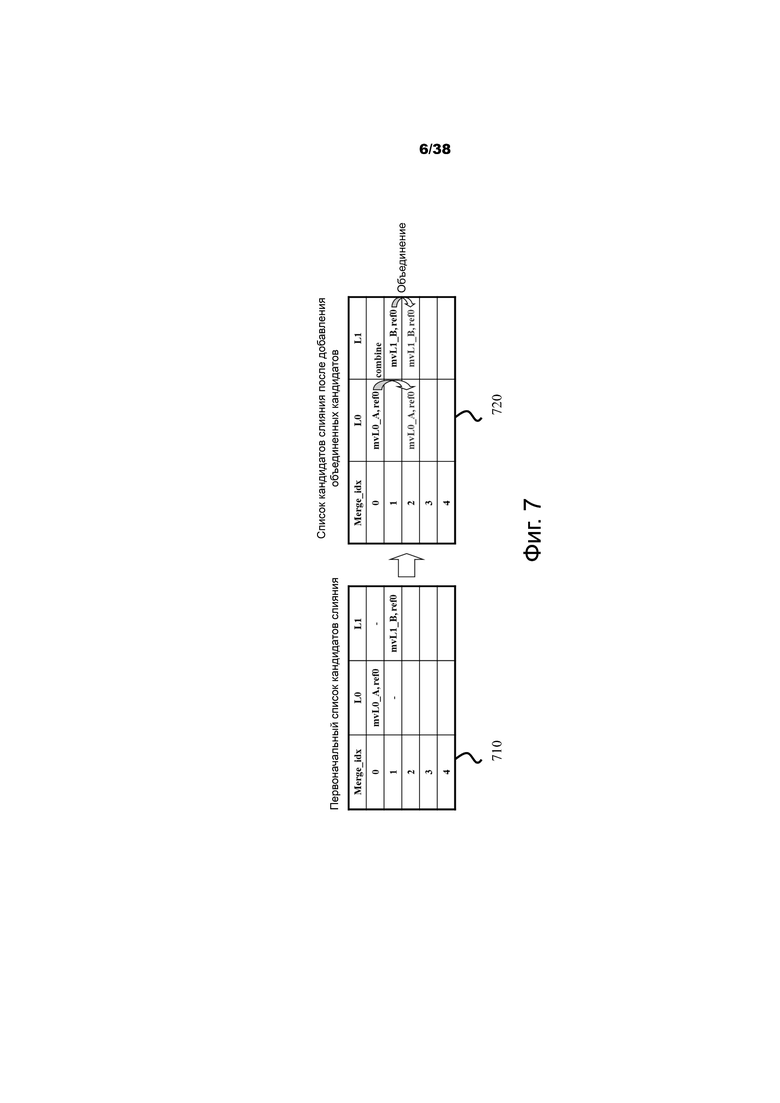

Фиг.7 – пример выработки объединенного кандидата слияния с би-предсказанием.

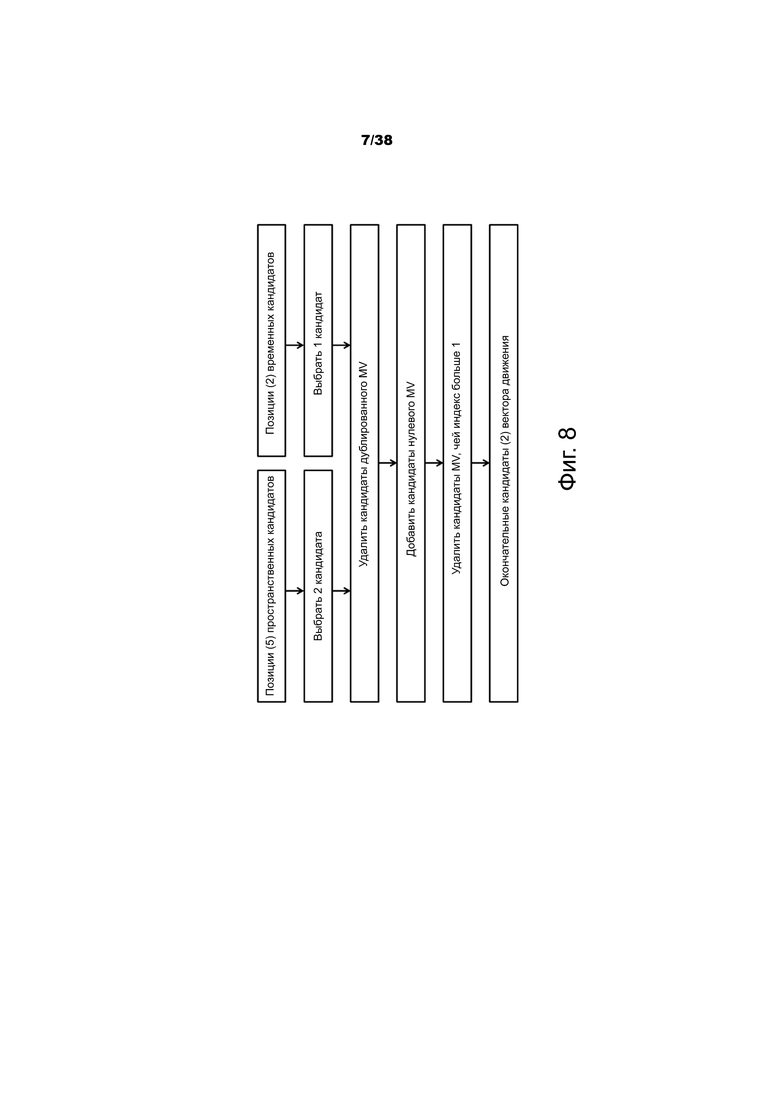

Фиг.8 – пример построения кандидатов предсказания вектора движения.

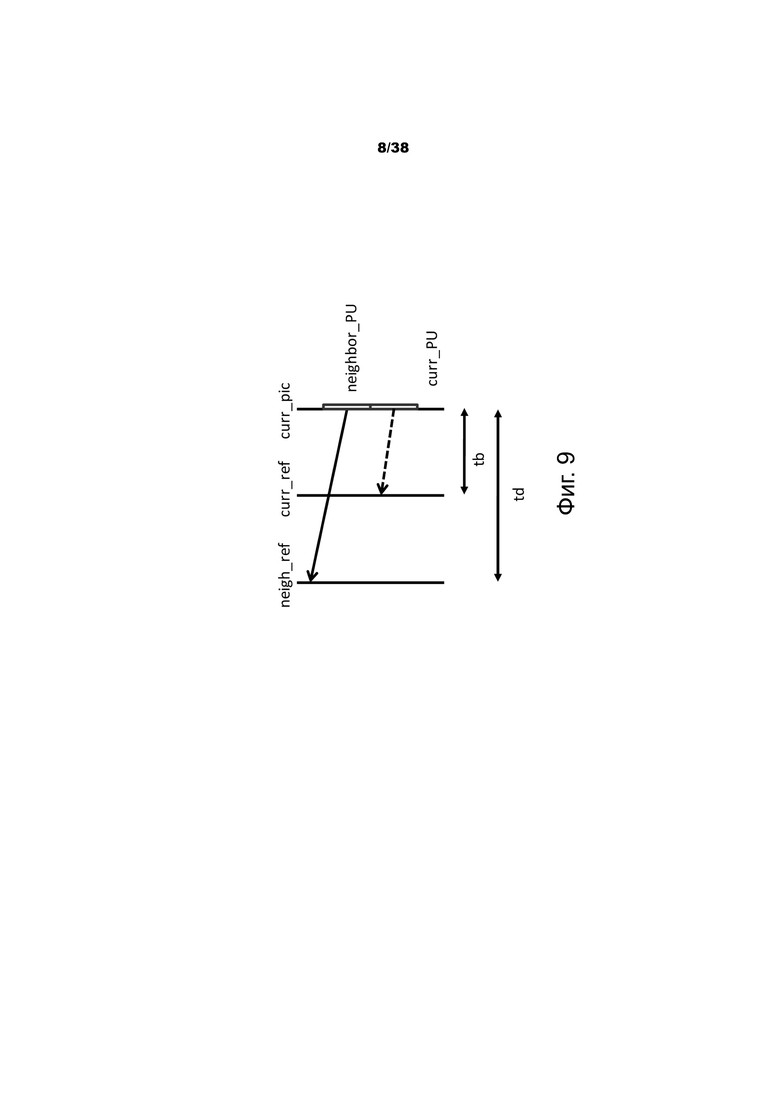

Фиг.9 – пример масштабирования вектора движения для пространственных кандидатов вектора движения.

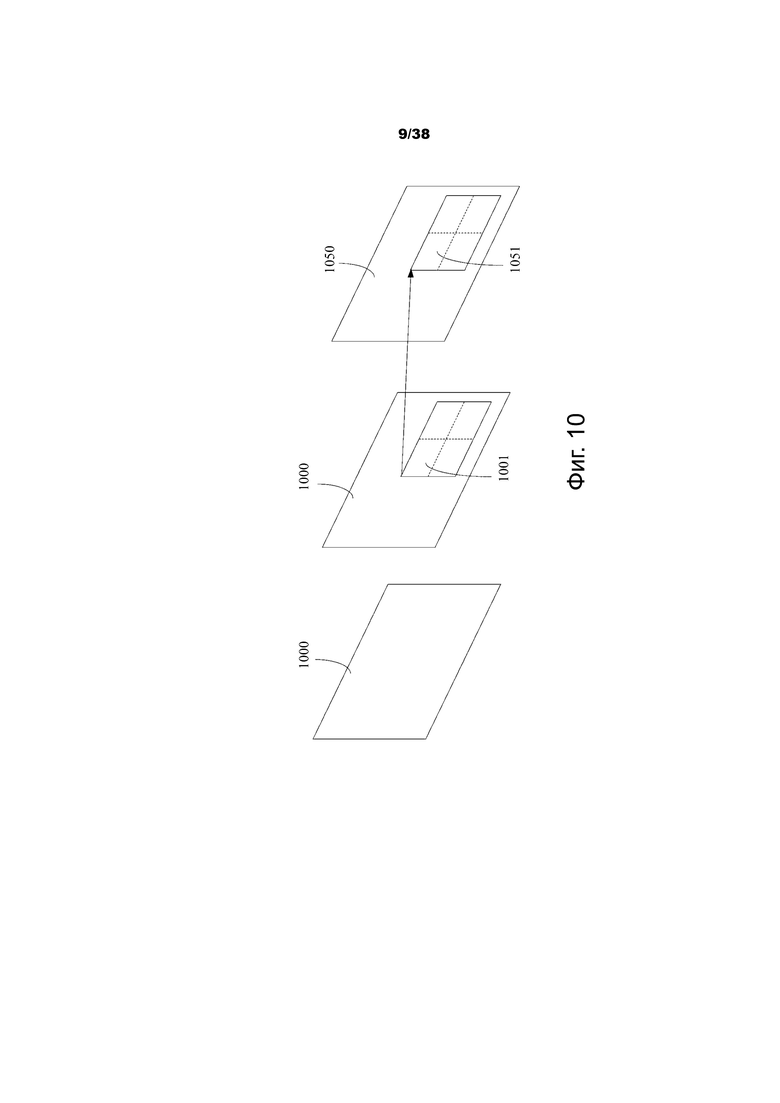

Фиг.10 – пример предсказания движения с использованием алгоритма альтернативного временного предсказания вектора движения (ATMVP) для единицы кодирования (CU).

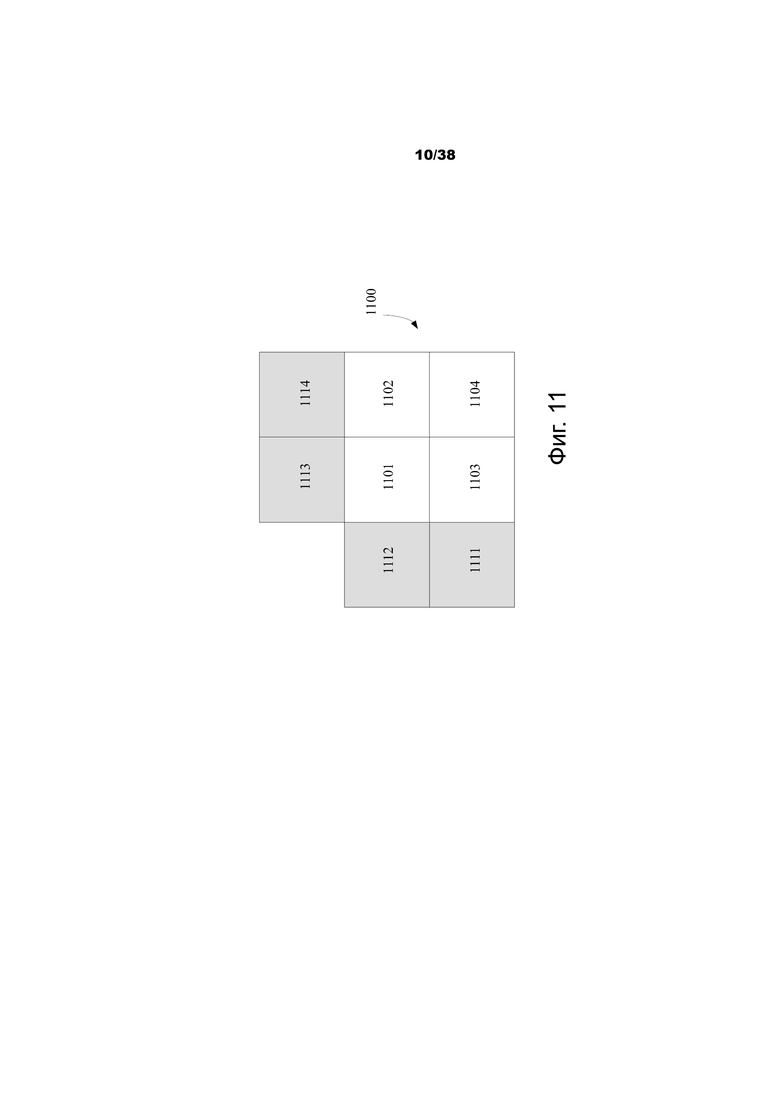

Фиг.11 – пример единицы кодирования (CU) с подблоками и соседними блоками, которые используются в алгоритме предсказания пространственно-временных векторов движения (STMVP).

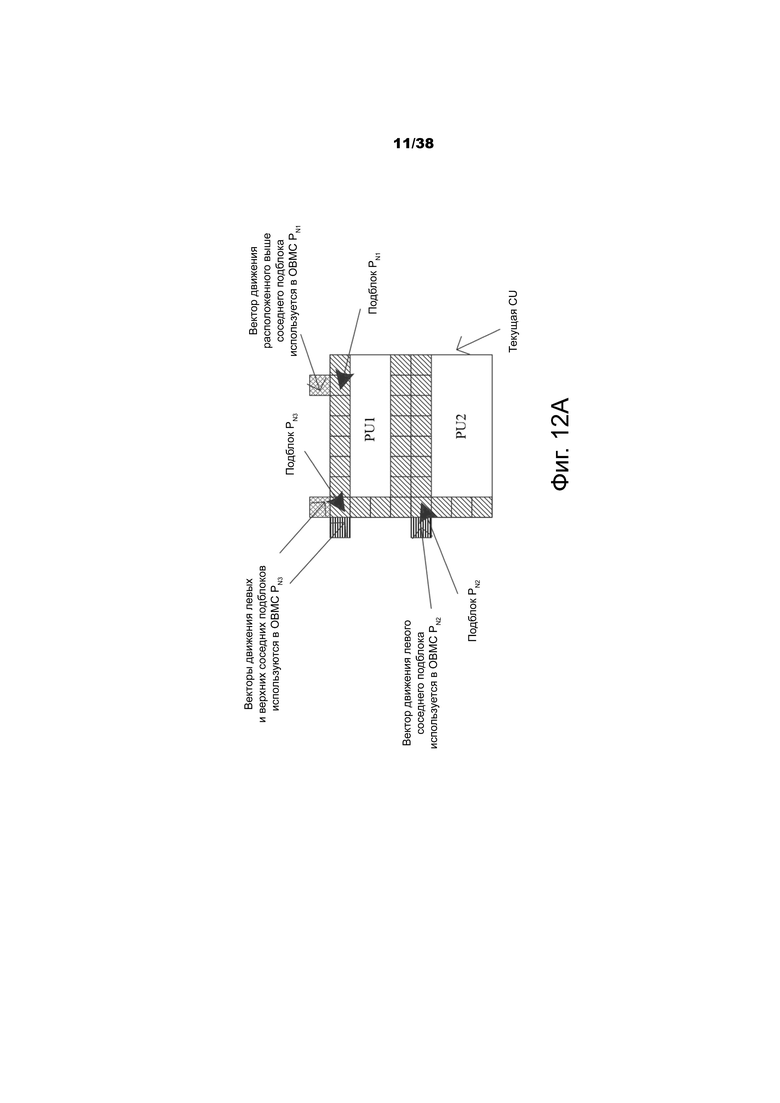

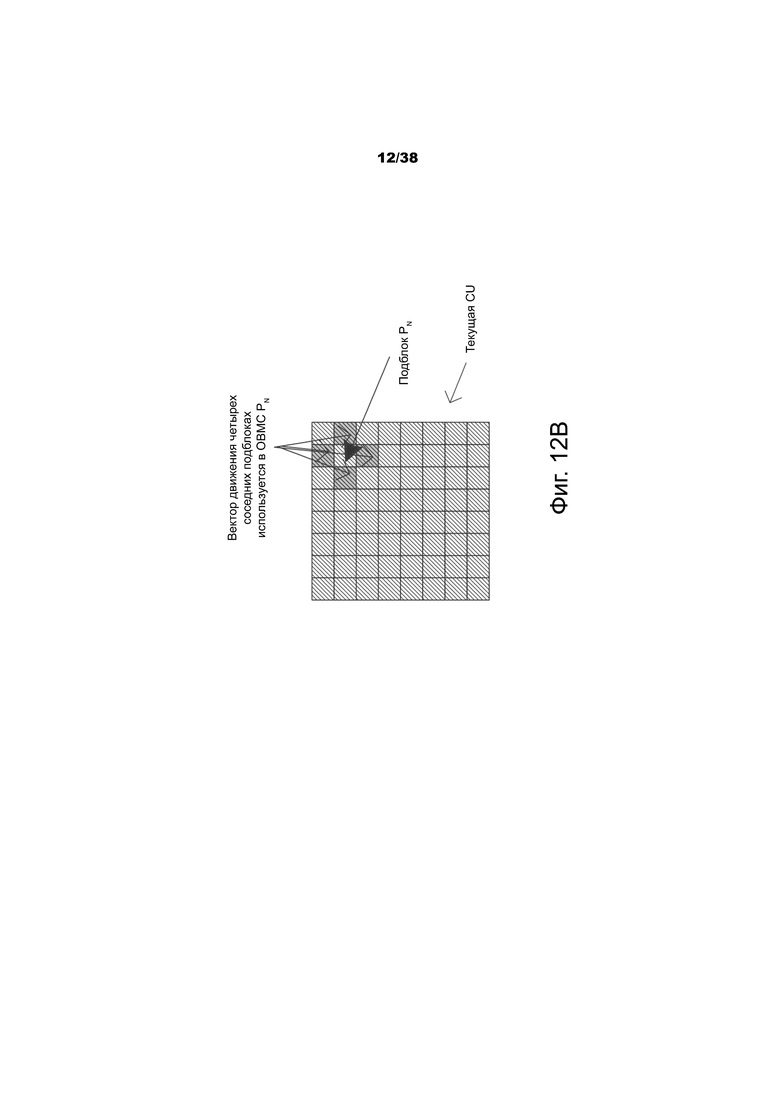

Фиг.12A и 12B – примерные снимки подблока при использовании алгоритма компенсации движения перекрывающихся блоков (OBMC).

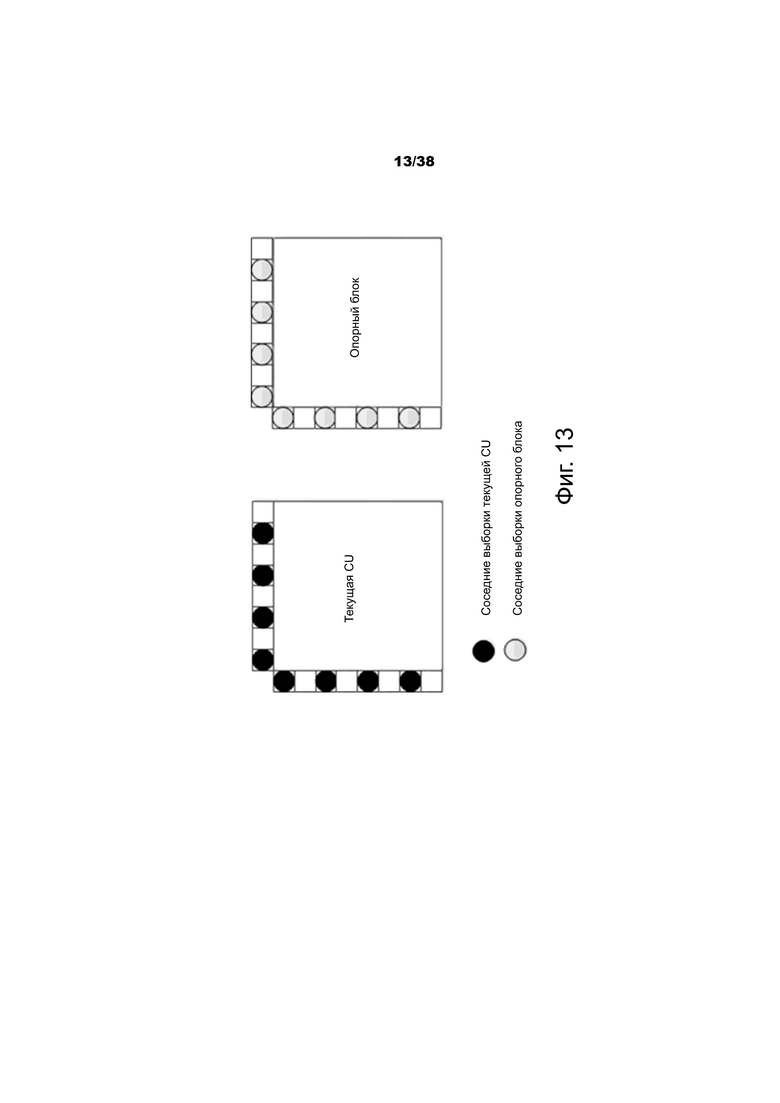

Фиг.13 – пример соседних выборок, используемых для получения параметров для алгоритма компенсации локальной освещенности (LIC).

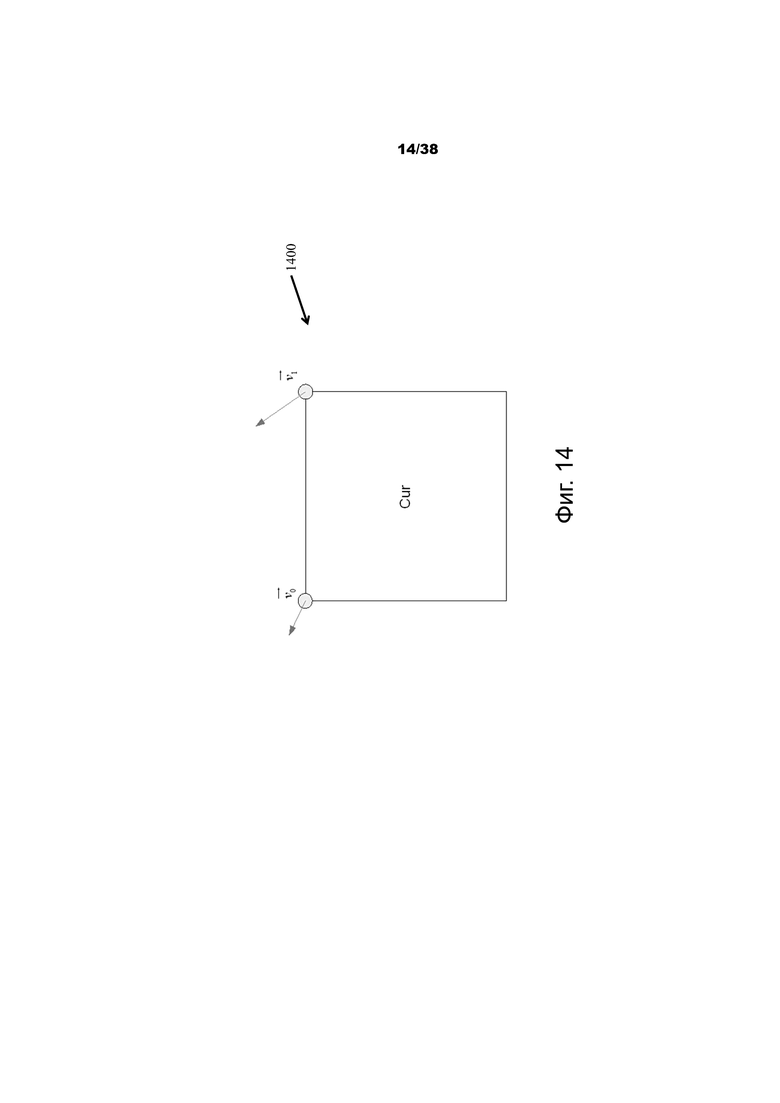

Фиг.14 – пример упрощенной модели аффинного движения.

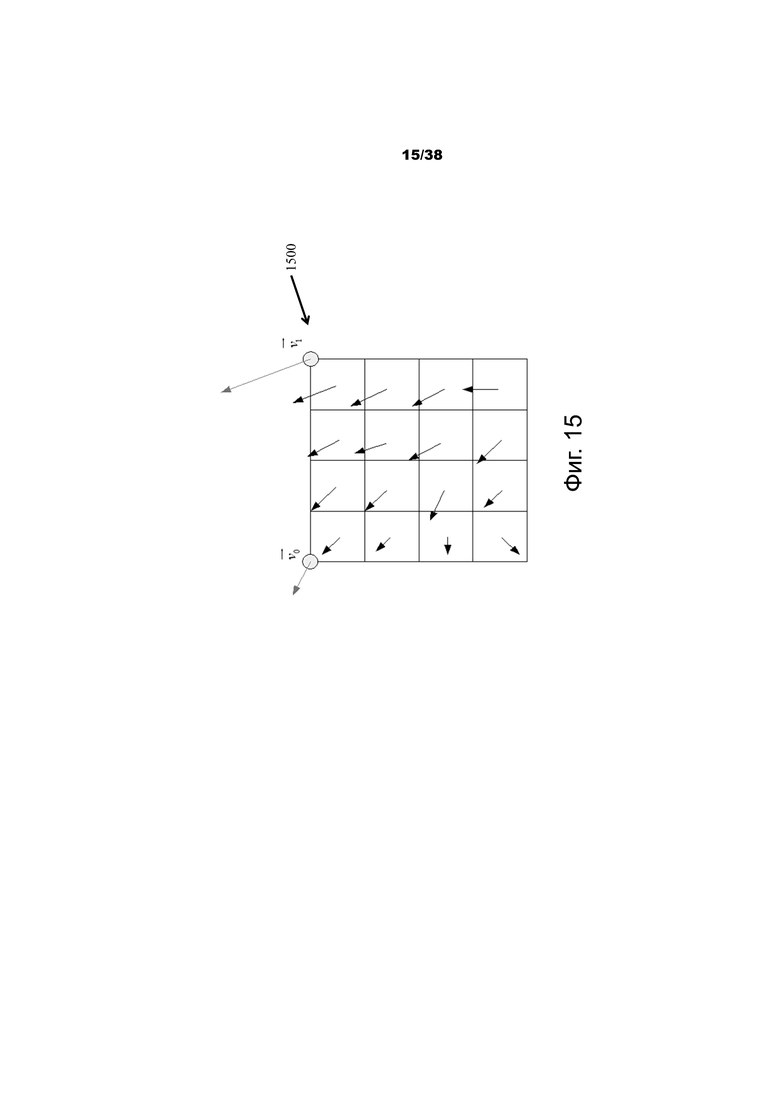

Фиг.15 – пример векторного поля аффинного движения (MVF) для каждого подблока.

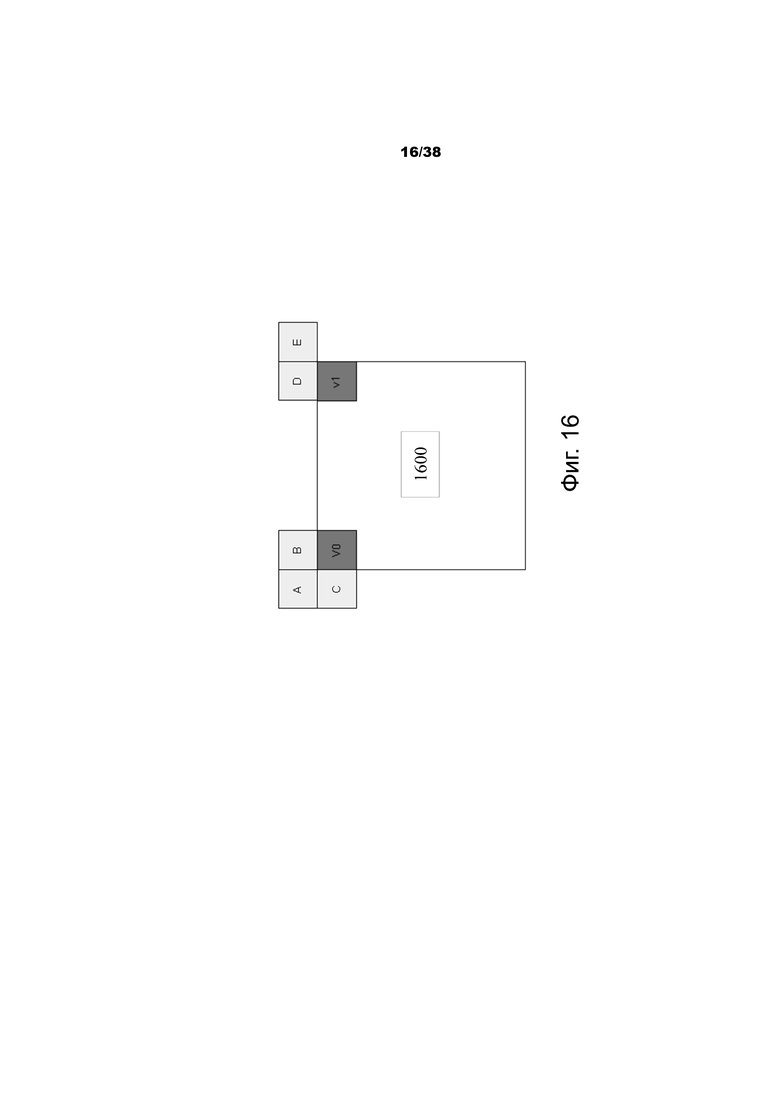

Фиг.16 – пример предсказания вектора движения (MVP) для режима аффинного движения AF_INTER.

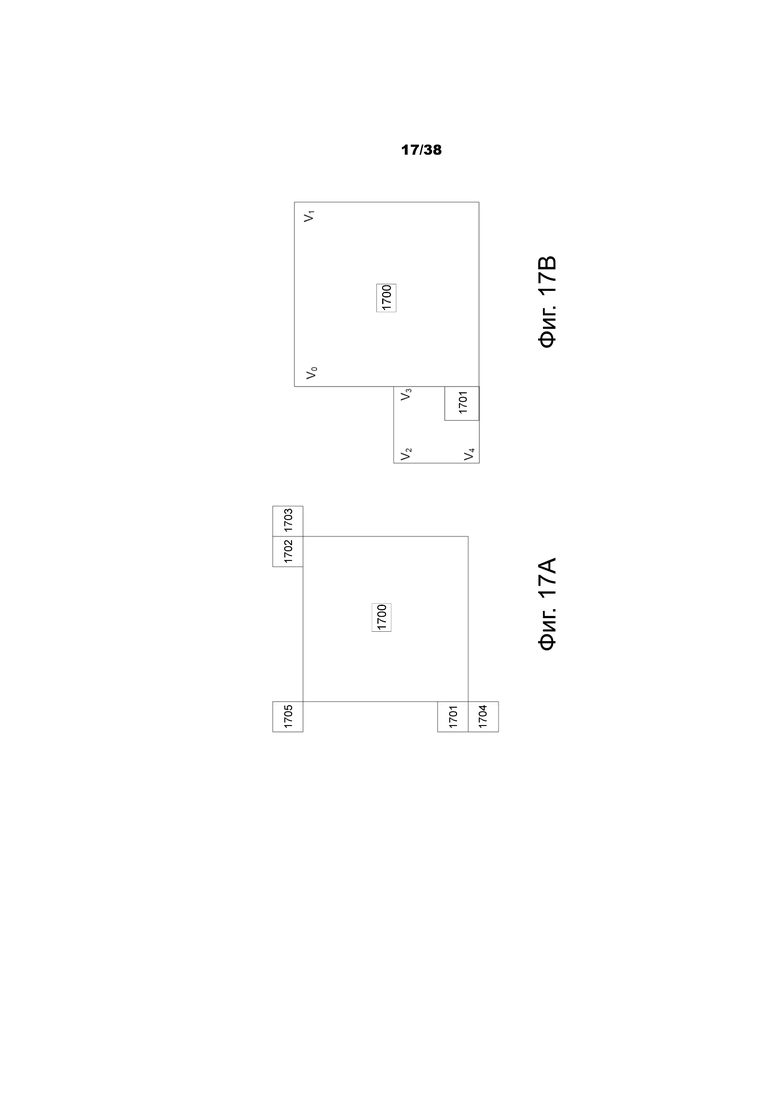

Фиг.17A и 17В – пример кандидатов в режиме аффинного движения AF_MERGE.

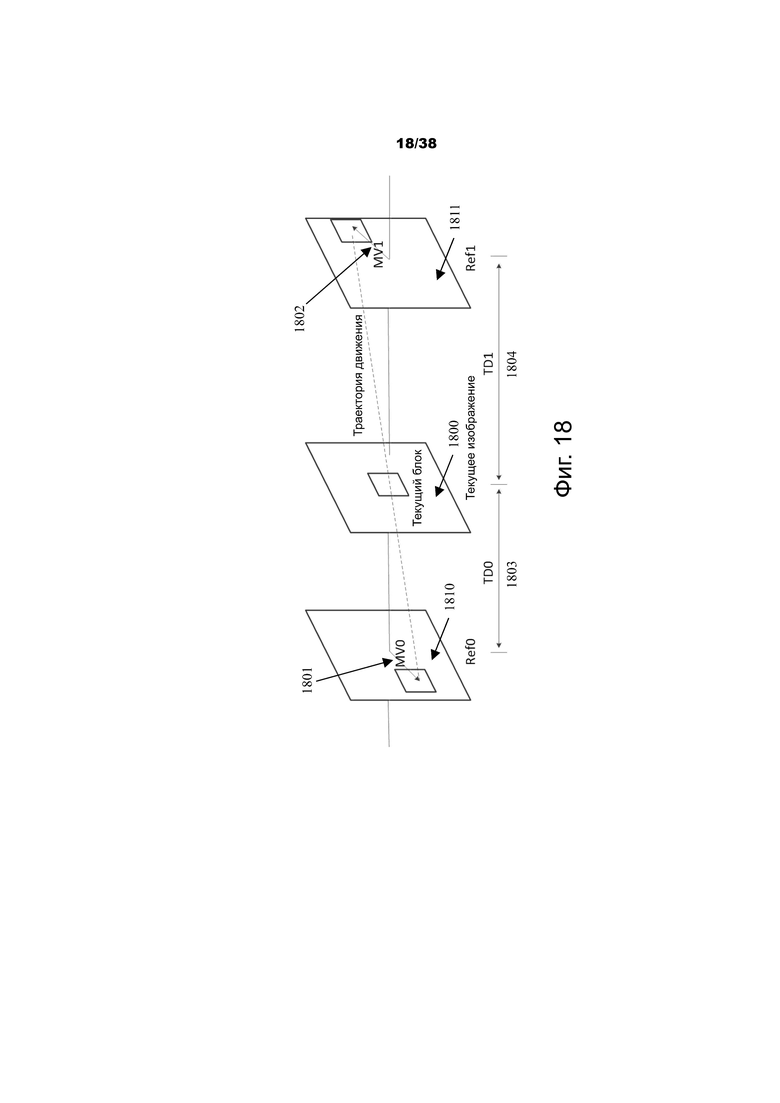

Фиг.18 – пример двустороннего согласования в режиме получения вектора движения, согласованного с шаблоном (PMMVD), который представляет собой специальный режим слияния, основанный на алгоритме преобразования с повышением частоты кадров (FRUC).

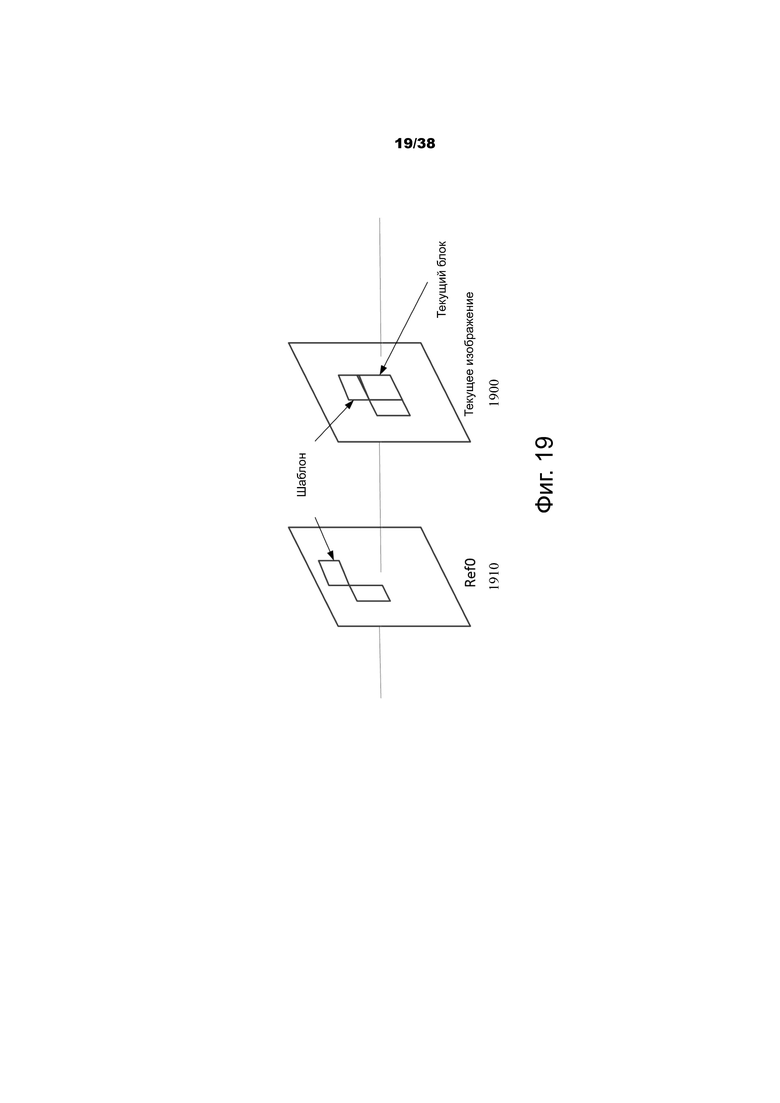

Фиг.19 – пример согласования с шаблоном в алгоритме FRUC.

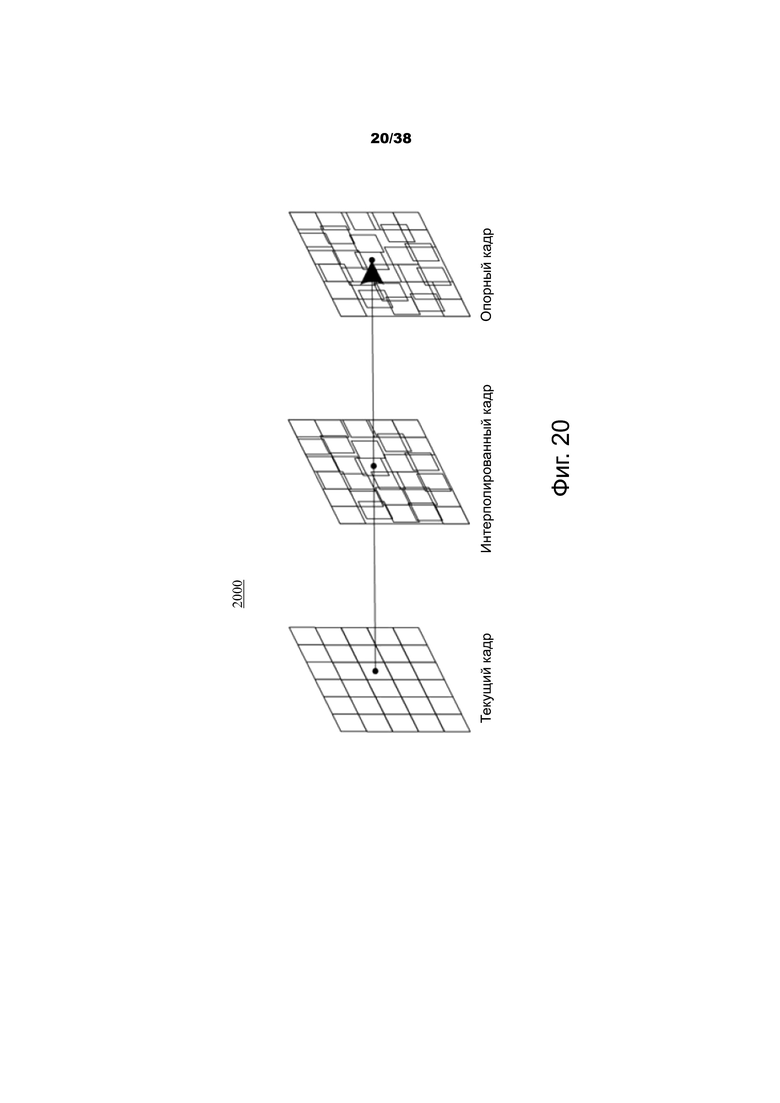

Фиг.20 – пример оценки одностороннего движения в алгоритме FRUC.

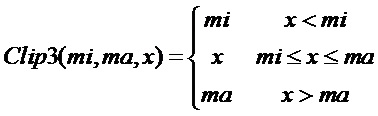

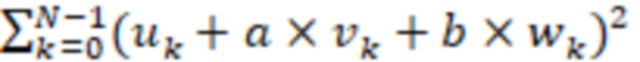

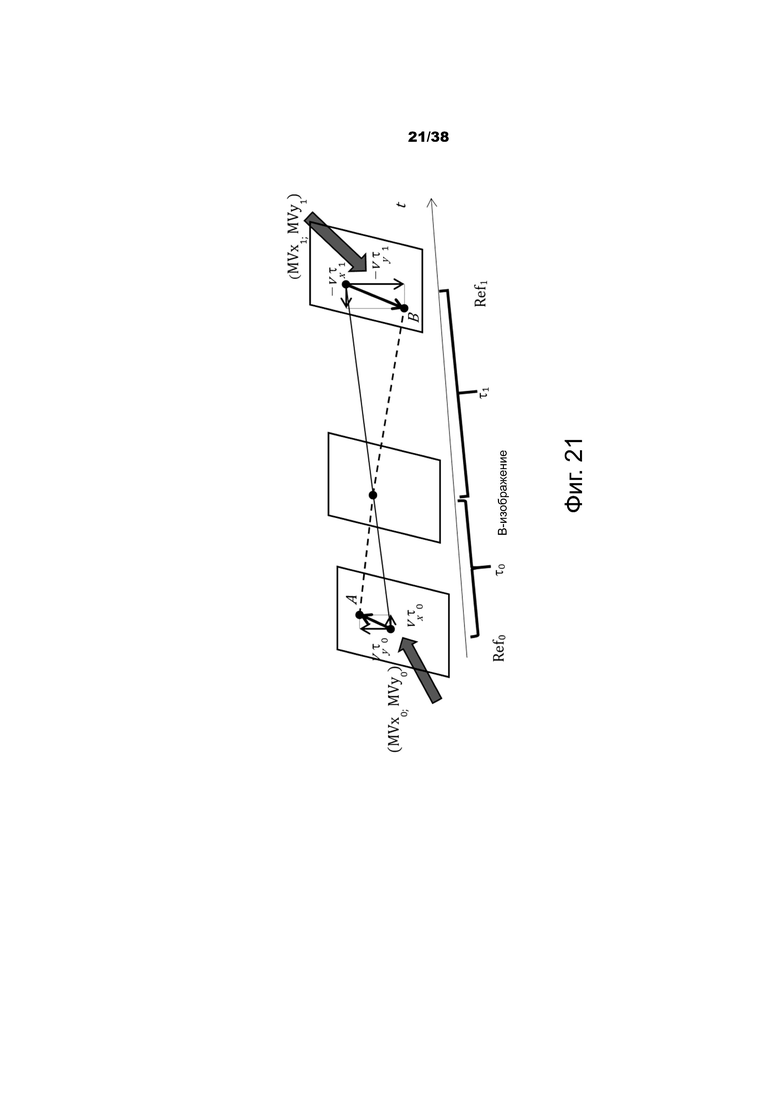

Фиг.21 – пример траектории оптического потока, используемой алгоритмом двунаправленного оптического потока (BDOF).

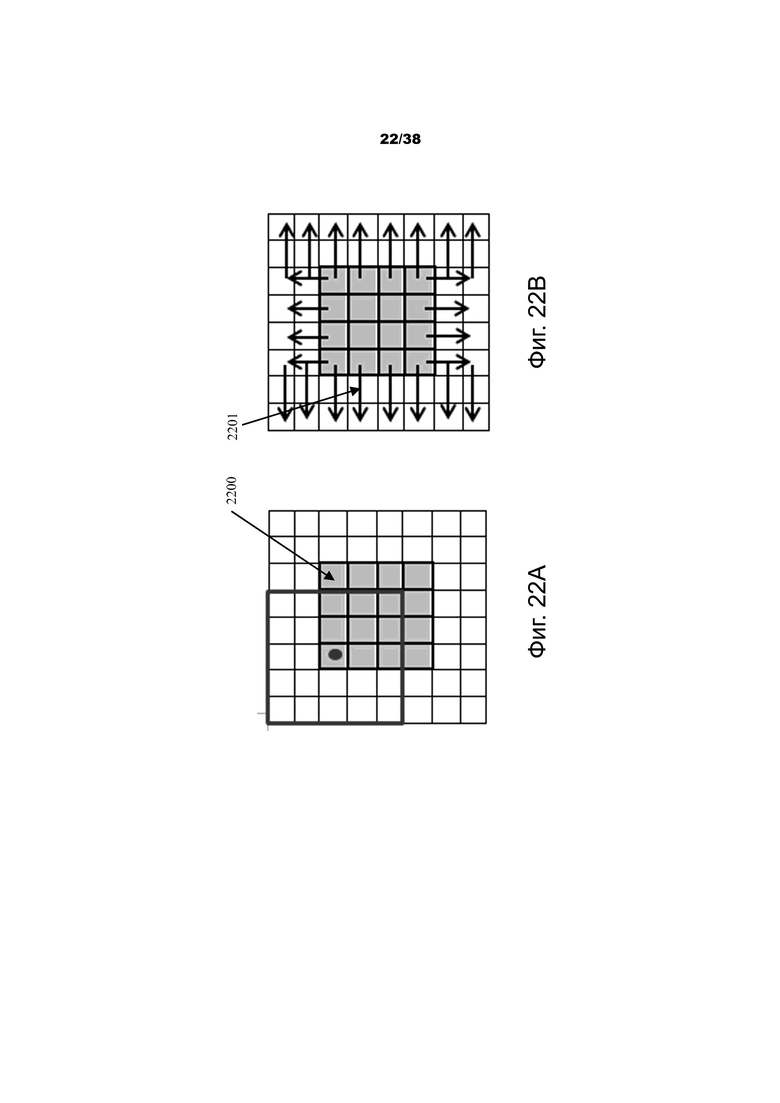

Фиг.22A и 22B – примерные снимки использования алгоритма двунаправленного оптического потока (BDOF) без расширения блока.

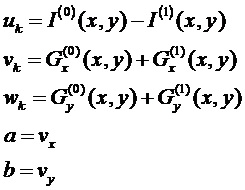

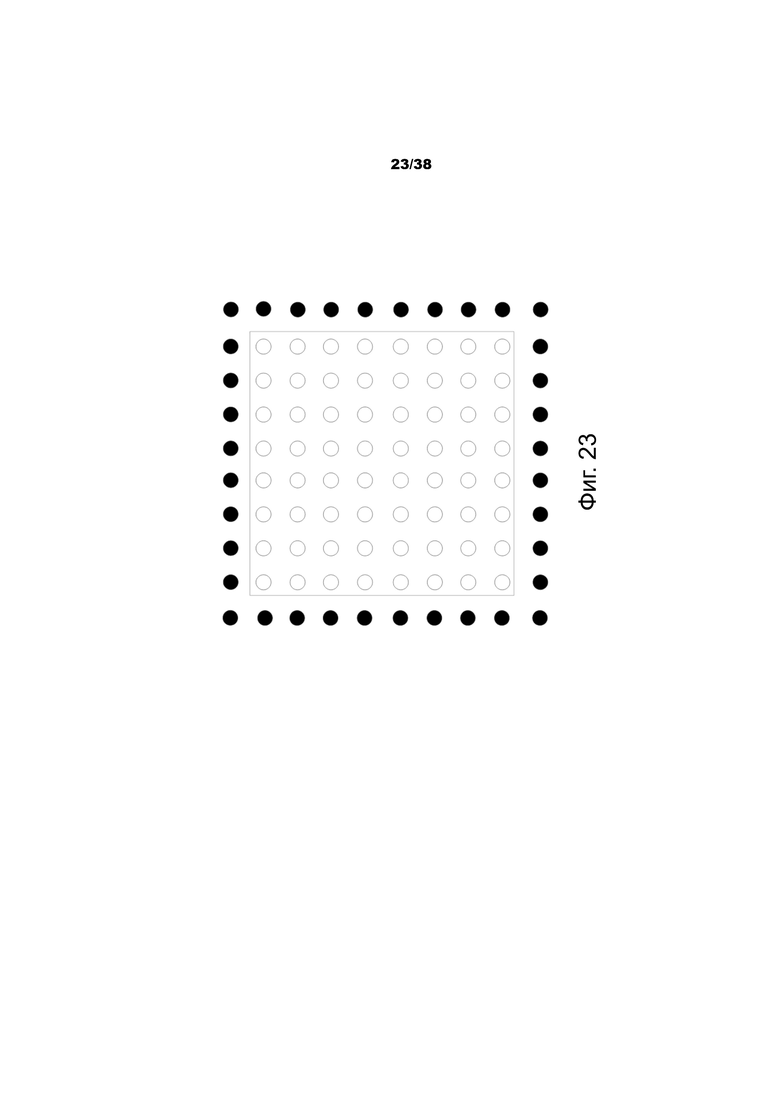

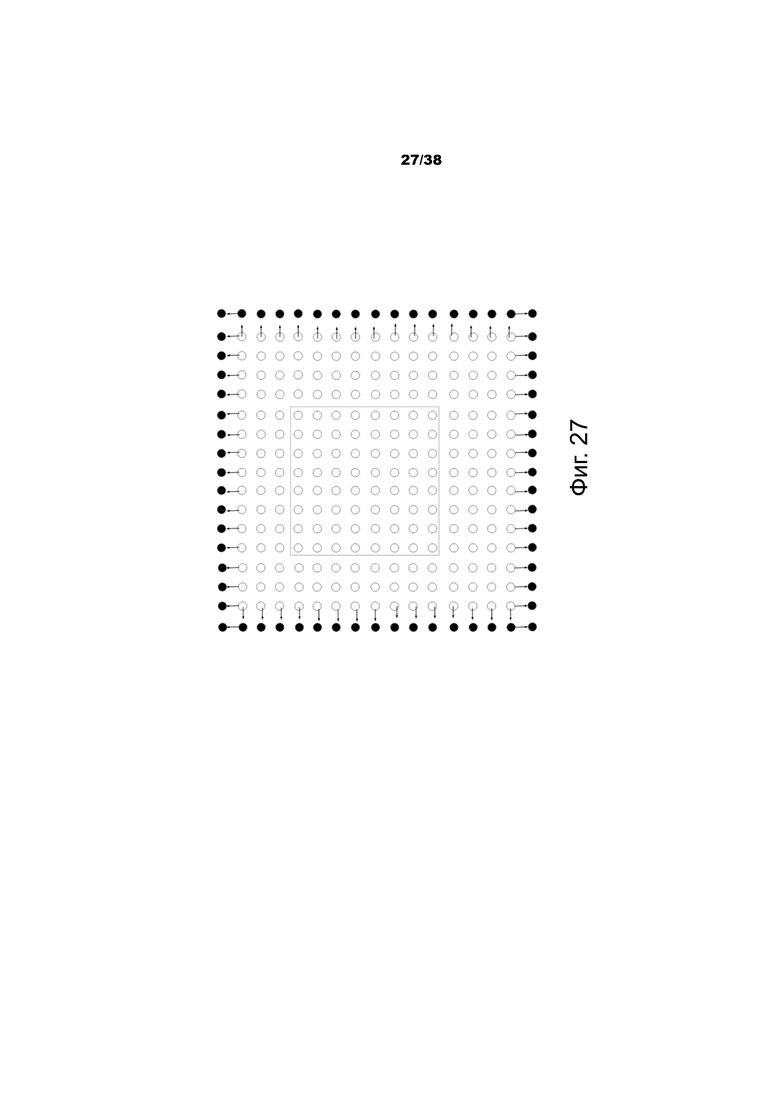

Фиг.23 – пример интерполированных выборок, используемых в BDOF.

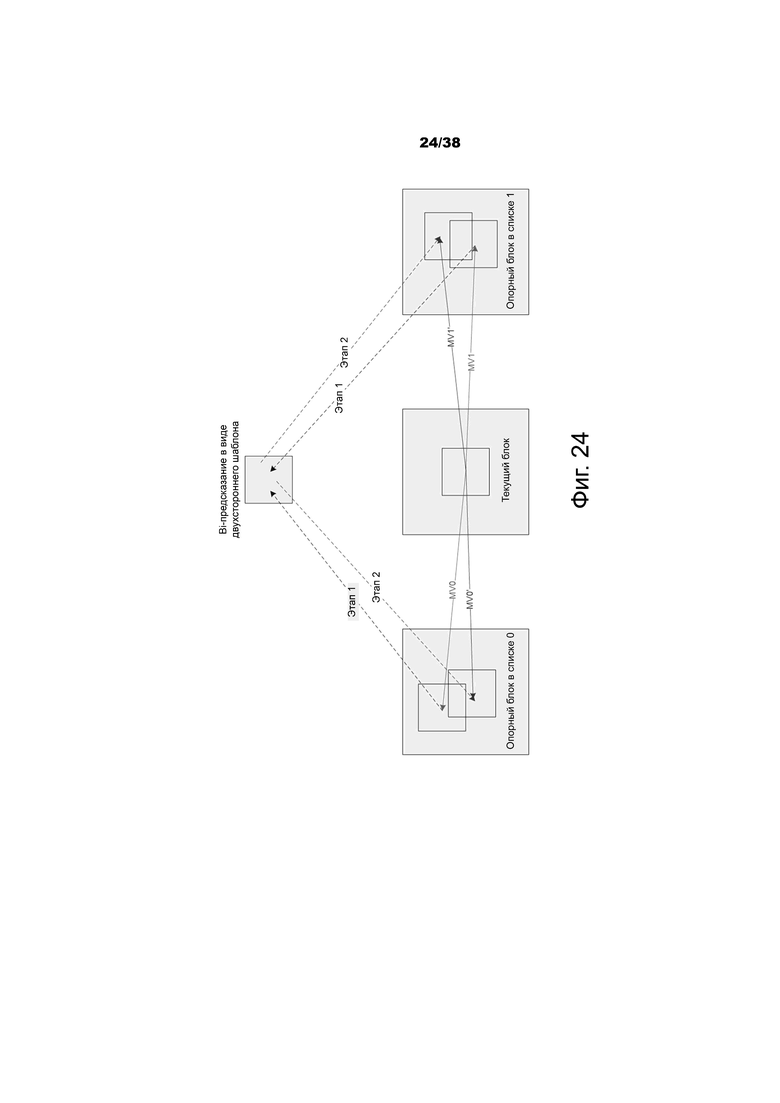

Фиг.24 – пример алгоритма уточнения вектора движения (DMVR) на стороне декодера на основе двустороннего согласования с шаблоном.

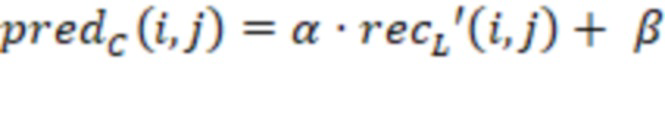

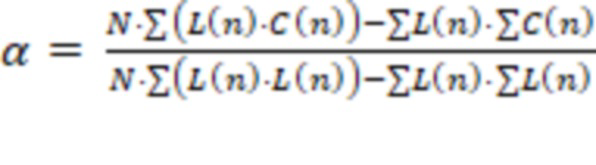

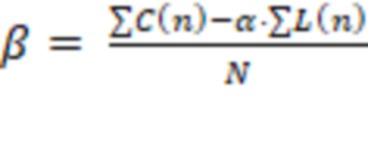

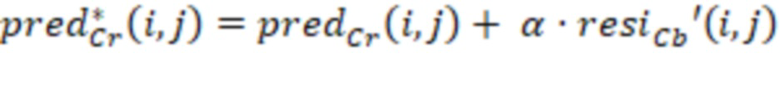

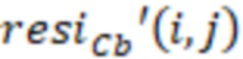

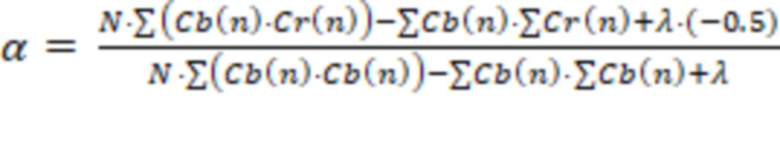

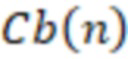

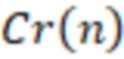

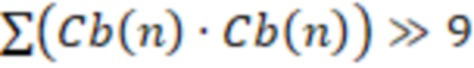

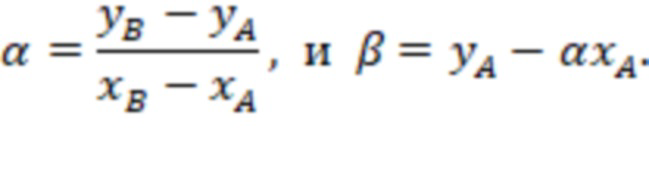

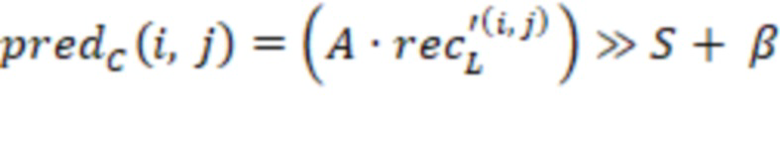

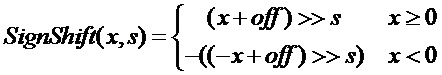

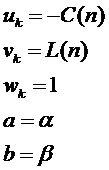

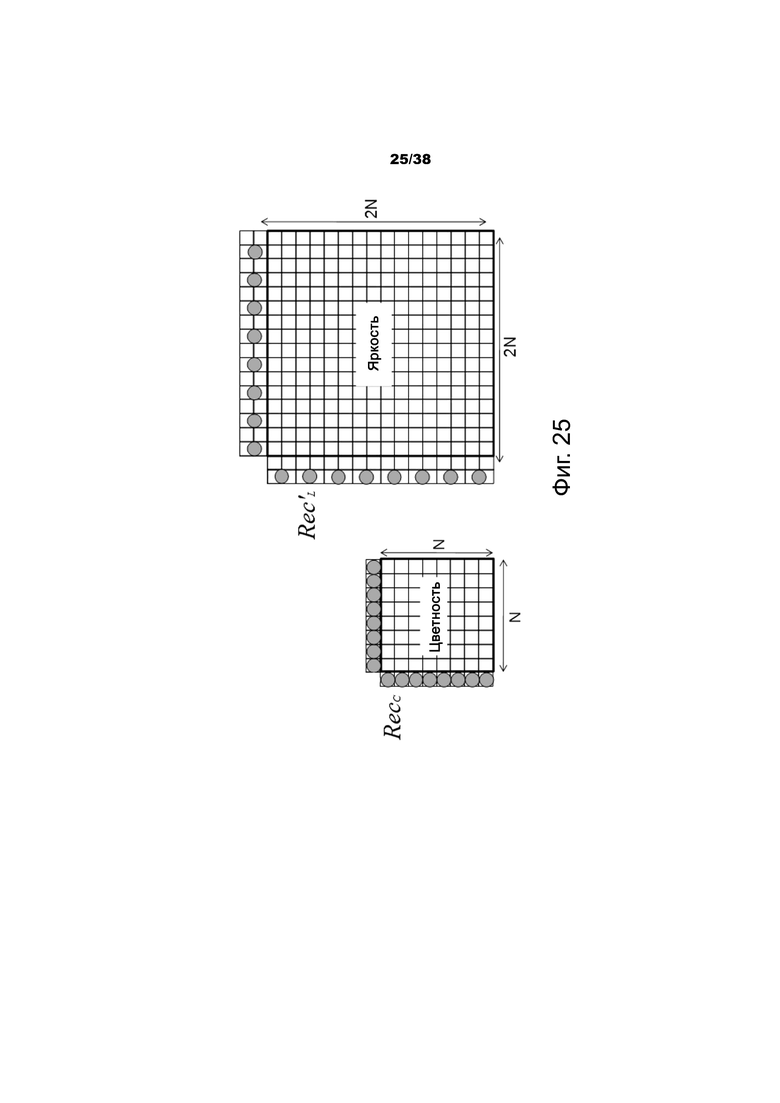

Фиг.25 – пример местоположений выборок, используемых для получения параметров линейной модели (α и β) в режиме линейного предсказания.

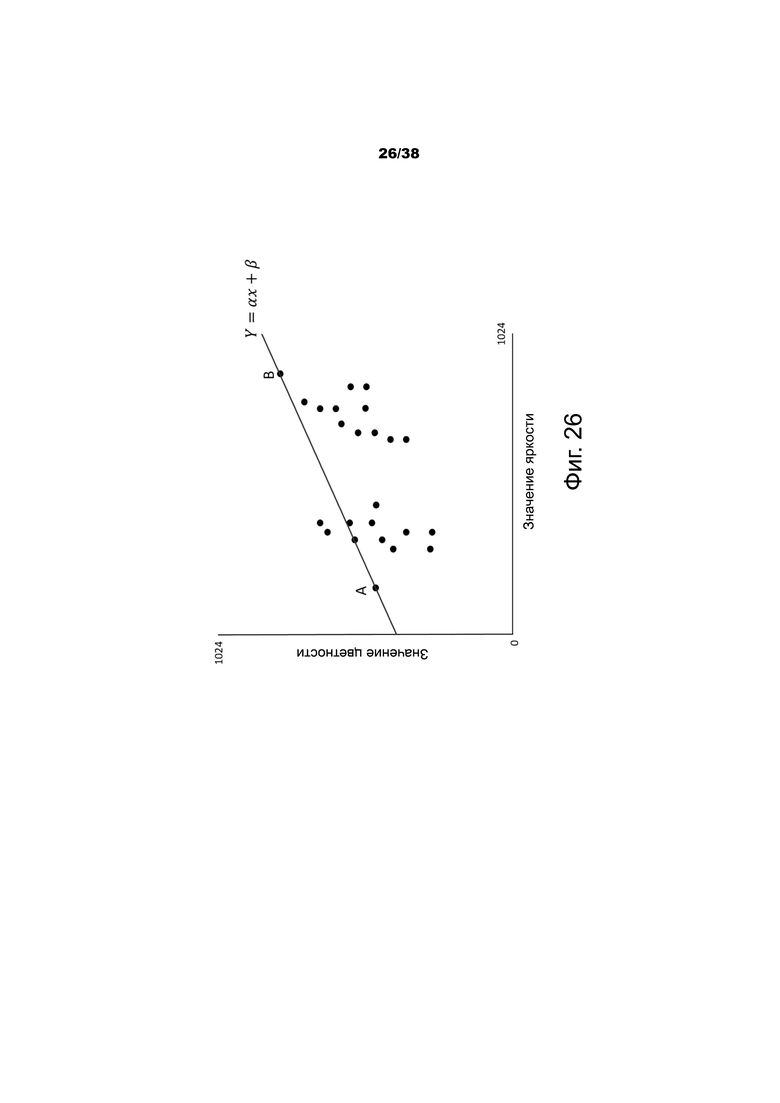

Фиг.26 – пример прямой линии (представляющей линейную модель) между максимальным и минимальным значениями яркости.

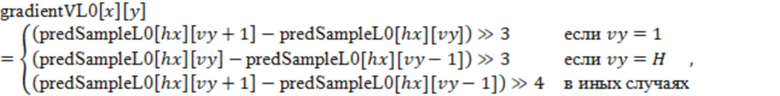

Фиг.27 – другой пример интерполированных выборок, используемых в BDOF.

Фиг.28А-28I – блок-схемы последовательностей операций примерных способов обработки видео.

Фиг.29 – блок-схема примера аппаратной платформы для реализации технологии декодирования визуального медиа или кодирования визуального медиа, описанной в настоящем документе.

Фиг.30 – блок-схема примерной системы обработки видео, в которой могут быть реализованы раскрытые технологии.

Осуществление изобретения

В связи с растущим спросом на видео с более высоким разрешением в современной технологии повсеместно используются способы и технологии кодирования видео. Видеокодеки, как правило, включают в себя электронную схему или программное обеспечение, которое сжимает или восстанавливает цифровое видео, и постоянно совершенствуется для того, чтобы обеспечить более высокую эффективность кодирования. Видеокодек преобразует несжатое видео в сжатый формат или наоборот. Существуют сложные взаимосвязи между качеством видео, объемом данных, используемым для представления видео (который определяется скоростью передачи данных), сложностью алгоритмов кодирования и декодирования, чувствительностью к потерям и ошибкам данных, простотой редактирования, произвольным доступом и сквозной задержкой (запаздыванием). Сжатый формат обычно соответствует стандартной спецификации сжатия видео, например, стандарту высокоэффективного кодирования видео (HEVC) (также известному как H.265 или MPEG-H, часть 2), стандарту универсального кодирования видео, который должен быть доработан, или другим современным стандартам и/или будущим стандартам кодирования видео.

Варианты осуществления раскрытой технологии могут применяться к существующим стандартам кодирования видео (например, HEVC, H.265) и будущим стандартам для повышения производительности сжатия. В настоящем документе заголовки разделов используются для улучшения удобочитаемости описания и никоим образом не ограничивают обсуждения или варианты осуществления (и/или реализации) только соответствующими разделами.

1. Примеры внешнего предсказания в HEVC/H.265

За последние годы значительно улучшились стандарты кодирования видео, которые теперь обеспечивают частично высокую эффективность кодирования и поддержку более высоких разрешений. Последние стандарты, такие как HEVC и H.265, основаны на структуре гибридного кодирования видео, в которой используется временное предсказание плюс кодирование с преобразованием.

1.1 Примеры режимов предсказания

Каждая внешне предсказанная единица предсказания (PU) имеет параметры движения для одного или двух списков опорных изображений. В некоторых вариантах осуществления параметры движения включают в себя вектор движения и индекс опорного изображения. В других вариантах осуществления использование одного из двух списков опорных изображений также может сигнализироваться с помощью inter_pred_idc. В еще одних вариантах осуществления векторы движения могут быть явно закодированы как дельты по отношению к предикторам.

Когда CU кодируются с режимом пропуска, одна PU ассоциируется с CU, и отсутствуют какие-либо существенные остаточные коэффициенты, дельта некодированных векторов движения или индекс опорного кадра. Режим слияния точно определяется, в результате чего параметры движения для текущей PU получаются из соседних PU, включая пространственные и временные кандидаты. Режим слияния может применяться к любой внешне предсказанной PU, а не только к режиму пропуска. Альтернативой режиму слияния является явной передачей параметров движения, где вектор движения, соответствующий индекс опорного кадра для каждого списка опорных изображений и использование списка опорных изображений сигнализируются в явном виде в расчете на одну PU.

Когда сигнализация указывает, что должен использоваться один из двух списков опорных изображений, PU создается из одного блока выборок. Это называется "универсальным предсказанием". Универсальное предсказание доступно как для P-срезов, так и для B-срезов.

Когда сигнализация указывает, что должны использоваться оба списка опорных изображений, PU создается из двух блоков выборок. Это упоминается как "двунаправленное предсказание". Би-предсказание доступно только для B-срезов.

1.1.1 Варианты построения кандидатов для режима слияния

Когда PU предсказывается с использованием режима слияния, индекс, указывающий на запись в списке кандидатов слияния, анализируется из битового потока и используется для извлечения информации о движении. Построение этого списка можно кратко представить в виде следующей последовательностью этапов:

Этап 1: Получение исходных кандидатов

Этап 1.1: Получение пространственных кандидатов

Этап 1.2: Проверка избыточности для пространственных кандидатов

Этап 1.3: Получение временных кандидатов

Этап 2: Добавление дополнительных кандидатов

Этап 2.1: Создание кандидатов с би-предсказанием

Этап 2.2: Вставка кандидатов с нулевым движением

На фиг.1 показан пример построения списка кандидатов слияния на основе последовательности этапов, кратко изложенных выше. Для получения пространственного кандидата слияния выбирается максимум четыре кандидата слияния из кандидатов, которые расположены в пяти разных позициях. Для получения временного кандидата слияния из двух кандидатов выбирается максимум один кандидат слияния. Так как в декодере предполагается постоянное количество кандидатов для каждой PU, дополнительные кандидаты вырабатываются тогда, когда количество кандидатов не достигает максимального количества кандидатов слияния (MaxNumMergeCand), которое сигнализируется в заголовке среза. Так как количество кандидатов является постоянным, индекс лучшего кандидата слияния кодируется с использованием усеченной унарной бинаризации (TU). Если размер CU равен 8, все PU текущей CU совместно используют один список кандидатов слияния, который идентичен списку кандидатов слияния блока предсказания 2N×2N.

1.1.2 Построение пространственных кандидатов слияния

При получении пространственных кандидатов слияния максимум четыре кандидата слияния выбираются среди кандидатов, расположенных в позициях, изображенных на фиг.2. Порядок получения является следующим: A1, B1, B0, A0 и B2. Позиция B2 рассматривается только тогда, когда любая PU из позиции A1, B1, B0, A0 недоступна (например, так как она принадлежит другому срезу или тайлу) или интракодирована. После того как добавлен кандидат в позиции A1, добавление оставшихся кандидатов подлежит проверке на избыточность, которая гарантирует, что кандидаты с одинаковой информацией о движении исключены из списка, поэтому повышается эффективность кодирования.

Чтобы уменьшить вычислительную сложность, не все возможные пары кандидатов рассматриваются в упомянутой проверке на избыточность. Вместо этого рассматриваются только пары, связанные стрелкой, показанной на фиг.3, и кандидат добавляется в список только в том случае, если соответствующий кандидат, используемый для проверки на избыточность, не имеет такой же информации о движении. Еще одним источником дублированной информации о движении является "вторая PU", ассоциированная с разделениями, которые отличаются от 2Nx2N. В качестве примера на фиг.4A и 4B показана вторая PU для случая N×2N и 2N×N, соответственно. Когда текущая PU разделена как N×2N, кандидат в позиции A1 не рассматривается для построения списка. В некоторых вариантах осуществления добавление этого кандидата может привести к двум блокам предсказания, имеющим одинаковую информацию о движении, которая является избыточной для того, чтобы иметь только одну PU в блоке кодирования. Аналогичным образом, позиция B1 не учитывается тогда, когда текущая PU разделена как 2N×N.

1.1.3 Создание временных кандидатов слияния

На этом этапе в список добавляется только один кандидат. В частности, при получении этого временного кандидата слияния масштабированный вектор движения получается на основе совмещенной PU, принадлежащей изображению, которое имеет наименьшую разницу POC с текущим изображением в данном списке опорных изображений. Список опорных изображений, который должен использоваться для получения совмещенной PU, явно указывается в заголовке среза.

На фиг.5 показан пример получения масштабируемого вектора движения для временного кандидата слияния (пунктирная стрелка), который масштабируется от вектора движения совмещенной PU с использованием расстояний tb и td POC, где tb определяется как разность POC между опорным изображением текущего изображения и текущим изображением, и td определяется как разность POC между опорным изображением совмещенного изображения и совмещенным изображением. Индекс опорного изображения временного кандидата объединения устанавливается равным нулю. Для B-среза два вектора движения, один для списка 0 опорных изображений, и другой - для списка 1 опорных изображений, получаются и объединяются для выработки кандидата слияния с би-предсказанием.

В совмещенной PU (Y), принадлежащей к опорному кадру, позиции для временного кандидата выбираются между кандидатами С0 и С1, как показано на фиг.6. Если PU в позиции С0 недоступна, внутренне кодирована или находится за пределами текущей CTU, используется позиция C1. В иных случаях позиция С0 используется при получении временного кандидата слияния.

1.1.4 Построение дополнительных типов кандидатов слияния

Помимо пространственно-временных кандидатов слияния, существует два дополнительных типа кандидатов слияния: объединенный кандидат слияния с би-предсказанием и нулевой кандидат слияния. Объединенные кандидаты слияния с би-предсказанием вырабатываются с использованием пространственно-временных кандидатов слияния. Объединенный кандидат слияния с двунаправленным предсказанием используется только для B-среза. Объединенные кандидаты с би-предсказанием вырабатываются путем объединения параметров движения из первого списка опорных изображений одного исходного кандидата с параметрами движения из второго списка опорных изображений другого. Если эти два кортежа будут предоставлять разные гипотезы движения, они сформируют новый кандидат с би-предсказанием.

На фиг.7 показан пример этого процесса, в котором два кандидата в исходном списке (поз.710 слева), которые имеют mvL0 и refIdxL0 или mvL1 и refIdxL1, используются для выработки объединенного кандидата слияния с би-предсказанием, добавленного в окончательный список (поз.720 справа).

Нулевые кандидаты движения вставляются для заполнения оставшихся записей в списке кандидатов слияния и, следовательно, достигают максимальной емкости MaxNumMergeCand. Эти кандидаты имеют нулевое пространственное смещение и индекс опорного изображения, который начинается с нуля и увеличивается каждый раз, когда новый кандидат нулевого движения добавляется в список. Количество опорных кадров, используемых этими кандидатами, равно одному и двум для однонаправленного предсказания (уно-предсказания) и двунаправленного предсказания (би-предсказания), соответственно. В некоторых вариантах осуществления этих кандидатов не выполняется проверка избыточности.

1.1.5 Примеры областей оценки движения для параллельной обработки

Чтобы ускорить процесс кодирования, оценка движения может выполняться параллельно, посредством чего векторы движения для всех единиц предсказания внутри заданной области получаются одновременно. Получение кандидатов слияния из пространственного соседства может мешать параллельной обработке, так как одна единица предсказания не может получать параметры движения из соседней PU до тех пор, пока не будет завершена ассоциированная с ней оценка движения. Чтобы смягчить компромисс между эффективностью кодирования и задержкой при обработке, можно определить область оценки движения (MER). Размер MER может сигнализироваться в наборе параметров изображения (PPS) с использованием элемента синтаксиса "log2_parallel_merge_level_minus2". Когда MER определена, кандидаты слияния, попадающие в одну и ту же область, помечаются как недоступные и, следовательно, не учитываются при построении списка.

1.2 Варианты осуществления улучшенного предсказания вектора движения (AMVP)

В AMVP используется пространственно-временная корреляция вектора движения с соседними PU, которая используется для явной передачи параметров движения. Она формирует список кандидатов вектора движения, сначала проверяя доступность левых верхних временных соседних позиций PU, удаляя избыточные кандидаты и добавляя нулевой вектор, чтобы сделать список кандидатов с постоянной длиной. Затем кодер может выбрать лучший предиктор из списка кандидатов и передать соответствующий индекс, указывающий выбранный кандидат. По аналогии с сигнализацией индекса слияния индекс лучшего кандидата вектора движения кодируется с использованием усеченного унарного кода. Максимальное значение, которое должно быть закодировано в этом случае, равно 2 (смотри фиг.8). В следующих разделах представлены подробности о процессе получения кандидата предсказания вектора движения.

1.2.1 Примеры построения кандидатов предсказания вектора движения

На фиг.8 обобщенно показан процесс получения кандидата предсказания вектора движения, который может быть реализован для каждого списка опорных изображений с refidx в качестве входных данных.

При предсказании вектора движения рассматриваются два типа кандидатов вектора движения: пространственный кандидат вектора движения и временный кандидат вектора движения. Для получения кандидатов векторов движения в конечном итоге получаются два кандидата вектора движения на основе векторов движения каждой PU, расположенной в пяти разных позициях, как ранее показано на фиг.2.

Для получения временных кандидатов вектора движения один кандидат вектора движения выбирается из двух кандидатов, которые получаются на основе двух разных совмещенных позиций. После составления первого списка пространственно-временных кандидатов удаляются дублированные кандидаты вектора движения в списке. Если число потенциальных кандидатов больше двух, из списка удаляются кандидаты вектора движения, чей индекс опорного изображения в ассоциированном списке опорных изображений больше 1. Если количество пространственно-временных кандидатов вектора движения меньше двух, в список добавляются дополнительные кандидаты нулевого вектора движения.

1.2.2 Построение пространственных кандидатов векторов движения

При получении пространственных кандидатов векторов движения рассматривается максимум два кандидата из пяти потенциальных кандидатов, которые получены из PU, расположенных в позициях, как ранее показано на фиг.2, причем эти позиции совпадают с позициями слияния движения. Порядок получения для левой стороны текущей PU определяется как A0, A1, масштабированный A0, масштабированный A1. Порядок получения для указанной выше стороны текущей PU определяется как B0, B1, B2, масштабированный B0, масштабированный B1, масштабированный B2. Таким образом, для каждой стороны существует четыре случая, которые можно использовать в качестве кандидата вектора движения: два случая, когда не требуется использовать пространственное масштабирование, и два случая, когда используется пространственное масштабирование. Четыре различных случая кратко изложены следующим образом:

– при отсутствии пространственного масштабирования

(1) один и тот же список опорных изображений и один и тот же индекс опорных изображений (один и тот же POC)

(2) другой список опорных изображений, но одно и то же опорное изображение (такой же POC)

- при наличии пространственного масштабирования

(3) один и тот же список опорных изображений, но другое опорное изображение (другой POC)

(4) другой список опорных изображений, и другое опорное изображение (другой POC)

Сначала проверяются случаи отсутствия пространственного масштабирования, а затем случаи, которые допускают пространственное масштабирование. Пространственное масштабирование учитывается тогда, когда POC отличается между опорным изображением соседней PU и опорным изображением текущей PU независимо от списка опорных изображений. Если все PU левых кандидатов недоступны или имеют внутреннее кодирование, допускается масштабирование для вышеупомянутого вектора движения, чтобы способствовать параллельному получению левого и верхнего MV-кандидатов. В иных случаях пространственное масштабирование для вышеуказанного вектора движения не допускается.

Как показано в примере на фиг.9, для случая пространственного масштабирования вектор движения соседней PU масштабируется таким же образом, как и для временного масштабирования. Одно отличие состоит в том, что список опорных изображений и индекс текущей PU задаются как входные данные, при этом фактический процесс масштабирования является таким же, как и при временном масштабировании.

1.2.3 Построение временных кандидатов векторов движения

Кроме опорного изображения индекса получения все процессы для получения временных кандидатов слияния являются такими же, как для получения пространственных кандидатов векторов движения (как показано в примере на фиг.6). В некоторых вариантах осуществления, индекс опорного изображения сигнализируется в декодер.

2. Пример способов внешнего предсказания в модели совместных исследований (JEM)

В некоторых вариантах осуществления будущие технологии кодирования видео исследуются с использованием эталонного программного обеспечения, известного как модель совместных исследований (JEM). В JEM предсказание, основанное на подблоках, принимается в нескольких инструментах кодирования, таких как аффинное предсказание, альтернативное предсказание временного вектора движения (ATMVP), предсказание пространственно-временного вектора движения (STMVP), двунаправленный оптический поток (BDOF или BIO), преобразование с повышением частоты кадров (FRUC), локально адаптивное разрешение вектора движения (LAMVR), компенсация перекрывающихся блоков движения (OBMC), локальная компенсация освещенности (LIC) и уточнение вектора движения на стороне декодера (DMVR).

2.1 Примеры предсказания вектора движения на основе под-CU

В JEM при использовании квадродеревьев плюс двоичных деревьев (QTBT) каждая CU может иметь не более одного набора параметров движения для каждого направления предсказания. В некоторых вариантах осуществления два способа предсказания вектора движения на уровне под-CU рассматриваются в кодере посредством разделения большой CU на под-CU и получения информации о движении для всех под-CU большой CU. Способ предсказания альтернативных временных векторов движения (ATMVP) позволяет каждой CU извлекать многочисленные наборы информации о движении из многочисленных блоков меньшего размера, чем текущая CU в совмещенном опорном изображении. В способе предсказания пространственно-временных векторов движения (STMVP) векторы движения под-CU получаются рекурсивно с использованием предиктора временного вектора движения и соседнего вектора движения. В некоторых вариантах осуществления и для сохранения более точного поля движения для предсказания движения под-CU можно отключить сжатие движения для опорных кадров.

2.1.1 Примеры альтернативного предсказания вектора движения (ATMVP)

В способе ATMVP способ предсказания временного вектора движения (TMVP) модифицируется путем извлечения многочисленных наборов информации о движении (включая векторы движения и опорные индексы) из блоков, меньших по размеру, чем текущая CU.

На фиг.10 показан пример процесса предсказания движения ATMVP для CU 1000. Способ ATMVP предсказывает векторы движения под-CU 1001 в CU 1000 в два этапа. На первом этапе идентифицируется соответствующий блок 1051 в качестве опорного изображения 1050 с временным вектором. Опорное изображение 1050 также называется изображением источника движения. На втором этапе разделяется текущая CU 1000 на под-CU 1001, и получаются векторы движения, а также опорные индексы каждой под-CU из блока, соответствующего каждой под-CU.

В первом этапе опорное изображение 1050 и соответствующий блок определяется с помощью информации о движении пространственных соседних блоков текущей CU 1000. Во избежание процесса повторного сканирования соседних блоков, используется первый кандидат слияния в списке кандидатов слияния текущей CU 1000. Первый доступный вектор движения, а также ассоциированный с ним опорный индекс устанавливаются как временной вектор и индекс для изображения источника движения. Таким образом, соответствующий блок можно идентифицировать более точно по сравнению с TMVP, при этом соответствующий блок (иногда называемый совмещенным блоком) всегда находится в нижней правой или центральной позиции по отношению к текущей CU.

На втором этапе соответствующий блок под-CU 1051 идентифицируется временным вектором в изображении 1050 источника движения путем добавления к координате текущей CU временного вектора. Для каждой под-CU информация о движении ее соответствующего блока (например, наименьшая сетка движения, которая покрывает центральную выборку) используется для получения информации о движении для под-CU. После того, как информация о движении соответствующего блока N×N идентифицирована, она преобразуется в векторы движения и опорные индексы текущего под-CU таким же образом, как и TMVP в HEVC, причем применяются масштабирование движения и другие процедуры. Например, декодер проверяет, выполняется ли условие низкой задержки (например, POC всех опорных изображений текущего изображения меньше, чем POC текущего изображения), и, возможно, использует вектор движения MVx (например, вектор движения, соответствующий списку X опорных изображений) для предсказания вектора движения MVy (например, при X, равном 0 или 1, и Y, равном 1-X) для каждой под-CU.

2.1.2 Примеры предсказания пространственно-временных векторов движения (STMVP)

В способе STMVP векторы движения под-CU получаются рекурсивно, следуя порядку сканирования растра. На фиг.11 показан пример одной CU с четырьмя подблоками и соседними блоками. Рассмотрим CU 1100 размером 8×8, которая включает в себя четыре под-CU A (1101), B (1102), C (1103) и D (1104) размером 4×4. Соседние блоки размером 4×4 в текущем кадре помечены как a (1111), b (1112), c (1113) и d (1114).

Получение движения для под-CU A начинается с идентификации двух его пространственных соседей. Первым соседом является блок размером N×N выше под-CU A1101 (блок c 1113). Если этот блок c (1113) недоступен или интракодирован, проверяются другие блоки N×N выше под-CU A(1101) (слева направо, начиная с блока c 1113). Вторым соседом является блок слева от под-CU A1101 (блок b 1112). Если блок b (1112) недоступен или внутренне закодирован, проверяются другие блоки слева от под-CU A1101 (сверху вниз, начиная с блока b 1112). Информация о движении, полученная из соседних блоков для каждого списка, масштабируется в соответствии с первым опорным кадром для данного списка. Затем предиктор временного вектора движения (TMVP) подблока A1101 получается, следуя той же процедуре получения TMVP, как определено в HEVC. Информация о движении совмещенного блока в блоке D 1104 извлекается и масштабируется соответствующим образом. Наконец, после извлечения и масштабирования информации о движении все доступные векторы движения усредняются отдельно для каждого списка опорных изображений. Усредненный вектор движения назначается как вектор движения текущей под-CU.

2.1.3 Примеры сигнализации режима предсказания движения под-CU

В некоторых вариантах осуществления режимы под-CU разрешены как дополнительные кандидаты слияния, и отсутствует дополнительный синтаксический элемент, необходимый для сигнализации режимов. Два дополнительных кандидата слияния добавляются в список кандидатов слияния каждой CU, чтобы представить режим ATMVP и режим STMVP. В других вариантах осуществления может использоваться до семи кандидатов слияния, если набор параметров последовательности указывает, что включены ATMVP и STMVP. Логика кодирования дополнительных кандидатов слияния такая же, как и для кандидатов слияния в HM, что означает, что для каждой CU в P или B срезе могут потребоваться еще две проверки RD для двух дополнительных кандидатов слияния. В некоторых вариантах осуществления, например, в JEM, все бины с индексом слияния представляют собой контекст, кодированный с помощью CABAC (контекста на основе адаптивного бинарного арифметического кодирования). В других вариантах осуществления, например, в HEVC, только первый бин кодируется контекстно, а остальные бины кодируются в обход контекста.

2.2 Примеры адаптивного разрешения разности векторов движения

В некоторых вариантах осуществления, разности векторов движения (MVD) (между вектором движения и предсказываемым вектором движения PU) передаются в единицах одной четверти выборок яркости тогда, когда в заголовке среза значение use_integer_mv_flag равно 0. В JEM вводится локально адаптивное разрешение вектора движения (LAMVR). В JEM MVD может быть закодировано в единицах одной четверти выборок яркости, целочисленных выборок яркости или четырех выборок яркости. Управление разрешением MVD осуществляется на уровне единицы кодирования (CU), и флаги разрешения MVD условно сигнализируются для каждой CU, которая имеет по меньшей мере один ненулевой компонент MVD.

Для CU, которая имеет по меньшей мере один ненулевой компонент MVD, первый флаг сигнализируется для того, чтобы указать, используется ли точность MV в одну четверть выборки яркости в CU. Когда первый флаг (равный 1) указывает, что точность MV в одну четверть выборки яркости не используется, другой флаг сигнализируется для того, чтобы указать, используется ли точность MV целочисленной выборки яркости или точность MV четырех выборок яркости.

Когда первый флаг разрешения MVD CU равен нулю или не закодирован для CU (что означает, что все MVD в CU равны нулю), для CU используется разрешение MV в одну четверть выборки яркости. Когда CU использует точность MV целочисленной выборки яркости или точность MV четырех выборок яркости, MVP в списке кандидатов AMVP для CU округляются до соответствующей точности.

В кодере используются проверки RD на уровне CU для того, чтобы определить, какое разрешение MVD должно использоваться для CU. То есть проверка RD на уровне CU выполняется три раза для каждого разрешения MVD. Для увеличения скорости кодера в JEM применяются следующие схемы кодирования:

- Во время проверки RD CU с нормальным разрешением MVD в одну четверть яркости сохраняется информация о движении текущей CU (точность целочисленной выборки яркости). Сохраненная информация о движении (после округления) используется в качестве начальной точки для дальнейшего уточнения вектора движения с малым диапазоном во время проверки RD для одной и той же CU с целочисленной выборкой яркости и разрешением MVD с 4 выборками яркости, поэтому трудоемкий процесс оценки движения не дублируется три раза.

- Проверка RD блока CU с разрешением MVD с 4 выборками яркости вызывается условно. Для CU, когда разрешение MVD целочисленной выборки яркости с издержками RD намного больше, чем разрешение MVD в одну четверть выборки яркости, проверка RD разрешения MVD 4-х выборок яркости для CU пропускается.

2.3 Примеры более высокой точности хранения векторов движения

В HEVC точность вектора движения составляет одну четверть пикселя (pel) (одну четвертую выборки яркости и одну восьмую выборки цветности для видео 4:2:0). В JEM точность внутреннего хранения вектора движения и кандидата слияния увеличивается до 1/16 пикселя. Более высокая точность вектора движения (1/16 пикселя) используется при межкадровом предсказании компенсации движения для CU, кодированной в режиме пропуска/слияния. Для CU, кодированной в нормальном режиме AMVP, используется движение целочисленного пикселя или четверти пикселя.

Интерполяционные фильтры с повышением частоты дискретизации SHVC, которые имеют такую же длину фильтра и коэффициент нормализации, как и интерполяционные фильтры компенсации движения HEVC, используются в качестве интерполяционных фильтров компенсации движения для дополнительных позиций дробных пикселей. Точность вектора движения компонента цветности составляет 1/32 выборки в JEM, дополнительные интерполяционные фильтры дробных позиций 1/32 пикселя получаются с использованием среднего значения фильтров двух соседних дробных позиций 1/16 пикселя.

2.4 Примеры компенсации движения перекрывающихся блоков (OBMC)

В JEM OBMC можно включать и выключать с использованием синтаксиса на уровне CU. Когда OBMC используется в JEM, OBMC выполняется для всех границ блока компенсации движения (MC), кроме правой и нижней границ CU. Более того, он применяется как для компонентов яркости, так и для компонентов цветности. В JEM блок MC соответствует блоку кодирования. Когда CU кодируется в режиме под-CU (включает в себя слияние под-CU, аффинный режим и режим FRUC), каждый подблок CU является блоком MC. Чтобы обрабатывать границы CU единообразным образом, OBMC выполняется на уровне подблока для всех границ блока MC, где размер подблока устанавливается равным 4×4, как показано на фиг.12A и 12В.

На фиг.12A показаны подблоки на границе CU/PU, и заштрихованные подблоки изображены там, где применяется OBMC. Аналогичным образом, на фиг.12B показаны под-PU в режиме ATMVP.

Когда OBMC применяется к текущему подблоку, помимо текущих векторов движения, векторы движения четырех связанных соседних подблоков, если они доступны и не идентичны текущему вектору движения, также используются для получения блока предсказания для текущего подблока. Эти многочисленные блоки предсказания на основе многочисленных векторов движения объединяются для выработки окончательного сигнала предсказания текущего подблока.

Блок предсказания, основанный на векторах движения соседнего подблока, обозначается как PN, где N указывает индекс для соседнего верхнего, нижнего, левого и правого подблоков, и блок предсказания на основе векторов движения текущего подблока обозначается как PC. Когда PN основан на информации движения соседнего подблока, который содержит ту же информацию движения, что и текущий подблок, OBMC не выполняется из PN. В иных случаях каждая выборка PN добавляется к той же выборке в PC, то есть четыре строки/столбца PN добавляются в PC. Весовые коэффициенты {1/4, 1/8, 1/16, 1/32} используются для PN, и весовые коэффициенты {3/4, 7/8, 15/16, 31/32} используются для PC. Исключением являются небольшие блоки MC (то есть когда высота или ширина блока кодирования равна 4 или CU кодируется в режиме под-CU), для которых только две строки/столбца PN добавляются в PC. В этом случае весовые коэффициенты {1/4, 1/8} используются для PN, и весовые коэффициенты {3/4, 7/8} используются для PC. Для PN, выработанного на основе векторов движения соседнего по вертикали (по горизонтали) подблока, выборки в той же строке (столбце) PN добавляются в PC с тем же весовым коэффициентом.

В JEM для CU с размером, меньшим или равным 256 выборкам яркости, сигнализируется флаг уровня CU для того, чтобы указать, применяется ли OBMC для текущей CU. Для блоков CU размером более 256 выборок яркости или не закодированных в режиме AMVP по умолчанию применяется OBMC. В кодере, когда OBMC применяется для CU, его влияние учитывается на этапе оценки движения. Сигнал предсказания, сформированный OBMC с использованием информации о движении верхнего соседнего блока и левого соседнего блока, используется для компенсации верхней и левой границ исходного сигнала текущей CU, и затем применяется нормальный процесс оценки движения.

2.5 Примеры компенсации локальной освещенности (LIC)

LIC основана на линейной модели для изменений освещенности с использованием коэффициента масштабирования а и смещения b, и она включается или выключается адаптивно для каждой единицы кодирования (CU), кодированной в режиме интрекодирования.

Когда LIC применяется для CU, способ наименьших квадратов ошибок используется для получения параметров a и b с использованием соседних выборок текущей CU и их соответствующих опорных выборок. На фиг.13 показан пример соседних выборок, используемых для получения параметров алгоритма IC. В частности, как показано на фиг.13, используется субдискретизированные (с субдискретизацией 2:1) соседние выборки CU и соответствующие выборки (идентифицированные с помощью информации движения текущей CU или под-CU) в опорном изображении. Параметры IC получаются и применяются отдельно для каждого направления предсказания.

Когда CU кодируется в режиме слияния, флаг LIC копируется из соседних блоков аналогично копированию информации о движении в режиме слияния; в иных случаях для CU сигнализируется флаг LIC, чтобы указать, применяется ли LIC или нет.

Когда LIC включена для изображения, необходима дополнительная проверка RD уровня CU, чтобы определить, применяется или нет LIC для CU. Когда LIC включена для CU, средняя удаленная сумма абсолютной разности (MR-SAD) и средняя удаленная сумма абсолютной разности, полученной с использованием преобразования Адамара (MR-SATD), используются вместо SAD и SATD для поиска движения целого пикселя и поиска движения дробного пикселя, соответственно.

Чтобы снизить сложность кодирования, в JEM применяется следующая схема кодирования:

- LIC отключается для всего изображения, когда отсутствуют очевидные изменения освещения между текущим изображением и его опорными изображениями. Для того, чтобы определить эту ситуацию, в кодере вычисляются гистограммы текущего изображения и каждого опорного изображения текущего изображения. Если разница гистограммы между текущим изображением и каждым опорным изображением текущего изображения меньше заданного порога, LIC отключается для текущего изображения; в иных случаях LIC включается для текущего изображения.

2.6 Примеры предсказания аффинной компенсации движения

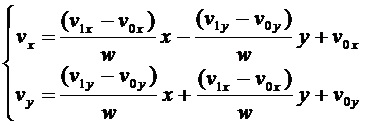

В HEVC для предсказания компенсации движения (MCP) применяется только модель поступательного движения. Однако камера и объекты могут иметь много видов движения, например, увеличение/уменьшение, вращение, перспективные движения и/или другое неравномерное движение. С другой стороны, в JEM применяется упрощенное предсказание компенсации движения с аффинным преобразованием. На фиг.14 показан пример аффинного поля движения блока 1400, описываемого двумя векторами движения V0 и V1 в контрольной точке. Поле вектора движения (MVF) блока 1400 можно описать следующим уравнением:

(1)

(1)

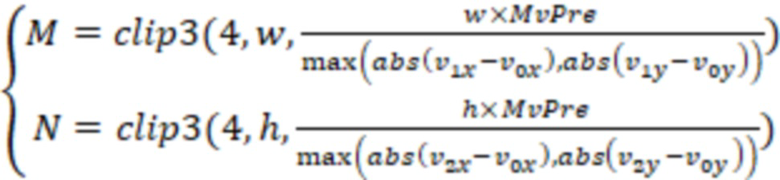

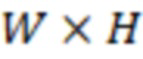

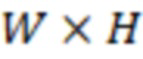

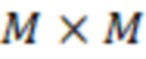

Как показано на фиг.14, (v0x, v0y) – вектор движения контрольной точки в верхнем левом углу, и (v1x, v1y) – вектор движения контрольной точки в верхнем правом углу. Чтобы упростить предсказание компенсации движения, можно применять предсказание аффинного преобразования на основе подблоков. Размер подблока M×N определяется следующим образом:

(2)

(2)

Здесь MvPre – точность доли вектора движения (например, 1/16 в JEM). (v2x, v2y) – вектор движения нижней левой контрольной точки, вычисленный согласно уравнению (1). При необходимости M и N можно уменьшить таким образом, чтобы они делились на w и h, соответственно.

На фиг.15 показан пример аффинного MVF в расчете на один подблок для блока 1500. Чтобы получить вектор движения каждого подблока M×N, вектор движения центральной выборки каждого подблока может быть вычислен согласно уравнению (1) и округлен с точностью доли вектора движения (например, 1/16 в JEM). Затем можно применить интерполяционные фильтры компенсации движения для выработки предсказания каждого подблока с полученным вектором движения. После MCP вектор движения с высокой точностью каждого подблока округляется и сохраняется с той же точностью, что и нормальный вектор движения.

2.6.1 Варианты реализации режима AF_INTER

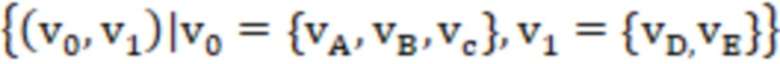

В JEM существует два режима аффинного движения: режим AF_INTER и режим AF_MERGE. Для CU с шириной и высотой больше 8 может применяться режим AF_INTER. В битовом потоке сигнализируется аффинный флаг на уровне CU, чтобы указать, используется ли режим AF_INTER. В режиме AF_INTER список кандидатов с парой векторов движения  создается с использованием соседних блоков.

создается с использованием соседних блоков.

На фиг.16 показан пример предсказания вектора движения (MVP) для блока 1600 в режиме AF_INTER. Как показано на фиг.16, v0 выбирается из векторов движения подблока A, B или C. Векторы движения из соседних блоков могут масштабироваться в соответствии со списком опорных изображений. Векторы движения также можно масштабировать в соответствии с взаимосвязью среди отсчета последовательности изображения (POC) опорного изображения для соседнего блока, POC опорного изображения для текущей CU и POC текущей CU. Подход к выбору v1 из соседних подблоков D и E является аналогичным. Если количество списков кандидатов меньше 2, список дополняется парой векторов движения, составленной путем дублирования каждого из кандидатов AMVP. Когда список кандидатов больше 2, кандидаты могут быть сначала отсортированы в соответствии с соседними векторами движения (например, на основе подобия двух векторов движения в паре кандидатов). В некоторых реализациях сохраняются первые два кандидата. В некоторых вариантах осуществления проверка издержек скорости-искажения (RD) используется для определения того, какой кандидат из пары векторов движения выбран в качестве предсказания вектора движения контрольной точки (CPMVP) текущей CU. Индекс, указывающий позицию CPMVP в списке кандидатов, может сигнализироваться в битовом потоке. После определения CPMVP текущей аффинной CU применяется оценка аффинного движения и определяется вектор движения контрольной точки (CPMV). Затем разность CPMV и CPMVP передается в битовом потоке.

2.6.3 Варианты реализации режима AF_MERGE

Когда CU применяется в режиме AF_MERGE, получается первый блок, кодированный в аффинном режиме, из допустимых соседних восстановленных блоков. На фиг.17А показан пример порядка отбора кандидатов блоков для текущей CU 1700. Как показано на фиг.17A, порядок отбора может быть слева (1701), сверху (1702), сверху справа (1703), слева снизу (1704) и сверху слева (1705) текущей CU 1700. На фиг.17B показан другой пример кандидатов блоков для текущей CU 1700 в режиме AF_MERGE. Если соседний левый нижний блок 1801 кодируется в аффинном режиме, как показано на фиг.17В, векторы движения v2, v3 и v4 получаются из верхнего левого угла, верхнего правого угла, и левого нижнего угла CU, содержащей подблок 1701. Вектор движения v0 в верхнем левом углу текущей CU 1700 вычисляется на основе v2, v3 и v4. Вектор v1 движения сверху справа текущей CU может быть вычислен соответствующим образом.

После того как CPMV v0 и v1 текущей CU вычислены в соответствии с упрощенной аффинной моделью движения согласно уравнению (1), можно выработать MVF текущей CU. Чтобы определить, кодируется ли текущая CU в режиме AF_MERGE, в битовом потоке может быть передан флаг аффинности, когда по меньшей мере один соседний блок кодируется в аффинном режиме.

2.7 Примеры получения вектора движения, согласованного с шаблоном (PMMVD)

Режим PMMVD представляет собой специальный режим слияния на основе способа преобразования с повышением частоты кадров (FRUC). В этом режиме информация о движении блока не передается, а получается на стороне декодера.

Флаг FRUC может быть просигнализирован для CU, когда его флаг слияния имеет значение "истина". Когда флаг FRUC имеет значение "ложь", можно сигнализировать об индексе слияния и использовать обычный режим слияния. Когда флаг FRUC имеет значение "истина", может быть передан дополнительный флаг режима FRUC, чтобы указать, какой способ (например, двустороннее согласование или согласование с шаблоном) должен использоваться для получения информации о движении для блока.

На стороне кодера решение о том, использовать ли режим слияния FRUC для CU, основано на выборе издержек RD, как это делается для нормального кандидата слияния. Например, несколько режимов согласования (например, двустороннее согласование и согласование с шаблоном) проверяются для CU с помощью выбора издержек RD. Тот режим, который ведет к минимальным издержкам, дополнительно сравнивается с другими режимами CU. Если режим согласования FRUC является наиболее эффективным, флаг FRUC устанавливается на значение "истина" для CU, и используется соответствующий режим согласования.

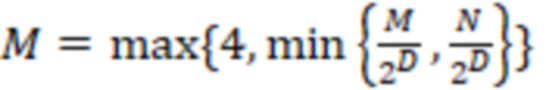

Как правило, процесс получения движения в режиме слияния FRUC имеет два этапа: сначала выполняется поиск движения на уровне CU, затем следует уточнение движения на уровне под-CU. На уровне CU начальный вектор движения получается для всей CU на основе двустороннего согласования или согласования с шаблоном. Сначала создается список кандидатов MV, и кандидат, который приводит к минимальным издержкам согласования, выбирается в качестве начальной точки для дальнейшего уточнения на уровне CU. Затем выполняется локальный поиск на основе двустороннего согласования или согласования с шаблоном около начальной точки. MV приводит к минимальным издержкам согласования и используется в качестве MV для всей CU. Впоследствии информация о движении дополнительно уточняется на уровне под-CU с полученными векторами движения CU в качестве начальных точек.

Например, следующий процесс получения выполняется для получения информации о движении CU размером  . На первом этапе получается MV для всей CU размером

. На первом этапе получается MV для всей CU размером  . На втором этапе CU делится на под-CU размером

. На втором этапе CU делится на под-CU размером  . Значение

. Значение  вычисляется как в уравнении (3),

вычисляется как в уравнении (3),  – заданная глубина разделения, которая в JEM по умолчанию установлена на 3. Затем получается MV для каждой под-CU.

– заданная глубина разделения, которая в JEM по умолчанию установлена на 3. Затем получается MV для каждой под-CU.

(3)

(3)

На фиг.18 показан пример двустороннего соответствия, используемого в способе преобразования с повышением частоты кадров (FRUC). Двустороннее согласование используется для получения информации о движении текущей CU путем нахождения наиболее близкого совпадения между двумя блоками вдоль траектории движения текущей CU (1800) в двух разных опорных изображениях (1810, 1811). Исходя из предположения о том, что траектория движения является непрерывной, векторы MV0 (1801) и MV1 (1802) движения, указывающие два опорных блока, пропорциональны временным расстояниям, например, TD0 (1803) и TD1 (1804) между текущим изображением и двумя опорными изображениями. В некоторых вариантах осуществления, когда текущее изображение 1800 временно находится между двумя опорными изображениями (1810, 1811), и временное расстояние от текущего изображения до двух опорных изображений является одинаковым, двустороннее согласование становится двунаправленным MV на основе зеркального отражения.

На фиг.19 показан пример согласования с шаблоном, используемого в способе преобразования частоты кадров (FRUC). Согласование с шаблоном может использоваться для получения информации о движении текущей CU 1900 путем нахождения наиболее близкого совпадения между шаблоном (например, верхним и/или левым соседними блоками текущей CU) в текущем изображении и блоком (например, такого же размера, как и шаблон) в опорном изображении 1910. За исключением вышеупомянутого режима слияния FRUC, согласование с шаблоном также может применяться к режиму AMVP. Как в JEM, так и в HEVC AMVP имеет два кандидата. Используя способ согласования с шаблоном можно получить новый кандидат. Если вновь полученный кандидат при согласовании с шаблоном отличается от первого существующего кандидата AMVP, он вставляется в самое начало списка кандидатов AMVP, и затем размер списка устанавливается равным двум (например, путем удаления второго существующего кандидата AMVP). Поиск на уровне CU используется только применительно к режиму AMVP.

Набор кандидатов MV на уровне CU может включать в себя следующее: (1) исходные кандидаты AMVP, если текущая CU находится в режиме AMVP, (2) все кандидаты слияния, (3) несколько MV в интерполированном поле MV (описано ниже), и соседние векторы движения сверху и слева.

При использовании двустороннего согласования каждый действительный MV кандидата слияния может использоваться в качестве входных данных для выработки пары MV с суммой двустороннего согласования. Например, один действительный MV кандидата слияния (MVa, refa) в списке А опорных изображений. Затем опорное изображение refb из его парного двустороннего MV находится в другом списке B опорных изображений, так что refa и refb находятся временно на разных сторонах текущего изображения. Если такое refb отсутствует в списке B опорных изображений, refb определяется как опорное изображение, которое отличается от refa, и его временное расстояние до текущего изображения e является минимальным в списке B. После того, как refb определено, MVb получается путем масштабирования MVa на основе временного расстояния между текущим изображением и refa, refb.

В некоторых реализациях четыре MV из интерполированного поля MV могут быть также добавлены в список кандидатов уровня CU. Более конкретно, добавляются интерполированные MV в позиции (0, 0), (W/2, 0), (0, H/2) и (W/2, H/2) текущей CU. Когда FRUC применяется в режиме AMVP, исходные кандидаты AMVP также добавляются в набор кандидатов MV уровня CU. В некоторых реализациях на уровне CU в список кандидатов можно добавить 15 MV для CU AMVP и 13 MV для CU слияния.

Набор кандидатов MV на уровне под-CU включает в себя MV, определенный из поиска на уровне CU, (2) верхний, левый, верхний левый и верхний правый соседние MV, (3) масштабированные версии совмещенных MV из опорного изображения, (4) один или более кандидатов ATMVP (например, до четырех) и (5) один или более кандидатов STMVP (например, до четырех). Масштабированные MV из опорных изображений получаются следующим образом. Опорные изображения в обоих списках пересекаются. MV в виде совмещенной позиции под-CU в опорном изображении масштабируется до опорного изображения начального MV CU-уровня. Кандидаты ATMVP и STMVP могут быть четырьмя первыми кандидатами. На уровне под-CU в список кандидатов добавляется один или более MV (например, до 17).

Генерирование интерполированного поля MV. Перед кодированием кадра создается интерполированное поле движения для всего изображения на основе односторонней ME. Далее, поле движения может использоваться в дальнейшем как кандидаты MV уровня CU или подуровня CU.

В некоторых вариантах осуществления поле движения каждого опорного изображения в обоих списках опорных изображений пересекается на уровне блоков 4×4. На фиг.20 показан пример односторонней оценки движения (ME) 2000 в способе FRUC. Для каждого блока 4×4, если движение, ассоциированное с блоком, проходящим через блок 4×4 в текущем изображении, и блоку не было назначено какое-либо интерполированное движение, движение опорного блока масштабируется до текущего изображения в соответствии с временным расстоянием TD0 и TD1 (аналогично масштабированию MV TMVP в HEVC), и масштабированное движение назначается блоку в текущем кадре. Если масштабированное MV не назначено для блока 4×4, движение блока помечается как недоступное в интерполированном поле движения.

Издержки интерполяции и согласования. Когда вектор движения указывает на позиции дробной выборки, требуется интерполяция с компенсацией движения. Чтобы снизить сложность, можно использовать билинейную интерполяцию вместо обычной 8-отводной интерполяции HEVC как для двустороннего согласования, так и для согласования с шаблоном.

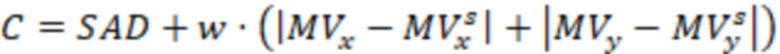

Вычисление издержек согласования отличается на разных этапах. При выборе кандидата из набора кандидатов на уровне CU издержки согласования могут представлять собой абсолютную сумму разницы (SAD) двустороннего согласования или согласования с шаблоном. После определения начального MV издержки C согласования двустороннего согласования при поиске на уровне под-CU вычисляются следующим образом:

(4)

(4)

Здесь w – весовой коэффициент. В некоторых вариантах осуществления w может быть эмпирически установлен на 4. MV и MVs указывают текущий MV и начальный MV, соответственно. SAD все еще может использоваться в качестве издержек согласования с шаблоном при поиске на уровне под-CU.

В режиме FRUC MV получается только с использованием выборок яркости. Полученное движение будет использоваться как для яркости, так и для цветности для внешнего предсказания MC. После определения MV выполняется окончательная MC с использованием 8-отводного интерполяционного фильтра для яркости и 4-отводного интерполяционного фильтра для цветности.

Уточнение MV представляет собой поиск MV на основе шаблона с использованием критерия издержек двустороннего согласования или издержек согласования с шаблоном. В JEM поддерживаются два шаблона поиска: неограниченный ромбовидный поиск со смещенным центром (UCBDS) и адаптивный перекрестный поиск для уточнения MV на уровне CU и под-CU, соответственно. Для уточнения MV как на уровне CU, так и на уровне под-CU, MV отыскивается напрямую с точностью MV одной четвертой выборки яркости, после чего выполняется уточнение MV одной восьмой выборки яркости. Диапазон поиска уточнения MV для CU и этапа под-CU устанавливается равным 8 выборкам яркости.

В режиме слияния с двусторонним согласованием применяется двунаправленное предсказание, так как информация о движении CU получается на основе наиболее близкого совпадения между двумя блоками вдоль траектории движения текущей CU в двух разных опорных изображениях. В режиме слияния для согласования с шаблоном кодер может выбирать между уни-предсказанием из list0, уни-предсказанием из list1 или би-предсказанием для CU. Выбор может быть основан на издержках согласования с шаблоном следующим образом:

Если costBi <= factor*min (cost0, cost1),

используется двунаправленное предсказание;

В иных случаях, если издержки0 <= издержки1,

используется уни-предсказание из list0;

В иных случаях

используется уни-предсказание из list1;

Здесь cost0 – SAD согласования с шаблоном list0, cost1 – SAD согласования с шаблоном list1, и costBi – SAD согласования с шаблоном с би-предсказанием. Например, когда значение множителя равно 1,25, это означает, что процесс выбора смещен в сторону би-предсказания. Выбор направления внешнего предсказания может применяться к процессу согласования с шаблоном на уровне CU.

2.8 Примеры улучшения обобщенного би-предсказания (GBi)

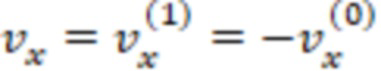

Обобщенное улучшение би-предсказания (GBi) адаптировано в VTM-3.0. GBi применяет неравные весовые коэффициенты к предикторам из L0 и L1 в режиме би-предсказания. В режиме внешнего предсказания несколько пар весовых коэффициентов, включая пару равных весовых коэффициентов (1/2, 1/2), оцениваются на основе оптимизации скорость-искажение (RDO), и индекс GBi выбранной пары весовых коэффициентов передается в декодер. В режиме слияния индекс GBi наследуется из соседней CU. Формула выработки предиктора показана в уравнении (5).

PGBi = (w0×PL0 + w1×PL1 + RoundingOffset) >> shiftNumGBi (5)

Здесь PGBi является окончательным предиктором GBi, w0 и w1 – выбранные весовые коэффициенты GBi, применяемые к предикторам (PL0 и PL1) из списка 0 (L0) и списка 1 (L1), соответственно. RoundingOffsetGBi и shiftNumGBi используются для нормирования окончательного предиктора в GBi. Поддерживаемый набор весовых коэффициентов w1 равен {-1/4, 3/8, 1/2, 5/8, 5/4}, в котором пять весовых коэффициентов соответствуют одной равной паре весовых коэффициентов и четырем неравным парам весовых коэффициентов. Усиление смешивания, то есть сумма w1 и w0, зафиксировано на 1,0. Таким образом, соответствующий набор весовых коэффициентов w0 равен {5/4, 5/8, 1/2, 3/8, -1/4}. Выбор пары весовых коэффициентов находится на уровне CU.

Для изображений без низкой задержки размер набора весовых коэффициентов уменьшается с пяти до трех, где набор весовых коэффициентов w1 принимает значения {3/8, 1/2, 5/8}, и набор весовых коэффициентов w0 принимает значения{5/8, 1/2, 3/8}. Уменьшение размера набора весовых коэффициентов для изображений без низкой задержки применяется к GBi BMS2.1 и ко всем тестам GBi в этой публикации.

2.8.1 Исправление ошибки кодера GBi

Чтобы уменьшить время кодирования GBi, в текущем исполнении кодера кодер будет хранить векторы движения с единым предсказанием, оцененные из весового коэффициента GBi, равного 4/8, и повторно использовать их для поиска уни-предсказания с другими весовыми коэффициентами GBi. Этот способ быстрого кодирования применяется как к модели поступательного движение, так и к модели аффинного движения. В VTM2.0 6-параметрическая аффинная модель была принята вместе с 4-параметрической аффинной моделью. Кодер BMS2.1 не различает 4-параметрическую аффинную модель и 6-параметрическую аффинную модель, когда он хранит аффинные MV с единым предсказанием, и когда весовой коэффициент GBi равен 4/8. Следовательно, 4-параметрические аффинные MV могут быть перезаписаны на 6-параметрические аффинные MV после кодирования с весовым коэффициентом GBi 4/8. Сохраненные 6-параметрические аффинные MV могут использоваться для 4-параметрических аффинных ME для других весовых коэффициентов GBi, или сохраненные 4-параметрические аффинные MV могут использоваться для 6-параметрических аффинных ME. Предлагаемое исправление ошибок кодера GBi состоит в том, чтобы разделить запоминающее устройство для 4-параметрических и 6-параметрических аффинных MV. Кодер сохраняет эти аффинные MV на основе типа аффинной модели, когда весовой коэффициент GBi равен 4/8, и повторно использует соответствующие аффинные MV на основе типа аффинной модели для других весовых коэффициентов GBi.

2.8.2 Ускорение кодера GBi

В этой существующей реализации предлагается пять способов ускорения кодера для сокращения времени кодирования, когда включено GBi.

(1) Условный пропуск оценки аффинного движения для некоторых весовых коэффициентов GBi

В BMS2.1 аффинный ME, включающий в себя 4-параметрический и 6-параметрический аффинный ME, выполняется для всех весовых коэффициентов GBi. Мы предлагаем условно пропустить аффинное ME для неравных весовых коэффициентов GBi (для весовых коэффициентов, не равных 4/8). В частности, аффинный ME будет выполняться для других весовых коэффициентов GBi в том случае и только в том случае, когда аффинный режим выбран в качестве текущего наилучшего режима, и он не является аффинным режимом слияния после оценки весового коэффициента GBi, равного 4/8. Если текущее изображение не является изображением с низкой задержкой, ME с би-предсказанием для модели поступательного движения будет пропущено из-за неравных весовых коэффициентов GBi, когда выполняется аффинная ME. Если аффинный режим не выбран в качестве текущего лучшего режима, или если аффинное слияние выбрано в качестве текущего лучшего режима, аффинная ME будет пропущена для всех других весовых коэффициентов GBi.

(2) Уменьшение количества весовых коэффициентов для проверки издержек RD для изображений с низкой задержкой при кодировании для точности MVD 1-pel и 4-pel

Для изображений с низкой задержкой существует пять весовых коэффициентов для проверки издержек RD для всех значений точности MVD, включая 1/4-pel, 1-pel и 4-pel. Кодер будет сначала проверять издержки RD для точности MVD 1/4-pel. Мы предлагаем пропустить часть весовых коэффициентов GBi для проверки издержек RD для значений точности MVD 1-pel и 4-pel. Мы упорядочиваем эти неравные весовые коэффициенты в соответствии с издержками их RD с точностью MVD 1/4-pel. Только первые два весовых коэффициента с наименьшими издержками RD вместе с весовым коэффициентом GBi 4/8 будут оцениваться во время кодирования со значениями точности MVD 1-pel и 4-pel. Таким образом, для изображений с малой задержкой будет оцениваться не более трех весовых коэффициентов для значений точности MVD 1-pel и 4-pel.

(3) Условный пропуск поиска би-предсказания, когда опорные изображения L0 и L1 являются одинаковыми

Для некоторых изображений в RA одно и то же изображение может встречаться в обоих списках опорных изображений (list-0 и list-1). Например, для конфигурации кодирования с произвольным доступом в CTC структура опорного изображения для первой группы изображений (GOP) указана следующим образом.

POC: 16, TL:0, [L0: 0] [L1: 0]

POC: 8, TL:1, [L0: 0 16] [L1: 16 0]

POC: 4, TL:2, [L0: 0 8] [L1: 8 16]

POC: 2, TL:3, [L0: 0 4] [L1: 4 8]

POC: 1, TL:4, [L0: 0 2] [L1: 2 4]

POC: 3, TL:4, [L0: 2 0] [L1: 4 8]

POC: 6, TL:3, [L0: 4 0] [L1: 8 16]

POC: 5, TL:4, [L0: 4 0] [L1: 6 8]

POC: 7, TL:4, [L0: 6 4] [L1: 8 16]

POC: 12, TL:2, [L0: 8 0] [L1: 16 8]

POC: 10, TL:3, [L0: 8 0] [L1: 12 16]

POC: 9, TL:4, [L0: 8 0] [L1: 10 12]

POC: 11, TL:4, [L0: 10 8] [L1: 12 16]

POC: 14, TL:3, [L0: 12 8] [L1: 12 16]

POC: 13, TL:4, [L0: 12 8] [L1: 14 16]

POC: 15, TL:4, [L0: 14 12] [L1: 16 14]

Следует отметить, что изображения 16, 8, 4, 2, 1, 12, 14 и 15 имеют одинаковое(ые) опорное(ые) изображение(я) в обоих списках. Для би-предсказания для этих изображений возможно, что опорные изображения L0 и L1 будут одинаковыми. Мы предлагаем, чтобы кодер пропускал ME с би-предсказанием для неравных весовых коэффициентов GBi тогда, когда 1) два опорных изображения при би-предсказании являются одинаковым, и 2) временной уровень больше 1, и 3) точность MVD составляет 1/4-pel. Для ME с аффинным би-предсказанием этот способ быстрого пропуска применяется только к 4-параметрической аффинной ME.

(4) Пропуск проверки издержек RD для неравного весового коэффициента GBi основан на временном уровне и расстоянии POC между опорным изображением и текущим изображением

Мы предлагаем пропустить эти оценки издержек RD для этих неравных весовых коэффициентов GBi, когда временной уровень равен 4 (самый высокий временной уровень в RA), или расстояние POC между опорным изображением (list-0 или list-1) и текущим изображением равно 1, и QP кодирования больше 32.

(5) Замена вычисления с плавающей запятой на вычисление с фиксированной запятой для неравного весового коэффициента GBi во время ME

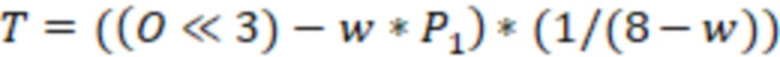

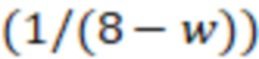

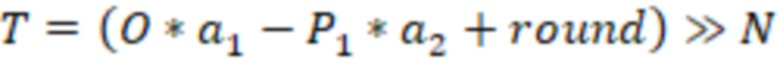

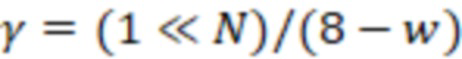

Для существующего поиска би-предсказания кодер зафиксирует MV из одного списка и уточнит MV в другом списке. Цель модифицируется перед ME, чтобы уменьшить сложность вычислений. Например, если MV из list-1 является фиксированным, и кодер должен уточнить MV из list-0, цель уточнения MV из list-0 модифицируется с помощью уравнения (6). O является исходным сигналом, и P1 – сигнал предсказания из list-1. w – весовой коэффициент GBi для list-1.

(6)

(6)

Здесь член  сохраняется с точностью вычисления с плавающей запятой, что увеличивает сложность вычислений. Мы предлагаем заменить уравнение (6) на фиксированную точку, как в уравнении (7).

сохраняется с точностью вычисления с плавающей запятой, что увеличивает сложность вычислений. Мы предлагаем заменить уравнение (6) на фиксированную точку, как в уравнении (7).

(7)

(7)

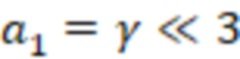

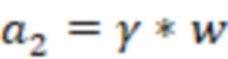

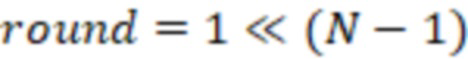

где a1 и a2 – коэффициенты масштабирования, и они вычисляются как:

;

;  ;

;  ;

;

2.8.3 Ограничение размера CU для GBi

В этом способе GBi отключено для небольших CU. В режиме внешнего предсказания, если используется би-предсказание и область CU меньше, чем 128 выборок яркости, GBi отключается без какой-либо сигнализации.

2.9 Примеры двунаправленного оптического потока (BDOF)

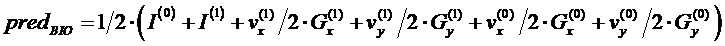

В двунаправленном оптическом потоке (BDOF или BIO) компенсация движения сначала выполняется для выработки первых предсказаний (в каждом направлении предсказания) текущего блока. Первые предсказания используются для получения пространственного градиента, временного градиента и оптического потока каждого подблока или пикселя внутри блока, которые затем используются для выработки второго предсказания, например, окончательного предсказания подблока или пикселя. Подробности этого описаны ниже.

BDOF представляет собой уточнение движения по выборкам, выполняемое поверх поблочной компенсации движения для би-предсказания. В некоторых реализациях уточнение движения на уровне выборки не использует сигнализацию.

Пусть I(k) будет значением яркости из опорного изображения k (k=0, 1) после компенсации движения блока, и обозначим  и

и  как горизонтальные и вертикальные составляющие градиента I(k), соответственно. Предполагая, что оптический поток является действительным, векторное поле движения определяется как:

как горизонтальные и вертикальные составляющие градиента I(k), соответственно. Предполагая, что оптический поток является действительным, векторное поле движения определяется как:

(5)

(5)

Объединение этого уравнения оптического потока с эрмитовой интерполяцией для траектории движения каждой выборки приводит к уникальному полиному третьего порядка, который соответствует как значениям I(k) функции, так и производным  и

и  на концах. Значение этого полинома при t=0 является предсказанием BDOF:

на концах. Значение этого полинома при t=0 является предсказанием BDOF:

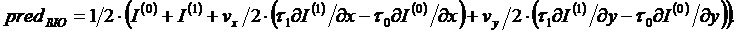

(6)

(6)

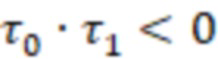

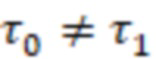

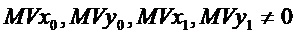

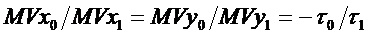

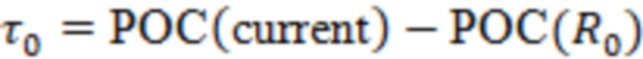

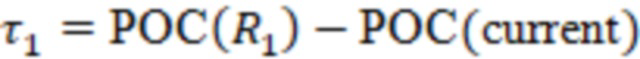

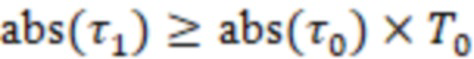

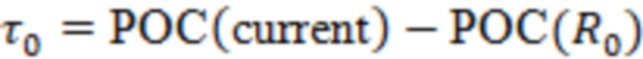

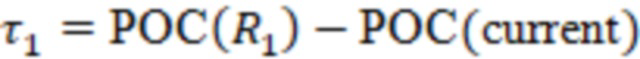

На фиг.24 показана примерная траектория оптического потока в способе двунаправленного оптического потока (BDOF).В данном случае  и

и  обозначают расстояния до опорных кадров. Расстояния

обозначают расстояния до опорных кадров. Расстояния  и

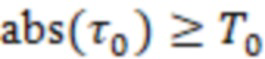

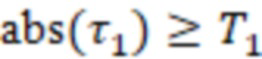

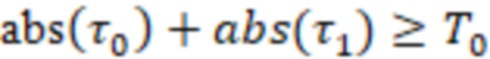

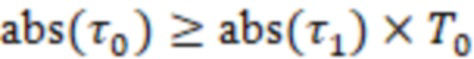

и  вычисляются на основе POC для Ref0 и Ref1: τ0=POC(текущий) − POC(Ref0), τ1= POC(Ref1) − POC(текущий). Если оба предсказания исходят из одного и того же временного направления (либо из прошлого, либо из будущего), то знаки являются разными (например,

вычисляются на основе POC для Ref0 и Ref1: τ0=POC(текущий) − POC(Ref0), τ1= POC(Ref1) − POC(текущий). Если оба предсказания исходят из одного и того же временного направления (либо из прошлого, либо из будущего), то знаки являются разными (например,  ). В этом случае BDOF применяется в тех случаях, если предсказание не относится к одному и тому же моменту времени (например,

). В этом случае BDOF применяется в тех случаях, если предсказание не относится к одному и тому же моменту времени (например,  ). Обе опорные области имеют ненулевое движение (например,

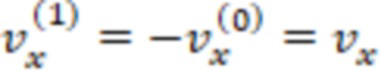

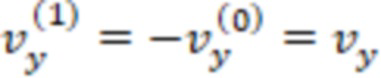

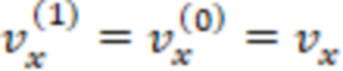

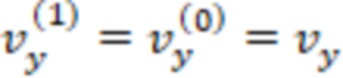

). Обе опорные области имеют ненулевое движение (например,  ), и векторы движения блоков пропорциональны временному расстоянию (например,

), и векторы движения блоков пропорциональны временному расстоянию (например,  ).

).

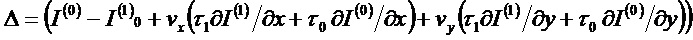

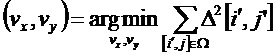

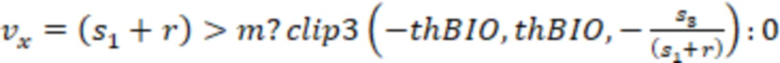

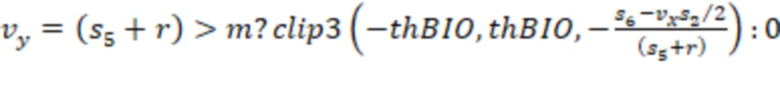

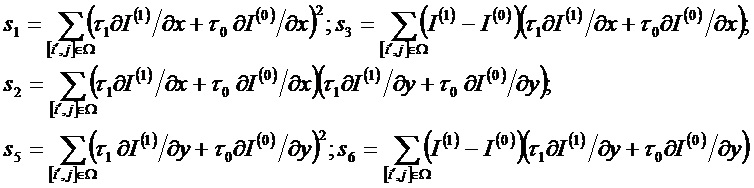

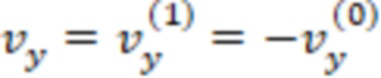

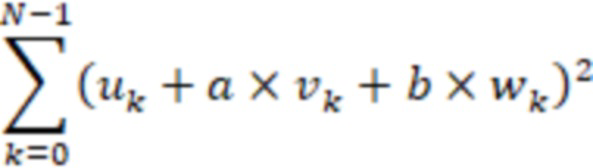

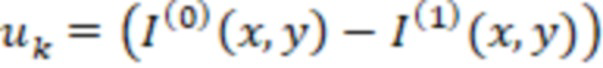

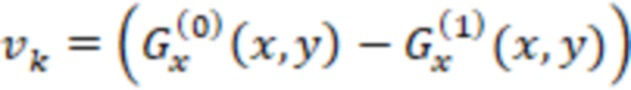

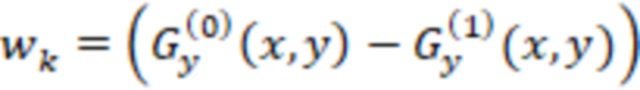

Поле (vx, vy) определяется путем минимизации разницы Δ между значениями в точках A и B. На фиг.9A-9B показан пример пересечения траекторий движения и плоскостей опорных кадров. В модели используется только первый линейный член локального разложения Тейлора для Δ:

(7)

(7)

Все значения в приведенном выше уравнении зависят от местоположения выборки, обозначенного как  . Предполагая, что движение согласовано в локальной окружающей области,

. Предполагая, что движение согласовано в локальной окружающей области,  можно минимизировать в пределах квадратного окна

можно минимизировать в пределах квадратного окна  размером (2M+1)×(2M+1) с центром в текущей предсказываемой точке, где M равно 2:

размером (2M+1)×(2M+1) с центром в текущей предсказываемой точке, где M равно 2:

(8)

(8)

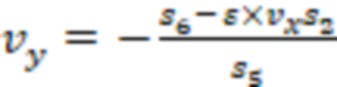

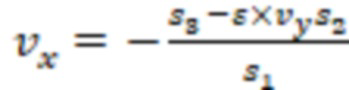

Для этой задачи оптимизации JEM использует упрощенный подход, выполняя сначала минимизацию в вертикальном направлении и затем в горизонтальном направлении. Это приводит к следующему:

(9)

(9)

(10)

(10)

где

(11)

(11)

Во избежание деления на ноль или на очень маленькое значение в уравнение (9) и уравнение (10) можно ввести параметры r и m регуляризации, где:

(12)

(12)

(13)

(13)

Здесь  является битовой глубиной выборок видео.

является битовой глубиной выборок видео.

Для того, чтобы сохранить доступ к памяти для BDOF таким же, как для регулярной компенсации движения с би-предсказанием, все значения предсказания и градиентов  вычисляются для позиций внутри текущего блока. На фиг.22А показан пример позиций доступа за пределами блока 2200. Как показано на фиг.22А, в уравнении (9) квадратное окно

вычисляются для позиций внутри текущего блока. На фиг.22А показан пример позиций доступа за пределами блока 2200. Как показано на фиг.22А, в уравнении (9) квадратное окно  размером (2M+1)×(2M+1) с центром в текущей предсказываемой точке на границе предсказываемого блока необходимо для доступа к позициям за пределами блока. В JEM значения

размером (2M+1)×(2M+1) с центром в текущей предсказываемой точке на границе предсказываемого блока необходимо для доступа к позициям за пределами блока. В JEM значения  за пределами блока устанавливаются равными ближайшему доступному значению внутри блока. Например, его можно реализовать в виде области 2201 заполнения, которая показана на фиг.22B.

за пределами блока устанавливаются равными ближайшему доступному значению внутри блока. Например, его можно реализовать в виде области 2201 заполнения, которая показана на фиг.22B.

При использовании BDOF возможно, что поле движения может быть уточнено для каждой выборки. Чтобы уменьшить вычислительную сложность, в JEM используется блочная конструкция BDOF. Уточнение движения можно вычислить на основе блока 4×4. В блочном BDOF значения sn в уравнении (9) всех выборок в блоке 4×4 можно агрегировать, и затем агрегированные значения sn используются для смещения полученных векторов движения BDOF для блока 4×4. Более конкретно, для получения блочного BDOF можно использовать следующие уравнения:

(14)

(14)

Здесь bk обозначает набор выборок, принадлежащих k-му блоку 4×4 предсказанного блока. sn в уравнении (9) и уравнении (10) заменяются на ((sn,bk) >> 4) для получения ассоциированных смещений вектора движения.

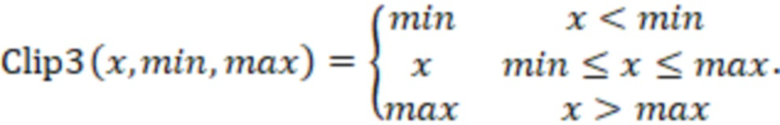

В некоторых сценариях многочисленные MV BIO могут быть ненадежными из-за шума или нерегулярного движения. Таким образом, в BDOF величина многочисленных MV ограничена пороговым значением. Пороговое значение определяется на основе того, поступают ли с одного направления все опорные изображения текущего изображения. Например, если все опорные изображения текущего изображения поступают с одного направления, значение порога устанавливается равным  ; в иных случаях устанавливается значение

; в иных случаях устанавливается значение  .

.

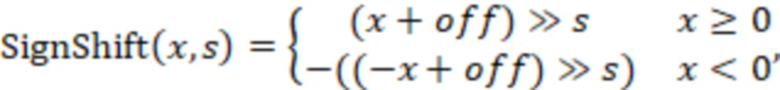

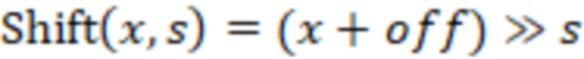

Градиенты для BDOF могут быть вычислены одновременно с интерполяцией компенсации движения с использованием операций, соответствующих процессу компенсации движения HEVC (например, 2D разделяемая конечная импульсная характеристика (FIR)). В некоторых вариантах осуществления, входными данными для 2D разделяемой FIR является такая же выборка опорного кадра, как для процесса компенсации движения и дробной позиции (fracX, fracY), соответствующей дробной части вектора движения блока. Для горизонтального градиента  сигнал сначала интерполируется по вертикали с использованием BIOfilterS, соответствующего дробной позиции fracY со сдвигом и уменьшением масштаба d−8. Затем применяется градиентный фильтр BIOfilterG в горизонтальном направлении, соответствующем дробной позиции fracX со сдвигом и уменьшением масштаба на 18−d. Для вертикального градиента

сигнал сначала интерполируется по вертикали с использованием BIOfilterS, соответствующего дробной позиции fracY со сдвигом и уменьшением масштаба d−8. Затем применяется градиентный фильтр BIOfilterG в горизонтальном направлении, соответствующем дробной позиции fracX со сдвигом и уменьшением масштаба на 18−d. Для вертикального градиента  градиентный фильтр применяется по вертикали с использованием BIOfilterG, соответствующего дробной позиции fracY со сдвигом и уменьшением масштаба d−8. Затем смещение сигнала выполняется с помощью BIOfilterS в горизонтальном направлении, соответствующем дробной позиции fracX со сдвигом и уменьшением масштаба на 18–d. Длина интерполяционного фильтра для вычисления градиентов BIOfilterG и смещения BIOfilterF сигнала может быть короче (например, 6 отводов) для поддержания разумной сложности. В таблице 1 представлены примеры фильтров, которые можно использовать для вычисления градиентов различных дробных позиций вектора движения блока в BDOF. В таблице 2 представлены примеры интерполяционных фильтров, которые можно использовать для выработки сигнала предсказания в BIO.

градиентный фильтр применяется по вертикали с использованием BIOfilterG, соответствующего дробной позиции fracY со сдвигом и уменьшением масштаба d−8. Затем смещение сигнала выполняется с помощью BIOfilterS в горизонтальном направлении, соответствующем дробной позиции fracX со сдвигом и уменьшением масштаба на 18–d. Длина интерполяционного фильтра для вычисления градиентов BIOfilterG и смещения BIOfilterF сигнала может быть короче (например, 6 отводов) для поддержания разумной сложности. В таблице 1 представлены примеры фильтров, которые можно использовать для вычисления градиентов различных дробных позиций вектора движения блока в BDOF. В таблице 2 представлены примеры интерполяционных фильтров, которые можно использовать для выработки сигнала предсказания в BIO.

Таблица 1. Примеры фильтров для вычислений градиента в BDOF (или BIO)

Таблица 2. Примерные интерполяционные фильтры для генерации сигнала предсказания в BDOF (или BIO)

В JEM BDOF может применяться ко всем блокам с би-предсказанием, когда два предсказания исходят из разных опорных изображений. Когда компенсация локальной освещенности (LIC) включена для CU, BDOF можно отключить.

В некоторых вариантах осуществления OBMC применяется для блока после обычного процесса MC. Чтобы уменьшить вычислительную сложность, BDOF не может применяться во время процесса OBMC. Это означает, что BDOF применяется в процессе MC для блока тогда, когда используется его собственный MV, и не применяется в процессе MC тогда, когда во время процесса OBMC используется MV соседнего блока.

2.9.1 Примеры BDOF в VTM-3.0

Этап 1: выполнить оценку того, применим ли BIO (W/H – ширина/высота текущего блока).

BIO не применяется в тех случаях, если

○ Текущий видеоблок имеет аффинный код или код ATMVP.

○ (iPOC - iPOC0) × (iPOC - iPOC1) ≥ 0

○ H==4 or (W==4 и H==8)

○ при взвешенном предсказании

○ Весовые коэффициенты GBi не равны (1,1)

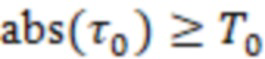

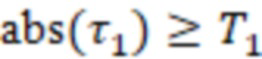

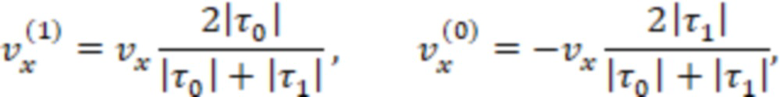

BDOF не используется, если общая SAD между двумя опорными блоками (обозначенными как R0 и R1) меньше порогового значения, где