ПЕРЕКРЕСТНАЯ ССЫЛКА НА СВЯЗАННЫЕ ЗАЯВКИ

[0001] Данная патентная заявка испрашивает приоритет по. предварительной патентной заявке США №. 62/871,524, поданной 8 июля 2019 года Ye-Kui Wang, et. al. и озаглавленной «Constraints for Mixed NAL Unit Types within One Picture in Video Coding», которая настоящим включена в данный документ по ссылке.

ОБЛАСТЬ ТЕХНИКИ

[0002] Настоящее раскрытие в целом относится к кодированию/декодированию видео и, в частности, относится к кодированию/декодированию субизображений из изображений при кодировании/декодировании видео.

УРОВЕНЬ ТЕХНИКИ

[0003] Объем видеоданных, необходимых для представления даже относительно короткого видео, может быть значительным, что может привести к трудностям, когда эти данные должны передаваться в потоковом режиме или иным образом передаваться по сети связи с ограниченной пропускной способностью. Таким образом, видеоданные обычно сжимаются перед передачей по современным телекоммуникационным сетям. Размер видео также может быть проблемой, когда видео сохраняется на запоминающем устройстве, поскольку ресурсы памяти могут быть ограничены. Устройства сжатия видео часто используют программное и/или аппаратное обеспечение в источнике для кодирования/декодирования видеоданных перед передачей или сохранением, тем самым уменьшая количество данных, необходимых для представления цифровых видеоизображений. Сжатые данные затем принимаются устройством декомпрессии видео получателя, которое декодирует видеоданные. С ограниченными сетевыми ресурсами и постоянно растущими потребностями в видео более высокого качества, желательны улучшенные методики сжатия и декомпрессии, которые улучшают степень сжатия с минимальными потерями качества изображения или вообще без таких потерь.

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

[0004] В варианте осуществления раскрытие включает в себя способ, реализуемый в декодере, причем способ содержит: прием, приемником декодера, битового потока, содержащего текущее изображение, включающее в себя множество единиц уровня сетевой абстракции (NAL) уровня кодирования/декодирования видео (VCL), которые не имеют одного и того же типа единицы NAL; получение, процессором декодера, активных записей списков опорных изображений для слайсов, расположенных в субизображении A (subpicA) в последующих изображениях, следующих за текущим изображением в порядке декодирования, при этом активные записи не включают в себя ссылку на какое-либо опорное изображение, предшествующее текущему изображению в порядке декодирования, когда subpicA в текущем изображении ассоциировано с типом единицы NAL интра-точки произвольного доступа (IRAP); декодирование, процессором, последующих изображений на основе активных записей списков опорных изображений; и пересылку процессором последующих изображений для отображения как части декодированной видеопоследовательности.

[0005] Системы кодирования/декодирования (coding) видео могут кодировать (encode) видео, используя IRAP-изображения и не-IRAP-изображения. IRAP-изображения являются изображениями, кодируемыми/декодируемыми согласно интра-предсказанию, которые служат в качестве точек произвольного доступа для видеопоследовательности. IRAP-изображение может быть декодировано без предварительного декодирования каких-либо других изображений. Соответственно, декодер может начинать декодирование видеопоследовательности с любого IRAP-изображения. В то же время декодер обычно не может начинать декодирование видеопоследовательности с не-IRAP-изображения. IRAP-изображения также могут обновлять DPB. Это связано с тем, что IRAP-изображение может действовать в качестве начальной точки для кодируемой/декодируемой видеопоследовательности (CVS), и изображения в этой CVS не ссылаются на изображения в предшествующей CVS. Таким образом, IRAP-изображения также могут разрывать/останавливать цепочки интер-предсказания и останавливать ошибки кодирования/декодирования, связанные с интер-предсказанием, поскольку такие ошибки не могут распространяться через IRAP-изображение.

[0006] В некоторых случаях для кодирования/декодирования видео виртуальной реальности (VR) могут использоваться системы кодирования/декодирования видео. Видео VR может включать в себя сферу видеоконтента, отображаемую так, как если бы пользователь находился в центре этой сферы. Пользователю отображается только участок сферы, называемый окном просмотра. Оставшаяся часть изображения отбрасывается без рендеринга. Все изображение обычно передается таким образом, что другое окно просмотра может быть динамически выбрано и отображено в ответ на движение головы пользователя. Такой подход может привести к очень большим размерам видеофайлов. Чтобы повысить эффективность кодирования/декодирования, некоторые системы делят изображения на субизображения. Видео может быть закодировано в двух или более разрешениях. Каждое разрешение кодируется в различном наборе битовых подпотоков, соответствующих субизображениям. Когда пользователь осуществляет потоковую передачу видео VR, система кодирования/декодирования может объединять битовые подпотоки в битовый поток для передачи на основе текущего окна просмотра, используемого пользователем. В частности, текущее окно просмотра получается из битового подпотока высокого разрешения, а окна просмотра, которые не просматриваются, получают из битового потока(потоков) низкого разрешения. Таким образом, для пользователя отображается видео наивысшего качества, а видео более низкого качества отбрасывается. В случае, если пользователь выбирает новое окно просмотра, пользователю отображается видео более низкого разрешения. Декодер может запросить, чтобы новое окно просмотра получило видео более высокого разрешения. Затем кодер может надлежащим образом изменить процесс объединения. Как только IRAP-изображение достигнуто, декодер может начинать декодирование видеопоследовательности более высокого разрешения в новом окне просмотра. Такой подход значительно увеличивает сжатие видео, не оказывая негативного влияния на впечатления пользователя от просмотра.

[0007] Одна проблема с вышеупомянутым подходом заключается в том, что продолжительность времени, необходимая для изменения разрешений, основана на продолжительности времени до момента, когда будет достигнуто IRAP-изображение. Это связано с тем, что, как описано выше, декодер не может начинать декодирование другой видеопоследовательности с не-IRAP-изображения. Одним из подходов к уменьшению такой задержки является включение большего числа IRAP-изображений. Однако это приводит к увеличению размера файла. Чтобы сбалансировать функциональность с эффективностью кодирования/декодирования, разные окна просмотра/субизображения могут включать в себя IRAP-изображения с разными частотами. Например, области просмотра, которые чаще всего просматриваются, могут иметь больше IRAP-изображений, чем другие области просмотра. Такой подход приводит к другим проблемам. В частности, изображения, следующие за IRAP-изображением, ограничены так, чтобы не ссылаться на изображения, которые предшествуют IRAP-изображению. Однако это ограничение делается на уровне изображений. Изображение, которое включает в себя смешанные единицы NAL, в том числе как IRAP-, так и не-IRAP-субизображения, может не рассматриваться в качестве IRAP-изображения на уровне изображений. Соответственно, такие ограничения на уровне изображений могут не быть подходящими. Это может привести к тому, что части изображений, которые следуют за IRAP-субизображением, неправильно ссылаются на изображения, которые предшествуют IRAP-изображению. В этом случае IRAP-субизображение не будет функционировать должным образом в качестве точки доступа, поскольку опорное изображение/субизображение может быть недоступным, что помешает декодированию субизображений, следующих за IRAP-субизображением. Кроме того, IRAP-субизображение не должно препятствовать такой ссылке не-IRAP-субизображения, поскольку это противоречило бы цели использования смешанных единиц NAL (например, интер-кодируемых/декодируемых последовательностей разной длины в зависимости от положения субизображения).

[0008] Настоящий пример включает в себя механизмы для смягчения ошибок кодирования/декодирования, когда изображения включают в себя как единицы NAL IRAP, так и единицы NAL не-IRAP. В частности, субизображение в текущем изображении может содержать единицу NAL IRAP. Когда это происходит, ссылка слайсов в изображении, следующем за текущим изображением, которые также содержатся в упомянутом субизображении, на опорные изображения, предшествующие текущему изображению, ограничивается. Это гарантирует, что единицы NAL IRAP остановят распространение интер-предсказания на уровне субизображений. Соответственно, декодер может начинать декодирование с IRAP-субизображения. Слайсы, ассоциированные с субизображением в более поздних изображениях, всегда могут быть декодированы, поскольку такие слайсы не ссылаются на какие-либо данные, которые предшествуют IRAP-субизображению (которое не было декодировано). Такое ограничение не применяется к единицам NAL не-IRAP. Соответственно, интер-предсказание не разрывается для субизображений, содержащих не-IRAP-данные. Таким образом, раскрытые механизмы позволяют реализовать дополнительную функциональность. Например, раскрытые механизмы поддерживают динамические изменения разрешения на уровне субизображений при использовании битовых потоков субизображений. Следовательно, раскрытые механизмы позволяют передавать битовые потоки субизображений более низкого разрешения при потоковой передаче видео VR без значительного ухудшения восприятия пользователем. Соответственно, раскрытые механизмы повышают эффективность кодирования/декодирования и, следовательно, уменьшают использование сетевых ресурсов, ресурсов памяти и/или ресурсов обработки в кодере и декодере.

[0009] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что тип единицы NAL IRAP представляет собой тип единицы NAL чистого произвольного доступа (CRA).

[0010] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что тип единицы NAL IRAP представляет собой тип единицы NAL мгновенного обновления декодера (IDR).

[0011] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что дополнительно содержится определение процессором того, что все слайсы текущего изображения, расположенные в subpicA, ассоциированы с одним и тем же типом единицы NAL.

[0012] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что дополнительно содержится определение процессором того, что первое значение типа единицы NAL для единиц NAL VCL текущего изображения отличается от второго значения типа единицы NAL для единиц NAL VCL текущего изображения на основе флага.

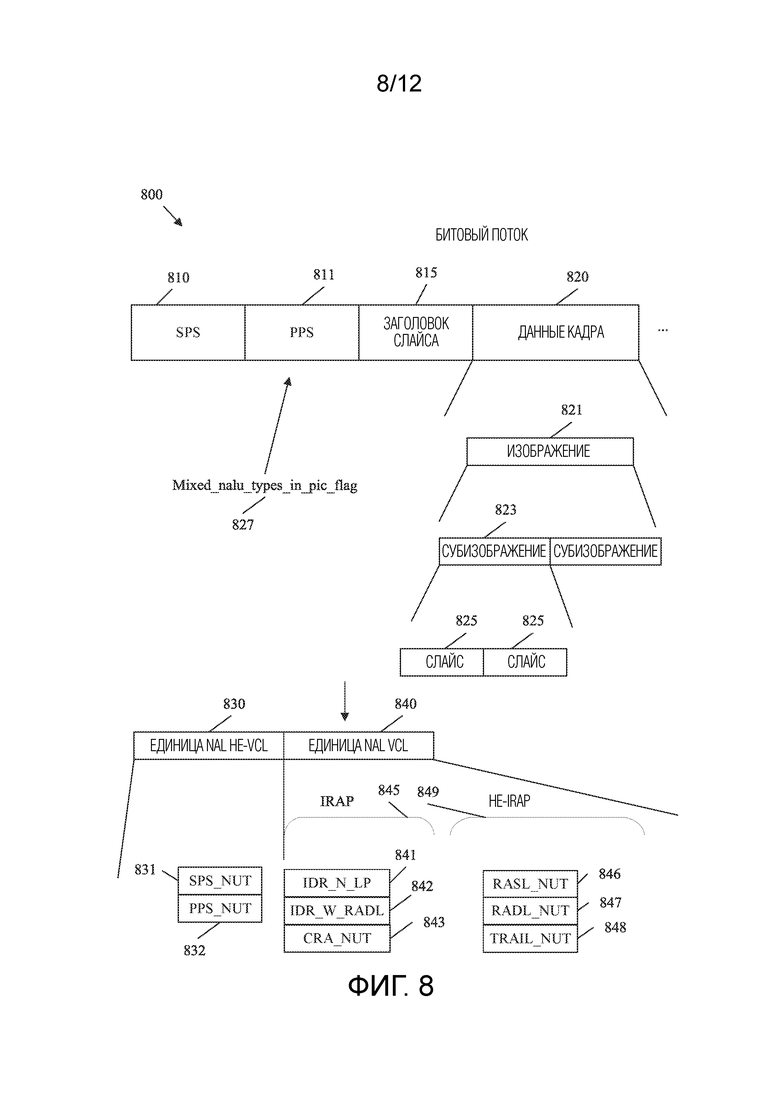

[0013] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что битовый поток включает в себя набор параметров изображения (PPS), и при этом флаг получают из PPS.

[0014] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что флаг представляет собой mixed_nalu_types_in_pic_flag, и при этом mixed_nalu_types_in_pic_flag равняется единице при специфицировании того, что каждое изображение, ссылающееся на PPS, имеет более одной единицы NAL VCL, и эти единицы NAL VCL не имеют одного и того же значения типа единицы NAL (nal_unit_type).

[0015] В варианте осуществления раскрытие включает в себя способ, реализуемый в кодере, причем способ содержит: определение процессором кодера того, что текущее изображение включает в себя множество единиц NAL VCL, которые не имеют одного и того же типа единицы NAL; определение процессором того, что subpicA в текущем изображении ассоциировано с типом единицы NAL IRAP; генерирование, процессором, активных записей списков опорных изображений для слайсов, расположенных в subpicA в последующих изображениях, следующих за текущим изображением в порядке декодирования, при этом активные записи не включают в себя ссылку на какое-либо опорное изображение, предшествующее текущему изображению в порядке декодирования, когда subpicA в текущем изображении ассоциировано с типом единицы NAL IRAP; кодирование, процессором, последующих изображений в битовый поток на основе списков опорных изображений; и сохранение памятью, соединенной с процессором, битового потока для передачи на декодер.

[0016] Системы кодирования/декодирования (coding) видео могут кодировать (encode) видео, используя IRAP-изображения и не-IRAP-изображения. IRAP-изображения являются изображениями, кодируемыми/декодируемыми согласно интра-предсказанию, которые служат в качестве точек произвольного доступа для видеопоследовательности. IRAP-изображение может быть декодировано без предварительного декодирования каких-либо других изображений. Соответственно, декодер может начинать декодирование видеопоследовательности с любого IRAP-изображения. В то же время декодер обычно не может начинать декодирование видеопоследовательности с не-IRAP-изображения. IRAP-изображения также могут обновлять DPB. Это связано с тем, что IRAP-изображение может действовать в качестве начальной точки для кодируемой/декодируемой видеопоследовательности (CVS), и изображения в этой CVS не ссылаются на изображения в предшествующей CVS. Таким образом, IRAP-изображения также могут разрывать цепочки интер-предсказания и останавливать ошибки кодирования/декодирования, связанные с интер-предсказанием, поскольку такие ошибки не могут распространяться через IRAP-изображение.

[0017] В некоторых случаях для кодирования/декодирования видео виртуальной реальности (VR) могут использоваться системы кодирования/декодирования видео. Видео VR может включать в себя сферу видеоконтента, отображаемую так, как если бы пользователь находился в центре этой сферы. Пользователю отображается только участок сферы, называемый окном просмотра. Оставшаяся часть изображения отбрасывается без рендеринга. Все изображение обычно передается таким образом, что другое окно просмотра может быть динамически выбрано и отображено в ответ на движение головы пользователя. Такой подход может привести к очень большим размерам видеофайлов. Чтобы повысить эффективность кодирования/декодирования, некоторые системы делят изображения на субизображения. Видео может быть закодировано в двух или более разрешениях. Каждое разрешение кодируется в различном наборе битовых подпотоков, соответствующих субизображениям. Когда пользователь осуществляет потоковую передачу видео VR, система кодирования/декодирования может объединять битовые подпотоки в битовый поток для передачи на основе текущего окна просмотра, используемого пользователем. В частности, текущее окно просмотра получается из битового подпотока высокого разрешения, а окна просмотра, которые не просматриваются, получают из битового потока(потоков) низкого разрешения. Таким образом, для пользователя отображается видео наивысшего качества, а видео более низкого качества отбрасывается. В случае, если пользователь выбирает новое окно просмотра, пользователю отображается видео более низкого разрешения. Декодер может запросить, чтобы новое окно просмотра получило видео более высокого разрешения. Затем кодер может надлежащим образом изменить процесс объединения. Как только IRAP-изображение достигнуто, декодер может начинать декодирование видеопоследовательности более высокого разрешения в новом окне просмотра. Такой подход значительно увеличивает сжатие видео, не оказывая негативного влияния на впечатления пользователя от просмотра.

[0018] Одна проблема с вышеупомянутым подходом заключается в том, что продолжительность времени, необходимая для изменения разрешений, основана на продолжительности времени до момента, когда будет достигнуто IRAP-изображение. Это связано с тем, что, как описано выше, декодер не может начинать декодирование другой видеопоследовательности с не-IRAP-изображения. Одним из подходов к уменьшению такой задержки является включение большего числа IRAP-изображений. Однако это приводит к увеличению размера файла. Чтобы сбалансировать функциональность с эффективностью кодирования/декодирования, разные окна просмотра/субизображения могут включать в себя IRAP-изображения с разными частотами. Например, области просмотра, которые чаще всего просматриваются, могут иметь больше IRAP-изображений, чем другие области просмотра. Такой подход приводит к другим проблемам. В частности, изображения, следующие за IRAP-изображением, ограничены так, чтобы не ссылаться на изображения, которые предшествуют IRAP-изображению. Однако это ограничение делается на уровне изображений. Изображение, которое включает в себя смешанные единицы NAL, в том числе как IRAP-, так и не-IRAP-субизображения, может не рассматриваться в качестве IRAP-изображения на уровне изображений. Соответственно, такие ограничения на уровне изображений могут не быть подходящими. Это может привести к тому, что части изображений, которые следуют за IRAP-субизображением, неправильно ссылаются на изображения, которые предшествуют IRAP-изображению. В этом случае IRAP-субизображение не будет функционировать должным образом в качестве точки доступа, поскольку опорное изображение/субизображение может быть недоступным, что помешает декодированию субизображений, следующих за IRAP-субизображением. Кроме того, IRAP-субизображение не должно препятствовать такой ссылке не-IRAP-субизображения, поскольку это противоречило бы цели использования смешанных единиц NAL (например, интер-кодируемых/декодируемых последовательностей разной длины в зависимости от положения субизображения).

[0019] Настоящий пример включает в себя механизмы для смягчения ошибок кодирования/декодирования, когда изображения включают в себя как единицы NAL IRAP, так и единицы NAL не-IRAP. В частности, субизображение в текущем изображении может содержать единицу NAL IRAP. Когда это происходит, ссылка слайсов в изображении, следующем за текущим изображением, которые также содержатся в упомянутом субизображении, на опорные изображения, предшествующие текущему изображению, ограничивается. Это гарантирует, что единицы NAL IRAP остановят распространение интер-предсказания на уровне субизображений. Соответственно, декодер может начинать декодирование с IRAP-субизображения. Слайсы, ассоциированные с субизображением в более поздних изображениях, всегда могут быть декодированы, поскольку такие слайсы не ссылаются на какие-либо данные, которые предшествуют IRAP-субизображению (которое не было декодировано). Такое ограничение не применяется к единицам NAL не-IRAP. Соответственно, интер-предсказание не разрывается для субизображений, содержащих не-IRAP-данные. Таким образом, раскрытые механизмы позволяют реализовать дополнительную функциональность. Например, раскрытые механизмы поддерживают динамические изменения разрешения на уровне субизображений при использовании битовых потоков субизображений. Следовательно, раскрытые механизмы позволяют передавать битовые потоки субизображений более низкого разрешения при потоковой передаче видео VR без значительного ухудшения восприятия пользователем. Соответственно, раскрытые механизмы повышают эффективность кодирования/декодирования и, следовательно, уменьшают использование сетевых ресурсов, ресурсов памяти и/или ресурсов обработки в кодере и декодере.

[0020] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что тип единицы NAL IRAP представляет собой тип единицы NAL CRA.

[0021] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что тип единицы NAL IRAP представляет собой тип единицы NAL IDR.

[0022] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что дополнительно содержится кодирование в битовый поток, процессором, текущего изображения посредством обеспечения того, что все слайсы текущего изображения, расположенные в subpicA, ассоциированы с одним и тем же типом единицы NAL.

[0023] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что дополнительно содержится кодирование в битовый поток, процессором, флага, указывающего, что первое значение типа единицы NAL для единиц NAL VCL текущего изображения отличается от второго значения типа единицы NAL для единиц NAL VCL текущего изображения.

[0024] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что флаг кодируется в PPS в битовом потоке.

[0025] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что флаг представляет собой mixed_nalu_types_in_pic_flag, и при этом mixed_nalu_types_in_pic_flag устанавливается равным единице при специфицировании того, что каждое изображение, ссылающееся на PPS, имеет более одной единицы NAL VCL, и эти единицы NAL VCL не имеют одного и того же значения nal_unit_type.

[0026] В одном варианте осуществления данное раскрытие включает в себя устройство кодирования/декодирования видео, содержащее: процессор, приемник, соединенный с процессором, память, соединенную с процессором, и передатчик, соединенный с процессором, при этом процессор, приемник, память и передатчик выполнены с возможностью осуществления способа по любому из предшествующих аспектов.

[0027] В одном варианте осуществления данное раскрытие включает в себя долговременный считываемый компьютером носитель, содержащий компьютерный программный продукт для использования устройством кодирования/декодирования видео, причем компьютерный программный продукт содержит исполняемые компьютером инструкции, хранящиеся на долговременном считываемом компьютером носителе, так что при исполнении процессор побуждает устройство кодирования/декодирования видео выполнять способ по любому из предшествующих аспектов.

[0028] В варианте осуществления данное раскрытие включает в себя декодер, содержащий: средство приема для приема битового потока, содержащего текущее изображение, включающее в себя множество единиц NAL VCL, которые не имеют одного и того же типа единицы NAL; средство получения для получения активных записей списков опорных изображений для слайсов, расположенных в subpicA в последующих изображениях, следующих за текущим изображением в порядке декодирования; средство определения для определения того, что активные записи не включают в себя ссылку на какое-либо опорное изображение, предшествующее текущему изображению в порядке декодирования, когда subpicA в текущем изображении ассоциировано с типом единицы NAL IRAP; средство декодирования для декодирования последующих изображений на основе активных записей списков опорных изображений; и средство пересылки для пересылки последующих изображений для отображения как части декодированной видеопоследовательности.

[0029] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что декодер дополнительно выполнен с возможностью выполнения способа по любому из предшествующих аспектов.

[0030] В варианте осуществления раскрытие включает в себя кодер, содержащий: средство определения для: определения того, что текущее изображение включает в себя множество единиц NAL VCL, которые не имеют одного и того же типа единицы NAL; и определения того, что subpicA в текущем изображении ассоциировано с типом единицы NAL IRAP; средство генерирования для генерирования активных записей списков опорных изображений для слайсов, расположенных в subpicA в последующих изображениях, следующих за текущим изображением в порядке декодирования, при этом активные записи не включают в себя ссылку на какое-либо опорное изображение, предшествующее текущему изображению в порядке декодирования, когда subpicA в текущем изображении ассоциировано с типом единицы NAL IRAP; средство кодирования для кодирования последующих изображений в битовый поток на основе списков опорных изображений; и средство хранения для сохранения битового потока для передачи на декодер.

[0031] Опционально, в любом из предшествующих аспектов, другая реализация аспекта обеспечивает, что кодер дополнительно выполнен с возможностью выполнения способа по любому из предшествующих аспектов.

[0032] Для ясности любой из вышеупомянутых вариантов осуществления изобретения может быть объединен с любым одним или более другими вышеупомянутыми вариантами осуществления, чтобы создать новый вариант осуществления в рамках объема настоящего раскрытия.

[0033] Эти и другие особенности будут более понятны из следующего подробного описания, рассматриваемого вместе с сопроводительными чертежами и формулой изобретения.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

[0034] Для более полного понимания этого раскрытия теперь обратимся к нижеследующему краткому описанию, рассматриваемому в связи с сопроводительными чертежами и подробным описанием, при этом одинаковые ссылочные позиции представляют одинаковые части.

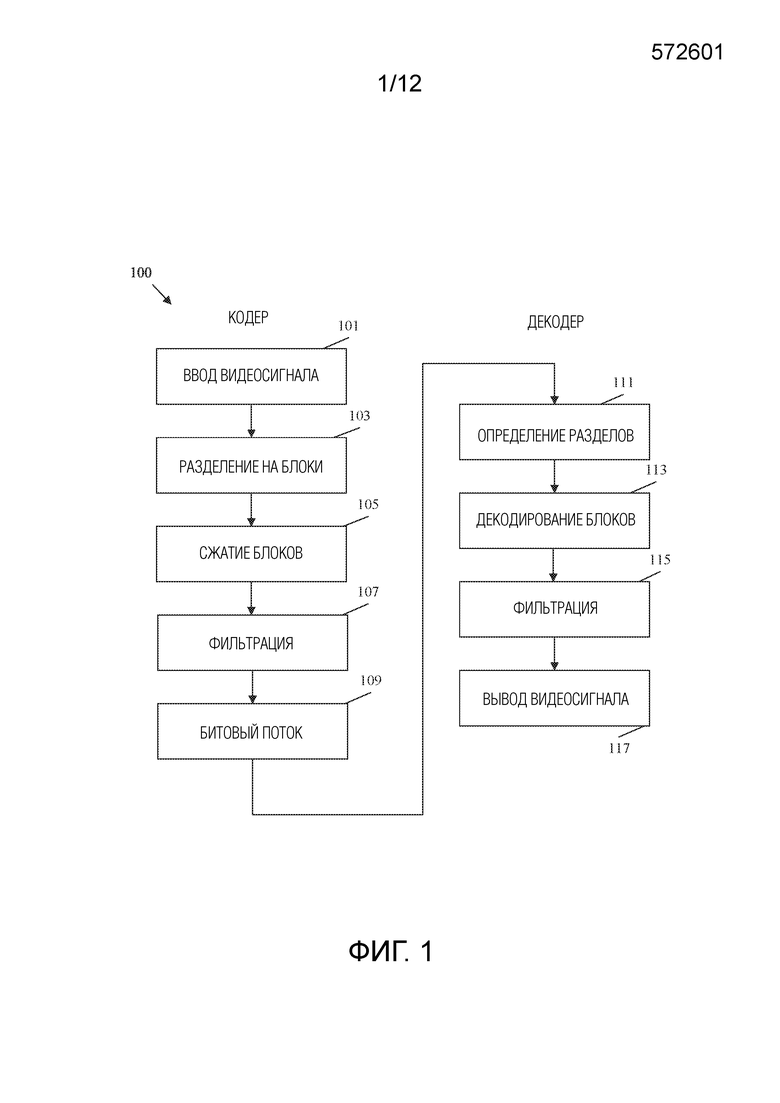

[0035] ФИГ. 1 представляет собой блок-схему последовательности операций примерного способа кодирования/декодирования видеосигнала.

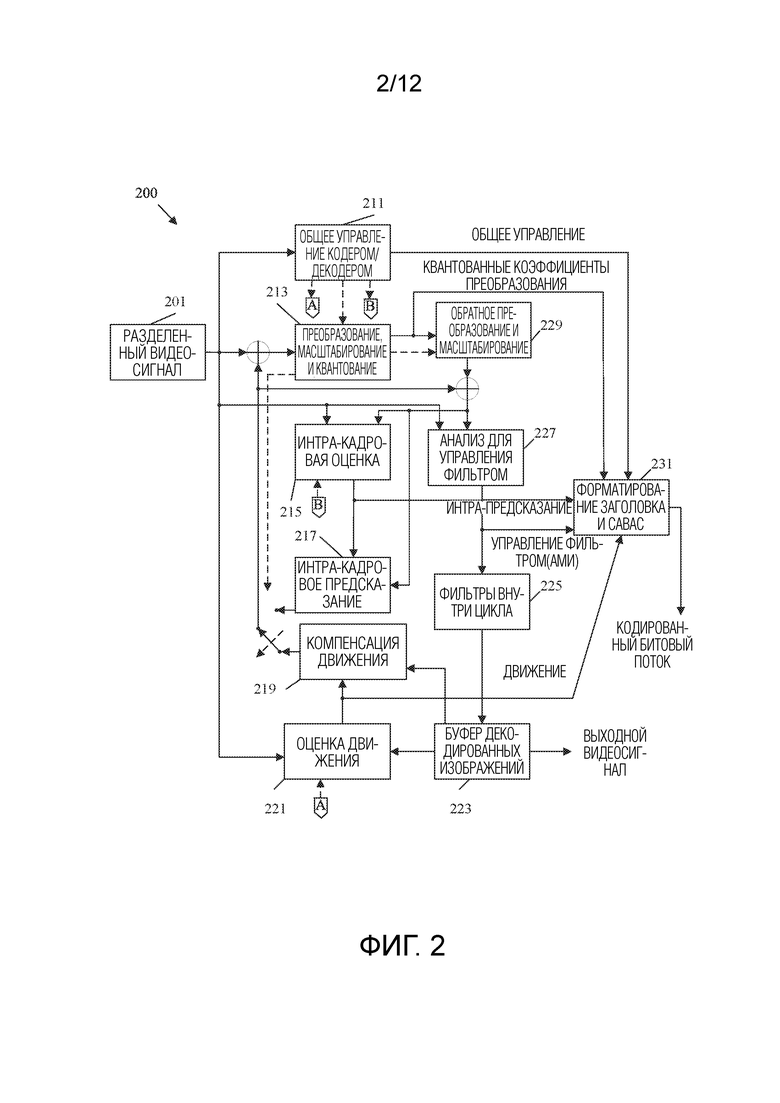

[0036] ФИГ. 2 представляет собой схематичное представление примерной системы кодирования и декодирования (кодека) для кодирования/декодирования видео.

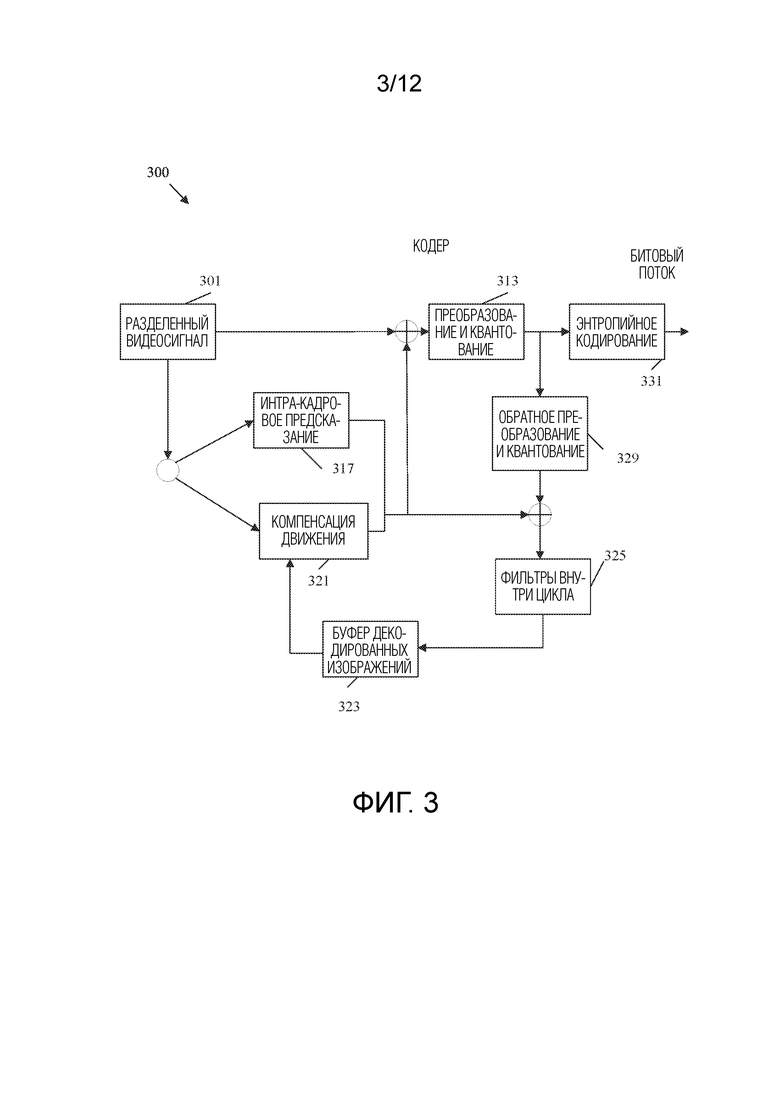

[0037] ФИГ. 3 представляет собой схематичное представление, иллюстрирующее примерный видеокодер.

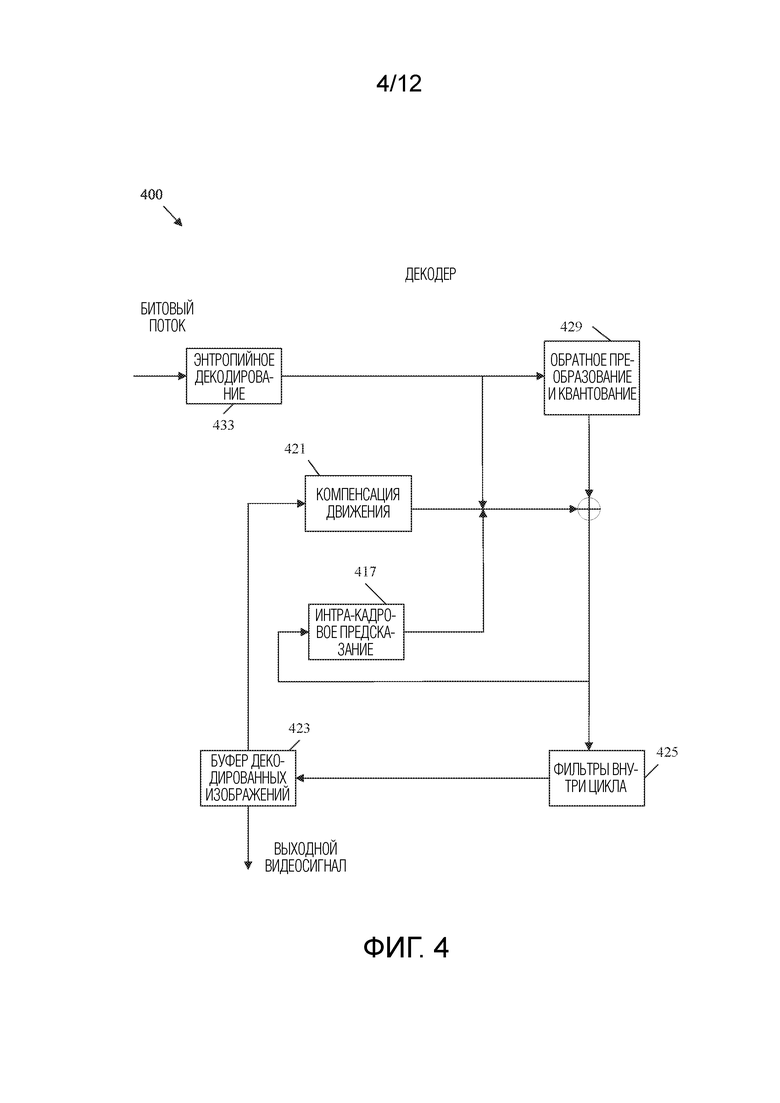

[0038] ФИГ. 4 представляет собой схематичное представление, иллюстрирующее примерный видеодекодер.

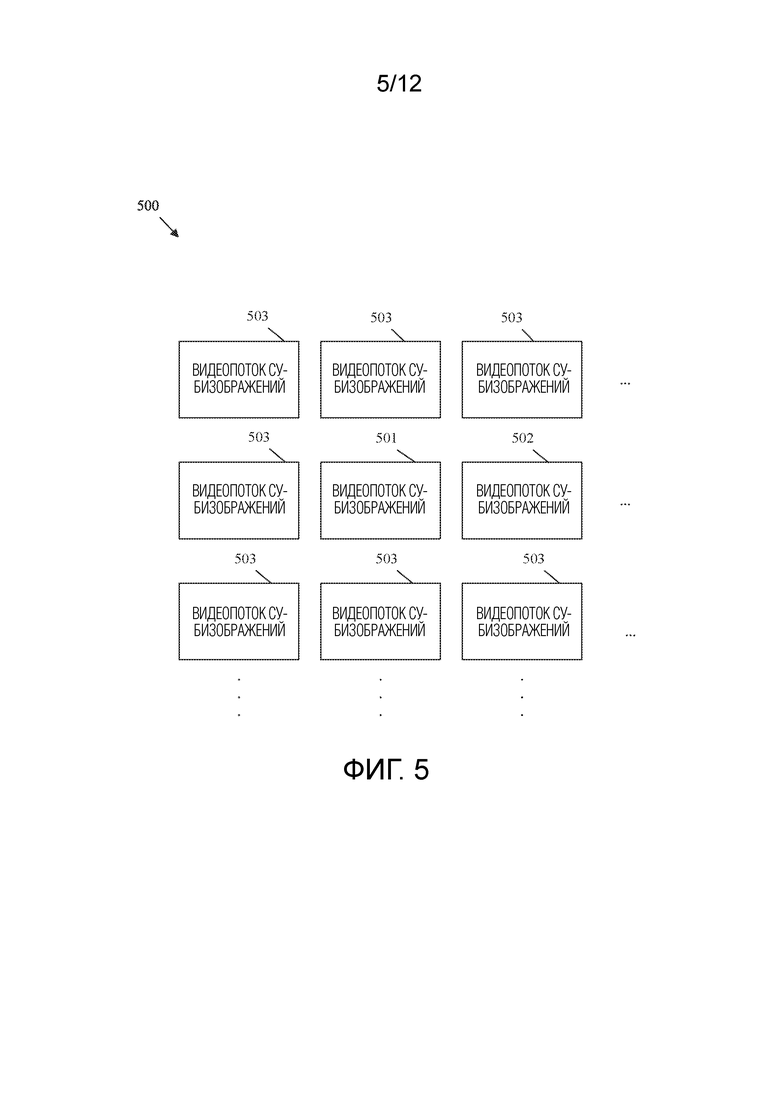

[0039] ФИГ. 5 представляет собой схематичное представление, иллюстрирующее множество видеопотоков субизображений, выделенных из видеопотока изображений виртуальной реальности (VR).

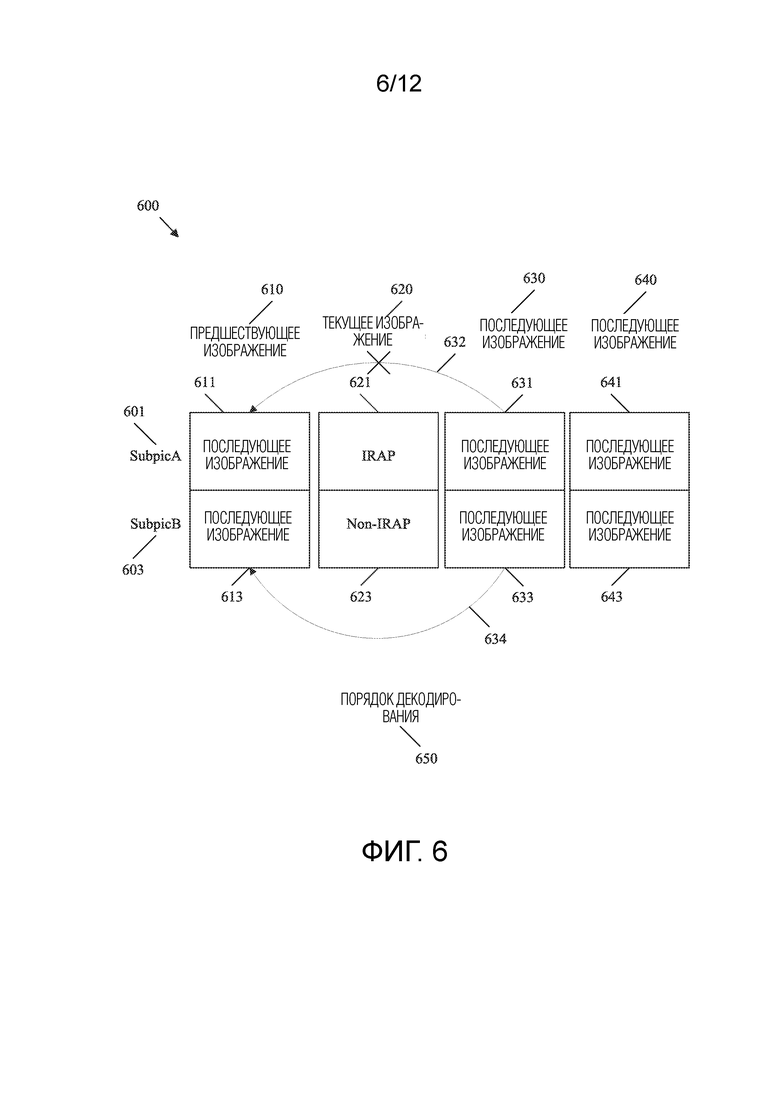

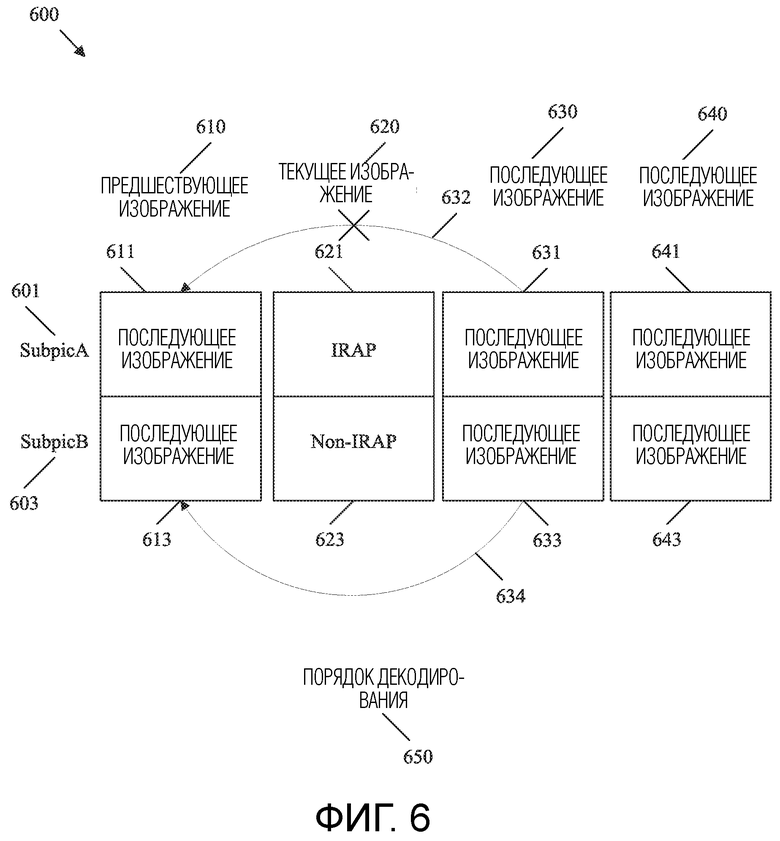

[0040] ФИГ. 6 представляет собой схематичное представление, иллюстрирующее ограничения, используемые, когда текущее изображение включает в себя смешанные типы единиц уровня сетевой абстракции (NAL).

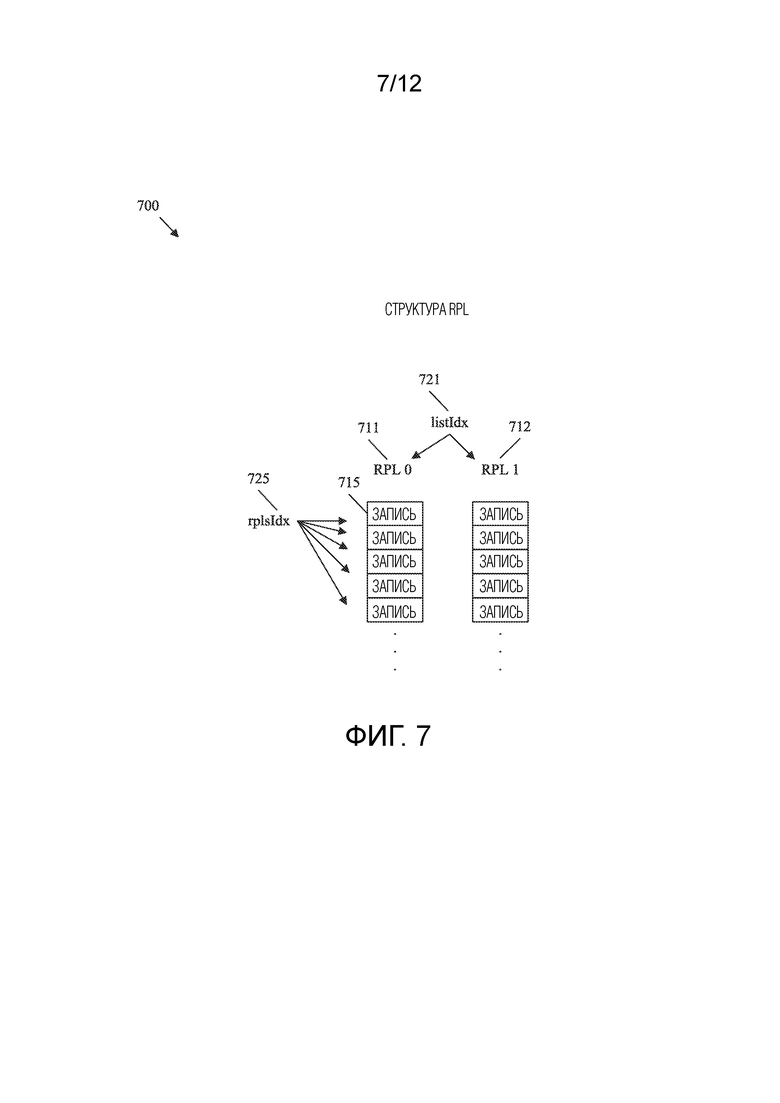

[0041] ФИГ. 7 представляет собой схематичное представление, иллюстрирующее примерную структуру списков опорных изображений, содержащую списки опорных изображений.

[0042] ФИГ. 8 представляет собой схематичное представление, иллюстрирующее примерный битовый поток, содержащий изображения со смешанными типами единиц NAL.

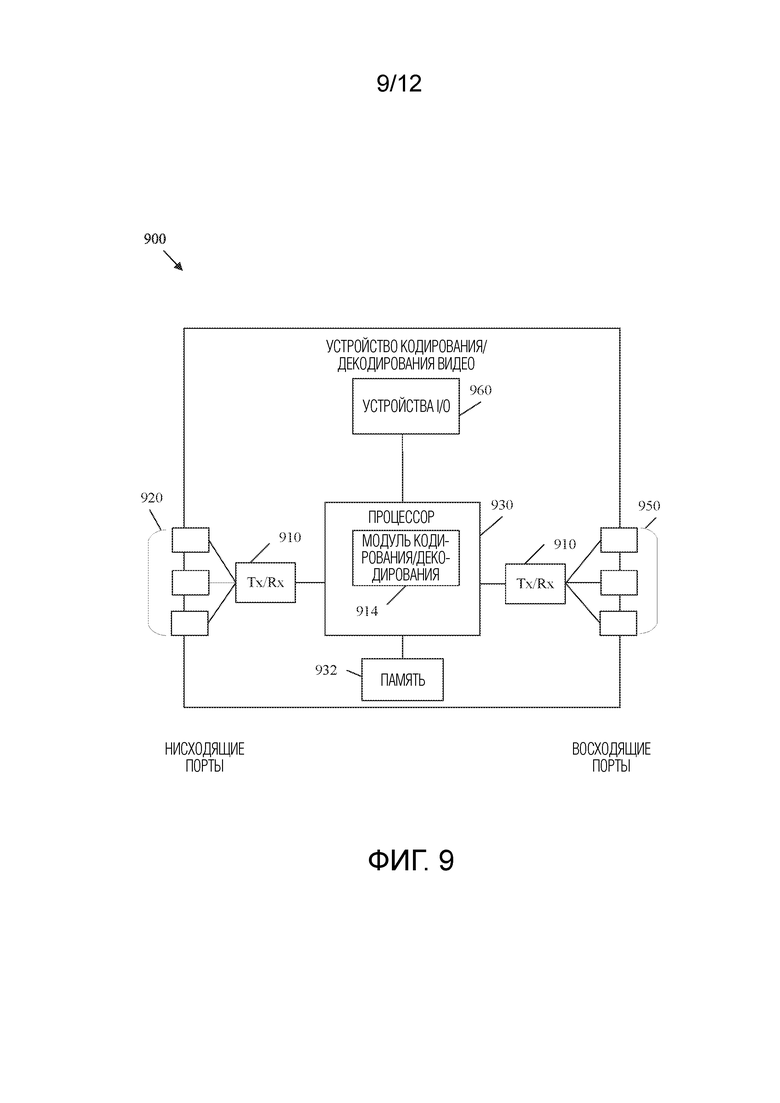

[0043] ФИГ. 9 представляет собой схематичное представление примерного устройства кодирования/декодирования видео.

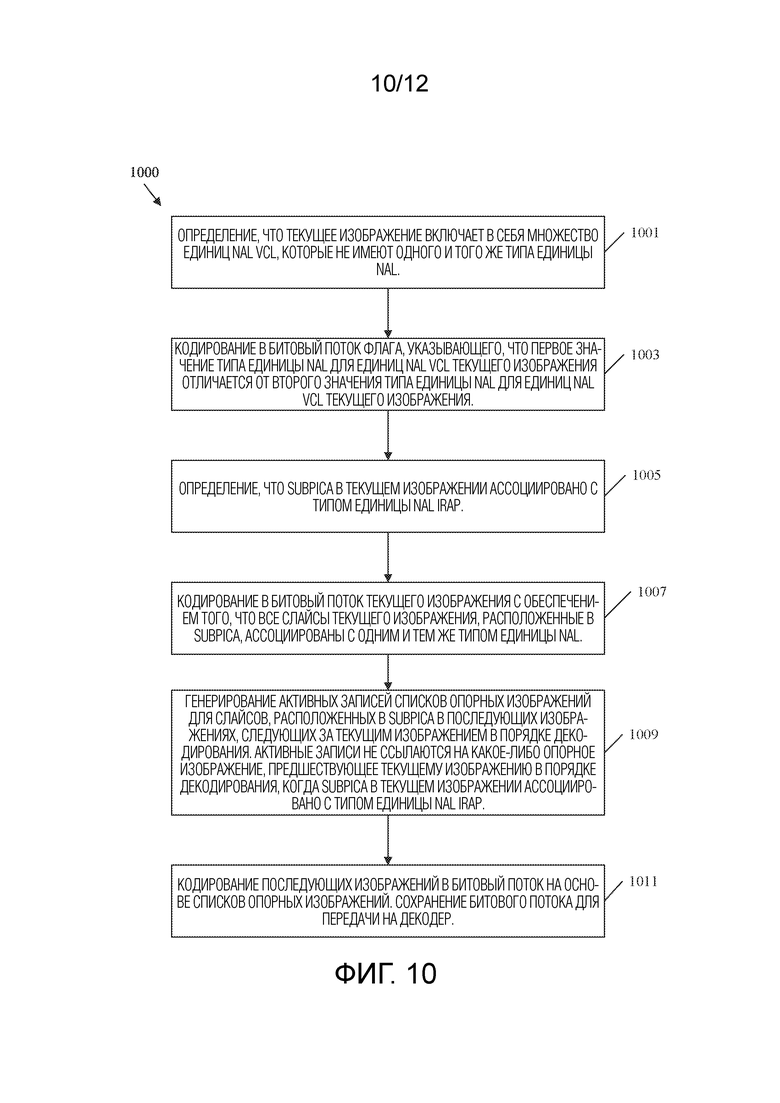

[0044] ФИГ. 10 представляет собой блок-схему последовательности операций примерного способа кодирования видеопоследовательности, содержащей изображение со смешанными типами единиц NAL, в битовый поток.

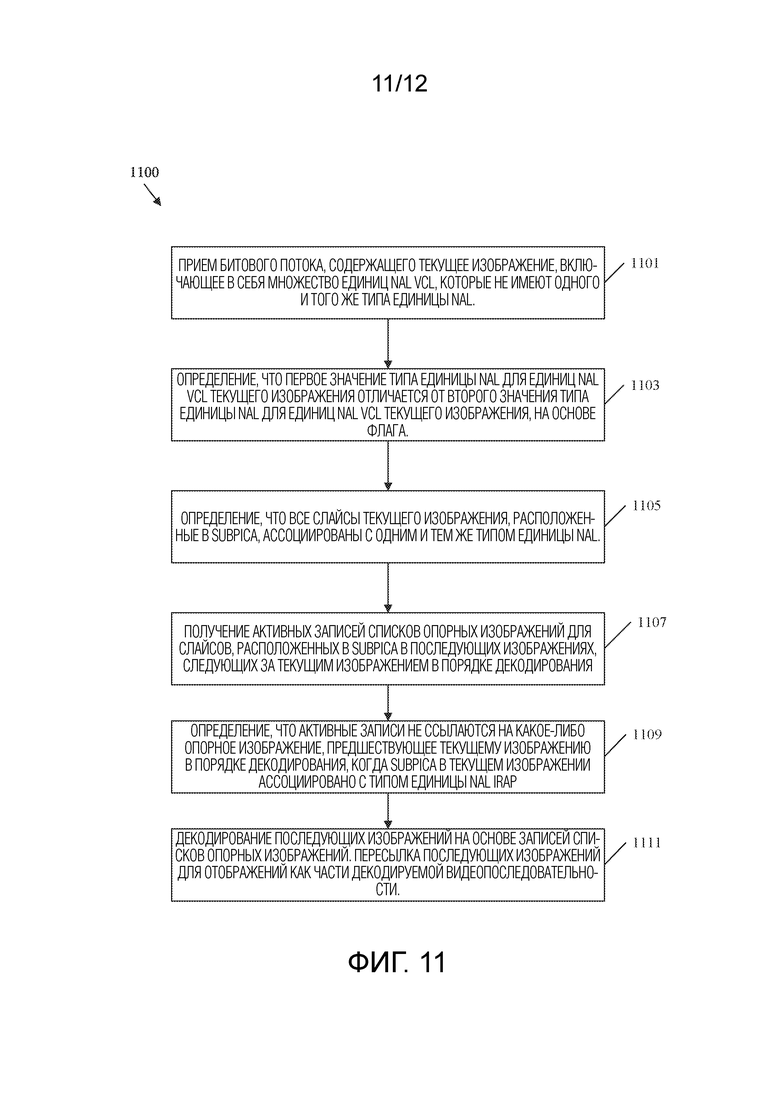

[0045] ФИГ. 11 представляет собой блок-схему последовательности операций примерного способа декодирования видеопоследовательности, содержащей изображение со смешанными типами единиц NAL, из битового потока.

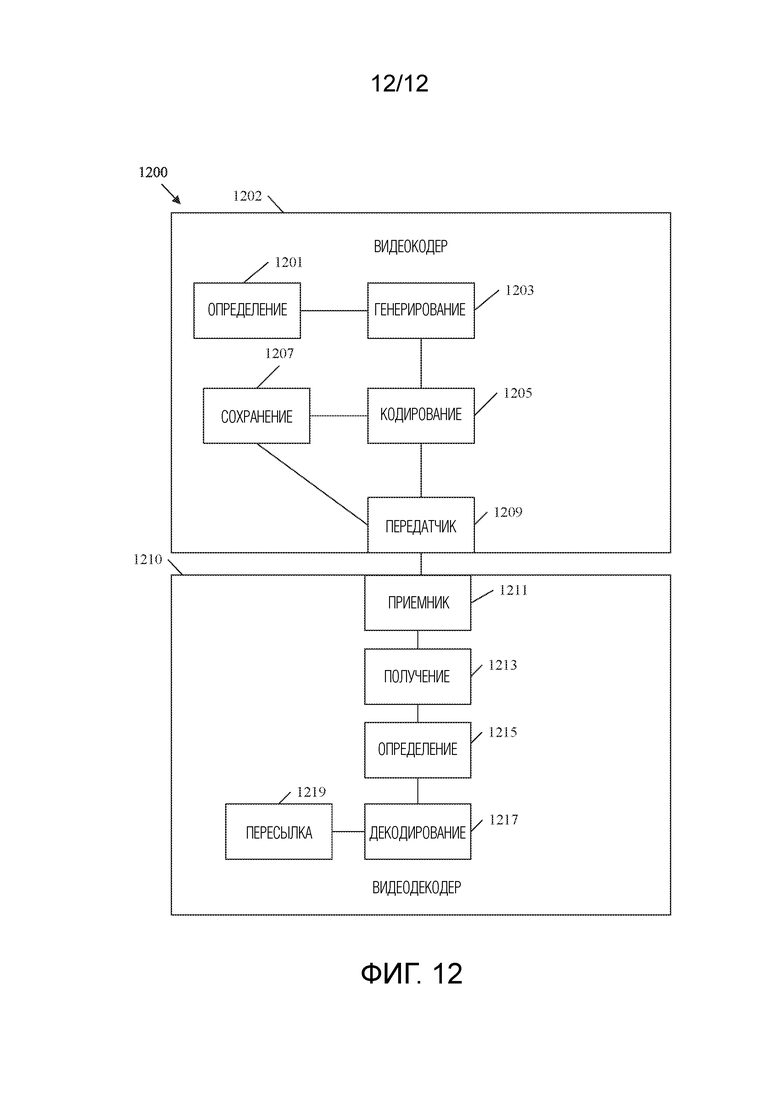

[0046] ФИГ. 12 представляет собой схематичное представление примерной системы для кодирования/декодирования видеопоследовательности, содержащей изображение со смешанными типами единиц NAL, в битовый поток.

ПОДРОБНОЕ ОПИСАНИЕ

[0047] Прежде всего следует понимать, что, хотя иллюстративная реализация одного или более вариантов осуществления представлена ниже, раскрытые системы и/или способы могут быть реализованы с использованием любого числа методик, известных в настоящее время или уже существующих. Раскрытие никоим образом не должно быть ограничено иллюстративными реализациями, чертежами и методиками, проиллюстрированными ниже, в том числе примерными конструкциями и реализациями, проиллюстрированными и описанными в настоящем документе, но может быть изменено в пределах объема прилагаемой формулы изобретения вместе с полным объемом ее эквивалентов.

[0048] Нижеследующие термины определяются следующим образом до тех пор, пока они не используются в данном документе в противоположном контексте. В частности, следующие определения призваны внести дополнительную ясность в настоящее раскрытие. Однако термины могут быть описаны иначе в других контекстах. Соответственно, следующие определения следует рассматривать в качестве дополнения и не следует рассматривать их в качестве ограничивающих любые другие определения в описании, обеспеченном для таких терминов в настоящем документе.

[0049] Битовый поток представляет собой последовательность битов, включающих в себя видеоданные, которые сжаты для передачи между кодером и декодером. Кодер представляет собой устройство, которое выполнено с возможностью использования процессов кодирования для сжатия видеоданных в битовый поток. Декодер представляет собой устройство, которое выполнено с возможностью использования процессов декодирования для восстановления видеоданных из битового потока для отображения. Изображение представляет собой массив выборок яркости и/или массив выборок цветности, которые создают кадр или его поле. Изображение, которое кодируется или декодируется, может называться текущим изображением для ясности обсуждения, а любое изображение, следующее за текущим изображением, может называться последующим изображением. Субизображение является прямоугольной областью из одного или более слайсов в пределах последовательности изображений. Следует отметить, что квадрат является типом прямоугольника, и, следовательно, субизображение может включать в себя квадратную область. Слайс может быть определен как целое число полных тайлов или целое число последовательных строк полных единиц дерева кодирования/декодирования (CTU) в пределах тайла изображения, которые содержатся исключительно в одной единице уровня сетевой абстракции (NAL). Единица NAL представляет собой синтаксическую структуру, содержащую байты данных и указание типа содержащихся в ней данных. Единицы NAL включают в себя единицы NAL уровня кодирования/декодирования видео (VCL), которые содержат видеоданные, и единицы NAL не-VCL, которые содержат поддерживающие синтаксические данные. Тип единицы NAL является типом структуры данных, содержащейся в единице NAL. Тип единицы NAL интра-точки произвольного доступа (IRAP) представляет собой структуру данных, содержащую данные из IRAP-изображения или субизображения. IRAP-изображение/субизображение представляет собой изображение/суб-изображение, которое кодируется/декодируется согласно интра-предсказанию, которое указывает, что декодер может начинать декодирование видеопоследовательности с соответствующего изображения/субизображения, не ссылаясь на изображения, предшествующие упомянутому IRAP-изображению/субизображению. Тип единицы NAL чистого произвольного доступа (CRA) представляет собой структуру данных, содержащую данные из CRA-изображения или субизображения. CRA-изображение/субизображение представляет собой IRAP-изображение/субизображение, которое не обновляет буфер декодированных изображений (DPB). Тип единицы NAL мгновенного обновления декодирования (IDR) представляет собой структуру данных, содержащую данные из IDR-изображения или субизображения. IDR-изображение/субизображение представляет собой IRAP-изображение/субизображение, которое обновляет DPB. Опорное изображение представляет собой изображение, которое содержит опорные выборки, которые могут быть использованы при кодировании других изображений по ссылке согласно интер-предсказанию. Список опорных изображений представляет собой список опорных изображений, используемых для интер-предсказания и/или межуровневого предсказания. Некоторые системы кодирования/декодирования видео ссылаются на два списка изображений, которые можно обозначить как первый список опорных изображений и нулевой список опорных изображений. Структура списков опорных изображений представляет собой адресуемую синтаксическую структуру, которая содержит несколько списков опорных изображений. Активная запись представляет собой запись в списке опорных изображений, которая ссылается на опорные изображения, которые доступны для использования текущим изображением при выполнении интер-предсказания. Флаг представляет собой структуру данных, содержащую последовательность битов, которая может быть установлена для указания соответствующих данных. Набор параметров изображения (PPS) представляет собой набор параметров, который содержит данные уровня изображений, относящиеся к одному или более изображениям. Порядок декодирования представляет собой порядок, в котором синтаксические элементы обрабатываются посредством процесса декодирования. Декодированная видеопоследовательность представляет собой последовательность изображений, которые были восстановлены посредством декодера при подготовке для отображения пользователю.

[0050] В настоящем документе используются следующие аббревиатуры: кодируемая/декодируемая видеопоследовательность (CVS), буфер декодированных изображений (DPB), мгновенное обновление декодирования (IDR), интра-точка произвольного доступа (IRAP), младший значащий бит (LSB), старший значащий бит (MSB), уровень сетевой абстракции (NAL), счетчик порядка изображений (POC), полезные данные последовательности необработанных байтов (RBSP), набор параметров последовательности (SPS) и рабочий проект (WD).

[0051] Многие методики сжатия видео могут использоваться для уменьшения размера видеофайлов с минимальной потерей данных. Например, методики сжатия видео могут включать в себя выполнение пространственного (например интра-кадрового) предсказания и/или временного (например интер-кадрового) предсказания для сокращения или устранения избыточности данных в видеопоследовательностях. Для кодирования/декодирования видео на основе блоков видеослайс (например, видеоизображение или часть видеоизображения) может быть разделен на видеоблоки, которые также могут называться древовидными блоками, блоками дерева кодирования/декодирования (CTB), единицами дерева кодирования/декодирования (CTU), единицами кодирования/декодирования (CU) и/или узлами кодирования/декодирования. Видеоблоки в интра-кодируемом/декодируемом (I) слайсе изображения кодируются/декодируются с использованием пространственного предсказания по отношению к опорным выборкам в соседних блоках в том же самом изображении. Видеоблоки в слайсе интер-кодируемого/декодируемого однонаправленного предсказания (P) или двунаправленного предсказания (B) в изображении могут кодироваться/декодироваться посредством использования пространственного предсказания относительно опорных выборок в соседних блоках в том же самом изображении или временного предсказания относительно опорных выборок в других опорных изображениях. Изображения могут называться кадрами и/или картинками, а опорные изображения могут называться опорными кадрами и/или опорными картинками. Пространственное или временное предсказание приводит к предиктивному блоку, представляющему блок картинки. Остаточные данные представляют собой разности пикселей между исходным блоком картинки и предиктивным блоком. Соответственно, интер-кодируемый/декодируемый блок кодируется согласно вектору движения, который указывает на блок опорных выборок, формирующих предиктивный блок, и остаточным данным, указывающими разность между кодируемым/декодируемым блоком и предиктивным блоком. Интра-кодируемый/декодируемый блок кодируется согласно режиму интра-кодирования/декодирования и остаточным данным. Для дальнейшего сжатия остаточные данные могут быть преобразованы из пиксельной области в область преобразования. Это приводит к остаточным коэффициентам преобразования, которые могут быть квантованы. Квантованные коэффициенты преобразования могут изначально размещаться в двумерном массиве. Квантованные коэффициенты преобразования могут быть просканированы для создания одномерного вектора коэффициентов преобразования. Энтропийное кодирование/декодирование может быть применено для достижения еще большего сжатия. Такие методики сжатия видео обсуждаются более подробно ниже.

[0052] Чтобы обеспечить точное декодирование закодированного видео, видео кодируется и декодируется согласно соответствующим стандартам кодирования/декодирования видео. Стандарты кодирования/декодирования видео включают в себя H.261 Сектора стандартизации (ITU-T) Международного союза электросвязи (ITU), H.262 ITU-T Экспертной группы по движущимся изображениям (MPEG)-1, Часть 2, Международной организации по стандартизации/Международной электротехнической комиссии (ISO/IEC) или H.263 ITU-T MPEG-2, Часть 2, ISO/IEC, Усовершенствованное кодирование/декодирование видео (AVC) MPEG-4, Часть 2, ISO/IEC, также известное как H.264 ITU-T или MPEG-4, Часть 10, ISO/IEC, и Высокоэффективное кодирование/декодирование видео (HEVC), также известное как H.265 ITU-T или MPEG-H, Часть 2. AVC включает в себя такие расширения, как Масштабируемое кодирование/декодирование видео (SVC), Многоракурсное кодирование/декодирование видео (MVC) и Многоракурсное кодирование/декодирование видео плюс Глубина (MVC+D), а также трехмерное (3D) AVC (3D-AVC). HEVC включает такие расширения, как Масштабируемое HEVC (SHVC), Многоракурсное HEVC (MV-HEVC) и 3D HEVC (3D-HEVC). Совместная группа экспертов по видео (JVET) ITU-T и ISO/IEC приступила к разработке стандарта кодирования/декодирования видео, называемого Универсальным кодированием/декодированием видео (VVC). VVC включено в рабочий проект (WD), который включает в себя JVET-N1001-v10.

[0053] Системы кодирования/декодирования (coding) видео могут кодировать (encode) видео, используя IRAP-изображения и не-IRAP-изображения. IRAP-изображения являются изображениями, кодируемыми/декодируемыми согласно интра-предсказанию, которые служат в качестве точек произвольного доступа для видеопоследовательности. При интра-предсказании блоки изображения кодируются/декодируются посредством ссылки на другие блоки в том же самом изображении. Это отличается от не-IRAP-изображений, которые используют интер-предсказание. При интер-предсказании блоки текущего изображения кодируются/декодируются посредством ссылки на другие блоки в опорном изображении, которое отличается от текущего изображения. Поскольку IRAP-изображение кодируется/декодируется без ссылки на другие изображения, IRAP-изображение может быть декодировано без предварительного декодирования каких-либо других изображений. Соответственно, декодер может начинать декодирование видеопоследовательности с любого IRAP-изображения. Для сравнения, не-IRAP-изображение кодируется/декодируется со ссылкой на другие изображения, и, следовательно, декодер, как правило, не может начинать декодирование видеопоследовательности с не-IRAP-изображения. IRAP-изображения также могут обновлять DPB. Это связано с тем, что IRAP-изображение может действовать в качестве начальной точки для CVS, и изображения в этой CVS не ссылаются на изображения в предшествующей CVS. Таким образом, IRAP-изображения также могут останавливать ошибки кодирования/декодирования, связанные с интер-предсказанием, поскольку такие ошибки не могут распространяться через IRAP-изображение. Однако с точки зрения размера данных IRAP-изображения значительно больше, чем не-IRAP-изображения. Таким образом, видеопоследовательность обычно включает в себя множество не-IRAP-изображений с меньшим числом перемежающихся IRAP-изображений, чтобы сбалансировать эффективность кодирования с функциональностью. Например, CVS из шестидесяти кадров может включать в себя одно IRAP-изображение и пятьдесят девять не-IRAP-изображений.

[0054] В некоторых случаях системы кодирования/декодирования видео могут использоваться для кодирования/декодирования видео виртуальной реальности (VR), которое также может упоминаться как видео с углом обзора 360 градусов. Видео VR может включать в себя сферу видеоконтента, отображаемую так, как если бы пользователь находился в центре этой сферы. Пользователю отображается только участок сферы, называемый окном просмотра. Например, пользователь может использовать головной дисплей (HMD), который выбирает и отображает окно просмотра сферы на основе движения головы пользователя. Это создает впечатление физического присутствия в виртуальном пространстве, которое представлено посредством видео. Для достижения этого результата каждое изображение видеопоследовательности включает в себя всю сферу видеоданных в соответствующий момент времени. Однако пользователю отображается только небольшая часть (например, одно окно просмотра) изображения. Оставшаяся часть изображения отбрасывается без рендеринга. Все изображение обычно передается таким образом, что другое окно просмотра может быть динамически выбрано и отображено в ответ на движение головы пользователя. Такой подход может привести к очень большим размерам видеофайлов.

[0055] Чтобы повысить эффективность кодирования/декодирования, некоторые системы делят изображения на субизображения. Субизображение представляет собой определенную пространственную область изображения. Каждое субизображение содержит соответствующее окно просмотра изображения. Видео может быть закодировано в двух или более разрешениях. Каждое разрешение кодируется в отдельный битовый подпоток. Когда пользователь осуществляет потоковую передачу видео VR, система кодирования/декодирования может объединять битовые подпотоки в битовый поток для передачи на основе текущего окна просмотра, используемого пользователем. В частности, текущее окно просмотра получается из битового подпотока высокого разрешения, а окна просмотра, которые не просматриваются, получают из битового потока(потоков) низкого разрешения. Таким образом, для пользователя отображается видео наивысшего качества, а видео более низкого качества отбрасывается. В случае, если пользователь выбирает новое окно просмотра, пользователю отображается видео более низкого разрешения. Декодер может запросить, чтобы новое окно просмотра получило видео более высокого разрешения. Затем кодер может надлежащим образом изменить процесс объединения. Как только IRAP-изображение достигнуто, декодер может начинать декодирование видеопоследовательности более высокого разрешения в новом окне просмотра. Такой подход значительно увеличивает сжатие видео, не оказывая негативного влияния на впечатления пользователя от просмотра.

[0056] Одна проблема с вышеупомянутым подходом заключается в том, что продолжительность времени, необходимая для изменения разрешений, основана на продолжительности времени до момента, когда будет достигнуто IRAP-изображение. Это связано с тем, что, как описано выше, декодер не может начинать декодирование другой видеопоследовательности с не-IRAP-изображения. Одним из подходов к уменьшению такой задержки является включение большего числа IRAP-изображений. Однако это приводит к увеличению размера файла. Чтобы сбалансировать функциональность с эффективностью кодирования/декодирования, разные окна просмотра/субизображения могут включать в себя IRAP-изображения с разными частотами. Например, области просмотра, которые чаще всего просматриваются, могут иметь больше IRAP-изображений, чем другие области просмотра. Например, в контексте баскетбола окна просмотра, относящиеся к корзинам и/или центральной зоне, могут включать в себя IRAP-изображения с большей частотой, чем окна просмотра, через которые видны трибуны или потолок, поскольку такие окна просмотра с меньшей вероятностью будут просматриваться пользователем.

[0057] Такой подход приводит к другим проблемам. В частности, изображения, следующие за IRAP-изображением, ограничены так, чтобы не ссылаться на изображения, которые предшествуют IRAP-изображению. Однако это ограничение делается на уровне изображений. Изображение, которое включает в себя смешанные единицы NAL, в том числе как IRAP-, так и не-IRAP-субизображения, может не рассматриваться в качестве IRAP-изображения на уровне изображений. Соответственно, такие ограничения на уровне изображений могут не быть подходящими. Это может привести к тому, что части изображений, которые следуют за IRAP-субизображением, неправильно ссылаются на изображения, которые предшествуют IRAP-изображению. В этом случае IRAP-субизображение не будет функционировать должным образом в качестве точки доступа, поскольку опорное изображение/субизображение может быть недоступным, что помешает декодированию субизображений, следующих за IRAP-субизображением. Кроме того, IRAP-субизображение не должно препятствовать такой ссылке не-IRAP-субизображения, поскольку это противоречило бы цели использования смешанных единиц NAL (например, интер-кодируемых/декодируемых последовательностей разной длины в зависимости от положения субизображения).

[0058] В настоящем документе раскрыты механизмы для смягчения ошибок кодирования/декодирования, когда изображения включают в себя как единицы NAL IRAP, так и единицы NAL не-IRAP. В частности, субизображение в текущем изображении может содержать единицу NAL IRAP. Когда это происходит, ссылка слайсов в изображении, следующем за текущим изображением, которые также содержатся в упомянутом субизображении, на опорные изображения, предшествующие текущему изображению, ограничивается. Это гарантирует, что единицы NAL IRAP разрывают интер-предсказание (например останавливают цепочки ссылок при интер-предсказании) на уровне субизображений. Соответственно, декодер может начинать декодирование с IRAP-субизображения. Слайсы, ассоциированные с субизображением в более поздних изображениях, всегда могут быть декодированы, поскольку такие слайсы не ссылаются на какие-либо данные, которые предшествуют IRAP-субизображению (которое не было декодировано). Такое ограничение не применяется к единицам NAL не-IRAP. Соответственно, интер-предсказание не разрывается для субизображений, содержащих не-IRAP-данные. Таким образом, раскрытые механизмы позволяют реализовать дополнительную функциональность. Например, раскрытые механизмы поддерживают динамические изменения разрешения на уровне субизображений при использовании битовых потоков субизображений. Следовательно, раскрытые механизмы позволяют передавать битовые потоки субизображений более низкого разрешения при потоковой передаче видео VR без значительного ухудшения восприятия пользователем. Соответственно, раскрытые механизмы повышают эффективность кодирования/декодирования и, следовательно, уменьшают использование сетевых ресурсов, ресурсов памяти и/или ресурсов обработки в кодере и декодере.

[0059] ФИГ. 1 представляет собой блок-схему последовательности операций примерного рабочего способа 100 кодирования/декодирования видеосигнала. В частности, видеосигнал кодируется в кодере. Процесс кодирования сжимает видеосигнал, используя различные механизмы для уменьшения размера видеофайла. Меньший размер файла позволяет передавать сжатый видеофайл пользователю, уменьшая при этом ассоциированное с этим потребление ресурсов полосы пропускания. Затем декодер декодирует сжатый видеофайл, чтобы восстановить исходный видеосигнал для отображения конечному пользователю. Процесс декодирования как правило зеркально отражает процесс кодирования, что позволяет декодеру последовательно восстанавливать видеосигнал.

[0060] На этапе 101 видеосигнал вводится в кодер. Например, видеосигнал может представлять собой несжатый видеофайл, хранящийся в памяти. В качестве другого примера, видеофайл может быть захвачен устройством видеозахвата, таким как видеокамера, и закодирован для поддержки потоковой передачи видео в режиме реального времени. Видеофайл может включать в себя как аудиокомпонент, так и видеокомпонент. Видеокомпонент содержит ряд кадров изображений, которые при последовательном просмотре создают визуальное впечатление движения. Кадры содержат пиксели, которые выражены в показателях света, называемых в данном документе компонентами яркости (или выборками яркости), и цвета, которые называются компонентами цветности (или выборками цветности). В некоторых примерах кадры могут также содержать значения глубины для поддержки трехмерного просмотра.

[0061] На этапе 103 видео разделяется на блоки. Разделение включает в себя подразделение пикселей в каждом кадре на квадратные и/или прямоугольные блоки для сжатия. Например, в высокоэффективном кодировании/декодировании видео (HEVC) (также известном как H.265 и MPEG-H, Часть 2) кадр можно сначала разбить на единицы дерева кодирования/декодирования (CTU), которые представляют собой блоки предопределенного размера (например, шестьдесят четыре пикселя на шестьдесят четыре пикселя). CTU содержат выборки как яркости, так и цветности. Деревья кодирования/декодирования могут использоваться для разбиения CTU на блоки, а затем рекурсивного подразделения блоков до тех пор, пока не будут достигнуты конфигурации, которые поддерживают дальнейшее кодирование. Например, компоненты яркости кадра могут быть подразделены до тех пор, пока отдельные блоки не будут содержать относительно однородные значения освещения. Кроме того, компоненты цветности кадра могут быть подразделены до тех пор, пока отдельные блоки не будут содержать относительно однородные значения цвета. Соответственно, механизмы разделения различаются в зависимости от содержимого видеокадров.

[0062] На этапе 105 используются различные механизмы сжатия для сжатия блоков изображения, полученных разделением на этапе 103. Например, может быть использовано интер-предсказание и/или интра-предсказание. Интер-предсказание предназначено для получения преимущества от того факта, что объекты в общей сцене имеют тенденцию появляться в последовательных кадрах. Соответственно, блок, представляющий объект в опорном кадре, не нужно повторно описывать в смежных кадрах. В частности, объект, такой как стол, может оставаться в постоянном положении в течение нескольких кадров. Следовательно, стол описывается один раз, и смежные кадры могут ссылаться обратно на опорный кадр. Механизмы сопоставления образов могут использоваться для сопоставления объектов в нескольких кадрах. Кроме того, движущиеся объекты могут быть представлены в нескольких кадрах, например, из-за движения объекта или движения камеры. В качестве конкретного примера видео может показывать автомобиль, который движется по экрану в течение нескольких кадров. Векторы движения могут быть использованы для описания такого движения. Вектор движения представляет собой двумерный вектор, который обеспечивает смещение из координат объекта в кадре в координаты объекта в опорном кадре. Таким образом, интер-предсказание может кодировать блок изображения в текущем кадре в качестве набора векторов движения, указывающих смещение от соответствующего блока в опорном кадре.

[0063] Интра-предсказание кодирует блоки в общем кадре. Интра-предсказание получает преимущество от того факта, что компоненты цветности и яркости имеют тенденцию группироваться в кадре. Например, фрагмент зелени в части дерева имеет тенденцию располагаться рядом с аналогичными фрагментами зелени. Интра-предсказание использует несколько направленных режимов предсказания (например, тридцать три в HEVC), планарный режим и режим постоянного тока (DC). Направленные режимы указывают, что текущий блок аналогичен/совпадает с выборками соседнего блока в соответствующем направлении. Планарный режим указывает, что ряд блоков вдоль строки/столбца (например, плоскости) может быть интерполирован на основе соседних блоков на краях строки. Планарный режим, по сути, указывает на плавный переход света/цвета через строку/столбец, используя относительно постоянный наклон при изменении значений. Режим DC используется для сглаживания границ и указывает, что блок похож/аналогичен среднему значению, ассоциированному с выборками всех соседних блоков, ассоциированных с угловыми направлениями направленных режимов предсказания. Соответственно, блоки интра-предсказания могут представлять блоки изображения как значения различных реляционных режимов предсказания вместо фактических значений. Кроме того, блоки интер-предсказания могут представлять блоки изображения как значения векторов движения вместо фактических значений. В любом случае в некоторых случаях блоки предсказания могут не точно представлять блоки изображения. Любые различия хранятся в остаточных блоках. Преобразования могут быть применены к остаточным блокам для дальнейшего сжатия файла.

[0064] На этапе 107 могут применяться различные методики фильтрации. В HEVC фильтры применяются по схеме фильтрации внутри цикла. Основанное на блоках предсказание, рассмотренное выше, может привести к созданию блочных изображений в декодере. Кроме того, схема основанного на блоках предсказания может кодировать блок, а затем восстановить закодированный блок для последующего использования в качестве опорного блока. Схема фильтрации внутри цикла итеративно применяет к блокам/кадрам фильтры шумоподавления, фильтры деблокирования, адаптивные циклические фильтры и фильтры адаптивного к выборке смещения (SAO). Эти фильтры смягчают такие артефакты блочности, чтобы можно было точно восстановить закодированный файл. Кроме того, эти фильтры смягчают артефакты в восстановленных опорных блоках, так что артефакты с меньшей вероятностью создают дополнительные артефакты в последующих блоках, которые кодируются на основе этих восстановленных опорных блоков.

[0065] После разделения, сжатия и фильтрации видеосигнала полученные данные кодируются в битовый поток на этапе 109. Битовый поток включает в себя данные, рассмотренные выше, а также любые данные сигнализации, необходимые для поддержки надлежащего восстановления видеосигнала в декодере. Например, такие данные могут включать данные разделения, данные предсказания, остаточные блоки и различные флаги, обеспечивающие инструкции кодирования/декодирования, для декодера. Битовый поток может быть сохранен в памяти для передачи на декодер по запросу. Битовый поток также может быть широковещательно и/или многоадресно передан множеству декодеров. Создание битового потока является итеративным процессом. Соответственно, этапы 101, 103, 105, 107 и 109 могут происходить непрерывно и/или одновременно в отношении многих кадров и блоков. Порядок, показанный на ФИГ. 1, представлен для ясности и простоты обсуждения и не предназначен для ограничения процесса кодирования/декодирования видео определенным порядком.

[0066] Декодер принимает битовый поток и начинает процесс декодирования на этапе 111. В частности, декодер использует схему энтропийного декодирования для преобразования битового потока в соответствующие синтаксические и видео данные. Декодер использует синтаксические данные из битового потока для определения разделов для кадров на этапе 111. Разделение должно совпадать с результатами разделения на блоки на этапе 103. Теперь описывается энтропийное кодирование/декодирование, используемое на этапе 111. Кодер принимает множество решений во время процесса сжатия, например выбирает схемы разделения на блоки из нескольких возможных вариантов на основе пространственного расположения значений во входном изображении(-ях). Для сигнализации точных выборов может использоваться большое число бинов. Как используется в данном документе, бин представляет собой двоичное значение, которое обрабатывается как переменная (например, битовое значение, которое может изменяться в зависимости от контекста). Энтропийное кодирование позволяет кодеру отбрасывать любые опции, которые явно не подходят для конкретного случая, оставляя набор допустимых опций. Каждой допустимой опции затем назначается кодовое слово. Длина кодовых слов основана на числе допустимых опций (например, один бин для двух опций, два бина для трех-четырех опций и т. д.). Затем кодер кодирует кодовое слово для выбранной опции. Эта схема уменьшает размер кодовых слов, поскольку кодовые слова настолько велики, насколько это необходимо, чтобы однозначно указывать выбор из небольшого подмножества допустимых опций, в отличие от однозначного указания выбора из потенциально большого набора всех возможных опций. Затем декодер декодирует выбор, определяя набор допустимых опций аналогично кодеру. Посредством определения набора допустимых опций, декодер может считывать кодовое слово и определять выбор, сделанный кодером.

[0067] На этапе 113 декодер выполняет декодирование блоков. В частности, декодер применяет обратные преобразования для генерирования остаточных блоков. Затем декодер применяет остаточные блоки и соответствующие блоки предсказания для восстановления блоков изображения согласно разделению. Блоки предсказания могут включать в себя как блоки интра-предсказания, так и блоки интер-предсказания, генерируемые кодером на этапе 105. Затем восстановленные блоки изображения размещаются в кадры восстанавливаемого видеосигнала согласно данным разделения, определенным на этапе 111. Синтаксис для этапа 113 также может быть просигнализирован в битовом потоке посредством энтропийного кодирования/декодирования, как описано выше.

[0068] На этапе 115 фильтрация выполняется над кадрами восстановленного видеосигнала способом, аналогичным этапу 107 в кодере. Например, фильтры шумоподавления, фильтры деблокирования, адаптивные циклические фильтры и фильтры SAO могут быть применены к кадрам для удаления артефактов блочности. Как только кадры отфильтрованы, видеосигнал может быть выведен на дисплей на этапе 117 для просмотра конечным пользователем.

[0069] ФИГ. 2 представляет собой схематичное представление примерной системы 200 кодирования и декодирования (кодека) для кодирования/декодирования видео. В частности, система 200 кодека обеспечивает функциональные возможности для поддержки реализации рабочего способа 100. Система 200 кодека обобщена так, чтобы представлять компоненты, применяемые как в кодере, так и в декодере. Система 200 кодека принимает и разделяет видеосигнал, как описано в отношении этапов 101 и 103 в рабочем способе 100, в результате чего получается разделенный видеосигнал 201. Затем система 200 кодека сжимает разделенный видеосигнал 201 в закодированный битовый поток, действуя в качестве кодера, как описано в отношении этапов 105, 107 и 109 в способе 100. Действуя в качестве декодера, система 200 кодека генерирует выходной видеосигнал из битового потока, как описано в отношении этапов 111, 113, 115 и 117 в рабочем способе 100. Система 200 кодека включает в себя компонент 211 общего управления кодером/декодером, компонент 213 преобразования, масштабирования и квантования, компонент 215 интра-кадровой оценки, компонент 217 интра-кадрового предсказания, компонент 219 компенсации движения, компонент 221 оценки движения, компонент 229 обратного преобразования и масштабирования, компонент 227 анализа для управления фильтром, компонент 225 фильтров внутри цикла, компонент 223 буфера декодированных изображений и компонент 231 форматирования заголовка и контекстно-адаптивного двоичного арифметического кодирования/декодирования (CABAC). Такие компоненты соединены, как показано. На ФИГ. 2 черные линии указывают перемещение данных, подлежащих кодированию/декодированию, а пунктирные линии указывают перемещение управляющих данных, которые управляют работой других компонентов. Все компоненты системы 200 кодека могут присутствовать в кодере. Декодер может включать в себя подмножество компонентов системы 200 кодека. Например, декодер может включать в себя компонент 217 интра-кадрового предсказания, компонент 219 компенсации движения, компонент 229 обратного преобразования и масштабирования, компонент 225 фильтров внутри цикла и компонент 223 буфера декодированных изображений. Эти компоненты описаны далее.

[0070] Разделенный видеосигнал 201 представляет собой захваченную видеопоследовательность, которая была разделена на блоки пикселей деревом кодирования/декодирования. Дерево кодирования/декодирования использует различные режимы фрагментации для подразделения блока пикселей на более мелкие блоки пикселей. Затем эти блоки могут быть дополнительно подразделены на более мелкие блоки. Блоки могут называться узлами в дереве кодирования/декодирования. Более крупные родительские узлы подвергаются фрагментации на более мелкие дочерние узлы. Число раз, которое узел подразделяется, называется глубиной узла/дерева кодирования/декодирования. Полученные разделением блоки могут быть включены в единицы кодирования/декодирования (CU) в некоторых случаях. Например, CU может быть частью CTU, которая содержит блок яркости, блок(-и) цветности красного (Cr) и блок(-и) цветности синего (Cb) вместе с соответствующими инструкциями синтаксиса для CU. Режимы фрагментации могут включать двоичное дерево (BT), троичное дерево (TT) и квадратичное дерево (QT), используемые для разделения узла на два, три или четыре дочерних узла, соответственно, различных форм в зависимости от используемых режимов фрагментации. Разделенный видеосигнал 201 пересылается в компонент 211 общего управления кодером/декодером, компонент 213 преобразования, масштабирования и квантования, компонент 215 интра-кадровой оценки, компонент 227 анализа для управления фильтром и компонент 221 оценки движения для сжатия.

[0071] Компонент 211 общего управления кодером/декодером выполнен с возможностью принятия решений, связанных с кодированием изображений видеопоследовательности в битовый поток согласно ограничениям приложения. Например, компонент 211 общего управления кодером/декодером управляет оптимизацией битрейта/размера битового потока в зависимости от качества восстановления. Такие решения могут приниматься на основе доступности пространства хранения/полосы пропускания и запросов разрешения изображения. Компонент 211 общего управления кодером/декодером также управляет использованием буфера с учетом скорости передачи, чтобы смягчить проблемы недостаточного заполнения и переполнения буфера. Чтобы справиться с этими проблемами, компонент 211 общего управления кодером/декодером управляет разделением, предсказанием и фильтрацией посредством других компонентов. Например, компонент 211 общего управления кодером/декодером может динамически увеличивать сложность сжатия для увеличения разрешения и увеличения использования полосы пропускания или уменьшать сложность сжатия для уменьшения разрешения и использования полосы пропускания. Следовательно, компонент 211 общего управления кодером/декодером управляет другими компонентами системы 200 кодека, чтобы сбалансировать качество восстановления видеосигнала с учетом битрейта. Компонент 211 общего управления кодером/декодером создает управляющие данные, которые управляют работой других компонентов. Управляющие данные также пересылаются в компонент 231 форматирования заголовка и CABAC для кодирования в битовом потоке, чтобы сигнализировать параметры для декодирования в декодере.

[0072] Разделенный видеосигнал 201 также отправляется в компонент 221 оценки движения и компонент 219 компенсации движения для интер-предсказания. Кадр или слайс разделенного видеосигнала 201 может быть разбит на несколько видеоблоков. Компонент 221 оценки движения и компонент 219 компенсации движения выполняют кодирование с интер-предсказанием принятого видеоблока относительно одного или более блоков в одном или более опорных кадрах, чтобы обеспечить временное предсказание. Система 200 кодека может выполнять несколько проходов кодирования, например, для выбора надлежащего режима кодирования для каждого блока видеоданных.

[0073] Компонент 221 оценки движения и компонент 219 компенсации движения могут быть в высокой степени интегрированы, но показаны отдельно в концептуальных целях. Оценка движения, выполняемая компонентом 221 оценки движения, представляет собой процесс генерирования векторов движения, которые оценивают движение для видеоблоков. Вектор движения, например, может указать сдвиг кодируемого/декодируемого объекта относительно предиктивного блока. Предиктивный блок является блоком, который обнаружен как точно соответствующий блоку, который подлежит кодированию/декодированию, исходя из разности пикселей. Предиктивный блок также может именоваться опорным блоком. Такая разность пикселей может быть определена суммой абсолютных разностей (SAD), суммой квадратов разностей (SSD) или другими показателями различия. HEVC использует несколько кодируемых/декодируемых объектов, в том числе CTU, блоки дерева кодирования/декодирования (CTB) и CU. Например, CTU можно разбить на CTB, которые затем можно разбить на CB для включения в CU. CU может быть закодирована как единица предсказания (PU), содержащая данные предсказания, и/или единица преобразования (TU), содержащая преобразованные остаточные данные для CU. Компонент 221 оценки движения генерирует векторы движения, PU и TU с использованием анализа скорость-искажение в рамках процесса оптимизации скорость-искажение. Например, компонент 221 оценки движения может определять несколько опорных блоков, несколько векторов движения и т.д. для текущего блока/кадра и может выбирать опорные блоки, векторы движения и т.д., имеющие наилучшие характеристики скорость-искажение. Наилучшие характеристики скорость-искажение уравновешивают качество восстановления видео (например, объем потерь данных при сжатии) с эффективностью кодирования/декодирования (например, размер окончательного кодирования).

[0074] В некоторых примерах система 200 кодека может вычислять значения для положений субцелочисленных пикселей опорных изображений, сохраненных в компоненте 223 буфера декодированных изображений. Например, система 200 кодека может интерполировать значения положений одной четверти пикселя, положений одной восьмой пикселя или других положений дробных пикселей опорного изображения. Следовательно, компонент 221 оценки движения может выполнять поиск движения относительно положений полных пикселей и положений дробных пикселей и выводить вектор движения с точностью до дробных пикселей. Компонент 221 оценки движения вычисляет вектор движения для PU видеоблока в интер-кодируемом/декодируемом слайсе путем сравнения положения PU с положением предиктивного блока опорного изображения. Компонент 221 оценки движения выводит вычисленный вектор движения в качестве данных движения в компонент 231 форматирования заголовка и CABAC для кодирования и движения для компонента 219 компенсации движения.

[0075] Компенсация движения, выполняемая компонентом 219 компенсации движения, может включать в себя получение или генерирование предиктивного блока на основе вектора движения, определенного компонентом 221 оценки движения. Опять же, компонент 221 оценки движения и компонент 219 компенсации движения могут быть функционально интегрированы в некоторых примерах. После приема вектора движения для PU текущего блока видео компонент 219 компенсации движения может находить предиктивный блок, на который указывает вектор движения. Затем формируется остаточный видеоблок путем вычитания значений пикселей предиктивного блока из значений пикселей текущего кодируемого видеоблока, что формирует значения разности пикселей. В общем, компонент 221 оценки движения выполняет оценку движения относительно компонентов яркости, а компонент 219 компенсации движения использует векторы движения, вычисленные на основе компонентов яркости, как для компонентов цветности, так и для компонентов яркости. Предиктивный блок и остаточный блок пересылаются в компонент 213 преобразования, масштабирования и квантования.

[0076] Разделенный видеосигнал 201 также отправляется в компонент 215 интра-кадровой оценки и компонент 217 интра-кадрового предсказания. Как и в случае с компонентом 221 оценки движения и компонентом 219 компенсации движения, компонент 215 интра-кадровой оценки и компонент 217 интра-кадрового предсказания могут быть в высокой степени интегрированы, но в концептуальных целях проиллюстрированы отдельно. Компонент 215 интра-кадровой оценки и компонент 217 интра-кадрового предсказания осуществляют интра-предсказание текущего блока относительно блоков в текущем кадре, в качестве альтернативы интер-предсказанию, выполняемому компонентом 221 оценки движения и компонентом 219 компенсации движения между кадрами, как описано выше. В частности, компонент 215 интра-кадровой оценки определяет режим интра-предсказания для использования, чтобы кодировать текущий блок. В некоторых примерах компонент 215 интра-кадровой оценки выбирает надлежащий режим интра-предсказания для кодирования текущего блока из множества проверяемых режимов интра-предсказания. Выбранные режимы интра-предсказания затем пересылаются в компонент 231 форматирования заголовка и CABAC для кодирования.

[0077] Например, компонент 215 интра-кадровой оценки вычисляет значения скорость-искажение, используя анализ скорость-искажение для различных проверяемых режимов интра-предсказания, и выбирает режим интра-предсказания, имеющий лучшие характеристики скорость-искажение среди проверенных режимов. Анализ скорость-искажение обычно определяет степень искажения (или ошибку) между закодированным блоком и исходным незакодированным блоком, который был закодирован для получения упомянутого закодированного блока, а также битрейт (например, число битов), используемый для получения упомянутого закодированного блока. Компонент 215 интра-кадровой оценки вычисляет отношения по искажениям и скоростям для различных закодированных блоков, чтобы определить, какой режим интра-предсказания демонстрирует наилучшее значение скорость-искажение для блока. Кроме того, компонент 215 интра-кадровой оценки может быть выполнен с возможностью кодирования блоков глубины карты глубины с использованием режима моделирования глубины (DMM) на основе оптимизации скорость-искажение (RDO).

[0078] Компонент 217 интра-кадрового предсказания может генерировать остаточный блок из предиктивного блока на основе выбранных режимов интра-предсказания, определенных компонентом 215 интра-кадровой оценки, при реализации в кодере, или считывать остаточный блок из битового потока при реализации в декодере. Остаточный блок включает в себя разность значений между предиктивным блоком и исходным блоком, представленную в виде матрицы. Остаточный блок затем пересылается в компонент 213 преобразования, масштабирования и квантования. Компонент 215 интра-кадровой оценки и компонент 217 интра-кадрового предсказания могут работать как над компонентами яркости, так и над компонентами цветности.

[0079] Компонент 213 преобразования, масштабирования и квантования выполнен с возможностью дальнейшего сжатия остаточного блока. Компонент 213 преобразования, масштабирования и квантования применяет преобразование, такое как дискретное косинусное преобразование (DCT), дискретное синусное преобразование (DST) или концептуально аналогичное преобразование, к остаточному блоку, создавая видеоблок, содержащий остаточные значения коэффициентов преобразования. Также могут быть использованы вейвлет-преобразования, целочисленные преобразования, преобразования поддиапазонов или другие типы преобразований. Преобразование может переводить остаточную информацию из области значений пикселей в область преобразования, такую как частотная область. Компонент 213 преобразования, масштабирования и квантования также выполнен с возможностью масштабирования преобразованной остаточной информации, например на основе частоты. Такое масштабирование включает в себя применение коэффициента масштабирования к остаточной информации, так что информация разных частот квантуется с разными степенями детализации, что может повлиять на конечное визуальное качество восстановленного видео. Компонент 213 преобразования, масштабирования и квантования также выполнен с возможностью квантования коэффициентов преобразования для дальнейшего снижения битрейта. Процесс квантования может уменьшать битовую глубину, ассоциированную с некоторыми или всеми коэффициентами. Степень квантования может быть изменена посредством корректировки параметра квантования. В некоторых примерах компонент 213 преобразования, масштабирования и квантования может затем выполнять сканирование матрицы, включающей в себя квантованные коэффициенты преобразования. Квантованные коэффициенты преобразования пересылаются в компонент 231 форматирования заголовка и CABAC для кодирования в битовый поток.

[0080] Компонент 229 обратного преобразования и масштабирования применяет обратную операцию компонента 213 преобразования, масштабирования и квантования для поддержки оценки движения. Компонент 229 обратного преобразования и масштабирования применяет обратное масштабирование, преобразование и/или квантование для восстановления остаточного блока в пиксельной области, например для последующего использования в качестве опорного блока, который может стать предиктивным блоком для другого текущего блока. Компонент 221 оценки движения и/или компонент 219 компенсации движения могут вычислять опорный блок путем прибавления остаточного блока обратно к соответствующему предиктивному блоку для использования при оценке движения более позднего блока/кадра. Фильтры применяются к восстановленным опорным блокам для смягчения артефактов, создаваемых во время масштабирования, квантования и преобразования. В противном случае такие артефакты могут вызвать неточное предсказание (и создать дополнительные артефакты) при предсказании последующих блоков.

[0081] Компонент 227 анализа для управления фильтром и компонент 225 фильтров внутри цикла применяют фильтры к остаточным блокам и/или к восстановленным блокам изображения. Например, преобразованный остаточный блок из компонента 229 обратного преобразования и масштабирования может быть объединен с соответствующим блоком предсказания из компонента 217 интра-кадрового предсказания и/или компонента 219 компенсации движения для восстановления исходного блока изображения. Затем фильтры могут быть применены к восстановленному блоку изображения. В некоторых примерах фильтры могут быть применены к остаточным блокам. Как и в случае с другими компонентами на ФИГ. 2, компонент 227 анализа для управления фильтром и компонент 225 фильтров внутри цикла являются в высокой степени интегрируемыми и могут быть реализованы вместе, но представлены в концептуальных целях по-отдельности. Фильтры, применяемые к восстановленным опорным блокам, применяются к определенным пространственным областям и включают в себя несколько параметров для корректировки того, как такие фильтры применяются. Компонент 227 анализа для управления фильтром анализирует восстановленные опорные блоки для определения того, где такие фильтры должны применяться, и устанавливает соответствующие параметры. Такие данные пересылаются в компонент 231 форматирования заголовка и CABAC в качестве управляющих фильтром данных для кодирования. Компонент 225 фильтров внутри цикла применяет такие фильтры на основе управляющих фильтром данных. Фильтры могут включать в себя деблокирующий фильтр, фильтр шумоподавления, SAO-фильтр и адаптивный циклический фильтр. Такие фильтры могут применяться в пространственной/пиксельной области (например, к восстановленному блоку пикселей) или в частотной области, в зависимости от примера.

[0082] При работе в качестве кодера отфильтрованный восстановленный блок изображения, остаточный блок и/или блок предсказания сохраняются в компоненте 223 буфера декодированных изображений для последующего использования при оценке движения, как описано выше. При работе в качестве декодера компонент 223 буфера декодированных изображений сохраняет и пересылает восстановленные и отфильтрованные блоки на дисплей в ходе вывода видеосигнала. Компонент 223 буфера декодированных изображений может представлять собой любое запоминающее устройство, способное сохранять блоки предсказания, остаточные блоки и/или восстановленные блоки изображения.

[0083] Компонент 231 форматирования заголовка и CABAC принимает данные от различных компонентов системы 200 кодека и кодирует такие данные в кодируемый/декодируемый битовый поток для передачи на декодер. В частности, компонент 231 форматирования заголовка и CABAC генерирует различные заголовки для кодирования управляющих данных, таких как общие управляющие данные и управляющие фильтром данные. Кроме того, данные предсказания, включающие в себя данные движения и интра-предсказания, а также остаточные данные в форме данных квантованных коэффициентов преобразования, все кодируются в битовом потоке. Окончательный битовый поток включает в себя всю информацию, необходимую декодеру для восстановления исходного разделенного видеосигнала 201. Такая информация может также включать в себя таблицы индексов режимов интра-предсказания (также называемые таблицами отображения кодовых слов), определения контекстов кодирования для различных блоков, указания наиболее вероятных режимов интра-предсказания, указание информации разделения и т. д. Такие данные могут быть закодированы с помощью энтропийного кодирования. Например, информация может быть закодирована с использованием контекстно-адаптивного кодирования с переменной длиной слова (CAVLC), CABAC, синтаксического контекстно-адаптивного двоичного арифметического кодирования (SBAC), энтропийного кодирования с разделением вероятностных интервалов (PIPE) или другой методики энтропийного кодирования. После энтропийного кодирования кодированный битовый поток может быть передан на устройство (например, видеодекодер) или помещен в архив для последующей передачи или извлечения.

[0084] ФИГ. 3 представляет собой блок-схему, иллюстрирующую примерный видеокодер 300. Видеокодер 300 может использоваться для реализации функций кодирования системы 200 кодека и/или реализации этапов 101, 103, 105, 107 и/или 109 рабочего способа 100. Кодер 300 разделяет входной видеосигнал, в результате чего получается разделенный видеосигнал 301, который по существу аналогичен разделенному видеосигналу 201. Затем разделенный видеосигнал 301 сжимается и кодируется в битовый поток компонентами кодера 300.

[0085] В частности, разделенный видеосигнал 301 пересылается в компонент 317 интра-кадрового предсказания для интра-предсказания. Компонент 317 интра-кадрового предсказания может быть по существу аналогичен компоненту 215 интра-кадровой оценки и компоненту 217 интра-кадрового предсказания. Разделенный видеосигнал 301 также пересылается в компонент 321 компенсации движения для интер-предсказания на основе опорных блоков в компоненте 323 буфера декодированных изображений. Компонент 321 компенсации движения может быть по существу аналогичен компоненту 221 оценки движения и компоненту 219 компенсации движения. Блоки предсказания и остаточные блоки из компонента 317 интра-кадрового предсказания и компонента 321 компенсации движения пересылаются в компонент 313 преобразования и квантования для преобразования и квантования остаточных блоков. Компонент 313 преобразования и квантования может быть по существу аналогичен компоненту 213 преобразования, масштабирования и квантования. Преобразованные и квантованные остаточные блоки и соответствующие блоки предсказания (вместе с ассоциированными управляющими данными) пересылаются в компонент 331 энтропийного кодирования для кодирования в битовый поток. Компонент 331 энтропийного кодирования может быть по существу аналогичен компоненту 231 форматирования заголовка и CABAC.

[0086] Преобразованные и квантованные остаточные блоки и/или соответствующие блоки предсказания также пересылаются из компонента 313 преобразования и квантования в компонент 329 обратного преобразования и квантования для восстановления в опорные блоки для использования компонентом 321 компенсации движения. Компонент 329 обратного преобразования и квантования может быть по существу аналогичен компоненту 229 обратного преобразования и масштабирования. Фильтры внутри цикла в компоненте 325 фильтров внутри цикла также применяются к остаточным блокам и/или восстановленным опорным блокам, в зависимости от примера. Компонент 325 фильтров внутри цикла может быть по существу аналогичен компоненту 227 анализа для управления фильтром и компоненту 225 фильтров внутри цикла. Компонент 325 фильтров внутри цикла может включать в себя несколько фильтров, как описано в отношении компонента 225 фильтров внутри цикла. Затем отфильтрованные блоки сохраняются в компоненте 323 буфера декодированных изображений для использования в качестве опорных блоков компонентом 321 компенсации движения. Компонент 323 буфера декодированных изображений может быть по существу аналогичен компоненту 223 буфера декодированных изображений.

[0087] ФИГ. 4 представляет собой блок-схему, иллюстрирующую примерный видеодекодер 400. Видеодекодер 400 может использоваться для реализации функций декодирования системы 200 кодека и/или реализации этапов 111, 113, 115, и/или 117 рабочего способа 100. Декодер 400 принимает битовый поток, например от кодера 300, и генерирует восстановленный выходной видеосигнал на основе битового потока для отображения конечному пользователю.