Эта заявка испрашивает приоритет на основании предварительной заявки 61/221804, которая была подана в Патентное ведомство США 30 июня 2009 года, полное раскрытие которой настоящим включено в состав посредством ссылки.

ОБЛАСТЬ ТЕХНИКИ, К КОТОРОЙ ОТНОСИТСЯ ИЗОБРЕТЕНИЕ

Раскрытие относится к использованию одного или более алгоритмов извлечения правил ассоциации для извлечения наборов данных, содержащих признаки, созданные из, по меньшей мере, одного основанного на растениях или животных молекулярного генетического маркера, нахождения правил ассоциации и использования признаков, созданных по этим правилам ассоциации, для классификации или прогнозирования.

ПРЕДШЕСТВУЮЩИЙ УРОВЕНЬ РАЗВИТИЯ ТЕХНИКИ

Одна из основных целей улучшения растений и животных состоит в том, чтобы получать новые культурные сорта, которые превосходны в показателях желательных целевых признаков, таких как урожайность, содержание масла в зерне, устойчивость к болезням и устойчивость к абиотическим нагрузкам.

Традиционный подход к улучшению растений и животных состоит в том, чтобы отбирать отдельные растения или животные на основе их фенотипов или фенотипов их потомков. Отобранные особи могут затем, например, подвергаться дополнительному испытанию или становиться родителями будущих поколений. Полезно, чтобы некоторые программы разведения имели прогнозирования продуктивности до того, как формируются фенотипы для определенной особи, или когда только несколько записей фенотипа было получено для такой особи.

Некоторыми ключевыми ограничениями для улучшения растений и животных, которые основываются только на фенотипическом отборе, являются себестоимость и скорость формирования таких данных, и что есть сильное влияние окружающей среды (например, температуры, организации работ, грунтовые условия, дневной свет, ирригационные условия) на выражение целевых признаков.

В последнее время, развитие молекулярных генетических маркеров открыло возможность использования основанных на ДНК признаков растений или животных в дополнение к их фенотипам, информации об окружающей среде и другим типам признаков, для выполнения многих задач, в том числе, задач, описанных выше.

Некоторыми важными соображениями касательно способа анализа данных для этого типа наборов данных, являются способность извлекать исторические данные, быть стойким к мультиколлинеарности и учитывать взаимодействия между признаками, включенными в эти наборы данных (например, эпистатические эффекты и генотип от взаимодействий с окружающей средой). Способность извлекать исторические данные избегает потребности в хорошо структурированных данных для анализа данных. Способы, которые требуют хорошо структурированных данных, из планируемых экспериментов, обычно являются ресурсоемкими в показателях человеческих ресурсов, денег и времени. Сильное воздействие окружающей среды на выражение многих из наиболее важных особенностей в экономически важных растениях и животных, требует, чтобы такие эксперименты были большими, тщательно разработанными и тщательно контролируемыми. Ограничение мультиколлинеарности указывает на ситуацию, в которой два или более признака (или поднабора признаков) линейно коррелированы в отношении друг друга. Мультиколлинеарность может приводить к менее точной оценке влияния признака (или поднабора признаков) на целевой признак и, следовательно, на смещенные прогнозы.

Основные принципы, основанные на извлечении правил ассоциации и использовании признаков, созданных по этим правилам, для улучшения прогнозирования или классификации, пригодны для принятия мер в ответ на три соображения, упомянутые выше. Предпочтительные способы для классификации или прогнозирования являются способами машинного обучения. Правила ассоциации, поэтому, могут использоваться для классификации или прогнозирования касательно одного или более целевых признаков.

Подход, описанный в настоящем раскрытии, основывается на реализации одного или более основанных на машинном обучении алгоритмов извлечения правил ассоциации для извлечения наборов данных, содержащих в себе, по меньшей мере, один растительный или животный молекулярный генетический маркер, создает признаки на основании найденных правил ассоциации и использует эти признаки для классификации и прогнозирования целевых признаков.

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

В варианте осуществления раскрыты способы для извлечения наборов данных, содержащих в себе признаки, созданные из, по меньшей мере, одного основанного на растениях молекулярного генетического маркера для нахождения, по меньшей мере, одного правила ассоциации, а затем, для использования признаков, созданных по этим правилам ассоциации для классификации или прогнозирования. Некоторые из этих способов пригодны для классификации или прогнозирования по наборам данных, содержащим в себе признаки растений и животных.

В варианте осуществления этапы для извлечения набора данных с, по меньшей мере, одним признаком, созданным из, по меньшей мере, одного основанного на растениях молекулярного генетического маркера, для нахождения, по меньшей мере, одного правила ассоциации, и использования признаков, созданных по этим правилам ассоциации для классификации или прогнозирования касательно одного или более целевых признаков, включают в себя:

(a) выявление правил ассоциации;

(b) создание новых признаков на основании выводов этапа (a), и добавление этих признаков в набор данных;

(c) разработку модели для прогнозирования или классификации касательно одного или более целевых признаков с, по меньшей мере, одним признаком, созданным с использованием признаков, созданных на этапе (b);

(d) отбора поднабора признаков из признаков в наборе данных; и

(e) выявление правил ассоциации из пространственных и временных ассоциаций с использованием самоорганизующихся карт (смотрите Teuvo Kohonen (2000), Self-Organizing Map, Springer, 3rd edition (Теуво Кохонен (2000), Самоорганизующаяся карта, Спрингер, 3-е издание)).

В варианте осуществления раскрыт способ извлечения набора данных с одним или более признаков, при этом, способ включает в себя использование, по меньшей мере, одного основанного на растениях молекулярного маркера для нахождения, по меньшей мере, одного правила ассоциации и использование признаков, созданных по этим правилам ассоциации, для классификации или прогнозирования, причем способ содержит этапы: (a) выявления правил ассоциации; (b) создания новых признаков на основании выводов этапа (a), и добавления этих признаков в набор данных; (c) отбора поднабора признаков из признаков в наборе данных.

В варианте осуществления, алгоритмы извлечения правил ассоциации используются для классификации или прогнозирования одним или более алгоритмами машинного обучения, выбранными из: алгоритмов оценки признаков, алгоритмов отбора поднабора признаков, байесовых сетей (смотрите Cheng and Greiner (1999), Comparing Bayesian network classifiers. Proceedings UAI, pp. 101-107 (Ченг и Грейнер (1999), Сравнение классификаторов байесовских сетей. Труды UAI, стр. 101-107)), алгоритмов, основанных на примерах, машин опорных векторов (например, смотрите Shevade et al., (1999), Improvements to SMO Algorithm for SVM Regression. Technical Report CD-99-16, Control Division Dept of Mechanical and Production Engineering, National University of Singapore (Шивади и другие, (1999), Усовершенствования в алгоритм SMO для регрессии SVM. Технический отчет CD-99-16, Департамент отдела управления механической и технологической подготовки производства, Государственный университет Сингапура); Smola et al., (1998). A Tutorial on Support Vector Regression. NeuroCOLT2 Technical Report Series - NC2-TR-1998-030 (Смола и другие, (1998). Пособие по регрессии опорных векторов. Серия технических отчетов NeuroCOLT2 - NC2-TR-1998-030); Scholkopf, (1998). SVMs - a practical consequence of learning theory. IEEE Intelligent Systems. IEEE Intelligent Systems 13.4: 18-21 (Шолкоф, (1998). SVM - практические следствия теории обучения. Интеллектуальные системы IEEE. Интеллектуальные системы 13.4 IEEE: 18-21); Boser et al., (1992), A Training Algorithm for Optimal Margin Classifiers V 144-52 (Бозер и другие, (1992), Алгоритм обучения для классификаторов с оптимальным допуском, V 144-52); и Burges (1998), A tutorial on support vector machines for pattern recognition. Data Mining and Knowledge Discovery 2 (1998): 121-67 (Бурже (1998), Пособие по машинам опорных векторов для распознавания шаблона. Извлечение данных и обнаружение знаний, 2 (1998): 121-67)), алгоритма голосований, чувствительного к стоимости классификатора, алгоритма укладки, правил классификации и алгоритмов дерева решений (смотрите Witten and Frank (2005), Data Mining: Practical machine learning Tools and Techniques. Morgan Kaufmann, San Francisco, Second Edition. (Виттен и Франк (2005), Извлечение данных: практические инструменты и технологии машинного обучения. Морган Кауфман, Сан-Франциско, второе издание).

Подходящие алгоритмы извлечения правил ассоциации включают в себя, но не в качестве ограничения, априорный алгоритм (смотрите Witten and Frank (2005), Data Mining: Practical machine learning Tools and Techniques. Morgan Kaufmann, San Francisco, Second Edition (Виттен и Франк (2005), Извлечение данных: Практические инструменты и техники машинного обучения. Морган Кауфман, Сан-Франциско, Второе издание), алгоритм FP-growth, алгоритмы извлечения правил ассоциации, которые могут обрабатывать большое количество признаков, алгоритмы извлечения огромных шаблонов, алгоритм извлечения прямых различительных шаблонов, деревья решений, неточные множества (смотрите Zdzislaw Pawlak (1992), Rough Sets: Theoretical Aspects of Reasoning About Data. Kluwer Academic Print on Demand (Ждзислав Павак (1992), Неточные множества: теоретические аспекты осмысления данных. Академическая печать Клювера по требованию)) и алгоритм самоорганизующихся карт (SOM).

В варианте осуществления, пригодный алгоритм извлечения правил ассоциации для обработки больших количеств признаков включает в себя, но не в качестве ограничения, CLOSET+ (see Wang et. al (2003), CLOSET+: Searching for best strategies for mining frequent closed itemsets, ACM SIGKDD 2003, pp. 236-245 (смотрите Ванг и другие (2003), CLOSET+: Поиск наилучших стратегий для извлечения часто встречающихся близких наборов элементов, ACM SIGKDD 2003, стр. 236-245), CHARM (смотрите Zaki et. al (2002), CHARM: An efficient algorithm for closed itemset mining, SIAM 2002, pp. 457-473 (Заки и другие (2002), CHARM: Эффективный алгоритм для извлечения близких наборов элементов)), CARPENTER (see Pan et. al (2003), CARPENTER: Finding Closed Patterns in Long Biological Datasets, ACM SIGKDD 2003, pp. 637-642 (Пан и другие, (2003), CARPENTER: Обнаружение близких шаблонов в длинных биологических наборах данных, ACM SIGKDD 2003, стр. 637-642 )), и COBBLER (смотрите Pan et al (2004), COBBLER: Combining Column and Row Enumeration for Closed Pattern Discovery, SSDBM 2004, pp. 21 (Пан и другие (2004) COBBLER: Объединение нумерации столбцов и строк для обнаружения близких шаблонов, SSDBM 2004, стр. 21)).

В варианте осуществления, подходящий алгоритм для обнаружения прямых различительных шаблонов включает в себя, но не в качестве ограничения, DDPM (смотрите Cheng et. al (2008), Direct Discriminative Pattern Mining for Effective Classification, ICDE 2008, pp. 169- 178 (Ченг и другие (2008), Извлечение прямых различительных шаблонов для эффективной классификации, ICDE 2008, стр. 169-178)), HARMONY (смотрите Jiyong et. al (2005), HARMONY: Efficiently Mining the Best Rules for Classification, SIAM 2005, pp. 205-216 (Джиенг и другие (2005) HARMONY: Эффективное извлечение наилучших правил для классификации, SIAM 2005, стр. 205-216)), RCBT (смотрите Cong et. al (2005), Mining top-K covering rule groups for gene expression data, ACM SIGMOD 2005, pp. 670-681 (Конг и другие (2005), Извлечение верхних K покрывающих групп правил для данных экспрессии генов, ACM SIGMOD 2005, стр. 670-681 )), CAR (смотрите Kianmehr et al (2008), CARSVM: A class association rule-based classification framework and its application in gene expression data, Artificial Intelligence in Medicine 2008, pp. 7-25 (Кианмер и другие (2008), CARSVM: Основанная на правилах ассоциации классов инфраструктура классификации и ее применение в данных экспрессии генов, Искусственный интеллект в медицине, 2008, стр. 7-25)), и PATCLASS (смотрите Cheng et. al (2007), Discriminative Frequent Pattern Analysis for Effective Classification, ICDE 2007, pp. 716-725 (Ченг и другие (2007), Анализ часто встречающихся различительных шаблонов для эффективной классификации, ICDE 2007, стр. 716-725)).

В варианте осуществления, пригодный алгоритм для нахождения огромных шаблонов включает в себя, но не в качестве ограничения, алгоритм слияния шаблонов (смотрите Zhu et. al (2007), Mining Colossal Frequent Patterns by Core Pattern Fusion, ICDE 2007, pp. 706-715 (Жу и другие, (2007), Извлечения часто встречающихся огромных шаблонов посредством слияния основных шаблонов, ICDE 2007, стр. 706-715)).

В варианте осуществления, подходящий алгоритм оценки признака выбирается из группы алгоритма прироста информации, алгоритма Relief (например, смотрите Robnik-Sikonja and Kononenko (2003), Theoretical and empirical analysis of Relief and ReliefF. Machine learning, 53:23-69 (Робник-Зиконжа и Кононенко (2003), Теоретический и эмпирический анализ Relief и ReliefF, Машинное обучение, 53:23-69); и Kononenko (1995). On biases in estimating multi-valued attributes. In IJCAI95, pages 1034-1040 (Кононенко (1995). О смещениях при оценке многозначных атрибутов. В IJCAI95, страницы 1034-1040)), алгоритма ReliefF (например, смотрите Kononenko, (1994), Estimating attributes: analysis and extensions of Relief. In: L. De Raedt and F. Bergadano (eds.): Machine learning: ECML-94. 171-182, Springer Verlag. (Кононенко, (1994), Оценка атрибутов: анализ и расширения Relief. В: Л. де-Раедт и Ф. Бергано (и др.): Машинное обучение: ECML-94. 171-182, Спрингер Верлаг)), алгоритма RReliefF, алгоритма симметричных неопределенностей, алгоритма отношений прироста и алгоритма ранжировщика.

В варианте осуществления, подходящим алгоритмом машинного обучения является алгоритм отбора поднабора признаков, выбранный из группы алгоритма основанного на корреляции отбора признаков (CFS) (смотрите Hall, M. A. 1999. Correlation-based feature selection for Machine Learning. Ph.D. thesis. Department of Computer Science - The University of Waikato, New Zealand (Холл, M. A. 1999. Основанный на корреляции отбор признаков для машинного обучения. Ph.D. диссертация. Департамент вычислительной техники - университет Уайкато, Новая Зеландия)), и алгоритма упаковки в ассоциации с любым другим алгоритмом машинного обучения. Эти алгоритмы отбора поднабора признаков могут быть ассоциативно связаны с методом поиска, выбранным из группы жадного алгоритма многошагового поиска, алгоритма поиска наилучшего первого, алгоритма исчерпывающего поиска, алгоритма поиска с состязаниями, и алгоритма рангового поиска.

В варианте осуществления, подходящим алгоритмом машинного обучения является алгоритм байесовской сети, включающий в себя наивный алгоритм Байеса.

В варианте осуществления, подходящим алгоритмом машинного обучения является основанный на примерах алгоритм, выбранный из группы, состоящей из основанного на примерах алгоритма 1 (IB1), основанного на примерах алгоритма k ближайших соседей (IBK), KStar, алгоритма облегченных правил Байеса (LBR) и алгоритма локально взвешенного обучения (LWL).

В варианте осуществления, подходящим алгоритмом машинного обучения является для классификации или прогнозирования алгоритм машины опорных векторов. В предпочтительном варианте осуществления, подходящим алгоритмом машинного обучения является алгоритм машины опорных векторов, который использует алгоритм последовательной минимальной оптимизации (SMO). В предпочтительном варианте осуществления, алгоритм машинного обучения является алгоритмом машины опорных векторов, который использует алгоритм последовательной минимальной оптимизации для регрессии (SMOReg) (например, смотрите Shevade et al., (1999), Improvements to SMO Algorithm for SVM Regression. Technical Report CD-99-16, Control Division Dept of Mechanical and Production Engineering, National University of Singapore (Шивади и другие, (1999), Усовершенствования в алгоритм SMO для регрессии SVM. Технический отчет CD-99-16, Департамент отдела управления механической и технологической подготовки производства, Государственный университет Сингапура); Smola & Scholkopf (1998), A Tutorial on Support Vector Regression. NeuroCOLT2 Technical Report Series - NC2-TR-1998-030 (Смола и Чолкопф (1998), Пособие по регрессии опорных векторов. Серия технических отчетов NeuroCOLT2 - NC2-TR-1998-030)).

В варианте осуществления, подходящим алгоритмом машинного обучения является самоорганизующаяся карта (Самоорганизующиеся карты, Теуво Кохонен, Спрингер).

В варианте осуществления, подходящим алгоритмом машинного обучения является алгоритм дерева решений, выбранный из группы алгоритма дерева логистической модели (LMT), алгоритма дерева переменных решений (ADTree) (Смотрите Freund and Mason (1999), The alternating decision tree learning algorithm. Proc. Sixteenth International Conference on machine learning, Bled, Slovenia, pp. 124-133 (Фреунд и Мейсон (1999), Алгоритм дерева переменных решений. Ученые записки, Шестнадцатая международная конференция по машинному обучению, Блед, Словения, стр. 124-133)), алгоритма M5P (смотрите Quinlan (1992), Learning with continuous classes, in Proceedings AI'92, Adams & Sterling (Eds.), World Scientific, pp. 343-348 (Куинлан (1992), Обучение с непрерывными классами, в трудах AI'92, Адамс & Стерлинг (и другие), Научный мир, стр. 343-348); Wang and Witten (1997), Inducing Model Trees for Continuous Classes. 9th European Conference on machine learning, pp. 128-137 (Ванг и Виттен (1997), Деревья индукционной модели для непрерывных классов. 9-ая европейская конференция по машинному обучению, стр. 128-137)), и алгоритма REPTree (Виттен и Франк, 2005).

В варианте осуществления, целевой признак выбирается из группы непрерывного целевого признака и дискретного целевого признака. Дискретный целевой признак может быть двоичным целевым признаком.

В варианте осуществления, по меньшей мере, один основанный на растениях молекулярный генетический маркер происходит из популяции растений, а популяция растений может быть неструктурированной популяцией растений. Популяция растений может включать в себя инбредные растения или гибридные растения или их комбинацию. В варианте осуществления, пригодная популяция растений выбирается из группы кукурузы, сои, сахарного тростника, сорго, пшеницы, подсолнечника, риса, канола, хлопка и просо. В варианте осуществления, популяция растений может включать в себя от приблизительно 2 до приблизительно 100000 членов.

В варианте осуществления, количество молекулярных генетических маркеров может находиться в диапазоне от приблизительно 1 до приблизительно 1000000 маркеров. Признаки могут включать в себя данные молекулярных генетических маркеров, которые включают в себя, но не в качестве ограничения, один или более из простой повторяющейся последовательности (SSR), расщепленных амплифицированных полиморфных последовательностей (CAPS), полиморфизма длин простой последовательности (SSLP), полиморфизма длин рестрикционных фрагментов (RFLP), маркера произвольной амплифицированной полиморфной ДНК (RAPD), полиморфизма одиночных нуклеотидов (SNP), полиморфизма длины произвольного фрагмента (AFLP), вставки, удаления или любого другого типа молекулярного генетического маркера, выведенного из ДНК, РНК, белка или метаболита, гаплотипа, созданного из двух или более из описанных выше молекулярных генетических маркеров, выведенных из ДНК, и их комбинации.

В варианте осуществления, признаки также могут включать в себя один или более из простой повторяющейся последовательности (SSR), расщепленных амплифицированных полиморфных последовательностей (CAPS), полиморфизма длин простой последовательности (SSLP), полиморфизма длин рестрикционных фрагментов (RFLP), маркера произвольной амплифицированной полиморфной ДНК (RAPD), полиморфизма одиночных нуклеотидов (SNP), полиморфизма длины произвольного фрагмента (AFLP), вставки, удаления или любого другого типа молекулярного генетического маркера, выведенного из ДНК, РНК, белка или метаболита, гаплотипа, созданного из двух или более из описанных выше молекулярных генетических маркеров, выведенных из ДНК, и их комбинацию в соединении с одним или более измерений фенотипа, данных микроматрицы уровней экспрессии РНК, включающих в себя m-РНК, микро-РНК (mi-РНК), некодирующую РНК (nc-РНК), аналитических измерений, биохимических измерений или относящихся к окружающей среде измерений, либо их комбинации, в качестве признаков.

Подходящий целевой признак в популяции растений включает в себя одну или более численно представимых и/или количественно выражаемых особенностей фенотипа, включающих в себя устойчивость к болезням, урожайность, зерновой выход, прочность пряжи, белковый состав, содержание белка, устойчивость к насекомым, влагосодержание зерна, содержание масла в зерне, качество зерновых масел, засухоустойчивость, устойчивость к корневому полеганию, высота растения, высота колоса, содержание белка в зерне, содержание аминокислот в зерне, цвет зерна и устойчивость к стеблевому полеганию.

В варианте осуществления, генотип выборочной популяции растений для одного или более молекулярных генетических маркеров определяется экспериментально прямым секвенированием ДНК.

В варианте осуществления, способ извлечения набора данных с, по меньшей мере, одним основанным на растениях молекулярным генетическим маркером для нахождения правила ассоциации и использования признаков, созданных по этим правилам ассоциации, для классификации или прогнозирования касательно одного или более целевых признаков, при этом, способ включает в себя этапы:

(a) выявления правил ассоциации;

(b) создания новых признаков на основании выводов этапа (a), и добавление этих признаков в набор данных;

(c) оценки признаков;

(d) отбора поднабора признаков из признаков в наборе данных; и

(e) разработки модели для прогнозирования или классификации касательно одного или более целевых признаков с, по меньшей мере, одним признаком, созданным на этапе (b).

В варианте осуществления, способ для отбора инбредных линий, отбора гибридов, ранжирования гибридов, ранжирования гибридов для определенной географии, отбора родителей новых инбредных популяций, нахождения участков для интрогрессии в элитные инбредные линии, или любой их комбинации выполняется с использованием комбинации этапов (a)-(e), приведенных выше.

В варианте осуществления, выявление правил ассоциации включает в себя пространственные и временные ассоциации с использованием самоорганизующихся карт.

В варианте осуществления, по меньшей мере, один признак модели для прогнозирования или классификации является поднабором признаков, выбранных ранее с использованием алгоритма оценки признаков.

В варианте осуществления перекрестная проверка используется для сравнения алгоритмов и наборов значений параметров. В варианте осуществления, кривые рабочих характеристик приемника (ROC) используются для сравнения алгоритмов и наборов значений параметров.

В варианте осуществления, один или более признаков выводятся математически или вычислительным образом из других признаков.

В варианте осуществления, раскрыт способ извлечения набора данных, который включает в себя, по меньшей мере, один основанный на растениях молекулярный генетический маркер для нахождения, по меньшей мере, одного правила ассоциации и использования признаков по этим правилам ассоциации для классификации или прогнозирования касательно одного или более целевых признаков, при этом, способ включает в себя этапы:

(a) выявления правил ассоциации;

(i) при этом, правила ассоциации, пространственные и временные ассоциации выявляются с использованием самоорганизующихся карт;

(b) создания новых признаков на основании выводов этапа (a), и добавление этих признаков в набор данных;

(c) разработки модели для прогнозирования или классификации касательно одного или более целевых признаков с, по меньшей мере, одним признаком, созданным на этапе (b);

при этом этапы (a), (b) и (c) могут предваряться этапом отбора поднабора признаков из признаков в наборе данных.

В варианте осуществления, раскрыт способ извлечения набора данных, который включает в себя, по меньшей мере, один основанный на растениях молекулярный генетический маркер для нахождения, по меньшей мере, одного правила ассоциации и использования признаков, созданных по этим правилам ассоциации, для классификации или прогнозирования, при этом, способ включает в себя этапы:

(a) выявления правил ассоциации;

(b) создания новых признаков на основании выводов, основанных на выводах этапа (a), и добавления этих признаков в набор данных;

(c) отбора поднабора признаков из признаков в наборе данных.

В варианте осуществления при этом результаты этих способов содержат набор данных с, по меньшей мере, одним основанным на растениях молекулярным генетическим маркером, используемым для нахождения, по меньшей мере, одного правила ассоциации, и с использованием признаков, созданных из этих правил ассоциации для классификации или прогнозирования, применяются для:

(a) прогнозирования продуктивности гибрида,

(b) прогнозирования продуктивности гибрида по различным географическим местоположениям;

(c) отбора инбредных линий;

(d) отбора гибридов;

(e) ранжирования гибридов для определенных географий;

(f) отбора родителей новых инбредных популяций;

(g) нахождения участков ДНК для интрогрессии в элитные инбредные линии;

(h) или любой их комбинации (a)-(g).

В варианте осуществления набор данных с, по меньшей мере, одним основанным на растениях молекулярным генетическим маркером используется для нахождения, по меньшей мере, одного правила ассоциации, и признаки, созданные из этих правил ассоциации, используются для классификации или прогнозирования и отбора, по меньшей мере, одного растения из популяции растений для одного или более интересующих целевых признаков.

В варианте осуществления, учитываются априорные знания, состоящие из предварительного исследования, количественных исследований генетики растения, генных сетей, анализов последовательностей или любой их комбинации.

В варианте осуществления, способы, описанные выше, модифицированы, чтобы включать в себя следующие этапы:

(a) понижения размерности заменой исходных признаков комбинацией одного или более признаков, включенных в одно или более из правил ассоциации;

(b) извлечения различительных и присущих часто встречающихся шаблонов посредством основанного на модели дерева поиска.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

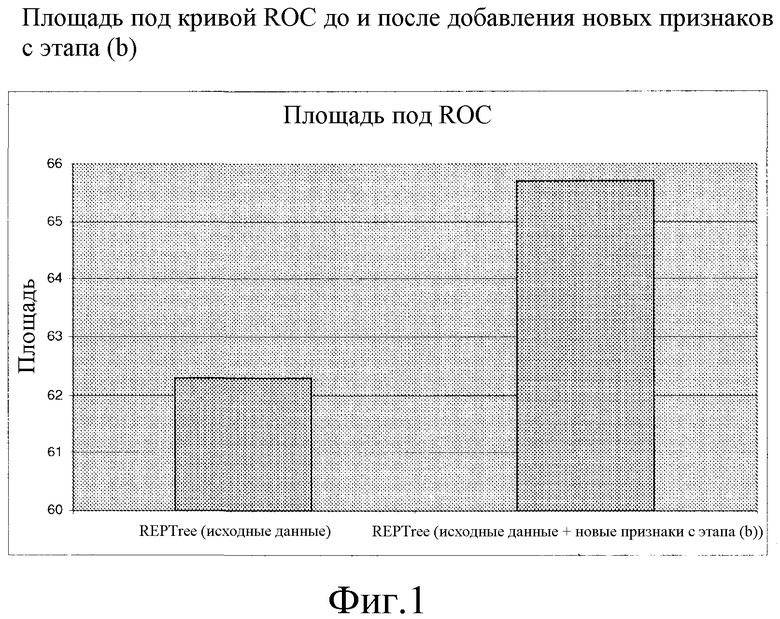

Фиг. 1: площадь под кривой ROC до и после добавления новых признаков с этапа (b).

ПОДРОБНОЕ ОПИСАНИЕ

Алгоритмы извлечения правил ассоциации предоставляют инфраструктуру и масштабируемость, необходимую для нахождения значимых взаимодействий на очень больших наборах данных.

Способы, раскрытые в материалах настоящей заявки, полезны для идентификации многолокусных взаимодействий, оказывающих влияние на фенотипы. Способы, раскрытые в материалах настоящей заявки, полезны для идентификации взаимодействий между молекулярными генетическими маркерами, гаплотипами и факторами влияния окружающей среды. Новые признаки, созданные на основании этих взаимодействий, полезны для классификации или прогнозирования.

Устойчивость некоторых из этих способов по отношению к проблемам мультиколлинеарности и отсутствующих значений для признаков, а также пропускная способность этих способов для описания сложных зависимостей между признаками, делают такие способы пригодными для анализа больших сложных наборов данных, которые включают в себя признаки, основанные на молекулярных генетических маркерах.

WEKA (Среда Уайкато для анализа знаний, разработанная в Университете Уайкато, Новая Зеландия) является комплектом программного обеспечения машинного обучения, написанным с использованием языка программирования Java, который реализует многочисленные алгоритмы машинного обучения из различных парадигм обучения. Эти инструментальные средства программного обеспечения машинного обучения содействуют реализации алгоритмов машинного обучения и поддерживают разработку алгоритма или адаптацию способов извлечения данных и вычислительных способов. WEKA также предоставляет инструмент для надлежащего испытания качества функционирования каждого алгоритма и наборов значений параметров посредством способов, таких как перекрестная проверка и кривые ROC (рабочих характеристик приемника). WEKA использовался для реализации алгоритмов машинного обучения для моделирования. Однако, специалист в данной области техники принял бы во внимание, что другое программное обеспечение машинного обучения может использоваться для осуществления на практике настоящего изобретения.

Более того, извлечение данных с использованием подходов, описанных в материалах настоящей заявки, дает гибкую масштабируемую инфраструктуру для моделирования с наборами данных, которые включают в себя признаки, основанные на молекулярных генетических маркерах. Эта инфраструктура гибка, так как она включает в себя встроенные средства испытания (то есть, перекрестную проверку и кривые ROC) для определения, какой алгоритм и конкретные настройки параметров должны использоваться для анализа набора данных. Эта инфраструктура является масштабируемой, так как она пригодна для очень больших наборов данных.

В варианте осуществления раскрыты способы для извлечения наборов данных, содержащих в себе признаки, созданные из, по меньшей мере, одного основанного на растениях молекулярного генетического маркера для нахождения, по меньшей мере, одного правила ассоциации, а затем, для использования признаков, созданных по этим правилам ассоциации для классификации или прогнозирования. Некоторые из этих способов пригодны для классификации или прогнозирования по наборам данных, содержащим в себе признаки растений и животных.

В варианте осуществления этапы для извлечения набора данных с, по меньшей мере, одним признаком, созданным из, по меньшей мере, одного основанного на растениях молекулярного генетического маркера, для нахождения, по меньшей мере, одного правила ассоциации, и использования признаков, созданных по этим правилам ассоциации для классификации или прогнозирования касательно одного или более целевых признаков, включают в себя:

(a) выявления правил ассоциации;

(b) создание новых признаков на основании выводов этапа (a), и добавление этих признаков в набор данных;

(c) разработку модели для одного или более целевых признаков с, по меньшей мере, одним признаком, созданным с использованием признаков, созданных на этапе (b);

(d) отбора поднабора признаков из признаков в наборе данных; и

(e) выявления правил ассоциации из пространственных и временных ассоциаций с использованием самоорганизующихся карт.

В варианте осуществления раскрыт способ извлечения набора данных с, одним или более, признаками, при этом, способ включает в себя использование, по меньшей мере, одного основанного на растениях молекулярного маркера для нахождения, по меньшей мере, одного правила ассоциации и использование признаков, созданных по этим правилам ассоциации, для классификации или прогнозирования, способ содержит этапы: (a) выявления правил ассоциации; (b) создания новых признаков на основании выводов этапа (a), и добавления этих признаков в набор данных; (c) отбора поднабора признаков из признаков в наборе данных.

В варианте осуществления, алгоритмы извлечения правил ассоциации используются для классификации или прогнозирования одним или более алгоритмами машинного обучения, выбранными из: алгоритмов оценки признаков, алгоритмов отбора поднабора признаков, байесовых сетей, основанных на примерах алгоритмов, машин опорных векторов, алгоритма голосований, чувствительного к стоимости классификатора, алгоритма укладки, правил классификации и алгоритмов дерева решений.

Подходящие алгоритмы извлечения правил ассоциации включают в себя, но не в качестве ограничения, априорный алгоритм, алгоритм FP-growth, алгоритмы извлечения правил ассоциации, которые могут обрабатывать большое количество признаков, алгоритмы извлечения огромных шаблонов, алгоритм извлечения прямого различительного шаблона, деревья решений, неточные множества и алгоритм самоорганизующейся карты (SOM).

В варианте осуществления, подходящий алгоритм извлечения правил ассоциации для обработки больших количеств признаков включает в себя, но не в качестве ограничения, CLOSET+, CHARM, CARPENTER и COBBLER.

В варианте осуществления, подходящий алгоритм для нахождения прямых различительных шаблонов, включает в себя, но не в качестве ограничения, DDPM, HARMONY, RCBT, CAR и PATCLASS.

В варианте осуществления, подходящий алгоритм для нахождения огромных шаблонов, включает в себя, но не в качестве ограничения, алгоритм слияния шаблонов.

В варианте осуществления, подходящим алгоритмом машинного обучения является алгоритм отбора поднабора признаков, выбранный из группы алгоритма основанного на корреляции отбора признаков (CFS) и алгоритма упаковки в ассоциации с любым другим алгоритмом машинного обучения. Алгоритмы отбора поднабора признаков могут быть ассоциативно связаны методом поиска, выбранным из группы жадного алгоритма многошагового поиска, алгоритма поиска наилучшего первого, алгоритма исчерпывающего поиска, алгоритма поиска с состязаниями и алгоритма рангового поиска.

В варианте осуществления, подходящим алгоритмом машинного обучения является алгоритм байесовской сети, включающий в себя наивный алгоритм Байеса.

В варианте осуществления, подходящий алгоритм машинного обучения является основанным на примерах алгоритмом, выбранным из группы, состоящей из основанного на примерах алгоритма 1 (IB1), основанного на примерах алгоритма k ближайших соседей (IBK), KStar, алгоритма облегченных правил Байеса (LBR) и алгоритма локально взвешенного обучения (LWL).

В варианте осуществления, подходящим алгоритмом машинного обучения является для классификации или прогнозирования алгоритм машины опорных векторов. В предпочтительном варианте осуществления, подходящим алгоритмом машинного обучения является алгоритм машины опорных векторов, который использует алгоритм последовательной минимальной оптимизации (SMO). В предпочтительном варианте осуществления, алгоритм машинного обучения является алгоритмом машины опорных векторов, который использует алгоритм последовательной минимальной оптимизации для регрессии (SMOReg).

В варианте осуществления, подходящим алгоритмом машинного обучения является самоорганизующаяся карта.

В варианте осуществления, подходящим алгоритмом машинного обучения является алгоритм дерева решений, выбранный из группы алгоритма дерева логистической модели (LMT), алгоритма дерева переменных решений (ADTree), алгоритма M5P и алгоритма REPTree.

В варианте осуществления, целевой признак выбирается из группы непрерывного целевого признака и дискретного целевого признака. Дискретный целевой признак может быть двоичным целевым признаком.

В варианте осуществления, по меньшей мере один основанный на растениях молекулярный генетический маркер происходит из популяции растений, а популяция растений может быть неструктурированной популяцией растений. Популяция растений может включать в себя инбредные растения или гибридные растения, или их комбинацию. В варианте осуществления, пригодная популяция растений выбирается из группы кукурузы, сои, сахарного тростника, сорго, пшеницы, подсолнечника, риса, канола, хлопка и просо. В варианте осуществления, популяция растений может включать в себя приблизительно 2 и приблизительно 100000 членов.

В варианте осуществления, количество молекулярных генетических маркеров может находиться в диапазоне от приблизительно 1 до приблизительно 1000000 маркеров. Признаки могут включать в себя данные молекулярных генетических маркеров, которые включают в себя, но не в качестве ограничения, один или более из простой повторяющейся последовательности (SSR), расщепленных амплифицированных полиморфных последовательностей (CAPS), полиморфизма длин простой последовательности (SSLP), полиморфизма длин рестрикционных фрагментов (RFLP), маркера произвольной амплифицированной полиморфной ДНК (RAPD), полиморфизма одиночных нуклеотидов (SNP), полиморфизма длины случайного фрагмента (AFLP), вставки, удаления или любого другого типа молекулярного генетического маркера, выведенного из ДНК, РНК, белка или метаболита, гаплотипа, созданного из двух или более из описанных выше молекулярных генетических маркеров, выведенных из ДНК, и их комбинации.

В варианте осуществления, признаки также могут включать в себя один или более из простой повторяющейся последовательности (SSR), расщепленных амплифицированных полиморфных последовательностей (CAPS), полиморфизма длин простой последовательности (SSLP), полиморфизма длин рестрикционных фрагментов (RFLP), маркера произвольной амплифицированной полиморфной ДНК (RAPD), полиморфизма одиночных нуклеотидов (SNP), полиморфизма длины случайного фрагмента (AFLP), вставки, удаления или любого другого типа молекулярного генетического маркера, выведенного из ДНК, РНК, белка или метаболита, гаплотипа, созданного из двух или более из описанных выше молекулярных генетических маркеров, выведенных из ДНК, и их комбинацию в соединении с одним или более измерений фенотипа, данных микроматрицы, аналитических измерений, биохимических измерений или относящихся к окружающей среде измерений, либо их комбинации, в качестве признаков.

Подходящий целевой признак в популяции растений включает в себя одну или более численно представимых особенностей фенотипа, включающих в себя устойчивость к болезням, урожайность, зерновой выход, прочность пряжи, белковый состав, содержание белка, устойчивость к насекомым, влагосодержание зерна, содержание масла в зерне, качество зерновых масел, засухоустойчивость, устойчивость к корневому полеганию, высота растения, высота колоса, содержание белка в зерне, содержание аминокислот в зерне, цвет зерна и устойчивость к стеблевому полеганию.

В варианте осуществления, генотип выборочной популяции растений для одного или более молекулярных генетических маркеров определяется экспериментально прямым секвенированием ДНК.

В варианте осуществления, способ извлечения набора данных с, по меньшей мере, одним основанным на растениях молекулярным генетическим маркером для нахождения правила ассоциации и использования признаков, созданных по этим правилам ассоциации, для классификации или прогнозирования касательно одного или более целевых признаков, при этом, способ включает в себя этапы:

(a) выявления правил ассоциации;

(b) создания новых признаков на основании выводов этапа (a), и добавление этих признаков в набор данных;

(c) оценки признаков;

(d) отбора поднабора признаков из признаков в наборе данных; и

(e) разработки модели для прогнозирования или классификации касательно одного или более целевых признаков с, по меньшей мере, одним признаком, созданным на этапе (b).

В варианте осуществления, способ для отбора инбредных линий, отбора гибридов, ранжирования гибридов, ранжирования гибридов для определенной географии, отбора родителей новых инбредных популяций, нахождения участков для интрогрессии в элитные инбредные линии, или любой их комбинации выполняется с использованием комбинации этапов (a)-(e), приведенных выше.

В варианте осуществления, где выявление правил ассоциации включает в себя пространственные и временные ассоциации с использованием самоорганизующихся карт.

В варианте осуществления, по меньшей мере, один признак модели для прогнозирования или классификации является поднабором признаков, выбранных ранее с использованием алгоритма оценки признаков.

В варианте осуществления перекрестная проверка используется для сравнения алгоритмов и наборов значений параметров. В варианте осуществления, кривые рабочих характеристик приемника (ROC) используются для сравнения алгоритмов и наборов значений параметров.

В варианте осуществления, один или более признаков выводятся математически или вычислительным образом из других признаков.

В варианте осуществления, раскрыт способ извлечения набора данных, который включает в себя, по меньшей мере, один основанный на растениях молекулярный генетический маркер для нахождения, по меньшей мере, одного правила ассоциации и использования признаков по этим правилам ассоциации для классификации или прогнозирования касательно одного или более целевых признаков, при этом, способ включает в себя этапы:

(a) выявления правил ассоциации;

(i) при этом, правила ассоциации, пространственные и временные ассоциации выявляются с использованием самоорганизующейся карты;

(b) создание новых признаков на основании выводов этапа (a), и добавление этих признаков в набор данных;

(c) разработки модели для прогнозирования или классификации касательно одного или более целевых признаков с, по меньшей мере, одним признаком, созданным на этапе (b);

при этом этапы (a), (b) и (c), приведенные выше, могут быть предварены этапом отбора поднабора признаков из признаков в наборе данных.

В варианте осуществления, раскрыт способ извлечения набора данных, который включает в себя, по меньшей мере, один основанный на растениях молекулярный генетический маркер для нахождения, по меньшей мере, одного правила ассоциации и использования признаков, созданных по этим правилам ассоциации, для классификации или прогнозирования, при этом, способ включает в себя этапы:

(a) выявления правил ассоциации;

(b) создания новых признаков на основании выводов, основанных на выводах этапа (a), и добавления этих признаков в набор данных;

(c) отбора поднабора признаков из признаков в наборе данных.

В варианте осуществления, при этом, результаты этих способов содержат набор данных с, по меньшей мере, одним основанным на растениях молекулярным генетическим маркером, используемым для нахождения, по меньшей мере, одного правила ассоциации, и с использованием признаков, созданных из этих правил ассоциации для классификации или прогнозирования, применяются для:

(a) прогнозирования продуктивности гибрида,

(b) прогнозирования продуктивности гибрида по различным географическим местоположениям;

(c) отбора инбредных линий;

(d) отбора гибридов;

(e) ранжирования гибридов для определенных географий;

(f) отбора родителей новых инбредных популяций;

(g) нахождения участков ДНК для интрогрессии в элитные инбредные линии;

(h) или любой их комбинации (a)-(g).

В варианте осуществления, при этом, набор данных с, по меньшей мере, одним основанным на растениях молекулярным генетическим маркером используется для нахождения, по меньшей мере, одного правила ассоциации, и признаки, созданные из этих правил ассоциации, используются для классификации или прогнозирования и отбора, по меньшей мере, одного растения из популяции растений ради одного или более интересующих целевых признаков.

В варианте осуществления, учитываются априорные знания, состоящие из предварительного исследования, количественных исследований генетики растения, генных сетей, секвенирования или любой их комбинации.

В варианте осуществления, способы, описанные выше, модифицированы, чтобы включать в себя следующие этапы:

(a) понижения размерности заменой исходных признаков комбинацией одного или более признаков, включенных в одно или более из правил ассоциации;

(b) извлечения различительных и присущих часто встречающихся шаблонов посредством основанного на модели дерева поиска.

В варианте осуществления, алгоритмы оценки признаков, такие как прирост информации, симметричных неопределенностей и семейство алгоритмов Relief являются пригодными алгоритмами. Эти алгоритмы способны к оценке всех признаков вместе вместо одного признака за раз. Некоторые из этих алгоритмов устойчивы к проблемам смещения, отсутствующих значений или коллинеарности. Семейство алгоритмов Relief предусматривает инструментальные средства, способные к учету взаимодействий глубокого уровня, но требует пониженной коллинеарности между признаками в наборе данных.

В варианте осуществления, технологии отбора поднаборов применяются посредством алгоритмов, таких как оценщик поднаборов CFS. Технологии отбора поднаборов могут использоваться для снижения сложности посредством устранения избыточных отвлекающих признаков и сохранения поднабора, способного к надлежащему выражению целевого признака. Устранение этих отвлекающих признаков обычно повышает качество функционирования алгоритмов моделирования, когда оцениваются с использованием способов, таких как перекрестная проверка и кривые ROC. Известно, что некоторые классы алгоритмов, таких как основанные на примерах алгоритмы, должны быть очень чувствительными к отклоняющим признакам, а другие, такие как машины опорных векторов в средней степени подвержены влиянию отвлекающих признаков. Понижение сложности посредством формирования новых признаков на основании существующих признаков также часто ведет к повышенным прогнозирующим характеристикам алгоритмов машинного обучения.

В варианте осуществления, фильтровые и алгоритмы упаковки могут использоваться для отбора поднабора признаков. Для выполнения отбора поднабора признаков с использованием фильтров, является обычным ассоциативно связывать эффективный метод поиска (например, жадного многошагового, наилучшего первого и поиска с состязаниями) для нахождения наилучшего поднабора признаков (то есть, исчерпывающий поиск может не всегда быть осуществимым с вычислительной точки зрения) с формулой полезных качеств (например, оценщиком поднабора CFS). Оценщик поднабора CFS надлежащим образом учитывает уровень избыточности в пределах поднабора наряду с отсутствием игнорирования локально прогнозирующих признаков. Кроме снижения сложности для поддержки моделирования, основанные на машинном обучении технологии отбора поднаборов, также могут использоваться для отбора поднабора признаков, которые надлежащим образом выражают целевой признак наряду с обладанием низким уровнем избыточности между признаками, включенными в поднабор. Одной из целей подходов отбора поднабора является снижение потерь во время сбора данных о признаках, усилий по обращению и сохранению, фокусируясь только на поднаборе, найденном для надлежащего выражения целевого признака. Технологии машинного обучения, используемые для снижения сложности, описанного в материалах настоящей заявки, могут сравниваться, например, с использованием перекрестной проверки и кривых ROC. Алгоритм отбора поднабора признаков с наилучшим качеством функционирования, в таком случае, может выбираться для заключительного анализа. Это сравнение обычно выполняется посредством перекрестной проверки и кривых ROC, применяемых к разным комбинациям алгоритмов отбора поднабора и алгоритмов моделирования. Чтобы прогонять перекрестную проверку во время этапов отбора признаков и моделирования, могут использоваться многочисленные компьютеры, выполняющие распараллеленный вариант программного обеспечения машинного обучения (например, WEKA). Технологии, описанные в материалах настоящей заявки, для отбора поднаборов признаков используют эффективные методы поиска для обнаружения наилучшего поднабора признаков (то есть, исчерпывающий поиск не всегда возможен).

Аспект способов моделирования, раскрытый в материалах настоящей заявки, состоит в том, что, так как одиночный алгоритм может не всегда быть наилучшим вариантом отбора для моделирования каждого набора данных, инфраструктура, представленная в материалах настоящей заявки, использует технологии перекрестной проверки, кривые ROC, а также точность и отмену для отбора наилучшего алгоритма для каждого набора данных из различных вариантов в пределах области машинного обучения. В варианте осуществления, несколько алгоритмов и настроек параметров могут сравниваться с использованием перекрестной проверки, кривых ROC, а также точности и повторного вызова, во время разработки модели. Некоторые алгоритмы машинного обучения устойчивы к проблемам мультиколлинеарности (предоставляя возможность моделирования с большим количеством признаков), устойчивы к отсутствующим значениям и способны к учету взаимодействий глубокого уровня между признаками без избыточной подгонки данных.

В варианте осуществления, алгоритмами машинного обучения для моделирования являются машины опорных векторов, такие как SMOReg, деревья решений, такие как M5P, RepTree и ADTree, в дополнение к байесовым сетям и основанным на примерах алгоритмам. Деревья, сформированные алгоритмом M5P, REPTree и ADTree растут, сосредотачиваясь на снижении отклонения целевого признака в поднаборе выборок, назначенных каждому вновь созданному узлу. M5P обычно используется для обработки непрерывных целевых признаков, ADTree обычно используется для обработки двоичных (или приведенных к двоичным) целевых признаков, а REPTree может использоваться для обработки как непрерывных, так и дискретных целевых признаков.

Аспект способов машинного обучения, раскрытых в материалах настоящей заявки, состоит в том, что алгоритмы, используемые в материалах настоящей заявки, могут не требовать хорошо структурированных наборов данных, в отличие от некоторых способов, основанных строго на статистических техниках, которые часто полагаются на хорошо структурированные наборы данных. Структурированные эксперименты часто являются ресурсозатратными в показателях рабочей силы, затрат и времени, так как сильное воздействие окружающей среды на выражение многих из наиболее важных количественно унаследованных особенностей в экономически важных растениях и животных, требует, чтобы такие эксперименты были большими, тщательно разработанными и тщательно контролируемыми. Извлечение данных с использованием алгоритмов машинного обучения, однако, может эффективно использовать существующие данные, которые не были сформированы специально для этой цели извлечения данных.

В варианте осуществления, способы, раскрытые в материалах настоящей заявки, могут использоваться для прогнозирования значения целевого признака у одного или более членов второй целевой популяции растений на основании их генотипа для одного или более молекулярных генетических маркеров или гаплотипов, ассоциативно связанных с особенностью. Значения могут прогнозироваться заранее или вместо определения экспериментально.

В варианте осуществления, способы, раскрытые в материалах настоящей заявки, имеют некоторое количество применений в прикладных программах разведения по растениям (например, гибридным зерновым растениям) в ассоциации с или без других статистических способов, таких как BLUP (наилучшее линейное несмещенное прогнозирование). Например, способы могут использоваться для прогнозирования характеристик фенотипа гибридного потомства, например, гибрида простого скрещивания, порожденного (либо фактически либо в умозрительной ситуации) скрещиванием заданной пары инбредных линий генотипа с известным молекулярным генетическим маркером. Способы также полезны при селекции растений (например, инбредных растений, гибридных растений, и т. д.) для использования в качестве родителей в одном или более скрещиваниях; способы дают возможность отбора родительских растений, чей потомок имеет наивысшую вероятность обладания требуемым фенотипом.

В варианте осуществления, изучаются ассоциации между, по меньшей мере, одним признаком и целевым признаком. Ассоциации могут оцениваться в выборочной популяции растений (например, воспроизводящейся популяции). Ассоциации оцениваются в первой популяции растений посредством тренировки алгоритма машинного обучения с использованием набора данных с признаками, которые включают в себя генотипы для, по меньшей мере, одного молекулярного генетического маркера и значения для целевого признака у, по меньшей мере, одного члена популяции растений. Значения целевого признака, в таком случае, могут прогнозироваться на второй популяции с использованием алгоритма машинного обучения и значений для, по меньшей мере, одного признака. Значения могут прогнозироваться заранее или вместо этого определяться экспериментально.

В варианте осуществления, целевой признак может быть количественной особенностью, например, для которой предусмотрено количественное значение. В еще одном варианте осуществления, целевой признак может быть качественной особенностью, например, для которой предусмотрено качественное значение. Особенности фенотипа, которые могут быть включены в некоторые признаки, могут определяться одиночным геном или множеством генов.

В вариантах осуществления, способы также могут включать в себя отбор, по меньшей мере, одного из членов целевой популяции растений, имеющего требуемое прогнозируемое значение целевого признака, и включать в себя размножение, по меньшей мере, одного выбранного члена целевой популяции растений с, по меньшей мере, одним другим растением (или самоопыление, по меньшей мере, одного выбранного члена, например, для создания инбредной линии).

В варианте осуществления, выборочная популяция растений может включать в себя множество инбредов, гибридов простого скрещивания F1 или их комбинацию. Инбреды могут происходить из инбредных линий, которые родственны и/или неродственны друг другу, а гибриды простого скрещивания могут порождаться из простых скрещиваний инбредных линий и/или одной или более дополнительных инбредных линий.

В варианте осуществления, члены выборочной популяции растений включают в себя членов из существующей устоявшейся, воспроизводящейся популяции (например, промышленной воспроизводящейся популяции). Члены устоявшейся, воспроизводящейся популяции обычно являются потомками относительно небольшого количества основателей и обычно наделены внутренним родством. Достаточная по количеству для дальнейшего размножения популяция может покрывать большее количество поколений и циклов размножения. Например, устоявшаяся, достаточная по количеству для дальнейшего размножения популяция может охватывать три, четыре, пять, шесть, семь, восемь, девять или более циклов размножения.

В варианте осуществления, выборочной популяции растений не нужно быть воспроизводящейся популяцией. Выборочная популяция может быть подпопуляцией какой-нибудь существующей популяции растений, для которой, полностью или частично, имеются в распоряжении генотипические и данные о фенотипе. Выборочная популяция растений может включать в себя любое количество членов. Например, выборочная популяция растений включает в себя от приблизительно 2 до приблизительно 100000 членов. Выборочная популяция растений может содержать, по меньшей мере, около 50, 100, 200, 500, 1000, 2000, 3000, 4000, 5000 или даже 6000, либо 10000, или большее количество членов. Выборочная популяция растений обычно демонстрирует изменчивость в отношении интересующего целевого признака (например, количественную изменчивость для качественного целевого признака). Выборочная популяция растений может извлекаться из одной или более растительных клеточных культур.

В варианте осуществления значение целевого признака в выборочной популяции растений получается посредством оценки целевого признака среди членов выборочной популяции растений (например, количественного определения количественного целевого признака среди членов популяции). Фенотип может оцениваться среди членов (например, инбредов и/или гибридов простого скрещивания F1), составляющих первую популяцию растений. Целевой признак может включать в себя любой количественный или качественный признак, например, один из агрономической или экономической значимости. Например, целевой признак может выбираться из урожайности, влагосодержания зерна, содержания масла в зерне, прочности пряжи, высоты растения, высоты колоса, устойчивости к болезням, устойчивости к насекомым, засухоустойчивости, содержания белка в зерне, натуральной массы, визуальной или эстетической наружности и цвета початка. Эти особенности и техники для их оценки (например, количественного определения) широко известны в данной области техники.

В варианте осуществления, генотип выборочной популяции растений для набора молекулярных генетических маркеров может определяться экспериментально, прогнозироваться или определяться по их комбинации. Например, в одном из классов вариантов осуществления, генотип каждого инбреда, присутствующего в популяции растений, определяется экспериментально, и прогнозируется генотип каждого гибрида простого скрещивания F1, присутствующего в первой популяции растений (например, экспериментально определенные генотипы двух инбредных родителей каждого гибрида простого скрещивания). Генотипы растений могут определяться экспериментально посредством любой подходящей техники. В варианте осуществления, множество участков ДНК из каждого инбреда секвенируются для экспериментального определения генотипа каждого инбреда. В варианте осуществления, генеологические деревья и вероятностный подход могут использоваться для расчета вероятностей генотипа в разных локусах маркера для двух инбредных родителей гибридов простого скрещивания.

В варианте осуществления, способы, раскрытые в материалах настоящей заявки, могут использоваться для отбора растений для выбранного генотипа, включающего в себя, по меньшей мере, один молекулярный генетический маркер, ассоциативно связанный с целевым признаком.

«Аллель» или «тип аллели» относится к альтернативной форме генетического локуса. Одиночная аллель для каждого локуса наследуется отдельно от каждого родителя. Диплоидная особь является гомозиготной, если одна и та же аллель присутствует дважды (то есть, один раз в каждой гомологичной хромосоме), или гетерозиготной, если присутствуют две разные аллели.

В качестве используемого в материалах настоящей заявки, термин «животное» подразумевается охватывающим нечеловеческие организмы, отличающиеся от растений, в том числе, но не в качестве ограничения, одомашненных животные (то есть, домашние животные), мясомолочный скот, рабочие животные или животные зоопарков. Предпочтительные животные включают в себя, но не в качестве ограничения, рыбу, кошек, собак, лошадей, хорьков и других куньих, крупный рогатый скот, овец и свиней. Более предпочтительные животные включают в себя кошек, собак, лошадей и других одомашненных животных, причем, кошки, собаки и лошади являются даже еще более предпочтительными. В качестве используемого в материалах настоящей заявки, термин «одомашненное животное» относится к любому животному, которое человек рассматривает в качестве домашнего животного. В качестве используемого в материалах настоящей заявки, кошка относится к любому члену семейства кошачьих (то есть, кошачьи), в том числе, к одомашненным кошкам, диким кошкам и кошкам зоопарков. Примеры кошек включают в себя, но не в качестве ограничения, одомашненных кошек, львов, тигров, леопардов, пантер, когуаров, рыжих рысей, рысей, ягуаров, гепардов и сервалов. Предпочтительной кошкой является одомашненная кошка. В качестве используемой в материалах настоящей заявки, собака относится к любому члену семейства собачьих, в том числе, но не в качестве ограничения, к одомашненным собакам, диким собакам, лисицам, волкам, шакалам и койотам, и другим членам семейства собачьих. Предпочтительной собакой является одомашненная собака. В качестве используемой в материалах настоящей заявки, лошадь относится к любому члену семейства лошадиных. Непарнокопытное является копытным и включает в себя, но не в качестве ограничения, одомашненных лошадей и диких лошадей, таких как лошади, ишаки, ослы и зебры. Предпочтительные лошади включают в себя одомашненных лошадей, в том числе, скаковых лошадей.

Термин «ассоциация», в контексте машинного обучения, относится к любой взаимосвязи между признаками, но не только теми, которые прогнозируют конкретный класс или числовое значение. Ассоциация включает в себя, но не в качестве ограничения, нахождение правил ассоциации, обнаружение шаблонов, выполнение оценки признаков, выполнение отбора поднаборов признаков, разработку прогнозирующих моделей и осмысление взаимодействий между признаками.

Термин «правила ассоциации», в контексте этого изобретения, относится к элементам, которые часто появляются вместе в пределах набора данных. Он включает в себя, но не в качестве ограничения, ассоциативные шаблоны, различительные шаблоны, частные шаблоны, близкие шаблоны и огромные шаблоны.

Термин «преобразованный в двоичную форму», в контексте машинного обучения, относится к непрерывному или безусловному признаку, который был преобразован в двоичный признак.

«Воспроизводящаяся популяция» в целом указывает на совокупность растений, используемых в качестве родителей в программе разведения. Обычно, отдельные растения в воспроизводящейся популяции характеризуются как по генотипу, так и по фенотипу.

Термин «извлечение данных» относится к идентификации или извлечению зависимостей и шаблонов из данных с использованием вычислительных алгоритмов для сокращения, моделирования, осмысления или анализа данных.

Термин «деревья решений» относится к любому типу основанных на деревьях алгоритмов обучения, в том числе, но не в качестве ограничения, деревья моделей, деревья классификаций и деревья регрессий.

Термин «признак» или «атрибут» в контексте машинного обучения относится к одной или более необработанных входных переменных, на одну или более обработанных переменных или на одно или более математических сочетаний других переменных, в том числе, необработанных переменных и обработанных переменных. Признаки могут быть непрерывными или дискретными. Признаки могут формироваться благодаря обработке любым фильтровым алгоритмом или любым статистически методом. Признаки могут включать в себя, но не в качестве ограничения, данные маркера ДНК, данные гаплотипа, данные о фенотипе, биохимические данные, данные микроматрицы, относящиеся к окружающей среде данные, белковые данные и метаболические данные.

Термин «оценка признака» в контексте этого изобретения относится к ранжированию признаков или к ранжированию, сопровождаемому отбором признаков на основании их влияния на целевой признак.

Фраза «поднабор признаков» относится к группе одного или более признаков.

«Генотип» относится к генетическому строению клетки или отдельного растения или организма относительно одного или более молекулярных генетических маркеров или аллелей.

«Гаплотип» относится к набору аллелей, которые особь наследует от одного родителя. Термин гаплотип также может относиться к физически связанным и/или несвязанным молекулярным генетическим маркерам (например, полиморфным последовательностям), ассоциированным с целевым признаком. Гаплотип также может указывать ссылкой на группу из двух или более молекулярных генетических маркеров, которые физически связаны в хромосоме.

Термин «пример» в контексте машинного обучения относится к образцу из набора данных.

Термин «взаимодействие» в контексте этого изобретения относится к ассоциативной связи между признаками и целевыми признаками в виде зависимости одного признака от другого признака.

Термин «обучение» в контексте машинного обучения относится к идентификации и обучению подходящих алгоритмов для выполнения интересующих задач. Термин «обучение» включает в себя, но не в качестве ограничения, обучение ассоциаций, обучение классификации, кластеризацию и числовое прогнозирование.

Термин «машинное обучение» указывает ссылкой на область вычислительной техники, которая изучает проектирование компьютерных программ, способных выводить шаблоны, закономерности или правила из прошлого опыта для совершенствования надлежащей реакции на будущие данные или описания данных некоторым содержательным образом. Под алгоритмами «машинного обучения», в контексте этого изобретения, подразумеваются алгоритмы правил ассоциации (например, априорные, извлечения различительных шаблонов, извлечения часто встречающихся шаблонов, извлечения близких шаблонов, извлечения огромных шаблонов и самоорганизующихся карт), алгоритмы оценки признаков (например, прироста информации, Relief, ReliefF, RReliefF, симметричных неопределенностей, алгоритма отношений прироста и ранжировщика), алгоритмы отбора поднаборов (например, упаковки, непротиворечивости, классификатора, основанного на корреляции отбора признаков (CFS)), машины опорных векторов, байесовы сети, правила классификации, деревья решений, нейронные сети, основанные на примерах алгоритмы, другие алгоритмы, которые используют перечисленные в материалах настоящей заявки алгоритмы (например, голосования, укладки, чувствительного к стоимости классификатора) и любой другой алгоритм в области вычислительной техники, который относится к выведению шаблонов, закономерностей или правил из прошлого опыта для совершенствования надлежащей реакции на будущие данные или описания данных некоторым содержательным образом.

Термин «разработка модели» относится к процессу построения одной или более моделей для извлечения данных.

Термин «молекулярный генетический маркер» относится к одному из простой повторяющейся последовательности (SSR), расщепленных амплифицированных полиморфных последовательностей (CAPS), полиморфизма длин простой последовательности (SSLP), полиморфизма длин рестрикционных фрагментов (RFLP), маркера произвольной амплифицированной полиморфной ДНК (RAPD), полиморфизма одиночных нуклеотидов (SNP), полиморфизма длины случайного фрагмента (AFLP), вставки, удаления или любого другого типа молекулярного маркера, выведенного из ДНК, РНК, белка или метаболита и их комбинации. Молекулярный генетический маркер также относится к полинуклеотидным последовательностям, используемым в качестве проб.

Термин «особенность фенотипа» или «фенотип» относится к наблюдаемым физическим или биохимическим характеристикам организма, которые определены как генетической конструкцией, так и влияниями окружающей среды. Фенотип указывает ссылкой на наблюдаемое выражение (экспрессию) конкретного генотипа.

Термин «растение» включает в себя класс высших или низших растений, в том числе, покрытосеменные (однодольные и двудольные растения), голосеменные, папоротники и многоклеточные водоросли. Он включает в себя растения в многообразии уровней плоидности, в том числе, анэуплоидные, полиплоидные, диплоидные, гаплоидные и гемизиготные.

Термин «основанный на растениях молекулярный генетический маркер» относится к одному из простой повторяющейся последовательности (SSR), расщепленных амплифицированных полиморфных последовательностей (CAPS), полиморфизма длин простой последовательности (SSLP), полиморфизма длин рестрикционных фрагментов (RFLP), маркера произвольной амплифицированной полиморфной ДНК (RAPD), полиморфизма одиночных нуклеотидов (SNP), полиморфизма длины случайного фрагмента (AFLP), вставки, удаления или любого другого типа молекулярного маркера, выведенного из ДНК, РНК, белка или метаболита и их комбинации. Молекулярный генетический маркер также относится к полинуклеотидной последовательности, используемой в качестве проб.

Термин «априорные знания», в контексте этого изобретения относится к любой форме информации, которая может использоваться для модификации качества функционирования алгоритма машинного обучения. Матрица зависимостей, указывающая родственность между особями, является примером априорных знаний.

«Качественная особенность» обычно относится к признаку, который управляется одним или несколькими генами и является дискретным по природе. Примеры качественных особенностей включают цвет цветка, цвет початка и устойчивость к болезням.

«Количественная особенность» обычно относится к признаку, который может быть определен количественно. Количественная особенность типично показывает непрерывное изменение между особями популяции. Количественная особенность часто является результатом взаимодействия генетического локуса с окружающей средой, или взаимодействия многочисленных генетических локусов друг с другом и/или с окружающей средой. Примеры количественных особенностей включают в себя зерновой выход, содержание белка и прочность пряжи.

Термин «ранжирование» в отношении признаков относится к упорядоченной компоновке признаков, например, молекулярные генетические маркеры могут быть ранжированы по их прогнозирующей способности в отношении особенности.

Термин «самоорганизующаяся карта» относится к технике обучения без учителя, часто используемую для визуализации и анализа высокоразмерных данных.

Термин «с учителем», в контексте машинного обучения, относится к способам, которые работают под контролем, с предоставлением фактического результата для каждого из обучающих примеров.

Термин «машина опорных векторов», в контексте машинного обучения, включает в себя, но не в качестве ограничения, классификатор опорных векторов, используемый для целей классификации, и регрессию опорных векторов, используемую для числового прогнозирования. Другие алгоритмы (например, последовательная минимальная оптимизация (SMO)) могут быть реализованы для обучения машины опорных векторов.

Термин «целевой признак» в контексте этого изобретения относится к, но не в качестве ограничения, признаку, который представляет интерес для прогнозирования или объяснения, или с которым интересно развивать ассоциацию. Усилия по извлечению данных могут включать в себя один целевой признак или более чем один целевой признак, и термин «целевой признак» может относиться к одному или более чем одному признаку. «Целевой признак» может включать в себя, но не в качестве ограничения, данные маркера ДНК, данные о фенотипе, биохимические данные, данные микроматрицы, относящиеся к окружающей среде данные, белковые данные и метаболические данные. В области техники машинного обучения, когда «целевой признак» является дискретным, его часто называют «классом». Зерновой выход является примером целевого признака.

Термин «без учителя», в контексте машинного обучения, относится к способам, которые работают без контроля без предоставления фактического результата для каждого из обучающих примеров.

Обзор теоретических и практических аспектов некоторых применимых способов

Извлечение правил ассоциации

Извлечение правил ассоциации (ARM) - техника для извлечения содержательных шаблонов ассоциаций между признаками. Одним из алгоритмов машинного обучения, пригодных для обучения правилам ассоциации, является априорный алгоритм.

Обычный основной этап алгоритмов ARM состоит в том, чтобы находить набор элементов или признаков, которые наиболее часто встречаются среди всех наблюдений. Таковые известны как часто встречающиеся наборы элементов. Их частота также известна как опора (пользователь может идентифицировать минимальное опорное пороговое значение для набора элементов, которые должны считаться часто встречающимися). Как только получены часто встречающиеся наборы элементов, правила извлекаются из них (например, с предписанной пользователем минимальной степенью доверия). Последняя часть не настолько напряженна по вычислениям, как первая. Отсюда, цель алгоритмов ARM фокусируется на нахождении часто встречающихся множеств элементов.

Не всегда является определенным, что часто встречающиеся наборы элементов являются базовыми (наиболее применимыми) информационными шаблонами набора данных, так как часто есть много избыточности среди шаблонов. Как результат, многие приложения полагаются на получение часто встречающихся близких шаблонов. Часто встречающийся близкий шаблон является шаблоном, который удовлетворяет требованию минимальной опоры, заданному пользователем, и не имеет такой же опоры, как его непосредственные надмножества. Часто встречающийся шаблон не является близким, если, по меньшей мере, одно из его непосредственных надмножеств имеет такой же счет опоры, как у него. Обнаружение часто встречающихся близких шаблонов предоставляет нам возможность находить поднабор значимых взаимодействий среди признаков.

Априорный алгоритм работает итерационно, комбинируя повторяющиеся наборы элементов с n-1 признаками для формирования повторяющегося набора элементов с признаками. Эта процедура является экспоненциальной по времени выполнения с ростом количества признаков. Отсюда, извлечение повторяющихся наборов элементов априорным алгоритмом становится затратным по вычислениям для наборов данных с очень большим количеством признаков.

С проблемой масштабируемости для нахождения часто встречающихся близких наборов элементов могут хорошо справляться некоторые существующие алгоритмы. CARPENTER, алгоритм нумерации строк первой глубины, способен к обнаружению часто встречающихся близких шаблонов из больших биологических наборов данных с большим количеством признаков. CARPENTER не осуществляет хорошее масштабирование с ростом количества выборок.

Другими алгоритмами извлечения часто встречающихся шаблонов являются CHARM, CLOSET. Оба из них являются эффективными алгоритмами нумерации столбцов первой глубины.

COBBLER - алгоритм нумерации столбцов и строк, который осуществляет хорошее масштабирование с ростом количества признаков и выборок.

Для многих разных целей, обнаружение различительных часто встречающихся шаблонов полезно даже больше, чем нахождение часто встречающихся близких шаблонов ассоциаций. Некоторые алгоритмы эффективно извлекают только различительные шаблоны из наборов данных. Большинство существующих алгоритмов осуществляют двухэтапный подход для обнаружения различительных шаблонов: (a) найти часто встречающиеся шаблоны, (b) из часто встречающихся шаблонов, получить различительные шаблоны. Этап (a) является очень времязатратным процессом и имеет результатом много избыточных часто встречающихся шаблонов.

DDPMine (извлечение прямого различительного шаблона), алгоритм извлечения различительного шаблона не придерживается описанного выше двухэтапного подхода. Вместо извлечения часто встречающихся шаблонов, он формирует сокращенное представление дерева FP данных. Эта процедура не только уменьшает размер проблемы, но также ускоряет процесс извлечения. Она использует прирост информации в качестве меры для извлечения различительных шаблонов.

Другими алгоритмами извлечения различительных шаблонов являются HARMONY, RCBT и PatClass. HARMONY - центрирующийся на примере основанный на правилах классификатор. Он непосредственно извлекает окончательный набор правил классификации. Классификатор RCBT действует сначала посредством идентификации верхних k групп правил покрытия для каждой строки и их использования для инфраструктуры классификации. PatClass предпринимает двухэтапную процедуру сначала посредством извлечения набора повторяющихся наборов элементов, сопровождаемого этапом выбора признаков.

Большинство существующих алгоритмов извлечения правил ассоциации возвращают малоразмерные часто встречающиеся или близкие шаблоны. С ростом количества признаков, количество крупноразмерных часто встречающихся или близких шаблонов также возрастает. Является слишком напряженным по вычислениям, скорее даже невозможным, выводить все часто встречающиеся шаблоны всех длин для наборов данных с большим количеством признаков. Алгоритм слияния шаблонов пытается принять меры в ответ на эту проблему, объединяя небольшие часто встречающиеся шаблоны в огромные шаблоны, предпринимая скачки в пространстве поиска шаблонов.

Самоорганизующиеся карты

Самоорганизующаяся карта (SOM), также известная как сохраняющая карта сети Кохонена, является техникой обучения без учителя, часто используемой для визуализации и анализа данных высокой размерности. Типичные применения фокусируются на визуализации центральных зависимостей в пределах данных на карте. Некоторые области, где они использовались, включают в себя автоматическое распознавание речи, клинический анализ голоса, классификация спутниковых снимков, анализ электрических сигналов из мозга и организация и поиск данных из больших массивов документов.

Карта, формируемая посредством SOM, использовалась для ускорения идентификации правил ассоциации способами, подобными априорному, посредством использования кластеров SOM (визуальные кластеры, идентифицированные во время обучения SOM).

Карта SOM состоит из сетки блоков обработки, «нейронов». Каждый нейрон ассоциативно связан с вектором признаков (наблюдением). Карта пытается представить все имеющиеся в распоряжении наблюдения с оптимальной точностью с использованием ограниченного набора моделей. Одновременно, модели становятся упорядоченными в сетке, так что подобные модели близки друг к другу, а несходные модели отдалены друг от друга. Эта процедура дает возможность идентификации, а также визуализации зависимостей или ассоциаций между признаками в данных.

В течение фазы обучения SOM, алгоритм соревновательного обучения используется для подгонки векторов модели к сетке нейронов. Это процесс последовательной регрессии, где t=1, 2,... - индекс этапа: Для каждой выборки x(t), первый победивший индекс c (нейрон наибольшего совпадения) идентифицируется условием

∀i, ||x(t)-mc (t)||≤||x(t)-mi(t)||

После того, все векторы модели или их поднабор, которые принадлежат узлам, центрированным вокруг узла c=c(x), обновляются как

mi(t+1)=mi(t)+hc(x),i(x(t)-mi(t))

где:

mc - вектор средних весов сого узла (то есть, победителя).

mi - вектор средних весов iого узла.

hc(x),i - «функция соседства», убывающая функция расстояния между iым и cым узлами в сетке карты.

mi(t+1) - обновленный вектор весов после tого этапа.

Эта регрессия обычно многократно повторяется на имеющихся в распоряжении наблюдениях.

Алгоритмы SOM также часто использовались для исследования пространственных и временных зависимостей между сущностями. Зависимости и ассоциации между наблюдениями выводятся на основании пространственной кластеризации этих наблюдений в карте. Если нейроны представляют разные временные состояния, то карта визуализирует временные шаблоны между наблюдениями.

Оценка признаков

Одно из основных назначений алгоритмов оценки признаков состоит в том, чтобы понять лежащий в основе процесс, который формирует данные. Эти способы также часто применяются для уменьшения количества «отвлекающих» признаков с целью улучшения качества функционирования алгоритмов классификации (смотрите Guyon and Elisseeff (2003). An Introduction to Variable and Feature Selection. Journal of Machine learning Research 3, 1157-1182 (Гийон и Елисеев (2003). Введение в отбор переменных и признаков. Журнал исследований по машинному обучению, 3, 1157-1182)). Термин «переменная» иногда используется вместо более широких терминов «признак» или «атрибут». Отбор признаков (или атрибутов) относится к выбору переменных, обрабатываемых посредством методов, таких как ядерные методы, но иногда относится к выбору необработанных входных переменных. Требуемыми выходными данными этих алгоритмов оценки признаков обычно является ранжирование признаков на основании их влияния на целевой признак, или ранжирование, сопровождаемое отбором признаков. Это влияние может быть измерено разными путями.

Прирост информации является одним из способов машинного обучения, пригодных для оценки признаков. Определение прироста информации требует определения энтропии, которая является мерой инородности в совокупности обучающих примеров. Снижение энтропии целевого признака, которое происходит посредством узнавания значений определенного признака, называется приростом информации. Прирост информации может использоваться в качестве параметра для определения эффективности признака в объяснении целевого признака.