Настоящее изобретение относится к кодированию, обработке и декодированию звукового сигнала, и в частности - к устройству и способу для улучшенного плавного изменения сигнала для систем с переключаемым кодированием звука во время маскирования ошибок.

В последующем описано современное состояние по отношению к плавному изменению во время маскирования потери пакетов (PLC) для речевых и звуковых кодеков. Объяснения по отношению к современному состоянию начинаются с кодеков ITU-T G-серии (G.718, G.719, G.722, G.722.1, G.729. G.729.1), за ними следуют 3GPP кодеки (AMR, AMR-WB, AMR-WB+) и один кодек IETF (OPUS), и заканчиваются двумя кодеками MPEG (HE-AAC, HILN) (ITU= международный союз по телекоммуникациям; 3GPP=проект партнерства 3-го поколения; AMR=адаптивное кодирование с переменной скоростью; WB=широкополосное; IETF=целевая группа разработки Интернет). Впоследствии анализируется современное состояние по отношению к отслеживанию уровня фонового шума, за которым следует итоговая информация, которая обеспечивает краткий обзор.

Сначала рассматривают G.718. G.718-узкополосный и широкополосный кодек для речевых сигналов, который поддерживает DTX/CNG (DTX=системы цифрового театра; CNG=генерация комфортного шума). Поскольку варианты осуществления, в частности, относятся к коду с низкой задержкой, версия режима с низкой задержкой будет описана более подробно в данной работе.

Рассматривая ACELP (уровень 1) (ACELP=линейное предсказание с алгебраическим кодовым возбуждением), ITU-T рекомендует для G.718 [ITU08a, раздел 7.11] адаптивное плавное изменение в области линейного предсказания для управления скоростью плавного изменения. В общем случае маскирование следует этому принципу:

Согласно G.718, в случае стираний кадра стратегия маскирования может обобщаться как сходимость энергии сигнала и спектральной огибающей к оцененным параметрам фонового шума. Периодичность сигнала сходится к нулю. Скорость сходимости зависит от параметров последнего правильно принятого кадра и количества последовательных стертых кадров, и управляется с помощью коэффициента ослабления α. Коэффициент ослабления α дополнительно зависит от стабильности θ фильтра LP (LP=линейное предсказание) для «невокализованных» кадров. В общем случае сходимость является медленной, если последний хороший принятый кадр находится в устойчивом сегменте, и быстрой, если кадр находится в сегменте перехода.

Коэффициент ослабления α зависит от класса речевого сигнала, который извлекается с помощью классификации сигнала, описанной в [ITU08a, раздел 6.8.1.3.1 и 7.1 1.1.1]. Коэффициент стабильности α вычисляется, основываясь на измерении расстояния между смежными фильтрами ISF (спектральной частоты иммитанса) [ITU08a, раздел 7.1.2.4.2].

показывает схему вычисления α:

>3

0,4

=2

>2

0,6

0,4

Таблица 1: Значения коэффициента ослабления α, значение α является коэффициентом стабильности, вычисленным из измерения расстояния между смежными фильтрами LP. [ITU08a, раздел 7.1.2.4.2].

Кроме того, G.718 обеспечивает способ плавного изменения для изменения спектральной огибающей. Общей идеей является выполнение схождения параметров последней ISF к адаптивному вектору средних значений ISF. Сначала усредненный вектор ISF вычисляется из последних 3 известных векторов ISF. Затем усредненный вектор ISF снова усредняется с автономно подготовленным долгосрочным вектором ISF (который является постоянным вектором) [ITU08a, раздел 7.1 1.1.2].

Кроме того, G.718 обеспечивает способ плавного изменения для управления долгосрочным режимом работы и таким образом - для взаимодействия с фоновым шумом, где энергия тонального возбуждения (и таким образом периодичность возбуждения) сходится к 0, в то время как случайная энергия возбуждения сходится к энергии возбуждения CNG [ITU08a, раздел 7.1 1.1.6]. Ослабление инновационного усиления вычисляется как

где gs[1] является инновационным усилением в начале следующего кадра, gs[0] является инновационным усилением в начале текущего кадра, gn является усилением возбуждения, используемыми во время генерации комфортного шума и коэффициенте ослабления α.

Аналогично периодическому ослаблению возбуждения, усиление ослабляется линейно по всему кадру на основе «выборка за выборкой», начиная с gs[0] и достигая gs[1] в начале следующего кадра.

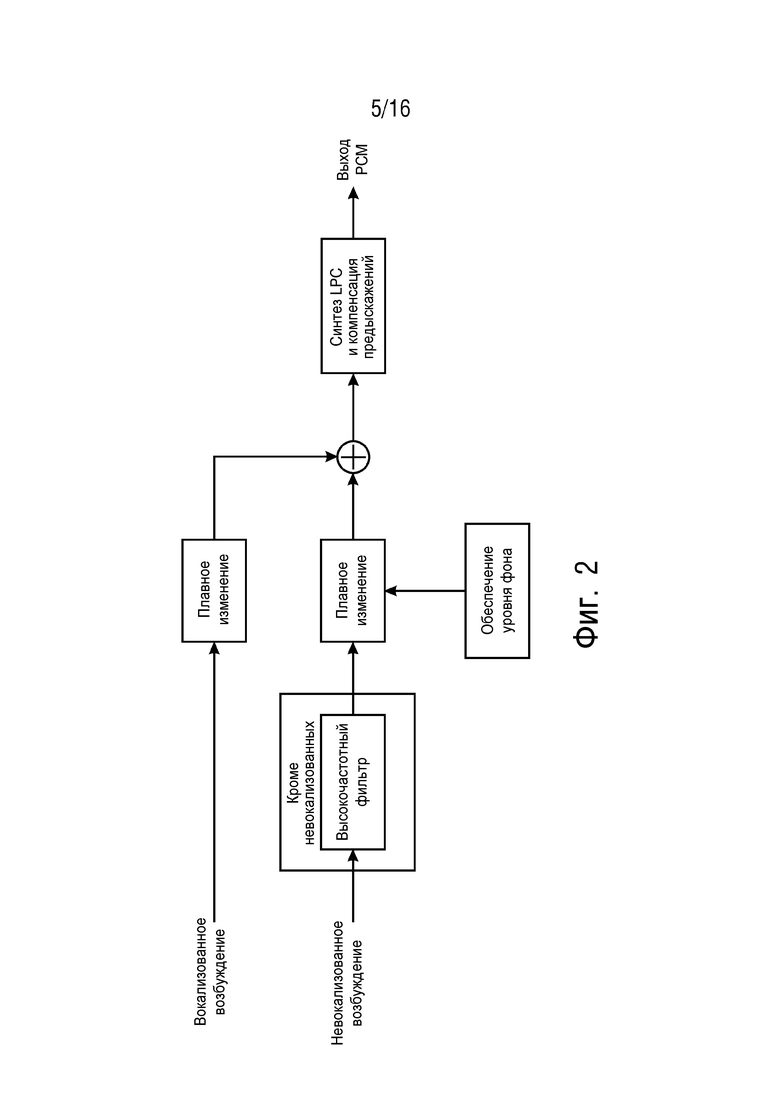

Фиг. 2 схематично представляет структуру декодера G.718. В частности, фиг. 2 показывает высокоуровневую структуру декодера G.718 для PLC, показывая высокочастотный фильтр.

С помощью вышеописанного подхода G.718 инновационное усиление gs сходится к усилению, используемому во время генерации комфортного шума gn для потерь длинных пачек пакетов. Как описано в [ITU08a, раздел 6.12.3], усиление gn комфортного шума задается как квадратный корень из энергии Ẽ. Условия обновления Ẽ не описаны подробно. Следуя эталонному воплощению (C-код с плавающей запятой, stat_noise_uv_mod.c), Ẽ извлекают следующим образом:

if(unvoiced_vad == 0){

if(unv_cnt>20){

ftmp=lp_gainc * lp_gainc;

lp_ener=0.7f * lp_ener+0.3f * ftmp;

}

else{

unv_cnt++;

}

}

else{

unv_cnt=0;

}

причем unvoiced_vad охватывает обнаружение активности речи, причем unv_cnt охватывает количество расположенных подряд невокализованных кадров, причем lp_gainc охватывает низкочастотное усиление фиксированной кодовой книги, и причем lp_ener охватывает низкочастотную CNG оценку энергии Ẽ, она инициализируется в 0.

К тому же G.718 обеспечивает высокочастотный фильтр, введенный в тракт передачи сигналов невокализованного возбуждения, если сигнал последнего хорошего кадра был классифицирован отличающимся от «невокализованного», см. фиг. 2, также см. [ITU08a, раздел 7.1 1.1.6). Этот фильтр имеет характеристику «низкой полки» с частотной характеристикой по DC, расположенной приблизительно на 5 дБ ниже, чем частота Найквиста.

Кроме того, G.718 предлагает разъединенный цикл обратной связи LTP (LTP=долгосрочное предсказание): хотя во время обычного функционирования цикл обратной связи для адаптивной кодовой книги обновляется по субкадрам ([ITU08a, раздел 7.1.2.1.4]), основываясь на полном возбуждении. Во время маскирования этот цикл обратной связи обновляется по кадрам (см. [ITU08a, раздел 7.11.1.4, 7.1 1.2.4, 7.1 1.1.6, 7.1 1.2.6; dec_GV_exc@dec_gen_voic.c и syn_bfi_post@syn_bfi_pre_post.c]), основываясь только на вокализованном возбуждении. С этим подходом адаптивная кодовая книга не «засоряется» шумом, возникающим в случайно выбранном инновационном возбуждении.

Рассматривая уровни (3-5) улучшения кодирования с преобразованием из G.718, во время маскирования декодер ведет себя по отношению к верхнему уровню декодирования аналогично обычному функционированию, только спектр MDCT устанавливают в нуль. Никакой специальный режим плавного изменения не применяется во время маскирования.

По отношению к CNG, в G.718 синтез CNG выполняется в следующем порядке. Сначала декодируются параметры кадра комфортного шума. Затем синтезируется кадр комфортного шума. Впоследствии сбрасывается буфер тонов. Затем сохраняется классификация синтеза для FER (устранения ошибок кадра). Впоследствии проводится компенсация предыскажений спектра. Затем проводится низкочастотное постфильтрование. Затем обновляются переменные CNG.

В случае маскирования выполняется точно то же самое, кроме того, что параметры CNG не декодируются из битового потока. Это означает, что параметры не обновляются во время потери кадра, а используются декодированные параметры из последнего хорошего кадра SID (описателя вставки тишины).

Теперь рассматривают G.719. G.719, который основан на Siren 22, является основанным на преобразовании звуковым кодеком полного диапазона. ITU-T рекомендует для G.719 плавное изменение с повторением кадра в спектральной области [ITU08b, раздел 8.6]. Согласно G.719, механизм маскирования стирания кадра внедряется в декодер. Когда кадр правильно принимается, восстановленные коэффициенты преобразования сохраняются в буфере. Если декодеру сообщают, что кадр потерян или что кадр поврежден, то коэффициенты преобразования, восстановленные в последнем принятом кадре масштабируются в сторону уменьшения с коэффициентом 0,5 и затем используются в качестве восстановленных коэффициентов преобразования для текущего кадра. Декодер действует с помощью преобразования их во временную область и выполнения операции «кадрированного перекрытия с суммированием».

В последующем описан G.722. G.722 является системой кодирования 50-7000 Гц, которая использует адаптивную дифференциальную импульсно-кодовую модуляцию поддиапазона (SB-ADPCM) в пределах скорости передачи битов до 64 кбит/сек. Сигнал делится на верхний и нижний поддиапазоны, используя анализ QMF (QMF=квадратурный зеркальный фильтр). Два полученных в результате диапазона кодируются с помощью ADPCM (ADPCM= адаптивная дифференциальная импульсно-кодовая модуляция).

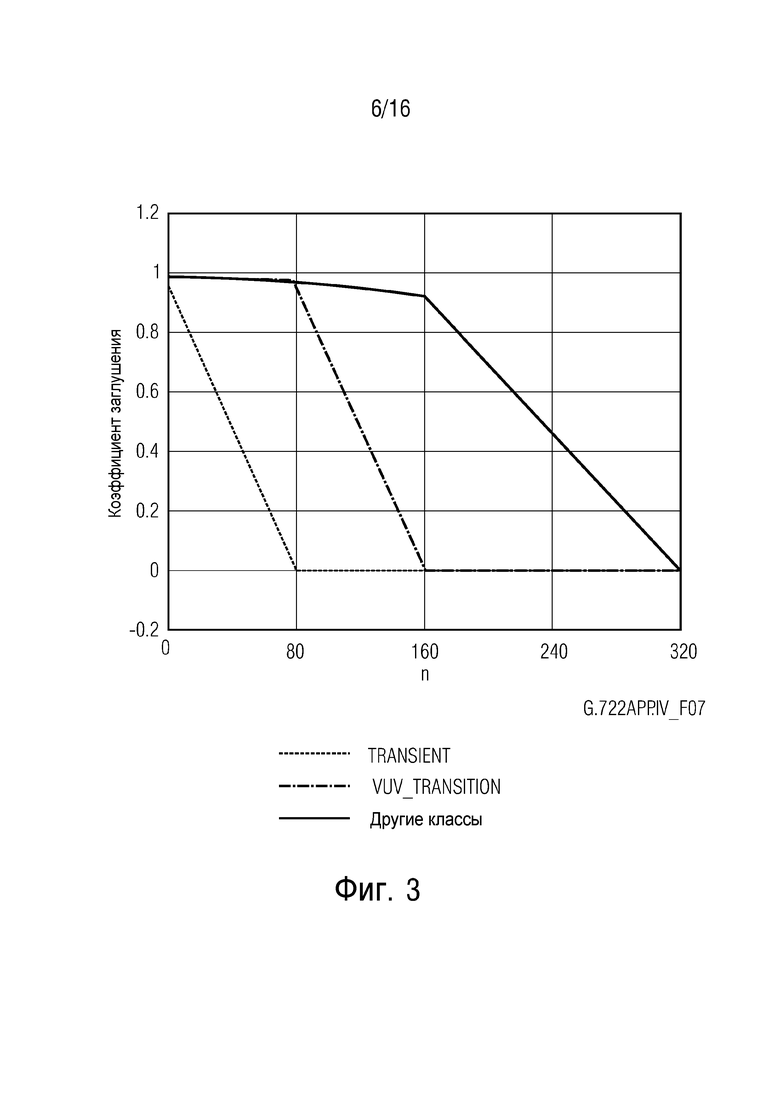

Для G.722 алгоритм с высокой сложностью для маскирования потери пакетов определен в приложении III [ITU06a], а алгоритм с низкой сложностью для маскирования потери пакетов определен в приложении IV [ITU07]. G.722 - приложение III ([ITU06a, раздел III.5]) предлагает выполнение постепенного заглушения, которое начинается после 20 мс потери кадров и которое заканчивается после 60 мс потери кадров. Кроме того, G.722 - приложение IV предлагает методику плавного изменения, которая применяет «к каждой выборке коэффициент усиления, который вычисляется и адаптируется «выборка за выборкой»» [ITU07, раздел IV.6.1.2.7].

В G.722 процесс заглушения происходит в области поддиапазона непосредственно перед синтезом QMF и как последний этап модуля PLC. Вычисление коэффициента заглушения выполняется, используя информацию о классе от классификатора сигнала, который также является частью модуля PLC. Различие делается между классами TRANSIENT, UV_TRANSITION и другими. К тому же различие сделано между одиночными потерями кадров 10 мс и другими случаями (множественными потерями кадров 10 мс и одиночными/множественными потерями кадров 20 мс).

Это показано на фиг. 3. В частности, фиг. 3 изображает сценарий, где коэффициент плавного изменения G.722 зависит от информации о классе, и в котором 80 выборок эквивалентны 10 мс.

Согласно G.722, модуль PLC создает сигнал для недостающего кадра и некоторый дополнительный сигнал (10 мс), который, как предполагается, плавно переходит в следующий хороший кадр. Заглушение для этого дополнительного сигнала придерживается тех же самых правил. При маскировании высокочастотного диапазона G.722 плавный переход не происходит.

В последующем рассматривают G.722.1. G.722.1, который основан на Siren 7, является основанным на преобразовании звуковым кодеком широкого диапазона с режимом расширения на сверхширокий диапазон, называемым G.722.1C.G. 722.1C основан на Siren 14. ITU-T рекомендует для G.722.1 повторение кадра с последующим заглушением [ITU05, раздел 4.7]. Если декодеру сообщают, посредством внешнего механизма сигнализации, не определенного в данной рекомендации, что кадр потерян или поврежден, то он повторяет декодированные коэффициенты MLT (модулированного задержанного преобразования) предыдущего кадра. Он действует с помощью выполнения их преобразования во временную область и выполнения операции перекрытия с суммированием декодированной информации предыдущего и последующего кадров. Если предыдущий кадр был также потерян или поврежден, то декодер устанавливает все коэффициенты MLT текущего кадра в ноль.

Теперь рассматривают G.729. G.729 является алгоритмом сжатия звуковых данных для голоса, который сжимает цифровой голос в пакетах продолжительностью 10 миллисекунд. Это официально описано как кодирование речи со скоростью 8 кбит/сек, используя речевое кодирование с линейным предсказанием с кодовым возбуждением (CS-ACELP) [ITU12].

Как описано в [CPK08], G.729 рекомендует плавное изменение в области LP. Алгоритм PLC, используемый в стандарте G.729, восстанавливает речевой сигнал для текущего кадра, основываясь на принятой ранее речевой информации. Другими словами, алгоритм PLC заменяет недостающее возбуждение эквивалентной характеристикой ранее принятого кадра, хотя энергия возбуждения постепенно затухает в конечном счете, усиление адаптивной и фиксированной кодовых книг ослабляется с постоянным коэффициентом.

Ослабленное усиление фиксированной кодовой книги задают с помощью:

где m является индексом субкадра.

Усиление адаптивной кодовой книги основано на ослабленной версии предыдущего усиления адаптивной кодовой книги:

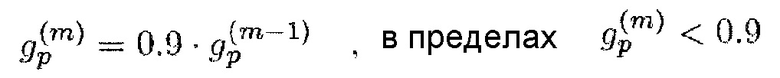

Nam in Park и др. предлагают для G.729 контроль за амплитудой сигнала, используя предсказание посредством линейной регрессии [CPK08, PKJ+11]. Оно адресовано потере пачки пакетов и использует линейную регрессию в качестве основной методики. Линейная регрессия основана на линейной модели следующим образом

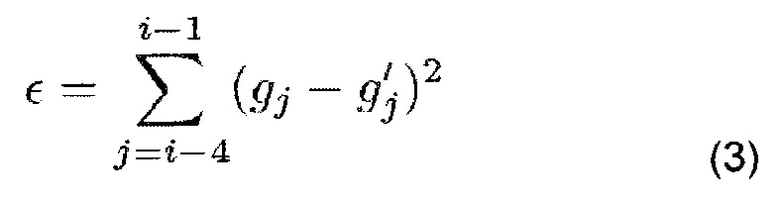

где gi' - вновь предсказанная текущая амплитуда, a и b- коэффициенты для линейной функции первого порядка, и i - индекс кадра. Чтобы найти оптимизированные коэффициенты a* и b*, суммирование квадратичной ошибки предсказания минимизируется:

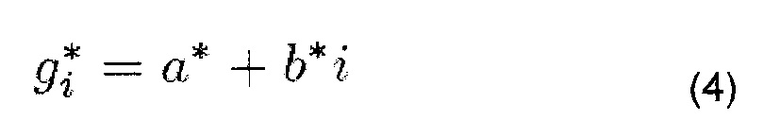

ε - квадратичная ошибка, gj - оригинал предыдущей j-й амплитуды. Для минимизации этой ошибки производная, относящаяся к a и b, просто устанавливается в ноль. При использовании оптимизированных параметров a* и b* оценка каждого gi* обозначается с помощью

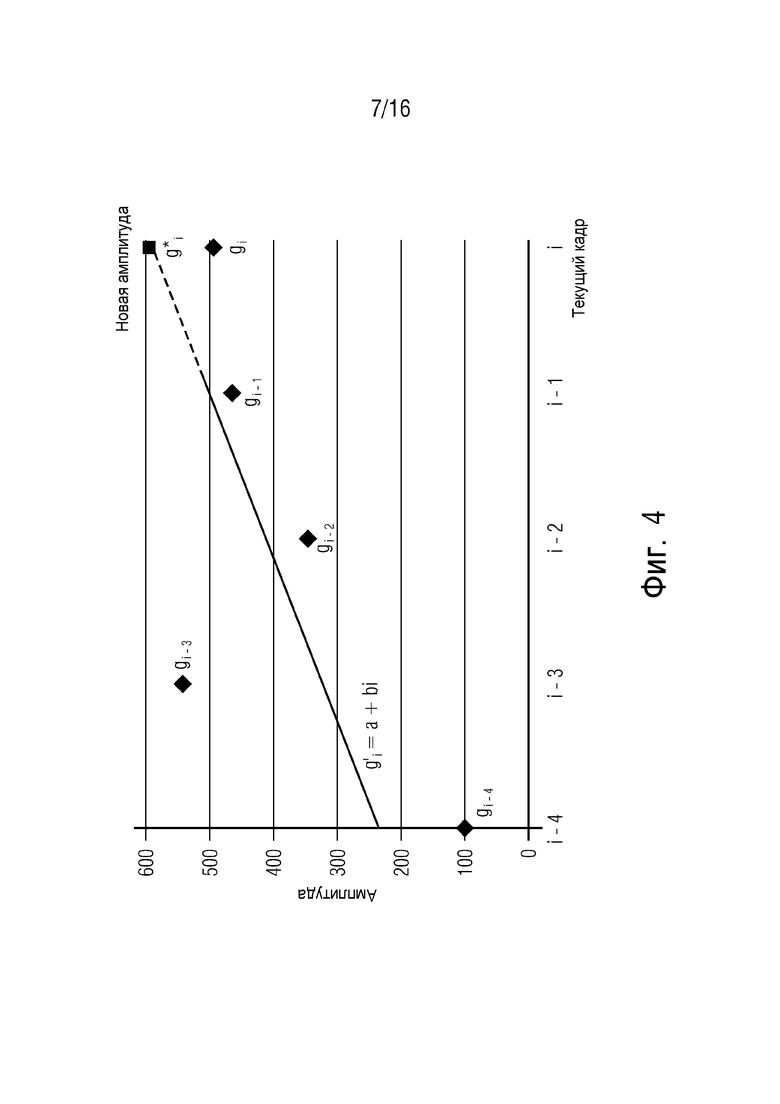

Фиг. 4 показывает предсказание амплитуды, в частности предсказание амплитуды gi*, при использовании линейной регрессии.

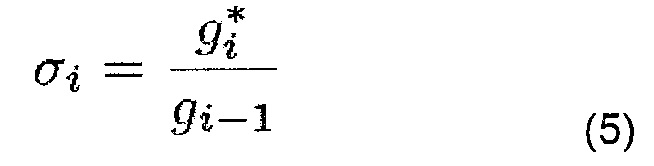

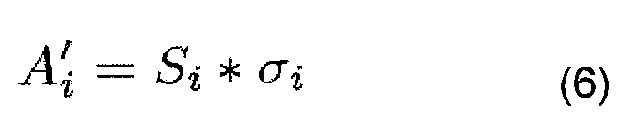

Для получения амплитуды Ai' потерянного пакета i, отношение σi

умножают на коэффициент Si масштабирования:

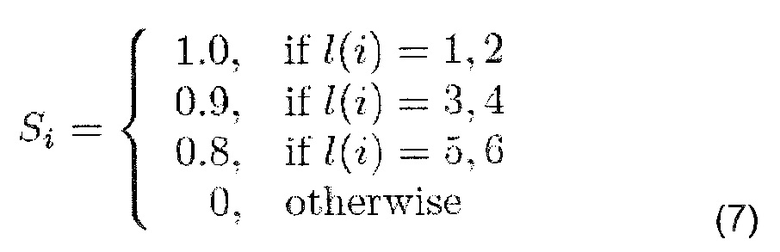

причем коэффициент Si масштабирования зависит от количества последовательных маскируемых кадров l(i):

В [PKJ+11] предложено немного отличающееся масштабирование.

Согласно G.729, впоследствии Ai' будет сглаживаться для предотвращения дискретного ослабления на границах кадра. Окончательная сглаженная амплитуда Ai(n) умножается на возбуждение, полученное из предыдущих компонент PLC.

В последующем рассматривают G.729.1. G.729.1 является основанным на G.729 внедренным кодером с переменной скоростью передачи битов: масштабируемым широкополосным кодером битового потока на 8-32 кбит/сек, совместимым с G.729 [ITU06b].

Согласно G.729.1, как в G.718 (см. выше), предложено адаптивное плавное изменение, которое зависит от стабильности характеристик сигнала ([ITU06b, раздел 7.6.1]). Во время маскирования сигнал обычно ослабляется, основываясь на коэффициенте ослабления, который зависит от параметров класса последнего хорошего принятого кадра и количества последовательно стертых кадров. Коэффициент ослабления дополнительно зависит от стабильности LP фильтров для «невокализованных» кадров. В общем случае ослабление является медленным, если последний хороший принятый кадр находится в устойчивом сегменте, и быстрым, если кадр находится в сегменте перехода.

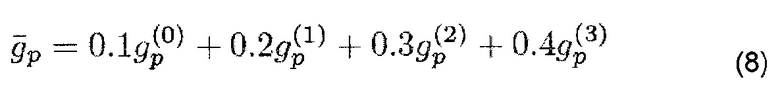

К тому же коэффициент α ослабления зависит от среднего значения тонового усиления за субкадр  ([ITU06b, eq. 163, 164]):

([ITU06b, eq. 163, 164]):

где gp(i) - тоновое усиление в субкадре i.

Таблица 2 показывает схему вычисления α, где

Во время процесса маскирования α используется в следующих средствах маскирования:

2,3

>3

0,4

2,3

>3

ḡp

0,4

2,3

>3

ḡp

0,4

>2

0,2

2,3

>3

0,6θ+0,4

0,4

Таблица 2: Значения коэффициента ослабления α, значение θ является коэффициентом стабильности, вычисляемым из измерения расстояния между смежными фильтрами LP. [ITU06b, раздел 7.6.1].

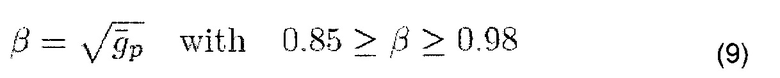

Согласно G.729.1, относительно повторной синхронизации глоттального импульса, поскольку последний импульс возбуждения предыдущего кадра используется для создания периодической части, ее усиление является приблизительно правильным в начале маскируемого кадра и может устанавливаться в 1. Усиление затем линейно ослабляется по всему кадру на основе «выборка за выборкой» для достижения значения α в конце кадра. Формирование энергии вокализованных сегментов экстраполируется при использовании значений усиления тонального возбуждения каждого субкадра последнего хорошего кадра. В общем случае, если эти усиления больше 1, то энергия сигнала увеличивается, если они ниже 1, то энергия уменьшается. α таким образом устанавливается в  , как описано выше, см. [ITU06b, eq. 163, 164]. Значение β обрезается между 0,98 и 0,85, чтобы избежать сильных увеличений и уменьшений энергии, см. [ITU06b, раздел 7.6.4].

, как описано выше, см. [ITU06b, eq. 163, 164]. Значение β обрезается между 0,98 и 0,85, чтобы избежать сильных увеличений и уменьшений энергии, см. [ITU06b, раздел 7.6.4].

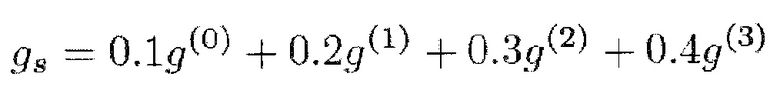

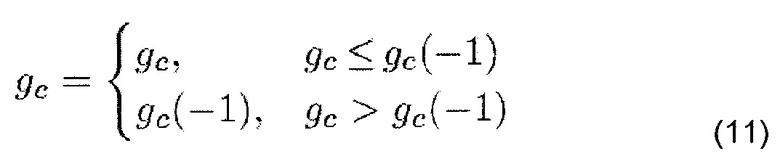

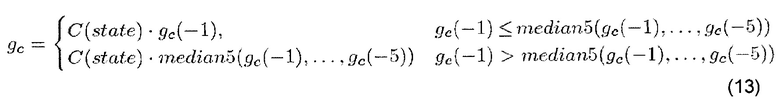

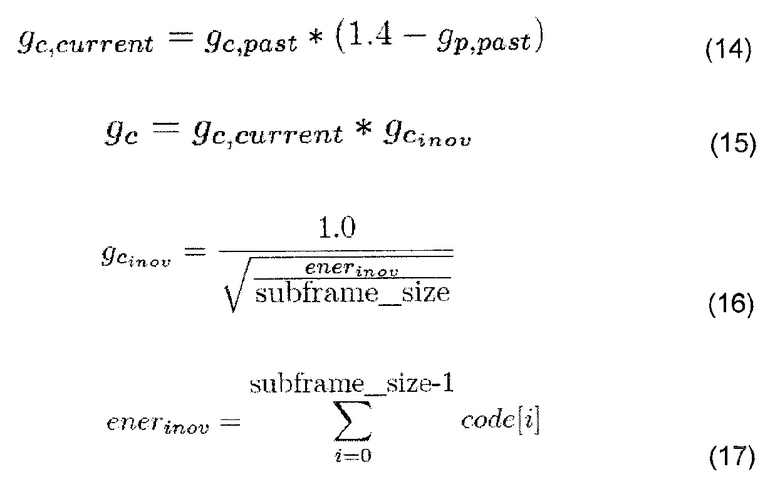

Рассматривая создание случайной части возбуждения, согласно G.729.1 в начале стертого блока инновационное усиление gs инициализируется при использовании инновационного усиления возбуждения каждого субкадра последнего хорошего кадра:

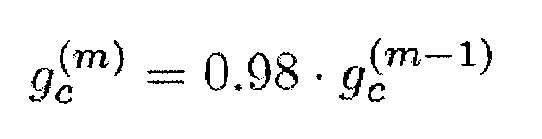

причем g(0), g(1), g(2) и g(3) являются усилениями фиксированной кодовой книги, или инновационными усилениями, четырех субкадров последнего правильно принятого кадра. Ослабление инновационного усиления выполняется следующим образом:

причем gs(1) является инновационным усилением в начале следующего кадра, gs(0) является инновационным усилением в начале текущего кадра, и α является тем, что определено выше в таблице 2. Аналогично периодическому ослаблению возбуждения, усиление таким образом линейно ослабляется по всему кадру на основе «выборка за выборкой», начиная с gs(0) и доходя до значения gs(1) , которое будет достигнуто в начале следующего кадра.

Соответственно, для G.729.1, если последний хороший кадр является «невокализованным», то используется только инновационное возбуждение, и оно дополнительно ослабляется с коэффициентом 0,8. В этом случае предыдущий буфер возбуждения обновляется инновационным возбуждением, поскольку периодическая часть возбуждения не доступна, см. [ITU06b, раздел 7.6.6].

В последующем рассматривают AMR. 3GPP AMR [3GP12b] является кодеком для разговорных сигналов, использующим алгоритм ACELP. AMR имеет возможность кодировать речь с частотой дискретизации 8000 выборок в секунду и скоростью передачи битов между 4,75 и 12,2 кбит/сек и поддерживает сигнализацию кадров описания тишины (DTX/CNG).

В AMR, во время маскирования ошибок (см. [3GP12a]), различают между собой кадры, которые подвергаются ошибкам (битовым ошибкам), и кадры, которые полностью потеряны (вообще нет данных).

Для маскирования ACELP AMR представляет конечный автомат, который оценивает качество канала: чем больше значение счетчика состояний, тем хуже качество канала. Система начинает работу в состоянии 0. Каждый раз, когда обнаруживается плохой кадр, счетчик состояний увеличивается на единицу и насыщается, когда он достигает 6. Каждый раз, когда обнаруживается хороший речевой кадр, счетчик состояний возвращается в ноль, кроме тех случаев, когда состояние равно 6, в этом случае счетчик состояний устанавливается в 5. Поток команд управления конечным автоматом может описываться с помощью следующего C-кода (BFI - индикатор плохого кадра, State - переменная состояния):

if(BFI != 0) {

State = State+1;

}

else if(State == 6) {

State=5;

}

else {

State=0;

}

if(State>6) {

State=6;

}

В дополнение к этому конечному автомату, в AMR проверяются флажки плохого кадра из текущего и предыдущего кадров (prevBFI).

Возможны три различные комбинации:

Первая из этих трех комбинаций - BFI=0, prevBFI=0, состояние=0: ошибки не обнаружены в принятом или в предыдущем принятом речевом кадре. Принятые речевые параметры используются обычным способом при синтезе речи. Текущий кадр речевых параметров сохраняется.

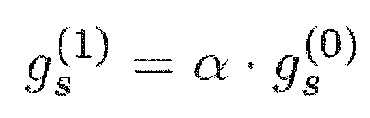

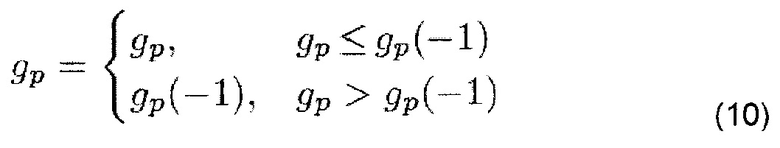

Вторая из этих трех комбинаций - BFI=0, prevBFI=1, состояние = 0 или 5: ошибки не обнаружены в принятом речевом кадре, но предыдущий принятый речевой кадр был плохим. Усиление LTP и усиление фиксированной кодовой книги ограничиваются ниже значений, используемых для последнего принятого хорошего субкадра:

где gp = текущее декодированное усиление LTP, gp (-1)= усиление LTP, используемое для последнего хорошего субкадра (BFI=0), и

где gc=текущее декодированное усиление фиксированной кодовой книги, и gc (-1)=усиление фиксированной кодовой книги, используемое для последнего хорошего субкадра (BFI=0).

Остальная часть принятых речевых параметров обычно используется при синтезе речи. Текущий кадр речевых параметров сохраняется.

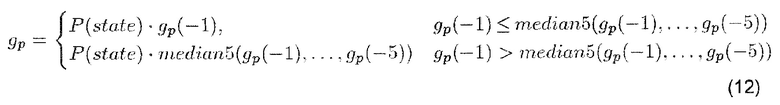

Третья из этих трех комбинаций - BFI=1, prevBFI=0 или 1, состояние = 1... 6: ошибка обнаружена в принятом речевом кадре, и начинается процедура замены и заглушения. Усиление LTP и усиление фиксированной кодовой книги заменяются ослабленными значениями из предыдущих субкадров:

где gp обозначает текущее декодированное усиление LTP и gp(-1),..., gp(-n) обозначают усиление LTP, используемое для последних n субкадров, и median5() обозначает операцию усреднения по 5 точкам и

P(state)=коэффициент ослабления,

где (P(1)=0,98, P(2)=0,98, P(3)=0,8, P(4)=0,3, P(5)=0,2, P(6)=0,2) и state=количество состояний, и

где gc обозначает текущее декодированное усиление фиксированной кодовой книги и gc(-1), ..., gc(-n) обозначают усиление фиксированной кодовой книги, используемое для последних n субкадров, и median5() обозначает операцию усреднения по 5 точкам и C(state)=коэффициент ослабления, где (C(1)=0,98, C(2)=0,98, C(3)=0,98, C(4)=0,98, C(5)=0,98, C(6)=0,7) и state = количество состояний.

В AMR значения LTP-отставания (LTP = долгосрочное предсказание) заменяются предыдущим значением из 4-го субкадра предыдущего кадра (режим 12,2) или немного модифицированными значениями, основываясь на последнем правильно принятом значении (все другие режимы).

Согласно AMR, инновационные принятые импульсы фиксированной кодовой книги из ошибочного кадра используются в том состоянии, в котором они были приняты, когда принимаются поврежденные данные. В случае, когда никакие данные не были приняты, должны использоваться случайные индексы фиксированной кодовой книги.

Рассматривая CNG в AMR, согласно [3GP12a, раздел 6.4] каждый первый потерянный кадр SID заменяют при использовании информации SID из ранее принятых действительных кадров SID, и данная процедура применяется для действительных кадров SID. Для последующих потерянных кадров SID методика ослабления применяется к комфортному шуму, уровень которого будет плавно изменяться на выходе. Поэтому проверяется, выполняется или нет условие, что последнее обновление SID больше 50 кадров (=1 с) назад, если да, то выходной сигнал будет заглушаться (ослабление уровня -6/8 дБ за кадр [3GP12d, dtx_dec{}@sp_dec.c], что приводит к 37,5 дБ в секунду). Следует отметить, что плавное изменение, относящееся к CNG, выполняется в области LP.

В последующем рассматривают AMR-WB. Адаптивное кодирование с переменной скоростью - WB [ITU03, 3GP09c] является кодеком для разговорных сигналов ACELP, основанным на AMR (см. раздел 1.8). Он использует параметрическое расширение полосы пропускания и также поддерживает DTX/CNG. В описании стандарта [3GP12g] приведены примерные решения маскирования, которые являются такими же, как для AMR [3GP12a] с незначительными отклонениями. Поэтому, только различия с AMR описаны в данной работе. Для описания стандарта см. приведенное выше описание.

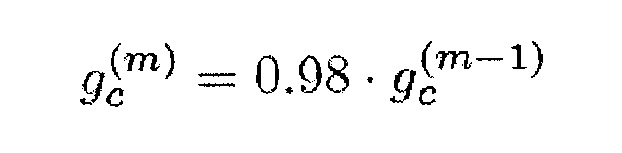

Рассматривая ACELP, в AMR-WB плавное изменение ACELP выполняется, основываясь на эталонном исходном коде [3GP12c] с помощью модификации тонового усиления gp (для вышеприведенного AMR называется усилением LTP), и с помощью модификации кодового усиления gp.

В случае потерянного кадра тоновое усиление gp для первого субкадра является тем же самым, как в последнем хорошем кадре, за исключением того, что оно ограничено между 0,95 и 0,5. Для второго, третьего и последующих субкадров тоновое усиления gp уменьшается с коэффициентом 0,95 и снова ограничивается.

AMR-WB предлагает, чтобы в маскируемом кадре gc было основано на последнем gc:

Для маскирования LTP-отставания в AMR-WB хронология пяти прошлых хороших LTP-отставаний и LTP-усилений используется для поиска наилучшего способа обновления в случае потери кадра. В случае, если кадр принимается с ошибками в символе, выполняется предсказание, пригодно или нет принятое отставание LTP для использования [3GP12g].

Рассматривая CNG, в AMR-WB, если последним правильно принятым кадром был кадр SID и кадр классифицирован как потерянный, то он должен быть заменен информацией последнего действительного кадра SID и должна применяться процедура для действительных кадров SID.

Для последовательно потерянных кадров SID AMR-WB предлагает применять методику ослабления к комфортному шуму, которая будет постепенно уменьшать уровень на выходе. Поэтому проверяется, выполняется или нет условие, что последнее обновление SID было больше чем 50 кадров (=1 с) назад, если да, то выходной сигнал будет заглушаться (ослабление уровня -3/8 дБ за кадр [3GP12f, dtx_dec {} @dtx.c], что приводит к 18,75 дБ в секунду). Следует отметить, что плавное изменение, относящееся к CNG, выполняется в области LP.

Теперь рассматривают AMR-WB+. Адаптивное кодирование с переменной скоростью - WB+ [3GP09a] является переключаемым кодеком, использующим ACELP и TCX (TCX=преобразование кодированного возбуждения) в качестве основных кодеков. Он использует параметрическое расширение полосы пропускания и также поддерживает DTX/CNG.

В AMR-WB+ применяется логика экстраполяции режима для экстраполяции режимов потерянных кадров в пределах искаженного суперкадра. Эта экстраполяция режима основана на том факте, что существует избыточность в определении индикаторов режима. Логика решения (заданная в [3GP09a, фиг. 18]), предложенная AMR-WB+, является следующей:

- Определяется векторный режим (m−1, m0, m1, m2, m3), где m−1 указывает режим последнего кадра предыдущего суперкадра и m0, m1, m2, m3, указывают режимы кадров в текущем суперкадре (декодированном из битового потока), где mk= -1, 0, 1, 2 или 3 (-1: потерянный, 0: ACELP, 1: TCX20, 2: TCX40, 3: TCX80), и где количество потерянных кадров nloss может быть между 0 и 4.

- Если m−1=3 и два из индикаторов режима кадров 0-3 будут равны трем, то все индикаторы будут установлены в три, потому что наверняка, что один кадр TCX80 указан в пределах суперкадра.

- Если только один индикатор кадров 0-3 равен трем (и количество потерянных кадров nloss равно трем), то режим будет установлен в (1, 1, 1, 1), потому что в таком случае 3/4 целевого спектра TCX80 потеряно, и вероятно, что глобальное усиление TCX потеряно.

- Если режим укажет (x, 2, -1, x, x) или (x, -1, 2, x, x), то он будет экстраполироваться к (x, 2, 2, x, x), указывая кадр TCX40. Если режим укажет (x, x, x, 2, -1) или (x, x, -1, 2), то он будет экстраполироваться к (x, x, x, 2, 2), также указывая кадр TCX40. Нужно отметить, что (x, [0, 1], 2, 2, [0, 1]) являются недействительными конфигурациями.

- После этого для каждого кадра, который потерян (режим = -1), режим устанавливается в ACELP (режим=0), если предыдущим кадром был ACELP, и режим устанавливается в TCX20 (режим = 1) для всех других случаев.

Рассматривая ACELP, согласно AMR-WB+, если режим потерянных кадров приводит к mk=0 после экстраполяции режима, тот же самый подход как в [3GP12g] применяется для этого кадра (см. выше).

В AMR-WB+, в зависимости от количества потерянных кадров и экстраполируемого режима, соотнесенные подходы маскирования следующего TCX отличаются (TCX=преобразование кодированного возбуждения):

- Если весь кадр потерян, то применяется аналогичное ACELP маскирование: последнее возбуждение повторяется и маскируемые коэффициенты ISF (немного сдвинутые к их адаптивному среднему значению) используются для синтеза сигнала во временной области. Дополнительно, коэффициент плавного изменения, равный 0,7 за кадр (20 мс) [3GP09b, dec_tcx.c], умножается в области линейного предсказания непосредственно перед синтезом LPC (кодирования с линейным предсказанием).

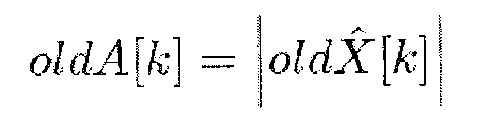

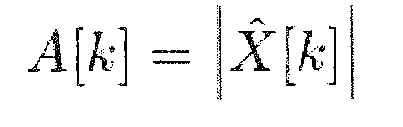

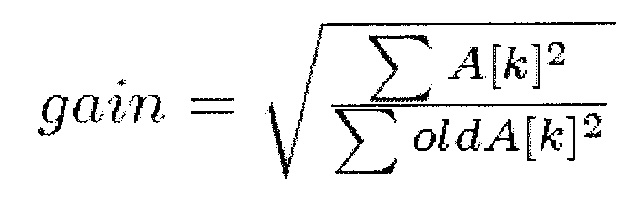

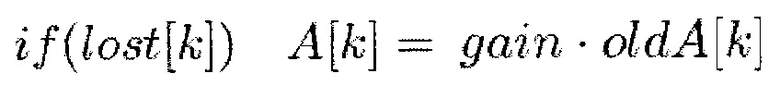

- Если последним режимом был TCX80, а так же режимом экстраполируемого (частично потерянного) суперкадра является TCX80 (nloss=[1, 2], режим=(3, 3, 3, 3, 3)), то маскирование выполняется в области FFT, используя экстраполяцию фазы и амплитуды, учитывая последний правильно принятый кадр. Подход экстраполяции информации фазы не имеет никакого интереса в данной работе (никакого отношения к стратегии плавного изменения) и поэтому не описан. Для дополнительных подробностей см. [3GP09a, раздел 6.5.1.2.4]. По отношению к модификации амплитуды A-WB+, подход, выполняемый для маскирования TCX, состоит из следующих этапов [3GP09a, раздел 6.5.1.2.3]:

- Вычисляется спектр значения предыдущего кадра:

- Вычисляется спектр значения текущего кадра:

- Вычисляется разница усиления энергии непотерянных спектральных коэффициентов между предыдущим и текущим кадром:

- Экстраполируется амплитуда недостающих спектральных коэффициентов, используя:

- В любом другом случае потерянного кадра с mk=[2, 3], целевой TCX (обратное FFT декодированного спектра плюс заполнение шумом (используя уровень шума, декодированный из битового потока)) синтезируется, используя всю доступную информацию (включающую в себя глобальное усиление TCX). Плавное изменение в этом случае не применяется.

Рассматривая CNG, в AMR-WB+ используется тот же самый подход, как в AMR-WB (см. выше).

В последующем рассматривают OPUS. OPUS [IET12] внедряет технологию из двух кодеков: ориентированного на речь SILK (известного как кодек Skype) и с низким временем ожидания CELT (CELT = перекрывающееся преобразование с ограниченной энергией). OPUS может беспроблемно адаптироваться между высокой и низкой скоростями передачи битов, и внутренне он переключается между кодеком линейного предсказания в более низкими скоростями передачи битов (SILK) и кодеком преобразования в более высокими скоростями передачи битов (CELT), так же как гибрид для короткого перекрытия.

Рассматривая сжатие и распаковку звуковых данных SILK, в OPUS существует несколько параметров, которые ослабляются во время маскирования в подпрограмме декодера SILK. Параметр усиления LTP ослабляется с помощью умножения всех коэффициентов LPC или на 0,99, 0,95 или на 0,90 за кадр, в зависимости от количества последовательных потерянных кадров, причем возбуждение создается с помощью использования последнего цикла тонов из возбуждения предыдущего кадра. Параметр отставания тона очень медленно увеличивается во время последовательных потерь. Для одиночных потерь он сохраняется постоянным по сравнению с последним кадром. Кроме того, параметр усиления возбуждения по экспоненте уменьшается с 0,99lostcnt за кадр, так, чтобы параметр усиления возбуждения был равен 0,99 для первого параметра усиления возбуждения, так, чтобы параметр усиления возбуждения был равен 0,992 для второго параметра усиления возбуждения, и так далее. Возбуждение генерируется, используя генератор случайных чисел, который генерирует белый шум с помощью переменного переполнения. К тому же коэффициенты LPC экстраполируются/усредняются, основываясь на последнем правильно принятом наборе коэффициентов. После генерации ослабленного вектора возбуждения маскируемые коэффициенты LPC используются в OPUS для синтеза выходного сигнала во временной области.

Теперь рассматривают CELT в контексте OPUS. CELT является основанным на преобразовании кодеком. Маскирование CELT показывает подход PLC, основанного на тоне, который применяется к до пяти последовательно потерянных кадров. Начиная с 6-го кадра применяется подход шумоподобного маскирования, который генерирует фоновый шум, характеристики которого, как предполагается, звучат как предшествующий фоновый шум.

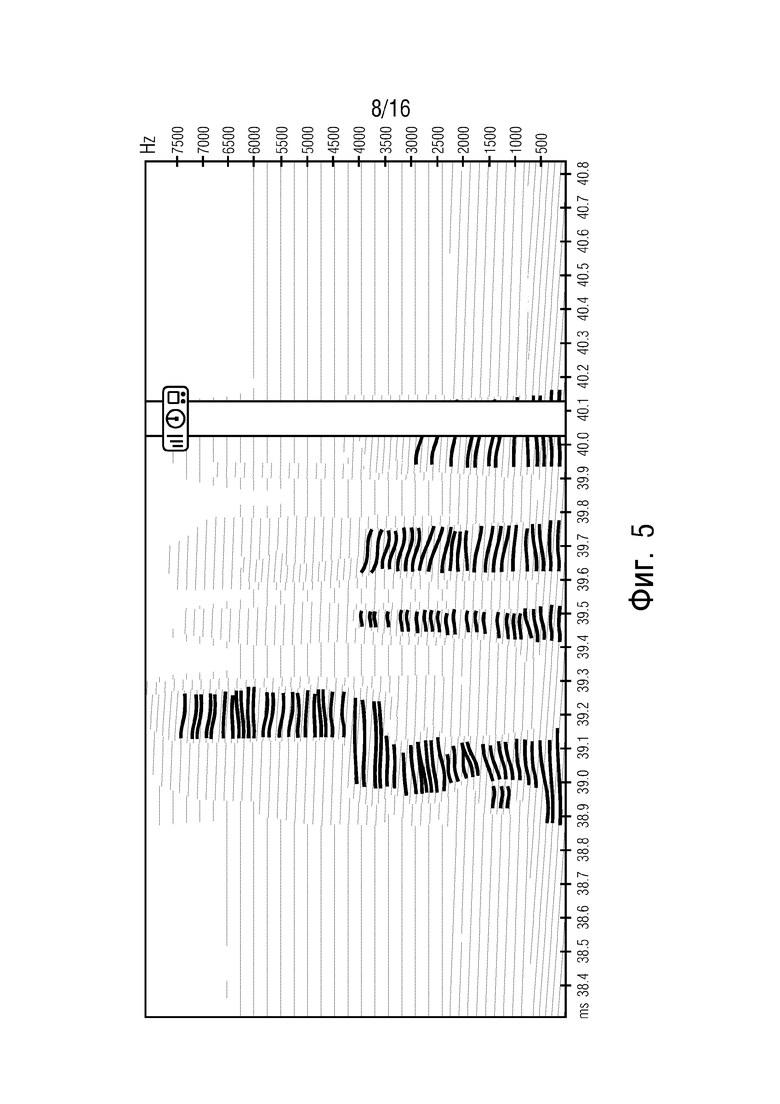

Фиг. 5 показывает режим работы CELT при потере пачки. В частности, фиг. 5 изображает спектрограмму (ось X: время; ось у: частота) маскируемого с помощью CELT речевого сегмента. Светло-серый квадрат указывает первые 5 последовательно потерянных кадров, где применяется основанный на тоне подход PLC. Кроме того, показано шумоподобное маскирование. Нужно отметить, что переключение выполняется немедленно, переход не происходит постепенно.

Рассматривая маскирование на основе тона, в OPUS маскирование на основе тона состоит из обнаружения периодичности в декодированном сигнале с помощью автокорреляции и повторения кадрированного колебательного сигнала (в области возбуждения, используя анализ и синтез LPC), используя смещение тона (отставание тона). Кадрированный колебательный сигнал перекрывается таким образом, чтобы сохранить маскирование наложения спектров во временной области с предыдущим кадром и следующим кадром [IET12]. Дополнительно коэффициент плавного изменения извлекается и применяется с помощью следующего кода:

opus_val32 E1=1, E2=1;

int period;

if (pitch_index <= MAX_PERIOD/2) {

period = pitch_index;

}

else {

period = MAX_PERIOD/2;

}

for (i=0;i<period;i++)

{

E1 += exc[MAX_PERIOD- period+i]* exc[MAX_PERIOD- period+i];

E2+=exc[MAX_PERIOD-2*period+i]* exc[MAX_PERIOD-2*period+i];

}

if (E1>E2) {

E1=E2;

}

decay = sqrt(E1/E2));

attenuation = decay;

В этом коде exc содержит сигнал возбуждения до выборок MAX_PERIOD перед потерей.

Сигнал возбуждения позже умножается на ослабление, затем синтезируется и выводится через синтез LPC.

Алгоритм плавного изменения для подхода во временной области может быть получен в итоге в таком виде:

- Находят равновесную энергию тона последнего цикла тонов перед потерей.

- Находят равновесную энергию тона второго последнего цикла тонов перед потерей.

- Если энергия увеличивается, то ее ограничивают так, чтобы она оставалась постоянной: ослабление =1.

- Если энергия уменьшается, то продолжают то же самое ослабление во время маскирования.

Рассматривая шумоподобное маскирование, согласно OPUS для 6-ого и последующих последовательных потерянных кадров подход замены шумом в области MDCT выполняется для моделирования фонового комфортного шума.

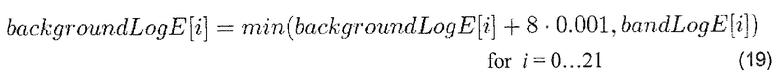

Рассматривая отслеживание уровня и формы фонового шума, в OPUS оценка фонового шума выполняется следующим образом: после анализа MDCT квадратный корень энергий диапазона MDCT вычисляется для диапазона частот, где группирование элементов MDCT выполняется в соответствии со шкалой барков согласно [IET12, таблица 55]. Затем квадратный корень энергий преобразовывается в область log2 с помощью:

причем e - число Юлера, bandE - квадратный корень из диапазона MDCT, и eMeans - вектор констант (необходимый для получения результирующего нулевого среднего значения, которое приводит к усовершенствованному усилению кодирования).

В OPUS фоновый шум регистрируется на стороне декодера следующим образом [IET12, amp2Log2 и log2Amp@quant_bands.c]:

МБ! Вставить формулу 19 на стр. 19 оригинала

Отслеживаемая минимальная энергия в основном определяется с помощью квадратного корня из энергии диапазона текущего кадра, но увеличение от одного кадра к следующему ограничено 0,05 дБ.

Рассматривая применение уровня и формы фонового шума, согласно OPUS, если применяется шумоподобное PLC, то backgroundLogE, который извлекается в последнем хорошем кадре, используется и преобразовывается обратно в линейную область:

где e - число Юлера, и eMeans - тот же самый вектор констант, как для преобразования из «линейной в логарифмическую область».

Текущей процедурой маскирования является заполнение кадра MDCT белым шумом, произведенным с помощью генератора случайных чисел, и масштабирование этого белого шума таким способом, чтобы он соответствовал в диапазоне энергии bandE. Впоследствии применяется обратное MDCT, что приводит к сигналу во временной области. После перекрытия со сложением и компенсации предыскажений (как при обычном декодировании) он выводится.

В последующем рассматривают MPEG-4 HE-AAC (MPEG=экспертная группа по кинематографии; HE-AAC=высокоэффективное усовершенствованное кодирование звука). Высокоэффективное усовершенствованное кодирование звука состоит из основанного на преобразовании звукового кодека (AAC), дополненного параметрическим расширением полосы пропускания (SBR).

Рассматривая AAC (AAC=перспективное кодирование звука), консорциум DAB определяет для AAC в DAB+ плавное изменение к нулю в частотной области [EBU10, раздел A1.2] (DAB-цифровое радиовещание). Характер плавного изменения, например, пилообразный сигнал ослабления, может устанавливаться или корректироваться пользователем. Спектральные коэффициенты из последнего AU (AU=блок доступа) ослабляются с помощью коэффициента, соответствующего характеристикам плавного изменения, и затем передаются к сопоставлению «частота/время». В зависимости от пилообразного сигнала ослабления маскирование переключается на заглушение после множества последовательных недействительных AU, что означает, что весь спектр будет установлен в 0.

Консорциум DRM (DRM=цифровое управление правами) определяет для AAC в DRM плавное изменение в частотной области [EBU12, раздел 5.3.3]. Маскирование воздействует на спектральные данные непосредственно перед окончательным преобразованием «частота/время». Если множество кадров повреждены, то маскирование сначала воплощает плавное изменение, основываясь на немного модифицированных спектральных значениях из последнего действительного кадра. Кроме того, аналогично DAB+, характер плавного изменения, например, пилообразный сигнал ослабления, может устанавливаться или корректироваться пользователем. Спектральные коэффициенты из последнего кадра ослабляются с помощью коэффициента, соответствующего характеристикам плавного изменения, и затем передаются к сопоставлению «частота/время». В зависимости от пилообразного сигнала ослабления маскирование переключается на заглушение после множества последовательных недействительных кадров, что означает, что весь спектр будет установлен в 0.

3GPP представляет для AAC в усовершенствованном aacPlus плавное изменение в частотной области, аналогичное DRM [3GP12e, раздел 5.1]. Маскирование воздействует на спектральные данные непосредственно перед окончательным преобразованием «частота/время». Если множество кадров повреждены, то маскирование сначала воплощает постепенное изменение, основываясь на немного модифицированных спектральных значениях из последнего хорошего кадра. Полное плавное изменение использует 5 кадров. Спектральные коэффициенты из последнего хорошего кадра копируются и ослабляются с коэффициентом:

fadeOutFac=2-(nFadeOutFrame/2)

с nFadeOutFrame в качестве счетчика кадров с последнего хорошего кадра. После пяти кадров плавного изменения маскирование переключается к заглушению, что означает, что весь спектр будет установлен в 0.

Lauber и Sperschneider представляют для AAC покадровое плавное изменение спектра MDCT, основываясь на экстраполяции энергии [LS01, раздел 4.4]. Формы энергии предыдущего спектра могут использоваться для экстраполяции формы оцененного спектра. Экстраполяция энергии может выполняться независимо от методик маскирования в качестве вида последующего маскирования.

Рассматривая AAC, вычисление энергии выполняется на основе диапазона коэффициента масштабирования для того, чтобы быть близко к критическим диапазонам человеческой слуховой системы. Отдельные значения энергии уменьшаются на основе «кадр за кадром» для постепенного уменьшения громкости, например, для плавного изменения сигнала. Это становится необходимым, поскольку вероятность того, что оцененные значения представляют текущий сигнал, уменьшается быстро с течением времени.

Для генерации спектра, который будет выводиться, предлагают повторение кадра или замену шумом [LS01, разделы 3.2 и 3.3].

Quackenbusch и Driesen предлагают для AAC экспоненциальное покадровое плавное изменение к нулю [QD03]. Предлагается повторение смежного набора коэффициентов времени/частоты, причем каждое повторение имеет экспоненциально увеличивающееся ослабление, таким образом постепенно выполняя плавное изменение к заглушению в случае длительных перерывов в работе.

Рассматривая SBR (SBR=репликация спектральной полосы) в MPEG-4 HE-AAC, 3GPP предлагает для SBR в усовершенствованном aacPlus буферизовать декодированные данные огибающей и, в случае потери кадра, многократно использовать буферизированные энергии переданных данных огибающей и уменьшать их с помощью постоянного показателя, равного 3 дБ для каждого маскируемого кадра. Результат подается в обычный процесс декодирования, где корректировка огибающей использует его для вычисления усиления, используемого для коррекции исправленных высокочастотных диапазонов, созданных с помощью генератора ВЧ. Декодирование SBR затем происходит как обычно. Кроме того, дельта-кодированный уровень шума и значения уровня гармонических перегрузок удаляются. Поскольку нет никакого отличия от предыдущей информации, декодированный уровень шума и уровни гармонических перегрузок остаются пропорциональными энергии сгенерированного сигнала ВЧ [3GP12e, раздел 5.2].

Консорциум DRM определил для SBR вместе с AAC ту же самую методику, как 3GPP [EBU12, раздел 5.6.3.1]. Кроме того, консорциум DAB определяет для SBR в DAB+ ту же самую методику, как 3GPP [EBU10, раздел A2].

В последующем MPEG-4 CELP и MPEG-4 рассматривают HVXC (HVXC = гармоническое кодирование с векторным возбуждением). Консорциум DRM определяет для SBR вместе с CELP и HVXC [EBU12, раздел 5.6.3.2], что минимальное требуемое маскирование для SBR для кодеков для разговорных сигналов должно применять предопределенный набор значений данных всякий раз, когда обнаруживается поврежденный кадр SBR. Эти значения приводят к статической спектральной огибающей высокочастотного диапазона на относительно низком уровне воспроизведения, показывая спад к высоким частотам. Цель состоит просто в обеспечении того, чтобы никакие потенциально громкие пачки звуков с плохими характеристиками не достигали ушей слушателя посредством вставки «комфортного шума» (в противоположность строгому заглушению). Фактически это не является реальным плавным изменением, а скорее переходом к конкретному уровню энергии для вставки некоторого комфортного шума.

Впоследствии упоминается альтернативный вариант [EBU12, раздел 5.6.3.2], который многократно использует последние правильно декодированные данные и медленное плавное изменение уровней (L) к 0, аналогично случаю AAC+SBR.

Теперь рассматривают MPEG-4 HILN (HILN=гармоники и одиночные линии плюс шум). Meine и др. представляют плавное изменение для параметрического кодека MPEG-4 HILN [ISO09] в параметрической области [MEP01]. Для длительных гармонических компонент хорошим заданным по умолчанию режимом работы для замены поврежденных дифференцированно кодированных параметров является сохранение частоты постоянной для уменьшения амплитуды с коэффициентом ослабления (например, -6 дБ), и предоставление возможности спектральной огибающей сходиться к амплитуде усредненной низкочастотной характеристики. Альтернативно, спектральная огибающая должна сохраняться неизменной. Рассматривая амплитуды и спектральные огибающие, компоненты шума могут обрабатываться тем же самым образом, как гармонические компоненты.

В последующем рассматривают отслеживание уровня фонового шума в предшествующем уровне техники. Rangachari и Loizou [RL06] обеспечивают хороший краткий обзор нескольких способов и обсуждают некоторые из их ограничений. Способами для отслеживания уровня фонового шума являются, например, процедура отслеживания минимума [RL06] [Coh03] [SFB00] [Dob95], основанная на VAD (VAD = обнаружение речевой активности); фильтр Калмана, [Gan05] [BJH06], декомпозиция подпространства [BP06] [HJHOSj; мягкое решение [SS98] [MPC89] [HE95] и статистическая информация о минимумах.

Подход статистической информации о минимумах выбран для использования в рамках USAC-2 (USAC=объединенное кодирование речи и звука) и впоследствии изложен более подробно.

Оценка спектральной плотности мощности шума, основанная на оптимальном сглаживании и статистической информации о минимумах [Mar01], представляет оценочную функцию шума, которая имеет возможность работать независимо от сигнала, являющегося активным речевым или фоновым шумом. В отличие от других способов, алгоритм статистической информации о минимумах не использует явного порогового значения, чтобы различать речевую активность и паузу в речи, и поэтому более близко соотносится со способами мягкого решения, чем с традиционными способами распознавания активности речи. Аналогично способам мягкого решения, может также обновляться PSD (спектральная плотность мощности) оцененного шума во время речевой активности.

Способ статистической информации о минимумах базируется на двух наблюдениях, а именно, что речь и шум обычно статистически независимы и что мощность шумного речевого сигнала часто уменьшается к уровню мощности шума. Поэтому можно извлекать точную оценку PSD (PSD = спектральная плотность мощности) шума с помощью отслеживания минимума PSD сигнала шума. Так как минимум меньше (или в других случаях равен) среднего значения, то способ отслеживания минимума требует компенсации смещения.

Смещение является функцией дисперсии сглаженного сигнала PSD и как таковое зависит от параметра сглаживания оценочной функции PSD. В отличие от ранее разработанного отслеживания минимума, которое использует постоянный параметр сглаживания и постоянную коррекцию смещения минимума, используется зависящее от времени и частоты сглаживание PSD, которое также требует зависящей от времени и частоты компенсации смещения.

Использование отслеживания минимума обеспечивает грубую оценку мощности шума. Однако существуют некоторые недостатки. Сглаживание с фиксированным параметром сглаживания расширяет пики речевой активности сглаженной оценки PSD. Это приведет к неточным оценкам шума, поскольку подвижное окно для поиска минимума может смещаться в широкие максимумы. Поэтому близкие к единице параметры сглаживания не могут использоваться, и, как следствие, у оценки шума будет относительно большая дисперсия. Кроме того, оценка шума смещается к нижним значениям. К тому же в случае увеличения мощности шума отслеживание минимумов отстает.

Основанное на MMSE отслеживание PSD шума с низкой сложностью [HHJ10], представляет подход PSD фонового шума, использующий поиск MMSE, используемый на спектре DFT (дискретного преобразования Фурье). Алгоритм состоит из следующих этапов обработки:

- Вычисляется оценочная функция максимальной вероятности, основываясь на PSD шума предыдущего кадра.

- Вычисляется минимальная среднеквадратическая оценочная функция.

- Оценивается оценочная функция максимальной вероятности, используя направленный на решение подход [EM84].

- Вычисляется обратный коэффициент смещения, предполагая, что речевые и шумовые коэффициенты DFT имеют распределение Гаусса.

- Сглаживается оцененная спектральная плотность мощности шума.

Также существует подход системы обеспечения безопасности, применяемый для того, чтобы избежать полной блокировки алгоритма.

Отслеживание нестационарного шума, основанное на управляемой данными рекурсивной оценке мощности шума [EH08], представляет способ оценки дисперсии спектра шума из речевых сигналов, засоренных источниками в значительной мере нестационарного шума. Этот способ также использует сглаживание в направлении времени/частоты.

Алгоритм оценки шума с низкой сложностью, основанный на сглаживании оценки мощности шума и коррекции смещения оценки [Yu09], расширяет подход, представленный в [EH08]. Основным отличием является то, что спектральная функция усиления для оценки мощности шума находится с помощью итерационного управляемого данными способа.

Статистические способы улучшения шумной речи [Mar03] комбинируют подход статистической информации о минимумах, приведенный в [Mar01], с модификацией усиления с помощью мягкого решения [MCA99], с оценкой априорного SNR [MCA99], с адаптивным ограничением усиления [MC99] и со средством оценки логарифма спектральной амплитуды MMSE [EM85].

Плавное изменение особенно интересно для множества речевых и звуковых кодеков, в частности, для AMR (см. [3GP12b]) (включающего в себя ACELP и CNG), AMR-WB (см. [3GP09c]) (включающего в себя ACELP и CNG), AMR-WB+ (см. [3GP09a]) (включающего в себя ACELP, TCX и CNG), G.718 (см. [ITU08a]), G.719 (см. [ITU08b]), G.722 (см. [ITU07]), G.722.1 (см. [ITU05]), G.729 (см. [ITU12, CPK08, PKJ+11]), MPEG-4 HE-AAC/усовершенствованного aacPlus (см. [EBU10, EBU12, 3GP126, LS01, QD03]) (включающего в себя AAC и SBR), MPEG-4 HILN (см. [ISO09, MEP01]), и OPUS (см. [IET12]) (включающего в себя SILK и CELT).

В зависимости от кодека плавное изменение выполняется в различных областях:

Для кодеков, которые используют LPC, постепенное изменение выполняется в области линейного предсказания (также известной, как область возбуждения). Это сохраняется для кодеков, которые основаны на ACELP, например, для AMR, AMR-WB, ядра ACELP AMR-WB+, G.718, G.729, G.729.1, ядра SILK в OPUS; кодеков, которые дополнительно обрабатывают сигнал возбуждения, используя частотно-временное преобразование, например, для ядра TCX AMR-WB+, ядра CELT в OPUS; и для схем генерации комфортного шума (CNG), которые работают в области линейного предсказания, например, для CNG в AMR, CNG в AMR-WB, CNG в AMR-WB+.

Для кодеков, которые непосредственно преобразовывают временной сигнал в частотную область, плавное изменение выполняется в спектральной области/области поддиапазонов. Это остается правильным для кодеков, которые основаны на MDCT или аналогичном преобразовании, таких как AAC в MPEG-4 HE-AAC, G.719, G.722 (в области поддиапазонов) и G.722.1.

Для параметрических кодеков плавное изменение применяется в параметрической области. Это остается правильным для MPEG-4 HILN.

Рассматривая скорость плавного изменения и кривую плавного изменения, плавное изменение обычно реализуется с помощью применения коэффициента ослабления, который применяется к представлению сигнала в соответствующей области. Размер коэффициента ослабления управляет скоростью плавного изменения и кривой плавного изменения. В большинстве случаев коэффициент ослабления применяется по кадрам, но также используется и применение «по выборкам», см., например, G.718 и G.722.

Коэффициент ослабления для конкретного сегмента сигнала может обеспечиваться двумя способами, абсолютным и относительным.

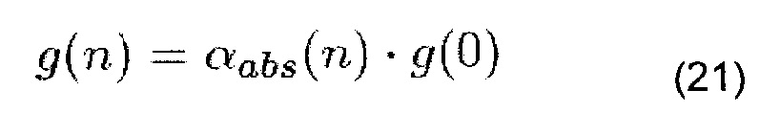

В случае, когда коэффициент ослабления обеспечивается абсолютно, эталонным уровнем всегда является уровень последнего принятого кадра. Абсолютные коэффициенты ослабления обычно начинаются со значения, которое близко к 1, для сегмента сигнала непосредственно после последнего хорошего кадра, и затем снижаются быстрее или медленнее к 0. Кривая плавного изменения непосредственно зависит от этих коэффициентов. Это, например, случай маскирования, описанного в приложении IV G.722 (см., в частности [ITU07, фиг. IV.7]), где кривые возможного плавного изменения линейны или фракционно линейны. Учитывая коэффициент усиления g(n), где g(0) представляет коэффициент усиления последнего хорошего кадра, коэффициент αabs(n) абсолютного ослабления, коэффициент усиления любого последующего потерянного кадра, может извлекаться следующим образом

В случае, когда коэффициент ослабления обеспечивается относительно, эталонным уровнем является уровень из предыдущего кадра. У этого есть преимущество в случае процедуры рекурсивного маскирования, например, если уже ослабленный сигнал дополнительно повторно обрабатывается и ослабляется.

Если коэффициент ослабления применяется рекурсивно, то он может быть постоянным значением, независимым из количества последовательно потерянных кадров, например, 0,5 для G.719 (см. выше); постоянным значением по отношению к количеству последовательно потерянных кадров, например, как предложено для G.729 в [CPK08]: 1,0 для первых двух кадров, 0,9 для следующих двух кадров, 0,8 для кадров 5 и 6, и 0 для всех последующих кадров (см. выше); или значением, которое соотносится с количеством последовательно потерянных кадров и которое зависит от характеристик сигнала, например, более быстрым плавным изменением для неустойчивого сигнала и более медленным плавным изменением для устойчивого сигнала, например, G.718 (см. вышеуказанный раздел и [ITU08a, таблица 44]);

Принимая, что относительный коэффициент постепенного изменения 0≤arel(n)≤1, тогда как n является количеством потерянных кадров (n≥1); коэффициент усиления любого последующего кадра может извлекаться следующим образом

что приводит к экспоненциальному плавному изменению.

Рассматривая процедуру плавного изменения, обычно определяется коэффициент ослабления, но в некоторых стандартах применения (DRM, DAB+) его оставляют на усмотрение изготовителя.

Если различные части сигнала плавно изменяются отдельно, то различные коэффициенты ослабления могут применяться, например, для плавного изменения тональных компонент с конкретной скоростью, а шумоподобных компонент - с другой скоростью (например, AMR, SILK).

Обычно, конкретное усиление применяется к целому кадру. Когда плавное изменение выполняется в спектральной области, это - единственный возможный путь. Однако, если плавное изменение выполняется во временной области или в области линейного предсказания, то возможно более детализированное плавное изменение. Такое более детализированное плавное изменение применяется в G.718, где отдельные коэффициенты усиления извлекаются для каждой выборки с помощью линейной интерполяции между коэффициентом усиления последнего кадра и коэффициентом усиления текущего кадра.

Для кодеков с переменной продолжительностью кадра постоянный коэффициент относительного ослабления приводит к отличающейся скорости плавного изменения в зависимости от продолжительности кадра. Это, например, случай AAC, где продолжительность кадра зависит от частоты дискретизации.

Для применения применяемой плавно изменяющейся кривой к временной форме последнего принятого сигнала, (статические) коэффициенты плавного изменения могут дополнительно корректироваться. Такая дополнительная динамическая корректировка, например, применяется для AMR, где учитывается среднее значение предыдущих пяти коэффициентов усиления (см. [3GP12b] и раздел 1.8.1). Прежде, чем выполняется какое-либо ослабление, текущее усиление устанавливается в среднее значение, если данное среднее значение меньше последнего усиления, иначе используется последнее усиление. Кроме того, такая дополнительная динамическая корректировка, например, применяется для G729, где амплитуда предсказывается с помощью использования линейной регрессии предыдущих коэффициентов усиления (см. [CPK08, PKJ+11] и раздел 1.6). В этом случае результирующий коэффициент усиления для первых маскированных кадров может превышать коэффициент усиления последнего принятого кадра.

Рассматривая целевой уровень плавного изменения, за исключением G.718 и CELT, целевой уровень 0 для всех проанализированных кодеков включает в себя генерацию комфортного шума этих кодеков (CNG).

В G.718 плавное изменение тонального возбуждения (представляющего тональные компоненты) и плавное изменение случайного возбуждения (представляющего шумоподобные компоненты) выполняются отдельно. Хотя коэффициент усиления тона плавно изменяется к нулю, инновационный коэффициент усиления плавно изменяется к энергии возбуждения CNG.

Предполагая, что коэффициенты относительного ослабления заданы, это приводит - основываясь на формуле (23)- к следующему коэффициенту абсолютного ослабления:

с gn, являющимся усилением возбуждения, используемым во время генерации комфортного шума. Эта формула соответствует формуле (23), когда gn=0.

G.718 не выполняет плавного изменения в случае DTX/CNG.

В CELT нет никакого плавного изменения к целевому уровню, но после 5 кадров тонального маскирования (включающего в себя плавное изменение), уровень немедленно переключается к целевому уровню в 6-ом последовательно потерянном кадре. Уровень извлекается по диапазонам, используя формулу (19).

Рассматривая целевую форму спектра плавного изменения, все проанализированные кодеки, основанные на чистом преобразовании (AAC, G.719, G.722, G.722.1), так же как SBR просто продлевают форму спектра последнего хорошего кадра во время плавного изменения.

Различные кодеки для разговорных сигналов плавно изменяют форму спектра к среднему значению, используя синтез LPC. Среднее значение может быть статичным (AMR) или адаптивным (AMR-WB, AMR-WB+, G.718), тогда как последнее извлекают из статического среднего значения и краткосрочного среднего значения (извлекаемого с помощью усреднения последних n наборов коэффициентов LP) (LP=линейное предсказание).

Все модули CNG в обсуждаемых кодеках AMR, AMR-WB, AMR-WB+, G.718 продлевает форму спектра последнего хорошего кадра во время плавного изменения.

Рассматривая отслеживания уровня фонового шума, существует пять разных подходов, известных из литературы:

- основанный на детекторе голосовой активности: основан на SNR/VAD, но его очень сложно настраивать и тяжело использовать для речи с низким SNR.

- схема мягкого решения: подход мягкого решения учитывает вероятность присутствия речи [SS98] [MPC89] [HE95].

- статистическая информация о минимумах: минимум PSD отслеживается, удерживая некоторое количество значений в течение времени в буфере, таким образом предоставляя возможность найти минимальный шум из прошлых выборок [Mar01] [HHJ10] [EH08] [Yu09].

- фильтрование Калмана: алгоритм использует последовательность измерений, наблюдаемых в течение времени, содержащих шум (случайные колебания), и производит оценки PSD шума, которые имеют тенденцию быть более точными, чем основанные только на одном единственном измерении. Фильтр Калмана воздействует рекурсивно на потоки шумных входных данных для создания статистически оптимальной оценки состояния системы [Gan05] [BJH06].

- декомпозиция подпространства: этот подход пытается выполнить декомпозицию шумоподобного сигнала на чистый речевой сигнал и шумовую часть, используя, например, KLT (преобразование Карунена-Лоэва, также известное как анализ главных компонент) и/или DFT (дискретное преобразование Фурье). Затем собственные векторы/собственные значения могут отслеживаться, используя произвольный алгоритм сглаживания [BP06] [HJH08].

EP 2 026 330 A1 раскрывает устройство и способ маскирования потери кадров. Тоновый период текущего потерянного кадра получается на основе тонового периода последнего хорошего кадра перед текущим потерянным кадром. Сигнал возбуждения текущего потерянного кадра восстанавливается на основе тонового периода текущего потерянного кадра и сигнала возбуждения последнего хорошего кадра перед потерянным кадром. Таким образом уменьшается контраст прослушивания в приемнике, и улучшается качество речи. Дополнительно, в EP 2 026 330 A1 тоновый период последовательных потерянных кадров корректируется на основе тенденции изменения тонового периода последнего хорошего кадра перед потерянным кадром.

Задачей настоящего изобретения является обеспечение улучшенных концепций для систем кодирования звука. Задача настоящего изобретения решается с помощью устройства по п. 1, способа по п. 12 и компьютерной программы по п. 13.

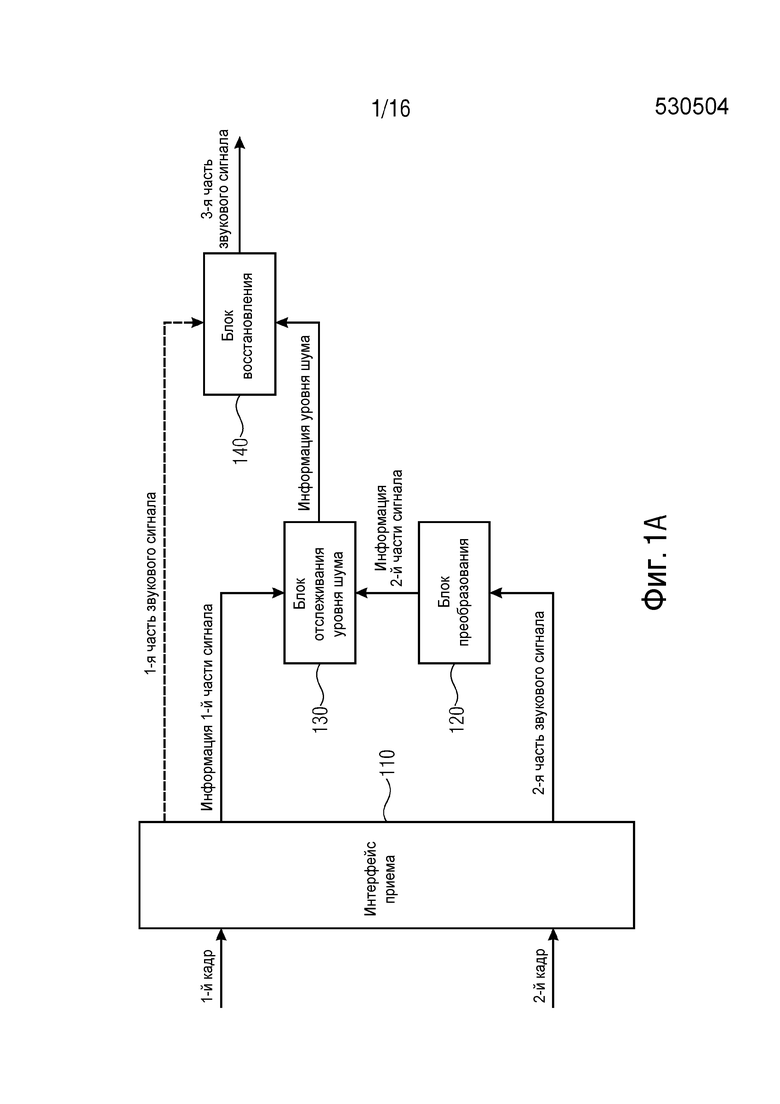

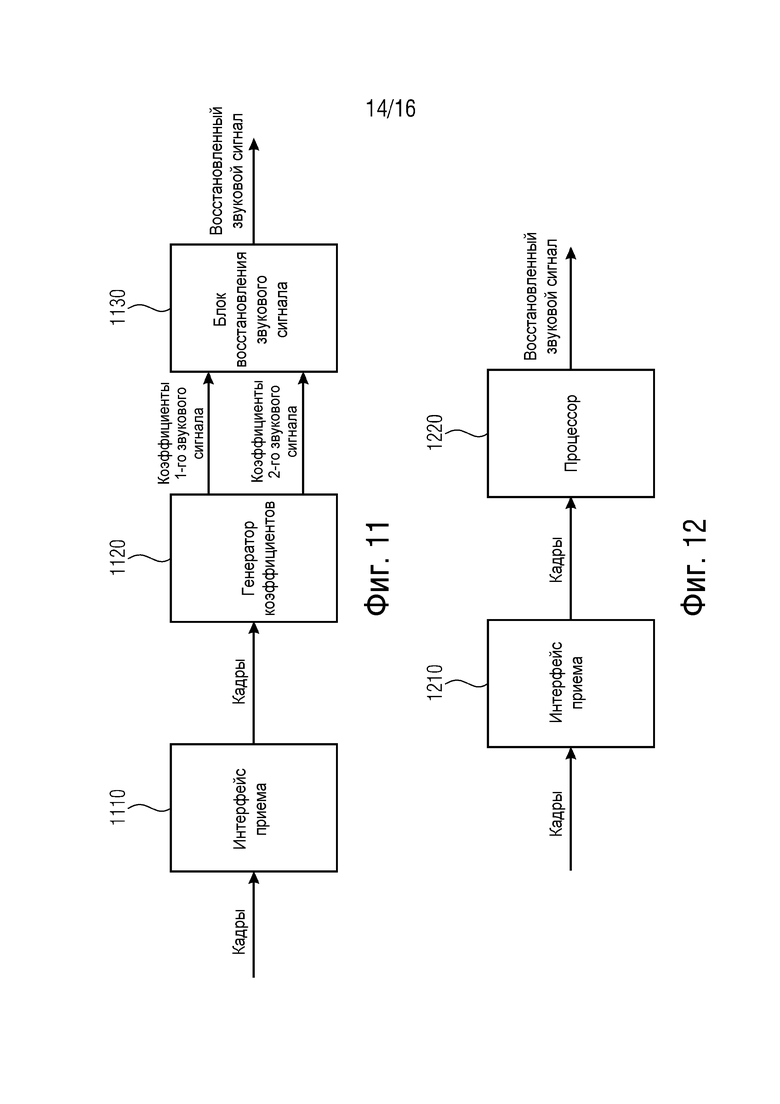

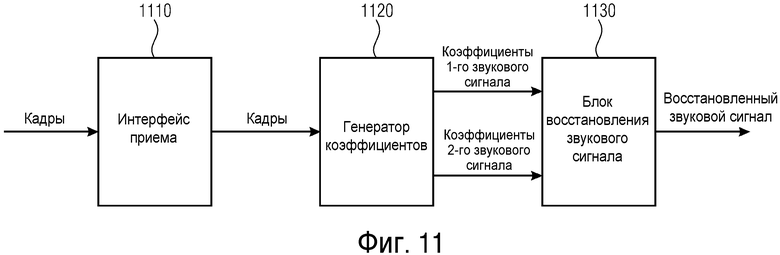

Обеспечено устройство для декодирования кодированного звукового сигнала для получения восстановленного звукового сигнала. Данное устройство содержит интерфейс приема для приема одного или большего количества кадров, генератор коэффициентов и средство восстановления сигнала. Генератор коэффициентов конфигурируется для определения, если текущий кадр из одного или большего количества кадров принимается с помощью интерфейса приема и если текущий кадр, принимаемый с помощью интерфейса приема, не поврежден, одного или большего количества коэффициентов первого звукового сигнала, содержащихся в текущем кадре, причем указанный один или большее количество коэффициентов первого звукового сигнала указывают характеристику кодированного звукового сигнала, и одного или большего количества коэффициентов шума, указывающих фоновый шум кодированного звукового сигнала. Кроме того, генератор коэффициентов конфигурируется для генерации одного или большего количества коэффициентов второго звукового сигнала в зависимости от одного или большего количества коэффициентов первого звукового сигнала и в зависимости от одного или большего количества коэффициентов шума, если текущий кадр не принимается с помощью интерфейса приема или если текущий кадр, принимаемый с помощью интерфейса приема, поврежден. Средство восстановления звукового сигнала конфигурируется для восстановления первой части восстановленного звукового сигнала в зависимости от одного или большего количества коэффициентов первого звукового сигнала, если текущий кадр принимается с помощью интерфейса приема и если текущий кадр, принимаемый с помощью интерфейса приема, не поврежден. Кроме того, средство восстановления звукового сигнала конфигурируется для восстановления второй части восстановленного звукового сигнала в зависимости от одного или большего количества коэффициентов второго звукового сигнала, если текущий кадр не принимается с помощью интерфейса приема или если текущий кадр, принимаемый с помощью интерфейса приема, поврежден.

В некоторых вариантах осуществления один или большее количество коэффициентов первого звукового сигнала могут, например, быть одним или большим количеством коэффициентов фильтра линейного предсказания кодированного звукового сигнала. В некоторых вариантах осуществления один или большее количество коэффициентов первого звукового сигнала могут, например, быть одним или большим количеством коэффициентов фильтра линейного предсказания кодированного звукового сигнала.

Согласно варианту осуществления один или большее количество коэффициентов шума могут, например, быть одним или большим количеством коэффициентов фильтра линейного предсказания, указывающих фоновый шум кодированного звукового сигнала. В варианте осуществления один или большее количество коэффициентов фильтра линейного предсказания могут, например, представлять форму спектра фонового шума.

В варианте осуществления генератор коэффициентов может, например, конфигурироваться для определения одной или большего количества вторых частей звукового сигнала таким образом, чтобы одна или большее количество вторых частей звукового сигнала были одним или большим количеством коэффициентов фильтра линейного предсказания восстановленного звукового сигнала, или таким образом, чтобы один или большее количество коэффициентов первого звукового сигнала были одной или большим количеством спектральных пар иммитанса восстановленного звукового сигнала.

Согласно варианту осуществления генератор коэффициентов может, например, конфигурироваться для генерации одного или большего количества коэффициентов второго звукового сигнала с помощью применения формулы:

fcurrent[i]=α∙flast[i]+(1-α)-ptmean[i]

в которой fcurrent[i] обозначает один из одного или большего количества коэффициентов второго звукового сигнала, в которой flast[i] обозначает один из одного или большего количества коэффициентов первого звукового сигнала, в которой ptmean[i] является одним из одного или большего количества коэффициентов шума, в которой α является действительным числом при 0≤α≤1, и в которой i является индексом. В варианте осуществления 0<α<1.

Согласно варианту осуществления flast[i] обозначает коэффициент фильтра линейного предсказания кодированного звукового сигнала и причем fcurrent[i] обозначает коэффициент фильтра линейного предсказания восстановленного звукового сигнала.

В варианте осуществления ptmean [i] может, например, обозначать фоновый шум кодированного звукового сигнала.

В варианте осуществления генератор коэффициентов может, например, конфигурироваться для определения, если текущий кадр из одного или большего количества кадров принимается с помощью интерфейса приема и если текущий кадр, принимаемый с помощью интерфейса приема, не поврежден, одного или большего количества коэффициентов шума с помощью определения спектра шума кодированного звукового сигнала.

Согласно варианту осуществления генератор коэффициентов может, например, конфигурироваться для определения коэффициентов LPC, представляющих фоновый шум, при использовании подхода статистической информации о минимумах к спектру сигнала для определения спектра фонового шума и вычисления коэффициентов LPC, представляющих форму фонового шума, из спектра фонового шума.

Кроме того, обеспечен способ декодирования кодированного звукового сигнала для получения восстановленного звукового сигнала. Данный способ содержит этапы, на которых:

- Принимают один или большее количество кадров.

- Определяют, если текущий кадр из одного или большего количества кадров принимается и если текущий принимаемый кадр не поврежден, один или большее количество коэффициентов первого звукового сигнала, содержащихся в текущем кадре, причем указанный один или большее количество коэффициентов первого звукового сигнала указывают характеристику кодированного звукового сигнала, и один или большее количество коэффициентов шума, указывающих фоновый шум кодированного звукового сигнала.

- Генерируют один или большее количество коэффициентов второго звукового сигнала в зависимости от одного или большего количества коэффициентов первого звукового сигнала и в зависимости от одного или большего количества коэффициентов шума, если текущий кадр не принимается или если текущий принимаемый кадр поврежден.

- Восстанавливают первую часть восстановленного звукового сигнала в зависимости от одного или большего количества коэффициентов первого звукового сигнала, если текущий кадр принимается и если текущий принимаемый кадр не поврежден. И:

- Восстанавливают вторую часть восстановленного звукового сигнала в зависимости от одного или большего количества коэффициентов второго звукового сигнала, если текущий кадр не принимается или если текущий принимаемый кадр поврежден.

Кроме того, обеспечена компьютерная программа для реализации вышеописанного способа, когда она выполняется на компьютере или процессоре обработки сигналов.

Наличие общего средства отслеживания и применения формы спектра комфортного шума во время плавного изменения имеет несколько преимуществ. С помощью отслеживания и применения формы спектра таким образом, чтобы это можно было сделать аналогично для обоих основных кодеков, предоставляет возможность простого общего подхода. CELT предлагает отслеживание энергий только по диапазонам в спектральной области и формирование по диапазонам формы спектра в спектральной области, что невозможно для ядра CELP.

Напротив, в предшествующем уровне техники форма спектра комфортного шума, представленного во время потерь пачки, или полностью статична, или частично статична и частично адаптивна к краткосрочному среднему значению формы спектра (как реализовано в G.718 [ITU08a]), и не будет обычно соответствовать фоновому шуму в сигнале перед потерей пакета. Это несовпадение характеристик комфортного шума может вызывать беспокойство. Согласно предшествующему уровню техники может использоваться автономно подготовленная (статическая) форма фонового шума, который может звучать приятно для конкретных сигналов, но менее приятно для других, например, автомобильный шум звучит полностью отличающимся образом от офисного шума.

Кроме того, в предшествующем уровне техники может использоваться адаптация к краткосрочному среднему значению формы спектра ранее принятых кадров, которая может приближать характеристику сигнала к сигналу, принятому раньше, но не обязательно к характеристикам фонового шума. В предшествующем уровне техники отслеживание формы спектра по диапазонам в спектральной области (как реализовано в CELT [IET12]) не применяется для переключаемого кодека, используя не только основанное на области MDCT ядро (TCX), но также и основанное на ACELP ядро. Вышеупомянутые варианты осуществления таким образом предпочтительны по сравнению с предшествующим уровнем техники.

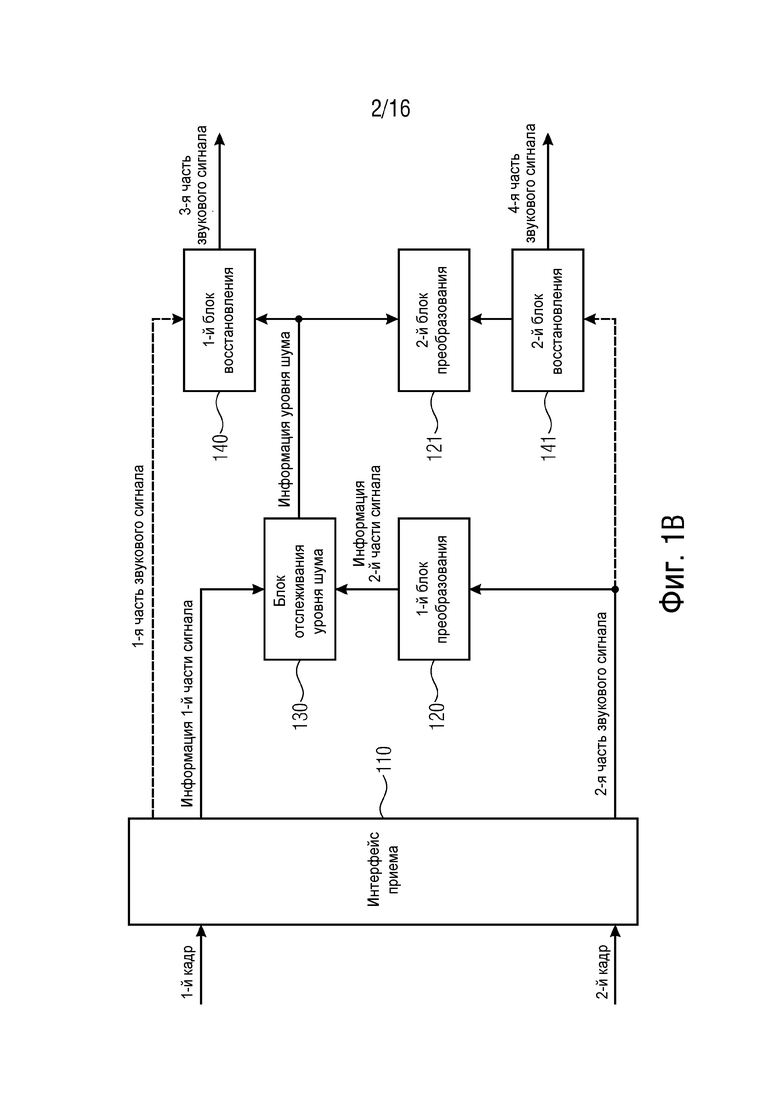

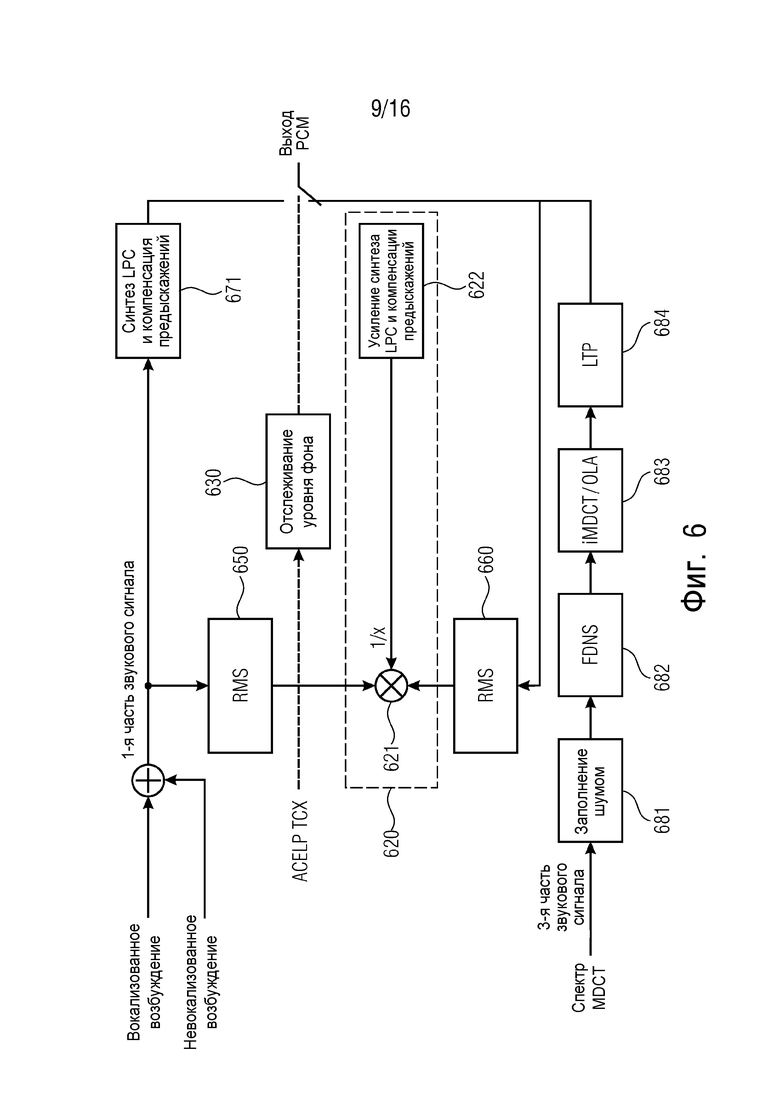

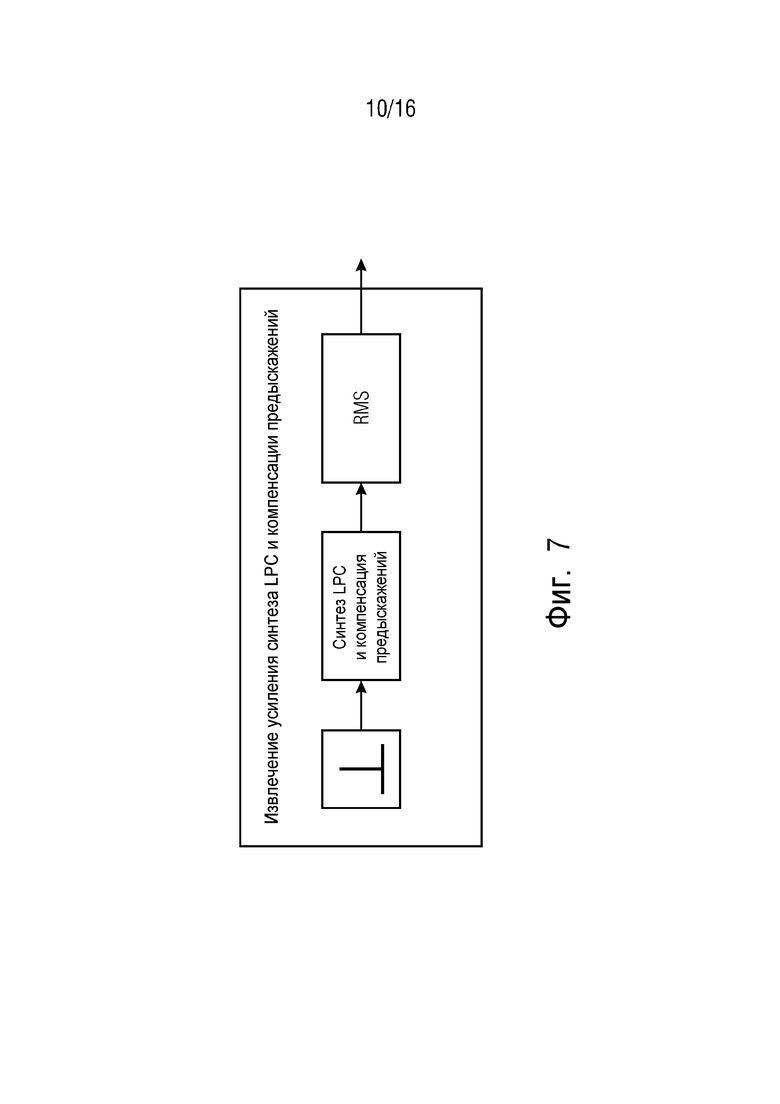

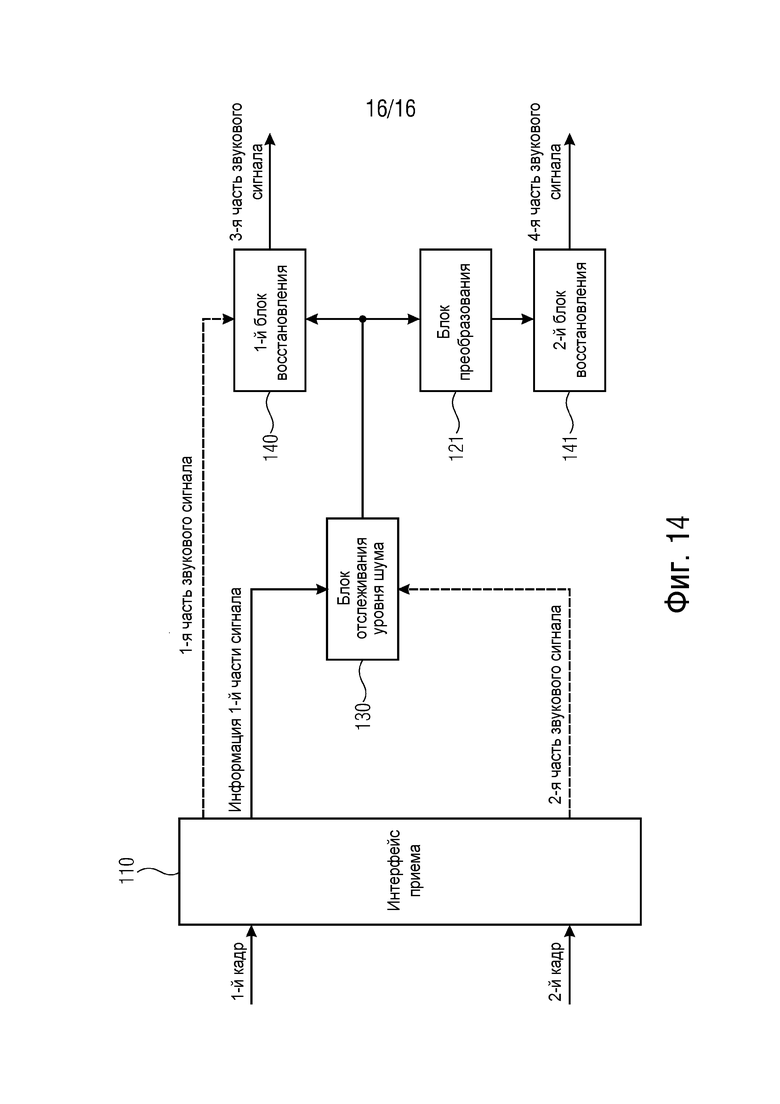

Кроме того, обеспечено устройство для декодирования звукового сигнала.

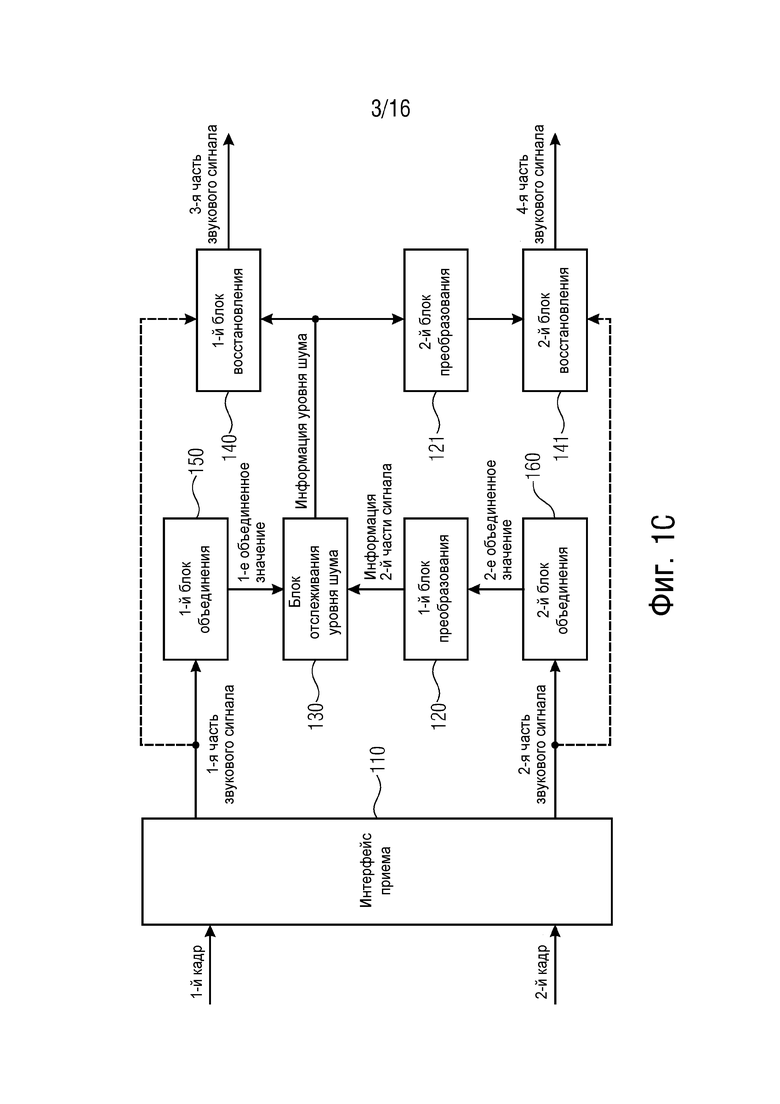

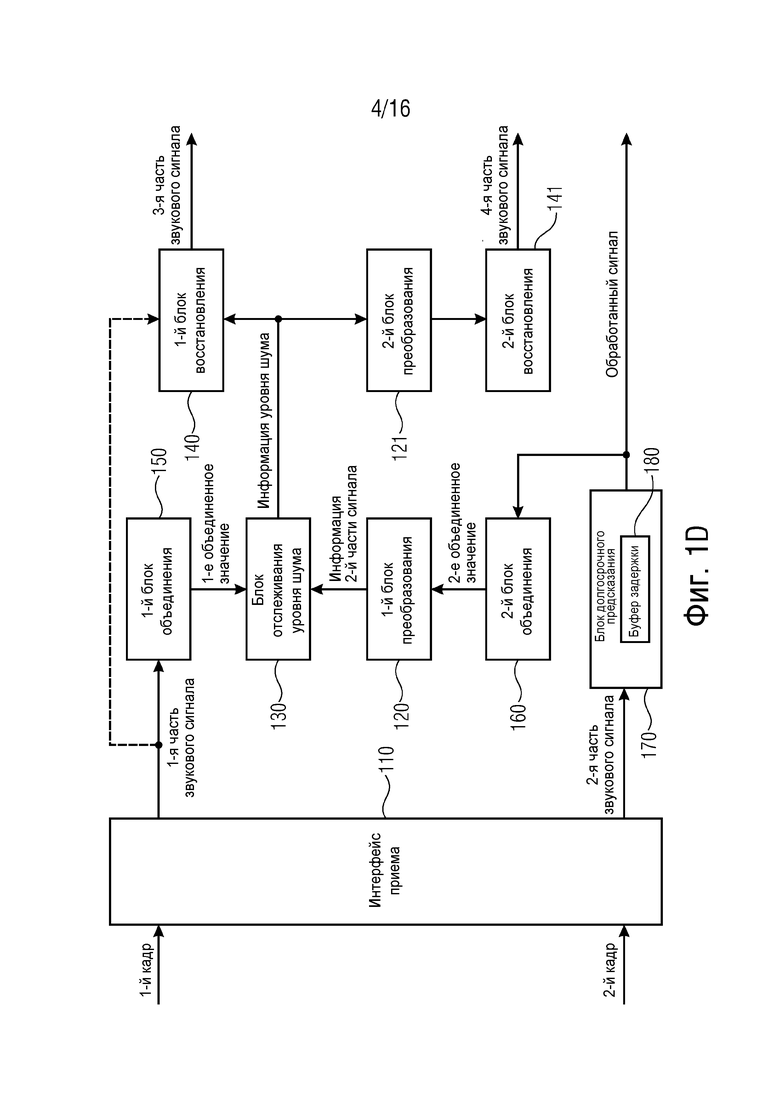

Данное устройство содержит интерфейс приема. Интерфейс приема конфигурируется для приема множества кадров, причем интерфейс приема конфигурируется для приема первого кадра из множества кадров, указанный первый кадр содержит первую часть звукового сигнала, указанная первая часть звукового сигнала представлена в первой области, и причем интерфейс приема конфигурируется для приема второго кадра из множества кадров, указанный второй кадр содержит вторую часть звукового сигнала.

Кроме того, устройство содержит блок преобразования для преобразования второй части звукового сигнала или значения или сигнала, извлеченного из второй части звукового сигнала, из второй области в область отслеживания для получения информации второй части сигнала, причем вторая область отличается от первой области, причем область отслеживания отличается от второй области, и причем область отслеживания равна или отличается от первой области.

К тому же устройство содержит блок отслеживания уровня шума, причем блок отслеживания уровня шума конфигурируется для приема информации первой части сигнала, представленной в области отслеживания, причем информация первой части сигнала зависит от первой части звукового сигнала. Блок отслеживания уровня шума конфигурируется для приема второй части сигнала, представленной в области отслеживания, и причем блок отслеживания уровня шума конфигурируется для определения информации уровня шума в зависимости от информации первой части сигнала, представленной в области отслеживания, и в зависимости от информации второй части сигнала, представленной в области отслеживания.

Кроме того, устройство содержит блок восстановления для восстановления третьей части звукового сигнала в зависимости от информации уровня шума, если третий кадр из множества кадров не принимается с помощью интерфейса приема, но он поврежден.

Звуковой сигнал может, например, быть речевым сигналом, или музыкальным сигналом, или сигналом, который содержит речь и музыку, и т.д.

Утверждение, что информация первой части сигнала зависит от первой части звукового сигнала, подразумевает, что информация первой части сигнала или является первой частью звукового сигнала, или что информация первой части сигнала получена / сгенерирована в зависимости от первой части звукового сигнала или другим способом зависит от первой части звукового сигнала. Например, первая часть звукового сигнала, возможно, была преобразована из одной области в другую область для получения информации первой части сигнала.

Аналогично, утверждение, что информация второй части сигнала зависит от второй части звукового сигнала, подразумевает, что информация второй части сигнала или является второй частью звукового сигнала, или что информация второй части сигнала получена/сгенерирована в зависимости от второй части звукового сигнала или другим способом зависит от второй части звукового сигнала. Например, вторая часть звукового сигнала, возможно, была преобразована из одной области в другую область для получения информации второй части сигнала.

В варианте осуществления первая часть звукового сигнала может, например, быть представлена во временной области в качестве первой области. Кроме того, блок преобразования может, например, конфигурироваться для преобразования второй части звукового сигнала или значения, извлеченного из второй части звукового сигнала, из области возбуждения, являющейся второй областью, во временную область, являющуюся областью отслеживания. К тому же блок отслеживания уровня шума может, например, конфигурироваться для приема информации первой части сигнала, представленной во временной области в качестве области отслеживания. Кроме того, блок отслеживания уровня шума может, например, конфигурироваться для приема второй части сигнала, представленной во временной области в качестве области отслеживания.

Согласно варианту осуществления первая часть звукового сигнала может, например, быть представлена в области возбуждения в качестве первой области. Кроме того, блок преобразования может, например, конфигурироваться для преобразования второй части звукового сигнала или значения, извлеченного из второй части звукового сигнала, из временной области, являющейся второй областью, в область возбуждения, являющуюся областью отслеживания. К тому же блок отслеживания уровня шума может, например, конфигурироваться для приема информации первой части сигнала, представленной в области возбуждения в качестве области отслеживания. Кроме того, блок отслеживания уровня шума может, например, конфигурироваться для приема второй части сигнала, представленной в области возбуждения в качестве области отслеживания.

В варианте осуществления первая часть звукового сигнала может, например, быть представлена в области возбуждения в качестве первой области, причем блок отслеживания уровня шума может, например, конфигурироваться для приема информации первой части сигнала, причем указанная информация первой части сигнала представлена в области FFT, которая является областью отслеживания, и причем указанная информация первой части сигнала зависит от указанной первой части звукового сигнала, представленной в области возбуждения, причем блок преобразования может, например, конфигурироваться для преобразования второй части звукового сигнала или значения, извлеченного из второй части звукового сигнала, из временной области, являющейся второй областью, в область FFT, являющуюся областью отслеживания, и причем блок отслеживания уровня шума может, например, конфигурироваться для приема второй части звукового сигнала, представленной в области FFT.

В варианте осуществления устройство может, например, дополнительно содержать первый блок объединения для определения первого объединенного значения в зависимости от первой части звукового сигнала. Кроме того, устройство может, например, дополнительно содержать второй блок объединения для определения, в зависимости от второй части звукового сигнала, второго объединенного значения в качестве значения, извлеченного из второй части звукового сигнала. К тому же блок отслеживания уровня шума может, например, конфигурироваться для приема первого объединенного значения в качестве информации первой части сигнала, представленной в области отслеживания, причем блок отслеживания уровня шума может, например, конфигурироваться для приема второго объединенного значения в качестве информации второй части сигнала, представленной в области отслеживания, и причем блок отслеживания уровня шума может, например, конфигурироваться для определения информации уровня шума в зависимости от первого объединенного значения, представленного в области отслеживания, и в зависимости от второго объединенного значения, представленного в области отслеживания.

Согласно варианту осуществления первый блок объединения может, например, конфигурироваться для определения первого объединенного значения таким образом, чтобы первое объединенное значение указывало среднеквадратическое значение первой части звукового сигнала или сигнала, извлеченного из первой части звукового сигнала. Кроме того, второй блок объединения может, например, конфигурироваться для определения второго объединенного значения таким образом, чтобы второе объединенное значение указывало среднеквадратическое значение второй части звукового сигнала или сигнала, извлеченного из второй части звукового сигнала.

В варианте осуществления блок преобразования может, например, конфигурироваться для преобразования значения, извлеченного из второй части звукового сигнала, из второй области в область отслеживания с помощью применения значения усиления к значению, извлеченному из второй части звукового сигнала.

Согласно вариантам осуществления значение усиления может, например, указывать усиление, представленное с помощью синтеза кодирования с линейным предсказанием, или значение усиления может, например, указывать усиление, представленное с помощью синтеза кодирования с линейным предсказанием и компенсации предыскажений.

В варианте осуществления блок отслеживания уровня шума может, например, конфигурироваться для определения информации уровня шума с помощью применения подхода статистической информации о минимумах.

Согласно варианту осуществления блок отслеживания уровня шума может, например, конфигурироваться для определения уровня комфортного шума в качестве информации уровня шума. Блок восстановления может, например, конфигурироваться для восстановления третьей части звукового сигнала в зависимости от информации уровня шума, если указанный третий кадр из множества кадров не принимается с помощью интерфейса приема или если указанный третий кадр принимается с помощью интерфейса приема, но он поврежден.

В варианте осуществления блок отслеживания уровня шума может, например, конфигурироваться для определения уровня комфортного шума в качестве информации уровня шума, извлеченной из спектра уровня шума, причем указанный спектр уровня шума получается с помощью применения подхода статистической информации о минимумах. Блок восстановления может, например, конфигурироваться для восстановления третьей части звукового сигнала в зависимости от множества коэффициентов линейного предсказания, если указанный третий кадр из множества кадров не принимается с помощью интерфейса приема или если указанный третий кадр принимается с помощью интерфейса приема, но он поврежден.

Согласно другому варианту осуществления блок отслеживания уровня шума может, например, конфигурироваться для определения множества коэффициентов линейного предсказания, указывающих уровень комфортного шума в качестве информации уровня шума, и блок восстановления может, например, конфигурироваться для восстановления третьей части звукового сигнала в зависимости от множества коэффициентов линейного предсказания.

В варианте осуществления блок отслеживания уровня шума конфигурируется для определения множества коэффициентов FFT, указывающих уровень комфортного шума в качестве информации уровня шума, и первый блок восстановления конфигурируется для восстановления третьей части звукового сигнала в зависимости от уровня комфортного шума, извлеченного из указанных коэффициентов FFT, если указанный третий кадр из множества кадров не принимается с помощью интерфейса приема или если указанный третий кадр принимается с помощью интерфейса приема, но он поврежден.

В варианте осуществления блок восстановления может, например, конфигурироваться для восстановления третьей части звукового сигнала в зависимости от информации уровня шума и в зависимости от первой части звукового сигнала, если указанный третий кадр из множества кадров не принимается с помощью интерфейса приема или если указанный третий кадр принимается с помощью интерфейса приема, но он поврежден.

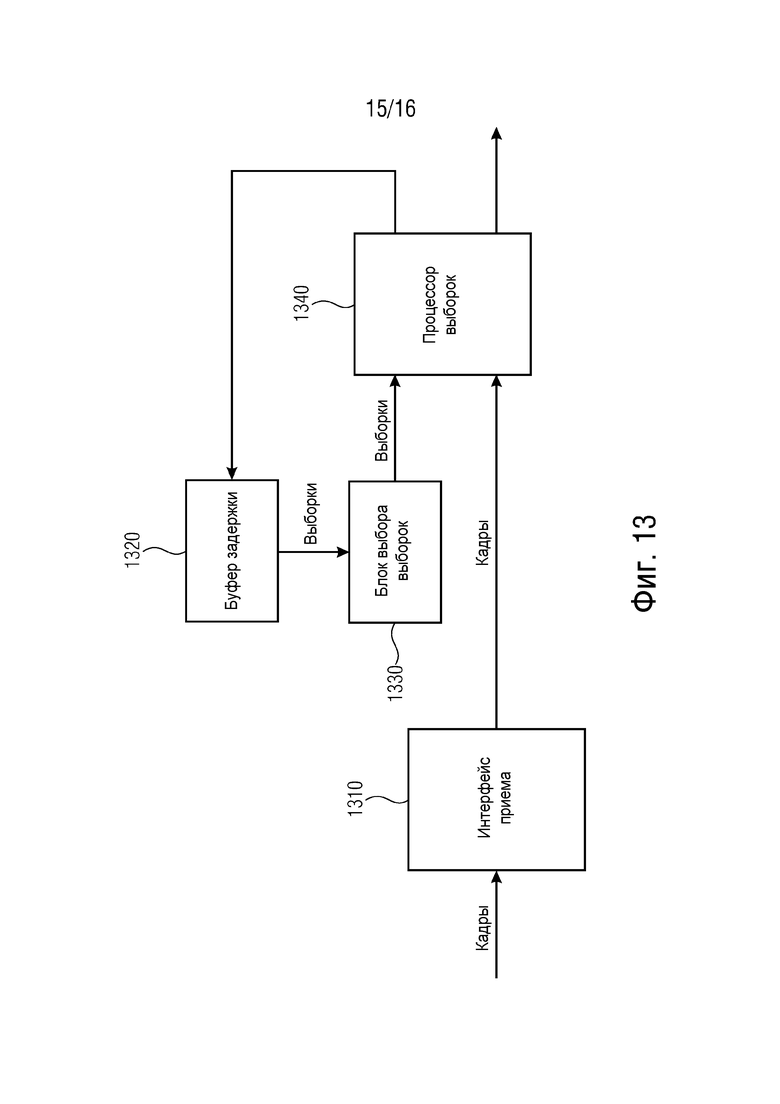

Согласно варианту осуществления блок восстановления может, например, конфигурироваться для восстановления третьей части звукового сигнала с помощью ослабления или усиления сигнала, извлеченного из первой или второй части звукового сигнала.