ОБЛАСТЬ ТЕХНИКИ, К КОТОРОЙ ОТНОСИТСЯ ИЗОБРЕТЕНИЕ

Варианты осуществления согласно изобретению создают аудиодекодеры для обеспечения декодированной аудиоинформации на основании кодированной аудиоинформации.

Некоторые варианты осуществления согласно изобретению создают способы для обеспечения декодированной аудиоинформации на основании кодированной аудиоинформации.

Некоторые варианты осуществления согласно изобретению создают компьютерные программы для осуществления одного из упомянутых способов.

Некоторые варианты осуществления согласно изобретению относятся к маскированию во временной области для кодека области преобразования.

УРОВЕНЬ ТЕХНИКИ

В последние годы наблюдается увеличение потребности в цифровой передаче и хранении аудиоконтента. Однако аудиоконтент часто передается по ненадежным каналам, что создает опасность того, что блоки данных (например, пакеты), содержащие один или более кадров аудио (например, в форме кодированного представления, например, кодированного представления частотной области или кодированного представления временной области) теряются. В ряде случаев, можно запрашивать повторение (повторную отправку) потерянных кадров аудио (или блоков данных, например, пакетов, содержащих один или более потерянных кадров аудио). Однако это обычно вносит существенную задержку, и поэтому требует обширной буферизации кадров аудио. В других случаях, вряд ли возможно запрашивать повторение потерянных кадров аудио.

Для получения хорошего, или, по меньшей мере, приемлемого, качества аудиосигнала при условии, что кадры аудио теряются без обеспечения обширной буферизации (которая потребляет большой объем памяти и также существенно снижает возможности аудиокодирования в реальном времени) желательно иметь принципы обработки потери одного или более кадров аудио. В частности, желательно иметь принципы, которые способствуют хорошее качество аудиосигнала, или, по меньшей мере, приемлемое качество аудиосигнала, даже в случае, когда кадры аудио теряются.

В прошлом разработаны некоторые принципы маскирования ошибки, которые можно применять в разных принципах аудиокодирования.

В дальнейшем будет описан традиционный принцип аудиокодирования.

В стандарте 3gpp TS 26.290, объяснено декодирование возбуждение, кодированное преобразованием (декодирование TCX) с маскированием ошибки. В дальнейшем, будут обеспечены некоторые объяснения, которые основаны на разделе ʺдекодирование и синтез сигнала в режиме TCXʺ в ссылке [1].

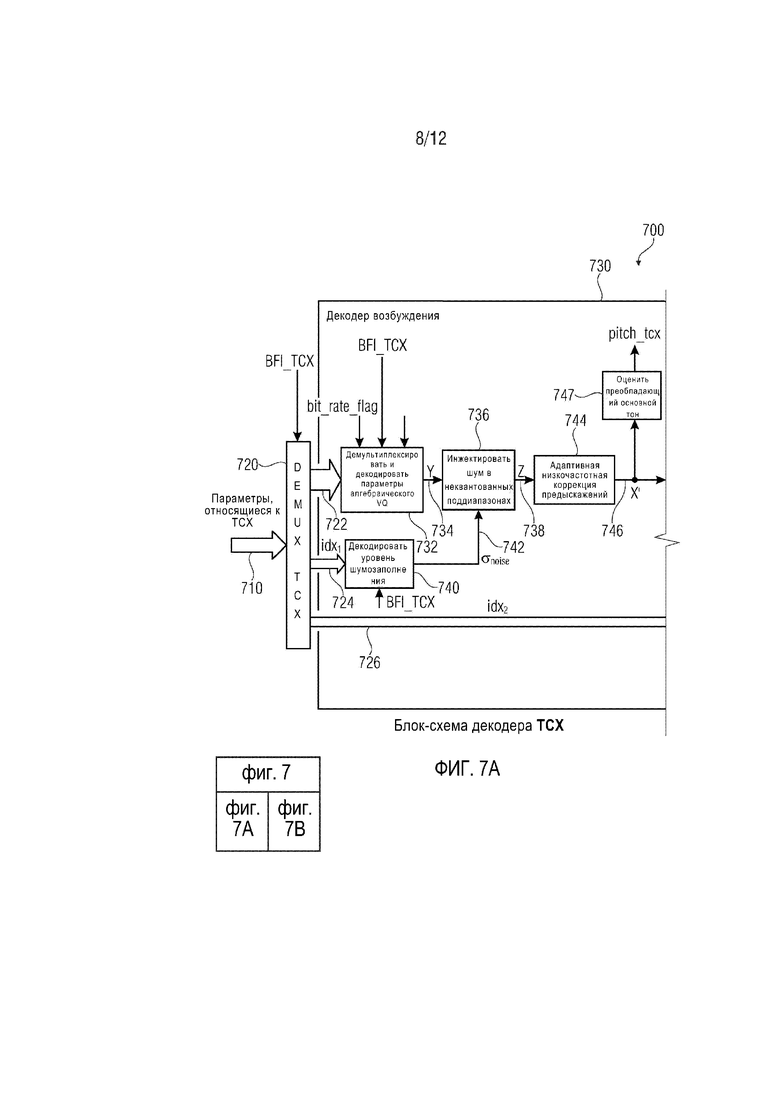

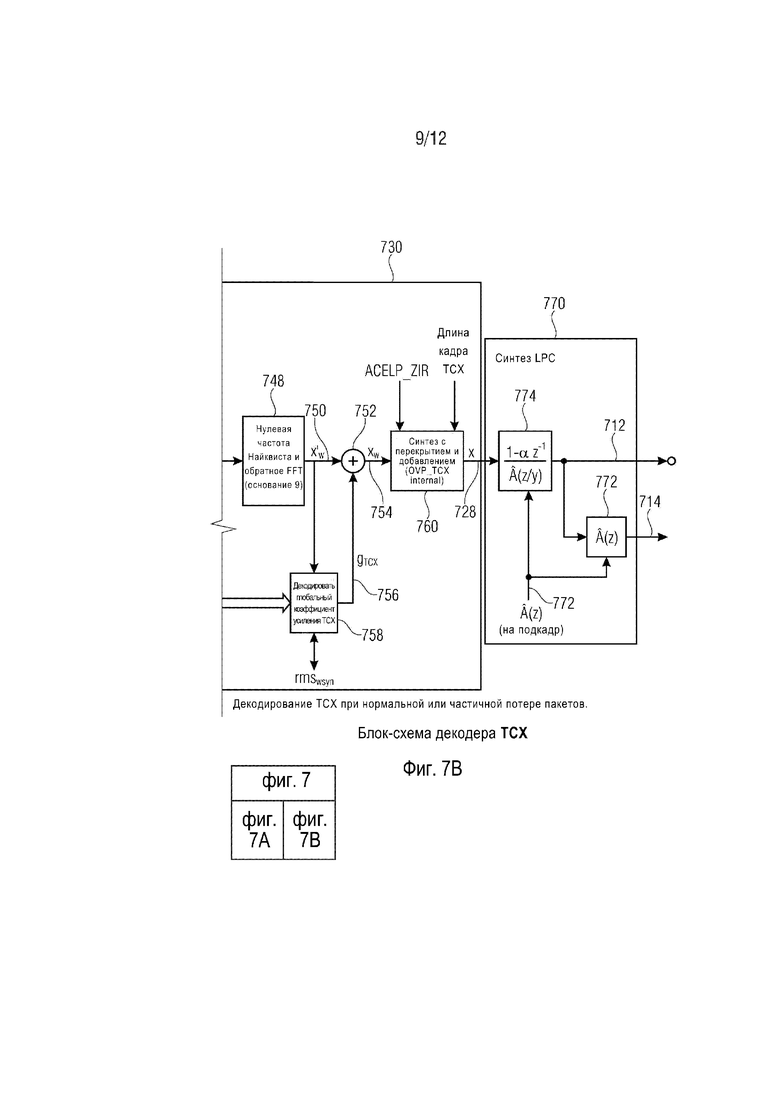

Декодер TCX согласно международному стандарту 3gpp TS 26.290 показан на фиг. 7 и 8, где фиг. 7 и 8 демонстрируют блок-схемы декодера TCX. Однако фиг. 7 демонстрирует эти функциональные блоки, которые имеют отношение к декодированию TCX в нормальном режиме работы или к случаю частичной потере пакетов. Напротив, фиг. 8 демонстрирует соответствующую обработку декодирования TCX в случае маскирования удаления пакета TCX-256.

Иначе говоря, фиг. 7 и 8 демонстрируют блок-схему декодера TCX, включающую в себя следующие случаи:

случай 1 (фиг. 8): маскирование удаления пакета в TCX-256, когда длина кадра TCX равна 256 выборок, и соответствующий пакет теряется, т.е. BFI_TCX=(1); и

случай 2 (фиг. 7): нормальное декодирование TCX, возможно, с частичными потерями пакетов.

В дальнейшем, будут обеспечены некоторые объяснения, касающиеся фиг. 7 и 8.

Как упомянуто, фиг. 7 демонстрирует блок-схему декодера TCX, осуществляющего декодирование TCX в нормальном режиме работы или в случае частичной потери пакетов. Декодер 700 TCX согласно фиг. 7 принимает параметры 710, относящиеся к TCX, и обеспечивает, на их основании, декодированную аудиоинформацию 712, 714.

Аудиодекодер 700 содержит демультиплексор ʺDEMUX TCX 720ʺ, который выполнен с возможностью приема параметров 710, относящихся к TCX, и информации ʺBFI_TCXʺ. Демультиплексор 720 разделяет параметры 710, относящиеся к TCX, и обеспечивает кодированную информацию 722 возбуждения, кодированную информацию 724 шумозаполнения и кодированную информацию 726 глобального коэффициента усиления. Аудиодекодер 700 содержит декодер 730 возбуждения, который выполнен с возможностью приема кодированной информации 722 возбуждения, кодированной информации 724 шумозаполнения и кодированной информации 726 глобального коэффициента усиления, а также некоторой дополнительной информации (например, флага битовой скорости ʺbit_rate_flagʺ, информации ʺBFI_TCXʺ и информации длины кадра TCX. Декодер 730 возбуждения обеспечивает, на ее основании, сигнал 728 возбуждения во временной области (также обозначенный ʺxʺ). Декодер 730 возбуждения содержит процессор 732 информации возбуждения, который демультиплексирует кодированную информацию 722 возбуждения и декодирует параметры алгебраического векторного квантования. Процессор 732 информации возбуждения обеспечивает промежуточный сигнал 734 возбуждения, который обычно представлен в частотной области, и который обозначен Y. Кодер 730 возбуждения также содержит инжектор 736 шума, который выполнен с возможностью инжекции шума в неквантованных поддиапазонах, для вывода шумозаполненного сигнала 738 возбуждения из промежуточного сигнала 734 возбуждения. Шумозаполненный сигнал 738 возбуждения обычно находится в частотной области и обозначен Z. Инжектор 736 шума принимает информацию 742 интенсивности шума от декодера 740 уровня шумозаполнения. Декодер возбуждения также содержит адаптивную низкочастотную коррекцию 744 предыскажений, которая выполнена с возможностью осуществления операции низкочастотной коррекции предыскажений на основании шумозаполненного сигнала 738 возбуждения, для получения, таким образом, обработанного сигнала 746 возбуждения, который все еще находится в частотной области, и который обозначен X'. Декодер 730 возбуждения также содержит преобразователь 748 из частотной области во временную область, который выполнен с возможностью приема обработанного сигнала 746 возбуждения и обеспечения, на его основании, сигнала 750 возбуждения во временной области, который связан с определенным временным участком, представленным набором параметров возбуждения в частотной области (например, обработанного сигнала 746 возбуждения). Декодер 730 возбуждения также содержит блок 752 масштабирования, который выполнен с возможностью масштабирования сигнала 750 возбуждения во временной области для получения, таким образом, масштабированного сигнала 754 возбуждения во временной области. Блок 752 масштабирования принимает информацию 756 глобального коэффициента усиления от декодера 758 глобального коэффициента усиления, в котором, в ответ, декодер 758 глобального коэффициента усиления принимает кодированную информацию 726 глобального коэффициента усиления. Декодер 730 возбуждения также содержит синтез 760 с перекрытием и добавлением, который принимает масштабированные сигналы 754 возбуждения во временной области, связанные с множеством временных участков. Синтез 760 с перекрытием и добавлением осуществляет операцию перекрытия и добавления (которая может включать в себя операцию взвешивания с помощью финитной функции) на основании масштабированных сигналов 754 возбуждения во временной области, для получения объединенного во времени сигнала 728 возбуждения во временной области на протяжении более длинного периода времени (более длинного, чем периоды времени, в течение которых обеспечиваются отдельные сигналы 750, 754 возбуждения во временной области).

Аудиодекодер 700 также содержит синтез 770 LPC, который принимает сигнал 728 возбуждения во временной области, обеспеченный синтезом 760 с перекрытием и добавлением, и один или более коэффициентов LPC, задающих функцию синтезирующего фильтра 772 LPC. Синтез 770 LPC может, например, содержать первый фильтр 774, который может, например, синтетически фильтровать сигнал 728 возбуждения во временной области, для получения, таким образом, декодированного аудиосигнала 712. Опционально, синтез 770 LPC также может содержать второй синтезирующий фильтр 772, который выполнен с возможностью синтетически фильтровать выходной сигнал первого фильтра 774 с использованием другой функции синтезирующего фильтра, для получения, таким образом, декодированного аудиосигнала 714.

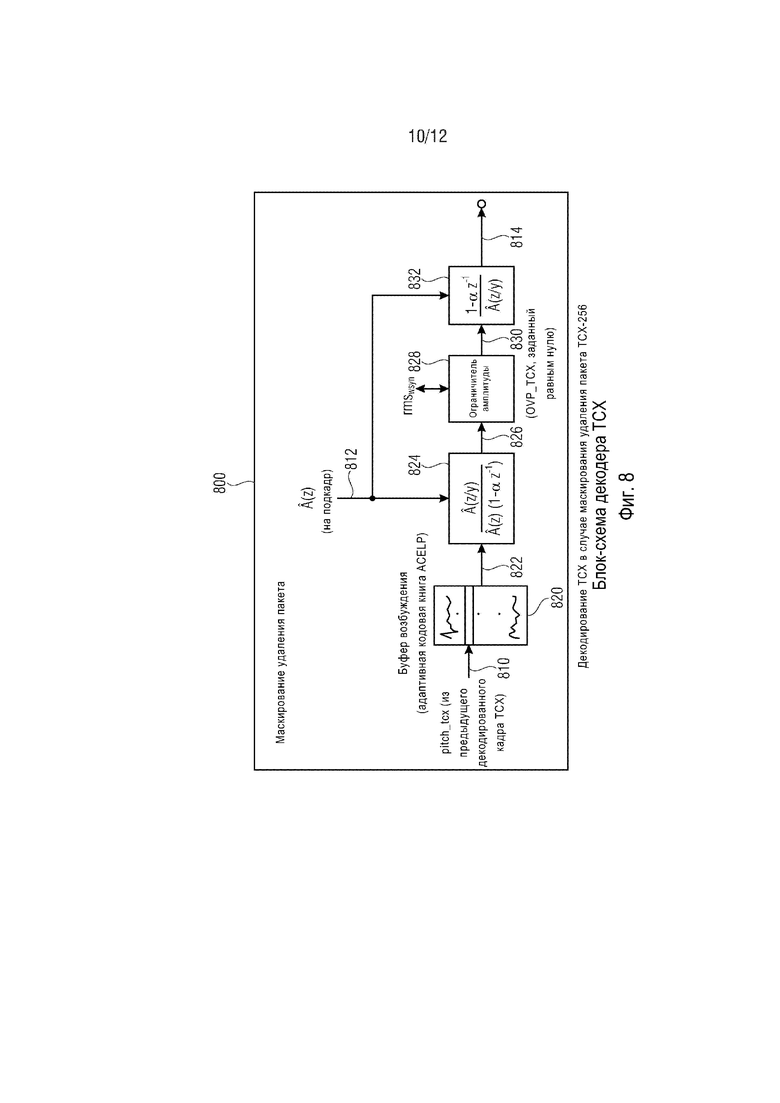

В дальнейшем, декодирование TCX будет описано в случае маскирования удаления пакета TCX-256. Фиг. 8 демонстрирует блок-схему декодера TCX в этом случае.

Маскирование 800 удаления пакета принимает информацию 810 основного тона, которая также обозначена ʺpitch_tcxʺ и получена из предыдущего декодированного кадра TCX. Например, информацию 810 основного тона можно получать с использованием блока 747 оценивания преобладающего основного тона из обработанного сигнала 746 возбуждения на декодере 730 возбуждения (в ходе ʺнормальногоʺ декодирования). Кроме того, маскирование 800 удаления пакета принимает параметры 812 LPC, которые могут представлять функцию синтезирующего фильтра LPC. Параметры 812 LPC могут, например, быть идентичны параметрам 772 LPC. Соответственно, маскирование 800 удаления пакета может быть выполнено с возможностью обеспечения, на основании информации 810 основного тона и параметров 812 LPC, сигнала 814 с маскированием ошибки, который можно рассматривать как аудиоинформацию с маскированием ошибки. Маскирование 800 удаления пакета содержит буфер 820 возбуждения, который может, например, буферизовать предыдущее возбуждение. Буфер 820 возбуждения может, например, использовать адаптивную кодовую книгу ACELP и может обеспечивать сигнал 822 возбуждения. Маскирование 800 удаления пакета может дополнительно содержать первый фильтр 824, функцию фильтра которого можно задать, как показано на фиг. 8. Таким образом, первый фильтр 824 может фильтровать сигнал 822 возбуждения на основании параметров 812 LPC, для получения фильтрованной версии 826 сигнала 822 возбуждения. Маскирование удаления пакета также содержит ограничитель 828 амплитуды, который может ограничивать амплитуду фильтрованного сигнала 826 возбуждения на основании целевой информации или информации уровня rmswsyn. Кроме того, маскирование 800 удаления пакета может содержать второй фильтр 832, который может быть выполнен с возможностью приема ограниченного по амплитуде фильтрованного сигнала возбуждения 830 от ограничителя 822 амплитуды и обеспечения, на его основании, сигнала 814 с маскированием ошибки. Функция фильтра второго фильтра 832 может быть, например, задана, как показано на фиг. 8.

В дальнейшем будут описаны некоторые детали, касающиеся декодирования и маскирования ошибки.

В случае 1 (маскирование удаления пакета в TCX-256), информация для декодирования кадра TCX в 256 выборок недоступна. Синтез TCX находится посредством обработки прошлого возбуждения с задержкой на T, где T=pitch_tcx это отставание основного тона, оцененное в ранее декодированном кадре TCX, нелинейным фильтром, примерно эквивалентным  . Нелинейный фильтр используется вместо

. Нелинейный фильтр используется вместо  во избежание щелчков в синтезе. Этот фильтр разлагается на 3 этапа:

во избежание щелчков в синтезе. Этот фильтр разлагается на 3 этапа:

этап 1: фильтрация посредством

для отображения возбуждения с задержкой на T в целевую область TCX;

этап 2: применение ограничителя (величина ограничена±rmswsyn)

этап 3: фильтрация посредством

для нахождения синтеза. Заметим, что в этом случае буфер OVLP_TCX задается равным нулю.

Декодирование параметров алгебраического VQ

В случае 2, декодирование TCX предусматривает декодирование параметров алгебраического VQ, описывающих каждый квантованный блок  масштабированного спектра X', где X' описан на этапе 2 раздела 5.3.5.7 3gpp TS 26.290. Напомним, что X' имеет размер N, где N=288, 576 и 1152 для TCX-256, 512 и 1024 соответственно, и что каждый блок B'k имеет размер 8. Количество K блоков B'k, таким образом, равно 36, 72 и 144 для TCX-256, 512 и 1024 соответственно. Параметры алгебраического VQ для каждого блока B'k описаны на этапе 5 раздела 5.3.5.7. Для каждого блока B'k кодер отправляет три набора двоичных индексов:

масштабированного спектра X', где X' описан на этапе 2 раздела 5.3.5.7 3gpp TS 26.290. Напомним, что X' имеет размер N, где N=288, 576 и 1152 для TCX-256, 512 и 1024 соответственно, и что каждый блок B'k имеет размер 8. Количество K блоков B'k, таким образом, равно 36, 72 и 144 для TCX-256, 512 и 1024 соответственно. Параметры алгебраического VQ для каждого блока B'k описаны на этапе 5 раздела 5.3.5.7. Для каждого блока B'k кодер отправляет три набора двоичных индексов:

a) индекс кодовой книги nk, передаваемый в унарном коде, описанном на этапе 5 раздела 5.3.5.7;

b) ранг Ik выбранного узла c решетки в так называемой базовой кодовой книге, который указывает, какую перестановку применять к конкретному лидеру (см. этап 5 раздела 5.3.5.7) для получения узла c решетки;

c) и, если квантованный блок  (узел решетки) отсутствует в базовой кодовой книге, 8 индексов вектора k индекса удлинения Вороного, вычисленного на подэтапе V1 этапа 5 в разделе; из индексов удлинения Вороного, вектор z удлинения можно вычислять, как в ссылке [1] 3gpp TS 26.290. Количество битов в каждой составляющей вектора k индекса определяется порядком r удлинения, который можно получить из значения унарного кода индекса nk. Масштабный коэффициент M удлинения Вороного определяется как M=2r.

(узел решетки) отсутствует в базовой кодовой книге, 8 индексов вектора k индекса удлинения Вороного, вычисленного на подэтапе V1 этапа 5 в разделе; из индексов удлинения Вороного, вектор z удлинения можно вычислять, как в ссылке [1] 3gpp TS 26.290. Количество битов в каждой составляющей вектора k индекса определяется порядком r удлинения, который можно получить из значения унарного кода индекса nk. Масштабный коэффициент M удлинения Вороного определяется как M=2r.

Затем, из масштабного коэффициента M, вектор z удлинения Вороного (узел решетки в RE8) и узел решетки c в базовой кодовой книге (также узел решетки в RE8), каждый квантованный масштабированный блок  можно вычислить, как

можно вычислить, как

В отсутствие удлинения Вороного (т.е. nk < 5, M=1 и z=0), базовой кодовой книгой является любая кодовая книга Q0, Q2, Q3 или Q4 из ссылки [1] 3gpp TS 26.290. Тогда для передачи вектора k биты не требуется. В противном случае, когда удлинение Вороного используется, поскольку  достаточно велик, в качестве базовой кодовой книги используется только Q3 или Q4 из ссылки [1]. Выбор Q3 или Q4 является неявным в значении nk индекса кодовой книги, описанном на этапе 5 раздела 5.3.5.7.

достаточно велик, в качестве базовой кодовой книги используется только Q3 или Q4 из ссылки [1]. Выбор Q3 или Q4 является неявным в значении nk индекса кодовой книги, описанном на этапе 5 раздела 5.3.5.7.

Оценивание значения преобладающего основного тона

Оценивание преобладающего основного тона осуществляется таким образом, чтобы следующий кадр, подлежащий декодированию, можно было правильно экстраполировать, если он соответствует TCX-256, и если соответствующий пакет потерян. Это оценивание основано на предположении о том, что пик максимальной величины в спектре цели TCX соответствует преобладающему основному тону. Поиск максимума M ограничен частотой ниже Fs/64 кГц

M=maxi=1..N/32(X'2i)2+(X'2i+1)2

и также находится минимальный индекс 1≤imax≤N/32, при котором (X'2i)2+(X'2i+1)2=M. Затем преобладающий основной тон оценивается по количеству выборок как Test=N/imax (это значение может не быть целочисленным). Напомним, что преобладающий основной тон вычисляется для маскирования удаления пакета в TCX-256. Во избежание проблем буферизации (ограничения буфера возбуждения 256 выборками), если Test>256 выборок, pitch_tcx задается равным 256; в противном случае, если Test≤256, множественные периоды основного тона 256 выборках устраняются путем задания pitch_tcx в виде

где  обозначает округление до ближайшего целого числа в направлении к -∞.

обозначает округление до ближайшего целого числа в направлении к -∞.

В дальнейшем будут кратко рассмотрены некоторые дополнительные традиционные принципы.

В ISO_IEC_DIS_23003-3 (ссылка [3]), декодирование TCX с использованием MDCT объяснено в контексте унифицированного речевого и аудиокодека.

В AAC, отвечающем уровню техники (согласно, например, ссылке [4]), описан только режим интерполяции. Согласно ссылке [4], декодер ядра AAC включает в себя функцию маскирования, которая увеличивает задержку декодера на один кадр.

В европейском патенте EP 1207519 B1 (ссылка [5]), он описан для обеспечения речевого декодера и способа компенсации ошибок, способного достигать дополнительного улучшения декодированной речи в кадре, в котором обнаружена ошибка. Согласно патенту, параметр кодирования речи включает в себя информацию режима, которая выражает особенности каждого короткого сегмента (кадра) речи. Речевой кодер адаптивно вычисляет параметры отставания и параметры коэффициента усиления, используемые для декодирования речи, согласно информации режима. Кроме того, речевой декодер адаптивно регулирует отношение адаптивного коэффициента усиления возбуждения и фиксированного коэффициента усиления коэффициент усиления возбуждения согласно информации режима. Кроме того, принцип согласно патенту содержит адаптивную регулировку адаптивных параметров коэффициента усиления возбуждения и фиксированных параметров коэффициента усиления возбуждения используемый для декодирования речи согласно значениям декодированных параметров коэффициента усиления в блоке нормального декодирования, в котором не обнаружено ошибок, сразу после блока декодирования, в отношении кодированных данных которого установлено, что они содержат ошибку.

В соответствии с уровнем техники, существует потребность в дополнительном улучшении маскирования ошибки, которое обеспечивает улучшенное слуховое восприятие.

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

Вариант осуществления согласно изобретению создает аудиодекодер для обеспечения декодированной аудиоинформации на основании кодированной аудиоинформации. Аудиодекодер содержит маскирование ошибки, выполненное с возможностью обеспечения аудиоинформации с маскированием ошибки для маскировки потери кадра аудио (или потери более одного кадра), следующего за кадром аудио, кодированным в представлении частотной области, с использованием сигнала возбуждения во временной области.

Этот вариант осуществления согласно изобретению основан на том факте, что улучшенное маскирование ошибки можно получить путем обеспечения аудиоинформации с маскированием ошибки на основании сигнала возбуждения во временной области, даже если кадр аудио, предшествующий потерянному кадру аудио, кодируется в представлении частотной области. Другими словами, было установлено, что качество маскирования ошибки обычно повышается, если маскирование ошибки осуществляется на основании сигнала возбуждения во временной области, по сравнению с маскированием ошибки, осуществляемым в частотной области, таким образом, что целесообразно переключаться на маскирование ошибки во временной области с использованием сигнала возбуждения во временной области, даже если аудиоконтент, предшествующий потерянному кадру аудио, кодируется в частотной области (т.е. в представлении частотной области). Это, например, справедливо для монофонического сигнала и, по большей части, для речи.

Соответственно, настоящее изобретение позволяет получать хорошее маскирование ошибки, даже если кадр аудио, предшествующий потерянному кадру аудио, кодируется в частотной области (т.е. в представлении частотной области).

В предпочтительном варианте осуществления, представление частотной области содержит кодированное представление множества спектральных значений и кодированное представление множества масштабных коэффициентов для масштабирования спектральных значений, или аудиодекодер выполнен с возможностью вывода множества масштабных коэффициентов для масштабирования спектральных значений из кодированного представления параметров LPC. Это можно делать с использованием FDNS (формирования шума в частотной области). Однако было установлено, что целесообразно выводить сигнал возбуждения во временной области (который может служить возбуждением для синтеза LPC (синтеза методом кодирования с линейным предсказанием)), даже если кадр аудио, предшествующий потерянному кадру аудио, первоначально закодирован в представлении частотной области, содержащем существенно другую информацию (а именно, кодированное представление множества спектральных значений в кодированном представлении множества масштабных коэффициентов для масштабирования спектральных значений). Например, в случае TCX мы отправляем (с кодера на декодер) не масштабные коэффициенты, а LPC и затем на декодере мы преобразуем LPC в представление масштабных коэффициентов для бинов MDCT. Иначе говоря, в случае TCX мы отправляем коэффициент LPC и затем на декодере мы преобразуем эти коэффициенты LPC в представление масштабных коэффициентов для TCX в USAC или в AMR-WB+ вовсе не существует масштабных коэффициентов.

В предпочтительном варианте осуществления, аудиодекодер содержит ядро декодера частотной области, выполненное с возможностью применения масштабирования на основе масштабных коэффициентов к множеству спектральных значений, выведенных из представления частотной области. В этом случае, маскирование ошибки выполнено с возможностью обеспечения аудиоинформации с маскированием ошибки для маскировки потери кадра аудио, следующего за кадром аудио, кодированным в представлении частотной области, содержащем множество кодированных масштабных коэффициентов, с использованием сигнала возбуждения во временной области, выведенного из представления частотной области. Этот вариант осуществления согласно изобретению основан на том факте, что вывод сигнала возбуждения во временной области из вышеупомянутого представления частотной области обычно обеспечивает лучший результат маскирования ошибки по сравнению с маскированием ошибки, осуществляемым непосредственно в частотной области. Например, сигнал возбуждения создается на основе синтеза предыдущего кадра, поэтому в действительности не имеет значения, является ли предыдущий кадр кадром частотной области (MDCT, FFT…) или кадром временной области. Однако конкретные преимущества можно наблюдать, если предыдущий кадр был кадром частотной области. Кроме того, следует отметить, что особенно хорошие результаты достигаются, например, для монофонического сигнала, например речи. В порядке другого примера, масштабные коэффициенты можно передавать как коэффициенты LPC, например, с использованием полиномиального представления, которое затем преобразуется в масштабные коэффициенты на стороне декодера.

В предпочтительном варианте осуществления, аудиодекодер содержит ядро декодера частотной области, выполненное с возможностью вывода представления аудиосигнала во временной области из представления частотной области без использования сигнала возбуждения во временной области в качестве промежуточной величины для кадра аудио, кодированного в представлении частотной области. Другими словами, было установлено, что использование сигнала возбуждения во временной области для маскирования ошибки имеет преимущество, даже если кадр аудио, предшествующий потерянному кадру аудио, кодируется в ʺистинномʺ частотном режиме, который не использует никакой сигнал возбуждения во временной области в качестве промежуточной величины (и который, следовательно, не основан на синтезе LPC).

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью получения сигнала возбуждения во временной области на основании кадра аудио, кодированного в представлении частотной области, предшествующего потерянному кадру аудио. В этом случае, маскирование ошибки выполнено с возможностью обеспечения аудиоинформации с маскированием ошибки для маскировки потерянного кадра аудио с использованием упомянутого сигнала возбуждения во временной области. Другими словами, было установлено, что сигнал возбуждения во временной области, который используется для маскирования ошибки, следует выводить из кадра аудио, кодированного в представлении частотной области, предшествующего потерянному кадру аудио, поскольку этот сигнал возбуждения во временной области, выведенный из кадра аудио, кодированного в представлении частотной области, предшествующего потерянному кадру аудио, обеспечивает хорошее представление аудиоконтента кадра аудио, предшествующего потерянному кадру аудио, таким образом, что маскирование ошибки может осуществляться с умеренными затратами и хорошей точностью.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью осуществления анализа LPC (анализа методом кодирования с линейным предсказанием) на основании кадра аудио, кодированного в представлении частотной области, предшествующего потерянному кадру аудио, для получения набора параметров кодирования с линейным предсказанием и сигнала возбуждения во временной области, представляющего аудиоконтент кадра аудио, кодированного в представлении частотной области, предшествующего потерянному кадру аудио. Было установлено, что целесообразны затраты для осуществления анализа LPC, для вывода параметров кодирования с линейным предсказанием и сигнала возбуждения во временной области, даже если кадр аудио, предшествующий потерянному кадру аудио, кодируется в представлении частотной области (которое не содержит никаких параметров кодирования с линейным предсказанием и никакого представления сигнала возбуждения во временной области), поскольку аудиоинформацию с маскированием ошибки хорошего качества можно получить для многих входных аудиосигналов на основании упомянутого сигнала возбуждения во временной области. Альтернативно, маскирование ошибки может быть выполнено с возможностью осуществления анализа LPC на основании кадра аудио, кодированного в представлении частотной области, предшествующего потерянному кадру аудио, для получения сигнала возбуждения во временной области, представляющего аудиоконтент кадра аудио, кодированного в представлении частотной области, предшествующего потерянному кадру аудио. В качестве дополнительной альтернативы, аудиодекодер может быть выполнен с возможностью получения набора параметров кодирования с линейным предсказанием с использованием оценивания параметра кодирования с линейным предсказанием, или аудиодекодер может быть выполнен с возможностью получения набора параметров кодирования с линейным предсказанием на основании набора масштабных коэффициентов с использованием преобразования. Иначе говоря, параметры LPC можно получать с использованием оценивания параметров LPC. Это можно делать либо посредством взвешивания с помощью финитной функции/автокорреляции/алгоритма Левинсона-Дарбина на основании кадра аудио, кодированного в представлении частотной области, либо посредством преобразования из предыдущего масштабного коэффициента непосредственно в и представление LPC.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью получения информации основного тона (или отставания), описывающей основной тон кадра аудио, кодированного в частотной области предшествующий потерянному кадру аудио, и обеспечения аудиоинформации с маскированием ошибки в зависимости от информации основного тона. С учетом информации основного тона, можно добиться, чтобы аудиоинформация с маскированием ошибки (которая обычно является аудиосигналом с маскированием ошибки, охватывающим временную длительность, по меньшей мере, одного потерянного кадра аудио) была хорошо адаптирована к фактическому аудиоконтенту.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью получения информации основного тона на основании сигнала возбуждения во временной области, выведенного из кадра аудио, кодированного в представлении частотной области, предшествующего потерянному кадру аудио. Было установлено, что вывод информации основного тона из сигнала возбуждения во временной области способствует высокой точности. Кроме того, было установлено, что преимущественно, если информация основного тона хорошо адаптирована к сигналу возбуждения во временной области, поскольку информация основного тона используется для модификации сигнала возбуждения во временной области. Выводя информацию основного тона из сигнала возбуждения во временной области, можно добиться такого близкого соотношения.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью оценивания кросс-корреляции сигнала возбуждения во временной области, для определения грубой информации основного тона. Кроме того, маскирование ошибки может быть выполнено с возможностью уточнения грубой информации основного тона с использованием поиска по замкнутому циклу вокруг основного тона, определенного грубой информацией основного тона. Соответственно, высокоточной информации основного тона можно добиться с умеренными вычислительными затратами.

В предпочтительном варианте осуществления, аудиодекодер с маскированием ошибки может быть выполнен с возможностью получения информации основного тона на основании вспомогательной информации кодированной аудиоинформации.

В предпочтительном варианте осуществления, маскирование ошибки может быть выполнено с возможностью получения информации основного тона на основании информации основного тона, доступной для ранее декодированного кадра аудио.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью получения информации основного тона на основании поиска основного тона, осуществляемого по сигналу временной области или по остаточному сигналу.

Иначе говоря, основной тон может передаваться как вспомогательная информация или может также поступать из предыдущего кадра, например, при наличии LTP. Информация основного тона также может передаваться в битовом потоке при наличии на кодере. Опционально, поиск основного тона можно производить непосредственно по сигналу временной области или по остатку, причем обычно лучшие результаты выдаются по остатку (сигнал возбуждения во временной области).

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью копирования цикла основного тона сигнала возбуждения во временной области, выведенного из кадра аудио, кодированного в представлении частотной области, предшествующего потерянному кадру аудио, один раз или несколько раз, для получения сигнала возбуждения для синтеза аудиосигнала с маскированием ошибки. Копированием сигнала возбуждения во временной области один раз или несколько раз, можно добиться, чтобы детерминированная (т.е., по существу, периодическая) составляющая аудиоинформации с маскированием ошибки получалась с хорошей точностью и была хорошим продолжением детерминированной (например, по существу, периодической) составляющей аудиоконтента кадра аудио, предшествующего потерянному кадру аудио.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью фильтрации низких частот цикла основного тона сигнала возбуждения во временной области, выведенного из представления частотной области кадра аудио, кодированного в представлении частотной области, предшествующего потерянному кадру аудио, с использованием фильтра, зависящего от частоты дискретизации, полоса пропускания которого зависит от частоты дискретизации кадра аудио, кодированного в представлении частотной области. Соответственно, сигнал возбуждения во временной области может быть адаптирован к доступной полосе пропускания аудиосигнала, что приводит к хорошему слуховому восприятию аудиоинформации с маскированием ошибки. Например, пропускание низких частот предпочтительно только на первом потерянном кадре, и предпочтительно, пропускание низких частот также возможно, только если сигнал не является на 100% стабильным. Однако следует отметить, что низкочастотная фильтрация является необязательной, и может осуществляться только на первом цикле основного тона. Например, фильтр может зависеть от частоты дискретизации, в результате чего частота среза не будет зависеть от полосы пропускания.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью предсказания основного тона на конце потерянного кадра для адаптации сигнала возбуждения во временной области или одной или более его копий, к предсказанному основному тону. Соответственно, можно рассматривать ожидаемые изменения основного тона на протяжении потерянного кадра аудио. Это позволяет избегать артефактов при переходе между аудиоинформацией с маскированием ошибки и аудиоинформацией правильно декодированного кадра, следующего за одним или более потерянными кадрами аудио (или, по меньшей мере, ослаблять их, поскольку только предсказанный основной тон не является действительным). Например, адаптация идет от последнего хорошего основного тона к предсказанному. Это осуществляется путем ресинхронизации импульсов [7].

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью объединения экстраполированного сигнала возбуждения во временной области и шумового сигнала, для получения входного сигнала для синтеза LPC. В этом случае, маскирование ошибки выполнено с возможностью осуществления синтеза LPC, причем синтез LPC выполнен с возможностью фильтрации входного сигнала синтеза LPC в зависимости от параметров кодирования с линейным предсказанием, для получения аудиоинформации с маскированием ошибки. Соответственно, можно рассматривать как детерминированную (например, приблизительно периодическую) составляющую аудиоконтента, так и шумоподобную составляющую аудиоконтента. Соответственно, получается, что аудиоинформация с маскированием ошибки содержит ʺестественноеʺ слуховое восприятие.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью вычисления коэффициента усиления экстраполированного сигнала возбуждения во временной области, который используется для получения входного сигнала для синтеза LPC, с использованием корреляции во временной области, которая осуществляется на основании представления временной области кадра аудио, кодированного в частотной области предшествующий потерянному кадру аудио, причем интервал корреляции устанавливается в зависимости от информации основного тона, полученной на основании сигнала возбуждения во временной области. Другими словами, интенсивность периодической составляющей определяется в кадре аудио, предшествующем потерянному кадру аудио, и эта определенная интенсивность периодической составляющей используется для получения аудиоинформации с маскированием ошибки. Однако было установлено, что вышеупомянутое вычисление интенсивности периодической составляющей обеспечивает особенно хорошие результаты, поскольку рассматривается фактический аудиосигнал временной области кадра аудио, предшествующего потерянному кадру аудио. Альтернативно, для получения информации основного тона можно использовать корреляцию в области возбуждения или непосредственно во временной области. Однако существуют также различные возможности, зависящие от того, какой вариант осуществления используется. Согласно варианту осуществления, информацией основного тона может быть только основной тон, полученный из ltp последнего кадра или основной тон, который передается как вспомогательная информация или вычисляется.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью фильтрации высоких частот шумового сигнала который объединяется с экстраполированным сигналом возбуждения во временной области. Было установлено, что высокочастотная фильтрация шумового сигнала (который обычно поступает в синтез LPC) приводит к естественному слуховому восприятию. Например, характеристика пропускания высоких частот может изменяться с величиной потери кадра, после определенной величины потери кадра может больше не существовать высокочастотного пропускания. Характеристика пропускания высоких частот также может зависеть от частоты дискретизации, на которой работает декодер. Например, высокочастотное пропускание зависит от частоты дискретизации, и характеристика фильтр может изменяться во времени (по мере потери последовательных кадров). Характеристика пропускания высоких частот также может, опционально, изменяться по мере потери последовательных кадров таким образом, что после определенной величины потери кадра больше не существует фильтрации, чтобы получить только полнодиапазонный сформированный шум для получения хорошего комфортного шума, близкого к фоновому шуму.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью выборочного изменения спектральной формы шумового сигнала (562) с использованием фильтра коррекции предыскажений, причем шумовой сигнал объединяется с экстраполированным сигналом возбуждения во временной области, если кадр аудио, кодированный в представлении частотной области, предшествующего потерянному кадру аудио является вокализованным кадром аудио или содержит начало звука (onset). Было установлено, что, согласно такому принципу, можно улучшить слуховое восприятие аудиоинформации с маскированием ошибки. Например, в ряде случаев лучше снижать коэффициенты усиления и форму и некотором месте лучше повышать их.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью вычисления коэффициента усиления шумового сигнала в зависимости от корреляции во временной области, которая осуществляется на основании представления временной области кадра аудио, кодированного в представлении частотной области, предшествующего потерянному кадру аудио. Было установлено, что такое определение коэффициента усиления шумового сигнала обеспечивает особенно точные результаты, поскольку можно рассматривать фактический аудиосигнал временной области, связанный с кадром аудио, предшествующим потерянному кадру аудио. С использованием этого принципа, можно иметь возможность получения энергии замаскированного кадра вблизи энергии предыдущего хорошего кадра. Например, коэффициент усиления для шумового сигнала можно генерировать путем измерения энергии результата: возбуждение входного сигнала - возбуждение на основе сгенерированного основного тона.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью модификации сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, для получения аудиоинформации с маскированием ошибки. Было установлено, что модификация сигнала возбуждения во временной области позволяет адаптировать сигнал возбуждения во временной области к желаемому временному развитию. Например, модификация сигнала возбуждения во временной области допускает ʺзатуханиеʺ детерминированной (например, по существу, периодической) составляющей аудиоконтента в аудиоинформации с маскированием ошибки. Кроме того, модификация сигнала возбуждения во временной области также позволяет адаптировать сигнал возбуждения во временной области к (оцененному или ожидаемому) изменению основного тона. Это позволяет регулировать характеристики аудиоинформации с маскированием ошибки во времени.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью использования одной или более модифицированных копий сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, для получения информации маскирования ошибки. Модифицированные копии сигнала возбуждения во временной области можно получить с умеренными затратами, и модификация может осуществляться с использованием простого алгоритма. Таким образом, желаемые характеристики аудиоинформации с маскированием ошибки можно добиться с умеренными затратами.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью модификации сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий, для уменьшения, таким образом, периодической составляющей аудиоинформации с маскированием ошибки во времени. Соответственно, можно полагать, что корреляция между аудиоконтентом кадра аудио, предшествующего потерянному кадру аудио, и аудиоконтентом одного или более потерянных кадров аудио снижается во времени. Также можно избежать неестественного слухового восприятия, вызванного длительным сохранением периодической составляющей аудиоинформации с маскированием ошибки.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью масштабирования сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий, для модификации, таким образом, сигнала возбуждения во временной области. Было установлено, что операцию масштабирование можно осуществлять с малыми затратами, причем масштабированный сигнал возбуждения во временной области обычно обеспечивает хорошую аудиоинформацию с маскированием ошибки.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью постепенного снижения коэффициента усиления, применяемого для масштабирования сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий. Соответственно, можно добиться затухания периодической составляющей в аудиоинформации с маскированием ошибки.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью регулировки скорости, используемой для постепенного снижения коэффициента усиления, применяемого для масштабирования сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий, в зависимости от одного или более параметров одного или более кадров аудио, предшествующих потерянному кадру аудио, и/или в зависимости от количества последовательных потерянных кадров аудио. Соответственно, можно регулировать скорость, с которой детерминированная (например, по меньшей мере, приблизительно периодическая) составляющая затухает в аудиоинформации с маскированием ошибки. Скорость затухания может быть адаптирована к конкретным характеристикам аудиоконтента, что обычно можно видеть из одного или более параметров одного или более кадров аудио, предшествующих потерянному кадру аудио. Альтернативно или дополнительно, количество последовательных потерянных кадров аудио можно рассматривать при определении скорости, используемой для ослабления детерминированной (например, по меньшей мере, приблизительно периодическая) составляющей аудиоинформации с маскированием ошибки, что помогает адаптировать маскирование ошибки к конкретной ситуации. Например, коэффициент усиления тональной части и коэффициент усиления шумовой части можно уменьшать по отдельности. Коэффициент усиления для тональной части может сходиться к нулю после определенной величины потери кадра, тогда как коэффициент усиления шума может сходиться к коэффициенту усиления, определенному для достижения определенного комфортного шума.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью регулировки скорости, используемой для постепенного снижения коэффициента усиления, применяемого для масштабирования сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий, в зависимости от длины периода основного тона сигнала возбуждения во временной области, таким образом, что сигнал возбуждения во временной области, поступающий в синтез LPC, затухает быстрее для сигналов, имеющих меньшую длину периода основного тона, по сравнению с сигналами, имеющими бóльшую длину периода основного тона. Соответственно, можно избежать слишком частого повторения сигналов, имеющих меньшую длину периода основного тона, с высокой интенсивностью, поскольку это обычно приводит к неестественному слуховому восприятию. Таким образом, можно улучшить общее качество аудиоинформации с маскированием ошибки.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью регулировки скорости, используемой для постепенного снижения коэффициента усиления, применяемого для масштабирования сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий, в зависимости от результата анализа основного тона или предсказания основного тона, таким образом, что детерминированная составляющая сигнала возбуждения во временной области, поступающего в синтез LPC, затухает быстрее для сигналов, имеющих большее изменение основного тона за единицу времени по сравнению с сигналами, имеющими меньшее изменение основного тона за единицу времени, и/или таким образом, что детерминированная составляющая сигнала возбуждения во временной области, поступающего в синтез LPC, затухает быстрее для сигналов, основной тон которых не удается предсказать, по сравнению с сигналами, основной тон которых удается предсказать. Соответственно, затухание можно ускорить для сигналов, где присутствует большая неопределенность основного тона по сравнению с сигналами, для которых неопределенность основного тона меньше. Однако, благодаря более быстрому затуханию детерминированной составляющей для сигналов, которые содержат сравнительно большую неопределенность основного тона, слышимых артефактов можно избежать или, по меньшей мере, существенно ослабить их.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью масштабирования по времени сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий, в зависимости от предсказания основного тона в течение времени одного или более потерянных кадров аудио. Соответственно, сигнал возбуждения во временной области может быть адаптирован к изменяющемуся основному тону, таким образом, что аудиоинформация с маскированием ошибки содержит более естественное слуховое восприятие.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью обеспечения аудиоинформации с маскированием ошибки в течение времени, превышающего временную длительность одного или более потерянных кадров аудио. Соответственно, можно осуществлять операцию перекрытия и добавления на основании аудиоинформации с маскированием ошибки, что помогает ослабить артефакты блочности.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью осуществления перекрытия и добавления аудиоинформации с маскированием ошибки и представления временной области одного или более правильно принятых кадров аудио, следующих за одним или более потерянными кадрами аудио. Таким образом, можно избежать артефактов блочности (или, по меньшей мере, ослабить их).

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью вывода аудиоинформации с маскированием ошибки на основании, по меньшей мере, трех частично перекрывающихся кадров или окон, предшествующих потерянному кадру аудио или потерянному окну. Соответственно, аудиоинформацию с маскированием ошибки можно получить с хорошей точностью даже для режимов кодирования, в которых более двух кадров (или окон) перекрываются (причем такое перекрытие может способствовать уменьшению задержки).

Другой вариант осуществления согласно изобретению создает способ обеспечения декодированной аудиоинформации на основании кодированной аудиоинформации. Способ содержит обеспечение аудиоинформации с маскированием ошибки для маскировки потери кадра аудио, следующего за кадром аудио, кодированным в представлении частотной области, с использованием сигнала возбуждения во временной области. Этот способ основан на тех же соображениях, что и вышеупомянутый аудиодекодер.

Еще один вариант осуществления согласно изобретению создает компьютерную программу для осуществления упомянутого способа, когда компьютерная программа выполняется на компьютере.

Другой вариант осуществления согласно изобретению создает аудиодекодер для обеспечения декодированной аудиоинформации на основании кодированной аудиоинформации. Аудиодекодер содержит маскирование ошибки, выполненное с возможностью обеспечения аудиоинформации с маскированием ошибки для маскировки потери кадра аудио. Маскирование ошибки выполнено с возможностью модификации сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, для получения аудиоинформации с маскированием ошибки.

Этот вариант осуществления согласно изобретению основан на идее о том, что маскирование ошибки с хорошим качеством аудиосигнала можно получить на основании сигнала возбуждения во временной области, причем модификация сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, позволяет адаптировать аудиоинформацию с маскированием ошибки к ожидаемым (или предсказанным) изменениям аудиоконтента на протяжении потерянного кадра. Соответственно, можно избежать артефактов и, в частности, неестественного слухового восприятия, вызванного неизменным использованием сигнала возбуждения во временной области. Следовательно, достигается улучшенное обеспечение аудиоинформации с маскированием ошибки, что позволяет маскировать потерянные кадры аудио с улучшенными результатами.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью использования одной или более модифицированных копий сигнала возбуждения во временной области, полученного для одного или более кадров аудио, предшествующих потерянному кадру аудио, для получения информации маскирования ошибки. С использованием одна или более модифицированных копий сигнала возбуждения во временной области, полученного для одного или более кадров аудио, предшествующих потерянному кадру аудио, хорошего качества аудиоинформации с маскированием ошибки можно добиться с малыми вычислительными затратами.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью модификации сигнала возбуждения во временной области, полученного для одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий, для уменьшения, таким образом, периодической составляющей аудиоинформации с маскированием ошибки во времени. Благодаря уменьшению периодической составляющей аудиоинформации с маскированием ошибки во времени, можно избежать неестественно длительного сохранения детерминированного (например, приблизительно периодического) звука, что помогает добиться естественного звучания аудиоинформации с маскированием ошибки.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью масштабирования сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий, для модификации, таким образом, сигнала возбуждения во временной области. Масштабирование сигнала возбуждения во временной области позволяет особенно эффективно изменять аудиоинформацию с маскированием ошибки во времени.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью постепенного снижения коэффициента усиления, применяемого для масштабирования сигнала возбуждения во временной области, полученного для одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий. Было установлено, что постепенное уменьшение коэффициента усиления, применяемого для масштабирования сигнала возбуждения во временной области, полученного для одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий, позволяет получать сигнала возбуждения во временной области для обеспечения аудиоинформации с маскированием ошибки, таким образом, что детерминированные составляющие (например, по меньшей мере, приблизительно, периодические составляющие) затухают. Например, может существовать не только один коэффициент усиления. Например, может существовать один коэффициент усиления для тональной части (также именуемой приблизительно периодической частью), и один коэффициент усиления для шумовой части. Оба возбуждения (или составляющие возбуждения) могут затухать по отдельности с разными коэффициентами скорости и затем два результирующих возбуждения (или составляющих возбуждения) могут объединяться до подачи на LPC для синтеза. В случае, когда отсутствует какая-либо оценка фонового шума, коэффициент затухания для шумовой и тональной части может быть аналогичным, и тогда можно применять одно-единственное затухание к результатам двух возбуждений, умноженным на их собственные коэффициенты усиления и объединенным друг с другом.

Таким образом, можно избежать, чтобы аудиоинформация с маскированием ошибки содержала расширенную во времени детерминированную (например, по меньшей мере, приблизительно периодическую) аудиосоставляющая, что обычно обеспечивает неестественное слуховое восприятие.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью регулировки скорости, используемой для постепенного снижения коэффициента усиления, применяемого для масштабирования сигнала возбуждения во временной области, полученного для одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий, в зависимости от одного или более параметров одного или более кадров аудио, предшествующих потерянному кадру аудио, и/или в зависимости от количества последовательных потерянных кадров аудио. Таким образом, скорость затухания детерминированной (например, по меньшей мере, приблизительно периодической) составляющей в аудиоинформации с маскированием ошибки можно адаптировать к конкретной ситуации с умеренными вычислительными затратами. Поскольку сигнал возбуждения во временной области, используемый для обеспечения аудиоинформации с маскированием ошибки обычно является масштабированной версией (масштабированной с использованием вышеупомянутого коэффициента усиления) сигнала возбуждения во временной области, полученного для одного или более кадров аудио, предшествующих потерянному кадру аудио, изменение упомянутого коэффициента усиления (используемого для вывода сигнала возбуждения во временной области для обеспечения аудиоинформации с маскированием ошибки) дает простой, но эффективный способ адаптации аудиоинформации с маскированием ошибки к конкретным потребностям. Однако скоростью затухания также можно управлять с очень малыми затратами.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью регулировки скорости, используемой для постепенного снижения коэффициента усиления, применяемого для масштабирования сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий, в зависимости от длины периода основного тона сигнала возбуждения во временной области, таким образом, что сигнал возбуждения во временной области, поступающий в синтез LPC, затухает быстрее для сигналов, имеющих меньшую длину периода основного тона, по сравнению с сигналами, имеющими бóльшую длину периода основного тона. Соответственно, затухание осуществляется быстрее для сигналов, имеющих меньшую длину периода основного тона, что позволяет избежать копирования периода основного тона слишком много раз (что обычно приводят к неестественному слуховому восприятию).

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью регулировки скорости, используемой для постепенного снижения коэффициента усиления, применяемого для масштабирования сигнала возбуждения во временной области, полученного для одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий, в зависимости от результата анализа основного тона или предсказания основного тона, таким образом, что детерминированная составляющая сигнала возбуждения во временной области, поступающий в синтез LPC, затухает быстрее для сигналов, имеющих большее изменение основного тона за единицу времени по сравнению с сигналами, имеющими меньшее изменение основного тона за единицу времени, и/или таким образом, что детерминированная составляющая сигнала возбуждения во временной области, поступающий в синтез LPC, затухает быстрее для сигналов, основной тон которых не удается предсказать, по сравнению с сигналами, основной тон которых удается предсказать. Соответственно, детерминированная (например, по меньшей мере, приблизительно периодическая) составляющая затухает быстрее для сигналов с большей неопределенностью основного тона (где большее изменение основного тона за единицу времени, или даже неудача предсказания основного тона, указывает сравнительно большую неопределенность основного тона). Таким образом, можно избежать артефактов, возникающих вследствие обеспечения сильно детерминированной аудиоинформации с маскированием ошибки в ситуации неопределенного фактического основного тона.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью масштабирования по времени сигнала возбуждения во временной области, полученного для (или на основании) одного или более кадров аудио, предшествующих потерянному кадру аудио, или одной или более его копий, в зависимости от предсказания основного тона в течение времени одного или более потерянных кадров аудио. Соответственно, сигнал возбуждения во временной области, который используется для обеспечения аудиоинформации с маскированием ошибки, модифицируется (по сравнению с сигналом возбуждения во временной области, полученным для (или на основании) одного или более кадров аудио, предшествующих потерянному кадру аудио, таким образом, что основной тон сигнала возбуждения во временной области отвечает требованиям периода времени потерянного кадра аудио. Следовательно, можно улучшить слуховое восприятие, которого можно добиться посредством аудиоинформации с маскированием ошибки.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью получения сигнала возбуждения во временной области, который использовался для декодирования одного или более кадров аудио, предшествующих потерянному кадру аудио, и для модификации упомянутого сигнала возбуждения во временной области, который использовался для декодирования одного или более кадров аудио, предшествующих потерянному кадру аудио, для получения модифицированного сигнала возбуждения во временной области. В этом случае, маскирование во временной области выполнен с возможностью обеспечения аудиоинформации с маскированием ошибки на основании модифицированного аудиосигнала временной области. Соответственно, можно повторно использовать сигнал возбуждения во временной области, который уже был использован для декодирования одного или более кадров аудио, предшествующих потерянному кадру аудио. Таким образом, вычислительные затраты могут оставаться очень малым, если сигнал возбуждения во временной области уже получен для декодирования одного или более кадров аудио, предшествующих потерянному кадру аудио.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью получения информации основного тона, которая использовалась для декодирования одного или более кадров аудио, предшествующих потерянному кадру аудио. В этом случае, маскирование ошибки также выполнено с возможностью обеспечения аудиоинформации с маскированием ошибки в зависимости от упомянутой информации основного тона. Соответственно, можно повторно использовать ранее использованную информацию основного тона, что позволяет избежать вычислительных затрат для нового вычисления информации основного тона. Таким образом, маскирование ошибки особенно вычислительно эффективно. Например, в случае ACELP получается по 4 отставания и коэффициентов усиления основного тона на кадр. Можно использовать последние два кадра, чтобы иметь возможность предсказания основного тона в конце кадра, который нужно маскировать.

Сравним с вышеописанным кодеком частотной области, где выводятся только один или два основных тона на кадр (можно иметь более двух, но это дает значительное усложнение без особого выигрыша в качестве). В случае переключающегося кодека, который проходит, например, ACELP - FD - потеря, получается гораздо лучшую точность основного тона, поскольку основной тон передаются в битовом потоке и основаны на исходном входном сигнале (а не на декодированном, как на декодере). В случае высокой битовой скорости, например, также можно отправлять одну информация отставания и коэффициента усиления основного тона, или информацию LTP, для каждого кадра, кодированного в частотной области.

В предпочтительном варианте осуществления, аудиодекодер с маскированием ошибки может быть выполнен с возможностью получения информации основного тона на основании вспомогательной информации кодированной аудиоинформации.

В предпочтительном варианте осуществления, маскирование ошибки может быть выполнено с возможностью получения информации основного тона на основании информации основного тона, доступной для ранее декодированного кадра аудио.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью получения информации основного тона на основании поиска основного тона, осуществляемого по сигналу временной области или по остаточному сигналу.

Иначе говоря, основной тон может передаваться как вспомогательная информация или может также поступать из предыдущего кадра, например, при наличии LTP. Информация основного тона также может передаваться в битовом потоке при наличии на кодере. Опционально, поиск основного тона можно производить непосредственно по сигналу временной области или по остатку, причем обычно лучшие результаты выдаются по остатку (сигнал возбуждения во временной области).

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью получения набора коэффициентов линейного предсказания, которые использовались для декодирования одного или более кадров аудио, предшествующих потерянному кадру аудио. В этом случае, маскирование ошибки выполнено с возможностью обеспечения аудиоинформации с маскированием ошибки в зависимости от упомянутого набора коэффициентов линейного предсказания. Таким образом, эффективность маскирования ошибки увеличивается за счет повторного использования ранее сгенерированной (или ранее декодированной) информации, например, ранее использованного набора коэффициентов линейного предсказания. Это позволяет избежать чрезмерно высокой вычислительной сложности.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью экстраполяции нового набора коэффициентов линейного предсказания на основании набора коэффициентов линейного предсказания, которые использовались для декодирования одного или более кадров аудио, предшествующих потерянному кадру аудио. В этом случае, маскирование ошибки выполнено с возможностью использования нового набора коэффициентов линейного предсказания для обеспечения информации маскирования ошибки. Выводя новый набор коэффициентов линейного предсказания, используемый для обеспечения аудиоинформации с маскированием ошибки, из набора ранее использованных коэффициентов линейного предсказания с использованием экстраполяции, можно избежать полного повторного вычисления коэффициентов линейного предсказания, что помогает сохранять вычислительные затраты довольно малыми. Кроме того, осуществляя экстраполяцию на основании ранее использованного набора коэффициентов линейного предсказания, можно гарантировать, что новый набор коэффициентов линейного предсказания, по меньшей мере, аналогичен ранее использованному набору коэффициентов линейного предсказания, что помогает избежать нарушений непрерывности при обеспечении информации маскирования ошибки. Например, после определенной величины потери кадра целесообразно оценивать форму LPC фонового шума. Скорость этого схождения, может, например, зависеть от характеристики сигнала.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью получения информации об интенсивности детерминированной составляющей сигнала в одном или более кадрах аудио, предшествующих потерянному кадру аудио. В этом случае, маскирование ошибки выполнено с возможностью сравнения информации об интенсивности детерминированной составляющей сигнала в одном или более кадрах аудио, предшествующих потерянному кадру аудио, с пороговым значением, для принятия решения, вводить ли детерминированную составляющую сигнала возбуждения во временной области в синтез LPC (синтез на основе коэффициентов линейного предсказания), или вводить ли только шумовую составляющую сигнала возбуждения во временной области в синтез LPC. Соответственно, можно исключить обеспечение детерминированной (например, по меньшей мере, приблизительно периодической) составляющей аудиоинформации с маскированием ошибки в случае, когда существует лишь малый вклад детерминированного сигнала в один или более кадров, предшествующих потерянному кадру аудио. Было установлено, что это помогает получить хорошее слуховое восприятие.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью получения информации основного тона, описывающей основной тон кадра аудио, предшествующего потерянному кадру аудио, и обеспечения аудиоинформации с маскированием ошибки в зависимости от информации основного тона. Соответственно, можно адаптировать основной тон информации маскирования ошибки к основному тону кадра аудио, предшествующего потерянному кадру аудио. Соответственно, можно избежать нарушений непрерывности и добиться естественного слухового восприятия.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью получения информации основного тона на основании сигнала возбуждения во временной области, связанного с кадром аудио, предшествующим потерянному кадру аудио. Было установлено, что информация основного тона, полученная на основании сигнала возбуждения во временной области, особенно достоверна и также очень хорошо адаптирована к обработке сигнала возбуждения во временной области.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью оценивания кросс-корреляции сигнала возбуждения во временной области (или, альтернативно, аудиосигнала временной области), для определения грубой информации основного тона, и для уточнения грубой информации основного тона с использованием поиска по замкнутому циклу вокруг основного тона, определенного (или описанного) грубой информацией основного тона. Было установлено, что этот принцип позволяет получать очень точную информацию основного тона с умеренными вычислительными затратами. Другими словами, в некотором кодеке поиск основного тона осуществляется непосредственно по сигналу временной области, тогда как в каком-либо другом поиск основного тона осуществляется по сигналу возбуждения во временной области.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью получения информации основного тона для обеспечения аудиоинформации с маскированием ошибки на основании ранее вычисленной информации основного тона, которая использовалась для декодирования одного или более кадров аудио, предшествующих потерянному кадру аудио, и на основании оценивания кросс-корреляции сигнала возбуждения во временной области, который модифицируется для получения модифицированного сигнала возбуждения во временной области для обеспечения аудиоинформации с маскированием ошибки. Было установлено, что учет ранее вычисленной информации основного тона и информации основного тона, полученной на основании сигнала возбуждения во временной области (с использованием кросс-корреляции) повышает достоверность информации основного тона и, следовательно, помогает избежать артефактов и/или нарушений непрерывности.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью выбора пика кросс-корреляции, из множества пиков кросс-корреляции, в качестве пика, представляющего основной тон, в зависимости от ранее вычисленной информации основного тона, таким образом, что выбирается пик, который представляет основной тон, ближайший к основному тону, представленному ранее вычисленной информацией основного тона. Соответственно, можно преодолеть возможную неопределенность кросс-корреляции, которая может, например, приводить к множественным пикам. Таким образом, ранее вычисленная информация основного тона используется для выбора ʺправильногоʺ пика кросс-корреляции, что помогает существенно повысить достоверность. С другой стороны, фактический сигнал возбуждения во временной области рассматривается в основном для определения основного тона, что обеспечивает хорошую точность (которая существенно выше точности, которую можно получить на основании только ранее вычисленной информации основного тона).

В предпочтительном варианте осуществления, аудиодекодер с маскированием ошибки может быть выполнен с возможностью получения информации основного тона на основании вспомогательной информации кодированной аудиоинформации.

В предпочтительном варианте осуществления, маскирование ошибки может быть выполнено с возможностью получения информации основного тона на основании информации основного тона, доступной для ранее декодированного кадра аудио.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью получения информации основного тона на основании поиска основного тона, осуществляемого по сигналу временной области или по остаточному сигналу.

Иначе говоря, основной тон может передаваться как вспомогательная информация или может также поступать из предыдущего кадра, например, при наличии LTP. Информация основного тона также может передаваться в битовом потоке при наличии на кодере. Опционально, поиск основного тона можно производить непосредственно по сигналу временной области или по остатку, причем обычно лучшие результаты выдаются по остатку (сигнал возбуждения во временной области).

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью копирования цикла основного тона сигнала возбуждения во временной области, связанного с кадром аудио, предшествующим потерянному кадру аудио, один раз или несколько раз, для получения сигнала возбуждения (или, по меньшей мере, его детерминированной составляющей) для синтеза аудиоинформации с маскированием ошибки. Благодаря копированию цикла основного тона сигнала возбуждения во временной области, связанного с кадром аудио, предшествующим потерянному кадру аудио, один раз или несколько раз, и благодаря модификации упомянутых одной или более копий с использованием сравнительно простого алгоритма модификации, сигнал возбуждения (или, по меньшей мере, его детерминированная составляющая) для синтеза аудиоинформации с маскированием ошибки можно получить с малыми вычислительными затратами. Однако повторное использование сигнала возбуждения во временной области, связанного с кадром аудио, предшествующим потерянному кадру аудио (благодаря копированию упомянутого сигнала возбуждения во временной области), позволяет избежать слышимых нарушений непрерывности.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью фильтрации низких частот цикла основного тона сигнала возбуждения во временной области, связанного с кадром аудио, предшествующим потерянному кадру аудио, с использованием фильтра, зависящего от частоты дискретизации, полоса пропускания которого зависит от частоты дискретизации кадра аудио, кодированного в представлении частотной области. Соответственно, сигнал возбуждения во временной области адаптируется к полосе пропускания сигнала аудиодекодера, что приводит к хорошему воспроизведению аудиоконтента. За деталями и необязательными улучшениями обратимся, например, к вышеприведенным объяснениям.

Например, пропускание низких частот предпочтительно только на первом потерянном кадре, и предпочтительно, пропускание низких частот также возможно, только если сигнал не является невокализованным. Однако следует отметить, что низкочастотная фильтрация является необязательной. Кроме того, фильтр может зависеть от частоты дискретизации, в результате чего частота среза не будет зависеть от полосы пропускания.

В предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью предсказания основного тона на конце потерянного кадра. В этом случае, маскирование ошибки выполнено с возможностью адаптации сигнала возбуждения во временной области или одной или более его копий, к предсказанному основному тону. Благодаря модификации сигнала возбуждения во временной области, таким образом, что сигнал возбуждения во временной области, который фактически используется для обеспечения аудиоинформации с маскированием ошибки модифицируется в отношении сигнала возбуждения во временной области, связанного с кадром аудио, предшествующим потерянному кадру аудио, можно рассматривать ожидаемые (или предсказанные) изменения основного тона на протяжении потерянного кадра аудио, таким образом, что аудиоинформация с маскированием ошибки хорошо адаптирована к фактическому развитию (или, по меньшей мере, к ожидаемому или предсказанному развитию) аудиоконтента. Например, адаптация идет от последнего хорошего основного тона к предсказанному. Это осуществляется путем ресинхронизации импульсов [7].

в предпочтительном варианте осуществления, маскирование ошибки выполнено с возможностью объединения экстраполированного сигнала возбуждения во временной области и шумового сигнала, для получения входного сигнала для синтеза LPC. В этом случае, маскирование ошибки выполнено с возможностью осуществления синтеза LPC, причем синтез LPC выполнен с возможностью фильтрации входного сигнала синтеза LPC в зависимости от параметров кодирования с линейным предсказанием, для получения аудиоинформации с маскированием ошибки. Путем объединения экстраполированного сигнала возбуждения во временной области (который обычно является модифицированной версией сигнала возбуждения во временной области, выведенного для одного или более кадров аудио, предшествующих потерянному кадру аудио) и шумового сигнала, детерминированные (например, приблизительно периодические) составляющие и шумовые составляющие аудиоконтента можно рассматривать в маскировании ошибки. Таким образом, можно добиться, чтобы аудиоинформация с маскированием ошибки обеспечивала слуховое восприятие, аналогичное слуховому восприятию, обеспеченному кадрами, предшествующими потерянному кадру.

Также, путем объединения сигнала возбуждения во временной области и шумового сигнала, для получения входного сигнала для синтеза LPC (который можно рассматривать как объединенный сигнал возбуждения во временной области), можно изменять процент детерминированной составляющей входного аудиосигнала для синтеза LPC при поддержании энергии (входного сигнала синтеза LPC, или даже выходного сигнала синтеза LPC). Следовательно, можно изменять характеристики аудиоинформации с маскированием ошибки (например, характеристики тональности) без существенного изменения энергии или громкости аудиосигнала с маскированием ошибки, что позволяет модифицировать сигнал возбуждения во временной области, не вызывая неприемлемые слышимые искажения.

Вариант осуществления согласно изобретению создает способ обеспечения декодированной аудиоинформации на основании кодированной аудиоинформации. Способ содержит обеспечение аудиоинформации с маскированием ошибки для маскировки потери кадра аудио. Обеспечение аудиоинформации с маскированием ошибки содержит модификацию сигнала возбуждения во временной области, полученного на основании одного или более кадров аудио, предшествующих потерянному кадру аудио, для получения аудиоинформации с маскированием ошибки.

Этот способ основан на тех же соображениях, что и вышеописанный аудиодекодер.

Дополнительный вариант осуществления согласно изобретению создает компьютерную программу для осуществления упомянутого способа, когда компьютерная программа выполняется на компьютере.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

Варианты осуществления настоящего изобретения описаны ниже со ссылкой на прилагаемые чертежи, в которых:

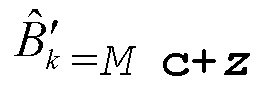

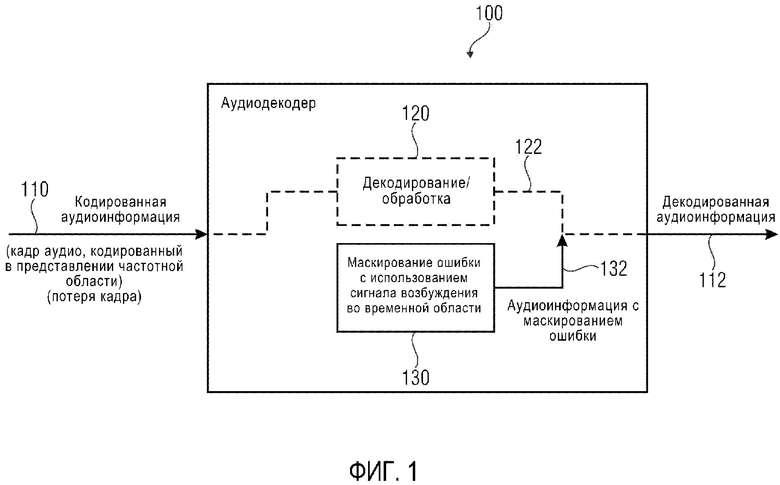

фиг. 1 демонстрирует блок-схему аудиодекодера, согласно варианту осуществления изобретения;

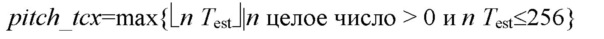

фиг. 2 демонстрирует блок-схему аудиодекодера, согласно другому варианту осуществления настоящего изобретения;

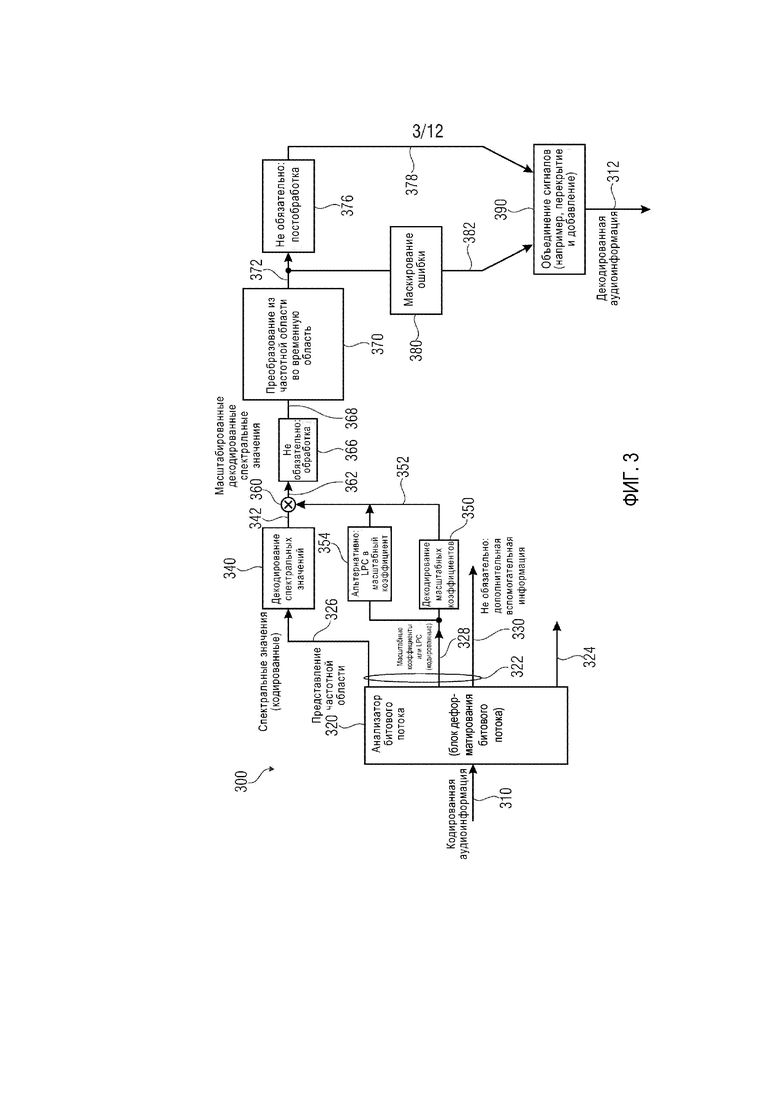

фиг. 3 демонстрирует блок-схему аудиодекодера, согласно другому варианту осуществления настоящего изобретения;

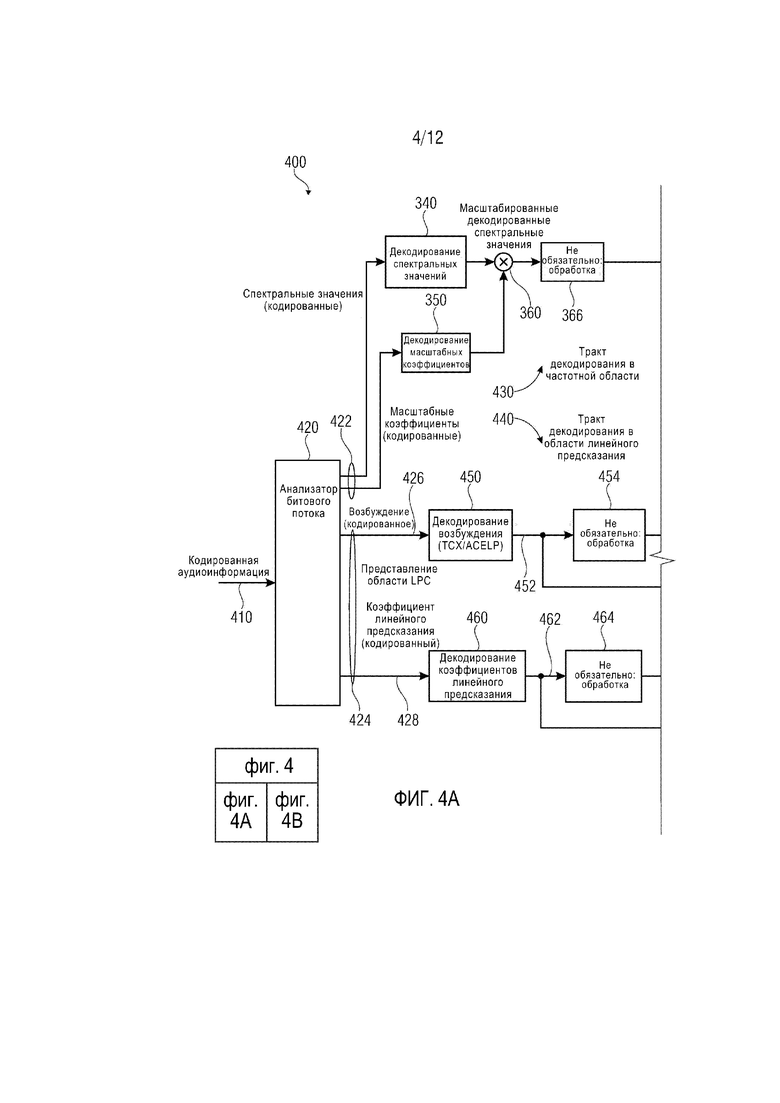

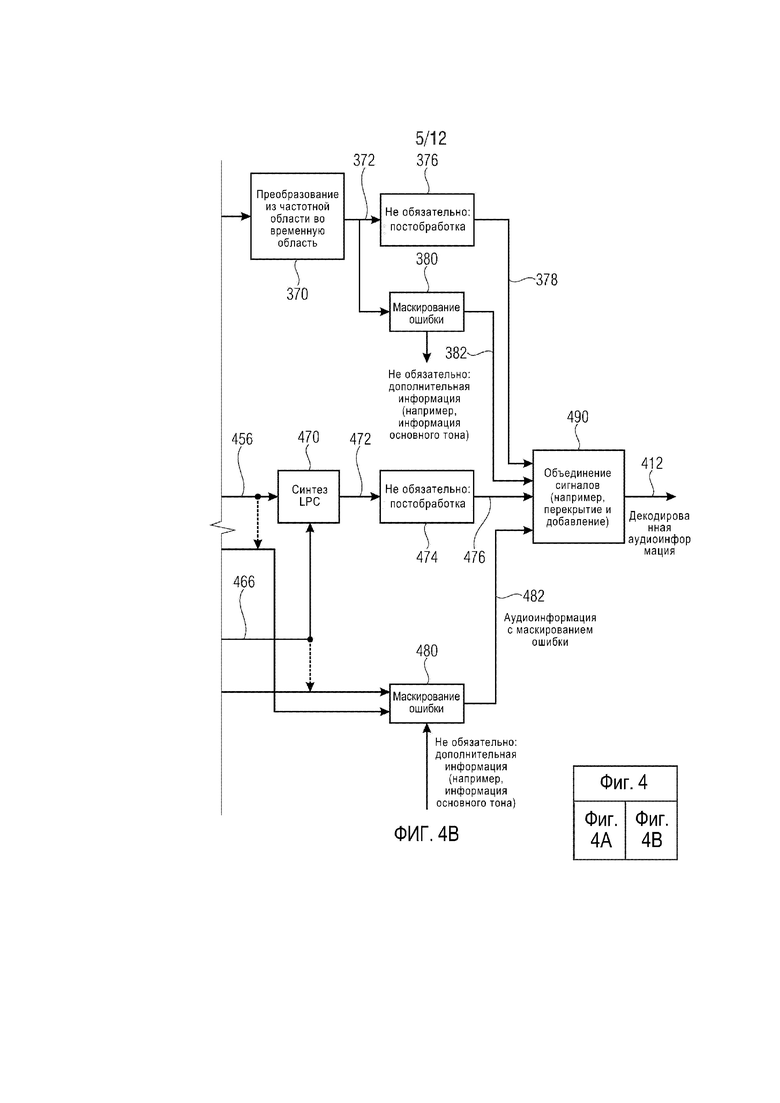

фиг. 4 демонстрирует блок-схему аудиодекодера, согласно другому варианту осуществления настоящего изобретения;

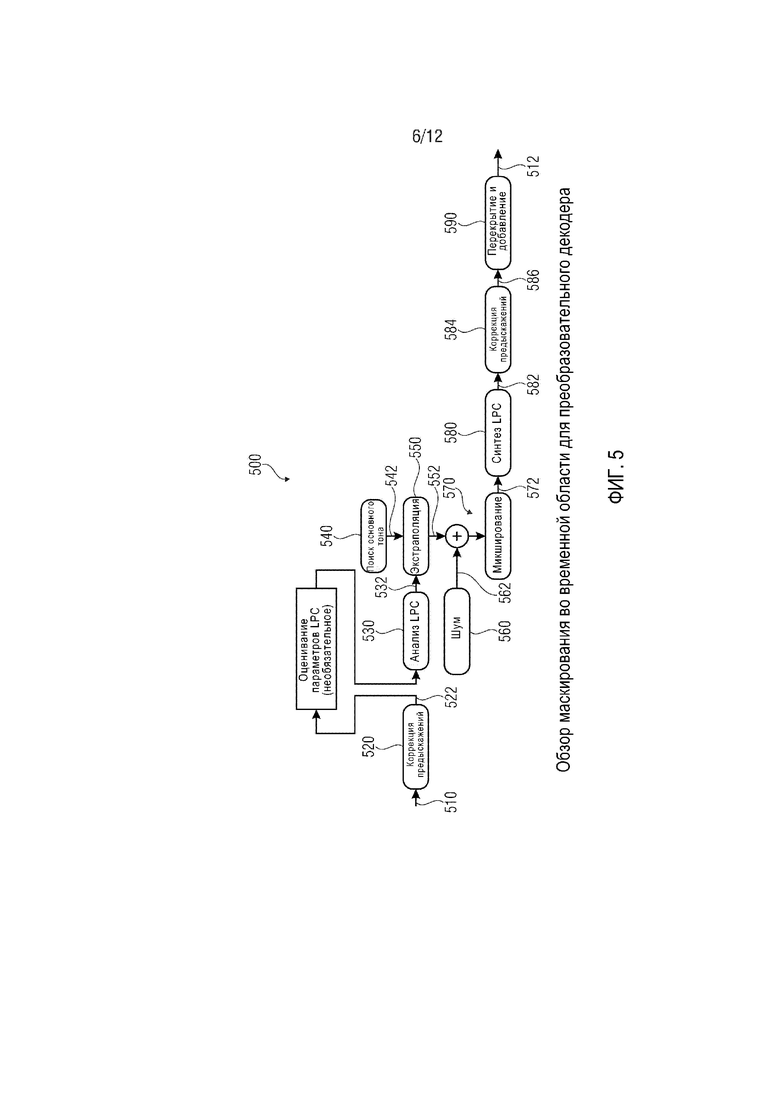

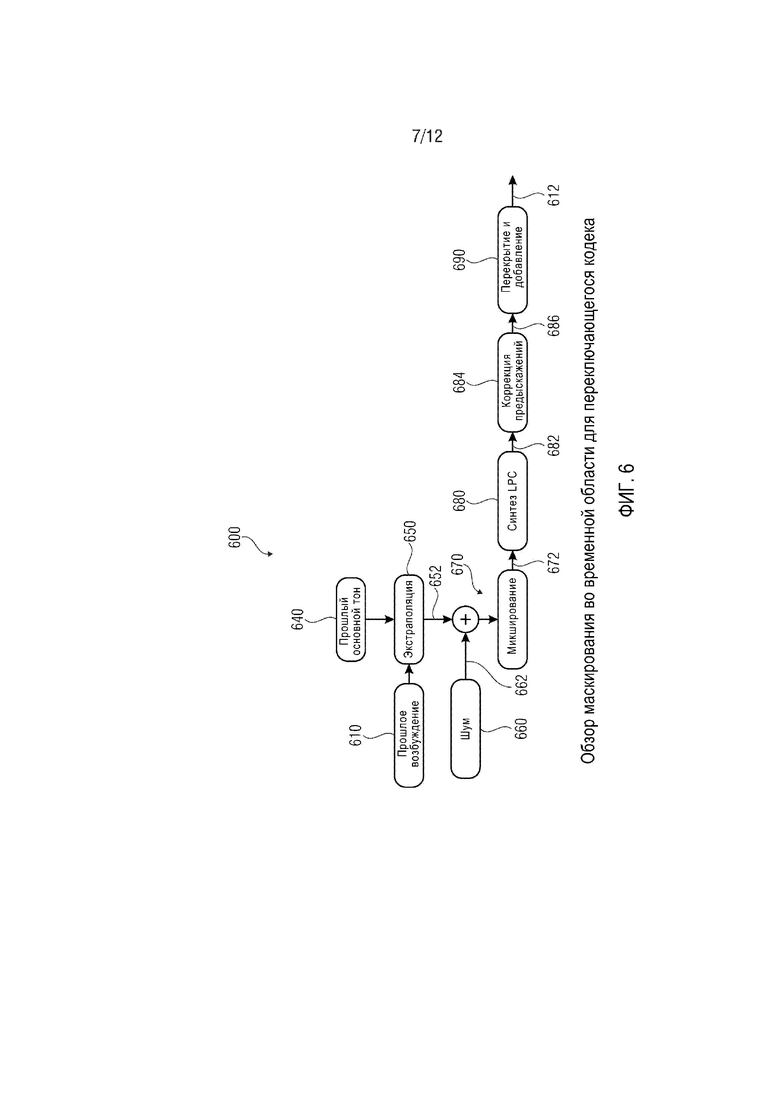

фиг. 5 демонстрирует блок-схему маскирования во временной области для преобразовательного кодера;

фиг. 6 демонстрирует блок-схему маскирования во временной области для переключающегося кодека;

фиг. 7 демонстрирует блок-схему декодера TCX, осуществляющего декодирование TCX в нормальном режиме работы или в случае частичной потери пакетов;

фиг. 8 демонстрирует блок-схему декодера TCX, осуществляющего декодирование TCX в случае маскирования удаления пакета TCX-256;

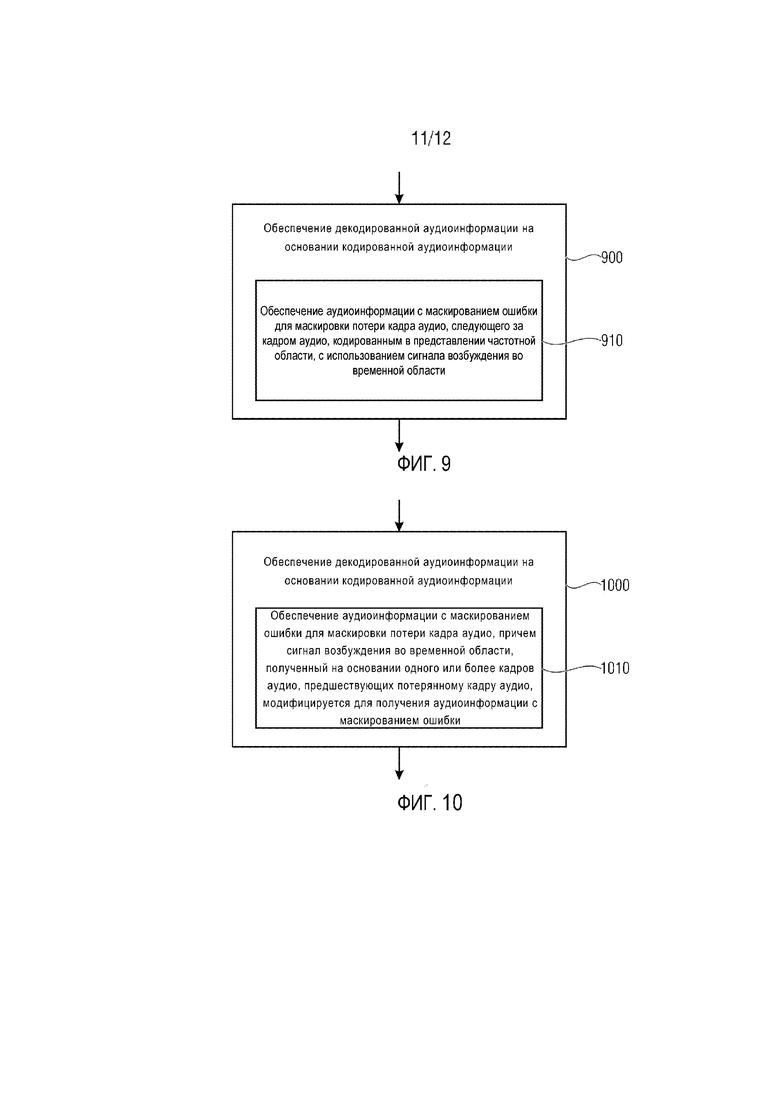

фиг. 9 демонстрирует блок-схему операций способа обеспечения декодированной аудиоинформации на основании кодированной аудиоинформации, согласно варианту осуществления настоящего изобретения; и

фиг. 10 демонстрирует блок-схему операций способа обеспечения декодированной аудиоинформации на основании кодированной аудиоинформации, согласно другому варианту осуществления настоящего изобретения;

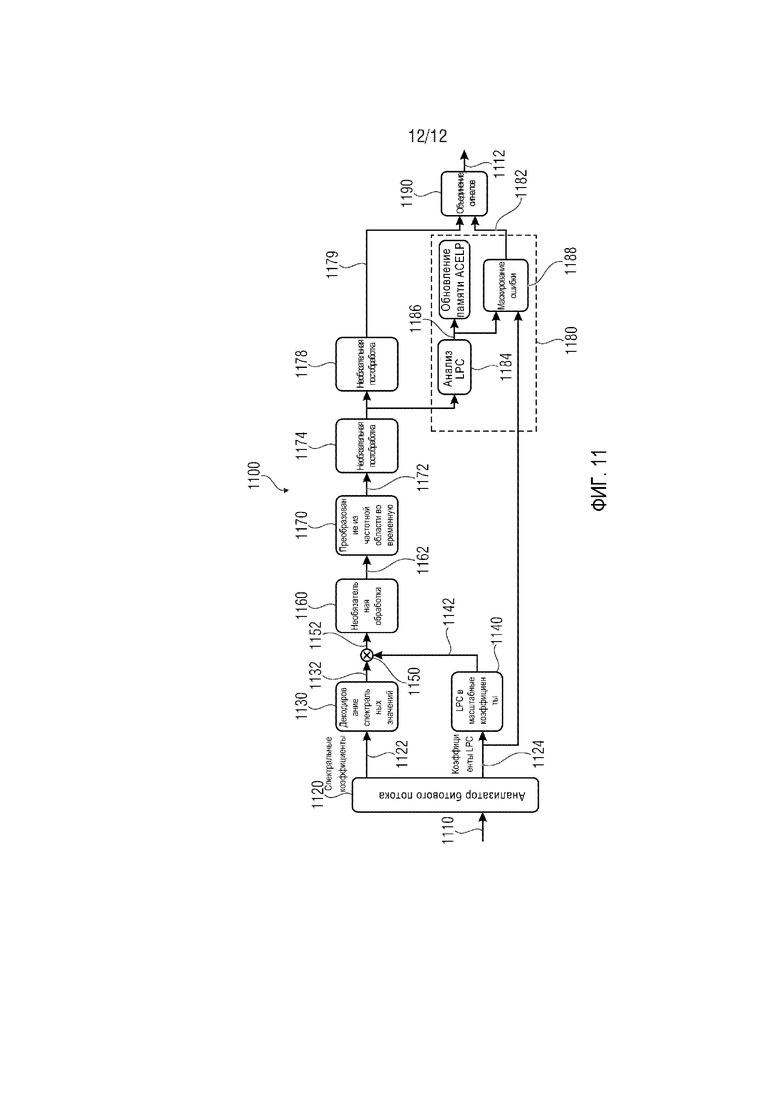

фиг. 11 демонстрирует блок-схему аудиодекодера, согласно другому варианту осуществления настоящего изобретения.

ПОДРОБНОЕ ОПИСАНИЕ ВАРИАНТОВ ОСУЩЕСТВЛЕНИЯ

1. Аудиодекодер согласно фиг. 1

Фиг. 1 демонстрирует блок-схему аудиодекодера 100, согласно варианту осуществления настоящего изобретения. Аудиодекодер 100 принимает кодированную аудиоинформацию 110, которая может, например, содержать кадр аудио, кодированный в представлении частотной области. Кодированная аудиоинформация может, например, приниматься по ненадежному каналу, в результате чего время от времени происходит потерю кадра. Аудиодекодер 100 дополнительно обеспечивает, на основании кодированной аудиоинформации 110, декодированную аудиоинформацию 112.

Аудиодекодер 100 может содержать декодирование/обработку 120, которая обеспечивает декодированную аудиоинформацию на основании кодированной аудиоинформации в отсутствие потери кадра.

Аудиодекодер 100 дополнительно содержит маскирование 130 ошибки, которое обеспечивает аудиоинформацию с маскированием ошибки. Маскирование 130 ошибки выполнено с возможностью обеспечения аудиоинформации 132 с маскированием ошибки для маскировки потери кадра аудио, следующего за кадром аудио, кодированным в представлении частотной области, с использованием сигнала возбуждения во временной области.