УРОВЕНЬ ТЕХНИКИ

В настоящее время корпоративная сеть организации является магистралью связи, которая надежно соединяет различные офисы и подразделения корпорации. Эта сеть обычно представляет собой глобальную сеть (WAN), которая соединяет (1) пользователей в филиальных офисах и региональных кампусах, (2) корпоративные дата-центры, в которых размещаются бизнес-приложения, интрасети и соответствующие им данные, и (3) глобальный Интернет через корпоративные файрволы и DMZ (демилитаризованную зону). Сети организации включают в себя специализированное оборудование, такое как коммутаторы, маршрутизаторы и мидлбокс-устройства, соединенные дорогостоящими арендованными линиями, такими как Frame Relay и MPLS (многопротокольная коммутация по меткам).

За последние несколько лет произошла смена парадигмы в том, как корпорации обслуживают и потребляют сервисы связи. Во-первых, революция мобильности позволила пользователям получать доступ к сервисам из любого места в любое время с помощью мобильных устройств, в основном смартфонов. Такие пользователи получают доступ к сервисам для бизнеса через общедоступный Интернет и сотовые сети. В то же время сторонние вендоры SaaS (программного обеспечения как сервиса) (например, Salesforce, Workday, Zendesk) заменили традиционные локальные приложения, а другие приложения, размещенные в частных дата-центрах, были перемещены в общедоступные облака. Несмотря на то, что этот трафик по-прежнему передается внутри сети организации, значительная его часть исходит и заканчивается за пределами периметра корпоративной сети и должна пересекать как общедоступный Интернет (один или два раза), так и корпоративную сеть. Недавние исследования показали, что 40% корпоративных сетей сообщают, что процент транзитного трафика (т.е. Интернет-трафика, наблюдаемого в корпоративной сети) превышает 80%. Это означает, что большая часть корпоративного трафика проходит как по дорогим выделенным линиям, так и по потребительскому Интернету.

В качестве сервиса, ориентированного на потребителя. Интернет сам по себе является плохой средой для бизнес-трафика. Ему не хватает надежности, гарантий QoS (качества сервисов) и безопасности, ожидаемых от критически важных бизнес-приложений. Кроме того, постоянно растущие потребности потребителей трафика, правила сетевой нейтральности и технологии обхода Интернета, созданные крупными игроками (например, Netflix, Google, общедоступными облаками), снизили денежную отдачу на единицу трафика. Эти тенденции уменьшили стимулы провайдеров сервисов к быстрому удовлетворению запросов потребителей и предложению соответствующих сервисов для бизнеса.

В условиях роста общедоступных облаков корпорации переносят большую часть своей вычислительной инфраструктуры в дата-центры общедоступных облаков. Провайдеры общедоступных облаков были в авангарде инвестиций в вычислительную и сетевую инфраструктуру. Эти облачные сервисы создали множество дата-центров по всему миру, при этом в 2016 году Azure, AWS, IBM и Google расширились соответственно до 38, 16, 25 и 14 регионов мира. Каждый провайдер общедоступного облака связал свои собственные дата-центры с помощью дорогостоящих высокоскоростных сетей, которые используют темное волокно и подводные кабели, развертываемые подводными лодками.

В настоящее время, несмотря на эти изменения, политика корпоративных сетей зачастую вынуждают весь корпоративный трафик проходить через свои безопасные шлюзы WAN. По мере того, как пользователи становятся мобильными, а приложения переносятся в SaaS и общедоступные облака, корпоративные WAN становятся дорогостоящими обходными путями, замедляющими все корпоративные коммуникации. Большая часть корпоративного трафика WAN поступает из Интернета или направляется в Интернет. Альтернативные безопасные решения, которые отправляют этот трафик через Интернет, не подходят из-за своей плохой и ненадежной работы.

КРАТКОЕ СОДЕРЖАНИЕ

Некоторые варианты осуществления создают для организации виртуальную сеть поверх нескольких дата-центров общедоступных облаков одного или более провайдеров общедоступных облаков в одном или более регионах (например, в нескольких городах, штатах, странах и т.д.). Пример организации, для которой может быть создана такая виртуальная сеть, включает в себя коммерческую организацию (например, корпорацию), некоммерческую организацию (например, больницу, исследовательскую организацию и т.д.) и образовательную организацию (например, университет, колледж и т.д.) или любой другой тип организации. Примеры провайдеров общедоступных облаков включают в себя Amazon Web Services (AWS), Google Cloud Platform (GCP), Microsoft Azure и т.д.

В некоторых вариантах осуществления высокоскоростные надежные частные сети соединяют два или более дата-центров общедоступных облаков (общедоступные облака) друг с другом. Некоторые варианты осуществления определяют виртуальную сеть как оверлейную сеть, которая охватывает несколько общедоступных облаков для соединения одной или нескольких частных сетей (например, сетей внутри филиалов, подразделений, отделов организации или связанных с ними дата-центров), мобильных пользователей, машин провайдеров SaaS (программного обеспечения как сервиса), машин и/или сервисов в общедоступном(ых) облаке(ах) и других web-приложений друг с другом.

В некоторых вариантах осуществления виртуальная сеть может быть сконфигурирована для оптимизации маршрутизации сообщений с данными организации к их пунктам назначения для достижения наилучшей сквозной производительности, надежности и безопасности при стремлении минимизировать маршрутизацию этого трафика через Интернет. Кроме того, в некоторых вариантах осуществления виртуальная сеть может быть сконфигурирована для оптимизации обработки уровня 4 потоков сообщений с данными, проходящих через сеть. Например, в некоторых вариантах осуществления виртуальная сеть оптимизирует сквозную скорость ТСР-соединений (TCP - протокол управления транспортом) за счет разделения механизмов управления скоростью по пути соединения.

Некоторые варианты осуществления создают виртуальную сеть в результате конфигурирования нескольких компонентов, которые развернуты в нескольких общедоступных облаках. В некоторых вариантах осуществления эти компоненты включают в себя программные агенты измерений, программные элементы пересылки (например, программные маршрутизаторы, коммутаторы, шлюзы и т.д.), прокси-серверы соединений уровня 4 и машины мидлбокс-обслуживания (например, устройства, VM, контейнеры и т.д.). В некоторых вариантах осуществления один или более из этих компонентов используют стандартизированные или общедоступные решения, такие как Open vSwitch, OpenVPN, strong Swan и Ryu.

Некоторые варианты осуществления используют логически централизованный кластер контроллеров (например, набор из одного или более серверов контроллеров), который конфигурирует компоненты общедоступных облаков для реализации виртуальной сети поверх нескольких общедоступных облаков. В некоторых вариантах осуществления контроллеры в этом кластере находятся в разных местоположениях (например, в разных дата-центрах общедоступных облаков), чтобы улучшить избыточность и высокую доступность. В некоторых вариантах осуществления кластер контроллеров увеличивает или уменьшает число компонентов общедоступных облаков, которые используются для создания виртуальной сети, или вычислительных или сетевых ресурсов, выделенных этим компонентам.

Некоторые варианты осуществления создают разные виртуальные сети для разных организаций поверх одного и того же набора общедоступных облаков одних и тех же провайдеров общедоступных облаков и/или поверх разных наборов общедоступных облаков одного и того же или разных провайдеров общедоступных облаков. В некоторых вариантах осуществления провайдер виртуальных сетей предоставляет программное обеспечение и сервисы, которые позволяют разным арендаторам определять разные виртуальные сети поверх одних и тех же или разных общедоступных облаков. В некоторых вариантах осуществления один и тот же кластер контроллеров или разные кластеры контроллеров могут быть использованы для конфигурирования компонентов общедоступных облаков для реализации разных виртуальных сетей поверх одних и тех же или разных наборов общедоступных облаков для нескольких разных организаций.

Чтобы развернуть виртуальную сеть для арендатора поверх одного или более общедоступных облаков кластер контроллеров (1) идентифицирует возможные входные и выходные маршрутизаторы для входа в виртуальную сеть и выхода из нее для арендатора на основе местоположений филиальных офисов арендатора, дата-центров, мобильных пользователей и провайдеров SaaS и (2) идентифицирует маршруты, которые проходят от идентифицированных входных маршрутизаторов к идентифицированным выходным маршрутизаторам через другие промежуточные маршрутизаторы общедоступных облаков, реализующие виртуальную сеть. После идентификации этих маршрутов кластер контроллеров направляет эти маршруты в таблицы пересылки виртуальных сетевых маршрутизаторов в общедоступном(ых) облаке(ах). В вариантах осуществления, которые используют виртуальные сетевые маршрутизаторы на основе OVS, контроллер распределяет маршруты с помощью OpenFlow.

Приведенное выше краткое содержание предназначено для использования в качестве краткого введения в некоторые варианты осуществления изобретения. Оно не является введением или обзором всего объекта изобретения, раскрытого в этом документе. Подробное описание, которое следует ниже, и чертежи, которые упоминаются в подробном описании, будут дополнительно описывать варианты осуществления, описанные в кратком содержании, а также другие варианты осуществления. Таким образом, чтобы понять все варианты осуществления, описанные в этом документе, требуется полный обзор краткого содержания, подробного описания, чертежей и формулы изобретения. Кроме того, заявленные объекты не должны ограничиваться иллюстративными деталями в кратком описании, подробном описании и на чертежах.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

Новые признаки изобретения изложены в прилагаемой формуле изобретения. Однако в целях пояснения описание нескольких вариантов осуществления изобретения представлено с иллюстрациями на следующих фигурах.

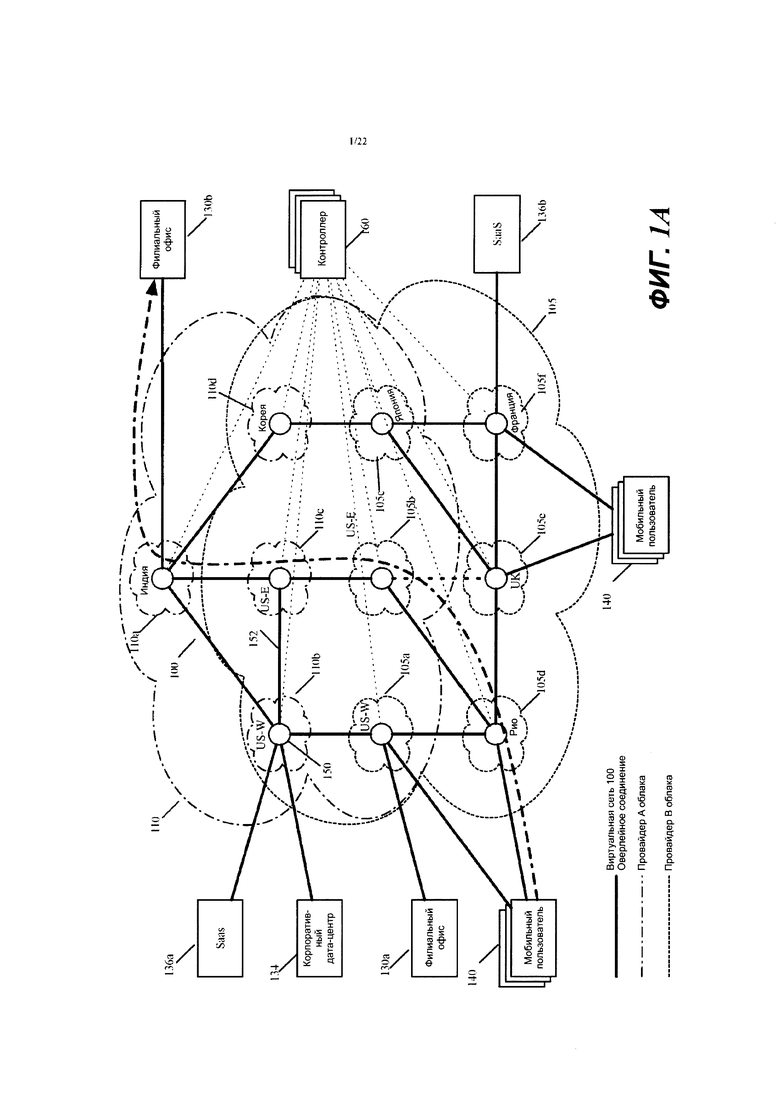

Фиг. 1А представляет виртуальную сеть, которая определена для корпорации поверх нескольких дата-центров общедоступных облаков двух провайдеров общедоступных облаков.

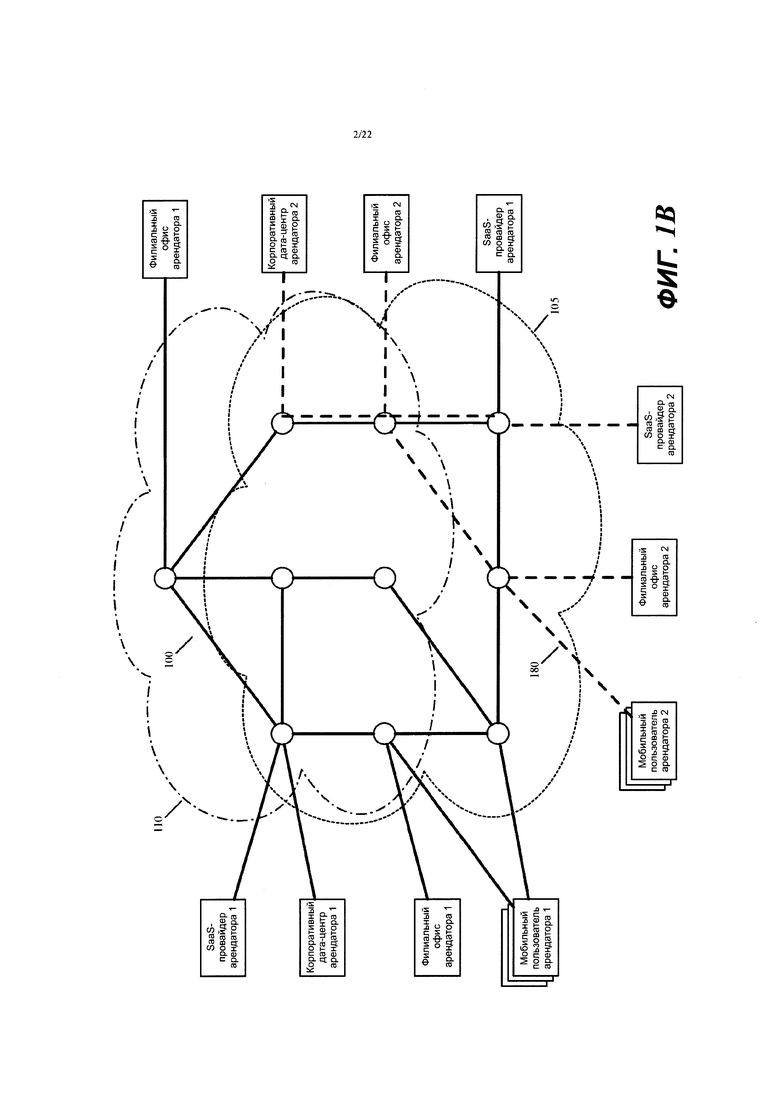

Фиг. 1В иллюстрирует пример двух виртуальных сетей для двух корпоративных арендаторов, которые развернуты поверх общедоступных облаков.

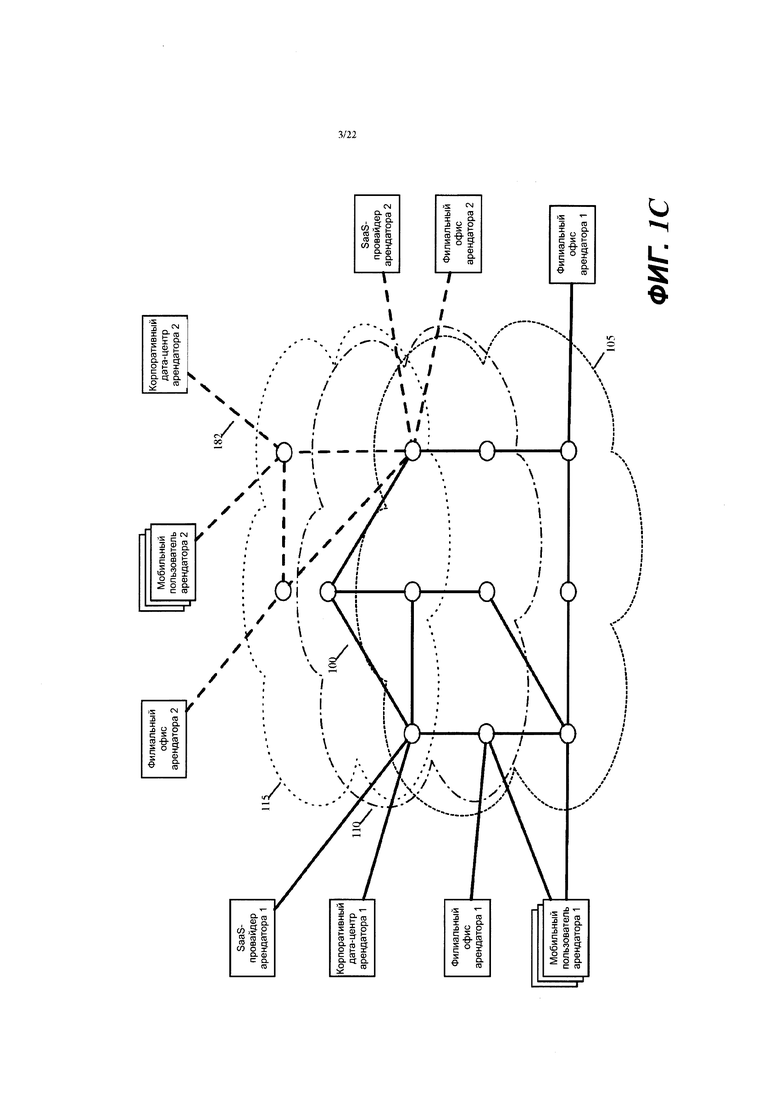

Фиг. 1С в качестве альтернативы иллюстрирует пример двух виртуальных сетей, при этом одна сеть развернута поверх одной пары общедоступных облаков, а другая виртуальная сеть развернута поверх другой пары общедоступных облаков.

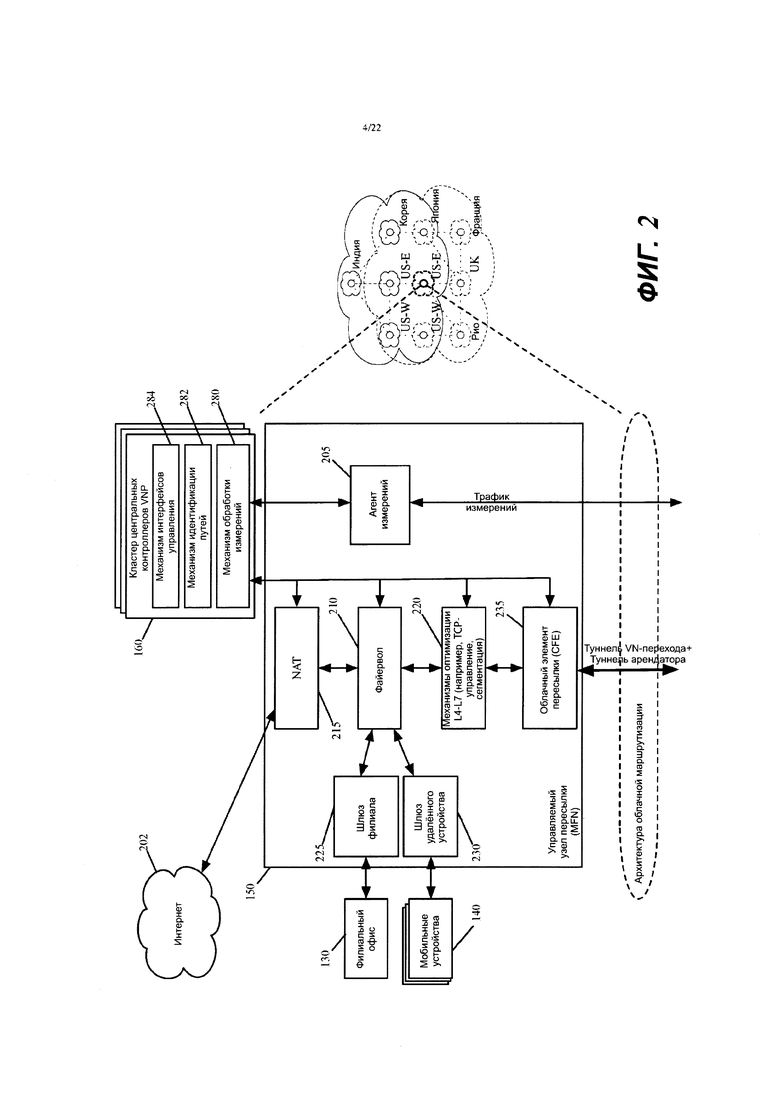

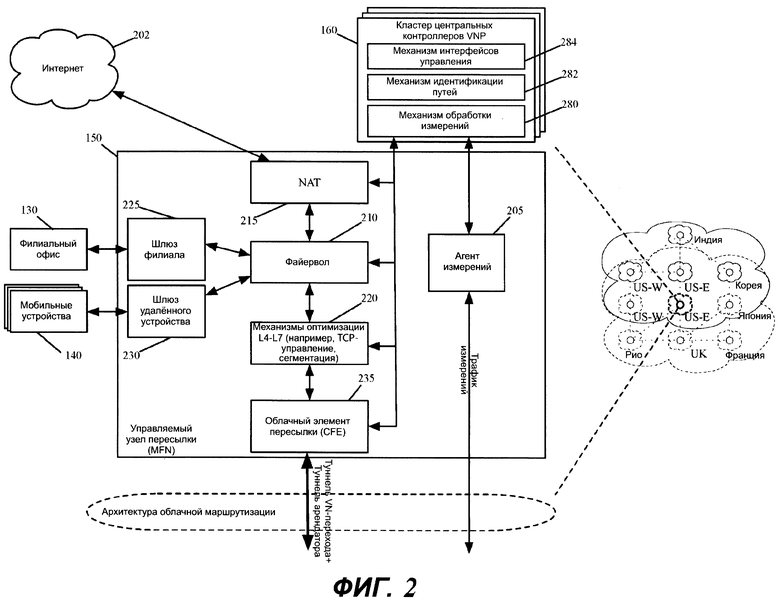

Фиг. 2 иллюстрирует пример управляемого узла пересылки и кластера контроллеров в некоторых вариантах осуществления изобретения.

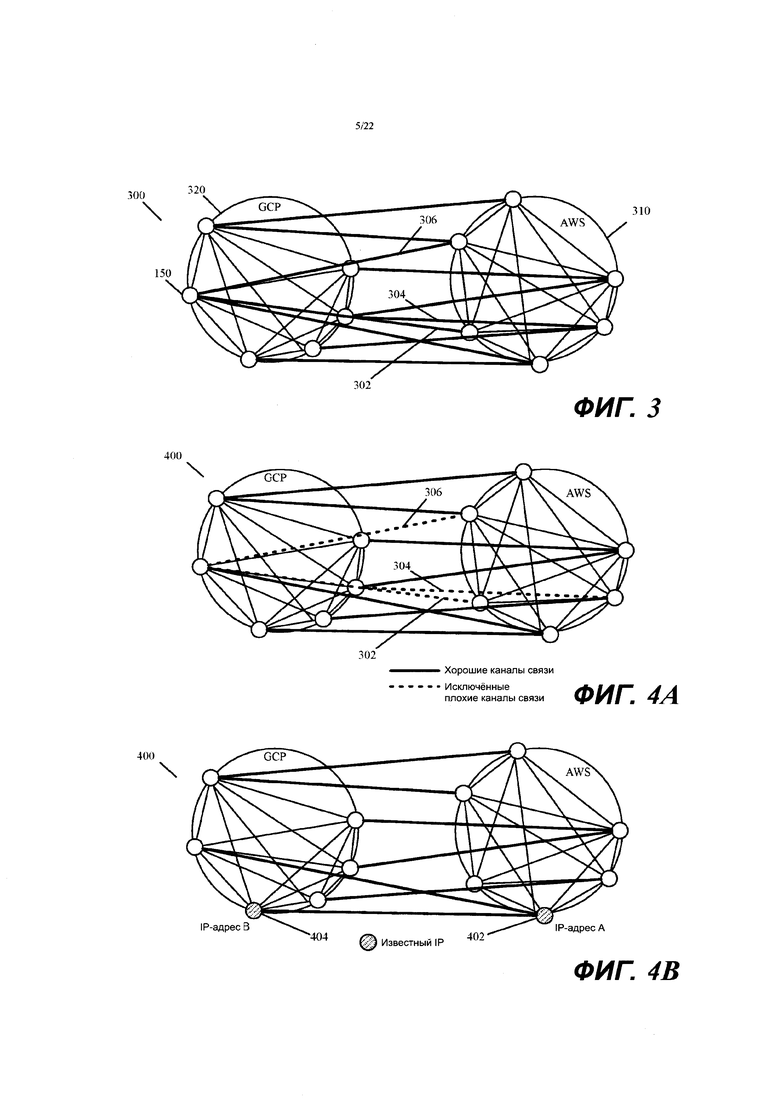

Фиг. 3 иллюстрирует пример графа измерений, который уровень обработки результатов измерений контроллера создает в некоторых вариантах осуществления.

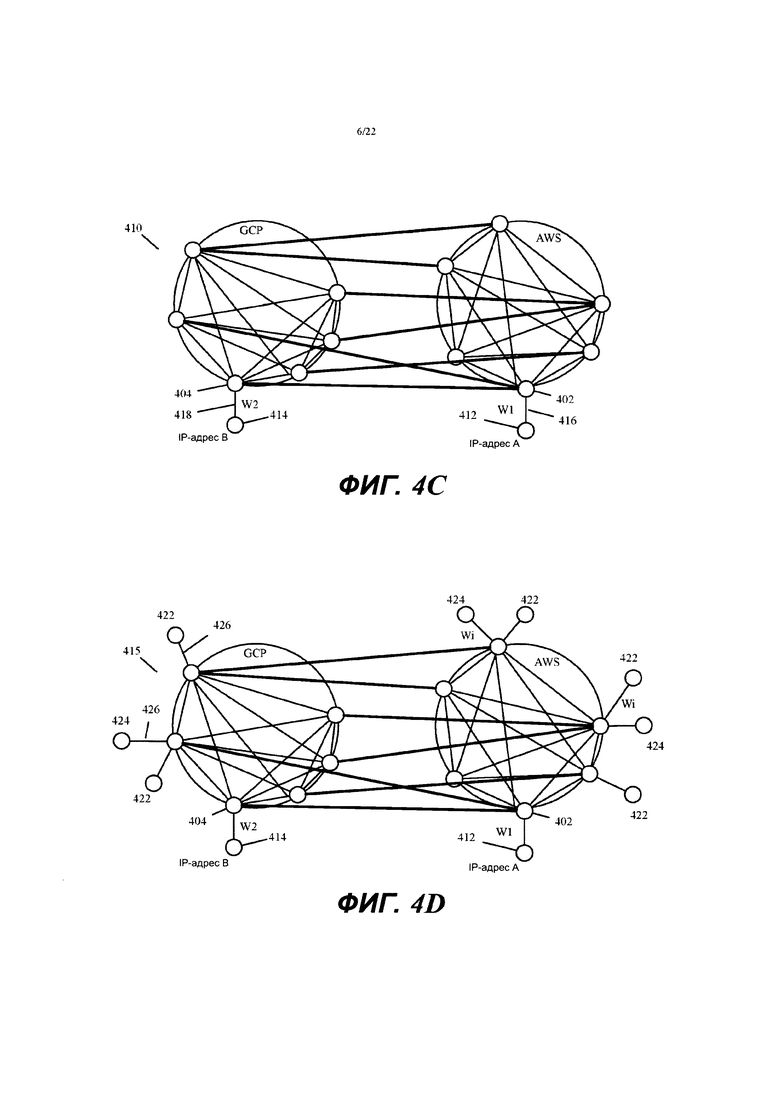

Фиг. 4А иллюстрирует пример графа маршрутизации, который уровень идентификации пути контроллера создает в некоторых вариантах осуществления из графа измерений.

Фиг. 4В иллюстрирует пример добавления известных IP-адресов для двух провайдеров SaaS к двум узлам в графе маршрутизации, которые находятся в дата-центрах, ближайших к дата-центрам этих провайдеров SaaS.

Фиг. 4С иллюстрирует граф маршрутизации, который сгенерирован в результате добавления двух узлов для представления двух провайдеров SaaS.

Фиг. 4D иллюстрирует граф маршрутизации с дополнительными узлами, добавленными для представления филиальных офисов и дата-центров с известными IP-адресами, которые соединяются с каждым из двух общедоступных облаков.

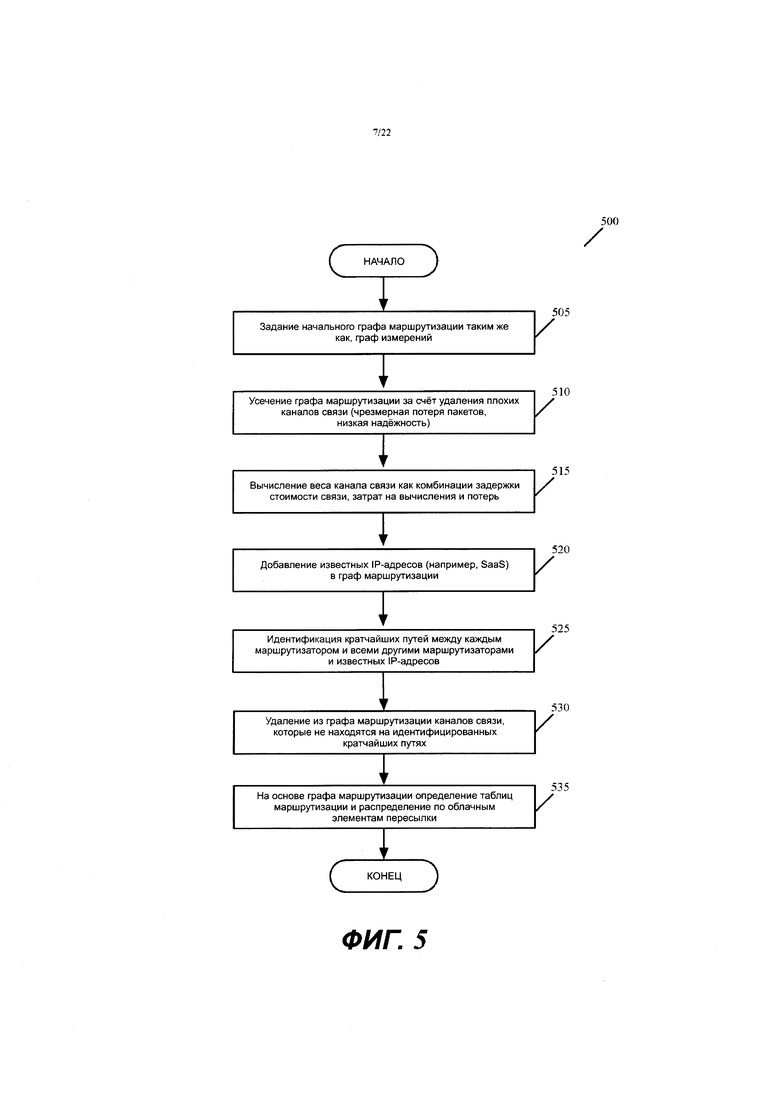

Фиг. 5 иллюстрирует процесс, который уровень идентификации пути контроллера использует, чтобы генерировать граф маршрутизации из графа измерений, полученного из уровня измерений контроллера.

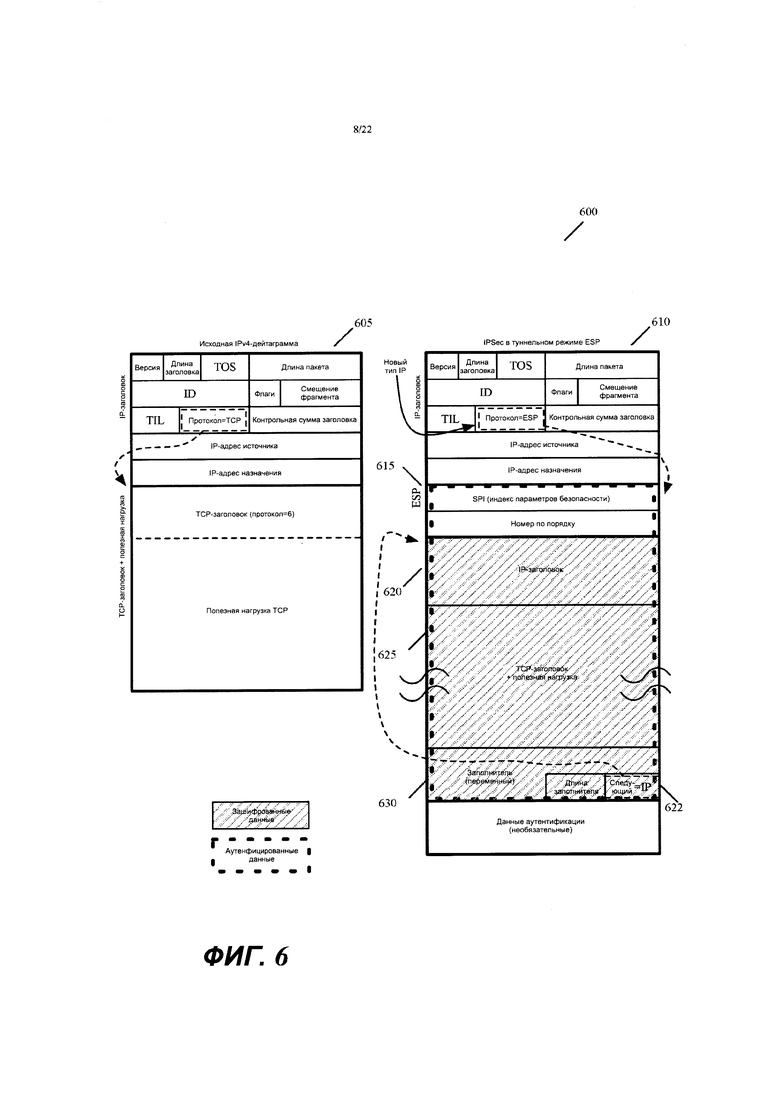

Фиг. 6 иллюстрирует формат сообщения с IPsec-данными в соответствии с некоторыми вариантами осуществления.

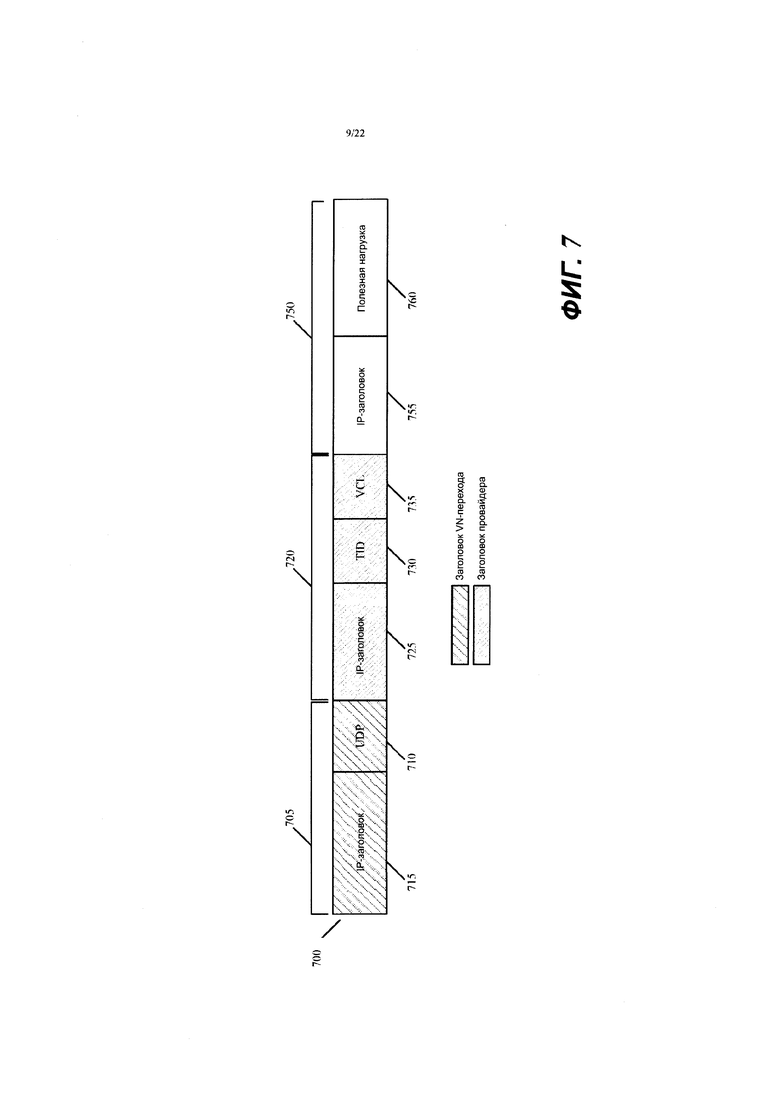

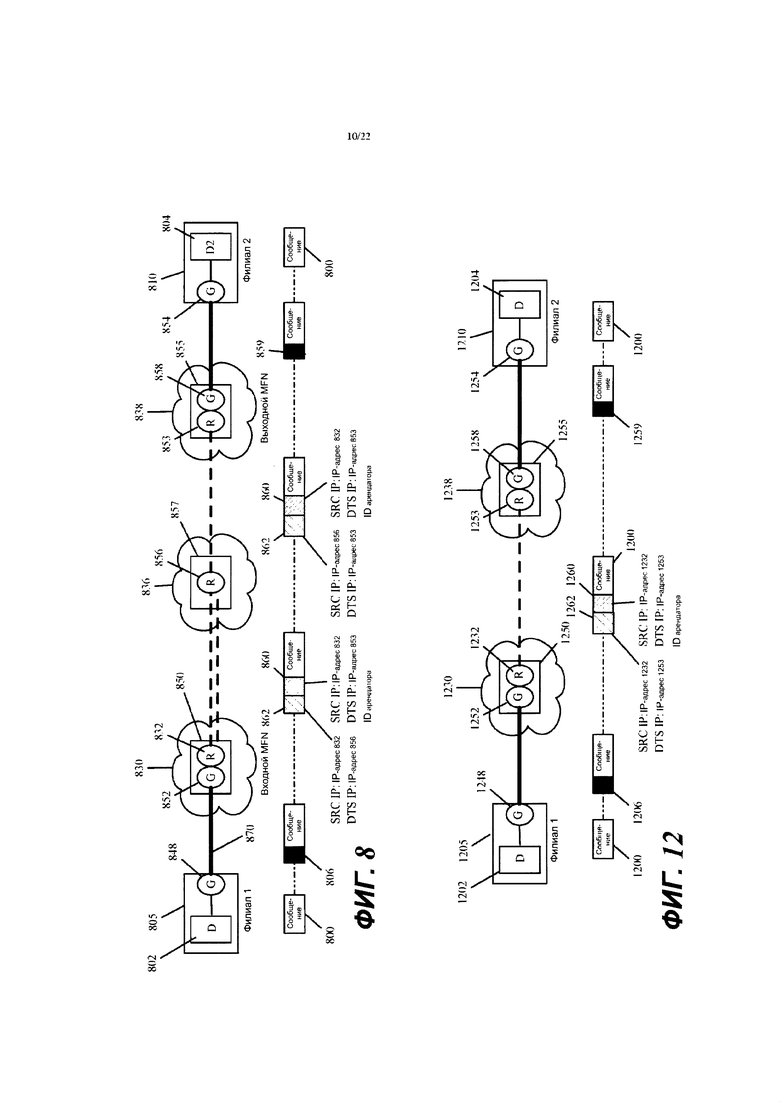

Фиг. 7 иллюстрирует пример двух инкапсулирующих заголовков в соответствии с некоторыми вариантами осуществления, а фиг. 8 представляет пример, который иллюстрирует, как эти два заголовка используются в некоторых вариантах осуществления.

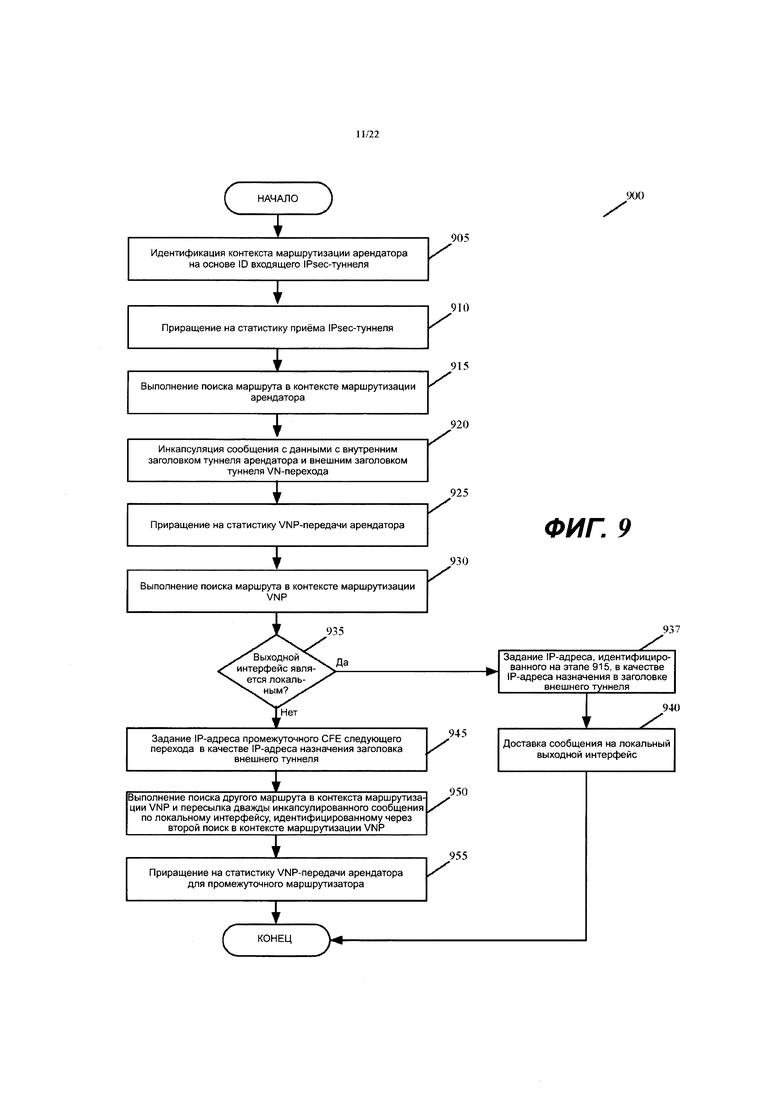

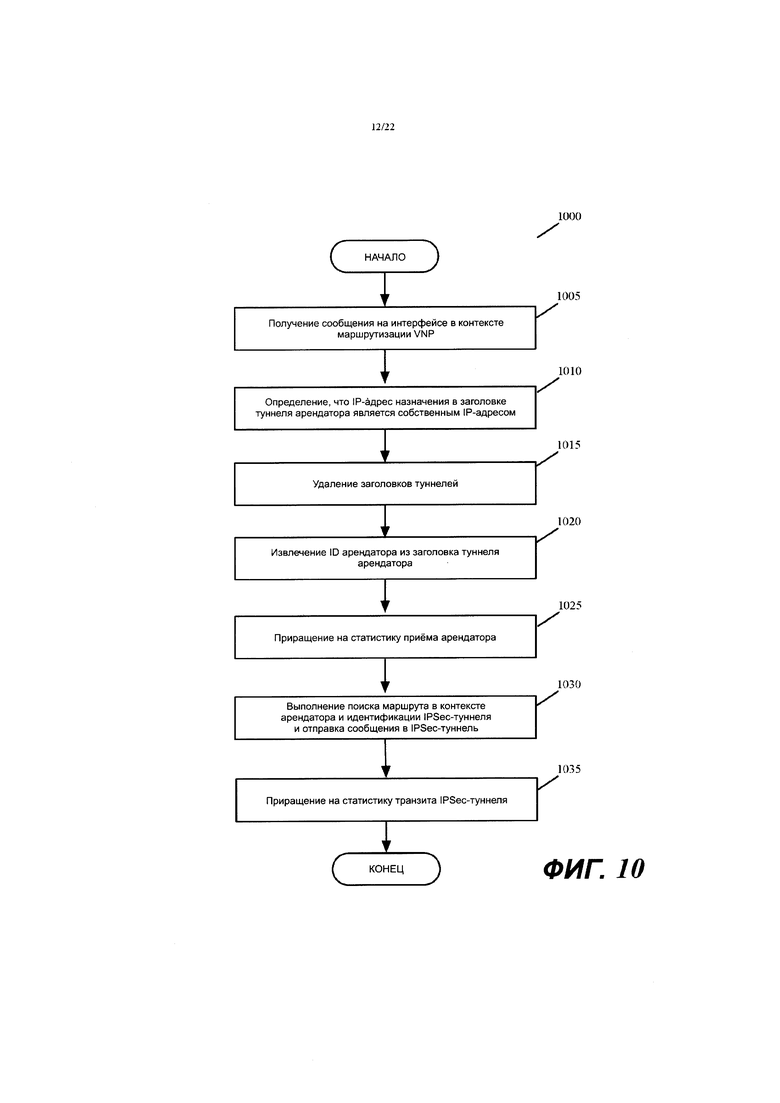

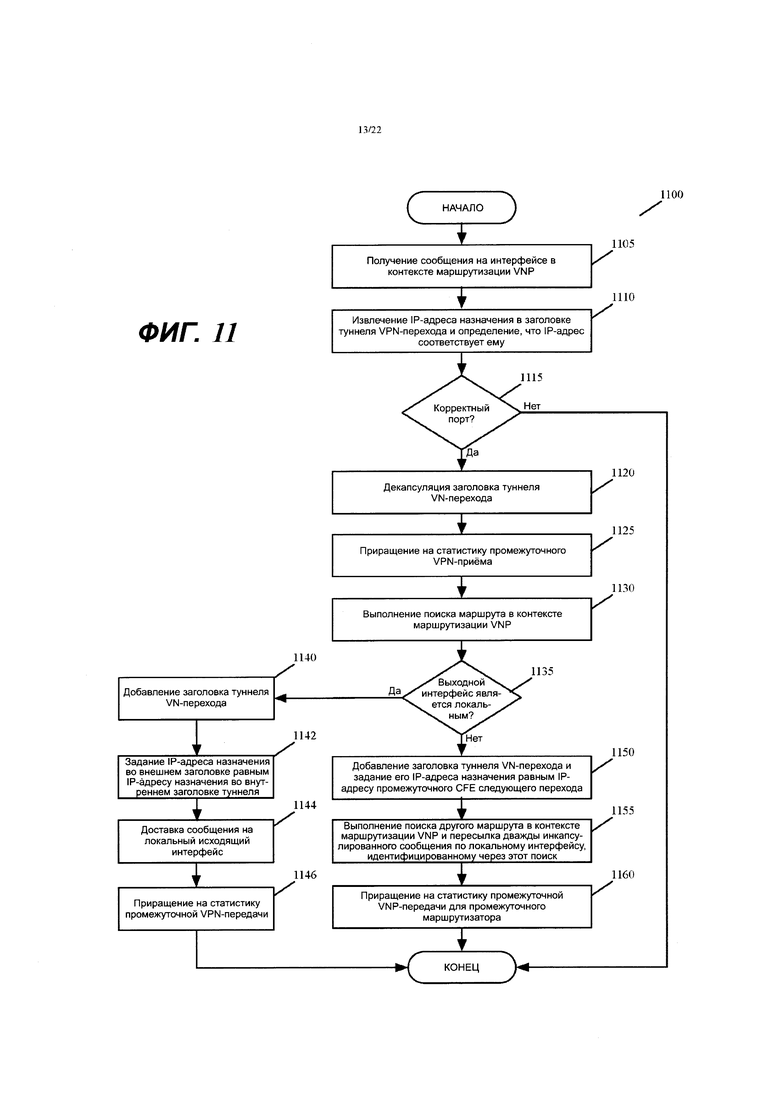

Фиг. 9-11 иллюстрируют процессы обработки сообщений, которые выполняются соответственно входным, промежуточным и выходным MFN, когда они принимают сообщение, которое отправляется между двумя вычислительными устройствами в двух разных филиальных офисах.

Фиг. 12 иллюстрирует пример, который не включает в себя промежуточный MFN между входным и выходным MFN.

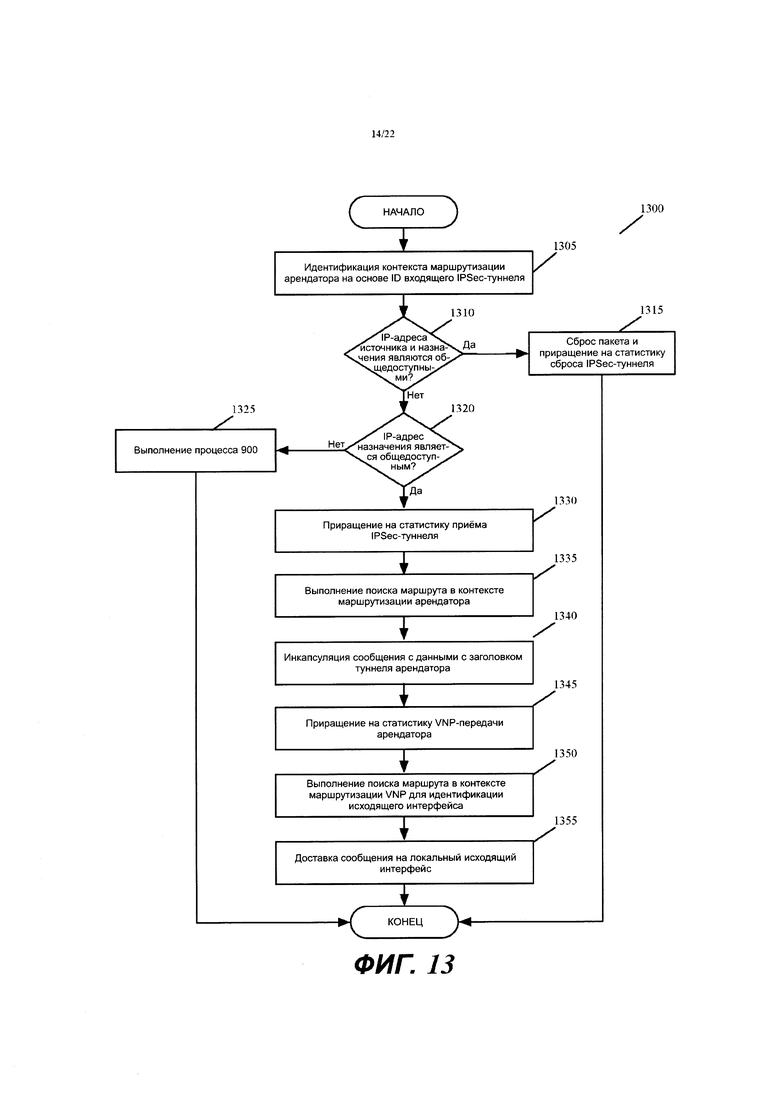

Фиг. 13 иллюстрирует процесс обработки сообщений, который выполняется CFE входного MFN, когда он принимает сообщение, которое отправлено с корпоративного вычислительного устройства в филиальном офисе на другое устройство в другом филиальном офисе или в дата-центре провайдера SaaS.

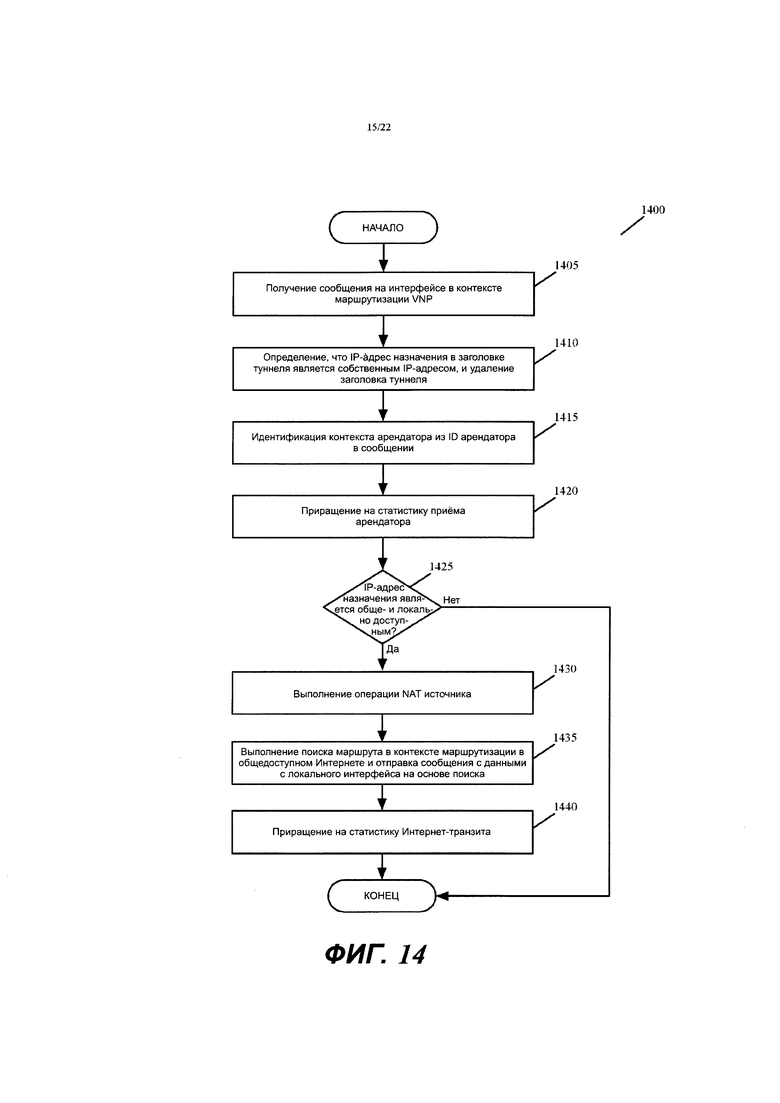

Фиг. 14 иллюстрирует операцию NAT, выполняемую на выходном маршрутизаторе.

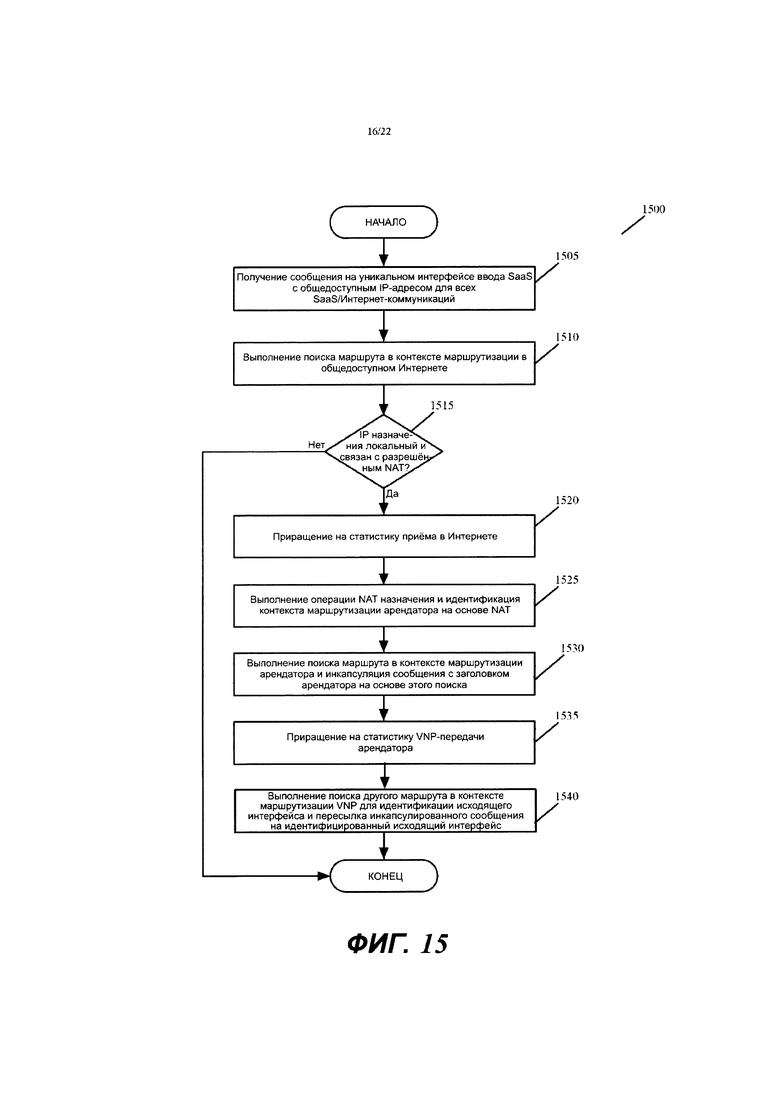

Фиг. 15 иллюстрирует процесс обработки сообщений, который выполняется входным маршрутизатором, который принимает сообщение, которое отправлено с машины провайдера SaaS на машину арендатора.

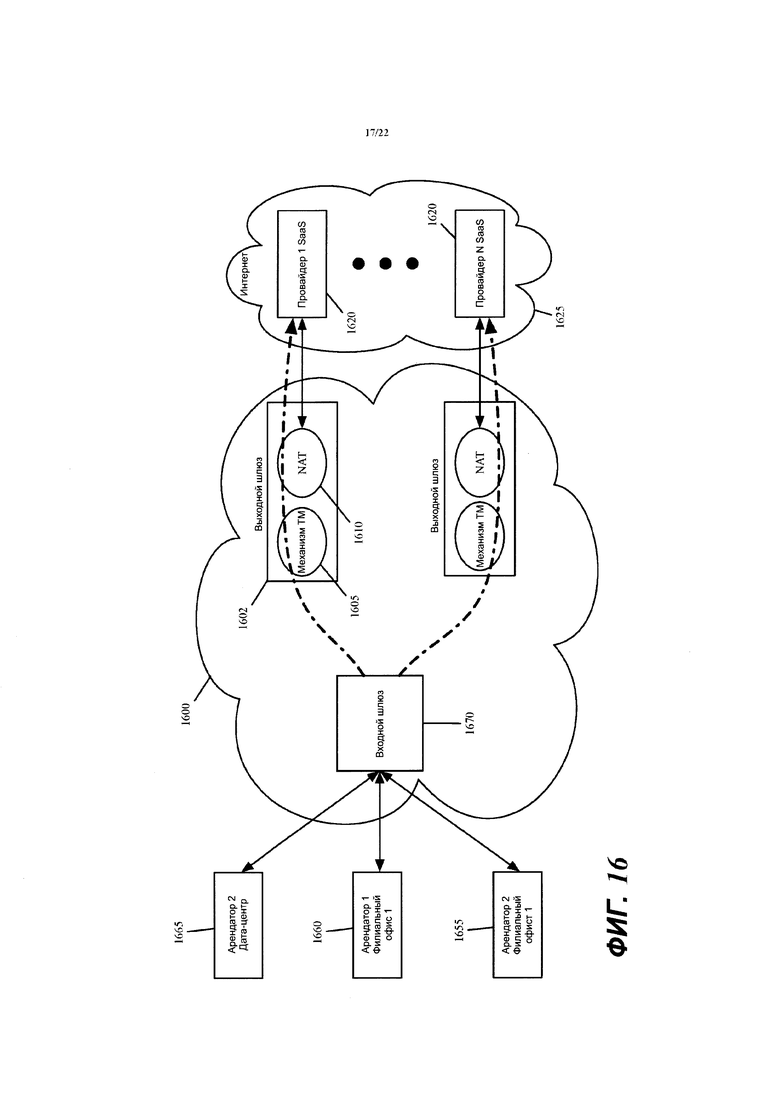

Фиг. 16 иллюстрирует такие механизмы ТМ, которые размещены в каждом шлюзе виртуальной сети, который находится на пути выхода виртуальной сети в Интернет.

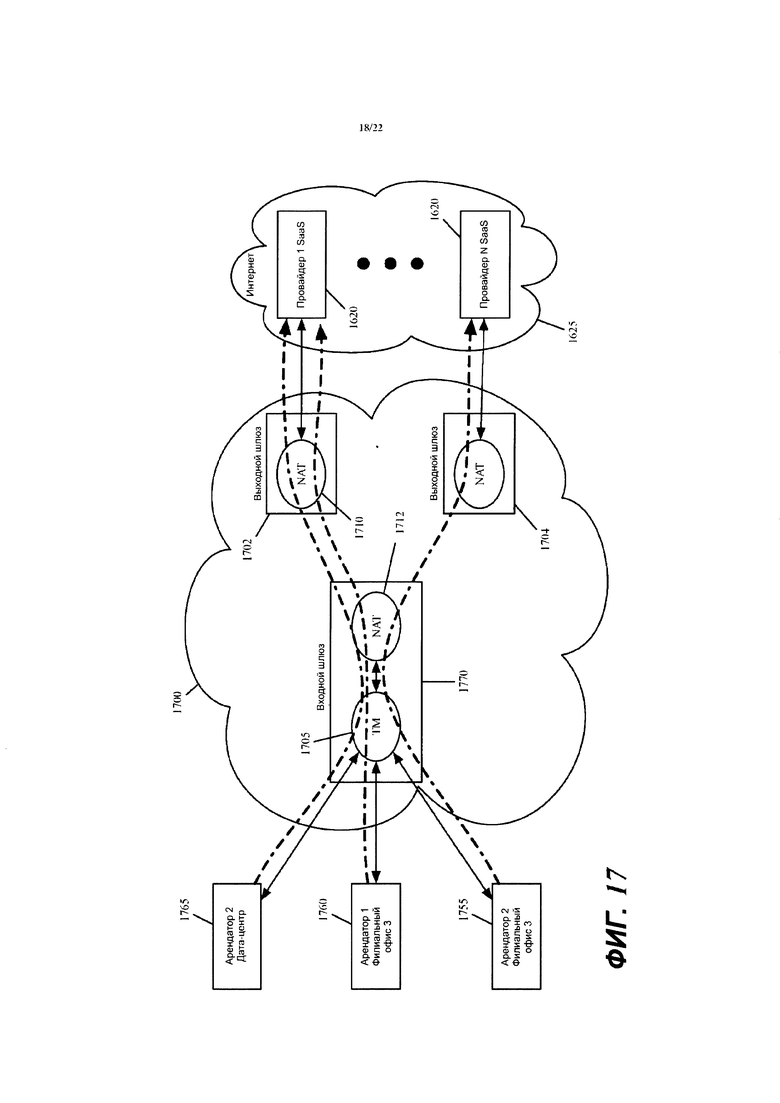

Фиг. 17 иллюстрирует метод двойного NAT, который используется в некоторых вариантах осуществления вместо метода одиночного NAT с иллюстрацией на фиг. 16.

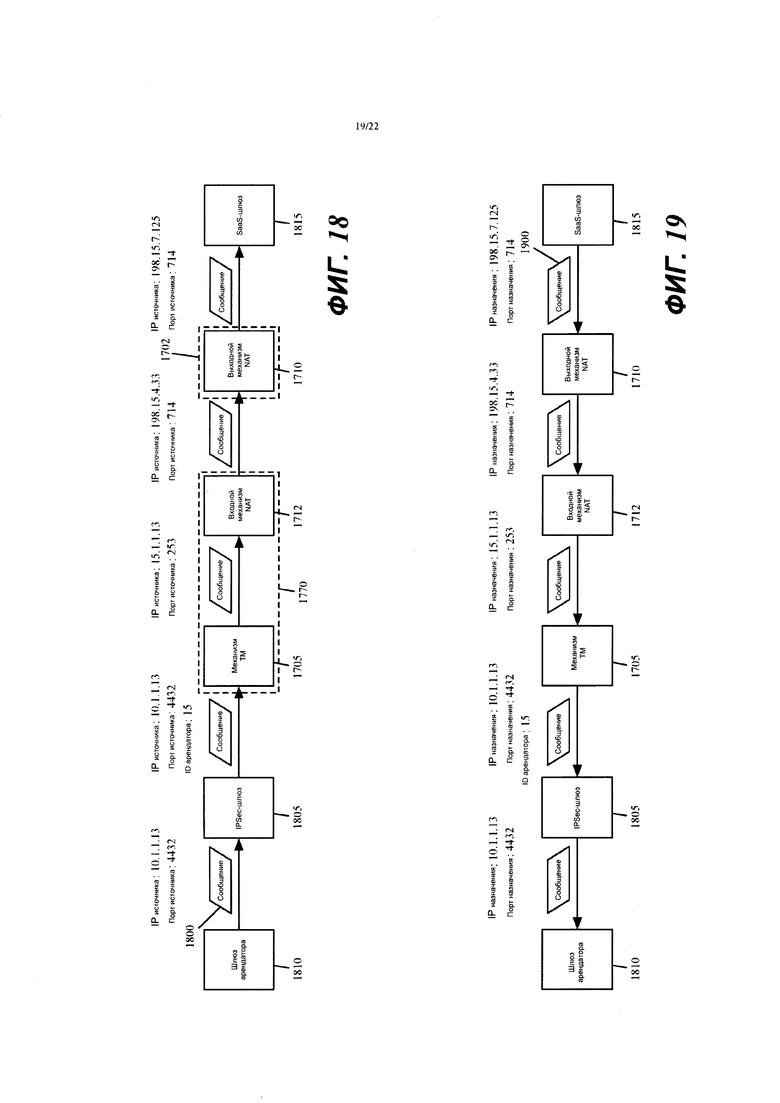

Фиг. 18 представляет пример, который иллюстрирует преобразование порта источника входным механизмом NAT.

Фиг. 19 иллюстрирует обработку ответного сообщения, которое SaaS-машина отправляет в ответ на обработку сообщения с данными на фиг. 18.

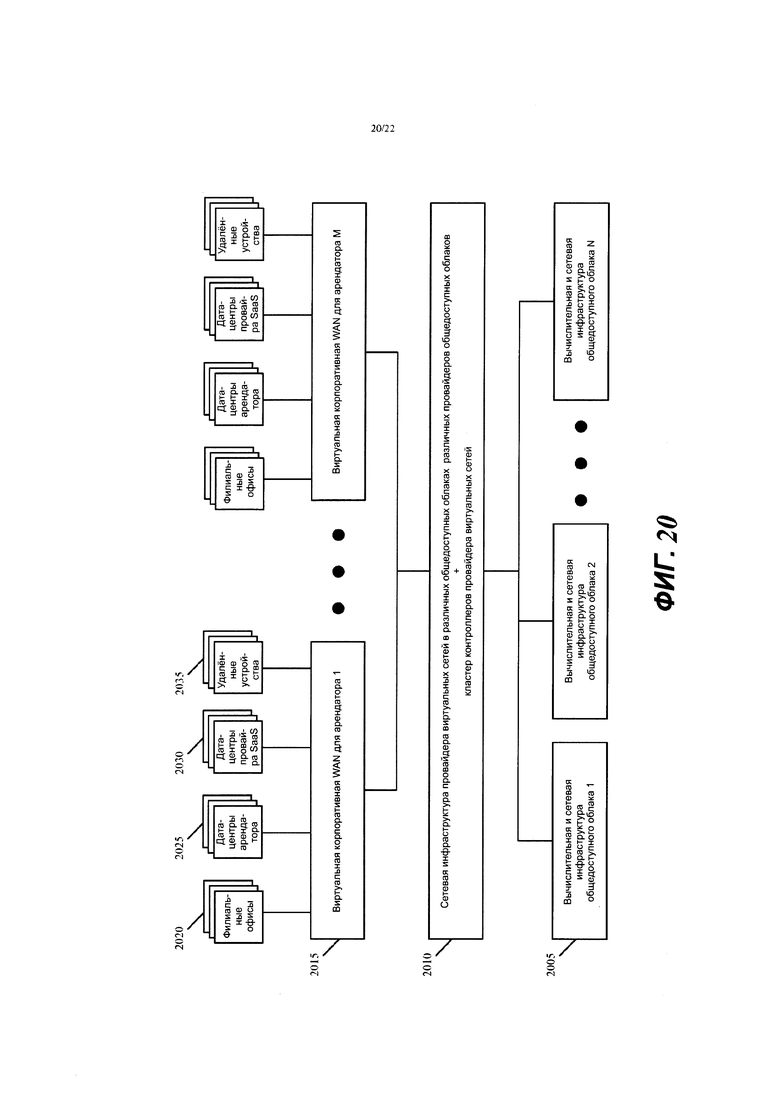

Фиг. 20 представляет пример, который показывает М виртуальных корпоративных WAN для М арендаторов провайдера виртуальных сетей, который имеет сетевую инфраструктуру и кластер(ы) контроллеров в N общедоступных облаках одного или нескольких провайдеров общедоступных облаков.

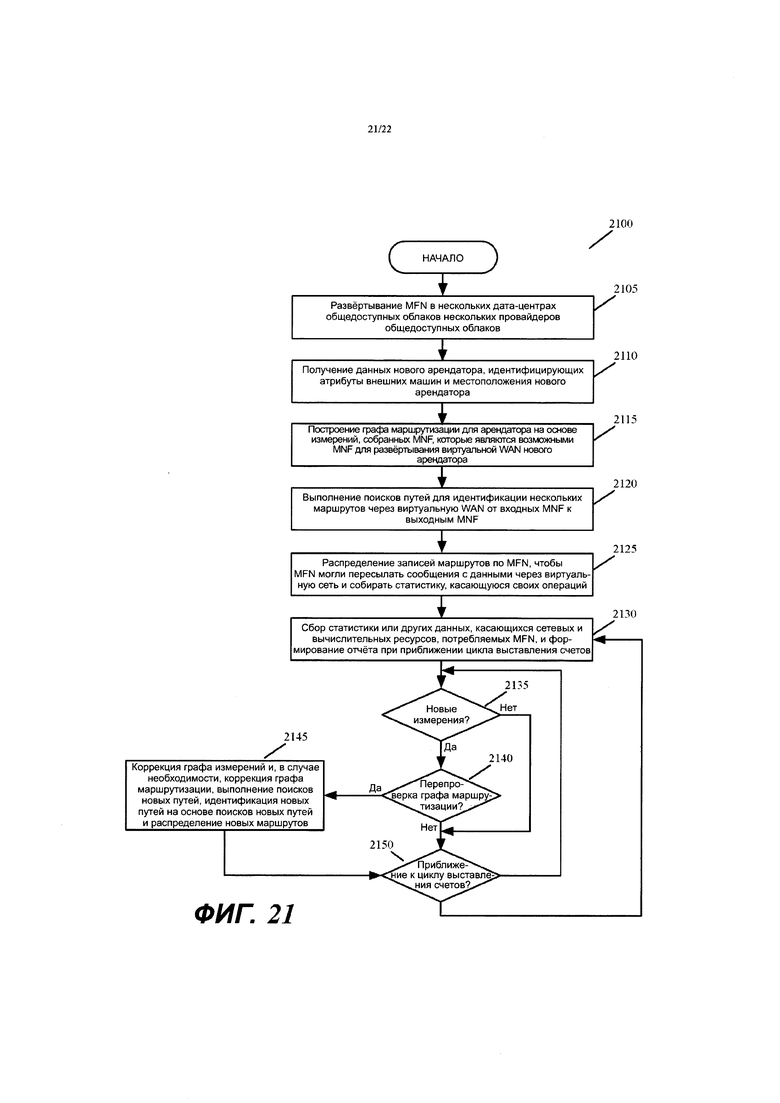

Фиг. 21 концептуально иллюстрирует процесс, выполняемый кластером контроллеров провайдера виртуальных сетей для развертывания и управления виртуальной WAN для конкретного арендатора.

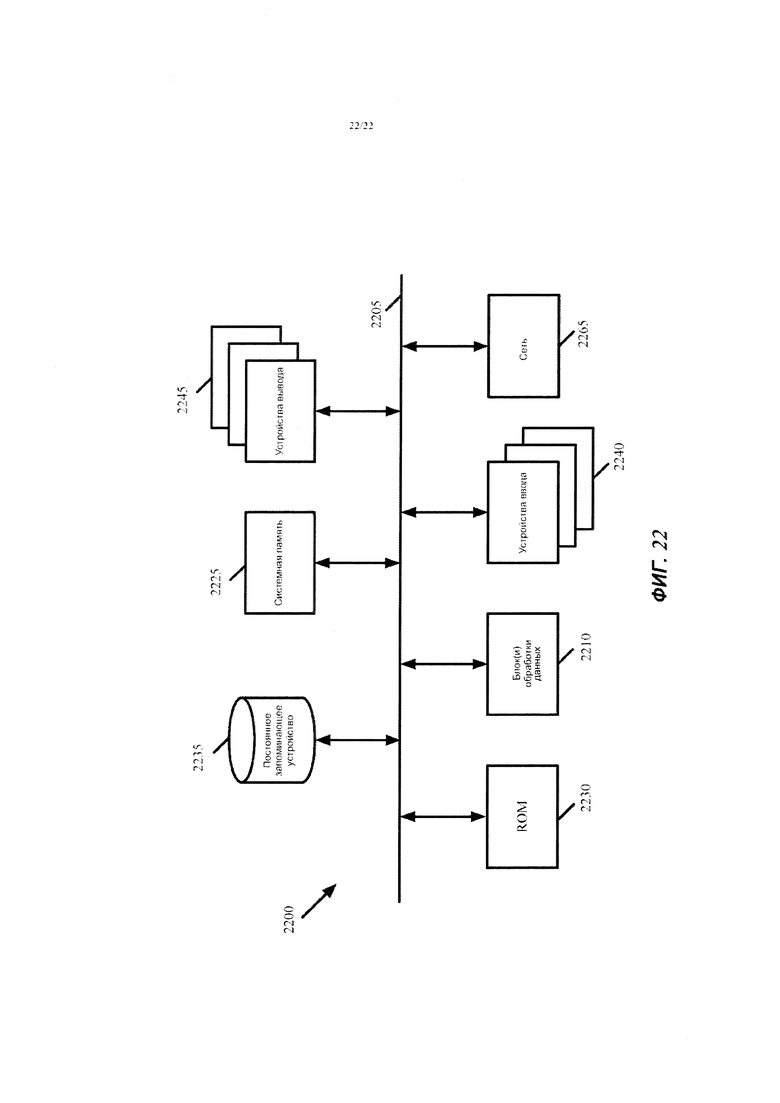

Фиг. 22 концептуально иллюстрирует компьютерную систему, в которой реализованы некоторые варианты осуществления изобретения.

ПОДРОБНОЕ ОПИСАНИЕ

В приводимом ниже подробном описании настоящего изобретения изложены и описаны многочисленные детали, примеры и варианты осуществления настоящего изобретения. Однако для специалиста в данной области техники будет ясно и очевидно, что настоящее изобретение не ограничивается изложенными вариантами осуществления и что настоящее изобретение может быть реализовано на практике без некоторых обсуждаемых конкретных деталей и примеров.

Некоторые варианты осуществления создают для организации виртуальную сеть поверх нескольких дата-центров общедоступных облаков одного или нескольких провайдеров общедоступных облаков в одном или нескольких регионах (например, в нескольких городах, штатах, странах и т.д.). Пример организации, для которой может быть создана такая виртуальная сеть, включает в себя коммерческую организацию (например, корпорацию), некоммерческую организацию (например, больницу, исследовательскую организацию и т.д.) и образовательную организацию (например, университет, колледж и т.д.) или любой другой тип организации. Примеры провайдеров общедоступных облаков включают в себя Amazon Web Services (AWS), Google Cloud Platform (GCP), Microsoft Azure и т.д.

Некоторые варианты осуществления определяют виртуальную сеть как оверлейную сеть, которая охватывает несколько дата-центров общедоступных облаков (несколько общедоступных облаков) для соединения одной или нескольких частных сетей (например, сетей в филиалах, подразделениях, отделах организации или связанных с ними дата-центров), мобильных пользователей, машин провайдеров SaaS (программного обеспечение как сервиса), машин и/или сервисов в общедоступном(ых) облаке(ах) и других web-приложений друг с другом. В некоторых вариантах осуществления высокоскоростные, надежные частные сети соединяют два или более дата-центров общедоступных облаков друг с другом.

В некоторых вариантах осуществления виртуальная сеть может быть сконфигурирована так, чтобы оптимизировать маршрутизацию сообщений с данными организации к их пунктам назначения для наилучшей сквозной производительности, надежности и безопасности при стремлении минимизировать маршрутизацию этого трафика через Интернет. Кроме того, в некоторых вариантах осуществления виртуальная сеть может быть сконфигурирована для оптимизации обработки уровня 4 потоков сообщений с данными, проходящих через сеть. Например, в некоторых вариантах осуществления виртуальная сеть оптимизирует сквозную скорость TCP (протокол управления транспортом) - соединений за счет разделения механизмов управления скоростью по пути соединения.

Некоторые варианты осуществления создают виртуальную сеть в результате конфигурирования нескольких компонентов, которые развернуты в нескольких общедоступных облаках. В некоторых вариантах осуществления эти компоненты включают в себя программные агенты измерений, программные элементы пересылки (например, программные маршрутизаторы, коммутаторы, шлюзы и т.д.), прокси-серверы соединений уровня 4 и машины мидлбокс-обслуживания (например, устройства, VM, контейнеры и т.д.).

Некоторые варианты осуществления используют логически централизованный кластер контроллеров (например, набор из одного или более серверов контроллеров), который конфигурирует компоненты общедоступных облаков для реализации виртуальной сети поверх нескольких общедоступных облаков. В некоторых вариантах осуществления контроллеры в этом кластере находятся в разных местоположениях (например, в разных дата-центрах общедоступных облаков), чтобы улучшить избыточность и высокую доступность. Когда разные контроллеры в кластере контроллеров расположены в разных дата-центрах общедоступных облаков, в некоторых вариантах осуществления контроллеры совместно используют свое состояние (например, данные конфигурации, которые они генерируют для идентификации арендаторов, маршрутов через виртуальные сети и т.д.). В некоторых вариантах осуществления кластер контроллеров увеличивает или уменьшает число компонентов общедоступных облаков, которые используются для создания виртуальной сети, или вычислительных или сетевых ресурсов, выделяемых этим компонентам.

Некоторые варианты осуществления создают разные виртуальные сети для разных организаций поверх одного и того же набора общедоступных облаков одних и тех же провайдеров общедоступных облаков и/или поверх разных наборов общедоступных облаков одного и того же или разных провайдеров общедоступных облаков. В некоторых вариантах осуществления провайдер виртуальных сетей обеспечивает программное обеспечение и сервисы, которые позволяют разным арендаторам определять разные виртуальные сети поверх одного и того же или разных общедоступных облаков. В некоторых вариантах осуществления один и тот же кластер контроллеров или разные кластеры контроллеров могут быть использованы для конфигурирования компонентов общедоступных облаков для реализации разных виртуальных сетей поверх одного и того же или разных наборов общедоступных облаков для нескольких разных организаций.

Несколько примеров корпоративных виртуальных сетей представлены на обсуждение ниже. Однако рядовой специалист поймет, что некоторые варианты осуществления определяют виртуальные сети для других типов организаций, таких как другие бизнес-организации, некоммерческие организации, образовательные учреждения и т.д. Кроме того, как используется в данном документе, сообщения с данными относятся к набору битов в определенном формате, отправляемому по сети. Специалист в данной области техники поймет, что термин «сообщение с данными» используется в данном документе для ссылки на разные форматированные наборы битов, которые отправляются по сети. Форматирование этих битов может быть определено стандартизированными протоколами или нестандартизированными протоколами. Примеры сообщений с данными, следующих стандартизованным протоколам, включают в себя кадры Ethernet, IP-пакеты, TCP-сегменты, UDP-дейтаграммы и т.д. Также, как используется в данном документе, ссылки на уровни L2, L3, L4 и L7 (или уровень 2, уровень 3, уровень 4 и уровень 7) являются ссылками соответственно на второй уровень канала связи данных, третий сетевой уровень, четвертый транспортный уровень и седьмой прикладной уровень OSI (уровень взаимодействия открытых систем).

Фиг. 1А представляет виртуальную сеть 100, которая определена для корпорации поверх нескольких дата-центров 105 и 110 общедоступных облаков провайдеров А и В общедоступных облаков. Как показано, виртуальная сеть 100 представляет собой защищенную оверлейную сеть, которая создана в результате развертывания разных узлов 150 управляемой пересылки в разных общедоступных облаках и соединения узлов управляемой пересылки (MFN) друг с другом через оверлейные туннели 152. В некоторых вариантах осуществления MFN представляет собой концептуальную группировку нескольких различных компонентов в дата-центре общедоступного облака, которые вместе с другими MFN (с другими группами компонентов) в других дата-центрах общедоступных облаков создают одну или более оверлейных виртуальных сетей для одной или более организаций.

Как дополнительно описано ниже, в некоторых вариантах осуществления группа компонентов, которые образуют MFN, включает в себя (1) один или более шлюзов VPN для создания VPN-соединений с вычислительными узлами организации (например, офисами, частными дата-центрами, удаленными пользователями и т.д.), которые являются местоположениями внешних машин за пределами дата-центров общедоступных облаков, (2) один или более элементов пересылки для пересылки инкапсулированных сообщений с данными между собой, чтобы определить оверлейную виртуальную сеть поверх общей сетевой архитектуры общедоступных облаков, (3) одну или более машин обслуживания для выполнения операций мидлбокс-обслуживания, а также оптимизации L4-L7 и (4) один или более агентов измерений для получения измерений, касающихся качества сетевых соединений между дата-центрами общедоступных облаков, чтобы идентифицировать требуемые пути через дата-центры общедоступных облаков. В некоторых вариантах осуществления разные MFN могут иметь разную компоновку и разное число таких компонентов, и один MFN может иметь разное число таких компонентов по причинам избыточности и масштабируемости.

Кроме того, в некоторых вариантах осуществления каждая группа компонентов MFN исполняется на разных компьютерах в дата-центре общедоступного облака MFN. В некоторых вариантах осуществления несколько или все компоненты MFN могут исполняться на одном компьютере дата-центра общедоступного облака. В некоторых вариантах осуществления компоненты MFN исполняются на хост-компьютерах, которые также исполняют другие машины других арендаторов. Эти другие машины могут быть другими машинами других MFN других арендаторов или они могут быть не связанными между собой машинами других арендаторов (например, вычислительными VM или контейнерами).

В некоторых вариантах осуществления виртуальная сеть 100 развертывается провайдером виртуальных сетей (VNP), который развертывает разные виртуальные сети поверх одних и тех же или разных дата-центров общедоступных облаков для разных организаций (например, поверх разных корпоративных потребителей/арендаторов провайдера виртуальных сетей). В некоторых вариантах осуществления провайдер виртуальных сетей является организацией, которая развертывает MFN и предоставляет кластер контроллеров для конфигурирования и управления этими MFN.

Виртуальная сеть 100 соединяет корпоративные конечные точки вычислений (такие как дата-центры, филиальные офисы и мобильные пользователи) друг с другом и с внешними сервисами (например, с общедоступными web-сервисами или SaaS-сервисами, такими как Office365 или Salesforce), которые находятся в общедоступном облаке или в частном дата-центре, доступном через Интернет. Эта виртуальная сеть эффективно использует разные местоположения разных общедоступных облаков для соединения разных корпоративных конечных точек вычислений (например, разных частных сетей и/или разных мобильных пользователей корпорации) с общедоступными облаками поблизости от них. Ниже корпоративные конечные точки вычислений также называются корпоративными вычислительными узлами.

В некоторых вариантах осуществления виртуальная сеть 100 также эффективно использует высокоскоростные сети, которые соединяют эти общедоступные облака друг с другом, для пересылки сообщений с данными через общедоступные облака к их пунктам назначения или для максимально возможного приближения к их пунктам назначения при сокращении их прохождения через Интернет. Когда корпоративные конечные точки вычислений находятся за пределами дата-центров общедоступных облаков, которые охватывает виртуальная сеть, эти конечные точки называются местоположениями внешних машин. Это касается корпоративных филиальных офисов, частных дата-центров и устройств удаленных пользователей.

В примере с иллюстрацией на фиг. 1А, виртуальная сеть 100 охватывает шесть дата-центров 105а-105f провайдера А общедоступного облака и четыре дата-центра 110a-110d провайдера В общедоступного облака. При охвате этих общедоступных облаков эта виртуальная сеть соединяет несколько филиальных офисов, корпоративных дата-центров, провайдеров SaaS и мобильных пользователей корпоративного арендатора, которые находятся в разных географических регионах. В частности, виртуальная сеть 100 соединяет два филиальных офиса 130а и 130b в двух разных городах (например, Сан-Франциско, Калифорния и Пуна, Индия), корпоративный дата-центр 134 в другом городе (например, Сиэтл, Вашингтон), два дата-центра 136а и 136b провайдера SaaS в двух других городах (Редмонд, Вашингтон и Париж, Франция) и мобильных пользователей 140 в разных точках мира. Таким образом, эту виртуальную сеть можно рассматривать как виртуальную корпоративную WAN.

В некоторых вариантах осуществления филиальные офисы 130а и 130b имеют свои собственные частные сети (например, локальные сети), которые соединяют компьютеры в местоположениях филиалов и частных дата-центрах филиалов, которые находятся за пределами общедоступных облаков. Точно так же в некоторых вариантах осуществления корпоративный дата-центр 134 имеет свою собственную частную сеть и находится за пределами любого дата-центра общедоступного облака. Однако в других вариантах осуществления корпоративный дата-центр 134 или дата-центр филиала 130а или 130b может находиться в общедоступном облаке, но виртуальная сеть не охватывает это общедоступное облако, так как корпоративный дата-центр или дата-центр филиала соединен с границей виртуальной сети 100.

Как указано выше, виртуальная сеть 100 создана в результате соединения различных развернутых управляемых узлов 150 пересылки в разных общедоступных облаках через оверлейные туннели 152. Каждый управляемый узел 150 пересылки включает в себя несколько конфигурируемых компонентов. Как дополнительно указано выше и дополнительно указано ниже, в некоторых вариантах осуществления компоненты MFN включают себя программные агенты измерений, программные элементы пересылки (например, программные маршрутизаторы, коммутаторы, шлюзы и т.д.), прокси-серверы уровня 4 (например, прокси-серверы TCP) и машины мидлбокс-обслуживания (например. VM, контейнеры и т.д.). В некоторых вариантах осуществления один или несколько из этих компонентов используют стандартизированные или общедоступные решения, такие как Open vSwitch. Open VPN, strongSwan и т.д.

В некоторых вариантах осуществления каждый MFN (то есть группа компонентов, которые концептуально формируют MFN) может быть совместно использована разными арендаторами провайдера виртуальных сетей, который развертывает и конфигурирует MFN в дата-центрах общедоступного облака. В комбинации или альтернативно в некоторых вариантах осуществления провайдер виртуальных сетей может развернуть уникальный набор MFN в одном или нескольких дата-центрах общедоступного облака для конкретного арендатора. Например, по соображениям безопасности или качества обслуживания конкретный арендатор может не захотеть делиться ресурсами MFN с другим арендатором. Для такого арендатора провайдер виртуальных сетей может развернуть свой собственный набор MFN в нескольких дата-центрах общедоступного облака.

В некоторых вариантах осуществления логически централизованный кластер 160 контроллеров (например, набор из одного или более серверов контроллеров) работает внутри или за пределами одного или более общедоступных облаков 105 и 110 и конфигурирует компоненты управляемых узлов 150 пересылки в общедоступных облаках для реализации виртуальной сети поверх общедоступных облаков 105 и 110. В некоторых вариантах осуществления контроллеры в этом кластере находятся в разных местоположениях (например, в разных дата-центрах общедоступных облаков), чтобы улучшить избыточность и высокую доступность. В некоторых вариантах осуществления кластер контроллеров увеличивает или уменьшает число компонентов общедоступных облаков, которые используются для создания виртуальной сети, или вычислительных или сетевых ресурсов, выделяемых этим компонентам.

В некоторых вариантах осуществления кластер 160 контроллеров или другой кластер контроллеров провайдера виртуальных сетей создает другую виртуальную сеть для другого корпоративного арендатора поверх одних и тех же общедоступных облаков 105 и 110 и/или поверх разных общедоступных облаков разных провайдеров общедоступных облаков. В дополнение к кластеру(ам) контроллеров в других вариантах осуществления провайдер виртуальных сетей развертывает элементы пересылки и машины обслуживания в общедоступных облаках, которые позволяют разным арендаторам развертывать разные виртуальные сети поверх одного и того же или разных общедоступных облаков. Фиг. 1В иллюстрирует пример двух виртуальных сетей 100 и 180 для двух корпоративных арендаторов, которые развернуты поверх общедоступных облаков 105 и 110. Фиг 1С в качестве альтернативы иллюстрирует пример двух виртуальных сетей 100 и 182. при этом одна сеть 100 развернута поверх общедоступных облаков 105 и 110 а другая виртуальная сеть 182 развернута поверх другой пары общедоступных облаков 110 и 115.

Через сконфигурированные компоненты узлов MFN виртуальная сеть 100 на фиг. 1А позволяет различным частным сетям и/или разным мобильным пользователям корпоративного арендатора соединяться с разными общедоступными облаками, которые находятся в оптимальных местоположениях (например, при измерении в терминах физического расстояния, в терминах скорости соединения, потерь, задержки и/или стоимости, и/или в терминах надежности сетевых соединений и т.д.) в отношении этих частных сетей и/или мобильных пользователей. В некоторых вариантах осуществления эти компоненты также позволяют виртуальной сети 100 использовать высокоскоростные сети, которые соединяют между собой общедоступные облака, для пересылки сообщений с данными через общедоступные облака в их пункты назначения при сокращении их прохождения через Интернет.

В некоторых вариантах осуществления компоненты MFN также сконфигурированы для запуска новых процессов на сетевом, транспортном и прикладном уровнях, чтобы оптимизировать сквозную производительность, надежность и безопасность. В некоторых вариантах осуществления один или более из этих процессов реализуют проприетарные высокопроизводительные сетевые протоколы, свободные от консервативности существующих сетевых протоколов. По существу в некоторых вариантах осуществления виртуальная сеть 100 не ограничена автономными системами Интернета, протоколами маршрутизации или даже механизмами сквозного транспорта.

Например, в некоторых вариантах осуществления компоненты узлов MFN 150 (1) создают оптимизированную многопутевую и адаптивную централизованную маршрутизацию, (2) предоставляют надежные гарантии QoS (качества обслуживания), (3) оптимизируют скорости сквозного TCP за счет разделения и/или завершения промежуточного TCP, и (4) перемещают масштабируемые мидлбокс-сервисы уровня приложений (например, файрволы, системы обнаружения вторжений (IDS), систему предотвращения вторжений (IPS), оптимизацию WAN и т.д.) в вычислительную часть облака в рамках глобальной виртуализации сетевых функций (NFV). Таким образом, виртуальная сеть может быть оптимизирована для удовлетворения индивидуальных и меняющихся требований корпорации без привязки к существующему сетевому протоколу. Кроме того, в некоторых вариантах осуществления виртуальная сеть может быть сконфигурирована как инфраструктура с оплатой по мере использования, которую можно динамически и гибко масштабировать вверх и вниз как по производительности, так и по географическому охвату в соответствии с постоянными изменениями требований.

Для реализации виртуальной сети 100 по меньшей мере один управляемый узел 150 пересылки в каждом дата-центре 105а-105f и 110а-110d общедоступных облаков, охватываемых виртуальной сетью, должен быть сконфигурирован набором контроллеров. Фиг. 2 иллюстрирует пример управляемого узла 150 пересылки и кластера 160 контроллеров в некоторых вариантах осуществления изобретения. В некоторых вариантах осуществления каждый управляемый узел 150 пересылки представляет собой машину (например, VM или контейнер), которая исполняется на хост-компьютере в дата-центре общедоступного облака. В других вариантах осуществления каждый управляемый узел 150 пересылки реализован множеством машин (например, множеством VM или контейнеров), которые исполняются на одном и том же хост-компьютере в одном дата-центре общедоступного облака. В еще одних других вариантах осуществления два или более компонентов одного MFN могут быть реализованы двумя или более машинами, исполняющимися на двух или более хост-компьютерах в одном или более дата-центрах общедоступных облаков.

Как показано, управляемый узел 150 пересылки включает в себя агент 205 измерений, механизмы 210 и 215 мидлбокс-обслуживания файрвола и NAT, один или более механизмов 220 оптимизации, краевые шлюзы 225 и 230 и облачный элемент 235 пересылки (например, облачный маршрутизатор). В некоторых вариантах осуществления каждый из этих компонентов 205235 может быть реализован как кластер из двух или более компонентов.

В некоторых вариантах осуществления кластер 160 контроллеров может динамически увеличивать или уменьшать каждый кластер компонентов (1) для добавления или удаления машин (например, VM или контейнеров) для реализации функциональности каждого компонента и/или (2) для добавления или удаления вычислительных и/или сетевых ресурсов для ранее развернутых машин, которые реализуют компоненты этого кластера. При этом каждый развернутый MFN 150 в дата-центре общедоступного облака может рассматриваться как кластер узлов MFN, или он может рассматриваться как узел, который включает в себя множество различных кластеров компонентов, которые выполняют разные операции MFN.

Кроме того, в некоторых вариантах осуществления кластер контроллеров развертывает разные наборы узлов MFN в дата-центрах общедоступных облаков для разных арендаторов, для которых кластер контроллеров определяет виртуальные сети поверх дата-центров общедоступных облаков. При таком методе виртуальные сети любых двух арендаторов не имеют никакого общего MFN. Однако в вариантах осуществления, описываемых ниже, каждый MFN может быть использован для реализации разных виртуальных сетей для разных арендаторов. Специалист в данной области техники поймет, что в других вариантах осуществления кластер 160 контроллеров может реализовать виртуальную сеть каждого арендатора из первого набора арендаторов со своим собственным выделенным набором развернутых MFN при реализации виртуальной сети каждого арендатора из второго набора арендаторов с общим набором развернутых MFN.

В некоторых вариантах осуществления шлюз 225 филиала и шлюз 230 удаленного устройства создают безопасные VPN-соединения соответственно с одним или несколькими филиальными офисами 130 и удаленными устройствами (например, мобильными устройствами 140), которые соединяются с MFN 150, как показано на фиг. 2. Одним примером таких VPN-соединений являются IPsec-соединения, которые будут описаны ниже. Однако специалист в данной области техники поймет, что в других вариантах осуществления такие шлюзы 225 и/или 230 создают различные типы VPN-соединений.

В некоторых вариантах осуществления MFN 150 включает в себя один или более мидлбокс-механизмов, которые выполняют одну или более операций мидлбокс-обслуживания, такие как операции файрвола, операции NAT, операции IPS, операции IDS, операции балансировки нагрузки, операции оптимизации WAN и т.д. За счет включения этих операций мидлбоксов (например, операций файрвола, операций оптимизации WAN и т.д.) в MFN, которые развернуты в общедоступном облаке, виртуальная сеть 100 реализует в общедоступном облаке многие из функций, которые традиционно выполняются корпоративной инфраструктурой WAN в дата-центре(ах) и/или филиальном(ых) офисе(ах).

Таким образом, для многих мидлбокс-сервисов корпоративные вычислительные узлы (например, удаленные устройства, филиальные офисы и дата-центры) больше не должны иметь доступ к корпоративной инфраструктуре WAN корпорации в частном дата-центре или филиальном офисе, так как многие из этих сервисов теперь развернуты в общедоступных облаках. Такой метод ускоряет доступ корпоративных вычислительных узлов (например, удаленных устройств, филиальных офисов и дата-центров) к этим сервисам и позволяет избежать дорогостоящих узких мест перегруженных сетей в частных дата-центрах, которые в противном случае были бы предназначены для предоставления таких сервисов.

Такой метод эффективно распределяет функциональность шлюза WAN между разными MFN в дата-центрах общедоступных облаков. Например, в некоторых вариантах осуществления в виртуальной сети 100 большая часть или все традиционные функции безопасности корпоративного шлюза WAN (например, операции файрвола, операции обнаружения вторжений, операции предотвращения вторжений и т.д.) перемещены в MFN общедоступных облаков (например, во входные MFN, на которых данные от конечных точек вычислений поступают в виртуальную сеть). Это эффективно позволяет виртуальной сети 100 иметь распределенный шлюз WAN, который реализован на многих различных MFN, которые реализуют виртуальную сеть 100.

В примере с иллюстрацией на фиг. 2 показано, что MFN 150 включает в себя механизм 210 файрвола, механизм 215 NAT и один или более механизмов оптимизации L4-L7. Специалист в данной области техники поймет, что в других вариантах осуществления MFN 150 включает в себя другие мидлбокс-механизмы для выполнения других мидлбокс-операций. В некоторых вариантах осуществления механизм 210 файрвола обеспечивает принудительное применение правил файрвола в отношении (1) потоков сообщений с данными на их входных путях в виртуальную сеть (например, потоков сообщений с данными, которые шлюзы 225 и 230 получают и обрабатывают из филиальных офисов 130 и мобильных устройств 140) и (2) потоков сообщений с данными на их выходных путях из виртуальной сети (например, потоков сообщений с данными, которые отправляются в дата-центры провайдера SaaS через механизм 215 NAT и Интернет 202).

В некоторых вариантах осуществления механизм 210 файрвола MFN 150 также обеспечивает принудительное применение правил файрвола, когда механизм файрвола принадлежит MFN, который является промежуточным переходом между входным MFN, на котором поток сообщений с данными входит в виртуальную сеть, и выходным MFN, на котором поток сообщений с данными выходит из виртуальной сети. В других вариантах осуществления механизм 210 файрвола обеспечивает принудительное применение правил файрвола только тогда, когда он является частью входного MFN и/или выходного MFN потока сообщений с данными.

В некоторых вариантах осуществления механизм 215 NAT выполняет преобразование сетевых адресов для изменения сетевых адресов источников потоков сообщений с данными на их путях выхода из виртуальной сети на сторонние устройства (например, на машины провайдера SaaS) через Интернет 202. Такие преобразования сетевых адресов гарантируют, что сторонние машины (например, SaaS-машины) могут быть надлежащим образом сконфигурированы для обработки потоков сообщений с данными, которые без преобразования адресов могут определять частные сетевые адреса арендаторов и/или провайдеров общедоступных облаков. Это особенно проблематично, так как адреса частных сетей разных арендаторов и/или провайдеров облаков могут перекрываться. Преобразование адресов также гарантирует, что ответные сообщения от сторонних устройств (например, от SaaS-машин) могут быть надлежащим образом получены виртуальной сетью (например, механизмом NAT MFN, из которого сообщение вышло из виртуальной сети).

В некоторых вариантах осуществления механизмы 215 NAT MFN выполняют операции двойного NAT над каждым потоком сообщений с данными, который покидает виртуальную сеть, чтобы достичь сторонней машины, или который входит в виртуальную сеть от сторонней машины. Как дополнительно описано ниже, одна операция NAT в двух операциях NAT выполняется над таким потоком сообщений с данными на его входном MFN, когда он входит в виртуальную сеть, а другая операция NAT выполняется над потоком сообщений с данными на его выходном MFN, когда он выходит из виртуальной сети.

Такой метод двойного NAT позволяет сопоставить большее число частных сетей арендаторов с сетями провайдеров общедоступных облаков. Такой метод также снижает нагрузку для распределения в MFN данных, касающихся изменений в частных сетях арендаторов. Некоторые варианты осуществления перед операциями входного или выходного NAT выполняют операция сопоставления арендатора, которая использует идентификатор арендатора для первого сопоставления сетевого адреса источника арендатора с другим сетевым адресом источника, который затем сопоставляется с еще одним другим сетевым адресом источника с помощью операции NAT. Выполнение операции двойного NAT снижает нагрузку распределения данных для распределения данных, касающихся изменений в частных сетях арендаторов.

Механизм 220 оптимизации исполняет новые процессы, которые оптимизируют пересылку сообщений с данными в их пункты назначения для наилучшей сквозной производительности и надежности. Некоторые из этих процессов реализуют проприетарные высокопроизводительные сетевые протоколы, свободные от консервативности существующих сетевых протоколов. Например, в некоторых вариантах осуществления механизм 220 оптимизации оптимизирует скорости сквозного TCP за счет разделения и/или завершения промежуточного TCP.

Облачный элемент 235 пересылки представляет собой механизм MFN, который отвечает за пересылку потока сообщений с данными к облачному элементу пересылки (CFE) MFN следующего перехода, когда поток сообщений с данными должен пройти к другому общедоступному облаку, чтобы достичь своего пункта назначения, или к выходному маршрутизатору в том же общедоступном облаке, когда поток сообщений с данными может достичь своего пункта назначения через то же общедоступное облако. В некоторых вариантах осуществления CFE 235 MFN 150 представляет собой программный маршрутизатор.

Для пересылки сообщений с данными CFE инкапсулирует сообщения с заголовками туннелей. Разные варианты осуществления используют различные методы для инкапсуляции сообщений с данными с заголовками туннелей. Некоторые варианты осуществления, описываемые ниже, используют один заголовок туннеля для идентификации сетевых входных/выходных адресов для входа и выхода из виртуальной сети и используют другой заголовок туннеля для идентификации MFN следующего перехода, когда сообщение с данными должно пройти один или более промежуточных MFN для достижения выходного MFN.

В частности, в некоторых вариантах осуществления CFE отправляет сообщение с данными с двумя заголовками туннелей: (1) с внутренним заголовком, который идентифицирует входной CFE и выходной CFE для входа и выхода из виртуальной сети, и (2) с внешним заголовком, который идентифицирует CFE следующего перехода. В некоторых вариантах осуществления внутренний заголовок туннеля также включает в себя идентификатор арендатора (TID), чтобы позволить множеству разных арендаторов провайдера виртуальных сетей использовать общий набор CFE MFN провайдера виртуальных сетей. Другие варианты осуществления определяют заголовки туннеля по-разному, чтобы определить оверлейную виртуальную сеть.

Чтобы развернуть виртуальную сеть для арендатора поверх одного или более общедоступных облаков, кластер контроллеров (1) идентифицирует возможные входные и выходные маршрутизаторы для входа и выхода из виртуальной сети для арендатора на основе местоположений корпоративных вычислительных узлов арендатора (например, филиальных офисов, дата-центров, мобильных пользователей и провайдеров SaaS) и (2) идентифицирует маршруты, которые проходят от идентифицированных входных маршрутизаторов к идентифицированным выходным маршрутизаторам через другие промежуточные маршрутизаторы общедоступных облаков, которые реализуют виртуальную сеть. После идентификации этих маршрутов кластер контроллеров передает эти маршруты в таблицы пересылки CFE 235 MFN в общедоступном(ых) облаке(ах). В вариантах осуществления, которые используют виртуальные сетевые маршрутизаторы на основе OVS, контроллер распределяет маршруты с помощью OpenFlow.

В некоторых вариантах осуществления кластер 160 контроллеров также может конфигурировать компоненты 205-235 каждого MFN 150, который реализует виртуальную сеть, чтобы оптимизировать несколько уровней сетевой обработки для достижения наилучшей сквозной производительности, надежности и безопасности. Например, в некоторых вариантах осуществления эти компоненты сконфигурированы (1) для оптимизации маршрутизации трафика уровня 3 (например, кратчайшего пути, дублирования пакетов), (2) для оптимизации управления перегрузкой TCP уровня 4 (например, сегментации, управления скоростью), (3) для реализации функций безопасности (например, шифрования, глубокой проверки пакетов, файрвола) и (4) для реализации функций сжатия на уровне приложений (например, дедублирования, кэширования). Внутри виртуальной сети корпоративный трафик защищается, проверяется и регистрируется.

В некоторых вариантах осуществления один агент измерений развернут для каждого MFN в дата-центре общедоступного облака. В других вариантах осуществления множество MFN в дата-центре общедоступного облака или в группе дата-центров (например, в группе соседних связанных дата-центров, таких как дата-центры в одной зоне доступности) совместно используют один агент измерений. Чтобы оптимизировать обработку уровней 3 и 4, агент 205 измерений, связанный с каждым управляемым узлом 150 пересылки, с повторением генерирует значения измерений, которые количественно оценивают качество сетевого соединения между своим узлом и каждым из нескольких других «соседних» узлов.

Разные варианты осуществления определяют соседние узлы по-разному. Для конкретного MFN в одном дата-центре общедоступного облака конкретного провайдера общедоступного облака в некоторых вариантах осуществления соседний узел включает в себя (1) любой другой MFN, который работает в любом дата-центре общедоступного облака конкретного провайдера общедоступного облака, и (2) любой другой MFN, который работает в дата-центре другого провайдера общедоступного облака, который находится в том же «регионе», что и конкретный MFN.

Разные варианты осуществления определяют один и тот же регион по-разному. Например, некоторые варианты осуществления определяют регион с точки зрения расстояния, которое задает форму границы вокруг конкретного управляемого узла пересылки. Другие варианты осуществления определяют регионы с точки зрения городов, штатов или региональных областей, таких как северная Калифорния, южная Калифорния и т.д. Предполагается, что этот метод состоит в том, что разные дата-центры одного и того же провайдера общедоступного облака соединены с помощью чрезвычайно высокоскоростных сетевых соединений, а сетевые соединения между дата-центрами разных провайдеров общедоступных облаков могут быть быстрыми, когда дата-центры находятся в том же регионе, но, по-видимому, не такими быстрыми, когда дата-центры находятся в разных регионах. Когда дата-центры находятся в разных регионах, соединение между дата-центрами разных провайдеров общедоступных облаков может осуществляться через общедоступный Интернет с пересечением больших расстояний.

В разных вариантах осуществления агент 205 измерений генерирует значения измерений по-разному. В некоторых вариантах осуществления агент измерений периодически (например, раз в секунду, каждые N секунд, каждую минуту, каждые М минут и т.д.) отправляет сообщения проверки связи (например, UDP-эхо-сообщения) каждому из агентов измерений своих соседних управляемых узлов пересылки. С учетом небольшого размера сообщений проверки связи они не требуют больших расходов на соединение с сетью. Например, для 100 узлов, каждый из которых отправляет эхо-запрос на каждый другой узел каждые 10 секунд, для каждого узла генерируется около 10 кбит/с входного и выходного трафика измерений, и с учетом текущих цен на общедоступные облака это приводит к расходам на потребление сети в несколько долларов (например, 5 долларов США) за узел в год.

На основе скорости получаемых ответных сообщений агент 205 измерений вычисляет и обновляет значения показателей измерений, таких как производительность сетевого соединения, задержка, потери и надежность соединения. За счет повторного выполнения этих операций агент 205 измерений определяет и обновляет матрицу результатов измерений, которая выражает качество сетевых соединений со своими соседними узлами. Когда агент 205 взаимодействует с агентами измерений своих соседних узлов, его матрица измерений количественно оценивает только качество соединений с его локальной кликой узлов.

Агенты измерений разных управляемых узлов пересылки отправляют свои матрицы измерений к кластеру 160 контроллеров, который затем агрегирует все данные разных кликовых соединений для получения агрегированного вида сетки соединений между разными парами управляемых узлов пересылки. Когда кластер 160 контроллеров собирает различные измерения для канала связи между двумя парами узлов пересылки (например, измерения, выполненные одним узлом в разное время), кластер контроллеров создает смешанное значение из разных измерений (например, создает среднее или средневзвешенное значение измерений). В некоторых вариантах осуществления агрегированный вид сетки является полным видом сетки всех сетевых соединений между каждой парой управляемых узлов пересылки, а в других вариантах осуществления является более полным видом, чем тот, который создается агентами измерений отдельных управляемых узлов пересылки.

Как показано на Фиг. 2, кластер 160 контроллеров включает в себя кластер из одного или нескольких механизмов 280 обработки измерений, одного или нескольких механизмов 282 идентификации пути и одного или нескольких интерфейсов 284 управления. Чтобы не затруднять понимания описания ненужными деталями, каждый из этих кластеров будет именоваться ниже в терминах отдельных уровней механизма или интерфейса, то есть в терминах уровня 280 обработки измерений, уровня 282 идентификации пути и уровня 284 интерфейса управления.

Уровень 280 обработки измерений принимает матрицы измерений от агентов 205 измерений управляемых узлов пересылки и обрабатывает эти матрицы измерений для создания агрегированной матрицы сетки, которая выражает качество соединений между различными парами управляемых узлов пересылки. Уровень 280 обработки измерений доставляет агрегированную матрицу сетки на уровень 282 идентификации пути. На основе агрегированной матрицы сетки уровень 282 идентификации пути идентифицирует различные требуемые пути маршрутизации через виртуальную сеть для соединения различных конечных точек корпоративных данных (например, различные филиальные офисы, корпоративные дата-центры, дата-центры провайдеров SaaS и/или удаленные устройства). Затем этот уровень 282 доставляет эти пути маршрутизации в таблицы маршрутов, которые распределяются по облачным элементам 235 пересылки управляемых узлов 150 пересылки.

В некоторых вариантах осуществления идентифицированный путь маршрутизации для каждой пары конечных точек сообщений с данными является путем маршрутизации, который считается оптимальным на основании набора критериев оптимизации, например, это самый быстрый путь маршрутизации, самый короткий путь маршрутизации или путь который меньше всего использует Интернет. В других вариантах осуществления механизм идентификации пути может идентифицировать и доставлять (в таблицу маршрутизации) несколько разных путей маршрутизации между одними и теми же двумя конечными точками. В этих вариантах осуществления облачные элементы 235 пересылки в составе управляемых узлов 150 пересылки затем выбирают один из путей на основе QoS-критериев или других критериев времени выполнения, принудительное применение которых они обеспечивают. В некоторых вариантах осуществления каждый CFE 235 получает не весь путь маршрутизации от CFE до выходной точки виртуальной сети, а следующий переход для пути.

В некоторых вариантах осуществления уровень 282 идентификации пути использует значения измерений в агрегированной матрице сетки в качестве входных данных для алгоритмов маршрутизации, которые он исполняет для построения глобального графа маршрутизации. Этот глобальный граф маршрутизации представляет собой агрегированную и оптимизированную версию графа измерений, который уровень 280 обработки создает в некоторых вариантах осуществления. Фиг. 3 иллюстрирует пример графа 300 измерений, который уровень 280 обработки результатов измерений контроллера создает в некоторых вариантах осуществления. Этот граф показывает сетевые соединения между различными управляемыми узлами 150 пересылки в общедоступных облаках 310 и 320 AWS и GCP (т.е. в дата-центрах AWS и GCP). Фиг. 4А иллюстрирует пример графа 400 маршрутизации, который уровень 282 идентификации пути контроллера создает в некоторых вариантах осуществления из графа 300 измерений.

Фиг. 5 иллюстрирует процесс 500, который уровень идентификации путей контроллеров использует, чтобы генерировать граф маршрутизации из графа измерений, полученного из уровня измерений контроллера. Уровень 282 идентификации путей выполняет этот процесс 500 с повторением, когда он с повторением принимает обновленные графы измерений из уровня измерений контроллера (например, выполняет процесс 500 каждый раз, когда он получает новый граф измерений, или каждый N-раз, когда он получает новый граф измерений). В других вариантах осуществления уровень 282 идентификации путей периодически выполняет этот процесс (например, каждые 12 часов или 24 часа).

Как показано, уровень идентификации пути сначала определяет (на этапе 505) граф маршрутизации как идентичный графу измерений (то есть, чтобы иметь одни и те же каналы связи между одними и теми же парами управляемых узлов пересылки). На этапе 510 процесс удаляет плохие каналы связи из графа 300 измерений. Примеры плохих каналов связи - это каналы связи с чрезмерной потерей сообщений или низкой надежностью (например, каналы связи с потерей сообщений более 2% за последние 15 минут или с потерей сообщений более 10% за последние 2 минуты). На фиг. 4А показано, что каналы 302, 304 и 306 связи на графе 300 измерений исключены из графа 400 маршрутизации. Эта фигура иллюстрирует исключение этих каналов связи в результате обозначения этих каналов связи пунктирными линиями.

Затем на этапе 515 процесс 500 вычисляет оценку веса (оценку стоимости) канала как взвешенную комбинацию нескольких вычисленных и зависящих от провайдера значений. В некоторых вариантах осуществления оценка веса представляет собой взвешенную комбинацию (1) вычисленного значения задержки канала связи, (2) вычисленного значения потерь в канале связи, (3) стоимости сетевого соединения провайдера с каналом связи и (4) затрат провайдера на вычисления в канале связи. В некоторых вариантах осуществления затраты провайдера на вычисления учитываются, когда управляемые узлы пересылки, соединенные каналом связи, являются машинами (например, виртуальными машинами или контейнерами), которые исполняются на хост-компьютерах в дата-центре(ах) общедоступного(ых) облака(ов).

На этапе 520 процесс добавляет к графу маршрутизации известные IP-адреса источника и назначения (например, известные IP-адреса провайдеров SaaS, используемых корпоративной организацией) для потоков сообщений с данными в виртуальной сети. В некоторых вариантах осуществления процесс добавляет каждый известный IP-адрес возможной конечной точки потока сообщений к узлу (например, к узлу, представляющему MFN) в графе маршрутизации, который является ближайшим к этой конечной точке. При этом в некоторых вариантах осуществления процесс предполагает, что каждая такая конечная точка соединена с виртуальной сетью через канал связи с нулевой стоимостью задержки и нулевой стоимостью потерь. Фиг. 4В иллюстрирует пример добавления известных IP-адресов для двух провайдеров SaaS к двум узлам 402 и 404 (представляющим два MFN) в графе маршрутизации, которые находятся в дата-центрах, ближайших к дата-центрам этих провайдеров SaaS. В этом примере один узел находится в общедоступном облаке AWS, а другой узел - в общедоступном облаке GCP.

В качестве альтернативы или в комбинации в некоторых вариантах осуществления процесс 500 добавляет известные IP-адреса источника и назначения к графу маршрутизации за счет добавления узлов к этому графу для представления конечных точек источника и назначения, назначения IP-адресов этим узлам и присвоения значений веса каналам связи, которые соединяют эти добавленные узлы с другими узлами в графе маршрутизации (например, с узлами в графе маршрутизации, которые представляют MFN в общедоступных облаках). Когда конечные точки источника и назначения для потоков добавляются как узлы, механизм 282 идентификации пути может учитывать стоимость (например, стоимость расстояния, стоимость задержки и/или финансовые затраты и т.д.) достижения этих узлов, когда он идентифицирует различные маршруты через виртуальную сеть между разными конечными точками источника и назначения.

Фиг. 4С иллюстрирует граф 410 маршрутизации, который генерируется в результате добавления двух узлов 412 и 414 к графу 400 узлов на фиг. 4А, чтобы представлять двух провайдеров SaaS. В этом примере известные IP-адреса назначаются узлам 412 и 414, и эти узлы соединяются с узлами 402 и 404 (представляющими два MFN) через каналы 416 и 418 связи, которым присвоены веса W1 и W2. Этот метод является альтернативным методом для добавления известных IP-адресов двух провайдеров SaaS по отношению к методу с иллюстрацией на фиг. 4В.

Фиг. 4D иллюстрирует более подробный граф 415 маршрутизации. В этом более подробном графе маршрутизации добавлены дополнительные узлы 422 и 424 для представления внешних корпоративных вычислительных узлов (например, филиальных офисов и дата-центров) с известными IP-адресами, которые соединяются с каждым из общедоступны облаков 310 и 320 AWS и GCP. Каждый из этих узлов 422/424 соединен по меньшей мере одним каналом 426 связи со связанным значением Wi веса по меньшей мере с одним из узлов графа маршрутизации, который представляет MFN. Некоторые из этих узлов (например, некоторые из филиальных офисов) соединены с помощью множества каналов связи с одним и тем же MFN или с разными MFN.

Затем на этапе 525 процесс 500 вычисляет пути с наименьшей стоимостью (например, кратчайшие пути и т.д.) между каждым MFN и каждым другим MFN. который может служить в качестве выходного местоположения виртуальной сети для потока сообщений с данными корпоративной организации. В некоторых вариантах осуществления выходные MFN включают в себя MFN, соединенные с внешними корпоративными вычислительными узлами (например, с филиальными офисами, корпоративными дата-центрами и дата-центрами провайдеров SaaS), а также MFN, которые являются местоположениями-кандидатами для соединений мобильных устройств и выходных Интернет-соединений. В некоторых вариантах осуществления это вычисление использует традиционный процесс идентификации с наименьшими затратами (например, кратчайшего пути), который идентифицирует кратчайшие пути между разными парами MFN.

Для каждой пары MFN-кандидатов, когда существует множество таких путей между парами MFN, процесс идентификации с наименьшей стоимостью использует вычисленные оценки веса (то есть оценки, вычисленные на этапе 510), чтобы идентифицировать путь с наименьшей оценкой. Ниже приводится описание некоторых способов вычисления путей с наименьшей стоимостью. Как указано выше, в некоторых вариантах осуществления уровень 282 идентификации пути идентифицирует множество путей между двумя парами MFN. Это должно позволить облачным элементам 235 пересылки использовать разные пути при разных обстоятельствах. Таким образом, в этих вариантах осуществления процесс 500 может идентифицировать множество путей между двумя парами MFN.

На этапе 530 процесс удаляет из графа маршрутизации каналы связи между парами MFN, которые не используются ни одним из путей с наименьшей стоимостью, идентифицированных на этапе 525. Затем на этапе 535 процесс генерирует таблицы маршрутизации для облачных элементов пересылки 235 из графа маршрутизации. На этапе 535 процесс распределяет эти таблицы маршрутизации по облачным элементам 235 пересылки управляемых узлов пересылки. После этапа 535 процесс завершается.

В некоторых вариантах осуществления виртуальная сеть имеет два типа внешних соединений, а именно: (1) внешние безопасные соединения с вычислительными узлами (например, филиальными офисами, дата-центрами, мобильными пользователями и т.д.) организации и (2) внешние соединения со сторонними компьютерами (например, серверами провайдера SaaS) через Интернет. Некоторые варианты осуществления оптимизируют виртуальную сеть за счет нахождения оптимальных местоположений входа и выхода виртуальной сети для каждого пути данных, который заканчивается на узлах источника и назначения за пределами виртуальной сети. Например, чтобы соединить филиальный офис с сервером провайдера SaaS (например, с сервером salesforce.com) некоторые варианты осуществления соединяют филиальный офис с оптимальным краевым MFN (например, MFN. который имеет самое быстрое сетевое соединение с филиальным офисом или ближайшим к филиальному офису) и идентифицируют оптимальный краевой MFN для оптимально расположенного сервера провайдера SaaS (например, провайдера SaaS, ближайшего к краевому MFN для филиального офиса или имеющего самый быстрый путь к краевому MFN для филиального офиса через краевой MFN, соединенный с сервером провайдера SaaS).

В некоторых вариантах осуществления, чтобы связать каждый вычислительный узел (например, филиальный офис, мобильного пользователя и т.д.) организации с ближайшим MFN через VPN-соединение, провайдер виртуальных сетей развертывает один или более авторитетных серверов доменных имен (DNS) в общедоступных облаках для соединения с вычислительными узлами. В некоторых вариантах осуществления каждый раз, когда корпоративному вычислительному узлу в некоторых вариантах осуществления необходимо создать VPN-соединение (т.е. инициализировать или повторно инициализировать VPN-соединение) с MFN провайдера виртуальных сетей, вычислительный узел сначала разрешает адрес, связанный со своей виртуальной сетью (например, virtualnetworkX.net) с помощью этого авторитетного DNS-сервера, чтобы получить от этого сервера идентификационные данные MFN, который этот сервер идентифицирует как MFN, ближайший к корпоративному вычислительному узлу. В некоторых вариантах осуществления, чтобы идентифицировать этот MFN, авторитетный DNS-сервер предоставляет идентификатор MFN (например, IP-адрес MFN). Затем корпоративный вычислительный узел создает VPN-соединение с этим управляемым узлом пересылки.

В других вариантах осуществления корпоративный вычислительный узел не выполняет сначала DNS-разрешения (т.е. не сначала разрешает сетевой адрес для конкретного домена) каждый раз, когда ему необходимо создать соединение VPN с MFN VNP. Например, в некоторых вариантах осуществления корпоративный вычислительный узел продолжает использование MFN с DNS-разрешением в течение определенного времени (например, в течение дня, недели и т.д.) перед выполнением другого DNS-разрешения, чтобы определить, является ли этот MFN по-прежнему оптимальным MFN, с которым он должен соединиться.

Когда IP-адрес источника в DNS-запросе является IP-адресом источника локального DNS-сервера корпоративного вычислительного узла, а не самого узла, в некоторых вариантах осуществления авторитетный DNS-сервер идентифицирует MFN, ближайший к локальному DNS-серверу, а не MFN, ближайший к корпоративному вычислительному узлу. Для решения этой проблемы в некоторых вариантах осуществления DNS-запрос идентифицирует корпоративный вычислительный узел с точки зрения доменного имени, которое включает в себя одну или более частей (меток), которые объединены и разделены точками, где одна из этих частей идентифицирует корпорацию, а другая часть идентифицирует вычислительный узел корпорации.

В некоторых вариантах осуществления это доменное имя определяет иерархию доменов и поддоменов в порядке убывания от правой метки до левой метки в имени домена. Самая правая первая метка идентифицирует конкретный домен, вторая метка слева от первой метки идентифицирует корпоративную организацию, а третья метка слева от второй метки идентифицирует местоположение внешней машины организации в тех случаях, когда организация имеет более, чем одно местоположение внешних машин. Например, в некоторых вариантах осуществления DNS-запрос идентифицирует корпоративный вычислительный узел как myNode компании myCompany и запрашивает разрешение адреса myNode.myCompany.virtualnetwork.net. Затем DNS-сервер использует идентификатор myNode, чтобы лучше выбрать входной MFN, с которым корпоративный вычислительный узел должен создать VPN-соединение. В разных вариантах осуществления идентификатор myNode выражается по-разному. Например, он может быть адресован как IP-адрес, описание широты/долготы местоположения, GPS-местоположение (с помощью глобальной системы позиционирования), почтовый адрес и т.д.

Даже когда IP-адрес правильно отражает местоположение, может существовать несколько потенциальных входных маршрутизаторов, например, принадлежащих разным дата-центрам в одном и том же облаке или разным облакам в одном и том же регионе. В таком случае в некоторых вариантах осуществления авторитетный сервер виртуальной сети отправляет обратно список IP-адресов потенциальных CFE (например, С5, С8, С12) MFN. Затем в некоторых вариантах осуществления корпоративный вычислительный узел проверяет различные CFE в списке, чтобы произвести измерения (например, измерения расстояния или скорости), и выбирает ближайший из них в результате сравнения измерений среди набора CFE-кандидатов.

Кроме того, корпоративный вычислительный узел может базировать этот выбор на идентификации MFN, в настоящее время используемых другими вычислительными узлами корпоративной организации. Например, в некоторых вариантах осуществления корпоративный вычислительный узел добавляет затраты на соединение с каждым MFN, так что, если многие из корпоративных филиалов уже соединены с данным облаком, новые вычислительные узлы будут иметь стимул для соединения с тем же облаком и тем самым минимизировать межоблачные затраты с точки зрения обработки, задержки и долларов.

Другие варианты осуществления используют другие методы DNS-разрешения. Например, каждый раз, когда корпоративному вычислительному узлу (например, филиальному офису, дата-центру, мобильному пользователю и т.д.) необходимо выполнить DNS-разрешение, корпоративный вычислительный узел (например, мобильное устройство или локальный DNS-преобразователь в филиальном офисе или дата-центре) обменивается данными с провайдером DNS-сервиса, который служит авторитетным DNS-преобразователем для ряда организаций. В некоторых вариантах осуществления этот провайдер DNS-сервиса имеет машины DNS-разрешения, расположенные в одном или более частных дата-центрах, а в других вариантах осуществления он является частью одного или более дата-центров общедоступных облаков.

Чтобы идентифицировать, какой из N управляемых узлов пересылки, которые соединяются напрямую с Интернетом, следует использовать для доступа к серверу провайдера SaaS, в некоторых вариантах осуществления виртуальная сеть (например, входной MFN или кластер контроллеров, который конфигурирует MFN) идентифицирует набор из одного или более краевых MFN-кандидатов из N управляемых узлов пересылки. Как дополнительно описано ниже, в некоторых вариантах осуществления каждый краевой MFN-кандидат является краевым MFN, который считается оптимальным на основе набора критериев, таких как расстояние до сервера провайдера SaaS, скорость сетевого соединения, стоимость, задержка и/или потери, затраты на сетевые вычисления и т.д.).

Чтобы помочь в идентификации оптимальных краевых точек, в некоторых вариантах осуществления кластер контроллеров поддерживает для организации список наиболее популярных провайдеров SaaS и потребительских web-пунктов назначения и их подсетей IP-адресов. Для каждого такого пункта назначения кластер контроллеров назначает один или более оптимальных MFN (также с оценкой по физическому расстоянию, скорости сетевого соединения, стоимости, потерям и/или задержке, затратам на вычисления и т.д.) в качестве выходных узлов-кандидатов. Для каждого выходного MFN-кандидата кластер контроллеров затем вычисляет лучший маршрут от каждого возможного входного MNF к MFN-кандидату и настраивает результирующую таблицу следующих переходов в MFN соответственно так, чтобы Интернет-провайдер SaaS или wed-пункт назначения был связан с корректным узлом следующего перехода в виртуальной сети.

С учетом того, что пункт назначения сервиса зачастую может быть достигнут через несколько IP-подсетей (предоставляемых авторитетным DNS-сервером) в нескольких местоположениях, существует несколько потенциальных выходных узлов, чтобы минимизировать задержку и обеспечить балансировку нагрузки. Таким образом, в некоторых вариантах осуществления кластер контроллеров вычисляет наилучшее местоположение и выходной узел для каждого MFN и соответственно обновляет следующий переход. Кроме того, лучший выходной узел для доступа к провайдеру SaaS (например, office365.com) может находиться через одного провайдера общедоступного облака (например, через Microsoft Azure), но лучший с точки зрения расстояния или скорости соединения входной MFN может принадлежать другому провайдеру общедоступного облака (например, AWS). В таких ситуациях прохождение в другое облако (то есть в общедоступное облако с наилучшим выходным MFN) перед выходом из виртуальной сети может быть неоптимальным с точки зрения задержки, обработки и стоимости. В таких ситуациях предоставление множества краевых узлов-кандидатов позволяет выбрать оптимальный краевой MFN и оптимальный путь к выбранному краевому MFN.

Чтобы идентифицировать оптимальный путь через виртуальную сеть к выходному MFN, который соединяется с Интернетом или соединяется с корпоративным вычислительным узлом корпоративной организации, кластер контроллеров идентифицирует оптимальные пути маршрутизации между MFN. Как указано выше, в некоторых вариантах осуществления кластер контроллеров идентифицирует лучший путь между любыми двумя MFN сначала в результате оценки стоимости каждого канала связи между парой соединенных напрямую MFN. например, на основе метрической оценки, которая отражает взвешенную сумму предполагаемой задержки и финансовых затрат. В некоторых вариантах осуществления задержка и финансовые затраты включают в себя (1) измерения задержки канала связи, (2) расчетную задержку обработки сообщений, (3) облачные расходы на исходящий трафик из конкретного дата-центра или до другого дата-центра того же провайдера общедоступного облака или для выхода из облака провайдера общедоступного облака (PC) (например, в другой дата-центр общедоступного облака другого провайдера общедоступного облака или в Интернет), и (4) расчетные затраты на обработку сообщений, связанные с исполнением MFN на хост-компьютерах в общедоступных облаках.

Использование вычисленной стоимости этих парных каналов связи позволяет кластеру контроллеров вычислить стоимость каждого пути маршрутизации, который использует один или несколько из этих парных каналов связи, за счет агрегирования затрат на отдельные парные каналы связи, которые используются по пути маршрутизации. Как указано выше, кластер контроллеров затем определяет свой граф маршрутизации на основе вычисленных затрат на пути маршрутизации и генерирует таблицы пересылки облачных маршрутизаторов MFN на основе определенных графов маршрутизации. Кроме того, как указано выше, кластер контроллеров периодически (например, каждые 12 часов. 24 часа и т.д.) или при получении обновлений измерений от агентов измерений MFN выполняет эти операции по вычислению стоимости, построению графов и обновлению и распределению таблиц пересылки.

Каждый раз, когда таблица пересылки в месте расположения CFE Ci MFN указывает на CFE Cj MFN следующего перехода, CFE Ci рассматривает Cj в качестве соседа. В некоторых вариантах осуществления CFE Ci создает безопасный, активно поддерживаемый VPN-туннель к CFE Cj. В некоторых вариантах осуществления безопасный туннель представляет собой туннель, который требует, чтобы полезные нагрузки инкапсулированных сообщений с данными были зашифрованы. Кроме того, в некоторых вариантах осуществления туннель активно поддерживается одной или обеими конечными точками туннеля, отправляющими сигналы подтверждения активности другой конечной точке.

В других вариантах осуществления CFE не создает безопасных, активно поддерживаемых VPN-туннелей. Например, в некоторых вариантах осуществления туннели между CFE являются статическими туннелями, которые не отслеживаются активно за счет передачи сигналов подтверждения активности. Кроме того, в некоторых вариантах осуществления эти туннели между CFE не шифруют свои полезные нагрузки. В некоторых вариантах осуществления туннели между парой CFE включают в себя два инкапсулирующих заголовка, причем внутренний заголовок идентифицирует ID арендатора, а также входные и выходные CFE для сообщения с данными, входящего в виртуальную сеть и выходящего из нее (т.е. входящего и выходящего из общедоступного(ых) облак(ов), а внешний инкапсулирующий заголовок определяет сетевые адреса источника и назначения (например, IP-адреса) для прохождения через ноль или более CFE от входного CFE к выходному CFE.

В дополнение к внутренним туннелям в некоторых вариантах осуществления, как указано выше, виртуальная сеть соединяет корпоративные вычислительные узлы с их краевыми MFN с помощью VPN-туннелей. Поэтому в вариантах осуществления, где для соединения CFE используются безопасные туннели, сообщения с данными проходят через виртуальную сеть с использованием полностью защищенного VPN-пути.

Так как сообщения с данными виртуальной сети пересылаются с использованием инкапсуляции внутри виртуальной сети, в некоторых вариантах осуществления виртуальная сеть использует свои собственные уникальные сетевые адреса, которые отличаются от частных адресов, используемых различными частными сетями арендатора. В других вариантах осуществления виртуальная сеть использует адресные пространства частных и общедоступных сетей общедоступных облаков, поверх которых она определена. В еще одних других вариантах осуществления виртуальная сеть использует для некоторых из своих компонентов (например, для некоторых из своих MFN, CFE и/или сервисов) некоторые из своих собственных уникальных сетевых адресов, а для других своих компонентов - адресные пространства частных и общедоступных сетей общедоступных облаков.

Кроме того, в некоторых вариантах осуществления виртуальная сеть использует коммуникационную платформу «с чистого листа» со своими собственными проприетарными протоколами. В вариантах осуществления, в которых сообщения с данными пересылаются полностью через программные маршрутизаторы MFN (например, через программные CFE), виртуальная сеть может обеспечивать оптимизированное управление скоростью для сквозных соединений на большие расстояния. В некоторых вариантах осуществления это достигается за счет работы прокси-механизма 220 оптимизации TCP на каждом MFN 150. В других вариантах осуществления, которые не нарушают сам TCP (например, с использованием HTTPS), это достигается за счет прокси-механизма 220, сегментирующего управление скоростью с помощью промежуточной буферизации каждого потока вместе с окном приемника TCP и манипуляцией с ACK.

За счет своей природы «с чистого листа» в некоторых вариантах осуществления виртуальная сеть оптимизирует многие из своих компонентов для обеспечения еще более качественных обслуживания. Например, в некоторых вариантах осуществления виртуальная сеть использует многопутевую маршрутизацию для поддержки настроек VPN с гарантированной полосой пропускания для маршрутизации через виртуальную сеть. В некоторых вариантах осуществления такие VPN включают в себя данные о состоянии в каждом MFN аналогично маршрутизации ATM/MPLS, и их создание и удаление контролируются централизованно. Некоторые варианты осуществления идентифицируют доступную полосу пропускания для каждого исходящего канала связи либо за счет ее измерения напрямую (через пару пакетов или аналогичный процесс), либо за счет наличия заданной пропускной способности для канала связи и сокращения этой пропускной способности на трафик, который уже был отправлен через этот канал связи.

Некоторые варианты осуществления в качестве ограничения используют остаточную полосу пропускания канала связи. Например, когда канал связи не имеет доступной полосы пропускания, составляющей по меньшей мере 2 Мбит/с, кластер контроллеров в некоторых вариантах осуществления удаляет канал связи из набора каналов связи, которые используются для вычисления пути с наименьшей стоимостью (например, кратчайшего пути) к любому пункту назначения (например, удаляет канал связи из графа маршрутизации, такого как граф 400). Если сквозной маршрут является все еще доступным после удаления этого канала связи, новые VPN будут маршрутизироваться по этому новому маршруту. Удаление VPN может восстановить доступную пропускную способность данного канала связи, что, в свою очередь, может позволить включить этот канал связи в расчет наименее затратного пути (например, кратчайшего пути). Некоторые варианты осуществления используют другие варианты многопутевой маршрутизации, такие как балансировка нагрузки трафика по множеству путей, например, с использованием МРТСР (многопутевого TCP).