Область техники, к которой относится изобретение

[0001] Настоящее изобретение относится к обучающему устройству и к способу обучения.

Уровень техники

[0002] В последние годы, попытка заменять функцию людей большим объемом данных предпринимается во многих областях техники посредством использования машинного обучения, которое является общеизвестным относительно искусственного интеллекта (AI). Эта область техники по-прежнему тщательно разрабатывается день за днем, но возникают определенные проблемы при текущих обстоятельствах. Их характерные примеры включают в себя предел точности, включающий в себя обобщающую способность для извлечения универсальных знаний из данных, и предел скорости обработки вследствие большой вычислительной нагрузки. В качестве известного алгоритма для высокопроизводительного машинного обучения, известны глубокое обучение (DL), сверточная нейронная сеть (CNN), в которой входной вектор ограничен периферией, и т.п. По сравнению с этими способами, при текущих обстоятельствах, известно, что градиентный бустинг (например, дерево решений на основе градиентного бустинга (GBDT)) имеет плохую точность для входных данных, таких как изображение, голос и язык, поскольку затруднительно извлекать набор признаков, но обеспечивает более высокую производительность для других структурированных данных. По существу, в Kaggle в качестве соревнований специалистов по обработке и анализу данных, GBDT представляет собой наиболее стандартный алгоритм. В реальном мире, считается, что 70% проблем, которые должны разрешаться посредством машинного обучения, представляют собой структурированные данные, отличные от изображения, голоса и языка, так что не подлежит сомнению, что GBDT представляет собой важный алгоритм для того, чтобы разрешать проблемы в реальном мире. Дополнительно, в последние годы, разработан способ извлечения признака из данных, таких как изображение и голос, с использованием дерева решений.

[0003] При градиентном бустинге, обработка обучения выполняется с более высокой скоростью, чем при глубоком обучении, таком как CCN. Тем не менее, фактически, обычная практика заключается в том, чтобы выполнять обучение несколько сотен раз или более для регулирования гиперпараметра и выбора признаков в качестве обязательной работы при практическом применении и для такой работы, как моделирование ансамбля и помещение в стек для повышения производительности, посредством комбинирования множества моделей для целей оценки обобщающей способности и повышения производительности. Таким образом, время вычисления становится проблемой даже при градиентном бустинге, обработка которого выполняется на относительно высокой скорости. Таким образом, в последние годы, сообщается о большом числе исследований для увеличения скорости обработки для обработки обучения посредством градиентного бустинга.

[0004] Чтобы увеличивать скорость обработки обучения посредством градиентного бустинга, обучающие данные должны разделяться на фрагменты, которые должны храниться посредством множества блоков памяти, и обработка обучения должна выполняться параллельно. При условии, что гистограмма информации градиентов и набор признаков обучающих данных, используемых при градиентном бустинге, вычисляются для сохранения, число блоков памяти, которые сохраняют гистограмму, просто увеличивается пропорционально числу разделений памяти, которая хранит обучающие данные, и размер схем также увеличивается.

[0005] Относительно гистограммы, описанной выше, чтобы увеличивать скорость гистограммы, раскрыта технология вычисления гистограммы для значений, которые вводятся параллельно (см. патентный документ 1). Чтобы вычислять набор признаков в форме гистограмм ориентированных градиентов (HOG) в качестве набора локальных признаков посредством программируемой пользователем вентильной матрицы (FPGA), раскрывается операция использования определенной переменной в качестве элемента разрешения гистограммы, чтобы интегрировать другие переменные (см. непатентный документ 1).

Сущность изобретения

Техническая задача

[0006] Хотя гистограмма параллельных вводов вычисляется в технологии, раскрытой в патентном документе 1, раскрывается только операция для гистограммы для одной переменной, т.е. гистограммы, которая подсчитывает значение переменной в качестве предварительно определенного элемента разрешения, так что технология не может применяться к созданию гистограммы информации градиентов и набора признаков, как описано выше. Дополнительно, с помощью технологии, раскрытой в непатентном документе 1, может создаваться гистограмма двух переменных, описанных выше, но две переменные не могут вводиться параллельно для того, чтобы создавать гистограмму.

[0007] Настоящее изобретение осуществлено с учетом такой ситуации и предлагает обучающее устройство и способ обучения для создания гистограммы набора признаков и информации градиентов, которые вводятся параллельно, и уменьшения размера схем памяти, которая хранит информацию гистограммы.

Решение задачи

[0008] Согласно аспекту настоящего изобретения, обучающее устройство выполнено с возможностью выполнять обучение посредством градиентного бустинга. Обучающее устройство включает в себя множество блоков памяти данных, множество блоков вывода градиентов, блок суммирования и блок памяти гистограмм. Множество блоков памяти данных выполнены с возможностью сохранять обучающие данные, включающие в себя, по меньшей мере, один тип набора признаков и информацию градиентов, соответствующую обучающим данным. Множество блоков вывода градиентов предусмотрены согласно множеству блоков памяти данных, и каждый из них выполнен с возможностью принимать ввод набора признаков и информации градиентов, соответствующей набору признаков, из соответствующего одного из множества блоков памяти данных и выводить информацию градиентов, соответствующую набору признаков, через порт вывода, соответствующий каждому значению входного набора признаков. Блок суммирования выполнен с возможностью суммировать один или более фрагментов информации градиентов, соответствующей идентичному значению набора признаков из числа фрагментов информации градиентов, выводимой из множества блоков вывода градиентов, и выводить суммированное значение информации градиентов, соответствующей каждому значению набора признаков. Блок памяти гистограмм выполнен с возможностью сохранять гистограмму, полученную посредством интегрирования суммированных значений информации градиентов, соответствующей каждому значению набора признаков, выводимого из блока суммирования, для каждого элемента разрешения в случае, в котором каждое значение задается в качестве элемента разрешения.

Преимущества изобретения

[0009] Согласно настоящему изобретению, можно создавать гистограмму набора признаков и информации градиентов, которые вводятся параллельно, и уменьшать размер схем памяти, которая хранит информацию гистограммы.

Краткое описание чертежей

[0010] Фиг. 1 является схемой, иллюстрирующей пример модели в виде дерева решений.

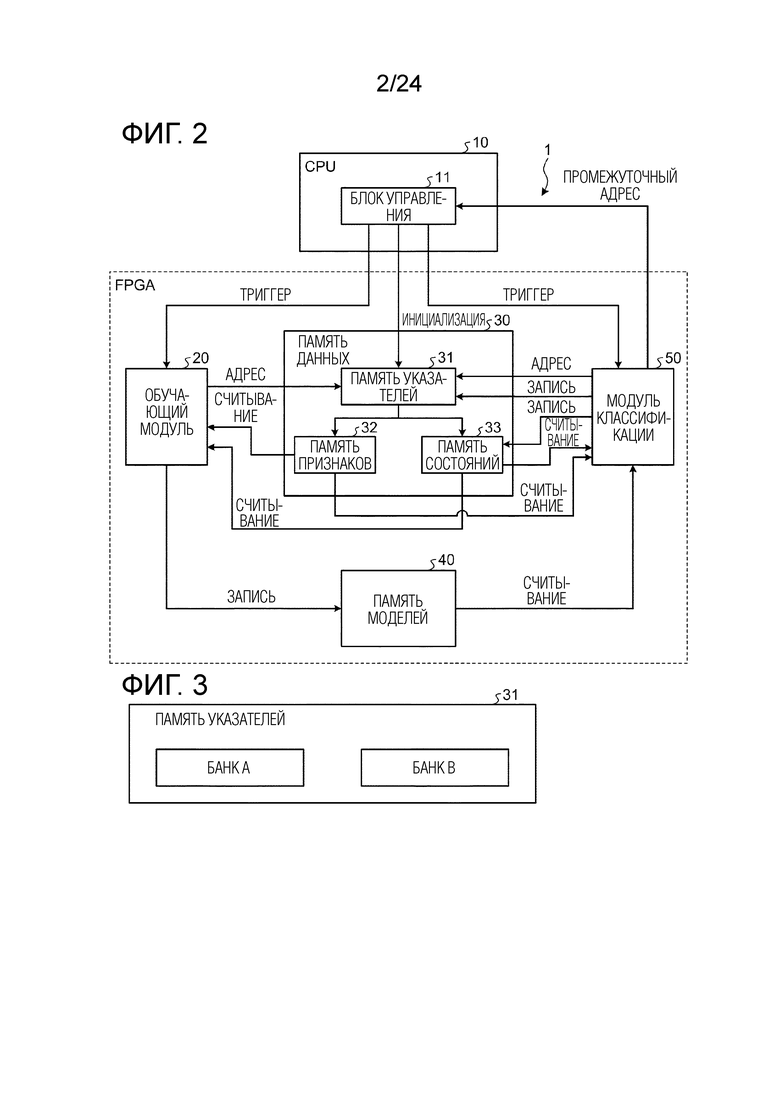

Фиг. 2 является схемой, иллюстрирующей пример модульной конфигурации обучающего и различающего устройства согласно первому варианту осуществления.

Фиг. 3 является схемой, иллюстрирующей пример конфигурации памяти указателей.

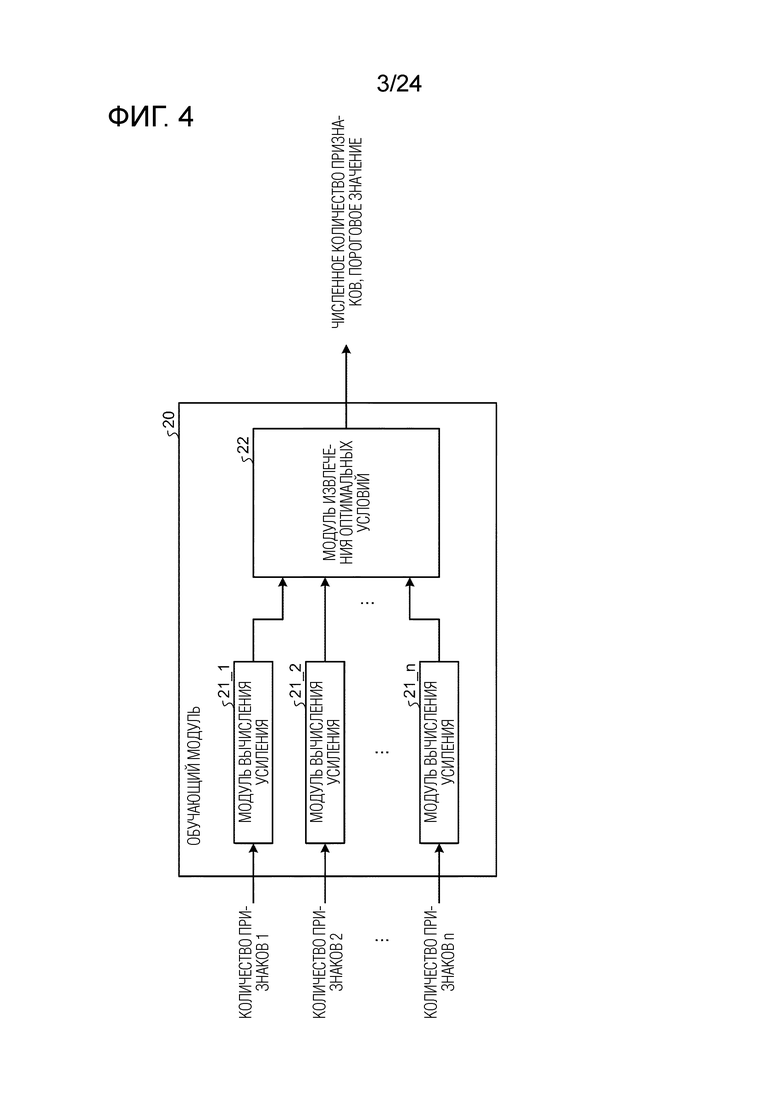

Фиг. 4 является схемой, иллюстрирующей пример модульной конфигурации обучающего модуля.

Фиг. 5 является схемой, иллюстрирующей работу модуля во время инициализации обучающего и различающего устройства согласно первому варианту осуществления.

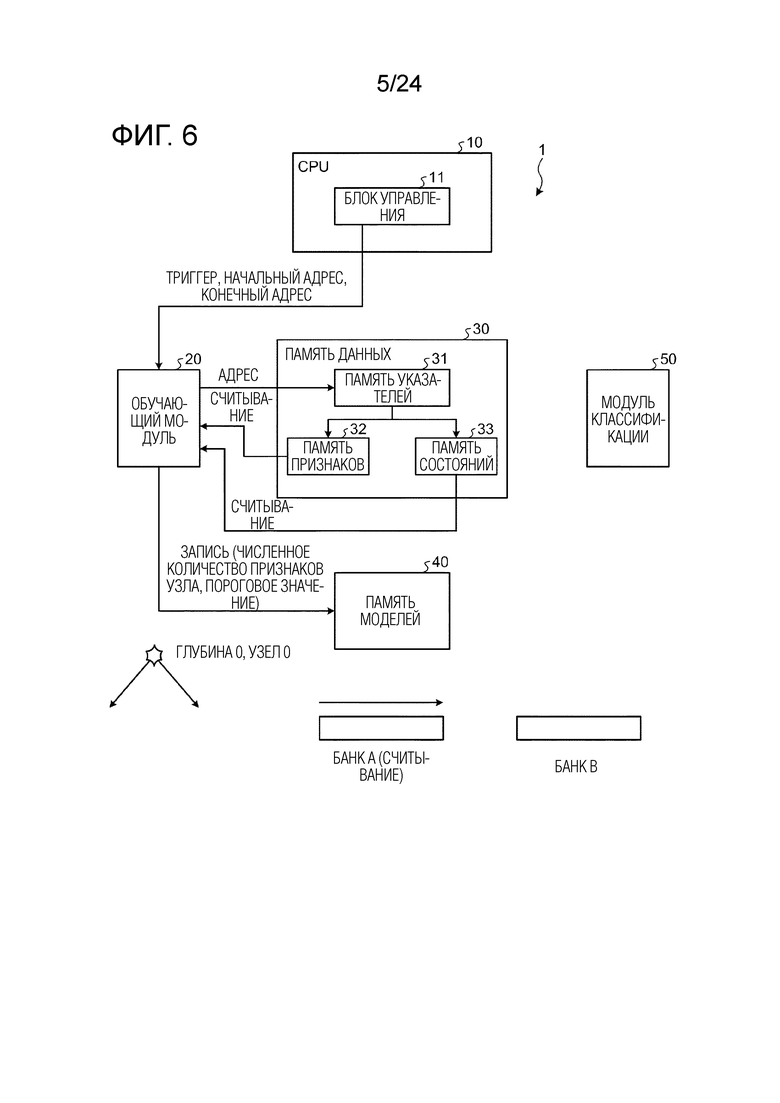

Фиг. 6 является схемой, иллюстрирующей работу модуля в случае определения параметров узла на глубине 0, в узле 0 обучающего и различающего устройства согласно первому варианту осуществления.

Фиг. 7 является схемой, иллюстрирующей работу модуля во время ветвления на глубине 0, в узле 0 обучающего и различающего устройства согласно первому варианту осуществления.

Фиг. 8 является схемой, иллюстрирующей работу модуля в случае определения параметров узла на глубине 1, в узле 0 обучающего и различающего устройства согласно первому варианту осуществления.

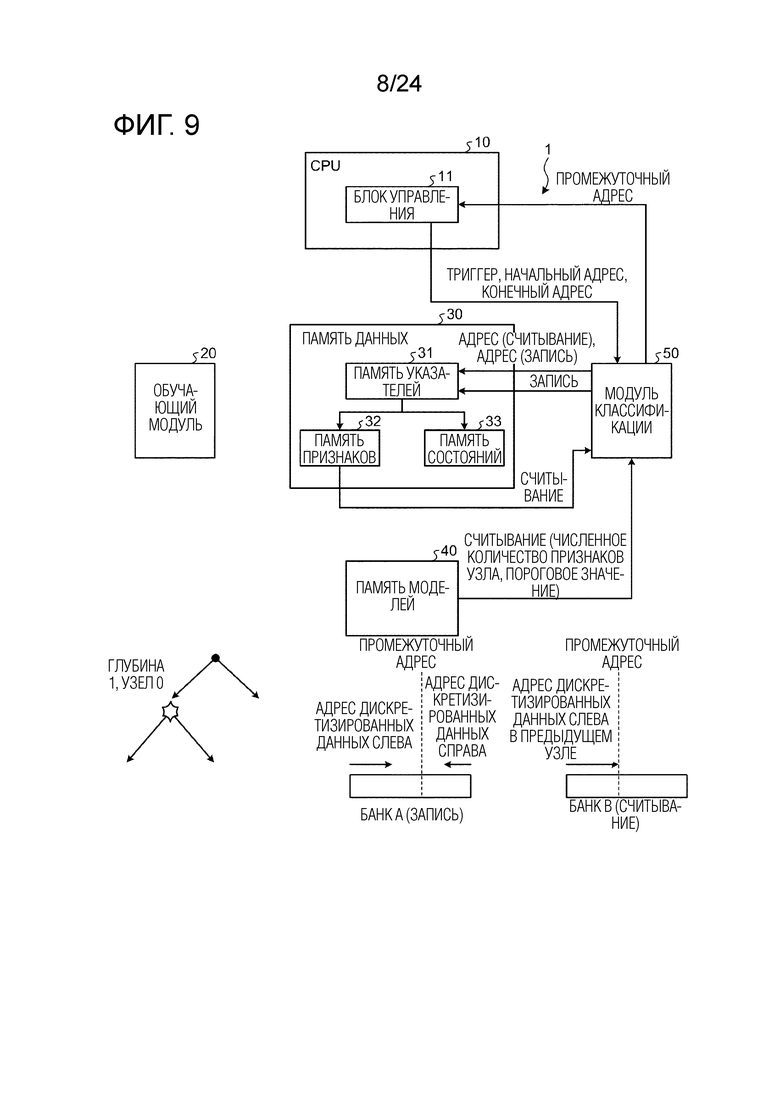

Фиг. 9 является схемой, иллюстрирующей работу модуля во время ветвления на глубине 1, в узле 0 обучающего и различающего устройства согласно первому варианту осуществления.

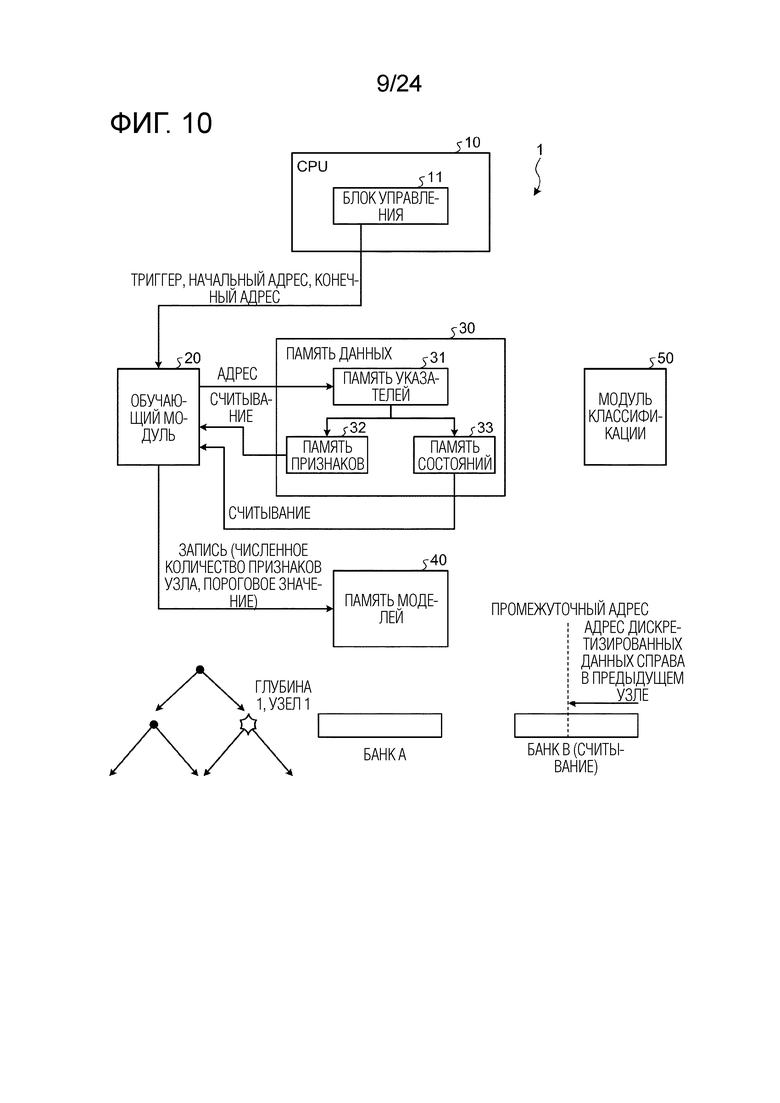

Фиг. 10 является схемой, иллюстрирующей работу модуля в случае определения параметров узла на глубине 1, в узле 1 обучающего и различающего устройства согласно первому варианту осуществления.

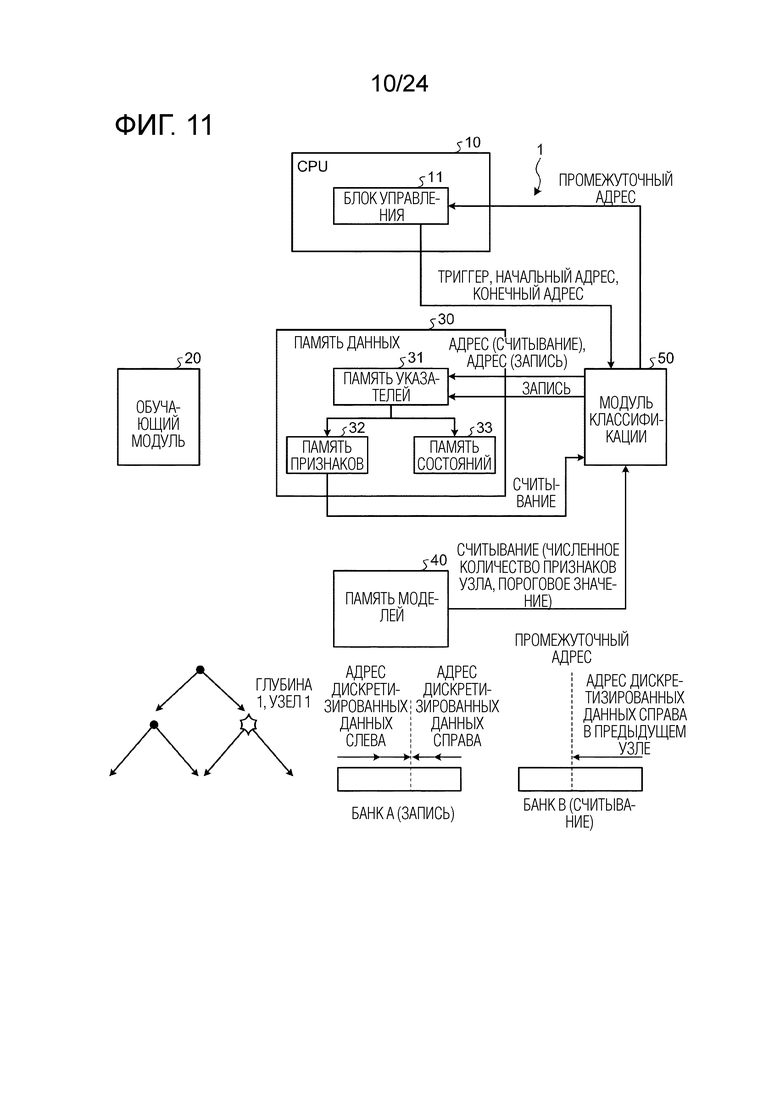

Фиг. 11 является схемой, иллюстрирующей работу модуля во время ветвления на глубине 1, в узле 1 обучающего и различающего устройства согласно первому варианту осуществления.

Фиг. 12 является схемой, иллюстрирующей работу модуля в случае, в котором ветвление не выполняется в результате определения параметров узла на глубине 1, в узле 1 обучающего и различающего устройства согласно первому варианту осуществления.

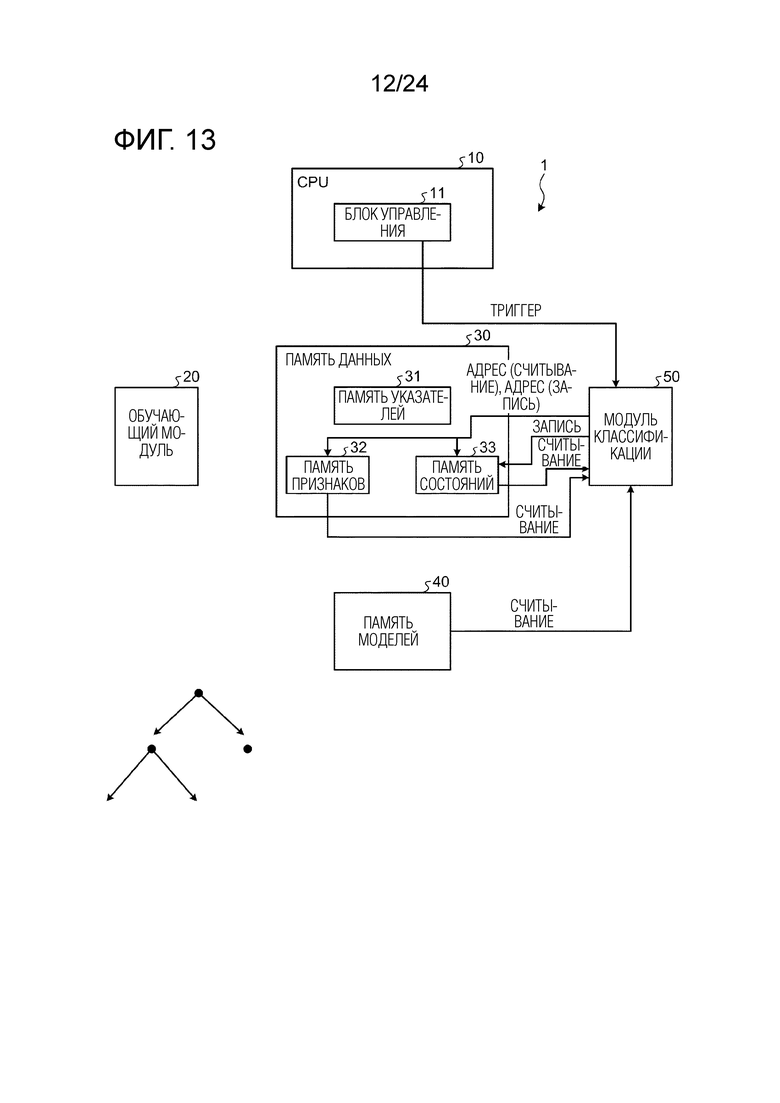

Фиг. 13 является схемой, иллюстрирующей работу модуля во время обновления информации состояния всех фрагментов выборочных данных в случае, в котором обучение дерева решений завершается посредством обучающего и различающего устройства согласно первому варианту осуществления.

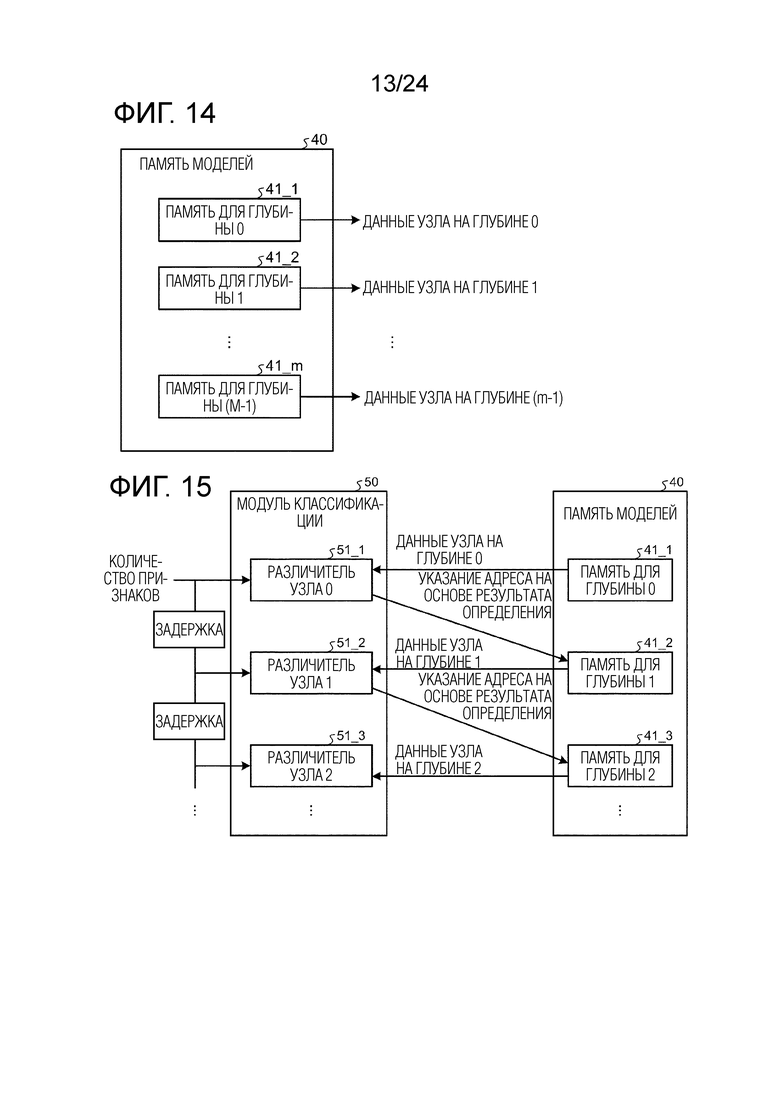

Фиг. 14 является схемой, иллюстрирующей пример конфигурации памяти моделей обучающего и различающего устройства согласно модификации первого варианта осуществления.

Фиг. 15 является схемой, иллюстрирующей пример конфигурации модуля классификации обучающего и различающего устройства согласно модификации первого варианта осуществления.

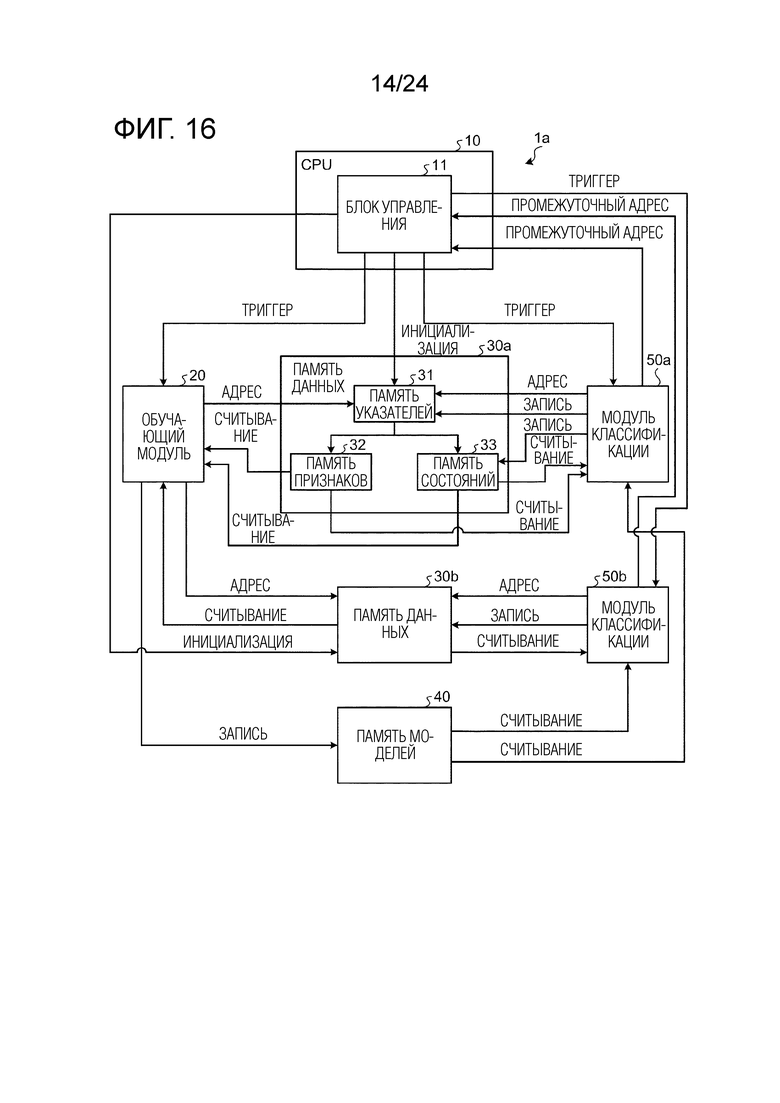

Фиг. 16 является схемой, иллюстрирующей пример модульной конфигурации обучающего и различающего устройства, к которому применяется параллелизм данных.

Фиг. 17 является схемой, иллюстрирующей пример конкретной модульной конфигурации обучающего модуля.

Фиг. 18 является схемой, иллюстрирующей пример модульной конфигурации модуля вычисления гистограмм градиентов обучающего модуля.

Фиг. 19 является схемой, иллюстрирующей пример модульной конфигурации модуля вычисления накопленных градиентов обучающего модуля.

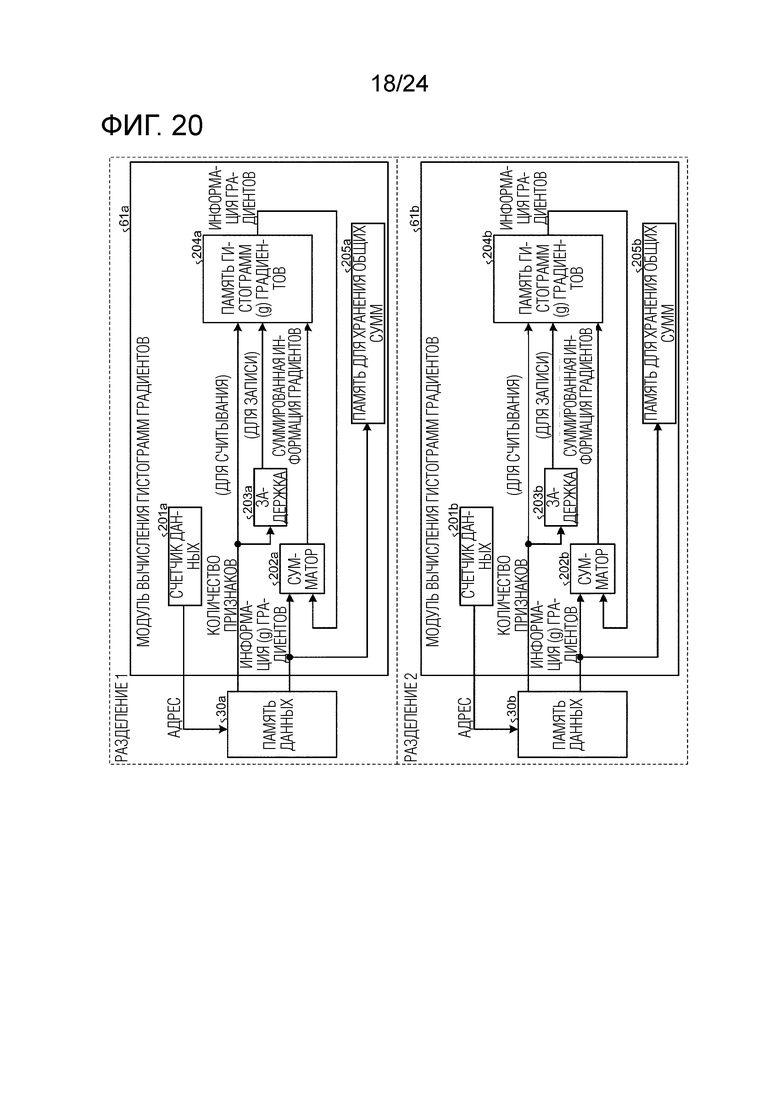

Фиг. 20 является схемой, иллюстрирующей пример модульной конфигурации модуля вычисления гистограмм градиентов в случае, в котором реализуется параллелизм данных.

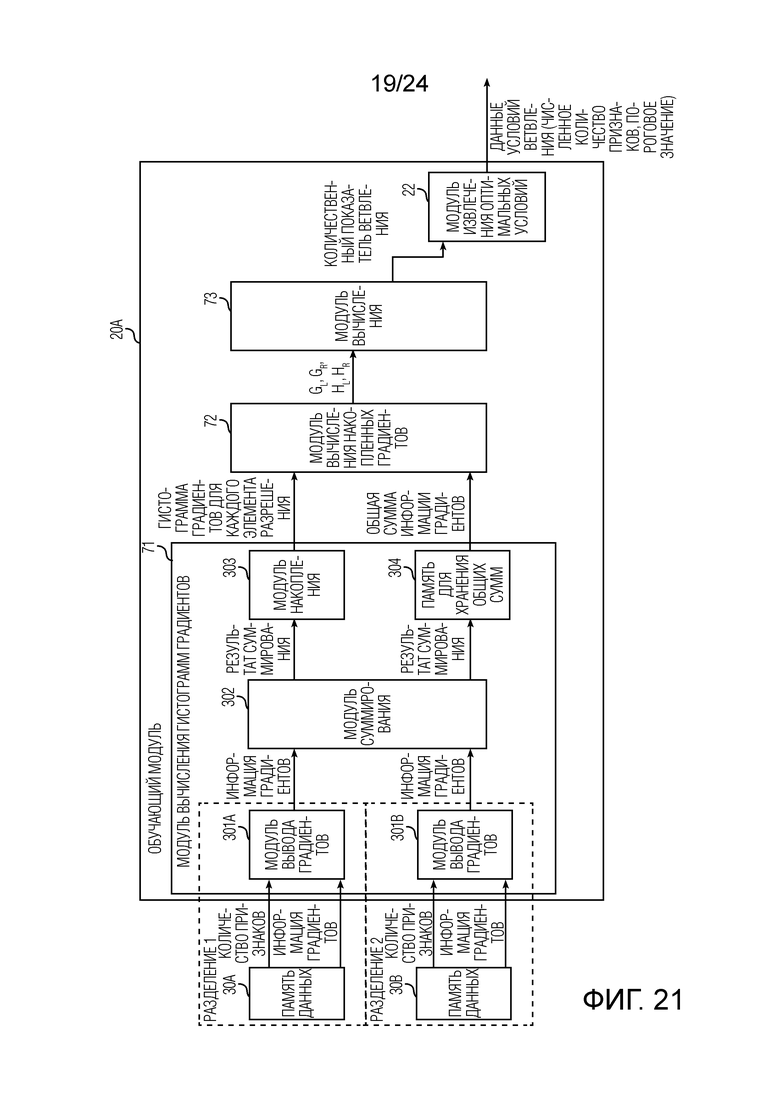

Фиг. 21 является схемой, иллюстрирующей пример модульной конфигурации обучающего модуля обучающего и различающего устройства согласно второму варианту осуществления.

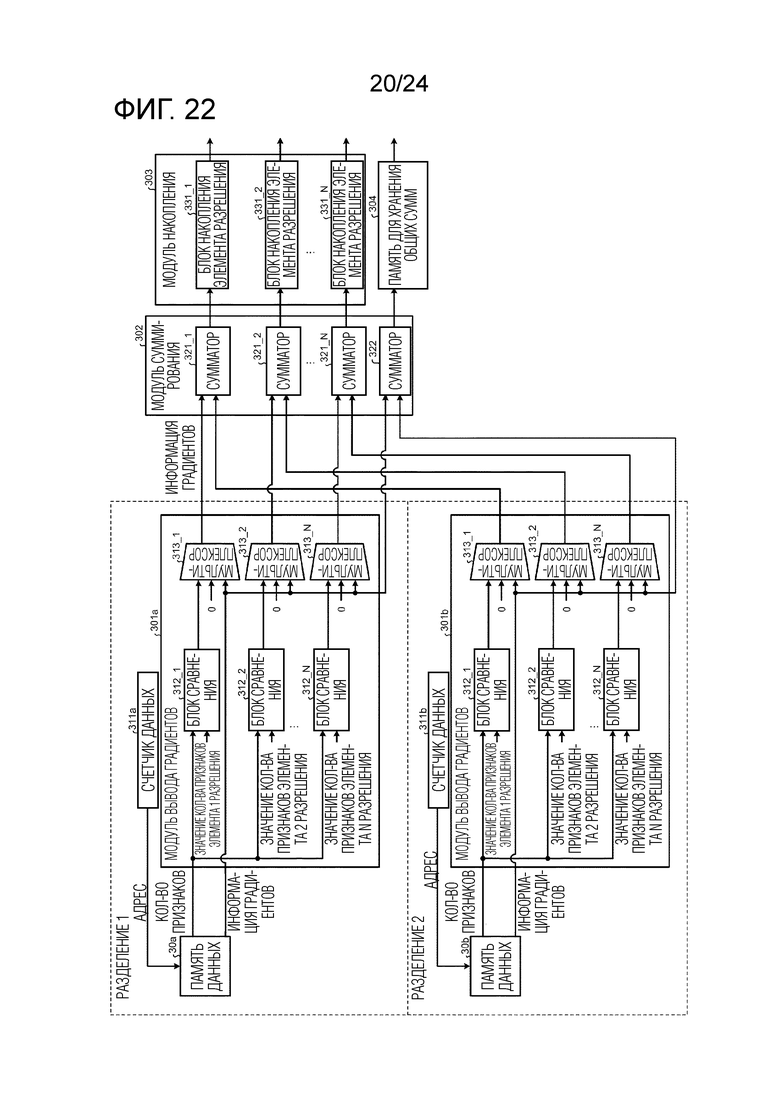

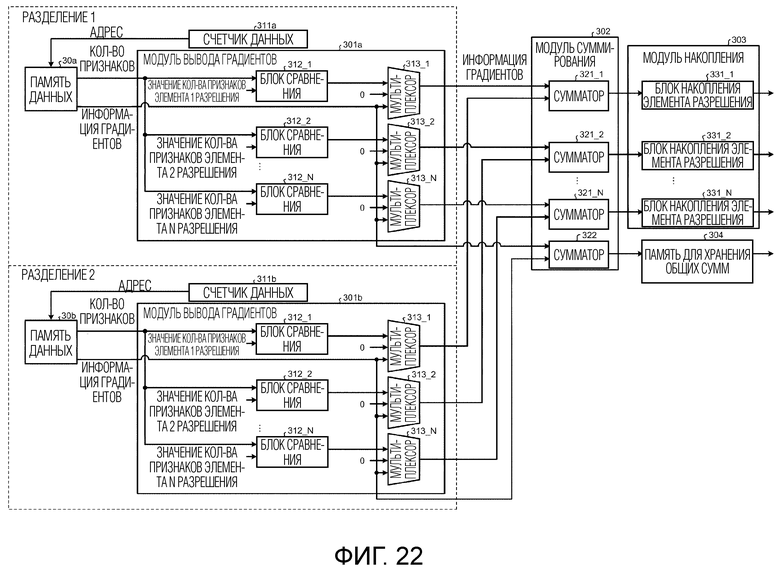

Фиг. 22 является схемой, иллюстрирующей пример модульной конфигурации модуля вычисления гистограмм градиентов обучающего модуля согласно второму варианту осуществления.

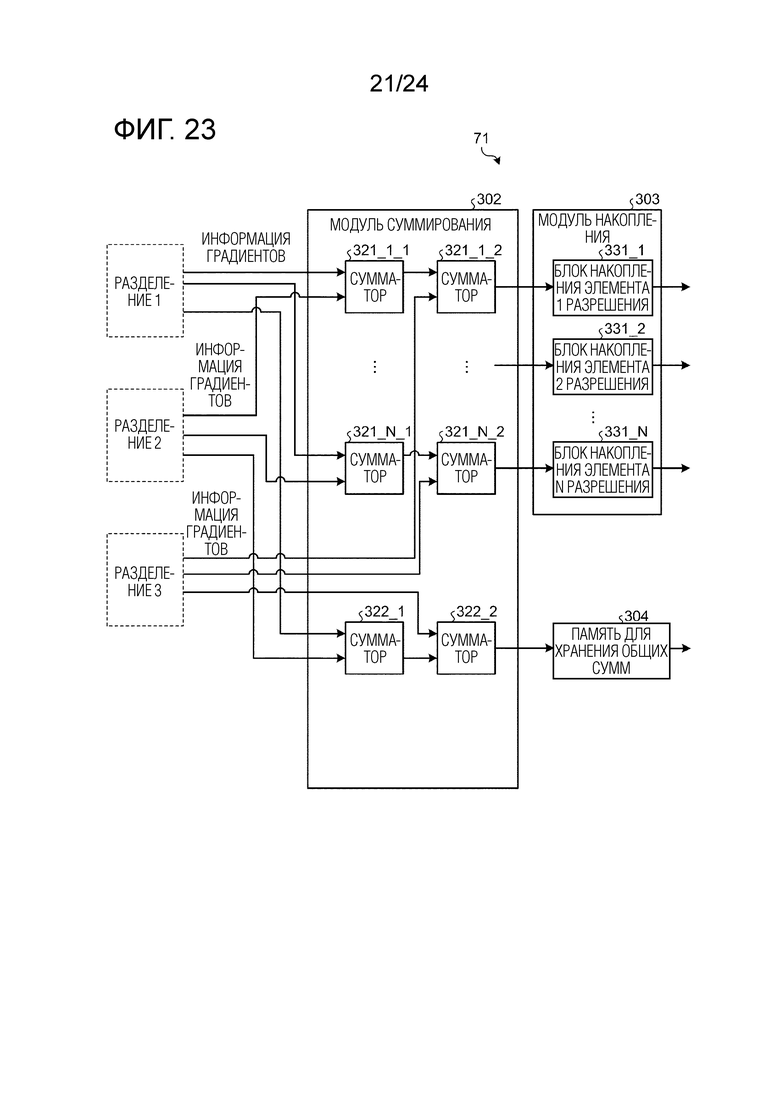

Фиг. 23 является схемой, иллюстрирующей пример модульной конфигурации модуля вычисления гистограмм градиентов в случае, в котором число разделений предположительно равно 3 в обучающем модуле согласно второму варианту осуществления.

Фиг. 24 является схемой, иллюстрирующей пример модульной конфигурации модуля вычисления накопленных градиентов обучающего модуля согласно второму варианту осуществления.

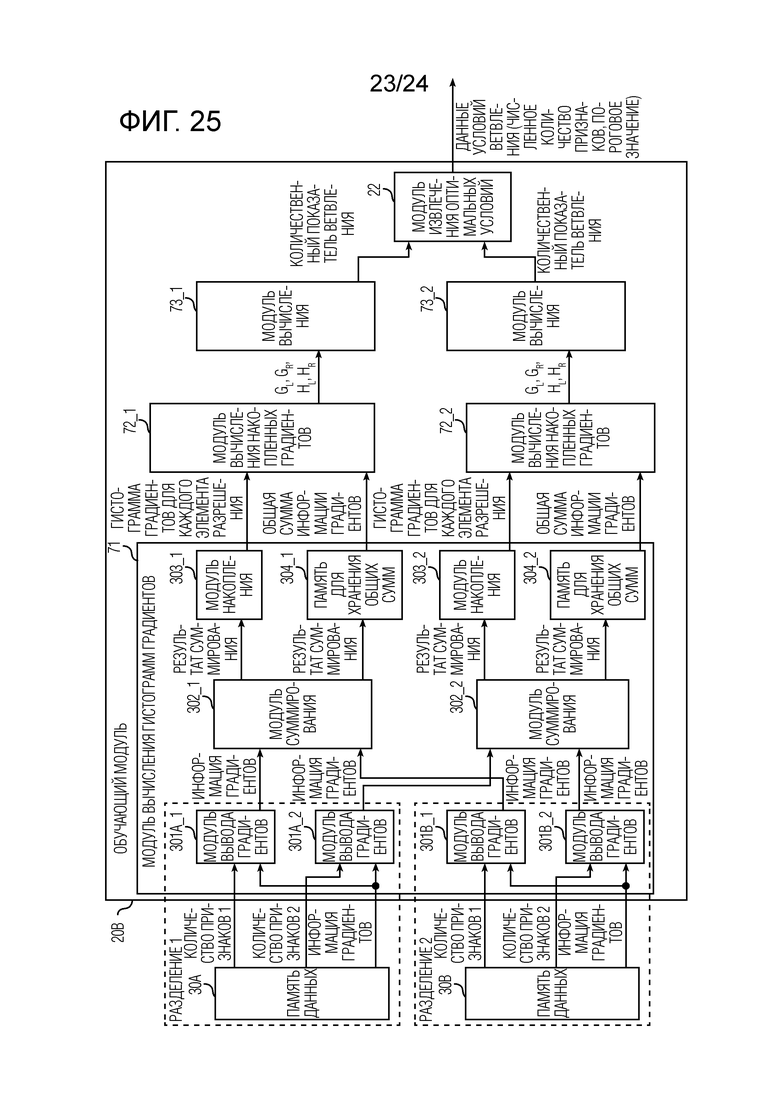

Фиг. 25 является схемой, иллюстрирующей пример модульной конфигурации обучающего модуля в случае, в котором число типов наборов признаков предположительно равно 2 в обучающем и различающем устройстве согласно второму варианту осуществления.

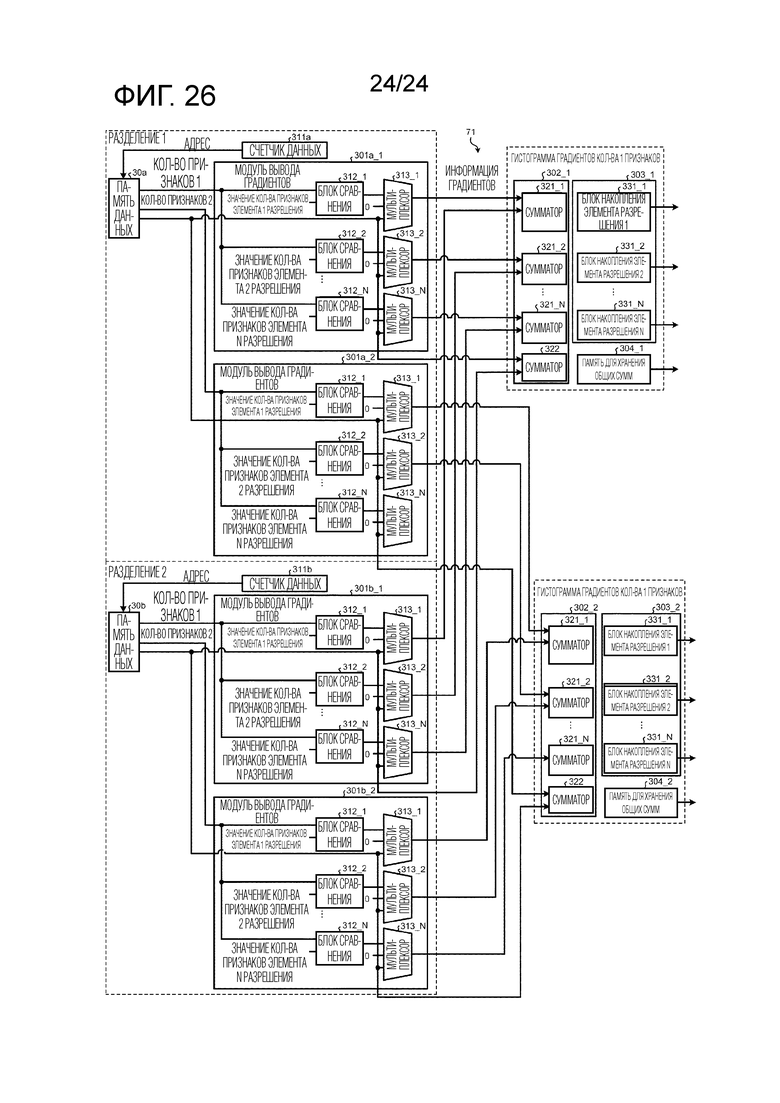

Фиг. 26 является схемой, иллюстрирующей пример модульной конфигурации модуля вычисления гистограмм градиентов в случае, в котором число типов наборов признаков предположительно равно 2 в обучающем модуле согласно второму варианту осуществления.

Осуществление изобретения

[0011] Далее подробно описываются варианты осуществления обучающего устройства и способа обучения согласно настоящему изобретению со ссылкой на фиг. 1-26. Настоящее изобретение не ограничено нижеприведенными вариантами осуществления. Компоненты в нижеприведенных вариантах осуществления охватывают компонент, который легко предполагается специалистами в данной области техники, практически идентичный компонент и то, что называется "эквивалентом". Дополнительно, компоненты могут различными способами опускаться, заменяться, модифицироваться и комбинироваться без отступления от сущности вариантов осуществления, описанных ниже.

[0012] Первый вариант осуществления

Относительно логики GBDT

В DL, в качестве алгоритма высокопроизводительного машинного обучения, предпринимается попытка реализовывать различитель посредством различных видов жесткой логики, которая, как обнаружено, имеет более высокую эффективность по мощности по сравнению с обработкой с использованием графического процессора (GPU). Тем не менее архитектура GPU тесно совпадает, в частности, с CNN в области техники DL, так что, с учетом скорости, скорость различения, выполняемого посредством программируемой пользователем вентильной матрицы (FPGA), реализованной с помощью логики, не выше скорости GPU. С другой стороны, предпринимается попытка реализовывать жесткую логику FPGA в алгоритме на основе дерева решений, таком как GBDT, и получены сведения в отношении результата с более высокой скоростью, чем GPU. Это обусловлено тем, что, как описано ниже, алгоритм на основе дерева решений не подходит для архитектуры GPU с учетом его признака компоновки данных.

[0013] Анализ касательно обучения отстает от анализа касательно различения в мире. Фактически отсутствуют сообщения в отношении текущих обстоятельств DL, и число сообщений в отношении системы на основе дерева решений является небольшим. В частности, отсутствуют сообщения в отношении обучения посредством GBDT при текущих обстоятельствах, что в данный момент может считаться неразработанной областью техники. Чтобы получать точную модель различения, выбор и расчет набора признаков и выбор гиперпараметра обучающего алгоритма выполняются во время обучения, так что требуется огромное количество подборов. В частности, в случае, в котором имеется большой объем обучающих данных, скорость обработки обучения значительно влияет на точность конечной модели на практике. Дополнительно, в области техники, в которой требуется работа в реальном времени для обеспечения соответствия изменениям окружающей среды, к примеру, в робототехнике, высокочастотной торговле (HFT) и торгах в реальном времени (RTB), скорость непосредственно связана с производительностью. Таким образом, в случае, в котором высокоскоростная обработка обучения достигается посредством GBDT с высокой точностью, может рассматриваться возможность существенно повышать производительность системы с использованием GBDT в конечном счете.

[0014] Подобие GBDT для FPGA

Далее описывается, с учетом подобия GBDT для FPGA, то, почему скорость обработки дерева решений или GBDT посредством GPU не является высокой, и то, почему скорость его обработки посредством FPGA является высокой.

[0015] Во-первых, приводится описание с точки зрения того, что GBDT представляет собой алгоритм с использованием бустинга. В случае случайного леса (RF) с использованием ансамблевого обучения в области техники дерева решений, деревья не зависят друг от друга, так что параллелизация легко выполняется посредством GPU. Тем не менее, GBDT представляет собой способ соединения большого числа деревьев с использованием бустинга, так что обучение последующего дерева не может начинаться до тех пор, пока результат предыдущего дерева не получается. Таким образом, обработка представляет собой последовательную обработку, и важно обучать каждое дерево на высокой скорости в максимально возможной степени. С другой стороны, в RF, вариант увеличения общей скорости обучения может использоваться посредством увеличения скорости обучения для большого числа деревьев параллельно, даже если скорость обучения для каждого дерева является низкой. Таким образом, также в случае использования GPU, можно считать, что проблема задержки при доступе динамического оперативного запоминающего устройства (DRAM) (описывается ниже) может скрываться в определенной степени.

[0016] Далее приводится описание с точки зрения предела скорости доступа (в частности, при произвольном доступе) GPU-устройства к оперативному запоминающему устройству (RAM). Статическое оперативное запоминающее устройство (SRAM), встроенное в FPGA, может значительно увеличивать ширину шины RAM в FPGA, так что, например, 3,2 [ТБ/секунда] достигается следующим образом даже в случае использования XC7k325T, изготовленного компанией Xilinx Inc., в качестве FPGA со средними характеристиками. Емкость встроенного RAM составляет 16 [Мбит].

[0017] 445 BRAM * 36 битов * 100 МГц * 2 порта=445 * 36 * 2 * 100 * 10^6/10^12=3,2 ТБ/секунда

[0018] В случае использования VU9P, изготовленного компанией Xilinx Inc., в качестве высокопроизводительной FPGA, 6,9 [ТБ/секунда] достигается. Емкость встроенного RAM 270 составляет [Мбит].

[0019] 960 URAM * 36 битов * 100 МГц * 2 порта=960 * 36 * 2 * 100 * 10^6/10^12=6,9 ТБ/секунда

[0020] Эти значения получаются в случае инструктирования тактовой частоте составлять 100 [МГц], но фактически, операция может выполняться приблизительно при 200-500 [МГц] посредством создания схемной конфигурации, и предельная скорость передачи информации повышается в несколько раз. С другой стороны, RAM текущего поколения, соединенное с центральным процессором (CPU), представляет собой стандарт с удвоенной скоростью передачи данных версия 4 (DDR4), но скорость передачи информации, сформированная с одним запоминающим модулем с двухрядным расположением выводов (DIMM), остается равной 25,6 [ГБ/с], как описано ниже. Даже с чередующейся конфигурацией (256-битовая ширина) из четырех DIMM, скорость передачи информации достигает приблизительно 100 [ГБ/с]. В случае, в котором стандарт изготовления микросхем DDR4 представляет собой DDR4-3200 (ширина шины в 64 бита, 1 DIMM), следующее выражение удовлетворяется.

[0021] 200 МГц * 2 (DDR) * 64=200 * 10^6 * 2 * 64/10^9=25,6 ГБ/с

[0022] Скорость передачи информации стандарта с удвоенной скоростью передачи данных для графики версия 5 (GDDR5), смонтированного на GPU, приблизительно в четыре раза больше скорости передачи информации DDR4, но составляет приблизительно 400 [ГБ/с] максимум.

[0023] Таким образом, скорости передачи информации значительно отличаются друг от друга между RAM в FPGA и внешней памятью GPU и CPU. Хотя выше описывается случай последовательного доступа к адресу, время доступа во время произвольного доступа работает более существенно. Встроенное RAM FPGA представляет собой SRAM, так что задержка при доступе составляет 1 синхросигнал как при последовательном доступе, так и при произвольном доступе. Тем не менее каждое из DDR4 и GDDR5 представляет собой DRAM, так что задержка увеличивается в случае осуществления доступа к различным столбцам вследствие считывающего усилителя. Например, типичная задержка строба адреса столбца (CAS-задержка) составляет 16 синхросигналов в RAM DDR4, и вкратце, пропускная способность вычисляется как составляющая 1/16 от пропускной способности последовательного доступа.

[0024] В случае CNN, фрагменты данных смежных пикселов последовательно обрабатываются, так что задержка произвольного доступа не является существенной проблемой. Тем не менее, в случае дерева решений, адреса исходных данных соответствующих ветвей становятся прерывистыми по мере того, как ветвление продолжается, что по существу становится произвольным доступом. Таким образом, в случае сохранения данных в DRAM, его пропускная способность приводит к узкому месту, и скорость значительно понижается. GPU включает в себя кэш для того, чтобы подавлять снижение производительности в таком случае, но дерево решений по существу представляет собой алгоритм осуществления доступа ко всем данным, так что отсутствует локальность в доступе к данным, и эффект кэша практически на демонстрируется. В структуре GPU, GPU включает в себя совместно используемую память, включающее в себя SRAM, назначенную каждому арифметическому ядру (SM), и высокоскоростная обработка может выполняться посредством использования совместно используемой памяти в некоторых случаях. Тем не менее, в случае, в котором емкость каждого SM является небольшой, т.е. 16-48 [КБ], и доступ выполняется через SM, вызывается большая задержка. Далее представляется тестовое вычисление емкости совместно используемой памяти в случае Nvidia K80 в качестве дорогого крупномасштабного GPU в настоящее время.

[0025] K80=2 * 13 SMX=26 SMX=4 992 CUDA-ядра

26 * 48 * 8=9 Мбит

[0026] Как описано выше, даже в крупномасштабном GPU, который стоит сотни тысяч иен, емкость совместно используемой памяти составляет только 9 [Мбит], что является слишком небольшим. Дополнительно, в случае GPU, как описано выше, поскольку SM, которое выполняет обработку, не может непосредственно осуществлять доступ к совместно используемой памяти другого SM, имеется такое ограничение, что высокоскоростное кодирование затруднительно выполнять в случае использования для обучения дерева решений.

[0027] Как описано выше, при условии, что данные сохраняются в SRAM на FPGA, можно считать, что FPGA может реализовывать обучающий алгоритм GBDT с более высокой скоростью по сравнению с GPU.

[0028] Алгоритм GBDT

Фиг. 1 является схемой, иллюстрирующей пример модели в виде дерева решений. Далее описывается основная логика GBDT со ссылкой на выражения (1)-(22) и фиг. 1.

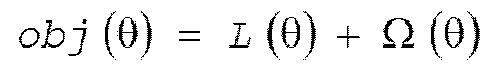

[0029] GBDT представляет собой способ контролируемого обучения, и контролируемое обучение представляет собой обработку оптимизации целевой функции obj(θ), включающей в себя функцию L(θ) потерь, представляющую степень подгонки относительно обучающих данных, и член Ω(θ) регуляризации, представляющий сложность обученной модели с использованием некоторой шкалы, как представлено посредством следующего выражения (1). Член Ω(θ) регуляризации имеет роль недопущения слишком сильного усложнения модели (дерева решений), т.е. повышения обобщающей способности.

(1)

(1)

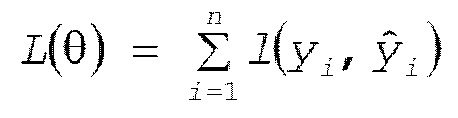

[0030] Функция потерь первого члена выражения (1), например, получается посредством суммирования потерь, вычисленных из l функции ошибок для соответствующих фрагментов выборочных данных (обучающих данных), как представлено посредством следующего выражения (2). В этом случае, n является числом фрагментов выборочных данных, i является номером выборки, γ является меткой, и γ (со шляпкой) модели является прогнозным значением.

(2)

(2)

[0031] В этом случае, например, в качестве l функции ошибок используется квадратическая функция ошибок или логистическая функция потерь, как представлено посредством следующего выражения (3) и выражения (4).

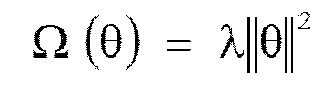

[0032] В качестве члена Ω(θ) регуляризации второго члена выражения (1), например, используется возведенная в квадрат норма параметра θ, как представлено посредством следующего выражения (5). В этом случае, λ является гиперпараметром, представляющим весовой коэффициент регуляризации.

(5)

(5)

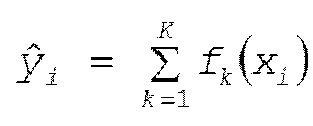

[0033] В данном документе рассматривается случай GBDT. Во-первых, прогнозное значение для i-х выборочных данных xi GBDT может представляться посредством следующего выражения (6).

(6)

(6)

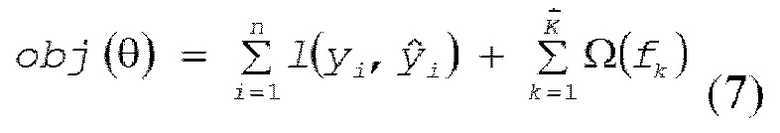

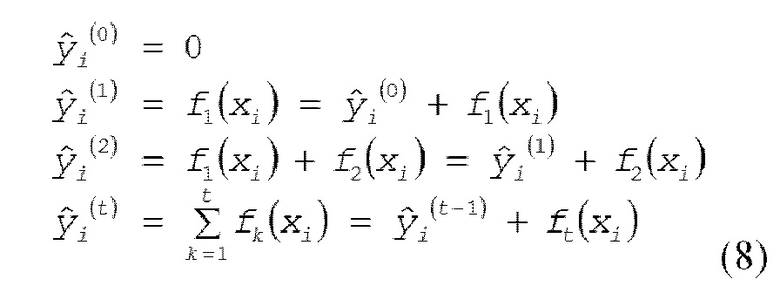

[0034] В этом случае, K является общим числом деревьев решений, k является номером дерева решений, fK() является выводом k-го дерева решений, и xi является значением набора признаков выборочных данных, которые должны вводиться. Соответственно, обнаружено, что конечный вывод получается посредством суммирования выводов соответствующих деревьев решений в GBDT, аналогично RF и т.п. Параметр θ представляется как θ = {f1, f2, ..., fK}. Согласно вышеприведенному описанию, целевая функция GBDT представляется посредством следующего выражения (7).

[0035] Обучение выполняется для целевой функции, описанной выше, но способ, такой как стохастический градиентный спуск (SGD), используемый для обучения нейронной сети и т.п., не может использоваться для модели в виде дерева решений. Таким образом, обучение выполняется посредством использования аддитивного обучения (бустинга). При аддитивном обучении, прогнозированное значение в определенном раунде t (число обучений, число моделей в виде дерева решений) представляется посредством следующего выражения (8).

[0036] Из выражения (8) обнаружено, что (вывод) дерева ft(xi) решений должен получаться в определенном раунде t. С другой стороны, не требуется рассматривать другие раунды в определенном раунде t. Таким образом, нижеприведенное описание рассматривает раунд t. Целевая функция в раунде t представляется посредством следующего выражения (9).

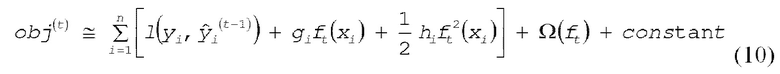

[0037] В этом случае, разложение в ряд Тейлора (усеченное в члене второго порядка) целевой функции в раунде t представляется посредством следующего выражения (10).

[0038] В этом случае, в выражении (10) фрагменты gi и hi информации градиентов представляются посредством следующего выражения (11).

[0039] Когда постоянный член игнорируется в выражении (10), целевая функция в раунде t представляется посредством следующего выражения (12).

[0040] В выражении (12) целевая функция в раунде t представляется посредством члена регуляризации и значения, полученного посредством выполнения дифференцирования первого порядка и дифференцирования второго порядка для функции ошибок посредством прогнозированного значения в предыдущем раунде, так что обнаружено, что может применяться функция ошибок, для которой могут выполняться дифференцирование первого порядка и дифференцирование второго порядка.

[0041] Далее рассматривается модель в виде дерева решений. Фиг. 1 иллюстрирует пример модели в виде дерева решений. Модель в виде дерева решений включает в себя узлы и листья. В узле, ввод вводится в следующий узел или лист при определенном условии ветвления, и лист имеет весовой коэффициент листа, который становится выводом, соответствующим вводу. Например, фиг. 1 иллюстрирует тот факт, что весовой коэффициент W2 листа для "листа 2" составляет "-1".

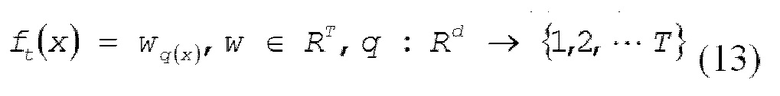

[0042] Модель в виде дерева решений формулируется так, как представлено посредством следующего выражения (13).

[0043] В выражении (13) w представляет весовой коэффициент листа, и q представляет структуру дерева. Таким образом, ввод (выборочные данные x) назначается любому из листьев в зависимости от структуры q дерева, и весовой коэффициент листа для листа выводится.

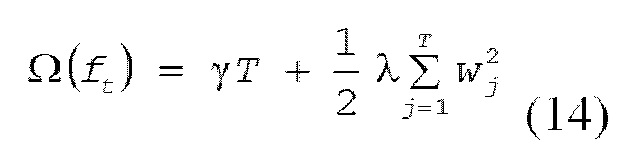

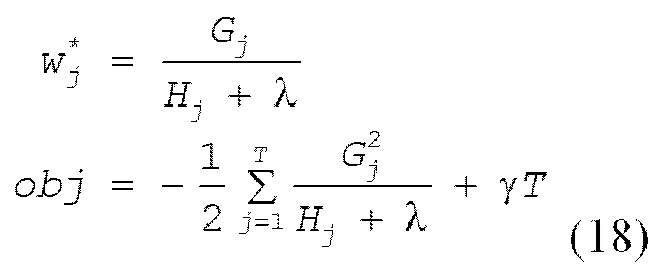

[0044] В этом случае, сложность модели в виде дерева решений задается так, как представлено посредством следующего выражения (14).

[0045] В выражении (14), первый член представляет сложность вследствие числа листьев, и второй член представляет возведенную в квадрат норму весового коэффициента листа; γ является гиперпараметром для управления важностью члена регуляризации. На основе вышеприведенного описания, целевая функция в раунде t организуется так, как представлено посредством следующего выражения (15).

[0046] Тем не менее в выражении (15), Ij, Gj и Hj представляются посредством следующего выражения (16).

[0047] Из выражения (15), целевая функция в определенном раунде t является квадратической функцией, связанной с весовым коэффициентом w листа, и минимальное значение квадратической функции и ее условие типично представляются посредством следующего выражения (17).

[0048] Таким образом, когда структура q дерева решений в определенном раунде t определяется, его целевая функция и весовой коэффициент листа представляются посредством следующего выражения (18).

[0049] В этот момент, весовой коэффициент листа может вычисляться в то время, когда структура дерева решений определяется в определенном раунде. Далее описывается процедура обучения структуры дерева решений.

[0050] Способы обучения структуры дерева решений включают в себя жадный метод (жадный алгоритм). Жадный метод представляют собой алгоритм начала древовидной структуры с глубины 0 и обучения структуры дерева решений посредством вычисления количественного показателя ветвления (усиления) в каждом узле, чтобы определять то, следует или нет ветвиться. Количественный показатель ветвления получается посредством следующего выражения (19).

[0051] В этом случае, каждое из GL и HL является суммой информации градиентов выборки, ответвляющейся в левый узел, каждое из GR и HR является суммой информации градиентов выборки, ответвляющейся в правый узел, и γ является членом регуляризации. Первый член в [] выражения (19) представляет собой количественный показатель (целевую функцию) выборочных данных, ответвляющихся в левый узел, второй член представляет собой количественный показатель выборочных данных, ответвляющихся в правый узел, и третий член представляет собой количественный показатель в случае, в котором выборочные данные не ветвятся, что представляет степень улучшения целевой функции вследствие ветвления.

[0052] Количественный показатель ветвления, представленный посредством выражения (19), описанного выше, представляет добротность во время ветвления с определенным пороговым значением определенного набора признаков, но оптимальное условие не может определяться на основе одного количественного показателя ветвления. Таким образом, в жадном методе, количественный показатель ветвления получается для всех возможных вариантов пороговых значений всех наборов признаков, чтобы находить условие, при котором количественный показатель ветвления является наибольшим. Жадный метод представляет собой очень простой алгоритм, как описано выше, но его затраты на вычисление являются высокими, поскольку количественный показатель ветвления получается для всех возможных вариантов пороговых значений всех наборов признаков. Таким образом, для библиотеки, такой как XGBoost (описывается ниже), создается способ уменьшения затрат на вычисление при поддержании производительности.

[0053] Относительно XGBoost

Далее описывается XGBoost, который известен в качестве библиотеки GBDT. В обучающем алгоритме XGBoost, создаются два аспекта, т.е. уменьшение возможных вариантов пороговых значений и обработка отсутствующего значения.

[0054] Во-первых, далее описывается уменьшение возможных вариантов пороговых значений. Жадный метод, описанный выше, имеет такую проблему, что затраты на вычисление являются высокими. В XGBoost, число возможных вариантов пороговых значений уменьшается за счет способа эскиза взвешенных квантилей. В этом способе, сумма информации градиентов выборочных данных, ответвляющихся влево и вправо, является важной при вычислении количественного показателя ветвления (усиления), и только пороговое значение, при котором сумма информации градиентов варьируется с постоянным отношением, принудительно задается в качестве возможного варианта, поиск которого должен выполняться. В частности, используется градиент h второго порядка выборки. При условии, что число размерностей набора признаков составляет f, совокупность набор набора признаков и градиента h второго порядка выборочных данных представляются посредством следующего выражения (20).

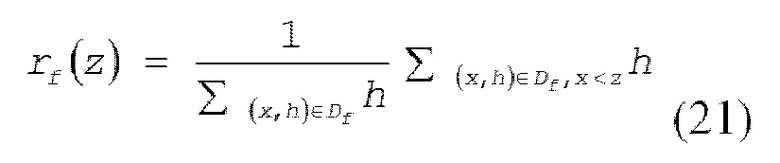

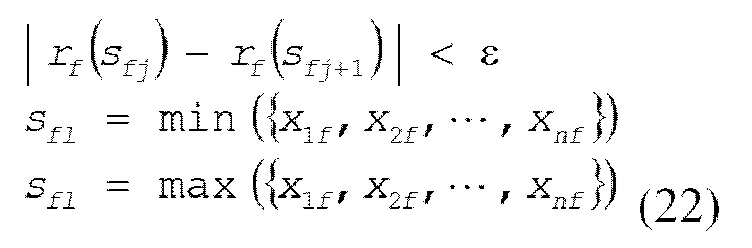

[0055] Функция rf ранга задается так, как представлено посредством следующего выражения (21).

[0056] В этом случае, z является возможным вариантом порогового значения. Функция rf ранга в выражении (21) представляет отношение суммы градиентов второго порядка выборочных данных, меньшей определенного возможного варианта порогового значения, к сумме градиентов второго порядка всех фрагментов выборочных данных. В конечном счете, совокупность определенных возможных вариантов {sf1, sf2,…, SfL} пороговых значений должен получаться для набора признаков, представленного посредством размерности f, которая получается посредством следующего выражения (22).

[0057] В этом случае, ε представляет собой параметр для определения степени уменьшения возможных вариантов пороговых значений, и может получаться примерно 1/ε возможных вариантов пороговых значений.

[0058] В качестве эскиза взвешенных квантилей, могут рассматриваться два шаблона, т.е. глобальный шаблон, в котором эскиз взвешенных квантилей выполняется в первом узле дерева решений (совместно выполняется для всех фрагментов выборочных данных), и локальный шаблон, в котором эскиз взвешенных квантилей выполняется в каждом узле (выполняется каждый раз для выборки, назначенной соответствующему узлу). Обнаружено, что локальный шаблон является соответствующим с учетом обобщающей способности, так что локальный шаблон используется в XGBoost.

[0059] Далее описывается обработка отсутствующего значения. Типично отсутствует эффективный способ обработки отсутствующего значения выборочных данных, который должен вводиться в области техники машинного обучения, независимо от GBDT и дерева решений. Предусмотрен способ дополнения отсутствующего значения со средним значением, медианой, совместным фильтром и т.п., и способ исключения набора признаков, включающего в себя большое число отсутствующих значений, например, но эти способы успешно реализуются не в очень большом числе случаев с учетом производительности. Тем не менее, структурированные данные зачастую включают в себя отсутствующее значение, так что некоторый показатель требуется при практическом применении.

[0060] В XGBoost, обучающий алгоритм создается для того, чтобы непосредственно обрабатывать выборочные данные, включающие в себя отсутствующее значение. Он представляет собой способ получения количественного показателя в то время, когда все фрагменты данных отсутствующего значения назначаются любому из левого и правого узлов при получении количественного показателя ветвления в узле. В случае выполнения эскиза взвешенных квантилей, описанного выше, возможный вариант порогового значения может получаться для набора, за исключением выборочных данных, включающих в себя отсутствующее значение.

[0061] Относительно LightGBM

Далее описывается LightGBM в качестве библиотеки GBDT. LightGBM использует быстрый алгоритм с использованием квантования набора признаков, что называется "группированием в элементы разрешения", для предварительной обработки и использования GPU для вычисления количественного показателя ветвления. Производительность LightGBM является практически идентичной производительности XGBoost, а скорость обучения LightGBM в несколько раз превышает скорость обучения XGBoost. В последние годы, число пользователей LightGBM растет.

[0062] Во-первых, далее описывается квантование набора признаков. Когда набор данных является крупномасштабным, количественный показатель ветвления должен вычисляться для большого числа возможных вариантов пороговых значений. В LightGBM, число возможных вариантов пороговых значений уменьшается посредством квантования набора признаков в качестве предварительной обработки обучения. Дополнительно, вследствие квантования, значения и число возможных вариантов пороговых значений не варьируются для каждого узла, как в XGBoost, так что LightGBM представляет собой обязательную обработку в случае использования GPU.

[0063] Различные исследования проведены для квантования набора признаков с названием "группирование в элементы разрешения". В LightGBM, набор признаков разделяется на k элементов разрешения, и только k возможных вариантов пороговых значений присутствуют; k равно 255, 63 и 15, например, и производительность или скорость обучения варьируется в зависимости от набора данных.

[0064] Вычисление количественного показателя ветвления упрощается вследствие квантования набора признаков. В частности, возможный вариант порогового значения становится простым квантованным значением. Таким образом, достаточно создавать гистограмму градиента первого порядка и градиента второго порядка для каждого набора признаков и получать количественный показатель ветвления для каждого элемента разрешения (квантованного значения). Это называется "гистограммой набора признаков".

[0065] Далее описывается вычисление количественного показателя ветвления с использованием GPU. Шаблонов вычисления количественного показателя ветвления имеется 256 максимум, поскольку набор признаков квантуется, но число фрагментов выборочных данных может превышать десятки тысяч в зависимости от набора данных, так что создание гистограммы преобладает над временем обучения. Как описано выше, гистограмма набора признаков должна получаться при вычислении количественного показателя ветвления. В случае использования GPU, множество подпроцессов должны обновлять идентичную гистограмму, но идентичный элемент разрешения может обновляться в этот момент. Таким образом, должна использоваться атомарная операция, и производительность снижается, когда отношение обновления идентичного элемента разрешения является высоким. Таким образом, в LightGBM, то, какая из гистограмм градиента первого порядка и градиента второго порядка используется для обновления значения, определяется для каждого подпроцесса при создании гистограммы, что понижает частоту обновления идентичного элемента разрешения.

[0066] Конфигурация обучающего и различающего устройства

Фиг. 2 является схемой, иллюстрирующей пример модульной конфигурации обучающего и различающего устройства согласно варианту осуществления. Фиг. 3 является схемой, иллюстрирующей пример конфигурации памяти указателей. Фиг. 4 является схемой, иллюстрирующей пример модульной конфигурации обучающего модуля. Далее описывается модульная конфигурация обучающего и различающего устройства 1 согласно настоящему варианту осуществления со ссылкой на фиг. 2-4.

[0067] Как проиллюстрировано на фиг. 2, обучающее и различающее устройство 1 согласно настоящему варианту осуществления включает в себя CPU 10, обучающий модуль 20 (обучающий блок), память 30 данных, память 40 моделей и модуль 50 классификации (различающий блок). Из них, обучающий модуль 20, память 30 данных, память 40 моделей и модуль 50 классификации сконфигурированы посредством FPGA. CPU 10 может выполнять обмен данными с FPGA через шину. В дополнение к компонентам, проиллюстрированным на фиг. 2, обучающее и различающее устройство 1 может включать в себя другие компоненты, такие как, например, RAM, служащее в качестве рабочей области CPU 10, постоянное запоминающее устройство (ROM,) сохраняющее компьютерную программу и т.п., выполняемую посредством CPU 10, вспомогательное устройство хранения данных, сохраняющее различные виды данных (компьютерную программу и т.п.), и интерфейс связи для обмена данными с внешним устройством.

[0068] CPU 10 представляет собой арифметическое устройство, которое управляет обучением GBDT в целом. CPU 10 включает в себя блок 11 управления. Блок 11 управления управляет соответствующими модулями, включающими в себя обучающий модуль 20, память 30 данных, память 40 моделей и модуль 50 классификации. Блок 11 управления реализуется посредством компьютерной программы, выполняемой посредством CPU 10.

[0069] Обучающий модуль 20 представляет собой аппаратный модуль, который вычисляет номер оптимального набора признаков (в дальнейшем в этом документе также называемое "номером набора признаков" в некоторых случаях) для каждого узла, составляющего дерево решений, и порогового значения, и в случае, в котором узел представляет собой лист, вычисляет весовой коэффициент листа, который должен записываться в память 40 моделей. Как проиллюстрировано на фиг. 4, обучающий модуль 20 также включает в себя модули 21_1, 21_2, ..., и 21_n вычисления усиления (блоки вычисления усиления) и модуль 22 извлечения оптимальных условий (блок извлечения). В этом случае, n является числом, по меньшей мере, равным или большим числа наборов признаков выборочных данных (включающих в себя как обучающие данные, так и различающие данные). В случае указания необязательного модуля вычисления усиления из числа модулей 21_1, 21_2, …, и 21_n вычисления усиления, либо в случае, в котором модули 21_1, 21_2, ..., и 21_n вычисления усиления совместно называются, они упоминаются просто как "модуль 21 вычисления усиления".

[0070] Модуль 21 вычисления усиления представляет собой модуль, который вычисляет количественный показатель ветвления при каждом пороговом значении с использованием выражения (19), описанного выше, для соответствующего набора признаков из числа наборов признаков, включенных в выборочные данные, которые должны вводиться. В этом случае, обучающие данные выборочных данных включают в себя метку (истинное значение) в дополнение к набору признаков, и различающие данные выборочных данных включают в себя набор признаков и не включают в себя метку. Каждый модуль 21 вычисления усиления включает в себя память, которая выполняет операцию для соответствующих гистограмм всех наборов признаков, вводимых за один раз (в 1 синхросигнале), и сохраняет гистограммы и выполняет операцию для всех наборов признаков параллельно. На основе результатов гистограмм, усиления соответствующих наборов признаков вычисляются параллельно. Вследствие этого, обработка может выполняться для всех наборов признаков за один раз или одновременно, так что скорость обработки обучения может значительно повышаться. Этот способ параллельного считывания и обработки всех наборов признаков называется "параллелизмом признаков". Чтобы реализовывать этот способ, память данных должна иметь возможность считывать все набора признаков за один раз (в 1 синхросигнале). Таким образом, этот способ не может реализовываться с памятью, имеющей нормальную ширину данных, такую как 32-битовая или 256-битовая ширина. При использовании программного обеспечения, число битов данных, которые могут обрабатываться посредством CPU за один раз, типично составляет 64 бита максимум, и даже когда число в отношении наборов признаков равно 100, и число битов каждого набора признаков составляет 8 битов, 8000 битов требуются, так что способ вообще не может реализовываться. Таким образом, в предшествующем уровне техники, используется способ сохранения различного набора признаков для каждого адреса памяти (например, 64-битовой ширины, которая может обрабатываться посредством CPU) и сохранения наборов признаков в целом для множества адресов. С другой стороны, настоящий способ включает в себя новый технический контент таким образом, что все набора признаков сохраняются в одном адресе памяти, и все набора признаков считываются посредством одного доступа.

[0071] Как описано выше, в GBDT, обучение дерева решений не может быть параллелизованным. Таким образом, то, как быстро каждое дерево решений обучается, преобладает над скоростью обработки обучения. С другой стороны, в RF для выполнения ансамблевого обучения, отсутствует зависимость между деревьями решений во время обучения, так что обработка обучения для каждого дерева решений может быть легко параллелизована, но ее точность типично меньше точности GBDT. Как описано выше, посредством применения параллелизма признаков, как описано выше, к обучению GBDT, имеющего большую точность, чем точность RF, скорость обработки обучения дерева решений может повышаться.

[0072] Модуль 21 вычисления усиления выводит вычисленный количественный показатель ветвления в модуль 22 извлечения оптимальных условий.

[0073] Модуль 22 извлечения оптимальных условий представляет собой модуль, который принимает ввод каждого количественного показателя ветвления, соответствующего набору признаков, выводимому из каждого модуля 21 вычисления усиления, и извлекает пороговое значение и число набора признаков (номер набора признаков), количественный показатель ветвления которого является наибольшим. Модуль 22 извлечения оптимальных условий записывает извлеченное номер набора признаков и пороговое значение в память 40 моделей в качестве данных условий ветвления соответствующего узла (примера данных узла).

[0074] Память 30 данных представляет собой SRAM, которое сохраняет различные виды данных. Память 30 данных включает в себя память 31 указателей, память 32 признаков и память 33 состояний.

[0075] Память 31 указателей представляет собой память, которая сохраняет адрес назначения хранения выборочных данных, сохраненных в памяти 32 признаков. Как проиллюстрировано на фиг. 3, память 31 указателей включает в себя банк A (область банка) и банк B (область банка). Ниже подробнее поясняется операция разделения области на два банка, включающие в себя банк A и банк B, и сохранения адреса назначения хранения выборочных данных со ссылкой на фиг. 5-13. Память 31 указателей может иметь три или более банков.

[0076] Память 32 признаков представляет собой память, которая сохраняет выборочные данные (включающие в себя обучающие данные и различающие данные).

[0077] Память 33 состояний представляет собой память, которая сохраняет информацию состояния (w, g и h, описанные выше) и информацию метки.

[0078] Память 40 моделей представляет собой SRAM, которое сохраняет данные условий ветвления (номер набора признаков и пороговое значение) для каждого узла дерева решений, флаг листа (информацию флага, пример данных узла), указывающий то, представляет узел собой лист или нет, и весовой коэффициент листа в случае, в котором узел представляет собой лист.

[0079] Модуль 50 классификации представляет собой аппаратный модуль, который распределяет фрагменты выборочных данных для каждого узла и каждого дерева решений. Модуль 50 классификации вычисляет информацию (w, g, h) состояния, которая должна записываться в память 33 состояний.

[0080] Не только при различении (ветвлении) выборочных данных (обучающих данных) при обработке обучения, описанной выше, но также и при обработке различения для выборочных данных (различающих данных), модуль 50 классификации может различать различающие данные с идентичной модульной конфигурацией. Во время обработки различения, обработка, выполняемая посредством модуля 50 классификации, может быть конвейерной за счет совместного считывания всех наборов признаков, и скорость обработки может увеличиваться таким образом, что один фрагмент выборочных данных различается для каждого синхросигнала. С другой стороны, в случае, в котором набора признаков не могут совместно считываться, как описано выше, то, какое из наборов признаков требуется, не может обнаруживаться, если не ветвление в соответствующий узел, так что обработка не может быть конвейерной в форме осуществления доступа к адресу соответствующего набора признаков каждый раз.

[0081] При условии, что предусмотрено множество модулей 50 классификации, описанных выше, множество фрагментов различающих данных могут разделяться (параллелизм данных) для распределения в соответствующие модули 50 классификации, и каждому из модулей 50 классификации может инструктироваться выполнять обработку различения для того, чтобы увеличивать скорость обработки различения.

[0082] Обработка обучения обучающего и различающего устройства

Далее конкретно описывается обработка обучения обучающего и различающего устройства 1 со ссылкой на фиг. 5-13.

[0083] Инициализация

Фиг. 5 является схемой, иллюстрирующей работу модуля во время инициализации обучающего и различающего устройства согласно варианту осуществления. Как проиллюстрировано на фиг. 5, во-первых, блок 11 управления инициализирует память 31 указателей. Например, как проиллюстрировано на фиг. 5, блок 11 управления записывает, в банк A памяти 31 указателей, адреса фрагментов выборочных данных (обучающих данных) в памяти 32 признаков, соответствующих числу фрагментов обучающих данных в порядке (например, в порядке возрастания адреса).

[0084] Все фрагменты обучающих данных не обязательно используются (все адреса не обязательно записываются), и может быть возможным использовать фрагменты обучающих данных, которые случайно выбираются (записывать адреса выбранных фрагментов обучающих данных) на основе вероятности, соответствующей предварительно определенному случайному числу, посредством того, что называется "субдискретизацией данных". Например, в случае, в котором результат субдискретизации данных равен 0,5, половина всех адресов фрагментов обучающих данных может записываться в память 31 указателей (в этом случае, банк A) с половиной вероятности, соответствующей случайному числу. Чтобы формировать случайное число, может использоваться псевдослучайное число, созданное посредством сдвигового регистра с линейной обратной связью (LFSR).

[0085] Все набора признаков фрагментов обучающих данных, используемых для обучения, не обязательно используются, и может быть возможным использовать только набора признаков, которые случайно выбираются (например, выбранную половину этого) на основе вероятности, соответствующей случайному числу аналогично вышеприведенному описанию посредством того, что называется "субдискретизацией признаков". В этом случае, например, в качестве данных наборов признаков, отличных от наборов признаков, выбранных посредством субдискретизации признаков, константы могут выводиться из памяти 32 признаков. Вследствие этого, демонстрируется такой эффект, что обобщающая способность для неизвестных данных (различающих данных) улучшается.

[0086] Определение данных условий ветвления на глубине 0, в узле 0

Фиг. 6 является схемой, иллюстрирующей работу модуля в случае определения параметров узла на глубине 0, в узле 0 обучающего и различающего устройства согласно варианту осуществления. Предполагается, что вершина иерархии дерева решений представляет собой "глубину 0", иерархические уровни ниже вершины упоминаются как "глубина 1", "глубина 2", ..., по порядку, самый левый узел в конкретном иерархическом уровне упоминается как "узел 0", и узлы справа от него упоминаются как "узел 1", "узел 2", ..., по порядку.

[0087] Как проиллюстрировано на фиг. 6, во-первых, блок 11 управления передает начальный адрес и конечный адрес в обучающий модуль 20 и инструктирует обучающему модулю 20 начинать обработку посредством триггера. Обучающий модуль 20 указывает адрес целевого фрагмента обучающих данных из памяти 31 указателей (банка A) на основе начального адреса и конечного адреса, считывает обучающие данные (набор признаков) из памяти 32 признаков и считывает информацию (w, g, h) состояния из памяти 33 состояний на основе адреса.

[0088] В этом случае, как описано выше, каждый модуль 21 вычисления усиления обучающего модуля 20 вычисляет гистограмму соответствующего набора признаков, сохраняет гистограмму в своем SRAM и вычисляет количественный показатель ветвления при каждом пороговом значении на основе результата гистограммы. Модуль 22 извлечения оптимальных условий обучающего модуля 20 принимает ввод количественного показателя ветвления, соответствующего каждому набору признаков, выводимому из модуля 21 вычисления усиления, и извлекает пороговое значение и число набора признаков (номер набора признаков), количественный показатель ветвления которого является наибольшим. Модуль 22 извлечения оптимальных условий затем записывает извлеченный номер набора признаков и пороговое значение в память 40 моделей в качестве данных условий ветвления соответствующего узла (глубины 0, узла 0). В этот момент, модуль 22 извлечения оптимальных условий задает флаг листа равным "0", чтобы указывать то, что ветвление дополнительно выполняется из узла (глубины 0, узла 0), и записывает данные узла (они могут представлять собой часть данных условий ветвления) в память 40 моделей.

[0089] Обучающий модуль 20 выполняет операцию, описанную выше, посредством указания адресов фрагментов обучающих данных, записываемых в банк A по порядку, и считывания соответствующих фрагментов обучающих данных из памяти 32 признаков на основе адресов.

[0090] Обработка ветвления данных на глубине 0, в узле 0

Фиг. 7 является схемой, иллюстрирующей работу модуля во время ветвления на глубине 0, в узле 0 обучающего и различающего устройства согласно варианту осуществления.

[0091] Как проиллюстрировано на фиг. 7, блок 11 управления передает начальный адрес и конечный адрес в модуль 50 классификации и инструктирует модулю 50 классификации начинать обработку посредством триггера. Модуль 50 классификации указывает адрес целевых обучающих данных из памяти 31 указателей (банка A) на основе начального адреса и конечного адреса и считывает обучающие данные (набор признаков) из памяти 32 признаков на основе адреса. Модуль 50 классификации также считывает данные условий ветвления (номер набора признаков, пороговое значение) соответствующего узла (глубины 0, узла 0) из памяти 40 моделей. Модуль 50 классификации определяет то, следует инструктировать считываемым выборочным данным ветвиться в левую сторону или в правую сторону узла (глубины 0, узла 0), в соответствии с данными условий ветвления, и на основе результата определения, модуль 50 классификации записывает адрес обучающих данных в памяти 32 признаков в другой банк (записывающий банк) (в этом случае, банк B) (область банка для записи), отличающийся от считывающего банка (в этом случае, банка A) (области банка для считывания) памяти 31 указателей.

[0092] В этот момент, если определяется то, что ветвление выполняется в левую сторону узла, модуль 50 классификации записывает адрес обучающих данных в порядке возрастания адреса в банке B, как проиллюстрировано на фиг. 7. Если определяется то, что ветвление выполняется в правую сторону узла, модуль 50 классификации записывает адрес обучающих данных в порядке убывания адреса в банке B. Вследствие этого, в записывающем банке (в банке B), адрес обучающих данных, ответвляющихся в левую сторону узла, записывается в качестве младшего адреса, и адрес обучающих данных, ответвляющихся в правую сторону узла, записывается в качестве старшего адреса, с четким разделением. Альтернативно, в записывающем банке, адрес обучающих данных, ответвляющихся в левую сторону узла, может записываться в качестве старшего адреса, и адрес обучающих данных, ответвляющихся в правую сторону узла, может записываться в качестве младшего адреса, с разделением.

[0093] Таким образом, два банка, т.е. банк A и банк B сконфигурированы в памяти 31 указателей, как описано выше, и память может эффективно использоваться посредством попеременного выполнения считывания и записи в нем, хотя емкость SRAM в FPGA ограничена. В качестве упрощенного способа, предусмотрен собой способ конфигурирования каждой из памяти 32 признаков и памяти 33 состояний таким образом, что они имеют два банка. Тем не менее, данные, указывающие адрес в памяти 32 признаков, типично меньше выборочных данных, так что использование памяти может дополнительно снижаться посредством способа подготовки памяти 31 указателей таким образом, чтобы косвенно указывать адрес, аналогично настоящему варианту осуществления.

[0094] В качестве операции, описанной выше, модуль 50 классификации выполняет обработку ветвления для всех фрагментов обучающих данных. Тем не менее после того, как обработка ветвления завершается, соответствующие числа фрагментов обучающих данных, разделяемых в левую сторону и правую сторону узла (глубины 0, узла 0), не являются идентичными, так что модуль 50 классификации возвращает, в блок 11 управления, адрес (промежуточный адрес) в записывающем банке (в банке B), соответствующий границе между адресами обучающих данных, ответвляющихся в левую сторону, и адреса обучающих данных, ответвляющихся в правую сторону. Промежуточный адрес используется в следующей обработке ветвления.

[0095] Определение данных условий ветвления на глубине 1, в узле 0

Фиг. 8 является схемой, иллюстрирующей работу модуля в случае определения параметров узла на глубине 1, в узле 0 обучающего и различающего устройства согласно варианту осуществления. Работа является по существу идентичной работе при обработке определения данных условий ветвления на глубине 0, в узле 0, проиллюстрированной на фиг. 6, но иерархический уровень целевого узла изменяется (с глубины 0 на глубину 1), так что роли банка A и банка B в памяти 31 указателей изменяются на противоположные. В частности, банк B служит в качестве считывающего банка, и банк A служит в качестве записывающего банка (см. фиг. 9).

[0096] Как проиллюстрировано на фиг. 8, блок 11 управления передает начальный адрес и конечный адрес в обучающий модуль 20 на основе промежуточного адреса, принимаемого из модуля 50 классификации через обработку на глубине 0, и инструктирует обучающему модулю 20 начинать обработку посредством триггера. Обучающий модуль 20 указывает адрес целевых обучающих данных из памяти 31 указателей (банка B) на основе начального адреса и конечного адреса, считывает обучающие данные (набор признаков) из памяти 32 признаков на основе адреса и считывает информацию (w, g, h) состояния из памяти 33 состояний. В частности, как проиллюстрировано на фиг. 8, обучающий модуль 20 указывает адреса в порядке с левой стороны (с младшего адреса) до промежуточного адреса в банке B.

[0097] В этом случае, как описано выше, каждый модуль 21 вычисления усиления обучающего модуля 20 сохраняет набор признаков считываемых обучающих данных в своем SRAM и вычисляет количественный показатель ветвления при каждом пороговом значении. Модуль 22 извлечения оптимальных условий обучающего модуля 20 принимает ввод количественного показателя ветвления, соответствующего каждому набору признаков, выводимому из модуля 21 вычисления усиления, и извлекает пороговое значение и число набора признаков (номер набора признаков), количественный показатель ветвления которого является наибольшим. Модуль 22 извлечения оптимальных условий затем записывает извлеченное номер набора признаков и пороговое значение в память 40 моделей в качестве данных условий ветвления соответствующего узла (глубины 1, узла 0). В этот момент, модуль 22 извлечения оптимальных условий задает флаг листа равным "0", чтобы указывать то, что ветвление дополнительно выполняется из узла (глубины 1, узла 0), и записывает данные узла (они могут представлять собой часть данных условий ветвления) в память 40 моделей.

[0098] Обучающий модуль 20 выполняет операцию, описанную выше, посредством указания адресов в порядке с левой стороны (с младшего адреса) до промежуточного адреса в банке B и считывания каждого фрагмента обучающих данных из памяти 32 признаков на основе адресов.

[0099] Обработка ветвления данных на глубине 1, в узле 0

Фиг. 9 является схемой, иллюстрирующей работу модуля во время ветвления на глубине 1, в узле 0 обучающего и различающего устройства согласно варианту осуществления.

[0100] Как проиллюстрировано на фиг. 9, блок 11 управления передает начальный адрес и конечный адрес в модуль 50 классификации на основе промежуточного адреса, принимаемого из модуля 50 классификации через обработку на глубине 0, и инструктирует модулю 50 классификации начинать обработку посредством триггера. Модуль 50 классификации указывает адрес целевых обучающих данных с левой стороны памяти 31 указателей (банка B) на основе начального адреса и конечного адреса и считывает обучающие данные (набор признаков) из памяти 32 признаков на основе адреса. Модуль 50 классификации также считывает данные условий ветвления (номер набора признаков, пороговое значение) соответствующего узла (глубины 1, узла 0) из памяти 40 моделей. Модуль 50 классификации определяет то, следует инструктировать считываемым выборочным данным ветвиться в левую сторону или в правую сторону узла (глубины 1, узла 0), в соответствии с данными условий ветвления, и на основе результата определения, модуль 50 классификации записывает адрес обучающих данных в памяти 32 признаков в другой банк (записывающий банк) (в этом случае, банк A) (область банка для записи), отличающийся от считывающего банка (в этом случае, банка B) (области банка для считывания) памяти 31 указателей.

[0101] В этот момент, если определяется то, что ветвление выполняется в левую сторону узла, модуль 50 классификации записывает адрес обучающих данных в порядке возрастания адреса в банке A, как проиллюстрировано на фиг. 9. Если определяется то, что ветвление выполняется в правую сторону узла, модуль 50 классификации записывает адрес обучающих данных в порядке убывания адреса в банке A. Вследствие этого, в записывающем банке (в банке A), адрес обучающих данных, ответвляющихся в левую сторону узла, записывается в качестве младшего адреса, и адрес обучающих данных, ответвляющихся в правую сторону узла, записывается в качестве старшего адреса, с четким разделением. Альтернативно, в записывающем банке, адрес обучающих данных, ответвляющихся в левую сторону узла, может записываться в качестве старшего адреса, и адрес обучающих данных, ответвляющихся в правую сторону узла, может записываться в качестве младшего адреса, с разделением.

[0102] В качестве операции, описанной выше, модуль 50 классификации выполняет обработку ветвления для фрагмента обучающих данных, указанного посредством адреса, записываемого слева от промежуточного адреса в банке B из всех фрагментов обучающих данных. Тем не менее после того, как обработка ветвления завершается, соответствующие числа фрагментов обучающих данных, разделяемых в левую сторону и правую сторону узла (глубины 1, узла 0), не являются идентичными, так что модуль 50 классификации возвращает, в блок 11 управления, адрес (промежуточный адрес) в записывающем банке (в банке A), соответствующий середине адресов обучающих данных, ответвляющихся в левую сторону, и адреса обучающих данных, ответвляющихся в правую сторону. Промежуточный адрес используется в следующей обработке ветвления.

[0103] Определение данных условий ветвления на глубине 1, в узле 1

Фиг. 10 является схемой, иллюстрирующей работу модуля в случае определения параметров узла на глубине 1, в узле 1 обучающего и различающего устройства согласно варианту осуществления. Аналогично случаю по фиг. 8, иерархический уровень является идентичным иерархическому уровню узла на глубине 1, в узле 0, так что банк B служит в качестве считывающего банка, и банк A служит в качестве записывающего банка (см. фиг. 11).

[0104] Как проиллюстрировано на фиг. 10, блок 11 управления передает начальный адрес и конечный адрес в обучающий модуль 20 на основе промежуточного адреса, принимаемого из модуля 50 классификации через обработку на глубине 0, и инструктирует обучающему модулю 20 начинать обработку посредством триггера. Обучающий модуль 20 указывает адрес целевых обучающих данных из памяти 31 указателей (банка B) на основе начального адреса и конечного адреса, считывает обучающие данные (набор признаков) из памяти 32 признаков на основе адреса и считывает информацию (w, g, h) состояния из памяти 33 состояний. В частности, как проиллюстрировано на фиг. 10, обучающий модуль 20 указывает адреса в порядке с правой стороны (со старшего адреса) до промежуточного адреса в банке B.

[0105] В этом случае, как описано выше, каждый модуль 21 вычисления усиления обучающего модуля 20 сохраняет каждое набор признаков считываемых обучающих данных в своем SRAM и вычисляет количественный показатель ветвления при каждом пороговом значении. Модуль 22 извлечения оптимальных условий обучающего модуля 20 принимает ввод количественного показателя ветвления, соответствующего каждому набору признаков, выводимому из модуля 21 вычисления усиления, и извлекает пороговое значение и число набора признаков (номер набора признаков), количественный показатель ветвления которого является наибольшим. Модуль 22 извлечения оптимальных условий затем записывает извлеченное номер набора признаков и пороговое значение в память 40 моделей в качестве данных условий ветвления соответствующего узла (глубины 1, узла 1). В этот момент, модуль 22 извлечения оптимальных условий задает флаг листа равным "0", чтобы указывать то, что ветвление дополнительно выполняется из узла (глубины 1, узла 1), и записывает данные узла (они могут представлять собой часть данных условий ветвления) в память 40 моделей.

[0106] Обучающий модуль 20 выполняет операцию, описанную выше, посредством указания адресов в порядке с правой стороны (со старшего адреса) до промежуточного адреса в банке B и считывания каждого фрагмента обучающих данных из памяти 32 признаков на основе адресов.

[0107] Обработка ветвления данных на глубине 1, в узле 1

Фиг. 11 является схемой, иллюстрирующей работу модуля во время ветвления на глубине 1, в узле 1 обучающего и различающего устройства согласно варианту осуществления.

[0108] Как проиллюстрировано на фиг. 11, блок 11 управления передает начальный адрес и конечный адрес в модуль 50 классификации на основе промежуточного адреса, принимаемого из модуля 50 классификации через обработку на глубине 0, и инструктирует модулю 50 классификации начинать обработку посредством триггера. Модуль 50 классификации указывает адрес целевых обучающих данных с правой стороны памяти 31 указателей (банка B) на основе начального адреса и конечного адреса и считывает обучающие данные (набор признаков) из памяти 32 признаков на основе адреса. Модуль 50 классификации считывает данные условий ветвления (номер набора признаков, пороговое значение) соответствующего узла (глубины 1, узла 1) из памяти 40 моделей. Модуль 50 классификации затем определяет то, следует инструктировать считываемым выборочным данным ветвиться в левую сторону или в правую сторону узла (глубины 1, узла 1), в соответствии с данными условий ветвления, и на основе результата определения, модуль 50 классификации записывает адрес обучающих данных в памяти 32 признаков в другой банк (записывающий банк) (в этом случае, банк A) (область банка для записи), отличающийся от считывающего банка (в этом случае, банка B) (области банка для считывания) памяти 31 указателей.

[0109] В этот момент, если определяется то, что ветвление выполняется в левую сторону узла, модуль 50 классификации записывает адрес обучающих данных в порядке возрастания адреса в банке A, как проиллюстрировано на фиг. 11. Если определяется то, что ветвление выполняется в правую сторону узла, модуль 50 классификации записывает адрес обучающих данных в порядке убывания адреса в банке A. Вследствие этого, в записывающем банке (в банке A), адрес обучающих данных, ответвляющихся в левую сторону узла, записывается в качестве младшего адреса, и адрес обучающих данных, ответвляющихся в правую сторону узла, записывается в качестве старшего адреса, с четким разделением. Альтернативно, в записывающем банке, адрес обучающих данных, ответвляющихся в левую сторону узла, может записываться в качестве старшего адреса, и адрес обучающих данных, ответвляющихся в правую сторону узла, может записываться в качестве младшего адреса, с разделением. В таком случае, операция на фиг. 9 должна выполняться одновременно.

[0110] В качестве операции, описанной выше, модуль 50 классификации выполняет обработку ветвления для фрагмента обучающих данных, указанного посредством адреса, записываемого справа от промежуточного адреса в банке B из всех фрагментов обучающих данных. Тем не менее, после того, как обработка ветвления завершается, соответствующие числа фрагментов обучающих данных, разделяемых в левую сторону и правую сторону узла (глубины 1, узла 1), не являются идентичными, так что модуль 50 классификации возвращает, в блок 11 управления, адрес (промежуточный адрес) в записывающем банке (в банке A), соответствующий середине адресов обучающих данных, ответвляющихся в левую сторону, и адреса обучающих данных, ответвляющихся в правую сторону. Промежуточный адрес используется в следующей обработке ветвления.

[0111] Случай, в котором ветвление не выполняется во время определения данных условий ветвления на глубине 1, в узле 1

Фиг. 12 является схемой, иллюстрирующей работу модуля в случае, в котором ветвление не выполняется в результате определения параметров узла на глубине 1, в узле 1 обучающего и различающего устройства согласно варианту осуществления. Аналогично случаю по фиг. 8, иерархический уровень является идентичным иерархическому уровню узла на глубине 1, в узле 0, так что банк B служит в качестве считывающего банка.

[0112] Как проиллюстрировано на фиг. 12, блок 11 управления передает начальный адрес и конечный адрес в обучающий модуль 20 на основе промежуточного адреса, принимаемого из модуля 50 классификации через обработку на глубине 0, и инструктирует обучающему модулю 20 начинать обработку посредством триггера. Обучающий модуль 20 указывает адрес целевых обучающих данных из памяти 31 указателей (банка B) на основе начального адреса и конечного адреса, считывает обучающие данные (набор признаков) из памяти 32 признаков на основе адреса и считывает информацию (w, g, h) состояния из памяти 33 состояний. В частности, как проиллюстрировано на фиг. 12, обучающий модуль 20 указывает адреса в порядке с правой стороны (со старшего адреса) до промежуточного адреса в банке B.

[0113] Если определяется то, что ветвление не должно дополнительно выполняться из узла (глубины 1, узла 1) на основе вычисленного количественного показателя ветвления и т.п., обучающий модуль 20 задает флаг листа равным "1", записывает данные узла (они могут представлять собой часть данных условий ветвления) в память 40 моделей и передает, в блок 11 управления, тот факт, что флаг листа узла равен "1". Вследствие этого, следует признавать то, что ветвление не выполняется до более низкого иерархического уровня, чем узел (глубина 1, узел 1). В случае, в котором флаг листа узла (глубины 1, узла 1) равен "1", обучающий модуль 20 записывает весовой коэффициент (w) листа (он может представлять собой часть данных условий ветвления) в память 40 моделей вместо численного набора признаков и порогового значения. Вследствие этого, емкость памяти 40 моделей может уменьшаться по сравнению со случаем, в котором емкости обеспечиваются в памяти 40 моделей отдельно.

[0114] Посредством продолжения вышеуказанной обработки, проиллюстрированной на фиг. 6-12, для каждого иерархического уровня (глубины), все дерево решений завершается (дерево решений обучается).

[0115] Случай, в котором обучение дерева решений завершается

Фиг. 13 является схемой, иллюстрирующей работу модуля во время обновления информации состояния всех фрагментов выборочных данных в случае, в котором обучение дерева решений завершается посредством обучающего и различающего устройства согласно варианту осуществления.

[0116] В случае, в котором обучение одного дерева решений, составляющего GBDT, завершается, градиент g первого порядка и градиент h второго порядка, соответствующие функции ошибок каждого фрагмента обучающих данных, и весовой коэффициент w листа для каждого фрагмента обучающих данных должны вычисляться для использования при бустинге (в этом случае, градиентном бустинге) в следующее дерево решений. Как проиллюстрировано на фиг. 13, блок 11 управления инструктирует модулю 50 классификации начинать вычисление, описанное выше, посредством триггера. Модуль 50 классификации выполняет обработку определения ветвления для узлов на всех глубинах (иерархических уровнях) для всех фрагментов обучающих данных и вычисляет весовой коэффициент листа, соответствующий каждому фрагменту обучающих данных. Модуль 50 классификации затем вычисляет информацию (w, g, h) состояния для вычисленного весового коэффициента листа на основе информации метки и записывает информацию (w, g, h) состояния обратно в исходный адрес памяти 33 состояний. Таким образом, обучение следующего дерева решений выполняется посредством использования обновленной информации состояния.

[0117] Как описано выше, в обучающем и различающем устройстве 1 согласно настоящему варианту осуществления, обучающий модуль 20 включает в себя памяти (например, SRAM) для считывания соответствующих наборов признаков входных выборочных данных. Вследствие этого, все набора признаков выборочных данных могут считываться посредством одного доступа, и каждый модуль 21 вычисления усиления может выполнять обработку для всех наборов признаков за один раз, так что скорость обработки обучения для дерева решений может значительно повышаться.

[0118] В обучающем и различающем устройстве 1 согласно настоящему варианту осуществления, два банка, т.е. банк A и банк B сконфигурированы в памяти 31 указателей, и считывание и запись выполняются попеременно. Вследствие этого, память может эффективно использоваться. В качестве упрощенного способа, предусмотрен собой способ конфигурирования каждой из памяти 32 признаков и памяти 33 состояний таким образом, что они имеют два банка. Тем не менее, данные, указывающие адрес в памяти 32 признаков, типично меньше выборочных данных, так что емкость памяти может дополнительно сокращаться посредством способа подготовки памяти 31 указателей таким образом, чтобы косвенно указывать адрес, аналогично настоящему варианту осуществления. Если определяется то, что ветвление выполняется в левую сторону узла, модуль 50 классификации записывает адрес обучающих данных в порядке от младшего адреса в записывающем банке двух банков, и если определяется то, что ветвление выполняется в правую сторону узла, модуль 50 классификации записывает адрес обучающих данных в порядке от старшего адреса в записывающем банке. Вследствие этого, в записывающем банке, адрес обучающих данных, ответвляющихся в левую сторону узла, записывается в качестве младшего адреса, и адрес обучающих данных, ответвляющихся в правую сторону узла, записывается в качестве старшего адреса, с четким разделением.

[0119] Модификация

Фиг. 14 является схемой, иллюстрирующей пример конфигурации памяти моделей обучающего и различающего устройства согласно модификации. Со ссылкой на фиг. 14, далее описывается конфигурация, в которой память предоставляется для каждой глубины (иерархического уровня) дерева решений в памяти 40 моделей обучающего и различающего устройства 1 согласно настоящей модификации.

[0120] Как проиллюстрировано на фиг. 14, память 40 моделей обучающего и различающего устройства 1 согласно настоящей модификации включает в себя память 41_1 для глубины 0, память 41_2 для глубины 1, …, и память 41_m для глубины (m-1) для сохранения данных (в частности, данных условий ветвления) для каждой глубины (иерархического уровня) модельных данных обученного дерева решений. В этом случае, m является числом, по меньшей мере, равным или большим числа глубины (иерархического уровня) модели дерева решений. Таким образом, память 40 моделей включает в себя независимый порт для извлечения данных (данных узла на глубине 0, данных узла на глубине 1…, данных узла на глубине (m-1)) одновременно для каждой глубины (иерархического уровня) модельных данных обученного дерева решений. Вследствие этого, модуль 50 классификации может считывать данные (данные условий ветвления), соответствующие следующему узлу на всех глубинах (иерархических уровнях), параллельно на основе результата ветвления в первом узле дерева решений, и может выполнять обработку ветвления на соответствующих глубинах (иерархических уровнях) одновременно в 1 синхросигнале (конвейерную обработку) для фрагмента выборочных данных (различающих данных) без использования памяти. Вследствие этого, обработка различения, выполняемая посредством модуля 50 классификации, занимает только время, соответствующее числу фрагментов выборочных данных, и скорость обработки различения может значительно повышаться. С другой стороны, в предшествующем уровне техники, выборочные данные копируются в новую область памяти для каждого узла, что влияет на скорость вследствие времени для считывания и записи, выполняемого посредством памяти, и время, требуемое для обработки различения равно (число фрагментов выборочных данных * номер глубины (иерархического уровня)), так что обработка различения согласно настоящей модификации имеет большое преимущество, как описано выше.

[0121] Фиг. 15 является схемой, иллюстрирующей пример конфигурации модуля классификации обучающего и различающего устройства согласно модификации. Как проиллюстрировано на фиг. 15, модуль 50 классификации включает в себя различитель 51_1 узла 0, различитель 51_2 узла 1, различитель 51_3 узла 2, ... Фрагмент выборочных данных для каждого синхросигнала подается из памяти 32 признаков в качестве набора признаков. Как проиллюстрировано на фиг. 15, набор признаков вводится в различитель 51_1 узла 0 сначала, и различитель 51_1 узла 0 принимает данные узла (данные узла на глубине 0) (условие того, следует ветвиться вправо или влево либо нет, и номер набора признаков, которое должно использоваться) из соответствующей памяти 41_1 для глубины 0 памяти 40 моделей. Различитель 51_1 узла 0 различает то, ветвятся либо нет соответствующие выборочные данные вправо или влево, в соответствии с условием. В этом случае, задержка каждой памяти для глубины (памяти 41_1 для глубины 0, памяти 41_2 для глубины 1, памяти 41_3 для глубины 2, ...,) предположительно составляет 1 синхросигнал. На основе результата, полученного посредством различителя 51_1 узла 0, то, ветвятся или нет выборочные данные и в какой номер узла, указывается посредством адреса в следующей памяти 41_2 для глубины 1, и данные соответствующего узла (данные узла на глубине 1) извлекаются и вводятся в различитель 51_2 узла 1.

[0122] Задержка памяти 41_1 для глубины 0 составляет 1 синхросигнал, так что набор признаков аналогично вводится в различитель 51_2 узла 1 с задержкой в 1 синхросигнал. Набор признаков следующих выборочных данных вводится в различитель 51_1 узла 0 с идентичным синхросигналом. Таким образом, посредством выполнения различения через конвейерную обработку, одно дерево решений в целом может различать один фрагмент выборочных данных с 1 синхросигналом при таком предварительном условии, что памяти выполняют вывод одновременно для каждой глубины. Только один адрес требуется для памяти 41_1 для глубины 0, поскольку предусмотрен один узел на глубине 0, два адреса требуются для памяти 41_2 для глубины 1, поскольку предусмотрено два узла на глубине 1, аналогично, четыре адреса требуются для памяти 41_3 для глубины 2, и восемь адресов требуются для памяти для глубины 3 (не проиллюстрировано). Хотя модуль 50 классификации различает все дерево, обучение может выполняться только с использованием различителя 51_1 узла 0 во время обучения узла, чтобы уменьшать размер схем посредством использования идентичной схемы.

[0123] Второй вариант осуществления

Далее описывается обучающее и различающее устройство согласно второму варианту осуществления, главным образом в отношении отличий от обучающего и различающего устройства 1 согласно первому варианту осуществления. Первый вариант осуществления описывает обработку обучения и обработку различения посредством GBDT при условии, что предусмотрено одна память 30 данных, в которой сохраняются выборочные данные. Настоящий вариант осуществления описывает операцию выполнения обработки обучения посредством разделения памяти данных на множество частей для того, чтобы реализовывать параллелизм данных для обработки множества фрагментов выборочных данных параллельно.

[0124] Относительно параллелизма данных

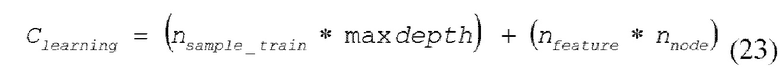

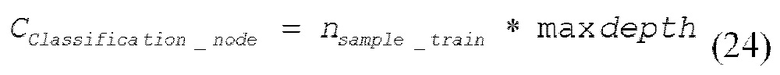

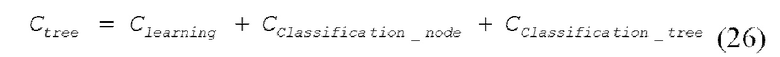

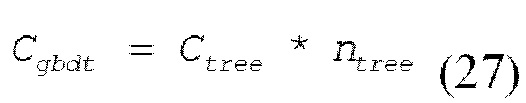

Фиг. 16 является схемой, иллюстрирующей пример модульной конфигурации обучающего и различающего устройства, к которому применяется параллелизм данных. Со ссылкой на фиг. 16, далее описывается конфигурация обучающего и различающего устройства 1a в качестве примера конфигурации для реализации параллелизма данных.