ОБЛАСТЬ ТЕХНИКИ

[01] Настоящая технология относится к электронным устройствам и способам создания прогностической модели. Конкретнее, настоящая технология относится к способу и системе для преобразования значения категориальной фактора в его числовое представление для использования прогностической моделью.

УРОВЕНЬ ТЕХНИКИ

[02] Алгоритмы машинного обучения (MLA) используются для различных задач в компьютерных технологиях. Обычно, MLA используются для создания прогнозов, связанных с пользовательским взаимодействием с компьютерным устройством. Примером сферы использования MLA является пользовательское взаимодействие с содержимым, доступным, например, в сети Интернет.

[03] Объем доступной информации на различных интернет-ресурсах экспоненциально вырос за последние несколько лет. Были разработаны различные решения, которые позволяют обычному пользователю находить информацию, которую он(а) ищет. Примером такого решения является поисковая система. Примеры поисковых систем включают в себя такие поисковые системы как GOOGLE™, YANDEX™, YAHOO!™ и другие. Пользователь может получить доступ к интерфейсу поисковой системы и подтвердить поисковый запрос, связанный с информацией, которую пользователь хочет найти в Интернете. В ответ на поисковый запрос поисковые системы предоставляют ранжированный список результатов поиска. Ранжированный список результатов поиска создается на основе различных алгоритмов ранжирования, которые реализованы в конкретной поисковой системе, и которые используются пользователем, производящим поиск. Общей целью таких алгоритмов ранжирования является представление наиболее релевантных результатов вверху ранжированного списка, а менее релевантных результатов - на менее высоких позициях ранжированного списка результатов поиска (а наименее релевантные результаты поиска будут расположены внизу ранжированного списка результатов поиска).

[04] Поисковые системы обычно являются хорошим поисковым инструментом в том случае, когда пользователю заранее известно, что именно он(а) хочет найти. Другими словами, если пользователь заинтересован в получении информации о наиболее популярных местах в Италии (т.е. поисковая тема известна), пользователь может ввести поисковый запрос: «Наиболее популярные места в Италии». Поисковая система предоставит ранжированный список интернет-ресурсов, которые потенциально являются релевантными по отношению к поисковому запросу. Пользователь далее может просматривать ранжированный список результатов поиска для того, чтобы получить информацию, в которой он заинтересован, в данном случае - о посещаемых местах в Италии. Если пользователь по какой-либо причине не удовлетворен представленными результатами, пользователь может произвести вторичный поиск, уточнив запрос, например «наиболее популярные места в Италии летом», «наиболее популярные места на юге Италии», «Наиболее популярные места в Италии для романтичного отдыха».

[05] В примере поисковой системы, алгоритм машинного обучения (MLA) используется для создания ранжированных поисковых результатов. Когда пользователь вводит поисковый запрос, поисковая система создает список релевантных веб-ресурсов (на основе анализа просмотренных веб-ресурсов, указание на которые хранится в базе данных поискового робота в форме списков словопозиций или тому подобного). Далее поисковая система выполняет MLA для ранжирования таким образом созданного списка поисковых результатов. MLA ранжирует список поисковых результатов на основе их релевантности для поискового запроса. Подобный MLA "обучается" для прогнозирования релевантности данного поискового результата для поискового запроса на основе множества "факторов", связанных с данным поисковым результатом, а также указаний на взаимодействия прошлых пользователей с поисковыми результатами, когда они вводили аналогичные поисковые запросы в прошлом.

[06] Как было упомянуто ранее, поисковые системы полезны в случаях когда пользователь знает, что именно он(а) ищет (т.е. обладает конкретным поисковым намерением). Существует и другой подход, в котором пользователю предоставляется возможность обнаруживать содержимое и, конкретнее, позволяется отображать и/или рекомендовать содержимое, в поиске которого пользователь не был явно заинтересован. В некоторым смысле, подобные системы рекомендуют пользователю содержимое без отдельного поискового запроса, на основе явных или неявных интересов пользователя.

[07] Примерами таких систем являются система рекомендаций FLIPBOARD™, которая агрегирует и рекомендует содержимое из различных социальных сетей. Система рекомендаций FLIPBOARD предоставляет содержимое в «журнальном формате», где пользователь может «пролистывать» страницы с рекомендуемым/агрегированным содержимым. Системы рекомендаций собирают содержимое из социальных медиа и других веб-сайтах, представляет его в журнальном формате, и позволяют пользователям «пролистывать» ленты социальных новостей и ленты веб-сайтов, которые поддерживают партнерские отношения с компанией, что позволяет эффективно «рекомендовать» содержимое пользователю, даже если пользователь явно не выражал свой интерес в конкретном содержимом. Другим примером системы рекомендаций является система рекомендаций YANDEX.ZEN™, которая создает и представляет персонализированный контент пользователю, когда пользователь запускает приложение, связанное с Yandex.Zen, которым может быть специальное приложение или соответствующая страница браузерного приложения.

[08] Для создания ранжированных результатов поиска в поисковой системе или списка рекомендуемых ресурсов в обычной системе рекомендаций, соответствующие системы используют алгоритм машинного обучения рекомендуемый контент из различных источников, доступных в Интернете.

[09] Обзор алгоритмов машинного обучения

[10] Существует множество типов MLA, известных в данной области техники. В широком смысле, можно выделить три типа MLA: алгоритм машинного обучения на основе обучения с учителем, алгоритм машинного обучения на основе обучения без учителя и алгоритм машинного обучения на основе обучения с подкреплением.

[11] Процесс MLA с учителем основан на целевом значении - итоговой переменной (или зависимой переменной), которая будет прогнозироваться из заданного набора предикторов (независимых переменных). Используя набор переменных, MLA (во время обучения) создает функцию, которая сопоставляет исходные данные с желаемыми результатами. Процесс обучения продолжается до тех пор пока MLA не достигнет желаемого уровня точности проверки данных. Примеры MLA на основе обучения с учителем включают в себя: Регрессию, Дерево решений, Случайный Лес, Логистическую Регрессию и т.д.

[12] MLA без учителя не использует для прогнозирования целевое значение или итоговую переменную как таковые. Подобные MLA используются для кластеризации множества значений в различные группы, которые широко используются для сегментирования клиентов в различные группы для конкретных целей. Примеры MLA без учителя включают в себя: Алгоритм Apriori, метод K-средних.

[13] MLA с подкреплением обучается принятию конкретных решений. Во время обучения, MLA находится обучающей среде, где он обучает сам себя постоянно используя систему проб и ошибок. MLA обучается на основе предыдущего опыта и пытается усвоить максимально качественные знания для принятия точных решений. Примером MLA с подкреплением может быть Марковский процесс.

[14] MLA на основе деревьев решений является примером MLA с учителем. Этот тип MLA использует дерево решений (как прогностическую модель) для перехода от наблюдений за элементом (представлены в виде ветвей) к выводам о целевом значении элемента (представлены в виде листьев). Древовидные модели, в которых итоговая переменная может принимать дискретный набор значений, называются деревьями классификации; в этих древовидных структурах, листья представляют собой отметки класса, а ветви представляют собой сочетание факторов, которое приводит к этим отметкам класса. Деревья решений, в которых итоговая переменная может принимать непрерывные значения (как правило, вещественные числа), называются регрессионными деревьями.

[15] Для того чтобы MLA на основе деревьев решений работали, необходимо "создать" или обучить их с помощью обучающего набора объектов, содержащего множество обучающих объектов (например, документы, события и тому подобное). Эти обучающие объекты были "размечены" людьми-асессорами. Например, человек-асессор может ранжировать данный обучающий объект как "неинтересный", "интересный" или "очень интересный".

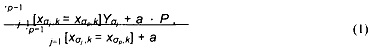

[16] Градиентный бустинг

[17] Градиентный бустинг - один из подходов к созданию MLA на основе деревьев решений, в котором создается прогностическая модель в форме ансамбля деревьев. Ансамбль деревьев создается ступенчатым способом. Каждое последующее дерево решений в ансамбле деревьев решений сосредоточено на обучении на основе тех итераций в предыдущем дереве решений, которые были "слабыми моделями" в предыдущей(их) итерации(ях) в ансамбле деревьев решений (т.е. теми, которые связаны с маловероятным прогнозом / высокой вероятностью ошибки).

[18] В общем случае, бустинг представляет собой способ, нацеленный на улучшение качества прогнозирования MLA. В этом сценарии, вместо того, чтобы полагаться на прогноз одного обученного алгоритма (например, одного дерева решений) система использует несколько обученных алгоритмов (т.е. ансамбль деревьев решений) и принимает окончательное решение на основе множества прогнозируемых результатов этих алгоритмов.

[19] В бустинге деревьев решений, MLA сначала создает первое дерево, затем второе, что улучшает прогноз результата, полученного от первого дерева, а затем третье дерево, которое улучшает прогноз результата, полученного от первых двух деревьев, и так далее. Таким образом, MLA в некотором смысле создает ансамбль деревьев решений, где каждое последующее дерево становится лучше предыдущего, конкретно сосредотачиваясь на слабых моделях из предыдущих итераций деревьев решений. Другими словами, каждое дерево создается на одном и том же обучающем наборе обучающих объектов, и, тем не менее, обучающие объекты, в которых первое дерево совершает "ошибки" в прогнозировании, являются приоритетными для второго дерева и т.д. Эти "сильные" обучающие объекты (те, которые на предыдущих итерациях деревьев решений были спрогнозированы менее точно), получают более высокие весовые коэффициенты, чем те, для которых были получены удовлетворительные прогнозы.

[20] Жадные алгоритмы

[21] При создании деревьев решений (например, с помощью градиентного бустинга), широко используются жадные алгоритмы. Жадный алгоритм - это алгоритмическая парадигма, которая связана с решением задач эвристическим путем принятия локально оптимального решения на каждом этапе (например, на каждом уровне дерева решений) с предположением о том, что таким образом будет найдено глобальное оптимальное значение. При создании деревьев решений использование жадного алгоритма может быть сведено к следующему: для каждого уровня дерева решений, алгоритм машинного обучения пытается найти наиболее оптимальное значение (фактора и/или разделения) - оно будет являться локально оптимальным решением. Когда определено оптимальное значение для данного узла, MLA переходит к созданию более низкого уровня дерева решений, ранее определенные значения для более высоких узлов являются "зафиксированными" - т.е. учитываются "без изменений" для данной итерации дерева решений в ансамбле дерева решений.

[22] Как и в случае с одним деревом, каждое дерево в ансамбле деревьев создается с помощью жадного алгоритма, что означает то, что когда MLA выбирает фактор и разделяющее значение для каждого узла дерева, MLA осуществляет выбор, который является локально оптимальным, например, для конкретного узла, а не для всего дерева в целом.

[23] Забывчивые деревья решений

[24] После того как были выбраны лучшие фактор и разделение для данного узла, алгоритм переходит к дочернему узлу данного узла и выполняет жадный выбор фактора и разделения для этого дочернего узла. В некоторых вариантах осуществления технологии, при выборе фактора для данного узла, алгоритм машинного обучения не может использовать факторы, использованные в узлах на более глубинных уровнях дерева. В других вариантах осуществления технологии, каждый глубинный уровень MLA анализирует все возможные факторы, вне зависимости от того, были ли они использованы на предыдущих уровнях. Подобные деревья называются "забывчивыми" деревьями, поскольку на каждом уровне дерево "забывает" о том, что оно использовало конкретный фактор на предыдущем уровне и снова учитывает этот фактор. Для выбора наилучшего фактора и разделителя для узла, для каждого возможного варианта вычисляется функция усиления). Выбирается опция (фактор или разделяющее значение) с наибольшим усилением.

[25] Параметр Качества Прогноза

[26] Когда создается данное дерево, для определения качества прогноза данного дерева (или данного уровня данного дерева при создании данного дерева), MLA вычисляет метрику (т.е. "оценку"), которая означает, насколько близко текущая итерация модели, которая включает в себя данное дерево (или данный уровень данного дерева) и предыдущие деревья, подходит к прогнозу правильного ответа (целевого значения). Оценка модели вычисляется на основе сделанных прогнозов и фактических целевых значений (правильных значений) обучающих объектов, использованных для обучения.

[27] Когда создается первое дерево, MLA выбирает значения для первого фактора и первого разделяющего значения для корневого узла первого дерева и оценивает качество подобной модели. Для этого, MLA "скармливает" обучающие объекты первому дереву в том смысле, что он спускает обучающие объекты по ветвям дерева решений, и эти "скормленные" обучающие объекты разделяются на два (или более) различных листа первого дерева на разделении первого узла (т.е. они "категоризируются" деревом решений или, конкретнее, модель дерева решений пытается спрогнозировать целевое значение обучающего объекта, который проходит через модель дерева решений). После того, как все обучающие объекты были категоризированы, вычисляется параметр качества прогноза - определяется то, насколько близка категоризация объектов к фактическим значениям целевых объектов.

[28] Конкретнее, зная целевые значения обучающих объектов, MLA вычисляет параметр качества прогноза (например, усиление информации и тому подобное) для этого первого фактора - первого разделения узла, и далее выбирает второй фактор со вторым разделением для корневого узла. Для этого второго варианта фактора и разделения корневого узла, MLA осуществляет те же этапы, что и в первом варианте (MLA "скармливает" обучающие объекты дереву и вычисляет результирующую метрику с помощью второго варианта комбинации фактора и разделения для корневого узла).

[29] MLA далее повторяет тот же процесс с третьим, четвертым, пятым и т.д. вариантам фактора и разделениям для корневого узла до тех пор пока MLA не проверит все возможные варианты фактора и разделяющего значения, и далее MLA выбирает тот вариант фактора и разделяющего значения для корневого узла, который дает наилучший результат прогноза (т.е. обладает самой высокой метрикой).

[30] После того как были выбраны фактор и разделяющее значение для корневого узла, MLA переходит к дочерним узлам корневого узла и выбирает свойства и разделяющие значения для дочерних узлов тем же способом, что и для корневого узла. Этот процесс далее повторяется для дочерних узлов первого дерева до тех пор пока дерево решений не будет создано.

[31] Далее, в соответствии с методом применения бустинга, MLA переходит к созданию второго дерева. Второе дерево нацелено на улучшение результатов прогнозирования, созданных первым деревом. Оно должно "исправлять" ошибки в прогнозировании, которые допущены первым деревом. Для этого второе дерево создается на обучающем объекте, и примеры, в которых были допущены ошибки первым деревом, обладают более высоким весовым коэффициентом, чем примеры, для которых первое дерево выдало правильный прогноз. Второе дерево создается аналогично тому как создавалось первое дерево.

[32] Этот подход позволяет последовательно создавать, десятки, сотни и даже тысячи деревьев. Каждое последующее дереве в ансамбле деревьев улучшает качество прогноза предыдущего дерева.

[33] Числовые и Категориальные Факторы

[34] В широком смысле, деревья решений могут использовать два типа факторов для анализа - числовые факторы и категориальные факторы.

[35] Примерами числовых факторов могут быть: возраст, число хитов для документов, число раз, когда данный поисковый запрос появлялся в документе и т.д. В широком смысле, числовые факторы могут быть бинарными (т.е. 0 или 1) или непрерывными (например, вес, высота и т.д.).

[36] Числовые факторы могут легко сравниваться друг с другом. Например, когда числовые факторы представляют то, насколько высоким является пользователь, их легко можно сравнить друг с другом, чтобы сделать вывод о том, что Пользователь А выше пользователя В.

[37] Числовые факторы анализируются деревом путем сравнения числового фактора с заранее определенным значением на каждом из разделений дерева. Например, числовой фактор "число кликов" может сравниваться на каждом разделении: "выше 10000?" В зависимости от значения числового фактора, спуск по дереву на каждом разделении может идти в "левую" или "правую" сторону.

[38] MLA может быть обучен на числовых факторах для прогноза числового целевого значения. Например, MLA может быть обучен прогнозировать "КЛИК" или "ОТСУТСТВИЕ КЛИКА" для конкретного документа/веб-ресурса (т.е. 1 для клика и 0 для отсутствия клика).

[39] Категориальные факторы могут быть как непрерывно-дискретными (например, породы собак) так и бинарными (например, самец/самка).

[40] Обычным подходом в данной области техники является преобразование категориального фактора в его числовое представление и обработка числового представления категориального фактора. Существуют различные подходы к преобразованию категориальных факторов в их числовое представление: категориальное кодирование, числовое кодирование, унитарное кодирование, бинарное кодирование и т.д.

[41] Американская патентная заявка 8,572,071 (Опубликованная 29 октября 2013 года, под авторством Поттера и др., и выданная Ратгерскому университету в Нью-Джерси) описывает способ и устройство преобразования данных в векторную форму. Каждый вектор состоит из набора свойств, которые либо являются логическими, либо представлены в логической (булевой) форме. Векторы могу попадать или не попадать в категории, размеченные предметными экспертами (SME). Если категории существуют, метки категорий разделяют вектора на подмножества. Первое преобразование вычисляет предварительную вероятность для каждого свойства на основе связей между свойствами в каждом подмножестве векторов. Второе преобразование вычисляет новое числовое значение для каждого свойства на основе связей между свойствами в каждом подмножестве векторов. Третье преобразование работает с категоризованными векторами. На основе автоматического выбора категорий из свойств, это преобразование вычисляет новое числовое значение для каждого свойства на основе связей между свойствами в каждом подмножестве векторов.

[42] Американская патентная заявка US 7,113,932 (опубликованная 26 сентября 2006 под авторством Тайбнеджад и др., и выданная "MCI" LLC) описывает системную программу обработки данных для разработки, обучения и реализации нейронной сети, которая может идентифицировать покупателей с риском безнадежного долга. Вектор фактора применяется к нейронной сети для создания выводов, которые выдают примерное значение относительной вероятности того, что для клиентов, которые упоминаются в записях, используемых для создания вектора фактора, существует риск безнадежного долга. Статистические значения, относящиеся к категориальным свойствам клиентов в отношении вероятности того, что существует риск безнадежного долга, заменяются на категориальные свойства, и свойства нормализуются до того как вектор фактора применяется к сети. В одном варианте осуществления технологии, клиенты являются клиентами удаленного поставщика услуг.

РАСКРЫТИЕ ТЕХНОЛОГИИ

[43] Варианты осуществления настоящей технологии были разработаны с учетом определения разработчиками по меньшей мере одной технической проблемы, связанной с известными подходами к использованию категориальных факторов в деревьях решений.

[44] Для целей иллюстрации предположим, что фактор, который необходимо обработать алгоритму машинного обучения, представляет собой "музыкальный жанр", и целью прогнозирования функции для MLA является способность прогнозировать "прослушано" или "не послушно" на основе музыкального жанра. Фактор "музыкальный жанр" является категориальным или, иным словами, может принимать множество значений - например: джаз, классика, регги, фолк, хип-хоп, поп, панк, опера, кантри, хеви-метал, рок и т.д.

[45] Для того, чтобы MLA мог обработать категориальный фактор, этот фактор необходимо преобразовать в числовое значение. Конкретнее, значение данного категориального фактора (т.е. одного из вариантов джаз, классика, регги, фолк, хип-хоп, поп, панк, опера, кантри, хеви-метал, рок) необходимо преобразовать в его числовое значение).

[46] В соответствии с неограничивающими вариантами осуществления настоящей технологии, MLA сначала создает упорядоченный список всех обучающих объектов, обладающих категориальными факторами, которые будут обработаны во время этапа обучения MLA.

[47] В случае если обучающие объекты с категориальными факторами обладают присущими им временными связями (например, месяцы года, года и т.д.), алгоритм машинного обучения организует обучающие объекты, обладающие категориальными факторами, в соответствии с этими временными связями. В случае если обучающие объекты с категориальными факторами не обладают присущими временными связями, алгоритм машинного обучения создает упорядоченный список обучающих объектов, обладающих категориальными факторами, на основе правила. Например, MLA может создавать случайный порядок обучающих объектов, обладающих категориальными факторами. Случайный порядок становится основой для временного порядка обучающих объектов, обладающих категориальными факторами, которые, в ином случае, не обладают никакими присущими временными связями.

[48] В вышеприведенном примере, где категориальные факторы представляют собой музыкальные жанры - эти обучающие объекты, обладающие категориальными факторами, могут быть связаны или не связаны с присущими им временными связями. Например, в тех сценариях, где обучающие объекты, которые обладают категориальными факторами, связаны с аудиотреками, воспроизводимыми на музыкальном он-лайн хранилище или загруженными с него, обучающие объекты, которые обладают категориальными факторами, могут быть обладать присущими им временными связями на основе времени воспроизведения/загрузки.

[49] Вне зависимости от того, как создается порядок, MLA далее "замораживает" обучающие объекты, обладающие категориальными факторами, в таким образом организованном порядке. Таким образом организованный порядок, в некотором роде, может указывать для каждого обучающего объекта, обладающего категориальным фактором, на то, какие другие обучающие объекты, обладающие категориальными факторами, находятся "до" и какие находятся "после" (даже если обучающие объекты, обладающие категориальными факторами, не связаны с присущими временными связями).

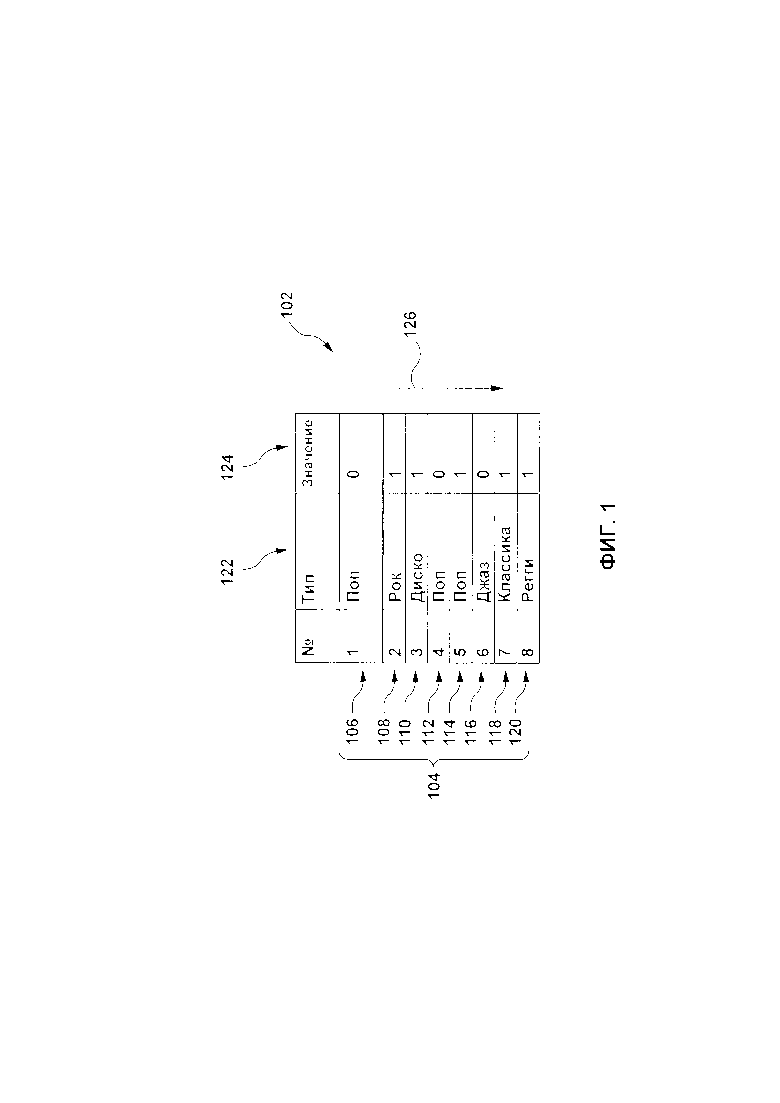

[50] На Фиг. 1 представлен неограничивающий пример упорядоченного списка обучающих объектов 102, обучающие объекты связаны с категориальными факторами (продолжая пример, в котором категориальные факторы представляют собой музыкальные жанры - джаз, классика, регги, фолк, хип-хоп, поп, панк, опера, кантри, хеви-метал, рок и т.д.).

[51] Упорядоченный список обучающих объектов 102 обладает множеством обучающих объектов 104. Исключительно в целях иллюстрации, множество обучающих объектов 104 включает в себя первый обучающий объект 106, второй обучающий объект 108, третий обучающий объект 110, четвертый обучающий объект 112, пятый обучающий объект 114, шестой обучающий объект 116, седьмой обучающий объект 118 и восьмой обучающий объект 120. Естественно, множество обучающих объектов 104 может содержать меньшее или большее количество обучающих объектов. Каждый из обучающих объектов из множества обучающих объектов 104 обладает категориальным фактором 122, связанным с ним, а также значением 124 события. Используя в качестве примера первый обучающий объект 106, его категориальный фактор 112 связан с жанром "поп", а значение 124 события равно "0" (что указывает, например, на отсутствие клика во время взаимодействия с первым обучающим объектом 106 предыдущим пользователем или асессором).

[52] Продолжая описание примера, представленного на Фиг. 1:

- для второго обучающего объекта 108, категориальный фактор 112 связан с жанром "рок", а значение 124 события равно "1" (что указывает, например, на наличие клика);

- для третьего обучающего объекта 110, категориальный фактор 112 связан с жанром "диско", а значение 124 события равно "1" (что указывает, например, на наличие клика);

- для четвертого обучающего объекта 112, категориальный фактор 112 связан с жанром "поп", а значение 124 события равно "0" (что указывает, например, на отсутствие клика);

- для пятого обучающего объекта 114, категориальный фактор 112 связан с жанром "поп", а значение 124 события равно "1" (что указывает, например, на наличие клика);

- для пятого обучающего объекта 116, категориальный фактор 112 связан с жанром "джаз", а значение 124 события равно "0" (что указывает, например, на отсутствие клика);

- для шестого обучающего объекта 118, категориальный фактор 112 связан с жанром "классика", а значение 124 события равно "1" (что указывает, например, на наличие клика);

- для седьмого обучающего объекта 120, категориальный фактор 112 связан с жанром "регги", а значение 124 события равно "1" (что указывает, например, на наличие клика).

[53] Порядок упорядоченного списка обучающих объектов 102 показан на Фиг. 1 указан под номером 126. В соответствии с неограничивающими вариантами осуществления настоящей технологии, в соответствии с порядком 126 упорядоченного списка обучающих объектов 102, данный обучающий объект в упорядоченном списке обучающих объектов 102 может находиться до или после другого обучающего объекта в упорядоченном списке обучающих объектов 102. Например, первый обучающий объект 106, можно сказать, находится до любого другого обучающего объекта из множества обучающих объектов 104. В качестве другого примера, четвертый обучающий объект 112 может находиться (i) после первого обучающего объекта 106, второго обучающего объекта 108, третьего обучающего объекта 110 и (ii) до пятого обучающего объекта 114, шестого обучающего объекта 116, седьмого обучающего объекта 118 и восьмого обучающего объекта 120. В качестве последнего примера, восьмой обучающий объект 120 находится после всех других обучающих объектов из множества обучающих объектов 104.

[54] В соответствии с неограничивающими вариантами осуществления настоящей технологии, когда алгоритму машинного обучения необходимо преобразовать категориальный фактор в его числовое представление, алгоритм высчитывает число вхождений данного категориального фактора по отношению к другим категориальным факторам, связанным с обучающими объектами, которые находятся до данного категориального фактора в упорядоченном списке обучающих объектов 102.

[55] Другими словами, в широком смысле, MLA создает указание на "счетчик" данного категориального фактора, как будет более подробно описано далее. Для создания временной аналогии, MLA использует только те категориальные факторы, которые произошли "раньше" по отношению к данному категориальному фактору. Таким образом, при преобразовании категориального фактора в его числовое представление, MLA не "заглядывает" в будущее данного категориального фактора (т.е. целевые значения этих категориальных факторов, которые случились "в будущем" в отношении данного категориального фактора). Таким образом, по меньшей мере в некоторых вариантах осуществления настоящей технологии возможно по меньшей мере снизить существующую проблему переобучения MLA.

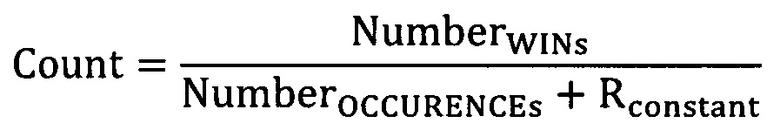

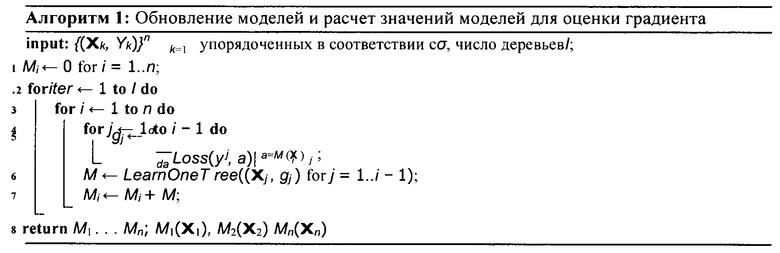

[56] В конкретном варианте осуществления из неограничивающих вариантов осуществления настоящей технологии, MLA вычисляет функцию на основе значений срабатывания (WIN) и несрабатывания (LOSS), связанных с категориальным фактором и его "прошлым".

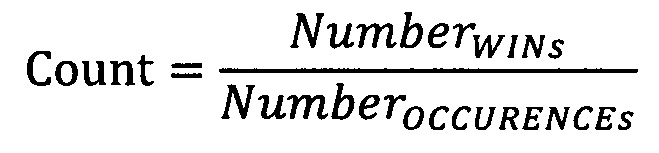

[57] В качестве иллюстрации рассмотрим пятый обучающий объект 114 (обладающий значением категориального фактора 112 "поп" и связанный со значением 124 события, которое равно "1"). MLA переводит значение категориального фактора 112 (т.е. "поп") в числовой фактор с помощью формулы:

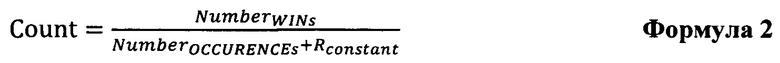

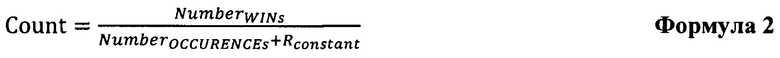

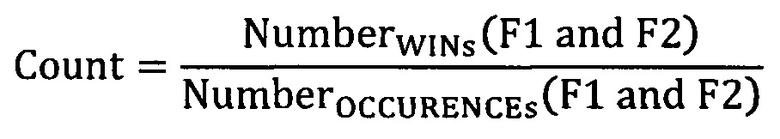

[58] Где счетчик - это числовое представление значения категориального фактора для данного объекта, NumberWINs - число событий для данного значения категориального фактора, которые считаются связанными со срабатываниями, а NumberOCCURENCEs - число вхождений одинакового значения обрабатываемого категориального фактора, причем, как число событий, которые считаются срабатываниями, так и число вхождений значения категориального фактора, находятся по порядку 126 до данного обрабатываемого категориального фактора.

[59] В качестве примера, числом событий, которые считаются срабатываниями, может быть успешное событие, которое связано с данным объектом, связанным с данным значением категориального фактора (т.е. песня конкретного жанра, связанного с данным объектом, которая проигрывалась или была загружена или была отмечена как "понравившееся"), т.е. значение 124 события равно "1", а не "0". Число вхождений представляет собой общее число вхождений значения данного категориального фактора в упорядоченный список обучающих объектов 102, которые "находятся" до текущего вхождения (т.е. до категориального фактора, счетчик для которого обрабатывается алгоритмом машинного обучения). Другими словами, система вычисляет счетчик для данного фактора путем просмотра "снизу вверх" упорядоченного списка обучающих объектов 102. В качестве примера, для данного значения фактора (рок) данного объекта, число событий, которые считаются срабатываниями, может являться числом вхождений объектов с конкретном типом события (например, песня, связанная с обучающим объектом, была воспроизведена или загружена или отмечена как "понравившееся", т.е. значение 124 события равно "1", а не "0"), и число вхождений может представлять собой общее число вхождений того же значения фактора (рок), что и данный объект.

[60] В альтернативных вариантах осуществления настоящей технологии, формула 1 может быть модифицирована таким образом, что вместо NumberOCCURENCEs для данного объекта, что является числом вхождений объектов с тем же значением категориального фактора в упорядоченном списке до данного объекта, NumberOCCURENCEs может представлять собой число всех объектов в упорядоченном списке до данного объекта, вне зависимости от их значений категориального фактора.

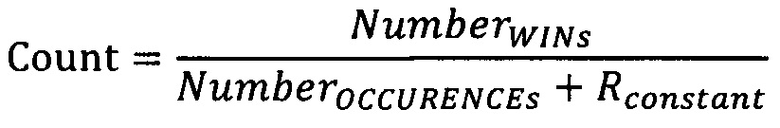

[61] В некоторых вариантах осуществления настоящей технологии, Формула 1 может быть модифицирована с помощью константы.

[62] В которой Rconstant может являться заранее определенным значением.

[63] Формула 2 может быть особенно полезной для избежания ошибок при вычислениях, в которых данный категориальный фактор появляется в первый раз (т.е. в которых существует ноль предыдущих вхождений и ноль предыдущих срабатываний, и Rconstant позволяет избежать ошибки при попытке деления на ноль).

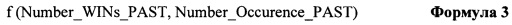

[64] В широком смысле, неограничивающие варианты осуществления настоящей технологии могут использовать любую формулу, в которой используются "прошлые" появления ситуаций срабатывания и общее число вхождений текущего обрабатываемого категориального фактора.

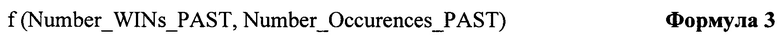

[65] Таким образом, в широком смысле, формула может выглядеть следующим образом:

[66] В некоторых вариантах осуществления настоящей технологии, MLA может вычислять, для значения данного категориального фактора для данного объекта, множество счетчиков. Например, каждый счетчик из множества счетчиков может быть вычислен с помощью Формулы 2 с другим Rconstant. Конкретнее, первый счетчик из множества счетчиков может быть вычислен с помощью Формулы 2 с первым Rconstant, а второй счетчик из множества счетчиков может быть вычислен с помощью Формулы 2 со вторым Rconstant- Альтернативно, первый счетчик из множества счетчиков может быть вычислен с помощью Формулы 1 с NumberOCCURENCEs, что представляет все предыдущие вхождения того же категориального фактора, а второй счетчик из множества счетчиков может быть вычислен с помощью Формулы 1 с NumberOCCURENCEs, что представляет собой все предыдущие вхождения всех категориальных факторов.

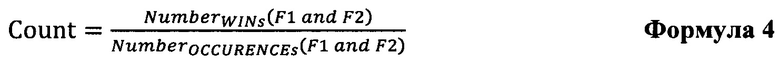

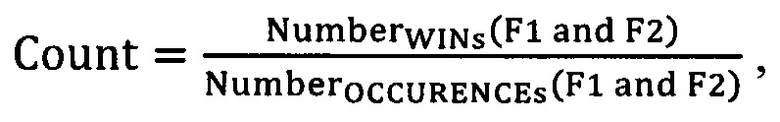

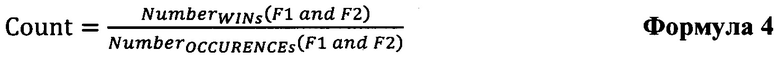

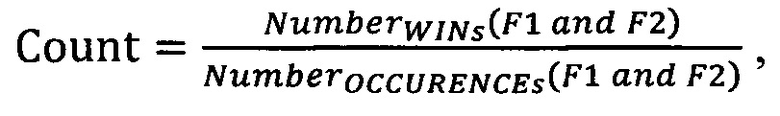

[67] В альтернативных вариантах осуществления технологии, любая из формул 1, 2 или 3 может быть модифицирована для анализа группы факторов, а не одного фактора.

[68] Например, вместо жанра песни формула может анализировать совместное вхождение жанра и данного исполнителя (в качестве примеров двух категориальных факторов или группы категориальных факторов, которые могут быть связаны с одним обучающим объектом). При анализе групп категориальных факторов MLA применяет способ "динамического бустинга". Как и в случае обработки одного категориального фактора, когда MLA обрабатывает группу факторов, MLA анализирует совместное вхождение группы факторов, которые находятся до текущего вхождения группы анализируемых категориальных факторов (т.е. MLA не "смотрит вперед" в упорядоченном списке факторов).

[69] Формула может быть модифицирована следующим образом:

[70] Где оба NumberWINs(F1 and F2) и NumberOCCURENCEs(F1 and F2) учитывают срабатывания и совместные вхождения группы значений факторов (F1 и F2), которые находятся выше текущего вхождения группы факторов в упорядоченном списке обучающих объектов 102.

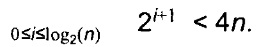

[71] По мере того как растет число факторов (например, для обучающих объектов, которые являются песнями, категориальные факторы могут включать в себя: жанр, исполнитель, альбом и т.д.), растет и число возможных комбинаций в группах значений факторов, которые обрабатываются MLA с целью обучения, и, в конечном итоге, применения формулы обученного MLA.

[72] В зависимости от типа обучающих объектов, число комбинаций может возрастать экспоненциально. Следовательно, с точки зрения затрачиваемых ресурсов, может не быть оправдано вычисление счетчиков для всех возможных комбинаций категориальных факторов и/или значений категориальных факторов. Вместо предварительного вычисления, для данного объекта, всех возможных комбинаций значений категориальных факторов, в неограничивающих вариантах осуществления настоящей технологии предусмотрено создание счетчиков комбинаций факторов "внутри" алгоритма машинного обучения, по мере того как алгоритм проходит по всем значениям категориальных факторов (т.е. "на ходу", когда MLA создает дерево решений (и его конкретную итерацию), а не заранее вычисляя все возможные счетчики для всех возможных комбинаций категориальных факторов). Основным техническим преимуществом этого подхода является то, что MLA необходимо вычислять только те комбинации, которые фактически возникают, а не каждую возможную комбинацию категориальных факторов и/или значений категориальных факторов.

[73] Например, вместо вычисления счетчиков (т.е. числового представления) для каждого возможной комбинации жанра и исполнителя, MLA может вычислять счетчики (т.е. числовое представление) только для тех комбинаций значений категориальных факторов, которые MLA находит в упорядоченном списке обучающих объектов 102, что позволяет значительно сократить вычислительные мощности и ресурсы памяти, которые требуются для хранения информации о каждой возможной комбинации категориальных факторов.

[74] В широком смысле, когда MLA создает конкретную итерацию модели дерева решений (например, конкретное дерево решений в ансамбле деревьев решений, которые обучаются в случае использования градиентного бустинга). Для каждого узла дерева решений, MLA преобразовывает категориальные факторы (или группу категориальных факторов, в зависимости от ситуации) в их числовое представление, как было описано ранее.

[75] После того как для данного узла или данного уровня был выбран лучший из таких образом преобразованных категориальных факторов (а также любые другие числовые факторы, которые могут быть обработаны данным узлом) - они "замораживаются" для этого узла/этого уровня дерева решений на данной итерации бустинга дерева решений. В некоторых вариантах осуществления настоящей технологии, когда MLA спускается к более низкоуровневым узлам, он вычисляет только счетчики для тех комбинаций категориальных факторов, которые он встречает для текущей вариации дерева решений (т.е. учитывает категориальные факторы, которые были выбраны как лучшие, и были "заморожены" на более высоких уровнях деревьев решений).

[76] В альтернативных вариантах осуществления настоящей технологии, когда MLA спускается к более низкоуровневым узлам, он вычисляет только счетчики для тех комбинаций категориальных факторов, которые он встречает для текущей вариации дерева решений (т.е. учитывает категориальные факторы, которые были выбраны как лучшие, и были "заморожены" на более высоких уровнях деревьев решений), а также предыдущие вариации деревьев решений, которые создаются во время предыдущей итерации бустинга деревьев решений как части процесса создания ансамбля деревьев решений.

[77] Используя в качестве примера текущий уровень дерева решения - третий уровень (т.е. третий уровень, которому предшествуют корневой узел, первый уровень и второй уровень дерева решений), когда MLA вычисляет числовое представление категориальных факторов для третьего уровня, MLA вычисляет все возможные комбинации категориальных факторов для третьего уровня в комбинации с "замороженными" категориальными факторами, которые были выбраны как лучшие и которые были "заморожены" для корневого узла, узла первого уровня и узла второго уровня.

[78] Другими словами, можно сказать, что для данного узла на данном уровне дерева решений, MLA вычисляет "счетчики" возможных категориальных факторов для данного узла данного уровня дерева решений путем добавления всех возможных категориальных факторов к уже выбранным лучшим категориальным факторам, которые были "заморожены" на предыдущих уровнях, в отношении данного уровня дерева решений.

[79] Далее рассмотрим разделения, которые выбраны в связи с данным категориальным фактором (или, конкретнее, его счетчиком) на данном уровне дерева решений. Разделения также вычисляются "внутри" алгоритма MLA, т.е. "на ходу", когда MLA создает дерево решений (на данной его итерации) вместо предварительного вычисления всех возможных разделений для всех возможных счетчиков.

[80] В одном конкретном варианте осуществления технологии, MLA создает разделения путем создания диапазона всех возможных значений для разделений (для данного счетчика, который был создан на основе данного категориального фактора) и применения заранее определенной сетки. В некоторых вариантах осуществления настоящей технологии, диапазон может находиться между значениями 0 и 1. В других вариантах осуществления настоящей технологии, в которых важно применение коэффициента (Rconstant) при вычислении значений счетчиков, диапазон может находиться в следующих пределах: (i) значение коэффициента (ii) значение коэффициента плюс единица.

[81] В некоторых вариантах осуществления настоящей технологии, заранее определенная сетка представляет собой сетку с постоянным интервалом, которая разделяет диапазон на постоянные интервалы. В других вариантах осуществления настоящей технологии, заранее определенная сетка представляет собой сетку с непостоянным интервалом, которая разделяет диапазон на непостоянные интервалы.

[82] В результате отсутствия предварительной обработки всех возможных комбинаций категориальных факторов и обработки счетчиков "внутри" алгоритма машинного обучения, возможно обрабатывать разделения для узлов "внутри" MLA, который создает дерево решений. В соответствии с неограничивающими вариантами осуществления технологии, MLA определяет разделения для узлов деревьев, не зная все возможные значения для счетчиков на основе вышеописанного подхода с использованием сеток. MLA создает диапазон комбинации факторов и разделяет его на равные "области", границы которых становятся значениями для разделений. В фазе использования, MLA необходимо определить, в какую область "попадает" данный счетчик - это и становится значением разделения.

[83] В некоторых вариантах осуществления настоящей технологии, MLA вычисляет разделения для каждого уровня дерева решений и, после того как данный уровень дерева решений оптимизирован (т.е. после того как MLA выбрал "лучший" фактор и разделение для данного уровня дерева решений), MLA стирает вычисленные разделения. Когда MLA переходит на следующий уровень, MLA заново вычисляет разделения. В других вариантах осуществления настоящей технологии, разделения вычисляются и "забываются" при переходе от дерева к дереву, а не от уровня к уровню.

[84] Когда MLA создает дерево решений на конкретной итерации создания модели дерева решений, для каждого уровня, MLA проверяет и оптимизирует лучшее из: какой фактор расположить на узле уровня, и какое разделяющее значение (из всех возможных заранее определенных значений) расположить на узле.

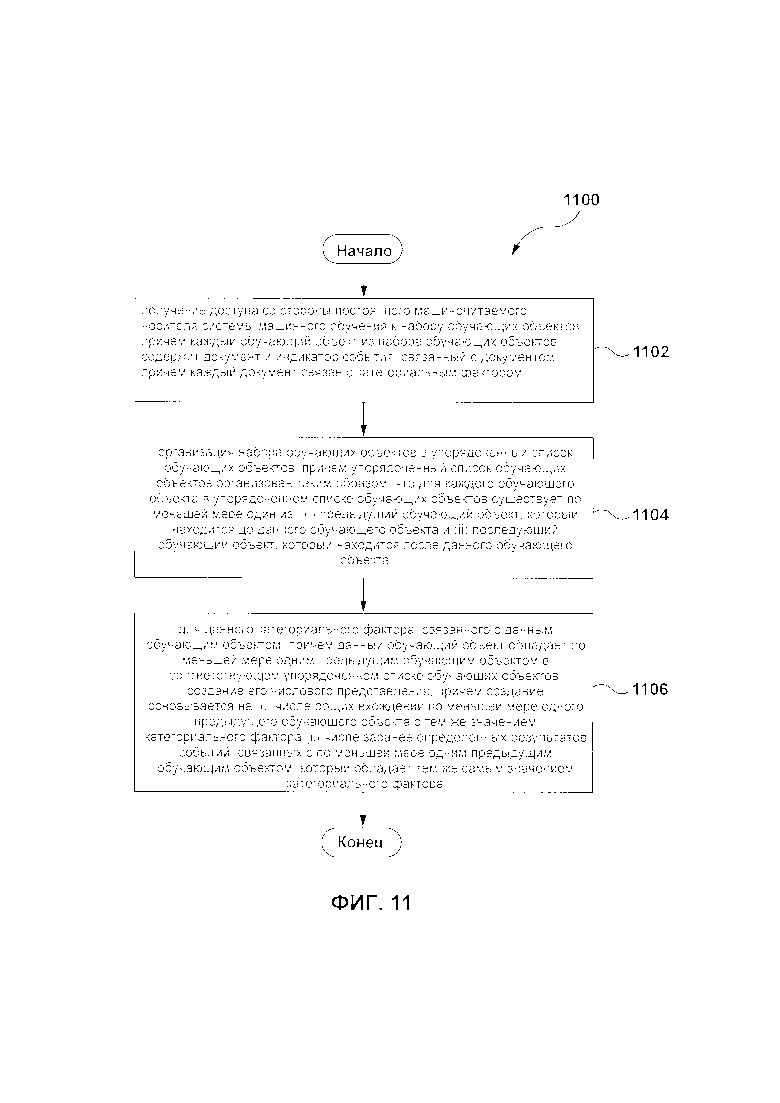

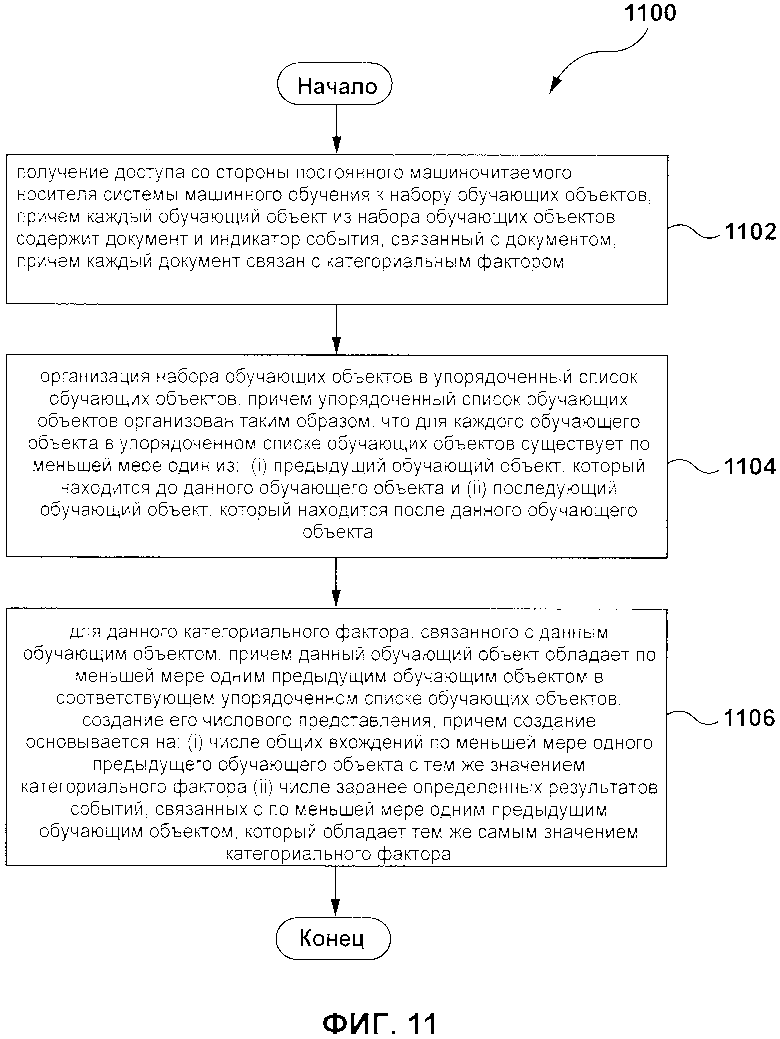

[85] Первым объектом настоящей технологии является способ преобразования значения категориального фактора в его числовое представление, категориальный фактор связан с обучающим объектом, используемым для обучения алгоритма машинного обучения (MLA). MLA выполняется системой машинного обучения для прогнозирования целевого значения объекта фазы использования. Способ включает в себя: получение доступа со стороны постоянного машиночитаемого носителя системы машинного обучения, к набору обучающих объектов, причем каждый обучающий объект из набора обучающих объектов содержит документ и индикатор события, связанный с документом, причем каждый документ связан с категориальным фактором; создание набора моделей для MLA, причем каждая модель из набора моделей основана на ансамбле деревьев решений; для каждой модели из набора моделей: организация набора обучающих объектов в соответствующий упорядоченный список обучающих объектов, причем соответствующий упорядоченный список обучающих объектов организован таким образом, что для каждого обучающего объекта в соответствующем упорядоченном списке обучающих объектов существует по меньшей мере одно из: (i) предыдущий обучающий объект, который находится до данного обучающего объекта и (ii) последующий обучающий объект, который находится после данного обучающего объекта; при создании данной итерации дерева решений в данном ансамбле деревьев решений: выбор одной из набора моделей и соответствующего упорядоченного списка; создание структуры дерева решений с помощью одной модели из набора моделей; при обработке данного категориального фактора с помощью структуры дерева решений данный категориальный фактор связан с данным обучающим объектом; причем данный обучающий объект обладает по меньшей мере одним предыдущим обучающим объектом в упорядоченном списке обучающих объектов, создание его числового представления, которое основано на: (i) числе общих вхождений по меньшей мере одного предыдущего обучающего объекта с тем же значением категориального фактора в соответствующем упорядоченном списке (ii) числе заранее определенных результатов событий, связанных с по меньшей мере одним предыдущим обучающим объектом, который обладает тем же самым значением категориального фактора в соответствующем упорядоченном списке.

[86] В некоторых вариантах осуществления способа, создание включает в себя применение формулы:

[87] где:

[88] NumberOCCURENCEs число общих вхождений по меньшей мере одного предыдущего обучающего объекта с тем же самым значением категориального фактора; и

[89] NumberWINs число заранее определенных результатов событий, связанных с по меньшей мере одним предыдущим обучающим объектом, который обладает тем же самым значением категориального фактора.

[90] В некоторых вариантах осуществления способа, создание включает в себя применение формулы:

[91] где:

[92] NumberOCCURENCEs число общих вхождений по меньшей мере одного предыдущего обучающего объекта с тем же самым категориальным фактором; и

[93] NumberWINs число заранее определенных результатов событий, связанных с по меньшей мере одним предыдущим обучающим объектом, который обладает тем же самым категориальным фактором; и

[94] Rconstant является заранее определенным значением.

[95] В некоторых вариантах осуществления способа, данный категориальный фактор является набором категориальных факторов, который включает в себя по меньшей мере первый категориальный фактор и второй категориальный фактор, причем создание их числового представления включает в себя: (i) использование в качестве числа общих вхождений по меньшей мере одного предыдущего обучающего объекта с тем же самым значением категориального фактора: числа общих вхождений по меньшей мере одного предыдущего обучающего объекта, обладающего как значением первого категориального фактора, так и значением второго категориального фактора; и (ii) использование в качестве числа заранее определенных результатов событий, связанных с по меньшей мере одним обучающим объектом, обладающим тем же значением категориального фактора: числа заранее определенных результатов событий, связанных с по меньшей мере одним обучающим объектом, обладающим как как значением первого категориального фактора, так и значением второго категориального фактора.

[96] В некоторых вариантах осуществления способа, создание числового представления включает в себя применение формулы:

[97] где

[98] (i) NumberWINs(F1 and F2) is - число общих вхождений по меньшей мере одного предыдущего обучающего объекта с тем же самым набором значений категориальных факторов; и

[99] (ii) NumberOCCURENCEs(F1 and F2)is the - число заранее определенных результатов событий, связанных с по меньшей мере одним предыдущим обучающим объектом, который обладает тем же самым набором значений категориальных факторов.

[100] В некоторых вариантах осуществления способа, индикатор события обладает заранее определенным значением, и это заранее определенное значение является одним из положительного результата или отрицательного результата.

[101] В некоторых вариантах осуществления способа, организация набора обучающих объектов в упорядоченный список обучающих объектов выполняется в момент времени до создания числового значения.

[102] В некоторых вариантах осуществления способа, обучающие объекты связаны с присущим им временным порядком, и причем организация набора обучающих объектов в упорядоченный список, и причем организация набора обучающих объектов в упорядоченный список обучающих объектов включает в себя организацию обучающих объектов в соответствии с временным порядком.

[103] В некоторых вариантах осуществления способа, обучающие объекты не связаны с присущим им временным порядком, и причем организация набора обучающих объектов в упорядоченный список, и причем организация набора обучающих объектов в упорядоченный список обучающих объектов включает в себя организацию обучающих объектов в соответствии заранее определенным правилом.

[104] В некоторых вариантах осуществления способа, обучающие объекты не связаны с присущим им временным порядком, и причем организация набора обучающих объектов в упорядоченный список обучающих объектов включает в себя создание случайного порядка обучающих объектов, который будет использован как упорядоченный список.

[105] В некоторых вариантах осуществления способа, способ далее включает в себя использование структуры дерева решений для других моделей из набора моделей для данной итерации дерева решений.

[106] В некоторых вариантах осуществления способа, способ далее включает в себя заполнение каждой из набора моделей с помощью набора обучающих объектов, причем значения категориальных факторов документов преобразованы в свои числовые представления с помощью соответствующего упорядоченного списка обучающих объектов.

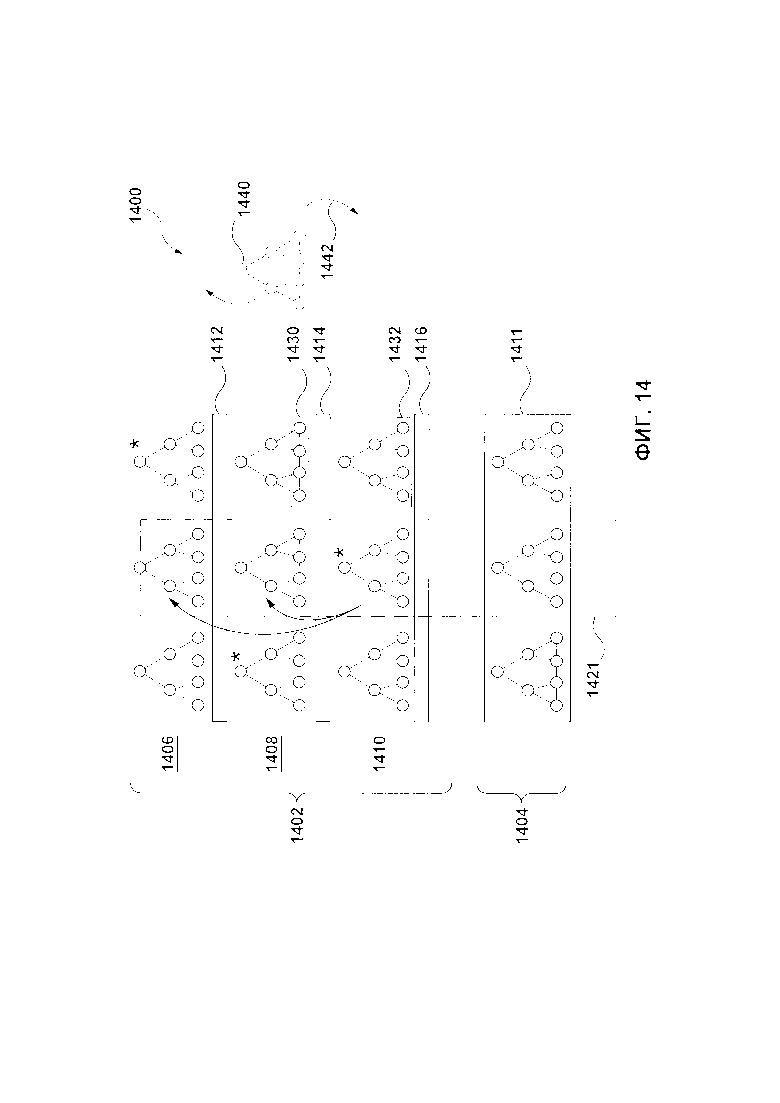

[107] В некоторых вариантах осуществления способа, набор моделей включает в себя набора протомоделей, и причем набор моделей далее включает в себя итоговую модель, и причем способ далее включает в себя: на каждой итерации обучения, выбор наилучшей работающей из набора протомоделей, и использование наилучшей работающей из набора протомоделей для создания дерева решений итоговой модели для итерации обучения.

[108] В некоторых вариантах осуществления способа, способ далее включает в себя определение наилучшей работающей из набора протомоделей путем применения алгоритма проверки.

[109] В некоторых вариантах осуществления способа, алгоритм проверки учитывает работу данной итерации каждой из набора моделей и предыдущих деревьев решений в соответствующей модели из набора моделей.

[110] В некоторых вариантах осуществления способа, использование различных соответствующих упорядоченных наборов приводит к тому, что значения в листьях разных моделей из набора моделей по меньшей мере частично отличаются.

[111] В некоторых вариантах осуществления способа, использование набора других моделей со связанными соответствующими упорядоченными списками приводит к снижению эффекта переобучения во время обучения.

[112] В некоторых вариантах осуществления способа, любой из упорядоченных списков отличается от других из упорядоченных списков.

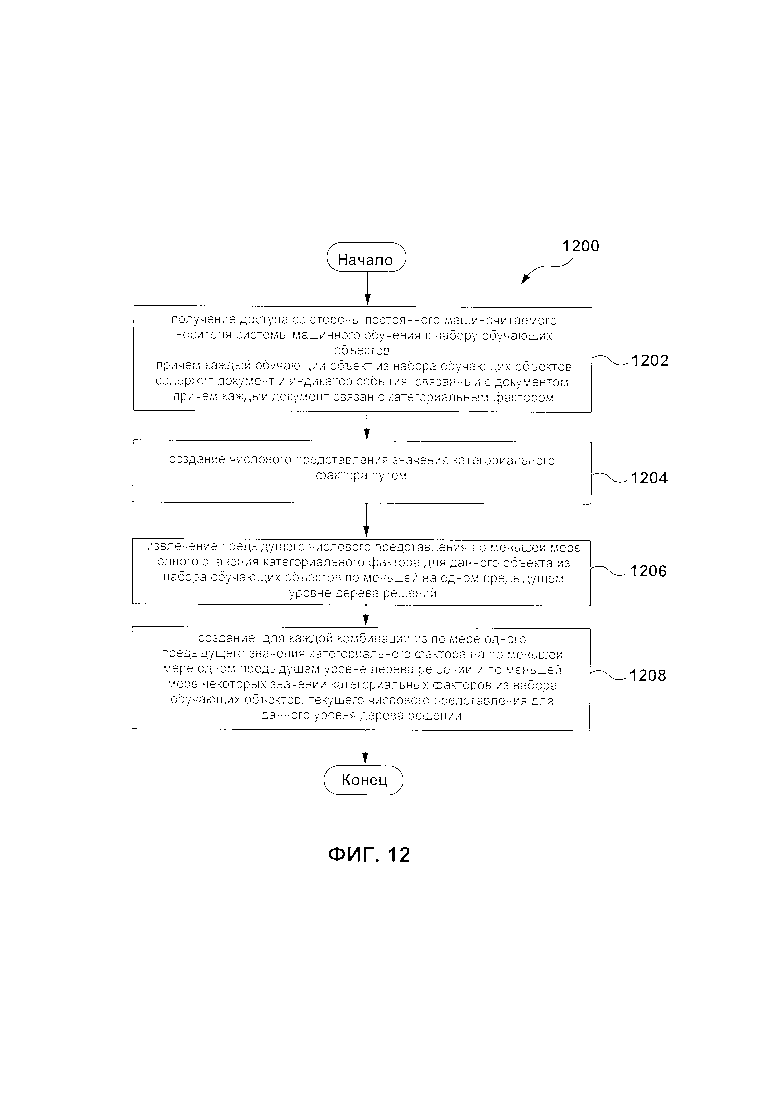

[113] Другим объектом настоящей технологии является способ преобразования значения категориального фактора в его числовое представление, категориальный фактор связан с обучающим объектом, используемым для обучения алгоритма машинного обучения (MLA). Алгоритм машинного обучения выполняется электронным устройством для прогнозирования объекта фазы использования. Способ включает в себя: получение доступа со стороны постоянного машиночитаемого носителя системы машинного обучения, к набору обучающих объектов, причем каждый обучающий объект из набора обучающих объектов содержит документ и индикатор события, связанный с документом, причем каждый документ связан с категориальным фактором; создание набора моделей для MLA, причем каждая модель из набора моделей основана на ансамбле деревьев решений; для каждой модели из набора моделей: организация набора обучающих объектов в соответствующий упорядоченный список обучающих объектов, причем соответствующий упорядоченный список обучающих объектов организован таким образом, что для каждого обучающего объекта в соответствующем упорядоченном списке обучающих объектов существует по меньшей мере одно из: (i) предыдущий обучающий объект, который находится до данного обучающего объекта и (ii) последующий обучающий объект, который находится после данного обучающего объекта; при создании данной итерации дерева решений в данном ансамбле деревьев решений: выбор одной из набора моделей и соответствующего упорядоченного списка; создание структуры дерева решений с помощью одной модели из набора моделей; при обработке данного категориального фактора с помощью структуры дерева решений, для данного категориального фактора, связанного с данным обучающим объектом, данный обучающий объект обладает по меньшей мере одним предыдущим обучающим объектом в соответствующем упорядоченном списке обучающих объектов, создание включает в себя вычисление функции с помощью формулы:

f (Number_WINs_PAST, Number_Occurence_PAST),

[114] где:

[115] Number_WINs_PAST - число заранее определенных результатов событий, связанных с по меньшей мере одним предыдущим обучающим объектом, который обладает теми же самыми значениями категориального фактора в соответствующем упорядоченном списке; и

[116] Number_Occurence_PAST - число общих вхождений по меньшей мере одного предыдущего обучающего объекта с тем же самым значением категориального фактора в соответствующем упорядоченном списке.

[117] Еще одним объектом настоящей технологии является сервер, выполненный с возможностью выполнять алгоритм машинного обучения, который основан на прогностической модели дерева решений на основе дерева решений, причем дерево решений предназначено для обработки значения категориального фактора путем преобразования его в его числовое представление, причем категориальный фактор связан с обучающим объектом, используемым для обучения MLA. MLA используется сервером для прогнозирования целевого значения объекта фазы использования. Сервер включает в себя: постоянный машиночитаемый носитель; процессор, связанный с постоянным машиночитаемым носителем, причем процессор выполнен с дополнительной возможностью осуществлять: получение доступа со стороны постоянного машиночитаемого носителя системы машинного обучения, к набору обучающих объектов, причем каждый обучающий объект из набора обучающих объектов содержит документ и индикатор события, связанный с документом, причем каждый документ связан с категориальным фактором; создание набора моделей для MLA, причем каждая модель из набора моделей основана на ансамбле деревьев решений; для создания, процессор далее выполнен с возможностью, для каждой модели из набора моделей осуществлять: организацию набора обучающих объектов в соответствующий упорядоченный список обучающих объектов, причем соответствующий упорядоченный список обучающих объектов организован таким образом, что для каждого обучающего объекта в соответствующем упорядоченном списке обучающих объектов существует по меньшей мере одно из: (i) предыдущий обучающий объект, который находится до данного обучающего объекта и (ii) последующий обучающий объект, который находится после данного обучающего объекта; при создании данной итерации дерева решений в данном ансамбле деревьев решений, процессор далее выполнен с возможностью осуществлять: выбор одной из набора моделей и соответствующего упорядоченного списка; создание структуры дерева решений с помощью одной модели из набора моделей; при обработке данного категориального фактора с помощью структуры дерева решений, для данного категориального фактора, который фактор связан с данным обучающим объектом, причем данный обучающий объект обладает по меньшей мере одним предыдущим обучающим объектом в упорядоченном списке обучающих объектов, создание его числового представления, которое основано на: (i) числе общих вхождений по меньшей мере одного предыдущего обучающего объекта с тем же значением категориального фактора (ii) числе заранее определенных результатов событий, связанных с по меньшей мере одним предыдущим обучающим объектом, который обладает тем же самым значением категориального фактора.

[118] Еще одним объектом настоящей технологии является способ преобразования в числовое представление значения категориального фактора, который связан с обучающим объектом для обучения алгоритма машинного обучения (MLA), причем MLA использует модель, основанную на дерева решений, обладающую деревом решений, причем обучающий объект обрабатывается на узле данного уровня дерева решений, причем дерево решений обладает по меньшей мере одним предыдущим уровнем дерева решений, причем на по меньшей мере одном предыдущем уровне значение по меньшей мере одного категориального фактора преобразовано в свое предыдущее числовое представление для по меньшей мере одного предыдущего уровня дерева решений. Алгоритм машинного обучения выполняется электронным устройством для прогнозирования объекта фазы использования. Способ включает в себя: получение доступа со стороны постоянного машиночитаемого носителя системы машинного обучения, к набору обучающих объектов, причем каждый обучающий объект из набора обучающих объектов содержит документ и индикатор события, связанный с документом, причем каждый документ связан с категориальным фактором; создание числового представления значения категориального фактора путем: извлечения предыдущего числового представления по меньшей мере одного значения категориального фактора для данного объекта из набора обучающих объектов на по меньшей мере одном предыдущем уровне дерева решений; создание, для каждой комбинации из по меньшей мере одного предыдущего значения категориального фактора на по меньшей мере одном предыдущем уровне дерева решений и по меньшей мере некоторых значений категориальных факторов из набора обучающих объектов, текущего числового представления для данного уровня дерева решений, причем создание осуществляется в процессе создания дерева решений.

[119] В некоторых вариантах осуществления способа, набор обучающих объектов организован в упорядоченный список таким образом, что: для каждого данного обучающего объекта в упорядоченном списке обучающих объектов существует по меньшей мере один из: (i) предыдущий обучающий объект, который находится до данного обучающего объекта и (ii) последующий обучающий объект, который находится после данного обучающего объекта, и при этом по меньшей мере некоторые из значений категориальных факторов являются значениями категориальных факторов, которые связаны с обучающими объектами, находящимися раньше в упорядоченном списке обучающих объектов.

[120] В некоторых вариантах осуществления способа, создание выполняется только для тех предыдущих значений категориальных факторов, которые были созданы по меньшей мере на один уровень раньше в дереве решений.

[121] В некоторых вариантах осуществления способа, создание выполняется только для тех предыдущих значений категориальных факторов, которые были созданы по меньшей мере на один уровень раньше в дереве решений и по меньшей мере на предыдущей итерации дерева решений.

[122] В некоторых вариантах осуществления способа, индикатор события обладает заранее определенным значением, и это заранее определенное значение является одним из положительного результата или отрицательного результата.

[123] В некоторых вариантах осуществления способа, способ далее включает в себя организацию набора обучающих объектов в упорядоченный список обучающих объектов.

[124] В некоторых вариантах осуществления способа, организация обучающих объектов в упорядоченный список обучающих объектов выполняется в момент времени до создания числового значения.

[125] В некоторых вариантах осуществления способа, организация набора обучающих объектов в упорядоченный список обучающих объектов включает в себя организацию множества наборов упорядоченных списков, и в котором способ далее включает в себя, до этапа создания числового значения, выбор одного из множества наборов из упорядоченных списков.

[126] В некоторых вариантах осуществления способа, обучающие объекты связаны с присущим им временным порядком, и причем организация набора обучающих объектов в упорядоченный список, и причем организация набора обучающих объектов в упорядоченный список обучающих объектов включает в себя организацию обучающих объектов в соответствии с временным порядком.

[127] В некоторых вариантах осуществления способа, обучающие объекты не связаны с присущим им временным порядком, и причем организация набора обучающих объектов в упорядоченный список, и причем организация набора обучающих объектов в упорядоченный список обучающих объектов включает в себя организацию обучающих объектов в соответствии заранее определенным правилом.

[128] В некоторых вариантах осуществления способа, обучающие объекты не связаны с присущим им временным порядком, и причем организация набора обучающих объектов в упорядоченный список обучающих объектов включает в себя создание случайного порядка обучающих объектов, который будет использован как упорядоченный список.

[129] Еще одним объектом настоящей технологии является сервер, который выполнен с возможностью выполнять алгоритм машинного обучения, который основан на прогностической модели дерева решений на основе дерева решений, дерево решений выполнено с возможностью обрабатывать значение категориального фактора путем преобразования его в его числовое представление, категориальный фактор связан с обучающим объектом, используемым для обучения алгоритма машинного обучения, обучающий объект обрабатывается в узле данного уровня дерева решений, дерево решений обладает по меньшей мере одним предыдущим уровнем дерева решений, по меньшей мере один предыдущий уровень обладает по меньшей мере одним предыдущим обучающим объектом, который обладает по меньшей мере одним значением категориального фактора, которое было преобразовано в свое предыдущее числовое представление по меньшей мере для одного предыдущего уровня дерева решений. Сервер включает в себя: постоянный машиночитаемый носитель; процессор, соединенный с постоянным машиночитаемым носителем, причем процессор выполнен с возможностью осуществлять: получение доступа со стороны постоянного машиночитаемого носителя системы машинного обучения, к набору обучающих объектов, причем каждый обучающий объект из набора обучающих объектов содержит документ и индикатор события, связанный с документом, причем каждый документ связан с категориальным фактором; создание числового представления значения категориального фактора путем: извлечения предыдущего числового представления по меньшей мере одного значения категориального фактора для данного объекта из набора обучающих объектов на по меньшей мере одном предыдущем уровне дерева решений; создание, для каждой комбинации из по меньшей мере одного предыдущего значения категориального фактора на по меньшей мере одном предыдущем уровне дерева решений и по меньшей мере некоторых значений категориальных факторов из набора обучающих объектов, текущего числового представления для данного уровня дерева решений, причем создание осуществляется в процессе создания дерева решений.

[130] В некоторых вариантах осуществления сервера, набор обучающих объектов организован в упорядоченный список таким образом, что: для каждого данного обучающего объекта в упорядоченном списке обучающих объектов существует по меньшей мере один из: (i) предыдущий обучающий объект, который находится до данного обучающего объекта и (ii) последующий обучающий объект, который находится после данного обучающего объекта, и при этом по меньшей мере некоторые из значений категориальных факторов являются значениями категориальных факторов, которые связаны с обучающими объектами, находящимися раньше в упорядоченном списке обучающих объектов.

[131] В некоторых вариантах осуществления сервера, для создания числового представления значений категориальных факторов, процессор выполнен с возможностью выполнять создание только для тех предыдущих значений категориальных факторов, которые были созданы по меньшей мере на один уровень раньше в дереве решений.

[132] В некоторых вариантах осуществления сервера, для создания числового представления значения категориальных факторов, процессор выполнен с возможностью выполнять создание только для тех предыдущих значений категориальных факторов, которые были созданы по меньшей мере на один уровень раньше в дереве решений и по меньшей мере на предыдущей итерации дерева решений.

[133] В некоторых вариантах осуществления сервера, индикатор события обладает заранее определенным значением, и это заранее определенное значение является одним из положительного результата или отрицательного результата.

[134] В некоторых вариантах осуществления сервера, процессор выполнен с возможностью организовать набор обучающих объектов в упорядоченный список обучающих объектов.

[135] В некоторых вариантах осуществления сервера, для организации обучающих объектов в упорядоченный список обучающих объектов, процессор выполнен с возможностью осуществлять организацию набора обучающих объектов в упорядоченный список обучающих объектов выполняется в момент времени до этапа создания числового значения.

[136] В некоторых вариантах осуществления сервера, для организации обучающих объектов в упорядоченный список обучающих объектов, процессор выполнен с возможностью осуществлять организацию множества из набора упорядоченным списков, и в котором способ далее включает в себя, до этапа создания числового значения, выбор данного одного из набора упорядоченного списка.

[137] В некоторых вариантах осуществления сервера, обучающие объекты связаны с присущим им временным порядком, и причем для организации набора обучающих объектов в упорядоченный список, процессор выполнен с возможностью осуществлять организацию набора обучающих объектов в упорядоченный список обучающих объектов для организации обучающих объектов в соответствии с временным порядком.

[138] В некоторых вариантах осуществления сервера, обучающие объекты связаны с присущим им временным порядком, и причем для организации набора обучающих объектов в упорядоченный список, процессор выполнен с возможностью осуществлять организацию набора обучающих объектов в упорядоченный список обучающих объектов для организации обучающих объектов в соответствии с заранее определенным правилом.

[139] В некоторых вариантах осуществления сервера, обучающие объекты не связаны с присущим им временным порядком, и причем для организации набора обучающих объектов в упорядоченный список обучающих объектов процессор выполнен с возможностью осуществлять создание случайного порядка обучающих объектов, который будет использован как упорядоченный список.

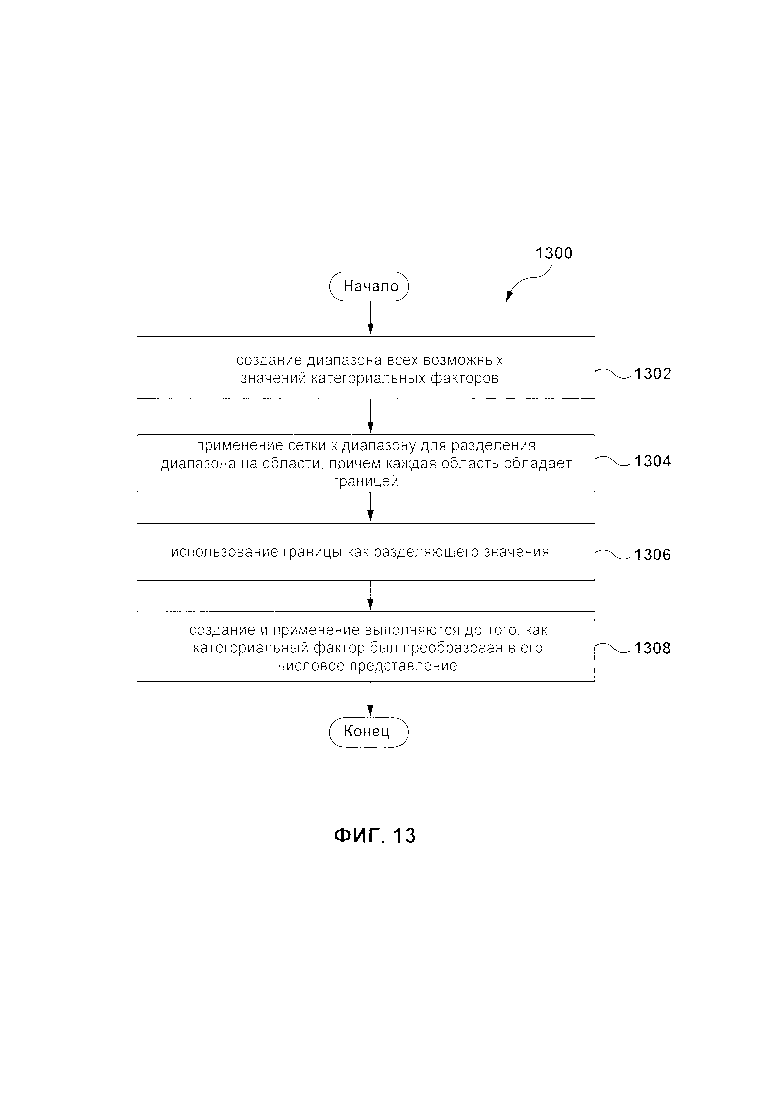

[140] Еще одним объектом настоящей технологии является способ создания разделяющего значения для узла дерева решений в модели дерева решений, используемой алгоритмом машинного обучения (MLA), разделяющее значение относится к узлу на конкретном уровне дерева решений, узел для классификации объекта, обладающего значением категориального фактора, которое будет преобразовано в свое числовое представление, разделение инициирует классификацию объекта в один из дочерних узлов на основе числового значения и разделяющего значения, алгоритм машинного обучения выполняется электронным устройством для прогнозирования значения для объекта фазы использования. Способ включает в себя: создание диапазона всех возможных значений категориальных факторов; применение сетки к диапазону для разделения диапазона на области, причем каждая область обладает границами; использование границ в качестве разделяющего значения; создание и применение осуществляются до того как значение категориального фактора преобразуется в его числовое представление.

[141] В некоторых вариантах осуществления способа, сетка обладает заранее определенным форматом.

[142] В некоторых вариантах осуществления способа, сетка является сеткой с постоянным интервалом.

[143] В некоторых вариантах осуществления способа, сетка является сеткой с непостоянным интервалом.

[144] В некоторых вариантах осуществления способа, диапазон находится между нулем и единицей.

[145] В некоторых вариантах осуществления способа, числовые представления значений категориальных факторов вычисляются с помощью Rconstant, и в котором диапазон находится между Rconstant и 1+(Rconstant).

[146] В некоторых вариантах осуществления способа, способ далее включает в себя, во время фазы использования, для данного значения счетчика, представляющего собой категориальный фактор, определение того, в какую часть, определенную сеткой, попадает данное значение счетчика, и использование соответствующих границ как значений для разделения.

[147] В некоторых вариантах осуществления способа, использование границы как разделяющего значения выполняется для каждого уровня дерева решений и причем способ далее включает в себя, после обучения данного уровня дерева решений, новое вычисление разделяющего значения.

[148] В некоторых вариантах осуществления способа, использование границы как разделяющего значения выполняется для каждого дерева решений и причем способ далее включает в себя, после обучения данного дерева решений, новое вычисление разделяющего значения.

[149] В некоторых вариантах осуществления способа, использование границы как разделяющего значения выполняется во время этапа обучения MLA, и в котором обучение MLA во время текущей итерации одного из: (i) данного уровня дерева решений и (ii) данной итерации дерева решений, включает в себя: выбор лучшего значения фактора, которое будет находиться на данной итерации, и лучшего значения разделения, связанного с ним.

[150] Еще одним объектом настоящей технологии является сервер, который выполнен с возможностью выполнять MLA, MLA основан на дереве решений, относящегося к модели дерева решений, дерево решений обладает узлом, узел обладает разделяющим значением, узел представляет собой данный уровень дерева решений, узел используется для классификации объекта, обладающего категориальным фактором, которые будет преобразован в свое числовое представление значения, разделение используется для инициирования классификации объекта в один из дочерних узлов данного узла на основе числового значения и разделяющего значения. Сервер включает в себя: постоянный машиночитаемый носитель; процессор, соединенный с постоянным машиночитаемым носителем, причем процессор выполнен с возможностью осуществлять: создание диапазона всех возможных значений категориальных факторов; применение сетки к диапазону для разделения диапазона на области, причем каждая область обладает границами; использование границ в качестве разделяющего значения; создание и применение осуществляются до того как категориальный фактор преобразуется в его числовое представление.

[151] В некоторых вариантах осуществления сервера, сетка обладает заранее определенным форматом.

[152] В некоторых вариантах осуществления сервера, сетка является сеткой с постоянным интервалом.

[153] В некоторых вариантах осуществления сервера, сетка является сеткой с непостоянным интервалом.

[154] В некоторых вариантах осуществления сервера, диапазон находится между нулем и единицей.

[155] В некоторых вариантах осуществления сервера, числовое представление значения категориального фактора вычисляется с помощью Rconstant, и в котором диапазон находится между Rconstant и 1+(Rconstant).

[156] В некоторых вариантах осуществления сервера, процессор далее выполнен с возможностью, во время фазы использования, для данного значения счетчика, представляющего собой категориальный фактор, осуществлять определение того, в какую часть, определенную сеткой, попадает данное значение счетчика, и использование соответствующих границ как значений для разделения.

[157] В некоторых вариантах осуществления сервера, для использования границы как разделяющего значения, процессор выполнен с возможностью использовать границу как разделяющее значение для каждого уровня дерева решений, и причем процессор далее выполнен с возможностью, после обучения данного уровня дерева решений, осуществлять новое вычисление разделяющего значения.

[158] В некоторых вариантах осуществления сервера, для использования границы как разделяющего значения, процессор выполнен с возможностью использовать границу как разделяющее значение для каждой итерации дерева решений, и причем процессор далее выполнен с возможностью, после обучения данной итерации дерева решений, осуществлять новое вычисление разделяющего значения.

[159] В некоторых вариантах осуществления сервера, для использования границы как разделяющего значения, процессор выполнен с возможностью осуществлять использование границы как разделяющего значения во время этапа обучения MLA, и в котором обучение MLA во время текущей итерации одного из: (i) данного уровня дерева решений и (ii) данной итерации дерева решений, процессор дополнительно выполнен с возможностью осуществлять: выбор лучшего значения фактора, которое будет находиться на данной итерации, и лучшего значения разделения, связанного с ним.

[160] В контексте настоящего описания, если четко не указано иное, "электронное устройство", "пользовательское устройство", "сервер", "удаленный сервер" и "компьютерная система" подразумевают под собой аппаратное и/или системное обеспечение, подходящее к решению соответствующей задачи. Таким образом, некоторые неограничивающие примеры аппаратного и/или программного обеспечения включают в себя компьютеры (серверы, настольные компьютеры, ноутбуки, нетбуки и так далее), смартфоны, планшеты, сетевое оборудование (маршрутизаторы, коммутаторы, шлюзы и так далее) и/или их комбинацию.

[161] В контексте настоящего описания, если четко не указано иное, «машиночитаемый носитель» и «память» подразумевает под собой носитель абсолютно любого типа и характера, и примеры, не ограничивающие настоящую технологию, включают в себя ОЗУ, ПЗУ, диски (компакт диски, DVD-диски, дискеты, жесткие диски и т.д.), USB-ключи, флеш-карты, твердотельные накопители и накопители на магнитной ленте.

[162] В контексте настоящего описания, если четко не указано иное, «указание» информационного элемента может представлять собой сам информационный элемент или указатель, отсылку, ссылку или другой косвенный способ, позволяющий получателю указания найти сеть, память, базу данных или другой машиночитаемый носитель, из которого может быть извлечен информационный элемент. Например, указание на документ может включать в себя сам документ (т.е. его содержимое), или же оно может являться уникальным дескриптором документа, идентифицирующим файл по отношению к конкретной файловой системе, или каким-то другими средствами передавать получателю указание на сетевую папку, адрес памяти, таблицу в базе данных или другое место, в котором можно получить доступ к файлу. Как будет понятно специалистам в данной области техники, степень точности, необходимая для такого указания, зависит от степени первичного понимания того, как должна быть интерпретирована информация, которой обмениваются получатель и отправитель указателя. Например, если до установления связи между отправителем и получателем понятно, что признак информационного элемента принимает вид ключа базы данных для записи в конкретной таблице заранее установленной базы данных, содержащей информационный элемент, то передача ключа базы данных - это все, что необходимо для эффективной передачи информационного элемента получателю, несмотря на то, что сам по себе информационный элемент не передавался между отправителем и получателем указания.

[163] В контексте настоящего описания, если конкретно не указано иное, слова «первый», «второй», «третий» и и т.д. используются в виде прилагательных исключительно для того, чтобы отличать существительные, к которым они относятся, друг от друга, а не для целей описания какой-либо конкретной взаимосвязи между этими существительными. Так, например, следует иметь в виду, что использование терминов «первый сервер» и «третий сервер» не подразумевает какого-либо порядка, отнесения к определенному типу, хронологии, иерархии или ранжирования (например) серверов/между серверами, равно как и их использование (само по себе) не предполагает, что некий "второй сервер" обязательно должен существовать в той или иной ситуации. В дальнейшем, как указано здесь в других контекстах, упоминание «первого» элемента и «второго» элемента не исключает возможности того, что это один и тот же фактический реальный элемент. Так, например, в некоторых случаях, «первый» сервер и «второй» сервер могут являться одним и тем же программным и/или аппаратным обеспечением, а в других случаях они могут являться разным программным и/или аппаратным обеспечением.

[164] Каждый вариант осуществления настоящей технологии преследует по меньшей мере одну из вышеупомянутых целей и/или объектов, но наличие всех не является обязательным. Следует иметь в виду, что некоторые объекты данной технологии, полученные в результате попыток достичь вышеупомянутой цели, могут не удовлетворять этой цели и/или могут удовлетворять другим целям, отдельно не указанным здесь. Дополнительные и/или альтернативные характеристики, аспекты и преимущества вариантов осуществления настоящей технологии станут очевидными из последующего описания, прилагаемых чертежей и прилагаемой формулы изобретения.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

[165] Для лучшего понимания настоящей технологии, а также других ее аспектов и характерных черт, сделана ссылка на следующее описание, которое должно использоваться в сочетании с прилагаемыми чертежами, где:

[166] На Фиг. 1 представлен неограничивающий пример упорядоченного списка обучающих объектов, причем обучающие объекты связаны с категориальными факторами, упорядоченный список обучающих объектов осуществлен в соответствии с неограничивающими вариантами осуществления настоящей технологии.

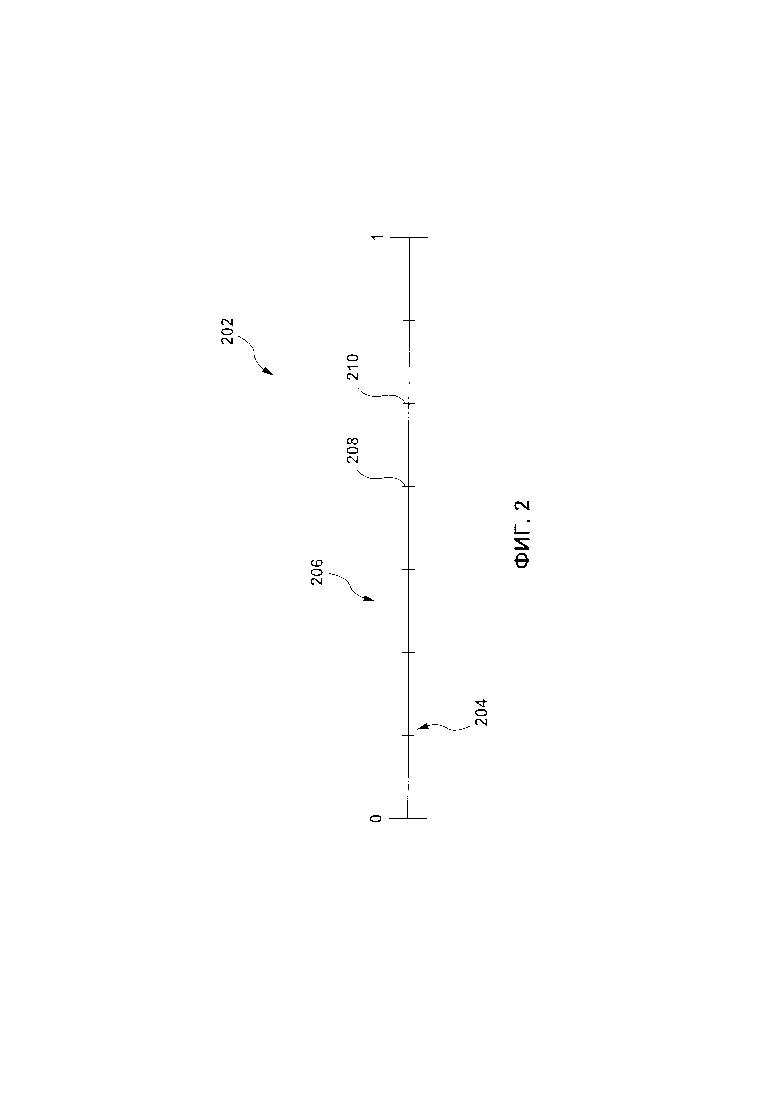

[167] На Фиг. 2 представлен диапазон всех возможных значений для разделений (для данного счетчика, который был создан на основе данного категориального фактора), и заранее определенная сетка применяется к диапазону, причем и диапазон и применяемая сетка реализованы в соответствии с неограничивающими вариантами осуществления настоящей технологии.

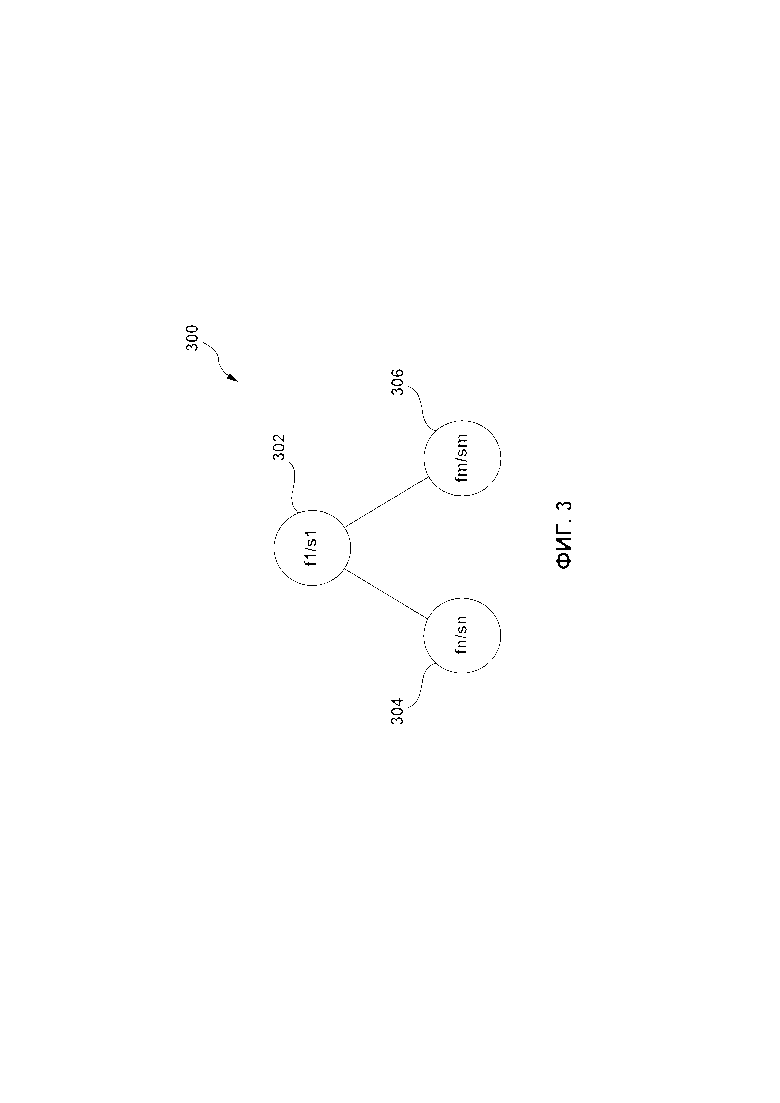

[168] На Фиг. 3 представлена схема части прото-дерева с одним узлом первого уровня и двумя узлами второго уровня, созданными в соответствии с другими вариантами осуществления настоящей технологии.

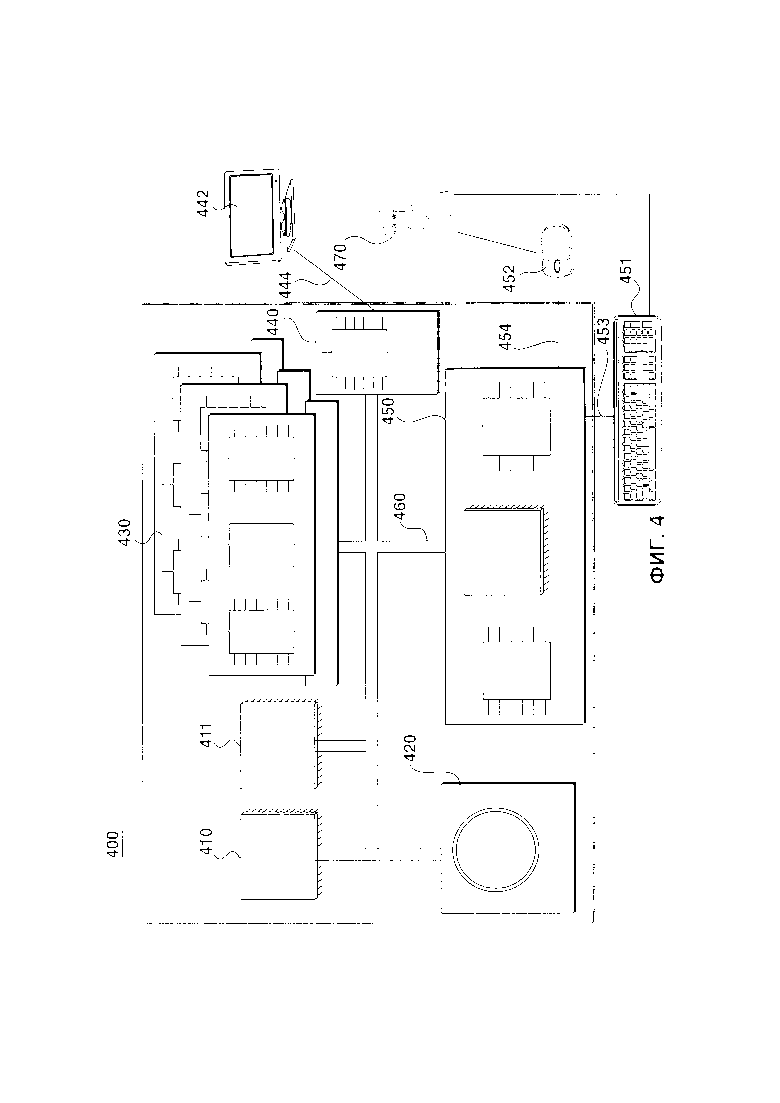

[169] На Фиг. 4 представлена диаграмма компьютерной системы, которая подходит для реализации настоящей технологии, и/или которая используется в сочетании с вариантами осуществления настоящей технологи.

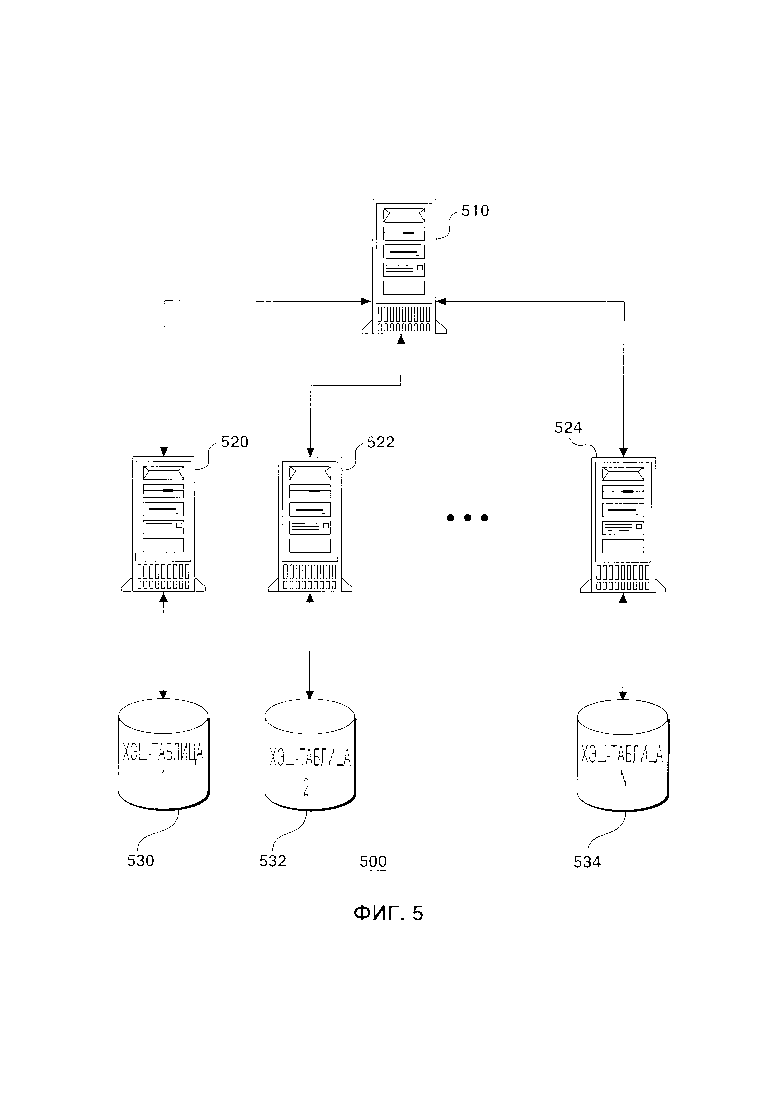

[170] На Фиг. 5 представлена схема сетевой вычислительной среды в соответствии с вариантом осуществления настоящей технологии;

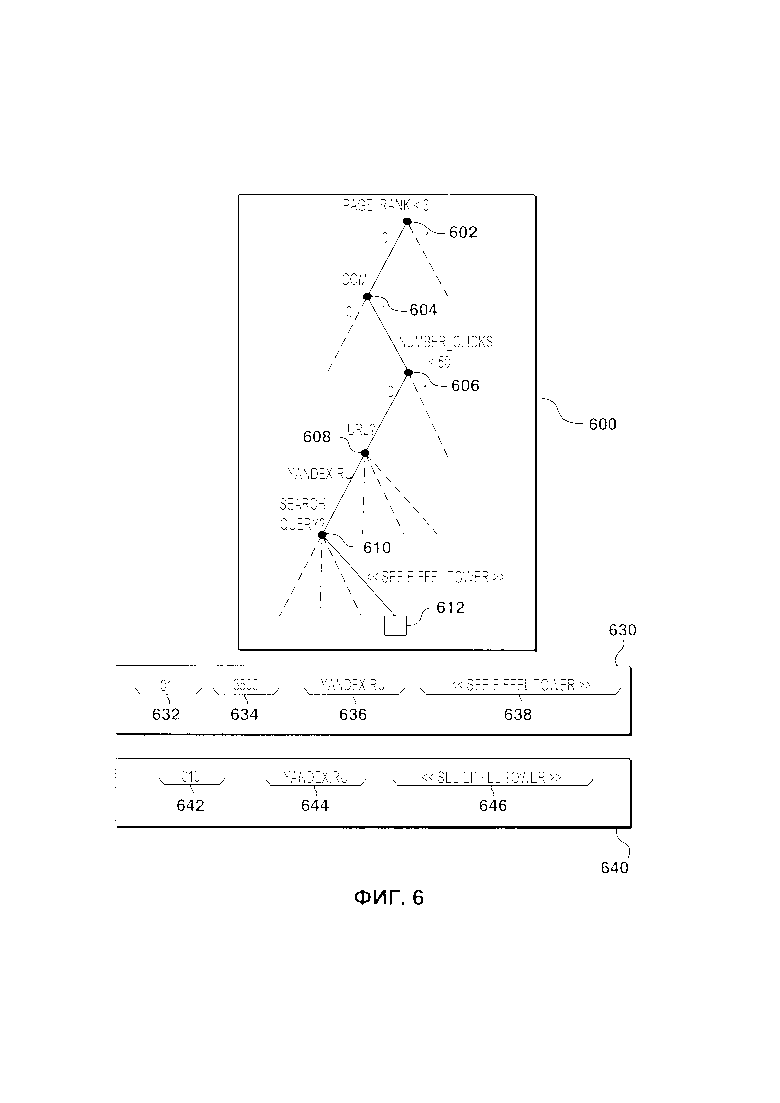

[171] На Фиг. 6 представлена схема, показывающая древовидную модель частично, и два примера векторов признаков в соответствии с вариантом осуществления настоящей технологии.

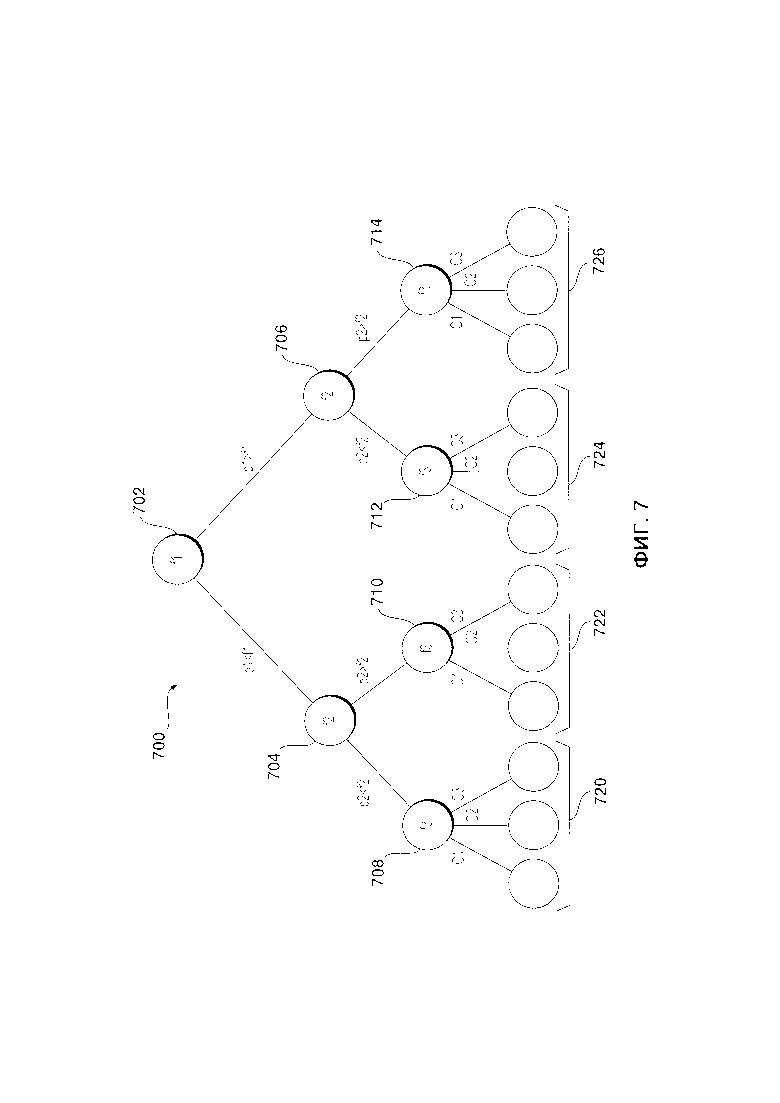

[172] На Фиг. 7 представлена схема полной древовидной модели в соответствии с вариантом осуществления настоящей технологии.

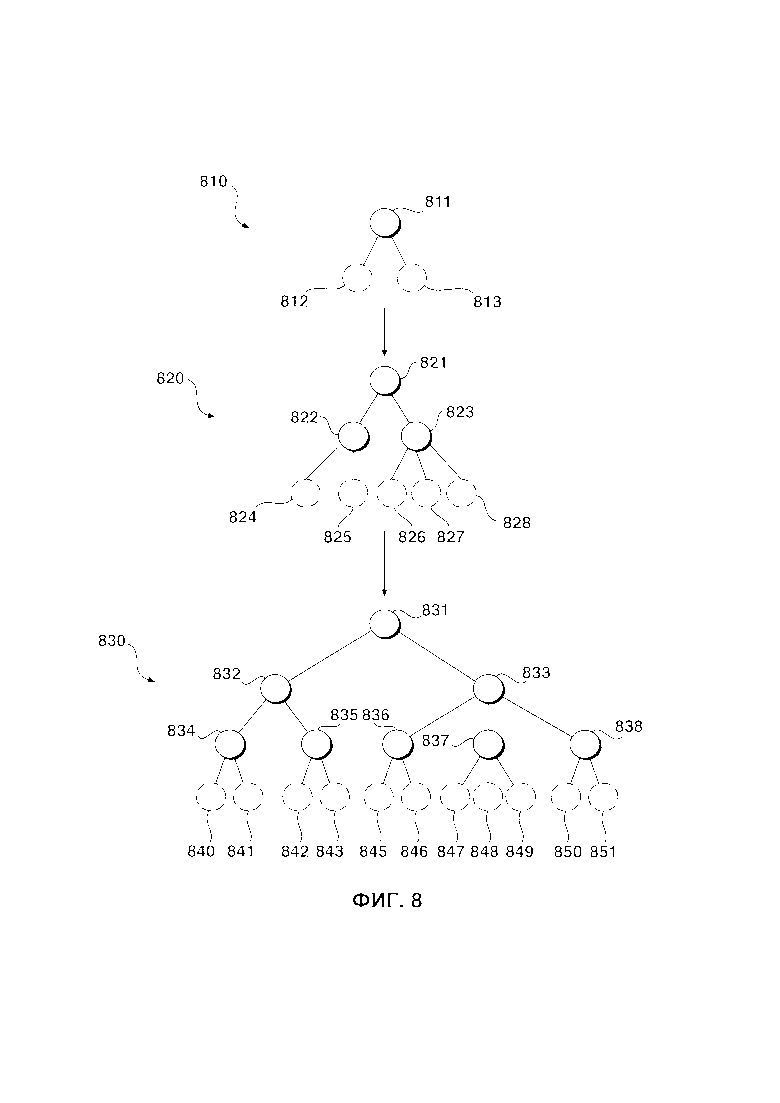

[173] На Фиг. 8 представлена схема, показывающая части предварительной древовидной модели и полную предварительную древовидную модель в соответствии с вариантом осуществления настоящей технологии.

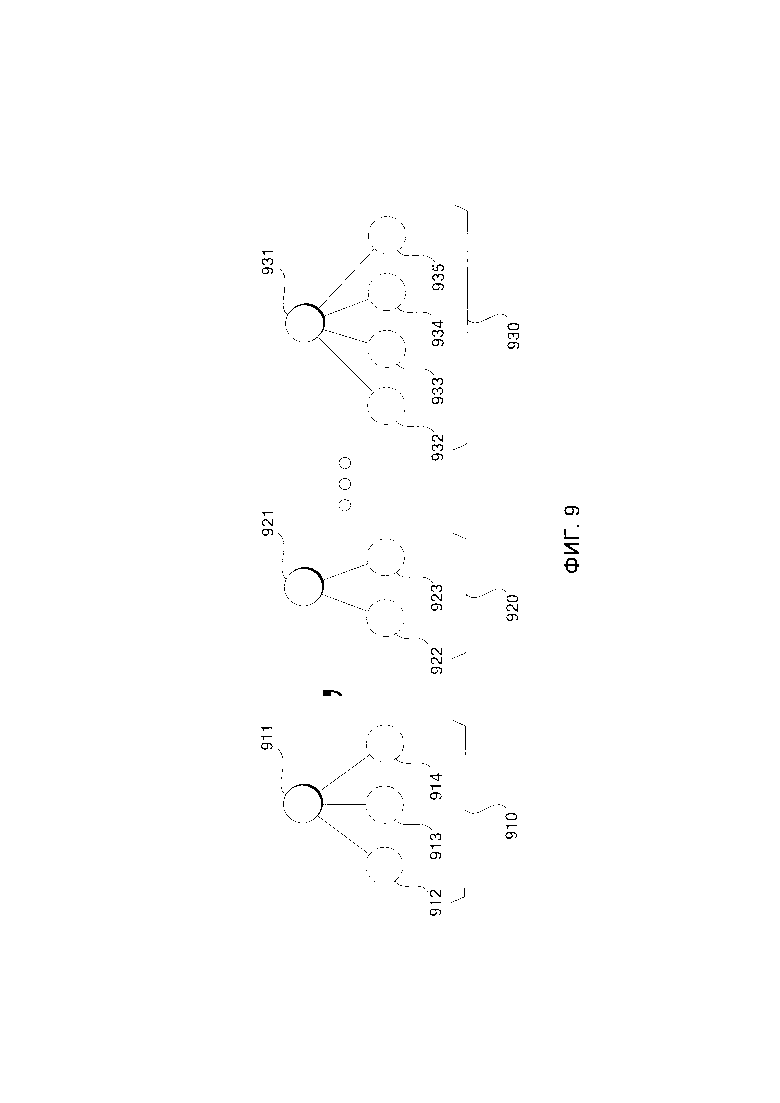

[174] На Фиг. 9 представлена схема, показывающая части предварительной древовидной модели в соответствии с другим вариантом осуществления настоящей технологии.

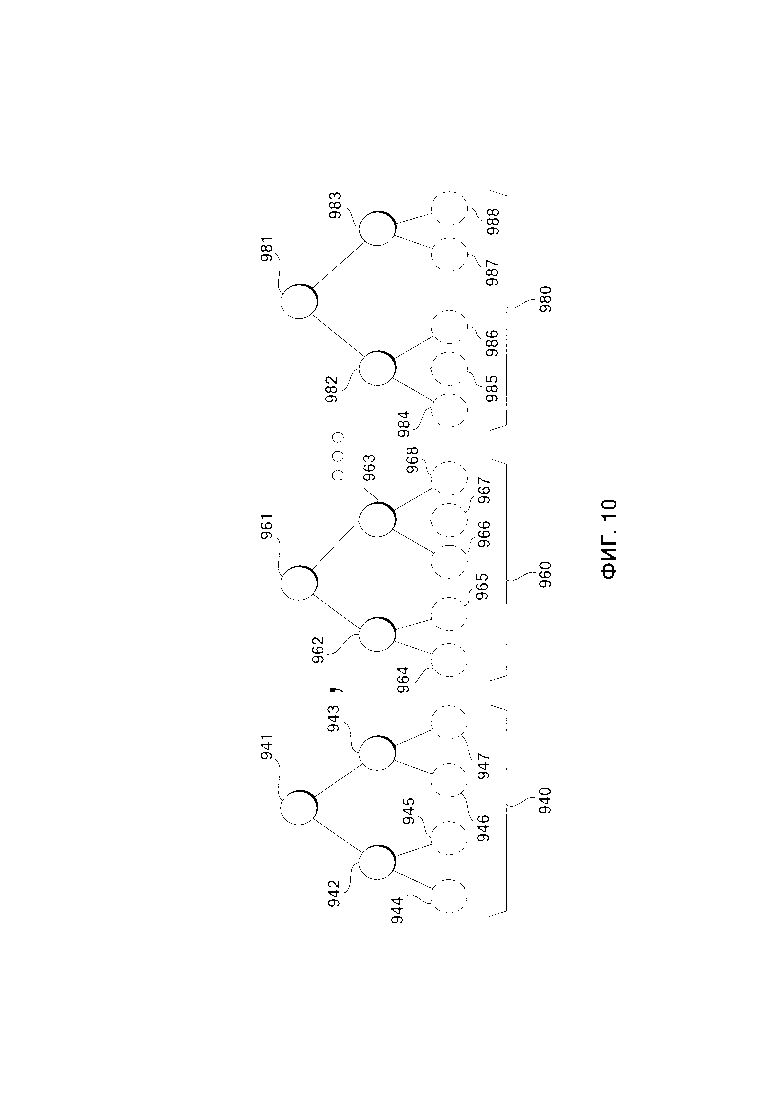

[175] На Фиг. 10 представлена схема полной предварительной древовидной модели в соответствии с другим вариантом осуществления настоящей технологии.

[176] На Фиг. 11 представлена схема части прото-дерева с одним узлом первого уровня и двумя узлами второго уровня, а также упорядоченный список обучающих объектов, созданные в соответствии с другими вариантами осуществления настоящей технологии.

[177] На Фиг. 12 представлена схема, показывающая первый компьютерный способ, являющийся вариантом осуществления настоящей технологии;

[178] На Фиг. 13 представлена схема, показывающая второй компьютерный способ, являющийся вариантом осуществления настоящей технологии.

[179] На Фиг. 14 представлена схема набора моделей и связанных соответствующих упорядоченных наборов обучающих объектов, используемых для обучения алгоритма машинного обучения в соответствии с некоторыми неограничивающими вариантами осуществления настоящей технологии.

[180] Также следует отметить, что чертежи выполнены не в масштабе, если не специально указано иное.

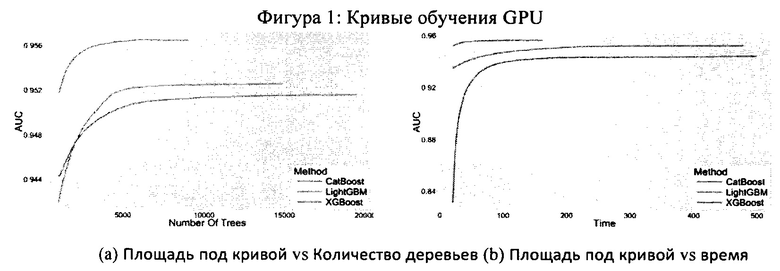

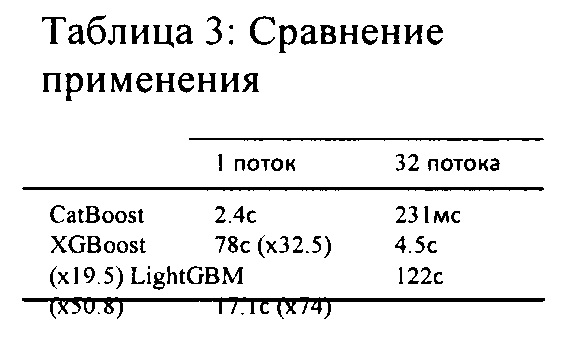

[181] В конце настоящего описания предусмотрено приложение А. Приложение А включает в себя копию еще не опубликованной статьи под заголовком "CatBoost: градиентный бустинг с использованием категориальных факторов". Статья предоставляет дополнительную информацию об известном уровне техники, описание реализации неограничивающих вариантов осуществления настоящей технологии, а также некоторые дополнительные примеры. Эта статья включена здесь в полном объеме посредством ссылки для всех юрисдикции, допускающих включение в описание сведений посредством ссылки.

ОСУЩЕСТВЛЕНИЕ