ОБЛАСТЬ ТЕХНИКИ

Настоящий документ относится к обработке изображений и оптическому распознаванию символов и, в частности, к способам и системам, которые определяют и характеризуют содержащие документы фрагменты изображений таким образом, чтобы к содержащим документы фрагментам изображений можно было применить методы оптического распознавания символов для извлечения информации из полученных изображений документов.

УРОВЕНЬ ТЕХНИКИ

Печатные документы на естественном языке по-прежнему представляют собой широко используемое средство связи между отдельными лицами, в организациях, для распространения информации среди потребителей информации, а также для операций обмена информацией различных видов. С появлением повсеместно используемых мощных вычислительных ресурсов, включая персональные вычислительные ресурсы, реализованные в смартфонах, планшетах, ноутбуках и персональных компьютерах, а также с распространением более мощных вычислительных ресурсов облачных вычислительных сервисов, центров обработки данных и корпоративных серверов организаций и предприятий, шифрование и обмен информацией на естественном языке все более часто выполняются в виде электронных документов. В отличие от печатных документов, которые по своей сути представляют собой изображения, электронные документы содержат последовательности цифровых кодов символов и знаков естественного языка. Поскольку электронные документы имеют перед печатными документами преимущества по стоимости, возможностям передачи и распространения, простоте редактирования и изменения, а также по надежности хранения, за последние 50 лет развилась целая отрасль, поддерживающая способы и системы преобразования печатных документов в электронные. Вычислительные способы и системы оптического распознавания символов совместно с электронными сканерами являются надежными и экономичными средствами получения изображений печатных документов и компьютерной обработки получаемых цифровых изображений содержащих текст документов с целью создания электронных документов, соответствующих печатным.

Раньше электронные сканеры представляли собой крупногабаритные настольные или напольные электронные устройства. Однако с появлением смартфонов, оснащенных камерами, а также других мобильных устройств формирования изображения с процессорным управлением появилась возможность получения цифровых изображений содержащих текст документов с помощью широкого диапазона различных типов широко распространенных переносных устройств, включая смартфоны, недорогие цифровые камеры, недорогие камеры видеонаблюдения, а также устройства получения изображений, встроенные в мобильные вычислительные приборы, включая планшетные компьютеры и ноутбуки. Цифровые изображения содержащих текст документов, создаваемые этими переносными устройствами и приборами, могут обрабатываться вычислительными системами оптического распознавания символов, в том числе приложениями оптического распознавания символов в смартфонах для создания соответствующих электронных документов.

К сожалению, создание изображений документов с помощью переносных устройств связано с повышенными уровнями шумов, оптическим смазом изображения, нестандартным положением и ориентацией устройства формирования изображения относительно документа, изображение которого требуется получить, мешающего освещения и эффектов контраста, вызванных неоднородными фонами, и других дефектов и недостатков содержащих текст цифровых изображений, полученных с помощью переносных устройств и приборов по сравнению со специализированными устройствами сканирования документов. Эти дефекты и недостатки могут значительно снизить производительность вычислительного оптического распознавания символов и значительно увеличить частоту ошибочного распознавания символов, а также привести к отказу способов и систем оптического распознавания символов при кодировании текста во всех или больших областях содержащих текст цифровых изображений. Таким образом, несмотря на то что переносные устройства и приборы получения изображений документов имеют значительные преимущества по стоимости и доступности для пользователя, им присущи недостатки, которые могут затруднить и исключить возможность создания электронных документов из содержащих текст цифровых изображений, полученных переносными устройствами и приборами. Кроме того, даже содержащие текст цифровые изображения, полученные с помощью стационарных систем формирования изображения, могут иметь дефекты и недостатки, которые могут привести к неудовлетворительным результатам применяемых позднее способов обработки изображений. По этой причине проектировщики и разработчики устройств, приборов для получения изображений и способов, систем оптического распознавания символов, а также пользователи устройств, приборов и систем оптического распознавания символов продолжают искать способы и системы для устранения дефектов и недостатков, присущих многим содержащим текст цифровым изображениям, включая содержащие текст цифровые изображения, полученные с помощью мобильных устройств, которые затрудняют дальнейшую вычислительную обработку содержащих текст цифровых изображений.

РАСКРЫТИЕ ИЗОБРЕТЕНИЯ

Настоящий документ относится к способам и подсистемам, которые выявляют и характеризуют содержащие документ фрагменты изображения в содержащем документ изображении. В одном варианте осуществления изобретения для каждого типа документа создается модель, представляющая собой набор признаков, которые извлекаются из набора изображений, о котором известно, что в нем содержится этот документ. С целью выявления и получения характеристик содержащего документ фрагмента изображения в изображении описанные в настоящем документе способы и подсистемы используются для извлечения признаков изображения, а затем для сопоставления признаков каждой модели из набора моделей с извлеченными признаками, чтобы выбрать модель, которая наилучшим образом соответствует извлеченным признакам. Затем содержащаяся в выбранной модели дополнительная информация используется для определения местоположения соответствующего документу фрагмента изображения, а также для обработки содержащего документ фрагмента изображения для коррекции различных искажений и дефектов с целью облегчения последующего извлечения данных из исправленного содержащего документ фрагмента изображения.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

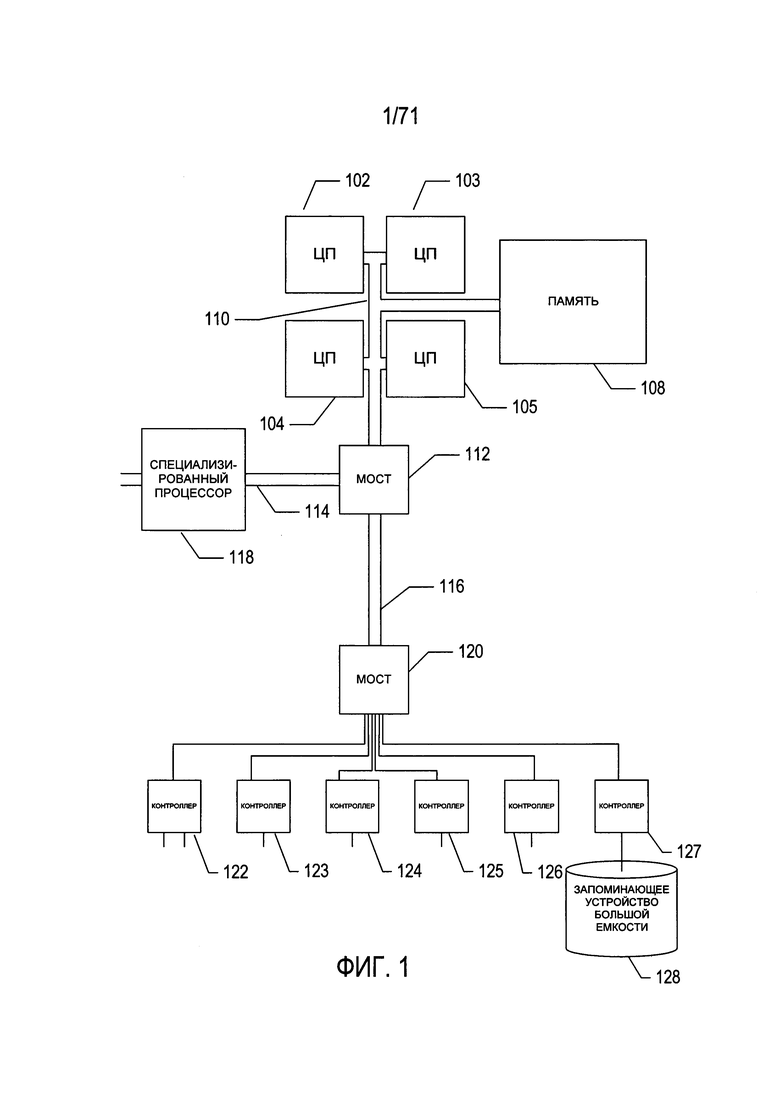

На Фиг. 1 представлена архитектурная схема высокого уровня вычислительной системы, например, вычислительной системы, в которой реализована раскрываемая в этом документе подсистема распознавания содержащих документ фрагментов изображения.

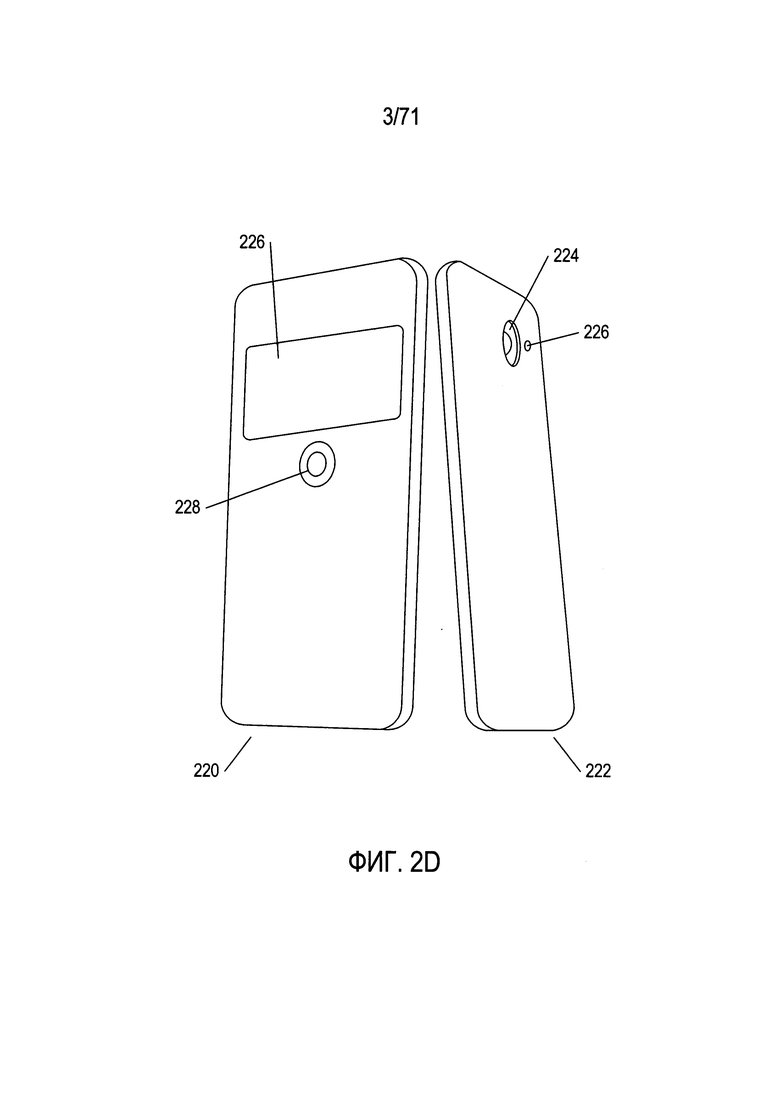

На Фиг. 2A-D показаны два типа переносных устройств, предназначенных для получения изображений.

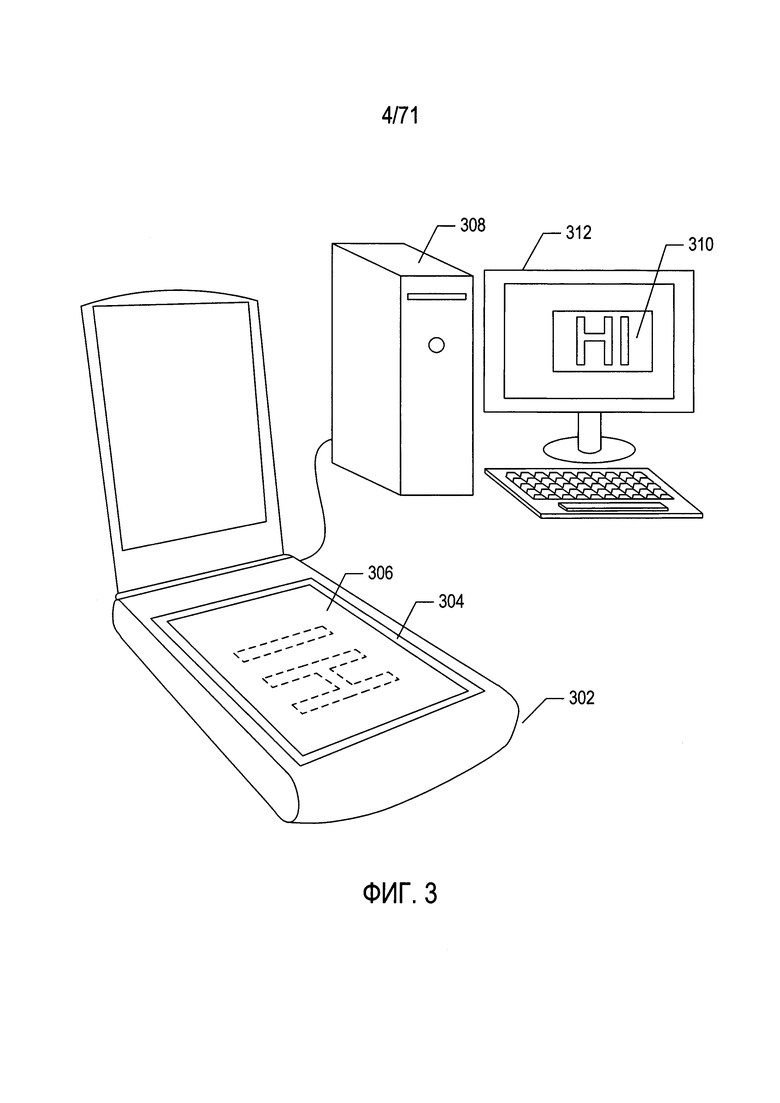

На Фиг. 3 показаны обычный настольный сканер и персональный компьютер, которые используются совместно для преобразования печатных документов в электронные документы, которые можно хранить в запоминающих устройствах и (или) в электронной памяти.

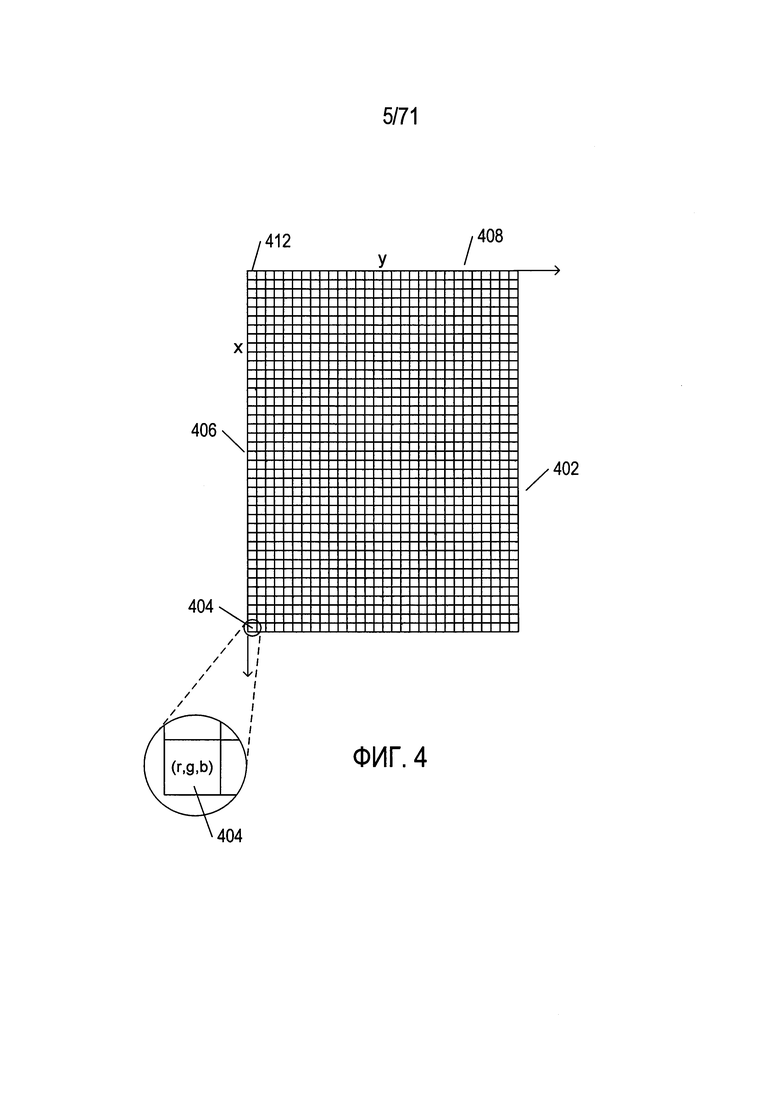

На Фиг. 4 показано типовое изображение с цифровым кодированием.

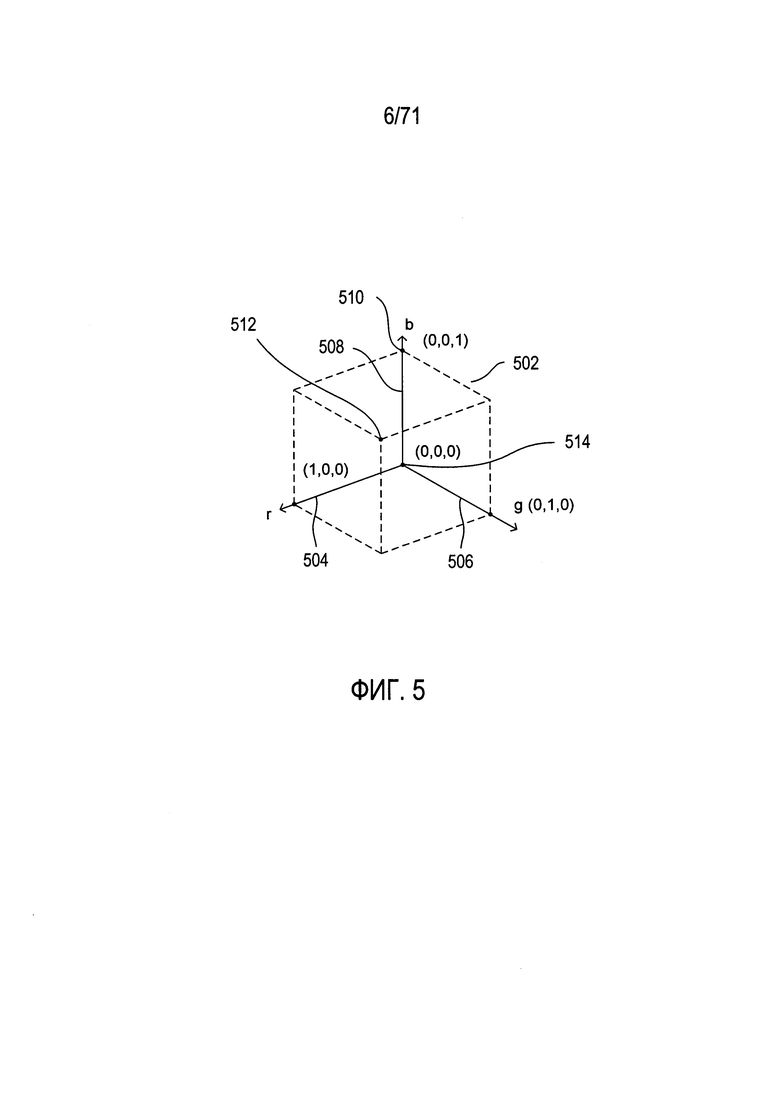

На Фиг. 5 показан один вариант цветовой модели RGB.

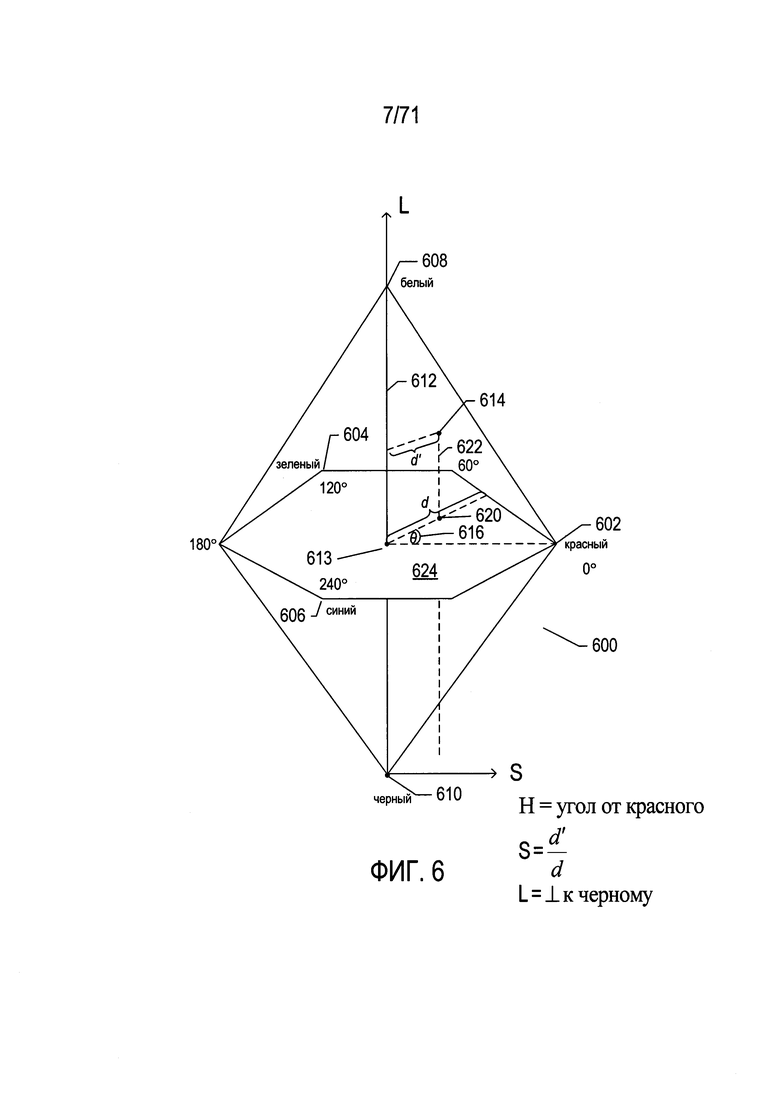

На Фиг. 6 показана другая цветовая модель «Оттенок-насыщенность-светлота» (HSL).

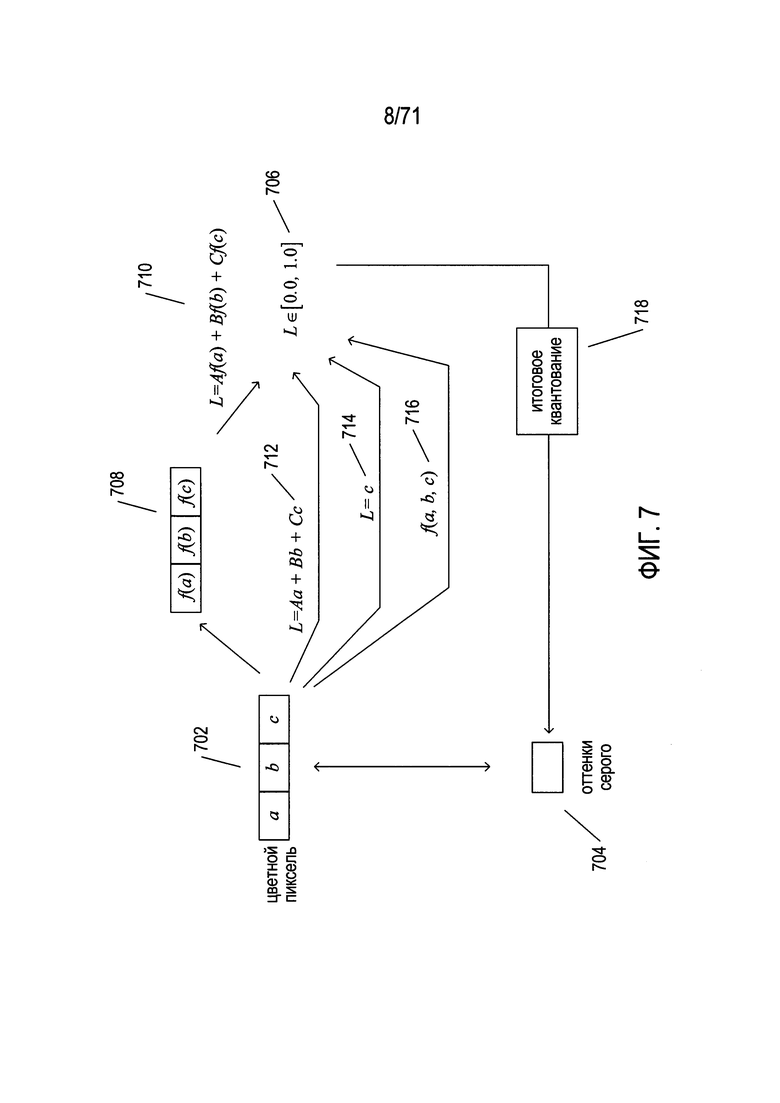

На Фиг. 7 показано формирование полутонового или бинаризованного изображения из цветного изображения.

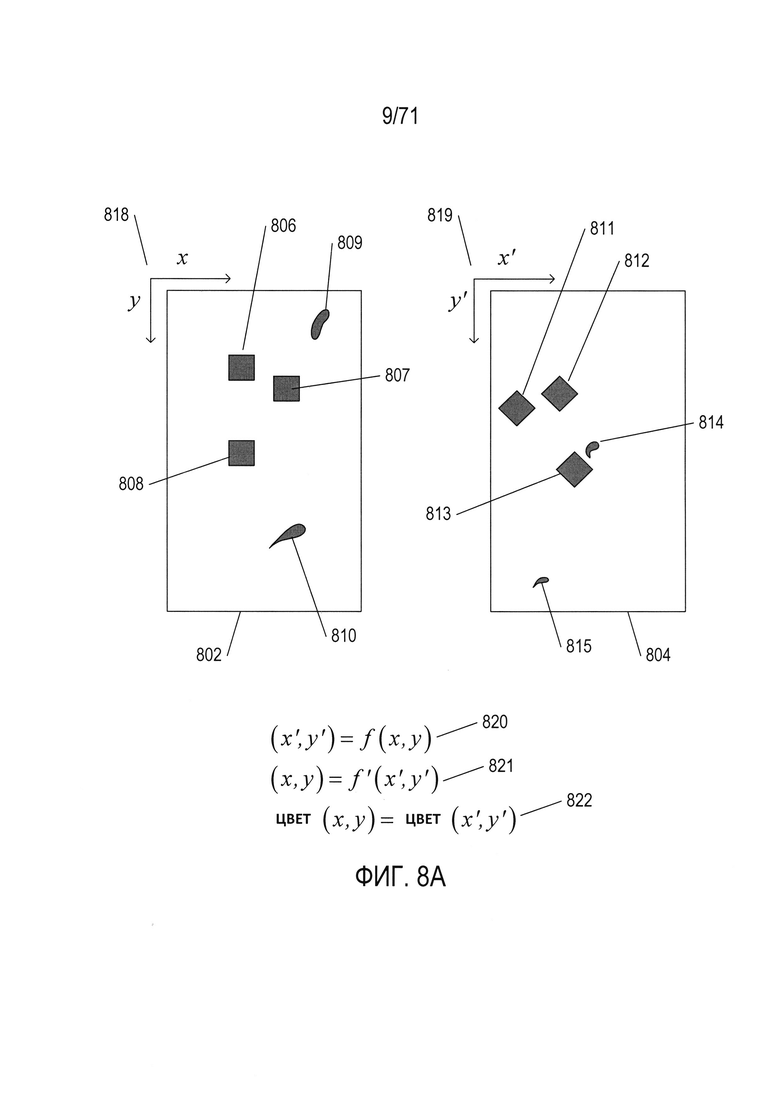

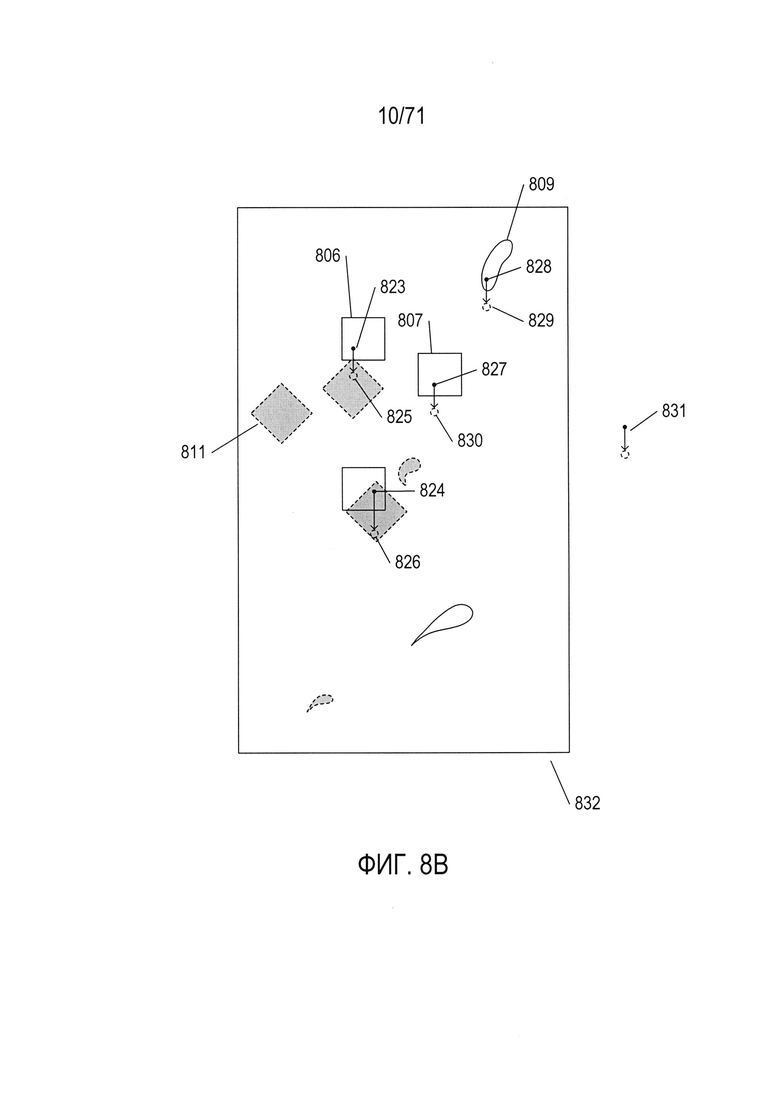

На Фиг. 8A-N показаны модели, которые описывают преобразования первого изображения документа во второе изображение документа и способ выбора конкретной модели из множества моделей-кандидатов для описания конкретного преобразования для двух соответствующих изображений документа.

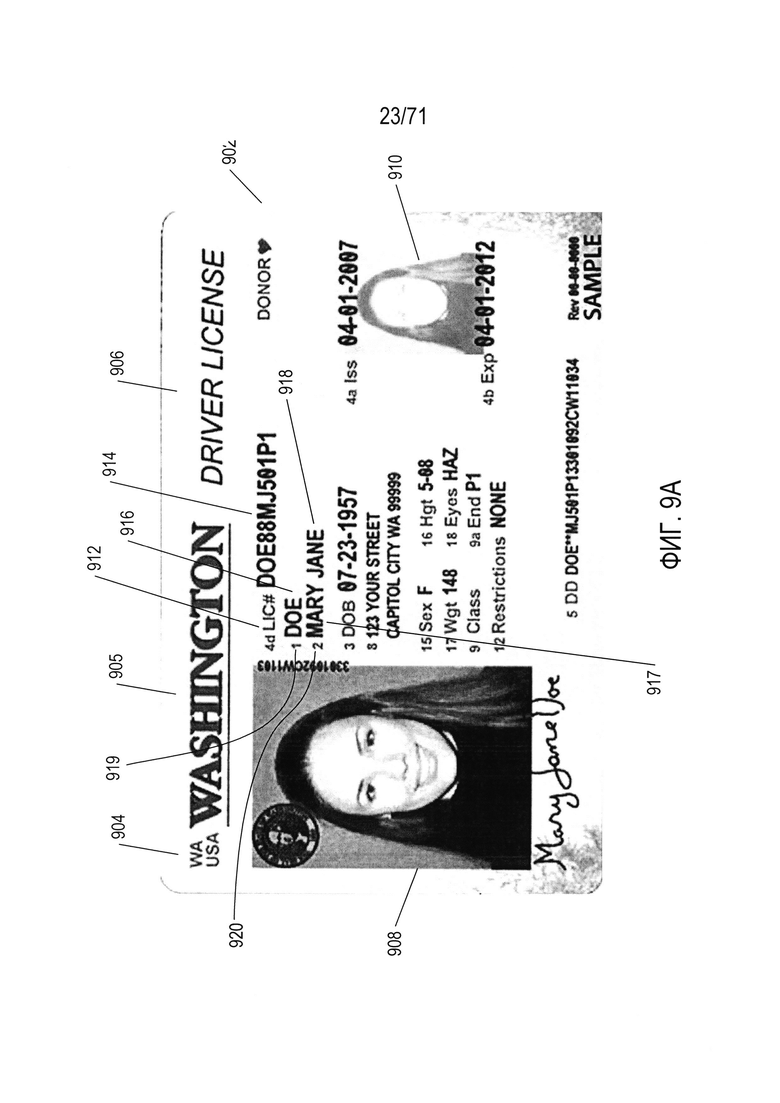

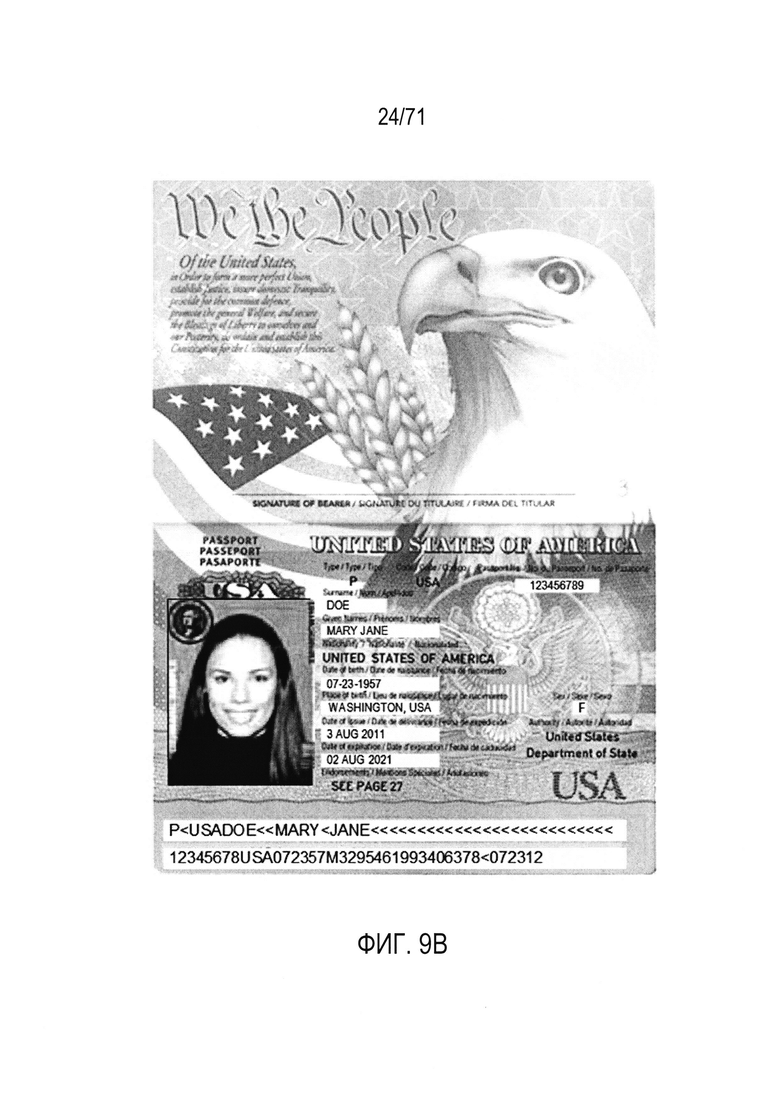

На Фиг. 9А-В показаны два документа, используемые в качестве примеров при обсуждении раскрываемых в настоящем описании способов и подсистем.

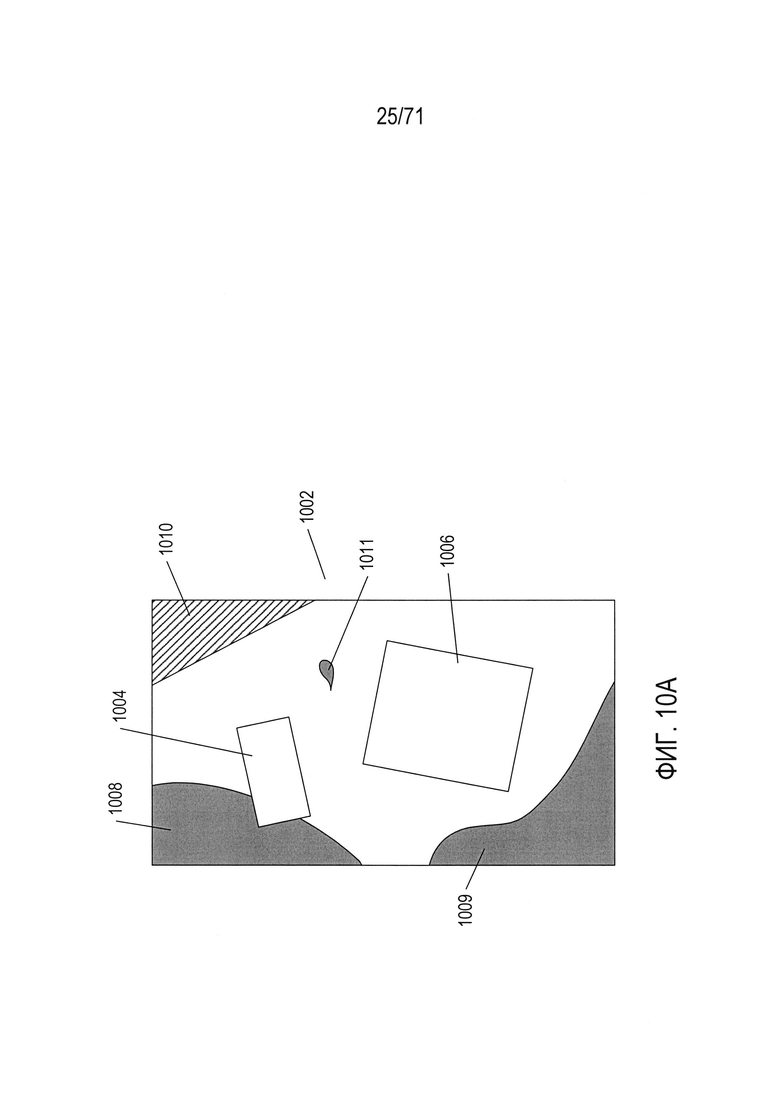

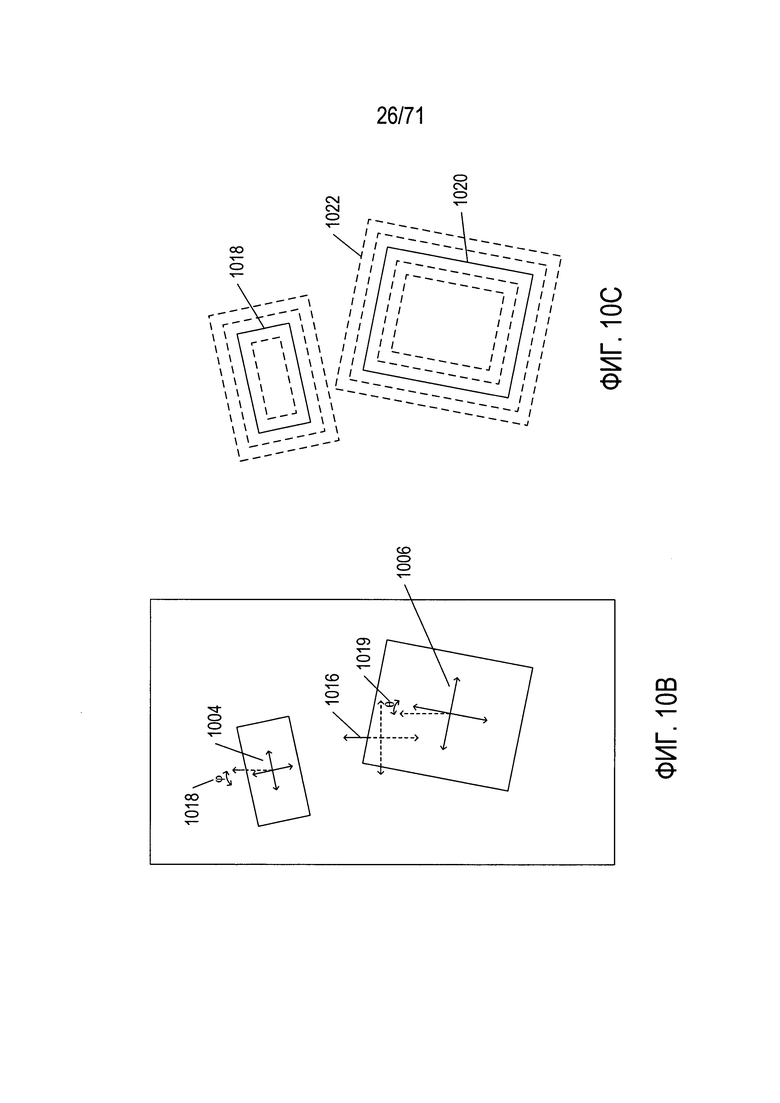

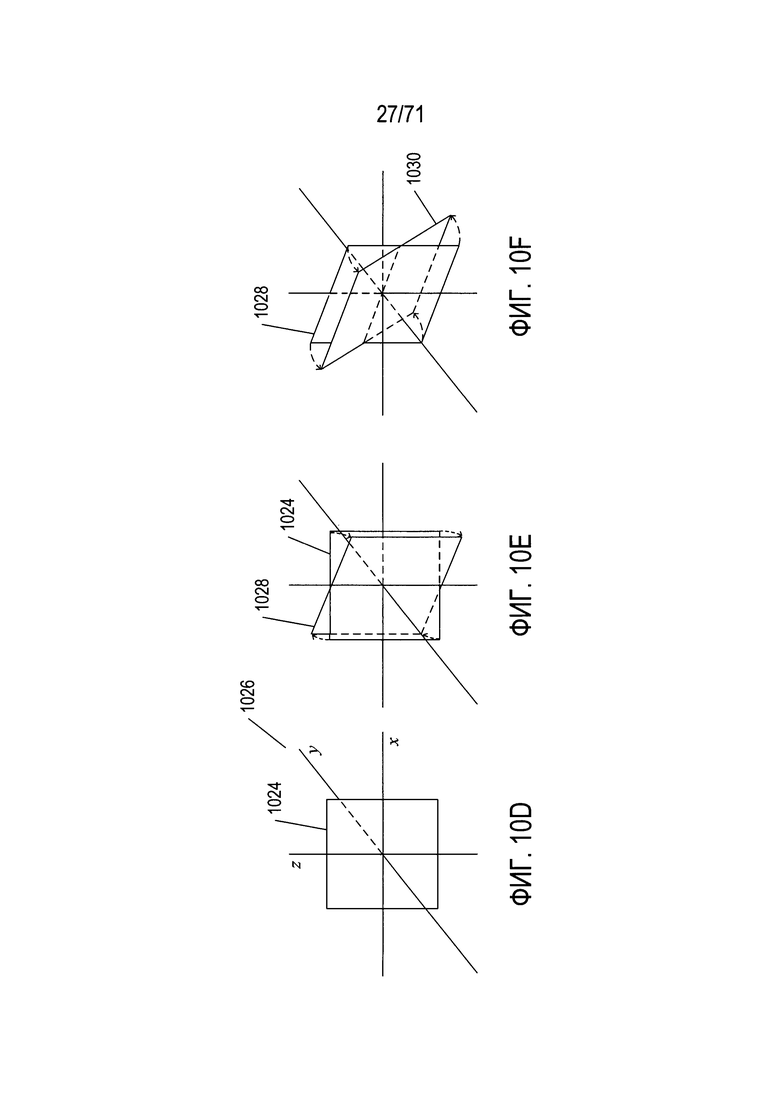

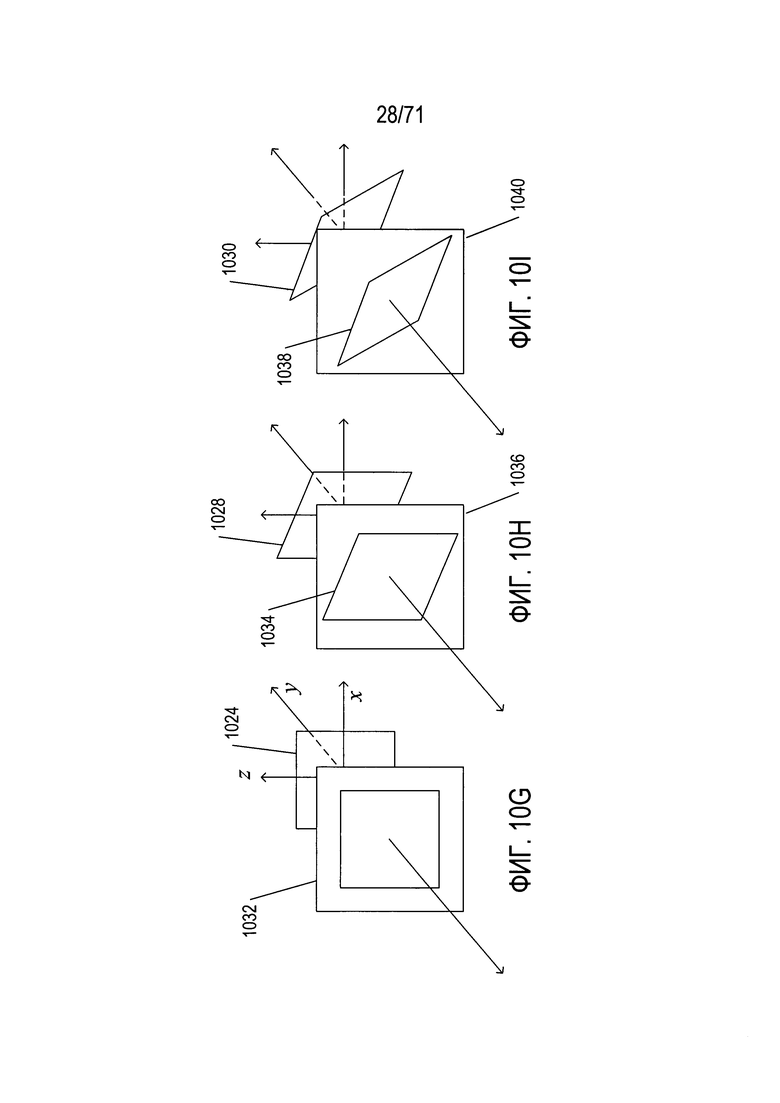

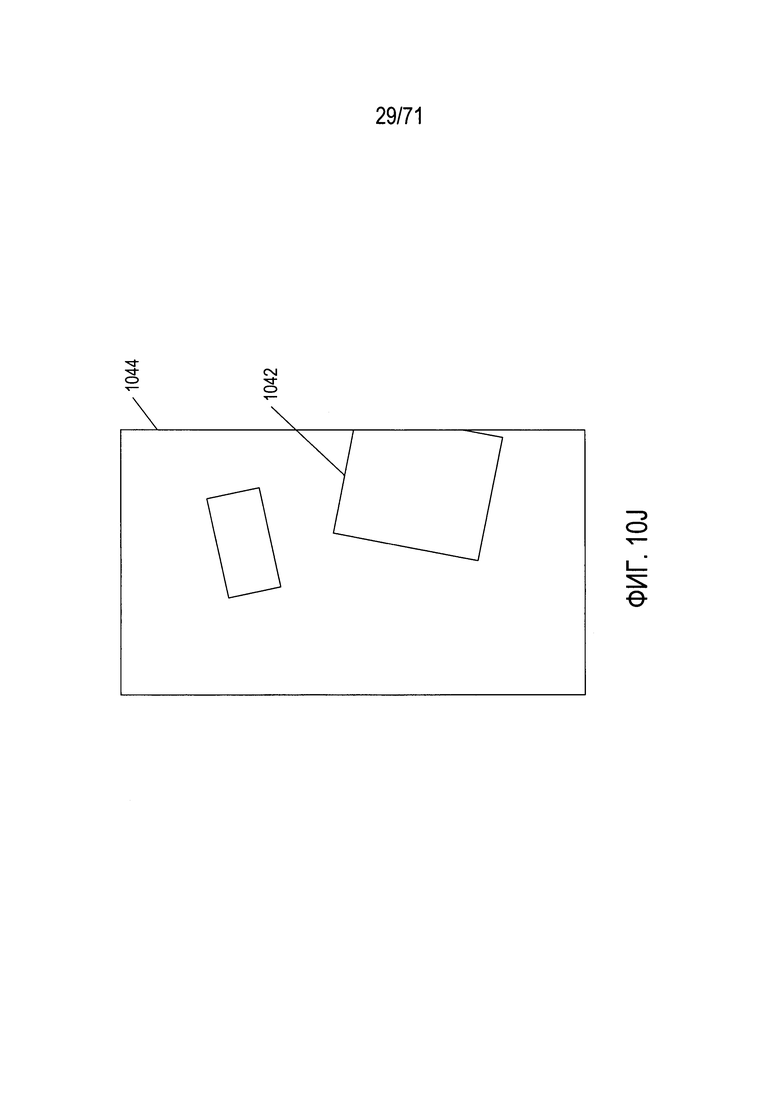

На Фиг. 10A-10J показаны некоторые из многочисленных проблем и задач, связанных с выявлением содержащих документ фрагментов цифрового изображения, особенно для цифрового изображения, полученного с помощью портативного смартфона или другого мобильного устройства с процессорным управлением.

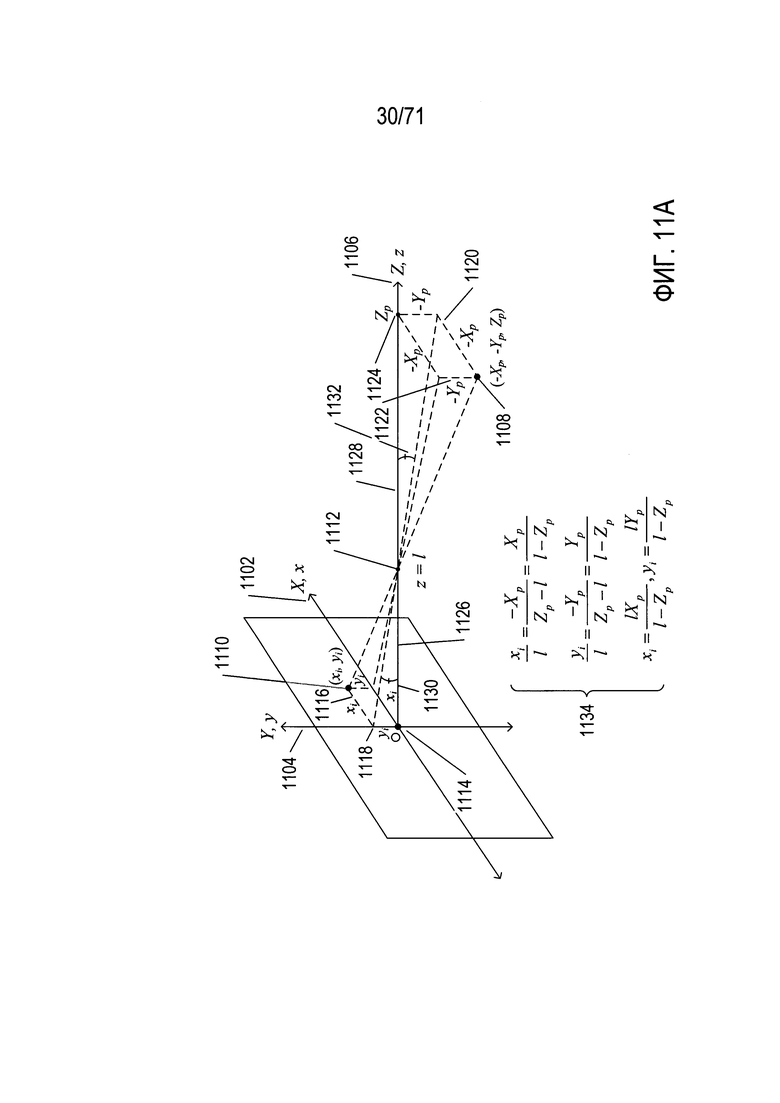

На Фиг. 11A-F показан один подход к установлению соответствия между точками в глобальной системе координат и соответствующими точками в плоскости изображения камеры.

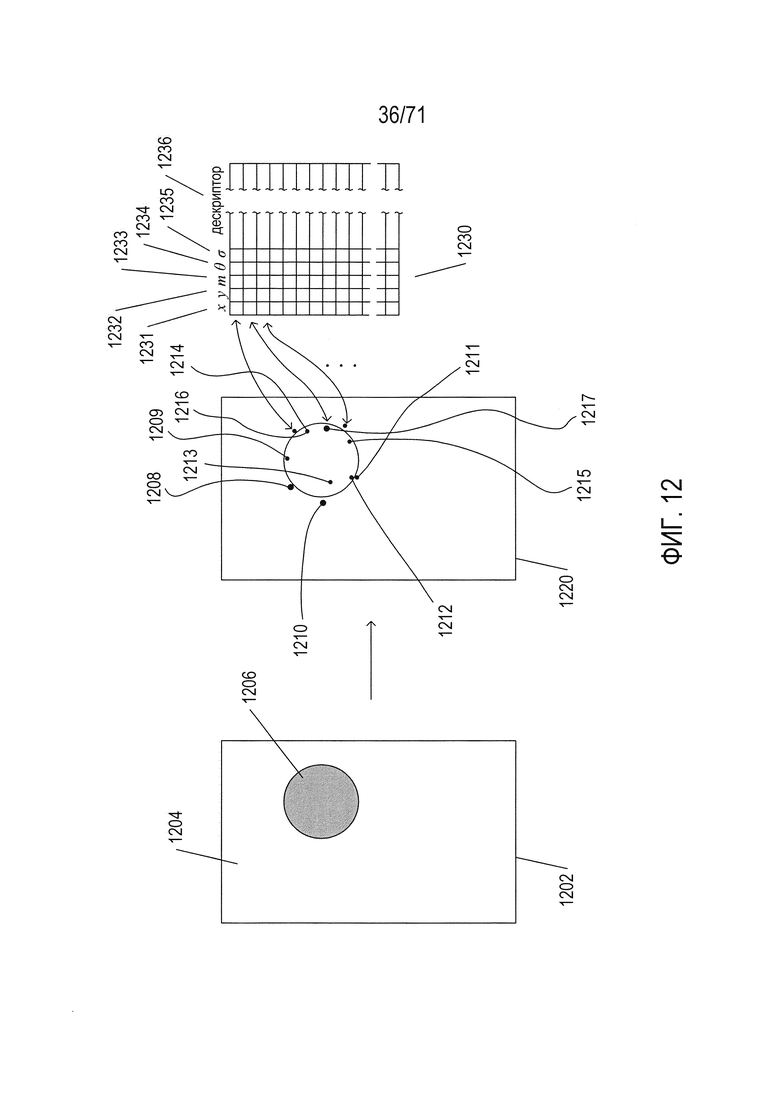

На Фиг. 12 показано выявление признаков методом SIFT.

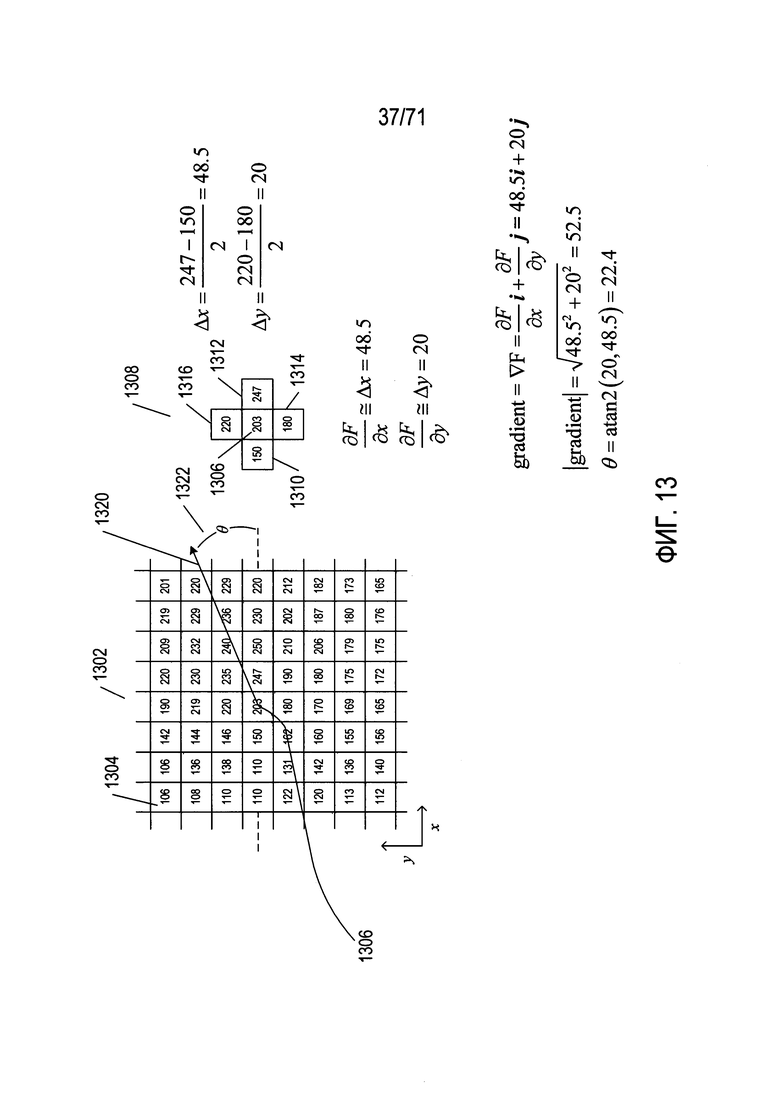

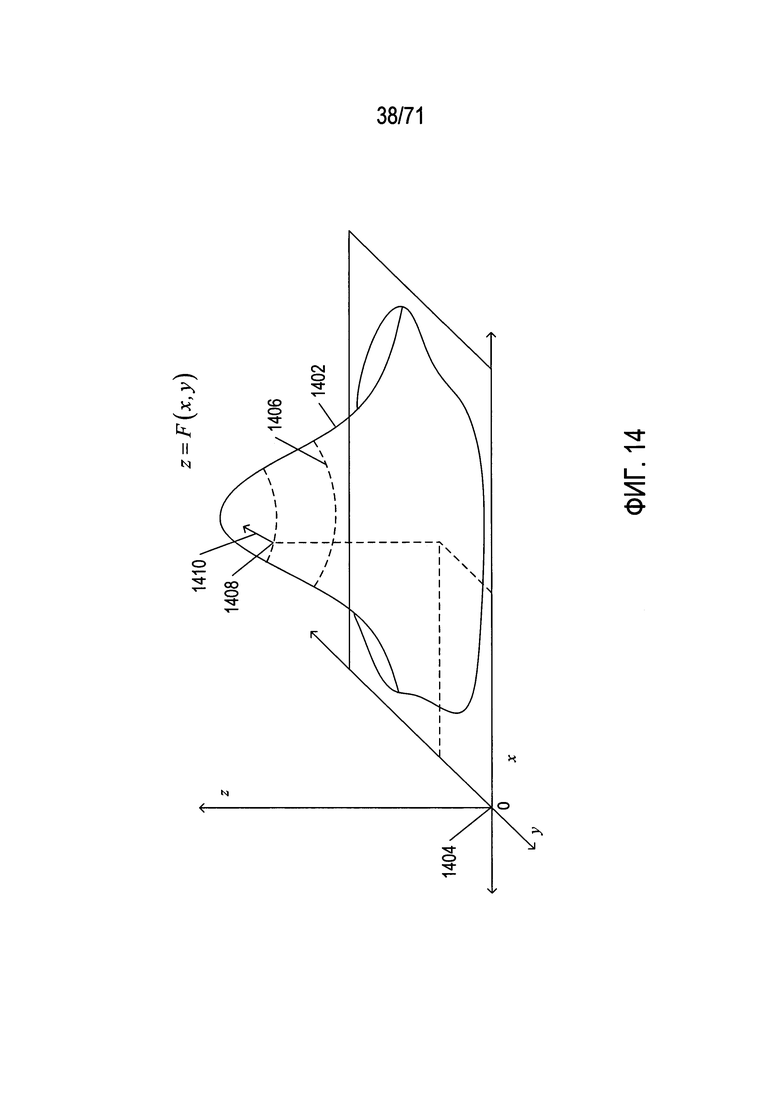

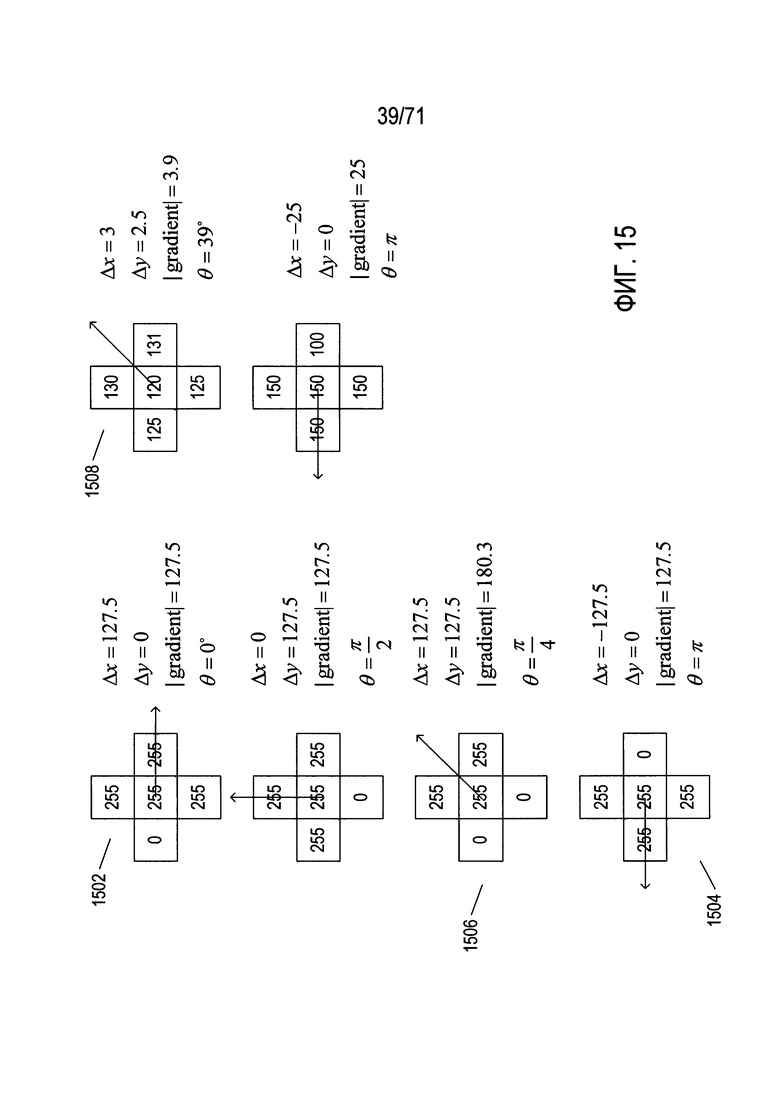

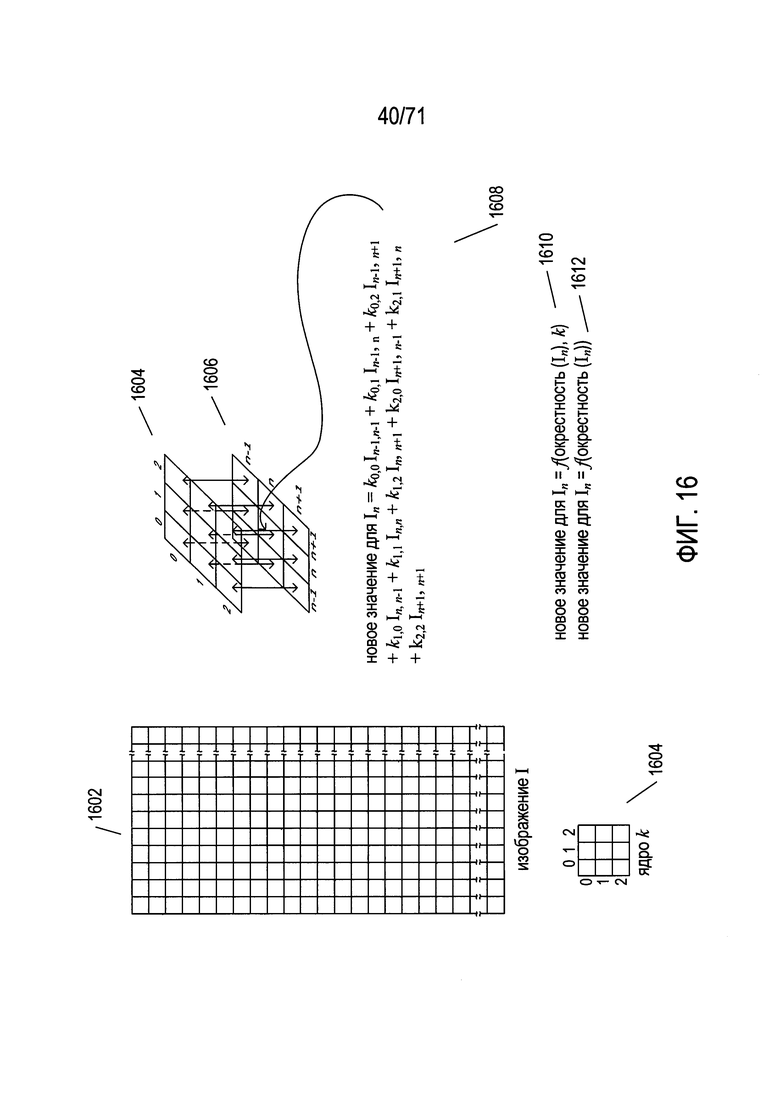

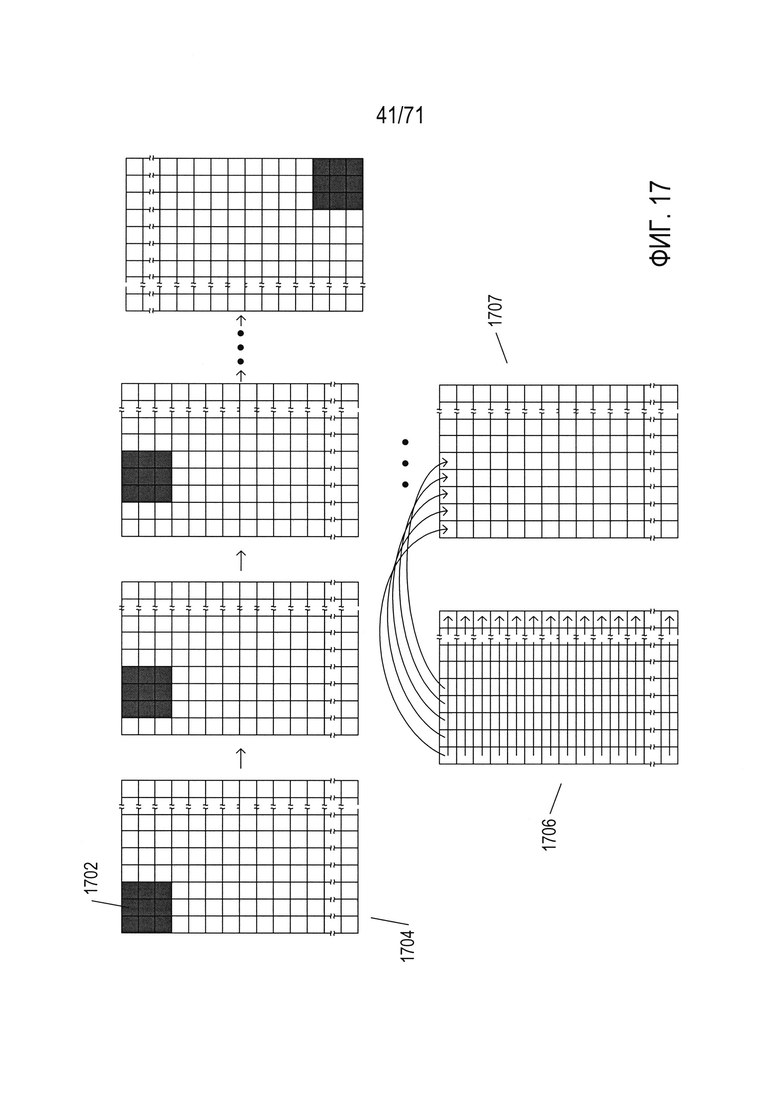

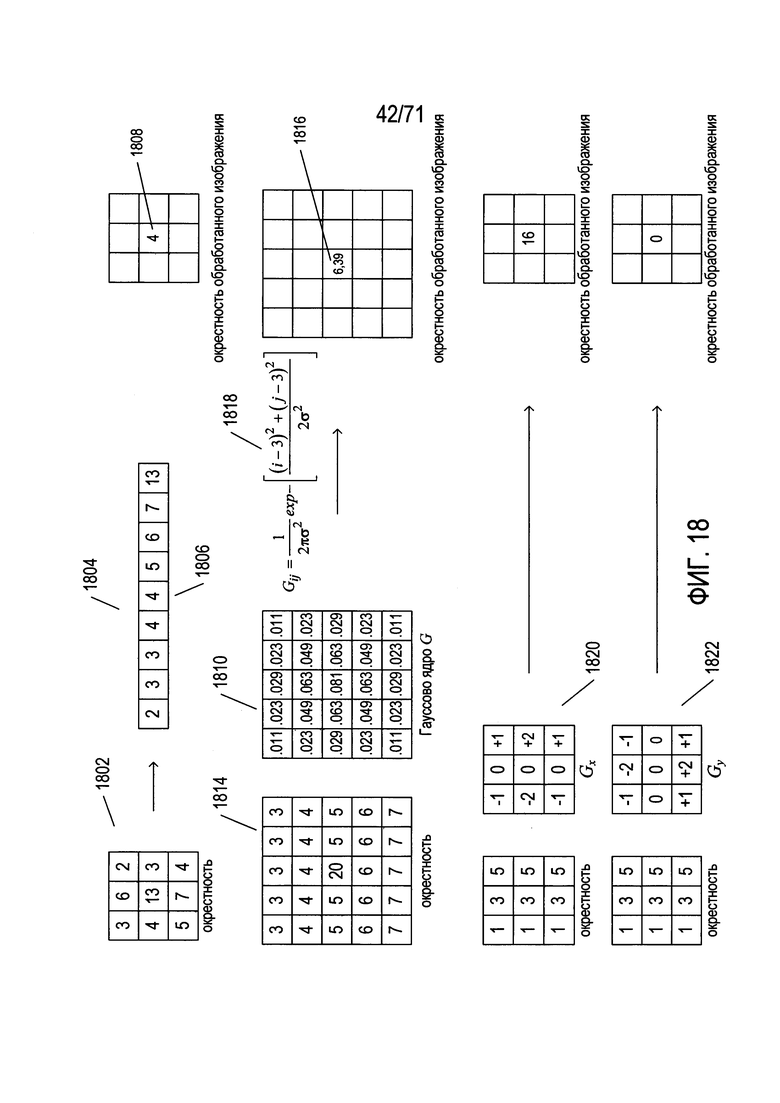

Фиг. 13-18 содержат справочную информацию по различным концепциям, используемым методом SIFT для выявления признаков в изображениях.

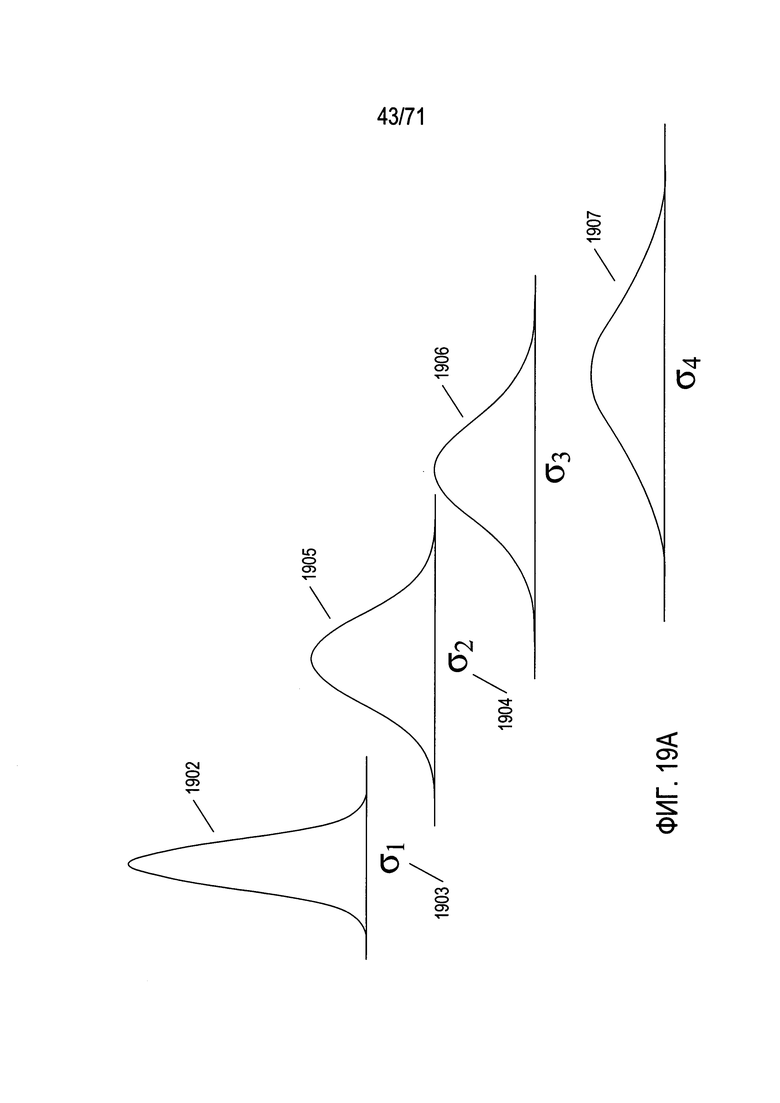

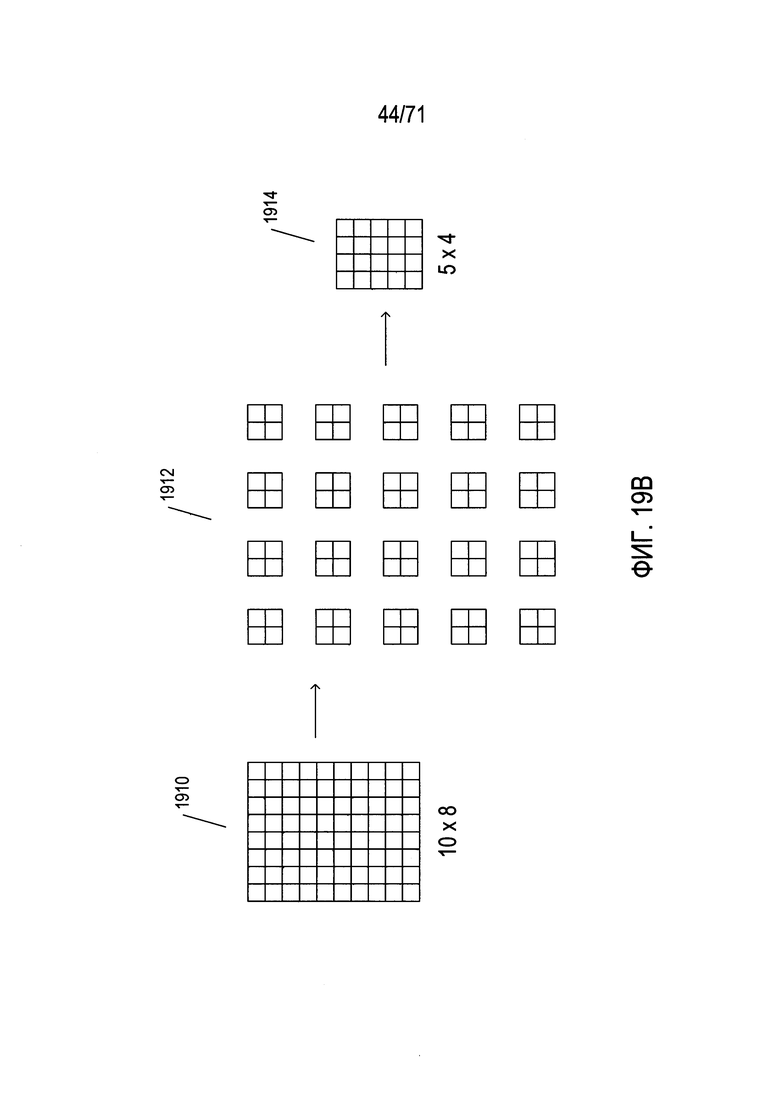

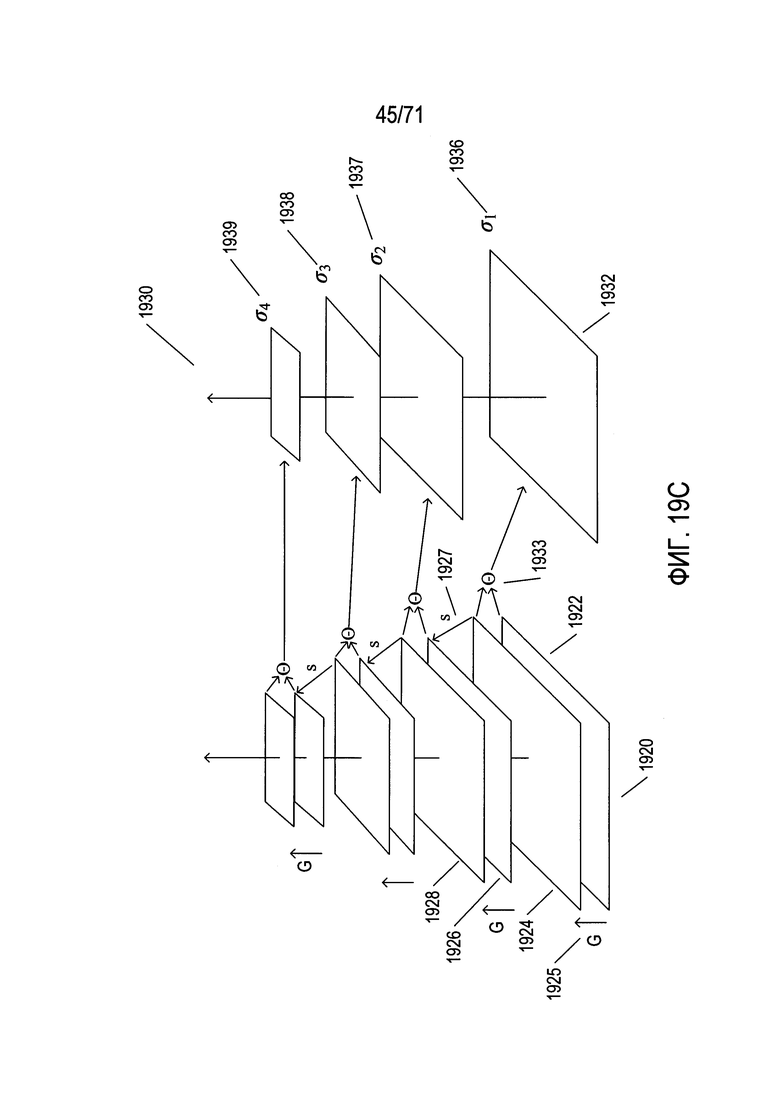

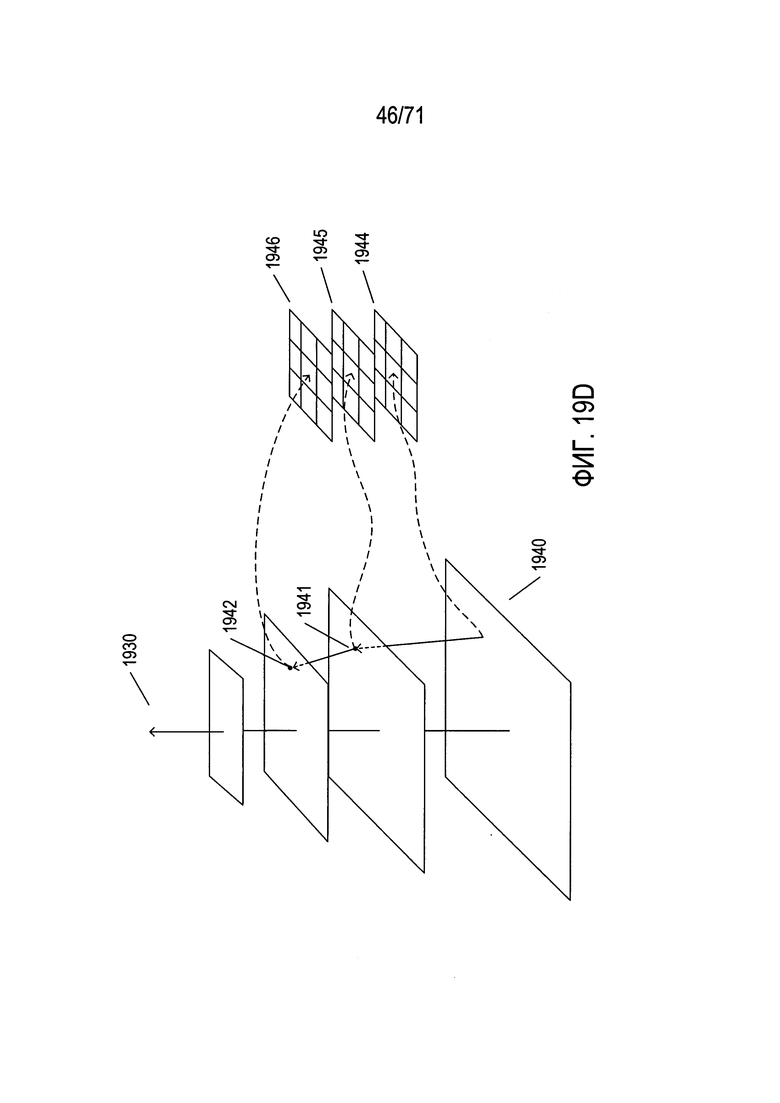

На Фиг. 19A-D показан выбор кандидатов на ключевые точки в изображении.

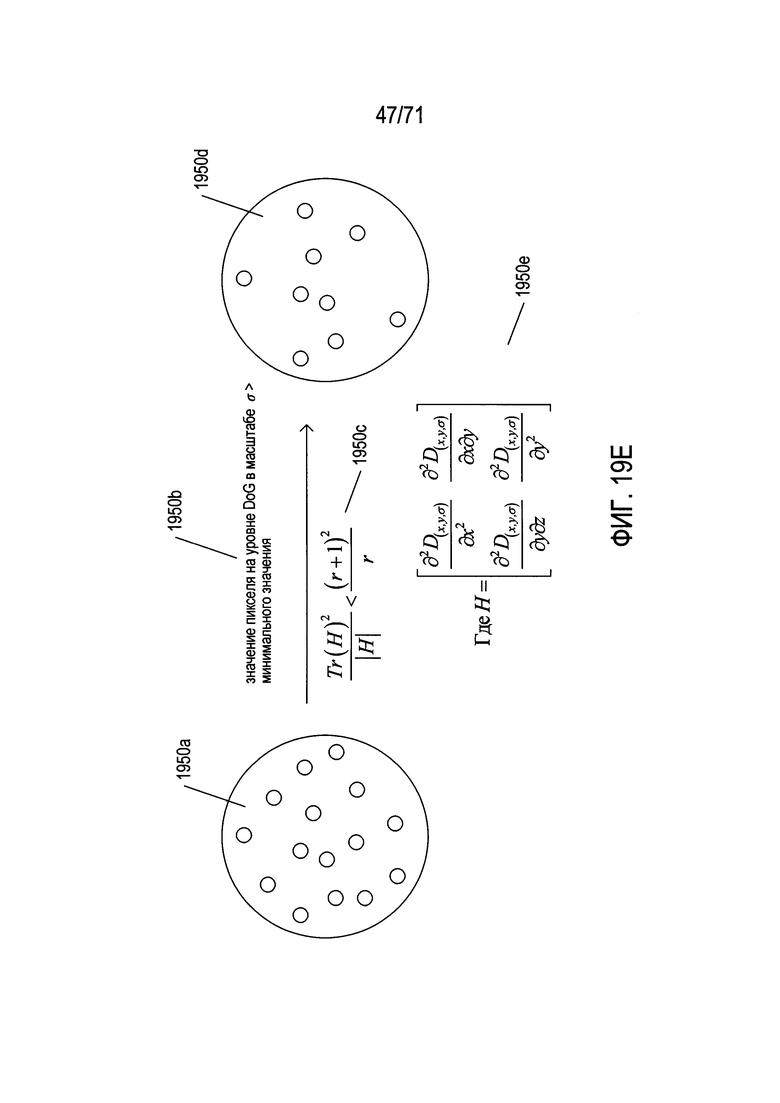

На Фиг. 19Е показана фильтрация кандидатов на ключевые точки, или признаков, в пирамиде разностей гауссианов, полученных методом SIFT.

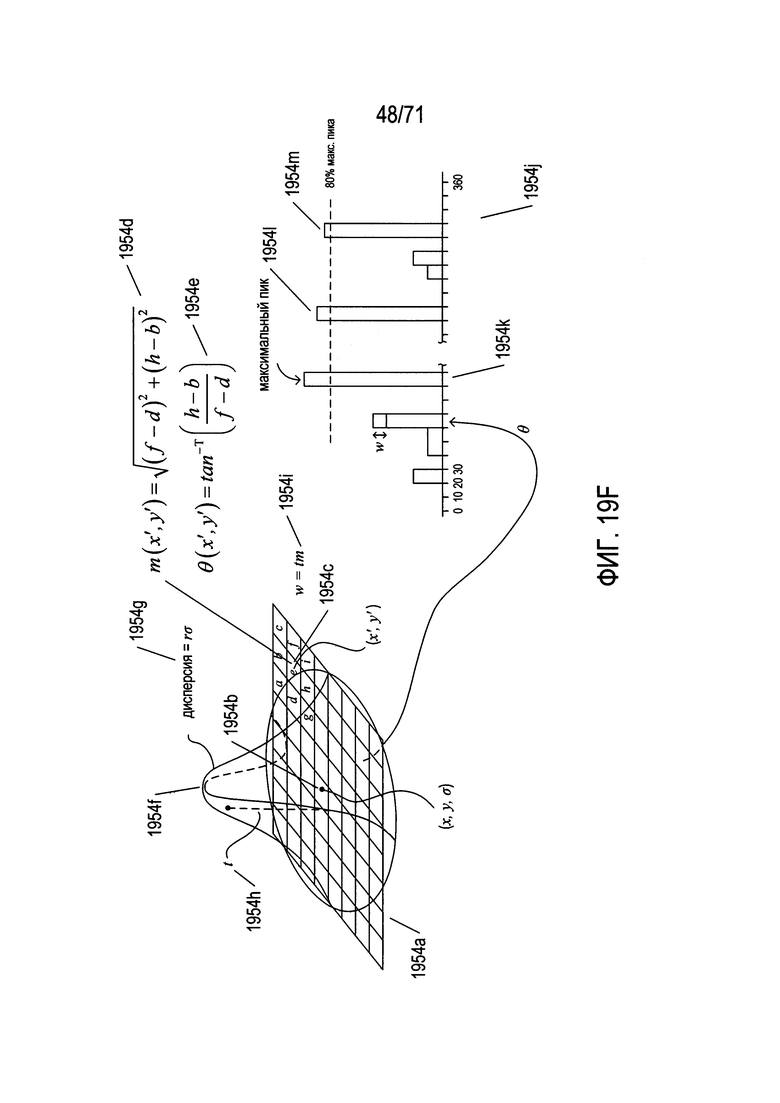

На Фиг. 19F показано, как назначается величина и ориентация признака из значений в пирамиде разностей гауссианов.

На Фиг. 19G показано вычисление дескриптора признака.

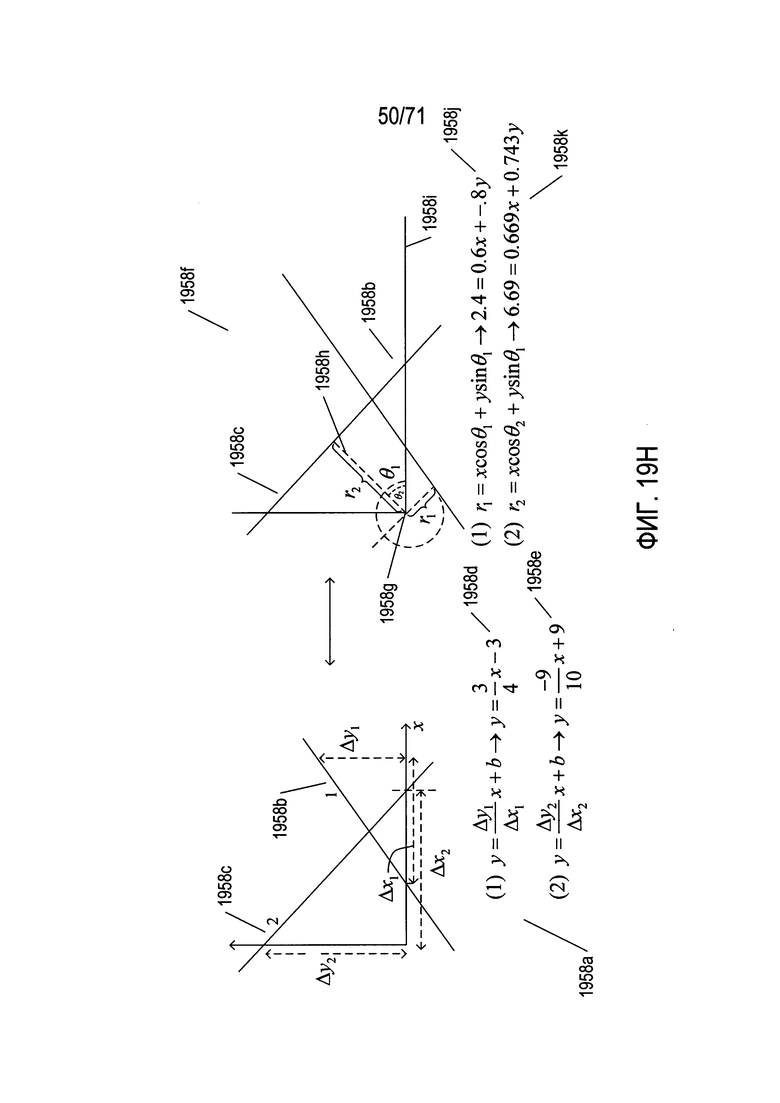

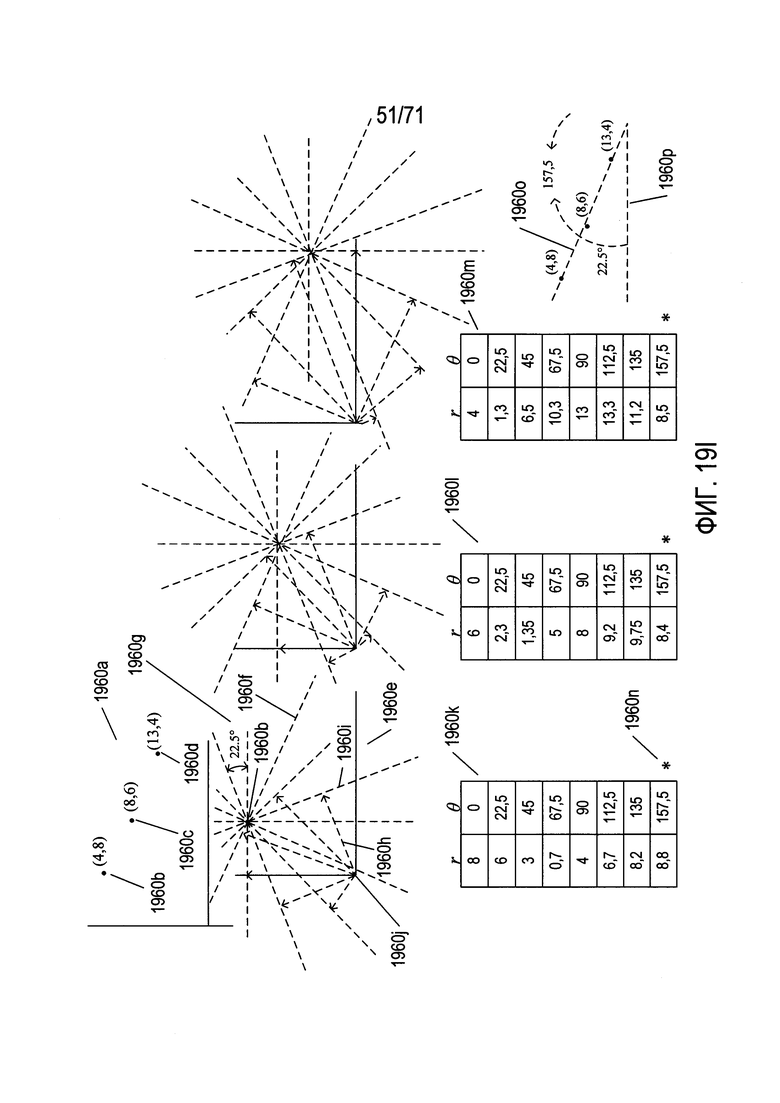

На Фиг. 19H-I показано простое приложение преобразования Хафа с одним параметром.

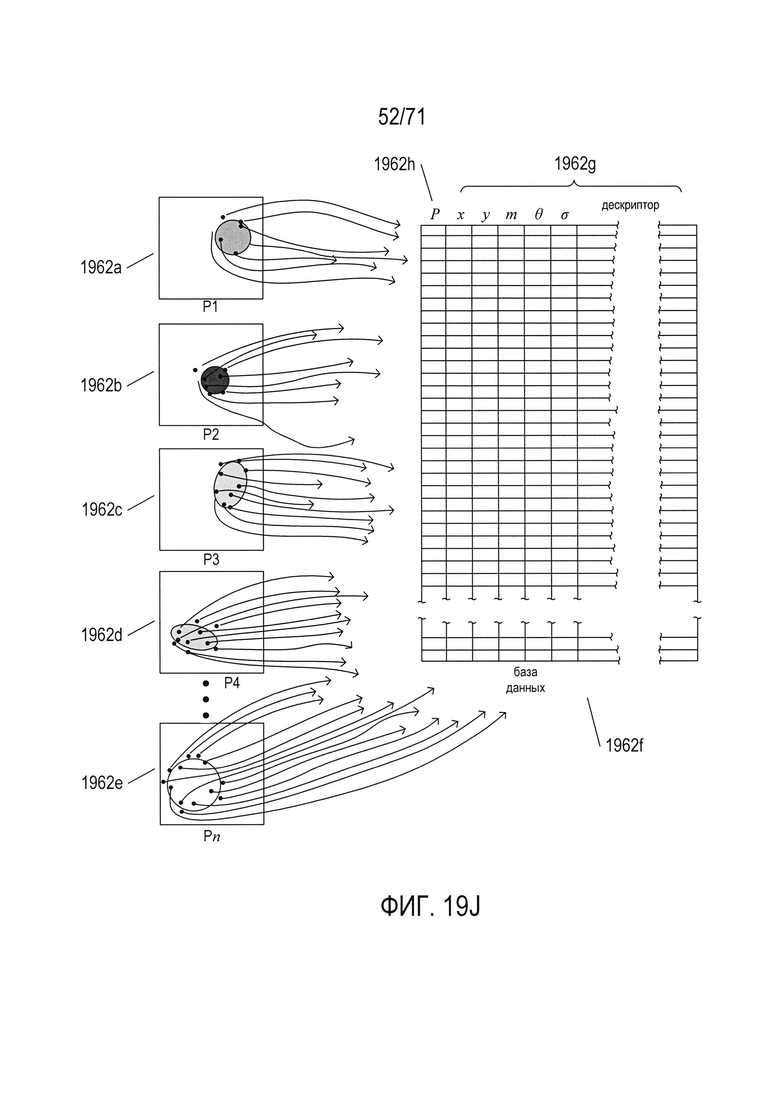

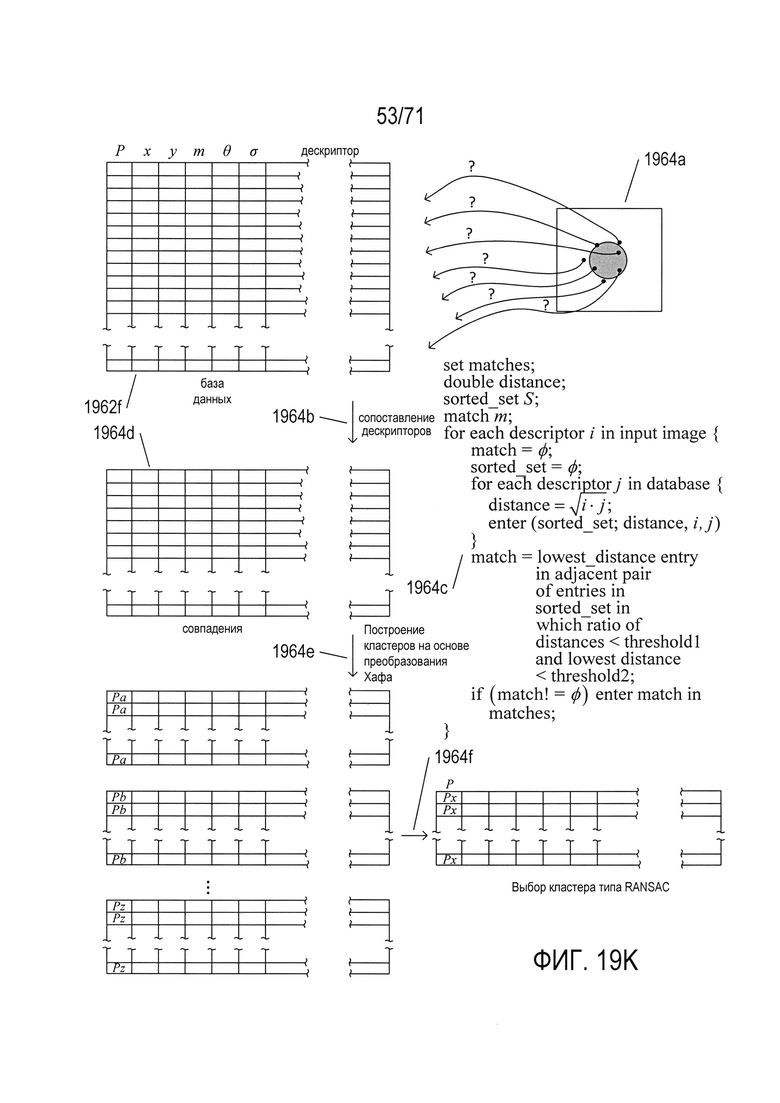

На Фиг. 19J-K показано использование точек SIFT для распознавания объектов в изображениях.

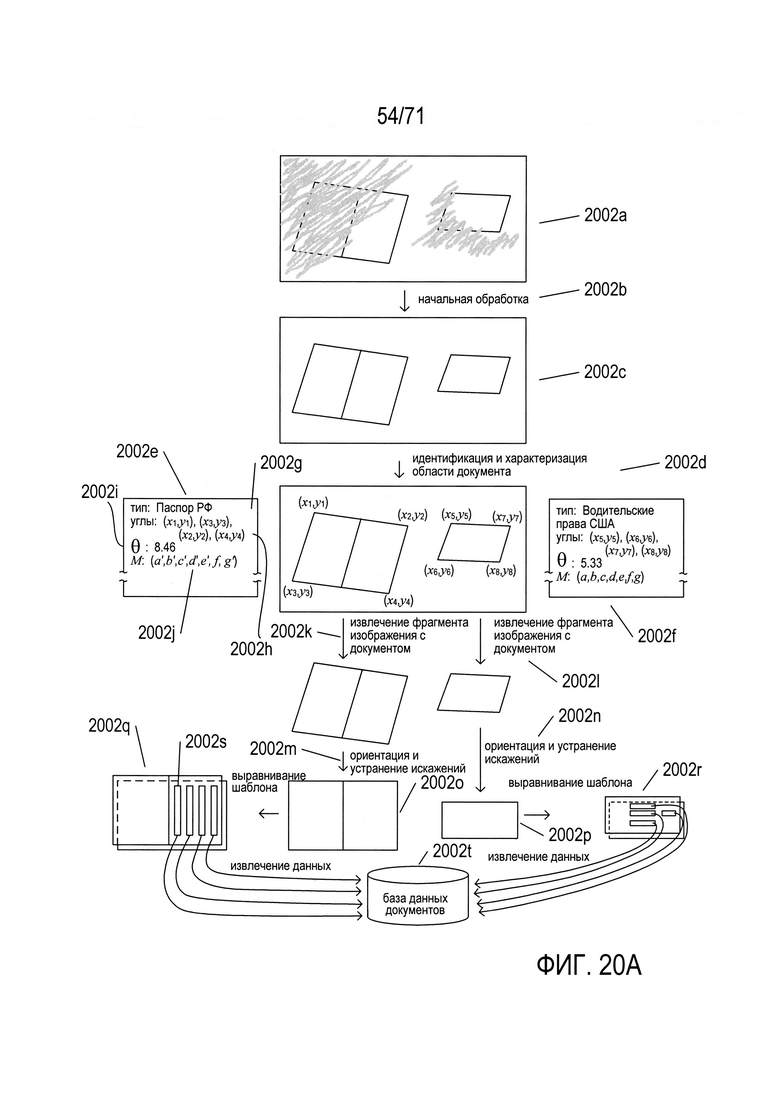

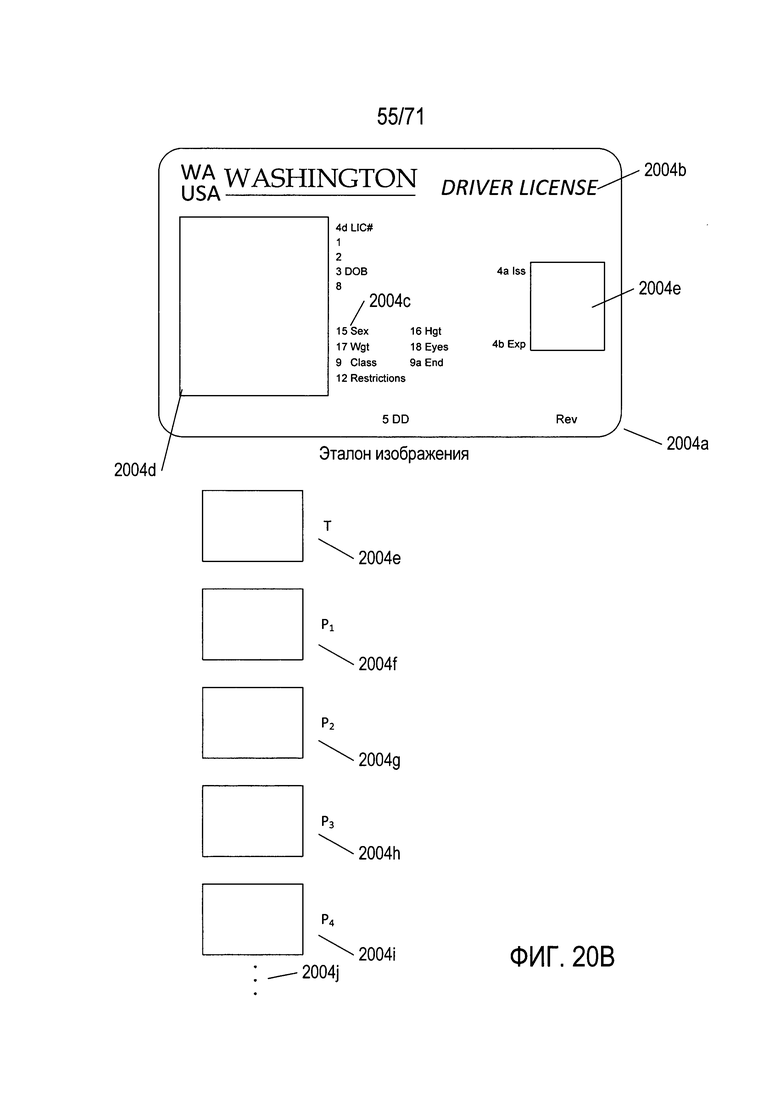

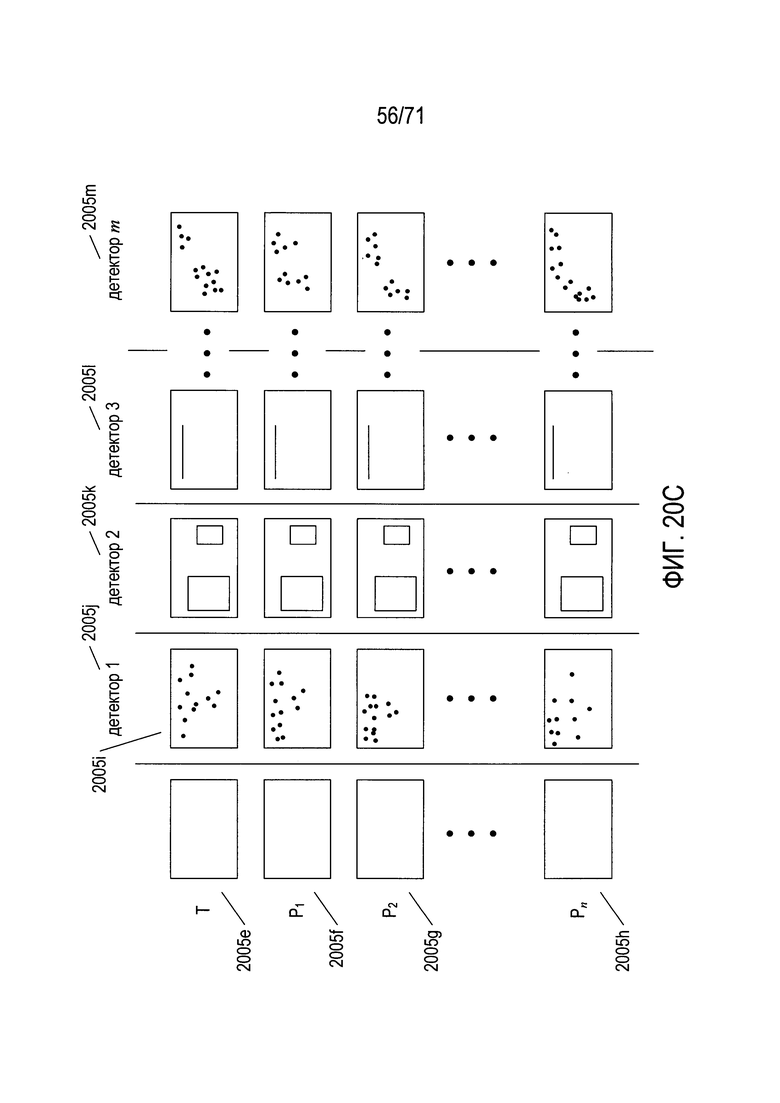

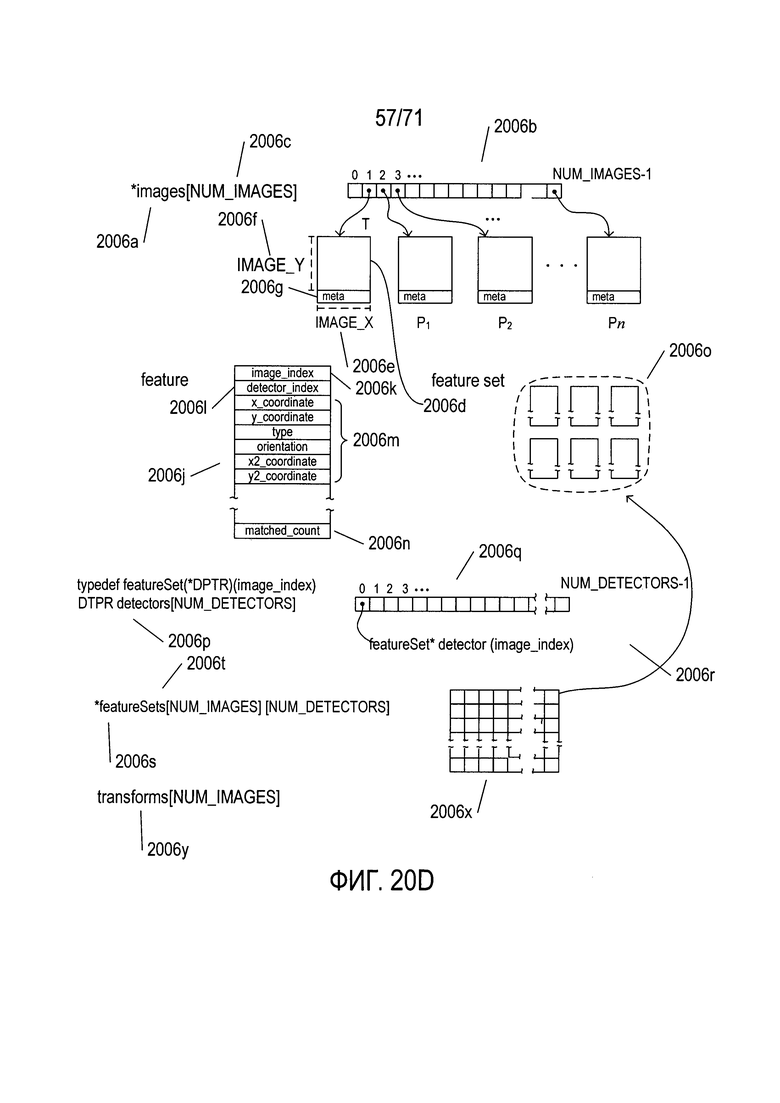

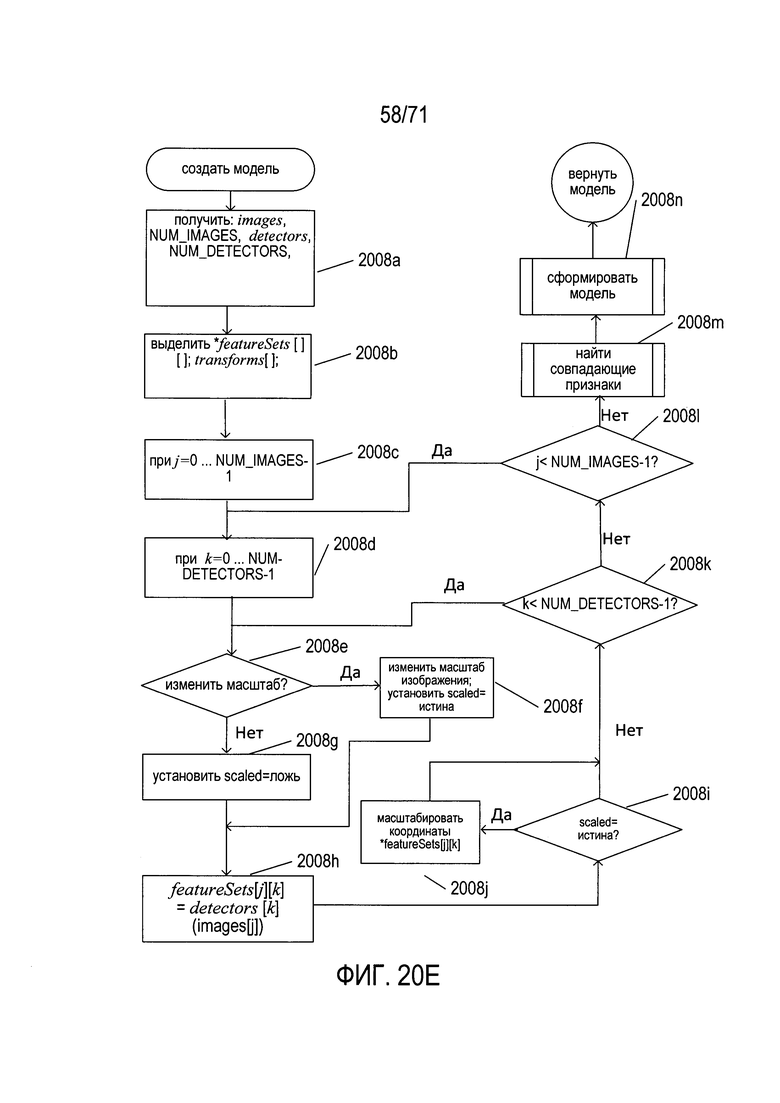

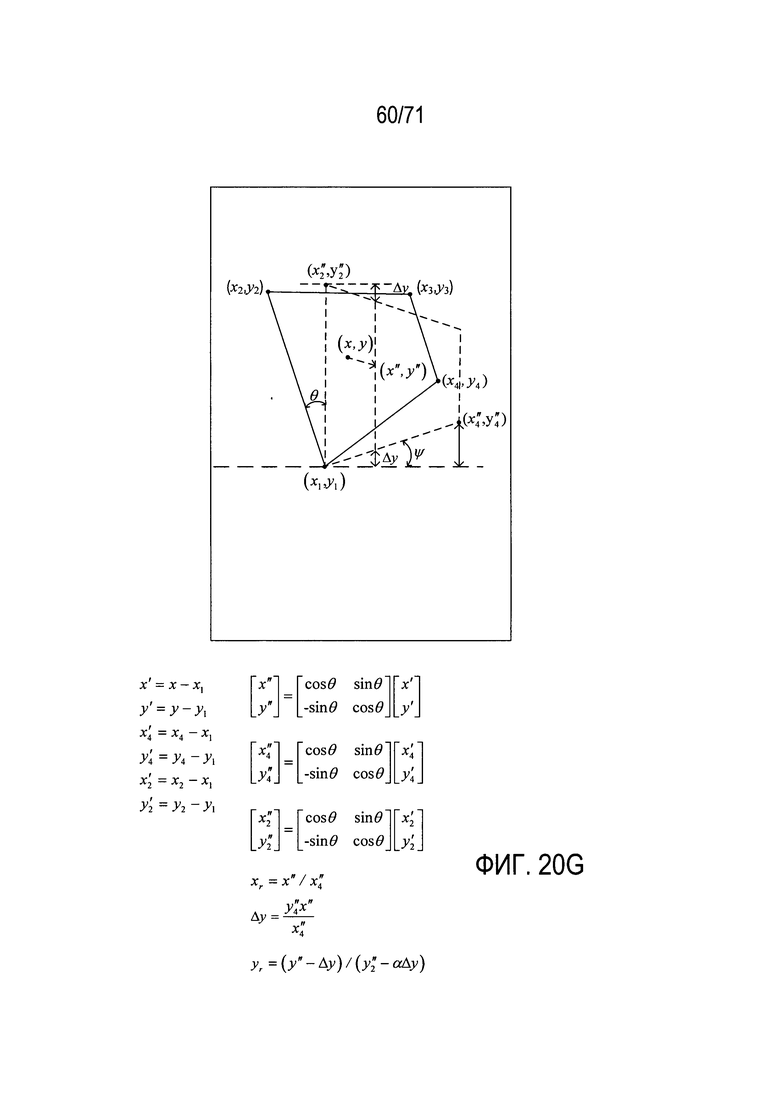

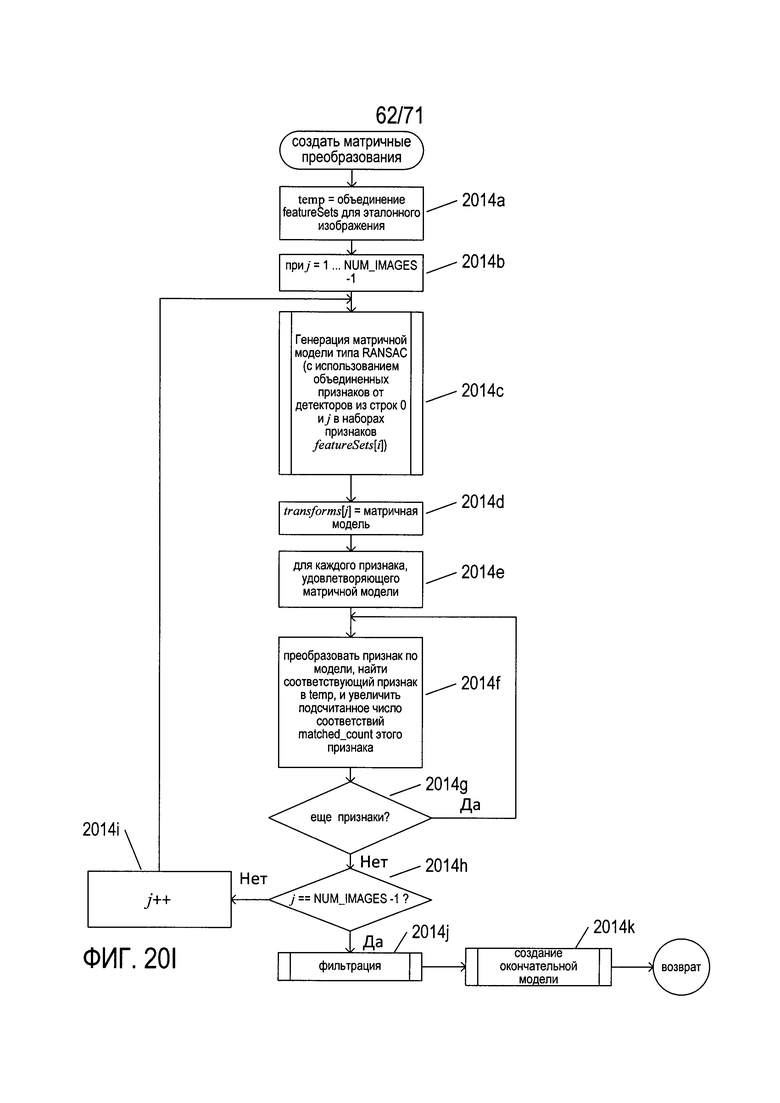

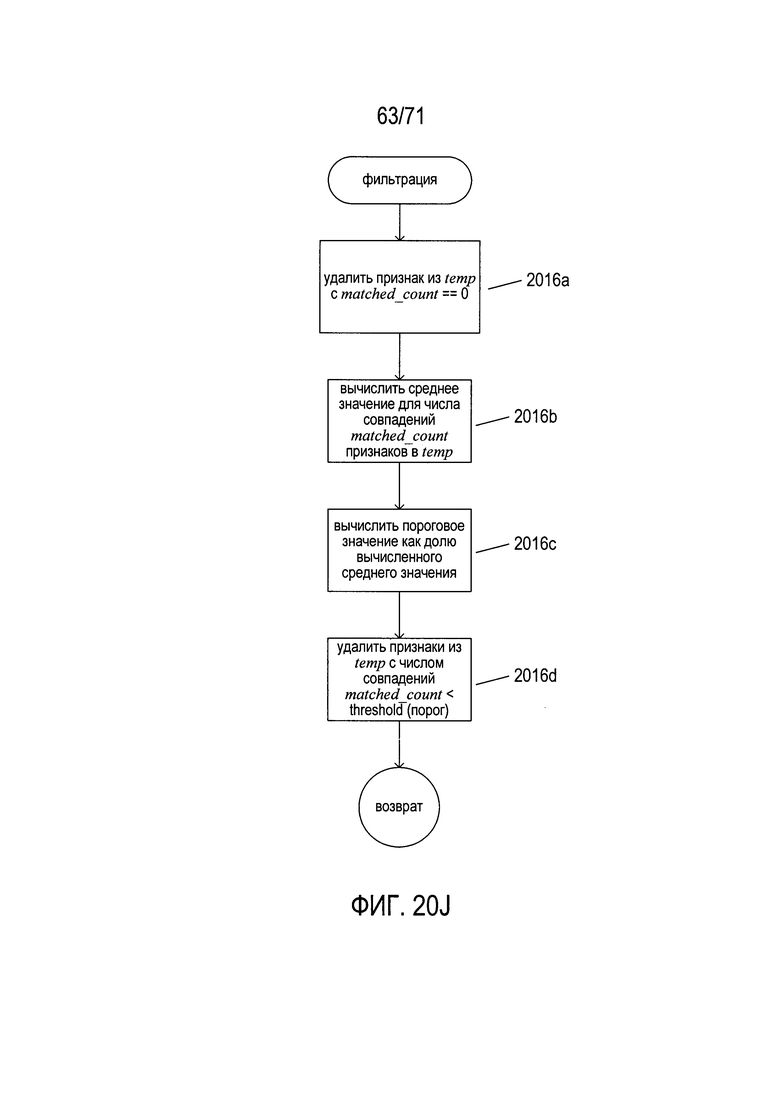

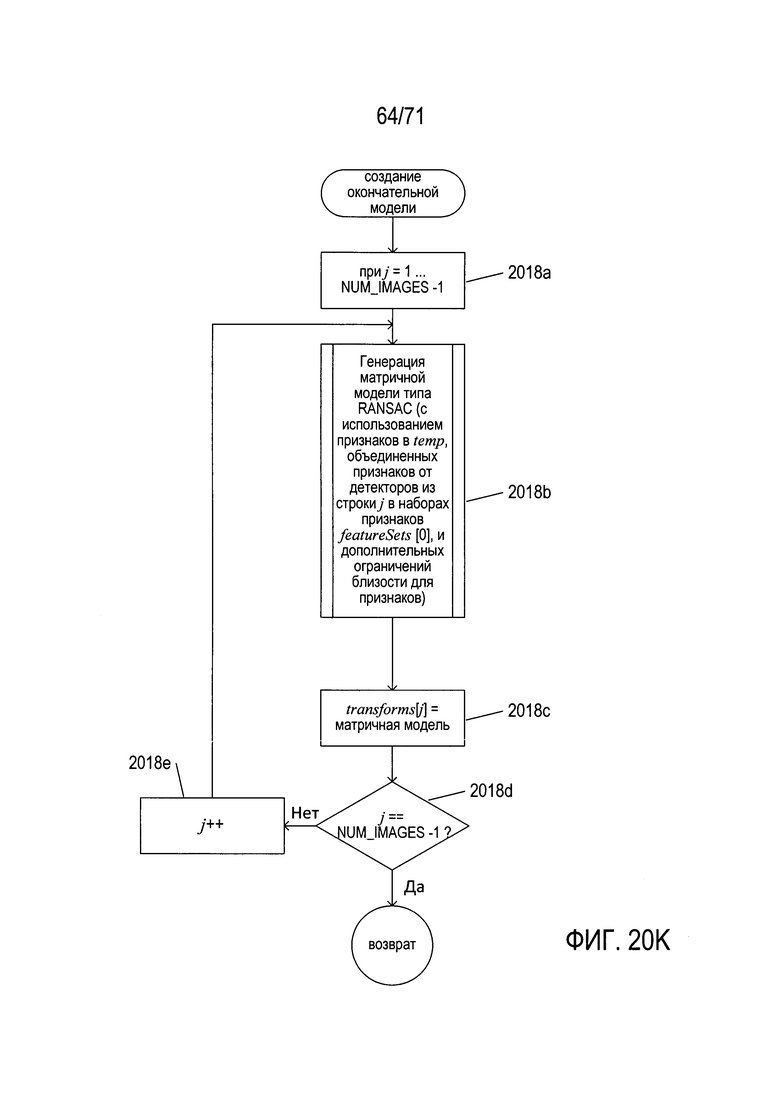

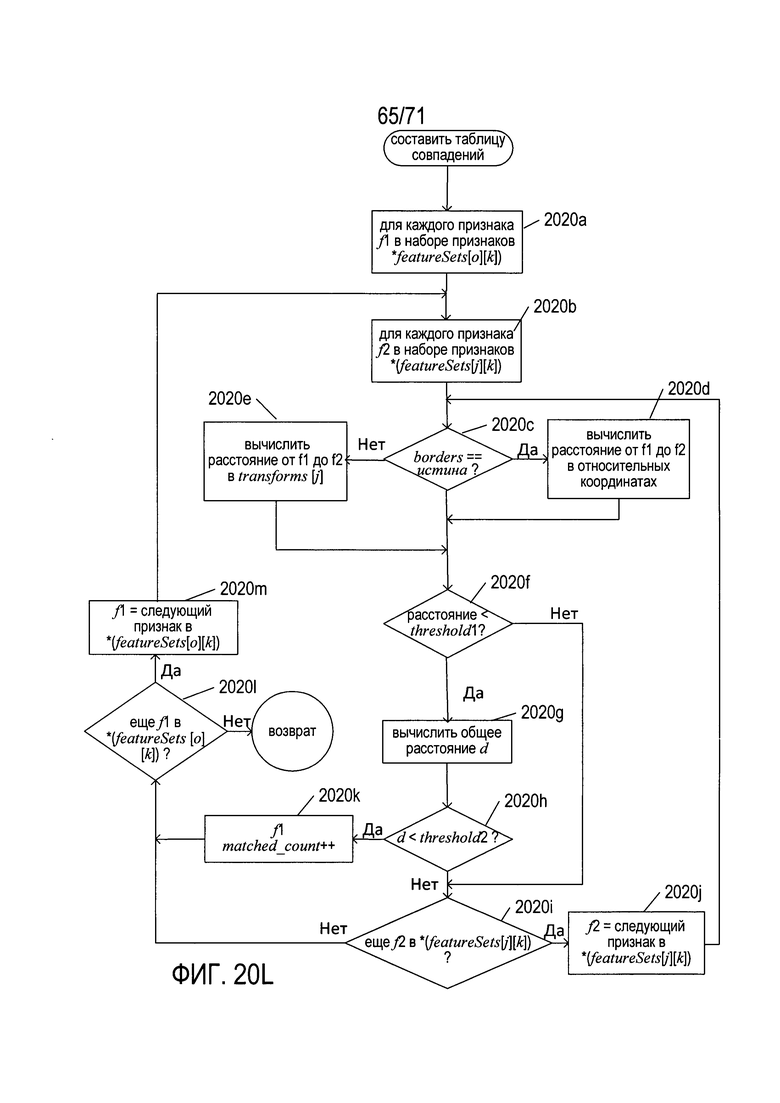

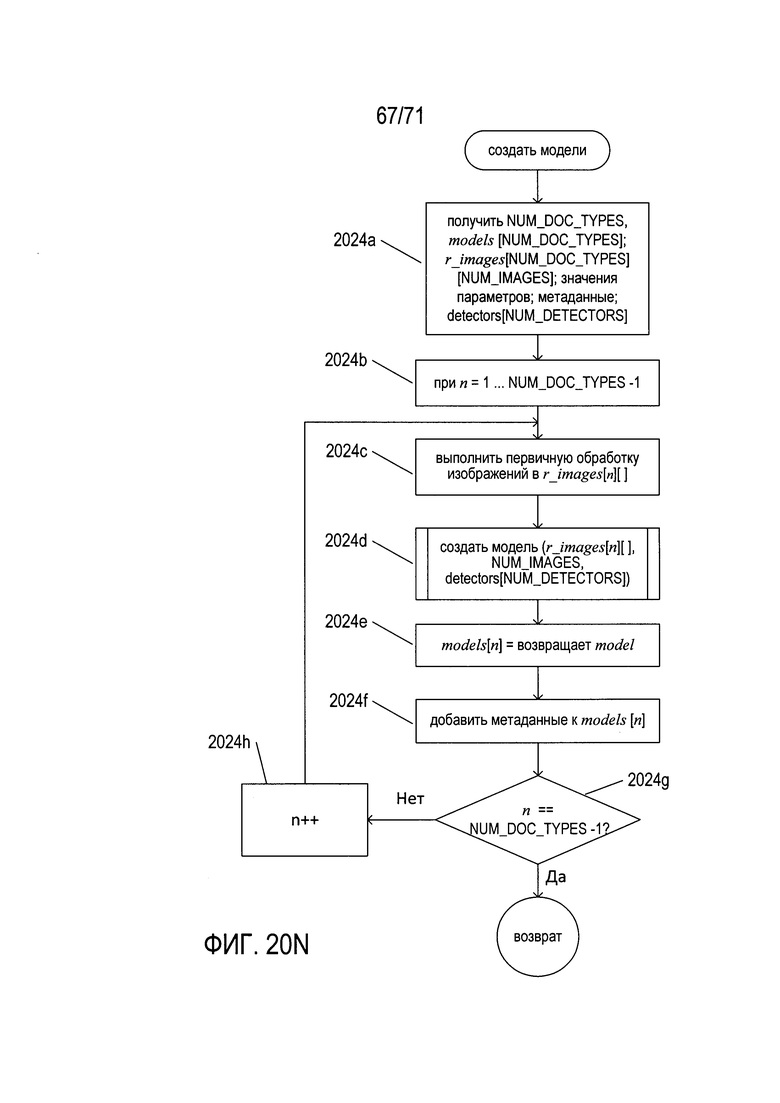

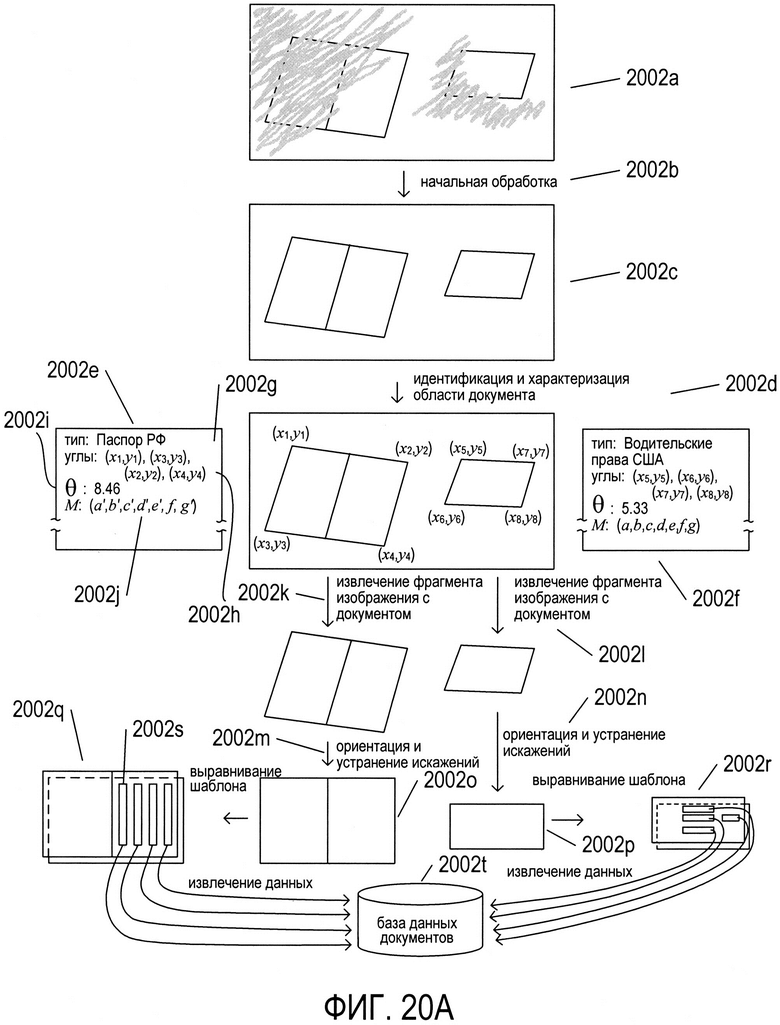

На Фиг. 20A-N представлен обзор способов и систем, к которым относится настоящий документ, а также подробное описание создания модели документа в соответствии со способами и системами настоящего изобретения.

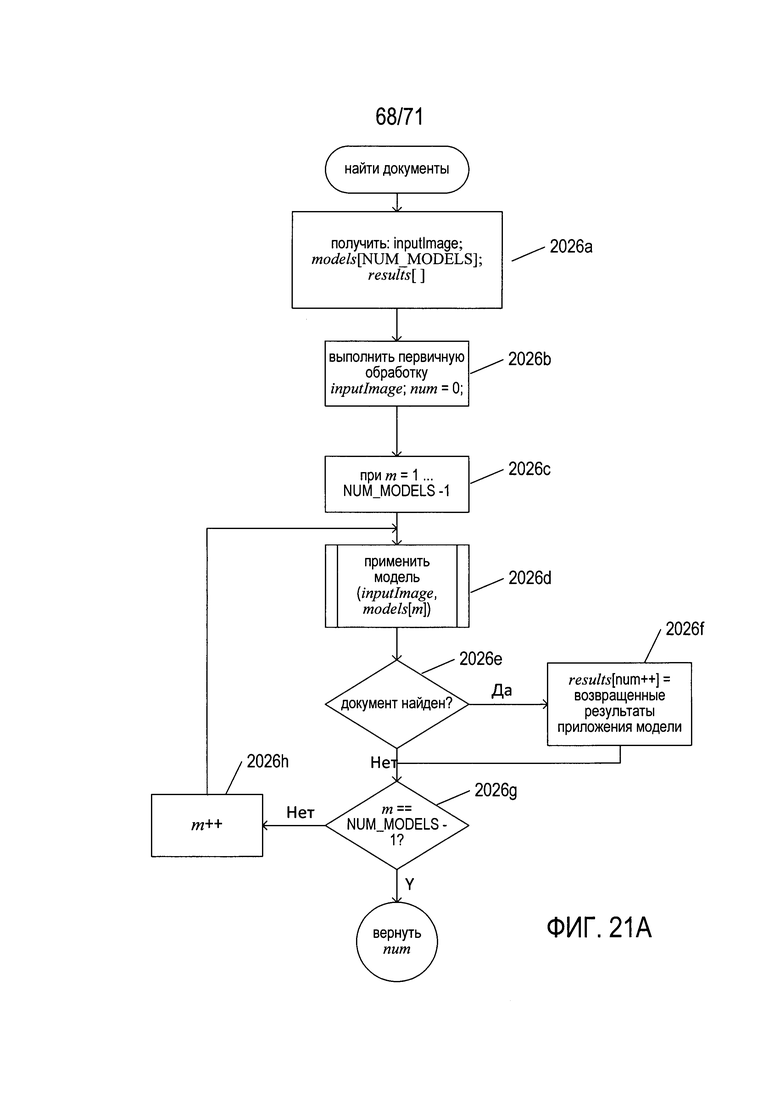

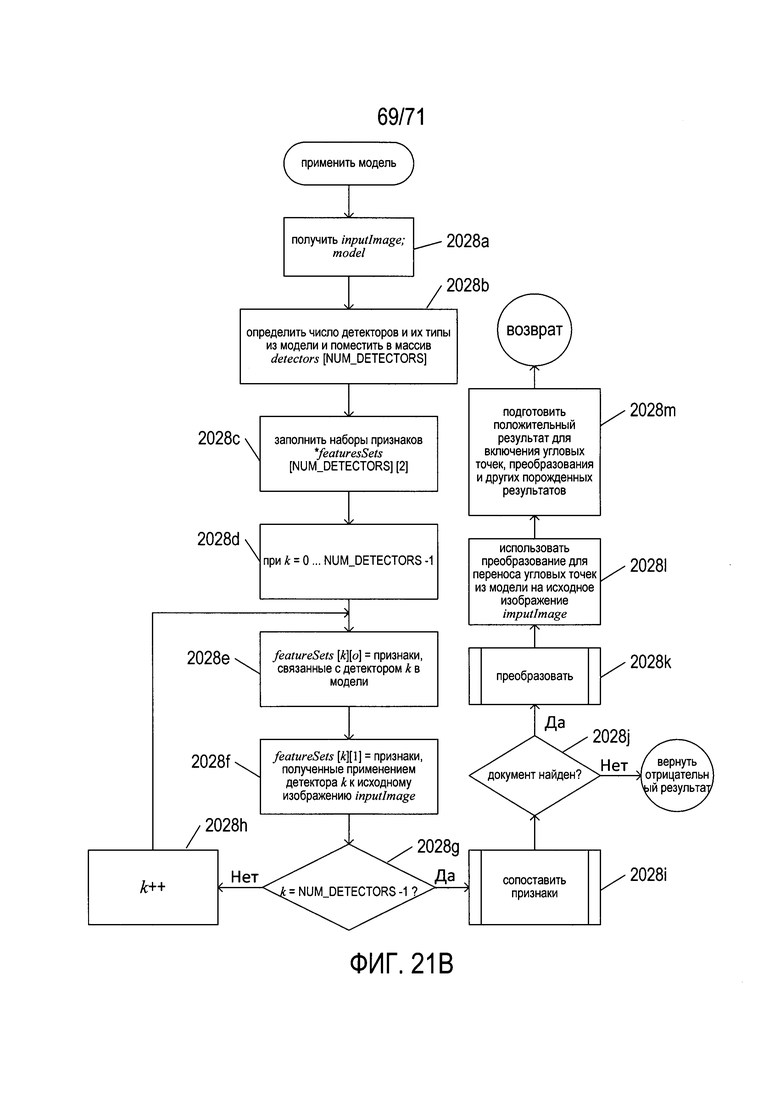

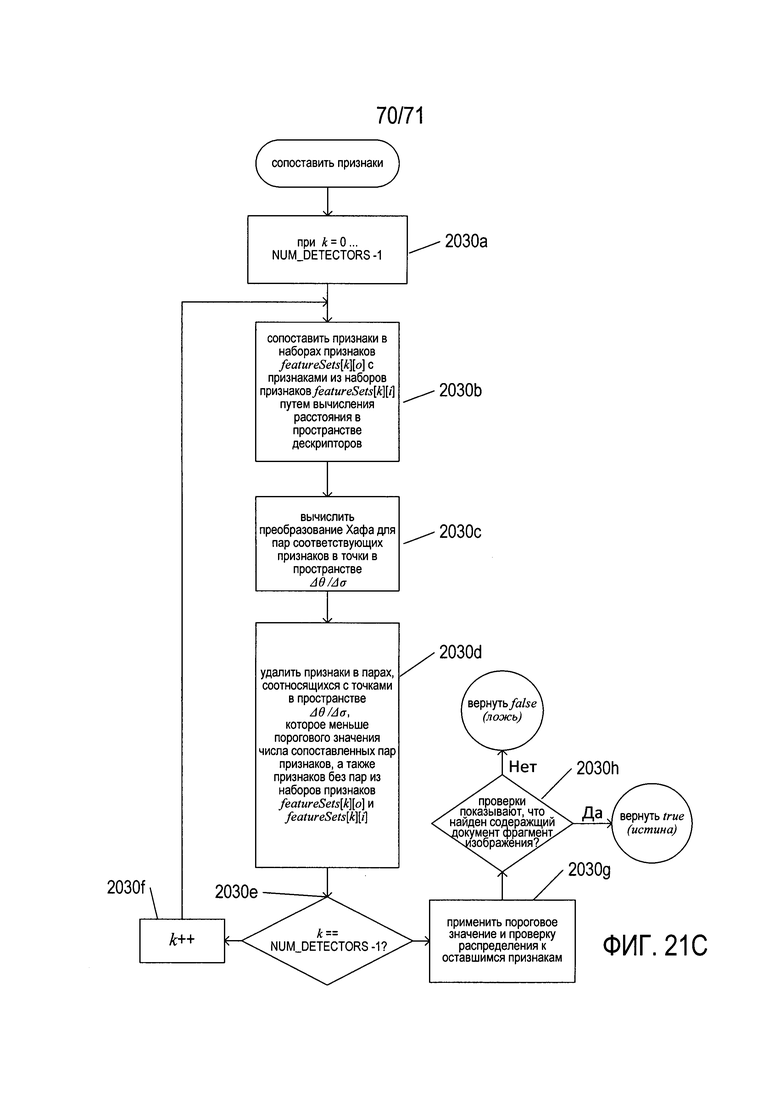

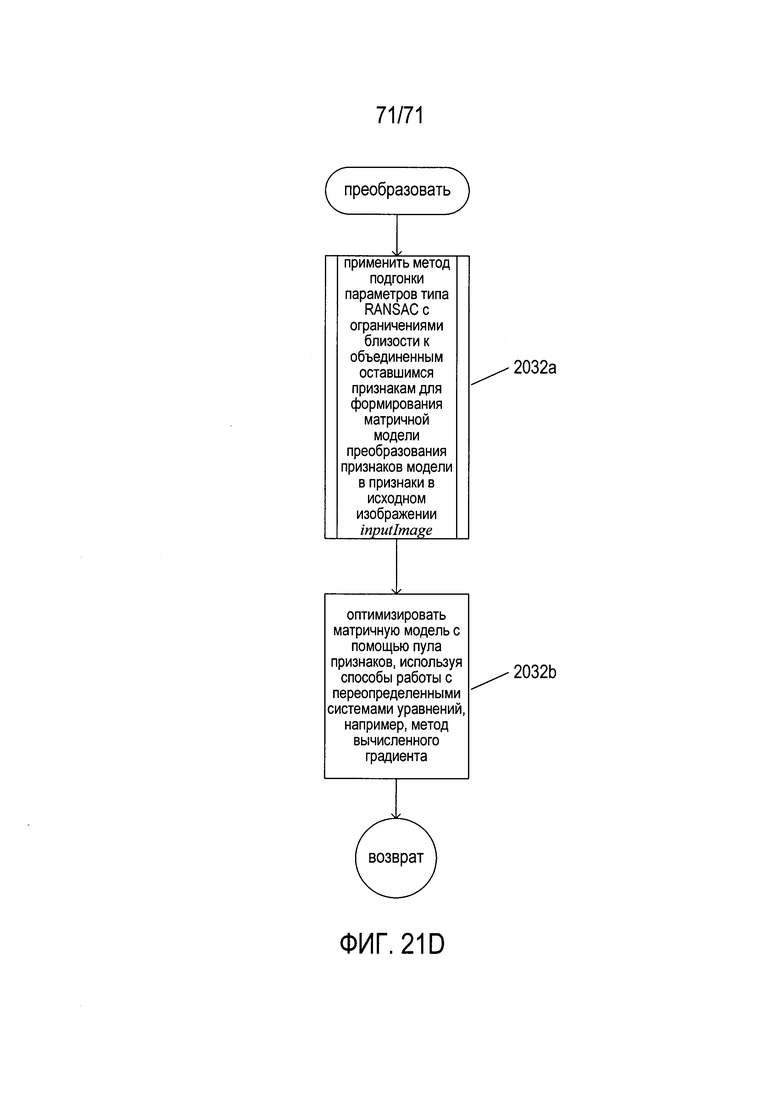

На Фиг. 21A-D показаны блок-схемы процедуры «найти документы» (find documents), которая выявляет содержащие документ фрагменты в исходном изображении, как уже обсуждалось ранее со ссылкой на Фиг. 20А.

ОПИСАНИЕ ПРЕДПОЧТИТЕЛЬНЫХ ВАРИАНТОВ РЕАЛИЗАЦИИ

Настоящий документ относится к способам и подсистемам, которые выявляют и характеризуют содержащие документ фрагменты изображений в содержащем документ изображении. Приведенное ниже обсуждение разбито на несколько подразделов, в том числе: (1) Обзор архитектуры вычислительных систем и цифровых изображений; (2) Пример способа выбора с использованием модели, похожей на RANSAC; (3) Область рассматриваемых проблем и несколько примеров типов документов; (4) Преобразования перспективы; (5) Детекторы признаков; и (6) заключительный подраздел, в котором обсуждаются способы и подсистемы, рассматриваемые в настоящем документе.

Обзор архитектуры вычислительных систем и цифровых изображений

На Фиг. 1 представлена схема архитектуры вычислительной системы верхнего уровня, подобной той вычислительной системе, в которой реализована раскрываемая в этом документе подсистема распознавания содержащих документ фрагментов изображения. Мобильные устройства получения изображений, включая смартфоны и цифровые камеры, могут быть изображены на диаграмме аналогичным образом, а также могут содержать процессоры, память и внутренние шины. Тем, кто знаком с современной наукой и технологиями, будет понятно, что программа управления или подпрограмма управления, включающая машинные команды, которые хранятся в физической памяти устройства с процессорным управлением, представляют собой компонент управления данным устройством и являются столь же физическими, реальными и важными, как и любой другой компонент электромеханического устройства, включая устройства формирования изображений. Компьютерная система содержит один или более центральных процессоров (ЦП) 102-105, один или более электронных модулей памяти 108, взаимосвязанных с ЦП через шину подсистемы ЦП/память 110 или несколько шин, первый мост 112, который соединяет шину подсистемы ЦП/память 110 с дополнительными шинами 114 и 116, либо другие виды средств высокоскоростного соединения, в том числе несколько высокоскоростных последовательных соединений. Эти шины или последовательные межсоединения в свою очередь соединяют ЦП и память со специализированными процессорами, такими как графический процессор 118, и с одним или более мостами 120, которые соединены по высокоскоростным последовательным каналам или несколькими контроллерами 122-127, такими как контроллер 127, которые предоставляют доступ к различным типам запоминающих устройств большой емкости 128, электронных дисплеев, устройств ввода и прочих подобных компонентов, подкомпонентов и вычислительных ресурсов.

На Фиг. 2A-D показаны два типа переносных устройств, предназначенных для получения изображений. На Фиг. 2А-С показана цифровая камера 202. Цифровая камера содержит объектив 204, кнопку спуска затвора 205, нажатие которой пользователем приводит к получению цифрового изображения, которое соответствует отраженному свету, попадающему в объектив 204 цифровой камеры. В задней части цифровой камеры, которая видна пользователю, когда он держит камеру при съемке цифровых изображений, имеются видоискатель 206 и жидкокристаллический дисплей видоискателя 208. С помощью видоискателя 206 пользователь может напрямую просматривать создаваемое объективом 204 камеры изображение, а с помощью жидкокристаллического (ЖК) дисплея 208 - просматривать электронное отображение создаваемого в настоящей момент объективом изображения. Обычно пользователь камеры настраивает фокус камеры с помощью кольца фокусировки 210, смотря при этом через видоискатель 206 или на жидкокристаллический экран видоискателя 208, чтобы выбрать требуемое изображение перед тем, как нажать на кнопку 205 спуска затвора для получения цифрового снимка изображения и его сохранения в электронной памяти цифровой камеры.

На Фиг. 2D показан типичный смартфон с передней стороны 220 и задней стороны 222. На задней стороне 222 имеется объектив 224 цифровой камеры и датчик приближения и (или) цифровой экспонометр 226. На передней стороне смартфона 220 может отображаться получаемое изображение 226 (под управлением приложения), аналогично работе жидкокристаллического дисплея 208 видоискателя цифровой камеры, а также может находиться сенсорная кнопка 228 спуска затвора, при прикосновении к которой происходит получение цифрового изображения и сохранение его в памяти смартфона.

На Фиг. 3 показаны обычный настольный сканер и персональный компьютер, которые используются совместно для преобразования печатных документов в электронные документы, которые можно хранить в запоминающих устройствах большой емкости и (или) в электронной памяти. В настольном сканере 302 имеется прозрачное стекло планшета 304, на которое помещен документ 306 лицевой стороной вниз. Запуск сканирования приводит к получению оцифрованного изображения отсканированного документа, которое можно передать на персональный компьютер (ПК) 308 для хранения на запоминающем устройстве большой емкости. Программа визуализации изображения сканируемого документа может отобразить оцифрованное отсканированное изображение документа для отображения на экране 310 устройства отображения 312 ПК. Настольный сканер обеспечивает более стабильную и точную платформу для получения изображения документа, чем переносное устройство, но он также может формировать изображения документа, в которых имеются проблемы контраста, искажения и другие дефекты.

На Фиг. 4 показано типовое изображение с цифровым кодированием. Кодированное изображение включает двухмерный массив пикселей 402. На Фиг. 4 каждый небольшой квадрат, например, квадрат 404, является пикселем, который обычно определяется как наименьшая часть детализации изображения, для которой предусматривается цифровая кодировка. Каждый пиксель представляет собой место, обычно представленное как пара цифровых значений, соответствующих значениям на осях прямоугольных координат x и y (406 и 408, соответственно). Таким образом, например, пиксель 404 имеет координаты x, y (39,0), а пиксель 412 имеет координаты (0,0). В цифровой кодировке пиксель представлен числовыми значениями, указывающими на то, как область изображения, соответствующая пикселю, представляется при печати, отображается на экране компьютера или ином дисплее. Обычно для черно-белых изображений для представления каждого пикселя используется единичное значение в интервале от 0 до 255 с числовым значением, соответствующим уровню серого, с которым отображается этот пиксель. Согласно общепринятому правилу значение «0» соответствует черному цвету, а значение «255» - белому. Для цветных изображений может применяться множество различных наборов числовых значений, указывающих на цвет. В одной широко используемой цветовой модели, показанной на Фиг. 4, каждый пиксель связан с тремя значениями, или координатами (r, g, b), которые указывают на яркость красного, зеленого и синего компонента цвета, отображаемого в соответствующей пикселю области.

На Фиг. 5 показан один вариант цветовой модели RGB. Тремя координатами основных цветов (r,g,b) представлен весь спектр цветов, как было показано выше со ссылкой на Фиг. 4. Цветовая модель может считаться соответствующей точкам в пределах единичного куба 502, в котором трехмерное цветовое пространство определяется тремя осями координат: (1) r 504; (2) g 506; и (3) b 508. Таким образом, координаты отдельного цвета находятся в диапазоне от 0 до 1 по каждой из трех цветовых осей. Например, чистый синий цвет максимально возможной яркости соответствует точке 510 по оси b с координатами (0,0,1). Белый цвет соответствует точке 512 с координатами (1,1,1,), а черный цвет - точке 514, началу системы координат с координатами (0,0,0).

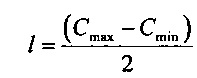

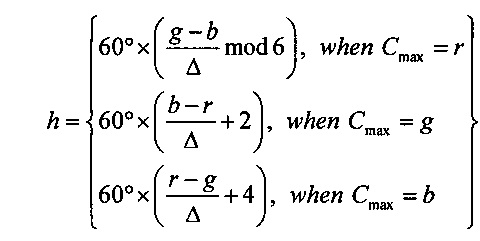

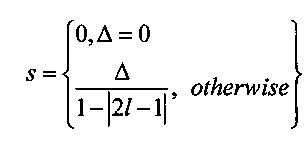

На Фиг. 6 показана другая цветовая модель «Оттенок-насыщенность-светлота» (HSL). В этой цветовой модели цвета содержатся в трехмерной бипирамидальной призме 600, имеющей шестигранное сечение. Оттенок (h) связан с доминантной длиной волны излучения света, воспринимаемого наблюдателем. Значение оттенка изменяется от 0° до 360°, начиная с красного 602 при 0°, проходит через зеленый 604 при 120°, синий 606 при 240°, и заканчивается красным 602 при 360°. Насыщенность (s), изменяющаяся в интервале от 0 до 1, обратно связана с количеством белого и черного цвета, смешанного при определенной длине волны или оттенке. Например, чистый красный цвет 602 полностью насыщен при насыщенности s=1,0, в то время как розовый цвет имеет значение насыщенности меньше 1,0, но больше 0,0, белый цвет 608 является полностью ненасыщенным, для него s=0,0, а черный цвет 610 также является полностью ненасыщенным, для него s=0,0. Полностью насыщенные цвета располагаются по периметру среднего шестигранника, содержащего точки 602, 604 и 606. Шкала оттенков серого проходит от черного 610 до белого 608 по центральной вертикальной оси 612, представляющей полностью ненасыщенные цвета без оттенка, но с различными пропорциональными сочетаниями черного и белого. Например, черный цвет 610 содержит 100% черного цвета и совсем не содержит белый цвет, белый цвет 608 содержит 100% белого цвета и совсем не содержит черный цвет, а точка начала координат 613 содержит 50% черного цвета и 50% белого цвета. Светлота (l) представлена центральной вертикальной осью 612, она указывает на уровень освещенности, который изменяется от 0 для черного цвета 610 (l=0,0), до 1 для белого цвета 608 (l=1,0). Для произвольного цвета, представленного точкой 614 на Фиг. 6, оттенок определяется как угол θ 616 между первым вектором из исходной точки 613 к точке 602 и вторым вектором из исходной точки 613 к точке 620, в которой вертикальная линия 622, проходящая через точку 614, пересекает плоскость 624, включающую исходную точку 613 и точки 602, 604 и 606. Насыщенность представлена отношением расстояния представленной точки 614 от вертикальной оси 612 d' к длине горизонтальной линии, проходящей через точку 620 от исходной точки 613, к поверхности бипирамидальной призмы 600, d. Светлота представлена вертикальным расстоянием от репрезентативной точки 614 до вертикального уровня точки, представляющей черный цвет 610. Координаты конкретного цвета в цветовой модели (h, s, l), могут быть получены на основе координат цвета в цветовой модели RGB (r, g ,b) следующим образом:

,

,

, и

, и

,

,

где значения r, g и b соответствуют яркости красного, зеленого и синего первичных цветов, нормализованных на интервале [0, 1]; Cmax представляет нормализованное значение яркости, равное максимальному значению из r, g и b; Cmin представляет собой нормализованное значение яркости, равное минимальному значению из r, g и b; а Δ определяется как Cmax-Cmin.

На Фиг. 7 показано формирование полутонового или бинаризованного изображения из цветного изображения. В цветном изображении каждый пиксель обычно описывается тремя значениями: а, b и с 702. В разных цветовых моделях для представления конкретного цвета используются разные значения a, b и с. Полутоновое изображение содержит для каждого пикселя только одно значение яркости 704. Бинаризованное изображение является частным случаем полутонового изображения, которое имеет только два значения яркости «0» и «1». Обычно полутоновые изображения могут иметь 256 или 65 536 разных значений яркости для каждого пикселя, представленного байтом или 16-битным словом соответственно. Таким образом, чтобы преобразовать цветное изображение в полутоновое, три значения а, b и с цветных пикселей необходимо преобразовать в одно значение яркости для полутонового или бинаризованного изображения. На первом этапе три цветовых значения а, b и с преобразуются в значение яркости L, обычно находящееся в диапазоне [0,0, 1,0] 706. В некоторых цветовых моделях к каждому из цветовых значений 708 применяется функция, а результаты суммируются 710 для получения значения яркости. В других цветовых моделях каждое цветовое значение умножается на коэффициент, и полученные результаты суммируются 712, давая значение яркости. В других цветовых системах одно из трех значений цвета фактически является значением яркости 714. Наконец, в общем случае к трем цветовым значениям 716 применяется функция, которая дает значение яркости. Затем значение яркости квантуется 718, позволяя получить значение яркости оттенков серого в требуемом интервале, обычно [0, 255] для полутоновых изображений и (0,1) для бинаризованных изображений.

Пример выбора модели для способа типа RANSAC

На Фиг. 8A-N показаны модели, которые описывают преобразования первого изображения документа во второе изображение документа и способ выбора конкретной модели из множества моделей-кандидатов для описания конкретного преобразования для двух соответствующих изображений документа. Преобразования могут отражать различные типы физического или связанного с получением изображения искажения или изменения документа по отношению к нормализованному документу такого же типа. Например, нормализованный документ может представлять собой точное изображение сертификата или удостоверения определенного типа. При получении изображения такого сертификата или удостоверения в неидеальных условиях могут возникнуть различные типы искажения изображения вследствие нестандартного расположения и ориентации устройства формирования изображения по отношению к документу, отсутствия фокусировки и других подобных условий, вызывающих искажения. В другом примере сертификат или удостоверение, для которых получают изображение, могут быть физически искажены из-за того, что этот документ смяли, сложили, испачкали, либо в результате других таких физических событий, вызывающих искажения. В обсуждаемых ниже способах и системах для выявления конкретных типов фрагментов изображений документов из изображений выбирается преобразование для описания любых искажений или других различий между нормированным документом или эталонным документом, и соответствующим фрагментом изображения документа внутри изображения. Во многих случаях определение преобразования включает определение не только модели, но также одного или нескольких параметров модели, которые наилучшим образом соответствуют наблюдаемым искажениям и различиям нормализованного изображения и соответствующего фрагмента изображения. Один из способов определения параметров математической модели из множества наблюдаемых данных называется способом оценки параметров на основе случайных выборок (random sample consensus или RANSAC). В обсуждаемом ниже примере со ссылкой на Фиг. 8A-N используется похожий на RANSAC метод оценки параметров для определения параметра модели, который наилучшим образом согласует модель с наблюдаемыми данными. Цель этого примера - для общего случая проиллюстрировать похожие на RANSAC методы выбора модели параметров. В раскрываемых в настоящем описании способах и подсистемах используются различные похожие на RANSAC методы для нескольких более сложных типов подгонки параметров и построения модели.

На Фиг. 8А показан пример проблемной области, для которой используется похожий на RANSAC метод подгонки параметра, а также выбор модели для определения преобразования, которое связывает первое изображение image1 со вторым изображением image2. На Фиг. 8А первое изображение 802 и второе изображение 804 показаны в верхней части чертежа. Первое изображение 802 содержит пять темных объектов на светлом фоне, в том числе три темных объекта квадратной формы 806-808 и два объекта неправильной формы 809 и 810. Второе изображение 804 также содержит пять объектов, в том числе три объекта квадратной формы 811-813 и два объекта неправильной формы 814 и 815. Первое изображение представляет собой двумерную матрицу пикселей, индексированных координатами (x, y) 818, а второе изображение 804 представляет собой двумерную матрицу пикселей, индексированных координатами (x', y') 819. Предположение заключается в том, что некоторые объекты или все объекты второго изображении 804 связаны с объектами первого изображения с помощью математически выраженного преобразования. Прямое преобразование 820 включает функцию f(x, y), возвращающую соответствующие координаты (x', y') для точки с координатами (x, y) в первом изображении. Обратное преобразование 821 преобразует координаты пикселя второго изображения в координаты пикселя первого изображения. Третье предположение для конкретного примера проблемы заключается в том, что цвет и (или) яркость пикселя (x, y) в первом изображении равны цвету и (или) яркости соответствующего пикселя (x', y') во втором изображении 822 или что они близки.

На Фиг. 8B-D показаны три различные возможные модели, представленные математическими выражениями, для преобразования объектов первого изображения 802, показанного на Фиг. 8А, в соответствующие объекты второго изображения 804, показанного на Фиг. 8А. Первая возможность, показанная на Фиг. 8В, представляет собой вертикальное перемещение объектов первого изображения в соответствующие позиции, которые, если бы модель была правильной, совпадали бы с позициями соответствующих объектов второго изображения. На Фиг. 8В объекты первого изображения показаны как незаштрихованные объекты, такие как квадратный объект 806, в то время как объекты второго изображения показаны как заштрихованные объекты, имеющие границы в виде пунктирных линией, такие как объект 811. Приемлемое преобразование преобразует пиксели объектов первого изображения в соответствующие пиксели объектов второго изображения. В случае модели вертикального перемещения, показанной на Фиг. 8В, некоторые пиксели, расположенные внутри объектов первого изображения, такие как пиксели 823 и 824, преобразуются согласно показанному преобразованию в соответствующие пиксели 825 и 826, расположенные внутри объектов второго изображения. Однако в других случаях, например, для пикселей 827 и 828, расположенных внутри объектов первого изображения 807 и 809, рассматриваемое преобразование преобразует пиксели в точки 829 и 830, расположенные вне объектов. Таким образом, модель вертикального перемещения по-видимому не является особенно устойчивой и точной моделью преобразования объектов первого изображения в объекты второго изображения. Модель вертикального перемещения вниз показана 831 сбоку от составного изображения 832, приведенного на Фиг. 8В.

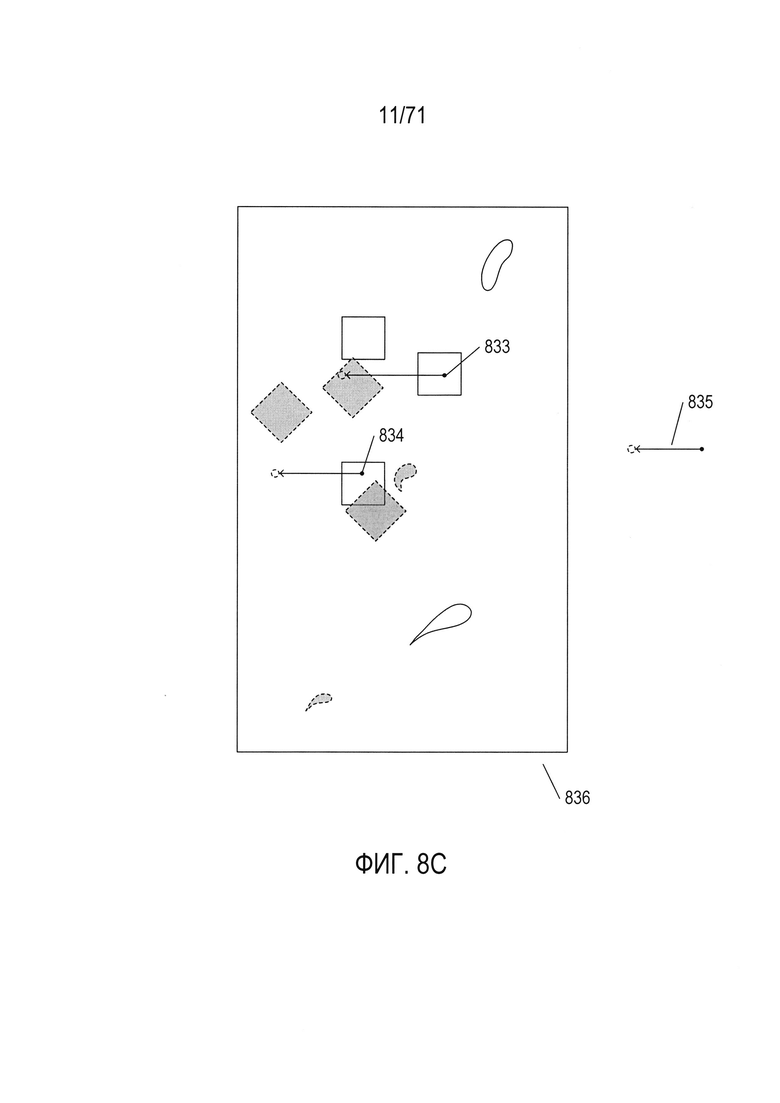

На Фиг. 8С показана модель горизонтального перемещения, при этом для иллюстрации используются те же понятия, что и на Фиг. 8В. Здесь также некоторые пиксели, такие как пиксель 833, преобразуются из объектов первого изображения в объекты второго изображения, в то время как другие пиксели, такие как пиксель 834, преобразуются из объектов первого изображения в места, расположенные вне объектов. Как и на Фиг. 8В, модель горизонтального перемещения влево схематически представлена 835 справа от составного изображения 836, показанного на Фиг. 8С.

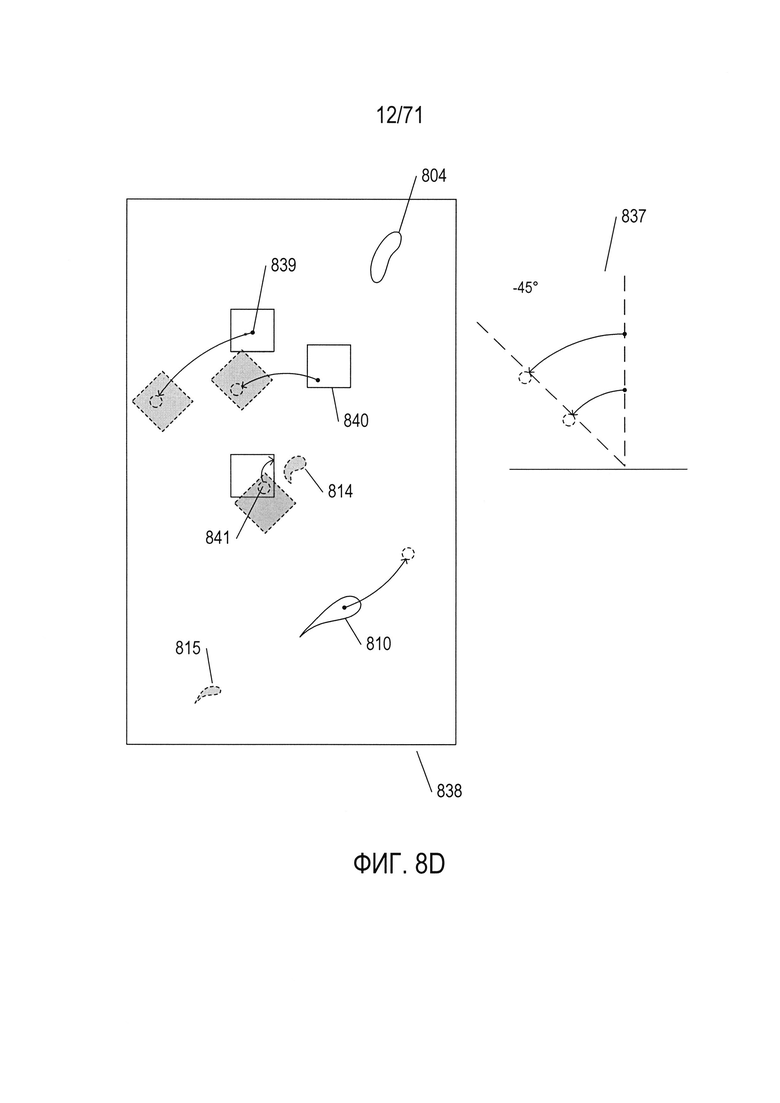

Наконец, на Фиг. 8D показана третья модель преобразования объектов изображения image1 в изображение image2, в ней в целях иллюстрации используются те же понятия, которые использовались на Фиг. 8В и 8С. Эта модель представляет собой поворот изображения image1 на 45 градусов вокруг центральной точки изображения image1 в направлении против часовой стрелки, что показано представлением модели 837 справа от составного изображения 838, показанного на Фиг. 8D. В целом каждая точка каждого квадратного объекта первого изображения, например, точки 839-841, преобразуется в соответствующие квадратные объекты второго изображения. Однако объекты неправильной формы первого изображения 809 и 810 не преобразуются в объекты неправильной формы второго изображения 814 и 815. Тем не менее именно эта модель будет считаться наиболее правильной из трех описанных моделей, поскольку фактически второе изображение 804 на Фиг. 8А было получено из первого изображения 802 поворотом квадратных объектов на 45 градусов против часовой стрелки вокруг центральной точки изображения. Объекты неправильной формы намеренно не были преобразованы поворотом на 45 градусов. Этот пример показывает, что может существовать основная модель, которая представляет преобразование положений отдельных объектов, представляющих интерес в первом изображении, в положение этих объектов во втором изображении, и что могут существовать другие признаки изображения, включая шум, оптические искажения и другие признаки, которые не так легко преобразовать. Таким образом, процесс оценки различных возможных моделей, а также выбора наилучшего значения параметра модели может включать сравнение результатов для того, чтобы выбрать лучшую, хотя и не полностью объясняющую модель. Следует обратить внимание на то, что для каждой из моделей, показанных на Фиг. 8B-D, имеется один параметр, значение которого требуется определить. Две модели преобразования имеют параметр «расстояние перемещения», в то время как модель вращения имеет параметр «угол поворота». В общем случае для модели могут потребоваться два или более значений параметров, которые необходимо определить. Похожие на RANSAC методы были разработаны для решения общей задачи определения параметров модели.

На Фиг. 8E-N с помощью таблицы показаны входные и выходные характеристики, а также ряд блок-схем для основанного на методе RANSAC подхода к определению того, какая из моделей, показанных на Фиг. 8B-D, наилучшим образом объясняет преобразование объектов первого изображения 802 (Фиг. 8А) в различные положения на втором изображении 804, показанном на Фиг. 8А, а также определяет оптимальное значение параметров модели для входных данных.

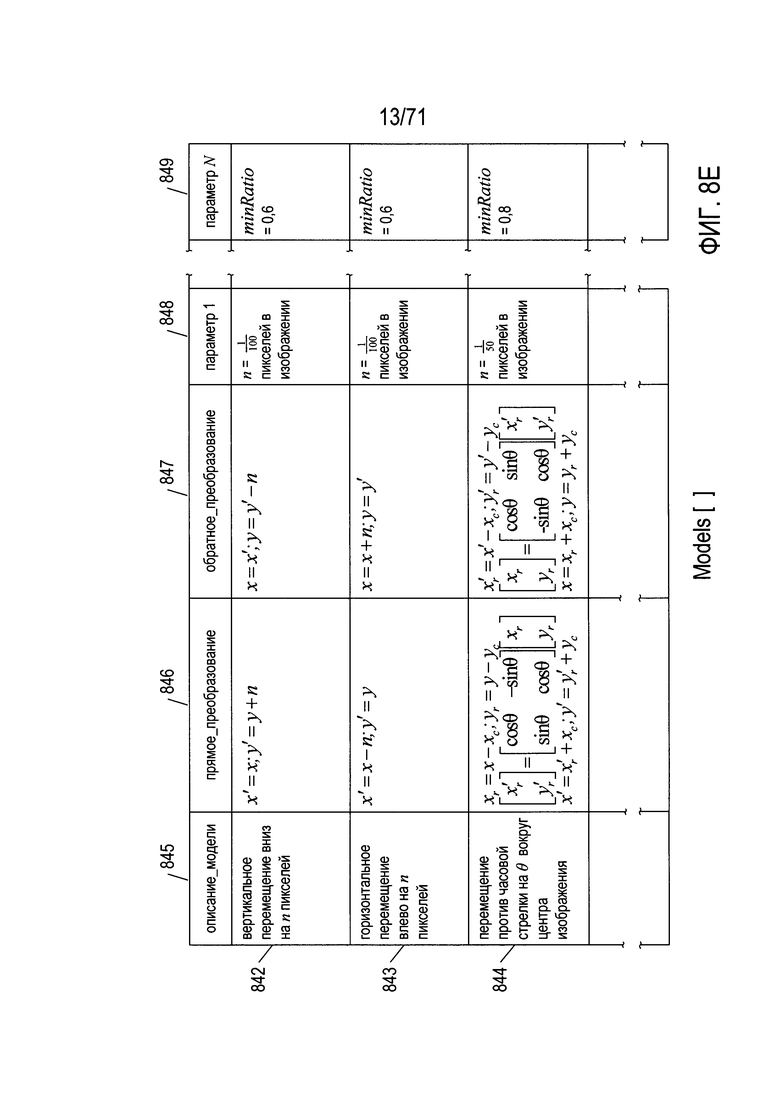

На Фиг. 8Е показана таблица, которая включает характеристики трех моделей. Три строки 842-844 представляют преобразование при вертикальном перемещении вниз, показанное на Фиг. 8В, преобразование при горизонтальном перемещении влево, показанное на Фиг. 8С, и преобразование поворотом против часовой стрелки, показанное на Фиг. 8D. Столбцы таблицы соответствуют представленным рядами полям в записях. Таким образом, каждая модель включает текстовое описание, соответствующее столбцу 845, математическое выражение прямого преобразования, соответствующее столбцу 846, одно или несколько математических выражений обратного преобразования, соответствующие столбцу 847, а также различные неизменяемые параметры, используемые в похожем на RANSAC методе подгонки параметра, которые обсуждаются ниже, соответствующие столбцам 848-849. Каждая модель математически описывается одним переменным параметром: параметром р в первых двух моделях и параметром θ в третьей модели.

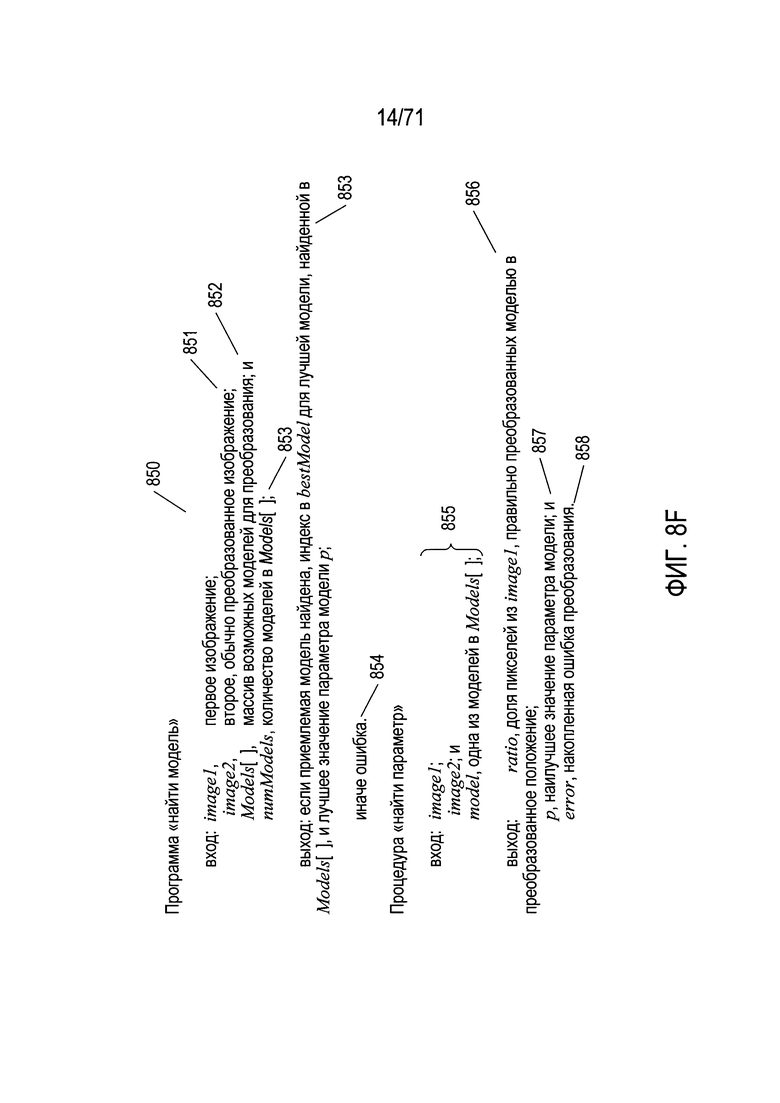

На Фиг. 8F показаны входные и выходные аргументы программы «найти модель» (find model) и подпрограммы «найти параметр» (find parameter). Программа «найти модель» получает в качестве входных данных два изображения 850 и 851, массив моделей 852 и указание количества моделей в массиве моделей 853. Эта программа оценивает каждую модель в отношении исходных изображений. Если выявлена приемлемо точная модель, объясняющая систематические различия между положениями и цветами объектов в двух изображениях, то программа «найти модель» возвращает индекс наилучшей модели, определенной в массиве «Models», а также значение параметра р или θ, используемое в математических выражениях для преобразования, представленного моделью 853. В противном случае программа «найти модель» возвращает индикацию ошибки 854. В подпрограмме «найти параметр» реализован похожий на RANSAC метод, определяющий значение параметра модели р, который наилучшим образом описывает входные данные. Подпрограмма «найти параметр» получает в качестве входных данных 855 два изображения и массив моделей и на выходе определяет долю пикселей первого изображения, которые правильно преобразуются моделью в преобразованные положения во втором изображении 856, наилучшее значение параметра модели р 857, а также общую ошибку приложения, характеризующую применение преобразования к первому изображению 858.

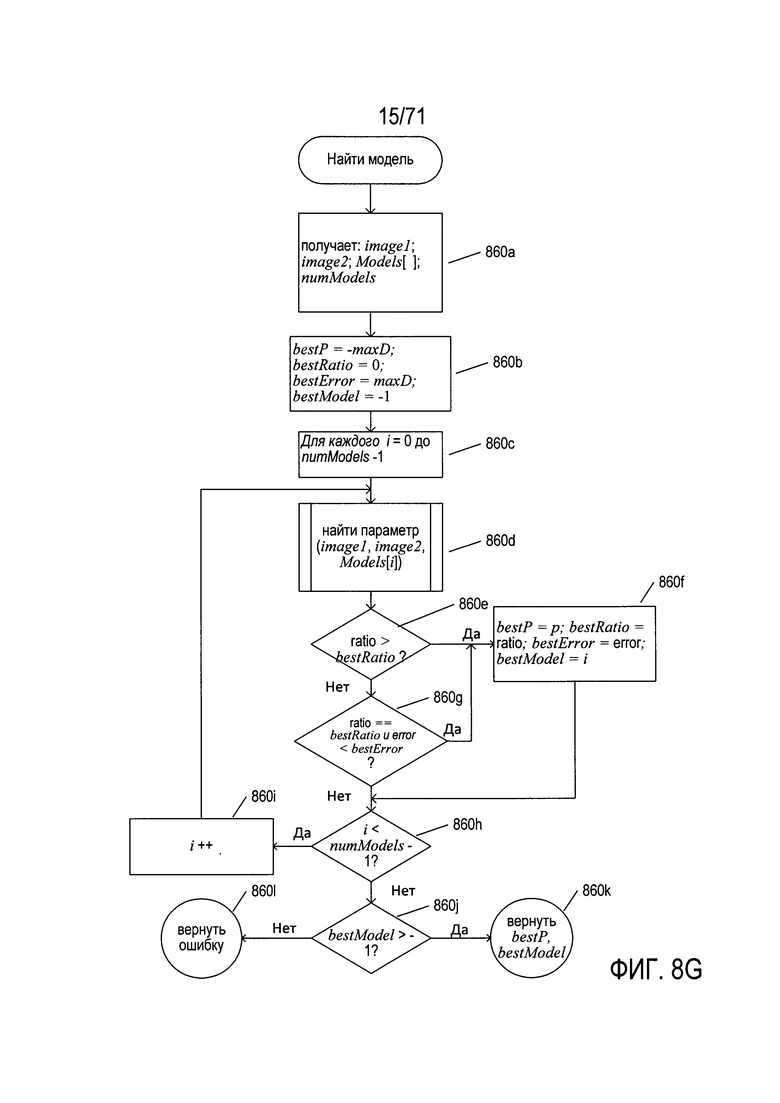

На Фиг. 8G приведена блок-схема программы «найти модель». На шаге 860а программа «найти модель» получает первое и второе изображение, массив «Models» и указание количества моделей или записей в массиве «Models». Изображения могут быть получены в виде ссылок на файлы изображений, в виде ссылок на массивы пикселей или с помощью других стандартных вычислительных методик ввода. На шаге 860b программа «найти модель» инициализирует несколько локальных переменных, включая следующие: (1) bestP - наилучшее значение параметра; (2) bestRatio - наилучшее отношение правильно преобразованных пикселей к общему количеству пикселей в первом изображении; (3) bestError - общая ошибка для наилучшей модели; и (4) bestModel - индекс массива «Models», соответствующий модели, которая лучше всего объясняет различия между изображениями image1 и image2. В цикле for на шагах 860C-860i рассматривается каждая модель в массиве «Models». На шаге 860d вызывается подпрограмма «найти параметр» (find parameter) для определения наилучшего значения параметра модели. Если возвращаемое подпрограммой «найти параметр» отношение превышает значение, хранящегося в локальной переменной best Ratio, которое было определено на шаге 860е, то локальные переменные на шаге 860f обновляются значениями, возвращенными подпрограммой «найти параметр» для рассматриваемой в текущий момент модели. В противном случае, если возвращаемое подпрограммой «найти параметр» отношение равно значению, сохраненному в локальной переменной bestRatio, и общая ошибка, возвращенная подпрограммой «найти параметр», меньше значения, хранящегося в локальной переменной bestError, то на шаге 860f локальные параметры обновляются. В противном случае, если переменная цикла / меньше, чем значение numModels - 1, что определено на шаге 860h, то переменная цикла увеличивается на шаге 860i, и происходит переход к шагу 860d для следующей итерации цикла for. Если после завершения цикла for сохраненный в локальной переменной индекс bestModel превышает значение -1, определенное на шаге 860j, то затем на шаге 860k возвращаются значения, сохраненные в локальных переменных bestP и bestModel. В противном случае на шаге 860l возвращается индикация ошибки. Таким образом, программа «найти модель» оценивает все модели в массиве «Models» и возвращает указание на модель, которая наилучшим образом описывает преобразование признаков между первым и вторым исходными изображениями, а также наилучшее значение параметра для этой модели. Однако если приемлемая модель не найдена, как описано далее ниже, то программа «найти модель» возвращает индикацию ошибки.

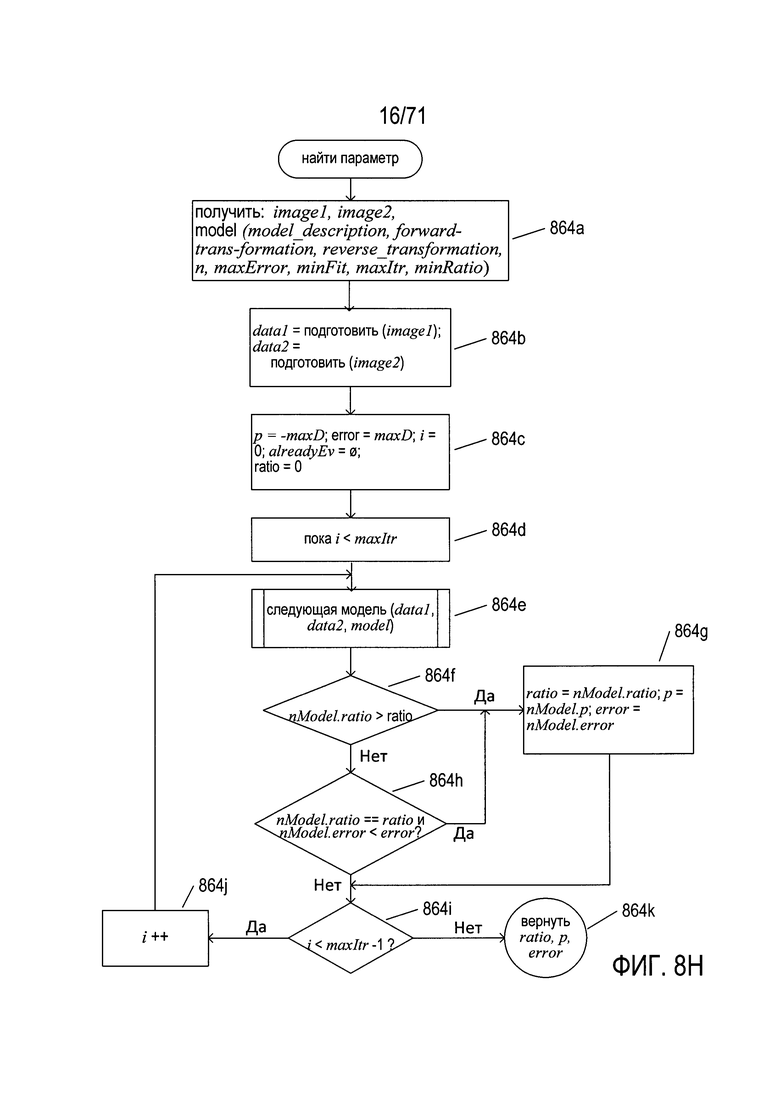

На Фиг. 8H-N показана подпрограмма «найти параметр», вызываемая на шаге 860d на Фиг. 8G. Это похожий на RANSAC метод определения наилучшего значения параметра для модели с одним параметром. Эта подпрограмма легко расширяется на определение нескольких значений параметров для моделей, имеющих два или более переменных параметра, однако при использовании простейших подходов объем дополнительных расчетов возрастает в геометрической прогрессии.

На Фиг. 8Н показана блок-схема высшего уровня для подпрограммы «найти параметр». На шаге 864а подпрограмма «найти параметр» принимает два изображения и конкретную модель для оценки того, как она выражает преобразование между двумя изображениями. На шаге 864b подпрограмма «найти параметр» подготавливает оба изображения к анализу, причем для ссылки на подготовленные изображения используются переменные data1 и data2. Подготовка изображения может включать изменение цветовой модели, превращение изображения в полутоновое, преобразование изображения в бинаризованное и другие подобные преобразования. На шаге 864 с инициализируется несколько локальных переменных, в том числе: (1)р - текущее наилучшее значение параметра; (2) error - текущая общая ошибка наилучшего определенного значения параметра на текущий момент; (3) i - переменная цикла; (4) alreadyEv - набор параметров, которые уже были ранее оценены в ходе текущего выполнения подпрограммы «найти параметр»; и (5) ratio - наилучшее отношение, уже определенное для текущего наилучшего значения параметра. В цикле while, состоящем из шагов 864d-864j, испытываются различные значения параметра модели, а наилучший параметр, опробованный во время выполнения цикла while, используется в качестве значения параметра, которое наиболее точно подгоняет модель к данным исходного изображения. Параметр модели maxItr управляет количеством различных значений опробованных параметров. В альтернативных вариантах реализации цикл while может прерываться, если найдено значение параметра, которое обеспечивает результат лучший, чем требуется пороговым значением. На шаге 864е вызывается подпрограмма «следующая модель» (next model) для определения и оценки следующего значения параметра. Если отношение правильно преобразованных пикселей к общему количеству пикселей, полученных при применении модели ко входным данным со значением параметра, превышающим значение, хранящееся в локальной переменной ratio, которая определена на шаге 864f, то локальные переменные ratio, р и error обновляются соответствующими значениями, возвращенными подпрограммой «следующая модель». Если отношение, возвращаемое подпрограммой «следующая модель» совпадает со значением, хранящемся в локальной переменной ratio (отношение), а общая ошибка, полученная при применении модели с рассматриваемым в настоящее время параметром к входным данным, меньше значения, хранящегося в локальной переменной error (ошибка), которое определено на шаге 864h, то локальные переменные ratio, р и error обновляются на шаге 864g. В любом случае, если на условных шагах 864f и 864h возвращаются значения true (истина), рассматриваемый в настоящее время параметр является наилучшим определенным до сих пор параметром. Затем, если переменная цикла i меньше значения maxItr - 1, которое определено на шаге 864i, то переменная цикла обновляется на шаге 864j, и происходит переход обратно к шагу 864е для еще одной итерации цикла while. Когда цикл while завершается, подпрограмма «найти параметр» на шаге 864k возвращает значения локальных переменных ratio, р и error. Следует обратить внимание на возможность того, что приемлемое значение параметра может быть не найдено, в этом случае локальные переменные ratio, р и error имеют те значения, с которыми они были инициализированы на шаге 864с. Фактически эти начальные значения указывают на состояние ошибки.

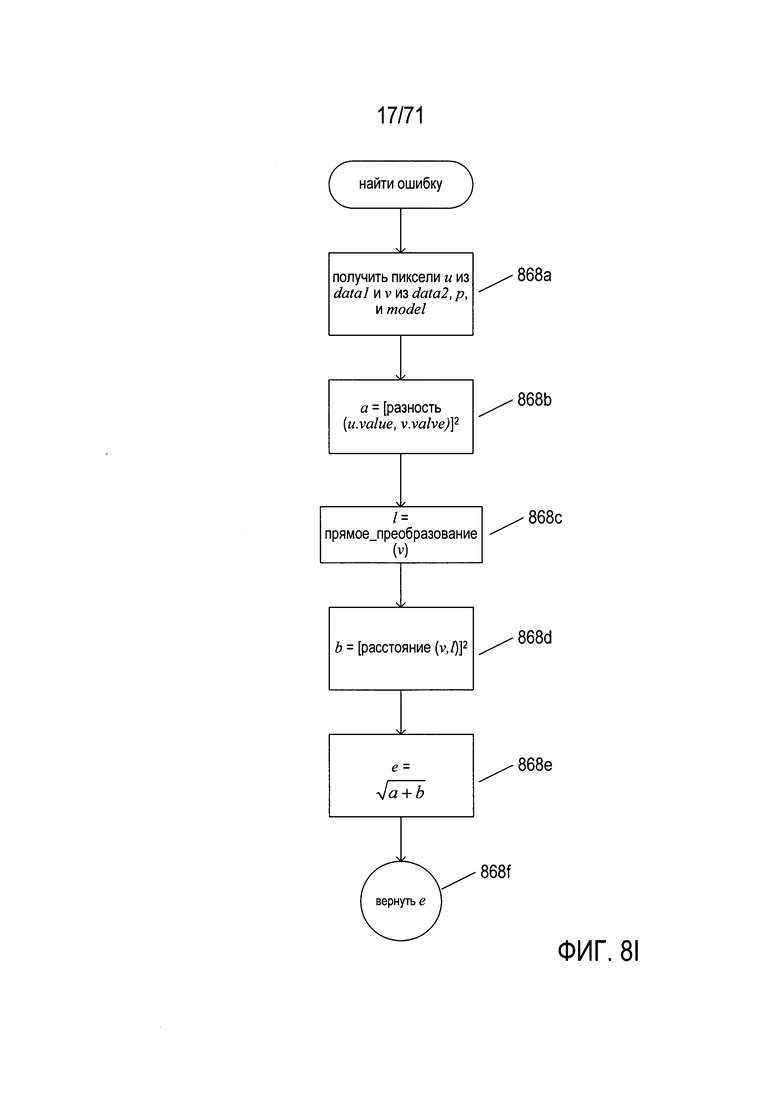

На Фиг. 8I показана блок-схема подпрограммы «найти ошибку» (find error). Эта подпрограмма определяет значение ошибки для двух пикселей, преобразованных текущей моделью при текущем значении параметра. На шаге 868а подпрограмма «найти ошибку» получает два пикселя u и v из наборов данных data1 и data2, соответственно, текущее значение параметра модели р, а также текущую модель. На шаге 868b подпрограмма «найти ошибку» назначает для локальной переменной а квадрат разности между значениями пикселей u и v. Эта разность может представлять собой отношение расстояния между значениями пикселей к максимально возможному различию значений пикселей или некоторую другую меру различий. На шаге 868с подпрограмма «найти ошибку» преобразует пиксель u в пиксель l согласно модели и текущему значению параметра. Другими словами, используя прямое преобразование для модели, подпрограмма «найти ошибку» вычисляет преобразованное положение для пикселя u. Далее, на шаге 868d, подпрограмма «найти ошибку» вычисляет квадрат расстояния между положениями точек v и l и записывает это значение в локальную переменную b. Можно использовать различные метрики расстояния, включая метрику городских кварталов или евклидово расстояние. Наконец, на шаге 868е подпрограмма «найти ошибку» вычисляет общую ошибку как квадратный корень из суммы локальных переменных а и b и возвращает вычисленную ошибку на шаге 868f.

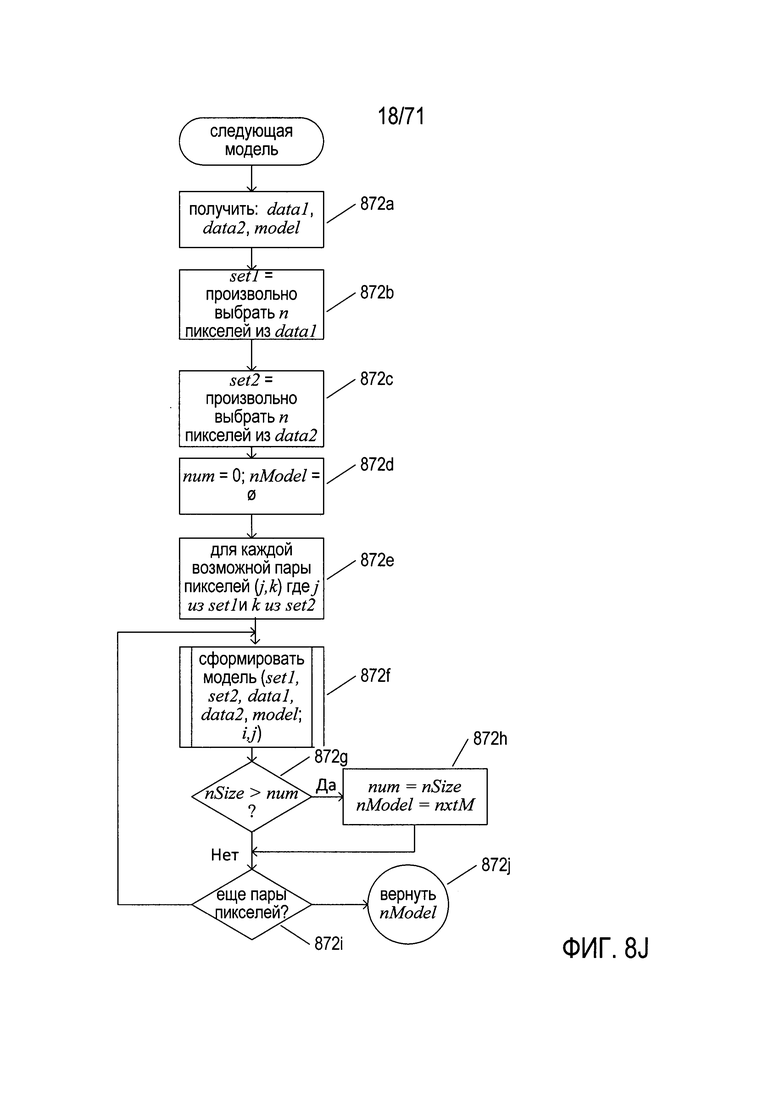

На Фиг. 8J показана блок-схема высокого уровня для подпрограммы «следующая модель» (next model), вызываемой на шаге 864е (Фиг. 8Н). На шаге 872а подпрограмма «следующая модель» получает наборы данных data1 и data2, а также рассматриваемую в настоящее время модель - запись в массиве «Models». На шаге 872b подпрограмма «следующая модель» случайным образом выбирает n пикселей из набора данных data1 и помещает их в локальную переменную-множество set1. Значение n является одним из неизменяемых параметров модели, оно обсуждалось выше со ссылкой на Фиг. 8Е (848-849). На шаге 872с подпрограмма «следующая модель» случайным образом выбирает n пикселей из второго набора данных и помещает их в локальную переменную-множество set2. На шаге 872d локальные переменные num и nModel устанавливаются равными 0 и пустому множеству, соответственно. В цикле for на шагах 872e-872i подпрограмма «следующая модель» рассматривает каждую возможную пару пикселей (j, k) из локальных переменных-множеств set1 и set2, причем первый пиксель пары выбран из set1, а второй пиксель пары выбран из set2. На шаге 872f подпрограмма «следующая модель» вызывает подпрограмму «создать модель» (generate model) для создания и оценки нового значения параметра для входной модели, как описано ниже. Если на шаге 872g установлено, что значение nSize, возвращаемое подпрограммой «создать модель», больше значения, хранящегося в настоящее время в локальной переменной num, то локальные переменные num и nModel обновляются до соответствующих значений подпрограммой «создать модель» на шаге 872h. Если имеются другие пары пикселей для рассмотрения, что определяется в шаге 872i, то выполняется переход обратно на шаг 872f для еще одной итерации в цикле for, содержащем шаги 872e-872i. Наконец, на шаге 872j возвращаются значения, содержащиеся в текущей переменной-множестве или записи параметра nModel.

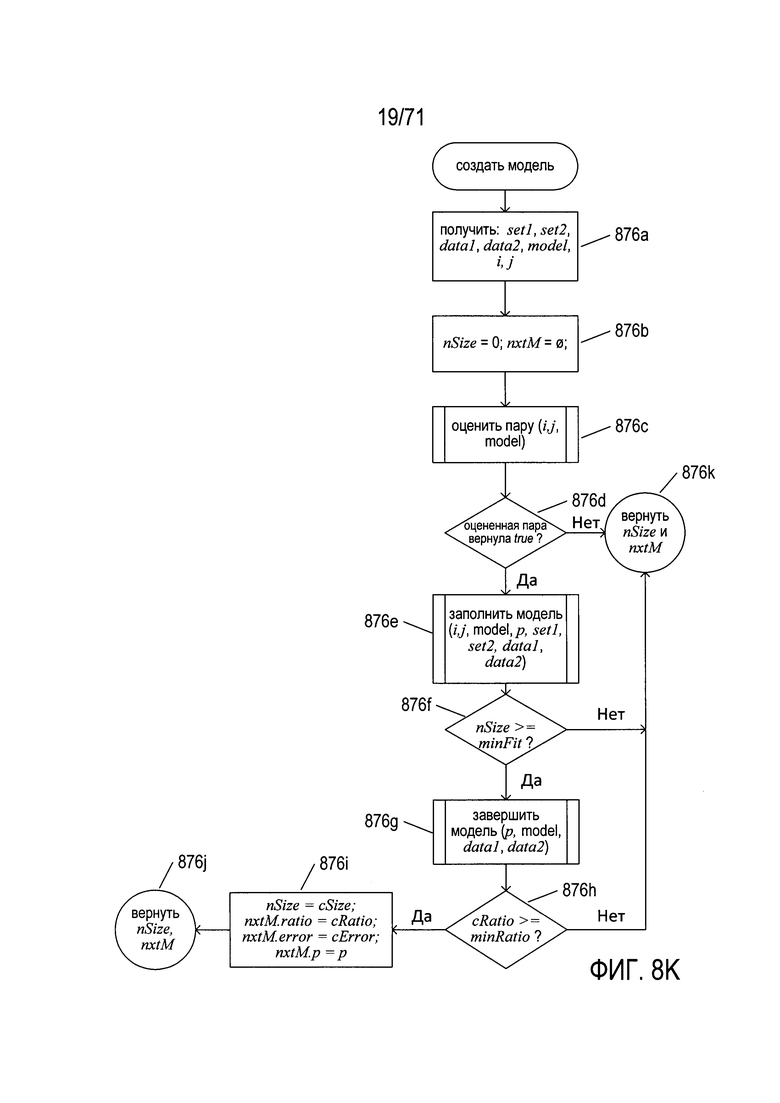

На Фиг. 8К показана блок-схема подпрограммы «создать модель» (generate model), вызываемой на шаге 872f, показанном на Фиг. 8J. На шаге 876а подпрограмма «создать модель» получает наборы set1 и set2, первоначально подготовленные входные данные data1 и data2, рассматриваемую в настоящее время модель и пару пикселей (i, j). Подпрограмма «создать модель» пытается сформировать значение параметра для рассматриваемой в настоящее время модели на основании пары пикселей (i, j). На шаге 876b локальные переменные nSize и nxtM устанавливаются равными 0 и пустому множеству, соответственно. На шаге 876с подпрограмма «создать модель» вызывает подпрограмму «оценить пару» (evaluate pair), чтобы определить, может ли пара пикселей (i, j) быть объяснена как преобразование в соответствии с моделью и выбранным значением параметра. Если на шаге 876d установлено, что процедура «оценить пару», возвращает значение «истина» (true), то затем на шаге 876е подпрограмма «создать модель» вызывает подпрограмму «заполнить модель» (fill model) с целью получить характеристики из множеств set1 и set2 для преобразования, представленного моделью с текущим значением параметра. Если на шаге 876f было установлено, что число пар пикселей со случайно выбранными наборами пикселей set1 и set2, которые объяснены моделью и текущим значением параметра, больше значения minFit, то на шаге 876g подпрограмма «создать модель» вызывает подпрограмму «закончить модель» (complete model) для формирования характеристик преобразования, содержащих текущую модель и выбранный параметр модели. Если на шаге 876h было установлено, что отношение cRatio для правильно преобразованных пикселей, возвращаемое подпрограммой «закончить модель», больше или равно значению minRatio, то возвращаемые значения nSize и nextM устанавливаются равными характеристикам, возвращаемым подпрограммой «закончить модель» на шаге 876i и выдаются на шаге 876j. Следует обратить внимание на то, что значения minFit и minRatio являются неизменяемыми значениями параметров, описанными выше со ссылкой на Фиг. 8Е. Если процедура «оценить пару» возвращает значение «ложь» (false), то начальные значения локальных переменных nSize и nxtM возвращаются на шаге 876k как индикация ошибки.

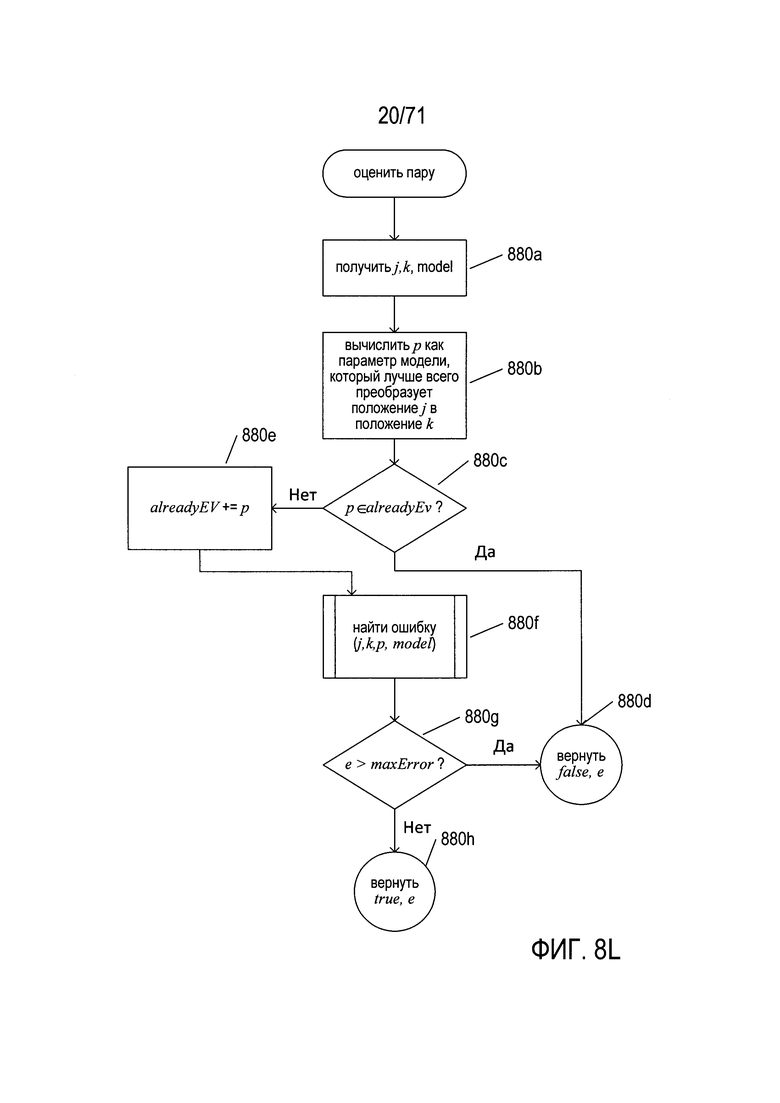

На Фиг. 8L показана блок-схема подпрограммы «оценить пару» (evaluate pair), она вызывается на шаге 876d (см. Фиг. 8К). На шаге 880а подпрограмма «оценить пару» получает два пикселя (j, k) в рассматриваемой в настоящее время модели. На шаге 880b подпрограмма «оценить пару» вычисляет значение параметра модели р в качестве параметра модели, который наилучшим образом преобразует положение j в положение k. Если значение параметра р уже оценивалось на шаге 880с, то процедура «оценить пару» возвращает значение «ложь» (false) на шаге 880d. В противном случае значение р добавляется к множеству alreadyEv на шаге 880е. На шаге 880f подпрограмма «оценить пару» вызывает подпрограмму «найти ошибку», чтобы определить ошибку, связанную с двумя пикселями j и k. Если на шаге 880g установлено, что ошибка, возвращаемая подпрограммой «найти ошибку», больше значения maxError, то подпрограмма «оценить пару» возвращает значение «ложь» (false) на шаге 880d. В противном случае на шаге 880h возвращаются значение «истина» (true) и вычисленная ошибка. Следует обратить внимание на то, что значение maxError является еще одним из параметров подгонки, рассмотренных выше со ссылкой на Фиг. 8Е.

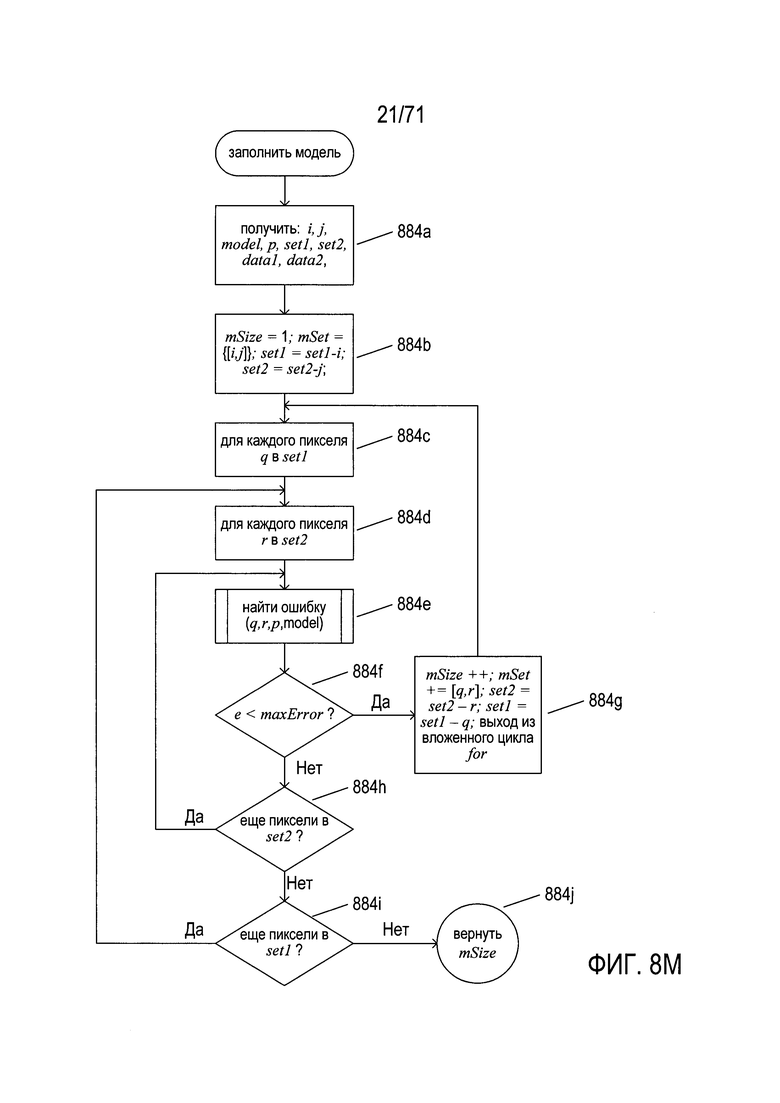

На Фиг. 8М показана блок-схема подпрограммы «заполнить модель» (fill model), которая вызывается на шаге 876е на Фиг. 8K. На шаге 884а подпрограмма «заполнить модель» получает пару пикселей, текущие параметр модели и модель, случайным образом выбранные наборы пикселей set1 и set2, а также подготовленные входные данные data1 и data2. На шаге 884b подпрограмма «заполнить модель» устанавливает локальную переменную mSize равной 1, а локальная переменная-набор mSet включает полученную пару пикселей (i,j), и удаляет пиксели i и j из переменных-множеств set1 и set2. Затем, во вложенном цикле for с шагами 884c-884i, для каждого пикселя в set1 производится попытка согласования с пикселем в set2, используя рассматриваемую в настоящее время модель и текущее значение параметра для этой модели. Если два пикселя представляют собой преобразованную пару с ошибкой меньше maxError, что определяется на шаге 884f, то значение локальной переменной mSize увеличивается, рассматриваемая в настоящее время пара пикселей q и r добавляется к локальной переменной-набору mSet, пиксели q и r удаляются из переменных-наборов set1 и set2, а на шаге 884g выполняется выход из вложенного цикла for. На шаге 884j после завершения вложенных циклов for в локальной переменной mSize возвращается значение, которое отражает количество пикселей в случайным образом выбранном множестве set1, которые корректно преобразуются рассматриваемыми в настоящее время моделью и значением параметра. Именно это значение сравнивается с подгоняемым параметром minFit на шаге 876f на Фиг. 8К, чтобы определить, являются ли рассматриваемые в настоящее время модель и значение параметра приемлемой моделью для преобразования исходного изображения image1 в изображение image2.

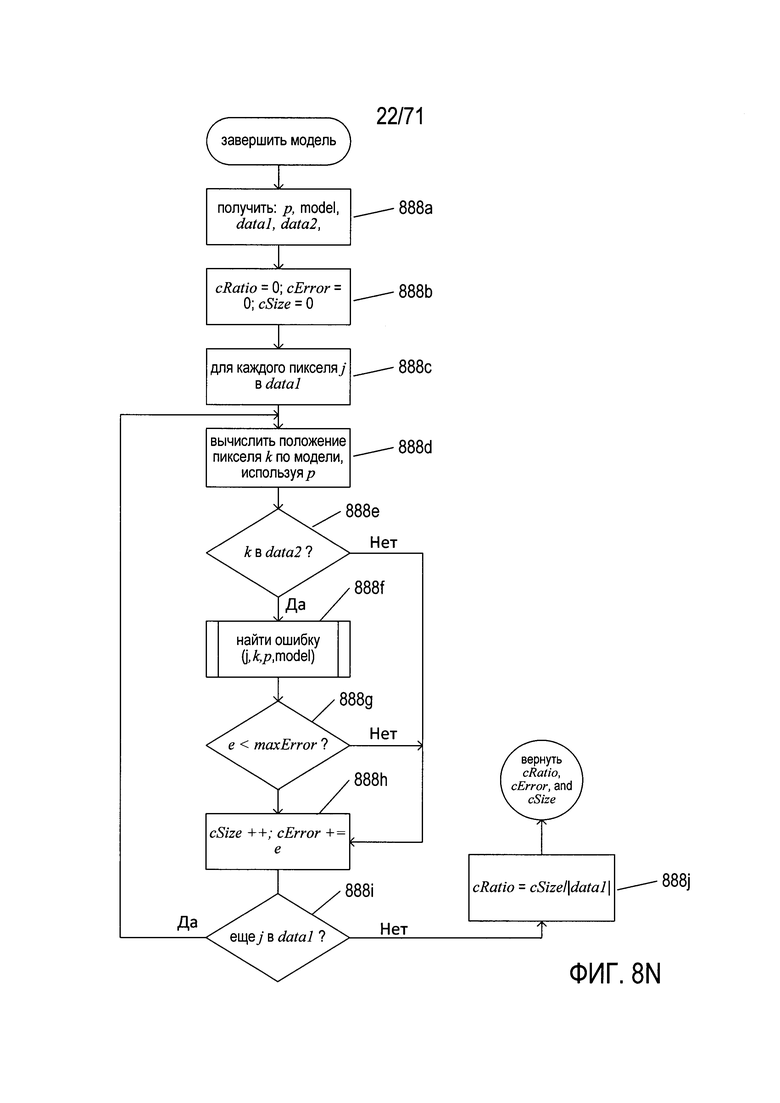

На Фиг. 8N показана блок-схема подпрограммы «завершить модель» (complete model), которая вызывается на шаге 876g на Фиг. 8K. На шаге 888а подпрограмма «завершить модель» получает рассматриваемые в настоящее время модель и значение параметра model и р, а также входные наборы данных data1 и data2. На шаге 888b локальные переменные инициализируются со значением 0, в том числе: (1) переменная cRatio - отношение правильно преобразованных пикселей к общему количеству пикселей, (2) переменная cError - общая ошибка преобразования первого набора данных во второй набор данных с помощью модели и параметра модели и (3) переменная cSize - количество преобразуемых пикселей. Затем, в цикле for с шагами 888c-888i, каждый пиксель в исходном наборе данных преобразуется текущей моделью и значением параметра модели на шаге 888d, и если вычисленное положение пикселя находится в наборе данных data2, а ошибка, связанная с рассматриваемым в настоящее время пикселем и перемещенным пикселем, меньше значения maxError, как определено на шаге 888g, то значение локальной переменной cSize увеличивается, а ошибка для двух пикселей добавляется к общей ошибке cError на шаге 888h. На шаге 888j, после завершения цикла for, отношение правильно преобразованных пикселей к общему количеству пикселей cRatio вычисляется путем деления значения локальной переменной cSize на мощность входного набора данных data1.

Подпрограмма «найти параметр» не гарантирует возвращение приемлемого значения параметра для модели. Однако при выборе подходящих значений подгоняемых параметров весьма вероятно, что если модель достаточно точно выражает преобразование между двумя исходными изображениями, то будет найдено приемлемое значение параметра. Похожий на RANSAC метод можно использовать для подгонки параметров для множества различных типов моделей с целью объяснения различных наборов данных. Например, одно исходное изображение может быть каноническим или нормализованным изображением определенного типа документа, и дополнительные исходные изображения представляют собой различные изображения реальных документов того же типа документа, что и у исходного канонического документа или эталонного документа. В этом случае процедуру необходимо дополнить сравнением эталонного документа или канонического документа с несколькими изображениями для каждого набора, состоящего из одного или более значений параметров, вычисленных для подгонки модели к входным данным. Как уже обсуждалось выше, похожие на RANSAC методы могут соответствовать нескольким параметрам модели, имеющей несколько параметров. Типы входных данных также могут различаться. Единственным реальным ограничением является то, что несмотря на данные, должна существовать норма или критерии оценки для определения того, насколько хорошо преобразованные данные соответствуют входным данным, не имеющим эталона, либо которые не являются каноническими.

Текущая предметная область и несколько примеров типов документов

В настоящем документе рассматриваются способы, системы и подсистемы, которые определяют границы или очертания содержащих документы фрагментов изображений в цифровых изображениях. Из-за повсеместного использования смартфонов для получения изображений к цифровым изображениям документов, полученным с помощью смартфонов и других мобильных устройств, содержащих цифровые камеры, применяются многочисленные методы и приложения для обработки документов. Обычно в качестве первого шага или подпроцесса при интерпретации цифровых изображений документов используется цифровая обработка изображения для выявления фрагментов изображений в цифровом изображении, соответствующих различным типам содержащих текст документов, причем фрагменты изображений определены границами или краями физических документов, изображение которых получено с помощью цифровой камеры для получения цифрового изображения, содержащего фрагменты изображений документа. После выявления в цифровом изображении соответствующих документам фрагментов изображений можно применить множество методик и подсистем различных типов для извлечения информации из содержащих документы фрагментов изображений, в том числе способы и подсистемы оптического распознавание символов (OCR), которые преобразуют содержащие документы изображения или фрагменты изображений в соответствующие электронные документы, содержащие цифровые кодировки текста, а не изображения текста. Обычно электронный документ содержит цифровые значения, соответствующие текстовым символам, а также дополнительную информацию, закодированную в цифровом виде, которые регулируют и задают форматирование документа, шрифты символов, а также другую подобную информацию. Способы и подсистемы, раскрываемые в настоящем документе, направлены на выявление фрагментов изображений, соответствующих конкретным типам документов и цифровых изображений таким образом, чтобы для извлечения информации из содержащих документы фрагментов изображений могли применяться методы OCR и (или) другие методы обработки.

Во многих случаях подсистемы и методики цифровой обработки изображений направлены на извлечение информации из фрагментов изображений, соответствующих документам конкретного типа, например, водительских удостоверений, паспортов, страховых полисов, свидетельств военнослужащих и других подобных документов, которые имеют относительно точно заданные форматы, компоновки и организации. На Фиг. 9А-В показаны два документа, используемые в качестве примеров при обсуждении раскрываемых в настоящем описании способов и подсистем. На Фиг. 9А показано водительское удостоверение, а на Фиг. 9 В показаны первые две страницы паспорта. Как будет рассмотрено ниже, эти типы документов можно описать с помощью соответствующих эталонов. Фактически эти документы представляют собой физические записи или структуры данных, аналогичные записям и структурам данных, используемым при компьютерном программировании. Например, водительское удостоверение 902 на Фиг. 9А содержит шапку с аббревиатурой штата и аббревиатуру страны 904, название штата, выдавшего водительское удостоверение 905, и строку текста «Водительское удостоверение» (Driver License) 906. Все водительские удостоверения, выданные данным конкретным штатом по меньшей мере в течение некоторого последнего периода времени содержат одну и ту же идентичную шапку. Водительское удостоверение содержит две фотографии 908 и 910, причем размеры фотографий и их положения являются общими для всех выданных штатом водительских удостоверений. Кроме того, имеется множество информационных полей. В качестве одного примера, после общей отметки «4d LIC#» 912 следует номер водительского удостоверения 914, уникальный для каждого лица, которому выдано водительское удостоверение. Фамилия этого лица 916 и первое и второе имя этого лица 917-918 представлены в двух дополнительных информационных полях, которым предшествуют цифровые метки «1» и «2» 919 и 920.

Разворот паспорта, показанный на Фиг. 9В, также аналогичен записям или структурам данных, включая обитую графику, текст, фотографию стандартного размера в стандартном месте, а также несколько информационных полей, содержащих информацию, которая является уникальной или индивидуальной для физического лица, которому был выдан этот паспорт.

На Фиг. 10A-10J показаны некоторые из многочисленных проблем и задач, связанных с выявлением содержащих документ фрагментов изображений в цифровом изображении, особенно для цифрового изображения, полученного с помощью портативного смартфона или другого мобильного устройства с процессорным управлением. На Фиг. 10А приведен пример цифрового изображения, содержащий два содержащих документ фрагмента изображения. Цифровое изображение 1002 включает первый фрагмент изображения 1004, соответствующий водительскому удостоверению, и второй фрагмент изображения 1006, соответствующий первому развороту паспорта. Однако кроме этого цифровое изображение содержит различные участки фона и объекты 1008-1011. Первая проблема при выявлении фрагментов изображений, соответствующих изображениям документов, состоит в необходимости отличать эти фрагменты изображений от различных типов дополнительных признаков, шаблонов и объектов, содержащихся в цифровом изображении.

На Фиг. 10В-С иллюстрируются две дополнительные проблемы. Как показано на Фиг. 10В, угловая ориентация водительского удостоверения 1004 и паспорта 1006 отличается от угловой ориентации цифрового изображения 1016. Таким образом, угловая ориентация цифровых фрагментов изображений, соответствующих документам, например, углы ϕ 1018 и θ 1019 на Фиг. 10В, являются примерами параметров, которые могут иметь различные значения в зависимости от того, как было получено цифровое изображение и как документы были физически расположены перед получением изображения. Как показано на Фиг. 10С, другим параметром является масштаб изображения документа. В примере содержащего фрагменты изображений документа изображения 1002, показанном на Фиг. 10А, водительское удостоверение имеет границу 1018, а фрагмент изображения паспорта имеет границу 1020 определенного размера. Однако в зависимости от расстояния от цифровой камеры до этих документов размер фрагментов изображений может изменяться непрерывно в широком диапазоне размеров, как показано на Фиг. 10С пунктирными границами различных масштабов, такими как пунктирная граница 1022.

На Фиг. 10D-I показаны дополнительные проблемы, связанные с выявлением содержащих документы фрагментов изображений в цифровых изображениях, особенно полученных с помощью управляемых процессорами мобильных устройств, например, смартфонов. На Фиг. 10D показан квадратный документ 1024 в плоскости x, z трехмерного декартова пространства x, y, z 1026. На Фиг. 10Е документ повернут в плоскости x, z 1024 вокруг оси z, при этом получена повернутая версия документа 1028. На Фиг. 10F повернутая версия документа 1028 повернута вокруг проходящей через документ центральной горизонтальной линии, и получен дважды повернутый документ 1030. На Фиг. 10G-I показано изображение квадратного документа, сфотографированного при трех различных состояниях поворота, показанных на Фиг. 10D-F с помощью камеры, у которой внутренняя поверхность, на которой формируется изображение, направлена перпендикулярно к оси у. На Фиг. 10G изображение 1032 квадратного документа 1024 представляет собой точное воспроизведение документа, возможные различия определяют его масштаб или размер; фрагмент изображения документа зависит от увеличения объективом камеры и отображения снятого изображения на устройстве отображения. В отличие от него, изображение 1034 повернутого документа 1028 на Фиг. 10Е искажено, что показано на Фиг. 10Н. Полученное двухмерное изображение 1036 выглядит как параллелограмм, а не квадрат. Аналогичным образом показанное на Фиг. 10I изображение 1038 дважды повернутого документа 1030, ранее показанного на Фиг. 10F, в полученном цифровом изображении 1040 представляет собой еще сильнее искаженный параллелограмм. Таким образом, относительная ориентация поверхности съемки изображения в цифровой камере и снимаемого документа могут вводить различные вызванные относительной ориентацией искажения формы фрагмента изображения, соответствующего документу.

На Фиг. 10J показана еще одна проблема, связанная с выявлением содержащих документы фрагментов изображений в цифровом изображении. На Фиг. 10J камера перед получением изображения была смещена влево, в результате чего фрагмент изображения, соответствующий паспорту 1042 в полученном изображении 1044, теперь обрезан или усечен. Таким образом, представляющий паспорт фрагмент изображения не содержит полные границы или очертания для этого типа документа, что может создать серьезные проблемы при определении той части фрагмента изображения, которая вошла в цифровое изображение 1044.

Разумеется, могут возникнуть проблемы и задачи многих других типов в зависимости от различных параметров, связанных с получением изображений документов и с физическими документами, их расположением и ориентацией. Например, конкретное изображение может содержать только один фрагмент изображения документа, либо оно может содержать фрагменты изображений двух или более документов. Физические документы могут быть физически искажены в результате того, что документ скомкали, испачкали, разорвали, или с ним произошли другие подобные физические изменения. Документ может быть неправильно напечатан или смазан из-за неправильной подготовки документа. Из-за всех этих и дополнительных причин примитивный подход к идентификации в цифровых изображениях фрагментов документов может не обеспечивать точность и надежность, необходимую во многих приложениях. В настоящем документе описываются надежные и точные способы выявления содержащих документы фрагментов изображений в цифровых изображениях, несмотря на различные типы изменений, которые могут наблюдаться в цифровых изображениях, содержащих фрагменты изображений, соответствующие документам определенного типа.

Преобразования перспективы

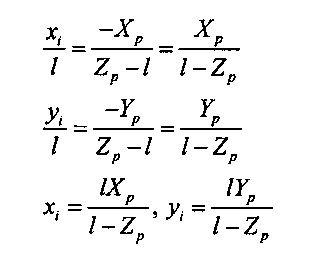

На Фиг. 11A-F показан один подход к установлению соответствия между точками в глобальной системе координат и соответствующими точками в плоскости изображения камеры. На Фиг. 11А показана плоскость захвата изображения камеры, система координат камеры, совмещенная с глобальной системой координат, а также точка в трехмерном пространстве, изображение которой проецируется на плоскость захвата изображения камеры. На Фиг. 11А система координат камеры, включающая оси х, у и z, совмещена с системой глобальных координат X, Y и Z. Это обозначено на Фиг. 11А с помощью двойной маркировки осей х и X 1102, осей y и Y 1104, и осей z и Z 1106. Показано, что фотографируемая точка 1108 имеет координаты (Xp, Yp и Zp). Изображение этой точки в плоскости захвата изображения камеры 1110 имеет координаты (xi, yi). Центр виртуального объектива расположен в точке 1112, в координатах камеры (0, 0, l) и глобальных координатах (0, 0, l). Если точка 1108 находится в фокусе, то расстояние l между началом координат 1114 и точкой 1112 представляет собой фокусное расстояние камеры. В плоскости захвата изображения показан небольшой прямоугольник, его углы на одной диагонали совпадают с началом координат 1114 и точкой 1110 с координатами (xi, yi). Этот прямоугольник имеет горизонтальные стороны, включающие горизонтальную сторону 1116 длиной xi и вертикальные стороны, включающие вертикальную сторону 1118 длиной уi. Соответствующий прямоугольник имеет горизонтальные стороны длиной -Xp, включая горизонтальную сторону 1120 и вертикальные стороны длиной -Yp, включая вертикальную сторону 1122. Точка 1108 с глобальными координатами (-Xp, -Yp и Zp) и точка 1124 с глобальными координатами (0, 0, Zp) расположены в углах одной диагонали соответствующего прямоугольника. Следует обратить внимание на то, что положения двух прямоугольников инвертируются в точке 1112. Длина отрезка линии 1128 между точкой 1112 и точкой 1124 равна Zp - l. Углы, под которыми каждая из показанных на Фиг. 11а линий, проходящих через точку 1112, пересекает оси z u Z, равны по обе стороны от точки 1112. Например, угол 1130 равен углу 1132. Поэтому можно использовать соотношения между длинами подобных сторон подобных треугольников для получения выражений для координат в плоскости захвата изображения (xi, yi) точки, для которой формируется изображение, в трехмерном пространстве с глобальными координатами (Хр, Yp и Zp) 1134:

В общем случае система координат камеры не совмещена с системой глобальных координат. Поэтому требуется немного более сложный анализ для разработки функций или процессов, преобразующих точки трехмерного пространства в точки, расположенные в плоскости захвата изображения камеры.

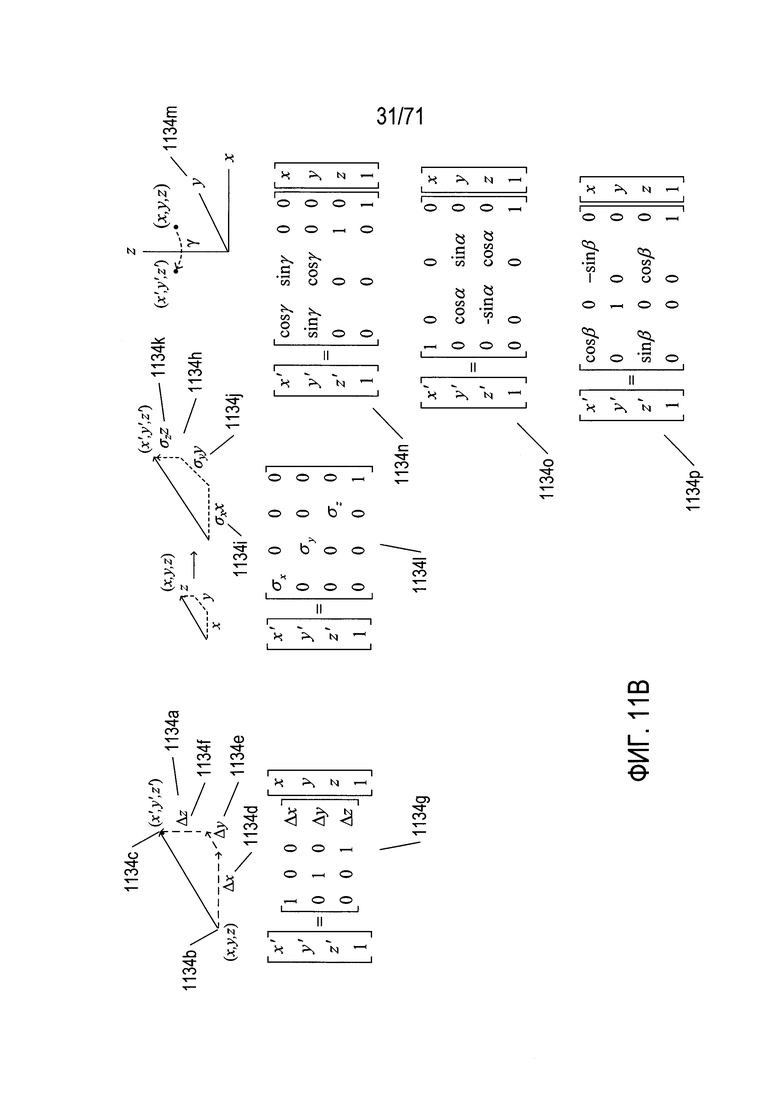

На Фиг. 11В показаны матричные уравнения, которые описывают различные типы операций с точками в трехмерном пространстве. Преобразование 1134а перемещает первую точку с координатами (x, y, z) 1134b во вторую точку 1134с с координатами (x', y', z'). Это преобразование включает смещения в направлении х 1134d, в направлении у 1134е и в направлении z 1134f. Ниже для иллюстрации преобразования 1134а приводится матричное уравнение для преобразования 1134g. Следует отметить, что четвертое измерение добавлено к векторным представлениям точек для выражения преобразования в виде матричной операции. Значение «1» используется для четвертого измерения векторов; после вычисления координат преобразуемой точки его можно отбросить. Аналогичным образом операция масштабирования 1134h производит умножение каждой координаты вектора на масштабный коэффициент σх, σу и σz (соответственно 1134i, 1134j и 1134k). Матричное уравнение для операции масштабирования задается матричным уравнением 1134l. Наконец, точка может быть повернута вокруг каждой из трех координатных осей. На схеме 1134m показан поворот точки (x, y, z) в точку (x', y', z') путем поворота на угол γ радиан вокруг оси z. Матричное уравнение для этого поворота показано в виде матричного уравнения 1134n на Фиг. 11В. Матричные уравнения 1134о и 1134р описывают повороты вокруг осей x и y, соответственно, на углы α и β радиан, соответственно.

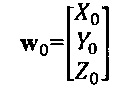

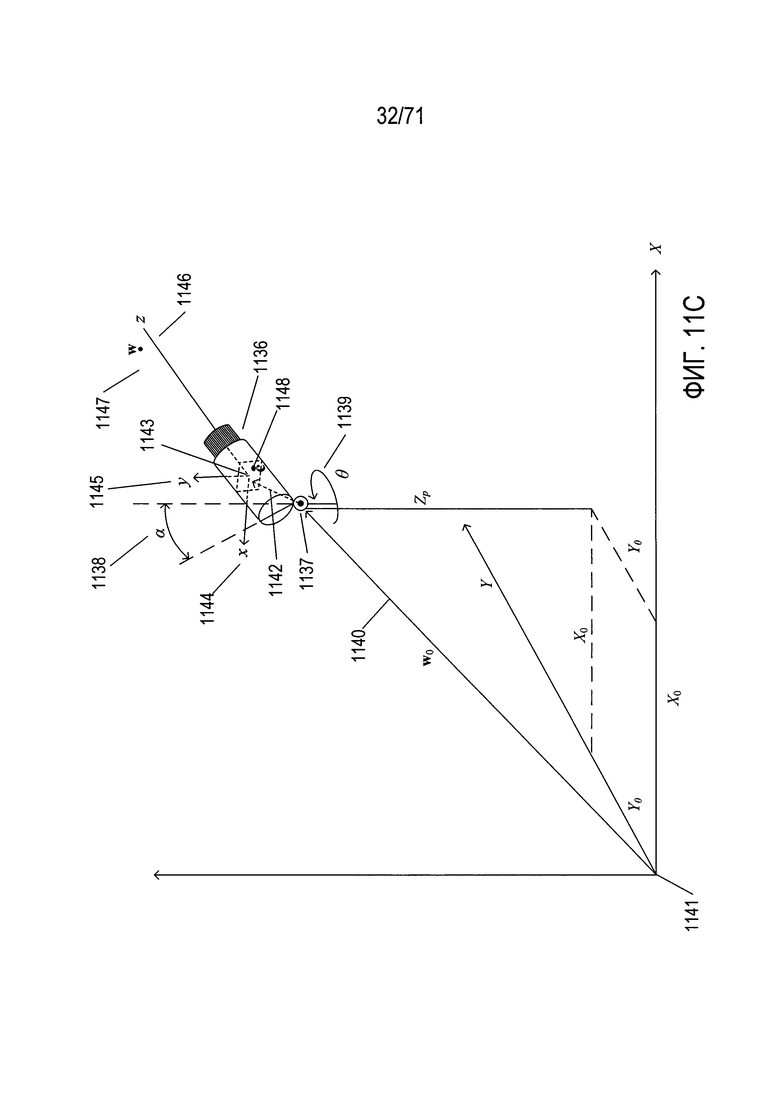

На Фиг. 11С-Е показан процесс вычисления изображения точек в трехмерном пространстве на плоскости захвата изображения произвольно ориентированной и расположенной камеры. На Фиг. 11С показана расположенная в произвольной точке и произвольным образом ориентированная камера. Камера 1136 установлена на штативе 1137, который позволяет наклонить камеру под углом α 1138 относительно вертикальной оси Z и повернуть ее на угол θ 1139 вокруг вертикальной оси. Штатив 1137 можно расположить в любом месте в трехмерном пространстве, его положение представлено вектором положения w0 1140 от начала системы глобальных координат 1141 к штативу 1137. Второй вектор r 1142 представляет относительное положение центра плоскости изображения 1143 в камере 1136 по отношению к штативу 1137. Ориентация и положение начала системы координат камеры совпадают с центром плоскости захвата изображения 1143 внутри камеры 1136. Плоскость захвата изображения 1143 лежит в плоскости x, y осей координат камеры 1144-1146. На Фиг. 11С показана камера, которая получает изображение точки w 1147, которой соответствует сформированное изображение точки w в виде точки изображения с 1148 в плоскости изображения 1143, лежащей внутри камеры. Вектор w0, который определяет положение штатива камеры 1137 на Фиг. 11С, показан как вектор

.

.

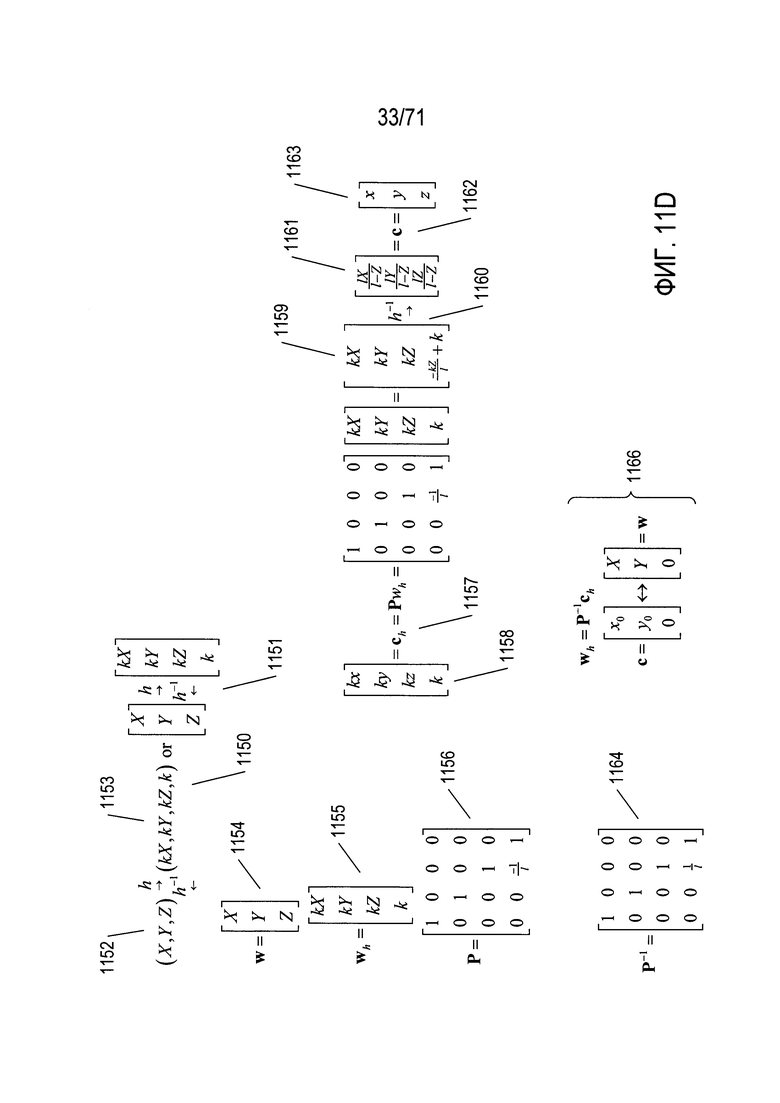

На Фиг. 11D-E показан процесс, с помощью которого координаты точки в трехмерном пространстве, например, точки, соответствующей вектору w в системе глобальных координат, преобразуются в плоскости захвата изображения произвольно расположенной и ориентированной камеры. Прежде всего на Фиг. 11D с помощью выражений 1150 и 1151 показано преобразование между глобальными координатами и однородными координатами h и обратное преобразование h-l. Прямой переход от глобальных координат 1152 к однородным координатам 1153 включает умножение каждой компоненты координат на произвольную константу к и добавление компонента четвертой координаты, имеющего значение k. Вектор w, соответствующий точке 1147 в фотографируемом камерой трехмерном пространстве, выражается как вектор-столбец, как показано в выражении 1154 на Фиг. 11D. Соответствующий вектор-столбец wh в однородных координатах показан в выражении 1155. Матрица Р - это матрица перспективного преобразования, которая приведена в выражении 1156 на Фиг. 11D. Матрица перспективного преобразования используется для осуществления преобразования глобальных координат в координаты камеры (1134 на Фиг. 11А), это преобразование обсуждалось выше со ссылкой на Фиг 11А. Форма вектора с в однородных координатах, соответствующая изображению 1148 точки 1147 ch, вычисляется с помощью умножения слева wh на матрицу перспективного преобразования, как показано в выражении 1157 на Фиг. 11D. Таким образом, выражение для ch в однородных координатах камеры 1158 соответствует однородному выражению для ch в глобальных координатах 1159. Обратное преобразование однородных координат 1160 используется для преобразования последнего в векторное выражение в глобальных координатах 1161 для вектора с 1162. Сравнение выражения в координатах камеры 1163 для вектора с с выражением для того же вектора в глобальных координатах 1161 показывает, что координаты камеры связаны с глобальными координатами преобразованиями (1134 на Фиг. 11А), описанными выше со ссылкой на Фиг. 11А. Обратная матрица перспективного преобразования Р-1 показана в выражении 1164 на Фиг. 11D. Обратную матрицу перспективного преобразования можно использовать для вычисления точки глобальных координат в трехмерном пространстве, соответствующей точке изображения, выраженной в координатах камеры, как показано выражением 1166 на Фиг. 11D. Следует отметить, что в общем случае координата Z фотографируемой камерой трехмерной точки не восстанавливается с помощью перспективного преобразования. Причина этого заключается в том, что все точки, расположенные перед камерой на линии от точки изображения до фотографируемой точки, отображаются в точке изображения. Для определения координаты Z фотографируемых камерой точек в трехмерном пространстве необходима дополнительная информация, например, информации о глубине, полученная из набора стереоизображений или информации о глубине, полученная с помощью отдельного датчика глубины.

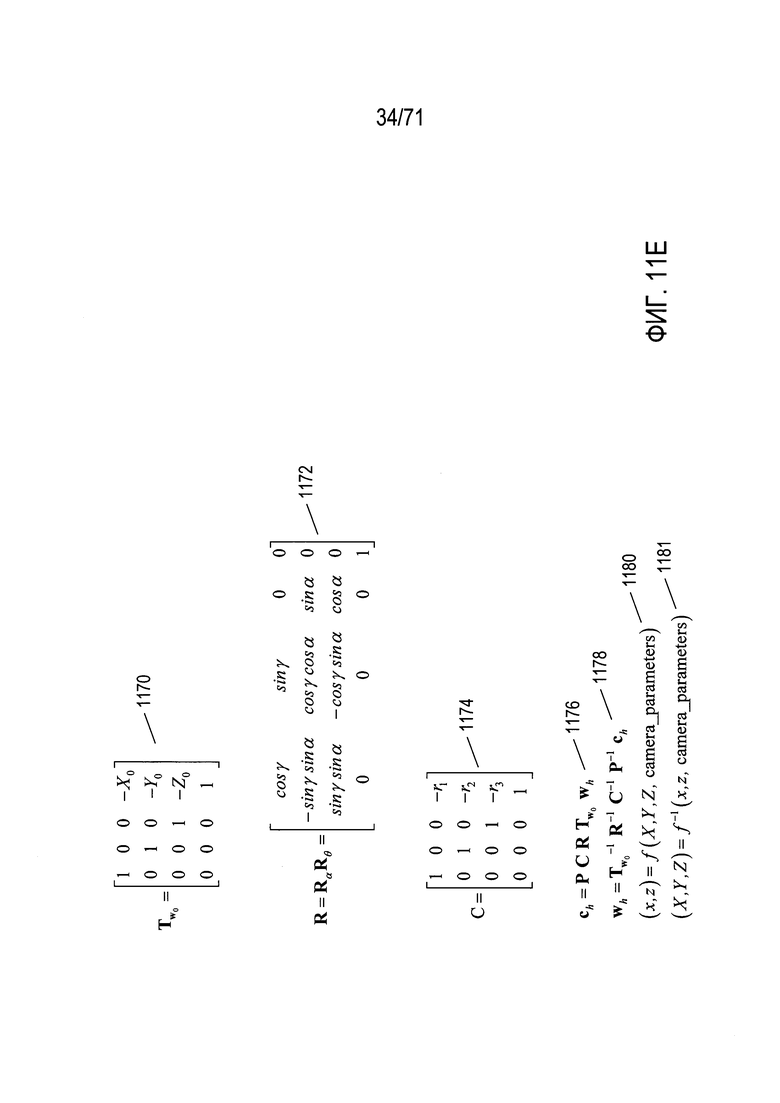

На Фиг. 11Е показаны три дополнительные матрицы, которые представляют положение и ориентацию камеры в системе глобальных координат. Матрица преобразований  1170 представляет преобразование штатива камеры (1137 на Фиг. 11С) из его положения в трехмерном пространстве в начало координат (1141 на Фиг. 11С) глобальной системы координат. Матрица R представляет повороты на углы α и θ, необходимые для совмещения системы координат камеры с системой глобальных координат 1172. Матрица преобразования С 1174 представляет преобразование плоскости захвата изображения камеры со штатива камеры (1137 на Фиг. 11С) в положение плоскости захвата изображения в камере, представленной вектором r (1142 на Фиг. 11С). Полное выражение преобразования вектора точки в трехмерном пространстве wh в вектор, представляющий положение точки изображения в плоскости захвата изображения камеры ch, задается выражением 1176 на Фиг. 11Е. Вектор wh сначала умножают слева на матрицу преобразования 1170 для получения первого промежуточного результата, затем первый промежуточный результат умножают слева на матрицу R для получения второго промежуточного результата, второй промежуточный результат умножают слева на матрицу С для получения третьего промежуточного результата, а третий промежуточный результат умножают слева на матрицу перспективного преобразования Р для получения вектора ch. Выражение 1178 показывает обратное преобразование. Таким образом, в целом существует прямое преобразование из точек системы глобальных координат в точки изображения 1180, а при наличии достаточной информации также существует и обратное преобразование 1181. Именно прямое преобразование 1180 используется для создания двухмерных изображений из трехмерной модели или объекта, соответствующего произвольно ориентированным и расположенным камерам. Каждая точка на поверхности трехмерного объекта или модели преобразуется прямым преобразованием 1180 в точки на плоскости захвата изображения камеры.

1170 представляет преобразование штатива камеры (1137 на Фиг. 11С) из его положения в трехмерном пространстве в начало координат (1141 на Фиг. 11С) глобальной системы координат. Матрица R представляет повороты на углы α и θ, необходимые для совмещения системы координат камеры с системой глобальных координат 1172. Матрица преобразования С 1174 представляет преобразование плоскости захвата изображения камеры со штатива камеры (1137 на Фиг. 11С) в положение плоскости захвата изображения в камере, представленной вектором r (1142 на Фиг. 11С). Полное выражение преобразования вектора точки в трехмерном пространстве wh в вектор, представляющий положение точки изображения в плоскости захвата изображения камеры ch, задается выражением 1176 на Фиг. 11Е. Вектор wh сначала умножают слева на матрицу преобразования 1170 для получения первого промежуточного результата, затем первый промежуточный результат умножают слева на матрицу R для получения второго промежуточного результата, второй промежуточный результат умножают слева на матрицу С для получения третьего промежуточного результата, а третий промежуточный результат умножают слева на матрицу перспективного преобразования Р для получения вектора ch. Выражение 1178 показывает обратное преобразование. Таким образом, в целом существует прямое преобразование из точек системы глобальных координат в точки изображения 1180, а при наличии достаточной информации также существует и обратное преобразование 1181. Именно прямое преобразование 1180 используется для создания двухмерных изображений из трехмерной модели или объекта, соответствующего произвольно ориентированным и расположенным камерам. Каждая точка на поверхности трехмерного объекта или модели преобразуется прямым преобразованием 1180 в точки на плоскости захвата изображения камеры.

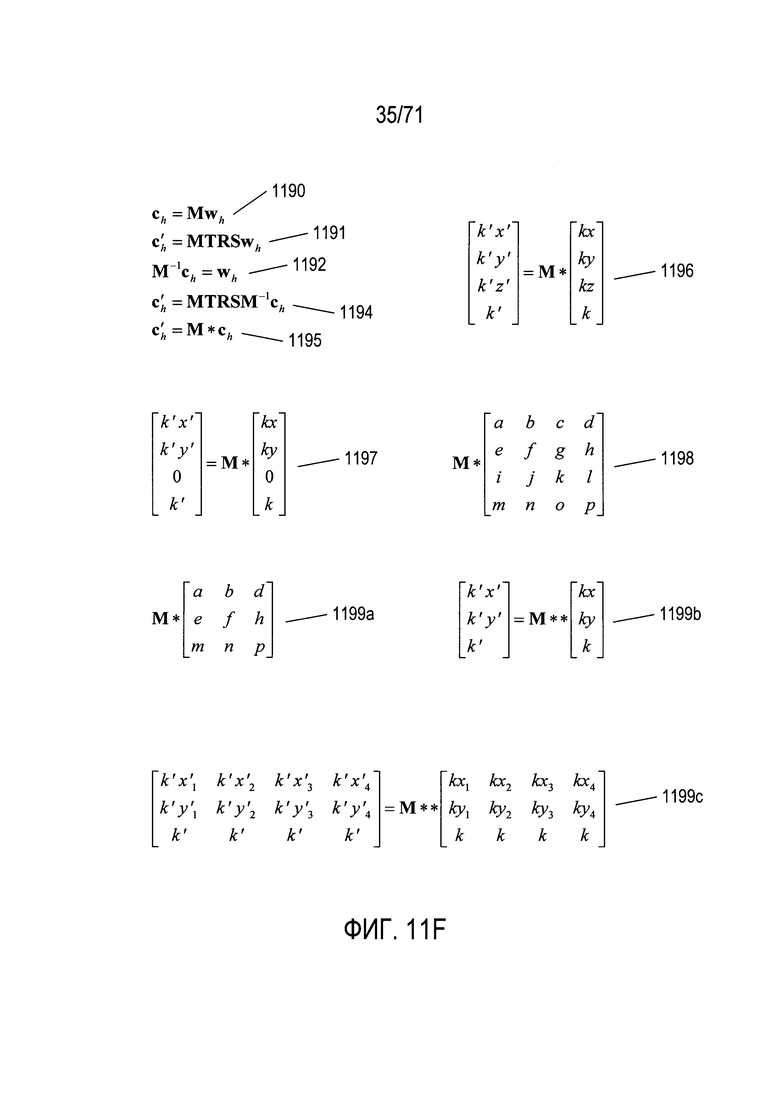

На Фиг. 11F показаны матричные уравнения, которые связывают два различных изображения объекта, если два различных изображения отличаются из-за относительных изменений положения, ориентации и расстояния от камеры до объектов, возникающих в связи с изменением относительного положения и ориентации камеры, положения и ориентации фотографируемых объектов или и того и другого. Поскольку при умножении квадратных матриц получается другая квадратная матрица, показанное на Фиг. 11Е уравнение 1176 можно кратко выразить формулой 1190 на Фиг. 11F. Это уравнение определяет положение точек изображения по положению соответствующих точек в трехмерном пространстве. Уравнение 1191 представляет вычисление точек во втором изображении из соответствующих точек в трехмерном пространстве, причем положение точек в трехмерном пространстве или их ориентация изменялась по отношению к соответствующим точкам, используемым для получения точек ch в первой операции создания изображения, представленной уравнением 1190. Матрицы Т, R и S в уравнении 1191 представляют операции перемещения, поворота и масштабирования. Уравнение 1190 можно переписать в виде уравнения 1192, умножив обе части уравнения 1190 на обратную матрицу М. Подставляя левую часть уравнения 1192 в уравнение 1191, получаем уравнение 1194, связывающее положения в первом изображении ch с положениями во втором изображении  . Уравнение 1194 можно более кратко представить в виде уравнения 1195 и, как вариант, в виде уравнения 1196. Поскольку уравнение 1196 выражает зависимость между положениями точек на двух изображениях, координата z не представляет интереса, и уравнение 1196 можно переписать в виде уравнения 1197, где значения координаты z заменяются на 0. Представляя матрицу М* абстрактно в уравнении 1198, можно создать новую матрицу М** путем удаления третьей строки и третьего столбца из матрицы М*, как показано в уравнении 1199а. После удаления значений координаты z из векторов ch и

. Уравнение 1194 можно более кратко представить в виде уравнения 1195 и, как вариант, в виде уравнения 1196. Поскольку уравнение 1196 выражает зависимость между положениями точек на двух изображениях, координата z не представляет интереса, и уравнение 1196 можно переписать в виде уравнения 1197, где значения координаты z заменяются на 0. Представляя матрицу М* абстрактно в уравнении 1198, можно создать новую матрицу М** путем удаления третьей строки и третьего столбца из матрицы М*, как показано в уравнении 1199а. После удаления значений координаты z из векторов ch и  получается уравнение 1199b. Если имеются четыре пары точек с известными координатами на каждом из двух изображений, то отношения между этими четырьмя парами точек можно выразить как уравнение 1199с. Это уравнение немного переопределено, но его можно использовать для определения с помощью известных методик значений девяти элементов матрицы М**. Таким образом, независимо от различий в части ориентации, положения и расстояния от камеры до набора объектов при двух различных операциях получения изображения, можно определить матрицу путем сравнения положений ряда известных соответствующих признаков на двух изображениях, что представляет собой [прямое] преобразование и обратное преобразование, связывающие эти два изображения.

получается уравнение 1199b. Если имеются четыре пары точек с известными координатами на каждом из двух изображений, то отношения между этими четырьмя парами точек можно выразить как уравнение 1199с. Это уравнение немного переопределено, но его можно использовать для определения с помощью известных методик значений девяти элементов матрицы М**. Таким образом, независимо от различий в части ориентации, положения и расстояния от камеры до набора объектов при двух различных операциях получения изображения, можно определить матрицу путем сравнения положений ряда известных соответствующих признаков на двух изображениях, что представляет собой [прямое] преобразование и обратное преобразование, связывающие эти два изображения.

Детекторы признаков

Детекторы признаков - это другой тип методов обработки изображений, различные типы которых используются в способах и системах, раскрываемых ниже в настоящем описании. Конкретный детектор признаков, который называется «преобразование масштабно-инвариантных признаков» (SIFT), обсуждается более подробно в этом подразделе как пример различных детекторов признаков, которые могут использоваться в способах и подсистемах, раскрываемым в настоящем документе.

На Фиг. 12 показано обнаружение признаков методом SIFT. На Фиг. 12 приведено первое простое цифровое изображение 1202, которое включает в себя, как правило, не имеющий признаков фон 1204 и область затененного диска 1206. Применение метода обнаружения признаков SIFT к этому изображению формирует набор ключевых точек или признаков, таких как признаки 1208-1217, наложенные на копию 1220 исходного изображения, как показано на рисунке 12 справа от исходного изображения. По существу признаки - это особые точки в цифровом изображении, имеющие координаты (x, y) относительно осей координат изображения, которые обычно параллельны верхнему и левому краям изображения. Эти точки выбираются так, чтобы они были относительно инвариантными к преобразованию изображения, масштабированию и повороту, а также частично инвариантными к изменениям освещения и аффинным проекциям. Таким образом, в том случае, когда сначала получают изображение конкретного объекта для формирования канонического изображения объекта, признаки, которые формируются с помощью метода SIFT для этого первого канонического образа, можно использовать для выявления этого объекта на дополнительных изображениях, в которых получение изображения может во многом отличаться, включая перспективу, освещение, расположение объекта по отношению к камере, ориентацию объекта относительно камеры или даже физическое искажение объекта. Каждый признак, сформированный методом SIFT, кодируется, в виде набора значений и сохраняется в базе данных, в файле, в структуре, находящейся в памяти данных, или другом таком устройстве хранения данных. На Фиг. 12 сохраненные дескрипторы содержатся в таблице 1230, каждая строка которой представляет тот или иной признак. Каждая строка содержит несколько различных полей, соответствующих столбцам в таблице: (1) x 1231, x - координата признака; (2) y 1232, y - координата признака; (3) m 1233 - значение признака; (4) θ 1234 - угол ориентации признака; (5) σ 1235 - значение масштаба для признака; и (6) дескриптор 1236 - закодированный набор признаков локального окружения признака, который можно использовать для определения того, можно ли считать локальное окружение точки в другом изображении того же признака, который был выявлен в другом изображении.