Область техники

Изобретение относится к области компьютерной безопасности, а более конкретно к системам и способам определения источников аномалии в кибер-физической системе.

Уровень техники

Одной из актуальных проблем промышленной безопасности является проблема безопасного функционирования технологических процессов (ТП). Например, ТП в нефтехимической отрасли характеризуются высокой степенью опасности производства, поскольку оперируют с легковоспламеняющимися и взрывоопасными жидкостями и газами, находящимися при высокой температуре и давлении. К основным угрозам для таких ТП можно отнести непреднамеренные ошибки или злонамеренные действия в операционном управлении, износ и отказ оборудования и агрегатов, компьютерные атаки на системы управления и информационную систему и др.

Для противодействия упомянутым угрозам используют системы безопасности кибер-физических систем (КФС), например, производственных объектов и предприятий. Построение таких систем традиционно проводится в несколько этапов. При проектировании предприятия выстраивается система противоаварийной защиты (ПАЗ), которая затем интегрируется с автоматизированной системой управления технологическим процессом (АСУ ТП), однако допускает и ручное управление. К недостаткам системы ПАЗ можно отнести достаточную инертность процессов и присутствие человеческого фактора в принятии решений. Кроме того, ПАЗ функционирует в предположении корректного функционировании контрольно-измерительных приборов (КИП). Обеспечить выполнение безотказного функционирования КИП в полном объеме на практике не представляется возможным, поскольку КИП периодически выходят из строя, имеют тенденцию к временным сбоям, а дублирование всех КИП крайне затратное и не всегда технически возможно.

К способу контроля корректности ТП можно отнести мониторинг отдельных агрегатов, оборудования, КИП, контуров управления и т.д. встроенными в них системами самодиагностики. В случае обнаруженного сбоя такие системы подают сигнал оператору ТП и, как правило, подразумевают ручное вмешательство в тот или иной агрегат. Несмотря на очевидные достоинства таких систем, например, учет специфики функционирования того или иного агрегата, разработка поставщиком оборудования и т.д., имеется ряд очевидных недостатков. К последним можно отнести упомянутые проблемы КИП, на которых строятся отдельные системы самоконтроля. Другой недостаток таких систем - их локальность и оторванность от мониторинга процессов во всей их полноте. Другими словами, каждая из таких систем «видит» процесс только в рамках того оборудования или агрегата, к которому она привязана, без логической и физической корреляции между взаимосвязанными агрегатами и установками. В результате, обнаружение той или иной аномалии в технологическом процессе, зачастую, происходит уже на стадии ее перехода в состояние угрозы корректного функционирования того или иного оборудования и требует немедленного реагирования. Кроме того, в некоторых случаях, такие системы в силу физических особенностей КИП (например, запарафинивания уровнемера тяжелыми нефтепродуктами) имеют тенденцию к многократным ложным срабатываниям, что приводит к их принудительному отключению персоналом.

Нельзя не отметить еще один традиционный способ неразрушающего контроля оборудования и процессов технологических систем (ТС), состоящий в установке дополнительных внешних по отношению к оборудованию и АСУ ТП систем контроля. Фактически при таком способе контроля выстраивается параллельная инфраструктура, включающая КИП, линии связи, сервера сбора и обработки данных и т.д. Такие системы могут быть интегрированы с существующими системами АСУ ТП и ПАЗ, или оставаться внешними по отношению к ним. Несмотря на очевидные плюсы таких систем, как дублирование диагностических КИП, узкоспециальные и эффективные методы диагностики, практически неограниченные мощности по обработке диагностической информации и т.д., основным их недостатком является высокая стоимость и сложность, а порой и невозможность развертывания на реальном производстве.

Аналогичные проблемы актуальны для всех кибер-физических систем (КФС), содержащих датчики и исполнительные механизмы - как для описанных ранее технологических процессов, являющихся частью ТС, так и для интернета вещей и, в частности, для промышленного интернета вещей. Например, из-за компьютерных атак, датчики интернета вещей предоставляют неверные значения, вследствие чего некорректным образом функционируют компьютерные устройства интернета вещей, что может повлечь такие проблемы, как повышение потребления электроэнергии, несанкционированный доступ к информации и др.

Возникает техническая проблема, заключающаяся в создании системы определения аномалий в кибер-физической системе (КФС), обладающей определенными характеристиками, в которой время, прошедшее с момента возникновения аномалии в КФС до момента ее обнаружения ниже, чем у существующих аналогов.

Одним из аналогов является технология, предложенная в заявке US 20140189860, которая описывает способы обнаружения компьютерных атак путем обнаружения отклонений функционирования системы от нормы, где для обнаружения отклонений используются различные методы, также определяются вектора компьютерных атак. Также описываются способы отличия аномалий от «шумов», вызывающих отклонения в частном случае установлением пороговых значений. Однако данная технология не решает заявленной технической проблемы.

Раскрытие сущности изобретения

Первый технический результат заключается в реализации назначения.

Второй технический результат заключается в снижении ошибки второго рода при обнаружении аномалий в КФС.

Согласно варианту реализации используется способ источников аномалии в кибер-физической системе (КФС), в котором: с помощью средства прогнозирования получают значения признаков КФС за входное окно, являющееся интервалом времени и содержащееся внутри периода наблюдений, при этом входное окно определяется обученной моделью прогнозирования, при этом признаки КФС являются численными характеристиками субъектов управления; с помощью средства прогнозирования с использованием обученной модели прогнозирования и по данным полученных значений признаков КФС за входное окно выполняют прогнозирование значений признаков КФС на окно прогноза, являющееся интервалом времени и содержащееся внутри периода наблюдений; с помощью средства определения аномалий для окна прогноза определяют общую ошибку прогноза для признаков КФС; с помощью средства определения аномалий при превышении общей ошибкой прогноза порога общей ошибки, определяют аномалию в КФС; с помощью средства определения аномалий определяют по меньшей мере один признак КФС, являющийся источником аномалии, если вклад ошибки прогноза упомянутого по меньшей мере одного признака КФС в общую ошибку прогноза выше, чем вклад по меньшей мере одного другого признака КФС в общую ошибку прогноза.

Согласно одному частному варианту реализации в случае, если значения признаков КФС поступают в режиме реального времени, для окна прогноза определяют общую ошибку прогноза спустя время, равное сумме горизонта прогноза и входного окна.

Согласно другому частному варианту реализации в случае, если значения признаков КФС содержатся в исходной выборке за исторический период наблюдения, для окна прогноза определяют общую ошибку прогноза по данным исходной выборки за исторический период наблюдения.

Согласно еще одному частному варианту реализации кибер-физическая система обладает по меньшей мере одной из следующих характеристик: отраслью производства, в которой функционирует кибер-физическая система; типы процессов, которые описывают параметры КФС, в частности, один из: непрерывный, конвейерный, циклический; наличием сезонности и/или трендов в признаках КФС; инертностью процессов КФС; временем реакции КФС на изменения, происходящие в КФС и во внешней среде; уровнем опасности производства для персонала и экологии; стоимостью простоя технологический процессов из-за нештатных ситуаций; типом управления, в частности, выполненный с использованием ПИД-регуляторов, конечных автоматов или комбинированным способом; типом субъекта управления, который характеризуется по меньшей мере одним признаком, при этом тип субъекта управления является одним из: датчиком, исполнительный механизмом или ПИД-регулятором; данными самодиагностики КФС; состоянием субъекта управления: рабочее или нерабочее; взаимосвязью субъектов управления на уровне техпроцесса.

Согласно одному из частных вариантов реализации при вычислении общей ошибки прогноза используют ошибки каждого признака КФС, определяющие вклад ошибки прогноза упомянутого по меньшей мере одного признака КФС в общую ошибку прогноза, а для упомянутых ошибок каждого признака КФС используют весовые коэффициенты, при этом: присваивают с помощью средства обучения низкое значение весовому коэффициенту для признака, если субъект управления, характеризующийся этим признаком, предоставляет данные с шумами, или невалидные данные или периодически отключается пользователем КФС; присваивают с помощью средства обучения низкое значение весовому коэффициенту для признака, в котором возникновение аномалии не влияет на работу КФС, и высокое значение весовому коэффициенту для признака, в котором возникновение аномалии влияет на работу КФС.

Согласно другому частному варианту реализации выбирают с помощью средства обучения значение весового коэффициента признака, которое зависит от точности прогнозирования признаков КФС.

Согласно еще одному из частных вариантов реализации в модели прогнозирования используют нейронную сеть.

Согласно одному из частных вариантов реализации оптимизируют нейронную сеть с использованием генетических алгоритмов.

Согласно другому частному варианту реализации выбирают нейронную сеть по данными размеченной исходной выборки, с использованием одной из метрик качества: NAB-метрика, F1-метрика.

Согласно еще одному частному варианту реализации получают техническую документацию КФС или отчет пользователя по ранее обнаруженным обученной системой аномалиям, при этом весовой коэффициент признака выбирают с помощью средства обучения в зависимости от значимости указанного признака и на основании технической документации КФС или отчета пользователя.

Согласно варианту реализации используется система определения источников аномалии в кибер-физической системе (КФС), содержащая: средство прогнозирования, предназначенное для: получения значений признаков КФС за входное окно, являющееся интервалом времени и содержащееся внутри периода наблюдений, при этом входное окно определяется обученной моделью прогнозирования, при этом признаки КФС являются численными характеристиками субъектов управления; прогнозирования значений признаков КФС на окно прогноза, являющееся интервалом времени и содержащееся внутри периода наблюдений, с использованием обученной модели прогнозирования и по данным полученных значений признаков КФС за входное окно; средство определения аномалий, предназначенное для: определения общей ошибки прогноза для окна прогноза для признаков КФС; определения аномалии в КФС при превышении общей ошибкой прогноза порога общей ошибки; определения по меньшей мере одного признака КФС, являющегося источником аномалии, если вклад ошибки прогноза упомянутого по меньшей мере одного признака КФС в общую ошибку прогноза выше, чем вклад по меньшей мере одного другого признака КФС в общую ошибку прогноза.

Краткое описание чертежей

Дополнительные цели, признаки и преимущества настоящего изобретения будут очевидными из прочтения последующего описания осуществления изобретения со ссылкой на прилагаемые чертежи, на которых:

На Фиг. 1а схематично изображен пример технологической системы.

На Фиг. 1б схематично изображен частный пример имплементации технологической системы.

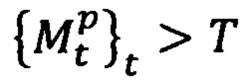

На Фиг. 1в представлен возможный вариант организации интернета вещей на примере носимых устройств.

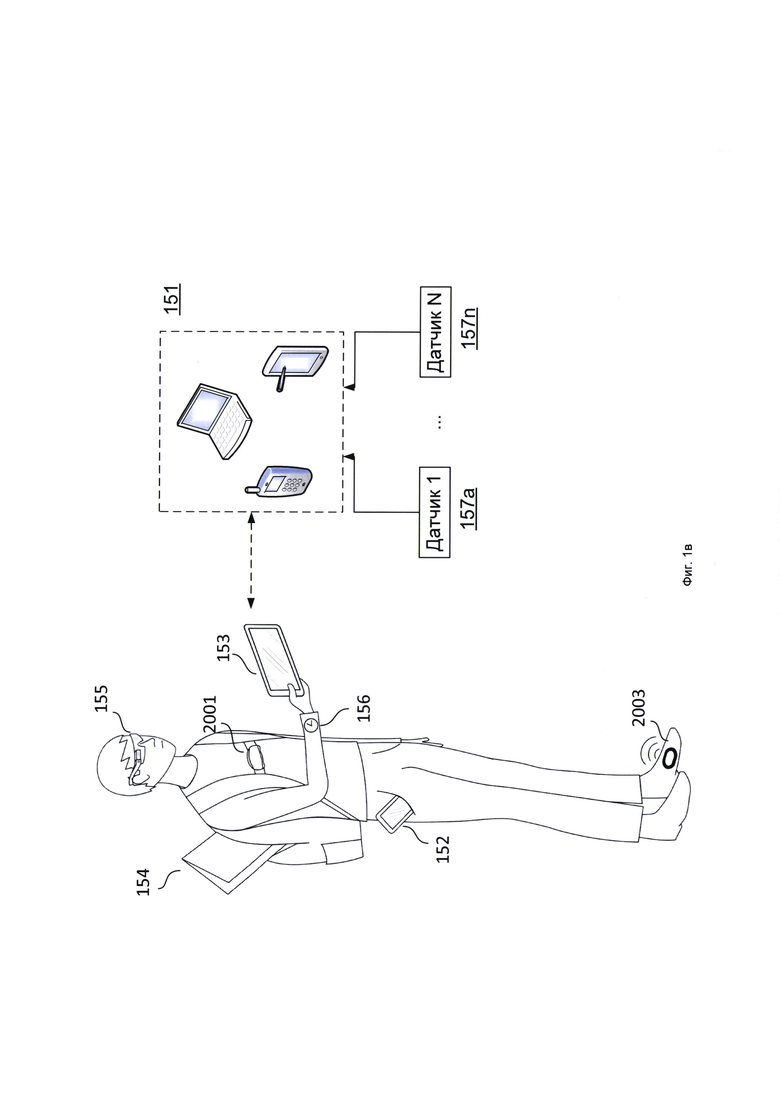

На Фиг. 1г представлен возможный набор датчиков устройств.

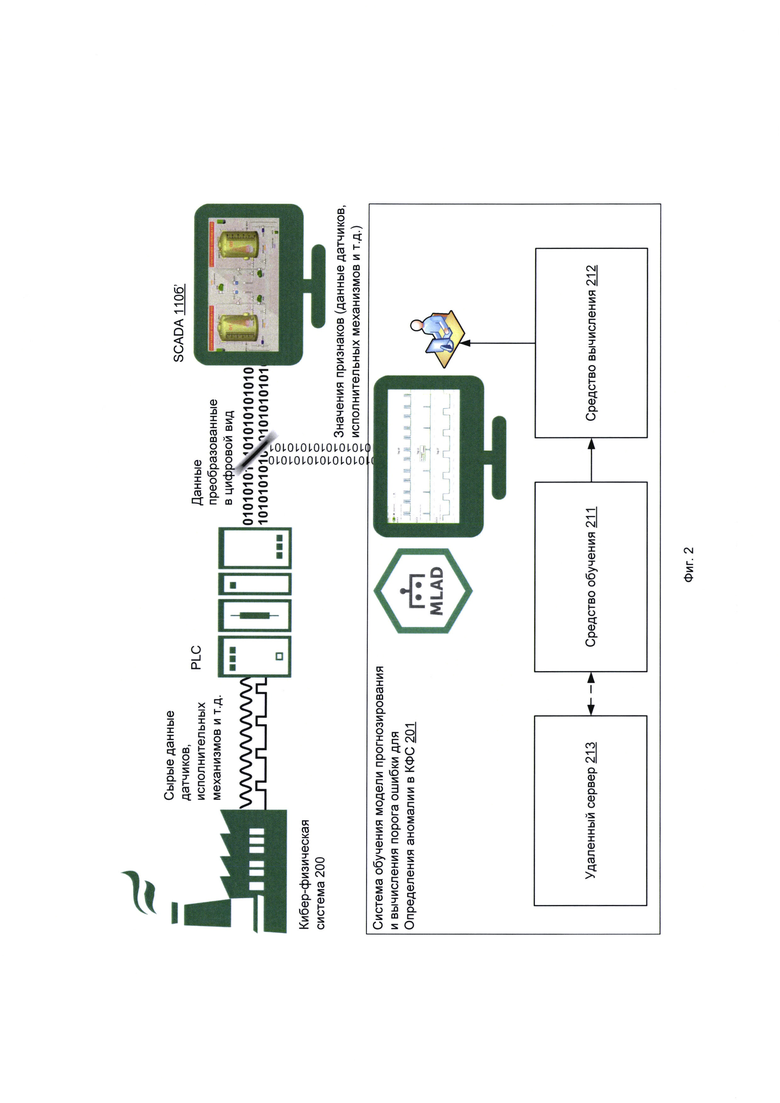

На Фиг. 2 представлена система обучения модели прогнозирования значений признаков КФС, обладающей определенными характеристиками, и вычисления порога ошибки для определения аномалии в упомянутой КФС.

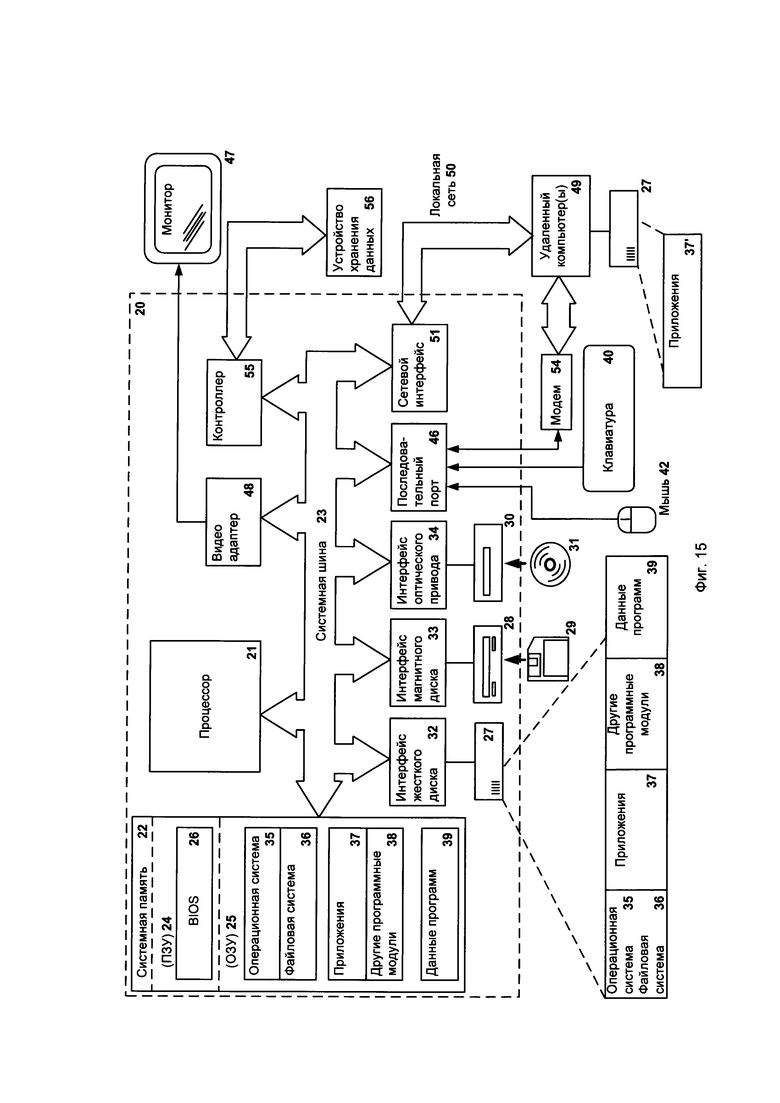

Фиг. 3 представлен способ обучения модели прогнозирования значений признаков КФС и вычисления порога ошибки для определения аномалии в обладающей определенными характеристиками КФС.

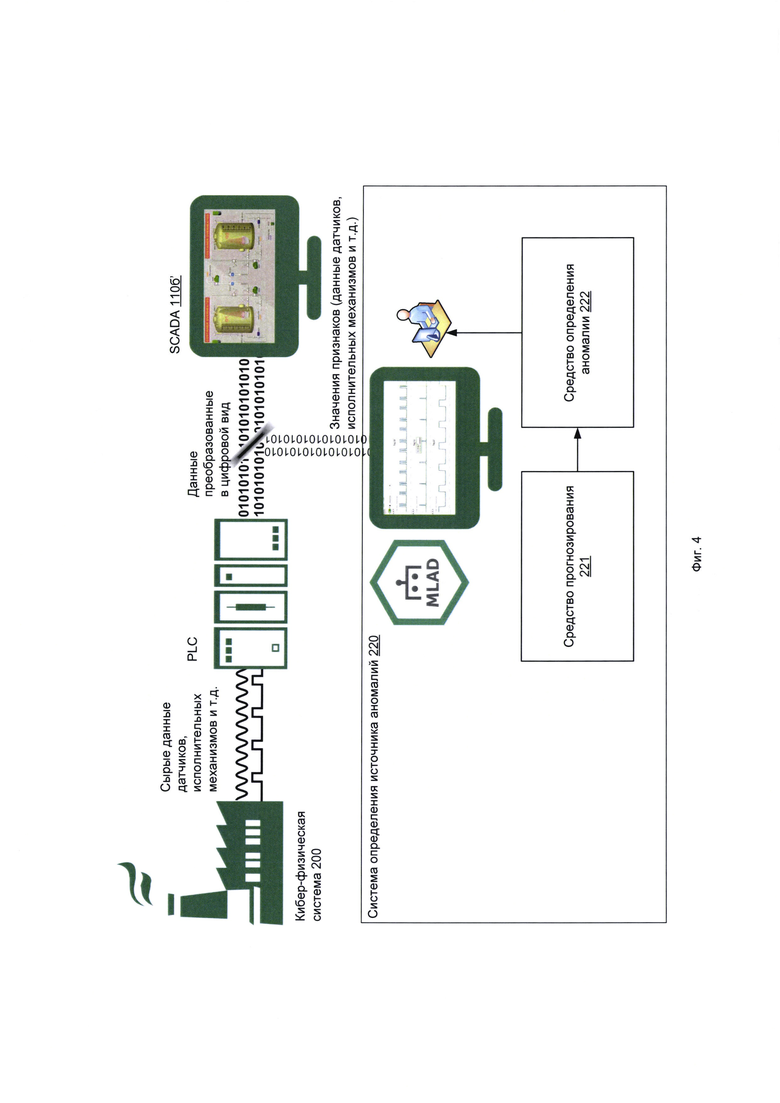

На Фиг. 4 представлена система определения источника аномалии КФС.

На Фиг. 5 представлен пример определения источника аномалии в КФС, обладающей определенными характеристиками.

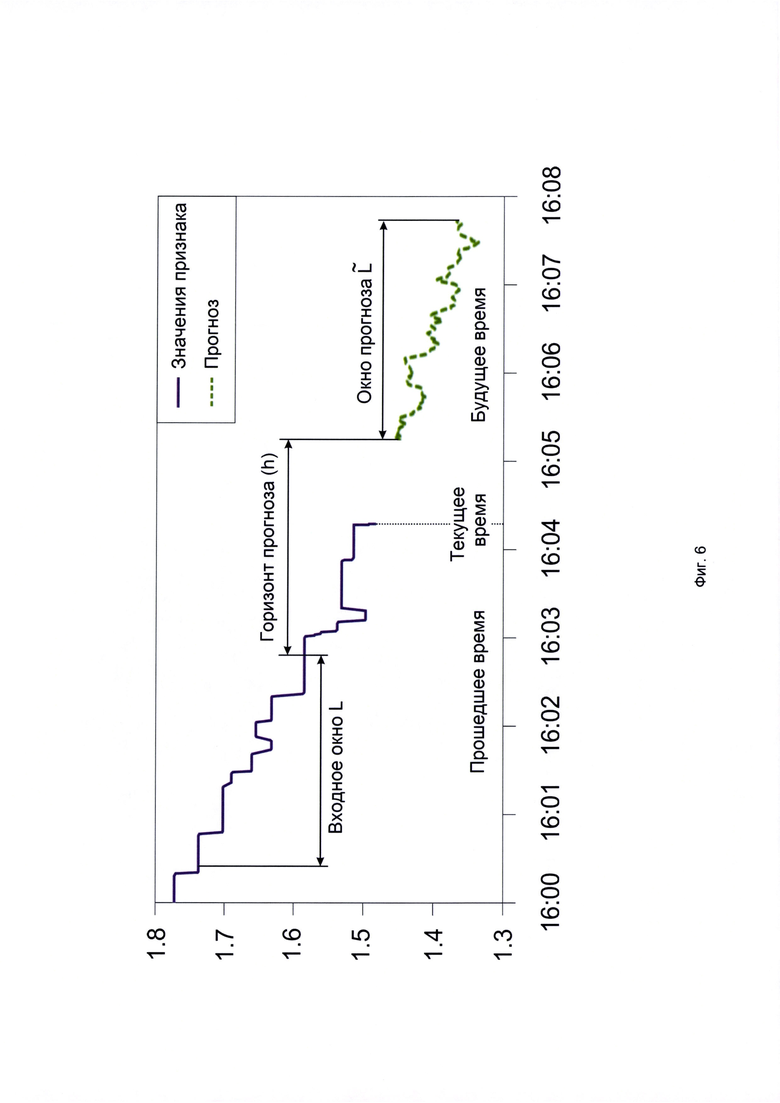

На Фиг. 6 представлен пример зависимости значений одного признака от времени, а также обозначены входное окно, окно прогноза и горизонт прогноза.

На Фиг. 7 представлены примеры зависимостей значений признаков, значений прогнозов признаков и общей ошибки прогноза от времени в окрестности времени момента возникновения аномалии.

На Фиг. 8 представлен пример динамики общей ошибки прогноза до сглаживания и после сглаживания.

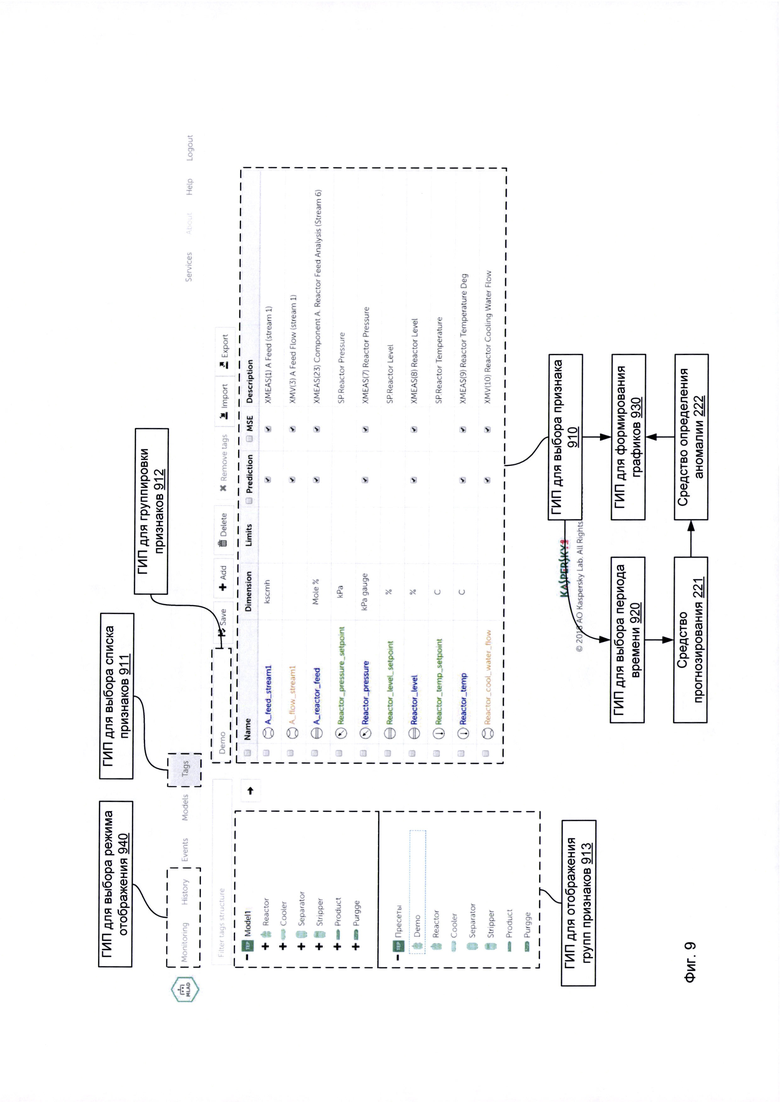

На Фиг. 9 представлена система формирования данных для мониторинга кибер-физической системы с целью раннего определения аномалий в системе графического интерфейса пользователя (ГИП), содержащая совокупность элементов ГИП.

На Фиг. 10а-10в представлены элемент ГИП для выбора режима отображения, элемент ГИП для формирования ошибки прогноза признака и элемент ГИП для выбора порядка отображения.

На Фиг. 11а представлен элемент ГИП для настроек ошибок прогноза.

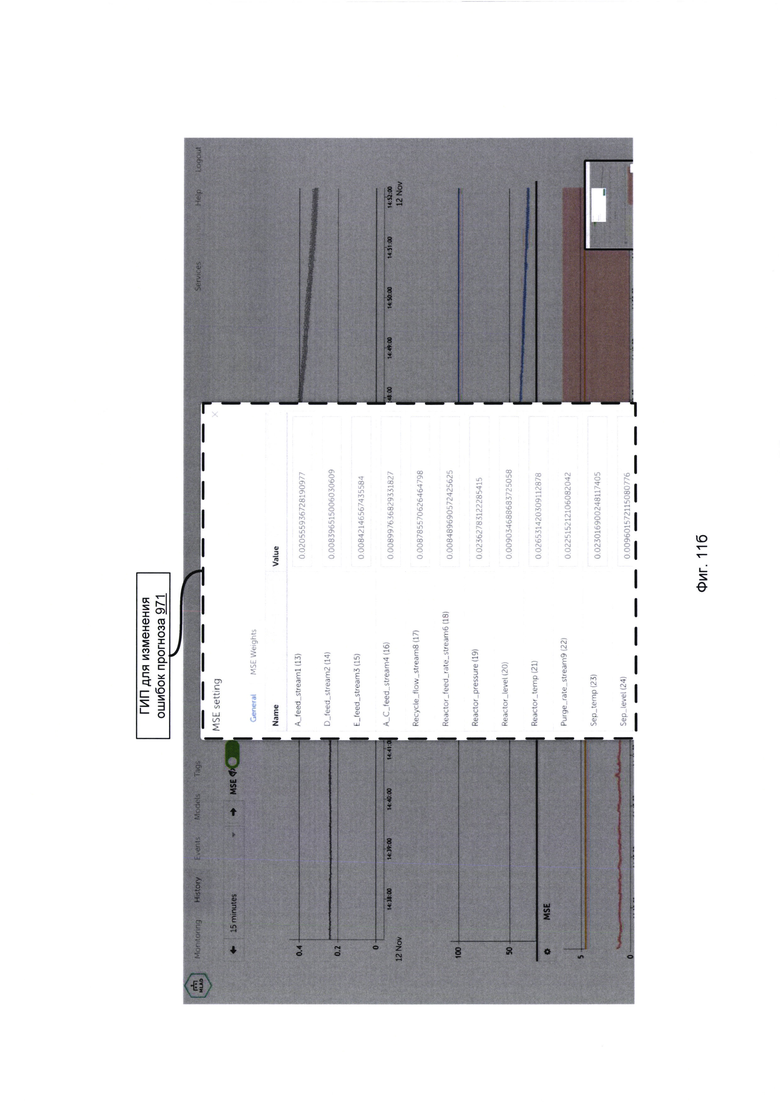

На Фиг. 11б ГИП для изменения ошибок прогноза.

На Фиг. 12 представлен элемент ГИП для выбора событий.

На Фиг. 13 представлен элемент ГИП для выбора моделей.

На Фиг. 14 представлен способ формирования данных для мониторинга кибер-физической системы с целью раннего определения аномалий в системе графического интерфейса пользователя (ГИП), содержащей совокупность элементов ГИП.

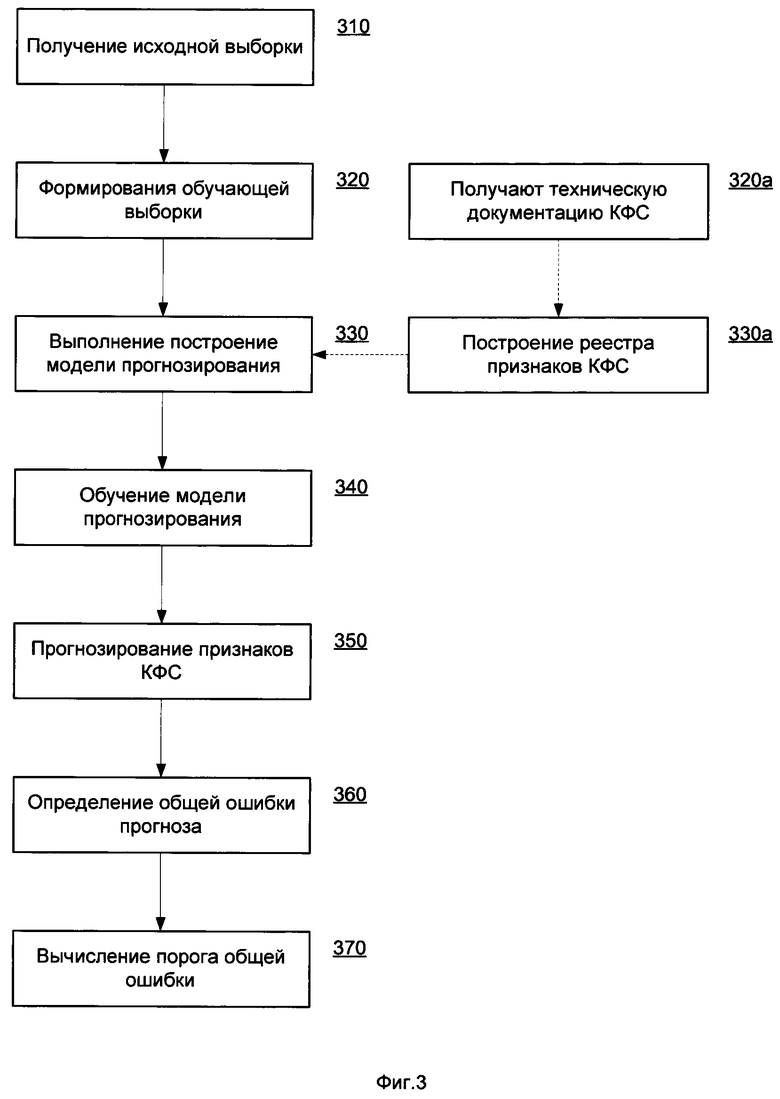

Фиг. 15 представляет пример компьютерной системы общего назначения, с помощью которой может быть реализовано настоящее изобретение.

Осуществление изобретения

Объекты и признаки настоящего изобретения, способы для достижения этих объектов и признаков станут очевидными посредством отсылки к примерным вариантам осуществления. Однако настоящее изобретение не ограничивается примерными вариантами осуществления, раскрытыми ниже, оно может воплощаться в различных видах. Приведенное описание предназначено для помощи специалисту в области техники для исчерпывающего понимания изобретения, которое определяется только в объеме приложенной формулы.

Объект управления - технологический объект, на который направляются внешние воздействия (управляющие и/или возмущающие) с целью изменения его состояния, в частном случае такими объектами являются устройство (например, электродвигатель) или технологический процесс (или его часть).

Технологический процесс (ТП) - процесс материального производства, заключающийся в последовательной смене состояний материальной сущности (предмета труда).

Управление технологическим процессом (англ. Process Control) - набор методов, используемых для управления технологическими параметрами при производстве конечного продукта.

Контур управления (англ. control loop) - состоит из материальных сущностей и управляющих функций, необходимых для автоматизированной регулировки значений измеренных технологических параметров к значениям желаемых уставок. Контур управления содержит датчики и сенсоры, контроллеры и исполнительные механизмы.

Технологический параметр (англ. Process Variable, PV) - текущее измеренное значение определенной части ТП, который наблюдается или контролируется. Технологическим параметром может быть, например, измерение датчика.

Уставка (англ. Setpoint) - поддерживаемое значение технологического параметра.

Управляемый параметр (англ. Manipulated Variable, MV) - параметр, который регулируется для того чтобы значение технологического параметра поддерживалось на уровне уставки.

Внешнее воздействие - способ изменения состояния элемента, на которое направлено воздействие (например, элемента технологической системы (ТС)), в определенном направлении, воздействие от элемента ТС к другому элементу ТС передается в виде сигнала.

Состояние объекта управления - совокупность его существенных свойств, выраженных параметрами состояний, изменяемых или удерживаемых под влиянием внешних воздействий, в том числе и управляющих воздействий со стороны подсистемы управления. Параметр состояния - одно или несколько числовых значений характеризующих существенное свойство объекта, в частном случае параметр состояния является числовым значением физической величины.

Формальное состояние объекта управления - состояние объекта управления, соответствующее технологической карте и другой технологической документации (если речь идет о ТП) или расписанию движения (если речь идет об устройстве).

Управляющее воздействие - целенаправленное (цель воздействия - воздействие на состояние объекта) легитимное (предусмотренное ТП) внешнее воздействие со стороны субъектов управления подсистемы управления на объект управления, приводящее к изменению состояния объекта управления или удержанию состояния объекта управления.

Возмущающее воздействие - целенаправленное или нецеленаправленное нелегитимное (непредусмотренное ТП) внешнее воздействие на состояние объекта управления, в том числе и со стороны субъекта управления.

Субъект управления - устройство, которое направляет управляющее воздействие на объект управления или передает управляющее воздействие другому субъекту управления для преобразования перед непосредственным направлением на объект.

Многоуровневая подсистема управления - включающая несколько уровней совокупность субъектов управления.

Кибер-физическая система (англ. cyber-physical system) - информационно-технологическая концепция, подразумевающая интеграцию вычислительных ресурсов в физические процессы. В такой системе датчики, оборудование и информационные системы соединены на протяжении всей цепочки создания стоимости, выходящей за рамки одного предприятия или бизнеса. Эти системы взаимодействуют друг с другом с помощью стандартных интернет-протоколов для прогнозирования, самонастройки и адаптации к изменениям. Примерами кибер-физической системы является технологическая система, интернет вещей (в том числе носимые устройства), индустриальный интернет вещей.

Интернет вещей (англ. Internet of Things, IoT) - вычислительная сеть физических предметов («вещей»), оснащенных встроенными технологиями для взаимодействия друг с другом или с внешней средой. Интернет вещей включает такие технологии, как носимые устройства, электронные системы транспортных средств, умные автомобили, умные города, промышленные системы и пр.

Промышленный Интернет вещей (англ. Industrial Internet of Things, IIoT) - это подкатегория Интернета вещей, который также включает приложения, ориентированные на потребителя, например, носимые устройства, технологии «умного дома» и автомобили с автоматическим управлением. Отличительной чертой обеих концепций являются устройства со встроенными датчиками, станки и инфраструктура, которые передают данные через Интернет и управляются с помощью программного обеспечения1 (1 https://www.hpe.com/ru/ru/what-is/industrial-iot.html).

Технологическая система (ТС) - функционально взаимосвязанная совокупность субъектов управления многоуровневой подсистемы управления и объекта управления (ТП или устройство), реализующая через изменение состояний субъектов управления изменение состояния объекта управления. Структуру технологической системы образуют основные элементы технологической системы (взаимосвязанные субъекты управления многоуровневой подсистемы управления и объект управления), а также связи между этими элементами. В том случае, когда объектом управления в технологической системе является технологический процесс, конечной целью управления является: через изменение состояния объекта управления изменить состояние предмета труда (сырья, заготовки и т.д.). В том случае, когда объектом управления в технологической системе является устройство, конечной целью управления является изменение состояния устройства (транспортное средство, космический объект). Функциональная взаимосвязь элементов ТС подразумевает взаимосвязь состояний этих элементов. При этом непосредственной физической связи между элементами может и не быть, например, физическая связь между исполнительными механизмами и технологической операцией отсутствует, но, например, скорость резания функционально связана с частотой вращения шпинделя, несмотря на то, что физически эти параметры состояний не связаны.

Состояние субъекта управления - совокупность его существенных свойств, выраженных параметрами состояний, изменяемых или удерживаемых под влиянием внешних воздействий.

Существенными свойствами (соответственно и существенными параметрами состояния) субъекта управления являются свойства, оказывающие непосредственное влияние на существенные свойства состояния объекта управления. При этом существенными свойствами объекта управления являются свойства, оказывающие непосредственное влияние на контролируемые факторы (точность, безопасность, эффективность) функционирования ТС. Например, соответствие режимов резания формально заданным режимам, движение поезда в соответствии с расписанием, удержание температуры реактора в допустимых границах. В зависимости от контролируемых факторов выбираются параметры состояния объекта управления и соответственно связанные с ними параметры состояний субъектов управления, оказывающих управляющее воздействие на объект управления.

Состояние элемента технологической системы - состояние субъекта управления, объекта управления.

Реальное состояние элемента технологической системы - состояние элемента технологической системы в некоторый момент времени воздействия на объект управления, определенное путем измерения параметров состояний и перехвата сигналов (трафика) между элементами ТС. Измерение параметров состояния осуществляется, например, с помощью датчиков, установленных в ТС.

Реальное состояние технологической системы - совокупность взаимосвязанных реальных состояний элементов технологической системы.

Кибернетический блок - элемент кибер-физической системы контроля, контролирующий процесс функционирования элемента технологической системы.

Пространство состояний - способ формализации изменения состояний динамической системы (технологической системы или кибер-физической системы).

Компьютерная атака (также кибератака, от англ. cyber attack) - целенаправленное воздействие на информационные системы и информационно-телекоммуникационные сети программно-техническими средствами, осуществляемое в целях нарушения безопасности информации в этих системах и сетях (см. «Основные направления государственной политики в области обеспечения безопасности автоматизированных систем управления производственными и технологическими процессами критически важных объектов инфраструктуры Российской Федерации» (утв. Президентом РФ 03.02.2012 N 803).

На Фиг. 1a схематично изображен пример технологической системы 100, которая включает в себя элементы 110а и 110б, где элементы ТС: объект управления 110а; субъекты управления 110б, образующие многоуровневую подсистему управления 120; горизонтальные связи 130а и вертикальные связи 130б. Субъекты управления 110б сгруппированы по уровням 140.

На Фиг. 1б схематично изображен частный пример имплементации технологической системы 100'. Объектом управления 110а' является ТП или устройство, на объект управления 110а' направляются управляющие воздействия, которые вырабатываются и реализуются автоматизированной системой управления (АСУ) 120', в АСУ различают три уровня 140', состоящих из субъектов управления 110б', взаимосвязанных между собой как по горизонтали горизонтальными связями (связи внутри уровня, на фигуре не указаны), так и по вертикали вертикальные связи 130б' (связи между уровнями). Взаимосвязи являются функциональными, т.е. в общем случае изменение состояния субъекта управления 110б' на одном уровне вызывает изменение состояний связанных с ним субъектов управления 110б' на этом уровне и других уровнях. Информация об изменении состояния субъекта управления передается в виде сигнала по горизонтальным и вертикальным связям, установленным между субъектами управления, т.е. информация об изменении состояния рассматриваемого субъекта управления является внешним воздействием по отношению к другим субъектам управления 110б'. Уровни 140' в АСУ 120' выделяют в соответствии с назначением субъектов управления 110б'. Количество уровней может варьироваться в зависимости от сложности автоматизированной системы управления 120'. Простые системы могут содержать в себе один или несколько нижних уровней. Для физической связи элементов ТС (110а, 110б) и подсистем ТС 100 используются проводные сети, беспроводные сети, интегральные микросхемы, для логической связи между элементами ТС (110а, 110б) и подсистемами ТС 100 используются Ethernet, промышленный Ethernet, я промышленные сети. При этом промышленные сети и протоколы используются различных типов и стандартов: Profibus, FIP, ControlNet, Interbus-S, DeviceNet, P-NET, WorldFIP, LongWork, Modbus и др.

Верхний уровень (уровень supervisory control and data acquisition, SCADA) - это уровень диспетчерско-операторского управления, включает в себя, по меньшей мере, следующие субъекты управления 110б': контроллеры, управляющие компьютеры, человеко-машинные интерфейсы (англ. human-machine interface, HMI) (на Фиг. 1б изображены в рамках одного субъекта управления SCADA). Уровень предназначен для отслеживания состояний элементов ТС (110а', 110б'), получения и накопления информации о состоянии элементов ТС (110а', 110б') и при необходимости их корректировки.

Средний уровень (уровень CONTROL) - это уровень контроллеров, включает, по меньшей мере, следующие субъекты управления: программируемые логические контроллеры (англ. programmable Logic Controller, PLC), счетчики, реле, регуляторы. Субъекты управления 110б' типа «PLC» получают информацию с субъектов управления типа «контрольно-измерительное оборудование» и субъектов управления 110б' типа «датчики» о состоянии объекта управления 110а'. Субъекты управления типа «PLC» вырабатывают (создают) управляющее воздействие в соответствии с запрограммированным алгоритмом управления на субъекты управления типа «исполнительные механизмы». Исполнительные механизмы его непосредственно реализуют (применяют к объекту управления) на нижнем уровне. Исполнительный механизм (англ. actuator) - часть исполнительного устройства (оборудования). Регуляторы, например, ПИД-регуляторы (Пропорционально-интегрально-дифференцирующий регулятор, англ. proportional-integral-derivative controller - PID controller) являются устройством в контуре управления с обратной связью.

Нижний уровень (уровень Input/Output) - это уровень таких субъектов управления как: датчики и сенсоры (англ. sensors), контрольно-измерительные приборы (КИП), контролирующих состояние объекта управления 110а', а также исполнительные механизмы (actuators). Исполнительные механизмы непосредственно воздействуют на состояние объекта управления 110а', для приведения его в соответствие с формальным состоянием, т.е. состоянием, соответствующим технологическому заданию, технологической карте или другой технологической документации (если речь идет о ТП) или расписанию движения (если речь идет об устройстве). На этом уровне осуществляется согласование сигналов от субъектов управления 110б' типа «датчики» с входами субъектов управления среднего уровня, и согласование вырабатываемых субъектами управления 110б' типа «PLC» управляющих воздействий с субъектами управления 110б' типа «исполнительные механизмы», которые их реализуют. Исполнительный механизм - это часть исполнительного устройства. Исполнительное устройство осуществляет перемещение регулирующего органа в соответствии с сигналами, поступающими от регулятора или управляющего устройства. Исполнительные устройства являются последним звеном цепи автоматического управления и в общем случае состоят из блоков:

• устройства усиления (контактор, частотный преобразователь, усилитель, и т.п.);

• исполнительного механизма (электро-, пневмо-, гидропривод) с элементами обратной связи (датчики положения выходного вала, сигнализации конечных положений, ручного привода и т.п.);

• регулирующего органа (вентили, клапаны, заслонки, шиберы и т.п.).

В зависимости от условий применения исполнительные устройства конструктивно могут различаться между собой. К основным блокам исполнительных устройств обычно относят исполнительные механизмы и регулирующие органы.

В частном примере исполнительное устройство в целом называют исполнительным механизмом.

АСУП 120а' - автоматическая система управления предприятием.

На Фиг. 1в представлен возможный вариант организации интернета вещей на примере носимых устройств. Система содержит множество различных компьютерных устройств пользователя 151. Среди устройств пользователя 151 могут быть, например: смартфон 152, планшет 153, ноутбук 154, носимые устройства, такие, как очки дополненной реальности 155, фитнес-трекер, «умные» часы 156 (англ. smart watch) и др. Устройства пользователя 151 содержат множество различных датчиков 157а-157n, например, монитор сердечного ритма 2001 и шагомер 2003.

Стоит отметить, что датчики 157а-157n могут находиться как на одном устройстве пользователя 151, так и на нескольких. Более того, некоторые датчики могут находиться на нескольких устройствах одновременно. Часть датчиков может быть представлена в нескольких экземплярах. Например, модуль Bluetooth может находиться на всех устройствах, а смартфон может содержать два и более микрофона, необходимых для шумоподавления и определения расстояния до источника звука.

На Фиг. 1г представлен возможный набор датчиков устройств 151. Среди датчиков 157а-157n могут быть, например, следующие:

• монитор сердечного ритма (датчик сердцебиения) 2001 для определения частоты пульса пользователя. В одном примере реализации монитор сердечного ритма может содержать электроды и измерять электрокардиограмму;

• датчик насыщения крови кислородом 2002;

• шагомер 2003;

• датчик определения отпечатков пальцев 2004;

• датчик жестов 2005, служащий для распознавания жестов пользователя;

• камера, направленная на глаза пользователя 2006, служащая для определения движения глаз пользователя, а также аутентификации личности пользователя по радужной оболочке или сетчатке глаза;

• датчик температуры тела пользователя 2007 (например, имеющий непосредственный контакт с телом пользователя или бесконтактный);

• микрофон 2008;

• датчик ультрафиолетового излучения 2009;

• приемник системы геолокации 2010, например, приемник GPS, ГЛОНАСС, BeiDou, Galileo, DORIS, IRNSS, QZSS и др.;

• О8М-модуль2011;

• модуль Bluetooth 2012;

• модуль Wi-Fi 2013;

• камера 2014, направленная на окружающую устройство пользователя среду;

• датчик температуры окружающей среды 2015;

• барометр 2016, необходимый для измерения атмосферного давления и определения высоты над уровнем моря в соответствии с атмосферным давлением;

• геомагнитный датчик 2017 (электронный компас), необходимый для определения сторон света и азимута;

• датчик определения влажности воздуха 2018;

• датчик уровня освещения 2019, необходимый для определения цветовой температуры и освещенности;

• датчик приближения 2020, служащий для определения расстояния до различных предметов, находящихся поблизости;

• датчик глубины изображения 2021, служащий для получения трехмерного изображения пространства;

• акселерометр 2022, служащий для измерения ускорения в пространстве;

• гироскоп 2023, необходимый для определения положения в пространстве;

• датчик Холла 2024 (магнитного поля), для определения напряженности магнитного поля;

• дозиметр-радиометр 2025, для определения уровня радиации;

• модуль NFC 2026;

• LTE-модуль 2027.

На Фиг. 2 представлена система обучения модели прогнозирования значений признаков кибер-физической системы (КФС), обладающей определенными характеристиками (то есть при обучении модели прогнозирования учитываются характеристики КФС), и вычисления порога ошибки для определения аномалии в упомянутой КФС 201. Кибер-физическая система 200 представлена в упрощенном варианте. Примерами кибер-физической системы 200 являются описанные ранее технологическая система 100 (см. Фиг. 1а-1б), интернет вещей (см. Фиг. 1в-1г), индустриальный интернет вещей. Для определенности далее в заявке в качестве основного примера КФС 200 будет рассматриваться ТС.

Система 201 содержит средство обучения 211 и связанное с ним средство вычисления 212. Как уже упоминалось ранее при описании Фиг. 1а-1б КФС содержит множество субъектов управления, таких как датчики, исполнительные механизмы, ПИД-регуляторы. Данные упомянутых субъектов в необработанном виде передаются на PLC. При этом может использоваться аналоговый сигнал. Затем PLC выполняет обработку данных и преобразовывает данные в цифровой вид, после чего передает системе SCADA 110б' и рассматриваемой системе 201. Таким образом, средство обучения 211 получает исходную выборку, содержащую значения признаков КФС 200 за исторический период наблюдения за КФС (то есть данные телеметрии КФС), в которой доля аномалий не превышает заданное значение (например, не более 1%). Признаки КФС являются численными характеристиками субъектов управления - датчиков, исполнительных механизмов, ПИД-регуляторов. Средство обучения 211 на основании исходной выборки и с учетом характеристик КФС формирует обучающую выборку, включающую значения по меньшей мере одного из полученных признаков КФС за период наблюдения не превосходящий исторический период наблюдения. При этом, в частном примере реализации включают в обучающую выборку по меньшей мере один момент времени, в котором произошла аномалия. Формирование обучающей выборки может включать этапы очистки данных исходной выборки от шумов, пропусков в данных, выбросах в значениях признаков, невалидных наборов данных, перевод на равномерную временную сетку, исключения из исходной выборки признаков вызывающих ложные срабатывания (например, показания неисправного датчика). В частном примере реализации формирование обучающей выборки может происходить с использованием технической документации КФС (например, описывающей возможные состояния и технические характеристики датчиков и исполнительных механизмов), а также на основании предоставленных данных пользователями КФС (например, об известных неисправных датчиках).

Затем средство обучения 211 выполняет построение модели прогнозирования значений признаков КФС в каждый момент времени окна прогноза по данным значений признаков КФС в каждый момент времени входного окна. То есть, входное окно и окно прогноза являются интервалами времени, которые находятся внутри периода наблюдений и выбраны в соответствии с характеристиками КФС. А значения признаков КФС сохранены с заданной периодичностью в пределах периода наблюдения. Например, если значения признаков КФС сохраняются каждую секунду, то и упомянутые выше моменты времени также отличаются через каждую секунду. Расстояние между входным окном и окном прогноза является горизонтом прогноза (например, от конца входного окна до начала окна прогноза), который также зависит от характеристик КФС. В частном примере реализации входное окно и окно прогноза могут пересекаться. В другом частном примере реализации входное окно и окно прогноза не пересекаются. Горизонт прогноза может принимать как неотрицательные значения (прогноз на будущее), так и отрицательные значения (например, анализ типа кодирование-декодирование).

Средство обучения 211 затем выполняет обучение модели прогнозирования на данных обучающей выборки. Затем средство вычисления 212 с использованием обученной модели прогнозирования выполняет прогнозирование значений признаков КФС в каждый момент времени периода наблюдения. Средство вычисления 212 определяет общую ошибку прогноза (то есть для спрогнозированных значений признаков КФС), например, как среднюю ошибку или средневзвешенную ошибку между наблюдаемыми значениями признаков и прогнозными значениями признаков, вычисленную в каждый момент времени окна прогноза. Затем вычисляют с помощью средства обучения 211 порог общей ошибки в зависимости от характеристик КФС, таким образом, что превышение вычисленного порога общей ошибкой прогноза означает аномалию в КФС. В частном примере реализации - как квантиль заданной точности от общей ошибки прогноза, например, на уровне значимости 99%.

Аномалия в КФС может возникнуть, например, из-за компьютерной атаки, из-за вмешательства в работу ТС или ТП человека, из-за сбоя или отклонения технологического процесса, связанного с периодами смены режимов, из-за перевода контуров управления в ручной режим или из-за некорректных показаний датчиков, а также по другим причинам, известным из уровня техники.

В частном примере реализации система 201 дополнительно содержит удаленный сервер 213, который может выполнять часть функций средства обучения 211 и средства вычисления 212: построение модели прогнозирования и обучение модели прогнозирования, а также прогнозирование значений признаков КФС на период наблюдения, определение общей ошибки прогноза и вычисление порога общей ошибки прогноза. В еще одном частном примере реализации средство обучения 211 и средство вычисления 212 могут быть размещены на удаленном сервере 213. Ввиду того, что удаленный сервер 213 может обладать существенно большими вычислительными возможностями, чем средство обучения 211 и средство вычисления 212, выполнение указанных функций удаленным сервером 213 позволит повысить скорость и качество работы системы 201.

Таким образом, система 201 позволяет обучить модель прогнозирования, определить размеры входного окна и окна прогноза, а также порог общей ошибки прогноза, которые могут быть использованы в системе и способе определения источника аномалии в КФС (см. Фиг. 4-5).

В частном примере реализации признаки КФС включают по меньшей мере один из:

• измерение датчика (технологический параметр датчика);

• управляемый параметр исполнительного механизма;

• уставка исполнительного механизма;

• входные сигналы или выходной сигнал ПИД-регулятора, внутренние параметры ПИД-регулятора.

В еще одном частном примере реализации в исходной выборке размечены моменты времени с известными аномалиями КФС, при этом упомянутые моменты времени с известными аномалиями КФС включают в обучающую выборку. То есть исходная выборка будет также содержать информацию о моментах времени возникновения известных аномалий в КФС (разметку). Это позволит обучить модель прогнозирования и определить порог общей ошибки точнее.

В другом частном примере реализации при формировании обучающей выборки выполняют разметку моментов времени возникновения аномалий КФС. В еще одном частном примере реализации из исходной выборки формируют тестовую выборку, по данным которой оценивают качество прогноза и, если оценка качества прогноза не удовлетворяет заданным критериям, повторяют обучение модели прогнозирования до тех пор, пока оценка качества прогноза не удовлетворит заданным критериям (так, чтобы не было переобучения). Если же оценка качества прогноза не удовлетворит заданным критериям, может быть выбрана другая модель прогнозирования. В частном примере качество прогноза определяется, например, одной из метрик качества: NAB-метрика (англ. Numenta Anomaly Benchmark)2 (2 Lavin and S. Ahmad, "Evaluating Real-time Anomaly Detection Algorithms - the Numenta Anomaly Benchmark," in 14th International Conference on Machine Learning and Applications (IEEE ICMLA'15), 2015. http://arxiv.org/abs/1510.03336), F1 -метрика.

В частном примере реализации кибер-физическая система обладает по меньшей мере одной из следующих характеристик:

• отраслью производства, в которой функционирует кибер-физическая система;

• типами процессов, которые описывают параметры КФС, в частности, один из: непрерывный, конвейерный, циклический (например, для циклических процессов может быть выбран период наблюдения, кратный периоду одного цикла);

• наличием сезонности и/или трендов в признаках КФС;

• инертностью процессов КФС;

• временем реакции КФС на изменения, происходящие в КФС и во внешней среде;

• уровнем опасности производства для персонала и экологии;

• стоимостью простоя технологических процессов из-за нештатных ситуаций;

• типом управления, в частности, выполненным с использованием ПИД-регуляторов, конечных автоматов или комбинированным способом;

• типом субъекта управления, который характеризуется по меньшей мере одним признаком, при этом тип субъекта управления является одним из: датчиком, исполнительный механизмом или ПИД-регулятором;

• данными самодиагностики КФС;

• статусом исправности субъекта управления (исправный или неисправный);

• взаимосвязью субъектов управления на уровне техпроцесса.

В качестве примера КФС можно привести предприятия нефтехимической отрасли, их отдельные блоки и установки. КФС таких предприятий может обладать одной или несколькими из следующих характеристик КФС:

• высоким значением периода времени непрерывного функционирования технологических процессов (например, от года);

• высоким временем реакции ТП (например, более одной минуты), поэтому при построении модели прогнозирования, выбирают больший период наблюдения для типа КФС, характеризующегося большим временем реакции параметров КФС на изменения других параметров КФС и внешних факторов;

• наличием сезонности ТП;

• высоким уровнем опасности производства для персонала и экологии. Соответственно при построении модели прогнозирования, выбирают низкий порог общей ошибки для КФС, характеризующегося высоким уровнем опасности производства, с целью обнаружения большего числа аномалий. То есть порог общей ошибки может быть вычислен как квантиль заданной точности от общей ошибки прогноза квантиль более низкого порядка (например, 0,90). При этом, вероятно, возникнут ложные срабатывания, однако, это никак не повлияет на производственный процесс, но позволит на этапе анализа типа кодирование-декодирование данных с помощью построенной модели выявить больше аномалий и с участием пользователя КФС уточнить значение порога ошибки таким образом, чтобы отсеять ложные срабатывания и оставить все важные проанализированные аномалии;

• высокой стоимостью простоя в ТП.

Для технологических процессов первичной нефтепереработки характерно наличие систем управления, выполненных на принципах ПИД-регулирования (каскадного) и содержащих большое количество (обычно более ста) саморегулирующихся контуров управления, взаимосвязанных как спроектированной и заложенной логикой управления, так и физикой процесса, и контролирующих такие величины как температура, давление, уровни жидкости и др. Специфика такого дизайна системы управления позволяет реализовать целый спектр методов мониторинга процесса, включая нейронные сети, методы анализа целостности прошивок ПИД-регуляторов и анализа корректности их уставок и др. Наличие таких специфических факторов нефтепереработки, как высокое парафиносодержание жидких компонент процесса, высокие температуры переработки (обычно порядка 350 градусов Цельсия), коксообразование и коксозабивка в агрегатах и другие, обуславливает такие особенности данных параметров, как присутствие сильных шумов, пропусков, выбросов в данных КИП, наличие трендовых составляющих в данных регулирования, невалидность некоторых наборов данных КИП и т.д. Кроме того, к особенностям системы управления на основе ПИД-регуляторов надо отнести такие факторы, как периодический перевод ПИД-регуляторов в ручной режим, применяющийся как для штатного управления установками, так и в нештатных ситуациях (оказывающих существенное влияние на данные параметров). Таким образом, в приведенном примере характеристики КФС влияют на значения признаков КФС, построение модели прогнозирования и определение общей ошибки прогноза.

Поэтому описанный метод позволяет достичь заявленные технические результаты, снизить ошибку второго рода при обнаружении аномалий в КФС. Кроме того, будет решена заявленная техническая проблема, заключающаяся в создании системы определения аномалий в КФС, обладающей определенными характеристиками, в которой время, прошедшее с момента возникновения аномалии в КФС до момента ее обнаружения, ниже, чем у существующих аналогов.

Таким образом, в одном частном примере реализации выбирают низкий порог общей ошибки для типа КФС, характеризующегося высоким уровнем опасности производства для персонала и экологии. В другом частном примере реализации выбирают больший период наблюдения для КФС, характеризующегося большим временем реакции признаков КФС на изменения других признаков КФС и внешних факторов.

В еще одном частном примере реализации при расчете общей ошибки прогноза для ошибок каждого признака КФС используют весовые коэффициенты, при этом:

а) присваивают низкое значение весовому коэффициенту для признака, если субъект управления, характеризующийся этим признаком, предоставляет данные с шумами или невалидные данные или периодически отключается пользователем КФС;

б) присваивают низкое значение весовому коэффициенту для признака, в котором возникновение аномалии не влияет на работу КФС, и высокое значение весовому коэффициенту для признака, в котором возникновение аномалии влияет на работу КФС.

Значения весовых коэффициентов признаков равных единице характерны для основного варианта реализации (равносильно отсутствию весовых коэффициентов).

В еще одном частном примере реализации обучающая выборка дополнительно содержит признаки по меньшей мере одной другой КФС, которая обладает по меньшей мере заранее определенным количеством таких же характеристик как текущая КФС. Таким образом, система 201 сможет более точно обучить модель прогнозирования и определить порог ошибки по данным нескольких КФС, обладающих такими же характеристиками.

В одном частном примере реализации применяют экспоненциальное сглаживание к общей ошибке прогноза. Это необходимо, чтобы снизить значение ошибки первого рода.

В частном примере реализации моделью прогнозирования является нейронная сеть. В еще одном частном примере реализации модель прогнозирования содержит в себе набор моделей, то есть ансамбль, принимающий решение путем усреднения результатов работы отдельных моделей из набора. В еще одном частном примере реализации оптимизируют нейронную сеть с использованием генетических алгоритмов. В другом частном примере реализации выбирают нейронную сеть с использованием одной из метрик качества: NAB-метрика, F1-метрика.

В еще одном частном примере реализации при расчете общей ошибки прогноза для ошибок каждого признака КФС используют весовые коэффициенты, при этом значение весового коэффициента признака определяется тем, насколько точно прогнозируемы значения данного признака КФС (например, по предыдущим результатам прогнозирования модели). В этом случае в качестве ошибки прогноза могут считать взвешенную ошибку с определенными весовыми коэффициентами.

В частном примере реализации при формировании обучающей выборки используют техническую документацию КФС (априорная информация, в которой описаны возможные состояния и технические характеристики датчиков и исполнительных механизмов). Это позволит построить более качественную модель за счет использования технической документации КФС для настройки параметров модели (выбор весовых коэффициентов при расчете общей ошибки прогноза, выбор периода наблюдения, изменение порога общей ошибки и пр.).

В другом частном примере реализации могут использовать отчет пользователя (также - оператора, отчет пользователя является апостериорной информацией) для улучшения качества модели или для построения новой модели в будущем за счет использования отчета пользователя для настройки параметров модели.

Значение весового коэффициента признака может быть присвоено средством обучения 211 в зависимости от значимости указанного признака и на основании технической документации КФС или отчета пользователя. Например, если определенный датчик часто выходит из строя или дает ложные показания, ему может быть присвоено низкое значение весового коэффициента или вовсе нулевое, в результате чего его показания не будут влиять на модель прогнозирования и значение порога ошибки для определения аномалии в КФС.

В частном примере реализации строят с использование средства обучения 211 реестр признаков КФС с использованием технической документации КФС или отчета пользователя, при этом реестр содержит, в частности, описание признака, физическую размерность признака, если признак описывает физическую величину объекта КФС, паспортная точность измерения признака, весовой коэффициент признака и наименование объекта, который описывается упомянутым признаком. При этом выполняют построение модели прогнозирования с учетом реестра признаков КФС, используя его для настройки параметров модели.

В другом частном примере реализации при построении обучающей выборки не включают в период наблюдения значения признаков КФС в моменты времени, в которые известно, что значения признаков КФС аномальные, в частности, периоды времени в которые проводятся пуско-наладочные или диагностические мероприятия на КФС, периоды времени ручного управления КФС.

В частном примере реализации построение модели прогнозирования средством обучения 211 происходит следующем образом. Вначале выбирают шаблон архитектуры нейронной сети. Например, многослойный перцептрон, сверточную нейронную сеть, рекуррентную нейронную сеть или другие. Далее формируют описание выбранной архитектуры:

• оптимизатор и его параметры;

• начальные значения весовых коэффициентов и сдвигов;

• максимальное количество слоев;

• для каждого слоя:

список возможных типов слоя, состоящий по меньшей мере из подмножества следующих слоев: Dense, Convolutional, GRU, LSTM, Dropout;

список возможных типов слоя, состоящий по меньшей мере из подмножества следующих слоев: Dense, Convolutional, GRU, LSTM, Dropout;

функция активации: линейная, ReLU, Tanh, сигмоида, Softmax и др.;

функция активации: линейная, ReLU, Tanh, сигмоида, Softmax и др.;

возможный размер слоя (число нейронов в слое).

возможный размер слоя (число нейронов в слое).

Затем производят оптимизацию архитектуры нейронной сети с использованием оптимизатора. В частном примере реализации оптимизация архитектуры нейронной сети производится с использованием генетических алгоритмов. Для выбора лучшей архитектуры также используется метрика качества. В частном примере реализации используется одна из следующих метрик качества: NAB-метрика, F1-метрика.

На Фиг. 3 представлен способ обучения модели прогнозирования значений признаков кибер-физической системы (КФС) и вычисления порога ошибки для определения аномалии в обладающей определенными характеристиками КФС. На шаге 310 получают исходную выборку, содержащую значения признаков КФС за исторический период наблюдения за КФС. В частном примере реализации в исходной выборке доля аномалий не превышает заданное значение. Затем, на шаге 320 на основании исходной выборки и с учетом характеристик КФС формируют обучающую выборку, включающую значения по меньшей мере одного из упомянутых признаков КФС, за период наблюдения не превосходящий исторический период наблюдения. В частном примере реализации включают в обучающую выборку по меньшей мере один момент времени, в котором произошла аномалия. На шаге 330 выполняют построение модели прогнозирования значений признаков КФС в каждый момент времени окна прогноза по данным значений упомянутых признаков КФС в каждый момент времени входного окна, при этом входное окно и окно прогноза находятся внутри периода наблюдений и выбраны в зависимости от характеристик КФС, а расстояние между входным окном и окном прогноза равно горизонту прогноза, который выбирают в зависимости от характеристик КФС. Затем, на шаге 340 выполняют обучение модели прогнозирования на данных обучающей выборки.

На шаге 350 с использованием обученной модели прогнозирования выполняют прогнозирование значений признаков КФС в каждый момент времени периода наблюдения. После чего, на шаге 360 определяют общую ошибку прогноза, полученного с использованием построенной модели прогнозирования в каждый момент времени периода наблюдения. На шаге 370 вычисляют порог общей ошибки в зависимости от характеристик КФС, таким образом, что превышение вычисленного порога общей ошибкой прогноза означает аномалию в КФС. Стоит отметить, что частные примеры реализации, раскрытые ранее применительно к системе 201, представленной на Фиг. 2, также применимы и к описанному на Фиг. 3 способу. Например, в одном из частных примеров реализации на шаге 320а получают техническую документацию КФС или отчет пользователя по ранее обнаруженным аномалиям. Затем, на шаге 330а строят с использованием средства обучения 211 реестр признаков КФС с использованием технической документации КФС или отчета пользователя, при этом реестр содержит, в частности, описание признака, физическую размерность признака, если признак описывает физическую величину объекта КФС, паспортная точность измерения признака, весовой коэффициент признака и наименование объекта, который описывается упомянутым признаком, при этом выполняют построение модели прогнозирования (шаг 330) с учетом реестра признаков КФС. Другие частные примеры реализации были перечислены ранее, на Фиг. 2.

На Фиг. 4 представлена система определения источника аномалии в кибер-физической системе. Система определения источника аномалии 220 содержит средство прогнозирования 221 и средство определения аномалии 222. Средство прогнозирования 221 предназначено для получения значений признаков КФС за входное окно, которое определяется обученной моделью прогнозирования, а также выполняет прогнозирование значений признаков КФС на окно прогноза с использованием обученной модели прогнозирования и по данным полученных значений признаков КФС за входное окно. Признаки КФС являются численными характеристиками датчиков, исполнительных механизмов, ПИД-регуляторов. Входное окно и окно прогноза - это заданные в обученной модели прогнозирования интервалы времени, при этом входное окно содержит значения признаков, по значениям которых выполняют прогнозирование значений признаков для окна прогноза. То есть они определяются системой и способом, описанными на Фиг. 2-3. Входное окно и окно прогноза находятся внутри периода наблюдений и выбраны в соответствии с характеристиками КФС. Расстояние между входным и окном прогноза является горизонтом прогноза (например, от конца входного окна до начала окна прогноза), который также зависит от характеристик КФС. Горизонт прогноза может принимать как неотрицательные значения (прогноз на будущее), так и отрицательные значения. В частном примере реализации входное окно и окно прогноза могут пересекаться (горизонт прогноза отрицателен). В другом частном примере реализации входное окно и окно прогноза не пересекаются (горизонт прогноза положителен).

Средство определения аномалии 222 предназначено для определения общей ошибки прогноза для признаков КФС для окна прогноза, определения аномалии в КФС при превышении общей ошибкой прогноза порога общей ошибки (то есть порогового значения общей ошибки), а также для определения по меньшей мере одного признака КФС, являющегося источником аномалии, если вклад ошибки прогноза упомянутого по меньшей мере одного признака КФС (из числа всех признаков КФС из упомянутого списка признаков) в общую ошибку прогноза выше, чем вклад других признаков КФС (из числа всех признаков КФС из упомянутого списка признаков) в общую ошибку прогноза. Например, определяют 5 признаков КФС с наибольшей ошибкой прогноза среди всех признаков КФС из упомянутого списка признаков. В частном примере реализации порог общей ошибки является квантилем заданной точности от общей ошибки прогноза, например, на уровне значимости 99%.

В частном примере реализации значения признаков КФС поступают в режиме реального времени, поэтому для окна прогноза определяют общую ошибку прогноза спустя время, равное сумме горизонта прогноза и входного окна, то есть когда будут получены реальные значения признаков КФС в каждый момент времени окна прогноза.

В другом частном случае, если значения признаков КФС содержатся в исходной выборке за исторический период наблюдения (то есть за весь период времени, в течение которого проводилось наблюдение), для окна прогноза определяют общую ошибку прогноза по данным исходной выборки за исторический период наблюдения.

В частном примере реализации признаки КФС включают по меньшей мере один из: измерение датчика (технологический параметр датчика); управляемый параметр исполнительного механизма; уставку исполнительного механизма; входные сигналы или выходной сигнал ПИД-регулятора.

В частном примере реализации кибер-физическая система обладает по меньшей мере одной из следующих характеристик:

• отраслью производства, в которой функционирует кибер-физическая система;

• типами процессов, которые описывают параметры КФС, в частности, один из: непрерывный, конвейерный, циклический;

• наличием сезонности и/или трендов в признаках КФС;

• инертностью процессов КФС;

• временем реакции КФС на изменения, происходящие в КФС и во внешней среде;

• уровнем опасности производства для персонала и экологии;

• стоимостью простоя технологический процессов из-за нештатных ситуаций;

• типом управления, в частности, выполненный с использованием ПИД-регуляторов, конечных автоматов или комбинированным способом;

• типом субъекта управления, который характеризуется по меньшей мере одним признаком, при этом тип субъекта управления является одним из: датчиком, исполнительный механизмом или ПИД-регулятором;

• данными самодиагностики КФС;

• статусом исправности субъекта управления;

• взаимосвязью субъектов управления на уровне техпроцесса.

В частном примере реализации моделью прогнозирования является нейронная сеть. В еще одном частном примере реализации модель прогнозирования содержит в себе набор моделей, то есть ансамбль - принимающий решение путем усреднения результатов работы отдельных моделей из набора. В еще одном частном примере реализации оптимизируют нейронную сеть с использованием генетических алгоритмов. В другом частном примере реализации выбирают нейронную сеть с использованием одной из метрик качества: NAB-метрика, F1 -метрика.

В еще одном частном примере реализации при расчете общей ошибки прогноза для ошибок каждого признака КФС используют весовые коэффициенты, при этом:

а) присваивают низкое значение весовому коэффициенту для признака, если субъект управления, характеризующийся этим признаком, предоставляет данные с шумами, или невалидные данные или периодически отключается пользователем КФС;

б) присваивают низкое значение весовому коэффициенту для признака, в котором возникновение аномалии не влияет на работу КФС, и высокое значение весовому коэффициенту для признака, в котором возникновение аномалии влияет на работу КФС.

В одном частном примере реализации применяют экспоненциальное сглаживание к общей ошибке прогноза. Это необходимо, чтобы снизить ошибку первого рода.

В другом частном примере реализации при расчете общей ошибки прогноза для ошибок каждого признака КФС используют весовые коэффициенты, при этом значение весового коэффициента признака определяется тем, насколько точно прогнозируемы значения данного признака КФС. В этом случае в качестве ошибки прогноза могут считать взвешенную с определенными весовыми коэффициентами ошибку.

В еще одном частном примере реализации получают техническую документацию КФС или отчет пользователя по ранее обнаруженным обученной системой аномалиям, при этом весовой коэффициент признака выбирают с помощью средства обучения 211 в зависимости от значимости указанного признака и на основании технической документации КФС или отчета пользователя.

На Фиг. 5 представлен пример способа определения источника аномалии в кибер-физической системе, обладающей определенными характеристиками. На шаге 510 получают значения признаков КФС за входное окно, которое определяется обученной моделью прогнозирования (использующейся в системе и способе, которые представлены на Фиг. 3-4). Затем на шаге 520 с использованием обученной модели прогнозирования и по данным полученных значений признаков КФС за входное окно выполняют прогнозирование значений признаков КФС за окно прогноза. После чего на шаге 530 для окна прогноза определяют общую ошибку прогноза для признаков КФС и, при превышении общей ошибкой прогноза порога общей ошибки на шаге 540 определяют аномалию в КФС. В итоге на шаге 550 определяют по меньшей мере один признак КФС, являющийся источником аномалии, если вклад ошибки прогноза упомянутого по меньшей мере одного признака КФС в общую ошибку прогноза выше чем вклад других признаков КФС в общую ошибку прогноза. Например, определяют 5 признаков КФС с наибольшей ошибкой прогноза среди всех признаков КФС из упомянутого списка признаков.

В частном примере реализации значения признаков КФС поступают в режиме реального времени, поэтому для окна прогноза определяют общую ошибку прогноза спустя время, равное сумме горизонта прогноза и входного окна, то есть когда будут получены реальные значения признаков КФС в каждый момент времени окна прогноза.

В другом частном случае, если значения признаков КФС содержатся в исходной выборке за исторический период наблюдения, для окна прогноза определяют общую ошибку прогноза по данным исходной выборки за исторический период наблюдения.

В частном примере реализации признаки КФС включают по меньшей мере один из: измерение датчика (технологический параметр датчика); управляемый параметр исполнительного механизма; уставка исполнительного механизма; входные сигналы или выходной сигнал ПИД-регулятора.

В частном примере реализации кибер-физическая система обладает по меньшей мере одной из следующих характеристик:

• отраслью производства, в которой функционирует кибер-физическая система;

• типами процессов, которые описывают параметры КФС, в частности, один из: непрерывный, конвейерный, циклический;

• наличием сезонности и/или трендов в признаках КФС;

• инертностью процессов КФС;

• временем реакции КФС на изменения, происходящие в КФС и во внешней среде;

• уровнем опасности производства для персонала и экологии;

• стоимостью простоя технологических процессов из-за нештатных ситуаций;

• типом управления, в частности, выполненный с использованием ПИД-регуляторов, конечных автоматов или комбинированным способом;

• типом субъекта управления, который характеризуется по меньшей мере одним признаком, при этом тип субъекта управления является одним из: датчиком, исполнительный механизмом или ПИД-регулятором;

• данными самодиагностики КФС;

• статусом исправности субъекта управления;

• взаимосвязью субъектов управления на уровне техпроцесса.

В частном примере реализации моделью прогнозирования является нейронная сеть. В еще одном частном примере реализации модель прогнозирования содержит в себе набор моделей, то есть ансамбль - принимающий решение путем усреднения результатов работы отдельных моделей из набора. В еще одном частном примере реализации оптимизируют нейронную сеть с использованием генетических алгоритмов. В другом частном примере реализации выбирают нейронную сеть с использованием одной из метрик качества: NAB-метрика, F1-метрика.

В еще одном частном примере реализации при расчете общей ошибки прогноза для ошибок каждого признака КФС используют весовые коэффициенты, при этом:

а) присваивают низкое значение весовому коэффициенту для признака, если субъект управления, характеризующийся этим признаком, предоставляет данные с шумами, или невалидные данные или периодически отключается пользователем КФС;

б) присваивают низкое значение весовому коэффициенту для признака, в котором возникновение аномалии не влияет на работу КФС, и высокое значение весовому коэффициенту для признака, в котором возникновение аномалии влияет на работу КФС.

В одном частном примере реализации применяют экспоненциальное сглаживание к общей ошибке прогноза. Это необходимо, чтобы снизить ошибку первого рода.

В одном частном примере реализации при расчете общей ошибки прогноза для ошибок каждого признака КФС используют весовые коэффициенты, при этом значение весового коэффициента признака определяется тем, насколько точно прогнозируемы значения данного признака КФС. В этом случае в качестве ошибки прогноза могут считать взвешенную с определенными весовыми коэффициентами ошибку.

В еще одном частном примере реализации получают техническую документацию КФС или отчет пользователя по ранее обнаруженным обученной системой аномалиям, при этом весовой коэффициент признака выбирают с помощью средства обучения 211 в зависимости от значимости указанного признака и на основании технической документации КФС или отчета пользователя.

Ниже рассматривается пример работы описанных систем и способов по Фиг. 2-5. После получения исходной выборки, содержащей значения признаков КФС за исторический период наблюдения за КФС - Т0, формируют обучающую выборку - за период наблюдения Т1⊆Т0 (то есть период наблюдения Т1 является подмножеством Т0). Обучающая выборка состоит из m признаков КФС в каждый момент времени наблюдения xt (вектор значений признаков КФС) периода наблюдения Т1:

t≥0 - время, а m>0 - число признаков.

Входное окно времени для упомянутых признаков - L (так, что длина окна положительна), h - горизонт прогноза,  - окно прогноза (так, что длина окна положительна), т.е. период времени, на который прогнозируют значения признаков по данным значений признаков за период времени L. При этом L,

- окно прогноза (так, что длина окна положительна), т.е. период времени, на который прогнозируют значения признаков по данным значений признаков за период времени L. При этом L,  .

.

На Фиг. 6 представлен пример зависимости значений одного признака от времени, а также обозначены входное окно L, окно прогноза  и горизонт прогноза h. В общем случае, входное окно L и окно прогноза

и горизонт прогноза h. В общем случае, входное окно L и окно прогноза  могут как пересекаться, так и не пересекаться. Применительно к представленному примеру далее рассматривается работа системы и способа обучения модели прогнозирования значений признаков КФС и вычисления порога ошибки R для определения аномалии и обладающей определенными характеристиками КФС по Фиг. 2-3. Обучающая выборка, сформированная на основании исходной выборки и с учетом характеристик КФС, включает значения признаков КФС за период наблюдения (например, весь интервал с 16:00 до 16:08). С использованием обучающей выборки выполняют построение модели прогнозирования значений параметров КФС, в каждый момент времени окна прогноза

могут как пересекаться, так и не пересекаться. Применительно к представленному примеру далее рассматривается работа системы и способа обучения модели прогнозирования значений признаков КФС и вычисления порога ошибки R для определения аномалии и обладающей определенными характеристиками КФС по Фиг. 2-3. Обучающая выборка, сформированная на основании исходной выборки и с учетом характеристик КФС, включает значения признаков КФС за период наблюдения (например, весь интервал с 16:00 до 16:08). С использованием обучающей выборки выполняют построение модели прогнозирования значений параметров КФС, в каждый момент времени окна прогноза  по данным значений признаков КФС в каждый момент времени входного окна L. Входное окно L и окно прогноза

по данным значений признаков КФС в каждый момент времени входного окна L. Входное окно L и окно прогноза  находятся внутри периода наблюдения и выбираются в зависимости от характеристик КФС. Горизонт прогноза h также выбирают в зависимости от характеристик КФС. Прогнозные значения признаков вычисляются по формуле:

находятся внутри периода наблюдения и выбираются в зависимости от характеристик КФС. Горизонт прогноза h также выбирают в зависимости от характеристик КФС. Прогнозные значения признаков вычисляются по формуле:

F(⋅) - модель прогнозирования.

Обучение модели прогнозирования происходит на данных всей обучающей выборки. Затем выполняют прогнозирование значений признаков КФС в каждый момент времени периода наблюдения. Это может происходить путем передвижения входного окна и горизонта прогноза таким образом, чтобы в конечном итоге получить прогнозные значения признаков КФС в каждый момент времени периода наблюдения. После чего определяют общую ошибку прогноза для параметров КФС в каждый момент времени окна прогноза. В частном примере реализации общая ошибка прогноза в момент времени t является средней ошибкой:

Разница  может быть определена как ошибка прогноза признака с номером

может быть определена как ошибка прогноза признака с номером  в момент времени t≥0. В еще одном частном примере реализации порог общей ошибки прогноза R может быть вычислен как квантиль заданной точности от общей ошибки прогноза

в момент времени t≥0. В еще одном частном примере реализации порог общей ошибки прогноза R может быть вычислен как квантиль заданной точности от общей ошибки прогноза  (например, квантиль порядка 0,95). Таким образом, аномалия возникнет при

(например, квантиль порядка 0,95). Таким образом, аномалия возникнет при  . Кроме того, к общей ошибке прогноза может быть применено экспоненциальное сглаживание.

. Кроме того, к общей ошибке прогноза может быть применено экспоненциальное сглаживание.

Применительно к представленному примеру далее рассматривается работа системы и способа определения источника аномалии в КФС, обладающей определенными характеристиками по Фиг. 4-5. В зависимости от примера реализации значения признаков КФС поступают либо в режиме реального времени для определения источника аномалии в КФС в текущий момент времени, либо за исторический период наблюдения для ретроспективного определения источника аномалии в КФС. Для иллюстрации далее рассматривается пример реализации, в котором значения признаков КФС поступают в режиме реального времени. Таким образом, значения признаков КФС поступают за входное окно L (которое определяется обученной моделью прогнозирования, см. Фиг. 2-3). Затем с использованием обученной модели прогнозирования и по данным полученных значений признаков КФС за входное окно L выполняют прогнозирование значений признаков КФС на окно прогноза  . Для окна прогноза определяют общую ошибку прогноза для признаков КФС и при превышении общей ошибкой прогноза порога общей ошибки, определяют аномалию в КФС. После чего определяют по меньшей мере один признак КФС, являющийся источником аномалии, если вклад этого признака КФС в общую ошибку прогноза выше чем вклад других признаков КФС в общую ошибку прогноза.

. Для окна прогноза определяют общую ошибку прогноза для признаков КФС и при превышении общей ошибкой прогноза порога общей ошибки, определяют аномалию в КФС. После чего определяют по меньшей мере один признак КФС, являющийся источником аномалии, если вклад этого признака КФС в общую ошибку прогноза выше чем вклад других признаков КФС в общую ошибку прогноза.

На Фиг. 7 представлены примеры зависимостей значений признаков, значений прогнозов признаков и общей ошибки прогноза от времени в окрестности времени момента возникновения аномалии. На первых двух графиках представлена динамика изменения значений признаков, т.е. реальных значений, полученных от соответствующих субъектов управления (датчики, исполнительные механизмы и ПИД-регуляторы), а также динамика их прогнозных значений, полученных с использованием систем и способов, описанных на Фиг. 2-5. На нижнем графике представлена динамика общей ошибки прогноза (для обоих признаков) и момент превышения ею порога общей ошибки, что означает возникновение аномалии.

В одном частном примере реализации применяют экспоненциальное сглаживание к общей ошибке прогноза. Это необходимо, чтобы снизить ошибку первого рода.

На Фиг. 8 представлен пример динамики общей ошибки прогноза до сглаживания и после сглаживания. Из графика видно, что в первом случае с помощью системы и способа по Фиг. 4-5 средство определения аномалии 222 определило бы аномалию из-за превышения общей ошибкой порога общей ошибки, а во втором случае аномалию не определяют, что в большей мере соответствует действительности ввиду снижения кратковременных отклонений ошибки. То есть сглаживание общей ошибки прогноза позволяет снизить возможность многократного определения одной аномалии, а также шумы в упомянутой ошибке. После обнаружения аномалии определяют признаки КФС, являющиеся источником аномалии, с наибольшим вкладом в общую ошибку прогноза.

В частном примере реализации в качестве общей ошибки прогноза может быть использована средняя ошибка степени р>0 (например, среднеквадратическая ошибка). В еще одном частном примере реализации общая ошибка прогноза может быть взвешенной средней ошибкой степени р.

В частном примере реализации в системе и способе, описанным на Фиг. 4-5, при определении аномалии, пользователю (оператору) КФС может быть отображена сопутствующая информация об обнаруженной аномалии. Например, графики изменения значений параметров в период, охватывающий момент времени обнаружения аномалии. Кроме того, на графике могут быть отображены прогнозные значения параметров, порог общей ошибки и порог ошибки соответствующего параметра, а также указание на момент времени обнаружения аномалии и на параметры, являющиеся источниками аномалии. После дополнительного анализа, пользователь КФС может подтвердить или опровергнуть обнаружение аномалии, параметров, являющихся источником аномалии. Это позволит снизить ошибку первого рода и повысить точность определения аномалий и идентификации параметров, являющихся источником данной аномалии. Более подробно система формирования данных для мониторинга кибер-физической системы с целью раннего определения аномалий в системе графического интерфейса пользователя (ГИП) будет представлена далее, на Фиг. 9.

На Фиг. 9 представлена система формирования данных для мониторинга кибер-физической системы с целью раннего определения аномалий в системе графического интерфейса пользователя (далее - система графического интерфейса пользователя, сокр. ГИП). Система ГИП содержит по меньшей мере один элемент ГИП для выбора признака 910, содержащий, в частности, список признаков кибер-физической системы (далее - список признаков), и предназначенный для приема информации о выбранном пользователем (также - оператором) КФС по меньшей мере одном признаке КФС из упомянутого списка признаков. Выбор списка признаков осуществляется с использованием ГИП для выбора списка признаков 911. Кроме того, по меньшей мере один элемент ГИП для выбора периода времени 920 предназначен для приема информации о выбранном пользователем периоде времени для мониторинга за выбранными признаками КФС. Система также содержит средство прогнозирования 221, предназначенное для формирования прогноза для признаков КФС за указанный период времени мониторинга и средство определения аномалии 222, предназначенное для формирования общей ошибки прогноза для выбранных признаков КФС и ошибки прогноза для каждого из выбранных признаков КФС за указанный период времени мониторинга. При этом средство прогнозирования 221 и средство определения аномалии 222 могут функционировать согласно описанным ранее системе и способу по Фиг. 4-5 и в соответствующих частных вариантах реализации. Кроме того, к системе ГИП также применимы варианты реализации, описанные к Фиг. 2-5.

По меньшей мере один элемент ГИП для формирования графиков 930 предназначен для формирования за указанный период времени мониторинга для значений данных, сформированных средством прогнозирования 221 и средством определения аномалий 222. В частном примере реализации, упомянутые значения данных включают, в частности следующие:

• каждого выбранного признака КФС;

• прогноза для каждого выбранного признака КФС;

• общей ошибки прогноза для признаков КФС;

• ошибки прогноза для каждого выбранного признака КФС;

• порога общей ошибки прогноза.

Средство определения аномалии 222 дополнительно предназначено для определения аномалии в КФС при превышении общей ошибкой прогноза порога общей ошибки, при этом элемент ГИП для формирования графиков 930 дополнительно предназначен для формирования данных об аномалии в КФС и формирования графика значений по меньшей мере для одного из всех признаков КФС (то есть из упомянутого ранее списка признаков), если вклад ошибки прогноза упомянутого по меньшей мере одного признака КФС в общую ошибку прогноза выше чем вклад по меньшей мере одного другого признака КФС (также из числа всех признаков КФС из списка признаков) в общую ошибку прогноза.

На Фиг. 9 и на Фиг. 10а-10б также представлен иллюстративный пример работы описанной системы. А именно, с использованием элемента ГИП для выбора признака 910 пользователем выбраны признаки, для которых сформированы (построены) графики с использованием ГИП для формирования графиков 930 за указанный период времени мониторинга 920.

Например, на Фиг. 10а верхние два графика являются графиками реальных значений и прогнозных значений для выбранных признаков («A_feed_stream1» и «A_reactor_feed»). На нижнем третьем графике представлена общая ошибка прогноза для всех признаков КФС (то есть вычисленная на основании реальных и прогнозных значений всех признаков КФС из упомянутого списка признаков) и порог общей ошибки прогноза (горизонтальная линия). При этом, также отображен момент возникновения аномалии в КФС (вертикальная пунктирная линия по центру на каждом из графиков), - момент времени, когда общая ошибка прогноза превышает порог общей ошибки. Т.к. общая ошибка прогноза складывается из ошибок прогноза признаков, то ошибка прогноза каждого признака может быть незначительной, в то время как общая ошибка прогноза может превышать порог общей ошибки, в результате чего возникнет аномалия. Поэтому такую аномалию проблематично обнаружить пользователю КФС. Однако использование заявленной на Фиг. 9 системы позволяет упросить этот процесс, а именно определить момент возникновения аномалии и сформировать графики значений признаков КФС и прогнозных значений упомянутых признаков (с последующем предоставлением их пользователю). Упомянутые графики, сформированные ГИП для формирования графиков 930, могут быть сформированы (и отображены пользователю) как для выбранных пользователем признаков, так и для признаков (из числа всех признаков КФС) из упомянутого списка признаков, у которых наибольшая ошибка прогноза (то есть вклад в общую ошибку прогноза у этих признаков выше, чем вклад других выбранных признаков). Именно такие признаки являются наиболее вероятными источниками аномалии.

В частном примере реализации описанная на Фиг. 9 система ГИП дополнительно содержит элемент ГИП для выбора режима отображения 940, предназначенный для приема информации о выбранном пользователем режиме мониторинга за выбранными признаками КФС: в режиме реального времени, в режиме кодирование-декодирование, при этом если выбран режим реального времени, упомянутый элемент ГИП для формирования графиков 930 формирует графики упомянутых значений в текущий момент времени, (см. Фиг. 10а-10в).