Область техники

Изобретение относится к области информационной безопасности.

Уровень техники

В настоящее время, помимо традиционного вредоносного программного обеспечения (к которому относятся, например, вирусы, сетевые черви, клавиатурные шпионы, шифровальщики и пр.), широкое распространение получили компьютерные атаки и, в частности, направленные атаки (называются также целевыми или целенаправленными атаками, от англ. targeted attack - ТА), а также сложные атаки (англ. Advanced Persistent Threat - APT) на информационную систему (совокупность вычислительных устройств и используемых для их связи коммуникаций, информационную систему также называют корпоративной инфраструктурой). Злоумышленники могут иметь различные цели - от простой кражи личных данных сотрудников до промышленного шпионажа. Зачастую злоумышленники обладают информацией об архитектурах корпоративных сетей, о принципах внутреннего документооборота, об используемых средствах защиты сетей и компьютерных устройств или любой другой специфичной для информационной системы и зачастую закрытой информации. Обладание данной информацией позволяет злоумышленникам обходить существующие средства защиты, которые зачастую не обладают гибкостью настроек для удовлетворения всех потребностей информационной системы.

Существующие технологии защиты от вредоносного программного обеспечения (ПО) и компьютерных угроз, такие как: сигнатурный анализ, эвристический анализ, эмуляция и другие имеют ряд недостатков, которые не позволяют обеспечить должный уровень защиты от направленных атак и других компьютерных атак. Например, они не позволяют обнаружить и расследовать неизвестные ранее угрозы, компьютерные атаки без применения вредоносного программного обеспечения, сложные атаки (с применением технологий обхода средств защиты) и долго протекающие атаки (от нескольких дней до нескольких лет), признаки которых стали известны спустя продолжительное время с момента начала атаки.

Поэтому для защиты корпоративных сетей от перечисленных угроз, помимо классических антивирусных решений, систем обнаружения и предотвращения вторжений, используют более продвинутые системы. К числу которых относятся SIEM-системы с интегрированными потоками данных об угрозах, анти-АРТ-системы для обнаружения сложных угроз и направленных атак, системы исследования образцов ПО и поиска информации о характеристиках вредоносного ПО по индикаторам компрометации. При этом, кроме автоматических систем, используется анализ специалистами по информационной безопасности (ИБ). Автоматические системы служат для обнаружения инцидентов ИБ путем корреляции событий ИБ с данными об известных угрозах. В большинстве случаев обнаруженные инциденты ИБ требуют анализа специалистом ИБ для минимизации ущерба, сбора данных об инциденте и дальнейшего реагирования. Однако в существующих системах большое число инцидентов ИБ являются ложными срабатывания. В результате чего специалисты по ИБ тратят много времени на разбор ложных инцидентов, при этом увеличивается вероятность пропустить настоящий инцидент ИБ. Кроме того, возрастают расходы на содержание в штате большого количества квалифицированных специалистов ИБ.

Техническая проблема заключается в отсутствии способов корректировки параметров модели машинного обучения для определения инцидентов на основании результатов анализа событий.

Существуют технологии, осуществляющие обработку событий информационной безопасности. В частности, в патенте US 8839349 описана технология, позволяющая отображать информацию об обнаруженных инцидентах безопасности. В патенте US 8776241 описана технология для расследования инцидентов информационной безопасности путем определения причин возникновения инцидента и применения мер для исправления последствий и последующего предотвращения повторения подобного инцидента.

Однако известные технологии имеют недостатки, препятствующие решению заявленной технической проблемы, а именно отсутствуют способы корректировки параметров модели машинного обучения для определения инцидентов на основании результатов анализа событий.

Раскрытие сущности изобретения

Первый технический результат заключается в реализации назначения.

Второй технический результат заключается в снижении количества ложных срабатываний за счет корректировки параметров модели машинного обучения.

Третий технический результат заключается в контроле количества ложных срабатываний и количества событий, отправляемых на анализ.

Согласно варианту реализации используется реализуемый на сервере способ корректировки параметров модели машинного обучения для определения ложных срабатываний и инцидентов информационной безопасности (далее - инцидентов), в котором: изменяют вердикты для определенной части событий информационной безопасности (далее - первого множества событий) с вердиктом «ложное срабатывание» на вердикты «инцидент», где вердикты для событий определяют с использованием модели машинного обучения для определения ложных срабатываний и/или инцидентов; отправляют события первого множества событий на анализ; используя результаты анализа, корректируют параметры модели машинного обучения для определения ложных срабатываний и/или инцидентов.

Согласно одному из частных вариантов реализации модель машинного обучения определяет вердикт «ложное срабатывание» и/или вердикт «инцидент» путем определения для каждого события вероятности ложного срабатывания и сравнения определенной вероятности ложного срабатывания с заданным первым порогом, являющимся параметром модели машинного обучения, при этом событию выносят вердикт «ложное срабатывание», если вероятность ложного срабатывания события превышает первый порог, а в ином случае выносят вердикт «инцидент».

Согласно другому частному варианту реализации первое множество событий выбирают случайным образом среди событий с вердиктом «ложное срабатывание» таким образом, чтобы количество событий первого множества не превышало второй порог, являющийся параметром модели машинного обучения.

Согласно еще одному частному варианту реализации формируют обучающую и тестовую выборки путем включения в каждую выборку известных событий и соответствующих событиям вердиктов, при этом вердикт каждого события указывает на «инцидент» или «ложное срабатывание», при этом обучают модель машинного обучения на данных обучающей выборки.

Согласно одному из частных вариантов реализации задают значение первого порога равным числу, при котором значение метрики качества модели машинного обучения на тестовой выборке достигает максимального значения, при этом метрика качества является, в частности, полнотой классификации и/или показателем ROC-AUC.

Согласно другому частному варианту реализации задают значение второго порога следующим образом: определяют второе множество событий, состоящее из тех событий первого множества, для которых по результатам анализа был подтвержден вердикт «инцидент»; изменяют второй порог, если отношение количества событий второго множества к количеству событий первого множества превышает заданный третий порог.

Согласно еще одному частному варианту реализации изменяют второй порог в зависимости от вероятности ложного срабатывания событий из второго множества.

Согласно одному из частных вариантов реализации если второй порог превышает заданный четвертый порог, то для событий, определенных как ложное срабатывание и не входящих в первое множество событий, изменяют вердикт на «инцидент».

Согласно другому частному варианту реализации выбирают первый порог равным отношению доли фильтрации ко второму порогу, где доля фильтрации задана администратором как доля событий, которые будут определены как ложное срабатывание в зависимости от вероятности ложного срабатывания.

Согласно еще одному частному варианту реализации каждое событие содержит по меньшей мере одно уведомление безопасности, полученное от средства защиты, установленного на компьютерном устройстве пользователя.

Согласно одному из частных вариантов реализации получают уведомления безопасности, в частности, от одного из следующих источников событий: система обнаружения вторжений, средство защиты компьютерной системы, SIEM-система, средство защиты от направленных атак.

Согласно другому частному варианту реализации уведомление безопасности содержит информацию о средстве защиты и информацию по меньшей об мере одном объекте, расположенном на компьютерном устройстве пользователя и найденном в базе данных угроз.

Согласно еще одному частному варианту реализации информация об по меньшей мере одном объекте содержит, в частности, следующее: поведение процессов; события в операционной системе; информация о межсетевом взаимодействии; показатели компрометации; вердикты средства защиты.

Согласно одному из частных вариантов реализации в качестве признаков модели машинного обучения используют, в частности, следующие: источники уведомлений безопасности события; характеристики источника уведомления безопасности события; характеристики уведомлений безопасности события.

Согласно другому частному варианту реализации уведомления безопасности включают, в частности, по меньшей мере одно из следующих: взаимодействие с сервером управления из списка вредоносных; невозможность лечения зараженного объекта; заражение компьютерного устройства; ошибка в работе средства защиты; наличие неизвестного программного обеспечения в списках автозагрузки; появление неизвестных сервисов в списке сервисов операционной системы; запуск файлов из папок из списка запрещенных для запуска файлов папок; пользователь впервые выполнил аутентификацию на компьютере; произведен удаленный запуск объекта; выполнена очистка журнала операционной системы; осуществлена загрузка файла по сети от приложения, не являющегося браузером; выполнен запуск файлов, отсутствующих в белых списках, из подозрительных директорий; произведено удаление теневых копий; обнаружены переименованные утилиты удаленного администрирования; выполнено копирование файлов в сетевую папку администратора; использованы утилиты bcdedit.exe для отключения компонента ОС «восстановление системы»; системный процесс lsass.exe запустил файл или модифицировал файл на диске; выполнен обфусцированный сценарий PowerShell; произведен вызов функции Windows API; с помощью библиотеки Rundll32 запущены файлы из подозрительных путей.

Согласно еще одному частному варианту реализации получают события в течение заданного промежутка времени, где промежуток времени задают, в частности, одним из способов: равным времени, прошедшему с момента отправки на анализ предыдущих событий; произвольным значением; увеличивают промежуток времени на значение, при котором качество модели останется постоянным.

Согласно другому частному варианту реализации дополнительно включают в обучающую и тестовые выборки новые события и вердикты, определенные для этих новый событий по результатам анализа.

Согласно еще одному частному варианту реализации отправляют на анализ события с наименьшим значением вероятности ложного срабатывания, количество которых не превышает заданный пятый порог.

Согласно одному из частных вариантов реализации изменяют пятый порог в соответствии с временем, в течение которого происходит анализ.

Краткое описание чертежей

Дополнительные цели, признаки и преимущества настоящего изобретения будут очевидными из прочтения последующего описания осуществления изобретения со ссылкой на прилагаемые чертежи, на которых:

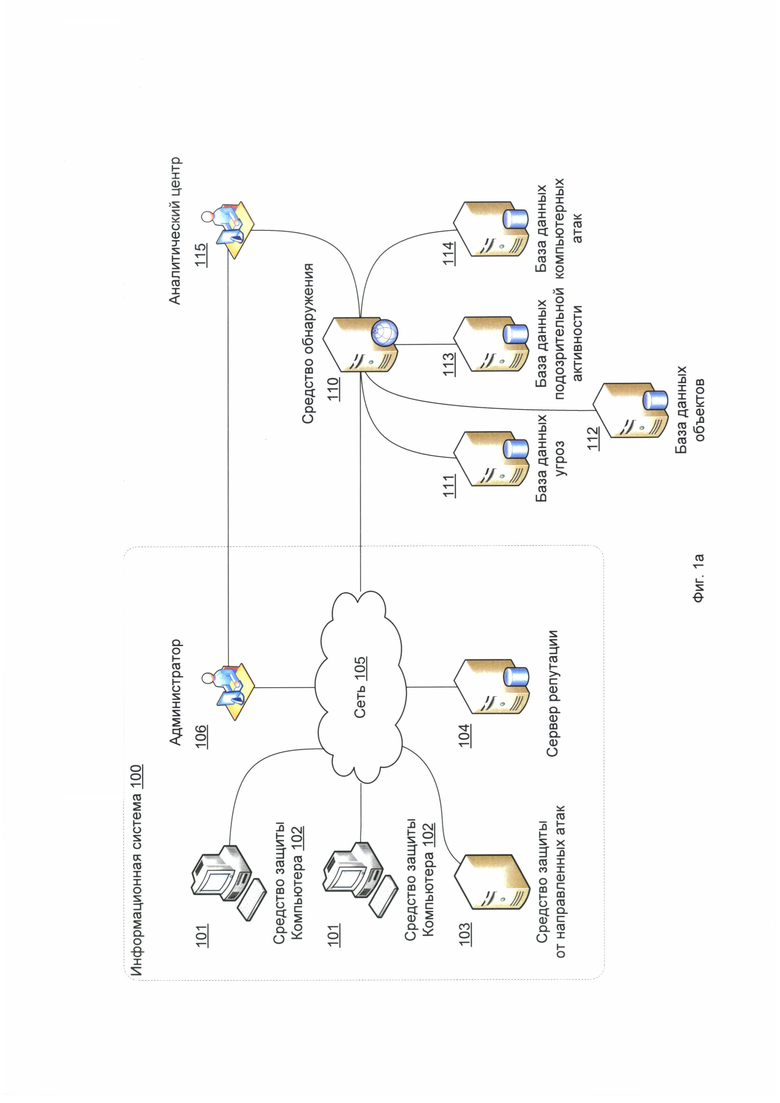

На Фиг. 1а представлена общая схема системы обнаружения признаков компьютерной атаки.

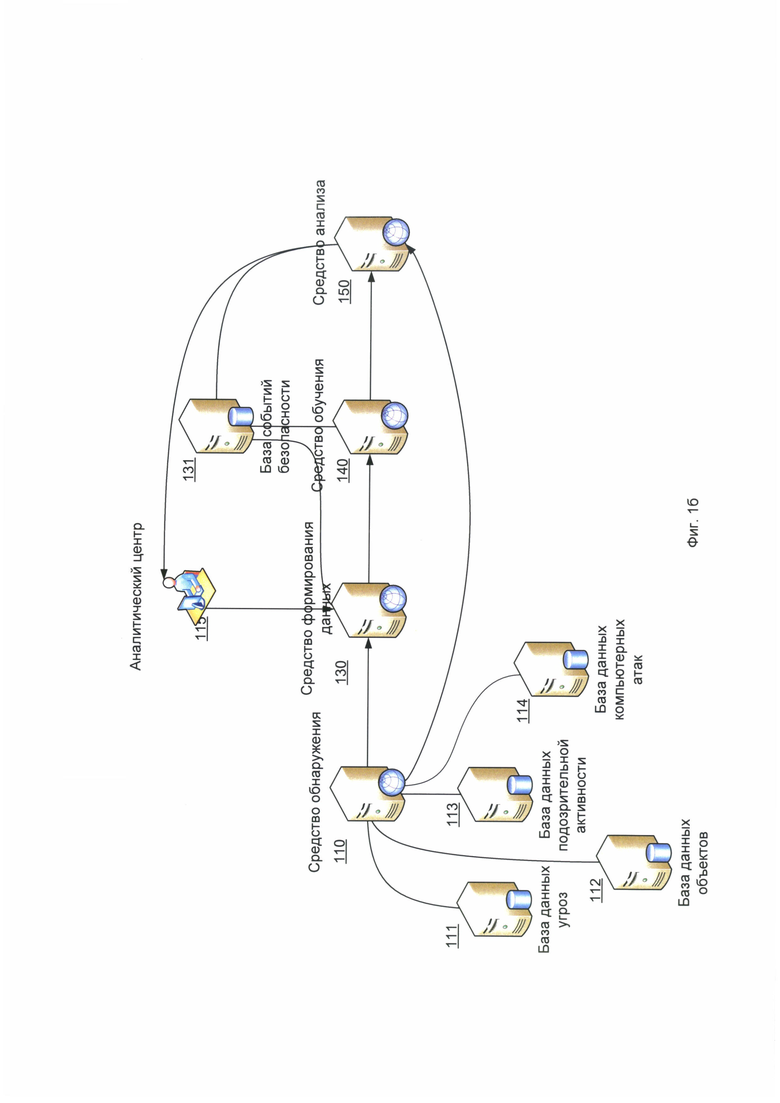

На Фиг. 1б представлена схема систем обработки событий информационной безопасности.

На Фиг. 2 приведен возможный пример модулей средства защиты компьютера.

На Фиг. 3 приведен возможный пример модулей средства защиты от направленных атак.

Фиг. 4 представлен способ обработки событий перед передачей на анализ.

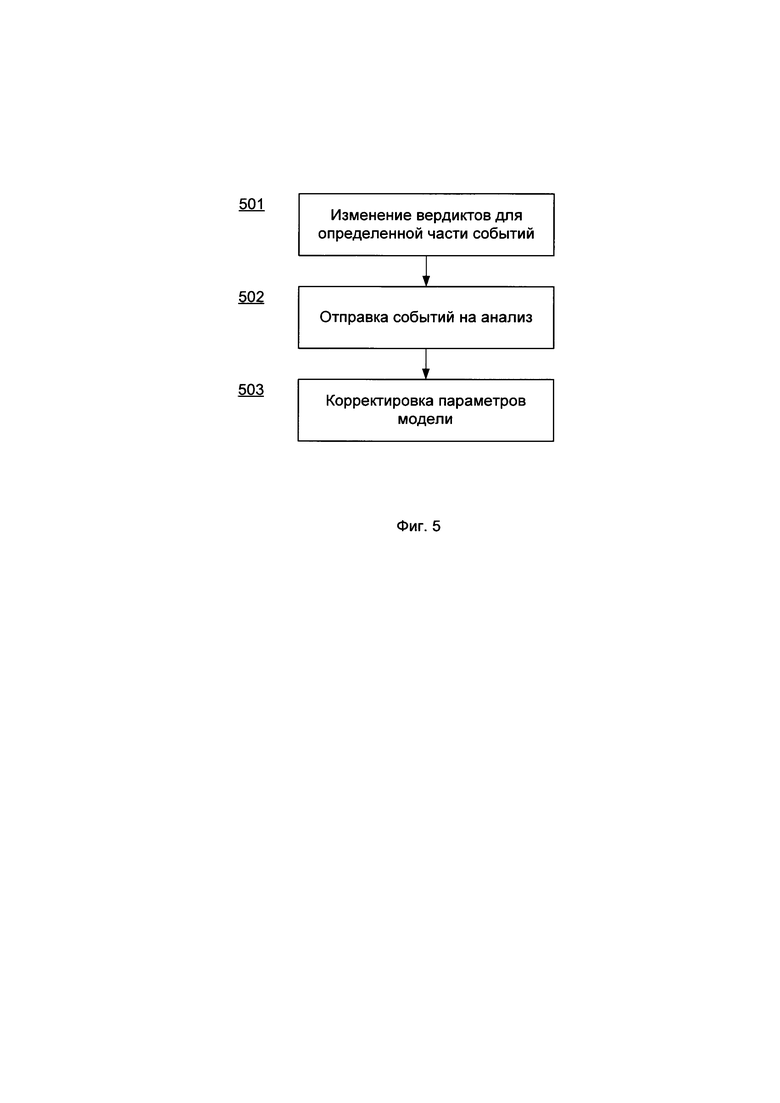

На Фиг. 5 представлен вариант способа корректировки параметров модели машинного обучения для определения ложных срабатываний и/или инцидентов информационной безопасности.

Фиг. 6 представляет пример компьютерной системы общего назначения.

Осуществление изобретения

Объекты и признаки настоящего изобретения, способы для достижения этих объектов и признаков станут очевидными посредством отсылки к примерным вариантам осуществления. Однако, настоящее изобретение не ограничивается примерными вариантами осуществления, раскрытыми ниже, оно может воплощаться в различных видах. Сущность, приведенная в описании, является ничем иным, как конкретными деталями, обеспеченными для помощи специалисту в области техники в исчерпывающем понимании изобретения, и настоящее изобретение определяется в объеме приложенной формулы.

Глоссарий

Ниже определен ряд терминов, которые будут использоваться при описании вариантов осуществления изобретения.

Информационная безопасность (ИБ) - сфера науки и техники, охватывающая совокупность проблем, связанных с обеспечением защищенности объектов информационной сферы в условиях существования угроз. Под информационной безопасностью также понимают защищенность информации от несанкционированного ознакомления, преобразования и уничтожения, защищенность информационных ресурсов от воздействий, направленных на нарушение их работоспособности.

Событие ИБ - любое идентифицированное явление в системе или сети.

Инцидент ИБ - нарушение или угроза нарушения ИБ информационной системы.

Угроза ИБ - потенциально возможное событие, действие (воздействие), процесс или явление, создающее опасность возникновения инцидента ИБ.

Уязвимость информационной системы (ИС) - недостаток в ИС, используя который внешний злоумышленник может намеренно реализовать угрозу ИБ.

Эксплоит (англ. exploit) - компьютерная программа, фрагмент программного кода или последовательность команд, использующие уязвимости в программном обеспечении и применяемые для проведения атаки на ИС.

Реагирование на инцидент ИБ - структурированная совокупность действий, направленная на установление деталей инцидента, минимизацию ущерба от инцидента и предотвращение повторения инцидента ИБ.

Компьютерная атака - множество скрытых и продолжительных мероприятий, проводимых злоумышленником и направленных на информационную систему организации или физического лица с целью проникновения в сеть и нанесения различного рода ущерба организации или физическому лицу.

Направленная атака (также целевая или целенаправленная атака, от англ. targeted attack - ТА) - компьютерная атака на конкретную информационную систему организации или физического лица с целью проникновения в сеть и нанесения различного рода ущерба организации или физическому лицу.

Сложная атака (англ. Advanced Persistent Threat - APT, также развитая устойчивая угроза или АРТ-атака) - сложная, продолжительная, хорошо спланированная многоходовая компьютерная атака, использующая сложное вредоносное программное обеспечение (ПО), методы социальной инженерии и данные об информационной системе атакуемого.

Жизненный цикл атаки (англ. kill chain) - последовательность шагов осуществления атаки.

SIEM (англ. security information and event management) - система, которая обеспечивает анализ событий ИБ, исходящих от сетевых устройств и приложений, в реальном времени. Одной из возможностей SIEM-систем является сопоставление событий с потоками данных об угрозах.

Потоки данных об угрозах (англ. feeds) - информация, содержащая индикаторы компрометации и позволяющая выявлять факт компрометации, используя SIEM-системы и другие сетевые устройства и средства защиты информации.

Показатели компрометации (англ. indicator of compromise, ЮС, реже - индикаторы заражения) -артефакты или остаточные признаки вторжения в информационную системы, наблюдаемые на компьютере или в сети. Типичными показателями компрометации являются, например, сработавшие вирусные сигнатуры, IP-адреса, с которых было загружено вредоносное ПО, контрольные суммы вредоносных и недоверенных файлов, URL-адреса вредоносных и недоверенных ресурсов, доменные имена командных центров ботнетов, которые были замечены в известных компьютерных атаках. Существует ряд стандартов показателей компрометации, в частности: OpenIOC1 (https://www.fireeye.com/blog/threat-research/2013/10/openioc-basics.html), STIX2 (https://oasis-open.github.io/cti-documentation/stix/intro) и др.

Нечеткий хеш (англ. fuzzy hash) или гибкая свертка - свертка файла, которая формируется таким образом, что небольшое изменения файла не повлечет за собой изменение свертки. То есть при обнаружении вредоносного файла при помощи значения его свертки также будут обнаружены множество похожих (возможно неизвестных) вредоносных файлов. Главная особенность такой свертки - инвариантность к небольшим изменениям файла3 (см, например: RU 2580036, RU 2614561).

Нечеткий вердикт - срабатывание средства защиты (антивирусного приложения) при обнаружении подозрительных действий файла, характерных для вредоносного файла. Нечеткий вердикт срабатывает, например, при обнаружении файла при помощи гибкой свертки. Нечеткий вердикт свидетельствует, что найденный файл является вредоносным с некоторой долей вероятности.

На Фиг. 1а представлена общая схема системы обнаружения признаков компьютерной атаки. Данная система подробно описана в патенте RU 2661533 и описывает средства, являющиеся источниками событий информационной безопасности (далее - событий). Стоит отметить, что представленная система является одним из возможных примером реализации настоящего изобретения. Поэтому возможна система, в которой будут отсутствовать некоторые из элементов, описанные ниже, а их функции будут реализованы другими элементами системы.

Информационная система 100 (также - корпоративная инфраструктура) включает совокупность компьютеров 101 (также - компьютерное устройство), связанных между собой через компьютерную сеть 105. Под компьютерами 101 в общем случае понимаются любые вычислительные устройства и сенсоры, в частности, персональные компьютеры, ноутбуки, смартфоны, а также коммуникационные устройства, такие как маршрутизаторы, коммутаторы, концентраторы и пр. При этом информационная система 100 может быть организована с использованием любой известной из уровня техники топологии сети 105, например, одного из следующих типов: полносвязная, шина, звезда, кольцо, ячеистая или смешанного типа. На части компьютеров 101 установлены средства защиты компьютеров 102. Информационная система 100 может включать средство защиты от направленных атак 103, которое может быть расположено, например, на отдельном сервере. Система может содержать сервер репутации 104, который может располагаться в информационной системе 100 или в облачном сервисе поставщика услуги (т.е. быть связанным со средством обнаружения 110). Стоит отметить, что компьютер 101 может быть, как физическим устройством, так и виртуальной машиной. Для подключения компьютеров 101 посредством сети 105 к Интернету и средству обнаружения 110 используются прокси-серверы (на фигуре не указаны).

Средства защиты компьютера 102 и, опционально, средство защиты от направленных атак 103 служат для сбора информации об объектах на компьютере 101 и в сети 105, а также для сбора информации о подозрительных событиях, которые связаны с упомянутыми объектами на компьютерах 101 и в сети 105, и последующей передачи по сети 105 средству обнаружения 110 (облачный сервис поставщика услуг) уведомления безопасности, включающего, в частности, информацию о самом средстве защиты (идентификатор и пр.) и собранную информацию об объектах. В частном примере реализации уведомление безопасности может также включать метку времени (момент времени или интервал времени, в течение которого была собрана упомянутая информация об объекте). В частном варианте реализации в качестве объекта может выступать, например, файл, процесс, URL-адрес, IP-адрес, сертификат электронно-цифровой подписи файла, журнал исполнения файла.

С помощью средств защиты 102, 103 собирают, в частности, следующую информацию о по меньшей мере одном объекте:

• поведение процессов (например, трасса выполнения);

• события в операционной системе (ОС) - записи журнала событий ОС;

• информация о межсетевом взаимодействии;

• показатели компрометации;

• вердикты средства защиты или модулей средства защиты (в том числе нечеткие вердикты) или тестовые сигнатуры;

• метаданные объекта, в том числе контрольная сумма объекта.

В другом частном варианте реализации информация об объекте дополнительно содержит, в частности, одно из:

• контрольная сумма объекта или его части (например, контрольная сумма файла или его части, в частности: MD5, CRC, SHA-1, SHA-2, Kessak, ГОСТ Р 34.11-2012 и др.);

• источник ресурса, откуда объект был внедрен на компьютер (например, IP-адрес ресурса, с которого была произведена загрузка объекта);

• результаты эмуляции исполнения объекта;

• журнал вызовов системных функций со стороны объекта (если объект - процесс);

• время появления объекта на вычислительном устройстве;

• данные, передаваемые по сети объектом.

Средство защиты от направленных атак 103 связано посредством сети 105 со средствами защиты компьютеров 102 и выполняет анализ сетевой активности информационной системы 100, а также обнаружение направленных атак в информационной системе путем обнаружения объектов компьютеров 101 с использованием, в частности, «песочницы» (от англ. «sandbox» - компьютерная среда для безопасного исполнения процессов) и других детектирующих технологий (см. подробнее на Фиг. 2, 3).

Средство защиты от направленных атак 103 предназначено для сбора информации, передаваемой в сетевом трафике. Таким образом средство защиты от направленных атак 103 собирает информацию о передаваемых по сети 105 объектах с компьютеров 101, в том числе с тех компьютеров 101, на которых не установлено средство защиты 102.

Информация об объектах в сети 105 может включать вердикты средства защиты от направленных атак 103, информацию о подозрительном поведении в сетевом трафике, в DNS-трафике, результаты эмуляции объектов из почты или Интернета.

В частном варианте реализации средства защиты 102, 103 собирают информацию о всех указанных выше объектах. В другом варианте реализации средства защиты 102, 103 могут содержать список безопасных (легитимных) объектов, о которых точно известно, что они не являются вредоносными и подозрительными, и список вредоносных и подозрительных объектов.

В еще одном примере реализации средства защиты 102, 103 могут содержать список дополнительных объектов, о которых необходимо собирать информацию. Такой список объектов может быть сформирован администратором 106. В еще одном частном примере реализации, администратор 106 может сформировать список вредоносных и подозрительных объектов и список безопасных объектов, добавляя или исключая объекты из указанных списков.

Администратор 106 может указать список запрещенных действий и список разрешенных действий. В информационной системе 100 может быть запрещено на части компьютеров 101 использование утилиты psexec, т.к. она может быть использована злоумышленниками для удаленного администрирования. Информация об объектах, связанных с запрещенными действиями, собирается средствами защиты 102, 103. Таким образом, если на каком-либо компьютере 101 или в сети 105 было зафиксировано использование утилиты psexec, информация об использовании будет передана средству обнаружения 110. Средство обнаружения 110 далее добавит соответствующую метку. При этом списки разрешенных и запрещенных действий могут храниться как в информационной системе 100, так и у средства обнаружения 110. Если средство защиты 103 обнаружило использование утилиты psexec на компьютере 101, на котором не установлено средство защиты 102, проверка допустимости использования psexec на данном компьютере и добавление соответствующей метки может быть выполнено как средством защиты 103, так и средством обнаружения 110 с использованием списка запрещенных действий. В еще одном частном примере реализации, в случае отсутствия информации в списке запрещенных действий и в списке разрешенных действий, аналитический центр 115 может уточнить у администратора 106, допустимо ли обнаруженное действие и, в случае если такое действие не допустимо, добавить соответствующую метку.

Средство обнаружения 110 сохраняет полученное уведомление безопасности в базе данных объектов 112 и затем осуществляет поиск объектов из базы данных угроз 111 в полученных уведомлениях безопасности. При нахождении объекта из уведомления безопасности в базе данных угроз 111, средство обнаружения 110 добавляет в базу данных объектов 112 к найденному объекту метку, соответствующую ему в базе данных угроз 111. Соответствие может быть определено, например, по совпадению контрольной суммы объекта в базе данных угроз 111 и в базе данных объектов 112.

Метка объекта является характеристикой произошедшего на компьютере 101 события, связанного с найденным объектом, или действия, произведенного самим объектом или произведенного над объектом. Таким образом, метка объекта будет добавлена к объекту в том и только том случае, когда на компьютере 101 произошло определенное событие или произведено определенное действие, связанное с объектом. В частном варианте реализации метки объекта характеризуют, например, вердикты средств защиты 102,103 и информацию о подозрительном поведении объекта (на основании информации об объекте). Таким образом, метка объекта включает, в частности, следующие события (здесь и далее подразумевается, что метка будет добавлена к объекту лишь в том случае, когда на компьютере 101 произошли указанные события, связанные с данным объектом, обнаруженные на основании полученной информации об объекте):

• подмену DNS-сервера на компьютере;

• отключение автоматического обновления операционной системы;

• отключение сетевого экрана;

• отключение средства защиты;

• отключение UAC (англ. User Account Control, UAC - компонент ОС Windows, Контроль учетных записей пользователей).

В еще одном частном примере реализации метки объекта, добавляемые к объекту средством обнаружения 110, могут дополнительно включать следующие события:

• информация о несовпадении контрольных сумм объекта (например, исполняемый файл, являющийся приложением для удаленного доступа - TeamViewer, был переименован);

• нарушение профиля аутентификации на компьютере (в течение заданного периода времени, в течение которого осуществлялся сбор информации об объекте, на компьютере 101 была выполнена аутентификация определенного списка пользователей, а сейчас на компьютере 101 был аутентифицирован пользователь, отсутствующий в указанном списке);

• нарушение профиля сетевой активности процесса (в течение заданного периода времени (один, два и более дней), в течение которого осуществлялся сбор информации об объекте, процесс взаимодействовал по сети с определенным IP-адресом из списка IP-адресов сети Интернет, после чего процесс связался по сети с IP-адресом, отсутствующим в указанном списке);

• уникальные в рамках данной информационной системы 100 задачи планировщика/настройки автозапуска/сервиса ОС/драйвера, отсутствующие в списке разрешенных задач;

• метки, связанные с результатами поиска объекта по внешним источникам разведки компьютерных атак (англ. cyber threat intelligence или threat intelligence);

• компьютеры 101, на которых обнаружены файлы, классифицированные как клавиатурный шпион (англ. keylogger), средство удаленного администрирования (англ. remote admin tool), средство мониторинга (англ. monitor), и встречающиеся на небольшом количестве компьютеров 101.

В частном примере реализации, если объект не содержится в списке вредоносных объектов, для него средством обнаружения 110 может быть вычислен нечеткий хеш. Затем может быть проверено, соответствуют ли данному нечеткому хешу какие-либо вредоносные объекты, и при положительном ответе исходный объект будет также помечен как вредоносный. Кроме того, для данного файла может быть создан и передан вердикт для средства защиты 102.

С использованием средства обнаружения 110 выполняют поиск признаков подозрительной активности (т.е. характерных признаков компьютерных атак) в базе данных подозрительной активности 113 на основании полученного уведомления безопасности и добавленных меток объекта, содержащегося в упомянутом уведомлении безопасности. При нахождении признака подозрительной активности добавляют с помощью средства обнаружения 110, в частности к уведомлению безопасности, метку, содержащуюся в базе данных подозрительной активности 113. Метка указывает на наличие найденного признака подозрительной активности. Затем выполняют обнаружение признаков компьютерной атаки путем выявления (также - корреляции) сигнатуры компьютерных атак из базы данных компьютерных атак 114 среди полученных объектов и уведомлений безопасности и меток упомянутых объектов и уведомлений безопасности из базы данных объектов 112.

В частном примере реализации признаки подозрительной активности зависят от тактик, технологий и процедур (англ. Tactics, Techniques and Procedures, TTP) компьютерных и, в частности, направленных атак.

Ниже приведен пример ТТР. Пользователь получил электронное письмо с вложенным офисным документом. Документ содержал макрос, пользователь согласился с его запуском. Макрос выполнился в PowerShell, который загрузил с сайта содержимое, закодированное по Base64, и запустил его без создания каких-либо файлов на диске. Запущенный код выполнился в контексте процесса PowerShell и настроил автоматический запуск в компьютерной системе путем создания записи в ветке реестре, обеспечив запуск данного кода всякий раз при входе пользователя под своим аккаунтом в ОС. Данный код является кодом приложения TeamViewer с измененным названием. Посредством этого кода злоумышленник осуществлял удаленный вход в скомпрометированную систему.

В данном примере присутствуют следующие признаки подозрительной активности:

• запуск PowerShell из офисного приложения;

• эвристический нечеткий вердикт на обфускацию параметров PowerShell (сжатие, кодирование BASE64 и т.п.);

• HTTP-запрос от интерпретатора PowerShell;

• сайт, с которого было загружено вложение, ранее был обнаружен в распространении вредоносного ПО (содержится в списке вредоносных объектов);

• сканер по доступу выдал нечеткий вердикт по загруженному вложению (например, по похожести - результат отработки гибкой свертки);

• репутация, полученная с использованием репутационного сервера, ниже заданного значения;

• средство защиты 102 выдало вердикт или нечеткий вердикт при сканировании памяти процесса PowerShell после загрузки с сайта вредоносного содержимого;

• PowerShell модифицировал ключи реестра для автозапуска;

• для файла, прописанного в автозапуске, хеш не соответствует имени (например, хеш файла соответствует хешу приложения TeamViewer, а имя файла - иное).

В еще одном примере реализации признаки подозрительной активности зависят от информации о направленных атаках, полученных при проведении тестирования на проникновение (англ. penetration test, сокращенно - pen test). Например, группа тестирования на проникновения с использованием уязвимости в протоколе SMB получила привилегированный доступ на компьютер администратора, где с помощью легальной утилиты создала дамп памяти процесса lsass.exe. Из дампа были извлечены аутентификационные данные, которые затем использовались для доступа к другим компьютерам в сети, откуда также были получены дампы памяти и также извлечены аутентификационные данные. Процесс повторялся многократно, пока не был получен доступ к аутентификационным данным администратора домена Windows.

Под признаком компьютерной атаки понимается выполнение условий, необходимых для заведения инцидента информационной безопасности (далее - инцидента) и дальнейшего подробного расследования и подтверждения инцидента или опровержения (в случае ложного срабатывания) направленной атаки аналитическим центром 115.

В частном примере реализации при выявлении сигнатуры компьютерных атак можно однозначно утверждать не только о выявлении признаков компьютерной атаки, но также можно подтвердить выявление компьютерной атаки без необходимости подтверждения аналитическом центром 115 и соответственно, будет заведен инцидент информационной безопасности. Далее аналитическим центром 115 будет проведено расследование и реагирование на подтвержденный инцидент ИБ. В другом примере реализации при выявлении сигнатуры компьютерных атак нельзя однозначно подтвердить направленную атаки, и в этом случае аналитический центр 115 определит, является ли признак подозрительной активности инцидентом или ложным срабатыванием. В случае, если будет определено ложное срабатывание, могут быть предприняты меры по изменению сигнатур компьютерных атак для снижения подобных ложных срабатываний в будущем.

Как к объектам, так и к уведомлениям безопасности добавляют метки, которые являются характеристикой произошедшего события на компьютере 101 (компьютер 101, с которого собрана информация, содержащаяся в уведомлении безопасности) или действия, произошедшего на компьютере 101. Таким образом, метка будет добавлена к уведомлению безопасности в том и только том случае, когда на компьютере 101 произошло определенное событие или произведено определенное действие, которое подпадает под признак подозрительной активности.

Метки к уведомлениям безопасности могут включать признаки подозрительной активности, которые в свою очередь являются, в частности, следующими:

• пользователь впервые выполнил аутентификацию на компьютере; пример сценария наступления такого подозрительного события в следующем. В течение месяца средство защиты 102 собирает список учетных записей пользователей (аккаунтов), успешно аутентифицированных на компьютере 101. Затем на компьютере 101 аутентифицируется пользователь с учетной записью, которая отсутствует в сформированном списке учетных записей;

• произведен удаленный запуск объекта (файла/процесса);

пример сценария наступления такого подозрительного события следующий. Был выполнен удаленный запуск объекта с использованием инфраструктуры Windows Management Instrumentation (WMI) или через службы ОС Windows;

• произведено удаление записей в журнале событий;

• осуществлена загрузка файла по сети от приложения, не являющегося браузером;

• выполнен запуск файлов, отсутствующих в белых списках, из подозрительных каталогов;

• произведено удаление теневых копий (например, с помощью утилиты vssadmin.exe - это свойственно многим вредоносным приложениям-шифровальщикам, для затруднения восстановления системы);

• обнаружены переименованные утилиты удаленного администрирования (AmmyyAdmin, TeamViewer и др.);

• выполнено копирование файлов в сетевую папку администратора (С$, ADMIN$);

• использованы утилиты bcdedit.exe для отключения компонента ОС «восстановление системы» (англ. System startup repair);

• системный процесс lsass.exe запустил файл или модифицировал файл на диске;

• выполнен обфусцированный сценарий PowerShell;

• произведен вызов функции Windows API;

была выполнена подозрительная команда PowerShell - вызов функций Windows API;

• с помощью библиотеки Rundll32 запущены файлы из подозрительных путей.

В частном примере реализации часть меток к объектам и меток к уведомлениям безопасности (и соответственно признаков подозрительной активности) могут совпадать. Например, несовпадение имени объекта и его контрольной суммы может являться как признаком подозрительной активности, так и может быть добавлено в качестве метки к объекту.

Сигнатура компьютерных (в частном примере - направленных) атак представляет собой набор следующих записей: список объектов, уведомления безопасности и метки упомянутых объектов и уведомлений безопасности, которые характерны для конкретных компьютерных атак и, в частности, для направленных атак. Таким образом, при нахождении определенной комбинации записей из сигнатуры направленной атаки можно утверждать об обнаружении атаки (или ее признаков). В одном частном примере реализации сигнатура компьютерной атаки содержит одновременно по меньшей мере одну запись об объекте, по меньшей мере одну запись об уведомлении безопасности, по меньшей мере одну метку объекта и по меньшей мере одну метку уведомления безопасности. В другом частном примере реализации сигнатура компьютерной атаки может содержать только одну или несколько из упомянутых записей - например, запись об одном объекте или запись об объекте и метке объекта. В еще одном частном примере реализации, сигнатура компьютерной атаки содержит по меньшей мере одну метку уведомления безопасности.

Для обнаружения всех видов признаков подозрительной активности (нарушение профиля сетевой активности процесса, компьютера, нарушение профиля сетевых входов и т.п.) может быть использована система машинного обучения без учителя - система сама обучается на основе поступающих уведомлений безопасности и проставленных меток. После обучения система будет ставить метки уведомлениям безопасности, для которых отсутствует метка в базе данных подозрительной активности 113. Кроме того, может быть использована система машинного обучения с учителем для решения задачи классификации поведения процесса или компьютера. При этом факторами являются признаки подозрительной активности, а обучение проводится на данных для известных обнаруженных компьютерных атак.

База данных объектов 112 служит для хранения уведомлений безопасности, содержащих информацию об объектах, а также добавленных меток к объектам и меток к уведомлениям безопасности.

База данных угроз 111 содержит данные об известных угрозах. В частности, в базе данных угроз 111 содержатся идентификаторы и информация об объектах, являющихся признаками угроз. Каждый объект в базе данных угроз 111 помечен соответствующей меткой. Например, вредоносным объектам может соответствовать метка «вредоносный объект». Если объект использовался в конкретной направленной атаке, ему будет присвоена соответствующая метка.

В качестве примера рассматривается известная направленная атака "Turla". С ней связаны известные URL-адреса. При обращении исполняемого файла к одному из упомянутых URL-адресов, к исполняемому файлу будет добавлена метка, указывающая на связь с направленной атакой. Например, метка «обращение к URL-адресу, связанному с APT Turla».

В еще одном примере с направленной атакой "Naikon APT" связан известный набор IP-адресов, и, если объект обращался к данному адресу, к объекту будет добавлена метка «обращение к IP-адресу, связанному с Naikon АРТ».

База данных подозрительной активности 113 содержит список признаков подозрительной активности. При этом каждый признак подозрительной активности помечен специальной меткой, указывающей на то, с какой направленной атакой указанный признак подозрительной активности связан (примеры признаков подозрительной активности были приведены ранее).

В частном примере реализации, если объект помечен определенной совокупностью меток, к указанному объекту может быть добавлена дополнительная метка, указывающая на данную особенность. Таким образом, совокупность меток может быть также помечена меткой.

База данных компьютерных атак 114 содержит список сигнатур компьютерных или направленных атак.

На Фиг. 1б представлена схема систем обработки событий информационной безопасности.

Средство формирования данных 130 служит для формирования обучающей и тестовой выборок путем включения в каждую выборку известных событий информационной безопасности (далее - событий) и соответствующих каждому событию вердиктов. Событиями информационной безопасности являются различные события, связанные с вероятным нарушением информационной безопасности информационной системы 100. События содержат по меньшей мере одно уведомление безопасности, полученное от средства защиты 102. В частном примере реализации уведомления безопасности получают от одного из: средства защиты компьютера 102, средства защиты от направленных атак 103, системы обнаружения вторжений, SIEM-системы. Другие частные примеры реализации уведомлений безопасности были описаны ранее на Фиг. 1а и применимы к системе, представленной на Фиг. 16.

При этом вердикт каждого события указывает на «инцидент информационной безопасности» (далее - «инцидент») или «ложное срабатывание». То есть выборка формируется с использованием размеченных данных по событиям и вердиктам, присвоенным упомянутым событиям аналитическим центром 115. Средство формирования данных 130 сохраняет обучающую выборку в базу событий безопасности 131. Средство обучения 140 связано со средством формирования данных 130 и с базой событий безопасности 131. Средство обучения служит для обучения модели машинного обучения для определения вероятности ложного срабатывания события на данных обучающей выборки из базы событий безопасности 131.

Средство анализа 150 связано со средством обучения 140 и базой событий безопасности 131. Средство анализа 150 получает события, для которых неизвестен вердикт и служит для вынесения вердиктов полученным событиям, применяя обученную модель машинного обучения для определения вероятности ложного срабатывания. События могут быть получены за определенный промежуток времени или в определенном пакете данных. При этом, средство анализа 150 выносит вердикт «ложное срабатывание», если вероятность ложного срабатывания для соответствующего события превышает заданный первый порог, а в ином случае средство анализа 150 выносит вердикт «инцидент». Стоит отметить, что в одном примере реализации вердикт, вынесенный средством анализа 150, является промежуточным. А итоговый вердикт принимают (подтверждают или опровергают вердикт, вынесенный средством анализа 150) в аналитическом центре 115.

В частном примере реализации средство обучения 140 задает значение первого порога следующим образом: первый порог равен числу, при котором значение метрики качества модели машинного обучения на тестовой выборке достигает максимального значения, где первый порог - это число, превышение которого вероятностью ложного срабатывания указывает на вердикт «ложное срабатывание», а в ином случае - на вердикт «инцидент». При этом метрика качества модели может являться, в частности, одной из: полнота классификации (англ. recall), показатель ROC-AUC. Далее, средство анализа 150 изменяет вердикт «ложное срабатывание» для определенной части событий (далее - первое множество событий) на вердикт «инцидент». В частном примере реализации первое множество событий выбирают случайным образом среди событий, вердикт которых указывает на «ложное срабатывание» таким образом, чтобы количество событий первого множества не превышало второй порог, являющийся параметром модели машинного обучения. После чего средство анализа 150 отправляет на анализ в аналитический центр 115 события, вердикт которых указывает на «инцидент».

В одном частном примере реализации средство обучения 140 задает второй порог в зависимости от результатов осуществленного анализа событий первого множества. При этом результаты анализа содержат вердикты, вынесенные для анализируемых событий.

В еще одном частном примере реализации дополнительно задают значение второго порога следующим образом: получают результаты анализа событий первого множества, затем определяют второе множество событий, состоящее из тех событий первого множества, для которых по результатам анализа был подтвержден вердикт «инцидент». В итоге изменяют второй порог, если отношение количества событий второго множества к количеству событий первого множества превышает заданный третий порог. Например, количество событий первого множества - 100, а количество событий второго множества по результатам анализа оказалось 15. Если третий порог равен 0.1, то отношение 15/100 превышает третий порог, поэтому второй порог будет изменен (например, увеличен на 10%).

В еще одном частном примере реализации изменяют второй порог в зависимости от вероятности ложного срабатывания событий из второго множества. Например, если у событий второго множества очень высокая вероятность ложного срабатывания, то второй порог повышают, чтобы включить во второе множество дополнительные события с низким значением вероятности ложного срабатывания.

В еще одном частном примере реализации, если второй порог превышает заданный четвертый порог, то для событий, определенных как ложное срабатывание и не входящих в первое множество событий, изменяют вердикт на «инцидент». Этот вариант реализации позволяет снизить ошибку второго рода в случае переобучения модели машинного обучения, то есть когда для большого количества событий был вынесен вердикт «ложное срабатывание», в то время как в действительности вердикт этих событий должен быть «инцидент». Таким образом, оставшиеся события, вердикт которых указывает на ложное срабатывание, не будут переданы на анализ. Кроме того, для этих событий вердикт не будет изменен на «инцидент».

В частном примере реализации задают промежуток времени (время, в течение которого получают события), равный времени, прошедшему с момента отправки на анализ предыдущих событий (например, сутки). В другом примере реализации задают произвольный промежуток времени. В еще одном примере реализации задают промежуток времени таким образом, чтобы снизить нагрузку на аналитический центр 115, при этом не снижая качество модели. То есть увеличивают промежуток времени на значение, при котором качество модели останется постоянным. Поэтому в еще одном частном примере реализации, если второй порог превышает заданный четвертый порог, то для событий, определенных как ложное срабатывание в течение заданного промежутка времени и не входящих в первое множество событий, изменяют вердикт на «инцидент». В еще одном частном примере реализации события получают в режиме реального времени.

В одном частном примере реализации средство формирования данных 130 дополнительно включает в обучающую и тестовые выборки новые события и вердикты, определенные для этих новый событий по результатам анализа аналитическим центром 115. То есть результаты анализа будут добавлены в обучающую и тестовые выборки для обучения модели машинного обучения, которая будет применена в будущем для анализа новых событий.

В частном примере реализации заданное число событий, определенных как ложное срабатывание, определяют в зависимости от вероятности ложного срабатывания этих событий.

В частном примере реализации средство обучения 140 использует одну из следующих моделей машинного обучения: логистическую регрессию, нейронную сеть, дерево принятия решений, случайный лес.

В частном примере реализации в качестве признаков модели машинного обучения используют, в частности, следующие:

а) источники уведомлений безопасности события;

б) характеристики источника уведомления безопасности события;

в) характеристики уведомлений безопасности события.

В другом частном примере реализации в качестве признаков модели машинного обучения используют параметры событий, объединенных по источникам упомянутых событий. Признаки модели машинного обучения - это любые входящие значения, которые передаются в модель4 (Джоэл Грас: Data Science. Наука о данных с нуля. BHV, 2020).

Как упоминалось ранее, источником уведомлений безопасности событий является, в частности, средство обнаружения 110, средство защиты 102, средство защиты от направленных атак 103, а также любая другая система безопасности, например, SIEM-система, системы IDS/IPS и др. В данном примере, характеристиками источника уведомления безопасности события могут являться характеристики средства защиты 102, такие как, версия средства защиты, версия антивирусных баз и др. Разным событиям может быть присвоен различный уникальный идентификатор. Характеристики объектов события зависят от событий и содержащихся в событиях объектах. Например, событие является следующим признаком подозрительной активности: для файла, прописанного в автозапуске, хеш не соответствует имени (например, хеш файла соответствует хешу приложения TeamViewer, а имя файла - иное). В этом примере, объектом события является файл. И, соответственно, характеристиками объекта события являются характеристики файла, такие как, например, хеш файла и другие метаданные файла.

Далее рассматривается возможный пример работы настоящей системы. Администратор 106 устанавливает долю фильтрации, то есть долю событий, которые будут определены как ложное срабатывание в зависимости от вероятности ложного срабатывания. Выбор значения доли фильтрации может зависеть от среднего количества событий, возникающих в информационной системе 100 за заданный промежуток времени, от загрузки аналитического центра 115. Чем меньше доля фильтрации, тем меньше количество ложных срабатываний, но больше нагрузка на аналитический центр 115.

Например, доля фильтрации установлена на уровне 30%. Соответственно 70% событий с меньшим значением вероятности ложного срабатывания, будут определены как «инциденты». Вероятность ложного срабатывания рассчитывается с использованием модели машинного обучения на обучающей выборке. С использованием определенных значений вероятности ложного срабатывания для событий, полученных за заданный промежуток времени, выбирают первый порог. Выбирают первый порог равным отношению доли фильтрации ко второму порогу.

Если второй порог будет равен 15%, то первый порог рассчитывается по формуле 30%/(100%-15%) и равен 35.3%. Соответственно, 35.3% событий с наибольшим значением вероятности ложного срабатывания будут определены как ложное срабатывание. Оставшимся 64.7% событиям будет определен вердикт «инцидент» и они будут отправлены на анализ. При этом, среди событий, определенных как ложное срабатывание, для 15% событий вердикт будет изменен на «инцидент», и они также будут отправлены на анализ. Упомянутые 15% событий выбираются случайным образом, например, в соответствии с равномерным законом распределения.

В итоге, на анализ будут отправлены 70% событий, и 30% событий будут определены как ложное срабатывание.

На Фиг. 2 приведен возможный пример модулей средства защиты компьютера. Средство защиты компьютера 102 может содержать модули, предназначенные для обеспечения безопасности компьютера 101: сканер по доступу, сканер по требованию, почтовый антивирус, веб-антивирус, модуль проактивной защиты, модуль HIPS (англ. Host Intrusion Prevention System - система предотвращения вторжений), DLP-модуль (англ. data loss prevention - предотвращение утечки данных), сканер уязвимостей, эмулятор, сетевой экран и др. В частном примере реализации указанные модули могут быть составной частью средства защиты 102. В еще одном примере реализации данные модули могут быть реализованы в виде отдельных программных компонент.

Сканер по доступу содержит функционал обнаружения вредоносной активности всех открываемых, запускаемых и сохраняемых файлов на компьютерной системе пользователя. Сканер по требованию отличается от сканера по доступу тем, что сканирует заданные пользователем файлы и директории по требованию пользователя.

Почтовый антивирус необходим для контроля входящей и исходящей электронной почты на предмет содержания вредоносных объектов. Веб-антивирус служит для предотвращения исполнения вредоносного кода, который может содержаться на веб-сайтах при их посещении пользователем, а также для блокирования открытия веб-сайтов. Модуль HIPS служит для обнаружения нежелательной и вредоносной активности программ и блокирования ее в момент исполнения. DLP-модуль служит для обнаружения и предотвращения утечки конфиденциальных данных за пределы компьютера или сети. Сканер уязвимостей необходим для обнаружения уязвимостей на компьютере 101 (например, отключены некоторые компоненты средства защиты 102, не актуальные вирусные базы, закрыт сетевой порт и пр.). Сетевой экран осуществляет контроль и фильтрацию сетевого трафика в соответствии с заданными правилами. Работа эмулятора заключается в имитации гостевой системы во время исполнения кода в эмуляторе. Модуль проактивной защиты использует поведенческие сигнатуры для обнаружения поведения исполняемых файлов и их классификации по уровню доверия.

Приведенные модули при обнаружении вредоносного программного обеспечения (подозрительного поведения, спама и других признаков компьютерной угрозы), создают соответствующее уведомление безопасности (которое далее может быть преобразовано в вердикт средства защиты 102), указывающее средству защиты об обнаруженной угрозе и необходимости выполнить действия по устранению угрозы (например, удаление или изменение файла, запрет исполнения и пр.). В частном примере реализации сам модуль, обнаруживший вредоносное ПО, может выполнить действия по устранению угрозы. В еще одном примере вердикт средства защиты 102 может быть нечетким или тестовым (т.к. данный вердикт может давать ложные срабатывания) - в этом случае средство защиты не будет выполнять действий по устранению угрозы, но передаст уведомление далее, средству обнаружения 110. Стоит отметить, что вердикт средства защиты 102 является частью информации об объекте (файле, процессе), которая затем будет передана средству обнаружения 110 в виде уведомления безопасности.

На Фиг. 3 приведен возможный пример модулей средства защиты от направленных атак. Средство защиты от направленных атак 103 может содержать, например, следующие модули защиты: «песочницу», систему обнаружения вторжений (англ. - Intrusion Detection System, IDS), репутационный сервис, модуль проверки YARA правил и другие модули обнаружения.

Модуль «выделенная среда» имеет функционал, аналогичный эмулятору средства защиты компьютера 102 с тем отличием, что «песочница» может использовать дополнительные вычислительные мощности и работать большее время, так как у средства защиты от направленных атак 103 отсутствуют ограничения по времени, присущие средству защиты компьютера 102.

«Выделенная среда» является компьютерной средой для безопасного исполнения процессов и служит для определения подозрительной активности при исполнении процесса, запущенного из файла.

«Выделенная среда» может быть реализована, например, в виде виртуальной машины, на основе частичной виртуализации файловой системы и реестра, на основе правил доступа к файловой системе и реестру или на основе смешанного подхода.

Система обнаружения вторжений является средством выявления фактов неавторизованного доступа на компьютер 101 или в сеть 105 либо несанкционированного управления ими.

Сервер репутации может быть зеркалом или кэшированной копией сервера репутации 104 и, кроме того, содержит информацию о популярности объектов на компьютерах 101 (количество компьютеров 101, на которых имеется объект, количество запусков объекта и пр.).

Модуль проверки YARA правил служит для проверки сигнатур YARA - открытого формата сигнатур5 (5 http://yararales.com/).

DLP-модуль служит для обнаружения и предотвращения утечки конфиденциальных данных за пределы компьютера или сети.

Анализатор TI (англ. threat intelligence - разведка угроз) - модуль, выполняющий соотнесение объектов из отчетов о компьютерных атаках с информацией об объектах и с признаками подозрительного поведение. Например, анализатор TI может определить список IP-адресов командных центров, участвующих в известных компьютерных атаках. Полученную информацию анализатор TI передает модулю скоринга, который ранжирует информацию об объектах и признаки подозрительного поведения по значению вероятности принадлежности их к компьютерной атаке.

На Фиг. 4 представлен способ обработки событий перед передачей на анализ. Способ реализуется средством анализа 150, расположенном на сервере.

На шаге 401 получают события и на шаге 402 выносят вердикт для каждого события, применяя обученную модель машинного обучения для определения вероятности ложного срабатывания. При этом выносят вердикт «ложное срабатывание», если вероятность ложного срабатывания для соответствующего события превышает заданный первый порог, а в ином случае выносят вердикт «инцидент информационной безопасности» (далее - вердикт «инцидент»). На шаге 403 изменяют вердикт «ложное срабатывание» для определенной части (первое множество событий) на вердикт «инцидент». В итоге, на шаге 404 отправляют на анализ (в аналитический центр 115) события с вердиктом «инцидент». Таким образом, обработка событий заключается в классификации событий. А также в изменении вердиктов для определенной части событий.

В частном примере реализации задают первый порог таким образом, чтобы повысить метрику качества модели машинного обучения. В другом примере реализации первое множество событий выбирают случайным образом среди событий, вердикт которых указывает на «ложное срабатывание» таким образом, чтобы количество событий первого множества не превышало второй порог.

В еще одном частном примере реализации задают второй порог в зависимости от результатов ранее осуществленного анализа событий первого множества. В другом частном примере реализации дополнительно:

а) получают результаты анализа событий первого множества;

б) определяют второе множество событий, состоящее из тех событий первого множества, для которых по результатам анализа был подтвержден вердикт «инцидент»;

в) изменяют второй порог, если отношение количества событий второго множества к количеству событий первого множества превышает заданный третий порог.

В одном частном примере реализации изменяют второй порог в зависимости от вероятности ложного срабатывания событий из второго множества. В другом частном примере реализации, в котором если второй порог превышает заданный четвертый порог, то для событий, определенных как ложное срабатывание и не входящих в первое множество событий, изменяют вердикт на «инцидент».

В еще одном частном примере реализации с помощью средства анализа 150 отправляют в аналитический центр 115 на анализ события с наименьшим значением вероятности ложного срабатывания, количество которых не превышает заданный пятый порог. При этом пятый порог задает аналитический центр 115. Указанный пятый порог может зависеть, например, от загрузки аналитического центра 115. Таким образом, если аналитический центр 115 испытывает повышенную загрузку и не успевает анализировать все события, присылаемые средством анализа 150, то ему будут отправлять только события с наименьшим значением вероятности ложного срабатывания. То есть наиболее приоритетные события, которые с наибольшей вероятностью являются «инцидентами». В другом частном примере реализации изменяют пятый порог в соответствии с временем, в течение которого происходит анализ (например, обратно пропорционально). Таким образом, если время анализа событий увеличивается, пятый порог снижают, чтобы снизить количество событий, отправляемых на анализ. Если же время анализа снижается, пятый порог увеличивают. Таким образом сокращается время реакции на инциденты.

Частные примеры реализации, раскрытые ранее для системы по Фиг. 1a - Фиг.1б также применимы и к способу по Фиг. 4.

На Фиг. 5 представлен вариант способа корректировки параметров модели машинного обучения для определения ложных срабатываний и инцидентов информационной безопасности. Представленный способ выполняется на сервере средством анализа 150.

На шаге 501 изменяют вердикты для определенной части (первое множество) событий с вердиктом «ложное срабатывание» на вердикт «инцидент». Вердикты для событий определяют с использованием модели машинного обучения для определения ложных срабатываний и/или инцидентов. Затем, на шаге 502 отправляют события из первого множества событий на анализ в аналитический центр 115. В итоге, используя результаты анализа, полученные от аналитического центра 115, на шаге 503 корректируют параметры машинного обучения для определения ложных срабатываний и/или инцидентов. Стоит отметить, что шаги 501-503 могут выполняться параллельно. Например, на шаге 501 могут изменять вердикты для событий по мере получения новых событий. При этом параллельно на шаге 502 будут отправлять те события, для которых был изменен вердикт, на анализ. К тому же, шаг 503 будет выполняться по мере получения результатов анализа событий.

В частном примере реализации модель машинного обучения определяет вердикт «ложное срабатывание» и/или вердикт «инцидент» путем определения для каждого события вероятности ложного срабатывания и сравнения определенной вероятности ложного срабатывания с заданным первым порогом, являющимся параметром модели машинного обучения, при этом событию выносят вердикт «ложное срабатывание», если вероятность ложного срабатывания события превышает первый порог, а в ином случае выносят вердикт «инцидент».

В еще одном частном примере реализации первое множество событий выбирают случайным образом среди событий, вердикт которых указывает на «ложное срабатывание» таким образом, чтобы количество событий первого множества не превышало второй порог, являющийся параметром модели машинного обучения.

В другом частном примере реализации формируют обучающую и тестовую выборки путем включения в каждую выборку известных событий и соответствующих событиям вердиктов, при этом вердикт каждого события указывает на «инцидент» или «ложное срабатывание», при этом обучают модель машинного обучения на данных обучающей выборки. В еще одном частном примере реализации задают значение первого порога равным числу, при котором значение метрики качества модели машинного обучения на тестовой выборке достигает максимального значения. Поиск такого значения первого порога может быть осуществлен с использованием известных из уровня техники методов решения задач оптимизации, таких как, градиентный спуск и другие. Первый порог - это число, превышение которого вероятностью ложного срабатывания указывает на вердикт «ложное срабатывание», а в ином случае - на вердикт «инцидент». При этом метрика качества является, в частности, полнотой классификации и/или показателем ROC-AUC.

В другом частном примере реализации, в котором задают значение второго порога следующим образом:

а) определяют второе множество событий, состоящее из тех событий первого множества, для которых по результатам анализа был подтвержден вердикт «инцидент»;

б) изменяют второй порог, если отношение количества событий второго множества к количеству событий первого множества превышает заданный третий порог.

В одном частном примере реализации, в котором выбирают первый порог равным отношению доли фильтрации ко второму порогу, где доля фильтрации задана администратором 106 или аналитическим центром 115 как доля событий, которые будут определены как ложное срабатывание в зависимости от вероятности ложного срабатывания. В другом частном примере реализации каждое событие содержит по меньшей мере одно уведомление безопасности, полученное от средства защиты 102, установленного на компьютерном устройстве пользователя. Частные варианты реализации, описанные ранее на Фиг.1а-1б и на Фиг. 4, также применимы и к способу, представленному на Фиг. 5.

Таким образом, достигаются технические результаты, заключающиеся в реализации назначения и в снижении количества ложных срабатываний за счет корректировки параметров модели машинного обучения. Кроме того, будет осуществлен контроль количества ложных срабатываний и количества событий, отправляемых на анализ за счет корректировки параметров модели машинного обучения с использованием результатов анализа. То есть изобретение позволяет добиться желаемого уровня ложных срабатываний (например, задаваемого администратором или аналитическим центром), изменяя количество событий, отправляемых на анализ.

Также решается заявленная техническая проблема.

Фиг. 6 представляет пример компьютерной системы общего назначения, персональный компьютер или сервер 20, содержащий центральный процессор 21, системную память 22 и системную шину 23, которая содержит разные системные компоненты, в том числе память, связанную с центральным процессором 21. Системная шина 23 реализована, как любая известная из уровня техники шинная структура, содержащая в свою очередь память шины или контроллер памяти шины, периферийную шину и локальную шину, которая способна взаимодействовать с любой другой шинной архитектурой. Системная память содержит постоянное запоминающее устройство (ПЗУ) 24, память с произвольным доступом (ОЗУ) 25. Основная система ввода/вывода (BIOS) 26, содержит основные процедуры, которые обеспечивают передачу информации между элементами персонального компьютера 20, например, в момент загрузки операционной системы с использованием ПЗУ 24.

Персональный компьютер 20 в свою очередь содержит жесткий диск 27 для чтения и записи данных, привод магнитных дисков 28 для чтения и записи на сменные магнитные диски 29 и оптический привод 30 для чтения и записи на сменные оптические диски 31, такие как CD-ROM, DVD-ROM и иные оптические носители информации. Жесткий диск 27, привод магнитных дисков 28, оптический привод 30 соединены с системной шиной 23 через интерфейс жесткого диска 32, интерфейс магнитных дисков 33 и интерфейс оптического привода 34 соответственно. Приводы и соответствующие компьютерные носители информации представляют собой энергонезависимые средства хранения компьютерных инструкций, структур данных, программных модулей и прочих данных персонального компьютера 20.

Настоящее описание раскрывает реализацию системы, которая использует жесткий диск 27, сменный магнитный диск 29 и сменный оптический диск 31, но следует понимать, что возможно применение иных типов компьютерных носителей информации 56, которые способны хранить данные в доступной для чтения компьютером форме (твердотельные накопители, флеш карты памяти, цифровые диски, память с произвольным доступом (ОЗУ) и т.п.), которые подключены к системной шине 23 через контроллер 55.

Компьютер 20 имеет файловую систему 36, где хранится записанная операционная система 35, а также дополнительные программные приложения 37, другие программные модули 38 и данные программ 39. Пользователь имеет возможность вводить команды и информацию в персональный компьютер 20 посредством устройств ввода (клавиатуры 40, манипулятора «мышь» 42). Могут использоваться другие устройства ввода (не отображены): микрофон, джойстик, игровая консоль, сканер и т.п. Подобные устройства ввода по своему обычаю подключают к компьютерной системе 20 через последовательный порт 46, который в свою очередь подсоединен к системной шине, но могут быть подключены иным способом, например, при помощи параллельного порта, игрового порта или универсальной последовательной шины (USB). Монитор 47 или иной тип устройства отображения также подсоединен к системной шине 23 через интерфейс, такой как видеоадаптер 48. В дополнение к монитору 47, персональный компьютер может быть оснащен другими периферийными устройствами вывода (не отображены), например, колонками, принтером и т.п.

Персональный компьютер 20 способен работать в сетевом окружении, при этом используется сетевое соединение с другим или несколькими удаленными компьютерами 49. Удаленный компьютер (или компьютеры) 49 являются такими же персональными компьютерами или серверами, которые имеют большинство или все упомянутые элементы, отмеченные ранее при описании существа персонального компьютера 20, представленного на Фиг. 6. В вычислительной сети могут присутствовать также и другие устройства, например, маршрутизаторы, сетевые станции, пиринговые устройства или иные сетевые узлы.

Сетевые соединения могут образовывать локальную вычислительную сеть (LAN) 50 и глобальную вычислительную сеть (WAN). Такие сети применяются в корпоративных компьютерных сетях (также - информационных системах), внутренних сетях компаний и, как правило, имеют доступ к сети Интернет. В LAN- или WAN-сетях персональный компьютер 20 подключен к локальной сети 50 через сетевой адаптер или сетевой интерфейс 51. При использовании сетей персональный компьютер 20 может использовать модем 54 или иные средства обеспечения связи с глобальной вычислительной сетью, такой как Интернет. Модем 54, который является внутренним или внешним устройством, подключен к системной шине 23 посредством последовательного порта 46. Следует уточнить, что сетевые соединения являются лишь примерными и не обязаны отображать точную конфигурацию сети, т.е. в действительности существуют иные способы установления соединения техническими средствами связи одного компьютера с другим.

В соответствии с описанием, компоненты, этапы исполнения, структура данных, описанные выше, могут быть выполнены, используя различные типы операционных систем, компьютерных платформ, программ.

В заключение следует отметить, что приведенные в описании сведения являются примерами, которые не ограничивают объем настоящего изобретения, определенного формулой.

| название | год | авторы | номер документа |

|---|---|---|---|

| Способ обработки событий информационной безопасности перед передачей на анализ | 2020 |

|

RU2762528C1 |

| Система и способ обнаружения признаков компьютерной атаки | 2017 |

|

RU2661533C1 |

| Система и способ корреляции событий для выявления инцидента информационной безопасности | 2019 |

|

RU2739864C1 |

| Способ фильтрации событий для передачи на удаленное устройство | 2022 |

|

RU2813239C1 |

| Система и способ создания антивирусной записи | 2018 |

|

RU2697954C2 |

| Система и способ определения вредоносного файла | 2017 |

|

RU2673407C1 |

| Способ выявления угроз информационной безопасности (варианты) | 2023 |

|

RU2802539C1 |

| Система и способ определения уровня опасности событий информационной безопасности | 2022 |

|

RU2800739C1 |

| Система и способ определения процесса, связанного с вредоносным программным обеспечением, шифрующим файлы компьютерной системы | 2020 |

|

RU2770570C2 |

| СИСТЕМА И СПОСОБ ОБНАРУЖЕНИЯ НАПРАВЛЕННЫХ АТАК НА КОРПОРАТИВНУЮ ИНФРАСТРУКТУРУ | 2013 |

|

RU2587426C2 |

Изобретение относится к вычислительной технике. Технический результат заключается в снижении количества ложных срабатываний. Реализуемый на сервере способ корректировки параметров модели машинного обучения для определения ложных срабатываний и инцидентов информационной безопасности (далее - инцидентов), в котором изменяют вердикты для определенной части событий информационной безопасности (далее - первого множества событий) с вердиктом «ложное срабатывание» на вердикты «инцидент», где вердикты для событий определяют с использованием модели машинного обучения для определения ложных срабатываний и/или инцидентов, при этом первое множество событий выбирают, в частности, случайным образом среди событий с вердиктом «ложное срабатывание», при этом выбирают такое количество событий первого множества, которое не превышает второй порог, являющийся параметром модели машинного обучения; отправляют по меньшей мере часть событий первого множества событий на анализ в аналитический центр; используя результаты анализа, содержащие вердикты, вынесенные отправленным на анализ событиям, корректируют параметры модели машинного обучения для определения ложных срабатываний и/или инцидентов. 18 з.п. ф-лы, 7 ил.

1. Реализуемый на сервере способ корректировки параметров модели машинного обучения для определения ложных срабатываний и инцидентов информационной безопасности (далее - инцидентов), в котором:

а) изменяют вердикты для определенной части событий информационной безопасности (далее - первого множества событий) с вердиктом «ложное срабатывание» на вердикты «инцидент», где вердикты для событий определяют с использованием модели машинного обучения для определения ложных срабатываний и/или инцидентов, при этом первое множество событий выбирают, в частности, случайным образом среди событий с вердиктом «ложное срабатывание», при этом выбирают такое количество событий первого множества, которое не превышает второй порог, являющийся параметром модели машинного обучения;

б) отправляют по меньшей мере часть событий первого множества событий на анализ в аналитический центр;

в) используя результаты анализа, содержащие вердикты, вынесенные отправленным на анализ событиям, корректируют параметры модели машинного обучения для определения ложных срабатываний и/или инцидентов.

2. Способ по п. 1, в котором модель машинного обучения определяет вердикт «ложное срабатывание» и/или вердикт «инцидент» путем определения для каждого события вероятности ложного срабатывания и сравнения определенной вероятности ложного срабатывания с заданным первым порогом, являющимся параметром модели машинного обучения, при этом событию выносят вердикт «ложное срабатывание», если вероятность ложного срабатывания события превышает первый порог, а в ином случае выносят вердикт «инцидент».

3. Способ по п. 1, в котором отправляют на анализ в аналитический центр одно из: все события первого множества событий; все события первого множества событий, а также события с вердиктом «инцидент».

4. Способ по п. 1, в котором предварительно в процессе обучения модели машинного обучения формируют обучающую и тестовую выборки путем включения в каждую выборку известных событий и соответствующих событиям вердиктов, при этом вердикт каждого события указывает на «инцидент» или «ложное срабатывание», при этом обучают модель машинного обучения на данных обучающей выборки.

5. Способ по п. 2, в котором задают значение первого порога равным числу, при котором значение метрики качества модели машинного обучения на тестовой выборке достигает максимального значения, при этом метрика качества является, в частности, полнотой классификации и/или показателем ROC-AUC, при этом обучающая и тестовая выборка предварительно сформированы путем включения в каждую выборку известных событий и соответствующих событиям вердиктов, при этом вердикт каждого события указывает на «инцидент» или «ложное срабатывание», при этом модель машинного обучения обучена на данных обучающей выборки.

6. Способ по п. 3, в котором задают значение второго порога следующим образом:

а) определяют второе множество событий, состоящее из тех событий первого множества, для которых по результатам анализа был подтвержден вердикт «инцидент»;

б) изменяют второй порог, если отношение количества событий второго множества к количеству событий первого множества превышает третий порог.

7. Способ по п. 6, в котором изменяют второй порог в зависимости от вероятности ложного срабатывания событий из второго множества.

8. Способ по п. 3, в котором, если второй порог превышает четвертый порог, то для событий, определенных как ложное срабатывание и не входящих в первое множество событий, изменяют вердикт на «инцидент».

9. Способ по п. 2, в котором выбирают первый порог равным отношению доли фильтрации ко второму порогу, где доля фильтрации - доля событий, которые будут определены как ложное срабатывание в зависимости от вероятности ложного срабатывания.

10. Способ по п. 1, в котором каждое событие содержит по меньшей мере одно уведомление безопасности, полученное от средства защиты, установленного на компьютерном устройстве пользователя.

11. Способ по п. 10, в котором получают уведомления безопасности, в частности, от одного из следующих источников событий: система обнаружения вторжений, средство защиты компьютерной системы, SIEM-система, средство защиты от направленных атак.

12. Способ по п. 10, в котором уведомление безопасности содержит информацию о средстве защиты и информацию по меньшей об мере одном объекте, расположенном на компьютерном устройстве пользователя и найденном в базе данных угроз.

13. Способ по п. 12, в котором информация об по меньшей мере одном объекте содержит, в частности, следующее:

• поведение процессов;

• события в операционной системе;

• информация о межсетевом взаимодействии;

• показатели компрометации;

• вердикты средства защиты.

14. Способ по п. 1, в котором в качестве признаков модели машинного обучения используют, в частности, следующие:

а) источники уведомлений безопасности события;

б) характеристики источника уведомления безопасности события;

в) характеристики уведомлений безопасности события.

15. Способ по п. 12, в котором уведомления безопасности включают, в частности, по меньшей мере одно из следующих:

а) взаимодействие с сервером управления из списка вредоносных;

б) невозможность лечения зараженного объекта;

в) заражение компьютерного устройства;

г) ошибка в работе средства защиты;

д) наличие неизвестного программного обеспечения в списках автозагрузки;

е) появление неизвестных сервисов в списке сервисов операционной системы;

ж) запуск файлов из папок из списка запрещенных для запуска файлов папок;

з) пользователь впервые выполнил аутентификацию на компьютере;

и) произведен удаленный запуск объекта;

к) выполнена очистка журнала операционной системы;

л) осуществлена загрузка файла по сети от приложения, не являющегося браузером;

м) выполнен запуск файлов, отсутствующих в белых списках, из подозрительных директорий;

н) произведено удаление теневых копий;

о) обнаружены переименованные утилиты удаленного администрирования;

п) выполнено копирование файлов в сетевую папку администратора;

р) использованы утилиты bcdedit.exe для отключения компонента ОС «восстановление системы»;

с) системный процесс lsass.exe запустил файл или модифицировал файл на диске;

т) выполнен обфусцированный сценарий PowerShell;

у) произведен вызов функции Windows API;

ф) с помощью библиотеки Rundll32 запущены файлы из подозрительных путей.

16. Способ по п. 1, в котором получают события в течение заданного промежутка времени, где промежуток времени задают, в частности, одним из способов:

а) равным времени, прошедшему с момента отправки на анализ предыдущих событий;

б) произвольным значением;

в) увеличивают промежуток времени, при этом контролируя, что качество модели не снижается.

17. Способ по п. 4, в котором дополнительно включают в обучающую и тестовые выборки новые события и вердикты, определенные для этих новый событий по результатам анализа.

18. Способ по п. 1, в котором отправляют на анализ события с наименьшим значением вероятности ложного срабатывания, количество которых не превышает заданный пятый порог.

19. Способ по п. 18, в котором изменяют пятый порог в соответствии с временем, в течение которого происходит анализ.

| US 9690933 B1, 27.06.2017 | |||

| Устройство для закрепления лыж на раме мотоциклов и велосипедов взамен переднего колеса | 1924 |

|

SU2015A1 |

| ФУНГИЦИДНАЯ КОМПОЗИЦИЯ, СОДЕРЖАЩАЯ ПИРИМЕТАНИЛ И ФОСЕТИЛ-AL, СПОСОБ ЛЕЧЕБНОГО И ПРОФИЛАКТИЧЕСКОГО КОНТРОЛЯ ФИТОПАТОГЕННЫХ ОРГАНИЗМОВ, ПРИМЕНЕНИЕ ФОСЕТИЛ-AL ДЛЯ УВЕЛИЧЕНИЯ ПРОДОЛЖИТЕЛЬНОСТИ ДЕЙСТВИЯ ПИРИМЕТАНИЛА | 2002 |

|

RU2278516C2 |

| NAYEEM KHAN et al., "Defending Malicious Script Attacks Using Machine Learning Classifiers", опубл | |||

| Способ восстановления хромовой кислоты, в частности для получения хромовых квасцов | 1921 |

|

SU7A1 |

| КАСКАДНЫЙ КЛАССИФИКАТОР ДЛЯ ПРИЛОЖЕНИЙ КОМПЬЮТЕРНОЙ БЕЗОПАСНОСТИ | 2016 |

|

RU2680738C1 |

Авторы

Даты

2021-12-27—Публикация

2020-06-19—Подача