Притязание на приоритет

[0001] По данной заявке испрашивается приоритет на основании предварительной заявки на патент США № 62/902,074, поданной 18 сентября 2019 г. и озаглавленной "COMPUTER-BASED SYSTEMS, COMPUTING COMPONENTS AND COMPUTING OBJECTS CONFIGURED TO IMPLEMENT DYNAMIC OUTLIER BIAS REDUCTION IN MACHINE LEARNING MODELS", которая полностью включена в данный документ путём ссылки.

Уведомление об авторском праве

[0002] Часть описания данного патентного документа содержит материалы, на которые распространяется охрана авторским правом. Обладатель авторского права не имеет возражений против факсимильного воспроизведения кем-либо патентного документа или описания патента в том виде, в котором он содержится в патентном фонде или базе Бюро по патентам и товарным знакам, но в иных случаях сохраняет за собой любые авторские права. Нижеследующее уведомление относится к программному обеспечению и данным, описанным ниже и на чертежах, которые составляют часть данного документа: авторское право, Hartford Steam Boiler Inspection and Insurance Company, все права защищены.

Область техники, к которой относится изобретение

[0003] Настоящее изобретение относится в общем к усовершенствованным компьютерным системам, вычислительным компонентам и вычислительным объектам, выполненным с возможностью реализации уменьшения отклонения в моделях машинного обучения.

Уровень техники

[0004] Модель машинного обучения может включать в себя один или более компьютеров или обрабатывающих устройств для формирования прогнозов или определений на основе тенденций и выводов, изученных из данных выборки/обучающих данных. Отклонение в выборе данных выборки/обучающих данных может распространяться на прогнозирования и определения на основе модели машинного обучения.

Раскрытие изобретения

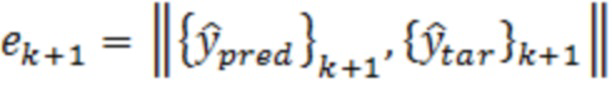

[0005] Варианты осуществления настоящего изобретения включают в себя способы для моделей машинного обучения с уменьшенным динамическим отклонением, обусловленным выбросовыми значениями. Способы включают в себя прием посредством по меньшей мере одного процессора набора обучающих данных целевых переменных, представляющих по меньшей мере один связанный с активностью атрибут по меньшей мере для одной пользовательской активности; прием посредством по меньшей мере одного процессора по меньшей мере одного критерия отклонения, используемого для определения одного или более выбросовых значений; определение посредством по меньшей мере одного процессора набора параметров модели для модели машинного обучения, что включает в себя: (1) применение посредством по меньшей мере одного процессора, модели машинного обучения, имеющей набор начальных параметров модели, к набору обучающих данных для того, чтобы определять набор прогнозируемых значений модели; (2) формирование посредством по меньшей мере одного процессора набора ошибок для ошибок в элементах данных посредством сравнения набора прогнозируемых значений модели с соответствующими фактическими значениями набора обучающих данных; (3) формирование посредством по меньшей мере одного процессора вектора выбора данных для того, чтобы идентифицировать невыбросовые целевые переменные по меньшей мере частично на основе набора ошибок для ошибок в элементах данных и по меньшей мере одного критерия отклонения; (4) использование посредством по меньшей мере одного процессора вектора выбора данных для набора обучающих данных для того, чтобы формировать набор невыбросовых данных; (5) определение посредством по меньшей мере одного процессора набора обновленных параметров модели для модели машинного обучения на основе набора невыбросовых данных; и (6) повторение посредством по меньшей мере одного процессора этапов (1)-(5) в качестве итерации до тех пор, пока не будет удовлетворен по меньшей мере один критерий завершения выполнения цензурирования, таким образом, чтобы получить набор параметров модели для модели машинного обучения в качестве обновленных параметров модели, за счет чего каждая итерация повторно формирует набор прогнозируемых значений, набор ошибок, вектор выбора данных и набор невыбросовых данных с использованием набора обновленных параметров модели в качестве набора начальных параметров модели; обучение посредством по меньшей мере одного процессора по меньшей мере частично на основе набора обучающих данных и вектора выбора данных, набора параметров классификационной модели для модели машинного обучения классификаторов выбросовых значений для того, чтобы получать обученную модель машинного обучения классификаторов выбросовых значений, которая выполнена с возможностью идентификации по меньшей мере одного выбросового элемента данных; применение посредством по меньшей мере одного процессора обученной модели машинного обучения классификаторов выбросовых значений к набору данных для связанных с активностью данных по меньшей мере для одной пользовательской активности, чтобы определять: i) набор выбросовых связанных с активностью данных в наборе данных для связанных с активностью данных и ii) набор невыбросовых связанных с активностью данных в наборе данных для связанных с активностью данных; и применение посредством по меньшей мере одного процессора модели машинного обучения к набору элементов невыбросовых связанных с активностью данных для того, чтобы прогнозировать будущий связанный с активностью атрибут, связанный по меньшей мере с одной пользовательской активностью.

[0006] Варианты осуществления настоящего изобретения включают в себя системы для моделей машинного обучения с уменьшенным динамическим отклонением, обусловленным выбросовыми значениями. Системы включают в себя по меньшей мере один процессор, осуществляющий связь с постоянным машиночитаемым носителем данных, на котором сохранены программные инструкции, причем программные инструкции при выполнении предписывают по меньшей мере одному процессору выполнять этапы для: приёма набора обучающих данных целевых переменных, представляющих по меньшей мере один связанный с активностью атрибут по меньшей мере для одной пользовательской активности; приёма по меньшей мере одного критерия отклонения, используемого для определения одного или более выбросовых значений; определения набора параметров модели для модели машинного обучения, что включает в себя: (1) применение модели машинного обучения, имеющей набор начальных параметров модели, к набору обучающих данных для определения набора прогнозируемых значений модели; (2) формирование набора ошибок для ошибок в элементах данных посредством сравнения набора прогнозируемых значений модели с соответствующими фактическими значениями набора обучающих данных; (3) формирование вектора выбора данных для идентификации невыбросовых целевых переменных по меньшей мере частично на основе набора ошибок для ошибок в элементах данных и по меньшей мере одного критерия отклонения; (4) использование вектора выбора данных для набора обучающих данных для формирования набора невыбросовых данных; (5) определение набора обновленных параметров модели для модели машинного обучения на основе набора невыбросовых данных; и (6) повторение этапов (1)-(5) в качестве итерации до тех пор, пока не будет удовлетворён по меньшей мере один критерий завершения выполнения цензурирования, таким образом, чтобы получить набор параметров модели для модели машинного обучения в качестве обновленных параметров модели, за счет чего каждая итерация повторно формирует набор прогнозируемых значений, набор ошибок, вектор выбора данных и набор невыбросовых данных с использованием набора обновленных параметров модели в качестве набора начальных параметров модели; обучения по меньшей мере частично на основе набора обучающих данных и вектора выбора данных, набора параметров классификационной модели для модели машинного обучения классификаторов выбросовых значений для получения обученной модели машинного обучения классификаторов выбросовых значений, которая выполнена с возможностью идентификации по меньшей мере одного выбросового элемента данных; применения обученной модели машинного обучения классификаторов выбросовых значений к набору данных для связанных с активностью данных по меньшей мере для одной пользовательской активности для определения: i) набора выбросовых связанных с активностью данных в наборе данных для связанных с активностью данных и ii) набора невыбросовых связанных с активностью данных в наборе данных для связанных с активностью данных; и применения модели машинного обучения к набору элементов невыбросовых связанных с активностью данных для прогнозирования будущего связанного с активностью атрибута, связанного по меньшей мере с одной пользовательской активностью.

[0007] Системы и способы вариантов осуществления настоящего изобретения, дополнительно включающие в себя: применение посредством по меньшей мере одного процессора вектора выбора данных к набору обучающих данных для определения набора выбросовых обучающих данных; обучение посредством по меньшей мере одного процессора с использованием набора выбросовых обучающих данных по меньшей мере одного параметра относящейся к выбросовым значениям модели для по меньшей мере одной относящейся к выбросовым значениям модели машинного обучения для прогнозирования выбросовых значений данных; и использование посредством по меньшей мере одного процессора относящейся к выбросовым значениям модели машинного обучения для прогнозирования выбросовых значений связанных с активностью данных для набора выбросовых связанных с активностью данных.

[0008] Системы и способы вариантов осуществления настоящего изобретения, дополнительно включающие в себя: обучение посредством по меньшей мере одного процессора с использованием набора обучающих данных, обобщенных параметров модели для обобщенной модели машинного обучения для прогнозирования значений данных; использование посредством по меньшей мере одного процессора обобщенной модели машинного обучения для прогнозирования выбросовых значений связанных с активностью данных для набора выбросовых связанных с активностью данных; и использование посредством по меньшей мере одного процессора обобщенной модели машинного обучения для прогнозирования значений связанных с активностью данных.

[0009] Системы и способы вариантов осуществления настоящего изобретения, дополнительно включающие в себя: применение посредством по меньшей мере одного процессора вектора выбора данных к набору обучающих данных для определения набора выбросовых обучающих данных; обучение посредством по меньшей мере одного процессора с использованием набора выбросовых обучающих данных, параметров относящейся к выбросовым значениям модели для относящейся к выбросовым значениям модели машинного обучения для прогнозирования выбросовых значений данных; обучение посредством по меньшей мере одного процессора, с использованием набора обучающих данных, обобщенных параметров модели для обобщенной модели машинного обучения для прогнозирования значений данных; использование посредством по меньшей мере одного процессора, относящейся к выбросовым значениям модели машинного обучения для прогнозирования выбросовых значений связанных с активностью данных для набора выбросовых связанных с активностью данных; и использование посредством по меньшей мере одного процессора относящейся к выбросовым значениям модели машинного обучения для прогнозирования значений связанных с активностью данных.

[0010] Системы и способы вариантов осуществления настоящего изобретения, дополнительно включающие в себя: обучение посредством по меньшей мере одного процессора с использованием набора обучающих данных, обобщенных параметров модели для обобщенной модели машинного обучения для прогнозирования значений данных; использование посредством по меньшей мере одного процессора обобщенной модели машинного обучения для прогнозирования значений связанных с активностью данных для набора связанных с активностью данных; использование посредством по меньшей мере одного процессора модели машинного обучения классификаторов выбросовых значений для идентификации выбросовых значений связанных с активностью данных из значений связанных с активностью данных; и удаление посредством по меньшей мере одного процессора выбросовых значений связанных с активностью данных.

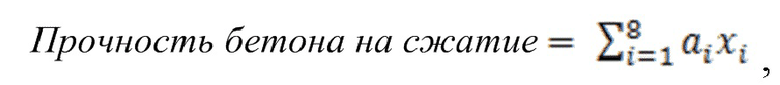

[0011] Системы и способы вариантов осуществления настоящего изобретения, в которых набор обучающих данных включает в себя по меньшей мере один связанный с активностью атрибут прочности на сжатие бетона в качестве функции от состава бетона и отверждающего возедйствия на бетон.

[0012] Системы и способы вариантов осуществления настоящего изобретения, в которых набор обучающих данных включает в себя по меньшей мере один связанный с активностью атрибут данных использования энергии в качестве функции от бытовых окружающих условий и условий освещения.

[0013] Системы и способы вариантов осуществления настоящего изобретения, дополнительно включающие в себя: прием посредством по меньшей мере одного процессора запроса интерфейса прикладного программирования (API), чтобы формировать прогнозирование по меньшей мере с одним элементом данных; и создание посредством по меньшей мере одного процессора экземпляра по меньшей мере одного облачного вычислительного ресурса для планирования выполнения модели машинного обучения; использование посредством по меньшей мере одного процессора согласно планированию для выполнения модели машинного обучения для прогнозирования по меньшей мере одного значения элемента связанных с активностью данных по меньшей мере для одного элемента данных; и возврат посредством по меньшей мере одного процессора по меньшей мере одного значения элемента связанных с активностью данных в вычислительное устройство, ассоциированное с запросом API.

[0014] Системы и способы вариантов осуществления настоящего изобретения, в которых набор обучающих данных включает в себя по меньшей мере один связанный с активностью атрибут формирования трехмерных изображений пациентов набора медицинских данных; и в которых модель машинного обучения выполнена с возможностью прогнозирования значений связанных с активностью данных, включающих в себя два или более параметров физического рендеринга на основе набора медицинских данных.

[0015] Системы и способы вариантов осуществления настоящего изобретения, в которых набор обучающих данных включает в себя по меньшей мере один связанный с активностью атрибут результатов моделированного управления для электронных машинных команд; и в которых модель машинного обучения выполнена с возможностью прогнозирования значений связанных с активностью данных, включающих в себя команды управления для электронной машины.

[0016] Системы и способы вариантов осуществления настоящего изобретения, дополнительно включающие в себя: разбиение посредством по меньшей мере одного процессора набора связанных с активностью данных на множество поднаборов связанных с активностью данных; определение посредством по меньшей мере одного процессора модели из ансамбля для каждого поднабора связанных с активностью данных из множества поднаборов связанных с активностью данных; причем модель машинного обучения включает в себя ансамбль моделей; причем каждая модель из ансамбля включает в себя случайное сочетание моделей из ансамбля моделей; использование посредством по меньшей мере одного процессора каждой модели из ансамбля по отдельности для прогнозирования относящихся к ансамблю значений связанных с активностью данных; определение посредством по меньшей мере одного процессора ошибки для каждой модели из ансамбля на основе относящихся к ансамблю значений связанных с активностью данных и известных значений; и выбор посредством по меньшей мере одного процессора модели из ансамбля с наилучшими функциональными параметрами на основе наименьшей ошибки.

Краткое описание чертежей

[0017] Различные варианты осуществления настоящего изобретения дополнительно могут поясняться со ссылкой на прилагаемые чертежи, на которых аналогичные структуры указаны аналогичными позициями на нескольких видах. Показанные чертежи не обязательно выполнены в масштабе, вместо этого акцент делается в общем на иллюстрации принципов настоящего изобретения. Следовательно, конкретные структурные и функциональные подробности, раскрытые в данном документе, должны интерпретироваться не в качестве ограничения, а просто в качестве характерной основы для обучения специалистов в данной области техники на предмет различного использования одного или более иллюстративных вариантов осуществления.

[0018] Фиг. 1-14B показывают одну или более принципиальных блок-схем, определенных компьютерных архитектур и/или снимков экрана различных специализированных графических пользовательских интерфейсов, которые иллюстрируют некоторые примерные аспекты по меньшей мере некоторых вариантов осуществления настоящего изобретения.

Осуществление изобретения

[0019] В данном документе раскрыты различные подробные варианты осуществления настоящего изобретения, рассматриваемые в сочетании с сопровождающими чертежами; однако следует понимать, что раскрытые варианты осуществления являются лишь иллюстративными. Кроме того, каждый из примеров, приведенных в связи с различными вариантами осуществления настоящего изобретения, подразумевается иллюстративным, а не ограничивающим.

[0020] Во всем подробном описании следующие термины принимают смысловые значения, явным образом присвоенные им в данном документе, если контекст явно не предписывает иное. Словосочетания «в одном варианте осуществления» и «в некоторых вариантах осуществления» при использовании в данном документе не обязательно означают одни и те же вариант(ы) осуществления, хотя и могут означать. Кроме того, словосочетания «в другом варианте осуществления» и «в некоторых других вариантах осуществления» при использовании в данном документе не обязательно означают другой вариант осуществления, хотя и могут означать. Таким образом, как описано ниже, различные варианты осуществления могут легко объединяться без отступления от объема или сущности настоящего изобретения.

[0021] Помимо этого, термин «на основе» не является исключающим и позволяет основываться на дополнительных, не описанных факторах, если контекст явно не предписывает иное. Помимо этого, во всем подробном описании, смысловое значение терминов в единственном числе включает в себя указания на множественное число. Значение «в» включает в себя «в» и «на».

[0022] Следует понимать, что по меньшей мере один аспект/функциональность различных вариантов осуществления, описанных в данном документе, может выполняться в реальном времени и/или динамически. При использовании в данном документе термин «реальное время» направлен на событие/действие, которое может происходить мгновенно или почти мгновенно со временем, когда произошло другое событие. Например, «обработка в реальном времени», «вычисление в реальном времени» и «выполнение в реальном времени» относятся к выполнению вычисления в течение фактического времени, когда происходит соответствующий физический процесс (например, взаимодействие пользователя с приложением на мобильном устройстве), так что результаты вычисления могут использоваться при управлении физическим процессом.

[0023] При использовании в данном документе термин «динамически» и термин «автоматически» и их логические и/или лингвистические родственные понятия и/или производные понятия означают, что определенные события и/или действия могут инициироваться и/или происходить вообще без вмешательства человека. В некоторых вариантах осуществления, события и/или действия в соответствии с настоящим изобретением могут осуществляться в реальном времени и/или на основе предварительно определенной периодичности как по меньшей мере одно из: наносекунды, нескольких наносекунд, миллисекунды, нескольких миллисекунд, секунды, нескольких секунд, минуты, нескольких минут, ежечасно, нескольких часов, ежедневно, нескольких дней, еженедельно, ежемесячно и т.д.

[0024] В некоторых вариантах осуществления, примерные специально программируемые вычислительные системы согласно изобретению с ассоциированными устройствами выполнены с возможностью работы в распределенном сетевом окружении, с обменом данными между собой по одной или более подходящих сетей передачи данных (например, Интернет, спутниковых и т.д.) и использованием одного или более подходящих протоколов/режимов обмена данными, таких как, не ограничиваясь, IPX/SPX, X.25, AX.25, AppleTalk(TM), TCP/IP (например, HTTP), беспроводная связь ближнего действия (NFC), RFID, узкополосный Интернет вещей (NBIoT), 3G, 4G, 5G, GSM, GPRS, Wi-Fi, WiMAX, CDMA, спутниковая связь, ZigBee и другие подходящие режимы связи. В некоторых вариантах осуществления, NFC может представлять технологию ближней беспроводной связи, в которой устройства с поддержкой NFC «проводятся», «соприкасаются», «быстро прикасаются» или иным образом перемещаются в непосредственной близости для обмена данными.

[0025] Материал, раскрытый в данном документе, может быть реализован в программном обеспечении или микропрограммном обеспечении либо в их сочетании, или в виде инструкций, сохраненных на машиночитаемом носителе, которые могут считываться и выполняться посредством одного или более процессоров. Машиночитаемый носитель может включать в себя любой носитель и/или механизм для сохранения или передачи информации в машиночитаемой форме (например, вычислительного устройства). Например, машиночитаемый носитель может включать в себя постоянное запоминающее устройство (ROM); оперативное запоминающее устройство (RAM); носители хранения данных на магнитных дисках; оптические носители хранения данных; устройства флэш-памяти; электрические, оптические, акустические или другие формы распространяемых сигналов (например, несущие волны, инфракрасные сигналы, цифровые сигналы и т.д.) и другие.

[0026] При использовании в данном документе, термины «компьютерный механизм» и «механизм» идентифицируют по меньшей мере один программный компонент и/либо сочетание по меньшей мере одного программного компонента и по меньшей мере одного аппаратного компонента, которые проектируются/программируются/конфигурируются с возможностью регулирования/управления другими программными и/или аппаратными компонентами (такими как библиотеки, комплекты разработки программного обеспечения (SDK), объекты и т.д.).

[0027] Примеры аппаратных элементов могут включать в себя процессоры, микропроцессоры, схемы, схемные элементы (такие как транзисторы, резисторы, конденсаторы, индукторы и т.п.), интегральные схемы, специализированные интегральные схемы (ASIC), программируемые логические устройства (PLD), процессоры цифровых сигналов (DSP), программируемую пользователем вентильную матрицу (FPGA), логические вентили, регистры, полупроводниковые устройства, микросхемы, небольшие микросхемы, наборы микросхем и т.п. В некоторых вариантах осуществления, один или более процессоров могут реализовываться как процессоры на базе архитектуры компьютера со сложным набором команд (CISC) или компьютера с сокращенным набором команд (RISC); совместимые с x86-набором команд процессоры, многоядерный или любой другой микропроцессор или центральный процессор (CPU). В различных реализациях, один или более процессоров могут представлять собой двухъядерный процессор(ы), двухъядерный мобильный процессор(ы) и т.д.

[0028] Примеры программного обеспечения могут включать в себя программные компоненты, программы, приложения, компьютерные программы, прикладные программы, системные программы, машинные программы, программное обеспечение операционной системы, промежуточное программное обеспечение, микропрограммное обеспечение, программные модули, стандартные программы, подпрограммы, функции, методы, процедуры, программные интерфейсы, интерфейсы прикладного программирования (API), наборы инструкций, вычислительный код, компьютерный код, сегменты кода, сегменты компьютерного кода, слова, значения, символы либо любое их сочетание. Определение того, реализуется ли вариант осуществления с использованием аппаратных элементов и/или программных элементов, может варьироваться в соответствии с любым числом факторов, таких как требуемая скорость вычислений, уровни мощности, теплостойкость, бюджет цикла обработки, скорости передачи входных данных, скорости передачи выходных данных, ресурсы запоминающего устройства, скорости шин данных и другие проектные ограничения или ограничения по производительности.

[0029] Один или более аспектов по меньшей мере одного варианта осуществления могут реализовываться посредством характерных инструкций, сохраненных на машиночитаемом носителе, которые представляют различную логику в процессоре, которые, при считывании посредством машины, предписывают машине создавать логику, чтобы выполнять технологии, описанные в данном документе. Такие представления, известные как «IP-ядра», могут сохраняться на материальном машиночитаемом носителе и передаваться различным клиентам или на различные заводы для загрузки в производственное оборудование, которое создает логику или процессор. Следует отметить, что различные варианты осуществления, описанные в данном документе, конечно, могут реализовываться с использованием любых соответствующих аппаратных средств и/или языков для создания вычислительного программного обеспечения (например, C++, Objective C, Swift, Java, JavaScript, Python, Perl, QT и т.д.).

[0030] В некоторых вариантах осуществления, одно или более примерных компьютерных устройств согласно изобретению по настоящему изобретению могут включать в себя или включаться, частично или полностью по меньшей мере в один персональный компьютер (PC), переносной компьютер, ультрапереносной компьютер, планшетный компьютер, сенсорную панель, портативный компьютер, карманный компьютер, карманный компьютер, карманный персональный компьютер (PDA), сотовый телефон, комбинированный сотовый телефон/PDA, телевизионный приемник, интеллектуальное устройство (например, смартфон, интеллектуальный планшетный компьютер или интеллектуальный телевизионный приемник), мобильное Интернет-устройство (MID), устройство для обмена сообщениями, устройство обмена данными и т.д.

[0031] При использовании в данном документе следует понимать, что термин «сервер» означает точку оказания услуг, которая обеспечивает средства обработки, управления базами данных и связи. В качестве примера, а не ограничения, термин «сервер» может означать один физический процессор с ассоциированными средствами связи и хранения данных и управления базами данных, либо он может означать сетевой или кластеризованный комплекс процессоров и ассоциированных сетевых устройств и устройств хранения данных, а также системного программного обеспечения и одной или более систем баз данных и прикладного программного обеспечения, которые поддерживают услуги, оказываемые посредством сервера. Облачные серверы представляют собой примеры.

[0032] В некоторых вариантах осуществления, как подробно описано в данном документе, одна или более примерных компьютерных систем согласно изобретению по настоящему изобретению могут получать, обрабатывать, передавать, сохранять, преобразовывать, формировать и/или выводить любой цифровой объект и/или единицу данных (например, изнутри и/или за пределами конкретного варианта применения), которая может иметь любую подходящую форму, к примеру, без ограничения, файла, контакта, задачи, почтового сообщения, твита, карты, целого приложения (например, калькулятора) и т.д. В некоторых вариантах осуществления, как подробно описано в данном документе, одна или более примерных компьютерных систем согласно изобретению по настоящему изобретению могут быть реализованы через одну или более различных компьютерных платформ, таких как, не ограничиваясь: (1) AmigaOS, AmigaOS 4, (2) FreeBSD, NetBSD, OpenBSD, (3) Linux, (4) Microsoft Windows, (5) OpenVMS, (6) OS X (Mac OS), (7) OS/2, (8) Solaris, (9) Tru64 UNIX, (10) VM, (11) Android, (12) Bada, (13) BlackBerry OS, (14) Firefox OS, (15) iOS, (16) Embedded Linux, (17) Palm OS, (18) Symbian, (19) Tizen, (20) WebOS, (21) Windows Mobile, (22) Windows Phone, (23) Adobe AIR, (24) Adobe Flash, (25) Adobe Shockwave, (26) Binary Runtime Environment for Wireless (BREW), (27) Cocoa (API), (28) Cocoa Touch, (29) Java Platforms, (30) JavaFX, (31) JavaFX Mobile, (32) Microsoft XNA, (33) Mono, (34) Mozilla Prism, XUL and XULRunner, (35).NET Framework, (36) Silverlight, (37) Open Web Platform, (38) Oracle Database, (39) Qt, (40) SAP NetWeaver, (41) Smartface, (42) Vexi и (43) Windows Runtime.

[0033] В некоторых вариантах осуществления, примерные компьютерные системы согласно изобретению и/или примерные компьютерные устройства согласно изобретению по настоящему изобретению могут быть выполнены с возможностью использования аппаратно реализованной схемы, которая может использоваться вместо или в сочетании с программными инструкциями для реализации признаков в соответствии с принципами изобретения. Таким образом, реализации, согласованные с принципами изобретения, не ограничены каким-либо конкретным сочетанием аппаратной схемы и программного обеспечения. Например, различные варианты осуществления могут осуществляться множеством различных способов в качестве программного компонента, к примеру, без ограничения, автономного программного пакета, сочетания программных пакетов, либо они могут представлять собой программный пакет, включенный в качестве «инструментального средства» в больший программный продукт.

[0034] Например, примерное программное обеспечение, специально программируемое в соответствии с одним или более принципов настоящего изобретения, может быть загружаемым из сети, например, из веб-узла, в качестве автономного продукта или в качестве надстраиваемого пакета для установки в существующем программном приложении. Например, примерное программное обеспечение, специально программируемое в соответствии с одним или более принципов настоящего изобретения, также может быть доступным в качестве клиент-серверного программного приложения или в качестве программного веб-приложения. Например, примерное программное обеспечение, специально программируемое в соответствии с одним или более принципов настоящего изобретения, также может осуществляться в качестве программного пакета, установленного на аппаратном устройстве.

[0035] В некоторых вариантах осуществления, примерные компьютерные системы/платформы согласно изобретению, примерные компьютерные устройства согласно изобретению и/или примерные компьютерные компоненты согласно изобретению по настоящему изобретению могут быть выполнены с возможностью обработки множества параллельных пользователей, которые могут составлять, не ограничиваясь, по меньшей мере 100 (например, не ограничиваясь, 100-999) по меньшей мере 1000 (например, не ограничиваясь, 1000-9999) по меньшей мере 10000 (например, не ограничиваясь, 10000-99999) по меньшей мере 100000 (например, не ограничиваясь, 100000-999999) по меньшей мере 1000000 (например, не ограничиваясь, 1000000-9999999) по меньшей мере 10000000 (например, не ограничиваясь, 10000000-99999999) по меньшей мере 100000000 (например, не ограничиваясь, 100000000-999999999) по меньшей мере 1000000000 (например, не ограничиваясь, 1000000000-10000000000).

[0036] В некоторых вариантах осуществления, примерные компьютерные системы согласно изобретению и/или примерные компьютерные устройства согласно изобретению по настоящему изобретению могут быть выполнены с возможностью вывода в отдельные реализации специально программируемого графического пользовательского интерфейса настоящего изобретения (например, в настольное приложение, веб-приложение и т.д.). В различных реализациях настоящего изобретения, конечный вывод может отображаться на отображающем экране, который, без ограничения, может представлять собой экран компьютера, экран мобильного устройства и т.п. В различных реализациях, дисплей может представлять собой голографический дисплей. В различных реализациях, дисплей может представлять собой прозрачную поверхность, которая может принимать визуальную проекцию. Такие проекции могут передавать различные формы информации, изображений и/или объектов. Например, такие проекции могут представлять собой визуальное наложение для приложения в стиле мобильной дополненной реальности (MAR).

[0037] При использовании в данном документе, термины «облако», «Интернет-облако», «облачные вычисления», «облачная архитектура» и аналогичные термины соответствуют по меньшей мере одному из следующего: (1) большое число компьютеров, соединенных через сеть связи в реальном времени (например, Интернет); (2) обеспечение возможности одновременного выполнения программы или приложения на множестве соединенных компьютеров (например, физических машин, виртуальных машин (VM)); (3) сетевые услуги, которые очевидно оказываются посредством реальных серверных аппаратных средств и фактически обслуживаются посредством виртуальных аппаратных средств (например, виртуальных серверов), моделированных посредством программного обеспечения, выполняющегося на одной или более реальных машин (например, с обеспечением возможности перемещения и увеличения (или уменьшения)непосредственного масштабирования без влияния на конечного пользователя).

[0038] В некоторых вариантах осуществления, примерные компьютерные системы согласно изобретению и/или примерные компьютерные устройства согласно изобретению по настоящему изобретению могут быть выполнены с возможностью защищенного сохранения и/или передачи данных посредством использования одной или более технологий шифрования (например, технологии на основе пары закрытого/открытого ключа, стандарта тройного шифрования данных (3DES), алгоритмов блочного шифрования (например, IDEA, RC2, RC5, CAST и Skipjack), криптографических хэш-алгоритмов (например, MD5, RIPEMD-160, RTR0, SHA-1, SHA-2, Tiger (TTH),WHIRLPOOL, RNG).

[0039] Вышеуказанные примеры, конечно, являются иллюстративными, а не ограничивающими.

[0040] При использовании в данном документе, термин «пользователь» должен иметь смысловое значение по меньшей мере одного пользователя. В некоторых вариантах осуществления, следует понимать, что термины «пользователь», «абонент», «потребитель» или «клиент» означают пользователя приложения или приложений, как описано в данном документе, и/или потребителя данных, обеспечиваемые поставщиком данных. В качестве примера, а не ограничения, термины «пользователь» или «абонент» могут означать пользователя, который принимает данные, обеспечиваемые поставщиком данных или услуг по Интернету в сеансе браузера, либо могут означать автоматизированное программное приложение, которое принимает данные и сохраняет или обрабатывает данные.

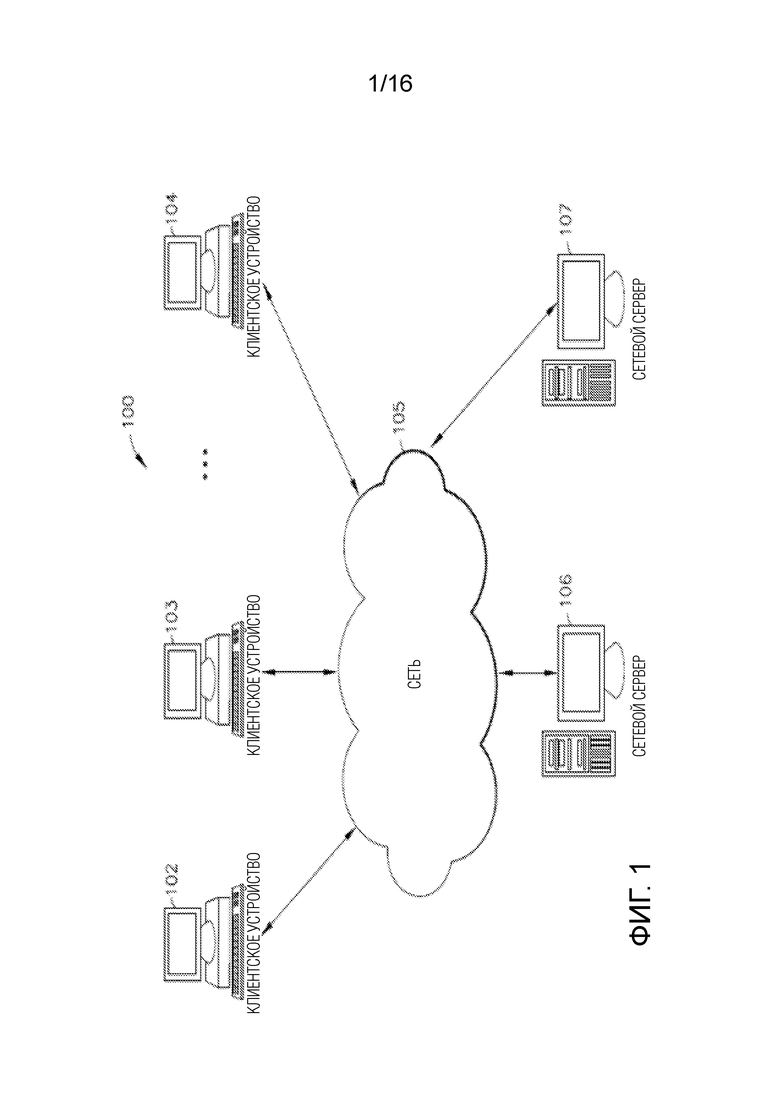

[0041] Фиг. 1 иллюстрирует блок-схему примерной компьютерной системы 100 для уменьшения отклонения в машинном обучении в соответствии с одним или более вариантов осуществления настоящего изобретения. Тем не менее, не все эти компоненты могут требоваться для осуществления на практике одного или более вариантов осуществления, и варьирования в компоновку и тип компонентов могут вноситься без отступления от сущности или объема различных вариантов осуществления настоящего изобретения. В некоторых вариантах осуществления, примерные вычислительные устройства согласно изобретению и/или примерные вычислительные компоненты согласно изобретению в примерной компьютерной системе 100 могут быть выполнены с возможностью управления большим числом членов и/или параллельных транзакций, как подробно описано в данном документе. В некоторых вариантах осуществления, примерная компьютерная система/платформа 100 может быть основана на масштабируемой компьютерной и/или сетевой архитектуре, которая включает варьирующиеся стратегии для оценки данных, кэширования, выполнения поиска и/или объединения в пул соединений с базой данных, включающие в себя уменьшение динамического отклонения, обусловленного выбросовыми значениями (DOBR), как описано в вариантах осуществления в данном документе. Пример масштабируемой архитектуры представляет собой архитектуру, которая допускает работу нескольких серверов.

[0042] В некоторых вариантах осуществления, обращаясь к фиг. 1, члены 102-104 (например, клиенты) примерной компьютерной системы 100 могут включать в себя фактически любое вычислительное устройство, допускающее прием и отправку сообщения по сети (например, по облачной сети), к примеру, сети 105, в/из другого вычислительного устройства, к примеру, серверов 106 и 107, между собой и т.п. В некоторых вариантах осуществления, устройства-члены 102-104 могут представлять собой персональные компьютеры, многопроцессорные системы, микропроцессорные или программируемые бытовые электронные приборы, сетевые PC и т.п. В некоторых вариантах осуществления, одно или более устройств-членов в устройствах-членах 102-104 могут включать в себя вычислительные устройства, которые типично соединяются с использованием беспроводной среды связи, такие как сотовые телефоны, смартфоны, устройства поискового вызова, рации, радиочастотные (RF) устройства, инфракрасные (IR) устройства, CB, интегрированные устройства, комбинирующие одно или более предыдущих устройств, либо фактически любое мобильное вычислительное устройство и т.п. В некоторых вариантах осуществления, одно или более устройств-членов в устройствах-членах 102-104 могут представлять собой устройства, которые допускают соединение с использованием носителя проводной или беспроводной связи, такие как PDA, карманный компьютер, носимый компьютер, переносной компьютер, планшетный компьютер, настольный компьютер, нетбук, устройство для видеоигр, устройство поискового вызова, смартфон, ультрамобильный персональный компьютер (UMPC) и/или любое другое устройство, которое оснащается возможностями обмениваться данными по проводной и/или беспроводной среде связи (например, NFC, RFID, NBIoT, 3G, 4G, 5G, GSM, GPRS, Wi-Fi, WiMAX, CDMA, спутниковая связь, ZigBee и т.д.). В некоторых вариантах осуществления, одно или более устройств-членов в устройствах-членах 102-104 могут включать в себя, могут выполнять одно или более приложений, таких как Интернет-браузеры, мобильные приложения, голосовые вызовы, видеоигры, видеоконференц-связь и электронная почта, в числе других. В некоторых вариантах осуществления, одно или более устройств-членов в устройствах-членах 102-104 могут быть выполнены с возможностью приёма и отправки веб-страниц и т.п. В некоторых вариантах осуществления, примерное специально программируемое приложение браузера настоящего изобретения может быть выполнено с возможностью приёма и отображения графики, текста, мультимедиа и т.п. с использованием фактически любого веб-языка, включающего в себя, но не только, стандартный обобщенный язык разметки (SMGL), такой как язык разметки гипертекста (HTML), прикладной протокол беспроводной связи (WAP), язык разметки для карманных устройств (HDML), такой как язык разметки для беспроводной связи (WML), WMLScript, XML, JavaScript и т.п. В некоторых вариантах осуществления, устройство-член в устройствах-членах 102-104 может специально программироваться посредством Java.NET, QT, C, C++ и/или другого подходящего языка программирования. В некоторых вариантах осуществления, одно или более устройств-членов в устройствах-членах 102-104 могут специально программироваться таким образом, что они включают в себя или выполняют приложение для выполнения множества возможных задач, таких как, без ограничения, функциональность обмена сообщениями, просмотр, выполнение поиска, воспроизведение, потоковая передача или отображение различных форм контента, включающих в себя локально сохраненные или выгруженные сообщения, изображения и/или видео и/или игры.

[0043] В некоторых вариантах осуществления, примерная сеть 105 может обеспечивать сетевой доступ, транспортировку данных и/или другие услуги в любое вычислительное устройство, соединенное с ней. В некоторых вариантах осуществления, примерная сеть 105 может включать в себя и реализовывать по меньшей мере одну специализированную сетевую архитектуру, которая может быть основана по меньшей мере частично на одном или более стандартов, заданных, например, посредством, без ограничения, ассоциации по разработке стандартов глобальной системы мобильной связи (GSM), инженерной группы по развитию Интернета (IETF) и форума по разработке стандартов общемировой совместимости широкополосного беспроводного доступа (WiMax). В некоторых вариантах осуществления, примерная сеть 105 может реализовывать одно или более из архитектуры GSM, архитектуры на основе стандарта общей службы пакетной радиопередачи (GPRS), архитектуры на основе стандарта универсальной системы мобильной связи (UMTS) и развития архитектуры UMTS, называемого «стандартом долгосрочного развития (LTE)». В некоторых вариантах осуществления, примерная сеть 105 может включать в себя и реализовывать, в качестве альтернативы или в сочетании с одним или более из вышеуказанного, WiMAX-архитектуру, заданную посредством WiMAX-форума. В некоторых вариантах осуществления и, при необходимости, в сочетании любых вариантов осуществления, описанных выше или ниже, примерная сеть 105 также может включать в себя, например по меньшей мере одно из локальной вычислительной сети (LAN), глобальной вычислительной сети (WAN), Интернета, виртуальной LAN (VLAN), корпоративной LAN, виртуальной частной сети (VPN) уровня 3, корпоративной IP-сети либо любого их сочетания. В некоторых вариантах осуществления и, при необходимости, в сочетании любых вариантов осуществления, описанных выше или ниже по меньшей мере одна компьютерная сетевая связь по примерной сети 105 может передаваться по меньшей мере частично на основе одного из более режимов связи, таких как, но не только: NFC, RFID, узкополосный Интернет вещей (NBIoT), ZigBee, 3G, 4G, 5G, GSM, GPRS, Wi-Fi, WiMAX, CDMA, спутниковая связь и любое их сочетание. В некоторых вариантах осуществления, примерная сеть 105 также может включать в себя систему хранения данных большой емкости, такое как система хранения данных с подключением по сети (NAS), сеть хранения данных (SAN), сеть доставки контента (CDN) или другие формы компьютерных или машиночитаемых носителей.

[0044] В некоторых вариантах осуществления, примерный сервер 106 или примерный сервер 107 может представлять собой веб-сервер (или набор серверов), работающим под управлением сетевой операционной системы, примеры которого могут включать в себя, но не только, Microsoft Windows Server, Novell NetWare или Linux. В некоторых вариантах осуществления, примерный сервер 106 или примерный сервер 107 может использоваться для и/или обеспечивать облачные и/или сетевые вычисления. Хотя не показано на фиг. 1, в некоторых вариантах осуществления, примерный сервер 106 или примерный сервер 107 может иметь соединения с внешними системами, такими как электронная почта, обмен SMS-сообщениями, обмен текстовыми сообщениями, поставщики рекламного контента и т.д. Любой из признаков примерного сервера 106 также может реализовываться в примерном сервере 107, и наоборот.

[0045] В некоторых вариантах осуществления, один или более примерных серверов 106 и 107 могут специально программироваться с возможностью работы, в неограничивающем примере, в качестве серверов аутентификации, поисковых серверов, почтовых серверов, серверов обеспечения услуг общения в социальных сетях, серверов SMS, серверов IM, серверов MMS, обменных серверов, серверов оказания услуг обмена фотографиями, серверов оказания рекламных услуг, серверов оказания финансовых/банковских услуг, серверов оказания туристических услуг либо любых аналогично подходящих серверов оказания услуг для пользователей вычислительных устройств-членов 101-104.

[0046] В некоторых вариантах осуществления и, при необходимости, в сочетании любых вариантов осуществления, описанных выше или ниже, например, одно или более примерных вычислительных устройств-членов 102-104, примерный сервер 106 и/или примерный сервер 107 могут включать в себя специально программируемый программный модуль, который может быть выполнен с возможностью отправки, обработки и приёма информации с использованием языка подготовки сценариев, удаленного вызова процедур, электронной почты, твита, службы коротких сообщений (SMS), службы мультимедийных сообщений (MMS), мгновенного обмена сообщениями (IM), ретранслируемого Интернет-чата (IRC), mIRC, Jabber, интерфейса прикладного программирования, способов взаимодействия на основе простого протокола доступа к объектам (SOAP), общей архитектуры посредника запросов к объектам (CORBA), HTTP (протокола передачи гипертекста), REST (передачи репрезентативного состояния) либо любого их сочетания.

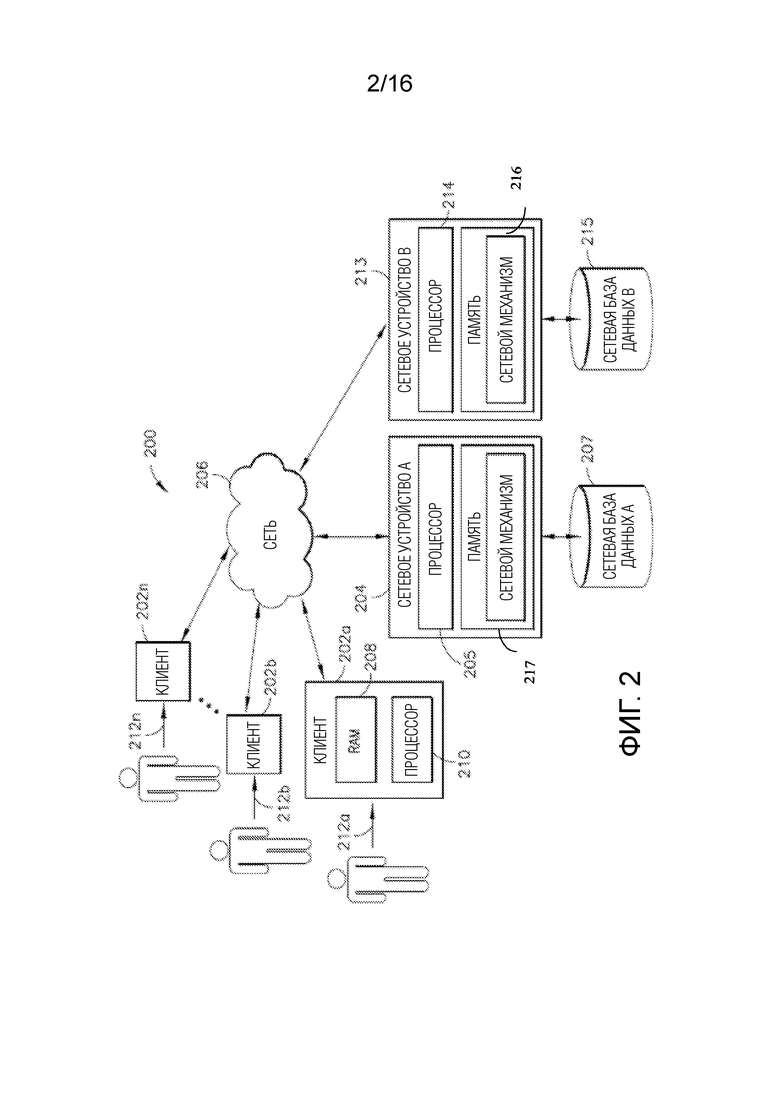

[0047] Фиг. 2 иллюстрирует блок-схему другой примерной компьютерной системы/платформы 200 в соответствии с одним или более вариантов осуществления настоящего изобретения. Тем не менее, не все эти компоненты могут требоваться для осуществления на практике одного или более вариантов осуществления, и изменения конфигурации и типа компонентов могут вноситься без отступления от сущности или объема различных вариантов осуществления настоящего изобретения. В некоторых вариантах осуществления, показанные вычислительные устройства-члены 202a, 202b-202n включают в себя по меньшей мере машиночитаемый носитель, такой как оперативное запоминающее устройство 208 (RAM), соединенное с процессором 210, или флэш-память. В некоторых вариантах осуществления, процессор 210 может выполнять машиноисполняемые программные инструкции, сохраненные в запоминающем устройстве 208. В некоторых вариантах осуществления, процессор 210 может включать в себя микропроцессор, ASIC и/или машину состояний. В некоторых вариантах осуществления, процессор 210 может включать в себя или может поддерживать связь с носителями, например, с машиночитаемыми носителями, которые сохраняют инструкции, которые, при выполнении посредством процессора 210, могут предписывать процессору 210 выполнять один или более этапов, описанных в данном документе. В некоторых вариантах осуществления, примеры машиночитаемых носителей могут включать в себя, но не только, электронное, оптическое, магнитное или другое устройство хранения или передачи данных, допускающее передачу в процессор, к примеру, в процессор 210 клиента 202a, машиночитаемых инструкций. В некоторых вариантах осуществления, другие примеры подходящих носителей могут включать в себя, но не только, гибкий диск, CD-ROM, DVD, магнитный диск, микросхему запоминающего устройства, ROM, RAM, ASIC, сконфигурированный процессор, все оптические носители, все магнитные ленты или другие магнитные носители либо любой другой носитель, с которого компьютерный процессор может считывать инструкции. Также различные другие формы машиночитаемых носителей могут передавать или переносить инструкции в компьютер, включающие в себя маршрутизатор, частную сеть или сеть общего пользования либо другое устройство или канал передачи, как проводной, так и беспроводной. В некоторых вариантах осуществления, инструкции могут содержать код из любого машинного языка программирования, включающего в себя, например, C, C++, Visual Basic, Java, Python, Perl, JavaScript и т.д.

[0048] В некоторых вариантах осуществления, вычислительные устройства-члены 202a-202n также могут содержать определенное число внешних или внутренних устройств, таких как мышь, CD-ROM, DVD, физическая или виртуальная клавиатура, дисплей либо другие устройства ввода или вывода. В некоторых вариантах осуществления, примеры вычислительных устройств-членов 202a-202n (например, клиентов) могут представлять собой любой тип процессорных платформ, которые соединяются с сетью 206, таких как, без ограничения, персональные компьютеры, цифровые помощники, персональные цифровые устройства, смартфоны, устройства поискового вызова, цифровые планшетные компьютеры, переносные компьютеры, приборы с подключением к Интернету и другие процессорные устройства. В некоторых вариантах осуществления, вычислительные устройства-члены 202a-202n могут специально программироваться с одной или более прикладных программ в соответствии с одними или более принципов/технологий, подробно описанных в данном документе. В некоторых вариантах осуществления, вычислительные устройства-члены 202a-202n могут работать в любой операционной системе, допускающей поддержку браузера или приложения с возможностями браузера, такого как Microsoft™, Windows™ и/или Linux. В некоторых вариантах осуществления, показанные вычислительные устройства-члены 202a-202n могут включать в себя, например, персональные компьютеры, выполняющие прикладную программу браузера, такую как Internet Explorer™ компании Microsoft Corporation, Safari™ компании Apple Computer, Inc., Mozilla Firefox и/или Opera. В некоторых вариантах осуществления, через вычислительные клиентские устройства-члены 202a-202n, пользователи, 212a-212n, могут обмениваться данными по примерной сети 206 друг с другом и/или с другими системами и/или устройствами, соединенными с сетью 206. Как показано на фиг. 2, примерные серверные устройства 204 и 213 также могут соединяться с сетью 206. В некоторых вариантах осуществления, одно или более вычислительных устройств-членов 202a-202n могут представлять собой мобильные клиенты.

[0049] В некоторых вариантах осуществления по меньшей мере одна база данных из примерных баз 207 и 215 данных может представлять собой любой тип базы данных, включающий в себя базу данных, управляемую посредством системы управления базами данных (DBMS). В некоторых вариантах осуществления, примерная DBMS-управляемая база данных может специально программироваться в качестве механизма, который управляет организацией, хранением, управлением и/или извлечением данных в соответствующей базе данных. В некоторых вариантах осуществления, примерная DBMS-управляемая база данных может специально программироваться с обеспечения возможности выполнения запроса, резервирования и репликации, принудительной активации правил, обеспечения безопасности, вычисления, выполнения регистрации изменений и доступа и/или автоматизации оптимизации. В некоторых вариантах осуществления, примерная DBMS-управляемая база данных может выбираться из базы данных Oracle, IBM DB2, Adaptive Server Enterprise, FileMaker, Microsoft Access, Microsoft SQL Server, MySQL-, PostgreSQL- и NoSQL-реализации. В некоторых вариантах осуществления, примерная DBMS-управляемая база данных может специально программироваться с возможностью задания каждой соответствующей схемы каждой базы данных в примерной DBMS, согласно конкретной модели баз данных настоящего изобретения, которая может включать в себя иерархическую модель, сетевую модель, реляционную модель, объектную модель или некоторую другую подходящую организацию, которая может приводить к одной или более применимых структур данных, которые могут включать в себя поля, записи, файлы и/или объекты. В некоторых вариантах осуществления, примерная DBMS-управляемая база данных может специально программироваться с возможностью включения метаданных, относящихся к сохраняемым данным.

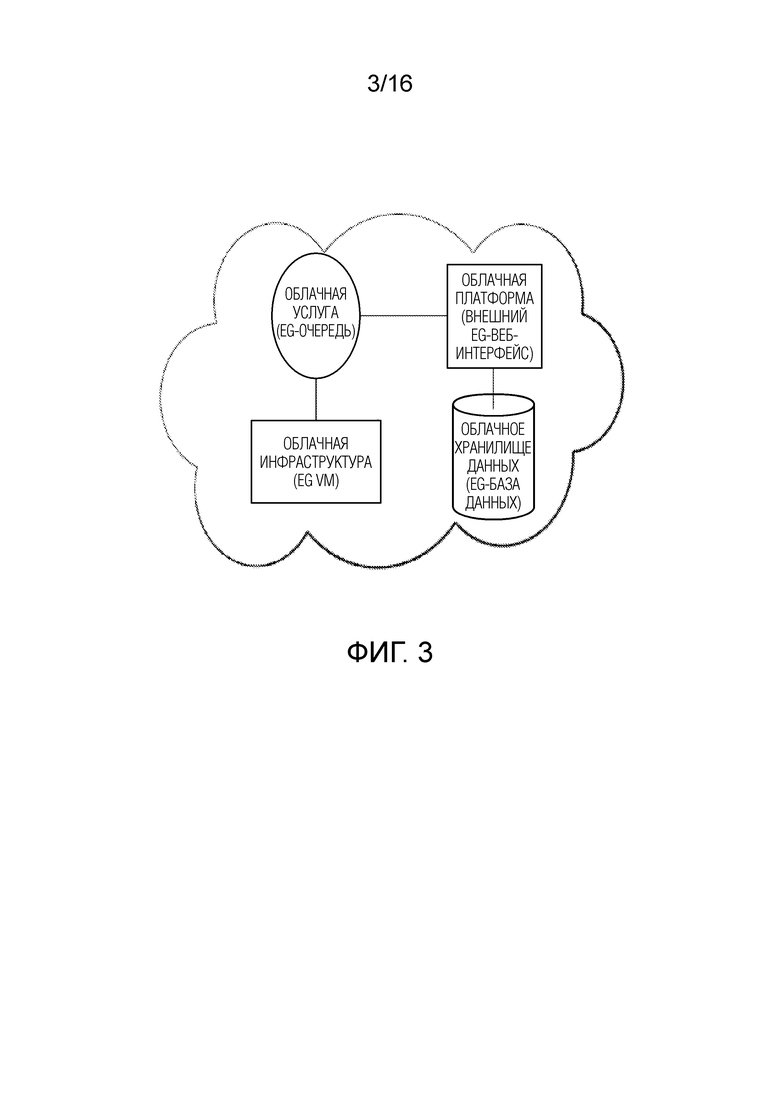

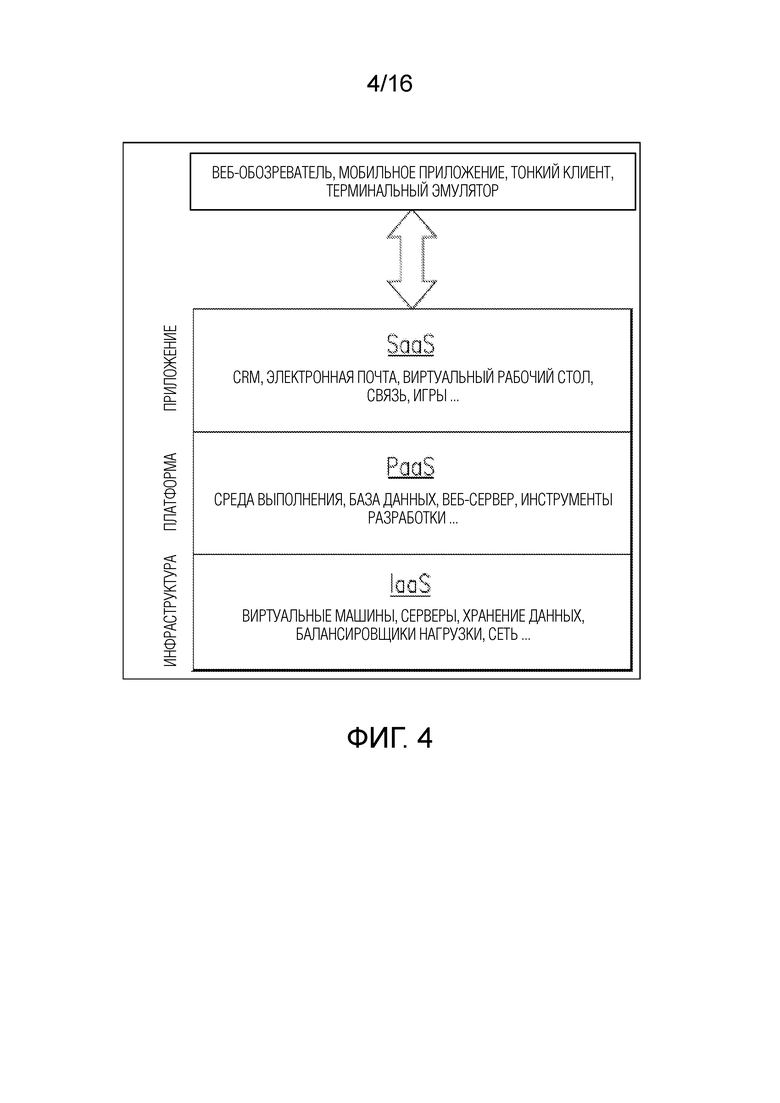

[0050] В некоторых вариантах осуществления, примерные компьютерные системы/платформы согласно изобретению, примерные компьютерные устройства согласно изобретению и/или примерные компьютерные компоненты согласно изобретению по настоящему изобретению, в частности, могут быть выполнены с возможностью работы в облачной вычислительной архитектуре, такой как, но не только: инфраструктура как услуга (IaaS), платформа как услуга (PaaS) и/или программное обеспечение как услуга (SaaS). Фиг. 3 и 4 иллюстрируют схематические виды примерных реализаций облачной вычислительной архитектуры, в которой примерные компьютерные системы/платформы согласно изобретению, примерные компьютерные устройства согласно изобретению и/или примерные компьютерные компоненты согласно изобретению по настоящему изобретению, в частности, могут быть выполнены с возможностью работы.

[0051] В вариантах осуществления примерных компьютерных систем и/или устройств согласно изобретению, уменьшение динамического отклонения, обусловленного выбросовыми значениями (DOBR) может использоваться для повышения точности и понимания обобщенных линейных моделей специально для исследований на основе сравнительного тестирования. Тем не менее, оно представляет собой способ, который может применяться к широкому спектру аналитических моделей, в которых имеются одна или более независимых переменных и одна зависимая переменная. Настоящее изобретение и его варианты осуществления иллюстрируют применение DOBR согласно изобретению для повышения точности прогнозирований на основе модели машинного обучения.

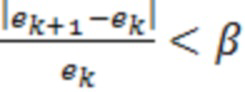

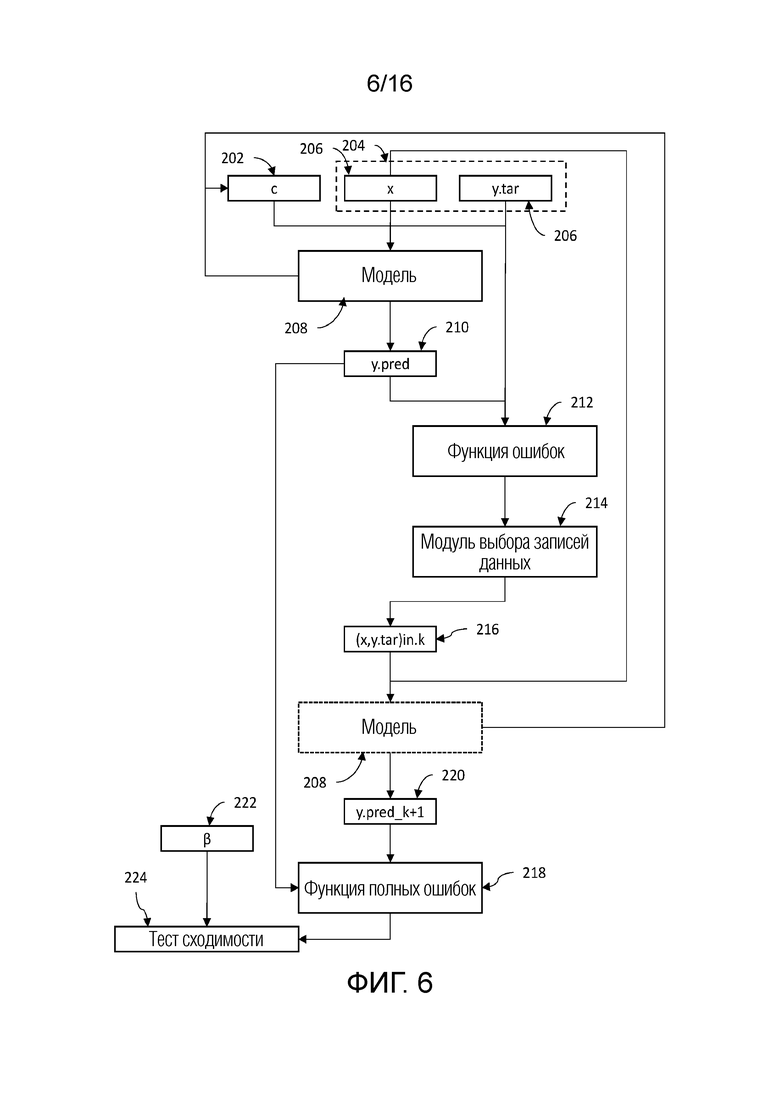

[0052] В вариантах осуществления, DOBR не представляет собой прогнозирующую модель. Вместо этого, в вариантах осуществления, оно представляет собой надстраиваемый способ для прогнозирующих или интерпретирующих моделей, который позволяет повышать точность прогнозирований на основе модели. В вариантах осуществления, идентифицированные DOBR выбросовые значения основаны на разности между целевой переменной на основе обеспечиваемых данных и вычисленным с помощью модели значением. По мере того, как выбросовые значения идентифицируются, через предварительно определенный критерий выбора, зависимые от выбросовых значений записи данных и сформированные посредством модели зависимые переменные удаляются из анализа. Дополнительный анализ может продолжаться с этими записями, постоянно удаленными. Тем не менее, в других вариантах осуществления примерной системы и способов согласно изобретению, на каждой модельной итерации, процесс идентификации выбросовых данных включает в себя весь набор данных таким образом, что все записи подвергаются тщательному исследованию выбросовых значений с использованием прогнозирующей модели последней итерации, заданной посредством параметров вычисления. Соответственно, примерные варианты осуществления настоящего изобретения уменьшают отклонение в модели машинного обучения, например, посредством включения всего набора данных на каждой итерации, чтобы уменьшать распространение отклонения выбора обучающих данных. Таким образом, модели машинного обучения могут обучаться и реализовываться более точно и более эффективно для улучшения работы систем машинного обучения.

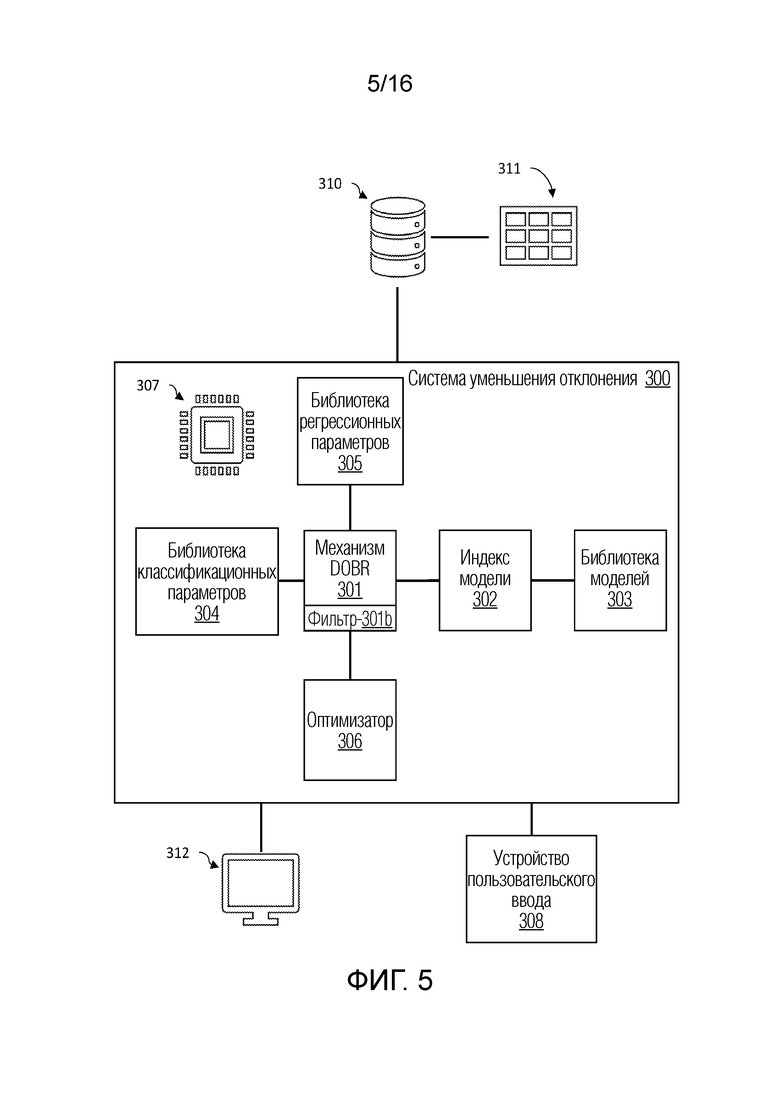

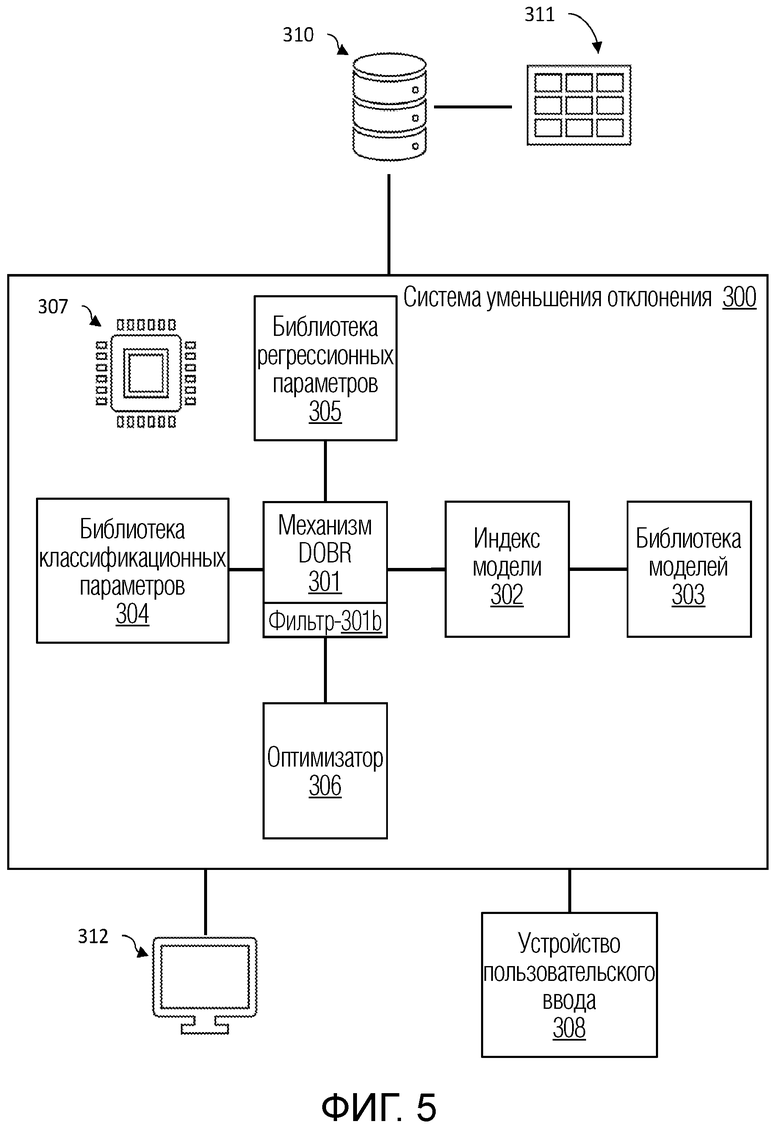

[0053] Фиг. 5 иллюстрирует блок-схему примерной системы уменьшения отклонения в машинном обучении согласно изобретению в соответствии с одним или более вариантов осуществления настоящего изобретения.

[0054] В некоторых вариантах осуществления, система 300 уменьшения отклонения может включать в себя компонент для уменьшения динамического отклонения, обусловленного выбросовыми значениями (DOBR) в наборах данных при анализе, например, посредством механизмов машинного обучения. В некоторых вариантах осуществления, DOBR обеспечивает итеративный процесс для удаления выбросовых записей согласно предварительно заданному критерию. Это условие представляет собой определяемое пользователем значение приемлемости ошибки, выражаемое как процентная доля. Это означает то, какую часть ошибки пользователь имеет намерение считать приемлемой в модели потенциально на основе своего понимания и других результатов анализа, которые описываются ниже в этом пояснении. Значение в 100% обозначает то, что ошибка считается полностью приемлемой, и записи не должны удаляться в процессе DOBR. Если выбирается 0%, то все записи удаляются. В общем, значения приемлемости ошибки в диапазоне 80-95% наблюдаются для промышленных вариантов применения.

[0055] В некоторых вариантах осуществления, пользователь может взаимодействовать с системой 300 уменьшения отклонения, чтобы администрировать значение приемлемости ошибки через устройство 308 пользовательского ввода и просматривать результаты через устройство 312 отображения, в числе других поведений пользовательского взаимодействия с использованием устройства 312 отображения и устройства 308 пользовательского ввода. На основе значения приемлемости ошибки, система 300 уменьшения отклонения может анализировать набор 311 данных, принимаемый в базе 310 данных или в другом устройстве хранения данных, поддерживающем связь с системой 300 уменьшения отклонения. Система 300 уменьшения отклонения может принимать набор 311 данных через базу 310 данных или другое устройство хранения данных и выполнять прогнозирования с использованием одной или более моделей машинного обучения с уменьшением динамического отклонения, обусловленного выбросовыми значениями, для повышенной точности и эффективности.

[0056] В некоторых вариантах осуществления, система 300 уменьшения отклонения включает в себя сочетание аппаратных и программных компонентов, включающих в себя, например, устройства хранения данных и запоминающие устройства, кэш, буферы, шину, интерфейсы ввода-вывода, процессоры, контроллеры, сетевые устройства и устройства связи, операционную систему, ядро, драйверы устройств, в числе других компонентов. В некоторых вариантах осуществления, процессор 307 поддерживает связь с несколькими другими компонентами, чтобы реализовывать функции других компонентов. В некоторых вариантах осуществления, каждый компонент имеет время, планируемое в процессоре 307 для выполнения компонентных функций; тем не менее, в некоторых вариантах осуществления, каждый компонент планируется в один или более процессоров в системе обработки процессора 307. В других вариантах осуществления, каждый компонент имеет включенный собственный процессор.

[0057] В некоторых вариантах осуществления, компоненты системы 300 уменьшения отклонения могут включать в себя, например, механизм 301 DOBR, поддерживающий связь с индексом 302 модели и библиотекой 303 моделей, библиотеку 305 регрессионных параметров, библиотеку 304 классификационных параметров и фильтр 306 DOBR, в числе других возможных компонентов. Каждый компонент может включать в себя сочетание аппаратных средств и программного обеспечения, чтобы реализовывать компонентные функции, таких как, например, запоминающие устройства и устройства хранения данных, обрабатывающие устройства, устройства связи, интерфейсы ввода-вывода, контроллеры, сетевые устройства и устройства связи, операционная система, ядро, драйверы устройств, набор инструкций, в числе других компонентов.

[0058] В некоторых вариантах осуществления, механизм 301 DOBR включает в себя модельный механизм для создания экземпляра и выполнения моделей машинного обучения. Механизм 301 DOBR может осуществлять доступ к моделям для создания экземпляра в библиотеке 303 моделей с помощью индекса 302 модели. Например, библиотека 303 моделей может включать в себя библиотеку моделей машинного обучения, которые могут быть избирательно доступными и подвергаться созданию экземпляра для использования посредством механизма, такого как механизм 301 DOBR. В некоторых вариантах осуществления, библиотека 303 моделей может включать в себя модели машинного обучения, такие как, например, метод опорных векторов (SVM), линейный регрессор, модель LASSO, регрессоры на основе дерева решений, классификаторы на основе дерева решений, регрессоры на основе случайного леса, классификаторы на основе случайного леса, регрессоры на основе принципа K соседних узлов, классификаторы на основе принципа K соседних узлов, регрессоры на основе градиентного бустинга, классификаторы на основе градиентного бустинга, в числе других возможных классификаторов и регрессоров. Например, библиотека 303 моделей может импортировать модели согласно нижеприведенному примерному псевдокоду 1:

Псевдокод 1

import sys

sys.path.append("analytics-lanxess-logic")

import numpy as np

import pandas as pd

import random, time

import xgboost as xgb

from xgboost import XGBClassifier, XGBRegressor

from scipy import stats

from scipy.stats import mannwhitneyu, wilcoxon

from sklearn.metrics import mean_squared_error, roc_auc_score, classification_report, confusion_matrix

from sklearn import svm

from sklearn.svm import SVR, SVC

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression, Lasso

from sklearn.tree import DecisionTreeRegressor, DecisionTreeClassifier

from sklearn.ensemble import RandomForestRegressor, RandomForestClassifier, BaggingClassifier,BaggingRegressor

from sklearn.neighbors import KNeighborsRegressor , KNeighborsClassifier

from sklearn.ensemble import GradientBoostingRegressor, GradientBoostingClassifier

from optimizers.hyperparameters.hyperband_optimizer import Hyperband, HyperparameterOptimizer

from optimizers.hyperparameters.base_optimizer import HyperparameterOptimizer

import warnings

from warnings import simplefilter

simplefilter(action='ignore', category=FutureWarning)

simplefilter(action='ignore', category=DeprecationWarning)

warnings.filterwarnings(module='numpy*' , action='ignore', category=DeprecationWarning)

warnings.filterwarnings(module='numpy*' , action='ignore', category=FutureWarning)

warnings.filterwarnings(module='scipy*' , action='ignore', category=FutureWarning)

warnings.filterwarnings(module='scipy*' , action='ignore', category=DeprecationWarning)

warnings.filterwarnings(module='sklearn*', action='ignore', category=DeprecationWarning)

[0059] Тем не менее, в некоторых вариантах осуществления, чтобы упрощать доступ к библиотеке моделей машинного обучения в библиотеке 303 моделей, механизм 301 DOBR может использовать индекс 302 модели, который индексирует каждую модель согласно идентификатору модели, который следует использовать в качестве функции посредством механизма 301 DOBR. Например, модели, включающие в себя, например, линейную регрессию, регрессию XGBoost, регрессию на основе метода опорных векторов, регрессию LASSO, регрессию на основе принципа K соседних узлов, регрессию на основе принципа улучшения агрегации, регрессию на основе градиентного бустинга, регрессию на основе случайного леса, регрессия на основе дерева решений, в числе других регрессионных моделей и моделей классификации, могут индексироваться посредством числового идентификатора и помечаться с помощью названия. Например, нижеприведенный псевдокод 2 иллюстрирует пример индексного кода модели для использования посредством индекса 302 модели.

Псевдокод 2

model0=LinearRegression()

model1=xgb.XGBRegressor()

model2=SVR()

model3=Lasso()

model4=KNeighborsRegressor()

model5=BaggingRegressor()

model6=GradientBoostingRegressor()

model7=RandomForestRegressor()

model8=DecisionTreeRegressor()

#

ModelName0=" Linear Regression"

ModelName1="XGBoost Regression"

ModelName2="Support Vector Regression"

ModelName3=" Lasso"

ModelName4="K Neighbors Regression"

ModelName5="Bagging Regression"

ModelName6="Gradient Boosting Regression"

ModelName7="Random Forest Regression"

ModelName8="Decision Tree Regression"

[0060] Другие варианты осуществления псевдокода для библиотеки 303 моделей и индекса 302 модели предполагаются. В некоторых вариантах осуществления, программные инструкции сохраняются в запоминающем устройстве соответствующей библиотеки 303 моделей или индекса 302 модели и буферизуются в кэше для передачи в процессор 307. В некоторых вариантах осуществления, механизм 301 DOBR может использовать индекс 302 модели посредством осуществления доступа или вызова индекса через связь и/или устройства ввода-вывода, использовать индекс для вызова моделей в качестве функций из библиотеки 303 моделей через устройства связи и/или ввода-вывода.

[0061] В некоторых вариантах осуществления, чтобы упрощать оптимизацию и индивидуальную настройку моделей, вызываемых посредством механизма 301 DOBR, система 300 уменьшения отклонения может записывать параметры модели, например, в запоминающее устройство или устройство хранения данных, такое как, например, жесткие диски, полупроводниковые накопители, оперативное запоминающее устройство (RAM), флэш-память, в числе других устройств хранения данных и запоминающих устройств. Например, регрессионные параметры могут регистрироваться и регулироваться в библиотеке 305 регрессионных параметров. Таким образом, библиотека 305 регрессионных параметров может включать в себя аппаратные средства хранения данных и связи, сконфигурированные с достаточным объемом запоминающего устройства и полосой пропускания, чтобы сохранять, регулировать и передавать множество параметров для нескольких регрессоров, например, в реальном времени. Например, для каждой регрессионной модели машинного обучения, подвергающейся созданию экземпляра посредством механизма 301 DOBR, соответствующие параметры могут инициализироваться и обновляться в библиотеке 305 регрессионных параметров. В некоторых вариантах осуществления, пользователь, через устройство 308 пользовательского ввода, может устанавливать начальный набор параметров. Тем не менее, в некоторых вариантах осуществления, начальный набор параметров может предварительно определяться или случайно формироваться. После создания экземпляра регрессионной модели машинного обучения, механизм 301 DOBR может коррелировать модель, идентифицированную в индексе 302 модели, с набором параметров в библиотеке 305 регрессионных параметров. Например, механизм 301 DOBR может вызывать набор параметров, например, согласно идентификационному номеру, ассоциированному с данной регрессионной моделью. Например, библиотека 305 регрессионных параметров может идентифицировать параметры для каждой регрессионной модели, аналогично нижеприведенному псевдокоду 3:

Псевдокод 3

#from utilities.defaults import DefaultParameters

#print(DefaultParameters(ctr=0).__dict__)

#!conda install -y -c conda-forge xgboost

def gen_params(id):

# XGBoost

if id==1:

""" default parameters - best achieved in prototyping XGBOOST """

HYPERPARAMETERS={"objective": "reg:linear",

"tree_method": "exact",

"eval_metric": "rmse",

"eta": 1,

"gamma": 5,

"max_depth": 2,

"colsample_bytree": .5,

"colsample_bylevel": .5,

"min_child_weight": 1,

"subsample": 1,

"reg_lambda": 1,

"reg_alpha": 0,

"silent": 1}

""" fixed parameters which will not change in optimisation """

FIXED={"objective": "reg:linear",

"tree_method": "exact",

"eval_metric": "rmse"}

""" boundaries & types of optimisable parameters """

BOUNDARIES={"eta": (0, 1, np.float64),

"gamma": (0, 100, np.float64),

"max_depth": (1, 30, np.int32),

"colsample_bytree": (0, 1, np.float64),

"colsample_bylevel": (0, 1, np.float64),

"min_child_weight": (0, 100, np.int32),

"subsample": (0, 1, np.float64),

"reg_lambda": (0, 1, np.float64),

"reg_alpha": (0, 1, np.float64)}

elif id==2:

# SVR

""" default parameters - """

HYPERPARAMETERS={"kernel": "rbf",

"cache_size": 100000,

"C": 0.5,

"gamma": 0.023 }

""" fixed parameters which will not change in optimisation """

FIXED={"kernel": "rbf",

"cache_size": 100000,

"tol": 0.00001 }

""" boundaries & types of optimisable parameters """

BOUNDARIES={ "C": (0.01 , 1000, np.float64),

"gamma": (0.001, 100, np.float64)}

# "epsilon": (0.001, 100, np.float64)

elif id==3:

# LASSO

""" default parameters - """

HYPERPARAMETERS={"fit_intercept": "False",

"max_iter": 100000,

"tol": 0.0001,

"alpha": 25}

""" fixed parameters which will not change in optimisation """

FIXED={"fit_intercept": "False",

"max_iter": 100000,

"tol": 0.0001 }

""" boundaries & types of optimisable parameters """

BOUNDARIES={"alpha": (0.1, 100, np.float64) }

elif id==4:

# KNN PARAMETERS

""" default parameters - """

HYPERPARAMETERS={ "algorithm": "auto",

"n_neighbors": 7,

"leaf_size": 30}

""" fixed parameters which will not change in optimisation """

FIXED={"algorithm": "auto"}

""" boundaries & types of optimisable parameters """

BOUNDARIES={"n_neighbors": (3 , 51, np.int32),

"leaf_size": (2 , 500, np.int32)}

elif id==5:

# Bagging Regression

HYPERPARAMETERS={ "bootstrap_features": "False",

"bootstrap": "True",

"n_estimators": 21,

"max_samples": 23}

""" fixed parameters which will not change in optimisation """

FIXED={ "bootstrap_features": "False",

"bootstrap": "True"}

""" boundaries & types of optimisable parameters """

BOUNDARIES={"n_estimators": (1 , 50, np.int32),

"max_samples": (1 , 50, np.int32)}

elif id==6:

# GRADIENT BOOSTING PARAMETERS

""" default parameters - """

HYPERPARAMETERS={"criterion": "friedman_mse",

"min_impurity_split": 1.0e-07,

"max_features": "auto",

"learning_rate": 0.2,

"n_estimators": 100,

"max_depth": 10}

""" fixed parameters which will not change in optimisation """

FIXED={"criterion": "friedman_mse",

"min_impurity_split": 1.0e-07,

"max_features": "auto"}

""" boundaries & types of optimisable parameters """

BOUNDARIES={"learning_rate": (0.01, 1, np.float64),

"n_estimators": (50, 500, np.int32),

"max_depth": (1, 50, np.int32)}

elif id==7:

# RANDOM FOREST PARAMETERS

""" default parameters - """

HYPERPARAMETERS={"bootstrap": "True",

"criterion": "mse",

"n_estimators": 100,

"max_features": 'auto',

"max_depth": 50,

"min_samples_leaf": 1,

"min_samples_split": 2}

""" fixed parameters which will not change in optimisation """

FIXED={"bootstrap": "True",

"criterion": "mse",

"max_features": 'auto' }

""" boundaries & types of optimisable parameters """

BOUNDARIES={"n_estimators": (1 , 1000, np.int32),

"max_depth": (1 , 500, np.int32),

"min_samples_leaf": (1 , 50, np.int32),

"min_samples_split": (2 , 50, np.int32)}

else:

# DECISION TREE PARAMETERS

""" default parameters - """

HYPERPARAMETERS={"criterion": "mse",

"max_features": "auto",

"max_depth": 2,

"min_samples_leaf": 0.25,

"min_samples_split": 2 }

""" fixed parameters which will not change in optimisation """

FIXED={"criterion": "mse",

"max_features": "auto"}

""" boundaries & types of optimisable parameters """

BOUNDARIES={ "max_depth": (1 , 500, np.int32),

"min_samples_leaf": (1 , 50, np.int32),

"min_samples_split": (2 , 50, np.int32)}

return HYPERPARAMETERS, FIXED,BOUNDARIES

[0062] Аналогично, в некоторых вариантах осуществления, классификационные параметры могут регистрироваться и регулироваться в библиотеке 304 классификационных параметров. Таким образом, библиотека 304 классификационных параметров может включать в себя аппаратные средства хранения данных и связи, сконфигурированные с достаточным объемом запоминающего устройства и полосой пропускания, чтобы сохранять, регулировать и передавать множество параметров для нескольких регрессоров, например, в реальном времени. Например, для каждой классификационной модели машинного обучения, подвергающейся созданию экземпляра посредством механизма 301 DOBR, соответствующие параметры могут инициализироваться и обновляться в библиотеке 305 регрессионных параметров. В некоторых вариантах осуществления, пользователь, через устройство 308 пользовательского ввода, может устанавливать начальный набор параметров. Тем не менее, в некоторых вариантах осуществления, начальный набор параметров может быть предварительно определен. После создания экземпляра регрессионной модели машинного обучения, механизм 301 DOBR может коррелировать модель, идентифицированную в индексе 302 модели, с набором параметров в библиотеке 305 регрессионных параметров. Например, механизм 301 DOBR может вызывать набор параметров, например, согласно идентификационному номеру, ассоциированному с данной регрессионной моделью. Например, библиотека 305 регрессионных параметров может идентифицировать параметры для каждой регрессионной модели, аналогично нижеприведенному псевдокоду 4:

Псевдокод 4

def gen_paramsClass(II):

# XGBoost CLASSIFER PARAMETERS

if II==0:

""" default parameters - best achieved in prototyping """

HYPERPARAMETERS={"objective": "binary:hinge",

"tree_method": "exact",

"eval_metric": "error",

"n_estimators": 5,

"eta": 0.3,

"gamma": 0.1,

"max_depth": 5,

"min_child_weight": 5,

"subsample": 0.5,

"scale_pos_weight": 1,

"silent": 1}

""" fixed parameters which will not change in optimization """

FIXED={ "objective": "binary:hinge",

"tree_method": "exact",

"eval_metric": "error"}

""" boundaries & types of optimisable parameters """

BOUNDARIES={ "eta": (0, 10, np.float64),

"gamma": (0, 10, np.float64),

"min_child_weight": (0, 50, np.float64),

"subsample": (0, 1, np.float64),

"n_estimators": (1,1000, np.int32),

"max_depth": (1, 1000, np.int32),

"scale_pos_weight": (0, 1, np.float64) }

else:

# RANDOM FOREST CLASSIFIER PARAMETERS

""" default parameters - """

HYPERPARAMETERS={"bootstrap": "True",

"n_estimators": 500,

"max_features": 'auto',

"max_depth": 200,

"min_samples_leaf": 1,

"min_samples_split": 2 }

""" fixed parameters which will not change in optimisation """

FIXED={"bootstrap": "True",

"max_features": "auto" }

""" boundaries & types of optimisable parameters """

BOUNDARIES={"n_estimators": (10 , 1000, np.int32),

"max_depth": (10 , 50, np.int32),

"min_samples_leaf": (1 , 40, np.int32),

"min_samples_split": (2 , 40, np.int32)}#

return HYPERPARAMETERS, FIXED,BOUNDARIES

[0063] В некоторых вариантах осуществления, посредством вызова и приема набора моделей из библиотеки 303 моделей через индекс 302 модели и соответствующих параметров из библиотеки 305 регрессионных параметров и/или библиотеки 304 классификационных параметров, механизм 301 DOBR может загружать одну или более подвергающихся созданию экземпляра и инициализированных моделей, например, в кэш или буфер механизма 301 DOBR. В некоторых вариантах осуществления, набор 311 данных затем может загружаться из базы 310 данных, например, в идентичный или различный кэш или буфер либо в другое устройство хранения данных механизма 301 DOBR. Процессор 307 или процессор в механизме 301 DOBR затем может выполнять каждую модель, чтобы преобразовывать набор 311 данных, например, в соответствующее прогнозирование значений связанных с активностью данных, которые характеризуют результаты или параметры активности на основе определенных входных атрибутов, связанных с активностью. Например, использование энергии приборов в домашних и/или коммерческих окружениях, прочность на сжатие бетона во множестве вариантов применения и формулирований, распознавание объектов или изображений, распознавание речи или другие варианты применения на основе машинного обучения. Например, механизм 301 DOBR может моделировать использование энергии приборов на основе набора 311 данных статистического использования энергии, времени года, времени суток, местоположения, в числе прочих факторов. Механизм 301 DOBR может вызывать набор регрессоров из библиотеки 303 моделей через индекс 302 модели, соединенный с шиной механизма 301 DOBR. Механизм 301 DOBR затем может вызывать файл или журнал регистрации параметров, ассоциированный с регрессорами для оценки использования энергии приборов в библиотеке 305 регрессионных параметров, соединенной с шиной механизма 301 DOBR. -Затем механизм 301 DOBR может использовать процессор 307 для прогнозирования будущего энергопотребления на основе моделей и параметров модели, времени и даты, местоположения или другого фактора и их сочетаний.

[0064] Аналогично, например, механизм 301 DOBR может моделировать прочность на сжатие бетона на основе набора 311 данных материалов бетона, времени года, времени суток, местоположения, влажности, времени отверждения, возраста, в числе прочих факторов. Механизм 301 DOBR может вызывать набор регрессоров из библиотеки 303 моделей через индекс 302 модели, соединенный с шиной механизма 301 DOBR. Механизм 301 DOBR затем может вызывать файл или журнал регистрации параметров, ассоциированный с регрессорами для оценки прочности на сжатие бетона в библиотеке 305 регрессионных параметров, соединенной с шиной механизма 301 DOBR. Затем механизм 301 DOBR может использовать процессор 307 для прогнозирования будущей прочности на сжатие бетона на основе моделей и параметров модели для конкретного состава бетона, времени и даты, местоположения или другого фактора и их сочетаний.

[0065] В качестве другого примера, механизм 301 DOBR может выполнять распознавание речи на основе набора 311 данных речевых фрагментов и транскрипций экспериментально полученных проверочных данных, в числе прочих факторов. Механизм 301 DOBR может вызывать набор классификаторов из библиотеки 303 моделей через индекс 302 модели, соединенный с шиной механизма 301 DOBR. Затем механизм 301 DOBR может вызывать файл или журнал регистрации параметров, ассоциированный с классификаторами для распознавания речи в библиотеке 304 классификационных параметров, соединенной с шиной механизма 301 DOBR. Затем механизм 301 DOBR может использовать процессор 307 для прогнозирования транскрипции записанных речевых данных на основе моделей и параметров модели для набора из одного или более речевых фрагментов.

[0066] В качестве другого примера, механизм 301 DOBR может автоматически прогнозировать настройки рендеринга для формирования медицинских изображений на основе набора 311 данных настроек для нескольких параметров рендеринга через формирование изображений и/или визуализации, в числе прочих факторов, как описано в патенте США № 10339695. Механизм 301 DOBR может вызывать набор классификаторов из библиотеки 303 моделей через индекс 302 модели, соединенный с шиной механизма 301 DOBR. Затем механизм 301 DOBR может вызывать файл или журнал регистрации параметров, ассоциированный с классификаторами для рендеринга настроек в библиотеке 304 классификационных параметров, соединенной с шиной механизма 301 DOBR. Затем механизм 301 DOBR может использовать процессор 307 для прогнозирования данных настроек рендеринга на основе моделей и параметров модели для набора из одного или более наборов медицинских данных.

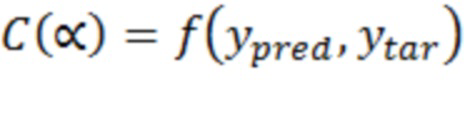

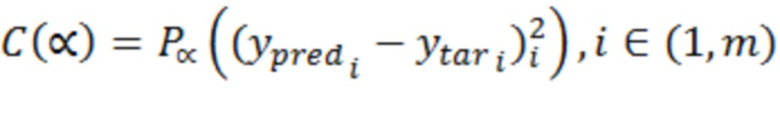

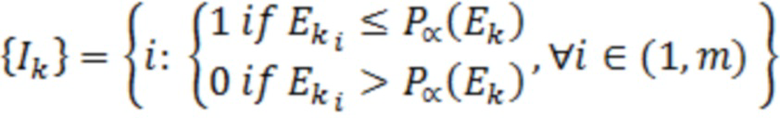

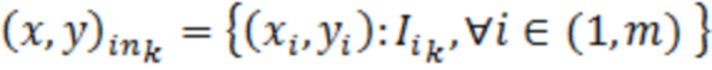

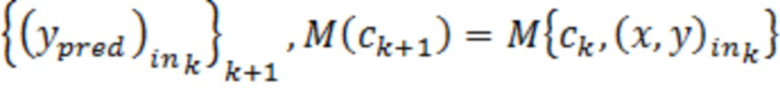

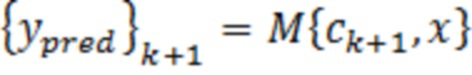

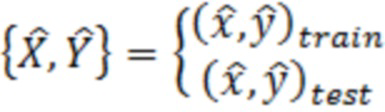

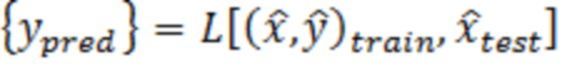

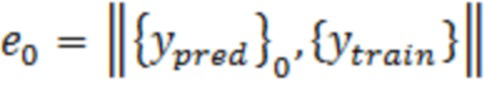

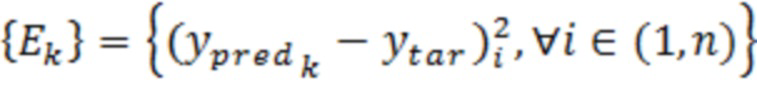

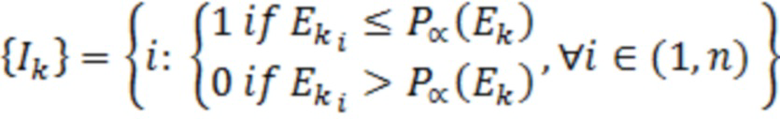

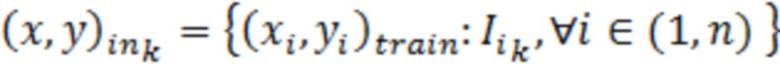

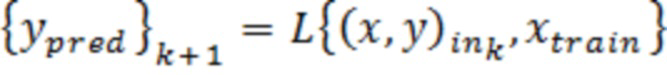

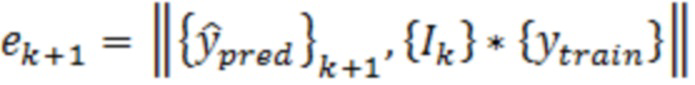

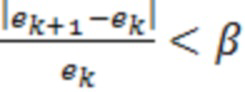

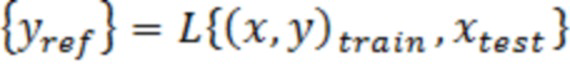

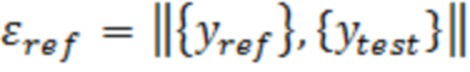

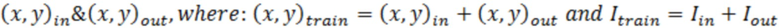

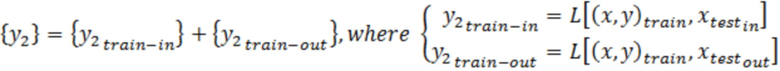

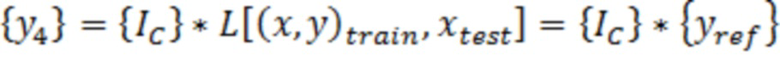

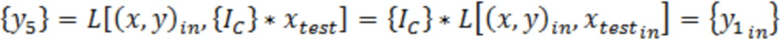

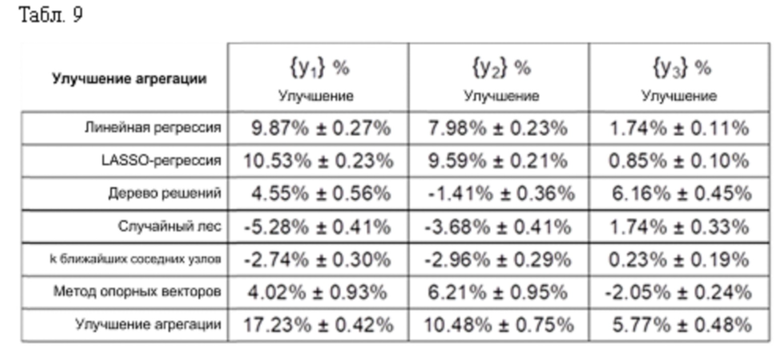

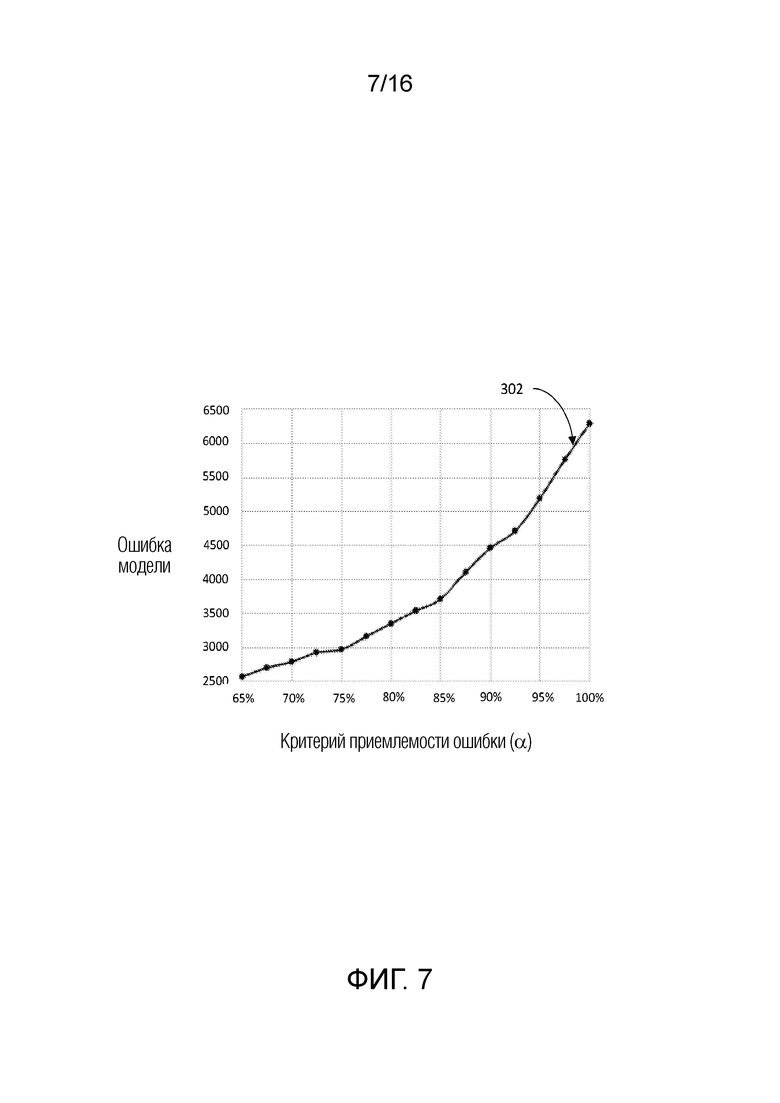

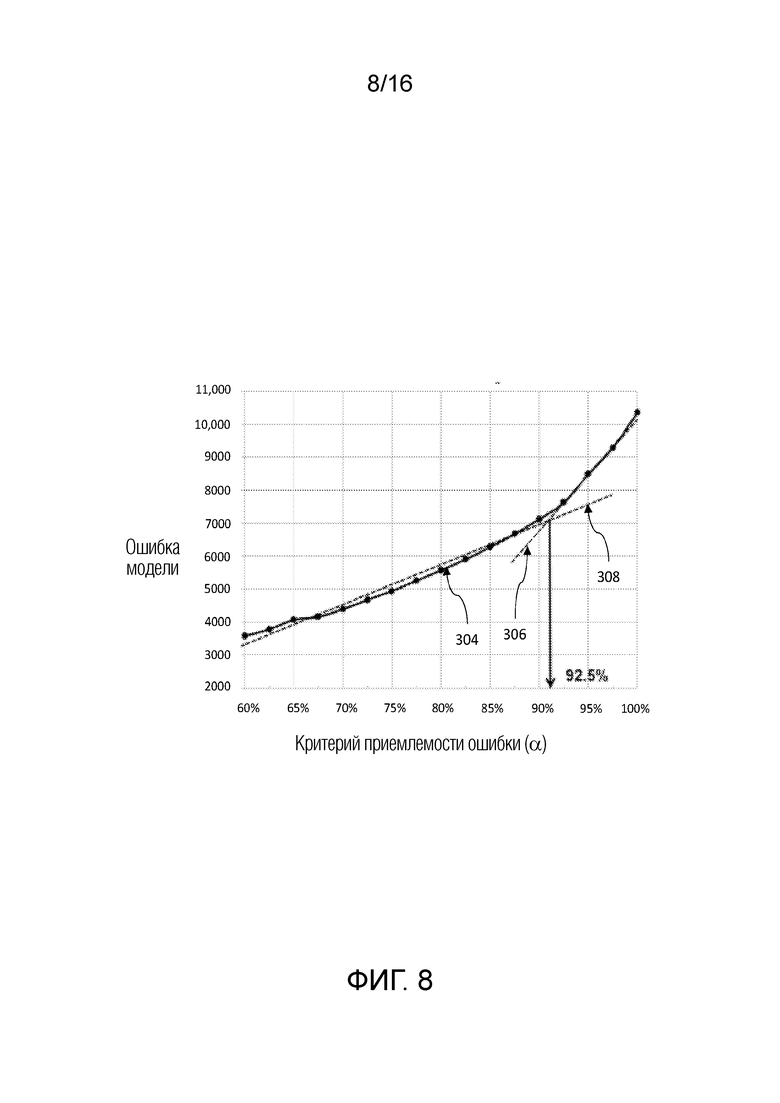

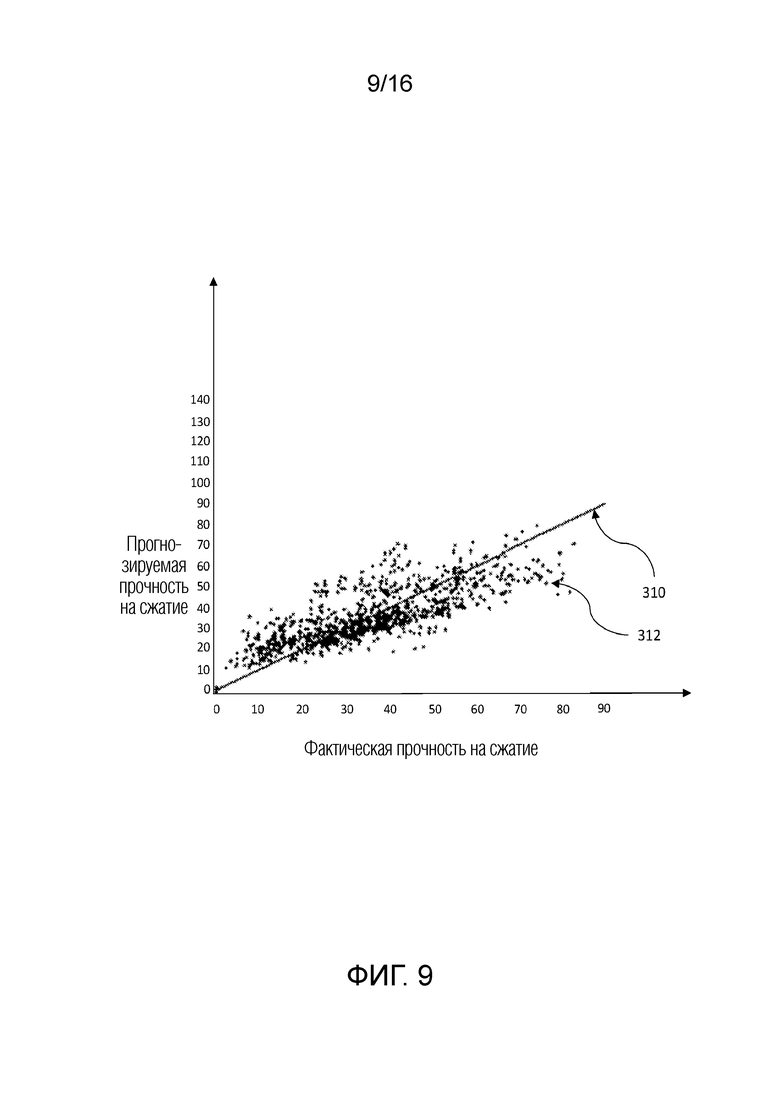

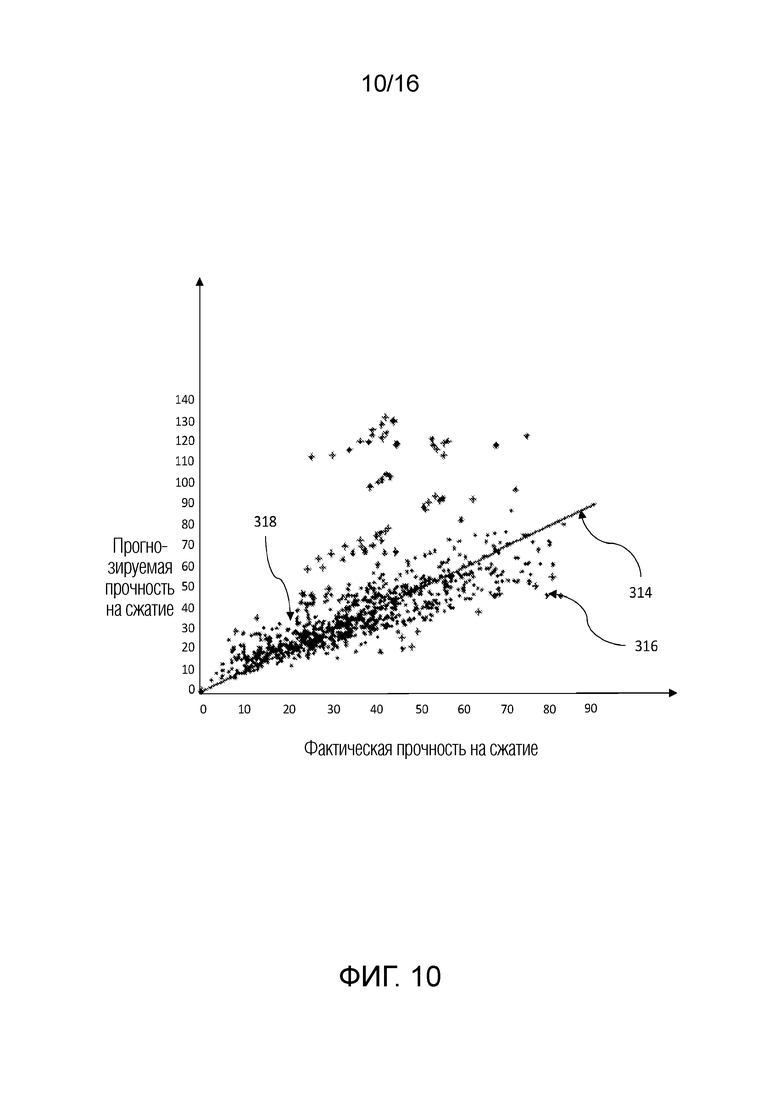

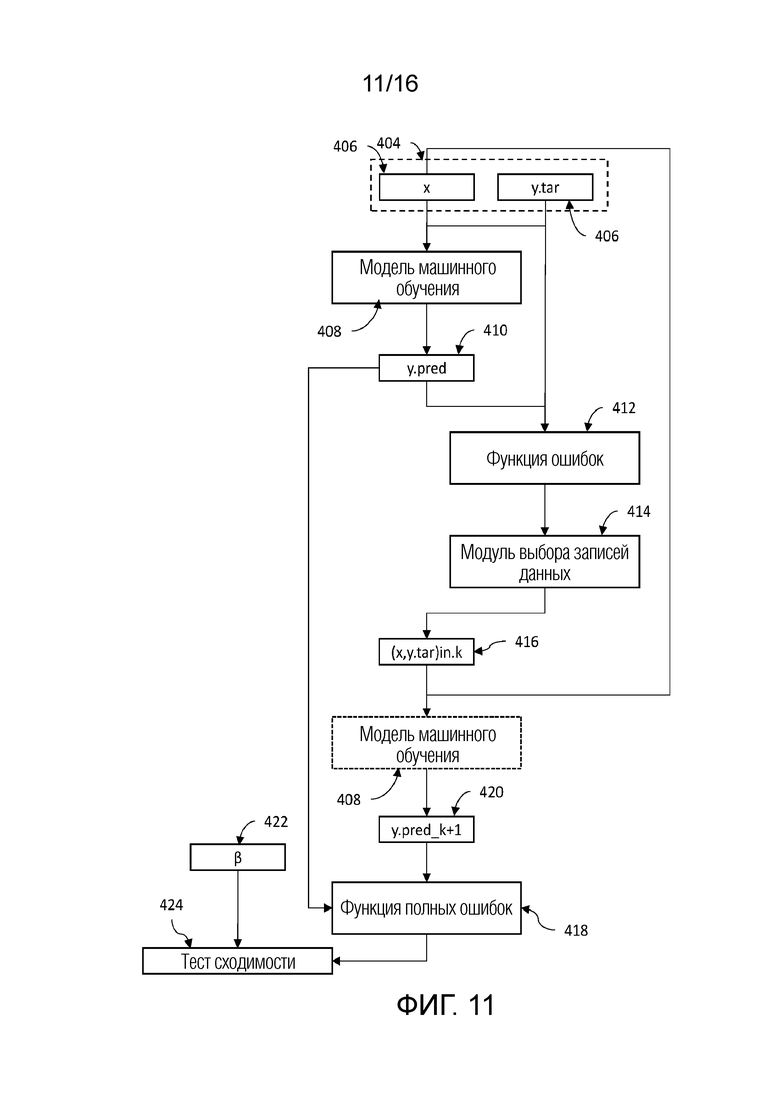

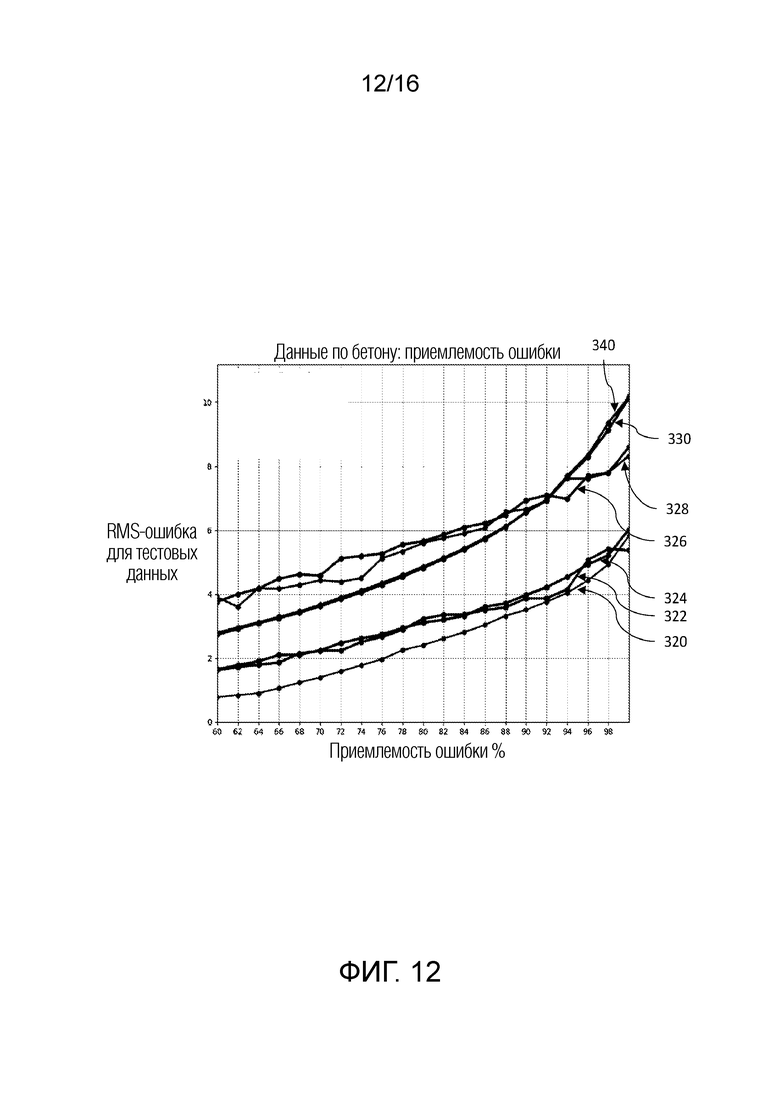

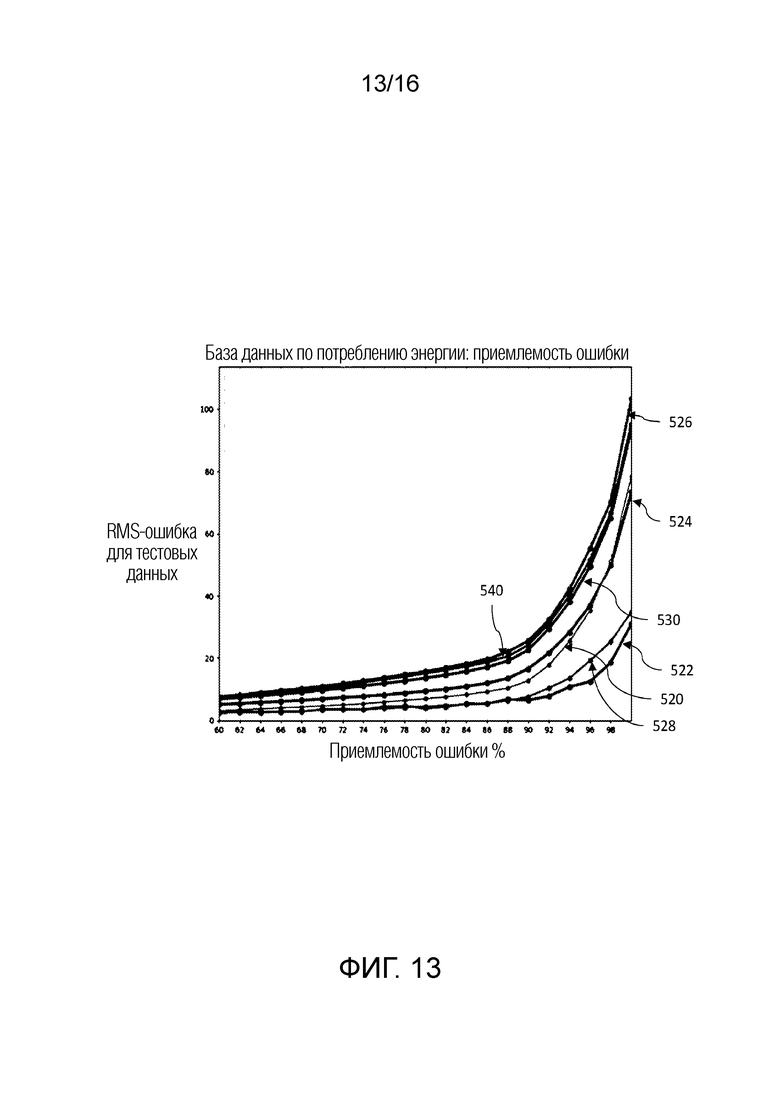

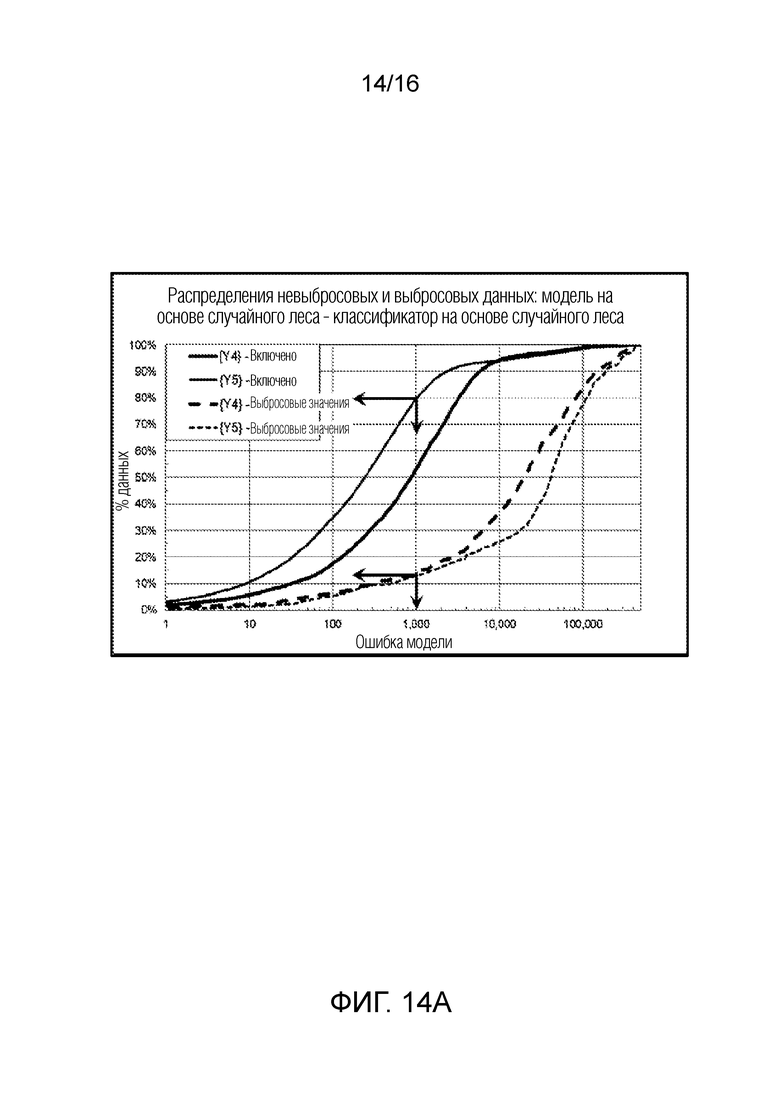

[0067] В качестве другого примера, механизм 301 DOBR может выполнять роботизированное управление машинным оборудованием на основе набора 311 данных результатов выполнения машинных команд управления и моделированных результатов машинных команд управления, в числе прочих факторов, как описано в патенте США № 10317854. Механизм 301 DOBR может вызывать набор регрессионных моделей из библиотеки 303 моделей через индекс 302 модели, соединенный с шиной механизма 301 DOBR. Затем механизм 301 DOBR может вызывать файл или журнал регистрации параметров, ассоциированный с регрессионной моделью для роботизированного управления в библиотеке 305 регрессионных параметров, соединенной с шиной механизма 301 DOBR. Затем механизм 301 DOBR может использовать процессор 307 для прогнозирования успешности или сбоя конкретных команд управления на основе моделей и параметров модели для набора команд управления, информации окружающей среды, данных датчиков и/или моделирований команд.