ОБЛАСТЬ ТЕХНИКИ, К КОТОРОЙ ОТНОСИТСЯ ИЗОБРЕТЕНИЕ

Настоящее изобретение относится, в общем, к вычислительной технике и, более конкретно, к системе обеспечения катастрофоустойчивости информационной инфраструктуры работающего приложения, а также к способам ее развертывания и функционирования.

УРОВЕНЬ ТЕХНИКИ

Повсеместная цифровизация производственных процессов привела к тому, что способность предприятия осуществлять свою деятельность напрямую зависит от работоспособности информационных систем и сервисов. Как следствие, задача обеспечения доступности соответствующих программных процессов и используемых ими данных становится критически важной, особенно для сценариев, когда инфраструктура информационных систем оказывается непригодной для дальнейшего использования, а сроки ее возврата к нормальному функционированию невозможно прогнозировать (например, вследствие стихийного бедствия, техногенной катастрофы или каких-либо иных факторов, имеющих масштабное влияние).

Традиционно вопросы готовности к такого рода ситуациям относят к сфере обеспечения катастрофоустойчивости информационных сервисов, понимая под этим комплекс технических и организационных мер, направленных на минимизацию влияния масштабных отказов инфраструктуры на деятельность предприятия и на контролируемое восстановление средств автоматизации. При этом подразумевается, что в силу масштабности отказов обеспечить полностью непрерывное функционирование приложений или технически невозможно, или экономически нецелесообразно, и, как следствие, допускаются некоторый простой приложения в течение заранее оговоренных временных рамок, которые могут быть охарактеризованы параметром RTO (Recovery Time Objective, целевое время восстановления), и частичная потеря данных, которая может быть охарактеризована параметром RPO (Recovery Point Objective, допустимый диапазон потери данных). Дополнительные пояснения касаемо целевых параметров катастрофоустойчивости RTO и RPO и их использования будут даны ниже.

Общепринятым подходом для решения задачи обеспечения катастрофоустойчивости приложения(й) является заблаговременная подготовка резервной инфраструктуры (в первую очередь, серверов и хранилищ данных) для исходной, основной инфраструктуры приложения и настройка механизма переноса данных с основной инфраструктуры на резервную. В зависимости от применяемых технических решений достигается различная степень синхронности основной и резервных инфраструктур, что непосредственно влияет на сроки готовности резервной инфраструктуры к активации и на ее пригодность к поддержанию деятельности предприятия в соответствии с целевыми характеристиками обеспечения катастрофоустойчивости (RTO и RPO). Однако, сложность решения связана с тем фактом, что современные приложения представляют собой многокомпонентные программно-аппаратные ландшафты, использующие различные технологические решения, для которых не существует единого способа создания резервных компонентов, поддержания их в актуальном состоянии в процессе нормального функционирования приложения на основной инфраструктуре и активации приложения на резервной инфраструктуре при отказе основной.

Конкретными практическими примерами подобных прикладных ландшафтов могут служить интернет-магазин, новостной портал-агрегатор, система обеспечения совместной работы пользователей, система комплексной автоматизации службы поддержки.

В соответствии с обобщенным иллюстративным примером, в состав информационной инфраструктуры приложения могут входить следующие компоненты:

подсистемы долговременного хранения и управления информацией в виде структурированных данных, включающие в себя одну или более баз данных, использующих в качестве базовой технологии некоторую реляционную СУБД (например, такую как PostgreSQL или Oracle DB) или no-SQL СУБД (например, такую как MongoDB или CouchDB);

подсистемы долговременного хранения информации в виде файлов, использующие в качестве базовой технологии файловые серверы или сервисы по управлению документами (например, такие как Microsoft SharePoint или NextCloud);

подсистемы накопления и аналитической обработки информации, использующие в качестве базовой технологии набор решений по консолидации, преобразованию и анализу данных из множества источников (например, такие как Hadoop, Informatica, Oralce BI);

подсистемы промежуточного кеширования данных, использующие некоторые in-memory хранилища данных (например, такие как Kafka, Redis или Tarantool);

разнообразные прикладные сервисы (например, программные компоненты, реализующие отдельные функции в составе сквозного бизнес-сервиса и в процессе своей работы могущие обращаться к другим подсистемам и/или прикладным сервисам), в том числе базирующиеся на микросервисных архитектурах;

подсистемы обеспечения взаимодействия конечных пользователей с приложением (например, Web-сервисы или сервисы приема и обработки вызовов API);

инфраструктурные сервисы (например, сервисные шины, подсистемы управления микросервисами, сервисы аутентификации и авторизации пользователей, службы каталогов, proxy-серверы, сервисы обеспечения информационной безопасности, сервисы мониторинга и т.п.).

Продолжая рассматриваемый обобщенный иллюстративный пример, информационно-технологическая инфраструктура, лежащая в основе такого многокомпонентного ландшафта приложения, может включать в себя:

платформы виртуализации и облачные платформы (например, такие как VMware ESXi, KVM, OpenStack, OpenNebula, Basis.Dynamix, AstraLinux Брест), предоставляющие вычислительные ресурсы для работы вышеперечисленных подсистем и программных компонентов;

физические серверы различных аппаратных архитектур, предоставляющие вычислительные ресурсы для работы вышеперечисленных подсистем и программных компонентов;

системы хранения данных (например, специализированные аппаратные системы хранения данных или программно-определяемые системы хранения данных), предоставляющие ресурсы хранения для вышеперечисленных подсистем и программных компонентов.

Для создания и поддержания актуальности резервных инфраструктурных компонентов в уровне техники предложен ряд технологических решений, применяемых в целях обеспечения катастрофоустойчивости приложений.

Так, репликация данных средствами специализированных систем хранения данных в определенных сценариях позволяет достичь почти идентичного состояния основной и резервной инфраструктур, однако не автоматизирует ни процедуры анализа и первичного создания резервной инфраструктуры, ни процесс переключения приложения как целостного информационного сервиса на резервную инфраструктуру, так как ограничена исключительно уровнем ресурсов хранения и не учитывает вышележащих слоев. Кроме того, такой подход требует идентичности аппаратных решений, применяемых в основной и резервных инфраструктурах, что не всегда приемлемо с технической или экономической точек зрения. Примерами подобного рода решений являются HPE StorageWorks Continuous Access, DELL VMAX SRDF.

Далее, решения, встроенные непосредственно в некоторый программный компонент ландшафта приложения, также способны обеспечивать почти идентичное состояние между такими компонентами в исходной и резервной инфраструктурах, частично автоматизируют как создание, так и переключение на резервный компонент, однако, ограничены только данным компонентом и сами по себе не обеспечивают согласованную защиту всего приложения, которое, как правило, состоит из множества разнообразных компонентов, некоторые из которых могут не иметь таких встроенных средств. Такие подходы, например, реализованы в Oracle DataGuard.

Решения на базе систем резервного копирования обеспечивают актуальность резервных копий только на некоторый момент времени в прошлом и характеризуются большей продолжительностью процесса активации резервной инфраструктуры по сравнению с другими решениями, что ограничивает их применимость для наиболее критичных с точки зрения производственного процесса приложений. Кроме того, они не автоматизируют ни анализ исходной инфраструктуры, ни создание резервной инфраструктуры, ни процедуры ее активации. В качестве примеров решений данного вида можно привести Veritas Netbackup, Veeam Backup & Replicator.

Затем, решения, встроенные в облачные платформы, способны обеспечивать почти идентичное состояние между исходной и резервной инфраструктурами и частично автоматизировать процедуру активации резервной инфраструктуры, однако существующие реализации ограничены платформой одного типа и не способны управлять гетерогенными конфигурациями, когда исходная и резервная инфраструктуры развернуты на разных платформах или используют разные технологии виртуализации. Подобного рода решения реализованы, в частности, в VMware Site Recovery Manager (SRM).

Наконец, решения для обеспечения мобильности серверов/прикладных сред позволяют достичь идентичности между исходной и резервной инфраструктурами на определенный момент во времени и в некоторых своих реализациях способны работать в гетерогенных конфигурациях, но не приспособлены для постоянного поддержания актуальности резервной инфраструктуры на протяжении длительного времени, что является неотъемлемым требованием обеспечения катастрофоустойчивости. Примерами таких решений могут служить Zerto или Double-Take Replication.

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

Задачей настоящего изобретения является создание технологий развертывания и соответствующего функционирования системы обеспечения катастрофоустойчивости работающего приложения, которые бы позволили избежать недостатков предшествующего уровня техники, обсужденных выше.

В контексте решения данной задачи, согласно первому аспекту настоящего изобретения предложен способ развертывания системы обеспечения катастрофоустойчивости в распределенной сетевой среде. Распределенная сетевая среда содержит по меньшей мере одну основную инфраструктуру приложения, реализованную на одном или более серверах основной инфраструктуры, при этом в каждой основной инфраструктуре приложения из по меньшей мере одной основной инфраструктуры приложения работает приложение, катастрофоустойчивость которого требуется обеспечить. Распределенная сетевая среда содержит мастер-контроллер системы обеспечения катастрофоустойчивости, реализованный на одном или более вычислительных устройствах. Предложенный способ содержит следующие этапы, выполняемые для каждой основной инфраструктуры приложения из по меньшей мере одной основной инфраструктуры приложения.

Конфигурируют в распределенной сетевой среде по меньшей мере одну резервную инфраструктуру для основной инфраструктуры приложения, причем резервная инфраструктура реализована на одном или более серверах резервной инфраструктуры.

В основной инфраструктуре приложения устанавливают и запускают подсистему системы обеспечения катастрофоустойчивости для основной инфраструктуры приложения (подсистему-источник) и в каждой резервной инфраструктуре из по меньшей мере одной резервной инфраструктуры устанавливают и запускают подсистему системы обеспечения катастрофоустойчивости для резервной инфраструктуры (подсистему-приемник).

Нижеследующие этапы предложенного способа осуществляются для каждой резервной инфраструктуры из по меньшей мере одной резервной инфраструктуры.

Посредством мастер-контроллера определяют один или более ресурсов хранения в основной инфраструктуре приложения, которые задействуются для работы приложения, для репликации в резервную инфраструктуру и, для каждого из определенных одного или более ресурсов хранения (ресурса-источника), выбирают в резервной инфраструктуре по меньшей мере один соответствующий ресурс хранения (ресурс-приемник), образуя репликационную пару из ресурса-источника и ресурса-приемника.

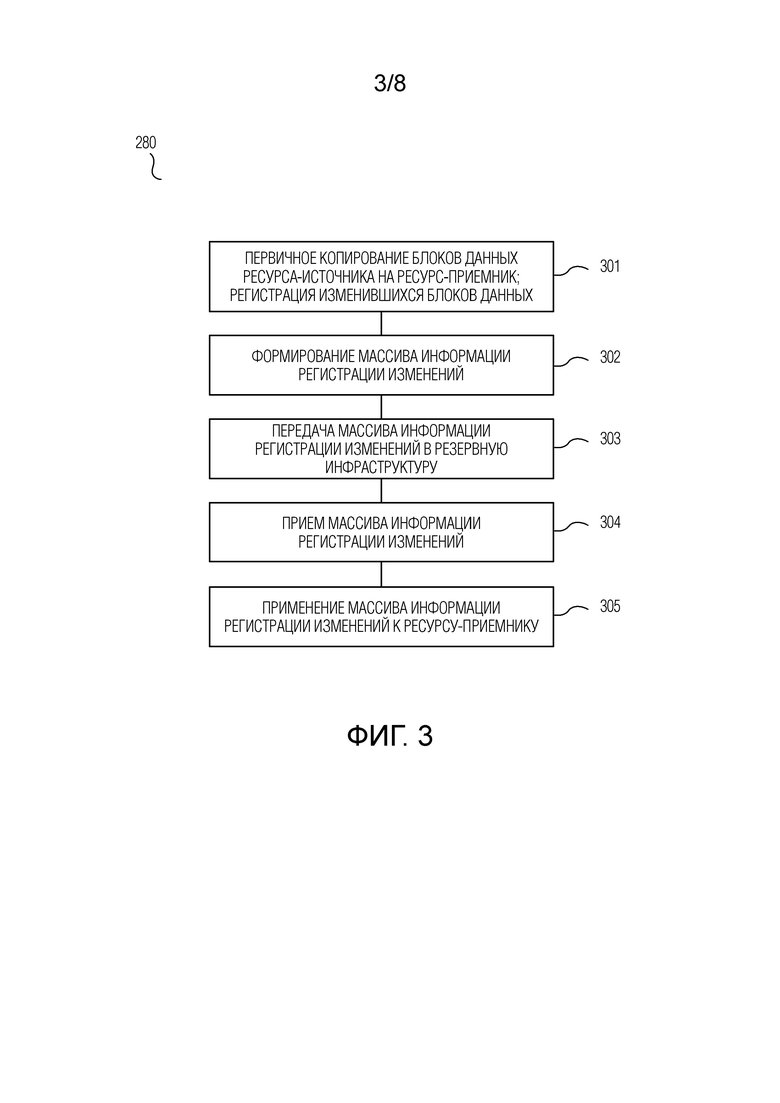

Для каждой репликационной пары, не останавливая работу приложения, выполняют предварительную репликацию данных с ресурса-источника на ресурс-приемник, при этом предварительная репликация данных содержит этапы, на которых: выполняют первичное копирование блоков данных ресурса-источника на ресурс-приемник; посредством подсистемы-источника выполняют регистрацию блоков данных ресурса-источника, подвергшихся изменению после начала первичного копирования, и, по завершении первичного копирования, формируют массив информации регистрации изменений в отношении зарегистрированных блоков данных и передают сформированный массив информации регистрации изменений в резервную инфраструктуру; и посредством подсистемы-приемника осуществляют запись на ресурс-приемник блоков данных с использованием принятого массива информации регистрации изменений.

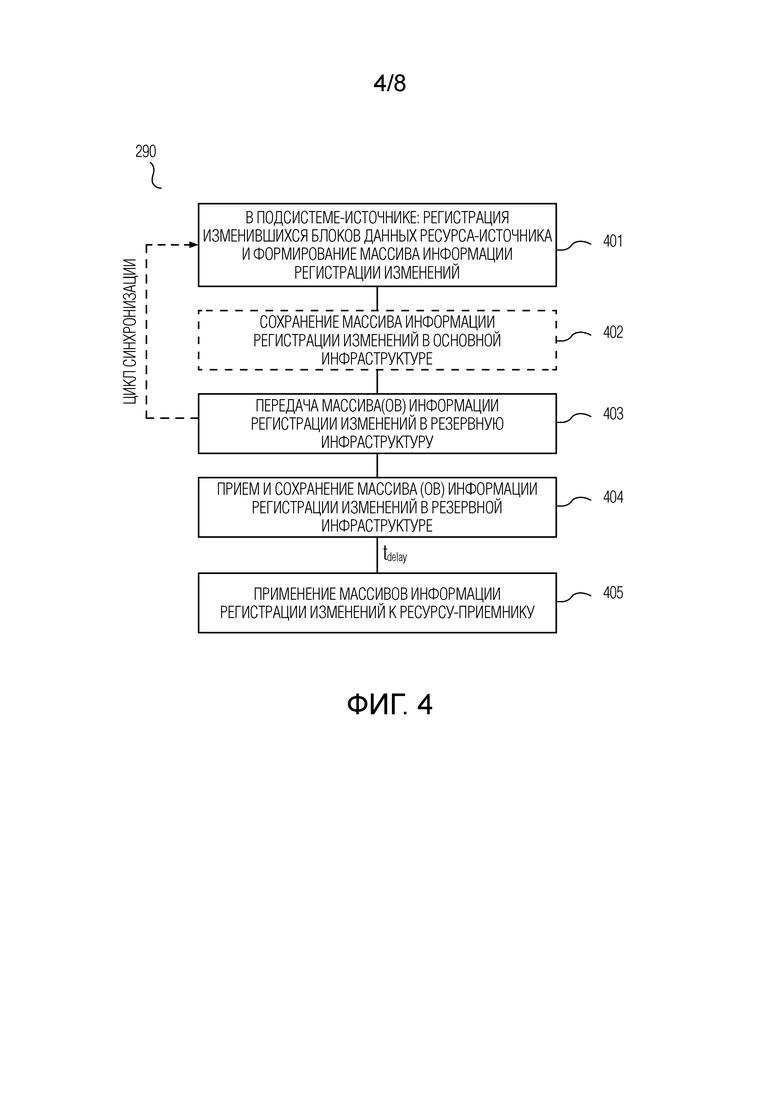

Для каждой репликационной пары, не останавливая работу приложения, выполняют циклы синхронизации, при этом каждый цикл синхронизации содержит этапы, на которых: в течение каждого интервала регистрации изменений из одного или более интервалов регистрации изменений, посредством подсистемы-источника выполняют регистрацию блоков данных ресурса-источника, подвергшихся изменению после начала интервала регистрации изменений, и, по истечении интервала регистрации изменений, формируют массив информации регистрации изменений в отношении зарегистрированных блоков данных; передают сформированные один или более массивов информации регистрации изменений в резервную инфраструктуру и сохраняют один или более массивов информации регистрации изменений в резервной инфраструктуре; и посредством подсистемы-приемника осуществляют запись на ресурс-приемник блоков данных с использованием массивов информации регистрации изменений, сохраненных в резервной инфраструктуре.

В соответствии с вариантом осуществления, предложенный способ дополнительно содержит, перед конфигурированием по меньшей мере одной резервной инфраструктуры, этапы, на которых, с использованием мастер-контроллера: получают информацию о технических характеристиках и настройках одного или более серверов основной инфраструктуры посредством установки и запуска специализированных служебных утилит на каждом из одного или более серверов основной инфраструктуры; и определяют параметры, характеризующие ресурсные потребности основной инфраструктуры приложения, с использованием полученной информации о технических характеристиках и настройках одного или более серверов основной инфраструктуры.

Упомянутые один или более серверов основной инфраструктуры могут представлять собой множество серверов основной инфраструктуры, и один или более из множества серверов основной инфраструктуры могут быть виртуальными серверами, реализованными посредством виртуальных машин, при этом получение информации о технических характеристиках и настройках серверов основной инфраструктуры согласно данному варианту осуществления осуществляется посредством обращения к API гипервизоров, обеспечивающих работу виртуальных машин.

Согласно одному варианту осуществления, конфигурирование по меньшей мере одной резервной инфраструктуры содержит этапы, на которых: получают информацию о технических характеристиках и настройках каждого из совокупности серверов в распределенной сетевой среде, которые могут быть использованы для по меньшей мере одной резервной инфраструктуры, посредством установки и запуска специализированных служебных утилит на каждом из совокупности серверов; и выполняют исходное конфигурирование одного или более из совокупности серверов для по меньшей мере одной резервной инфраструктуры на основе анализа, по меньшей мере, упомянутых параметров ресурсных потребностей основной инфраструктуры приложения и полученной информации о технических характеристиках и настройках совокупности серверов.

Согласно другому варианту осуществления, исходное конфигурирование одного или более серверов резервной инфраструктуры для основной инфраструктуры приложения выполнено заблаговременно, и при упомянутом конфигурировании по меньшей мере одной резервной инфраструктуры получают информацию о технических характеристиках и настройках одного или более серверов резервной инфраструктуры посредством установки и запуска специализированных служебных утилит на каждом из одного или более серверов резервной инфраструктуры.

Каждый из одного или более серверов резервной инфраструктуры до активации резервной инфраструктуры в качестве основной инфраструктуры приложения предпочтительно функционирует под управлением временной операционной системы, запущенной в режиме boot-to-RAM.

В соответствии с вариантом осуществления, предложенный способ дополнительно содержит этапы, на которых, перед упомянутыми установкой и запуском подсистемы-источника и подсистемы-приемника: выполняют оценку достижимости целевых характеристик обеспечения катастрофоустойчивости, предварительно заданных в мастер-контроллере, на основе упомянутой информации о технических характеристиках и настройках одного или более серверов основной инфраструктуры, упомянутых параметров ресурсных потребностей основной инфраструктуры приложения и информации о технических характеристиках и настройках одного или более серверов резервной инфраструктуры; и выполняют корректировку по меньшей мере одной из целевых характеристик обеспечения катастрофоустойчивости, если в результате оценки установлена недостижимость этой по меньшей мере одной целевой характеристики обеспечения катастрофоустойчивости, при этом целевые характеристики обеспечения катастрофоустойчивости содержат параметр RTO и параметр RPO, причем по меньшей мере один из параметра RTO и параметра RPO является индивидуальным для каждого сочетания «основная инфраструктура приложения - резервная инфраструктура».

Согласно варианту осуществления, конфигурирование по меньшей мере одной резервной инфраструктуры содержит этапы, на которых: конфигурируют правила автоматического преобразования настроек сетевых интерфейсов на одном или более серверах резервной инфраструктуры на случай активации резервной инфраструктуры в качестве основной инфраструктуры приложения; и/или конфигурируют правила автоматического изменения системных настроек операционной системы каждого из одного или более серверов резервной инфраструктуры на случай активации резервной инфраструктуры в качестве основной инфраструктуры приложения; и/или конфигурируют зависящие от приложения правила, причем данное конфигурирование содержит задание одной или более контрольных точек для приложения, в каждой из которых в резервной инфраструктуре может быть запущен соответствующий пользовательский исполняемый сценарий для выполнения действий, специфических для приложения, в целях дополнительного обеспечения целостности данных приложения на случай активации резервной инфраструктуры в качестве основной инфраструктуры приложения.

В соответствии с предпочтительным вариантом осуществления, для выполнения регистрации блоков данных ресурса-источника, подвергшихся изменению, при выполнении предварительной репликации и выполнении циклов синхронизации используются CBT-журналы и COW-журналы, а каждый массив информации регистрации изменений содержит stash-файл.

Согласно предпочтительному варианту осуществления, предварительная репликация дополнительно содержит этап, на котором, перед выполнением первичного копирования данных, в подсистеме-источнике открывают первый CBT-журнал, при этом, при выполнении предварительной репликации, выполняются следующие действия. Упомянутое выполнение регистрации содержит этапы, на которых: регистрируют информацию о блоках данных ресурса-источника, подвергшихся изменению во время первичного копирования, в первом CBT-журнале; в момент завершения первичного копирования, закрывают первый CBT-журнал и открывают второй COW-журнал и второй CBT-журнал; регистрируют блоки данных ресурса-источника, подвергшиеся изменению, во втором COW-журнале и втором CBT-журнале. Упомянутое формирование массива информации регистрации изменений содержит этапы, на которых: создают stash-файл и для каждого блока данных ресурса-источника, который в закрытом первом CBT-журнале помечен как подвергшийся изменению: проверяют, помечен ли блок данных как подвергшийся изменению во втором CBT-журнале; если это так, соответственно записывают в созданный stash-файл содержимое блока данных из второго COW-журнала, в противном случае соответственно записывают в созданный stash-файл текущее содержимое блока данных с ресурса-источника. При упомянутом осуществлении записи на ресурс-приемник применяют принятый stash-файл к ресурсу-приемнику.

Согласно предпочтительному варианту осуществления, при выполнении циклов синхронизации, для каждого текущего интервала регистрации изменений, выполняются следующие действия. Упомянутое выполнение регистрации содержит этапы, на которых: открывают текущий COW-журнал и текущий CBT-журнал; регистрируют блоки данных ресурса-источника, подвергшиеся изменению после начала текущего интервала регистрации изменений, в текущем COW-журнале и текущем CBT-журнале. Упомянутое формирование массива информации регистрации содержит этапы, на которых: создают stash-файл и для каждого блока данных ресурса-источника, который помечен в CBT-журнале, закрытом по истечении предыдущего интервала регистрации изменений, как подвергшийся изменению: проверяют, помечен ли блок данных как подвергшийся изменению в текущем CBT-журнале; если это так, соответственно записывают в созданный stash-файл содержимое блока данных из текущего COW-журнала, в противном случае соответственно записывают в созданный stash-файл текущее содержимое блока данных с ресурса-источника. Упомянутое выполнение регистрации дополнительно содержит этап, на котором, по истечении текущего интервала регистрации изменений, закрывают текущий COW-журнал и текущий CBT-журнал. При упомянутом осуществлении записи на ресурс-приемник последовательно применяют stash-файлы, сохраненные в резервной инфраструктуре, к ресурсу-приемнику. Длительность интервала регистрации изменений предпочтительно определяется параметром RPO. Упомянутое осуществление записи на ресурс-приемник блоков данных с использованием сохраненных массивов информации регистрации изменений предпочтительно выполняется с задержкой после упомянутого сохранения одного или более массивов информации регистрации изменений в резервной инфраструктуре, причем задержка является заранее заданной в мастер-контроллере.

Согласно варианту осуществления, при выполнении циклов синхронизации, анализируют достижимость параметра RPO на основе темпа передачи сформированных массивов информации регистрации изменений из основной инфраструктуры приложения в резервную инфраструктуру и, в случае обнаружения недостижимости параметра RPO, выдают в мастер-контроллер сообщение о недостижимости RPO; и анализируют достижимость параметра RTO на основе упомянутой задержки и темпа применения сохраненных массивов информации регистрации к ресурсу-приемнику и, в случае обнаружения недостижимости параметра RTO, выдают в мастер-контроллер сообщение о недостижимости RTO.

В соответствии со вторым аспектом настоящего изобретения, предложена система обеспечения катастрофоустойчивости, развернутая в распределенной сетевой среде, содержащей основную инфраструктуру приложения, реализованную на одном или более серверах основной инфраструктуры, причем в основной инфраструктуре приложения работает приложение, катастрофоустойчивость которого требуется обеспечить. Для основной инфраструктуры приложения сконфигурирована резервная инфраструктура, реализованная на одном или более серверах резервной инфраструктуры в распределенной сетевой среде. Каждый из одного или более серверов резервной инфраструктуры предпочтительно функционирует под управлением временной операционной системы, запущенной в режиме boot-to-RAM.

Предложенная система обеспечения катастрофоустойчивости содержит: мастер-контроллер, реализованный на одном или более вычислительных устройствах распределенной сетевой среды; подсистему для основной инфраструктуры приложения (подсистему-источник), функционирующую в основной инфраструктуре приложения; и подсистему для резервной инфраструктуры (подсистему-приемник), функционирующую в резервной инфраструктуре.

Мастер-контроллер выполнен с возможностью определять один или более ресурсов хранения в основной инфраструктуре приложения, которые задействуются для работы приложения, для репликации в резервную инфраструктуру и, для каждого из определенных одного или более ресурсов хранения (ресурса-источника), выбирать в резервной инфраструктуре по меньшей мере один соответствующий ресурс хранения (ресурс-приемник), образуя репликационную пару из ресурса-источника и ресурса-приемника.

Подсистема-источник содержит: хост-контроллер подсистемы-источника, выполненный с возможностью взаимодействия с мастер-контроллером, диспетчер репликационной пары подсистемы-источника и компоненты репликации подсистемы-источника под управлением диспетчера репликационной пары подсистемы-источника. На каждом из одного или более серверов основной инфраструктуры, который содержит один или более ресурсов-источников соответствующих репликационных пар, запущен экземпляр хост-контроллера подсистемы-источника, для каждой из этих соответствующих репликационных пар запущен экземпляр диспетчера репликационной пары подсистемы-источника, который находится на связи с экземпляром хост-контроллера подсистемы-источника, и для каждого экземпляра диспетчера репликационной пары подсистемы-источника запущен соответствующий экземпляр компонентов репликации подсистемы-источника.

Подсистема-приемник содержит: хост-контроллер подсистемы-приемника, выполненный с возможностью взаимодействия с мастер-контроллером, диспетчер репликационной пары подсистемы-приемника и компоненты репликации подсистемы-приемника под управлением диспетчера репликационной пары подсистемы-приемника. На каждом из одного или более серверов резервной инфраструктуры, который содержит один или более ресурсов-приемников соответствующих репликационных пар, запущен экземпляр хост-контроллера подсистемы-приемника, для каждой из этих соответствующих репликационных пар запущен экземпляр диспетчера репликационной пары подсистемы-приемника, который находится на связи с экземпляром хост-контроллера подсистемы-приемника, и для каждого экземпляра диспетчера репликационной пары подсистемы-приемника запущен соответствующий экземпляр компонентов репликации подсистемы-приемника.

Экземпляр диспетчера репликационной пары подсистемы-источника, соответствующий экземпляр компонентов репликации подсистемы-источника, экземпляр диспетчера репликационной пары подсистемы-приемника и соответствующий экземпляр компонентов репликации подсистемы-приемника, запущенные для каждой репликационной пары, выполнены с возможностью осуществлять, не останавливая работу приложения, следующие операции.

Выполняется предварительная репликация данных с ресурса-источника на ресурс-приемник, содержащая: первичное копирование блоков данных ресурса-источника на ресурс-приемник; регистрацию блоков данных ресурса-источника, подвергшихся изменению после начала первичного копирования, и, по завершении первичного копирования, формирование массива информации регистрации изменений в отношении зарегистрированных блоков данных и передачу сформированного массива информации регистрации изменений в резервную инфраструктуру; и запись на ресурс-приемник блоков данных с использованием принятого массива информации регистрации изменений.

Выполняются циклы синхронизации, при этом каждый цикл синхронизации содержит: в течение каждого интервала регистрации изменений из одного или более интервалов регистрации изменений, регистрацию блоков данных ресурса-источника, подвергшихся изменению после начала интервала регистрации изменений, и, по истечении интервала регистрации изменений, формирование массива информации регистрации изменений в отношении зарегистрированных блоков данных; передачу сформированных одного или более массивов информации регистрации изменений в резервную инфраструктуру и сохранение одного или более массивов информации регистрации изменений в резервной инфраструктуре; и запись на ресурс-приемник блоков данных с использованием массивов информации регистрации изменений, сохраненных в резервной инфраструктуре.

Согласно предпочтительному варианту осуществления, для каждой репликационной пары экземпляр диспетчера репликационной пары подсистемы-источника и экземпляр диспетчера репликационной пары подсистемы-приемника выполнены с возможностью непосредственного взаимодействия друг с другом.

Согласно варианту осуществления, компоненты репликации подсистемы-источника содержат, по меньшей мере: средство обнаружения изменений, средство формирования истории изменений и средство передачи. Для каждой репликационной пары: соответствующий экземпляр средства обнаружения изменений выполнен с возможностью отслеживать операции ввода-вывода на ресурсе-источнике и выполнять регистрацию происходящих изменений блоков данных; соответствующий экземпляр средства формирования истории изменений выполнен с возможностью формировать массивы информации регистрации изменений на основе регистрации, выполненной экземпляром средства обнаружения изменений; и соответствующий экземпляр средства передачи выполнен с возможностью осуществлять передачу массивов информации регистрации изменений в резервную инфраструктуру.

В соответствии с вариантом осуществления, компоненты репликации подсистемы-приемника содержат, по меньшей мере: средство приема и средство применения изменений. Для каждой репликационной пары: соответствующий экземпляр средства приема выполнен с возможностью осуществлять прием массивов информации регистрации изменений от средства приема подсистемы-источника и обеспечивать сохранение принятых массивов информации регистрации изменений в резервной инфраструктуре; и соответствующий экземпляр средства применения изменений выполнен с возможностью обрабатывать массивы информации регистрации изменений и применять их к ресурсу-приемнику для записи соответствующих блоков данных на ресурс-приемник.

Согласно варианту осуществления, подсистема-источник дополнительно содержит хранилище истории изменений подсистемы-источника для сохранения массивов информации регистрации изменений перед их передачей, и/или подсистема-приемник дополнительно содержит хранилище истории изменений подсистемы-приемника для сохранения принимаемых массивов информации регистрации изменений перед их применением.

Согласно одному варианту осуществления, экземпляры хост-контроллера подсистемы-источника, диспетчера репликационной пары подсистемы-источника и компонентов репликации подсистемы-источника, установленные на соответствующем сервере основной инфраструктуры, реализованы посредством машиноисполняемых процессов, функционирующих на уровне операционной системы этого сервера, и/или экземпляры хост-контроллера подсистемы-приемника, диспетчера репликационной пары подсистемы-приемника и компонентов репликации подсистемы-приемника, установленные на соответствующем сервере резервной инфраструктуры, реализованы посредством машиноисполняемых процессов, функционирующих на уровне операционной системы этого сервера.

В соответствии с другим вариантом осуществления, экземпляры хост-контроллера подсистемы-источника, диспетчера репликационной пары подсистемы-источника и компонентов репликации подсистемы-источника реализованы посредством машиноисполняемых процессов, функционирующих в специализированной аппаратной плате, устанавливаемой в соответствующий сервер основной инфраструктуры, изолированно от операционной системы этого сервера, причем машиноисполняемые процессы выполнены с возможностью перехватывать обращения к ресурсам-источникам, инициируемые на уровне процессов операционной системы, и/или экземпляры хост-контроллера подсистемы-приемника, диспетчера репликационной пары подсистемы-приемника и компонентов репликации подсистемы-приемника реализованы посредством машиноисполняемых процессов, функционирующих в специализированной аппаратной плате, устанавливаемой в соответствующий сервер резервной инфраструктуры, изолированно от операционной системы этого сервера, причем машиноисполняемые процессы выполнены с возможностью перехватывать обращения к ресурсам-приемникам, инициируемые на уровне процессов операционной системы. Согласно данному варианту осуществления, хранилище истории изменений подсистемы-источника может быть реализовано на специализированной аппаратной плате, устанавливаемой в соответствующий сервер основной инфраструктуры, и/или хранилище истории изменений подсистемы-приемника может быть реализовано на специализированной аппаратной плате, устанавливаемой в соответствующий сервер резервной инфраструктуры.

Согласно еще одному варианту осуществления, упомянутые один или более серверов основной инфраструктуры представляют собой множество серверов основной инфраструктуры, причем один или более из множества серверов основной инфраструктуры являются виртуальными серверами, реализованными посредством виртуальных машин, при этом соответствующие экземпляры хост-контроллера подсистемы-источника, диспетчера репликационной пары подсистемы-источника и компонентов репликации подсистемы-источника реализованы посредством машиноисполняемых процессов, функционирующих на уровне гипервизоров, обеспечивающих работу виртуальных машин; и/или упомянутые один или более серверов резервной инфраструктуры представляют собой множество серверов резервной инфраструктуры, причем один или более из множества серверов резервной инфраструктуры являются виртуальными серверами, реализованными посредством виртуальных машин, при этом соответствующие экземпляры хост-контроллера подсистемы-приемника, диспетчера репликационной пары подсистемы-приемника и компонентов репликации подсистемы-приемника реализованы посредством машиноисполняемых процессов, функционирующих на уровне гипервизоров, обеспечивающих работу виртуальных машин.

Резервная инфраструктура может быть активирована в качестве основной инфраструктуры приложения по приему в подсистеме-приемнике соответствующей команды от мастер-контроллера. Согласно возможной реализации, перед указанной активацией резервной инфраструктуры приостанавливается выполнение циклов синхронизации в основной инфраструктуре приложения и в резервной инфраструктуре и останавливается работа приложения в основной инфраструктуре приложения.

Согласно третьему аспекту настоящего изобретения, предложен способ функционирования системы обеспечения катастрофоустойчивости, развернутой в распределенной сетевой среде. Распределенная сетевая среда содержит основную инфраструктуру приложения, реализованную на одном или более серверах основной инфраструктуры, причем в основой инфраструктуре приложения работает приложение, катастрофоустойчивость которого требуется обеспечить. Для основной инфраструктуры приложения сконфигурирована резервная инфраструктура, реализованная на одном или более серверах резервной инфраструктуры в распределенной сетевой среде. Система обеспечения катастрофоустойчивости содержит: мастер-контроллер, реализованный на одном или более вычислительных устройствах распределенной сетевой среды; подсистему для основной инфраструктуры приложения (подсистему-источник), функционирующую в первой инфраструктуре; и подсистему для резервной инфраструктуры (подсистему-приемник), функционирующую в резервной инфраструктуре. Посредством мастер-контроллера в основной инфраструктуре приложения и резервной инфраструктуре определены репликационные пары путем выбора, для каждого из одного или более ресурсов хранения, которые задействуются для работы приложения в основной инфраструктуре приложения (ресурса-источника), соответствующего ресурса хранения в резервной инфраструктуре (ресурса-приемника), с образованием репликационной пары из ресурса-источника и ресурса-приемника, причем для каждой репликационной пары выполнена предварительная репликация данных с ресурса-источника на ресурс-приемник.

Предложенный способ содержит следующие этапы, выполняемые для каждой репликационной пары, не останавливая работу приложения.

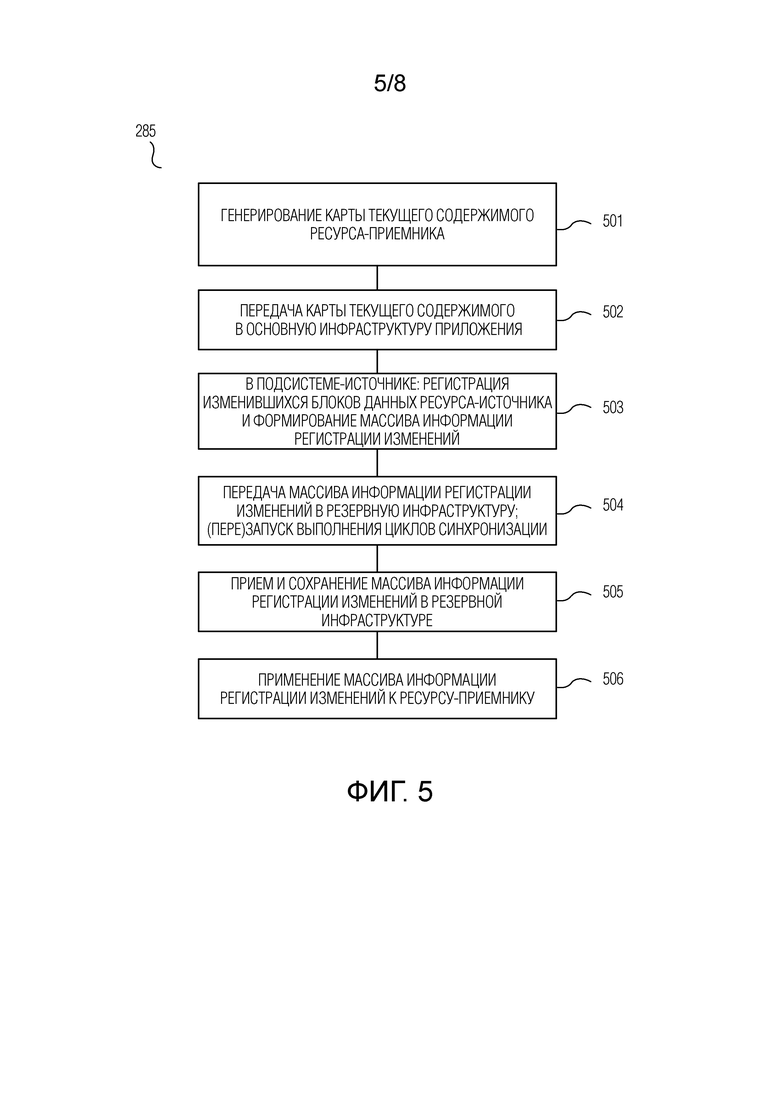

Выполняют частичную ресинхронизацию данных ресурса-источника и ресурса-приемника. Частичная ресинхронизация содержит этапы, на которых: посредством подсистемы-приемника генерируют карту текущего содержимого ресурса-приемника и передают карту текущего содержимого ресурса-приемника в подсистему-источник; по приему карты текущего содержимого ресурса-приемника, посредством подсистемы-источника выполняют регистрацию блоков данных ресурса-источника, подвергшихся изменению, формируют массив информации регистрации изменений на основе карты текущего содержимого ресурса-приемника и зарегистрированных блоков данных и передают сформированный массив информации регистрации изменений в резервную инфраструктуру; сохраняют массив информации регистрации изменений в резервной инфраструктуре; и посредством подсистемы-приемника осуществляют запись на ресурс-приемник блоков данных с использованием сохраненного массива информации регистрации изменений.

Выполняют циклы синхронизации, при этом каждый цикл синхронизации содержит этапы, на которых: по завершении упомянутой передачи массива информации регистрации изменений, сформированного при частичной ресинхронизации, в течение каждого интервала регистрации изменений из одного или более интервалов регистрации изменений, посредством подсистемы-источника выполняют регистрацию блоков данных ресурса-источника, подвергшихся изменению после начала интервала регистрации изменений, и, по истечении интервала регистрации изменений, формируют массив информации регистрации изменений в отношении зарегистрированных блоков данных; передают сформированные один или более массивов информации регистрации изменений в резервную инфраструктуру и сохраняют один или более массивов информации регистрации изменений в резервной инфраструктуре; и после завершения упомянутой записи блоков данных при частичной ресинхронизации, посредством подсистемы-приемника осуществляют запись на ресурс-приемник блоков данных с использованием массивов информации регистрации изменений, сохраненных в резервной инфраструктуре.

Согласно варианту осуществления, формирование карты текущего содержимого ресурса-приемника содержит этапы, на которых в системе-приемнике: для каждого блока данных ресурса-приемника в соответствии с заранее заданным алгоритмом вычисляют уникальный идентификатор на основе содержимого этого блока данных и записывают результаты вычислений в файл, причем данный файл представляет карту текущего содержимого ресурса-приемника. При передаче карты текущего содержимого ресурса-приемника в подсистему-источник передают упомянутый файл. В качестве упомянутого заранее заданного алгоритма может использоваться алгоритм вычисления хеш-суммы содержимого блока данных.

В соответствии с предпочтительным вариантом осуществления, для выполнения регистрации блоков данных ресурса-источника, подвергшихся изменению, при выполнении частичной ресинхронизации и выполнении циклов синхронизации используются CBT-журналы и COW-журналы, а каждый массив информации регистрации изменений содержит stash-файл.

Согласно предпочтительному варианту осуществления, при выполнении частичной ресинхронизации выполняются следующие действия. Упомянутое выполнение регистрации содержит этапы, на которых: открывают COW-журнал и CBT-журнал и регистрируют блоки данных ресурса-источника, подвергшиеся изменению, в COW-журнале и CBT-журнале. Упомянутое формирование массива информации регистрации изменений содержит этапы, на которых: создают stash-файл; и, для каждого блока данных ресурса-источника, проверяют, помечен ли блок данных ресурса-источника как подвергшийся изменению в CBT-журнале, если это так, берут содержимое блока данных ресурса-источника из COW-журнала, в противном случае берут содержимое блока данных ресурса-источника с ресурса-источника, в соответствии с упомянутым заранее заданным алгоритмом вычисляют уникальный идентификатор блока данных ресурса-источника на основе содержимого этого блока данных, если вычисленный уникальный идентификатор блока данных ресурса-источника отличается от уникального идентификатора соответствующего блока данных ресурса-приемника согласно принятому файлу карты текущего содержимого ресурса-приемника, соответственно записывают содержимое блока данных ресурса-источника в stash-файл.

В соответствии с предпочтительным вариантом осуществления, при выполнении циклов синхронизации выполняются следующие действия, для каждого текущего интервала регистрации изменений. Упомянутое выполнение регистрации содержит этапы, на которых: открывают текущий COW-журнал и текущий CBT-журнал; регистрируют блоки данных ресурса-источника, подвергшиеся изменению после начала текущего интервала регистрации изменений, в текущем COW-журнале и текущем CBT-журнале. Упомянутое формирование массива информации регистрации содержит этапы, на которых: создают stash-файл; и для каждого блока данных ресурса-источника, который помечен в CBT-журнале, закрытом по истечении предыдущего интервала регистрации изменений, как подвергшийся изменению: проверяют, помечен ли блок данных как подвергшийся изменению в текущем CBT-журнале, если это так, соответственно записывают в созданный stash-файл содержимое блока данных из текущего COW-журнала, в противном случае соответственно записывают в созданный stash-файл текущее содержимое блока данных с ресурса-источника Упомянутое выполнение регистрации дополнительно содержит этап, на котором, по истечении текущего интервала регистрации изменений, закрывают текущий COW-журнал и текущий CBT-журнал. При упомянутом осуществлении записи на ресурс-приемник последовательно применяют stash-файлы, сохраненные в резервной инфраструктуре, к ресурсу-приемнику.

В соответствии с четвертым аспектом настоящего изобретения, предложена система обеспечения катастрофоустойчивости, развернутая в распределенной сетевой среде, содержащей основную инфраструктуру приложения, реализованную на одном или более серверах основной инфраструктуры, причем в основной инфраструктуре приложения работает приложение, катастрофоустойчивость которого требуется обеспечить. Для основной инфраструктуры приложения сконфигурирована резервная инфраструктура, реализованная на одном или более серверах резервной инфраструктуры в распределенной сетевой среде.

Предложенная система обеспечения катастрофоустойчивости содержит: мастер-контроллер, реализованный на одном или более вычислительных устройствах распределенной сетевой среды; подсистему для основной инфраструктуры приложения (подсистему-источник), функционирующую в основной инфраструктуре приложения; и подсистему для резервной инфраструктуры (подсистему-приемник), функционирующую в резервной инфраструктуре. Посредством мастер-контроллера в основной инфраструктуре приложения и резервной инфраструктуре определены репликационные пары путем выбора, для каждого из одного или более ресурсов хранения, которые задействуются для работы приложения в основной инфраструктуре приложения (ресурса-источника), соответствующего ресурса хранения в резервной инфраструктуре (ресурса-приемника), с образованием репликационной пары из ресурса-источника и ресурса-приемника, причем для каждой репликационной пары выполнена предварительная репликация данных с ресурса-источника на ресурс-приемник.

Подсистема-источник содержит: хост-контроллер подсистемы-источника, выполненный с возможностью взаимодействия с мастер-контроллером; диспетчер репликационной пары подсистемы-источника; и компоненты репликации подсистемы-источника под управлением диспетчера репликационной пары подсистемы-источника. На каждом из одного или более серверов основной инфраструктуры, который содержит один или более ресурсов-источников соответствующих репликационных пар, запущен экземпляр хост-контроллера подсистемы-источника, для каждой из этих соответствующих репликационных пар запущен экземпляр диспетчера репликационной пары подсистемы-источника, который находится на связи с экземпляром хост-контроллера подсистемы-источника, и для каждого экземпляра диспетчера репликационной пары подсистемы-источника запущен соответствующий экземпляр компонентов репликации подсистемы-источника.

Подсистема-приемник содержит: хост-контроллер подсистемы-приемника, выполненный с возможностью взаимодействия с мастер-контроллером; диспетчер репликационной пары подсистемы-приемника; и компоненты репликации подсистемы-приемника под управлением диспетчера репликационной пары подсистемы-приемника. На каждом из одного или более серверов резервной инфраструктуры, который содержит один или более ресурсов-приемников соответствующих репликационных пар, запущен экземпляр хост-контроллера подсистемы-приемника, для каждой из этих соответствующих репликационных пар запущен экземпляр диспетчера репликационной пары подсистемы-приемника, который находится на связи с экземпляром хост-контроллера подсистемы-приемника, и для каждого экземпляра диспетчера репликационной пары подсистемы-приемника запущен соответствующий экземпляр компонентов репликации подсистемы-приемника.

Экземпляр диспетчера репликационной пары подсистемы-источника, соответствующий экземпляр компонентов репликации подсистемы-источника, экземпляр диспетчера репликационной пары подсистемы-приемника и соответствующий экземпляр компонентов репликации подсистемы-приемника, запущенные для каждой репликационной пары, выполнены с возможностью осуществлять, не останавливая работу приложения, следующие операции.

Выполняется частичная ресинхронизация данных ресурса-источника и ресурса-приемника, содержащая: генерирование карты текущего содержимого ресурса-приемника и передачу карты текущего содержимого ресурса-приемника в подсистему-источник; по приему карты текущего содержимого ресурса-приемника, регистрацию блоков данных ресурса-источника, подвергшихся изменению, формирование массива информации регистрации изменений на основе карты текущего содержимого ресурса-приемника и зарегистрированных блоков данных и передачу сформированного массива информации регистрации изменений в резервную инфраструктуру; сохранение массива информации регистрации изменений в резервной инфраструктуре; и осуществление записи на ресурс-приемник блоков данных с использованием сохраненного массива информации регистрации изменений.

Выполняются циклы синхронизации, при этом каждый цикл синхронизации содержит: по завершении упомянутой передачи массива информации регистрации изменений, сформированного при частичной ресинхронизации, в течение каждого интервала регистрации изменений из одного или более интервалов регистрации изменений, выполнение регистрации блоков данных ресурса-источника, подвергшихся изменению после начала интервала регистрации изменений, и, по истечении интервала регистрации изменений, формирование массива информации регистрации изменений в отношении зарегистрированных блоков данных; передачу сформированных одного или более массивов информации регистрации изменений в резервную инфраструктуру и сохранение одного или более массивов информации регистрации изменений в резервной инфраструктуре; и после завершения упомянутой записи блоков данных при частичной ресинхронизации, осуществление записи на ресурс-приемник блоков данных с использованием массивов информации регистрации изменений, сохраненных в резервной инфраструктуре.

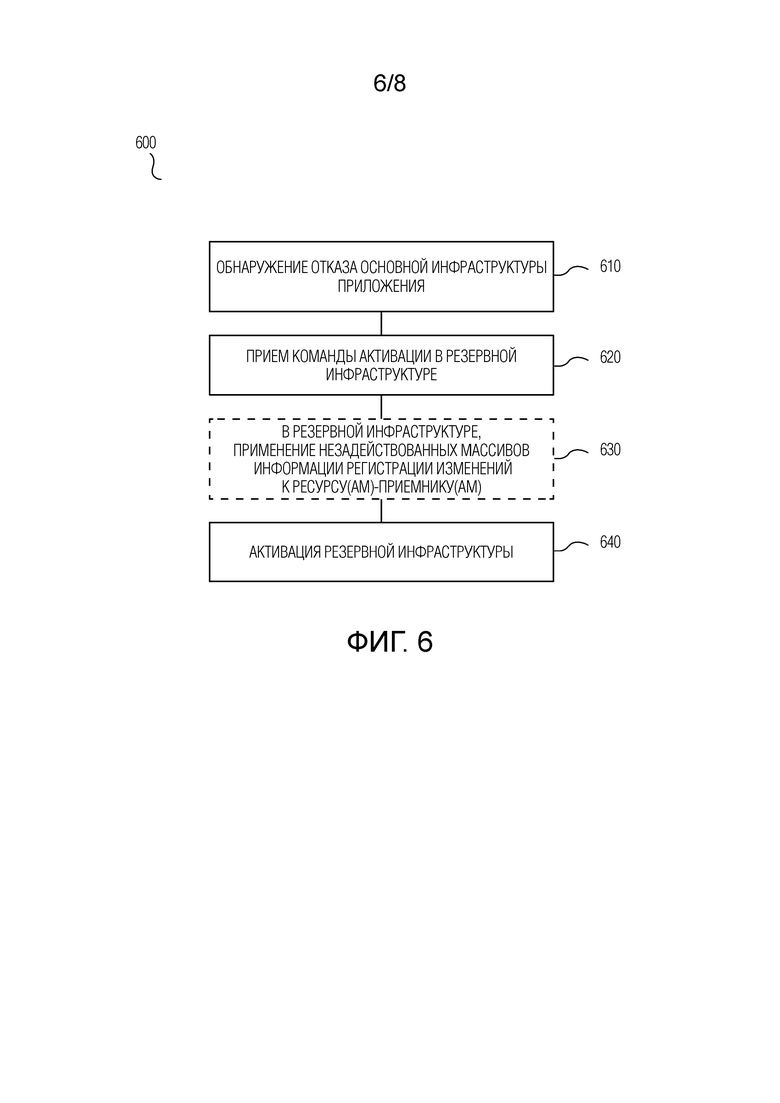

Согласно пятому аспекту настоящего изобретения, предложен способ функционирования системы обеспечения катастрофоустойчивости, развернутой в распределенной сетевой среде согласно в соответствии со способом согласно любому из вариантов осуществления первого аспекта. Предложенный способ функционирования содержит этапы, на которых: обнаруживают событие, идентифицируемое как отказ основной инфраструктуры приложения; и по приему, в подсистеме-приемнике в резервной инфраструктуре для основной инфраструктуры приложения, команды активации от мастер-контроллера, выданной вследствие данного обнаружения, активируют резервную инфраструктуру в качестве основной инфраструктуры приложения.

В соответствии с вариантом осуществления, предложенный способ дополнительно содержит, после упомянутого обнаружения, этап, на котором выполняют оценку обнаруженного события, при этом команда активации выдается из мастер-контроллера на основе выполненной оценки.

Согласно варианту осуществления, предложенный способ дополнительно содержит, перед упомянутой активацией, этап, на котором в резервной инфраструктуре: для ресурса-приемника каждой репликационной пары, посредством подсистемы-приемника осуществляют запись блоков данных на ресурс-приемник на основе, по меньшей мере, некоторых из массивов информации регистрации изменений, которые были сохранены в резервной инфраструктуре и которые еще не были использованы для осуществления записи блоков данных на ресурс-приемник.

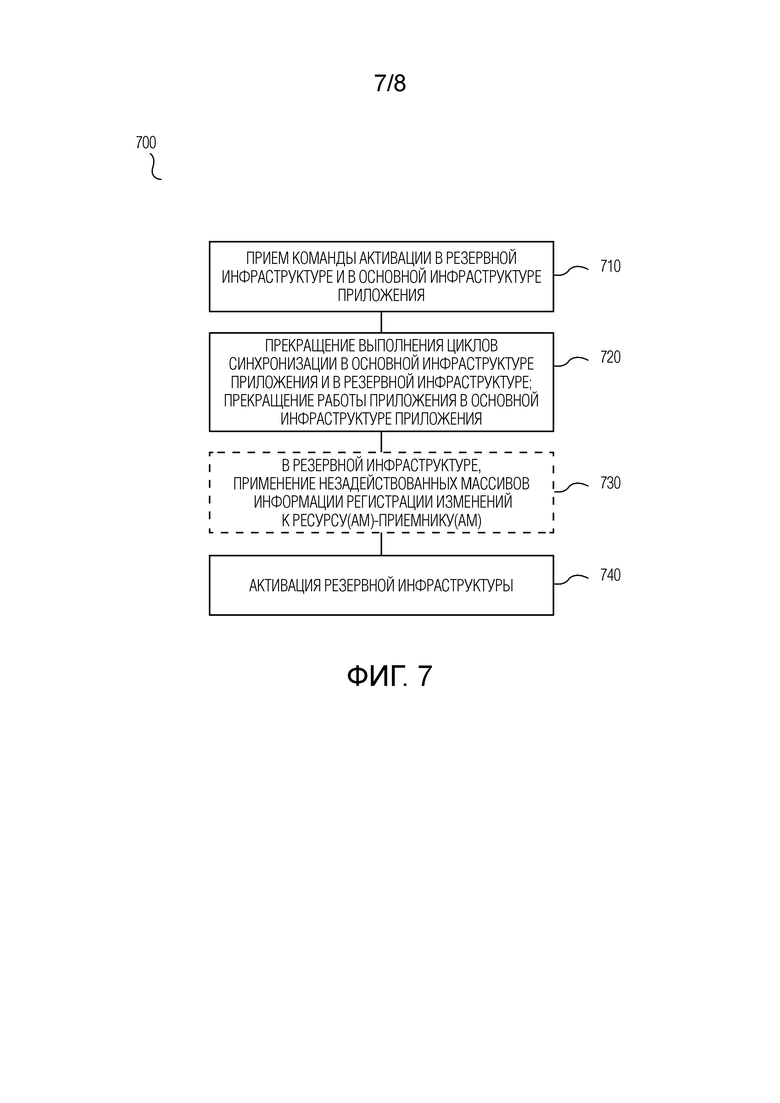

Согласно шестому аспекту настоящего изобретения, предложен способ функционирования системы обеспечения катастрофоустойчивости, развернутой в распределенной сетевой среде согласно в соответствии со способом согласно любому из вариантов осуществления первого аспекта. Предложенный способ функционирования содержит этапы, на которых, по приему в подсистеме-источнике в основной инфраструктуре приложения и в подсистеме-приемнике в резервной инфраструктуре для основной инфраструктуры приложения команды активации от мастер-контроллера: останавливают выполнение циклов синхронизации в основной инфраструктуре приложения и в резервной инфраструктуре и останавливают работу приложения в основной инфраструктуре приложения; и активируют резервную инфраструктуру в качестве основной инфраструктуры приложения, при этом, по меньшей мере, некоторые из одного или более серверов основной инфраструктуры могут быть выключены.

В соответствии с вариантом осуществления, предложенный способ дополнительно содержит, перед упомянутой активацией, этапы, на которых, для каждой репликационной пары: посредством подсистемы-источника в основной инфраструктуре приложения передают в резервную инфраструктуру все из массивов информации регистрации изменений, которые еще не были переданы в резервную инфраструктуру, и сохраняют эти массивы информации регистрации изменений в резервной инфраструктуре; и/или посредством подсистемы-приемника в резервной инфраструктуре осуществляют запись блоков данных на ресурс-приемник на основе, по меньшей мере, некоторых из массивов информации регистрации изменений, которые были сохранены в резервной инфраструктуре и которые еще не были использованы для осуществления записи.

Согласно варианту осуществления пятого или шестого аспекта настоящего изобретения, на случай активации резервной инфраструктуры в качестве основной инфраструктуры приложения: на одном или более серверах резервной инфраструктуры преконфигурированы правила автоматического преобразования настроек сетевых интерфейсов; преконфигурированы правила автоматического изменения системных настроек операционной системы каждого из одного или более серверов резервной инфраструктуры; преконфигурированы зависящие от приложения правила посредством задания одной или более контрольных точек для приложения, в каждой из которых в резервной инфраструктуре может быть запущен соответствующий пользовательский исполняемый сценарий для выполнения действий, специфических для приложения, в целях дополнительного обеспечения целостности данных приложения; каждый из одного или более серверов резервной инфраструктуры до активации резервной инфраструктуры в качестве основной инфраструктуры приложения функционирует под управлением временной операционной системы, запущенной в режиме boot-to-RAM. В рассматриваемом варианте осуществления активация резервной инфраструктуры содержит этапы, на которых: согласно преконфигурированным правилам автоматического преобразования, преобразуют настройки сетевых интерфейсов на, по меньшей мере, некоторых из одного или более серверов резервной инфраструктуры, и/или согласно преконфигурированным правилам автоматического изменения, изменяют системные настройки операционной системы, по меньшей мере, некоторых из одного или более серверов резервной инфраструктуры, и/или согласно преконфигурированным зависящим от приложения правилам, в резервной инфраструктуре для требующейся контрольной точки запускают соответствующий пользовательский исполняемый сценарий; перезагружают один или более серверов резервной инфраструктуры для обеспечения работы приложения в резервной инфраструктуре и запускают приложение в резервной инфраструктуре, причем после перезагрузки один или более серверов резервной инфраструктуры функционируют под управлением основной операционной системы.

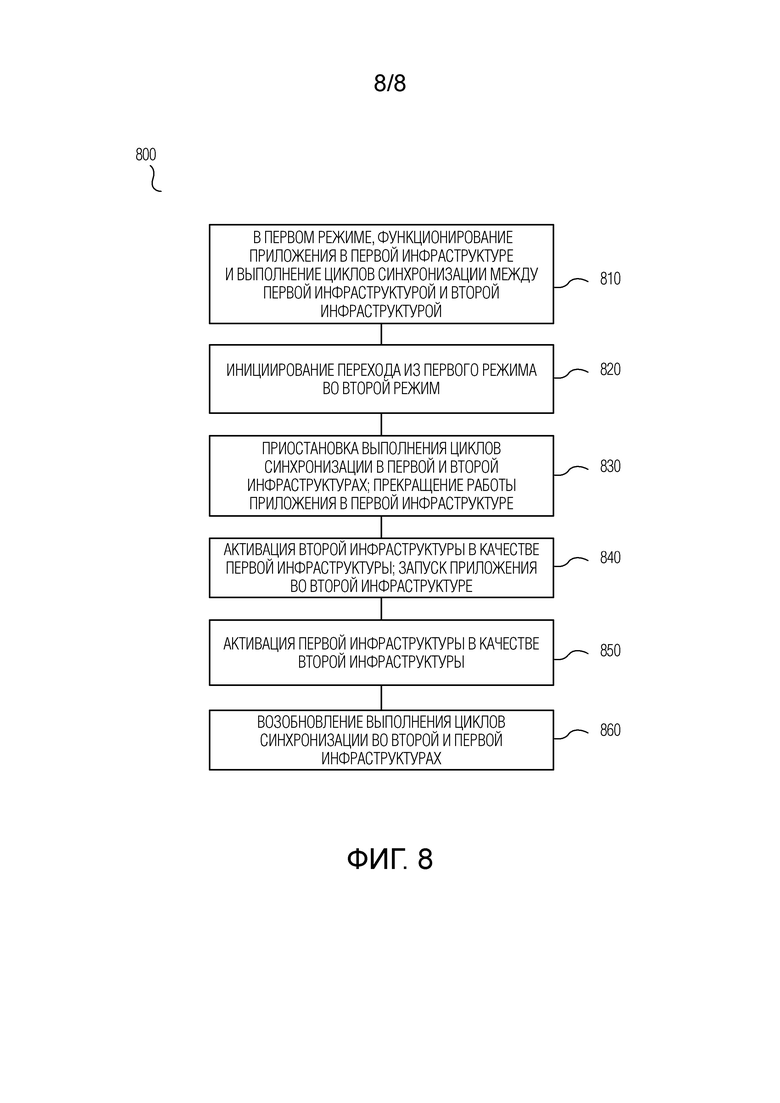

В соответствии с седьмым аспектом настоящего изобретения, предложен способ функционирования системы обеспечения катастрофоустойчивости, развернутой в распределенной сетевой среде. Распределенная сетевая среда содержит: первую инфраструктуру, реализованную на одном или более первых серверах в распределенной сетевой среде, причем в первой инфраструктуре, в первом режиме, работает приложение, катастрофоустойчивость которого требуется обеспечить, и вторую инфраструктуру, реализованную на одном или более вторых серверах в распределенной сетевой среде, при этом первая инфраструктура и вторая инфраструктура коммуникационно связаны друг с другом, причем вторая инфраструктура выполнена с возможностью исполнения упомянутого приложения. Система обеспечения катастрофоустойчивости содержит: мастер-контроллер, реализованный на одном или более вычислительных устройствах распределенной сетевой среды, подсистему для первой инфраструктуры (первую подсистему), функционирующую в первой инфраструктуре, и подсистему для второй инфраструктуры (вторую подсистему), функционирующую во второй инфраструктуре. Посредством мастер-контроллера в первой инфраструктуре и второй инфраструктуре определены репликационные пары путем выбора, для каждого из одного или более ресурсов хранения, которые задействуются для работы приложения в первой инфраструктуре (ресурса-источника), соответствующего ресурса хранения во второй инфраструктуре (ресурса-приемника), с образованием репликационной пары из ресурса-источника и ресурса-приемника. Для каждой репликационной пары выполнена предварительная репликация данных с ресурса-источника на ресурс-приемник.

Предложенный способ содержит следующие этапы, выполняемые для каждой репликационной пары, не останавливая работу приложения.

Выполняют циклы синхронизации, причем каждый цикл синхронизации содержит этапы, на которых: в течение каждого интервала регистрации изменений из одного или более интервалов регистрации изменений, посредством первой подсистемы выполняют регистрацию блоков данных ресурса-источника, подвергшихся изменению после начала интервала регистрации изменений, и, по истечении интервала регистрации изменений, формируют массив информации регистрации изменений в отношении зарегистрированных блоков данных; передают сформированные один или более массивов информации регистрации изменений во вторую инфраструктуру и сохраняют один или более массивов информации регистрации изменений во второй инфраструктуре, и посредством второй подсистемы осуществляют запись на ресурс-приемник блоков данных с использованием массивов информации регистрации изменений, сохраненных во второй инфраструктуре.

При переходе из первого режима во второй режим: приостанавливают выполнение циклов синхронизации в первой инфраструктуре и во второй инфраструктуре и останавливают работу приложения в первой инфраструктуре; активируют вторую инфраструктуру в качестве первой инфраструктуры и запускают приложение во второй инфраструктуре, функционирующей в качестве первой инфраструктуры; активируют первую инфраструктуру в качестве второй инфраструктуры; и возобновляют выполнение циклов синхронизации во второй инфраструктуре, функционирующей в качестве первой инфраструктуры, и в первой инфраструктуре, функционирующей в качестве второй инфраструктуры.

Согласно варианту осуществления, на случай перехода из первого режима во второй режим: на одном или более серверах второй инфраструктуры преконфигурированы правила автоматического преобразования настроек сетевых интерфейсов; для каждого из одного или более серверов второй инфраструктуры преконфигурированы правила автоматического изменения системных настроек операционной системы; преконфигурированы зависящие от приложения правила посредством задания одной или более контрольных точек для приложения, в каждой из которых во второй инфраструктуре может быть запущен соответствующий пользовательский исполняемый сценарий для выполнения действий, специфических для приложения, в целях дополнительного обеспечения целостности данных приложения. В соответствии с рассматриваемым вариантом осуществления, активация второй инфраструктуры в качестве первой инфраструктуры при переходе из первого режима во второй режим дополнительно содержит этапы, на которых, перед упомянутым запуском приложения: согласно преконфигурированным правилам автоматического преобразования, преобразуют настройки сетевых интерфейсов на, по меньшей мере, некоторых из одного или более серверов второй инфраструктуры; и/или согласно преконфигурированным правилам автоматического изменения, изменяют системные настройки операционной системы, по меньшей мере, некоторых из одного или более серверов второй инфраструктуры; и/или согласно преконфигурированным зависящим от приложения правилам, во второй инфраструктуре для требующейся контрольной точки запускают соответствующий пользовательский исполняемый сценарий; перезагружают один или более серверов второй инфраструктуры для обеспечения работы приложения во второй резервной инфраструктуре.

Согласно одному варианту осуществления, первым режимом является штатный режим работы приложения, при этом первой инфраструктурой является основная инфраструктура приложения, а второй инфраструктурой является резервная инфраструктура, сконфигурированная для основной инфраструктуры приложения, при этом вторым режимом является режим, отличающийся от штатного режима. В частности, вторым режимом может быть режим реверса репликации, при этом переход во второй режим происходит по команде реверса репликации от мастер-контроллера.

Согласно другому варианту осуществления, первым режимом является режим реверса репликации, при этом второй инфраструктурой является инфраструктура, которая изначально была основной инфраструктурой приложения и временно функционирует в качестве резервной инфраструктуры, а первой инфраструктурой является резервная инфраструктура, временно функционирующая в качестве основной инфраструктуры приложения, причем вторым режимом является штатный режим работы приложения, при этом переход во второй режим осуществляется по команде реверса репликации от мастер-контроллера.

В соответствии с восьмым аспектом настоящего изобретения, предложена система обеспечения катастрофоустойчивости, развернутая в распределенной сетевой среде, содержащей первую инфраструктуру, реализованную на одном или более первых серверах в распределенной сетевой среде, причем в первой инфраструктуре, в первом режиме, работает приложение, катастрофоустойчивость которого требуется обеспечить, и вторую инфраструктуру, реализованную на одном или более вторых серверах в распределенной сетевой среде, при этом первая инфраструктура и вторая инфраструктура коммуникационно связаны друг с другом, причем вторая инфраструктура выполнена с возможностью исполнения упомянутого приложения.

Предложенная система обеспечения катастрофоустойчивости содержит: мастер-контроллер, реализованный на одном или более вычислительных устройствах распределенной сетевой среды; подсистему для первой инфраструктуры (первую подсистему), функционирующую в первой инфраструктуре; и подсистему для второй инфраструктуры (вторую подсистему), функционирующую во второй инфраструктуре. Посредством мастер-контроллера в первой инфраструктуре и второй инфраструктуре определены репликационные пары путем выбора, для каждого из одного или более ресурсов хранения, которые задействуются для работы приложения в первой инфраструктуре (ресурса-источника), соответствующего ресурса хранения во второй инфраструктуре (ресурса-приемника), с образованием репликационной пары из ресурса-источника и ресурса-приемника.

Первая подсистема содержит: первый хост-контроллер, выполненный с возможностью взаимодействия с мастер-контроллером; первый диспетчер репликационной пары; и первые компоненты репликации под управлением первого диспетчера репликационной пары. На каждом из одного или более первых серверов, который содержит один или более ресурсов-источников соответствующих репликационных пар, запущен экземпляр первого хост-контроллера, для каждой из этих соответствующих репликационных пар запущен экземпляр первого диспетчера репликационной пары, который находится на связи с экземпляром первого хост-контроллера, и для каждого экземпляра первого диспетчера репликационной пары запущен соответствующий экземпляр первых компонентов репликации.

Вторая подсистема содержит: второй хост-контроллер, выполненный с возможностью взаимодействия с мастер-контроллером; второй диспетчер репликационной пары; и вторые компоненты репликации под управлением второго диспетчера репликационной пары. На каждом из одного или более вторых серверов, который содержит один или более ресурсов-приемников соответствующих репликационных пар, запущен экземпляр второго хост-контроллера, для каждой из этих соответствующих репликационных пар запущен экземпляр второго диспетчера репликационной пары, который находится на связи с экземпляром второго хост-контроллера, и для каждого экземпляра второго диспетчера репликационной пары запущен соответствующий экземпляр вторых компонентов репликации.

Экземпляр первого диспетчера репликационной пары, соответствующий экземпляр первых компонентов репликации, экземпляр второго диспетчера репликационной пары и соответствующий экземпляр вторых компонентов репликации, запущенные для каждой репликационной пары, выполнены с возможностью осуществлять, не останавливая работу приложения, циклы синхронизации. Каждый цикл синхронизации содержит: в течение каждого интервала регистрации изменений из одного или более интервалов регистрации изменений, регистрацию блоков данных ресурса-источника, подвергшихся изменению после начала интервала регистрации изменений, и, по истечении интервала регистрации изменений, формирование массива информации регистрации изменений в отношении зарегистрированных блоков данных; передачу сформированных одного или более массивов информации регистрации изменений во вторую инфраструктуру и сохранение одного или более массивов информации регистрации изменений во второй инфраструктуре; и запись на ресурс-приемник блоков данных с использованием массивов информации регистрации изменений, сохраненных во второй инфраструктуре. При переходе из первого режима во второй режим: приостанавливается выполнение циклов синхронизации в первой инфраструктуре и во второй инфраструктуре и останавливается работа приложения в первой инфраструктуре; и выполняется активация второй инфраструктуры в качестве первой инфраструктуры и первой инфраструктуры в качестве второй инфраструктуры, при этом активация содержит: запуск приложения во второй инфраструктуре, функционирующей в качестве первой инфраструктуры, и возобновление выполнения циклов синхронизации во второй инфраструктуре, функционирующей в качестве первой инфраструктуры, и в первой инфраструктуре, функционирующей в качестве второй инфраструктуры.

Достигаемый настоящим изобретением технический результат заключается в предоставлении системы обеспечения катастрофоустойчивости работающего приложения и соответствующих способов ее развертывания и функционирования, которыми обеспечивается: по меньшей мере, частичная автоматизация конфигурирования, для основной инфраструктуры приложения, одной или нескольких резервных инфраструктур, которые могут быть гетерогенными по отношению к основной инфраструктуре приложения; постоянная и согласованная синхронизация состояния резервной инфраструктур(ы) с изменениями, происходящими в основной инфраструктуре приложения, в соответствии с заранее заданными целевыми характеристиками обеспечения катастрофоустойчивости; поддержание постоянной готовности к активации приложения на резервной инфраструктуре(ах) и автоматизация технологических операций по такой активации, а также мониторинг достижимости целевых параметров обеспечения защиты приложения и информирование оператора об их потенциальном нарушении, в общем, минимизируя человеческое участие и сокращая длительность и обеспечивая должную надежность восстановления работы приложения.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

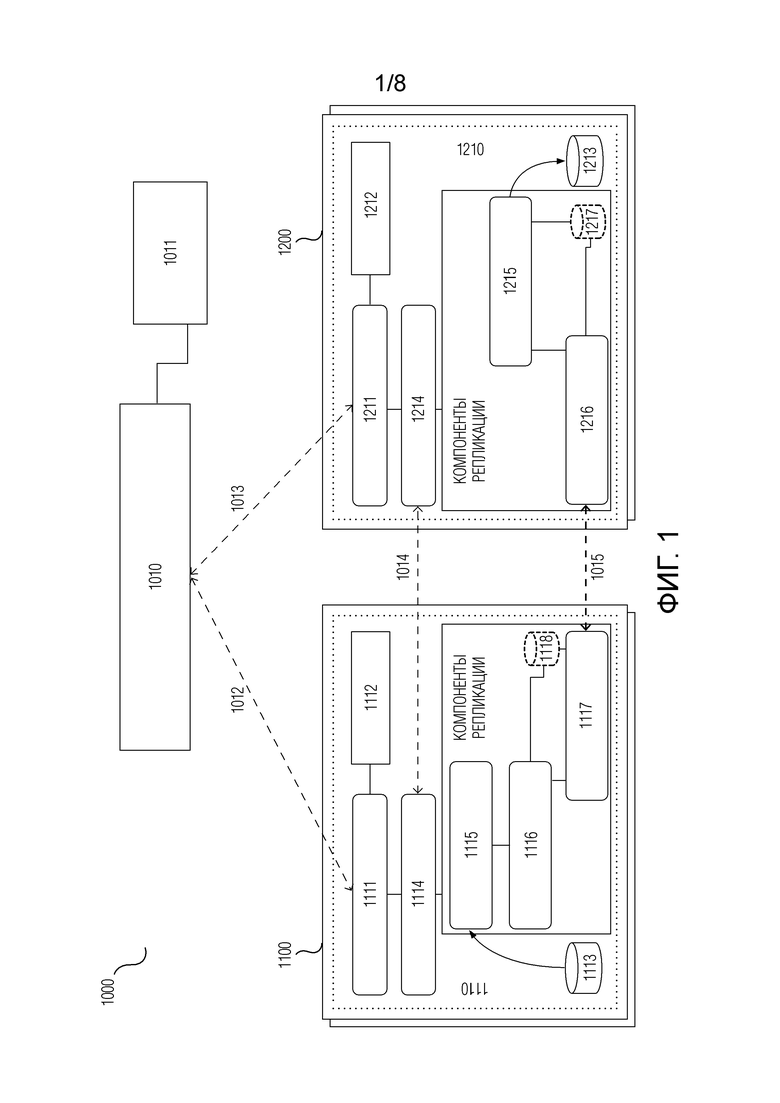

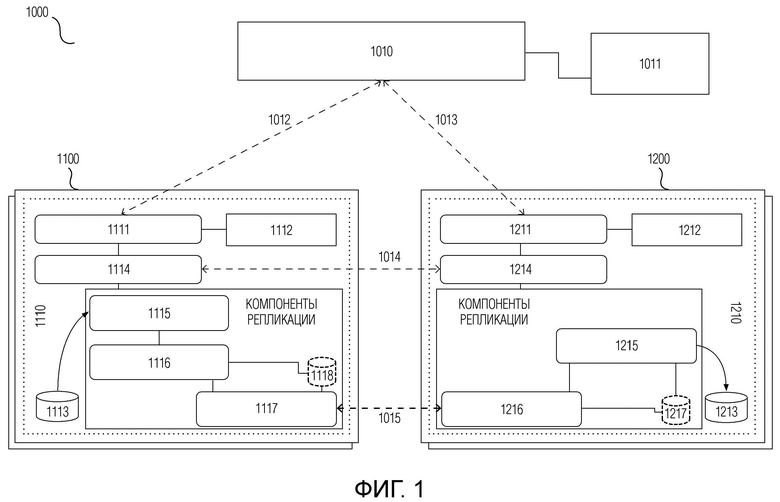

Фиг.1 - иллюстративная схема компонентов системы обеспечения катастрофоустойчивости согласно варианту осуществления настоящего изобретения;

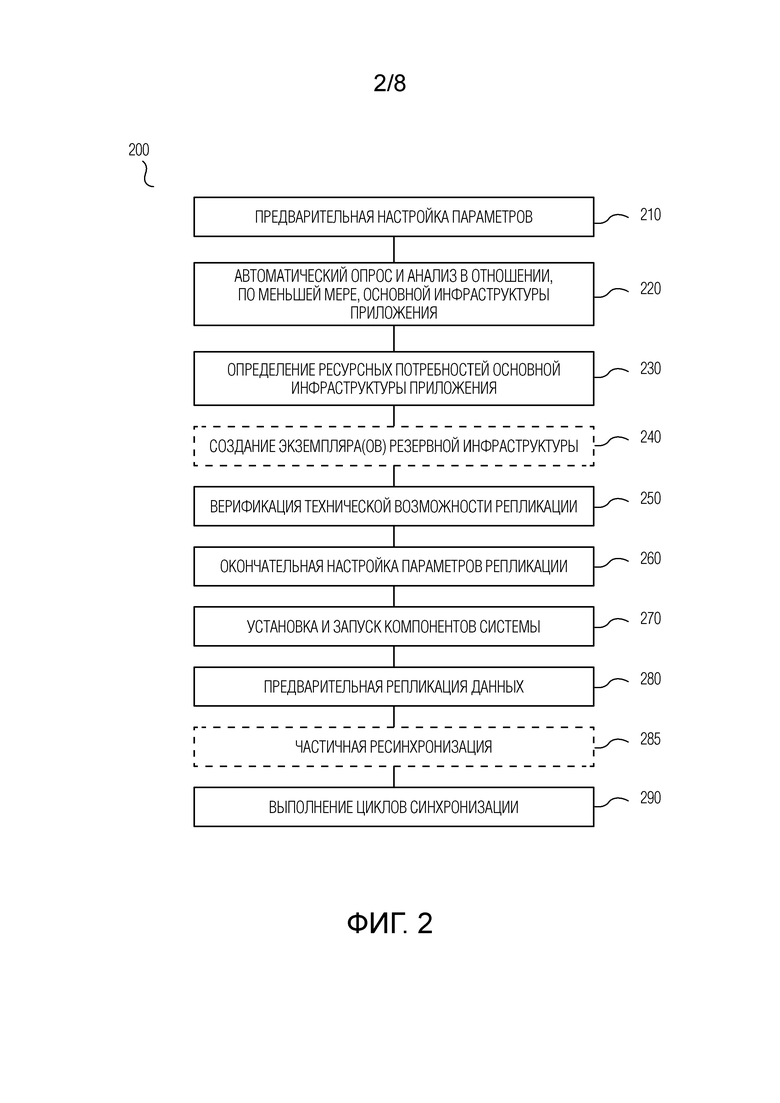

Фиг.2 - блок-схема способа 200 развертывания и запуска системы обеспечения катастрофоустойчивости согласно варианту осуществления настоящего изобретения;

Фиг.3 - блок-схема выполнения этапа 280 предварительной репликации способа 200 согласно варианту осуществления настоящего изобретения;

Фиг.4 - блок-схема осуществления этапа 290 выполнения циклов синхронизации способа 200 согласно варианту осуществления настоящего изобретения;

Фиг.5 - блок-схема выполнения этапа 285 частичной ресинхронизации способа 200 согласно варианту осуществления настоящего изобретения;

Фиг.6 - блок-схема способа функционирования системы обеспечения катастрофоустойчивости согласно одному варианту осуществления настоящего изобретения;

Фиг.7 - блок-схема способа функционирования системы обеспечения катастрофоустойчивости согласно другому варианту осуществления настоящего изобретения;

Фиг.8 - блок-схема способа функционирования системы обеспечения катастрофоустойчивости согласно еще одному варианту осуществления настоящего изобретения.

ПОДРОБНОЕ ОПИСАНИЕ ИЗОБРЕТЕНИЯ

Далее делается отсылка к примерным вариантам осуществления настоящего изобретения, которые иллюстрируются на сопровождающих чертежах, где одинаковые ссылочные номера обозначают аналогичные элементы. Следует при этом понимать, что варианты осуществления изобретения могут принимать различные формы и не должны рассматриваться как ограниченные приведенными здесь описаниями. Соответственно, иллюстративные варианты осуществления описываются ниже со ссылкой на фигуры чертежей для пояснения существа аспектов настоящего изобретения.

На Фиг.1 в общем виде проиллюстрированы компоненты системы обеспечения катастрофоустойчивости, развертываемой в распределенной сетевой среде 1000, согласно варианту осуществления настоящего изобретения.

Под распределенной сетевой средой 1000 в настоящей заявке понятным для специалиста образом, в общем, подразумевается совокупность распределенных специализированных сетевых устройств и систем (таких как различного рода серверные устройства, облачные хранилища, интерфейсные и защитные сетевые устройства и т.п.) и оконечных устройств (таких как пользовательские компьютеры, смартфоны, телеметрическое оборудование и т.п.), между которыми обеспечена проводная и/или беспроводная связность и на которых установлено или прошито соответствующее программное обеспечение.

На по меньшей мере одном сервере 1100 распределенной сетевой среды 1000 реализована инфраструктура рабочего приложения, катастрофоустойчивость которого требуется обеспечить (далее по тексту настоящей заявки и на чертежах такое приложение без ограничения общности может именоваться как «защищаемое приложение»). Примеры таких инфраструктур приложений приведены в разделе “Уровень техники“ настоящей заявки, и для реализации самой рассматриваемой инфраструктуры приложения на сервере(ах) 1100 в данном варианте осуществления могут использоваться аналогичные известные подходы. Далее по тексту настоящей заявки и на чертежах такая инфраструктура приложения, в которой в штатном режиме работает защищаемое приложение, без ограничения общности может именоваться как «основная инфраструктура приложения», а любой из по меньшей мере одного сервера 1100, на котором реализована основная инфраструктура приложения, может именоваться как «сервер основной инфраструктуры». При этом понятие «сервер основной инфраструктуры» может понятным для специалиста образом относиться как к физическому серверу, так и к виртуальному серверу, реализованному на основе соответствующей технологии виртуализации посредством виртуальной машины на физическом вычислительном устройстве. Иными словами, часть серверов основной инфраструктуры могут быть физическими серверами, часть - виртуальными, причем некоторые из виртуальных серверов могут быть реализованы на этих физических серверах. Помимо этого, без ограничения общности рассматриваемый по меньшей мере один сервер основной инфраструктуры может упоминаться в тексте настоящей заявки как «серверы основной инфраструктуры» или как «сервер основной инфраструктуры», в зависимости от контекста.

Также в распределенной сетевой среде 1000 на по меньшей мере одном сервере 1200 распределенной сетевой среды 1000 должна быть предусмотрена резервная инфраструктура для основной инфраструктуры приложения. В соответствии с заранее заданным планом обеспечения катастрофоустойчивости, защищаемое приложение, в случае возникновения нештатной ситуации в основной инфраструктуре приложения, должно продолжить работу в резервной инфраструктуре. Далее по тексту настоящей заявки и на чертежах такая инфраструктура без ограничения общности может именоваться как «резервная инфраструктура», а любой из по меньшей мере одного сервера 1200, на котором реализована резервная инфраструктура, может именоваться как «сервер резервной инфраструктуры». Аналогично, понятие «сервер резервной инфраструктуры» может понятным для специалиста образом относиться как к физическому серверу, так и к виртуальному серверу, т.е. часть серверов резервной инфраструктуры могут быть физическими серверами, часть - виртуальными, причем некоторые из виртуальных серверов могут быть реализованы на этих физических серверах. Также без ограничения общности по меньшей мере один сервер резервной инфраструктуры может упоминаться в настоящей заявке как «серверы резервной инфраструктуры» или как «сервер резервной инфраструктуры», в зависимости от контекста.

Для возможных вариантов воплощения физических серверов основной и резервной инфраструктур с точки зрения компонентной структуры базовых аппаратных средств и программного обеспечения, а также возможных технологий виртуализации могут использоваться известные, в том числе коммерчески доступные, технические решения (см., в частности, раздел “Уровень техники“ настоящей заявки). При этом, для серверов основной и резервной инфраструктур могут использоваться схожие или отличающиеся программно-аппаратные платформы и/или технологии виртуализации.

Одним из основных компонентов системы обеспечения катастрофоустойчивости согласно настоящему изобретению является мастер-контроллер 1010, который в типичном случае реализуется на одном или более вычислительных устройствах распределенной сетевой среды 1000. Мастер-контроллер 1010, с одной стороны, реализует пользовательский интерфейс для предоставления возможности взаимодействия с системой обеспечения катастрофоустойчивости, а, с другой стороны, взаимодействует с основной инфраструктурой приложения и резервной инфраструктурой, в том числе - с другими компонентами системы обеспечения катастрофоустойчивости, для управления и контроля выполнения ими соответствующих действий и для получения информации о статусе и результатах выполнения. Также мастер-контроллер 1010 хранит необходимую для работы системы обеспечения катастрофоустойчивости информацию, для чего может быть предусмотрена база 1011 данных мастер-контроллера. База 1011 данных мастер-контроллера может быть известным для специалиста образом реализована на упомянутых вычислительных устройствах, на которых функционирует мастер-контроллер 1010, либо отдельно от них.

Ниже со ссылкой на блок-схему по Фиг.2 описывается способ 200 развертывания и запуска системы обеспечения катастрофоустойчивости согласно варианту осуществления настоящего изобретения.

На этапе 210 выполняется предварительная настройка параметров. На данном этапе пользователь, обладающий достаточными полномочиями (к примеру, администратор основной инфраструктуры приложения или администратор системы обеспечения катастрофоустойчивости), взаимодействует с мастер-контроллером 1010 системы обеспечения катастрофоустойчивости и задает, по меньшей мере, следующие параметры:

параметры доступа к, по меньшей мере, серверам 1100 основной инфраструктуры;

первичные требования к целевым характеристикам обеспечения катастрофоустойчивости;

прочие параметры функционирования системы обеспечения катастрофоустойчивости.

Такой пользователь по тексту настоящей заявки может без ограничения общности именоваться как «оператор».

К упомянутым параметрам доступа могут относится, к примеру, сетевые адреса серверов 1100 основной инфраструктуры, протокол доступа в их операционную систему (ОС), авторизационная информация и т.п. Целевыми характеристикам обеспечения катастрофоустойчивости являются, как минимум, параметры RTO и RPO, описанные выше. Примеры упомянутых прочих параметров, которые требуются для функционирования системы обеспечения катастрофоустойчивости согласно настоящему изобретению, будут указаны ниже.

Взаимодействие оператора с мастер-контроллером 1010 на этапе 210 может быть известным для специалиста образом реализовано через графический пользовательский интерфейс (GUI) или через интерфейс прикладного программирования (API). Следует понимать, что указанные параметры могут быть сообщены в мастер-контроллер 1010 и иным известным для специалиста образом.

Введенная информация запоминается, например, в базе 1011 данных мастер-контроллера и может использоваться в дальнейшем мастер-контроллером 1010, в частности, для управления процессом обеспечения катастрофоустойчивости и отслеживания текущего статуса, информирования пользователя о выполненных действиях и результатах.

На этапе 220 выполняют автоматический опрос и анализ в отношении, по меньшей мере, основной инфраструктуры приложения в целях получения детальной информации о ее конфигурации и технических характеристиках. На этом этапе мастер-контроллер 1010 осуществляет доступ в операционную систему каждого из, по меньшей мере, некоторых из серверов 1100 основной инфраструктуры. Данный доступ может быть осуществлен посредством авторизации по одному из общепринятых протоколов, к примеру, в соответствии с параметрами доступа, заданными на этапе 210. Далее, на этапе 220 на соответствующих серверах 1100 основной инфраструктуры устанавливаются и запускаются специализированные утилиты, опрашивающие различные подсистемы сервера и анализирующие их конфигурационные файлы. Упомянутые установка и запуск могут быть осуществлены посредством мастер-контроллера 1010; в то же время, для специалиста должно быть понятно, что данные операции могут быть выполнены и иным образом, не задействуя мастер-контроллер 1010. Результатом работы этих специализированных утилит является структурированный набор данных о настройках и конфигурации основной инфраструктуры приложения, включая, для каждого из упомянутых соответствующих серверов 1100 основной инфраструктуры, в частности:

тип, производитель, версия ОС;

версии ядра ОС и системных библиотек;

количество процессоров (ЦПУ) и объем оперативной памяти (ОЗУ);

тип сервера, а именно является ли данный сервер физическим сервером или соответствует использованию некоторой технологии серверной виртуализации, включая облачные платформы;

конфигурация ресурсов хранения и используемый на данном сервере механизм управления разметкой дисков (например, sfdisk или Windows diskpart), а также наличие логических структур поверх базовых ресурсов хранения (например, программные RAID-массивы по типу mdraid, логические менеджеры томов по типу LVM);

конфигурация сетевых ресурсов и используемый на данном сервере механизм управления ими (например, network manager, netplan, network-scripts или Windows netsh);

конфигурация и состояние системных сервисов и используемый на данном сервере механизм управления ими (к примеру, systemctl или Windows services);

конфигурация активных сетевых соединений;

конфигурация специальных утилит, например, обеспечивающих интеграцию ОС с платформой виртуализации, на которой функционирует данный сервер (примером таких специальных утилит является VMware Tools);

статистика использования ресурсов данного сервера (загрузка ЦПУ, использование ОЗУ, занятый объем на ресурсах хранения, использование полосы пропускания сетей и т.п.).

Если какой-либо из соответствующих серверов основной инфраструктуры является виртуальным сервером, реализованным посредством виртуальной машины, то набор данных о настройках и конфигурации основной инфраструктуры приложения, подобный указанному выше, может быть получен, по меньшей мере отчасти, посредством обращения со стороны упомянутых специализированных утилит к API гипервизора, обеспечивающего работу виртуальной машины.

Затем, на этапе 220 мастер-контроллер сохраняет набор данных о настройках и конфигурации основной инфраструктуры приложения, полученный в результате исполнения специализированных утилит, например, в базе 1011 данных мастер-контроллера. Следует отметить, что специализированные утилиты, используемые на этапе 220, могут устанавливаться на временной основе, т.е. они могут быть удалены с соответствующих серверов 1100 основной инфраструктуры после завершения их работы по сбору требующейся информации.

На этапе 230 выполняется обработка по анализу набора данных о настройках и конфигурации основной инфраструктуры приложения, полученного на этапе 220, для определения параметров, характеризующих ресурсные потребности основной инфраструктуры приложения. В частности, исходя из полученного набора данных может оцениваться достаточность фактических ресурсов основной инфраструктуры приложения путем сравнения наблюдаемой нагрузки на ЦПУ/ОЗУ/ресурсы хранения данных с заранее заданными пороговыми величинами (к примеру, известными из практики эксплуатации подобных инфраструктур приложений), по достижении которых происходит деградация производительности. Соответственно, определяемые параметры потребностей могут превышать фактические ресурсные показатели основной инфраструктуры приложения. Обработка по этапу 230 может выполняться мастер-контроллером 1010.