УРОВЕНЬ ТЕХНИКИ

Хотя на сегодня достигнут прогресс в повышении устойчивости систем распознавания речи к шумам, распознавание речи в присутствии параллельно говорящего (смешанная речь) остается большой проблемой. В случае распознавания речи с одного микрофона в присутствии параллельно говорящего разработчики применяют множество различных технических приемов для обработки выборки смешанной речи и сравнивают результаты между собой. Эти технические приемы включают в себя подходы на основе моделей, в которых используются факториальные модели на основе смеси нормальных распределений-скрытые Марковские модели (GMM-HMM) для описания взаимосвязей между целевым и параллельным речевыми сигналами, и их динамическими показателями. При использовании такого подхода совместный вывод или совместное декодирование идентифицируют два наиболее вероятных речевых сигнала или сказанных предложений.

При компьютерном анализе акустической сцены (CASA) и подходах на основе так называемой «недостающей функции» правила сегментации действуют на признаках нижнего слоя для оценки частотно-временной маски, которая выделяет компоненты сигнала, принадлежащие каждому говорителю. Эта маска может быть использована для восстановления сигнала или для передачи информации для процесса декодирования. В других подходах используется неотрицательная матричная факторизация (NMF) для разделения сигнала и повышения качества на основе основного тона.

В одном подходе в системе разделения применяются факториальные генеративные модели на основе GMM-HMM с использованием 256 нормальных распределений для моделирования акустического пространства для каждого говорителя. Хотя это полезно в случае небольшого объема словарных данных, для задачи, характеризующейся большим объемом словарных данных, эта модель весьма примитивна. При использовании большего количества нормальных распределений получение результата на основе факториальной GMM-HMM модели становится практически неприемлемым с точки зрения объема вычислений. Кроме того, такая система предполагает доступность данных обучения, зависимых от говорителя, и замкнутого множества говорителей в период между обучением и тестированием, что может оказаться практически неприемлемым при большом количестве говорителей.

СУЩНОСТЬ ИЗОБРЕТЕНИЯ

Далее в упрощенном виде представлено описание сущности изобретения, обеспечивающее базовое понимание некоторых описанных здесь аспектов. Этот раздел не дает расширенное представление о заявленной сущности изобретения. Здесь не предполагается ни идентификация ключевых элементов заявленной сущности изобретения, ни определение объема заявленной сущности изобретения. Единственной целью этого раздела является представление ряда концепций заявленной сущности изобретения в упрощенном виде в качестве прелюдии к более подробному описанию, представленному ниже.

Система и способ распознают смешанную речь от источника. Способ включает в себя обучение первой нейронной сети для распознавания речевого сигала говорителя с более высоким уровнем речевой характеристики из выборки смешанной речи. Способ также включает в себя обучение второй нейронной сети для распознавания речевого сигала говорителя с более низким уровнем речевой характеристики из выборки смешанной речи. Вдобавок, способ включает в себя декодирование выборки смешанной речи первой нейронной сетью и второй нейронной сетью путем оптимизации совместной вероятности наблюдения двух речевых сигналов с учетом вероятности того, что специальный кадр является точкой коммутации мощности говорителей.

Варианты осуществления изобретения включают в себя одно или несколько считываемых компьютером запоминающих устройств для хранения считываемых компьютером команд. Считываемые компьютером команды выполняются одним или несколькими обрабатывающими устройствами. Считываемые компьютером команды включают в себя код, сконфигурированный для обучения первой нейронной сети для распознавания более высокого уровня речевой характеристики в первом речевом сигнале из выборки смешанной речи. Обучение второй нейронной сети выполняется для распознавания более низкого уровня речевой характеристики во втором речевом сигнале из выборки смешанной речи. Обучение третьей нейронной сети выполняется для оценки вероятности коммутация для каждого кадра. Выборка смешанной речи декодируется первой нейронной сетью, второй нейронной сетью и третьей нейронной сетью путем оптимизации совместной вероятности наблюдения двух речевых сигналов, где совместная вероятность означает вероятность того, что специальный кадр является точкой коммутации речевой характеристики.

В последующем описании и прилагаемых чертежах подробно раскрываются некоторые иллюстративные аспекты заявленной сущности изобретения. Однако эти аспекты указывают несколько различных путей возможного использования принципов изобретения, причем здесь предполагается, что заявленная сущность изобретения включает в себя все такие аспекты и их эквиваленты. Другие преимущества и новые признаки заявленной сущности изобретения станут очевидными из последующего подробного описания изобретения вместе с упомянутыми чертежами.

КРАТКОЕ ОПИСАНИЕ ЧЕРТЕЖЕЙ

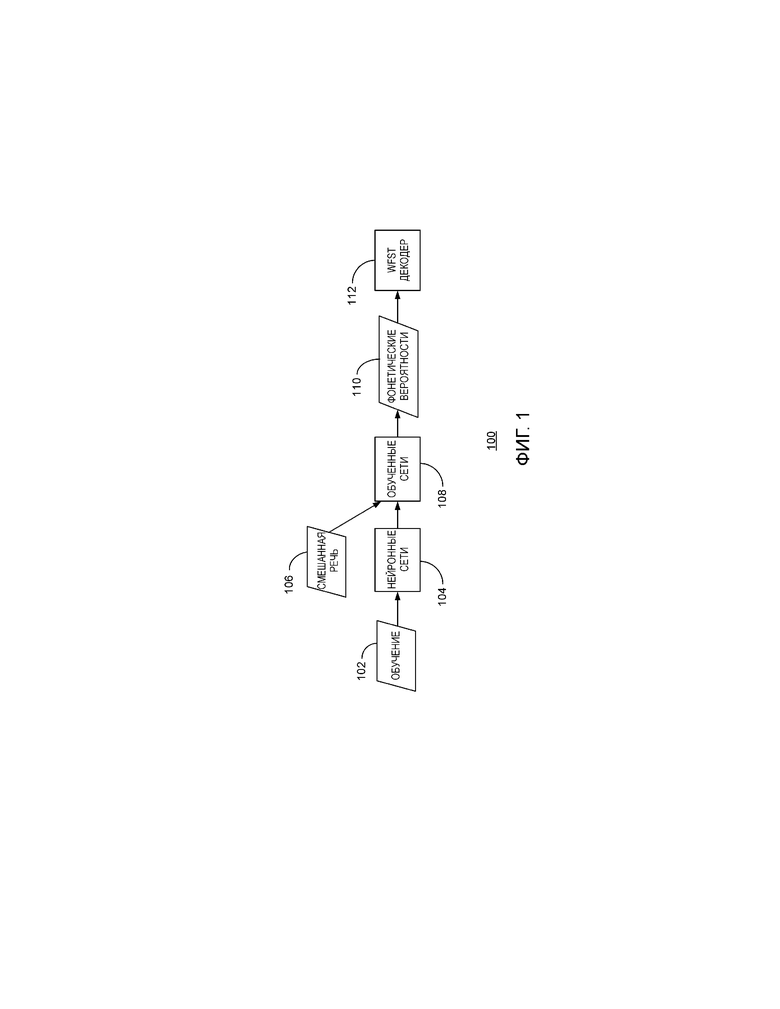

Фиг. 1 – блок-схема потока данных в примерной системе для одноканального распознавания смешанной речи согласно описанным здесь вариантам осуществления изобретения;

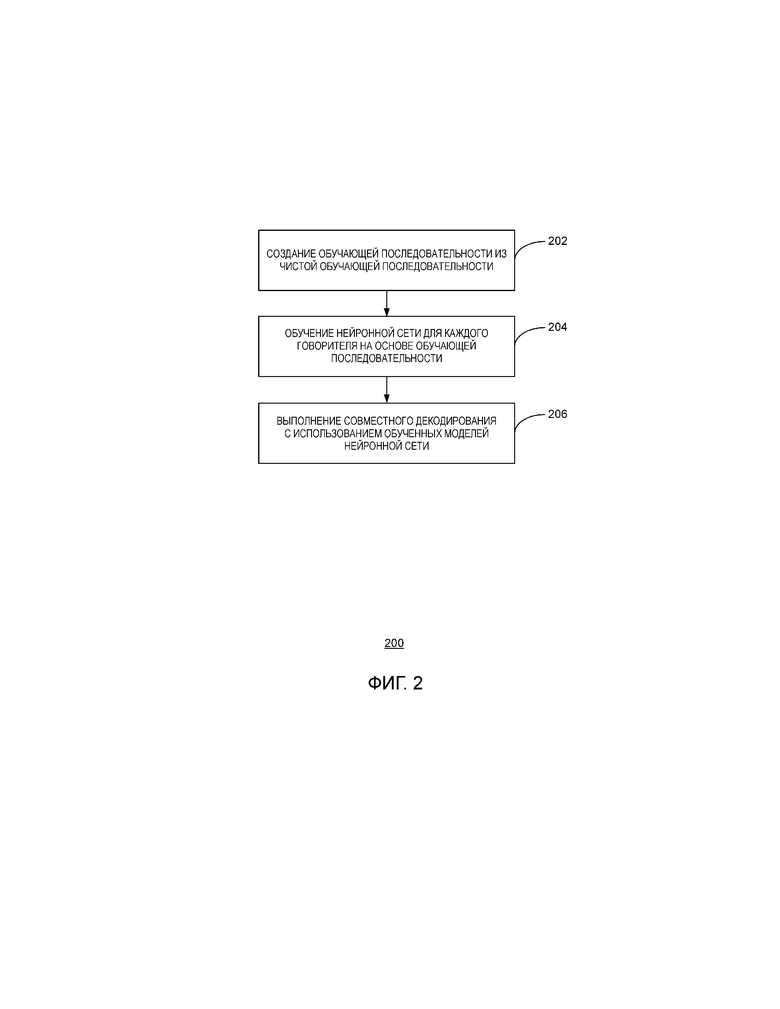

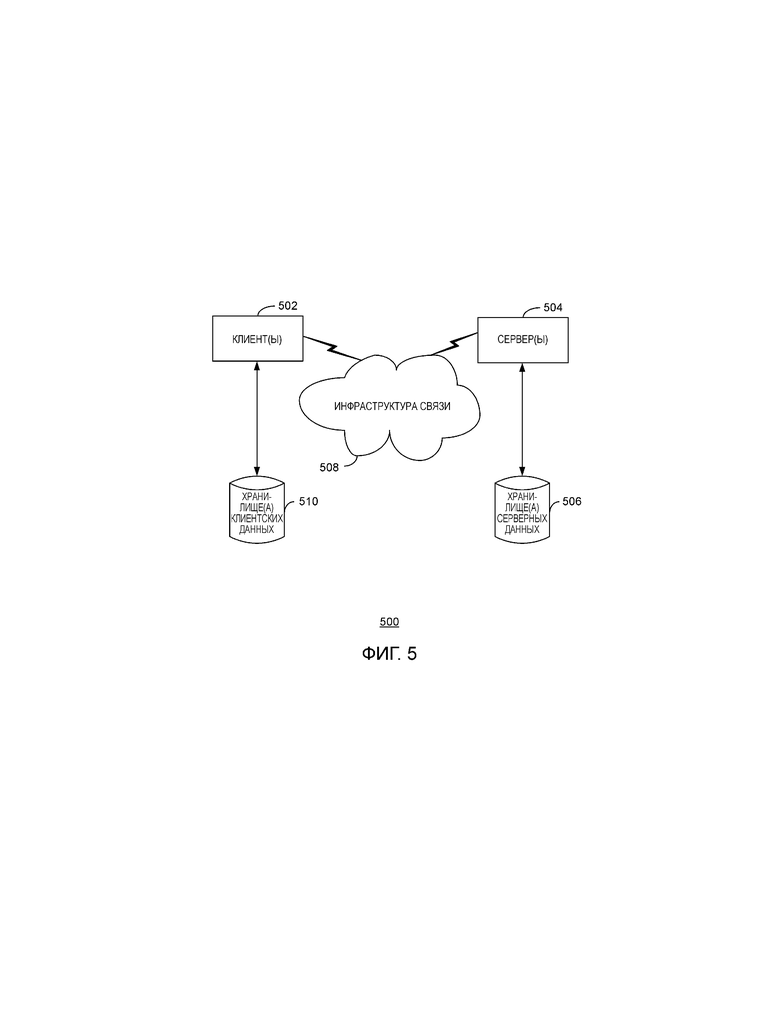

фиг. 2 – блок-схема потока операций способа для одноканального распознавания смешанной речи согласно описанным здесь вариантам осуществления изобретения;

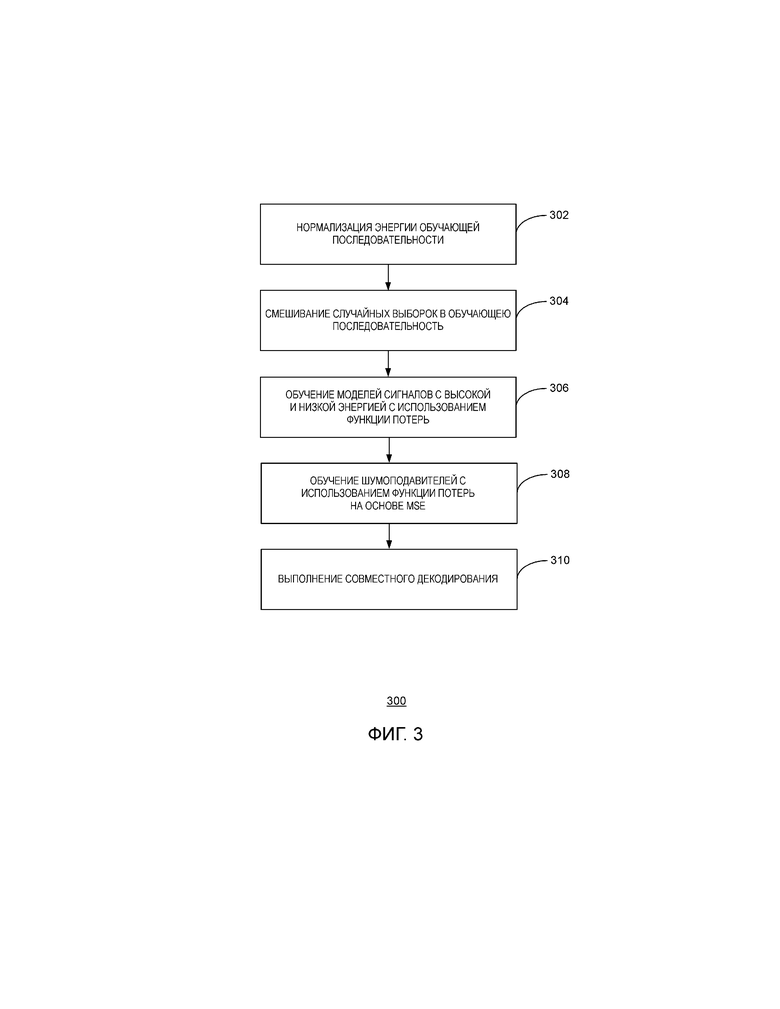

фиг. 3 – блок-схема потока операций способа для одноканального распознавания смешанной речи согласно описанным здесь вариантам осуществления изобретения;

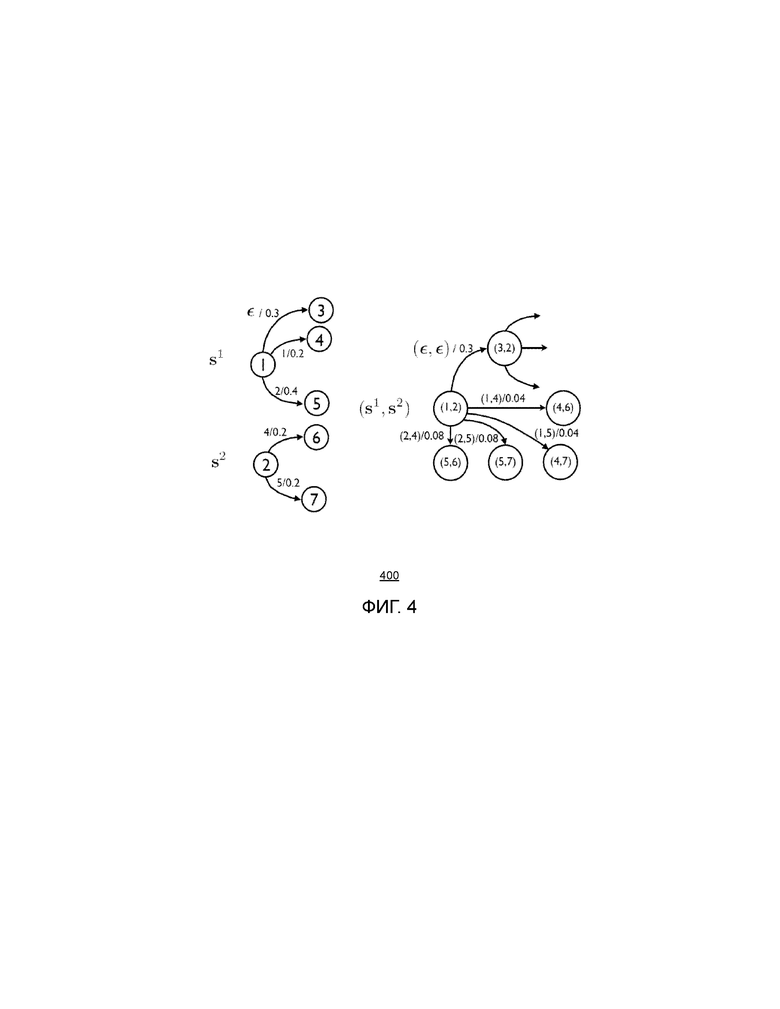

фиг. 4 - блок-схема примерной системы для одноканального распознавания смешанной речи согласно описанным здесь вариантам осуществления изобретения;

фиг. 5 – блок-схема примерной сетевой среды для реализации различных аспектов заявленной сущности изобретения; и

фиг. 6 - блок-схема примерной операционной среды для реализации различных аспектов заявленной сущности изобретения.

ПОДРОБНОЕ ОПИСАНИЕ ИЗОБРЕТЕНИЯ

В качестве преамбулы, с привлечением некоторых фигур описываются концепции в контексте одной или нескольких структурных компонент, называемых здесь по-разному: функциональные возможности, модули, функциональные компоненты, элементы или т.п. Показанные на этих фигурах различные компоненты могут быть реализованы любым образом, например, программными средствами, аппаратными средствами, программно-аппаратными средствами или их комбинациями. В некоторых вариантах осуществления различные компоненты отражают использование соответствующих компонент при их действительной реализации. В других вариантах осуществления любая отдельная компонента, показанная на упомянутых фигурах, может быть реализована несколькими реальными компонентами. Отображение любых двух или более отдельных компонент на фигурах может отражать разные функции, выполняемые одной реальной компонентой. На фиг. 1, обсуждаемой ниже, представлены детали, относящиеся к одной системе, которую можно использовать для реализации показанных на фигурах функций.

На других фигурах описание концепций представлено в виде блок-схем операций. В таком виде конкретные операции описываются в виде отдельных составляющих блоков, выполняемых в определенном порядке. Такие реализации являются примерами, но не ограничениями. Некоторые, из описанных здесь блоков, могут быть сгруппированы вместе и выполняться в одной операции; некоторые блоки могут быть разбиты на множество составляющих блоков, а другие блоки могут выполняться в порядке, отличающемся от показанного здесь порядка, включая параллельное выполнение этих блоков. Блоки, показанные в блок-схемах, могут быть реализованы путем программной, аппаратной, программно-аппаратной и ручной обработки или т.п. Используемые здесь аппаратные средства могут включать в себя компьютерные системы, дискретные логические компоненты, такие как прикладные специализированные интегральные схемы (ASIC) или т.п.

Что касается терминологии, то оборот «сконфигурированный для» распространяется на любой возможный способ построения функциональных возможностей любого вида для выполнения идентифицированной операции. Эти функциональные возможности могут быть сконфигурированы для выполнения одной операции с использованием, например, программных, аппаратных, программно-аппаратных средств или т.п. Термин «логика» охватывает любые функциональные возможности для выполнения некоторой задачи. Например, каждая операция, показанная на блок-схемах, соответствует логике для выполнения этой операции. Операция может выполняться с использованием программных, аппаратных, программно-аппаратных средств и т.п. Термины «компонента», «система» и т.п. могут относиться к компьютерным объектам, аппаратным средствам и исполняемым программным средствам, программно-аппаратным средствам или их комбинации. Компонента может представлять собой процесс, выполняющийся в процессоре, объект, исполняемый файл, программу, функцию, подпрограмму, компьютер или комбинацию программных и аппаратных средств. Термин «процессор» может относиться к аппаратной компоненте, такой как обрабатывающий блок в компьютерной системе.

Кроме того, заявленная сущность изобретения может быть реализована в виде способа, устройства или изделия с использованием стандартных приемов программирования и инженерного проектирования для создания программных, программно-аппаратных, аппаратных средств или любой их комбинации для управления вычислительным устройством с целью реализации раскрытой здесь сущности изобретения. Используемый здесь термин «изделие», как предполагается, охватывает компьютерную программу, доступную из любого считываемого компьютером запоминающего устройства или запоминающей среды. Считываемая компьютером запоминающая среда может включать в себя, но не только: магнитные запоминающие устройства, например, среди прочего, жесткий диск, гибкий диск, магнитные полосы, оптический диск, компакт-диск (CD), цифровой универсальный диск (DVD), смарт-карты, запоминающие устройства типа «флэш-память». В противоположность этому, считываемая компьютером среда, то есть, не запоминающая среда, может включать в себя среду связи, такую как среда передачи для беспроводных сигналов и т.п.

Нейронные сети представляют собой вычислительные модели, пытающиеся имитировать деятельность мозга животных. В нейронных сетях взаимосвязанные системы вычисляют значения на основе входных данных путем передачи информации через сеть. Эти системы взаимосвязаны подобно тому, как взаимосвязаны нейроны в мозге. Глубокая нейронная сеть (DNN), как правило, представляет собой сеть, имеющую более одного скрытого слоя, где слои являются полносвязными. Другими словами, все нейроны одного слоя соединены со всеми нейронами последующего слоя.

При распознавании речи множество входных нейронов может быть активировано речевым сигналом входного кадра смешанной речи. Эти входные кадры могут обрабатываться нейронами первого слоя и передаваться на нейроны других слоев, которые также обрабатывают их входы и передают их на выходы. Выходные данные нейронной сети генерируются выходными нейронами, которые задают вероятность наблюдения конкретных фонемных или субфонемных единиц.

Как правило, в системах разделения речи используются признаки с высоким разрешением, но традиционная система автоматического распознавания речи (ASR) на основе GMM-HMM не способна обеспечить эффективное моделирование признаков с высоким разрешением. Разработчики по сути дела при использовании традиционных систем ASR на основе GMM-HMM обычно разделяют обработку для разделения речи и обработку для распознавания речи.

Однако системы на основе нейронных сетей показали свое преимущество при использовании признаков в спектральной области по сравнению с обработкой признаков в кепстральной области. Кроме того, нейронные сети продемонстрировали свою надежность в отношении речевых вариаций говорителей и искажений со стороны окружающей среды. В вариантах осуществления заявленной сущности изобретения унифицированная система на основе нейронной сети может выполнять как обработку разделения, так и обработку распознавания речи двух говорителей. Преимуществом является то, что эта нейронная сеть может выполнять это более качественно в плане масштабирования, чем традиционные системы ASR.

На фиг. 1 представлена блок-схема примерной системы 100 для одноканального распознавания смешанной речи согласно описанным здесь вариантам осуществления. В системе 100 обучающие последовательности 102 вводятся во множество нейронных сетей 104. Обучение нейронных сетей 104 выполняется с использованием обучающих последовательностей 102, создающих обученные сети 106. Кадры 108 смешанной речи вводятся в обученные сети 106, которые создают фонетические вероятности 110. Фонетические вероятности 110 представляют множество вероятностей наблюдения конкретной фонемной или субфонемной единицы в сигнале. В одном варианте осуществления фонетические вероятности 110 вводятся в преобразователи 112 с конечным числом взвешенных состояний (WFST), которые выполняют совместное декодирование для выбора произнесенных слов. Система 100 использует несколько способов распознавания соканальной речи, которые объединяют обучение с разными объектными функциями, определенными для задачи с множеством говорителей.

Примерные реализации продемонстрировали устойчивость к помехам со стороны параллельно говорителя. В одной из реализаций достигается общая частота словных ошибок, равная 19,7%, что на 1,9% абсолютно лучше по сравнению с существующими системами. Преимуществом является то, что варианты осуществления заявленной сущности изобретения выполняют распознавание при меньшем уровне сложности и с меньшими допущениями.

1. ВВЕДЕНИЕ

Варианты осуществления заявленной сущности изобретения выполняют одноканальное распознавание смешанной речи с использованием глубоких нейронных сетей (нейронные сети 104). Используя стратегию многостилевого обучения на искусственно созданных данных смешанной речи, например, на кадрах 108 смешанной речи, несколько различных обучающих настроек позволяют DNN системам обобщать соответствующие подобные звуковые образы. Вдобавок, WFST декодер 112 представляет собой декодер для совместного декодирования, который работает с обученными нейронными сетями 104.

2. Многостилевое обучение DNN c использованием смешанной речи

На фиг. 2 представлена блок-схема способа 200 для одноканального распознавания смешанной речи согласно описанным здесь вариантам осуществления. Понятно, что эта блок-схема представляет только технические приемы заявленной сущности изобретения, но не обязательно представляет их последовательность. Способ 200 может выполняться системой 100, начиная с блока 202, где создается обучающая последовательность 102 на основе чистой обучающей последовательности. Хотя акустическая модель на основе нейронных сетей подтвердила свою более высокую устойчивость в отношении искажений со стороны окружающей среды по сравнению с традиционными системами, эта надежность недостаточно поддерживается при более высоких уровнях искажений между обучающей последовательностью 102 и кадрами 108 смешанной речи. Как таковые, существующие примеры репрезентативных вариаций в отношении нейронных сетей 104 во время обучения помогают обученным сетям 106 выполнять обобщения применительно к искаженной речи.

Модель на основе нейронных сетей, обученная на речи одного говорителя, не обеспечивает должный уровень обобщения. Однако, варианты осуществления заявленной сущности изобретения снимают эту проблему путем использования стратегии многостилевого обучения. В этой стратегии чистые обучающие данные модифицируют для представления ожидаемой речи. В примерной обучающей последовательности 102 база данных чистой речи одного говорителя «искажается» выборками сигнала параллельной речи от других говорителей с различными уровнями громкости, энергии и т.д. В блоке 204 нейронные сети 104 обучаются с использованием этих модифицированных обучающих данных, которые включают в себя множественные формы сигналов. Преимуществом является то, что эти данные могут быть использованы для создания обученных сетей 106, которые могут разделять звуковые сигналы в речи множества говорителей. В вариантах осуществления обучение нейронной сети 104 может выполняться для каждого из говорителей.

В блоке 206 может быть выполнено совместное декодирование. В одном варианте осуществления WFST декодер модифицирован для декодирования речи множества говорителей.

2.1 МОДЕЛИ СИГНАЛОВ С ВЫСОКОЙ И НИЗКОЙ ЭНЕРГИЕЙ

При каждом произнесении смешанной речи с множеством речевых сигналов предполагается, что один сигнал представляет собой целевую речь, и один сигнал представляет собой помехи. Присваивание индексов является произвольным, когда система декодирует оба сигнала. В одном варианте осуществления используют допущение относительно энергии речевых сигналов. В этом варианте осуществления полагают, что один сигнал имеет более высокую среднюю энергию, чем другой. Приняв это допущение можно идентифицировать целевую речь как сигнал с более высокой энергией (положительное отношение сигнал-шум (SNR)), либо как сигнал с более низкой энергией (отрицательное SNR). Таким образом используются две нейронные сети 104: при условии ввода смешанной речи одну сеть обучают для распознавания речевого сигнала с более высокой энергии, в то время как другую сеть обучают для распознавания речевого сигнала с более низкой энергией.

На фиг. 3 представлена блок-схема способа распознавания одноканальной смешанной речи согласно описанным здесь вариантам осуществления. Понятно, что блок-схема процесса представляет только технические приемы, используемые в заявленной сущности изобретения, но не обязательно представляют их последовательность. Способ 300 может выполняться системой 100, начиная с блока 302, где система 100 нормализует энергию обучающей последовательности 102. Нормализация энергии выполняется при заданной чистой обучающей последовательности данных  , так что каждое произнесение речи в этом наборе данных имеет одинаковый уровень мощности. В блоке 304 выполняется смешивание случайных выборок с получением обучающей последовательности 102. Для имитации акустических сред, где целевой речевой сигнал имеет более высокую или более низкую среднюю энергию, другой сигнал выбирают случайным образом из обучающей последовательности 102, масштабируют соответствующим образом его амплитуду и добавляют к обучающей последовательности 102. Таким путем выполняется модификация обучающей последовательности 102 для создания двух многопараметрических последовательностей данных, обозначенных как XH, XL, для данных с высокой и низкой энергией.

, так что каждое произнесение речи в этом наборе данных имеет одинаковый уровень мощности. В блоке 304 выполняется смешивание случайных выборок с получением обучающей последовательности 102. Для имитации акустических сред, где целевой речевой сигнал имеет более высокую или более низкую среднюю энергию, другой сигнал выбирают случайным образом из обучающей последовательности 102, масштабируют соответствующим образом его амплитуду и добавляют к обучающей последовательности 102. Таким путем выполняется модификация обучающей последовательности 102 для создания двух многопараметрических последовательностей данных, обозначенных как XH, XL, для данных с высокой и низкой энергией.

В блоке 306 выполняется обучение нейронной сети 104 для каждой из последовательностей данных  ,

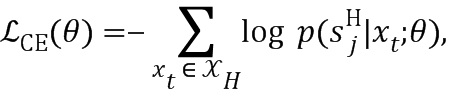

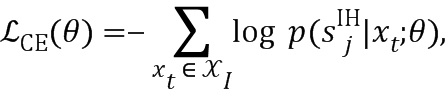

, , генерирующих две обученные сети 106. Для целевого говорителя с высокой энергией выполнение обучения нейронных сетей 104 возможно с использованием функции потерь,

, генерирующих две обученные сети 106. Для целевого говорителя с высокой энергией выполнение обучения нейронных сетей 104 возможно с использованием функции потерь,

где  - эталонная сенонная метка в t-м кадре. Заметим, что термин «сенонные метки» взят из выравнивания на чистых данных. Это оказалось полезным для получения хороших рабочих характеристик в примерных реализациях. Аналогично можно выполнить обучение нейронной сети 104 для целевого говорителя с низкой энергией на последовательности данных

- эталонная сенонная метка в t-м кадре. Заметим, что термин «сенонные метки» взят из выравнивания на чистых данных. Это оказалось полезным для получения хороших рабочих характеристик в примерных реализациях. Аналогично можно выполнить обучение нейронной сети 104 для целевого говорителя с низкой энергией на последовательности данных  . Дополнительно, в случае двух последовательностей данных

. Дополнительно, в случае двух последовательностей данных  и

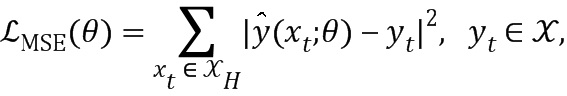

и  , можно выполнить обучение нейронных сетей 104 в качестве шумоподавителей с использованием функции потерь на основе минимальной среднеквадратической ошибки (MSE),

, можно выполнить обучение нейронных сетей 104 в качестве шумоподавителей с использованием функции потерь на основе минимальной среднеквадратической ошибки (MSE),

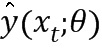

где  - соответствующие отличительные признаки чистой речи, а

- соответствующие отличительные признаки чистой речи, а  - оценка неискаженных входных данных с использованием глубокого шумоподавителя. Аналогичным образом можно выполнить обучение шумоподавителя целевого говорителя с низкой энергией на последовательности данных

- оценка неискаженных входных данных с использованием глубокого шумоподавителя. Аналогичным образом можно выполнить обучение шумоподавителя целевого говорителя с низкой энергией на последовательности данных  . В блоке 310 может быть выполнено совместное декодирование.

. В блоке 310 может быть выполнено совместное декодирование.

2.2. МОДЕЛИ СИГНАЛА С БОЛЬШОЙ И МАЛОЙ ВЫСОТОЙ ТОНА

Одна из потенциальных проблем, связанных с вышеизложенной стратегией обучения на основе речевых сигналов с высокой и низкой средней энергией, состоит в том, что обученные модели могут оказаться неэффективными, когда смешанные сигналы имеют средние уровни энергии, например, SNR близкие к 0 дБ. Имея ввиду обучение, проблема становится недостаточно определенной, поскольку для одних и тех же входных данных смешанной речи метка обучения имеет противоречивые значения (могут быть метки от говорителей с более высокой энергией и более низкой энергией). Однако маловероятно, что оба говорителя говорят с использованием одной и той же высоты тона. Таким образом, в другом варианте осуществления обучение нейронных сетей 104 для распознавания речи выполняется с более высокой или более низкой высотой тона. В этом варианте осуществления создается одна обучающая последовательность 102  из исходной чистой последовательности данных

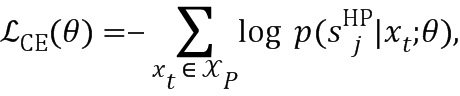

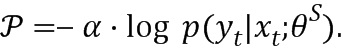

из исходной чистой последовательности данных  путем случайного выбора помехообразующего речевого сигнала и смешивания его с целевым речевым сигналом. Обучение также включает в себя оценку высоты тона как для целевого, так и для помехообразующего речевых сигналов, которую используют для выбора меток для обучения. Таким образом, функция потерь для обучения нейронных сетей 104 для речевых сигналов с большой высотой тона выглядит следующим образом,

путем случайного выбора помехообразующего речевого сигнала и смешивания его с целевым речевым сигналом. Обучение также включает в себя оценку высоты тона как для целевого, так и для помехообразующего речевых сигналов, которую используют для выбора меток для обучения. Таким образом, функция потерь для обучения нейронных сетей 104 для речевых сигналов с большой высотой тона выглядит следующим образом,

где  является эталонной сенонной меткой, полученной на основе выравниваний речевого сигнала с использованием более высокой средней высоты тона. Подобным же образом можно выполнить обучение нейронной сети 104 для речевых сигналов с более низкой высотой тона с использованием сенонных выравниваний речевого сигнала с более низкой высотой тона.

является эталонной сенонной меткой, полученной на основе выравниваний речевого сигнала с использованием более высокой средней высоты тона. Подобным же образом можно выполнить обучение нейронной сети 104 для речевых сигналов с более низкой высотой тона с использованием сенонных выравниваний речевого сигнала с более низкой высотой тона.

2.3. МОДЕЛИ СИГНАЛОВ С ВЫСОКОЙ И НИЗКОЙ МГНОВЕННОЙ ЭНЕРГИЕЙ

Обучение нейронных сетей также можно выполнить на основе мгновенной энергии в каждом кадре 108. Произнесение речи даже со средней энергией 0 дБ содержит ненулевые мгновенные значения SNR в каждом кадре, что означает отсутствие неоднозначности при создании меток. Обучающая последовательность данных  , может быть создана путем смешивания речевых сигналов и вычисления мгновенных энергий кадра в целевом и помехообразующем сигнале. Функция потерь для сигнала с высокой мгновенной энергией задается в виде,

, может быть создана путем смешивания речевых сигналов и вычисления мгновенных энергий кадра в целевом и помехообразующем сигнале. Функция потерь для сигнала с высокой мгновенной энергией задается в виде,

где  - соответствует сенонной метке из источника сигнала, который содержит более высокую энергию в кадре t. В этом сценарии в качестве критерия для разделения используют энергию на основе кадра, а не энергию на основе произнесения. По существу не определено, какие выходные данные из кадра 108 соответствуют целевому говорителю, а какие помехообразующему. Например, целевой говоритель может иметь более высокую энергию в одном кадре и боле низкую энергию в следующем кадре.

- соответствует сенонной метке из источника сигнала, который содержит более высокую энергию в кадре t. В этом сценарии в качестве критерия для разделения используют энергию на основе кадра, а не энергию на основе произнесения. По существу не определено, какие выходные данные из кадра 108 соответствуют целевому говорителю, а какие помехообразующему. Например, целевой говоритель может иметь более высокую энергию в одном кадре и боле низкую энергию в следующем кадре.

3. СОВМЕСТНОЕ ДЕКОДИРОВАНИЕ С ИСПОЛЬЗОВАНИЕМ МОДЕЛЕЙ НА ОСНОВЕ DNN

Для нейронных сетей 104 на основе мгновенных энергий каждая из двух обученных сетей 106 определяет, какие выходные данные принадлежат тому или иному говорителю в каждом кадре 108. Для этого декодер для совместного декодирования использует оценки апостериорной вероятности, например, фонетические вероятности 110 из обученных сетей 106, для совместного обнаружения двух последовательностей состояния, по одной для каждого говорителя. Стандартное правило для создания графа декодирования в инфраструктуре WFST можно записать в виде,

где H, C, L и G представляют структуру HMM, фонетическую контекстную зависимость, лексикон и грамматику соответственно, а - WFST композицию. Входные метки для HCLG представляют собой идентификаторы контекстно зависимых HMM состояний (сенонные метки), а выходные метки представляют слова. Сети, обозначенные как

- WFST композицию. Входные метки для HCLG представляют собой идентификаторы контекстно зависимых HMM состояний (сенонные метки), а выходные метки представляют слова. Сети, обозначенные как  и

и  , представляют собой обученные сети на основе сигналов с высоким и низким мгновенным значением энергии. Задачей совместных декодеров является нахождение двух наилучших последовательностей состояний в двумерном совместном пространстве состояний, так чтобы обеспечить максимум суммы логарифмических вероятностей для каждой последовательности состояний,

, представляют собой обученные сети на основе сигналов с высоким и низким мгновенным значением энергии. Задачей совместных декодеров является нахождение двух наилучших последовательностей состояний в двумерном совместном пространстве состояний, так чтобы обеспечить максимум суммы логарифмических вероятностей для каждой последовательности состояний,

Декодирующий алгоритм выполняет прохождение совместного речевого оборота по двум  декодирующим графам. При этом различие между прохождением речевого оборота совместного декодирования и традиционного декодирования состоит в том, что при совместном декодировании каждый речевой оборот связан с двумя состояниями в декодирующем графе, а не с одним состоянием.

декодирующим графам. При этом различие между прохождением речевого оборота совместного декодирования и традиционного декодирования состоит в том, что при совместном декодировании каждый речевой оборот связан с двумя состояниями в декодирующем графе, а не с одним состоянием.

На фиг. 4 представлена блок-схема примерной системы для распознавания одноканальной смешанной речи согласно описанным здесь вариантам осуществления. На фиг. 4 показан модельный пример, иллюстрирующий прохождение совместного речевого оборота. На двух WFST графах:  ,

,  обозначают пространство состояний, соответствующее одному из двух говорителей;

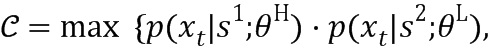

обозначают пространство состояний, соответствующее одному из двух говорителей;  представляет совместное пространство состояний. Положим, что речевой оборот для первого говорителя S1, находится в состоянии 1, а речевой оборот, связанный со вторым говорителем S2 в состоянии 2. Для выходящих дуг с метками, не принадлежащими входным данным (дуги, использующие акустические кадры), расширенные дуги представляют декартово произведение двух наборов выходящих дуг. Цена каждой дуги представляет собой произведение их полуколец. Акустическая цена каждой расширенной дуги вычисляется с использованием сенонных гипотез на основе двух нейронных сетей 104 для высокой и низкой мгновенной энергии. Рассмотрены оба случая, когда каждый из двух источников имеет более высокую энергию. Акустическая цена задается комбинацией с более высокой вероятностью,

представляет совместное пространство состояний. Положим, что речевой оборот для первого говорителя S1, находится в состоянии 1, а речевой оборот, связанный со вторым говорителем S2 в состоянии 2. Для выходящих дуг с метками, не принадлежащими входным данным (дуги, использующие акустические кадры), расширенные дуги представляют декартово произведение двух наборов выходящих дуг. Цена каждой дуги представляет собой произведение их полуколец. Акустическая цена каждой расширенной дуги вычисляется с использованием сенонных гипотез на основе двух нейронных сетей 104 для высокой и низкой мгновенной энергии. Рассмотрены оба случая, когда каждый из двух источников имеет более высокую энергию. Акустическая цена задается комбинацией с более высокой вероятностью,

При использовании уравнения 7 также можно определить признак, указывающий на то, какой говоритель имеет более высокую энергию в соответствующем сигнале в определенном кадре t на всем пути поиска. Для дуг с метками, относящимися к входным данным, дуги со знаком  , не используют акустические кадры. Таким образом, чтобы гарантировать синхронизацию речевых оборотов на двух декодирующих графах, создают новое совместное состояние для текущего кадра. Смотри, например, состояние (3,2) на фиг. 4.

, не используют акустические кадры. Таким образом, чтобы гарантировать синхронизацию речевых оборотов на двух декодирующих графах, создают новое совместное состояние для текущего кадра. Смотри, например, состояние (3,2) на фиг. 4.

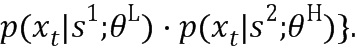

Одной из потенциальных проблем совместного декодера 12 является то, что он допускает свободную коммутацию энергии от кадра к кадру при декодировании всей произнесенной речи. На практике коммутация энергии, как правило, происходит не часто. Варианты осуществления заявленной сущности изобретения решают эту проблему путем введения постоянного штрафа на пути поиска, где более громкий сигнал изменился с последнего кадра. В качестве альтернативы, можно оценить вероятность того, что конкретный кадр является точкой коммутация энергии, и с помощью него можно адаптивно изменять значение штрафа. Поскольку обучающая последовательность 102 создается путем смешивания речевых сигналов, энергия каждого кадра исходной речи известна. Обучающую последовательность можно использовать для обучения нейронной сети 104 для предсказания того, появится ли точка коммутации энергии в конкретном кадре. Пусть  представляет модели, обученные обнаруживать точку коммутации энергии, и тогда адаптивный штраф за коммутацию энергии задается выражением,

представляет модели, обученные обнаруживать точку коммутации энергии, и тогда адаптивный штраф за коммутацию энергии задается выражением,

4. ЭКСПЕРИМЕНТЫ

4.1. ПРИМЕРНАЯ РЕАЛИЗАЦИЯ

В приведенной в качестве примера реализации речевые данные извлекались из фонда GRID. Обучающая последовательность 102 содержала 17000 чистых произнесенных речевых отрезков от 34 разных говорителей (500 произнесенных речевых отрезков для каждого говорителя). Оценочная последовательность включала в себя 4200 произнесенных отрезков смешанной речи при 7 состояниях отношения «цель-маска» (TMR): чисто, 6 дБ, 3 дБ, 0 дБ, -3 дБ, -6 дБ, -9 дБ, а развивающая последовательность содержала 1800 отрезков смешанной речи при 6 состояниях (без значения «чисто»). Фиксированная грамматика содержала шесть частей: команда, цвет, предлог, буква (исключая W), число и наречие, например, «place white at L3 now». Во время тестовой фазы говоритель, который произносит название цвета ‘белый’, трактуется как целевой говоритель. Оценочная метрика представляет собой WER на буквах и цифрах, произнесенных целевым говорителем. Заметим, что WER на всех словах имеет меньшее значение, если не определено иное, все WER в нижеследующих экспериментах оценивались только на буквах и числах.

4.2. БАЗОВАЯ СИСТЕМА

Базовая система была построена с использованием DNN, обученной на исходной обучающей последовательности, состоящей из 17000 произнесенных отрезков чистой речи. Система на основе GMM-HMM обучалась с использованием 39-размерных признаков MFCC с использованием 271 отдельных синонов. Вдобавок, в качестве функциональной компоненты был использован 64-размерный банк мел-фильтров, и контекстное окно из 9 кадров для обучения сети DNN. Сеть DNN имела 7 скрытых слоев с 1024 скрытыми блоками на каждом слое 271-рзмерный выходной слой с многопеременной логистической функцией, соответствующий синонам системы на основе GMM-HMM. Эта схема обучения была использована во всех экспериментах с DNN. Инициализация параметров выполнялась от слоя к слою с использованием генеративного предварительного обучения, за которым следовало дискриминантное предварительное обучение. Дискриминантное обучение сети выполнялось с использованием метода обратного распространения. Размер минипакета был установлен равным 256, а начальная скорость изучения установлена равной 0,008. После каждого этапа обучения выполнялась проверка точности кадра на развивающей последовательности. Если улучшение составляло менее 0,5%, то скорость изучения уменьшалась с коэффициентом 0,5. Процесс обучения останавливался после того, как улучшение точности кадра становилось равным менее 0,1%. Показатели WER базовой системы на основе GMM-HMM и на основе DNN-HMM показаны в Таблице 1. Как показано в Таблице 1, система на основе DNN-HMM, обученная на чистых данных, функционирует неэффективно при всех состояниях SNR за исключением «чистого» состояния, что указывает на преимущество многостилевого обучения DNN.

4.3. СИСТЕМЫ DNN, ОБУЧЕННЫЕ С ИСПОЛЬЗОВАНИЕМ МНОГОСТИЛЕВОГО ОБУЧЕНИЯ

Для исследования возможностей использования многостилевого обучения для моделей сигналов с высокой и низкой энергией были сгенерированы две обучающие последовательности данных смешанной речи. Обучающая последовательность с высокой энергией, названная последовательностью I, была создана следующим образом: для каждого чисто произнесенного отрезка случайным образом выбиралось три других произнесенных отрезка, которые смешивались с целевым чисто произнесенным отрезком при 4 состояниях: чисто, 6 дБ, 3 дБ, 0 дБ (17000×12). Последовательность II (Обучающая последовательность с низкой энергией) была создана подобным же образом, но смешивание выполнялось для 5 состояний: чисто и значениях TMR, равных 0 дБ, -3 дБ, -6 дБ, -9 дБ (17000×15). Эти две обучающие последовательности 102 были использованы для обучения двух моделей DNN, DNN I и DNN II, для сигналов с высокой и низкой энергией соответственно. Результаты исследования представлены в Таблице 2.

Из этой Таблицы следует, что хорошие результаты получаются в случаях, когда два смешивающихся сигнала сильно отличаются по уровню энергии, то есть 6 дБ, -6 дБ, -9 дБ. Кроме того, путем комбинирования результатов, полученных от систем DNN I и II с использованием правила, состоящего в том, что целевой говоритель всегда произносит название цвета «белый», комбинированная система DNN I+II достигает значения 25,4% для WER по сравнению с 67,4%, полученных с DNN, обученной только на чистых данных.

С использованием той же обучающей последовательности I, выполнялось обучение DNN в качестве фронтэндного шумоподавителя. С обученным глубоким шумоподавителем были опробованы две разные настройки: при первой настройке признаки шумоподавления непосредственно вводились в сеть DNN, обученную на чистых данных. При второй настройке на данных с подавленным шумом была переобучена другая DNN. Результаты обеих настроек показаны в Таблице 3.

Из вышеописанных экспериментов следует, что система с DNN, обученной для предсказания сенонных меток, функционирует несколько лучше, чем системы с обученным глубоким шумоподавителем, за которой следует другая переобученная DNN. Из указанного следует, что DNN способна автоматически выучить надежные способы представления. Как таковые, ручные признаки могут в фронтэнде не извлекаться. Комбинированная система DNN I+II еще не так эффективна, как известные системы. Причина этого состоит в том, что упомянутая система функционирует очень плохо в тех случаях, когда два смешивающихся сигнала имеют очень близкие уровни энергии, то есть 0 дБ, -3 дБ. В частности, стратегия многостилевого обучения для сигналов с высокой и низкой энергией связана с потенциальной проблемой присваивания конфликтующих меток во время обучения. В Таблице 3 показаны WER (%) глубоких шумоподавителей для сигналов с высокой и низкой энергией.

Для моделей сигналов с высокой и низкой высотой тона высота тона оценивалась для каждого говорителя из чистой обучающей последовательности. Затем обучающая последовательность I и обучающая последовательность II были объединены для образования обучающей последовательности III (17000×24) для обучения двух нейронных сетей 104 для сигналов с высокой и низкой высотой тона соответственно. При обучении нейронных сетей 104 для сигналов с большой высотой тона метку присваивают исходя из выравниваний на произнесенных отрезках чистой речи, соответствующих говорителю с большой высотой тона. При обучении нейронных сетей 104 для сигналов с низкой высотой тона метка присваивается исходя из выравниваний, соответствующих говорителю с низкой высотой тона. При использовании двух обученных сетей 106 декодирование выполняется независимо, как и раньше. В частности, результаты декодирования объединены с использованием правил, заключающихся в том, что целевой говоритель всегда произносит название цвета ‘белый’. Значения показателя WER показаны в Таблице 4.

Как здесь показано, система с моделями сигналов с большой и малой высотой тона функционирует лучше, чем система с моделями с высокой и низкой энергией в случае 0дБ, но хуже в других случаях.

4.4. СИСТЕМА DNN С СОВМЕСТНЫМ ДЕКОДЕРОМ

Обучающая последовательность III также была использована для обучения двух моделей DNN для сигналов с высокой и низкой мгновенной энергией, описанных в разделе 3. При использовании этих двух обученных моделей совместное декодирование выполняется так, как описано в разделе 3. Результаты подхода на основе использования совместного декодера показаны в Таблице 5. Две последние системы соответствуют случаям, когда введены штрафы за коммутацию энергии. Совместный декодер I представляет собой систему с постоянным штрафом за коммутацию энергии, а совместный декодер II представляет систему с адаптивным штрафом за коммутацию. Для получения значения штрафов за коммутацию энергии, определенных в (8), было выполнено обучение DNN для оценки вероятности коммутации энергии для каждого кадра. В Таблице 5 показаны значения WER (%) систем DNR с совместными декодерами.

4.5. СИСТЕМНАЯ КОМБИНАЦИЯ

В Таблице 5 показано, что система DNN I+II эффективно функционирует в тех случаях, когда два смешивающихся речевых сигнала сильно отличаются по уровню энергии, то есть, 6 дБ, -6 дБ, -9 дБ, в то время как система на основе совместного декодера II эффективно функционирует в тех случаях, когда два смешивающихся сигнала имеют близкий уровень энергии. Это предполагает, что можно использовать комбинацию систем в соответствии с различием в энергии между упомянутыми двумя сигналами. Смешанный сигнал вводится в два глубоких шумоподавителя, а два результирующих выходных сигнала используют для оценки сигналов с высокой и низкой энергией. Используя эти разделенные сигналы, можно вычислить отношение энергий для аппроксимации различия в энергии двух исходных сигналов. Выполняется настройка порогового значения для отношения энергий на развивающей последовательности, которое используют для объединения систем, то есть, если отношение энергий двух разделенных сигналов от шумоподавителей превышает пороговое значение, то используют систему DNN I+II для декодирования произнесенного тестового отрезка речи, в противном случае используют системный совместный декодер II. Полученные результаты представлены в Таблице 5.

5. ВЫВОДЫ

В этой работе исследовались системы на основе DNN для распознавания одноканальной смешанной речи путем использования стратегии многостилевого обучения. Также предложен совместный декодер на основе WFST для работы с обученными нейронными сетями 104. Эксперименты на 2006 неполноценных данных, касающихся разделения и распознавания речи, показали, что предложенная система на основе DNN имеет превосходную устойчивость к помехам со стороны параллельно говорителя. При наилучшей настройке предложенных в изобретении систем достигается значение 19,7% для общей WER, что лучше на 1,9% по абсолютной величине результатов, полученных суперпроизводительной системой IBM, причем это достигнуто с меньшим количеством сделанных допущений и более низким уровнем сложности вычислений.

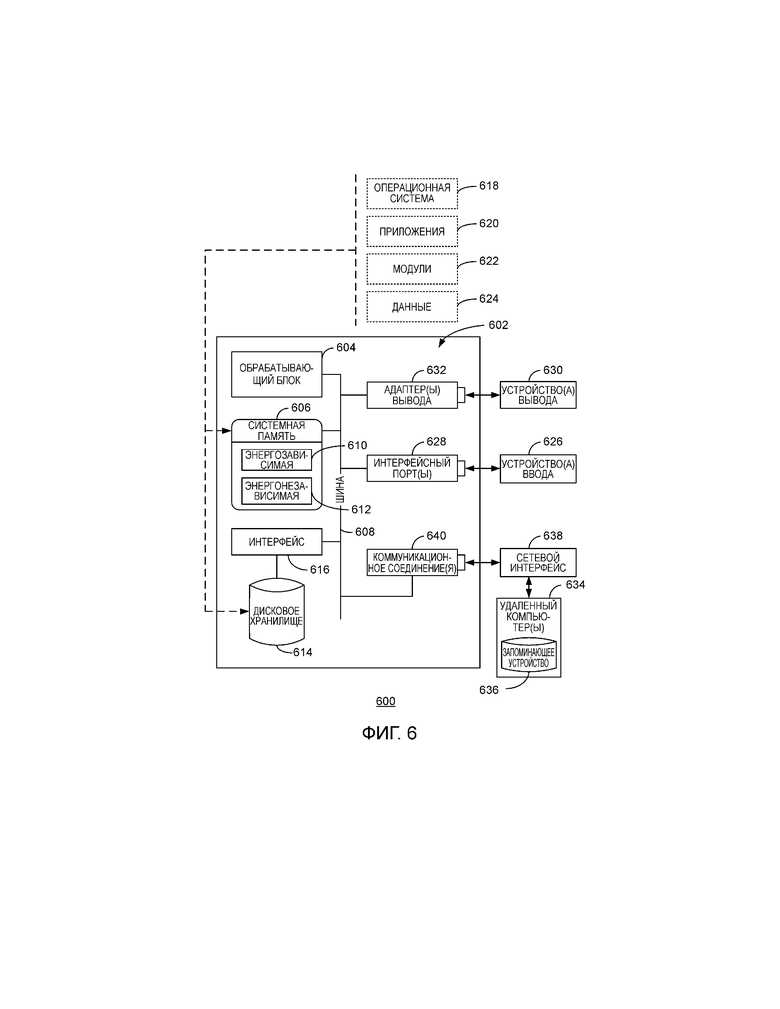

На фиг. 5 представлена блок-схема примерной сетевой среды 500 для реализации различных аспектов заявленной сущности изобретения. Кроме того, это примерная сетевая среда 500 может быть использована для реализации системы и способа, которые обеспечивают обработку внешних последовательностей данных с помощью процессора системы управления базами данных (DBMS).

Сетевая среда 500 включает в себя один или несколько клиентов 502. Клиент (клиенты) 502 может представлять собой аппаратные средства и/или программные средства (например, цепочки подпрограмм, процессы, вычислительные устройства). Например, клиент (клиенты) 502 может представлять собой клиентские устройства, обеспечивающие доступ к серверу 504 через инфраструктуру 508 связи, такую как Интернет.

Среда 500 также включает в себя один или несколько серверов 504. Сервер (серверы) 504 может представлять собой аппаратные средства и/или программные средства (например, цепочки подпрограмм, процессы, вычислительные устройства). Сервер (серверы) 504 может включать в себя серверное устройство. Сервер (серверы) 504 может быть доступен клиенту (клиентам) 502.

Одним из возможных видов связи между клиентом 502 и сервером 504 может быть пакет данных, адаптированный для передачи между двумя или более компьютерными процессами. Среда 500 включает в себя инфраструктуру 508 связи, которую можно использовать для обеспечения связи между клиентом (клиентами) 502 и сервером (серверами) 504.

Клиент (клиенты) 502 оперативно соединены с одним или несколькими хранилищами 510 клиентских данных, которые можно использовать для хранения информации локально для клиента (клиентов) 502. Хранилище (хранилища) 510 клиентских данных могут находится у клиента (клиентов) 502 или удаленно, например, в облачном сервере. Подобным же образом сервер (серверы) 504 оперативно соединены с одним или несколькими хранилищами 506 серверных данных, которые можно использовать для хранения информации локально для серверов 504.

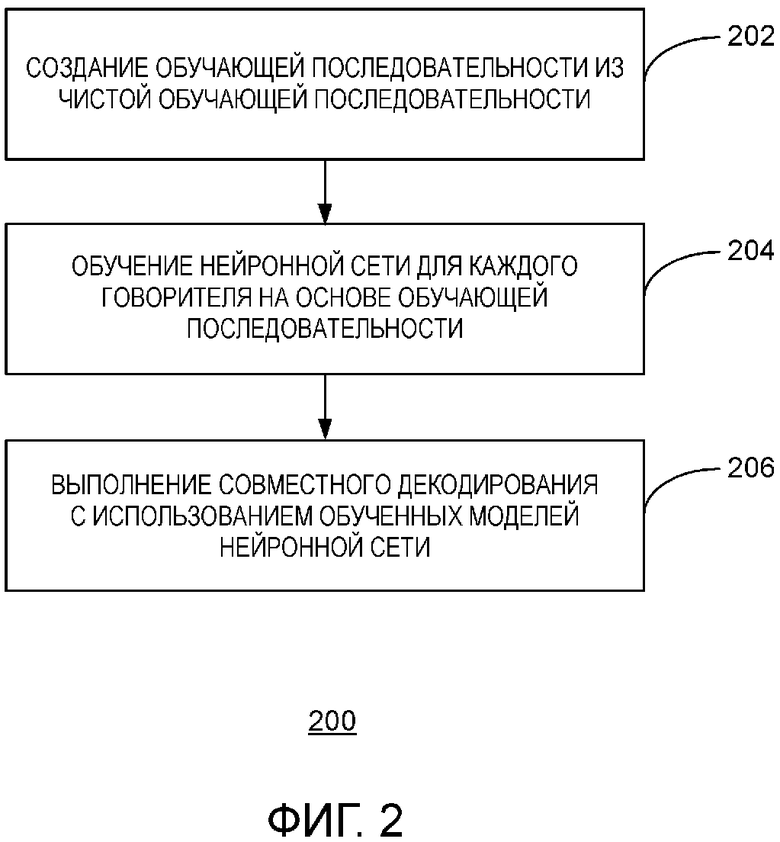

Чтобы обеспечить контекст для реализации различных аспектов заявленной сущности изобретения, предложена фиг. 6, обеспечивающая краткое общее описание вычислительной среды, в которой могут быть реализованы различные аспекты заявленной сущности изобретения. Например, в упомянутой вычислительной среде могут быть реализованы способ и система для изготовления полноцветных 3D-объектов. Хотя заявленная сущность изобретения была описана выше в общем контексте исполняемых компьютером команд, компьютерной программы, которая выполняется на местном компьютере или удаленном компьютере, заявленная сущность изобретения также может быть реализована в комбинации с другими программными модулями. В общем случае программные модули включают в себя стандартные программы, программы, компоненты, структуры данных или т.п., которые выполняют конкретные задачи или реализуют конкретные типы абстрактных данных.

На фиг. 6 представлена блок-схема примерной операционной среды 600 для реализации различных аспектов заявленной сущности изобретения. Примерная операционная среда 600 включает в себя компьютер 602. Компьютер 602 включает в себя обрабатывающий блок 604, системную память 606 и системную шину 608.

Системная шина 608 соединяет системные компоненты, в том числе, но не только, системную память 606 с обрабатывающим блоком 604. Обрабатывающий блок 604 может представлять собой любой из имеющихся различных процессоров. В качестве обрабатывающего блока 604 могут использоваться сдвоенные микропроцессоры и другие микропроцессорные архитектуры.

Системной шиной 608 может быть шинная структура любого из нескольких типов, включая шину памяти или контроллер памяти, периферийную шину или внешнюю шину, а также локальную шину с использованием любой комбинации из имеющихся шинных архитектур, известных специалистам в данной области техники. Системная память 606 включает в себя считываемую компьютером запоминающую среду, которая включает в себя энергозависимую память 610 и энергонезависимую память 612.

Базовая система ввода/вывода (BOIOS), содержащая базовые стандартные программы для пересылки информации между элементами в компьютере 602, например, во время запуска, хранится в энергонезависимой памяти 612. В качестве примера, но не как ограничение, энергонезависимая память 612 может включать в себя память только для считывания (ROM), программируемую ROM (PROM), электрически программируемую ROM (EPROM), электрически стираемую PROM (EEPROM) или флэш-память.

Энергозависимая память 610 включает в себя память с произвольной выборкой (RAM), которая действует в качестве внешней кэш-памяти. Как иллюстрация, но не как ограничение, память RAM доступна во многих видах, таких как статическая RAM (SRAM), динамическая RAM (DRAM), синхронная DRAM (SDRAM), память SDRAM с удвоенной скоростью пересылки данных (DDR SDRAM), усовершенствованная SDRAM (ESDRAM), Synchlink™ DRAM (SLDRAM), память Rambus® RAM (RDRAM) прямого доступа, динамическую память Rambus® RAM (DRDRAM) прямого доступа и динамическую память Rambus® RAM (RDRAM).

Компьютер 602 также включает в себя другие считываемые компьютером среды, такие как съемные/несъемные, энергозависимые/энергонезависимые компьютерные запоминающие среды. В качестве примера на фиг. 6 показано дисковое запоминающее устройство 614. Дисковое запоминающее устройство 614 включает в себя, но не только, устройства типа накопителя на магнитном диске, накопителя на гибком диске, накопителя на магнитной ленте, накопителя Jaz, накопителя Zip, накопителя LS-210, карты флеш-памяти, или флэш-накопителя.

Вдобавок, дисковое запоминающее устройство 614 может включать в себя запоминающую среду по отдельности или в комбинации с другими запоминающими средами, в том числе, но не только, накопитель на оптическом диске, такой как постоянное запоминающее устройство на компакт-диске (CD-ROM), накопитель с однократной записью (накопитель CD-R), накопитель с возможностью многократной записи (накопитель CD-RW) или накопитель на цифровом универсальном диске (DVD-ROM). Для обеспечения соединения дисковых запоминающих устройств 614 с системной шиной 608, как правило, используют съемный или несъемный интерфейс, например, интерфейс 616.

Следует понимать, что на фиг. 6 представлено программное обеспечение, действующее в качестве средства взаимосвязи между пользователями и базовыми компьютерными ресурсами, описанными в подходящей операционной среде 600. Такое программное обеспечение включает в себя операционную систему 618. Операционная система 618, которая может храниться на дисковом запоминающем устройстве 614, обеспечивает управление и распределение ресурсов компьютерной системы 602.

Системные приложения 620 используют управление ресурсами, обеспечиваемого операционной системой 618, посредством программных модулей 622 и программных данных 624, хранящихся в системной памяти 606 или в дисковом запоминающем устройстве 614. Следует понимать, что заявленная сущность изобретения может быть реализована разными операционными системами или их комбинацией.

Пользователь вводит команды или информацию в компьютер 602 через устройства 626 ввода. Устройства 626 ввода включают в себя, но не только, указательное устройство, такое как мышь, шаровой манипулятор, перо и т.п., клавиатуру, микрофон, джойстик, спутниковую тарелку, сканер, карту переключателя каналов TV, цифровую камеру, цифровую видеокамеру, Web-камеру и т.п. Устройства 626 ввода соединены с обрабатывающим блоком 604 посредством системной шины 608 через интерфейсные порты 628. Интерфейсные порты 628 включают в себя, например, последовательный порт, параллельный порт, игровой порт, и универсальную последовательную шину (USB).

Устройства 630 вывода используют некоторые из портов того же типа, что и устройства 626 ввода. Например, порт USB может быть использован для обеспечения ввода в компьютер 602 и вывода информации из компьютера 602 на устройство 610 вывода. Адаптер 632 вывода предусмотрен для иллюстрации того, что имеется ряд устройств 630 вывода типа мониторов, динамиков и принтеров среди других устройств 630 вывода, которые доступны через адаптеры. Адаптеры 632 вывода включают в себя (в качестве иллюстрации, но не как ограничение) видеокарты и аудиокарты, обеспечивающие средство соединения устройства 630 вывода с системной шиной 608. Заметим, что ряд других устройств и систем устройств обеспечивают возможности как ввода, так и вывода, например, удаленные компьютеры 634.

Компьютер 602 может представлять собой сервер, выступающий в качестве хоста для различных программных приложений в сетевой среде, используя логические соединения с одним или несколькими удаленными компьютерами, такими как удаленные компьютеры 634. Удаленные компьютеры 634 могут представлять собой клиентские системы, сконфигурированные с Web-браузерами, PC приложениями, приложениями для мобильной связи и т.п.

Удаленные компьютеры 634 могут представлять собой персональный компьютер, сервер, маршрутизатор, сетевой PC, рабочую станции, бытовой электроприбор на основе микропроцессора, мобильный телефон, одноранговое устройство или другой общий сетевой узел и т.п., и, как правило, включает в себя многие или все элементы, описанные применительно к компьютеру 602.

Для краткости запоминающее устройство 636 показано вместе с удаленными компьютерами 634. Удаленные компьютеры 634 логически соединены с компьютером 602 через сетевой интерфейс 638, а затем подсоединены через соединение 640 беспроводной связи.

Сетевой интерфейс 638 охватывает сети беспроводной связи, такие как локальные сети (LAN) и глобальные сети (WAN). Технологии LAN включают в себя распределенный интерфейс передачи данных по оптоволоконному кабелю (FDDI), распределенный интерфейс передачи данных по медному кабелю(CDDI), Ethernet, Token Ring и т.п. Технологии WAN включают в себя, но не только, линии связи «точка-точка», сети с коммутацией каналов типа цифровых сетей с интегрированными услугами (ISDN) и их версии, сети с пакетной коммутацией и цифровые абонентские линии (DSL).

Коммуникационные соединения 640 относятся к аппаратным/программным средствам, используемым для соединения сетевого интерфейса 638 с шиной 608. Хотя коммуникационное соединение 640 показано для ясности внутри компьютера 602, оно также может быть внешним по отношению к компьютеру 602. Аппаратные/программные средства для соединения с сетевым интерфейсом 638 могут включать в себя, например, внутренние и внешние технологии, такие как коммутаторы мобильной телефонной связи, модемы, включая стандартные телефонные модемы, кабельные модемы и модемы DSL, ISDN адаптеры и карты Ethernet.

Примерный обрабатывающий блок 604 для сервера может представлять собой вычислительный кластер, содержащий центральные процессоры Intel® Xeon. Дисковое хранилише614 может содержать корпоративную систему хранения данных, где, например, хранится множество печатных материалов.

Вышеописанное включает в себя примеры заявленной сущности изобретения. Конечно, невозможно описать каждую потенциально возможную комбинацию компонент или технологий для описания заявленной сущности изобретения, но специалистам в данной области техники понятно, что возможны многие дополнительные комбинации и вариации заявленной сущности изобретения. Соответственно заявленная сущность изобретения предназначена для охвата всех таких вариантов, модификаций и версий, которые не выходят за рамки сущности и объема прилагаемой формулы изобретения.

В частности, в отношении различных функций, выполняемых вышеописанными компонентами, устройствами, схемами, системами и т.п. предполагается, что термины (включая термин «средство»), используемые для описания таких компонент, предназначены для соответствия, если не указано иное, любой компоненте, которая выполняет заданную функцию описанной компоненты, например, термин «функциональный эквивалент», хотя он не является структурным эквивалентом, относящимся к раскрытой структуре, который выполняет указанную функцию в приведенных здесь в качестве примера аспектах заявленной сущности изобретения. В этой связи также следует понимать, что нововведение включает в себя систему, а также считываемую компьютером запоминающую среду, содержащую исполняемые компьютером команды для выполнения действий и событий для различных способов заявленной сущности изобретения.

Имеется множество путей реализации заявленной сущности изобретения, например, подходящий интерфейс API, пакет инструментальных средств разработки программ, код драйвера, операционная система, средство управления, автономный или загружаемый программный объект и т.д., который позволяет приложениям и сервисам использовать описанные здесь технические приемы. Использование заявленной сущности изобретения рассматривается под углом зрения API (или другого программного объекта), а также программного или аппаратного объекта, который действует согласно изложенным здесь технологиям. Таким образом, различные реализации описанной здесь заявленной сущности изобретения могут содержать аспекты, которые реализованы полностью аппаратными средствами, частично программными средствами и частично аппаратными средствами, а также программными средствами.

Вышеупомянутые системы были описаны в плане взаимодействия между несколькими компонентами. Очевидно, что такие системы и компоненты могут включать в себя компоненты или специализированные субкомпоненты, некоторые из специализированных компонент или субкомпонент и дополнительные компоненты согласно различным перестановкам и комбинациям из вышеизложенного. Субкомпоненты также могут быть реализованы в виде компонент, коммуникационно связанных с другими компонентами, вместо того чтобы быть включенными в состав исходных компонент (иерархическая связь).

Вдобавок, следует заметить, что одна или несколько компонент могут быть объединены в единую компоненту, обеспечивающую агрегированные функциональные возможности, или разделить на несколько отдельных субкомпонент, причем может быть обеспечен один или несколько промежуточных уровней, например, уровень управления для коммуникационного соединения с такими субкомпонентами, чтобы обеспечить реализацию интегрированных функциональных возможностей. Любые описанные здесь компоненты также могут взаимодействовать с одной или несколькими другими компонентами, которые здесь подробно не описаны, но в целом известны специалистам в данной области техники.

Вдобавок, хотя конкретный признак заявленной сущности изобретения может быть раскрыт применительно к одной из нескольких реализаций, такой признак может быть объединен с одним или несколькими другими признаками других реализаций, когда это может потребоваться и оказаться перспективным для любого данного или конкретного приложения. Кроме того, предполагается, что термины «включает в себя», «включая», «имеет», «содержит», их варианты и другие подобные слова, использованные в подробном описании или формуле изобретения, являются инклюзивными, в том же смысле, что и термин «содержащий», как открытое переходное слово, не исключающее наличия любых дополнительных или иных элементов.

| название | год | авторы | номер документа |

|---|---|---|---|

| АДАПТИВНОЕ УЛУЧШЕНИЕ АУДИО ДЛЯ РАСПОЗНАВАНИЯ МНОГОКАНАЛЬНОЙ РЕЧИ | 2016 |

|

RU2698153C1 |

| УСТРОЙСТВО, СПОСОБ ИЛИ КОМПЬЮТЕРНАЯ ПРОГРАММА ДЛЯ ГЕНЕРАЦИИ АУДИОСИГНАЛА С РАСШИРЕННОЙ ПОЛОСОЙ С ИСПОЛЬЗОВАНИЕМ ПРОЦЕССОРА НЕЙРОННОЙ СЕТИ | 2018 |

|

RU2745298C1 |

| ОБУЧЕНИЕ DNN-СТУДЕНТА ПОСРЕДСТВОМ РАСПРЕДЕЛЕНИЯ ВЫВОДА | 2014 |

|

RU2666631C2 |

| СИСТЕМА ДЛЯ ВЕРИФИКАЦИИ ГОВОРЯЩЕГО | 1996 |

|

RU2161336C2 |

| СПОСОБ И УСТРОЙСТВО ДЛЯ ОПРЕДЕЛЕНИЯ ГЛУБОКОГО ФИЛЬТРА | 2020 |

|

RU2788939C1 |

| СПОСОБ И ОБОРУДОВАНИЕ РАСПОЗНАВАНИЯ ЭМОЦИЙ В РЕЧИ | 2019 |

|

RU2720359C1 |

| СПОСОБ И УСТРОЙСТВО ДЛЯ ПОВЫШЕНИЯ РАЗБОРЧИВОСТИ РЕЧИ С ИСПОЛЬЗОВАНИЕМ НЕСКОЛЬКИХ ДАТЧИКОВ | 2004 |

|

RU2373584C2 |

| СПОСОБЫ И СИСТЕМА ДЛЯ КОДИРОВАНИЯ НА ОСНОВЕ ФОРМЫ СИГНАЛОВ АУДИОСИГНАЛОВ С ПОМОЩЬЮ ПОРОЖДАЮЩЕЙ МОДЕЛИ | 2020 |

|

RU2823081C1 |

| СИСТЕМА И СПОСОБ ПЕРЕВОДА РЕЧЕВОГО СИГНАЛА В ТРАНСКРИПЦИОННОЕ ПРЕДСТАВЛЕНИЕ С МЕТАДАННЫМИ | 2014 |

|

RU2589851C2 |

| Способ определения признаков паркинсонизма по голосу с использованием искусственного интеллекта | 2023 |

|

RU2841464C2 |

Изобретение относится к средствам для распознавания смешанной речи. Технический результат заключается в повышении точности распознавания смешанной речи. Обучают первую нейронную сеть для распознавания речевого сигнала, произнесенного говорящим с более высоким уровнем речевой характеристики, из выборки смешанной речи. Обучают вторую нейронную сеть для распознавания речевого сигнала, произнесенного говорящим с более низким уровнем речевой характеристики, из выборки смешанной речи. Декодируют выборку смешанной речи первой нейронной сетью и второй нейронной сетью путем оптимизации объединенной вероятности наблюдения упомянутых двух речевых сигналов, где объединенная вероятность означает вероятность того, что конкретный кадр является точкой переключения речевой характеристики. Обучают третью нейронную сеть для предсказания переключения речевой характеристики. Декодируют выборку смешанной речи на основе упомянутого предсказания. 3 н. и 12 з.п. ф-лы, 5 табл., 6 ил.

1. Способ для распознавания смешанной речи от источника, содержащий:

обучение первой нейронной сети для распознавания речевого сигнала, произнесенного говорящим с более высоким уровнем речевой характеристики, из выборки смешанной речи;

обучение второй нейронной сети для распознавания речевого сигнала, произнесенного говорящим с более низким уровнем речевой характеристики, из выборки смешанной речи; и

декодирование выборки смешанной речи первой нейронной сетью и второй нейронной сетью путем оптимизации объединенной вероятности наблюдения упомянутых двух речевых сигналов, где объединенная вероятность означает вероятность того, что конкретный кадр является точкой переключения речевой характеристики.

2. Способ по п. 1, содержащий декодирование путем учета вероятности, что конкретный кадр является точкой переключения говорящих.

3. Способ по п. 2, содержащий компенсацию для точки переключения, появляющейся в процессе декодирования, на основе вероятности переключения, оцененной из другой нейронной сети.

4. Способ по п. 1, где выборка смешанной речи содержит один аудиоканал, причем упомянутый один аудиоканал генерируется микрофоном.

5. Способ по п. 1, где речевая характеристика содержит одно из:

мгновенной энергии в кадре выборки смешанной речи;

энергии; и

высоты тона.

6. Способ по п. 1, содержащий:

обучение третьей нейронной сети для предсказания переключения речевой характеристики;

предсказание, переключается ли энергия из одного кадра на следующий кадр; и

декодирование выборки смешанной речи на основе упомянутого предсказания.

7. Способ по п. 6, содержащий взвешивание вероятности переключения энергии в кадре, следующем после кадра, в котором предсказано переключение энергии.

8. Система распознавания смешанной речи от источника, причем система содержит:

первую нейронную сеть, содержащую первое множество взаимосвязанных систем; и

вторую нейронную сеть, содержащую второе множество взаимосвязанных систем,

причем каждая взаимосвязанная система содержит:

обрабатывающий блок; и

системную память, причем системная память содержит код, сконфигурированный для инициирования выполнения обрабатывающим блоком:

обучения первой нейронной сети для распознавания более высокого уровня речевой характеристики в первом речевом сигнале из выборки смешанной речи;

обучения второй нейронной сети для распознавания более низкого уровня речевой характеристики во втором речевом сигнале из выборки смешанной речи; и

декодирования выборки смешанной речи первой нейронной сетью и второй нейронной сетью путем оптимизации объединенной вероятности наблюдения упомянутых двух речевых сигналов, где объединенная вероятность означает вероятность того, что конкретный кадр является точкой переключения речевой характеристики.

9. Система по п. 8, содержащая код, сконфигурированный для декодирования выборки смешанной речи путем учета вероятности, что конкретный кадр является точкой переключения речевой характеристики.

10. Система по п. 8, содержащая код, сконфигурированный для инициирования выполнения обрабатывающим блоком компенсации точки переключения, появляющейся в процессе декодирования, на основе вероятности, оцененной из нейронной сети.

11. Система по п. 8, где первая нейронная сеть и вторая нейронная сеть являются глубокими нейронными сетями.

12. Система по п. 8, где речевая характеристика содержит выбранное одно из:

высоты тона, энергии и мгновенной энергии в кадре выборки смешанной речи.

13. Система по п. 8, содержащая код, сконфигурированный для инициирования выполнения обрабатывающим блоком:

обучения третьей нейронной сети для предсказания переключения энергии;

предсказания, переключается ли энергия из одного кадра на следующий кадр; и

декодирования выборки смешанной речи на основе упомянутого предсказания.

14. Система по п. 13, содержащая взвешивание вероятности переключения энергии в кадре, следующем после кадра, в котором предсказано переключение энергии.

15. Одно или несколько считываемых компьютером запоминающих устройств для хранения считываемых компьютером команд, содержащих код, который при его выполнении одним или несколькими обрабатывающими устройствами инициирует выполнение этими одним или несколькими обрабатывающими устройствами:

обучения первой нейронной сети для распознавания более высокого уровня речевой характеристики в первом речевом сигнале из выборки смешанной речи, содержащей один аудиоканал;

обучения второй нейронной сети для распознавания более низкого уровня речевой характеристики во втором речевом сигнале из выборки смешанной речи; и

обучения третьей нейронной сети для оценки вероятности переключения для каждого кадра; и

декодирования выборки смешанной речи первой нейронной сетью, второй нейронной сетью и третьей нейронной сетью путем оптимизации объединенной вероятности наблюдения упомянутых двух речевых сигналов, причем упомянутая объединенная вероятность означает вероятность, что конкретный кадр является точкой переключения речевой характеристики.

| Многоступенчатая активно-реактивная турбина | 1924 |

|

SU2013A1 |

| Приспособление для суммирования отрезков прямых линий | 1923 |

|

SU2010A1 |

| Приспособление для суммирования отрезков прямых линий | 1923 |

|

SU2010A1 |

| Пресс для выдавливания из деревянных дисков заготовок для ниточных катушек | 1923 |

|

SU2007A1 |

| Пресс для выдавливания из деревянных дисков заготовок для ниточных катушек | 1923 |

|

SU2007A1 |

| Приспособление для суммирования отрезков прямых линий | 1923 |

|

SU2010A1 |

| Станок для изготовления деревянных ниточных катушек из цилиндрических, снабженных осевым отверстием, заготовок | 1923 |

|

SU2008A1 |

| СПОСОБ АВТОМАТИЧЕСКОЙ ИДЕНТИФИКАЦИИ ЛИЧНОСТИ | 1998 |

|

RU2161826C2 |

Авторы

Даты

2019-04-29—Публикация

2015-03-19—Подача