Изобретение относится к компьютерным системам, а именно искусственным нейронным сетям (ИНС), и может быть использовано, например, для обучения нейронной сети при моделировании физических явлений технологических процессов.

Известен способ обучения искусственной нейронной сети с учителем, широко применяемый для решения различных задач (1 - Хайкин С. Нейронные сети: полный курс.- М.: Издательский дом «Вильяме», 2006. - 1104 с.), (2 - Пучков Е.В. Разработка нейросетевой системы управления технологическими процессами на сортировочных горках: диссертация на соискание ученой степени кандидата технических наук по специальности 05.13.06. - Ростов-на-Дону, 2011. - 213 с.). Обучение с учителем предполагает, что для каждого входного вектора существует целевой вектор, представляющий собой требуемый выход. Вместе они называются обучающей парой. Эти пары образуют обучающую выборку. При этом количество обучающих пар определяет объем обучающей выборки. Обучающие выборки формируются статистически на основе достаточного ряда наблюдений исследуемых объектов. Источником данных могут быть локальные данные организаций (базы данных, табличные файлы и т.д.), внешние данные, доступные через Интернет (курсы акций, сведения о погоде и т.д.), данные, получаемые от различных устройств (датчики оборудования, видеокамеры и т.д.). Нейронная сеть обучается при помощи обучающей выборки некоторого объема путем задания входного вектора, вычисления выходного вектора сети и сравнения его с соответствующим целевым вектором. Разность (градиент ошибки) с помощью обратной связи подается в сеть и весовые коэффициенты изменяются в направлении антиградиента, минимизируя ошибку. Векторы обучающей выборки предъявляются последовательно и многократно, вычисляются ошибки, и весовые коэффициенты подстраиваются для каждого вектора до тех пор, пока ошибка по всему обучающему массиву не достигнет приемлемо низкого уровня. Недостатком этого способа является невозможность его применения в случае отсутствия статистически достаточного ряда наблюдений исследуемых объектов, что не позволяет сформировать обучающие выборки с объемом, достаточным для корректного обучения ИНС способом «обучение с учителем».

Известен способ обучения искусственной нейронной сети, основанный на оптимизации весов скрытого и выходного слоев нейронной сети, предназначенный для обучения многослойной искусственной нейронной сети персептрона (3 - Chen Н.-Н., Manry М.Т., Chandrasekaran Н.A neural network training algorithm utilizing multiple set of linear equations // Neurocomputing, 1999. - V. 25. - №1-3, P. 55-72), (4 - Патент РФ №2566979, МПК: (2006.01) G06N 3/08. Способ обучения искусственной нейронной сети, Федеральное государственное бюджетное образовательное учреждение высшего профессионального образования «Тульский государственный университет». Сальников B.C., Хоанг В.Ч., Анцев А.В. Публ. - 27.10.2015 г.). Он заключается в том, что в ходе процедуры обучения после последовательной передачи многомерного входного вектора в многослойную нейронную сеть вычисляют соответствующие кросскорреляционные и автокорреляционные функции, и далее определяют веса скрытого и выходного слоев на основе решения системы уравнений для антиградиента для минимизации средней квадратичной ошибки между выходными значениями нейронной сети и их желаемыми значениями.

Способ позволяет ускорить процесс обучения искусственной нейронной сети, однако его недостатком является невозможность применения в случае отсутствия статистически достаточного ряда наблюдений исследуемых объектов, что не позволяет сформировать обучающие выборки с объемом, достаточным для корректного обучения ИНС способом «обучение с учителем».

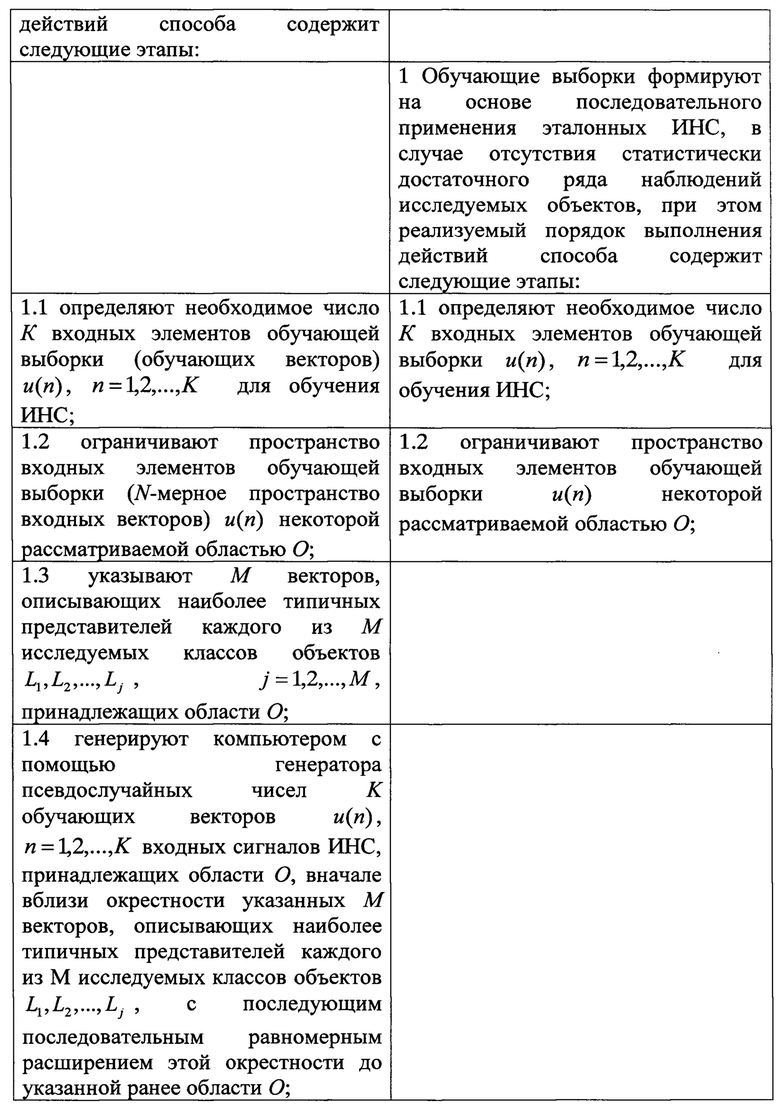

Известен способ обучения искусственной нейронной сети (5 - Патент РФ №2504006, МПК: (2006.01) G06N 3/08. Способ обучения искусственной нейронной сети, Цуриков А.Н. Публ. - 10.01.2014 г.), принятый за прототип. Этот способ обучения искусственной нейронной сети, предназначенной для решения задач классификации объектов, описываемых наборами числовых признаков (векторами), реализуется в виде следующей последовательности операций: обучающие векторы u(n)=(u1(n) u2(n) … uN(n))T, n=1, 2, …, K, Т - знак транспонирования, формируют на основе знаний человека, компетентного в рассматриваемой области (эксперта), в случае отсутствия статистически достаточного ряда наблюдений исследуемых объектов, причем эксперт последовательно определяет классы исследуемых объектов, к которым относятся сгенерированные с помощью генератора псевдослучайных чисел обучающие векторы входных сигналов ИНС, принадлежащие некоторой рассматриваемой области, и созданные компьютером визуальные образы, наглядно описывающие объекты, задаваемые сгенерированными обучающими векторами, при этом реализуемый с использованием компьютера порядок выполнения действий этого способа содержит следующие этапы:

- определяют необходимое число К обучающих векторов u(n), n=1, 2, …, K для обучения ИНС;

- ограничивают N-мерное пространство входных векторов u(n) некоторой рассматриваемой областью О;

- указывают М векторов, описывающих наиболее типичных представителей каждого из М исследуемых классов объектов L1, L2, …, Lj, j=1, 2, …, M, принадлежащих области О;

- генерируют компьютером с помощью генератора псевдослучайных чисел K обучающих векторов u(n), n=1, 2, …, K входных сигналов ИНС, принадлежащих области О, вначале вблизи окрестности указанных М векторов, описывающих наиболее типичных представителей каждого из М исследуемых классов объектов L1, L2, .… Lj, с последующим последовательным равномерным расширением этой окрестности до указанной ранее области О;

- создают компьютером визуальные образы, наглядно описывающие объекты, задаваемые сгенерированными обучающими векторами;

- демонстрируют эксперту сгенерированные обучающие векторы и визуальные образы, наглядно описывающие объекты, задаваемые сгенерированными обучающими векторами;

- определяют, на основе знаний эксперта об исследуемых объектах, в пределах рассматриваемой области О, один из М классов, к которому относится каждый из K сгенерированных обучающих векторов u(n) входных сигналов ИНС;

- записывают сгенерированные обучающие векторы u(n) и эталонные сигналы dj(n), соответствующие классам Lj(n) объектов, к которым, по мнению эксперта, относятся сгенерированные вектора, в виде пар 〈u(n), dj(n)〉 на материальный носитель;

- считывают записанные пары вида 〈u(n), dj(n)〉 с материального носителя, и подают на входы ИНС считанные сигналы обучающих векторов u(n) и соответствующие эталонные сигналы dj(n);

- корректируют вектор синаптических весов нейронов w(n) с шагом коррекции η до завершения обучения ИНС.

Способ позволяет решать задачи классификации объектов при отсутствии статистически достаточного ряда наблюдений исследуемых объектов. Его недостатком является применение в случае отсутствия статистически достаточного ряда наблюдений исследуемых объектов только для решения задач классификации объектов, описываемых наборами числовых признаков (векторами), что не позволяет сформировать обучающие выборки с объемом, достаточным для корректного обучения широкого круга ИНС способом «обучение с учителем», а также большая длительность обучения за счет длительной процедуры формирования обучающей выборки людьми, компетентными в рассматриваемой области.

Технической проблемой является расширение арсенала технических средств, реализующих технологию ИНС, на случаи отсутствия статистически достаточного ряда наблюдений исследуемых объектов и ограничения времени обучения ИНС.

Для решения данной технической проблемы предлагается способ обучения искусственной нейронной сети, для реализации которого определяют необходимое число К входных элементов обучающей выборки u(n), n=1, 2, …, K для обучения ИНС, ограничивают пространство входных элементов обучающей выборки u(n) некоторой рассматриваемой областью О, считывают записанные пары вида 〈u(n), dj(n)〉 с материального носителя, и подают на входы ИНС считанные сигналы обучающих векторов u(n) и соответствующие эталонные сигналы dj(n), корректируют вектор синаптических весов нейронов w(n) до завершения обучения ИНС.

Согласно изобретению, дополнительно обучающие выборки формируют на основе последовательного применения эталонных ИНС, в случае отсутствия статистически достаточного ряда наблюдений исследуемых объектов, при этом реализуемый порядок выполнения действий способа содержит следующие этапы: после ограничения пространства входных элементов обучающей выборки генерируют входные элементы обучающей выборки u(n), n=1, 2, …, K, принадлежащих области О, для обучения ИНС, выбирают L эталонных ИНС, последовательно на вход каждой  эталонной ИНС подают сигналы обучающей выборки u(n), n=1, 2, …, K, а на ее выходе фиксируют выходные сигналы

эталонной ИНС подают сигналы обучающей выборки u(n), n=1, 2, …, K, а на ее выходе фиксируют выходные сигналы

преобразуют сигналы

преобразуют сигналы  в эталонные сигналы dj(n), записывают сгенерированные входные элементы обучающей выборки u(n) и эталонные сигналы dj(n), соответствующие подлежащей решению с применением ИНС задаче, в виде пар 〈u(n), dj(n)〉 на материальный носитель.

в эталонные сигналы dj(n), записывают сгенерированные входные элементы обучающей выборки u(n) и эталонные сигналы dj(n), соответствующие подлежащей решению с применением ИНС задаче, в виде пар 〈u(n), dj(n)〉 на материальный носитель.

Техническим результатом является возможность обучения ИНС (т.е. настройка технического устройства) в случае отсутствия статистически достаточного ряда наблюдений исследуемых объектов и сокращение времени обучения ИНС.

Указанный технический результат достигают за счет введения новых операций: формирование обучающих выборок на основе последовательного применения эталонных ИНС, в случае отсутствия статистически достаточного ряда наблюдений исследуемых объектов, генерирования входных элементов обучающей выборки u(n), n=1, 2, …, K, принадлежащих области О, для обучения ИНС, выбора L эталонных ИНС, последовательной подаче на вход каждой  эталонной ИНС сигналов обучающей выборки u(n), n=1, 2,..., K, и фиксации на ее выходе выходные сигналы

эталонной ИНС сигналов обучающей выборки u(n), n=1, 2,..., K, и фиксации на ее выходе выходные сигналы  ,

,  , преобразования сигналов

, преобразования сигналов  в эталонные сигналы dj(n), записи сгенерированных входных элементов обучающей выборки u(n) и эталонных сигналов dj(n), соответствующих подлежащей решению с применением ИНС задаче, в виде пар 〈u(n), dj(n)〉 на материальный носитель.

в эталонные сигналы dj(n), записи сгенерированных входных элементов обучающей выборки u(n) и эталонных сигналов dj(n), соответствующих подлежащей решению с применением ИНС задаче, в виде пар 〈u(n), dj(n)〉 на материальный носитель.

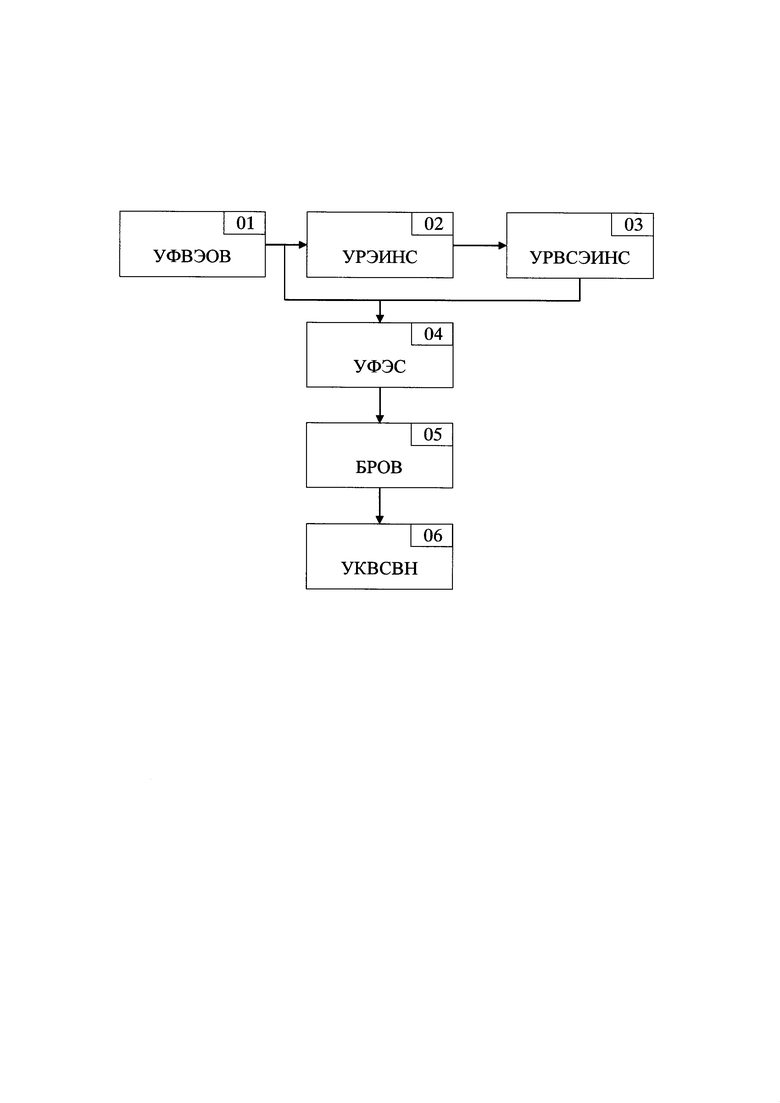

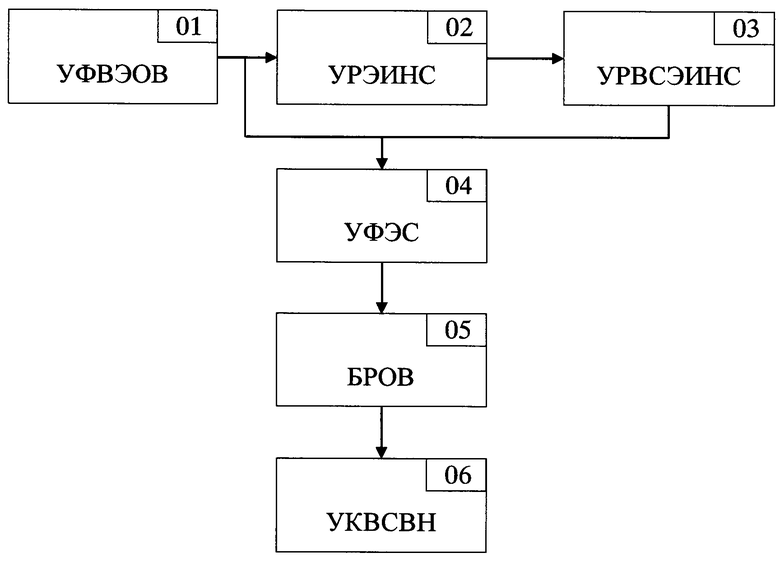

На фиг. приведена структурная схема устройства, реализующего предлагаемый способ обучения искусственной нейронной сети.

Сочетание отличительных признаков и свойств предлагаемого способа из литературы не известны, поэтому он соответствует критериям новизны и изобретательского уровня.

Способ обучения искусственной нейронной сети реализуется следующим образом.

1 Обучающие выборки формируют на основе последовательного применения эталонных ИНС, в случае отсутствия статистически достаточного ряда наблюдений исследуемых объектов, при этом реализуемый порядок выполнения действий способа содержит следующие этапы:

1.1 определяют необходимое число К входных элементов обучающей выборки u(n), n=1, 2, …, K для обучения ИНС;

1.2 ограничивают пространство входных элементов обучающей выборки u(n) неакоторой рассматриваемой областью О;

1.3 генерируют входные элементы обучающей выборки u(n), n=1, 2, …, K, принадлежащие области О, для обучения ИНС;

1.4 выбирают L эталонных ИНС;

1.5 последовательно на вход каждой  эталонной ИНС подают сигналы обучающей выборки u(n), n=1, 2, …, K, а на ее выходе фиксируют выходные сигналы

эталонной ИНС подают сигналы обучающей выборки u(n), n=1, 2, …, K, а на ее выходе фиксируют выходные сигналы

;

;

1.6 преобразуют сигналы  в эталонные сигналы dj(n).

в эталонные сигналы dj(n).

2. Записывают сгенерированные входные элементы обучающей выборки u(n) и эталонные сигналы dj(n), соответствующие подлежащей решению с применением ИНС задаче, в виде пар 〈u(n), dj(n)〉 на материальный носитель.

3. Считывают записанные пары вида 〈u(n), dj(n)〉 с материального носителя, и подают на входы ИНС считанные сигналы обучающих векторов u(n) и соответствующие эталонные сигналы dj(n).

4. Корректируют вектор синаптических весов нейронов w(n) до завершения обучения ИНС.

Для реализации пункта 1.1 для обучения ИНС определяют необходимое число К входных элементов обучающей выборки u(n), n=1, 2, …, K, где сущность входного элемента u(n) и его размерность определяются подлежащей решению с применением ИНС прикладной задачей. Например, для задачи классификации объектов, описываемых наборами числовых признаков, входной элемент обучающей выборки u(n) является N-мерным вектором u(n)=(u1(n) u2(n) … uN(n))T, каждый элемент которого количественно характеризует один из признаков.

Для задачи распознавания растровых изображений входной элемент обучающей выборки u(n) является матрицей, размерность которой определяется размерностью подлежащих распознаванию изображений в пикселях.

Непосредственно сам выбор числа К входных элементов обучающей выборки опирается на реализуемую архитектуру ИНС и зависимость ошибки решения прикладной задачи от объема обучающей выборки. При фиксированной архитектуре ИНС эта зависимость имеет ярко выраженный минимум (6 - Манусов В.З., Марков И.С., Дмитриев С.А., Кокин С.Е., Ерошенко С.А. Размер обучающей выборки и ее влияние на архитектуру искусственной нейронной сети в энергосистеме // Вестник ТГУ. - 2013. - т.18. - вып. 4. - С. 1417-1420.).

Для реализации пункта 1.2 для ограничения пространства входных элементов обучающей выборки u(n) некоторой рассматриваемой областью О определяют область допустимых значений u(n). Например, для задачи классификации объектов, описываемых наборами числовых признаков, с u(n)=(u1(n) u2(n) … uN(n)T, область О определяется допустимыми значениями элементов этого вектора. Для задачи распознавания растровых изображений область О определяется допустимыми значениями элементов матрицы u(n). В частности, если распознаванию подлежат только черно-белые изображения, то соответствующие ограничения накладываются на значения элементов матрицы u(n), характеризующих цвет пикселей.

Для реализации пункта 1.3 генерируют для обучения ИНС входные элементы обучающей выборки u(n), n=1, 2, …, K принадлежащие области О. Например, для задачи классификации объектов, описываемых наборами числовых признаков, обучающие векторы входных сигналов ИНС могут быть сформированы с помощью генератора псевдослучайных чисел. При этом сначала указывают М входных векторов, описывают наиболее типичных представителей каждого из исследуемых классов объектов Ωj, j=1, 2, …, М, принадлежащих области О. Затем с помощью генератора псевдослучайных чисел формируют K обучающих векторов u(n), n=1, 2, …, K входных сигналов ИНС, принадлежащих области О, вначале вблизи окрестности указанных точек, т.е. вблизи окрестности точек М векторов, описывающих наиболее типичных представителей каждого из М исследуемых классов объектов Ωj, j= 1, 2, …, М, с последующим последовательным равномерным расширением этой окрестности до указанной ранее области О.

Для задачи распознавания растровых изображений входные матрицы u(n) могут формироваться на основе применения операций поворота, сдвига и масштабирования имеющихся трехмерных моделей или изображений распознаваемых объектов, а также операций скрытия части изображений. Кроме того, генерация может быть реализована путем использования данных, получаемых из следующих источников: локальные данные организации, внешние данные, доступные через Интернет, данные, получаемые от различных устройств [5].

Для реализации пункта 1.4 выбирают L эталонных ИНС. При этом руководствуются принципами доступности и реализованными возможностями этих ИНС. Например, могут быть выбраны реализации ИНС, доступные через Интернет, или на основе программных пакетов для работы с ИНС (7 - Туровский Я.А., Кургалин С.Д., Адаменко А.А. Сравнительный анализ программных пакетов для работы с искусственными нейронными сетями // Вестник ВГУ: Системный анализ и информационные технологии. -2016. - №1. - С. 161-168.).

Для реализации пункта 1.5 последовательно на вход каждой  эталонной ИНС подают сигналы обучающей выборки u(n), n=1, 2,..., K, а на ее выходе фиксируют выходные сигналы

эталонной ИНС подают сигналы обучающей выборки u(n), n=1, 2,..., K, а на ее выходе фиксируют выходные сигналы

. При этом сигналы

. При этом сигналы  для задачи классификации объектов соответствуют классам объектов Ωj, j=1, 2, …, М, к которым по результатам применения

для задачи классификации объектов соответствуют классам объектов Ωj, j=1, 2, …, М, к которым по результатам применения  эталонной ИНС относятся входные элементы обучающей выборки u(n).

эталонной ИНС относятся входные элементы обучающей выборки u(n).

Для реализации пункта 1.6 преобразуют сигналы

в эталонные сигналы dj(n). При этом правило преобразования может быть различным, например, в виде мажоритарной выборки из L элементов, реализуемой устройствами для мажоритарного выбора сигналов (8 - Патент РФ №2396591, МПК: (2006.01) G06F 11/18. Устройство для мажоритарного выбора сигналов, Леденев Г.Я., Сухов Б.М., Ефимов С.Н. Публ. - 10.08.2010 г.).

в эталонные сигналы dj(n). При этом правило преобразования может быть различным, например, в виде мажоритарной выборки из L элементов, реализуемой устройствами для мажоритарного выбора сигналов (8 - Патент РФ №2396591, МПК: (2006.01) G06F 11/18. Устройство для мажоритарного выбора сигналов, Леденев Г.Я., Сухов Б.М., Ефимов С.Н. Публ. - 10.08.2010 г.).

Для реализации пункта 2 записывают сгенерированные входные элементы обучающей выборки u(n) и эталонные сигналы dj(n), соответствующие подлежащей решению с применением ИНС задаче, в виде пар 〈u(n), dj(n)〉, n=1, 2, …, K на материальный носитель. При этом запись пар может быть реализована в виде двух индексированных массивов u(n), n=1, 2, …, K и dj(n), n=1, 2, …, K.

Для реализации пункта 3 считывают записанные пары вида 〈u(n), dj(n)〉 с материального носителя, и подают на входы ИНС считанные сигналы обучающих векторов u(n) и соответствующие эталонные сигналы dj(n). При этом считанные сигналы обучающих векторов u(n) на входы ИНС подают последовательно, результаты с выхода ИНС сравнивают с соответствующими эталонными сигналами dj(n).

Для реализации пункта 4 корректируют вектор синаптических весов нейронов w(n) до завершения обучения ИНС. Например, для задачи классификации объектов, решаемой ИНС, реализованной на основе персептрона, обучение заключается в рекуррентной коррекции вектора весов w(n) с некоторым шагом коррекции 0<η<1 [5].

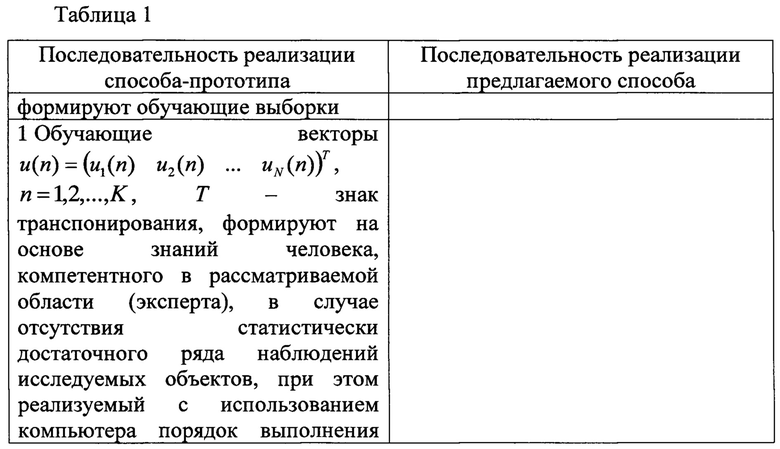

Таким образом, предлагаемый способ имеет следующие отличительные признаки в последовательности его реализации от способа-прототипа, которые представлены в таблице 1.

Из представленной таблицы 1 сравнения последовательностей реализации способа-прототипа и предлагаемого способа видно, что в предлагаемом способе, относительно способа-прототипа, дополнительно обучающие выборки формируют на основе последовательного применения эталонных ИНС, в случае отсутствия статистически достаточного ряда наблюдений исследуемых объектов, при этом реализуемый порядок выполнения действий способа содержит следующие этапы: после ограничения пространства входных элементов обучающей выборки генерируют входные элементы обучающей выборки u(n), n=1, 2, …, K, принадлежащие области О, для обучения ИНС, выбирают L эталонных ИНС, последовательно на вход каждой  эталонной ИНС подают сигналы обучающей выборки u(n), n=1, 2, …, K, а на ее выходе фиксируют выходные сигналы

эталонной ИНС подают сигналы обучающей выборки u(n), n=1, 2, …, K, а на ее выходе фиксируют выходные сигналы

, преобразуют сигналы

, преобразуют сигналы  в эталонные сигналы dj(n), записывают сгенерированные входные элементы обучающей выборки u(n) и эталонные сигналы dj(n), соответствующие подлежащей решению с применением ИНС задаче, в виде пар 〈u(n), dj(n)〉 на материальный носитель.

в эталонные сигналы dj(n), записывают сгенерированные входные элементы обучающей выборки u(n) и эталонные сигналы dj(n), соответствующие подлежащей решению с применением ИНС задаче, в виде пар 〈u(n), dj(n)〉 на материальный носитель.

Структурная схема устройства, реализующего предлагаемый способ, изображена на фигуре. В состав устройства входят:

01 - устройство формирования входных элементов обучающей выборки (УФВЭОВ);

02 - устройство реализации эталонных искусственных нейронных сетей (УРЭИНС);

03 - устройство регистрации выходных сигналов эталонных искусственных нейронных сетей (УРВСЭИНС);

04 - устройство формирования эталонных сигналов (УФЭС);

05 - блок регистрации обучающей выборки (БРОВ);

06 - устройство коррекции вектора синаптических весов нейронов (УКВСВН).

Выход УФВЭОВ 01 соединен со входом УРЭИНС 02 и входом УФЭС 04. Выход УРЭИНС 02 соединен со входом УРВСЭИНС 03, выход которого соединен со входом УФЭС 04. Выход УФЭС 04 соединен со входом БРОВ 05, выход которого соединен со входом УКВСВН 06.

УФВЭОВ 01 формирует входные элементы обучающей выборки, передает их в УРЭИНС 02 и УФЭС 04. Полученные входные элементы обучающей выборки u(n), n=1, 2, …, K используются в УРЭИНС 02 для последовательного применения в качестве входных сигналов для L выбранных и реализуемых в УРЭИНС 02 эталонных ИНС. Каждая  эталонная ИНС на поданный входной сигнал u(n) вырабатывает выходной сигнал

эталонная ИНС на поданный входной сигнал u(n) вырабатывает выходной сигнал  . Совокупность этих сигналов

. Совокупность этих сигналов

для каждого n в УРЭИНС 02 преобразуется в эталонный сигнал dj(n). Этот эталонный сигнал с выхода УРЭИНС 02 подается на вход УРВСЭИНС 03, где осуществляется его регистрация. Зарегистрированный эталонный сигнал dj(n) с выхода УРВСЭИНС 03 подается на вход УФЭС 04, на который с выхода УФВЭОВ 01 поступает ему соответствующий элемент обучающей выборки u(n). В УФЭС 04 реализуется их попарное объединение в виде наборов 〈u(n), dj(n)〉. С выхода УФЭС 04 эти пары 〈u(n), dj(n)〉 поступают на вход БРОВ 05, где записываются на материальный носитель. Записанные пары 〈u(n), dj(n)〉 по мере реализации процедуры обучения ИНС в УКВСВН 06 подаются с выхода БРОВ 05 на вход УКВСВН 06. По результатам их поступления в УКВСВН 06 корректируется вектор синаптических весов нейронов w(n) до завершения обучения ИНС.

для каждого n в УРЭИНС 02 преобразуется в эталонный сигнал dj(n). Этот эталонный сигнал с выхода УРЭИНС 02 подается на вход УРВСЭИНС 03, где осуществляется его регистрация. Зарегистрированный эталонный сигнал dj(n) с выхода УРВСЭИНС 03 подается на вход УФЭС 04, на который с выхода УФВЭОВ 01 поступает ему соответствующий элемент обучающей выборки u(n). В УФЭС 04 реализуется их попарное объединение в виде наборов 〈u(n), dj(n)〉. С выхода УФЭС 04 эти пары 〈u(n), dj(n)〉 поступают на вход БРОВ 05, где записываются на материальный носитель. Записанные пары 〈u(n), dj(n)〉 по мере реализации процедуры обучения ИНС в УКВСВН 06 подаются с выхода БРОВ 05 на вход УКВСВН 06. По результатам их поступления в УКВСВН 06 корректируется вектор синаптических весов нейронов w(n) до завершения обучения ИНС.

Таким образом, предлагаемый способ позволяет реализовать обучение искусственной нейронной сети и расширяет арсенал технических средств, реализующих технологию ИНС, на случаи отсутствия статистически достаточного ряда наблюдений исследуемых объектов и ограничения времени обучения ИНС.

Изобретение относится к компьютерным системам, а именно искусственным нейронным сетям, и может быть использовано для обучения нейронной сети при моделировании физических явлений технологических процессов. Техническим результатом является обеспечение возможности обучения ИНС в случае отсутствия статистически достаточного ряда наблюдений исследуемых объектов и сокращение времени обучения ИНС. Способ содержит операции: ограничивают пространство входных элементов обучающей выборки некоторой областью, подают на входы искусственной нейронной сети сигналы обучающих векторов и эталонные сигналы, корректируют вектор синаптических весов нейронов, формируют обучающие выборки на основе последовательного применения эталонных ИНС, в случае отсутствия статистически достаточного ряда наблюдений исследуемых объектов, генерируют входные элементы обучающей выборки u(n), n=1, 2, …, K, принадлежащие области О, для обучения ИНС, для обучения ИНС выбирают L эталонных ИНС, последовательно подают на вход каждой  эталонной ИНС сигналы обучающей выборки u(n), n=1, 2, …, K, и фиксируют на ее выходе выходные сигналы

эталонной ИНС сигналы обучающей выборки u(n), n=1, 2, …, K, и фиксируют на ее выходе выходные сигналы  ,

,  , преобразуют сигналы

, преобразуют сигналы  в эталонные сигналы dj(n), записывают сгенерированные входные элементы обучающей выборки u(n) и эталонные сигналы dj(n), соответствующие подлежащей решению с применением ИНС задаче, в виде пар 〈u(n),dj(n)〉 на материальный носитель. 1 табл.

в эталонные сигналы dj(n), записывают сгенерированные входные элементы обучающей выборки u(n) и эталонные сигналы dj(n), соответствующие подлежащей решению с применением ИНС задаче, в виде пар 〈u(n),dj(n)〉 на материальный носитель. 1 табл.

Способ обучения искусственной нейронной сети, для реализации которого определяют необходимое число К входных элементов обучающей выборки u(n), n=1, 2, …, K для обучения искусственной нейронной сети, ограничивают пространство входных элементов обучающей выборки u(n) некоторой рассматриваемой областью О, считывают записанные пары вида 〈u(n),dj(n)〉 с материального носителя, и подают на входы искусственной нейронной сети считанные сигналы обучающих векторов u(n) и соответствующие эталонные сигналы dj(n), корректируют вектор синаптических весов нейронов w(n) до завершения обучения искусственной нейронной сети, отличающийся тем, что дополнительно обучающие выборки формируют на основе последовательного применения эталонных искусственных нейронных сетей, в случае отсутствия статистически достаточного ряда наблюдений исследуемых объектов, при этом реализуемый порядок выполнения действий способа содержит следующие этапы: после ограничения пространства входных элементов обучающей выборки генерируют входные элементы обучающей выборки u(n), n=1, 2, …, K, принадлежащие области О, для обучения искусственной нейронной сети, выбирают L эталонных искусственных нейронных сетей, последовательно на вход каждой  эталонной искусственной нейронной сети подают сигналы обучающей выборки u(n), n=1, 2, …, K, а на ее выходе фиксируют выходные сигналы

эталонной искусственной нейронной сети подают сигналы обучающей выборки u(n), n=1, 2, …, K, а на ее выходе фиксируют выходные сигналы  ,

,  , преобразуют сигналы

, преобразуют сигналы  в эталонные сигналы dj(n), записывают сгенерированные входные элементы обучающей выборки u(n) и эталонные сигналы dj(n), соответствующие подлежащей решению с применением искусственной нейронной сети задаче, в виде пар 〈u(n),dj(n)〉 на материальный носитель.

в эталонные сигналы dj(n), записывают сгенерированные входные элементы обучающей выборки u(n) и эталонные сигналы dj(n), соответствующие подлежащей решению с применением искусственной нейронной сети задаче, в виде пар 〈u(n),dj(n)〉 на материальный носитель.

| Автомобиль-сани, движущиеся на полозьях посредством устанавливающихся по высоте колес с шинами | 1924 |

|

SU2017A1 |

| Приспособление для суммирования отрезков прямых линий | 1923 |

|

SU2010A1 |

| Способ получения цианистых соединений | 1924 |

|

SU2018A1 |

| СПОСОБ ОБУЧЕНИЯ ИСКУССТВЕННОЙ НЕЙРОННОЙ СЕТИ | 2012 |

|

RU2504006C1 |

| Делительный механизм многопозиционного поворотного стола | 1961 |

|

SU151549A1 |

Авторы

Даты

2020-06-09—Публикация

2019-08-13—Подача