Область техники, к которой относится изобретение

[0001] Настоящее изобретение относится к способу управления устройством отображения, а также относится к устройству отображения.

Уровень техники

[0002] В данной области техники известна технология визуального отображения чувствительности обнаружения бортовой камеры пользователю (например, патентный документ 1).

Документы предшествующего уровня техники

Патентные документы

[0003] Патентный документ 1. JP2012-73926A

Сущность изобретения

Задачи, решаемые изобретением

[0004] Согласно вышеуказанному предшествующему уровню техники, водителю может предоставляться возможность воспринимать то, является чувствительность обнаружения бортовой камеры хорошей или плохой. Тем не менее, вышеуказанный предшествующий уровень техники не может обеспечивать возможность водителю интуитивно воспринимать состояние обнаружения бортовой камеры, к примеру, то, находится либо нет бортовая камера в состоянии поиска объекта или в состоянии обнаружения объекта.

[0005] Проблема, которая должна разрешаться посредством настоящего изобретения, заключается в том, чтобы предоставлять способ управления устройством отображения и устройства отображения, которые обеспечивают возможность водителю интуитивно воспринимать состояние обнаружения датчика обнаружения окружающих условий.

Средство решения задач

[0006] Настоящее изобретение разрешает вышеуказанную проблему посредством определения состояния обнаружения детектора на основе результата обнаружения детектора, задания формы для отображения глаз выражения лица изображения, имитирующего лицо, включающее в себя, по меньшей мере, глаза, на основе состояния обнаружения детектора и отображения изображения, имитирующего лицо, на устройстве отображения.

Преимущества изобретения

[0007] Согласно настоящему изобретению, состояние обнаружения датчика обнаружения окружающих условий может выражаться с использованием формы для отображения глаз выражения лица изображения, имитирующего лицо, включающее в себя, по меньшей мере, глаза и в силу этого интуитивно восприниматься водителем.

Краткое описание чертежей

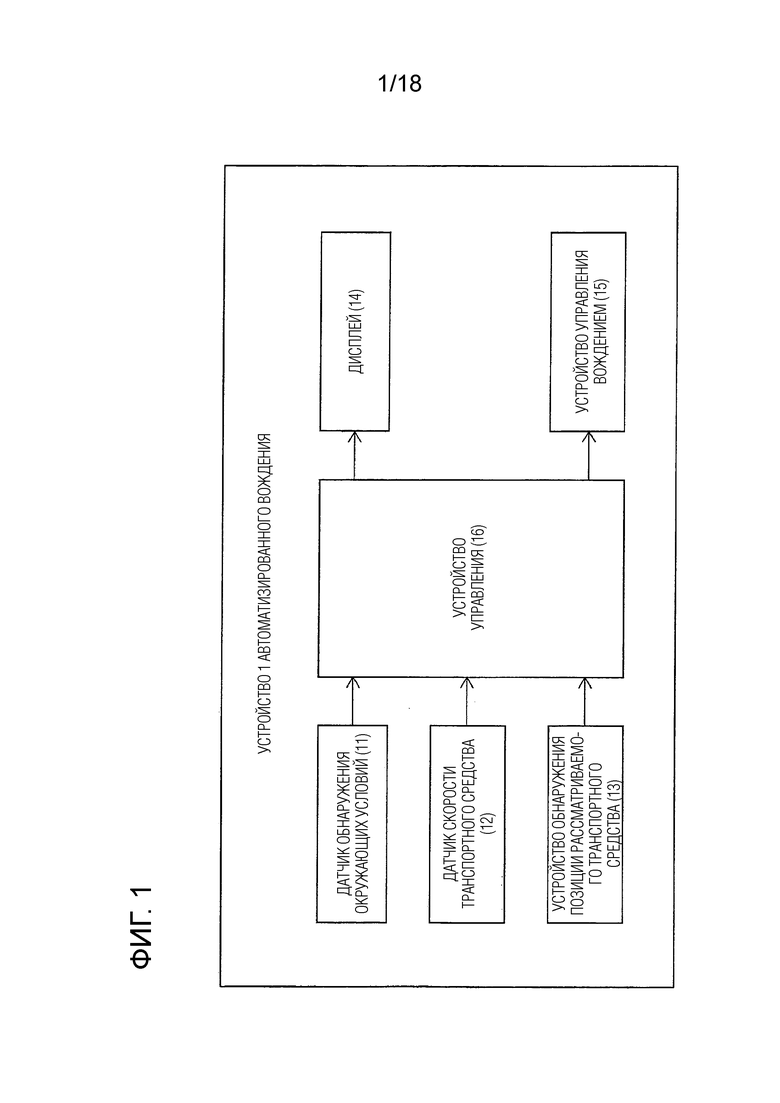

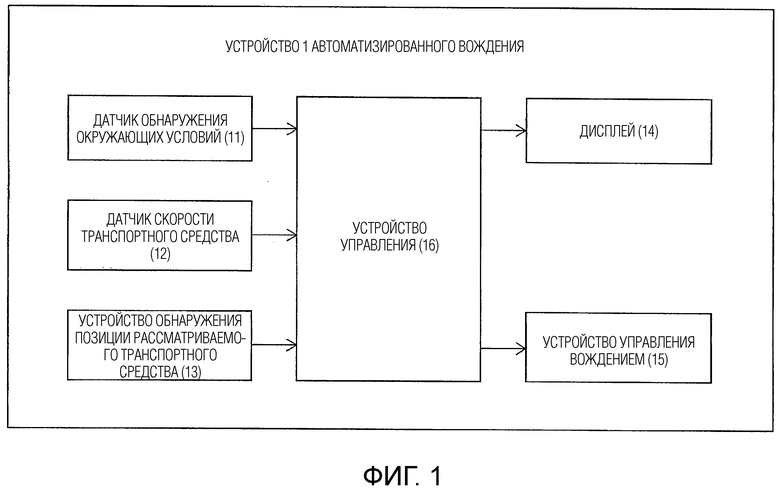

[0008] Фиг. 1 является блок-схемой, иллюстрирующей конфигурацию устройства автоматизированного вождения согласно одному или более вариантов осуществления настоящего изобретения.

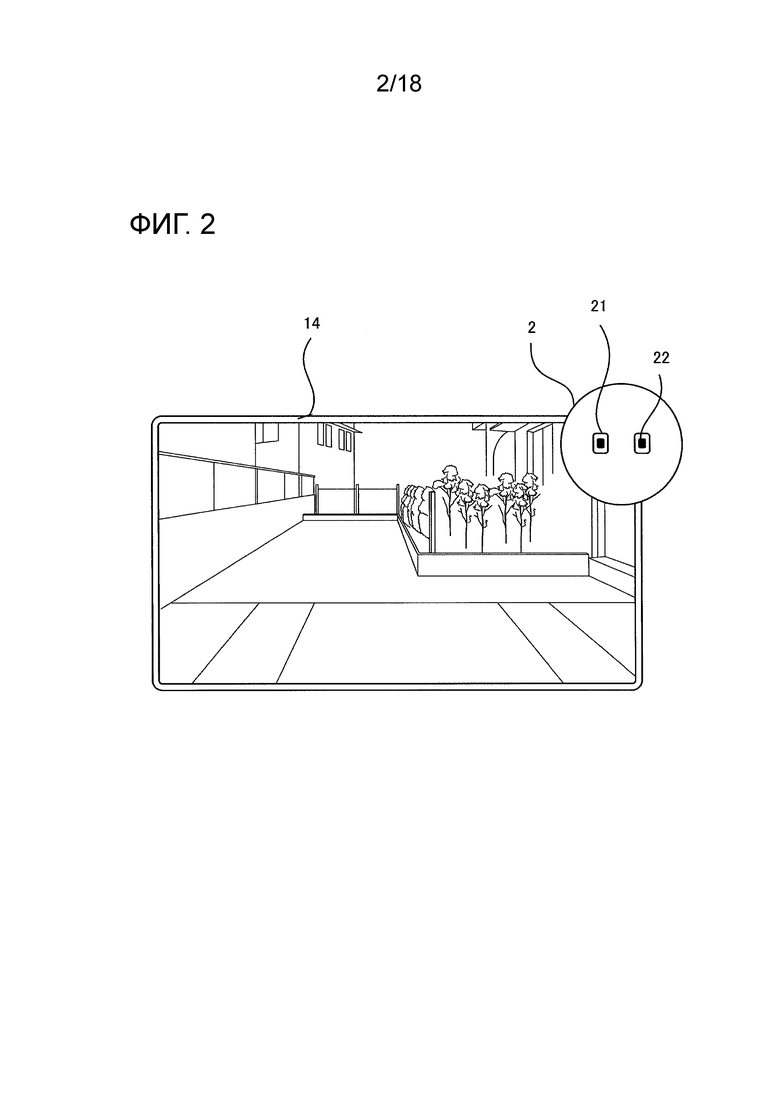

Фиг. 2 является схемой, иллюстрирующей пример экрана, отображаемого на дисплее согласно одному или более вариантов осуществления настоящего изобретения.

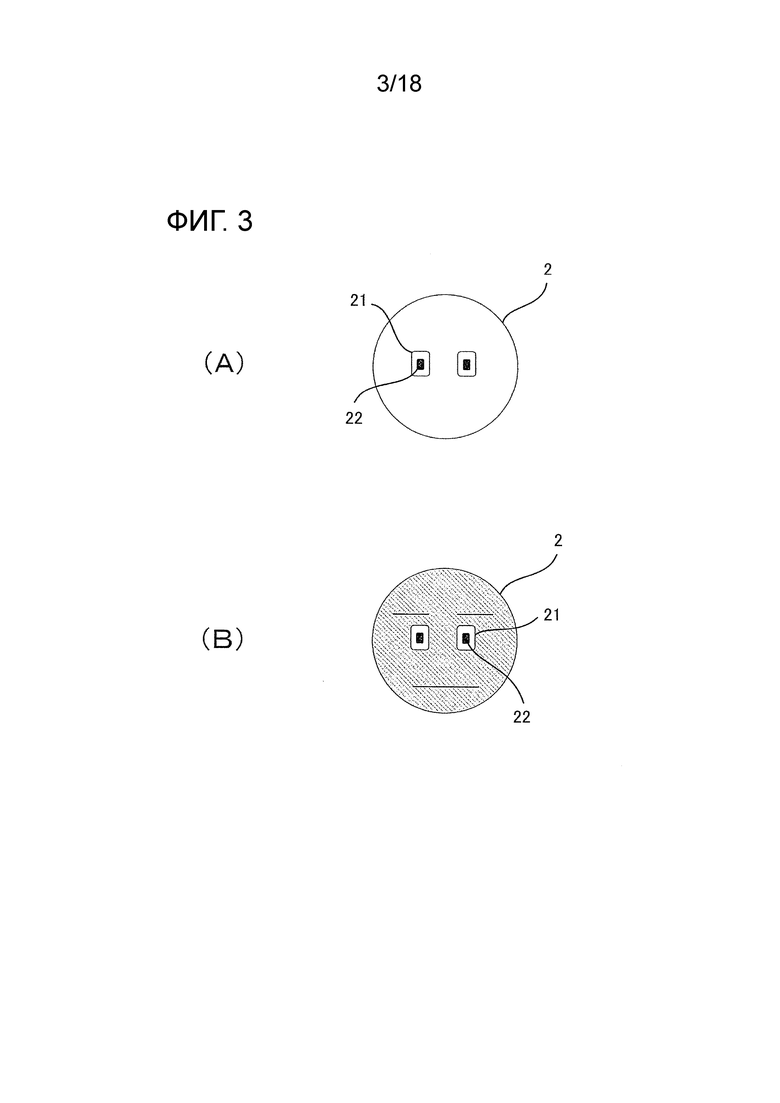

Фиг. 3 является набором схем, иллюстрирующих пример выражения лица агента согласно одному или более вариантов осуществления настоящего изобретения.

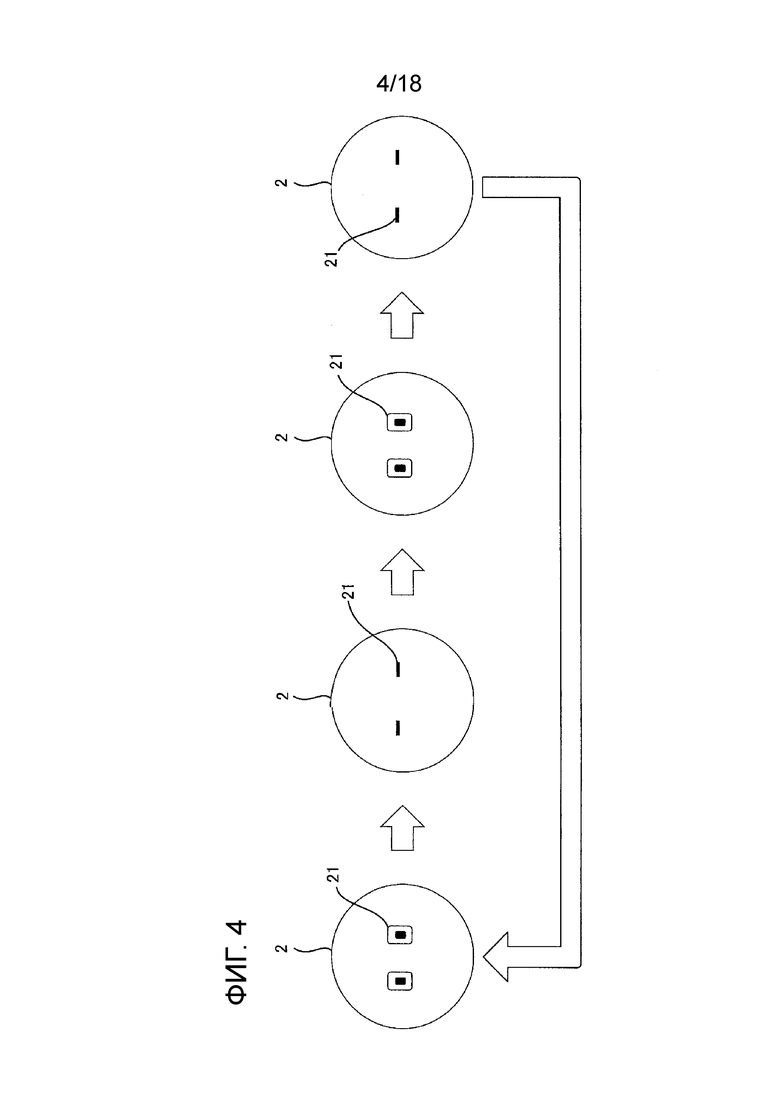

Фиг. 4 является схемой, иллюстрирующей пример выражения лица агента, выполняющего поиск объекта в одном или более вариантов осуществления настоящего изобретения.

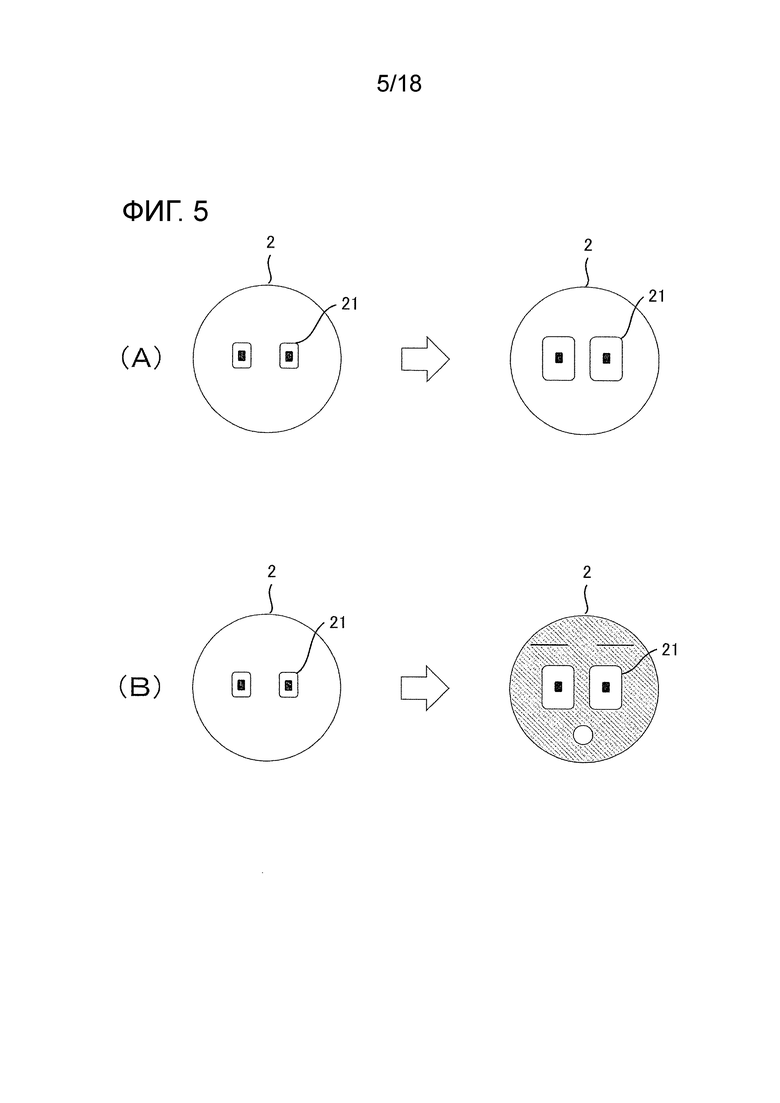

Фиг. 5 является набором схем, иллюстрирующих пример выражения лица агента, обнаруживающего объект в одном или более вариантов осуществления настоящего изобретения.

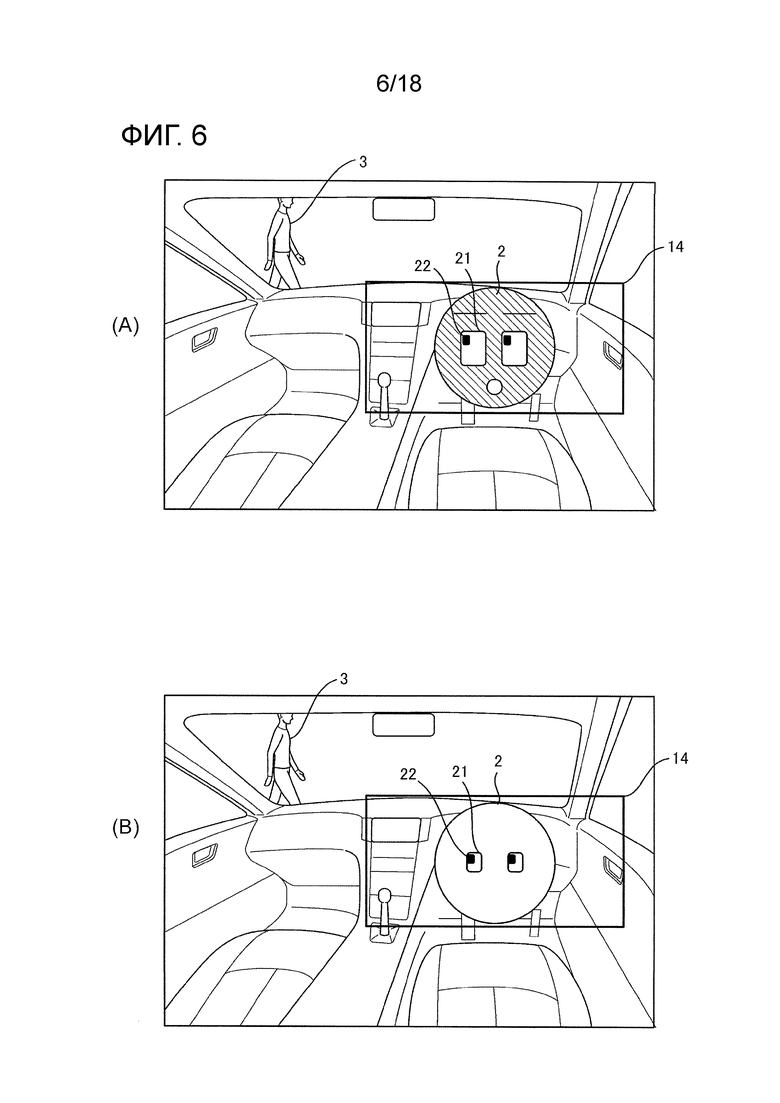

Фиг. 6 является набором схем, иллюстрирующих взаимосвязь между позицией объекта и выражением лица агента в одном или более вариантов осуществления настоящего изобретения.

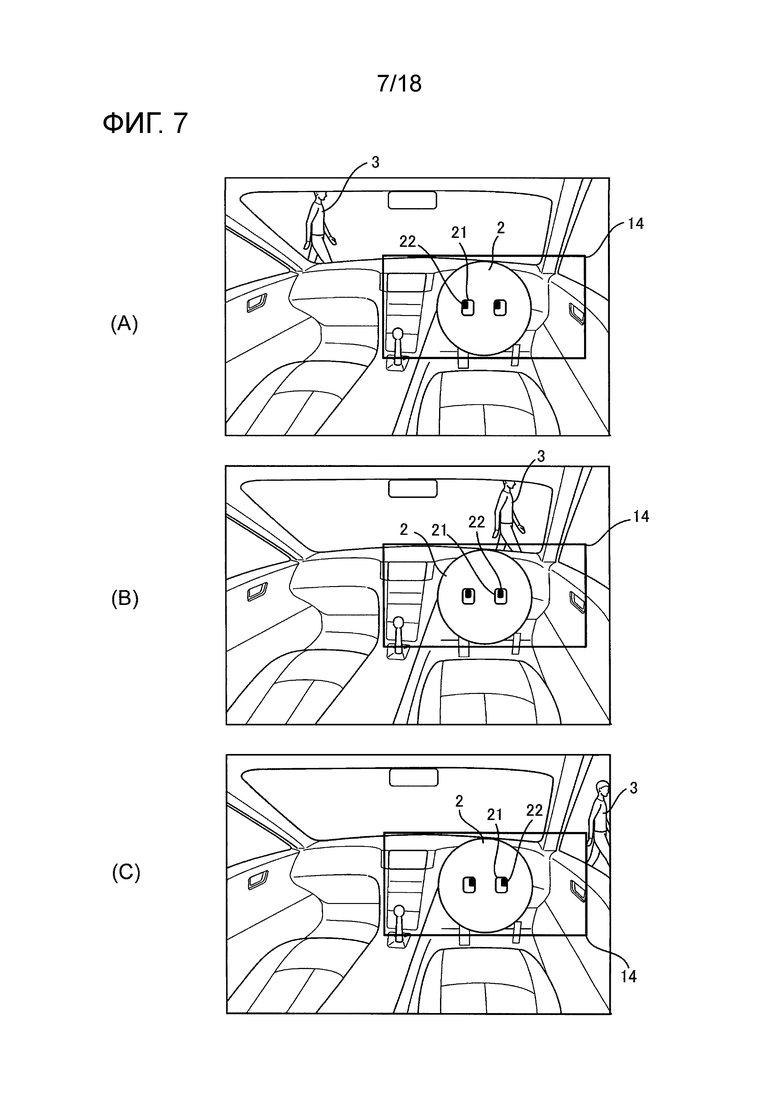

Фиг. 7 является набором схем, иллюстрирующих пример выражения лица агента, отслеживающего объект в одном или более вариантов осуществления настоящего изобретения.

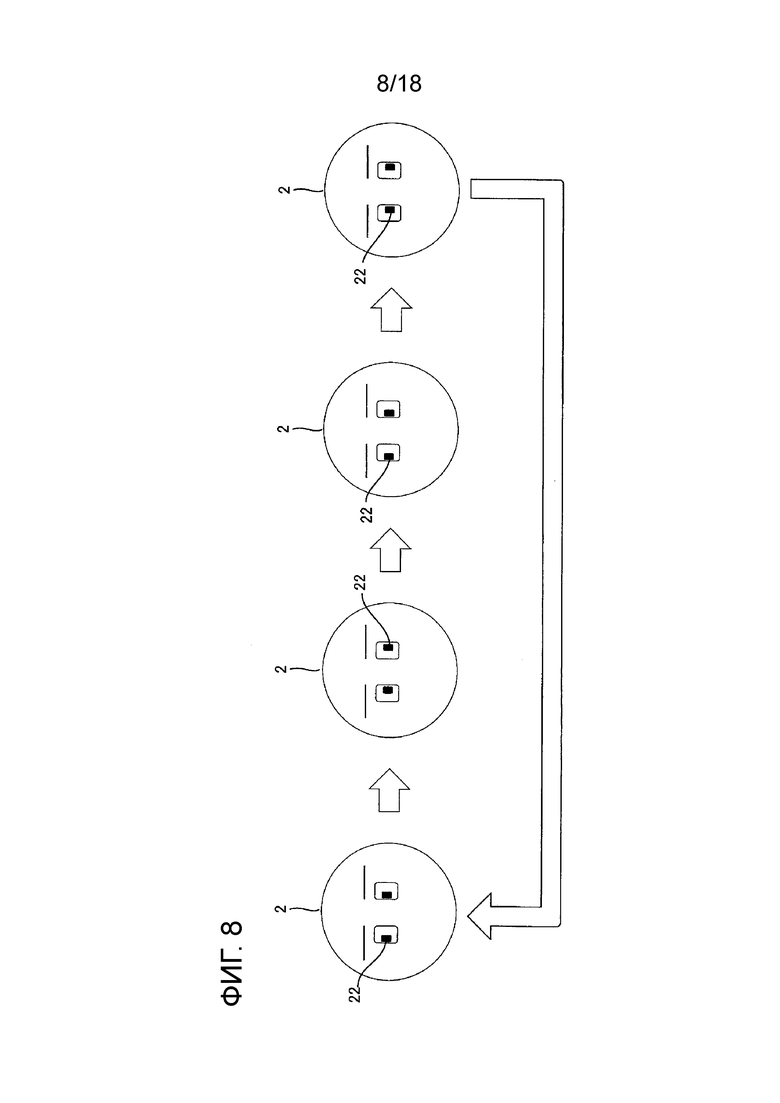

Фиг. 8 является схемой, иллюстрирующей пример выражения лица агента при потере из виду объекта в одном или более вариантов осуществления настоящего изобретения.

Фиг. 9 является схемой, иллюстрирующей пример выражения лица агента, когда обнаружение объекта не может выполняться в одном или более вариантов осуществления настоящего изобретения.

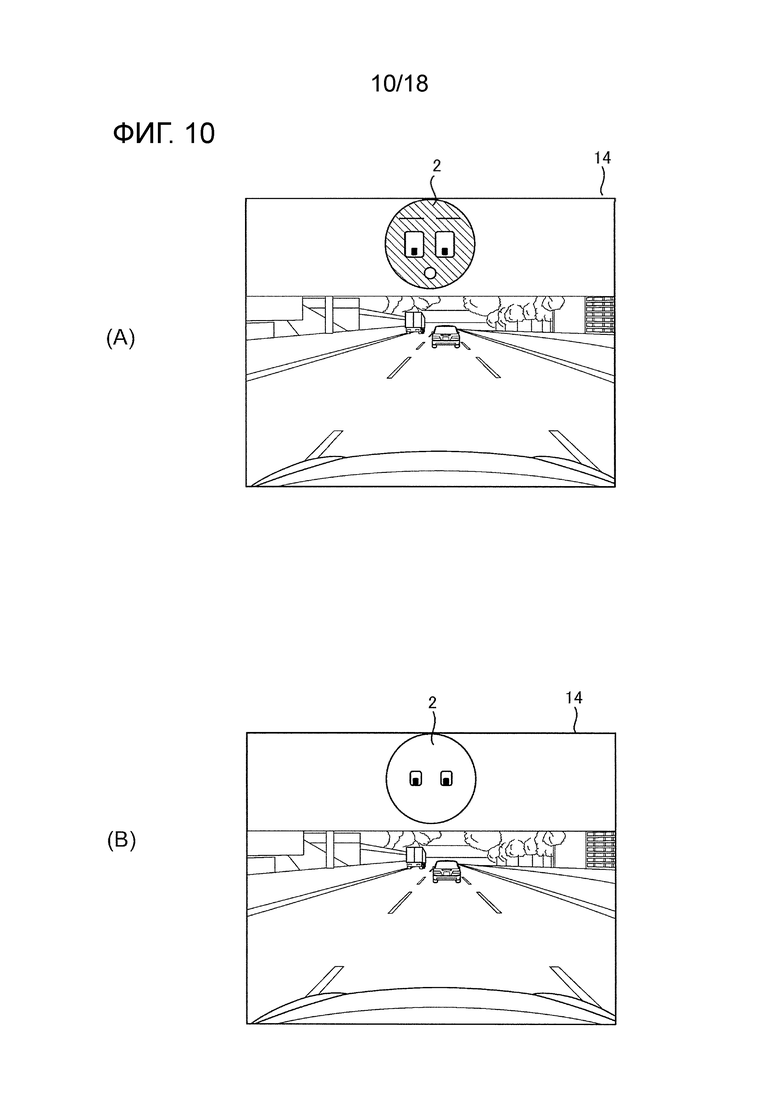

Фиг. 10 является набором схем, иллюстрирующих пример отображения агента, когда захваченное изображение объекта отображается на дисплее в одном или более вариантов осуществления настоящего изобретения.

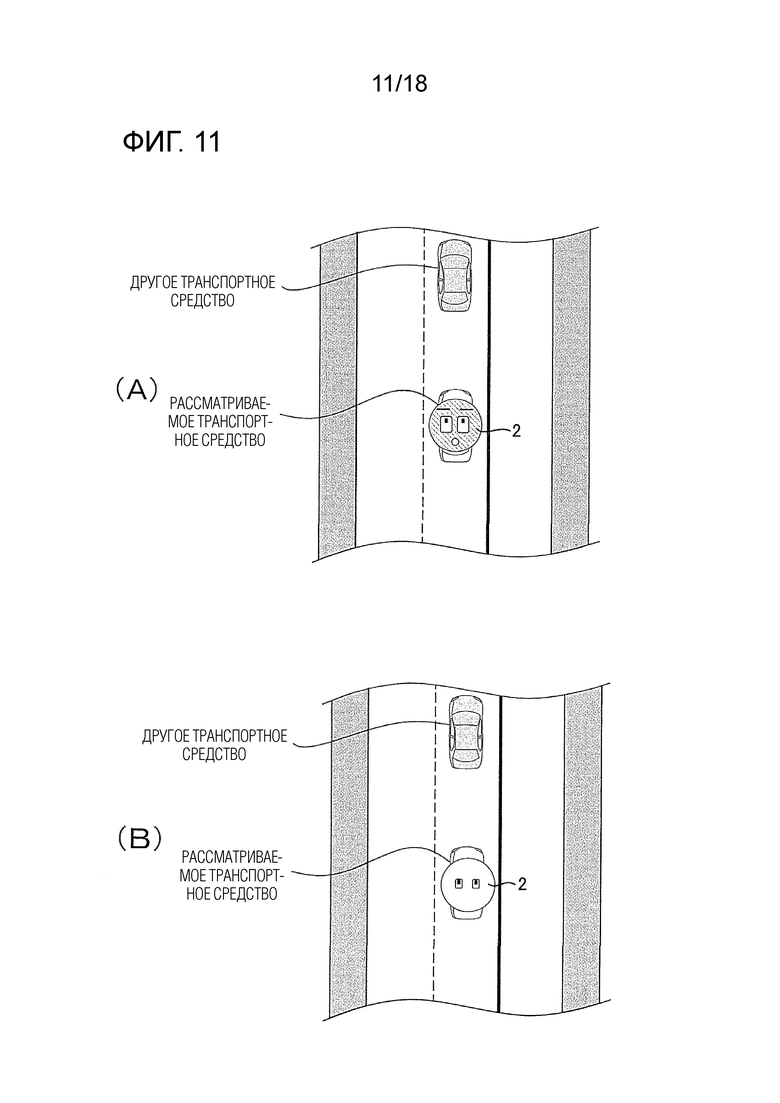

Фиг. 11 является набором схем, иллюстрирующих пример отображения агента, когда имитированное изображение объекта отображается на дисплее в одном или более вариантов осуществления настоящего изобретения.

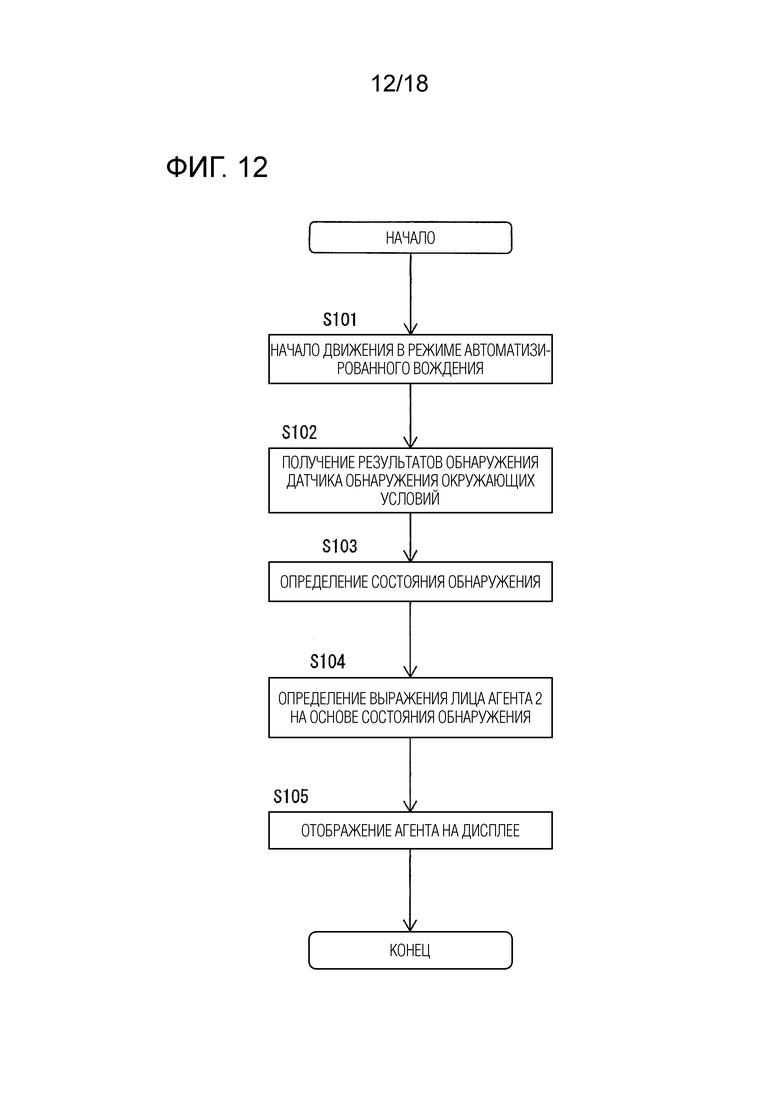

Фиг. 12 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса автоматизированного вождения согласно первому варианту осуществления настоящего изобретения.

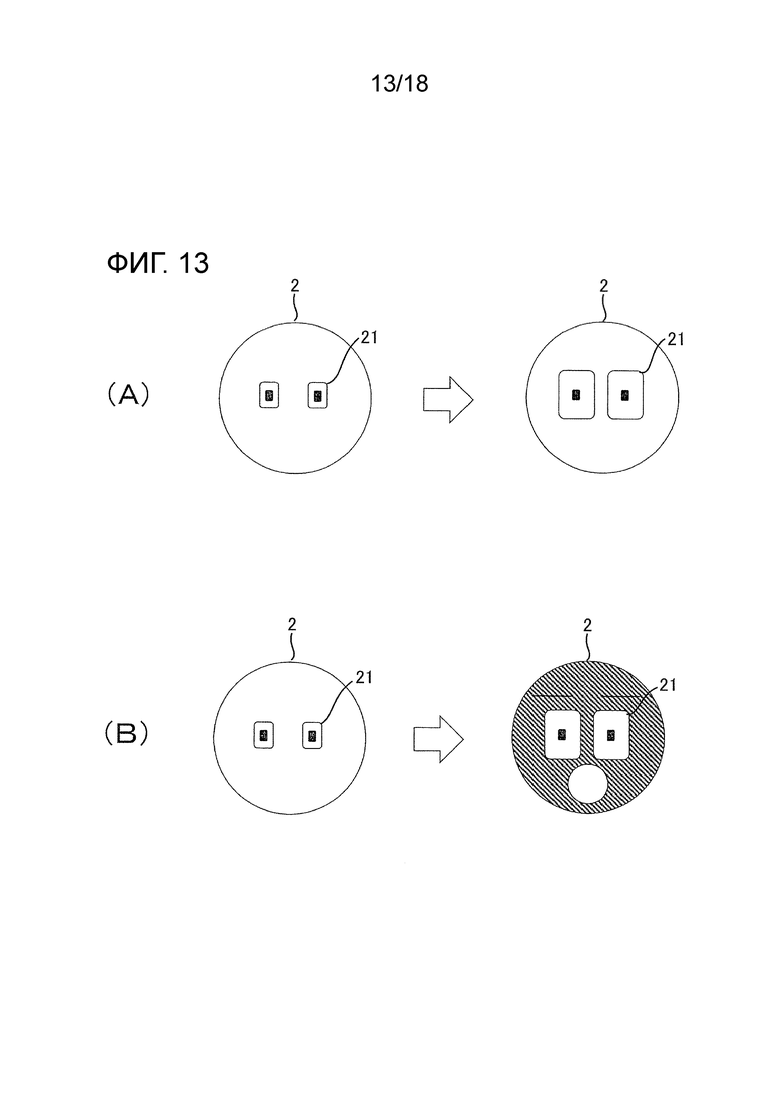

Фиг. 13 является набором схем, иллюстрирующих пример выражения лица агента, когда значение определения явности является высоким в одном или более вариантов осуществления настоящего изобретения.

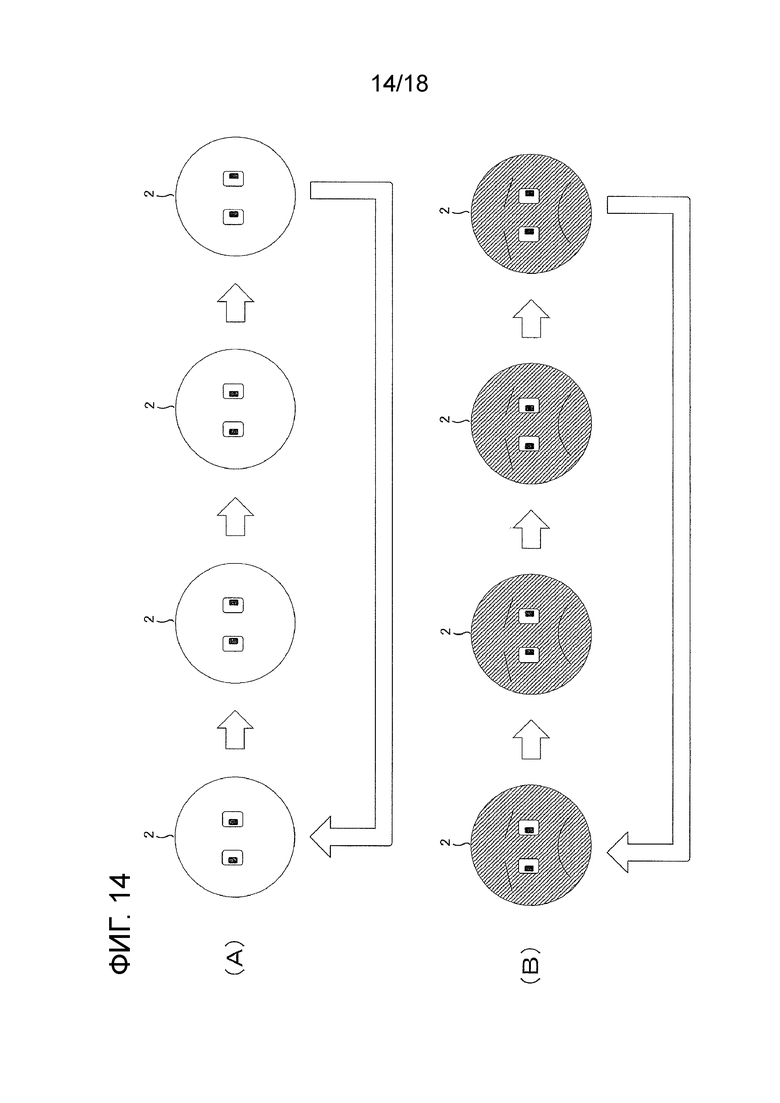

Фиг. 14 является набором схем, иллюстрирующих пример выражения лица агента, когда значение определения неявности является высоким в одном или более вариантов осуществления настоящего изобретения.

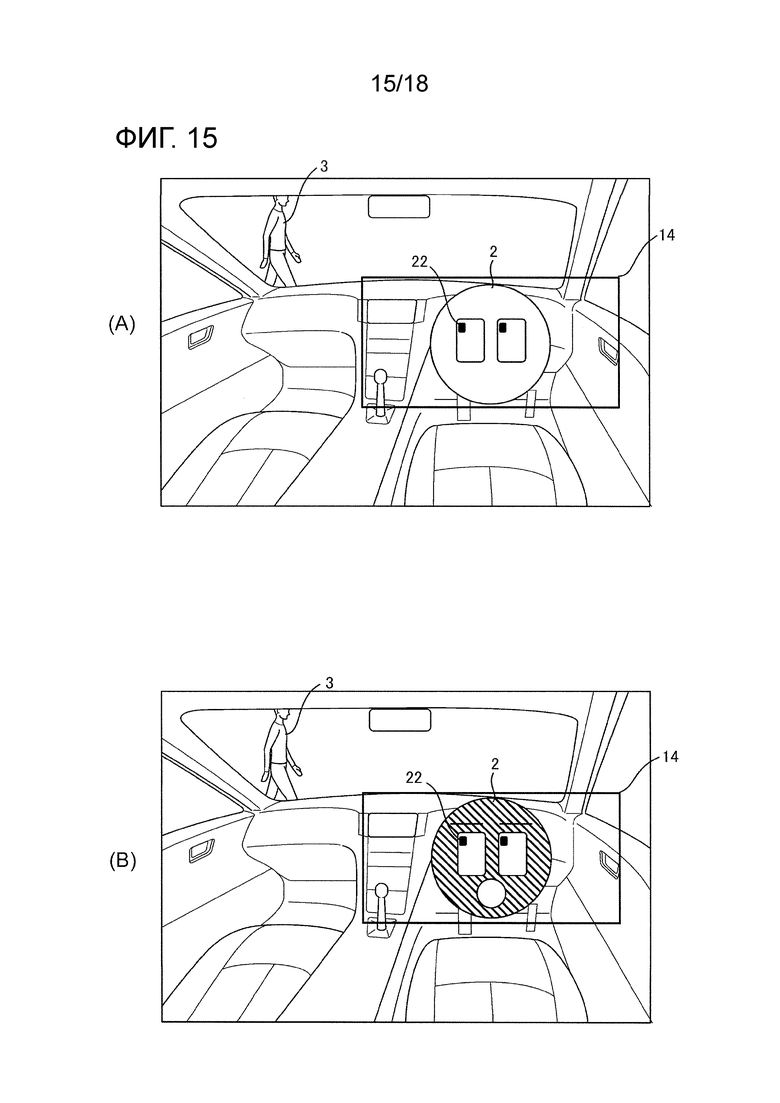

Фиг. 15 является набором схем, иллюстрирующих взаимосвязь между позицией явного объекта и выражением лица агента в одном или более вариантов осуществления настоящего изобретения.

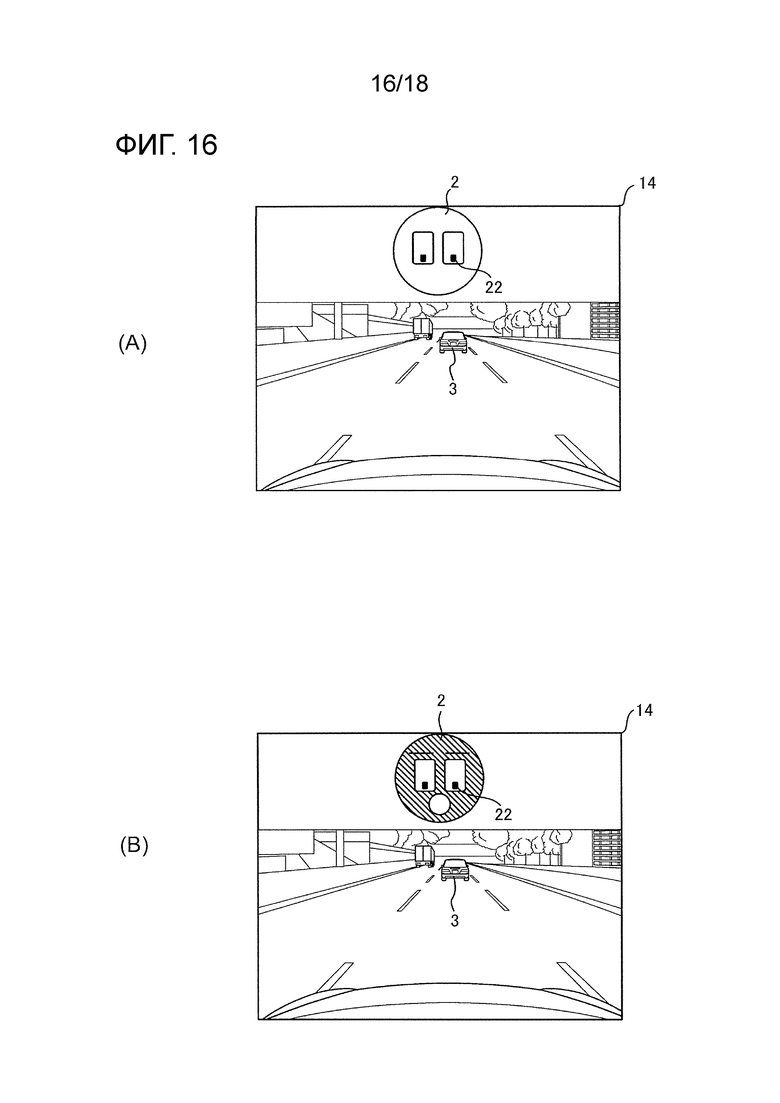

Фиг. 16 является набором схем, иллюстрирующих пример отображения агента, когда захваченное изображение явного объекта отображается на дисплее в одном или более вариантов осуществления настоящего изобретения.

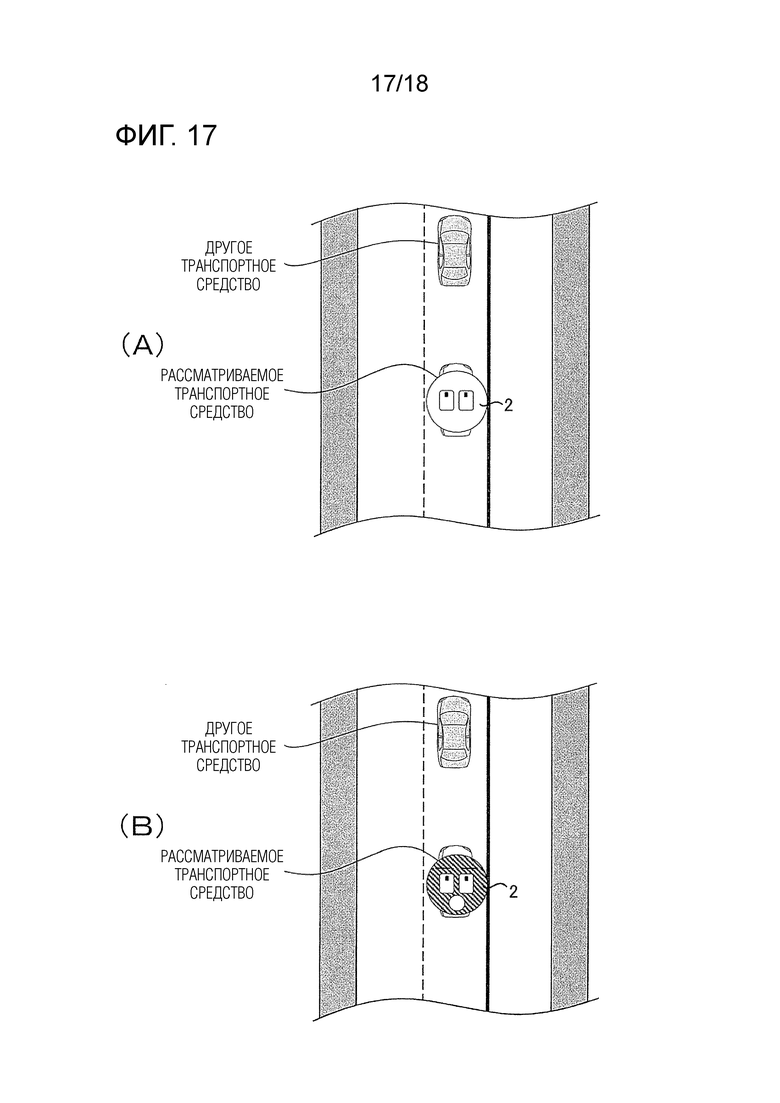

Фиг. 17 является набором схем, иллюстрирующих пример отображения агента, когда имитированное изображение явного объекта отображается на дисплее в одном или более вариантов осуществления настоящего изобретения.

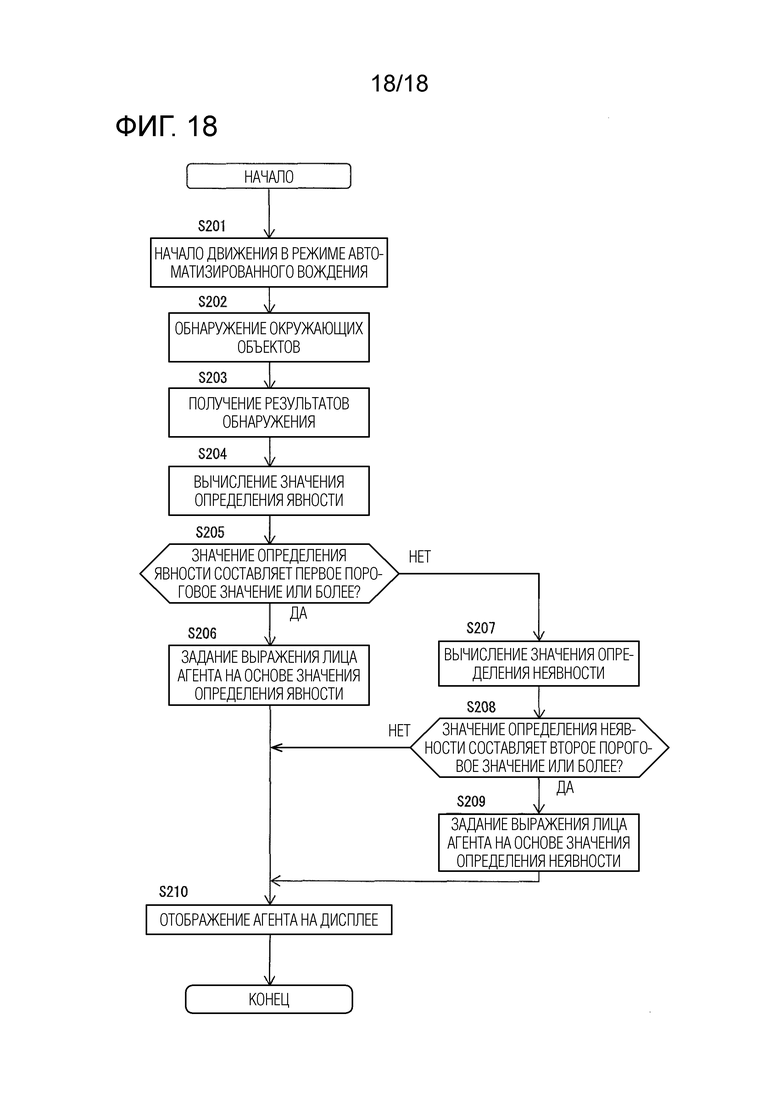

Фиг. 18 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса автоматизированного вождения согласно второму варианту осуществления настоящего изобретения.

Оптимальный режим осуществления изобретения

[0009] Далее описываются один или более вариантов осуществления настоящего изобретения со ссылками на чертежи. В вариантах осуществления, описываются примерные случаи, в которых способ управления устройством отображения и устройство отображения настоящего изобретения применяются к устройству 1 автоматизированного вождения, оснащенному в транспортном средстве.

[0010] Первый вариант осуществления

Фиг. 1 является блок-схемой, иллюстрирующей конфигурацию устройства 1 автоматизированного вождения согласно первому варианту осуществления настоящего изобретения. Как проиллюстрировано на фиг. 1, устройство 1 автоматизированного вождения согласно настоящему варианту осуществления включает в себя датчик 11 обнаружения окружающих условий, датчик 12 скорости транспортного средства, устройство 13 обнаружения позиции рассматриваемого транспортного средства, дисплей 14, устройство 15 управления вождением и устройство 16 управления. Эти устройства соединяются друг с другом через контроллерную сеть (CAN) или другую бортовую LAN для взаимного обмена информацией.

[0011] Датчик 11 обнаружения окружающих условий обнаруживает объект 3, существующий рядом с рассматриваемым транспортным средством. Примеры такого датчика 11 обнаружения окружающих условий включают в себя камеру переднего вида, которая захватывает изображения впереди рассматриваемого транспортного средства, камеру заднего вида, которая захватывает изображения позади рассматриваемого транспортного средства, передний радар, который обнаруживает помехи впереди рассматриваемого транспортного средства, задний радар, который обнаруживает помехи позади рассматриваемого транспортного средства, и боковые радары, которые обнаруживают помехи, существующие по бокам от рассматриваемого транспортного средства. Примеры объекта 3, обнаруженного посредством датчика 11 обнаружения окружающих условий, включают в себя пешеходов, велосипеды, мотоциклы, автомобили, помехи на дороге, конструкции, светофоры, дорожные знаки, разделительные линии, края дороги (к примеру, бордюрные камни и дорожные ограждения) и формы дорог (к примеру, изгибы). Датчик 11 обнаружения окружающих условий может быть сконфигурирован с использованием одного из вышеописанных датчиков либо также может быть сконфигурирован с использованием комбинации из двух или более датчиков. Результаты обнаружения датчика 11 обнаружения окружающих условий выводятся в устройство 16 управления.

[0012] Датчик 12 скорости транспортного средства измеряет частоту вращения приводной системы, к примеру, ведущего вала и определяет скорость движения транспортного средства (также в дальнейшем называемую "скоростью транспортного средства") на основе измеренной частоты вращения. Информация скорости транспортного средства, определенная посредством датчика 12 скорости транспортного средства, выводится в устройство 16 управления.

[0013] Устройство 13 обнаружения позиции рассматриваемого транспортного средства состоит из GPS-модуля, гиродатчика и других необходимых компонентов. Устройство 13 обнаружения позиции рассматриваемого транспортного средства обнаруживает радиоволны, передаваемые из множества спутников связи, с использованием GPS-модуля, чтобы периодически получать позиционную информацию целевого транспортного средства (рассматриваемого транспортного средства). Затем устройство 13 обнаружения позиции рассматриваемого транспортного средства обнаруживает текущую позицию целевого транспортного средства на основе полученной позиционной информации целевого транспортного средства, информации варьирования угла, полученной из гиродатчика, и скорости транспортного средства, полученной из датчика 12 скорости транспортного средства. Позиционная информация целевого транспортного средства, обнаруженная посредством устройства 13 обнаружения позиции рассматриваемого транспортного средства, выводится в устройство 16 управления.

[0014] Дисплей 14, например, может представлять собой такое устройство, как дисплей навигационного устройства, дисплей, включенный в зеркало заднего вида, дисплей, включенный в приборный блок приборной панели, или дисплей на лобовом стекле, проецируемый на ветровое стекло. Дисплей 14 отображает агента 2 в соответствии с управлением посредством устройства 16 управления. Ниже описывается агент 2.

[0015] Устройство 15 управления вождением управляет движением рассматриваемого транспортного средства. Например, когда рассматриваемое транспортное средство содержит режим следования за едущим впереди транспортным средством, устройство 15 управления вождением управляет работой приводного механизма (которая включает в себя работу двигателя внутреннего сгорания в случае автомобиля с двигателем и работу электромотора в случае электромобиля и дополнительно включает в себя распределение крутящего момента между двигателем внутреннего сгорания и электромотором в случае гибридного автомобиля) и операцией нажатия педали тормоза, чтобы достигать ускорения, замедления и скорости транспортного средства таким образом, что расстояние между рассматриваемым транспортным средством и едущим впереди транспортным средством может поддерживаться равным постоянному расстоянию. Когда рассматриваемое транспортное средство содержит режим выполнения автоматического руления, к примеру, правый и левый повороты или смена полосы движения рассматриваемого транспортного средства, устройство 15 управления вождением управляет работой актуатора рулевого управления таким образом, чтобы управлять работой колес, и в силу этого выполняет управление при повороте рассматриваемого транспортного средства. Устройство 15 управления вождением управляет движением рассматриваемого транспортного средства в соответствии с командами из устройства 16 управления, которое описывается ниже. Другие известные способы также могут использоваться в качестве способа управления движением, осуществляемого посредством устройства 15 управления вождением.

[0016] Устройство 16 управления состоит из постоянного запоминающего устройства (ROM), которое сохраняет программы для отображения агента 2 (подробности описываются ниже), представляющего состояние обнаружения (состояние сканирования) датчика 11 обнаружения окружающих условий, на дисплее 14, центрального процессора (CPU), который выполняет программы, сохраненные в ROM, и оперативного запоминающего устройства (RAM), которое служит в качестве доступного устройства хранения данных. В качестве замены или в дополнение к CPU, в качестве функциональной схемы также может использоваться микропроцессор (MPU), процессор цифровых сигналов (DSP), специализированная интегральная схема (ASIC), программируемая пользователем вентильная матрица (FPGA) или другой соответствующий компонент и т.п.

[0017] Устройство 16 управления выполняет программы, сохраненные в ROM, с использованием CPU, чтобы за счет этого достигать следующих различных функций: функция получения результатов обнаружения для получения результатов обнаружения датчика 11 обнаружения окружающих условий; функция определения состояния обнаружения для определения состояния обнаружения датчика 11 обнаружения окружающих условий на основе результатов обнаружения датчика 11 обнаружения окружающих условий; функция отображения агента для отображения агента 2 на дисплее 14; функция задания выражений лица для задания выражения лица агента 2, который должен отображаться на дисплее 14, на основе состояния обнаружения датчика 11 обнаружения окружающих условий; и функция управления движением для управления движением в режиме автоматизированного вождения. Ниже описываются эти функции устройства 16 управления.

[0018] Устройство 16 управления может использовать функцию получения результатов обнаружения для того, чтобы получать результаты обнаружения из датчика 11 обнаружения окружающих условий. Например, устройство 16 управления может использовать функцию получения результатов обнаружения для того, чтобы получать информацию внешних изображений вокруг транспортного средства, захваченных посредством камеры переднего вида и камеры заднего вида, и/или результатов обнаружения, полученных посредством переднего радара, заднего радара и боковых радаров, в качестве результатов обнаружения датчика 11 обнаружения окружающих условий.

[0019] Устройство 16 управления может использовать функцию определения состояния обнаружения для того, чтобы определять состояние обнаружения (состояние сканирования) датчика 11 обнаружения окружающих условий на основе результатов обнаружения датчика 11 обнаружения окружающих условий, полученных с использованием функции получения результатов обнаружения. В частности, устройство 16 управления может использовать функцию определения состояния обнаружения для того, чтобы определять то, представляет собой состояние обнаружения состояние поиска объекта 3, состояние обнаружения объекта 3, состояние отслеживания объекта 3, состояние потери из виду объекта 3 или состояние неспособности обнаружения объекта 3, на основе результатов обнаружения датчика окружения 11. Помимо этого, когда рассматриваемое транспортное средство находится в состоянии обнаружения объекта 3 или в состоянии отслеживания объекта 3, устройство 16 управления может использовать функцию определения состояния обнаружения для того, чтобы вычислять позицию обнаруженного объекта 3.

[0020] Здесь, состояние поиска объекта 3 означает состояние, в котором обнаружение объекта 3 выполняется, но объект 3 не обнаруживается. Состояние обнаружения объекта 3 означает состояние, в котором объект 3 заново обнаруживается. Состояние обнаружения объекта 3 продолжается в течение определенного периода времени, и после этого начинается состояние отслеживания объекта 3. Состояние отслеживания объекта 3 означает состояние, в котором объект 3 после однократного обнаружения многократно обнаруживается через регулярные временные интервалы. Состояние потери из виду объекта 3 означает состояние, в котором объект 3 обнаружен, но после этого не может обнаруживаться. В настоящем варианте осуществления, когда объект 3 не может обнаруживаться, состояние обнаружения представляет собой состояние потери из виду объекта 3. Состояние неспособности обнаружения объекта 3 означает состояние нахождения в окружении, в котором затруднительно выполнять обнаружение объекта 3, вследствие погоды, к примеру, тумана, дождя или снега, либо окружающего освещения, к примеру, ночью.

[0021] Устройство 16 управления использует функцию отображения агента для того, чтобы отображать агента, представляющего состояние обнаружения датчика 11 обнаружения окружающих условий, на экране дисплея 14. Агент 2 в настоящем варианте осуществления представляет собой тип среды передачи информации для указания состояния обнаружения датчика 11 обнаружения окружающих условий водителю. В частности, персонифицированное изображение символа используется в настоящем варианте осуществления таким образом, что водитель может интуитивно воспринимать такой информационный контент, что датчик 11 обнаружения окружающих условий находится в состоянии обнаружения. Фиг. 2 является схемой, иллюстрирующей пример экрана, отображаемого на дисплее 14, и фиг. 3 является набором схем, иллюстрирующих пример отображения агента 2. Как проиллюстрировано на фиг. 2 и фиг. 3, например, персонифицированный агент 2 настоящего варианта осуществления предпочтительно имеет, по меньшей мере, части 21, которые имитируют глаза (в дальнейшем называемые просто "глазами 21").

[0022] Очертание или форма персонифицированного агента 2 настоящего варианта осуществления не ограничены конкретным образом, и агент 2 может представлять собой изображение, которое имитирует человека или человеческое лицо, например, как проиллюстрировано на фиг. 2 и фиг. 3. Персонифицированный агент 2 не ограничен только изображением, которое имитирует человека или человеческое лицо, и также может представлять собой изображение, которое имитирует собаку, кошку либо другое животное или морду животного. Это обусловлено тем, что, в общем, для животных, отличных от людей, считается, что выражения, т.е. переживания и эмоции в сердце не выражаются в выражениях лица и жестах, но если выражения лица, которые напоминают выражения лица человека, задаются в изображениях животных, отличных от людей, могут получаться действия и эффекты, идентичные действиям и эффектам касательно изображений людей. Примеры агента 2 настоящего варианта осуществления в силу этого включают в себя агентов, которые имитируют животных.

[0023] Агент 2 предпочтительно имеет, по меньшей мере, места, соответствующие глазам 21, и другие места могут надлежащим образом задаваться. Например, как проиллюстрировано на фиг. 3(A), агент 2 может быть выполнен с возможностью иметь контур лица. В альтернативном варианте осуществления, хотя не проиллюстрировано, агент 2 может быть выполнен с возможностью иметь тело в дополнение к контуру лица. Помимо этого или альтернативно, как проиллюстрировано на фиг. 3(B), агент 2 может быть выполнен с возможностью иметь брови и рот. Помимо этого или альтернативно, как проиллюстрировано на фиг. 3(B), цвет лица может изменяться на основе состояния обнаружения датчика 11 обнаружения окружающих условий. Нижеприведенное описание приводится при условии, что выражение лица агента 2, проиллюстрированного на фиг. 3(A) или фиг. 3(B), представляет собой выражение лица в начальном состоянии.

[0024] Устройство 16 управления использует функцию задания выражений лица для того, чтобы задавать выражение лица агента 2. В частности, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать выражение лица агента 2 на основе состояния обнаружения датчика 11 обнаружения окружающих условий. Ниже описываются формы задания выражения лица агента 2 на основе соответствующих состояний обнаружения.

[0025] Фиг. 4 является схемой, иллюстрирующей пример отображения агента 2, когда датчик 11 обнаружения окружающих условий выполняет поиск объекта 3. Когда датчик 11 обнаружения окружающих условий выполняет поиск объекта 3, устройство 16 управления использует функцию задания выражений лица для того, чтобы повторять состояние, в котором агент 2 открывает глаза 21, и состояние, в котором агент 2 закрывает глаза 21, т.е. чтобы заставлять агента 2 мигать глазами, например, как проиллюстрировано на фиг. 4, за счет этого задавая выражение лица, как если агент 2 намеренно мигает. Поскольку люди зачастую мигают глазами при пристальном вглядывании в окрестности, такое задание выражения лица обеспечивает возможность водителю интуитивно воспринимать то, что датчик 11 обнаружения окружающих условий выполняет поиск объекта 3, существующего рядом с рассматриваемым транспортным средством.

[0026] Фиг. 5 является набором схем, иллюстрирующих пример выражения лица агента 2, когда датчик 11 обнаружения окружающих условий обнаруживает объект 3. Когда датчик 11 обнаружения окружающих условий обнаруживает объект 3, устройство 16 управления использует функцию задания выражений лица для того, чтобы задавать выражение лица, например, как проиллюстрировано на фиг. 5(A), как если агент 2 широко открывает глаза 21. Помимо этого или альтернативно, брови и открытый рот могут добавляться агенту 2, например, как проиллюстрировано на фиг. 5(B) и цвет лица агента 2 может изменяться на желтый (указывается посредством тонких диагональных линий в примере, проиллюстрированном на фиг. 5(B), это применимо к фиг. 6(A), к фиг. 10(A), к фиг. 11(A) и к фиг. 14(B)) в течение определенного периода времени (например, нескольких секунд). Когда люди замечают окружающий объект 3, они зачастую широко открывают глаза, так что получается удивленное выражение или изменяется цвет лица. Такое задание выражения лица в силу этого обеспечивает возможность водителю интуитивно воспринимать то, что датчик 11 обнаружения окружающих условий обнаруживает объект 3.

[0027] Фиг. 6 является набором схем для описания взаимосвязи между позицией объекта 3 и выражением лица агента 2. Примеры, проиллюстрированные на фиг. 6, примерно иллюстрируют окружения, в которых агент 2 отображается на дисплее 14, установленном в приборной панели, но дисплей 14 и агент 2 проиллюстрированы с увеличенным размером, превышающим фактический размер, для простого понимания выражения лица агента 2 (это применимо к фиг. 7 и к фиг. 15). Когда датчик 11 обнаружения окружающих условий обнаруживает объект 3, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать выражение лица агента 2 на основе позиции, в которой существует обнаруженный объект 3.

[0028] Ниже это описывается подробнее. Когда датчик 11 обнаружения окружающих условий обнаруживает объект 3, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать позиции зрачков 22 агента 2, например, как проиллюстрировано на фиг. 6(A), так что линия взгляда агента 2 направлена в направлении, в котором существует обнаруженный объект 3. Более конкретно, когда объект 3 представляет собой пешехода, велосипед, мотоцикл, автомобиль, помеху на дороге, конструкцию, светофор или дорожный знак, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать позиции зрачков 22 агента 2, например, как проиллюстрировано на фиг. 6(A), так что расстояния от объекта 3 до зрачков 22 агента 2 являются кратчайшими. Другими словами, позиции зрачков 22 в глазах 21 могут задаваться таким образом, что линия взгляда агента 2 направлена в направлении, в котором существует объект 3. Когда объект 3 представляет собой разделительную линию или край дороги, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать позиции зрачков 22 агента 2 таким образом, что расстояния между центральной позицией разделительной линии или края дороги и зрачками 22 агента 2 являются кратчайшими. Другими словами, позиции зрачков 22 в глазах 21 могут задаваться таким образом, что линия взгляда агента 2 направлена в направлении к центральной позиции разделительной линии или края дороги.

[0029] Когда определенный период времени проходит от обнаружения объекта 3, и состояние обнаружения датчика 11 обнаружения окружающих условий переходит из состояния обнаружения объекта 3 в состояние отслеживания объекта 3, устройство 16 управления использует функцию задания выражений лица для того, чтобы возвращать выражение лица агента 2 в начальное состояние (выражение лица, проиллюстрированное на фиг. 3(A)), как проиллюстрировано на фиг. 6(B). Также в этом случае, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать позиции зрачков 22 агента 2 таким образом, что линия взгляда агента 2 направлена в направлении, в котором существует обнаруженный объект 3.

[0030] Далее описывается способ задания выражения лица агента 2, когда датчик 11 обнаружения окружающих условий отслеживает объект 3. Фиг. 7 является набором схем, иллюстрирующих пример выражения лица агента 2, когда датчик 11 обнаружения окружающих условий отслеживает объект 3. Когда датчик 11 обнаружения окружающих условий отслеживает объект 3, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы сдвигать позиции зрачков 22 агента 2, например, как проиллюстрировано на фиг. 7(A)-7(C), так что линия взгляда агента 2 перемещается таким образом, что она следует за объектом 3. В настоящем варианте осуществления, датчик 11 обнаружения окружающих условий многократно обнаруживает окрестности рассматриваемого транспортного средства с предварительно определенными временными интервалами и периодически передает результаты обнаружения в устройство 16 управления. В настоящем варианте осуществления, датчик 11 обнаружения окружающих условий и устройство 16 управления могут непрерывно обнаруживать (отслеживать) обнаруженный объект 3 посредством сохранения признаков (таких как форма и цвет) объекта 3 после однократного обнаружения. Устройство 16 управления использует функцию задания выражений лица для того, чтобы многократно обнаруживать позицию объекта 3 (включающего в себя отслеживаемый объект 3) на основе полученных результатов обнаружения датчика 11 обнаружения окружающих условий, и многократно задавать зрачки 22 агента 2 в позициях, в которых расстояния между объектом 3 и зрачками 22 являются кратчайшими. Таким образом, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать выражение лица агента 2, как проиллюстрировано на фиг. 7(A)-7(C), так что линия взгляда агента 2 перемещается таким образом, что она следует за объектом 3.

[0031] Когда датчик 11 обнаружения окружающих условий обнаруживает множество объектов 3, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать выражение лица агента 2 таким образом, что агент 2 попеременно бросает взгляд на множество объектов 3. Например, когда датчик 110 обнаружения окружающих условий обнаруживает два объекта 3: объекты 3A и 3B, функция задания выражений лица может служить для того, чтобы задавать зрачки 22 агента 2 в позициях, в которых расстояния между объектом 3A и зрачками 22 агента 2 являются кратчайшими. После того, как предварительно определенный период времени проходит, функция задания выражений лица может служить для того, чтобы сдвигать зрачки 22 агента 2 в позиции, в которых расстояния между объектом 3B и зрачками 22 агента 2 являются кратчайшими. После этого могут выполняться повторяющиеся аналогичные операции, при которых, после того, как предварительно определенный период времени проходит, функция задания выражений лица служит для того, чтобы сдвигать зрачки 22 агента 2 в позиции, в которых расстояния между объектом 3A и зрачками 22 агента 2 являются кратчайшими, и затем, после того, как предварительно определенный период времени проходит, функция задания выражений лица служит для того, чтобы сдвигать зрачки 22 агента 2 в позиции, в которых расстояния между объектом 3B и зрачками 22 агента 2 являются кратчайшими. Вышеуказанный предварительно определенный период времени, например, может составлять, но не только, одну секунду.

[0032] Фиг. 8 примерно иллюстрирует пример выражения лица агента 2, когда датчик 11 обнаружения окружающих условий теряет из виду объект 3. Когда датчик 11 обнаружения окружающих условий теряет из виду объект 3, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы сдвигать позиции зрачков 22 агента 2 попеременно вправо и влево, например, как проиллюстрировано на фиг. 8, за счет этого задавая выражение лица агента 2, как если агент 2 ищет объект 3. Когда люди теряют из виду объект 3, они зачастую окидывают взглядом объект 3. Такое задание выражения лица в силу этого обеспечивает возможность водителю интуитивно воспринимать то, что датчик 11 обнаружения окружающих условий теряет из виду объект 3.

[0033] Фиг. 9 примерно иллюстрирует пример выражения лица агента 2, когда датчик 11 обнаружения окружающих условий не может обнаруживать объект 3. В некоторых случаях, датчик 11 обнаружения окружающих условий может не иметь возможность обнаруживать объект 3 вследствие погоды, к примеру, дождя, снега или тумана, окружающей обстановки при движении, к примеру, ночью, либо пыли, прилипшей к датчику 11 обнаружения окружающих условий. В таких случаях, устройство 16 управления использует функцию задания выражений лица для того, чтобы задавать выражение лица, как если агент 2 опускает (закрывает) глаза 21, например, как проиллюстрировано на фиг. 9. Люди не видят окружающих объектов с закрытыми глазами, так что такое задание выражения лица обеспечивает возможность водителю интуитивно воспринимать то, что датчик 11 обнаружения окружающих условий не может обнаруживать объект 3.

[0034] В вышеописанных вариантах осуществления, примерно иллюстрируется конфигурация, в которой агент 2 отображается на дисплее 14, расположенном на приборной панели рассматриваемого транспортного средства, в то время как изображение, захваченное рядом с рассматриваемым транспортным средством, не отображается на дисплее 14. В этом случае, как проиллюстрировано на фиг. 6(A) и фиг. 6(B), когда пешеход (объект 3) обнаруживается впереди рассматриваемого транспортного средства слева, выражение лица агента 2 задается таким образом, что линия взгляда агента 2 направлена в левую переднюю сторону рассматриваемого транспортного средства. Тем не менее, настоящее изобретение не ограничено такой конфигурацией, и также может использоваться другая конфигурация, как пояснено ниже.

[0035] Фиг. 10 является набором схем, иллюстрирующих пример отображения агента 2 в случае отображения изображения захваченного рядом с рассматриваемым транспортным средством на дисплее 14. При отображении изображения, захваченного рядом с рассматриваемым транспортным средством на дисплее 14, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать выражение лица агента 2 таким образом, что линия взгляда агента 2 направлена в направлении объекта 3, отображаемого на дисплее 14. В примерах, проиллюстрированных на фиг. 10(A) и фиг. 10(B), агент 2 отображается на верхней части дисплея 14, в то время как изображение, захваченное рядом с рассматриваемым транспортным средством, отображается в нижней части дисплея 14. В этом случае, как проиллюстрировано на фиг. 10(A) и фиг. 10(B), функция задания выражений лица служит для того, чтобы задавать выражение лица агента 2 таким образом, что линия взгляда агента 2 направлена в направлении объекта 3 (едущего впереди транспортного средства в проиллюстрированных примерах), отображаемого в нижней части дисплея 14. В частности, функция задания выражений лица служит для того, чтобы задавать зрачки 22 агента 2 в позициях, в которых расстояния между объектом 3 (едущим впереди транспортным средством в проиллюстрированных, примерах), отображаемым в захваченном изображении, и зрачками 22 агента 2 являются кратчайшими.

[0036] Помимо этого или альтернативно, когда объект 3 обнаруживается, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы укрупнять глаза 21 агента 2, добавлять брови и открытый рот агенту 2 и задавать цвет лица агента 2 как желтый цвет, например, как проиллюстрировано на фиг. 10(A). После этого, когда определенный период времени проходит, и состояние обнаружения датчика 11 обнаружения окружающих условий переходит из состояния обнаружения объекта 3 в состояние отслеживания объекта 3, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы возвращать выражение лица агента 2 в начальное состояние, как проиллюстрировано на фиг. 10(B).

[0037] Фиг. 11 является набором схем, примерно иллюстрирующих окружение, в котором изображение, которое имитирует объект 3, существующий рядом с рассматриваемым транспортным средством, отображается на дисплее 14. В примерах, проиллюстрированных на фиг. 11, дисплей 14 отображает изображение вида сверху, которое включает в себя изображение, имитирующее рассматриваемое транспортное средство, и изображение, имитирующее объект 3 (другое транспортное средство), существующий рядом с рассматриваемым транспортным средством. В примерах, проиллюстрированных на фиг. 11, позиция размещения изображения, имитирующего другое транспортное средство, представляет собой позицию на экране, соответствующую фактическим относительным позициям рассматриваемого транспортного средства и другого транспортного средства и относительному расстоянию между ними. Например, в примерах, проиллюстрированных на фиг. 11, другое транспортное средство движется впереди рассматриваемого транспортного средства, и изображение, имитирующее другое транспортное средство, в силу этого размещается перед изображением, имитирующим рассматриваемое транспортное средство.

[0038] Когда изображение, которое имитирует объект, существующий рядом с рассматриваемым транспортным средством, отображается на дисплее 14, агент 2 может накладываться и отображаться на изображении, имитирующем рассматриваемое транспортное средство. В этом случае, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать выражение лица агента 2 на основе позиции другого транспортного средства. В частности, как проиллюстрировано на фиг. 11(A) и фиг. 11(B), устройство 16 управления использует функцию задания выражений лица для того, чтобы задавать выражение лица агента 2 таким образом, что линия взгляда агента 2 направлена в направлении другого транспортного средства 3, существующего впереди рассматриваемого транспортного средства.

[0039] Также в окружениях, проиллюстрированных на фиг. 11, когда объект 3 обнаруживается, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы укрупнять глаза 21 агента 2, добавлять брови и открытый рот агенту 2 и задавать цвет лица агента 2 как желтый цвет и т.п., как проиллюстрировано на фиг. 11(A). После этого, когда определенный период времени проходит, и состояние обнаружения датчика 11 обнаружения окружающих условий переходит из состояния обнаружения объекта 3 в состояние отслеживания объекта 3, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы возвращать выражение лица агента 2 в начальное состояние, как проиллюстрировано на фиг. 11(B).

[0040] Устройство 160 управления может использовать функцию управления движением для того, чтобы управлять движением в режиме автоматизированного вождения рассматриваемого транспортного средства. В частности, устройство 16 управления использует функцию управления движением для того, чтобы автоматически выполнять операцию вождения, которая обычно выполняется водителем, через операцию с устройством 15 управления вождением таким образом, чтобы управлять приводными механизмами, такими как двигатель и тормоз, и механизмом рулевого управления, таким как актуатор рулевого управления, на основе результатов обнаружения датчика 11 обнаружения окружающих условий и данных условий движения (к примеру, правил дорожного движения и запланированного маршрута движения). Например, устройство 16 управления использует функцию управления движением для того, чтобы выполнять управление удержанием на полосе движения, которое управляет позицией движения рассматриваемого транспортного средства в направлении ширины через операцию с устройством 15 управления вождением таким образом, чтобы управлять работой актуатора рулевого управления и т.п. таким образом, что рассматриваемое транспортное средство движется в определенной полосе движения. Помимо этого или альтернативно, устройство 16 управления может использовать функцию управления движением для того, чтобы выполнять управление движением в режиме "ехать за", которое предназначено для автоматического следования за едущим впереди транспортным средством, через операцию с устройством 15 управления вождением таким образом, чтобы управлять работой приводных механизмов, таких как двигатель и тормоз, таким образом, что рассматриваемое транспортное средство движется с определенным расстоянием от едущего впереди транспортного средства. Помимо этого или альтернативно, устройство 16 управления может использовать функцию управления движением для того, чтобы автоматически выполнять правый или левый поворот на перекрестке, смену полосы движения, парковку, остановку и другие необходимые операции, через управление приводными механизмами, такими как двигатель и тормоз, и механизмом рулевого управления, таким как актуатор рулевого управления, на основе результатов обнаружения датчика 11 обнаружения окружающих условий и данных условий движения.

[0041] Далее описывается процесс автоматизированного вождения согласно первому варианту осуществления со ссылкой на фиг. 12. Фиг. 12 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса автоматизированного вождения согласно первому варианту осуществления. Процесс автоматизированного вождения, описанный ниже, выполняется посредством устройства 16 управления. Во-первых, на этапе S101, функция управления движением служит для того, чтобы начинать движение в режиме автоматизированного вождения. Например, когда водитель включает переключатель автоматизированного вождения (не проиллюстрирован), функция управления движением служит для того, чтобы получать стартовый сигнал для движения в режиме автоматизированного вождения из переключателя автоматизированного вождения, и начинает движение в режиме автоматизированного вождения.

[0042] На этапе S102, функция получения результатов обнаружения служит для того, чтобы получать результаты обнаружения датчика 11 обнаружения окружающих условий. Затем на этапе S103, функция определения состояния обнаружения служит для того, чтобы определять состояние обнаружения датчика 11 обнаружения окружающих условий на основе результатов обнаружения датчика 11 обнаружения окружающих условий, полученных на этапе S102.

[0043] На этапе S104, функция задания выражений лица служит для того, чтобы задавать выражение лица агента 2 на основе состояния обнаружения датчика 11 обнаружения окружающих условий, определенного на этапе S103. Например, как проиллюстрировано на фиг. 4-9, выражение лица агента 2 задается в качестве выражения лица, соответствующего состоянию обнаружения датчика 11 обнаружения окружающих условий, определенному на этапе S103.

[0044] На этапе S105, функция отображения агента служит для того, чтобы выполнять процесс отображения агента 2 на экране дисплея 14 с выражением лица агента 2, которое задается на этапе S104.

[0045] Как описано выше, в настоящем варианте осуществления, выражение лица агента 2, который должен отображаться на дисплее 14, задается на основе состояния обнаружения датчика 11 обнаружения окружающих условий. В настоящем варианте осуществления, агент 2 имеет, по меньшей мере, места, соответствующие глазам 21, и форма для отображения глаз 21 агента 2 может задаваться в соответствии с состоянием обнаружения датчика 11 обнаружения окружающих условий, чтобы за счет этого выражать состояние обнаружения датчика 11 обнаружения окружающих условий. Например, когда датчик 11 обнаружения окружающих условий выполняет поиск объекта 3, состояние открытия глаз 21 и состояние закрытия глаз 21 повторяются, как проиллюстрировано на фиг. 4, чтобы за счет этого задавать выражение лица, как если агент 2 выполняет поиск объекта 3. Помимо этого или альтернативно, когда датчик 11 обнаружения окружающих условий обнаруживает объект, глаза агента 2 укрупняются, как проиллюстрировано на фиг. 5(A), чтобы за счет этого задавать выражение лица, как если агент 2 что-либо находит. Помимо этого или альтернативно, когда датчик 11 обнаружения окружающих условий отслеживает объект 3, выражение лица агента 2 задается, как проиллюстрировано на фиг. 7(A)-7(C), так что зрачки 22 агента 2 сдвигаются таким образом, что они следуют за объектом 3. Помимо этого или альтернативно, когда датчик 11 обнаружения окружающих условий теряет из виду объект 3, зрачки 22 агента 2 сдвигаются попеременно вправо и влево, как проиллюстрировано на фиг. 8, чтобы за счет этого задавать выражение лица агента 2, как если агент 2 ищет потерянный объект 3. Помимо этого или альтернативно, когда датчик 11 обнаружения окружающих условий не может выполнять обнаружение объекта 3, выражение лица задается, как если агент 2 опускает (закрывает) глаза 21, как проиллюстрировано на фиг. 9. Таким образом, состояние обнаружения датчика 11 обнаружения окружающих условий может выражаться с использованием выражения лица агента 2, чтобы за счет этого обеспечивать возможность водителю интуитивно воспринимать состояние обнаружения датчика 11 обнаружения окружающих условий.

[0046] Когда водитель не может воспринимать состояние обнаружения датчика 11 обнаружения окружающих условий во время движения в режиме автоматизированного вождения, для водителя может быть затруднительным выполнять прогнозирование касательно того, как движение в режиме автоматизированного вождения выполняет вождение и движение рассматриваемого транспортного средства, либо касательно того, выполняется либо нет необходимое вождение и движение, такое как недопущение объектов. Тем не менее, к счастью, в устройстве 1 автоматизированного вождения согласно настоящему варианту осуществления, состояние обнаружения датчика 11 обнаружения окружающих условий отображается с использованием персонифицированного агента 2 в качестве посредника во время движения в режиме автоматизированного вождения, и в силу этого водителю может разрешаться интуитивно воспринимать состояние обнаружения датчика 11 обнаружения окружающих условий. Как результат, водитель может прогнозировать вождение и движение, выполняемое посредством движения в режиме автоматизированного вождения, например, внезапную остановку вследствие внезапного появления впереди пешехода или велосипеда, и чувство защищенности для автоматизированного вождения может вызываться у водителя. Помимо этого, когда датчик 11 обнаружения окружающих условий не обнаруживает объект, водитель может интуитивно воспринимать то, что датчик 110 обнаружения окружающих условий не обнаруживает объект. Когда объект 3, который не обнаруживается посредством датчика 11 обнаружения окружающих условий, приближается к рассматриваемому транспортному средству, в силу этого водитель может принудительно выполнять необходимую операцию вождения, например, операцию торможения.

[0047] Кроме того, в настоящем варианте осуществления, когда датчик 11 обнаружения окружающих условий обнаруживает объект 3, позиции зрачков 22 агента 2 могут задаваться таким образом, что линия взгляда агента 2 направлена в направлении, в котором обнаруженный объект 3 существует, как проиллюстрировано на фиг. 6 и фиг. 7. Это обеспечивает возможность водителю надлежащим образом воспринимать объект 3 (либо его позицию), обнаруженный посредством датчика 11 обнаружения окружающих условий.

[0048] Кроме того, в настоящем варианте осуществления, состояние обнаружения датчика 11 обнаружения окружающих условий отображается с использованием агента 2, и информация относительно объекта 3, обнаруженного посредством датчика 11 обнаружения окружающих условий, в силу этого может интегрированно передаваться водителю по сравнению со случаем, в котором агент 2 не используется. Например, в захваченном изображении, отображаемом на дисплее 14, когда агент 2 не используется, как и в случае, в котором линия рамки, указывающая обнаружение, накладывается и отображается на объекте 3, обнаруженном посредством датчика 11 обнаружения окружающих условий, объем информации, представленный водителю, увеличивается по мере того, как увеличивается точность обнаружения датчика 11 обнаружения окружающих условий. Таким образом, для водителя может быть затруднительным интуитивно воспринимать состояние обнаружения датчика 11 обнаружения окружающих условий, поскольку информация относительно захваченного изображения и линии рамки, накладываемой и отображаемой на информацию, отображается запутанным способом. Даже в таком случае, состояние обнаружения датчика 11 обнаружения окружающих условий может отображаться интегрированно с использованием агента 2, чтобы за счет этого обеспечивать возможность водителю интуитивно воспринимать состояние обнаружения датчика 11 обнаружения окружающих условий без считывания состояния обнаружения из всего захваченного изображения.

[0049] Второй вариант осуществления

Ниже описывается устройство автоматизированного вождения согласно второму варианту осуществления. Устройство 1 автоматизированного вождения согласно второму варианту осуществления имеет конфигурацию, идентичную конфигурации устройства 1 автоматизированного вождения согласно первому варианту осуществления проиллюстрированного на фиг. 1, и работает идентично вышеописанному первому варианту осуществления, за исключением того, что оно работает так, как описано ниже.

[0050] Устройство 16 управления согласно второму варианту осуществления имеет функцию вычисления значений определения явности и функцию вычисления значений определения неявности в дополнение к функциям первого варианта осуществления. Функция вычисления значений определения явности служит для того, чтобы вычислять значение определения явности для определения того, следует или нет привлекать внимание водителя, на основе объекта, обнаруженного посредством датчика 11 обнаружения окружающих условий (в дальнейшем этот объект называется "явным объектом"). Функция вычисления значений определения неявности служит для того, чтобы оценивать то, существует или нет объект, который не обнаруживается посредством датчика 11 обнаружения окружающих условий (в дальнейшем этот объект называется "неявным объектом"), и вычислять значение определения неявности для определения того, следует или нет привлекать внимание водителя.

[0051] Во-первых, описывается функция вычисления значений определения явности устройства 16 управления. Функция вычисления значений определения явности представляет собой функцию указания объекта 3, обнаруженного посредством датчика 11 обнаружения окружающих условий, в качестве явного объекта на основе результатов обнаружения датчика 11 обнаружения окружающих условий. Примеры такого явного объекта включают в себя пешеходов, велосипеды, мотоциклы, автомобили, помехи на дороге, конструкции, светофоры, дорожные знаки, разделительные линии и края дороги, которые обнаруживаются посредством датчика 11 обнаружения окружающих условий.

[0052] Когда явный объект представляет собой трехмерный объект на дороге, такой как пешеход, велосипед, мотоцикл, автомобиль, помеха на дороге или конструкция, устройство 16 управления может использовать функцию вычисления значений определения явности для того, чтобы вычислять степень близости между рассматриваемым транспортным средством и явным объектом. В частности, устройство 16 управления использует функцию вычисления значений определения явности для того, чтобы вычислять расстояние от рассматриваемого транспортного средства до явного объекта, время до контакта (TTC) с явным объектом или время проезда расстояния между движущимися в потоке транспортными средствами (THW) на основе позиционной информации и информации скорости явного объекта, обнаруженной посредством датчика 11 обнаружения окружающих условий, позиционной информации рассматриваемого транспортного средства, обнаруженной посредством устройства 13 обнаружения позиции рассматриваемого транспортного средства, и информации скорости рассматриваемого транспортного средства, обнаруженной посредством датчика 12 скорости транспортного средства. Затем устройство 16 управления использует функцию вычисления значений определения явности для того, чтобы вычислять степень близости (возможность приближения) между рассматриваемым транспортным средством и явным объектом в качестве значения определения явности на основе расстояния от рассматриваемого транспортного средства до явного объекта, TTC или THW. Например, устройство 16 управления использует функцию вычисления значений определения явности для того, чтобы вычислять более высокое значение определения явности по мере того, как расстояние от рассматриваемого транспортного средства до явного объекта меньше, TTC с явным объектом меньше, или THW для явного объекта меньше.

[0053] Помимо этого или альтернативно, когда явный объект представляет собой линейный двумерный объект, такой как разделительная линия или край дороги, устройство 16 управления может использовать функцию вычисления значений определения явности для того, чтобы вычислять кратчайшее расстояние от рассматриваемого транспортного средства до явного объекта или время до пересечения полосы движения (TTC) для рассматриваемого транспортного средства, чтобы пересекать явный объект. Затем устройство 16 управления может использовать функцию вычисления значений определения явности для того, чтобы вычислять значение определения явности на основе кратчайшего расстояния между рассматриваемым транспортным средством и явным объектом или TLC. Например, устройство 16 управления использует функцию вычисления значений определения явности для того, чтобы вычислять более высокое значение определения явности по мере того, как кратчайшее расстояние от рассматриваемого транспортного средства до явного объекта меньше, или TLC меньше.

[0054] Помимо этого или альтернативно, когда явный объект представляет собой светофор, устройство 16 управления может использовать функцию вычисления значений определения явности для того, чтобы вычислять значение определения явности на основе цвета сигнала светофора. Например, когда цвет сигнала светофора является желтым, устройство 16 управления использует функцию вычисления значений определения явности для того, чтобы вычислять более высокое значение определения явности, чем значение определения явности, когда цвет сигнала светофора является синим (зеленым). Когда цвет сигнала светофора является красным, устройство 16 управления использует функцию вычисления значений определения явности для того, чтобы вычислять более высокое значение определения явности, чем значение определения явности, когда цвет сигнала светофора является желтым. Когда цвет сигнала светофора является красным, устройство 16 управления использует функцию вычисления значений определения явности для того, чтобы вычислять более высокое значение определения явности по мере того, как скорость движения рассматриваемого транспортного средства является более высокой, или расстояние от рассматриваемого транспортного средства до стоп-линии меньше.

[0055] Помимо этого или альтернативно, когда явный объект представляет собой дорожный знак, устройство 16 управления может использовать функцию вычисления значений определения явности для того, чтобы вычислять значение определения явности на основе разности между разрешенной скоростью и скоростью движения рассматриваемого транспортного средства. Например, устройство 16 управления использует функцию вычисления значений определения явности для того, чтобы вычислять более высокое значение определения явности по мере того, как разность между разрешенной скоростью и скоростью движения рассматриваемого транспортного средства (скорость движения рассматриваемого транспортного средства - разрешенная скорость) становится больше.

[0056] Когда обнаруживаются два или более явных объектов, устройство 16 управления может использовать функцию вычисления значений определения явности для того, чтобы вычислять соответствующие значения определения явности для этих явных объектов и выбирать наибольшее значение определения явности из вычисленных соответствующих значений определения явности в качестве конечного значения определения явности.

[0057] Таким образом, на основе явного объекта, обнаруженного посредством датчика 11 обнаружения окружающих условий, устройство 16 управления может использовать функцию вычисления значений определения явности для того, чтобы оценивать степень близости между рассматриваемым транспортным средством и явным объектом, вероятность того, что рассматриваемое транспортное средство отклоняется от полосы движения или дороги, или вероятность того, что рассматриваемое транспортное средство нарушает правила дорожного движения, в качестве значения определения явности.

[0058] Далее описывается функция вычисления значений определения неявности устройства 16 управления. Функция вычисления значений определения неявности представляет собой функцию оценки того, существует или нет объект (неявный объект), который не обнаруживается посредством датчика 11 обнаружения окружающих условий, и вычисления значения определения неявности для определения того, следует или нет привлекать внимание водителя.

[0059] В частности, устройство 16 управления использует функцию вычисления значений определения неявности для того, чтобы обнаруживать остановленный автобус и припаркованное транспортное средство, поскольку неявный объект, такой как пешеход или велосипед, зачастую может внезапно появляться впереди вследствие остановленного автобуса или припаркованного транспортного средства. После этого, когда остановленный автобус или припаркованное транспортное средство обнаруживается, устройство 16 управления использует функцию вычисления значений определения неявности для того, чтобы оценивать то, что неявный объект, такой как пешеход или велосипед, существует позади остановленного автобуса или припаркованного транспортного средства, и вычислять более высокое значение определения неявности, чем значение определения неявности, когда остановленный автобус или припаркованное транспортное средство не обнаруживается. Помимо этого или альтернативно, при приближении к пешеходному переходу или перекрестку без светофоров, устройство 16 управления может использовать функцию вычисления значений определения неявности для того, чтобы оценивать то, что неявный объект, такой как пешеход или велосипед, внезапно появляется впереди на пешеходном переходе или перекрестке без светофоров, и вычислять более высокое значение определения неявности, чем значение определения неявности в случае неприближения к пешеходному переходу или перекрестку без светофоров.

[0060] Помимо этого или альтернативно, устройство 16 управления использует функцию вычисления значений определения неявности для того, чтобы выполнять прогнозирование степени вероятности того, что рассматриваемое транспортное средство должно отклоняться от полосы движения или дороги в будущем (эта степень вероятности может упоминаться как вероятность возникновения события), на основе неявного объекта, который не обнаруживается посредством датчика 11 обнаружения окружающих условий, и вычислять значение определения неявности на основе прогнозной степени вероятности. Например, устройство 16 управления использует функцию вычисления значений определения неявности для того, чтобы определять то, существует или нет изгиб впереди рассматриваемого транспортного средства, из картографической информации. Когда изгиб существует впереди рассматриваемого транспортного средства, устройство 16 управления использует функцию вычисления значений определения неявности для того, чтобы определять то, что степень вероятности (вероятность появления) того, что рассматриваемое транспортное средство должно отклоняться от полосы движения или дороги в будущем, является высокой, и вычислять более высокое значение определения неявности, чем значение определения неявности, когда изгиб не существует впереди рассматриваемого транспортного средства. Устройство 16 управления может использовать функцию вычисления значений определения неявности для того, чтобы вычислять более высокое значение определения неявности по мере того, как кривизна изгиба является более высокой, расстояние от рассматриваемого транспортного средства до изгиба меньше, или скорость рассматриваемого транспортного средства является более высокой.

[0061] Таким образом, устройство 16 управления использует функцию вычисления значений определения неявности для того, чтобы оценивать существование неявного объекта, который не обнаруживается посредством датчика 11 обнаружения окружающих условий (т.е. при условии, что объект 3 существует), и вычислять степень вероятности того, что рассматриваемое транспортное средство и неявный объект приближаются друг к другу, или вероятность того, что рассматриваемое транспортное средство должно отклоняться от полосы движения или дороги в будущем, в качестве значения определения неявности для определения того, следует или нет привлекать внимание водителя.

[0062] Устройство 16 управления согласно второму варианту осуществления может использовать функцию задания выражений лица для того, чтобы задавать выражение лица агента 2 на основе значения определения явности, вычисленного с использованием функции вычисления значений определения явности, и значения определения неявности, вычисленного с использованием функции вычисления значений определения неявности.

[0063] Когда значение определения явности составляет первое пороговое значение или более, устройство 16 управления использует функцию задания выражений лица для того, чтобы укрупнять глаза 21 агента 2, например, как проиллюстрировано на фиг. 13(A), чтобы за счет этого задавать выражение лица, как если агент 2 удивлен. Помимо этого или альтернативно, когда значение определения явности составляет первое пороговое значение или более, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы добавлять брови и открытый рот агенту 2, например, как проиллюстрировано на фиг. 13(B), и изменять цвет лица агента 2 на красный (указывается посредством толстых диагональных линий на фиг. 13(B), это применимо к фиг. 15(B), к фиг. 16(B) и к фиг. 17(B)). Это может привлекать внимание водителя к явному объекту, обнаруженному посредством датчика 11 обнаружения окружающих условий.

[0064] Когда значение определения неявности составляет второе пороговое значение или более, устройство 16 управления использует функцию задания выражений лица для того, чтобы сдвигать зрачки 22 агента 2 вправо и влево, например, как проиллюстрировано на фиг. 14(A), чтобы за счет этого задавать выражение лица, как если агент 2 демонстрирует тревожный вид. Устройство 16 управления также может использовать функцию задания выражений лица для того, чтобы сдвигать зрачки 22 агента 2 вправо и влево, опускать внешние уголки бровей, опускать внешние уголки рта и задавать цвет лица как желтый цвет, как проиллюстрировано на фиг. 14(B). Это может привлекать внимание водителя к неявному объекту, который не обнаруживается посредством датчика 11 обнаружения окружающих условий.

[0065] Помимо этого или альтернативно, когда значение определения явности составляет первое пороговое значение или более, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать позиции зрачков 22 агента 2, например, как проиллюстрировано на фиг. 15(A), так что расстояния между явным объектом и зрачками 22 агента 2 являются кратчайшими. Это обеспечивает возможность водителю воспринимать явный объект (либо его позицию), обнаруженный посредством датчика 11 обнаружения окружающих условий. Помимо этого или альтернативно, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы укрупнять глаза 21 агента 2, добавлять брови и открытый рот агенту 2 и изменять цвет лица агента 2 на красный цвет, например, как проиллюстрировано на фиг. 15(B). Это может в большей степени способствовать привлечению внимания водителя.

[0066] Помимо этого или альтернативно, когда явный объект перемещается, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать выражение лица агента 2 таким образом, что линия взгляда агента 2 следует за объектом 3. Например, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы многократно сдвигать зрачки 22 агента 2 в позиции, в которых расстояния между явным объектом и зрачками 22 агента 2 являются кратчайшими, за счет этого позволяя линии взгляда агента 2 следовать за явным объектом.

[0067] Помимо этого или альтернативно, когда явный объект, изображение которого сформировано посредством камеры, отображается на дисплее 14, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать выражение лица агента 2, например, как проиллюстрировано на фиг. 16(A), так что линия взгляда агента 2 направлена на явный объект (объект 3 на чертеже представляет собой едущее впереди транспортное средство), отображаемый на дисплее 14. Например, когда значение определения явности для едущего впереди транспортного средства становится первым пороговым значением или более вследствие внезапного замедления едущего впереди транспортного средства в качестве явного объекта или вследствие внезапного вклинивания другого транспортного средства в качестве явного объекта впереди рассматриваемого транспортного средства, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы укрупнять глаза 21 агента 2 и задавать выражение лица агента 2 таким образом, что линия взгляда агента 2 направлена на явный объект, отображаемый на дисплее 14, как проиллюстрировано на фиг. 16(A). В таком случае, как проиллюстрировано на фиг. 16(B), устройство 16 управления также может использовать функцию задания выражений лица для того, чтобы укрупнять глаза 21 агента 2, добавлять брови и открытый рот агенту 2 и изменять цвет лица агента 2 на красный цвет.

[0068] Помимо этого или альтернативно, когда изображение, которое имитирует явный объект, существующий рядом с рассматриваемым транспортным средством, отображается на дисплее 14, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать выражение лица агента 2 таким образом, что линия взгляда агента 2 направлена в направлении, в котором существует изображение явного объекта, подготовленное посредством рендеринга на дисплее 14. Например, когда значение определения явности для едущего впереди транспортного средства становится первым пороговым значением или более вследствие внезапного замедления едущего впереди транспортного средства в качестве явного объекта или вследствие внезапного вклинивания другого транспортного средства в качестве явного объекта впереди рассматриваемого транспортного средства, устройство 16 управления может использовать функцию задания выражений лица для того, чтобы задавать выражение лица агента 2 таким образом, что линия взгляда агента 2 направлена в направлении, в котором изображение явного объекта 3, отображаемого на дисплее 14, существует, например, как проиллюстрировано на фиг. 17(A). В таком случае, как проиллюстрировано на фиг. 17(B), устройство 16 управления также может использовать функцию задания выражений лица для того, чтобы укрупнять глаза 21 агента 2, добавлять брови и открытый рот агенту 2 и изменять цвет лица агента 2 на красный цвет.

[0069] Далее описывается процесс автоматизированного вождения согласно второму варианту осуществления. Фиг. 18 является блок-схемой последовательности операций способа, иллюстрирующей пример процесса автоматизированного вождения согласно второму варианту осуществления. Процесс автоматизированного вождения, описанный ниже, выполняется посредством устройства 16 управления.

[0070] На этапах S201 в S203, выполняется процесс, идентичный процессу на этапах S101 в S103 первого варианта осуществления. Таким образом, когда движение в режиме автоматизированного вождения начинается (этап S201), объект 3, существующий рядом с рассматриваемым транспортным средством, обнаруживается (этап S202), и результаты обнаружения получаются (этап S203).

[0071] На этапе S204, функция вычисления значений определения явности служит для того, чтобы вычислять значение определения явности на основе результатов обнаружения датчика 11 обнаружения окружающих условий, обнаруженных на этапе S203. Например, функция вычисления значений определения явности служит для того, чтобы вычислять расстояние от рассматриваемого транспортного средства до явного объекта, TTC с явным объектом или THW для явного объекта в качестве значения определения явности.

[0072] Затем на этапе S205, функция вычисления значений определения явности служит для того, чтобы определять то, составляет либо нет значение определения явности, вычисленное на этапе S204, первое пороговое значение или более. Хотя первое пороговое значение не ограничено конкретным образом, предпочтительно надлежащим образом задавать значение, подходящее для того, чтобы привлекать внимание водителя, когда значение определения явности составляет первое пороговое значение или более, посредством эксперимента и т.п. Когда значение определения явности составляет первое пороговое значение или более, процедура переходит к этапу S206, в то время как, когда значение определения явности меньше первого порогового значения, процедура переходит к этапу S207.

[0073] На этапе S206, функция задания выражений лица служит для того, чтобы задавать выражение лица агента 2 на основе значения определения явности, вычисленного на этапе S204. Например, функция задания выражений лица служит для того, чтобы укрупнять глаза 21 агента 2, как проиллюстрировано на фиг. 15(A), фиг. 16(A) или фиг. 17(A), или добавлять брови и открытый рот в лицо агента 2 и изменять цвет лица агента 2 на красный цвет, как проиллюстрировано на фиг. 15(B), фиг. 16(B) или фиг. 17(B). Помимо этого или альтернативно, функция задания выражений лица может служить для того, чтобы задавать позиции зрачков 22 агента 2 таким образом, что расстояния между зрачками 22 агента 2 и явного объекта являются кратчайшими.

[0074] С другой стороны, когда на этапе S205 выполняется определение в отношении того, что значение определения явности меньше первого порогового значения, процедура переходит к этапу S207. На этапе S207, функция вычисления значений определения неявности служит для того, чтобы вычислять значение определения неявности на основе результатов обнаружения, полученных на этапе S203. Например, функция вычисления значений определения неявности служит для того, чтобы оценивать существование неявного объекта, который не обнаруживается посредством датчика 11 обнаружения окружающих условий, и вычислять степень близости между рассматриваемым транспортным средством и неявным объектом, или вероятность того, что рассматриваемое транспортное средство должно отклоняться от полосы движения или края дороги в будущем, в качестве значения определения неявности.

[0075] Затем на этапе S208, функция вычисления значений определения неявности служит для того, чтобы определять то, составляет либо нет значение определения неявности, вычисленное на этапе S207, второе пороговое значение или более. Хотя второе пороговое значение не ограничено конкретным образом, предпочтительно надлежащим образом задавать значение, подходящее для того, чтобы привлекать внимание водителя, когда значение определения неявности составляет второе пороговое значение или более, посредством эксперимента и т.п. Когда значение определения неявности составляет второе пороговое значение или более, процедура переходит к этапу S209. На этапе S209, функция задания выражений лица служит для того, чтобы задавать выражение лица агента 2 на основе значения определения неявности. Например, как проиллюстрировано на фиг. 14(A) и фиг. 14(B), функция задания выражений лица служит для того, чтобы задавать выражение лица, как если агент 2 демонстрирует тревожный вид. С другой стороны, когда значение определения неявности меньше второго порогового значения, выражение лица агента 2 задается в начальное состояние, и затем процедура переходит к этапу S210.

[0076] На этапе S210, функция отображения агента служит для того, чтобы отображать агента 2 на экране дисплея 14 с выражением лица, заданным на этапе S206 или на этапе S209.

[0077] Как описано выше, процесс второго варианта осуществления включает в себя указание объекта 3, обнаруженного посредством датчика 11 обнаружения окружающих условий, в качестве явного объекта и вычисление любого из степени близости между рассматриваемым транспортным средством и явным объектом, степени вероятности того, что рассматриваемое транспортное средство переезжает через разделительную линию или край дороги в качестве явного объекта, так что оно отклоняется от полосы движения или дороги, и степени вероятности того, что рассматриваемое транспортное средство нарушает правило дорожного движения, представленное посредством светофора или знака ограничения скорости в качестве явного объекта, в качестве значения определения явности. После этого, когда значение определения явности составляет первое пороговое значение или более, выражение лица задается, как если агент 2 удивлен, как проиллюстрировано на фиг. 13(A) и фиг. 13(B). Это обеспечивает возможность водителю интуитивно воспринимать то, что рассматриваемое транспортное средство и явный объект могут приближаться друг к другу, рассматриваемое транспортное средство может отклоняться от полосы движения или дороги, и рассматриваемое транспортное средство может нарушать правило дорожного движения и может привлекать внимание водителя.

[0078] Кроме того, процесс второго варианта осуществления включает в себя оценку существования неявного объекта, который не обнаруживается посредством датчика 11 обнаружения окружающих условий, и вычисление любого из степени близости между рассматриваемым транспортным средством и неявным объектом (например, пешехода или велосипеда) и степени вероятности того, что рассматриваемое транспортное средство переезжает через неявный объект (к примеру, разделительную линию или край дороги), так что оно отклоняется от полосы движения или дороги, в качестве значения определения неявности. После этого, когда значение определения неявности составляет второе пороговое значение или более, выражение лица задается, как если агент 2 демонстрирует тревожный вид, как проиллюстрировано на фиг. 14(A) и фиг. 14(B). Через эту операцию, даже когда объект 3 не обнаруживается посредством датчика 11 обнаружения окружающих условий, водитель может интуитивно воспринимать то, что рассматриваемое транспортное средство и неявный объект могут приближаться друг к другу, и рассматриваемое транспортное средство возможно должно отклоняться от полосы движения или дороги в будущем. Это может привлекать внимание водителя.

[0079] Варианты осуществления, поясненные выше, описываются для того, чтобы упрощать понимание настоящего изобретения, а не для того, чтобы ограничивать настоящее изобретение. Следовательно, подразумевается, что элементы, раскрытые в вышеописанных вариантах осуществления, включают в себя все конструктивные модификации и эквиваленты, которые попадают в пределы объема настоящего изобретения.

[0080] Например, в вышеописанном первом варианте осуществления, примерно иллюстрируется конфигурация, в которой выражение лица агента 2 задается так, как проиллюстрировано на фиг. 5(A) и фиг. 5(B), когда датчик 11 обнаружения окружающих условий обнаруживает объект 3, но помимо этого или альтернативно, когда объект 3, такой как пешеход или велосипед, внезапно появляется впереди, выражение лица может задаваться, как если агент 2 удивлен, как проиллюстрировано на фиг. 5(A) и фиг. 5(B). Способ определения того, появляется внезапно впереди либо нет объект 3, такой как пешеход или велосипед, не ограничен конкретным образом, и определение может выполняться, например, на основе результата идентификации объекта 3 и/или скорости объекта 3, приближающегося к рассматриваемому транспортному средству.

[0081] В вышеописанном втором варианте осуществления, примерно иллюстрируется конфигурация, в которой когда значение определения явности составляет первое пороговое значение или более, выражение лица задается, как если агент 2 удивлен, как проиллюстрировано на фиг. 13(A) и фиг. 13(B), но настоящее изобретение не ограничено этой конфигурацией. В альтернативной конфигурации, например, когда расстояние от рассматриваемого транспортного средства до явного объекта, TTC или THW составляет предварительно определенное значение или менее, выражение лица может задаваться, как если агент 2 демонстрирует тревожный вид, как проиллюстрировано на фиг. 14(A) и фиг. 14(B), в то время как, когда едущее впереди транспортное средство внезапно замедляется, другое транспортное средство внезапно вклинивается, либо пешеход или велосипед внезапно появляется впереди, выражение лица может задаваться, как если агент 2 удивлен, как проиллюстрировано на фиг. 13(A) и фиг. 13(B).

[0082] В вышеописанных вариантах осуществления, примерно иллюстрируется конфигурация, в которой агент 2 отображается на дисплее 14 плоским способом, но настоящее изобретение не ограничено этой конфигурацией. В альтернативной конфигурации, например, агент 2 может стереоскопически отображаться с использованием трехмерного дисплея или конфигурироваться в качестве трехмерного объекта. Помимо этого или альтернативно, агент 2 может быть сконфигурирован как роботизированный агент или другой трехмерный объект и т.п., и сам агент 2 может использоваться в качестве устройства отображения.

[0083] В вышеописанных вариантах осуществления, датчик 11 обнаружения окружающих условий соответствует детектору настоящего изобретения, дисплей 14 соответствует устройству отображения или устройству отображения настоящего изобретения, и устройство 16 управления соответствует контроллеру настоящего изобретения.

Описание номеров ссылок

[0084] 1 - устройство автоматизированного вождения

11 - датчик обнаружения окружающих условий

12 - датчик скорости транспортного средства

13 - устройство обнаружения позиции рассматриваемого транспортного средства

14 - дисплей

15 - устройство управления вождением

16 - устройство управления

2 - агент

21 - глаз

22 - зрачок

3 - объект

Изобретение относится к средствам управления устройством отображения, на котором отображается изображение, имитирующее лицо, включающее в себя, по меньшей мере, глаз, и которое установлено в транспортном средстве. Технический результат заключается в обеспечении возможности водителю интуитивно воспринимать состояние обнаружения датчика обнаружения окружающих условий. Используют детектор, обнаруживающий объект рядом с транспортным средством, чтобы обнаруживать, по меньшей мере, любое из состояния поиска объекта, состояния обнаружения объекта, состояния отслеживания объекта, состояния потери из виду объекта и состояния неспособности обнаружения объекта. Определяют состояние обнаружения детектора на основе результата обнаружения детектора. Задают форму для отображения глаза на основе этого определенного состояния обнаружения. 4 н. и 8 з.п. ф-лы, 30 ил.

1. Способ управления устройством отображения, на котором отображается изображение, имитирующее лицо, включающее в себя, по меньшей мере, глаз, и которое установлено в транспортном средстве, при этом способ содержит этапы, на которых:

используют детектор, обнаруживающий объект рядом с транспортным средством, чтобы обнаруживать, по меньшей мере, любое из состояния поиска объекта, состояния обнаружения объекта, состояния отслеживания объекта, состояния потери из виду объекта и состояния неспособности обнаружения объекта;

определяют состояние обнаружения детектора на основе результата обнаружения детектора и

задают форму для отображения глаза на основе этого определенного состояния обнаружения.

2. Способ управления устройством отображения, на котором отображается изображение, имитирующее лицо, включающее в себя, по меньшей мере, глаз, и которое установлено в транспортном средстве, при этом способ содержит этапы, на которых:

используют детектор, обнаруживающий объект рядом с транспортным средством, чтобы обнаруживать, по меньшей мере, состояние обнаружения объекта и состояние неспособности обнаружения объекта;

определяют состояние обнаружения детектора на основе результата обнаружения детектора;

задают форму для отображения открытия глаза, когда это определенное состояние обнаружения представляет собой состояние обнаружения объекта; и

задают форму для отображения закрытия глаза, когда данное определенное состояние обнаружения представляет собой состояние неспособности обнаружения объекта.

3. Способ управления устройством отображения по п. 1 или 2, в котором:

глаз включает в себя зрачок, и

зрачок размещается в позиции, в которой расстояние между объектом и зрачком является кратчайшим, в соответствии с позицией обнаруженного объекта.

4. Способ управления устройством отображения по п. 1 или 2, содержащий этапы, на которых:

указывают объект, обнаруженный посредством детектора, в качестве явного объекта;

вычисляют значение определения явности на основе, по меньшей мере, любого из степени близости между рассматриваемым транспортным средством и явным объектом, степени вероятности того, что рассматриваемое транспортное средство переезжает через явный объект, и степени вероятности того, что рассматриваемое транспортное средство нарушает правило дорожного движения, представленное посредством явного объекта; и

задают выражение лица изображения, имитирующего лицо, на основе значения определения явности.

5. Способ управления устройством отображения по п. 4, в котором, когда явный объект представляет собой трехмерный объект на дороге, степень близости между рассматриваемым транспортным средством и трехмерным объектом вычисляется как значение определения явности.

6. Способ управления устройством отображения по п. 4, в котором, когда явный объект представляет собой разделительную линию на дороге или краю дороги, степень вероятности того, что рассматриваемое транспортное средство переезжает через разделительную линию или край дороги, вычисляется как значение определения явности.

7. Способ управления устройством отображения по п. 4, в котором, когда явный объект представляет собой светофор, степень вероятности того, что рассматриваемое транспортное средство нарушает правило дорожного движения, вычисляется как значение определения явности на основе цвета сигнала светофора.

8. Способ управления устройством отображения по п. 1 или 2, содержащий этапы, на которых:

оценивают то, существует или нет неявный объект, который не обнаруживается посредством детектора;

при существовании такого неявного объекта вычисляют значение определения неявности на основе, по меньшей мере, любого из степени близости между рассматриваемым транспортным средством и неявным объектом и степени вероятности того, что рассматриваемое транспортное средство переезжает через неявный объект; и

задают выражение лица изображения, имитирующего лицо, на основе значения определения неявности.

9. Способ управления устройством отображения по п. 1 или 2, в котором, когда управление движением в режиме автоматизированного вождения выполняется для рассматриваемого транспортного средства, выражение лица изображения, имитирующего лицо, задается на основе состояния обнаружения детектора.

10. Устройство отображения для транспортного средства, содержащее:

детектор, выполненный с возможностью обнаруживать объект рядом с транспортным средством;

дисплей, приспособленный для установки в транспортном средстве и выполненный с возможностью отображать изображение, имитирующее лицо, включающее в себя, по меньшей мере, глаз; и